Red Hat Training

A Red Hat training course is available for OpenShift Container Platform

아키텍처

OpenShift Container Platform 3.11 아키텍처 정보

초록

1장. 개요

OpenShift v3은 개발자가 애플리케이션을 쉽게 구성하는 데 중점을 두고 가능한 한 정확하게 기본 Docker 형식의 컨테이너 이미지와 Kubernetes 개념을 노출하도록 설계된 계층화된 시스템입니다. 예를 들어 Ruby, 내보내기 코드를 설치하고 MySQL을 추가합니다.

OpenShift v2와 달리, 모델의 모든 측면에 생성한 후 구성의 유연성이 향상됩니다. 별도의 개체로서의 애플리케이션 개념은 "서비스"를 보다 유연하게 구성하기 위해 제거되며, 두 웹 컨테이너에서 데이터베이스를 재사용하거나 네트워크 에지에 직접 데이터베이스를 노출할 수 있습니다.

1.1. 계층은 무엇입니까?

Docker 서비스는 Linux 기반 경량 컨테이너 이미지를 패키징하고 생성하는 데 대한 추상화를 제공합니다. Kubernetes는 클러스터 관리를 제공하고 여러 호스트에서 컨테이너를 오케스트레이션합니다.

OpenShift Container Platform은 다음을 추가합니다.

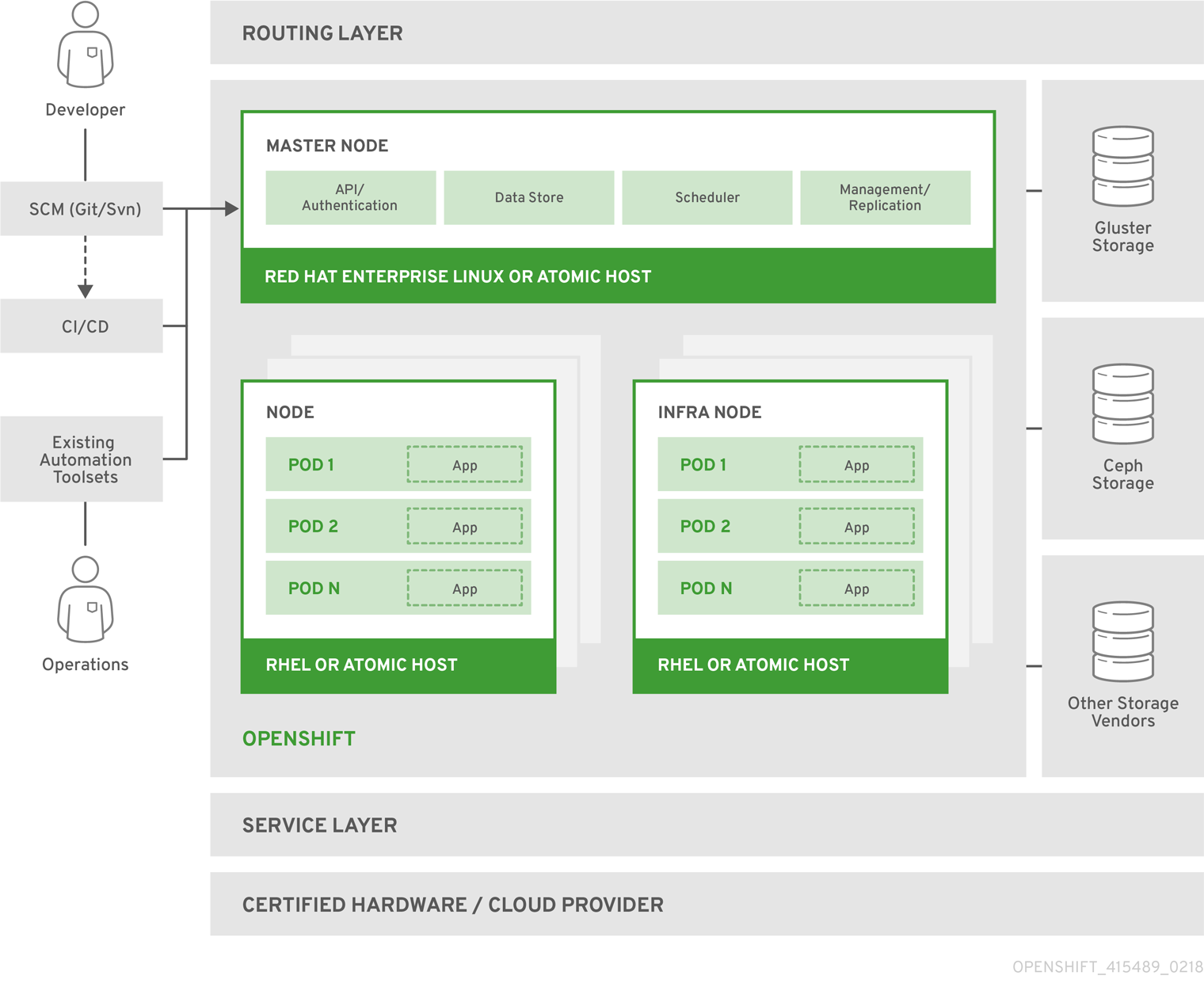

그림 1.1. OpenShift Container Platform 아키텍처 개요

아키텍처 개요의 노드 유형에 대한 자세한 내용은 Kubernetes 인프라를 참조하십시오.

1.2. OpenShift Container Platform 아키텍처란 무엇입니까?

OpenShift Container Platform에는 분리된 작은 단위의 마이크로 서비스 기반 아키텍처가 함께 작동합니다. 안정적인 클러스터형 키-값 저장소인 etcd 에 저장된 오브젝트에 대한 데이터를 사용하여 Kubernetes 클러스터에서 실행됩니다. 이러한 서비스는 다음과 같은 기능으로 분류됩니다.

- REST API - 각 핵심 오브젝트를 노출합니다.

- 해당 API를 읽고 변경 사항을 다른 오브젝트에 적용하고 상태를 보고하거나 오브젝트에 다시 쓰는 컨트롤러입니다.

사용자는 REST API를 호출하여 시스템 상태를 변경합니다. 컨트롤러는 REST API를 사용하여 사용자의 원하는 상태를 읽은 다음 시스템의 다른 부분을 동기화합니다. 예를 들어 사용자가 빌드를 요청하면 "build" 오브젝트를 생성합니다. 빌드 컨트롤러는 새 빌드가 생성되었음을 확인하고 클러스터에서 프로세스를 실행하여 해당 빌드를 수행합니다. 빌드가 완료되면 컨트롤러에서 REST API를 통해 빌드 오브젝트를 업데이트하고 사용자가 빌드가 완료되었음을 확인합니다.

컨트롤러 패턴은 OpenShift Container Platform의 대부분의 기능이 확장 가능함을 의미합니다. 이미지를 관리하는 방법 또는 배포의 발생 방식과 관계없이 빌드가 실행 및 시작되는 방식은 사용자 지정할 수 있습니다. 컨트롤러는 시스템의 "비즈니스 로직"을 수행하여 사용자 작업을 수행하고 현실로 변환합니다. 이러한 컨트롤러를 사용자 정의하거나 자체 논리로 교체하면 다양한 동작을 구현할 수 있습니다. 시스템 관리 관점에서는 API를 사용하여 반복 스케줄에 일반적인 관리 작업을 스크립팅할 수 있습니다. 이러한 스크립트는 변경 사항을 조사하고 조치를 취하는 컨트롤러이기도 합니다. OpenShift Container Platform을 사용하면 이러한 방식으로 최상위 동작으로 클러스터를 사용자 지정할 수 있습니다.

이를 가능하게 하기 위해 컨트롤러는 안정적인 시스템 변경 스트림을 활용하여 시스템 보기를 사용자가 수행하는 작업과 동기화합니다. 이 이벤트 스트림은 etcd의 변경 사항을 REST API로 푸시한 다음 변경 사항이 발생하는 즉시 컨트롤러에 푸시되므로 변경 사항이 시스템을 통해 빠르고 효율적으로 제거할 수 있습니다. 그러나 언제든지 오류가 발생할 수 있으므로 컨트롤러는 시작 시 시스템의 최신 상태를 가져오고 모든 항목이 올바른 상태에 있는지 확인할 수 있어야 합니다. 이러한 재동기화는 문제가 발생해도 Operator가 영향을 받는 구성 요소를 다시 시작할 수 있다는 것을 의미하기 때문에 시스템이 계속하기 전에 모든 것을 재동기화할 수 있다는 의미이기 때문에 중요합니다. 컨트롤러에서 항상 시스템을 동기화할 수 있으므로 시스템은 결국 사용자의 의도와 통합되어야 합니다.

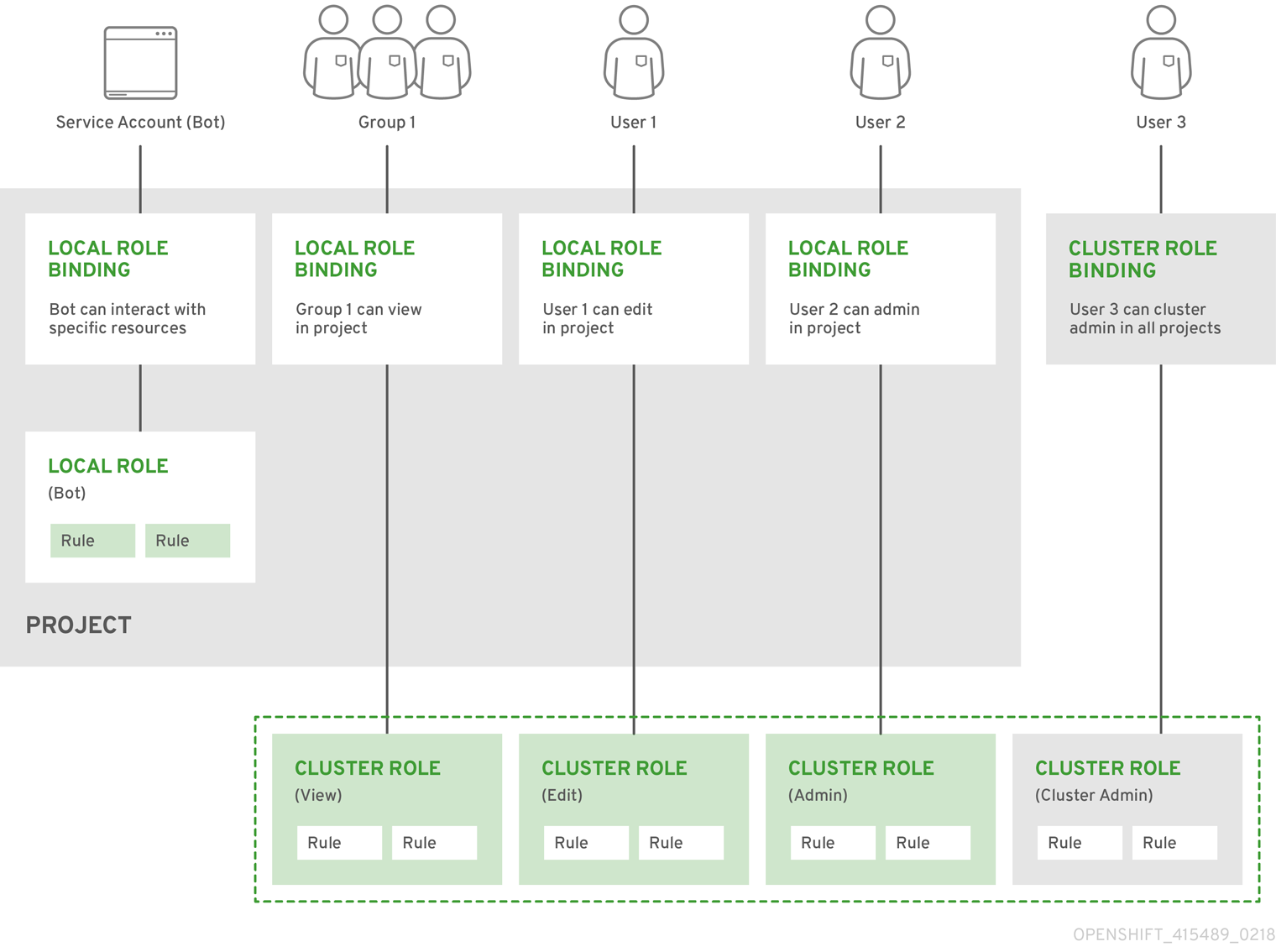

1.3. OpenShift Container Platform은 어떻게 보호됩니까?

OpenShift Container Platform 및 Kubernetes API는 자격 증명을 제공하는 사용자를 인증한 다음 역할에 따라 권한을 부여합니다. 개발자와 관리자는 모두 주로 OAuth 토큰과 X.509 클라이언트 인증서 등 여러 가지 수단을 통해 인증할 수 있습니다. OAuth 토큰은 SHA-256을 사용한 RSA 서명 알고리즘인 PKCS#1 v1.5인 JSON Web Algorithm RS256 으로 서명됩니다.

개발자(시스템의 클라이언트)는 일반적으로 브라우저를 통해 oc 또는 웹 콘솔과 같은 클라이언트 프로그램에서 REST API 호출을 수행하고 대부분의 통신에 OAuth 전달자 토큰을 사용합니다. 인프라 구성 요소(노드와 같은)는 ID가 포함된 시스템에서 생성한 클라이언트 인증서를 사용합니다. 컨테이너에서 실행되는 인프라 구성 요소는 서비스 계정 과 연결된 토큰을 사용하여 API에 연결합니다.

권한 부여는 "Pod 생성" 또는 "list services"와 같은 작업을 정의하고 정책 문서의 역할에 그룹화하는 OpenShift Container Platform 정책 엔진에서 처리됩니다. 역할은 사용자 또는 그룹 식별자로 사용자 또는 그룹에 바인딩됩니다. 사용자 또는 서비스 계정이 작업을 시도하면 정책 엔진은 계속 허용하기 전에 사용자에게 할당된 하나 이상의 역할(예: 현재 프로젝트의 클러스터 관리자 또는 관리자)을 확인합니다.

클러스터에서 실행되는 모든 컨테이너는 서비스 계정과 연결되므로 시크릿 을 해당 서비스 계정에 연결하고 컨테이너에 자동으로 제공할 수도 있습니다. 이를 통해 인프라는 이미지, 빌드 및 배포 구성 요소를 가져오고 푸시하기 위한 시크릿을 관리할 수 있으며 애플리케이션 코드에서 이러한 시크릿을 쉽게 활용할 수 있습니다.

1.3.1. TLS 지원

REST API와의 모든 통신 채널은 물론 etcd 및 API 서버 등의 마스터 구성 요소 간 통신 채널은 TLS로 보호됩니다. TLS는 X.509 서버 인증서 및 공개 키 인프라를 사용하여 서버의 강력한 암호화, 데이터 무결성 및 인증을 제공합니다. 기본적으로 OpenShift Container Platform의 각 배포에 대해 새로운 내부 PKI가 생성됩니다. 내부 PKI는 2048비트 RSA 키와 SHA-256 서명을 사용합니다. 공용 호스트에 대한 사용자 지정 인증서 도 지원됩니다.

OpenShift Container Platform은 Golang의 crypto/tls 표준 라이브러리 구현을 사용하며 외부 암호화 및 TLS 라이브러리를 사용하지 않습니다. 또한 클라이언트는 GSSAPI 인증 및 OpenPGP 서명을 위한 외부 라이브러리에 의존합니다. GSSAPI는 일반적으로 MIT Kerberos 또는 Heimdal Kerberos에서 제공하며, 둘 다 OpenSSL의 libcrypto를 사용합니다. OpenPGP 서명 확인은 libgpgme 및 GnuPG에서 처리합니다.

안전하지 않은 버전의 SSL 2.0 및 SSL 3.0은 지원되지 않으며 사용할 수 없습니다. OpenShift Container Platform 서버 및 oc 클라이언트는 기본적으로 TLS 1.2만 제공합니다. TLS 1.0 및 TLS 1.1은 서버 구성에서 활성화할 수 있습니다. 서버와 클라이언트 모두 인증된 암호화 알고리즘과 완벽한 전달 보안을 갖춘 최신 암호화 제품군을 선호합니다. RC4, 3DES, MD5와 같이 더 이상 사용되지 않고 안전하지 않은 알고리즘이 있는 암호화 제품군이 비활성화됩니다. 일부 내부 클라이언트(예: LDAP 인증)는 TLS 1.0에서 1.2로 설정이 덜 제한되고 더 많은 암호 제품군이 활성화되어 있습니다.

표 1.1. 지원되는 TLS 버전

| TLS 버전 | OpenShift Container Platform Server | oc 클라이언트 | 기타 클라이언트 |

|---|---|---|---|

| SSL 2.0 | 지원되지 않음 | 지원되지 않음 | 지원되지 않음 |

| SSL 3.0 | 지원되지 않음 | 지원되지 않음 | 지원되지 않음 |

| TLS 1.0 | 아니요 [1] | 아니요 [1] | 아마도 [2] |

| TLS 1.1 | 아니요 [1] | 아니요 [1] | 아마도 [2] |

| TLS 1.2 | 있음 | 있음 | 있음 |

| TLS 1.3 | N/A [3] | N/A [3] | N/A [3] |

- 기본적으로 비활성화되지만 서버 구성에서 활성화할 수 있습니다.

- LDAP 클라이언트 등의 일부 내부 클라이언트.

- TLS 1.3은 아직 개발 중입니다.

OpenShift Container Platform 서버 및 oc 클라이언트에서 활성화된 암호화 제품군의 다음 목록은 기본으로 정렬됩니다.

-

TLS_ECDHE_ECDSA_WITH_CHACHA20_POLY1305 -

TLS_ECDHE_RSA_WITH_CHACHA20_POLY1305 -

TLS_ECDHE_ECDSA_WITH_AES_128_GCM_SHA256 -

TLS_ECDHE_RSA_WITH_AES_128_GCM_SHA256 -

TLS_ECDHE_ECDSA_WITH_AES_256_GCM_SHA384 -

TLS_ECDHE_RSA_WITH_AES_256_GCM_SHA384 -

TLS_ECDHE_ECDSA_WITH_AES_128_CBC_SHA256 -

TLS_ECDHE_RSA_WITH_AES_128_CBC_SHA256 -

TLS_ECDHE_ECDSA_WITH_AES_128_CBC_SHA -

TLS_ECDHE_ECDSA_WITH_AES_256_CBC_SHA -

TLS_ECDHE_RSA_WITH_AES_128_CBC_SHA -

TLS_ECDHE_RSA_WITH_AES_256_CBC_SHA -

TLS_RSA_WITH_AES_128_GCM_SHA256 -

TLS_RSA_WITH_AES_256_GCM_SHA384 -

TLS_RSA_WITH_AES_128_CBC_SHA -

TLS_RSA_WITH_AES_256_CBC_SHA

2장. 인프라 구성 요소

2.1. Kubernetes 인프라

2.1.1. 개요

OpenShift Container Platform 내에서 Kubernetes는 컨테이너 또는 호스트 집합에서 컨테이너화된 애플리케이션을 관리하고 배포, 유지 관리 및 애플리케이션 확장에 대한 메커니즘을 제공합니다. 컨테이너화된 애플리케이션을 인스턴스화 및 실행합니다. Kubernetes 클러스터는 하나 이상의 마스터와 노드 집합으로 구성됩니다.

클러스터에 단일 장애 지점이 없는지 확인하기 위해 선택적으로 HA(고가용성 )를 위해 마스터를 구성할 수 있습니다.

OpenShift Container Platform은 Kubernetes 1.11 및 Docker 1.13.1을 사용합니다.

2.1.2. 마스터

마스터는 API 서버, 컨트롤러 관리자 서버 및 etcd를 포함하여 컨트롤 플레인 구성 요소가 포함된 호스트 또는 호스트입니다. 마스터는 Kubernetes 클러스터에서 노드를 관리하고 해당 노드에서 실행되도록 포드를 예약합니다.

표 2.1. 마스터 구성 요소

| 구성 요소 | 설명 |

|---|---|

| API 서버 | Kubernetes API 서버는 포드, 서비스 및 복제 컨트롤러의 데이터를 검증하고 구성합니다. 또한 노드에 포드를 할당하고 서비스 구성과 포드 정보를 동기화합니다. |

| etcd | etcd는 영구 마스터 상태를 저장하고 다른 구성 요소는 etcd에서 변경 사항을 원하는 상태로 표시합니다. 고가용성을 위해 etcd를 선택적으로 구성할 수 있으며 일반적으로 2n+1 피어 서비스로 배포할 수 있습니다. |

| 컨트롤러 관리자 서버 | 컨트롤러 관리자 서버는 etcd에서 복제 컨트롤러 오브젝트의 변경 사항을 감시한 다음 API를 사용하여 원하는 상태를 적용합니다. 이러한 여러 프로세스는 한 번에 하나의 활성 리더가 있는 클러스터를 생성합니다. |

| HAProxy |

API 마스터 엔드포인트 간에 부하를 분산하도록 |

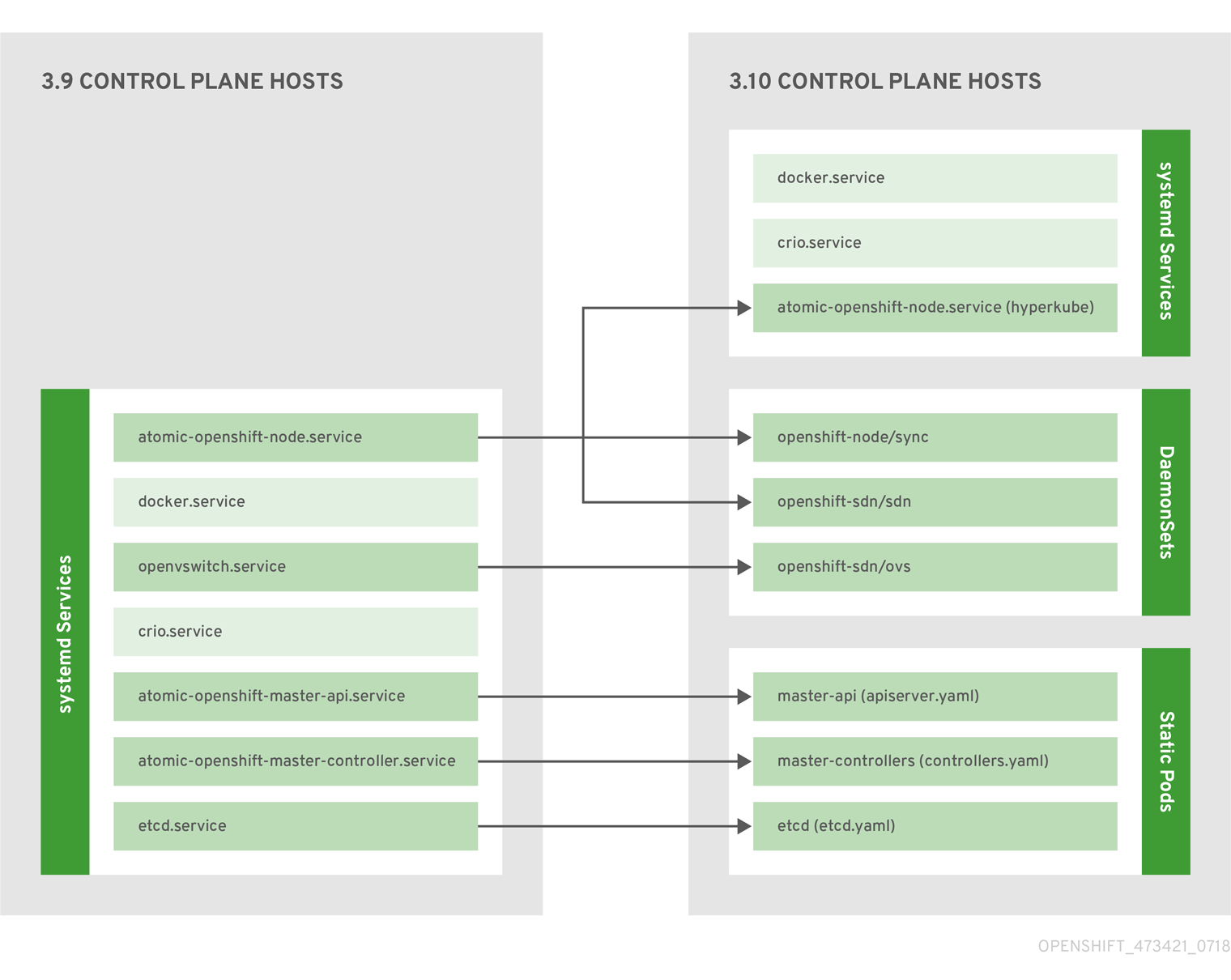

2.1.2.1. 컨트롤 플레인 정적 포드

핵심 컨트롤 플레인 구성 요소, API 서버 및 컨트롤러 관리자 구성 요소는 kubelet에서 작동하는 정적 Pod 로 실행됩니다.

etcd가 동일한 호스트에 공동 배치된 마스터의 경우 etcd도 정적 포드로 이동합니다. RPM 기반 etcd는 여전히 마스터가 아닌 etcd 호스트에서 지원됩니다.

또한 노드 구성 요소 openshift-sdn 및 openvswitch 는 systemd 서비스 대신 DaemonSet을 사용하여 실행됩니다.

그림 2.1. 컨트롤 플레인 호스트 아키텍처 변경

컨트롤 플레인 구성 요소가 정적 포드로 실행되는 경우에도 마스터 호스트는 마스터 및 노드 구성 항목에 설명된 대로 /etc/origin/master/master-config.yaml 파일에서 구성을 계속 제공합니다.

시작 순서 개요

Hyperkube 는 모든 Kubernetes(kube-apiserver,controller- manager,스케줄러,프록시, kubelet)를 포함하는 바이너리입니다. 시작 시 kubelet 은 kubepods.slice 를 생성합니다. 다음으로 kubelet 은 kubepods.slice 내에 QoS 수준 슬라이스 burstable.slice 및 best-effort.slice 를 생성합니다. Pod가 시작되면 kubelet 은 pod<UUID-of-pod>.slice 형식을 사용하여 Pod 수준 슬라이스를 생성하고 CRI(컨테이너 런타임 인터페이스)의 다른 쪽의 런타임에 해당 경로를 전달합니다. 그런 다음 Docker 또는 CRI-O가 Pod 수준 슬라이스 내에 컨테이너 수준 슬라이스를 생성합니다.

미러 Pod

마스터 노드의 kubelet은 kube-system 프로젝트의 클러스터에 표시되도록 각 컨트롤 플레인 정적 Pod에 대해 API 서버에 미러 Pod를 자동으로 생성합니다. 이러한 정적 포드의 매니페스트는 기본적으로 마스터 호스트의 /etc/origin/node/pods 디렉터리에 있는 openshift-ansible 설치 프로그램에서 설치합니다.

이러한 Pod에는 다음과 같은 hostPath 볼륨이 정의되어 있습니다.

| /etc/origin/master | 모든 인증서, 구성 파일 및 admin.kubeconfig 파일을 포함합니다. |

| /var/lib/origin | 바이너리의 볼륨 및 잠재적인 코어 덤프를 포함합니다. |

| /etc/origin/cloudprovider | 클라우드 공급자별 구성(AWS, Azure 등)을 포함합니다. |

| /usr/libexec/kubernetes/kubelet-plugins | 추가 타사 볼륨 플러그인을 포함합니다. |

| /etc/origin/kubelet-plugins | 시스템 컨테이너용 추가 타사 볼륨 플러그인을 포함합니다. |

정적 Pod에서 수행할 수 있는 작업 세트는 제한됩니다. 예를 들면 다음과 같습니다.

$ oc logs master-api-<hostname> -n kube-system

API 서버에서 표준 출력을 반환합니다. 그러나 다음을 수행합니다.

$ oc delete pod master-api-<hostname> -n kube-system

포드를 실제로 삭제하지 않습니다.

또 다른 예로 클러스터 관리자는 문제가 발생하는 경우 더 자세한 데이터를 제공하기 위해 API 서버의 로그 수준을 늘리는 등 일반적인 작업을 수행해야 할 수 있습니다. 이 값이 컨테이너 내부에서 실행되는 프로세스로 전달되므로 /etc/origin/master/master.env 파일을 편집해야 합니다. 여기서 OPTIONS 변수의 --loglevel 매개 변수를 수정할 수 있습니다. 변경 사항을 적용하려면 컨테이너 내부에서 실행 중인 프로세스를 다시 시작해야 합니다.

마스터 서비스 다시 시작

컨트롤 플레인 정적 포드에서 실행 중인 컨트롤 플레인 서비스를 다시 시작하려면 마스터 호스트에서 master-restart 명령을 사용합니다.

마스터 API를 다시 시작하려면 다음을 수행합니다.

# master-restart api

컨트롤러를 다시 시작하려면 다음을 수행합니다.

# master-restart controllers

etcd를 다시 시작하려면 다음을 수행합니다.

# master-restart etcd

마스터 서비스 로그 보기

컨트롤 플레인 정적 Pod에서 실행되는 컨트롤 플레인 서비스의 로그를 보려면 해당 구성 요소에 대해 master-logs 명령을 사용합니다.

# master-logs api api

# master-logs controllers controllers

# master-logs etcd etcd

2.1.2.2. 고가용성 마스터

클러스터에 단일 장애 지점이 없는지 확인하기 위해 선택적으로 HA(고가용성)를 위해 마스터를 구성할 수 있습니다.

마스터 가용성에 대한 우려를 완화하려면 다음 두 가지 활동을 사용하는 것이 좋습니다.

- 마스터를 다시 만들기 위해 런북 항목을 만들어야 합니다. 런북 항목은 고가용성 서비스에 필요한 백플레이스입니다. 추가 솔루션은 런북을 참조해야 하는 빈도만 제어합니다. 예를 들어 마스터 호스트의 콜드 대기 모드는 새 애플리케이션을 생성하거나 실패한 애플리케이션 구성 요소를 복구하기 위해 몇 분 이상의 다운타임이 필요한 SLA를 적절히 이행할 수 있습니다.

-

고가용성 솔루션을 사용하여 마스터를 구성하고 클러스터에 단일 장애 지점이 없는지 확인합니다. 클러스터 설치 문서에서는

기본HA 방법을 사용하고 HAProxy를 구성하는 특정 예를 제공합니다. HAProxy 대신기본방법을 사용하여 개념을 사용하여 기존 HA 솔루션에 적용할 수도 있습니다.

프로덕션 OpenShift Container Platform 클러스터에서는 API 서버 로드 밸런서의 고가용성을 유지 관리해야 합니다. API 서버 로드 밸런서를 사용할 수 없는 경우 노드에서 상태를 보고할 수 없으며, 모든 포드가 dead으로 표시되며 포드 엔드포인트가 서비스에서 제거됩니다.

OpenShift Container Platform용 HA를 구성하는 것 외에도 API 서버 로드 밸런서에 대해 HA를 별도로 구성해야 합니다. HA를 구성하려면 F5 Big-IP™ 또는 Citrix Netscaler™ 어플라이언스와 같은 LB(엔터프라이즈 로드 밸런서)를 통합하는 것이 좋습니다. 이러한 솔루션을 사용할 수 없는 경우 여러 HAProxy 로드 밸런서를 실행하고 Keepalived를 사용하여 HA에 유동 가상 IP 주소를 제공할 수 있습니다. 그러나 이 솔루션은 프로덕션 인스턴스에 권장되지 않습니다.

HAProxy와 함께 기본 HA 방법을 사용하는 경우 마스터 구성 요소는 다음과 같은 가용성을 갖습니다.

표 2.2. HAProxy를 사용한 가용성 매트릭스

| Role | 스타일 | 참고 |

|---|---|---|

| etcd | active-active | 부하 분산을 통해 배포를 완전히 중복합니다. 별도의 호스트에 설치하거나 마스터 호스트에 배치할 수 있습니다. |

| API 서버 | active-active | HAProxy에서 관리합니다. |

| 컨트롤러 관리자 서버 | active-passive | 한 번에 하나의 인스턴스가 클러스터 리더로 선택됩니다. |

| HAProxy | active-passive | API 마스터 엔드포인트 간에 부하 분산. |

클러스터형 etcd에는 쿼럼에 대한 홀수의 호스트가 필요하지만 마스터 서비스에는 홀수의 호스트가 있다는 쿼럼이나 요구 사항이 없습니다. 그러나 HA에 대해 두 개 이상의 마스터 서비스가 필요하므로 마스터 서비스 및 etcd를 함께 배치할 때 일관된 홀수의 호스트를 유지하는 것이 일반적입니다.

2.1.3. 노드

노드는 컨테이너를 위한 런타임 환경을 제공합니다. Kubernetes 클러스터의 각 노드에는 마스터에서 관리하는 데 필요한 서비스가 있습니다. 노드에는 컨테이너 런타임, kubelet 및 서비스 프록시를 포함하여 Pod를 실행하는 데 필요한 서비스도 있습니다.

OpenShift Container Platform은 클라우드 공급자, 물리적 시스템 또는 가상 시스템에서 노드를 생성합니다. Kubernetes는 해당 노드를 나타내는 노드 오브젝트 와 상호 작용합니다. 마스터는 노드 오브젝트의 정보를 사용하여 상태 점검에서 노드를 검증합니다. 노드는 상태 점검을 통과할 때까지 무시되며 마스터는 노드가 유효할 때까지 노드를 계속 확인합니다. Kubernetes 설명서 에는 노드 상태 및 관리에 대한 자세한 정보가 있습니다.

관리자는 CLI를 사용하여 OpenShift Container Platform 인스턴스에서 노드를 관리할 수 있습니다. 노드 서버를 시작할 때 전체 구성 및 보안 옵션을 정의하려면 전용 노드 구성 파일을 사용합니다.

권장되는 최대 노드 수는 클러스터 제한 섹션을 참조하십시오.

2.1.3.1. kubelet

각 노드에는 Pod를 설명하는 YAML 파일인 컨테이너 매니페스트에서 지정한 대로 노드를 업데이트하는 kubelet이 있습니다. kubelet은 매니페스트 세트를 사용하여 해당 컨테이너가 시작되고 계속 실행되도록 합니다.

다음을 통해 kubelet에 컨테이너 매니페스트를 제공할 수 있습니다.

- 20초마다 확인되는 명령줄의 파일 경로입니다.

- 20초마다 확인되는 명령줄에서 HTTP 엔드포인트가 전달됩니다.

- kubelet은 /registry/hosts/$(hostname -f) 와 같은 etcd 서버를 모니터링하고 변경 사항을 적용합니다.

- HTTP를 수신 대기하고 간단한 API에 응답하여 새 매니페스트를 제출하는 kubelet입니다.

2.1.3.2. 서비스 프록시

각 노드는 해당 노드의 API에 정의된 서비스를 반영하는 간단한 네트워크 프록시도 실행합니다. 이를 통해 노드는 백엔드 집합에서 간단한 TCP 및 UDP 스트림 전달을 수행할 수 있습니다.

2.1.3.3. 노드 오브젝트 정의

다음은 Kubernetes의 노드 오브젝트 정의의 예입니다.

apiVersion: v1 1 kind: Node 2 metadata: creationTimestamp: null labels: 3 kubernetes.io/hostname: node1.example.com name: node1.example.com 4 spec: externalID: node1.example.com 5 status: nodeInfo: bootID: "" containerRuntimeVersion: "" kernelVersion: "" kubeProxyVersion: "" kubeletVersion: "" machineID: "" osImage: "" systemUUID: ""

2.1.3.4. 노드 부트스트랩

노드의 구성이 마스터에서 부트스트랩되므로 노드가 마스터에서 사전 정의된 구성과 클라이언트 및 서버 인증서를 가져옵니다. 따라서 노드 간 차이점을 줄이고 더 많은 구성을 중앙 집중화하고 원하는 상태에 클러스터가 병합되므로 더 빠른 노드 시작이 가능합니다. 인증서 교체 및 중앙 집중식 인증서 관리는 기본적으로 활성화되어 있습니다.

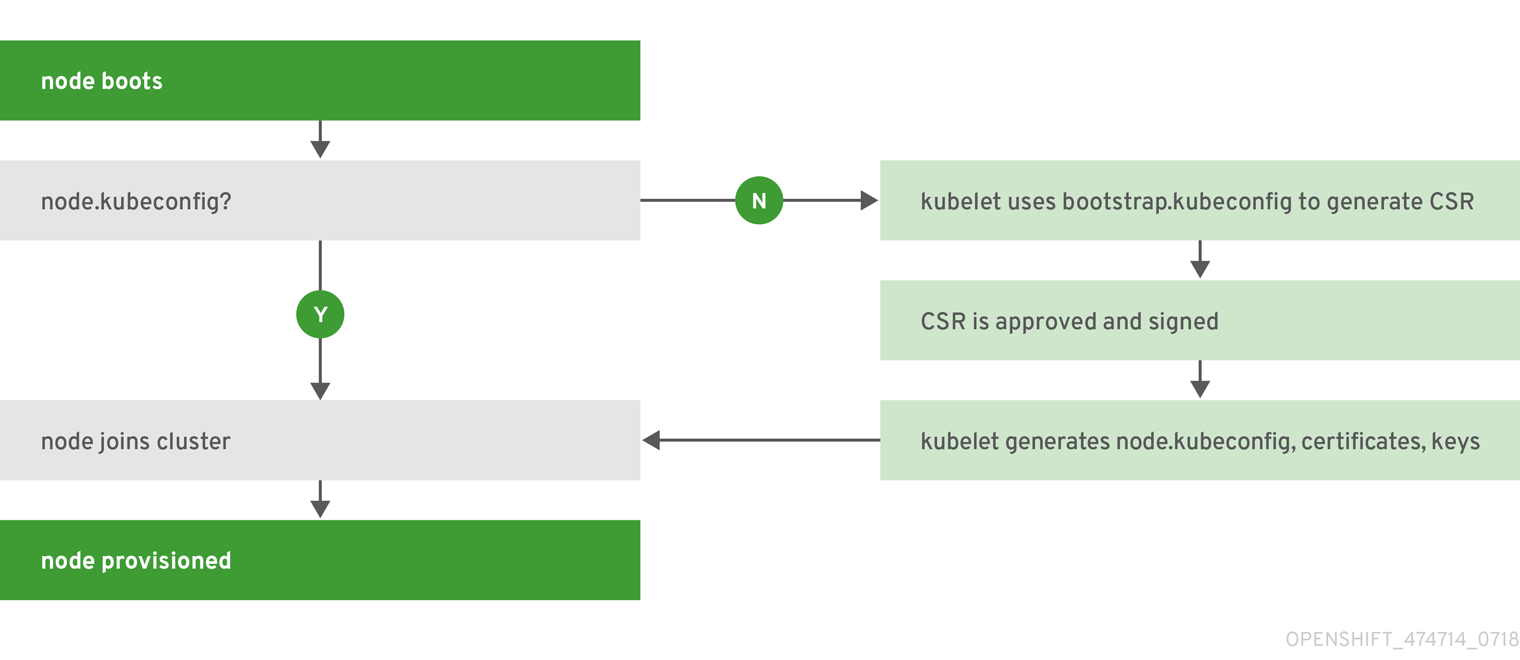

그림 2.2. 노드 부트스트랩 워크플로 개요

노드 서비스가 시작되면 노드는 클러스터에 참여하기 전에 /etc/origin/node/node.kubeconfig 파일 및 기타 노드 구성 파일이 있는지 확인합니다. 노드가 없는 경우 노드는 마스터에서 구성을 가져온 다음 클러스터에 결합합니다.

ConfigMaps 는 /etc/origin/node/node-config.yaml 의 노드 호스트에서 구성 파일을 채우는 클러스터에 노드 구성을 저장하는 데 사용됩니다. 기본 노드 그룹 및 해당 ConfigMap 세트의 정의는 클러스터 설치에서 노드 그룹 및 호스트 맵핑 정의를 참조하십시오.

노드 부트스트랩 워크플로

자동 노드 부트스트랩 프로세스는 다음 워크플로우를 사용합니다.

기본적으로 클러스터 설치 중에 노드 부트스트랩에 사용하기 위해

clusterrole, clusterrolebindingserviceaccount오브젝트 세트가 생성됩니다.system:node-bootstrapper 클러스터 역할은 노드 부트스트랩 중에 CSR(인증서 서명 요청)을 생성하는 데 사용됩니다.

$ oc describe clusterrole.authorization.openshift.io/system:node-bootstrapper

출력 예

Name: system:node-bootstrapper Created: 17 hours ago Labels: kubernetes.io/bootstrapping=rbac-defaults Annotations: authorization.openshift.io/system-only=true openshift.io/reconcile-protect=false Verbs Non-Resource URLs Resource Names API Groups Resources [create get list watch] [] [] [certificates.k8s.io] [certificatesigningrequests]

다음 node-bootstrapper 서비스 계정이 openshift-infra 프로젝트에 생성됩니다.

$ oc describe sa node-bootstrapper -n openshift-infra

출력 예

Name: node-bootstrapper Namespace: openshift-infra Labels: <none> Annotations: <none> Image pull secrets: node-bootstrapper-dockercfg-f2n8r Mountable secrets: node-bootstrapper-token-79htp node-bootstrapper-dockercfg-f2n8r Tokens: node-bootstrapper-token-79htp node-bootstrapper-token-mqn2q Events: <none>다음 system:node-bootstrapper 클러스터 역할 바인딩은 노드 부트스트랩자 클러스터 역할 및 서비스 계정에 사용됩니다.

$ oc describe clusterrolebindings system:node-bootstrapper

출력 예

Name: system:node-bootstrapper Created: 17 hours ago Labels: <none> Annotations: openshift.io/reconcile-protect=false Role: /system:node-bootstrapper Users: <none> Groups: <none> ServiceAccounts: openshift-infra/node-bootstrapper Subjects: <none> Verbs Non-Resource URLs Resource Names API Groups Resources [create get list watch] [] [] [certificates.k8s.io] [certificatesigningrequests]

클러스터 설치 중에 openshift-ansible 설치 프로그램은 OpenShift Container Platform 인증 기관과 다양한 다른 인증서, 키 및 kubeconfig 파일을 /etc/origin/master 디렉터리에 생성합니다. 두 개의 참고 파일은 다음과 같습니다.

/etc/origin/master/admin.kubeconfig

system:admin 사용자를 사용합니다.

/etc/origin/master/bootstrap.kubeconfig

마스터 이외의 노드 부트스트랩 노드에 사용됩니다.

설치 프로그램이 다음과 같이 node- bootstrapper 서비스 계정을 사용하는 경우 /etc/origin/master/bootstrap.kubeconfig 가 생성됩니다.

$ oc --config=/etc/origin/master/admin.kubeconfig \ serviceaccounts create-kubeconfig node-bootstrapper \ -n openshift-infra- 마스터 노드에서 /etc/origin/master/admin.kubeconfig 는 부트스트랩 파일로 사용되며 /etc/origin/node/boostrap.kubeconfig 에 복사됩니다. 다른 비마스터 노드에서 /etc/origin/master/bootstrap.kubeconfig 파일이 각 노드 호스트의 /etc/origin/node/boostrap.kubeconfig 의 다른 모든 노드에 복사됩니다.

그런 다음 /etc/origin/master/bootstrap.kubeconfig 가 다음과 같이

--bootstrap-kubeconfig플래그를 사용하여 kubelet에 전달됩니다.--bootstrap-kubeconfig=/etc/origin/node/bootstrap.kubeconfig

- kubelet은 제공된 /etc/origin/node/bootstrap.kubeconfig 파일로 처음 시작됩니다. 내부적으로 초기 연결 후 kubelet은 CSR(인증서 서명 요청)을 생성하여 마스터로 보냅니다.

CSR은 컨트롤러 관리자(특히 인증서 서명 컨트롤러)를 통해 확인하고 승인합니다. 승인되면 kubelet 클라이언트 및 서버 인증서가 /etc/origin/node/ceritificates 디렉터리에 생성됩니다. 예를 들면 다음과 같습니다.

# ls -al /etc/origin/node/certificates/

출력 예

total 12 drwxr-xr-x. 2 root root 212 Jun 18 21:56 . drwx------. 4 root root 213 Jun 19 15:18 .. -rw-------. 1 root root 2826 Jun 18 21:53 kubelet-client-2018-06-18-21-53-15.pem -rw-------. 1 root root 1167 Jun 18 21:53 kubelet-client-2018-06-18-21-53-45.pem lrwxrwxrwx. 1 root root 68 Jun 18 21:53 kubelet-client-current.pem -> /etc/origin/node/certificates/kubelet-client-2018-06-18-21-53-45.pem -rw-------. 1 root root 1447 Jun 18 21:56 kubelet-server-2018-06-18-21-56-52.pem lrwxrwxrwx. 1 root root 68 Jun 18 21:56 kubelet-server-current.pem -> /etc/origin/node/certificates/kubelet-server-2018-06-18-21-56-52.pem

- CSR 승인 후 node.kubeconfig 파일이 /etc/origin/node/node.kubeconfig 에 생성됩니다.

- kubelet은 /etc/origin/node/node.kubeconfig 파일과 /etc/origin/node/certificates/ 디렉터리의 인증서로 다시 시작됩니다. 이 인증서는 클러스터에 참여할 준비가 되었습니다.

노드 설정 워크플로

노드의 구성을 소싱하려면 다음 워크플로우를 사용합니다.

- 처음에 노드의 kubelet은 노드 프로비저닝 시 생성된 /etc/origin/ node/ 디렉터리에 부트스트랩 구성 파일 bootstrap-node -config.yaml 로 시작됩니다.

- 각 노드에서 노드 서비스 파일은 /usr/local/bin/ 디렉터리에 있는 로컬 스크립트 openshift-node 를 사용하여 제공된 bootstrap-node-config.yaml 을 사용하여 kubelet을 시작합니다.

- 각 마스터에서 /etc/origin/node/pods 디렉터리에는 마스터에서 정적 포드로 생성되는 apiserver,controller 및 etcd 의 Pod 매니페스트가 포함되어 있습니다.

클러스터 설치 중에 각 노드에 동기화 Pod를 생성하는 동기화 DaemonSet이 생성됩니다. 동기화 포드는 /etc/sysconfig/atomic-openshift-node 파일의 변경 사항을 모니터링합니다.

BOOTSTRAP_CONFIG_NAME이 설정되도록 특히 감시합니다.BOOTSTRAP_CONFIG_NAME은 openshift-ansible 설치 프로그램에서 설정하며 노드가 속하는 노드 구성 그룹에 따라 ConfigMap의 이름입니다.기본적으로 설치 프로그램은 다음 노드 구성 그룹을 생성합니다.

- node-config-master

- node-config-infra

- node-config-compute

- node-config-all-in-one

- node-config-master-infra

각 그룹의 ConfigMap은 openshift-node 프로젝트에 생성됩니다.

-

동기화 Pod는

BOOTSTRAP_CONFIG_NAME에 설정된 값을 기반으로 적절한 ConfigMap을 추출합니다. - 동기화 Pod는 ConfigMap 데이터를 kubelet 구성으로 변환하고 해당 노드 호스트에 대한 /etc/origin/node/node-config.yaml 을 생성합니다. 이 파일(또는 파일의 초기 생성)을 변경하면 kubelet이 다시 시작됩니다.

노드 구성 수정

노드의 구성은 openshift-node 프로젝트에서 적절한 ConfigMap을 편집하여 수정합니다. /etc/origin/node/node-config.yaml 은 직접 수정해서는 안 됩니다.

예를 들어 node -config-compute 그룹에 있는 노드 의 경우 다음을 사용하여 ConfigMap을 편집합니다.

$ oc edit cm node-config-compute -n openshift-node

2.2. 컨테이너 레지스트리

2.2.1. 개요

OpenShift Container Platform은 Docker Hub, 타사가 실행하는 프라이빗 레지스트리, 통합된 OpenShift Container Platform 레지스트리 등 컨테이너 이미지 레지스트리 API를 이미지의 소스로 구현하는 모든 서버를 활용할 수 있습니다.

2.2.2. 통합된 OpenShift Container Registry

OpenShift Container Platform은 필요에 따라 새 이미지 리포지토리를 자동으로 프로비저닝하는 기능을 추가하는 OCR(OpenShift Container Registry )이라는 통합 컨테이너 이미지 레지스트리를 제공합니다. 이를 통해 사용자는 애플리케이션 빌드에 결과 이미지를 푸시할 수 있는 기본 제공 위치를 제공합니다.

새 이미지를 OCR로 내보낼 때마다 레지스트리는 OpenShift Container Platform에 새 이미지에 대해 알리고 네임스페이스, 이름, 이미지 메타데이터와 같은 해당 이미지에 대한 모든 정보를 전달합니다. 다른 OpenShift Container Platform은 새 이미지에 반응하여 새 빌드 및 배포를 생성합니다.

OCR은 빌드 및 배포 통합 없이 컨테이너 이미지 레지스트리 역할을 하는 독립 실행형 구성 요소로도 배포할 수 있습니다. 자세한 내용은 OpenShift Container Registry 독립 실행형 배포 설치를 참조하십시오.

2.2.3. 타사 레지스트리

OpenShift Container Platform은 타사 레지스트리의 이미지를 사용하여 컨테이너를 생성할 수 있지만 이러한 레지스트리가 통합된 OpenShift Container Platform 레지스트리와 동일한 이미지 알림 지원을 제공하지는 않습니다. 이 경우 OpenShift Container Platform은 이미지 스트림 생성 시 원격 레지스트리에서 태그를 가져옵니다. oc import-image <stream>을 실행하여 가져온 태그를 간단하게 업데이트할 수 있습니다. 새 이미지가 감지되면 이전에 설명된 빌드 및 배포에 대한 응답이 발생합니다.

2.2.3.1. 인증

OpenShift Container Platform은 레지스트리와 통신하여 사용자가 지정한 인증 정보를 사용하여 개인 이미지 저장소에 액세스할 수 있습니다. 이를 통해 OpenShift Container Platform은 프라이빗 리포지토리에서 이미지 푸시 및 풀 작업을 수행할 수 있습니다. 인증 항목에는 자세한 정보가 있습니다.

2.2.4. Red Hat Quay 레지스트리

엔터프라이즈급 컨테이너 이미지 레지스트리가 필요한 경우 Red Hat Quay는 호스팅 서비스와 자체 데이터 센터 또는 클라우드 환경에 설치할 수있는 소프트웨어로 사용할 수 있습니다. Red Hat Quay의 고급 레지스트리에는 리전 복제, 이미지 스캔 및 이미지 롤백 기능이 포함되어 있습니다.

Quay.io 사이트를 방문하여 호스팅된 Quay 레지스트리 계정을 설정합니다. 그런 다음 Quay 튜토리얼 에 따라 Quay 레지스트리에 로그인하고 이미지 관리를 시작합니다. 또는 고유한 Red Hat Quay 레지스트리 설정에 대한 정보는 Red Hat Quay로 시작하기 를 참조하십시오.

원격 컨테이너 이미지 레지스트리와 마찬가지로 OpenShift Container Platform에서 Red Hat Quay 레지스트리에 액세스할 수 있습니다. Red Hat Quay에 보안 레지스트리로 액세스하기 위한 자격 증명을 설정하는 방법을 알아보려면 다른 보안 레지스트리의 참조 이미지에 포드 허용을 참조하십시오.

2.2.5. 인증 활성화 Red Hat 레지스트리

Red Hat Container Catalog를 통해 사용할 수 있는 모든 컨테이너 이미지는 이미지 레지스트리인 registry.access.redhat.com 에 호스팅됩니다. OpenShift Container Platform 3.11 Red Hat Container Catalog를 registry.access.redhat.com에서 로 이동했습니다.

registry. redhat.io

새 레지스트리 registry.redhat.io 는 OpenShift Container Platform의 이미지 및 호스팅 콘텐츠에 액세스할 수 있는 인증이 필요합니다. 새 레지스트리로 마이그레이션한 후 기존 레지스트리를 일정 기간 동안 사용할 수 있습니다.

OpenShift Container Platform은 registry.redhat.io에서 이미지를 가져 오므로 이를 사용할 수 있도록 클러스터를 설정해야합니다.

새 레지스트리는 다음과 같은 방법으로 인증에 표준 OAuth 메커니즘을 사용합니다.

- 인증 토큰: 관리자가 생성한 토큰은 시스템에 컨테이너 이미지 레지스트리에 대한 인증 기능을 제공하는 서비스 계정입니다. 서비스 계정은 사용자 계정 변경의 영향을 받지 않으므로 인증에 토큰을 사용하는 것은 안정적이고 유연한 인증 방법입니다. 이는 프로덕션 클러스터에 대해 지원되는 유일한 인증 옵션입니다.

-

웹 사용자 이름 및 암호: 이는

access.redhat.com과 같은 리소스에 로그인하는 데 사용하는 표준 인증 정보 집합입니다. OpenShift Container Platform에서 이 인증 방법을 사용할 수는 있지만 프로덕션 배포에는 지원되지 않습니다. 이 인증 방법은 OpenShift Container Platform 외부의 독립형 프로젝트에서만 사용해야합니다.

사용자 이름 및 암호 또는 인증 토큰 중 하나의 자격 증명으로 Docker 로그인을 사용하여 새 레지스트리의 콘텐츠에 액세스할 수 있습니다.

모든 이미지 스트림은 새 레지스트리를 가리킵니다. 새 레지스트리에는 액세스에 대한 인증이 필요하므로 OpenShift 네임스페이스에 imagestreamsecret 이라는 새 시크릿이 있습니다.

다음 두 위치에 인증 정보를 배치해야 합니다.

- OpenShift 네임 스페이스: OpenShift 네임스페이스의 이미지 스트림을 가져올 수 있도록 인증 정보가 OpenShift 네임스페이스에 있어야 합니다.

- 호스트: Kubernetes에서 이미지를 가져올 때 호스트의 인증 정보를 사용하므로 호스트에 인증 정보가 있어야합니다.

새 레지스트리에 액세스하려면 다음을 수행합니다.

-

이미지 가져오기 시크릿

imagestreamsecret이 OpenShift 네임스페이스에 있는지 확인합니다. 해당 시크릿에는 새 레지스트리에 액세스할 수 있는 인증 정보가 있습니다. -

모든 클러스터 노드에 마스터에서 복사된

/var/lib/origin/.docker/config.json이 Red Hat 레지스트리에 액세스할 수 있도록 합니다.

2.3. 웹 콘솔

2.3.1. 개요

OpenShift Container Platform 웹 콘솔은 웹 브라우저에서 액세스할 수 있는 사용자 인터페이스입니다. 개발자는 웹 콘솔을 사용하여 프로젝트의 콘텐츠를 시각화, 탐색 및 관리할 수 있습니다.

웹 콘솔을 사용하려면 JavaScript가 활성화되어 있어야합니다. WebSockets을 지원하는 웹 브라우저를 사용하는 것이 좋습니다.

웹 콘솔은 마스터에서 포드로 실행됩니다. Pod에서는 웹 콘솔을 실행하는 데 필요한 정적 환경을 제공합니다. 관리자는 확장 기능을 사용하여 웹 콘솔을 사용자 지정할 수도 있습니다. 그러면 웹 콘솔이 로드될 때 스크립트를 실행하고 사용자 지정 스타일시트를 로드할 수 있습니다.

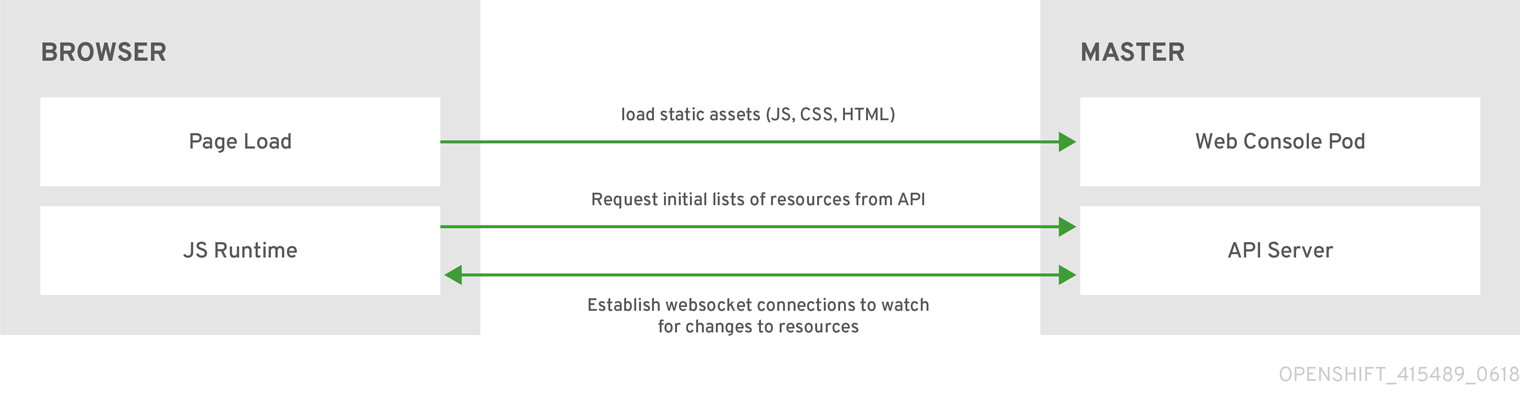

브라우저에서 웹 콘솔에 액세스하면 먼저 필요한 모든 정적 자산을 로드합니다. 그런 다음 openshift start 옵션 정의된 --public-master에서 정의한 값을 사용하거나 openshift - web- console 네임스페이스에webconsole-config 구성 맵의 관련 매개변수 masterPublicURL 에서 OpenShift Container Platform API에 요청합니다. 웹 콘솔에서는 WebSockets를 사용하여 API 서버와의 지속적인 연결을 유지하고 사용 가능한 즉시 업데이트된 정보를 받습니다.

그림 2.3. 웹 콘솔 요청 아키텍처

웹 콘솔에 대해 구성된 호스트 이름과 IP 주소는 브라우저에서 요청을 교차 원본으로 간주하는 경우에도 API 서버에 안전하게 액세스하도록 허용 목록에 표시됩니다. 다른 호스트 이름을 사용하여 웹 애플리케이션에서 API 서버에 액세스하려면 openshift start 또는 관련 마스터 구성 파일 corsAllowedOrigin

s에서 --cors-allowed-origin s 옵션을 지정하여 해당 호스트 이름을 허용해야 합니다.

corsAllowedOrigins 매개 변수는 구성 필드에 의해 제어됩니다. 해당 값에 고정 또는 이스케이핑이 수행되지 않습니다. 다음은 호스트 이름 및 이스케이프 지점을 고정할 수 있는 방법의 예입니다.

corsAllowedOrigins: - (?i)//my\.subdomain\.domain\.com(:|\z)

-

(?i)는 대소문자를 구분하지 않습니다. -

는도메인의 시작 부분에 고정되고http: 또는뒤에 있는 이중 슬래시와 일치합니다.https: -

\.은 도메인 이름에서 점을 이스케이프합니다. -

(:|\z)는 도메인 이름(\z)의 끝 또는 포트 구분 기호(:)과 일치하는지 확인합니다.

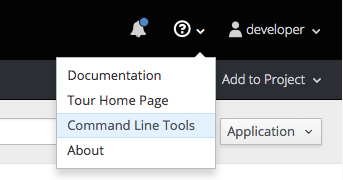

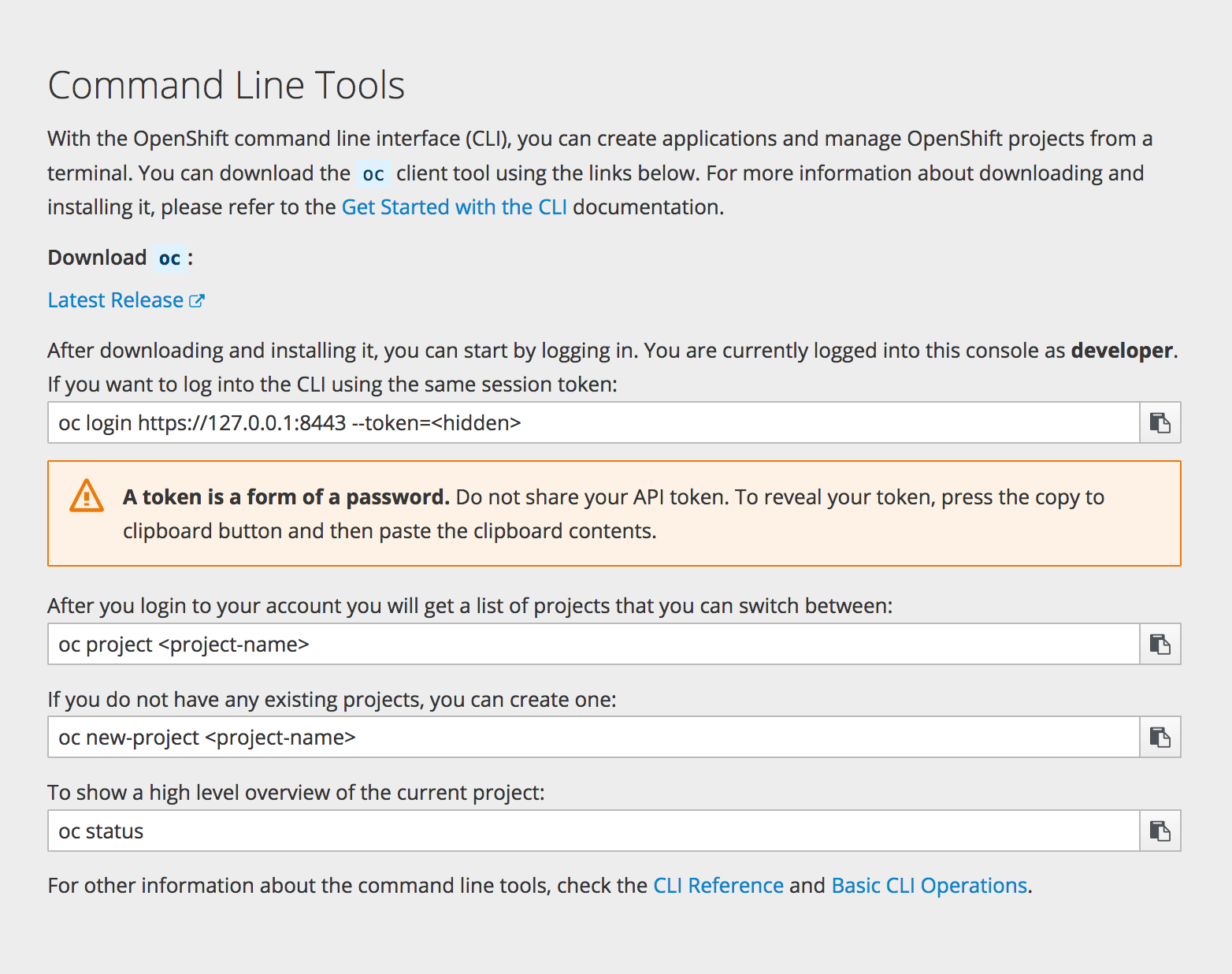

2.3.2. CLI 다운로드

웹 콘솔의 도움말 아이콘에서 CLI 다운로드에 액세스할 수 있습니다.

클러스터 관리자는 이러한 링크를 추가로 사용자 지정할 수 있습니다.

2.3.3. 브라우저 요구 사항

OpenShift Container Platform 에 대해 테스트된 통합을 검토합니다.

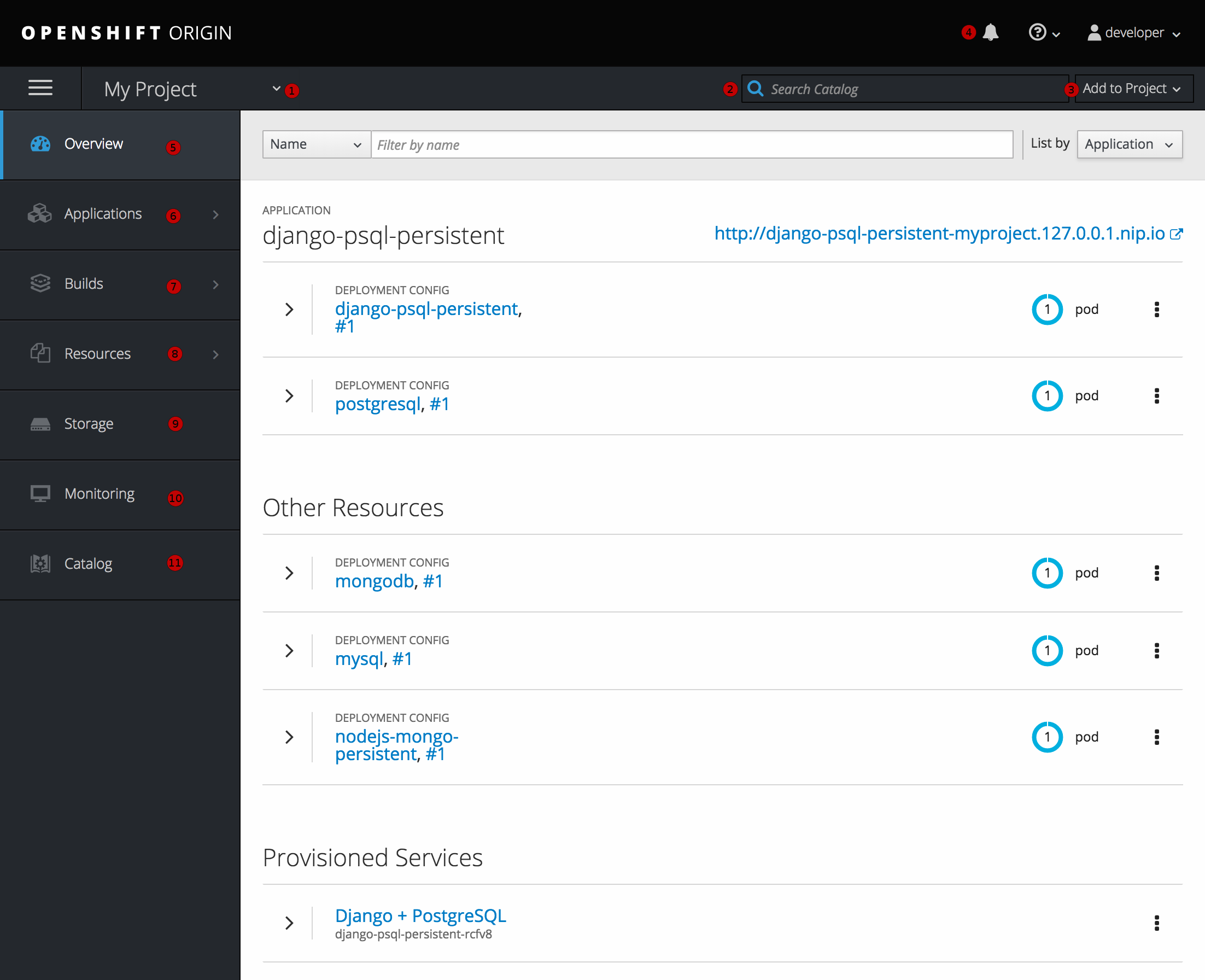

2.3.4. 프로젝트 개요

로그인 후 웹 콘솔에서는 현재 선택한 프로젝트에 대한 개요를 개발자에게 제공합니다.

그림 2.4. 웹 콘솔 프로젝트 개요

- 프로젝트 선택기를 사용하면 액세스할 수 있는 프로젝트를 전환 할 수 있습니다.

- 프로젝트 내에서 서비스를 빠르게 찾으려면 검색 기준을 입력하십시오.

- 서비스 카탈로그에서 소스 리포지토리 또는 서비스를 사용하여 새 애플리케이션을 만듭니다.

- 프로젝트 관련 알림.

- Overview(개요 ) 탭(현재 선택됨)은 각 구성 요소에 대한 높은 수준의 보기로 프로젝트 내용을 시각화합니다.

- 애플리케이션 탭: 배포, 포드, 서비스 및 경로에 대한 작업을 검색하고 수행합니다.

- Build 탭: 빌드 및 이미지 스트림에서 작업을 검색하고 수행합니다.

- Resources 탭: 현재 할당량 소비 및 기타 리소스를 확인합니다.

- Storage 탭: 영구 볼륨 클레임을 보고 애플리케이션의 스토리지를 요청합니다.

- 모니터링 탭: 빌드, 포드 및 배포에 대한 로그와 프로젝트의 모든 오브젝트에 대한 이벤트 알림을 확인합니다.

- Catalog 탭: 프로젝트 내에서 신속하게 카탈로그로 이동합니다.

Cockpit 은 개발 환경을 모니터링하는 데 도움이 되도록 에서 자동으로 설치 및 활성화됩니다. Red Hat Enterprise Linux Atomic Host: Cockpit 시작하기는 Cockpit 사용에 대한 자세한 정보를 제공합니다.

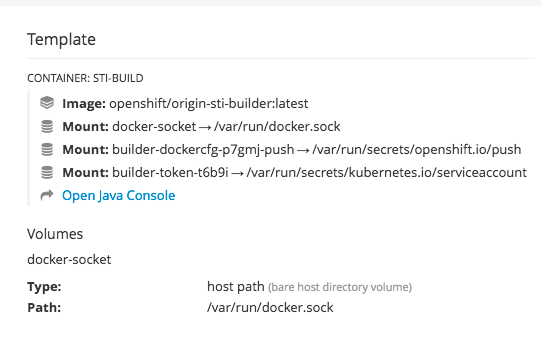

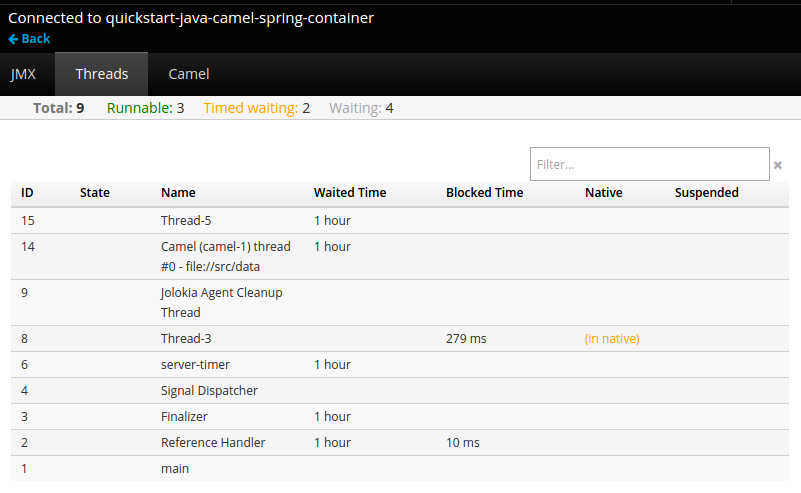

2.3.5. JVM 콘솔

Java 이미지를 기반으로 하는 Pod의 경우 웹 콘솔은 관련된 통합 구성 요소를 보고 관리하기 위해 hawt.io기반 JVM 콘솔에 대한 액세스도 노출합니다. 컨테이너에 jolokia 라는 포트가 있는 경우 연결 링크가 Browse → Pods 페이지의 Pod 세부 정보에 표시됩니다.

그림 2.5. JVM 콘솔에 연결되는 Pod

JVM 콘솔에 연결하면 연결된 포드와 관련된 구성 요소에 따라 다른 페이지가 표시됩니다.

그림 2.6. JVM 콘솔

다음 페이지를 사용할 수 있습니다.

| 페이지 | 설명 |

|---|---|

| JMX | JMX 도메인 및 mbean을 보고 관리합니다. |

| 스레드 | 스레드 상태를 보고 모니터링합니다. |

| ActiveMQ | Apache ActiveMQ 브로커를 보고 관리합니다. |

| Camel | Apache Camel 경로 및 종속성을 보고 관리합니다. |

| OSGi | JBoss Fuse OSGi 환경 보기 및 관리. |

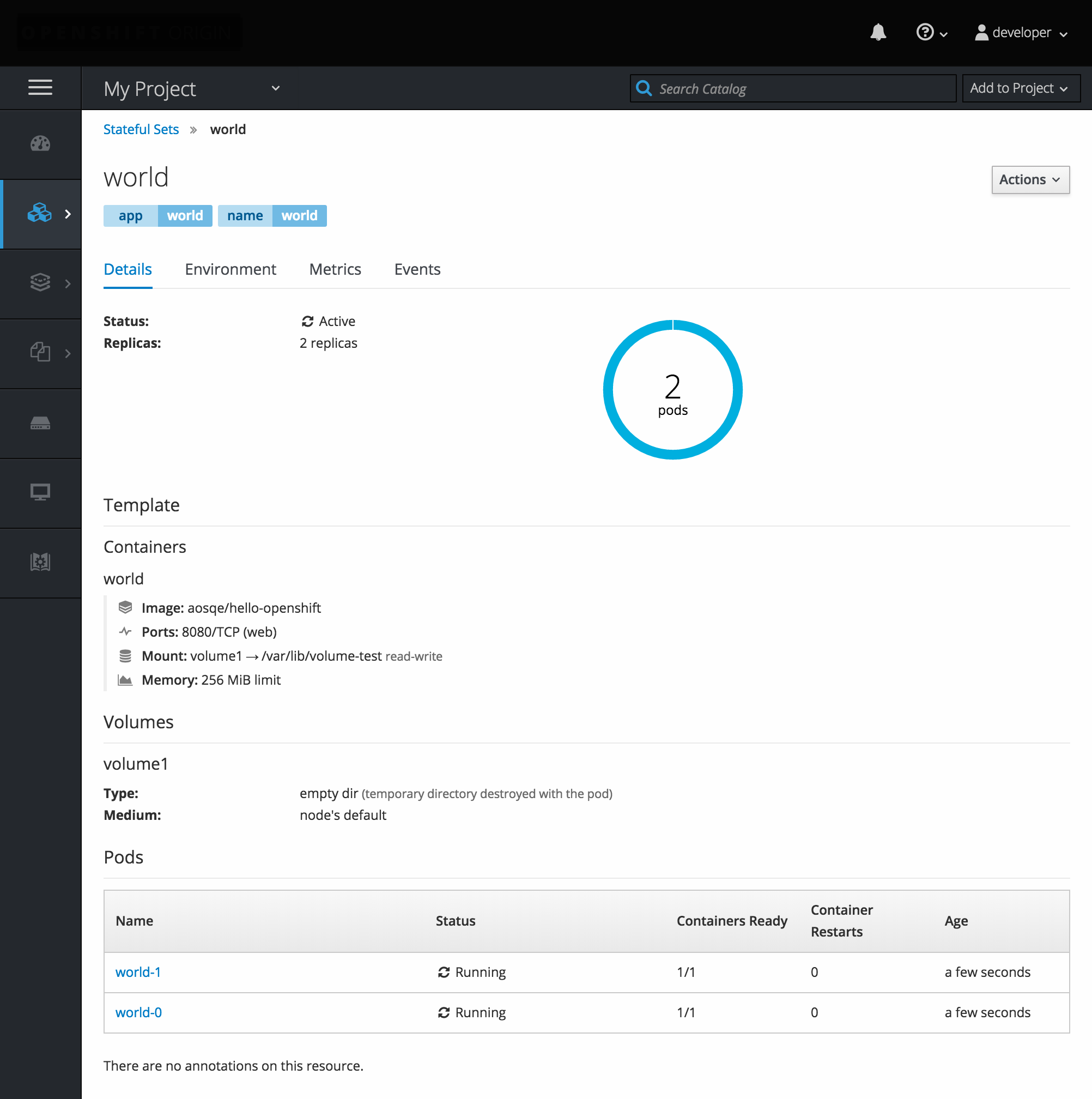

2.3.6. StatefulSets

StatefulSet 컨트롤러는 Pod에 고유한 ID를 제공하고 배포 및 스케일링 순서를 결정합니다. StatefulSet 는 고유한 네트워크 식별자, 영구저장장치, 정상 배포 및 확장, 정상적인 삭제 및 종료에 유용합니다.

그림 2.7. OpenShift Container Platform의 StatefulSet

3장. 핵심 개념

3.1. 개요

다음 주제는 OpenShift Container Platform을 사용할 때 발생하는 핵심 개념 및 오브젝트에 대한 고급 아키텍처 정보를 제공합니다. 이러한 오브젝트 중 상당수는 Kubernetes에서 제공되며 OpenShift Container Platform에서 확장하여 기능이 풍부한 개발 라이프사이클 플랫폼을 제공합니다.

- 컨테이너 및 이미지는 애플리케이션 배포를 위한 구성 요소입니다.

- 포드 및 서비스를 사용하면 컨테이너가 서로 통신하고 프록시 연결과 통신할 수 있습니다.

- 프로젝트와 사용자는 커뮤니티에서 콘텐츠를 함께 구성하고 관리할 수 있는 공간을 제공합니다.

- 빌드 및 이미지 스트림을 사용하면 작업 이미지를 빌드하고 새 이미지에 대응할 수 있습니다.

- 배포 시 소프트웨어 개발 및 배포 라이프사이클에 대한 확장된 지원이 추가되었습니다.

- 경로가 서비스를 전 세계에 알립니다.

- 템플릿 을 사용하면 사용자 지정 매개 변수를 기반으로 한 번에 많은 오브젝트를 생성할 수 있습니다.

3.2. 컨테이너 및 이미지

3.2.1. 컨테이너

OpenShift Container Platform 애플리케이션의 기본 단위는 컨테이너라고 합니다. Linux 컨테이너 기술은 실행 중인 프로세스를 격리하는 데 필요한 간단한 메커니즘으로, 이를 통해 실행 중인 프로세스는 지정된 리소스하고만 상호 작용하도록 제한됩니다.

많은 애플리케이션 인스턴스는 서로의 프로세스, 파일, 네트워크 등을 보지 않으며 단일 호스트의 컨테이너에서 실행될 수 있습니다. 컨테이너를 임의의 워크로드에 사용할 수는 있지만 일반적으로 각 컨테이너는 웹 서버나 데이터베이스 같은 단일 서비스(흔히 “마이크로 서비스”라고 함)를 제공합니다.

Linux 커널은 수년간 컨테이너 기술을 위한 기능을 통합해 왔습니다. 최근에 Docker 프로젝트는 호스트의 Linux 컨테이너용 편리한 관리 인터페이스를 개발했습니다. OpenShift Container Platform 및 Kubernetes는 다중 호스트 설치에서 Docker 형식의 컨테이너를 오케스트레이션하는 기능을 추가합니다.

OpenShift Container Platform을 사용할 때 Docker CLI 또는 서비스와 직접 상호 작용하지는 않지만 OpenShift Container Platform에서 역할과 애플리케이션이 컨테이너 내에서 작동하는 방식을 이해하는 데 필요한 기능 및 용어를 이해하는 것이 중요합니다. Docker RPM은 RHEL 7과 CentOS 및 Fedora의 일부로 제공되므로 OpenShift Container Platform과 별도로 시험할 수 있습니다. 가이드 소개는 Red Hat Systems의 Docker Formatted Container Images 문서를 참조하십시오.

3.2.1.1. Init 컨테이너

포드에는 애플리케이션 컨테이너 외에도 init 컨테이너가 있을 수 있습니다. Init Container를 사용하면 설정 스크립트 및 바인딩 코드를 재구성할 수 있습니다. init 컨테이너는 항상 완료되기 때문에 일반 컨테이너와 다릅니다. 각 init 컨테이너는 다음 컨테이너를 시작하기 전에 성공적으로 완료해야 합니다.

자세한 내용은 Pod 및 Service를 참조하십시오.

3.2.2. 이미지

OpenShift Container Platform의 컨테이너는 Docker 형식의 컨테이너 이미지를 기반으로 합니다. 이미지는 단일 컨테이너를 실행하는 데 필요한 모든 요구 사항과 필요성 및 기능에 대해 설명하는 메타데이터가 포함되어 있는 바이너리입니다.

이미지는 패키징 기술로 생각할 수 있습니다. 컨테이너를 생성할 때 컨테이너에 추가 액세스 권한을 부여하지 않는 경우 컨테이너는 이미지에 정의된 리소스에만 액세스할 수 있습니다. OpenShift Container Platform은 여러 호스트의 여러 컨테이너에 동일한 이미지를 배포하고 컨테이너 간에 부하를 분산하여 서비스 패키지 이미지에 중복성과 수평 확장을 제공할 수 있습니다.

Docker CLI를 직접 사용하여 이미지를 빌드할 수 있지만 OpenShift Container Platform에서는 기존 이미지에 코드 또는 구성을 추가하여 새 이미지를 생성하는 데 도움이 되는 빌더 이미지도 제공합니다.

시간이 지남에 따라 애플리케이션이 개발되기 때문에 단일 이미지 이름은 실제로 "동일한" 이미지의 다양한 버전을 참조할 수 있습니다. 서로 다른 각 이미지는 해시 (예: fd44297e2ddb050ec4f…) 일반적으로 12자로 단축됩니다(예: fd44297e2ddb).

이미지 버전 태그 정책

버전 번호 대신 Docker 서비스를 사용하면 원하는 이미지를 추가로 지정하는 이미지 이름 외에도 태그(예: v1, v2.1GA 또는 기본 최신)를 적용할 수 있으므로 as centos(가장 최신 태그 사용),centos:centos7 또는 fd44297e2ddb 와 동일한 이미지를 볼 수 있습니다.

공식 OpenShift Container Platform 이미지에 latest 태그를 사용하지 마십시오. openshift3/ 로 시작하는 이미지입니다. latest 는 3.10 또는 3.11 과 같은 여러 버전을 참조할 수 있습니다.

이미지에 태그를 지정하는 방법에 따라 업데이트 정책이 지정됩니다. 세부적인 내용이 있을수록 이미지가 업데이트되는 빈도가 줄어듭니다. 다음을 사용하여 선택한 OpenShift Container Platform 이미지 정책을 확인합니다.

- vX.Y

-

vX.Y 태그는 X.Y.Z-<number>를 가리킵니다. 예를 들어

registry-console이미지가 v3.11로 업데이트되면 3.11.1-8과 같은 최신 3.11.Z-<number> 태그를 가리킵니다. - X.Y.Z

- 위의 vX.Y 예와 유사하게 X.Y.Z 태그는 최신 X.Y.Z-<number>를 가리킵니다. 예를 들어 3.11.1은 3.11.1-8을 가리킵니다.

- X.Y.Z-<number>

- 태그는 고유하며 변경되지 않습니다. 이 태그를 사용하면 이미지가 업데이트되면 이미지가 업데이트되지 않습니다. 예를 들어, 3.11.1-8은 이미지가 업데이트되는 경우에도 항상 3.11.1-8을 가리킵니다.

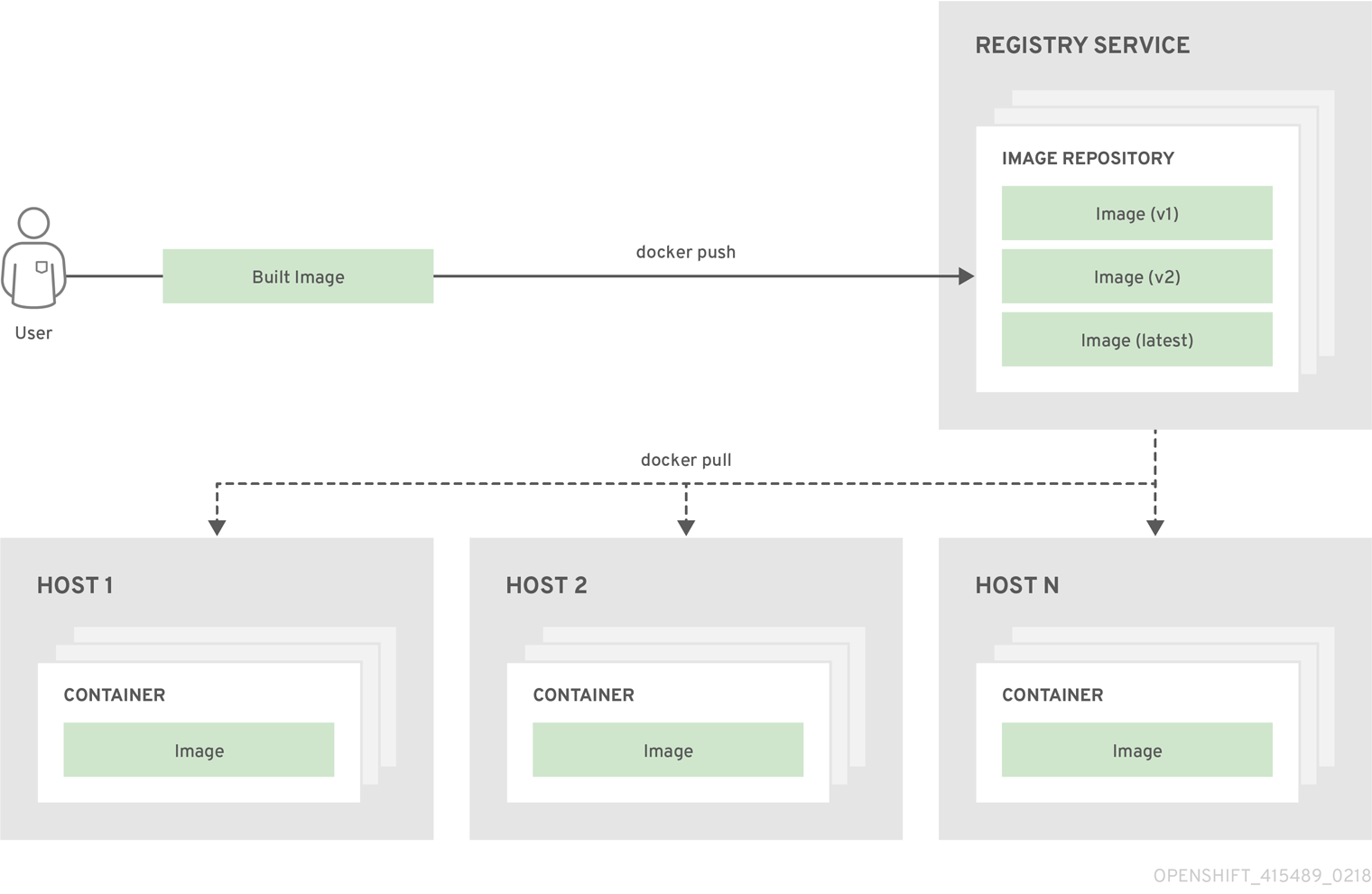

3.2.3. 컨테이너 이미지 레지스트리

컨테이너 이미지 레지스트리는 Docker 형식 컨테이너 이미지를 저장하고 검색하는 서비스입니다. 레지스트리에는 하나 이상의 이미지 리포지토리로 이루어진 컬렉션이 포함되어 있습니다. 각 이미지 리포지토리에는 하나 이상의 태그된 이미지가 포함되어 있습니다. Docker는 자체 레지스트리인 Docker Hub 를 제공하며 개인 또는 타사 레지스트리도 사용할 수 있습니다. Red Hat은 registry.redhat.io의 레지스트리를 구독자에게 제공합니다. OpenShift Container Platform은 사용자 정의 컨테이너 이미지 관리에 사용되는 자체 내부 레지스트리도 제공할 수 있습니다.

컨테이너, 이미지 및 레지스트리 간의 관계는 다음 다이어그램에 표시되어 있습니다.

3.3. Pod 및 서비스

3.3.1. Pod

OpenShift Container Platform은 하나의 호스트에 함께 배포되는 하나 이상의 컨테이너 이자 정의, 배포 및 관리할 수 있는 최소 컴퓨팅 단위인 Pod 의 Kubernetes 개념을 활용합니다.

Pod는 컨테이너에 대한 머신 인스턴스(실제 또는 가상)와 대략적으로 동일합니다. 각 Pod에는 자체 내부 IP 주소가 할당되므로 해당 Pod가 전체 포트 공간을 소유하고 Pod 내의 컨테이너는 로컬 스토리지와 네트워킹을 공유할 수 있습니다.

Pod에는 라이프사이클이 정의되어 있으며 노드에서 실행되도록 할당된 다음 컨테이너가 종료되거나 기타 이유로 제거될 때까지 실행됩니다. Pod는 정책 및 종료 코드에 따라 종료 후 제거되거나 컨테이너 로그에 대한 액세스를 활성화하기 위해 유지될 수 있습니다.

OpenShift Container Platform에서는 대체로 Pod를 변경할 수 없는 것으로 취급합니다. 실행 중에는 Pod 정의를 변경할 수 없습니다. OpenShift Container Platform은 기존 Pod를 종료한 후 수정된 구성이나 기본 이미지 또는 둘 다 사용하여 Pod를 다시 생성하는 방식으로 변경 사항을 구현합니다. Pod를 다시 생성하면 확장 가능한 것으로 취급되고 상태가 유지되지 않습니다. 따라서 일반적으로 포드는 사용자가 직접 관리하는 대신 상위 수준 컨트롤러에서 관리해야 합니다.

OpenShift Container Platform 노드 호스트당 최대 pod 수는 클러스터 최대값을 참조하십시오.

복제 컨트롤러에서 관리하지 않는 베어 Pod는 노드 중단 시 다시 예약되지 않습니다.

다음은 실제로 OpenShift Container Platform 인프라(통합 컨테이너 이미지 레지스트리)의 일부인 장기 실행 서비스를 제공하는 Pod 정의의 예입니다. 이 예제에서는 Pod의 다양한 기능을 보여줍니다. 대부분 다른 주제에서 설명하므로 여기에서는 간단히 언급합니다.

Pod 오브젝트 정의(YAML)

apiVersion: v1

kind: Pod

metadata:

annotations: { ... }

labels: 1

deployment: docker-registry-1

deploymentconfig: docker-registry

docker-registry: default

generateName: docker-registry-1- 2

spec:

containers: 3

- env: 4

- name: OPENSHIFT_CA_DATA

value: ...

- name: OPENSHIFT_CERT_DATA

value: ...

- name: OPENSHIFT_INSECURE

value: "false"

- name: OPENSHIFT_KEY_DATA

value: ...

- name: OPENSHIFT_MASTER

value: https://master.example.com:8443

image: openshift/origin-docker-registry:v0.6.2 5

imagePullPolicy: IfNotPresent

name: registry

ports: 6

- containerPort: 5000

protocol: TCP

resources: {}

securityContext: { ... } 7

volumeMounts: 8

- mountPath: /registry

name: registry-storage

- mountPath: /var/run/secrets/kubernetes.io/serviceaccount

name: default-token-br6yz

readOnly: true

dnsPolicy: ClusterFirst

imagePullSecrets:

- name: default-dockercfg-at06w

restartPolicy: Always 9

serviceAccount: default 10

volumes: 11

- emptyDir: {}

name: registry-storage

- name: default-token-br6yz

secret:

secretName: default-token-br6yz

- 1

- Pod는 단일 작업에서 Pod 그룹을 선택하고 관리하는 데 사용할 수 있는 하나 이상의 레이블을 사용하여 "태그"할 수 있습니다. 레이블은

메타데이터해시의 키/값 형식으로 저장됩니다. 이 예에서 하나의 레이블은 docker-registry=default 입니다. - 2

- Pod에는 네임스페이스 내에 고유한 이름이 있어야 합니다. 포드 정의는

generateName속성이 있는 이름의 기반을 지정할 수 있으며, 고유 이름을 생성하기 위해 임의 문자가 자동으로 추가됩니다. - 3

containers는 컨테이너 정의의 배열을 지정합니다. 이 경우 (대부분과 동일) 하나뿐입니다.- 4

- 각 컨테이너에 필요한 값을 전달하도록 환경 변수를 지정할 수 있습니다.

- 5

- 포드의 각 컨테이너는 자체 Docker 형식 컨테이너 이미지에서 인스턴스화됩니다.

- 6

- 컨테이너는 포드의 IP에서 사용할 수 있는 포트에 바인딩할 수 있습니다.

- 7

- OpenShift Container Platform은 컨테이너에 대한 보안 컨텍스트를 정의합니다. 보안 컨텍스트는 권한 있는 컨테이너로 실행하거나 선택한 사용자로 실행할 수 있는지의 여부 등을 지정합니다. 기본 컨텍스트는 매우 제한적이지만 필요에 따라 관리자가 수정할 수 있습니다.

- 8

- 컨테이너는 컨테이너 내에서 외부 스토리지 볼륨을 마운트해야 하는 위치를 지정합니다. 이 경우 레지스트리의 데이터를 저장하는 볼륨이 있으며 레지스트리에서 OpenShift Container Platform API에 요청하는 데 필요한 인증 정보에 액세스하기 위한 볼륨이 있습니다.

- 9

- Pod는 가능한 값

Always,OnFailure및Never로 정책을 다시 시작합니다. 기본값은Always입니다. - 10

- OpenShift Container Platform API에 대해 요청하는 Pod는 요청 시 포드에서 인증해야 하는 서비스 계정 사용자를 지정하는

serviceAccount필드가 있는 일반적인 패턴입니다. 따라서 사용자 정의 인프라 구성 요소에 대한 액세스 권한을 세부적으로 제어할 수 있습니다. - 11

- Pod는 사용할 컨테이너에서 사용할 수 있는 스토리지 볼륨을 정의합니다. 이 경우 레지스트리 스토리지의 임시 볼륨과 서비스 계정 자격 증명을 포함하는

secret볼륨을 제공합니다.

이 Pod 정의에는 Pod가 생성되고 해당 라이프사이클이 시작된 후 OpenShift Container Platform에 의해 자동으로 채워지는 특성은 포함되지 않습니다. Kubernetes Pod 설명서에는 Pod의 기능 및 용도에 대한 세부 정보가 있습니다.

3.3.1.1. Pod 재시작 정책

Pod 재시작 정책에 따라 해당 Pod의 컨테이너가 종료될 때 OpenShift Container Platform에서 응답하는 방법이 결정됩니다. 정책은 해당 포드의 모든 컨테이너에 적용됩니다.

가능한 값은 다음과 같습니다.

-

Always- Pod를 다시 시작할 때까지 급격한 백오프 지연(10초, 20초, 40초)을 사용하여 Pod에서 성공적으로 종료된 컨테이너를 지속적으로 재시작합니다. 기본값은Always입니다. -

OnFailure- 급격한 백오프 지연(10초, 20초, 40초)을 5분으로 제한하여 Pod에서 실패한 컨테이너를 재시작합니다. -

Never- Pod에서 종료되거나 실패한 컨테이너를 재시작하지 않습니다. Pod가 즉시 실패하고 종료됩니다.

노드에 바인딩되면 Pod가 다른 노드에 바인딩되지 않습니다. 따라서 노드 장애 시 Pod가 작동하려면 컨트롤러가 필요합니다.

| 상태 | 컨트롤러 유형 | 재시작 정책 |

|---|---|---|

| 종료할 것으로 예상되는 Pod(예: 일괄 계산) |

| |

| 종료되지 않을 것으로 예상되는 Pod(예: 웹 서버) |

| |

| 머신당 하나씩 실행해야 하는 Pod | DaemonSet | Any |

Pod의 컨테이너가 실패하고 재시작 정책이 OnFailure 로 설정되면 Pod가 노드에 남아 있고 컨테이너가 다시 시작됩니다. 컨테이너를 재시작하지 않으려면 재시작 정책 Never 를 사용합니다.

전체 Pod가 실패하면 OpenShift Container Platform에서 새 Pod를 시작합니다. 개발자는 애플리케이션이 새 포드에서 다시 시작될 수 있는 가능성을 해결해야 합니다. 특히 애플리케이션은 이전 실행으로 발생한 임시 파일, 잠금, 불완전한 출력 등을 처리해야 합니다.

Kubernetes 아키텍처에서는 클라우드 공급자의 끝점이 안정적인 것으로 예상합니다. 클라우드 공급자가 중단되면 kubelet에서 OpenShift Container Platform이 재시작되지 않습니다.

기본 클라우드 공급자 끝점이 안정적이지 않은 경우 클라우드 공급자 통합을 사용하여 클러스터를 설치하지 마십시오. 클라우드가 아닌 환경에서처럼 클러스터를 설치합니다. 설치된 클러스터에서 클라우드 공급자 통합을 설정하거나 해제하는 것은 권장되지 않습니다.

OpenShift Container Platform에서 실패한 컨테이너에 재시작 정책을 사용하는 방법에 대한 자세한 내용은 Kubernetes 설명서의 예제 상태를 참조하십시오.

3.3.2. Init 컨테이너

init 컨테이너 는 Pod 앱 컨테이너를 시작하기 전에 시작되는 Pod의 컨테이너입니다. Init 컨테이너는 나머지 컨테이너가 시작되기 전에 볼륨을 공유하고, 네트워크 작업을 수행하고, 계산을 수행할 수 있습니다. Init 컨테이너는 일부 사전 조건이 충족될 때까지 애플리케이션 컨테이너의 시작을 차단하거나 지연할 수도 있습니다.

Pod가 시작되면 네트워크와 볼륨을 초기화한 후 init 컨테이너가 순서대로 시작됩니다. 각 init 컨테이너는 다음이 호출되기 전에 성공적으로 종료해야 합니다. init 컨테이너가 시작되지 않거나(런타임) 실패로 종료되면 Pod 재시작 정책에 따라 다시 시작됩니다.

Pod는 모든 init 컨테이너가 성공할 때까지 준비할 수 없습니다.

일부 init 컨테이너 사용 예는 Kubernetes 설명서를 참조하십시오.

다음 예제에서는 두 개의 init 컨테이너가 있는 간단한 포드를 간략하게 설명합니다. 첫 번째 init 컨테이너는 myservice 를 대기하고 두 번째 컨테이너는 mydb 를 기다립니다. 두 컨테이너가 모두 성공하면 Pod가 시작됩니다.

샘플 Init Container Pod 오브젝트 정의(YAML)

apiVersion: v1

kind: Pod

metadata:

name: myapp-pod

labels:

app: myapp

spec:

containers:

- name: myapp-container

image: busybox

command: ['sh', '-c', 'echo The app is running! && sleep 3600']

initContainers:

- name: init-myservice 1

image: busybox

command: ['sh', '-c', 'until nslookup myservice; do echo waiting for myservice; sleep 2; done;']

- name: init-mydb 2

image: busybox

command: ['sh', '-c', 'until nslookup mydb; do echo waiting for mydb; sleep 2; done;']

각 init 컨테이너에는 readinessProbe 를 제외한 모든 app 컨테이너의 필드가 있습니다. Pod가 계속 시작되려면 Init 컨테이너가 종료되어야 하며 완료 이외의 준비는 정의할 수 없습니다.

Init 컨테이너는 컨테이너에 activeDeadlineSeconds 및 livenessProbe 를 포함하여 init 컨테이너가 영구적으로 실패하지 않도록 할 수 있습니다. 활성 데드라인에는 init 컨테이너가 포함됩니다.

3.3.3. 서비스

Kubernetes 서비스는 내부 로드 밸런서 역할을 합니다. 수신 연결을 프록시하기 위해 복제된 포드 집합을 식별합니다. 서비스에 의존하는 모든 항목이 일관된 주소에서 참조할 수 있도록 백업 포드를 서비스에 임의로 추가하거나 제거할 수 있습니다. 기본 서비스 clusterIP 주소는 OpenShift Container Platform 내부 네트워크에서 제공되며 포드가 서로 액세스할 수 있도록 허용하는 데 사용됩니다.

서비스에 대한 외부 액세스를 허용하려면 클러스터 외부에 있는 추가 externalIP 및 ingressIP 주소를 서비스에 할당할 수 있습니다. 이러한 externalIP 주소는 서비스에 대한 고가용성 액세스를 제공하는 가상 IP 주소일 수도 있습니다.

서비스에 액세스할 때 적절한 지원 포드로 프록시하는 IP 주소 및 포트 쌍이 할당됩니다. 서비스는 레이블 선택기를 사용하여 특정 포트에서 특정 네트워크 서비스를 제공하는 실행 중인 모든 컨테이너를 찾습니다.

포드와 마찬가지로 서비스는 REST 개체입니다. 다음 예는 위에서 정의한 Pod에 대한 서비스 정의를 보여줍니다.

서비스 오브젝트 정의(YAML)

apiVersion: v1 kind: Service metadata: name: docker-registry 1 spec: selector: 2 docker-registry: default clusterIP: 172.30.136.123 3 ports: - nodePort: 0 port: 5000 4 protocol: TCP targetPort: 5000 5

Kubernetes 설명서 에는 서비스에 대한 자세한 정보가 있습니다.

3.3.3.1. 서비스 externalIPs

클러스터의 내부 IP 주소 외에도 사용자는 클러스터 외부에 있는 IP 주소를 구성할 수 있습니다. 관리자는 트래픽이 이 IP를 사용하여 노드에 도착하는지 확인합니다.

master-config.yaml 파일에 구성된 externalIPNetworkCIDRs 범위에서 클러스터 관리자가 externalIP를 선택해야 합니다. master-config.yaml 이 변경되면 마스터 서비스를 다시 시작해야 합니다.

Sample externalIPNetworkCIDR /etc/origin/master/master-config.yaml

networkConfig: externalIPNetworkCIDRs: - 192.0.1.0.0/24

서비스 externalIPs 정의(JSON)

{

"kind": "Service",

"apiVersion": "v1",

"metadata": {

"name": "my-service"

},

"spec": {

"selector": {

"app": "MyApp"

},

"ports": [

{

"name": "http",

"protocol": "TCP",

"port": 80,

"targetPort": 9376

}

],

"externalIPs" : [

"192.0.1.1" 1

]

}

}

- 1

- 포트를 노출하는 외부 IP 주소 목록입니다. 이 목록은 내부 IP 주소 목록에 추가되어 있습니다.

3.3.3.2. 서비스 ingressIPs

클라우드 이외의 클러스터에서 externalIP 주소는 주소 풀에서 자동으로 할당할 수 있습니다. 이렇게 하면 관리자가 수동으로 할당할 필요가 없습니다.

이 풀은 /etc/origin/master/master-config.yaml 파일에 구성됩니다. 이 파일을 변경한 후 마스터 서비스를 다시 시작합니다.

ingressIPNetworkCIDR 은 기본적으로 172.29.0.0/16 으로 설정됩니다. 클러스터 환경에서 이 프라이빗 범위를 아직 사용하지 않는 경우 기본 범위를 사용하거나 사용자 지정 범위를 설정합니다.

고가용성 을 사용하는 경우 이 범위는 256 주소 미만이어야 합니다.

Sample ingressIPNetworkCIDR /etc/origin/master/master-config.yaml

networkConfig: ingressIPNetworkCIDR: 172.29.0.0/16

3.3.3.3. Service NodePort

서비스 type=NodePort 를 설정하면 플래그 구성 범위에서 포트가 할당됩니다(기본값: 30000~32767), 각 노드는 해당 포트(모든 노드에서 동일한 포트 번호)를 서비스에 프록시합니다.

선택한 포트는 spec.ports[*].nodePort 의 서비스 구성에 보고됩니다.

사용자 지정 포트를 지정하려면 nodePort 필드에 포트 번호를 배치하면 됩니다. 사용자 지정 포트 번호는 nodePorts에 대해 구성된 범위에 있어야 합니다. 'master-config.yaml'이 변경되면 마스터 서비스를 다시 시작해야 합니다.

Sample servicesNodePortRange /etc/origin/master/master-config.yaml

kubernetesMasterConfig: servicesNodePortRange: ""

서비스는 <NodeIP>:spec.ports[].nodePort 및

spec.clusterIp:spec.ports[].port로 표시됩니다.

nodePort 설정은 권한 있는 작업입니다.

3.3.3.4. 서비스 프록시 모드

OpenShift Container Platform에는 서비스 라우팅 인프라에 대한 두 가지 다른 구현이 있습니다. 기본 구현은 전적으로 iptables기반이며 probabilistic iptables 재작성 규칙을 사용하여 수신되는 서비스 연결을 엔드포인트 포드에 배포합니다. 이전 구현에서는 사용자 공간 프로세스를 사용하여 들어오는 연결을 수락한 다음 클라이언트와 엔드포인트 포드 중 하나 간 트래픽을 프록시합니다.

iptables기반 구현은 훨씬 더 효율적이지만 모든 엔드포인트가 항상 연결을 허용할 수 있어야 합니다. 사용자 공간 구현이 느리지만 작동되는 엔드포인트를 찾을 때까지 여러 끝점을 차례로 시도할 수 있습니다. 준비 상태 검사 (또는 일반적으로 신뢰할 수 있는 노드 및 Pod)가 있으면 iptables기반 서비스 프록시가 최적의 선택입니다. 그렇지 않으면 노드 구성 파일을 편집하여 클러스터를 설치할 때 또는 클러스터를 배포한 후 사용자 공간 기반 프록시를 활성화할 수 있습니다.

3.3.3.5. 헤드리스 서비스

애플리케이션에 부하 분산 또는 단일 서비스 IP 주소가 필요하지 않은 경우 헤드리스 서비스를 생성할 수 있습니다. 헤드리스 서비스를 생성하면 부하 분산 또는 프록시가 수행되지 않으며 이 서비스에 대한 클러스터 IP가 할당되지 않습니다. 이러한 서비스의 경우 서비스에 선택기가 정의되어 있는지 여부에 따라 DNS가 자동으로 구성됩니다.

선택기가 있는 서비스: 선택기를 정의하는 헤드리스 서비스의 경우 엔드포인트 컨트롤러는 API에 엔드포인트 레코드 를 생성하고 DNS 구성을 수정하여 서비스를 지원하는 포드를 직접 가리키는 A 레코드(주소)를 반환합니다.

선택기 없는 서비스: 선택기를 정의하지 않는 헤드리스 서비스의 경우 엔드포인트 컨트롤러에서 엔드포인트 레코드 를 생성하지 않습니다. 그러나 DNS 시스템은 다음 레코드를 찾아 구성합니다.

-

ExternalName유형 서비스의 경우CNAME레코드. -

다른 모든 서비스 유형의 경우 이름을 서비스와 공유하는 모든 엔드포인트에 대한

A레코드입니다.

3.3.3.5.1. 헤드리스 서비스 생성

헤드리스 서비스 생성은 표준 서비스 생성과 비슷하지만 ClusterIP 주소를 선언하지 않습니다. 헤드리스 서비스를 생성하려면 clusterIP를 추가합니다. none 서비스 YAML 정의에 대한 매개변수 값입니다.

예를 들어 동일한 클러스터 또는 서비스의 일부가 되고자 하는 Pod 그룹의 경우입니다.

Pod 목록

$ oc get pods -o wide

출력 예

NAME READY STATUS RESTARTS AGE IP NODE frontend-1-287hw 1/1 Running 0 7m 172.17.0.3 node_1 frontend-1-68km5 1/1 Running 0 7m 172.17.0.6 node_1

헤드리스 서비스를 다음과 같이 정의할 수 있습니다.

헤드리스 서비스 정의

apiVersion: v1

kind: Service

metadata:

labels:

app: ruby-helloworld-sample

template: application-template-stibuild

name: frontend-headless 1

spec:

clusterIP: None 2

ports:

- name: web

port: 5432

protocol: TCP

targetPort: 8080

selector:

name: frontend 3

sessionAffinity: None

type: ClusterIP

status:

loadBalancer: {}

또한 헤드리스 서비스에는 자체 IP 주소가 없습니다.

$ oc get svc

출력 예

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE frontend ClusterIP 172.30.232.77 <none> 5432/TCP 12m frontend-headless ClusterIP None <none> 5432/TCP 10m

3.3.3.5.2. 헤드리스 서비스를 사용하여 끝점 검색

헤드리스 서비스를 사용하면 포드의 IP 주소를 직접 검색할 수 있다는 이점이 있습니다. 표준 서비스는 로드 밸런서 또는 프록시 역할을 하며 서비스 이름을 사용하여 워크로드 오브젝트에 대한 액세스 권한을 부여합니다. 헤드리스 서비스를 사용하면 서비스 이름이 서비스에서 그룹화한 포드의 IP 주소 집합으로 확인됩니다.

표준 서비스의 DNS A 레코드를 조회하면 서비스의 부하 분산된 IP가 표시됩니다.

$ dig frontend.test A +search +short

출력 예

172.30.232.77

하지만 헤드리스 서비스의 경우 개별 포드의 IP 목록을 가져옵니다.

$ dig frontend-headless.test A +search +short

출력 예

172.17.0.3 172.17.0.6

StatefulSet 및 초기화 및 종료 중에 Pod의 DNS를 확인해야 하는 관련 사용 사례와 함께 헤드리스 서비스를 사용하려면 publishNotReadyAddresses 를 true 로 설정합니다(기본값은 false임). publishNotReadyAddresses 를 true 로 설정하면 DNS 구현에서 서비스와 연결된 엔드포인트에 대한 notReadyAddresses 의 하위 집합을 게시해야 함을 나타냅니다.

3.3.4. 라벨

레이블은 API 오브젝트를 구성, 그룹화 또는 선택하는 데 사용됩니다. 예를 들어 Pod 는 레이블이 있는 "태그"에 해당된 다음 서비스에서 라벨 선택기를 사용하여 프록시할 포드를 식별합니다. 이렇게 하면 잠재적으로 다른 컨테이너가 있는 Pod를 관련 엔터티로 처리해도 서비스가 포드 그룹을 참조할 수 있습니다.

대부분의 오브젝트는 메타데이터에 레이블을 포함할 수 있습니다. 따라서 레이블을 사용하여 임의로 관련된 오브젝트를 그룹화할 수 있습니다. 예를 들어 특정 애플리케이션의 모든 포드,서비스,복제 컨트롤러 및 배포 구성을 그룹화할 수 있습니다.

레이블은 다음 예와 같이 간단한 키/값 쌍입니다.

labels: key1: value1 key2: value2

고려 사항:

- 레이블이 role=webserver 인 nginx 컨테이너로 구성된 포드입니다.

- 동일한 레이블이 role=webserver 인 Apache httpd 컨테이너로 구성된 포드입니다.

role=webserver 레이블이 있는 포드를 사용하도록 정의된 서비스 또는 복제 컨트롤러는 이러한 포드를 모두 동일한 그룹의 일부로 취급합니다.

Kubernetes 설명서 에는 레이블에 대한 자세한 정보가 있습니다.

3.3.5. 엔드포인트

서비스를 지원하는 서버를 엔드포인트라고 하며, 서비스와 동일한 이름으로 Endpoints 유형의 오브젝트에 의해 지정됩니다. Pod에서 서비스를 지원하는 경우 일반적으로 해당 Pod는 서비스 사양의 라벨 선택기에 의해 지정되며 OpenShift Container Platform은 해당 Pod를 가리키는 Endpoints 오브젝트를 자동으로 생성합니다.

경우에 따라 서비스를 생성하지만 OpenShift Container Platform 클러스터의 Pod가 아닌 외부 호스트에서 지원하도록 할 수 있습니다. 이 경우 서비스에서 selector 필드를 종료하고 끝점 오브젝트를 수동으로 생성할 수 있습니다.

OpenShift Container Platform에서는 대부분의 사용자가 Pod 및 서비스 IP용으로 예약된 네트워크 블록에서 IP 주소를 가리키는 엔드포인트 오브젝트를 수동으로 생성하지 않습니다. 엔드포인트/제한에서 리소스를 오브젝트를 생성할 수 있습니다.

생성할 수 있는 권한이 있는 클러스터 관리자 또는 기타 사용자만 이러한 엔드포인트

3.4. 프로젝트 및 사용자

3.4.1. 사용자

OpenShift Container Platform과의 상호 작용은 사용자와 연결되어 있습니다. OpenShift Container Platform 사용자 오브젝트는 시스템에서 역할을 추가하여 권한을 부여받을 수 있는 행위자를 나타냅니다.

다음과 같이 여러 유형의 사용자가 존재할 수 있습니다.

| Regular users |

대부분의 대화형 OpenShift Container Platform 사용자를 나타냅니다. 일반 사용자는 처음 로그인할 때 시스템에서 자동으로 생성되거나 API를 통해 생성할 수 있습니다. 일반 사용자는 |

| System users |

대부분의 시스템 사용자는 주로 인프라와 API 간의 안전한 상호 작용을 목적으로 인프라가 정의될 때 자동으로 생성됩니다. 여기에는 클러스터 관리자(전체 액세스 권한 보유), 노드별 사용자, 라우터 및 레지스트리용 사용자를 비롯하여 기타 다양한 사용자가 포함됩니다. 마지막으로 인증되지 않은 요청에 기본적으로 사용되는 |

| Service accounts |

프로젝트와 관련된 특별한 시스템 사용자입니다. 일부는 프로젝트가 처음 생성될 때 자동으로 생성되는 반면 프로젝트 관리자는 각 프로젝트 내용에 대한 액세스를 정의하기 위해 추가로 생성할 수 있습니다. 서비스 계정은 |

모든 사용자가 OpenShift Container Platform에 액세스하려면 어떠한 방식으로든 인증 해야 합니다. 인증이 없거나 인증이 유효하지 않은 API 요청은 anonymous 시스템 사용자가 요청한 것으로 인증됩니다. 인증되고 나면 정책에 따라 사용자가 수행할 수 있는 작업이 결정됩니다.

3.4.2. 네임스페이스

Kubernetes 네임스페이스는 클러스터의 리소스 범위를 지정하는 메커니즘을 제공합니다. OpenShift Container Platform에서 프로젝트는 추가 주석이 있는 Kubernetes 네임스페이스입니다.

네임스페이스는 다음에 대한 고유 범위를 제공합니다.

- 기본 이름 지정 충돌을 피하기 위해 이름이 지정된 리소스

- 신뢰할 수 있는 사용자에게 위임된 관리 권한

- 커뮤니티 리소스 사용을 제한하는 기능

시스템에 있는 대부분의 오브젝트는 네임스페이스에 따라 범위가 지정되지만, 노드 및 사용자를 비롯한 일부는 여기에 해당하지 않으며 네임스페이스가 없습니다.

쿠버네티스 설명서에 네임스페이스에 대한 자세한 정보가 있습니다.

3.4.3. 프로젝트

프로젝트는 추가 주석이 있는 Kubernetes 네임스페이스이며 일반 사용자의 리소스에 대한 액세스를 관리하는 핵심 수단입니다. 사용자 커뮤니티는 프로젝트를 통해 다른 커뮤니티와 별도로 콘텐츠를 구성하고 관리할 수 있습니다. 사용자는 관리자로부터 프로젝트에 대한 액세스 권한을 부여받아야 합니다. 프로젝트를 생성하도록 허용된 경우 자신의 프로젝트에 액세스할 수 있는 권한이 자동으로 제공됩니다.

프로젝트에는 별도의 이름, displayName 및 설명이 있을 수 있습니다.

-

필수

name은 프로젝트의 고유 식별자이며 CLI 툴 또는 API를 사용할 때 가장 잘 표시됩니다. 최대 이름 길이는 63자입니다. -

선택적

displayName은 프로젝트가 웹 콘솔에 표시되는 방식입니다(기본값:name). -

선택적

설명은프로젝트에 대한 자세한 설명이 될 수 있으며 웹 콘솔에도 표시됩니다.

각 프로젝트의 범위는 다음과 같습니다.

| Objects | Pod, 서비스, 복제 컨트롤러 등입니다. |

| Policies | 사용자는 오브젝트에서 이 규칙에 대해 작업을 수행할 수 있거나 수행할 수 없습니다. |

| Constraints | 제한할 수 있는 각 종류의 오브젝트에 대한 할당량입니다. |

| Service accounts | 서비스 계정은 프로젝트의 오브젝트에 지정된 액세스 권한으로 자동으로 작동합니다. |

클러스터 관리자는 프로젝트를 생성하고 프로젝트에 대한 관리 권한을 사용자 커뮤니티의 모든 멤버에게 위임할 수 있습니다. 클러스터 관리자는 개발자가 자신의 프로젝트를 만들 수 있도록 허용할 수도 있습니다.

개발자와 관리자는 CLI 또는 웹 콘솔을 사용하여 프로젝트와 상호 작용할 수 있습니다.

3.4.3.1. 설치 시 제공되는 프로젝트

OpenShift Container Platform에는 기본적으로 많은 프로젝트가 제공되며 openshift- 로 시작하는 프로젝트가 사용자에게 가장 중요합니다. 이러한 프로젝트는 Pod 및 기타 인프라 구성 요소로 실행되는 마스터 구성 요소를 호스팅합니다. 중요한 Pod 주석이 있는 네임스페이스에 생성된 Pod는 중요한 Pod로 간주되며 kubelet의 승인이 보장되었습니다. 이러한 네임스페이스에서 마스터 구성 요소용으로 생성된 Pod는 이미 중요로 표시되어 있습니다.

3.5. 빌드 및 이미지 스트림

3.5.1. 빌드

빌드는 입력 매개 변수를 결과 오브젝트로 변환하는 프로세스입니다. 대부분의 경우 프로세스는 입력 매개변수 또는 소스 코드를 실행 가능한 이미지로 변환하는 데 사용됩니다. BuildConfig 오브젝트는 전체 빌드 프로세스에 대한 정의입니다.

OpenShift Container Platform은 빌드 이미지에서 Docker 형식 컨테이너를 생성하고 컨테이너 이미지 레지스트리로 내보내 Kubernetes를 활용합니다.

빌드 오브젝트는 공통 특성을 공유합니다. 빌드에 대한 입력, 빌드 프로세스를 완료하고, 빌드 프로세스를 로깅하고, 빌드에 성공한 빌드의 리소스를 게시하고, 빌드의 최종 상태를 게시해야 합니다. 빌드에서는 CPU 사용량, 메모리 사용량, 빌드 또는 Pod 실행 시간과 같은 리소스 제한 사항을 활용합니다.

OpenShift Container Platform 빌드 시스템은 빌드 API에 지정된 선택 가능한 유형을 기반으로 하는 빌드 전략에 대한 확장 가능한 지원을 제공합니다. 다음은 세 가지 주요 빌드 전략입니다.

기본적으로 Docker 빌드 및 S2I 빌드가 지원됩니다.

빌드의 결과 오브젝트는 빌드를 생성하는 데 사용된 빌더에 따라 다릅니다. Docker 및 S2I 빌드의 경우 결과 오브젝트는 실행 가능한 이미지입니다. 사용자 정의 빌드의 경우 결과 오브젝트는 빌더 이미지 작성자가 지정한 모든 항목입니다.

또한 Pipeline 빌드 전략을 사용하여 정교한 워크플로를 구현할 수 있습니다.

- 연속 통합

- 연속 배포

빌드 명령 목록은 개발자 가이드를 참조하십시오.

OpenShift Container Platform이 빌드를 위해 Docker를 활용하는 방법에 대한 자세한 내용은 업스트림 문서를 참조하십시오.

3.5.1.1. Docker 빌드

Docker 빌드 전략에서는 Docker 빌드 명령을 호출하므로 실행 가능한 이미지를 생성하기 위해 Dockerfile 및 모든 필수 아티팩트가 있는 리포지토리가 필요합니다.

3.5.1.2. S2I(Source-to-Image) 빌드

S 2I(Source-to-Image) 는 재현 가능한 Docker 형식의 컨테이너 이미지를 빌드하는 툴입니다. 컨테이너 이미지에 애플리케이션 소스를 삽입하고 새 이미지를 어셈블하여 실행할 수 있는 이미지를 생성합니다. 새 이미지는 기본 이미지(빌더)와 빌드된 소스를 통합하며 docker run 명령과 함께 사용할 준비가 되었습니다. S2I는 이전에 다운로드한 종속성, 이전에 빌드한 아티팩트 등을 다시 사용하는 증분 빌드를 지원합니다.

S2I의 장점은 다음과 같습니다.

| 이미지 유연성 |

S2I 스크립트는 기존 에코시스템을 활용하여 거의 모든 Docker 형식의 컨테이너 이미지에 애플리케이션 코드를 삽입하도록 작성할 수 있습니다. 현재 S2I는 |

| 속도 | S2I를 사용하면 각 단계에서 새 계층을 생성하지 않고도 assemble 프로세스에서 많은 수의 복잡한 작업을 수행할 수 있으므로 프로세스가 빨라집니다. 또한 S2I 스크립트는 빌드가 실행될 때마다 다운로드하거나 빌드할 필요 없이 이전 버전의 애플리케이션 이미지에 저장된 아티팩트를 다시 사용하도록 작성할 수 있습니다. |

| 패치 가능성 | 보안 문제로 인해 기본 이미지에 패치가 필요한 경우 S2I를 사용하면 애플리케이션을 일관되게 다시 빌드할 수 있습니다. |

| 운영 효율성 | Dockerfile 에서 허용하므로 임의의 작업을 허용하는 대신 빌드 작업을 제한하면 PaaS 운영자가 실수로 빌드 시스템의 오용을 방지할 수 있습니다. |

| 운영 보안 | 임의의 Dockerfile 을 구축하면 호스트 시스템을 루트 권한 에스컬레이션에 노출합니다. 전체 Docker 빌드 프로세스가 Docker 권한이 있는 사용자로 실행되므로 악의적인 사용자가 악용할 수 있습니다. S2I는 root 사용자로 수행되는 작업을 제한하며 스크립트를 루트가 아닌 사용자로 실행할 수 있습니다. |

| 사용자 효율성 |

S2I를 사용하면 개발자가 임의의 |

| 에코시스템 | S2I는 애플리케이션의 모범 사례를 활용할 수 있는 이미지의 공유 에코시스템을 권장합니다. |

| 재현 가능성 | 생성된 이미지에는 특정 버전의 빌드 툴 및 종속성을 포함하여 모든 입력이 포함될 수 있습니다. 이렇게 하면 이미지를 정확하게 재현할 수 있습니다. |

3.5.1.3. 사용자 정의 빌드

사용자 정의 빌드 전략을 사용하면 개발자가 전체 빌드 프로세스를 담당하는 특정 빌더 이미지를 정의할 수 있습니다. 자체 빌더 이미지를 사용하면 빌드 프로세스를 사용자 정의할 수 있습니다.

사용자 정의 빌더 이미지는 빌드 프로세스 논리에 포함된 일반 Docker 형식 컨테이너 이미지입니다(예: RPM 또는 기본 이미지 빌드). openshift/origin-custom-docker-builder 이미지는 사용자 지정 빌더 이미지의 예제 구현으로 Docker Hub 레지스트리에서 사용할 수 있습니다.

3.5.1.4. 파이프 라인 빌드

파이프라인 빌드 전략을 사용하면 개발자가 Jenkins 파이프라인 플러그인에 의해 실행할 Jenkins 파이프라인을 정의할 수 있습니다. 다른 빌드 유형과 동일한 방식으로 OpenShift Container Platform에서 빌드를 시작, 모니터링, 관리할 수 있습니다.

파이프라인 워크플로는 Jenkinsfile에 정의되거나 빌드 구성에 직접 포함되거나 Git 리포지토리에 제공되고 빌드 구성에서 참조됩니다.

프로젝트에서 Pipeline 전략을 사용하여 빌드 구성을 정의하면 OpenShift Container Platform에서 Jenkins 서버를 인스턴스화하여 파이프라인을 실행합니다. 프로젝트의 이후 파이프라인 빌드 구성은 이 Jenkins 서버를 공유합니다.

Jenkins 서버가 배포되는 방법과 자동 프로비저닝 동작을 구성하거나 비활성화하는 방법에 대한 자세한 내용은 파이프라인 실행 구성을 참조하십시오.

모든 Pipeline 빌드 구성이 삭제되어도 Jenkins 서버가 자동으로 제거되지 않습니다. 사용자가 수동으로 삭제해야 합니다.

Jenkins 파이프라인에 대한 자세한 내용은 Jenkins 설명서 를 참조하십시오.

3.5.2. 이미지 스트림

이미지 스트림 및 관련 태그는 OpenShift Container Platform 내에서 컨테이너 이미지를 참조하기 위한 추상화를 제공합니다. 이미지 스트림 및 해당 태그를 사용하면 사용 가능한 이미지를 볼 수 있으며 리포지터리의 이미지가 변경되어도 필요한 특정 이미지를 사용하도록 할 수 있습니다.

이미지 스트림에는 실제 이미지 데이터가 포함되어 있지 않지만 이미지 리포지터리와 유사하게 관련 이미지에 대한 단일 가상 뷰가 있습니다.

새 이미지가 추가되는 경우 이미지 스트림에서 알림을 보고 빌드 또는 배포를 각각 수행하여 대응하도록 빌드 및 배포를 구성할 수 있습니다.

예를 들어 배포에서 특정 이미지를 사용하고 있는데 해당 이미지의 새 버전이 생성되는 경우 배포가 자동으로 수행되어 새 버전의 이미지를 가져올 수 있습니다.

그러나 배포 또는 빌드에서 사용하는 이미지 스트림 태그가 업데이트되지 않으면 컨테이너 이미지 레지스트리의 컨테이너 이미지가 업데이트되어도 빌드 또는 배포에서 이전(알려진 정상) 이미지를 계속 사용합니다.

소스 이미지를 저장할 수 있는 위치는 다음과 같습니다.

- OpenShift Container Platform의 통합 레지스트리

-

외부 레지스트리(예:

registry.redhat.io또는hub.docker.com) - OpenShift Container Platform 클러스터의 기타 이미지 스트림

이미지 스트림 태그(예: 빌드 또는 배포 구성)를 참조하는 오브젝트를 정의하는 경우 Docker 리포지토리가 아닌 이미지 스트림 태그를 가리킵니다. 애플리케이션을 빌드하거나 배포할 때 OpenShift Container Platform은 이미지 스트림 태그를 사용하여 Docker 리포지토리를 쿼리하여 관련 이미지 ID를 찾고 바로 그 이미지를 사용합니다.

이미지 스트림 메타데이터는 다른 클러스터 정보와 함께 etcd 인스턴스에 저장됩니다.

다음 이미지 스트림에는 두 개의 태그가 포함되어 있습니다. 34 Python v3.4 이미지와 35 를 가리켜 Python v3.5 이미지를 가리킵니다.

$ oc describe is python

출력 예

Name: python

Namespace: imagestream

Created: 25 hours ago

Labels: app=python

Annotations: openshift.io/generated-by=OpenShiftWebConsole

openshift.io/image.dockerRepositoryCheck=2017-10-03T19:48:00Z

Docker Pull Spec: docker-registry.default.svc:5000/imagestream/python

Image Lookup: local=false

Unique Images: 2

Tags: 2

34

tagged from centos/python-34-centos7

* centos/python-34-centos7@sha256:28178e2352d31f240de1af1370be855db33ae9782de737bb005247d8791a54d0

14 seconds ago

35

tagged from centos/python-35-centos7

* centos/python-35-centos7@sha256:2efb79ca3ac9c9145a63675fb0c09220ab3b8d4005d35e0644417ee552548b10

7 seconds ago

이미지 스트림을 사용하면 다음과 같은 여러 중요한 이점이 있습니다.

- 명령줄을 사용하여 다시 푸시하지 않고도 태그하고, 태그를 롤백하고, 이미지를 빠르게 처리할 수 있습니다.

- 새 이미지가 레지스트리로 푸시되면 빌드 및 배포를 트리거할 수 있습니다. 또한 OpenShift Container Platform에는 다른 리소스(예: Kubernetes 오브젝트)에 대한 일반 트리거가 있습니다.

- 정기적인 다시 가져오기를 위해 태그를 표시할 수 있습니다. 소스 이미지가 변경되면 해당 변경 사항이 이미지 스트림에 반영되며, 이 변경 사항은 빌드 또는 배포 구성에 따라 빌드 및/또는 배포 흐름을 트리거합니다.

- 세분화된 액세스 제어를 사용하여 이미지를 공유하고 팀 전체에 이미지를 빠르게 배포할 수 있습니다.

- 소스 이미지가 변경되면 이미지 스트림 태그는 계속 알려진 양호한 버전의 이미지를 가리키므로 애플리케이션이 예기치 않게 손상되지 않도록 합니다.

- 이미지 스트림 오브젝트에 대한 권한을 통해 이미지를 보고 사용할 수 있는 사람에 대한 보안을 구성할 수 있습니다.

- 클러스터 수준에서 이미지를 읽거나 나열할 수 있는 권한이 없는 사용자도 이미지 스트림을 사용하여 프로젝트의 태그된 이미지를 검색할 수 있습니다.

조정된 이미지 스트림 세트는 OpenShift Image Streams 및 Templates 라이브러리 를 참조하십시오.

이미지 스트림을 사용할 때는 이미지 스트림 태그가 가리키는 사항과 태그 및 이미지를 변경하는 방법을 이해해야 합니다. 예를 들면 다음과 같습니다.

-

이미지 스트림 태그가 컨테이너 이미지 태그를 가리키는 경우 컨테이너 이미지 태그 업데이트 방법을 이해해야 합니다. 예를 들어 컨테이너 이미지 태그

docker.io/ruby:2.5는 v2.5 ruby 이미지를 가리키지만 컨테이너 이미지 태그docker.io/ruby:latest는 주요 버전에서 변경됩니다. 따라서 이미지 스트림 태그가 가리키는 컨테이너 이미지 태그는 이미지 스트림 태그의 안정성을 나타낼 수 있습니다. - 이미지 스트림 태그가 컨테이너 이미지 태그를 직접 가리키는 대신 다른 이미지 스트림 태그를 따르는 경우 나중에 다른 이미지 스트림 태그를 따르도록 이미지 스트림 태그를 업데이트할 수 있습니다. 이러한 변경으로 인해 호환되지 않는 버전 변경이 발생할 수 있습니다.

3.5.2.1. 중요한 용어

- Docker 리포지토리

관련 컨테이너 이미지와 이를 식별하는 태그의 컬렉션입니다. 예를 들어 OpenShift Jenkins 이미지는 Docker 리포지토리에 있습니다.

docker.io/openshift/jenkins-2-centos7

- 컨테이너 레지스트리

Docker 리포지토리에서 이미지를 저장하고 서비스할 수 있는 콘텐츠 서버입니다. 예를 들면 다음과 같습니다.

registry.redhat.io

- 컨테이너 이미지

- 컨테이너로 실행할 수 있는 특정 콘텐츠 세트입니다. 일반적으로 Docker 리포지토리 내의 특정 태그와 연결됩니다.

- 컨테이너 이미지 태그

- 특정 이미지를 구분하는 리포지토리의 컨테이너 이미지에 적용되는 레이블입니다. 예를 들어, 여기에서 3.6.0 은 태그입니다.

docker.io/openshift/jenkins-2-centos7:3.6.0

언제든지 새 컨테이너 이미지 콘텐츠를 가리키도록 컨테이너 이미지 태그를 업데이트할 수 있습니다.

- 컨테이너 이미지 ID

- 이미지를 가져오는 데 사용할 수 있는 SHA(Secure Hash Algorithm) 코드입니다. 예를 들면 다음과 같습니다.

docker.io/openshift/jenkins-2-centos7@sha256:ab312bda324

SHA 이미지 ID는 변경할 수 없습니다. 특정 SHA 식별자는 항상 정확히 동일한 컨테이너 이미지 콘텐츠를 참조합니다.

- 이미지 스트림

- 태그로 식별되는 Docker 형식 컨테이너 이미지의 포인터가 포함된 OpenShift Container Platform 오브젝트입니다. 이미지 스트림을 Docker 리포지토리에 해당하는 것으로 간주할 수 있습니다.

- 이미지 스트림 태그

- 이미지 스트림의 이미지에 대한 명명된 포인터. 이미지 스트림 태그는 컨테이너 이미지 태그와 유사합니다. 아래 이미지 스트림 태그를 참조하십시오.

- 이미지 스트림 이미지

- 태그된 특정 이미지 스트림에서 특정 컨테이너 이미지를 검색할 수 있는 이미지입니다. 이미지 스트림 이미지는 특정 이미지 SHA 식별자에 대한 일부 메타데이터를 함께 가져오는 API 리소스 오브젝트입니다. 아래 이미지 스트림 이미지를 참조하십시오.

- 이미지 스트림 트리거

- 이미지 스트림 태그가 변경되면 특정 작업을 수행하는 트리거입니다. 예를 들어 가져오기로 인해 태그 값이 변경되고 이어서 해당 태그를 수신하는 배포, 빌드 또는 기타 리소스에서 트리거가 실행될 수 있습니다. 아래 이미지 스트림 트리거 를 참조하십시오.

3.5.2.2. 이미지 스트림 구성

이미지 스트림 오브젝트 파일에는 다음 요소가 포함되어 있습니다.

이미지 및 이미지 스트림 관리에 대한 자세한 내용은 개발자 가이드를 참조하십시오.

이미지 스트림 오브젝트 정의

apiVersion: v1

kind: ImageStream

metadata:

annotations:

openshift.io/generated-by: OpenShiftNewApp

creationTimestamp: 2017-09-29T13:33:49Z

generation: 1

labels:

app: ruby-sample-build

template: application-template-stibuild

name: origin-ruby-sample 1

namespace: test

resourceVersion: "633"

selflink: /oapi/v1/namespaces/test/imagestreams/origin-ruby-sample

uid: ee2b9405-c68c-11e5-8a99-525400f25e34

spec: {}

status:

dockerImageRepository: 172.30.56.218:5000/test/origin-ruby-sample 2

tags:

- items:

- created: 2017-09-02T10:15:09Z

dockerImageReference: 172.30.56.218:5000/test/origin-ruby-sample@sha256:47463d94eb5c049b2d23b03a9530bf944f8f967a0fe79147dd6b9135bf7dd13d 3

generation: 2

image: sha256:909de62d1f609a717ec433cc25ca5cf00941545c83a01fb31527771e1fab3fc5 4

- created: 2017-09-29T13:40:11Z

dockerImageReference: 172.30.56.218:5000/test/origin-ruby-sample@sha256:909de62d1f609a717ec433cc25ca5cf00941545c83a01fb31527771e1fab3fc5

generation: 1

image: sha256:47463d94eb5c049b2d23b03a9530bf944f8f967a0fe79147dd6b9135bf7dd13d

tag: latest 5

이미지 스트림을 참조하는 샘플 빌드 구성은 구성의 Strategy 스탠자의 BuildConfig이란? 을 참조하십시오.

이미지 스트림을 참조하는 샘플 배포 구성은 구성의 전략 스탠자의 배포 구성 생성을 참조하십시오.

3.5.2.3. 이미지 스트림 이미지

이미지 스트림 이미지는 이미지 스트림 내에서 특정 이미지 ID를 가리킵니다.

이미지 스트림 이미지를 사용하면 태그된 특정 이미지 스트림에서 이미지에 대한 메타데이터를 검색할 수 있습니다.

이미지 스트림 이미지 오브젝트는 이미지 스트림으로 이미지를 가져오거나 태그할 때마다 OpenShift Container Platform에서 자동으로 생성됩니다. 이미지 스트림을 생성하는 데 사용하는 이미지 스트림 정의에서는 이미지 스트림 태그 오브젝트를 명시적으로 정의할 필요가 없습니다.

이미지 스트림 이미지는 리포지터리의 이미지 스트림 이름과 이미지 ID로 구성됩니다. 이름 및 ID는 @ 기호로 구분됩니다.

<image-stream-name>@<image-id>

위의 이미지 스트림 오브젝트 예에서 이미지를 참조하려면 이미지 스트림 이미지가 다음과 같이 표시됩니다.

origin-ruby-sample@sha256:47463d94eb5c049b2d23b03a9530bf944f8f967a0fe79147dd6b9135bf7dd13d

3.5.2.4. 이미지 스트림 태그

이미지 스트림 태그는 이미지 스트림 의 이미지에 대한 이름 지정된 포인터입니다. istag로 축약되는 경우가 많습니다. 이미지 스트림 태그는 지정된 이미지 스트림 및 태그의 이미지를 참조하거나 검색하는 데 사용됩니다.

이미지 스트림 태그는 로컬 또는 외부 관리 이미지를 참조할 수 있습니다. 태그가 가리켰던 모든 이미지의 스택으로 표시되는 이미지 기록이 이미지 스트림 태그에 포함되어 있습니다. 새 이미지 또는 기존 이미지가 특정 이미지 스트림 태그 아래에 태그될 때마다 기록 스택의 첫 번째 위치에 배치됩니다. 이전에 맨 위 위치를 차지했던 이미지는 두 번째 위치에서 사용할 수 있으며 이러한 방식으로 계속 배치됩니다. 이렇게 하면 태그가 다시 과거 이미지를 가리키도록 손쉽게 롤백할 수 있습니다.

다음 이미지 스트림 태그는 위의 이미지 스트림 오브젝트 예제에서 가져온 것입니다.

기록에 두 개의 이미지가 있는 이미지 스트림 태그

tags:

- items:

- created: 2017-09-02T10:15:09Z

dockerImageReference: 172.30.56.218:5000/test/origin-ruby-sample@sha256:47463d94eb5c049b2d23b03a9530bf944f8f967a0fe79147dd6b9135bf7dd13d

generation: 2

image: sha256:909de62d1f609a717ec433cc25ca5cf00941545c83a01fb31527771e1fab3fc5

- created: 2017-09-29T13:40:11Z

dockerImageReference: 172.30.56.218:5000/test/origin-ruby-sample@sha256:909de62d1f609a717ec433cc25ca5cf00941545c83a01fb31527771e1fab3fc5

generation: 1

image: sha256:47463d94eb5c049b2d23b03a9530bf944f8f967a0fe79147dd6b9135bf7dd13d

tag: latest

이미지 스트림 태그는 영구 태그일 수도 있고 추적 태그일 수도 있습니다.

- 영구 태그는 Python 3.5 같은 특정 버전의 이미지를 가리키는 버전 특정 태그입니다.

추적 태그는 다른 이미지 스트림 태그를 따르는 참조 태그이며 symlink와 매우 유사하게 나중에 업데이트하여 후속 이미지를 변경할 수 있습니다. 이러한 새 수준은 이전 버전과 호환되지 않을 수 있습니다.

예를 들어 OpenShift Container Platform과 함께 제공되는

latest이미지 스트림 태그는 추적 태그입니다. 즉,latest이미지 스트림 태그 사용자는 새 수준을 사용할 수 있게 되면 이미지에서 제공하는 프레임워크의 최신 수준으로 업데이트됩니다.v3.10의latest이미지 스트림 태그는 언제든v3.11로 변경될 수 있습니다. 이러한latest이미지 스트림 태그는 Dockerlatest태그와 다르게 동작한다는 사실을 알고 있는 것이 중요합니다. Docker의 경우latest이미지 스트림 태그가 Docker 리포지터리의 최신 이미지를 가리키지 않습니다. 다른 이미지 스트림 태그를 가리키며, 이것은 이미지의 최신 버전이 아닐 수도 있습니다. 예를 들어latest이미지 스트림 태그가 이미지의v3.10을 가리키는 경우3.11버전이 릴리스되면latest태그가v3.11로 자동 업데이트되지 않고v3.11이미지 스트림 태그를 가리키도록 수동 업데이트될 때까지v3.10으로 남아 있습니다.참고추적 태그는 단일 이미지 스트림으로 제한되며 다른 이미지 스트림을 참조할 수 없습니다.

고유한 요구 사항에 맞게 자체 이미지 스트림 태그를 생성할 수 있습니다. 권장 태그 지정 규칙을 참조하십시오.

이미지 스트림 태그는 콜론으로 구분된 이미지 스트림 이름 및 태그로 구성됩니다.

<image stream name>:<tag>

예를 들어 위의 이미지 스트림 오브젝트 예에서 sha256:47463d94eb5c049b2d23b03a9530bf944f8f967a0fe79147dd6b9135bf7dd13d 이미지를 참조하려면 이미지 스트림 태그는 다음과 같습니다.

origin-ruby-sample:latest

3.5.2.5. 이미지 스트림 변경 트리거

이미지 스트림 트리거를 사용하면 새 버전의 업스트림 이미지가 준비될 때 빌드 및 배포가 자동으로 호출됩니다.

예를 들어 이미지 스트림 태그가 수정되면 빌드 및 배포를 자동으로 시작할 수 있습니다. 이 과정은 해당하는 특정 이미지 스트림 태그를 모니터링하다가 변경이 탐지되면 빌드 또는 배포에 알리는 방식으로 이루어집니다.

ImageChange 트리거를 사용하면 이미지 스트림 태그의 내용이 변경될 때마다(새 버전의 이미지를 푸시할 때) 새 복제 컨트롤러가 생성됩니다.

이미지 변경 트리거

triggers:

- type: "ImageChange"

imageChangeParams:

automatic: true 1

from:

kind: "ImageStreamTag"

name: "origin-ruby-sample:latest"

namespace: "myproject"

containerNames:

- "helloworld"

- 1

imageChangeParams.automatic필드를false로 설정하면 트리거가 비활성화됩니다.

위의 예에서 origin-ruby-sample 이미지 스트림의 latest 태그 값이 변경되고 새 이미지 값이 배포 구성의helloworld 컨테이너에 지정된 현재 이미지와 다르면 helloworld 컨테이너의 새 이미지를 사용하여 새 복제 컨트롤러가 생성됩니다 .

ImageChange 트리거가 배포 구성(Config Change 트리거 및 automatic =false 또는 automatic=true사용)에 정의되어 있고 ImageChange 트리거가 가리키는 ImageStreamTag 가 아직 존재하지 않는 경우 빌드에서 이미지를 가져오거나 ImageStreamTag 로 내보내는 즉시 초기 배포 프로세스가 자동으로 시작됩니다.

3.5.2.6. 이미지 스트림 매핑

통합 레지스트리에서 새 이미지를 수신하면 이미지 스트림 매핑을 생성하여 OpenShift Container Platform으로 전송하여 이미지의 프로젝트, 이름, 태그 및 이미지 메타데이터를 제공합니다.

이미지 스트림 매핑 구성은 고급 기능입니다.

이 정보는 새 이미지를 생성하고(아직 없는 경우) 이미지를 이미지 스트림에 태그하는 데 사용됩니다. OpenShift Container Platform은 명령, 진입점, 환경 변수 등 각 이미지에 대한 완전한 메타데이터를 저장합니다. OpenShift Container Platform의 이미지는 변경 불가능하며 이름의 최대 길이는 63자입니다.

이미지 태그에 대한 자세한 내용은 개발자 가이드를 참조하십시오.

다음 이미지 스트림 매핑 예에서는 test/origin-ruby-sample:latest로 이미지가 태그됩니다.

이미지 스트림 매핑 오브젝트 정의

apiVersion: v1

kind: ImageStreamMapping

metadata:

creationTimestamp: null

name: origin-ruby-sample

namespace: test

tag: latest

image:

dockerImageLayers:

- name: sha256:5f70bf18a086007016e948b04aed3b82103a36bea41755b6cddfaf10ace3c6ef

size: 0

- name: sha256:ee1dd2cb6df21971f4af6de0f1d7782b81fb63156801cfde2bb47b4247c23c29

size: 196634330

- name: sha256:5f70bf18a086007016e948b04aed3b82103a36bea41755b6cddfaf10ace3c6ef

size: 0

- name: sha256:5f70bf18a086007016e948b04aed3b82103a36bea41755b6cddfaf10ace3c6ef

size: 0

- name: sha256:ca062656bff07f18bff46be00f40cfbb069687ec124ac0aa038fd676cfaea092

size: 177723024

- name: sha256:63d529c59c92843c395befd065de516ee9ed4995549f8218eac6ff088bfa6b6e

size: 55679776

- name: sha256:92114219a04977b5563d7dff71ec4caa3a37a15b266ce42ee8f43dba9798c966

size: 11939149

dockerImageMetadata:

Architecture: amd64

Config:

Cmd:

- /usr/libexec/s2i/run

Entrypoint:

- container-entrypoint

Env:

- RACK_ENV=production

- OPENSHIFT_BUILD_NAMESPACE=test

- OPENSHIFT_BUILD_SOURCE=https://github.com/openshift/ruby-hello-world.git

- EXAMPLE=sample-app

- OPENSHIFT_BUILD_NAME=ruby-sample-build-1

- PATH=/opt/app-root/src/bin:/opt/app-root/bin:/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin

- STI_SCRIPTS_URL=image:///usr/libexec/s2i

- STI_SCRIPTS_PATH=/usr/libexec/s2i

- HOME=/opt/app-root/src

- BASH_ENV=/opt/app-root/etc/scl_enable

- ENV=/opt/app-root/etc/scl_enable

- PROMPT_COMMAND=. /opt/app-root/etc/scl_enable

- RUBY_VERSION=2.2

ExposedPorts:

8080/tcp: {}

Labels:

build-date: 2015-12-23

io.k8s.description: Platform for building and running Ruby 2.2 applications

io.k8s.display-name: 172.30.56.218:5000/test/origin-ruby-sample:latest

io.openshift.build.commit.author: Ben Parees <bparees@users.noreply.github.com>

io.openshift.build.commit.date: Wed Jan 20 10:14:27 2016 -0500

io.openshift.build.commit.id: 00cadc392d39d5ef9117cbc8a31db0889eedd442

io.openshift.build.commit.message: 'Merge pull request #51 from php-coder/fix_url_and_sti'

io.openshift.build.commit.ref: master

io.openshift.build.image: centos/ruby-22-centos7@sha256:3a335d7d8a452970c5b4054ad7118ff134b3a6b50a2bb6d0c07c746e8986b28e

io.openshift.build.source-location: https://github.com/openshift/ruby-hello-world.git

io.openshift.builder-base-version: 8d95148

io.openshift.builder-version: 8847438ba06307f86ac877465eadc835201241df

io.openshift.s2i.scripts-url: image:///usr/libexec/s2i

io.openshift.tags: builder,ruby,ruby22

io.s2i.scripts-url: image:///usr/libexec/s2i

license: GPLv2

name: CentOS Base Image

vendor: CentOS

User: "1001"

WorkingDir: /opt/app-root/src

Container: 86e9a4a3c760271671ab913616c51c9f3cea846ca524bf07c04a6f6c9e103a76

ContainerConfig:

AttachStdout: true

Cmd:

- /bin/sh

- -c

- tar -C /tmp -xf - && /usr/libexec/s2i/assemble

Entrypoint:

- container-entrypoint

Env:

- RACK_ENV=production

- OPENSHIFT_BUILD_NAME=ruby-sample-build-1

- OPENSHIFT_BUILD_NAMESPACE=test

- OPENSHIFT_BUILD_SOURCE=https://github.com/openshift/ruby-hello-world.git

- EXAMPLE=sample-app

- PATH=/opt/app-root/src/bin:/opt/app-root/bin:/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin

- STI_SCRIPTS_URL=image:///usr/libexec/s2i

- STI_SCRIPTS_PATH=/usr/libexec/s2i

- HOME=/opt/app-root/src

- BASH_ENV=/opt/app-root/etc/scl_enable

- ENV=/opt/app-root/etc/scl_enable

- PROMPT_COMMAND=. /opt/app-root/etc/scl_enable

- RUBY_VERSION=2.2

ExposedPorts:

8080/tcp: {}

Hostname: ruby-sample-build-1-build

Image: centos/ruby-22-centos7@sha256:3a335d7d8a452970c5b4054ad7118ff134b3a6b50a2bb6d0c07c746e8986b28e

OpenStdin: true

StdinOnce: true

User: "1001"

WorkingDir: /opt/app-root/src

Created: 2016-01-29T13:40:00Z

DockerVersion: 1.8.2.fc21

Id: 9d7fd5e2d15495802028c569d544329f4286dcd1c9c085ff5699218dbaa69b43

Parent: 57b08d979c86f4500dc8cad639c9518744c8dd39447c055a3517dc9c18d6fccd

Size: 441976279

apiVersion: "1.0"

kind: DockerImage

dockerImageMetadataVersion: "1.0"

dockerImageReference: 172.30.56.218:5000/test/origin-ruby-sample@sha256:47463d94eb5c049b2d23b03a9530bf944f8f967a0fe79147dd6b9135bf7dd13d

3.5.2.7. 이미지 스트림 작업

다음 섹션에서는 이미지 스트림 및 이미지 스트림 태그를 사용하는 방법에 대해 설명합니다. 이미지 스트림 사용에 대한 자세한 내용은 이미지 관리를 참조하십시오.

3.5.2.7.1. 이미지 스트림에 대한 정보 가져오기

이미지 스트림에 대한 일반 정보와 해당 이미지 스트림이 가리키는 모든 태그에 대한 자세한 정보를 얻으려면 다음 명령을 사용합니다.

$ oc describe is/<image-name>

예를 들면 다음과 같습니다.

$ oc describe is/python

출력 예

Name: python

Namespace: default

Created: About a minute ago

Labels: <none>

Annotations: openshift.io/image.dockerRepositoryCheck=2017-10-02T17:05:11Z

Docker Pull Spec: docker-registry.default.svc:5000/default/python

Image Lookup: local=false

Unique Images: 1

Tags: 1

3.5

tagged from centos/python-35-centos7

* centos/python-35-centos7@sha256:49c18358df82f4577386404991c51a9559f243e0b1bdc366df25

About a minute ago

특정 이미지 스트림 태그에 대한 사용 가능한 모든 정보를 얻으려면 다음을 수행합니다.

$ oc describe istag/<image-stream>:<tag-name>

예를 들면 다음과 같습니다.

$ oc describe istag/python:latest

출력 예

Image Name: sha256:49c18358df82f4577386404991c51a9559f243e0b1bdc366df25 Docker Image: centos/python-35-centos7@sha256:49c18358df82f4577386404991c51a9559f243e0b1bdc366df25 Name: sha256:49c18358df82f4577386404991c51a9559f243e0b1bdc366df25 Created: 2 minutes ago Image Size: 251.2 MB (first layer 2.898 MB, last binary layer 72.26 MB) Image Created: 2 weeks ago Author: <none> Arch: amd64 Entrypoint: container-entrypoint Command: /bin/sh -c $STI_SCRIPTS_PATH/usage Working Dir: /opt/app-root/src User: 1001 Exposes Ports: 8080/tcp Docker Labels: build-date=20170801

표시된 것보다 더 많은 정보가 출력됩니다.

3.5.2.7.2. 이미지 스트림에 태그 추가

기존 태그 중 하나를 가리키는 태그를 추가하려면 oc tag 명령을 사용할 수 있습니다.

oc tag <image-name:tag> <image-name:tag>

예를 들면 다음과 같습니다.

$ oc tag python:3.5 python:latest

출력 예

Tag python:latest set to python@sha256:49c18358df82f4577386404991c51a9559f243e0b1bdc366df25.

oc describe 명령을 사용하여 이미지 스트림에 외부 컨테이너 이미지를 가리키는 하나의 태그(3.5)와 첫 번째 태그를 기반으로 생성되었기 때문에 동일한 이미지를 가리키는 다른 태그(최신) 태그가 있는지 확인합니다.

$ oc describe is/python

출력 예

Name: python

Namespace: default

Created: 5 minutes ago

Labels: <none>

Annotations: openshift.io/image.dockerRepositoryCheck=2017-10-02T17:05:11Z

Docker Pull Spec: docker-registry.default.svc:5000/default/python

Image Lookup: local=false

Unique Images: 1

Tags: 2

latest

tagged from python@sha256:49c18358df82f4577386404991c51a9559f243e0b1bdc366df25

* centos/python-35-centos7@sha256:49c18358df82f4577386404991c51a9559f243e0b1bdc366df25

About a minute ago

3.5

tagged from centos/python-35-centos7

* centos/python-35-centos7@sha256:49c18358df82f4577386404991c51a9559f243e0b1bdc366df25

5 minutes ago

3.5.2.7.3. 외부 이미지의 태그 추가

내부 또는 외부 이미지를 가리키는 태그 추가와 같은 모든 태그 관련 작업에 oc tag 명령을 사용합니다.

$ oc tag <repositiory/image> <image-name:tag>

예를 들어 이 명령은 python 이미지 스트림에서 docker.io/python:3.6.0 이미지를 3.6 태그에 매핑합니다.

$ oc tag docker.io/python:3.6.0 python:3.6

출력 예

Tag python:3.6 set to docker.io/python:3.6.0.

외부 이미지를 보호하는 경우 해당 레지스트리에 액세스하기 위한 자격 증명으로 시크릿을 생성해야 합니다. 자세한 내용은 프라이빗 레지스트리에서 이미지 가져오기를 참조하십시오.

3.5.2.7.4. 이미지 스트림 태그 업데이트

이미지 스트림의 다른 태그를 반영하도록 태그를 업데이트하려면 다음을 수행합니다.

$ oc tag <image-name:tag> <image-name:latest>

예를 들어 다음에서는 이미지 스트림의 3.6 태그를 반영하도록 latest 태그를 업데이트합니다.

$ oc tag python:3.6 python:latest

출력 예

Tag python:latest set to python@sha256:438208801c4806548460b27bd1fbcb7bb188273d13871ab43f.

3.5.2.7.5. 이미지 스트림에서 이미지 스트림 태그 제거

이미지 스트림에서 이전 태그를 제거하려면 다음을 수행합니다.

$ oc tag -d <image-name:tag>

예를 들면 다음과 같습니다.

$ oc tag -d python:3.5

출력 예

Deleted tag default/python:3.5.

3.5.2.7.6. 태그 가져오기 주기 구성

외부 컨테이너 이미지 레지스트리로 작업하는 경우 이미지(예: 최신 보안 업데이트를 얻기 위해)를 정기적으로 다시 가져오려면 --scheduled 플래그를 사용합니다.

$ oc tag <repositiory/image> <image-name:tag> --scheduled

예를 들면 다음과 같습니다.

$ oc tag docker.io/python:3.6.0 python:3.6 --scheduled

출력 예

Tag python:3.6 set to import docker.io/python:3.6.0 periodically.

이 명령은 OpenShift Container Platform이 특정 이미지 스트림 태그를 주기적으로 업데이트하도록 합니다. 이 기간은 기본적으로 15분으로 설정되는 클러스터 전체 설정입니다.

정기적인 검사를 제거하려면 위의 명령을 다시 실행하되 --scheduled 플래그를 생략합니다. 이렇게 하면 동작이 기본값으로 재설정됩니다.

$ oc tag <repositiory/image> <image-name:tag>

3.6. 배포

3.6.1. 복제 컨트롤러

복제 컨트롤러를 사용하면 항상 지정된 수의 포드 복제본이 실행됩니다. Pod가 종료되거나 삭제되면 복제 컨트롤러가 작동하여 정의된 수까지 추가로 인스턴스화합니다. 마찬가지로 필요한 것보다 많은 Pod가 실행되고 있는 경우에는 정의된 수에 맞게 필요한 개수의 Pod를 삭제합니다.

복제 컨트롤러 구성은 다음과 같이 구성됩니다.

- 원하는 복제본 수(런타임 시 조정할 수 있음).

- 복제된 포드를 생성할 때 사용할 포드 정의입니다.

- 관리형 Pod를 확인하는 선택기

선택기는 복제 컨트롤러에서 관리하는 Pod에 할당한 라벨 세트입니다. 이러한 레이블은 복제 컨트롤러가 인스턴스화하는 포드 정의에 포함됩니다. 복제 컨트롤러에서는 필요에 따라 조정할 수 있도록 선택기를 사용하여 이미 실행 중인 Pod의 인스턴스 수를 결정합니다.

복제 컨트롤러에서 로드나 트래픽을 추적하지 않으므로 로드 또는 트래픽을 기반으로 자동 스케일링하지 않습니다. 대신 외부 자동 확장기에서 복제본 수를 조정해야 합니다.

복제 컨트롤러는 ReplicationController 라는 핵심 Kubernetes 오브젝트입니다.

다음은 ReplicationController 정의의 예입니다.

apiVersion: v1 kind: ReplicationController metadata: name: frontend-1 spec: replicas: 1 1 selector: 2 name: frontend template: 3 metadata: labels: 4 name: frontend 5 spec: containers: - image: openshift/hello-openshift name: helloworld ports: - containerPort: 8080 protocol: TCP restartPolicy: Always

3.6.2. 복제 세트

복제 컨트롤러와 유사하게 복제본 세트는 지정된 수의 포드 복제본이 언제든지 실행되도록 합니다. 복제본 세트와 복제 컨트롤러의 차이점은 복제본 세트는 세트 기반 선택기 요구 사항을 지원하는 반면 복제 컨트롤러는 일치 기반 선택기 요구 사항만 지원한다는 점입니다.

사용자 정의 업데이트 오케스트레이션이 필요한 경우에만 복제본 세트를 사용하거나 업데이트가 필요하지 않은 경우에만 배포를 사용하십시오. 복제본 세트는 독립적으로 사용할 수 있지만 배포에서 Pod 생성, 삭제, 업데이트를 오케스트레이션하는 데 사용합니다. 배포는 복제본 세트를 자동으로 관리하고 Pod에 선언적 업데이트를 제공하며 생성한 복제본 세트를 수동으로 관리할 필요가 없습니다.

복제본 세트는 ReplicaSet 이라는 핵심 Kubernetes 오브젝트입니다.

다음은 ReplicaSet 정의의 예입니다.

apiVersion: apps/v1

kind: ReplicaSet

metadata:

name: frontend-1

labels:

tier: frontend

spec:

replicas: 3

selector: 1

matchLabels: 2

tier: frontend

matchExpressions: 3

- {key: tier, operator: In, values: [frontend]}

template:

metadata:

labels:

tier: frontend

spec:

containers:

- image: openshift/hello-openshift

name: helloworld

ports:

- containerPort: 8080

protocol: TCP

restartPolicy: Always3.6.3. Jobs

작업은 복제 컨트롤러와 비슷하며, 이는 지정된 이유로 포드를 생성하는 것입니다. 차이점은 복제 컨트롤러는 지속적으로 실행 중인 포드를 위해 설계된 반면 작업은 일회성 포드를 위한 것입니다. 작업은 완료를 추적하며 지정된 수의 완료에 도달하면 작업 자체가 완료됩니다.

다음 예제에서는 ✓~ 2000개의 위치를 계산하여 출력한 다음 다음과 같이 완료합니다.

apiVersion: extensions/v1

kind: Job

metadata:

name: pi

spec:

selector:

matchLabels:

app: pi

template:

metadata:

name: pi

labels:

app: pi

spec:

containers:

- name: pi

image: perl

command: ["perl", "-Mbignum=bpi", "-wle", "print bpi(2000)"]

restartPolicy: Never작업 사용 방법에 대한 자세한 내용은 Jobs (작업) 주제를 참조하십시오.

3.6.4. 배포 및 배포 구성

복제 컨트롤러를 기반으로 OpenShift Container Platform은 배포 개념을 사용하여 소프트웨어 개발 및 배포 라이프사이클에 대한 확장된 지원을 추가합니다. 가장 간단한 경우 배포는 새 복제 컨트롤러만 생성하고 포드를 시작할 수 있도록 합니다. 그러나 OpenShift Container Platform 배포에서는 이미지의 기존 배포에서 새 배포로 전환하고 복제 컨트롤러를 생성하기 전이나 후에 실행할 후크도 정의할 수 있습니다.

OpenShift Container Platform DeploymentConfig 오브젝트는 배포에 대한 다음 세부 정보를 정의합니다.

-

ReplicationController정의의 요소입니다. - 새 배포를 자동으로 생성하는 트리거

- 배포 간 전환을 위한 전략

- 라이프사이클 후크.

배포가 수동 또는 자동으로 트리거될 때마다 배포자 Pod에서 배포를 관리합니다(이전 복제 컨트롤러 축소, 새 복제 컨트롤러 확장, 후크 실행 포함). 배포 Pod는 배포 로그를 유지하기 위해 배포 완료 후 무기한으로 유지됩니다. 배포가 다른 배포로 대체되면 필요한 경우 쉽게 롤백할 수 있도록 이전 복제 컨트롤러가 유지됩니다.

배포를 만들고 상호 작용하는 방법에 대한 자세한 지침은 배포를 참조하십시오.

다음은 일부 omissions 및 callouts가 포함된 예제 DeploymentConfig 정의입니다.

apiVersion: v1

kind: DeploymentConfig

metadata:

name: frontend

spec:

replicas: 5

selector:

name: frontend

template: { ... }

triggers:

- type: ConfigChange 1

- imageChangeParams:

automatic: true

containerNames:

- helloworld

from:

kind: ImageStreamTag

name: hello-openshift:latest

type: ImageChange 2

strategy:

type: Rolling 33.7. 템플릿

3.7.1. 개요

템플릿은 OpenShift Container Platform에서 생성할 오브젝트 목록을 생성하기 위해 매개 변수화 및 처리할 수 있는 오브젝트 세트를 설명합니다. 생성할 오브젝트에는 서비스, 빌드 구성 및 배포 구성과 같이 프로젝트 내에서 생성할 권한이 있는 모든 항목이 포함될 수 있습니다. 템플릿은 템플릿에 정의된 모든 오브젝트에 적용할 레이블 집합도 정의할 수 있습니다.

템플릿 생성 및 사용에 대한 자세한 내용은 템플릿 가이드를 참조하십시오.

4장. 추가 개념

4.1. 인증

4.1.1. 개요

그러면 인증 계층에서 OpenShift Container Platform API에 대한 요청과 관련된 사용자를 확인합니다. 그런 다음 권한 부여 계층에서는 요청하는 사용자에 대한 정보를 사용하여 요청을 허용해야 하는지 여부를 결정합니다.

관리자는 마스터 구성 파일을 사용하여 인증을 구성할 수 있습니다.

4.1.2. 사용자 및 그룹

OpenShift Container Platform에서 사용자는 OpenShift Container Platform API에 요청할 수 있는 엔티티입니다. 일반적으로 OpenShift Container Platform과 상호 작용하는 개발자 또는 관리자 계정을 의미합니다.

사용자는 하나 이상의 그룹에 할당될 수 있으며, 각 그룹은 특정 사용자 집합을 나타냅니다. 그룹은 사용자에게 개별적으로 부여하는 대신 권한 부여 정책을 관리하여 여러 사용자에게 한 번에 권한을 부여할 때 유용합니다(예: 프로젝트 내 오브젝트에 대한 액세스 허용).

명시적으로 정의된 그룹 외에도 OpenShift에서 자동으로 프로비저닝하는 시스템 그룹 또는 가상 그룹이 있습니다. 클러스터 바인딩을 볼 때 볼 수 있습니다.

가상 그룹의 기본 집합에서는 특히 다음 사항에 유의하십시오.

| 가상 그룹 | 설명 |

|---|---|

| system:authenticated | 인증된 모든 사용자와 자동으로 연결됩니다. |

| system:authenticated:oauth | OAuth 액세스 토큰을 사용하여 인증된 모든 사용자와 자동으로 연결됩니다. |

| system:unauthenticated | 인증되지 않은 모든 사용자와 자동으로 연결됩니다. |

4.1.3. API 인증

OpenShift Container Platform API에 대한 요청은 다음과 같은 방법으로 인증됩니다.

- OAuth 액세스 토큰

-

<master>

/oauth/authorize 및끝점을 사용하여 OpenShift Container Platform OAuth 서버에서 가져옵니다.<master>/oauth/token -

인증: 전달자…헤더. -

WebSocket 요청의 경우

base64url.bearer.authorization.k8s.io.<base64url-encoded-token>형식의 WebSocket 하위 프로토콜 헤더로 전송됩니다.

-

<master>

- X.509 클라이언트 인증서

- API 서버에 대한 HTTPS 연결이 필요합니다.

- 신뢰할 수 있는 인증 기관 번들과 대조하여 API 서버에서 확인합니다.

- API 서버는 인증서를 작성하고 컨트롤러에 분배하여 자체적으로 인증합니다.

유효하지 않은 액세스 토큰 또는 유효하지 않은 인증서가 있는 요청은 401 오류와 함께 인증 계층에서 거부됩니다.

액세스 토큰이나 인증서가 없는 경우 인증 계층은 system:anonymous 가상 사용자 및 system:unauthenticated 가상 그룹을 요청에 할당합니다. 그러면 권한 부여 계층에서 익명 사용자가 할 수 있는 요청(있는 경우)을 결정합니다.

4.1.3.1. 가장

OpenShift Container Platform API 요청에는 Impersonate-User 헤더가 포함될 수 있습니다. 이 헤더는 요청자가 지정된 사용자로부터 온 것처럼 요청을 처리하려고 함을 나타냅니다. 요청에 --as=<user> 플래그를 추가하여 사용자를 가장합니다.

사용자 A가 사용자 B를 가장할 수 있으려면 사용자 A가 인증됩니다. 그런 다음 권한 부여 확인이 발생하여 사용자 A가 User B라는 사용자를 가장할 수 있는지 확인합니다. 사용자 A가 서비스 계정을 가장하도록 요청하는 경우 system:serviceaccount:namespace:name 은 OpenShift Container Platform에서 User A가 이름이 인 serviceaccount 를 네임스페이스 에서 가장할 수 있는지 확인합니다. 검사에 실패하면 403(Forbidden) 오류 코드와 함께 요청이 실패합니다.

기본적으로 프로젝트 관리자 및 편집기는 해당 네임스페이스의 서비스 계정을 가장할 수 있습니다. sudoers 역할을 사용하면 system:admin 을 가장할 수 있으며, 이로 인해 클러스터 관리자 권한이 부여됩니다. system:admin 은 클러스터를 관리하는 사용자를 위해 보안이 아닌 오타에 대해 일부 보호 권한을 부여합니다. 예를 들어 oc delete nodes --all 을 실행하면 실패하지만 oc delete nodes --all --as=system:admin 을 실행하면 성공합니다. 다음 명령을 실행하여 권한을 사용자에게 부여할 수 있습니다.

$ oc create clusterrolebinding <any_valid_name> --clusterrole=sudoer --user=<username>

사용자를 대신하여 프로젝트 요청을 생성해야 하는 경우 명령에 --as=<user> --as-group=<group1> --as-group=<group2> 플래그를 포함합니다. system:authenticated:oauth 는 프로젝트 요청을 생성할 수 있는 유일한 부트스트랩 그룹이므로 다음 예와 같이 해당 그룹을 가장해야 합니다.

$ oc new-project <project> --as=<user> \ --as-group=system:authenticated --as-group=system:authenticated:oauth

4.1.4. OAuth

OpenShift Container Platform 마스터에는 내장 OAuth 서버가 포함되어 있습니다. 사용자는 API 인증을 위해 OAuth 액세스 토큰을 가져옵니다.

사용자가 새 OAuth 토큰을 요청하면 OAuth 서버는 구성된 ID 공급자를 사용하여 요청한 사용자의 ID를 확인합니다.

그런 다음 해당 ID와 매핑되는 사용자를 결정하고 그 사용자를 위한 액세스 토큰을 만들어 제공합니다.

4.1.4.1. OAuth 클라이언트

OAuth 토큰을 요청할 때마다 토큰을 받고 사용할 OAuth 클라이언트를 지정해야 합니다. OpenShift Container Platform API를 시작하면 다음 OAuth 클라이언트가 자동으로 생성됩니다.

| OAuth 클라이언트 | 사용법 |

|---|---|

| openshift-web-console | 웹 콘솔의 토큰을 요청합니다. |

| openshift-browser-client |

대화형 로그인을 처리할 수 있는 사용자 에이전트를 사용하여 |

| openshift-challenging-client |

|

추가 클라이언트를 등록하려면 다음을 수행합니다.

$ oc create -f <(echo ' kind: OAuthClient apiVersion: oauth.openshift.io/v1 metadata: name: demo 1 secret: "..." 2 redirectURIs: - "http://www.example.com/" 3 grantMethod: prompt 4 ')

- 1

- OAuth 클라이언트의

이름은<master>/oauth/authorize 및에 요청할 때<master>/oauth/tokenclient_id매개변수로 사용됩니다. - 2

secret은<master>/oauth/token에 요청할 때client_secret매개변수로 사용됩니다.- 3

<master> /oauth/authorize 및에 대한 요청에 지정된<master>/oauth/tokenredirect_uri매개변수는redirectURIs의 URI 중 하나와 같아야 합니다.- 4

grantMethod는 이 클라이언트에서 토큰을 요청할 때 사용자가 아직 액세스 권한을 부여받지 않은 경우 수행할 조치를 결정하는 데 사용됩니다. grant Options(제한 옵션)에 표시되는 동일한 값을 사용합니다.

4.1.4.2. OAuth 클라이언트로서의 서비스 계정

서비스 계정은 제한된 형태의 OAuth 클라이언트로 사용할 수 있습니다. 서비스 계정은 서비스 계정의 자체 네임스페이스 내에서 일부 기본 사용자 정보 및 역할 기반 권한에 액세스할 수 있는 부분만 요청할 수 있습니다.

-

user:info -

user:check-access -

role:<any_role>:<serviceaccount_namespace> -

role:<any_role>:<serviceaccount_namespace>:!

서비스 계정을 OAuth 클라이언트로 사용하는 경우에는 다음과 같습니다.

-

client_id는system:serviceaccount:<serviceaccount_namespace>:<serviceaccount_name>입니다. client_secret은 해당 서비스 계정의 API 토큰 중 하나일 수 있습니다. 예를 들면 다음과 같습니다.$ oc sa get-token <serviceaccount_name>

-

WWW-Authenticate챌린지를 가져오려면 서비스 계정의serviceaccounts.openshift.io/oauth-want-challenges주석을 true로 설정합니다. -

redirect_uri는 서비스 계정의 주석과 일치해야 합니다. 서비스 계정의 URI를 OAuth 클라이언트에서 자세한 정보를 제공하므로 리디렉션합니다.

4.1.4.3. 서비스 계정의 URI를 OAuth 클라이언트로 리디렉션

주석 키에는 접두사 serviceaccounts.openshift.io/oauth-redirecturi. 또는 serviceaccounts.openshift.io/oauth-redirectreference.가 있어야 합니다. 예를 들면 다음과 같습니다.

serviceaccounts.openshift.io/oauth-redirecturi.<name>

가장 간단한 형식의 주석을 사용하여 유효한 리디렉션 URI를 직접 지정할 수 있습니다. 예를 들면 다음과 같습니다.

"serviceaccounts.openshift.io/oauth-redirecturi.first": "https://example.com" "serviceaccounts.openshift.io/oauth-redirecturi.second": "https://other.com"

위 예에서 first 및 second라는 접미사는 두 개의 유효한 리디렉션 URI를 구분하는 데 사용됩니다.

복잡한 구성에서는 정적 리디렉션 URI로는 충분하지 않을 수 있습니다. 예를 들어 경로의 모든 인그레스가 유효한 것으로 간주될 수 있습니다. 이 경우 serviceaccounts.openshift.io/oauth-redirectreference 접두사를 통한 동적 리디렉션 URI가 작동합니다.

예를 들면 다음과 같습니다.

"serviceaccounts.openshift.io/oauth-redirectreference.first": "{\"kind\":\"OAuthRedirectReference\",\"apiVersion\":\"v1\",\"reference\":{\"kind\":\"Route\",\"name\":\"jenkins\"}}"이 주석의 값은 직렬화된 JSON 데이터를 포함하므로 확장된 형식으로 쉽게 볼 수 있습니다.

{

"kind": "OAuthRedirectReference",

"apiVersion": "v1",

"reference": {

"kind": "Route",

"name": "jenkins"

}

}

이제 OAuthRedirectReference를 통해 jenkins라는 경로를 참조할 수 있음을 확인할 수 있습니다. 따라서 해당 경로의 모든 인그레스가 이제 유효한 것으로 간주됩니다. OAuthRedirectReference의 전체 사양은 다음과 같습니다.

{

"kind": "OAuthRedirectReference",

"apiVersion": "v1",

"reference": {

"kind": ..., 1

"name": ..., 2

"group": ... 3

}

}두 주석 접두사를 결합하여 참조 오브젝트에서 제공하는 데이터를 덮어쓸 수 있습니다. 예를 들면 다음과 같습니다.

"serviceaccounts.openshift.io/oauth-redirecturi.first": "custompath"

"serviceaccounts.openshift.io/oauth-redirectreference.first": "{\"kind\":\"OAuthRedirectReference\",\"apiVersion\":\"v1\",\"reference\":{\"kind\":\"Route\",\"name\":\"jenkins\"}}"

first 접미사는 주석을 연결하는 데 사용됩니다. jenkins 경로에 https://example.com 의 인그레스가 있다고 가정하면 이제 https://example.com/custompath 은 유효한 것으로 간주되지만 https://example.com 은 유효한 것으로 간주되지 않습니다. 데이터 덮어쓰기를 부분적으로 제공하는 형식은 다음과 같습니다.

| 유형 | 구문 |

|---|---|

| 스키마 | "https://" |

| 호스트 이름 | "//website.com" |

| 포트 | "//:8000" |

| 경로 | "examplepath" |

호스트 이름 덮어쓰기를 지정하면 참조된 오브젝트의 호스트 이름 데이터가 교체되며 이는 바람직한 동작이 아닙니다.

위 구문의 모든 조합은 다음과 같은 형식을 사용하여 결합할 수 있습니다.

<scheme:>//<hostname><:port>/<path>

유연성을 개선하기 위해 동일한 오브젝트를 두 번 이상 참조할 수 있습니다.

"serviceaccounts.openshift.io/oauth-redirecturi.first": "custompath"

"serviceaccounts.openshift.io/oauth-redirectreference.first": "{\"kind\":\"OAuthRedirectReference\",\"apiVersion\":\"v1\",\"reference\":{\"kind\":\"Route\",\"name\":\"jenkins\"}}"

"serviceaccounts.openshift.io/oauth-redirecturi.second": "//:8000"

"serviceaccounts.openshift.io/oauth-redirectreference.second": "{\"kind\":\"OAuthRedirectReference\",\"apiVersion\":\"v1\",\"reference\":{\"kind\":\"Route\",\"name\":\"jenkins\"}}"

jenkins 라는 경로에 https://example.com 수신이 있다고 가정하면 https://example.com:8000 및 https://example.com/custompath 가 모두 유효한 것으로 간주됩니다.

정적 및 동적 주석을 동시에 사용하여 원하는 동작을 수행할 수 있습니다.

"serviceaccounts.openshift.io/oauth-redirectreference.first": "{\"kind\":\"OAuthRedirectReference\",\"apiVersion\":\"v1\",\"reference\":{\"kind\":\"Route\",\"name\":\"jenkins\"}}"

"serviceaccounts.openshift.io/oauth-redirecturi.second": "https://other.com"4.1.4.3.1. OAuth에 대한 API 이벤트