コマンドラインを使用したセルフホストエンジンの Red Hat Virtualization のインストール

コマンドラインを使用して、Red Hat Virtualization Manager の管理するホスト上で動作する仮想マシンとして Manager をインストールする方法

概要

前書き

セルフホストエンジンのインストールは、Ansible により自動化されています。最初のデプロイメントホスト上でインストールスクリプト (hosted-engine --deploy) を実行し、デプロイメントホスト上に作成される仮想マシンに Red Hat Virtualization Manager (または engine) をインストールおよび設定します。Manager および Data Warehouse データベースは Manager 用仮想マシンにインストールされますが、必要であればインストール後に別のサーバーに移行することができます。

Manager 用仮想マシンを実行することのできるホストは、セルフホストエンジンノードと呼ばれます。高可用性機能に対応するためには、少なくとも 2 台のセルフホストエンジンノードが必要です。

Manager 用仮想マシン専用のストレージドメインは、セルフホストエンジン用ストレージドメインと呼ばれます。このストレージドメインはインストールのスクリプトにより作成されるので、インストールの開始前にベースとなるストレージを準備する必要があります。

環境オプションおよび推奨される設定については、プランニングおよび前提条件ガイド を参照してください。セルフホストエンジン環境に特化した設定については、Self-Hosted Engine Recommendations を参照してください。

Red Hat Virtualization の主要コンポーネント

| コンポーネント名 | 説明 |

|---|---|

| Red Hat Virtualization Manager | 環境内のリソースを管理するグラフィカルユーザーインターフェイスと REST API を提供するサービス。Manager は、Red Hat Enterprise Linux を実行する物理マシンまたは仮想マシンにインストールされます。 |

| ホスト | サポートされているホストには、Red Hat Enterprise Linux ホスト (RHEL ホスト) と Red Hat Virtualization Host (イメージベースのハイパーバイザー) の 2 つのタイプがあります。ホストは、Kernel-based Virtual Machine (KVM) テクノロジーを使用して、仮想マシンを実行するためのリソースを提供します。 |

| 共有ストレージ | 仮想マシンに関連付けられたデータの保管に使用するストレージサービス。 |

| Data Warehouse | Manager から設定情報および統計データを収集するサービス。 |

セルフホストエンジンのアーキテクチャー

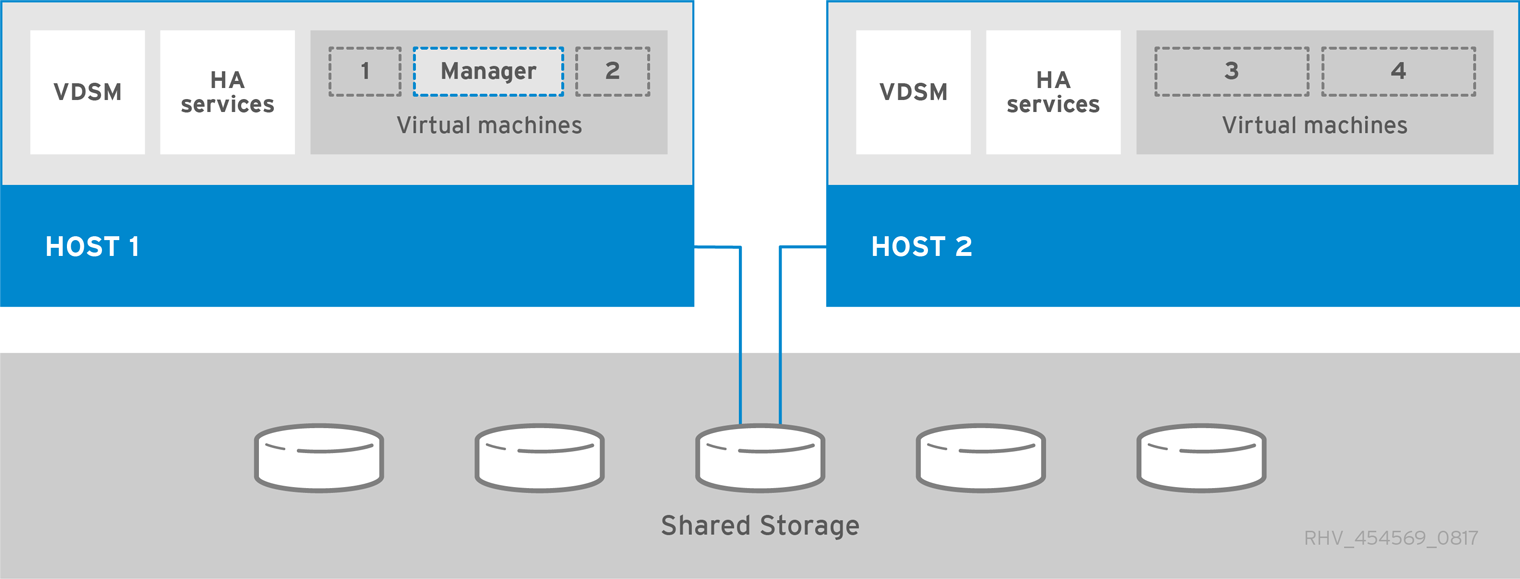

Red Hat Virtualization Manager は、管理している環境と同じ環境内のセルフホストエンジンノード (特化したホスト) で仮想マシンとして実行されます。セルフホストエンジン環境に必要な物理サーバーは 1 台少なくなりますが、デプロイと管理を行うための管理オーバーヘッドがより高くなります。Manager は、外部の HA 管理を使用せずに高可用性になります。

セルフホストエンジン環境の最小限のセットアップには、以下が含まれます。

- セルフホストエンジンノードでホストされている Red Hat Virtualization Manager 用仮想マシン 1 台。Red Hat Enterprise Linux 8 仮想マシンのインストールおよびその仮想マシンへの Manager のインストールを自動化するために、RHV-M Appliance が使用されます。

- 仮想マシンの高可用性には、最小でセルフホストエンジンノード 2 台。Red Hat Enterprise Linux ホストまたは Red Hat Virtualization Host (RHVH) を使用することができます。VDSM (ホストエージェント) は全ホストで実行され、Red Hat Virtualization Manager との通信を円滑に行います。HA サービスは、すべてのセルフホストエンジンノードで実行され、Manager 用仮想マシンの高可用性を管理します。

- ストレージサービスを 1 つ。使用するストレージタイプに応じて、ローカルまたはリモートサーバーでホストすることができます。ストレージサービスは全ホストからアクセス可能である必要があります。

図1 セルフホストエンジンの Red Hat Virtualization アーキテクチャー

第1章 インストールの概要

セルフホストエンジンのインストールには Ansible および RHV-M Appliance (事前設定された Manager 用仮想マシンのイメージ) が使用され、以下のタスクを自動化しています。

- 最初のセルフホストエンジンノードの設定

- そのノードへの Red Hat Enterprise Linux 仮想マシンのインストール

- その仮想マシンへの Red Hat Virtualization Manager のインストールと設定

- セルフホストエンジン用ストレージドメインの設定

RHV-M Appliance が使用されるのはインストール時だけです。Manager のアップグレードには使用されません。

セルフホストエンジン環境をインストールするステップは、以下のとおりです。

セルフホストエンジン用ストレージドメインおよび通常のストレージドメインに使用するストレージを準備します。以下のストレージタイプのいずれかを使用することができます。

インストールを実行するデプロイメントホストをインストールします。このホストが最初のセルフホストエンジンノードになります。以下のホストタイプのいずれかを使用することができます。

Manager にセルフホストエンジンノードおよび通常のホストをさらに追加します。セルフホストエンジンノードは Manager 用仮想マシンおよびその他の仮想マシンを実行することができます。通常のホストは Manager 用仮想マシンを実行することはできませんが、その他すべての仮想マシンを実行することができます。

以下のホストタイプのいずれか、または両方を使用します。

- Manager にセルフホストエンジンノードのホストを追加します。

- Manager に通常のホストを追加します。

- Manager にストレージドメインをさらに追加します。セルフホストエンジン用ストレージドメインは、Manager 用仮想マシンだけが使用することを推奨します。

- データベースまたはサービスを Manager とは別のサーバーでホストする場合には、インストールの完了後にそれらを移行することができます。

環境を最新の状態に維持してください。詳細は、How do I update my Red Hat Virtualization system? を参照してください。既知の問題に対するバグ修正が頻繁にリリースされるため、ホストおよび Manager の更新タスクをスケジュール化してください。

第2章 要件

2.1. Red Hat Virtualization Manager の要件

2.1.1. ハードウェアの要件

以下に記載するハードウェアの最低要件および推奨要件は、一般的な中小規模のインストールをベースとしています。正確な要件は、デプロイメントの規模や負荷により異なります。

Red Hat Virtualization のハードウェア認定には、Red Hat Enterprise Linux のハードウェア認定が適用されます。詳細は、Does Red Hat Virtualization also have hardware certification? を参照してください。特定のハードウェア項目が Red Hat Enterprise Linux での使用に認定されているかどうかを確認するには、Red Hat 認定ハードウェア を参照してください。

表2.1 Red Hat Virtualization Manager ハードウェアの要件

| リソース | 最低要件 | 推奨要件 |

|---|---|---|

| CPU | デュアルコア x86_64 CPU | クアッドコア x86_64 CPU または複数のデュアルコア x86_64 CPU |

| メモリー | 利用可能なシステムメモリー 4 GB (Data Warehouse が未インストールで、かつ既存のプロセスによって消費されていないこと) | システムメモリー 16 GB |

| ハードディスク | ディスクの空き容量 25 GB (ローカルアクセス、書き込みが可能であること) | ディスクの空き容量 50 GB (ローカルアクセス、書き込みが可能であること) Manager 履歴データベースのサイズに適したディスク容量を算出するには、RHV Manager History Database Size Calculator ツールを使用できます。 |

| ネットワークインターフェイス | 1 Gbps 以上の帯域幅のネットワークインターフェイスカード (NIC) 1 基 | 1 Gbps 以上の帯域幅のネットワークインターフェイスカード (NIC) 1 基 |

2.1.2. ブラウザーの要件

管理ポータルと仮想マシンポータルには、以下のブラウザーバージョンとオペレーティングシステムを使用してアクセスすることができます。

ブラウザーのサポートは下記のように階層に分かれます。

- 階層 1: 全面的に検証済みで、完全にサポートされているブラウザーおよびオペレーティングシステムの組み合わせ。Red Hat のエンジニアリングチームは、この階層のブラウザーで問題が発生した場合には、必ず修正を行います。

- 階層 2: 部分的に検証済みで、正常に機能する可能性の高いブラウザーとオペレーティングシステムの組み合わせ。この階層のサポートは限定されます。Red Hat のエンジニアリングチームは、この階層のブラウザーで問題が発生した場合には、修正を試みます。

- 階層 3: 未検証だが、正常に機能することが予想されるブラウザーとオペレーティングシステムの組み合わせ。この階層では、最小限のサポートが提供されます。Red Hat のエンジニアリングチームは、この階層のブラウザー問題が発生した場合には、マイナーな問題に対してのみ修正を試みます。

表2.2 ブラウザーの要件

| サポート階層 | オペレーティングシステムファミリー | ブラウザー |

|---|---|---|

| 階層 1 | Red Hat Enterprise Linux | Mozilla Firefox 延長サポート版 (ESR) のバージョン |

| 任意 | Google Chrome、Mozilla Firefox、または Microsoft Edge の最新バージョン | |

| 階層 2 | ||

| 階層 3 | 任意 | Google Chrome または Mozilla Firefox の旧バージョン |

| 任意 | その他のブラウザー |

2.1.3. クライアントの要件

仮想マシンコンソールは、Red Hat Enterprise Linux および Windows でサポートされている Remote Viewer (virt-viewer) クライアントを使用した場合にのみアクセスすることができます。virt-viewer をインストールするには、仮想マシン管理ガイドの クライアントマシンへのコンポーネントのインストール を参照してください。virt-viewer のインストールには管理者権限が必要です。

仮想マシンコンソールには、SPICE、VCN、または RDP (Windows のみ) プロトコルを使用してアクセスできます。ゲストオペレーティングシステムに QXLDOD グラフィカルドライバーをインストールして、SPICE の機能を向上させることができます。SPICE が現在サポートしている最大解像度は 2560 x 1600 ピクセルです。

クライアントオペレーティングシステムの SPICE サポート

サポートされている QXLDOD ドライバーは、Red Hat Enterprise Linux 7.2 以降および Windows 10 で利用できます。

SPICE は QXLDOD ドライバーを使用して Windows 8 または 8.1 で動作しますが、認定もテストもされていません。

2.1.4. オペレーティングシステムの要件

Red Hat Virtualization Manager は、Red Hat Enterprise Linux 8.6 のベースインストールにインストールする必要があります。

Manager に必要なパッケージのインストールを試みる際に、依存関係の問題が発生する可能性があるため、ベースのインストール後に他のパッケージをインストールしないでください。

Manager のインストールに必要なリポジトリー以外は有効にしないでください。

2.2. ホストの要件

Red Hat Virtualization のハードウェア認定には、Red Hat Enterprise Linux のハードウェア認定が適用されます。詳細は、Does Red Hat Virtualization also have hardware certification? を参照してください。特定のハードウェア項目が Red Hat Enterprise Linux での使用に認定されているかどうかを確認するには、認定ソリューションの検索 を参照してください。

ゲストに適用される要件と制限の詳細については、Red Hat Enterprise Linux テクノロジーの機能と制限 および Supported Limits for Red Hat Virtualization を参照してください。

2.2.1. CPU の要件

すべての CPU が Intel® 64 または AMD64 CPU の拡張機能をサポートし、AMD-V™ または Intel VT® のハードウェア仮想化拡張機能が有効化されている必要があります。No eXecute flag (NX) のサポートも必要です。

以下の CPU モデルがサポートされています。

AMD

- Opteron G4

- Opteron G5

- EPYC

Intel

- Nehalem

- Westmere

- SandyBridge

- IvyBridge

- Haswell

- Broadwell

- Skylake (クライアント)

- Skylake (サーバー)

- Cascadelake サーバー

CPU タイプ は、セキュリティー更新のある CPU モデルごとに、基本的なタイプと安全なタイプを一覧表示します。以下に例を示します。

- Intel Cascadelake Server Family

- Secure Intel Cascadelake Server Family

Secure CPU タイプには最新の更新が含まれます。詳細は、BZ#1731395 を参照してください。

2.2.1.1. プロセッサーが必要なフラグをサポートしているかどうかのチェック

BIOS で仮想化を有効にする必要があります。この設定を行った後には、ホストの電源をオフにしてから再起動して、変更が適用されるようにします。

手順

- Red Hat Enterprise Linux または Red Hat Virtualization Host の起動画面で任意のキーを押し、一覧から Boot か Boot with serial console のエントリーを選択します。

-

Tabを押して、選択したオプションのカーネルパラメーターを編集します。 -

最後のカーネルパラメーターの後にスペースがあることを確認し、パラメーター

rescueを追加します。 -

Enterを押して、レスキューモードで起動します。 プロンプトが表示されたら以下のコマンドを実行して、プロセッサーに必要な拡張機能があるかどうか、またそれらが有効になっているかどうかを確認します。

# grep -E 'svm|vmx' /proc/cpuinfo | grep nx

何らかの出力が表示されれば、プロセッサーはハードウェアの仮想化に対応しています。出力が何も表示されない場合でも、プロセッサーがハードウェアの仮想化に対応している可能性があります。場合によっては、メーカーが BIOS で仮想化拡張機能を無効にしていることがあります。これに該当すると思われる場合には、メーカーが提供しているシステムの BIOS やマザーボードに関するマニュアルを参照してください。

2.2.2. メモリーの要件

必要最小限の RAM は 2 GB です。クラスターレベル 4.2 から 4.5 の場合、Red Hat Virtualization Host で仮想マシンごとにサポートされる最大 RAM は 6 TB です。クラスターレベル 4.6 から 4.7 の場合、Red Hat Virtualization Host で仮想マシンごとにサポートされる最大 RAM は 16 TB です。

ただし、必要な RAM 容量は、ゲストオペレーティングシステムの要件、ゲストのアプリケーションの要件、ゲストのメモリーアクティビティーと使用状況によって異なります。全ゲストがピークの負荷で同時に稼働しないことを前提とした場合、KVM は仮想ゲストに対して物理 RAM をオーバーコミットし、物理的に存在する RAM を超える要件でゲストをプロビジョニングすることも可能です。KVM は、ゲストが必要とする RAM だけを割り当てて、使用率の低いゲストを swap に移動することによって、オーバーコミットします。

2.2.3. ストレージの要件

ホストには、設定、ログ、カーネルダンプを格納し、swap 領域として使用するためのストレージが必要です。ストレージはローカルまたはネットワークベースとすることができます。Red Hat Virtualization Host (RHVH) は、ネットワークストレージのデフォルト割り当ての 1 つ、一部、またはすべてを使用して起動することができます。ネットワークストレージから起動する場合、ネットワークの接続が失われるとフリーズする場合があります。ドロップインマルチパス設定ファイルを追加すると、ネットワーク接続の喪失に対処することができます。SAN ストレージから起動した RHVH がネットワーク接続を失うと、接続が回復するまでファイルは読み取り専用になります。ネットワークストレージを使用すると、パフォーマンスが低下する場合があります。

本セクションでは、RHVH の最低ストレージ要件について説明します。Red Hat Enterprise Linux ホストのストレージ要件は、既存の設定で使用されるディスク容量によって異なりますが、RHVH の要件よりも多くなるはずです。

ホストのインストールの最低ストレージ要件を以下に示します。ただし、より多くのストレージ領域を利用できるデフォルトの割り当てを使用してください。

- / (root): 6 GB

- /home: 1 GB

- /tmp: 1 GB

- /boot: 1 GB

- /var: 5 GB

- /var/crash: 10 GB

- /var/log: 8 GB

- /var/log/audit: 2 GB

- /var/tmp: 10 GB

- スワップ - 1 GB詳細は、What is the recommended swap size for Red Hat platforms? を参照してください。

- Anaconda では、将来のメタデータ拡張用に、ボリュームグループ内のシンプールサイズの 20% が確保されます。これは、通常の使用条件においてデフォルト設定でストレージを使い果たすのを防ぐためです。インストール中のシンプールのオーバープロビジョニングもサポートされていません。

- 最少の合計: 64 GiB

セルフホストエンジンのインストールに RHV-M Appliance もインストールする場合には、/var/tmp は 10 GB 以上である必要があります。

メモリーのオーバーコミットを使用する場合には、すべての仮想マシンに仮想メモリーを提供するのに十分な swap 領域を追加してください。メモリーの最適化 を参照してください。

2.2.4. PCI デバイスの要件

ホストには、1 Gbps 以上の帯域幅のネットワークインターフェイスが少なくとも 1 基搭載されている必要があります。各ホストに 2 つのネットワークインターフェイスを搭載し、そのうちの 1 つは仮想マシンの移行などネットワークへの負荷が高い作業専用にする必要があります。このように負荷の高い操作のパフォーマンスは、利用可能な帯域幅により制限されます。

Intel Q35 ベースの仮想マシンで PCI Express と従来の PCI デバイスを使用する方法に関する情報は、Using PCI Express and Conventional PCI Devices with the Q35 Virtual Machine を参照してください。

2.2.5. デバイス割り当ての要件

仮想マシンがホストから特定の PCIe デバイスを使用できるように、デバイス割り当ておよび PCI パススルーを実装する予定がある場合は、以下の要件を満たしていることを確認してください。

- CPU が IOMMU (例: VT-d または AMD-Vi) をサポートしていること。IBM POWER8 はデフォルトで IOMMU をサポートしています。

- ファームウェアが IOMMU をサポートしていること。

- 使用する CPU ルートポートが ACS または ACS と同等の機能をサポートしていること。

- PCIe デバイスが ACS または ACS と同等の機能をサポートしていること。

- PCIe デバイスとルートポート間の PCIe スイッチとブリッジはすべて、ACS をサポートしていること。たとえば、スイッチが ACS をサポートしていない場合には、そのスイッチの背後にあるデバイスはすべて同じ IOMMU グループを共有し、同じ仮想マシンにしか割り当てることができません。

- GPU のサポートについては、Red Hat Enterprise Linux 8 は VGA 以外のグラフィックデバイスとして PCIe ベースの NVIDIA K シリーズ Quadro (モデル 2000 シリーズ以降)、GRID、Tesla の PCI デバイス割り当てをサポートしていること。現在、標準のエミュレーションされた VGA インターフェイスの 1 つ以外に、仮想マシンには GPU を 2 つまでアタッチすることができます。エミュレーションされた VGA は、起動前やインストールに使用され、NVIDIA グラフィックドライバーが読み込まれると NVDIA GPU に引き継がれます。NVIDIA Quadro 2000 も、Quadro K420 カードもサポートされていない点にご注意ください。

ベンダーの仕様とデータシートをチェックして、お使いのハードウェアが要件を満たしていることを確認してください。lspci -v コマンドを使用すると、システムにインストールされている PCI デバイスの情報を表示できます。

2.2.6. vGPU の要件

ホスト上の仮想マシンが仮想 GPU を使用するためには、ホストが以下の要件を満たす必要があります。

- GPU が vGPU に対応していること。

- ホストカーネルで GPU が有効であること。

- 適切なドライバーと共に GPU がインストールされていること。

- 仮想マシンの Administration Portal の Host Devices タブにある Manage vGPU ダイアログを使用して、この仮想マシンで使用する vGPU のタイプとインスタンスの数を選択します。

- クラスター内の各ホストに vGPU に対応したドライバーがインストールされていること。

- vGPU ドライバーと共に vGPU に対応した仮想マシンのオペレーティングシステムがインストールされていること。

2.3. ネットワークの要件

2.3.1. 一般要件

Red Hat Virtualization では、Manager を実行している物理または仮想マシンで IPv6 を有効にしたままにしておく必要があります。お使いのシステムが IPv6 を使用しない場合でも、Manager マシンで IPv6 を無効にしないでください。

2.3.2. セルフホストエンジンデプロイメントのネットワーク範囲

セルフホストエンジンのデプロイメントプロセスは、192.168 下の /24 ネットワークアドレスを一時的に使用します。デフォルトは 192.168.222.0/24 で、このアドレスが使用されている場合は、使用されていないアドレスが見つかるまで、192.168 下にある他の /24 アドレスを試します。この範囲で未使用のネットワークアドレスが見つからない場合は、デプロイメントに失敗します。

コマンドラインを使用してセルフホストエンジンをインストールする場合は、オプション --ansible-extra-vars=he_ipv4_subnet_prefix=PREFIX を使用して、別の /24 ネットワーク範囲を使用するようにデプロイメントスクリプトを設定できます。PREFIX はデフォルト範囲の接頭辞に置き換えます。以下に例を示します。

# hosted-engine --deploy --ansible-extra-vars=he_ipv4_subnet_prefix=192.168.222

コマンドラインで Red Hat Virtualization をセルフホストエンジンとしてインストールすることでのみ、別の範囲を設定することができます。

2.3.3. DNS、NTP、および IPMI フェンシングに対するファイアウォールの要件

以下のトピックに対するファイアウォールの要件は特殊なケースで、個別に検討する必要があります。

DNS および NTP

Red Hat Virtualization では DNS または NTP サーバーは作成されません。したがって、ファイアウォールには、受信トラフィックに対するオープンポートは必要ありません。

デフォルトでは、Red Hat Enterprise Linux は任意のアドレス上の DNS および NTP への出力トラフィックを許可します。出力トラフィックを無効にする場合には、DNS および NTP サーバーに送付されるリクエストに例外を定義します。

- Red Hat Virtualization Manager およびすべてのホスト (Red Hat Virtualization Host および Red Hat Enterprise Linux ホスト) には、完全修飾ドメイン名と、全面的かつ完全な正引きおよび逆引きの名前解決が必要です。

- DNS サービスを Red Hat Virtualization 環境内の仮想マシンとして実行する方法はサポートされていません。Red Hat Virtualization 環境が使用する DNS サービスは、すべて環境の外部でホストする必要があります。

-

名前解決には、

/etc/hostsファイルの代わりに DNS を使用します。hosts ファイルを使用すると、より多くの作業が必要となり、誤設定の可能性がより高くなります。

IPMI およびその他のフェンシング機構 (オプション)

IPMI (Intelligent Platform Management Interface) およびその他のフェンシング機構については、ファイアウォールには、受信トラフィックに対するオープンポートは必要ありません。

デフォルトでは、Red Hat Enterprise Linux は任意のアドレス上のポートへの送信 IPMI トラフィックを許可します。発信トラフィックを無効にする場合には、IPMI またはフェンシングサーバーに送付されるリクエストに例外を設定します。

クラスター内の各 Red Hat Virtualization Host および Red Hat Enterprise Linux ホストは、クラスター内にある残りの全ホストのフェンシングデバイスに接続できる必要があります。クラスターホストにエラー (ネットワークエラー、ストレージエラーなど) が発生し、ホストとして機能できない場合は、データセンターの他のホストに接続できる必要があります。

具体的なポート番号は、使用するフェンスエージェントのタイプおよびその設定により異なります。

以降のセクションで説明するファイアウォール要件の表には、このオプションは含まれていません。

2.3.4. Red Hat Virtualization Manager ファイアウォールの要件

Red Hat Virtualization Manager では、ネットワークトラフィックがシステムのファイアウォールを通過できるように複数のポートを開放しておく必要があります。

engine-setup スクリプトは、ファイアウォールを自動的に設定できます。

本セクションに記載するファイアウォール設定は、デフォルトの設定を前提としています。

これらのファイアウォール要件の模式図が、https://access.redhat.com/articles/3932211 に記載されています。表に書かれた ID を使用して、模式図内の接続を検索できます。

表2.3 Red Hat Virtualization Manager ファイアウォールの要件

| ID | ポート | プロトコル | 送信元 | 送信先 | 目的 | デフォルトで暗号化 |

|---|---|---|---|---|---|---|

| M1 | - | ICMP | Red Hat Virtualization Hosts Red Hat Enterprise Linux ホスト | Red Hat Virtualization Manager | オプション 診断に役立つ場合があります。 | ✕ |

| M2 | 22 | TCP | バックエンドの設定やソフトウェアのアップグレードなど、Manager のメンテナンスに使うシステム | Red Hat Virtualization Manager | Secure Shell (SSH) アクセス オプション | ◯ |

| M3 | 2222 | TCP | 仮想マシンのシリアルコンソールにアクセスするクライアント | Red Hat Virtualization Manager | 仮想マシンのシリアルコンソールへの接続を可能にするための Secure Shell (SSH) アクセス。 | ◯ |

| M4 | 80、443 | TCP | 管理ポータルのクライアント 仮想マシンポータルのクライアント Red Hat Virtualization Hosts Red Hat Enterprise Linux ホスト REST API クライアント | Red Hat Virtualization Manager | Manager に HTTP (ポート 80、暗号化なし) および HTTPS (ポート 443、暗号化あり) のアクセスを提供します。HTTP は接続を HTTPS にリダイレクトします。 | ◯ |

| M5 | 6100 | TCP | 管理ポータルのクライアント 仮想マシンポータルのクライアント | Red Hat Virtualization Manager |

Manager 上で WebSocket プロキシーを実行している場合に、Web ベースのコンソールクライアント ( | ✕ |

| M6 | 7410 | UDP | Red Hat Virtualization Hosts Red Hat Enterprise Linux ホスト | Red Hat Virtualization Manager |

ホストの Kdump が有効な場合には、Manager の fence_kdump リスナー用にこのポートを開きます。fence_kdump の高度な設定 を参照してください。 | ✕ |

| M7 | 54323 | TCP | 管理ポータルのクライアント |

Red Hat Virtualization Manager ( |

| ○ |

| M8 | 6642 | TCP | Red Hat Virtualization Hosts Red Hat Enterprise Linux ホスト | Open Virtual Network (OVN) southbound データベース | Open Virtual Network (OVN) データベースへの接続 | ○ |

| M9 | 9696 | TCP | OVN 用外部ネットワークプロバイダーのクライアント | OVN 用外部ネットワークプロバイダー | OpenStack Networking API | ◯ engine-setup によって生成された設定による暗号化。 |

| M10 | 35357 | TCP | OVN 用外部ネットワークプロバイダーのクライアント | OVN 用外部ネットワークプロバイダー | OpenStack Identity API | ◯ engine-setup によって生成された設定による暗号化。 |

| M11 | 53 | TCP、UDP | Red Hat Virtualization Manager | DNS サーバー | 1023 より大きいポート番号からポート 53 への DNS ルックアップリクエストおよび応答。デフォルトで開いています。 | ✕ |

| M12 | 123 | UDP | Red Hat Virtualization Manager | NTP サーバー | 1023 より大きいポート番号からポート 123 への NTP リクエストおよび応答。デフォルトで開いています。 | ✕ |

-

デフォルトの設定では、OVN northbound データベース (6641) のクライアントは

ovirt-provider-ovnのみなので、OVN northbound データベースのポート (6641) は記載されていません。両者は同じホスト上で動作しているので、その通信はネットワークには現れません。 - デフォルトでは、Red Hat Enterprise Linux は任意のアドレス上の DNS および NTP への出力トラフィックを許可します。出力トラフィックを無効にする場合には、Manager がリクエストを DNS および NTP サーバーに送信するように例外を設定します。他のノードでも DNS および NTP が必要な場合があります。その際には、それらのノードの要件を確認し、適切にファイアウォールを設定してください。

2.3.5. ホストファイアウォールの要件

Red Hat Enterprise Linux ホストおよび Red Hat Virtualization Host (RHVH) では、ネットワークトラフィックがシステムのファイアウォールを通過できるように複数のポートを開放しておく必要があります。新たなホストを Manager に追加する際に、ファイアウォールルールがデフォルトで自動的に設定され、既存のファイアウォール設定はすべて上書きされます。

新規ホストの追加時のファイアウォール自動設定を無効にするには、Advanced Parameters の下の Automatically configure host firewall のチェックボックスからチェックを外します。

ホストのファイアウォールルールをカスタマイズするには、RHV: How to customize the Host’s firewall rules? を参照してください。

これらのファイアウォール要件の図は、Red Hat Virtualization: Firewall Requirements Diagram で入手できます。表に書かれた ID を使用して、模式図内の接続を検索できます。

表2.4 仮想化ホストファイアウォールの要件

| ID | ポート | プロトコル | 送信元 | 送信先 | 目的 | デフォルトで暗号化 |

|---|---|---|---|---|---|---|

| H1 | 22 | TCP | Red Hat Virtualization Manager | Red Hat Virtualization Hosts Red Hat Enterprise Linux ホスト | Secure Shell (SSH) アクセス オプション | ○ |

| H2 | 2223 | TCP | Red Hat Virtualization Manager | Red Hat Virtualization Hosts Red Hat Enterprise Linux ホスト | 仮想マシンのシリアルコンソールへの接続を可能にするための Secure Shell (SSH) アクセス。 | ○ |

| H3 | 161 | UDP | Red Hat Virtualization Hosts Red Hat Enterprise Linux ホスト | Red Hat Virtualization Manager | Simple Network Management Protocol (SNMP)。ホストから 1 つまたは複数の外部 SNMP マネージャーに Simple Network Management Protocol のトラップを送信する場合にのみ必要です。 オプション | ✕ |

| H4 | 111 | TCP | NFS ストレージサーバー | Red Hat Virtualization Hosts Red Hat Enterprise Linux ホスト | NFS 接続 オプション | ✕ |

| H5 | 5900 - 6923 | TCP | 管理ポータルのクライアント 仮想マシンポータルのクライアント | Red Hat Virtualization Hosts Red Hat Enterprise Linux ホスト | VNC および SPICE を介したリモートゲストのコンソールアクセス。クライアントが仮想マシンに容易にアクセスできるように、これらのポートは開放しておく必要があります。 | ◯ (オプション) |

| H6 | 5989 | TCP、UDP | Common Information Model Object Manager (CIMOM) | Red Hat Virtualization Hosts Red Hat Enterprise Linux ホスト | Common Information Model Object Managers (CIMOM) がホスト上で実行中の仮想マシンをモニタリングするために使用します。このポートは、仮想化環境内の仮想マシンのモニタリングに CIMOM を使用する場合にのみ開放する必要があります。 オプション | ✕ |

| H7 | 9090 | TCP | Red Hat Virtualization Manager クライアントマシン | Red Hat Virtualization Hosts Red Hat Enterprise Linux ホスト | Cockpit がインストールされている場合には、Cockpit Web インターフェイスにアクセスするために必要です。 | ○ |

| H8 | 16514 | TCP | Red Hat Virtualization Hosts Red Hat Enterprise Linux ホスト | Red Hat Virtualization Hosts Red Hat Enterprise Linux ホスト | libvirt を使った仮想マシンの移行 | ○ |

| H9 | 49152 - 49215 | TCP | Red Hat Virtualization Hosts Red Hat Enterprise Linux ホスト | Red Hat Virtualization Hosts Red Hat Enterprise Linux ホスト | VDSM を使用した仮想マシンの移行とフェンシング。仮想マシンの自動および手動での移行を容易に実行できるように、これらのポートを開放しておく必要があります。 | ◯フェンスエージェントに応じて、libvirt を介して移行が行われます。 |

| H10 | 54321 | TCP | Red Hat Virtualization Manager Red Hat Virtualization Hosts Red Hat Enterprise Linux ホスト | Red Hat Virtualization Hosts Red Hat Enterprise Linux ホスト | VDSM による Manager およびその他の仮想化ホストとの通信 | ○ |

| H11 | 54322 | TCP |

Red Hat Virtualization Manager | Red Hat Virtualization Hosts Red Hat Enterprise Linux ホスト |

| ○ |

| H12 | 6081 | UDP | Red Hat Virtualization Hosts Red Hat Enterprise Linux ホスト | Red Hat Virtualization Hosts Red Hat Enterprise Linux ホスト | Open Virtual Network (OVN) をネットワークプロバイダーとして使用している場合に、OVN がホスト間にトンネルを作成するために必要です。 | ✕ |

| H13 | 53 | TCP、UDP | Red Hat Virtualization Hosts Red Hat Enterprise Linux ホスト | DNS サーバー | 1023 より大きいポート番号からポート 53 への DNS ルックアップリクエストおよび応答。このポートは必須で、デフォルトで開いています。 | ✕ |

| H14 | 123 | UDP | Red Hat Virtualization Hosts Red Hat Enterprise Linux ホスト | NTP サーバー | 1023 より大きいポート番号からポート 123 への NTP リクエストおよび応答。このポートは必須で、デフォルトで開いています。 | |

| H15 | 4500 | TCP、UDP | Red Hat Virtualization Hosts | Red Hat Virtualization Hosts | インターネットセキュリティープロトコル (IPSec) | ○ |

| H16 | 500 | UDP | Red Hat Virtualization Hosts | Red Hat Virtualization Hosts | インターネットセキュリティープロトコル (IPSec) | ○ |

| H17 | - | AH、ESP | Red Hat Virtualization Hosts | Red Hat Virtualization Hosts | インターネットセキュリティープロトコル (IPSec) | ○ |

デフォルトでは、Red Hat Enterprise Linux は任意のアドレス上の DNS および NTP への出力トラフィックを許可します。出力トラフィックを無効にする場合には、Red Hat Virtualization Host に例外を設定します。

Red Hat Enterprise Linux ホストは DNS および NTP サーバーにリクエストを送信します。他のノードでも DNS および NTP が必要な場合があります。その際には、それらのノードの要件を確認し、適切にファイアウォールを設定してください。

2.3.6. データベースサーバーファイアウォールの要件

Red Hat Virtualization では、Manager データベース (engine) および Data Warehouse データベース (ovirt-engine-history) でのリモートデータベースサーバーの使用をサポートしています。リモートデータベースサーバーを使用する予定がある場合は、Manager および Data Warehouse サービス (Manager と分離することが可能) からの接続を許可する必要があります。

同様に、外部システムからローカルまたはリモートの Data Warehouse データベースにアクセスする予定がある場合は、そのシステムからのアクセスをデータベースで許可する必要があります。

外部システムからの Manager データベースへのアクセスはサポートされていません。

これらのファイアウォール要件の模式図が、https://access.redhat.com/articles/3932211 に記載されています。表に書かれた ID を使用して、模式図内の接続を検索できます。

表2.5 データベースサーバーファイアウォールの要件

| ID | ポート | プロトコル | 送信元 | 送信先 | 目的 | デフォルトで暗号化 |

|---|---|---|---|---|---|---|

| D1 | 5432 | TCP、UDP | Red Hat Virtualization Manager Data Warehouse サービス |

Manager (

Data Warehouse ( | PostgreSQL データベース接続のデフォルトポート | |

| D2 | 5432 | TCP、UDP | 外部のシステム |

Data Warehouse ( | PostgreSQL データベース接続のデフォルトポート | デフォルトでは無効です。無効、ただし有効にできます。 |

2.3.7. 最大伝送単位の要件

デプロイメント中のホストで推奨される最大伝送単位 (MTU) の設定は 1500 です。環境が別の MTU に設定された後で、この設定を更新することができます。MTU 設定の変更に関する詳細は、How to change the Hosted Engine VM network MTU を参照してください。

第3章 Red Hat Virtualization 用ストレージの準備

新たな環境のストレージドメインとして使用するストレージを準備する必要があります。Red Hat Virtualization 環境には少なくとも 1 つのデータストレージドメインが必要ですが、さらに追加することを推奨します。

ホストのオペレーティングシステムのインストールまたは再インストールを行う場合、Red Hat では、ホストにアタッチされている既存の OS 以外のストレージを最初にデタッチすることを強く推奨しています。これは、ディスクを誤って初期化してデータが失われる可能性を避けるためです。

データドメインには、データセンター内の仮想マシンおよびテンプレートの仮想ハードディスクと OVF ファイルを格納します。このドメインは、アクティブな間は複数のデータセンター間で共有することはできません (ただし、データセンター間で移行することは可能です)。複数のストレージタイプのデータドメインを同じデータセンターに追加することは可能ですが、それらはすべてローカルドメインではなく、全ホストがアクセス可能なドメインであることが条件となります。

以下のストレージタイプのいずれかを使用することができます。

前提条件

セルフホストエンジンには、Manager 用仮想マシン専用の 74 GiB 以上のデータドメインが追加で必要です。セルフホストエンジンのインストーラーがこのドメインを作成します。インストール前にこのドメイン用のストレージを準備します。

警告セルフホストエンジンのデプロイメント後にセルフホストエンジン用ストレージドメインを拡張または変更することはサポートされていません。このような変更により、セルフホストエンジンが起動できなくなる可能性があります。

- ブロックストレージドメイン (FCP または iSCSI のいずれか) を使用する場合、セルフホストエンジンでサポートされる設定は、単一のターゲット LUN のみとなります。

- iSCSI ストレージを使用する場合には、セルフホストエンジン用ストレージドメインは専用の iSCSI ターゲットを使用する必要があります。追加のストレージドメインは、異なる iSCSI ターゲットを使用しなければなりません。

- セルフホストエンジン用ストレージドメインと同じデータセンター内に追加のデータストレージドメインを作成することを強く推奨します。セルフホストエンジンをデータセンター内にデプロイする際に、アクティブなデータストレージドメインを 1 つしか用意していない場合、そのストレージドメインが破損しても、新しいストレージドメインを追加したり、破損したストレージドメインを削除することはできません。セルフホストエンジンを再デプロイしなければなりません。

3.1. NFS ストレージの準備

ファイルストレージまたはリモートサーバーで NFS 共有を設定し、Red Hat Enterprise Virtualization Host システムのストレージドメインとして機能するようにします。リモートストレージで共有をエクスポートし、Red Hat Virtualization Manager で共有を設定すると、共有は Red Hat Virtualization Host に自動的にインポートされます。

NFS の準備、設定、マウント、およびエクスポートに関する詳細は、Red Hat Enterprise Linux 8 の ファイルシステムの管理 を参照してください。

Red Hat Virtualization には、特定のシステムユーザーアカウントおよびシステムユーザーグループが必要です。これにより、Manager はストレージドメイン (エクスポートしたディレクトリー) にデータを保管することができます。以下の手順では、1 つのディレクトリーのパーミションを設定しています。Red Hat Virtualization のストレージドメインとして使用するすべてのディレクトリーについて、chown および chmod のステップを繰り返す必要があります。

前提条件

NFS

utilsパッケージをインストールする。# dnf install nfs-utils -y

以下のコマンドを実行して、有効なバージョンを確認する。

# cat /proc/fs/nfsd/versions

以下のサービスを有効にする。

# systemctl enable nfs-server # systemctl enable rpcbind

手順

kvmグループを作成します。# groupadd kvm -g 36

kvmグループにvdsmユーザーを作成します。# useradd vdsm -u 36 -g kvm

storageディレクトリーを作成し、アクセス権を変更します。# mkdir /storage # chmod 0755 /storage # chown 36:36 /storage/

storageディレクトリーを、適切なパーミッションで/etc/exportsに追加します。# vi /etc/exports # cat /etc/exports /storage *(rw)

以下のサービスを再起動します。

# systemctl restart rpcbind # systemctl restart nfs-server

特定の IP アドレスで利用可能なエクスポートを確認するには、以下のコマンドを実行します。

# exportfs /nfs_server/srv 10.46.11.3/24 /nfs_server <world>

サービス起動後に /etc/exports を変更した場合は、exportfs -ra コマンドを使用してその変更を再読み込みできます。上記のすべての手順を実行すると、exports ディレクトリーが準備でき、利用可能かどうかを確認するため、別のホストでテストすることができます。

3.2. iSCSI ストレージの準備

Red Hat Virtualization は、LUN で設定されるボリュームグループから作成されるストレージドメインである iSCSI ストレージをサポートします。ボリュームグループおよび LUN は、いずれも同時に複数のストレージドメインにアタッチすることはできません。

iSCSI ストレージのセットアップおよび設定に関する詳細は、Red Hat Enterprise Linux 8 の ストレージデバイスの管理 で、iSCSI ターゲットの設定 を参照してください。

ブロックストレージを使用する際に、仮想マシンを Raw デバイスまたは直接 LUN にデプロイして論理ボリュームマネージャー (LVM) で管理する場合は、フィルターを作成してゲストの論理ボリュームを除外する必要があります。これにより、ホストの起動時にゲストの論理ボリュームがアクティブ化されるのを防ぐことができます。アクティブ化されると、論理ボリュームの内容が古くなり、データ破損が生じる可能性があります。vdsm-tool config-lvm-filter コマンドを使用して、LVM のフィルターを作成します。LVM フィルターの作成 を参照してください。

現状、Red Hat Virtualization はブロックサイズ 4K のブロックストレージはサポートしていません。ブロックストレージはレガシー (512b ブロック) モードで設定する必要があります。

SAN ストレージから起動したホストがストレージへの接続を失うと、ストレージファイルシステムは読み取り専用になり、接続が回復した後もその状態が続きます。

この状態を回避するには、ブート LUN の SAN のルートファイルシステムにドロップインマルチパス設定ファイルを追加し、接続可能な場合にキューに置かれるようにしてください。

# cat /etc/multipath/conf.d/host.conf

multipaths {

multipath {

wwid boot_LUN_wwid

no_path_retry queue

}3.3. FCP ストレージの準備

Red Hat Virtualization は、既存の LUN で設定されるボリュームグループからストレージドメインを作成することで、SAN ストレージをサポートしています。ボリュームグループおよび LUN は、いずれも同時に複数のストレージドメインにアタッチすることはできません。

Red Hat Virtualization システムの管理者には Storage Area Networks (SAN) に関する作業知識が必要になります。SAN は通常、ホストと外部の共有ストレージ間のトラフィックにファイバーチャネルプロトコル (FCP) を使用します。このため、SAN は FCP ストレージとも呼ばれています。

Red Hat Enterprise Linux での FCP またはマルチパスの準備および設定に関する情報は、ストレージ管理ガイド および DM Multipath ガイド を参照してください。

ブロックストレージを使用する際に、仮想マシンを Raw デバイスまたは直接 LUN にデプロイして論理ボリュームマネージャー (LVM) で管理する場合は、フィルターを作成してゲストの論理ボリュームを除外する必要があります。これにより、ホストの起動時にゲストの論理ボリュームがアクティブ化されるのを防ぐことができます。アクティブ化されると、論理ボリュームの内容が古くなり、データ破損が生じる可能性があります。vdsm-tool config-lvm-filter コマンドを使用して、LVM のフィルターを作成します。LVM フィルターの作成 を参照してください。

現状、Red Hat Virtualization はブロックサイズ 4K のブロックストレージはサポートしていません。ブロックストレージはレガシー (512b ブロック) モードで設定する必要があります。

SAN ストレージから起動したホストがストレージへの接続を失うと、ストレージファイルシステムは読み取り専用になり、接続が回復した後もその状態が続きます。

この状態を回避するには、ブート LUN の SAN のルートファイルシステムにドロップインマルチパス設定ファイルを追加し、接続可能な場合にキューに置かれるようにしてください。

# cat /etc/multipath/conf.d/host.conf

multipaths {

multipath {

wwid boot_LUN_wwid

no_path_retry queue

}

}3.4. Red Hat Gluster Storage の準備

Red Hat Gluster Storage の準備および設定に関する情報は、Red Hat Gluster Storage インストールガイド を参照してください。

Red Hat Virtualization でサポートされている Red Hat Gluster Storage のバージョンについては、Red Hat Gluster Storage バージョンの互換性とサポート を参照してください。

3.5. SAN ベンダーのマルチパス設定のカスタマイズ

RHV 環境が SAN とのマルチパス接続を使用するように設定されている場合には、ストレージベンダーが指定する要件を満たすようにマルチパス設定をカスタマイズできます。このカスタマイズは、/etc/multipath.conf で指定した設定と、デフォルトの設定の両方を上書きできます。

マルチパス設定を上書きする場合は、/etc/multipath.conf をカスタマイズしないでください。VDSM は /etc/multipath.conf を所有しているため、VDSM または Red Hat Virtualization をインストールまたはアップグレードすると、カスタマイズを含むこのファイルが上書きされます。この上書きにより、重大なストレージ障害が発生する可能性があります。

代わりに、カスタマイズまたは上書きする設定が含まれる /etc/multipath/conf.d ディレクトリーにファイルを作成します。

VDSM は、/etc/multipath/conf.d のファイルをアルファベット順に実行します。実行の順番を制御するには、ファイル名を番号で開始し、アルファベット順後の最後に来るようにします。たとえば、/etc/multipath/conf.d/90-myfile.conf です。

重大なストレージ障害を引き起こさないように、以下のガイドラインに従ってください。

-

/etc/multipath.confは変更しないでください。ファイルにユーザー変更が含まれる場合にこのファイルが上書きされると、想定外のストレージ障害が発生する可能性があります。 -

user_friendly_namesとfind_multipathsの設定を上書きしないでください。詳細については、Recommended Settings for Multipath.conf を参照してください。 -

ストレージベンダーから明示的に求められない限り、

no_path_retryとpolling_intervalの設定を上書きしないようにします。詳細については、Recommended Settings for Multipath.conf を参照してください。

これらのガイドラインに従わないと、非常に深刻なストレージ障害が発生する可能性があります。

前提条件

VDSM がマルチパスモジュールを使用するように設定されている。これを確認するには、以下を入力します。

# vdsm-tool is-configured --module multipath

手順

-

/etc/multipath/conf.dディレクトリーに新しい設定ファイルを作成します。 -

上書きする個々の設定を、

/etc/multipath.confから/etc/multipath/conf.d/<my_device>.conf内の新しい設定ファイルにコピーします。コメントマークを削除して設定値を編集し、変更を保存します。 以下を入力して、新しい設定を適用します。

# systemctl reload multipathd

注記multipathd サービスを再起動しないでください。これにより、VDSM ログにエラーが生成されます。

検証手順

- さまざまな障害シナリオで実稼働クラスター以外のクラスターを使用して、新しい設定が想定どおりに実行されことをテストします。たとえば、ストレージの接続をすべて無効にします。

- 一度に 1 つの接続を有効にし、これによりストレージドメインに到達可能であることを確認します。

3.6. 推奨される Multipath.conf 設定

以下の設定は上書きしないでください。

- user_friendly_names no

デバイス名は、すべてのハイパーバイザーで一貫性を保つ必要があります。たとえば、

/dev/mapper/{WWID}です。この設定のデフォルト値noは、さまざまなハイパーバイザー上の/dev/mapper/mpath{N}など、任意で一貫性のないデバイス名の割り当てを阻止するため、システムの動作が予測できない可能性があります。警告この設定を

user_friendly_names yesに変更しないでください。ユーザーフレンドリーな名前を使用すると、システムの想定外の動作や障害が発生する可能性が高く、サポートされていません。find_multipaths no複数のパスを利用できる場合に RHVH がマルチパスを介してデバイスへのアクセスを試みるかどうかを制御します。現在の値

noを使用すると、利用できるパスが 1 つしかない場合でも、RHV がマルチパスを介してデバイスにアクセスできるようになります。警告この設定は上書きしないでください。

ストレージシステムベンダーが必要な場合を除き、以下の設定は上書きしないでください。

no_path_retry 4-

利用可能なパスがない場合にポーリングを再試行する回数を制御します。RHV バージョン 4.2 より前は、パスが利用できない場合に QEMU の I/O キューに問題が生じていたため、

no_path_retryの値はfailでした。fail値により、仮想マシンはすぐに失敗し、一時停止していました。RHV バージョン 4.2 ではこの値が4に変更されました。これにより、multipathd は最後のパスが失敗したことを検知すると、すべてのパスをさらに 4 回確認します。ポーリングがデフォルトの 5 秒間隔で行われると仮定すると、パスの確認には 20 秒かかります。パスが起動しない場合、multipathd は、パスが復元されるまでキューを停止するようにカーネルに指示し、未処理および将来の I/O をすべて失敗させます。パスが復元されると、次にすべてのパスが失敗したときのために、20 秒間のパスの確認時間がリセットされます。詳細は、この設定を変更したコミット を参照してください。 polling_interval 5- パスが開いているか、または失敗したかを検出するポーリングの試行間隔の秒数を決定します。ベンダーが値を増やす明確な理由を提供しない限り、VDSM が生成するデフォルト値を維持します。これにより、システムはパスの失敗に早めの対応することができます。

第4章 セルフホストエンジン用デプロイメントホストのインストール

セルフホストエンジンは、Red Hat Virtualization Host または Red Hat Enterprise Linux ホスト からデプロイすることができます。

高可用性のためにボンドインターフェイスを使用する、またはトラフィックをタイプごとに分離するために VLAN を使用する場合は (例: ストレージ用の接続と管理用の接続)、セルフホストエンジンのデプロイメント開始前にホストに設定する必要があります。詳細は、プランニングおよび前提条件ガイド の ネットワークの推奨事項 を参照してください。

4.1. Red Hat Virtualization Host のインストール

Red Hat Virtualization Host (RHVH) は、Red Hat Virtualization 環境でハイパーバイザーとして機能する物理マシンの簡単な設定方法を提供するために設計された、Red Hat Enterprise Linux をベースとする最小設定のオペレーティングシステムです。この最小設定のオペレーティングシステムには、マシンがハイパーバイザーとして機能するのに必要なパッケージのみが含まれており、ホストの監視や管理タスクの実行用に Cockpit Web インターフェイスが備えられています。ブラウザーの最小要件については、Cockpit の実行 を参照してください。

RHVH は NIST SP 800-53 パーティショニングの要件をサポートし、より強固なセキュリティーを提供します。RHVH は、デフォルトで NIST 800-53 パーティションレイアウトを使用します。

ホストは最低限の ホスト要件 を満たしている必要があります。

ホストのオペレーティングシステムのインストールまたは再インストールを行う場合、Red Hat では、ホストにアタッチされている既存の OS 以外のストレージを最初にデタッチすることを強く推奨しています。これは、ディスクを誤って初期化してデータが失われる可能性を避けるためです。

手順

- Red Hat カスタマーポータルの Red Hat Virtualization を使い始める にアクセスし、ログインします。

- Download Latest をクリックして、製品のダウンロードページに移動します。

- 一覧から RHV に適した Hypervisor Image for RHV を選択し、Download Now をクリックします。

- RHVH のインストール先となるマシンを起動し、準備したインストールメディアから起動します。

起動メニューから Install RHVH 4.4 を選択し、

Enterを押します。注記ま

Tabキーを押してカーネルパラメーターを編集することもできます。カーネルパラメーターはスペースで区切る必要があります。また、指定したカーネルパラメーターを使用してシステムを起動するには、Enterキーを押します。Escキーを押してカーネルパラメーターへの変更を消去し、起動メニューに戻ります。- 言語を選択し、Continue をクリックします。

- Keyboard Layout の画面からキーボードのレイアウトを選択して Done をクリックします。

Installation Destination の画面から RHVH のインストール先のデバイスを選択します。オプションで暗号化を有効にします。Done をクリックします。

重要Automatically configure partitioning オプションを使用します。

- Time & Date の画面からタイムゾーンを選択し、Done をクリックします。

Network & Host Name の画面からネットワークを選択し、Configure… をクリックして接続の詳細を設定します。

注記システムを起動するたびに接続を使用する場合は、Connect automatically with priority のチェックボックスを選択します。詳細は、標準的な RHEL 8 インストールの実行 の ネットワークおよびホスト名のオプションの設定 を参照してください。

ホスト名を Host Name フィールドに入力し、Done をクリックします。

- オプション: Security Policy と Kdump を設定します。Installation Summary 画面の各セクションの詳細は、Red Hat Enterprise Linux 8 標準的な RHEL インストールの実行 の GUI を使用したインストールのカスタマイズ を参照してください。

- Begin Installation をクリックします。

RHVH のインストールの際に root パスワードを設定して、オプションで追加のユーザーを作成します。

警告ローカルのセキュリティー脆弱性が攻撃される可能性があるので、RHVH に信頼できないユーザーを作成しないでください。

Reboot をクリックしてインストールを完了します。

注記RHVH の再起動時に、

nodectl checkはホストでヘルスチェックを実行し、コマンドラインへのログイン時に結果を表示します。node status: OKまたはnode status: DEGRADEDのメッセージはヘルスステータスを示します。nodectl checkを実行して詳細情報を取得します。注記必要に応じて、 カーネルモジュールが自動的に読み込まれないようにする ことができます。

4.1.1. Red Hat Virtualization Host のリポジトリーの有効化

更新を受け取るには、システムを登録する必要があります。Red Hat Virtualization Host に必要なリポジトリーは 1 つだけです。本セクションでは、RHVH を コンテンツ配信ネットワーク または Red Hat Satellite 6 に登録する手順について説明します。

コンテンツ配信ネットワークへの RHVH の登録

コンテンツ配信ネットワークにシステムを登録します。プロンプトが表示されたら、カスタマーポータルのユーザー名とパスワードを入力します。

# subscription-manager register

Red Hat Virtualization Host 8のリポジトリーを有効にして、Red Hat Virtualization Host に対する後続の更新を可能にします。# subscription-manager repos --enable=rhvh-4-for-rhel-8-x86_64-rpms

Red Hat Satellite 6 への RHVH の登録

-

https://HostFQDNorIP:9090で Cockpit Web インターフェイスにログインします。 - Terminal をクリックします。

RHVH を Red Hat Satellite 6 に登録します。

# rpm -Uvh http://satellite.example.com/pub/katello-ca-consumer-latest.noarch.rpm # subscription-manager register --org="org_id" # subscription-manager list --available # subscription-manager attach --pool=pool_id # subscription-manager repos \ --disable='*' \ --enable=rhvh-4-for-rhel-8-x86_64-rpms

virt-who を使用して、Red Hat Satellite で仮想マシンのサブスクリプションを設定することもできます。virt-who を使用したホストベースのサブスクリプションの管理 を参照してください。

4.2. Red Hat Enterprise Linux ホストのインストール

Red Hat Enterprise Linux ホストは、Red Hat Enterprise Linux Server および Red Hat Virtualization サブスクリプションがアタッチされた、物理サーバー上の Red Hat Enterprise Linux 8 の標準的な基本インストールをベースにしています。

詳細なインストール手順は、標準的な RHEL インストールの実行 を参照してください。

ホストは最低限の ホスト要件 を満たしている必要があります。

ホストのオペレーティングシステムのインストールまたは再インストールを行う場合、Red Hat では、ホストにアタッチされている既存の OS 以外のストレージを最初にデタッチすることを強く推奨しています。これは、ディスクを誤って初期化してデータが失われる可能性を避けるためです。

ホストの BIOS 設定で仮想化が有効になっている必要があります。ホストの BIOS 設定の変更に関する詳細は、そのホストのハードウェアのマニュアルを参照してください。

サードパーティー製の watchdogs は、Red Hat Enterprise Linux ホストにインストールしないでください。VDSM が提供する watchdog デーモンを妨げる可能性があります。

4.2.1. Red Hat Enterprise Linux ホストのリポジトリーの有効化

Red Hat Enterprise Linux マシンをホストとして使用するには、システムをコンテンツ配信ネットワークに登録し、Red Hat Enterprise Linux Server および Red Hat Virtualization サブスクリプションを割り当て、ホストのリポジトリーを有効にする必要があります。

手順

コンテンツ配信ネットワークにシステムを登録します。プロンプトが表示されたら、カスタマーポータルのユーザー名とパスワードを入力します。

# subscription-manager register

Red Hat Enterprise Linux ServerおよびRed Hat Virtualizationのサブスクリプションプールを見つけ、プール ID を記録します。# subscription-manager list --available

上記のプール ID を使用して、サブスクリプションをシステムにアタッチします。

# subscription-manager attach --pool=poolid注記現在アタッチされているサブスクリプションを表示するには、以下のコマンドを実行します。

# subscription-manager list --consumed

有効なリポジトリーをすべて一覧表示するには、以下のコマンドを実行します。

# dnf repolist

リポジトリーを設定します。

# subscription-manager repos \ --disable='*' \ --enable=rhel-8-for-x86_64-baseos-eus-rpms \ --enable=rhel-8-for-x86_64-appstream-eus-rpms \ --enable=rhv-4-mgmt-agent-for-rhel-8-x86_64-rpms \ --enable=fast-datapath-for-rhel-8-x86_64-rpms \ --enable=advanced-virt-for-rhel-8-x86_64-rpms \ --enable=openstack-16.2-cinderlib-for-rhel-8-x86_64-rpms \ --enable=rhceph-4-tools-for-rhel-8-x86_64-rpms \ --enable=rhel-8-for-x86_64-appstream-tus-rpms \ --enable=rhel-8-for-x86_64-baseos-tus-rpmsRHEL のバージョンを 8.6 に設定します。

# subscription-manager release --set=8.6

virtモジュールをリセットします。# dnf module reset virt

注記Advanced Virtualization ストリームでこのモジュールがすでに有効になっている場合は、この手順は必要なく、マイナス要因となることもありません。

以下を入力してストリームの値を確認できます。

# dnf module list virt

-

以下のコマンドを使用して、Advanced Virtualization ストリームで

virtモジュールを有効にします。

RHV 4.4.2 の場合:

# dnf module enable virt:8.2

RHV 4.4.3 から 4.4.5 に対応しています。

# dnf module enable virt:8.3

RHV 4.4.6 - 4.4.10 の場合:

# dnf module enable virt:av

RHV 4.4 以降の場合:

# dnf module enable virt:rhel

注記RHEL 8.6 以降、Advanced Virtualization パッケージは標準の

virt:rhelモジュールを使用します。RHEL 8.4 および 8.5 では、1 つの Advanced Virtualization ストリームrhel:avのみが使用されます。現在インストールされている全パッケージを最新の状態にします。

# dnf upgrade --nobest

マシンを再起動します。

注記必要に応じて、 カーネルモジュールが自動的に読み込まれないようにする ことができます。

第5章 Red Hat Virtualization Manager のインストール

5.1. RHV-M Appliance の手動インストール

セルフホストエンジンをデプロイすると、以下の一連のイベントが発生します。

- インストーラーは RHV-M Appliance をデプロイメントホストにインストールします。

- Appliance は Manager 用仮想マシンをインストールします。

- Appliance は Manager 用仮想マシンに Manager をインストールします。

ただし、必要な場合は、事前にデプロイメントホストに Appliance を手動でインストールできます。Appliance は大規模なため、ネットワーク接続の問題により Appliance のインストールに長時間を要するか、または失敗する可能性があります。

手順

Red Hat Enterprise Linux ホスト上

virtモジュールをリセットします。# dnf module reset virt

注記Advanced Virtualization ストリームでこのモジュールがすでに有効になっている場合は、この手順は必要なく、マイナス要因となることもありません。

以下を入力してストリームの値を確認できます。

# dnf module list virt

-

以下のコマンドを使用して、Advanced Virtualization ストリームで

virtモジュールを有効にします。

RHV 4.4.2 の場合:

# dnf module enable virt:8.2

RHV 4.4.3 から 4.4.5 に対応しています。

# dnf module enable virt:8.3

RHV 4.4.6 - 4.4.10 の場合:

# dnf module enable virt:av

RHV 4.4 以降の場合:

# dnf module enable virt:rhel

注記RHEL 8.6 以降、Advanced Virtualization パッケージは標準の

virt:rhelモジュールを使用します。RHEL 8.4 および 8.5 では、1 つの Advanced Virtualization ストリームrhel:avのみが使用されます。インストール済みのパッケージを同期して、利用可能な最新バージョンに更新します。

# dnf distro-sync --nobest

RHV-M Appliance を手動でホストにインストールします。

# dnf install rhvm-appliance

これで、セルフホストエンジンをデプロイすると、インストーラーは Appliance がすでにインストールされていることを検出します。

5.2. ファイアウォールの有効化および設定

セルフホストデプロイメントスクリプトを実行する前に、firewalld をインストールして実行する必要があります。インターフェイスが設定されたアクティブなゾーンも必要です。

前提条件

-

firewalldがインストールされている。hosted-engine-setupにはfirewalldパッケージが必要なため、追加の手順を行う必要はありません。

手順

firewalldを起動します。# systemctl unmask firewalld # systemctl start firewalld

システムの起動時に firewalld を確実に自動起動させるには、root で以下のコマンドを実行します。

# systemctl enable firewalld

firewalld が以下を実行していることを確認します。

# systemctl status firewalld

以下を実行して、管理インターフェイスがファイアウォールゾーンにあることを確認します。

# firewall-cmd --get-active-zones

これで、セルフホストエンジンをデプロイする準備が整いました。

5.3. コマンドラインを使用したセルフホストエンジンのデプロイ

コマンドラインからセルフホストエンジンをデプロイすることができます。セットアップパッケージをインストールしてコマンド hosted-engine --deploy を実行すると、スクリプトがご自分の環境の情報を収集し、その情報を使用してホストおよび Manager を設定します。

デプロイメント中に、手動で、デプロイメントを一時停止するか、自動化を使用して、Manager 仮想マシンをカスタマイズできます。

-

変数

he_pause_hostをtrueに設定すると、Manager をインストールし、デプロイメントホストを Manager に追加した後にデプロイメントを一時停止します。 変数

he_pause_before_engine_setupをtrueに設定すると、Manager のインストール前およびhe_restore_from_fileを使用して Manager を復元する前にデプロイメントを一時停止します。注記変数

he_pause_hostまたはhe_pause_before_engine_setupを true に設定すると、デプロイメントホストの接尾辞が_he_setup_lockのロックファイルが/tmpに作成されます。その後、必要に応じて仮想マシンを手動でカスタマイズできます。ロックファイルを削除した後、または 24 時間後のいずれか早い方で、デプロイメントが続行されます。デプロイメントホスト上の次のディレクトリーのいずれかに Ansible Playbook を追加すると、Playbook が自動的に実行されます。

/usr/share/ansible/collections/ansible_collections/redhat/rhv/roles/hosted_engine_setup/hooks/の配下に以下のディレクトリーに Playbook を追加します。-

enginevm_before_engine_setup -

enginevm_after_engine_setup -

after_add_host -

after_setup

-

前提条件

engine-setupを実行する前に、アプライアンスのコンテンツを最新の製品バージョンにアップグレードしておく。-

手動で行うには、

he_pause_before_engine_setupを使用してデプロイを一時停止し、dnf updateを実行します。 -

自動的に行うには、

enginevm_before_engine_setupフックを適用します。

-

手動で行うには、

- Manager およびホスト用の完全修飾ドメイン名 (FQDN)。正引き (フォワードルックアップ) と逆引き (リバースルックアップ) の記録は両方とも DNS で設定する必要があります。

- ブロックストレージドメイン (FCP または iSCSI のいずれか) を使用する場合、セルフホストエンジンでサポートされる設定は、単一のターゲット LUN のみとなります。

- オプション: 自動化を使用してデプロイ中に Manager 仮想マシンをカスタマイズする場合は、Ansible Playbook を追加する必要があります。デプロイメント時の自動化を使用したエンジン仮想マシンのカスタマイズ を参照してください。

セルフホストエンジンセットアップスクリプトでは、エンジン仮想マシンからベアメタルホストの root アカウントへの 2048 ビット RSA キーを使用した ssh 公開キーアクセスが必要です。

/etc/ssh/sshd_configで、これらの値を次のように設定する必要があります。PubkeyAcceptedKeyTypesは、2048 ビット以上の RSA キーを許可する必要があります。デフォルトでは、この設定はシステム全体の暗号化ポリシーを使用します。詳細については、マニュアルページ

crypto-policies (7)を参照してください。注記4.4.5.5 より前のバージョンで Manager に登録されている RHVH ホストでは、すべてのキーが移行されるまで、下位互換性のために RSA 2048 が必要です。

4.4.5.5 以降に登録された RHVH ホストは、Manager と RHVH の両方でサポートされている最強のアルゴリズムを使用します。

PubkeyAcceptedKeyTypes設定は、使用されるアルゴリズムを決定するのに役立ちます。-

PermitRootLoginがwithout-passwordまたはyesに設定されている -

PubkeyAuthenticationがyesに設定されている

手順

デプロイメントツールをインストールします。

# dnf install ovirt-hosted-engine-setup

ネットワークやターミナルが切断された場合などにセッションが失われないように、

tmuxウィンドウマネージャーを使用してスクリプトを実行します。tmuxをインストールし、実行します。# dnf -y install tmux # tmux

デプロイメントスクリプトを開始します。

# hosted-engine --deploy

または、デプロイメントホストを Manager に追加した後にデプロイメントを一時停止するには、コマンドラインオプション

--ansible-extra-vars=he_pause_host=trueを使用します。# hosted-engine --deploy --ansible-extra-vars=he_pause_host=true

注記Ctrl+D のキーの組み合わせを使用してデプロイメントを中断すると、スクリプトをいつでも終了することができます。セッションがタイムアウトした場合や接続が中断された場合には、

tmux attachを実行してデプロイメントセッションを復元します。確認を要求されたら、Yes と入力してデプロイメントを開始します。

Continuing will configure this host for serving as hypervisor and will create a local VM with a running engine. The locally running engine will be used to configure a new storage domain and create a VM there. At the end the disk of the local VM will be moved to the shared storage. Are you sure you want to continue? (Yes, No)[Yes]:

ネットワークを設定します。表示されたゲートウェイが正しいことを確認し、Enter キーを押します。スクリプトがホストの接続性を確認することができるように、同じサブネット上の ping 送信可能なアドレスを入力します。

Please indicate a pingable gateway IP address [X.X.X.X]:

スクリプトにより、環境の管理ブリッジとして使用する NIC 候補が検出されます。候補のいずれかを入力するか、Enter キーを押してデフォルトをそのまま使用します。

Please indicate a nic to set ovirtmgmt bridge on: (ens1, ens0) [ens1]:

ネットワーク接続の確認方法を指定します。デフォルトは

dnsです。Please specify which way the network connectivity should be checked (ping, dns, tcp, none) [dns]:

ping- ゲートウェイの ping を試行します。

dns- DNS サーバーへの接続を確認します。

TCP- ホストとポートの組み合わせへの TCP 接続を作成します。宛先 IP アドレスとポートを指定する必要があります。接続が正常に作成されると、ネットワークは動作しているとみなされます。指定したホストが、指定したポートで着信 TCP 接続を許可できることを確認します。

none- ネットワークは常に接続されているとみなされます。

セルフホストエンジンのホストをデプロイするデータセンターの名前を入力します。デフォルトの名前は Default です。

Please enter the name of the data center where you want to deploy this hosted-engine host. Data center [Default]:

アップグレードガイドのセルフホストエンジンの更新セルフホストエンジンのホストをデプロイするクラスターの名前を入力します。デフォルトの名前は Default です。

Please enter the name of the cluster where you want to deploy this hosted-engine host. Cluster [Default]:

- 仮想マシンのインストールにカスタムアプライアンスを使用する場合は、OVA アーカイブへのパスを入力します。使用しない場合は、このフィールドを空欄のままにして RHV-M Appliance を使用します。

カスタム RHV-M アプライアンスアプライアンスイメージを使用してデプロイするには、OVA アーカイブへのパスを指定します。使用しない場合は、このフィールドを空欄のままにして RHV-M Appliance を使用します。

If you want to deploy with a custom engine appliance image, please specify the path to the OVA archive you would like to use. Entering no value will use the image from the rhvm-appliance rpm, installing it if needed. Appliance image path []:

Manager 用仮想マシンの CPU およびメモリー設定を入力します。

Please specify the number of virtual CPUs for the VM. The default is the appliance OVF value [4]: Please specify the memory size of the VM in MB. The default is the maximum available [6824]:

manager.example.comなどの Manager 用仮想マシンの FQDN を指定します。Please provide the FQDN you would like to use for the engine. Note: This will be the FQDN of the engine VM you are now going to launch, it should not point to the base host or to any other existing machine. Engine VM FQDN []:

Manager 用仮想マシンのドメインを指定します。たとえば、FQDN が

manager.example.comの場合、example.comを入力します。Please provide the domain name you would like to use for the engine appliance. Engine VM domain: [example.com]

Manager の root パスワードを作成し、確認のために同じパスワードを再入力します。

Enter root password that will be used for the engine appliance: Confirm appliance root password:

オプションとして、パスワードを入力せずに Manager 用仮想マシンに root ユーザーとしてログインできるように SSH 公開鍵を入力し、root ユーザーの SSH アクセスを有効にするかどうかを指定します。

You may provide an SSH public key, that will be added by the deployment script to the authorized_keys file of the root user in the engine appliance. This should allow you passwordless login to the engine machine after deployment. If you provide no key, authorized_keys will not be touched. SSH public key []: Do you want to enable ssh access for the root user (yes, no, without-password) [yes]:

オプション: Manager 仮想マシンに DISA STIG セキュリティープロファイルを適用できます。DISA STIG プロファイルは、デフォルトの OpenSCAP プロファイルです。

Do you want to apply a default OpenSCAP security profile? (Yes, No) [No]:

Manager 用仮想マシンの MAC アドレスを入力するか、無作為に生成される MAC アドレスを適用します。Manager 用仮想マシンへの IP アドレス割り当てに DHCP を使用する場合は、この MAC アドレスに有効な DHCP 予約があることを確認してください。デプロイメントスクリプトは、DHCP サーバーの設定は行いません。

You may specify a unicast MAC address for the VM or accept a randomly generated default [00:16:3e:3d:34:47]:

Manager 用仮想マシンのネットワークの詳細を入力します。

How should the engine VM network be configured (DHCP, Static)[DHCP]?

Static を指定した場合には、Manager 用仮想マシンの IP アドレスを入力します。

重要- 静的 IP アドレスは、ホストと同じサブネットに属している必要があります。たとえばホストが 10.1.1.0/24 内にある場合、Manager 用仮想マシンの IP は同じサブネット範囲 (10.1.1.1-254/24) になければなりません。

- IPv6 の場合、Red Hat Virtualization でサポートされるのは静的アドレスのみです。

Please enter the IP address to be used for the engine VM [x.x.x.x]: Please provide a comma-separated list (max 3) of IP addresses of domain name servers for the engine VM Engine VM DNS (leave it empty to skip):

Manager 用仮想マシンおよびベースホストのエントリーを仮想マシンの

/etc/hostsファイルに追加するかどうかを指定します。ホスト名は解決可能でなければなりません。Add lines for the appliance itself and for this host to /etc/hosts on the engine VM? Note: ensuring that this host could resolve the engine VM hostname is still up to you. Add lines to /etc/hosts? (Yes, No)[Yes]:

SMTP サーバーの名前と TCP ポート番号、メール通知を送信するメールアドレス、メール通知を受信するメールアドレス (複数ある場合はコンマ区切りリスト) を指定します。あるいは、Enter キーを押してデフォルトをそのまま使用します。

Please provide the name of the SMTP server through which we will send notifications [localhost]: Please provide the TCP port number of the SMTP server [25]: Please provide the email address from which notifications will be sent [root@localhost]: Please provide a comma-separated list of email addresses which will get notifications [root@localhost]:

管理ポータルにアクセスするための

admin@internalユーザーのパスワードを作成し、確認のために再度入力します。Enter engine admin password: Confirm engine admin password:

デプロイメントホストのホスト名を指定します。

Please provide the hostname of this host on the management network [hostname.example.com]:

スクリプトにより仮想マシンが作成されます。デフォルトでは、スクリプトは最初に RHV-M アプライアンスをダウンロードしてインストールします。これにより、インストール時間が長くなります。

(オプション): 変数

he_pause_host: trueを設定すると、デプロイメントホストを Manager に追加した後にデプロイメントを一時停止します。これで、デプロイメントホストから Manager 仮想マシンにログインしてカスタマイズできます。Manager の FQDN または IP アドレスのいずれかを使用してログインできます。たとえば、Manager の FQDN がmanager.example.comの場合には以下のコマンドを実行します。$ ssh root@manager.example.com

ヒントインストールログでは、IP アドレスは

local_vm_ipにあります。インストールログは、/var/log/ovirt-hosted-engine-setup/ovirt-hosted-engine-setup-ansible-bootstrap_local_vm*の最新のインスタンスです。- 必要に応じて、Manager 仮想マシンをカスタマイズします。

- 完了したら、Manager FQDN を使用してブラウザーを使用して管理ポータルにログインし、ホストの状態がUpであることを確認します。

- ロックファイルを削除すると、展開スクリプトが自動的に続行され、Manager 仮想マシンが設定されます。

使用するストレージのタイプを選択します。

Please specify the storage you would like to use (glusterfs, iscsi, fc, nfs)[nfs]:

NFS の場合は、バージョン、完全なアドレス、およびストレージへのパスならびにマウントオプションを入力します。

Please specify the nfs version you would like to use (auto, v3, v4, v4_1)[auto]: Please specify the full shared storage connection path to use (example: host:/path): storage.example.com:/hosted_engine/nfs If needed, specify additional mount options for the connection to the hosted-engine storage domain []:iSCSI の場合は、ポータルの詳細を入力し、自動検出された一覧からターゲットおよび LUN を選択します。デプロイメント時に選択できる iSCSI ターゲットは 1 つだけですが、マルチパスがサポートされているので、同じポータルグループのポータルをすべて接続できます。

注記複数の iSCSI ターゲットを指定するには、セルフホストエンジンをデプロイする前にマルチパスを有効にする必要があります。詳細は、Red Hat Enterprise Linux DM マルチパス を参照してください。Multipath Helper ツールを使用して、さまざまなオプションでマルチパスをインストールおよび設定するスクリプトを生成することもできます。

Please specify the iSCSI portal IP address: Please specify the iSCSI portal port [3260]: Please specify the iSCSI discover user: Please specify the iSCSI discover password: Please specify the iSCSI portal login user: Please specify the iSCSI portal login password: The following targets have been found: [1] iqn.2017-10.com.redhat.example:he TPGT: 1, portals: 192.168.1.xxx:3260 192.168.2.xxx:3260 192.168.3.xxx:3260 Please select a target (1) [1]: 1 The following luns have been found on the requested target: [1] 360003ff44dc75adcb5046390a16b4beb 199GiB MSFT Virtual HD status: free, paths: 1 active Please select the destination LUN (1) [1]:Gluster ストレージの場合は、完全なアドレスおよびストレージへのパスならびにマウントオプションを入力します。

重要レプリカ 1 およびレプリカ 3 Gluster ストレージのみがサポートされます。必ず以下のようにボリュームを設定します。

gluster volume set VOLUME_NAME group virt gluster volume set VOLUME_NAME performance.strict-o-direct on gluster volume set VOLUME_NAME network.remote-dio off gluster volume set VOLUME_NAME storage.owner-uid 36 gluster volume set VOLUME_NAME storage.owner-gid 36 gluster volume set VOLUME_NAME network.ping-timeout 30

Please specify the full shared storage connection path to use (example: host:/path): storage.example.com:/hosted_engine/gluster_volume If needed, specify additional mount options for the connection to the hosted-engine storage domain []:ファイバーチャネルの場合は、自動検出された一覧から LUN を選択します。ホストのバスアダプターが設定および接続されている必要があります。また、LUN には既存のデータが含まれないようにする必要があります。既存の LUN を再利用するには、管理ガイド の Reusing LUNs を参照してください。

The following luns have been found on the requested target: [1] 3514f0c5447600351 30GiB XtremIO XtremApp status: used, paths: 2 active [2] 3514f0c5447600352 30GiB XtremIO XtremApp status: used, paths: 2 active Please select the destination LUN (1, 2) [1]:

Manager 用仮想マシンのディスクサイズを入力します。

Please specify the size of the VM disk in GB: [50]:

デプロイメントが正常に完了すると、1 つのデータセンター、クラスター、ホスト、ストレージドメイン、および Manager 用仮想マシンがすでに稼働しているはずです。管理ポータルにログインして、その他のリソースを追加することができます。

- オプション: 追加のユーザーを環境に追加できるように Red Hat Single Sign On をインストールして設定します。詳細は、管理ガイド の Red Hat Single Sign-On のインストールおよび設定 を参照してください。

- オプション: Grafana をデプロイして、RHV 環境からのレポートをモニターおよび表示できるようにします。詳細は、管理ガイドの Configuring Grafana を参照してください。

管理ポータルで、Manager 用仮想マシン、仮想マシンを実行しているホスト、およびセルフホストエンジン用ストレージドメインに金色の王冠のフラグが付けられます。

Manager の I/O スケジューラーと、Manager の並べ替え I/O 要求をホストするハイパーバイザーの両方。この二重の並べ替えは、ストレージレイヤーへの I/O 要求を遅らせ、パフォーマンスに影響を与える可能性があります。

データセンターによっては、I/O スケジューラーを none に変更すると、パフォーマンスを向上させることができます。詳細については、RHEL のMonitoring and managing system status and performanceの Available disk schedulers を参照してください。

次のステップは、Red Hat Virtualization Manager のリポジトリーを有効にすることです。

5.4. Red Hat Virtualization Manager リポジトリーの有効化

ログインして、Red Hat Subscription Manager で Manager マシンを登録し、Red Hat Virtualization Manager のサブスクリプションをアタッチして Manager のリポジトリーを有効にする必要があります。

手順

コンテンツ配信ネットワークにシステムを登録します。プロンプトが表示されたら、カスタマーポータルのユーザー名とパスワードを入力します。

# subscription-manager register

注記IPv6 ネットワークを使用している場合は、IPv6 移行メカニズムを使用して、コンテンツ配信ネットワークおよびサブスクリプションマネージャーにアクセスします。

Red Hat Virtualization Managerのサブスクリプションプールを見つけ、プール ID を記録します。# subscription-manager list --available

上記のプール ID を使用して、サブスクリプションをシステムにアタッチします。

# subscription-manager attach --pool=pool_id注記現在アタッチされているサブスクリプションを表示するには、以下のコマンドを実行します。

# subscription-manager list --consumed

有効なリポジトリーをすべて一覧表示するには、以下のコマンドを実行します。

# dnf repolist

リポジトリーを設定します。

# subscription-manager repos \ --disable='*' \ --enable=rhel-8-for-x86_64-baseos-eus-rpms \ --enable=rhel-8-for-x86_64-appstream-eus-rpms \ --enable=rhv-4.4-manager-for-rhel-8-x86_64-rpms \ --enable=fast-datapath-for-rhel-8-x86_64-rpms \ --enable=jb-eap-7.4-for-rhel-8-x86_64-rpms \ --enable=openstack-16.2-cinderlib-for-rhel-8-x86_64-rpms \ --enable=rhceph-4-tools-for-rhel-8-x86_64-rpms \ --enable=rhel-8-for-x86_64-appstream-tus-rpms \ --enable=rhel-8-for-x86_64-baseos-tus-rpmsRHEL のバージョンを 8.6 に設定します。

# subscription-manager release --set=8.6

pki-depsモジュールを有効にします。# dnf module -y enable pki-deps

postgresqlモジュールのバージョン 12 を有効にします。# dnf module -y enable postgresql:12

nodejsモジュールのバージョン 14 を有効にします。# dnf module -y enable nodejs:14

- アップグレードガイド の セルフホストエンジンの更新 の手順を使用して、セルフホストエンジンを更新します。

関連情報

モジュールおよびモジュールストリームの詳細は、ユーザー空間コンポーネントのインストール、管理、および削除 の以下のセクションを参照してください。

次に管理ポータルにログインします。ここで、環境にホストおよびストレージを追加することができます。

5.5. 管理ポータルへの接続

Web ブラウザーを使って管理ポータルへアクセスします。

Web ブラウザーで、

https://manager-fqdn/ovirt-engineに移動します。manager-fqdn は、インストール時に指定した FQDN に置き換えます。注記別のホスト名または IP アドレスを使用して、管理ポータルにアクセスすることができます。これには、/etc/ovirt-engine/engine.conf.d/ に設定ファイルを追加する必要があります。以下に例を示します。

# vi /etc/ovirt-engine/engine.conf.d/99-custom-sso-setup.conf SSO_ALTERNATE_ENGINE_FQDNS="alias1.example.com alias2.example.com"代替ホスト名の一覧は、スペースで区切る必要があります。また、Manager の IP アドレスを一覧に追加することもできますが、DNS で解決可能なホスト名の代わりに IP アドレスを使用することは推奨していません。

- Administration Portal をクリックすると、SSO ログインページが表示されます。SSO ログインにより、管理ポータルと仮想マシンポータルに同時にログインすることができます。

- ユーザー名 と パスワード を入力します。初回ログインの場合は、ユーザー名 admin とインストール時に指定したパスワードを使用してください。

- 認証する Domain を選択します。内部の admin ユーザー名を使用してログインする場合は、プロファイルに internal を選択します。

- Log In をクリックします。

- 管理ポータルは複数の言語で表示することができます。デフォルトの選択は、お使いの Web ブラウザーのロケール設定をベースに決定されます。デフォルト以外の言語で管理ポータルを表示する場合は、ウェルカムページのドロップダウンリストから任意の言語を選択してください。

Red Hat Virtualization 管理ポータルからログアウトするには、ヘッダーバーでユーザー名をクリックして、Sign Out をクリックします。すべてのポータルからログアウトされ、Manager のウェルカム画面が表示されます。

第6章 Red Hat Virtualization 用ホストのインストール

Red Hat Virtualization は、Red Hat Virtualization Hosts (RHVH) および Red Hat Enterprise Linux ホスト の 2 つのタイプのホストをサポートしています。環境に応じて、1 タイプのみまたは両方のタイプを使用することができます。移行や高可用性などの機能を利用するには、少なくとも 2 台のホストが必要です。

ネットワーク情報については、ホストネットワーク設定の推奨プラクティス を参照してください。

SELinux は インストール時に enforcing モードに設定されます。確認するには、getenforce を実行します。Red Hat Virtualization 環境をサポートするには、すべてのホストと Manager で SELinux を enforcing モードに設定する必要があります。

表6.1 ホストタイプ

| ホストタイプ | 別名 | 説明 |

|---|---|---|

| Red Hat Virtualization Host | RHVH、シンホスト | Red Hat Enterprise Linux をベースとする最小限のオペレーティングシステム。カスタマーポータルから ISO ファイルとして配布され、マシンがホストとして機能するためのパッケージのみが含まれています。 |

| Red Hat Enterprise Linux ホスト | RHEL ホスト、シックホスト | 適切なサブスクリプションがアタッチされた Red Hat Enterprise Linux システムは、ホストとして使用することができます。 |

ホストの互換性

新規データセンターの作成時に、互換バージョンを設定することができます。データセンター内の全ホストに適した互換バージョンを選択します。一旦設定されると、それよりも古いバージョンに変更することはできません。Red Hat Virtualization を新規インストールした場合には、最新の互換バージョンがデフォルトのデータセンターとデフォルトのクラスターに設定されるので、それ以前の互換バージョンを使用するには、追加でデータセンターおよびクラスターを作成する必要があります。互換バージョンに関する詳細は、Red Hat Virtualization のライフサイクル の Red Hat Virtualization Manager の互換性 を参照してください。

6.1. Red Hat Virtualization Hosts

6.1.1. Red Hat Virtualization Host のインストール

Red Hat Virtualization Host (RHVH) は、Red Hat Virtualization 環境でハイパーバイザーとして機能する物理マシンの簡単な設定方法を提供するために設計された、Red Hat Enterprise Linux をベースとする最小設定のオペレーティングシステムです。この最小設定のオペレーティングシステムには、マシンがハイパーバイザーとして機能するのに必要なパッケージのみが含まれており、ホストの監視や管理タスクの実行用に Cockpit Web インターフェイスが備えられています。ブラウザーの最小要件については、Cockpit の実行 を参照してください。

RHVH は NIST SP 800-53 パーティショニングの要件をサポートし、より強固なセキュリティーを提供します。RHVH は、デフォルトで NIST 800-53 パーティションレイアウトを使用します。

ホストは最低限の ホスト要件 を満たしている必要があります。

ホストのオペレーティングシステムのインストールまたは再インストールを行う場合、Red Hat では、ホストにアタッチされている既存の OS 以外のストレージを最初にデタッチすることを強く推奨しています。これは、ディスクを誤って初期化してデータが失われる可能性を避けるためです。

手順

- Red Hat カスタマーポータルの Red Hat Virtualization を使い始める にアクセスし、ログインします。

- Download Latest をクリックして、製品のダウンロードページに移動します。

- 一覧から RHV に適した Hypervisor Image for RHV を選択し、Download Now をクリックします。

- RHVH のインストール先となるマシンを起動し、準備したインストールメディアから起動します。

起動メニューから Install RHVH 4.4 を選択し、

Enterを押します。注記ま

Tabキーを押してカーネルパラメーターを編集することもできます。カーネルパラメーターはスペースで区切る必要があります。また、指定したカーネルパラメーターを使用してシステムを起動するには、Enterキーを押します。Escキーを押してカーネルパラメーターへの変更を消去し、起動メニューに戻ります。- 言語を選択し、Continue をクリックします。

- Keyboard Layout の画面からキーボードのレイアウトを選択して Done をクリックします。

Installation Destination の画面から RHVH のインストール先のデバイスを選択します。オプションで暗号化を有効にします。Done をクリックします。

重要Automatically configure partitioning オプションを使用します。

- Time & Date の画面からタイムゾーンを選択し、Done をクリックします。

Network & Host Name の画面からネットワークを選択し、Configure… をクリックして接続の詳細を設定します。

注記システムを起動するたびに接続を使用する場合は、Connect automatically with priority のチェックボックスを選択します。詳細は、標準的な RHEL 8 インストールの実行 の ネットワークおよびホスト名のオプションの設定 を参照してください。

ホスト名を Host Name フィールドに入力し、Done をクリックします。

- オプション: Security Policy と Kdump を設定します。Installation Summary 画面の各セクションの詳細は、Red Hat Enterprise Linux 8 標準的な RHEL インストールの実行 の GUI を使用したインストールのカスタマイズ を参照してください。

- Begin Installation をクリックします。

RHVH のインストールの際に root パスワードを設定して、オプションで追加のユーザーを作成します。

警告ローカルのセキュリティー脆弱性が攻撃される可能性があるので、RHVH に信頼できないユーザーを作成しないでください。

Reboot をクリックしてインストールを完了します。

注記RHVH の再起動時に、

nodectl checkはホストでヘルスチェックを実行し、コマンドラインへのログイン時に結果を表示します。node status: OKまたはnode status: DEGRADEDのメッセージはヘルスステータスを示します。nodectl checkを実行して詳細情報を取得します。注記必要に応じて、 カーネルモジュールが自動的に読み込まれないようにする ことができます。

6.1.2. Red Hat Virtualization Host のリポジトリーの有効化

更新を受け取るには、システムを登録する必要があります。Red Hat Virtualization Host に必要なリポジトリーは 1 つだけです。本セクションでは、RHVH を コンテンツ配信ネットワーク または Red Hat Satellite 6 に登録する手順について説明します。

コンテンツ配信ネットワークへの RHVH の登録

コンテンツ配信ネットワークにシステムを登録します。プロンプトが表示されたら、カスタマーポータルのユーザー名とパスワードを入力します。

# subscription-manager register

Red Hat Virtualization Host 8のリポジトリーを有効にして、Red Hat Virtualization Host に対する後続の更新を可能にします。# subscription-manager repos --enable=rhvh-4-for-rhel-8-x86_64-rpms

Red Hat Satellite 6 への RHVH の登録

-

https://HostFQDNorIP:9090で Cockpit Web インターフェイスにログインします。 - Terminal をクリックします。

RHVH を Red Hat Satellite 6 に登録します。

# rpm -Uvh http://satellite.example.com/pub/katello-ca-consumer-latest.noarch.rpm # subscription-manager register --org="org_id" # subscription-manager list --available # subscription-manager attach --pool=pool_id # subscription-manager repos \ --disable='*' \ --enable=rhvh-4-for-rhel-8-x86_64-rpms

virt-who を使用して、Red Hat Satellite で仮想マシンのサブスクリプションを設定することもできます。virt-who を使用したホストベースのサブスクリプションの管理 を参照してください。

6.1.3. 高度なインストール

6.1.3.1. カスタムパーティション設定

Red Hat Virtualization Host (RHVH) でのカスタムパーティション設定は推奨されません。Installation Destination ウィンドウの Automatically configure partitioning オプションを使用してください。

インストールでカスタムのパーティション設定が必要な場合は、インストール時に I will configure partitioning オプションを選択します。ただし、以下の制限が適用される点に注意してください。

- Manual Partitioning ウィンドウで、デフォルトの LVM Thin Provisioning オプションを選択する必要があります。

以下のディレクトリーが必要で、シンプロビジョニングされた論理ボリューム上になければなりません。

-

root (

/) -

/home -

/tmp -

/var -

/var/crash/ -

/var/log /var/log/audit重要/usr用に別のパーティションを作成しないでください。別のパーティションを作成すると、インストールに失敗します。/usrは、RHVH と共にバージョンを変更できる論理ボリューム上になければなりません。したがって、root (/) 上に残す必要があります。各パーティションに必要なストレージサイズについては、Storage Requirements を参照してください。

-

root (

-

/bootディレクトリーは、標準のパーティションとして定義する必要があります。 -

/varディレクトリーは、別のボリュームまたはディスク上になければなりません。 - XFS または Ext4 ファイルシステムのみがサポートされます。

キックスタートファイルでの手動パーティション設定の定義

以下の例は、キックスタートファイルでパーティションを手動設定する方法を示しています。

clearpart --all part /boot --fstype xfs --size=1000 --ondisk=sda part pv.01 --size=42000 --grow volgroup HostVG pv.01 --reserved-percent=20 logvol swap --vgname=HostVG --name=swap --fstype=swap --recommended logvol none --vgname=HostVG --name=HostPool --thinpool --size=40000 --grow logvol / --vgname=HostVG --name=root --thin --fstype=ext4 --poolname=HostPool --fsoptions="defaults,discard" --size=6000 --grow logvol /var --vgname=HostVG --name=var --thin --fstype=ext4 --poolname=HostPool --fsoptions="defaults,discard" --size=15000 logvol /var/crash --vgname=HostVG --name=var_crash --thin --fstype=ext4 --poolname=HostPool --fsoptions="defaults,discard" --size=10000 logvol /var/log --vgname=HostVG --name=var_log --thin --fstype=ext4 --poolname=HostPool --fsoptions="defaults,discard" --size=8000 logvol /var/log/audit --vgname=HostVG --name=var_audit --thin --fstype=ext4 --poolname=HostPool --fsoptions="defaults,discard" --size=2000 logvol /home --vgname=HostVG --name=home --thin --fstype=ext4 --poolname=HostPool --fsoptions="defaults,discard" --size=1000 logvol /tmp --vgname=HostVG --name=tmp --thin --fstype=ext4 --poolname=HostPool --fsoptions="defaults,discard" --size=1000

logvol --thinpool --grow を使用する場合は、シンプールを拡張するために、volgroup --reserved-space または volgroup --reserved-percent のボリュームグループに領域を確保する必要があります。

6.1.3.2. インストーラーのサポートなしでホストに DUD ドライバーをインストールする

RHVH のデフォルト設定でサポートされていないハードウェア RAID デバイスを使用する場合など、Red Hat Virtualization Host (RHVH) のインストールにドライバー更新ディスク (DUD) が必要な場合があります。Red Hat Enterprise Linux ホストとは対照的に、RHVH は DUD の使用を完全にはサポートしていません。その後、ホストは RAID を認識しないため、インストール後に正常に起動できません。代わりに、緊急モードで起動します。

出力例:

Warning: /dev/test/rhvh-4.4-20210202.0+1 does not exist Warning: /dev/test/swap does not exist Entering emergency mode. Exit the shell to continue.

このような場合、インストールを完了する前に手動でドライバーを追加できます。

前提条件

- RHVH をインストールするマシン

- DUD

- DUD と RHVH に USB ドライブを使用している場合は 2 つ以上の使用可能な USB ポート

手順

- DUD をホストマシンにロードします。

RHVH をインストールします。コマンドラインを使用したセルフホストエンジンの Red Hat Virtualization のインストール の Red Hat Virtualization Hosts のインストール を参照してください。

重要インストールが完了したら、システムを再起動しないでください。

ヒントSSH を使用して DUD にアクセスする場合は、次の手順を実行します。

文字列

inst.sshdをカーネルコマンドラインに追加します。<kernel_command_line> inst.sshd- インストール中にネットワークを有効にします。

- Ctrl + Alt + F3 を押して、コンソールモードに入ります。または、SSH を使用して接続することもできます。

DUD をマウントします。

# mkdir /mnt/dud # mount -r /dev/<dud_device> /mnt/dudDUD 内の RPM ファイルをターゲットマシンのディスクにコピーします。

# cp /mnt/dud/rpms/<path>/<rpm_file>.rpm /mnt/sysroot/root/

以下に例を示します。

# cp /mnt/dud/rpms/x86_64/kmod-3w-9xxx-2.26.02.014-5.el8_3.elrepo.x86_64.rpm /mnt/sysroot/root/

root ディレクトリーを

/mnt/sysroot/に変更します。# chroot /mnt/sysroot

現在の initrd イメージをバックアップします。以下に例を示します。

# cp -p /boot/initramfs-4.18.0-240.15.1.el8_3.x86_64.img /boot/initramfs-4.18.0-240.15.1.el8_3.x86_64.img.bck1 # cp -p /boot/rhvh-4.4.5.1-0.20210323.0+1/initramfs-4.18.0-240.15.1.el8_3.x86_64.img /boot/rhvh-4.4.5.1-0.20210323.0+1/initramfs-4.18.0-240.15.1.el8_3.x86_64.img.bck1

以前に作成したコピーからドライバーの RPM ファイルをインストールします。

以下に例を示します。

# dnf install /root/kmod-3w-9xxx-2.26.02.014-5.el8_3.elrepo.x86_64.rpm

注記インストールされた環境で再起動すると、このパッケージはシステムに表示されなくなるため、たとえば

initramfsを再構築するために必要な場合は、そのパッケージをもう一度インストールする必要があります。インストールすると、パッケージは残ります。dnfを使用してホストを更新する場合、ドライバーの更新は保持されるため、このプロセスを繰り返す必要はありません。ヒントインターネットに接続していない場合は、

dnfの代わりにrpmコマンドを使用してください。# rpm -ivh /root/kmod-3w-9xxx-2.26.02.014-5.el8_3.elrepo.x86_64.rpm

新しいイメージを作成し、ドライバーを強制的に追加します。

# dracut --force --add-drivers <module_name> --kver <kernel_version>

以下に例を示します。

# dracut --force --add-drivers 3w-9xxx --kver 4.18.0-240.15.1.el8_3.x86_64

結果を確認します。新しいイメージは大きくなり、ドライバーが含まれているはずです。たとえば、元のバックアップされたイメージファイルと新しいイメージファイルのサイズを比較します。

この例では、新しいイメージファイルは 88739013 バイトであり、元の 88717417 バイトよりも大きくなっています。

# ls -ltr /boot/initramfs-4.18.0-240.15.1.el8_3.x86_64.img* -rw-------. 1 root root 88717417 Jun 2 14:29 /boot/initramfs-4.18.0-240.15.1.el8_3.x86_64.img.bck1 -rw-------. 1 root root 88739013 Jun 2 17:47 /boot/initramfs-4.18.0-240.15.1.el8_3.x86_64.img

イメージファイルの一部として、新しいドライバーが含まれている必要があります。たとえば、3w-9xxx モジュールが含まれている必要があります。

# lsinitrd /boot/initramfs-4.18.0-240.15.1.el8_3.x86_64.img | grep 3w-9xxx drwxr-xr-x 2 root root 0 Feb 22 15:57 usr/lib/modules/4.18.0-240.15.1.el8_3.x86_64/weak-updates/3w-9xxx lrwxrwxrwx 1 root root 55 Feb 22 15:57 usr/lib/modules/4.18.0-240.15.1.el8_3.x86_64/weak-updates/3w-9xxx/3w-9xxx.ko-../../../4.18.0-240.el8.x86_64/extra/3w-9xxx/3w-9xxx.ko drwxr-xr-x 2 root root 0 Feb 22 15:57 usr/lib/modules/4.18.0-240.el8.x86_64/extra/3w-9xxx -rw-r--r-- 1 root root 80121 Nov 10 2020 usr/lib/modules/4.18.0-240.el8.x86_64/extra/3w-9xxx/3w-9xxx.ko

インストールするレイヤーで使用されるカーネルを含む

/bootの下のディレクトリーにイメージをコピーします。以下はその例です。# cp -p /boot/initramfs-4.18.0-240.15.1.el8_3.x86_64.img /boot/rhvh-4.4.5.1-0.20210323.0+1/initramfs-4.18.0-240.15.1.el8_3.x86_64.img

- chroot を終了します。

- シェルを終了します。

- Ctrl + Alt + F3 を使用して仮想端末にアクセスした場合は、Ctrl + Alt + F_ <n> _ (通常は F1 または F5) を押してインストーラーに戻ります。

- インストーラー画面で、再起動します。

検証

マシンは正常に再起動するはずです。

6.1.3.3. Red Hat Virtualization Host デプロイメントの自動化

物理メディアデバイスなしに Red Hat Virtualization Host (RHVH) をインストールすることができます。そのためには、インストールの質問に対する回答が含まれたキックスタートファイルを使用し、ネットワーク経由で PXE サーバーから起動します。

ホストのオペレーティングシステムのインストールまたは再インストールを行う場合、Red Hat では、ホストにアタッチされている既存の OS 以外のストレージを最初にデタッチすることを強く推奨しています。これは、ディスクを誤って初期化してデータが失われる可能性を避けるためです。

RHVH は Red Hat Enterprise Linux とほぼ同じ方法でインストールされます。キックスタートファイルを使用して PXE サーバーからインストールする手順については、Red Hat Enterprise Linux インストールガイドの キックスタートを使ったインストール を参照してください。RHVH に固有の手順 (Red Hat Satellite を使用した RHVH のデプロイメントを例として使用) については、この後に説明します。

RHVH の自動デプロイメントは、以下の 3 つのステージで設定されます。

6.1.3.3.1. インストール環境の準備

- Red Hat カスタマーポータルの Red Hat Virtualization を使い始める にアクセスし、ログインします。

- Download Latest をクリックして、製品のダウンロードページに移動します。

- 一覧から RHV に適した Hypervisor Image for RHV を選択し、Download Now をクリックします。

- RHVH ISO イメージをネットワーク経由で提供できるようにします。Red Hat Enterprise Linux インストールガイド の インストールソース - ネットワーク を参照してください。

RHVH ISO から squashfs.img ハイパーバイザーイメージファイルを抽出します。

# mount -o loop /path/to/RHVH-ISO /mnt/rhvh # cp /mnt/rhvh/Packages/redhat-virtualization-host-image-update* /tmp # cd /tmp # rpm2cpio redhat-virtualization-host-image-update* | cpio -idmv注記/tmp/usr/share/redhat-virtualization-host/image/ディレクトリーにある squashfs.img ファイルの名前は redhat-virtualization-host-version_number_version.squashfs.img です。物理マシンにインストールするためのハイパーバイザーイメージが含まれます。Anacondainst.stage2オプションで使用される /LiveOS/squashfs.img ファイルと混同しないでください。

6.1.3.3.2. PXE サーバーおよびブートローダーの設定

- PXE サーバーを設定します。Red Hat Enterprise Linux インストールガイド の ネットワークからのインストールの準備 を参照してください。

RHVH 起動イメージを

/tftpbootディレクトリーにコピーします。# cp mnt/rhvh/images/pxeboot/{vmlinuz,initrd.img} /var/lib/tftpboot/pxelinux/ブートローダー設定で RHVH 起動イメージを指定して、

rhvhラベルを作成します。LABEL rhvh MENU LABEL Install Red Hat Virtualization Host KERNEL /var/lib/tftpboot/pxelinux/vmlinuz APPEND initrd=/var/lib/tftpboot/pxelinux/initrd.img inst.stage2=URL/to/RHVH-ISORed Hat Satellite の RHVH ブートローダー設定の例

Red Hat Satellite からの情報を使用してホストをプロビジョニングする場合には、グローバルまたはホストグループレベルのパラメーターを作成し (ここでは

rhvh_image)、ISO をマウントまたは抽出するディレクトリーの URL を定義する必要があります。<%# kind: PXELinux name: RHVH PXELinux %> # Created for booting new hosts # DEFAULT rhvh LABEL rhvh KERNEL <%= @kernel %> APPEND initrd=<%= @initrd %> inst.ks=<%= foreman_url("provision") %> inst.stage2=<%= @host.params["rhvh_image"] %> intel_iommu=on console=tty0 console=ttyS1,115200n8 ssh_pwauth=1 local_boot_trigger=<%= foreman_url("built") %> IPAPPEND 2RHVH ISO の内容をローカルで利用可能な状態にし、たとえば HTTPD サーバーを使用して、ネットワークにエクスポートします。

# cp -a /mnt/rhvh/ /var/www/html/rhvh-install # curl URL/to/RHVH-ISO/rhvh-install

6.1.3.3.3. キックスタートファイルの作成と実行

- キックスタートファイルを作成し、ネットワーク経由で提供できるようにします。Red Hat Enterprise Linux インストールガイド の キックスタートを使ったインストール を参照してください。

キックスタートファイルは以下に示す RHV 固有の要件を満たす必要があります。

RHVH に

%packagesセクションは必要ありません。代わりに、liveimgオプションを使用して、RHVH ISO イメージから redhat-virtualization-host-version_number_version.squashfs.img ファイルを指定します。liveimg --url=example.com/tmp/usr/share/redhat-virtualization-host/image/redhat-virtualization-host-version_number_version.squashfs.img

自動パーティション設定は強く推奨されますが、使用に際して注意が必要です。最初にローカルディスクが検出されることを確認し、

ignorediskコマンドを追加してsdaのようにローカルディスクが無視するように指定します。特定のドライブを使用する場合、Red Hat は、ignoredisk --only-use=/dev/disk/<path>またはignoredisk --only-use=/dev/disk/<ID>の使用を推奨します。autopart --type=thinp ignoredisk --only-use=sda ignoredisk --only-use=/dev/disk/<path> ignoredisk --only-use=/dev/disk/<ID>

注記自動パーティション設定には、シンプロビジョニングが必要です。

/homeは必須のディレクトリーであるため、RHVH では--no-homeオプションは機能しません。インストールで手動パーティション設定が必要な場合は、パーティション設定に適用される制限の一覧およびキックスタートファイルでの手動パーティション設定の例を カスタムパーティション設定 で確認してください。

nodectl initコマンドを呼び出す%postセクションが必要です。%post nodectl init %end

注記nodectl initコマンドが%postセクションの最後で、再起動コードがある場合はその前にあることを確認してください。RHVH を独自にデプロイするためのキックスタート例

このキックスタートの例では、RHVH のデプロイ方法を示しています。必要に応じて、コマンドとオプションをさらに追加してください。

警告この例では、すべてのディスクが空であり、初期化可能であることを前提としています。データを含むディスクが割り当てられている場合は、そのディスクを削除するか、

ignoredisksプロパティーに追加します。liveimg --url=http://FQDN/tmp/usr/share/redhat-virtualization-host/image/redhat-virtualization-host-version_number_version.squashfs.img clearpart --all autopart --type=thinp rootpw --plaintext ovirt timezone --utc America/Phoenix zerombr text reboot %post --erroronfail nodectl init %end

Satellite から登録およびネットワーク設定を使用した RHVH をデプロイするためのキックスタートの例

このキックスタートの例では、Red Hat Satellite からの情報を使用してホストネットワークを設定し、ホストを Satellite サーバーに登録します。グローバルまたはホストグループレベルのパラメーターを作成し (ここでは

rhvh_image)、squashfs.img ファイルを格納するディレクトリーの URL を定義する必要があります。ntp_server1もグローバルまたはホストグループレベルの変数です。警告この例では、すべてのディスクが空であり、初期化可能であることを前提としています。データを含むディスクが割り当てられている場合は、そのディスクを削除するか、

ignoredisksプロパティーに追加します。<%# kind: provision name: RHVH Kickstart default oses: - RHVH %> install liveimg --url=<%= @host.params['rhvh_image'] %>squashfs.img network --bootproto static --ip=<%= @host.ip %> --netmask=<%= @host.subnet.mask %> --gateway=<%= @host.subnet.gateway %> --nameserver=<%= @host.subnet.dns_primary %> --hostname <%= @host.name %> zerombr clearpart --all autopart --type=thinp rootpw --iscrypted <%= root_pass %> # installation answers lang en_US.UTF-8 timezone <%= @host.params['time-zone'] || 'UTC' %> keyboard us firewall --service=ssh services --enabled=sshd text reboot %post --log=/root/ks.post.log --erroronfail nodectl init <%= snippet 'subscription_manager_registration' %> <%= snippet 'kickstart_networking_setup' %> /usr/sbin/ntpdate -sub <%= @host.params['ntp_server1'] || '0.fedora.pool.ntp.org' %> /usr/sbin/hwclock --systohc /usr/bin/curl <%= foreman_url('built') %> sync systemctl reboot %end

キックスタートファイルの場所を、PXE サーバーのブートローダー設定ファイルに追加します。

APPEND initrd=/var/tftpboot/pxelinux/initrd.img inst.stage2=URL/to/RHVH-ISO inst.ks=URL/to/RHVH-ks.cfg

- Red Hat Enterprise Linux インストールガイド の PXE を使ったネットワークからの起動 に記載された手順に従って、RHVH をインストールします。

6.2. Red Hat Enterprise Linux ホスト

6.2.1. Red Hat Enterprise Linux ホストのインストール

Red Hat Enterprise Linux ホストは、Red Hat Enterprise Linux Server および Red Hat Virtualization サブスクリプションがアタッチされた、物理サーバー上の Red Hat Enterprise Linux 8 の標準的な基本インストールをベースにしています。

詳細なインストール手順は、標準的な RHEL インストールの実行 を参照してください。

ホストは最低限の ホスト要件 を満たしている必要があります。

ホストのオペレーティングシステムのインストールまたは再インストールを行う場合、Red Hat では、ホストにアタッチされている既存の OS 以外のストレージを最初にデタッチすることを強く推奨しています。これは、ディスクを誤って初期化してデータが失われる可能性を避けるためです。

ホストの BIOS 設定で仮想化が有効になっている必要があります。ホストの BIOS 設定の変更に関する詳細は、そのホストのハードウェアのマニュアルを参照してください。

サードパーティー製の watchdogs は、Red Hat Enterprise Linux ホストにインストールしないでください。VDSM が提供する watchdog デーモンを妨げる可能性があります。

6.2.2. Red Hat Enterprise Linux ホストのリポジトリーの有効化

Red Hat Enterprise Linux マシンをホストとして使用するには、システムをコンテンツ配信ネットワークに登録し、Red Hat Enterprise Linux Server および Red Hat Virtualization サブスクリプションを割り当て、ホストのリポジトリーを有効にする必要があります。

手順

コンテンツ配信ネットワークにシステムを登録します。プロンプトが表示されたら、カスタマーポータルのユーザー名とパスワードを入力します。

# subscription-manager register

Red Hat Enterprise Linux ServerおよびRed Hat Virtualizationのサブスクリプションプールを見つけ、プール ID を記録します。# subscription-manager list --available

上記のプール ID を使用して、サブスクリプションをシステムにアタッチします。

# subscription-manager attach --pool=poolid注記現在アタッチされているサブスクリプションを表示するには、以下のコマンドを実行します。

# subscription-manager list --consumed

有効なリポジトリーをすべて一覧表示するには、以下のコマンドを実行します。

# dnf repolist

リポジトリーを設定します。

# subscription-manager repos \ --disable='*' \ --enable=rhel-8-for-x86_64-baseos-eus-rpms \ --enable=rhel-8-for-x86_64-appstream-eus-rpms \ --enable=rhv-4-mgmt-agent-for-rhel-8-x86_64-rpms \ --enable=fast-datapath-for-rhel-8-x86_64-rpms \ --enable=advanced-virt-for-rhel-8-x86_64-rpms \ --enable=openstack-16.2-cinderlib-for-rhel-8-x86_64-rpms \ --enable=rhceph-4-tools-for-rhel-8-x86_64-rpms \ --enable=rhel-8-for-x86_64-appstream-tus-rpms \ --enable=rhel-8-for-x86_64-baseos-tus-rpmsRHEL のバージョンを 8.6 に設定します。

# subscription-manager release --set=8.6

現在インストールされている全パッケージを最新の状態にします。

# dnf upgrade --nobest

マシンを再起動します。

注記必要に応じて、 カーネルモジュールが自動的に読み込まれないようにする ことができます。

6.2.3. Red Hat Enterprise Linux ホストへの Cockpit のインストール

ホストのリソースの監視および管理タスクの実施のために、Cockpit をインストールすることができます。

手順

dashboard パッケージをインストールします。

# dnf install cockpit-ovirt-dashboard

cockpit.socketサービスを有効にして起動します。# systemctl enable cockpit.socket # systemctl start cockpit.socket

ファイアウォールで Cockpit がアクティブなサービスかどうかを確認します。

# firewall-cmd --list-services

cockpitのリストが表示されるはずです。表示されない場合には、root 権限で以下のコマンドを入力し、cockpitをサービスとしてファイアウォールに追加します。# firewall-cmd --permanent --add-service=cockpit

--permanentオプションは、再起動後もcockpitサービスをアクティブな状態で維持します。

https://HostFQDNorIP:9090 で Cockpit Web インターフェイスにログインできます。

6.3. ホストネットワーク設定の推奨プラクティス

クラスター内のホストのネットワーク設定を変更するには、RHV Manager を常に使用します。使用しない場合は、サポート対象外の設定が作成される可能性があります。詳細は、Network Manager のステートフル設定 (nmstate) を参照してください。

お使いのネットワーク環境が複雑な場合には、ホストを Red Hat Virtualization Manager に追加する前に、ホストネットワークを手動で設定しなければならない場合があります。

以下に示すホストネットワーク設定のプラクティスを検討してください。

-

Cockpit を使用してネットワークを設定。

nmtuiまたはnmcliを使用することも可能。 - セルフホストエンジンのデプロイメントまたは Manager へのホスト追加にネットワークが必要ない場合には、ホストを Manager に追加した後に、管理ポータルでネットワークを設定します。データセンターまたはクラスターでの新しい論理ネットワークの作成 を参照。

以下の命名規則を使用する。

-

VLAN デバイス:

VLAN_NAME_TYPE_RAW_PLUS_VID_NO_PAD -

VLAN インターフェイス:

physical_device.VLAN_ID(例:eth0.23,eth1.128,enp3s0.50) -

ボンディングインターフェイス:

bondnumber(例:bond0,bond1) -

ボンディングインテリアの VLAN:

bondnumber.VLAN_ID(例:bond0.50,bond1.128)

-

VLAN デバイス:

- ネットワークボンディング を使用。Red Hat Virtualization ではネットワークチーミングはサポートされておらず、セルフホストエンジンのデプロイメントにホストが使用されたりホストが Manager に追加されたりすると、エラーが発生する原因となります。

推奨されるボンディングモードを使用。

-

仮想マシンが

ovirtmgmtネットワークを使用しない場合には、ネットワークではサポートされるいずれかのボンディングモードが使用される。 -

仮想マシンが

ovirtmgmtネットワークを使用する場合には、仮想マシンのゲストが接続するブリッジで使用される場合にどのボンディングモードが有効ですか? を参照。 -

Red Hat Virtualization のデフォルトのボンディングモードは

(Mode 4) Dynamic Link Aggregationです。お使いのスイッチがリンクアグリゲーション制御プロトコル (LACP) に対応していない場合には、(Mode 1) Active-Backupを使用してください。詳細は、ボンドモード を参照。

-

仮想マシンが

以下の例に示すように、物理 NIC 上に VLAN を設定します (以下の例では

nmcliを使用していますが、任意のツールを使用できます)。# nmcli connection add type vlan con-name vlan50 ifname eth0.50 dev eth0 id 50 # nmcli con mod vlan50 +ipv4.dns 8.8.8.8 +ipv4.addresses 123.123.0.1/24 +ipv4.gateway 123.123.0.254

以下の例に示すように、ボンディング上に VLAN を設定すします (以下の例では

nmcliを使用していますが、任意のツールを使用することができます)。# nmcli connection add type bond con-name bond0 ifname bond0 bond.options "mode=active-backup,miimon=100" ipv4.method disabled ipv6.method ignore # nmcli connection add type ethernet con-name eth0 ifname eth0 master bond0 slave-type bond # nmcli connection add type ethernet con-name eth1 ifname eth1 master bond0 slave-type bond # nmcli connection add type vlan con-name vlan50 ifname bond0.50 dev bond0 id 50 # nmcli con mod vlan50 +ipv4.dns 8.8.8.8 +ipv4.addresses 123.123.0.1/24 +ipv4.gateway 123.123.0.254

-

firewalldは無効にしないでください。 - ホストを Manager に追加した後に、管理ポータルでファイアウォールルールをカスタマイズします。ホストファイアウォールルールの設定 を参照してください。

6.4. Red Hat Virtualization Manager へのセルフホストエンジンノードの追加

セルフホスト型エンジンノードは、通常のホストと同じ方法で追加しますが、セルフホスト型エンジンノードとしてホストをデプロイするという追加のステップが必要です。共有ストレージドメインは自動的に検出され、ノードは必要に応じて Manager 用仮想マシンをホストするフェイルオーバー用ホストとして使用できます。セルフホスト型エンジン環境に通常のホストをアタッチできますが、Manager 用仮想マシンはホストできません。Manager 用仮想マシンの高可用性を確保するためには、セルフホスト型エンジンノードを最低でも 2 つ用意します。追加のホストは、REST API を使用して追加することもできます。REST API ガイド の ホスト を参照してください。

前提条件

- セルフホスト型エンジンノードがすべて同じクラスター内にある。

- セルフホスト型エンジンノードを再利用する場合は、既存のセルフホスト型エンジン設定を削除する。セルフホスト型エンジン環境からのホストの削除 を参照してください。

手順

- 管理ポータルで Compute → Hosts をクリックします。

New をクリックします。

ホストの追加設定に関する情報は、管理ガイド の New Host および Edit Host ウィンドウの設定とコントロールの説明 を参照してください。

- ドロップダウンリストを使用して、新規ホスト用の Data Center および Host Cluster を選択します。

- 新規ホストの Name と Address を入力します。SSH Port フィールドには、標準の SSH ポートであるポート 22 が自動入力されます。

Manager がホストにアクセスするために使用する認証メソッドを選択します。

- パスワード認証を使用するには、root ユーザーのパスワードを入力します。

- または、SSH PublicKey フィールドに表示される鍵をホスト上の /root/.ssh/authorized_keys にコピーして、公開鍵認証を使用します。

- ホストにサポート対象の電源管理カードが搭載されている場合は、オプションとして電源管理を設定できます。電源管理の設定にについて、詳しくは 管理ガイド の ホストの Power Management 設定の説明 を参照してください。

- Hosted Engine タブをクリックします。

- Deploy を選択します。

- OK をクリックします。

6.5. Red Hat Virtualization Manager への通常のホストの追加

クラスター内のホストのネットワーク設定を変更するには、必ず RHV Manager を使用します。使用しない場合は、サポート対象外の設定が作成される可能性があります。詳細は、Network Manager Stateful Configuration (nmstate) を参照してください。

Red Hat Virtualization 環境にホストを追加するには、仮想化のチェック、パッケージのインストール、およびブリッジ作成の各ステップをプラットフォームで完了する必要があるため、多少時間がかかります。

手順

- 管理ポータルから Compute → Hosts をクリックします。

- New をクリックします。

- ドロップダウンリストを使用して、新規ホスト用の Data Center および Host Cluster を選択します。

- 新規ホストの Name と Address を入力します。SSH Port フィールドには、標準の SSH ポートであるポート 22 が自動入力されます。

Manager がホストにアクセスするために使用する認証メソッドを選択します。

- パスワード認証を使用するには、root ユーザーのパスワードを入力します。

- または、SSH PublicKey フィールドに表示される鍵をホスト上の /root/.ssh/authorized_keys にコピーして、公開鍵認証を使用します。

オプションで、Advanced Parameters ボタンをクリックして、以下に示すホストの詳細設定を変更します。

- ファイアウォールの自動設定を無効にします。

- ホストの SSH フィンガープリントを追加し、セキュリティーを強化します。手動での追加または自動取得が可能です。

- ホストにサポート対象の電源管理カードが搭載されている場合は、オプションとして電源管理を設定することができます。電源管理の設定に関する詳細は、管理ガイド の ホストパワーマネージメント設定の説明 を参照してください。

- OK をクリックします。

新規ホストが Installing のステータスでホスト一覧に表示され、通知トレイ (

![]() ) の イベント セクションでインストールの進捗状況を確認できます。しばらくすると、ホストのステータスが

) の イベント セクションでインストールの進捗状況を確認できます。しばらくすると、ホストのステータスが Up に変わります。

第7章 Red Hat Virtualization 用ストレージの追加

新たな環境にデータドメインとしてストレージを追加します。Red Hat Virtualization 環境には少なくとも 1 つのデータドメインが必要ですが、さらに追加することを推奨します。

前の手順で準備したストレージを追加します。

iSCSI ストレージを使用する場合には、新しいデータドメインはセルフホストエンジン用ストレージドメインと同じ iSCSI ターゲットを使用することはできません。

セルフホストエンジン用ストレージドメインと同じデータセンター内に追加のデータドメインを作成することを強く推奨します。セルフホストエンジンをデータセンター内にデプロイする際に、アクティブなデータストレージドメインを 1 つしか用意していない場合、そのストレージドメインが破損しても、新しいストレージドメインを追加したり、破損したストレージドメインを削除することはできません。セルフホストエンジンを再デプロイしなければなりません。

7.1. NFS ストレージの追加

ここでは、既存の NFS ストレージをデータドメインとして Red Hat Virtualization 環境にアタッチする手順を説明します。

ISO またはエクスポートドメインが必要な場合も、この手順を使用します。ただし、Domain Function の一覧では ISO または Export を選択します。

手順

- 管理ポータルで Storage → Domains をクリックします。

- New Domain をクリックします。

- ストレージドメインの Name を入力します。

- Data Center、Domain Function、Storage Type、Format、および Host のリストのデフォルト値をそのまま使用します。

- ストレージドメインに使用する Export Path を入力します。エクスポートパスは、123.123.0.10:/data (IPv4 の場合)、[2001:0:0:0:0:0:0:5db1]:/data (IPv6 の場合)、または domain.example.com:/data の形式で指定する必要があります。

オプションで、詳細パラメーターを設定できます。

- Advanced Parameters をクリックします。

- Warning Low Space Indicator フィールドに、パーセンテージ値を入力します。ストレージドメインの空き容量がこの値を下回ると、ユーザーに警告メッセージが表示され、ログに記録されます。

- Critical Space Action Blocker のフィールドに GB 単位で値を入力します。ストレージドメインの空き容量がこの値を下回ると、ユーザーにエラーメッセージが表示され、ログに記録されます。容量を消費する新規アクションは、一時的であってもすべてブロックされます。

- 削除後にワイプするオプションを有効にするには、Wipe After Delete チェックボックスを選択します。このオプションは、ドメインの作成後に編集できますが、その場合はすでに存在している wipe after delete プロパティーは変更されません。

- OK をクリックします。

新しい NFS データドメインのステータスは、ディスクの準備ができるまで Locked になります。その後、データドメインはデータセンターに自動的にアタッチされます。

7.2. iSCSI ストレージの追加

ここでは、既存の iSCSI ストレージをデータドメインとして Red Hat Virtualization 環境にアタッチする手順について説明します。

手順

- Storage → Domains をクリックします。

- New Domain をクリックします。

- 新規ストレージドメインの Name を入力します。

- ドロップダウンリストから Data Center を選択します。

- Domain Function として Data を、Storage Type として iSCSI を、それぞれ選択します。

Host としてアクティブなホストを選択します。

重要ストレージドメインへの通信は、Manager から直接ではなく、選択したホストを介して行われます。したがって、ストレージドメインを設定する前には、全ホストがストレージデバイスにアクセスできる状態でなければなりません。

Manager は iSCSI ターゲットを LUN に、または LUN を iSCSI ターゲットにマッピングすることができます。New Domain ウィンドウでストレージタイプに iSCSI を選択すると、未使用の LUN が割り当てられた既知のターゲットが自動的に表示されます。ストレージの追加に使用するターゲットが表示されない場合は、ターゲットの検出機能を使用して検索することができます。表示されている場合は、次の手順に進んでください。