管理ガイド

Red Hat Virtualization の管理タスク

概要

パート I. Red Hat Virtualization 環境の管理と保守

Red Hat Virtualization 環境の稼働を維持するには管理者が必要です。管理者のタスクには以下が含まれます。

- ホストや仮想マシンなどの物理リソースおよび仮想リソースの管理。これには、ホストのアップグレードおよび追加、ドメインのインポート、外部ハイパーバイザーで作成された仮想マシンの変換、および仮想マシンプールの管理が含まれます。

- ホストのいずれかに対する極端な負荷、メモリーやディスク容量不足、必要なアクション (仮想マシンをシャットダウンして仮想マシンの別ホストへの移行して負荷を軽減したりリソースを解放するなど) などの潜在的な問題について、全体的なシステムリソースのモニターリングを行います。

- 仮想マシンの新しい要件に対応します (たとえば、オペレーティングシステムのアップグレードまたはより多くのメモリーの割り当てなど)。

- タグを使用したカスタムオブジェクトプロパティーの管理。

- パブリックブックマーク として保存された検索の管理。

- ユーザー設定の管理とパーミッションレベルの設定。

- システム機能全体の特定ユーザーまたは仮想マシンのトラブルシューティング。

- 一般および特定レポートの生成。

第1章 グローバル設定

Administration → Configure をクリックしてアクセスします。Configure ウィンドウでは、ユーザー、ロール、システムパーミッション、スケジューリングポリシー、インスタンスタイプ、MAC アドレスプールなどの Red Hat Virtualization 環境のグローバルリソースを複数設定できます。このウィンドウでは、ユーザーが環境のリソースと対話する方法をカスタマイズし、複数のクラスターに適用できるオプションを設定する一元的な場所を提供します。

1.1. ロール

ロールは、Red Hat Virtualization Manager から設定できる事前定義された権限のセットです。ロールは、データセンター内の異なるレベルのリソースや、特定の物理リソースおよび仮想リソースに対するアクセスおよび管理のパーミッションを提供します。

マルチレベル管理では、コンテナーオブジェクトに適用されるパーミッションは、そのコンテナー内のすべての個別オブジェクトにも適用されます。たとえば、特定のホスト上のユーザーにホスト管理者ロールが割り当てられた場合、そのユーザーは利用可能なホスト操作のいずれかを実行する権限を得ますが、割り当てられたホスト上でのみ実行できます。ただし、ホスト管理者ロールがデータセンターのユーザーに割り当てられている場合、ユーザーはデータセンターのクラスター内の全ホストでホスト操作を実行するパーミッションを取得します。

1.1.1. 新しいロールの作成

必要なロールが Red Hat Virtualization のデフォルトロールリストにない場合は、新しいロールを作成して、目的に合わせてカスタマイズできます。

新しいロールの作成

- Administration → Configure をクリックして Configure ウィンドウを開きます。Roles タブはデフォルトで選択され、デフォルトのユーザーおよび管理者ロールおよびカスタムロールのリストが表示されます。

- New をクリックします。

- 新規ロールの Name および Description を入力します。

- Account Type に Admin または User のいずれかを選択します。

- Expand All または Collapse All ボタンを使用して、Check Boxes to Allow Action リストに記載されているオブジェクトのパーミッションの表示を拡大または縮小します。また、各オブジェクトのオプションを展開したり、折りたたんだりすることもできます。

- それぞれのオブジェクトについて、設定しているロールを許可または拒否するアクションを選択または消去します。

- OK をクリックして変更を適用します。ロールの一覧に新しいロールが表示されます。

1.1.2. ロールの編集またはコピー

作成したロールの設定を変更できますが、デフォルトのロールを変更することはできません。デフォルトのロールを変更するには、そのロールのクローンを作成して、要件に合わせて変更します。

ロールの編集またはコピー

- Administration → Configure をクリックして Configure ウィンドウを開きます。ウィンドウには、デフォルトの User および Administrator ロールのリストとカスタムロールが表示されます。

- 変更するロールを選択します。Edit をクリックして Edit Role ウィンドウを開くか、Copy をクリックして Copy Role ウィンドウを開きます。

- 必要に応じて、ロールの Name および Description を編集します。

- Expand All または Collapse All ボタンを使用して、リストされているオブジェクトのパーミッションの表示を拡大または縮小します。また、各オブジェクトのオプションを展開したり、折りたたんだりすることもできます。

- それぞれのオブジェクトについて、編集するロールを許可または拒否するアクションを選択または消去します。

- OK をクリックして、加えた変更を適用します。

1.1.3. ユーザーロールと承認の例

以下の例は、本章で説明する承認システムの異なる機能を使用して、さまざまなシナリオに対して承認制御を適用する方法を示しています。

例1.1 クラスターパーミッション

Sarah は、ある企業の経理部門のシステム管理者です。彼女の部署のすべての仮想リソースは、Accounts という名前の Red Hat Virtualization クラスターの下に編成されています。彼女には Accounts クラスターの ClusterAdmin ロールが割り当てられています。これにより、仮想マシンはクラスターの子オブジェクトであるため、彼女はクラスター内のすべての仮想マシンを管理できます。仮想マシンの管理には、ディスクなどの仮想リソースの編集、追加、削除、およびスナップショットの作成などが含まれます。このクラスターの外部にあるリソースを管理することはできません。ClusterAdmin は管理者ロールであるため、管理ポータルまたは VM ポータルを使用してこれらのリソースを管理できます。

例1.2 VM PowerUser パーミッション

John は、経理部のソフトウェア開発者です。彼は仮想マシンを使用してソフトウェアを構築し、テストします。Sarah は、John に johndesktop という仮想デスクトップを作成しました。John は、johndesktop 仮想マシンで UserVmManager ロールが割り当てられています。これにより、VM ポータルを使用してこの単一仮想マシンにアクセスすることができます。彼は UserVmManager のパーミッションを持っているため、仮想マシンを変更できます。UserVmManager はユーザーロールであるため、管理ポータルを使用できません。

例1.3 データセンターパワーユーザーロールパーミッション

Penelope はオフィスマネージャーです。自分の仕事に加えて、面接の日程調整やリファレンスチェックのフォローアップなど、人事マネージャーの採用業務を手伝うこともあります。会社の方針により、Penelope は採用業務に特定のアプリケーションを使用する必要があります。

Penelope はオフィス管理用に自分のマシンを持っていますが、採用アプリケーションを実行するために別の仮想マシンを作成したいと考えています。彼女には、新しい仮想マシンが設置されるデータセンターの PowerUserRole パーミッションが割り当てられています。これは、新しい仮想マシンを作成することにより、ストレージドメインでの仮想ディスクの作成など、データセンター内の複数のコンポーネントに変更を加える必要があるためです。

これは、Penelope に DataCenterAdmin 権限を割り当てることとは違うことに注意してください。データセンターの PowerUser として、Penelope は VM ポータルにログインして、データセンター内の仮想マシン固有のアクションを実行できます。彼女は、ホストまたはストレージをデータセンターに割り当てるなど、データセンターレベルの操作を実行できません。

例1.4 ネットワーク管理者のパーミッション

Chris は、IT 部門のネットワーク管理者です。彼女の日常的な仕事は、部内の Red Hat Virtulization 環境におけるネットワークの作成、操作、削除などです。彼女には、リソースおよび各リソースのネットワークにおける管理者権限が必要です。たとえば、Chris が IT 部門のデータセンターのNetworkAdmin 権限を持っている場合、データセンター内のネットワークを追加および削除したり、データセンターに属するすべての仮想マシンのネットワークをアタッチおよびデタッチすることができます。

例1.5 カスタムロールパーミッション

レイチェルは IT 部門に所属し、Red Hat Virtualization のユーザーアカウント管理を担当しています。彼女には、ユーザーアカウントを追加し、適切なロールおよびパーミッションを割り当てる権限が必要です。彼女自身は仮想マシンを使用せず、ホスト、仮想マシン、クラスター、データセンターの管理にアクセスしてはいけません。彼女にこのような特定のパーミッションを与える組み込みのロールはありません。レイチェルの役職に適したパーミッションセットを定義するために、カスタムロールを作成する必要があります。

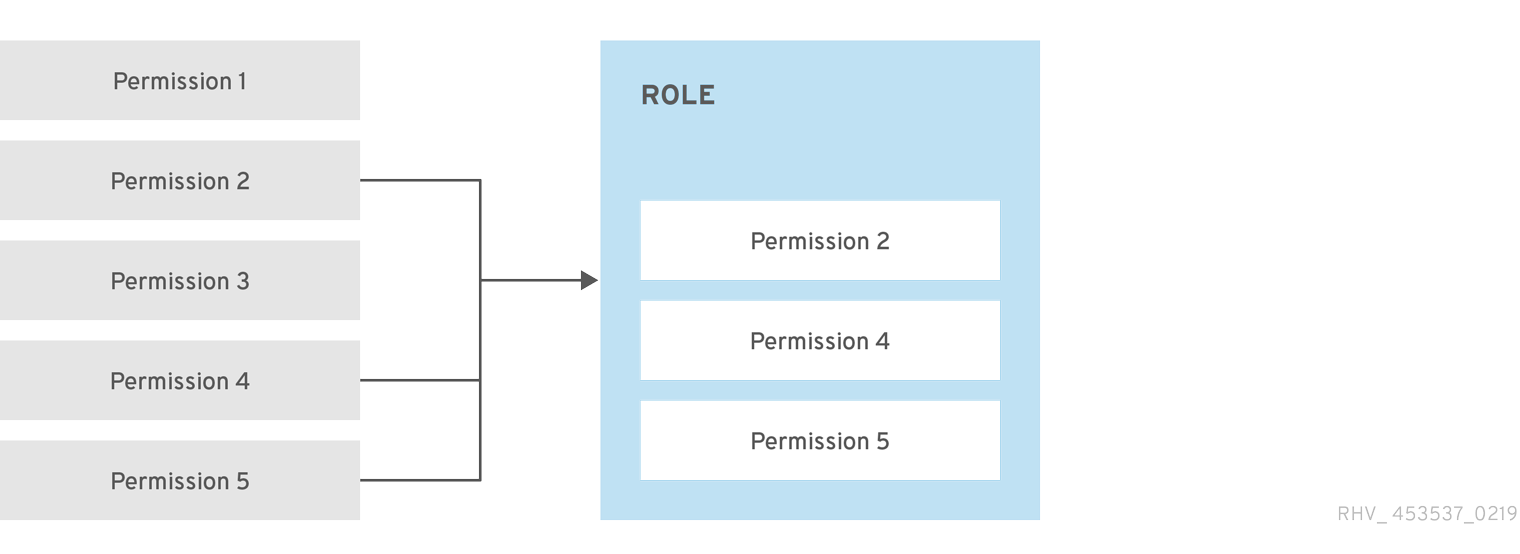

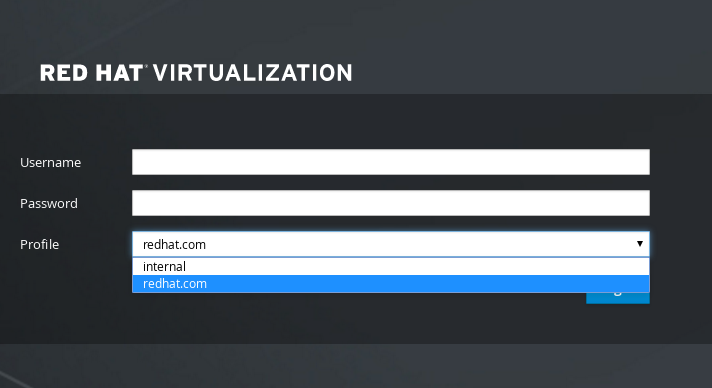

図1.1 UserManager カスタムロール

上記の UserManager のカスタムロールは、ユーザー、パーミッション、およびロールの操作を可能にします。これらのアクションは、図1.3「Red Hat Virtualization オブジェクトの階層」 に示す階層の上位オブジェクトである System の下に整理されています。これは、システム内のすべてのオブジェクトに適用されることを意味します。ロールの Account Type は Admin に設定されます。つまり、このロールが割り当てられると、Rachel は Administration Portal と VM Portal の両方を使用できるようになります。

1.2. システムパーミッション

パーミッションにより、ユーザーはオブジェクトに対してアクションを実行できます。オブジェクトは個別のオブジェクトまたはコンテナーオブジェクトのいずれかになります。コンテナーオブジェクトに適用されるパーミッションは、そのコンテナーのすべてのメンバーにも適用されます。

図1.2 パーミッションおよびロール

図1.3 Red Hat Virtualization オブジェクトの階層

1.2.1. ユーザープロパティー

ロールおよびパーミッションはユーザーのプロパティーです。ロールとは、異なるレベルの物理および仮想リソースへのアクセスを許可する、事前定義された一連の権限のことです。マルチレベル管理では、パーミッションを細かく階層化できます。たとえば、データセンター管理者はデータセンター内の全オブジェクトを管理するパーミッションを持ち、ホスト管理者は 1 つの物理ホストのシステム管理者パーミッションを持ちます。あるユーザーは、単一の仮想マシンを使用するパーミッションを持っていても、仮想マシンの設定を変更できません。一方、別のユーザーは、仮想マシンのシステムパーミッションを割り当てることができます。

1.2.2. ユーザーおよび管理者ロール

Red Hat Virtualization は、システム全体のパーミッションを持つ管理者から、1 台の仮想マシンにアクセスできるエンドユーザーまで、事前設定されたさまざまなロールを提供します。デフォルトのロールを変更または削除することはできませんが、そのロールのクローンを作成してカスタマイズしたり、要件に合わせて新しいロールを作成したりできます。以下の 2 つのタイプがあります。

- 管理者ロール: 物理リソースおよび仮想リソースを管理するための 管理ポータル へのアクセスを許可します。管理者ロールは、VM ポータルで実行するアクションのパーミッションを付与しますが、ユーザーが VM ポータルで見ることができる内容には影響しません。

- ユーザーロール: VM ポータル にアクセスして、仮想マシンおよびテンプレートを管理し、アクセスできるようにします。ユーザーロールは、ユーザーが VM ポータルで表示できる内容を決定します。管理者ロールを持つユーザーに付与されるパーミッションは、そのユーザーが VM ポータルで利用できるアクションに反映されます。

1.2.3. ユーザーロールの概要

以下の表は、VM ポータルで仮想マシンにアクセスし、設定するパーミッションを付与する基本的なユーザーロールを説明しています。

表1.1 Red Hat Virtualization ユーザーロール: 基本

| ロール | 権限 | 注記 |

|---|---|---|

| UserRole | 仮想マシンおよびプールにアクセスし、使用できる。 | VM ポータルへのログイン、割り当てられた仮想マシンやプールの使用、仮想マシンの状態や詳細の表示が可能。 |

| PowerUserRole | 仮想マシンおよびテンプレートを作成および管理できる。 | このロールを Configure ウィンドウで環境全体のユーザーまたは特定のデータセンターやクラスターのユーザーに適用します。たとえば、PowerUserRole がデータセンターレベルに適用されると、PowerUser はデータセンターで仮想マシンおよびテンプレートを作成できます。 |

| UserVmManager | 仮想マシンのシステム管理者。 | 仮想マシンの管理、スナップショットの作成と使用が可能。VM ポータルで仮想マシンを作成したユーザーには、そのマシンの UserVmManager ロールが自動的に割り当てられます。 |

以下の表は、VM ポータルのリソースに対するパーミッションの細かな調整を可能にする高度なユーザーロールについて説明しています。

表1.2 Red Hat Virtualization のユーザーロール - 高度

| ロール | 権限 | 注記 |

|---|---|---|

| UserTemplateBasedVm | テンプレートのみを使用できる限定的な権限。 | テンプレートを使用して仮想マシンを作成できます。 |

| DiskOperator | 仮想ディスクユーザー。 | 仮想ディスクの使用、表示、編集が可能です。仮想ディスクが接続されている仮想マシンを使用するパーミッションを継承します。 |

| VmCreator | VM ポータルで仮想マシンを作成できる。 | このロールは特定の仮想マシンには適用されません。Configure ウィンドウで環境全体のユーザーにこのロールを適用します。または、特定のデータセンターまたはクラスターにこのロールを適用することもできます。このロールをクラスターに適用する場合、データセンター全体または特定のストレージドメインに DiskCreator ロールを適用する必要もあります。 |

| TemplateCreator | 割り当てられたリソース内で仮想マシンテンプレートを作成、編集、管理、および削除できる。 | このロールは特定のテンプレートには適用されません。Configure ウィンドウで環境全体のユーザーにこのロールを適用します。また、特定のデータセンター、クラスター、またはストレージドメインにこのロールを適用することもできます。 |

| DiskCreator | 割り当てられたクラスターまたはデータセンター内の仮想ディスクを作成、編集、管理、および削除できる。 | このロールは特定の仮想ディスクには適用されません。Configure ウィンドウで環境全体のユーザーにこのロールを適用します。また、特定のデータセンターまたはストレージドメインにこのロールを適用することもできます。 |

| TemplateOwner | テンプレートの編集および削除、テンプレートのユーザーパーミッションの割り当ておよび管理が可能。 | このロールは、テンプレートを作成したユーザーに自動的に割り当てられます。テンプレートに TemplateOwner パーミッションを持たない他のユーザーは、そのテンプレートを表示または使用することができません。 |

| VnicProfileUser | 仮想マシンおよびテンプレートの論理ネットワークおよびネットワークインターフェイスユーザー。 | 特定の論理ネットワークからネットワークインターフェイスを接続または切断できます。 |

1.2.4. 管理者ロールの概要

以下の表は、管理ポータルのリソースにアクセスおよび設定するパーミッションを付与する基本的な管理者ロールについて説明しています。

表1.3 Red Hat Virtualization システム管理者ロール - 基本

| ロール | 権限 | 注記 |

|---|---|---|

| SuperUser | Red Hat Virtualization 環境のシステム管理者 | すべてのオブジェクトおよびレベルでの完全なパーミッションを持ち、全データセンターで全オブジェクトを管理できます。 |

| ClusterAdmin | クラスター管理者。 | 特定のクラスター下にある全オブジェクトの管理パーミッションを持ちます。 |

| DataCenterAdmin | データセンター管理者。 | 特定のデータセンターの下にある、ストレージを除くすべてのオブジェクトの管理権限を保有しています。 |

ディレクトリーサーバーの管理ユーザーを、Red Hat Virtualization の管理ユーザーとして使用しないでください。Red Hat Virtualization の管理ユーザーとして使用するように、ディレクトリーサーバーにユーザーを作成します。

以下の表は、管理者ポータルのリソースに対するパーミッションの細かな調整を可能にする高度な管理者ロールについて説明しています。

表1.4 Red Hat Virtualization システム管理者ロール - 高度

| ロール | 権限 | 注記 |

|---|---|---|

| TemplateAdmin | 仮想マシンテンプレートの管理者。 | テンプレートのストレージドメインやネットワークの詳細を作成、削除、設定したり、ドメイン間でテンプレートを移動できます。 |

| StorageAdmin | ストレージ管理者。 | 割り当てられたストレージドメインを作成、削除、設定、および管理できます。 |

| HostAdmin | ホスト管理者。 | 特定のホストをアタッチ、削除、設定、および管理できます。 |

| NetworkAdmin | ネットワーク管理者。 | 特定のデータセンターまたはクラスターのネットワークを設定および管理できます。データセンターまたはクラスターのネットワーク管理者は、クラスター内の仮想プールのネットワークパーミッションを継承します。 |

| VmPoolAdmin | 仮想プールのシステム管理者。 | 仮想プールを作成、削除、および設定できます。仮想プールユーザーを割り当ておよび削除し、プールの仮想マシンに基本操作を実行できます。 |

| GlusterAdmin | Gluster Storage 管理者。 | Gluster ストレージボリュームを作成、削除、設定、および管理できます。 |

| VmImporterExporter | 仮想マシンの管理者をインポートおよびエクスポートします。 | 仮想マシンをインポートおよびエクスポートできます。他のユーザーがエクスポートした仮想マシンおよびテンプレートをすべて表示できます。 |

1.2.5. 管理者またはユーザーロールのリソースへの割り当て

管理者またはユーザーロールをリソースに割り当て、ユーザーがそのリソースにアクセスしたり、管理したりできるようにします。

リソースへのロールの割り当て

- リソースの名前を見つけ、クリックして詳細ビューを開きます。

- Permissions タブをクリックして、割り当てられたユーザー、ユーザーのロール、および選択したリソースの継承されたパーミッションを一覧表示します。

- Add をクリックします。

- Search テキストボックスに既存のユーザーの名前またはユーザー名を入力し、Go をクリックします。表示された候補の中からユーザーを選択します。

- Role to Assign ドロップダウンリストからロールを選択します。

- OK をクリックします。

ユーザーは、そのリソースに対して有効になっているロールの継承されたパーミッションを持つようになります。

1.2.6. リソースからの管理者またはユーザーロールの削除

管理者またはユーザーのロールをリソースから削除すると、ユーザーはそのリソースのロールに関連付けられ継承されたパーミッションを失います。

リソースからのロールの削除

- リソースの名前を見つけ、クリックして詳細ビューを開きます。

- Permissions タブをクリックして、割り当てられたユーザー、ユーザーのロール、および選択したリソースの継承されたパーミッションを一覧表示します。

- リソースから削除するユーザーを選択します。

- Remove をクリックします。

- OK をクリックします。

1.2.7. データセンターのシステムパーミッションの管理

システム管理者は SuperUser として、管理ポータルのすべての側面を管理します。他のユーザーに特定の管理ロールを割り当てることができます。このような制限された管理者ロールは、特定のリソースに制限される管理者権限をユーザーに付与する際に役立ちます。たとえば、DataCenterAdmin ロールは、割り当てられたデータセンターのストレージを除いて、そのデータセンターのみの管理者権限を持ち、ClusterAdmin は割り当てられたクラスターのみの管理者権限を持ちます。

データセンターの管理者は、特定のデータセンターのみのシステム管理ロールです。これは、各データセンターが管理者を必要とする複数のデータセンターを持つ仮想化環境で有用です。DataCenterAdmin ロールは階層モデルです。あるデータセンターのデータセンター管理者ロールを割り当てられたユーザーは、そのデータセンターのストレージを除くすべてのオブジェクトを管理することができます。ヘッダーバーの Configure ボタンを使用して、環境内のすべてのデータセンターにデータセンター管理者を割り当てます。

データセンターの管理者ロールでは、以下のアクションが許可されます。

- データセンターに関連付けられたクラスターの作成と削除。

- データセンターに関連付けられたホスト、仮想マシン、およびプールを追加および削除。

- データセンターに関連付けられた仮想マシンのユーザーパーミッションの編集。

ロールやパーミッションは、既存のユーザーにのみ割り当てることができます。

既存のシステム管理者を削除し、新しいシステム管理者を追加すると、データセンターのシステム管理者を変更できます。

1.2.8. データセンター管理者ロールの概要

データセンターのパーミッションロール

以下の表は、データセンターの管理に適用される管理者ロールおよび権限を示しています。

表1.5 Red Hat Virtualization システム管理者ロール

| ロール | 権限 | 注記 |

|---|---|---|

| DataCenterAdmin | データセンター管理者 | クラスター、ホスト、テンプレート、仮想マシンなど、特定のデータセンター内の物理リソースおよび仮想リソースすべての作成、削除、管理が可能です。 |

| NetworkAdmin | ネットワーク管理者 | 特定のデータセンターのネットワークを設定および管理できます。データセンターのネットワーク管理者は、データセンター内の仮想マシンのネットワークパーミッションも継承します。 |

1.2.9. クラスターのシステムパーミッションの管理

システム管理者は SuperUser として、管理ポータルのすべての側面を管理します。他のユーザーに特定の管理ロールを割り当てることができます。このような制限された管理者ロールは、特定のリソースに制限される管理者権限をユーザーに付与する際に役立ちます。たとえば、DataCenterAdmin ロールは、割り当てられたデータセンターのストレージを除いて、そのデータセンターのみの管理者権限を持ち、ClusterAdmin は割り当てられたクラスターのみの管理者権限を持ちます。

クラスターの管理者は、特定のクラスターのみのシステム管理ロールです。これは、複数のクラスターを持つデータセンターで、各クラスターにシステム管理者が必要な場合に有効です。ClusterAdmin ロールは階層モデルです。あるクラスターのクラスター管理者ロールを割り当てられたユーザーは、クラスターのすべてのオブジェクトを管理できます。ヘッダーバーの Configure ボタンを使用して、環境のすべてのクラスターにクラスター管理者を割り当てます。

クラスター管理者ロールは以下のアクションを許可します。

- 関連付けられたクラスターの作成および削除。

- クラスターに関連付けられたホスト、仮想マシン、およびプールの追加および削除。

- クラスターに関連付けられた仮想マシンのユーザーパーミッションを編集します。

ロールやパーミッションは、既存のユーザーにのみ割り当てることができます。

また、既存のシステム管理者を削除し、新しいシステム管理者を追加すると、クラスターのシステム管理者を変更できます。

1.2.10. クラスター管理者ロールの概要

クラスターパーミッションロール

以下の表は、クラスターの管理に適用される管理者ロールおよび権限について説明しています。

表1.6 Red Hat Virtualization システム管理者ロール

| ロール | 権限 | 注記 |

|---|---|---|

| ClusterAdmin | クラスター管理者 | ホスト、テンプレート、および仮想マシンなど、特定のクラスター内の物理リソースおよび仮想リソースをすべて使用、作成、削除、管理することができます。ディスプレイネットワークの指定や、ネットワークを必須とマークするなど、クラスター内でネットワークプロパティーを設定できます。 ただし、ClusterAdmin には、ネットワークをクラスターにアタッチまたはデタッチするパーミッションがないため、NetworkAdmin パーミッションが必要です。 |

| NetworkAdmin | ネットワーク管理者 | 特定のクラスターのネットワークを設定および管理できます。クラスターのネットワーク管理者は、データセンター内のクラスターネットワークパーミッションも継承します。 |

1.2.11. ネットワークのシステムパーミッションの管理

システム管理者は SuperUser として、管理ポータルのすべての側面を管理します。他のユーザーに特定の管理ロールを割り当てることができます。このような制限された管理者ロールは、特定のリソースに制限される管理者権限をユーザーに付与する際に役立ちます。たとえば、DataCenterAdmin ロールは、割り当てられたデータセンターのストレージを除いて、そのデータセンターのみの管理者権限を持ち、ClusterAdmin は割り当てられたクラスターのみの管理者権限を持ちます。

ネットワーク管理者は、特定のネットワークまたはデータセンター、クラスター、ホスト、仮想マシン、またはテンプレートにあるすべてのネットワークに適用できるシステム管理ロールです。ネットワークユーザーは、特定の仮想マシンまたはテンプレート上のネットワークの表示やアタッチなど、制限された管理ロールを実行できます。ヘッダーバーの Configure ボタンを使用して、環境内の全ネットワークにネットワーク管理者を割り当てできます。

ネットワーク管理者ロールは以下のアクションを許可します。

- ネットワークの作成、編集、および削除。

- ポートミラーリングの設定など、ネットワークの設定を編集。

- クラスターや仮想マシンを含むリソースからのネットワークをアタッチおよびデタッチ。

ネットワークを作成するユーザーには、作成されたネットワークに NetworkAdmin パーミッションが自動的に割り当てられます。また、既存の管理者を削除し、新しい管理者を追加すると、ネットワークの管理者を変更できます。

1.2.12. ネットワーク管理者およびユーザーロールの概要

ネットワークパーミッションロール

以下の表は、ネットワークの管理に適用される管理者およびユーザーロールと権限について説明しています。

表1.7 Red Hat Virtualization ネットワーク管理者およびユーザーロール

| ロール | 権限 | 注記 |

|---|---|---|

| NetworkAdmin | データセンター、クラスター、ホスト、仮想マシン、またはテンプレートのネットワーク管理者。ネットワークを作成するユーザーには、作成されたネットワークに NetworkAdmin パーミッションが自動的に割り当てられます。 | 特定のデータセンター、クラスター、ホスト、仮想マシン、またはテンプレートのネットワークを設定および管理できます。データセンターまたはクラスターのネットワーク管理者は、クラスター内の仮想プールのネットワークパーミッションを継承します。仮想マシンのネットワークにポートミラーリングを設定するには、ネットワークに NetworkAdmin ロールを、仮想マシンに UserVmManager ロールを適用します。 |

| VnicProfileUser | 仮想マシンおよびテンプレートの論理ネットワークおよびネットワークインターフェイスユーザー。 | 特定の論理ネットワークからネットワークインターフェイスを接続または切断できます。 |

1.2.13. ホストのシステムパーミッションの管理

システム管理者は SuperUser として、管理ポータルのすべての側面を管理します。他のユーザーに特定の管理ロールを割り当てることができます。このような制限された管理者ロールは、特定のリソースに制限される管理者権限をユーザーに付与する際に役立ちます。たとえば、DataCenterAdmin ロールは、割り当てられたデータセンターのストレージを除いて、そのデータセンターのみの管理者権限を持ち、ClusterAdmin は割り当てられたクラスターのみの管理者権限を持ちます。

ホスト管理者は、特定のホストのみのシステム管理ロールです。これは、複数のホストを持つクラスターで、各ホストにシステム管理者が必要な場合に有効です。ヘッダーバーの Configure ボタンを使用して、環境内の全ホストにホスト管理者を割り当てできます。

ホスト管理者ロールは以下のアクションを許可します。

- ホストの設定編集。

- 論理ネットワークの設定。

- ホストを削除。

また、既存のシステム管理者を削除し、新しいシステム管理者を追加すると、ホストのシステム管理者を変更できます。

1.2.14. ホスト管理者ロールの概要

ホストパーミッションロール

以下の表は、ホスト管理に適用される管理者ロールおよび権限について説明しています。

表1.8 Red Hat Virtualization システム管理者ロール

| ロール | 権限 | 注記 |

|---|---|---|

| HostAdmin | ホスト管理者 | 特定のホストを設定、管理、および削除できます。特定のホストでネットワーク関連の操作も実行できます。 |

1.2.15. ストレージドメインのシステムパーミッションの管理

システム管理者は SuperUser として、管理ポータルのすべての側面を管理します。他のユーザーに特定の管理ロールを割り当てることができます。このような制限された管理者ロールは、特定のリソースに制限される管理者権限をユーザーに付与する際に役立ちます。たとえば、DataCenterAdmin ロールは、割り当てられたデータセンターのストレージを除いて、そのデータセンターのみの管理者権限を持ち、ClusterAdmin は割り当てられたクラスターのみの管理者権限を持ちます。

ストレージ管理者は、特定のストレージドメインのみのシステム管理ロールです。これは、複数のストレージドメインを持つデータセンターで、各ストレージドメインにシステム管理者が必要な場合に有効です。ヘッダーバーの Configure ボタンを使用して、環境内のすべてのストレージドメインにストレージ管理者を割り当てます。

ストレージドメイン管理者ロールは、以下のアクションを許可します。

- ストレージドメインの設定の編集。

- ストレージドメインのメンテナンスモードへの切り替え。

- ストレージドメインの削除。

ロールやパーミッションは、既存のユーザーにのみ割り当てることができます。

また、既存のシステム管理者を削除し、新しいシステム管理者を追加すると、ストレージドメインのシステム管理者を変更できます。

1.2.16. ストレージ管理者ロールの概要

ストレージドメインパーミッションロール

以下の表は、ストレージドメインの管理に適用される管理者ロールおよび権限について説明しています。

表1.9 Red Hat Virtualization システム管理者ロール

| ロール | 権限 | 注記 |

|---|---|---|

| StorageAdmin | ストレージ管理者 | 特定のストレージドメインを作成、削除、設定、および管理できます。 |

| GlusterAdmin | Gluster Storage 管理者 | Gluster ストレージボリュームを作成、削除、設定、および管理できます。 |

1.2.17. 仮想マシンプールのシステムパーミッションの管理

システム管理者は SuperUser として、管理ポータルのすべての側面を管理します。他のユーザーに特定の管理ロールを割り当てることができます。このような制限された管理者ロールは、特定のリソースに制限される管理者権限をユーザーに付与する際に役立ちます。たとえば、DataCenterAdmin ロールは、割り当てられたデータセンターのストレージを除いて、そのデータセンターのみの管理者権限を持ち、ClusterAdmin は割り当てられたクラスターのみの管理者権限を持ちます。

仮想マシンプールの管理者は、データセンター内の仮想マシンプールのシステム管理ロールです。このロールは、特定の仮想マシンプール、データセンター、または仮想化環境全体に適用できます。これは、異なるユーザーが特定の仮想マシンプールリソースを管理できるようにするのに役立ちます。

仮想マシンプールの管理者ロールは、以下のアクションを許可します。

- プールの作成、編集、および削除。

- プールからの仮想マシンを追加およびデタッチ。

ロールやパーミッションは、既存のユーザーにのみ割り当てることができます。

1.2.18. 仮想マシンプール管理者ロールの概要

プールパーミッションロール

以下の表は、プール管理に適用される管理者ロールおよび権限について説明しています。

表1.10 Red Hat Virtualization システム管理者ロール

| ロール | 権限 | 注記 |

|---|---|---|

| VmPoolAdmin | 仮想プールのシステム管理者ロール。 | 仮想プールを作成、削除、および設定できます。仮想プールユーザーを割り当ておよび削除し、仮想マシンに基本操作を実行できます。 |

| ClusterAdmin | クラスター管理者 | 特定のクラスター内のすべての仮想マシンプールを使用、作成、削除、および管理できます。 |

1.2.19. 仮想ディスクのシステムパーミッションの管理

システム管理者は SuperUser として、管理ポータルのすべての側面を管理します。他のユーザーに特定の管理ロールを割り当てることができます。このような制限された管理者ロールは、特定のリソースに制限される管理者権限をユーザーに付与する際に役立ちます。たとえば、DataCenterAdmin ロールは、割り当てられたデータセンターのストレージを除いて、そのデータセンターのみの管理者権限を持ち、ClusterAdmin は割り当てられたクラスターのみの管理者権限を持ちます。

Red Hat Virtualization Manager では、デフォルトの仮想ディスクユーザーロールが 2 つ提供されますが、デフォルトの仮想ディスク管理者ロールはありません。ユーザーロールの 1 つである DiskCreator ロールは、VM ポータルから仮想ディスクの管理を可能にします。このロールは、特定の仮想マシン、データセンター、特定のストレージドメイン、または仮想化環境全体に適用することができます。これは、異なるユーザーが異なる仮想リソースを管理できるようにするのに役立ちます。

仮想ディスク作成者ロールは、以下のアクションを許可します。

- 仮想マシンまたは他のリソースに関連付けられた仮想ディスクの作成、編集、および削除。

- 仮想ディスクのユーザーパーミッションを編集します。

ロールやパーミッションは、既存のユーザーにのみ割り当てることができます。

1.2.20. 仮想ディスクユーザーロールの概要

仮想ディスクユーザーパーミッションロール

以下の表は、VM ポータルでの仮想ディスクの使用および管理に適用されるユーザーロールおよび権限について説明しています。

表1.11 Red Hat Virtualization システム管理者ロール

| ロール | 権限 | 注記 |

|---|---|---|

| DiskOperator | 仮想ディスクユーザー。 | 仮想ディスクの使用、表示、編集が可能です。仮想ディスクが接続されている仮想マシンを使用するパーミッションを継承します。 |

| DiskCreator | 割り当てられたクラスターまたはデータセンター内の仮想ディスクを作成、編集、管理、および削除できる。 | このロールは特定の仮想ディスクには適用されません。Configure ウィンドウで環境全体のユーザーにこのロールを適用します。また、特定のデータセンター、クラスター、またはストレージドメインにこのロールを適用することもできます。 |

1.2.21. レガシー SPICE 暗号の設定

SPICE コンソールでは、デフォルトで FIPS 準拠の暗号化を行い、暗号文字列を使用します。デフォルトの SPICE 暗号文字列は kECDHE+FIPS:kDHE+FIPS:kRSA+FIPS:!eNULL:!aNULL です。

通常、この文字列で十分です。ただし、古いオペレーティングシステムまたは SPICE クライアントの仮想マシンがあり、そのうちのいずれかが FIPS 準拠の暗号化に対応していない場合は、弱い暗号文字列を使用する必要があります。そうしないと、新規クラスターまたは新規ホストを既存のクラスターにインストールし、その仮想マシンへの接続を試みると、接続のセキュリティーエラーが発生します。

Ansible Playbook を使用して暗号文字列を変更できます。

暗号文字列の変更

Manager マシンで、

/usr/share/ovirt-engine/playbooksディレクトリーにファイルを作成します。以下に例を示します。# vim /usr/share/ovirt-engine/playbooks/change-spice-cipher.yml

ファイルに以下を入力し、保存します。

name: oVirt - setup weaker SPICE encryption for old clients hosts: hostname vars: host_deploy_spice_cipher_string: 'DEFAULT:-RC4:-3DES:-DES' roles: - ovirt-host-deploy-spice-encryption作成したファイルを実行します。

# ansible-playbook -l hostname /usr/share/ovirt-engine/playbooks/change-spice-cipher.yml

または、以下のように変数 host_deploy_spice_cipher_string に --extra-vars オプションを指定して、Ansible Playbook ovirt-host-deploy でホストを再設定できます。

# ansible-playbook -l hostname \

--extra-vars host_deploy_spice_cipher_string=”DEFAULT:-RC4:-3DES:-DES” \

/usr/share/ovirt-engine/playbooks/ovirt-host-deploy.yml1.3. スケジューリングポリシー

スケジューリングポリシーは、スケジューリングポリシーが適用されるクラスター内のホスト間で仮想マシンが分散されるロジックを定義するルールのセットです。スケジューリングポリシーは、フィルター、重み付け、および負荷分散ポリシーの組み合わせにより、このロジックを決定します。フィルターモジュールはハード強制を適用し、そのフィルターで指定された条件を満たさないホストを除外します。加重モジュールはソフト強制を適用し、仮想マシンが実行できるクラスター内のホストを決定する際に考慮される要因の相対優先度を制御するために使用されます。

Red Hat Virtualization Manager には 5 つのデフォルトスケジューリングポリシー Evenly_Distributed、Cluster_Maintenance、None、Power_Saving、および VM_Evenly_Distributed があります。また、新しいスケジューリングポリシーを定義することで、仮想マシンの配布をきめ細かく制御することができます。スケジューリングポリシーに関わらず、CPU が過負荷状態のホストでは仮想マシンが起動しません。デフォルトでは、ホストの CPU が 5 分間 80% 以上の負荷がかかった場合に過負荷と判断されますが、この値はスケジューリングポリシーを使って変更できます。各スケジューリングポリシーのプロパティーに関する詳細は、「スケジューリングポリシー設定に関する説明」 を参照してください。

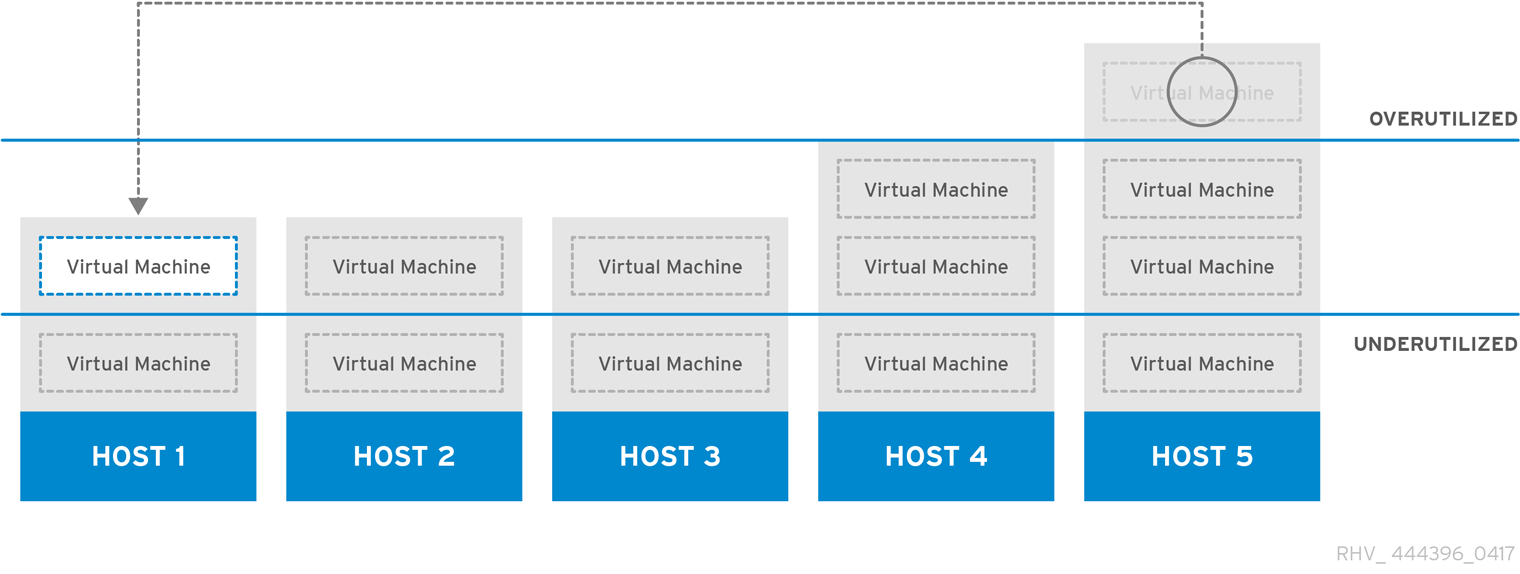

図1.4 Evenly Distributed スケジューリングポリシー

Evenly_Distributed スケジューリングポリシーは、クラスター内のすべてのノードでメモリーおよび CPU 処理の負荷を均等に分散します。ホストが定義された CpuOverCommitDurationMinutes、HighUtilization、または MaxFreeMemoryForOverUtilized に達した場合、ホストにアタッチされた追加の仮想マシンは起動しません。

VM_Evenly_Distributed スケジューリングポリシー仮想マシンは、仮想マシンの数に基づいてホスト間で均等に分散されます。HighVmCount よりも多くの仮想マシンを実行しているホストがあり、仮想マシン数が MigrationThreshold の範囲外であるホストが少なくとも 1 つ存在する場合、クラスターはアンバランスであると判断されます。

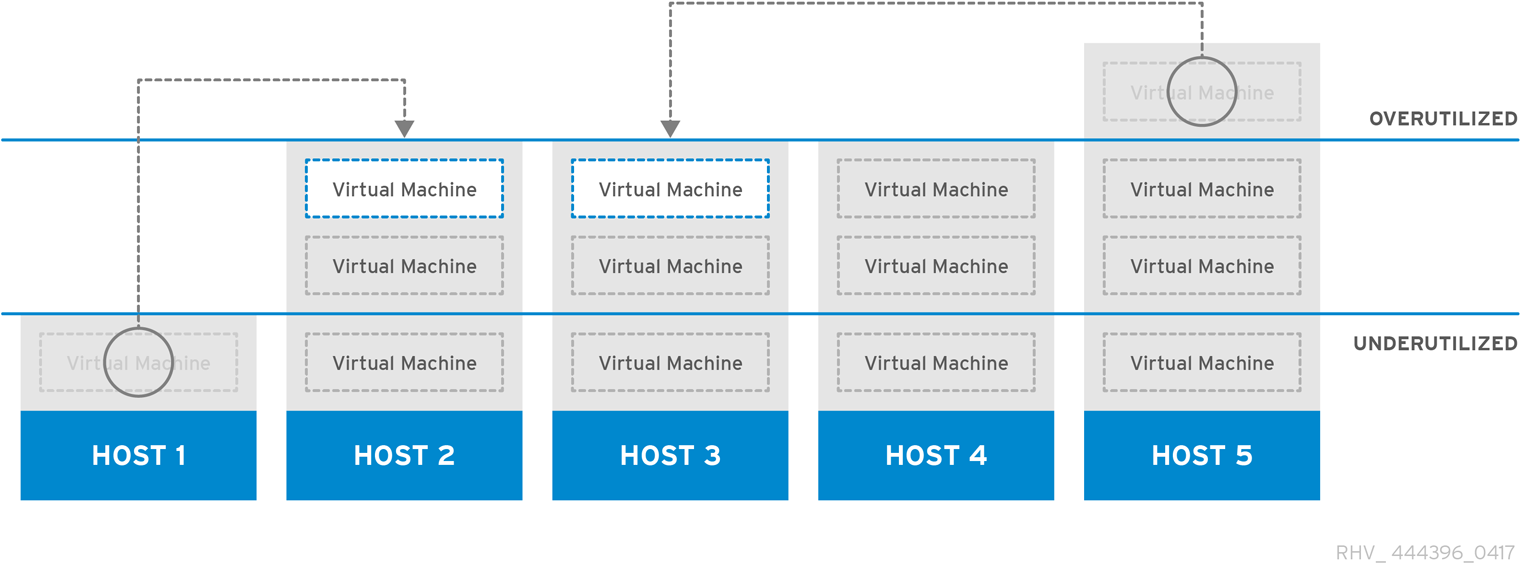

図1.5 Power Saving スケジューリングポリシー

Power_Saving スケジューリングポリシーは、利用可能なホストのサブセットにメモリーおよび CPU 処理の負荷を分散し、使用率の低いホストの消費電力を減らします。CPU 負荷が低稼働率の値を下回っている状態が定義された時間以上続いたホストは、すべての仮想マシンを他のホストに移行させ、電源を切れるようにします。ホストにアタッチされた追加の仮想マシンは、そのホストが定義された高使用率値に達した場合には起動しません。

仮想マシンの実行でホスト間で負荷やパワーを共有しないように、None ポリシーを設定します。これはデフォルトのモードです。仮想マシンが起動すると、メモリーと CPU 処理の負荷がクラスター内の全ホストに均等に分散されます。ホストが定義された CpuOverCommitDurationMinutes、HighUtilization、または MaxFreeMemoryForOverUtilized に達した場合、ホストにアタッチされた追加の仮想マシンは起動しません。

Cluster_Maintenance スケジューリングポリシーは、メンテナンスタスク時にクラスター内のアクティビティーを制限します。Cluster_Maintenance ポリシーが設定されている場合、高可用性仮想マシンを除き、新しい仮想マシンを起動できません。ホストの障害が発生した場合、高可用性仮想マシンが正しく再起動し、どの仮想マシンも移行できます。

1.3.1. スケジューリングポリシーの作成

新規のスケジューリングポリシーを作成して、仮想マシンを Red Hat Virtualization 環境の特定のクラスターに分散するロジックを制御できます。

スケジューリングポリシーの作成

- Administration → Configure をクリックします。

- Scheduling Policies タブをクリックします。

- New をクリックします。

- スケジュールポリシーの Name と Description を入力します。

フィルターモジュールを設定します。

- Filter Modules セクションで、Disabled Filters セクションから Enabled Filters セクションに、優先するフィルターモジュールをドラッグアンドドロップしてスケジューリングポリシーに適用します。

- また、特定のフィルターモジュールを First として設定して優先度を最も高くしたり、Last として設定して優先度を最も低くすることもできます。優先度を設定するには、フィルターモジュールを右クリックし、Position にカーソルを合わせ、First または Last を選択します。

加重モジュールを設定します。

- Weights Modules セクションで、Disabled Weights セクションから Enabled Weights セクションに、優先する加重モジュールをドラッグアンドドロップしてスケジューリングポリシーに適用します。

- 有効な加重モジュールの左側にある + および - ボタンを使用して、これらのモジュールの重みを増減します。

ロードバランシングポリシーを指定します。

- Load Balancer セクションのドロップダウンメニューから、スケジューリングポリシーに適用する負荷分散ポリシーを選択します。

- Properties セクションのドロップダウンメニューから、スケジューリングポリシーに適用する負荷分散プロパティーを選択し、そのプロパティーの右側にある text フィールドを使用して値を指定します。

- + ボタンおよび - ボタンを使用して、プロパティーを追加または削除します。

- OK をクリックします。

1.3.2. New Scheduling Policy および Edit Scheduling Policy ウィンドウの設定の説明

以下の表は、New Scheduling Policy および Edit Scheduling Policy ウィンドウで利用可能なオプションの詳細を示しています。

表1.12 New Scheduling Policy および Edit Scheduling Policy の設定

| フィールド名 | 説明 |

|---|---|

| Name | スケジューリングポリシーの名前。これは、Red Hat Virtualization Manager のスケジューリングポリシーを参照するために使用される名前です。 |

| 説明 | スケジューリングポリシーの説明。このフィールドは推奨されますが、必須ではありません。 |

| Filter Modules | クラスター内の仮想マシンが実行できるホストを制御するフィルターセット。フィルターを有効にすると、以下のように、フィルターで指定された条件を満たさないホストが除外されます。

|

| Weights Modules | 仮想マシンを実行できるクラスター内のホストを決定する際に考慮される要因の相対優先度を制御する重みのセット。

|

| ロードバランサー | このドロップダウンメニューでは、適用する負荷分散モジュールを選択できます。負荷分散モジュールは、使用率が高いホストから、使用率が低いホストに仮想マシンを移行するために使用されるロジックを決定します。 |

| プロパティー | このドロップダウンメニューでは、負荷分散モジュールのプロパティーを追加または削除でき、スケジューリングポリシーに負荷分散モジュールを選択している場合にのみ利用できます。デフォルトではプロパティーは定義されておらず、利用可能なプロパティーは、選択された負荷分散モジュールに固有です。+ および - ボタンを使用して、負荷分散モジュールにプロパティーを追加または削除します。 |

1.4. インスタンスタイプ

インスタンスタイプを使用して、仮想マシンのハードウェア設定を定義できます。仮想マシンの作成時または編集時にインスタンスタイプを選択すると、ハードウェア設定フィールドが自動的に入力されます。これにより、すべてのフィールドを手動で入力しなくても、同じハードウェア設定で複数の仮想マシンを作成できます。

以下の表で説明されているように、事前定義されたインスタンスタイプのセットはデフォルトで利用できます。

表1.13 事前定義されたインスタンスタイプ

| Name | メモリー | vCPU |

|---|---|---|

| Tiny | 512 MB | 1 |

| Small | 2 GB | 1 |

| 中 | 4 GB | 2 |

| Large | 8 GB | 2 |

| XLarge | 16 GB | 4 |

管理者は Configure ウィンドウの Instance Types タブから、インスタンスタイプを作成、編集、および削除できます。

インスタンスタイプにバインドされる New Virtual Machine および Edit Virtual Machine ウィンドウのフィールドの横にチェーンリンクイメージ (

) があります。これらのフィールドの値の 1 つが変更されると、仮想マシンはインスタンスタイプから切り離され、Custom に変更され、チェーンが切れたよう見えます (

) があります。これらのフィールドの値の 1 つが変更されると、仮想マシンはインスタンスタイプから切り離され、Custom に変更され、チェーンが切れたよう見えます (

)。しかし、値が元に戻されると、チェーンは再度リンクし、インスタンスタイプは選択されたものに戻ります。

)。しかし、値が元に戻されると、チェーンは再度リンクし、インスタンスタイプは選択されたものに戻ります。

1.4.1. インスタンスタイプの作成

管理者は、仮想マシンの作成時または編集時にユーザーが選択する新しいインスタンスタイプを作成できます。

インスタンスタイプの作成

- Administration → Configure をクリックします。

- Instance Types タブをクリックします。

- New をクリックします。

- インスタンスタイプの Name および Description を入力します。

- Show Advanced Options をクリックし、必要に応じてインスタンスタイプを設定します。New Instance Type ウィンドウに表示される設定は、New Virtual Machine ウィンドウの設定と同じですが、関連するフィールドのみが表示されます。Virtual Machine Management Guideの Explanation of Settings in the New Virtual Machine and Edit Virtual Machine Windows を参照してください。

- OK をクリックします。

新規インスタンスタイプは Configure ウィンドウの Instance Types タブに表示され、仮想マシンの作成時または編集時に Instance Type ドロップダウンリストから選択できます。

1.4.2. インスタンスタイプの編集

管理者は、Congifure ウインドウから既存のインスタンスタイプを編集できます。

インスタンスタイププロパティーの編集

- Administration → Configure をクリックします。

- Instance Types タブをクリックします。

- 編集するインスタンスタイプを選択します。

- Edit をクリックします。

- 必要に応じて設定を変更します。

- OK をクリックします。

インスタンスタイプの設定が更新されます。このインスタンスタイプに基づく新しい仮想マシンが作成されるか、このインスタンスタイプに基づく既存の仮想マシンが更新されると、新しい設定が適用されます。

このインスタンスタイプに基づく既存の仮想マシンには、更新されるチェーンアイコンが付いたフィールドが表示されます。インスタンスタイプの変更時に既存の仮想マシンが稼働していた場合は、その横にオレンジ色の Pending Changes アイコンが表示され、次回の再起動時にチェーンのアイコンが付いたフィールドが更新されます。

1.4.3. インスタンスタイプの削除

インスタンスタイプの削除

- Administration → Configure をクリックします。

- Instance Types タブをクリックします。

- 削除するインスタンスタイプを選択します。

- Remove をクリックします。

- 削除するインスタンスタイプに基づいた仮想マシンがある場合は、アタッチされた仮想マシンをリストする警告ウィンドウが表示されます。インスタンスタイプの削除を続行するには、Approve Operation チェックボックスを選択します。それ以外の場合は、Cancel をクリックします。

- OK をクリックします。

インスタンスタイプが Instance Types リストから削除され、新規仮想マシンの作成時に使用できなくなります。削除されたインスタンスタイプにアタッチされた仮想マシンは Custom (インスタンスタイプなし) にアタッチされるようになります。

1.5. MAC アドレスプール

MAC アドレスプールは、各クラスターに割り当てられる MAC アドレスの範囲を定義します。各クラスターに MAC アドレスプールが指定されます。MAC アドレスプールを使用すると、Red Hat Virtualization は MAC アドレスを自動的に新しい仮想ネットワークデバイスに生成して割り当てることができます。これは、MAC アドレスの重複を防ぐのに役立ちます。MAC アドレスプールは、クラスターに関連するすべての MAC アドレスが、割り当てられた MAC アドレスプールの範囲内にあると、メモリー効率が高くなります。

同じ MAC アドレスプールを複数のクラスターで共有できますが、各クラスターには MAC アドレスプールが 1 つ割り当てられます。デフォルトの MAC アドレスプールは Red Hat Virtualization によって作成され、別の MAC アドレスプールが割り当てられない場合に使用されます。MAC アドレスプールをクラスターに割り当てる方法は、「新規クラスターの作成」 を参照してください。

複数の Red Hat Virtualization クラスターがネットワークを共有する場合は、デフォルトの MAC アドレスプールのみに依存しないでください。これは、各クラスターの仮想マシンが同じ範囲の MAC アドレスを使用しようとするため、競合が発生するためです。MAC アドレスの競合を回避するには、MAC アドレスプールの範囲をチェックして、各クラスターに一意の MAC アドレス範囲が割り当てられていることを確認します。

MAC アドレスプールでは、最後にプールに戻されたアドレスの次に利用可能な MAC アドレスが割り当てられます。範囲内に残されたアドレスがない場合には、範囲の先頭から検索を再開します。1 つの MAC アドレスプールに、利用可能な MAC アドレスがある複数の MAC アドレスの範囲が定義されている場合、利用可能な MAC アドレスが選択されるのと同じように、範囲が順番に受信リクエストに対応します。

1.5.1. MAC アドレスプールの作成

新しい MAC アドレスプールを作成できます。

MAC アドレスプールの作成

- Administration → Configure をクリックします。

- MAC Address Pool タブをクリックします。

- Add をクリックします。

- 新しい MAC アドレスプールの Name および Description を入力します。

Allow Duplicates チェックボックスを選択し、MAC アドレスをプールで複数回使用できるようにします。MAC アドレスプールでは、重複した MAC アドレスを自動的に使用することはありませんが、duplicates オプションを有効にすると、ユーザーが重複した MAC アドレスを手動で使用できます。

注記ある MAC アドレスプールで重複を無効にし、別の MAC アドレスプールで重複を有効にした場合、重複を無効にしたプールでは各 MAC アドレスは 1 回しか使用できませんが、重複を有効にしたプールでは複数回使用できます。

- 必要な MAC Address Ranges を入力します。複数の範囲を入力するには、From フィールドおよび To フィールドの横にあるプラスボタンをクリックします。

- OK をクリックします。

1.5.2. MAC アドレスプールの編集

MAC アドレスプールを編集して、プールで利用可能な MAC アドレスの範囲や重複が許可されるかどうかなどの詳細を変更できます。

MAC アドレスプールプロパティーの編集

- Administration → Configure をクリックします。

- MAC Address Pool タブをクリックします。

- 編集する MAC アドレスプールを選択します。

- Edit をクリックします。

必要に応じて Name、Description、Allow Duplicates、および MAC Address Ranges フィールドを変更します。

注記MAC アドレス範囲を更新すると、既存の NIC の MAC アドレスは再割り当てされません。すでに割り当てられている MAC アドレスで、新しい MAC アドレスの範囲外のものは、ユーザー指定の MAC アドレスとして追加され、その MAC アドレスプールで追跡されます。

- OK をクリックします。

1.5.3. MAC アドレスプールのパーミッションの編集

MAC アドレスプールの作成後に、そのユーザー権限を編集できます。ユーザーパーミッションにより、どのデータセンターが MAC アドレスプールを使用できるかが制御されます。新規ユーザーパーミッションの追加に関する詳細は、「ロール」 を参照してください。

MAC アドレスプールのパーミッションの編集

- Administration → Configure をクリックします。

- MAC Address Pool タブをクリックします。

- 必要な MAC アドレスプールを選択します。

MAC アドレスプールのユーザーパーミッションを編集します。

ユーザーパーミッションを MAC アドレスプールに追加するには、以下を実行します。

- Configure ウィンドウの下にあるユーザー権限ペインで Add をクリックします。

- 必要なユーザーを検索して選択します。

- Role to Assign ドロップダウンリストから必要なロールを選択します。

- OK をクリックしてユーザーパーミッションを追加します。

ユーザーパーミッションを MAC アドレスプールから削除するには、以下を実行します。

- Configure ウィンドウの下にあるユーザー権限ペインで、削除するユーザー権限を選択します。

- ユーザーの権限を削除するには、Remove をクリックします。

1.5.4. MAC アドレスプールの削除

作成した MAC アドレスプールがクラスターに関連付けられていない場合は削除できますが、デフォルトの MAC アドレスプールは削除できません。

MAC アドレスプールの削除

- Administration → Configure をクリックします。

- MAC Address Pool タブをクリックします。

- 削除する MAC アドレスプールを選択します。

- Remove をクリックします。

- OK をクリックします。

第2章 ダッシュボード

ダッシュボードは、Red Hat Virtualization のリソースと使用率の概要を表示することで、Red Hat Virtualization のシステム状態の概要を提供します。この概要により、問題を警告することができ、問題領域を分析できます。

ダッシュボードの情報は、Data Warehouse からはデフォルトで 15 分ごと、Manager API からはデフォルトで 15 秒 ごと、またはダッシュボードが更新されるたびに更新されます。ダッシュボードは、ユーザーが他のページから戻ったときや、手動でリフレッシュしたときに更新されます。ダッシュボードは自動的に更新されません。インベントリーカードの情報は Manager API から提供され、利用状況の情報は Data Warehouse から提供されます。ダッシュボードは、UI プラグインコンポーネントとして実装されており、Manager と一緒に自動的にインストールおよびアップグレードされます。

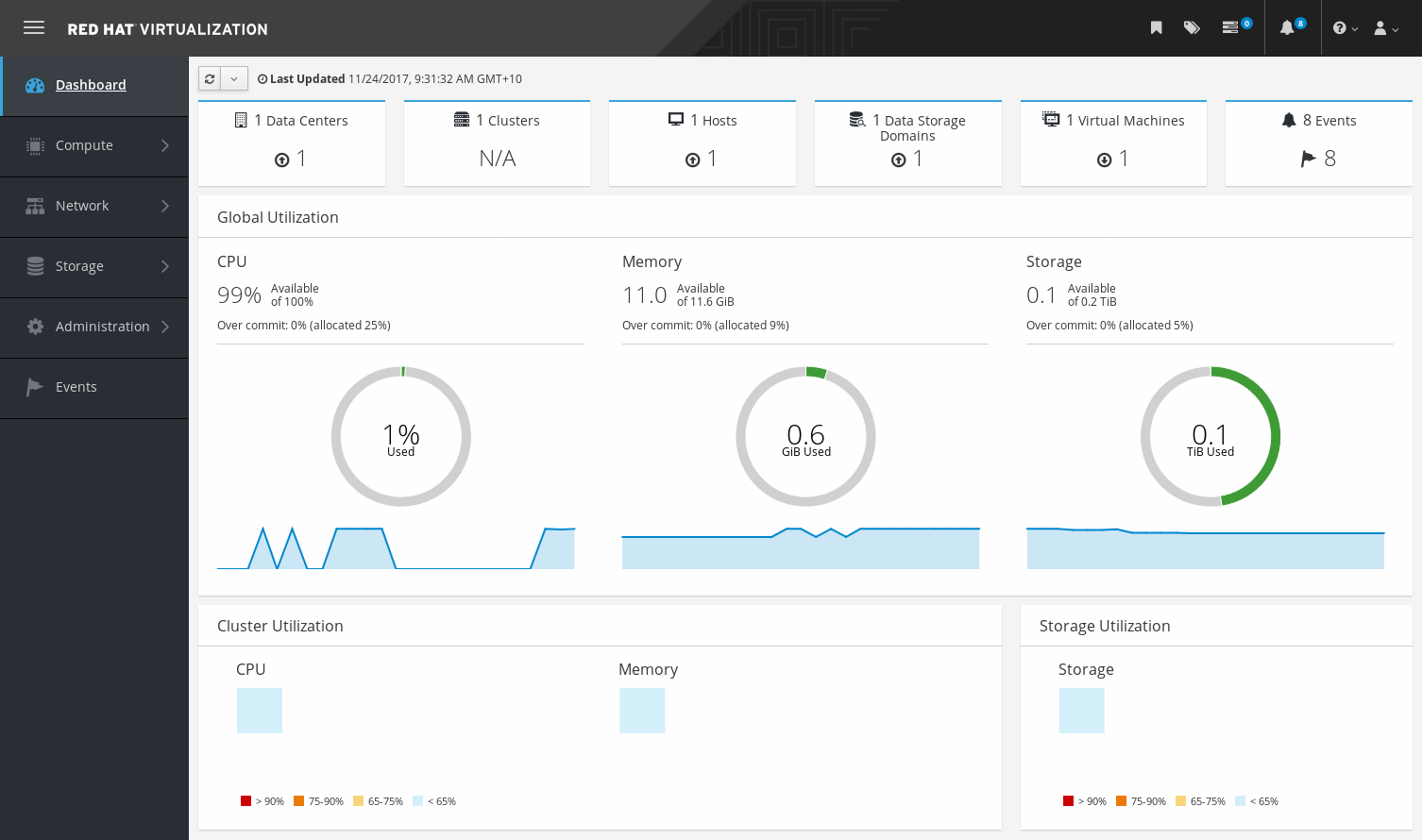

図2.1 ダッシュボード

2.1. 前提条件

ダッシュボードを使用するには、Data Warehouse がインストールされ、設定されている必要があります。Data Warehouse Guideの Installing and Configuring Data Warehouse を参照してください。

2.2. グローバルインベントリー

ダッシュボードの上部には、Red Hat Virtualization リソースのグローバルインベントリーが表示され、データセンター、クラスター、ホスト、ストレージドメイン、仮想マシン、イベントなどの項目が含まれます。アイコンは各リソースの状態、数字はその状態にある各リソースの数量を表しています。

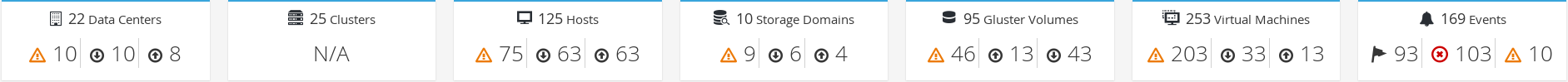

図2.2 グローバルインベントリー

タイトルにはリソースの種類別の数が表示され、その下にはステータスが表示されます。リソースのタイトルをクリックすると、Red Hat Virtualization Manager の関連ページに移動します。Clusters のステータスは常に N/A と表示されます。

表2.1 リソースの状況

| アイコン | 状態 |

|---|---|

|

| Red Hat Virtualization にはそのようなリソースは一切追加されていません。 |

|

| 警告ステータスを持つリソースの番号を表示します。アイコンをクリックすると、該当ページに移動し、検索対象は警告状態のリソースに限定されます。検索の制限は、リソースごとに異なります。

|

|

| up ステータスを持つリソースの番号を表示します。アイコンをクリックすると、該当ページに移動し、検索対象は up 状態のリソースに限定されます。 |

|

| down 状態のリソースの番号を表示します。アイコンをクリックすると、該当ページに移動し、検索対象は down 状態のリソースに限定されます。検索の制限は、リソースごとに異なります。

|

|

| アラートステータスを持つイベントの数を表示します。アイコンをクリックすると Events に移動しますが、検索対象は深刻度が警告のイベントに限定されます。 |

|

| エラーステータスを持つイベントの数を表示します。アイコンをクリックすると Events に移動しますが、検索対象は深刻度がエラーのイベントに限定されます。 |

2.3. グローバルでの活用

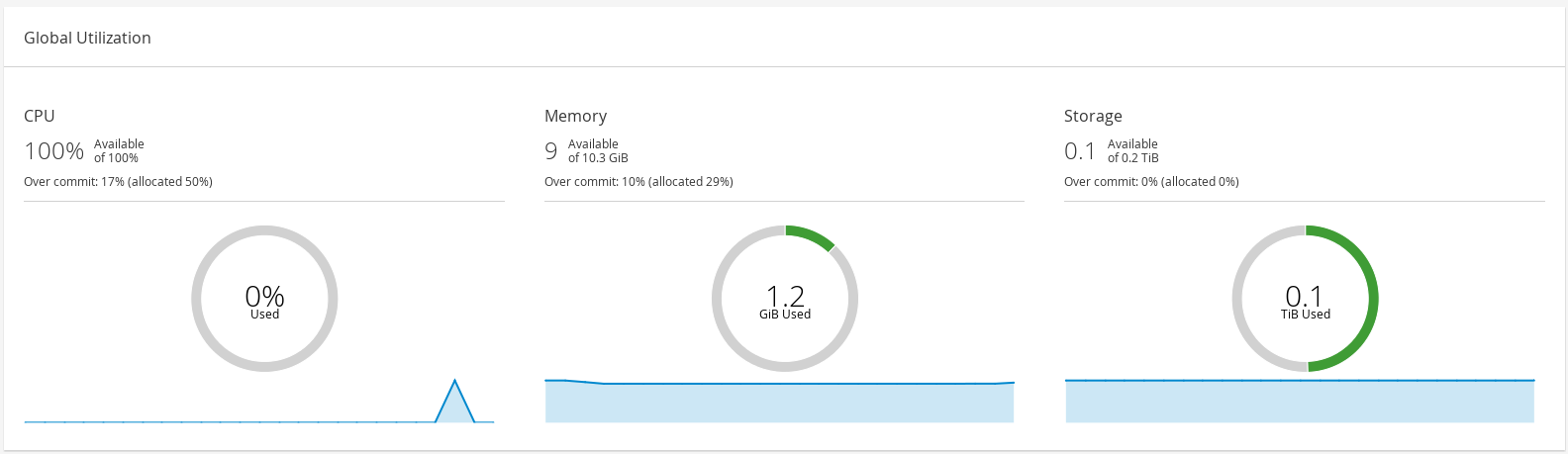

Global Utilization セクションでは、CPU、Memory、Storage のシステム使用状態が表示されます。

図2.3 グローバルでの活用

- 上段には、利用可能な CPU、メモリー、ストレージ、およびオーバーコミット率の割合が表示されます。たとえば、CPU のオーバーコミット率は、Data Warehouse の最新データに基づいて、仮想コアの数を実行中の仮想マシンで利用可能な物理コアの数で割って算出します。

- ドーナツは、CPU、メモリー、またはストレージの使用率をパーセンテージで表示し、過去 5 分間の平均使用率に基づいて、すべてのホストの平均使用率を表示します。ドーナツの断面にカーソルを合わせると、選択したセクションの値が表示されます。

- 下部の折れ線グラフは、過去 24 時間の傾向を表示しています。各データポイントは、特定の時間の平均使用量を示しています。グラフ上のポイントにカーソルを合わせると、CPU のグラフでは時間と使用率が、メモリーとストレージのグラフでは使用量が表示されます。

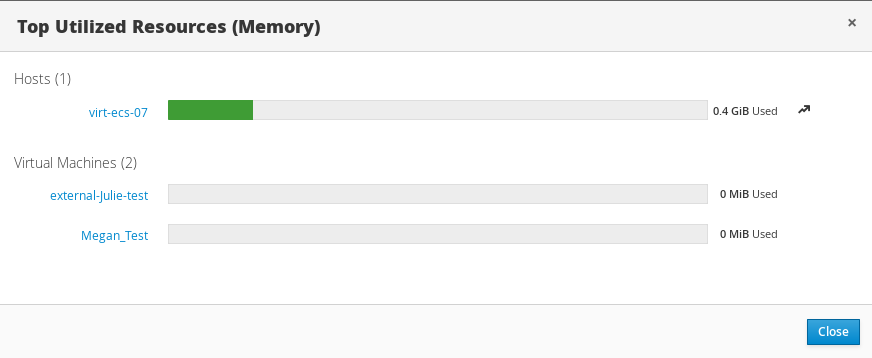

2.3.1. 最も使用されているリソース

図2.4 最も使用されているリソース (メモリー)

ダッシュボードのグローバル使用率の項目にあるドーナツをクリックすると、CPU、メモリー、ストレージのうち、使用率の高いリソースのリストが表示されます。CPU とメモリーについては、最も使用率の高い 10 台のホストと仮想マシンのリストがポップアップで表示されます。ストレージについては、利用されているストレージドメインと仮想マシンのトップ 10 のリストがポップアップで表示されます。使用量バーの右にある矢印は、そのリソースの直近 1 分間の使用量の傾向を示しています。

2.4. クラスターの活用

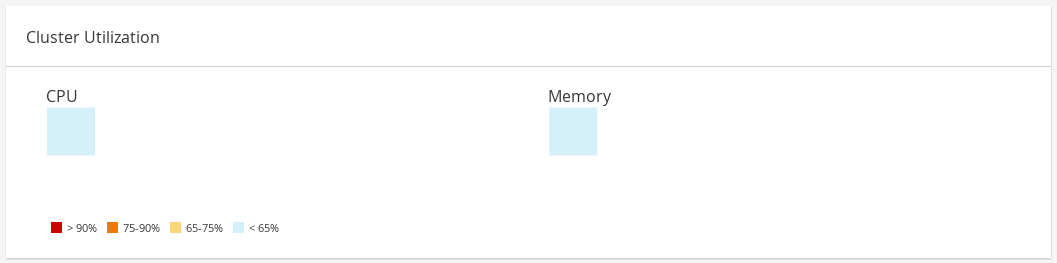

Cluster Utilization セクションは、CPU とメモリーのクラスター使用率をヒートマップで表示します。

図2.5 クラスターの活用

2.4.1. CPU

過去 24 時間の CPU の平均使用率を示す特定クラスターの CPU 使用率のヒートマップ。ヒートマップにカーソルを合わせると、クラスター名が表示されます。ヒートマップをクリックすると、Compute → Hosts に移動し、特定のクラスターの検索を CPU 使用率でソートした結果が表示されます。クラスターによる CPU の使用率を計算するために使用される式は、クラスターのホスト CPU 使用率の平均です。これは、クラスターによる CPU の合計平均使用率を出すために、過去 24 時間の各ホストの CPU 使用率の平均値を用いて算出されます。

2.4.2. メモリー

過去 24 時間のメモリーの平均使用率を示す特定クラスターのメモリー使用率のヒートマップ。ヒートマップにカーソルを合わせると、クラスター名が表示されます。ヒートマップをクリックすると、Compute → Hosts に移動し、特定のクラスターの検索をメモリー使用率でソートした結果が表示されます。クラスターによるメモリー使用率を計算するために使用される式は、クラスターのメモリー使用率の合計 (GB 単位) です。これは、クラスターによるメモリー合計平均使用率を出すために、過去 24 時間の各ホストの平均メモリー使用率を用いて算出されます。

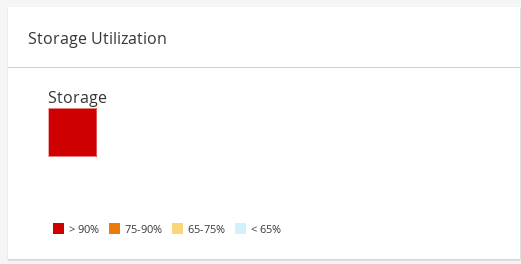

2.5. ストレージの活用

Storage Utilization セクションは、ヒートマップでストレージ使用率を表示します。

図2.6 ストレージの活用

ヒートマップは、過去 24 時間のストレージの平均利用率を表します。クラスターによるストレージ使用率を計算するために使用される式は、クラスターのストレージ使用率の合計です。これは、クラスターによる ストレージ の合計平均使用率を出すために、過去 24 時間の各ホストの平均ストレージ使用率を用いて算出されます。ヒートマップにカーソルを合わせると、ストレージドメイン名が表示されます。ヒートマップをクリックすると Storage → Domains に移動し、ストレージドメインが使用率でソートされます。

第3章 検索

3.1. Red Hat Virtualization での検索

管理ポータルでは、仮想マシン、ホスト、ユーザーなど、何千ものリソースを管理することができます。検索を行うには、各リソースのメインページにある検索バーに、検索クエリー (フリーテキストまたは構文ベース) を入力します。検索条件をブックマークとして保存しておけば、検索結果を必要とするたびに検索条件を再入力する必要はありません。検索では大文字小文字の区別はありません。

3.2. 検索構文と例

Red Hat Virtualization リソースの検索クエリーの構文は以下のとおりです。

result type: {criteria} [sortby sort_spec]

構文の例

以下の例は、検索クエリーの使用方法と、Red Hat Virtualization が検索クエリーの構築を支援する方法を理解するのに役立ちます。

表3.1 検索クエリーの例

| 例 | 結果 |

|---|---|

| Hosts: Vms.status = up page 2 | 稼働中の仮想マシンを実行しているすべてのホストのリストの 2 ページ目を表示します。 |

| Vms: domain = qa.company.com | 指定されたドメインで稼働しているすべての仮想マシンの一覧を表示します。 |

| Vms: users.name = Mary | ユーザー名が Mary のユーザーに属する全仮想マシンの一覧を表示します。 |

| Events: severity > normal sortby time | 重大度が Normal よりも高いすべての Events の一覧を表示します。 |

3.3. 自動完了の検索

管理ポータルは、有効で強力な検索クエリーの作成に役立つ自動補完を提供します。検索クエリーの各部分を入力すると、検索の次の部分を選択するドロップダウンリストが、Search Bar の下に開きます。一覧から選択して、検索の次の部分の入力/選択を続けたり、オプションを無視したりして、手動でクエリーを入力を続けたりできます。

以下の表は、管理ポータルの自動補完がクエリーの構築を助けるする方法の例を示しています。

Hosts: Vms.status = down

表3.2 自動補完を使用した検索クエリーの例

| 入力 | 表示されているリスト項目 | アクション |

|---|---|---|

| h |

|

|

| Hosts: | すべてのホストプロパティー | v を入力 |

| Hosts: v |

|

|

| Hosts: Vms | すべての仮想マシンプロパティー | s を入力 |

| Hosts: Vms.s |

|

|

| Hosts: Vms.status |

| = を選択または入力 |

| Hosts: Vms.status = | すべてのステータス値 | down を選択または入力 |

3.4. 検索結果タイプオプション

結果のタイプを使用すると、以下のタイプのリソースを検索できます。

- Vms、仮想マシンのリスト。

- Host、ホストのリスト。

- Pools、プールのリスト。

- Template、テンプレートのリスト。

- Events、イベントのリスト。

- Users、ユーザーのリスト。

- Cluster、クラスターのリスト。

- DataCenter、データセンターのリスト。

- Storage、ストレージドメインのリスト。

各タイプのリソースには、一意のプロパティーセットと、関連付けられたその他のリソースタイプのセットがあるため、各検索タイプには、有効な構文の組み合わせがあります。自動補完機能を使用して、有効なクエリーも簡単に作成できます。

3.5. 検索基準

クエリーのコロンの後に検索条件を指定できます。{criteria} の構文は以下のようになります。

<prop><operator><value>

または

<obj-type><prop><operator><value>

例

以下の表は、構文の部分を示しています。

表3.3 検索基準の例

| 部分 | 説明 | 値 | 例 | 注記 |

|---|---|---|---|---|

| prop |

検索対象リソースのプロパティー。リソースタイプのプロパティー ( | 検索対象を特定のプロパティーを持つオブジェクトに制限します。たとえば、status プロパティーでオブジェクトを検索します。 | 状態 | 該当なし |

| obj-type | 検索対象のリソースに関連付けることができるリソースタイプ。 | これは、データセンターや仮想マシンなどのシステムオブジェクトです。 | Users | 該当なし |

| operator | 比較演算子。 | = != (等しくない) > < >= <= | 該当なし | 値オプションはプロパティーによって異なります。 |

| 値 | その式が何と比較されるか。 | String Integer ランキング 日付 (Regional Settings に応じた書式設定) | Jones 256 normal |

|

3.6. 検索: 複数の基準およびワイルドカード

ワイルドカードは文字列の構文の <value> 部分で使用できます。たとえば、m で始まる全ユーザーを検索するには、m* を入力します。

ブール演算子の AND および OR を使用して、2 つの基準を持つ検索を実行できます。以下に例を示します。

Vms: users.name = m* AND status = Up

このクエリーは、名前が m で始まるユーザーに対して実行中の仮想マシンをすべて返します。

Vms: users.name = m* AND tag = "paris-loc"

このクエリーは、名前が m で始まるユーザーに対して paris-loc でタグ付けされたすべての仮想マシンを返します。

AND または OR を使用せずに 2 つの基準を指定した場合、AND が暗黙的に指定されます。AND は OR よりも優先され、OR は暗黙の AND よりも優先されます。

3.7. 検索: 検索順序の決定

返される情報の並び替え順序は、sortby を使用して決定できます。並べ替え方向 (昇順は asc、降順は desc) を含めることができます。

以下に例を示します。

events: severity > normal sortby time desc

このクエリーは、重大度が Normal よりも大きいすべての Events を時刻でソートして返します (降順)。

3.8. データセンターの検索

以下の表は、データセンターのすべての検索オプションを示しています。

表3.4 データセンターの検索

| プロパティー (リソースまたはリソースタイプの) | タイプ | 説明 (参照) |

|---|---|---|

|

| プロパティータイプによります。 | データセンターに関連付けられたクラスターのプロパティー。 |

|

| String | データセンターの名前。 |

|

| String | データセンターの説明 |

|

| String | データセンターのタイプ。 |

|

| リスト | データセンターの可用性 |

|

| リスト | 返された結果をリソースプロパティーの 1 つで並べ替えます。 |

|

| Integer | 表示する結果のページ番号。 |

例

datacenter: type = nfs and status != up

この例では、ストレージタイプが NFS で up 以外状態のデータセンターの一覧を返します。

3.9. クラスターの検索

以下の表は、クラスターのすべての検索オプションについて説明しています。

表3.5 クラスターの検索

| プロパティー (リソースまたはリソースタイプの) | タイプ | 説明 (参照) |

|---|---|---|

|

| プロパティータイプによります。 | クラスターに関連付けられたデータセンターのプロパティー。 |

|

| String | クラスターが属するデータセンター。 |

|

| String | ネットワーク上のクラスターを識別する一意の名前。 |

|

| String | クラスターの説明。 |

|

| String | クラスターのステータスを示す true または False。 |

|

| リスト | 返された結果をリソースプロパティーの 1 つで並べ替えます。 |

|

| Integer | 表示する結果のページ番号。 |

例

Clusters: initialized = true or name = Default

この例では、初期化されたクラスターまたは Default という名前のクラスターの一覧を返します。

3.10. ホストの検索

以下の表は、ホストの全検索オプションを示しています。

表3.6 ホストの検索

| プロパティー (リソースまたはリソースタイプの) | タイプ | 説明 (参照) |

|---|---|---|

|

| プロパティータイプによります。 | ホストに関連付けられた仮想マシンのプロパティー。 |

|

| プロパティータイプによります。 | ホストに関連付けられたテンプレートのプロパティー。 |

|

| プロパティータイプによります。 | ホストに関連付けられたイベントのプロパティー。 |

|

| プロパティータイプによります。 | ホストに関連付けられたユーザーのプロパティー。 |

|

| String | ホストの名前。 |

|

| リスト | ホストの可用性。 |

|

| String | 外部システムおよびプラグインによって報告されるホストのヘルスステータス。 |

|

| String | ホストが属するクラスター。 |

|

| String | ネットワーク上のホストを識別する一意の名前。 |

|

| Integer | 使用される処理能力の割合。 |

|

| Integer | 使用されるメモリーの割合。 |

|

| Integer | ネットワーク使用率の割合。 |

|

| Integer | 特定のタイムスライスで、プロセッサーごとに run-queue で実行されるのを待っているジョブ。 |

|

| Integer | オペレーティングシステムのバージョン番号。 |

|

| Integer | ホスト上の CPU 数。 |

|

| Integer | 使用可能なメモリーの量。 |

|

| Integer | CPU の処理速度。 |

|

| String | CPU のタイプ。 |

|

| Integer | 現在実行中の仮想マシンの数。 |

|

| Integer | 現在移行中の仮想マシンの数。 |

|

| Integer | コミットされたメモリーの割合 |

|

| String | ホストに割り当てられたタグ。 |

|

| String | ホストのタイプ。 |

|

| String | ホストが属するデータセンター。 |

|

| リスト | 返された結果をリソースプロパティーの 1 つで並べ替えます。 |

|

| Integer | 表示する結果のページ番号。 |

例

Hosts: cluster = Default and Vms.os = rhel6

この例では、Default クラスターの一部であるホストの一覧と、Red Hat Enterprise Linux 6 オペレーティングシステムを実行するホスト仮想マシンを返します。

3.11. ネットワークの検索

以下の表は、ネットワークの全検索オプションを説明しています。

表3.7 ネットワークの検索

| プロパティー (リソースまたはリソースタイプの) | タイプ | 説明 (参照) |

|---|---|---|

|

| プロパティータイプによります。 | ネットワークに関連付けられたクラスターのプロパティー。 |

|

| プロパティータイプによります。 | ネットワークに関連付けられたホストのプロパティー。 |

|

| String | ネットワークを識別するための人が判読可能な名前。 |

|

| String | ネットワークを記述するキーワードまたはテキスト。オプションでネットワークの作成時に使用されます。 |

|

| Integer | ネットワークの VLAN ID。 |

|

| String | Spanning Tree Protocol (STP) がネットワークで有効または無効になっているかどうか。 |

|

| Integer | 論理ネットワークの最大伝送単位。 |

|

| String | ネットワークが仮想マシントラフィックのみに使用されているかどうか。 |

|

| String | ネットワークが接続されているデータセンター。 |

|

| リスト | 返された結果をリソースプロパティーの 1 つで並べ替えます。 |

|

| Integer | 表示する結果のページ番号。 |

例

Network: mtu > 1500 and vmnetwork = true

この例では、最大転送単位が 1500 バイトを超え、仮想マシンのみが使用するように設定されているネットワークの一覧を返します。

3.12. ストレージの検索

以下の表は、ストレージのすべての検索オプションについて説明しています。

表3.8 ストレージの検索

| プロパティー (リソースまたはリソースタイプの) | タイプ | 説明 (参照) |

|---|---|---|

|

| プロパティータイプによります。 | ストレージに関連付けられたホストのプロパティー。 |

|

| プロパティータイプによります。 | ストレージに関連付けられたクラスターのプロパティー。 |

|

| String | ネットワーク上のストレージを識別する一意の名前。 |

|

| String | ストレージドメインのステータス。 |

|

| String | 外部システムおよびプラグインによって報告されるストレージドメインのヘルスステータス。 |

|

| String | ストレージが属するデータセンター。 |

|

| String | ストレージのタイプ。 |

|

| Integer | ストレージのサイズ。 |

|

| Integer | 使用中のストレージの量。 |

|

| Integer | コミットされるストレージの量。 |

|

| リスト | 返された結果をリソースプロパティーの 1 つで並べ替えます。 |

|

| Integer | 表示する結果のページ番号。 |

例

ストレージサイズ > 200 または 使用済み < 50

以下の例では、合計ストレージ容量が 200 GB 以上のストレージ、または使用済みストレージ容量が 50 GB 未満のストレージ一覧を返します。

3.13. ディスクの検索

以下の表は、ディスクの全検索オプションを示しています。

Disk Type および Content Type フィルターオプションを使用して、表示される仮想ディスクの数を減らすことができます。

表3.9 ディスクの検索

| プロパティー (リソースまたはリソースタイプの) | タイプ | 説明 (参照) |

|---|---|---|

|

| プロパティータイプによります。 | ディスクに関連付けられたデータセンターのプロパティー。 |

|

| プロパティータイプによります。 | ディスクに関連付けられたストレージのプロパティー。 |

|

| String | ネットワーク上のストレージを識別する人が判読可能な名前。 |

|

| String | ディスクを記述するキーワードまたはテキスト。オプションでディスクの作成時に使用されます。 |

|

| Integer | ディスクの仮想サイズ |

|

| Integer | ディスクのサイズ。 |

|

| Integer | ディスクに割り当てられる実際のサイズ。 |

|

| Integer | ディスクが作成された日付。 |

|

| String |

ディスクを起動できるかどうか。有効な値は |

|

| String |

ディスクを一度に複数の仮想マシンにアタッチできるかどうか。有効な値は |

|

| String |

ディスクの形式。 |

|

| String |

ディスクのステータス |

|

| String |

ディスクのタイプ。 |

|

| Integer | ディスクがアタッチされている仮想マシンの数。 |

|

| String | ディスクがアタッチされている仮想マシンの名前。 |

|

| String | 仮想ディスクで強制されるクォータの名前。 |

|

| リスト | 返された結果をリソースプロパティーの 1 つで並べ替えます。 |

|

| Integer | 表示する結果のページ番号。 |

例

Disks: format = cow and provisioned_size > 8

以下の例では、QCOW 形式の仮想ディスクの一覧と、8 GB を超える割り当て済みのディスクサイズを返します。

3.14. ボリュームの検索

以下の表は、ボリュームのすべての検索オプションについて説明しています。

表3.10 ボリュームの検索

| プロパティー (リソースまたはリソースタイプの) | タイプ | 説明 (参照) |

|---|---|---|

|

| String | ボリュームに関連付けられたクラスターの名前。 |

|

| プロパティータイプ (例: name、description、comment、architecture) による | ボリュームに関連付けられたクラスターのプロパティー。 |

|

| String | ボリュームを識別する、人が判読可能な名前。 |

|

| String | distribute、replicate、distributed_replicate、stripe、または distributed_stripe のいずれか。 |

|

| Integer | TCP または RDMA のいずれか。 |

|

| Integer | レプリカの数。 |

|

| Integer | ストライプの数。 |

|

| String | ボリュームのステータスUp または Down のいずれかです。 |

|

| リスト | 返された結果をリソースプロパティーの 1 つで並べ替えます。 |

|

| Integer | 表示する結果のページ番号。 |

例

Volume: transport_type = rdma and stripe_count >= 2

この例では、トランスポートタイプが RDMA に設定され、ストライプが 2 つ以上あるボリュームのリストを返します。

3.15. 仮想マシンの検索

以下の表は、仮想マシンのすべての検索オプションについて説明しています。

現時点で、Network Label、Custom Emulated Machine、および Custom CPU Type プロパティーはサポートされていない検索プロパティーです。

表3.11 仮想マシンの検索

| プロパティー (リソースまたはリソースタイプの) | タイプ | 説明 (参照) |

|---|---|---|

|

| プロパティータイプによります。 | 仮想マシンに関連付けられたホストのプロパティー。 |

|

| プロパティータイプによります。 | 仮想マシンに関連付けられたテンプレートのプロパティー。 |

|

| プロパティータイプによります。 | 仮想マシンに関連付けられたイベントのプロパティー。 |

|

| プロパティータイプによります。 | 仮想マシンに関連付けられたユーザーのプロパティー。 |

|

| プロパティータイプによります。 | 仮想マシンに関連付けられたストレージデバイスのプロパティー。 |

|

| プロパティータイプによります。 | 仮想マシンに関連付けられた VNIC のプロパティー。 |

|

| String | 仮想マシンの名前。 |

|

| リスト | 仮想マシンの可用性 |

|

| Integer | 仮想マシンの IP アドレス。 |

|

| Integer | 仮想マシンが実行されている期間 (分単位)。 |

|

| String | これらのマシンをグループ化するドメイン (通常は Active Directory ドメイン)。 |

|

| String | 仮想マシンの作成時に選択されたオペレーティングシステム。 |

|

| 日付 | 仮想マシンが作成された日付。 |

|

| String | ネットワーク上の仮想マシンを識別する一意の名前。 |

|

| Integer | 使用される処理能力の割合。 |

|

| Integer | 使用されるメモリーの割合。 |

|

| Integer | 使用されるネットワークの割合。 |

|

| Integer | 定義された最大メモリー。 |

|

| String | 仮想マシンに現在インストールされているアプリケーション。 |

|

| リスト | 仮想マシンが属するクラスター。 |

|

| リスト | 仮想マシンが属する仮想マシンプール。 |

|

| String | 仮想マシンに現在ログインしているユーザーの名前。 |

|

| リスト | 仮想マシンが属するタグ。 |

|

| String | 仮想マシンが属するデータセンター。 |

|

| リスト | 仮想マシンタイプ (サーバーまたはデスクトップ)。 |

|

| String | 仮想マシンに関連付けられたクォータの名前。 |

|

| String | 仮想マシンを記述するキーワードまたはテキスト。オプションとして、仮想マシンの作成時に使用されます。 |

|

| リスト | 返された結果をリソースプロパティーの 1 つで並べ替えます。 |

|

| Integer | 表示する結果のページ番号。 |

|

| ブール値 | 仮想マシンに保留中の設定変更があります。 |

例

Vms: template.name = Win* and user.name = ""

この例では、ベーステンプレート名が Win で始まり、任意のユーザーに割り当てられている仮想マシンの一覧を返します。

例

Vms: cluster = Default and os = windows7

この例では、Default クラスターに属し、Windows 7 を実行している仮想マシンの一覧を返します。

3.16. プールの検索

以下の表は、プールの全検索オプションを示しています。

表3.12 プールの検索

| プロパティー (リソースまたはリソースタイプの) | タイプ | 説明 (参照) |

|---|---|---|

|

| String | プールの名前。 |

|

| String | プールの説明。 |

|

| リスト | プールのタイプ。 |

|

| リスト | 返された結果をリソースプロパティーの 1 つで並べ替えます。 |

|

| Integer | 表示する結果のページ番号。 |

例

Pools: type = automatic

この例では、タイプが automatic のプールの一覧を返します。

3.17. テンプレートの検索

以下の表は、テンプレートの全検索オプションを示しています。

表3.13 テンプレートの検索

| プロパティー (リソースまたはリソースタイプの) | タイプ | 説明 (参照) |

|---|---|---|

|

| String | テンプレートに関連付けられた仮想マシンのプロパティー。 |

|

| String | テンプレートに関連付けられたホストのプロパティー。 |

|

| String | テンプレートに関連付けられたイベントのプロパティー。 |

|

| String | テンプレートに関連付けられたユーザーのプロパティー。 |

|

| String | テンプレートの名前。 |

|

| String | テンプレートのドメイン。 |

|

| String | オペレーティングシステムのタイプ。 |

|

| Integer | テンプレートが作成された日付。 日付の形式は mm/dd/yy です。 |

|

| Integer | テンプレートから作成された仮想マシンの数。 |

|

| Integer | 定義されたメモリー。 |

|

| String | テンプレートの説明。 |

|

| String | テンプレートのステータス |

|

| String | テンプレートに関連付けられたクラスター。 |

|

| String | テンプレートに関連付けられたデータセンター。 |

|

| String | テンプレートに関連付けられたクォータ。 |

|

| リスト | 返された結果をリソースプロパティーの 1 つで並べ替えます。 |

|

| Integer | 表示する結果のページ番号。 |

例

Template: Events.severity >= normal and Vms.uptime > 0

この例では、テンプレートから派生した仮想マシンで重大度が Normal 以上のイベントが発生し、仮想マシンがまだ実行されているテンプレートの一覧が返されます。

3.18. ユーザーの検索

以下の表は、ユーザーの全検索オプションについて説明しています。

表3.14 ユーザーの検索

| プロパティー (リソースまたはリソースタイプの) | タイプ | 説明 (参照) |

|---|---|---|

|

| プロパティータイプによります。 | ユーザーに関連付けられた仮想マシンのプロパティー。 |

|

| プロパティータイプによります。 | ユーザーに関連付けられたホストのプロパティー。 |

|

| プロパティータイプによります。 | ユーザーに関連付けられたテンプレートのプロパティー。 |

|

| プロパティータイプによります。 | ユーザーに関連するイベントのプロパティー。 |

|

| String | ユーザーの名前。 |

|

| String | ユーザーの名字を。 |

|

| String | ユーザーの一意の名前。 |

|

| String | ユーザーが属する部。 |

|

| String | ユーザーが属するグループ。 |

|

| String | ユーザーのタイトル。 |

|

| String | ユーザーの状態。 |

|

| String | ユーザーのロール。 |

|

| String | ユーザーが属するタグ。 |

|

| String | ユーザーが属するプール。 |

|

| リスト | 返された結果をリソースプロパティーの 1 つで並べ替えます。 |

|

| Integer | 表示する結果のページ番号。 |

例

Users: Events.severity > normal and Vms.status = up or Vms.status = pause

この例では、仮想マシンで重大度が Normal よりも高いイベントが発生し、かつ仮想マシンがまだ稼働している場合や、ユーザーの仮想マシンが一時停止している場合のユーザーの一覧を返します。

3.19. イベントの検索

以下の表は、イベントの検索に使用できるすべての検索オプションについて説明しています。自動補完は、必要に応じて多くのオプションに対して提供されます。

表3.15 イベントの検索

| プロパティー (リソースまたはリソースタイプの) | タイプ | 説明 (参照) |

|---|---|---|

|

| プロパティータイプによります。 | イベントに関連付けられた仮想マシンのプロパティー。 |

|

| プロパティータイプによります。 | イベントに関連付けられたホストのプロパティー。 |

|

| プロパティータイプによります。 | イベントに関連付けられたテンプレートのプロパティー。 |

|

| プロパティータイプによります。 | イベントに関連付けられたユーザーのプロパティー。 |

|

| プロパティータイプによります。 | イベントに関連付けられたクラスターのプロパティー。 |

|

| プロパティータイプによります。 | イベントに関連付けられたボリュームのプロパティー。 |

|

| リスト | イベントのタイプ。 |

|

| リスト | イベントの重大度: Warning/Error/Normal |

|

| String | イベントタイプの説明。 |

|

| リスト | イベントが発生した日。 |

|

| String | イベントに関連付けられたユーザー名。 |

|

| String | イベントに関連付けられたホスト。 |

|

| String | イベントに関連付けられた仮想マシン。 |

|

| String | イベントに関連付けられたテンプレート。 |

|

| String | イベントに関連付けられたストレージ。 |

|

| String | イベントに関連付けられたデータセンター。 |

|

| String | イベントに関連付けられたボリューム。 |

|

| Integer | イベントの識別番号。 |

|

| リスト | 返された結果をリソースプロパティーの 1 つで並べ替えます。 |

|

| Integer | 表示する結果のページ番号。 |

例

Events: Vms.name = testdesktop and Hosts.name = gonzo.example.com

この例では、ホスト gonzo.example.com での実行中に testdesktop という名前の仮想マシンで発生したイベントの一覧を返します。

第4章 ブックマーク

4.1. クエリー文字列をブックマークとして保存

ブックマークは、検索クエリーを記憶し、他のユーザーとの共有するために使用できます。

クエリー文字列をブックマークとして保存

- 検索バーに希望の検索クエリーを入力し、検索を実行します。

- 検索バーの右側にある星の ブックマーク ボタンをクリックして、新規ブックマーク ウィンドウを開きます。

- ブックマークの Name を入力します。

- 必要に応じて Search string フィールドを編集します。

- OK をクリックします。

ヘッダーバーの Bookmarks アイコン (

) をクリックして、ブックマークを見つけて選択します。

) をクリックして、ブックマークを見つけて選択します。

4.2. ブックマークの編集

ブックマークの名前および検索文字列を変更できます。

ブックマークの編集

-

ヘッダーバーの Bookmarks アイコン (

) をクリックします。

) をクリックします。

- ブックマークを選択し、Edit をクリックします。

- 必要に応じて Name および Search string フィールドを変更します。

- OK をクリックします。

4.3. ブックマークの削除

ブックマークが必要なくなったら、その設定を削除します。

ブックマークの削除

-

ヘッダーバーの Bookmarks アイコン (

) をクリックします。

) をクリックします。

- ブックマークを選択し、Remove をクリックします。

- OK をクリックします。

第5章 タグ

5.1. タグを使用して Red Hat Virtualization とのやり取りをカスタマイズ

Red Hat Virtualization プラットフォームをセットアップし、要件に合わせて設定したら、タグを使用して作業方法をカスタマイズできます。タグを使用すると、システムリソースをグループまたはカテゴリーに分類できます。これは、仮想化環境に多くのオブジェクトが存在し、管理者が特定のオブジェクトセットに集中したい場合に便利です。

このセクションでは、タグの作成と編集、ホストまたは仮想マシンへの割り当て、タグを基準として使用した検索などの方法について説明します。タグは、企業のニーズに合わせて、構造に一致する階層に配置できます。

管理ポータルのタグを作成、変更、および削除するには、ヘッダーバーの Tags アイコン (

) をクリックします。

) をクリックします。

5.2. タグの作成

タグを作成して、タグを使用して検索結果を絞り込みできるようにします。

タグの作成

-

ヘッダーバーの Tags アイコン (

) をクリックします。

) をクリックします。

- Add をクリックして新規タグを作成するか、タグを選択して New をクリックし、子孫タグを作成します。

- 新規タグの Name および Description を入力します。

- OK をクリックします。

5.3. タグの変更

タグの名前と説明を編集できます。

タグの変更

-

ヘッダーバーの Tags アイコン (

) をクリックします。

) をクリックします。

- 変更するタグを選択し、Edit をクリックします。

- 必要に応じて Name および Description フィールドを変更します。

- OK をクリックします。

5.4. タグの削除

タグが不要になったら、それを削除します。

タグの削除

-

ヘッダーバーの Tags アイコン (

) をクリックします。

) をクリックします。

- 削除するタグを選択し、Remove をクリックします。タグを削除すると、そのタグのすべての子孫も削除されることを警告するメッセージが表示されます。

- OK をクリックします。

タグとその子孫をすべて削除しました。タグは、アタッチされたすべてのオブジェクトからも削除されます。

5.5. オブジェクトに対するタグの追加および削除

ホスト、仮想マシン、およびユーザーにタグを割り当てたり、削除したりできます。

オブジェクトに対するタグの追加および削除

- タグ付けまたはタグ付け解除するオブジェクトを選択します。

-

More Actions (

) をクリックしてから Assign Tags をクリックします。

) をクリックしてから Assign Tags をクリックします。

- チェックボックスを選択してタグをオブジェクトに割り当てるか、選択を解除してオブジェクトからタグの割り当てを解除します。

- OK をクリックします。

指定したタグが、選択したオブジェクトのカスタムプロパティーとして追加または削除されます。

5.6. タグを使用したオブジェクトの検索

tag プロパティーとしてタグを使用し、検索条件として目的の値または値のセットを使用して、検索クエリーを入力します。

指定された基準でタグ付けされたオブジェクトは結果リストに表示されます。

tag をプロパティーとして使用し、不等式演算子 (!=、たとえば、Host: Vms.tag!=server1) を使用してオブジェクトを検索する場合、結果リストにはタグなしオブジェクトは含まれません。

5.7. タグを使用したホストのカスタマイズ

タグを使用してホストに関する情報を保存できます。その後、タグに基づいてホストを検索できます。検索の詳細は、3章検索 を参照してください。

タグを使用したホストのカスタマイズ

- Compute → Hosts をクリックし、ホストを選択します。

-

More Actions (

) をクリックしてから Assign Tags をクリックします。

) をクリックしてから Assign Tags をクリックします。

- 該当するタグのチェックボックスを選択します。

- OK をクリックします。

ホストに関する検索可能な追加情報がタグとして追加されます。

パート II. リソースの管理

第6章 QoS (Quality of Service)

Red Hat Virtualization では、環境のリソースがアクセスできる入出力、処理、およびネットワーク機能のレベルを詳細に制御する QoS エントリーを定義できます。QoS (Quality of Service) エントリーはデータセンターレベルで定義され、クラスターおよびストレージドメイン下で作成されるプロファイルに割り当てられます。これらのプロファイルは、プロファイルが作成されたクラスターおよびストレージドメインの個々のリソースに割り当てられます。

6.1. ストレージ QoS

ストレージ QoS はスループットの最大レベルと、ストレージドメインの仮想ディスクの入出力操作の最大レベルを定義します。ストレージ QoS を仮想ディスクに割り当てると、ストレージドメインのパフォーマンスを細かく調整でき、1 つの仮想ディスクに関連付けられたストレージ操作が、同じストレージドメインでホストされる他の仮想ディスクで利用できるストレージ機能に影響しないようにすることができます。

6.1.1. ストレージ QoS エントリーの作成

ストレージ QoS エントリーの作成

- Compute → Data Centers をクリックします。

- データセンターの名前をクリックして、詳細ビューを開きます。

- QoS タブをクリックします。

- Storage で、New をクリックします。

- QoS Name と QoS エントリーの Description を入力します。

次のいずれかのラジオボタンをクリックして、Throughput Quality of Service を指定します。

- None

- Total - MB/s フィールドに最大許容合計スループットを入力します。

- Read/Write: 左のMB/s フィールドに読み取り操作の最大許容スループットを入力し、右の MB/s フィールドに書き込み操作の最大許容スループットを入力します。

次のいずれかのラジオボタンをクリックして、入出力 (IOps) の QoS を指定します。

- None

- Total - IOps フィールドに 1 秒あたりの入出力操作の最大許容数を入力します。

- Read/Write - 左の IOps フィールドに 1 秒あたりの入力操作の最大許容数を入力し、右の IOps フィールドに 1 秒あたりの出力操作の最大許容数を入力します。

- OK をクリックします。

ストレージ QoS エントリーが作成され、データセンターに属するデータストレージドメインのそのエントリーに基づいてディスクプロファイルを作成できます。

6.1.2. ストレージ Quality of Service エントリーの削除

既存のストレージ QoS(Quality of Service) エントリーを削除します。

ストレージ Quality of Service エントリーの削除

- Compute → Data Centers をクリックします。

- データセンターの名前をクリックして、詳細ビューを開きます。

- QoS タブをクリックします。

- Storage でストレージの QoS エントリーを選択し、Remove をクリックします。

- OK をクリックします。

そのエントリーに基づくディスクプロファイルが存在する場合、それらのプロファイルのストレージ QOS エントリーは自動的に [unlimited] に設定されます。

6.2. 仮想マシンのネットワーク QoS

仮想マシンネットワーク QoS は、個々の仮想ネットワークインターフェイスコントローラーの受信および送信トラフィックの両方を制限するためのプロファイルを作成できる機能です。この機能により、複数のレイヤーで帯域幅を制限し、ネットワークリソースの使用を制御できます。

6.2.1. 仮想マシンのネットワーク QoS エントリーの作成

仮想マシンネットワーク QoS エントリーを作成し、仮想ネットワークインターフェイスコントローラー (vNIC) プロファイル (仮想マシンネットワークインターフェイスプロファイル) に適用される際にネットワークトラフィックを規制します。

仮想マシンのネットワーク QoS エントリーの作成

- Compute → Data Centers をクリックします。

- データセンターの名前をクリックして、詳細ビューを開きます。

- QoS タブをクリックします。

- VM Network で、New をクリックします。

- 仮想マシンネットワーク QoS(Quality of Service) エントリーの Name を入力します。

- Inbound および Outbound ネットワークトラフィックの制限を入力します。

- OK をクリックします。

仮想ネットワークインターフェイスコントローラーで使用可能な仮想マシンネットワーク QoS エントリーが作成されました。

6.2.2. New Virtual Machine Network QoS および Edit Virtual Machine Network QoS ウインドウの設定の説明

仮想マシンのネットワーク QoS 設定により、3 つの異なるレベルで送受信トラフィックの両方に帯域幅の制限を設定できます。

表6.1 仮想マシンネットワーク QoS 設定

| フィールド名 | 説明 |

|---|---|

| Data Center | 仮想マシンのネットワーク QoS ポリシーを追加するデータセンター。このフィールドは、選択したデータセンターに応じて自動的に設定されます。 |

| Name | Manager 内の仮想マシンネットワーク QoS ポリシーを表す名前。 |

| Inbound | 受信トラフィックに適用される設定。Inbound チェックボックスを選択または選択解除して、これらの設定を有効または無効にします。

|

| Outbound | 送信トラフィックに適用される設定。Outbound チェックボックスを選択または選択解除して、これらの設定を有効または無効にします。

|

Average、Peak、または Burst フィールドによって許可される最大値を変更するには、engine-config コマンドを使用して MaxAverageNetworkQoSValue、MaxPeakNetworkQoSValue、または MaxBurstNetworkQoSValue の設定キーの値を変更します。変更を反映するには、ovirt-engine サービスを再起動する必要があります。以下に例を示します。

# engine-config -s MaxAverageNetworkQoSValue=2048 # systemctl restart ovirt-engine

6.2.3. 仮想マシンのネットワーク QoS(Quality of Service) エントリーの削除

既存の仮想マシンネットワーク QoS(Quality of Service) エントリーを削除します。

仮想マシンのネットワーク QoS(Quality of Service) エントリーの削除

- Compute → Data Centers をクリックします。

- データセンターの名前をクリックして、詳細ビューを開きます。

- QoS タブをクリックします。

- VM Network で、仮想マシンネットワーク QoS (Quality of Service) エントリーを選択して Remove をクリックします。

- OK をクリックします。

6.3. ホストネットワーク QoS

ホストネットワーク QoS は、ホスト上のネットワークを設定し、物理インターフェイス経由のネットワークトラフィックの制御を可能にします。ホストネットワーク QoS により、同じ物理ネットワークインターフェイスコントローラー上のネットワークリソースの使用を制御することで、ネットワークのパフォーマンスをより細かく調整できます。これにより、1 つのネットワークが原因で、同じ物理ネットワークインターフェイスコントローラーにアタッチされている他のネットワークがトラフィックの輻輳により機能しなくなる状況を防ぐことができます。ホストネットワーク QoS 設定により、これらのネットワークは、輻輳問題なしに同じ物理ネットワークインターフェイスコントローラー上で機能できるようになります。

6.3.1. ホストネットワーク QoS エントリーの作成

ホストネットワーク QoS(Quality of Service) エントリーを作成します。

ホストネットワーク QoS エントリーの作成

- Compute → Data Centers をクリックします。

- データセンターの名前をクリックして、詳細ビューを開きます。

- QoS タブをクリックします。

- Host Network で、New をクリックします。

- QoS Name と QoS エントリーの説明を入力します。

- Weighted Share、Rate Limit [Mbps]、および Committed Rate [Mbps] に必要な値を入力します。

- OK をクリックします。

6.3.2. New Host Network Quality of Service および Edit Host Network Quality of Service ウィンドウの設定の説明

ホストネットワーク QoS 設定により、送信トラフィックの帯域幅制限を設定できます。

表6.2 ホストネットワーク QoS 設定

| フィールド名 | 説明 |

|---|---|

| Data Center | ホストネットワーク QoS ポリシーを追加するデータセンター。このフィールドは、選択したデータセンターに応じて自動的に設定されます。 |

| QoS Name | Manager 内のホストネットワーク QoS ポリシーを表す名前。 |

| 説明 | ホストネットワーク QoS ポリシーの説明 |

| Outbound | 送信トラフィックに適用される設定。

|

Rate Limit [Mbps] または Committed Rate [Mbps] フィールドで許可される最大値を変更するには、engine-config コマンドを使用して MaxAverageNetworkQoSValue 設定キーの値を変更します。変更を反映するには、ovirt-engine サービスを再起動する必要があります。以下に例を示します。

# engine-config -s MaxAverageNetworkQoSValue=2048 # systemctl restart ovirt-engine

6.3.3. ホストネットワーク QoS エントリーの削除

既存のネットワーク QoS(Quality of Service) エントリーを削除します。

ホストネットワーク QoS エントリーの削除

- Compute → Data Centers をクリックします。

- データセンターの名前をクリックして、詳細ビューを開きます。

- QoS タブをクリックします。

- Host Network で、ホストネットワーク QoS (Quality of Service) エントリーを選択して Remove をクリックします。

- プロンプトが表示されたら OK をクリックします。

6.4. CPU QoS (Quality of Service)

CPU QoS は、仮想マシンが実行されているホスト上で仮想マシンがアクセスできる処理能力の最大量を定義します。これは、そのホストで使用可能な処理能力の合計に対する割合で表されます。CPU QoS を仮想マシンに割り当てると、クラスター内の 1 つの仮想マシンのワークロードが、そのクラスターの他の仮想マシンで利用できる処理リソースに影響を与えないようにすることができます。

6.4.1. CPU QoS エントリーの作成

CPU QoS (Quality of Service) エントリーを作成します。

CPU QoS エントリーの作成

- Compute → Data Centers をクリックします。

- データセンターの名前をクリックして、詳細ビューを開きます。

- QoS タブをクリックします。

- CPU で New をクリックします。

- QoS Name と QoS エントリーの Description を入力します。

-

QoS (Quality of Service) エントリーで許可される最大処理能力を Limit (%) フィールドに入力します。

%記号は含めないでください。 - OK をクリックします。

CPU QoS エントリーが作成され、データセンターに属するクラスターのそのエントリーに基づいて CPU プロファイルを作成できます。

6.4.2. CPU QoS エントリーの削除

既存の CPU QoS(Quality of Service) エントリーを削除します。

CPU QoS エントリーの削除

- Compute → Data Centers をクリックします。

- データセンターの名前をクリックして、詳細ビューを開きます。

- QoS タブをクリックします。

- CPU で CPU QoS エントリーを選択し、Remove をクリックします。

- OK をクリックします。

そのエントリーに基づく CPU プロファイルが存在する場合、それらのプロファイルの CPU QOS エントリーは自動的に [unlimited] に設定されます。

第7章 データセンター

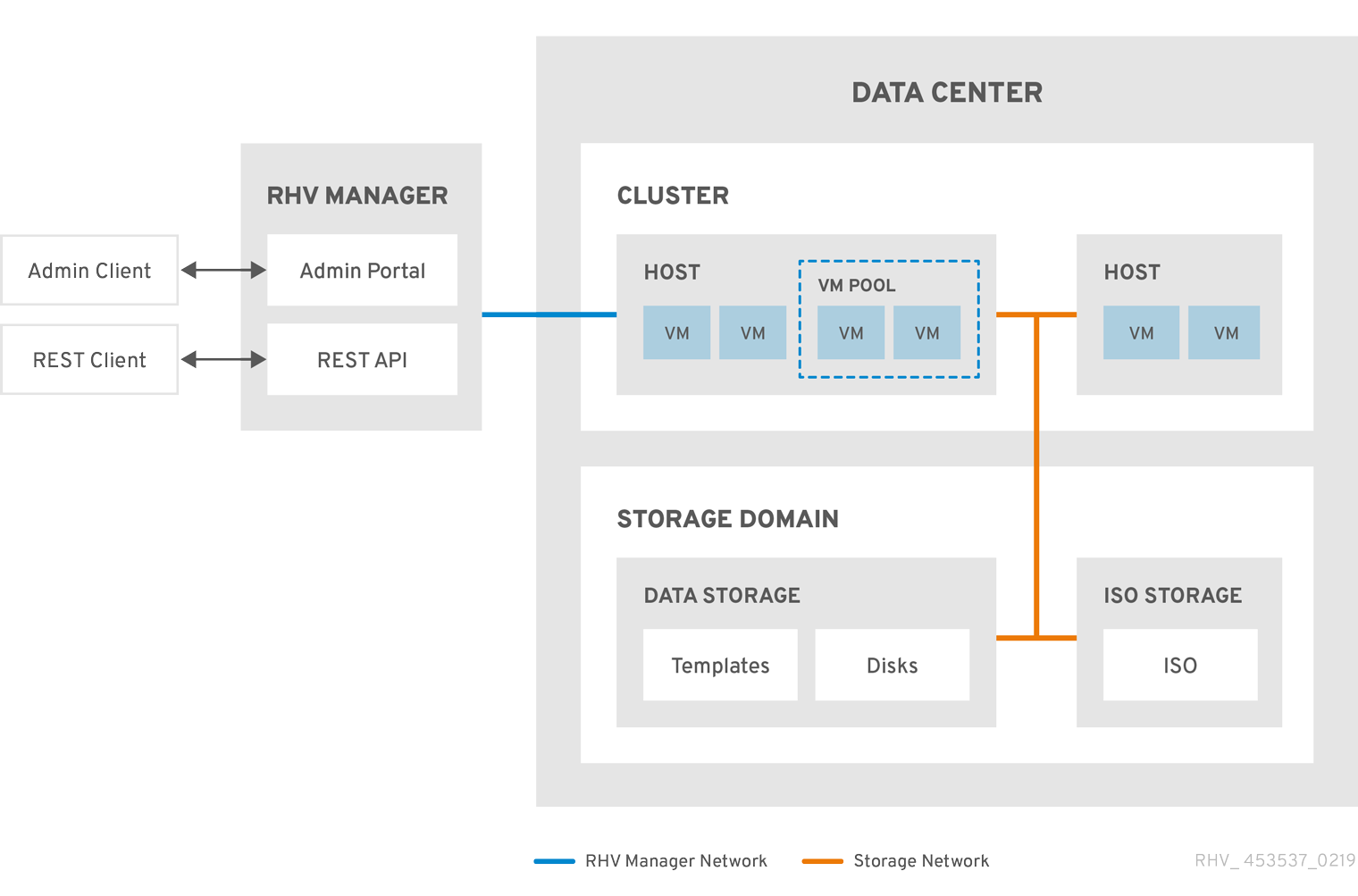

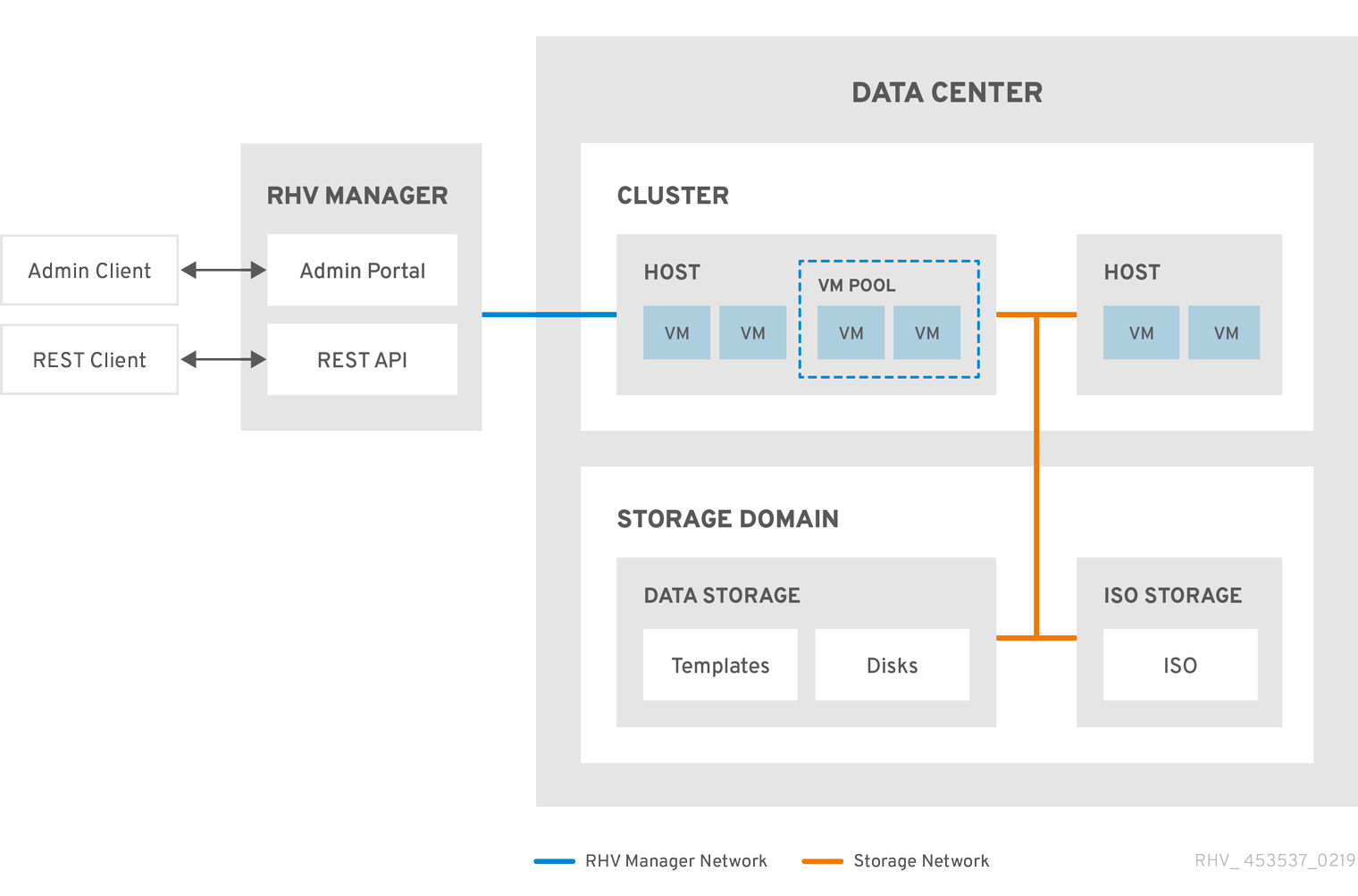

7.1. データセンターの概要

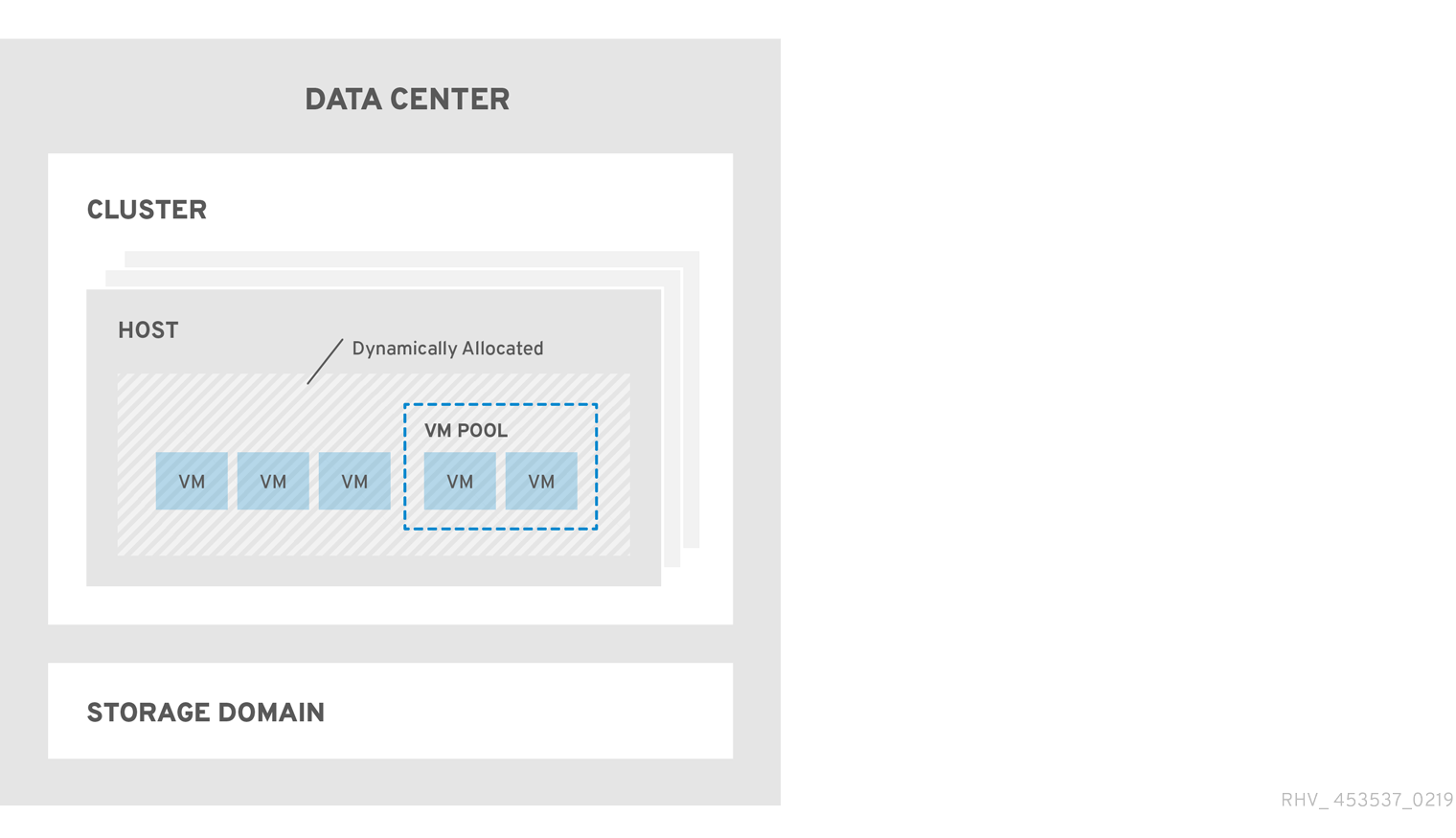

データセンターとは、特定の環境で使用するリソースのセットを定義する論理エンティティーです。データセンターは、コンテナーリソース (クラスターとホストの形式の論理リソースで設定)、ネットワークリソース (論理ネットワークと物理 NIC の形式)、およびストレージリソース (ストレージドメインの形式) と見なされます。

データセンターには、複数のホストを含む複数のクラスターを含めることができます。複数のストレージドメインが関連付けられており、各ホスト上の複数の仮想マシンをサポートすることができます。Red Hat Virtualization 環境には複数のデータセンターを含めることができます。データセンターインフラストラクチャーを使用すると、これらのセンターを分離した状態にすることができます。

すべてのデータセンターは、1 つの管理ポータルから管理されます。

図7.1 データセンター

Red Hat Virtualization は、インストール時にデフォルトのデータセンターを作成します。デフォルトのデータセンターを設定するか、または適切に名前が付けられたデータセンターを設定できます。

7.2. ストレージプールマネージャー

Storage Pool Manager(SPM) は、データセンター内のホストのいずれかに渡すロールで、データセンターのストレージドメインを管理できるようにします。SPM エンティティーはデータセンター内の任意のホストで実行できます。Red Hat Virtualization Manager はいずれかのホストにロールを付与します。SPM は標準の操作からホストを事前に設定しません。SPM として実行されているホストは依然として仮想リソースをホストできます。

SPM エンティティーは、ストレージドメイン全体でメタデータを調整することにより、ストレージへのアクセスを制御します。これには、仮想ディスク (イメージ)、スナップショット、およびテンプレートの作成、削除、およびテンプレート、およびスパースブロックデバイス (SAN 上) のストレージの割り当てが含まれます。これは唯一の責任です。メタデータの整合性を確保するために、データセンターの SPM となるホスト 1 つのみです。

Red Hat Virtualization Manager は、SPM が常に利用できることを確認します。SPM ホストがストレージへのアクセスに問題がある場合は、Manager は SPM ロールを別のホストに移動します。SPM が起動すると、これがロールが付与された唯一のホストであることを確認します。したがって、ストレージ中心のリースを取得します。このプロセスには時間がかかる場合があります。

7.3. SPM の優先度

SPM ロールは、ホストの利用可能なリソースの一部を使用します。ホストの SPM 優先度の設定により、ホストが SPM ロールが割り当てられる可能性があります。SPM 優先度が高いホストには、SPM の優先度が低いホストの前に SPM ロールが割り当てられます。SPM 優先度が低いホストの重要な仮想マシンは、ホストリソースの SPM 操作と連動させる必要はありません。

Edit Host ウィンドウの SPM タブでホストの SPM タブの優先度を変更できます。

7.4. データセンタータスク

7.4.1. 新規データセンターの作成

以下の手順では、お使いの仮想化環境にデータセンターを作成します。データセンターが機能するには、機能しているクラスター、ホスト、およびストレージドメインが必要です。

互換バージョン を設定すると、後で低くすることはできず、バージョンを下げることはできません。

データセンターに MAC プール範囲を指定するオプションが無効になり、クラスターレベルで実行されるようになりました。

新規データセンターの作成

- Compute → Data Centers をクリックします。

- New をクリックします。

- データセンターの Name および Description を入力します。

- ドロップダウンメニューから、データセンターの Storage Type、Compatibility Version、Quota Mode を選択します。

- OK をクリックしてデータセンターを作成し、データセンター - Guide Me ウィンドウを開きます。

-

Guide Me ウィンドウには、データセンター用に設定する必要のあるエンティティーが一覧表示されます。これらのエンティティーを設定するか、Configure Later ボタンをクリックして設定を延期します。設定を再開するには、データセンターを選択し、More Actions (

) をクリックしてから Guide Me をクリックします。

) をクリックしてから Guide Me をクリックします。

新しいデータセンターは、クラスター、ホスト、およびストレージドメインが設定されるまで Uninitialized になります。Guide Me を使用してこれらのエンティティーを設定します。

7.4.2. New Data Center および Edit Data Center Windows の設定についての説明

以下の表は、New Data Center および Edit Data Center ウィンドウに表示されるデータセンターの設定について説明しています。OK をクリックすると、無効なエントリーがオレンジ色で囲まれ、変更が承認されません。さらに、フィールドプロンプトは予想される値または値の範囲を示します。

表7.1 データセンターのプロパティー

| フィールド | 説明/アクション |

|---|---|

| Name | データセンターの名前。このテキストフィールドには 40 文字の制限があり、大文字、小文字、数字、ハイフン、およびアンダースコアの組み合わせが含まれる一意の名前である必要があります。 |

| 説明 | データセンターの説明このフィールドは推奨されますが、必須ではありません。 |

| Storage Type | Shared または Local ストレージタイプを選択します。 異なるタイプのストレージドメイン (iSCSI、NFS、FC、POSIX、および Gluster) を同じデータセンターに追加できます。ただし、ローカルドメインおよび共有ドメインは混在させることはできません。 データセンターの初期化後にストレージタイプを変更できます。「データセンターストレージタイプの変更」 を参照してください。 |

| 互換バージョン | Red Hat Virtualization のバージョン。 Red Hat Virtualization Manager をアップグレードした後には、ホスト、クラスター、およびデータセンターが以前のバージョンにある可能性があります。データセンターの互換性レベルをアップグレードする前に、すべてのホストをアップグレードし、クラスターをアップグレードしていることを確認します。 |

| クォータモード | クォータは、Red Hat Virtualization で提供されるリソース制限ツールです。以下のいずれかを選択します。

|

| Comment | オプションで、データセンターに関するプレーンテキストコメントを追加します。 |

7.4.3. データセンターの再初期化: リカバリー手順

この復旧手順は、データセンターのマスターデータドメインを新しいマスターデータドメインに置き換えます。データが破損している場合は、マスターデータドメインを再初期化する必要があります。データセンターを再初期化すると、クラスター、ホスト、および問題以外のストレージドメインなど、データセンターに関連付けられた他のリソースをすべて復元できます。

バックアップまたはエクスポートした仮想マシンまたはテンプレートを新しいマスターデータドメインにインポートできます。

データセンターの再初期化

- Compute → Data Centers をクリックし、データセンターを選択します。

- データセンターに接続されたストレージドメインがメンテナンスモードにあることを確認します。

-

More Actions (

) をクリックしてから、Re-Initialize Data Center をクリックします。

) をクリックしてから、Re-Initialize Data Center をクリックします。

- Data Center Re-Initialize ウィンドウには、利用可能なすべての (割り当て解除あり、メンテナンスモードの場合) ストレージドメインが一覧表示されます。データセンターに追加するストレージドメインのラジオボタンをクリックします。

- Approve operation チェックボックスを選択します。

- OK をクリックします。

ストレージドメインは、マスターデータドメインとしてデータセンターにアタッチされ、アクティベートされます。バックアップまたはエクスポートした仮想マシンまたはテンプレートを新しいマスターデータドメインにインポートできるようになりました。

7.4.4. データセンターの削除

データセンターを削除するには、アクティブなホストが必要です。データセンターを削除しても、関連付けられたリソースは削除されません。

データセンターの削除

- データセンターに接続されたストレージドメインがメンテナーンスモードにあることを確認します。

- Compute → Data Centers をクリックし、削除するデータセンターを選択します。

- Remove をクリックします。

- OK をクリックします。

7.4.5. データセンターの強制削除

アタッチされたストレージドメインが破損したり、ホストが Non Responsive になった場合、データセンターが Non Responsive になります。いずれの状況においても、データセンターを 削除 できません。

Force Remove では、アクティブなホストは必要ありません。また、アタッチされているストレージドメインも完全に削除します。

データセンターを Force Remove する前に、破損したストレージドメインを 破棄 する必要がある場合があります。

データセンターの強制削除

- Compute → Data Centers をクリックし、削除するデータセンターを選択します。

-

More Actions (

) をクリックしてから、Force Remove をクリックします。

) をクリックしてから、Force Remove をクリックします。

- Approve operation チェックボックスを選択します。

- OK をクリックします。

データセンターおよび割り当てられたストレージドメインは、Red Hat Virtualization 環境から完全に削除されます。

7.4.6. データセンターストレージタイプの変更

データセンターの初期化後に、データセンターのストレージタイプを変更できます。これは、仮想マシンまたはテンプレートの移動に使用されるデータドメインに役立ちます。

制限事項

- ローカルデータセンターの共有 - 複数のホストおよび複数のクラスターを含まないデータセンターの場合は、ローカルデータセンターがこれをサポートしないためです。

- Local to Shared: ローカルストレージドメインを含まないデータセンターの場合。

データセンターストレージタイプの変更

- Compute → Data Centers をクリックし、変更するデータセンターを選択します。

- Edit をクリックします。

- Storage Type を必要な値に変更します。

- OK をクリックします。

7.4.7. データセンターの互換バージョンの変更

Red Hat Virtualization データセンターには、互換バージョンがあります。互換バージョンとは、データセンターが互換性を持つ Red Hat Virtualization のバージョンを指します。データセンター内のクラスターは、すべて指定の互換性レベルをサポートする必要があります。

データセンターの互換バージョンを変更するには、事前にデータセンター内のクラスターおよび仮想マシンの互換バージョンがすべて更新されている必要があります。

手順

- 管理ポータルで コンピュート → データセンター をクリックします。

- 変更を行うデータセンターを選択し、編集 をクリックします。

- 互換バージョン を必要な値に変更します。

- OK をクリックします。データセンターの互換バージョンを変更 の確認ダイアログが開きます。

- OK をクリックして確定します。

7.5. データセンターおよびストレージドメイン

7.5.1. 既存のデータドメインをデータセンターにアタッチ

アタッチされていない データドメインは、データセンターにアタッチすることができます。複数のタイプ (iSCSI、NFS、FC、POSIX、および Gluster) の共有ストレージドメインを同じデータセンターに追加できます。

既存のデータドメインをデータセンターにアタッチ

- Compute → Data Centers をクリックします。

- データセンターの名前をクリックして、詳細ビューを開きます。

- Storage タブをクリックして、データセンターにすでにアタッチされているストレージドメインを一覧表示します。

- Attach Data をクリックします。

- データセンターにアタッチするデータドメインのチェックボックスを選択します。複数のデータドメインを割り当てる場合は、複数のチェックボックスを選択できます。

- OK をクリックします。

データドメインはデータセンターにアタッチされ、自動的にアクティブになります。

7.5.2. 既存の ISO ドメインをデータセンターにアタッチ

Unattached の ISO ドメインは、データセンターにアタッチすることができます。ISO ドメインは、データセンターと同じ Storage Type である必要があります。

データセンターに 1 つの ISO ドメインのみをアタッチできます。

既存の ISO ドメインをデータセンターにアタッチ

- Compute → Data Centers をクリックします。

- データセンターの名前をクリックして、詳細ビューを開きます。

- Storage タブをクリックして、データセンターにすでにアタッチされているストレージドメインを一覧表示します。

- Attach ISO をクリックします。

- 適切な ISO ドメインのラジオボタンをクリックします。

- OK をクリックします。

ISO ドメインはデータセンターにアタッチされ、自動的にアクティブになります。

7.5.3. 既存のエクスポートドメインをデータセンターにアタッチ

エクスポートストレージドメインは非推奨になりました。ストレージデータドメインはデータセンターから接続を解除し、同じ環境または別の環境にある別のデータセンターにインポートすることができます。仮想マシン、フローティング仮想ディスク、およびテンプレートは、インポートされたストレージドメインからアタッチされたデータセンターにアップロードできます。ストレージドメインのインポートに関する詳細は、「既存のストレージドメインのインポート」 を参照してください。

Unattached のドメインは、データセンターにアタッチ することができます。データセンターには、エクスポートドメインを 1 つだけアタッチできます。

既存のエクスポートドメインをデータセンターにアタッチ

- Compute → Data Centers をクリックします。

- データセンターの名前をクリックして、詳細ビューを開きます。

- Storage タブをクリックして、データセンターにすでにアタッチされているストレージドメインを一覧表示します。

- Attach Export をクリックします。

- 適切なエクスポートドメインのラジオボタンをクリックします。

- OK をクリックします。

エクスポートドメインはデータセンターにアタッチされ、自動的にアクティブになります。

7.5.4. データセンターからストレージドメインをデタッチ

データセンターからストレージドメインをデタッチすると、データセンターがそのストレージドメインとの関連付けをできなくなります。ストレージドメインは Red Hat Virtualization 環境から削除されず、別のデータセンターにアタッチすることができます。

仮想マシンやテンプレートなどのデータは、引き続きストレージドメインにアタッチされます。

マスターストレージ (これが最後の利用可能なストレージドメインである場合) は削除できません。

データセンターからストレージドメインをデタッチ

- Compute → Data Centers をクリックします。

- データセンターの名前をクリックして、詳細ビューを開きます。

- Storage タブをクリックして、データセンターにアタッチされているストレージドメインを一覧表示します。

-

デタッチするストレージドメインを選択します。ストレージドメインが

Activeの場合は、Maintenance をクリックします。 - OK をクリックしてメンテナーンスモードを開始します。

- デタッチ をクリックします。

- OK をクリックします。

ストレージドメインが詳細ビューから消えるまでに数分かかる場合があります。

第8章 クラスター

8.1. クラスターの概要

クラスターは、同じストレージドメインを共有し、同じタイプの CPU(Intel または AMD) を持つホストの論理グループです。ホストに異なる CPU モデルの生成がある場合は、すべてのモデルに存在する機能のみを使用します。

システム内の各クラスターはデータセンターに属し、システム内の各ホストはクラスターに属している必要があります。仮想マシンはクラスター内の任意のホストに動的に割り当てられ、仮想マシン上のクラスターおよび設定に合わせて、それらのホスト間で移行することができます。クラスターは、電源および負荷分散ポリシーを定義できる最上位です。

クラスターに属するホストおよび仮想マシンの数は、Host Count および VM Count のそれぞれ結果一覧にそれぞれ表示されます。

クラスターは仮想マシンまたは Red Hat Gluster Storage サーバーを実行します。これら 2 つの目的は相互排他的です。単一クラスターでは仮想化とストレージホストをまとめてサポートできません。

Red Hat Virtualization は、インストール時にデフォルトのデータセンターにデフォルトのクラスターを作成します。

図8.1 Cluster

8.2. クラスタータスク

一部のクラスターオプションは Gluster クラスターには適用されません。Red Hat Virtualization で Red Hat Gluster Storage を使用する方法の詳細は、Configuring Red Hat Virtualization with Red Hat Gluster Storage を参照してください。

8.2.1. 新規クラスターの作成

データセンターには複数のクラスターを含めることができ、クラスターには複数のホストを含めることができます。クラスター内のホストすべては、同じ CPU タイプ (Intel または AMD) である必要があります。CPU タイプの最適化を確保するには、クラスターを作成する前にホストを作成することが推奨されます。ただし、Guide Me ボタンを使用してホストを後で設定できます。

新規クラスターの作成

- Compute → Clusters をクリックします。

- New をクリックします。

- ドロップダウンリストからクラスターが所属するData Center を選択します。

- クラスターの Name および Description を入力します。

- Management Network のドロップダウンリストからネットワークを選択して、管理ネットワークロールを割り当てます。

ドロップダウンリストから CPU Architecture と CPU Type を選択します。クラスターに接続するホストの最小 CPU プロセッサータイプと、CPU プロセッサーファミリーとを一致させることが重要です。そうでないと、ホストが機能しなくなります。

注記Intel タイプおよび AMD CPU タイプの両方の場合、リストされた CPU モデルは、最も古いものから最新の順に論理的に使用されます。CPU モデルが異なるホストがクラスターに含まれる場合は、最も古い CPU モデルを選択します。各 CPU モデルの詳細は、https://access.redhat.com/solutions/634853 を参照してください。

- ドロップダウンリストから、クラスターの互換バージョンを選択します。

- ドロップダウンリストから Switch Type を選択します。

クラスターのホストに Firewall Type を選択します (iptables または firewalld のいずれか)。

注記iptablesは非推奨になりました。- Enable Virt Service または Enable Gluster Service チェックボックスを選択して、クラスターが仮想マシンホストまたは Gluster 対応ノードと共に設定されるかどうかを定義します。

- 仮想マシンを Manager からシャットダウンする際に任意の reason フィールドを有効にするようにEnable to set VM maintenance reason のチェックボックスを選択し、管理者がメンテナンスの説明を提供できるようにします。

- ホストを Manager からメンテナンスモードにする時に任意の reason フィールドを有効にするようにEnable to set Host maintenance reason のチェックボックスを選択し、管理者がメンテナンスの説明を提供できるようにします。

- オプションで /dev/hwrng ソース(外部ハードウェアデバイス) のチェックボックスを選択し、クラスター内のすべてのホストが使用する乱数ジェネレーターデバイスを指定します。/dev/urandom ソース(Linux が提供するデバイス) はデフォルトで有効です。

- Optimizationタブをクリックしてクラスターのメモリーページ共有のしきい値を選択し、必要に応じてクラスター内のホストで CPU スレッド処理とメモリーバルーンを有効にします。

- Migration Policy タブをクリックして、クラスターの仮想マシン移行ポリシーを定義します。

- Scheduling Policy(スケジューリングポリシー) タブをクリックして、スケジューリングポリシーの設定、スケジューラー最適化の設定、クラスター内のホストの信頼できるサービスの有効化、HA Reservation の有効化を行い、カスタムのシリアル番号ポリシーを追加します。

- Console タブをクリックしてオプションでグローバル SPICE プロキシーを上書きし (ある場合)、クラスター内のホストの SPICE プロキシーのアドレスを指定します。

- Fencing policy タブをクリックして、クラスターでフェンシングを有効または無効にします。また、フェンスオプションを選択します。

- MAC Address Poolタブをクリックして、クラスターのデフォルトのプール以外の MAC アドレスプールを指定します。MAC アドレスプールの作成、編集、または削除に関する詳細は、「MAC アドレスプール」 を参照してください。

- OK をクリックしてクラスターを作成し、Cluster - Guide Me ウインドウを開きます。

-

Guide Me ウィンドウには、クラスターに設定する必要のあるエンティティーが一覧表示されます。これらのエンティティーを設定するか、Configure Later ボタンをクリックして設定を延期します。設定を再開するには、クラスターを選択し、More Actions (

) をクリックしてから、Guide Me をクリックします。

) をクリックしてから、Guide Me をクリックします。

8.2.2. 一般的なクラスター設定に関する説明

以下の表は、New Cluster および Edit Cluster ウィンドウの General タブの設定について説明しています。OK をクリックすると、無効なエントリーがオレンジ色で囲まれ、変更が承認されません。さらに、フィールドプロンプトは予想される値または値の範囲を示します。

表8.1 一般的なクラスター設定

| フィールド | 説明/アクション |

|---|---|

| Data Center | クラスターが含まれるデータセンター。クラスターを追加する前にデータセンターを作成する必要があります。 |

| Name | クラスターの名前。このテキストフィールドには 40 文字の制限があり、大文字、小文字、数字、ハイフン、およびアンダースコアの組み合わせが含まれる一意の名前である必要があります。 |

| Description / Comment | クラスターまたは追加のメモの説明。これらのフィールドは推奨されますが、必須ではありません。 |

| Management Network | 管理ネットワークロールを割り当てる論理ネットワーク。デフォルトは ovirtmgmt です。移行ネットワークが移行元または移行先ホストに正しくアタッチされていない場合は、このネットワークは仮想マシンの移行にも使用されます。 既存のクラスターでは、詳細ビューの Logical Networks タブにある Manage Networks ボタンを使用すると管理ネットワークを変更できます。 |

| CPU アーキテクチャー | クラスターの CPU アーキテクチャー。選択した CPU アーキテクチャーに応じて、さまざまな CPU タイプを利用できます。

|

| CPU Type | クラスターの CPU タイプ。サポートされる CPU タイプの一覧は、Planning and Prerequisites Guideの CPU Requirements を参照してください。クラスター内のホストはすべて、Intel、AMD、または IBM POWER 8 の CPU タイプのいずれかを実行している必要があり、これは作成後には、大きな中断なしで変更することはできません。CPU タイプは、クラスター内の最も古い CPU モデルに設定する必要があります。すべてのモデルに存在する機能のみを使用できます。Intel タイプおよび AMD CPU タイプの両方の場合、リストされた CPU モデルは、最も古いものから最新の順に論理的に使用されます。 |

| 互換バージョン | Red Hat Virtualization のバージョン。データセンターに指定したバージョンよりも、以前のバージョンを選択することはできません。 |

| Switch Type | クラスターが使用するスイッチのタイプ。Linux Bridge は、標準の Red Hat Virtualization スイッチです。OVS は Open vSwitch のネットワーク機能をサポートします。 |

| Firewall Type | クラスター内のホストのファイアウォールタイプを指定します (iptables または firewalld のいずれか)。

注記: 既存のクラスターのファイアウォールタイプを変更する場合は、クラスターで すべてのホストを再インストールして、変更を適用する必要があります。 |

| Default Network Provider | クラスターが使用するデフォルトの外部ネットワークプロバイダーを指定します。Open Virtual Network (OVN) を選択する場合、クラスターに追加されたホストは OVN プロバイダーと通信するように自動的に設定されます。 デフォルトのネットワークプロバイダーを変更する場合には、クラスターのすべてのホストを再インストールして、変更を適用する必要があります。 |

| ログメモリーの最大しきい値 |

最大メモリー消費のロギングしきい値をパーセンテージまたは絶対値 (MB 単位) で指定します。ホストのメモリー使用量がパーセンテージ値を超えている場合や、ホストで利用可能なメモリーが絶対値 (MB 単位) を下回る場合にログに記録されます。デフォルトは |

| Enable Virt Service | このラジオボタンを選択すると、このクラスター内のホストは仮想マシンを実行するために使用されます。 |

| Enable Gluster Service | このラジオボタンが選択される場合、このクラスターのホストは Red Hat Gluster Storage Server ノードとして使用されるため、仮想マシンの実行には使用されません。 |

| Import existing gluster configuration | このチェックボックスは、Enable Gluster Service ラジオボタンが選択されている場合にのみ利用できます。このオプションを使用すると、既存の Gluster 対応クラスターおよびその割り当てられたすべてのホストを Red Hat Virtualization Manager にインポートできます。 以下のオプションは、インポートされているクラスター内のホストごとに必要になります。

|

| Enable to set VM maintenance reason | このチェックボックスを選択すると、クラスターの仮想マシンが Manager からシャットダウンすると、オプションの reason フィールドが表示されます。これにより、ログに表示されるメンテナーンスの説明と、仮想マシンの電源が再びオンになります。 |

| ホストのメンテナーンス理由の設定の有効化 | このチェックボックスを選択すると、クラスターのホストが Manager からメンテナーンスモードに移動すると、オプションの reason フィールドが表示されます。これにより、ログに表示されるメンテナーンスの説明と、ホストが再度アクティベートされたタイミングを指定できます。 |

| 追加の乱数ジェネレーターソース | このチェックボックスを選択した場合には、クラスター内の全ホストには、追加の乱数ジェネレーターデバイスが利用可能になります。これにより、乱数ジェネレーターデバイスから仮想マシンへのエントロピーのパススルーが可能になります。 |

8.2.3. 最適化設定の説明

メモリーに関する考慮事項

メモリーページの共有により、仮想マシンは、他の仮想マシンで未使用のメモリーを利用することで、割り当てられたメモリーの最大 200% を使用できます。このプロセスは、Red Hat Virtualization 環境内の仮想マシンが同時に実行されるという前提であり、未使用のメモリーを特定の仮想マシンに一時的に割り当てられるようにします。

CPU の考慮事項

CPU 集約型ではないワークロードの場合、ホスト内のコア数よりも大きいプロセッサーコアの合計数を持つ仮想マシンを実行できます。これを実行することで、以下が可能になります。

- より多くの仮想マシンを実行することができます。これにより、ハードウェアの要件が減少します。

- 仮想コアの数がホストコア数とホストスレッドの数の間にある場合など、それ以外の CPU トポロジーで仮想マシンを設定できます。

- 最適なパフォーマンス、特に CPU 集約型のワークロードの場合、ホストと同じトポロジーを使用する必要があります。ホストと仮想マシンは同じキャッシュの使用を期待します。ホストのハイパースレッディングが有効な場合、QEMU がホストのハイパースレッドをコアとして扱うため、仮想マシンは複数のスレッドを持つ単一のコアで実行されていることを認識しません。ホストコアのハイパースレッドに実際に対応する仮想コアは、仮想マシンのパフォーマンスに影響する可能性があります。これは、同じホストコアのハイパースレッドと単一のキャッシュを共有する可能性がありますが、仮想マシンは別のコアとして扱います。

以下の表は、New Cluster および Edit Cluster ウィンドウの Optimization タブの設定について説明しています。

表8.2 最適化の設定

| フィールド | 説明/アクション |

|---|---|

| メモリーの最適化 |

|

| CPU スレッド | Count Threads As Cores チェックボックスを選択すると、ホストは、ホストのコア数よりも大きいプロセッサーコアの合計数で仮想マシンを実行することができます。 このチェックボックスを選択すると、公開されるホストスレッドは仮想マシンが使用できるコアとして扱われます。たとえば、コアごとに 2 つのスレッドがある 24 コアのシステム (全部で 48 スレッド) では、それぞれ最大 48 コアを持つ仮想マシンを実行できます。そして、ホストの CPU 負荷を計算するアルゴリズムは、使用量の多くのコアを 2 回比較します。 |

| メモリーバルーン | Enable Memory Balloon Optimization のチェックボックスを選択し、このクラスターのホストで実行している仮想マシンでメモリーのオーバーコミットを有効にします。このチェックボックスを選択すると、Memory Overcommit Manager(MoM) は、可能な限りバルーニングを開始し、可能な場合はすべての仮想マシンのメモリーサイズが保証されます。

バルーンが実行しているには、仮想マシンに適切なドライバーを持つバルーンデバイスが必要です。各仮想マシンには、特別に削除しない限り、バルーンデバイスが含まれます。このクラスター内の各ホストは、ステータスが シナリオのバルーンでは、KSM と一致している可能性がある点を理解することが重要です。このような場合は、MoM は競合の可能性を最小限に抑えるためにバルーンサイズの調整を試みます。さらに、シナリオのバルーンによっては、仮想マシンに対して最大のパフォーマンスが最適化される可能性があります。管理者は、バルーンの最適化を注意して使用することが推奨されます。 |

| KSM コントロール | Enable KSM チェックボックスを選択すると、MoM が必要に応じて Kernel Same-page Merging(KSM) を実行できるため、メモリーの保存で CPU コストの重み付けがメリットを得ることができます。 |

8.2.4. 移行ポリシー設定の説明

移行ポリシーは、ホストに障害が発生した場合に仮想マシンのライブマイグレーションの条件を定義します。これらの状態には、移行中の仮想マシンのダウンタイム、ネットワーク帯域幅、および仮想マシンの優先順位が含まれます。

表8.3 移行ポリシーの説明

| Policy | 説明 |

|---|---|

| Legacy |

3.6 バージョンのレガシー動作 |

| 最小ダウンタイム | 仮想マシンを一般的な状況で移行できるようにするポリシー。仮想マシンは、ダウンタイムを大幅に発生しません。移行は、長時間 (QEMU の反復により最大 500 ミリ秒) 後に仮想マシンの移行が収束されない場合に中止されます。ゲストエージェントフックメカニズムが有効になっている。 |

| コピー後の移行 | 仮想マシンは、ダウンタイムを最小限に抑えるポリシーと同様の、大きなダウンタイムは発生しません。コピー後のポリシーは、最初に事前コピーして、コンバージェンスが発生したかどうかを検証します。仮想マシンの移行が長時間後に収束されない場合、移行は post-copy に切り替わります。このポリシーの欠点は、コピー後のフェーズでは、メモリーの不足している部分がホスト間で転送されるため、仮想マシンが大幅に遅くなる可能性があります。 ホスト間の移行ネットワークのネットワーク障害など、コピー後のフェーズで異常が発生した場合は、移行プロセスで仮想マシンが一貫性がなく、一時停止されて結果が失われます。そのため、コピー後のフェーズで移行を中止することはできません。 制限 コピー後のプロセスの完了前にネットワーク接続が破損すると、Manager は一時停止し、実行中の仮想マシンを強制終了します。仮想マシンの可用性が重要である場合や、移行ネットワークが不安定な場合は、コピー後の移行を使用しないでください。 |

| 必要に応じてワークロードを一時停止 | 負荷が大きい仮想マシンを含む、ほとんどの状況で仮想マシンが移行できるようにするポリシー。このため、仮想マシンでは、他の設定よりも大きなダウンタイムが生じる場合があります。移行は、極端なワークロードに対して中止される場合があります。ゲストエージェントフックメカニズムが有効になっている。 |

帯域幅設定は、ホストごとの送信移行と受信両方の最大帯域幅を定義します。

表8.4 帯域幅の説明

| Policy | 説明 |

|---|---|

| Auto | 帯域幅は、データセンターの Host Network QoS の Rate Limit [Mbps] 設定からコピーされます。レート制限が定義されていない場合は、ネットワークインターフェイス送受信の最小リンク速度として計算されます。レート制限が設定されていない場合や、リンク速度が利用できない場合には、ホスト送信時にローカルの VDSM 設定により決定されます。 |

| ハイパーバイザーのデフォルト | 帯域幅は、ホスト送信時にローカルの VDSM 設定によって制御されます。 |

| カスタム | ユーザーで定義されます (Mbps 単位)。この値は、同時移行の数 (デフォルトは 2 で、継続的な移行および送信移行のために考慮するには 2) で分割されます。したがって、ユーザー定義の帯域幅は、すべての同時移行に対応できるように十分な大きさである必要があります。

たとえば、 |

耐障害性ポリシーは、移行での仮想マシンの優先順位を定義します。

表8.5 耐障害性ポリシーの設定

| フィールド | 説明/アクション |

|---|---|

| 仮想マシンの移行 | 定義された優先順位で、すべての仮想マシンを移行します。 |

| 高可用性仮想マシンのみの移行 | 他のホストのオーバーロードを防ぐために、高可用性の仮想マシンのみを移行します。 |

| Do not migrate Virtual Machines(仮想マシンを移行しない) | 仮想マシンを移行しないようにします。 |

Additional Properties は、Legacy 移行ポリシーにのみ適用されます。

表8.6 その他のプロパティーの説明

| プロパティー | 説明 |

|---|---|

| 自動コンバージション | 仮想マシンのライブマイグレーション中に自動コンバージェンスが使用されるかどうかを設定できます。負荷が大きいが大きい仮想マシンでは、ライブマイグレーション中に行われる転送速度よりも速くメモリーがダーティーなり、移行が収束できなくなります。QEMU の自動調整機能を使用すると、仮想マシン移行の収束を強制的に実行できます。QEMU は、コンバージェンスの欠如を自動的に検出し、仮想マシン上の vCPU のスロットルダウンをトリガーします。オートコンバージェンスはデフォルトで無効になっています。

|

| 移行圧縮の有効化 | 仮想マシンのライブマイグレーション中に移行圧縮を使用するかどうかを設定できます。この機能は、Xor Binary Zero Run-Length-Encoding を使用して、メモリー書き込みを必要とするワークロードまたはスパースメモリー更新パターンを使用するアプリケーションに対して、仮想マシンのダウンタイムと合計移行時間を短縮します。移行圧縮は、デフォルトでは無効になっています。

|

8.2.5. スケジューリングポリシー設定に関する説明

スケジューリングポリシーにより、利用可能なホスト間での仮想マシンの使用状況および分散を指定することができます。スケジューリングポリシーを定義して、クラスター内のホスト全体で自動負荷分散を有効にします。スケジューリングポリシーに関わらず、CPU が過負荷状態のホストでは仮想マシンが起動しません。デフォルトでは、ホストの CPU が 5 分間 80% 以上の負荷がかかった場合に過負荷と判断されますが、この値はスケジューリングポリシーを使って変更できます。スケジューリングポリシーの詳細情報は、「スケジューリングポリシー」 を参照してください。

表8.7 スケジューリングポリシータブプロパティー

| フィールド | 説明/アクション |

|---|---|

| ポリシーの選択 | ドロップダウンリストからポリシーを選択します。

|

| プロパティー | 以下のプロパティーは選択したポリシーをもとに表示され、必要に応じて編集できます。

|

| スケジューラーの最適化 | ホストの重み付け/順序のスケジューリングを最適化します。

|

| 信頼できるサービスの有効化 |

OpenAttestation サーバーとのインテグレーションを有効にします。これを有効にする前に、 |

| HA 予約の有効化 | Manager が高可用性仮想マシンのクラスター容量を監視できるようにします。Manager は、既存のホストが予期せずに失敗した場合に移行するために、高可用性として指定された仮想マシンのクラスター内に適切な容量が存在することを確認します。 |

| Provide custom serial number policy | このチェックボックスを選択すると、クラスター内の仮想マシンのシリアル番号ポリシーを指定できます。以下のオプションのいずれかを選択します。

|

ホストの空きメモリーが 20% 未満になると、mom.Controllers.Balloon - INFO Ballooning guest:half1 from 1096400 to 1991580 が /var/log/vdsm/mom.log に記録されます。/var/log/vdsm/mom.log は、Memory Overcommit Manager のログファイルです。

8.2.6. クラスターコンソール設定の説明

以下の表は、New Cluster および Edit Cluster ウィンドウの Console タブの設定について説明しています。

表8.8 コンソールの設定

| フィールド | 説明/アクション |

|---|---|

| クラスターの SPICE プロキシーの定義 | このチェックボックスを選択し、グローバル設定で定義された SPICE プロキシーの上書きを有効にします。この機能は、ユーザー (たとえば、仮想マシンポータル経由で接続する) がハイパーバイザーが存在するネットワーク外にある場合に役に立ちます。 |

| SPICE プロキシーアドレスのオーバーライド | SPICE クライアントが仮想マシンに接続するプロキシーアドレスは以下の形式でなければなりません。 protocol://[host]:[port] |

8.2.7. フェンシングポリシー設定の説明

以下の表は、New Cluster および Edit Cluster ウィンドウの Fencing Policy タブの設定について説明しています。

表8.9 フェンシングポリシーの設定

| フィールド | 説明/アクション |

|---|---|

| フェンシングの有効化 | クラスターのフェンシングを有効にします。フェンシングはデフォルトで有効になっていますが、必要に応じて無効にできます。たとえば、一時的なネットワークの問題が発生したり、予想される場合に、管理者は診断またはメンテナンスアクティビティーが完了するまでフェンシングを無効にできます。フェンシングが無効になっている場合は、応答しないホストで実行している高可用性仮想マシンは、別の場所で再起動されないことに注意してください。 |

| ホストのストレージにライブリースがある場合はフェンシングをスキップ | このチェックボックスを選択しないと、Non Responsive のクラスター内のホストは、ストレージに接続されたホストはフェンスされません。 |

| クラスター接続の問題のフェンシングをスキップ | このチェックボックスを選択すると、接続の問題が発生するクラスター内のホストのパーセンテージが、定義された Threshold 以上になると、フェンシングが一時的に無効になります。Threshold 値はドロップダウンリストから選択されます。利用可能な値は 25、50、75、および 100 です。 |

| gluster ブリックが起動している場合は、フェンシングをスキップ | このオプションは、Red Hat Gluster Storage 機能が有効にされている場合にのみ利用できます。このチェックボックスを選択すると、ブリックが実行中で、他のピアから到達できる場合にフェンシングはスキップされます。 2 章を参照してください。フェンシングポリシー を使用して高可用性を設定します。詳細は、Maintaining Red Hat Hyperconverged Infrastructure の Appendix A. Fencing Policies for Red Hat Gluster Storage を参照してください。 |

| Gluster クォーラムが満たされない場合は、フェンシングをスキップします。 | このオプションは、Red Hat Gluster Storage 機能が有効にされている場合にのみ利用できます。このチェックボックスを選択している場合、ブリックが実行されているとフェンシングがスキップされ、ホストをシャットダウンするとクォーラムが失われます。 2 章を参照してください。フェンシングポリシー を使用して高可用性を設定します。詳細は、Maintaining Red Hat Hyperconverged Infrastructure の Appendix A. Fencing Policies for Red Hat Gluster Storage を参照してください。 |