Red Hat Training

A Red Hat training course is available for Red Hat Virtualization

セルフホストエンジンガイド

Red Hat Virtualization のセルフホストエンジンのインストールおよびメンテナンス

概要

第1章 はじめに

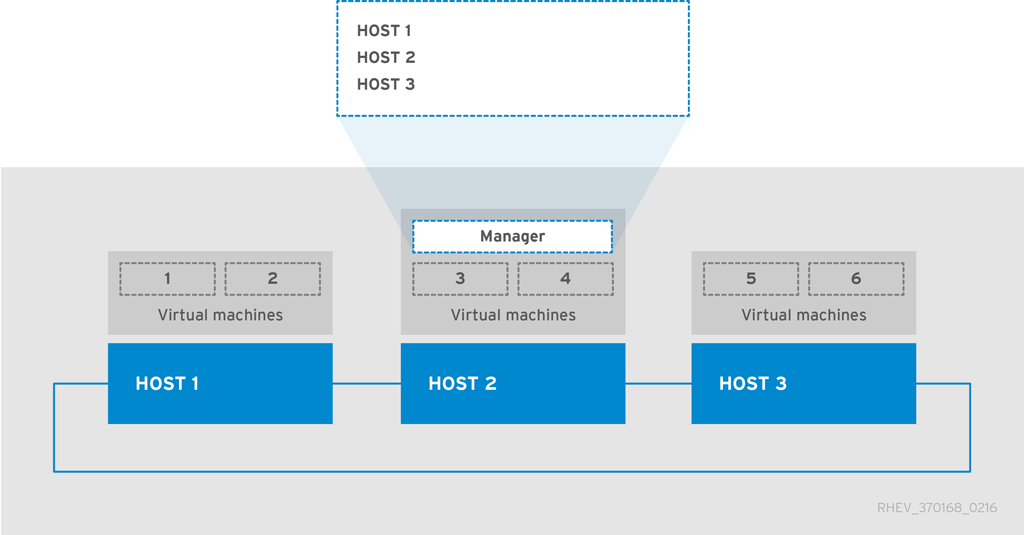

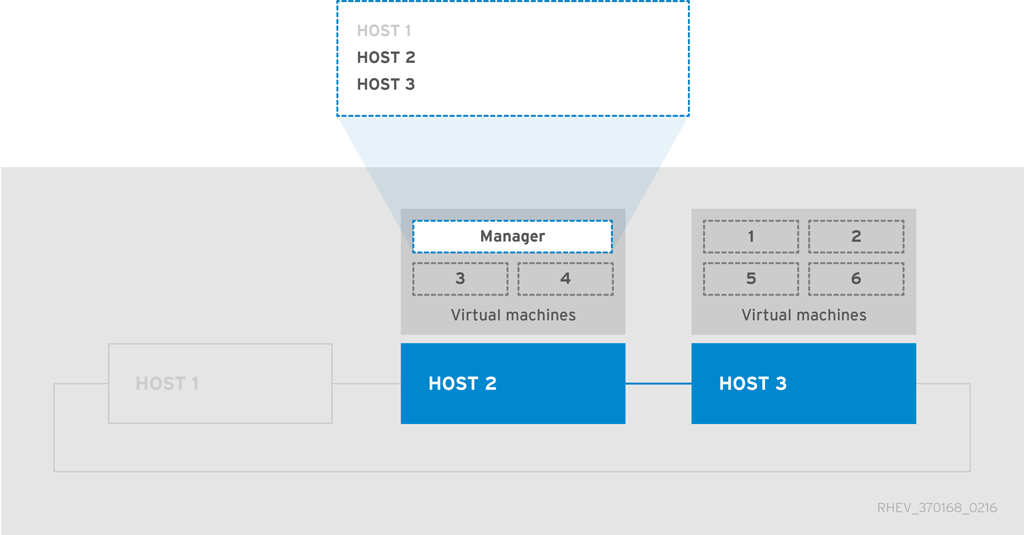

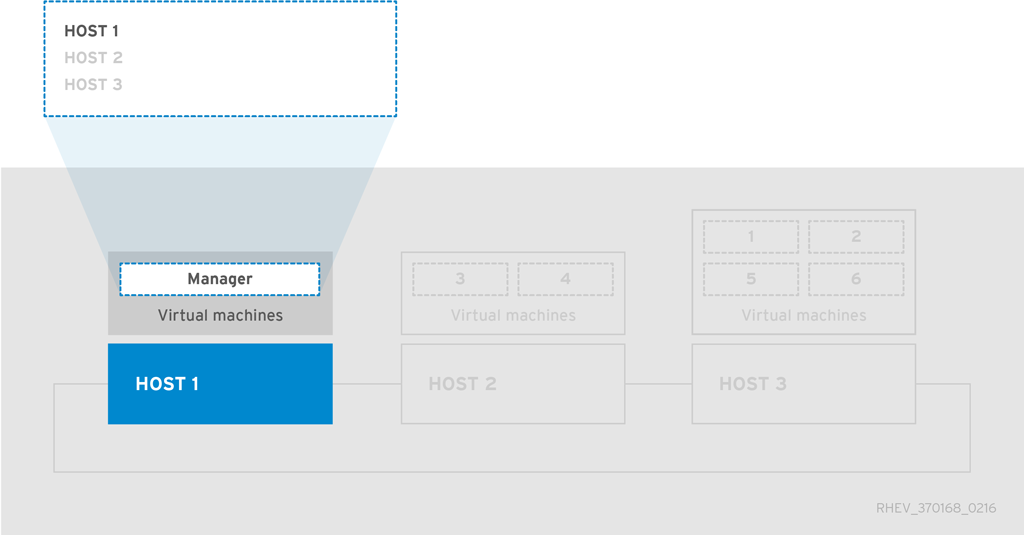

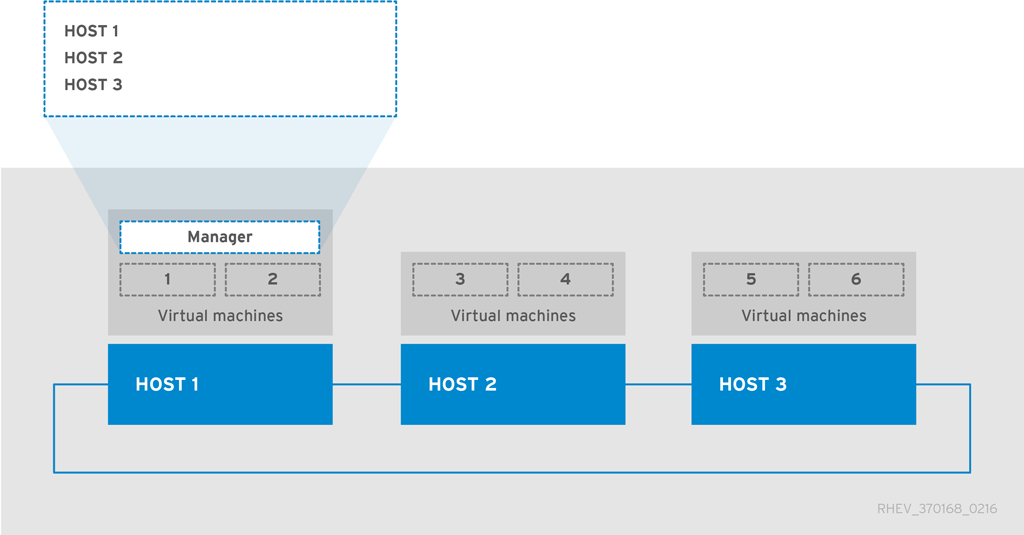

セルフホストエンジンとは、Red Hat Virtualization Manager (engine) が管理するホスト上にある仮想マシンでその Manager を実行する仮想化環境のことを指します。仮想マシンは、ホスト設定の一環として作成され、そのホスト設定のプロセスと並行して Manager がインストール、設定されます。セルフホストエンジンの主な利点は、Manager が物理ハードウェアではなく、仮想マシンとして実行されるため、Red Hat Virtualization のインスタンスをデプロイする際に必要なハードウェアが少なくて済む点です。また、Manager は高可用性として設定されます。Manager 用仮想マシンを実行するホストがメンテナンスモードに遷移、または予期せず終了すると、仮想マシンは自動的に環境内の別のホストに移行します。Manager 用仮想マシンを実行することのできるホストは、セルフホストエンジンノードと呼ばれます。高可用性機能をサポートするには、少なくとも 2 つのセルフホストエンジンノードが必要です。

Manager 用仮想マシンのインストールでは、RHV-M Appliance が提供されます。Manager 用仮想マシンの手動インストールはサポートされていません。

セルフホストエンジンのデプロイメントは、Cockpit ユーザーインターフェースの簡単なウィザードにより、または hosted-engine --deploy を使用してコマンドラインから実施されます。Cockpit の使用が推奨されるインストール方法です。

表1.1 セルフホストエンジンのデプロイをサポートする OS バージョン

| システムのタイプ | サポートされているバージョン |

|---|---|

|

Red Hat Enterprise Linux ホスト |

7.5 |

|

Red Hat Virtualization Host |

7.5 |

|

HostedEngine-VM (Manager) |

7.5 |

ハードウェア要件については、『プランニングおよび前提条件ガイド』の「ホストの要件」を参照してください。

タイミングまたは認証に関する問題を避けるために、環境内のホスト、Manager およびその他のサーバーにネットワークタイムプロトコル (NTP) を設定して、同じ NTP サーバーに同期させます。詳細については、『Red Hat Enterprise Linux 7 システム管理者のガイド』の「chrony スイートを使用した NTP 設定」および「システムクロックのリモートサーバーとの同期」を参照してください。

第2章 セルフホストエンジンのデプロイ

セルフホストエンジンは、コマンドラインから、または Cockpit のユーザーインターフェースを使用してデプロイすることができます。Red Hat Virtualization Host では Cockpit がデフォルトで利用可能ですが、Red Hat Enterprise Linux ホストに Cockpit をインストールすることもできます。両方の手法で Ansible が使用され、プロセスの大部分を自動化しています。

セルフホストエンジンのインストールでは、RHV-M Appliance を使用して Manager 用仮想マシンを作成します。アプライアンスはデプロイメントプロセス中にインストールされますが、必要であればデプロイメントを開始する前にホストにインストールすることもできます。

# yum install rhvm-appliance

セルフホストエンジン環境に関する個別の推奨事項については、『プランニングおよび前提条件ガイド』の「セルフホストエンジンに関する推奨事項」を参照してください。

高可用性のためにボンドインターフェースを使用する、またはトラフィックをタイプごとに分離するために VLAN を使用する場合は (例: ストレージ用の接続と管理用の接続)、デプロイメントの前に設定する必要があります。詳細については、『プランニングおよび前提条件ガイド』の「ネットワークに関する推奨事項」を参照してください。

Red Hat Hyperconverged Infrastructure (RHHI) 環境の一環として、Red Hat Gluster Storage と共にセルフホストエンジンをデプロイする場合は、『Red Hat Hyperconverged Infrastructure のデプロイ』を参照してください。

2.1. Cockpit を使用したセルフホストエンジンのデプロイ

ご自分の環境の情報を収集する簡単なウィザードを使用して、Cockpit からセルフホストエンジンをデプロイすることができます。これが推奨される方法です。

Red Hat Virtualization Host では Cockpit がデフォルトで有効です。Red Hat Enterprise Linux ホストを使用している場合は、『インストールガイド』の「Red Hat Enterprise Linux ホストへの Cockpit のインストール」を参照してください。

前提条件

- 新規にインストールされた Red Hat Virtualization Host または Red Hat Enterprise Linux 7。必要なリポジトリーが有効化されていること。詳細については、『インストールガイド』の「Red Hat Virtualization Host のインストール」または「Red Hat Enterprise Linux ホストリポジトリーの有効化」を参照してください。

- Manager およびホスト用の完全修飾ドメイン名。正引き (フォワードルックアップ) と逆引き (リバースルックアップ) の両方を DNS で設定する必要があります。

- RHV-M Appliance 用に、少なくとも 5 GB の容量を持つホスト上のディレクトリー。デプロイメントのプロセスは、アプライアンスのファイルを抽出するのに十分なスペースが /var/tmp にあるかどうかチェックします。スペースが足りない場合には、別のディレクトリーを指定するか、外部ストレージをマウントすることができます。VDSM ユーザーおよび KVM グループには、このディレクトリーでの読み取り、書き込み、実行権限を指定する必要があります。

Manager 用仮想マシン専用のデータストレージドメインとして準備されたストレージ。このストレージドメインはセルフホストエンジンのデプロイメント中に作成され、容量は少なくとも 74 GiB 必要です。高可用性ストレージを推奨します。デプロイメント用ストレージの準備に関する詳しい情報は、『管理ガイド』の「ストレージ」の章を参照してください。

警告Red Hat では、セルフホストエンジンのストレージドメインとして、同じデータセンター内に別のアクティブなデータストレージドメインを用意することを強く推奨します。

セルフホストエンジンをデータセンター内にデプロイする際に、アクティブなデータストレージドメインを 1 つしか用意しないと、そのデータストレージドメインが破損した場合に、新たなデータストレージドメインを追加することや破損したデータストレージドメインを削除することができません。セルフホストエンジンを再デプロイしなければなりません。

重要iSCSI ストレージを使用する場合には、セルフホストエンジンのストレージドメインと追加のストレージドメインに同じ iSCSI ターゲットを使用しないでください。

手順

-

https://HostIPorFQDN:9090から Cockpit にログインし、Virtualization → Hosted Engine をクリックします。 - Hosted Engine オプションの下の Start をクリックします。

Manager 用仮想マシンに関する情報を入力します。

- Engine VM FQDN に、ベースホストではなく Manager 用仮想マシンの FQDN を入力します。

- MAC Address に、Manager 用仮想マシンの MAC アドレスを入力します。あるいは、無作為に生成される MAC アドレスを適用します。

Network Configuration のドロップダウンリストから、DHCP または Static のいずれかを選択します。

- DHCP を選択した場合には、ホスト名が DHCP から受け取るアドレスに解決されるように、Manager 用仮想マシンの DHCP 予約がなければなりません。その MAC アドレスを MAC Address フィールドで指定します。

Static を選択した場合には、以下の情報を入力します。

- VM IP Address: IP アドレスは、ホストと同じサブネットに属している必要があります。たとえばホストが 10.1.1.0/24 内にある場合、Manager 用仮想マシンの IP は同じサブネット範囲 (10.1.1.1-254/24) になければなりません。

- Gateway Address: ゲートウェイの IP アドレス

- DNS Servers: DNS サーバーの IP アドレス

- Bridge Interface のドロップダウンリストから、ブリッジインターフェースを選択します。

- Root Password に仮想マシンの root パスワードを入力し、それを確認します。

- Root SSH Access で、root に SSH アクセスを許可するかどうかを指定します。

- Number of Virtual CPUs に、仮想マシンの CPU 数を入力します。

- Memory Size (MiB) に、メモリーのサイズを入力します。使用可能なメモリー容量が入力フィールドの横に表示されます。

オプションとして、Advanced フィールドを展開します。

- Root SSH Public Key に、root ユーザーが Manager 用仮想マシンにアクセスする際に使用する公開鍵を入力します。

-

Edit Hosts File のチェックボックスを選択/選択解除して、Manager 用仮想マシンおよびベースホストのエントリーを仮想マシンの

/etc/hostsファイルに追加するかどうかを指定します。ホスト名は解決可能でなければなりません。 -

Bridge Name で管理ブリッジの名前を変更します。あるいは、デフォルトの

ovirtmgmtを適用します。 - Gateway Address に、管理ブリッジのゲートウェイ IP アドレスを入力します。

- Host FQDN に、Manager に追加する第 1 ホストの FQDN を入力します。これは、デプロイメントを実行しているベースホストの FQDN です。

- Next をクリックします。

-

Admin Portal Password に

admin@internalユーザーのパスワードを入力し、それを確認します。 イベント通知を設定します。

- Server Name および Server Port Number に、SMTP サーバーの名前およびポート番号を入力します。

- Sender E-Mail Address に、送信元のメールアドレスを入力します。

- Recipient E-Mail Addresses に、受け取り先のメールアドレスを入力します。

- Next をクリックします。

- Manager およびその仮想マシンの設定を見直します。情報が正しければ、Prepare VM をクリックします。

- 仮想マシンのインストールが完了したら、Next をクリックします。

Storage Type のドロップダウンリストからストレージのタイプを選択し、セルフホストエンジンのストレージドメインの情報を入力します。

NFS の場合:

- Storage Connection フィールドに、完全なアドレスおよびストレージへのパスを入力します。

- 必要に応じて、Mount Options にマウントオプションを入力します。

- Disk Size (GiB) にディスクのサイズを入力します。

- NFS Version のドロップダウンリストから、NFS のバージョンを選択します。

- Storage Domain Name にストレージのドメイン名を入力します。

iSCSI の場合:

- Portal IP Address、Portal Port、Portal Username、および Portal Password に、ポータルの IP アドレス、ポート、ユーザー名、およびパスワードを入力します。

Retrieve Target List をクリックしてターゲットを選択します。デプロイメント時に選択できる iSCSI ターゲットは 1 つだけですが、マルチパスがサポートされているので、同じポータルグループのポータルをすべて接続することができます。

注記複数の iSCSI ターゲットを指定するには、セルフホストエンジンをデプロイする前にマルチパスを有効にする必要があります。詳細については、『Red Hat Enterprise Linux DM Multipath』を参照してください。Multipath Helper ツールを使用して、さまざまなオプションでマルチパスをインストールおよび設定するスクリプトを生成することもできます。

- Disk Size (GiB) にディスクのサイズを入力します。

- Discovery Username および Discovery Password に、ターゲット自動検出時のユーザー名およびそのパスワードを入力します。

ファイバーチャネルの場合:

- LUN ID に LUN ID を入力します。ホストのバスアダプターが設定、接続されている必要があります。また、LUN には既存のデータが含まれないようにする必要があります。既存の LUN を再使用する場合には、『管理ガイド』の「LUN の再使用」を参照してください。

- Disk Size (GiB) にディスクのサイズを入力します。

Red Hat Gluster Storage の場合:

- Storage Connection フィールドに、完全なアドレスおよびストレージへのパスを入力します。

- 必要に応じて、Mount Options にマウントオプションを入力します。

- Disk Size (GiB) にディスクのサイズを入力します。

- Next をクリックします。

- ストレージの設定を見直します。情報が正しければ、Finish Deployment をクリックします。

デプロイメントが完了したら、Close をクリックします。

1 つのデータセンター、クラスター、ホスト、ストレージドメイン、および Manager 用仮想マシンがすでに稼働しているはずです。管理ポータルにログインして、その他のリソースを追加することができます。

- Manager 用仮想マシンで必要なリポジトリーを有効にします。詳細については、『インストールガイド』の「Red Hat Virtualization Manager リポジトリーの有効化」を参照してください。

-

オプションとして、

ovirt-engine-extension-aaa-ldap-setupの対話型設定スクリプトを使用して、ディレクトリーサーバーを追加します。これにより、環境に新規ユーザーを追加することができます。詳細については、『管理ガイド』の「外部の LDAP プロバイダーの設定」を参照してください。

セルフホストエンジンのステータスが Cockpit の Virtualization → Hosted Engine タブに表示されます。管理ポータルで、Manager 用仮想マシン、仮想マシンを実行しているホスト、およびセルフホストエンジンのストレージドメインに金色の王冠のフラグが付けられます。

2.2. コマンドラインを使用したセルフホストエンジンのデプロイ

ご自分の環境の情報を収集する hosted-engine --deploy を使用して、コマンドラインからセルフホストエンジンをデプロイすることができます。

必要であれば、hosted-engine --deploy --noansible を実行して、引き続き以前のバージョンの Red Hat Virtualization の 非 Ansible スクリプトを使用することができます。

前提条件

- 新規にインストールされた Red Hat Virtualization Host または Red Hat Enterprise Linux 7。必要なリポジトリーが有効化されていること。詳細については、『インストールガイド』の「Red Hat Virtualization Host のインストール」または「Red Hat Enterprise Linux ホストリポジトリーの有効化」を参照してください。

- Manager およびホスト用の完全修飾ドメイン名。正引き (フォワードルックアップ) と逆引き (リバースルックアップ) の両方を DNS で設定する必要があります。

- RHV-M Appliance 用に、少なくとも 5 GB の容量を持つホスト上のディレクトリー。デプロイメントのプロセスは、アプライアンスのファイルを抽出するのに十分なスペースが /var/tmp にあるかどうかチェックします。スペースが足りない場合には、別のディレクトリーを指定するか、外部ストレージをマウントすることができます。VDSM ユーザーおよび KVM グループには、このディレクトリーでの読み取り、書き込み、実行権限を指定する必要があります。

Manager 用仮想マシン専用のデータストレージドメインとして準備されたストレージ。このストレージドメインはセルフホストエンジンのデプロイメント中に作成され、容量は少なくとも 74 GiB 必要です。高可用性ストレージを推奨します。デプロイメント用ストレージの準備に関する詳しい情報は、『管理ガイド』の「ストレージ」の章を参照してください。

警告Red Hat では、セルフホストエンジンのストレージドメインとして、同じデータセンター内に別のアクティブなデータストレージドメインを用意することを強く推奨します。

セルフホストエンジンをデータセンター内にデプロイする際に、アクティブなデータストレージドメインを 1 つしか用意しないと、そのデータストレージドメインが破損した場合に、新たなデータストレージドメインを追加することや破損したデータストレージドメインを削除することができません。セルフホストエンジンを再デプロイしなければなりません。

重要iSCSI ストレージを使用する場合には、セルフホストエンジンのストレージドメインと追加のストレージドメインに同じ iSCSI ターゲットを使用しないでください。

手順

デプロイメントツールをインストールします。

# yum install ovirt-hosted-engine-setup

Red Hat では、ネットワークやターミナルが切断された場合などにセッションが失われないように、

screenウィンドウマネージャーを使用してスクリプトを実行することを推奨します。screenをインストールして起動します。# yum install screen # screen

デプロイメントスクリプトを開始します。

# hosted-engine --deploy

注記Ctrl+D のキーの組み合わせを使用してデプロイメントを中断すると、スクリプトをいつでも終了することができます。セッションがタイムアウトした場合や接続が中断された場合には、

screen -d -rを実行してデプロイメントセッションを復元します。Yes を選択してデプロイメントを開始します。

Continuing will configure this host for serving as hypervisor and create a local VM with a running engine. The locally running engine will be used to configure a storage domain and create a VM there. At the end the disk of the local VM will be moved to the shared storage. Are you sure you want to continue? (Yes, No)[Yes]:

ネットワークを設定します。スクリプトにより、環境の管理ブリッジとして使用する NIC 候補が検出されます。

Please indicate a pingable gateway IP address [X.X.X.X]: Please indicate a nic to set ovirtmgmt bridge on: (eth1, eth0) [eth1]:

仮想マシンのインストールにカスタムアプライアンスを使用する場合は、OVA アーカイブへのパスを入力します。該当しなければ、このフィールドを空欄のままにして RHV-M Appliance を使用します。

If you want to deploy with a custom engine appliance image, please specify the path to the OVA archive you would like to use (leave it empty to skip, the setup will use rhvm-appliance rpm installing it if missing):

Manager 用仮想マシンの FQDN を指定します。

Please provide the FQDN you would like to use for the engine appliance. Note: This will be the FQDN of the engine VM you are now going to launch, it should not point to the base host or to any other existing machine. Engine VM FQDN: manager.example.com Please provide the domain name you would like to use for the engine appliance. Engine VM domain: [example.com]Manager の root パスワードを入力します。

Enter root password that will be used for the engine appliance: Confirm appliance root password:

Manager に root ユーザーとしてログインできるようにするための SSH 公開鍵を入力し、root ユーザーの SSH アクセスを有効にするかどうかを指定します。

Enter ssh public key for the root user that will be used for the engine appliance (leave it empty to skip): Do you want to enable ssh access for the root user (yes, no, without-password) [yes]:

仮想マシンの CPU およびメモリー構成を入力します。

Please specify the number of virtual CPUs for the VM (Defaults to appliance OVF value): [4]: Please specify the memory size of the VM in MB (Defaults to maximum available): [7267]:

Manager 用仮想マシンの MAC アドレスを入力するか、無作為に生成される MAC アドレスを適用します。Manager 用仮想マシンへの IP アドレス割り当てに DHCP を使用するには、この MAC アドレスに有効な DHCP 予約があることを確認してください。デプロイメントスクリプトは、DHCP サーバーの設定は行いません。

You may specify a unicast MAC address for the VM or accept a randomly generated default [00:16:3e:3d:34:47]:

仮想マシンのネットワークの詳細を入力します。

How should the engine VM network be configured (DHCP, Static)[DHCP]?

Static を指定した場合には、Manager の IP アドレスを入力します。

重要静的 IP アドレスは、ホストと同じサブネットに属している必要があります。たとえば、ホストが 10.1.1.0/24 内にある場合、Manager 用仮想マシンの IP は同じサブネット範囲 (10.1.1.1-254/24) になければなりません。

Please enter the IP address to be used for the engine VM [x.x.x.x]: Please provide a comma-separated list (max 3) of IP addresses of domain name servers for the engine VM Engine VM DNS (leave it empty to skip):

Manager 用仮想マシンおよびベースホストのエントリーを仮想マシンの

/etc/hostsファイルに追加するかどうかを指定します。ホスト名は解決可能でなければなりません。Add lines for the appliance itself and for this host to /etc/hosts on the engine VM? Note: ensuring that this host could resolve the engine VM hostname is still up to you (Yes, No)[No]

SMTP サーバーの名前と TCP ポート番号、メール通知に使用するメールアドレス、通知を受信するメールアドレス (複数ある場合はコンマ区切りリスト) を指定します。

Please provide the name of the SMTP server through which we will send notifications [localhost]: Please provide the TCP port number of the SMTP server [25]: Please provide the email address from which notifications will be sent [root@localhost]: Please provide a comma-separated list of email addresses which will get notifications [root@localhost]:

admin@internalユーザーが管理ポータルにアクセスするためのパスワードを入力します。Enter engine admin password: Confirm engine admin password:

スクリプトにより仮想マシンが作成されます。RHV-M Appliance をインストールする必要がある場合には、時間がかかることがあります。

使用するストレージのタイプを選択します。

Please specify the storage you would like to use (glusterfs, iscsi, fc, nfs)[nfs]:

NFS の場合は、バージョン、完全なアドレス、およびストレージへのパスならびにマウントオプションを入力します。

Please specify the nfs version you would like to use (auto, v3, v4, v4_1)[auto]: Please specify the full shared storage connection path to use (example: host:/path): storage.example.com:/hosted_engine/nfs If needed, specify additional mount options for the connection to the hosted-engine storage domain []:iSCSI の場合は、ポータルの詳細を入力し、自動検出されたリストからターゲットおよび LUN を選択します。デプロイメント時に選択できる iSCSI ターゲットは 1 つだけですが、マルチパスがサポートされているので、同じポータルグループのポータルをすべて接続することができます。

注記複数の iSCSI ターゲットを指定するには、セルフホストエンジンをデプロイする前にマルチパスを有効にする必要があります。詳細については、『Red Hat Enterprise Linux DM Multipath』を参照してください。Multipath Helper ツールを使用して、さまざまなオプションでマルチパスをインストールおよび設定するスクリプトを生成することもできます。

Please specify the iSCSI portal IP address: Please specify the iSCSI portal port [3260]: Please specify the iSCSI discover user: Please specify the iSCSI discover password: Please specify the iSCSI portal login user: Please specify the iSCSI portal login password: The following targets have been found: [1] iqn.2017-10.com.redhat.example:he TPGT: 1, portals: 192.168.1.xxx:3260 192.168.2.xxx:3260 192.168.3.xxx:3260 Please select a target (1) [1]: 1 The following luns have been found on the requested target: [1] 360003ff44dc75adcb5046390a16b4beb 199GiB MSFT Virtual HD status: free, paths: 1 active Please select the destination LUN (1) [1]:Gluster ストレージの場合は、完全なアドレスおよびストレージへのパスならびにマウントオプションを入力します。

重要サポートされるストレージは、レプリカ 3 の Gluster ストレージのみです。以下の設定を完了しておいてください。

3 つすべての Gluster サーバーの /etc/glusterfs/glusterd.vol ファイルで、

rpc-auth-allow-insecureをonに設定します。option rpc-auth-allow-insecure on

以下のようにボリュームを設定します。

gluster volume set _volume_ cluster.quorum-type auto gluster volume set _volume_ network.ping-timeout 10 gluster volume set _volume_ auth.allow \* gluster volume set _volume_ group virt gluster volume set _volume_ storage.owner-uid 36 gluster volume set _volume_ storage.owner-gid 36 gluster volume set _volume_ server.allow-insecure on

Please specify the full shared storage connection path to use (example: host:/path): storage.example.com:/hosted_engine/gluster_volume If needed, specify additional mount options for the connection to the hosted-engine storage domain []:ファイバーチャネルの場合は、自動検出されたリストから LUN を選択します。ホストのバスアダプターが設定、接続されている必要があります。設定/接続がされている場合には、デプロイメントスクリプトにより利用可能な LUN が自動で検出されます。また、LUN には既存のデータが含まれないようにする必要があります。既存の LUN を再使用する場合には、『管理ガイド』の「LUN の再使用」を参照してください。

The following luns have been found on the requested target: [1] 3514f0c5447600351 30GiB XtremIO XtremApp status: used, paths: 2 active [2] 3514f0c5447600352 30GiB XtremIO XtremApp status: used, paths: 2 active Please select the destination LUN (1, 2) [1]:

Manager のディスク容量を入力します。

Please specify the size of the VM disk in GB: [50]:

デプロイメントが正常に完了すると、1 つのデータセンター、クラスター、ホスト、ストレージドメイン、および Manager 用仮想マシンがすでに稼働しているはずです。管理ポータルにログインして、その他のリソースを追加することができます。

- Manager 用仮想マシンで必要なリポジトリーを有効にします。詳細については、『インストールガイド』の「Red Hat Virtualization Manager リポジトリーの有効化」を参照してください。

-

オプションとして、

ovirt-engine-extension-aaa-ldap-setupの対話型設定スクリプトを使用して、ディレクトリーサーバーを追加します。これにより、環境に新規ユーザーを追加することができます。詳細については、『管理ガイド』の「外部の LDAP プロバイダーの設定」を参照してください。

管理ポータルで、Manager 用仮想マシン、仮想マシンを実行しているホスト、およびセルフホストエンジンのストレージドメインに金色の王冠のフラグが付けられます。

第3章 セルフホストエンジンのデプロイメントのトラブルシューティング

セルフホストエンジンがすでにデプロイされているかどうかを確認するには、hosted-engine --check-deployed を実行します。セルフホストエンジンがデプロイされていない場合にだけ、エラーが表示されます。

3.1. Manager 用仮想マシンのトラブルシューティング

hosted-engine --vm-status を実行して Manager 用仮想マシンのステータスを確認します。

Manager 用仮想マシンに加えた変更がステータスコマンドの出力に反映されるには、20 秒ほどかかります。

出力の Engine status ごとに、問題を特定または解決するためのアドバイスを以下に示します。

Engine status: "health": "good", "vm": "up", "detail": "up"

Manager 用仮想マシンが通常通りに稼働中の場合には、以下のような出力が表示されます。

--== Host 1 status ==-- Status up-to-date : True Hostname : hypervisor.example.com Host ID : 1 Engine status : {"health": "good", "vm": "up", "detail": "up"} Score : 3400 stopped : False Local maintenance : False crc32 : 99e57eba Host timestamp : 248542- 出力は正常だが Manager に接続することができない場合は、ネットワーク接続を確認してください。

Engine status: "reason": "failed liveliness check", "health": "bad", "vm": "up", "detail": "up"

healthがbadでvmがupの場合、HA サービスは Manager 用仮想マシンを再起動して Manager の復旧を試みます。数分で復旧しない場合は、コマンドラインからグローバルメンテナンスモードを有効にして、ホストを HA サービスの管理対象外にします。# hosted-engine --set-maintenance --mode=global

コンソールに接続します。プロンプトが表示されたら、オペレーティングシステムの root パスワードを入力します。コンソールのオプションについての詳しい説明は、「How to access Hosted Engine VM console from RHEV-H host?」を参照してください。

# hosted-engine --console

- Manager 用仮想マシンにログインして、オペレーティングシステムが動作していることを確認します。

ovirt-engineサービスのステータスを確認します。# systemctl status -l ovirt-engine # journalctl -u ovirt-engine

- ログ /var/log/messages、/var/log/ovirt-engine/engine.log、および /var/log/ovirt-engine/server.log を確認します。

問題を解決したら、セルフホストエンジンノードのいずれかから、手動で Manager 用仮想マシンを再起動します。

# hosted-engine --vm-shutdown # hosted-engine --vm-start

注記セルフホストエンジンノードがグローバルメンテナンスモードにある場合は、Manager 用仮想マシンを手動で再起動する必要があります。コマンドラインから

rebootコマンドを送信して Manager 用仮想マシンを再起動しようとしても、設計上 Manager 用仮想マシンは電源オフのままです。Manager 用仮想マシンで

ovirt-engineサービスが稼働中であることを確認します。# systemctl status ovirt-engine.service

Manager 用仮想マシンが稼働中であることを確認した後には、コンソールセッションを終了して、メンテナンスモードを無効にし、HA サービスを再び有効にします。

# hosted-engine --set-maintenance --mode=none

Engine status: "vm": "down", "health": "bad", "detail": "unknown", "reason": "vm not running on this host"

- 環境内に複数のホストがある場合は、現在別のホストが Manager 用仮想マシンの再起動を試みていないことを確認します。

- グローバルメンテナンスモードにないことを確認します。

- /var/log/ovirt-hosted-engine-ha/agent.log で ovirt-ha-agent のログを確認します。

セルフホストエンジンノードのいずれかから、手動で Manager 用仮想マシンの再起動を試みます。

# hosted-engine --vm-shutdown # hosted-engine --vm-start

Engine status: "vm": "unknown", "health": "unknown", "detail": "unknown", "reason": "failed to getVmStats"

このステータスは、ovirt-ha-agent が VDSM から仮想マシンの詳細を取得できなかったことを意味しています。

- /var/log/vdsm/vdsm.log で VDSM のログを確認します。

- /var/log/ovirt-hosted-engine-ha/agent.log で ovirt-ha-agent のログを確認します。

Engine status: セルフホストエンジンの設定が共有ストレージから取得されていない

ステータスが The hosted engine configuration has not been retrieved from shared storage. Please ensure that ovirt-ha-agent is running and the storage server is reachable と表示される場合は、ovirt-ha-agent サービスもしくはストレージ (またはその両方) に問題があります。

ホストの

ovirt-ha-agentのステータスを確認します。# systemctl status -l ovirt-ha-agent # journalctl -u ovirt-ha-agent

ovirt-ha-agentが停止状態の場合は、再起動します。# systemctl start ovirt-ha-agent

-

/var/log/ovirt-hosted-engine-ha/agent.log で

ovirt-ha-agentのログを確認します。 - 共有ストレージに ping を送信できることを確認します。

- 共有ストレージがマウントされているかどうかを確認します。

その他のトラブルシューティング用コマンド

以下のコマンドのいずれかを実行してセルフホストエンジン環境のトラブルシューティングを行う必要がある場合には、Red Hat サポートまでご連絡ください。

-

hosted-engine --reinitialize-lockspace: このコマンドは、sanlock ロックスペースが壊れている場合に使用します。sanlock ロックスペースを再初期化する前に、グローバルメンテナンスモードが有効で Manager 用仮想マシンが停止していることを確認してください。 -

hosted-engine --clean-metadata: ホストのエージェントのメタデータをグローバルステータスデータベースから削除します。これにより、他のホストではすべて、このホストについての情報はなくなります。ターゲットのホストが停止状態でグローバルメンテナンスモードが有効であることを確認してください。 -

hosted-engine --check-liveliness: このコマンドは、ovirt-engine サービスの liveliness ページを確認します。また、Web ブラウザーでhttps://engine-fqdn/ovirt-engine/services/health/に接続して確認することもできます。 -

hosted-engine --connect-storage: このコマンドは、ホストと Manager 用仮想マシンに必要な全ストレージ接続の準備をするように VDSM に指示します。これは通常、セルフホストエンジンのデプロイ中にバックエンドで実行します。このコマンドを実行してストレージの問題のトラブルシューティングを行う必要がある場合には、グローバルメンテナンスモードを必ず有効にしてください。

3.2. 失敗したセルフホストエンジンのデプロイメントのクリーンアップ

セルフホストエンジンのデプロイが中断された場合には、その後のデプロイメントは失敗して、エラーメッセージが表示されます。このエラーはデプロイメントが失敗した段階によって異なります。エラーメッセージが表示された場合には、クリーンアップスクリプトを実行して、失敗したデプロイメントをクリーンアップしてください。

クリーンアップスクリプトの実行

/usr/sbin/ovirt-hosted-engine-cleanupを実行してyを選択し、失敗したセルフホストエンジンのデプロイメントで残された項目を削除します。# /usr/sbin/ovirt-hosted-engine-cleanup This will de-configure the host to run ovirt-hosted-engine-setup from scratch. Caution, this operation should be used with care. Are you sure you want to proceed? [y/n]

同じ共有ストレージデバイスに再インストールするか、異なる共有ストレージデバイスを選択するかを定義します。

同じストレージドメインにインストール環境をデプロイする場合には、NFS、Gluster、PosixFS サーバーまたはローカルストレージドメインの適切なディレクトリーで以下のコマンドを実行し、そのストレージドメインをクリーンアップします。

# rm -rf storage_location/*- iSCSI またはファイバーチャネルプロトコル (FCP) のストレージの場合には、「How to Clean Up a Failed Self-hosted Engine Deployment?」でストレージのクリーンアップ方法を参照してください。

- または、別の共有ストレージデバイスを選択します。

- セルフホストエンジンを再デプロイします。

第4章 ベアメタルから RHEL ベースのセルフホスト環境への移行

4.1. セルフホスト環境の移行

標準的な Red Hat Virtualization の既存インスタンスをセルフホストエンジン環境に移行する際には、hosted-engine スクリプトを使用してこのタスクを容易化します。このスクリプトは、一連の質問を尋ね、提示された回答に基づいて環境を設定します。以下の手順では、標準的な Red Hat Virtualization 環境からの Manager を BareMetal-Manager としています。

RHV-M Virtual Appliance によって、Manager 用仮想マシンとユーザー間で必要な対話が削減され、プロセスが短縮されます。ただし、標準のインストールではアプライアンスは engine-setup を自動化できますが、移行のプロセスでは、予め新しい Manager 用仮想マシンに BareMetal-Manager のバックアップファイルを復元できるように、engine-setup を手動で実行する必要があります。

この移行は、以下の主要な操作で構成されます。

-

hosted-engineスクリプトを実行して、セルフホストエンジンノードに使用するホストを設定して、新しい Red Hat Virtualization の仮想マシンを作成します。 -

engine-backupツールを使用して、engine データベースと設定ファイルをバックアップし、そのバックアップを新しい Manager 用仮想マシンにコピーして、engine-backupの--mode=restoreパラメーターを使用してバックアップを復元します。engine-setupを実行して、Manager 用仮想マシンの設定を完了します。 -

hosted-engineスクリプトに従って設定を完了します。

前提条件

ovirt-hosted-engine-setupパッケージがインストールされた新規ホストを用意してください。サブスクリプションやパッケージのインストールに関する詳細情報は、「コマンドラインを使用したセルフホストエンジンのデプロイ」を参照してください。ホストは、現在の Red Hat Virtualization 環境でサポートされているバージョンでなければなりません。注記既存のホストを使用する場合には、ホストをメンテナンスモードに設定して、既存の環境からホストを削除します。詳しい情報は、『管理ガイド』の「ホストの削除」を参照してください。

セルフホストエンジン環境向けにストレージを準備します。セルフホストエンジンには、Manager 用仮想マシン専用の共有ストレージドメインが必要です。このドメインはデプロイメント中に作成され、容量は少なくとも 68 GB 必要です。デプロイメント用のストレージの準備に関する詳しい情報は、『管理ガイド』の「ストレージ」の章を参照してください。

重要iSCSI ストレージを使用する場合には、共有ストレージドメインとデータストレージドメインに同じ iSCSI ターゲットは使用しないでください。

-

rhvm-applianceパッケージをインストールして RHV-M Virtual Appliance を取得します。RHV-M Virtual Appliance は常に Manager の最新のサポート対象バージョンをベースとします。移行するには、Manager のバージョンが同じでなければならないため、現在の環境の Manager バージョンを最新のサポート対象 Y ストリームバージョンに更新するようにしてください。 -

Manager のインストールに RHV-M Virtual Appliance を使用するには、1 つのディレクトリーに少なくとも 5 GB の容量が必要です。

hosted-engineスクリプトは最初に、アプライアンスのファイルを抽出するのに十分なスペースが /var/tmp にあるかどうかチェックします。スペースが足りない場合には、別のディレクトリーを指定するか、外部ストレージをマウントすることができます。VDSM ユーザーおよび KVM グループには、このディレクトリーでの読み取り、書き込み、実行権限を指定する必要があります。 - 新しい Manager の完全修飾ドメイン名と、バックアップした BareMetal-Manager の完全修飾ドメイン名は同じでなければなりません。また、正引き (フォワードルックアップ) と逆引き (リバースルックアップ) の両方を DNS で設定する必要があります。

- BareMetal-Manager へのアクセスが可能で、変更を加えることができる必要があります。

- BareMetal-Manager の移行先となる仮想マシンには、BareMetal-Manager の移行元の物理マシンと同じ RAM 容量が割り当てられている必要があります。BareMetal-Manager の移行元の物理マシンよりも RAM が少ない仮想マシンに移行する必要がある場合には、Red Hat ナレッジベースの記事「Configuring the amount of RAM in Red Hat Virtualization Hosted Engine」を参照してください。

セルフホスト環境の移行

セルフホストエンジンのデプロイメントの開始

注記元の環境がバージョン 3.5 以前で管理ネットワークの名前が rhevm の場合は、

hosted-engine --deploy --noansibleを実行する前に回答ファイルを修正する必要があります。詳細については、「RHV: Non-Operational Hosts after Restoring Backup or Migrating to Self-Hosted Engine」を参照してください。hosted-engineスクリプトを実行します。CTRL+Dのキーの組み合わせを使用してデプロイメントを中断すると、スクリプトをいつでも終了することができます。ネットワークやターミナルが切断された場合などにセッションが失われないように、screenウィンドウマネージャーを使用してスクリプトを実行することを推奨します。このウィンドウマネージャーがインストールされていない場合は、標準の Red Hat Enterprise Linux リポジトリーに含まれているscreenパッケージをインストールしてください。# yum install screen

# screen

# hosted-engine --deploy --noansible

注記セッションがタイムアウトした場合や接続が中断された場合には、

screen -d -rを実行してhosted-engineデプロイメントセッションを復元します。ストレージの設定

使用するストレージのタイプを選択します。

During customization use CTRL-D to abort. Please specify the storage you would like to use (glusterfs, iscsi, fc, nfs3, nfs4)[nfs3]:

NFS ストレージタイプの場合には、完全修飾ドメイン名または IP アドレスを使用した完全なアドレスと、共有ストレージドメインのパス名を指定します。

Please specify the full shared storage connection path to use (example: host:/path): storage.example.com:/hosted_engine/nfsiSCSI の場合には、iSCSI ポータルの IP アドレス、ポート、ターゲット自動検出時のユーザー名、そのパスワード、ポータルログインのユーザー名、およびそのパスワードを指定します。自動検出されたリストからターゲット名を選択します。デプロイメント時に選択できる iSCSI ターゲットは 1 つのみです。

注記複数の iSCSI ターゲットを指定するには、セルフホストエンジンをデプロイする前にマルチパスを有効にする必要があります。詳細については、『DM Multipath』を参照してください。Multipath Helper ツールを使用して、さまざまなオプションでマルチパスをインストールおよび設定するスクリプトを生成することもできます。

Please specify the iSCSI portal IP address: Please specify the iSCSI portal port [3260]: Please specify the iSCSI discover user: Please specify the iSCSI discover password: Please specify the iSCSI portal login user: Please specify the iSCSI portal login password: [ INFO ] Discovering iSCSI targets

Gluster ストレージタイプの場合には、完全修飾ドメイン名または IP アドレスを使用した完全なアドレスと、共有ストレージドメインのパス名を指定します。

重要サポートされるストレージは、レプリカ 3 の Gluster ストレージのみです。以下の設定を完了しておいてください。

3 つすべての Gluster サーバーの /etc/glusterfs/glusterd.vol ファイルで、

rpc-auth-allow-insecureをonに設定します。option rpc-auth-allow-insecure on

以下のようにボリュームを設定します。

gluster volume set _volume_ cluster.quorum-type auto gluster volume set _volume_ network.ping-timeout 10 gluster volume set _volume_ auth.allow \* gluster volume set _volume_ group virt gluster volume set _volume_ storage.owner-uid 36 gluster volume set _volume_ storage.owner-gid 36 gluster volume set _volume_ server.allow-insecure on

Please specify the full shared storage connection path to use (example: host:/path): _storage.example.com:/hosted_engine/gluster_volume_

ファイバーチャネルについては、ホストのバスアダプターが設定、接続されている必要があります。設定/接続がされている場合には、

hosted-engineスクリプトにより利用可能な LUN が自動で検出されます。また、LUN には既存のデータが含まれないようにする必要があります。The following luns have been found on the requested target: [1] 3514f0c5447600351 30GiB XtremIO XtremApp status: used, paths: 2 active [2] 3514f0c5447600352 30GiB XtremIO XtremApp status: used, paths: 2 active Please select the destination LUN (1, 2) [1]:

ネットワークの設定

このスクリプトは、環境の管理ブリッジとして使用可能なネットワークインターフェースコントローラー (NIC) を検出し、次にファイアウォールの設定をチェックして、その設定を HostedEngine-VM にコンソールで (SPICE または VNC) アクセスできるように変更するかどうかを確認します。ping 送信可能なゲートウェイの IP アドレスを指定し

ovirt-ha-agentがそれを使用すると、HostedEngine-VM を実行するのに適したホストであるかどうかを判断しやすくなります。Please indicate a nic to set rhvm bridge on: (eth1, eth0) [eth1]: iptables was detected on your computer, do you wish setup to configure it? (Yes, No)[Yes]: Please indicate a pingable gateway IP address [X.X.X.X]:

仮想マシンの設定

このスクリプトにより、Red Hat Virtualization Manager として設定する仮想マシンが作成されます。本手順では、この仮想マシンを HostedEngine-VM と呼びます。ブートデバイスタイプに disk を選択すると、スクリプトにより利用可能な RHV-M Appliances が自動的に検出されます。アプライアンスを選択します。

Please specify the device to boot the VM from (choose disk for the oVirt engine appliance) (cdrom, disk, pxe) [disk]: Please specify the console type you would like to use to connect to the VM (vnc, spice) [vnc]: _vnc_ [ INFO ] Detecting available oVirt engine appliances The following appliance have been found on your system: [1] - The oVirt Engine Appliance image (OVA) [2] - Directly select an OVA file Please select an appliance (1, 2) [1]: [ INFO ] Checking OVF archive content (could take a few minutes depending on archive size)cloud-init で Manager 用仮想マシンの初期設定を行う場合には

Yesを指定します。root パスワードの設定、ネットワークやホスト名の設定などのタスクを cloud-init で処理する場合には Generate を指定します。または、cloud-init の高度な機能を活用できるように既存の cloud-init スクリプトがある場合には、Existing を選択します。次に、Manager 用仮想マシンの FQDN を指定します。この値は、BareMetal-Manager に指定した FQDN と同じでなければなりません。注記cloud-init に関する詳しい情報は cloud-init のドキュメント を参照してください。

Would you like to use cloud-init to customize the appliance on the first boot (Yes, No)[Yes]? Yes Would you like to generate on-fly a cloud-init no-cloud ISO image or do you have an existing one(Generate, Existing)[Generate]? Generate Please provide the FQDN you would like to use for the engine appliance. Note: This will be the FQDN of the engine VM you are now going to launch. It should not point to the base host or to any other existing machine. Engine VM FQDN: (leave it empty to skip): manager.example.com

engine-setupを実行する前に、BareMetal-Manager バックアップファイルを HostedEngine-VM に復元することができるようにするには、以下の質問にNoと答える必要があります。Automatically execute engine-setup on the engine appliance on first boot (Yes, No)[Yes]? NoManager のドメイン名、root パスワード、ネットワーク、ハードウェア、およびコンソールアクセスについての情報を設定します。

Enter root password that will be used for the engine appliance (leave it empty to skip): p@ssw0rd Confirm appliance root password: p@ssw0rd The following CPU types are supported by this host: - model_SandyBridge: Intel SandyBridge Family - model_Westmere: Intel Westmere Family - model_Nehalem: Intel Nehalem Family Please specify the CPU type to be used by the VM [model_Nehalem]: Please specify the number of virtual CPUs for the VM [Defaults to appliance OVF value: 4]: You may specify a MAC address for the VM or accept a randomly generated default [00:16:3e:77:b2:a4]: How should the engine VM network be configured (DHCP, Static)[DHCP]? Static Please enter the IP address to be used for the engine VM: 192.168.x.x Please provide a comma-separated list (max3) of IP addresses of domain name servers for the engine VM Engine VM DNS (leave it empty to skip): Add lines for the appliance itself and for this host to /etc/hosts on the engine VM? Note: ensuring that this host could resolve the engine VM hostname is still up to you (Yes, No)[No] Yes

セルフホストエンジンの設定

Red Hat Virtualization 環境内で識別するための Host-HE1 の名前と、管理ポータルへアクセスするための

admin@internalユーザーのパスワードを指定します。最後に、SMTP サーバーの名前と TCP ポート番号、メール通知に使用するメールアドレス、通知を受信するメールアドレス (複数ある場合はコンマ区切りリスト) を指定します。Enter engine admin password: p@ssw0rd Confirm engine admin password: p@ssw0rd Enter the name which will be used to identify this host inside the Administrator Portal [hosted_engine_1]: Please provide the FQDN for the engine you would like to use. This needs to match the FQDN that you will use for the engine installation within the VM. Note: This will be the FQDN of the VM you are now going to create, it should not point to the base host or to any other existing machine. Engine FQDN: []: manager.example.com Please provide the name of the SMTP server through which we will send notifications [localhost]: Please provide the TCP port number of the SMTP server [25]: Please provide the email address from which notifications will be sent [root@localhost]: Please provide a comma-separated list of email addresses which will get notifications [root@localhost]:

設定のプレビュー

先に進む前に、

hosted-engineスクリプトは入力された設定値を表示して、これらの値で設定を続行するかどうかを尋ねます。Bridge interface : eth1 Engine FQDN : manager.example.com Bridge name : ovirtmgmt Host address : host.example.com SSH daemon port : 22 Firewall manager : iptables Gateway address : X.X.X.X Host name for web application : Host-HE1 Host ID : 1 Image size GB : 50 Storage connection : storage.example.com:/hosted_engine/nfs Console type : vnc Memory size MB : 4096 MAC address : 00:16:3e:77:b2:a4 Boot type : pxe Number of CPUs : 2 CPU Type : model_Nehalem Please confirm installation settings (Yes, No)[Yes]:

HostedEngine-VM の作成

次にこのスクリプトは、HostedEngine-VM として設定する仮想マシンを作成し、接続情報を表示します。Host-HE1 上で

hosted-engineスクリプトを続行するためには、HostedEngine-VM でバックアップファイルを復元した後にengine-setupを手動で実行する必要があります。[ INFO ] Stage: Transaction setup ... [ INFO ] Creating VM You can now connect to the VM with the following command: /bin/remote-viewer vnc://localhost:5900 Use temporary password "3463VnKn" to connect to vnc console. Please note that in order to use remote-viewer you need to be able to run graphical applications. This means that if you are using ssh you have to supply the -Y flag (enables trusted X11 forwarding). Otherwise you can run the command from a terminal in your preferred desktop environment. If you cannot run graphical applications you can connect to the graphic console from another host or connect to the serial console using the following command: socat UNIX-CONNECT:/var/run/ovirt-vmconsole-console/8f74b589-8c6f-4a32-9adf-6e615b69de07.sock,user=ovirt-vmconsole STDIO,raw,echo=0,escape=1 Please ensure that your Guest OS is properly configured to support serial console according to your distro documentation. Follow http://www.ovirt.org/Serial_Console_Setup#I_need_to_access_the_console_the_old_way for more info. If you need to reboot the VM you will need to start it manually using the command: hosted-engine --vm-start You can then set a temporary password using the command: hosted-engine --add-console-password Please install and setup the engine in the VM. You may also be interested in subscribing to "agent" RHN/Satellite channel and installing rhevm-guest-agent-common package in the VM. The VM has been rebooted. To continue please install oVirt-Engine in the VM (Follow http://www.ovirt.org/Quick_Start_Guide for more info). Make a selection from the options below: (1) Continue setup - oVirt-Engine installation is ready and ovirt-engine service is up (2) Abort setup (3) Power off and restart the VM (4) Destroy VM and abort setup (1, 2, 3, 4)[1]:以下のコマンドで VNC プロトコルを使用して仮想マシンに接続します。FQDN は、セルフホストエンジンノードの完全修飾ドメイン名または IP アドレスに置き換えます。

# /bin/remote-viewer vnc://FQDN:5900HostedEngine-VM での SSH の有効化

RHV-M Virtual Appliance では、デフォルトで SSH パスワード認証は有効になっていません。VNC から HostedEngine-VM に接続して SSH パスワード認証を有効にし、後で BareMetal-Manager のバックアップファイルを復元して新しい Manager を設定する際に SSH を介して仮想マシンにアクセスできるようにします。

sshdサービスが実行されていることを確認します。/etc/ssh/sshd_config を編集して以下の 2 つのオプションをyesに変更します。[...] PermitRootLogin yes [...] PasswordAuthentication yes

sshdサービスを再起動して、変更を有効にします。# systemctl restart sshd.service

BareMetal-Manager の無効化

BareMetal-Manager (構築済みの Red Hat Virtualization 環境の Manager) に接続して

ovirt-engineサービスを停止し、実行されないようにします。# systemctl stop ovirt-engine.service # systemctl disable ovirt-engine.service

注記BearMetal-Manager の停止は必須ではありませんが、バックアップ作成後に環境に変更が加えられないようにするために停止することを推奨します。これは、BareMetal-Manager と HostedEngine-VM が同時に既存のリソースを管理するのを防ぐことにもなります。

DNS の更新

Red Hat Virtualization 環境の FQDN が、HostedEngine-VM の IP アドレスおよび Host-HE1 で

hosted-engineデプロイメントスクリプトを設定する際に指定した以前の FQDN と相関するように、DNS を更新します。本手順では、FQDN は manager.example.com に設定されています。これは、移行先のホストエンジン設定では、engine に指定する FQDN は移行元の engine に設定したものと同じでなければならないためです。BareMetal-Manager のバックアップ作成

バックアップを実施する前に、管理ネットワーク (ovirtmgmt) が VM ネットワークとして設定されていることを確認します。詳細については、『管理ガイド』の「論理ネットワークの全般の設定」を参照してください。

BareMetal-Manager に接続して、

--mode=backup、--file=FILE、および--log=LogFILEのパラメーターを指定してengine-backupコマンドを実行し、バックアップモード、バックアップ用に作成および使用するバックアップファイルの名前、バックアップログを格納するために作成するログファイルの名前を指定します。# engine-backup --mode=backup --file=FILE --log=LogFILE

バックアップファイルの HostedEngine-VM へのコピー

BareMetal-Manager 上から、バックアップファイルを HostedEngine-VM にセキュアコピーします。以下の例では、manager.example.com が HostedEngine-VM の FQDN で、/backup/ が指定のフォルダーまたはパスです。指定のフォルダーまたはパスが存在しない場合は、HostedEngine-VM に接続して、そのフォルダーまたはパスを作成した後に BareMetal-Manager からバックアップをセキュアコピーします。

# scp -p FILE LogFILE manager.example.com:/backup/

HostedEngine-VM でのバックアップファイルの復元

engine-backupツールを使用して、完全なバックアップを復元します。engine-setupの実行中に BareMetal-Manager データベースを手動で設定した場合には、「セルフホストエンジン Manager の手動での復元」の手順に従って、バックアップ環境を手動で復元してください。Manager のみを復元する場合は、以下を実行します。

# engine-backup --mode=restore --file=file_name --log=log_file_name --provision-db --restore-permissions

Manager と Data Warehouse を復元する場合には、以下を実行します。

# engine-backup --mode=restore --file=file_name --log=log_file_name --provision-db --provision-dwh-db --restore-permissions

正常に終了すると、以下のような出力が表示されます。

You should now run engine-setup. Done.

HostedEngine-VM の設定

復元した Manager 用仮想マシンを設定します。このプロセスにより、既存の構成設定およびデータベースの内容が特定されるので、設定を確認してください。完了すると、この設定で SSH フィンガープリントと内部認証局のハッシュが提供されます。

# engine-setup

[ INFO ] Stage: Initializing [ INFO ] Stage: Environment setup Configuration files: ['/etc/ovirt-engine-setup.conf.d/10-packaging.conf', '/etc/ovirt-engine-setup.conf.d/20-setup-ovirt-post.conf'] Log file: /var/log/ovirt-engine/setup/ovirt-engine-setup-20140304075238.log Version: otopi-1.1.2 (otopi-1.1.2-1.el6ev) [ INFO ] Stage: Environment packages setup [ INFO ] Yum Downloading: rhel-65-zstream/primary_db 2.8 M(70%) [ INFO ] Stage: Programs detection [ INFO ] Stage: Environment setup [ INFO ] Stage: Environment customization --== PACKAGES ==-- [ INFO ] Checking for product updates... [ INFO ] No product updates found --== NETWORK CONFIGURATION ==-- Setup can automatically configure the firewall on this system. Note: automatic configuration of the firewall may overwrite current settings. Do you want Setup to configure the firewall? (Yes, No) [Yes]: [ INFO ] iptables will be configured as firewall manager. --== DATABASE CONFIGURATION ==-- --== OVIRT ENGINE CONFIGURATION ==-- --== PKI CONFIGURATION ==-- --== APACHE CONFIGURATION ==-- --== SYSTEM CONFIGURATION ==-- --== END OF CONFIGURATION ==-- [ INFO ] Stage: Setup validation [ INFO ] Cleaning stale zombie tasks --== CONFIGURATION PREVIEW ==-- Default SAN wipe after delete : False Firewall manager : iptables Update Firewall : True Host FQDN : manager.example.com Engine database secured connection : False Engine database host : X.X.X.X Engine database user name : engine Engine database name : engine Engine database port : 5432 Engine database host name validation : False Engine installation : True PKI organization : example.com NFS mount point : /var/lib/exports/iso Configure VMConsole Proxy : True Engine Host FQDN : manager.example.com Configure WebSocket Proxy : True Please confirm installation settings (OK, Cancel) [OK]:ホストと Manager の同期

Host-HE1 に戻り、オプション 1 を選択して

hosted-engineデプロイメントスクリプトを続行します。(1) Continue setup - oVirt-Engine installation is ready and ovirt-engine service is up

スクリプトにより、内部認証局のハッシュが表示され、Host-HE1 を追加するクラスターを選択するように要求されます。

[ INFO ] Engine replied: DB Up!Welcome to Health Status! [ INFO ] Acquiring internal CA cert from the engine [ INFO ] The following CA certificate is going to be used, please immediately interrupt if not correct: [ INFO ] Issuer: C=US, O=example.com, CN=manager.example.com.23240, Subject: C=US, O=example.com, CN=manager.example.com.23240, Fingerprint (SHA-1): XXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXX [ INFO ] Connecting to the Engine Enter the name of the cluster to which you want to add the host (DB1, DB2, Default) [Default]: [ INFO ] Waiting for the host to become operational in the engine. This may take several minutes... [ INFO ] The VDSM Host is now operational [ INFO ] Saving hosted-engine configuration on the shared storage domain Please shutdown the VM allowing the system to launch it as a monitored service. The system will wait until the VM is down.

HostedEngine-VM の終了

HostedEngine-VM を終了します。

# shutdown -h now

設定の確認

Host-HE1 に戻り、HostedEngine-VM の停止が検出されていることを確認します。

[ INFO ] Enabling and starting HA services [ INFO ] Stage: Clean up [ INFO ] Generating answer file '/var/lib/ovirt-hosted-engine-setup/answers/answers-20160509162843.conf' [ INFO ] Generating answer file '/etc/ovirt-hosted-engine/answers.conf' [ INFO ] Stage: Pre-termination [ INFO ] Stage: Termination [ INFO ] Hosted Engine successfully set up

Red Hat Virtualization engine がセルフホストエンジンの設定環境に移行され、Manager は (同環境で HostedEngine-VM と呼ばれる) Host-HE1 の仮想マシンで実行されるようになりました。HostedEngine-VM は高可用性であるため、必要に応じて、この仮想マシンは環境内の別のセルフホストエンジンノードに移行されます。

第5章 セルフホストエンジンの管理

5.1. セルフホストエンジンのメンテナンス

メンテナンスモードでは、高可用性エージェントからの干渉なしに、Manager 用仮想マシンを起動、停止、変更することが可能です。また Manager を中断せずに、環境内のセルフホストエンジンノードを再起動および変更することができます。

有効にすることができるメンテナンスモードは 3 つあります。

-

global: クラスター内の全高可用性エージェントで、Manager 用仮想マシンの状態のモニタリングが無効化されます。global メンテナンスモードは、Red Hat Virtualization を新しいバージョンにアップグレードする操作などのovirt-engineサービスの停止を必要とする設定やアップグレード操作に適用する必要があります。 -

local: コマンドを発行するノード上の高可用性エージェントで、Manager 用仮想マシンのモニタリングが無効化されます。local メンテナンスモードの場合には、ノードは Manager 用仮想マシンのホスティングから除外されます。このモードに変更された際に Manager 用仮想マシンがホストされている場合には、可能であれば Manager は別のノードに移行されます。システム変更や更新をセルフホストエンジンノードに適用する場合に local メンテナンスモードを使用することを推奨します。 -

none: メンテナンスモードを無効にし、高可用性エージェントが稼働を続けるようにします。

RHEL ベースのセルフホストエンジンのメンテナンス (ローカルメンテナンス)

セルフホストエンジンノードをローカルメンテナンスモードに切り替えます。

- 管理ポータルで コンピュート → ホスト をクリックし、セルフホストエンジンノードを選択します。

- 管理 → メンテナンス をクリックします。そのノードにローカルメンテナンスモードが自動的にトリガーされます。

メンテナンスモードはコマンドラインから設定することもできます。

# hosted-engine --set-maintenance --mode=local

メンテナンスタスクが完了したら、メンテナンスモードを無効にします。

# hosted-engine --set-maintenance --mode=none

RHEL ベースのセルフホストエンジンのメンテナンス (グローバルメンテナンス)

セルフホストエンジンノードをグローバルメンテナンスモードに切り替えます。

- 管理ポータルで コンピュート → ホスト をクリックし、任意のセルフホストエンジンノードを選択して その他の操作 → グローバル HA メンテナンスを有効にする をクリックします。

メンテナンスモードはコマンドラインから設定することもできます。

# hosted-engine --set-maintenance --mode=global

メンテナンスタスクが完了したら、メンテナンスモードを無効にします。

# hosted-engine --set-maintenance --mode=none

5.2. Manager 用仮想マシンの管理

hosted-engine ユーティリティーは、Manager 用仮想マシンの管理を補助するために提供されています。このユーティリティーは、環境内の任意のセルフホストエンジンノードで実行することができます。全オプションを確認するには、hosted-engine --help コマンドを実行してください。また、特定のコマンドに関する追加情報を確認するには、hosted-engine --command --help コマンドを実行してください。詳しくは、「Manager 用仮想マシンのトラブルシューティング」を参照してください。

以下の手順は、初回のデプロイメント後に、共有ストレージドメインにあるセルフホストエンジンの設定ファイル (/var/lib/ovirt-hosted-engine-ha/broker.conf) を更新する方法について説明します。現在は、セルフホストエンジンノードの HA 状態の遷移に関するメール通知 (SMTP を使用) を設定できます。更新可能なキーには、smtp-server、smtp-port、source-email、destination-emails、state_transition などがあります。

共有ストレージドメイン上のセルフホストエンジン設定の更新

セルフホストエンジンノードで、

smtp-serverキーに目的の SMTP サーバーのアドレスを設定します。# hosted-engine --set-shared-config smtp-server smtp.example.com --type=broker注記セルフホストエンジンの設定ファイルが更新されたことを確認するには、以下のコマンドを実行します。

# hosted-engine --get-shared-config smtp-server --type=broker broker : smtp.example.com, type : broker

デフォルトの SMTP ポート (ポート 25) が設定されているかどうかを確認します。

# hosted-engine --get-shared-config smtp-port --type=broker broker : 25, type : broker

SMTP サーバーがメール通知の送信元に使用するメールアドレスを指定します。指定できるのは 1 つのアドレスのみです。

# hosted-engine --set-shared-config source-email source@example.com --type=brokerメール通知を受信する宛先のメールアドレスを指定します。複数のメールアドレスを指定するには、各アドレスをコンマで区切ってください。

# hosted-engine --set-shared-config destination-emails destination1@example.com,destination2@example.com --type=broker

SMTP がお使いのセルフホストエンジン環境に対して適切に設定されているかどうかを確認するには、セルフホストエンジンノードの HA 状態を変更して、メール通知が送信されたかどうかをチェックします。たとえば、HA エージェントをメンテナンスモードに切り替えることで、HA 状態を変更できます。詳しくは、「セルフホストエンジンのメンテナンス」を参照してください。

5.3. Manager 用仮想マシンの更新

セルフホストエンジンを現在お使いの 4.2 のバージョンから最新の 4.2 のバージョンに更新するには、環境をグローバルメンテナンスモードに切り替えてから、マイナーバージョン間で更新を行う標準的な手順に従います。

グローバルメンテナンスモードへの切り替え

Manager 用仮想マシンで何らかのセットアップ/アップグレードタスクを実施する前に、セルフホストエンジン環境をグローバルメンテナンスモードに切り替える必要があります。

手順

セルフホストエンジンノードのいずれかにログインして、グローバルメンテナンスモードに切り替えます。

# hosted-engine --set-maintenance --mode=global

次の手順に進む前に、環境がメンテナンスモードにあることを確認します。

# hosted-engine --vm-status

Red Hat Virtualization Manager の更新

Red Hat Virtualization Manager の更新はコンテンツ配信ネットワーク (CDN) 経由でリリースされます。

手順

Red Hat Virtualization Manager マシンで、更新パッケージが利用可能かどうかを確認します。

# engine-upgrade-check

注記更新があるにもかかわらず、入手できない場合には、必要なリポジトリーを有効にしてください。『インストールガイド』の「Red Hat Virtualization Manager リポジトリーの有効化」を参照してください。

setup のパッケージを更新します。

# yum update ovirt\*setup\*

Red Hat Virtualization Manager を更新します。

engine-setupスクリプトにより、設定に関する質問への回答が求められます。その後、ovirt-engine サービスの停止、更新パッケージのダウンロード/インストール、データベースのバックアップ/更新、インストール後設定の実施を経てから、ovirt-engine サービスが起動します。# engine-setup

注記engine-setupスクリプトは Red Hat Virtualization Manager のインストールプロセス中にも使用され、指定した設定値が保存されます。更新時には、設定のプレビューの際に保存された値が表示されますが、インストール後の設定変更にengine-configを使用している場合には、表示される値が最新のものではない可能性があります。たとえば、インストール後にengine-configを使用してSANWipeAfterDeleteをtrueに変更している場合、engine-setupによる設定プレビューでは「Default SAN wipe after delete: False」と出力されますが、変更した値がengine-setupにより上書きされるわけではありません。重要更新プロセスには時間がかかる場合があるため、更新プロセスが完了するまでの時間を計算に入れて、一旦更新を開始したらプロセスを停止しないようにしてください。

Manager にインストールされているベースオペレーティングシステムと、オプションパッケージを更新します。

# yum update

重要いずれかのカーネルパッケージが更新された場合には、ホストを再起動して更新を完了してください。

グローバルメンテナンスモードの終了

手順

セルフホストエンジンノードのいずれかにログインして、グローバルメンテナンスモードを終了します。

# hosted-engine --set-maintenance --mode=none

環境が稼働していることを確認します。

# hosted-engine --vm-status

5.4. 追加ホスト上にセルフホストエンジン用として確保するメモリースロットの設定

Manager 用仮想マシンを終了する、または移行する必要がある場合、Manager 用仮想マシンを再起動または移行するのに十分なメモリーがセルフホストエンジンノードになければなりません。スケジューリングポリシーを使用することで、このメモリーを複数のセルフホストエンジンノードに確保することができます。スケジューリングポリシーは、Manager 用仮想マシンを起動するのに十分なメモリーが指定した数の追加セルフホストエンジンノードにあるかどうかを確認してから、仮想マシンを起動または移行します。スケジューリングポリシーの詳細については、『管理ガイド』の「スケジューリングポリシーの作成」を参照してください。

Red Hat Virtualization Manager にさらにセルフホストエンジンノードを追加するには、「追加セルフホストエンジンノードのインストール」を参照してください。

追加ホスト上にセルフホストエンジン用として確保するメモリースロットの設定

- コンピュート → クラスター をクリックし、セルフホストエンジンノードが含まれるクラスターを選択します。

- 編集 をクリックします。

- スケジューリングポリシー タブをクリックします。

- + をクリックし、HeSparesCount を選択します。

- Manager 用仮想マシンを起動するのに十分なメモリーを確保するための、追加セルフホストエンジンノードの数を入力します。

- OK をクリックします。

5.5. 追加セルフホストエンジンノードのインストール

セルフホストエンジンノードは、通常のホストと同じ方法でさらに追加することができますが、セルフホストエンジンノードとしてホストをデプロイするという追加のステップが必要です。共有ストレージドメインは自動的に検出され、ノードは必要に応じて Manager 用仮想マシンをホストするフェイルオーバー用ホストとして使用することができます。セルフホストエンジン環境に通常のホストをアタッチすることもできますが、Manager 用仮想マシンをホストすることはできません。Red Hat では、Manager 用仮想マシンの高可用性を確保するために、セルフホストエンジンノードを最低でも 2 つ用意することを強く推奨します。追加ホストは、REST API を使用して追加することもできます。『REST API Guide』の「Hosts」を参照してください。

前提条件

- RHEL ベースのセルフホストエンジン環境では、物理ホストに Red Hat Enterprise Linux システムを新規インストールし、必要なサブスクリプションをアタッチしておく必要があります。サブスクリプションの詳細については、『インストールガイド』の「Red Hat Enterprise Linux ホストリポジトリーの有効化」を参照してください。

- RHVH ベースのセルフホストエンジン環境では、物理ホストに Red Hat Virtualization Host システムを新規インストールしておく必要があります。『インストールガイド』の「Red Hat Virtualization Host」を参照してください。

- セルフホストエンジンノードを再利用する場合は、既存のセルフホストエンジン設定を削除してください。「セルフホストエンジン環境からのホストの削除」を参照してください。

セルフホストエンジンノードの追加

- 管理ポータルで コンピュート → ホスト をクリックします。

新規作成 をクリックします。

追加ホストの設定に関する情報は『管理ガイド』の「新規ホストおよびホストの編集ウィンドウの設定とコントロール」を参照してください。

- ドロップダウンリストを使用して、新規ホスト用の データセンター および ホストクラスター を選択します。

- 新規ホストの 名前 と ホスト名 を入力します。SSH ポート フィールドには、標準の SSH ポートであるポート 22 が自動入力されます。

Manager がホストにアクセスするために使用する認証メソッドを選択します。

- パスワード認証を使用するには、root ユーザーのパスワードを入力します。

- または、SSH 公開鍵 フィールドに表示される鍵をホスト上の /root/.ssh/authorized_keys にコピーして、公開鍵認証を使用します。

- オプションで、ホストが電源管理カードをサポートしている場合には、電源管理を設定することができます。電源管理の設定に関する情報は、『管理ガイド』の「ホストの電源管理の設定」のセクションを参照してください。

- ホストエンジン タブをクリックします。

- デプロイ を選択します。

- OK をクリックします。

5.6. 既存ホストのセルフホストエンジンノードとしての再インストール

セルフホストエンジン環境にある既存の通常ホストを、Manager 用仮想マシンをホストできるセルフホストエンジンノードに変更することができます。

既存ホストのセルフホストエンジンノードとしての再インストール

- コンピュート → ホスト をクリックし、ホストを選択します。

- 管理 → メンテナンス をクリックし、OK をクリックします。

- インストール → 再インストール をクリックします。

- セルフホストエンジン タブをクリックし、ドロップダウンリストから DEPLOY を選択します。

- OK をクリックします。

ホストがセルフホストエンジン設定で再インストールされ、管理ポータルではこのホストに王冠のフラグが付けられます。

5.7. セルフホストエンジン環境からのホストの削除

セルフホストエンジンノードを環境から削除するには、そのノードをメンテナンスモードに切り替えてからアンデプロイします。ノードの削除はオプションです。HA サービスが停止されて、セルフホストエンジンの設定ファイルが削除された後には、このノードを通常のホストとして管理することができます。

セルフホストエンジン環境からのホストの削除

- 管理ポータルで コンピュート → ホスト をクリックし、セルフホストエンジンノードを選択します。

- 管理 → メンテナンス をクリックし、OK をクリックします。

- インストール → 再インストール をクリックします。

-

セルフホストエンジン タブをクリックし、ドロップダウンリストから UNDEPLOY を選択します。この操作により

ovirt-ha-agentおよびovirt-ha-brokerサービスが停止し、セルフホストエンジンの設定ファイルが削除されます。 - OK をクリックします。

- オプションとして、削除 をクリックすると ホストの削除 の確認ウィンドウが開くので、OK をクリックしてください。

第6章 セルフホストエンジンのアップグレード

本章では、現在お使いの環境を Red Hat Virtualization 4.2 にアップグレードする方法について説明します。

以下の表から、お使いの環境に合った正しい手順を選択してください。Manager とホストのバージョンが異なる場合は (過去に Manager はアップグレードしたがホストはアップグレードしていない場合など)、Manager のバージョンに該当する手順に従ってください。

表6.1 サポート対象のアップグレードパス

| 現在の Manager のバージョン | アップグレード後の Manager のバージョン | 該当セクション |

|---|---|---|

|

3.6 |

4.2 |

「セルフホストエンジンの Red Hat Enterprise Virtualization 3.6 から Red Hat Virtualization 4.2 へのアップグレード」 |

|

4.0 |

4.2 | |

|

4.1 |

4.2 | |

|

4.2.x |

4.2.y |

対話式のアップグレード手順については、Red Hat Virtualization Upgrade Helper を利用することもできます。このアプリケーションに、アップグレードパスおよび現在の環境についての情報を入力すると、適切なアップグレード手順と、アップグレードシナリオ固有の既知の問題を回避する手順が表示されます。

6.1. セルフホストエンジンの Red Hat Enterprise Virtualization 3.6 から Red Hat Virtualization 4.2 へのアップグレード

お使いの環境で次世代の RHVH または Red Hat Enterprise Linux ホストが使われている場合に、この手順を使用してください。

お使いの環境で従来の RHEV-H 3.6 ホストのみが使われている場合には、「付録A RHEV-H 3.6 セルフホストエンジンの RHVH 4.2 セルフホストエンジンへのアップグレード」に記載の手順を使用してアップグレードする必要があります。

Manager を 3.6 から 4.2 に直接アップグレードすることはできません。以下のフローに従って、お使いの環境をアップグレードする必要があります。

6.1.1. グローバルメンテナンスモードへの切り替え

Manager 用仮想マシンで何らかのセットアップ/アップグレードタスクを実施する前に、セルフホストエンジン環境をグローバルメンテナンスモードに切り替える必要があります。

手順

セルフホストエンジンノードのいずれかにログインして、グローバルメンテナンスモードに切り替えます。

# hosted-engine --set-maintenance --mode=global

次の手順に進む前に、環境がメンテナンスモードにあることを確認します。

# hosted-engine --vm-status

6.1.2. Red Hat Virtualization Manager の更新

Red Hat Virtualization Manager の更新はコンテンツ配信ネットワーク (CDN) 経由でリリースされます。

手順

Red Hat Virtualization Manager マシンで、更新パッケージが利用可能かどうかを確認します。

# engine-upgrade-check

setup のパッケージを更新します。

# yum update rhevm-setup

Red Hat Virtualization Manager を更新します。

engine-setupスクリプトにより、設定に関する質問への回答が求められます。その後、ovirt-engine サービスの停止、更新パッケージのダウンロード/インストール、データベースのバックアップ/更新、インストール後設定の実施を経てから、ovirt-engine サービスが起動します。# engine-setup

注記engine-setupスクリプトは Red Hat Virtualization Manager のインストールプロセス中にも使用され、指定した設定値が保存されます。更新時には、設定のプレビューの際に保存された値が表示されますが、インストール後の設定変更にengine-configを使用している場合には、表示される値が最新のものではない可能性があります。たとえば、インストール後にengine-configを使用してSANWipeAfterDeleteをtrueに変更している場合、engine-setupによる設定プレビューでは「Default SAN wipe after delete: False」と出力されますが、変更した値がengine-setupにより上書きされるわけではありません。重要更新プロセスには時間がかかる場合があるため、更新プロセスが完了するまでの時間を計算に入れて、一旦更新を開始したらプロセスを停止しないようにしてください。

Manager にインストールされているベースオペレーティングシステムと、オプションパッケージを更新します。

# yum update

重要いずれかのカーネルパッケージが更新された場合には、ホストを再起動して更新を完了してください。

6.1.3. セルフホストエンジン の 3.6 から 4.0 へのアップグレード

Red Hat Enterprise Virtualization 3.6 では、Manager は Red Hat Enterprise Linux 6 上で動作します。Manager 用仮想マシンの Red Hat Enterprise Linux 7 へのインプレースアップグレードはサポートされません。

Red Hat Enterprise Virtualization 3.6 セルフホストエンジン環境を Red Hat Virtualization 4.0 にアップグレードするには、Red Hat Virtualization 4.0 と共に提供されるアップグレードユーティリティーを使用して Red Hat Enterprise Linux 7 に新たな Manager をインストールし、新たな Manager で 3.6 Manager データベースのバックアップを復元する必要があります。

アップグレードユーティリティーは、テンプレートをベースとして新しい Manager を構築します。カスタムユーザー、SSH キー、監視など、アップグレード前の Manager に加えたカスタムの設定や手動の変更は、新しい Manager 上で再度手動で適用する必要があります。

前提条件

- 環境内のホストは、すべて Red Hat Enterprise Linux 7 を実行している必要があります。

- 環境内のデータセンターおよびクラスターの互換バージョンは、すべて 3.6 に設定されている必要があります。

- /var/tmp ディレクトリーには、アプライアンスファイルを抽出するために少なくとも 5 GB の空き容量が必要です。空き容量がない場合には、別のディレクトリーを指定するか、必要な容量がある別のストレージをマウントするようにしてください。VDSM ユーザーおよび KVM グループには、このディレクトリーでの読み取り、書き込み、実行のパーミッションを付与する必要があります。

- セルフホストエンジンのストレージドメインには、デプロイされる新たなアプライアンス用にさらに空き容量が必要です (デフォルトでは 50 GB)。iSCSI または Fibre Channel ストレージのストレージ容量を増やすには、Manager を使用してストレージの LUN サイズを手動で拡張し、その後ストレージドメインを拡張する必要があります。LUN のサイズ変更の詳細については、『Red Hat Enterprise Virtualization 3.6 Administration Guide』の「Increasing iSCSI or FCP Storage」を参照してください。

手順

現在 SPM に設定されており、Manager 用仮想マシンを含むホストで、Red Hat Virtualization 4.0 に必要なリポジトリーを有効にします。

# subscription-manager repos --enable=rhel-7-server-rhv-4-mgmt-agent-rpms

- Manager 用仮想マシン以外の仮想マシンをすべてを別のホストに移行します。

ホストで Manager 用仮想マシンのパッケージを更新します。

# yum update ovirt-hosted-engine-setup rhevm-appliance

rhevm-applianceパッケージがない場合には、ovirt-hosted-engine-setupを更新する前に手動でパッケージをインストールします。# yum install rhevm-appliance # yum update ovirt-hosted-engine-setup

アップグレードユーティリティーを実行して、Manager 用仮想マシンをアップグレードします。標準の Red Hat Enterprise Linux リポジトリーで入手可能な

screenパッケージがインストールされていない場合は、パッケージをインストールします。# yum install screen # screen # hosted-engine --upgrade-appliance

アプライアンスが複数検出された場合にはアプライアンスを選択し、Manager データベースのバックアップを作成してその完全パスを指定するように求められます。

アップグレード時に問題が発生した場合には、hosted-engine --vm-poweroff コマンドを使用して Manager の電源を切り、hosted-engine --rollback-upgrade を実行してアップグレードをロールバックします。

アップグレード中に作成されたバックアップは、自動的には削除されません。アップグレードが正常に完了したことを確認した後に、手動で削除することができます。バックアップディスクには、hosted-engine-backup-* のラベルが付けられます。

6.1.4. Manager の 4.0 から 4.1 へのアップグレード

Red Hat Virtualization Manager を 4.0 から 4.1 にアップグレードします。

アップグレードに失敗すると、engine-setup コマンドは Red Hat Virtualization Manager のインストール設定を以前の状態にロールバックするように試みます。そのため、アップグレードを完了するまで、前のバージョンのリポジトリーを削除するべきではありません。アップグレードに失敗した場合は、インストールの復元方法を詳しく説明した手順が表示されます。

手順

Red Hat Virtualization Manager 4.1 と Red Hat Virtualization Tools のリポジトリーを有効にします。

# subscription-manager repos --enable=rhel-7-server-rhv-4.1-rpms # subscription-manager repos --enable=rhel-7-server-rhv-4-tools-rpms

setup のパッケージを更新します。

# yum update ovirt\*setup\*

engine-setupコマンドを実行し、プロンプトに従って Red Hat Virtualization Manager をアップグレードします。# engine-setup

Red Hat Virtualization Manager 4.0 のリポジトリーを削除または無効にして、このシステムで 4.0 のパッケージが使用されないようにします。

# subscription-manager repos --disable=rhel-7-server-rhv-4.0-rpms

ベースオペレーティングシステムを更新します。

# yum update

重要いずれかのカーネルパッケージが更新された場合には、システムを再起動して更新を完了してください。

6.1.5. Manager の 4.1 から 4.2 へのアップグレード

Red Hat Virtualization Manager を 4.1 から 4.2 にアップグレードします。

アップグレードに失敗すると、engine-setup コマンドは Red Hat Virtualization Manager のインストール設定を以前の状態にロールバックするように試みます。そのため、アップグレードを完了するまで、前のバージョンのリポジトリーを削除するべきではありません。アップグレードに失敗した場合は、インストールの復元方法を詳しく説明した手順が表示されます。

手順

Red Hat Virtualization Manager 4.2、Red Hat Virtualization Tools、および Ansible Engine のリポジトリーを有効にします。

# subscription-manager repos --enable=rhel-7-server-rhv-4.2-manager-rpms # subscription-manager repos --enable=rhel-7-server-rhv-4-manager-tools-rpms # subscription-manager repos --enable=rhel-7-server-ansible-2-rpms

重要Red Hat Virtualization Manager 4.2 では、Red Hat JBoss Enterprise Application Platform (JBoss EAP) 7.1 を Manager マシンにインストールする必要があります。

jb-eap-7-for-rhel-7-server-rpmsリポジトリーが有効であること、およびjb-eap-7.0-for-rhel-7-server-rpmsリポジトリーを無効であることを確認してください。どちらのリポジトリーが有効であるかを確認するには、subscription-manager repos --listを実行します。setup のパッケージを更新します。

# yum update ovirt\*setup\*

engine-setupコマンドを実行し、プロンプトに従って Red Hat Virtualization Manager をアップグレードします。# engine-setup

Red Hat Virtualization Manager 4.1 のリポジトリーを削除または無効にして、このシステムで 4.1 のパッケージが使用されないようにします。

# subscription-manager repos --disable=rhel-7-server-rhv-4.1-rpms # subscription-manager repos --disable=rhel-7-server-rhv-4.1-manager-rpms # subscription-manager repos --disable=rhel-7-server-rhv-4-tools-rpms

ベースオペレーティングシステムを更新します。

# yum update

重要いずれかのカーネルパッケージが更新された場合には、システムを再起動して更新を完了してください。

6.1.6. グローバルメンテナンスモードの終了

手順

セルフホストエンジンノードのいずれかにログインして、グローバルメンテナンスモードを終了します。

# hosted-engine --set-maintenance --mode=none

環境が稼働していることを確認します。

# hosted-engine --vm-status

次に、セルフホストエンジンノードおよびすべての標準ホストの更新を行います。手順は、両方のホストタイプで同じです。

6.1.7. ホストの更新

以下の手順を使用して、Red Hat Enterprise Linux ホストまたは Red Hat Virtualization Host (RHVH) を更新します。

Red Hat Virtualization では、レガシーの Red Hat Enterprise Virtualization Hypervisor (RHEV-H) はサポートされません。それらを RHVH にインストールし直す必要があります。『インストールガイド』の「Red Hat Virtualization Host のインストール」を参照してください。ホスト上のローカルストレージを維持する必要がある場合には、「付録B ローカルストレージを維持した状態での RHEV-H 3.6 から RHVH 4.2 へのアップグレード」を参照してください。

RHEV-H と RHVH のどちらを使用しているか分からない場合は、以下のコマンドを実行します。

# imgbase check

コマンドの実行に失敗する場合には、ホストは RHEV-H です。コマンドの実行に成功すれば、ホストは RHVH です。

ホストのアップグレードマネージャーを使用して、Red Hat Virtualization Manager から直接個別のホストを更新します。

アップグレードマネージャーが確認するのは、ステータスが Up または Non-operational のホストだけです。ステータスが Maintenance のホストは確認されません。

RHVH の更新時には、/etc および /var ディレクトリー内の変更データしか維持されません。他のパスに含まれる変更データは更新時に上書きされます。

前提条件

- クラスターレベルで移行が有効化されている場合には、仮想マシンはそのクラスター内の別のホストに自動的に移行されるので、ホストの更新は、ホストの使用率が比較的に低い時間帯に実行することを推奨します。

- 更新の前に、クラスターに複数のホストが含まれていることを確認します。全ホストを同時に更新しないようにしてください。Storage Pool Manager (SPM) のタスクを実行するために、ホストが 1 台使用可能である必要があります。

- ホストが属するクラスターに、ホストがメンテナンスを実行するのに十分なメモリーが確保されていることを確認してください。クラスターに十分なメモリーがない場合には、仮想マシンの移行操作がハングして失敗してしまいます。ホストを更新する前に一部またはすべての仮想マシンをシャットダウンしておくと、この操作のメモリー使用量を低減することができます。

- vGPU を使用している仮想マシンを別のホストに移行することはできません。ホストを更新する前に、vGPU がインストールされた仮想マシンを停止する必要があります。

手順

「What channels should be used for RHEV 3.6 ELS?」の説明に従って Red Hat Enterprise Linux ホストをバージョン 7.3 に設定している場合は、更新する前に通常の RHEL 7 バージョンに再設定する必要があります。

subscription-manager release --showを実行して、バージョン 7.3 に設定されているかどうかを確認することができます。# subscription-manager release --set=7Server

現在のリポジトリーを無効にします。

# subscription-manager repos --disable=*

適切なリポジトリーを有効にします。

yum repolistを実行して、現在有効なリポジトリーを確認することができます。Red Hat Virtualization Host の場合:

# subscription-manager repos --enable=rhel-7-server-rhvh-4-rpms

Red Hat Enterprise Linux ホストの場合:

# subscription-manager repos --enable=rhel-7-server-rpms # subscription-manager repos --enable=rhel-7-server-rhv-4-mgmt-agent-rpms # subscription-manager repos --enable=rhel-7-server-ansible-2-rpms

- 管理ポータルで コンピュート → ホスト をクリックし、更新するホストを選択します。

インストール → アップグレードを確認 をクリックし、OK をクリックします。

イベントおよびアラートの通知 アイコン (

) をクリックし、イベント セクションを展開して結果を確認します。

) をクリックし、イベント セクションを展開して結果を確認します。

- 更新が利用可能であれば、インストール → アップグレード をクリックします。

OK をクリックしてホストを更新します。実行中の仮想マシンは、その移行ポリシーに従って移行されます。いずれかの仮想マシンの移行が無効になっている場合は、シャットダウンするよう求められます。

コンピュート → ホスト にホストの情報が更新され、ステータスが以下の順序で変わります。

- Maintenance

- Installing

- Reboot

Up

このホストから別のホストに移行していた仮想マシンがあれば、この時点で元に戻すことができます。

注記更新が失敗すると、ホストのステータスは Install Failed に変わります。Install Failed の状態から インストール → アップグレード を再度クリックすることができます。

Red Hat Virtualization 環境内のホストごとに同じ手順を繰り返してください。

6.1.8. クラスターの互換バージョンの変更

Red Hat Virtualization のクラスターには互換バージョンがあります。クラスターの互換バージョンは、そのクラスター内の全ホストがサポートする Red Hat Virtualization の機能を示します。クラスターの互換バージョンは、そのクラスター内で最も機能性の低いホストのバージョンに応じて設定されます。

クラスターの互換バージョンを変更するには、まず、クラスター内の全ホストを更新して、必要な互換性レベルをサポートするレベルにする必要があります。更新が利用可能であることを示すアイコンがホストの横にあるかどうかを確認します。

手順

- コンピュート → クラスター をクリックし、変更するクラスターを選択します。

- 編集 をクリックします。

- 互換バージョン を必要な値に変更します。

- OK をクリックして、クラスターの互換バージョンを変更 の確認ウィンドウを開きます。

- OK をクリックして確定します。

一部の仮想マシンおよびテンプレートが不適切に設定されていることを警告するエラーメッセージが表示される場合があります。このエラーを修正するには、それぞれの仮想マシンを手動で編集します。仮想マシンの編集 ウィンドウには、修正すべき項目を確認することのできる新たな検証および警告が表示されます。問題が自動的に修正され、仮想マシンの設定を再度保存するだけで十分な場合もあります。それぞれの仮想マシンを編集したら、クラスターの互換バージョンを変更することができます。

クラスターの互換バージョンを変更したら、実行中またはサスペンド中のすべての仮想マシンについてクラスターの互換バージョンを変更する必要があります。そのためには、ゲストオペレーティングシステム内ではなく、Manager 内から、または REST API を使用して仮想マシンを再起動します。再起動するまで、仮想マシンは以前のクラスターの互換性レベルで動作を続けます。再起動が必要な仮想マシンには、変更が保留されていることを示すアイコン (

) が付きます。プレビュー状態にある仮想マシンスナップショットについては、クラスター互換バージョンを変更することができません。まずコミットするか、プレビューを取り消す必要があります。

) が付きます。プレビュー状態にある仮想マシンスナップショットについては、クラスター互換バージョンを変更することができません。まずコミットするか、プレビューを取り消す必要があります。

セルフホストエンジンの仮想マシンを再起動する必要はありません。

データセンター内の全クラスターの互換バージョンの更新が完了したら、次にデータセンター自体の互換バージョンも変更することができます。

6.1.9. データセンターの互換バージョンの変更

Red Hat Virtualization データセンターには、互換バージョンがあります。互換バージョンとは、データセンターと互換性のある Red Hat Virtualization のバージョンを指します。データセンター内のクラスターはすべて、指定の互換性レベルをサポートします。

データセンターの互換バージョンを変更するには、まず、データセンター内の全クラスターを更新して、必要な互換性レベルをサポートするレベルにしておく必要があります。

手順

- コンピュート → データセンター をクリックし、変更するデータセンターを選択します。

- 編集 をクリックします。

- 互換バージョン を必要な値に変更します。

- OK をクリックして、データセンターの互換バージョンを変更 の確認ウィンドウを開きます。

- OK をクリックして確定します。

6.1.10. SHA-1 証明書の SHA-256 証明書への置き換え

Red Hat Virtualization 4.2 では SHA-256 署名が使用され、SHA-1 よりセキュアに SSL 証明書に署名することができます。新たにインストールした 4.2 システムでは、Red Hat Virtualization の公開鍵インフラストラクチャー (PKI) が SHA-256 署名を使用できるようにするのに、特別な手順は必要ありません。ただし、アップグレードしたシステムでは、以下のオプションのどちらかを実施することを推奨します。

- 管理ポータルに接続する際に警告メッセージがブラウザーに表示されないようにする。この警告はポップアップウィンドウとして、またはブラウザーの Web コンソール ウィンドウに表示されます。アップグレード後にすでに Red Hat Virtualization Manager の Apache SSL 証明書を置き換えている場合には、このオプションは必要ありません。ただし、証明書が SHA-1 で署名されている場合には、それを SHA-256 証明書に置き換える必要があります。詳細については、『管理ガイド』の「Red Hat Virtualization Manager の SSL/TLS 証明書の変更」を参照してください。

- システム全体の SHA-1 証明書を SHA-256 証明書に置き換える。

ブラウザーでの警告メッセージ表示の防止

- Manager マシンに root ユーザーとしてログインします。

/etc/pki/ovirt-engine/openssl.conf に

default_md = sha256行が含まれているかどうかを確認します。# cat /etc/pki/ovirt-engine/openssl.conf

まだ

default_md = sha1が含まれていたら、既存の設定のバックアップを作成してデフォルトをsha256に変更します。# cp -p /etc/pki/ovirt-engine/openssl.conf /etc/pki/ovirt-engine/openssl.conf."$(date +"%Y%m%d%H%M%S")" # sed -i 's/^default_md = sha1/default_md = sha256/' /etc/pki/ovirt-engine/openssl.conf

署名し直す必要のある証明書を定義します。

# names="apache"

セルフホストエンジンノードのいずれかにログインして、グローバルメンテナンスモードに切り替えます。

# hosted-engine --set-maintenance --mode=global

Manager で Apache 証明書を署名し直します。

for name in $names; do subject="$( openssl \ x509 \ -in /etc/pki/ovirt-engine/certs/"${name}".cer \ -noout \ -subject \ | sed \ 's;subject= \(.*\);\1;' \ )" /usr/share/ovirt-engine/bin/pki-enroll-pkcs12.sh \ --name="${name}" \ --password=mypass \ --subject="${subject}" \ --keep-key donehttpd サービスを再起動します。

# systemctl restart httpd

セルフホストエンジンノードのいずれかにログインして、グローバルメンテナンスモードを終了します。

# hosted-engine --set-maintenance --mode=none

- 管理ポータルに接続して、警告が表示されなくなったことを確認します。

-

以前に CA または https 証明書をブラウザーにインポートしている場合は、その証明書を探してブラウザーから削除し、新しい CA 証明書をインポートし直します。ブラウザーから提供される手順に従って、認証局の証明書をインストールしてください。認証局の証明書を取得するには、

http://your-manager-fqdn/ovirt-engine/services/pki-resource?resource=ca-certificate&format=X509-PEM-CAにアクセスします (your-manager-fqdn は、完全修飾ドメイン名 (FQDN) に置き換えてください)。

すべての署名済み証明書の SHA-256 への置き換え

- Manager マシンに root ユーザーとしてログインします。

/etc/pki/ovirt-engine/openssl.conf に

default_md = sha256行が含まれているかどうかを確認します。# cat /etc/pki/ovirt-engine/openssl.conf

まだ

default_md = sha1が含まれていたら、既存の設定のバックアップを作成してデフォルトをsha256に変更します。# cp -p /etc/pki/ovirt-engine/openssl.conf /etc/pki/ovirt-engine/openssl.conf."$(date +"%Y%m%d%H%M%S")" # sed -i 's/^default_md = sha1/default_md = sha256/' /etc/pki/ovirt-engine/openssl.conf

CA 証明書のバックアップを作成して ca.pem.new に新しい証明書を作成し、CA 証明書を署名し直します。

# cp -p /etc/pki/ovirt-engine/private/ca.pem /etc/pki/ovirt-engine/private/ca.pem."$(date +"%Y%m%d%H%M%S")" # openssl x509 -signkey /etc/pki/ovirt-engine/private/ca.pem -in /etc/pki/ovirt-engine/ca.pem -out /etc/pki/ovirt-engine/ca.pem.new -days 3650 -sha256

既存の証明書を新しい証明書に置き換えます。

# mv /etc/pki/ovirt-engine/ca.pem.new /etc/pki/ovirt-engine/ca.pem

署名し直す必要のある証明書を定義します。

# names="engine apache websocket-proxy jboss imageio-proxy"

アップグレード後に Red Hat Virtualization Manager SSL 証明書を置き換えている場合は、上記のコマンドの代わりに以下のコマンドを実行します。

# names="engine websocket-proxy jboss imageio-proxy"

詳細については、『管理ガイド』の「Red Hat Virtualization Manager の SSL/TLS 証明書の変更」を参照してください。

セルフホストエンジンノードのいずれかにログインして、グローバルメンテナンスモードに切り替えます。

# hosted-engine --set-maintenance --mode=global

Manager で証明書を署名し直します。

for name in $names; do subject="$( openssl \ x509 \ -in /etc/pki/ovirt-engine/certs/"${name}".cer \ -noout \ -subject \ | sed \ 's;subject= \(.*\);\1;' \ )" /usr/share/ovirt-engine/bin/pki-enroll-pkcs12.sh \ --name="${name}" \ --password=mypass \ --subject="${subject}" \ --keep-key done以下のサービスを再起動します。

# systemctl restart httpd # systemctl restart ovirt-engine # systemctl restart ovirt-websocket-proxy # systemctl restart ovirt-imageio-proxy

セルフホストエンジンノードのいずれかにログインして、グローバルメンテナンスモードを終了します。

# hosted-engine --set-maintenance --mode=none

- 管理ポータルに接続して、警告が表示されなくなったことを確認します。

-

以前に CA または https 証明書をブラウザーにインポートしている場合は、その証明書を探してブラウザーから削除し、新しい CA 証明書をインポートし直します。ブラウザーから提供される手順に従って、認証局の証明書をインストールしてください。認証局の証明書を取得するには、

http://your-manager-fqdn/ovirt-engine/services/pki-resource?resource=ca-certificate&format=X509-PEM-CAにアクセスします (your-manager-fqdn は、完全修飾ドメイン名 (FQDN) に置き換えてください)。 ホストで証明書を登録します。それぞれのホストについて以下の手順を繰り返します。

- 管理ポータルで コンピュート → ホスト をクリックします。

- ホストを選択し、管理 → メンテナンス をクリックします。

- ホストがメンテナンスモードに変わったら、インストール → 証明書を登録 をクリックします。

- 管理 → アクティブ化 をクリックします。

6.2. セルフホストエンジンの Red Hat Virtualization 4.0 から 4.2 へのアップグレード

Manager を 4.0 から 4.2 に直接アップグレードすることはできません。以下のフローに従って、お使いの環境をアップグレードする必要があります。

6.2.1. グローバルメンテナンスモードへの切り替え

Manager 用仮想マシンで何らかのセットアップ/アップグレードタスクを実施する前に、セルフホストエンジン環境をグローバルメンテナンスモードに切り替える必要があります。

手順

セルフホストエンジンノードのいずれかにログインして、グローバルメンテナンスモードに切り替えます。

# hosted-engine --set-maintenance --mode=global

次の手順に進む前に、環境がメンテナンスモードにあることを確認します。

# hosted-engine --vm-status

6.2.2. Red Hat Virtualization Manager の更新

Red Hat Virtualization Manager の更新はコンテンツ配信ネットワーク (CDN) 経由でリリースされます。

手順

Red Hat Virtualization Manager マシンで、更新パッケージが利用可能かどうかを確認します。

# engine-upgrade-check

setup のパッケージを更新します。

# yum update ovirt\*setup\*

Red Hat Virtualization Manager を更新します。

engine-setupスクリプトにより、設定に関する質問への回答が求められます。その後、ovirt-engine サービスの停止、更新パッケージのダウンロード/インストール、データベースのバックアップ/更新、インストール後設定の実施を経てから、ovirt-engine サービスが起動します。# engine-setup

注記engine-setupスクリプトは Red Hat Virtualization Manager のインストールプロセス中にも使用され、指定した設定値が保存されます。更新時には、設定のプレビューの際に保存された値が表示されますが、インストール後の設定変更にengine-configを使用している場合には、表示される値が最新のものではない可能性があります。たとえば、インストール後にengine-configを使用してSANWipeAfterDeleteをtrueに変更している場合、engine-setupによる設定プレビューでは「Default SAN wipe after delete: False」と出力されますが、変更した値がengine-setupにより上書きされるわけではありません。重要更新プロセスには時間がかかる場合があるため、更新プロセスが完了するまでの時間を計算に入れて、一旦更新を開始したらプロセスを停止しないようにしてください。

Manager にインストールされているベースオペレーティングシステムと、オプションパッケージを更新します。

# yum update

重要いずれかのカーネルパッケージが更新された場合には、ホストを再起動して更新を完了してください。

6.2.3. Manager の 4.0 から 4.1 へのアップグレード

Red Hat Virtualization Manager を 4.0 から 4.1 にアップグレードします。

アップグレードに失敗すると、engine-setup コマンドは Red Hat Virtualization Manager のインストール設定を以前の状態にロールバックするように試みます。そのため、アップグレードを完了するまで、前のバージョンのリポジトリーを削除するべきではありません。アップグレードに失敗した場合は、インストールの復元方法を詳しく説明した手順が表示されます。

手順

Red Hat Virtualization Manager 4.1 と Red Hat Virtualization Tools のリポジトリーを有効にします。

# subscription-manager repos --enable=rhel-7-server-rhv-4.1-rpms # subscription-manager repos --enable=rhel-7-server-rhv-4-tools-rpms

setup のパッケージを更新します。

# yum update ovirt\*setup\*

engine-setupコマンドを実行し、プロンプトに従って Red Hat Virtualization Manager をアップグレードします。# engine-setup

Red Hat Virtualization Manager 4.0 のリポジトリーを削除または無効にして、このシステムで 4.0 のパッケージが使用されないようにします。

# subscription-manager repos --disable=rhel-7-server-rhv-4.0-rpms

ベースオペレーティングシステムを更新します。

# yum update

重要いずれかのカーネルパッケージが更新された場合には、システムを再起動して更新を完了してください。

6.2.4. Manager の 4.1 から 4.2 へのアップグレード

Red Hat Virtualization Manager を 4.1 から 4.2 にアップグレードします。

アップグレードに失敗すると、engine-setup コマンドは Red Hat Virtualization Manager のインストール設定を以前の状態にロールバックするように試みます。そのため、アップグレードを完了するまで、前のバージョンのリポジトリーを削除するべきではありません。アップグレードに失敗した場合は、インストールの復元方法を詳しく説明した手順が表示されます。

手順

Red Hat Virtualization Manager 4.2、Red Hat Virtualization Tools、および Ansible Engine のリポジトリーを有効にします。

# subscription-manager repos --enable=rhel-7-server-rhv-4.2-manager-rpms # subscription-manager repos --enable=rhel-7-server-rhv-4-manager-tools-rpms # subscription-manager repos --enable=rhel-7-server-ansible-2-rpms

重要Red Hat Virtualization Manager 4.2 では、Red Hat JBoss Enterprise Application Platform (JBoss EAP) 7.1 を Manager マシンにインストールする必要があります。

jb-eap-7-for-rhel-7-server-rpmsリポジトリーが有効であること、およびjb-eap-7.0-for-rhel-7-server-rpmsリポジトリーを無効であることを確認してください。どちらのリポジトリーが有効であるかを確認するには、subscription-manager repos --listを実行します。setup のパッケージを更新します。

# yum update ovirt\*setup\*

engine-setupコマンドを実行し、プロンプトに従って Red Hat Virtualization Manager をアップグレードします。# engine-setup

Red Hat Virtualization Manager 4.1 のリポジトリーを削除または無効にして、このシステムで 4.1 のパッケージが使用されないようにします。

# subscription-manager repos --disable=rhel-7-server-rhv-4.1-rpms # subscription-manager repos --disable=rhel-7-server-rhv-4.1-manager-rpms # subscription-manager repos --disable=rhel-7-server-rhv-4-tools-rpms

ベースオペレーティングシステムを更新します。

# yum update

重要いずれかのカーネルパッケージが更新された場合には、システムを再起動して更新を完了してください。

6.2.5. グローバルメンテナンスモードの終了

手順

セルフホストエンジンノードのいずれかにログインして、グローバルメンテナンスモードを終了します。

# hosted-engine --set-maintenance --mode=none

環境が稼働していることを確認します。

# hosted-engine --vm-status

次に、セルフホストエンジンノードおよびすべての標準ホストの更新を行います。手順は、両方のホストタイプで同じです。

6.2.6. ホストの更新

ホストのアップグレードマネージャーを使用して、Red Hat Virtualization Manager から直接個別のホストを更新します。

アップグレードマネージャーが確認するのは、ステータスが Up または Non-operational のホストだけです。ステータスが Maintenance のホストは確認されません。

RHVH の更新時には、/etc および /var ディレクトリー内の変更データしか維持されません。他のパスに含まれる変更データは更新時に上書きされます。

前提条件

- クラスターレベルで移行が有効化されている場合には、仮想マシンはそのクラスター内の別のホストに自動的に移行されるので、ホストの更新は、ホストの使用率が比較的に低い時間帯に実行することを推奨します。

- 更新の前に、クラスターに複数のホストが含まれていることを確認します。全ホストを同時に更新しないようにしてください。Storage Pool Manager (SPM) のタスクを実行するために、ホストが 1 台使用可能である必要があります。

- ホストが属するクラスターに、ホストがメンテナンスを実行するのに十分なメモリーが確保されていることを確認してください。クラスターに十分なメモリーがない場合には、仮想マシンの移行操作がハングして失敗してしまいます。ホストを更新する前に一部またはすべての仮想マシンをシャットダウンしておくと、この操作のメモリー使用量を低減することができます。

- vGPU を使用している仮想マシンを別のホストに移行することはできません。ホストを更新する前に、vGPU がインストールされた仮想マシンを停止する必要があります。

RHVH 4.0 ホストは、Red Hat Virtualization Manager 4.2 を使用して更新することができません。コマンドラインから手動で更新する必要があります。

# yum update redhat-virtualization-host-image-update

この制約は、RHVH 4.0 にのみ適用されます。その他のバージョンの RHVH およびすべての RHEL ホストは、Red Hat Virtualization Manager 4.2 を使用してアップグレードすることができます。

手順

適切なリポジトリーを有効にします。

yum repolistを実行して、現在有効なリポジトリーを確認することができます。Red Hat Virtualization Host の場合:

# subscription-manager repos --enable=rhel-7-server-rhvh-4-rpms

Red Hat Enterprise Linux ホストの場合:

# subscription-manager repos --enable=rhel-7-server-rpms # subscription-manager repos --enable=rhel-7-server-rhv-4-mgmt-agent-rpms # subscription-manager repos --enable=rhel-7-server-ansible-2-rpms

- 管理ポータルで コンピュート → ホスト をクリックし、更新するホストを選択します。

インストール → アップグレードを確認 をクリックし、OK をクリックします。

イベントおよびアラートの通知 アイコン (

) をクリックし、イベント セクションを展開して結果を確認します。

) をクリックし、イベント セクションを展開して結果を確認します。

- 更新が利用可能であれば、インストール → アップグレード をクリックします。

OK をクリックしてホストを更新します。実行中の仮想マシンは、その移行ポリシーに従って移行されます。いずれかの仮想マシンの移行が無効になっている場合は、シャットダウンするよう求められます。

コンピュート → ホスト にホストの情報が更新され、ステータスが以下の順序で変わります。

- Maintenance

- Installing

- Reboot

Up

このホストから別のホストに移行していた仮想マシンがあれば、この時点で元に戻すことができます。

注記更新が失敗すると、ホストのステータスは Install Failed に変わります。Install Failed の状態から インストール → アップグレード を再度クリックすることができます。

Red Hat Virtualization 環境内のホストごとに同じ手順を繰り返してください。

6.2.7. クラスターの互換バージョンの変更

Red Hat Virtualization のクラスターには互換バージョンがあります。クラスターの互換バージョンは、そのクラスター内の全ホストがサポートする Red Hat Virtualization の機能を示します。クラスターの互換バージョンは、そのクラスター内で最も機能性の低いホストのバージョンに応じて設定されます。

クラスターの互換バージョンを変更するには、まず、クラスター内の全ホストを更新して、必要な互換性レベルをサポートするレベルにする必要があります。更新が利用可能であることを示すアイコンがホストの横にあるかどうかを確認します。

手順

- コンピュート → クラスター をクリックし、変更するクラスターを選択します。

- 編集 をクリックします。

- 互換バージョン を必要な値に変更します。

- OK をクリックして、クラスターの互換バージョンを変更 の確認ウィンドウを開きます。

- OK をクリックして確定します。

一部の仮想マシンおよびテンプレートが不適切に設定されていることを警告するエラーメッセージが表示される場合があります。このエラーを修正するには、それぞれの仮想マシンを手動で編集します。仮想マシンの編集 ウィンドウには、修正すべき項目を確認することのできる新たな検証および警告が表示されます。問題が自動的に修正され、仮想マシンの設定を再度保存するだけで十分な場合もあります。それぞれの仮想マシンを編集したら、クラスターの互換バージョンを変更することができます。

クラスターの互換バージョンを変更したら、実行中またはサスペンド中のすべての仮想マシンについてクラスターの互換バージョンを変更する必要があります。そのためには、ゲストオペレーティングシステム内ではなく、Manager 内から、または REST API を使用して仮想マシンを再起動します。再起動するまで、仮想マシンは以前のクラスターの互換性レベルで動作を続けます。再起動が必要な仮想マシンには、変更が保留されていることを示すアイコン (

) が付きます。プレビュー状態にある仮想マシンスナップショットについては、クラスター互換バージョンを変更することができません。まずコミットするか、プレビューを取り消す必要があります。

) が付きます。プレビュー状態にある仮想マシンスナップショットについては、クラスター互換バージョンを変更することができません。まずコミットするか、プレビューを取り消す必要があります。

セルフホストエンジンの仮想マシンを再起動する必要はありません。

データセンター内の全クラスターの互換バージョンの更新が完了したら、次にデータセンター自体の互換バージョンも変更することができます。

6.2.8. データセンターの互換バージョンの変更

Red Hat Virtualization データセンターには、互換バージョンがあります。互換バージョンとは、データセンターと互換性のある Red Hat Virtualization のバージョンを指します。データセンター内のクラスターはすべて、指定の互換性レベルをサポートします。

データセンターの互換バージョンを変更するには、まず、データセンター内の全クラスターを更新して、必要な互換性レベルをサポートするレベルにしておく必要があります。

手順

- コンピュート → データセンター をクリックし、変更するデータセンターを選択します。

- 編集 をクリックします。

- 互換バージョン を必要な値に変更します。

- OK をクリックして、データセンターの互換バージョンを変更 の確認ウィンドウを開きます。

- OK をクリックして確定します。

6.2.9. SHA-1 証明書の SHA-256 証明書への置き換え

Red Hat Virtualization 4.2 では SHA-256 署名が使用され、SHA-1 よりセキュアに SSL 証明書に署名することができます。新たにインストールした 4.2 システムでは、Red Hat Virtualization の公開鍵インフラストラクチャー (PKI) が SHA-256 署名を使用できるようにするのに、特別な手順は必要ありません。ただし、アップグレードしたシステムでは、以下のオプションのどちらかを実施することを推奨します。

- 管理ポータルに接続する際に警告メッセージがブラウザーに表示されないようにする。この警告はポップアップウィンドウとして、またはブラウザーの Web コンソール ウィンドウに表示されます。アップグレード後にすでに Red Hat Virtualization Manager の Apache SSL 証明書を置き換えている場合には、このオプションは必要ありません。ただし、証明書が SHA-1 で署名されている場合には、それを SHA-256 証明書に置き換える必要があります。詳細については、『管理ガイド』の「Red Hat Virtualization Manager の SSL/TLS 証明書の変更」を参照してください。

- システム全体の SHA-1 証明書を SHA-256 証明書に置き換える。

ブラウザーでの警告メッセージ表示の防止

- Manager マシンに root ユーザーとしてログインします。

/etc/pki/ovirt-engine/openssl.conf に

default_md = sha256行が含まれているかどうかを確認します。# cat /etc/pki/ovirt-engine/openssl.conf

まだ

default_md = sha1が含まれていたら、既存の設定のバックアップを作成してデフォルトをsha256に変更します。# cp -p /etc/pki/ovirt-engine/openssl.conf /etc/pki/ovirt-engine/openssl.conf."$(date +"%Y%m%d%H%M%S")" # sed -i 's/^default_md = sha1/default_md = sha256/' /etc/pki/ovirt-engine/openssl.conf

署名し直す必要のある証明書を定義します。

# names="apache"

セルフホストエンジンノードのいずれかにログインして、グローバルメンテナンスモードに切り替えます。

# hosted-engine --set-maintenance --mode=global

Manager で Apache 証明書を署名し直します。

for name in $names; do subject="$( openssl \ x509 \ -in /etc/pki/ovirt-engine/certs/"${name}".cer \ -noout \ -subject \ | sed \ 's;subject= \(.*\);\1;' \ )" /usr/share/ovirt-engine/bin/pki-enroll-pkcs12.sh \ --name="${name}" \ --password=mypass \ --subject="${subject}" \ --keep-key donehttpd サービスを再起動します。

# systemctl restart httpd

セルフホストエンジンノードのいずれかにログインして、グローバルメンテナンスモードを終了します。

# hosted-engine --set-maintenance --mode=none

- 管理ポータルに接続して、警告が表示されなくなったことを確認します。

-

以前に CA または https 証明書をブラウザーにインポートしている場合は、その証明書を探してブラウザーから削除し、新しい CA 証明書をインポートし直します。ブラウザーから提供される手順に従って、認証局の証明書をインストールしてください。認証局の証明書を取得するには、

http://your-manager-fqdn/ovirt-engine/services/pki-resource?resource=ca-certificate&format=X509-PEM-CAにアクセスします (your-manager-fqdn は、完全修飾ドメイン名 (FQDN) に置き換えてください)。

すべての署名済み証明書の SHA-256 への置き換え

- Manager マシンに root ユーザーとしてログインします。

/etc/pki/ovirt-engine/openssl.conf に

default_md = sha256行が含まれているかどうかを確認します。# cat /etc/pki/ovirt-engine/openssl.conf

まだ

default_md = sha1が含まれていたら、既存の設定のバックアップを作成してデフォルトをsha256に変更します。# cp -p /etc/pki/ovirt-engine/openssl.conf /etc/pki/ovirt-engine/openssl.conf."$(date +"%Y%m%d%H%M%S")" # sed -i 's/^default_md = sha1/default_md = sha256/' /etc/pki/ovirt-engine/openssl.conf

CA 証明書のバックアップを作成して ca.pem.new に新しい証明書を作成し、CA 証明書を署名し直します。

# cp -p /etc/pki/ovirt-engine/private/ca.pem /etc/pki/ovirt-engine/private/ca.pem."$(date +"%Y%m%d%H%M%S")" # openssl x509 -signkey /etc/pki/ovirt-engine/private/ca.pem -in /etc/pki/ovirt-engine/ca.pem -out /etc/pki/ovirt-engine/ca.pem.new -days 3650 -sha256

既存の証明書を新しい証明書に置き換えます。

# mv /etc/pki/ovirt-engine/ca.pem.new /etc/pki/ovirt-engine/ca.pem

署名し直す必要のある証明書を定義します。

# names="engine apache websocket-proxy jboss imageio-proxy"

アップグレード後に Red Hat Virtualization Manager SSL 証明書を置き換えている場合は、上記のコマンドの代わりに以下のコマンドを実行します。

# names="engine websocket-proxy jboss imageio-proxy"

詳細については、『管理ガイド』の「Red Hat Virtualization Manager の SSL/TLS 証明書の変更」を参照してください。

セルフホストエンジンノードのいずれかにログインして、グローバルメンテナンスモードに切り替えます。

# hosted-engine --set-maintenance --mode=global

Manager で証明書を署名し直します。

for name in $names; do subject="$( openssl \ x509 \ -in /etc/pki/ovirt-engine/certs/"${name}".cer \ -noout \ -subject \ | sed \ 's;subject= \(.*\);\1;' \ )" /usr/share/ovirt-engine/bin/pki-enroll-pkcs12.sh \ --name="${name}" \ --password=mypass \ --subject="${subject}" \ --keep-key done以下のサービスを再起動します。

# systemctl restart httpd # systemctl restart ovirt-engine # systemctl restart ovirt-websocket-proxy # systemctl restart ovirt-imageio-proxy

セルフホストエンジンノードのいずれかにログインして、グローバルメンテナンスモードを終了します。

# hosted-engine --set-maintenance --mode=none

- 管理ポータルに接続して、警告が表示されなくなったことを確認します。

-

以前に CA または https 証明書をブラウザーにインポートしている場合は、その証明書を探してブラウザーから削除し、新しい CA 証明書をインポートし直します。ブラウザーから提供される手順に従って、認証局の証明書をインストールしてください。認証局の証明書を取得するには、

http://your-manager-fqdn/ovirt-engine/services/pki-resource?resource=ca-certificate&format=X509-PEM-CAにアクセスします (your-manager-fqdn は、完全修飾ドメイン名 (FQDN) に置き換えてください)。 ホストで証明書を登録します。それぞれのホストについて以下の手順を繰り返します。

- 管理ポータルで コンピュート → ホスト をクリックします。

- ホストを選択し、管理 → メンテナンス をクリックします。

- ホストがメンテナンスモードに変わったら、インストール → 証明書を登録 をクリックします。

- 管理 → アクティブ化 をクリックします。

6.3. セルフホストエンジンの Red Hat Virtualization 4.1 から 4.2 へのアップグレード

セルフホストエンジン環境のバージョンを 4.1 から 4.2 にアップグレードするステップは、以下のとおりです。

- 環境をグローバルメンテナンスモードに切り替える

- 4.1 Manager を最新バージョンの 4.1 に更新する

- Manager を 4.1 から 4.2 にアップグレードする

- グローバルメンテナンスモードを終了する

- セルフホストエンジンノードおよびすべての標準ホストをアップグレードする

- クラスターの互換バージョンを更新する

- データセンターの互換バージョンを更新する

- テクノロジープレビューバージョンの Open Virtual Network (OVN) を Red Hat Virtualization 4.1 にインストールしている場合には、OVN プロバイダーのネットワークプラグインを更新する

- SHA-1 証明書を SHA-256 証明書に置き換える

6.3.1. グローバルメンテナンスモードへの切り替え

Manager 用仮想マシンで何らかのセットアップ/アップグレードタスクを実施する前に、セルフホストエンジン環境をグローバルメンテナンスモードに切り替える必要があります。

手順

セルフホストエンジンノードのいずれかにログインして、グローバルメンテナンスモードに切り替えます。

# hosted-engine --set-maintenance --mode=global

次の手順に進む前に、環境がメンテナンスモードにあることを確認します。

# hosted-engine --vm-status

6.3.2. Red Hat Virtualization Manager の更新

Red Hat Virtualization Manager の更新はコンテンツ配信ネットワーク (CDN) 経由でリリースされます。

手順

Red Hat Virtualization Manager マシンで、更新パッケージが利用可能かどうかを確認します。

# engine-upgrade-check

setup のパッケージを更新します。

# yum update ovirt\*setup\*

Red Hat Virtualization Manager を更新します。

engine-setupスクリプトにより、設定に関する質問への回答が求められます。その後、ovirt-engine サービスの停止、更新パッケージのダウンロード/インストール、データベースのバックアップ/更新、インストール後設定の実施を経てから、ovirt-engine サービスが起動します。# engine-setup

注記engine-setupスクリプトは Red Hat Virtualization Manager のインストールプロセス中にも使用され、指定した設定値が保存されます。更新時には、設定のプレビューの際に保存された値が表示されますが、インストール後の設定変更にengine-configを使用している場合には、表示される値が最新のものではない可能性があります。たとえば、インストール後にengine-configを使用してSANWipeAfterDeleteをtrueに変更している場合、engine-setupによる設定プレビューでは「Default SAN wipe after delete: False」と出力されますが、変更した値がengine-setupにより上書きされるわけではありません。重要更新プロセスには時間がかかる場合があるため、更新プロセスが完了するまでの時間を計算に入れて、一旦更新を開始したらプロセスを停止しないようにしてください。

Manager にインストールされているベースオペレーティングシステムと、オプションパッケージを更新します。

# yum update

重要いずれかのカーネルパッケージが更新された場合には、ホストを再起動して更新を完了してください。

6.3.3. Manager の 4.1 から 4.2 へのアップグレード

Red Hat Virtualization Manager を 4.1 から 4.2 にアップグレードします。