Red Hat Training

A Red Hat training course is available for Red Hat Virtualization

管理ガイド

Red Hat Virtualization の管理タスク

概要

パート I. Red Hat Virtualization 環境の管理と保守

- ホストや仮想マシンなどの物理リソースおよび仮想リソースの管理。これには、ホストのアップグレードおよび追加、ドメインのインポート、外部ハイパーバイザーで作成された仮想マシンの変換、および仮想マシンプールの管理が含まれます。

- ホストのいずれかに対する極端な負荷、メモリーやディスク容量不足、必要なアクション (仮想マシンをシャットダウンして仮想マシンの別ホストへの移行して負荷を軽減したりリソースを解放するなど) などの潜在的な問題について、全体的なシステムリソースのモニターリングを行います。

- 仮想マシンの新しい要件に対応します (たとえば、オペレーティングシステムのアップグレードまたはより多くのメモリーの割り当てなど)。

- タグを使用したカスタムオブジェクトプロパティーの管理。

- パブリックブックマークとして保存された検索の管理。

- ユーザー設定の管理とパーミッションレベルの設定。

- システム機能全体の特定ユーザーまたは仮想マシンのトラブルシューティング。

- 一般および特定レポートの生成。

第1章 グローバル設定

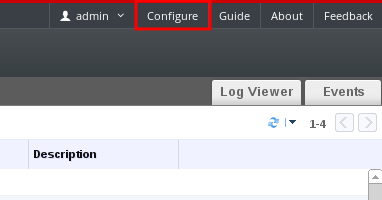

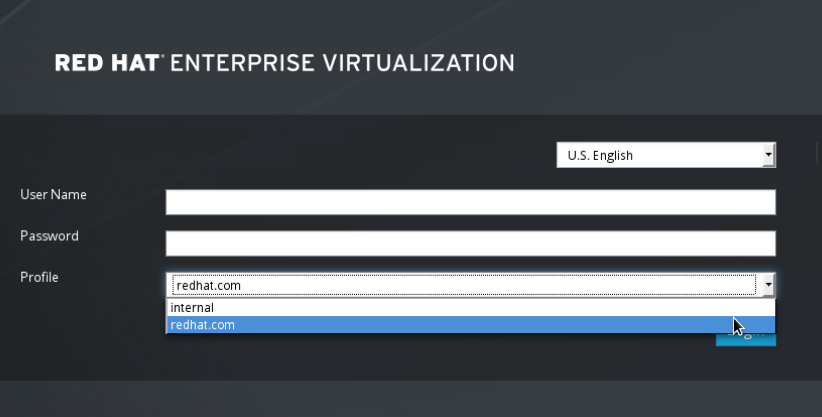

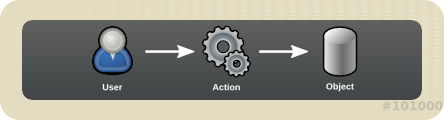

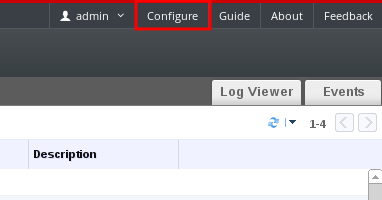

図1.1 Configure ウィンドウへのアクセス

1.1. ロール

1.1.1. 新しいロールの作成

手順1.1 新しいロールの作成

- ヘッダーバーで Configure ボタン を クリックして Configure ウィンドウを開きます。ウィンドウには、デフォルトの User および Administrator ロールのリストとカスタムロールが表示されます。

- New をクリックします。New Role ダイアログボックスが表示されます。

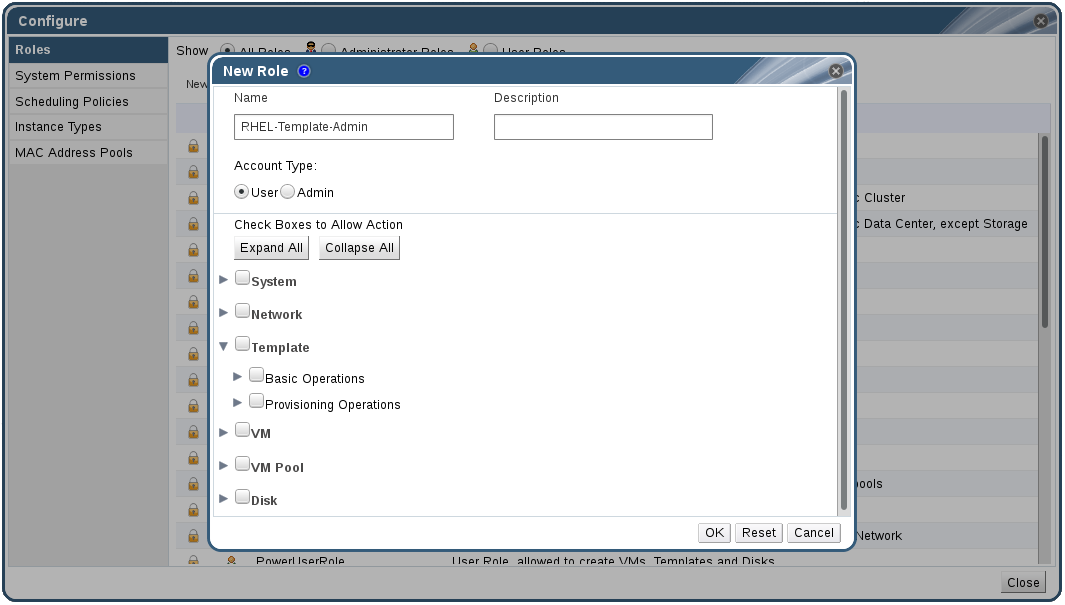

図1.2 新規ロールダイアログ

- 新規ロールの Name および Description を入力します。

- Account Type として Admin または User を選択します。

- Expand All または Collapse All ボタンを使用して、Check Boxes to Allow Action リストに記載されているオブジェクトのパーミッションを増減します。また、各オブジェクトのオプションを展開したり、折りたたんだりすることもできます。

- それぞれのオブジェクトについて、設定しているロールを許可または拒否するアクションを選択または消去します。

- OK をクリックして、加えた変更を適用します。ロールの一覧に新しいロールが表示されます。

1.1.2. ロールの編集またはコピー

手順1.2 ロールの編集またはコピー

- ヘッダーバーで Configure ボタン を クリックして Configure ウィンドウを開きます。ウィンドウには、デフォルトの User および Administrator ロールのリストとカスタムロールが表示されます。

- 変更するロールを選択します。Edit をクリックして Edit Role ウィンドウを開くか、Copy をクリックして Copy Role ウィンドウを開きます。

- 必要に応じて、ロールの Name および Description を編集します。

- Expand All または Collapse All ボタンを使用して、一覧表示されたオブジェクトのパーミッションの表示を拡大または縮小します。また、各オブジェクトのオプションを展開したり、折りたたんだりすることもできます。

- それぞれのオブジェクトについて、編集するロールを許可または拒否するアクションを選択または消去します。

- OK をクリックして、加えた変更を適用します。

1.1.3. ユーザーロールと承認の例

例1.1 クラスターパーミッション

Accounts と呼ばれる Red Hat Virtualization クラスター の下に編成されています。アカウントクラスターで ClusterAdmin ロールが割り当てられています。これにより、仮想マシンはクラスターの子オブジェクトであるため、彼女はクラスター内のすべての仮想マシンを管理できます。仮想マシンの管理には、ディスクなどの仮想リソースの編集、追加、削除、およびスナップショットの作成などが含まれます。このクラスターの外部にあるリソースを管理することはできません。ClusterAdmin は管理者ロールであるため、管理ポータルを使用してこれらのリソースを管理できますが、ユーザーポータルからのアクセスは付与されません。

例1.2 VM PowerUser パーミッション

johndesktop という仮想デスクトップを作成しました。John には、johndesktop 仮想マシンの UserVmManager ロールが割り当てられています。これにより、ユーザーポータルを使用してこの単一の仮想マシンにアクセスできます。UserVmManager のパーミッションを持っているため、新しい仮想ディスクなど、仮想マシンを変更してリソースを追加できます。UserVmManager はユーザーロールであるため、管理ポータルを使用できません。

例1.3 データセンターパワーユーザーロールパーミッション

PowerUserRole パーミッションが割り当てられています。これは、新しい仮想マシンを作成するため、ストレージドメインでの仮想ディスクイメージの作成など、データセンター内の複数のコンポーネントに変更を加える必要があるためです。

DataCenterAdmin 権限を割り当てることとは異なります。データセンターの PowerUser として、Penelope は User Portal にログインし、データセンター内の仮想マシン固有のアクションを実行できます。彼女は、ホストまたはストレージをデータセンターに割り当てるなど、データセンターレベルの操作を実行できません。

例1.4 ネットワーク管理者のパーミッション

NetworkAdmin 権限を持っている場合、データセンター内のネットワークを追加および削除したり、データセンターに属するすべての仮想マシンのネットワークをアタッチおよびデタッチできます。

VnicProfileUser パーミッションと UserVmManager パーミッションが割り当てられています。これらのパーミッションを使用すると、Pat はユーザーポータルの Extended タブでネットワークインターフェイスを仮想マシンに追加するなどの簡単な管理タスクを実行できます。ただし、仮想マシンを実行するホストのネットワークや、仮想マシンが属するデータセンターのネットワークを変更するパーミッションがありません。

例1.5 カスタムロールパーミッション

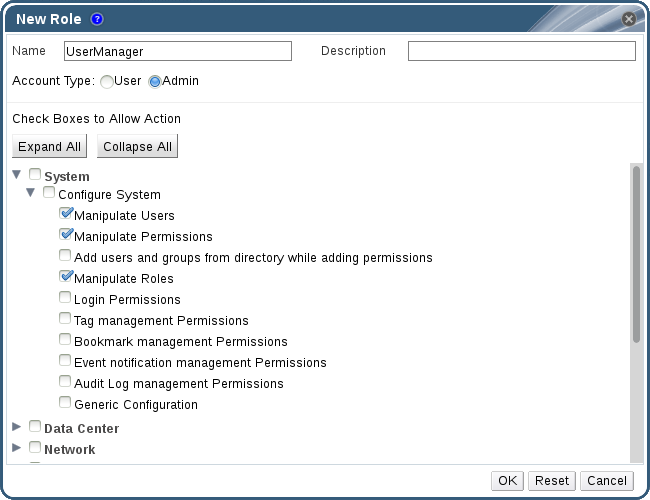

図1.3 UserManager カスタムロール

System の下に整理されています。これは、システム内のすべてのオブジェクトに適用されることを意味します。ロールの Account Type は Admin に設定されます。つまり、このロールが割り当てられている場合、Rachel はユーザーポータルではなく管理ポータルのみを使用できます。

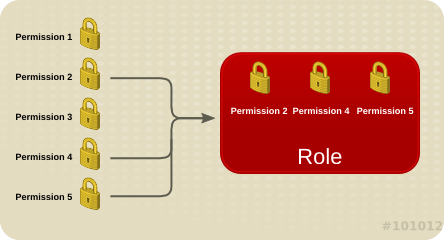

1.2. システムパーミッション

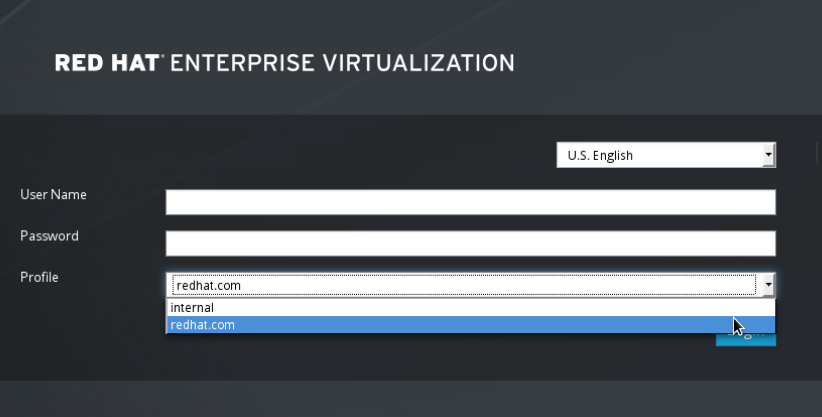

図1.4 パーミッションおよびロール

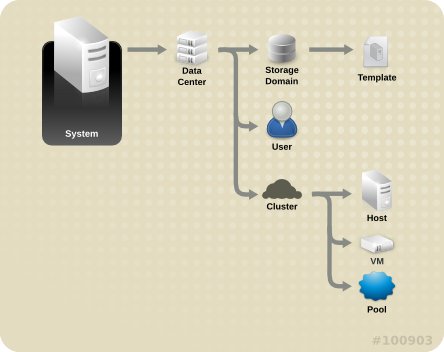

図1.5 Red Hat Virtualization オブジェクトの階層

1.2.1. ユーザープロパティー

1.2.2. ユーザーおよび管理者ロール

- 管理者ロール:物理リソースおよび仮想リソースを 管理するための管理ポータル へのアクセスを許可します。管理者ロールは、ユーザーポータルで実行できるアクションのパーミッションを制限しますが、ユーザーがユーザーポータルで表示できる内容には影響しません。

- ユーザーロール:仮想マシンおよびテンプレートを管理およびアクセスするための ユーザーポータル へのアクセスを許可します。ユーザーロールは、ユーザーがユーザーポータルで表示できるものを決定します。管理者ロールを持つユーザーに付与されるパーミッションは、ユーザーポータルでそのユーザーが利用できるアクションに反映されます。

者 ロールがある場合は、管理 ポータル を使用してクラスター内のすべての仮想マシンを管理 できます。ただし、ユーザー ポータル のこれらの仮想マシンにはアクセスできません。これには ユーザー ロールが必要です。

1.2.3. ユーザーロールの概要

表1.1 Red Hat Virtualization ユーザーロール: 基本

| ロール | 権限 | 注記 |

|---|---|---|

| UserRole | 仮想マシンおよびプールにアクセスし、使用できる。 | ユーザーポータルへのログイン、割り当てられた仮想マシンおよびプールの使用、仮想マシンの状態と詳細の表示が可能です。 |

| PowerUserRole | 仮想マシンおよびテンプレートを作成および管理できる。 | このロールを Configure ウィンドウを使用して環境全体のユーザーに適用するか、または特定のデータセンターまたはクラスターのユーザーに適用します。たとえば、PowerUserRole がデータセンターレベルに適用されると、PowerUser はデータセンターで仮想マシンおよびテンプレートを作成できます。 |

| UserVmManager | 仮想マシンのシステム管理者。 | 仮想マシンの管理、スナップショットの作成と使用が可能。ユーザーポータルで仮想マシンを作成するユーザーには、マシンの UserVmManager ロールが自動的に割り当てられます。 |

表1.2 Red Hat Virtualization のユーザーロール - 高度

| ロール | 権限 | 注記 |

|---|---|---|

| UserTemplateBasedVm | テンプレートのみを使用できる限定的な権限。 | テンプレートを使用して仮想マシンを作成できます。 |

| DiskOperator | 仮想ディスクユーザー。 | 仮想ディスクの使用、表示、編集が可能です。仮想ディスクが接続されている仮想マシンを使用するパーミッションを継承します。 |

| VmCreator | ユーザーポータルで仮想マシンを作成できます。 | このロールは特定の仮想マシンには適用されません。Configure ウィンドウで環境全体のユーザーにこのロールを適用します。または、特定のデータセンターまたはクラスターにこのロールを適用することもできます。このロールをクラスターに適用する場合、データセンター全体または特定のストレージドメインに DiskCreator ロールを適用する必要もあります。 |

| TemplateCreator | 割り当てられたリソース内で仮想マシンテンプレートを作成、編集、管理、および削除できる。 | このロールは特定のテンプレートには適用されません。Configure ウィンドウで環境全体のユーザーにこのロールを適用します。また、特定のデータセンター、クラスター、またはストレージドメインにこのロールを適用することもできます。 |

| DiskCreator | 割り当てられたクラスターまたはデータセンター内の仮想ディスクを作成、編集、管理、および削除できる。 | このロールは特定の仮想ディスクには適用されません。Configure ウィンドウで環境全体のユーザーにこのロールを適用します。また、特定のデータセンターまたはストレージドメインにこのロールを適用することもできます。 |

| TemplateOwner | テンプレートの編集および削除、テンプレートのユーザーパーミッションの割り当ておよび管理が可能。 | このロールは、テンプレートを作成したユーザーに自動的に割り当てられます。テンプレートに TemplateOwner パーミッションを持たない他のユーザーは、テンプレートを表示または使用することはできません。 |

| VnicProfileUser | 仮想マシンおよびテンプレートの論理ネットワークおよびネットワークインターフェイスユーザー。 | 特定の論理ネットワークからネットワークインターフェイスを接続または切断できます。 |

1.2.4. 管理者ロールの概要

表1.3 Red Hat Virtualization システム管理者ロール - 基本

| ロール | 権限 | 注記 |

|---|---|---|

| SuperUser | Red Hat Virtualization 環境のシステム管理者 | すべてのオブジェクトおよびレベルでの完全なパーミッションを持ち、全データセンターで全オブジェクトを管理できます。 |

| ClusterAdmin | クラスター管理者。 | 特定のクラスター下にある全オブジェクトの管理パーミッションを持ちます。 |

| DataCenterAdmin | データセンター管理者。 | 特定のデータセンターの下にある、ストレージを除くすべてのオブジェクトの管理権限を保有しています。 |

表1.4 Red Hat Virtualization システム管理者ロール - 高度

| ロール | 権限 | 注記 |

|---|---|---|

| TemplateAdmin | 仮想マシンテンプレートの管理者。 | テンプレートのストレージドメインやネットワークの詳細を作成、削除、設定したり、ドメイン間でテンプレートを移動できます。 |

| StorageAdmin | ストレージ管理者。 | 割り当てられたストレージドメインを作成、削除、設定、および管理できます。 |

| HostAdmin | ホスト管理者。 | 特定のホストをアタッチ、削除、設定、および管理できます。 |

| NetworkAdmin | ネットワーク管理者。 | 特定のデータセンターまたはクラスターのネットワークを設定および管理できます。データセンターまたはクラスターのネットワーク管理者は、クラスター内の仮想プールのネットワークパーミッションを継承します。 |

| VmPoolAdmin | 仮想プールのシステム管理者。 | 仮想プールを作成、削除、および設定できます。仮想プールユーザーを割り当ておよび削除し、プールの仮想マシンに基本操作を実行できます。 |

| GlusterAdmin | Gluster Storage 管理者。 | Gluster ストレージボリュームを作成、削除、設定、および管理できます。 |

| VmImporterExporter | 仮想マシンの管理者をインポートおよびエクスポートします。 | 仮想マシンをインポートおよびエクスポートできます。他のユーザーがエクスポートした仮想マシンおよびテンプレートをすべて表示できます。 |

1.3. スケジューリングポリシー

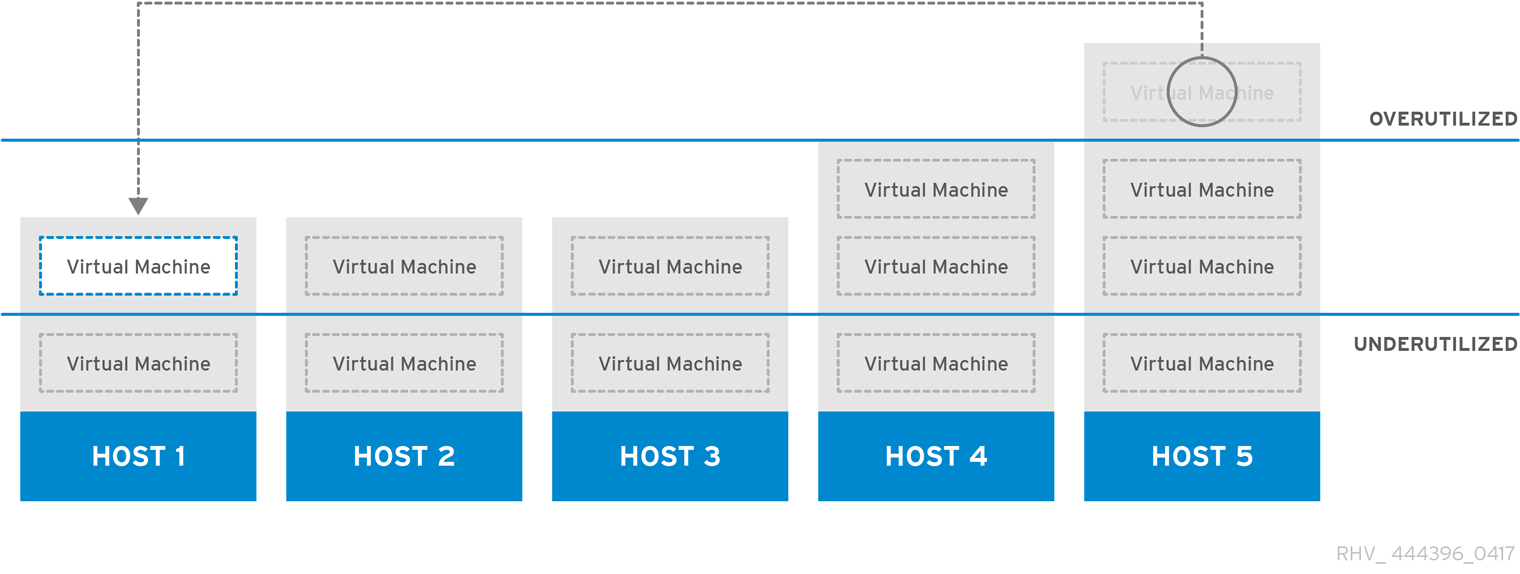

図1.6 Evenly Distributed スケジューリングポリシー

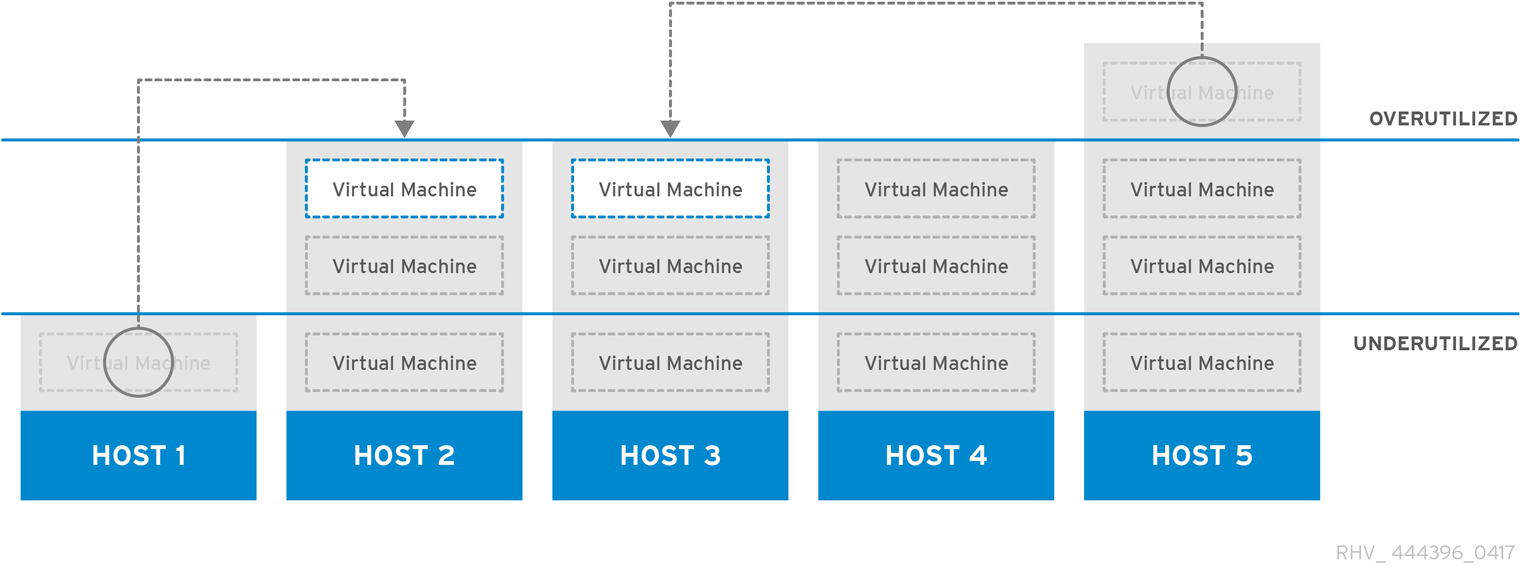

図1.7 Power Saving スケジューリングポリシー

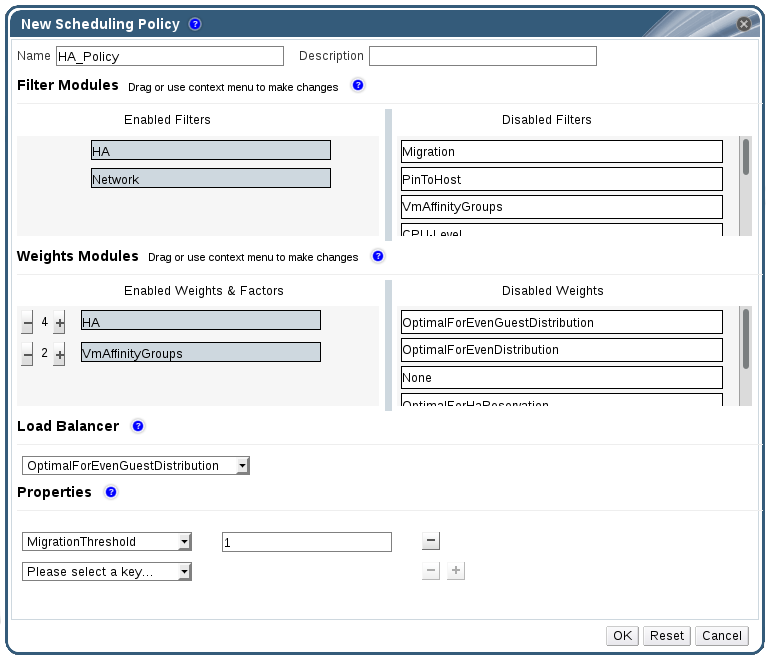

1.3.1. スケジューリングポリシーの作成

手順1.3 スケジューリングポリシーの作成

- 管理ポータルのヘッダーバーの Configure ボタンをクリックして、Configure ウィンドウを開きます。

- Scheduling Policies をクリックして、スケジューリングポリシータブを表示します。

- New をクリックして New Scheduling Policy ウィンドウを開きます。

図1.8 新しいスケジューリングポリシーウィンドウ

- スケジューリングポリシーの Name および Description を入力します。

- フィルターモジュールを設定します。

- Filter Modules セクションで、Disabled Filters セクションから Enabled Filters セクションに、優先するフィルターモジュールをドラッグアンドドロップしてスケジューリングポリシーに適用します。

- 特定のフィルターモジュールは First として設定して、優先度が高い( Last )で、基本的な最適化のために優先度を最も低いものにすることもできます。優先度を設定するには、フィルターモジュールを右クリックし、Position にカーソルを合わせ、First または Last を選択します。

- 加重モジュールを設定します。

- Weights Modules セクションで、Disabled Weights セクションから Enabled Weights セクションに、優先する重みモジュールをドラッグアンドドロップしてスケジューリングポリシーに適用し ます。

- 有効な加重モジュールの左側にある + および - ボタンを使用して、これらのモジュールの重みを増減します。

- ロードバランシングポリシーを指定します。

- Load Balancer セクションのドロップダウンメニューから、スケジューリングポリシーに適用する負荷分散ポリシーを選択します。

- Properties セクションのドロップダウンメニューから、スケジューリングポリシーに適用する負荷分散プロパティーを選択し、そのプロパティーの右側にある text フィールドを使用して値を指定します。

- + ボタンおよび - ボタンを使用して、プロパティーを追加または削除します。

- OK をクリックします。

1.3.2. New Scheduling Policy および Edit Scheduling Policy ウィンドウの設定の説明

表1.5 New Scheduling Policy および Edit Scheduling Policy の設定

|

フィールド名

|

説明

|

|---|---|

|

Name

|

スケジューリングポリシーの名前。これは、Red Hat Virtualization Manager のスケジューリングポリシーを参照するために使用される名前です。

|

|

説明

|

スケジューリングポリシーの説明。このフィールドは推奨されますが、必須ではありません。

|

|

Filter Modules

|

クラスター内の仮想マシンが実行できるホストを制御するフィルターセット。フィルターを有効にすると、以下のように、フィルターで指定された条件を満たさないホストが除外されます。

|

|

Weights Modules

|

仮想マシンを実行できるクラスター内のホストを決定する際に考慮される要因の相対優先度を制御する重みのセット。

|

|

ロードバランサー

|

このドロップダウンメニューでは、適用する負荷分散モジュールを選択できます。負荷分散モジュールは、使用率が高いホストから、使用率が低いホストに仮想マシンを移行するために使用されるロジックを決定します。

|

|

プロパティー

|

このドロップダウンメニューでは、負荷分散モジュールのプロパティーを追加または削除でき、スケジューリングポリシーに負荷分散モジュールを選択している場合にのみ利用できます。デフォルトではプロパティーは定義されておらず、利用可能なプロパティーは、選択された負荷分散モジュールに固有です。+ および - ボタンを使用して、負荷分散モジュールにプロパティーを追加または削除します。

|

1.4. インスタンスタイプ

表1.6 事前定義されたインスタンスタイプ

|

Name

|

メモリー

|

vCPU

|

|---|---|---|

|

Tiny

|

512 MB

|

1

|

|

Small

|

2 GB

|

1

|

|

中

|

4 GB

|

2

|

|

Large

|

8 GB

|

2

|

|

XLarge

|

16 GB

|

4

|

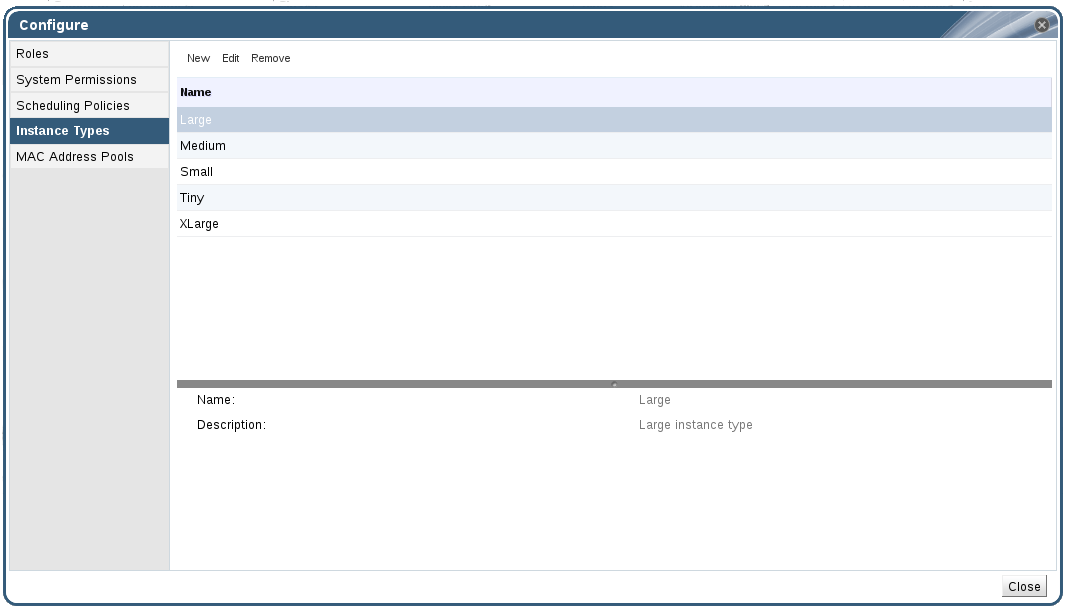

図1.9 インスタンスタイプタブ

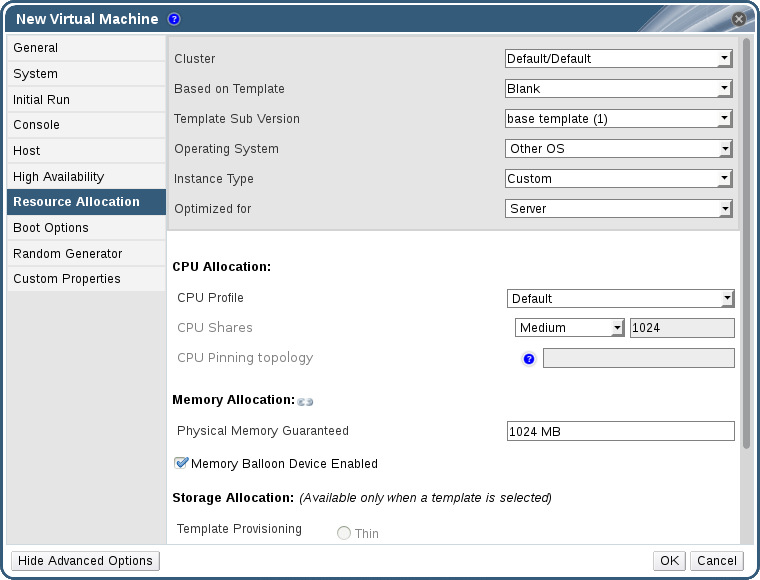

これらのフィールドの値のいずれかが変更されると、仮想マシンはインスタンスタイプから切り離され、Custom に変更され、チェーンが破損しているように見えます(

これらのフィールドの値のいずれかが変更されると、仮想マシンはインスタンスタイプから切り離され、Custom に変更され、チェーンが破損しているように見えます(

しかし、値が元に戻されると、チェーンは再度リンクし、インスタンスタイプは選択されたものに戻ります。

しかし、値が元に戻されると、チェーンは再度リンクし、インスタンスタイプは選択されたものに戻ります。

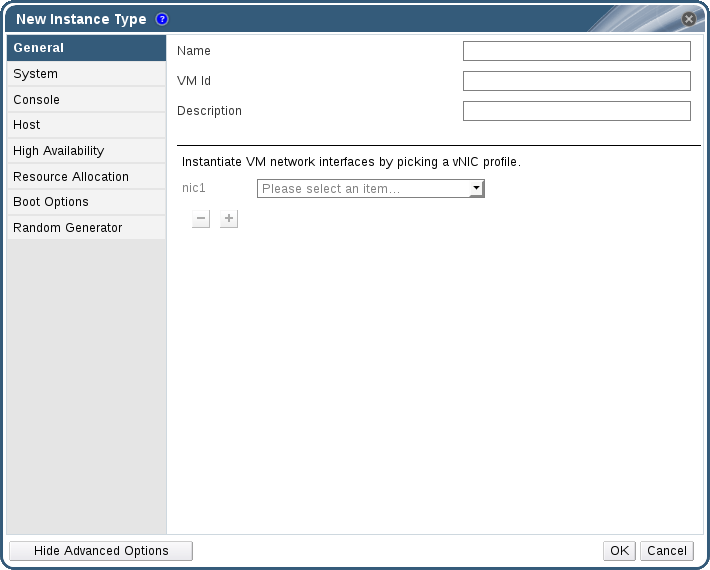

1.4.1. インスタンスタイプの作成

手順1.4 インスタンスタイプの作成

- ヘッダーバーで Configure を クリックします。

- Instance Types タブをクリックします。

- New をクリックして New Instance Type ウィンドウを開きます。

図1.10 New Instance Type ウィンドウ

- インスタンスタイプの Name および Description を入力します。

- Show Advanced Options をクリックし、必要に応じてインスタンスタイプの設定を設定します。New Instance Type ウィンドウに表示される設定は、New Virtual Machine ウィンドウの設定と同じですが、関連するフィールドのみが表示されます。『Virtual Machine Management Guide』 の Explanation of Settings in the New Virtual Machine and Edit Virtual Machine Windows を参照してください。

- OK をクリックします。

1.4.2. インスタンスタイプの編集

手順1.5 インスタンスタイププロパティーの編集

- ヘッダーバーで Configure を クリックします。

- Instance Types タブをクリックします。

- 編集するインスタンスタイプを選択します。

- Edit をクリックして Edit Instance Type ウィンドウを開きます。

- 必要に応じて設定を変更します。

- OK をクリックします。

1.4.3. インスタンスタイプの削除

手順1.6 インスタンスタイプの削除

- ヘッダーバーで Configure を クリックします。

- Instance Types タブをクリックします。

- 削除するインスタンスタイプを選択します。

- Remove をクリックして、Remove Instance Type ウィンドウを開きます。

- 削除するインスタンスタイプに基づいた仮想マシンがある場合は、アタッチされた仮想マシンをリストする警告ウィンドウが表示されます。インスタンスタイプの削除を続行するには、Approve Operation チェックボックスを選択します。それ以外の場合は、Cancel をクリックします。

- OK をクリックします。

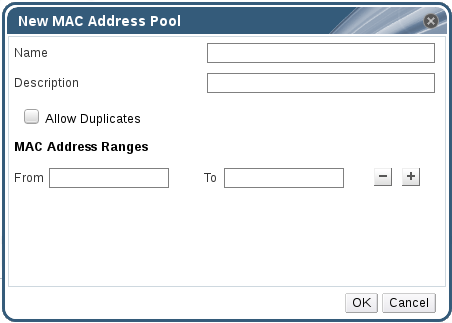

1.5. MAC アドレスプール

1.5.1. MAC アドレスプールの作成

手順1.7 MAC アドレスプールの作成

- ヘッダーバーで Configure ボタン を クリックして Configure ウィンドウを開きます。

- MAC Address Pools タブをクリックします。

- Add ボタンをクリックして New MAC Address Pool ウィンドウを開きます。

図1.11 新しい MAC アドレスプールウィンドウ

- 新しい MAC アドレスプールの Name および Description を入力します。

- Allow Duplicates チェックボックスを選択し、MAC アドレスをプールで複数回使用できるようにします。MAC アドレスプールでは、重複した MAC アドレスを自動的に使用することはありませんが、duplicates オプションを有効にすると、ユーザーが重複した MAC アドレスを手動で使用できます。注記ある MAC アドレスプールで重複を無効にし、別の MAC アドレスプールで重複を有効にした場合、重複を無効にしたプールでは各 MAC アドレスは 1 回しか使用できませんが、重複を有効にしたプールでは複数回使用できます。

- 必要な MAC Address Ranges を入力します。複数の範囲を入力するには、From および To フィールドの横にあるプラスボタンをクリックします。

- OK をクリックします。

1.5.2. MAC アドレスプールの編集

手順1.8 MAC アドレスプールプロパティーの編集

- ヘッダーバーで Configure ボタン を クリックして Configure ウィンドウを開きます。

- MAC Address Pools タブをクリックします。

- 編集する MAC アドレスプールを選択します。

- Edit ボタンをクリックして、Edit MAC Address Pool ウィンドウを開きます。

- 必要に応じて Name、Description、Allow Duplicates、および MAC Address Ranges フィールドを変更します。注記MAC アドレス範囲を更新すると、既存の NIC の MAC アドレスは再割り当てされません。すでに割り当てられている MAC アドレスで、新しい MAC アドレスの範囲外のものは、ユーザー指定の MAC アドレスとして追加され、その MAC アドレスプールで追跡されます。

- OK をクリックします。

1.5.3. MAC アドレスプールのパーミッションの編集

手順1.9 MAC アドレスプールのパーミッションの編集

- ヘッダーバーで Configure ボタン を クリックして Configure ウィンドウを開きます。

- MAC Address Pools タブをクリックします。

- 必要な MAC アドレスプールを選択します。

- MAC アドレスプールのユーザーパーミッションを編集します。

- ユーザーパーミッションを MAC アドレスプールに追加するには、以下を実行します。

- Configure ウィンドウの下にあるユーザー権限ペインで Add をクリックします。

- 必要なユーザーを検索して選択します。

- Role to Assign ドロップダウンリストから必要なロールを選択します。

- OK をクリックしてユーザーパーミッションを追加します。

- ユーザーパーミッションを MAC アドレスプールから削除するには、以下を実行します。

- Configure ウィンドウの下にあるユーザー権限ペインで削除するユーザーパーミッションを選択します。

- 削除 をクリックしてユーザーパーミッションを削除します。

1.5.4. MAC アドレスプールの削除

手順1.10 MAC アドレスプールの削除

- ヘッダーバーで Configure ボタン を クリックして Configure ウィンドウを開きます。

- MAC Address Pools タブをクリックします。

- 削除する MAC アドレスプールを選択します。

- Remove ボタンをクリックして、Remove MAC Address Pool ウィンドウを開きます。

- OK をクリックします。

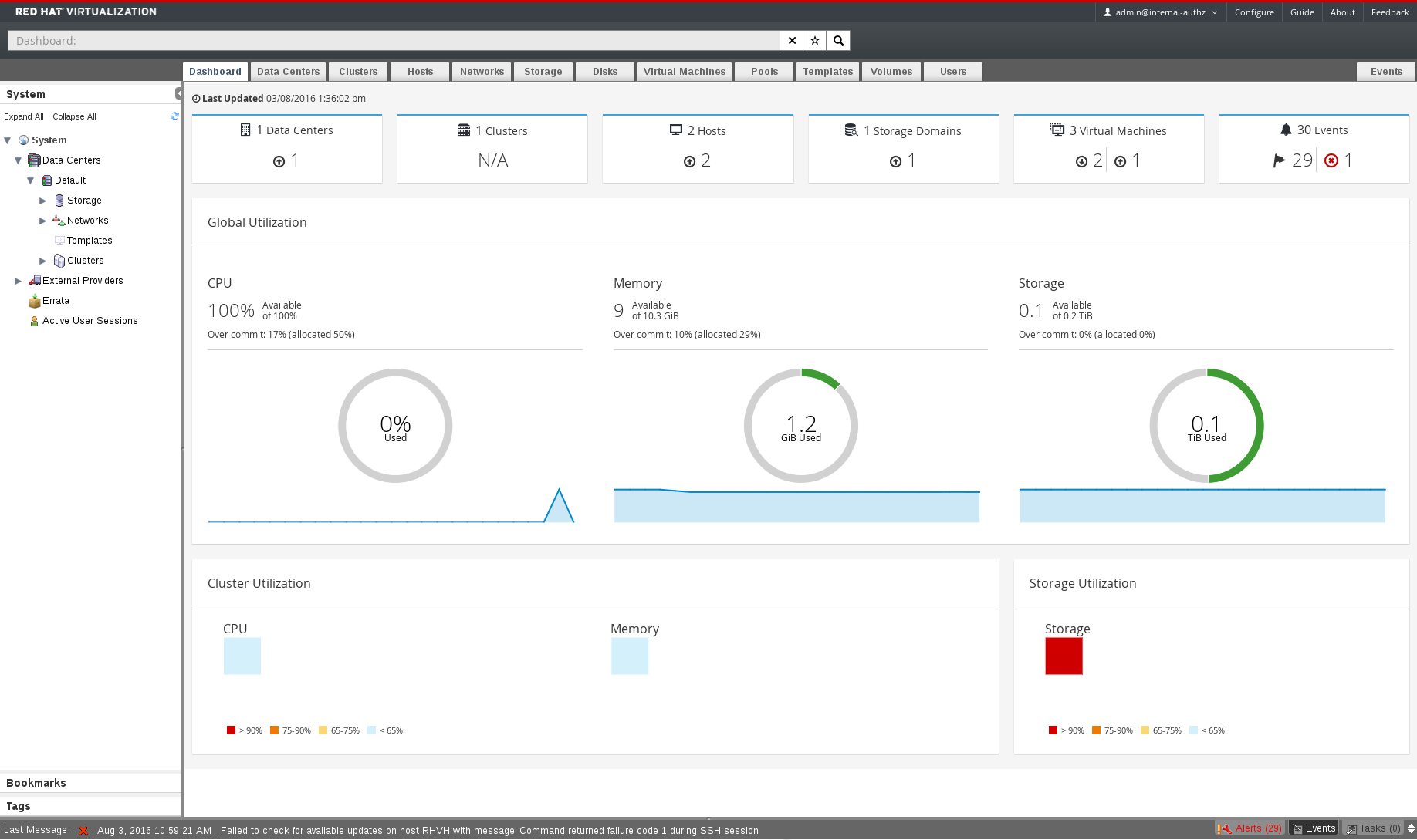

第2章 ダッシュボード

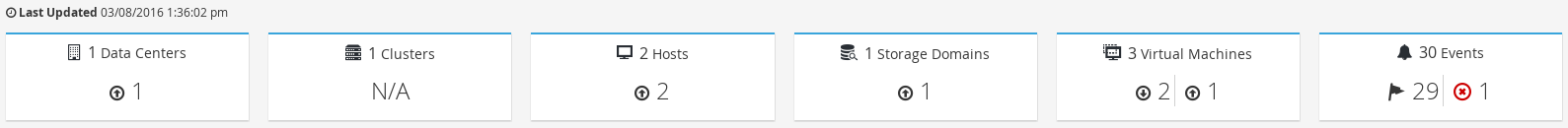

図2.1 ダッシュボード

2.1. 前提条件

2.2. グローバルインベントリー

図2.2 グローバルインベントリー

表2.1 リソースの状況

|

アイコン

|

Status

|

|---|---|

|

Red Hat Virtualization にはそのようなリソースは一切追加されていません。

|

|

警告ステータスを持つリソースの番号を表示します。アイコンをクリックすると適切なタブに移動し、検索対象は警告ステータスでそのリソースに限定されます。検索の制限は、リソースごとに異なります。

|

|

up ステータスを持つリソースの番号を表示します。アイコンをクリックすると、適切なタブに移動し、検索対象は up になっているリソースに限定されます。

|

|

down 状態のリソースの番号を表示します。アイコンをクリックすると適切なタブに移動し、検索対象は down 状態のリソースに限定されます。検索の制限は、リソースごとに異なります。

|

|

アラートステータスを持つイベントの数を表示します。アイコンをクリックすると Events タブに移動し、検索対象は重大度がアラートのイベントに限定されます。

|

|

エラーステータスを持つイベントの数を表示します。アイコンをクリックすると Events タブに移動し、検索対象は重大度がエラーのイベントに限定されます。

|

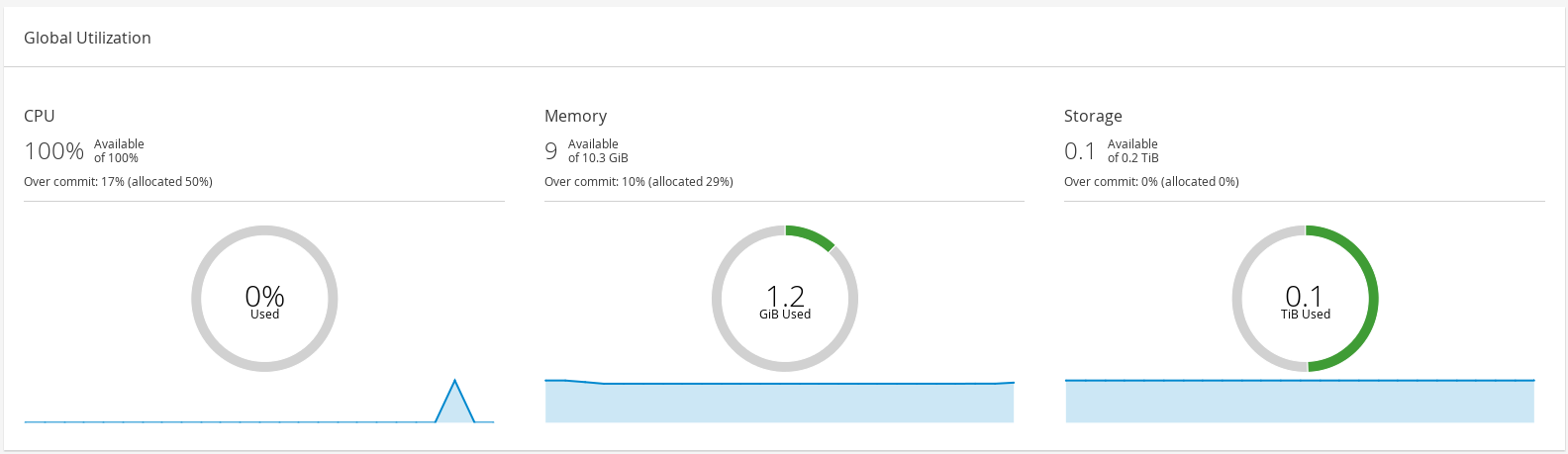

2.3. グローバルでの活用

図2.3 グローバルでの活用

- 上段には、利用可能な CPU、メモリー、ストレージ、およびオーバーコミット率の割合が表示されます。たとえば、CPU のオーバーコミット率は、Data Warehouse の最新データに基づいて実行中の仮想マシンで利用可能な物理コアの数で仮想コア数を除算して計算されます。

- ドーナツは、CPU、メモリー、またはストレージの使用率をパーセンテージで表示し、過去 5 分間の平均使用率に基づいて、すべてのホストの平均使用率を表示します。ドーナツの断面にカーソルを合わせると、選択したセクションの値が表示されます。

- 下部の折れ線グラフは、過去 24 時間の傾向を表示しています。各データポイントは、特定の時間の平均使用量を示しています。グラフ上のポイントにカーソルを合わせると、CPU のグラフでは時間と使用率が、メモリーとストレージのグラフでは使用量が表示されます。

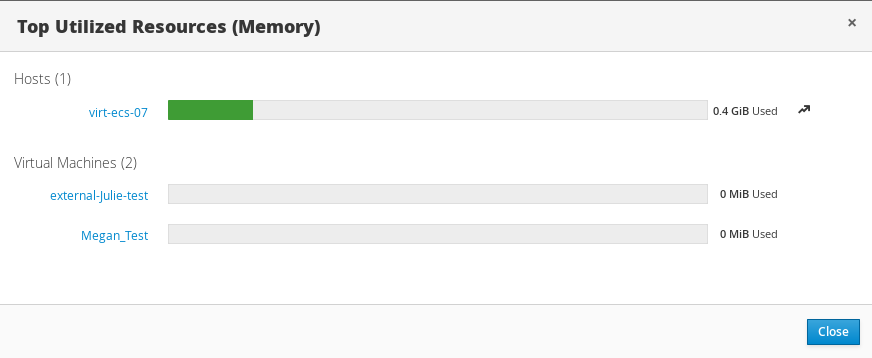

2.3.1. 最も使用されているリソース

図2.4 最も使用されているリソース (メモリー)

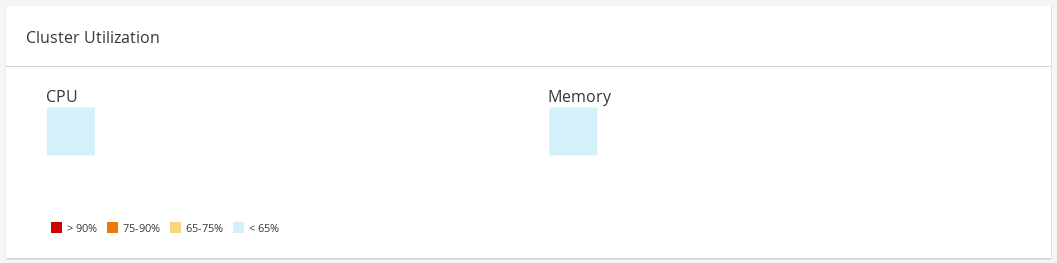

2.4. クラスターの活用

図2.5 クラスターの活用

2.4.1. CPU

2.4.2. メモリー

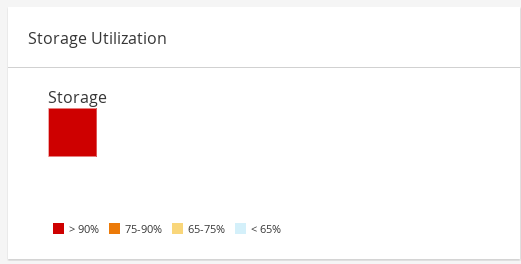

2.5. ストレージの活用

図2.6 ストレージの活用

パート II. リソースの管理

第3章 QoS (Quality of Service)

3.1. ストレージ QoS

3.1.1. ストレージ QoS エントリーの作成

手順3.1 ストレージ QoS エントリーの作成

- Data Centers resource タブをクリックし、データセンターを選択します。

- 詳細ペインで QoS をクリックします。

- Storage をクリックします。

- New をクリックします。

- QoS Name フィールドにサービス品質エントリーの名前を入力します。

- Description フィールドに、Quality of Service エントリーの 説明 を入力します。

- スループット QoS (Quality of Service)を指定します。

- Throughput チェックボックスを選択します。

- Total フィールドに最大許容合計スループットを入力します。

- Read フィールドに、読み取り操作の最大許容スループットを入力します。

- Write フィールドに、書き込み操作の最大許容スループットを入力します。

- 入出力 QoS を指定します。

- IOps チェックボックスを選択します。

- Total フィールドに、1 秒あたりの入出力操作の最大許容数を入力します。

- Read フィールドに、1 秒あたりの入力操作の最大許容数を入力します。

- Write フィールドに、1 秒あたりの出力操作の最大許容数を入力します。

- OK をクリックします。

3.1.2. ストレージ Quality of Service エントリーの削除

手順3.2 ストレージ Quality of Service エントリーの削除

- Data Centers resource タブをクリックし、データセンターを選択します。

- 詳細ペインで QoS をクリックします。

- Storage をクリックします。

- 削除するストレージの QoS エントリーを選択します。

- 削除 をクリックします。

- プロンプトが表示されたら OK をクリックします。

[unlimited] に設定されます。

3.2. 仮想マシンのネットワーク QoS

3.2.1. 仮想マシンのネットワーク QoS エントリーの作成

手順3.3 仮想マシンのネットワーク QoS エントリーの作成

- Data Centers resource タブをクリックし、データセンターを選択します。

- 詳細ペインの QoS タブをクリックします。

- VM Network をクリックします。

- New をクリックします。

- 仮想マシンネットワーク QoS (Quality of Service)エントリーの名前を Name フィールドに入力します。

- Inbound および Outbound ネットワークトラフィックの制限を入力します。

- OK をクリックします。

3.2.2. New Virtual Machine Network QoS および Edit Virtual Machine Network QoS ウインドウの設定の説明

表3.1 仮想マシンネットワーク QoS 設定

|

フィールド名

|

説明

|

|---|---|

|

Data Center

|

仮想マシンのネットワーク QoS ポリシーを追加するデータセンター。このフィールドは、選択したデータセンターに応じて自動的に設定されます。

|

|

Name

|

Manager 内の仮想マシンネットワーク QoS ポリシーを表す名前。

|

|

Inbound

|

受信トラフィックに適用される設定。Inbound チェックボックスを選択または選択解除して、これらの設定を有効または無効にします。

|

|

Outbound

|

送信トラフィックに適用される設定。Outbound チェックボックスを選択または選択解除して、これらの設定を有効または無効にします。

|

3.2.3. 仮想マシンのネットワーク QoS(Quality of Service) エントリーの削除

手順3.4 仮想マシンのネットワーク QoS(Quality of Service) エントリーの削除

- Data Centers resource タブをクリックし、データセンターを選択します。

- 詳細ペインの QoS タブをクリックします。

- VM Network をクリックします。

- 削除する仮想マシンネットワーク QoS エントリーを選択します。

- 削除 をクリックします。

- プロンプトが表示されたら OK をクリックします。

3.3. ホストネットワーク QoS

3.3.1. ホストネットワーク QoS エントリーの作成

手順3.5 ホストネットワーク QoS エントリーの作成

- Data Centers resource タブをクリックし、データセンターを選択します。

- 詳細ペインで QoS をクリックします。

- Host Network をクリックします。

- New をクリックします。

- QoS Name フィールドにサービス品質エントリーの名前を入力します。

- Description フィールドに、Quality of Service エントリーの 説明 を入力します。

- Weighted Share、Rate Limit [Mbps]、および Committed Rate [Mbps] に必要な値を入力します。

- OK をクリックします。

3.3.2. New Host Network Quality of Service および Edit Host Network Quality of Service ウィンドウの設定の説明

表3.2 ホストネットワーク QoS 設定

|

フィールド名

|

説明

|

|---|---|

|

Data Center

|

ホストネットワーク QoS ポリシーを追加するデータセンター。このフィールドは、選択したデータセンターに応じて自動的に設定されます。

|

|

QoS Name

|

Manager 内のホストネットワーク QoS ポリシーを表す名前。

|

|

説明

|

ホストネットワーク QoS ポリシーの説明

|

|

Outbound

|

送信トラフィックに適用される設定。

|

3.3.3. ホストネットワーク QoS エントリーの削除

手順3.6 ホストネットワーク QoS エントリーの削除

- Data Centers resource タブをクリックし、データセンターを選択します。

- 詳細ペインの QoS タブをクリックします。

- Host Network をクリックします。

- 削除するネットワーク QoS エントリーを選択します。

- 削除 をクリックします。

- プロンプトが表示されたら OK をクリックします。

3.4. CPU QoS (Quality of Service)

3.4.1. CPU QoS エントリーの作成

手順3.7 CPU QoS エントリーの作成

- Data Centers resource タブをクリックし、データセンターを選択します。

- 詳細ペインで QoS をクリックします。

- CPU をクリックします。

- New をクリックします。

- QoS Name フィールドにサービス品質エントリーの名前を入力します。

- Description フィールドに、Quality of Service エントリーの 説明 を入力します。

- Limit フィールドに許可されるサービス品質エントリーの最大処理機能をパーセンテージで入力します。

%記号は含めないでください。 - OK をクリックします。

3.4.2. CPU QoS エントリーの削除

手順3.8 CPU QoS エントリーの削除

- Data Centers resource タブをクリックし、データセンターを選択します。

- 詳細ペインで QoS をクリックします。

- CPU をクリックします。

- 削除する CPU QoS エントリーを選択します。

- 削除 をクリックします。

- プロンプトが表示されたら OK をクリックします。

[unlimited] に設定されます。

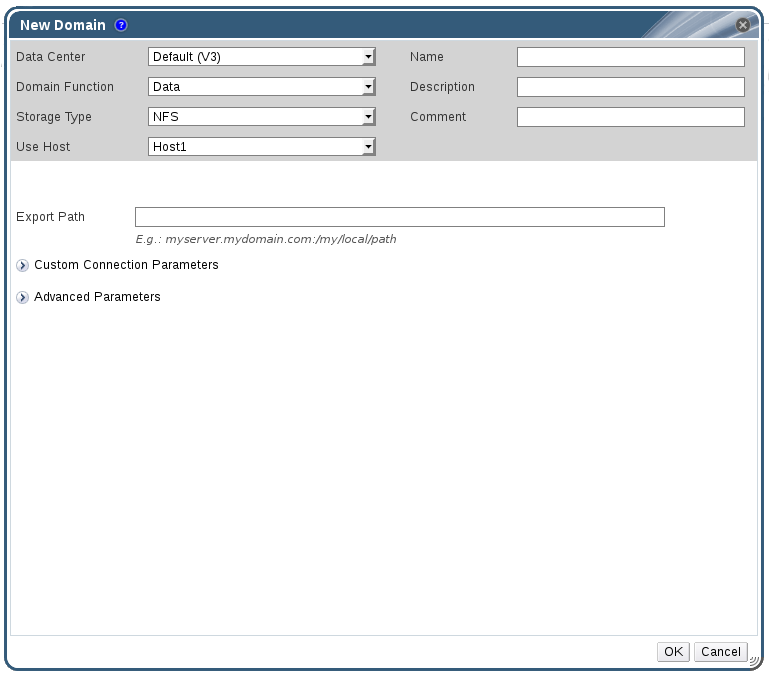

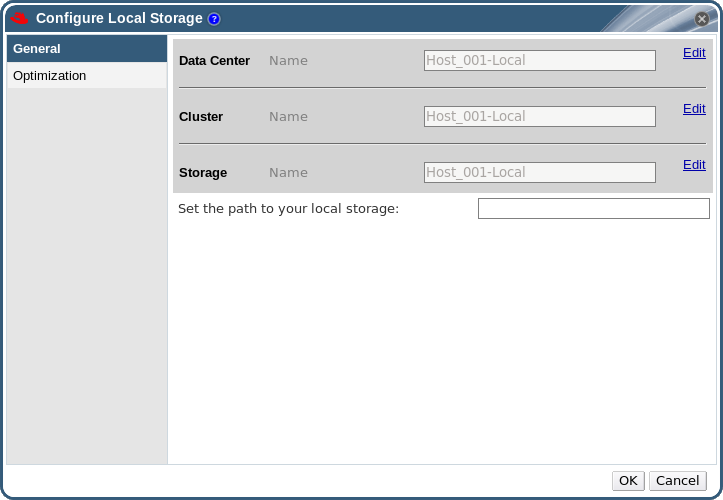

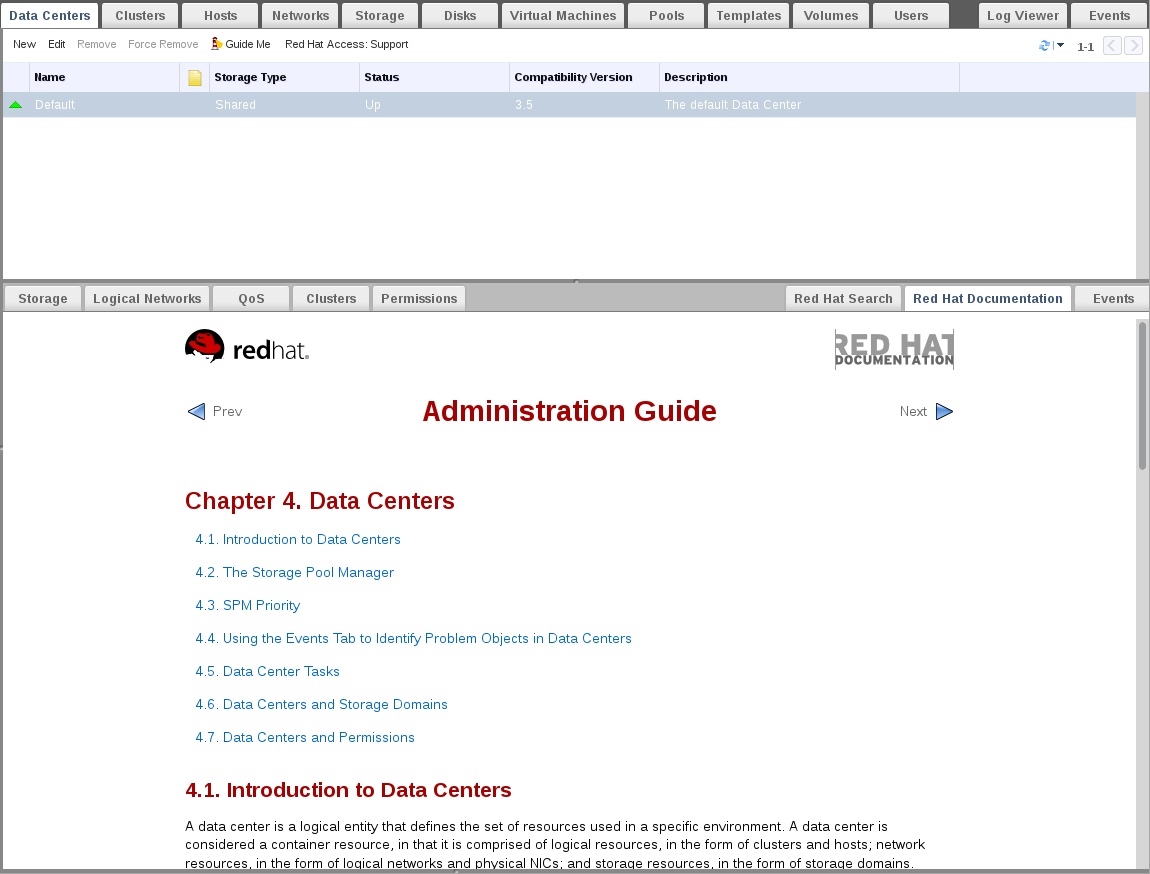

第4章 データセンター

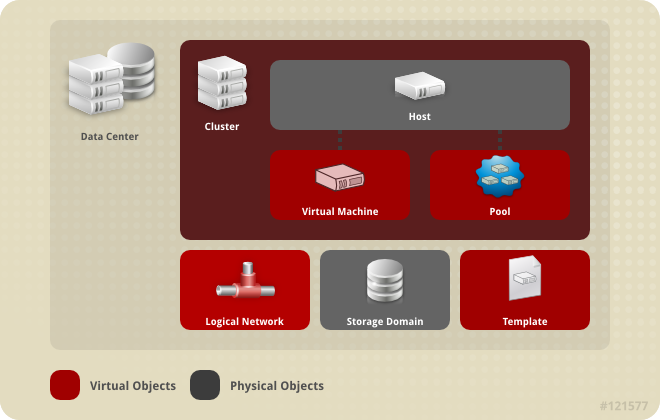

4.1. データセンターの概要

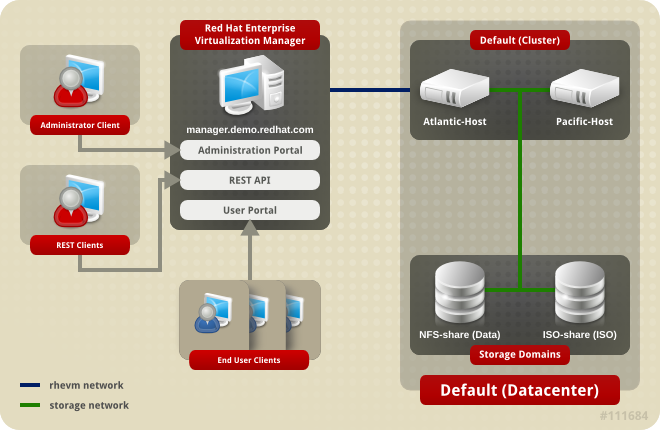

図4.1 データセンター

図4.2 データセンターオブジェクト

4.2. Storage Pool Manager

4.3. SPM の優先度

4.4. イベントタブを使用したデータセンターの問題オブジェクトの特定

4.5. データセンタータスク

4.5.1. 新規データセンターの作成

手順4.1 新規データセンターの作成

- Data Centers resource タブを選択して、結果一覧内のすべてのデータセンターを一覧表示します。

- New をクリックして New Data Center ウィンドウを開きます。

- データセンターの Name および Description を入力します。

- ドロップダウンメニュー から、データセンターのストレージタイプ、互換バージョン、および クォータモード を選択します。

- 必要に応じて、データセンターの MAC アドレスプールを変更します。デフォルトの MAC アドレスプールはデフォルトで事前に選択されます。MAC アドレスプールの作成に関する詳細は、「MAC アドレスプール」 を参照してください。

- MAC Address Pool タブをクリックします。

- MAC Address Pool ドロップダウンリストから必要な MAC アドレスプールを選択します。

- OK をクリックしてデータセンターを作成し、New Data Center - Guide Me ウィンドウを開きます。

- Guide Me ウィンドウには、データセンター用に設定する必要のあるエンティティーが一覧表示されます。Configure Later ボタンをクリックして、これらのエンティティーを設定するか、または設定を延期します。設定は、データセンターを選択して Guide Me ボタンをクリックして再開できます。

4.5.2. New Data Center および Edit Data Center Windows の設定についての説明

表4.1 データセンターのプロパティー

|

フィールド

|

説明/アクション

|

|---|---|

|

Name

|

データセンターの名前。このテキストフィールドには 40 文字の制限があり、大文字、小文字、数字、ハイフン、およびアンダースコアの組み合わせが含まれる一意の名前である必要があります。

|

|

説明

| データセンターの説明このフィールドは推奨されますが、必須ではありません。 |

|

タイプ

|

ストレージタイプ。以下のいずれかを選択します。

データドメインのタイプはデータセンターのタイプを決定し、大きな中断なしに作成後に変更することはできません。複数のタイプのストレージドメイン(iSCSI、NFS、FC、POSIX、および Gluster)を同じデータセンターに追加できますが、ローカルドメインと共有ドメインを混在させることはできません。

|

|

互換バージョン

|

Red Hat Virtualization のバージョン。以下のいずれかを選択します。

|

|

クォータモード

| クォータは、Red Hat Virtualization で提供されるリソース制限ツールです。以下のいずれかを選択します。

|

|

MAC アドレスプール

|

データセンターの MAC アドレスプール。他の MAC アドレスプールが割り当てられていない場合は、デフォルトの MAC アドレスプールが使用されます。MAC アドレスプールの詳細は、を参照してください。 「MAC アドレスプール」

|

4.5.3. データセンターの再初期化: リカバリー手順

手順4.2 データセンターの再初期化

- Data Centers resource タブをクリックし、再初期化するデータセンターを選択します。

- データセンターに接続されたストレージドメインがメンテナンスモードにあることを確認します。

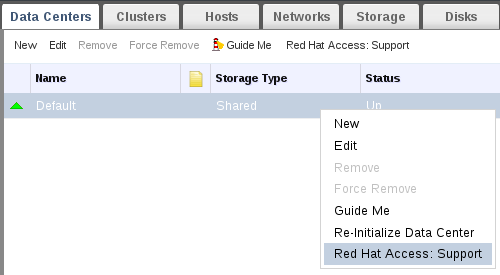

- データセンターを右クリックし、ドロップダウンメニューから Re-Initialize Data Center を選択して、Data Center Re-Initialize ウィンドウを開きます。

- Data Center Re-Initialize ウィンドウには、利用可能なすべての(割り当て解除あり、メンテナーンスモードの場合)ストレージドメインが一覧表示されます。データセンターに追加するストレージドメインのラジオボタンをクリックします。

- Approve operation チェックボックスを選択します。

- OK をクリックしてウィンドウを閉じ、データセンターを再初期化します。

4.5.4. データセンターの削除

手順4.3 データセンターの削除

- データセンターに接続されたストレージドメインがメンテナーンスモードにあることを確認します。

- Data Centers resource タブをクリックし、削除するデータセンターを選択します。

- Remove をクリックして、Remove Data Center (s) 確認ウィンドウを開きます。

- OK をクリックします。

4.5.5. データセンターの強制削除

Non Responsive になった場合、データセンターが Non Responsive になります。いずれの状況でもデータセンターを 削除 することはできません。

手順4.4 データセンターの強制削除

- Data Centers resource タブをクリックし、削除するデータセンターを選択します。

- Force Remove をクリックして、Force Remove Data Center の確認ウィンドウを開きます。

- Approve operation チェックボックスを選択します。

- OKをクリックします。

4.5.6. データセンターの互換バージョンの変更

手順4.5 データセンターの互換バージョンの変更

- 管理ポータルから、Data Centers タブをクリックします。

- 表示される一覧から変更するデータセンターを選択します。

- Edit をクリックします。

- 互換バージョン を必要な値に変更します。

- OK をクリックして Change Data Center Compatibility Version の確認ウィンドウを開きます。

- OK をクリックして確定します。

4.6. データセンターおよびストレージドメイン

4.6.1. 既存のデータドメインをデータセンターにアタッチ

手順4.6 既存のデータドメインをデータセンターにアタッチ

- Data Centers resource タブをクリックし、適切なデータセンターを選択します。

- 詳細ペインで Storage タブを選択して、データセンターにすでにアタッチされているストレージドメインを一覧表示します。

- Attach Data をクリックして、Attach Storage ウィンドウを開きます。

- データセンターにアタッチするデータドメインのチェックボックスを選択します。複数のデータドメインを割り当てる場合は、複数のチェックボックスを選択できます。

- OK をクリックします。

4.6.2. 既存の ISO ドメインをデータセンターにアタッチ

手順4.7 既存の ISO ドメインをデータセンターにアタッチ

- Data Centers resource タブをクリックし、適切なデータセンターを選択します。

- 詳細ペインで Storage タブを選択して、データセンターにすでにアタッチされているストレージドメインを一覧表示します。

- Attach ISO をクリックして、Attach ISO Library ウィンドウを開きます。

- 適切な ISO ドメインのラジオボタンをクリックします。

- OK をクリックします。

4.6.3. 既存のエクスポートドメインをデータセンターにアタッチ

手順4.8 既存のエクスポートドメインをデータセンターにアタッチ

- Data Centers resource タブをクリックし、適切なデータセンターを選択します。

- 詳細ペインで Storage タブを選択して、データセンターにすでにアタッチされているストレージドメインを一覧表示します。

- Attach Export をクリックして、Attach Export Domain ウィンドウを開きます。

- 適切な エクスポートドメイン のラジオボタンをクリックします。

- OK をクリックします。

4.6.4. データセンターからストレージドメインをデタッチ

手順4.9 データセンターからストレージドメインをデタッチ

- Data Centers resource タブをクリックし、適切なデータセンターを選択します。

- 詳細ペインで Storage タブを選択して、データセンターに接続されているストレージドメインを一覧表示します。

- デタッチするストレージドメインを選択します。ストレージドメインが

Activeの場合は、Maintenance をクリックして Maintenance Storage Domain (s) の確認ウィンドウを開きます。 - OK をクリックしてメンテナンスモードを開始します。

- Detach をクリックして、Detach Storage の確認ウィンドウを開きます。

- OK をクリックします。

4.7. データセンターおよびパーミッション

4.7.1. データセンターのシステムパーミッションの管理

- データセンターに関連付けられたクラスターの作成と削除。

- データセンターに関連付けられたホスト、仮想マシン、およびプールを追加および削除。

- データセンターに関連付けられた仮想マシンのユーザーパーミッションの編集。

4.7.2. データセンター管理者ロールの概要

データセンターのパーミッションロール

以下の表は、データセンターの管理に適用される管理者ロールおよび権限を示しています。

表4.2 Red Hat Virtualization システム管理者ロール

| ロール | 権限 | 注記 |

|---|---|---|

| DataCenterAdmin | データセンター管理者 | クラスター、ホスト、テンプレート、仮想マシンなど、特定のデータセンター内の物理リソースおよび仮想リソースすべての作成、削除、管理が可能です。 |

| NetworkAdmin | ネットワーク管理者 | 特定のデータセンターのネットワークを設定および管理できます。データセンターのネットワーク管理者は、データセンター内の仮想マシンのネットワークパーミッションも継承します。 |

4.7.3. 管理者またはユーザーロールのリソースへの割り当て

手順4.10 リソースへのロールの割り当て

- リソースタブ、ツリーモード、または検索機能を使用してリソースを検索し、結果一覧で選択します。

- 詳細ペインの Permissions タブをクリックして、割り当てられたユーザー、ユーザーのロール、および選択したリソースに対する継承されたパーミッションを一覧表示します。

- Add をクリックします。

- Search テキストボックスに既存ユーザーの名前またはユーザー名を入力し、Go をクリックします。表示された候補の中からユーザーを選択します。

- Role to Assign: ドロップダウンリストからロールを選択します。

- OK をクリックします。

4.7.4. リソースからの管理者またはユーザーロールの削除

手順4.11 リソースからのロールの削除

- リソースタブ、ツリーモード、または検索機能を使用してリソースを検索し、結果一覧で選択します。

- 詳細ペインの Permissions タブをクリックして、割り当てられたユーザー、ユーザーのロール、および選択したリソースに対する継承されたパーミッションを一覧表示します。

- リソースから削除するユーザーを選択します。

- Remove をクリックします。Remove Permission 画面が開き、パーミッションの削除を確認します。

- OK をクリックします。

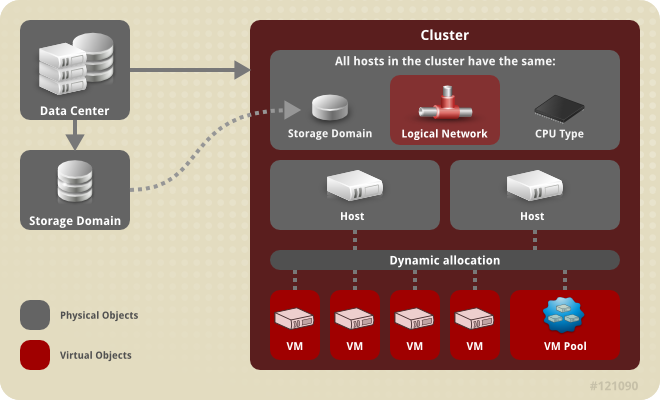

第5章 クラスター

5.1. クラスターの概要

図5.1 Cluster

5.2. クラスタータスク

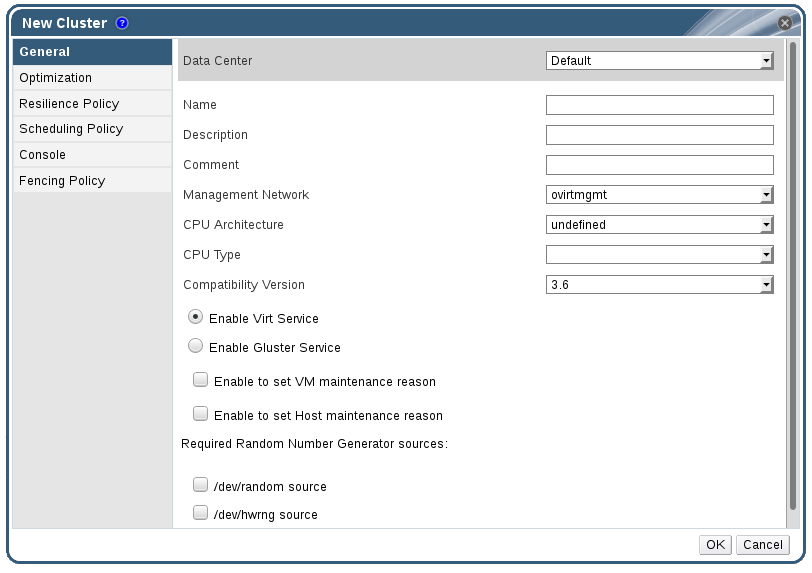

5.2.1. 新規クラスターの作成

手順5.1 新規クラスターの作成

- Clusters resource タブを選択します。

- New をクリックします。

- ドロップダウンリストからクラスターが属する Data Center を選択します。

- クラスターの Name および Description を入力します。

- Management Network ドロップダウンリストからネットワークを選択して、管理ネットワークロールを割り当てます。

- ドロップダウンリストから CPU Architecture および CPU Type を選択します。クラスターに接続するホストの最小 CPU プロセッサータイプと、CPU プロセッサーファミリーとを一致させることが重要です。そうでないと、ホストが機能しなくなります。注記Intel タイプおよび AMD CPU タイプの両方の場合、リストされた CPU モデルは、最も古いものから最新の順に論理的に使用されます。CPU モデルが異なるホストがクラスターに含まれる場合は、最も古い CPU モデルを選択します。各 CPU モデルの詳細は、を参照してください https://access.redhat.com/solutions/634853。

- ドロップダウンリストから、クラスターの 互換バージョン を選択します。

- Enable Virt Service または Enable Gluster Service ラジオボタンを選択し、クラスターに仮想マシンホストまたは Gluster 対応ノードが設定されるかどうかを定義します。Red Hat Virtualization Host (RHVH)を Gluster 対応クラスターに追加できないことに注意してください。

- Manager から仮想マシンをシャットダウンする際に任意の reason フィールドを有効にするには、Enable to set VM maintenance reason チェックボックスを選択し、管理者がメンテナーンスの説明を提供できるようにします。

- ホストを Manager からメンテナンスモードに移行する際に任意の reason フィールドを有効にするには、Enable to set Host maintenance reason チェックボックスを選択して、管理者がメンテナーンスの説明を提供できるようにします。

- /dev/random ソース (Linux が提供するデバイス)または /dev/hwrng ソース (外部ハードウェアデバイス)のチェックボックスを選択し、クラスター内のすべてのホストが使用する乱数ジェネレーターデバイスを指定します。

- Optimization タブをクリックして、クラスターのメモリーページ共有のしきい値を選択し、必要に応じてクラスター内のホストで CPU スレッド処理およびメモリーバルーンを有効にします。

- Migration Policy タブをクリックして、クラスターの仮想マシンの移行ポリシーを定義します。

- Scheduling Policy タブをクリックして、スケジューリングポリシーの設定、スケジューラー最適化の設定、クラスター内のホストの信頼できるサービスの有効化、HA Reservation の有効化、およびカスタムシリアル番号ポリシーの追加を行います。

- Console タブをクリックしてオプションでグローバル SPICE プロキシーを上書きし(ある場合)、クラスター内のホストの SPICE プロキシーのアドレスを指定します。

- Fencing policy タブをクリックして、クラスターでフェンシングを有効または無効にします。また、フェンスオプションを選択します。

- OK をクリックしてクラスターを作成し、New Cluster - Guide Me ウィンドウを開きます。

- Guide Me ウィンドウには、クラスター用に設定する必要のあるエンティティーが一覧表示されます。Configure Later ボタンをクリックしてこれらのエンティティーを設定するか、または設定を延期します。設定を再開するには、クラスターを選択し、Guide Me ボタンをクリックします。

5.2.2. 新規クラスターの設定および制御の説明およびクラスターウィンドウの編集

5.2.2.1. 一般的なクラスター設定に関する説明

図5.2 新規クラスターウィンドウ

表5.1 一般的なクラスター設定

|

フィールド

|

説明/アクション

|

|---|---|

|

Data Center

|

クラスターが含まれるデータセンター。クラスターを追加する前にデータセンターを作成する必要があります。

|

|

Name

|

クラスターの名前。このテキストフィールドには 40 文字の制限があり、大文字、小文字、数字、ハイフン、およびアンダースコアの組み合わせが含まれる一意の名前である必要があります。

|

|

Description / Comment

| クラスターまたは追加のメモの説明。これらのフィールドは推奨されますが、必須ではありません。 |

|

Management Network

|

管理ネットワークロールを割り当てる論理ネットワーク。デフォルトは ovirtmgmt です。既存のクラスターでは、詳細ペインの Logical Networks タブの Manage Networks ボタンからのみ管理ネットワークを変更できます。

|

| CPU アーキテクチャー | クラスターの CPU アーキテクチャー。選択した CPU アーキテクチャーに応じて、さまざまな CPU タイプを利用できます。

|

|

CPU Type

| クラスターの CPU タイプ。以下のいずれかを選択します。

|

|

互換バージョン

| Red Hat Virtualization のバージョン。以下のいずれかを選択します。

|

|

Enable Virt Service

| このラジオボタンを選択すると、このクラスター内のホストは仮想マシンを実行するために使用されます。 |

|

Enable Gluster Service

| このラジオボタンが選択される場合、このクラスターのホストは Red Hat Gluster Storage Server ノードとして使用されるため、仮想マシンの実行には使用されません。このオプションを有効にしたクラスターに Red Hat Virtualization Host を追加することはできません。 |

|

Import existing gluster configuration

|

このチェックボックスは、Enable Gluster Service ラジオボタンが選択されている場合にのみ利用できます。このオプションを使用すると、既存の Gluster 対応クラスターおよびその割り当てられたすべてのホストを Red Hat Virtualization Manager にインポートできます。

以下のオプションは、インポートされているクラスター内のホストごとに必要になります。

|

| Enable to set VM maintenance reason | このチェックボックスを選択すると、クラスターの仮想マシンが Manager からシャットダウンすると、オプションの reason フィールドが表示されます。これにより、ログに表示されるメンテナーンスの説明と、仮想マシンの電源が再びオンになります。 |

| ホストのメンテナーンス理由の設定の有効化 | このチェックボックスを選択すると、クラスターのホストが Manager からメンテナーンスモードに移動すると、オプションの reason フィールドが表示されます。これにより、ログに表示されるメンテナーンスの説明と、ホストが再度アクティベートされたタイミングを指定できます。 |

| 必要な乱数ジェネレーターソース: |

以下のチェックボックスを選択した場合には、クラスター内のすべてのホストにそのデバイスが利用可能な状態でなければなりません。これにより、乱数ジェネレーターデバイスから仮想マシンへのエントロピーのパススルーが可能になります。

|

5.2.2.2. 最適化設定の説明

表5.2 最適化の設定

|

フィールド

|

説明/アクション

|

|---|---|

|

メモリーの最適化

|

|

|

CPU スレッド

|

Count Threads As Cores チェックボックスを選択すると、ホストは、ホストのコア数よりも大きいプロセッサーコアの合計数で仮想マシンを実行できます。

公開されるホストスレッドは、仮想マシンで使用できるコアとして処理されます。たとえば、コアごとに 2 つのスレッドがある 24 コアのシステム (全部で 48 スレッド) では、それぞれ最大 48 コアを持つ仮想マシンを実行できます。そして、ホストの CPU 負荷を計算するアルゴリズムは、使用量の多くのコアを 2 回比較します。

|

|

メモリーバルーン

|

Enable Memory Balloon Optimization チェックボックスを選択すると、このクラスターのホストで実行されている仮想マシンでメモリーのオーバーコミットが有効になります。このオプションを設定すると、Memory Overcommit Manager (MoM)はバルーンを開始します。可能な場合は、すべての仮想マシンのメモリーサイズが保証されます。

バルーンが実行しているには、仮想マシンに適切なドライバーを持つバルーンデバイスが必要です。各仮想マシンには、特別に削除しない限り、バルーンデバイスが含まれます。このクラスター内の各ホストは、ステータスが

Up に変わったときにバルーンポリシーの更新を受け取ります。必要に応じて、ステータスを変更せずに、ホストのバルーンポリシーを手動で更新できます。「クラスター内のホストでの MoM ポリシーの更新」 を参照してください。

シナリオのバルーンでは、KSM と一致している可能性がある点を理解することが重要です。このような場合は、MoM は競合の可能性を最小限に抑えるためにバルーンサイズの調整を試みます。さらに、シナリオのバルーンによっては、仮想マシンに対して最大のパフォーマンスが最適化される可能性があります。管理者は、バルーンの最適化を注意して使用することが推奨されます。

|

|

KSM コントロール

|

Enable KSM チェックボックスを選択すると、MoM は必要に応じて Kernel Same-page Merging (KSM)を実行できます。メモリーの保存により、CPU コストを上回る利点が得られます。

|

5.2.2.3. 移行ポリシー設定の説明

表5.3 移行ポリシーの説明

|

Policy

|

説明

|

|---|---|

|

Legacy

|

3.6 バージョンのレガシー動作

vdsm.conf のオーバーライドは引き続き適用されます。ゲストエージェントフックメカニズムが無効になっている。

|

|

最小ダウンタイム

|

仮想マシンを一般的な状況で移行できるようにするポリシー。仮想マシンは、ダウンタイムを大幅に発生しません。移行は、長時間 (QEMU の反復により最大 500 ミリ秒) 後に仮想マシンの移行が収束されない場合に中止されます。ゲストエージェントフックメカニズムが有効になっている。

|

|

必要に応じてワークロードを一時停止

|

負荷が大きい仮想マシンを含む、ほとんどの状況で仮想マシンが移行できるようにするポリシー。仮想マシンでは、より大きなダウンタイムが発生する可能性があります。移行は、極端なワークロードに対して中止される場合があります。ゲストエージェントフックメカニズムが有効になっている。

|

表5.4 帯域幅の説明

|

Policy

|

説明

|

|---|---|

|

Auto

|

帯域幅は、データセンターの Host Network QoS の Rate Limit [Mbps] 設定からコピーされます。レート制限が定義されていない場合は、ネットワークインターフェイス送受信の最小リンク速度として計算されます。レート制限が設定されていない場合や、リンク速度が利用できない場合には、ホスト送信時にローカルの VDSM 設定により決定されます。

|

|

ハイパーバイザーのデフォルト

|

帯域幅は、ホスト送信時にローカルの VDSM 設定によって制御されます。

|

|

カスタム

|

ユーザーで定義されます (Mbps 単位)。

|

表5.5 耐障害性ポリシーの設定

|

フィールド

|

説明/アクション

|

|---|---|

|

仮想マシンの移行

|

定義された優先順位で、すべての仮想マシンを移行します。

|

|

高可用性仮想マシンのみの移行

|

他のホストのオーバーロードを防ぐために、高可用性の仮想マシンのみを移行します。

|

|

Do not migrate Virtual Machines(仮想マシンを移行しない)

| 仮想マシンを移行しないようにします。 |

表5.6 その他のプロパティーの説明

|

プロパティー

|

説明

|

|---|---|

|

自動コンバージション

|

仮想マシンのライブマイグレーション中に自動コンバージェンスが使用されるかどうかを設定できます。負荷が大きいが大きい仮想マシンでは、ライブマイグレーション中に行われる転送速度よりも速くメモリーがダーティーなり、移行が収束できなくなります。QEMU の自動調整機能を使用すると、仮想マシン移行の収束を強制的に実行できます。QEMU は、コンバージェンスの欠如を自動的に検出し、仮想マシン上の vCPU のスロットルダウンをトリガーします。オートコンバージェンスはデフォルトで無効になっています。

|

|

Enable migration compression

|

このオプションを使用すると、仮想マシンのライブマイグレーション中に移行圧縮を使用するかどうかを設定できます。この機能は、Xor Binary Zero Run-Length-Encoding を使用して、メモリー書き込みを必要とするワークロードまたはスパースメモリー更新パターンを使用するアプリケーションに対して、仮想マシンのダウンタイムと合計移行時間を短縮します。移行圧縮は、デフォルトでは無効になっています。

|

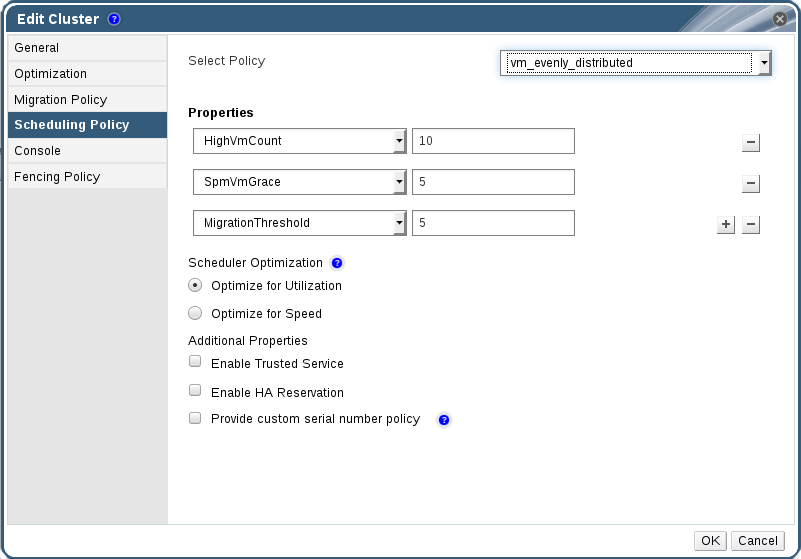

5.2.2.4. スケジューリングポリシー設定に関する説明

図5.3 スケジューリングポリシー設定:vm_evenly_distributed

表5.7 スケジューリングポリシータブプロパティー

|

フィールド

|

説明/アクション

|

|---|---|

|

ポリシーの選択

|

ドロップダウンリストからポリシーを選択します。

|

|

プロパティー

|

以下のプロパティーは選択したポリシーをもとに表示され、必要に応じて編集できます。

|

|

スケジューラーの最適化

|

ホストの重み付け/順序のスケジューリングを最適化します。

|

|

信頼できるサービスの有効化

|

OpenAttestation サーバーとのインテグレーションを有効にします。これを有効にする前に、engine-config ツールを使用して OpenAttestation サーバーの詳細を入力します。詳細は、「信頼できるコンピュートプール」 を参照してください。

|

|

HA 予約の有効化

|

Manager が高可用性仮想マシンのクラスター容量を監視できるようにします。Manager は、既存のホストが予期せずに失敗した場合に移行するために、高可用性として指定された仮想マシンのクラスター内に適切な容量が存在することを確認します。

|

|

Provide custom serial number policy

|

このチェックボックスを選択すると、クラスター内の仮想マシンのシリアル番号ポリシーを指定できます。以下のオプションのいずれかを選択します。

|

/var/log/vdsm/mom.log に記録されます。/var/log/vdsm/mom.log は、Memory Overcommit Manager ログファイルです。

5.2.2.5. クラスターコンソール設定の説明

表5.8 コンソールの設定

|

フィールド

|

説明/アクション

|

|---|---|

|

クラスターの SPICE プロキシーの定義

|

このチェックボックスを選択し、グローバル設定で定義された SPICE プロキシーの上書きを有効にします。この機能は、ユーザー(ユーザーポータル経由で接続するなど)がハイパーバイザーが存在するネットワーク外にある場合に役に立ちます。

|

|

SPICE プロキシーアドレスのオーバーライド

|

SPICE クライアントが仮想マシンに接続するプロキシー。アドレスは以下の形式でなければなりません。

protocol://[host]:[port] |

5.2.2.6. フェンシングポリシー設定の説明

表5.9 フェンシングポリシーの設定

| フィールド | 説明/アクション |

|---|---|

| フェンシングの有効化 | クラスターのフェンシングを有効にします。フェンシングはデフォルトで有効になっていますが、必要に応じて無効にできます。たとえば、一時的なネットワークの問題が発生したり、予想される場合に、管理者は診断またはメンテナンスアクティビティーが完了するまでフェンシングを無効にできます。フェンシングが無効になっている場合は、応答しないホストで実行している高可用性仮想マシンは、別の場所で再起動されないことに注意してください。 |

| ホストのストレージにライブリースがある場合はフェンシングをスキップ | このチェックボックスを選択しないと、Non Responsive のクラスター内のホストは、ストレージに接続されたホストはフェンスされません。 |

| クラスター接続の問題のフェンシングをスキップ | このチェックボックスを選択すると、接続問題が発生しているクラスター内のホストのパーセンテージが定義された Threshold 以上になると、フェンシングが一時的に無効になります。Threshold 値はドロップダウンリストから選択されます。利用可能な値は 25、50、75、および 100 です。 |

5.2.3. リソースの編集

概要

リソースのプロパティーを編集します。

手順5.2 リソースの編集

- リソースタブ、ツリーモード、または検索機能を使用してリソースを検索し、結果一覧で選択します。

- Edit をクリックして Edit ウィンドウを開きます。

- 必要なプロパティーを変更し、OK をクリックします。

結果

新しいプロパティーは リソースに保存されます。プロパティーフィールドが無効であれば、Edit ウィンドウは閉じません。

5.2.4. クラスター内のホストの負荷および電源管理ポリシーの設定

手順5.3 ホストの負荷および電源管理ポリシーの設定

- リソースタブ、ツリーモード、または検索機能を使用して、結果一覧でクラスターを見つけて選択します。

- Edit をクリックして Edit Cluster ウィンドウを開きます。

図5.4 スケジューリングポリシーの編集

- 以下のポリシーのいずれかを選択します。

- none

- vm_evenly_distributed

- HighVmCount フィールドで負荷分散を有効にするために、少なくとも 1 台のホストで実行されている必要がある仮想マシンの最小数を設定します。

- 最も使用率の高いホスト上の仮想マシン数と、MigrationThreshold フィールドで使用率の低いホストにある仮想マシン数との間の許容可能な最大差を定義します。

- SpmVmGrace フィールドの SPM ホストで予約される仮想マシンのスロット数を定義します。

- evenly_distributed

- スケジューリングポリシーで CpuOverCommitDurationMinutes フィールドでアクションが実行される前に、定義された使用率値外でホストが CPU 負荷を実行できる時間(分単位)を設定します。

- HighUtilization フィールドに、仮想マシンが他のホストへの移行を開始する CPU 使用率のパーセンテージを入力します。

- MinFreeMemoryForUnderUtilized で、仮想マシンが他のホストへの移行を開始するのに必要な最小空きメモリーを MB 単位で入力します。

- MaxFreeMemoryForOverUtilized で、仮想マシンが他のホストへの移行を開始するために必要な最大空きメモリーを MB 単位で入力します。

- power_saving

- スケジューリングポリシーで CpuOverCommitDurationMinutes フィールドでアクションが実行される前に、定義された使用率値外でホストが CPU 負荷を実行できる時間(分単位)を設定します。

- 以下の CPU 使用率の割合を入力します。このパーセンテージは、LowUtilization フィールドでホストの使用率が低いと見なされます。

- HighUtilization フィールドに、仮想マシンが他のホストへの移行を開始する CPU 使用率のパーセンテージを入力します。

- MinFreeMemoryForUnderUtilized で、仮想マシンが他のホストへの移行を開始するのに必要な最小空きメモリーを MB 単位で入力します。

- MaxFreeMemoryForOverUtilized で、仮想マシンが他のホストへの移行を開始するために必要な最大空きメモリーを MB 単位で入力します。

- クラスターの Scheduler Optimization として、以下のいずれかを選択します。

- Optimize for Utilization を選択し、スケジューリングに重みモジュールを追加して、最適な選択を可能にします。

- Optimize for Speed を選択して、保留中のリクエストが 10 個以上ある場合にホストの重みをスキップします。

- OpenAttestation サーバーを使用してホストを確認し、engine-config ツールを使用してサーバーの詳細を設定している場合は、Enable Trusted Service チェックボックスを選択します。

- 必要に応じて、Enable HA Reservation チェックボックスを選択し、Manager が高可用性仮想マシンのクラスター容量を監視できるようにします。

- オプションで Provide custom serial number policy チェックボックスを選択し、クラスター内の仮想マシンのシリアル番号ポリシーを指定し、以下のオプションのいずれかを選択します。

- Host ID を選択して、ホストの UUID を仮想マシンのシリアル番号として設定します。

- Vm ID を選択して、仮想マシンの UUID をシリアル番号として設定します。

- Custom serial number を選択し、テキストフィールドにカスタムのシリアル番号を指定します。

- OK をクリックします。

5.2.5. クラスター内のホストでの MoM ポリシーの更新

手順5.4 ホストでの MoM ポリシーの同期

- Clusters タブをクリックして、ホストが属するクラスターを選択します。

- 詳細ペインで Hosts タブをクリックし、更新された MoM ポリシーを必要とするホストを選択します。

- Sync MoM Policy をクリックします。

5.2.6. CPU プロファイル

5.2.6.1. CPU プロファイルの作成

手順5.5 CPU プロファイルの作成

- Clusters resource タブをクリックし、クラスターを選択します。

- 詳細ペインの CPU プロファイル サブタブをクリックします。

- New をクリックします。

- 名前 フィールドに CPU プロファイルの名前を入力 し ます。

- Description フィールドに、CPU プロファイルの 説明 を入力します。

- QoS 一覧から CPU プロファイルに適用するサービスの品質を選択します。

- OK をクリックします。

5.2.6.2. CPU プロファイルの削除

手順5.6 CPU プロファイルの削除

- Clusters resource タブをクリックし、クラスターを選択します。

- 詳細ペインの CPU プロファイル サブタブをクリックします。

- 削除する CPU プロファイルを選択します。

- 削除 をクリックします。

- OK をクリックします。

デフォルト の CPU プロファイルが自動的に割り当てられます。

5.2.7. 既存の Red Hat Gluster Storage クラスターのインポート

手順5.7 既存の Red Hat Gluster Storage クラスターの Red Hat Virtualization Manager へのインポート

- Clusters resource タブを選択して、結果一覧のすべてのクラスターを一覧表示します。

- New をクリックして New Cluster ウィンドウを開きます。

- ドロップダウンメニューから、クラスターが属する データセンター を選択します。

- クラスターの Name および Description を入力します。

- Enable Gluster Service ラジオボタンを選択し、Import existing gluster configuration チェックボックスを選択します。Import existing gluster configuration フィールドは、Enable Gluster Service ラジオボタンを選択した場合にのみ表示されます。

- Address フィールドに、クラスター内のサーバーのホスト名または IP アドレスを入力します。ホスト Fingerprint が表示され、正しいホストに接続していることを確認します。ホストが到達不能な場合や、ネットワークエラーが発生した場合には、Error in fetching fingerprint のエラーが Fingerprint フィールドに表示されます。

- サーバーの Root パスワード を 入力し、OK をクリックします。

- ホストの 追加 画面が開き、クラスターの一部であるホストの一覧が表示されます。

- 各ホストに Name および Root Password を入力します。

- すべてのホストに同じパスワードを使用する場合は、Use a Common Password チェックボックスを選択して、指定のテキストフィールドにパスワードを入力します。Apply をクリックして、入力したパスワードをすべて設定します。フィンガープリントが有効であることを確認し、OK をクリックして変更を送信します。

5.2.8. ホストウィンドウの追加設定の説明

表5.10 Gluster ホスト設定の追加

| フィールド | 説明 |

|---|---|

| 一般的なパスワードを使用します。 | このチェックボックスにチェックマークを入れ、クラスターに属する全ホストに同じパスワードを使用します。パスワード フィールドにパスワードを入力 し、適用 ボタンをクリックしてすべてのホストにパスワードを設定します。 |

| Name | ホストの名前を入力します。 |

| ホスト名/IP | このフィールドには、新規クラスター ウィンドウで指定したホストの完全修飾ドメイン名または IP が自動的に設定されます。 |

| root パスワード | 各ホストに異なる root パスワードを使用するには、このフィールドにパスワードを入力します。このフィールドは、クラスター内のすべてのホストに提供される共通のパスワードを上書きします。 |

| Fingerprint | ホストのフィンガープリントが表示され、正しいホストに接続していることを確認します。このフィールドには、新規クラスター ウィンドウで指定したホストのフィンガープリントが自動的に入力されます。 |

5.2.9. クラスターの削除

概要

クラスターを削除する前に、すべてのホストをクラスターから移動します。

手順5.8 クラスターの削除

- リソースタブ、ツリーモード、または検索機能を使用して、結果一覧でクラスターを見つけて選択します。

- クラスターにホストがないことを確認します。

- Remove をクリックして、Remove Cluster (s) 確認ウィンドウを開きます。

- OK をクリックします。

結果

クラスターが削除されます。

5.2.10. クラスターの互換バージョンの変更

手順5.9 クラスターの互換バージョンの変更

- 管理ポータルで、Clusters タブをクリックします。

- 表示される一覧から変更するクラスターを選択します。

- Edit をクリックします。

- 互換バージョン を必要な値に変更します。

- OK をクリックして、Change Cluster Compatibility Version の確認ウィンドウを開きます。

- OK をクリックして確定します。

5.3. クラスターおよびパーミッション

5.3.1. クラスターのシステムパーミッションの管理

- 関連付けられたクラスターの作成および削除。

- クラスターに関連付けられたホスト、仮想マシン、およびプールの追加および削除。

- クラスターに関連付けられた仮想マシンのユーザーパーミッションを編集します。

5.3.2. クラスター管理者ロールの概要

クラスターパーミッションロール

以下の表は、クラスターの管理に適用される管理者ロールおよび権限について説明しています。

表5.11 Red Hat Virtualization システム管理者ロール

| ロール | 権限 | 注記 |

|---|---|---|

| ClusterAdmin | クラスター管理者 |

ホスト、テンプレート、および仮想マシンなど、特定のクラスター内の物理リソースおよび仮想リソースをすべて使用、作成、削除、管理することができます。ディスプレイネットワークの指定や、ネットワークを必須とマークするなど、クラスター内でネットワークプロパティーを設定できます。

ただし、ClusterAdmin には、ネットワークをクラスターにアタッチまたはデタッチするパーミッションがないため、NetworkAdmin パーミッションが必要になります。

|

| NetworkAdmin | ネットワーク管理者 | 特定のクラスターのネットワークを設定および管理できます。クラスターのネットワーク管理者は、データセンター内のクラスターネットワークパーミッションも継承します。 |

5.3.3. 管理者またはユーザーロールのリソースへの割り当て

手順5.10 リソースへのロールの割り当て

- リソースタブ、ツリーモード、または検索機能を使用してリソースを検索し、結果一覧で選択します。

- 詳細ペインの Permissions タブをクリックして、割り当てられたユーザー、ユーザーのロール、および選択したリソースに対する継承されたパーミッションを一覧表示します。

- Add をクリックします。

- Search テキストボックスに既存ユーザーの名前またはユーザー名を入力し、Go をクリックします。表示された候補の中からユーザーを選択します。

- Role to Assign: ドロップダウンリストからロールを選択します。

- OK をクリックします。

5.3.4. リソースからの管理者またはユーザーロールの削除

手順5.11 リソースからのロールの削除

- リソースタブ、ツリーモード、または検索機能を使用してリソースを検索し、結果一覧で選択します。

- 詳細ペインの Permissions タブをクリックして、割り当てられたユーザー、ユーザーのロール、および選択したリソースに対する継承されたパーミッションを一覧表示します。

- リソースから削除するユーザーを選択します。

- Remove をクリックします。Remove Permission 画面が開き、パーミッションの削除を確認します。

- OK をクリックします。

第6章 論理ネットワーク

6.1. 論理ネットワークタスク

6.1.1. ネットワークタブの使用

- クラスターやホストにネットワークを割り当てまたは割り当て解除する

- 仮想マシンやテンプレートからネットワークインターフェイスを削除する

- ネットワークへのアクセスや管理を行うユーザーの権限を追加、削除する

- ディレクトリーサービス

- DNS

- ストレージ

6.1.2. データセンターまたはクラスターでの新しい論理ネットワークの作成

手順6.1 データセンターまたはクラスターでの新しい論理ネットワークの作成

- Data Centers または Clusters リソースタブをクリックし、結果一覧でデータセンターまたはクラスターを選択します。

- 詳細ペインの Logical Networks タブをクリックして、既存の論理ネットワークを一覧表示します。

- Data Centers の詳細ペインから New をクリックし、 New Logical Network ウィンドウを開きます。

- Clusters の詳細ペインで Add Network をクリックし、New Logical Network ウィンドウを開きます。

- 論理ネットワークの Name、Description、および Comment を入力します。

- オプションで、Create on external provider チェックボックスを選択します。ドロップダウンリストから External Provider を選択し、Physical Network の IP アドレスを指定します。External Provider ドロップダウンリストには、外部プロバイダーが読み取り専用モードで一覧表示されません。外部プロバイダーで Create を選択すると、Network Label、VM Network、および MTU オプションが無効になります。

- Network Label テキストフィールドに、論理ネットワークの新しいラベルを入力するか、既存のラベルを選択します。

- 必要に応じて、Enable VLAN tagging を有効にします。

- 必要に応じて、VM Network を無効にします。

- MTU 値を Default (1500) または Custom に設定します。

- Cluster タブで、ネットワークを割り当てるクラスターを選択します。また、論理ネットワークを必須ネットワークにするかどうかも指定できます。

- 外部プロバイダーで Create を 選択すると、サブネット タブが表示されます。サブネット タブ で サブネットの作成 を選択し、名前、CIDR、および ゲート ウェイアドレスを入力し、論理ネットワークが提供するサブネットの IP バージョン を選択します。また、必要に応じて DNS サーバーを追加することもできます。

- vNIC Profiles タブから、必要に応じて vNIC プロファイルを論理ネットワークに追加します。

- OK をクリックします。

6.1.3. 論理ネットワークの編集

手順6.2 論理ネットワークの編集

- Data Centers resource タブをクリックし、結果一覧で論理ネットワークのデータセンターを選択します。

- 詳細ペインの Logical Networks タブをクリックして、データセンター内の論理ネットワークを一覧表示します。

- 論理ネットワークを選択し、編集 をクリックして 論理ネットワークの 編集 ウィンドウを 開きます。

- 必要な設定を編集します。注記デフォルトのネットワーク除き、新規または既存のネットワークの名前は、仮想マシンを停止することなく編集することができます。

- OK をクリックして変更を保存します。

6.1.4. 論理ネットワークの削除

ovirtmgmt 管理ネットワークとして少なくとも 1 つの論理ネットワークを使用する必要があります。

手順6.3 論理ネットワークの削除

- Data Centers resource タブをクリックし、結果一覧で論理ネットワークのデータセンターを選択します。

- 詳細ペインの Logical Networks タブをクリックして、データセンター内の論理ネットワークを一覧表示します。

- 論理ネットワークを選択し、Remove をクリックして、Remove Logical Network (s) ウィンドウを開きます。

- オプションで、Remove external network (s) from the provider (s) well チェックボックスを選択し、ネットワークが外部プロバイダーによって提供されている場合は Manager と外部プロバイダーの両方から論理ネットワークを削除します。外部プロバイダーが読み取り専用モードの場合、チェックボックスはグレーアウトされます。

- OK をクリックします。

6.1.5. 論理ネットワークのゲートウェイの表示と編集

手順6.4 論理ネットワークのゲートウェイの表示と編集

- Hosts resource タブをクリックし、目的のホストを選択します。

- 詳細ペインの ネットワークインターフェイス タブをクリックして、ホストに接続されているネットワークインターフェイスとその設定を一覧表示します。

- Setup Host Networks ボタンをクリックして Setup Host Networks ウィンドウを開きます。

- 割り当てられた論理ネットワークにカーソルを合わせ、鉛筆アイコンをクリックして Edit Management Network ウィンドウを開きます。

6.1.6. 新しい論理ネットワークおよび論理ネットワークの編集ウィンドウの設定とコントロールの説明

6.1.6.1. 論理ネットワーク一般設定の説明

表6.1 新しい論理ネットワーク と 論理ネットワーク設定の編集

|

フィールド名

|

説明

|

|---|---|

|

Name

|

論理ネットワークの名前。このテキストフィールドには 15 文字の制限があり、大文字、小文字、数字、ハイフン、およびアンダースコアの組み合わせが含まれる一意の名前である必要があります。

|

|

説明

|

論理ネットワークの説明。このテキストフィールドには 40 文字の制限があります。

|

|

Comment

|

論理ネットワークに関するプレーンテキストの人間が読めるコメントを追加するためのフィールド。

|

|

外部プロバイダーでの作成

|

外部プロバイダーとして Manager に追加された OpenStack Networking インスタンスへの論理ネットワークを作成できます。

外部プロバイダー: 論理ネットワークが作成される外部プロバイダーを選択できます。

|

|

VLAN タグの有効化

|

VLAN タグは、論理ネットワークで伝送されるすべてのネットワークトラフィックに特別な特性を与えるセキュリティー機能です。VLAN タグ付きのトラフィックは、その特性のないインターフェイスでは読み取れません。また、論理ネットワークに VLAN を使用すると、1 つのネットワークインターフェイスに、VLAN タグが異なる論理ネットワークを複数、関連付けることができます。VLAN タグ付けが有効な場合は、テキストエントリーフィールドに数値を入力します。

|

|

VM ネットワーク

|

仮想マシンのみがこのネットワークを使用する場合は、このオプションを選択します。ストレージの通信など、仮想マシンを介さないトラフィックにネットワークを使用する場合は、このチェックボックスを選択しないでください。

|

|

MTU

|

最大伝送単位(MTU)を括弧()で指定された値に設定する デフォルト のいずれかを選択するか、論理ネットワークのカスタム MTU を設定します。これを利用して、新しい論理ネットワークがサポートする MTU を、そのネットワークがインターフェイスするハードウェアがサポートする MTU に合わせることができます。カスタム が選択されている場合は、テキスト入力フィールドに数値を入力します。

|

|

ネットワークラベル

|

ネットワークの新しいラベルを指定したり、ホストネットワークインターフェイスに既に取り付けられている既存のラベルを選択したりすることができます。既存のラベルを選択した場合には、そのラベルが指定されたすべてのホストネットワークインターフェイスに論理ネットワークが自動的に割り当てられます。

|

6.1.6.2. 論理ネットワーククラスターの設定の説明

表6.2 新しい論理ネットワーク 設定

|

フィールド名

|

説明

|

|---|---|

|

クラスターへのネットワークの接続/クラスターからのネットワークの切断

|

論理ネットワークをデータセンター内のクラスターにアタッチまたはデタッチでき、論理ネットワークを個々のクラスターに必要なネットワークとするかどうかを指定することができます。

name: 設定が適用されるクラスターの名前。この値は編集できません

Attach All - 論理ネットワークをデータセンター内のすべてのクラスターにアタッチまたはデタッチできます。または、各クラスターの名前の横にある Attach チェックボックスを選択または選択解除して、論理ネットワークを特定のクラスターにアタッチまたはデタッチします。

Required All - 論理ネットワークがすべてのクラスターに必要なネットワークであるかどうかを指定できます。または、各クラスターの名前の横にある Required チェックボックスを選択または選択解除して、論理ネットワークが特定のクラスターに必要なネットワークであるかどうかを指定します。

|

6.1.6.3. 論理ネットワークの vNIC プロファイル設定の説明

表6.3 新しい論理ネットワーク 設定

|

フィールド名

|

説明

|

|---|---|

|

vNIC Profiles

|

論理ネットワークの 1 つまたは複数の vNIC プロファイルを指定できます。vNIC プロファイルの横にあるプラスボタンまたはマイナスボタンをクリックして、vNIC プロファイルを論理ネットワークに追加したり、論理ネットワークから削除したりすることができます。最初のフィールドでは、vNIC プロファイルの名前を入力します。

public - プロファイルをすべてのユーザーが利用できるようにするかどうかを指定できます。

QoS - vNIC プロファイルにネットワーク QoS (Quality of Service)プロファイルを指定できます。

|

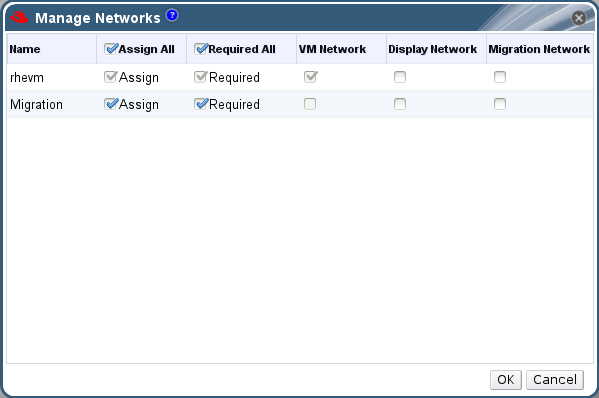

6.1.7. ネットワークの管理ウィンドウでの論理ネットワークに対する特定のトラフィックタイプの指定

手順6.5 論理ネットワークのトラフィックタイプの指定

- Clusters resource タブをクリックし、結果リストからクラスターを選択します。

- 詳細ペインの Logical Networks タブを選択して、クラスターに割り当てられた論理ネットワークを一覧表示します。

- Manage Networks をクリックして、Manage Networks ウィンドウを開きます。

図6.1 ネットワークの管理

- 適切なチェックボックスを選択します。

- OK をクリックして変更を保存し、ウィンドウを閉じます。

6.1.8. ネットワーク管理画面での設定内容の説明

表6.4 ネットワーク設定の管理

|

フィールド

|

説明/アクション

|

|---|---|

|

Assign

|

クラスター内の全ホストへの論理ネットワークの割り当てます。

|

|

必須。

|

Required (必須) と表示されたネットワークは、そのネットワークに関連するホストを正しく機能させるには、常に稼働している必要があります。必要なネットワークが機能しなくなると、そのネットワークに関連するホストはすべて動作しなくなります。

|

|

VM ネットワーク

| VM ネットワークとマークされている論理ネットワークは、仮想マシンのネットワークに関連するネットワークトラフィックを伝送します。 |

|

ディスプレイネットワーク

| ディスプレイネットワークとマークされた論理ネットワークは、SPICE と仮想ネットワークコントローラーに関連するネットワークトラフィックを伝送します。 |

|

移行ネットワーク

| Migration Network とマークされた論理ネットワークは、仮想マシンとストレージの移行トラフィックを伝送します。 |

6.1.9. NIC の仮想機能設定の編集

手順6.6 NIC の仮想機能設定の編集

- SR-IOV 対応ホストを選択し、詳細ペインで ネットワークインターフェイス タブをクリックします。

- Setup Host Networks をクリックして Setup Host Networks ウィンドウを開きます。

- SR-IOV 対応 NIC (

が付いている)を選択し、鉛筆アイコンをクリックして NICの Edit Virtual Functions (SR-IOV)設定 を開きます。

が付いている)を選択し、鉛筆アイコンをクリックして NICの Edit Virtual Functions (SR-IOV)設定 を開きます。

- 仮想機能の数を編集するには、Number of VFs setting ドロップダウンボタンをクリックし、Number of VFs テキストフィールドを編集します。重要VF の数を変更すると、新しい VF を作成する前に、ネットワークインターフェイス上の以前の VF がすべて削除されます。これには、仮想マシンが直接接続されている VF が含まれます。

- All Networks チェックボックスがデフォルトで選択され、すべてのネットワークが Virtual Function にアクセスできるようになります。Virtual Function へのアクセスを許可する仮想ネットワークを指定するには、Specified networks ラジオボタンを選択 して、すべてのネットワークを一覧表示します。次に、任意のネットワークのチェックボックスを選択するか、Labels テキストフィールドを使用して 1 つ以上のネットワークラベルに基づいてネットワークを自動的に選択できます。

- OK をクリックしてウィンドウを閉じます。Setup Host Networks ウィンドウの OK ボタンをクリックするまで、設定の変更は反映されません。

6.2. 仮想ネットワークインターフェイスカード

6.2.1. vNIC プロファイルの概要

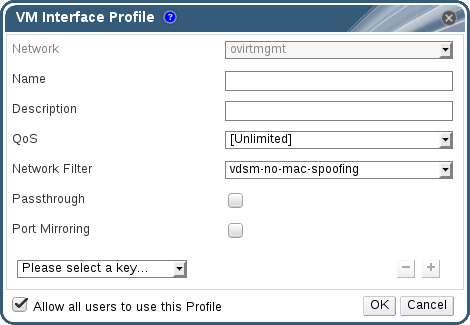

6.2.2. vNIC プロファイルの作成と編集

手順6.7 vNIC プロファイルの作成または編集

- Networks resource タブをクリックし、結果一覧で論理ネットワークを選択します。

- 詳細ペインで vNIC Profiles タブを選択します。ツリーモードで論理ネットワークを選択した場合は、結果一覧で vNIC Profiles タブを選択できます。

- New または Edit をクリックして、VM Interface Profile ウィンドウを開きます。

図6.2 VM Interface Profile ウィンドウ

- プロファイルの Name および Description を入力します。

- QoS 一覧から該当する Quality of Service ポリシーを選択します。

- ドロップダウンリストから ネットワークフィルター を選択して、仮想マシンとの間のネットワークパケットのトラフィックを管理します。ネットワークフィルターの詳細は、『Red Hat Enterprise Linux Virtualization Deployment and Administration Guide』 の Applying network filtering を参照してください。

- パス スルー チェックボックスを選択して、vNIC のパススルーを有効にし、仮想機能を直接デバイス割り当てできるようにします。パススルーのプロパティーを有効にすると、QoS、ネットワークフィルターリング、ポートミラーリングに互換性がないため、これらが無効になります。パススルーの詳細は、「vNIC プロファイルでのパススルーの有効化」 を参照してください。

- Port Mirroring および Allow all users to use this Profile チェックボックスを使用して、これらのオプションを切り替えます。

- カスタムプロパティーリストからカスタムプロパティーを選択すると、デフォルトで Please select a key... が表示されます。+ ボタンおよび - ボタンを使用して、カスタムプロパティーを追加または削除します。

- OK をクリックします。

6.2.3. VM インターフェイスプロファイルウィンドウの設定内容の説明

表6.5 VM インターフェイスプロファイルウィンドウ

|

フィールド名

|

説明

|

|---|---|

|

ネットワーク

|

vNIC プロファイルの適用先の利用可能なネットワークのドロップダウンリストです。

|

|

Name

|

vNIC プロファイルの名前。これは、1 から 50 文字までの大文字と小文字、数字、ハイフン、およびアンダースコアの組み合わせが含まれる一意の名前である必要があります。

|

| 説明 |

vNIC プロファイルの説明。このフィールドは推奨されますが、必須ではありません。

|

| QoS |

vNIC プロファイルに適用する、利用可能な Network Quality of Service ポリシーのドロップダウンリストです。QoS ポリシーは、vNIC のインバウンドおよびアウトバウンドのネットワークトラフィックを規制します。

|

| ネットワークフィルター |

vNIC プロファイルに適用するネットワークフィルターのドロップダウンリストです。ネットワークフィルターは、仮想マシンとの間で送信可能なパケットの種類をフィルターリングして、ネットワークセキュリティーを向上させます。デフォルトのフィルターは、

vdsm-no-mac-spoofing で no-mac-spoofing と no-arp-mac-spoofing を組み合わせたものです。libvirt が提供するネットワークフィルターの詳細は、『Red Hat Enterprise Linux Virtualization Deployment and Administration Guide』 の Pre-existing network filters セクションを参照してください。

& lt;no Network Filter> は、仮想マシンの VLAN およびボンドに使用する必要があります。信頼できる仮想マシンでネットワークフィルターを使用しない場合には、パフォーマンスが向上します。

|

| passthrough |

パススルーのプロパティーを切り替えるためのチェックボックス。パススルーでは、vNIC がホスト NIC の仮想機能に直接接続できるようになります。vNIC プロファイルが仮想マシンにアタッチされている場合には、パススルーのプロパティーは編集できません。

パススルーを有効にすると、vNIC プロファイルで QoS、ネットワークフィルター、ポートミラーリングが無効になります。

|

| Port Mirroring |

ポートミラーリングを切り替えるためのチェックボックスです。ポートミラーリングは、論理ネットワーク上のレイヤー 3 のネットワークトラフィックを、仮想マシン上の仮想インターフェイスにコピーします。デフォルトでは選択されていません。詳細は、『Technical Reference』 の Port Mirroring を参照してください。

|

| Device Custom Properties |

vNIC プロファイルに適用する利用可能なカスタムプロパティーを選択するためのドロップダウンメニューです。+ ボタンおよび - ボタンを使用してプロパティーをそれぞれ追加および削除します。

|

| Allow all users to use this Profile |

環境内の全ユーザーがプロファイルを利用できるかどうかを切り替えるためのチェックボックスです。これはデフォルトで選択されます。

|

6.2.4. vNIC プロファイルでのパススルーの有効化

手順6.8 パススルーの有効化

- Networks results 一覧から論理ネットワークを選択し、詳細ペインの vNIC Profiles タブをクリックして、その論理ネットワークのすべての vNIC プロファイルを一覧表示します。

- New をクリックして、VM Interface Profile ウィンドウを開きます。

- プロファイルの Name および Description を入力します。

- Passthrough チェックボックスを選択します。これにより、QoS および ポートミラーリング が無効になります。

- 必要に応じて、カスタムプロパティーリストからカスタムプロパティーを選択すると、デフォルトで Please select a key... が表示されます。+ ボタンおよび - ボタンを使用して、カスタムプロパティーを追加または削除します。

- OK をクリックしてプロファイルを保存し、ウィンドウを閉じます。

6.2.5. vNIC プロファイルの削除

手順6.9 vNIC プロファイルの削除

- Networks resource タブをクリックし、結果一覧で論理ネットワークを選択します。

- 詳細ペインで Profiles タブを選択して、利用可能な vNIC プロファイルを表示します。ツリーモードで論理ネットワークを選択した場合は、結果一覧で VNIC Profiles タブを選択します。

- 1 つ以上のプロファイルを選択し、Remove をクリックして Remove VM Interface Profile (s) ウィンドウを開きます。

- OK をクリックしてプロファイルを削除し、ウィンドウを閉じます。

6.2.6. vNIC プロファイルへのセキュリティーグループの割り当て

# neutron security-group-list

手順6.10 vNIC プロファイルへのセキュリティーグループの割り当て

- ネットワーク タブを クリック して、結果リストから論理ネットワークを選択します。

- 詳細ペインの vNIC Profiles タブをクリックします。

- New をクリックするか、既存の vNIC プロファイルを選択して Edit をクリックし、VM Interface Profile ウィンドウを開きます。

- カスタムプロパティーのドロップダウンリストから、SecurityGroups を選択します。カスタムプロパティーのドロップダウンを空白のままにすると、デフォルトのセキュリティー設定が適用され、すべてのアウトバウンドトラフィックとの相互通信が許可されますが、デフォルトのセキュリティーグループ外からのインバウンドトラフィックはすべて拒否されます。後で SecurityGroups プロパティーを削除しても、適用されたセキュリティーグループには影響がないことに注意してください。

- テキストフィールドに、vNIC プロファイルにアタッチするセキュリティーグループの ID を入力します。

- OK をクリックします。

6.2.7. vNIC プロファイルのユーザー権限

手順6.11 vNIC プロファイルのユーザー権限

- ネットワーク タブを クリック して、結果リストから論理ネットワークを選択します。

- vNIC Profiles resource タブをクリックして vNIC プロファイルを表示します。

- 詳細ペインの Permissions タブをクリックして、プロファイルの現在のユーザーパーミッションを表示します。

- Add ボタンをクリックして Add Permission to User ウィンドウを開き、Remove ボタンをクリックして Remove Permission ウィンドウを開き、vNIC プロファイルのユーザーパーミッションを変更します。

- Add Permissions to User ウィンドウで My Groups をクリックし、ユーザーグループを表示します。このオプションを使用して、グループ内の他のユーザーに権限を付与できます。

6.2.8. UCS 統合用の vNIC プロファイルの設定

vdsm-hook-vmfex-dev フックを使用すると、vNIC プロファイルを設定して、仮想マシンは Cisco の UCS 定義のポートプロファイルに接続できます。UCS で定義されたポートプロファイルには、UCS で仮想インターフェイスを設定するために使用されるプロパティーと設定が含まれています。vdsm-hook-vmfex-dev フックは、VDSM とともにデフォルトでインストールされます。詳細は、付録A VDSM およびフック を参照してください。

手順6.12 カスタムデバイスプロパティーの設定

- Red Hat Virtualization Manager で、

vmfexカスタムプロパティーを設定し、--cverを使用してクラスターの互換性レベルを設定します。# engine-config -s CustomDeviceProperties='{type=interface;prop={vmfex=^[a-zA-Z0-9_.-]{2,32}$}}' --cver=3.6 vmfexカスタムデバイスプロパティーが追加されていることを確認します。# engine-config -g CustomDeviceProperties

- エンジンを再始動します。

# systemctl restart ovirt-engine.service

手順6.13 UCS 統合用の vNIC プロファイルの設定

- Networks resource タブをクリックし、結果一覧で論理ネットワークを選択します。

- 詳細ペインで vNIC Profiles タブを選択します。ツリーモードで論理ネットワークを選択した場合は、結果一覧で vNIC Profiles タブを選択できます。

- New または Edit をクリックして、VM Interface Profile ウィンドウを開きます。

- プロファイルの Name および Description を入力します。

- カスタムプロパティー リストから

vmfexカスタムプロパティーを選択し、UCS ポートプロファイル名を入力します。 - OK をクリックします。

6.3. 外部プロバイダーネットワーク

6.3.1. 外部プロバイダーからのネットワークのインポート

手順6.14 外部プロバイダーからのネットワークのインポート

- Networks タブをクリックします。

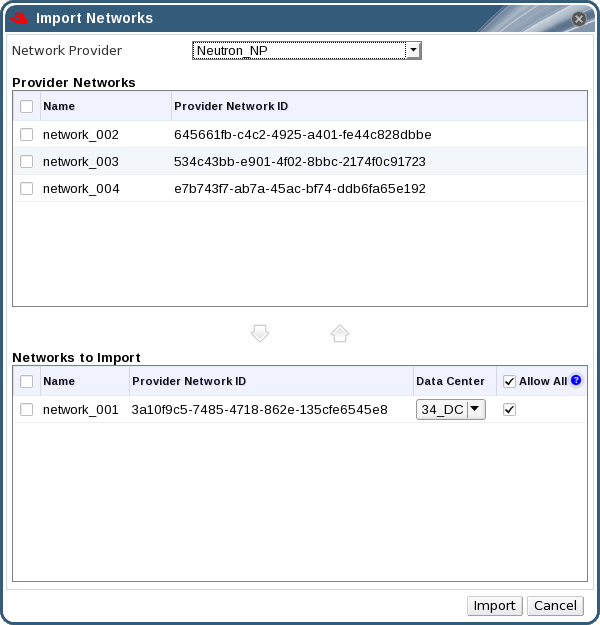

- Import ボタンをクリックして、Import Networks ウィンドウを開きます。

図6.3 ネットワークのインポートウィンドウ

- Network Provider ドロップダウンリストから、外部プロバイダーを選択します。そのプロバイダーが提供するネットワークは自動的に検出され、プロバイダーネットワークの一覧に表示 さ れます。

- チェックボックスを使用して、Provider Networks 一覧でインポートするネットワークを選択し、下矢印をクリックしてそれらのネットワークを Networks to Import 一覧に移動します。

- インポートするネットワークの名前をカスタマイズすることができます。名前をカスタマイズするには、名前 列でネットワークの名前をクリックし、テキストを変更します。

- Data Center ドロップダウンリストから、ネットワークをインポートするデータセンターを選択します。

- 必要に応じて、Networks to Import 一覧のネットワークの Allow All チェックボックスをオフにして、そのネットワークがすべてのユーザーで利用可能にならないようにします。

- Import ボタンをクリックします。

6.3.2. 外部プロバイダーネットワークの使用に関するの制限

- 外部プロバイダーが提供する論理ネットワークは、仮想マシンのネットワークとして使用する必要があり、ディスプレイネットワークとして使用できません。

- 同一の論理ネットワークを複数回インポートできますが、インポートできるのは異なるデータセンターのみです。

- 外部プロバイダーが提供する論理ネットワークを Manager で編集できません。外部のプロバイダーが提供する論理ネットワークの詳細を編集するには、対象の論理ネットワークを提供している外部のプロバイダーから直接編集する必要があります。

- 外部のプロバイダーが提供する論理ネットワークに接続された仮想ネットワークインターフェイスカードでは、ポートミラーリングは利用できません。

- 仮想マシンが外部のプロバイダーが提供する論理ネットワークを使用している場合には、その論理ネットワークが仮想マシンで使用されている間は、そのプロバイダーを Manager から削除できません。

- 外部のプロバイダーが提供するネットワークは必須ではありません。そのため、ホスト選択時には、このような論理ネットワークのインポート先のクラスターのスケジューリングでこれらの論理ネットワークは考慮されません。さらに、このような論理ネットワークのインポート先のクラスターで、ユーザーが責任を持ってホストで論理ネットワークを利用できるようにしてください。

6.3.3. 外部プロバイダーの論理ネットワークのサブネット設定

6.3.3.1. 外部プロバイダーの論理ネットワークのサブネット設定

6.3.3.2. 外部プロバイダー論理ネットワークへのサブネットの追加

手順6.15 外部プロバイダー論理ネットワークへのサブネットの追加

- Networks タブをクリックします。

- サブネットを追加する外部プロバイダーが提供する論理ネットワークをクリックします。

- 詳細ペインの サブネット タブをクリックします。

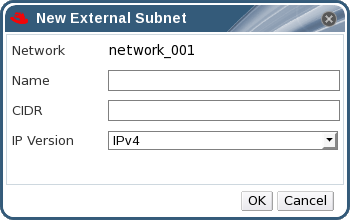

- 新規 ボタンをクリックして 新規外部サブネット ウィンドウを開きます。

図6.4 新しい外部サブネットウィンドウ

- 新規サブネットの Name および CIDR を入力します。

- IP Version ドロップダウンメニューから、IPv4 または IPv6 のいずれかを選択します。

- OK をクリックします。

6.3.3.3. 外部プロバイダー論理ネットワークからのサブネットの削除

手順6.16 外部プロバイダー論理ネットワークからのサブネットの削除

- Networks タブをクリックします。

- サブネットを削除する外部プロバイダーが提供する論理ネットワークをクリックします。

- 詳細ペインの サブネット タブをクリックします。

- 削除するサブネットをクリックします。

- Remove ボタンをクリックし、プロンプトが表示されたら OK をクリックします。

6.4. 論理ネットワークとパーミッション

6.4.1. ネットワークのシステムパーミッションの管理

- ネットワークの作成、編集、および削除。

- ポートミラーリングの設定など、ネットワークの設定を編集。

- クラスターや仮想マシンを含むリソースからのネットワークをアタッチおよびデタッチ。

6.4.2. ネットワーク管理者およびユーザーロールの概要

ネットワークパーミッションロール

以下の表は、ネットワークの管理に適用される管理者およびユーザーロールと権限について説明しています。

表6.6 Red Hat Virtualization ネットワーク管理者およびユーザーロール

| ロール | 権限 | 注記 |

|---|---|---|

| NetworkAdmin | データセンター、クラスター、ホスト、仮想マシン、またはテンプレートのネットワーク管理者。ネットワークを作成するユーザーには、作成されたネットワークに NetworkAdmin パーミッションが自動的に割り当てられます。 | 特定のデータセンター、クラスター、ホスト、仮想マシン、またはテンプレートのネットワークを設定および管理できます。データセンターまたはクラスターのネットワーク管理者は、クラスター内の仮想プールのネットワークパーミッションを継承します。仮想マシンネットワークにポートミラーリングを設定するには、ネットワークに NetworkAdmin ロールを適用し、仮想マシンに UserVmManager ロールを適用します。 |

| VnicProfileUser | 仮想マシンおよびテンプレートの論理ネットワークおよびネットワークインターフェイスユーザー。 | 特定の論理ネットワークからネットワークインターフェイスを接続または切断できます。 |

6.4.3. 管理者またはユーザーロールのリソースへの割り当て

手順6.17 リソースへのロールの割り当て

- リソースタブ、ツリーモード、または検索機能を使用してリソースを検索し、結果一覧で選択します。

- 詳細ペインの Permissions タブをクリックして、割り当てられたユーザー、ユーザーのロール、および選択したリソースに対する継承されたパーミッションを一覧表示します。

- Add をクリックします。

- Search テキストボックスに既存ユーザーの名前またはユーザー名を入力し、Go をクリックします。表示された候補の中からユーザーを選択します。

- Role to Assign: ドロップダウンリストからロールを選択します。

- OK をクリックします。

6.4.4. リソースからの管理者またはユーザーロールの削除

手順6.18 リソースからのロールの削除

- リソースタブ、ツリーモード、または検索機能を使用してリソースを検索し、結果一覧で選択します。

- 詳細ペインの Permissions タブをクリックして、割り当てられたユーザー、ユーザーのロール、および選択したリソースに対する継承されたパーミッションを一覧表示します。

- リソースから削除するユーザーを選択します。

- Remove をクリックします。Remove Permission 画面が開き、パーミッションの削除を確認します。

- OK をクリックします。

6.5. ホストとネットワーキング

6.5.1. ホスト機能のリフレッシュ

手順6.19 ホスト機能の更新

- リソースタブ、ツリーモード、または検索機能を使用して、結果一覧でホストを見つけて選択します。

- Refresh Capabilities ボタンをクリックします。

6.5.2. ホストのネットワークインターフェイスの編集とホストへの論理ネットワークの割り当て

Changing certain properties (e.g. VLAN, MTU) of the management network could lead to loss of connectivity to hosts in the data center, if its underlying network infrastructure isn't configured to accommodate the changes. Are you sure you want to proceed?

手順6.20 ホストのネットワークインターフェイスの編集とホストへの論理ネットワークの割り当て

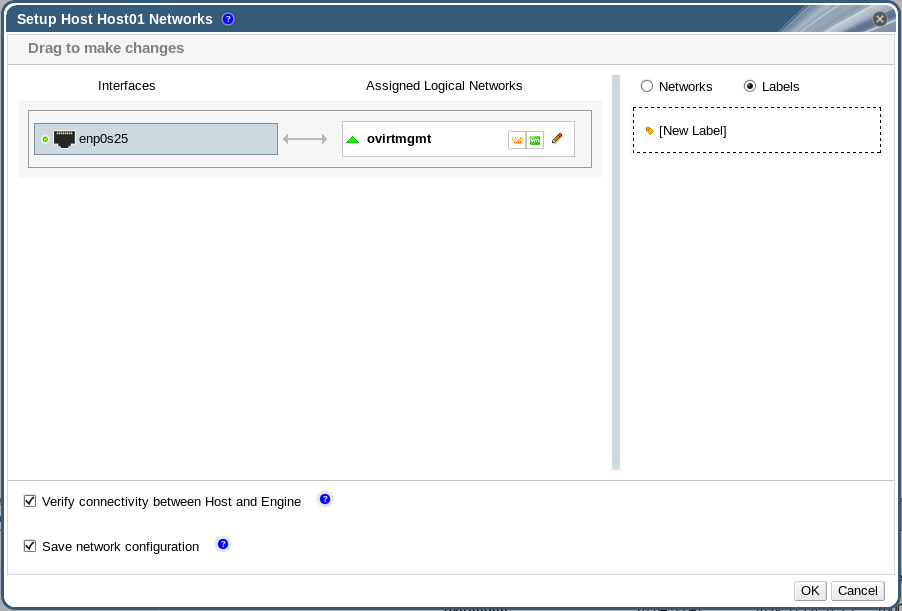

- Hosts resource タブをクリックし、目的のホストを選択します。

- 詳細ペインの ネットワークインターフェイス タブをクリックします。

- Setup Host Networks ボタンをクリックして Setup Host Networks ウィンドウを開きます。

- 物理ホストネットワークインターフェイスの横にある Assigned Logical Networks 領域に論理ネットワークを選択してドラッグし、物理ホストネットワークインターフェイスに論理ネットワークをアタッチします。または、論理ネットワークを右クリックして、ドロップダウンメニューからネットワークインターフェイスを選択します。

- 論理ネットワークの設定

- 割り当てられた論理ネットワークにカーソルを合わせ、鉛筆アイコンをクリックして Edit Management Network ウィンドウを開きます。

- IPv4 タブで、None、DHCP、または Static から Boot Protocol を選択します。Static を選択した場合は、IP、Netmask / Routing Prefix、および Gateway を入力します。注記各論理ネットワークには、管理ネットワークのゲートウェイとは別にゲートウェイを定義できます。これにより、論理ネットワークに到達するトラフィックは、管理ネットワークで使用されるデフォルトゲートウェイではなく、論理ネットワークのゲートウェイを使用して転送されます。注記IPv6 タブは現在サポートされていないため、使用しないでください。

- QoS タブを使用して、デフォルトのホストネットワーク QoS を上書きします。Override QoS を選択し、以下のフィールドに必要な値を入力します。

- 加重共有: 同じ論理リンクリンクに接続されている他のネットワークと比較して、特定のネットワークを割り当てる必要がある論理リンクの容量を示します。正確な共有は、そのリンクの全ネットワークの共有の合計によって異なります。デフォルトでは、この値は 1-100 の範囲の数字になります。

- Rate Limit [Mbps]: ネットワークが使用する最大帯域幅。

- Committed Rate [Mbps]: ネットワークに必要な最小帯域幅。要求される Committed Rate は保証されず、ネットワークインフラストラクチャーおよび同じ論理リンクの他のネットワークによって要求される Commmitted Rate によって異なります。

ホストネットワーク QoS の設定に関する詳細は、を参照してください。 「ホストネットワーク QoS」 - ネットワークブリッジを設定するには、Custom Properties タブをクリックし、ドロップダウンリストから bridge_opts を選択します。key = value の構文で有効な キーと値 を入力します。複数の項目を空白文字で区切ります。以下のキーが有効で、値は例として示されています。これらのパラメーターに関する詳しい情報は、「bridge_opts パラメーターの説明」 を参照してください。

forward_delay=1500 gc_timer=3765 group_addr=1:80:c2:0:0:0 group_fwd_mask=0x0 hash_elasticity=4 hash_max=512 hello_time=200 hello_timer=70 max_age=2000 multicast_last_member_count=2 multicast_last_member_interval=100 multicast_membership_interval=26000 multicast_querier=0 multicast_querier_interval=25500 multicast_query_interval=13000 multicast_query_response_interval=1000 multicast_query_use_ifaddr=0 multicast_router=1 multicast_snooping=1 multicast_startup_query_count=2 multicast_startup_query_interval=3125

- イーサネットプロパティーを設定するには、Custom Properties タブをクリックし、ドロップダウンリストから ethtool_opts を選択します。ethtool のコマンドライン引数の形式で、有効な値を入力してください。以下に例を示します。

--coalesce em1 rx-usecs 14 sample-interval 3 --offload em2 rx on lro on tso off --change em1 speed 1000 duplex half

このフィールドは、ワイルドカードを使用できます。たとえば、このネットワークのすべてのインターフェイスに同じオプションを適用するには、以下を使用します。--coalesce * rx-usecs 14 sample-interval 3

ethtool_opts オプションはデフォルトでは使用できないため、エンジン設定ツールを使用して追加する必要があります。詳細は、「Red Hat Virtualization Manager を使用するように Red Hat Virtualization Manager を設定する方法」 を参照してください。ethtool プロパティーの詳細は、コマンドラインで man ethtool を入力して man ページを参照してください。 - Fibre Channel over Ethernet (FCoE)を設定するには、Custom Properties タブをクリックし、ドロップダウンリストから fcoe を選択します。key = value の構文で有効な キーと値 を入力します。最低でも

enable=yesが必要です。dcb=を追加することもできます。複数の項目を空白文字で区切ります。fcoe オプションはデフォルトでは使用できないため、エンジン設定ツールを使用して追加する必要があります。詳細は、「FCoE を使用するように Red Hat Virtualization Manager を設定する方法」 を参照してください。[yes|no]およびauto_vlan=[yes|no]注記FCoE を使用する場合は、別途、専用の論理ネットワークを用意することをお勧めします。 - 論理ネットワークの定義がホストのネットワーク設定と同期していない場合は、ネットワークの同期 チェックボックスを選択します。論理ネットワークは、同期されるまで編集したり、別のインターフェイスに移動したりすることはできません。注記以下の条件のいずれかがある場合、ネットワークは同期されないと見なされます。

- VM ネットワークは、物理ホストネットワークとは異なります。

- VLAN 識別子は、物理ホストネットワークとは異なります。

- カスタム MTU は論理ネットワーク上に設定され、物理ホストネットワークとは異なります。

- Verify connectivity between Host and Engine チェックボックスを選択し、ネットワーク接続を確認します。このアクションは、ホストがメンテナンスモードの場合にのみ機能します。

- Save network configuration チェックボックスを選択し、環境の再起動時に変更を永続化します。

- OK をクリックします。

6.5.3. 論理ネットワークを使用した単一のネットワークインターフェイスへの複数の VLAN の追加

手順6.21 論理ネットワークを使用したネットワークインターフェイスへの複数の VLAN の追加

- Hosts resource タブをクリックして、結果に VLAN タグ付き論理ネットワークが割り当てられているクラスターに関連付けられたホストを一覧表示します。

- 詳細ペインの ネットワークインターフェイス タブをクリックして、データセンターに接続された物理ネットワークインターフェイスを一覧表示します。

- Setup Host Networks をクリックして Setup Host Networks ウィンドウを開きます。

- VLAN タグ付き論理ネットワークを、物理ネットワークインターフェイスの横にある Assigned Logical Networks 領域にドラッグします。物理ネットワークインターフェイスには、VLAN タグがあるので複数の論理ネットワークを割り当てることができます。

- 割り当てられた論理ネットワークの上にカーソルをかざし、鉛筆アイコンをクリックして Edit Network ウィンドウを開きます。論理ネットワークの定義がホストのネットワーク設定と同期していない場合は、ネットワークの同期 チェックボックスを選択します。以下から Boot Protocol を選択します。OK をクリックします。

- なし、、

- DHCP、または

- 静的,IP と サブネットマスク を指定します。

- Verify connectivity between Host and Engine チェックボックスを選択し、ネットワークチェックを実行します。これは、ホストがメンテナンスモードの場合にのみ機能します。

- ネットワーク設定の保存 チェックボックスを選択します。

- OK をクリックします。

6.5.4. ホストネットワークへの追加の IPv4 アドレスの割り当て

ovirtmgmt 管理ネットワークなどのホストネットワークは、初期設定時に 1 つの IP アドレスのみで作成されます。つまり、NIC の設定ファイル(例: /etc/sysconfig/network-scripts/ifcfg-eth01)に複数の IP アドレスが設定されている場合、最初に一覧表示される IP アドレスのみがホストネットワークに割り当てられます。ストレージに接続する場合や、同じ NIC を使って別のプライベートサブネット上のサーバーに接続する場合は、追加の IP アドレスが必要になることがあります。

vdsm-hook-extra-ipv4-addrs フックでは、ホストネットワークに追加の IPv4 アドレスを設定することができます。フックに関する詳細は、付録A VDSM およびフック を参照してください。

手順6.22 ホストネットワークへの追加の IPv4 アドレスの割り当て

- 追加の IPv4 アドレスを設定したいホストに、VDSM のフックパッケージをインストールします。Red Hat Virtualization Host ではこのパッケージがデフォルトで利用可能ですが、Red Hat Enterprise Linux ホストにインストールする必要があります。

# yum install vdsm-hook-extra-ipv4-addrs

- Manager で以下のコマンドを実行してキーを追加します。

# engine-config -s 'UserDefinedNetworkCustomProperties=ipv4_addrs=.*'

- ovirt-engine サービスを再起動します。

# systemctl restart ovirt-engine.service

- 管理ポータルで Hosts resource タブをクリックし、追加の IP アドレスを設定するホストを選択します。

- 詳細ペインの Network Interfaces タブをクリックし、Setup Host Networks ボタンをクリックして Setup Host Networks ウィンドウを開きます。

- 割り当てられた論理ネットワークの上にカーソルをかざし、鉛筆アイコンをクリックして、ホストネットワークインターフェイスを 編集し ます。

- Custom Properties ドロップダウンリストから ipv4_addr を選択し、IP アドレスと接頭辞を追加します(5.5.5.5/24 など)。複数の IP アドレスはコンマで区切る必要があります。

- OK をクリックします。

- ネットワーク設定の保存 チェックボックスを選択します。

- OK をクリックします。

6.5.5. ホストネットワークインターフェイスへのネットワークラベルの追加

手順6.23 ホストネットワークインターフェイスへのネットワークラベルの追加

- Hosts resource タブをクリックして、結果に VLAN タグ付き論理ネットワークが割り当てられているクラスターに関連付けられたホストを一覧表示します。

- 詳細ペインの ネットワークインターフェイス タブをクリックして、データセンターに接続された物理ネットワークインターフェイスを一覧表示します。

- Setup Host Networks をクリックして Setup Host Networks ウィンドウを開きます。

- Labels をクリックし、[New Label] を右クリックします。ラベルを貼る物理ネットワークインターフェイスを選択します。

- ラベルテキストフィールドにネットワークラベルの名前を 入力 します。

- OK をクリックします。

6.5.6. ボンド

6.5.6.1. Red Hat Virtualization でのロゴのボンディング

- いずれのデバイスにもすでに論理ネットワークが搭載されていますか ?

- デバイスは互換性のある論理ネットワークを提供していますか ?

表6.7 ボンディングシナリオとその結果

| ボンディングシナリオ | 結果 |

|---|---|

|

NIC + NIC

|

Create New Bond ウィンドウが表示され、新しいボンドデバイスを設定できます。

ネットワークインターフェイスに互換性のない論理ネットワークがある場合、互換性のない論理ネットワークを新しいボンディングを設定するデバイスからデタッチするまでボンディング操作は失敗します。

|

|

NIC + Bond

|

NIC がボンドデバイスに追加されます。NIC とボンディングが伝送する論理ネットワークはすべて、互換性がある場合は、結果として得られるボンドデバイスに追加されます。

ボンディングデバイスに互換性のない論理ネットワークがある場合、互換性のない論理ネットワークをデバイスから切り離して新しいボンディングを作成するまで、ボンディング操作は失敗します。

|

|

ボンディング + ボンディング

|

ボンディングデバイスが論理ネットワークに接続されていない場合、または互換性のある論理ネットワークに接続されている場合は、新しいボンドデバイスが作成されます。これには、すべてのネットワークインターフェイスが含まれ、コンポーネントボンディングデバイスのすべての論理ネットワークが伝送されます。Create New Bond ウィンドウが表示され、新しいボンディングを設定できます。

ボンディングデバイスに互換性のない論理ネットワークがある場合、互換性のない論理ネットワークをデバイスから切り離して新しいボンディングを作成するまで、ボンディング操作は失敗します。

|

6.5.6.2. ボンド

ボンディングモード

Mode 0 (round-robin policy)- ネットワークインターフェイスカードを介してパケットを順番に送信します。パケットは、ボンディングで最初に利用可能なネットワークインターフェイスカードで始まり、ボンドで最後に使用可能なネットワークインターフェイスカードで終わるループで送信されます。その後のすべてのループは、最初に使用可能なネットワークインターフェイスカードから始まります。モード 0 はフォールトトレランスを提供し、ボンド内のすべてのネットワークインターフェイスカード間で負荷を分散します。ただし、モード 0 はブリッジと組み合わせて使用できないため、仮想マシンの論理ネットワークとの互換性はありません。

モード 1 (active-backup ポリシー)- 1 枚のネットワークインターフェイスカードがアクティブなまま、すべてのネットワークインターフェイスカードをバックアップ状態に設定します。アクティブなネットワークインターフェイスカードに障害が発生した場合、バックアップネットワークインターフェイスカードの 1 つが、ボンド内の唯一のアクティブなネットワークインターフェイスカードとしてそのネットワークインターフェイスカードに置き換わります。モード 1 のボンディングの MAC アドレスは、1 つのポートにのみ表示され、ボンディングの MAC アドレスがアクティブなネットワークインターフェイスカードを反映するように変更された場合に混乱を防ぐことができます。モード 1 はフォールトトレランスを提供し、Red Hat Virtualization でサポートされています。

Mode 2 (XOR policy)- ネットワークインターフェイスカードのスレーブ数をモジュロとして、送信元および宛先 MAC アドレスでの XOR 操作の結果に基づいて、パケットの送信に使用するネットワークインターフェイスカードを選択します。この計算により、使用される宛先 MAC アドレスごとに同じネットワークインターフェイスカードが確実に選択されます。モード 2 は、フォールトトレランスと負荷分散を提供し、Red Hat Virtualization でサポートされています。

Mode 3 (broadcast policy)- すべてのパケットをすべてのネットワークインターフェイスカードに送信します。モード 3 はフォールトトレランスを提供し、Red Hat Virtualization でサポートされています。

Mode 4 (IEEE 802.3ad policy)- インターフェイスが同じ速度とデュプレックス設定を共有するアグリゲーショングループを作成します。モード 4 は、IEEE 802.3ad 仕様に従って、アクティブなアグリゲーショングループ内のすべてのネットワークインターフェイスカードを使用し、Red Hat Virtualization でサポートされます。

Mode 5 (adaptive send load balancing policy)- 送信トラフィックの分散がボンド内の各ネットワークインターフェイスカードの負荷を考慮し、現在のネットワークインターフェイスカードがすべての受信トラフィックを受信するようにします。トラフィックの受信に割り当てられたネットワークインターフェイスカードに障害が発生した場合、別のネットワークインターフェイスカードが着信トラフィックの受信のロールに割り当てられます。モード 5 はブリッジと組み合わせて使用できないため、仮想マシンの論理ネットワークとは互換性がありません。

Mode 6 (adaptive load balancing policy)- 特別なスイッチ要件なしで、モード 5 (適応型送信負荷分散ポリシー) と IPv4 トラフィックの受信負荷分散を組み合わせます。ARP ネゴシエーションは、受信負荷のバランスを取るために使用されます。モード 6 はブリッジと組み合わせて使用できないため、仮想マシンの論理ネットワークとは互換性がありません。

6.5.6.3. 管理ポータルを使用したボンドデバイスの作成

手順6.24 管理ポータルを使用したボンドデバイスの作成

- Hosts resource タブをクリックし、結果一覧でホストを選択します。

- 詳細ペインの ネットワークインターフェイス タブをクリックして、ホストに接続されている物理ネットワークインターフェイスを一覧表示します。

- Setup Host Networks をクリックして Setup Host Networks ウィンドウを開きます。

- 別のデバイスの上部にデバイスのいずれかを選択してドラッグし、これを削除して Create New Bond ウィンドウを開きます。または、デバイスを右クリックし、ドロップダウンメニューから別のデバイスを選択します。デバイスが互換性のない場合は、ボンド操作が失敗し、互換性の問題を修正する方法を提案します。

- ドロップダウンメニューから Bond Name および Bonding Mode を選択します。ボンディングモード 1、2、4、および 5 を選択できます。他のモードは、カスタム オプションを使用して設定できます。

- OK をクリックしてボンディングを作成し、Create New Bond ウィンドウを閉じます。

- 新しく作成されたボンドデバイスに論理ネットワークを割り当てます。

- 必要に応じて 、ホストとエンジン間の接続の確認 と ネットワーク設定の保存 を選択します。

- OK をクリックして変更を受け入れ、Setup Host Networks ウィンドウを閉じます。

6.5.6.4. ホストインターフェイスでのカスタムボンディングオプションの使用例

例6.1 xmit_hash_policy

mode=4 xmit_hash_policy=layer2+3

例6.2 ARP 監視

arp_interval を設定します。

mode=1 arp_interval=1 arp_ip_target=192.168.0.2

例6.3 プライマリー

mode=1 primary=eth0

6.5.7. ホストの FQDN の変更

手順6.25 ホストの FQDN の更新

- ホストをメンテナンスモードにして、仮想マシンが別のホストにライブマイグレーションされるようにします。詳細は、「ホストのメンテナンスモードへの切り替え」 を参照してください。あるいは、すべての仮想マシンを手動でシャットダウンするか、別のホストに移行してください。詳細は、『Virtual Machine Management Guide』 の Manually Migrating Virtual Machines を参照してください。

- Remove をクリックし、OK をクリックして管理ポータルからホストを削除します。

- hostnamectl ツールを使用してホスト名を更新します。その他のオプションは、『Red Hat Enterprise Linux 7 ネットワークガイド』 の ホスト名の設定 を参照してください。

# hostnamectl set-hostname NEW_FQDN

- ホストを再起動します。

- ホストをマネージャーに再登録する。詳細は、「Red Hat Virtualization Manager へのホストの追加」 を参照してください。

第7章 ホスト

7.1. ホストの HQL の概要

- システム内の 1 つのクラスターにのみ属すること。

- AMD-V または Intel VT ハードウェア仮想化拡張をサポートする CPU を搭載していること。

- クラスター作成時に選択された仮想 CPU タイプで提供されるすべての機能をサポートする CPU が必要です。

- 最小 2 GB の メモリー。

- システム権限を持つシステム管理者を割り当てることができる。

ifcfg ファイルを手動で作成する必要があります。詳細は、『Red Hat Enterprise Linux ネットワークガイド』 を参照してください。

7.2. Red Hat Virtualization Host

grub.cfg ファイルに永続的な変更を加えます。ホストの Cockpit ユーザーインターフェイスの Tools > Terminal サブタブに移動し、grubby コマンドを使用します。詳細は、『Red Hat Enterprise Linux System Administrator's Guide』 を参照してください。

7.3. Red Hat Enterprise Linux Hosts

Red Hat Enterprise Linux Server エンタイトルメントと Red Hat Virtualization のエンタイトルメントも割り当てる必要があります。

7.4. サテライトホストプロバイダーホスト

7.5. ホストのタスク

7.5.1. Red Hat Virtualization Manager へのホストの追加

手順7.1 Red Hat Virtualization Manager へのホストの追加

- 管理ポータルから、Hosts resource タブをクリックします。

- New をクリックします。

- ドロップダウンリストを使用して、新規ホストの Data Center および Host Cluster を選択します。

- 新規ホストの 名前 および Address を入力します。標準の SSH ポート 22 は、SSH Port フィールドに自動入力されます。

- Manager がホストにアクセスするために使用する認証メソッドを選択します。

- パスワード認証を使用するには、root ユーザーのパスワードを入力します。

- または、SSH PublicKey フィールドに表示されるキーをホスト上の

/root/.ssh/authorized_keysにコピーして、公開鍵認証を使用します。

- Advanced Parameters ボタンをクリックして、高度なホスト設定を展開します。

- オプションでファイアウォールの自動設定を無効にします

- 必要の応じてホストの SSH フィンガープリントを追加し、セキュリティーを強化する。手動での追加または自動取得が可能です。

- オプションで、電源管理、SPM、コンソール、ネットワーク プロバイダー、 および カーネルを設定します。詳細は、「新規ホスト、ホスト編集ウィンドウの設定とコントロールの説明」 を参照してください。Hosted Engine は、セルフホストエンジンのデプロイメント用にホストのデプロイまたはアンデプロイ時に使用されます。

- OK をクリックします。

Installing のステータスでホスト一覧に表示され、詳細ペインでインストールの進捗状況を確認できます。しばらくすると、ホストのステータスが Up に変わります。

7.5.2. サテライトホストプロバイダーホストの追加

手順7.2 サテライトホストプロバイダーホストの追加

- Hosts resource タブをクリックして、結果一覧のホストを一覧表示します。

- New をクリックして、New Host ウィンドウを開きます。

- ドロップダウンメニューを使用して、新規ホストの Host Cluster を選択します。

- Foreman/Satellite チェックボックスを選択して、Satellite ホストプロバイダーホストを追加するオプションを表示し、ホストを追加するプロバイダーを選択します。

- Discovered Hosts または Provisioned Hosts を選択します。

- Discovered Hosts (デフォルトオプション): ドロップダウンリストからホスト、ホストグループ、およびコンピュートリソースを選択します。

- provisioned Hosts: Providers Hosts ドロップダウンリストからホストを選択します。

外部プロバイダーから取得できるホストに関する詳細は自動的に設定され、必要に応じて編集できます。 - 新規ホストの Name、Address、および SSH Port (Provisioned Hosts のみ)を入力します。

- ホストで使用する認証方法を選択します。

- パスワード認証を使用するには、root ユーザーのパスワードを入力します。

- SSH PublicKey フィールドに表示されるキーをホスト上の

/root/.ssh/authorized_hostsにコピーして、公開鍵認証を使用します(プロビジョニングされたホストのみ)。

- これで、Red Hat Enterprise Linux ホストを追加するための必須手順が完了しました。Advanced Parameters ドロップダウンボタンをクリックして、高度なホスト設定を表示します。

- オプションでファイアウォールの自動設定を無効にします

- 必要の応じてホストの SSH フィンガープリントを追加し、セキュリティーを強化する。手動での追加または自動取得が可能です。

- 現在該当するタブを使用して、Power Management、SPM、Console、および Network Provider を設定できます。ただし、これらは Red Hat Enterprise Linux ホストを追加する上で基本的ではないため、この手順では説明しません。

- OK をクリックすると、ホストが追加され、ウィンドウが閉じます。

Installing のステータスでホスト一覧に表示され、詳細ペインでインストールの進捗状況を確認できます。インストールが完了すると、ステータスが Reboot に更新されます。ステータスが Up に変わるには、ホストが起動している必要があります。

7.5.3. ホストの Satellite エラータ管理の設定

手順7.3 ホストの Satellite エラータ管理の設定

- 外部プロバイダーとして Satellite Server を追加します。詳細は、「ホストのプロビジョニング用の Red Hat Satellite インスタンスの追加」 を参照してください。

- 必要なホストを Satellite サーバーに関連付けます。注記

- ホスト タブ で、結果一覧でホストを選択します。

- Edit をクリックして Edit Host ウィンドウを開きます。

- Use Foreman/Satellite チェックボックスをオンにします。

- ドロップダウンリストから、必要な Satellite サーバーを選択します。

- OK をクリックします。

7.5.4. 新規ホスト、ホスト編集ウィンドウの設定とコントロールの説明

7.5.4.1. ホストの一般設定の説明

表7.1 一般的な 設定

|

フィールド名

|

説明

|

|---|---|

|

Data Center

|

ホストが属するデータセンター。Red Hat Virtualization Host (RHVH)を Gluster 対応クラスターに追加することはできません。

|

|

Host Cluster

|

ホストが属するクラスター。

|

|

Use Foreman/Satellite

|

このチェックボックスを選択またはクリアすると、サテライトホストプロバイダーが提供するホストを追加するためのオプションが表示または非表示になります。以下のオプションを利用できます。

検出されたホスト

プロビジョニングされたホスト

|

|

Name

|

クラスターの名前。このテキストフィールドには 40 文字の制限があり、大文字、小文字、数字、ハイフン、およびアンダースコアの組み合わせが含まれる一意の名前である必要があります。

|

|

Comment

|

ホストに関するプレーンテキストで人間が読めるコメントを追加するためのフィールドです。

|

|

アドレス

|

ホストの IP アドレスまたは解決可能なホスト名。

|

|

Password

|

ホストの root ユーザーのパスワード。これは、ホストの追加時にのみ付与でき、後で編集することはできません。

|

|

SSH PublicKey

|

テキストボックスのコンテンツをホストの

/root/.known_hosts ファイルにコピーし、パスワードを使用してホストで認証するのではなく、Manager の ssh キーを使用します。

|

|

ホストのファイアウォールを自動的に設定

|

新規ホストを追加する場合、Manager はホストのファイアウォールで必要なポートを開くことができます。これはデフォルトで有効になっています。これは Advanced Parameter です。

|

|

SSH Fingerprint

|

ホストの SSH フィンガープリントを 取得 し、ホストが返すと予想されるフィンガープリントと比較し、一致することを確認します。これは Advanced Parameter です。

|

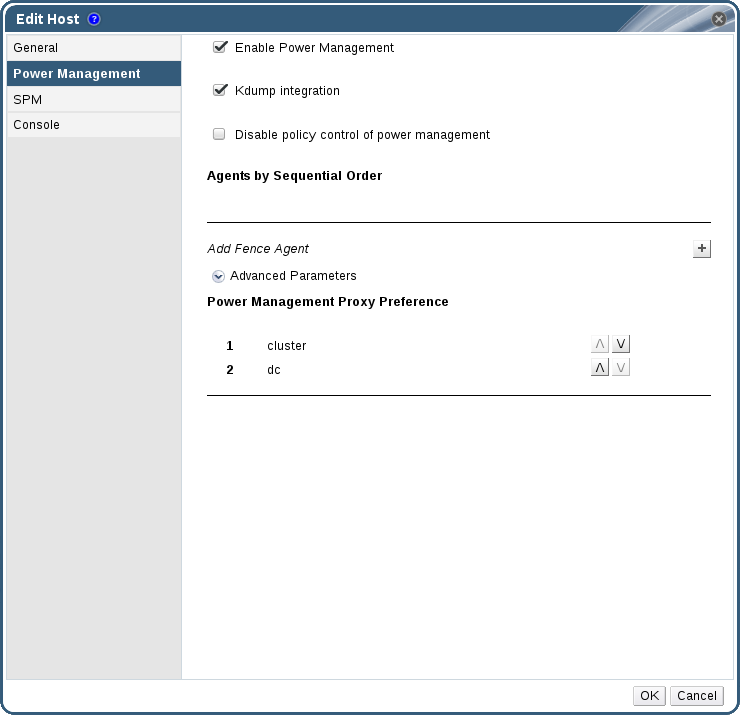

7.5.4.2. ホストパワーマネージメント設定の説明

表7.2 電源管理 設定

|

フィールド名

|

説明

|

|---|---|

|

電源管理の有効化

|

ホストの電源管理を有効にする。Power Management タブの残りのフィールドを有効にするには、このチェックボックスを選択します。

|

|

Kdump 統合

|

カーネルのクラッシュダンプの実行中にホストがフェンシングするのを防ぎ、クラッシュダンプが中断されないようにします。Red Hat Enterprise Linux 7.1 以降では、デフォルトで kdump が利用できます。ホストで kdump が利用できるものの、その設定が有効でない場合(kdump サービスを開始できない)、Kdump 統合 を有効にするとホスト(再)のインストールに失敗します。この場合は、「fence_kdump の高度な設定」 を参照してください。

|

|

電源管理のポリシー制御を無効にする

|

電源管理は、ホストの クラスター の スケジューリングポリシー によって制御されます。パワーマネージメントが有効で、定義された低使用率の値に達した場合、マネージャーはホストマシンをパワーダウンさせ、ロードバランシングが必要な場合や、クラスター内に十分な空きホストがない場合には、再びホストマシンを再起動させます。ポリシーコントロールを無効にする場合は、このチェックボックスを選択します。

|

|

順番待ちのエージェント

|

ホストのフェンスエージェントを一覧表示します。フェンスエージェントには、シーケンシャル、コンカレント、またはその両方の組み合わせがあります。

フェンスエージェントはデフォルトではシーケンシャルです。上下のボタンでフェンス剤の使用順序を変更できます。

2 つのフェンスエージェントを同時に作成するには、他のフェンスエージェントの横にある Concurrent with ドロップダウンリストからフェンスエージェントを 1 つ選択します。追加のフェンスエージェントの横にある Concurrent with ドロップダウンリストからグループを選択することにより、同時フェンスエージェントのグループに追加できます。

|

|

フェンスエージェントの追加

|

プラス(+)ボタンをクリックして、新しいフェンスエージェントを追加します。フェンスエージェントの編集 画面 が開きます。このウィンドウのフィールドの詳細は、以下の表を参照してください。

|

|

電源管理プロキシープリファレンス

|

デフォルトでは、Manager がホストと同じ クラスター 内でフェンシングプロキシーを検索し、フェンシングプロキシーが見つからない場合は、同じ dc (データセンター)で検索するように指定します。上下のボタンで、これらのリソースの使用順序を変更することができます。このフィールドは、Advanced Parameters で利用できます。

|

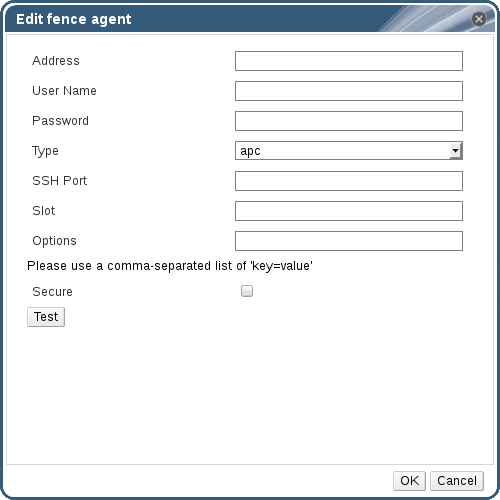

表7.3 フェンスエージェント設定の編集

|

フィールド名

|

説明

|

|---|---|

|

アドレス

|

ホストの電源管理デバイスにアクセスするためのアドレス。解決可能なホスト名または IP アドレスのいずれか。

|

|

User Name

|

電源管理デバイスにアクセスするユーザーアカウント。デバイスにユーザーを設定するか、デフォルトのユーザーを使用します。

|

|

Password

|

電源管理デバイスにアクセスするユーザーのパスワード。

|

|

タイプ

|

ホストの電源管理デバイスのタイプ。

以下のいずれかを選択します。

|

|

ポート

|

電源管理デバイスがホストとの通信に使用するポート番号。

|

|

Slot

|

電源管理デバイスのブレードを識別するための番号。

|

|

Service Profile

|

電源管理デバイスのブレードを識別するために使用されるサービスプロファイル名です。デバイスタイプが

cisco_ucs の場合、Slot の代わりにこのフィールドが表示されます。

|

|

オプション

|

電源管理デバイス固有のオプション。これらを key=value として入力します。利用可能なオプションは、お使いのホストの電源管理デバイスのドキュメントを参照してください。

Red Hat Enterprise Linux 7 ホストの場合は、電源管理デバイスとして cisco_ucs を使用している場合は、Options フィールドに

ssl_insecure=1 を追加する必要があります。

|

|

Secure

|

電源管理デバイスがホストに安全に接続できるようにするには、このチェックボックスを選択します。これは、電源管理エージェントに応じて、ssh、ssl、または他の認証プロトコルを介して行うことができます。

|

7.5.4.3. SPM のプライオリティー設定の説明

表7.4 SPM の設定

|

フィールド名

|

説明

|

|---|---|

|

SPM の優先度

|

ホストにストレージプールマネージャー (SPM) のロールが与えられる可能性を定義します。オプションは、Low、Normal、および High priority です。優先度が低いとは、ホストに SPM のロールが割り当てられる可能性が低いことを意味し、優先度が高いとは、その可能性が高いことを意味しています。デフォルト設定は Normal です。

|

7.5.4.4. ホストクラスター設定の説明

表7.5 コンソールの 設定

|

フィールド名

|

説明

|

|---|---|

|

表示アドレスの上書き

|

ホストの表示アドレスを上書きする場合は、このチェックボックスを選択します。この機能は、ホストが内部 IP で定義されており、NAT ファイアウォールの内側にある場合に有効です。ユーザーが内部ネットワークの外から仮想マシンに接続した場合、仮想マシンが動作しているホストのプライベートアドレスを返すのではなく、パブリック IP または FQDN(外部ネットワークではパブリック IP に解決される) を返します。

|

|

表示アドレス

|

ここで指定した表示アドレスは、このホスト上で動作するすべての仮想マシンに使用されます。アドレスは、完全修飾ドメイン名または IP の形式でなければなりません。

|

7.5.4.5. ネットワークプロバイダー設定の説明

表7.6 ネットワークプロバイダーの 設定

|

フィールド名

|

説明

|

|---|---|

|

外部ネットワークプロバイダー

|

外部ネットワークプロバイダーを追加し、ホストのネットワークを外部ネットワークプロバイダーによってプロビジョニングする場合は、一覧から 1 つ選択します。

|

7.5.4.6. カーネル設定の説明

表7.7 カーネル 設定

|

フィールド名

|

説明

|

|---|---|

|

Hostdev パススルーおよび SR-IOV

|

カーネルの IOMMU フラグを有効にして、デバイスが仮想マシン自体に直接アタッチされているデバイスであるかのように、ホストデバイスを仮想マシンで使用できるようにします。また、ホストのハードウェアとファームウェアも IOMMU に対応している必要があります。ハードウェア上で仮想化拡張機能と IOMMU 拡張機能が有効になっている必要があります。『インストールガイド』 の Configuring a Host for PCI Passthrough を参照してください。IBM POWER8 では、デフォルトで IOMMU が有効になっています。

|

|

Nested Virtualization

|

vmx フラグまたは svm フラグを有効にして、仮想マシン内で仮想マシンを実行できるようにします。このオプションは評価目的のみで、実稼働での使用はサポートされません。

vdsm-hook-nestedvt フックはホストにインストールされている必要があります。

|

|

安全でない割り込み

|

IOMMU が有効になっているが、ハードウェアが割り込みの再マッピングをサポートしていないためにパススルーが失敗する場合は、このオプションを有効にすることを検討できます。このオプションは、ホスト上の仮想マシンが信頼できる場合にのみ有効にしてください。このオプションを有効にすると、仮想マシンからの MSI 攻撃を受ける可能性があります。このオプションは、評価目的で認定されていないハードウェアを使用する場合のみ、回避策として使用することを目的としています。

|

|

PCI 再割り当て

|

メモリーの問題で SR-IOV NIC が仮想機能を割り当てられない場合は、このオプションを有効にすることを検討してください。また、ホストのハードウェアとファームウェアが PCI の再配置をサポートしている必要があります。このオプションは、評価目的で認定されていないハードウェアを使用する場合のみ、回避策として使用することを目的としています。

|

|

カーネルコマンドライン

|

このフィールドでは、デフォルトのパラメーターにさらにカーネルパラメーターを追加することができます。

|

7.5.4.7. ホストエンジン設定の説明

表7.8 ホストエンジンの 設定

|

フィールド名

|

説明

|

|---|---|

|

ホストされたエンジンの展開方法を選択

|

利用可能な 3 つのオプションは以下のとおりです。

|

7.5.5. ホストパワーマネージメントの設定

メンテナーンスモード にあることを確認します。そうしないと、ホストの再起動時に、そのホストで実行しているすべての仮想マシンが正常に停止されるため、実稼働環境で中断が生じる可能性があります。ホストを メンテナーンスモードに正しく設定していない場合は、警告ダイアログが表示されます。

手順7.4 電源管理状態の設定

- ホスト タブ で、結果一覧でホストを選択します。

- Edit をクリックして Edit Host ウィンドウを開きます。

- Power Management タブをクリックして、電源管理設定を表示します。

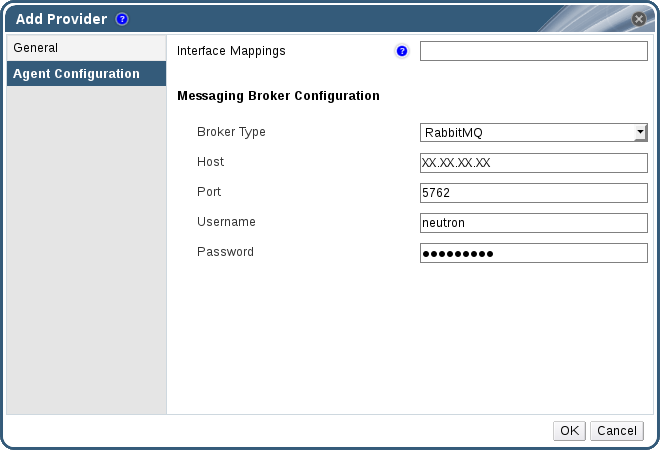

- Enable Power Management チェックボックスを選択してフィールドを有効にします。