Spring Boot Runtime Guide

Spring Boot 2.2 を使用して、OpenShift およびスタンドアロン RHEL で実行するアプリケーションを開発

概要

前書き

本ガイドでは、概念と、開発者が Spring Boot ランタイムの使用に必要な実用的な詳細情報を説明します。OpenShift 上の Linux コンテナーとしてデプロイされた Spring Boot アプリケーションの設計を管理する情報を提供します。

Red Hat ドキュメントへのフィードバック (英語のみ)

ご意見やご意見をお聞かせください。フィードバックを行うには、ドキュメント内のテキストを強調表示し、コメントを追加します。

本セクションでは、フィードバックの送信方法を説明します。

前提条件

- Red Hat カスタマーポータルにログインします。

- Red Hat カスタマーポータルで、Multi-page HTML 形式のドキュメントを表示します。

手順

フィードバックを提供するには、以下の手順を実施します。

ドキュメントの右上隅にある Feedback ボタンをクリックして、既存のフィードバックを表示します。

注記フィードバック機能は、Multi-page HTML 形式でのみ有効です。

- フィードバックを提供するドキュメントのセクションを強調表示します。

強調表示されているテキストの近くに表示される Add Feedback ポップアップをクリックします。

ページの右側のフィードバックセクションに、テキストボックスが表示されます。

テキストボックスにフィードバックを入力し、Submit をクリックします。

ドキュメントの問題が作成されました。

- 問題を表示するには、フィードバックビューで問題トラッカーリンクをクリックします。

第1章 Spring Boot でのアプリケーション開発の概要

本セクションでは、Red Hat ランタイムでのアプリケーション開発の基本概念を説明します。Spring Boot ランタイムの概要も説明します。

1.1. Red Hat Runtimes でのアプリケーション開発の概要

Red Hat OpenShift は、クラウドネイティブランタイムのコレクションを提供するコンテナーアプリケーションプラットフォームです。ランタイムを使用して、OpenShift で Java または JavaScript アプリケーションを開発、ビルド、およびデプロイできます。

Red Hat Runtimes for OpenShift を使用したアプリケーション開発には、以下が含まれます。

- OpenShift 上で実行されるように設計された Eclipse Vert.x、Thorntail、Spring Boot などのランタイムのコレクション。

- OpenShift でのクラウドネイティブ開発への規定的なアプローチ。

OpenShift は、アプリケーションのデプロイメントおよび監視の管理、保護、自動化に役立ちます。ビジネス上の問題を小規模なマイクロサービスに分割し、OpenShift を使用してマイクロサービスをデプロイし、監視し、維持することができます。サーキットブレーカー、ヘルスチェック、サービス検出などのパターンをアプリケーションに実装できます。

クラウドネイティブな開発は、クラウドコンピューティングを最大限に活用します。

以下でアプリケーションをビルドし、デプロイし、管理できます。

- OpenShift Container Platform

- Red Hat のプライベートオンプレミスクラウド。

- Red Hat Container Development Kit (Minishift)

- ローカルマシンにインストールおよび実行できるローカルクラウド。この機能は、Red Hat Container Development Kit (CDK) または Minishift で提供されます。

- Red Hat CodeReady Studio

- アプリケーションの開発、テスト、デプロイを行う統合開発環境 (IDE)。

アプリケーション開発を開始できるようにするため、サンプルアプリケーションですべてのランタイムが利用可能になります。これらのサンプルアプリケーションは Developer Launcher からアクセスできます。サンプルをテンプレートとして使用してアプリケーションを作成することができます。

本ガイドでは、Spring Boot ランタイムに関する詳細情報を提供します。その他のランタイムの詳細は、関連する ランタイムドキュメント を参照してください。

1.2. Developer Launcher を使用した Red Hat OpenShift でのアプリケーション開発

Developer Launcher (developers.redhat.com/launch) を使用して、OpenShift でのクラウドネイティブアプリケーションの開発を開始することができます。これは、Red Hat が提供するサービスです。

Developer Launcher はスタンドアロンのプロジェクトジェネレーターです。これを使用して、OpenShift Container Platform、Minishift、CDK などの OpenShift インスタンスでアプリケーションをビルドし、デプロイできます。

1.3. Spring Boot の概要

Spring Boot では、スタンドアロン Spring ベースのアプリケーションを作成できます。Spring Boot に関するドキュメントの一覧は、「関連情報」を参照してください。https://access.redhat.com/documentation/ja-jp/red_hat_support_for_spring_boot/2.2/html-single/spring_boot_runtime_guide/#additional-springboot-resources_spring-boot

OpenShift 上の Spring Boot は、以下のように、Spring Boot の合理化されたアプリケーション開発機能と OpenShift のインフラストラクチャーおよびコンテナーオーケストレーション機能を組み合わせたものです。

- ローリング更新

- サービス検出

- カナリアデプロイメント

- 一般的なマイクロサービスパターンを実装する方法: 外部化設定、ヘルスチェック、サーキットブレーカー、およびフェイルオーバー

1.3.1. Spring Boot の機能およびフレームワークの概要

本ガイドでは、Spring Boot を使用した OpenShift でのクラウドネイティブアプリケーションの開発について説明します。これ以降のセクションのアプリケーション例では、Spring Boot を他の Red Hat テクノロジーと統合する方法を説明します。これらの統合機能を使用して、クラウドネイティブの Java アプリケーションを設定する最新の設計パターンを実装することができます。

- resilient

- responsive

- scalable

- secure

通常の Web サーバースタックまたはノンブロッキングリアクティブスタックで Spring Boot アプリケーションをビルドできます。

Developer Launcher を使用して、サンプルアプリケーションを OpenShift クラスターにデプロイすることもできます。アプリケーションはパッケージ化や変更せずにデプロイできます。または、それらをカスタマイズして、追加のクラウドネイティブ機能を使用し、OpenShift に組み込まれた継続的な統合機能を使用してそれらを更新で再デプロイすることもできます。

Red Hat は、Snowdrop コミュニティープロジェクトをベースとした Spring Boot のリリースをサポートします。

サポートされるランタイムフレームワークのコンポーネントには以下が含まれます。

- Apache Tomcat (Red Hat Java Web Server 製品オファリングで提供) および JBoss Undertow (Red Hat Enterprise Application Platform で提供) をベースとしたクラウドネイティブの Java ベースのアプリケーションを開発するための Spring Boot Starter のセット。

- Spring WebFlux 非ブロッキング API、Eclipse Vert.x および Reactor Netty によって提供されるネットワークコンポーネントを使用して、リアクティブスタックでクラウドネイティブの Java ベースのアプリケーションを開発するための Spring Boot Starters のセット。

-

Spring Boot と統合する OpenShift および Kubernetes のアノテーションパーサーのコレクションおよびアプリケーションテンプレートジェネレーターのコレクションである Dekorate。Dekorate を使用すると、OpenShift クラスターへのデプロイメント用にアプリケーションを設定するのに使用可能なテンプレートを自動的に作成できます。アプリケーションのビルド時、Dokorate は、アプリケーションプロジェクトの設定プロパティー (例:

application.properties) が含まれるファイル、またはアプリケーションのソースファイルにあるアノテーションから設定パラメーターを抽出します。次に、Dekorate は抽出されたパラメーターを使用して、アプリケーションを OpenShift クラスターにデプロイするのに使用できるリソースファイルを作成し、設定します。Dekorate は、使用する言語とビルドツールとは独立して機能し、複数のクラウドネイティブなアプリケーションフレームワークと統合します。Red Hat は Dekorate を使用して、OpenShift Container Platform に Java ベースのアプリケーションをデプロイするアプリケーションテンプレートを生成するためのサポートを提供します。Red Hat は、Maven で Dekorate の使用に対するサポートを提供しています。他のビルドツールはサポートされていません。

1.3.2. Spring Boot でサポートされるアーキテクチャー

Spring Boot は以下のアーキテクチャーをサポートします。

- x86_64 (AMD64)

- OpenShift 環境の IBM Z (s390x)

アーキテクチャーによって異なるイメージがサポートされています。本ガイドのコード例は、x86_64 アーキテクチャーのコマンドを示しています。他のアーキテクチャーを使用している場合は、コマンドに該当するイメージ名を指定します。

イメージ名の詳細は、Spring Boot でサポートされる Java イメージ のセクションを参照してください。

1.3.3. サンプルアプリケーションの概要

クラウドネイティブのアプリケーションおよびサービスをビルドする方法を実証する作業アプリケーションがあります。これらは、アプリケーションの開発時に使用する必要のある規範的なアーキテクチャー、設計パターン、ツール、およびベストプラクティスを示しています。サンプルアプリケーションは、クラウドネイティブのマイクロサービスを作成するためのテンプレートとして使用できます。本ガイドで説明しているデプロイメントプロセスを使用して、例を更新および再デプロイできます。

この例では、以下のような マイクロサービスパターン を実装します。

- REST API の作成

- データベースの相互運用

- ヘルスチェックパターンの実装

- アプリケーションの設定を外部化してセキュア化し、容易なスケーリング

サンプルアプリケーションは以下のように使用できます。

- テクノロジーのデモの実行

- プロジェクトのアプリケーションの開発方法を理解するツールまたはサンドボックスの学習

- 独自のユースケースを更新または拡張するためのヒント

各サンプルアプリケーションは 1 つ以上のランタイムに実装されます。たとえば、REST API Level 0 のサンプルは以下のランタイムで利用できます。

以降のセクションでは、Spring Boot ランタイムに実装されたサンプルアプリケーションを説明します。

すべてのサンプルアプリケーションを以下にダウンロードおよびデプロイできます。

- x86_64 アーキテクチャー - 本ガイドのアプリケーションの例では、サンプルアプリケーションを x86_64 アーキテクチャーにビルドおよびデプロイする方法を説明します。

s390x アーキテクチャー - IBM Z インフラストラクチャーでプロビジョニングされた OpenShift 環境にサンプルアプリケーションをデプロイするには、コマンドに関連する IBM Z イメージ名を指定します。イメージ名の詳細は、Spring Boot でサポートされる Java イメージ のセクションを参照してください。

サンプルアプリケーションの一部には、ワークフローを実証するために Red Hat Data Grid などの他の製品も必要になります。この場合、これらの製品のイメージ名をサンプルアプリケーションの YAML ファイルで関連する IBM Z イメージ名に変更する必要もあります。

第2章 Spring Boot を使用するようにアプリケーションを設定

Red Hat ビルドの Spring Boot で提供される依存関係を使用するようにアプリケーションを設定します。BOM を使用して依存関係を管理することで、アプリケーションが Red Hat が提供するこれらの依存関係の製品バージョンを常に使用するようにしてください。アプリケーションのルートディレクトリーにある pom.xml ファイルの Spring Boot BOM (Bill of Materials) アーティファクトを参照します。アプリケーションプロジェクトで BOM を使用することもできます。2 種類の方法を使用できます。

-

pom.xmlの<dependencyManagement>セクションの 依存関係として。BOM を依存関係として使用する場合、プロジェクトは BOM の<dependencyManagement>セクションからすべての Spring Boot 依存関係のバージョン設定を継承します。 pom.xmlの<parent>セクションで 親 BOM として。BOM を親として使用する場合、プロジェクトのpom.xmlは、親 BOM から以下の設定値を継承します。-

<dependencyManagement>セクションのすべての Spring Boot 依存関係のバージョン -

<pluginManagement>セクションのバージョンプラグイン -

<repositories>セクションのリポジトリーの URL および名前 -

<pluginRepositories>セクションに Spring Boot プラグインが含まれるリポジトリーの URL および名前

-

2.1. 前提条件

-

pom.xmlファイルを使用して設定する Maven ベースのアプリケーションプロジェクト。 - Red Hat JBoss Middleware General Availability Maven リポジトリーへのアクセス。

2.2. Spring Boot BOM を使用した依存関係バージョンの管理

製品 BOM を使用して、アプリケーションプロジェクトで Spring Boot 製品依存関係のバージョンを管理します。

手順

dev.snowdrop:snowdrop-dependenciesアーティファクトをプロジェクトのpom.xmlの<dependencyManagement>セクションに追加し、<type>属性値および<scope>属性値を指定します。<project> ... <dependencyManagement> <dependencies> <dependency> <groupId>dev.snowdrop</groupId> <artifactId>snowdrop-dependencies</artifactId> <version>2.2.11.SP1-redhat-00001</version> <type>pom</type> <scope>import</scope> </dependency> </dependencies> </dependencyManagement> ... </project>以下のプロパティーを追加して、使用している Spring Boot Maven プラグインのバージョンを追跡します。

<project> ... <properties> <spring-boot-maven-plugin.version>2.2.11.RELEASE</spring-boot-maven-plugin.version> </properties> ... </project>BOM およびサポートされる Spring Boot Starters および Spring Boot Maven プラグインを含むリポジトリーの名前と URL を指定します。

<!-- Specify the repositories containing Spring Boot artifacts. --> <repositories> <repository> <id>redhat-ga</id> <name>Red Hat GA Repository</name> <url>https://maven.repository.redhat.com/ga/</url> </repository> </repositories> <!-- Specify the repositories containing the plugins used to execute the build of your application. --> <pluginRepositories> <pluginRepository> <id>redhat-ga</id> <name>Red Hat GA Repository</name> <url>https://maven.repository.redhat.com/ga/</url> </pluginRepository> </pluginRepositories>spring-boot-maven-pluginを Maven がアプリケーションのパッケージ化に使用するプラグインとして追加します。<project> ... <build> ... <plugins> ... <plugin> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-maven-plugin</artifactId> <version>${spring-boot-maven-plugin.version}</version> <executions> <execution> <goals> <goal>repackage</goal> </goals> </execution> </executions> <configuration> <redeploy>true</redeploy> </configuration> </plugin> ... </plugins> ... </build> ... </project>

2.3. Spring Boot BOM を使用したアプリケーションの親 BOM として使用

以下を自動的に管理します。

- 製品依存関係のバージョン

- Spring Boot Maven プラグインのバージョン

- 製品アーティファクトおよびプラグインが含まれる Maven リポジトリーの設定

製品の Spring Boot BOM をプロジェクトの親 BOM として含めて、アプリケーションプロジェクトで使用する内容。この方法では、BOM をアプリケーションの依存関係として使用する代替方法を提供します。

手順

dev.snowdrop:snowdrop-dependenciesアーティファクトをpom.xmlの<parent>セクションに追加します。<project> ... <parent> <groupId>dev.snowdrop</groupId> <artifactId>snowdrop-dependencies</artifactId> <version>2.2.11.SP1-redhat-00001</version> </parent> ... </project>spring-boot-maven-pluginを Maven がアプリケーションをpom.xmlの<build>セクションにパッケージ化するために使用するプラグインとして追加します。プラグインバージョンは、親 BOM により自動的に管理されます。<project> ... <build> ... <plugins> ... <plugin> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-maven-plugin</artifactId> <executions> <execution> <goals> <goal>repackage</goal> </goals> </execution> </executions> <configuration> <redeploy>true</redeploy> </configuration> </plugin> ... </plugins> ... </build> ... </project>

2.4. 関連情報

- Spring Boot アプリケーションのパッケージ化に関する詳細は、Spring Boot Maven Plugin のドキュメントを参照してください。

第3章 Developer Launcher を使用したアプリケーションのダウンロードおよびデプロイ

このセクションでは、ランタイムで提供されるサンプルアプリケーションをダウンロードおよびデプロイする方法を説明します。アプリケーションのサンプルは Developer Launcher で利用できます。

3.1. Developer Launcher の使用

Developer Launcher (developers.redhat.com/launch) は OpenShift 上で実行します。アプリケーションのサンプルをデプロイする場合、Developer Launcher は以下のプロセスを説明します。

- ランタイムの選択

- アプリケーションのビルドおよび実行

選択に基づいて、Developer Launcher はカスタムプロジェクトを生成します。プロジェクトの ZIP バージョンをダウンロードするか、または OpenShift Online インスタンスでアプリケーションを直接起動できます。

Developer Launcher を使用してアプリケーションを OpenShift にデプロイする場合は、Source-to-Image (S2I) ビルドプロセスが使用されます。このビルドプロセスは、OpenShift でアプリケーションを実行するために必要なすべての設定、ビルド、およびデプロイメントのステップを処理します。

3.2. Developer Launcher を使用したサンプルアプリケーションのダウンロード

Red Hat は、Spring Boot ランタイムを使い始めるのに役立つサンプルアプリケーションを提供します。これらの例は、Developer Launcher (developers.redhat.com/launch) で利用できます。

サンプルアプリケーションをダウンロードして、ビルドし、デプロイできます。本セクションでは、サンプルアプリケーションをダウンロードする方法を説明します。

サンプルアプリケーションをテンプレートとして使用し、独自のクラウドネイティブアプリケーションを作成できます。

手順

- Developer Launcher (developers.redhat.com/launch) に移動します。

- Start をクリックします。

- Deploy an Example Application をクリックします。

- Select an Example をクリックし、ランタイムで使用できるサンプルアプリケーションの一覧を表示します。

- ランタイムを選択します。

サンプルアプリケーションを選択します。

注記複数のランタイムで利用できるアプリケーションの例もあります。前の手順でランタイムを選択していない場合は、サンプルアプリケーションで利用できるランタイムの一覧からランタイムを選択できます。

- ランタイムのリリースバージョンを選択します。ランタイムに一覧表示されているコミュニティーまたは製品リリースから選択できます。

- Save をクリックします。

Download をクリックして、サンプルアプリケーションをダウンロードします。

ソースおよびドキュメントファイルを含む ZIP ファイルがダウンロードされます。

3.3. OpenShift Container Platform または CDK (Minishift) へのサンプルアプリケーションのデプロイメント

サンプルアプリケーションを OpenShift Container Platform または CDK (Minishift) のいずれかにデプロイできます。アプリケーションをデプロイする場所に応じて、認証に該当する Web コンソールを使用します。

前提条件

- Developer Launcher を使用して、サンプルアプリケーションプロジェクトを作成している。

- アプリケーションを OpenShift Container Platform にデプロイする場合は、OpenShift Container Platform Web コンソールにアクセスできるようにしている。

- CDK (Minishift) にアプリケーションをデプロイする場合は、CDK (Minishift) Web コンソールにアクセスできるようにしている。

-

OCコマンドラインクライアントがインストールされている。

手順

- サンプルアプリケーションをダウンロードします。

ocコマンドラインクライアントを使用して、サンプルアプリケーションを OpenShift Container Platform または CDK (Minishift) にデプロイできます。Web コンソールによって提供されるトークンを使用してクライアントを認証する必要があります。アプリケーションをデプロイする場所に応じて、OpenShift Container Platform Web コンソールまたは CDK (Minishift) Web コンソールを使用します。以下の手順を実行してクライアントの認証を取得します。

- Web コンソールにログインします。

- Web コンソールの右上隅にあるクエスチョンマークアイコンをクリックします。

- 一覧から Command Line Tools を選択します。

-

oc loginコマンドをコピーします。 ターミナルにコマンドを貼り付け、CLI クライアント

ocをアカウントで認証します。$ oc login OPENSHIFT_URL --token=MYTOKEN

ZIP ファイルの内容を展開します。

$ unzip MY_APPLICATION_NAME.zip

OpenShift で新規プロジェクトを作成します。

$ oc new-project MY_PROJECT_NAME

-

MY_APPLICATION_NAMEの root ディレクトリーに移動します。 Maven を使用してサンプルアプリケーションをデプロイします。

$ mvn clean fabric8:deploy -Popenshift

注記: アプリケーションの例によっては、追加の設定が必要になる場合があります。サンプルアプリケーションをビルドおよびデプロイするには、

READMEファイルに記載されている手順に従います。アプリケーションのステータスを確認し、Pod が実行していることを確認します。

$ oc get pods -w NAME READY STATUS RESTARTS AGE MY_APP_NAME-1-aaaaa 1/1 Running 0 58s MY_APP_NAME-s2i-1-build 0/1 Completed 0 2m

MY_APP_NAME-1-aaaaaPod は完全にデプロイされ起動するとRunningステータスになります。アプリケーションの Pod 名は異なる場合があります。Pod 名の数値は、新しいビルドごとに増加します。末尾の文字は、Pod の作成時に生成されます。アプリケーションのサンプルをデプロイして起動すると、そのルートを決定します。

ルート情報の例

$ oc get routes NAME HOST/PORT PATH SERVICES PORT TERMINATION MY_APP_NAME MY_APP_NAME-MY_PROJECT_NAME.OPENSHIFT_HOSTNAME MY_APP_NAME 8080

Pod のルート情報は、アクセスできるベース URL を提供します。この例では、

http://MY_APP_NAME-MY_PROJECT_NAME.OPENSHIFT_HOSTNAMEをベース URL として使用し、アプリケーションにアクセスできます。

第4章 Spring Boot ランタイムアプリケーションの開発およびデプロイ

サンプルを使用する 他に、ゼロから新しい Spring Boot アプリケーションを作成して、OpenShift にデプロイできます。

Spring Boot アプリケーションでサポート対象でテスト済みの Maven アーティファクトを指定する方法や使用の推奨される方法は、OpenShift Application Runtimes Spring Boot BOM の使用が推奨されます。

4.1. Spring Boot アプリケーションの開発

基本的な Spring Boot アプリケーションには、以下を作成する必要があります。

- Spring Boot メソッドが含まれる Java クラス。

-

アプリケーションをビルドするために Maven が必要とする情報が含まれる

pom.xmlファイル。

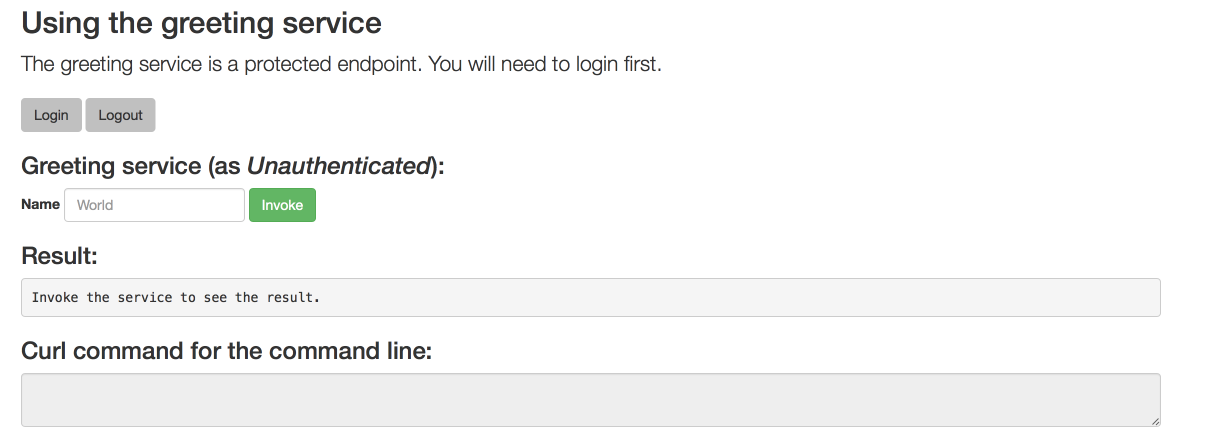

以下の手順では、応答として "{"content":"Greetings!"}" を返す単純な Greeting アプリケーションを作成します。

アプリケーションを OpenShift にビルドおよびデプロイする場合、Spring Boot 2.2 は OpenJDK 8 および OpenJDK 11 をベースとしたビルダーイメージのみをサポートします。Oracle JDK および OpenJDK 9 のビルダーイメージはサポートされていません。

前提条件

- OpenJDK 8 または OpenJDK 11 がインストールされている。

- Maven がインストールされている。

手順

myAppディレクトリーを新規作成し、そのディレクトリーに移動します。$ mkdir myApp $ cd myApp

これは、アプリケーションのルートディレクトリーです。

ルートディレクトリーにディレクトリー構造

src/main/java/com/example/を作成し、これに移動します。$ mkdir -p src/main/java/com/example/ $ cd src/main/java/com/example/

アプリケーションコードを含む Java クラスファイル

MyApp.javaを作成します。package com.example; import org.springframework.boot.SpringApplication; import org.springframework.boot.autoconfigure.SpringBootApplication; import org.springframework.web.bind.annotation.RequestMapping; import org.springframework.web.bind.annotation.ResponseBody; import org.springframework.web.bind.annotation.RestController; @SpringBootApplication @RestController public class MyApp { public static void main(String[] args) { SpringApplication.run(MyApp.class, args); } @RequestMapping("/") @ResponseBody public Message displayMessage() { return new Message(); } static class Message { private String content = "Greetings!"; public String getContent() { return content; } public void setContent(String content) { this.content = content; } } }以下の内容を含むアプリケーションルートディレクトリー

myAppにpom.xmlファイルを作成します。<?xml version="1.0" encoding="UTF-8"?> <project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd"> <modelVersion>4.0.0</modelVersion> <groupId>com.example</groupId> <artifactId>my-app</artifactId> <version>1.0.0-SNAPSHOT</version> <name>MyApp</name> <description>My Application</description> <!-- Specify the JDK builder image used to build your application. --> <!-- Use OpenJDK 8 and OpenJDK 11-based images. OracleJDK-based images are not supported. --> <properties> <fabric8.generator.from>registry.access.redhat.com/redhat-openjdk-18/openjdk18-openshift:latest</fabric8.generator.from> </properties> <!-- Import dependencies from the Spring Boot BOM. --> <dependencyManagement> <dependencies> <dependency> <groupId>dev.snowdrop</groupId> <artifactId>snowdrop-dependencies</artifactId> <version>2.2.11.SP1-redhat-00001</version> <type>pom</type> <scope>import</scope> </dependency> </dependencies> </dependencyManagement> <dependencies> <dependency> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-tomcat</artifactId> </dependency> <dependency> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-actuator</artifactId> </dependency> <dependency> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-web</artifactId> </dependency> </dependencies> <build> <plugins> <plugin> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-maven-plugin</artifactId> <version>2.2.11.RELEASE</version> </plugin> </plugins> </build> <!-- Specify the repositories containing Spring Boot artifacts --> <repositories> <repository> <id>redhat-ga</id> <name>Red Hat GA Repository</name> <url>https://maven.repository.redhat.com/ga/</url> </repository> </repositories> <pluginRepositories> <pluginRepository> <id>redhat-ga</id> <name>Red Hat GA Repository</name> <url>https://maven.repository.redhat.com/ga/</url> </pluginRepository> </pluginRepositories> </project>アプリケーションのルートディレクトリーから Maven を使用してアプリケーションをビルドします。

$ mvn spring-boot:run

アプリケーションが実行していることを確認します。

curlまたはブラウザーを使用して、アプリケーションがhttp://localhost:8080で稼働していることを確認します。$ curl http://localhost:8080 {"content":"Greetings!"}

追加情報

- 推奨されるプラクティスとして、Liveness プローブおよび Readiness プローブを設定し、OpenShift で実行する際にアプリケーションのヘルスモニターリングを有効にできます。OpenShift でのアプリケーションのヘルスモニターリングの仕組みを確認するには、ヘルスチェックの例 を試してください。

4.2. Spring Boot アプリケーションの OpenShift へのデプロイ

Spring Boot アプリケーションを OpenShift にデプロイするには、アプリケーションで pom.xml ファイルを設定し、Fabric8 Maven プラグインを使用します。pom.xml ファイルの fabric8.generator.from URL を置き換えて、Java イメージを指定できます。

イメージは Red Hat Ecosystem Catalog で利用できます。

<fabric8.generator.from>IMAGE_NAME</fabric8.generator.from>

たとえば、OpenJDK 8 を使用する RHEL 7 の Java イメージは、以下のように指定します。

<fabric8.generator.from>registry.access.redhat.com/redhat-openjdk-18/openjdk18-openshift:latest</fabric8.generator.from>

4.2.1. Spring Boot でサポートされる Java イメージ

Spring Boot は、さまざまなオペレーティングシステムで利用可能なさまざまな Java イメージで認定およびテストされています。たとえば、Java イメージは、RHEL 7 で OpenJDK 8 または OpenJDK 11 で利用できます。

Spring Boot では、RHEL 8 上の Red Hat OpenJDK 8 および Red Hat OpenJDK 11 用の OCI 準拠の ユニバーサルベースイメージ を使用して、Spring Boot アプリケーションを OpenShift にビルドおよびデプロイできるようになりました。

同様のイメージが IBM Z で利用できます。

Red Hat Ecosystem Catalog で RHEL 8 イメージにアクセスするには、Docker または Podman 認証が必要です。

以下の表は、さまざまなアーキテクチャー向けに Spring Boot でサポートされるイメージの一覧です。また、Red Hat Ecosystem Catalog で利用可能なイメージへのリンクも提供します。イメージページには、RHEL 8 イメージへのアクセスに必要な認証手順が含まれています。

4.2.1.1. x86_64 アーキテクチャー上のイメージ

| OS | Java | Red Hat Ecosystem Catalog |

|---|---|---|

| RHEL 7 | OpenJDK 8 | |

| RHEL 7 | OpenJDK 11 | |

| RHEL 8 | OpenJDK 8 | |

| RHEL 8 | OpenJDK 11 |

RHEL 7 ホストでの RHEL 8 ベースのコンテナーの使用 (OpenShift 3 や OpenShift 4 など) は、サポートが限定されています。詳細は、Red Hat Enterprise Linux Container Compatibility Matrix を参照してください。

4.2.1.2. s390x (IBM Z) アーキテクチャー上のイメージ

| OS | Java | Red Hat Ecosystem Catalog |

|---|---|---|

| RHEL 8 | Eclipse OpenJ9 11 |

RHEL 7 ホストでの RHEL 8 ベースのコンテナーの使用 (OpenShift 3 や OpenShift 4 など) は、サポートが限定されています。詳細は、Red Hat Enterprise Linux Container Compatibility Matrix を参照してください。

4.2.2. OpenShift デプロイメント向け Spring Boot アプリケーションの準備

Spring Boot アプリケーションを OpenShift にデプロイするには、以下を含める必要があります。

-

アプリケーションの

pom.xmlファイルにあるランチャープロファイル情報。

以下の手順では、Fabric8 Maven プラグインを使用したプロファイルは、アプリケーションを OpenShift にビルドおよびデプロイするために使用されます。

前提条件

- Maven がインストールされている。

- Red Hat Ecosystem Catalog での Docker または Podman 認証による RHEL 8 イメージへのアクセスができる。

手順

以下の内容を、アプリケーションルートディレクトリーの

pom.xmlファイルに追加します。... <profiles> <profile> <id>openshift</id> <build> <plugins> <plugin> <groupId>io.fabric8</groupId> <artifactId>fabric8-maven-plugin</artifactId> <version>4.4.1</version> <executions> <execution> <goals> <goal>resource</goal> <goal>build</goal> </goals> </execution> </executions> </plugin> </plugins> </build> </profile> </profiles>pom.xmlファイルのfabric8.generator.fromプロパティーを置き換えて、使用する OpenJDK イメージを指定します。x86_64 アーキテクチャー

OpenJDK 8 を使用した RHEL 7

<fabric8.generator.from>registry.access.redhat.com/redhat-openjdk-18/openjdk18-openshift:latest</fabric8.generator.from>

OpenJDK 11 を使用した RHEL 7

<fabric8.generator.from>registry.access.redhat.com/openjdk/openjdk-11-rhel7:latest</fabric8.generator.from>

OpenJDK 8 を使用した RHEL 8

<fabric8.generator.from>registry.access.redhat.com/ubi8/openjdk-8:latest</fabric8.generator.from>

OpenJDK 11 を使用した RHEL 8

<fabric8.generator.from>registry.access.redhat.com/ubi8/openjdk-11:latest</fabric8.generator.from>

s390x (IBM Z) アーキテクチャー

Eclipse OpenJ9 11 を使用した RHEL 8

<fabric8.generator.from>registry.access.redhat.com/openj9/openj9-11-rhel8:latest</fabric8.generator.from>

4.2.3. Fabric8 Maven プラグインを使用した Spring Boot アプリケーションの OpenShift へのデプロイ

Spring Boot アプリケーションを OpenShift にデプロイするには、以下を実行する必要があります。

- OpenShift インスタンスにログインします。

- OpenShift インスタンスにアプリケーションをデプロイします。

前提条件

-

CLI クライアント

ocがインストールされている。 - Maven がインストールされている。

手順

ocクライアントを使用して OpenShift インスタンスにログインします。$ oc login ...

OpenShift インスタンスで新規プロジェクトを作成します。

$ oc new-project MY_PROJECT_NAME

アプリケーションのルートディレクトリーから Maven を使用してアプリケーションを OpenShift にデプロイします。アプリケーションのルートディレクトリーには

pom.xmlファイルが含まれます。$ mvn clean fabric8:deploy -Popenshift

このコマンドは Fabric8 Maven プラグインを使用して OpenShift で S2I プロセス を起動し、Pod を起動します。

デプロイメントを確認します。

アプリケーションのステータスを確認し、Pod が実行していることを確認します。

$ oc get pods -w NAME READY STATUS RESTARTS AGE MY_APP_NAME-1-aaaaa 1/1 Running 0 58s MY_APP_NAME-s2i-1-build 0/1 Completed 0 2m

MY_APP_NAME-1-aaaaaPod は、完全にデプロイされて起動すると、ステータスがRunningになるはずです。特定の Pod 名が異なります。

Pod のルートを確認します。

ルート情報の例

$ oc get routes NAME HOST/PORT PATH SERVICES PORT TERMINATION MY_APP_NAME MY_APP_NAME-MY_PROJECT_NAME.OPENSHIFT_HOSTNAME MY_APP_NAME 8080

Pod のルート情報には、アクセスに使用するベース URL が提供されます。

この例では、

http://MY_APP_NAME-MY_PROJECT_NAME.OPENSHIFT_HOSTNAMEをベース URL として使用し、アプリケーションにアクセスできます。アプリケーションが OpenShift で実行していることを確認します。

$ curl http://MY_APP_NAME-MY_PROJECT_NAME.OPENSHIFT_HOSTNAME {"content":"Greetings!"}

4.3. スタンドアロン Red Hat Enterprise Linux への Spring Boot アプリケーションのデプロイ

Spring Boot アプリケーションをスタンドアロンの Red Hat Enterprise Linux にデプロイするには、アプリケーションで pom.xml ファイルを設定し、Maven を使用してパッケージ化し、java-jar コマンドを使用してデプロイします。

前提条件

- RHEL 7 または RHEL 8 がインストールされている。

4.3.1. スタンドアロン Red Hat Enterprise Linux デプロイメント用の Spring Boot アプリケーションの準備

Spring Boot アプリケーションをスタンドアロンの Red Hat Enterprise Linux にデプロイするには、最初に Maven を使用してアプリケーションをパッケージ化する必要があります。

前提条件

- Maven がインストールされている。

手順

以下の内容をアプリケーションの root ディレクトリーの

pom.xmlファイルに追加します。... <!-- Specify target artifact type for the repackage goal. --> <packaging>jar</packaging> ... <build> <plugins> <plugin> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-maven-plugin</artifactId> <version>${spring-boot.version}</version> <executions> <execution> <goals> <goal>repackage</goal> </goals> </execution> </executions> </plugin> </plugins> </build> ...Maven を使用してアプリケーションをパッケージ化します。

$ mvn clean package

作成される JAR ファイルは

targetディレクトリーに置かれます。

4.3.2. jar を使用したスタンドアロン Red Hat Enterprise Linux への Spring Boot アプリケーションのデプロイ

Spring Boot アプリケーションをスタンドアロンの Red Hat Enterprise Linux にデプロイするには、java -jar コマンドを使用します。

前提条件

- RHEL 7 または RHEL 8 がインストールされている。

- OpenJDK 8 または OpenJDK 11 がインストールされている。

- アプリケーションが含まれる JAR ファイル。

手順

そのアプリケーションで JAR ファイルをデプロイします。

$ java -jar my-project-1.0.0.jar

デプロイメントを確認します。

curlまたはブラウザーを使用して、アプリケーションがhttp://localhost:8080で稼働していることを確認します。$ curl http://localhost:8080

第5章 Eclipse Vert.x で Spring Boot を使用したリアクティブアプリケーションの開発

本セクションでは、Spring Boot および Eclipse Vert.x をベースとした Spring Boot スターターを使用して、リアクティブでアプリケーションを開発する方法を説明します。以下の例は、スターターを使用してリアクティブアプリケーションを作成する方法を表しています。

5.1. Eclipse Vert.x での Spring Boot の概要

Spring リアクティブスタックは Project Reactor 上に構築され、バックプレーシャーを実装し、Reactive Streams 仕様に準拠しています。非同期イベントストリーム処理を有効にする Flux および Mono 機能 API タイプを提供します。

Spring は、Project Reactor の上部に WebFlux (非同期イベント駆動型の Web アプリケーションフレームワーク) を提供します。WebFlux は、主に Reactor Netty と連携するように設計されていますが、Eclipse Vert.x などの他のリアクティブ HTTP サーバーでも操作できます。

Spring WebFlux および Reactor を使用すると、以下のアプリケーションを作成できます。

- ブロックなし: アプリケーションは、現在の要求の完了に必要なリモートコンポーネントまたはサービスからの応答を待機しているときに、追加の要求を引き続き処理します。

- 非同期: アプリケーションは応答イベントを生成し、それらをアプリケーション内の他のクライアントが取得できるイベントストリームに再び公開することで、イベントストリームからイベントに応答します。

- イベント駆動型: アプリケーションは、マウスクリック、HTTP 要求、ストレージに追加される新しいファイルなど、ユーザーまたは別のサービスが生成するイベントに応答します。

- スケーラブル: アプリケーションの必要なイベント処理容量のみに一致する Publisher または Subscriber の数が増えると、アプリケーションの個別クライアント間のルーティング要求の複雑性が向上します。リアクティブアプリケーションは、他のアプリケーションプログラミングモデルと比較して、コンピューティングおよびネットワークリソースを使用して多数のイベントを処理できます。

- 耐久性: アプリケーションは、サービス全体に影響を与えることなく、依存するサービス障害を処理できます。

Spring WebFlux を使用する追加の利点には以下が含まれます。

- SpringMVC での類似性

- SpringMVC API タイプと WebFlux API タイプは類似しており、開発者は SpringMVC の知識を WebFlux を使用したプログラミングアプリケーションに簡単に適用できます。

Red Hat による Spring Reactive 製品は、Reactor と WebFlux から OpenShift とスタンドアロンの RHEL の利点を提供し、WebFLux フレームワークの Eclipse Vert.x 拡張のセットを導入します。これにより、Spring Boot の抽象化および高速なプロトタイプ機能を保持でき、アプリケーション内のサービス間のネットワーク通信を完全にリアクティブで処理する非同期 IO API を利用できます。

- アノテーション付きコントローラーのサポート

- WebFlux は、SpringMVC により導入されるエンドポイントコントローラーアノテーションを保持します (SpringMVC および WebFlux はリアクティブな RxJava2 および Reactor の戻り値タイプ)。

- 機能的なプログラミングサポート

-

Reactor の Java 8 Functional API とだけでなく、

CompletablebFutureAPI、およびStreamAPI とも相互作用します。アノテーションベースのエンドポイントに加えて、WebFlux は機能的なエンドポイントもサポートします。

その他のリソース

Spring Reactive スタックの一部であるテクノロジーの実装に関する詳細は、以下のリソースを参照してください。

5.2. リアクティブ Spring Web

spring-web モジュールは、Spring WebFlux のリアクティブ機能の基盤要素を提供します。以下が含まれます。

-

HttpHandlerAPI によって提供される HTTP 抽象化 - サポートされるサーバーのリアクティブストリームアダプター (Eclipse Vert.x、Undertow など)

イベントストリームデータをエンコードおよびデコードするためのコードデックです。これには、以下が含まれます。

-

DataBuffer、さまざまなタイプのバイトバッファー表現 NettyByteBuf、java.nio.ByteBufferなど) の抽象化 - HTTP とは関係なくコンテンツをエンコードおよびデコードする低レベルの契約

-

HTTP メッセージコンテンツのエンコードおよびデコードを行う

HttpMessageReaderおよびHTTPMessageWriterコントラクト

-

-

WebHandlerAPI (非ブロッキング契約を使用する Servlet 3.1 I/O API に対応)

Web アプリケーションを設計する場合は、Spring WebFlux が以下を提供する 2 つのプログラミングモデルのいずれかを選択できます。

- アノテーション付きコントローラー

-

Spring WebFlux のアノテーションが付けられたコントローラーは Spring MVC と一致しており、

spring-webモジュールと同じアノテーションに基づいています。SpringMVC のspring-webモジュールに加えて、WebFlux の対応する@RequestBody引数もサポートしています。 - 機能エンドポイント

- Java 8 Lambda 式および機能 API の Spring WebFlux が提供する機能エンドポイント。このプログラミングモデルは、要求をルーティングおよび処理する専用のライブラリー (この場合は Reactor など) に依存します。インテントの宣言とコールバックの使用に依存してアクティビティーを完了するアノテーションベースのエンドポイントコントローラーとは対照的に、機能エンドポイントに基づくリアクティブモデルでは、要求の処理をアプリケーションで完全に制御できます。

5.3. WebFlux でのリアクティブ Spring Boot HTTP サービスの作成

Spring Boot および WebFlux を使用して、基本的なリアクティブ Hello World HTTP Web サービスを作成します。

前提条件

- JDK 8 または JDK 11 がインストールされている。

- Maven がインストールされている。

- Spring Boot を使用するよう設定されたMaven ベースのアプリケーションプロジェクト

手順

vertx-spring-boot-starter-httpをプロジェクトのpom.xmlファイルに依存関係として追加します。pom.xml<project> ... <dependencies> ... <dependency> <groupId>dev.snowdrop</groupId> <artifactId>vertx-spring-boot-starter-http</artifactId> </dependency> ... <dependencies> ... </project>アプリケーションのメインクラスを作成し、ルーターおよびハンドラーメソッドを定義します。

HttpSampleApplication.javapackage dev.snowdrop.vertx.sample.http; import org.springframework.boot.SpringApplication; import org.springframework.boot.autoconfigure.SpringBootApplication; import org.springframework.context.annotation.Bean; import org.springframework.web.reactive.function.server.RouterFunction; import org.springframework.web.reactive.function.server.ServerRequest; import org.springframework.web.reactive.function.server.ServerResponse; import reactor.core.publisher.Mono; import static org.springframework.web.reactive.function.BodyInserters.fromObject; import static org.springframework.web.reactive.function.server.RouterFunctions.route; import static org.springframework.web.reactive.function.server.ServerResponse.ok; @SpringBootApplication public class HttpSampleApplication { public static void main(String[] args) { SpringApplication.run(HttpSampleApplication.class, args); } @Bean public RouterFunction<ServerResponse> helloRouter() { return route() .GET("/hello", this::helloHandler) .build(); } private Mono<ServerResponse> helloHandler(ServerRequest request) { String name = request .queryParam("name") .orElse("World"); String message = String.format("Hello, %s!", name); return ok() .body(fromObject(message)); } }オプション: アプリケーションをローカルで実行し、テストします。

Maven プロジェクトのルートディレクトリーへ移動します。

$ cd myApp

アプリケーションをパッケージ化します。

$ mvn clean package

コマンドラインからアプリケーションを起動します。

$ java -jar target/vertx-spring-boot-sample-http.jar

新しいターミナルウィンドウで、

/helloエンドポイントで HTTP 要求を発行します。$ curl localhost:8080/hello Hello, World!

カスタム名と、パーソナルな応答を取得するために要求を指定します。

$ curl http://localhost:8080/hello?name=John Hello, John!

その他のリソース

- Fabric8 Maven プラグインを使用して、アプリケーションを OpenShift クラスターにデプロイ できます。

- また、スタンドアロンの Red Hat Enterprise Linux でのデプロイメント 用にアプリケーションを設定することもできます。

- Spring Boot でリアクティブ Web サービスの作成に関する詳細は、Spring コミュニティードキュメントの リアクティブ REST サービスの開発ガイド を参照してください。

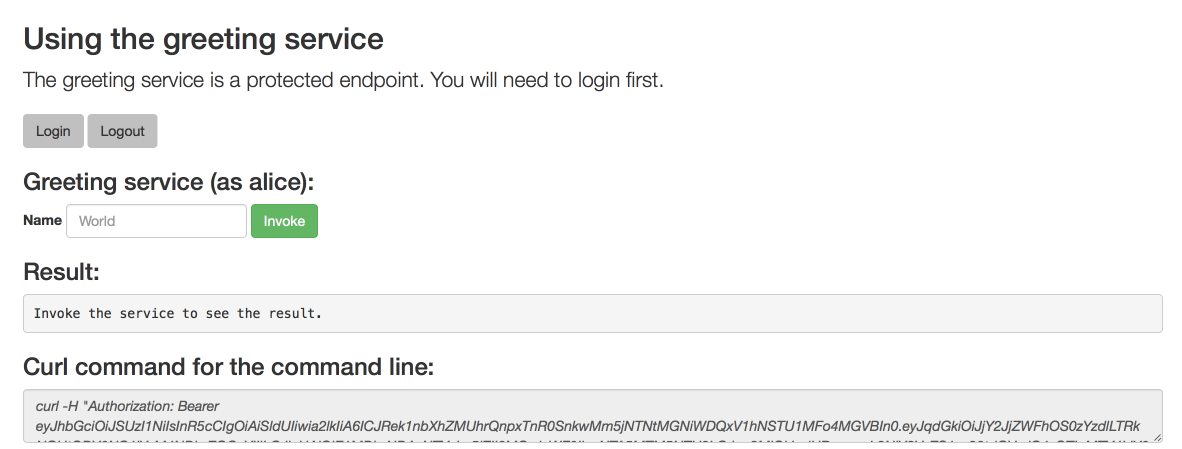

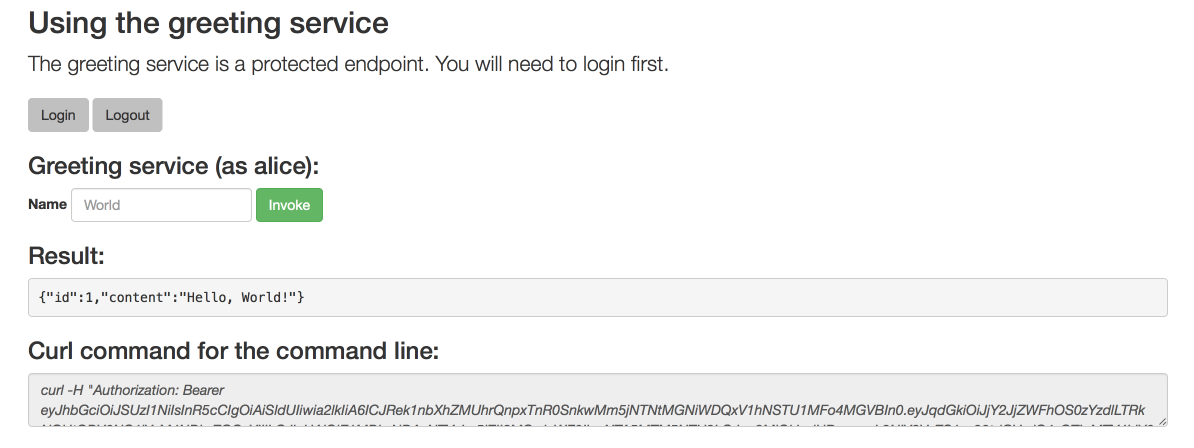

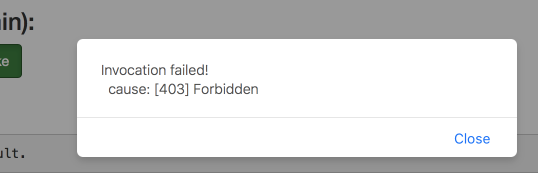

5.4. リアクティブ Spring Boot WebFlux アプリケーションで Basic 認証の使用

Spring Security および WebFlux スターターを使用して、リアクティブ Hello World HTTP Web サービスを作成し、基本的なフォームベースの認証を作成します。

前提条件

- JDK 8 または JDK 11 がインストールされている。

- Maven がインストールされている。

- Spring Boot を使用するよう設定されたMaven ベースのアプリケーションプロジェクト

手順

vertx-spring-boot-starter-httpおよびspring-boot-starter-securityをプロジェクトのpom.xmlファイルに依存関係として追加します。pom.xml<project> ... <dependencies> ... <dependency> <groupId>dev.snowdrop</groupId> <artifactId>vertx-spring-boot-starter-http</artifactId> </dependency> <dependency> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-security</artifactId> </dependency> ... <dependencies> ... </project>アプリケーションのエンドポイントコントローラークラスを作成します。

HelloController.javapackage dev.snowdrop.vertx.sample.http.security; import java.security.Principal; import org.springframework.web.bind.annotation.GetMapping; import org.springframework.web.bind.annotation.RestController; import reactor.core.publisher.Mono; @RestController public class HelloController { @GetMapping("/") public Mono<String> hello(Mono<Principal> principal) { return principal .map(Principal::getName) .map(this::helloMessage); } private String helloMessage(String username) { return "Hello, " + username + "!"; } }アプリケーションのメインクラスを作成します。

HttpSecuritySampleApplication.javapackage dev.snowdrop.vertx.sample.http.security; import org.springframework.boot.SpringApplication; import org.springframework.boot.autoconfigure.SpringBootApplication; @SpringBootApplication public class HttpSecuritySampleApplication { public static void main(String[] args) { SpringApplication.run(HttpSecuritySampleApplication.class, args); } }/helloエンドポイントにアクセスするためのユーザー認証情報を格納するSecurityConfigurationクラスを作成します。SecurityConfiguration.javapackage dev.snowdrop.vertx.sample.http.security; import org.springframework.context.annotation.Bean; import org.springframework.security.config.annotation.web.reactive.EnableWebFluxSecurity; import org.springframework.security.core.userdetails.MapReactiveUserDetailsService; import org.springframework.security.core.userdetails.User; import org.springframework.security.core.userdetails.UserDetails; @EnableWebFluxSecurity public class SecurityConfiguration { @Bean public MapReactiveUserDetailsService userDetailsService() { UserDetails user = User.withDefaultPasswordEncoder() .username("user") .password("user") .roles("USER") .build(); return new MapReactiveUserDetailsService(user); } }オプション: アプリケーションをローカルで実行し、テストします。

Maven プロジェクトのルートディレクトリーへ移動します。

$ cd myApp

アプリケーションをパッケージ化します。

$ mvn clean package

コマンドラインからアプリケーションを起動します。

$ java -jar target/vertx-spring-boot-sample-http-security.jar

-

ブラウザーを使用して

http://localhost:8080に移動し、ログイン画面にアクセスします。 以下の認証情報を使用してログインします。

- username: user

- password: user

以下のログイン時に、カスタマイズされた挨拶文を受け取ります。

Hello, user!

-

Web ブラウザーを使用して

http://localhost:8080/logoutに移動し、Log out ボタンを使用してアプリケーションからログアウトします。 または、ターミナルを使用して

localhost:8080で認証されていない HTTP 要求を実行します。アプリケーションから HTTP401 Unauthorized応答を受信します。$ curl -I http://localhost:8080 HTTP/1.1 401 Unauthorized WWW-Authenticate: Basic realm="Realm" Cache-Control: no-cache, no-store, max-age=0, must-revalidate Pragma: no-cache Expires: 0 X-Content-Type-Options: nosniff X-Frame-Options: DENY X-XSS-Protection: 1 ; mode=block Referrer-Policy: no-referrer

サンプルユーザー認証情報を使用して認証された要求を発行します。パーソナルな応答を受け取ります。

$ curl -u user:user http://localhost:8080 Hello, user!

その他のリソース

- Fabric8 Maven プラグインを使用して、アプリケーションを OpenShift クラスターにデプロイ できます。

- また、スタンドアロンの Red Hat Enterprise Linux でのデプロイメント 用にアプリケーションを設定することもできます。

- Basic HTTP 認証スキームの詳細は RFC-7617 のドキュメントを参照してください。

- フォームベースの認証など、対話式クライアントの HTTP 認証拡張の完全仕様は、RFC-8053 を参照してください。

5.5. リアクティブ Spring Boot アプリケーションで OAuth2 認証の使用。

リアクティブ Spring Boot アプリケーションの OAuth2 認証 を設定し、クライアント ID およびクライアントシークレットを使用して認証します。

前提条件

- JDK 8 または JDK 11 がインストールされている。

- Maven がインストールされている。

- Spring Boot を使用するよう設定されたMaven ベースのアプリケーションプロジェクト

- GitHub アカウント

手順

Github アカウントに 新規 OAuth 2 アプリケーションを登録 します。登録フォームに以下の値を指定するようにしてください。

-

ホームページ URL:

http://localhost:8080 承認コールバック URL:

http://localhost:8080/login/oauth2/code/github登録が完了したら、クライアント ID とクライアントシークレットを保存します。

-

ホームページ URL:

プロジェクトの

pom.xmlファイルに以下の依存関係を追加します。-

vertx-spring-boot-starter-http -

spring-boot-starter-security -

spring-boot-starter-oauth2-client reactor-nettyspring-boot-starter-oauth2-clientが適切に動作するには、reactor-nettyクライアントが必要です。pom.xml<project> ... <dependencies> ... <dependency> <groupId>dev.snowdrop</groupId> <artifactId>vertx-spring-boot-starter-http</artifactId> </dependency> <dependency> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-security</artifactId> </dependency> <dependency> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-oauth2-client</artifactId> </dependency> <!-- Spring OAuth2 client only works with Reactor Netty client --> <dependency> <groupId>io.projectreactor.netty</groupId> <artifactId>reactor-netty</artifactId> </dependency> ... <dependencies> ... </project>

-

アプリケーションのエンドポイントコントローラークラスを作成します。

HelloController.javapackage dev.snowdrop.vertx.sample.http.oauth; import org.springframework.security.core.annotation.AuthenticationPrincipal; import org.springframework.security.oauth2.core.user.OAuth2User; import org.springframework.web.bind.annotation.GetMapping; import org.springframework.web.bind.annotation.RestController; import reactor.core.publisher.Mono; @RestController public class HelloController { @GetMapping public Mono<String> hello(@AuthenticationPrincipal OAuth2User oauth2User) { return Mono.just("Hello, " + oauth2User.getAttributes().get("name") + "!"); } }アプリケーションのメインクラスを作成します。

OAuthSampleApplication.javapackage dev.snowdrop.vertx.sample.http.oauth; import org.springframework.boot.SpringApplication; import org.springframework.boot.autoconfigure.SpringBootApplication; @SpringBootApplication public class OAuthSampleApplication { public static void main(String[] args) { SpringApplication.run(OAuthSampleApplication.class, args); } }YAML 設定ファイルを作成して、アプリケーション登録時に GitHub から受け取った OAuth2 クライアント ID およびクライアントシークレットを保存します。

src/main/resources/application.ymlspring: security: oauth2: client: registration: github: client-id: YOUR_GITHUB_CLIENT_ID client-secret: YOUR_GITHUB_CLIENT_SECRETオプション: アプリケーションをローカルで実行し、テストします。

Maven プロジェクトのルートディレクトリーへ移動します。

$ cd myApp

アプリケーションをパッケージ化します。

$ mvn clean package

コマンドラインからアプリケーションを起動します。

$ java -jar target/vertx-spring-boot-sample-http-oauth.jar

-

Web ブラウザーを使用して

http://localhost:8080に移動します。GitHub の OAuth2 アプリケーション認可画面にリダイレクトされます。プロンプトが表示されたら、GitHub アカウントの認証情報を使用してログインします。 - Authorize をクリックして確定します。パーソナライズされたグリーティングメッセージを示す画面にリダイレクトされます。

その他のリソース

- Fabric8 Maven プラグインを使用して、アプリケーションを OpenShift クラスターにデプロイ できます。

- また、スタンドアロンの Red Hat Enterprise Linux でのデプロイメント 用にアプリケーションを設定することもできます。

- 詳細は、Spring コミュニティードキュメントの OAuth2 チュートリアル を参照してください。または、Spring Security の OAuth2 を使用するためのチュートリアルを参照してください。

- OAuth2 認証フレームワークの完全な仕様については、RFC-6749 を参照してください。

5.6. リアクティブ Spring Boot SMTP メールアプリケーションの作成

Eclipse Vert.x を使用して Spring Boot でリアクティブ SMTP メールサービスを作成します。

前提条件

- JDK 8 または JDK 11 がインストールされている。

- Maven がインストールされている。

- Spring Boot を使用するよう設定されたMaven ベースのアプリケーションプロジェクト

- マシンに設定された SMTP メールサーバー

手順

vertx-spring-boot-starter-httpおよびvertx-spring-boot-starter-mailをプロジェクトのpom.xmlファイルに依存関係として追加します。pom.xml<project> ... <dependencies> ... <dependency> <groupId>dev.snowdrop</groupId> <artifactId>vertx-spring-boot-starter-http</artifactId> </dependency> <dependency> <groupId>dev.snowdrop</groupId> <artifactId>vertx-spring-boot-starter-mail</artifactId> </dependency> ... <dependencies> ... </project>アプリケーションのメールハンドラークラスを作成します。

MailHandler.javapackage dev.snowdrop.vertx.sample.mail; import dev.snowdrop.vertx.mail.MailClient; import dev.snowdrop.vertx.mail.MailMessage; import dev.snowdrop.vertx.mail.SimpleMailMessage; import org.springframework.stereotype.Component; import org.springframework.util.MultiValueMap; import org.springframework.web.reactive.function.server.ServerRequest; import org.springframework.web.reactive.function.server.ServerResponse; import reactor.core.publisher.Mono; import static org.springframework.web.reactive.function.server.ServerResponse.noContent; @Component public class MailHandler { private final MailClient mailClient; public MailHandler(MailClient mailClient) { this.mailClient = mailClient; } public Mono<ServerResponse> send(ServerRequest request) { return request.formData() .log() .map(this::formToMessage) .flatMap(mailClient::send) .flatMap(result -> noContent().build()); } private MailMessage formToMessage(MultiValueMap<String, String> form) { return new SimpleMailMessage() .setFrom(form.getFirst("from")) .setTo(form.get("to")) .setSubject(form.getFirst("subject")) .setText(form.getFirst("text")); } }アプリケーションのメインクラスを作成します。

MailSampleApplication.javapackage dev.snowdrop.vertx.sample.mail; import org.springframework.boot.SpringApplication; import org.springframework.boot.autoconfigure.SpringBootApplication; import org.springframework.context.annotation.Bean; import org.springframework.core.io.ClassPathResource; import org.springframework.web.reactive.function.server.RouterFunction; import org.springframework.web.reactive.function.server.ServerResponse; import static org.springframework.http.MediaType.APPLICATION_FORM_URLENCODED; import static org.springframework.web.reactive.function.server.RequestPredicates.accept; import static org.springframework.web.reactive.function.server.RouterFunctions.resources; import static org.springframework.web.reactive.function.server.RouterFunctions.route; @SpringBootApplication public class MailSampleApplication { public static void main(String[] args) { SpringApplication.run(MailSampleApplication.class, args); } @Bean public RouterFunction<ServerResponse> mailRouter(MailHandler mailHandler) { return route() .POST("/mail", accept(APPLICATION_FORM_URLENCODED), mailHandler::send) .build(); } @Bean public RouterFunction<ServerResponse> staticResourceRouter() { return resources("/**", new ClassPathResource("static/")); } }application.propertiesファイルを作成して、SMTP サーバー認証情報を保存します。application.propertiesvertx.mail.host=YOUR_SMTP_SERVER_HOSTNAME vertx.mail.username=YOUR_SMTP_SERVER_USERNAME vertx.mail.password=YOUR_SMTP_SERVER_PASSWORD

-

アプリケーションのフロントエンドとして機能する

src/main/resources/static/index.htmlファイルを作成します。または、この手順で使用できる HTML メールフォームの例 を使用してください。 オプション: アプリケーションをローカルで実行し、テストします。

Maven プロジェクトのルートディレクトリーへ移動します。

$ cd myApp

アプリケーションをパッケージ化します。

$ mvn clean package

コマンドラインからアプリケーションを起動します。

$ java -jar target/vertx-spring-boot-sample-mail.jar

-

Web ブラウザーを使用して

http://localhost:8080/index.htmlに移動し、メールフォームにアクセスします。

その他のリソース

- RHEL 7 で SMTP メールサーバーを設定する方法は、RHEL 7 ドキュメントの Mail Transport Agent Configuration セクションを参照してください。

- Fabric8 Maven プラグインを使用して、アプリケーションを OpenShift クラスターにデプロイ できます。

- また、スタンドアロンの Red Hat Enterprise Linux でのデプロイメント 用にアプリケーションを設定することもできます。

5.7. サーバー向けイベント

サーバー送信イベント (SSE) は、HTTP サーバーがクライアントに単方向の更新を送信できるようにするプッシュテクノロジーです。SSE は、イベントソースとクライアント間の接続を確立することで機能します。イベントソースはこの接続を使用してイベントをクライアント側にプッシュします。サーバーがイベントをプッシュした後、接続は開いたままになり、後続のイベントをプッシュするのに使用できます。クライアントがサーバー上のリクエストを終了すると、接続は閉じられます。SSE は、クライアントが更新のためにイベントソースをポーリングするたびに新しい接続を確立する必要があるポーリングの代替手段を表します。WebSocket とは対照的に、SSE は 1 つの方向でイベントをプッシュします (つまり、ソースからクライアントへ)。イベントソースとクライアント間の双方向通信を処理しません。

SSE の指定は HTML5 に組み込まれており、レガシーバージョンを含む Web ブラウザーで広くサポートされます。SSE はコマンドラインから使用でき、他のプロトコルと比較してセットアップが比較的簡単です。

SSE は、サーバーからクライアントに頻繁に更新を必要とするユースケースに適していますが、クライアント側からサーバーへの更新の頻度は低くなることが予想されます。クライアント側からサーバーへの更新は、REST などの別のプロトコルで処理できます。このようなユースケースの例には、新規ファイルがファイルサーバーにアップロードされる時に、ソーシャルメディアフィードの更新やクライアントに送信される通知が含まれます。

5.8. リアクティブ Spring Boot アプリケーションでのサーバー送信イベントの使用

HTTP リクエストを受け入れ、サーバー送信イベント (SSE) のストリームを返す単純なサービスを作成します。クライアントがサーバーへの接続を確立し、ストリーミングを開始すると、接続は開いたままになります。サーバーは接続を再利用して、新しいイベントをクライアントに継続的にプッシュします。リクエストをキャンセルすると、接続が閉じられてストリームが停止し、クライアントがサーバーの更新フォームの受信を停止させます。

前提条件

- JDK 8 または JDK 11 がインストールされている。

- Maven がインストールされている。

- Spring Boot を使用するよう設定されたMaven ベースのアプリケーションプロジェクト

手順

vertx-spring-boot-starter-httpをプロジェクトのpom.xmlファイルに依存関係として追加します。pom.xml<project> ... <dependencies> ... <dependency> <groupId>dev.snowdrop</groupId> <artifactId>vertx-spring-boot-starter-http</artifactId> </dependency> ... <dependencies> ... </project>アプリケーションのメインクラスを作成します。

SseExampleApplication.javapackage dev.snowdrop.vertx.sample.sse; import org.springframework.boot.SpringApplication; import org.springframework.boot.autoconfigure.SpringBootApplication; @SpringBootApplication public class SseSampleApplication { public static void main(String[] args) { SpringApplication.run(SseSampleApplication.class, args); } }アプリケーションのサーバー送信イベントコントローラークラスを作成します。この例では、クラスはランダムな整数のストリームを生成し、それらをターミナルアプリケーションに出力します。

SseController.javapackage dev.snowdrop.vertx.sample.sse; import java.time.Duration; import java.util.Random; import org.springframework.http.MediaType; import org.springframework.web.bind.annotation.GetMapping; import org.springframework.web.bind.annotation.RestController; import reactor.core.publisher.Flux; @RestController public class SseController { @GetMapping(produces = MediaType.TEXT_EVENT_STREAM_VALUE) public Flux<Integer> getRandomNumberStream() { Random random = new Random(); return Flux.interval(Duration.ofSeconds(1)) .map(i -> random.nextInt()) .log(); } }オプション: アプリケーションをローカルで実行し、テストします。

Maven プロジェクトのルートディレクトリーへ移動します。

$ cd myApp

アプリケーションをパッケージ化します。

$ mvn clean package

コマンドラインからアプリケーションを起動します。

$ java -jar target/vertx-spring-boot-sample-sse.jar

新しいターミナルウィンドウで、HTTP 要求を

localhostに発行します。サーバーから送信されたイベントコントローラーからランダムな整数の連続ストリームの受信を開始します。$ curl localhost:8080 data:-2126721954 data:-573499422 data:1404187823 data:1338766210 data:-666543077 ...

Ctrl+Cを押して HTTP 要求をキャンセルし、応答のストリームを終了します。

その他のリソース

- Fabric8 Maven プラグインを使用して、アプリケーションを OpenShift クラスターにデプロイ できます。

- また、スタンドアロンの Red Hat Enterprise Linux でのデプロイメント 用にアプリケーションを設定することもできます。

5.9. WebSocket プロトコル

WebSocket プロトコルは標準の HTTP 接続をアップグレードして、これを永続化し、その接続を使用してアプリケーションのクライアントとサーバーの間に特別にフォーマットされたメッセージを渡します。プロトコルは、TCP を介してクライアントとサーバー間で最初の接続を確立するためにハンドシェイクなどの HTTP に依存しますが、クライアントとサーバー間の通信に特別なメッセージ形式が使用されます。

標準の HTTP 接続、WebSocket 接続とは異なり、以下を実行します。

- 両方の方向でメッセージを送信するために使用できます。

- 最初の要求が完了した後も開いたままになります。

- メッセージで特別なフレーミングヘッダーを使用します。これにより、HTTP 要求内で HTTP 形式ではないメッセージペイロード (制御データなど) を送信できます。

その結果、WebSockets プロトコルは、必要なネットワークリソースを減らし、ネットワークタイムアウトが原因でサービスが失敗するリスクを減らしながら、標準の HTTP 接続の可能性を拡張します (HTTP Long Polling などのリアルタイムメッセージング機能を提供する代替方法と比較して)。

Websocket 接続は、デフォルトで、さまざまなオペレーティングシステムやハードウェアアーキテクチャー全体で現在利用可能なほとんどの Web ブラウザーでサポートされます。これにより、WebSocket は Web ブラウザーのみを使用するために接続できるクロスプラットフォームの Web ベースのアプリケーションを作成するのに適しています。

5.10. WebFlux をベースとしたリアクティブアプリケーションでの WebSocket の使用

以下の例は、Web ブラウザーを使用して接続できるバックエンドサービスを提供するアプリケーションで WebSocket プロトコルを使用する方法を示しています。Web ブラウザーを使用してアプリケーションの Web フロントエンド URL にアクセスすると、フロントエンドはバックエンドサービスへの WebSocket 接続を開始します。Web サイトで利用可能な Web フォームを使用して、WebSocket 接続を使用して、テキスト文字列としてフォーマットされた値をバックエンドサービスに送信できます。アプリケーションは、すべての文字を大文字に変換して受信した値を処理し、同じ WebSocket 接続を使用して結果をフロントエンドに送信します。

以下で設定される Reactive Stack で Spring を使用してアプリケーションを作成します。

- WebSocket ハンドラーを使用したバックエンド Java ベースのサービス

- HTML および JavaScript に基づく Web フロントエンド

前提条件

- Spring Boot を使用する Maven ベースの Java アプリケーションプロジェクト

- JDK 8 または JDK 11 がインストールされている。

- Maven がインストールされている。

手順:

vertx-spring-boot-starter-httpをアプリケーションプロジェクトのpom.xmlファイルに依存関係として追加します。pom.xml

... <dependencies> ... <dependency> <groupId>dev.snowdrop</groupId> <artifactId>vertx-spring-boot-starter-http</artifactId> </dependency> ... </dependencies> ...バックエンドアプリケーションコードが含まれるクラスファイルを作成します。

/src/main/java/webSocketSampleApplication.java

package dev.snowdrop.WebSocketSampleApplication; import java.util.Collections; import java.util.Map; import org.springframework.boot.SpringApplication; import org.springframework.boot.autoconfigure.SpringBootApplication; import org.springframework.context.annotation.Bean; import org.springframework.web.reactive.HandlerMapping; import org.springframework.web.reactive.handler.SimpleUrlHandlerMapping; import org.springframework.web.reactive.socket.WebSocketHandler; import org.springframework.web.reactive.socket.WebSocketMessage; import org.springframework.web.reactive.socket.WebSocketSession; import reactor.core.publisher.Flux; import reactor.core.publisher.Mono; @SpringBootApplication public class WebSocketSampleApplication { public static void main(String[] args) { SpringApplication.run(WebSocketSampleApplication.class, args); } @Bean public HandlerMapping handlerMapping() { // Define URL mapping for the socket handlers Map<String, WebSocketHandler> handlers = Collections.singletonMap("/echo-upper", this::toUppercaseHandler); SimpleUrlHandlerMapping handlerMapping = new SimpleUrlHandlerMapping(); handlerMapping.setUrlMap(handlers); // Set a higher precedence than annotated controllers (smaller value means higher precedence) handlerMapping.setOrder(-1); return handlerMapping; } private Mono<Void> toUppercaseHandler(WebSocketSession session) { Flux<WebSocketMessage> messages = session.receive() // Get incoming messages stream .filter(message -> message.getType() == WebSocketMessage.Type.TEXT) // Filter out non-text messages .map(message -> message.getPayloadAsText().toUpperCase()) // Execute service logic .map(session::textMessage); // Create a response message return session.send(messages); // Send response messages } }アプリケーションのフロントエンドとして機能する HTML ドキュメントを作成します。以下の例の

<script>要素には、アプリケーションのバックエンドとの通信を処理する JavaScript コードが含まれます。/src/main/resources/static/index.html

<!doctype html> <html> <head> <meta charset="utf-8"/> <title>WebSocket Example</title> <script> const socket = new WebSocket("ws://localhost:8080/echo-upper"); socket.onmessage = function(e) { console.log("Received a value: " + e.data); const messages = document.getElementById("messages"); const message = document.createElement("li"); message.innerHTML = e.data; messages.append(message); } window.onbeforeunload = function(e) { console.log("Closing socket"); socket.close(); } function send(event) { event.preventDefault(); const value = document.getElementById("value-to-send").value.trim(); if (value.length > 0) { console.log("Sending value to socket: " + value); socket.send(value); } } </script> </head> <body> <div> <h1>Vert.x Spring Boot WebSocket example</h1> <p> Enter a value to the form below and click submit. The value will be sent via socket to a backend service. The service will then uppercase the value and send it back via the same socket. </p> </div> <div> <form onsubmit="send(event)"> <input type="text" id="value-to-send" placeholder="A value to be sent"/> <input type="submit"/> </form> </div> <div> <ol id="messages"></ol> </div> </body> </html>オプション: アプリケーションをローカルで実行し、テストします。

Maven プロジェクトのルートディレクトリーへ移動します。

$ cd myApp

アプリケーションをパッケージ化します。

$ mvn clean package

コマンドラインからアプリケーションを起動します。

$ java -jar target/vertx-spring-boot-sample-websocket.jar

Web ブラウザーを使用して

http://localhost:8080/index.htmlに移動します。Web サイトには、次を含む Web インターフェイスが表示されます。- 入力テキストボックス

- 処理された結果のリスト

- Submit ボタン。

- テキストボックスに文字列値を入力して Submit を選択します。

- 入力テキストボックスの配下にあるリストで大文字でレンダリングされた値を確認します。

その他のリソース

- Fabric8 Maven プラグインを使用して、アプリケーションを OpenShift クラスターにデプロイ できます。

- また、スタンドアロンの Red Hat Enterprise Linux でのデプロイメント 用にアプリケーションを設定することもできます。

5.11. Advanced Message Queuing Protocol

Advanced Message Queuing Protocol (AMQP) は、ブロック以外の方法でアプリケーション間でメッセージを移動するために設計された通信プロトコルです。このプロトコルは AMQP 1.0 として標準化され、異なるネットワークトポロジーと環境における新しいアプリケーションとレガシーアプリケーションとの間の相互運用性とメッセージング統合を提供します。AMQP は複数のブローカーアーキテクチャーと連携し、さまざまな方法でメッセージの配信、受信、キューイング、およびルーティングを提供します。また、AMQP はブローカーを使用しない場合にピアツーピアも機能します。ハイブリッドクラウド環境では、AMQP を使用してさまざまな異なるメッセージ形式を処理することなく、サービスをレガシーアプリケーションに統合できます。AMQP はリアルタイムの非同期メッセージ処理機能をサポートするため、リアクティブアプリケーションでの使用に適しています。

5.12. AMQP リアクティブサンプルの仕組み

この例の機能があるメッセージング統合パターンは、2 つのキューとブローカーを持つ Publisher-Subscriber パターンです。

- Request キューは、テキスト文字列プロセッサーによって処理される Web インターフェイスを使用して入力する文字列を含む HTTP リクエストを保存します。

- Result キューは、Uppercase に変換され、表示される準備が整う文字列が含まれる応答を保存します。

アプリケーションで設定されるコンポーネントは、以下のとおりです。

- テキスト文字列をアプリケーションに送信するのに使用できるフロントエンドサービス。

- 文字列を大文字に変換するバックエンドサービス。

- Spring Boot HTTP Starter によって設定され、提供される HTTP コントローラー。

- 2 つのメッセージングキュー間でメッセージをルーティングする組み込み Artemis AMQP Broker インスタンス。

要求キューは、テキスト文字列を含むメッセージをフロントエンドからテキスト文字列プロセッサーサービスに渡します。処理用の文字列を送信する場合は、以下を行います。

-

フロントエンドサービスは、リクエストのペイロードとして文字列を含む HTTP

POSTリクエストを HTTP コントローラーに送信します。 - リクエストは、AMQP ブローカーへメッセージをルーティングするメッセージングマネージャーによって選択されます。

- ブローカーはメッセージをテキスト文字列プロセッサーサービスにルーティングします。テキストプロセッサーサービスがリクエストを取得できない場合には、このようなインスタンスが利用可能な場合、ブローカーはメッセージを次の利用可能なプロセッサーインスタンスにルーティングします。または、ブローカーは、再度利用可能になったときに、同じインスタンスにリクエストを再送信するまで待機します。

- テキスト文字列プロセッサーサービスはメッセージを取得して、文字列の文字を大文字に変換します。プロセッサーサービスは処理済みのリクエストを大文字で AMQP ブローカーに送信します。

- AMQP ブローカーは、処理された結果とともにリクエストをメッセージングマネージャーにルーティングします。

- メッセージングマネージャーは、処理済みのリクエストを、フロントエンドサービスがアクセスできる送信キューに格納します。

応答キューは、文字列プロセッサーサービスによって処理される結果が含まれる HTTP 応答を保存します。フロントエンドアプリケーションは、このキューを一定間隔でポーリングして結果を取得します。処理された結果が表示される準備が整ったら、以下を行います。

-

フロントエンドサービスは、HTTP

GETリクエストを Spring Boot HTTP Starter によって提供される HTTP コントローラーに送信します。 - HTTP コントローラーはリクエストをメッセージングマネージャーにルーティングします。

-

フロントエンドによって以前に送信されたリクエストが処理の準備ができ、送信キューで利用可能な場合、メッセージングマネージャーは結果を HTTP

GETリクエストとして HTTP コントローラーに送信します。 - HTTP コントローラーは、応答をフロントエンドサービスにルーティングし、結果を表示します。

5.13. リアクティブアプリケーションでの AMQP の使用

Spring Boot HTTP コントローラーで AMQP Client Starter を使用して、簡易メッセージングリアクティブアプリケーションを開発します。このサンプルアプリケーションは、2 つのメッセージングキューとブローカーを使用する Publisher-Subscriber メッセージング統合パターンで 2 つのサービスを統合します。

この例は、AMQP メッセージングを使用して統合された 2 つのサービスで設定される Reactor Netty 上の Spring Boot および Eclipse Vert.x で基本的なアプリケーションを作成する方法を示しています。アプリケーションは以下のコンポーネントで設定されます。

- テキスト文字列をアプリケーションに送信するために使用できるフロントエンドサービス

- 文字列を大文字に変換するバックエンドサービス

- サービス間でマッサージをルーティングし、要求キューと応答キューを管理する Artemis AMQP ブローカー。

- Spring Boot HTTP Starter によって提供される HTTP コントローラー

前提条件

- Spring Boot を使用するよう設定された Maven ベースの Java アプリケーションプロジェクト

- JDK 8 または JDK 11 がインストールされている。

- Maven がインストールされている。

手順

以下の依存関係をアプリケーションプロジェクトの

pom.xmlファイルに追加します。pom.xml

... <dependencies> ... <dependency> <groupId>dev.snowdrop</groupId> <artifactId>vertx-spring-boot-starter-http</artifactId> </dependency> <dependency> <groupId>dev.snowdrop</groupId> <artifactId>vertx-spring-boot-starter-amqp</artifactId> </dependency> <dependency> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-artemis</artifactId> </dependency> <dependency> <groupId>org.apache.activemq</groupId> <artifactId>artemis-jms-server</artifactId> </dependency> <dependency> <groupId>org.apache.activemq</groupId> <artifactId>artemis-amqp-protocol</artifactId> <exclusions> <exclusion> <groupId>org.apache.qpid</groupId> <artifactId>proton-j</artifactId> </exclusion> </exclusions> </dependency> ... </dependencies> ...サンプルアプリケーションのメインクラスファイルを作成します。このクラスには、要求と結果に対応する処理キューを定義するメソッドが含まれています。

/src/main/java/AmqpExampleApplication.java

package dev.snowdrop.AmqpExampleApplication.java; import java.util.HashMap; import java.util.Map; import dev.snowdrop.vertx.amqp.AmqpProperties; import org.apache.activemq.artemis.api.core.TransportConfiguration; import org.apache.activemq.artemis.core.remoting.impl.netty.NettyAcceptorFactory; import org.springframework.boot.SpringApplication; import org.springframework.boot.autoconfigure.SpringBootApplication; import org.springframework.boot.autoconfigure.jms.artemis.ArtemisConfigurationCustomizer; import org.springframework.context.annotation.Bean; @SpringBootApplication public class AmqpExampleApplication { final static String PROCESSING_REQUESTS_QUEUE = "processing-requests"; final static String PROCESSING_RESULTS_QUEUE = "processing-results"; public static void main(String[] args) { SpringApplication.run(AmqpExampleApplication.class, args); } /** * Add Netty acceptor to the embedded Artemis server. */ @Bean public ArtemisConfigurationCustomizer artemisConfigurationCustomizer(AmqpProperties properties) { Map<String, Object> params = new HashMap<>(); params.put("host", properties.getHost()); params.put("port", properties.getPort()); return configuration -> configuration .addAcceptorConfiguration(new TransportConfiguration(NettyAcceptorFactory.class.getName(), params)); } }GET および POST リクエストを処理する REST エンドポイントを公開して、要求キューと応答キューを管理する HTTP REST コントローラーのコードを含むクラスファイルを作成します。

/src/main/java/Controller.java

package dev.snowdrop.vertx.sample.amqp; import org.springframework.web.bind.annotation.GetMapping; import org.springframework.web.bind.annotation.PostMapping; import org.springframework.web.bind.annotation.RequestBody; import org.springframework.web.bind.annotation.RestController; import reactor.core.publisher.Flux; import reactor.core.publisher.Mono; import static org.springframework.http.MediaType.TEXT_EVENT_STREAM_VALUE; /** * Rest controller exposing GET and POST resources to receive processed messages and submit messages for processing. */ @RestController public class Controller { private final MessagesManager messagesManager; public Controller(MessagesManager messagesManager) { this.messagesManager = messagesManager; } /** * Get a flux of messages processed up to this point. */ @GetMapping(produces = TEXT_EVENT_STREAM_VALUE) public Flux<String> getProcessedMessages() { return Flux.fromIterable(messagesManager.getProcessedMessages()); } /** * Submit a message for processing by publishing it to a processing requests queue. */ @PostMapping public Mono<Void> submitMessageForProcessing(@RequestBody String body) { return messagesManager.processMessage(body.trim()); } }メッセージングマネージャーを含むクラスファイルを作成します。Manager は、アプリケーションコンポーネントがリクエストキューにリクエストを公開する方法を制御し、その後に応答キューにサブスクライブして処理された結果を取得します。

/src/main/java/MessagesManager.java:

package dev.snowdrop.vertx.sample.amqp; import java.util.List; import java.util.concurrent.CopyOnWriteArrayList; import dev.snowdrop.vertx.amqp.AmqpClient; import dev.snowdrop.vertx.amqp.AmqpMessage; import dev.snowdrop.vertx.amqp.AmqpSender; import org.apache.activemq.artemis.core.server.embedded.EmbeddedActiveMQ; import org.slf4j.Logger; import org.slf4j.LoggerFactory; import org.springframework.beans.factory.DisposableBean; import org.springframework.beans.factory.InitializingBean; import org.springframework.stereotype.Component; import reactor.core.Disposable; import reactor.core.publisher.Mono; import static dev.snowdrop.vertx.sample.amqp.AmqpSampleApplication.PROCESSING_REQUESTS_QUEUE; import static dev.snowdrop.vertx.sample.amqp.AmqpSampleApplication.PROCESSING_RESULTS_QUEUE; /** * Processor client submits messages to the requests queue and subscribes to the results queue for processed messages. */ @Component public class MessagesManager implements InitializingBean, DisposableBean { private final Logger logger = LoggerFactory.getLogger(MessagesManager.class); private final List<String> processedMessages = new CopyOnWriteArrayList<>(); private final AmqpClient client; private Disposable receiverDisposer; // Injecting EmbeddedActiveMQ to make sure it has started before creating this component. public MessagesManager(AmqpClient client, EmbeddedActiveMQ server) { this.client = client; } /** * Create a processed messages receiver and subscribe to its messages publisher. */ @Override public void afterPropertiesSet() { receiverDisposer = client.createReceiver(PROCESSING_RESULTS_QUEUE) .flatMapMany(receiver -> receiver.flux() .doOnCancel(() -> receiver.close().block())) // Close the receiver once subscription is disposed .subscribe(this::handleMessage); } /** * Cancel processed messages publisher subscription. */ @Override public void destroy() { if (receiverDisposer != null) { receiverDisposer.dispose(); } } /** * Get messages which were processed up to this moment. * * @return List of processed messages. */ public List<String> getProcessedMessages() { return processedMessages; } /** * Submit a message for processing by publishing it to a processing requests queue. * * @param body Message body to be processed. * @return Mono which is completed once the message is sent. */ public Mono<Void> processMessage(String body) { logger.info("Sending message '{}' for processing", body); AmqpMessage message = AmqpMessage.create() .withBody(body) .build(); return client.createSender(PROCESSING_REQUESTS_QUEUE) .map(sender -> sender.send(message)) .flatMap(AmqpSender::close); } private void handleMessage(AmqpMessage message) { String body = message.bodyAsString(); logger.info("Received processed message '{}'", body); processedMessages.add(body); } }要求キューからテキスト文字列を受け取る大文字プロセッサーを含むクラスファイルを作成し、それを大文字に変換します。その後、プロセッサーは結果を応答キューに公開します。

/src/main/java/UppercaseProcessor.java

package dev.snowdrop.vertx.sample.amqp; import dev.snowdrop.vertx.amqp.AmqpClient; import dev.snowdrop.vertx.amqp.AmqpMessage; import dev.snowdrop.vertx.amqp.AmqpSender; import org.apache.activemq.artemis.core.server.embedded.EmbeddedActiveMQ; import org.slf4j.Logger; import org.slf4j.LoggerFactory; import org.springframework.beans.factory.DisposableBean; import org.springframework.beans.factory.InitializingBean; import org.springframework.stereotype.Component; import reactor.core.Disposable; import reactor.core.publisher.Mono; import static dev.snowdrop.vertx.sample.amqp.AmqpSampleApplication.PROCESSING_REQUESTS_QUEUE; import static dev.snowdrop.vertx.sample.amqp.AmqpSampleApplication.PROCESSING_RESULTS_QUEUE; /** * Uppercase processor subscribes to the requests queue, converts each received message to uppercase and send it to the * results queue. */ @Component public class UppercaseProcessor implements InitializingBean, DisposableBean { private final Logger logger = LoggerFactory.getLogger(UppercaseProcessor.class); private final AmqpClient client; private Disposable receiverDisposer; // Injecting EmbeddedActiveMQ to make sure it has started before creating this component. public UppercaseProcessor(AmqpClient client, EmbeddedActiveMQ server) { this.client = client; } /** * Create a processing requests receiver and subscribe to its messages publisher. */ @Override public void afterPropertiesSet() { receiverDisposer = client.createReceiver(PROCESSING_REQUESTS_QUEUE) .flatMapMany(receiver -> receiver.flux() .doOnCancel(() -> receiver.close().block())) // Close the receiver once subscription is disposed .flatMap(this::handleMessage) .subscribe(); } /** * Cancel processing requests publisher subscription. */ @Override public void destroy() { if (receiverDisposer != null) { receiverDisposer.dispose(); } } /** * Convert the message body to uppercase and send it to the results queue. */ private Mono<Void> handleMessage(AmqpMessage originalMessage) { logger.info("Processing '{}'", originalMessage.bodyAsString()); AmqpMessage processedMessage = AmqpMessage.create() .withBody(originalMessage.bodyAsString().toUpperCase()) .build(); return client.createSender(PROCESSING_RESULTS_QUEUE) .map(sender -> sender.send(processedMessage)) .flatMap(AmqpSender::close); } }オプション: アプリケーションをローカルで実行し、テストします。

Maven プロジェクトのルートディレクトリーへ移動します。

$ cd myApp

アプリケーションをパッケージ化します。

$ mvn clean package

コマンドラインからアプリケーションを起動します。

$ java -jar target/vertx-spring-boot-sample-amqp.jar

新しいターミナルウィンドウで、

localhostへ処理されるテキスト文字列が含まれる HTTPPOSTリクエストを多数送信します。$ curl -H "Content-Type: text/plain" -d 'Hello, World' -X POST http://localhost:8080 $ curl -H "Content-Type: text/plain" -d 'Hello again' -X POST http://localhost:8080

HTTP

GET要求をlocalhostに送信します。文字列を大文字で HTTP 応答を受け取ります。$ curl http://localhost:8080 HTTP/1.1 200 OK Content-Type: text/event-stream;charset=UTF-8 transfer-encoding: chunked data:HELLO, WORLD data:HELLO AGAIN

その他のリソース

- Fabric8 Maven プラグインを使用して、アプリケーションを OpenShift クラスターにデプロイ できます。

- また、スタンドアロンの Red Hat Enterprise Linux でのデプロイメント 用にアプリケーションを設定することもできます。

5.14. Apache Kafka

Apache Kafka は、プロセス、アプリケーション、およびサービスの間でメッセージを交換するために設計されたスケーラブルなメッセージング統合システムです。Kafka は、トピックのセットを維持する 1 つ以上のブローカーを持つクラスターを基にします。基本的に、トピックは、トピック ID を使用してすべてのクラスターに定義できるカテゴリーです。各トピックには、アプリケーション内で行うイベントに関する情報が含まれるレコードと呼ばれるデータの一部が含まれています。システムに接続されているアプリケーションは、これらのトピックにレコードを追加したり、先に追加したメッセージを処理したり、再処理したりできます。

ブローカーは、クライアントアプリケーションとの通信を処理し、トピックでレコードを管理します。レコードが失われないように、ブローカーはコミットログのすべてのレコードを追跡し、各アプリケーションのオフセット値を追跡します。オフセットは、最後に追加したレコードを示すポインターと似ています。

アプリケーションは、トピックから最新のレコードをプルするか、オフセットを変更して以前のメッセージが追加されたレコードを読み取ることができます。この機能は、クライアントアプリケーションがリアルタイムで処理できない場合に、着信要求に圧倒されるのを防ぎます。これが発生した場合、Kafka は、リアルタイムで処理できないレコードをコミットログに保存することにより、データの損失を防ぎます。クライアントアプリケーションが着信要求に追いつくことができると、リアルタイムでレコードの処理を再開します

ブローカーは、トピックパーティションに分類することで、複数のトピックのレコードを管理できます。Apache Kafka はこれらのパーティションを複製して、単一のトピックからのレコードを複数のブローカーで並行して処理できるようにし、アプリケーションがトピック内のレコードを処理する速度をスケーリングできるようにします。レプリケートされたトピックパーティション (別名フォロワー) は、レコード処理の冗長性を回避するために、元のトピックパーティション (別名 Leader) と同期します。新しいレコードが Leader パーティションにコミットされ、フォロワーはリーダーに加えられた変更のみを複製します。

5.15. Apache Kafka reactive サンプルの仕組み

このサンプルアプリケーションは、Apache Kafka を使用して実装された Publisher-Subscriber メッセージストリーミングパターンに基づいています。アプリケーションで設定されるコンポーネントは、以下のとおりです。

-

ログメッセージプロデューサーおよびコンシューマーをインスタンス化する

KafkaExampleApplicationクラス - Spring Boot HTTP Starter によって設定され、提供される WebFlux HTTP コントローラー。コントローラーは、メッセージの公開および読み取りに使用される残りのリソースを提供します。

-

プロデューサーが Kafka の

logトピックにメッセージを公開する方法を定義するKafkaLoggerクラス。 -

Kafka の

logトピックからサンプルアプリケーションが受け取るメッセージを表示するKafkaLogクラス。

メッセージを公開します。

- ログメッセージをペイロードとして使用して、サンプルアプリケーションに対して HTTP POST 要求を実行します。

- HTTP コントローラーはメッセージを公開するのに使用される REST エンドポイントにルーティングし、そのメッセージをロガーインスタンスに渡します。

-

HTTP コントローラーは、受け取ったメッセージを Kafka の

logトピックに公開します。 - KafkaLog インスタンスは、Kafka トピックからログメッセージを受け取ります。

メッセージの読み取り:

-

HTTP

GETリクエストをサンプルアプリケーション URL に送信します。 -

コントローラーは

KafkaLogインスタンスからメッセージを取得し、HTTP 応答のボディーとして返します。

5.16. リアクティブアプリケーションでの Kafka の使用

この例は、Reactor Netty 上の Spring Boot および Eclipse Vert.x で Apache Kafka を使用するメッセージングアプリケーションのサンプルを作成する方法を示しています。アプリケーションはメッセージを Kafka トピックに公開してから、リクエストの送信時にメッセージを取得して表示します。

Kafka クラスターによって使用されるメッセージトピック、URL、およびメタデータの Kafka 設定プロパティーは src/main/resources/application.yml に保存されます。

前提条件

- Spring Boot を使用するよう設定された Maven ベースの Java アプリケーションプロジェクト

- JDK 8 または JDK 11 がインストールされている。

- Maven がインストールされている。

手順

WebFlux HTTP Starter および Apache Kafka Starter をアプリケーションプロジェクトの

pom.xmlファイルに依存関係として追加します。pom.xml

... <dependencies> ... <!-- Vert.x WebFlux starter used to handle HTTP requests --> <dependency> <groupId>dev.snowdrop</groupId> <artifactId>vertx-spring-boot-starter-http</artifactId> </dependency> <!-- Vert.x Kafka starter used to send and receive messages to/from Kafka cluster --> <dependency> <groupId>dev.snowdrop</groupId> <artifactId>vertx-spring-boot-starter-kafka</artifactId> </dependency> ... </dependencies> ...

KafkaLoggerクラスを作成します。このクラスはプロデューサーと sendas メッセージを機能させます。KafkaLoggerクラスは、Producer がメッセージ (別名レコード) をトピックに公開する方法を定義します。/src/main/java/KafkaLogger.java

... final class KafkaLogger { private final KafkaProducer<String, String> producer; KafkaLogger(KafkaProducer<String, String> producer) { this.producer = producer; } public Mono<Void> logMessage(String body) { // Generic key and value types can be inferred if both key and value are used to create a builder ProducerRecord<String, String> record = ProducerRecord.<String, String>builder(LOG_TOPIC, body).build(); return producer.send(record) .log("Kafka logger producer") .then(); } } ...KafkaLogクラスを作成します。このクラスは、kafka メッセージのコンシューマーとして機能します。KafkaLogは、トピックからメッセージを取得してターミナルに表示されるメッセージを取得します。/src/main/java/KafkaLog.java

... final class KafkaLog implements InitializingBean, DisposableBean { private final List<String> messages = new CopyOnWriteArrayList<>(); private final KafkaConsumer<String, String> consumer; private Disposable consumerDisposer; KafkaLog(KafkaConsumer<String, String> consumer) { this.consumer = consumer; } @Override public void afterPropertiesSet() { consumerDisposer = consumer.subscribe(LOG_TOPIC) .thenMany(consumer.flux()) .log("Kafka log consumer") .map(ConsumerRecord::value) .subscribe(messages::add); } @Override public void destroy() { if (consumerDisposer != null) { consumerDisposer.dispose(); } consumer.unsubscribe() .block(Duration.ofSeconds(2)); } public List<String> getMessages() { return messages; } } ...HTTP REST コントローラーが含まれるクラスファイルを作成します。アプリケーションがメッセージのロギングや読み取りを処理するために使用する REST リソースを公開するコントローラー。

/src/main/java/Controller.java

package dev.snowdrop.vertx.sample.kafka; import org.springframework.web.bind.annotation.GetMapping; import org.springframework.web.bind.annotation.PostMapping; import org.springframework.web.bind.annotation.RequestBody; import org.springframework.web.bind.annotation.RestController; import reactor.core.publisher.Flux; import reactor.core.publisher.Mono; import static org.springframework.http.MediaType.TEXT_EVENT_STREAM_VALUE; /** * HTTP controller exposes GET and POST resources to log messages and to receive the previously logged ones. */ @RestController public class Controller { private final KafkaLogger logger; private final KafkaLog log; public Controller(KafkaLogger logger, KafkaLog log) { this.logger = logger; this.log = log; } /** * Get a Flux of previously logged messages. */ @GetMapping(produces = TEXT_EVENT_STREAM_VALUE) public Flux<String> getMessages() { return Flux.fromIterable(log.getMessages()); } /** * Log a message. */ @PostMapping public Mono<Void> logMessage(@RequestBody String body) { return logger.logMessage(body.trim()); } }Apache Kafka Cluster のプロデューサーおよびコンシューマーが使用する URL が含まれる YAML テンプレートを作成して、メッセージのログおよび読み取りを行います。この例では、Apache Kafka Cluster のコンシューマーおよびプロデューサーは、デフォルトで

localhostでポート9092を使用して通信します。以下の例に示すように、プロデューサーとコンシューマーを個別に設定する必要があります。/src/main/resources/application.yml

vertx: kafka: producer: bootstrap: # The producer in your cluster uses this URL to publish messages to the log. servers: localhost:9092 key: # This class assigns the mandatory key attribute that is assigned to each message. serializer: org.apache.kafka.common.serialization.StringSerializer value: # This class assigns the mandatory value attribute that is assigned to each message. serializer: org.apache.kafka.common.serialization.StringSerializer consumer: bootstrap: servers: localhost:9092 # The consumer in your cluster uses this URL to read messages from the log. group: id: log # The consumer group IDs used to define a group of consumers that subscribe to the same topic. In this example, all consumers belong in the same consumer group. key: deserializer: org.apache.kafka.common.serialization.StringDeserializer # This class generates the mandatory key attribute that is assigned to each message. value: deserializer: org.apache.kafka.common.serialization.StringDeserializer # This class generates the mandatory value attribute that is assigned to each message.オプション: アプリケーションをローカルで実行し、テストします。

Maven プロジェクトのルートディレクトリーへ移動します。

$ cd vertx-spring-boot-sample-kafka

アプリケーションをパッケージ化します。

$ mvn clean package

コマンドラインからアプリケーションを起動します。

$ java -jar target/vertx-spring-boot-sample-kafka.jar

新しいターミナルウィンドウで、テキスト文字列としてフォーマットされたメッセージが含まれる HTTP

POSTリクエストをlocalhostに送信します。メッセージはすべてlogトピックに公開されます。$ curl -H "Content-Type: text/plain" -d 'Hello, World' -X POST http://localhost:8080 $ curl -H "Content-Type: text/plain" -d 'Hello again' -X POST http://localhost:8080 ...

HTTP

GET要求をlocalhostに送信します。コンシューマーがサブスクライブするトピック内の全メッセージが含まれる HTTP 応答を受け取ります。$ curl http://localhost:8080 HTTP/1.1 200 OK Content-Type: text/event-stream;charset=UTF-8 transfer-encoding: chunked data:Hello, World data:Hello, again ...

その他のリソース

- Fabric8 Maven プラグインを使用して、アプリケーションを OpenShift クラスターにデプロイ できます。

- また、スタンドアロンの Red Hat Enterprise Linux でのデプロイメント 用にアプリケーションを設定することもできます。

サンプルを使用 する他に、Eclipse Vert.x と Spring Boot を使用して、ゼロから新しい Spring Boot アプリケーションを作成し、それらを OpenShift にデプロイすることもできます。

第6章 Spring Boot アプリケーションでの Dekorate の使用

6.1. Dekorate の概要

Dekorate は、Red Hat ビルドの Spring Boot で提供される compile-time アノテーションパーサーおよびアプリケーションリソースジェネレーターのコレクションです。これは、アプリケーションをビルドして設定プロパティーを抽出する際に、コードでアノテーションを解析することで機能します。次に、Dekorate は、展開したプロパティーの値を使用して、アプリケーションを Kubernetes または OpenShift クラスターにデプロイするために使用できるアプリケーション設定リソースを生成します。

開発者は、コードにアノテーションを付けた後に Dekorate を使用してアプリケーションのビルド時にアプリケーションマニフェストを自動的に生成できます。これにより、アプリケーションをデプロイするためのリソースファイルを手動で作成する必要がなくなります。アプリケーションが、Spring Boot などのリッチアプリケーションのランタイムフレームワークに基づいていると、Spring Boot、Dokorate はフレームワークと直接統合でき、フレームワークによって提供される API から設定パラメーターを抽出できるため、コードにアノテーションを付ける必要がなくなります。Dekorate は、以下を使用してアプリケーションを自動的に設定できます。

- マニフェストファイルの設定に使用される値およびメタデータを取得するためにアプリケーションコードで Dekorate 固有のアノテーションを解析します。

-

application.properties、application.yamlなどの設定リソースから情報の抽出 -

リッチアプリケーションフレームワークから必要なメタデータを取得し、

application.propertiesファイルまたはapplication.ymlファイルから設定値を展開します。

アプリケーションのリソース定義の生成に加え、Dekorate はビルドフックを生成することもできます。これにより、OpenShift クラスターの Dekorate でアプリケーションをビルドおよびデプロイできます。これは、アプリケーションを作成する言語とは独立して機能し、幅広いビルドシステムで使用できます。Dekorate は、Maven BOM として配布されるライブラリーのセットで設定されます。ライブラリーをアプリケーションプロジェクトの依存関係として追加し、アプリケーションと Dekorate を使用することができます。

Red Hat は、Dekorate を使用したリソースファイルの生成およびビルドフックのサポートを提供します。このフックは、Spring Boot をベースとした Java アプリケーションを Apache Maven で OpenShift Container Platform にデプロイするために使用できます。

6.2. Dekorate を使用するようにアプリケーションプロジェクトを設定します。

Dekorate BOM および OpenShift Annotations Starter をアプリケーションプロジェクトの pom.xml ファイルに追加します。基本的なアノテーションをソースファイルに追加し、Maven でアプリケーションをパッケージ化してアプリケーションマニフェストを生成します。

前提条件

- Spring Bootを使用するよう設定された Maven ベースのアプリケーションプロジェクト

- Spring Boot を使用する Java ベースのアプリケーション

- Java JDK 8 または JDK 11 がインストールされている。

- Maven がインストールされている。

手順

OpenShift アノテーション Starter をアプリケーションの

pom.xmlファイルに追加します。<project> ... <dependencies> ... <dependency> <groupId>io.dekorate</groupId> <artifactId>openshift-annotations</artifactId> </dependency> <dependency> <groupId>io.dekorate</groupId> <artifactId>openshift-spring-starter</artifactId> </dependency> ... </dependencies> ... <project>@Dekorateアノテーションをアプリケーションプロジェクトのソースファイルに追加します。package org.acme; import io.dekorate.annotation.Dekorate; @Dekorate public class Application { }アプリケーションをパッケージ化します。

mvn clean package

-

生成されたアプリケーションテンプレートファイルを含む

target/classes/META-INF/dekorateディレクトリーに移動します。

6.3. Dekorate を使用したアプリケーション設定のカスタマイズ

Dekorate を使用して、OpenShift でのデプロイメント用にアプリケーションの設定をカスタマイズします。

- アプリケーションのソースのアノテーションで設定パラメーターを指定

-

application.propertiesファイルでのプロパティーの設定

以下の例は、OpenShift へのデプロイ時に 2 つのレプリカで始まるようにアプリケーションを設定する方法を示しています。

前提条件

- Spring Boot および Dekorate を使用するよう設定された Maven ベースのアプリケーションプロジェクト

- Spring Boot を使用する Java ベースのアプリケーション

- Java JDK 8 または JDK 11 がインストールされている。

- Maven がインストールされている。

手順

Dekorate OpenShift Annotations モジュールを、アプリケーションの

pom.xmlファイルの依存関係として追加します。<project> ... <dependencies> ... <dependency> <groupId>io.dekorate</groupId> <artifactId>openshift-annotations</artifactId> </dependency> ... </dependencies> ... <project>OpenShift へのデプロイ時に、アプリケーションが開始するデフォルトのレプリカ数を設定します。

@OpenshiftApplicationアノテーションをアプリケーションのメインソースファイルに追加し、レプリカの数を2に指定します。package org.acme; import io.dekorate.openshift.annotation.OpenshiftApplication; // include the parameter for the number of replicas to @OpenshiftApplication(replicas=2) public class Application { }または、アプリケーションの

application.propertiesファイルにdekorate.openshift.replicas=2プロパティーを設定します。/src/main/resources/application.properties

dekorate.openshift.replicas=2

アプリケーションをパッケージ化します。

mvn clean package

target/classes/META-INF/dekorateに移動して、Dekorate によって生成されたテンプレートを表示します。デプロイメント設定 YAML テンプレートのレプリカ数は 2 に設定されます。... spec: replicas: 2 selector: matchLabels: app: acme ...

6.4. Spring Boot アプリケーションでのアノテーションレス設定の使用

Dekorate を使用して、application.properties ファイルおよび application.yml ファイルから dekorate 設定プロパティーを抽出して、Spring Boot アプリケーションプロジェクトの OpenShift リソース設定ファイルを生成します。Dekorate は、Spring Boot から必要なメタデータとプロパティーファイルから設定パラメーターを取得できるため、このメソッドにはアプリケーションソースにアノテーションを付ける必要はありません。アノテーションのない設定は、Spring Boot と Dekorate の間のリッチフレームワーク統合機能です。

前提条件

- Spring Boot および Dekorate を使用するよう設定された Maven ベースのアプリケーションプロジェクト

-

@SpringBootApplicationアノテーションが付けられたアプリケーションプロジェクトの 1 つ以上のクラス。 - Java JDK 8 または JDK 11 がインストールされている。

- Maven がインストールされている。

手順

アプリケーションの

pom.xmlファイルに以下の依存関係を追加します。<project> ... <dependencies> ... <!-- The OpenShift Spring Starter automatically adds "io.dekorate:openshift-annotations" as a transitive dependency --> <dependency> <groupId>io.dekorate</groupId> <artifactId>openshfit-spring-starter</artifactId> </dependency> ... </dependencies> ... <project>-

Dekorate 設定プロパティーをプロジェクトの

application.propertiesファイルまたはapplication.ymlファイルに追加します。Dekorate プロパティーアノテーションをソースファイルに追加する必要はありません。ソースファイルのアノテーションを使用できますが、これを行う場合は、アノテーションで提供されるパラメーターをapplication.propertiesファイルまたはapplication.ymlファイルにあるパラメーターで上書きします。 アプリケーションをパッケージ化します。

mvn clean package

アプリケーションの Dekorate をビルドすると、アプリケーションプロジェクト内の以下のリソースの設定が解析されます。設定リソースは優先順に解析されます。つまり、異なるタイプの 2 つの異なるリソースが同じ設定パラメーターに異なる値を持っている場合、Dekorate は優先度のリストにあるリソースから取得した値を使用します。たとえば、ソースのアノテーションでパラメーター値が指定されていても、

application.ymlの同じパラメーターに別の値が指定されている場合、Dekorate はapplication.ymlの取得形式を使用します。Dekorate は、以下の優先順位でプロジェクトリソースを解析します。- アノテーション

-

application.properties -

application.yaml -

application.yml

-

生成された

application.jsonまたはapplication.ymlマニフェストファイルを含むtarget/classes/META-INF/dekorateディレクトリーに移動します。

6.5. Dekorate を使用した OpenShift Source-to-Image ビルドの自動実行

Maven でアプリケーションをコンパイルした後に、Dekorate を使用して OpenShift コンテナーイメージビルドを自動的に実行できます。

Dekorate を使用して Source-to-Image ビルドを自動的にトリガーする機能は テクノロジープレビュー として利用できます。Red Hat は、実稼働環境でのこの機能の使用に対するサポートを提供していません。

前提条件

- Spring Boot および Dekorate を使用するよう設定された Maven ベースのアプリケーションプロジェクト

- プロジェクトのソースファイルに追加された @OpenShiftApplication アノテーション

- Java JDK 8 または JDK 11 がインストールされている。

- Maven がインストールされている。

-

ocコマンドラインツールがインストールされている -

ocコマンドラインツールを使用して OpenShift クラスターにログインしている。

手順

Dekorate OpenShift Annotations モジュールを依存関係としてアプリケーションの

pom.xmlファイルに追加します。このモジュールは、すべての Dekorate Starters の推移的な依存関係として含まれています。<project> ... <dependencies> ... <dependency> <groupId>io.dekorate</groupId> <artifactId>openshift-annotations</artifactId> </dependency> ... </dependencies> ... <project>アプリケーションをビルドしてデプロイします。Maven がアプリケーションをコンパイルした後にコンテナーイメージビルドを実行するための

-Ddekorate.build=trueプロパティーを含めます。Source-to-Image ビルドを自動的に実行する機能は テクノロジープレビュー として提供されることに注意してください。$ mvn clean install -Ddekorate.build=true

Maven でアプリケーションをコンパイルした後に、コマンドラインから Source-to-image ビルドを手動で実行することもできます。

# Process your application YAML template that is generated by Dekorate: $ oc apply -f target/classes/META-INF/dekorate/openshift.yml # Execute the Source-to-image build and deploy your application to the OpenShift cluster: $ oc start-build example --from-dir=./target --follow

6.6. OpenShift での Spring Boot での Dekorate の使用

以下の例は、方法を示しています。

-

アプリケーションで

openshift-spring-staterを使用できます。 - Dekorate は、アプリケーションのタイプを自動的に識別し、OpenShift サービスルートおよびプローブを随時設定できます。

- Maven がアプリケーションをコンパイルした後に、source-to-image ビルドをトリガーするようにアプリケーションを設定できます。

前提条件

- Spring Boot および Dekorate を使用するよう設定された Maven ベースのアプリケーションプロジェクト

-

@SpringBootApplicationアノテーションがプロジェクトのソースファイルに追加されました。 - Java JDK 8 または JDK 11 がインストールされている。

- Maven がインストールされている。

-

ocコマンドラインツールがインストールされている -

ocコマンドラインツールを使用して OpenShift クラスターにログインしている。

手順

Dekorate Spring Starter は、アプリケーションプロジェクトの

pom.xmlファイルの依存関係として追加します。pom.xml

<project> ... <dependencies> ... <dependency> <groupId>io.dekorate</groupId> <artifactId>openshift-spring-starter</artifactId> </dependency> ... </dependencies> ... <project>Main.javaクラスファイルに@OpenShiftApplicationアノテーションを付けます。これにより、アプリケーションをコンパイルする際に Source-to-Image ビルドを起動できます。/src/main/java/io/dekorate/example/sbonopenshift/Main.java

package io.dekorate.example.sbonopenshift; import org.springframework.boot.SpringApplication; import org.springframework.boot.autoconfigure.SpringBootApplication; @OpenShiftApplication @SpringBootApplication public class Main { public static void main(String[] args) { SpringApplication.run(Main.class, args); } }Rest コントローラーをアプリケーションに追加します。

/src/main/java/io/dekorate/example/sbonopenshift/Controller.java