ネットワークガイド

Red Hat OpenStack Platform Networking の詳細ガイド

概要

前書き

OpenStack Networking サービス (コード名: neutron) は、Red Hat OpenStack Platform 16.0 のソフトウェア定義ネットワークのコンポーネントです。

ソフトウェア定義ネットワーク (SDN)

ソフトウェア定義ネットワーク (SDN) を使用することで、ネットワーク管理者は下層の機能の抽象化によりネットワークサービスを管理することができます。サーバーのワークロードを仮想環境に移行しても、データの送受信のためにそれらのサーバーがネットワーク接続を必要とすることに変わりありません。SDN は、ルーターやスイッチなどのネットワーク装置を同じ仮想化領域に移動することで、このニーズに対応します。すでにネットワークの基本概念に精通している場合には、接続先のサーバーと同様に、これらの物理ネットワークの概念が仮想化されていると考えるのに無理はないでしょう。

本ガイドの構成

- 前書き: ソフトウェア定義ネットワーク (SDN) の定義について簡単に説明します。

パート I: 一般的な管理タスクと基本的なトラブルシューティングのステップを説明します。

- ネットワークリソースの追加と削除

- 基本的なネットワークのトラブルシューティング

- プロジェクトネットワークのトラブルシューティング

パート II: 高度な Red Hat OpenStack Platform Networking 機能について、クックブック形式のシナリオがまとめられています。これには以下の項目が含まれます。

- 仮想ルーターのレイヤー 3 高可用性の設定

- DVR およびその他のネットワーク機能の設定

第1章 ネットワークの概要

1.1. ネットワークの仕組み

ネットワークという用語は、コンピューター間で情報を移動させる動作のことを指します。最も基本的なレベルでは、ネットワークインターフェースカード (NIC) がインストールされた 2 つのマシンをケーブルでつなぐことで達成されます。OSI ネットワークモデルでは、ケーブルがレイヤー 1 に相当します。

3 台以上のコンピューターを使用する場合には、スイッチというデバイスを追加してこの構成をスケールアウトする必要があります。エンタープライズスイッチには複数のイーサネットポートがあり、追加のマシンを接続することができます。複数のマシンで構成されるネットワークは、ローカルエリアネットワーク (LAN) と呼ばれます。

複雑さが増すので、スイッチは OSI モデルの新たなレイヤー (レイヤー 2) に相当します。各 NIC には、ハードウェアごとに一意な MAC アドレス番号が割り当てられ、この番号を使用することにより、同じスイッチに接続された複数のマシンはお互いを認識することができます。スイッチは、どの MAC アドレスがどのポートに結線されているかのリストを管理するので、コンピューター間でデータ送信を試みる際に、スイッチはそれら両方のコンピューターがどこに配置されているかを認識し、MAC アドレスからポートへのマッピングを監視する CAM (Content Addressable Memory) のエントリーを調整します。

1.1.1. VLAN

VLAN を使用して、同じスイッチ上で動作しているコンピューターのネットワークトラフィックを分割することができます。つまり、それぞれ別のネットワークのメンバーとなるようにポートを設定することで、スイッチを論理的に分割することができます。この場合、それぞれのネットワークは、セキュリティー上の理由からトラフィックを分割するのに使用できる、小規模な LAN ということになります。

たとえば、スイッチに合計 24 個のポートがある場合に、ポート 1 - 6 を VLAN200 に、ポート 7 - 18 を VLAN201 に、それぞれ割り当てることができます。その結果、VLAN200 に接続されているコンピューターは、VLAN201 のコンピューターと完全に分離され、直接通信することはできなくなります。通信する必要があれば、スイッチの VLAN200 部分と VLAN201 部分が 2 つの別個の物理スイッチであったかのように、トラフィックはルーターを通過する必要があります。相互に通信が可能な VLAN の組み合わせを制御するには、ファイアウォールも有用です。

1.2. 2 つの LAN の接続

2 つの LAN がそれぞれ別個のスイッチ上で稼働している状況で、LAN 間で情報を共有させたいとします。このような通信を可能にする設定としては、以下の 2 つのオプションがあります。

802.1Q VLAN タグ付けを使用して、両方の物理スイッチにまたがる単一の VLAN を設定する。

ネットワークケーブルの一方の端を 1 つのスイッチのポートに接続し、他の端を別のスイッチのポートに接続し、続いてこれらのポートを 802.1Q タグ付けポート (トランクポートとも呼ばれる) として設定する必要があります。これら 2 つのスイッチが 1 つの大きな論理スイッチとして機能し、接続されているコンピューターが互いを認識することができます。

このオプションの難点はスケーラビリティーです。オーバーヘッドの問題が発生することなくデイジーチェーン接続することのできるスイッチの数は限られています。

ルーターを用意し、ケーブルを使用して各スイッチに接続する。

ルーターは、両方のスイッチに設定されたネットワークを認識します。スイッチに結線した各ケーブル端には、ネットワークのデフォルトゲートウェイとして知られる IP アドレスが割り当てられます。デフォルトゲートウェイは、トラフィックの送付先マシンが送付元マシンと同じ LAN 上にないことが明らかな場合の送付先を定義します。デフォルトゲートウェイを設置することで、送付先に関する具体的な情報が無くても、各コンピューターは他のコンピューターにトラフィックを送付することができます。それぞれのコンピューターはデフォルトゲートウェイにトラフィックを送付し、ルーターはトラフィックを受け取る送付先コンピューターを決定します。ルーティングは、IP アドレスやサブネットなどの一般的に知られている概念と同様に、OSI モデルのレイヤー 3 で機能します。

1.2.1. ファイアウォール

ファイアウォールは、レイヤー 7 (実際のコンテンツを検査するレイヤー) を含む複数の OSI レイヤーにわたってトラフィックをフィルターすることができます。多くの場合、ファイアウォールはルーターと同じネットワークセグメントに存在し、全ネットワーク間を移動するトラフィックを制御します。そのために、ファイアウォールは、ネットワークを通過することのできるトラフィックを規定する事前定義済みのルールセットを参照します。これらのルールは粒度を細かくすることが可能です。以下に例を示します。

「VLAN200 のサーバーは、暗号化された Web トラフィック (HTTPS) を一方向に送付している場合にのみ、木曜の午後に限り、VLAN201 のコンピューターとだけ通信できるものとする」といった設定が可能です。

これらのルールを確実に適用するために、一部のファイアウォールはレイヤー 5 から 7 でディープパケットインスペクション (DPI) も実行し、パケットのコンテンツを検証して、正当なパケットであることを確認します。ハッカーは、トラフィックを実際の内容とは別のものに見せかけて、密かにデータを抜き出すことができます。DPI はこのような脅威を軽減する手段の 1 つです。

1.3. OpenStack Networking (neutron) の使用

OpenStack では、これと同じネットワーク概念が適用されており、ソフトウェア定義ネットワーク (SDN) として知られています。OpenStack Networking (neutron) のコンポーネントは、仮想ネットワーク機能向けの API を提供します。これには、スイッチ、ルーター、ファイアウォールが含まれます。仮想ネットワークインフラストラクチャーにより、インスタンスは相互に通信することができます。また、物理ネットワークを使用した外部との通信を許可することも可能です。Open vSwitch のブリッジは、仮想ポートをインスタンスに割り当て、送受信トラフィック用にネットワークインフラストラクチャーを物理ネットワークに橋渡しすることができます。

1.4. CIDR 形式の使用

一般的には、IP アドレスはサブネットのブロックにまず割り当てられます。たとえば、IP アドレスの範囲が 192.168.100.0 - 192.168.100.255 で、サブネットマスクが 255.555.255.0 の場合には、IP アドレス 254 個分を割り当てることができます (最初と最後のアドレスは予約されています)。

これらのサブネットは、複数の方法で表現することができます。

一般的な方法:

サブネットアドレスは一般的に、サブネットマスクとネットワークアドレスを使用して表示されます。

- ネットワークアドレス: 192.168.100.0

- サブネットマスク: 255.255.255.0

CIDR 形式:

サブネットマスクは、アクティブビットの合計に短縮されます。

192.168.100.0/24を例に取ると、/24は255.255.255.0の略式表現で、バイナリーに変換した際に反転したビットの合計数を指します。また、CIDR 形式は、

ifcfg-xxxスクリプトにおいてNETMASK値の代わりに使用することができます。#NETMASK=255.255.255.0 PREFIX=24

第2章 OpenStack Networking の概念

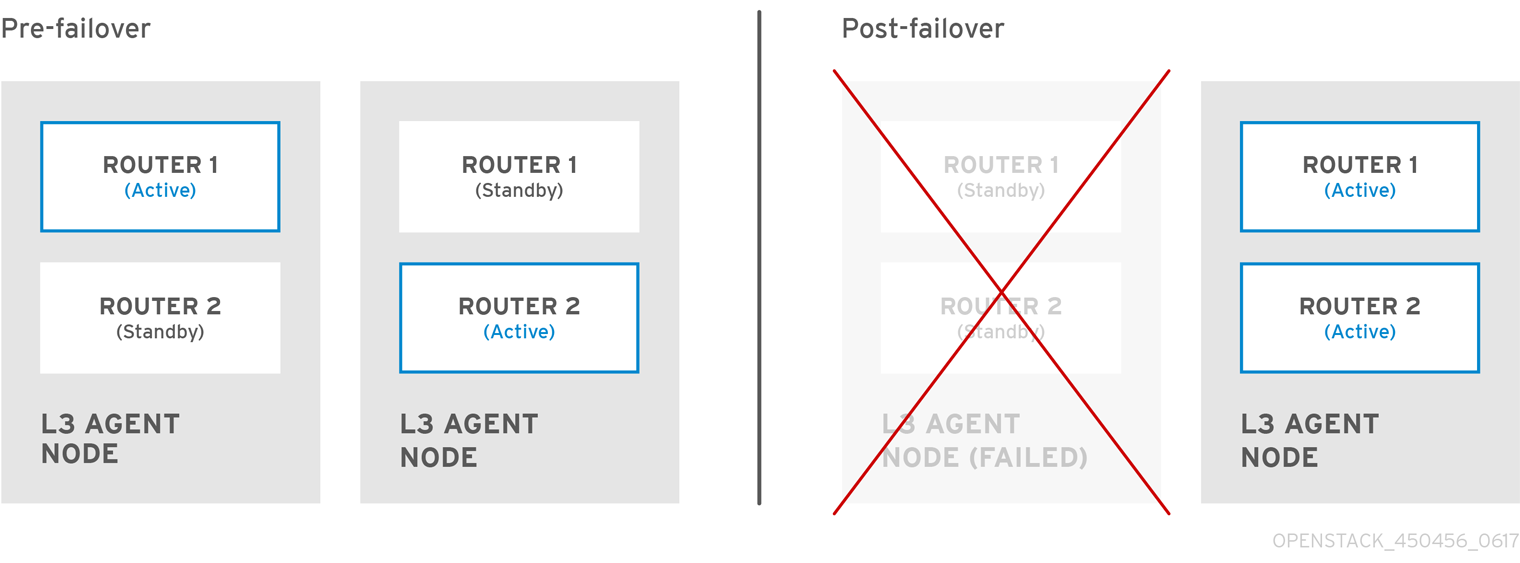

OpenStack Networking には、ルーティング、DHCP、メタデータなどのコアサービスを管理するシステムサービスがあります。これらのサービスが 1 つにまとまって、物理サーバーに割り当てられる概念的なロールであるコントローラーノードの概念に含まれます。物理サーバーは通常、ネットワークノード のロールが割り当てられ、インスタンスを発着するネットワークトラフィックのレイヤー 3 ルーティングを管理するタスクに特化して稼働します。OpenStack Networking では、このロールを実行する複数の物理ホストを指定することができ、ハードウェア障害が発生した場合に向けたサービスの冗長化が可能です。詳しい情報は、「レイヤー 3 の高可用性」の章を参照してください。

Red Hat OpenStack Platform 11 では、コンポーザブルロールのサポートが追加され、ネットワークサービスをカスタムロール別に分類することができます。ただし、本ガイドでは、内容をわかりやすくするために、デプロイメントにはデフォルトの Controller ロールを使用することを前提とします。

2.1. OpenStack Networking (neutron) のインストール

OpenStack Networking コンポーネントは、Red Hat OpenStack Platform director デプロイメントの一部としてインストールされます。director のデプロイメントに関する詳細な情報は、『director のインストールと使用方法』を参照してください。

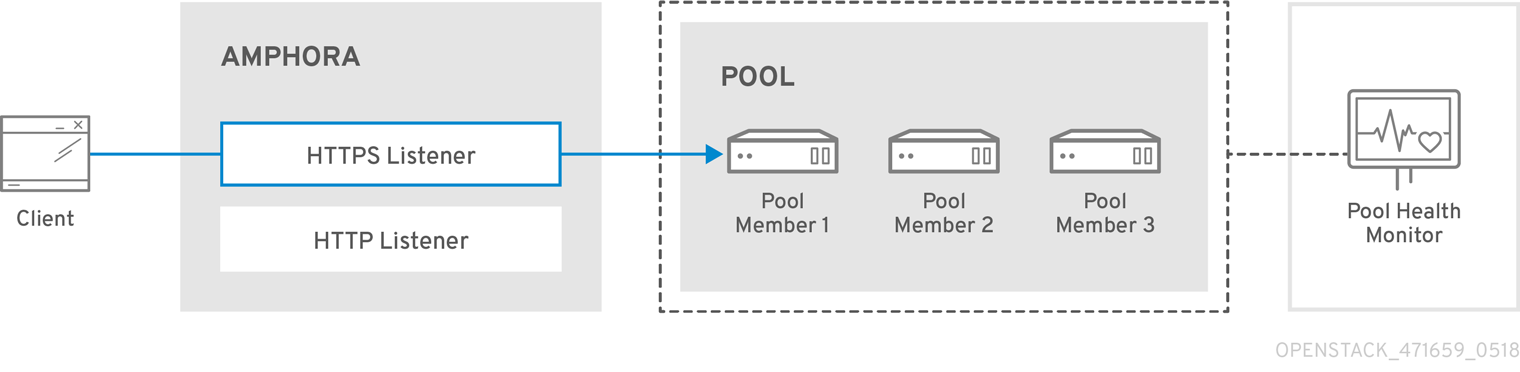

2.2. OpenStack Networking の図

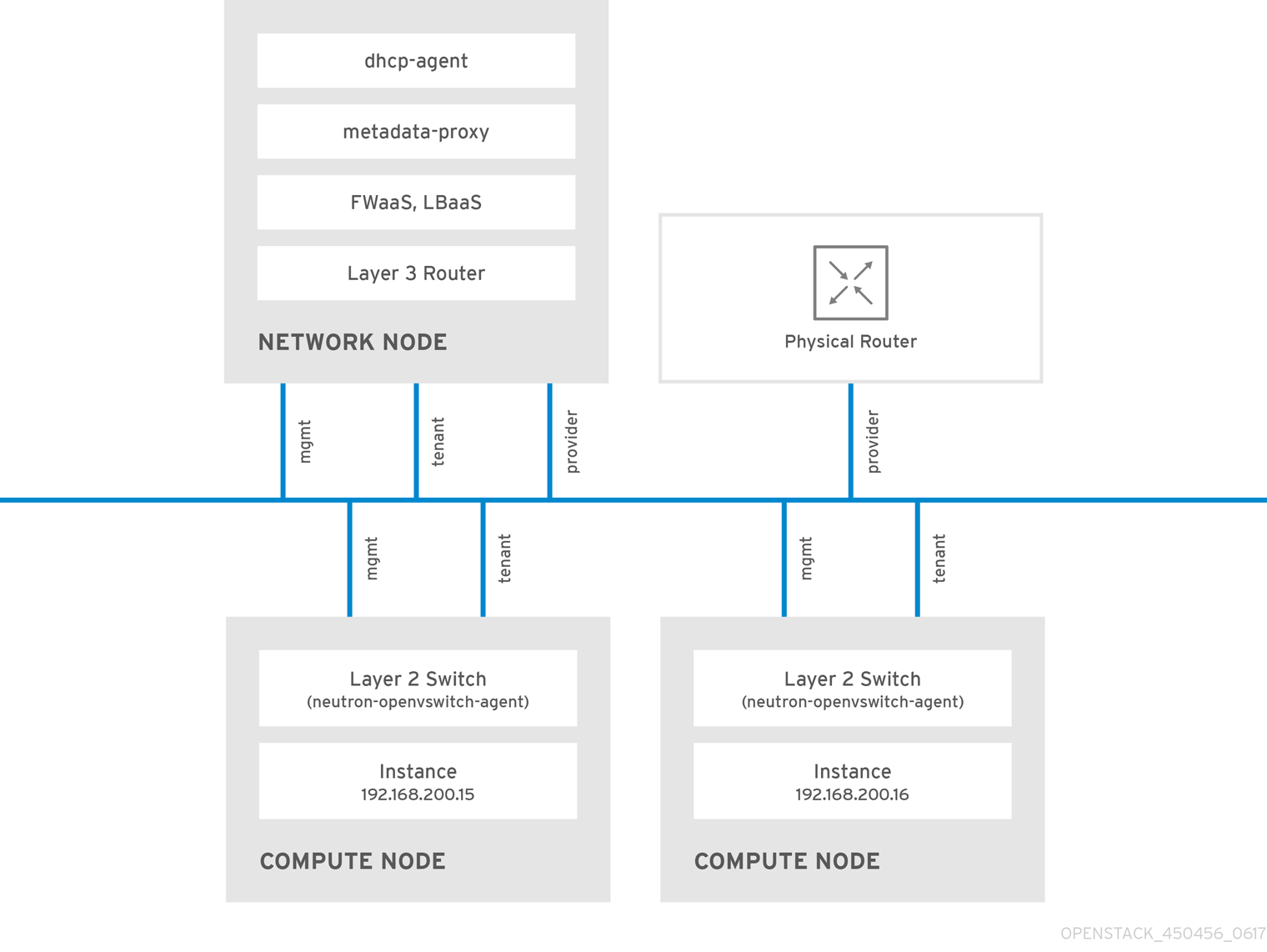

以下の図は、専用の OpenStack Networking ノードがレイヤー 3 ルーティングと DHCP の機能を果たし、Firewall-as-a-Service (FWaaS) および Load Balancing-as-a-Service (LBaaS) の高度なサービスを実行する、OpenStack Networking のデプロイメントの例です。2 つのコンピュートノードは Open vSwitch (openvswitch-agent) を実行し、それぞれにプロジェクトトラフィックと管理用の接続向けに物理ネットワークカードが 2 つ搭載されています。また、OpenStack Networking ノードには、プロバイダートラフィック専用の 3 枚目のネットワークカードがあります。

2.3. セキュリティーグループ

セキュリティーグループおよびルールを使用して、neutron ポートが送受信するネットワークトラフィックの種別と方向をフィルタリングします。これにより、セキュリティーにもう 1 つレイヤーが追加されて、コンピュートインスタンスに存在するファイアウォールルールが補完されます。セキュリティーグループとは、1 つ以上のセキュリティールールを含むコンテナーオブジェクトです。1 つのセキュリティーグループで複数のコンピュートインスタンスへのトラフィックを管理することができます。

Floating IP アドレス、OpenStack Networking LBaaS の仮想 IP、およびインスタンスのために作成されたポートは、セキュリティーグループに割り当てられます。セキュリティーグループを指定しない場合には、ポートは default のセキュリティーグループに割り当てられます。デフォルトでは、このグループは全受信トラフィックをドロップし、全送信トラフィックを許可します。ただし、デフォルトのセキュリティーグループのメンバーであるインスタンス間ではトラフィックが流れます。グループはそれ自体をポイントするリモートグループ ID を持つためです。

デフォルトセキュリティーグループのフィルターの動作を変更するには、グループにセキュリティールールを追加するか、まったく新しいセキュリティーグループを作成します。

2.4. Open vSwitch

Open vSwitch (OVS) は、レガシーの Linux ソフトウェアブリッジと同様の、ソフトウェア定義ネットワーク (SDN: Software-Defined Networking) の仮想スイッチです。OVS は業界標準の OpenFlow および sFlow をサポートし、仮想ネットワークにスイッチングサービスを提供します。OVS と物理スイッチの統合には、STP、LACP、802.1Q VLAN タグ付け等のレイヤー 2 (L2) 機能が必要です。Open vSwitch のバージョン 1.11.0-1.el6 以降は、VXLAN および GRE を使用したトンネリングもサポートします。

ネットワークインターフェースのボンディングに関する詳細は、『オーバークラウドの高度なカスタマイズ』の「ネットワークインターフェースボンディング」の章を参照してください。

1 つのブリッジには単一のインターフェースまたは単一のボンディングのみをメンバーにすると、OVS でネットワークループが発生するリスクを緩和することができます。複数のボンディングまたはインターフェースが必要な場合には、複数のブリッジを設定することが可能です。

2.5. Modular Layer 2 (ML2) によるネットワーク

ML2 とは、OpenStack Havana リリースで導入された OpenStack Networking コアプラグインです。以前のモノリシックなプラグインのモデルに置き換わる、ML2 モジュラー型設計により、複数のネットワーク技術を組み合わせた操作を同時に実行できます。モノリシックな Open vSwitch および Linux Bridge プラグインは非推奨となり、削除されました。これらの機能は、ML2 メカニズムドライバーにより実装されるようになりました。

ML2 はデフォルトの OpenStack Networking プラグインで、OVN がデフォルトのメカニズムドライバーとして設定されています。

2.5.1. ML2 が導入された理由

以前は、OpenStack Networking のデプロイでは、実装時に選択したプラグインしか使用することができませんでした。たとえば、Open vSwitch (OVS) プラグインを実行するデプロイは、OVS プラグインだけを使用する必要がありました。モノリシックなプラグインでは、linuxbridge 等の別のプラグインを同時に実行することはサポートされませんでした。この制約により、複数の異なる要件を伴う環境では、ニーズを満たすことが困難となっていました。

2.5.2. ML2 ネットワーク種別

ML2 ネットワーク種別では、複数のネットワークセグメントタイプを同時に操作することができます。また、これらのネットワークセグメントは、ML2 のマルチセグメントネットワークに対するサポートを利用して相互接続することが可能です。ポートは接続されているセグメントに自動的にバインドされ、特定のセグメントにバインドする必要はありません。メカニズムドライバーに応じて、ML2 は、以下のネットワークセグメントタイプをサポートします。

- flat

- GRE

- local

- VLAN

- VXLAN

- Geneve

ml2_conf.ini ファイルの ML2 セクションで、タイプドライバーを有効にします。以下に例を示します。

[ml2] type_drivers = local,flat,vlan,gre,vxlan,geneve

2.5.3. ML2 メカニズムドライバー

共通のコードベースを使用するメカニズムとして、プラグインが実装されるようになりました。このアプローチにより、コードの再利用が可能になる上、コードのメンテナンスとテストにおける複雑性が大幅に軽減されます。

サポート対象のメカニズムドライバーの一覧は、『リリースノート』 を参照してください。

デフォルトのメカニズムドライバーは OVN です。ml2_conf.ini ファイルの ML2 セクションで、メカニズムドライバーを有効にします。以下に例を示します。

[ml2] mechanism_drivers = ovn

これらの設定は、Red Hat OpenStack Platform director により管理されます。手動で変更しないでください。

2.6. ML2 タイプドライバーとメカニズムドライバーの互換性

| メカニズムドライバー | タイプドライバー | ||||

|---|---|---|---|---|---|

| flat | gre | vlan | vxlan | geneve | |

| ovn | 互換 | いいえ | はい | いいえ | 互換 |

| openvswitch | 互換 | はい | はい | はい | 非互換 |

2.7. ML2/OVN メカニズムドライバーの制約

2.7.1. 本リリースでは、サポートされる ML2/OVS から ML2/OVN への移行方法はありません。

Red Hat OpenStack Platform (RHOSP) の本リリースでは、ML2/OVS メカニズムドライバーから ML2/OVN メカニズムドライバーへの移行はサポートされません。RHOSP の本リリースでは、OpenStack コミュニティーの移行ストラテジーはサポートされません。移行サポートは、RHOSP の今後のリリースで予定されています。

移行サポートの進捗を追跡するには、https://bugzilla.redhat.com/show_bug.cgi?id=1862888 を参照してください。

2.7.2. ML2/OVN ではまだサポートされていない ML2/OVS 機能

| 機能 | 備考 | 本機能の経緯 |

|---|---|---|

| 断片化 / ジャンボフレーム | OVN では、まだ ICMP「fragmentation needed」パケットの送信はサポートされません。断片化が必要な大きな ICMP/UDPパケットは、ML2/OVN では ML2/OVS ドライバー実装のようには機能しません。TCP トラフィックは、最大セグメントサイズ (MSS) クランプにより処理されます。 | Bug 1547074 (ovn-network) Bug 1702331 (Core ovn) |

| ポート転送 | OVN ではポート転送はサポートされません。 | |

| セキュリティーグループロギング API | ML2/OVN では、セキュリティーグループイベント (インスタンスが制限された操作の実行やリモートサーバーの制限されたポートへのアクセスを試みるケース) を記録するログファイルを利用することはできません。 | |

| マルチキャスト | 統合ブリッジとして ML2/OVN を使用する場合には、マルチキャストトラフィックはブロードキャストトラフィックとして扱われます。 統合ブリッジは FLOW モードで動作します。したがって、IGMP スヌーピングを利用することはできません。この機能をサポートするためには、コア OVN が IGMP スヌーピングをサポートしている必要があります。 | |

| SR-IOV | 現状、SR-IOV は neutron DHCP エージェントがデプロイされている場合に限り機能します。 | |

| OVN と DHCP の組み合わせでのベアメタルマシンのプロビジョニング |

OVN 上の組み込み型 DHCP サーバーは、現状ベアメタルノードをプロビジョニングすることができません。プロビジョニングネットワーク用に、DHCP を提供することができません。iPXE のチェーンブートにはタグ付け (dnsmasq の | |

| OVS_DPDK | OVS_DPDK は、現在 OVN ではサポートされていません。 |

2.8. デフォルトの ML2/OVN ドライバーに代わる ML2/OVS メカニズムドライバーの使用

お使いのアプリケーションに ML2/OVS メカニズムドライバーが必要な場合、環境ファイル neutron-ovs.yaml を使用してオーバークラウドをデプロイすることができます。これにより、デフォルトの ML2/OVN メカニズムドライバーが無効になり ML2/OVS が有効化されます。

2.8.1. 新規 RHOSP 16.0 デプロイメントでの ML2/OVS の使用

オーバークラウドのデプロイメントコマンドに、以下の例に示すように環境ファイル neutron-ovs.yaml を追加します。

-e /usr/share/openstack-tripleo-heat-templates/environments/services/neutron-ovs.yaml

環境ファイルの使用に関する詳しい情報は、『 オーバークラウドの 高度なカスタマイズ』 ガイドの「オーバークラウド作成時 の環境ファイルの追加」を参照してください。

2.8.2. 以前の RHOSP の ML2/OVS から RHOSP 16.0 の ML2/OVS へのアップグレード

ML2/OVS を使用する以前のバージョンの RHOSP からのアップグレード後も ML2/OVS を使用し続けるには、文書化されている Red Hat のアップグレード手順に従い、ML2/OVS から ML2/OVN への移行は実施しないでください。

アップグレード手順には、オーバークラウドデプロイメントコマンドへの -e /usr/share/openstack-tripleo-heat-templates/environments/services/neutron-ovs.yaml の追加が含まれます。

2.9. L2 Population ドライバーの設定

L2 Population ドライバーはブロードキャスト、マルチキャスト、およびユニキャストのトラフィックを有効化して、大型のオーバーレイネットワークをスケールアウトします。デフォルトでは、Open vSwitch GRE および VXLAN がブロードキャストを各エージェントに複製します。これには、送信先のネットワークをホストしていないエージェントも含まれます。この設計には、多大なネットワークとプロセスのオーバーヘッドを受容する必要があります。L2 Population ドライバーにより導入される代替の設計は、ARP 解決および MAC 学習トラフィックのための部分的なメッシュを実装し、特定のネットワークをホストするノード間に、そのネットワーク用のトンネルも作成します。このトラフィックは、対象設定済みのユニキャストとしてカプセル化されることによって、必要なエージェントにのみ送信されます。

L2 Population ドライバーを有効にするには、以下の手順を実施します。

1.L2 Population ドライバーを有効にするには、メカニズムドライバーの一覧に追加します。また、少なくとも 1 つのトンネリングドライバーも有効にする必要があります (GRE と VXLAN のいずれか一方または両方)。ml2_conf.ini ファイルに適切な設定オプションを追加します。

[ml2] type_drivers = local,flat,vlan,gre,vxlan,geneve mechanism_drivers = l2population

Neutron の Linux Bridge ML2 ドライバーおよびエージェントは Red Hat OpenStack Platform 11 で非推奨となりました。一般的な用途の場合には、Red Hat では OpenStack Platform director のデフォルトである Open vSwitch (OVS) プラグインを推奨しています。

2.openvswitch_agent.ini ファイルで L2 Population を有効化します。その場合には、L2 エージェントが含まれる各ノードで有効にします。

[agent] l2_population = True

ARP 応答フローをインストールするには、arp_responder フラグを設定します。

[agent] l2_population = True arp_responder = True

2.10. OpenStack Networking サービス

Red Hat OpenStack Platform にはデフォルトで、ML2 および Open vSwitch のプラグインと統合してデプロイメントのネットワーク機能を提供するコンポーネントが含まれています。

2.10.1. L3 エージェント

L3 エージェントは openstack-neutron パッケージに含まれています。ネットワークの名前空間を使用して、各プロジェクトに独自の分離されたレイヤー 3 ルーターを提供します。レイヤー 3 ルーターは、トラフィックを誘導し、レイヤー 2 ネットワーク向けのゲートウェイサービスを提供します。L3 エージェントはこれらのルーターの管理を支援します。L3 エージェントをホストするノードでは、外部ネットワークに接続されたネットワークインターフェースに手動で IP アドレスを設定することはできません。代わりに、OpenStack Networking で利用可能な外部ネットワークの IP アドレスの範囲内で指定する必要があります。neutron は、これらの IP アドレスを内部ネットワークと外部ネットワークの間を接続するルーターに割り当てます。選択した IP 範囲は、デプロイメント内の各ルーターに一意の IP アドレスと、各 Floating IP を指定するのに十分な大きさである必要があります。

2.10.2. DHCP エージェント

OpenStack Networking DHCP エージェントは、各プロジェクトのサブネットが DHCP サーバーとして機能するために作成されるネットワークの名前空間を管理します。各名前空間は、ネットワーク上の仮想マシンへの IP アドレス確保が可能な dnsmasq プロセスを実行します。サブネットの作成時にこのエージェントが有効化されて稼働している場合には、そのサブネットにはデフォルトで DHCP が有効化されます。

2.10.3. Open vSwitch エージェント

Open vSwitch (OVS) neutron プラグインは、独自のエージェントを使用します。このエージェントは、各ノードで稼働し、OVS ブリッジを管理します。ML2 プラグインは専用のエージェントと統合して L2 ネットワークを管理します。デフォルトでは、Red Hat OpenStack Platform は ovs-agent を使用します。このエージェントは、OVS ブリッジを使用してオーバーレイネットワークを構築します。

2.11. プロジェクトネットワークとプロバイダーネットワーク

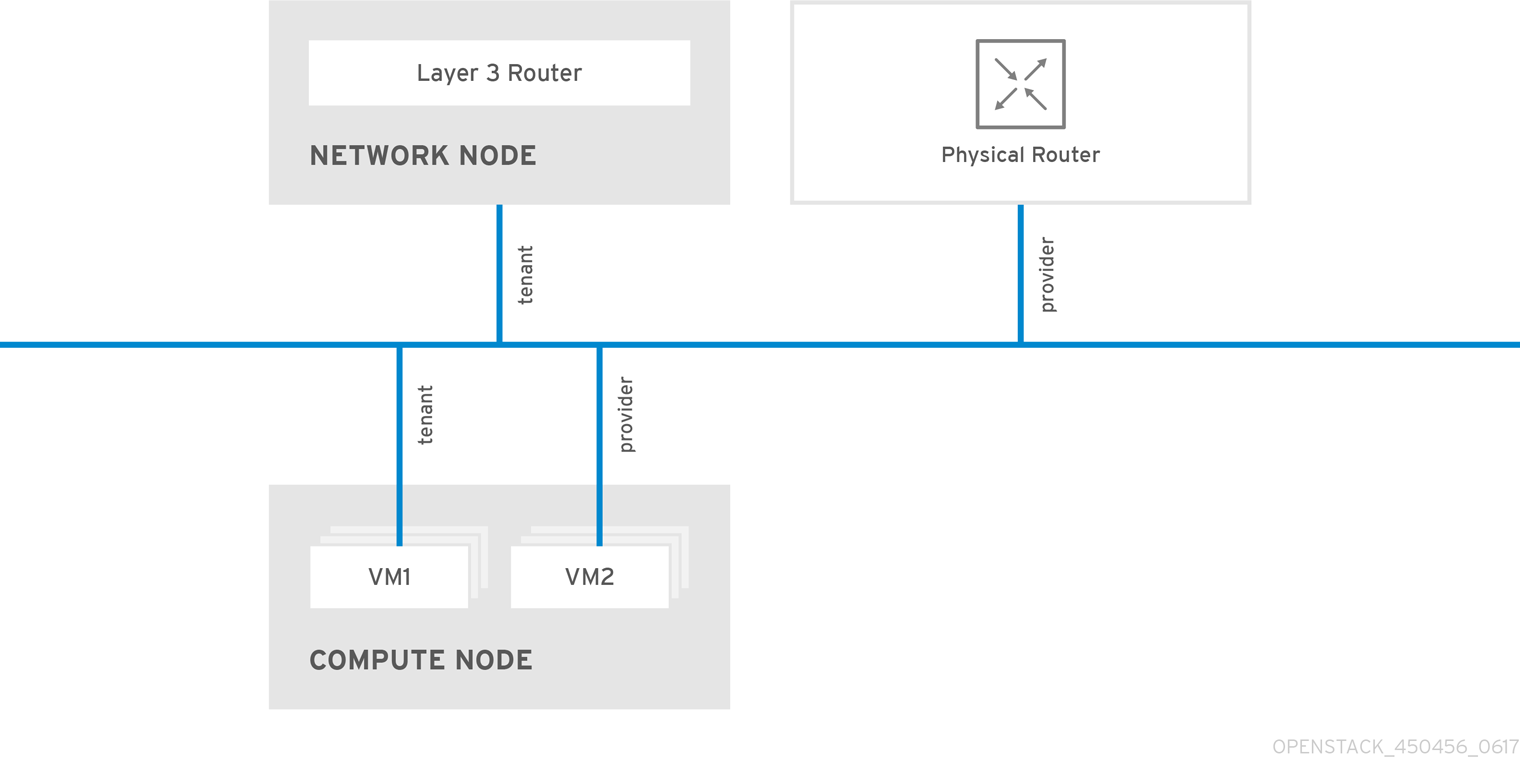

以下の図には、プロジェクトネットワークおよびプロバイダーネットワーク種別の概要と、それらが OpenStack Networking トポロジー全体でどのように対話するかを図解しています。

2.11.1. プロジェクトネットワーク

ユーザーは、プロジェクト内の接続のためにプロジェクトネットワークを作成します。デフォルトではプロジェクトネットワークは完全に分離され、他のプロジェクトとは共有されません。OpenStack Networking は、さまざまな種別のプロジェクトネットワークをサポートしています。

- フラット: 全インスタンスが同じネットワークに存在し、そのネットワークは、ホストと共有することも可能です。VLAN タグ付けやその他のネットワーク分離は行われません。

- VLAN: OpenStack Networking では、物理ネットワークにある VLAN に対応する VLAN ID (802.1Q タグ付け)を使用してユーザーが複数のプロバイダーネットワークまたはプロジェクトネットワークを作成することができます。これにより、インスタンスは環境全体で相互に通信を行うことが可能になります。また、専用のサーバー、ファイアウォール、ロードバランサー、および同じレイヤー 2 上にあるその他のネットワークインフラストラクチャーと通信することもできます。

- VXLAN および GRE のトンネル: VXLAN および GRE は、ネットワークオーバーレイを使用して、インスタンス間のプライベートの通信をサポートします。OpenStack Networking ルーターは、トラフィックが GRE または VXLAN プロジェクトネットワークの外部に通過できるようにするために必要です。また、ルーターは、直接接続されたプロジェクトネットワークを外部ネットワーク (インターネットを含む) に接続するのにも必要とされ、Floating IP アドレスを使用して外部ネットワークから直接インスタンスに接続する機能を提供します。VXLAN および GRE タイプドライバーは、ML2/OVS メカニズムドライバーと互換性があります。

- Geneve のトンネル: GENEVE は、ネットワーク仮想化における各種デバイスの変更機能を認識し、そのニーズに対応します。システム全体を規定するのではなく、トンネリングのフレームワークを提供します。GENEVE は、カプセル化中に追加されるメタデータの内容を柔軟に定義し、さまざまな仮想化シナリオへの対応を試みます。UDP をトランスポートプロトコルとして使用し、拡張可能なオプションヘッダーを使用してサイズを動的に変動させます。GNEVE はユニキャスト、マルチキャスト、およびブロードキャストをサポートします。GENEVE タイプドライバーは、ML2/OVN メカニズムドライバーと互換性があります。

プロジェクトネットワークの QoS ポリシーを設定することが可能です。詳細は、「10章Quality of Service (QoS) ポリシーの設定」を参照してください。

2.11.2. プロバイダーネットワーク

OpenStack の管理者は、プロバイダーネットワークを作成します。プロバイダーネットワークは、データセンター内の既存の物理ネットワークに直接マップします。このカテゴリーの中で有用なネットワークタイプには、フラット (タグなし) と VLAN (802.1Q タグ付き) があります。ネットワーク作成プロセスの一環で、プロジェクト間でプロバイダーネットワークを共有することもできます。

2.11.2.1. フラットプロバイダーネットワーク

フラットプロバイダーネットワークを使用してインスタンスを直接外部ネットワークに接続することができます。これは、複数の物理ネットワーク (例: physnet1 および physnet2)、さらにそれぞれ別の物理インターフェース (eth0 → physnet1 および eth1 → physnet2) があり、各コンピュートおよびネットワークノードをこれらの外部ネットワークに接続する場合に便利です。複数のプロバイダーネットワークに接続するために、単一のインターフェース上で VLAN タグ付けされたインターフェースを複数使用する場合には、「VLAN プロバイダーネットワークの使用」の項を参照してください。

2.11.2.2. コントローラーノード用ネットワークの設定

1. /etc/neutron/plugin.ini (/etc/neutron/plugins/ml2/ml2_conf.ini へのシンボリックリンク) を編集し、既存の値リストに flat を追加し、flat_networks を * に設定します。以下に例を示します。

type_drivers = vxlan,flat flat_networks =*

2. フラットネットワークとして外部ネットワークを作成して、設定済みの physical_network に関連付けます。このネットワークを共有ネットワークとして設定し (--share を使用)、他のユーザーが外部ネットワークに直接接続されたインスタンスを作成できるようにします。

# openstack network create --share --provider-network-type flat --provider-physical-network physnet1 --external public01

3. openstack subnet create コマンドまたは Dashboard を使用して、サブネットを作成します。以下に例を示します。

# openstack subnet create --no-dhcp --allocation-pool start=192.168.100.20,end=192.168.100.100 --gateway 192.168.100.1 --network public01 public_subnet

4.neutron-server サービスを再起動して、変更を適用します。

systemctl restart tripleo_neutron_api

2.11.2.3. ネットワークおよびコンピュートノード用ネットワークの設定

ノードを外部ネットワークに接続し、インスタンスが外部ネットワークと直接通信できるようにするには、ネットワークノードおよびコンピュートノードで以下の手順を実施します。

1. 外部ネットワークのブリッジ (br-ex) を作成して、関連付けたポート(eth1) を追加します。

/etc/sysconfig/network-scripts/ifcfg-br-ex に外部ネットワークのブリッジを作成します。

DEVICE=br-ex TYPE=OVSBridge DEVICETYPE=ovs ONBOOT=yes NM_CONTROLLED=no BOOTPROTO=none

/etc/sysconfig/network-scripts/ifcfg-eth1 で eth1 が br-ex に接続するように設定します。

DEVICE=eth1 TYPE=OVSPort DEVICETYPE=ovs OVS_BRIDGE=br-ex ONBOOT=yes NM_CONTROLLED=no BOOTPROTO=none

ノードを再起動するか、ネットワークサービスを再起動して、変更を適用します。

2. /etc/neutron/plugins/ml2/openvswitch_agent.ini で物理ネットワークを設定して、ブリッジをその物理ネットワークにマッピングします。

bridge_mappings = physnet1:br-ex

ブリッジマッピングについての詳しい情報は、「11章ブリッジマッピングの設定」を参照してください。

3. ネットワークノードとコンピュートノードの両方で neutron-openvswitch-agent サービスを再起動して、変更を適用します。

systemctl restart neutron-openvswitch-agent

2.11.2.4. ネットワークノードの設定

1. /etc/neutron/l3_agent.ini で external_network_bridge = に空の値を設定します。

external_network_bridge = に空の値を設定すると、複数の外部ネットワークブリッジを使用することができます。OpenStack Networking は、各外部ブリッジから br-int へのパッチポートを作成します。

external_network_bridge =

2. neutron-l3-agent を再起動して変更を適用します。

systemctl restart neutron-l3-agent

複数のフラットプロバイダーネットワークが存在する場合には、ネットワークごとに独立した物理インターフェースおよびブリッジを使用して外部ネットワークに接続する必要があります。ifcfg-* スクリプトを適切に設定し、bridge_mappings オプションで各ネットワークのコンマ区切りリストによりマッピングを指定します。ブリッジマッピングについての詳しい情報は、「11章ブリッジマッピングの設定」を参照してください。

2.12. レイヤー 2 およびレイヤー 3 ネットワーク

仮想ネットワークを設計する場合には、トラフィックの大半がどこで発生するかを予測する必要があります。ネットワークトラフィックは、複数の論理ネットワーク間よりも同じ論理ネットワーク内の方が早く移動します。これは、(異なるサブネットを使用した) 論理ネットワーク間のトラフィックはルーターを通過する必要があり、追加でレイテンシーが発生するためです。

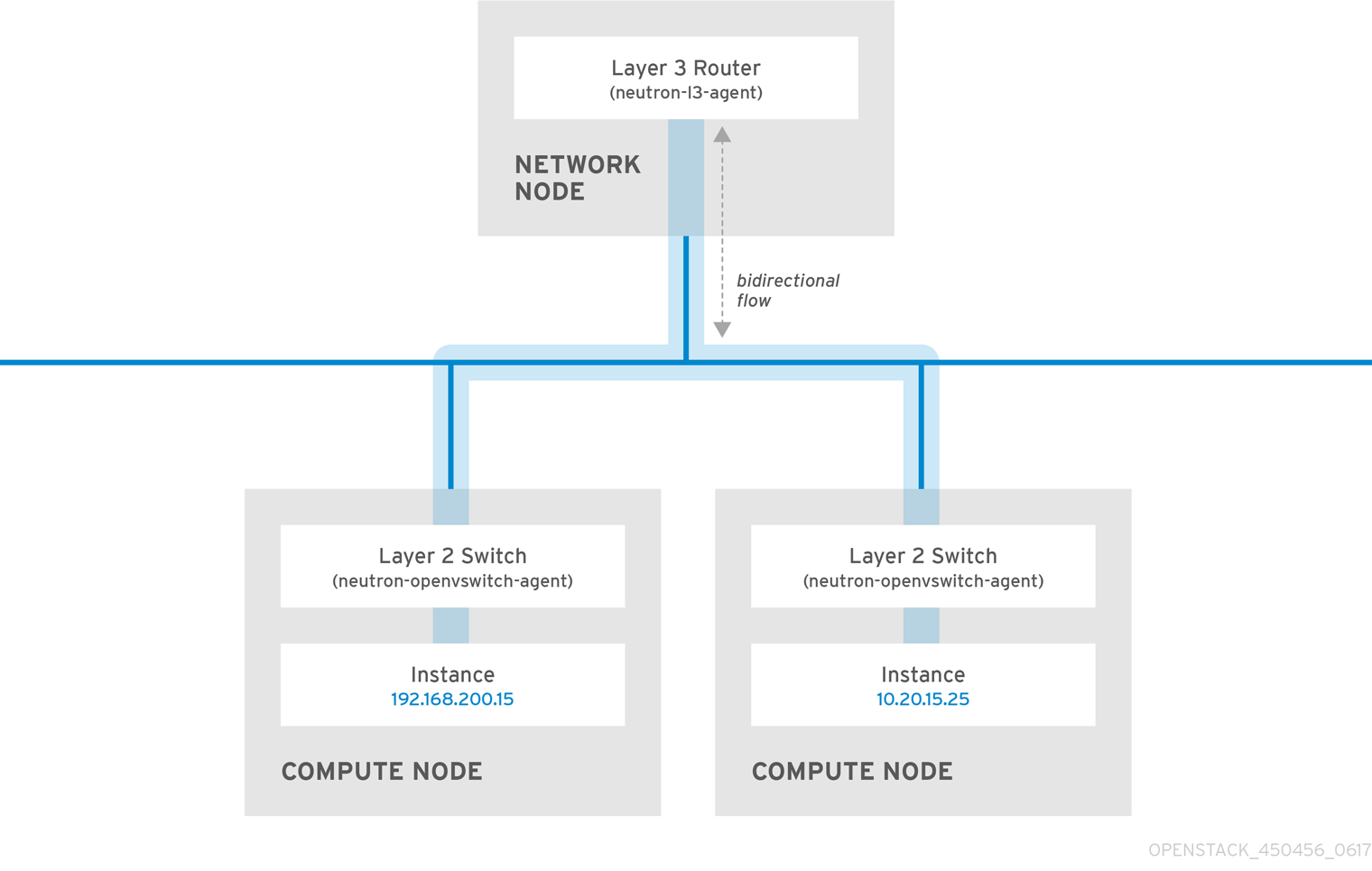

以下の図で、別の VLAN 上にあるインスタンス間を流れるネットワークトラフィックを見てみましょう。

高性能なハードウェアルーターでも、この構成では追加のレイテンシーが発生します。

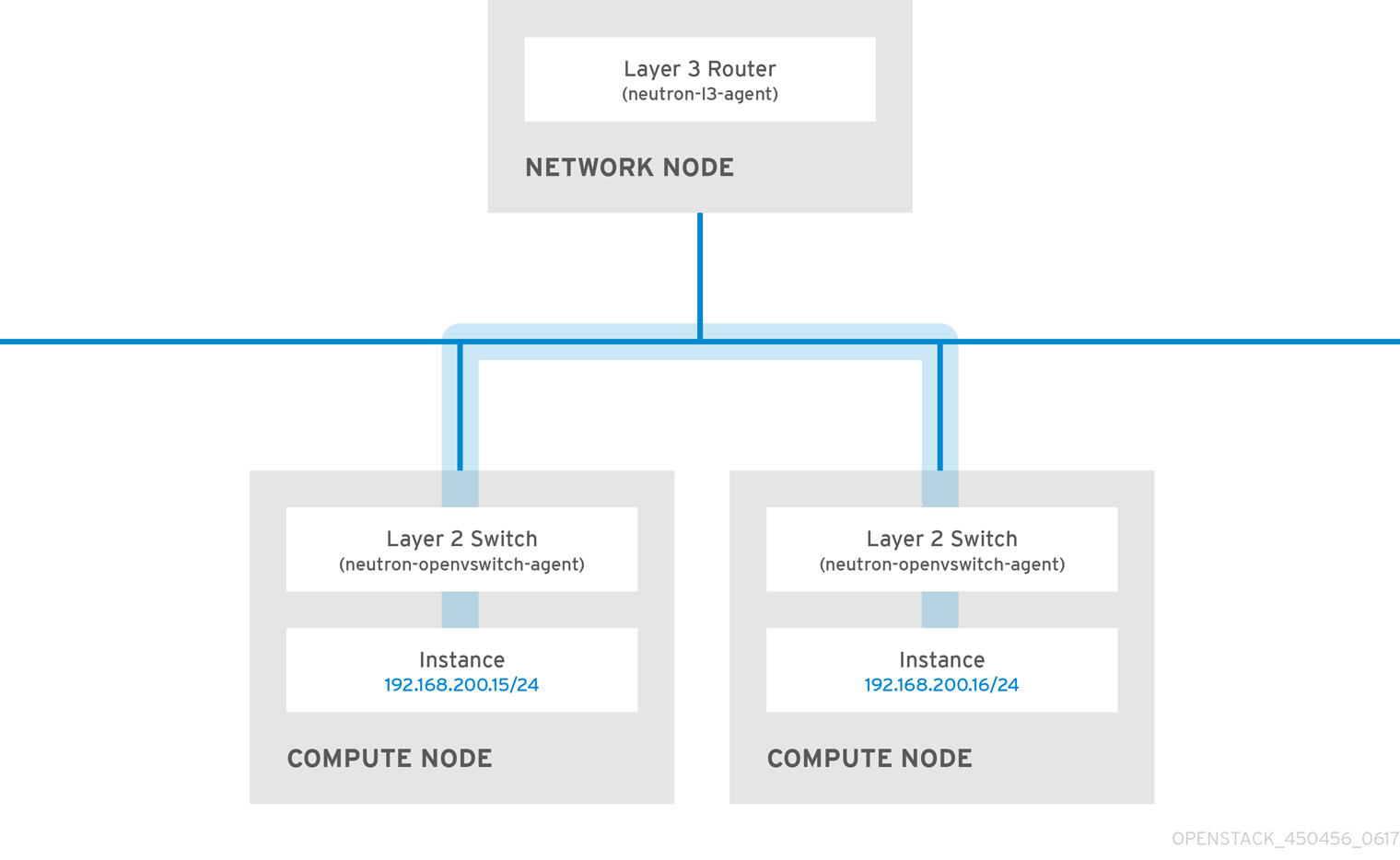

2.12.1. 可能な範囲でのスイッチの使用

スイッチングは、ネットワークの下層 (レイヤー 2) で行われるため、レイヤー 3 で行われるルーティングより高速に機能することが可能です。頻繁に通信するシステム間のホップ数ができる限り少なくなるように設計してください。たとえば、以下の図は 2 つの物理ノードにまたがるスイッチ付きのネットワークを示しています。この場合、ナビゲーション用のルーターを使用せずに 2 つのインスタンスは直接通信することができます。これらのインスタンスが同じサブネットを共有するようになり、同じ論理ネットワーク上に存在することが分かります。

別のノードにあるインスタンスが同じ論理ネットワークにあるかのように通信できるためには、VXLAN または GRE などのカプセル化トンネルを使用します。Red Hat では、トンネルヘッダーに必要な追加のビットに対応するために、エンドツーエンドで MTU サイズを調節することを推奨します。そうしなかった場合には、断片化が原因でネットワークのパフォーマンスが悪影響を受ける可能性があります。詳しい情報は、「MTU の設定」を参照してください。

VXLAN オフロード機能を搭載したサポート対象のハードウェアを使用すると、VXLAN トンネリングのパフォーマンスをさらに向上させることができます。完全な一覧は「Network Adapter Feature Support in RHEL」のアーティクルを参照してください。

パート I. 一般的なタスク

一般的な管理タスクと基本的なトラブルシューティングのステップを説明します。

第3章 一般的なネットワーク管理タスク

OpenStack Networking (neutron) は、Red Hat OpenStack Platform のソフトウェア定義ネットワークのコンポーネントです。仮想ネットワークインフラストラクチャーにより、インスタンスと外部の物理ネットワークとの間の接続が可能になります。

本項では、お使いの Red Hat OpenStack Platform デプロイメントに合わせてサブネットやルーターを追加/削除するなど、一般的な管理タスクについて説明します。

3.1. ネットワークの作成

インスタンスが相互に通信し DHCP を使用して IP アドレスを受け取ることができるように、ネットワークを作成します。ネットワークを Red Hat OpenStack Platform デプロイメント内の外部ネットワークと統合することや、他の物理ネットワークと統合することも可能です。このような統合を行うと、インスタンスは外部のシステムと通信できるようになります。外部ネットワーク接続に関する詳しい情報は、「物理ネットワークのブリッジ」を参照してください。

ネットワークの作成時には、ネットワークで複数のサブネットをホスト可能である点を認識しておくことが重要です。これは、まったく異なるシステムを同じネットワークでホストし、それらのシステムを分離する必要がある場合に役立ちます。たとえば、1 つのサブネットでは Web サーバーのトラフィックだけが伝送されるようにする一方で、別のサブネットはデータベースのトラフィックが通過するように指定することができます。サブネットは相互に分離され、別のサブネットと通信する必要のあるインスタンスのトラフィックは、ルーターによって転送する必要があります。大量のトラフィックを必要とする複数のシステムを、同じサブネットに配置すると、ルーティングの必要がなく、ルーティングに伴うレイテンシーや負荷を回避することができます。

- Dashboard で プロジェクト > ネットワーク > ネットワーク を選択します。

+ネットワークの作成 をクリックして、以下の値を指定します。

フィールド 説明 ネットワーク名

そのネットワークが果たす役割に基づいた説明的な名前。ネットワークを外部の VLAN と統合する場合には、名前に VLAN ID 番号を追記することを検討してください。たとえば、このサブネットで HTTP Web サーバーをホストし、VLAN タグが

122の場合にはwebservers_122とします。また、ネットワークトラフィックをプライベートにして、ネットワークを外部ネットワークと統合しない場合には、internal-onlyとします。管理状態有効

このオプションにより、ネットワークを即時に利用可能にするかどうかを制御することができます。ネットワークを Down の状態で作成するには、このフィールドを使用します。その場合、そのネットワークは論理的には存在しますが、アクティブではありません。このような設定は、そのネットワークを直ちに稼働させない場合に有用です。

次へ ボタンをクリックして、サブネット タブで以下の値を指定します。

フィールド 説明 サブネットの作成

サブネットを作成するかどうかを決定します。たとえば、ネットワーク接続のないプレースホルダーとしてこのネットワークを維持する場合には、サブネットを作成しない方がよいでしょう。

サブネット名

サブネットの説明的な名前を入力します。

ネットワークアドレス

IP アドレス範囲とサブネットマスクが 1 つの値としてまとめられた CIDR 形式でアドレスを入力します。アドレスを判断するには、サブネットマスクでマスキングされたビット数を算出して、IP アドレス範囲の値に追記します。たとえば、サブネットマスク 255.255.255.0 でマスクされるビット数は 24 です。このマスクを IPv4 アドレス範囲 192.168.122.0 に使用するには、アドレスを 192.168.122.0/24 と指定します。

IP バージョン

インターネットプロトコルバージョンを指定します (有効なタイプは IPv4 または IPv6)。ネットワークアドレス フィールドの IP アドレスの範囲は、選択したバージョンと一致する必要があります。

ゲートウェイ IP

デフォルトゲートウェイに指定したルーターのインターフェースの IP アドレス。このアドレスは、外部ロケーションを宛先とするトラフィックルーティングの次のホップとなり、ネットワークアドレス フィールドで指定した範囲内でなければなりません。たとえば、CIDR 形式のネットワークアドレスが 192.168.122.0/24 の場合には、通常デフォルトのゲートウェイは 192.168.122.1 となります。

ゲートウェイなし

転送を無効にして、サブネットを分離します。

次へ をクリックして DHCP オプションを指定します。

- DHCP 有効: そのサブネットの DHCP サービスを有効にします。DHCP を使用して、インスタンスへの IP 設定の割り当てを自動化することができます。

IPv6 アドレス設定モード : IPv6 ネットワークを作成する際の設定モード。IPv6 ネットワークを作成する場合には、IPv6 アドレスと追加の情報をどのように割り当てるかを指定する必要があります。

- オプション指定なし: IP アドレスを手動で設定する場合または OpenStack が対応していない方法を使用してアドレスを割り当てる場合には、このオプションを選択します。

- SLAAC (Stateless Address Autoconfiguration): インスタンスは、ルーターから送信されるルーター広告 (RA) メッセージに基づいて IPv6 アドレスを生成します。OpenStack Networking ルーターオプションまたは外部ルーターオプションを選択します。ra_mode が slaac に、address_mode が slaac に設定された OpenStack Networking サブネットを作成するには、この設定を使用します。

- DHCPv6 stateful: インスタンスは、OpenStack Networking DHCPv6 サービスから、IPv6 アドレスや追加のオプション (例: DNS) を受信します。ra_mode が dhcpv6-stateful に、address_mode が dhcpv6-stateful に設定されたサブネットを作成するには、この設定を使用します。

- DHCPv6 stateless: インスタンスは、OpenStack Networking ルーターから送信されるルーター広告 (RA) メッセージに基づいて IPv6 アドレスを生成します。追加のオプション (例: DNS) は、OpenStack Networking DHCPv6 サービスから割り当てられます。ra_mode が dhcpv6-stateless に、address_mode が dhcpv6-stateless に設定されたサブネットを作成するには、この設定を使用します。

- IP アドレス割り当てプール: DHCP によって割り当てられる IP アドレスの範囲。たとえば、192.168.22.100,192.168.22.100 という値を指定すると、その範囲内で使用可能なアドレスはすべて割り当ての対象として考慮されます。

- DNS サーバー: ネットワーク上で利用可能な DNS サーバーの IP アドレス。DHCP はこれらの IP アドレスをインスタンスに割り当てて名前解決します。

- 追加のルート設定: 静的ホストルート。まず CIDR 形式で宛先のネットワークを指定し、その後にルーティングに使用する次のホップを指定します (例: 192.168.23.0/24, 10.1.31.1)。静的ルートをインスタンスに分散する必要がある場合には、この値を指定します。

作成 をクリックします。

作成が完了したネットワークは、ネットワーク タブに表示されます。必要に応じて、ネットワークの編集 をクリックしてオプションを変更することもできます。インスタンスの作成時には、そのサブネットを使用するように設定できるようになりました。指定した DHCP オプションがインスタンスに適用されます。

3.2. 高度なネットワークの作成

管理者は、管理 の画面からネットワークを作成する際に高度なネットワークオプションを使用することができます。プロジェクトを指定し使用するネットワーク種別を定義するには、これらのオプションを使用します。

高度なネットワークを作成するには、以下の手順を実施します。

- Dashboard で、管理 > ネットワーク > ネットワーク > +ネットワークの作成 > プロジェクト を選択します。

- プロジェクト ドロップダウンリストを使用して、新規ネットワークをホストするプロジェクトを選択します。

プロバイダーネットワーク種別 でオプションを確認します。

- ローカル: トラフィックはローカルの Compute ホストに残り、実質的には外部のネットワークから分離されます。

- フラット: トラフィックは単一のネットワーク上に残り、ホストと共有することも可能となります。VLAN タグ付けやその他のネットワーク分離は行われません。

- VLAN: 物理ネットワークに存在する VLAN に対応した VLAN ID を使用してネットワークを作成します。このオプションを選択すると、インスタンスは同じレイヤー 2 VLAN 上のシステムと通信することができます。

- GRE: 複数のノードにまたがるネットワークオーバーレイを使用して、インスタンス間のプライベート通信を行います。オーバーレイの外部に送信されるトラフィックは、ルーティングする必要があります。

- VXLAN: GRE と同様に、複数のノードにまたがるネットワークオーバーレイを使用して、インスタンス間のプライベート通信を行います。オーバーレイの外部に送信されるトラフィックは、ルーティングする必要があります。

Create Network をクリックします。

プロジェクトのネットワークトポロジーをチェックして、ネットワークが適切に作成されたことを確認します。

3.3. ネットワークルーティングの追加

新規ネットワークからのトラフィックのルーティングを許可するには、そのサブネットを既存の仮想ルーターへのインターフェースとして追加する必要があります。

- Dashboard で プロジェクト > ネットワーク > ルーター を選択します。

ルーター 一覧で仮想ルーターの名前を選択し、+インターフェースの追加 をクリックします。

サブネット一覧で、新規サブネットの名前を選択します。インターフェースの IP アドレスを任意で指定することができます。

送信 をクリックします。

ネットワーク上のインスタンスが、サブネット外部のシステムと通信できるようになりました。

3.4. ネットワークの削除

以前に作成したネットワークを削除する必要がある場合があります (例: ハウスキーピングやデコミッションプロセスの一環としての処理など)。ネットワークを正常に削除するには、まず始めにまだネットワークが使用されているインターフェースを削除または切断する必要があります。

関連するインターフェースと共にプロジェクト内のネットワークを削除するには、以下の手順を実施します。

Dashboard で プロジェクト > ネットワーク > ネットワーク を選択します。

対象のネットワークサブネットに関連付けられたルーターインターフェースをすべて削除します。

インターフェースを削除するには、ネットワーク 一覧で対象のネットワークをクリックして ID フィールドを確認し、削除するネットワークの ID 番号を特定します。このネットワークに関連付けられたすべてのサブネットの ネットワーク ID フィールドには、この値が使用されます。

プロジェクト > ネットワーク > ルーター に移動し、ルーター 一覧で対象の仮想ルーターの名前をクリックし、削除するサブネットに接続されているインターフェースを特定します。

ゲートウェイ IP として機能していた IP アドレスで、削除するサブネットと他のサブネットを区別することができます。インターフェースのネットワーク ID が以前のステップで書き留めた ID と一致しているかどうかを確認することで、さらに確実に識別することができます。

- 削除するインターフェースの インターフェースの削除 ボタンをクリックします。

- プロジェクト > ネットワーク > ネットワーク を選択して、対象のネットワークの名前をクリックします。

削除するサブネットの サブネットの削除 ボタンをクリックします。

注記この時点でサブネットをまだ削除できない場合には、インスタンスがすでにそのサブネットを使用していないかどうかを確認してください。

- プロジェクト > ネットワーク > ネットワーク を選択し、削除するネットワークを選択します。

- ネットワークの削除 をクリックします。

3.5. プロジェクトのネットワークの削除

neutron purge コマンドを使用して、特定のプロジェクトに割り当てられた neutron リソースをすべて削除します。

たとえば、削除前に test-project プロジェクトの neutron リソースを削除するには、以下のコマンドを実行します。

# openstack project list +----------------------------------+--------------+ | ID | Name | +----------------------------------+--------------+ | 02e501908c5b438dbc73536c10c9aac0 | test-project | | 519e6344f82e4c079c8e2eabb690023b | services | | 80bf5732752a41128e612fe615c886c6 | demo | | 98a2f53c20ce4d50a40dac4a38016c69 | admin | +----------------------------------+--------------+ # neutron purge 02e501908c5b438dbc73536c10c9aac0 Purging resources: 100% complete. Deleted 1 security_group, 1 router, 1 port, 1 network. # openstack project delete 02e501908c5b438dbc73536c10c9aac0

3.6. サブネットの使用

サブネットを使用して、インスタンスにネットワーク接続を付与します。インスタンスの作成プロセスの一環として、各インスタンスはサブネットに割り当てられるため、最適なインスタンスの配置を考慮してインスタンスの接続性の要件に対応することが重要です。

既存のネットワークに対してのみ、サブネットを作成することができます。OpenStack Networking のプロジェクトネットワークでは、複数のサブネットをホストできることを念頭に入れておいてください。これは、まったく異なるシステムを同じネットワークでホストし、それらのシステムを分離する必要がある場合に役立ちます。

たとえば、1 つのサブネットでは Web サーバーのトラフィックだけが伝送されるようにする一方で、別のサブネットはデータベースのトラフィックが通過するように指定することができます。

サブネットは相互に分離され、別のサブネットと通信する必要のあるインスタンスのトラフィックは、ルーターによって転送する必要があります。したがって、互いに大量のトラフィックを送受信する必要があるシステムを同じサブネットにグルーピングすることで、ネットワークレイテンシーおよび負荷を軽減することができます。

3.6.1. サブネットの作成

サブネットを作成するには、以下の手順に従います。

- Dashboard で プロジェクト > ネットワーク > ネットワーク を選択して、ネットワーク ビューで対象のネットワークの名前をクリックします。

+サブネットの作成 をクリックして、以下の値を指定します。

フィールド 説明 サブネット名

サブネットの説明的な名前

ネットワークアドレス

IP アドレス範囲とサブネットマスクが 1 つの値としてまとめられた CIDR 形式のアドレス。CIDR 形式のアドレスを決定するには、サブネットマスクでマスキングされたビット数を算出して、IP アドレス範囲の値に追記します。たとえば、サブネットマスク 255.255.255.0 でマスクされるビット数は 24 です。このマスクを IPv4 アドレス範囲 192.168.122.0 に使用するには、アドレスを 192.168.122.0/24 と指定します。

IP バージョン

インターネットプロトコルバージョン (有効なタイプは IPv4 または IPv6)。ネットワークアドレス フィールドの IP アドレスの範囲は、選択したプロトコルバージョンと一致する必要があります。

ゲートウェイ IP

デフォルトゲートウェイに指定したルーターのインターフェースの IP アドレス。このアドレスは、外部ロケーションを宛先とするトラフィックルーティングの次のホップとなり、ネットワークアドレス フィールドで指定した範囲内でなければなりません。たとえば、CIDR 形式のネットワークアドレスが 192.168.122.0/24 の場合には、通常デフォルトのゲートウェイは 192.168.122.1 となります。

ゲートウェイなし

転送を無効にして、サブネットを分離します。

次へ をクリックして DHCP オプションを指定します。

- DHCP 有効: そのサブネットの DHCP サービスを有効にします。DHCP を使用して、インスタンスへの IP 設定の割り当てを自動化することができます。

IPv6 アドレス設定モード : IPv6 ネットワークを作成する際の設定モード。IPv6 ネットワークを作成する場合には、IPv6 アドレスと追加の情報をどのように割り当てるかを指定する必要があります。

- オプション指定なし: IP アドレスを手動で設定する場合または OpenStack が対応していない方法を使用してアドレスを割り当てる場合には、このオプションを選択します。

- SLAAC (Stateless Address Autoconfiguration): インスタンスは、ルーターから送信されるルーター広告 (RA) メッセージに基づいて IPv6 アドレスを生成します。OpenStack Networking ルーターオプションまたは外部ルーターオプションを選択します。ra_mode が slaac に、address_mode が slaac に設定された OpenStack Networking サブネットを作成するには、この設定を使用します。

- DHCPv6 stateful: インスタンスは、OpenStack Networking DHCPv6 サービスから、IPv6 アドレスや追加のオプション (例: DNS) を受信します。ra_mode が dhcpv6-stateful に、address_mode が dhcpv6-stateful に設定されたサブネットを作成するには、この設定を使用します。

- DHCPv6 stateless: インスタンスは、OpenStack Networking ルーターから送信されるルーター広告 (RA) メッセージに基づいて IPv6 アドレスを生成します。追加のオプション (例: DNS) は、OpenStack Networking DHCPv6 サービスから割り当てられます。ra_mode が dhcpv6-stateless に、address_mode が dhcpv6-stateless に設定されたサブネットを作成するには、この設定を使用します。

- IP アドレス割り当てプール: DHCP によって割り当てられる IP アドレスの範囲。たとえば、192.168.22.100,192.168.22.100 という値を指定すると、その範囲内で使用可能なアドレスはすべて割り当ての対象として考慮されます。

- DNS サーバー: ネットワーク上で利用可能な DNS サーバーの IP アドレス。DHCP はこれらの IP アドレスをインスタンスに割り当てて名前解決します。

- 追加のルート設定: 静的ホストルート。まず CIDR 形式で宛先のネットワークを指定し、その後にルーティングに使用する次のホップを指定します (例: 192.168.23.0/24, 10.1.31.1)。静的ルートをインスタンスに分散する必要がある場合には、この値を指定します。

作成 をクリックします。

サブネットは、サブネット の一覧に表示されます。必要に応じて、ネットワークの編集 をクリックしてオプションを変更することもできます。インスタンスの作成時には、そのサブネットを使用するように設定できるようになりました。指定した DHCP オプションがインスタンスに適用されます。

3.7. サブネットの削除

使用しなくなったサブネットは削除することができます。ただし、インスタンスがまだそのサブネットを使用するように設定されている場合には、削除を試みても失敗し、Dashboard にエラーメッセージが表示されます。

ネットワーク内の特定サブネットを削除するには、以下の手順を実施します。

- Dashboard で プロジェクト > ネットワーク > ネットワーク を選択します。

- 対象のネットワークの名前をクリックします。

- 対象のサブネットを選択して、サブネットの削除 をクリックします。

3.8. ルーターの追加

OpenStack Networking は、SDN をベースとする仮想ルーターを使用したルーティングサービスを提供します。インスタンスが外部のサブネット (物理ネットワーク内のサブネットを含む) と通信するには、ルーターは必須です。ルーターとサブネットはインターフェースを使用して接続します。各サブネットにはルーターに接続するための独自のインターフェースが必要です。

ルーターのデフォルトゲートウェイは、そのルーターが受信するトラフィックの次のホップを定義します。そのネットワークは通常、仮想ブリッジを使用して、外部の物理ネットワークにトラフィックをルーティングするように設定されます。

ルーターを作成するには、以下の手順を実施します。

- Dashboard で プロジェクト > ネットワーク > ルーター を選択し、+ルーターの作成 をクリックします。

- 新規ルーターの説明的な名前を入力し、ルーターの作成 をクリックします。

- ルーター 一覧に新たに追加されたルーターのエントリーの横にある ゲートウェイの設定 をクリックします。

- 外部ネットワーク の一覧で、外部ロケーション宛のトラフィックを受信するネットワークを指定します。

Set Gateway をクリックします。

ルーターを追加したら、作成済みのサブネットがこのルーターを使用してトラフィックを送信するように設定しなければなりません。そのためには、サブネットとルーター間のインターフェースを作成します。

サブネットのデフォルトルートを上書きすることはできません。サブネットのデフォルトルートが削除されると、L3 エージェントは自動的に対応するルーター名前空間のルートも削除するので、関連付けられたサブネットとの間でネットワークトラフィックの送受信ができなくなります。既存のルーター名前空間のルートが削除された場合にこの問題を解決するには、以下の手順を実施します。

- サブネット上の全 Floating IP の割り当てを解除します。

- ルーターをサブネットから切断します。

- ルーターをサブネットに再接続します。

- すべての Floating IP を再接続します。

3.9. ルーターの削除

インターフェースが接続されていないルーターは削除することができます。

インターフェースの接続を解除しルーターを削除するには、以下の手順を実施します。

- Dashboard で プロジェクト > ネットワーク > ルーター を選択し、削除するルーターの名前をクリックします。

- 種別が 内部インタフェース のインターフェースを選択し、インターフェースの削除 をクリックします。

- ルーター 一覧から対象のルーターを選択して ルーターの削除 をクリックします。

3.10. インターフェースの追加

ルーターとサブネットを橋渡しするインターフェースを使用することにより、ルーターはインスタンスが送信したトラフィックを中継サブネット外部の宛先に転送することができます。

ルーターのインターフェースを追加して、新しいインターフェースをサブネットに接続するには、以下の手順を実施します。

以下の手順では、ネットワークトポロジー機能を使用します。この機能を使用することで、ネットワーク管理タスクを実施する際に、全仮想ルーターおよびネットワークをグラフィカルに表した図を表示することができます。

- Dashboard で プロジェクト > ネットワーク > ネットワークトポロジー を選択します。

- 管理するルーターを特定してその上にカーソルを移動し、+インターフェースの追加 をクリックします。

ルーターに接続するサブネットを指定します。

IP アドレスを指定することもできます。インターフェースに対して ping を実行して成功した場合には、トラフィックのルーティングが想定通りに機能していることが確認できるので、このアドレスを指定しておくとテストやトラブルシューティングに役立ちます。

Add interface をクリックします。

ネットワークトポロジー の図が自動的に更新され、ルーターとサブネットの間の新規インターフェース接続が反映されます。

3.11. インターフェースの削除

ルーターがサブネットのトラフィックを転送する必要がなくなった場合には、サブネットへのインターフェースを削除することができます。

インターフェースを削除するには、以下の手順を実施します。

- Dashboard で プロジェクト > ネットワーク > ルーター を選択します。

- 削除するインターフェースをホストしているルーターの名前をクリックします。

- インターフェース種別 (内部インタフェース) を選択し、インターフェースの削除 をクリックします。

3.12. IP アドレスの設定

OpenStack Networking における IP アドレスの割り当てを管理するには、本項の手順に従います。

3.12.1. Floating IP アドレスプールの作成

Floating IP アドレスを使用して、ネットワークの受信ネットワークトラフィックを OpenStack インスタンスに転送することができます。まず適切にルーティング可能な外部 IP アドレスのプールを定義する必要があります。その後、それらの IP アドレスをインスタンスに動的に割り当てることができます。OpenStack Networking は、特定の Floating IP アドレス宛の受信トラフィックを、すべてその Floating IP アドレスを割り当てたインスタンスにルーティングします。

OpenStack Networking は、同じ IP 範囲/CIDR から全プロジェクト (テナント) に Floating IP アドレスを確保します。これにより、すべてのプロジェクトが全 Floating IP サブネットからの Floating IP を使用できることができます。この動作は、個別のプロジェクトごとのクォータを使用することで管理できます。たとえば、ProjectA と ProjectB のクォータのデフォルトを 10 に設定する一方、ProjectC のクォータを 0 に設定することができます。

外部サブネットを作成する際に、Floating IP 確保用プールを定義することもできます。サブネットが Floating IP アドレスのみをホストする場合には、openstack subnet create コマンドで --no-dhcp オプションを指定して、DHCP による割り当てを無効にすることを検討してください。

# openstack subnet create --no-dhcp --allocation-pool start=IP_ADDRESS,end=IP_ADDRESS --gateway IP_ADDRESS --network SUBNET_RANGE NETWORK_NAME

以下に例を示します。

# openstack subnet create --no-dhcp --allocation_pool start=192.168.100.20,end=192.168.100.100 --gateway 192.168.100.1 --network 192.168.100.0/24 public

3.12.2. 特定の Floating IP アドレスの割り当て

nova コマンドを使用して、特定の Floating IP アドレスをインスタンスに割り当てることが可能です。

# nova floating-ip-associate INSTANCE_NAME IP_ADDRESS

以下の例では、Floating IP アドレスは corp-vm-01 という名前のインスタンスに割り当てられます。

# nova floating-ip-associate corp-vm-01 192.168.100.20

3.12.3. Floating IP アドレスの無作為な割り当て

Floating IP アドレスをインスタンスに動的に確保するには、以下の手順を実施します。

以下の

openstackコマンドを入力します。# openstack floating ip create

以下の例では、特定の IP アドレスを選択する代わりに、OpenStack Networking にプールから Floating IP アドレスを確保するよう要求します。

# openstack floating ip create public +---------------------+--------------------------------------+ | Field | Value | +---------------------+--------------------------------------+ | fixed_ip_address | | | floating_ip_address | 192.168.100.20 | | floating_network_id | 7a03e6bc-234d-402b-9fb2-0af06c85a8a3 | | id | 9d7e2603482d | | port_id | | | router_id | | | status | ACTIVE | | tenant_id | 9e67d44eab334f07bf82fa1b17d824b6 | +---------------------+--------------------------------------+

IP アドレスを確保したら、特定のインスタンスに割り当てることができます。

以下のコマンドを入力し、インスタンスに関連付けられたポート ID を特定します。

# openstack port list

(ポート ID とインスタンスに割り当てられた固定 IP アドレスのマッピングが表示されます。)

# openstack port list +--------+------+-------------+--------------------------------------------------------+ | id | name | mac_address | fixed_ips | +--------+------+-------------+--------------------------------------------------------+ | ce8320 | | 3e:37:09:4b | {"subnet_id": "361f27", "ip_address": "192.168.100.2"} | | d88926 | | 3e:1d:ea:31 | {"subnet_id": "361f27", "ip_address": "192.168.100.5"} | | 8190ab | | 3e:a3:3d:2f | {"subnet_id": "b74dbb", "ip_address": "10.10.1.25"} | +--------+------+-------------+--------------------------------------------------------+インスタンス ID をインスタンスのポート ID に関連付けます。

openstack server add floating ipINSTANCE_NAME_OR_ID FLOATING_IP_ADDRESS以下に例を示します。

# openstack server add floating ip VM1 172.24.4.225

MAC アドレス (3 列目) がインスタンスのポートと一致していることを確認して、インスタンスの正しいポート ID を使用したことを確認します。

# openstack port list +--------+------+-------------+--------------------------------------------------------+ | id | name | mac_address | fixed_ips | +--------+------+-------------+--------------------------------------------------------+ | ce8320 | | 3e:37:09:4b | {"subnet_id": "361f27", "ip_address": "192.168.100.2"} | | d88926 | | 3e:1d:ea:31 | {"subnet_id": "361f27", "ip_address": "192.168.100.5"} | | 8190ab | | 3e:a3:3d:2f | {"subnet_id": "b74dbb", "ip_address": "10.10.1.25"}| +--------+------+-------------+--------------------------------------------------------+

3.13. 複数の Floating IP アドレスプールの作成

OpenStack Networking は、それぞれの L3 エージェントごとに 1 つの Floating IP プールをサポートします。したがって、追加の Floating IP プールを作成するには、L3 エージェントをスケールアウトする必要があります。

/var/lib/config-data/neutron/etc/neutron/neutron.conf で、属性 handle_internal_only_routers の値が環境内の 1 つの L3 エージェントに対してのみ True に設定されていることを確認します。このオプションにより、L3 エージェントは外部ルーター以外だけを管理するようになります。

3.14. 物理ネットワークのブリッジ

仮想インスタンスの送受信接続を可能にするには、仮想ネットワークと物理ネットワーク間をブリッジングします。

以下の手順では、例として示した物理インターフェース eth0 はブリッジ br-ex にマッピングされます。この仮想ブリッジは、物理ネットワークと仮想ネットワーク間を中継する機能を果たします。

これにより、eth0 を通過するすべてのトラフィックは、設定した Open vSwitch を使用してインスタンスに到達します。

詳細は、「11章ブリッジマッピングの設定」を参照してください。

物理 NIC を仮想 Open vSwitch ブリッジにマッピングするには、以下の手順を実施します。

テキストエディターで

/etc/sysconfig/network-scripts/ifcfg-eth0を開き、以下のパラメーターをご自分のサイトのネットワークに適した値で更新します。- IPADDR

- NETMASK GATEWAY

DNS1 (ネームサーバー)

以下は例です。

# vi /etc/sysconfig/network-scripts/ifcfg-eth0 DEVICE=eth0 TYPE=OVSPort DEVICETYPE=ovs OVS_BRIDGE=br-ex ONBOOT=yes

テキストエディターで

/etc/sysconfig/network-scripts/ifcfg-br-exを開き、前のステップで eth0 に確保した IP アドレスの値で仮想ブリッジのパラメーターを更新します。# vi /etc/sysconfig/network-scripts/ifcfg-br-ex DEVICE=br-ex DEVICETYPE=ovs TYPE=OVSBridge BOOTPROTO=static IPADDR=192.168.120.10 NETMASK=255.255.255.0 GATEWAY=192.168.120.1 DNS1=192.168.120.1 ONBOOT=yes

インスタンスに Floating IP アドレスを割り当てて、物理ネットワークが利用できるようにすることができます。

第4章 IP アドレス使用のプランニング

OpenStack のデプロイメントでは、予想以上の数の IP アドレスが使用される可能性があります。本項では、必要なアドレスの数を適切に予測する方法、およびそのアドレスが環境のどこで使用されるかについて説明します。

4.1. VLAN のプランニング

Red Hat OpenStack Platform のデプロイメントを計画する際は、個々の IP アドレスの確保元となるサブネットの数を把握することから始めます。複数のサブネットを使用する場合、システム間のトラフィックを VLAN に分割することができます。

たとえば、管理または API トラフィックは、Web トラフィックに対応するシステムと同じネットワーク上に置かないことが理想的です。VLAN 間のトラフィックはルーターを通過するので、ファイアウォールを実装してトラフィックフローを管理することができます。

VLAN は、全体計画 (トラフィックの分離、高可用性、およびデプロイメント内のさまざまな種類の仮想ネットワークリソースに対する IP アドレスの使用状況などが含まれます) の一部としてプランニングする必要があります。

1 つのネットワーク、あるいはネットワークノードの 1 つの OVS エージェントに設定できる VLAN の最大数は 4094 です。最大数を超える VLAN が必要な場合は、複数のプロバイダーネットワーク (VXLAN ネットワーク) および複数のネットワークノードを作成することができます。それぞれのノードには、最大で 4094 のプライベートネットワークを設定することができます。

4.2. ネットワークトラフィックの種別

異種のネットワークトラフィックをホストする場合は、別個の VLAN をトラフィックに割り当てます。たとえば、各種ネットワークごとに別の VLAN を指定することができます。外部ネットワークだけは、外部の物理ネットワークへのルーティングを可能にする必要があります。本リリースでは、director により DHCP サービスが提供されます。

本項で説明するすべての分離 VLAN が、すべての OpenStack デプロイメントで必要な訳ではありません。たとえば、クラウドユーザーがアドホックの仮想ネットワークをオンデマンドで作成しない場合には、プロジェクトネットワークは必要ない可能性があります。各仮想マシンを他の物理システムと同じスイッチに直接接続する場合には、コンピュートノードを直接プロバイダーネットワークに接続し、インスタンスが直接そのプロバイダーネットワークを使用するように設定します。

- プロビジョニングネットワーク: この VLAN は、PXE ブートで director を使用して新規ノードをデプロイするためだけに特化されています。OpenStack Orchestration (heat) は、OpenStack をオーバークラウドのベアメタルサーバーにインストールします。これらのサーバーは物理ネットワークにアタッチされ、アンダークラウドのインフラストラクチャーから OpenStack Platform のインストールイメージを取得します。

内部 API ネットワーク: OpenStack のサービスは、API 通信、RPC メッセージ、データベース通信などに内部 API ネットワークを使用します。さらに、このネットワークは、コントローラーノード間の稼働メッセージの通信にも使用されます。IP アドレスの割り当てを計画する際には、各 API サービスには独自の IP アドレスが必要である点を念頭に置いてください。具体的には、以下のサービスごとに IP アドレスの割当てを計画する必要があります。

- vip-msg (ampq)

- vip-keystone-int

- vip-glance-int

- vip-cinder-int

- vip-nova-int

- vip-neutron-int

- vip-horizon-int

- vip-heat-int

- vip-ceilometer-int

- vip-swift-int

- vip-keystone-pub

- vip-glance-pub

- vip-cinder-pub

- vip-nova-pub

- vip-neutron-pub

- vip-horizon-pub

- vip-heat-pub

- vip-ceilometer-pub

- vip-swift-pub

高可用性を使用する場合、Pacemaker により仮想 IP アドレスが物理ノード間で移動します。

- ストレージ: Block Storage、NFS、iSCSI、およびその他のストレージサービス。パフォーマンス上の理由から、このネットワークを別の物理イーサネットリンクに分離します。

- Storage Management: OpenStack Object Storage (swift) は、参加するレプリカノード間でデータオブジェクトを同期するために、このネットワークを使用します。プロキシーサービスは、ユーザー要求と下層のストレージレイヤーの間の仲介インターフェースとして機能します。プロキシーは、入着要求を受け取り、必要なレプリカの位置を特定して要求データを取得します。Ceph バックエンドを使用するサービスは、Ceph と直接対話せずにフロントエンドのサービスを使用するため、Storage Management ネットワーク経由で接続を確立します。RBD ドライバーは例外で、このトラフィックは直接 Ceph に接続する点に注意してください。

- プロジェクトネットワーク: Neutron は、VLAN 分離 (各プロジェクトネットワークがネットワーク VLAN) または VXLAN か GRE によるトンネリングを使用した独自のネットワークを各プロジェクトに提供します。ネットワークトラフィックは、プロジェクトのネットワークごとに分離されます。それぞれのプロジェクトネットワークには IP サブネットが割り当てられ、複数のプロジェクトネットワークが同じアドレスを使用する場合があります。

- 外部: 外部ネットワークは、パブリック API エンドポイントと Dashboard (horizon) への接続をホストします。このネットワークを SNAT に使用することもできます。実稼働環境のデプロイでは、大抵の場合、Floating IP アドレスと NAT に別のネットワークが使用されます。

- プロバイダーネットワーク: 既存のネットワークインフラストラクチャーにインスタンスをアタッチするには、プロバイダーネットワークを使用します。フラットネットワークまたは VLAN タグでデータセンターの既存の物理ネットワークに直接マッピングするために、プロバイダーネットワークを使用することができます。これにより、インスタンスは、OpenStack Networking インフラストラクチャー外部のシステムと同じレイヤー 2 ネットワークを共有することができます。

4.3. IP アドレスの消費

以下のシステムは割り当てられた範囲からの IP アドレスを消費します。

- 物理ノード: 物理 NIC ごとに IP アドレスが 1 つ必要です。物理 NIC に固有の機能を割り当てるのが一般的な慣習です。たとえば、管理トラフィックと NFS トラフィックを、それぞれ別の物理 NIC に割り当てます (冗長化の目的で、異なるスイッチに接続された複数の NIC が使用される場合があります)。

- 高可用性の仮想 IP (VIP): コントローラーノード間で共有されるネットワーク 1 つにつき、1 - 3 つの仮想 IP を割り当てる計画としてください。

4.4. 仮想ネットワーク

以下に示す仮想リソースは、OpenStack Networking の IP アドレスを消費します。これらのリソースはクラウドインフラストラクチャーではローカルとみなされ、外部の物理ネットワークにあるシステムから到達可能である必要はありません。

- プロジェクトネットワーク: 各プロジェクトネットワークには、サブネットが必要です。このサブネットを使用して、IP アドレスをインスタンスに割り当てることができます。

- 仮想ルーター: サブネットに結線する各ルーターのインターフェースには、IP アドレス が 1 つ必要です。DHCP を使用する場合は、各ルーターのインターフェースに 2 つの IP アドレスが必要です。

- インスタンス: 各インスタンスには、インスタンスをホストするプロジェクトサブネットからのアドレスが必要です。受信トラフィックが必要な場合には、指定の外部ネットワークからインスタンスに Floating IP アドレスを確保する必要があります。

- 管理トラフィック: OpenStack サービスと API トラフィックを含みます。すべてのサービスが、少数の仮想 IP アドレスを共有します。API、RPC、およびデータベースサービスは、内部 API の仮想 IP アドレスで通信します。

4.5. ネットワークプランの例

以下の例には、複数のサブネットに対応する、さまざまなネットワークを示しています。各サブネットには IP アドレスの範囲が 1 つ割り当てられます。

表4.1 サブネットプランの例

| サブネット名 | アドレス範囲 | アドレス数 | サブネットマスク |

|---|---|---|---|

| プロビジョニングネットワーク | 192.168.100.1 - 192.168.100.250 | 250 | 255.255.255.0 |

| 内部 API ネットワーク | 172.16.1.10 - 172.16.1.250 | 241 | 255.255.255.0 |

| ストレージ | 172.16.2.10 - 172.16.2.250 | 241 | 255.255.255.0 |

| ストレージ管理 | 172.16.3.10 - 172.16.3.250 | 241 | 255.255.255.0 |

| テナントネットワーク (GRE/VXLAN) | 172.16.4.10 - 172.16.4.250 | 241 | 255.255.255.0 |

| 外部ネットワーク (Floating IP など) | 10.1.2.10 - 10.1.3.222 | 469 | 255.255.254.0 |

| プロバイダーネットワーク (インフラストラクチャー) | 10.10.3.10 - 10.10.3.250 | 241 | 255.255.252.0 |

第5章 OpenStack Networking ルーターポートの確認

OpenStack Networking の仮想ルーターは、ポートを使用してサブネットと相互接続します。これらのポートの状態を確認して、想定通りに接続されているかどうかを判断できます。

5.1. ポートの現在のステータスの表示

特定のルーターに接続されたポートをすべて一覧表示し、ポートの現在の状態 (DOWN または ACTIVE) を取得するには、以下の手順を実施します。

r1 という名前のルーターに接続されたすべてのポートを表示するには、以下のコマンドを実行します。

# neutron router-port-list r1

結果の例:

+--------------------------------------+------+-------------------+--------------------------------------------------------------------------------------+ | id | name | mac_address | fixed_ips | +--------------------------------------+------+-------------------+--------------------------------------------------------------------------------------+ | b58d26f0-cc03-43c1-ab23-ccdb1018252a | | fa:16:3e:94:a7:df | {"subnet_id": "a592fdba-babd-48e0-96e8-2dd9117614d3", "ip_address": "192.168.200.1"} | | c45e998d-98a1-4b23-bb41-5d24797a12a4 | | fa:16:3e:ee:6a:f7 | {"subnet_id": "43f8f625-c773-4f18-a691-fd4ebfb3be54", "ip_address": "172.24.4.225"} | +--------------------------------------+------+-------------------+--------------------------------------------------------------------------------------+各ポートの詳細を表示するには、以下のコマンドを実行します。表示するポートのポート ID を指定します。コマンドの出力にはポートのステータスが含まれており、以下の例では状態が

ACTIVEであることが分かります。# openstack port show b58d26f0-cc03-43c1-ab23-ccdb1018252a

結果の例:

+-----------------------+--------------------------------------------------------------------------------------+ | Field | Value | +-----------------------+--------------------------------------------------------------------------------------+ | admin_state_up | True | | allowed_address_pairs | | | binding:host_id | node.example.com | | binding:profile | {} | | binding:vif_details | {"port_filter": true, "ovs_hybrid_plug": true} | | binding:vif_type | ovs | | binding:vnic_type | normal | | device_id | 49c6ebdc-0e62-49ad-a9ca-58cea464472f | | device_owner | network:router_interface | | extra_dhcp_opts | | | fixed_ips | {"subnet_id": "a592fdba-babd-48e0-96e8-2dd9117614d3", "ip_address": "192.168.200.1"} | | id | b58d26f0-cc03-43c1-ab23-ccdb1018252a | | mac_address | fa:16:3e:94:a7:df | | name | | | network_id | 63c24160-47ac-4140-903d-8f9a670b0ca4 | | security_groups | | | status | ACTIVE | | tenant_id | d588d1112e0f496fb6cac22f9be45d49 | +-----------------------+--------------------------------------------------------------------------------------+- ポートごとにステップ 2 を実施して、ステータスを取得します。

第6章 プロバイダーネットワークのトラブルシューティング

仮想ルーターとスイッチのデプロイメントは、ソフトウェア定義ネットワーク (SDN) としても知られており、(デプロイメントが) 複雑化しているように感じられる場合があります。しかし、OpenStack Networking のネットワークの接続性をトラブルシューティングする診断プロセスは、物理ネットワークの診断プロセスとよく似ています。VLAN を使用する場合は、仮想インフラストラクチャーは、全く別の環境ではなく、物理ネットワークのトランク接続による広帯域化と考えることができます。

6.1. 基本的な ping 送信テスト

ping コマンドは、ネットワーク接続の問題解析に役立つツールです。ping コマンドで返される結果は、ネットワーク接続に関する基本的な指標として機能しますが、実際のアプリケーショントラフィックをブロックするファイアウォールなど、すべての接続性の問題を完全に除外する訳ではありません。ping コマンドは、特定の宛先にトラフィックを送信し、次に ping 送信の試行に問題がなかったかどうかを報告します。

ping コマンドは ICMP プロトコルを使用した操作です。ping を使用するには、ICMP トラフィックが中間ファイアウォールを通過するのを許可する必要があります。

ping テストは、ネットワークの問題が発生しているマシンから実行すると最も有効です。そのため、マシンが完全にオフラインの場合には、VNC 管理コンソール経由でコマンドラインに接続する必要がある場合があります。

たとえば、以下に示す ping テストコマンドが成功するためには、複数のネットワークインフラストラクチャー層が検証されます。つまり、名前の解決、IP ルーティング、およびネットワークスイッチのすべてが正常に機能していなければなりません。

$ ping www.redhat.com PING e1890.b.akamaiedge.net (125.56.247.214) 56(84) bytes of data. 64 bytes from a125-56.247-214.deploy.akamaitechnologies.com (125.56.247.214): icmp_seq=1 ttl=54 time=13.4 ms 64 bytes from a125-56.247-214.deploy.akamaitechnologies.com (125.56.247.214): icmp_seq=2 ttl=54 time=13.5 ms 64 bytes from a125-56.247-214.deploy.akamaitechnologies.com (125.56.247.214): icmp_seq=3 ttl=54 time=13.4 ms ^C

ping コマンドの結果のサマリーが表示されたら、Ctrl+c で ping コマンドを終了することができます。パケットロスがゼロパーセントであれば、接続が安定し、タイムアウトが発生しなかったことを示しています。

--- e1890.b.akamaiedge.net ping statistics --- 3 packets transmitted, 3 received, 0% packet loss, time 2003ms rtt min/avg/max/mdev = 13.461/13.498/13.541/0.100 ms

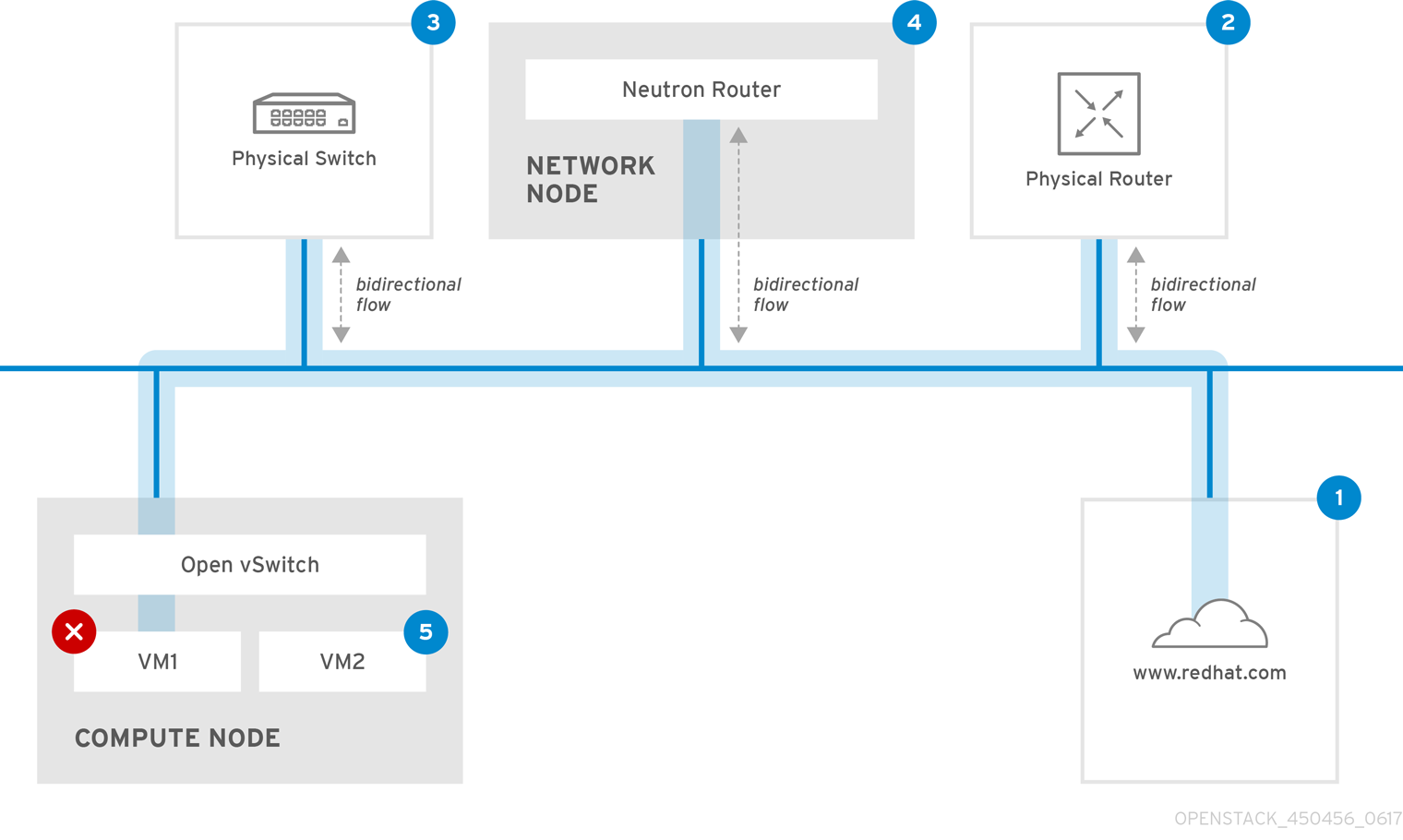

ping テストの送信先によっては、テストの結果は非常に明確な場合があります。たとえば、以下の図では、VM1 において何らかの接続性の問題が発生しています。ping 送信可能な宛先を青の番号で示しています。また、成功結果または失敗結果から導かれた結論を記載しています。

1. インターネット: 一般的な最初のステップは、www.redhat.com などのインターネットロケーションに ping テストを送信することです。

- 成功: このテストは、マシンとインターネットの間にあるさまざまなネットワークポイントすべてが正常に機能していることを示します。これには、仮想/物理インフラストラクチャーが含まれます。

- 失敗: 遠隔にあるインターネットロケーションへの ping テストは、さまざまな部分で失敗する可能性があります。ネットワーク上の他のマシンがインターネットに正常に ping 送信できる場合には、インターネット接続は機能していることが分かり、問題は概ねローカルマシンの設定にあると考えられます。

2.物理ルーター: これは、外部の送信先にトラフィックを転送するために、ネットワーク管理者が指定するルーターインターフェースです。

- 成功: 物理ルーターに ping テストを行って、ローカルネットワークと基盤のスイッチが機能しているかどうかを検証することができます。このパケットは、ルーターを通過しないため、デフォルトのゲートウェイにルーティングの問題があるかどうかは分かりません。

- 失敗: これは、VM1 とデフォルトゲートウェイの間で問題があることを示しています。ルーター/スイッチがダウンしているか、不正なデフォルトゲートウェイを使用している可能性があります。正常に機能していることを確認済みの別のサーバーと、設定内容を比較してください。また、ローカルネットワーク上の別のサーバーに ping 送信を試行してみてください。

3.Neutron ルーター: これは、Red Hat OpenStack Platform が仮想マシントラフィックの転送に使用する仮想 SDN (ソフトウェア定義ネットワーク) ルーターです。

- 成功: ファイアウォールが ICMP トラフィックを許可し、ネットワークノードがオンラインの状態です。

- 失敗: インスタンスのセキュリティーグループで、ICMP トラフィックが許可されているかどうかを確認してください。また、ネットワークノードがオンラインで、必要なサービスすべてが実行中であることをチェックし、L3 エージェントのログ (/var/log/neutron/l3-agent.log) を確認してください。

4.物理スイッチ: 物理スイッチは、同じ物理ネットワーク上にあるノード間のトラフィックを管理します。

- 成功: 仮想マシンが物理スイッチへ送信したトラフィックは、仮想ネットワークインフラストラクチャーを通過する必要があります。つまり、このセグメントが正常に機能していることが分かります。

- 失敗: 必要な VLAN をトランク接続するように物理スイッチポートが設定されていることを確認してください。

5.VM2: 同じコンピュートノード上にある、同じサブネットの仮想マシンに ping 送信を試行します。

- 成功: VM1 上の NIC ドライバーと基本的な IP 設定が機能しています。

- 失敗: VM1 のネットワーク設定を検証します。問題がない場合には、VM2 のファイアウォールが単に ping トラフィックをブロックしている可能性があります。また、仮想スイッチの設定を検証し、Open vSwitch (または Linux ブリッジ) のログファイルを確認します。

6.2. VLAN ネットワークのトラブルシューティング

OpenStack Newtorking は、VLAN ネットワークをトランク接続して SDN スイッチに到達することができます。VLAN タグ付けされたプロバイダーネットワークに対するサポートがあると、仮想インスタンスを物理ネットワークにあるサーバーのサブネットと統合することができます。

VLAN プロバイダーネットワークへの接続のトラブルシューティングを行うには、以下の手順を実施します。

ping <gateway-IP-address>コマンドを使用して、ゲートウェイに ping 送信を行います。以下のコマンドで作成されたネットワークを例にして説明します。

# openstack network create --provider-network-type vlan --provider-physical-network phy-eno1 --provider-segment 120 provider # openstack subnet create --no-dhcp --allocation-pool start=192.168.120.1,end=192.168.120.153 --gateway 192.168.120.254 --network provider public_subnet

上記の例では、ゲートウェイの IP アドレスは 192.168.120.254 です。

$ ping 192.168.120.254

ping 送信に失敗する場合は、以下の項目を確認します。

関連付けられた VLAN へのネットワークフローがあることを確認する。

VLAN ID が設定されていない可能性があります。上記の例では、OpenStack Networking は VLAN 120 をプロバイダーネットワークにトランク接続するように設定されています。(例のステップ 1 の --provider:segmentation_id=120 を参照してください。)

コマンド

ovs-ofctl dump-flows <bridge-name>を使用して、ブリッジインターフェースの VLAN フローを確認する。以下の例では、ブリッジは br-ex という名前です。

# ovs-ofctl dump-flows br-ex NXST_FLOW reply (xid=0x4): cookie=0x0, duration=987.521s, table=0, n_packets=67897, n_bytes=14065247, idle_age=0, priority=1 actions=NORMAL cookie=0x0, duration=986.979s, table=0, n_packets=8, n_bytes=648, idle_age=977, priority=2,in_port=12 actions=drop

6.2.1. VLAN 設定とログファイルの確認

OpenStack Networking (neutron) エージェント:

openstack network agent listコマンドを使用して、すべてのエージェントが稼働し、正しい名前で登録されていることを確認します。(overcloud)[stack@undercloud~]$ openstack network agent list +--------------------------------------+--------------------+-----------------------+-------+----------------+ | id | agent_type | host | alive | admin_state_up | +--------------------------------------+--------------------+-----------------------+-------+----------------+ | a08397a8-6600-437d-9013-b2c5b3730c0c | Metadata agent | rhelosp.example.com | :-) | True | | a5153cd2-5881-4fc8-b0ad-be0c97734e6a | L3 agent | rhelosp.example.com | :-) | True | | b54f0be7-c555-43da-ad19-5593a075ddf0 | DHCP agent | rhelosp.example.com | :-) | True | | d2be3cb0-4010-4458-b459-c5eb0d4d354b | Open vSwitch agent | rhelosp.example.com | :-) | True | +--------------------------------------+--------------------+-----------------------+-------+----------------+

- /var/log/containers/neutron/openvswitch-agent.log を確認します。このログでは、作成プロセスで ovs-ofctl コマンドを使用して VLAN のトランク接続が設定されたことが確認できるはずです。

-

/etc/neutron/l3_agent.ini ファイルで external_network_bridge を確認します。

external_network_bridgeパラメーターにハードコードされた値がある場合、L3 エージェントと共にプロバイダーネットワークを使用することができず、必要なフローを作成することはできません。external_network_bridgeの値は、external_network_bridge = "" の形式でなければなりません。 - /etc/neutron/plugin.ini ファイルで network_vlan_ranges の値を確認します。プロバイダーネットワークの場合には、数字の VLAN ID を指定しないでください。VLAN を分離したプロジェクトネットワークを使用している場合に限り、ID を指定します。

-

OVS エージェントの設定ファイルのブリッジマッピングを検証し、

phy-eno1にマッピングされているブリッジが存在することと、eno1に適切に接続されていることを確認します。

6.3. プロジェクトネットワーク内からのトラブルシューティング

OpenStack Networking では、プロジェクトが互いに干渉を生じさせることなくネットワークを設定できるように、すべてのプロジェクトトラフィックはネットワークの名前空間に含まれます。たとえば、ネットワークの名前空間を使用することで、異なるプロジェクトが 192.168.1.1/24 の同じサブネット範囲を指定しても、テナント間で干渉は生じません。

プロジェクトネットワークのトラブルシューティングを開始するに、まず対象のネットワークがどのネットワーク名前空間に含まれているかを確認します。

openstack network listコマンドを使用して、すべてのプロジェクトネットワークを一覧表示します。# (overcloud)[stack@osp13-undercloud ~]$ openstack network list +--------------------------------------+-------------+-------------------------------------------------------+ | id | name | subnets | +--------------------------------------+-------------+-------------------------------------------------------+ | 9cb32fe0-d7fb-432c-b116-f483c6497b08 | web-servers | 453d6769-fcde-4796-a205-66ee01680bba 192.168.212.0/24 | | a0cc8cdd-575f-4788-a3e3-5df8c6d0dd81 | private | c1e58160-707f-44a7-bf94-8694f29e74d3 10.0.0.0/24 | | baadd774-87e9-4e97-a055-326bb422b29b | private | 340c58e1-7fe7-4cf2-96a7-96a0a4ff3231 192.168.200.0/24 | | 24ba3a36-5645-4f46-be47-f6af2a7d8af2 | public | 35f3d2cb-6e4b-4527-a932-952a395c4bb3 172.24.4.224/28 | +--------------------------------------+-------------+-------------------------------------------------------+

上記の例では、web-servers ネットワークを確認します。web-servers 行の id の値 (9cb32fe0-d7fb-432c-b116-f483c6497b08) を書き留めてください。この値がネットワークの名前空間に追加されているので、次のステップで名前空間の特定が容易になります。

ip netns listコマンドを使用して、ネットワークの名前空間をすべて一覧表示します。# ip netns list qdhcp-9cb32fe0-d7fb-432c-b116-f483c6497b08 qrouter-31680a1c-9b3e-4906-bd69-cb39ed5faa01 qrouter-62ed467e-abae-4ab4-87f4-13a9937fbd6b qdhcp-a0cc8cdd-575f-4788-a3e3-5df8c6d0dd81 qrouter-e9281608-52a6-4576-86a6-92955df46f56

出力に、web-servers のネットワーク ID と一致する名前空間が表示されます。上記の例では、名前空間は qdhcp-9cb32fe0-d7fb-432c-b116-f483c6497b08 です。

名前空間内でトラブルシューティングのコマンド

ip netns exec <namespace>を実行し、web-servers ネットワークの設定を検証します。# ip netns exec qrouter-62ed467e-abae-4ab4-87f4-13a9937fbd6b route -n Kernel IP routing table Destination Gateway Genmask Flags Metric Ref Use Iface 0.0.0.0 172.24.4.225 0.0.0.0 UG 0 0 0 qg-8d128f89-87 172.24.4.224 0.0.0.0 255.255.255.240 U 0 0 0 qg-8d128f89-87 192.168.200.0 0.0.0.0 255.255.255.0 U 0 0 0 qr-8efd6357-96

6.3.1. 名前空間内での高度な ICMP テストの実行

tcpdumpコマンドを使用して、ICMP トラフィックを取得します。# ip netns exec qrouter-62ed467e-abae-4ab4-87f4-13a9937fbd6b tcpdump -qnntpi any icmp

別のコマンドラインウィンドウで、外部ネットワークへの ping テストを実行します。

# ip netns exec qrouter-62ed467e-abae-4ab4-87f4-13a9937fbd6b ping www.redhat.com

tcpdump セッションを実行中のターミナルで、ping テストの結果の詳細を確認します。

tcpdump: listening on any, link-type LINUX_SLL (Linux cooked), capture size 65535 bytes IP (tos 0xc0, ttl 64, id 55447, offset 0, flags [none], proto ICMP (1), length 88) 172.24.4.228 > 172.24.4.228: ICMP host 192.168.200.20 unreachable, length 68 IP (tos 0x0, ttl 64, id 22976, offset 0, flags [DF], proto UDP (17), length 60) 172.24.4.228.40278 > 192.168.200.21: [bad udp cksum 0xfa7b -> 0xe235!] UDP, length 32

トラフィックの tcpdump 解析を実行する際には、インスタンスではなくルータインターフェース方向の応答パケットが確認される場合があります。qrouter によりリターンパケットで DNAT が実行されるので、これは想定どおりの動作です。

第7章 物理ネットワークへのインスタンスの接続

本章では、プロバイダーネットワークを使用して外部ネットワークに直接インスタンスを接続する方法について説明します。

7.1. OpenStack Networking トポロジーの概要

OpenStack Networking (neutron) には、さまざまなノード種別に分散される 2 種類のサービスがあります。

- Neutron サーバー: このサービスは、エンドユーザーとサービスが OpenStack Networking と対話するための API を提供する OpenStack Networking API サーバーを実行します。このサーバーは、下層のデータベースと統合して、プロジェクトネットワーク、ルーター、ロードバランサーの詳細などを保管します。

Neutron エージェント: これらは、OpenStack Networking のネットワーク機能を実行するサービスです。

-

neutron-dhcp-agent: プロジェクトプライベートネットワークの DHCP IP アドレスを管理します。 -

neutron-l3-agent: プロジェクトプライベートネットワーク、外部ネットワークなどの間のレイヤー 3 ルーティングを実行します。

-

-

コンピュートノード: このノードは、仮想マシン (別称: インスタンス) を実行するハイパーバイザーをホストします。コンピュートノードは、インスタンスに外部への接続を提供するために、ネットワークに有線で直接接続する必要があります。このノードは通常、

neutron-openvswitch-agentなどの L2 エージェントが実行される場所です。

7.1.1. サービスの配置

OpenStack Networking サービスは、同じ物理サーバーまたは別の専用サーバー (ロールによって名前が付けられる) で実行することができます。

- コントローラーノード: API サービスを実行するサーバー

- ネットワークノード: OpenStack Networking エージェントを実行するサーバー

- コンピュートノード: インスタンスをホストするハイパーバイザー

本章の以下の手順は、これらの 3 つのノード種別が含まれる環境に適用されます。お使いのデプロイメントで、同じ物理ノードがコントローラーノードとネットワークノードの両方の役割を果たしている場合には、そのサーバーで両ノードのセクションの手順を実行する必要があります。これは、3 つの全ノードにおいてコントローラーノードおよびネットワークノードサービスが HA で実行されている高可用性 (HA) 環境にも適用されます。そのため、3 つすべてのノードで、コントローラーノードおよびネットワークノードに該当するセクションの手順を実行する必要があります。

7.2. フラットプロバイダーネットワークの使用

本項の手順では、外部ネットワークに直接インスタンスを接続可能なフラットプロバイダーネットワークを作成します。複数の物理ネットワーク (physnet1、physnet2) およびそれぞれ別の物理インターフェース (eth0 -> physnet1 および eth1 -> physnet2) があり、各コンピュートノードとネットワークノードをこれらの外部ネットワークに接続する必要がある場合に実行します。

単一の NIC 上の VLAN タグ付けされた複数のインターフェースを複数のプロバイダーネットワークに接続する場合には、「VLAN プロバイダーネットワークの使用」を参照してください。

7.2.1. コントローラーノードの設定

1. /etc/neutron/plugin.ini (/etc/neutron/plugins/ml2/ml2_conf.ini へのシンボリックリンク) を編集し、既存の値リストに flat を追加し、flat_networks を * に設定します。

type_drivers = vxlan,flat flat_networks =*

2. フラットな外部ネットワークを作成して、設定済みの physical_network に関連付けます。他のユーザーがインスタンスを直接接続できるように、このネットワークを共有ネットワークとして作成します。

# openstack network create --provider-network-type flat --provider-physical-network physnet1 --external public01

3. openstack subnet create コマンドまたは OpenStack Dashboard を使用して、この外部ネットワーク内にサブネットを作成します。

# openstack subnet create --dhcp --allocation-pool start=192.168.100.20,end=192.168.100.100 --gateway 192.168.100.1 --network public01 public_subnet

4.neutron-server サービスを再起動して、この変更を適用します。

# systemctl restart neutron-server.service

7.2.2. ネットワークノードとコンピュートノードの設定

ネットワークノードおよびコンピュートノードを外部ネットワークに接続し、インスタンスが外部ネットワークと直接通信できるように、これらのノードで以下の手順を実施します。

1. Open vSwitch ブリッジとポートを作成します。以下のコマンドを実行し、外部ネットワークのブリッジ (br-ex) を作成して、対応するポート (eth1) を追加します。

i. /etc/sysconfig/network-scripts/ifcfg-eth1 を編集します。

DEVICE=eth1 TYPE=OVSPort DEVICETYPE=ovs OVS_BRIDGE=br-ex ONBOOT=yes NM_CONTROLLED=no BOOTPROTO=none

ii. /etc/sysconfig/network-scripts/ifcfg-br-ex を編集します。

DEVICE=br-ex TYPE=OVSBridge DEVICETYPE=ovs ONBOOT=yes NM_CONTROLLED=no BOOTPROTO=none

2. network サービスを再起動して、これらの変更を適用します。

# systemctl restart network.service

3. /etc/neutron/plugins/ml2/openvswitch_agent.ini で物理ネットワークを設定して、ブリッジを物理ネットワークにマッピングします。

bridge_mappings の設定に関する詳しい情報は、「 11章ブリッジマッピングの設定 」を参照してください。

bridge_mappings = physnet1:br-ex

4.ネットワークノードとコンピュートノードで neutron-openvswitch-agent サービスを再起動して、これらの変更を適用します。

# systemctl restart neutron-openvswitch-agent

7.2.3. ネットワークノードの設定

1. /etc/neutron/l3_agent.ini の external_network_bridge = パラメーターに空の値を設定し、外部プロバイダーネットワークの使用を有効にします。

# Name of bridge used for external network traffic. This should be set to # empty value for the linux bridge external_network_bridge =

2. neutron-l3-agent を再起動して、これらの変更を適用します。

# systemctl restart neutron-l3-agent.service

複数のフラットプロバイダーネットワークが存在する場合には、ネットワークごとに独立した物理インターフェースおよびブリッジを使用して外部ネットワークに接続するようにします。ifcfg-* スクリプトを適切に設定し、bridge_mappings にコンマ区切りリストでネットワーク別のマッピングを指定します。bridge_mappings の設定に関する詳しい情報は、「 11章ブリッジマッピングの設定 」を参照してください。

7.2.4. 外部ネットワークへのインスタンスの接続

外部ネットワークを作成したら、インスタンスを接続して、接続性をテストすることができます。

1. 新規インスタンスを作成します。

2. Dashboard の ネットワーク タブから、新たに作成した外部ネットワークに新規インスタンスを直接追加します。

7.2.5. フラットプロバイダーネットワークのパケットフローが機能する仕組み

本項では、フラットプロバイダーネットワークが設定された状況で、インスタンスに対するトラフィックがどのように送付されるかについて詳しく説明します。

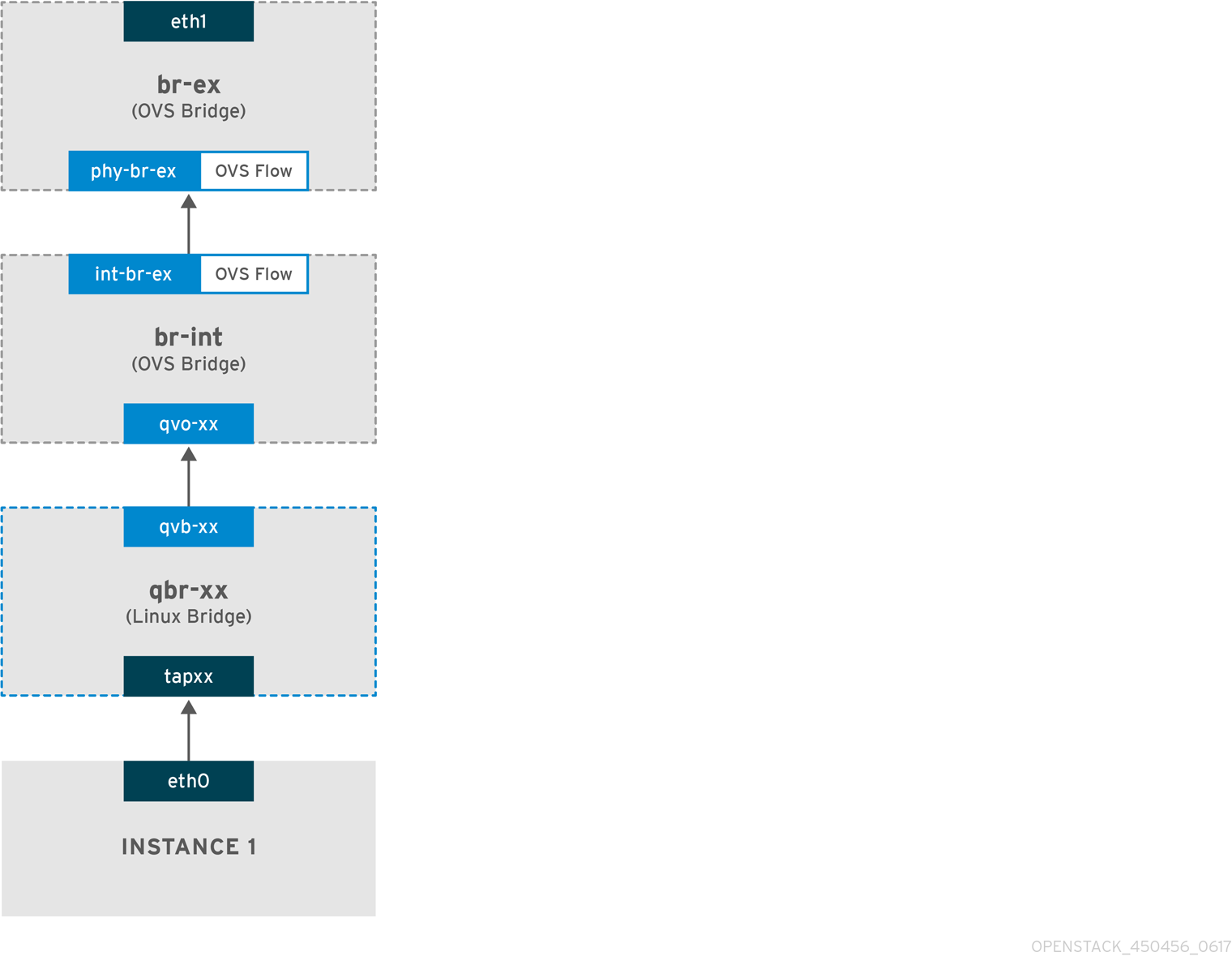

フラットプロバイダーネットワークでの送信トラフィックのフロー

以下の図で、インスタンスから送信され直接外部ネットワークに到達するトラフィックのパケットフローについて説明します。br-ex 外部ブリッジを設定した後に、物理インターフェースをブリッジに追加してインスタンスをコンピュートノードに作成すると、得られるインターフェースとブリッジの構成は、以下の図のようになります (iptables_hybrid ファイアウォールドライバーを使用する場合)。

1. パケットはインスタンスの eth0 インターフェースから送信され、linux ブリッジ qbr-xx に到達します。

2. ブリッジ qbr-xx は、veth ペア qvb-xx <-> qvo-xxx を使用して br-int に接続されます。これは、セキュリティーグループによって定義されている受信/送信のファイアウォールルールの適用にブリッジが使用されるためです。

3. インターフェース qvb-xx は qbr-xx linux ブリッジに、qvo-xx は br-int Open vSwitch (OVS) ブリッジに接続されています。

`qbr-xx`Linux ブリッジの設定例:

# brctl show qbr269d4d73-e7 8000.061943266ebb no qvb269d4d73-e7 tap269d4d73-e7

br-int 上の qvo-xx の設定:

# ovs-vsctl show

Bridge br-int

fail_mode: secure

Interface "qvof63599ba-8f"

Port "qvo269d4d73-e7"

tag: 5

Interface "qvo269d4d73-e7"

ポート qvo-xx は、フラットなプロバイダーネットワークに関連付けられた内部 VLAN タグでタグ付けされます。この例では VLAN タグは 5 です。パケットが qvo-xx に到達する際に、VLAN タグがパケットのヘッダーに追加されます。

次にこのパケットは、パッチピア int-br-ex <-> phy-br-ex を使用して br-ex OVS ブリッジに移動します。

br-int でのパッチピアの設定例を以下に示します。

# ovs-vsctl show

Bridge br-int

fail_mode: secure

Port int-br-ex

Interface int-br-ex

type: patch

options: {peer=phy-br-ex}

br-ex でのパッチピアの設定例

Bridge br-ex

Port phy-br-ex

Interface phy-br-ex

type: patch

options: {peer=int-br-ex}

Port br-ex

Interface br-ex

type: internal

このパケットが br-ex の phy-br-ex に到達すると、br-ex 内の OVS フローにより VLAN タグ (5) が取り除かれ、物理インターフェースに転送されます。

以下の出力例では、phy-br-ex のポート番号は 2 となっています。

# ovs-ofctl show br-ex

OFPT_FEATURES_REPLY (xid=0x2): dpid:00003440b5c90dc6

n_tables:254, n_buffers:256

capabilities: FLOW_STATS TABLE_STATS PORT_STATS QUEUE_STATS ARP_MATCH_IP

actions: OUTPUT SET_VLAN_VID SET_VLAN_PCP STRIP_VLAN SET_DL_SRC SET_DL_DST SET_NW_SRC SET_NW_DST SET_NW_TOS SET_TP_SRC SET_TP_DST ENQUEUE

2(phy-br-ex): addr:ba:b5:7b:ae:5c:a2

config: 0

state: 0

speed: 0 Mbps now, 0 Mbps max

以下の出力例では、VLAN タグが 5 (dl_vlan=5) の phy-br-ex (in_port=2) に到達するパケットを示しています。また、br-ex の OVS フローにより VLAN タグが取り除かれ、パケットが物理インターフェースに転送されます。

# ovs-ofctl dump-flows br-ex NXST_FLOW reply (xid=0x4): cookie=0x0, duration=4703.491s, table=0, n_packets=3620, n_bytes=333744, idle_age=0, priority=1 actions=NORMAL cookie=0x0, duration=3890.038s, table=0, n_packets=13, n_bytes=1714, idle_age=3764, priority=4,in_port=2,dl_vlan=5 actions=strip_vlan,NORMAL cookie=0x0, duration=4702.644s, table=0, n_packets=10650, n_bytes=447632, idle_age=0, priority=2,in_port=2 actions=drop

物理インターフェースが別の VLAN タグ付けされたインターフェースの場合、その物理インターフェースはパケットにタグを追加します。

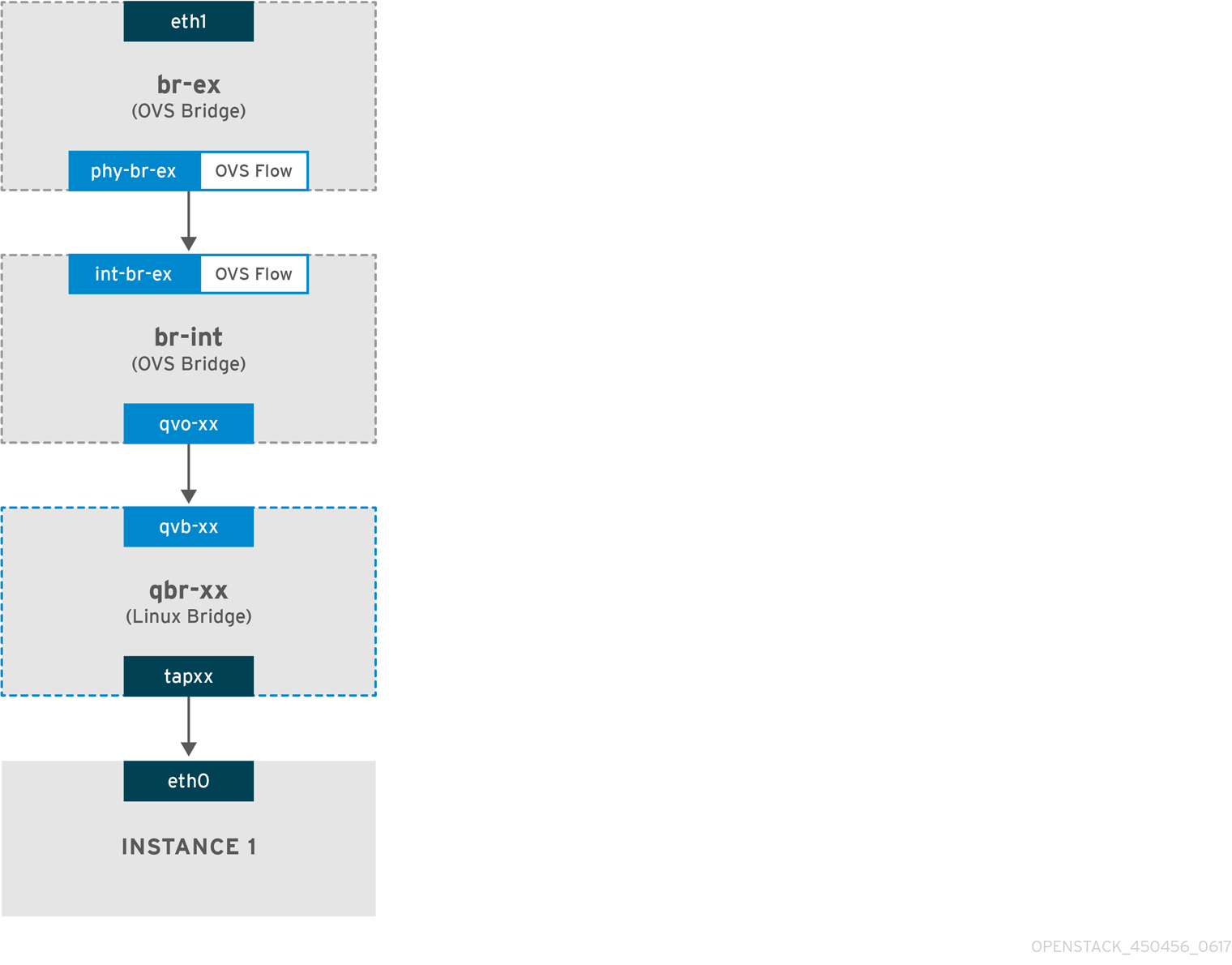

フラットプロバイダーネットワークでの受信トラフィックのフロー

本項では、外部ネットワークからの受信トラフィックがインスタンスのインターフェースに到達するまでのフローについて説明します。

1. 受信トラフィックは、物理ノードの eth1 に到達します。

2. パケットは br-ex ブリッジに移動します。

3. このパケットは、パッチピア phy-br-ex <--> int-br-ex を通じて br-int に移動します。

以下の例では、int-br-ex はポート番号 15 を使用します。15(int-br-ex) が含まれるエントリーに注目してください。

# ovs-ofctl show br-int

OFPT_FEATURES_REPLY (xid=0x2): dpid:00004e67212f644d

n_tables:254, n_buffers:256

capabilities: FLOW_STATS TABLE_STATS PORT_STATS QUEUE_STATS ARP_MATCH_IP

actions: OUTPUT SET_VLAN_VID SET_VLAN_PCP STRIP_VLAN SET_DL_SRC SET_DL_DST SET_NW_SRC SET_NW_DST SET_NW_TOS SET_TP_SRC SET_TP_DST ENQUEUE

15(int-br-ex): addr:12:4e:44:a9:50:f4

config: 0

state: 0

speed: 0 Mbps now, 0 Mbps maxbr-int のトラフィックフローの確認

1. パケットが int-br-ex に到達すると、br-int ブリッジ内の OVS フロールールにより、内部 VLAN タグ 5 を追加するようにパケットが変更されます。actions=mod_vlan_vid:5 のエントリーを参照してください。

# ovs-ofctl dump-flows br-int NXST_FLOW reply (xid=0x4): cookie=0x0, duration=5351.536s, table=0, n_packets=12118, n_bytes=510456, idle_age=0, priority=1 actions=NORMAL cookie=0x0, duration=4537.553s, table=0, n_packets=3489, n_bytes=321696, idle_age=0, priority=3,in_port=15,vlan_tci=0x0000 actions=mod_vlan_vid:5,NORMAL cookie=0x0, duration=5350.365s, table=0, n_packets=628, n_bytes=57892, idle_age=4538, priority=2,in_port=15 actions=drop cookie=0x0, duration=5351.432s, table=23, n_packets=0, n_bytes=0, idle_age=5351, priority=0 actions=drop

2. 2 番目のルールは、VLAN タグのない (vlan_tci=0x0000) int-br-ex (in_port=15) に到達するパケットを管理します。このルールにより、パケットに VLAN タグ 5 が追加され (actions=mod_vlan_vid:5,NORMAL)、qvoxxx に転送されます。

3. qvoxxx は、VLAN タグを削除した後に、パケットを受け入れて qvbxx に転送します。

4. 最終的にパケットはインスタンスに到達します。

VLAN tag 5 は、フラットプロバイダーネットワークを使用するテスト用コンピュートノードで使用したサンプルの VLAN です。この値は neutron-openvswitch-agent により自動的に割り当てられました。この値は、お使いのフラットプロバイダーネットワークの値とは異なる可能性があり、2 つの異なるコンピュートノード上にある同じネットワークにおいても異なる可能性があります。

7.2.6. フラットプロバイダーネットワーク上での、インスタンス/物理ネットワーク間の接続のトラブルシューティング

「フラットプロバイダーネットワークのパケットフローが機能する仕組み」で提供される出力で、フラットプロバイダーネットワークで問題が発生した場合にトラブルシューティングを行うのに十分なデバッグ情報が得られます。以下の手順で、トラブルシューティングのプロセスについてさらに詳しく説明します。

1. bridge_mappings を確認します。

以下の例に示すように、使用する物理ネットワーク名 (例: physnet1) が bridge_mapping 設定の内容と一致していることを確認します。

# grep bridge_mapping /etc/neutron/plugins/ml2/openvswitch_agent.ini bridge_mappings = physnet1:br-ex # openstack network show provider-flat ... | provider:physical_network | physnet1 ...

2.ネットワークの設定を確認します。

ネットワークが external として作成され、flat の種別が使用されていることを確認します。

# openstack network show provider-flat ... | provider:network_type | flat | | router:external | True | ...

3.パッチピアを確認します。

ovs-vsctl show コマンドを実行し、パッチピア int-br-ex <--> phy-br-ex を使用して br-int と br-ex が接続されていることを確認します。

# ovs-vsctl show

Bridge br-int

fail_mode: secure

Port int-br-ex

Interface int-br-ex

type: patch

options: {peer=phy-br-ex}

br-ex でのパッチピアの設定例

Bridge br-ex

Port phy-br-ex

Interface phy-br-ex

type: patch

options: {peer=int-br-ex}

Port br-ex

Interface br-ex

type: internal

/etc/neutron/plugins/ml2/openvswitch_agent.ini の bridge_mapping が正しく設定されていれば、この接続は neutron-openvswitch-agent サービスを再起動する際に作成されます。サービスを再起動してもこの接続が作成されない場合には、bridge_mapping の設定を再確認してください。

bridge_mappings の設定に関する詳しい情報は、「 11章ブリッジマッピングの設定 」を参照してください。

4.ネットワークフローを確認します。

ovs-ofctl dump-flows br-ex と ovs-ofctl dump-flows br-int を実行して、フローにより送信パケットの内部 VLAN ID が削除されたかどうかを確認します。まず、このフローは、特定のコンピュートノード上のこのネットワークにインスタンスを作成すると追加されます。

-

インスタンスの起動後にこのフローが作成されなかった場合には、ネットワークが

flatとして作成されていて、externalであることと、physical_networkの名前が正しいことを確認します。また、bridge_mappingの設定を確認してください。 -

最後に

ifcfg-br-exとifcfg-ethxの設定を確認します。ethXがbr-ex内のポートとして追加されていること、およびip aの出力でifcfg-br-exおよびifcfg-ethxにUPフラグが表示されることを確認します。

以下の出力では、eth1 が br-ex のポートであることが分かります。

Bridge br-ex

Port phy-br-ex

Interface phy-br-ex

type: patch

options: {peer=int-br-ex}

Port "eth1"

Interface "eth1"

以下の例では eth1 は OVS ポートとして設定されていて、カーネルはこのインターフェースからのパケットをすべて転送して OVS ブリッジ br-ex に送信することを認識していることが分かります。これは、master ovs-system のエントリーで確認することができます。

# ip a 5: eth1: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq master ovs-system state UP qlen 1000

7.3. VLAN プロバイダーネットワークの使用

単一の NIC 上の VLAN タグ付けされた複数のインターフェースを複数のプロバイダーネットワークに接続するには、本項の手順を実施して、インスタンスを直接外部ネットワークに接続することができる VLAN プロバイダーネットワークを作成します。以下の例では、VLAN 範囲が 171 - 172 の physnet1 という名前の物理ネットワークを使用します。ネットワークノードとコンピュートノードは、物理インターフェース eth1 を使用して物理ネットワークに接続されます。これらのインターフェースを接続するスイッチポートは、必要な VLAN 範囲をトランク接続するように設定する必要があります。サンプルの VLAN ID と名前を使用して VLAN プロバイダーネットワークを設定するには、以下の手順を実施します。

7.3.1. コントローラーノードの設定

1. /etc/neutron/plugin.ini (/etc/neutron/plugins/ml2/ml2_conf.ini へのシンボリックリンク) を編集して vlan メカニズムドライバーを有効にし、vlan を既存の値リストに追加します。

[ml2] type_drivers = vxlan,flat,vlan

2. network_vlan_ranges の設定を行い、使用する物理ネットワークおよび VLAN 範囲を反映します。

[ml2_type_vlan] network_vlan_ranges=physnet1:171:172

3. neutron-server サービスを再起動して変更を適用します。

systemctl restart neutron-server

4.外部ネットワークを種別 vlan として作成して、設定済みの physical_network に関連付けます。他のユーザーが直接インスタンスを接続できるように、外部ネットワークを作成する際に --shared を使用します。以下のサンプルコマンドを実行して、2 つのネットワーク (VLAN 171 用および VLAN 172 用) を作成します。

openstack network create --provider-network-type vlan --external --provider-physical-network physnet1 --segment 171 --share openstack network create --provider-network-type vlan --external --provider-physical-network physnet1 --segment 172 --share

5. 複数のサブネットを作成して、外部ネットワークを使用するように設定します。openstack subnet create または Dashboard のどちらかを使用して、これらのサブネットを作成することができます。ネットワーク管理者から取得した外部サブネットの詳細が、正しく各 VLAN に関連付けられるようにします。以下の例では、VLAN 171 はサブネット 10.65.217.0/24 を、VLAN 172 は 10.65.218.0/24 を、それぞれ使用しています。

openstack subnet create --network provider-171 --subnet-range 10.65.217.0/24 --dhcp --gateway 10.65.217.254 --subnet-provider-171 openstack subnet create --network provider-172 --subnet-range 10.65.218.0/24 --dhcp --gateway 10.65.218.254 --subnet-provider-172

7.3.2. ネットワークノードとコンピュートノードの設定

ノードを外部ネットワークに接続し、インスタンスが外部ネットワークと直接通信できるようにするには、ネットワークノードおよびコンピュートノードで以下の手順を実施します。

1. 外部ネットワークブリッジ (br-ex) を作成し、ポート (eth1) をそのブリッジに関連付けます。

- 以下の例では、eth1 が br-ex を使用するように設定します。

/etc/sysconfig/network-scripts/ifcfg-eth1 DEVICE=eth1 TYPE=OVSPort DEVICETYPE=ovs OVS_BRIDGE=br-ex ONBOOT=yes NM_CONTROLLED=no BOOTPROTO=none

- 以下の例では、br-ex ブリッジを設定します。

/etc/sysconfig/network-scripts/ifcfg-br-ex: DEVICE=br-ex TYPE=OVSBridge DEVICETYPE=ovs ONBOOT=yes NM_CONTROLLED=no BOOTPROTO=none

2. ノードをリブートするか、network サービスを再起動して、ネットワーク設定の変更を適用します。

# systemctl restart network

3. /etc/neutron/plugins/ml2/openvswitch_agent.ini で物理ネットワークを設定して、物理ネットワークに応じてブリッジをマッピングします。

bridge_mappings = physnet1:br-ex

bridge_mappings の設定に関する詳しい情報は、「 11章ブリッジマッピングの設定 」を参照してください。

4.ネットワークノードとコンピュートノードで neutron-openvswitch-agent サービスを再起動して、変更を適用します。

systemctl restart neutron-openvswitch-agent

7.3.3. ネットワークノードの設定

1. /etc/neutron/l3_agent.ini の external_network_bridge = パラメーターに空の値を設定します。これにより、ブリッジベースの外部ネットワーク (external_network_bridge = br-ex と設定する) ではなく、プロバイダー外部ネットワークを使用することができます。

# Name of bridge used for external network traffic. This should be set to # empty value for the linux bridge external_network_bridge =

2. neutron-l3-agent を再起動して変更を適用します。

systemctl restart neutron-l3-agent

3. 新規インスタンスを作成し、Dashboard の ネットワーク タブを使用して新しい外部ネットワークに直接、新規インスタンスを追加します。

7.3.4. VLAN プロバイダーネットワークのパケットフローが機能する仕組み

本項では、VLAN プロバイダーネットワークが設定された状況で、インスタンスに対するトラフィックがどのように送付されるかについて詳しく説明します。

VLAN プロバイダーネットワークでの送信トラフィックのフロー

以下の図で、インスタンスから送信され直接 VLAN プロバイダー外部ネットワークに到達するトラフィックのパケットフローについて説明します。この例では、2 つの VLAN ネットワーク (171 および 172) にアタッチされた 2 つのインスタンスを使用します。br-ex を設定した後に、物理インターフェースをブリッジに追加してインスタンスをコンピュートノードに作成すると、得られるインターフェースとブリッジの構成は、以下の図のようになります。

1. インスタンスの eth0 インターフェースから送信されたパケットは、インスタンスに接続された linux ブリッジ qbr-xx に到達します。

2. qbr-xx は、veth ペア qvbxx <→ qvoxx を使用して br-int に接続されます。

3. qvbxx は linux ブリッジ qbr-xx に、qvoxx は Open vSwitch ブリッジ br-int に接続されています。

Linux ブリッジ上の qvb-xx の設定例

以下の例には、2 つのインスタンスおよびこれに対応する 2 つの linux ブリッジが表示されています。

# brctl show bridge name bridge id STP enabled interfaces qbr84878b78-63 8000.e6b3df9451e0 no qvb84878b78-63 tap84878b78-63 qbr86257b61-5d 8000.3a3c888eeae6 no qvb86257b61-5d tap86257b61-5d

br-int 上の qvoxx の設定

options: {peer=phy-br-ex}

Port "qvo86257b61-5d"

tag: 3

Interface "qvo86257b61-5d"

Port "qvo84878b78-63"

tag: 2

Interface "qvo84878b78-63"

-

qvoxxには、VLAN プロバイダーネットワークが関連付けられた内部 VLAN のタグが付けられます。この例では、内部 VLAN タグ 2 には VLAN プロバイダーネットワークprovider-171、VLAN タグ 3 には VLAN プロバイダーネットワークprovider-172が関連付けられます。パケットが qvoxx に到達すると、この VLAN タグがパケットのヘッダーに追加されます。 -

パケットは次に、パッチピア

int-br-ex<→phy-br-exを使用して br-ex OVS ブリッジに移動します。br-int 上のパッチピアの例を以下に示します。

Bridge br-int

fail_mode: secure

Port int-br-ex

Interface int-br-ex

type: patch

options: {peer=phy-br-ex}br-ex 上のパッチピアの設定例を以下に示します。

Bridge br-ex

Port phy-br-ex

Interface phy-br-ex

type: patch

options: {peer=int-br-ex}

Port br-ex

Interface br-ex

type: internal- このパケットが br-ex 上の phy-br-ex に到達すると、br-ex 内の OVS フローが内部 VLAN タグを VLAN プロバイダーネットワークに関連付けられた実際の VLAN タグに置き換えます。

以下のコマンドの出力では、phy-br-ex のポート番号は 4 となっています。

# ovs-ofctl show br-ex

4(phy-br-ex): addr:32:e7:a1:6b:90:3e

config: 0

state: 0

speed: 0 Mbps now, 0 Mbps max

以下のコマンドでは、VLAN タグ 2 (dl_vlan=2) の付いた phy-br-ex (in_port=4) に到達するパケットが表示されます。Open vSwitch は VLAN タグを 171 に置き換え (actions=mod_vlan_vid:171,NORMAL)、パケットを物理インターフェースに転送します。このコマンドでは、VLAN タグ 3 (dl_vlan=3) の付いた phy-br-ex (in_port=4) に到達するパケットも表示されます。Open vSwitch は VLAN タグを 172 に置き換え (actions=mod_vlan_vid:172,NORMAL)、パケットを物理インターフェースに転送します。neutron-openvswitch-agent は、これらのルールを追加します。

# ovs-ofctl dump-flows br-ex NXST_FLOW reply (xid=0x4): NXST_FLOW reply (xid=0x4): cookie=0x0, duration=6527.527s, table=0, n_packets=29211, n_bytes=2725576, idle_age=0, priority=1 actions=NORMAL cookie=0x0, duration=2939.172s, table=0, n_packets=117, n_bytes=8296, idle_age=58, priority=4,in_port=4,dl_vlan=3 actions=mod_vlan_vid:172,NORMAL cookie=0x0, duration=6111.389s, table=0, n_packets=145, n_bytes=9368, idle_age=98, priority=4,in_port=4,dl_vlan=2 actions=mod_vlan_vid:171,NORMAL cookie=0x0, duration=6526.675s, table=0, n_packets=82, n_bytes=6700, idle_age=2462, priority=2,in_port=4 actions=drop

- このパケットは、次に物理インターフェース eth1 に転送されます。

VLAN プロバイダーネットワークでの受信トラフィックのフロー

以下のフローは、プロバイダーネットワーク provider-171 に VLAN タグ 2 を使用し、プロバイダーネットワーク provider-172 に VLAN タグ 3 を使用して、コンピュートノードでテストを行った際の例です。フローは、統合ブリッジ br-int のポート 18 を使用します。

実際の VLAN プロバイダーネットワークでは、異なる設定が必要な場合があります。また、ネットワークの設定要件は、2 つの別個のコンピュートノード間で異なる場合があります。

以下のコマンドの出力には、ポート番号 18 を使用する int-br-ex が表示されます。

# ovs-ofctl show br-int

18(int-br-ex): addr:fe:b7:cb:03:c5:c1

config: 0

state: 0

speed: 0 Mbps now, 0 Mbps max以下のコマンドの出力には、br-int のフローのルールが表示されます。

# ovs-ofctl dump-flows br-int NXST_FLOW reply (xid=0x4): cookie=0x0, duration=6770.572s, table=0, n_packets=1239, n_bytes=127795, idle_age=106, priority=1 actions=NORMAL cookie=0x0, duration=3181.679s, table=0, n_packets=2605, n_bytes=246456, idle_age=0, priority=3,in_port=18,dl_vlan=172 actions=mod_vlan_vid:3,NORMAL cookie=0x0, duration=6353.898s, table=0, n_packets=5077, n_bytes=482582, idle_age=0, priority=3,in_port=18,dl_vlan=171 actions=mod_vlan_vid:2,NORMAL cookie=0x0, duration=6769.391s, table=0, n_packets=22301, n_bytes=2013101, idle_age=0, priority=2,in_port=18 actions=drop cookie=0x0, duration=6770.463s, table=23, n_packets=0, n_bytes=0, idle_age=6770, priority=0 actions=drop

受信フローの例

ここでは、以下の br-int OVS フローの例を示しています。

cookie=0x0, duration=3181.679s, table=0, n_packets=2605, n_bytes=246456, idle_age=0, priority=3,in_port=18,dl_vlan=172 actions=mod_vlan_vid:3,NORMAL

- VLAN タグ 172 の付いた外部ネットワークからのパケットが、物理ノード上の eth1 から br-ex ブリッジに到達します。

-

このパケットは、パッチピア

phy-br-ex <-> int-br-exを通じて br-int に移動します。 -

パケットは、フローの条件 (

in_port=18,dl_vlan=172) を満たします。 -

フローのアクション (

actions=mod_vlan_vid:3,NORMAL) は VLAN タグ 172 を内部 VLAN タグ 3 に置き換え、通常のレイヤー 2 処理でパケットをインスタンスに転送します。

7.3.5. VLAN プロバイダーネットワーク上での、インスタンス/物理ネットワーク間の接続のトラブルシューティング

VLAN プロバイダーネットワークの接続についてトラブルシューティングを行う場合は、「VLAN プロバイダーネットワークのパケットフローが機能する仕組み」に記載のパケットフローを参照してください。さらに、以下の設定オプションを確認してください。

1. 一貫した物理ネットワーク名が使用されていることを確認してください。以下の例では、ネットワークの作成時と、bridge_mapping の設定において、一貫して physnet1 が使用されています。

# grep bridge_mapping /etc/neutron/plugins/ml2/openvswitch_agent.ini bridge_mappings = physnet1:br-ex # openstack network show provider-vlan171 ... | provider:physical_network | physnet1 ...

2.ネットワークが external として vlan の種別で作成され、正しい segmentation_id の値が使用されていることを確認します。

# openstack network show provider-vlan171 ... | provider:network_type | vlan | | provider:physical_network | physnet1 | | provider:segmentation_id | 171 | ...

3.ovs-vsctl show を実行して、br-int および br-ex がパッチピア int-br-ex <→ phy-br-ex を使用して接続されていることを確認します。

この接続は、/etc/neutron/plugins/ml2/openvswitch_agent.ini で bridge_mapping が正しく設定されていることを前提として、neutron-openvswitch-agent の再起動の後に作成されます。

サービスを再起動してもこの接続が作成されない場合には bridge_mapping の設定を再確認してください。

4.送信パケットのフローを確認するには、ovs-ofctl dump-flows br-ex および ovs-ofctl dump-flows br-int を実行して、このフローにより VLAN ID が外部 VLAN id (segmentation_id) にマッピングされていることを確認します。受信パケットには、外部 VLAN ID が内部 VLAN ID にマッピングされます。

このフローは、このネットワークに初めてインスタンスを作成した場合に neutron OVS エージェントにより追加されます。インスタンスの起動後にこのフローが作成されなかった場合には、ネットワークが vlan として作成されていて、external であることと、physical_network の名前が正しいことを確認します。また、bridge_mapping の設定を再確認してください。

5.最後に、ifcfg-br-ex と ifcfg-ethx の設定を再確認します。br-ex にポート ethX が含まれていること、および ip a コマンドの出力で ifcfg-br-ex と ifcfg- ethx の両方に UP フラグが表示されることを確認します。

たとえば、以下の出力では eth1 が br-ex のポートであることが分かります。

Bridge br-ex

Port phy-br-ex

Interface phy-br-ex

type: patch

options: {peer=int-br-ex}

Port "eth1"

Interface "eth1"

以下のコマンドでは、eth1 がポートとして追加されていること、およびカーネルがこのインターフェースからのパケットをすべて OVS ブリッジ br-ex に移動するように設定されていることが分かります。これは、エントリー master ovs-system で確認できます。

# ip a 5: eth1: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq master ovs-system state UP qlen 1000

7.4. コンピュートのメタデータアクセスの有効化

本章で説明する方法で接続されたインスタンスは、プロバイダー外部ネットワークに直接アタッチされ、外部ルーターがデフォルトゲートウェイとして設定されます。OpenStack Networking (neutron) ルーターは使用されません。これは、neutron ルーターはインスタンスから nova-metadata サーバーへのメタデータ要求をプロキシー化するために使用することができないため、cloud-init の実行中にエラーが発生する可能性があることを意味します。ただし、この問題は、dhcp エージェントがメタデータ要求をプロキシー化するように設定することによって解決することができます。この機能は、/etc/neutron/dhcp_agent.ini で有効にすることができます。以下に例を示します。

enable_isolated_metadata = True

7.5. Floating IP アドレス

Floating IP がすでにプライベートネットワークに割り当てられている場合でも、同じネットワークを使用して Floating IP アドレスをインスタンスに確保することができます。このネットワークから Floating IP として確保するアドレスは、ネットワークノードの qrouter-xxx の名前空間にバインドされ、割り当てられたプライベート IP アドレスに DNAT-SNAT を実行します。反対に、直接外部ネットワークにアクセスできるように確保する IP アドレスはインスタンス内に直接バインドされ、インスタンスが外部ネットワークと直接通信できるようになります。

第8章 OpenStack Networking での物理スイッチの設定

本章では、OpenStack Networking に必要な一般的な物理スイッチの設定手順を説明します。以下のスイッチに関するベンダー固有の設定を記載しています。

8.1. 物理ネットワーク環境のプランニング

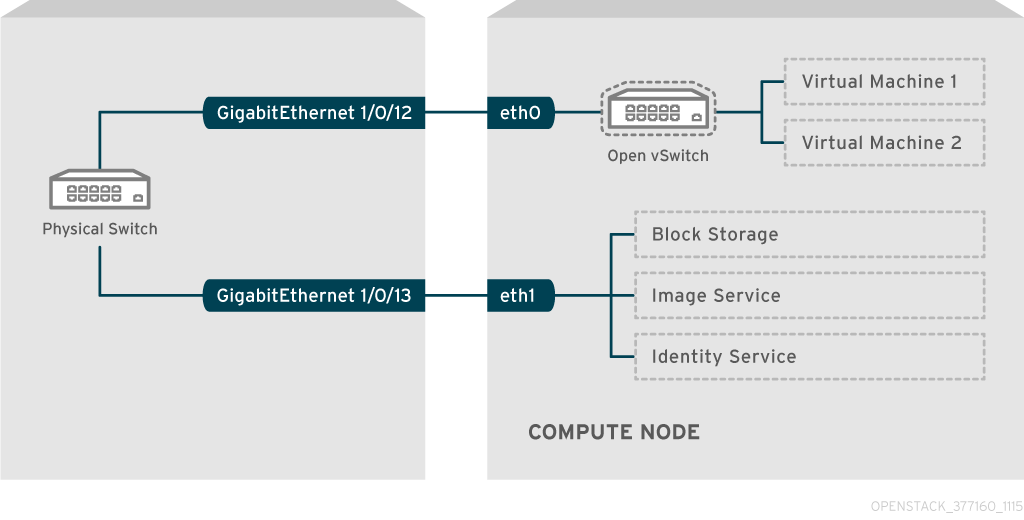

OpenStack ノード内の物理ネットワークアダプターは、異なる種別のネットワークトラフィックを伝送します。これには、インスタンストラフィック、ストレージデータ、および認証要求が含まれます。これらの NIC が伝送するトラフィックの種別によって、物理スイッチ上のポートの設定方法が異なります。

まず、コンピュートノード上のどの物理 NIC でどのトラフィック種別を伝送するかを決定する必要があります。次に、NIC が物理スイッチポートに接続される際に、そのスイッチポートがトランクトラフィックまたは一般のトラフィックを許可するように設定する必要があります。

たとえば、以下の図は、eth0 と eth1 の 2 つの NIC を搭載したコンピュートノードを示しています。各 NIC は、物理スイッチ上のギガビットイーサネットポートに接続され、eth0 がインスタンストラフィックを伝送し、eth1 が OpenStack サービスの接続性を提供します。

ネットワークレイアウト例

この図には、耐障害性に必要な追加の冗長 NIC は含まれていません。

ネットワークインターフェースのボンディングに関する詳細は、『オーバークラウドの高度なカスタマイズ』の「ネットワークインターフェースボンディング」の章を参照してください。

8.2. Cisco Catalyst スイッチの設定

8.2.1. トランクポートについて

OpenStack Networking により、インスタンスを物理ネットワーク上にすでに存在する VLAN に接続することができます。トランク という用語は、単一のポートで複数 VLAN の通過を許可することを意味します。これらのポートを使用することで、VLAN は仮想スイッチを含む複数のスイッチ間にまたがることができます。たとえば、物理ネットワークで VLAN110 のタグが付いたトラフィックがコンピュートノードに到達すると、タグの付いたトラフィックが 8021q モジュールによって vSwitch 上の適切な VLAN に転送されます。

8.2.2. Cisco Catalyst スイッチでのトランクポートの設定

Cisco IOS を実行する Cisco Catalyst スイッチを使用する場合には、以下の設定構文を使用して、VLAN 110 と 111 のトラフィックがインスタンスに到達できるように設定することが可能です。

この設定では、物理ノードの NIC がイーサネットケーブルにより物理スイッチポート (インターフェース GigabitEthernet1/0/12) に接続されていることを前提としています。

重要以下に示す値は、例として提示しています。この例で使用している値を、実際の環境に合わせて変更する必要があります。これらの値を調整せずにコピーしてご自分のスイッチ設定に貼り付けると、予期せぬ機能停止を招く可能性があります。

interface GigabitEthernet1/0/12 description Trunk to Compute Node spanning-tree portfast trunk switchport trunk encapsulation dot1q switchport mode trunk switchport trunk native vlan 2 switchport trunk allowed vlan 2,110,111

以下の一覧を使用して、上記のパラメーターについて説明します。

フィールド 説明 interface GigabitEthernet1/0/12X ノードの NIC の接続先となるスイッチポート。

GigabitEthernet1/0/12の値を、実際の環境の正しいポートの値で置き換えるようにしてください。ポートの一覧を表示するには、show interface コマンドを使用します。description Trunk to Compute Nodeこのインターフェースを識別するのに使用する一意の説明的な値。

spanning-tree portfast trunk環境で STP が使用される場合には、この値を設定して Port Fast に対してこのポートがトランクトラフィックに使用されることを指示します。

switchport trunk encapsulation dot1q802.1q のトランク標準 (ISL ではなく) を有効にします。この値は、スイッチがサポートする設定によって異なります。

switchport mode trunkこのポートは、アクセスポートではなく、トランクポートとして設定します。これで VLAN トラフィックが仮想スイッチに到達できるようになります。

switchport trunk native vlan 2ネイティブ VLAN を設定して、タグの付いていない (VLAN 以外の) トラフィックの送信先をスイッチに指示します。

switchport trunk allowed vlan 2,110,111トランクを通過できる VLAN を定義します。

8.2.3. アクセスポートについて

コンピュートノード上の全 NIC がインスタンスのトラフィックを伝送する訳ではないので、すべての NIC で複数の VLAN が通過できるように設定する必要はありません。アクセスポートに必要なのは 1 つの VLAN だけで、管理トラフィックやブロックストレージデータの転送などの、他の運用上の要件を満たす可能性があります。これらのポートは一般的にアクセスポートと呼ばれ、必要な設定は通常、トランクポートよりも簡単です。

8.2.4. Cisco Catalyst スイッチでのアクセスポートの設定

「ネットワークレイアウト例」の図に示した例を使用して、GigabitEthernet1/0/13 (Cisco Catalyst スイッチ上) を

eth1のアクセスポートとして設定します。この設定では、物理ノードの NIC がイーサネットケーブルにより物理スイッチポート (インターフェース GigabitEthernet1/0/12) に接続されています。

重要以下に示す値は、例として提示しています。この例で使用している値を、実際の環境に合わせて変更する必要があります。これらの値を調整せずにコピーしてご自分のスイッチ設定に貼り付けると、予期せぬ機能停止を招く可能性があります。

interface GigabitEthernet1/0/13 description Access port for Compute Node switchport mode access switchport access vlan 200 spanning-tree portfast

これらの設定についての説明を以下に記載します。

フィールド 説明 interface GigabitEthernet1/0/13X ノードの NIC の接続先となるスイッチポート。

GigabitEthernet1/0/12の値を、実際の環境の正しいポートの値で置き換えるようにしてください。ポートの一覧を表示するには、show interface コマンドを使用します。description Access port for Compute Nodeこのインターフェースを識別するのに使用する一意の説明的な値。

switchport mode accessこのポートは、トランクポートとしてではなく、アクセスポートとして設定します。

switchport access vlan 200VLAN 200 上でトラフィックを許可するポートを設定します。コンピュートノードには、この VLAN からの IP アドレスを設定する必要があります。

spanning-tree portfastSTP を使用する場合には、この値を設定し、STP がこのポートをトランクとして初期化を試みないように指示します。これにより、初回接続時 (例: サーバーのリブート時など) のポートハンドシェイクをより迅速に行うことができます。

8.2.5. LACP ポートアグリゲーションについて

LACP を使用して、複数の物理 NIC をバンドルして単一の論理チャネルを形成することができます。LACP は 802.3ad (または、Linux ではボンディングモード 4) としても知られており、負荷分散と耐障害性のための動的なボンディングを作成します。LACP は、物理 NIC と物理スイッチポートの両方の物理エンドで設定する必要があります。

8.2.6. 物理 NIC 上での LACP の設定

/home/stack/network-environment.yaml ファイルを編集します。

- type: linux_bond name: bond1 mtu: 9000 bonding_options:{get_param: BondInterfaceOvsOptions}; members: - type: interface name: nic3 mtu: 9000 primary: true - type: interface name: nic4 mtu: 9000Open vSwitch ブリッジが LACP を使用するように設定します。

BondInterfaceOvsOptions: "mode=802.3ad"

ネットワークボンディングの設定方法についての説明は、『オーバークラウドの高度なカスタマイズ』の「ネットワークインターフェースボンディング」の章を参照してください。

8.2.7. Cisco Catalyst スイッチでの LACP の設定

以下の例では、コンピュートノードに VLAN 100 を使用する NIC が 2 つあります。

- コンピュートノードの NIC を共に物理的にスイッチ (例: ポート 12 と 13) に接続します。

LACP ポートチャネルを作成します。

interface port-channel1 switchport access vlan 100 switchport mode access spanning-tree guard root

スイッチポート 12 (Gi1/0/12) および 13 (Gi1/0/13) を設定します。