セキュリティーおよび強化ガイド

グッドプラクティス、コンプライアンス、およびセキュリティーの強化

概要

第1章 はじめに

セキュリティーは重要な懸念事項であり、デプロイメントの重点を置く必要があります。データの漏洩やダウンタイムはコストがかかり、管理が難しくなります。また、法律によって監査やコンプライアンスのプロセスが必要になることもあり、プロジェクトでは一定レベルのプライバシーとデータのセキュリティーが求められます。このセクションでは、Red Hat OpenStack Platform のセキュリティーに関する全般的な概要と、お客様のシステムのセキュリティーをサポートする上での Red Hat の役割について説明します。

本ドキュメントでは、ディレクターベースのデプロイメントを中心に、Red Hat OpenStack Platform デプロイメントのセキュリティーを強化するためのアドバイスおよびグッドプラクティス情報を提供します。本書の指示に従って、お使いの環境のセキュリティーを強化しますが、これらの推奨事項に従ってセキュリティーやコンプライアンスを保証しません。

1.1. OpenStack の基本概念

1.1.1. OpenStack とは

OpenStack とは何かを理解するためには、まず クラウド とは何かを理解する必要があります。簡単に言うと、クラウドコンピューティングとは、処理能力、ディスクストレージ、データベース処理、ネットワークサービスを消費者が利用できるようにすることであり、顧客は一連の API を通じてプログラム的にそれらを操作することができます。

このアプローチを、仮想マシン (VM) のホスティングに特化した従来のハイパーバイザー製品と比較してみましょう。VM は、従来の物理的なスタンドアロンサーバーと同じように使用され、一人のシステム管理者が仮想マシンのプロビジョニングを行い、別のシステム管理者がログインしてデータベースアプリケーションやその他のソフトウェアをインストールします。その後、VM は数年間稼働し、データはローカル (または付属の SAN) に保存され、毎日バックアップされます。

OpenStack でも仮想マシンを運用するのは正しいのですが、その管理方法は上記のものとは大きく異なります。インスタンスは、作成後すぐに使用でき、アプリケーションの準備ができていて、さらに設定を行う必要はありません。問題が発生した場合は、障害のトラブルシューティングに時間を費やすのではなく、新しい代替インスタンスをデプロイする必要があります。

OpenStack には、上述したことを実現するために連携するサービスが揃っていますが、これは数あるユースケースの 1 つに過ぎません。

詳しい情報は、『OpenStack Product Guide』: https://access.redhat.com/documentation/ja-jp/red_hat_openstack_platform/15/html-single/product_guide/を参照してください。

1.1.2. 主要な用語

このガイドの残りの部分に進む前に、新規ユーザーが最初に遭遇するであろう OpenStack 固有の専門用語に慣れておくことをお勧めします。

-

インスタンス: これは仮想マシンです。これらは、Compute ノードと呼ばれる専用のハイパーバイザーサーバー上でホストされます。 -

プロジェクト: ユーザー、インスタンス、仮想ネットワーク(その他)を組み合わせた OpenStack リソースのパーティション化されたコレクション。プロジェクトでは、ユーザーやインスタンスのあるコレクションを、別のコレクションとは別に管理することができます。これは、複数の異なる部門や組織をホストする OpenStack のデプロイメントに有効です。管理者は、作成したユーザーやインスタンスごとに、送信先のプロジェクトを指定する必要があります。 -

イメージ: オペレーティングシステムテンプレート。インスタンスを作成する際には、どの OS で動作させるかを決定する必要があります。OpenStack では、イメージ と呼ばれる OS のテンプレートを選択することができます。CentOS および Red Hat Enterprise Linux では、ビルド済みのイメージが利用できます。 -

フレーバー: 仮想マシンのハードウェアテンプレート。インスタンスを構築するたびに RAM と CPU の割り当て量を指定するのではなく、フレーバー を定義してこれらの値をあらかじめ設定しておくことができます。Red Hat OpenStack Platform のデプロイメントでは、1GB の RAM を搭載したm1.tinyから 16GB のRAM を搭載したm1.xlargeまでのフレーバーがすでに定義されています。 -

セキュリティーグループ: ファイアウォールルールです。各プロジェクトには独自の セキュリティーグループ を設け、ネットワークへの出入りを許可するトラフィックを定義することができます。

1.1.3. ディレクターによる設定管理

Red Hat OpenStack Platform director では、YAML テンプレートを使用して OpenStack 環境をデプロイおよび管理を行うことができます。これにより、自分の設定がどのようになっているのかを簡単に把握することができます。OpenStack 設定ファイルは Puppet によって管理されるため、openstack overcloud deploy プロセスを実行するたびに、管理対象外の変更が上書きされます。これにより、YAML の設定が特定の時点での現実を表していることをある程度保証することができます。また、このアプローチにより、OpenStack 導入時のセキュリティー構成管理に一貫性、監査性、再現性を持たせることができます。障害復旧についても、Director が構成管理とオーケストレーションを使用することで、クラウドの導入と構成が体系化され、復旧時間が向上します。

さらに、デプロイ時に渡されるカスタム環境ファイルを使って、独自のカスタマイズを追加することもできます。

詳しくは、『director のインストールと使用方法』を参照してください。https://access.redhat.com/documentation/ja-jp/red_hat_openstack_platform/15/html-single/director_installation_and_usage/

1.2. セキュリティーの境界線と脅威

クラウドデプロイメントに存在するセキュリティーリスクを理解するためには、クラウドを、共通の機能、ユーザー、共通のセキュリティー問題を持つコンポーネントの集合体として抽象的に考えることが有効ですが、本書ではこれを セキュリティーゾーン と呼びます。脅威のアクターとベクターは、その動機とリソースへのアクセスに基づいて分類されます。目的に応じて、各ゾーンのセキュリティー上の懸念を把握することを目的としています。

1.2.1. セキュリティゾーン

セキュリティーゾーンは、一般的な信頼要件とシステム内で期待するユーザー、アプリケーション、サーバー、またはネットワークで構成されます。通常、これらは同じ認証と承認の要件とユーザーを共有します。これらのゾーンの定義はさらに細かく設定することができますが、本ガイドでは、セキュリティーが強化された OpenStack クラウドを展開するために必要な最低限のセキュリティーゾーンとして、以下の明確なセキュリティーゾーンを参照しています。これらのセキュリティゾーンは、少なくとも信頼されているものから順に一覧表示されます。

- パブリックゾーン - 外部の公開用 API、neutron の外部ネットワーク (Floating IP や SNAT による外部接続など)。

- ゲストゾーン - プロジェクトネットワーク (VLAN または VXLAN)。

- ストレージアクセスゾーン - ストレージ管理 (ストレージ監視およびクラスターリング)、ストレージ (SAN/オブジェクト/ブロックストレージ)。

- マネージメントゾーン - 一般的に、アンダークラウド、ホストのオペレーティングシステム、ハードウェア、ネットワーク、アンダークラウドのコントロールプレーン (オーバークラウドホストのプロビジョニング/管理)、オーバークラウドのシステム管理者/監視/バックアップを含みます。

- アドミンゾーン - オーバークラウドを介したエンドポイントアクセス、インフラストラクチャー API、DB、RPC を含む内部 API を許可します (オーバークラウド上のプロジェクトのさまざまな API アクセスロールによって異なります)。オーバークラウドへの管理者アクセスは、アンダークラウドとハードウェアへの管理アクセスを必要としないこと。

これらのセキュリティーゾーンは、個別にマッピングすることも、特定の OpenStack デプロイメント内で信頼の可能な領域の大部分を表すこともできます。たとえば、デプロイメントトポロジーによっては、1 つの物理ネットワーク上に複数のゾーンを組み合わせて構成していたり、他のトポロジーではこれらのゾーンが分離されていたりします。いずれの場合も、適切なセキュリティー上の注意点を知っておく必要があります。セキュリティーゾーンは、お客様の OpenStack デプロイメントトポロジーに合わせてマッピングする必要があります。ゾーンとその信頼要件は、クラウドインスタンスがパブリック、プライベート、またはハイブリッドのいずれであるかによって異なります。

1.2.1.1. パブリックゾーン

パブリックセキュリティーゾーンは、クラウドインフラストラクチャーの完全に信頼されていない領域です。この環境は、インターネット全体として参照することも、認証局がない Red Hat OpenStack Platform デプロイメント外部のネットワークにも言及することができます。このゾーンを経由する機密性または整合性要件があるデータはすべて、補正制御を使用して保護する必要があります。

このゾーンは常に信頼できないものと考えてください。

1.2.1.2. ゲストゾーン

通常、Compute インスタンス間のトラフィックに使用されるゲストセキュリティーゾーンは、クラウド上のインスタンスが生成するコンピュートデータを処理しますが、API コールなどのクラウドの運用をサポートするサービスは処理しません。

インスタンスの使用を厳格に管理していない、またはインスタンスへの無制限のインターネットアクセスを許可しているパブリックおよびプライベートクラウドプロバイダーは、このゾーンを信頼できないと考えるべきです。プライベートクラウドのプロバイダーは、インスタンスとそれに関連するすべてのプロジェクト (基盤となるハードウェアと内部ネットワークを含む) が信頼できることを保証するための適切なコントロールが実装されている場合に限り、このネットワークを内部で信頼できるものとみなすことができるでしょう。

1.2.1.3. ストレージアクセスゾーン

このネットワークを介して送信されるデータのほとんどは、高いレベルの完全性と機密性を必要とします。また、デプロイメントの形態によっては、強い可用性が求められる場合もあります。

ストレージアクセスネットワークは、絶対に必要な場合を除き、デプロイ外からアクセスできないようにする必要があります。このネットワークは、レプリケーションの要件を除いて、ストレージアプライアンス以外のクラウド外部からはアクセスできないと想定されており、このゾーンにデプロイされたコンポーネントは、セキュリティーの観点から機密のものとして扱われます。

このネットワークの信頼レベルはデプロイ時の判断に大きく依存するため、本ガイドではこのゾーンにデフォルトの信頼レベルを割り当てていません。

1.2.1.4. コントロールプレーン

コントロールプレーンは、サービスが相互に作用する場所です。このゾーンのネットワークは、設定パラメーター、ユーザー名、パスワードなどの機密データを伝送します。コマンドおよびコントロールのトラフィックは通常このゾーンに存在するため、厳しい整合性要件が必要となります。このゾーンへのアクセスは厳しく制限され、監視される必要があります。同時に、このゾーンでは、本ガイドに記載されているセキュリティーのグッドプラクティスをすべて採用する必要があります。

ほとんどのデプロイメントでは、このゾーンは信頼されていると見なされます。しかし、OpenStack の導入を考えると、このゾーンと他のゾーンを橋渡しするシステムが多く、このゾーンに置ける信頼度が低下する可能性があります。

1.2.1.5. Management ネットワーク

Management ネットワークは、システムの管理、監視、バックアップに使用されますが、OpenStack の API や制御インターフェイスはホストされない場所です。この場所は、オンプレミスまたはプライベートの Red Hat OpenStack Platform のデプロイメントに使用される PXE ネットワークを配置する場所で、director および compute、storage、management ノードのハードウェア管理インターフェイス、ネットワーク機器、基本的なオペレーティングシステムのアクセスを含みます。

1.3. セキュリティゾーンの接続

異なる信頼レベルまたは認証要件を持つ複数のセキュリティーゾーンにまたがるコンポーネントは、慎重に設定する必要があります。このような接続は、多くの場合、ネットワークアーキテクチャーの弱いポイントであるため、接続しているゾーンの最も高い信頼レベルに対応するよう常に設定する必要があります。多くの場合、攻撃の可能性があるため、接続されたゾーンのセキュリティー制御が主要な懸念事項になります。ゾーンが交わるポイントは、追加の攻撃サービスを提供し、攻撃者がデプロイメントのより繊細な部分に攻撃を移行する機会を増やします。

場合によっては、OpenStack 運用者は、統合ポイントのセキュリティーを、それが存在するどのゾーンよりも高い基準で確保することを検討する必要があるかもしれません。上記の API エンドポイントの例では、管理ゾーンが完全に分離されていない場合、敵対者はパブリックゾーンからパブリック API エンドポイントを標的とし、これを足掛かりにして管理ゾーン内の内部または管理者 API を侵害したりアクセスしたりする可能性があります。

OpenStack の設計は、セキュリティーゾーンの分離が難しいようになっています。通常、コアサービスは少なくとも 2 つのゾーンにまたがるため、セキュリティーコントロールを適用する際に特別な考慮を指定する必要があります。

1.4. 脅威の分類、アクター、および攻撃ベクター

パブリック、プライベート、ハイブリッドを問わず、ほとんどのタイプのクラウドデプロイメントは、何らかの形で攻撃を受けます。このセクションでは、攻撃者を分類し、各セキュリティーゾーンで起こりうる攻撃の種類をまとめています。

1.4.1. 脅威アクター

脅威アクターは、防御を試みる可能性のある敵のクラスを指す抽象的な方法です。アクターの能力が高いほど、攻撃の軽減と防止を成功させるために必要なセキュリティー制御が厳しくなります。セキュリティーは、要件に基づいて、利便性、防御、およびコストのバランスを取ることです。場合によっては、ここで説明したすべての脅威主体に対してクラウドのデプロイメントを保護することができないこともあります。OpenStack クラウドをデプロイする場合は、デプロイメントと使用方法のバランスを判断する必要があります。

リスク評価の一環として、保存するデータの種類やアクセス可能なリソースも考慮する必要があります。これは、特定のアクターにも影響するためです。しかし、お客様のデータが脅威アクターにとって魅力的でなくても、ボットネットに参加したり、不正な暗号通貨のマイニングを実行したりと、単純にお客様のコンピューティングリソースに惹かれる可能性があります。

- ネーションステートアクター - これは最も有能な敵です。国民国家の攻撃者は、ターゲットに対して莫大なリソースをもたらす可能性があります。彼らは他のどの攻撃者よりも優れた能力を持っています。人間と技術の両方で非常に厳格な管理が行われていなければ、これらの攻撃者から身を守ることは非常に困難です。

- 深刻な組織犯罪 - このクラスは、非常に有能で経済的に主導された攻撃者のグループを説明します。彼らは、社内のエクスプロイト開発とターゲット研究に資金を提供することができます。近年、大規模なサイバー犯罪企業である Russian Business Network などの組織の台頭により、サイバー攻撃がどのように商品になったかが実証されています。産業スパイは、深刻な組織犯罪グループに分類されます。

- 非常に有能なグループ - これは、通常は商業的には資金提供されていませんが、サービスプロバイダーやクラウドオペレーターに重大な脅威を招く可能性がる「ハクティビスト」タイプの組織を指します。

- 一人で行動するやる気のある個人 - この攻撃者は、不正または悪意のある従業員、不満を持った顧客、小規模な産業スパイなど、さまざまな形で登場します。

- 幼稚なクラッカー - この攻撃者は特定の組織をターゲットとしませんが、自動化された脆弱性スキャンと不正使用を実行します。多くの場合、これらは厄介なものにすぎませんが、これらの攻撃者の 1 人による侵害は、組織の評判に対する大きなリスクです。

次の方法は、上記で特定されたリスクの一部を軽減するのに役立ちます。

- セキュリティー更新 - ネットワーク、ストレージ、サーバーハードウェアなど、基礎となる物理インフラストラクチャーのエンドツーエンドのセキュリティーポジションを考慮する必要があります。このようなシステムには、独自のセキュリティー強化プラクティスが必要です。Red Hat OpenStack Platform のデプロイメントでは、セキュリティーアップデートを定期的にテストしてデプロイする計画を立てる必要があります。

- アクセス管理 - システムへのアクセスを個人に許可する際には、最小特権の原則 を適用し、実際に必要な粒度のシステム特権のみを許可する必要があります。AAA (access、authorization、および accounting) という手法を用いて、このポリシーを実施することができます。このアプローチは、システム管理者からの悪意のあるアクターと誤字エラーのリスクを軽減するのに役立ちます。

- インサイダーの管理 - ロールベースのアクセス制御 (最低限必要なアクセス) を慎重に割り当て、内部インターフェースで暗号化を使用し、認証/認可セキュリティー (集中管理など) を使用することで、悪意のあるインサイダーの脅威を軽減できます。また、職務の分離や不規則な職務のローテーションなど、技術以外の追加オプションを検討することもできます。

1.4.1.1. アウトバウンド攻撃と風評被害の危険

クラウドデプロイメントでは、アウトバウンドの不正使用の可能性を慎重に検討する必要があります。クラウドデプロイメントでは、多くのリソースが利用できる傾向にあります。ハッキングや不正を行う従業員などによる権限のあるアクセスによってクラウド内に存在感を示した攻撃者は、悪意のある目的のためにこれらのリソースを使用することができます。Compute サービスを備えたクラウドは、DDoS やブルートフォースエンジンに最適です。特にパブリッククラウドでは、ユーザーが責任を負うことがほとんどできず、アウトバウンド攻撃のために多数の使い捨てインスタンスをすぐに立ち上げることができるため、この問題は切実です。防止策としては、出口のセキュリティーグループ、トラフィック検査、侵入検知システム、お客様への教育啓発、詐欺不正行為の緩和策などがあります。インターネットなどのパブリックネットワークからアクセスできる、またはパブリックネットワークにアクセスできる環境では、理想的にアウトバウンドの不正使用を検出し、またそれに対処するためのプロセスとインフラストラクチャーを整備する必要があります。

1.5. ソフトウェアのサポート

Red Hat のソリューションスタック全体を支えているのは、安全なソフトウェアのサプライチェーンです。Red Hat のセキュリティー戦略の要であるこの戦略的に重要な一連の実践と手順の目標は、セキュリティーが前もって組み込まれ、長期的にサポートされるソリューションを提供することです。Red Hat の具体的な取り組みは以下の通りです。

- アップストリームの関係とコミュニティーの関係を維持することで、最初からセキュリティーに重点を合わせることができます。

- セキュリティーおよびパフォーマンス追跡レコードに基づいてパッケージを選択して設定します。

- (アップストリームビルドを受け入れる代わりに) 関連付けられたソースコードからバイナリーをビルドします。

- 検査および品質保証ツールのスイートを適用して、潜在的なセキュリティー問題やリグレッションを防ぎます。

- リリースされたすべてのパッケージにデジタル署名し、暗号化で認証されたディストリビューションチャンネルで配布します。

- パッチと更新を配信するための単一の統合メカニズムを提供します。また、OpenStack の基盤となる Red Hat Enterprise Linux と KVM コンポーネントも Common Criteria の認証を受けています。これは、サードパーティー監査人が実際にサイトを訪問し、サプライチェーンや開発などのグッドプラクティスを遵守しているかどうかをスタッフにインタビューするというものです。

さらに、Red Hat は、製品に対して脅威と脆弱性を分析する専用のセキュリティーチームを維持し、カスタマーポータルから適切なアドバイスと更新を提供します。このチームは、ほとんどが理論上の問題である問題とは対照的に、どの問題が重要であるかを決定します。Red Hat Product Security チームは専門知識を保ち、弊社のサブスクリプション製品に関連するアップストリームのコミュニティーへの大規模な貢献を行います。プロセスの重要な部分である RedHat Security アドバイザリーは、脆弱性が最初に公開された日に頻繁に配布されるパッチとともに、Red Hat ソリューションに影響を与えるセキュリティーの欠陥を事前に通知します。

1.6. システムドキュメント

1.6.1. システムロールと種類

一般的に OpenStack のインストールを構成するノードには、大きく分けて 2 つのタイプがあります。

- インフラストラクチャーノード- OpenStack API プロバイダー (neutron など)、メッセージキューイングサービス、ストレージ管理、モニターリング、ネットワークなど、クラウドの運用やプロビジョニングをサポートするために必要なクラウド関連サービスを実行します。

- コンピュート、ストレージ、またはその他のリソースノード - クラウド上で動作するインスタンスにコンピュートとストレージの容量を提供します。

1.6.2. システムインベントリー

ドキュメントは、OpenStack 環境の一般的な説明を提供し、使用されているすべてのシステム (たとえば、本番、開発、またはテスト) をカバーする必要があります。システムコンポーネント、ネットワーク、サービス、およびソフトウェアを文書化することは、多くの場合、セキュリティーに関する懸念事項、攻撃ベクトル、および考えられるセキュリティーゾーン障害点を重視するために必要な全体像を提供します。システムインベントリーでは、従来の IT 環境では永続的なリソースであった仮想マシンや仮想ディスクボリュームなどの一時的なリソースを捕捉することが必要になる場合があります。

1.6.3. ハードウェアインベントリー

文書化に関する厳格なコンプライアンス要件がないクラウドでは、構成管理データベース (CMDB) の導入が有効です。CMDB は通常、ハードウェアの資産追跡と全体的なライフサイクル管理のために使用されます。CMDB を活用することで、企業はコンピュートノード、ストレージノード、ネットワークデバイスなどのクラウドインフラストラクチャーハードウェアを迅速に特定することができます。CMDB は、ネットワーク上に存在する資産の中で、メンテナンスが不十分であったり、保護が不十分であったり、移動して忘れ去られていたりすることで脆弱性を持つ可能性のある資産を特定するのに役立ちます。OpenStack のプロビジョニングシステムは、基盤となるハードウェアが必要なオートディスカバリー機能をサポートしていれば、いくつかの基本的な CMDB 機能を提供することができます。

1.6.4. ソフトウェアインベントリー

ハードウェアと同様に、OpenStack デプロイメント内のすべてのソフトウェアコンポーネントを文書化する必要があります。以下に例を示します。

- MySQL や mongoDB などのシステムデータベース

- Identity や Compute などの OpenStack ソフトウェアコンポーネント

- ロードバランサー、リバースプロキシー、DNS、DHCP サービスなどのサポートコンポーネント: ソフトウェアコンポーネントの権威あるリストは、ソフトウェアのライブラリー、アプリケーション、クラスにおける侵害や脆弱性の影響を評価する際に重要となる場合があります。

1.6.5. ネットワークトポロジー

ネットワークトポロジーは、セキュリティーゾーン間のデータフローと橋渡しの場所を明確に示すハイライトを提供する必要があります。ネットワークの入口と出口のポイントは、OpenStack の論理システムの境界とともに特定する必要があります。システムを完全に視覚的に含めるには、複数の図が必要になる場合があります。ネットワークトポロジーのドキュメントには、システムによってプロジェクトに代わって作成された仮想ネットワーク、OpenStack によって作成された仮想マシンインスタンスおよびゲートウェイ、さらにノードと外部ネットワーク間の通信に使用される物理ネットワークおよびオーバーレイネットワークを含める必要があります。

1.6.6. サービス、プロトコル、およびポート

組織の資産に関する情報を知ることは、一般的にはグッドプラクティスです。資産表は、セキュリティー要件の検証を支援し、ファイアウォール構成、サービスポートの競合、セキュリティー修復領域、コンプライアンスなどの標準的なセキュリティーコンポーネントの維持に役立ちます。さらに、このテーブルは、OpenStack コンポーネント間の関係を特定するのにも役立ちます。テーブルには以下のようなものがあります。

- OpenStack のデプロイメントで使用されているサービス、プロトコル、およびポート。

- クラウドインフラストラクチャー内で動作するすべてのサービスの概要。

OpenStack のデプロイメントでは、この情報を記録しておくことが推奨されます。director のデプロイメントに必要なポートの一覧は、「 https://access.redhat.com/documentation/ja-jp/red_hat_openstack_platform/15/html-single/firewall_rules_for_red_hat_openstack_platform/ 」を参照してください。

ポートの設定は、各サービスのヒートテンプレートにも含まれています。この情報は、以下のコマンドで抽出できます。

find -L /usr/share/openstack-tripleo-heat-templates/ -type f | while read f;do if `grep -q firewall_rules $f`;then echo -e "\n $f " ; grep firewall_rules "$f" -A10;fi; done

第2章 暗号化および鍵管理

デバイス間通信は、セキュリティー上の重大な問題です。Heartbleed などの重大な脆弱性や、BEAST や CRIME などのより高度な攻撃に見られるように、ネットワーク上での安全な通信手段はますます重要になっています。しかし、暗号化は、より大きなセキュリティー戦略の一部に過ぎません。エンドポイントが侵害されると、攻撃者は使用されている暗号を解読する必要がなくなり、システムで処理されるメッセージを閲覧したり操作したりすることができるようになります。

本章では、TLS (Transport Layer Security) を設定して社内外のリソースを保護するための機能を確認し、特に注意すべきシステムのカテゴリを紹介します。

OpenStack のコンポーネントは、様々なプロトコルを使用して相互に通信しますが、その通信には機密データが含まれる場合があります。攻撃者は、機密情報にアクセスするために、チャネルを盗聴しようとするかもしれません。そのため、すべてのコンポーネントが安全な通信プロトコルを使用して相互に通信することが重要です。

2.1. TLS と SSL の概要

OpenStack の導入において、ネットワークトラフィックの機密性や完全性を保証するためのセキュリティー要件が必要となる場合があります。一般的には、TLS プロトコルなどの暗号化手段を用いて設定します。一般的な導入では、パブリックネットワークを介して送信されるすべてのトラフィックをセキュリティーで強化する必要がありますが、セキュリティーのグッドプラクティスでは、内部トラフィックもセキュリティーで保護されなければならないと考えられています。セキュリティーゾーンの分離に頼った保護では不十分です。攻撃者がハイパーバイザーやホストのリソースにアクセスしたり、API エンドポイントを侵害したり、その他のサービスにアクセスした場合は、メッセージやコマンドを簡単に注入したりキャプチャしたり、クラウドの管理機能に影響を与えたりすることができないようにする必要があります。

管理ゾーンのサービスやサービス内通信を含め、すべてのゾーンを TLS でセキュリティー強化する必要があります。TLS は、OpenStack サービスへのユーザー通信、および OpenStack サービスとサービスの間で、認証、否認防止、機密性、および完全性を確保するメカニズムを提供します。

SSL (Secure Sockets Layer) プロトコルの脆弱性が公開されているため、SSL よりも TLS 1.2 以上の使用を検討し、旧式のブラウザーやライブラリーとの互換性が必要な場合を除き、すべてのケースで SSL を無効にしてください。

2.1.1. 公開鍵インフラストラクチャー

PKI (Public Key Infrastructure) とは、データや認証を保護するための暗号化アルゴリズム、暗号モード、プロトコルを提供するためのフレームワークです。これは、当事者の身元を確認しながら、トラフィックを確実に暗号化して送信するための一連のシステムとプロセスで構成されています。ここで説明する PKI プロファイルは、PKIX ワーキンググループによって開発された Internet Engineering Task Force (IETF) の Public Key Infrastructure (PKIX) プロファイルです。PKI の中核となるコンポーネントは以下の通りです。

- デジタル証明書 - 署名入り公開鍵証明書は、エンティティーの検証可能なデータ、その公開鍵、およびその他の属性を持つデータ構造です。これらの証明書は、認証局 (CA) によって発行されます。証明書は信頼できる CA によって署名されているため、一度検証されれば、エンティティーに関連付けられた公開鍵は、当該エンティティーに関連付けられていることが保証されます。これらの証明書を定義するための最も一般的な規格は、X.509 規格です。現在の標準である X.509 v3 は、RFC5280 に詳細が記載されており、RFC6818 で更新されています。証明書は、オンラインエンティティーのアイデンティティを証明する仕組みとして、CA によって発行されます。CA は、証明書からメッセージダイジェストを作成し、そのダイジェストを自分の秘密鍵で暗号化することで、証明書にデジタル署名します。

- エンドエンティティー - 証明書の対象となるユーザー、プロセス、またはシステム。エンドエンティティーは、その証明書要求を登録機関 (RA) に送り、承認を得ます。承認された場合、RA は要求を認証局 (CA) に転送します。認証局はリクエストを検証し、情報が正しければ証明書を生成して署名します。この署名された証明書は、証明書レポジトリに送られます。

- 依拠当事者 - 証明書に記載されている公開鍵を参照して検証可能なデジタル署名された証明書を受け取ったエンドポイント。依拠当事者は、チェーン上の証明書を検証し、CRL に存在しないことを確認し、また、証明書の有効期限を検証できる立場にある必要があります。

- 認証局 (CA) - CA は、認証ポリシー、管理処理、および証明書の発行において、エンドパーティと、証明書に依存するパーティの両方から信頼されるエンティティーです。

- RA (REgistration Authority): CA が特定の管理機能を委譲するオプションのシステムです。これには、CA が証明書を発行する前の、エンドエンティティーの認証などの機能が含まれます。

- 証明書失効リスト (Certificate Revocation List、CRL): 証明書失効リスト (CRL) は、失効した証明書シリアル番号の一覧です。これらの証明書を表示するエンティティーは、PKI モデルでは信頼できません。たとえば、鍵が不正アクセスし、CA 侵害などの理由によって失効が発生することがあります。

- CRL 発行者: CA が証明書失効リストの公開を委譲するオプションのシステム。

- 証明書リポジトリー: エンドエンティティー証明書および証明書失効リストが保存され、クエリーされる場所 (証明書バンドルと呼ばれることもあります)。

API エンドポイント用の TLS の使用を含め、セキュリティーで公開鍵インフラストラクチャー (PKI) を使用してすべてのサービスを強化することが強く推奨されます。これらの問題すべてを解決するには、暗号化またはメッセージの署名だけでは不可能です。さらに、ホスト自体は強化され、ポリシー、名前空間、およびその他のコントロールを実装して、プライベートの認証情報および鍵を保護する必要があります。ただし、キー管理および保護の課題は、これらの制御の必要性が低くなったり、それらの重要度が低下することはありません。

2.1.2. 認証局

多くの組織には、独自の認証局 (CA)、証明書ポリシー、および内部 OpenStack ユーザーまたはサービスの証明書を発行するのに使用する公開鍵インフラストラクチャーが確立されています。パブリックセキュリティーゾーンがインターネットに接続される組織には、一般に認識されるパブリック CA によって署名された証明書が必要です。管理ネットワークを介した暗号化通信には、パブリック CA を使用しないことが推奨されます。その代わりに、ほとんどのデプロイメントでは独自の内部 CA をデプロイすることが推奨されます。

TLS の効果的な使用では、DNS のドメインまたはサブドメインが付与されたデプロイメントに依存します。これはワイルドカードまたは内部 CA のいずれかで使用できる、または一連の特定証明書の問題です。TLS 証明書を効果的に検証できるようにするには、プラットフォームサービスへのアクセスは、これらの DNS レコードを通じて行う必要があります。

OpenStack クラウドアーキテクトは、内部システムおよび顧客がアクセスするサービス用に別の PKI デプロイメントを使用することを検討することを推奨します。これにより、クラウドデプロイヤーが PKI インフラストラクチャーの制御を維持でき、内部システムの証明書の要求、署名、デプロイが容易になります。高度な設定では、異なるセキュリティーゾーンに別の PKI デプロイメントを使用する場合があります。これにより、OpenStack のオペレーターは環境の暗号化の分離を維持でき、発行された証明書が別の方法で認識されないようにします。

インターネット向けのクラウドエンドポイント (またはお客様が標準オペレーティングシステムが提供する証明書バンドル以外のインストールを期待しない) で TLS をサポートするために使用される証明書は、オペレーティングシステムの証明書バンドルにインストールされている認証局を使用してプロビジョニングする必要があります。

証明書の作成および署名に関する管理、ポリシー、および技術的な課題があります。これは、クラウドアーキテクトまたはオペレーターが推奨するガイダンスに加えて、業界のリーダーとベンダーのアドバイスを求めたい領域です。

2.1.3. director を使用した暗号化の設定

デフォルトでは、オーバークラウドはサービスに暗号化されていないエンドポイントを使用します。これは、オーバークラウドの設定に、パブリック API エンドポイントに SSL/TLS を有効化するための追加の環境ファイルが必要であることを意味します。『オーバークラウドの 高度なカスタマイズ』 では、SSL/TLS 証明書を設定して、オーバークラウドの作成プロセスの一部として追加する方法を説明します。https://access.redhat.com/documentation/ja-jp/red_hat_openstack_platform/15/html/advanced_overcloud_customization/sect-enabling_ssltls_on_the_overcloud

2.1.4. TLS ライブラリー

OpenStack エコシステム内の一部のコンポーネント、サービス、およびアプリケーションは TLS ライブラリーを使用するように設定できます。OpenStack 内の TLS および HTTP サービスは、通常、FIPS 140-2 で検証されているモジュールが含まれる OpenSSL を使用して実装されます。ただし、各アプリケーションまたはサービスは、OpenSSL ライブラリーを使用する方法においても脆弱点が発生することを考慮してください。

2.1.5. TLS 1.0 が非推奨に

FedRAMP 認可システムは、TLS 1.0 から離れる必要があります。推奨されるレベルは 1.2 で、幅広い互換性が必要な場合に 1.1 を使用できます。詳細は、https://www.fedramp.gov/assets/resources/documents/CSP_TLS_Requirements.pdf を参照してください。

Red Hat OpenStack Platform 13 デプロイメントでは、HAProxy によって TLS 1.0 接続が許可されません。これにより、TLS 対応の API の TLS 接続を処理します。これは、no-tlsv10 オプションで実装されます。InternalTLS が有効な HA デプロイメントでは、コントローラープレーン上のノード間のトラフィックも暗号化されます。これには、RabbitMQ、MariaDB、Redis などがあります。MariaDB と Redis の TLS1.0 が非推奨になり、RabbitMQ の非推奨化がアップストリームからバックポートされることが予想されます。

2.1.5.1. TLS 1.0 が使用されているかどうかを確認する

cipherscan を使用して、TLS 1.0 がデプロイメントで提示されているかどうかを判断できます。暗号スキャンは、https://github.com/mozilla/cipherscan からクローンできます。この出力例は、horizon から受信した結果を示しています。

実稼働以外のシステムから cipherscan を実行すると、初回実行時に追加の依存関係をインストールする場合があるためです。

$ ./cipherscan https://openstack.lab.local .............................. Target: openstack.lab.local:443 prio ciphersuite protocols pfs curves 1 ECDHE-RSA-AES128-GCM-SHA256 TLSv1.2 ECDH,P-256,256bits prime256v1 2 ECDHE-RSA-AES256-GCM-SHA384 TLSv1.2 ECDH,P-256,256bits prime256v1 3 DHE-RSA-AES128-GCM-SHA256 TLSv1.2 DH,1024bits None 4 DHE-RSA-AES256-GCM-SHA384 TLSv1.2 DH,1024bits None 5 ECDHE-RSA-AES128-SHA256 TLSv1.2 ECDH,P-256,256bits prime256v1 6 ECDHE-RSA-AES256-SHA384 TLSv1.2 ECDH,P-256,256bits prime256v1 7 ECDHE-RSA-AES128-SHA TLSv1.2 ECDH,P-256,256bits prime256v1 8 ECDHE-RSA-AES256-SHA TLSv1.2 ECDH,P-256,256bits prime256v1 9 DHE-RSA-AES128-SHA256 TLSv1.2 DH,1024bits None 10 DHE-RSA-AES128-SHA TLSv1.2 DH,1024bits None 11 DHE-RSA-AES256-SHA256 TLSv1.2 DH,1024bits None 12 DHE-RSA-AES256-SHA TLSv1.2 DH,1024bits None 13 ECDHE-RSA-DES-CBC3-SHA TLSv1.2 ECDH,P-256,256bits prime256v1 14 EDH-RSA-DES-CBC3-SHA TLSv1.2 DH,1024bits None 15 AES128-GCM-SHA256 TLSv1.2 None None 16 AES256-GCM-SHA384 TLSv1.2 None None 17 AES128-SHA256 TLSv1.2 None None 18 AES256-SHA256 TLSv1.2 None None 19 AES128-SHA TLSv1.2 None None 20 AES256-SHA TLSv1.2 None None 21 DES-CBC3-SHA TLSv1.2 None None Certificate: trusted, 2048 bits, sha256WithRSAEncryption signature TLS ticket lifetime hint: None NPN protocols: None OCSP stapling: not supported Cipher ordering: server Curves ordering: server - fallback: no Server supports secure renegotiation Server supported compression methods: NONE TLS Tolerance: yes Intolerance to: SSL 3.254 : absent TLS 1.0 : PRESENT TLS 1.1 : PRESENT TLS 1.2 : absent TLS 1.3 : absent TLS 1.4 : absent

サーバーのスキャン時に、Cipherscan インターバリーが、ネゴシエートする最大の TLS バージョンである特定の TLS バージョンのサポートをアドバータイズします。ターゲットサーバーが TLS プロトコルを正しく従うと、相互に対応している最新バージョンで応答します。これは、最初にアドバータイズされた Cipherscan よりも低くなる可能性があります。サーバーが特定のバージョンを使用するクライアントとの接続を確立し続けると、そのプロトコルバージョンに対する耐性があるとみなされません。(指定されたバージョンまたは下位バージョンを使用する) 接続を確立しない場合は、そのバージョンのプロトコルの耐性があることが考慮されます。以下に例を示します。

Intolerance to: SSL 3.254 : absent TLS 1.0 : PRESENT TLS 1.1 : PRESENT TLS 1.2 : absent TLS 1.3 : absent TLS 1.4 : absent

この出力では、TLS 1.0 および TLS 1.1 のイントレランスは PRESENT として報告されます。これは、接続を確立できず、その Cipherscan がこれらの TLS バージョンのアドバタイズメントサポート中に接続できなかったことを意味します。そのため、スキャンされたサーバーでプロトコルの (およびそれより低い) バージョンが有効ではないことを確認する必要があります。

2.1.6. 暗号化アルゴリズム、暗号モード、およびプロトコル

TLS 1.2 のみを使用することを検討してください。TLS 1.0 や 1.1 などのその他のバージョンは複数の攻撃に対して脆弱であり、多くの政府機関や規制対象者によって表現的に禁止されています。お使いの環境で TLS 1.0 を無効にする必要があります。TLS 1.1 は幅広いクライアント互換性に使用される場合がありますが、このプロトコルを有効にする際には注意が必要です。互換性要件が必須で、関係するリスクを認識している場合は、TLS バージョン 1.1 を有効にします。すべてのバージョンの SSL (TLS への前提条件) は、複数のパブリック脆弱性により使用すべきではありません。

TLS 1.2 を使用し、クライアントとサーバーの両方を制御する場合、暗号スイートは ECDHE-ECDSA-AES256-GCM-SHA384 に制限される必要があります。エンドポイントの両方を制御しておらず、TLS 1.1 または 1.2 を使用している場合、より一般的な HIGH:!aNULL:!eNULL:!DES:!3DES:!SSLv3:!TLSv1:!CAMELLIA は、妥当な暗号選択です。

本ガイドは暗号化の参照として意図されておらず、OpenStack サービスで有効化または無効化する必要のある特定のアルゴリズムまたは暗号モードに関する規定はありません。

2.2. TLS プロキシーおよび HTTP サービス

OpenStack のエンドポイントは、パブリックネットワーク上のエンドユーザーや管理ネットワーク上の他の OpenStack サービスの両方に API を提供する HTTP サービスです。現在、TLS を使用して外部要求を暗号化できます。Red Hat OpenStack Platform でこれを設定するには、HAproxy の背後にある API サービスをデプロイすることができます。これは、TLS セッションを確立および終了できます。

ソフトウェアの終了でパフォーマンスが不十分な場合には、ハードウェアアクセラレーターは代替オプションとして使用したものになるかもしれません。このアプローチにはプラットフォーム上で追加の設定が必要で、すべてのハードウェアロードバランサーが Red Hat OpenStack Platform と互換性がある訳ではありません。選択した TLS プロキシーによって処理される要求のサイズに留意する必要があります。

2.2.1. Perect Forward Secrecy

perfect forward secrecy の TLC 設定では、キーサイズ、セッション ID、およびセッションチケットに関する注意を払ってプランニングする必要があります。さらに、マルチサーバーデプロイメントの場合、共有状態は重要な考慮事項です。実際のデプロイメントでは、パフォーマンスを向上させるためにこの機能を有効にすることを検討してください。これはセキュリティーが強化された方法で行うことができますが、キー管理に関して特別な考慮が必要になります。このような構成については、本書では扱いません。

2.3. Barbican を使用したシークレットの管理

OpenStack Key Manager (barbican) は Red Hat OpenStack Platform のシークレットマネージャーです。barbican API とコマンドラインを使用して、OpenStack サービスの使用する証明書、キー、パスワードを一元管理することができます。barbican は現在以下のユースケースをサポートします。

- 対称暗号鍵: Block Storage (cinder) ボリュームの暗号化、一時ディスク暗号化、および Object Storage (swift) オブジェクトの暗号化に使用されます。

- 非対称鍵および証明書: glance イメージの署名および検証、Octavia TLS 負荷分散

本リリースでは、barbican は cinder、swift、Octavia、および Compute (nova) コンポーネントとの統合を提供します。たとえば、以下のユースケースに barbican を使用できます。

- 暗号化されたボリュームのサポート: barbican を使用して cinder 暗号化キーを管理できます。この設定は、LUKS を使用して、インスタンスに接続されているディスク (ブートディスクを含む) を暗号化します。キー管理の機能は、ユーザーに透過的に行われます。

- Glance Image Signing: Image Service (glance) を設定して、アップロードしたイメージが改ざんされていないことを検証することができます。イメージは、barbican に保管されているキーで最初に署名され、毎回そのイメージを使用する前に検証されます。

詳細は、Barbican のガイドを参照してください( https://access.redhat.com/documentation/ja-jp/red_hat_openstack_platform/15/html-single/manage_secrets_with_openstack_key_manager/)。

第3章 アイデンティティーおよびアクセス管理

3.1. アイデンティティー

このセクションには、ID に関する概念情報が含まれています。

3.1.1. 認証

認証は、あらゆる実際の OpenStack デプロイメントの不可欠な要素です。システム設計のこの側面に注意を払う必要があります。このトピックの完全な取り扱いについては、本書では扱いませんが、以下の主要なトピックについて記載します。

最も基本的な認証は、アイデンティティーを確認するプロセスです。システムにログインする際に、使い慣れている例は、ユーザー名とパスワードを提供します。

OpenStack Identity サービス (keystone) は、ユーザー名とパスワード、LDAP、およびその他の外部認証方法など、複数の認証メソッドをサポートしています。認証に成功すると、Identity サービスは、後続のサービスリクエストに使用される承認トークンを提供します。

TLS (Transport Layer Security) は、X.509 証明書を使用してサービスとユーザーの間の認証を提供します。TLS のデフォルトモードはサーバー側の認証のみですが、米国の政府標準で義務付けられているため、クライアント認証に証明書を使用することを検討する必要があります。

3.1.1.1. 無効なログイン試行

Identity Service (keystone) は、ログイン試行が繰り返し失敗した後にアカウントへのアクセスを制限する方法を提供していません。ログイン試行の失敗のパターンは、一般的にブルートフォース攻撃の指標です。このタイプの攻撃は、パブリッククラウドのデプロイメントでさらに複雑になります。設定された回数のログイン試行の失敗後にアカウントをブロックする外部認証システムを使用することで、これを軽減するのに役立ちます。その後、アカウントは他の管理者の介入でのみロックを解除できます。

検出技術を使用して、破損を軽減することもできます。検出では、アクセス制御ログの頻繁にレビューが行われ、承認されていないアカウントへのアクセス試行を特定します。修復には、ユーザーのパスワードの強度の確認やファイアウォールルールによる攻撃のネットワークソースのブロックなどが含まれます。接続の数を制限する keystone サーバーにファイアウォールルールを追加することができます。これにより、攻撃の効果を減らすことができます。

さらに、ログイン時間や疑わしいアクションについてアカウントアクティビティーを調べたり、アカウントを無効にするなどの修正措置を取ると役に立ちます。

3.1.1.2. マルチファクター認証

特権ユーザーアカウントへのネットワークアクセスに多要素認証を採用します。Identity サービスは、この機能を提供できる外部認証サービスと統合できます。たとえば、keystone は、Active Directory、Red Hat Identity Manager、Free IPA、または汎用 LDAP サーバーと統合でき、これらのいずれかによって多要素認証が適用されます。

この推奨事項は、パスワードを危険にさらす可能性のあるさまざまなブルートフォース、ソーシャルエンジニアリング、およびスピアフィッシングと大量フィッシング攻撃の両方を軽減するのに役立ちます。Red Hat Identity Management と統合するデプロイメントについては、『 Identity Management の計画』を参照してください。

3.2. 承認

Identity サービスは、グループおよびロールの概念をサポートします。ユーザーはグループに属している間にグループに属します。OpenStack サービスは、サービスへのアクセスを試みるユーザーのロールを参照します。OpenStack ポリシーエンフォーサーは、各リソースに関連付けられたポリシールールを考慮に入れて、次にユーザーのグループ/ロールと関連付けて、要求されたリソースにアクセスできるかどうかを判別します。

3.2.1. Formal Access Control Policies を確立

ロール、グループ、ユーザーを設定する前に、OpenStack インストールに必要なアクセス制御ポリシーを文書化する必要があります。ポリシーは、組織の規制要件または法的要件に準拠する必要があります。アクセス制御設定に対する今後の変更は、フォームポリシーを使用して一貫して実行するはずです。このポリシーには、アカウントの作成、削除、無効化、有効化、アカウントへの権限の割り当てを行う条件およびプロセスが含まれます。ポリシーを定期的に確認し、承認済みのポリシーで設定が準拠していることを確認します。

3.2.2. サービス承認

クラウド管理者は、各サービスの admin ロールを持つユーザーを定義する必要があります。このサービスアカウントは、ユーザーを認証するための承認をサービスに提供します。

Compute および Object Storage サービスは、Identity サービスを使用して認証情報を保存するように設定できます。Identity サービスは、TLS のクライアント認証をサポートしますが、これは有効にされる可能性があります。TLS クライアント認証は、ユーザー名とパスワードに加えて、ユーザー ID の信頼性を向上させる、ユーザー名とパスワードの他に追加の認証要素を提供します。ユーザー名とパスワードが侵害されると、承認されていないアクセスのリスクが軽減されます。ただし、すべてのデプロイメントで実行できないユーザーに証明書を発行するのに、追加の管理オーバーヘッドやコストが発生します。

クラウド管理者は、機密の設定ファイルを承認されていない変更から保護する必要があります。これは、/var/lib/config-data/puppet-generated/keystone/etc/keystone/keystone.conf ファイルや X.509 証明書など、SELinux などの強制アクセス制御フレームワークを使用して設定できます。

TLS を使用したクライアント認証では、証明書がサービスに発行される必要があります。これらの証明書は、外部または内部の認証局で署名できます。OpenStack サービスは、デフォルトで信頼できる CA に対して証明書署名の有効性をチェックし、署名が有効で CA が信頼されていない場合に接続は失敗します。クラウドデプロイヤーは自己署名証明書を使用できます。この場合、有効性チェックを無効にするか、証明書が信頼できるものとマークされる必要があります。自己署名証明書の検証を無効にするには、/etc/nova/api.paste.ini ファイルの [filter:authtoken] セクションに insecure=False を設定します。この設定は、他のコンポーネントの証明書も無効になります。コンテナー化されたサービスでは、ファイルパスが異なる場合があります。

3.2.3. 管理ユーザーアカウント

管理ユーザーアカウントは、keystone と、証明書などの 2 要素認証をサポートする外部認証サービスの両方を使用して認証する必要があります。外部認証サービスには、Red Hat Identity Management または Microsoft Active Directory を含めることができます。これらのサービスとの統合については、https://access.redhat.com/documentation/ja-jp/red_hat_openstack_platform/15/html-single/integrate_with_identity_service/ に記載されています。このアプローチは、侵害される可能性のあるパスワードによるリスクを軽減するのに役立ちます。この推奨事項は、特権アカウントへのネットワークアクセスに多要素認証を使用する際の NIST 800-53 IA-2(1) ガイダンスに準拠しています。

3.2.4. エンドユーザー

Identity サービスは、エンドユーザー認証を直接提供するか、または外部の認証方法を使用して、組織のセキュリティーポリシーおよび要件に準拠するように設定できます。

3.3. ポリシー

各 OpenStack サービスには、アクセスポリシーで管理されるリソースが含まれています。たとえば、リソースには以下の関数が含まれる場合があります。

- インスタンスを作成して起動するパーミッション

- インスタンスにボリュームを接続する機能

Red Hat OpenStack Platform (RHOSP) 管理者は、カスタムポリシーを作成して、さまざまなアクセスレベルで新しいロールを導入することや、既存のロールのデフォルト動作を変更することが必要になる場合があります。また、変更後に API アクセスポリシーを検証し、これらのポリシーが変更されない場合にデバッグする機能もあります。プロダクションデプロイメント以外の検証およびデバッグポリシー。構文エラーが発生すると、ダウンタイムが発生し、誤って認証が適用されないとセキュリティーやユーザビリティーに悪影響を及ぼす可能性があります。

3.3.1. 既存のポリシーの確認

サービスのポリシーファイルはこれまで /etc/$service ディレクトリーに存在していました。たとえば、Compute (nova) の policy.json ファイルの完全パスは /etc/nova/policy.json でした。

既存のポリシーを見つける方法に影響を与える重要なアーキテクチャーの変更には、以下の 2 つがあります。

Red Hat OpenStack Platform はコンテナー化されています。

サービスコンテナーからポリシーファイルを確認する場合は、ポリシーファイル (ある場合) は従来のパスにあります。

/etc/$service/policy.json

サービスコンテナーの外部からそれらを表示する場合は、以下のパスに配置されます。

/var/lib/config-data/puppet-generated/$service/etc/$service/policy.json

各サービスには、コードで提供されるデフォルトのポリシーがあります。これは、手動で作成した場合にのみ利用できるファイル、または

oslopolicyツールで生成された場合に限ります。ポリシーファイルを生成するには、以下の例のように、コンテナーからoslopolicy-policy-generatorを使用します。podman exec -it keystone oslopolicy-policy-generator --namespace keystone

デフォルトでは、生成されたポリシーは osly.policy CLI ツールにより stdout にプッシュされます。

3.3.2. サービスポリシーについて

サービスポリシーファイルステートメントは、エイリアス定義またはルールです。エイリアスの定義はファイルの先頭に存在します。以下の一覧には、Compute (nova) 用に生成された policy.json ファイルからのエイリアス定義の説明が記載されています。

"context_is_admin": "role:admin"

ターゲットの後に

rule:context_is_adminが表示されたら、そのアクションを許可する前にユーザーが管理コンテキストで動作していることを確認します。"admin_or_owner": "is_admin:True or project_id:%(project_id)s"

ターゲットの後に

admin_or_ownerが表示されると、ポリシーはそのユーザーが admin であるか、またはプロジェクト ID がターゲットオブジェクトの独自のプロジェクト ID と一致することを確認してからそのアクションを許可します。"admin_api": "is_admin:True

ターゲットの後に

admin_apiが表示されると、ポリシーはそのアクションを許可する前にそのユーザーが admin であることをチェックします。

3.3.3. ポリシー構文

Policy.json ファイルは特定のオペレーターをサポートするので、これらの設定のターゲットスコープを制御できます。たとえば、以下の keystone の設定には、ユーザー作成の管理ユーザーだけがルールが含まれます。

"identity:create_user": "rule:admin_required"

: 文字の左側にあるセクションでは、特権について説明し、右側のセクションは、特権を使用できるユーザーを定義します。右側にオペレーターを使用して、スコープをさらに制御することもできます。

-

!: このアクションを実行するユーザー (admin を含む) はありません。 -

@および"": 任意のユーザーがこのアクションを実行できます。 -

not、and、or: 標準の Operator 機能を利用できます。

たとえば、以下の設定は、新規ユーザーを作成するパーミッションを持たないことを意味します。

"identity:create_user": "!"

3.3.4. アクセス制御でのポリシーファイルの使用

デフォルトのルールを上書きするには、適切な OpenStack サービスの policy.json ファイルを編集します。たとえば、Compute サービスには nova ディレクトリーに policy.json があります。これは、コンテナーから表示する際にコンテナー化されたサービスの正しい場所となります。

- ステージング環境でポリシーファイルへの変更をよくテストしてから、それらを実稼働環境で実装する必要があります。

-

アクセス制御ポリシーへの変更が、リソースのセキュリティーを意図せずに脆弱化しないことを確認する必要があります。また、

policy.jsonファイルへの変更はすぐに有効であり、サービスの再起動は必要ありません。

3.3.4.1. 例: パワーユーザーロールの作成

keystone ロールのパーミッションをカスタマイズするには、サービスの policy.json ファイルを更新します。これは、ユーザーのクラスに割り当てるパーミッションをより詳細に定義できることを意味します。以下の例では、以下の特権を使用してデプロイメントの power user ロールを作成します。

- インスタンスを起動するには、以下のコマンドを実行します。

- インスタンスを停止します。

- インスタンスに割り当てられているボリュームを管理します。

このロールの意図は、admin アクセスを付与せずに、特定のユーザーに追加のパーミッションを付与することです。これらの特権を使用するには、以下のパーミッションをカスタムロールに付与する必要があります。

-

インスタンスを起動する:

"os_compute_api:servers:start": "role:PowerUsers" -

インスタンスを停止する:

"os_compute_api:servers:stop": "role:PowerUsers" -

特定のボリュームを使用するようにインスタンスを設定する:

"os_compute_api:servers:create:attach_volume": "role:PowerUsers" -

インスタンスに割り当てられているボリュームを一覧表示する:

"os_compute_api:os-volumes-attachments:index": "role:PowerUsers" -

ボリュームを割り当てる:

"os_compute_api:os-volumes-attachments:create": "role:PowerUsers" -

割り当てられたボリュームの詳細を表示する:

"os_compute_api:os-volumes-attachments:show": "role:PowerUsers" -

インスタンスに割り当てられているボリュームを変更する:

"os_compute_api:os-volumes-attachments:update": "role:PowerUsers" -

インスタンスに割り当てられているボリュームを削除する:

"os_compute_api:os-volumes-attachments:delete": "role:PowerUsers"

policy.json ファイルを変更すると、デフォルトのポリシーを上書きします。その結果、PowerUsers のメンバーは、これらのアクションを実行できる唯一のユーザーになります。admin ユーザーがこれらのパーミッションを保持できるようにするには、admin_or_power_user. のルールを作成できます。また、基本的な条件ロジックを使用して role:PowerUsers or role:Admin を定義することもできます。

コマンドラインセッションで keystone v3 API を使用するには、source コマンドで v3 エンドポイントおよび設定を定義する rc ファイルを読み込みます。

OS_AUTH_URL=http://controller-hostname.lab.local:5000/v3 OS_USERNAME=username OS_PASSWORD=password OS_USER_DOMAIN_NAME=Default OS_PROJECT_DOMAIN_NAME=Default OS_PROJECT_NAME=project-name OS_IDENTITY_API_VERSION=3

カスタム keystone ロールを作成します。

$ openstack role create PowerUsers +-----------+----------------------------------+ | Field | Value | +-----------+----------------------------------+ | domain_id | None | | id | 7061a395af43455e9057ab631ad49449 | | name | PowerUsers | +-----------+----------------------------------+

既存のユーザーをロールに追加し、ロールをプロジェクトに割り当てます。

$ openstack role add --project [PROJECT_NAME] --user [USER_ID] [PowerUsers-ROLE_ID]

注記ロールの割り当ては、1 つのプロジェクトのみとペアになります。つまり、ロールをユーザーに割り当てると、ターゲットプロジェクトも同時に定義します。ユーザーが同じロールを受信し、別のプロジェクトを対象にする場合は、ロールを別々に割り当てる必要がありますが、別のプロジェクトが対象となります。

デフォルトの nova ポリシー設定を表示します。

$ oslopolicy-policy-generator --namespace nova

以下のエントリーを

/etc/nova/policy.jsonに追加して、新しいPowerUsersロールのカスタムパーミッションを作成します。注記デプロイメント前にポリシーの変更をテストし、想定通りに機能していることを確認します。

{ "os_compute_api:servers:start": "role:PowerUsers", "os_compute_api:servers:stop": "role:PowerUsers", "os_compute_api:servers:create:attach_volume": "role:PowerUsers", "os_compute_api:os-volumes-attachments:index": "role:PowerUsers", "os_compute_api:os-volumes-attachments:create": "role:PowerUsers", "os_compute_api:os-volumes-attachments:show": "role:PowerUsers", "os_compute_api:os-volumes-attachments:update": "role:PowerUsers", "os_compute_api:os-volumes-attachments:delete": "role:PowerUsers" }このファイルを保存すると、変更はすぐに有効になります。

PowerUserskeystone ロールに追加したユーザーは、これらの権限を受信します。

3.3.4.2. 例: 属性に基づくアクセスの制限

API 呼び出しを実行するユーザーの属性に基づいて、API 呼び出しへのアクセスを制限するポリシーを作成できます。たとえば、以下のデフォルトのルールは、管理者コンテキストから実行された場合のキーペアの削除が許可されるか、またはトークンのユーザー ID がターゲットに関連付けられたユーザー ID と一致することを示しています。

"os_compute_api:os-keypairs:delete": "rule:admin_api or user_id:%(user_id)s"

注記: *新しい実装機能は、各リリースと共に各サービスに保証される訳ではありません。したがって、ターゲットサービスの既存のポリシーの規則を使用してルールを作成することが重要です。これらのポリシーの表示に関する詳細は、「既存ポリシーの確認」を参照してください。* すべてのポリシーは、リリース間の互換性の保証が保証されないため、デプロイするすべてのバージョンの非実稼働環境でテストする必要があります。

上記の例では、API ルールを作成し、リソースを所有するかどうかに基づいてユーザーへのアクセスを拡張または制限できます。また、属性と他の制限を組み合わせて、以下の例で示すようにルールを形成できます。

"admin_or_owner": "is_admin:True or project_id:%(project_id)s"

上記の例を考慮すると、管理者およびユーザーに限定した一意のルールを作成し、そのルールを使用してさらにアクションを制限することができます。

"admin_or_user": "is_admin:True or user_id:%(user_id)s" "os_compute_api:os-instance-actions": "rule:admin_or_user"

利用可能な policy.json 構文オプションの詳細は、「ポリシー構文」を参照してください。

3.3.4.3. ロール割り当ての確認

ロール割り当てのレポートを生成します。

openatck role assignment list --names +---------------+--------------------+-------+----------------------+--------+-----------+ | Role | User | Group | Project | Domain | Inherited | +---------------+--------------------+-------+----------------------+--------+-----------+ | admin | glance@Default | | services@Default | | False | | admin | ceilometer@Default | | services@Default | | False | | ResellerAdmin | ceilometer@Default | | services@Default | | False | | PowerUsers | demo-user@Default | | demo-project@Default | | False | | admin | swift@Default | | services@Default | | False | | admin | aodh@Default | | services@Default | | False | | admin | neutron@Default | | services@Default | | False | | admin | nova@Default | | services@Default | | False | | _member_ | demo@Default | | demo@Default | | False | | admin | cinder@Default | | services@Default | | False | | admin | admin@Default | | admin@Default | | False | | admin | gnocchi@Default | | services@Default | | False | +---------------+--------------------+-------+----------------------+--------+-----------

特定のユーザーのロール割り当てを表示します。

$ openstack role assignment list --user demo-user --project demo-project --names +-------------+----------------+-------+----------------------+--------+-----------+ | Role | User | Group | Project | Domain | Inherited | +-------------+----------------+-------+----------------------+--------+-----------+ | PowerUsers | demo-user@Default | | demo-project@Default | | False | +-------------+----------------+-------+----------------------+--------+-----------+

3.4. トークン

ユーザーが認証されると、OpenStack 環境の認証およびアクセスのためにトークンが生成されます。トークンには変数のライフサイクルを指定できますが、有効期限のデフォルト値は 1 時間です。推奨される期限切れ値は、内部サービスがタスクを完了するのに十分な時間を確保できるように、低い値に設定する必要があります。トークンがタスクが完了する前に期限切れになる場合、クラウドはサービスの提供を応答しなくなるか、または停止する可能性があります。使用中に展開される時間の例としては、Compute サービスがディスクイメージをローカルキャッシュ用にハイパーバイザーに転送するために必要な時間があります。

このトークンは、多くの場合、Identity サービスの応答の大きなコンテキストの構造内で渡されます。これらの応答は、さまざまな OpenStack サービスのカタログも提供します。各サービスは、その名前、内部、admin、およびパブリックアクセスのエンドポイントと共に一覧表示されます。Identity サービスは、トークンの失効をサポートします。トークンを取り消す API として、取り消したトークンや、取り消しされたトークンについてクエリーする個別の OpenStack サービスを一覧表示し、それらをキャッシュから削除し、キャッシュされた取り消したトークンの一覧に同じものを追加します。

サポートされているトークンタイプには、UUID と Hadoop の 2 つのタイプがあります。PKI トークンおよび PKIZ トークンは、Red Hat OpenStack Platform 11 で非推奨となりました。

3.4.1. UUID トークン

UUID トークンは永続トークンであり、長さが 32 バイトで、認証メタデータとともに Identity サービスバックエンドに保存されます。クライアントは検証のために UUID トークンを Identity サービスに渡す必要があります。UUID トークンは、デフォルトのトークンプロバイダーが 1 度でした。

3.4.2. fernet トークン

Fernet トークンがデフォルトのトークンプロバイダーになりました。fernet は、API トークンでの使用に対して明示的に設計されたセキュアなメッセージング形式です。fernet トークンは永続的ではなく (データベースに永続化する必要はありません)、軽量 (180 から 240 バイト)、クラウドの実行に必要な運用のオーバーヘッドを削減します。認証および認可メタデータは、メッセージパックのペイロードにバンドルされます。これは、Fernet トークンとして暗号化され、署名されます (180 から 240 バイトまで)。

UUID、PKI、PKIZ トークンとは異なり、Fernet トークンには永続性は必要ありません。keystone トークンデータベースには、認証の副次的な影響がなくなりました。Fernet トークンの使用時に、トークンデータベースからの期限切れのトークンのプルーニングが不要になりました。Fernet トークンは永続的ではないため、複製する必要はありません。各 keystone ノードが同じリポジトリーを共有している限り、ノード間で Fernet トークンを即時に作成/検証することができます。

PKI トークンおよび PKIZ トークンと比較すると、Fernet トークンのサイズは小さくなり、通常は 250 のバイト制限下に保持されます。PKI および PKIZ トークンの場合、サービスカタログが大きいとトークンの長さが長くなります。このパターンは、暗号化されたペイロードの内容が最小限に保持されるため、Fernet トークンには存在しません。

Hadoop トークンおよびローテーションキーの詳細は、https://access.redhat.com/documentation/ja-jp/red_hat_openstack_platform/15/html-single/deploy_fernet_on_the_overcloud/ を参照してください。

3.5. Keystone ドメイン

keystone ドメインは高レベルのセキュリティー境界で、プロジェクト、ユーザーおよびグループを論理的にグループ化します。そのため、keystone ベースのすべてのアイデンティティーコンポーネントを一元管理できます。アカウントドメイン、サーバー、ストレージ、およびその他のリソースの導入により、複数のプロジェクト (以前はテナントと呼ばれていました) に論理的にグループ化され、マスターアカウントのようなコンテナーでグループ化できるようになりました。さらに、アカウントドメイン内で複数のユーザーを管理でき、プロジェクトごとに異なるロールを割り当てることができます。

Identity V3 API は複数のドメインをサポートします。異なるドメインのユーザーは、異なる認証バックエンドで表される場合があります。また、さまざまなサービスリソースにアクセスするためにポリシー定義で使用される単一のロールおよび特権のセットにマップする必要がある異なる属性が存在する可能性があります。

ルールが、プロジェクトに属する admin ユーザーおよびユーザーのみへのアクセスを指定する場合には、マッピングが簡単な場合があります。他のシナリオでは、クラウド管理者はプロジェクトごとにマッピングルーチンを承認する必要がある場合があります。

ドメイン固有の認証ドライバーにより、ドメイン固有の設定ファイルを使用して Identity サービスを複数のドメインに設定できます。ドライバーを有効にし、ドメイン固有の設定ファイルの場所を設定することは、/var/lib/config-data/puppet-generated/keystone/etc/keystone/keystone.conf ファイルの [identity] セクションで行います。以下に例を示します。

[identity] domain_specific_drivers_enabled = True domain_config_dir = /var/lib/config-data/puppet-generated/keystone/etc/keystone/domains/

ドメイン固有の設定ファイルのないドメインは、プライマリー /var/lib/config-data/puppet-generated/keystone/etc/keystone/keystone.conf ファイルでオプションを使用します。

3.6. アイデンティティサービスとの連携

フェデレーション ID は、ID プロバイダーとサービスプロバイダー (SP) 間の信頼を確立するためのメカニズムです。この場合、サービスプロバイダーは OpenStack クラウドによって提供されるサービスです。

認証および承認サービスの場合、OpenStack アイデンティティーモデルは外部の認証データベースを別の keystone ドメインとみなします。各フェデレーション認証メカニズムは keystone ドメインに関連付けられ、複数の共存ドメインをサポートします。ロールを使用して、外部のドメインのユーザーにクラウドのリソースへのアクセスを許可できます。このアプローチは、ドメイン間のマルチテナントデプロイメントでも機能します。また、このアプローチは、すべての OpenStack ロールを外部認証ユーザーに戻すことができないため、コンポーネントごとのポリシーにも影響を与えます。たとえば、外部認証データベースのユーザーが admin ドメインの admin ユーザーと同様の管理アクセスが必要な場合は、通常は追加の設定や考慮が必要になります。

フェデレーション対応の Identity では、既存の認証情報を使用して、追加の ID を用意したり、複数回ログインしたりせずに、複数の認証クラウドで提供される複数のエンドポイント間で、サーバー、ボリューム、データベースなどのクラウドリソースにアクセスする方法を提供します。認証情報はユーザーの認証プロバイダーによって維持されます。

Identity サービスは、ユーザーの認証情報を SQL データベースに保存したり、LDAP 準拠のディレクトリーサーバーを使用したりできます。Identity データベースは、他の OpenStack サービスが使用するデータベースとは異なる可能性があり、保存された認証情報のリスクが軽減されます。

ユーザー名とパスワードを使用して認証する場合、Identity はパスワードの強度、有効期限、または失敗した認証試行でポリシーを強制しません。より強力なパスワードポリシーを強制する組織は、Identity 拡張機能または外部認証サービスを使用することを検討する必要があります。

LDAP は、Identity 認証を組織の既存のディレクトリーサービスおよびユーザーアカウントの管理プロセスに統合できるようにします。OpenStack の認証および承認ポリシーは、別のサービスに委譲される可能性があります。一般的なユースケースは、プライベートクラウドをデプロイするように組織で、LDAP システムに従業員およびユーザーのデータベースをすでに持つ組織です。これを認証機関として使用すると、Identity サービスへの要求は LDAP システムに委任され、そのポリシーに基づいて承認または拒否されます。認証に成功すると、Identity サービスは、承認されたサービスへのアクセスに使用されるトークンを生成します。

LDAP システムに admin、finance、HR など、ユーザーに属性が定義されている場合には、さまざまな OpenStack サービスで使用するために、Identity 内のロールおよびグループにマップされる必要があります。/var/lib/config-data/puppet-generated/keystone/etc/keystone/keystone.conf ファイルは、LDAP 属性を Identity 属性にマッピングします。

3.7. Red Hat Single Sign-On を使用した IdM でのフェデレーション

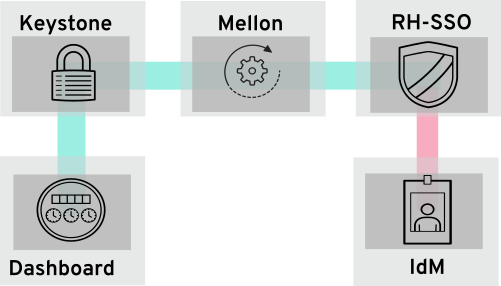

Red Hat Single Sign-On (RH-SSO) を使用して、OpenStack 認証 (authN) 用の IdM ユーザーをフェデレーションすることができます。フェデレーションにより、IdM ユーザーは OpenStack サービスに認証情報を公開せずに OpenStack Dashboard にログインすることができます。代わりに、Dashboard がユーザーの認証情報が必要な場合には、ユーザーを Red Hat Single Sign-On (RH-SSO) に転送し、そこで IdM 認証情報を入力できるようにします。これにより、RH-SSO はユーザーが正常に認証されたとして Dashboard に戻し、Dashboard はユーザーがプロジェクトにアクセスするのを許可します。

3.7.1. フェデレーションのワークフロー

本セクションでは、keystone、RH-SSO、および IdM が相互に対話する方法を説明します。OpenStack におけるフェデレーションは、認証プロバイダーとサービスプロバイダーの概念を使用します。

認証プロバイダー (IdP): ユーザーアカウントを保存するサービス。この場合、IdM に保持されるユーザーアカウントは、RH-SSO を使用して keystone に表示されます。

サービスプロバイダー (SP): IdP のユーザーからの認証を必要とするサービス。この場合、keystone は IdM ユーザーに Dashboard へのアクセスを付与するサービスプロバイダーです。

次の図では、keystone (SP) が RH-SSO (Id P)と通信し、必要な SAML2 WebSSO を提供します。RH-SSO は、他の IdP のユニバーサルアダプターとしても機能します。この構成では、RH-SSO に keystone をポイントすることができ、RH-SSO は要求をサポートする認証プロバイダー (認証モジュールと呼ばれます) に転送します。現在、これらには IdM および Active Directory が含まれます。これは、サービスプロバイダー (SP) および認証プロバイダー (IdP) がメタデータを交換し、各システム管理者が信頼する決定を行うことで行われます。その結果、IdP は確実に決定を行い、SP はこれらの決定を受け取ることができます。

詳細は、フェデレーションガイド( https://access.redhat.com/documentation/ja-jp/red_hat_openstack_platform/15/html-single/federate_with_identity_service/)を参照してください。

3.8. LDAP ベースのサービスとの統合

Identity サービス (keystone) は、Microsoft Active Directory Domain Services (AD DS) および Red Hat Identity Management (IdM) などの LDAP ベースのサービスに保存されているユーザーアカウントを認証できます。このユースケースでは、keystone は LDAP ユーザーデータベースの認証を読み取り専用でアクセスし、認証されたアカウントに割り当てられた authZ 権限で管理を維持します。authZ 機能 (パーミッション、ロール、プロジェクト) は keystone によって実行されます。この場合、パーミッションとロールは、keystone の管理ツールを使用して LDAP アカウントに割り当てられます。

3.8.1. LDAP 統合の仕組み

以下の図では、keystone は暗号化された LDAPS 接続を使用して Active Directory Domain Controller に接続します。ユーザーが horizon にログインすると、keystone は指定したユーザー認証情報を受け取り、authZ 向けに Active Directory に渡します。

OpenStack と AD DS の統合および IdM の統合に関する情報は、『統合ガイド』を参照してください。https://access.redhat.com/documentation/ja-jp/red_hat_openstack_platform/15/html-single/integrate_with_identity_service/

第4章 インフラストラクチャーおよび仮想化の強化

このセクションには、コンポーネント固有のアドバイスと情報が含まれています。

4.1. 脆弱性の認識

運用上の手順では、新しい脆弱性およびセキュリティー更新について把握する計画が必要です。ハードウェアおよびソフトウェアベンダーは、通常、脆弱性の存在を発表するため、これらの問題に対処するために回避策およびパッチが提供されます。

セキュリティー更新を認識できるように、Red Hat セキュリティーレスポンスチームサイトをご利用ください。

更新の追跡に加えて、定期的なセキュリティー更新のインストールに対応できるようにプロセスとデプロイメントが設計されていることを確認する必要があります。カーネルの更新の場合、これにはコンピューティングノードと管理ノードを再起動する必要があります。これらのプロセスを設計するときは、インスタンスのセキュリティー更新も深く考慮する必要があります。また、新しく作成されたインスタンスが最新の更新を確実に取得できるように、ホストされた Glance イメージも定期的に更新する必要があります。

4.2. ネットワークタイムプロトコル

Red Hat OpenStack Platform クラスター内のシステムが、システム間で正確かつ一貫性のあるタイムスタンプを持つことを確認する必要があります。RHEL8 上の Red Hat OpenStack Platform は、時間管理のために Chrony をサポートしています。詳細は、「Using the Chrony suite to configure NTP」を参照してください。

4.2.1. 一貫した時刻が重要な理由

運用とセキュリティー上のニーズの両方で、組織全体で時刻が一貫していることが重要です。

- セキュリティーイベントの特定

- 一貫した時刻を維持することにより、影響を受けるシステムのイベントのタイムスタンプを関連付けることができ、イベントのシーケンスを理解することができます。

- 認証システムおよびセキュリティーシステム

セキュリティーシステムは、以下の例のように、時刻のずれの影響を受ける場合があります。

- Kerberos ベースの認証システムは、時刻のずれの秒数により影響を受けるクライアントの認証を拒否する可能性があります。

- トランスポート層セキュリティー (TLS) 証明書は、有効な時刻ソースに依存します。クライアントとサーバーシステム間の差異が Valid From の日付範囲を超えると、クライアントからサーバーへの TLS 接続が失敗します。

- Red Hat OpenStack Platform のサービス

- 高可用性 (HA) や Ceph など、一部の OpenStack のコアサービスは、特に正確な時刻管理に依存しています。

4.2.2. NTP 設計

Network time protocol (NTP) は、階層的な構成で整理されています。各レイヤーは stratum と呼ばれます。階層の最上位は、原子時計などの stratum 0 デバイスです。NTP 階層では、Stratum 0 デバイスは、一般に利用可能な stratum 1 および stratum 2 の NTP 時刻サーバーに参照を提供します。

データセンタークライアントは、一般に利用可能な NTP stratum 1 または 2 サーバーに直接接続しないでください。直接接続の数は、パブリック NTP リソースに不必要な負荷をかけます。代わりに、データセンターで専用の時刻サーバーを割り当て、クライアントをその専用サーバーに接続します。

インスタンスがホストではなく専用の時刻サーバーから時刻を受信するように設定します。

Red Hat OpenStack Platform 環境内で実行中のサービスコンテナーは、それらのサービスが存在するホストから時刻を受信します。

4.2.3. Red Hat OpenStack プラットフォームでの NTP の構成

heat を使用して、アンダークラウドノードとオーバークラウドノードで NTP を構成します。

-

NTP を使用してアンダークラウドを構成するには、

openstack undercloud installコマンドを実行する前に、undercloud.conf のundercloud_ntp_serversパラメーターを使用します。アンダークラウドミニオンの場合は、minion_ntp_serversパラメーターを使用します。詳細は、Director Configuration Parameters を参照してください。 NTP を使用してオーバークラウドを構成するには、例として次のパラメーターを使用します。

parameter_defaults: TimeZone: 'US/Central' NtpServer: ['ntpserver01.example.com']

ネットワークタイムキーピングパラメーターの詳細は、Overcloud Parameters ガイドの Time Parameters を参照してください。

4.3. Compute

このセクションでは、Compute (nova) のセキュリティーに関する考慮事項について説明します。

4.3.1. OpenStack のハイパーバイザー

ハイパーバイザープラットフォームを評価する際には、ハイパーバイザーを実行するハードウェアのサポート可能性を考慮してください。また、ハードウェアで利用可能な追加機能と、それらの機能が OpenStack デプロイメントの一部として選択したハイパーバイザーによってどのようにサポートされているかについて検討してください。そのため、ハイパーバイザーには、それぞれ独自のハードウェア互換性一覧 (HCL) があります。互換性のあるハードウェアを選択する場合は、セキュリティーの観点から、ハードウェアベースの仮想化技術が重要なかを把握しておくことが重要です。

4.3.1.1. ハイパーバイザーとベアメタル

Linux コンテナーまたはベアメタルシステムの使用と KVM のようなハイパーバイザーの使用の違いを認識しておくことは重要です。具体的には、このセキュリティーガイドは、ハイパーバイザーと仮想化プラットフォームに非常に重点を置いています。ただし、実装にベアメタルまたはコンテナー化環境を使用する必要がある場合は、その環境のデプロイメントに関して、特定の違いに注意する必要があります。

ベアメタルの場合は、再プロビジョニングして使用を停止する前に、ノードが正しくデータがサニタイズされていることを確認します。また、ノードを再使用する前に、ハードウェアが改ざんされていないか、またはセキュリティーが侵害されていないことを保証する必要があります。詳細は https://docs.openstack.org/ironic/queens/admin/cleaning.htmlを参照してください。

4.3.1.2. ハイパーバイザーメモリーの最適化

特定のハイパーバイザーは、メモリーをゲスト仮想マシンにオーバーコミットするメモリー最適化手法を使用します。これは、非常に高密度のコンピュートクラスターをデプロイすることができる便利な機能です。この手法の 1 つは、メモリーページの重複排除または共有により、メモリーページに 2 つの仮想マシンが同じデータがある場合、同じメモリーを参照する利点があります。これは通常、カーネル same-page merging (KSM) などの Copy-On-Write (COW) メカニズムで実行されます。これらのメカニズムは攻撃に対して脆弱です。

- メモリーの重複排除システムは、サイドチャネル攻撃に対して脆弱です。攻撃者は、近傍の仮想マシンで実行しているソフトウェアパッケージとバージョンを特定し、攻撃者が仮想マシンのメモリーアクセス時間を分析することで、ソフトウェアのダウンロードやその他の機密情報を特定できていました。したがって、ある仮想マシンが別の状態について何かを推測できる可能性があります。これは、すべてのテナントが信頼されず、同じレベルの信頼レベルを共有する、マルチテナント環境に適さない場合があります。

- さらに重要なことは、KSM に対して row-hammer タイプ攻撃 を参照して、実行可能なメモリーのクロス修正を行います。つまり、悪意のあるインスタンスが、同じ Compute ホスト上の他のインスタンスへのコード実行アクセスを取得できることを意味します。

Deployer は、(パブリッククラウドやプライベートクラウドを使用して) 強力なプロジェクトの分離が必要な場合は、KSM を無効にする必要があります。

- KSM を無効にする場合は、「KSM の非アクティブ化」を参照してください。

4.3.2. 仮想化

4.3.2.1. 物理ハードウェア (PCI パススルー)

PCI パススルーを使用すると、インスタンスはノード上のハードウェアの一部に直接アクセスできます。たとえば、このパラメーターを使用して、インスタンスをビデオカードや GPU にアクセスできるようにし、高パフォーマンスの計算用にコンピュート統一されたデバイスアーキテクチャー (CUDA) を提供します。この機能は、ダイレクトメモリーアクセスとハードウェアの脆弱性の 2 種類のセキュリティーリスクを伴います。

ダイレクトメモリーアクセス (DMA) は、特定のハードウェアデバイスがホストコンピューター内の任意の物理メモリーアドレスにアクセスできるようにする機能です。多くの場合、ビデオカードにはこの機能があります。ただし、これにより、同じノードで実行されているホストシステムや他のインスタンスの両方を確認することがあるため、任意の物理メモリーアクセスを付与しないでください。ハードウェアベンダーは、出入力メモリー管理ユニット (IOMMU) を使用して、このような状況で DMA アクセスを管理します。ハイパーバイザーがこのハードウェア機能を使用するように設定されていることを確認する必要があります。

インスタンスがファームウェアや他のデバイスの一部に悪意のある変更を加えると、ハードウェア感染が発生します。他のインスタンスやホスト OS がこのデバイスが使用されるため、悪意のあるコードはこれらのシステムに配布できます。最終的には、あるインスタンスがそのセキュリティゾーン外でコードを実行できることです。これは、仮想ハードウェアよりも物理ハードウェアの状態をリセットすることが難しくなるため、管理ネットワークへのアクセスなどが追加で公開される可能性があるためです。

PCI パススルーに関連するリスクおよび複雑性により、デフォルトでは無効になっています。特定のニーズに応じて有効になっている場合は、ハードウェアを再利用する前に、ハードウェアがクリーンアップされるように適切なプロセスを用意する必要があります。

4.3.2.2. 仮想ハードウェア (QEMU)

仮想マシンを実行する場合、仮想ハードウェアは、仮想マシンのハードウェアインターフェイスを提供するソフトウェアレイヤーです。インスタンスはこの機能を使用して、必要になる可能性のあるネットワーク、ストレージ、ビデオ、およびその他のデバイスを提供します。これを念頭に置いて、環境内のほとんどのインスタンスは仮想ハードウェアのみを使用しますが、ハードウェアに直接アクセスする必要がある少数のインスタンスもあります。必要なハードウェアのみをプロビジョニングすることをお勧めします。たとえば、CD ドライブが必要ない場合は、プロビジョニングする必要はありません。

iptables にネットワークトラフィックをフィルターリングするように構成されたデフォルトのポリシーがあることを確認し、既存のルールセットを調べて各ルールを理解し、ポリシーを拡張する必要があるかどうかを判断することを検討してください。

QEMU プロセスの権限を制限し、必要なものだけに制限すると、強制アクセス制御により、攻撃が試行される影響を制限します。Red Hat OpenStack Platform では、SELinux は、個別のセキュリティーコンテキストで各 QEMU プロセスを実行するように設定されます。Red Hat OpenStack Platform サービス用に SELinux ポリシーが事前設定されています。

OpenStack の SELinux ポリシーでは、ハイパーバイザーホストと仮想マシンを 2 つの主要な脅威ベクトルから保護するのに役立ちます。

- ハイパーバイザーの脅威: ハイパーバイザーが基礎となるリソースにアクセスするためにハイパーバイザーを攻撃する、危険にさらされるアプリケーション。たとえば、仮想マシンがハイパーバイザー OS、物理デバイス、またはその他のアプリケーションにアクセスできる場合。この脅威ベクトルは、ハイパーバイザーで危険にさらされるリスクを表し、他の仮想マシンおよびネットワークセグメントを公開することも可能となります。

- 仮想マシン (multi-project) の脅威: ハイパーバイザーが、別の仮想マシンとそのリソースにアクセスしたり、制御したりするために、VM 攻撃内で実行される、危険にさらされたアプリケーションです。これは、仮想化に固有の脅威ベクトルであり、1 つのアプリケーションの脆弱性により、仮想マシンファイルイメージの多重化のリスクにさらされる可能性があるためです。この仮想ネットワーク攻撃は、実際のネットワークを保護する管理手法が仮想環境に直接適用されないため、大きな懸念となります。KVM ベースの各仮想マシンは SELinux によってラベル付けされ、各仮想マシンのセキュリティー境界を効果的に確立します。このセキュリティー境界は Linux カーネルによって監視および実施され、ホストマシンのデータファイルや他の仮想マシンなど、仮想マシンの境界外にあるリソースへのアクセスを制限します。

Red Hat の SELinux ベースの分離は、仮想マシン内で実行されるゲストオペレーティングシステムに関係なく提供されます。Linux または Windows 仮想マシンを使用できます。

4.3.2.3. ラベルとカテゴリー

KVM ベースの仮想マシンインスタンスには、svirt_image_t と呼ばれる独自の SELinux データ型でラベルが付けられます。カーネルレベルの保護により、マルウェアなどの未承認のシステムプロセスが、ディスク上で仮想マシンイメージファイルを操作できなくなります。仮想マシンの電源がオフの場合、イメージは以下のように svirt_image_t として保存されます。

system_u:object_r:svirt_image_t:SystemLow image1 system_u:object_r:svirt_image_t:SystemLow image2 system_u:object_r:svirt_image_t:SystemLow image3 system_u:object_r:svirt_image_t:SystemLow image4

svirt_image_t label はディスク上のイメージファイルを一意に識別し、SELinux ポリシーでアクセスを制限することができます。KVM ベースのコンピュートイメージの電源が入ると、SELinux は、イメージにランダムな数値 ID を追加します。SELinux は、ハイパーバイザーノードごとに仮想マシン (最大 524,288) に数値識別子を割り当てることができますが、ほとんどの OpenStack デプロイメントでは、この上限に達することはほとんどありません。以下の例は、SELinux カテゴリー ID を示しています。

system_u:object_r:svirt_image_t:s0:c87,c520 image1 system_u:object_r:svirt_image_t:s0:419,c172 image2

4.3.2.4. SELinux ユーザーおよびロール

SELinux はユーザーロールを管理します。これらは、-Z フラグまたは semanage コマンドで表示できます。ハイパーバイザーでは、管理者のみがシステムにアクセスできる必要があり、管理ユーザーとシステムにあるその他のユーザーの両方に適切なコンテキストが必要です。

4.3.2.5. コンテナー化されたサービス

nova、glance、keystone 等の特定のサービスは、コンテナー内で実行されるようになりました。このアプローチにより、サービスに更新を適用することが容易になりました。独自のコンテナーで各サービスを実行すると、同じベアメタル上で共存するサービス間の分離が強化されます。これは、隣接するサービスへの簡単なアクセスを回避することで、攻撃対象領域を低減するのに役立てることで、1 つのサービスが攻撃を受けることができるはずです。

コンテナーにマウントするホストマシン上のパスは、ro/rw として設定されている場合、コンテナーとホスト間でデータを転送するマウントポイントとして使用できます。

設定ファイルを更新する場合は、特定の管理プラクティスを考慮する必要があります。これにより、コンテナー化されたサービスは一時的なものになります。

-

物理ノードのホストオペレーティングシステム上の設定ファイル (例:

/etc/cinder/cinder.conf) は更新しないでください。コンテナー化されたサービスはこのようなファイルを参照しません。 - コンテナー内で実行されている設定ファイルは更新しないでください。コンテナーを再起動すると変更が失われてしまいます。

代わりに、コンテナー化されたサービスに変更を加える必要がある場合は、コンテナーのシードに使用される設定ファイルを更新する必要があります。これらのファイルは、puppet の初期デプロイメント時に生成され、クラウドの実行に重要な機密データが含まれ、それに応じて処理する必要があります。これらのファイルは /var/lib/config-data/puppet-generated/ 内に保管されています。以下に例を示します。

-

keystone:

/var/lib/config-data/puppet-generated/keystone/etc/keystone/keystone.conf -

cinder:

/var/lib/config-data/puppet-generated/cinder/etc/cinder/cinder.conf -

nova:

/var/lib/config-data/puppet-generated/nova_libvirt/etc/nova/nova.conf

これらのファイルに加えられた変更は、コンテナーが再起動されると適用されます。

4.3.3. コンピュートデプロイメントのハード化

OpenStack のデプロイメントに関する主なセキュリティー上の問題点の 1 つは、/var/lib/config-data/puppet-generated/nova_libvirt/etc/nova/nova.conf ファイルなどの機密ファイルのセキュリティー制御です。この設定ファイルには、設定の詳細やサービスパスワードなど、多くの機密オプションが含まれています。このような機密ファイルはすべて厳密にファイルレベルのパーミッションが付与され、AIDE などのファイル整合性監視(FIM)ツールの変更の有無を監視します。これらのユーティリティーは、既知の正常な状態のターゲットファイルのハッシュを取得して、ファイルの新しいハッシュを定期的に取得し、これを既知の適切なハッシュと比較します。アラートは、予期せずに変更された場合に作成できます。

ファイルのパーミッションは、ls -lh コマンドに含まれているディレクトリーに移動して実行します。これにより、ファイルへのアクセスがあるパーミッション、所有者、およびグループ、ファイルの最終変更日時などのその他の情報が表示されます。

/var/lib/nova ディレクトリーには、指定したコンピュートノード上のインスタンスに関する情報を保持します。このディレクトリーは、厳密にファイルパーミッションを適用して、高感度として考慮する必要があります。また、そのホストに関連付けられたインスタンスの情報やメタデータが含まれるため、定期的にバックアップする必要があります。

デプロイメントで完全な仮想マシンのバックアップが必要ない場合は、/var/lib/nova/instances ディレクトリーを除外して、そのノード上で実行される各インスタンスの結合領域として大きな値になることに留意してください。デプロイメントで完全な仮想マシンのバックアップが必要な場合は、このディレクトリーが正常にバックアップされることを確認する必要があります。

Block Storage (cinder) ボリュームに使用されているストレージサブシステム (Ceph) に保存されているデータも、高感度として考慮する必要があります。これは、ネットワークまたは論理アクセスでネットワークまたは論理アクセスにより、OpenStack コントロールをバイパスする可能性がある場合は、ストレージサブシステムから完全な仮想マシンイメージを取得できるためです。

4.3.4. ハードウェアの脆弱性の軽減

OpenStack は物理サーバーハードウェア上で実行されますが、これには本質的に独自のセキュリティー上の課題があります。この章では、ハードウェアベースの脅威と脆弱性を軽減するためのアプローチを紹介します。

4.3.4.1. PCI パススルーの強化

PCI パススルーを使用すると、ホストにインストールされている特定の物理ハードウェアにインスタンスが直接アクセスできるようになります。これは、多くのネットワーク機能仮想化 (NFV) のユースケースで発生する可能性があります。ただし、考慮すべきセキュリティー対策がいくつかあります。

PCI パススルーを使用する場合は、割り込みの再マッピングをサポートするハードウェアの導入を検討してください。そうしないと、allow_unsafe_interrupts 設定を有効にする必要があります。これにより、Compute ノードが悪意のあるインスタンスからの割り込みインジェクション攻撃に対して脆弱になる可能性があります。

詳しくは、『ネットワークガイド』の https://access.redhat.com/documentation/ja-jp/red_hat_openstack_platform/15/html-single/networking_guide/#review-the-allow_unsafe_interrupts-settingを参照してください。

4.3.4.2. セキュリティー強化管理コンソール

多くのサーバーベンダーには、サーバーへのリモートセッションを可能にする個別の管理コンソールが含まれています。このアクセスポイントをセキュリティー強化するためにベンダーが規定した慣行を確認することを検討してください。

4.3.4.3. ファームウェアの更新

物理サーバーは複雑なファームウェアを使用して、サーバーのハードウェアと軽量な管理カードを有効にして操作します。このカードでは、独自のセキュリティー脆弱性を持つことができ、システムアクセスと中断が可能になります。これに対処するために、ハードウェアベンダーは、オペレーティングシステムの更新とは別にインストールされるファームウェアの更新を発行します。この更新を取得、テスト、および実装する運用セキュリティープロセスが必要になります。ファームウェアの更新では多くの場合で、物理ホストの再起動が効果的に行われるためです。

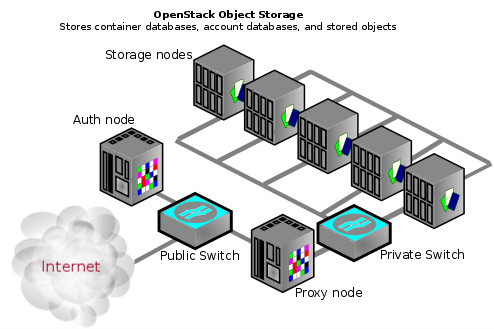

4.4. Block Storage

OpenStack Block Storage (cinder) は、ソフトウェア (サービスおよびライブラリー) を提供するサービスで、永続的なブロックレベルのストレージデバイスをセルフサービスで管理するサービスです。これにより、Compute (nova) インスタンスで使用する Block Storage リソースへのオンデマンドアクセスが作成されます。これにより、ブロックストレージのプールをさまざまなバックエンドストレージデバイスに仮想化することで、ソフトウェア定義のストレージが作成され、ソフトウェア実装または従来のハードウェアストレージ製品のいずれかになります。これの主な機能は、ブロックデバイスの作成、割り当て、切断を管理することです。コンシューマーは、バックエンドストレージ機器の種類や、そのタイプの配置先に関する知識は必要ありません。

コンピュートインスタンスは、iSCSI、ATA over Ethernet、または Fibre-Channel などの業界標準のストレージプロトコルを使用してブロックストレージを保存し、取得します。これらのリソースは、OpenStack ネイティブ HTTP RESTful API を使用して管理および設定されます。

4.4.1. ボリュームの接続

ブロックストレージデバイスを消去する方法は複数あります。従来の方法として、lvm_type を thin に設定し、続いて volume_clear パラメーターを使用します。または、ボリュームの暗号化機能があれば、ボリュームの暗号化キーが削除される場合にボリュームのワイプは必要ありません。

以前のバージョンでは、lvm_type=default は wipe を示すために使用されていました。この手法は依然として機能しますが、secure delete の設定に lvm_type=default は推奨されません。

volume_clear パラメーターは、zero または shred のいずれかを引数として受け入れることができます。zero は、デバイスにゼロのパスを 1 つ書き込みます。shred 操作は、事前に決定したビットパターンの 3 つを書き込みます。

4.4.2. ブロックストレージの強化

このセクションには、OpenStack Block Storage のセキュリティーを強化するための実践的なアドバイスが含まれています。

4.4.2.1. 設定ファイルのユーザー/グループ所有権を root/cinder に設定します。

設定ファイルには、コンポーネントのスムーズに機能するために必要な重要なパラメーターおよび情報が含まれます。非特権ユーザーが故意・過失で変更したり、ファイル自体を変更したり、削除したりすると、重大な可用性の問題が原因で、他のエンドユーザーにサービス拒否が発生します。そのため、このような重要な設定ファイルのユーザー所有権を root に設定し、グループの所有権を cinder に設定する必要があります。

次のコマンドを使用して、これらの構成ファイルのユーザーとグループの所有権がそれぞれ root と cinder に設定されていることを確認します。

$ stat -L -c "%U %G" /var/lib/config-data/puppet-generated/cinder/etc/cinder/cinder.conf | egrep "root cinder" $ stat -L -c "%U %G" /var/lib/config-data/puppet-generated/cinder/etc/cinder/api-paste.ini | egrep "root cinder" $ stat -L -c "%U %G" /var/lib/config-data/puppet-generated/cinder/etc/cinder/policy.json | egrep "root cinder" $ stat -L -c "%U %G" /var/lib/config-data/puppet-generated/cinder/etc/cinder/rootwrap.conf | egrep "root cinder"

4.4.2.2. 設定ファイルの厳密なパーミッションの設定

次のファイルの権限が 640 以上に設定されていることを確認してください。

$ stat -L -c "%a" /var/lib/config-data/puppet-generated/cinder/etc/cinder/cinder.conf $ stat -L -c "%a" /var/lib/config-data/puppet-generated/cinder/etc/cinder/api-paste.ini $ stat -L -c "%a" /var/lib/config-data/puppet-generated/cinder/etc/cinder/policy.json $ stat -L -c "%a" /var/lib/config-data/puppet-generated/cinder/etc/cinder/rootwrap.conf

4.4.2.3. 認証には keystone を使用します。

/var/lib/config-data/puppet-generated/cinder/etc/cinder/cinder.conf で、[DEFAULT] セクションの auth_strategy の値が、noauth ではなく keystone に設定されていることを確認します。

4.4.2.4. 認証用に TLS を有効にする

/var/lib/config-data/puppet-generated/cinder/etc/cinder/cinder.conf で、[keystone_authtoken] セクションの auth_uri の値が https: // で始まる Identity API エンドポイントに設定されており、[keystone_authtoken] も False に設定されている Identity API エンドポイントに設定されていることを確認します。

4.4.2.5. Block Storage が Compute との通信に TLS を使用するのを確認

cinder.conf で、[DEFAULT] セクションの glance_api_servers の値が https:// で始まる値に設定されていることを確認します。また、パラメーター glance_api_insecure の値が False に設定されていることを確認します。

4.4.2.6. NFS に使用される NAS デバイスが強化された環境で動作していることを確認します

ブロックストレージサービス (cinder) は、従来のブロックストレージドライバーとは異なる動作をする NFS ドライバーをサポートします。

NFS ドライバーは、インスタンスがブロックレベルでストレージデバイスにアクセスすることを実際には許可しません。代わりに、ファイルは NFS 共有上に作成され、ブロックデバイスをエミュレートするインスタンスにマップされます。

Block Storage サービスは、cinder ボリュームの作成時にファイルのアクセス許可を制御することにより、このようなファイルの安全な構成をサポートします。Cinder 構成では、ファイル操作を root ユーザーとして実行するか、現在の Red Hat OpenStack Platform プロセスユーザーとして実行するかを制御することもできます。

director のさまざまな heat パラメーターにより、NFS バックエンドまたは NetApp NFS Block Storage バックエンドが NetApp 機能 (NAS secure と呼ばれる) をサポートするかどうかが制御されます。

- CinderNetappNasSecureFileOperations

- CinderNetappNasSecureFilePermissions

- CinderNasSecureFileOperations

- CinderNasSecureFilePermissions

通常のボリューム操作に干渉するため、Red Hat では、この機能を有効にすることを推奨していません。director はデフォルトでこの機能を無効にするため、Red Hat OpenStack Platform はこの機能をサポートしません。

ベンダー固有のドライバーを使用して Block Storage サービスに統合された NAS デバイスは、機密性が高いと見なされ、強化された分離された環境にデプロイする必要があります。これらのデバイスに違反すると、インスタンスデータへのアクセスまたは変更につながる可能性があります。

cinder.confファイルの[DEFAULT]セクションのnas_secure_file_permissionsの値がautoに設定されているかどうかを確認します。nas_secure_file_permissionsパラメーターがautoに設定されている場合、起動時に、Block Storage サービスは既存の cinder ボリュームがあるかどうかを検出します。-

既存のボリュームがない場合、cinder はオプションを

Trueに設定し、安全なファイル権限を使用します。 -

cinder が既存のボリュームを検出した場合、cinder はオプションを

Falseに設定し、ファイルのアクセス許可を処理する安全でない方法を使用します。

-

既存のボリュームがない場合、cinder はオプションを

cinder.confファイルの[DEFAULT]セクションのnas_secure_file_operationsパラメーターがautoに設定されているかどうかを確認します。nas_secure_file_operationsパラメーターがautoに設定されている場合、起動時に、Block Storage サービスは既存のシンダーボリュームがあるかどうかを検出します。-

既存のボリュームがない場合、cinder はオプションを

Trueに設定し、root ユーザーとして実行しません。 -

cinder が既存のボリュームを検出した場合、cinder はオプションを

Falseに設定し、rootユーザーとして操作を実行する現在の方法を使用します。

-

既存のボリュームがない場合、cinder はオプションを

新規インストールの場合、Block Storage サービスはマーカーファイルを作成し、その後の再起動時に Block Storage サービスが元の決定を記憶するようにします。

4.4.2.7. 要求のボディーの最大サイズの設定

リクエストごとの最大ボディーサイズが定義されていない場合、攻撃者は大きなサイズの任意の OSAPI リクエストを作成します。すると、その結果サービスがクラッシュし、最終的にサービス拒否攻撃につながることになります。最大値を割り当てると、悪意のあるリクエストはすべてブロックされ、引き続きサービスの可用性が確保されます。

cinder.conf の [DEFAULT] セクションの osapi_max_request_body_size が 114688 に設定されているかどうか、cinder.conf の [oslo_middleware] セクションの max_request_body_size が 114688 に設定されているかどうかを確認します。

4.4.2.8. ボリュームの暗号化の有効化

暗号化されていないボリュームデータにより、攻撃者が多数の仮想マシンのデータを読み取ることができるため、ボリュームホスティングプラットフォームは特に攻撃者にとってハイバリューターゲットとなります。さらに、物理ストレージメディアは、盗まれたり、再マウントされたりする可能性ががあり、別のマシンからアクセスされることもあり得ます。ボリュームのデータとボリュームのバックアップを暗号化すると、これらのリスクを軽減し、ボリュームをホストしているプラットフォームに厚い防御を提供することができます。Block Storage (cinder) は、ディスクに書き込まれる前にボリュームデータを暗号化できるため、ボリュームの暗号化を有効にし、秘密鍵ストレージに Barbican を使用することを検討してください。

4.5. ネットワーキング

OpenStack Networking サービス (neutron) により、エンドユーザーまたはプロジェクトがネットワークリソースを定義および消費できるようになります。OpenStack Networking は、ネットワーク設定のオーケストレーションに加えて、クラウド内のインスタンスのネットワーク接続や IP アドレスを定義するためのプロジェクト向け API を提供します。API 中心のネットワークサービスへの移行により、クラウドアーキテクトと管理者は、物理ネットワークおよび仮想ネットワークのインフラストラクチャーおよびサービスをセキュアにするための優れたプラクティスを考慮する必要があります。

OpenStack Networking は、オープンソースのコミュニティーまたはサードパーティーサービスを使用して API を拡張性を提供するプラグインアーキテクチャーと共に設計されました。アーキテクチャーの設計要件を評価する上で、OpenStack Networking のコアサービス、サードパーティー製品で提供される追加のサービス、物理インフラストラクチャーに実装する必要のある補助サービスを判断しておくことは重要です。

本項では、OpenStack Networking の実装時に、プロセスと適切なプラクティスについて概説します。

4.5.1. ネットワークアーキテクチャー

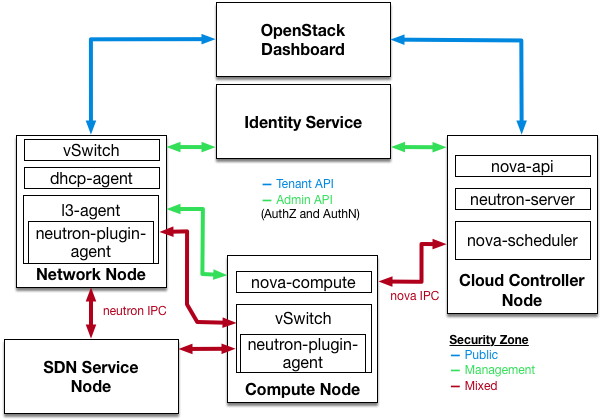

OpenStack Networking は、複数のノードに複数のプロセスをデプロイするスタンドアロンのサービスです。これらのプロセスは、相互、その他の OpenStack サービスと対話します。OpenStack Networking サービスの主なプロセスは、neutron-server で、OpenStack Networking API を公開し、追加の処理のためにプロジェクト要求をプラグインスイートに渡す Python デーモンです。

OpenStack Networking のコンポーネントは以下のとおりです。

-

Neutron サーバー (

neutron-serverおよびneutron-*-plugin): neutron-server サービスは、Networking API とその拡張機能 (またはプラグイン) と対話するためにコントローラーノード上で実行されます。また、各ポートのネットワークモデルと IP アドレス処理も実施します。neutron-server では、永続データベースへの直接アクセスが必要です。エージェントは、neutron-server を介してデータベースに間接的にアクセスできます。このデータベースは AMQP (Advanced Message Queuing Protocol) を使用して通信します。 - Neutron データベース: データベースは neutron 情報の一元化ソースで、API がデータベースのトランザクションをすべて記録します。これにより、複数の Neutron サーバーが同じデータベースクラスターを共有でき、すべてが同期され、ネットワーク設定トポロジーの永続性が可能になります。

-

プラグインエージェント (

neutron-*-agent): 各コンピュートノードおよびネットワークノード (L3 および DHCP エージェントあり) で実行され、ローカルの仮想スイッチ (vswitch) 設定を管理します。有効なプラグインは有効なエージェントを決定します。これらのサービスにはメッセージキューのアクセスが必要で、使用されているプラグインによっては、外部ネットワークコントローラーまたは SDN 実装へのアクセスが必要です。OpenDaylight (ODL) や Open Virtual Network (OVN) などの一部のプラグインでは、コンピュートノード上に python エージェントを必要としません。統合には、有効な Neutron プラグインのみが必要です。 -

DHCP エージェント (

neutron-dhcp-agent): プロジェクトネットワークへの DHCP サービスを提供します。このエージェントはすべてのプラグインで同じで、DHCP 設定を維持します。neutron-dhcp-agent にはメッセージキューのアクセスが必要です。プラグインに応じてオプションになります。 -

メタデータエージェント (

neutron-metadata-agent、neutron-ns-metadata-proxy): インスタンスオペレーティングシステムの設定とユーザー指定の初期スクリプト ('userdata') を適用するために使用されるメタデータサービスを提供します。この実装では、cloud-init が送信するメタデータ API 要求をメタデータエージェントにプロキシー化するために、L3 または DHCP エージェント名前空間でneutron-ns-metadata-proxyを実行する必要があります。 -

L3 エージェント (

neutron-l3-agent): プロジェクトネットワーク上の仮想マシンの外部ネットワークアクセスに L3/NAT 転送します。メッセージキューのアクセスが必要です。プラグインに応じてオプションになります。 - ネットワークプロバイダーサービス (SDN サーバー/サービス): プロジェクトネットワークに対して追加のネットワークサービスを提供します。これらの SDN サービスは、REST API などの通信チャネルを介して neutron-server、neutron-plugin、およびプラグインエージェントと対話する可能性があります。

以下の図は、OpenStack Networking コンポーネントのアーキテクチャーおよびネットワークフローの図を示しています。

このアプローチは、分散仮想ルーター (DVR) および Layer-3 高可用性 (L3HA) が使用された場合に大幅に変更されることに注意してください。L3HA はルーター間で VRRP を実装するため、これらのモードは neutron のセキュリティーランドスケープを変更します。デプロイメントは、ルーターに対する DoS 攻撃を軽減できるように適切にサイズで強化する必要があります。また、VRRP スプーフィングの脅威に対処するために、ルーター間のローカルネットワークトラフィックを機密として扱う必要があります。DVR はネットワークコンポーネント (ルーティングなど) をコンピュートノードに移行する一方で、まだネットワークノードが必要です。したがって、コンピュートノードはパブリックネットワーク間のアクセスを必要とするため、ファイアウォールルールとセキュリティーモデルがこのアプローチをサポートする必要があるため、公開機能が高まり、お客様が追加でセキュリティーを考慮する必要があります。

4.5.1.1. 物理サーバーでの Neutron サービスの配置

本項では、コントローラーノード、ネットワークノード、および実行中のインスタンス用のコンピュートノードセットが含まれる標準のアーキテクチャーを説明します。物理サーバーのネットワーク接続を確立するために、通常の neutron デプロイメントは、4 つの異なる物理データセンターネットワークで構成されます。

- 管理ネットワーク: OpenStack コンポーネント間の内部通信に使用されます。このネットワークの IP アドレスはデータセンター内でのみ到達でき、管理セキュリティーゾーンとみなされます。デフォルトでは、Management network ロールは Internal API ネットワークにより実行されます。

- ゲストネットワーク: ゲストクラウドデプロイメント内の仮想マシンデータ通信に使用します。このネットワークの IP アドレス要件は、使用中の OpenStack Networking プラグインや、プロジェクトによる仮想ネットワークの選択肢により異なります。このネットワークは、ゲストセキュリティーゾーンとみなされます。

- 外部ネットワーク: 一部のデプロイメントシナリオにおいて、インターネットにアクセスできる仮想マシンを提供するのに使用します。このネットワークの IP アドレスは、インターネット上の誰でも到達できるはずです。このネットワークは、パブリックセキュリティーゾーンにあると見なされます。このネットワークは、neutron 外部ネットワーク により提供されます。これらの neutron VLAN は、外部ブリッジ上でホストされます。これらは Red Hat OpenStack Platform director により作成されませんが、デプロイ後の neutron により作成されます。

- パブリック API ネットワーク: OpenStack Networking API を含むすべての OpenStack API をプロジェクトに公開する。このネットワークの IP アドレスは、インターネット上の誰でも到達できるはずです。これは、IP ブロック内の IP アドレスの完全な範囲より小さい IP 割り当て範囲を使用する外部ネットワークのサブネットを作成することができるので、外部ネットワークと同じネットワークである可能性があります。このネットワークは、パブリックセキュリティーゾーンにあると見なされます。

このトラフィックを別のゾーンに分割することを推奨します。詳細は次のセクションを参照してください。

4.5.2. セキュリティーゾーンの使用

重大なシステムは互いに分離させて、セキュリティゾーンという概念を使用することを推奨します。実用的な方法では、VLAN およびファイアウォールルールを使用してネットワークトラフィックを分離します。このキュレートは細かい詳細で行い、neutron に接続する必要のあるサービスのみがこれを実行できるようにする必要があります。

以下の図は、ゾーンが特定のコンポーネントを分離するために作成されていることがわかります。

- ダッシュボード: パブリックネットワークおよび管理ネットワークへのアクセス。

- keystone: 管理ネットワークへのアクセスが可能です。

- コンピュートノード: 管理用ネットワークおよびコンピュートインスタンスにアクセスできます。

- ネットワークノード: 使用中の neutron-plugin に応じて、管理ネットワーク、コンピュートインスタンス、およびパブリックネットワークへのアクセスが可能です。

- SDN サービスノード: 製品の使用および設定に応じて、管理サービス、コンピュートインスタンス、および公開されている。

.

4.5.3. ネットワークサービス

OpenStack Network インフラストラクチャーを設計するための初期アーキテクチャーフェーズでは、適切なセキュリティー制御および監査のメカニズムを特定できるようにするためにも、適切な専門知識で物理ネットワークインフラストラクチャーのデザインをアシストできるようにしておくことが重要です。

OpenStack Networking は、プロジェクト固有の仮想ネットワークをアーキテクトする機能を提供する、仮想ネットワークサービスのレイヤーを追加します。現在、これらの仮想化サービスは、従来のネットワークに対応するネットワークほど成熟していません。このような仮想化サービスの現在の状態を、仮想化および従来のネットワーク境界に実装する必要のあるコントロールを定めるため、それらを採用する前にこれらの仮想化サービスの現在の状態を考慮してください。

4.5.3.1. VLAN およびトンネリングを使用した L2 分離

OpenStack Networking は、プロジェクト/ネットワークの組み合わせ: VLAN (IEEE 802.1Q タグ付け) または VXLAN または GRE カプセル化を使用する L2 トンネルのトラフィック分離に、2 つの異なるメカニズムを使用できます。OpenStack デプロイメントのスコープおよびスケーリングは、トラフィックの分離または分離に使用する方法を決定します。

4.5.3.2. VLAN

VLAN は、特定の VLAN ID (VID) フィールド値を持つ IEEE 802.1Q ヘッダーが含まれる特定の物理ネットワーク上のパケットとして認識されます。同じ物理ネットワークを共有する VLAN ネットワークは、L2 で相互に分離され、IP アドレス空間が重複している可能性もあります。VLAN ネットワークをサポートする各物理ネットワークは、別個の VLAN トランク として扱われ、異なる領域の VID 値を持ちます。有効な VID の値は 1 から 4094 までです。

VLAN 設定は、OpenStack の設計要件によって異なります。OpenStack Networking が VLAN をより効率的に使用できるようにするには、VLAN 範囲 (各プロジェクトの 1 つ) を割り当てて、各コンピュートノードの物理スイッチポートを VLAN トランクポートに切り替える必要があります。

ネットワークで 4094 を超えるプロジェクトをサポートする場合は、VLAN よりも L2 トンネリング構成をお勧めします。

4.5.3.3. L2 トンネリング

ネットワークトンネリングは、各プロジェクト/ネットワークの組み合わせを、その組み合わせに属するネットワークトラフィックの特定に使用される一意の “tunnel-id” と組み合わせてカプセル化します。プロジェクトの L2 ネットワーク接続は、物理ローリティーまたは下層のネットワーク設計とは独立しています。IP パケット内にトラフィックをカプセル化することで、そのトラフィックはレイヤー 3 の境界をまたがり、事前設定済みの VLAN および VLAN トランク接続の必要性がなくなります。トンネリングにより、ネットワークデータのトラフィックに難読化のレイヤーが追加され、個別のプロジェクトトラフィックの可視性が、ビューのモニターポイントを模倣します。

OpenStack Networking は現在 GRE および VXLAN カプセル化の両方をサポートしています。L2 分離を提供する技術は、デプロイメントで作成されるプロジェクトネットワークのスコープおよびサイズによって異なります。

4.5.3.4. ネットワークサービス

プロジェクトネットワークの分離の選択は、プロジェクトサービスのネットワークセキュリティーと制御境界の実装方法に影響します。以下の追加のネットワークサービスは、OpenStack ネットワークアーキテクチャーのセキュリティー体制を強化するために利用可能であるか、現在開発中です。

4.5.3.5. アクセス制御リスト

Compute は、OpenStack Networking サービスの使用により、プロジェクトのネットワークトラフィックのアクセス制御をサポートします。セキュリティーグループにより、管理者およびプロジェクトがトラフィックの種別を指定することができ、かつ方向 (ingress/egress) が仮想インターフェースポートを通過できる方向 (ingress/egress) を指定することができます。セキュリティーグループルールは、ステートフル L2-L4 トラフィックフィルターです。

4.5.4. L3 ルーティングおよび NAT

OpenStack Networking ルーターは、複数の L2 ネットワークを接続でき、1 つ以上のプライベート L2 ネットワークを、インターネットにアクセスするためのパブリックネットワークなど、共有外部ネットワークに接続するゲートウェイを提供することもできます。

L3 ルーターは、ルーターを外部ネットワークにリンクするゲートウェイポートで、基本的なネットワークアドレス変換 (SNAT および DNAT) 機能を提供します。このルーター SNAT (ソース NAT) デフォルトですべての egress トラフィックをサポートし、Floating IP をサポートします。Floating IP は、外部ネットワーク上のパブリック IP からルーターに接続された他のサブネットにプライベート IP に静的 1 対 1 のプライベート IP へのマッピングを作成します。Floating IP (DNAT 経由) は、インスタンスに外部インバウンドの接続性を提供し、あるインスタンスから別のインスタンスから移行することができます。

プロジェクトインスタンスのより詳細な接続のために、プロジェクトごとの L3 ルーティングと Floating IP を使用することを検討してください。パブリックネットワークに接続されたインスタンス、または Floating IP を使用して、特別な考慮する必要があります。外部で公開される必要があるサービスのみに対して、セキュリティーグループの使用を慎重に検討することが推奨されます。

4.5.5. Quality of Service (QoS)

デフォルトでは、QoS (Quality of Service)ポリシーおよびルールはクラウド管理者によって管理されます。これにより、プロジェクトが特定の QoS ルールを作成できず、またポートに特定のポリシーをアタッチすることはできません。管理者が通信するアプリケーションなどの一部のユースケースでは、管理者がプロジェクトを信頼し、独自のポリシーをポートに作成および接続できるようにします。そのためには、policy.json ファイルを変更します。

Red Hat OpenStack Platform 12 から、neutron は、受信トラフィックと送信トラフィックの両方で、帯域幅を制限する QoS ルールをサポートしています。この QoS ルールは QosBandwidthLimitRule という名前で、毎秒キロビットで測定される負の整数を 2 つ受け取ります。

-

max-kbps: 帯域幅 -

max-burst-kbps: バーストバッファー

QoSBandwidthLimitRule は、neutron Open vSwitch、Linux ブリッジ、および SR-IOV ドライバーに実装されています。ただし、SR-IOV ドライバーでは、max-burst-kbps の値が使用されず、設定されている場合は無視されます。

QoS ルール QosDscpMarkingRule は、Red Hat OpenStack Platform 10 (Newton) リリースで追加されました。このルールは、IPv4 (RFC 2474) のサービスヘッダーのタイプに Differentiated Service Code Point (DSCP) 値を設定し、仮想マシンから出るすべてのトラフィックで、IPv6 のトラフィッククラスヘッダー (ルールが適用されます) を設定します。これは、ネットワークが輻輳に合致するように、パケットのドロップの優先度を示す、有効な値が 21 の 6 ビットヘッダーです。また、ファイアウォールで使用して、アクセス制御リストに対する有効なトラフィックまたは無効なトラフィックを一致させることもできます。

4.5.5.1. 負荷分散

OpenStack Networking には Load-Balancer-as-a-service(LBaaS)が含まれます。LBaaS リファレンス実装は HAProxy をベースにしています。仮想インターフェースポート用に豊富な L4-L7 機能を提供する OpenStack Networking の拡張機能用にサードパーティーのプラグインがあります。LBaaS は、パブリックネットワークからのインスタンスへの ingress 接続を提供する点で Floating IP と似ています。Floating IP とは異なり、LBaaS インスタンスは複数のインスタンスにアタッチして、接続済みのインスタンス上で実行されるサービスの負荷分散および高可用性を提供することができます。

LBaaS の詳細は、https://access.redhat.com/documentation/ja-jp/red_hat_openstack_platform/15/html-single/networking_guide/index#sec-lbaasを参照してください。

4.5.6. Networking サービスのハードニング

本項では、OpenStack デプロイメント内のプロジェクトネットワークセキュリティーに適用される、OpenStack Networking の設定に関する適切なプラクティスについて説明します。

4.5.6.1. API サーバーのバインドアドレスの制限: neutron-server

OpenStack Networking API サービスが受信クライアント接続用にネットワークソケットをバインドするインターフェースまたは IP アドレスを制限するには、/var/lib/config-data/puppet-generated/neutron/etc/neutron/neutron.conf ファイルで bind_host および bind_port を指定します。

# Address to bind the API server bind_host = IP ADDRESS OF SERVER # Port the bind the API server to bind_port = 9696

4.5.6.2. OpenStack Networking サービスの DB および RPC 通信を制限

OpenStack Networking サービスのさまざまなコンポーネントは、メッセージングキューまたはデータベース接続のいずれかを使用して、OpenStack Networking の他のコンポーネントと通信します。

RPC 通信を必要とするすべてのコンポーネント用に、??? に記載されているガイドラインに従うことが推奨されます。

4.5.6.3. プロジェクトネットワークサービスのワークフロー

OpenStack Networking は、ユーザーがネットワークリソースのセルフサービス設定を提供します。クラウドアーキテクトとオペレーターは、ユーザーが利用可能なネットワークリソースを作成、更新、破棄できる設計のユースケースを評価することが重要です。

4.5.6.4. ネットワークリソースポリシーエンジン

OpenStack Networking 内のポリシーエンジンと設定ファイル (policy.json) は、プロジェクトネットワークのメソッドおよびオブジェクトに対するユーザーの詳細な認可を提供する方法を提供します。OpenStack Networking ポリシーの定義は、ネットワークの可用性、ネットワークセキュリティー、および OpenStack セキュリティー全体に影響します。クラウドアーキテクトとオペレーターは、ネットワークリソースの管理に対するユーザーおよびプロジェクトアクセスに対して、ポリシーを慎重に評価する必要があります。

このポリシーはセキュリティーの問題に応じて変更できるため、デフォルトのネットワークリソースポリシーを確認することが重要です。

OpenStack が複数の外部アクセスポイントを提供する場合は、複数の仮想 NIC を複数の外部アクセスポイントにアタッチするプロジェクトの機能を制限することが重要です。よりこれらのセキュリティーゾーンがブリッジされ、セキュリティーへの不正アクセスの原因となる可能性があります。Compute が提供するホスト集約関数を使用するか、プロジェクトインスタンスを異なる仮想ネットワーク設定を持つ複数のプロジェクトに分割することで、このリスクを軽減することができます。ホストアグリゲートに関する詳しい情報は、「 https://access.redhat.com/documentation/ja-jp/red_hat_openstack_platform/15/html/instances_and_images_guide/ch-manage_instances#section-manage-host-aggregates 」を参照してください。

4.5.6.5. セキュリティーグループ

セキュリティーグループとは、セキュリティーグループルールのコレクションです。セキュリティーグループとそれらのグループにより、管理者およびプロジェクトがトラフィックの種別を指定することができ、かつ方向 (ingress/egress) が仮想インターフェースポートを通過できる方向 (ingress/egress) を指定することができます。OpenStack Networking で仮想インターフェースのポートが作成されると、セキュリティーグループが関連付けられます。デプロイメントごとに動作を変更するには、デフォルトのセキュリティーグループにルールを追加できます。

Compute API を使用してセキュリティーグループを変更する場合、更新されたセキュリティーグループはインスタンスのすべての仮想インターフェースポートに適用されます。これは、neutron にあるように、コンピュートセキュリティーグループ API がポートベースではなくインスタンスベースであるためです。

4.5.6.6. クォータ

クォータは、プロジェクトで利用可能なネットワークリソースの数を制限できます。すべてのプロジェクトに対してデフォルトのクォータを適用できます。クォータオプションを確認するには、/var/lib/config-data/puppet-generated/neutron/etc/neutron/neutron.conf を参照してください。

OpenStack Networking は、クォータ拡張 API 経由でプロジェクトごとのクォータ制限もサポートします。プロジェクトごとのクォータを有効にするには、/var/lib/config-data/puppet-generated/neutron/etc/neutron/neutron.conf で quota_driver オプションを設定する必要があります。以下に例を示します。

quota_driver = neutron.db.quota_db.DbQuotaDriver

4.5.6.7. ARP スプーフィングの緩和策

OpenStack Networking には、インスタンスの ARP スプーフィングの脅威を緩和するための組み込み機能が含まれています。これは、結果となるリスクに注意を払う場合を除き無効にしないでください。

4.5.6.8. 設定ファイルのユーザー/グループの所有権を root/neutron に設定します。

設定ファイルには、コンポーネントのスムーズに機能するために必要な重要なパラメーターおよび情報が含まれます。非特権ユーザーが故意または過失で変更したり、ファイル自体を変更したり、削除したりすると、重大な可用性の問題が原因で、他のエンドユーザーにサービス拒否が発生します。そのため、このような重要な設定ファイルのユーザー所有権を root に設定し、グループの所有権を neutron に設定する必要があります。

次のファイルのユーザーおよびグループの所有権がそれぞれ root と neutron に設定されていることを確認してください。コンテナー化されたサービスでは、ファイルパスが異なる場合があります。

$ stat -L -c "%U %G" /var/lib/config-data/puppet-generated/neutron/etc/neutron/neutron.conf | egrep "root neutron" $ stat -L -c "%U %G" /var/lib/config-data/puppet-generated/neutron/etc/neutron/api-paste.ini | egrep "root neutron" $ stat -L -c "%U %G" /var/lib/config-data/puppet-generated/neutron/etc/neutron/policy.json | egrep "root neutron" $ stat -L -c "%U %G" /var/lib/config-data/puppet-generated/neutron/etc/neutron/rootwrap.conf | egrep "root neutron"

4.5.6.9. 設定ファイルの厳密なパーミッションの設定

次のファイルの権限が 640 以上に設定されていることを確認してください。コンテナー化されたサービスでは、ファイルパスが異なる場合があります。

$ stat -L -c "%a" /var/lib/config-data/puppet-generated/neutron/etc/neutron/neutron.conf $ stat -L -c "%a" /var/lib/config-data/puppet-generated/neutron/etc/neutron/api-paste.ini $ stat -L -c "%a" /var/lib/config-data/puppet-generated/neutron/etc/neutron/policy.json $ stat -L -c "%a" /var/lib/config-data/puppet-generated/neutron/etc/neutron/rootwrap.conf

4.5.6.10. 認証には keystone を使用します。

/var/lib/config-data/puppet-generated/neutron/etc/neutron/neutron.conf で、[DEFAULT] セクションの auth_strategy の値が、noauth または noauth2 ではなく keystone に設定されていることを確認します。

4.5.6.10.1. 認証にセキュアプロトコルを使用

/var/lib/config-data/puppet-generated/neutron/etc/neutron/neutron.conf の [keystone_authtoken] セクションの auth_uri の値が https: // で始まる Identity API エンドポイントに設定され、[keystone_authtoken] でも セキュアでない パラメーターの値が False に設定されていることを確認してください。

4.5.6.10.2. Neutron API サーバーでの TLS の有効化

/var/lib/config-data/puppet-generated/neutron/etc/neutron/neutron.conf で、[DEFAULT] セクションのパラメーター use_ssl が True に設定されていることを確認します。

第5章 director を使用したセキュリティー強化の設定

この章では、Director がデプロイメントプロセスの一部としてセキュリティー強化値を適用する方法を説明します。

openstack overcloud deploy を実行する場合は、加える変更と共に、必ずオーバークラウドのデプロイに必要な環境ファイルをすべて含めなければならない点に注意してください。

5.1. SSH バナーテキストの使用

SSH 経由で接続する全ユーザーにコンソールメッセージを表示するバナーを設定できます。環境ファイルの以下のパラメーターを使用して、/etc/issue にバナーテキストを追加できます。実際の要件に合わせて、このサンプルテキストをカスタマイズすることを検討してください。

resource_registry:

OS::TripleO::Services::Sshd: ../puppet/services/sshd.yaml

parameter_defaults:

BannerText: |

******************************************************************

* This system is for the use of authorized users only. Usage of *

* this system may be monitored and recorded by system personnel. *

* Anyone using this system expressly consents to such monitoring *

* and is advised that if such monitoring reveals possible *

* evidence of criminal activity, system personnel may provide *

* the evidence from such monitoring to law enforcement officials.*

******************************************************************

この変更をデプロイメントに適用するには、設定を ssh_banner.yaml という名前のファイルで保存し、以下のように overcloud deploy コマンドに渡します。<full environment> は、元のデプロイメントパラメーターをすべて含める必要があることを示します。以下に例を示します。

openstack overcloud deploy --templates \

-e <full environment> -e ssh_banner.yaml5.2. システムイベントの監査

すべての監査イベントの記録を維持すると、システムベースラインの確立、トラブルシューティングの実行、特定の結果の原因となったイベントシーケンスの分析に役立ちます。監査システムは、システム時刻の変更、Mandatory/Discretionary アクセス制御の変更、ユーザーおよびグループの作成や削除など、多数のタイプのイベントをログに記録できます。

環境ファイルを使用してルールを作成し、director がそれを /etc/audit/audit.rules に挿入します。以下に例を示します。

resource_registry:

OS::Tripleo::Services::Auditd: /usr/share/openstack-tripleo-heat-templates/puppet/services/auditd.yaml

parameter_defaults:

AuditdRules:

'Record Events that Modify User/Group Information':

content: '-w /etc/group -p wa -k audit_rules_usergroup_modification'

order : 1

'Collects System Administrator Actions':

content: '-w /etc/sudoers -p wa -k actions'

order : 2

'Record Events that Modify the Systems Mandatory Access Controls':

content: '-w /etc/selinux/ -p wa -k MAC-policy'

order : 35.3. ファイアウォールルールの管理

ファイアウォールルールは、デプロイメント時にオーバークラウドノードに自動的に適用され、OpenStack の運用に必要なポートのみを公開することを目的としています。必要に応じて、追加のファイアウォールルールを指定できます。たとえば、Zabbix モニタリングシステムのルールを追加するには、以下のようにします。

parameter_defaults:

ControllerExtraConfig:

tripleo::firewall::firewall_rules:

'301 allow zabbix':

dport: 10050

proto: tcp

source: 10.0.0.8

action: accept

アクセスを制限するルールを追加することもできます。ルールの定義時に使用される数字は、ルールの優先順位を決定します。たとえば、RabbitMQ のルール番号は、デフォルトでは 109 です。これを抑制するには、小さい数字を使用するように切り替えます。

parameter_defaults:

ControllerExtraConfig:

tripleo::firewall::firewall_rules:

'098 allow rabbit from internalapi network':

dport: [4369,5672,25672]

proto: tcp

source: 10.0.0.0/24

action: accept

'099 drop other rabbit access':

dport: [4369,5672,25672]

proto: tcp

action: drop

この例では、098 と 099 は、RabbitMQ のルール番号 109 よりも小さい任意に選んだ番号です。ルールの番号を確認するには、適切なノードで iptables ルールを検査できます。RabbitMQ の場合は、コントローラーをチェックします。

iptables-save [...] -A INPUT -p tcp -m multiport --dports 4369,5672,25672 -m comment --comment "109 rabbitmq" -m state --state NEW -j ACCEPT

または、puppet 定義からポート要件を抽出することもできます。たとえば、RabbitMQ のルールは puppet/services/rabbitmq.yaml に保存されます。

tripleo.rabbitmq.firewall_rules:

'109 rabbitmq':

dport:

- 4369

- 5672

- 25672ルールには、以下のパラメーターを設定できます。

-

port: ルールに関連付けられたポート。puppetlabs-firewallにより非推奨になりました。 -

dport: ルールに関連付けられた宛先ポート -

sport: ルールに関連付けられた送信元ポート -

proto: ルールに関連付けられたプロトコル。デフォルトは tcp です。 -

action: ルールに関連付けられたアクションポリシー。デフォルトは accept です。 -

jump: ジャンプ先のチェーン -

state: ルールに関連付けられた状態の配列。デフォルトは [NEW] です。 -

source: ルールに関連付けられた送信元の IP アドレス -

iniface: ルールに関連付けられたネットワークインターフェース -

chain: ルールに関連付けられたチェーン。デフォルトは INPUT です。 -

destination: ルールに関連付けられた宛先の cidr -

extras:puppetlabs-firewallモジュールでサポートされる追加パラメーターのハッシュ

5.4. AIDE を使用した侵入検知

AIDE (Advanced Intrusion Detection Environment) は、ファイルとディレクトリーの整合性チェッカーです。これは、承認されていないファイルの改ざんまたは変更のインシデントを検出するために使用されます。たとえば、AIDE は、システムパスワードファイルが変更された場合に警告を出すことができます。

AIDE は、システムファイルを分析し、ファイルハッシュの整合性データベースをまとめることで機能します。次に、データベースは、ファイルとディレクトリーの整合性を検証し、変更を検出する際の比較ポイントとなります。

director には AIDE サービスが含まれており、AIDE 設定にエントリーを追加でき、AIDE サービスはこれを使用して整合性データベースを作成できます。以下に例を示します。

resource_registry:

OS::TripleO::Services::Aide: ../puppet/services/aide.yaml

parameter_defaults:

AideRules:

'TripleORules':

content: 'TripleORules = p+sha256'

order : 1

'etc':

content: '/etc/ TripleORules'

order : 2

'boot':

content: '/boot/ TripleORules'

order : 3

'sbin':

content: '/sbin/ TripleORules'

order : 4

'var':

content: '/var/ TripleORules'

order : 5

'not var/log':

content: '!/var/log.*'

order : 6

'not var/spool':

content: '!/var/spool.*'

order : 7

'not nova instances':

content: '!/var/lib/nova/instances.*'

order: 8上記の例は、積極的には保守やベンチマーク設定されないので、要件に合わせて AIDE の値を選択する必要があります。

-

TripleORulesという名前のエイリアスを宣言することで、毎回同じ属性を繰り返し除外する必要がなくなります。 -

エイリアスは

p+sha256の属性を受け取ります。AIDE では、これは次の命令として解釈されます。sha256の整合性チェックサムを使用してすべてのファイルパーミッションpを監視する。

AIDE の設定ファイルで利用可能な属性の完全リストは、http://aide.sourceforge.net/stable/manual.html#config の AIDE MAN ページを参照してください。

この変更をデプロイメントに適用するには、設定を aide.yaml という名前のファイルで保存し、以下のように overcloud deploy コマンドに渡します。<full environment> は、元のデプロイメントパラメーターをすべて含める必要があることを示します。以下に例を示します。

openstack overcloud deploy --templates -e <full environment> /usr/share/openstack-tripleo-heat-templates/environments/aide.yaml

5.4.1. 複雑な AIDE ルールの使用

前述の形式を使用して、複雑なルールを作成できます。以下に例を示します。

MyAlias = p+i+n+u+g+s+b+m+c+sha512

上記は、次の命令として解釈されます。チェックサムの生成に sha256 を使用して、パーミッション、inode、リンクの数、ユーザー、グループ、サイズ、ブロック数、mtime、ctime をモニターする。

エイリアスの順番の位置は常に 1 であることに注意してください。つまり、AIDE ルールの先頭に配置され、それ以下のすべての値に再帰的に適用されます。

エイリアスの後は、監視するディレクトリーになります。正規表現を使用できます。たとえば、var ディレクトリーの監視を設定しますが、! を使用して not 句で上書きします ('!/var/log.*' および '!/var/spool.*')。

5.4.2. その他の AIDE 値

以下の AIDE 値も使用できます。

AideConfPath: aide 設定ファイルへの完全な POSIX パス。デフォルトは /etc/aide.conf です。ファイルの場所を変更する要件がない場合は、デフォルトのパスのままにすることが推奨されます。

AideDBPath: AIDE 整合性データベースへの完全な POSIX パス。この値は設定が可能で、オペレーターが独自のフルパスを宣言できます。多くの場合、AIDE データベースファイルはノード外に保管されるためです (読み取り専用のファイルマウント)。

AideDBTempPath: AIDE 整合性一時データベースへの完全な POSIX パス。この一時ファイルは、AIDE が新規データベースを初期化する際に作成されます。

AideHour: この値は、AIDE cron 設定の一部として hour 属性を設定します。

AideMinute: この値は、AIDE cron 設定の一部として minute 属性を設定します。

AideCronUser: この値は、AIDE cron 設定の一部として linux ユーザーを設定します。

AideEmail: この値は、cron が実行されるたびに AIDE レポートを受信するメールアドレスを設定します。

AideMuaPath: この値は、AideEmail で設定したメールアドレスに AIDE レポートを送信するために使用される Mail User Agent へのパスを設定します。

5.4.3. AIDE の cron 設定

AIDE director サービスにより、cron ジョブを設定できます。デフォルトでは、レポートを /var/log/audit/ に送信します。メールアラートを使用する場合は、AideEmail パラメーターを有効にして、設定されたメールアドレスにアラートを送信します。重大なアラートをメールに依存することは、システム停止や意図しないメッセージフィルタリングに対して脆弱である可能性があることに注意してください。

5.4.4. システムアップグレードの影響に関する考慮

アップグレードが実行されると、AIDE サービスが新しい整合性データベースを自動的に再生成し、アップグレードしたすべてのファイルが正しく再計算され、更新されたチェックサムが生成されるようにします。

openstack overcloud deploy が初期デプロイメントに対して後続の実行として呼び出され、AIDE 設定ルールが変更されると、director AIDE サービスはデータベースを再構築して、整合性データベースに新規設定属性が取り込まれるようにします。

5.5. SecureTTY の確認

securetty を使用すると、コンソールデバイス (tty) に対する root アクセスを無効にできます。この動作は、/etc/securetty ファイルのエントリーで管理されます。以下に例を示します。

resource_registry:

OS::TripleO::Services::Securetty: ../puppet/services/securetty.yaml

parameter_defaults:

TtyValues:

- console

- tty1

- tty2

- tty3

- tty4

- tty5

- tty65.6. Identity サービスの CADF 監査

詳細な監査プロセスは、OpenStack デプロイメントの現在の状態を確認するのに役立ちます。これは、セキュリティーモデルにおけるそのロールにより、特に keystone で重要です。

Red Hat OpenStack Platform では、Identity およびトークン操作の CADF イベントを生成する keystone サービスにより、監査イベントのデータ形式として Cloud Auditing Data Federation (CADF) が採用されています。KeystoneNotificationFormat を使用して、keystone の CADF 監査を有効にできます。

parameter_defaults:

KeystoneNotificationFormat: cadf5.7. login.defs 値の確認