Red Hat Training

A Red Hat training course is available for Red Hat OpenStack Platform

director のインストールと使用方法

Red Hat OpenStack Platform director を使用した OpenStack クラウド作成のエンドツーエンドシナリオ

OpenStack Documentation Team Team

rhos-docs@redhat.com概要

第1章 はじめに

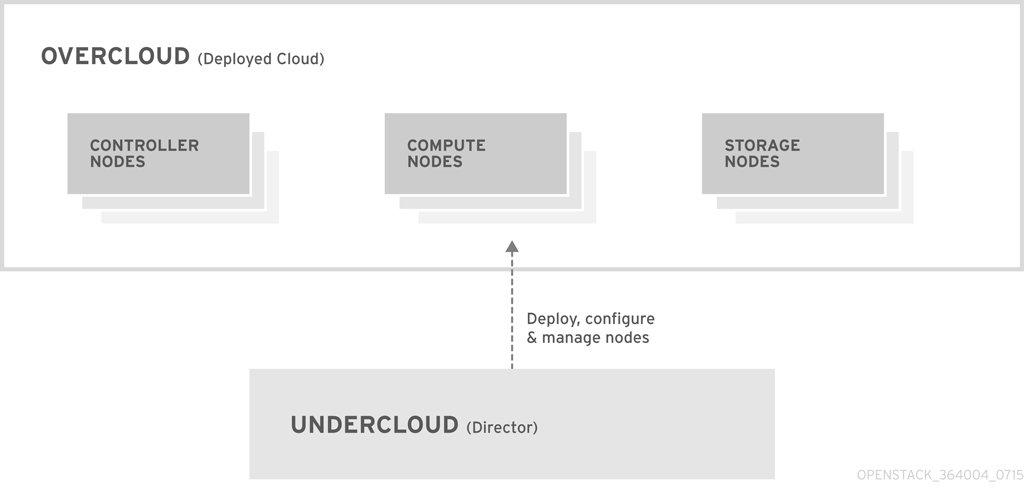

Red Hat OpenStack Platform director は、完全な OpenStack 環境のインストールおよび管理を行うためのツールセットです。director は、主に OpenStack プロジェクト TripleO (「OpenStack-On-OpenStack」の略語) をベースとしてます。このプロジェクトは、OpenStack のコンポーネントを活用して、完全に機能する OpenStack 環境をインストールします。これには、OpenStack ノードとして使用するベアメタルシステムをプロビジョニングし、制御する新しい OpenStack のコンポーネントが含まれます。

Red Hat OpenStack Platform director は、アンダークラウドとオーバークラウドという 2 つの主要な概念を採用しています。以下の数項では、それぞれの概念について説明します。

1.1. アンダークラウド

アンダークラウドは、OpenStack Platform director ツールセットが含まれる主要管理ノードです。OpenStack をインストールした単一システムで、OpenStack 環境 (オーバークラウド) を構成する OpenStack ノードをプロビジョニング/管理するためのコンポーネントが含まれます。アンダークラウドを形成するコンポーネントは、さまざまな機能を提供します。

- 環境のプランニング

- アンダークラウドは、ユーザーが特定のノードロールを作成するためのプランニング機能を提供します。アンダークラウドには、コンピュート、コントローラー、さまざまなストレージロールなどのデフォルトのノードセットが含まれるだけでなく、カスタムロールを使用する機能も提供されています。さらに、各ノードロールにどの OpenStack Platform サービスを含めるかを選択でき、新しいノード種別をモデル化するか、独自のホストで特定のコンポーネントを分離する方法を提供します。

- ベアメタルシステムの制御

- アンダークラウドは、各ノードの Intelligent Platform Management Interface (IPMI) などのアウトバウンド管理インターフェースを使用して電源管理機能を制御し、PXE ベースのサービスを使用してハードウェア属性を検出し、各ノードに OpenStack をインストールします。この機能により、ベアメタルシステムを OpenStack ノードとしてプロビジョニングする方法が提供されます。電源管理ドライバーの完全一覧については、「付録B 電源管理ドライバー」を参照します。

- Orchestration

- アンダークラウドでは、環境のプランとして機能する YAML テンプレートセットが提供されています。アンダークラウドは、これらのプランをインポートして、その指示に従い、目的の OpenStack 環境を作成します。このプランには、環境作成プロセスの途中にある特定のポイントで、カスタマイズを組み込めるようにするフックも含まれます。

- コマンドラインツールおよび Web UI

- Red Hat OpenStack Platform director は、ターミナルベースのコマンドラインインターフェースまたは Web ベースのユーザーインターフェースで、これらのアンダークラウド機能を実行します。

- アンダークラウドのコンポーネント

アンダークラウドは、OpenStack のコンポーネントをベースのツールセットとして使用します。各コンポーネントは、アンダークラウドの個別のコンテナー内で動作します。OpenStack のコンポーネントを以下に示します。

- OpenStack Identity (keystone): director のコンポーネントの認証および承認

- OpenStack Bare Metal (Ironic) および OpenStack Compute (Nova): ベアメタルノードの管理

- OpenStack Networking (Neutron) および Open vSwitch: ベアメタルノードのネットワークの制御

- OpenStack Image サービス (Glance): ベアメタルマシンへ書き込むイメージの格納

- OpenStack Orchestation (Heat) および Puppet: director がオーバークラウドイメージをディスクに書き込んだ後のノードのオーケストレーションおよび設定

OpenStack Telemetry (Ceilometer): 監視とデータの収集。これには、以下が含まれます。

- OpenStack Telemetry Metrics (gnocchi): メトリック向けの時系列データベース

- OpenStack Telemetry Alarming (aodh): モニタリング向けのアラームコンポーネント

- OpenStack Telemetry Event Storage (panko): モニタリング向けのイベントストレージ

- OpenStack Workflow サービス (mistral): プランのインポートやデプロイなど、特定の director 固有のアクションに対してワークフローセットを提供します。

- OpenStack Messaging Service (zaqar): OpenStack Workflow サービスのメッセージサービスを提供します。

OpenStack Object Storage (swift): 以下のさまざまな OpenStack Platform のコンポーネントに対してオブジェクトストレージを提供します。

- OpenStack Image サービスのイメージストレージ

- OpenStack Bare Metal のイントロスペクションデータ

- OpenStack Workflow サービスのデプロイメントプラン

1.2. オーバークラウド

オーバークラウドは、アンダークラウドを使用して構築した Red Hat OpenStack Platform 環境で、以下のノード種別の 1 つまたは複数で構成されます。これには、作成予定の OpenStack Platform 環境をベースに定義するさまざまなロールが含まれます。アンダークラウドには、以下などのオーバークラウドノードのロールがデフォルトで含まれます。

- コントローラー

OpenStack 環境に管理、ネットワーク、高可用性の機能を提供するノード。理想的な OpenStack 環境には、このノード 3 台で高可用性クラスターを構成することを推奨します。

デフォルトのコントローラーノードには、以下のコンポーネントが含まれます。

- OpenStack Dashboard (horizon)

- OpenStack Identity (keystone)

- OpenStack Compute (nova) API

- OpenStack Networking (neutron)

- OpenStack Image サービス (glance)

- OpenStack Block Storage (cinder)

- OpenStack Object Storage (swift)

- OpenStack Orchestration (heat)

- OpenStack Telemetry (ceilometer)

- OpenStack Telemetry Metrics (gnocchi)

- OpenStack Telemetry Alarming (aodh)

- OpenStack Telemetry Event Storage (panko)

- OpenStack Clustering (sahara)

- OpenStack Shared File Systems (manila)

- OpenStack Bare Metal (ironic)

- MariaDB

- Open vSwitch

- 高可用性サービス向けの Pacemaker および Galera

- Compute

これらのノードは OpenStack 環境にコンピュートリソースを提供します。コンピュートノードをさらに追加して、環境を徐々にスケールアウトすることができます。デフォルトのコンピュートノードには、以下のコンポーネントが含まれます。

- OpenStack Compute (nova)

- KVM/QEMU

- OpenStack Telemetry (ceilometer) エージェント

- Open vSwitch

- ストレージ

OpenStack 環境にストレージを提供するノード。これには、以下のストレージ用のノードが含まれます。

- Ceph Storage ノード: ストレージクラスターを構成するために使用します。各ノードには、Ceph Object Storage Daemon (OSD) が含まれており、Ceph Storage ノードをデプロイする場合には、director により Ceph Monitor がコンピュートノードにインストールされます。

Block storage (Cinder): HA コントローラーノードの外部ブロックストレージとして使用します。このノードには、以下のコンポーネントが含まれます。

- OpenStack Block Storage (cinder) ボリューム

- OpenStack Telemetry (ceilometer) エージェント

- Open vSwitch

Object Storage (swift): これらのノードは、OpenStack Swift の外部ストレージ層を提供します。コントローラーノードは、Swift プロキシーを介してこれらのノードにアクセスします。このノードには、以下のコンポーネントが含まれます。

- OpenStack Object Storage (swift) のストレージ

- OpenStack Telemetry (ceilometer) エージェント

- Open vSwitch

1.3. 高可用性

Red Hat OpenStack Platform director は、OpenStack Platform 環境に高可用性サービスを提供するためにコントローラーノードクラスターを使用します。director は、各コントローラーノードにコンポーネントの複製セットをインストールし、それらをまとめて単一のサービスとして管理します。このタイプのクラスター構成では、1 つのコントローラーノードが機能しなくなった場合にフォールバックするので、OpenStack のユーザーには一定の運用継続性が提供されます。

OpenStack Platform director は、複数の主要なソフトウェアを使用して、コントローラーノード上のコンポーネントを管理します。

- Pacemaker: Pacemaker はクラスターリソースマネージャーで、クラスター内の全ノードにおける OpenStack コンポーネントの可用性を管理/監視します。

- HA Proxy: クラスターに負荷分散およびプロキシーサービスを提供します。

- Galera: クラスター全体の OpenStack Platform データベースを複製します。

- Memcached: データベースのキャッシュを提供します。

- Red Hat OpenStack Platform director は複数のコントローラーノードの高可用性を一括に自動設定します。ただし、電源管理制御を有効化するには、ノードを手動で設定する必要があります。本ガイドでは、これらの手順を記載しています。

- バージョン 13 から、director を使用してコンピュートインスタンスの高可用性 (インスタンス HA) をデプロイできるようになりました。インスタンス HA により、コンピュートノードで障害が発生した際にそのノードからインスタンスを自動的に退避することができます。

1.4. コンテナー化

アンダークラウドおよびオーバークラウド上の各 OpenStack Platform サービスは、対応するノード上の個別の Linux コンテナー内で実行されます。これにより、それぞれのサービスを分離し、OpenStack Platform を簡単に維持およびアップグレードすることができます。以下に示すように、Red Hat では、オーバークラウド用コンテナーイメージを取得するためのさまざまな方法をサポートしています。

- Red Hat Container Catalog から直接イメージをプルする

- アンダークラウド上でイメージをホストする

- Satellite 6 サーバー上でイメージをホストする

本ガイドでは、レジストリー情報の設定および基本的なコンテナー操作の実施方法について説明します。

1.5. Ceph Storage

一般的に、OpenStack を使用する大規模な組織では、数千単位またはそれ以上のクライアントにサービスを提供します。OpenStack クライアントは、ブロックストレージリソースを消費する際には、それぞれに固有のニーズがある可能性が高く、Glance (イメージ)、Cinder (ボリューム)、Nova (コンピュート) を単一ノードにデプロイすると、数千単位のクライアントがある大規模なデプロイメントでの管理ができなくなる可能性があります。このような課題は、OpenStack をスケールアウトすることによって解決できます。

ただし、実際には、Red Hat Ceph Storage などのソリューションを活用して、ストレージ層を仮想化する必要もでてきます。ストレージ層の仮想化により、Red Hat OpenStack Platform のストレージ層を数十テラバイト規模からペタバイトさらにはエクサバイトのストレージにスケーリングすることが可能です。Red Hat Ceph Storage は、市販のハードウェアを使用しながらも、高可用性/高パフォーマンスのストレージ仮想化層を提供します。仮想化によってパフォーマンスが低下するというイメージがありますが、Ceph はブロックデバイスイメージをクラスター全体でオブジェクトとしてストライプ化するため、大きい Ceph のブロックデバイスイメージはスタンドアロンのディスクよりもパフォーマンスが優れているということになります。Ceph ブロックデバイスでは、パフォーマンスを強化するために、キャッシュ、Copy On Write クローン、Copy On Read クローンもサポートされています。

Red Hat Ceph Storage に関する情報は、Red Hat Ceph Storage を参照してください。

マルチアーキテクチャークラウドでは、事前にインストール済みの Ceph または外部の Ceph しかサポートされません。詳細は、『Integrating an Overcloud with an Existing Red Hat Ceph Cluster』および「付録G Red Hat OpenStack Platform for POWER」を参照してください。

パート I. director のインストールと設定

第2章 アンダークラウドのプランニング

2.1. コンテナー化されたアンダークラウド

アンダークラウド は、最終的な OpenStack Platform 環境 (オーバークラウド と呼ばれる) の設定、インストール、および管理をコントロールするノードです。アンダークラウド自体は、コンテナー化された OpenStack Platform コンポーネントを使用して、OpenStack Platform director と呼ばれるツールセットを作成します。この場合、アンダークラウドはレジストリーソースからコンテナーイメージのセットをプルし、コンテナーの設定を生成し、各 OpenStack Platform サービスをコンテナーとして実行します。その結果、アンダークラウドにより、オーバークラウドを作成/管理するためのツールセットとして機能する、コンテナー化されたサービスのセットが提供されます。

アンダークラウドおよびオーバークラウドの両方でコンテナーが使用されているので、どちらも同じアーキテクチャーを使用してコンテナーをプル、設定、および実行します。このアーキテクチャーは、ノードプロビジョニング用の OpenStack Orchestration サービス (Heat とも呼ばれる) ならびにサービスおよびコンテナー設定用の Ansible をベースにしています。異常発生時のトラブルシューティングに役立つので、Heat および Ansible に関する知識を習得することを推奨します。

2.2. アンダークラウドネットワークの準備

アンダークラウドでは、2 つの主要ネットワークへのアクセスが必要です。

- プロビジョニングまたはコントロールプレーンネットワーク: director は、このネットワークを使用してノードをプロビジョニングし、Ansible 設定の実行時に SSH 経由でこれらのノードにアクセスします。アンダークラウドからオーバークラウドノードへの SSH アクセスにも、このネットワークが使用されます。アンダークラウドは、このネットワークに他のノードのイントロスペクションおよびプロビジョニング用 DHCP サービスを提供します。つまり、このネットワーク上にその他の DHCP サービスが存在している必要はありません。director がこのネットワークのインターフェースを設定します。

- 外部ネットワーク: アンダークラウドは、このネットワークを使用して OpenStack Platform リポジトリー、コンテナーイメージソース、および DNS サーバーや NTP サーバー等の他のサーバーにアクセスすることができます。通常は、このネットワークを使用してご自分のワークステーションからアンダークラウドにアクセスします。つまり、外部ネットワークにアクセスするためには、アンダークラウド上で手動でインターフェースを設定する必要があります。

結果的に、アンダークラウドには少なくとも 2 枚の 1 Gbps ネットワークインターフェースカードが必要です。ただし、特にオーバークラウド環境で多数のノードをプロビジョニングする場合には、プロビジョニングネットワークのトラフィック用に 10 Gbps インターフェースの使用を推奨します。

以下の点に注意してください。

- プロビジョニング/コントロールプレーン用には、ワークステーションから director マシンへのアクセスに使用する NIC とは別の NIC を使用してください。director のインストールでは、プロビジョニング NIC を使用してブリッジが作成され、リモート接続はドロップされます。director システムへリモート接続する場合には、外部 NIC を使用します。

プロビジョニングネットワークには、環境のサイズに適した IP 範囲が必要です。以下のガイドラインを使用して、この範囲に含めるべき IP アドレスの総数を決定してください。

- イントロスペクション中は、プロビジョニングネットワークに接続されているノードごとに少なくとも 1 つの一時 IP アドレスを含めます。

- デプロイメント中は、プロビジョニングネットワークに接続されているノードごとに少なくとも 1 つの永続的な IP アドレスを含めます。

- プロビジョニングネットワーク上のオーバークラウド高可用性クラスターの仮想 IP 用に、追加の IP アドレスを含めます。

- 環境のスケーリング用に、この範囲にさらに IP アドレスを追加します。

2.3. 環境規模の判断

アンダークラウドをインストールする前に、環境の規模を判断することが重要です。検討すべき項目を以下に示します。

- オーバークラウド内のノードの数: アンダークラウドは、オーバークラウド内の各ノードを管理します。オーバークラウドノードのプロビジョニングには、アンダークラウドのリソースが使用されます。したがって、オーバークラウドノードを適切にプロビジョニングし管理するには、アンダークラウドに十分なリソースを提供する必要があります。

- アンダークラウドで実行する同時操作の数: アンダークラウド上の OpenStack サービスの多くは、ワーカー のセットを使用します。それぞれのワーカーは、そのサービスに固有の操作を実行します。複数のワーカーを用いると、同時に操作を実行することができます。アンダークラウドのワーカー数のデフォルト値は、アンダークラウド CPU の合計スレッド数の半分です[1]。たとえば、アンダークラウドが 16 スレッドの CPU を持つ場合、デフォルトでは director は 8 つのワーカーを提供します。デフォルトでは、director のサービスに最小および最大のワーカー数が適用される点にも注意してください。

| サービス | 最小値 | 最大値 |

|---|---|---|

|

OpenStack Orchestration (heat) |

4 |

24 |

|

その他すべてのサービス |

2 |

12 |

アンダークラウドの CPU およびメモリーの最低要件を以下に示します。

- Intel 64 または AMD64 CPU 拡張機能をサポートする、8 スレッド 64 ビット x86 プロセッサー。これにより、各アンダークラウドサービスに 4 つのワーカーが提供されます。

- 最小 24 GB の RAM。

より多くのワーカーを使用する場合には、アンダークラウドにより多くの仮想 CPU およびメモリーが必要になります。以下の要件に従ってください。

- 最小値: 1 スレッドあたり 1.5 GB のメモリーを使用します。たとえば、48 スレッドのマシンには 72 GB の RAM が必要です。これは、Heat 用 24 ワーカーとその他のサービス用 12 ワーカーを提供するのに最低限必要なリソースです。

- 推奨値: 1 スレッドあたり 3 GB のメモリーを使用します。たとえば、48 スレッドのマシンには 144 GB の RAM が必要です。これは、Heat 用 24 ワーカーとその他のサービス用 12 ワーカーを提供するのに推奨されるリソースです。

2.4. アンダークラウドのディスクサイズ

アンダークラウド用として、ルートディスク上に少なくとも 100 GB の空きディスク領域があることが推奨されます。この領域の内訳は以下のとおりです。

- コンテナーイメージ用に 20 GB

- QCOW2 イメージの変換とノードのプロビジョニングプロセスのキャッシュ用に 10 GB

- 一般用途、ログの記録、メトリック、および将来の拡張用に 70 GB 以上

2.5. アンダークラウドのリポジトリー

アンダークラウドのインストールおよび設定には、以下のリポジトリーが必要です。

表2.1 コアリポジトリー

| 名前 | リポジトリー | 要件の説明 |

|---|---|---|

|

Red Hat Enterprise Linux 7 Server (RPMS) |

|

x86_64 システム用ベースオペレーティングシステムのリポジトリー |

|

Red Hat Enterprise Linux 7 Server - Extras (RPMs) |

|

Red Hat OpenStack Platform の依存関係が含まれます。 |

|

Red Hat Enterprise Linux 7 Server - RH Common (RPMs) |

|

Red Hat OpenStack Platform のデプロイと設定ツールが含まれます。 |

|

Red Hat Satellite Tools for RHEL 7 Server RPMs x86_64 |

|

Red Hat Satellite 6 でのホスト管理ツール |

|

Red Hat Enterprise Linux High Availability (for RHEL 7 Server) (RPMs) |

|

Red Hat Enterprise Linux の高可用性ツール。コントローラーノードの高可用性に使用します。 |

|

Red Hat OpenStack Platform 14 for RHEL 7 (RPMs) |

|

Red Hat OpenStack Platform のコアリポジトリー。Red Hat OpenStack Platform director のパッケージが含まれます。 |

表2.2 Ceph 用リポジトリー

| 名前 | リポジトリー | 要件の説明 |

|---|---|---|

|

Red Hat Ceph Storage Tools 3 for Red Hat Enterprise Linux 7 Server (RPMs) |

|

ノードが Ceph Storage クラスターと通信するためのツールが提供されます。オーバークラウドで Ceph Storage を使用する場合には、アンダークラウドにこのリポジトリーからの |

IBM POWER 用リポジトリー

これらのリポジトリーは、POWER PC アーキテクチャー上で Openstack Platform を構築するのに使われます。コアリポジトリーの該当リポジトリーの代わりに、これらのリポジトリーを使用してください。

| 名前 | リポジトリー | 要件の説明 |

|---|---|---|

|

Red Hat Enterprise Linux for IBM Power, little endian |

|

ppc64le システム用ベースオペレーティングシステムのリポジトリー |

|

Red Hat OpenStack Platform 14 for RHEL 7 (RPMs) |

|

ppc64le システム用 Red Hat OpenStack Platform のコアリポジトリー |

第3章 director インストールの準備

3.1. アンダークラウドの準備

director のインストールには、以下の項目が必要です。

- コマンドを実行するための非 root ユーザー

- イメージとテンプレートを管理するためのディレクトリー

- 解決可能なホスト名

- Red Hat サブスクリプション

- イメージの準備および director のインストールを行うためのコマンドラインツール

手順

-

アンダークラウドに

rootユーザーとしてログインします。 stackユーザーを作成します。[root@director ~]# useradd stack

そのユーザーのパスワードを設定します。

[root@director ~]# passwd stack

sudoを使用する場合にパスワードを要求されないようにします。[root@director ~]# echo "stack ALL=(root) NOPASSWD:ALL" | tee -a /etc/sudoers.d/stack [root@director ~]# chmod 0440 /etc/sudoers.d/stack

新規作成した

stackユーザーに切り替えます。[root@director ~]# su - stack [stack@director ~]$

director はシステムのイメージと Heat テンプレートを使用して、オーバークラウド環境を構築します。これらのファイルを整理するには、イメージとテンプレート用にディレクトリーを作成するように推奨します。

[stack@director ~]$ mkdir ~/images [stack@director ~]$ mkdir ~/templates

アンダークラウドのベースおよび完全なホスト名を確認します。

[stack@director ~]$ hostname [stack@director ~]$ hostname -f

上記のコマンドのいずれかで正しいホスト名が出力されなかったり、エラーが表示される場合には、

hostnamectlでホスト名を設定します。[stack@director ~]$ sudo hostnamectl set-hostname manager.example.com [stack@director ~]$ sudo hostnamectl set-hostname --transient manager.example.com

director では、

/etc/hostsにシステムのホスト名とベース名も入力する必要があります。/etc/hostsの IP アドレスは、アンダークラウドのパブリック API に使用する予定のアドレスと一致する必要があります。たとえば、システムの名前がmanager.example.comで、IP アドレスに10.0.0.1を使用する場合には、/etc/hostsに以下のように入力する必要があります。10.0.0.1 manager.example.com manager

Red Hat コンテンツ配信ネットワークまたは Red Hat Satellite のどちらかにシステムを登録します。たとえば、プロンプトが表示されたら、カスタマーポータルのユーザー名とパスワードを使用してコンテンツ配信ネットワークに登録します。

[stack@director ~]$ sudo subscription-manager register

Red Hat OpenStack Platform director のエンタイトルメントプール ID を検索します。以下に例を示します。

[stack@director ~]$ sudo subscription-manager list --available --all --matches="Red Hat OpenStack" Subscription Name: Name of SKU Provides: Red Hat Single Sign-On Red Hat Enterprise Linux Workstation Red Hat CloudForms Red Hat OpenStack Red Hat Software Collections (for RHEL Workstation) Red Hat Virtualization SKU: SKU-Number Contract: Contract-Number Pool ID: Valid-Pool-Number-123456 Provides Management: Yes Available: 1 Suggested: 1 Service Level: Support-level Service Type: Service-Type Subscription Type: Sub-type Ends: End-date System Type: PhysicalPool IDの値を特定して、Red Hat OpenStack Platform 14 のエンタイトルメントをアタッチします。[stack@director ~]$ sudo subscription-manager attach --pool=Valid-Pool-Number-123456

デフォルトのリポジトリーをすべて無効にしてから、必要な Red Hat Enterprise Linux リポジトリーを有効にします。

[stack@director ~]$ sudo subscription-manager repos --disable=* [stack@director ~]$ sudo subscription-manager repos --enable=rhel-7-server-rpms --enable=rhel-7-server-extras-rpms --enable=rhel-7-server-rh-common-rpms --enable=rhel-ha-for-rhel-7-server-rpms --enable=rhel-7-server-openstack-14-rpms

これらのリポジトリーには、director のインストールに必要なパッケージが含まれます。

システムで更新を実行して、ベースシステムパッケージを最新の状態にします。

[stack@director ~]$ sudo yum update -y [stack@director ~]$ sudo reboot

director のインストールと設定を行うためのコマンドラインツールをインストールします。

[stack@director ~]$ sudo yum install -y python-tripleoclient

Ceph Storage ノードを使ってオーバークラウドを作成する場合は、さらに

ceph-ansibleパッケージをインストールします。[stack@director ~]$ sudo yum install -y ceph-ansible

3.2. コンテナーイメージの準備

アンダークラウドの設定には、イメージの取得先およびその保存方法を定義するための初期レジストリーの設定が必要です。以下のプロセスで、コンテナーイメージを準備するための環境ファイルを生成およびカスタマイズする方法を説明します。

手順

- アンダークラウドホストに stack ユーザーとしてログインします。

デフォルトのコンテナーイメージ準備ファイルを生成します。

$ openstack tripleo container image prepare default \ --local-push-destination \ --output-env-file containers-prepare-parameter.yaml

上記のコマンドでは、以下の追加オプションを使用しています。

-

--local-push-destination: コンテナーイメージの保管場所として、アンダークラウド上のレジストリーを設定します。つまり、director は必要なイメージを Red Hat Container Catalog からプルし、それをアンダークラウド上のレジストリーにプッシュします。アンダークラウドのインストール時に、director はこのレジストリーをコンテナーイメージのソースとして使用します。Red Hat Container Catalog から直接プルする場合には、このオプションを省略します。 --output-env-file: 環境ファイルの名前です。このファイルには、アンダークラウド用コンテナーイメージを準備するためのパラメーターが含まれます。ここでは、ファイル名をcontainers-prepare-parameter.yamlとしています。注記オーバークラウドをデプロイする場合にも、コンテナーイメージのソースを定義するのに

containers-prepare-parameter.yamlファイルを使用することができます。

-

-

containers-prepare-parameter.yamlを編集し、必要に応じて変更を加えます。

3.3. コンテナーイメージ準備のパラメーター

コンテナー準備用のこのデフォルトファイル (containers-prepare-parameter.yaml) には、ContainerImagePrepare Heat パラメーターが含まれます。このパラメーターで、イメージのセットを準備するためのさまざまな設定を定義します。

parameter_defaults: ContainerImagePrepare: - (strategy one) - (strategy two) - (strategy three) ...

それぞれの設定では、サブパラメーターのセットにより使用するイメージやイメージの使用方法を定義することができます。ContainerImagePrepare の各設定で使用するサブパラメーターの一覧を、以下の表に示します。

| パラメーター | 説明 |

|---|---|

|

|

目的のイメージのタグに追加する文字列 |

|

|

除外フィルターに使用するイメージ名に含まれる文字列のリスト |

|

|

イメージ名に含まれる文字列のリスト。少なくとも 1 つのイメージ名が一致している必要があります。includes パラメーターを指定すると、excludes の設定はすべて無視されます。 |

|

|

イメージのアップロード中 (ただし目的のレジストリーにプッシュする前) に実行する Ansible ロール名の文字列 |

|

|

|

|

|

変更するイメージを絞り込むのに使用するイメージラベルのディクショナリー。イメージが定義したラベルと一致する場合には、director はそのイメージを変更プロセスに含めます。 |

|

|

アップロードプロセス中にイメージをプッシュするレジストリーの名前空間。このパラメーターで名前空間を指定すると、すべてのイメージパラメーターでもこの名前空間が使用されます。 |

|

|

元のコンテナーイメージをプルするソースレジストリー |

|

|

初期イメージの取得場所を定義する、 |

|

|

得られたイメージをタグ付けするラベルパターンを定義します。通常は、 |

set パラメーターには、複数の キー:値 定義を設定することができます。それらのキーの一覧を、以下の表に示します。

| キー | 説明 |

|---|---|

|

|

Ceph Storage コンテナーイメージの名前 |

|

|

Ceph Storage コンテナーイメージの名前空間 |

|

|

Ceph Storage コンテナーイメージのタグ |

|

|

各 OpenStack サービスイメージの接頭辞 |

|

|

各 OpenStack サービスイメージの接尾辞 |

|

|

各 OpenStack サービスイメージの名前空間 |

|

|

使用する OpenStack Networking (neutron) コンテナーを定義するのに使用するドライバー。標準の |

|

|

プルするイメージを識別するタグ |

set セクションには、openshift_ で始まるさまざまなパラメーターを含めることができます。これらのパラメーターは、「OpenShift on OpenStack」を用いるさまざまなシナリオに使用されます。

3.4. イメージ準備エントリーの階層化

ContainerImagePrepare の値は YAML リストです。したがって、複数のエントリーを指定することができます。以下の例で、2 つのエントリーを指定するケースを説明します。この場合、director はすべてのイメージの最新バージョンを使用しますが、nova-api イメージについてのみ、14.0-44 とタグ付けされたバージョンを使用します。

ContainerImagePrepare:

- tag_from_label: "{version}-{release}"

push_destination: true

excludes:

- nova-api

set:

namespace: registry.access.redhat.com/rhosp14

name_prefix: openstack-

name_suffix: ''

tag: latest

- push_destination: true

includes:

- nova-api

set:

namespace: registry.access.redhat.com/rhosp14

tag: 14.0-44

includes および excludes のエントリーで、それぞれのエントリーでのイメージ絞り込み方法をコントロールします。includes 設定と一致するイメージが、excludes と一致するイメージに優先します。一致するとみなされるためには、イメージ名に設定値が含まれていなければなりません。

3.5. 準備プロセスにおけるイメージの変更

準備プロセス中にイメージを変更して必要な修正を加え、直ちにこれらの変更を反映してデプロイすることが可能です。イメージを変更するユースケースを以下に示します。

- デプロイメント前にテスト中の修正でイメージが変更される、継続的インテグレーションのパイプラインの一部として。

- ローカルの変更をテストおよび開発のためにデプロイしなければならない、開発ワークフローの一部として。

- 変更をデプロイしなければならないが、イメージビルドパイプラインでは利用することができない場合 (プロプライエタリーのアドオン、緊急の修正)。

変更が必要な各イメージで Ansible ロールを呼び出して、変更を行います。ロールはソースイメージを取得して必要な変更を行った後に、その結果をタグ付けします。続いて prepare コマンドでイメージをプッシュし、変更したイメージを参照するように heat パラメーターを設定することができます。

Ansible ロール tripleo-modify-image は要求されたロールインターフェースに従い、変更のユースケースに必要な処理を行います。変更は、ContainerImagePrepare パラメーターの modify 固有のキーでコントロールします。

-

modify_roleでは、変更する各イメージについて呼び出す Ansible ロールを指定します。 -

modify_append_tagは、ソースイメージタグの最後に文字列を追加するのに使用します。これにより、そのイメージが変更されていることが明確になります。すでに push_destination レジストリーに変更されたイメージが含まれている場合には、このパラメーターを使用して変更を省略することもできます。したがって、イメージを変更する場合には、必ず modify_append_tag を変更することを推奨します。 -

modify_varsは、ロールに渡す Ansible 変数のディクショナリーです。

ロール tripleo-modify-image が処理する別のユースケースを選択するには、tasks_from 変数をそのロールで必要なファイルに設定します。

イメージを変更する ContainerImagePrepare エントリーを開発およびテストする場合には、イメージが想定どおりに変更されていることを確認するために、prepare コマンド単体で実行することを推奨します。

sudo openstack tripleo container image prepare \ -e ~/containers-prepare-parameter.yaml

3.6. コンテナーイメージの既存パッケージの更新

以下のエントリーにより、イメージのパッケージが全て更新されます。ただし、アンダークラウドホストの yum リポジトリー設定が使用されます。

ContainerImagePrepare:

- push_destination: true

...

modify_role: tripleo-modify-image

modify_append_tag: "-updated"

modify_vars:

tasks_from: yum_update.yml

compare_host_packages: true

yum_repos_dir_path: /etc/yum.repos.d

...3.7. コンテナーイメージへの追加 RPM ファイルのインストール

RPM ファイルのディレクトリーをインストールすることができます。この機能は、ホットフィックス、ローカルパッケージビルド、またはパッケージリポジトリーからは入手できないパッケージのインストールに役立ちます。たとえば、以下のエントリーにより、centos-binary-nova-compute イメージだけにホットフィックスパッケージがインストールされます。

ContainerImagePrepare:

- push_destination: true

...

includes:

- nova-compute

modify_role: tripleo-modify-image

modify_append_tag: "-hotfix"

modify_vars:

tasks_from: rpm_install.yml

rpms_path: /home/stack/nova-hotfix-pkgs

...3.8. カスタム Dockerfile を使用したコンテナーイメージの変更

柔軟性を高めるために、Dockerfile を含むディレクトリーを指定して必要な変更を加えることが可能です。ロールが呼び出されると、Dockerfile.modified ファイルが生成され、これにより FROM ディレクティブが変更され新たな LABEL ディレクティブが追加されます。以下の例では、centos-binary-nova-compute イメージでカスタム Dockerfile が実行されます。

ContainerImagePrepare:

- push_destination: true

...

includes:

- nova-compute

modify_role: tripleo-modify-image

modify_append_tag: "-hotfix"

modify_vars:

tasks_from: modify_image.yml

modify_dir_path: /home/stack/nova-custom

.../home/stack/nova-custom/Dockerfile の例を以下に示します。USER root ディレクティブを実行した後は、元のイメージのデフォルトユーザーに戻す必要があります。

FROM docker.io/tripleomaster/centos-binary-nova-compute:latest USER root COPY customize.sh /tmp/ RUN /tmp/customize.sh USER "nova"

3.9. コンテナーイメージ管理用 Satellite サーバーの準備

Red Hat Satellite 6 には、レジストリーの同期機能が備わっています。これにより、複数のイメージを Satellite サーバーにプルし、アプリケーションライフサイクルの一環として管理することができます。また、他のコンテナー対応システムも Satellite をレジストリーとして使うことができます。コンテナーイメージ管理の詳細は、『Red Hat Satellite 6 コンテンツ管理ガイド』の「コンテナーイメージの管理」を参照してください。

以下の手順は、Red Hat Satellite 6 の hammer コマンドラインツールを使用した例を示しています。組織には、例として ACME という名称を使用しています。この組織は、実際に使用する Satellite 6 の組織に置き換えてください。

手順

デフォルトのオーバークラウドおよびアンダークラウド用に利用可能な全コンテナーイメージの一覧を作成します。

$ openstack overcloud container image prepare \ -r /usr/share/openstack-tripleo-heat-templates/roles_data.yaml \ --output-images-file /home/stack/satellite_images_overcloud $ openstack overcloud container image prepare \ -r /usr/share/openstack-tripleo-heat-templates/roles_data_undercloud.yaml \ --output-images-file /home/stack/satellite_images_undercloud

- これで、コンテナーイメージ情報が含まれる 2 つのファイルが作成されます。このファイルを使用して、コンテナーイメージを Satellite 6 サーバーに同期します。

ファイルから YAML 固有の情報を削除して、個別のイメージ一覧のみが記載されたフラットファイルにマージします。この操作は、以下のコマンドで実行します。

$ awk -F ':' '{if (NR!=1) {gsub("[[:space:]]", ""); print $2}}' ~/satellite_images_overcloud | sed "s/registry.access.redhat.com\///g" > ~/satellite_images_overcloud_names $ awk -F ':' '{if (NR!=1) {gsub("[[:space:]]", ""); print $2}}' ~/satellite_images_undercloud | sed "s/registry.access.redhat.com\///g" > ~/satellite_images_undercloud_names $ cat ~/satellite_images_overcloud_names ~/satellite_images_undercloud_names | sort | uniq > ~/satellite_images_namesこれにより、Satellite サーバーにプルするイメージのリストが提供されます。

-

satellite_images_namesファイルを、Satellite 6 のhammerツールが含まれるシステムにコピーします。あるいは、『Hammer CLI ガイド』に記載の手順に従って、hammerツールをアンダークラウドにインストールします。 以下の

hammerコマンドを実行して、実際の Satellite 組織に新規製品 (OSP14 Containers) を作成します。$ hammer product create \ --organization "ACME" \ --name "OSP14 Containers"

このカスタム製品に、イメージを保管します。

製品にベースコンテナーイメージを追加します。

$ hammer repository create \ --organization "ACME" \ --product "OSP14 Containers" \ --content-type docker \ --url https://registry.access.redhat.com \ --docker-upstream-name rhosp14/openstack-base \ --name base

satellite_imagesファイルからオーバークラウドのコンテナーイメージを追加します。$ while read IMAGE; do \ IMAGENAME=$(echo $IMAGE | cut -d"/" -f2 | sed "s/openstack-//g" | sed "s/:.*//g") ; \ hammer repository create \ --organization "ACME" \ --product "OSP14 Containers" \ --content-type docker \ --url https://registry.access.redhat.com \ --docker-upstream-name $IMAGE \ --name $IMAGENAME ; done < satellite_images_names

コンテナーイメージを同期します。

$ hammer product synchronize \ --organization "ACME" \ --name "OSP14 Containers"

Satellite サーバーが同期を完了するまで待ちます。

注記設定によっては、

hammerから Satellite サーバーのユーザー名およびパスワードが要求される場合があります。設定ファイルを使って自動的にログインするようにhammerを設定することができます。詳細は、『Hammer CLI ガイド』の「認証」セクションを参照してください。-

お使いの Satellite 6 サーバーでコンテンツビューが使われている場合には、新たなバージョンのコンテンツビューを作成してイメージを反映し、アプリケーションライフサイクルの環境に従ってプロモートします。この作業は、アプリケーションライフサイクルの構成状況に大きく依存します。たとえば、ライフサイクルで

productionという名称の環境を使用していて、その環境でコンテナーイメージを利用可能にする場合には、コンテナーイメージを含むコンテンツビューを作成し、そのコンテンツビューをproduction環境にプロモートします。詳細は、『Red Hat Satellite コンテンツ管理ガイド』の「コンテンツビューによるコンテナーイメージの管理」を参照してください。 baseイメージに利用可能なタグを確認します。$ hammer docker tag list --repository "base" \ --organization "ACME" \ --environment "production" \ --content-view "myosp14" \ --product "OSP14 Containers"

このコマンドにより、特定環境のコンテンツビューでの OpenStack Platform コンテナーイメージのタグが表示されます。

アンダークラウドに戻り、Satellite サーバーをソースとして使用して、イメージ準備用のデフォルト環境ファイルを生成します。環境ファイルを生成するコマンドの例を以下に示します。

(undercloud) $ openstack tripleo container image prepare default \ --output-env-file containers-prepare-parameter.yaml

-

--output-env-file: 環境ファイルの名前です。このファイルには、アンダークラウド用コンテナーイメージを準備するためのパラメーターが含まれます。ここでは、ファイル名をcontainers-prepare-parameter.yamlとしています。

-

containers-prepare-parameter.yamlファイルを編集して以下のパラメーターを変更します。-

namespace: Satellite サーバー上のレジストリーの URL およびポート。Red Hat Satellite のデフォルトのレジストリーポートは 5000 です。 name_prefix: プレフィックスは Satellite 6 の命名規則に基づきます。これは、コンテンツビューを使用するかどうかによって異なります。-

コンテンツビューを使用する場合、構成は

[org]-[environment]-[content view]-[product]-となります (例:acme-production-myosp14-osp14_containers-)。 -

コンテンツビューを使用しない場合、構成は

[org]-[product]-となります (例:acme-osp14_containers-)。

-

コンテンツビューを使用する場合、構成は

-

ceph_namespace、ceph_image、ceph_tag: Ceph Storage を使用する場合には、Ceph Storage のコンテナーイメージの場所を定義する追加のパラメーターを指定します。ceph_imageに Satellite 固有のプレフィックスが追加された点に注意してください。このプレフィックスは、name_prefixオプションと同じ値です。

-

Satellite 固有のパラメーターが含まれる環境ファイルの例を以下に示します。

parameter_defaults:

ContainerImagePrepare:

- push_destination: true

set:

ceph_image: acme-production-myosp14-osp14_containers-rhceph-3-rhel7

ceph_namespace: satellite.example.com:5000

ceph_tag: latest

name_prefix: acme-production-myosp14-osp14_containers-

name_suffix: ''

namespace: satellite.example.com:5000

neutron_driver: null

tag: latest

...

tag_from_label: '{version}-{release}'アンダークラウドおよびオーバークラウドの両方を作成する際に、この環境ファイルを使用します。

第4章 director のインストール

4.1. director の設定

director のインストールプロセスには、ネットワーク設定を判断する特定の設定が必要です。この設定は、stack ユーザーのホームディレクトリーに undercloud.conf として配置されているテンプレートに保存されています。以下の手順では、デフォルトのテンプレートをベースに使用して設定を行う方法についてを説明します。

手順

Red Hat は、インストールに必要な設定を判断しやすいように、基本テンプレートを提供しています。このテンプレートは、

stackユーザーのホームディレクトリーにコピーします。[stack@director ~]$ cp \ /usr/share/python-tripleoclient/undercloud.conf.sample \ ~/undercloud.conf

-

undercloud.confファイルを編集します。このファイルには、アンダークラウドを設定するための設定値が含まれています。パラメーターを省略したり、コメントアウトした場合には、アンダークラウドのインストールでデフォルト値が使用されます。

4.2. director の設定パラメーター

undercloud.conf ファイルで設定するパラメーターの一覧を以下に示します。

デフォルト

undercloud.conf ファイルの [DEFAULT] セクションで定義されているパラメーターを以下に示します。

- additional_architectures

オーバークラウドがサポートする追加の (カーネル) アーキテクチャーの一覧。現在、このパラメーターの値は

ppc64leだけに制限されています。注記ppc64le のサポートを有効にする場合には、

ipxe_enabledをFalseに設定する必要もあります。- certificate_generation_ca

-

要求した証明書を署名する CA の

certmongerのニックネーム。generate_service_certificateパラメーターを設定した場合のみこのオプションを使用します。localCA を選択する場合は、certmonger はローカルの CA 証明書を/etc/pki/ca-trust/source/anchors/cm-local-ca.pemに抽出して、トラストチェーンに追加します。 - clean_nodes

- デプロイメントを再実行する前とイントロスペクションの後にハードドライブを消去するかどうかを定義します。

- cleanup

-

一時ファイルをクリーンナップします。このパラメーターを

Falseに設定すると、デプロイメント時に使用した一時ファイルをコマンド実行後もそのまま残します。ファイルを残すと、生成されたファイルのデバッグを行う場合やエラーが発生した場合に役に立ちます。 - container_images_file

コンテナーイメージ情報が含まれる Heat 環境ファイル。このパラメーターは、以下のいずれかに設定します。

- 必要なすべてのコンテナーイメージのパラメーター。

-

必要なイメージの準備を実施する

ContainerImagePrepareパラメーター。このパラメーターが含まれるファイルの名前は、通常containers-prepare-parameter.yamlです。

- custom_env_files

- アンダークラウドのインストールに追加する新たな環境ファイル。

- deployment_user

-

アンダークラウドをインストールするユーザー。現在のデフォルトユーザー (

stack) を使用する場合には、このパラメーターを未設定のままにします。 - discovery_default_driver

-

自動的に登録されたノードのデフォルトドライバーを設定します。

enable_node_discoveryを有効にし、enabled_hardware_typesファイルにドライバーを含める必要があります。 - docker_insecure_registries

-

使用する

dockerのセキュアではないレジストリーの一覧。プライベートコンテナーレジストリー等の別のソースからイメージをプルする場合には、通常このパラメーターが必要になります。多くの場合、docker は Red Hat Container Catalog または Satellite サーバー (アンダークラウドが登録されている場合) のどちらかからコンテナーイメージをプルするための証明書を持ちます。 - docker_registry_mirror

-

/etc/docker/daemon.jsonで設定されるオプションのregistry-mirror。 - enable_ironic、enable_ironic_inspector、enable_mistral、enable_tempest、enable_validations、enable_zaqar

-

director で有効にするコアサービスを定義します。

trueに設定されたままにします。 - enable_ui

-

director の Web UI をインストールするかどうかを定義します。これにより、グラフィカル Web インターフェースを使用して、オーバークラウドのプランニングやデプロイメントが可能になります。UI は、

undercloud_service_certificateまたはgenerate_service_certificateのいずれかを使用して SSL/TLS を有効にしている場合にのみ使用できる点にご注意ください。 - enable_node_discovery

-

イントロスペクションの ramdisk を PXE ブートする不明なノードを自動的に登録します。新規ノードは、

fake_pxeドライバーをデフォルトとして使用しますが、discovery_default_driverを設定して上書きすることもできます。また、イントロスペクションルールを使用して、新しく登録したノードにドライバーの情報を指定することもできます。 - enable_novajoin

-

アンダークラウドの

novajoinメタデータサービスをインストールするかどうかを定義します。 - enable_routed_networks

- ルーティングされたコントロールプレーンネットワークのサポートを有効にします。

- enable_swift_encryption

- 保存データの Swift 暗号化を有効にするかどうかを定義します。

- enable_telemetry

-

アンダークラウドに OpenStack Telemetry サービス (ceilometer、aodh、panko、gnocchi) をインストールするかどうかを定義します。Red Hat OpenStack Platform では、Telemetry のメトリックバックエンドは gnocchi によって提供されます。

enable_telemetryパラメーターをtrueに設定すると、Telemetry サービスが自動的にインストール/設定されます。デフォルト値はfalseで、アンダークラウド上の telemetry が無効になります。このパラメーターは、Red Hat CloudForms などのメトリックデータを消費する他の製品を使用している場合に必要です。 - enabled_hardware_types

- アンダークラウドで有効にするハードウェアタイプの一覧。

- generate_service_certificate

-

アンダークラウドのインストール時に SSL/TLS 証明書を生成するかを定義します。これは

undercloud_service_certificateパラメーターに使用します。アンダークラウドのインストールで、作成された証明書/etc/pki/tls/certs/undercloud-[undercloud_public_vip].pemを保存します。certificate_generation_caパラメーターで定義される CA はこの証明書を署名します。 - heat_container_image

- 使用する heat コンテナーイメージの URL。未設定のままにします。

- heat_native

-

ネイティブの heat テンプレートを使用します。

trueのままにします。 - hieradata_override

-

hieradataオーバーライドファイルへのパス。設定されている場合は、アンダークラウドのインストールでこのファイルが/etc/puppet/hieradataにコピーされ、この階層の最初のファイルとして設定されます。サービスに対して、undercloud.confパラメーター以外に、サービスに対するカスタム設定を行うには、これを使用します。 - inspection_extras

-

イントロスペクション時に追加のハードウェアコレクションを有効化するかどうかを定義します。イントロスペクションイメージでは

python-hardwareまたはpython-hardware-detectパッケージが必要です。 - inspection_interface

-

ノードのイントロスペクションに director が使用するブリッジ。これは、director の設定により作成されるカスタムのブリッジです。

LOCAL_INTERFACEでこのブリッジをアタッチします。これは、デフォルトのbr-ctlplaneのままにします。 - inspection_runbench

-

ノードのイントロスペクション時に一連のベンチマークを実行します。有効にするには、

trueに設定します。このオプションは、登録ノードのハードウェアを検査する際にベンチマーク分析を実行する場合に必要です。 - ipa_otp

-

IPA サーバーにアンダークラウドノードを登録するためのワンタイムパスワードを定義します。これは、

enable_novajoinが有効な場合に必要です。 - ipxe_enabled

-

iPXE と標準の PXE のどちらを使用するかを定義します。デフォルトは

trueで、iPXE を有効にします。標準の PXE を選択するには、falseに設定します。 - local_interface

director のプロビジョニング NIC 用に選択するインターフェース。これは、director が DHCP および PXE ブートサービスに使用するデバイスでもあります。どのデバイスが接続されているかを確認するには、

ip addrコマンドを使用します。以下にip addrコマンドの出力結果の例を示します。2: eth0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP qlen 1000 link/ether 52:54:00:75:24:09 brd ff:ff:ff:ff:ff:ff inet 192.168.122.178/24 brd 192.168.122.255 scope global dynamic eth0 valid_lft 3462sec preferred_lft 3462sec inet6 fe80::5054:ff:fe75:2409/64 scope link valid_lft forever preferred_lft forever 3: eth1: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noop state DOWN link/ether 42:0b:c2:a5:c1:26 brd ff:ff:ff:ff:ff:ffこの例では、外部 NIC は

eth0を、プロビジョニング NIC は未設定のeth1を使用します。今回は、local_interfaceをeth1に設定します。この設定スクリプトにより、このインターフェースがinspection_interfaceパラメーターで定義したカスタムのブリッジにアタッチされます。- local_ip

-

director のプロビジョニング NIC 用に定義する IP アドレス。これは、director が DHCP および PXE ブートサービスに使用する IP アドレスでもあります。環境内の既存の IP アドレスまたはサブネットと競合するなど、プロビジョニングネットワークに別のサブネットを使用する場合以外は、この値はデフォルトの

192.168.24.1/24のままにします。 - local_mtu

-

local_interfaceに使用する MTU。 - local_subnet

-

PXE ブートと DHCP インターフェースに使用するローカルサブネット。

local_ipアドレスがこのサブネットに含まれている必要があります。デフォルトはctlplane-subnetです。 - net_config_override

-

ネットワーク設定のオーバーライドテンプレートへのパス。これが設定されている場合にはアンダークラウドは JSON 形式のテンプレートを使用して

os-net-configでネットワークを設定します。これは、undercloud.confに設定されているネットワークパラメーターを無視します。/usr/share/python-tripleoclient/undercloud.conf.sampleの例を参照してください。 - output_dir

- 状態、処理された heat テンプレート、および Ansible デプロイメントファイルを出力するディレクトリー。

- overcloud_domain_name

オーバークラウドのデプロイ時に使用する DNS ドメイン名。

注記オーバークラウドのパラメーター

CloudDomainは対応する一致する値に設定する必要があります。- roles_file

- オーバークラウドのインストールで上書きするロールファイル。director のインストールにデフォルトのロールファイルが使用されるように、未設定のままにすることを強く推奨します。

- scheduler_max_attempts

- スケジューラーがインスタンスのデプロイを試行する最大回数。これは、スケジューリング時に競合状態にならないように、1 度にデプロイする予定のベアメタルノードの数以上に指定するようにしてください。

- service_principal

- この証明書を使用するサービスの Kerberos プリンシパル。CA で FreeIPA などの Kerberos プリンシパルが必要な場合にのみ使用します。

- subnets

-

プロビジョニングおよびイントロスペクション用のルーティングネットワークのサブネットの一覧。詳しくは、「サブネット」を参照してください。デフォルト値に含まれるのは、

ctlplane-subnetサブネットのみです。 - templates

- 上書きするヒートテンプレートファイル。

- undercloud_admin_host

-

SSL/TLS を使用する際に、director の管理 API 用に定義する IP アドレス。これは、SSL/TLS で管理エンドポイントにアクセスするための IP アドレスです。director の設定により、この IP アドレスは

/32ネットマスクを使用するルーティングされた IP アドレスとしてソフトウェアブリッジに接続されます。 - undercloud_debug

-

アンダークラウドサービスのログレベルを

DEBUGに設定します。この値はtrueに設定して有効化します。 - undercloud_enable_selinux

-

デプロイメント時に、SELinux を有効または無効にします。問題をデバッグする場合以外は、

trueに設定されたままにすることを強く推奨します。 - undercloud_hostname

- アンダークラウドの完全修飾ホスト名を定義します。設定されている場合には、アンダークラウドのインストールで全システムのホスト名が設定されます。設定されていない場合には、アンダークラウドは現在のホスト名を使用しますが、ユーザーは適切に全システムのホスト名の設定を行う必要があります。

- undercloud_log_file

-

アンダークラウドのインストール/アップグレードログを保管するログファイルへのパス。デフォルトでは、ログファイルはホームディレクトリー内の

install-undercloud.logです (例:/home/stack/install-undercloud.log)。 - undercloud_nameservers

- アンダークラウドのホスト名解決に使用する DNS ネームサーバーの一覧

- undercloud_ntp_servers

- アンダークラウドの日付と時間を同期できるようにする Network Time Protocol サーバーの一覧

- undercloud_public_host

-

SSL/TLS を使用する際に、director のパブリック API 用に定義する IP アドレス。これは、SSL/TLS で外部の director エンドポイントにアクセスするための IP アドレスです。director の設定により、この IP アドレスは

/32ネットマスクを使用するルーティングされた IP アドレスとしてソフトウェアブリッジに接続されます。 - undercloud_service_certificate

- OpenStack SSL/TLS 通信の証明書の場所とファイル名。理想的には、信頼できる認証局からこの証明書を取得します。それ以外の場合は、独自の自己署名の証明書を作成します。

- undercloud_update_packages

- アンダークラウドのインストール時にパッケージを更新するかどうかを定義します。

サブネット

undercloud.conf ファイルには、各プロビジョニングサブネットの名前が付いたセクションがあります。たとえば、ctlplane-subnet という名前のサブネットを作成するとセクションは以下のようになります。

[ctlplane-subnet] cidr = 192.168.24.0/24 dhcp_start = 192.168.24.5 dhcp_end = 192.168.24.24 inspection_iprange = 192.168.24.100,192.168.24.120 gateway = 192.168.24.1 masquerade = true

プロビジョニングネットワークは、環境に応じて、必要なだけ指定することができます。

- gateway

-

オーバークラウドインスタンスのゲートウェイ。外部ネットワークにトラフィックを転送するアンダークラウドのホストです。director に別の IP アドレスを使用する場合または外部ゲートウェイを直接使用する場合以外は、この値はデフォルト (

192.168.24.1) のままにします。

director の設定は、適切な sysctl カーネルパラメーターを使用して IP フォワーディングも自動的に有効にします。

- cidr

-

オーバークラウドインスタンスの管理に director が使用するネットワーク。これは、アンダークラウドの

neutronが管理するプロビジョニングネットワークです。プロビジョニングネットワークに別のサブネットを使用しない限り、この値はデフォルト (192.168.24.0/24) のままにします。 - masquerade

-

外部アクセス向けに、

cidrで定義したネットワークをマスカレードするかどうかを定義します。このパラメーターにより、director 経由で外部ネットワークにアクセスすることができるように、プロビジョニングネットワークにネットワークアドレス変換 (NAT) の一部メカニズムが提供されます。 - dhcp_start; dhcp_end

- オーバークラウドノードの DHCP 割り当て範囲 (開始アドレスと終了アドレス)。ノードを割り当てるのに十分な IP アドレスがこの範囲に含まれるようにします。

これらのパラメーターの値は、構成に応じて変更してください。完了したら、ファイルを保存します。

4.3. director のインストール

以下の手順では、director をインストールしてインストール後の基本的なタスクを実行します。

手順

以下のコマンドを実行して、アンダークラウドに director をインストールします。

[stack@director ~]$ openstack undercloud install

このコマンドで、director の設定スクリプトを起動します。director により、追加のパッケージがインストールされ、

undercloud.confの設定に合わせてサービスを設定します。このスクリプトは、完了までに数分かかります。スクリプトにより、完了時には 2 つのファイルが生成されます。

-

undercloud-passwords.conf: director サービスの全パスワード一覧 -

stackrc: director のコマンドラインツールへアクセスできるようにする初期化変数セット

-

このスクリプトは、全 OpenStack Platform サービスのコンテナーも自動的に起動します。以下のコマンドを使用して、有効化されたコンテナーを確認してください。

[stack@director ~]$ sudo docker ps

スクリプトにより、

dockerグループにstackユーザーも追加され、そのstackユーザーはコンテナー管理コマンドを使用できるようになります。stackユーザーのアクセス権限を最新の状態に更新するには、以下のコマンドを実行します。[stack@director ~]$ exec su -l stack

このコマンドでは再度ログインを要求されます。stack ユーザーのパスワードを入力します。

stackユーザーを初期化してコマンドラインツールを使用するには、以下のコマンドを実行します。[stack@director ~]$ source ~/stackrc

プロンプトには、OpenStack コマンドがアンダークラウドに対して認証および実行されることが表示されるようになります。

(undercloud) [stack@director ~]$

director のインストールが完了しました。これで、director のコマンドラインツールが使用できるようになりました。

4.4. オーバークラウドノードのイメージの取得

director では、オーバークラウドのノードをプロビジョニングする際に、複数のディスクが必要です。必要なディスクは以下のとおりです。

- イントロスペクションのカーネルおよび ramdisk: PXE ブートでベアメタルシステムのイントロスペクションに使用

- デプロイメントカーネルおよび ramdisk: システムのプロビジョニングおよびデプロイメントに使用

- オーバークラウドカーネル、ramdisk、完全なイメージ: ノードのハードディスクに書き込まれるベースのオーバークラウドシステム

以下の手順は、これらのイメージの取得およびインストールの方法について説明します。

4.4.1. 単一アーキテクチャーのオーバークラウド

デプロイメントおよびオーバークラウドには、以下のイメージおよび手順が必要です。

手順

stackrcファイルを読み込んで、director のコマンドラインツールを有効にします。[stack@director ~]$ source ~/stackrc

rhosp-director-imagesおよびrhosp-director-images-ipaパッケージをインストールします。(undercloud) [stack@director ~]$ sudo yum install rhosp-director-images rhosp-director-images-ipa

stackユーザーのホームのimagesディレクトリー (/home/stack/images) にイメージアーカイブを展開します。(undercloud) [stack@director ~]$ cd ~/images (undercloud) [stack@director images]$ for i in /usr/share/rhosp-director-images/overcloud-full-latest-14.0.tar /usr/share/rhosp-director-images/ironic-python-agent-latest-14.0.tar; do tar -xvf $i; done

これらのイメージを director にインポートします。

(undercloud) [stack@director images]$ openstack overcloud image upload --image-path /home/stack/images/

このコマンドにより、以下のイメージが director にアップロードされます。

-

bm-deploy-kernel -

bm-deploy-ramdisk -

overcloud-full -

overcloud-full-initrd -

overcloud-full-vmlinuz

スクリプトにより、director の PXE サーバー上にイントロスペクションイメージもインストールされます。

-

これらのイメージが正常にアップロードされたことを確認するには、以下のコマンドを実行します。

(undercloud) [stack@director images]$ openstack image list +--------------------------------------+------------------------+ | ID | Name | +--------------------------------------+------------------------+ | 765a46af-4417-4592-91e5-a300ead3faf6 | bm-deploy-ramdisk | | 09b40e3d-0382-4925-a356-3a4b4f36b514 | bm-deploy-kernel | | ef793cd0-e65c-456a-a675-63cd57610bd5 | overcloud-full | | 9a51a6cb-4670-40de-b64b-b70f4dd44152 | overcloud-full-initrd | | 4f7e33f4-d617-47c1-b36f-cbe90f132e5d | overcloud-full-vmlinuz | +--------------------------------------+------------------------+

この一覧には、イントロスペクションの PXE イメージは表示されません。director は、これらのファイルを

/httpbootにコピーします。(undercloud) [stack@director images]$ ls -l /httpboot total 341460 -rwxr-xr-x. 1 root root 5153184 Mar 31 06:58 agent.kernel -rw-r--r--. 1 root root 344491465 Mar 31 06:59 agent.ramdisk -rw-r--r--. 1 ironic-inspector ironic-inspector 337 Mar 31 06:23 inspector.ipxe

4.4.2. 複数のアーキテクチャーのオーバークラウド

デプロイメントおよびオーバークラウドには、以下のイメージおよび手順が必要です。

手順

stackrcファイルを読み込んで、director のコマンドラインツールを有効にします。[stack@director ~]$ source ~/stackrc

rhosp-director-images-allパッケージをインストールします。(undercloud) [stack@director ~]$ sudo yum install rhosp-director-images-all

アーキテクチャー個別のディレクトリーにアーカイブを展開します。このディレクトリーは、

stackユーザーのホームのimagesディレクトリー (/home/stack/images) 下に作成します。(undercloud) [stack@director ~]$ cd ~/images (undercloud) [stack@director images]$ for arch in x86_64 ppc64le ; do mkdir $arch ; done (undercloud) [stack@director images]$ for arch in x86_64 ppc64le ; do for i in /usr/share/rhosp-director-images/overcloud-full-latest-14.0-${arch}.tar /usr/share/rhosp-director-images/ironic-python-agent-latest-14.0-${arch}.tar ; do tar -C $arch -xf $i ; done ; doneこれらのイメージを director にインポートします。

(undercloud) [stack@director ~]$ cd ~/images (undercloud) [stack@director images]$ openstack overcloud image upload --image-path ~/images/ppc64le --architecture ppc64le --whole-disk --http-boot /tftpboot/ppc64le (undercloud) [stack@director images]$ openstack overcloud image upload --image-path ~/images/x86_64/ --http-boot /tftpboot

このコマンドにより、以下のイメージが director にアップロードされます。

-

bm-deploy-kernel -

bm-deploy-ramdisk -

overcloud-full -

overcloud-full-initrd -

overcloud-full-vmlinuz -

ppc64le-bm-deploy-kernel -

ppc64le-bm-deploy-ramdisk ppc64le-overcloud-fullスクリプトにより、director の PXE サーバー上にイントロスペクションイメージもインストールされます。

-

これらのイメージが正常にアップロードされたことを確認するには、以下のコマンドを実行します。

(undercloud) [stack@director images]$ openstack image list +--------------------------------------+---------------------------+--------+ | ID | Name | Status | +--------------------------------------+---------------------------+--------+ | 6d1005ba-ec82-473b-8e33-88aadb5b6792 | bm-deploy-kernel | active | | fb723b33-9f11-45f5-b25b-c008bf509290 | bm-deploy-ramdisk | active | | 6a6096ba-8f79-4343-b77c-4349f7b94960 | overcloud-full | active | | de2a1bde-9351-40d2-bbd7-7ce9d6eb50d8 | overcloud-full-initrd | active | | 67073533-dd2a-4a95-8e8b-0f108f031092 | overcloud-full-vmlinuz | active | | 69a9ffe5-06dc-4d81-a122-e5d56ed46c98 | ppc64le-bm-deploy-kernel | active | | 464dd809-f130-4055-9a39-cf6b63c1944e | ppc64le-bm-deploy-ramdisk | active | | f0fedcd0-3f28-4b44-9c88-619419007a03 | ppc64le-overcloud-full | active | +--------------------------------------+---------------------------+--------+

この一覧には、イントロスペクションの PXE イメージは表示されません。director は、これらのファイルを

/tftpbootにコピーします。(undercloud) [stack@director images]$ ls -l /tftpboot /tftpboot/ppc64le/ /tftpboot: total 422624 -rwxr-xr-x. 1 root root 6385968 Aug 8 19:35 agent.kernel -rw-r--r--. 1 root root 425530268 Aug 8 19:35 agent.ramdisk -rwxr--r--. 1 ironic ironic 20832 Aug 8 02:08 chain.c32 -rwxr--r--. 1 ironic ironic 715584 Aug 8 02:06 ipxe.efi -rw-r--r--. 1 root root 22 Aug 8 02:06 map-file drwxr-xr-x. 2 ironic ironic 62 Aug 8 19:34 ppc64le -rwxr--r--. 1 ironic ironic 26826 Aug 8 02:08 pxelinux.0 drwxr-xr-x. 2 ironic ironic 21 Aug 8 02:06 pxelinux.cfg -rwxr--r--. 1 ironic ironic 69631 Aug 8 02:06 undionly.kpxe /tftpboot/ppc64le/: total 457204 -rwxr-xr-x. 1 root root 19858896 Aug 8 19:34 agent.kernel -rw-r--r--. 1 root root 448311235 Aug 8 19:34 agent.ramdisk -rw-r--r--. 1 ironic-inspector ironic-inspector 336 Aug 8 02:06 default

デフォルトの overcloud-full.qcow2 イメージは、フラットなパーティションイメージですが、ディスクイメージ全体をインポート、使用することも可能です。詳しい情報は、「付録C 完全なディスクイメージ」を参照してください。

4.5. コントロールプレーン用のネームサーバーの設定

オーバークラウドで cdn.redhat.com などの外部のホスト名を解決する予定の場合は、オーバークラウドノード上にネームサーバーを設定することを推奨します。ネットワークを分離していない標準のオーバークラウドの場合には、ネームサーバーはアンダークラウドのコントロールプレーンのサブネットを使用して定義されます。環境でネームサーバーを定義するには、以下の手順に従ってください。

手順

stackrcファイルを読み込んで、director のコマンドラインツールを有効にします。[stack@director ~]$ source ~/stackrc

ctlplane-subnetサブネット用のネームサーバーを設定します。(undercloud) [stack@director images]$ openstack subnet set --dns-nameserver [nameserver1-ip] --dns-nameserver [nameserver2-ip] ctlplane-subnet

各ネームサーバーに

--dns-nameserverオプションを使用します。サブネットを表示してネームサーバーを確認します。

(undercloud) [stack@director images]$ openstack subnet show ctlplane-subnet +-------------------+-----------------------------------------------+ | Field | Value | +-------------------+-----------------------------------------------+ | ... | | | dns_nameservers | 8.8.8.8 | | ... | | +-------------------+-----------------------------------------------+

サービストラフィックを別のネットワークに分離する場合は、オーバークラウドのノードはネットワーク環境ファイルの DnsServers パラメーターを使用します。

4.6. 次のステップ

これで director の設定およびインストールが完了しました。次の章では、ノードの登録、検査、さまざまなノードロールのタグ付けなど、オーバークラウドの基本的な設定について説明します。

パート II. 基本的なオーバークラウドのデプロイメント

第5章 オーバークラウドのプランニング

以下の項には、ノードロールの定義、ネットワークトポロジーのプランニング、ストレージなど、Red Hat OpenStack Platform 環境のさまざまな面のプランニングに関するガイドラインを記載します。

5.1. ノードロール

director はオーバークラウドの構築に、デフォルトで複数のノード種別を提供します。これらのノード種別は以下のとおりです。

- コントローラー

環境を制御するための主要なサービスを提供します。これには、Dashboard (Horizon)、認証 (Keystone)、イメージストレージ (Glance)、ネットワーク (Neutron)、オーケストレーション (Heat)、高可用性サービスが含まれます。高可用性の場合は、Red Hat OpenStack Platform 環境にコントローラーノードが 3 台必要です。

注記1 台のノードで構成される環境はテスト目的で使用することができます。2 台のノードまたは 4 台以上のノードで構成される環境はサポートされません。

- Compute

- ハイパーバイザーとして機能し、環境内で仮想マシンを実行するのに必要な処理能力を提供する物理サーバー。基本的な Red Hat OpenStack Platform 環境には少なくとも 1 つのコンピュートノードが必要です。

- Ceph Storage

- Red Hat Ceph Storage を提供するホスト。Ceph Storage ホストはクラスターに追加され、クラスターをスケーリングします。このデプロイメントロールはオプションです。

- Swift ストレージ

- OpenStack の Swift サービスに外部オブジェクトストレージを提供するホスト。このデプロイメントロールはオプションです。

以下の表には、オーバークラウドの構成例と各シナリオで使用するノードタイプの定義をまとめています。

表5.1 各種シナリオに使用するノードデプロイメントロール

|

コントローラー |

Compute |

Ceph Storage |

Swift ストレージ |

合計 | |

|

小規模のオーバークラウド |

3 |

1 |

- |

- |

4 |

|

中規模のオーバークラウド |

3 |

3 |

- |

- |

6 |

|

追加のオブジェクトストレージがある中規模のオーバークラウド |

3 |

3 |

- |

3 |

9 |

|

Ceph Storage クラスターがある中規模のオーバークラウド |

3 |

3 |

3 |

- |

9 |

さらに、個別のサービスをカスタムのロールに分割するかどうかを検討します。コンポーザブルロールのアーキテクチャーに関する詳しい情報は『オーバークラウドの高度なカスタマイズ』の「コンポーザブルサービスとカスタムロール」を参照してください。

5.2. オーバークラウドネットワーク

ロールとサービスを適切にマッピングして相互に正しく通信できるように、環境のネットワークトポロジーおよびサブネットのプランニングを行うことが重要です。Red Hat OpenStack Platform では、自律的に動作してソフトウェアベースのネットワーク、静的/Floating IP アドレス、DHCP を管理する Openstack Networking (neutron) サービスを使用します。

デフォルトでは、director は接続に プロビジョニング / コントロールプレーン を使用するようにノードを設定します。ただし、ネットワークトラフィックを一連の コンポーザブルネットワーク に分離し、カスタマイズしてサービスを割り当てることができます。

一般的な Red Hat OpenStack Platform のシステム環境では通常、ネットワーク種別の数は物理ネットワークのリンク数を超えます。全ネットワークを正しいホストに接続するには、オーバークラウドは VLAN タグ付けを使用して、1 つのインターフェースに複数のネットワークを提供します。ネットワークの多くは、サブネットが分離されていますが、インターネットアクセスまたはインフラストラクチャーにネットワーク接続ができるようにルーティングを提供するレイヤー 3 のゲートウェイが必要です。ネットワークトラフィックの種別を分離するのに VLAN を使用している場合には、802.1Q 標準をサポートするスイッチを使用してタグ付けされた VLAN を提供します。

デプロイ時に neutron VLAN モード (トンネリングは無効) を使用する場合でも、プロジェクトネットワーク (GRE または VXLAN でトンネリング) をデプロイすることを推奨します。これには、デプロイ時にマイナーなカスタマイズを行う必要があり、将来ユーティリティーネットワークまたは仮想化ネットワークとしてトンネルネットワークを使用するためのオプションが利用可能な状態になります。VLAN を使用してテナントネットワークを作成することは変わりませんが、テナントの VLAN を消費せずに特別な用途のネットワーク用に VXLAN トンネルを作成することも可能です。また、テナント VLAN を使用するデプロイメントに VXLAN 機能を追加することは可能ですが、サービスを中断せずにテナント VLAN を既存のオーバークラウドに追加することはできません。

director には、NIC を分離コンポーザブルネットワークと連携させるための、さまざまなテンプレートも用意されています。

- シングル NIC 構成: ネイティブ VLAN 上のプロビジョニングネットワークと、オーバークラウドネットワークの種別ごとのサブネットを使用するタグ付けされた VLAN 用に NIC を 1つ。

- ボンディングされた NIC 構成: ネイティブ VLAN 上のプロビジョニングネットワーク用に NIC を 1 つと、オーバークラウドネットワークの種別ごとのタグ付けされた VLAN 用にボンディング構成の 2 つの NIC。

- 複数 NIC 構成: 各 NIC は、オーバークラウドネットワークの種別ごとのサブセットを使用します。

専用のテンプレートを作成して、特定の NIC 構成をマッピングすることもできます。

ネットワーク構成を検討する上で、以下の点を考慮することも重要です。

- オーバークラウドの作成時には、全オーバークラウドマシンで 1 つの名前を使用して NIC を参照します。理想としては、混乱を避けるため、対象のネットワークごとに、各オーバークラウドノードで同じ NIC を使用してください。たとえば、プロビジョニングネットワークにはプライマリー NIC を使用して、OpenStack サービスにはセカンダリー NIC を使用します。

- すべてのオーバークラウドシステムをプロビジョニング NIC から PXE ブートするように設定して、同システム上の外部 NIC およびその他の NIC の PXE ブートを無効にします。また、プロビジョニング NIC の PXE ブートは、ハードディスクや CD/DVD ドライブよりも優先されるように、起動順序の最上位に指定します。

- オーバークラウドのベアメタルシステムにはすべて、Intelligent Platform Management Interface (IPMI) などのサポート対象の電源管理インターフェースが必要です。このインターフェースにより、director は各ノードの電源管理を制御することが可能となります。

- 各オーバークラウドシステムの詳細 (プロビジョニング NIC の MAC アドレス、IPMI NIC の IP アドレス、IPMI ユーザー名、IPMI パスワード) をメモしてください。この情報は、後でオーバークラウドノードを設定する際に役立ちます。

- インスタンスが外部のインターネットからアクセス可能である必要がある場合には、パブリックネットワークから Floating IP アドレスを割り当てて、そのアドレスをインスタンスに関連付けます。インスタンスは、引き続きプライベートの IP アドレスを確保しますが、ネットワークトラフィックは NAT を使用して、Floating IP アドレスに到達します。Floating IP アドレスは、複数のプライベート IP アドレスではなく、単一のインスタンスにのみ割り当て可能である点に注意してください、ただし、Floating IP アドレスは、単一のテナントで使用するように確保され、そのテナントは必要に応じて特定のインスタンスに関連付け/関連付け解除することができます。この構成を使用すると、インフラストラクチャーが外部のインターネットに公開されるので、適切なセキュリティープラクティスを順守しているかどうかを確認する必要があるでしょう。

- 1 つのブリッジには単一のインターフェースまたは単一のボンディングのみをメンバーにすると、Open vSwitch でネットワークループが発生するリスクを緩和することができます。複数のボンディングまたはインターフェースが必要な場合には、複数のブリッジを設定することが可能です。

- オーバークラウドノードが Red Hat Content Delivery Network やネットワークタイムサーバーなどの外部のサービスに接続できるようにするには、DNS によるホスト名解決を使用することを推奨します。

5.3. オーバークラウドのストレージ

任意のドライバーまたはバックエンド種別のバックエンド cinder ボリュームを使用するゲストインスタンスで LVM を使用すると、パフォーマンスとボリュームの可視性/可用性で問題が生じます。このような問題は、LVM フィルターを使用すると緩和することができます。詳しくは、『Storage Guide』の「Back Ends」および KCS の記事「Using LVM on a cinder volume exposes the data to the compute host」を参照してください。

director は、オーバークラウド環境にさまざまなストレージオプションを提供します。オプションは以下のとおりです。

- Ceph Storage ノード

director は、Red Hat Ceph Storage を使用して拡張可能なストレージノードセットを作成します。オーバークラウドは、各種ノードを以下の目的で使用します。

- イメージ: Glance は仮想マシンのイメージを管理します。イメージは変更できないため、OpenStack はイメージバイナリーブロブとして処理し、それに応じてイメージをダウンロードします。Ceph ブロックデバイスでイメージを格納するには、Glance を使用することができます。

- ボリューム: Cinder ボリュームはブロックデバイスです。OpenStack は、仮想マシンの起動や、実行中の仮想マシンへのボリュームのアタッチにボリュームを使用し、Cinder サービスを使用してボリュームを管理します。さらに、イメージの CoW (Copy-on-Write) のクローンを使用して仮想マシンを起動する際には Cinder を使用します。

- ファイルシステム: manila 共有はファイルシステムによりバッキングされます。OpenStack ユーザーは、manila サービスを使用して共有を管理します。manila を使用して、Ceph Storage ノードにデータを保管する CephFS ファイルシステムにバッキングされる共有を管理することができます。

ゲストディスク: ゲストディスクは、ゲストオペレーティングシステムのディスクです。デフォルトでは、Nova で仮想マシンを起動すると、ディスクは、ハイパーバイザーのファイルシステム上のファイルとして表示されます (通常

/var/lib/nova/instances/<uuid>/の配下)。Ceph 内にあるすべての仮想マシンは、Cinder を使用せずに起動することができます。これにより、ライブマイグレーションのプロセスを使用して、簡単にメンテナンス操作を実行することができます。また、ハイパーバイザーが停止した場合には、nova evacuateをトリガーして仮想マシンを別の場所で実行することもできるので便利です。重要サポートされるイメージフォーマットの情報については、『Instances and Images Guide』の「Image Service」の章を参照してください

その他の情報については、『Red Hat Ceph Storage Architecture Guide』を参照してください。

- Swift Storage ノード

- director は、外部オブジェクトストレージノードを作成します。これは、オーバークラウド環境でコントローラーノードをスケーリングまたは置き換える必要があるが、高可用性クラスター外にオブジェクトストレージを保持する必要がある場合に便利です。

5.4. オーバークラウドのセキュリティー

OpenStack Platform の実装のセキュリティーレベルは、その環境のセキュリティーレベルと同等です。ネットワーク環境内の適切なセキュリティー原則に従って、ネットワークアクセスが正しく制御されるようにします。以下に例を示します。

- ネットワークのセグメント化を使用して、ネットワークトラフィックを軽減し、機密データを分離します。フラットなネットワークはセキュリティーレベルがはるかに低くなります。

- サービスアクセスとポートを最小限に制限します。

- 適切なファイアウォールルールとパスワードが使用されるようにします。

- SELinux が有効化されていることを確認します。

システムのセキュリティー保護については、以下のドキュメントを参照してください。

5.5. オーバークラウドの高可用性

高可用性なオーバークラウドをデプロイするために、director は複数のコントローラー、コンピュート、およびストレージノードを単一のクラスターとして連携するように設定します。ノードで障害が発生すると、障害が発生したノードのタイプに応じて、自動フェンシングおよび再起動プロセスがトリガーされます。オーバークラウド高可用性アーキテクチャーおよびサービスに関する情報は、『Understanding Red Hat OpenStack Platform High Availability』を参照してください。

director を使用して、コンピュートインスタンスの高可用性 (インスタンス HA) を設定することもできます。このメカニズムにより、ノードで障害が発生するとコンピュートノード上のインスタンスが自動的に退避および再起動されます。インスタンス HA に対する要件は通常のオーバークラウドの要件と同じですが、追加のステップを実施してデプロイメントのために環境を準備する必要があります。インスタンス HA の仕組みおよびインストール手順に関する情報は、『High Availability for Compute Instances』を参照してください。

5.6. コントローラーノードの要件

コントローラーノードは、Red Hat OpenStack Platform 環境の中核となるサービス (例: Horizon Dashboard、バックエンドのデータベースサーバー、Keystone 認証、高可用性サービスなど) をホストする役割を果たします。

- プロセッサー

- Intel 64 または AMD64 CPU 拡張機能のサポートがある 64 ビットの x86 プロセッサー

- メモリー

最小のメモリー容量は 32 GB です。ただし、推奨のメモリー容量は、仮想 CPU の数によって異なります (CPU コアをハイパースレッディングの値で乗算した数値に基づいています)。以下の計算を参考にしてください。

コントローラーの最小メモリー容量の算出:

- 1 仮想 CPU あたり 1.5 GB のメモリーを使用します。たとえば、仮想 CPU が 48 個あるマシンにはメモリーは 72 GB 必要です。

コントローラーの推奨メモリー容量の算出:

- 1 仮想 CPU あたり 3 GB のメモリーを使用します。たとえば、仮想 CPU が 48 個あるマシンにはメモリーは 144 GB 必要です。

メモリーの要件に関する詳しい情報は、Red Hat カスタマーポータルで「Red Hat OpenStack Platform Hardware Requirements for Highly Available Controllers」の記事を参照してください。

- ディスクストレージとレイアウト

最小で 40 GB のストレージが必要です。ただし、Telemetry (

gnocchi) と Object Storage (swift) のサービスはいずれもコントローラーにインストールされ、ルートディスクを使用するように設定されます。これらのデフォルトは、コモディティーハードウェア上に構築される小型のオーバークラウドのデプロイに適しています。これは、概念検証およびテストの標準的な環境です。これらのデフォルトにより、最小限のプランニングでオーバークラウドをデプロイすることができますが、ワークロードキャパシティーとパフォーマンスの面ではあまり優れていません。ただし、Telemetry がストレージに絶えずアクセスするため、エンタープライズ環境では、これによって大きなボトルネックが生じる可能性があります。これにより、ディスク I/O が過度に使用されて、その他すべてのコントローラーサービスに深刻な影響をもたらします。このタイプの環境では、オーバークラウドのプランニングを行って、適切に設定する必要があります。

Red Hat は、Telemetry と Object Storage の両方の推奨設定をいくつか提供しています。詳しくは、『Deployment Recommendations for Specific Red Hat OpenStack Platform Services』を参照してください。

- ネットワークインターフェースカード

- 最小 2 枚の 1 Gbps ネットワークインターフェースカード。タグ付けされた VLAN トラフィックを委譲する場合や、ボンディングインターフェース向けの場合には追加のネットワークインターフェースを使用します。

- 電源管理

- 各コントローラーノードには、Intelligent Platform Management Interface (IPMI) 機能などのサポート対象の電源管理インターフェースがサーバーのマザーボードに搭載されている必要があります。

5.7. コンピュートノードの要件

コンピュートノードは、仮想マシンインスタンスが起動した後にそれらを稼働させる役割を果たします。コンピュートノードは、ハードウェアの仮想化をサポートしている必要があります。また、ホストする仮想マシンインスタンスの要件をサポートするのに十分なメモリーとディスク容量も必要です。

- プロセッサー

- Intel 64 または AMD64 CPU 拡張機能をサポートする 64 ビット x86 プロセッサーで Intel VT または AMD-V のハードウェア仮想化拡張機能が有効化されていること。このプロセッサーには最小でも 4 つのコアが搭載されていることを推奨しています。

- IBM POWER 8 プロセッサー

- メモリー

- 最小で 6 GB のメモリー。これに、仮想マシンインスタンスに割り当てるメモリー容量に基づいて、追加の RAM を加算します。

- ディスク領域

- 最小 40 GB の空きディスク領域

- ネットワークインターフェースカード

- 最小 1 枚の 1 Gbps ネットワークインターフェースカード (実稼働環境では最低でも NIC を 2 枚使用することを推奨)。タグ付けされた VLAN トラフィックを委譲する場合や、ボンディングインターフェース向けの場合には追加のネットワークインターフェースを使用します。

- 電源管理

- 各コンピュートノードには、Intelligent Platform Management Interface (IPMI) 機能などのサポート対象の電源管理インターフェースがサーバーのマザーボードに搭載されている必要があります。

5.8. Ceph Storage ノードの要件

Ceph Storage ノードは、Red Hat OpenStack Platform 環境でオブジェクトストレージを提供する役割を果たします。

- プロセッサー

- Intel 64 または AMD64 CPU 拡張機能のサポートがある 64 ビットの x86 プロセッサー

- メモリー

- 一般的には、OSD ホスト毎に 16 GB の RAM をベースとし、さらに OSD デーモン毎に 2 GB の RAM を追加することを推奨します。

- ディスクのレイアウト

サイズはストレージの要件によって異なります。Red Hat Ceph Storage ノードの推奨設定では、少なくとも 3 つ、またはそれ以上のディスクを以下と同様のレイアウトで構成する必要があります。

-

/dev/sda: ルートディスク。director は、主なオーバークラウドイメージをディスクにコピーします。このディスクには、少なくとも 40 GB の空き容量が必要です。 -

/dev/sdb: ジャーナルディスク。このディスクは、/dev/sdb1、/dev/sdb2、/dev/sdb3などのように、Ceph OSD ジャーナル向けにパーティションを分割します。ジャーナルディスクは通常、システムパフォーマンスの向上に役立つ Solid State Drive (SSD) です。 /dev/sdc以降: OSD ディスク。ストレージ要件で必要な数のディスクを使用します。注記Red Hat OpenStack Platform director では

ceph-ansibleが使われますが、OSD を Ceph Storage ノードのルートディスクにインストールすることには対応していません。つまり、サポートされる Ceph Storage ノード用に少なくとも 2 つのディスクが必要になります。

-

- ネットワークインターフェースカード

- 最小で 1 x 1 Gbps ネットワークインターフェースカード (実稼働環境では、最低でも NIC を 2 つ以上使用することを推奨します)。ボンディングインターフェース向けの場合や、タグ付けされた VLAN トラフィックを委譲する場合には、追加のネットワークインターフェースを使用します。特に大量のトラフィックにサービスを提供する OpenStack Platform 環境を構築する場合には、ストレージノードには 10 Gbps インターフェースを使用することを推奨します。

- 電源管理

- 各コントローラーノードには、Intelligent Platform Management Interface (IPMI) 機能などのサポート対象の電源管理インターフェースがサーバーのマザーボードに搭載されている必要があります。

Ceph Storage クラスターを使用するオーバークラウドのインストールについては、『Deploying an Overcloud with Containerized Red Hat Ceph』を参照してください。

5.9. オブジェクトストレージノードの要件

オブジェクトストレージノードは、オーバークラウドのオブジェクトストレージ層を提供します。Object Storage プロキシーは、コントローラーノードにインストールされます。ストレージ層には、ノードごとに複数のディスクを持つベアメタルノードが必要です。

- プロセッサー

- Intel 64 または AMD64 CPU 拡張機能のサポートがある 64 ビットの x86 プロセッサー

- メモリー

- メモリー要件はストレージ容量によって異なります。ハードディスク容量 1 TB あたり最小で 1 GB のメモリーを使用するのが理想的です。最適なパフォーマンスを得るには、特にワークロードが小さいファイル (100 GB 未満) の場合にはハードディスク容量 1 TB あたり 2 GB のメモリーを使用することを推奨します。

- ディスク領域

ストレージ要件は、ワークロードに必要とされる容量により異なります。アカウントとコンテナーのデータを保存するには SSD ドライブを使用することを推奨します。アカウントおよびコンテナーデータとオブジェクトの容量比率は、約 1 % です。たとえば、ハードドライブの容量 100 TB ごとに、アカウントおよびコンテナーデータの SSD 容量は 1 TB 用意するようにします。

ただし、これは保存したデータの種類により異なります。保存するオブジェクトサイズの大半が小さい場合には、SSD の容量がさらに必要です。オブジェクトが大きい場合には (ビデオ、バックアップなど)、SSD の容量を減らします。

- ディスクのレイアウト

推奨のノード設定には、以下のようなディスクレイアウトが必要です。

-

/dev/sda: ルートディスク。director は、主なオーバークラウドイメージをディスクにコピーします。 -

/dev/sdb: アカウントデータに使用します。 -

/dev/sdc: コンテナーデータに使用します。 -

/dev/sdc以降: オブジェクトサーバーディスク。ストレージ要件で必要な数のディスクを使用します。

-

- ネットワークインターフェースカード

- 最小 2 枚の 1 Gbps ネットワークインターフェースカード。タグ付けされた VLAN トラフィックを委譲する場合や、ボンディングインターフェース向けの場合には追加のネットワークインターフェースを使用します。

- 電源管理

- 各コントローラーノードには、Intelligent Platform Management Interface (IPMI) 機能などのサポート対象の電源管理インターフェースがサーバーのマザーボードに搭載されている必要があります。

5.10. オーバークラウドのリポジトリー

アンダークラウドのインストールおよび設定には、以下のリポジトリーが必要です。

表5.2 コアリポジトリー

| 名前 | リポジトリー | 要件の説明 |

|---|---|---|

|

Red Hat Enterprise Linux 7 Server (RPMS) |

|

x86_64 システム用ベースオペレーティングシステムのリポジトリー |

|

Red Hat Enterprise Linux 7 Server - Extras (RPMs) |

|

Red Hat OpenStack Platform の依存関係が含まれます。 |

|

Red Hat Enterprise Linux 7 Server - RH Common (RPMs) |

|

Red Hat OpenStack Platform のデプロイと設定ツールが含まれます。 |

|

Red Hat Satellite Tools for RHEL 7 Server RPMs x86_64 |

|

Red Hat Satellite 6 でのホスト管理ツール |

|

Red Hat Enterprise Linux High Availability (for RHEL 7 Server) (RPMs) |

|

Red Hat Enterprise Linux の高可用性ツール。コントローラーノードの高可用性に使用します。 |

|

Red Hat OpenStack Platform 14 for RHEL 7 (RPMs) |

|

Red Hat OpenStack Platform のコアリポジトリー |

表5.3 Ceph 用リポジトリー

| 名前 | リポジトリー | 要件の説明 |

|---|---|---|

|

Red Hat Ceph Storage OSD 3 for Red Hat Enterprise Linux 7 Server (RPMs) |

|

(Ceph Storage ノード向け) Ceph Storage Object Storage デーモンのリポジトリー。Ceph Storage ノードにインストールします。 |

|

Red Hat Ceph Storage MON 3 for Red Hat Enterprise Linux 7 Server (RPMs) |

|

(Ceph Storage ノード向け) Ceph Storage Monitor デーモンのリポジトリー。Ceph Storage ノードを使用して OpenStack 環境にあるコントローラーノードにインストールします。 |

|

Red Hat Ceph Storage Tools 3 for Red Hat Enterprise Linux 7 Server (RPMs) |

|

Ceph Storage クラスターと通信するためのノード用のツールを提供します。このリポジトリーは、Ceph Storage クラスターを使用するオーバークラウドをデプロイする際に、全ノードに有効化する必要があります。 |

表5.4 NFV 用リポジトリー

| 名前 | リポジトリー | 要件の説明 |

|---|---|---|

|

Enterprise Linux for Real Time for NFV (RHEL 7 Server) (RPMs) |

|

NFV 向けの Real Time KVM (RT-KVM) のリポジトリー。リアルタイムカーネルを有効化するためのパッケージが含まれています。このリポジトリーは、RT-KVM 対象の全コンピュートノードで有効化する必要があります。このリポジトリーにアクセスするためには、 |

IBM POWER 用リポジトリー

これらのリポジトリーは、POWER PC アーキテクチャー上で Openstack Platform を構築するのに使われます。コアリポジトリーの該当リポジトリーの代わりに、これらのリポジトリーを使用してください。

| 名前 | リポジトリー | 要件の説明 |

|---|---|---|

|

Red Hat Enterprise Linux for IBM Power, little endian |

|

ppc64le システム用ベースオペレーティングシステムのリポジトリー |

|

Red Hat OpenStack Platform 14 for RHEL 7 (RPMs) |

|

ppc64le システム用 Red Hat OpenStack Platform のコアリポジトリー |

第6章 CLI ツールを使用した基本的なオーバークラウドの設定

本章では、CLI ツールを使用した OpenStack Platform 環境の基本的な設定手順を説明します。基本設定のオーバークラウドには、カスタムの機能は含まれていませんが、『オーバークラウドの高度なカスタマイズ』に記載の手順に従って、この基本的なオーバークラウドに高度な設定オプションを追加して、仕様に合わせてカスタマイズすることができます。

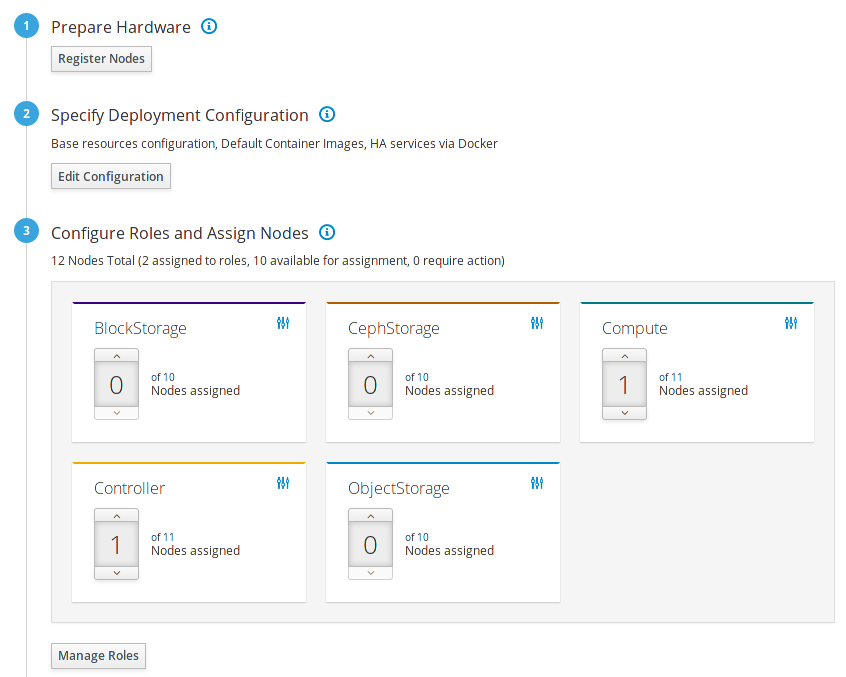

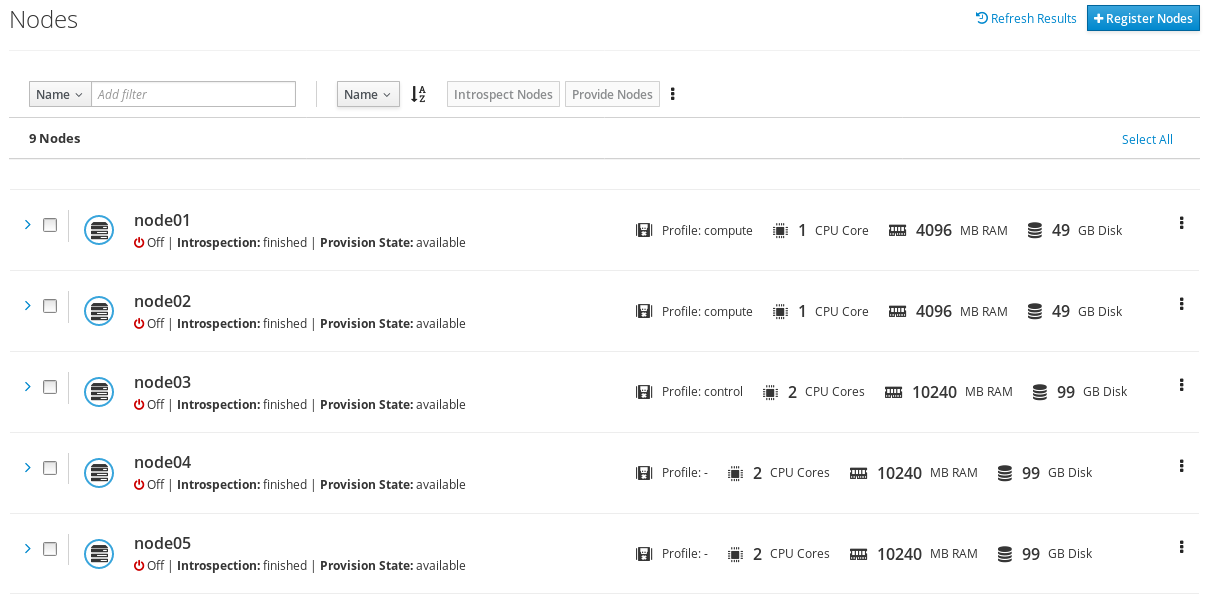

6.1. オーバークラウドへのノードの登録

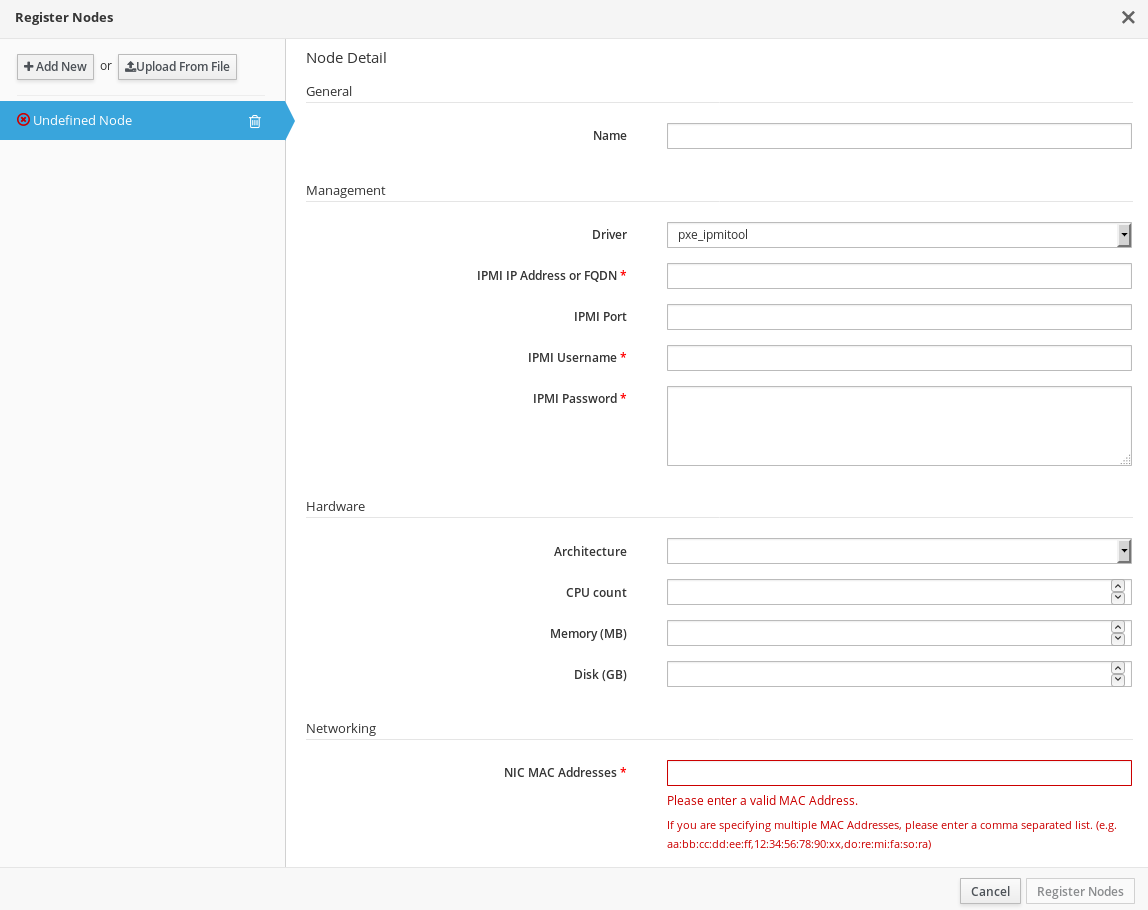

director では、手動で作成したノード定義のテンプレートが必要です。このファイルは JSON または YAML 形式を使用し、ノードのハードウェアおよび電源管理の情報が含まれます。

手順

ノードの一覧が含まれるテンプレートを作成します。JSON 形式のテンプレートの例を以下に示します。

{ "nodes":[ { "mac":[ "bb:bb:bb:bb:bb:bb" ], "name":"node01", "cpu":"4", "memory":"6144", "disk":"40", "arch":"x86_64", "pm_type":"ipmi", "pm_user":"admin", "pm_password":"p@55w0rd!", "pm_addr":"192.168.24.205" }, { "mac":[ "cc:cc:cc:cc:cc:cc" ], "name":"node02", "cpu":"4", "memory":"6144", "disk":"40", "arch":"x86_64", "pm_type":"ipmi", "pm_user":"admin", "pm_password":"p@55w0rd!", "pm_addr":"192.168.24.206" } ] }また、YAML 形式の類似ノードテンプレートの例を以下に示します。

nodes: - mac: - "bb:bb:bb:bb:bb:bb" name: "node01" cpu: 4 memory: 6144 disk: 40 arch: "x86_64" pm_type: "ipmi" pm_user: "admin" pm_password: "p@55w0rd!" pm_addr: "192.168.24.205" - mac: - cc:cc:cc:cc:cc:cc name: "node02" cpu: 4 memory: 6144 disk: 40 arch: "x86_64" pm_type: "ipmi" pm_user: "admin" pm_password: "p@55w0rd!" pm_addr: "192.168.24.206"このテンプレートでは、以下の属性を使用します。

- name

- ノードの論理名

- pm_type

使用する電源管理ドライバー。この例で使用しているのは IPMI ドライバー (

ipmi) で、電源管理の推奨ドライバーです。注記IPMI が推奨されるサポート対象電源管理ドライバーです。これ以外のサポート対象電源管理ドライバーおよびそのオプションに関する詳細は、「付録B 電源管理ドライバー」を参照してください。それらの電源管理ドライバーが想定どおりに機能しない場合には、電源管理に IPMI を使用してください。

- pm_user; pm_password

- IPMI のユーザー名およびパスワード

- pm_addr

- IPMI デバイスの IP アドレス

- mac

- (オプション) ノード上のネットワークインターフェースの MAC アドレス一覧。各システムのプロビジョニング NIC の MAC アドレスのみを使用します。

- cpu

- (オプション) ノード上の CPU 数

- memory

- (オプション) メモリーサイズ (MB)

- disk

- (オプション) ハードディスクのサイズ (GB)

- arch

(オプション) システムアーキテクチャー

重要マルチアーキテクチャークラウドをビルドする場合には、

x86_64アーキテクチャーを使用するノードとppc64leアーキテクチャーを使用するノードを区別するためにarchキーが必須です。

テンプレートの作成後に、

stackユーザーのホームディレクトリーにファイルを保存して (/home/stack/nodes.json)、以下のコマンドを使用して director にインポートします。$ source ~/stackrc (undercloud) $ openstack overcloud node import ~/nodes.json

このコマンドでテンプレートをインポートして、テンプレートから director に各ノードを登録します。

ノードを登録して設定が完了した後に、CLI でこれらのノードの一覧を表示します。

(undercloud) $ openstack baremetal node list

6.2. ノードのハードウェアの検査

director は各ノードでイントロスペクションプロセスを実行することができます。このプロセスを実行すると、各ノードが PXE を介してイントロスペクションエージェントを起動します。このエージェントは、ノードからハードウェアのデータを収集して、director に送り返します。次に director は、director 上で実行中の OpenStack Object Storage (swift) サービスにこのイントロスペクションデータを保管します。director は、プロファイルのタグ付け、ベンチマーキング、ルートディスクの手動割り当てなど、さまざまな目的でハードウェア情報を使用します。

手順

以下のコマンドを実行して、各ノードのハードウェア属性を検証します。

(undercloud) $ openstack overcloud node introspect --all-manageable --provide

-

--all-manageableオプションは、管理状態のノードのみをイントロスペクションします。上記の例では、すべてのノードが対象です。 -

--provideオプションは、イントロスペクション後に全ノードをavailableの状態にします。

-

別のターミナルウィンドウで以下のコマンドを使用してイントロスペクションの進捗状況をモニタリングします。

(undercloud) $ sudo journalctl -l -u openstack-ironic-inspector -u openstack-ironic-inspector-dnsmasq -u openstack-ironic-conductor -f

重要このプロセスが最後まで実行されて正常に終了したことを確認してください。ベアメタルの場合には、通常 15 分ほどかかります。

-

イントロスペクション完了後には、すべてのノードが

availableの状態に変わります。

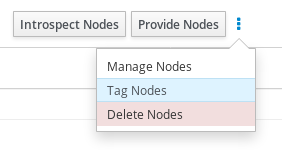

6.3. プロファイルへのノードのタグ付け

各ノードのハードウェアを登録、検査した後には、特定のプロファイルにノードをタグ付けします。このプロファイルタグにより、ノードがフレーバーに照合され、次にそのフレーバーがデプロイメントロールに割り当てられます。以下の例では、コントローラーノードのロール、フレーバー、プロファイル、ノード間の関係を示しています。

| タイプ | 説明 |

|---|---|

|

ロール |

|

|

フレーバー |

|

|

プロファイル |

|

|

ノード |

また、各ノードに |

アンダークラウドのインストール時に、デフォルトプロファイルのフレーバー compute、control、swift-storage、ceph-storage、block-storage が作成され、大半の環境で変更なしに使用することができます。

手順

特定のプロファイルにノードをタグ付けする場合には、各ノードの

properties/capabilitiesパラメーターにprofileオプションを追加します。たとえば、2 つのノードをタグ付けしてコントローラープロファイルとコンピュートプロファイルをそれぞれ使用するには、以下のコマンドを実行します。(undercloud) $ openstack baremetal node set --property capabilities='profile:compute,boot_option:local' 58c3d07e-24f2-48a7-bbb6-6843f0e8ee13 (undercloud) $ openstack baremetal node set --property capabilities='profile:control,boot_option:local' 1a4e30da-b6dc-499d-ba87-0bd8a3819bc0

profile:computeとprofile:controlオプションを追加することで、この 2 つのノードがそれぞれのプロファイルにタグ付けされます。これらのコマンドにより、各ノードの起動方法を定義する

boot_option:localパラメーターも設定されます。ノードのタグ付けが完了した後には、割り当てたプロファイルまたはプロファイルの候補を確認します。

(undercloud) $ openstack overcloud profiles list

6.4. UEFI ブートモードの設定

デフォルトのブートモードは、レガシー BIOS モードです。新しいシステムでは、レガシー BIOS モードの代わりに UEFI ブートモードが必要な可能性があります。以下の手順を使用して、UEFI モードに変更します。

手順

undercloud.confファイルで以下のパラメーターを設定します。ipxe_enabled = True inspection_enable_uefi = True

このファイルを保存して、アンダークラウドのインストールを実行します。

$ openstack undercloud install

インストールスクリプトが完了するまで待ちます。

登録済みの各ノードのブートモードを

uefiに設定します。たとえば、capabilitiesプロパティーにboot_modeパラメーターを追加する場合や既存のパラメーターを置き換える場合には、以下のコマンドを実行します。$ NODE=<NODE NAME OR ID> ; openstack baremetal node set --property capabilities="boot_mode:uefi,$(openstack baremetal node show $NODE -f json -c properties | jq -r .properties.capabilities | sed "s/boot_mode:[^,]*,//g")" $NODE

注記profileおよびboot_optionのケイパビリティーが保持されていることを確認してください。+

$ openstack baremetal node show r530-12 -f json -c properties | jq -r .properties.capabilities

各フレーバーのブートモードを

uefiに設定します。$ openstack flavor set --property capabilities:boot_mode='uefi' control

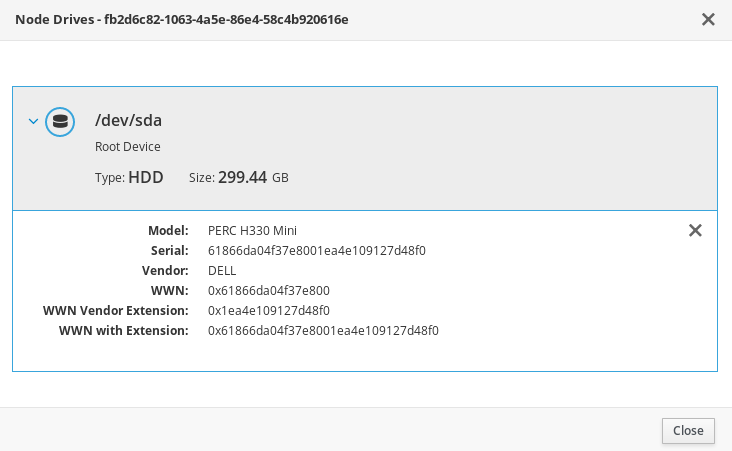

6.5. ノードのルートディスクの定義

一部のノードでは、複数のディスクが使用される場合があります。このため、director はプロビジョニング中ルートディスクとして使用するディスクを特定する必要があります。プロビジョニングプロセス中、director は QCOW2 overcloud-full イメージをルートディスクに書き込みます。

director がルートディスクを容易に特定できるようにするには、以下のようなプロパティーを使用することができます。

-

model(文字列): デバイスの ID -

vendor(文字列): デバイスのベンダー -

serial(文字列): ディスクのシリアル番号 -

hctl(文字列): SCSI のホスト:チャネル:ターゲット:Lun -

size(整数):デバイスのサイズ (GB) -

wwn(文字列): ストレージの一意識別子 -

wwn_with_extension(文字列): ベンダー拡張が末尾に付いたストレージの一意識別子 -

wwn_vendor_extension(文字列): ベンダーのストレージの一意識別子 -

rotational(ブール値): 回転式デバイス (HDD) には true、そうでない場合 (SSD) には false。 -

name(文字列): デバイス名 (例: /dev/sdb1)

name は、永続デバイス名が付いたデバイスのみに使用します。name で他のデバイスのルートディスクを設定しないでください。この値は、ノードのブート時に変更される可能性があります。

シリアル番号を使用してルートデバイスを指定する方法を、以下の例で説明します。

手順

各ノードのハードウェアイントロスペクションからのディスク情報を確認します。以下のコマンドは、ノードからのディスク情報を表示します。

(undercloud) $ openstack baremetal introspection data save 1a4e30da-b6dc-499d-ba87-0bd8a3819bc0 | jq ".inventory.disks"

たとえば、1 つのノードのデータで 3 つのディスクが表示される場合があります。

[ { "size": 299439751168, "rotational": true, "vendor": "DELL", "name": "/dev/sda", "wwn_vendor_extension": "0x1ea4dcc412a9632b", "wwn_with_extension": "0x61866da04f3807001ea4dcc412a9632b", "model": "PERC H330 Mini", "wwn": "0x61866da04f380700", "serial": "61866da04f3807001ea4dcc412a9632b" } { "size": 299439751168, "rotational": true, "vendor": "DELL", "name": "/dev/sdb", "wwn_vendor_extension": "0x1ea4e13c12e36ad6", "wwn_with_extension": "0x61866da04f380d001ea4e13c12e36ad6", "model": "PERC H330 Mini", "wwn": "0x61866da04f380d00", "serial": "61866da04f380d001ea4e13c12e36ad6" } { "size": 299439751168, "rotational": true, "vendor": "DELL", "name": "/dev/sdc", "wwn_vendor_extension": "0x1ea4e31e121cfb45", "wwn_with_extension": "0x61866da04f37fc001ea4e31e121cfb45", "model": "PERC H330 Mini", "wwn": "0x61866da04f37fc00", "serial": "61866da04f37fc001ea4e31e121cfb45" } ]以下の例では、ルートデバイスをシリアル番号が

61866da04f380d001ea4e13c12e36ad6の disk 2 に設定する方法を説明します。そのためには、ノード定義のroot_deviceパラメーターを変更する必要があります。(undercloud) $ openstack baremetal node set --property root_device='{"serial": "61866da04f380d001ea4e13c12e36ad6"}' 1a4e30da-b6dc-499d-ba87-0bd8a3819bc0注記各ノードの BIOS を設定して、選択したルートディスクからの起動が含まれるようにします。推奨のブート順は最初がネットワークブートで、次にルートディスクブートです。

6.6. アーキテクチャーに固有なロールの作成

マルチアーキテクチャークラウドをビルドする場合には、roles_data.yaml にアーキテクチャー固有のロールを追加する必要があります。以下に示す例では、デフォルトのロールに加えて ComputePPC64LE ロールを追加しています。『オーバークラウドの高度なカスタマイズ』の「roles_data ファイルの作成」セクションには、ロールについての情報が記載されています。

openstack overcloud roles generate \

--roles-path /usr/share/openstack-tripleo-heat-templates/roles -o ~/templates/roles_data.yaml \

Controller Compute ComputePPC64LE BlockStorage ObjectStorage CephStorage6.7. 環境ファイル

アンダークラウドには、オーバークラウドの作成プランとして機能するさまざまな Heat テンプレートが含まれます。YAML フォーマットの環境ファイルを使って、オーバークラウドの特性をカスタマイズすることができます。このファイルで、コア Heat テンプレートコレクションのパラメーターおよびリソースを上書きします。必要に応じていくつでも環境ファイルを追加することができますが、後で実行される環境ファイルで定義されているパラメーターとリソースが優先されることになるため、環境ファイルの順番は重要です。以下の一覧は、環境ファイルの順序の例です。

- 各ロールおよびそのフレーバーごとのノード数。オーバークラウドを作成するには、この情報の追加は不可欠です。

- コンテナー化された OpenStack サービスのコンテナーイメージの場所。

-

任意のネットワーク分離ファイル。Heat テンプレートコレクションの初期化ファイル (

environments/network-isolation.yaml) から開始して、次にカスタムの NIC 設定ファイル、最後に追加のネットワーク設定の順番です。 - 外部のロードバランシングの環境ファイル。

- Ceph Storage、NFS、iSCSI などのストレージ環境ファイル。

- Red Hat CDN または Satellite 登録用の環境ファイル。

- その他のカスタム環境ファイル。

カスタム環境ファイルは、別のディレクトリーで管理することを推奨します (たとえば、templates ディレクトリー)。

『オーバークラウドの高度なカスタマイズ』を使用して、オーバークラウドの詳細機能をカスタマイズできます。

基本的なオーバークラウドでは、ブロックストレージにローカルの LVM ストレージを使用しますが、この設定はサポートされません。ブロックストレージには、外部ストレージソリューション (Red Hat Ceph Storage 等) を使用することを推奨します。

これ以降の数セクションで、オーバークラウドに必要な環境ファイルを作成する方法について説明します。

6.8. ノード数とフレーバーを定義する環境ファイルの作成

デフォルトでは、director は baremetal フレーバーを使用して 1 つのコントローラーノードとコンピュートノードを持つオーバークラウドをデプロイします。ただし、この設定は概念検証のためのデプロイメントにしか適しません。異なるノード数およびフレーバーを指定して、デフォルトの設定をオーバーライドすることができます。小規模な実稼働環境では、コントローラーノードとコンピュートノードを少なくとも 3 つにし、適切なリソース仕様でノードが作成されるように特定のフレーバーを割り当てる必要があります。以下の手順では、ノード数およびフレーバー割り当てを定義する環境ファイル node-info.yaml の作成方法を説明します。

手順

/home/stack/templates/ディレクトリーにnode-info.yamlファイルを作成します。(undercloud) $ touch /home/stack/templates/node-info.yaml

ファイルを編集し、必要なノード数およびフレーバーを設定します。以下の例では、3 つのコントローラーノード、コンピュートノード、および Ceph Storage ノードをデプロイします。

parameter_defaults: OvercloudControllerFlavor: control OvercloudComputeFlavor: compute ControllerCount: 3 ComputeCount: 3

6.9. アンダークラウド CA を信頼するための環境ファイルの作成

アンダークラウドで TLS が使用され CA が一般に信頼できない場合には、以下の手順に従う必要があります。アンダークラウドでは、SSL エンドポイント暗号化のために自己の認証局 (CA) が運用されます。デプロイメントの他の要素からアンダークラウドのエンドポイントにアクセスできるようにするには、アンダークラウドの CA を信頼するようにオーバークラウドノードを設定します。

この手法が機能するためには、オーバークラウドノードにアンダークラウドの公開エンドポイントへのネットワークルートが必要です。スパイン/リーフ型ネットワークに依存するデプロイメントでは、この設定を適用する必要があります。

アンダークラウドで使用することのできるカスタム証明書には、2 つのタイプがあります。

-

ユーザーの提供する証明書: 自己の証明書を提供している場合がこれに該当します。自己の CA からの証明書、または自己署名の証明書がその例です。この証明書は

undercloud_service_certificateオプションを使用して渡されます。この場合、自己署名の証明書または CA のどちらかを信頼する必要があります (デプロイメントによります)。 -

自動生成される証明書:

certmongerにより自己のローカル CA を使用して証明書を生成する場合がこれに該当します。このプロセスは、generate_service_certificateオプションを使用して有効にします。この場合、CA 証明書 (/etc/pki/ca-trust/source/anchors/cm-local-ca.pem) およびアンダークラウドの HAProxy インスタンスが使用するサーバー証明書が用いられます。この証明書を OpenStack に提示するには、CA 証明書をinject-trust-anchor-hiera.yamlファイルに追加する必要があります。

手順

以下の例では、/home/stack/ca.crt.pem に保存された自己署名の証明書が使われています。自動生成される証明書を使用する場合には、代わりに /etc/pki/ca-trust/source/anchors/cm-local-ca.pem を使用してください。

証明書ファイルを開き、証明書部分だけをコピーします。鍵を含めないでください。

$ vi /home/stack/ca.crt.pem

必要となる証明書部分の例を、以下に示します。

-----BEGIN CERTIFICATE----- MIIDlTCCAn2gAwIBAgIJAOnPtx2hHEhrMA0GCSqGSIb3DQEBCwUAMGExCzAJBgNV BAYTAlVTMQswCQYDVQQIDAJOQzEQMA4GA1UEBwwHUmFsZWlnaDEQMA4GA1UECgwH UmVkIEhhdDELMAkGA1UECwwCUUUxFDASBgNVBAMMCzE5Mi4xNjguMC4yMB4XDTE3 -----END CERTIFICATE-----

以下に示す内容で

/home/stack/inject-trust-anchor-hiera.yamlという名称の新たな YAML ファイルを作成し、PEM ファイルからコピーした証明書を追加します。parameter_defaults: CAMap: ... undercloud-ca: content: | -----BEGIN CERTIFICATE----- MIIDlTCCAn2gAwIBAgIJAOnPtx2hHEhrMA0GCSqGSIb3DQEBCwUAMGExCzAJBgNV BAYTAlVTMQswCQYDVQQIDAJOQzEQMA4GA1UEBwwHUmFsZWlnaDEQMA4GA1UECgwH UmVkIEhhdDELMAkGA1UECwwCUUUxFDASBgNVBAMMCzE5Mi4xNjguMC4yMB4XDTE3 -----END CERTIFICATE-----注記証明書の文字列は、PEM の形式に従う必要があります。

オーバークラウドのデプロイメント時に CA 証明書がそれぞれのオーバークラウドノードにコピーされ、アンダークラウドの SSL エンドポイントが提示する暗号化を信頼するようになります。環境ファイル追加の詳細は、「オーバークラウドデプロイメントへの環境ファイルの追加」を参照してください。

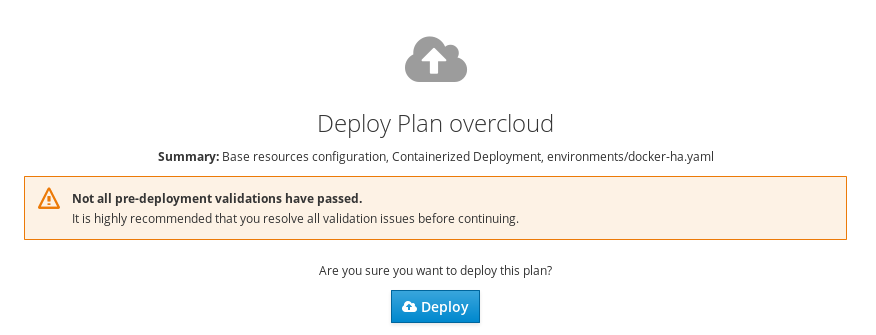

6.10. デプロイメントコマンド

OpenStack 環境作成における最後の段階では、openstack overcloud deploy コマンドを実行して OpenStack 環境を作成します。このコマンドを実行する前に、キーオプションやカスタムの環境ファイルの追加方法を十分に理解しておく必要があります。

バックグラウンドプロセスとして openstack overcloud deploy を実行しないでください。バックグラウンドのプロセスとして開始された場合にはオーバークラウドの作成は途中で停止してしまう可能性があります。

6.11. デプロイメントコマンドのオプション

以下の表では、openstack overcloud deploy コマンドを使用する際の追加パラメーターを一覧表示します。

表6.1 デプロイメントコマンドのオプション

| パラメーター | 説明 |

|---|---|

|

|

デプロイする Heat テンプレートが格納されているディレクトリー。空欄にした場合には、コマンドはデフォルトのテンプレートの場所である |

|

|

作成または更新するスタックの名前 |

|

|

デプロイメントのタイムアウト (分単位) |

|

|

ハイパーバイザーに使用する仮想化タイプ |

|

|

時刻の同期に使用する Network Time Protocol (NTP) サーバー。コンマ区切りリストで複数の NTP サーバーを指定することも可能です (例: |

|

|

環境変数 no_proxy のカスタム値を定義します。これにより、プロキシー通信から特定のホスト名は除外されます。 |

|

|

オーバークラウドノードにアクセスする SSH ユーザーを定義します。通常、SSH アクセスは |

|

|

オーバークラウドデプロイメントに渡す追加の環境ファイル。複数回指定することが可能です。 |

|

|

デプロイメントに追加する環境ファイルが格納されているディレクトリー。このコマンドは、これらの環境ファイルを最初に番号順、その後にアルファベット順で処理します。 |

|

|

オーバークラウドの作成プロセスでは、デプロイメントの前に一連のチェックが行われます。このオプションは、デプロイメント前のチェックで何らかの致命的でないエラーが発生した場合に終了します。どのようなエラーが発生してもデプロイメントが失敗するので、このオプションを使用することを推奨します。 |

|

|

オーバークラウドの作成プロセスでは、デプロイメントの前に一連のチェックが行われます。このオプションは、デプロイメント前のチェックで何らかのクリティカルではない警告が発生した場合に終了します。 |

|

|

オーバークラウドに対する検証チェックを実行しますが、オーバークラウドを実際には作成しません。 |

|

|

オーバークラウドのデプロイ後の設定を省略します。 |

|

|

オーバークラウドのデプロイ後の設定を強制的に行います。 |

|

|

|

|

|

引数とパラメーターが記載された YAML ファイルへのパス |

|

|

カスタマーポータルまたは Satellite 6 にオーバークラウドノードを登録します。 |

|

|

オーバークラウドノードに使用する登録方法。Red Hat Satellite 6 または Red Hat Satellite 5 は |

|

|

登録に使用する組織 |

|

|

すでに登録済みでもシステムを登録します。 |

|

|

オーバークラウドノードを登録する Satellite サーバーのベース URL。このパラメーターには、HTTPS URL ではなく、Satellite の HTTP URL を使用します。たとえば、https://satellite.example.com ではなく http://satellite.example.com を使用します。オーバークラウドの作成プロセスではこの URL を使用して、どのサーバーが Red Hat Satellite 5 または Red Hat Satellite 6 サーバーであるかを判断します。Red Hat Satellite 6 サーバーの場合は、オーバークラウドは |

|

|

登録に使用するアクティベーションキー |

オプションの完全一覧については、以下のコマンドを実行します。

(undercloud) $ openstack help overcloud deploy

環境ファイルの parameter_defaults セクションに追加する Heat テンプレートのパラメーターの使用が優先されるため、一部のコマンドラインパラメーターは古いか非推奨となっています。以下の表では、非推奨となったパラメーターと、それに相当する Heat テンプレートのパラメーターを対照しています。

表6.2 非推奨の CLI パラメーターと Heat テンプレートのパラメーターの対照表

| パラメーター | 説明 | Heat テンプレートのパラメーター |

|---|---|---|

|

|

スケールアウトするコントローラーノード数 |

|

|

|

スケールアウトするコンピュートノード数 |

|

|

|

スケールアウトする Ceph Storage ノードの数 |

|

|

|

スケールアウトする Cinder ノード数 |

|

|

|

スケールアウトする Swift ノード数 |

|

|

|

コントローラーノードに使用するフレーバー |

|

|

|

コンピュートノードに使用するフレーバー |

|

|

|

Ceph Storage ノードに使用するフレーバー |

|

|

|

Cinder ノードに使用するフレーバー |

|

|

|

Swift Storage ノードに使用するフレーバー |

|

|

|

フラットなネットワークが neutron プラグインで設定されるように定義します。外部ネットワークを作成ができるようにデフォルトは「datacentre」に設定されています。 |

|

|

|

各ハイパーバイザーで作成する Open vSwitch ブリッジ。デフォルト値は「br-ex」で、通常この値は変更する必要はないはずです。 |

|

|

|

使用する論理ブリッジから物理ブリッジへのマッピング。ホスト (br-ex) の外部ブリッジを物理名 (datacentre) にマッピングするようにデフォルト設定されています。これは、デフォルトの Floating ネットワークに使用されます。 |

|

|

|

ネットワークノード向けにインターフェースを br-ex にブリッジするインターフェースを定義します。 |

|

|

|

Neutron のテナントネットワーク種別 |

|

|

|

neutron テナントネットワークのトンネリング種別。複数の値を指定するには、コンマ区切りの文字列を使用します。 |

|

|

|

テナントネットワークを割り当てに使用できる GRE トンネリングの ID 範囲 |

|

|

|

テナントネットワークを割り当てに使用できる VXLAN VNI の ID 範囲 |

|

|

|

サポートされる Neutron ML2 および Open vSwitch VLAN マッピングの範囲。デフォルトでは、物理ネットワーク「datacentre」上の VLAN を許可するように設定されています。 |

|

|

|

neutron テナントネットワークのメカニズムドライバー。デフォルトでは、「openvswitch」に設定されており、複数の値を指定するにはコンマ区切りの文字列を使用します。 |

|

|

|

VLAN で区切られたネットワークまたは neutron でのフラットネットワークを使用するためにトンネリングを無効化します。 |

パラメーターのマッピングなし |

|

|

オーバークラウドの作成プロセスでは、デプロイメントの前に一連のチェックが行われます。このオプションは、デプロイメント前のチェックで何らかの致命的なエラーが発生した場合に終了します。どのようなエラーが発生してもデプロイメントが失敗するので、このオプションを使用することを推奨します。 |

パラメーターのマッピングなし |

これらのパラメーターは、Red Hat OpenStack Platform の今後のリリースで削除される予定です。

6.12. オーバークラウドデプロイメントへの環境ファイルの追加

オーバークラウドをカスタマイズするには、-e を指定して、環境ファイルを追加します。必要に応じていくつでも環境ファイルを追加することができますが、後で実行される環境ファイルで定義されているパラメーターとリソースが優先されることになるため、環境ファイルの順番は重要です。以下の一覧は、環境ファイルの順序の例です。

- 各ロールおよびそのフレーバーごとのノード数。オーバークラウドを作成するには、この情報の追加は不可欠です。

- コンテナー化された OpenStack サービスのコンテナーイメージの場所。

-

任意のネットワーク分離ファイル。Heat テンプレートコレクションの初期化ファイル (

environments/network-isolation.yaml) から開始して、次にカスタムの NIC 設定ファイル、最後に追加のネットワーク設定の順番です。 - 外部のロードバランシングの環境ファイル。

- Ceph Storage、NFS、iSCSI などのストレージ環境ファイル。

- Red Hat CDN または Satellite 登録用の環境ファイル。

- その他のカスタム環境ファイル。

-e オプションを使用してオーバークラウドに追加した環境ファイルは、すべてオーバークラウドのスタック定義の一部となります。

以下のコマンドは、本シナリオの初期に定義した環境ファイルを使用してオーバークラウドの作成を開始する方法の一例です。

(undercloud) $ openstack overcloud deploy --templates \ -e /home/stack/templates/node-info.yaml\ -e /home/stack/templates/overcloud_images.yaml \ -e /home/stack/inject-trust-anchor-hiera.yaml -r /home/stack/templates/roles_data.yaml \

上記のコマンドでは、以下の追加オプションも使用できます。

- --templates

-

/usr/share/openstack-tripleo-heat-templatesの Heat テンプレートコレクションをベースとして使用し、オーバークラウドを作成します。 - -e /home/stack/templates/node-info.yaml

- 各ロールに使用するノード数とフレーバーを定義する環境ファイルを追加します。

- -e /home/stack/templates/overcloud_images.yaml

- コンテナーイメージソースを含む環境ファイルを追加します。

- -e /home/stack/inject-trust-anchor-hiera.yaml

- アンダークラウドにカスタム証明書をインストールする環境ファイルを追加します。

- -r /home/stack/templates/roles_data.yaml

- (オプション) カスタムロールを使用する、またはマルチアーキテクチャークラウドを有効にする場合に生成されるロールデータ。詳しくは、「アーキテクチャーに固有なロールの作成」を参照してください。

director は、「9章オーバークラウド作成後のタスクの実行」に記載の再デプロイおよびデプロイ後の機能にこれらの環境ファイルを必要とします。これらのファイルが含まれていない場合には、オーバークラウドが破損する可能性があります。

オーバークラウド設定を後で変更する予定の場合には、以下の作業を行う必要があります。

- カスタムの環境ファイルおよび Heat テンプレートのパラメーターを変更します。

-

同じ環境ファイルを指定して

openstack overcloud deployコマンドを再度実行します。

オーバークラウドを手動で編集しても、director を使用してオーバークラウドスタックの更新を行う際に director の設定で上書きされてしまうので、設定は直接編集しないでください。

6.13. デプロイメント操作を行う前のオーバークラウド設定の検証

オーバークラウドのデプロイメント操作を実行する前に、Heat テンプレートと環境ファイルにエラーがないかどうかを検証します。

手順

オーバークラウドのコア Heat テンプレートは、Jinja2 形式となっています。テンプレートを検証するには、以下のコマンドを使用して Jinja 2 のフォーマットなしでバージョンをレンダリングします。

$ cd /usr/share/openstack-tripleo-heat-templates $ ./tools/process-templates.py -o ~/overcloud-validation

以下のコマンドを使用して、テンプレート構文を検証します。

(undercloud) $ openstack orchestration template validate --show-nested \ --template ~/overcloud-validation/overcloud.yaml -e ~/overcloud-validation/overcloud-resource-registry-puppet.yaml \ -e [ENVIRONMENT FILE] \ -e [ENVIRONMENT FILE]

検証には、

overcloud-resource-registry-puppet.yamlの環境ファイルにオーバークラウド固有のリソースを含める必要があります。環境ファイルをさらに追加するには、このコマンドに-eオプションを使用してください。また、--show-nestedオプションを追加して、ネストされたテンプレートからパラメーターを解決します。- 検証コマンドにより、テンプレート内の構文エラーが特定されます。テンプレートの構文の検証が正常に行われた場合には、出力には、作成されるオーバークラウドのテンプレートのプレビューが表示されます。

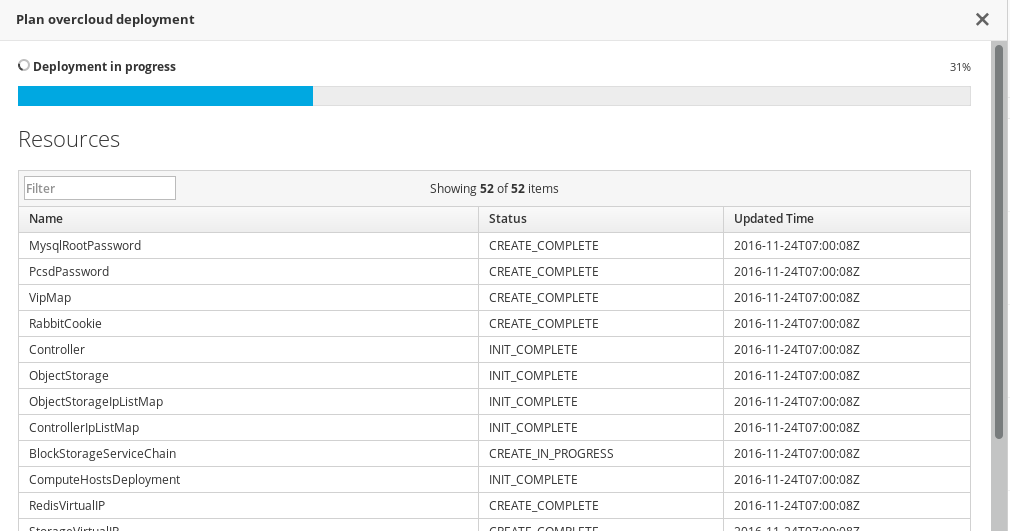

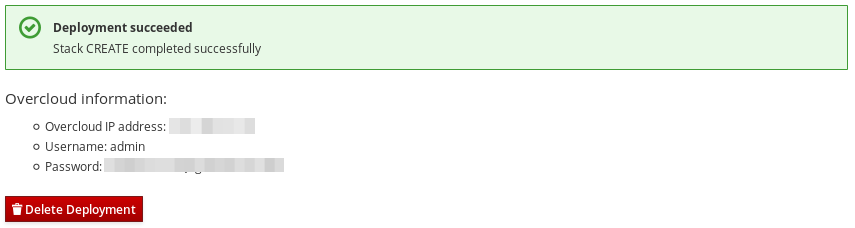

6.14. オーバークラウドデプロイメントの出力

オーバークラウドの作成が完了すると、オーバークラウドを設定するために実施された Ansible のプレイの概要が director により提示されます。

PLAY RECAP ************************************************************* overcloud-compute-0 : ok=160 changed=67 unreachable=0 failed=0 overcloud-controller-0 : ok=210 changed=93 unreachable=0 failed=0 undercloud : ok=10 changed=7 unreachable=0 failed=0 Tuesday 15 October 2018 18:30:57 +1000 (0:00:00.107) 1:06:37.514 ****** ========================================================================

director により、オーバークラウドへのアクセス情報も提供されます。