ネットワーク

Red Hat OpenShift Service on AWS ネットワーキングの設定

概要

第1章 Red Hat OpenShift Service on AWS の DNS Operator

DNS Operator は、Pod に対して名前解決サービスを提供するために CoreDNS をデプロイし、これを管理し、Red Hat OpenShift Service on AWS での DNS ベースの Kubernetes サービス検出を可能にします。

1.1. DNS 転送の使用

次の方法で、DNS 転送を使用して /etc/resolv.conf ファイル内のデフォルトの転送設定をオーバーライドできます。

すべてのゾーンにネームサーバーを指定します。転送されるゾーンが Red Hat OpenShift Service on AWS に管理される Ingress ドメインである場合は、アップストリームネームサーバーがドメインについて認証される必要があります。

重要少なくとも 1 つのゾーンを指定する必要があります。そうしないと、クラスターの機能が失われる可能性があります。

- アップストリーム DNS サーバーのリストを指定します。

- デフォルトの転送ポリシーを変更します。

デフォルトドメインの DNS 転送設定には、/etc/resolv.conf ファイルおよびアップストリーム DNS サーバーで指定されたデフォルトのサーバーの両方を設定できます。

手順

defaultという名前の DNS Operator オブジェクトを変更します。$ oc edit dns.operator/default

以前のコマンドを実行した後に、Operator は

Serverに基づく追加のサーバー設定ブロックを使用してdns-defaultという名前の config map を作成して更新します。重要zonesパラメーターの値を指定する場合は、イントラネットなどの特定のゾーンにのみ転送してください。少なくとも 1 つのゾーンを指定する必要があります。そうしないと、クラスターの機能が失われる可能性があります。クエリーに一致するゾーンがサーバーにない場合には、名前解決はアップストリーム DNS サーバーにフォールバックします。

DNS 転送の設定

apiVersion: operator.openshift.io/v1 kind: DNS metadata: name: default spec: servers: - name: example-server 1 zones: 2 - example.com forwardPlugin: policy: Random 3 upstreams: 4 - 1.1.1.1 - 2.2.2.2:5353 upstreamResolvers: 5 policy: Random 6 upstreams: 7 - type: SystemResolvConf 8 - type: Network address: 1.2.3.4 9 port: 53 10

- 1

rfc6335サービス名の構文に準拠する必要があります。- 2

rfc1123サービス名構文のサブドメインの定義に準拠する必要があります。クラスタードメインのcluster.localは、zonesフィールドの無効なサブドメインです。- 3

- アップストリームリゾルバーを選択するためのポリシーを定義します。デフォルト値は

Randomです。RoundRobinおよびSequentialの値を使用することもできます。 - 4

forwardPluginごとに最大 15 のupstreamsが許可されます。- 5

- オプション: これを使用して、デフォルトポリシーを上書きし、デフォルトドメインで指定された DNS リゾルバー (アップストリームリゾルバー) に DNS 解決を転送できます。アップストリームリゾルバーを指定しない場合に、DNS 名のクエリーは

/etc/resolv.confのサーバーに送信されます。 - 6

- クエリー用にアップストリームサーバーが選択される順序を決定します。

Random、Round Robin、またはSequentialのいずれかの値を指定できます。デフォルト値はSequentialです。 - 7

- オプション: これを使用して、アップストリームリゾルバーを指定できます。

- 8

SystemResolvConfとNetworkの 2 種類のアップストリームを指定できます。SystemResolvConfで、アップストリームが/etc/resolv.confを使用するように設定して、NetworkでNetworkresolverを定義します。1 つまたは両方を指定できます。- 9

- 指定したタイプが

Networkの場合には、IP アドレスを指定する必要があります。addressフィールドは、有効な IPv4 または IPv6 アドレスである必要があります。 - 10

- 指定したタイプが

Networkの場合、必要に応じてポートを指定できます。portフィールドには1-65535の値を指定する必要があります。アップストリームのポートを指定しない場合、デフォルトでポート 853 が試行されます。

オプション: 高度に規制された環境で作業する場合は、要求をアップストリームリゾルバーに転送する際に DNS トラフィックのセキュリティーを確保して、追加の DNS トラフィックおよびデータのプライバシーを確保できるようにする必要がある場合があります。

重要zonesパラメーターの値を指定する場合は、イントラネットなどの特定のゾーンにのみ転送してください。少なくとも 1 つのゾーンを指定する必要があります。そうしないと、クラスターの機能が失われる可能性があります。クラスター管理者は、転送された DNS クエリーに Transport Layer Security (TLS) を設定できるようになりました。

TLS を使用した DNS 転送の設定

apiVersion: operator.openshift.io/v1 kind: DNS metadata: name: default spec: servers: - name: example-server 1 zones: 2 - example.com forwardPlugin: transportConfig: transport: TLS 3 tls: caBundle: name: mycacert serverName: dnstls.example.com 4 policy: Random 5 upstreams: 6 - 1.1.1.1 - 2.2.2.2:5353 upstreamResolvers: 7 transportConfig: transport: TLS tls: caBundle: name: mycacert serverName: dnstls.example.com upstreams: - type: Network 8 address: 1.2.3.4 9 port: 53 10

- 1

rfc6335サービス名の構文に準拠する必要があります。- 2

rfc1123サービス名構文のサブドメインの定義に準拠する必要があります。クラスタードメインのcluster.localは、zonesフィールドの無効なサブドメインです。クラスタードメインのcluster.localは、zonesの無効なsubdomainです。- 3

- 転送された DNS クエリーの TLS を設定する場合、

transportフィールドの値をTLSに設定します。デフォルトでは、CoreDNS は転送された接続を 10 秒間キャッシュします。要求が発行されない場合、CoreDNS はその 10 秒間、TCP 接続を開いたままにします。大規模なクラスターでは、ノードごとに接続を開始できるため、DNS サーバーが多くの新しい接続を開いたまま保持する可能性があることを認識しているか確認してください。パフォーマンスの問題を回避するために、それに応じて DNS 階層を設定します。 - 4

- 転送された DNS クエリー用に TLS を設定する場合、これは、アップストリーム TLS サーバー証明書を検証するための Server Name Indication (SNI) の一部として使用される必須のサーバー名です。

- 5

- アップストリームリゾルバーを選択するためのポリシーを定義します。デフォルト値は

Randomです。RoundRobinおよびSequentialの値を使用することもできます。 - 6

- 必須。これを使用して、アップストリームリゾルバーを指定できます。

forwardPluginエントリーごとに最大 15 のupstreamsエントリーが許可されます。 - 7

- オプション: これを使用して、デフォルトポリシーを上書きし、デフォルトドメインで指定された DNS リゾルバー (アップストリームリゾルバー) に DNS 解決を転送できます。アップストリームリゾルバーを指定しない場合に、DNS 名のクエリーは

/etc/resolv.confのサーバーに送信されます。 - 8

Networkタイプは、このアップストリームリゾルバーが/etc/resolv.confにリストされているアップストリームリゾルバーとは別に転送されたリクエストを処理する必要があることを示します。TLS を使用する場合、Networkタイプのみが許可され、IP アドレスを指定する必要があります。- 9

addressフィールドは、有効な IPv4 または IPv6 アドレスである必要があります。- 10

- オプションでポートを指定できます。

portの値は1〜65535である必要があります。アップストリームのポートを指定しない場合、デフォルトでポート 853 が試行されます。

注記serversが定義されていないか無効な場合、config map にはデフォルトサーバーのみが含まれます。

検証

config map を表示します。

$ oc get configmap/dns-default -n openshift-dns -o yaml

以前のサンプル DNS に基づく DNS ConfigMap の例

apiVersion: v1 data: Corefile: | example.com:5353 { forward . 1.1.1.1 2.2.2.2:5353 } bar.com:5353 example.com:5353 { forward . 3.3.3.3 4.4.4.4:5454 1 } .:5353 { errors health kubernetes cluster.local in-addr.arpa ip6.arpa { pods insecure upstream fallthrough in-addr.arpa ip6.arpa } prometheus :9153 forward . /etc/resolv.conf 1.2.3.4:53 { policy Random } cache 30 reload } kind: ConfigMap metadata: labels: dns.operator.openshift.io/owning-dns: default name: dns-default namespace: openshift-dns- 1

forwardPluginへの変更により、CoreDNS デーモンセットのローリング更新がトリガーされます。

関連情報

- DNS 転送の詳細は、CoreDNS forward のドキュメント を参照してください。

第2章 Red Hat OpenShift Service on AWS の Ingress Operator

2.1. Red Hat OpenShift Service on AWS Ingress Operator

Red Hat OpenShift Service on AWS クラスターを作成すると、クラスターで実行されている Pod とサービスにそれぞれ独自の IP アドレスが割り当てられます。IP アドレスは、近くで実行されている他の Pod やサービスからアクセスできますが、外部クライアントの外部からはアクセスできません。Ingress Operator は IngressController API を実装し、Red Hat OpenShift Service on AWS クラスターサービスへの外部アクセスを可能にするコンポーネントです。

Ingress Operator を使用すると、ルーティングを処理する 1 つ以上の HAProxy ベースの Ingress Controller をデプロイおよび管理することにより、外部クライアントがサービスにアクセスできるようになります。Red Hat Site Reliability Engineer (SRE) は、Red Hat OpenShift Service on AWS クラスターの Ingress Operator を管理します。Ingress Operator の設定を変更することはできませんが、デフォルトの Ingress コントローラーの設定、ステータス、およびログおよび Ingress Operator ステータスを表示できます。

2.2. Ingress 設定アセット

インストールプログラムでは、config.openshift.io API グループの Ingress リソースでアセットを生成します (cluster-ingress-02-config.yml)。

Ingress リソースの YAML 定義

apiVersion: config.openshift.io/v1 kind: Ingress metadata: name: cluster spec: domain: apps.openshiftdemos.com

インストールプログラムは、このアセットを manifests/ ディレクトリーの cluster-ingress-02-config.yml ファイルに保存します。この Ingress リソースは、Ingress のクラスター全体の設定を定義します。この Ingress 設定は、以下のように使用されます。

- Ingress Operator は、クラスター Ingress 設定のドメインを、デフォルト Ingress Controller のドメインとして使用します。

-

OpenShift API Server Operator は、クラスター Ingress 設定からのドメインを使用します。このドメインは、明示的なホストを指定しない

Routeリソースのデフォルトホストを生成する際にも使用されます。

2.3. Ingress Controller 設定パラメーター

ingresscontrollers.operator.openshift.io リソースは以下の設定パラメーターを提供します。

| パラメーター | 説明 |

|---|---|

|

|

空の場合、デフォルト値は |

|

|

|

|

|

次の

設定されていない場合、デフォルト値は

|

|

|

シークレットには以下のキーおよびデータが含まれる必要があります: *

設定されていない場合、ワイルドカード証明書は自動的に生成され、使用されます。証明書は Ingress コントーラーの 使用中の証明書は、生成されたものでもユーザーが指定したものでも、Red Hat OpenShift Service on AWS のビルトイン OAuth サーバーと自動的に統合されます。 |

|

|

|

|

|

|

|

|

設定されていない場合は、デフォルト値が使用されます。 注記

nodePlacement:

nodeSelector:

matchLabels:

kubernetes.io/os: linux

tolerations:

- effect: NoSchedule

operator: Exists |

|

|

これが設定されていない場合、デフォルト値は

Ingress Controller の最小 TLS バージョンは 注記

設定されたセキュリティープロファイルの暗号および最小 TLS バージョンが 重要

Ingress Operator は TLS |

|

|

|

|

|

|

|

|

|

|

|

デフォルトでは、ポリシーは

これらの調整は、クリアテキスト、edge terminationd、および re-encrypt ルートにのみ適用され、HTTP/1 を使用する場合にのみ適用されます。

要求ヘッダーの場合、これらの調整は

|

|

|

|

|

|

|

|

|

キャプチャーするすべての Cookie について、次のパラメーターが

以下に例を示します。 httpCaptureCookies:

- matchType: Exact

maxLength: 128

name: MYCOOKIE

|

|

|

httpCaptureHeaders:

request:

- maxLength: 256

name: Connection

- maxLength: 128

name: User-Agent

response:

- maxLength: 256

name: Content-Type

- maxLength: 256

name: Content-Length

|

|

|

|

|

|

|

|

|

これらの接続は、ロードバランサーのヘルスプローブまたは Web ブラウザーの投機的接続 (事前接続) から取得され、無視しても問題はありません。ただし、これらの要求はネットワークエラーによって引き起こされる可能性があります。そのため、このフィールドを |

すべてのパラメーターはオプションです。

2.3.1. Ingress Controller の TLS セキュリティープロファイル

TLS セキュリティープロファイルは、サーバーに接続する際に接続クライアントが使用できる暗号を規制する方法をサーバーに提供します。

2.3.1.1. TLS セキュリティープロファイルについて

TLS (Transport Layer Security) セキュリティープロファイルを使用すると、さまざまな Red Hat OpenShift Service on AWS コンポーネントで必須にする TLS 暗号を定義できます。Red Hat OpenShift Service on AWS の TLS セキュリティープロファイルは、Mozilla の推奨設定 に基づいています。

コンポーネントごとに、以下の TLS セキュリティープロファイルのいずれかを指定できます。

表2.1 TLS セキュリティープロファイル

| プロファイル | 説明 |

|---|---|

|

| このプロファイルは、レガシークライアントまたはライブラリーでの使用を目的としています。このプロファイルは、Old 後方互換性 の推奨設定に基づいています。

注記 Ingress Controller の場合、TLS の最小バージョンは 1.0 から 1.1 に変換されます。 |

|

| このプロファイルは、大多数のクライアントに推奨される設定です。これは、Ingress Controller 、kubelet、およびコントロールプレーンのデフォルトの TLS セキュリティープロファイルです。このプロファイルは、Intermediate 互換性 の推奨設定に基づいています。

|

|

| このプロファイルは、後方互換性を必要としない Modern のクライアントでの使用を目的としています。このプロファイルは、Modern 互換性 の推奨設定に基づいています。

|

|

| このプロファイルを使用すると、使用する TLS バージョンと暗号を定義できます。 警告

無効な設定により問題が発生する可能性があるため、 |

事前定義されたプロファイルタイプのいずれかを使用する場合、有効なプロファイル設定はリリース間で変更される可能性があります。たとえば、リリース X.Y.Z にデプロイされた Intermediate プロファイルを使用する仕様がある場合、リリース X.Y.Z+1 へのアップグレードにより、新規のプロファイル設定が適用され、ロールアウトが生じる可能性があります。

2.3.1.2. Ingress Controller の TLS セキュリティープロファイルの設定

Ingress Controller の TLS セキュリティープロファイルを設定するには、IngressController カスタムリソース (CR) を編集して、事前定義済みまたはカスタムの TLS セキュリティープロファイルを指定します。TLS セキュリティープロファイルが設定されていない場合、デフォルト値は API サーバーに設定された TLS セキュリティープロファイルに基づいています。

Old TLS のセキュリティープロファイルを設定するサンプル IngressController CR

apiVersion: operator.openshift.io/v1

kind: IngressController

...

spec:

tlsSecurityProfile:

old: {}

type: Old

...

TLS セキュリティープロファイルは、Ingress Controller の TLS 接続の最小 TLS バージョンと TLS 暗号を定義します。

設定された TLS セキュリティープロファイルの暗号と最小 TLS バージョンは、Status.Tls Profile 配下の IngressController カスタムリソース (CR) と Spec.Tls Security Profile 配下の設定された TLS セキュリティープロファイルで確認できます。Custom TLS セキュリティープロファイルの場合、特定の暗号と最小 TLS バージョンは両方のパラメーターの下に一覧表示されます。

HAProxy Ingress Controller イメージは、TLS1.3 と Modern プロファイルをサポートしています。

また、Ingress Operator は TLS 1.0 の Old または Custom プロファイルを 1.1 に変換します。

前提条件

-

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。

手順

openshift-ingress-operatorプロジェクトのIngressControllerCR を編集して、TLS セキュリティープロファイルを設定します。$ oc edit IngressController default -n openshift-ingress-operator

spec.tlsSecurityProfileフィールドを追加します。CustomプロファイルのサンプルIngressControllerCRapiVersion: operator.openshift.io/v1 kind: IngressController ... spec: tlsSecurityProfile: type: Custom 1 custom: 2 ciphers: 3 - ECDHE-ECDSA-CHACHA20-POLY1305 - ECDHE-RSA-CHACHA20-POLY1305 - ECDHE-RSA-AES128-GCM-SHA256 - ECDHE-ECDSA-AES128-GCM-SHA256 minTLSVersion: VersionTLS11 ...- 変更を適用するためにファイルを保存します。

検証

IngressControllerCR にプロファイルが設定されていることを確認します。$ oc describe IngressController default -n openshift-ingress-operator

出力例

Name: default Namespace: openshift-ingress-operator Labels: <none> Annotations: <none> API Version: operator.openshift.io/v1 Kind: IngressController ... Spec: ... Tls Security Profile: Custom: Ciphers: ECDHE-ECDSA-CHACHA20-POLY1305 ECDHE-RSA-CHACHA20-POLY1305 ECDHE-RSA-AES128-GCM-SHA256 ECDHE-ECDSA-AES128-GCM-SHA256 Min TLS Version: VersionTLS11 Type: Custom ...

2.3.1.3. 相互 TLS 認証の設定

spec.clientTLS 値を設定して、相互 TLS (mTLS) 認証を有効にするように Ingress Controller を設定できます。clientTLS 値は、クライアント証明書を検証するように Ingress Controller を設定します。この設定には、ConfigMap の参照である clientCA 値の設定が含まれます。ConfigMap には、クライアントの証明書を検証するために使用される PEM でエンコードされた CA 証明書バンドルが含まれます。必要に応じて、証明書サブジェクトフィルターのリストも設定できます。

clientCA 値が X509v3 証明書失効リスト (CRL) ディストリビューションポイントを指定している場合、Ingress Operator は、提供された各証明書で指定されている HTTP URI X509v3 CRL Distribution Point に基づいて CRL config map をダウンロードおよび管理します。Ingress Controller は、mTLS/TLS ネゴシエーション中にこの config map を使用します。有効な証明書を提供しない要求は拒否されます。

前提条件

-

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。 - PEM でエンコードされた CA 証明書バンドルがある。

CA バンドルが CRL ディストリビューションポイントを参照する場合は、エンドエンティティーまたはリーフ証明書もクライアント CA バンドルに含める必要があります。この証明書には、RFC 5280 で説明されているとおり、この証明書の

CRL Distribution Pointsに HTTP URI が含まれている必要があります。以下に例を示します。Issuer: C=US, O=Example Inc, CN=Example Global G2 TLS RSA SHA256 2020 CA1 Subject: SOME SIGNED CERT X509v3 CRL Distribution Points: Full Name: URI:http://crl.example.com/example.crl

手順

openshift-confignamespace で、CA バンドルから config map を作成します。$ oc create configmap \ router-ca-certs-default \ --from-file=ca-bundle.pem=client-ca.crt \1 -n openshift-config- 1

- ConfigMap データキーは

ca-bundle.pemで、data の値は PEM 形式の CA 証明書である必要があります。

openshift-ingress-operatorプロジェクトでIngressControllerリソースを編集します。$ oc edit IngressController default -n openshift-ingress-operator

spec.clientTLSフィールドおよびサブフィールドを追加して相互 TLS を設定します。フィルタリングパターンを指定する

clientTLSプロファイルのサンプルIngressControllerCRapiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: clientTLS: clientCertificatePolicy: Required clientCA: name: router-ca-certs-default allowedSubjectPatterns: - "^/CN=example.com/ST=NC/C=US/O=Security/OU=OpenShift$"

2.4. デフォルト Ingress Controller の表示

Ingress Operator は Red Hat OpenShift Service on AWS のコア機能であり、すぐに有効にできます。

Red Hat OpenShift Service on AWS の新しいインストールにはすべて、default という名前の ingresscontroller があります。これは、追加の Ingress Controller で補足できます。デフォルトの ingresscontroller が削除される場合、Ingress Operator は 1 分以内にこれを自動的に再作成します。

手順

デフォルト Ingress Controller を表示します。

$ oc describe --namespace=openshift-ingress-operator ingresscontroller/default

2.5. Ingress Operator ステータスの表示

Ingress Operator のステータスを表示し、検査することができます。

手順

Ingress Operator ステータスを表示します。

$ oc describe clusteroperators/ingress

2.6. Ingress Controller ログの表示

Ingress Controller ログを表示できます。

手順

Ingress Controller ログを表示します。

$ oc logs --namespace=openshift-ingress-operator deployments/ingress-operator -c <container_name>

2.7. Ingress Controller ステータスの表示

特定の Ingress Controller のステータスを表示できます。

手順

Ingress Controller のステータスを表示します。

$ oc describe --namespace=openshift-ingress-operator ingresscontroller/<name>

2.8. Ingress Controller の設定

2.8.1. カスタムデフォルト証明書の設定

管理者として、 Secret リソースを作成し、IngressController カスタムリソース (CR) を編集して Ingress Controller がカスタム証明書を使用するように設定できます。

前提条件

- PEM エンコードされたファイルに証明書/キーのペアがなければなりません。ここで、証明書は信頼される認証局またはカスタム PKI で設定されたプライベートの信頼される認証局で署名されます。

証明書が以下の要件を満たしている必要があります。

- 証明書が Ingress ドメインに対して有効化されている必要があります。

-

証明書は拡張を使用して、

subjectAltName拡張を使用して、*.apps.ocp4.example.comなどのワイルドカードドメインを指定します。

IngressControllerCR がなければなりません。デフォルトの CR を使用できます。$ oc --namespace openshift-ingress-operator get ingresscontrollers

出力例

NAME AGE default 10m

Intermediate 証明書がある場合、それらはカスタムデフォルト証明書が含まれるシークレットの tls.crt ファイルに組み込まれる必要があります。証明書を指定する際の順序は重要になります。サーバー証明書の後に Intermediate 証明書をリスト表示します。

手順

以下では、カスタム証明書とキーのペアが、現在の作業ディレクトリーの tls.crt および tls.key ファイルにあることを前提とします。tls.crt および tls.key を実際のパス名に置き換えます。さらに、 Secret リソースを作成し、これを IngressController CR で参照する際に、custom-certs-default を別の名前に置き換えます。

このアクションにより、Ingress Controller はデプロイメントストラテジーを使用して再デプロイされます。

tls.crtおよびtls.keyファイルを使用して、カスタム証明書を含む Secret リソースをopenshift-ingressnamespace に作成します。$ oc --namespace openshift-ingress create secret tls custom-certs-default --cert=tls.crt --key=tls.key

IngressController CR を、新規証明書シークレットを参照するように更新します。

$ oc patch --type=merge --namespace openshift-ingress-operator ingresscontrollers/default \ --patch '{"spec":{"defaultCertificate":{"name":"custom-certs-default"}}}'更新が正常に行われていることを確認します。

$ echo Q |\ openssl s_client -connect console-openshift-console.apps.<domain>:443 -showcerts 2>/dev/null |\ openssl x509 -noout -subject -issuer -enddate

ここでは、以下のようになります。

<domain>- クラスターのベースドメイン名を指定します。

出力例

subject=C = US, ST = NC, L = Raleigh, O = RH, OU = OCP4, CN = *.apps.example.com issuer=C = US, ST = NC, L = Raleigh, O = RH, OU = OCP4, CN = example.com notAfter=May 10 08:32:45 2022 GM

ヒントまたは、以下の YAML を適用してカスタムのデフォルト証明書を設定できます。

apiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: defaultCertificate: name: custom-certs-default証明書シークレットの名前は、CR を更新するために使用された値に一致する必要があります。

IngressController CR が変更された後に、Ingress Operator はカスタム証明書を使用できるように Ingress Controller のデプロイメントを更新します。

2.8.2. カスタムデフォルト証明書の削除

管理者は、使用する Ingress Controller を設定したカスタム証明書を削除できます。

前提条件

-

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。 -

OpenShift CLI (

oc) がインストールされている。 - Ingress Controller のカスタムデフォルト証明書を設定している。

手順

カスタム証明書を削除し、Red Hat OpenShift Service on AWS に付属の証明書を復元するには、次のコマンドを入力します。

$ oc patch -n openshift-ingress-operator ingresscontrollers/default \ --type json -p $'- op: remove\n path: /spec/defaultCertificate'

クラスターが新しい証明書設定を調整している間、遅延が発生する可能性があります。

検証

元のクラスター証明書が復元されたことを確認するには、次のコマンドを入力します。

$ echo Q | \ openssl s_client -connect console-openshift-console.apps.<domain>:443 -showcerts 2>/dev/null | \ openssl x509 -noout -subject -issuer -enddate

ここでは、以下のようになります。

<domain>- クラスターのベースドメイン名を指定します。

出力例

subject=CN = *.apps.<domain> issuer=CN = ingress-operator@1620633373 notAfter=May 10 10:44:36 2023 GMT

2.8.3. Ingress Controller の自動スケーリング

Ingress Controller は、スループットを増大させるための要件を含む、ルーティングのパフォーマンスや可用性に関する各種要件に動的に対応するために自動でスケーリングできます。以下の手順では、デフォルトの IngressController をスケールアップする例を示します。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 -

cluster-adminロールを持つユーザーとして Red Hat OpenShift Service on AWS クラスターにアクセスできる。 - Custom Metrics Autoscaler Operator がインストールされている。

-

openshift-ingress-operatorプロジェクトの namespace に切り替えている。

手順

以下のコマンドを実行して、Thanos で認証するためのサービスアカウントを作成します。

$ oc create serviceaccount thanos && oc describe serviceaccount thanos

出力例

Name: thanos Namespace: openshift-ingress-operator Labels: <none> Annotations: <none> Image pull secrets: thanos-dockercfg-b4l9s Mountable secrets: thanos-dockercfg-b4l9s Tokens: thanos-token-c422q Events: <none>

サービスアカウントのトークンを使用して、

openshift-ingress-operatornamespace 内でTriggerAuthenticationオブジェクトを定義します。以下のコマンドを実行して、シークレットを含む変数

secretを定義します。$ secret=$(oc get secret | grep thanos-token | head -n 1 | awk '{ print $1 }')TriggerAuthenticationオブジェクトを作成し、secret変数の値をTOKENパラメーターに渡します。$ oc process TOKEN="$secret" -f - <<EOF | oc apply -f - apiVersion: template.openshift.io/v1 kind: Template parameters: - name: TOKEN objects: - apiVersion: keda.sh/v1alpha1 kind: TriggerAuthentication metadata: name: keda-trigger-auth-prometheus spec: secretTargetRef: - parameter: bearerToken name: \${TOKEN} key: token - parameter: ca name: \${TOKEN} key: ca.crt EOF

Thanos からメトリクスを読み取るためのロールを作成して適用します。

Pod およびノードからメトリクスを読み取る新規ロール

thanos-metrics-reader.yamlを作成します。thanos-metrics-reader.yaml

apiVersion: rbac.authorization.k8s.io/v1 kind: Role metadata: name: thanos-metrics-reader rules: - apiGroups: - "" resources: - pods - nodes verbs: - get - apiGroups: - metrics.k8s.io resources: - pods - nodes verbs: - get - list - watch - apiGroups: - "" resources: - namespaces verbs: - get

以下のコマンドを実行して新規ロールを適用します。

$ oc apply -f thanos-metrics-reader.yaml

以下のコマンドを入力して、新しいロールをサービスアカウントに追加します。

$ oc adm policy add-role-to-user thanos-metrics-reader -z thanos --role-namespace=openshift-ingress-operator

$ oc adm policy -n openshift-ingress-operator add-cluster-role-to-user cluster-monitoring-view -z thanos

注記引数

add-cluster-role-to-userは、namespace 間のクエリーを使用する場合にのみ必要になります。以下の手順では、この引数を必要とするkube-metricsnamespace からのクエリーを使用します。デフォルトの Ingress Controller デプロイメントをターゲットにする新しい

ScaledObjectYAML ファイルingress-autoscaler.yamlを作成します。ScaledObject定義の例apiVersion: keda.sh/v1alpha1 kind: ScaledObject metadata: name: ingress-scaler spec: scaleTargetRef: 1 apiVersion: operator.openshift.io/v1 kind: IngressController name: default envSourceContainerName: ingress-operator minReplicaCount: 1 maxReplicaCount: 20 2 cooldownPeriod: 1 pollingInterval: 1 triggers: - type: prometheus metricType: AverageValue metadata: serverAddress: https://thanos-querier.openshift-monitoring.svc.cluster.local:9091 3 namespace: openshift-ingress-operator 4 metricName: 'kube-node-role' threshold: '1' query: 'sum(kube_node_role{role="worker",service="kube-state-metrics"})' 5 authModes: "bearer" authenticationRef: name: keda-trigger-auth-prometheus

重要namespace 間クエリーを使用している場合は、

serverAddressフィールドのポート 9092 ではなくポート 9091 をターゲットにする必要があります。また、このポートからメトリクスを読み取るには、昇格した権限が必要です。以下のコマンドを実行してカスタムリソース定義を適用します。

$ oc apply -f ingress-autoscaler.yaml

検証

以下のコマンドを実行して、デフォルトの Ingress Controller が

kube-state-metricsクエリーによって返される値に一致するようにスケールアウトされていることを確認します。grepコマンドを使用して、Ingress Controller の YAML ファイルでレプリカを検索します。$ oc get ingresscontroller/default -o yaml | grep replicas:

出力例

replicas: 3

openshift-ingressプロジェクトで Pod を取得します。$ oc get pods -n openshift-ingress

出力例

NAME READY STATUS RESTARTS AGE router-default-7b5df44ff-l9pmm 2/2 Running 0 17h router-default-7b5df44ff-s5sl5 2/2 Running 0 3d22h router-default-7b5df44ff-wwsth 2/2 Running 0 66s

2.8.4. Ingress Controller のスケーリング

Ingress Controller は、スループットを増大させるための要件を含む、ルーティングのパフォーマンスや可用性に関する各種要件に対応するために手動でスケーリングできます。oc コマンドは、IngressController リソースのスケーリングに使用されます。以下の手順では、デフォルトの IngressController をスケールアップする例を示します。

スケーリングは、必要な数のレプリカを作成するのに時間がかかるため、すぐに実行できるアクションではありません。

手順

デフォルト

IngressControllerの現在の利用可能なレプリカ数を表示します。$ oc get -n openshift-ingress-operator ingresscontrollers/default -o jsonpath='{$.status.availableReplicas}'出力例

2

oc patchコマンドを使用して、デフォルトのIngressControllerを必要なレプリカ数にスケーリングします。以下の例では、デフォルトのIngressControllerを 3 つのレプリカにスケーリングしています。$ oc patch -n openshift-ingress-operator ingresscontroller/default --patch '{"spec":{"replicas": 3}}' --type=merge出力例

ingresscontroller.operator.openshift.io/default patched

デフォルトの

IngressControllerが指定したレプリカ数にスケーリングされていることを確認します。$ oc get -n openshift-ingress-operator ingresscontrollers/default -o jsonpath='{$.status.availableReplicas}'出力例

3

ヒントまたは、以下の YAML を適用して Ingress Controller を 3 つのレプリカにスケーリングすることもできます。

apiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: replicas: 3 1- 1

- 異なる数のレプリカが必要な場合は

replicas値を変更します。

2.8.5. Ingress アクセスロギングの設定

アクセスログを有効にするように Ingress Controller を設定できます。大量のトラフィックを受信しないクラスターがある場合、サイドカーにログインできます。クラスターのトラフィックが多い場合は、ロギングスタックの容量の超過を避けるために、または Red Hat OpenShift Service on AWS の外部のロギングインフラストラクチャーと統合するために、ログをカスタム syslog エンドポイントに転送できます。アクセスログの形式を指定することもできます。

コンテナーロギングは、既存の Syslog ロギングインフラストラクチャーがない場合や、Ingress Controller で問題を診断する際に短期間使用する場合に、低トラフィックのクラスターのアクセスログを有効にするのに役立ちます。

アクセスログが OpenShift Logging スタックの容量を超える可能性があるトラフィックの多いクラスターや、ロギングソリューションが既存の Syslog ロギングインフラストラクチャーと統合する必要のある環境では、syslog が必要です。Syslog のユースケースは重複する可能性があります。

前提条件

-

cluster-admin権限を持つユーザーとしてログインしている。

手順

サイドカーへの Ingress アクセスロギングを設定します。

Ingress アクセスロギングを設定するには、

spec.logging.access.destinationを使用して宛先を指定する必要があります。サイドカーコンテナーへのロギングを指定するには、Containerspec.logging.access.destination.typeを指定する必要があります。以下の例は、コンテナーContainerの宛先に対してログ記録する Ingress Controller 定義です。apiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: replicas: 2 logging: access: destination: type: ContainerIngress Controller をサイドカーに対してログを記録するように設定すると、Operator は Ingress Controller Pod 内に

logsという名前のコンテナーを作成します。$ oc -n openshift-ingress logs deployment.apps/router-default -c logs

出力例

2020-05-11T19:11:50.135710+00:00 router-default-57dfc6cd95-bpmk6 router-default-57dfc6cd95-bpmk6 haproxy[108]: 174.19.21.82:39654 [11/May/2020:19:11:50.133] public be_http:hello-openshift:hello-openshift/pod:hello-openshift:hello-openshift:10.128.2.12:8080 0/0/1/0/1 200 142 - - --NI 1/1/0/0/0 0/0 "GET / HTTP/1.1"

Syslog エンドポイントへの Ingress アクセスロギングを設定します。

Ingress アクセスロギングを設定するには、

spec.logging.access.destinationを使用して宛先を指定する必要があります。Syslog エンドポイント宛先へのロギングを指定するには、spec.logging.access.destination.typeにSyslogを指定する必要があります。宛先タイプがSyslogの場合、spec.logging.access.destination.syslog.endpointを使用して宛先エンドポイントも指定する必要があります。また、spec.logging.access.destination.syslog.facilityを使用してファシリティーを指定できます。以下の例は、Syslog宛先に対してログを記録する Ingress Controller の定義です。apiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: replicas: 2 logging: access: destination: type: Syslog syslog: address: 1.2.3.4 port: 10514注記syslog宛先ポートは UDP である必要があります。

特定のログ形式で Ingress アクセスロギングを設定します。

spec.logging.access.httpLogFormatを指定して、ログ形式をカスタマイズできます。以下の例は、IP アドレスが 1.2.3.4 およびポート 10514 のsyslogエンドポイントに対してログを記録する Ingress Controller の定義です。apiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: replicas: 2 logging: access: destination: type: Syslog syslog: address: 1.2.3.4 port: 10514 httpLogFormat: '%ci:%cp [%t] %ft %b/%s %B %bq %HM %HU %HV'

Ingress アクセスロギングを無効にします。

Ingress アクセスロギングを無効にするには、

spec.loggingまたはspec.logging.accessを空のままにします。apiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: replicas: 2 logging: access: null

サイドカーの使用時に Ingress Controller が HAProxy ログの長さを変更できるようにします。

spec.logging.access.destination.type: Syslogを使用している場合は、spec.logging.access.destination.syslog.maxLengthを使用します。apiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: replicas: 2 logging: access: destination: type: Syslog syslog: address: 1.2.3.4 maxLength: 4096 port: 10514spec.logging.access.destination.type: Containerを使用している場合は、spec.logging.access.destination.container.maxLengthを使用します。apiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: replicas: 2 logging: access: destination: type: Container container: maxLength: 8192

2.8.6. Ingress Controller スレッド数の設定

クラスター管理者は、スレッド数を設定して、クラスターが処理できる受信接続の量を増やすことができます。既存の Ingress Controller にパッチを適用して、スレッドの数を増やすことができます。

前提条件

- 以下では、Ingress Controller がすでに作成されていることを前提とします。

手順

Ingress Controller を更新して、スレッド数を増やします。

$ oc -n openshift-ingress-operator patch ingresscontroller/default --type=merge -p '{"spec":{"tuningOptions": {"threadCount": 8}}}'注記大量のリソースを実行できるノードがある場合、

spec.nodePlacement.nodeSelectorを、意図されているノードの容量に一致するラベルで設定し、spec.tuningOptions.threadCountを随時高い値に設定します。

2.8.7. 内部ロードバランサーを使用するための Ingress Controller の設定

クラウドプラットフォームで Ingress Controller を作成する場合、Ingress Controller はデフォルトでパブリッククラウドロードバランサーによって公開されます。管理者は、内部クラウドロードバランサーを使用する Ingress Controller を作成できます。

IngressControllerのscopeを変更する場合は、カスタムリソース (CR) の作成後に.spec.endpoint Publishing Strategy.load Balancer.scopeパラメーターを変更できます。

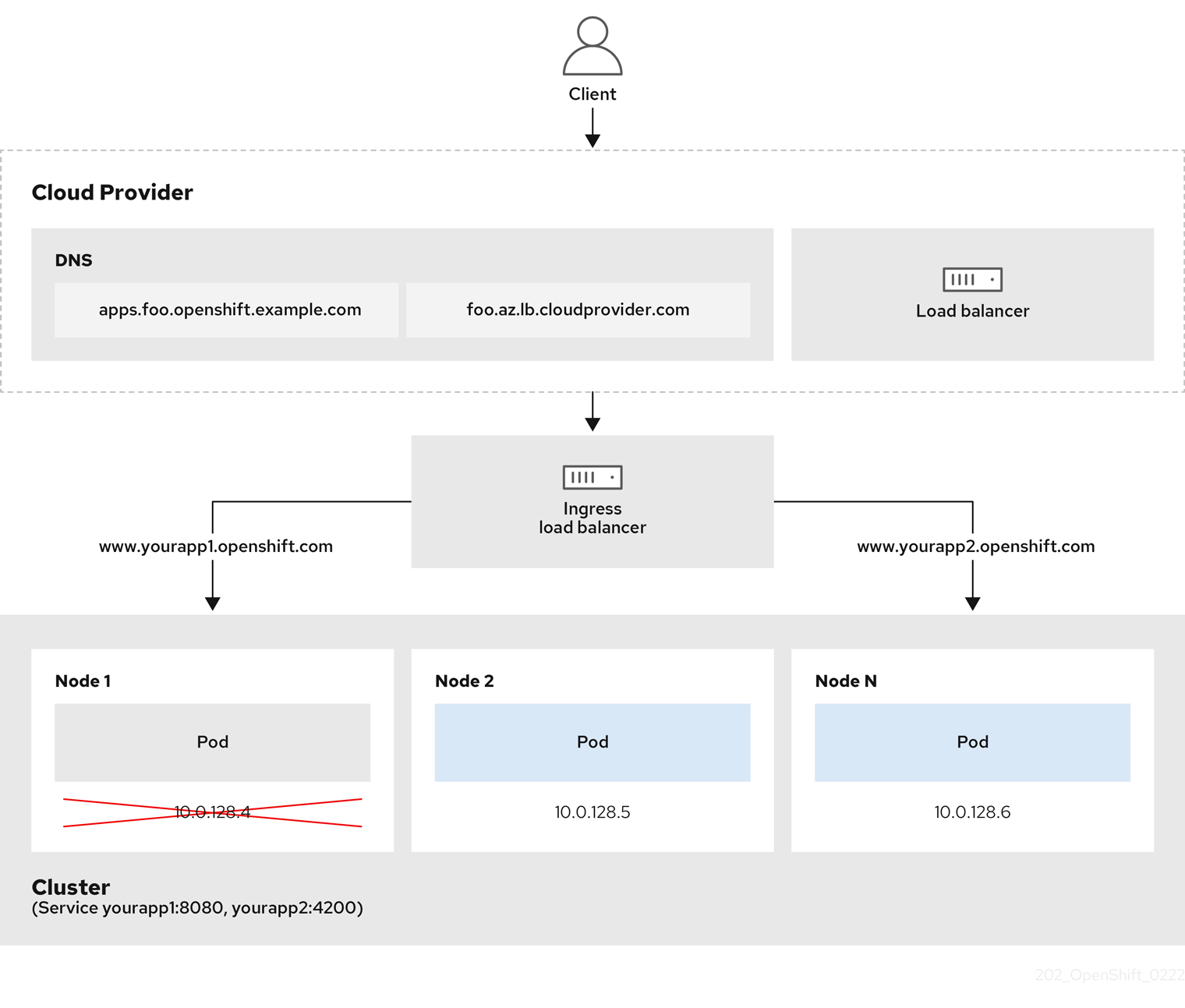

図2.1 ロードバランサーの図

上の図は、Red Hat OpenShift Service on AWS の Ingress LoadBalancerService エンドポイント公開ストラテジーに関する次の概念を示しています。

- 負荷は、外部からクラウドプロバイダーのロードバランサーを使用するか、内部から OpenShift Ingress Controller Load Balancer を使用して、分散できます。

- ロードバランサーのシングル IP アドレスと、図にあるクラスターのように、8080 や 4200 といった馴染みのあるポートを使用することができます。

- 外部のロードバランサーからのトラフィックは、ダウンしたノードのインスタンスで記載されているように、Pod の方向に進められ、ロードバランサーが管理します。実装の詳細については、Kubernetes サービスドキュメント を参照してください。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 -

cluster-admin権限を持つユーザーとしてログインしている。

手順

以下の例のように、

<name>-ingress-controller.yamlという名前のファイルにIngressControllerカスタムリソース (CR) を作成します。apiVersion: operator.openshift.io/v1 kind: IngressController metadata: namespace: openshift-ingress-operator name: <name> 1 spec: domain: <domain> 2 endpointPublishingStrategy: type: LoadBalancerService loadBalancer: scope: Internal 3

以下のコマンドを実行して、直前の手順で定義された Ingress Controller を作成します。

$ oc create -f <name>-ingress-controller.yaml 1- 1

<name>をIngressControllerオブジェクトの名前に置き換えます。

オプション: 以下のコマンドを実行して Ingress Controller が作成されていることを確認します。

$ oc --all-namespaces=true get ingresscontrollers

2.8.8. Ingress Controller のヘルスチェック間隔の設定

クラスター管理者は、ヘルスチェックの間隔を設定して、ルーターが連続する 2 回のヘルスチェックの間で待機する時間を定義できます。この値は、すべてのルートのデフォルトとしてグローバルに適用されます。デフォルト値は 5 秒です。

前提条件

- 以下では、Ingress Controller がすでに作成されていることを前提とします。

手順

Ingress Controller を更新して、バックエンドヘルスチェックの間隔を変更します。

$ oc -n openshift-ingress-operator patch ingresscontroller/default --type=merge -p '{"spec":{"tuningOptions": {"healthCheckInterval": "8s"}}}'注記単一ルートの

healthCheckIntervalをオーバーライドするには、ルートアノテーションrouter.openshift.io/haproxy.health.check.intervalを使用します

2.8.9. クラスターを内部に配置するためのデフォルト Ingress Controller の設定

削除や再作成を実行して、クラスターを内部に配置するように default Ingress Controller を設定できます。

IngressControllerのscopeを変更する場合は、カスタムリソース (CR) の作成後に.spec.endpoint Publishing Strategy.load Balancer.scopeパラメーターを変更できます。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 -

cluster-admin権限を持つユーザーとしてログインしている。

手順

削除や再作成を実行して、クラスターを内部に配置するように

defaultIngress Controller を設定します。$ oc replace --force --wait --filename - <<EOF apiVersion: operator.openshift.io/v1 kind: IngressController metadata: namespace: openshift-ingress-operator name: default spec: endpointPublishingStrategy: type: LoadBalancerService loadBalancer: scope: Internal EOF

2.8.10. ルートの受付ポリシーの設定

管理者およびアプリケーション開発者は、同じドメイン名を持つ複数の namespace でアプリケーションを実行できます。これは、複数のチームが同じホスト名で公開されるマイクロサービスを開発する組織を対象としています。

複数の namespace での要求の許可は、namespace 間の信頼のあるクラスターに対してのみ有効にする必要があります。有効にしないと、悪意のあるユーザーがホスト名を乗っ取る可能性があります。このため、デフォルトの受付ポリシーは複数の namespace 間でのホスト名の要求を許可しません。

前提条件

- クラスター管理者の権限。

手順

以下のコマンドを使用して、

ingresscontrollerリソース変数の.spec.routeAdmissionフィールドを編集します。$ oc -n openshift-ingress-operator patch ingresscontroller/default --patch '{"spec":{"routeAdmission":{"namespaceOwnership":"InterNamespaceAllowed"}}}' --type=mergeイメージコントローラー設定例

spec: routeAdmission: namespaceOwnership: InterNamespaceAllowed ...ヒントまたは、以下の YAML を適用してルートの受付ポリシーを設定できます。

apiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: routeAdmission: namespaceOwnership: InterNamespaceAllowed

2.8.11. ワイルドカードルートの使用

HAProxy Ingress Controller にはワイルドカードルートのサポートがあります。Ingress Operator は wildcardPolicy を使用して、Ingress Controller の ROUTER_ALLOW_WILDCARD_ROUTES 環境変数を設定します。

Ingress Controller のデフォルトの動作では、ワイルドカードポリシーの None (既存の IngressController リソースとの後方互換性がある) を持つルートを許可します。

手順

ワイルドカードポリシーを設定します。

以下のコマンドを使用して

IngressControllerリソースを編集します。$ oc edit IngressController

specの下で、wildcardPolicyフィールドをWildcardsDisallowedまたはWildcardsAllowedに設定します。spec: routeAdmission: wildcardPolicy: WildcardsDisallowed # or WildcardsAllowed

2.8.12. HTTP ヘッダーの設定

Red Hat OpenShift Service on AWS は、HTTP ヘッダーを操作するさまざまな方法を提供します。ヘッダーを設定または削除する場合、Ingress Controller の特定のフィールドまたは個々のルートを使用して、リクエストヘッダーと応答ヘッダーを変更できます。ルートアノテーションを使用して特定のヘッダーを設定することもできます。ヘッダーを設定するさまざまな方法は、連携時に課題となる可能性があります。

IngressController または Route CR 内のヘッダーは設定または削除のみ可能で、追加はできません。HTTP ヘッダーに値が設定されている場合、その値は完全である必要があるため、今後追加する必要はありません。X-Forwarded-For ヘッダーなどのヘッダーを追加することが適切な状況では、spec.httpHeaders.actions の代わりに spec.httpHeaders.forwardedHeaderPolicy フィールドを使用します。

2.8.12.1. 優先順位

同じ HTTP ヘッダーを Ingress Controller とルートの両方で変更すると、HAProxy は、それがリクエストヘッダーであるか応答ヘッダーであるかに応じて、特定の方法でアクションの優先順位を付けます。

- HTTP 応答ヘッダーの場合、Ingress Controller で指定されたアクションは、ルートで指定されたアクションの後に実行されます。これは、Ingress Controller で指定されたアクションが優先されることを意味します。

- HTTP リクエストヘッダーの場合、ルートで指定されたアクションは、Ingress Controller で指定されたアクションの後に実行されます。これは、ルートで指定されたアクションが優先されることを意味します。

たとえば、クラスター管理者は、次の設定を使用して、Ingress Controller で X-Frame-Options 応答ヘッダーに値 DENY を設定します。

IngressController 仕様の例

apiVersion: operator.openshift.io/v1

kind: IngressController

# ...

spec:

httpHeaders:

actions:

response:

- name: X-Frame-Options

action:

type: Set

set:

value: DENY

ルート所有者は、クラスター管理者が Ingress Controller に設定したものと同じ応答ヘッダーを設定しますが、次の設定を使用して値 SAMEORIGIN を設定します。

Route 仕様の例

apiVersion: route.openshift.io/v1

kind: Route

# ...

spec:

httpHeaders:

actions:

response:

- name: X-Frame-Options

action:

type: Set

set:

value: SAMEORIGIN

IngressController 仕様と Route 仕様の両方で X-Frame-Options ヘッダーを設定している場合、特定のルートでフレームが許可されている場合でも、Ingress Controller のグローバルレベルでこのヘッダーに設定された値が優先されます。

この優先順位付けは、haproxy.config ファイルが次のロジックを使用するために発生します。このロジックでは、Ingress Controller がフロントエンドとみなされ、個々のルートがバックエンドとみなされます。フロントエンド設定に適用されるヘッダー値 DENY は、バックエンドで設定されている値 SAMEORIGIN で同じヘッダーをオーバーライドします。

frontend public http-response set-header X-Frame-Options 'DENY' frontend fe_sni http-response set-header X-Frame-Options 'DENY' frontend fe_no_sni http-response set-header X-Frame-Options 'DENY' backend be_secure:openshift-monitoring:alertmanager-main http-response set-header X-Frame-Options 'SAMEORIGIN'

さらに、Ingress Controller またはルートのいずれかで定義されたアクションは、ルートアノテーションを使用して設定された値をオーバーライドします。

2.8.12.2. 特殊なケースのヘッダー

次のヘッダーは、設定または削除が完全に禁止されているか、特定の状況下で許可されています。

表2.2 特殊な場合のヘッダー設定オプション

| ヘッダー名 | IngressController 仕様を使用して設定可能かどうか | Route 仕様を使用して設定可能かどうか | 不許可の理由 | 別の方法で設定可能かどうか |

|---|---|---|---|---|

|

| いいえ | いいえ |

| いいえ |

|

| いいえ | はい |

| いいえ |

|

| いいえ | いいえ |

|

はい: |

|

| いいえ | いいえ | HAProxy が設定する Cookie は、クライアント接続を特定のバックエンドサーバーにマップするセッション追跡に使用されます。これらのヘッダーの設定を許可すると、HAProxy のセッションアフィニティーが妨げられ、HAProxy の Cookie の所有権が制限される可能性があります。 | はい:

|

2.8.13. Ingress Controller での HTTP リクエストおよびレスポンスヘッダーの設定または削除

コンプライアンス目的またはその他の理由で、特定の HTTP 要求および応答ヘッダーを設定または削除できます。これらのヘッダーは、Ingress Controller によって提供されるすべてのルート、または特定のルートに対して設定または削除できます。

たとえば、相互 TLS を使用するようにクラスター上で実行されているアプリケーションを移行する場合があります。このような場合、お使いのアプリケーションで X-Forwarded-Client-Cert リクエストヘッダーをチェックする必要がありますが、Red Hat OpenShift Service on AWS のデフォルトの Ingress Controller は X-SSL-Client-Der リクエストヘッダーを提供します。

次の手順では、Ingress Controller を変更して X-Forwarded-Client-Cert リクエストヘッダーを設定し、X-SSL-Client-Der リクエストヘッダーを削除します。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 -

cluster-adminロールを持つユーザーとして Red Hat OpenShift Service on AWS クラスターにアクセスできる。

手順

Ingress Controller リソースを編集します。

$ oc -n openshift-ingress-operator edit ingresscontroller/default

X-SSL-Client-Der HTTP リクエストヘッダーは X-Forwarded-Client-Cert HTTP リクエストヘッダーに置き換えます。

apiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: httpHeaders: actions: 1 request: 2 - name: X-Forwarded-Client-Cert 3 action: type: Set 4 set: value: "%{+Q}[ssl_c_der,base64]" 5 - name: X-SSL-Client-Der action: type: Delete- 1

- HTTP ヘッダーに対して実行するアクションのリスト。

- 2

- 変更するヘッダーのタイプ。この場合はリクエストヘッダーです。

- 3

- 変更するヘッダーの名前。設定または削除できる使用可能なヘッダーのリストについては、HTTP ヘッダーの設定 を参照してください。

- 4

- ヘッダーに対して実行されるアクションのタイプ。このフィールドには、

SetまたはDeleteの値を指定できます。 - 5

- HTTP ヘッダーの設定時は、

値を指定する必要があります。値は、そのヘッダーで使用可能なディレクティブのリストからの文字列 (例:DENY)にすることも、HAProxy の動的値構文を使用して解釈される動的値にすることもできます。この場合、動的な値が追加されます。

注記HTTP 応答の動的ヘッダー値を設定する場合、サンプルフェッチャーとして

res.hdrおよびssl_c_derを使用できます。HTTP リクエストの動的ヘッダー値を設定する場合、許可されるサンプルフェッチャーはreq.hdrおよびssl_c_derです。リクエストとレスポンスの両方の動的値で、lowerコンバーターとBase64コンバーターを使用できます。- 変更を適用するためにファイルを保存します。

2.8.14. X-Forwarded ヘッダーの使用

Forwarded および X-Forwarded-For を含む HTTP ヘッダーの処理方法についてのポリシーを指定するように HAProxy Ingress Controller を設定します。Ingress Operator は HTTPHeaders フィールドを使用して、Ingress Controller の ROUTER_SET_FORWARDED_HEADERS 環境変数を設定します。

手順

Ingress Controller 用に

HTTPHeadersフィールドを設定します。以下のコマンドを使用して

IngressControllerリソースを編集します。$ oc edit IngressController

specの下で、HTTPHeadersポリシーフィールドをAppend、Replace、IfNone、またはNeverに設定します。apiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: httpHeaders: forwardedHeaderPolicy: Append

使用例

クラスター管理者として、以下を実行できます。

Ingress Controller に転送する前に、

X-Forwarded-Forヘッダーを各リクエストに挿入する外部プロキシーを設定します。ヘッダーを変更せずに渡すように Ingress Controller を設定するには、

neverポリシーを指定します。これにより、Ingress Controller はヘッダーを設定しなくなり、アプリケーションは外部プロキシーが提供するヘッダーのみを受信します。外部プロキシーが外部クラスター要求を設定する

X-Forwarded-Forヘッダーを変更せずに渡すように Ingress Controller を設定します。外部プロキシーを通過しない内部クラスター要求に

X-Forwarded-Forヘッダーを設定するように Ingress Controller を設定するには、if-noneポリシーを指定します。外部プロキシー経由で HTTP 要求にヘッダーがすでに設定されている場合、Ingress Controller はこれを保持します。要求がプロキシーを通過していないためにヘッダーがない場合、Ingress Controller はヘッダーを追加します。

アプリケーション開発者として、以下を実行できます。

X-Forwarded-Forヘッダーを挿入するアプリケーション固有の外部プロキシーを設定します。他の Route のポリシーに影響を与えずに、アプリケーションの Route 用にヘッダーを変更せずに渡すように Ingress Controller を設定するには、アプリケーションの Route に アノテーション

haproxy.router.openshift.io/set-forwarded-headers: if-noneまたはhaproxy.router.openshift.io/set-forwarded-headers: neverを追加します。注記Ingress Controller のグローバルに設定された値とは別に、

haproxy.router.openshift.io/set-forwarded-headersアノテーションをルートごとに設定できます。

2.8.15. HTTP/2 Ingress 接続の有効化

HAProxy で透過的なエンドツーエンド HTTP/2 接続を有効にすることができます。これにより、アプリケーションの所有者は、単一接続、ヘッダー圧縮、バイナリーストリームなど、HTTP/2 プロトコル機能を使用できます。

個別の Ingress Controller またはクラスター全体について、HTTP/2 接続を有効にすることができます。

クライアントから HAProxy への接続について HTTP/2 の使用を有効にするために、ルートはカスタム証明書を指定する必要があります。デフォルトの証明書を使用するルートは HTTP/2 を使用することができません。この制限は、クライアントが同じ証明書を使用する複数の異なるルートに接続を再使用するなどの、接続の結合 (coalescing) の問題を回避するために必要です。

HAProxy からアプリケーション Pod への接続は、re-encrypt ルートのみに HTTP/2 を使用でき、edge termination ルートまたは非セキュアなルートには使用しません。この制限は、HAProxy が TLS 拡張である Application-Level Protocol Negotiation (ALPN) を使用してバックエンドで HTTP/2 の使用をネゴシエートするためにあります。そのため、エンドツーエンドの HTTP/2 はパススルーおよび re-encrypt 使用できますが、非セキュアなルートまたは edge termination ルートでは使用できません。

パススルー以外のルートの場合、Ingress コントローラーはクライアントからの接続とは独立してアプリケーションへの接続をネゴシエートします。つまり、クライアントが Ingress Controller に接続して HTTP/1.1 をネゴシエートし、Ingress Controller は次にアプリケーションに接続して HTTP/2 をネゴシエートし、アプリケーションへの HTTP/2 接続を使用してクライアント HTTP/1.1 接続からの要求の転送を実行できます。Ingress Controller は WebSocket を HTTP/2 に転送できず、その HTTP/2 接続を WebSocket に対してアップグレードできないため、クライアントが後に HTTP/1.1 から WebSocket プロトコルに接続をアップグレードしようとすると問題が発生します。そのため、WebSocket 接続を受け入れることが意図されたアプリケーションがある場合、これは HTTP/2 プロトコルのネゴシエートを許可できないようにする必要があります。そうしないと、クライアントは WebSocket プロトコルへのアップグレードに失敗します。

手順

単一 Ingress Controller で HTTP/2 を有効にします。

Ingress Controller で HTTP/2 を有効にするには、

oc annotateコマンドを入力します。$ oc -n openshift-ingress-operator annotate ingresscontrollers/<ingresscontroller_name> ingress.operator.openshift.io/default-enable-http2=true

<ingresscontroller_name>をアノテーションを付ける Ingress Controller の名前に置き換えます。

クラスター全体で HTTP/2 を有効にします。

クラスター全体で HTTP/2 を有効にするには、

oc annotateコマンドを入力します。$ oc annotate ingresses.config/cluster ingress.operator.openshift.io/default-enable-http2=true

ヒントまたは、以下の YAML を適用してアノテーションを追加できます。

apiVersion: config.openshift.io/v1 kind: Ingress metadata: name: cluster annotations: ingress.operator.openshift.io/default-enable-http2: "true"

2.8.16. Ingress Controller の PROXY プロトコルの設定

クラスター管理者は、Ingress Controller が HostNetwork または NodePortService エンドポイントの公開ストラテジータイプのいずれかを使用する際に PROXY プロトコル を設定できます。PROXY プロトコルにより、ロードバランサーは Ingress Controller が受信する接続の元のクライアントアドレスを保持することができます。元のクライアントアドレスは、HTTP ヘッダーのロギング、フィルタリング、および挿入を実行する場合に便利です。デフォルト設定では、Ingress Controller が受信する接続には、ロードバランサーに関連付けられるソースアドレスのみが含まれます。

この機能は、クラウドデプロイメントではサポートされていません。この制限があるのは、Red Hat OpenShift Service on AWS がクラウドプラットフォームで実行され、IngressController がサービスロードバランサーを使用するように指定している場合に、Ingress Operator がロードバランサーサービスを設定し、ソースアドレスを保持するプラットフォーム要件に基づいて PROXY プロトコルを有効にするためです。

PROXY プロトコルまたは TCP を使用するには、Red Hat OpenShift Service on AWS と外部ロードバランサーの両方を設定する必要があります。

PROXY プロトコルは、Keepalived Ingress VIP を使用するクラウド以外のプラットフォーム上のインストーラーによってプロビジョニングされたクラスターを使用するデフォルトの Ingress Controller ではサポートされていません。

前提条件

- Ingress Controller を作成している。

手順

Ingress Controller リソースを編集します。

$ oc -n openshift-ingress-operator edit ingresscontroller/default

PROXY 設定を設定します。

Ingress Controller が hostNetwork エンドポイント公開ストラテジータイプを使用する場合は、

spec.endpointPublishingStrategy.nodePort.protocolサブフィールドをPROXYに設定します。PROXYへのhostNetworkの設定例spec: endpointPublishingStrategy: hostNetwork: protocol: PROXY type: HostNetworkIngress Controller が NodePortService エンドポイント公開ストラテジータイプを使用する場合は、

spec.endpointPublishingStrategy.nodePort.protocolサブフィールドをPROXYに設定します。PROXYへのサンプルnodePort設定spec: endpointPublishingStrategy: nodePort: protocol: PROXY type: NodePortService

2.8.17. appsDomain オプションを使用した代替クラスタードメインの指定

クラスター管理者は、appsDomain フィールドを設定して、ユーザーが作成したルートのデフォルトのクラスタードメインの代わりとなるものを指定できます。appsDomain フィールドは、domain フィールドで指定されているデフォルトの代わりに使用する Red Hat OpenShift Service on AWS のオプションのドメインです。代替ドメインを指定する場合、これは新規ルートのデフォルトホストを判別できるようにする目的でデフォルトのクラスタードメインを上書きします。

たとえば、所属企業の DNS ドメインを、クラスター上で実行されるアプリケーションのルートおよび ingress のデフォルトドメインとして使用できます。

前提条件

- Red Hat OpenShift Service on AWS クラスターをデプロイしている。

-

ocコマンドラインインターフェイスをインストールしている。

手順

ユーザーが作成するルートに代替のデフォルトドメインを指定して

appsDomainフィールドを設定します。Ingress

clusterリソースを編集します。$ oc edit ingresses.config/cluster -o yaml

YAML ファイルを編集します。

test.example.comへのapps Domainの設定例apiVersion: config.openshift.io/v1 kind: Ingress metadata: name: cluster spec: domain: apps.example.com 1 appsDomain: <test.example.com> 2

ルートを公開し、ルートドメインの変更を確認して、既存のルートに、

appsDomainフィールドで指定したドメイン名が含まれていることを確認します。注記ルートを公開する前に

openshift-apiserverがローリング更新を終了するのを待機します。ルートを公開します。

$ oc expose service hello-openshift route.route.openshift.io/hello-openshift exposed

出力例:

$ oc get routes NAME HOST/PORT PATH SERVICES PORT TERMINATION WILDCARD hello-openshift hello_openshift-<my_project>.test.example.com hello-openshift 8080-tcp None

2.8.18. HTTP ヘッダーケースの変換

HAProxy では、デフォルトで HTTP ヘッダー名を小文字化します。たとえば、Host: xyz.com は host: xyz.com に変更されます。レガシーアプリケーションが HTTP ヘッダー名の大文字を認識する場合、Ingress Controller の spec.httpHeaders.headerNameCaseAdjustments API フィールドを、修正されるまでレガシーアプリケーションに対応するソリューションに使用します。

Red Hat OpenShift Service on AWS には HAProxy 2.6 が含まれるため、アップグレードする前に spec.httpHeaders.headerNameCaseAdjustments を使用して必要な設定を追加するようにしてください。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 -

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。

手順

クラスター管理者は、oc patch コマンドを入力するか、Ingress Controller YAML ファイルの HeaderNameCaseAdjustments フィールドを設定して HTTP ヘッダーのケースを変換できます。

oc patchコマンドを入力して、HTTP ヘッダーの大文字化を指定します。oc patchコマンドを入力して、HTTPhostヘッダーをHostに変更します。$ oc -n openshift-ingress-operator patch ingresscontrollers/default --type=merge --patch='{"spec":{"httpHeaders":{"headerNameCaseAdjustments":["Host"]}}}'アプリケーションのルートにアノテーションを付けます。

$ oc annotate routes/my-application haproxy.router.openshift.io/h1-adjust-case=true

次に、Ingress Controller は

host要求ヘッダーを指定どおりに調整します。

Ingress Controller の YAML ファイルを設定し、

HeaderNameCaseAdjustmentsフィールドを使用して調整を指定します。以下のサンプル Ingress Controller YAML は、適切にアノテーションが付けられたルートへの HTTP/1 要求について

hostヘッダーをHostに調整します。Ingress Controller YAML のサンプル

apiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: httpHeaders: headerNameCaseAdjustments: - Host以下のサンプルルートでは、

haproxy.router.openshift.io/h1-adjust-caseアノテーションを使用して HTTP 応答ヘッダー名のケース調整を有効にします。ルート YAML のサンプル

apiVersion: route.openshift.io/v1 kind: Route metadata: annotations: haproxy.router.openshift.io/h1-adjust-case: true 1 name: my-application namespace: my-application spec: to: kind: Service name: my-application- 1

haproxy.router.openshift.io/h1-adjust-caseを true に設定します。

2.8.19. ルーター圧縮の使用

特定の MIME タイプに対してルーター圧縮をグローバルに指定するように HAProxy Ingress Controller を設定します。mimeTypes変数を使用して、圧縮が適用される MIME タイプの形式を定義できます。タイプは、アプリケーション、イメージ、メッセージ、マルチパート、テキスト、ビデオ、または X-で始まるカスタムタイプです。MIME タイプとサブタイプの完全な表記を確認するには、RFC1341を参照してください。

圧縮用に割り当てられたメモリーは、最大接続数に影響を与える可能性があります。さらに、大きなバッファーを圧縮すると、正規表現による負荷が多い場合や正規表現のリストが長い場合など、レイテンシーが発生する可能性があります。

すべての MIME タイプが圧縮から利点を得るわけではありませんが、HAProxy は、指示された場合でもリソースを使用して圧縮を試みます。一般に、html、css、js などのテキスト形式は圧縮から利点を得ますが、イメージ、音声、ビデオなどのすでに圧縮済みの形式は、圧縮に時間とリソースが費やされるわりに利点はほぼありません。

手順

Ingress Controller の

httpCompressionフィールドを設定します。以下のコマンドを使用して

IngressControllerリソースを編集します。$ oc edit -n openshift-ingress-operator ingresscontrollers/default

specで、httpCompressionポリシーフィールドをmimeTypesに設定し、圧縮を適用する必要がある MIME タイプのリストを指定します。apiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: httpCompression: mimeTypes: - "text/html" - "text/css; charset=utf-8" - "application/json" ...

2.8.20. ルーターメトリクスの公開

デフォルトで、HAProxy ルーターメトリクスをデフォルトの stats ポート (1936) に Prometheus 形式で公開できます。Prometheus などの外部メトリクス収集および集約システムは、HAProxy ルーターメメトリクスにアクセスできます。HAProxy ルーターメトリクスは、HTML およびコンマ区切り値 (CSV) 形式でブラウザーに表示できます。

前提条件

- ファイアウォールを、デフォルトの stats ポート (1936) にアクセスするように設定している。

手順

次のコマンドを実行して、ルーター Pod 名を取得します。

$ oc get pods -n openshift-ingress

出力例

NAME READY STATUS RESTARTS AGE router-default-76bfffb66c-46qwp 1/1 Running 0 11h

ルーター Pod が

/var/lib/haproxy/conf/metrics-auth/statsUsernameおよび/var/lib/haproxy/conf/metrics-auth/statsPasswordファイルに保存しているルーターのユーザー名およびパスワードを取得します。次のコマンドを実行して、ユーザー名を取得します。

$ oc rsh <router_pod_name> cat metrics-auth/statsUsername

次のコマンドを実行して、パスワードを取得します。

$ oc rsh <router_pod_name> cat metrics-auth/statsPassword

次のコマンドを実行して、ルーター IP およびメトリクス証明書を取得します。

$ oc describe pod <router_pod>

つぎのコマンドを実行して、Prometheus 形式で未加工の統計情報を取得します。

$ curl -u <user>:<password> http://<router_IP>:<stats_port>/metrics

次のコマンドを実行して、安全にメトリクスにアクセスします。

$ curl -u user:password https://<router_IP>:<stats_port>/metrics -k

次のコマンドを実行して、デフォルトの stats ポート (1936) にアクセスします。

$ curl -u <user>:<password> http://<router_IP>:<stats_port>/metrics

例2.1 出力例

... # HELP haproxy_backend_connections_total Total number of connections. # TYPE haproxy_backend_connections_total gauge haproxy_backend_connections_total{backend="http",namespace="default",route="hello-route"} 0 haproxy_backend_connections_total{backend="http",namespace="default",route="hello-route-alt"} 0 haproxy_backend_connections_total{backend="http",namespace="default",route="hello-route01"} 0 ... # HELP haproxy_exporter_server_threshold Number of servers tracked and the current threshold value. # TYPE haproxy_exporter_server_threshold gauge haproxy_exporter_server_threshold{type="current"} 11 haproxy_exporter_server_threshold{type="limit"} 500 ... # HELP haproxy_frontend_bytes_in_total Current total of incoming bytes. # TYPE haproxy_frontend_bytes_in_total gauge haproxy_frontend_bytes_in_total{frontend="fe_no_sni"} 0 haproxy_frontend_bytes_in_total{frontend="fe_sni"} 0 haproxy_frontend_bytes_in_total{frontend="public"} 119070 ... # HELP haproxy_server_bytes_in_total Current total of incoming bytes. # TYPE haproxy_server_bytes_in_total gauge haproxy_server_bytes_in_total{namespace="",pod="",route="",server="fe_no_sni",service=""} 0 haproxy_server_bytes_in_total{namespace="",pod="",route="",server="fe_sni",service=""} 0 haproxy_server_bytes_in_total{namespace="default",pod="docker-registry-5-nk5fz",route="docker-registry",server="10.130.0.89:5000",service="docker-registry"} 0 haproxy_server_bytes_in_total{namespace="default",pod="hello-rc-vkjqx",route="hello-route",server="10.130.0.90:8080",service="hello-svc-1"} 0 ...ブラウザーで以下の URL を入力して、stats ウィンドウを起動します。

http://<user>:<password>@<router_IP>:<stats_port>

オプション: ブラウザーに次の URL を入力して、CSV 形式で統計情報を取得します。

http://<user>:<password>@<router_ip>:1936/metrics;csv

2.8.21. HAProxy エラーコードの応答ページのカスタマイズ

クラスター管理者は、503、404、またはその両方のエラーページにカスタムのエラーコード応答ページを指定できます。HAProxy ルーターは、アプリケーション Pod が実行していない場合や、要求された URL が存在しない場合に 404 エラーページを提供する 503 エラーページを提供します。たとえば、503 エラーコードの応答ページをカスタマイズする場合は、アプリケーション Pod が実行していないときにページが提供されます。また、デフォルトの 404 エラーコード HTTP 応答ページは、誤ったルートまたは存在しないルートについて HAProxy ルーターによって提供されます。

カスタムエラーコードの応答ページは ConfigMap に指定し、Ingress Controller にパッチを適用されます。ConfigMap キーには、error-page-503.http と error-page-404.http の 2 つの利用可能なファイル名があります。

カスタムの HTTP エラーコードの応答ページは、HAProxy HTTP エラーページ設定のガイドライン に従う必要があります。以下は、デフォルトの Red Hat OpenShift Service on AWS HAProxy ルーターの http 503 エラーコード応答ページ の例です。デフォルトのコンテンツを、独自のカスタムページを作成するためのテンプレートとして使用できます。

デフォルトで、HAProxy ルーターは、アプリケーションが実行していない場合や、ルートが正しくないまたは存在しない場合に 503 エラーページのみを提供します。このデフォルトの動作は、Red Hat OpenShift Service on AWS 4.8 以前の動作と同じです。HTTP エラーコード応答をカスタマイズするための ConfigMap が提供されておらず、カスタム HTTP エラーコード応答ページを使用している場合、ルーターはデフォルトの 404 または 503 エラーコード応答ページを提供します。

OpenShift Container Platform のデフォルトの 503 エラーコードページをカスタマイズのテンプレートとして使用する場合、ファイル内のヘッダーで CRLF 改行コードを使用できるエディターが必要になります。

手順

openshift-configにmy-custom-error-code-pagesという名前の ConfigMap を作成します。$ oc -n openshift-config create configmap my-custom-error-code-pages \ --from-file=error-page-503.http \ --from-file=error-page-404.http

重要カスタムエラーコードの応答ページに適した形式を指定しない場合は、ルーター Pod が停止します。この停止を解決するには、ConfigMap を削除するか、修正し、影響を受けるルーター Pod を削除して、正しい情報で再作成できるようにします。

Ingress Controller にパッチを適用し、名前を指定して

my-custom-error-code-pagesConfigMap を参照します。$ oc patch -n openshift-ingress-operator ingresscontroller/default --patch '{"spec":{"httpErrorCodePages":{"name":"my-custom-error-code-pages"}}}' --type=mergeIngress Operator は、

openshift-confignamespace からopenshift-ingressnamespace にmy-custom-error-code-pagesConfigMap をコピーします。Operator は、openshift-ingressnamespace のパターン<your_ingresscontroller_name>-errorpagesに従って ConfigMap に名前を付けます。コピーを表示します。

$ oc get cm default-errorpages -n openshift-ingress

出力例

NAME DATA AGE default-errorpages 2 25s 1- 1

defaultの Ingress Controller カスタムリソース (CR) にパッチが適用されているため、ConfigMap 名の例はdefault-errorpagesです。

カスタムエラー応答ページを含む ConfigMap がルーターボリュームにマウントされることを確認します。ConfigMap キーは、カスタム HTTP エラーコード応答を持つファイル名です。

503 カスタム HTTP カスタムエラーコード応答の場合:

$ oc -n openshift-ingress rsh <router_pod> cat /var/lib/haproxy/conf/error_code_pages/error-page-503.http

404 カスタム HTTP カスタムエラーコード応答の場合:

$ oc -n openshift-ingress rsh <router_pod> cat /var/lib/haproxy/conf/error_code_pages/error-page-404.http

検証

カスタムエラーコード HTTP 応答を確認します。

テストプロジェクトおよびアプリケーションを作成します。

$ oc new-project test-ingress

$ oc new-app django-psql-example

503 カスタム http エラーコード応答の場合:

- アプリケーションのすべての Pod を停止します。

以下の curl コマンドを実行するか、ブラウザーでルートのホスト名にアクセスします。

$ curl -vk <route_hostname>

404 カスタム http エラーコード応答の場合:

- 存在しないルートまたは正しくないルートにアクセスします。

以下の curl コマンドを実行するか、ブラウザーでルートのホスト名にアクセスします。

$ curl -vk <route_hostname>

errorfile属性がhaproxy.configファイルで適切にあるかどうかを確認します。$ oc -n openshift-ingress rsh <router> cat /var/lib/haproxy/conf/haproxy.config | grep errorfile

2.8.22. Ingress Controller の最大接続数の設定

クラスター管理者は、OpenShift ルーターデプロイメントの同時接続の最大数を設定できます。既存の Ingress Controller にパッチを適用して、接続の最大数を増やすことができます。

前提条件

- 以下では、Ingress Controller が作成済みであることを前提とします。

手順

Ingress Controller を更新して、HAProxy の最大接続数を変更します。

$ oc -n openshift-ingress-operator patch ingresscontroller/default --type=merge -p '{"spec":{"tuningOptions": {"maxConnections": 7500}}}'警告spec.tuningOptions.maxConnectionsの値を現在のオペレーティングシステムの制限よりも大きく設定すると、HAProxy プロセスは開始しません。このパラメーターの詳細は、Ingress Controller 設定パラメーターセクションの表を参照してください。

2.9. Red Hat OpenShift Service on AWS Ingress Operator の設定

以下の表は、Ingress Operator のコンポーネントおよび、Red Hat Site Reliability Engineers (SRE) が Red Hat OpenShift Service on AWS クラスターでこのコンポーネントを管理するかどうかについて詳しく説明します。

表2.3 Ingress Operator の責務チャート

| Ingress コンポーネント | 管理 | デフォルト設定? |

|---|---|---|

| Ingress コントローラーのスケーリング | SRE | ◯ |

| Ingress Operator のスレッド数 | SRE | ◯ |

| Ingress コントローラーのアクセスロギング | SRE | ◯ |

| Ingress コントローラーのシャード化 | SRE | ◯ |

| Ingress コントローラールートの受付ポリシー | SRE | ◯ |

| Ingress コントローラーのワイルドカードルート | SRE | ◯ |

| Ingress コントローラー X-Forwarded ヘッダー | SRE | ◯ |

| Ingress コントローラールートの圧縮 | SRE | ◯ |

第3章 AWS Load Balancer Operator

AWS Load Balancer Operator (ALBO) は、Red Hat でサポートされている Operator です。ユーザーは、オプションでこれを SRE が管理する Red Hat OpenShift Service on AWS (ROSA) クラスターにインストールできます。ALBO は、ROSA クラスターで実行されているアプリケーションに AWS Elastic Load Balancing v2 (ELBv2) サービスをプロビジョニングする、AWS マネージドの AWS Load Balancer Controller (ALBC) のライフサイクルを管理します。

3.1. AWS Load Balancer Operator のインストール

特定の要件を満たしている場合は、AWS Load Balancer Operator (ALBO) をインストールできます。

前提条件

- STS モードでインストールされた複数のアベイラビリティーゾーン (AZ) をまたいで、Bring-your-own-VPC (BYO-VPC) が設定された既存の Red Hat OpenShift Service on AWS (ROSA) クラスターがある。

-

dedicated-adminロールを持つユーザーとしてクラスターにアクセスできる。 - 作成された ROSA クラスターの VPC とサブネットを変更するためのアクセス権がある。

-

ROSA CLI (

rosa) ツールをインストールしている。 - Amazon Web Services (AWS) CLI がインストールされている。

- OpenShift CLI (oc) がインストールされている。

- OpenShift Container Platform (OCP) 4.13 以降を使用している。

AWS Local Zone (LZ) の ROSA クラスターで使用する ALBO をインストールには、使用するアカウントで AWS LZ を有効にし、その AWS LZ で AWS Elastic Load Balancing v2 (ELBv2) サービスを利用可能にする必要があります。

手順

次のコマンドを実行して、クラスターインフラストラクチャー ID とクラスター OpenID Connect (OIDC) DNS を特定します。

ROSA クラスターの INFRA ID を特定します。

$ rosa describe cluster --cluster=<cluster_name> | grep -i 'Infra ID'

または、以下を実行します。

$ oc get infrastructure cluster -o json | jq -r '.status.infrastructureName'

ROSA クラスターの OIDC DNS を特定します。

$ rosa describe cluster --cluster=<cluster_name> | grep -i 'OIDC'

コマンドからの出力を保存します。この情報は、この後の手順で使用します。

ALBO に必要な AWS IAM ポリシーを作成します。

dedicated-adminロールを持つユーザーとして ROSA クラスターにログインし、次のコマンドを使用して新しいプロジェクトを作成します。$ oc new-project aws-load-balancer-operator

新しく作成した AWS IAM ロールに次の信頼ポリシーを割り当てます。

$ IDP='{Cluster_OIDC_Endpoint}' $ IDP_ARN="arn:aws:iam::{AWS_AccountNo}:oidc-provider/${IDP}" 1 $ cat <<EOF > albo-operator-trusted-policy.json { "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Principal": { "Federated": "${IDP_ARN}" }, "Action": "sts:AssumeRoleWithWebIdentity", "Condition": { "StringEquals": { "${IDP}:sub": "system:serviceaccount:aws-load-balancer-operator:aws-load-balancer-operator-controller-manager" } } } ] } EOF- 1

- '{AWS_AccountNo}' を AWS アカウント番号に置き換え、'{Cluster_OIDC_Endpoint}' を前の手順で特定した OIDC DNS に置き換えます。

重要{Cluster_OIDC_Endpoint}を前に特定した OIDC DNS に置き換える際に、OIDC DNS URL のhttps部分は含めないでください。URL 内の/に続く英数字情報のみ必要です。信頼ポリシーを AWS IAM ロールに割り当てる方法について、詳細は IAM ロールで信頼ポリシーを使用する方法 を参照してください。

生成された信頼ポリシーを使用してロールを作成し、検証します。

$ aws iam create-role --role-name albo-operator --assume-role-policy-document file://albo-operator-trusted-policy.json $ OPERATOR_ROLE_ARN=$(aws iam get-role --role-name albo-operator --output json | jq -r '.Role.Arn') $ echo $OPERATOR_ROLE_ARN

AWS IAM ロールの作成について、詳細は IAM ロールの作成 を参照してください。

Operator の権限ポリシーをロールにアタッチします。

$ curl -o albo-operator-permission-policy.json https://raw.githubusercontent.com/alebedev87/aws-load-balancer-operator/aws-cli-commands-for-sts/hack/operator-permission-policy.json aws iam put-role-policy --role-name albo-operator --policy-name perms-policy-albo-operator --policy-document file://albo-operator-permission-policy.json

AWS IAM ロールへの AWS IAM 権限の追加について、詳細は IAM アイデンティティーの権限の追加と削除 を参照してください。

Operator の AWS 認証情報を生成します。

$ cat <<EOF> albo-operator-aws-credentials.cfg [default] sts_regional_endpoints = regional role_arn = ${OPERATOR_ROLE_ARN} web_identity_token_file = /var/run/secrets/openshift/serviceaccount/token EOF認証情報ファイルの形式について、詳細は Amazon Web Services Security Token Service を手動モードで使用する を参照してください。

生成された AWS 認証情報を使用して Operator の認証情報シークレットを作成します。

$ oc -n aws-load-balancer-operator create secret generic aws-load-balancer-operator --from-file=credentials=albo-operator-aws-credentials.cfg

AWS Load Balancer Controller (ALBC) に必要な AWS IAM ポリシーを作成します。

アイデンティティープロバイダー用の信頼ポリシーファイルを生成します。次の例では OpenID Connect を使用しています。

$ IDP='{Cluster_OIDC_Endpoint}' $ IDP_ARN="arn:aws:iam::{AWS_AccountNo}:oidc-provider/${IDP}" $ cat <<EOF > albo-controller-trusted-policy.json { "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Principal": { "Federated": "${IDP_ARN}" }, "Action": "sts:AssumeRoleWithWebIdentity", "Condition": { "StringEquals": { "${IDP}:sub": "system:serviceaccount:aws-load-balancer-operator:aws-load-balancer-controller-cluster" } } } ] } EOF生成された信頼ポリシーを使用してロールを作成し、検証します。

$ aws iam create-role --role-name albo-controller --assume-role-policy-document file://albo-controller-trusted-policy.json $ CONTROLLER_ROLE_ARN=$(aws iam get-role --role-name albo-controller --output json | jq -r '.Role.Arn') $ echo $CONTROLLER_ROLE_ARN

コントローラーの権限ポリシーをロールにアタッチします。

$ curl -o albo-controller-permission-policy.json https://raw.githubusercontent.com/kubernetes-sigs/aws-load-balancer-controller/v2.4.7/docs/install/iam_policy.json aws iam put-role-policy --role-name albo-controller --policy-name perms-policy-albo-controller --policy-document file://albo-controller-permission-policy.json

コントローラーの AWS 認証情報を生成します。

$ cat <<EOF > albo-controller-aws-credentials.cfg [default] sts_regional_endpoints = regional role_arn = ${CONTROLLER_ROLE_ARN} web_identity_token_file = /var/run/secrets/openshift/serviceaccount/token EOF生成された AWS 認証情報を使用して、コントローラーの認証情報シークレットを作成します。

$ oc -n aws-load-balancer-operator create secret generic aws-load-balancer-controller-cluster --from-file=credentials=albo-controller-aws-credentials.cfg

サブネットの検出に必要なタグを追加します。

ROSA クラスターをホストする VPC に、次の

{Key: Value}タグを追加します。{Cluster Infra ID}を、前に指定した Infra ID に置き換えます。* kubernetes.io/cluster/${Cluster Infra ID}:owned次の ELBv2

{Key: Value}タグをプライベートサブネットに追加します。必要な場合は、パブリックサブネットにも追加します。-

プライベートサブネット:

kubernetes.io/role/internal-elb:1 パブリックサブネット:

kubernetes.io/role/elb:1注記インターネットに接続された内部ロードバランサーは、これらのサブネットが属する AZ 内に作成されます。

VPC やサブネットなどの AWS リソースにタグを追加する方法について、詳細は Tag your Amazon EC2 resources を参照してください。

重要ALBO が作成した ELBv2 リソース (ALB や NLB など) は、ROSA クラスターに設定されたカスタムタグを継承しません。これらのリソースには、個別にタグを設定する必要があります。

-

プライベートサブネット:

ALBO を作成します。

apiVersion: operators.coreos.com/v1 kind: OperatorGroup metadata: name: aws-load-balancer-operator namespace: aws-load-balancer-operator spec: upgradeStrategy: Default --- apiVersion: operators.coreos.com/v1alpha1 kind: Subscription metadata: name: aws-load-balancer-operator namespace: aws-load-balancer-operator spec: channel: stable-v1.0 installPlanApproval: Automatic name: aws-load-balancer-operator source: redhat-operators sourceNamespace: openshift-marketplace startingCSV: aws-load-balancer-operator.v1.0.0

AWS ALBC を作成します。

apiVersion: networking.olm.openshift.io/v1 kind: AWSLoadBalancerController metadata: name: cluster spec: subnetTagging: Manual credentials: name: aws-load-balancer-controller-cluster重要AWS ALBC は AZ と AWS LZ の両方に関連付けられた ALB の作成をサポートしていないため、ROSA クラスターは AWS LZ または AZ のいずれかにのみ関連付けられた ALB を持つことができますが、両方を同時に持つことはできません。

AWS ALBC の設定について、詳細は次のトピックを参照してください。

検証

次のコマンドを実行して、インストールが成功したことを確認します。

プロジェクト内の Pod に関する情報を収集します。

$ oc get pods -n aws-load-balancer-operator

プロジェクト内のログを表示します。

$ oc logs -n aws-load-balancer-operator deployment/aws-load-balancer-operator-controller-manager -c manager

ROSA クラスターで実行されているアプリケーション用に ELBv2 が作成されたことを確認する詳細な手順は、AWS Load Balancer Controller のインスタンスの作成 を参照してください。

3.2. AWS Load Balancer Operator のアンインストール

AWS Load Balancer Operator (ALBO) をアンインストールし、関連リソース全体をクリーンアップするには、次の手順を実行します。

手順

- ALBO が作成および管理するロードバランサーを削除して、サンプルアプリケーションをクリーンアップします。ロードバランサーの削除について、詳細は Delete an Application Load Balancer を参照してください。

- サブネットの検出と Application Load Balancer (ALB) の作成のためにサブネットに追加された VPC タグを削除して、AWS VPC タグをクリーンアップします。詳細は、Tag basics を参照してください。

- ALBO と Application Load Balancer Controller (ALBC) の両方を削除して、ALBO コンポーネントをクリーンアップします。詳細は、クラスターからの Operator の削除 を参照してください。

第4章 OpenShift SDN デフォルト CNI ネットワークプロバイダー

4.1. プロジェクトのマルチキャストの有効化

OpenShift SDN CNI は、Red Hat OpenShift Service on AWS 4.14 で非推奨になりました。Red Hat OpenShift Service on AWS 4.15 の時点で、ネットワークプラグインは新規インストールのオプションではありません。今後のリリースでは、OpenShift SDN ネットワークプラグインは削除され、サポートされなくなる予定です。Red Hat は、この機能が削除されるまでバグ修正とサポートを提供しますが、この機能は拡張されなくなります。OpenShift SDN CNI の代わりに、OVN Kubernetes CNI を使用できます。

4.1.1. マルチキャストについて

IP マルチキャストを使用すると、データが多数の IP アドレスに同時に配信されます。

- 現時点で、マルチキャストは低帯域幅の調整またはサービスの検出での使用に最も適しており、高帯域幅のソリューションとしては適していません。

-

デフォルトでは、ネットワークポリシーは namespace 内のすべての接続に影響します。ただし、マルチキャストはネットワークポリシーの影響を受けません。マルチキャストがネットワークポリシーと同じ namespace で有効にされている場合、

deny-allネットワークポリシーがある場合でも、マルチキャストは常に許可されます。クラスター管理者は、これを有効にする前に、ネットワークポリシーからマルチキャストが除外されることの影響を考慮する必要があります。

Red Hat OpenShift Service on AWS Pod 間のマルチキャストトラフィックはデフォルトで無効になっています。OpenShift SDN ネットワークプラグインを使用している場合、プロジェクトごとにマルチキャストを有効にできます。

networkpolicy 分離モードで OpenShift SDN ネットワークプラグインを使用する場合は、以下を行います。

-

Pod によって送信されるマルチキャストパケットは、

NetworkPolicyオブジェクトに関係なく、プロジェクトの他のすべての Pod に送信されます。Pod はユニキャストで通信できない場合でもマルチキャストで通信できます。 -

1 つのプロジェクトの Pod によって送信されるマルチキャストパケットは、

NetworkPolicyオブジェクトがプロジェクト間の通信を許可する場合であっても、それ以外のプロジェクトの Pod に送信されることはありません。

multinenant 分離モードで OpenShift SDN ネットワークプラグインを使用する場合は、以下を行います。

- Pod で送信されるマルチキャストパケットはプロジェクトにあるその他の全 Pod に送信されます。

- あるプロジェクトの Pod によって送信されるマルチキャストパケットは、各プロジェクトが結合し、マルチキャストが結合した各プロジェクトで有効にされている場合にのみ、他のプロジェクトの Pod に送信されます。

4.1.2. Pod 間のマルチキャストの有効化

プロジェクトの Pod でマルチキャストを有効にすることができます。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 -

cluster-adminまたはdedicated-adminロールを持つユーザーでクラスターにログインする必要があります。

手順

以下のコマンドを実行し、プロジェクトのマルチキャストを有効にします。

<namespace>を、マルチキャストを有効にする必要のある namespace に置き換えます。$ oc annotate netnamespace <namespace> \ netnamespace.network.openshift.io/multicast-enabled=true

検証

マルチキャストがプロジェクトについて有効にされていることを確認するには、以下の手順を実行します。

現在のプロジェクトを、マルチキャストを有効にしたプロジェクトに切り替えます。

<project>をプロジェクト名に置き換えます。$ oc project <project>

マルチキャストレシーバーとして機能する Pod を作成します。

$ cat <<EOF| oc create -f - apiVersion: v1 kind: Pod metadata: name: mlistener labels: app: multicast-verify spec: containers: - name: mlistener image: registry.access.redhat.com/ubi9 command: ["/bin/sh", "-c"] args: ["dnf -y install socat hostname && sleep inf"] ports: - containerPort: 30102 name: mlistener protocol: UDP EOFマルチキャストセンダーとして機能する Pod を作成します。

$ cat <<EOF| oc create -f - apiVersion: v1 kind: Pod metadata: name: msender labels: app: multicast-verify spec: containers: - name: msender image: registry.access.redhat.com/ubi9 command: ["/bin/sh", "-c"] args: ["dnf -y install socat && sleep inf"] EOF新しいターミナルウィンドウまたはタブで、マルチキャストリスナーを起動します。

Pod の IP アドレスを取得します。

$ POD_IP=$(oc get pods mlistener -o jsonpath='{.status.podIP}')次のコマンドを入力して、マルチキャストリスナーを起動します。

$ oc exec mlistener -i -t -- \ socat UDP4-RECVFROM:30102,ip-add-membership=224.1.0.1:$POD_IP,fork EXEC:hostname

マルチキャストトランスミッターを開始します。

Pod ネットワーク IP アドレス範囲を取得します。

$ CIDR=$(oc get Network.config.openshift.io cluster \ -o jsonpath='{.status.clusterNetwork[0].cidr}')マルチキャストメッセージを送信するには、以下のコマンドを入力します。

$ oc exec msender -i -t -- \ /bin/bash -c "echo | socat STDIO UDP4-DATAGRAM:224.1.0.1:30102,range=$CIDR,ip-multicast-ttl=64"マルチキャストが機能している場合、直前のコマンドは以下の出力を返します。

mlistener

第5章 ROSA クラスターのネットワーク検証

Red Hat OpenShift Service on AWS (ROSA) クラスターを既存の Virtual Private Cloud (VPC) にデプロイするとき、またはクラスターに新しいサブネットを持つ追加のマシンプールを作成するときに、ネットワーク検証チェックが自動的に実行します。このチェックによりネットワーク設定が検証され、エラーが強調表示されるため、デプロイメント前に設定の問題を解決できます。

ネットワーク検証チェックを手動で実行して、既存のクラスターの設定を検証することもできます。

5.1. ROSA クラスターのネットワーク検証について

Red Hat OpenShift Service on AWS (ROSA) クラスターを既存の Virtual Private Cloud (VPC) にデプロイするか、クラスターに新しいサブネットを持つ追加のマシンプールを作成すると、ネットワーク検証が自動的に実行されます。これは、デプロイメント前に設定の問題を特定して解決するのに役立ちます。

Red Hat OpenShift Cluster Manager を使用してクラスターをインストールする準備をする場合は、Virtual Private Cloud (VPC) subnet settings ページのサブネット ID フィールドにサブネットを入力した後に自動チェックが実行します。ROSA CLI (rosa) を対話モードで使用してクラスターを作成する場合は、必要な VPC ネットワーク情報を指定した後にチェックが実行します。対話モードなしで CLI を使用する場合、チェックはクラスターの作成の直前に開始します。

新しいサブネットを持つマシンプールをクラスターに追加すると、マシンプールがプロビジョニングされる前に、自動ネットワーク検証によってサブネットがチェックされ、ネットワーク接続が利用可能であることが確認されます。

自動ネットワーク検証が完了すると、レコードがサービスログに送信されます。レコードには、ネットワーク設定エラーを含む検証チェックの結果が示されます。特定された問題をデプロイメント前に解決すると、デプロイメントが成功する可能性が高くなります。

既存のクラスターに対してネットワーク検証を手動で実行することもできます。これにより、設定を変更した後にクラスターのネットワーク設定を検証できます。ネットワーク検証チェックを手動で実行する手順は、ネットワーク検証を手動で実行する を参照してください。

5.2. ネットワーク検証チェックの範囲

ネットワーク検証には、次の各要件のチェックが含まれます。

- 親の Virtual Private Cloud (VPC) がある。

- 指定されたすべてのサブネットは VPC に属している。

-

VPC で

enableDnsSupportが有効になっている。 -

VPC で

enableDnsHostnames が有効になっている。 - Egress は、AWS ファイアウォールの前提条件 セクションで指定されている必要なドメインとポートの組み合わせで利用できます。

5.3. 自動ネットワーク検証のバイパス

既知のネットワーク設定の問題がある Red Hat OpenShift Service on AWS (ROSA) クラスターを既存の Virtual Private Cloud (VPC) にデプロイする場合は、自動ネットワーク検証を回避できます。

クラスターの作成時にネットワーク検証を回避すると、クラスターのサポートステータスは制限されます。インストール後、問題を解決してからネットワーク検証を手動で実行できます。制限付きサポートステータスは、検証が成功すると削除されます。

OpenShift Cluster Manager を使用した自動ネットワーク検証のバイパス

Red Hat OpenShift Cluster Manager を使用して既存の VPC にクラスターをインストールする時に、Virtual Private Cloud (VPC) subnet settings ページで Bypass network verification を選択することで自動検証を回避できます。

5.4. ネットワーク検証を手動で実行する

Red Hat OpenShift Service on AWS (ROSA) クラスターをインストールした後、Red Hat OpenShift Cluster Manager または ROSA CLI (rosa) を使用してネットワーク検証チェックを手動で実行できます。

OpenShift Cluster Manager を使用してネットワーク検証を手動で実行する

Red Hat OpenShift Cluster Manager を使用して、既存の Red Hat OpenShift Service on AWS (ROSA) クラスターのネットワーク検証チェックを手動で実行できます。

前提条件

- 既存の ROSA クラスターがあります。

- クラスター所有者になっているか、クラスター編集者のロールがある。

手順

- OpenShift Cluster Manager に移動し、クラスターを選択します。

- Actions ドロップダウンメニューから Verify networking を選択します。

CLI を使用してネットワーク検証を手動で実行する

ROSA CLI (rosa) を使用して、既存の Red Hat OpenShift Service on AWS (ROSA) クラスターのネットワーク検証チェックを手動で実行できます。

ネットワーク検証を実行するときは、一連の VPC サブネット ID またはクラスター名を指定できます。

前提条件

-

インストールホストに、最新の ROSA CLI (

rosa) をインストールして設定している。 - 既存の ROSA クラスターがあります。

- クラスター所有者になっているか、クラスター編集者のロールがある。

手順

次のいずれかの方法を使用して、ネットワーク設定を確認します。

クラスター名を指定してネットワーク設定を確認します。サブネット ID は自動的に検出されます。

$ rosa verify network --cluster <cluster_name> 1- 1

<cluster_name>は、クラスター名に置き換えます。

出力例

I: Verifying the following subnet IDs are configured correctly: [subnet-03146b9b52b6024cb subnet-03146b9b52b2034cc] I: subnet-03146b9b52b6024cb: pending I: subnet-03146b9b52b2034cc: passed I: Run the following command to wait for verification to all subnets to complete: rosa verify network --watch --status-only --region us-east-1 --subnet-ids subnet-03146b9b52b6024cb,subnet-03146b9b52b2034cc

すべてのサブネットに対する検証が完了していることを確認します。

$ rosa verify network --watch \ 1 --status-only \ 2 --region <region_name> \ 3 --subnet-ids subnet-03146b9b52b6024cb,subnet-03146b9b52b2034cc 4

- 1

watchフラグを使用すると、テスト対象のすべてのサブネットが失敗または合格状態になった後でコマンドが完了します。- 2

status-onlyフラグは、ネットワーク検証の実行をトリガーしませんが、現在の状態 (例:subnet-123 (検証はまだ進行中))を返します。デフォルトでは、このオプションを使用しない場合、このコマンドを呼び出すと、指定されたサブネットの検証が常にトリガーされます。- 3

- AWS_REGION 環境変数をオーバーライドする特定の AWS リージョンを使用します。

- 4

- コンマで区切られたサブネット ID のリストを入力して確認します。いずれかのサブネットが存在しない場合は、

Network verification for subnet 'subnet-<subnet_number> not foundというエラーメッセージが表示され、サブネットはチェックされません。

出力例

I: Checking the status of the following subnet IDs: [subnet-03146b9b52b6024cb subnet-03146b9b52b2034cc] I: subnet-03146b9b52b6024cb: passed I: subnet-03146b9b52b2034cc: passed

ヒント検証テストの完全なリストを出力するには、

rosa verify networkコマンドを実行するときに--debug引数を含めることができます。

VPC サブネット ID を指定してネットワーク設定を確認します。

<region_name>は AWS リージョンに置き換え、<AWS_account_ID>は AWS アカウント ID に置き換えます。$ rosa verify network --subnet-ids 03146b9b52b6024cb,subnet-03146b9b52b2034cc --region <region_name> --role-arn arn:aws:iam::<AWS_account_ID>:role/my-Installer-Role

出力例

I: Verifying the following subnet IDs are configured correctly: [subnet-03146b9b52b6024cb subnet-03146b9b52b2034cc] I: subnet-03146b9b52b6024cb: pending I: subnet-03146b9b52b2034cc: passed I: Run the following command to wait for verification to all subnets to complete: rosa verify network --watch --status-only --region us-east-1 --subnet-ids subnet-03146b9b52b6024cb,subnet-03146b9b52b2034cc

すべてのサブネットに対する検証が完了していることを確認します。

$ rosa verify network --watch --status-only --region us-east-1 --subnet-ids subnet-03146b9b52b6024cb,subnet-03146b9b52b2034cc

出力例

I: Checking the status of the following subnet IDs: [subnet-03146b9b52b6024cb subnet-03146b9b52b2034cc] I: subnet-03146b9b52b6024cb: passed I: subnet-03146b9b52b2034cc: passed

第6章 クラスター全体のプロキシーの設定

既存の Virtual Private Cloud (VPC) を使用している場合は、Red Hat OpenShift Service on AWS (ROSA) クラスターのインストール中またはクラスターのインストール後に、クラスター全体のプロキシーを設定できます。プロキシーを有効にすると、コアクラスターコンポーネントはインターネットへの直接アクセスを拒否されますが、プロキシーはユーザーのワークロードには影響しません。

クラウドプロバイダー API への呼び出しを含め、クラスターシステムの egress トラフィックのみがプロキシーされます。

クラスター全体のプロキシーを使用する場合は、責任をもってクラスターへのプロキシーの可用性を確保してください。プロキシーが利用できなくなると、クラスターの正常性とサポート性に影響を与える可能性があります。

6.1. クラスター全体のプロキシーを設定するための前提条件

クラスター全体のプロキシーを設定するには、次の要件を満たす必要があります。これらの要件は、インストール中またはインストール後にプロキシーを設定する場合に有効です。

一般要件

- クラスターの所有者である。

- アカウントには十分な権限がある。

- クラスターに既存の Virtual Private Cloud (VPC) がある。

- プロキシーは、クラスターの VPC および VPC のプライベートサブネットにアクセスできる。またクラスターの VPC および VPC のプライベートサブネットからもアクセスできる。

次のエンドポイントが VPC エンドポイントに追加されている。

-

ec2.<aws_region>.amazonaws.com -

elasticloadbalancing.<aws_region>.amazonaws.com s3.<aws_region>.amazonaws.comこれらのエンドポイントは、ノードから AWS EC2 API への要求を完了するために必要です。プロキシーはノードレベルではなくコンテナーレベルで機能するため、これらの要求を AWS プライベートネットワークを使用して AWS EC2 API にルーティングする必要があります。プロキシーサーバーの許可リストに EC2 API のパブリック IP アドレスを追加するだけでは不十分です。

注記クラスター全体のプロキシーを使用する場合は、

s3.<aws_region>.amazonaws.comエンドポイントをGatewayのタイプとして設定する必要があります。また、ec2.<aws_region>.amazonaws.comおよびelasticloadbalancing.<aws_region>.amazonaws.comエンドポイントをInterfaceのタイプとしてのみ設定できます。

-

ネットワーク要件

プロキシーが出力トラフィックを再登録する場合は、ドメインとポートの組み合わせに対する除外を作成する必要があります。次の表は、これらの例外のガイダンスを示しています。

プロキシーは、以下の OpenShift URL の再暗号化を除外する必要があります。

アドレス プロトコル/ポート 機能 observatorium-mst.api.openshift.comhttps/443

必須。Managed OpenShift 固有の Telemetry に使用されます。

sso.redhat.comhttps/443

https://cloud.redhat.com/openshift サイトでは、sso.redhat.com からの認証を使用してプルシークレットをダウンロードし、Red Hat SaaS ソリューションを使用してサブスクリプション、クラスターインベントリー、チャージバックレポートなどのモニタリングを行います。

プロキシーでは、次のサイトリライアビリティーエンジニアリング (SRE) および管理 URL の再暗号化を除外する必要があります。

アドレス プロトコル/ポート 機能 *.osdsecuritylogs.splunkcloud.comOR

inputs1.osdsecuritylogs.splunkcloud.cominputs2.osdsecuritylogs.splunkcloud.cominputs4.osdsecuritylogs.splunkcloud.cominputs5.osdsecuritylogs.splunkcloud.cominputs6.osdsecuritylogs.splunkcloud.cominputs7.osdsecuritylogs.splunkcloud.cominputs8.osdsecuritylogs.splunkcloud.cominputs9.osdsecuritylogs.splunkcloud.cominputs10.osdsecuritylogs.splunkcloud.cominputs11.osdsecuritylogs.splunkcloud.cominputs12.osdsecuritylogs.splunkcloud.cominputs13.osdsecuritylogs.splunkcloud.cominputs14.osdsecuritylogs.splunkcloud.cominputs15.osdsecuritylogs.splunkcloud.comtcp/9997

ログベースのアラートについて Red Hat SRE が使用するロギング転送エンドポイントとして splunk-forwarder-operator によって使用されます。

http-inputs-osdsecuritylogs.splunkcloud.comhttps/443

ログベースのアラートについて Red Hat SRE が使用するロギング転送エンドポイントとして splunk-forwarder-operator によって使用されます。

重要サーバーが

--http-proxyまたは--https-proxy引数を介してクラスター上で設定されていない透過的な転送プロキシーとして機能している場合は、プロキシーサーバーを使用して TLS 再暗号化を実行することは現在サポートされていません。透過的な転送プロキシーはクラスタートラフィックをインターセプトしますが、実際にはクラスター自体には設定されていません。

関連情報

- AWS Security Token Service (STS) を使用する ROSA クラスターのインストールの前提条件については、STS を使用した ROSA の AWS の前提条件 を参照してください。

- STS を使用しない ROSA クラスターのインストールの前提条件については、ROSA の AWS の前提条件 を参照してください。

6.2. 追加の信頼バンドルに対する責任

追加の信頼バンドルを指定する場合は、以下の要件を満たす必要があります。

- 追加の信頼バンドルの内容が有効であることを確認する

- 追加の信頼バンドルに含まれる中間証明書を含む証明書の有効期限が切れていないことを確認する

- 追加の信頼バンドルに含まれる証明書の有効期限を追跡して必要な更新を実行する

- 更新された追加の信頼バンドルを使用してクラスター設定を更新する

6.3. インストール中にプロキシーを設定する

Red Hat OpenShift Service on AWS (ROSA) クラスターを既存の Virtual Private Cloud (VPC) にインストールする時に、HTTP または HTTPS プロキシーを設定できます。Red Hat OpenShift Cluster Manager または ROSA CLI (rosa) を使用して、インストール中にプロキシーを設定できます。

6.3.1. OpenShift Cluster Manager を使用したインストール時のプロキシーの設定

Red Hat OpenShift Service on AWS (ROSA) クラスターを既存の Virtual Private Cloud (VPC) にインストールする場合、Red Hat OpenShift Cluster Manager を使用して、インストール中にクラスター全体の HTTP または HTTPS プロキシーを有効にすることができます。

インストールの前に、クラスターがインストールされている VPC からプロキシーにアクセスできることを確認する必要があります。プロキシーは VPC のプライベートサブネットからもアクセスできる必要があります。

OpenShift Cluster Manager を使用してインストール中にクラスター全体のプロキシーを設定する詳細な手順は、OpenShift Cluster Manager を使用したカスタマイズしたクラスターの作成 を参照してください。

6.3.2. CLI を使用したインストール時のプロキシーの設定

Red Hat OpenShift Service on AWS (ROSA) クラスターを既存の Virtual Private Cloud (VPC) にインストールする場合は、ROSA CLI (rosa) を使用して、インストール中にクラスター全体の HTTP または HTTPS プロキシーを有効にできます。

以下の手順では、インストール時にクラスター全体のプロキシーを設定するために使用される ROSA CLI (rosa) 引数の詳細を説明します。ROSA CLI を使用した一般的なインストール手順は、CLI を使用したカスタマイズしたクラスターの作成 を参照してください。

前提条件

- クラスターがインストールされている VPC からプロキシーにアクセスできることを確認している。プロキシーは VPC のプライベートサブネットからもアクセスできる必要があります。

手順

クラスターの作成時にプロキシー設定を指定します。

$ rosa create cluster \ <other_arguments_here> \ --additional-trust-bundle-file <path_to_ca_bundle_file> \ 1 2 3 --http-proxy http://<username>:<password>@<ip>:<port> \ 4 5 --https-proxy https://<username>:<password>@<ip>:<port> \ 6 7 --no-proxy example.com 8

- 1 4 6

additional-trust-bundle-file、http-proxy引数、およびhttps-proxy引数はすべてオプションです。- 2

http-proxyまたはhttps-proxy引数を指定せずにadditional-trust-bundle-file引数を使用する場合、信頼バンドルはトラストストアに追加され、クラスターシステムの egress トラフィックの検証に使用されます。このシナリオでは、バンドルがプロキシーで使用するように設定されていません。- 3

additional-trust-bundle-file引数は、PEM でエンコードされた X.509 証明書のバンドルを指すファイルパスであり、これはすべて連結されています。additionalTrustBundleパラメーターは、プロキシーのアイデンティティー証明書が RHCOS 信頼バンドルからの認証局によって署名されない限り必要になります。追加のプロキシー設定が必要ではなく、追加の CA を必要とする MITM の透過的なプロキシーネットワークを使用する場合には、MITM CA 証明書を指定する必要があります。- 5 7

http-proxy引数およびhttps-proxy引数は、有効な URL を指している必要があります。- 8

- プロキシーを除外する宛先ドメイン名、IP アドレス、またはネットワーク CIDR のコンマ区切りのリスト。

サブドメインのみと一致するように、ドメインの前に

.を付けます。たとえば、.y.comはx.y.comに一致しますが、y.comには一致しません。*を使用し、すべての宛先のプロキシーをバイパスします。インストール設定でnetworking.machineNetwork[].cidrフィールドで定義されるネットワークに含まれていないワーカーをスケールアップする場合、それらをこのリストに追加し、接続の問題を防ぐ必要があります。httpProxyまたはhttpsProxyフィールドのいずれも設定されていない場合に、このフィールドは無視されます。

6.4. インストール後のプロキシーの設定

Red Hat OpenShift Service on AWS (ROSA) クラスターを既存の Virtual Private Cloud (VPC)にインストールした後に、HTTP または HTTPS プロキシーを設定できます。Red Hat OpenShift Cluster Manager または ROSA CLI (rosa) を使用して、インストール後にプロキシーを設定できます。

6.4.1. OpenShift Cluster Manager を使用したインストール後のプロキシーの設定

Red Hat OpenShift Cluster Manager を使用して、Virtual Private Cloud (VPC) の既存の Red Hat OpenShift Service on AWS クラスターにクラスター全体のプロキシー設定を追加できます。

OpenShift Cluster Manager を使用して、既存のクラスター全体のプロキシー設定を更新することもできます。たとえば、プロキシーのネットワークアドレスを更新するか、プロキシーの認証局のいずれかが期限切れになる場合は追加の信頼バンドルを置き換える必要がある場合があります。

クラスターはプロキシー設定をコントロールプレーンおよびコンピュートノードに適用します。設定の適用時に、各クラスターノードは一時的にスケジュール不可能な状態になり、そのワークロードがドレイン (解放) されます。プロセスの一環として各ノードが再起動されます。

前提条件

- Red Hat OpenShift Service on AWS クラスターがある。

- クラスターが VPC にデプロイされている。

手順

- OpenShift Cluster Manager に移動し、クラスターを選択します。

- Networking ページの Virtual Private Cloud (VPC) セクションで、Edit cluster-wide proxy をクリックします。

Edit cluster-wide proxy ページで、プロキシー設定の詳細を指定します。

次のフィールドの少なくとも 1 つに値を入力します。

- 有効な HTTP proxy URL を指定します。

- 有効な HTTPS proxy URL を指定します。

Additional trust bundle フィールドに、PEM でエンコードされた X.509 証明書バンドルを指定します。既存の信頼バンドルファイルを置き換える場合は、Replace file を選択して フィールドを表示します。このバンドルはクラスターノードの信頼済み証明書ストアに追加されます。プロキシーのアイデンティティー証明書が Red Hat Enterprise Linux CoreOS (RHCOS) 信頼バンドルからの認証局によって署名されない限り、追加の信頼バンドルファイルが必要です。

追加のプロキシー設定が必要ではなく、追加の認証局 (CA) を必要とする MITM の透過的なプロキシーネットワークを使用する場合には、MITM CA 証明書を指定する必要があります。

注記HTTP または HTTPS プロキシー URL を指定せずに追加の信頼バンドルファイルをアップロードする場合、バンドルはクラスターに設定されますが、プロキシーで使用するように設定されていません。

- Confirm をクリックします。

検証

- Networking ページの Virtual Private Cloud (VPC) セクションで、クラスターのプロキシー設定が想定どおりであることを確認します。

6.4.2. CLI を使用したインストール後のプロキシーの設定

Red Hat OpenShift Service on AWS (ROSA) CLI (rosa) を使用して、Virtual Private Cloud (VPC) の既存の ROSA クラスターにクラスター全体のプロキシー設定を追加できます。

rosa を使用して、既存のクラスター全体のプロキシー設定を更新することもできます。たとえば、プロキシーのネットワークアドレスを更新するか、プロキシーの認証局のいずれかが期限切れになる場合は追加の信頼バンドルを置き換える必要がある場合があります。

クラスターはプロキシー設定をコントロールプレーンおよびコンピュートノードに適用します。設定の適用時に、各クラスターノードは一時的にスケジュール不可能な状態になり、そのワークロードがドレイン (解放) されます。プロセスの一環として各ノードが再起動されます。

前提条件

-

インストールホストに、最新の ROSA (

rosa) および OpenShift (oc) CLI をインストールして設定している。 - VPC にデプロイされた ROSA クラスターがある。

手順

クラスター設定を編集して、クラスター全体のプロキシーの詳細を追加または更新します。

$ rosa edit cluster \ --cluster $CLUSTER_NAME \ --additional-trust-bundle-file <path_to_ca_bundle_file> \ 1 2 3 --http-proxy http://<username>:<password>@<ip>:<port> \ 4 5 --https-proxy https://<username>:<password>@<ip>:<port> \ 6 7 --no-proxy example.com 8

- 1 4 6

additional-trust-bundle-file、http-proxy引数、およびhttps-proxy引数はすべてオプションです。- 2

http-proxyまたはhttps-proxy引数を指定せずにadditional-trust-bundle-file引数を使用する場合、信頼バンドルはトラストストアに追加され、クラスターシステムの egress トラフィックの検証に使用されます。このシナリオでは、バンドルがプロキシーで使用するように設定されていません。- 3

additional-trust-bundle-file引数は、PEM でエンコードされた X.509 証明書のバンドルを指すファイルパスであり、これはすべて連結されています。additionalTrustBundleパラメーターは、プロキシーのアイデンティティー証明書が RHCOS 信頼バンドルからの認証局によって署名されない限り必要になります。追加のプロキシー設定が必要ではなく、追加の CA を必要とする MITM の透過的なプロキシーネットワークを使用する場合には、MITM CA 証明書を指定する必要があります。注記プロキシーまたは追加の信頼バンドル設定をクラスターで直接変更しようとしないでください。これらの変更は、ROSA CLI (

rosa) または Red Hat OpenShift Cluster Manager を使用して適用する必要があります。クラスターに直接加えられた変更はすべて自動的に元に戻されます。- 5 7

http-proxy引数およびhttps-proxy引数は、有効な URL を指している必要があります。- 8

- プロキシーを除外する宛先ドメイン名、IP アドレス、またはネットワーク CIDR のコンマ区切りのリスト。

サブドメインのみと一致するように、ドメインの前に

.を付けます。たとえば、.y.comはx.y.comに一致しますが、y.comには一致しません。*を使用し、すべての宛先のプロキシーをバイパスします。インストール設定でnetworking.machineNetwork[].cidrフィールドで定義されるネットワークに含まれていないワーカーをスケールアップする場合、それらをこのリストに追加し、接続の問題を防ぐ必要があります。httpProxyまたはhttpsProxyフィールドのいずれも設定されていない場合に、このフィールドは無視されます。

検証

マシン設定プールのステータスを一覧表示し、それらが更新されていることを確認します。

$ oc get machineconfigpools

出力例

NAME CONFIG UPDATED UPDATING DEGRADED MACHINECOUNT READYMACHINECOUNT UPDATEDMACHINECOUNT DEGRADEDMACHINECOUNT AGE master rendered-master-d9a03f612a432095dcde6dcf44597d90 True False False 3 3 3 0 31h worker rendered-worker-f6827a4efe21e155c25c21b43c46f65e True False False 6 6 6 0 31h

クラスターのプロキシー設定を表示し、詳細が想定通りに表示されていることを確認します。