Hibernate アプリケーションの開発

Red Hat JBoss Enterprise Application Platform 向けの Jakarta Persistence API (JPA) または Hibernate アプリケーションを開発およびデプロイする開発者および管理者のための手順と情報。

概要

第1章 はじめに

1.1. Hibernate Core

Hibernate Core は、Java 言語用のオブジェクト関係マッピングフレームワークです。これにより、オブジェクト指向のドメインモデルをリレーショナルデータベースにマップするフレームワークが提供されるため、アプリケーションはデータベースとの直接的な対話を回避できます。Hibernate は、直接の永続データベースアクセスを高レベルのオブジェクト処理関数に置き換えることで、オブジェクト関係の不一致の問題を解決します。

1.2. Hibernate EntityManager

Hibernate EntityManager は、Jakarta Persistence 2.2 仕様で定義されているプログラミングインターフェイスおよびライフサイクルルールを実装します。Hibernate Annotations とともに、このラッパーは成熟した Hibernate Core の上に完全な (およびスタンドアロン) Jakarta Persistence ソリューションを実装します。プロジェクトのビジネスニーズおよび技術上のニーズに応じて、Jakarta Persistence プログラミングインターフェイスやライフサイクル、あるいは純粋なネイティブ Hibernate Core でさえすべて組み合わせて使用できます。いつでも、Hibernate ネイティブ API、または必要に応じてネイティブ JDBC および SQL にフォールバックできます。JBoss EAP には完全な Jakarta 永続ソリューションが提供されます。

JBoss EAP 7.3 リリースは、Jakarta EE 8 で定義されている Jakarta Persistence 2.2 specification に準拠しています。

また、Hibernate によってこの仕様に追加機能が提供されます。Jakarta Persistence および JBoss EAP を初めて使用する場合は、JBoss EAP に同梱される bean-validation、greeter、および kitchensink クイックスタートを参照してください。

Jakarta Persistence は、Jakarta Enterprise Beans 3 または、より新しい Jakarta Contexts and Dependency Injection などのコンテナーや、特定コンテナーの外部で実行するスタンドアロン Java SE アプリケーションで利用できます。以下のプログラミングインターフェイスおよびアーティファクトは、両方の環境で利用できます。

Hibernate でセキュリティーマネージャーの使用を計画している場合は、EntityManagerFactory が JBoss EAP サーバーによってブートストラップされている場合のみ Hibernate がサポートすることに注意してください。EntityManagerFactory または SessionFactory がアプリケーションによってブートストラップされている場合はサポートされません。

- EntityManagerFactory

- エンティティーマネージャーファクトリーはエンティティーマネージャーインスタンスを提供し、すべてのインスタンスは同じデータベースに接続するよう設定され、特定の実装で定義されたのと同じデフォルト設定を使用します。複数のデータストアにアクセスするための複数のエンティティーマネージャーファクトリーを準備できます。このインターフェイスは、ネイティブ Hibernate の SessionFactory と似ています。

- EntityManager

- EntityManager API は、特定の作業単位でデータベースにアクセスするために使用されます。これは、永続的なエンティティーインスタンスの作成および削除、それらのプライマリーキーアイデンティティーによるエンティティーの検索、およびすべてのエンティティーのクエリーに使用されます。このインターフェイスは、Hibernate の Session と似ています。

- 永続コンテキスト

- 永続コンテキストは、すべての永続エンティティーアイデンティティーに一意のエンティティーインスタンスがあるエンティティーインスタンスのセットです。永続コンテキスト内では、エンティティーインスタンスとそのライフサイクルは特定のエンティティーマネージャーによって管理されます。このコンテキストの範囲は、トランザクションまたは作業の拡張単位のいずれかになります。

- 永続ユニット

- 指定のエンティティーマネージャーで管理できるエンティティータイプのセットは永続ユニットによって定義されます。永続ユニットは、アプリケーションに関連する、またはアプリケーションによってグループ化されるすべてのクラスのセットを定義します。これらのクラスは、単一データストアへのマッピングに共存する必要があります。

- コンテナー管理のエンティティーマネージャー-

- コンテナーがライフサイクルを管理するエンティティーマネージャー。

- 例: アプリケーション管理のエンティティーマネージャー

- ライフサイクルがアプリケーションによって管理されているエンティティーマネージャー。

- Jakarta Transactions エンティティーマネージャー

- Jakarta Transactions トランザクションに関連するエンティティーマネージャー。

- Resource-local エンティティーマネージャー

- リソーストランザクションを使用するエンティティーマネージャー (Jakarta Transactions トランザクションではない)。

その他のリソース

- クイックスタートをダウンロードし、実行する方法は、JBoss EAP スタートガイド のクイックスタートサンプルの使用を参照してください。

- セキュリティーマネージャーに関する詳細は、サーバーセキュリティーの設定方法 のJava Security Managerを参照してください。

第2章 Hibernate の設定

2.1. Hibernate の設定

アプリケーションサーバーとスタンドアロンアプリケーションの両方のエンティティーマネージャーの設定は永続アーカイブにあります。永続アーカイブは、META-INF/ フォルダーにある persistence.xml ファイルを定義する必要がある JAR ファイルです。

persistence.xml ファイルを使用してデータベースに接続できます。これには、以下の方法があります。

JBoss EAP の

datasourcesサブシステムで設定されたデータソースを指定します。jta-data-sourceは、この永続ユニットマップ先となるデータソースの Java Naming and Directory Interface 名を参照します。ここでのjava:jboss/datasources/ExampleDSは、JBoss EAP に埋め込まれたH2 DBを指しています。persistence.xmlファイルのobject-logical -mappingの例<persistence> <persistence-unit name="myapp"> <provider>org.hibernate.jpa.HibernatePersistenceProvider</provider> <jta-data-source>java:jboss/datasources/ExampleDS</jta-data-source> <properties> ... ... </properties> </persistence-unit> </persistence>接続プロパティーを指定して

persistence.xmlファイルを明示的に設定します。persistence.xmlファイルで接続プロパティーを指定する例<property name="javax.persistence.jdbc.driver" value="org.hsqldb.jdbcDriver"/> <property name="javax.persistence.jdbc.user" value="sa"/> <property name="javax.persistence.jdbc.password" value=""/> <property name="javax.persistence.jdbc.url" value="jdbc:hsqldb:."/>

接続プロパティーの完全なリストは、

persistence.xmlの Connection Properties Configurable を参照してください。

ランタイム時に Hibernate の動作を制御するプロパティーは複数あります。すべてはオプションで、適切なデフォルト値を持ちます。これらの Hibernate プロパティーはすべて persistence.xml で使用されます。設定可能な Hibernate プロパティーの完全リストは、Hibernate Properties を参照してください。

2.2. 2 次キャッシュ

2.2.1. 2 次キャッシュ

2 次キャッシュとは、アプリケーションセッション外部で永続化された情報を保持するローカルデータストアのことです。このキャッシュは永続プロバイダーにより管理され、アプリケーションとデータを分離することでランタイムを改善します。

JBoss EAP では、以下の目的のためにキャッシュがサポートされます。

- Web セッションのクラスターリング

- ステートフルセッション Bean のクラスターリング

- SSO クラスターリング

- Hibernate 2 次キャッシュ

- Jakarta Persistence 2 次キャッシュ

各キャッシュコンテナーは repl および dist キャッシュを定義します。これらのキャッシュは、ユーザーアプリケーションで直接使用しないでください。

2.2.2. Hibernate の 2 次キャッシュの設定

Hibernate の 2 次キャッシュとして機能する Infinispan の設定は、以下の 2 ついずれかの方法で実行できます。

-

JBoss EAP Development Guideで説明されているように

persistence.xmlファイルを使用して Jakarta Persistence アプリケーションを介して 2 次キャッシュを設定することが推奨されます。 -

または、以下で説明されているように

hibernate.cfg.xmlファイルを使用して、Hibernate ネイティブアプリケーションで 2 次キャッシュを設定できます。

Hibernate ネイティブアプリケーションを使用した Hibernate 用 2 次キャッシュの設定

-

デプロイメントのクラスパスに

hibernate.cfg.xmlファイルを作成します。 以下の XML を

hibernate.cfg.xmlファイルに追加します。XML は<session-factory>タグ内になければなりません。<property name="hibernate.cache.use_second_level_cache">true</property> <property name="hibernate.cache.use_query_cache">true</property> <property name="hibernate.cache.region.factory_class">org.jboss.as.jpa.hibernate5.infinispan.InfinispanRegionFactory</property>

アプリケーション内で Hibernate ネイティブ API を使用するには、以下の依存関係を

MANIFEST.MFファイルに追加する必要があります。Dependencies: org.infinispan,org.hibernate

第3章 Hibernate アノテーション

3.1. Hibernate アノテーション

Org.hibernate.annotations パッケージには、標準の Jakarta Persistence アノテーションの上に Hibernate によって提供されるアノテーションが含まれます。

表3.1 一般的なアノテーション

| アノテーション | 説明 |

|---|---|

|

| クラス、プロパティー、またはコレクションレベルで定義できる任意の SQL チェック制約。 |

|

| エンティティーまたはコレクションにイミュータブルとしてマークを付けます。アノテーションがないということは、要素が変更されたことを意味します。 イミュータブルなエンティティーはアプリケーションによって更新されない可能性があります。イミュータブルなエンティティーの更新は無視されますが、例外は発生しません。

|

表3.2 キャッシュエンティティー

| アノテーション | 説明 |

|---|---|

|

| キャッシュストラテジーをルートエンティティーまたはコレクションに追加します。 |

表3.3 コレクション関連のアノテーション

| アノテーション | 説明 |

|---|---|

|

| 永続マップのキーのタイプを定義します。 |

|

|

異なるエンティティータイプを参照する |

|

| SQL 順序付け (HQL の順序ではなく) を使用してコレクションを順序付けます。 |

|

|

コレクション、アレイ、および結合されたサブクラスの削除で使用するストラテジー。現在、セカンダリーテーブルの |

|

| カスタム永続機能を指定します。 |

|

| コレクションのソート (Java レベルのソート)。 |

|

| コレクションのエンティティーまたはターゲットエンティティーに追加する要素。レシピは SQL で記述されます。 |

|

| コレクションジョインテーブルに追加する部分。レシピは SQL で記述されます。 |

表3.4 CRUD 操作のためのカスタム SQL

| アノテーション | 説明 |

|---|---|

|

|

Hibernate デフォルトの |

|

|

Hibernate デフォルトの |

|

|

Hibernate のデフォルト |

|

|

Hibernate のデフォルト |

|

|

Hibernate デフォルトの |

|

| イミュータブルで読み取り専用のエンティティーを指定の SQL サブ選択式にマッピングします。 |

|

|

自動フラッシュが正しく実行され、派生エンティティーに対するクエリーが古いデータを返さないようにします。大半は |

表3.5 エンティティー

| アノテーション | 説明 |

|---|---|

|

| 関連付けにカスケードストラテジーを適用します。 |

|

|

標準の

|

|

| ポリモーフィズム Hibernate のタイプを定義するために使用されます。 |

|

| 特定のクラスのレイジーおよびプロキシー設定。 |

|

| プライマリーまたはセカンダリーのテーブルに情報を補完します。 |

|

| Table の複数形のアノテーション。 |

|

| 明示的なターゲットを定義し、反映および汎用的な解決を回避します。 |

|

| エンティティーまたはコンポーネントの tuplizer を定義します。 |

|

| エンティティーまたはコンポーネントの一連の tuplizer を定義します。 |

表3.6 フェッチ

| アノテーション | 説明 |

|---|---|

|

| SQL 読み込みのバッチサイズ。 |

|

| フェッチストラテジープロファイルを定義します。 |

|

|

|

|

|

エンティティー属性が同じグループに属する他のすべての属性と共にフェッチされる必要があることを指定します。エンティティー属性をレイジーに読み込むには、バイトコード拡張が必要です。デフォルトでは、すべての非コレクション属性は |

表3.7 フィルター

| アノテーション | 説明 |

|---|---|

|

| フィルターをエンティティーまたはコレクションのターゲットエンティティーに追加します。 |

|

| フィルター定義。 |

|

| フィルター定義の配列。 |

|

| フィルターを結合テーブルコレクションに追加します。 |

|

|

複数の |

|

|

複数の |

|

| パラメーター定義。 |

表3.8 プライマリーキー

| アノテーション | 説明 |

|---|---|

|

| このアノテーション付きプロパティーはデータベースによって生成されます。 |

|

| タイプ解除された方法で、あらゆる Hibernate generator を記述するジェネレーターアノテーション。 |

|

| 汎用ジェネレーター定義のアレイ。 |

|

| プロパティーがエンティティーの純粋な ID の一部であることを指定します。 |

|

| キー/値のパターン。 |

|

|

Hibernate の |

表3.9 継承

| アノテーション | 説明 |

|---|---|

|

| ルートエンティティーに配置されるイデンティターの式。 |

|

| Hibernate 固有の識別子プロパティーを表示するオプションのアノテーションです。 |

|

| 指定の識別子値を対応するエンティティータイプにマッピングします。 |

表3.10 JP-QL/HQL クエリーのマッピング

| アノテーション | 説明 |

|---|---|

|

|

|

|

|

Hibernate 機能を使用した |

|

|

|

|

|

Hibernate 機能を使用して |

表3.11 簡単なプロパティーのマッピング

| アノテーション | 説明 |

|---|---|

|

| プロパティーアクセスタイプ。 |

|

| 列のアレイをサポートします。コンポーネントのユーザータイプマッピングに便利です。 |

|

| 値をコラムから読み取り、コラムに書き込むために使用するカスタムの SQL 式。クエリーとともにオブジェクトの直接読み込み/保存に使用します。書き込み式には、値に対して 1 つの '?' プレースホルダーが必ず含まれている必要があります。 |

|

|

|

表3.12 プロパティー

| アノテーション | 説明 |

|---|---|

|

|

大半の場所で、 |

|

| データベースインデックスを定義します。 |

|

|

大半の場所で、 |

|

| プロパティーを所有者 (通常は所有するエンティティー) へのポインターとして参照します。 |

|

| Hibernate タイプ。 |

|

| Hibernate タイプ定義。 |

|

| Hibernate タイプ定義の配列。 |

表3.13 単一の関連付け関連のアノテーション

| アノテーション | 説明 |

|---|---|

|

| 複数のエンティティータイプを参照するトール関連付けを定義します。一致したエンティティータイプのマッチングは、メタデータの識別子コラムを使用して行われます。このようなマッピングはマージのみにする必要があります。 |

|

|

|

|

|

|

|

| 指定の関連付けに使用されるフェッチストラテジーを定義します。 |

|

| コレクションのレイジーステータスを定義します。 |

|

|

ToOne 関連づけのレイジーステータスを定義します ( |

|

| 要素が関連上に見つからない場合に行うアクション。 |

表3.14 楽観的ロック

| アノテーション | 説明 |

|---|---|

|

| アノテーションが付けられたプロパティーの変更によってエンティティーバージョンの増分がトリガーされるかどうか。アノテーションが存在しない場合は、プロパティーが楽観的ロックストラテジーに関与します (デフォルト)。 |

|

| エンティティーに適用される楽観的ロックのスタイルを定義するために使用されます。階層では、ルートエンティティーでのみ有効です。 |

|

| Version および timestamp version プロパティーと併せてのオプションのアノテーションです。アノテーションの値で、タイムスタンプの生成先が決まります。 |

第4章 Hibernate Query 言語

4.1. Hibernate Query 言語について

Java Persistence クエリー言語の概要

Java Persistence Query Language (JPQL) は、Java Persistence API 仕様の一部として定義されるプラットフォームに依存しないオブジェクト指向のクエリー言語です。Java Persistence クエリー言語と同等の Jakarta Persistence クエリー言語は Jakarta Persistence クエリー言語であり、Jakarta Persistence 仕様 の一部として定義されています。

Java Persistence クエリー言語は、リレーショナルデータベースに保存されているエンティティーに対してクエリーを行うために使用されます。これは SQL に大きく影響を受けています。また、そのクエリーは構文の SQL クエリーに類似しますが、データベーステーブルと直接連携するのではなく Java Persistence API エンティティーオブジェクトに対して動作します。

HQL の概要

Hibernate Query Language (HQL) は、SQL と同様のパワフルなクエリー言語です。ただし、SQL と比較すると、HQL は完全にオブジェクト指向で、継承、ポリモーフィズム、関連付けなどの概念を認識します。

Hql は、Java Persistence クエリー言語のスーパーセットです。HQL クエリーは常に有効な Java Persistence クエリー言語クエリーではありませんが、Java Persistence クエリー言語のクエリーは常に有効な HQL クエリーになります。

HQL および Java Persistence クエリー言語は、クエリー操作を実行するためのタイプセーフでない方法です。条件クエリーは、クエリーにタイプセーフなアプローチを提供します。

4.2. HQL ステートメントについて

HQL および Java Persistence クエリー言語は、SELECT、UPDATE、および DELETE ステートメントの両方を許可します。さらに HQL では、SQL INSERT-SELECT と似た形式の INSERT ステートメントを使用できます。

以下の表は、さまざまな HQL ステートメントの Backus-Naur Form (BNF) 表記の構文を示しています。

表4.1 HQL ステートメント

| ステートメント | 説明 |

|---|---|

|

|

HQL における select_statement :: =

[select_clause]

from_clause

[where_clause]

[groupby_clause]

[having_clause]

[orderby_clause]

|

|

|

HQL の update_statement ::= update_clause [where_clause]

update_clause ::= UPDATE entity_name [[AS] identification_variable]

SET update_item {, update_item}*

update_item ::= [identification_variable.]{state_field | single_valued_object_field}

= new_value

new_value ::= scalar_expression |

simple_entity_expression |

NULL

|

|

|

HQL の delete_statement ::= delete_clause [where_clause] delete_clause ::= DELETE FROM entity_name [[AS] identification_variable] |

|

|

HQL の insert_statement ::= insert_clause select_statement insert_clause ::= INSERT INTO entity_name (attribute_list) attribute_list ::= state_field[, state_field ]* これと同等の Java Persistence クエリー言語はありません。 |

Hibernate では、DML (Data Manipulation Language) を使用して、HQL (Hibernate Query Language) を介して、マップされたデータベースにへのデータの直接挿入、更新、および削除を一括で行うことができます。

複数のオブジェクトまたは関係マッピングに違反し、オブジェクト状態に影響を与える可能性があります。オブジェクト状態は、基盤のデータベースで実行される操作によって、メモリー内オブジェクトの状態が影響を受けることはありません。インメモリーデータは、インメモリーデータが使用される場合は注意して使用する必要があります。

UPDATE ステートメントおよび DELETE ステートメント

UPDATE ステートメントおよび DELETE ステートメントの擬似構文は次のとおりです。

( UPDATE | DELETE ) FROM?EntityName (WHERE where_conditions)?.

FROM キーワードおよび WHERE Clause はオプションです。FROM 句は、残りのクエリーで使用できるオブジェクトモデルタイプのスコープを定義します。また、残りのクエリーで使用できるすべての識別変数も定義します。WHERE 句では、返されるインスタンスの一覧を絞り込むことができます。

UPDATE ステートメントまたは DELETE ステートメントの実行結果は、実際に影響を受ける (更新または削除される) 行数です。

例: 一括更新ステートメント

Session session = sessionFactory.openSession();

Transaction tx = session.beginTransaction();

String hqlUpdate = "update Company set name = :newName where name = :oldName";

int updatedEntities = s.createQuery( hqlUpdate )

.setString( "newName", newName )

.setString( "oldName", oldName )

.executeUpdate();

tx.commit();

session.close();

例: 一括削除ステートメント

Session session = sessionFactory.openSession();

Transaction tx = session.beginTransaction();

String hqlDelete = "delete Company where name = :oldName";

int deletedEntities = s.createQuery( hqlDelete )

.setString( "oldName", oldName )

.executeUpdate();

tx.commit();

session.close();

Query.executeUpdate() メソッドによって返される int 値は、オペレーションの影響を受けた、データベース内のエンティティーの数を示します。

内部では、複数の SQL ステートメントを使用して、DML Update または Delete 更新リクエストまたは削除リクエストに応答して操作を実行する場合があります。これは、テーブルと、更新または削除が必要な結合テーブルの間に存在する関係が原因です。

たとえば、上記の例のように delete ステートメントを実行すると、oldName という名前の企業用の Company テーブルだけでなく、結合したテーブルに対しても削除が実行されます。したがって、Employee テーブルと多対多関係の双方向の Company テーブルは、前回の例の実行に成功すると、一致する結合テーブル Company_Employee から行を失います。

上記の deletedEntries 値には、この操作によって影響を受けるすべての行の数 (結合テーブルの行を含む) が含まれます。

一括更新や削除の操作の実行時には、アクティブな永続コンテキストでデータベースとエンティティー間で不整合が生じる可能性があるため注意が必要です。一般的に、一括更新および削除操作は、新しい永続コンテキストのトランザクション内で、またはこのような操作の影響を受ける可能性のある状態を持つエンティティーをフェッチまたはアクセスする前にのみ実行する必要があります。

INSERT ステートメントについて

HQL は、INSERT ステートメントを定義する機能を追加します。これと同等の Java Persistence クエリー言語はありません。HQL INSERT ステートメントの Backus-Naur Form (BNF) は以下の通りです。

insert_statement ::= insert_clause select_statement insert_clause ::= INSERT INTO entity_name (attribute_list) attribute_list ::= state_field[, state_field ]*

tribute_list は、SQL INSERT ステートメントのコラム指定に似ています。マッピングされた継承に関連するエンティティーでは、名前付きエンティティーに直接定義された属性のみが attribute_list で使用できます。スーパークラスプロパティーは許可されておらず、サブクラスプロパティーは意味を成しません。つまり、INSERT ステートメントは本質的にはポリモーフィックではありません。

select_statement には、有効な HQL 選択クエリーを使用できます。この場合、戻り値のタイプは挿入で想定されるタイプと一致する必要があります。現在、これは、チェックによるデータベースへの再参照を許可するのではなく、クエリーのコンパイル時に確認されます。これにより、Hibernate Types が equal とは逆に equivalent であるため、問題が発生する可能性があります。たとえば、これにより、データベースが区別を行わなかったり、変換を処理できない場合でも、org.hibernate.type.DateType としてマップされた属性と org.hibernate.type.TimestampType として定義された属性間で不一致の問題が発生する可能性があります。

id 属性には、insert ステートメントに 2 つのオプションを付与します。attribute_list で id プロパティーを明示的に指定することができます。この場合、その値は、対応する select 式から取得されるか、生成された値が使用される場合は attribute_list から省略されます。後者のオプションは、データベースで (in the database) で動作する ID ジェネレーターを使用している場合にのみ利用できます。メモリー内 (in memory) タイプジェネレーターでこのオプションを使用しようとすると、解析中に例外が発生します。

ロック属性の場合、insert ステートメントでは、以下のいずれかのオプションが再度提供されます。attribute_list に属性を指定できます。この場合、その値は対応する選択式から取得されます。あるいは、attribute_list から除外できます。その場合は、対応する org.hibernate.type.VersionType で定義される seed value が使用されます。

例: INSERT Query ステートメント

String hqlInsert = "insert into DelinquentAccount (id, name) select c.id, c.name from Customer c where ..."; int createdEntities = s.createQuery(hqlInsert).executeUpdate();

例: Bulk Insert ステートメント

Session session = sessionFactory.openSession();

Transaction tx = session.beginTransaction();

String hqlInsert = "insert into Account (id, name) select c.id, c.name from Customer c where ...";

int createdEntities = s.createQuery( hqlInsert )

.executeUpdate();

tx.commit();

session.close();

SELECT ステートメントを使用して id 属性の値を指定しない場合、基礎となるデータベースが自動生成キーをサポートする限り、識別子が生成されます。この一括挿入操作の戻り値は、データベースで実際に作成されたエントリー数です。

4.3. HQL の順序について

クエリーの結果を順序付けすることもできます。ORDER BY は、結果の順序付けに使用される選択した値を指定するために使用されます。順序単位で有効とみなされる式のタイプには、以下が含まれます。

- ステートフィールド

- コンポーネント/組み込み可能な属性

- 算術演算、関数などのスカラー式。

- 前の式タイプに対して select 句で宣言された識別変数。

HQL は、order-by 句で参照されるすべての値が select 句内で命名されることを必須としませんが、Java Persistence クエリー言語で必要になります。データベースの移植性を求めるアプリケーションは、すべてのデータベースが、選択節で参照されていない order-by 句での参照値に対応しているわけではないことに注意してください。

order-by の個々の式は、必要な順序を示すために ASC (昇順) または DESC (下記) で修飾できます。

例: Order By

// legal because p.name is implicitly part of p

select p

from Person p

order by p.name

select c.id, sum( o.total ) as t

from Order o

inner join o.customer c

group by c.id

order by t

4.4. コレクションメンバーの参照について

コレクション値の関連付けへの参照は、実際にはそのコレクションの値を参照します。

例: コレクション参照

select c

from Customer c

join c.orders o

join o.lineItems l

join l.product p

where o.status = 'pending'

and p.status = 'backorder'

// alternate syntax

select c

from Customer c,

in(c.orders) o,

in(o.lineItems) l

join l.product p

where o.status = 'pending'

and p.status = 'backorder'

この例では、識別変数 o は実際には、Customer#orders 関連付けの要素タイプであるオブジェクトモデルタイプ Order を参照します。

この例では、IN 構文を使用してコレクションの関連付けジョインを指定する代替構文も示しています。両方の形式は同じです。アプリケーションの選択を選択するのは、単に好みの問題です。

4.5. 修飾パス式について

これまでは、コレクション値関連づけは、コレクションの値を実際に参照していると言及されました。コレクションのタイプによっては、明示的な修飾式のセットも利用できます。

表4.2 修飾パス式

| 式 | 説明 |

|---|---|

|

| コレクション値を参照します。修飾子を指定しないのと同じです。意図を明示的に表示するのに役立ちます。いずれかのタイプのコレクションと値の参照に有効です。 |

|

|

HQL ルールによると、これは、javax.persistence.OrderColumn アノテーションを指定して Map キーまたは List の場所 (別名 OrderColumn 値) を参照する Maps と List の両方に対して有効です。ただし、Java Persistence クエリー言語は、これを List ケースで使用するために予約し、MAP の場合に |

|

| Maps にのみ有効です。マップのキーを参照します。キー自体がエンティティーである場合は、さらに移動することができます。 |

|

|

Maps にのみ有効です。Map の論理 java.util.Map.Entry タプル (キーと値の組み合わせ) を参照します。 |

例: 修飾コレクション参照

// Product.images is a Map<String,String> : key = a name, value = file path

// select all the image file paths (the map value) for Product#123

select i

from Product p

join p.images i

where p.id = 123

// same as above

select value(i)

from Product p

join p.images i

where p.id = 123

// select all the image names (the map key) for Product#123

select key(i)

from Product p

join p.images i

where p.id = 123

// select all the image names and file paths (the 'Map.Entry') for Product#123

select entry(i)

from Product p

join p.images i

where p.id = 123

// total the value of the initial line items for all orders for a customer

select sum( li.amount )

from Customer c

join c.orders o

join o.lineItems li

where c.id = 123

and index(li) = 1

4.6. HQL 関数について

HQL は、使用中の基盤のデータベースに関係なく利用可能な標準の関数を定義します。HQL は、ダイアレクトおよびアプリケーションで定義される追加の機能を理解することもできます。

4.6.1. HQL の標準化機能

以下の関数は、使用中の基盤のデータベースに関係なく HQL で利用できます。

表4.3 HQL の標準化機能

| 関数 | 説明 |

|---|---|

|

| バイナリーデータの長さを返します。 |

|

| SQL キャストを実行します。cast ターゲットは、使用する Hibernate マッピングタイプに名前を付ける必要があります。 |

|

| Datetime 値に対して SQL の抽出を実行します。展開により、年などの日付/ 時間値の一部が返されます。以下の省略形式を参照してください。 |

|

| 2 つ目を抽出するための省略された抽出形式。 |

|

| 分を抽出するための省略された抽出形式。 |

|

| 時を抽出するための省略された抽出形式。 |

|

| 日を抽出するための省略された抽出形式。 |

|

| 月を抽出するための省略された抽出形式。 |

|

| 年を抽出するための省略された抽出形式。 |

|

| 値を文字データとしてキャストするための省略形式。 |

4.6.2. HQL 非標準化機能

Hibernate ダイアレクトは、その特定のデータベース製品で利用できると認識されている追加の関数を登録できます。これらは、そのデータベースまたはダイアレクトを使用する場合にのみ利用できます。データベースの移植性を目的とするアプリケーションは、このカテゴリーで関数を使用することを避ける必要があります。

アプリケーション開発者は、独自の機能のセットも提供します。これは、通常は、カスタムの SQL 関数、または SQL のスニペットのエイリアスを表します。このような関数宣言は、org.hibernate.cfg.Configuration の addSqlFunction メソッドを使用して作成されます。

4.6.3. 連結操作

HQL は、連結 (CONCAT) 関数のサポートのほかに連結演算子を定義します。これは Java Persistence クエリー言語では定義されないため、移植可能なアプリケーションは使用しないようにしてください。連結演算子は、SQL 連結演算子 (||) から取得されます。

例: 連結操作の例

select 'Mr. ' || c.name.first || ' ' || c.name.last from Customer c where c.gender = Gender.MALE

4.7. 動的インスタンス化について

select 句でのみ有効な特定の式タイプがあります。Hibernate では、これを動的なインスタンス化 (dynamic instantiation) と呼びます。Java Persistence クエリー言語はこの機能の一部をサポートしており、それをコンストラクター式を呼びます。

例: 動的インスタンス化の例 - コンストラクター

select new Family( mother, mate, offspr )

from DomesticCat as mother

join mother.mate as mate

left join mother.kittens as offspr

ここでは Object[] を扱うのではなく、クエリーの結果として返される型安全な java オブジェクトの値をラップします。クラス参照は完全修飾する必要があり、一致するコンストラクターが必要です。

ここでクラスをマッピングする必要はありません。エンティティーを表す場合、生成されるインスタンスは NEW 状態 (管理されない) で返されます。

これは、Java Persistence クエリー言語もサポートします。HQL は、追加の動的なインスタンス化機能に対応しています。まず、クエリーはスカラー結果に対して Object[] ではなく List を返すように指定できます。

例: 動的インスタンス化の例 - リスト

select new list(mother, offspr, mate.name)

from DomesticCat as mother

inner join mother.mate as mate

left outer join mother.kittens as offspr

このクエリーの結果は List<Object[]> ではなく List<List> になります。

HQL は、マップでのスカラー結果のラッピングもサポートします。

例: 動的インスタンス化の例 - マップ

select new map( mother as mother, offspr as offspr, mate as mate )

from DomesticCat as mother

inner join mother.mate as mate

left outer join mother.kittens as offspr

select new map( max(c.bodyWeight) as max, min(c.bodyWeight) as min, count(*) as n )

from Cat cxt

このクエリーの結果は List<Object[]> ではなく List<Map<String,Object>> になります。マップのキーは、選択式に対して提供されたエイリアスによって定義されます。

4.8. HQL 述語について

述語は、where 句、having 句、検索 CASE 式の基礎を形成します。これらは式であり、通常は TRUE または FALSE に解決されます。ただし、NULL 値が関係するブール値比較は一般的に UNKNOWN に解決します。

HQL の述語

Null 述語

Null の値を確認します。基本的な属性参照、エンティティーの参照、およびパラメーターに適用できます。さらに HQL を使用すると、コンポーネント/ 組み込み可能なタイプに適用できます。

例: NULL チェック

// select everyone with an associated address select p from Person p where p.address is not null // select everyone without an associated address select p from Person p where p.address is null

述語と同様

文字列値に対して、同様の比較を実行します。構文は以下のとおりです。

like_expression ::= string_expression [NOT] LIKE pattern_value [ESCAPE escape_character]セマンティクスは、式のような SQL のことに従います。

paattern_valueは、string_expressionで一致を試みるパターンです。SQL と同様に、pattern_valueはワイルドカードに_(アンダースコア) および%(パーセント) を使用できます。意味は同じです。_は、単一の文字に一致します。%は任意の数の文字に一致します。オプションの

escape_characterは、pattern_valueの_と%の特別な意味をエスケープするために使用されるエスケープ文字を指定するために使用されます。これは、_または%のいずれかを含むパターンを検索する必要がある場合に便利です。例: LIKE 述語

select p from Person p where p.name like '%Schmidt' select p from Person p where p.name not like 'Jingleheimmer%' // find any with name starting with "sp_" select sp from StoredProcedureMetadata sp where sp.name like 'sp|_%' escape '|'

BETWEEN 演算子

SQL

BETWEEN式と同様です。値が 2 つの他の値の範囲内にあるかどうかの評価を実行します。すべてのオペランドは、同等の型を持つ必要があります。例: BETWEEN 演算子

select p from Customer c join c.paymentHistory p where c.id = 123 and index(p) between 0 and 9 select c from Customer c where c.president.dateOfBirth between {d '1945-01-01'} and {d '1965-01-01'} select o from Order o where o.total between 500 and 5000 select p from Person p where p.name between 'A' and 'E'IN 述語

IN述語は、特定の値が値の一覧にあることを確認します。構文は次のとおりです。in_expression ::= single_valued_expression [NOT] IN single_valued_list single_valued_list ::= constructor_expression | (subquery) | collection_valued_input_parameter constructor_expression ::= (expression[, expression]*)single_valued_expressionのタイプとsingle_valued_listの個別の値は一致している必要があります。Java Persistence クエリー言語は、ここで有効なタイプを string、数値、日付、時刻、タイムスタンプ、および列挙型に制限します。Java Persistence クエリー言語では、single_valued_expressionは以下のみを参照できます。- 状態フィールド (state fields) は、単純な属性の用語です。具体的には、関連付けおよびコンポーネント/組み込み属性が除外されます。

エンティティー型式。

HQL では、

single_valued_expressionはより幅広い式タイプを参照することができます。1 価の関連づけが許可されています。コンポーネント/組み込み属性も同様です。ただし、この機能は基盤のデータベースのタプルのサポートレベルまたはロー値のコンストラクター構文 (row value constructor syntax) によって異なります。さらに、HQL では値のタイプは制限されませんが、アプリケーション開発者は、基盤のデータベースベンダーに基づいてサポートが制限される可能性があることに注意する必要があります。これは、Java Persistence クエリー言語の制限の主な理由です。値の一覧は多数の異なるソースから取得できます。

constructor_expressionおよびcollection_valued_input_parameterでは、値の一覧は空にすることはできません。少なくとも 1 つの値が含まれている必要があります。例: IN 述語

select p from Payment p where type(p) in (CreditCardPayment, WireTransferPayment) select c from Customer c where c.hqAddress.state in ('TX', 'OK', 'LA', 'NM') select c from Customer c where c.hqAddress.state in ? select c from Customer c where c.hqAddress.state in ( select dm.state from DeliveryMetadata dm where dm.salesTax is not null ) // Not Java Persistence query language compliant! select c from Customer c where c.name in ( ('John','Doe'), ('Jane','Doe') ) // Not Java Persistence query language compliant! select c from Customer c where c.chiefExecutive in ( select p from Person p where ... )

4.9. 関連比較について

比較には、等号の =、>、>=、<、⇐、<> のいずれかが関係します。HQL は、<> と比べる比較演算子として != も定義します。オペランドは同じタイプである必要があります。

例: 比較例

// numeric comparison

select c

from Customer c

where c.chiefExecutive.age < 30

// string comparison

select c

from Customer c

where c.name = 'Acme'

// datetime comparison

select c

from Customer c

where c.inceptionDate < {d '2000-01-01'}

// enum comparison

select c

from Customer c

where c.chiefExecutive.gender = com.acme.Gender.MALE

// boolean comparison

select c

from Customer c

where c.sendEmail = true

// entity type comparison

select p

from Payment p

where type(p) = WireTransferPayment

// entity value comparison

select c

from Customer c

where c.chiefExecutive = c.chiefTechnologist

また、比較には ALL、ANY、SOME などの修飾子を含めることもできます。some および ANY は同義語です。

ALL 修飾子は、サブくエリーの結果のすべての値に対して比較が true の場合に true に解決します。これは、値が空の場合は false に解決します。

例: すべてのサブクエリー比較修飾子の例

// select all players that scored at least 3 points // in every game. select p from Player p where 3 > all ( select spg.points from StatsPerGame spg where spg.player = p )

ANY/SOME 修飾子は、サブクエリーの結果の値いずれかの比較が true の場合に true に解決します。これは、値が空の場合は false に解決します。

4.10. バイトコードの機能強化

4.10.1. Lazy 属性の読み込み

Lazy 属性の読み込みはバイトコードの拡張機能です。これにより、データベースからフェッチする際にエンティティーの特定の部分のみがロードされ、残りの部分もロードする必要があることを Hibernate に指示できます。これは、エンティティーの状態が必要に応じて一度に読み込まれるエンティティーを中心とするレイジーロードのプロキシーベースの概念とは異なります。バイトコード拡張では、必要に応じて個別の属性または属性グループが読み込まれます。

レイジー属性は一緒にロードするように指定できます。これは lazy group と呼ばれます。デフォルトでは、すべての単数属性が単一のグループに含まれます。あるレイジーな singular 属性にアクセスすると、レイジーなすべての singular 属性が読み込まれます。レイジー singular グループに反して、レイジーな複数の属性はそれぞれ個別のレイジーグループです。この動作は、@org.hibernate.annotations.LazyGroup アノテーションで明示的に制御できます。

@Entity

public class Customer {

@Id

private Integer id;

private String name;

@Basic( fetch = FetchType.LAZY )

private UUID accountsPayableXrefId;

@Lob

@Basic( fetch = FetchType.LAZY )

@LazyGroup( "lobs" )

private Blob image;

public Integer getId() {

return id;

}

public void setId(Integer id) {

this.id = id;

}

public String getName() {

return name;

}

public void setName(String name) {

this.name = name;

}

public UUID getAccountsPayableXrefId() {

return accountsPayableXrefId;

}

public void setAccountsPayableXrefId(UUID accountsPayableXrefId) {

this.accountsPayableXrefId = accountsPayableXrefId;

}

public Blob getImage() {

return image;

}

public void setImage(Blob image) {

this.image = image;

}

}

上記の例では、accountsPayableXrefId と image の 2 つのレイジー属性があります。これらの各属性は、異なるフェッチグループの一部です。accountsPayableXrefId 属性はデフォルトのフェッチグループの一部です。accountsPayableXrefId へのアクセスは、image 属性の読み込みを強制しません (逆の場合もまた然り)。

第5章 Hibernate サービス

5.1. Hibernate サービスについて

サービスは、Hibernate を提供するクラスで、さまざまなタイプの機能のプラグ可能な実装を提供します。特に、特定のサービスコントラクトインターフェイスの実装です。このインターフェイスはサービ出力ルとして知られています。実装クラスはサービス実装として知られています。一般的に、ユーザーはすべての標準サービ出力ル (上書き) の代替の実装をプラグインできます。また、サービ出力ルのベースセット (拡張) 以外に追加のサービスを定義することもできます。

5.2. サービス契約について

サービスの基本的な要件は、org.hibernate.service.Service のマーカーインターフェイスを実装することです。Hibernate は、基本的なタイプの安全のためにこの内部で使用します。

オプションとして、サービスは org.hibernate.service.spi.Startable および org.hibernate.service.spi.Stoppable インターフェイスを実装し、開始および停止の通知を受信することもできます。別のオプションのサービスコントラクトは org.hibernate.service.spi.Manageable で、Jakaarta Management 統合が有効になっていると、Jakarta Management でサービスが管理可能であるとマークされます。

5.3. サービス依存関係の種類

サービスは、以下の方法のいずれかを使用して他のサービスの依存関係を宣言できます。

- @org.hibernate.service.spi.InjectService

単一のパラメーターを受け入れ、

@InjectServiceでアノテーションが付けられたサービス実装クラスのメソッドは 、別のサービスの挿入を要求していると見なされます。デフォルトでは、method パラメーターのタイプは、インジェクトされるサービ出力ルになることが想定されます。パラメーターのタイプがサービ出力ルと異なる場合は、

InjectServiceのserviceRole属性を使用してロールに明示的な名前を付ける必要があります。デフォルトでは、インジェクトされたサービスは必須とみなされ、名前付き依存サービスがないと、起動に失敗します。インジェクトされるサービスがオプションの場合、

InjectServiceの必要な属性はfalseとして宣言される必要があります。デフォルトはtrueです。- org.hibernate.service.spi.ServiceRegistryAwareService

次のアプローチは、単一の

injectServicesメソッドを宣言する、オプションのサービスインターフェイスorg.hibernate.service.spi.ServiceRegistryAwareServiceをサービスが実装するプルアプローチです。Hibernate は起動時に、

org.hibernate.service.ServiceRegistry自体をこのインターフェイスを実装するサービスに挿入します。その後、ServiceRegistry参照を使用して必要な追加サービスを見つけることができます。

5.3.1. サービスレジストリー

5.3.1.1. ServiceRegistry について

中央のサービス API はサービス自体以外に、org.hibernate.service.ServiceRegistry インターフェイスです。サービスレジストリーの主な目的は、サービスへのアクセスを保持し、管理し、提供することです。

サービスレジストリーは階層的です。あるレジストリーのサービスは、同じレジストリーのサービスや任意の親レジストリーに依存して使用できます。

org.hibernate.service.ServiceRegistryBuilder を使用して org.hibernate.service.ServiceRegistry インスタンスをビルドします。

ServiceRegistryBuilder を使用した ServiceRegistry の作成例

ServiceRegistryBuilder registryBuilder =

new ServiceRegistryBuilder( bootstrapServiceRegistry );

ServiceRegistry serviceRegistry = registryBuilder.buildServiceRegistry();

5.3.2. カスタムサービス

5.3.2.1. カスタムサービスについて

org.hibernate.service.ServiceRegistry を構築すると、不変とみなされます。このサービス自体は再設定を受け入れる可能性がありますが、ここでの不変性はサービスの追加または置き換えを意味します。そのため、org.hibernate.service.ServiceRegistryBuilder で利用できる別のロールは、これから生成される org.hibernate.service.ServiceRegistry に含まれるサービスの調整を許可することです。

カスタムサービスについて org.hibernate.service.ServiceRegistryBuilder に指示する方法は 2 つあります。

-

org.hibernate.service.spi.BasicServiceInitiatorクラスを実装し、サービスクラスのオンデマンド構築を制御し、addInitiatorメソッドを使用してorg.hibernate.service.ServiceRegistryBuilderに追加します。 -

サービスクラスをインスタンス化し、

addServiceメソッドを使用して、org.hibernate.service.ServiceRegistryBuilderに追加します。

新規サービ出力ルの追加やサービス実装の置き換えなどサービスの上書きなど、レジストリーの拡張にはいずれかのアプローチが有効です。

例: ServiceRegistryBuilder を使用して、既存のサービスをカスタムサービスに置き換える

ServiceRegistryBuilder registryBuilder =

new ServiceRegistryBuilder(bootstrapServiceRegistry);

registryBuilder.addService(JdbcServices.class, new MyCustomJdbcService());

ServiceRegistry serviceRegistry = registryBuilder.buildServiceRegistry();

public class MyCustomJdbcService implements JdbcServices{

@Override

public ConnectionProvider getConnectionProvider() {

return null;

}

@Override

public Dialect getDialect() {

return null;

}

@Override

public SqlStatementLogger getSqlStatementLogger() {

return null;

}

@Override

public SqlExceptionHelper getSqlExceptionHelper() {

return null;

}

@Override

public ExtractedDatabaseMetaData getExtractedMetaDataSupport() {

return null;

}

@Override

public LobCreator getLobCreator(LobCreationContext lobCreationContext) {

return null;

}

@Override

public ResultSetWrapper getResultSetWrapper() {

return null;

}

}

5.3.3. Boot-Strap レジストリー

5.3.3.1. Boot-strap レジストリーについて

boot-strap レジストリーは、ほとんどの機能を機能させるために絶対に利用できるようにする必要のあるサービスを保持します。ここでの主要なサービスは、ClassLoaderService です。これは最適な例です。設定ファイルを解決する場合でも、クラスローディングサービス (例: リソース検索) へのアクセスが必要になります。これは、通常の使用時に親ではなく、ルートレジストリーです。

boot-strap レジストリーのインスタンスは、org.hibernate.service.BootstrapServiceRegistryBuilder クラスを使用して作成されます。

BootstrapServiceRegistryBuilder の使用

例: BootstrapServiceRegistryBuilder の使用

BootstrapServiceRegistry bootstrapServiceRegistry =

new BootstrapServiceRegistryBuilder()

// pass in org.hibernate.integrator.spi.Integrator instances which are not

// auto-discovered (for whatever reason) but which should be included

.with(anExplicitIntegrator)

// pass in a class loader that Hibernate should use to load application classes

.with(anExplicitClassLoaderForApplicationClasses)

// pass in a class loader that Hibernate should use to load resources

.with(anExplicitClassLoaderForResources)

// see BootstrapServiceRegistryBuilder for rest of available methods

...

// finally, build the bootstrap registry with all the above options

.build();

5.3.3.2. BootstrapRegistry サービス

org.hibernate.service.classloading.spi.ClassLoaderServiceHibernate はクラスローダーと対話する必要があります。ただし、Hibernate または任意のライブラリーと対話する方法は、アプリケーションをホストしているランタイム環境によって異なります。アプリケーションサーバー、OSGi コンテナー、およびその他のモジュラークラスローディングシステムでは、非常に特殊なクラスローディング要件が課せられています。このサービスは、この環境的な複雑性からの抽象化を Hibernate に提供します。また、同様に重要な点として、単一スワップ可能なコンポーネントでこれを実行します。

クラスローダーとの対話では、Hibernate には以下の機能が必要になります。

- アプリケーションクラスを検索する機能

- インテグレーションクラスを検索する機能

- プロパティーファイルや XML ファイルなどのリソースを検索する機能

java.util.ServiceLoaderをロードする機能注記現在、アプリケーションクラスをロードする機能と、統合クラスをロードする機能が、サービス上の単一の load class 機能に統合されています。これは、今後のリリースで変更される可能性があります。

org.hibernate.integrator.spi.IntegratorServiceアプリケーション、アドオン、およびその他のモジュールは Hibernate と統合する必要があります。前述の方法では、各モジュールの登録を調整するために、通常アプリケーションなどのコンポーネントが必要でした。この登録は、各モジュールのインテグレーターに代わって実施されました。

このサービスは、検出機能に重点を置いています。

org.hibernate.integrator.spi.Integratorのコントラクトの実装を検出するために、org.hibernate.service.classloading.spi.ClassLoaderServiceが提供する標準の Javajava.util.ServiceLoader機能を利用します。インテグレーターは、単に

/META-INF/services/org.hibernate.integrator.spi.Integratorという名前のファイルを定義し、これをクラスパスで利用できるようにします。このファイルは、

java.util.ServiceLoaderメカニズムによって使用されます。これは、1 行ずつorg.hibernate.integrator.spi.Integratorインターフェイスを実装するクラスの完全修飾名を一覧表示します。

5.3.4. SessionFactory レジストリー

すべてのレジストリータイプのインスタンスを指定の org.hibernate.SessionFactory のターゲットとして扱うのがベストプラクティスですが、このグループのサービスのインスタンスは単一の org.hibernate.SessionFactory に明示的に所属します。

相違点は、開始タイミングに関する事項です。通常、org.hibernate.SessionFactory にアクセスするにはアクセスが必要になります。この特別なレジストリーは org.hibernate.service.spi.SessionFactoryServiceRegistry です。

5.3.4.1. SessionFactory サービス

org.hibernate.event.service.spi.EventListenerRegistry

- 説明

- イベントリスナーを管理するためのサービスです。

- イニシエーター

-

org.hibernate.event.service.internal.EventListenerServiceInitiator - 実装

-

org.hibernate.event.service.internal.EventListenerRegistryImpl

5.3.5. インテグレーター

org.hibernate.integrator.spi.Integrator は、開発者が機能している SessionFactory をビルドするプロセスにフックできるようにする簡単な方法を提供することを目的としています。org.hibernate.integrator.spi.Integrator インターフェイスは関連する以下のメソッドを定義します。

-

integrateでは、ビルドプロセスへのフックが可能になります。 -

disintegrateでは、SessionFactoryをシャットダウンできます。

統合のオーバーロード形式である org.hibernate.integrator.spi.Integrator で定義されている 3 つ目のメソッドがあります。これは、org.hibernate.cfg.Configuration ではなく、org.hibernate.metamodel.source.MetadataImplementor を受け入れます。

IntegratorService で利用できる検出アプローチに加え、BootstrapServiceRegistry のビルド時にアプリケーションが手動でインテグレーター実装を登録できます。

5.3.5.1. インテグレーターのユースケース

org.hibernate.integrator.spi.Integrator の主なユースケースは、イベントリスナーを登録し、サービスを提供します。org.hibernate.integrator.spi.ServiceContributingIntegrator を参照してください。

例: イベントリスナーの登録

public class MyIntegrator implements org.hibernate.integrator.spi.Integrator {

public void integrate(

Configuration configuration,

SessionFactoryImplementor sessionFactory,

SessionFactoryServiceRegistry serviceRegistry) {

// As you might expect, an EventListenerRegistry is the thing with which event listeners are registered It is a

// service so we look it up using the service registry

final EventListenerRegistry eventListenerRegistry = serviceRegistry.getService(EventListenerRegistry.class);

// If you wish to have custom determination and handling of "duplicate" listeners, you would have to add an

// implementation of the org.hibernate.event.service.spi.DuplicationStrategy contract like this

eventListenerRegistry.addDuplicationStrategy(myDuplicationStrategy);

// EventListenerRegistry defines 3 ways to register listeners:

// 1) This form overrides any existing registrations with

eventListenerRegistry.setListeners(EventType.AUTO_FLUSH, myCompleteSetOfListeners);

// 2) This form adds the specified listener(s) to the beginning of the listener chain

eventListenerRegistry.prependListeners(EventType.AUTO_FLUSH, myListenersToBeCalledFirst);

// 3) This form adds the specified listener(s) to the end of the listener chain

eventListenerRegistry.appendListeners(EventType.AUTO_FLUSH, myListenersToBeCalledLast);

}

}

第6章 Hibernate Envers

6.1. Hibernate Envers について

Hibernate Enver は監査およびバージョン管理システムであり、JBoss EAP に永続クラスへのこれまでの変更を追跡する手段を提供します。監査テーブルは @Audited アノテーションが付けられたエンティティーに対して作成されています。これは、エンティティーに加えられた変更の履歴が保存されます。その後、データを取得し、クエリーできます。

Envers では、開発者は以下を行うことができます。

- Jakarta Persistence 仕様によって定義されたすべてのマッピングの監査

- Jakarta Persistence 仕様を拡張するすべての hibernate マッピングの監査

- ネイティブ Hibernate API を使用する、または、これによってマッピングされるエンティティーの監査

- リビジョンエンティティーを使用した各リビジョンのデータのログ記録

- 履歴データのクエリー

6.2. 永続クラスの監査について

永続クラスの監査は、Hibernate 環境と @Audited アノテーションで JBoss EAP で実行されます。アノテーションがクラスに適用されると、エンティティーの改訂履歴を保存するテーブルが作成されます。

クラスに変更が行われるたびに、エントリーが監査テーブルに追加されます。エントリーにはクラスへの変更が含まれ、リビジョン番号が指定されます。これは、変更をロールバックしたり、以前のリビジョンを表示したりできることを意味します。

6.3. 監査ストラテジー

6.3.1. 監査ストラテジーについて

監査ストラテジーは、監査情報の永続化、クエリー、および保存方法を定義します。Hibernate Evers には現在、以下の 2 つの監査ストラテジーがあります。

- デフォルトの監査ストラテジー

- このストラテジーは、開始リビジョンとともに監査データの保存を永続化します。監査されたテーブルで挿入、更新、削除される行ごとに、有効性の開始リビジョンとともに、監査テーブルに 1 つ以上の行を挿入します。

- 監査テーブルの行は、挿入後には更新されません。監査情報のクエリーはサブクエリーを使用して、監査テーブルの適用可能な行を選択します。これはスピードが遅く、インデックス作成が困難です。

- 有効性監査ストラテジー

- このストラテジーは、監査上の開始リビジョンと最後のリビジョンを保存します。監査されたテーブルで挿入、更新、削除される行ごとに、有効性の開始リビジョンとともに、監査テーブルに 1 つ以上の行を挿入します。

- 同時に、以前の監査行 (利用可能な場合) の終了リビジョンフィールドは、このリビジョンに設定されます。監査情報のクエリーは、サブクエリーの代わりに、between start and end revision の間で使用できます。つまり、追加の更新により、監査情報の永続化は多少遅くなりますが、監査情報の取得はかなり速くなります。

- これは、インデックスを追加して改善することもできます。

監査の詳細は、永続クラスの監査について を参照してください。アプリケーションの監査ストラテジーを設定するには、Set the Auditing Strategy を参照してください。

6.3.2. 監査ストラテジーの設定

JBoss EAP では、以下の 2 つの監査ストラテジーがサポートされています。

- デフォルトの監査ストラテジー

- 有効性監査ストラテジー

監査ストラテジーの定義

アプリケーションの persistence.xml ファイルで org.hibernate.envers.audit_strategy プロパティーを設定します。プロパティーが persistence.xml ファイルで設定されていない場合は、デフォルトの監査ストラテジーが使用されます。

デフォルトの監査ストラテジーの設定

<property name="org.hibernate.envers.audit_strategy" value="org.hibernate.envers.strategy.DefaultAuditStrategy"/>

有効性監査ストラテジーの設定

<property name="org.hibernate.envers.audit_strategy" value="org.hibernate.envers.strategy.ValidityAuditStrategy"/>

6.3.3. Jakarta Persistence エンティティーへの監査サポートの追加

手順

JBoss EAP は Hibernate Envers を介してエンティティー監査を使用し、永続クラスのこれまでの変更を追跡します。ここでは、Jakarta Persistence エンティティーの監査サポートの追加について説明します。

Jakarta Persistence エンティティーへの監査サポートの追加

- デプロイメントに適した利用可能な監査パラメーターを設定します。詳細は Configure Envers Parameters を参照してください。

- 監査する Jakarta Persistence エンティティーを開きます。

-

org.hibernate.envers.Auditedインターフェイスをインポートします。 監査する各フィールドまたはプロパティーに

@Auditedアノテーションを適用するか、クラス全体に対して 1 度適用します。例: 2 つのフィールドの監査

import org.hibernate.envers.Audited; import javax.persistence.Entity; import javax.persistence.Id; import javax.persistence.GeneratedValue; import javax.persistence.Column; @Entity public class Person { @Id @GeneratedValue private int id; @Audited private String name; private String surname; @ManyToOne @Audited private Address address; // add getters, setters, constructors, equals and hashCode here }例: クラス全体の監査

import org.hibernate.envers.Audited; import javax.persistence.Entity; import javax.persistence.Id; import javax.persistence.GeneratedValue; import javax.persistence.Column; @Entity @Audited public class Person { @Id @GeneratedValue private int id; private String name; private String surname; @ManyToOne private Address address; // add getters, setters, constructors, equals and hashCode here }

Jakarta Persistence エンティティーが監査用に設定されている場合は、履歴の変更を保存するために _AUD というテーブルが作成されます。

6.4. Configuration (設定)

6.4.1. Envers パラメーターの設定

JBoss EAP は About Hibernate Envers を介してエンティティー監査を使用して、永続クラスのこれまでの変更を追跡します。

利用可能な Envers パラメーターの設定

-

アプリケーションの

persistence.xmlファイルを開きます。 必要に応じて Envers プロパティーを追加、削除、または設定します。利用可能なプロパティーの一覧は、Envers Configuration Properties を参照してください。

例: Envers パラメーター

<persistence-unit name="mypc"> <description>Persistence Unit.</description> <jta-data-source>java:jboss/datasources/ExampleDS</jta-data-source> <shared-cache-mode>ENABLE_SELECTIVE</shared-cache-mode> <properties> <property name="hibernate.hbm2ddl.auto" value="create-drop" /> <property name="hibernate.show_sql" value="true" /> <property name="hibernate.cache.use_second_level_cache" value="true" /> <property name="hibernate.cache.use_query_cache" value="true" /> <property name="hibernate.generate_statistics" value="true" /> <property name="org.hibernate.envers.versionsTableSuffix" value="_V" /> <property name="org.hibernate.envers.revisionFieldName" value="ver_rev" /> </properties> </persistence-unit>

6.4.2. ランタイム時の監査の有効化または無効化

ランタイム時のエンティティーバージョンの監査の有効化または無効化

-

AuditEventListenerクラスをサブクラス化します。 Hibernate イベントで呼び出される以下のメソッドを上書きします。

-

onPostInsert -

onPostUpdate -

onPostDelete -

onPreUpdateCollection -

onPreRemoveCollection -

onPostRecreateCollection

-

- イベントのリスナーとしてサブクラスを指定します。

- 変更を監査する必要があるかどうかを判断します。

- 変更を監査する必要がある場合には、スーパークラスに呼び出しを渡します。

6.4.3. 条件監査の設定

Hibernate Envers は、一連のイベントリスナーを使用して、さまざまな Hibernate イベントに対する応答で監査データを永続化します。Envers JAR がクラスパスにある場合、これらのリスナーは自動的に登録されます。

条件監査の実装

-

persistence.xmlファイルでhibernate.listeners.envers.autoRegisterを false に設定します。 - 上書きされる各イベントリスナーをサブクラス化します。条件付き監査ロジックをサブクラスに配置し、監査を実行する必要がある場合は super メソッドを呼び出します。

-

org.hibernate.envers.event.EnversIntegratorに類似した、org.hibernate.integrator.spi.Integratorのカスタム実装を作成します。デフォルトのクラスではなく、ステップ 2 で作成したイベントリスナーサブクラスを使用します。 -

META-INF/services/org.hibernate.integrator.spi.Integratorファイルを JAR に追加します。このファイルには、インターフェイスを実装するクラスの完全修飾名が含まれている必要があります。

6.4.4. Envers 設定プロパティー

表6.1 エンティティーデータのバージョン管理設定パラメーター

| プロパティー名 | デフォルト値 | 説明 |

|---|---|---|

|

| 監査されたエンティティーの名前の前に付加される文字列。監査情報を保持するエンティティーの名前を作成します。 | |

|

| _AUD |

監査されたエンティティーの名前に付加される文字列。監査情報を保持するエンティティーの名前を作成します。たとえば、テーブル名が |

|

| REV | 改訂番号を保持する監査エンティティーのフィールド名。 |

|

| REVTYPE |

改訂の種類を保持する監査エンティティーのフィールド名。現在の改訂の種類には、挿入を行う |

|

| true |

このプロパティーは、所有の変更のない関係フィールドがある場合にリビジョンを生成するかどうかを決定します。これは、一対多数の関係のコレクションであるか、一対一の関係で |

|

| true |

true の場合、( |

|

| false | このプロパティーは、ID のみではなく、エンティティーデータを削除するときに、エンティティーデータをリビジョンに保存するかどうかを定義します。その他のすべてのプロパティーは null とマークされます。通常、データは最後から 2 番目のバージョンにあるため、これは必須ではありません。ただし時折、最後のリビジョンでアクセスすることが簡単で、より効率的になる場合があります。ただし、これは、削除前に含まれるエンティティーのデータが 2 回保存されることを意味します。 |

|

| null (通常のテーブルと同じ) |

監査テーブルに使用されるデフォルトのスキーマ名。 |

|

| null (通常のテーブルと同じ) |

監査テーブルに使用するデフォルトのカタログ名。 |

|

|

|

このプロパティーは、監査データの永続化時に使用する必要のある監査ストラテジーを定義します。デフォルトでは、エンティティーが変更されたリビジョンのみが保存されます。または、 |

|

| REVEND | 監査エンティティーで終了リビジョン番号を保持するコラムの名前。このプロパティーは、妥当な監査ストラテジーが使用される場合にのみ有効です。 |

|

| false |

このプロパティーは、終了リビジョン自体に加えて、データが最後に有効であった終了リビジョンのタイムスタンプも保存すべきかどうかを定義します。これは、テーブルパーティションを使用して、リレーショナルデータベースから古い監査レコードをパージする場合に便利です。パーティショニングには、テーブルに存在するコラムが必要です。このプロパティーは |

|

| REVEND_TSTMP |

データがまだ有効であった時点での終了リビジョンのタイムスタンプのコラム名。 |

6.5. 監査情報のクエリー

6.5.1. クエリーを介した監査情報の取得

Hibernate Enver は、クエリーを介して監査情報を取得する機能を提供します。

監査されたデータでのクエリーは、関連する subselect を伴うため、多くの場合、live データに対するクエリーよりもはるかに遅くなります。

所定リビジョンでのクラスのエンティティーのクエリー

このタイプのクエリーのエントリーポイントは以下の通りです。

AuditQuery query = getAuditReader()

.createQuery()

.forEntitiesAtRevision(MyEntity.class, revisionNumber);

制約は AuditEntity ファクトリークラスを使用して指定できます。以下のクエリーは、name プロパティーが John と同等のエンティティーのみを選択します。

query.add(AuditEntity.property("name").eq("John"));以下のクエリーは、特定のエンティティーに関連するエンティティーのみを選択します。

query.add(AuditEntity.property("address").eq(relatedEntityInstance));

// or

query.add(AuditEntity.relatedId("address").eq(relatedEntityId));その結果は、順序付け、制限でき、集計と予測 (グループ化を除く) セットを設定することができます。以下の例は、フルクエリーです。

List personsAtAddress = getAuditReader().createQuery()

.forEntitiesAtRevision(Person.class, 12)

.addOrder(AuditEntity.property("surname").desc())

.add(AuditEntity.relatedId("address").eq(addressId))

.setFirstResult(4)

.setMaxResults(2)

.getResultList();所定クラスエンティティーが変更されるクエリーリビジョン

このタイプのクエリーのエントリーポイントは以下の通りです。

AuditQuery query = getAuditReader().createQuery()

.forRevisionsOfEntity(MyEntity.class, false, true);このクエリーには、前述の例と同じように制約を追加できます。このクエリーには、追加の方法が考えられます。

AuditEntity.revisionNumber()- 監査済みエンティティーが変更されたリビジョン番号の制約、展開、および順序を指定します。

AuditEntity.revisionProperty(propertyName)- 監査済みエンティティーが変更されたリビジョンに対応する、リビジョンエンティティーのプロパティーに対する制約、調整および順序付けを指定します。

AuditEntity.revisionType()- リビジョンのタイプ (ADD、MOD、DEL) へのアクセスを提供します。

クエリー結果は必要に応じて調整できます。以下のクエリーは、リビジョン番号 42 の後に entityId が変更された MyEntity クラスのエンティティーが変更する最小リビジョン番号を選択します。

Number revision = (Number) getAuditReader().createQuery()

.forRevisionsOfEntity(MyEntity.class, false, true)

.setProjection(AuditEntity.revisionNumber().min())

.add(AuditEntity.id().eq(entityId))

.add(AuditEntity.revisionNumber().gt(42))

.getSingleResult();

リビジョンのクエリーは、プロパティーを最小限に抑えたり、最大値にしたりすることもできます。以下のクエリーは、特定のエンティティーの actualDate の値が指定の値よりも大きくなるリビジョンを選択しますが、可能な限り小さくなります。

Number revision = (Number) getAuditReader().createQuery()

.forRevisionsOfEntity(MyEntity.class, false, true)

// We are only interested in the first revision

.setProjection(AuditEntity.revisionNumber().min())

.add(AuditEntity.property("actualDate").minimize()

.add(AuditEntity.property("actualDate").ge(givenDate))

.add(AuditEntity.id().eq(givenEntityId)))

.getSingleResult();

minimize() および maximize() のメソッドは基準を返します。これは、制約を追加でき、 maximized/minimized プロパティーを持つエンティティーによって満たされる必要があります。

クエリーの作成時に、2 つのブール値パラメーターが渡されます。

selectEntitiesOnly-

このパラメーターは、明示的な子が設定されていない場合のみ有効です。

trueの場合、クエリーの結果は、指定された制約を満たすリビジョンで変更されたエンティティーのリストになります。

falseの場合、結果は 3 つの要素の配列のリストになります。最初の要素は変更されたエンティティーインスタンスになります。次は、リビジョンデータを含むエンティティーです。カスタムエンティティーが使用されていない場合、DefaultRevisionEntityのインスタンスになります。3 番目の要素アレイはリビジョンのタイプ (ADD、MOD、DEL) になります。 selectDeletedEntities-

このパラメーターは、エンティティーが削除されたリビジョンを結果に含める必要があるかどうかを指定します。true の場合、エンティティーにはリビジョンタイプ

DELが指定され、id を除くすべてのフィールドの値はnullになります。

所定プロパティーを変更するエンティティーのクエリーの修正

以下のクエリーは、指定の id を持つ MyEntity のすべてのリビジョンを返します。ここでは、realDate プロパティーが変更になりました。

AuditQuery query = getAuditReader().createQuery()

.forRevisionsOfEntity(MyEntity.class, false, true)

.add(AuditEntity.id().eq(id));

.add(AuditEntity.property("actualDate").hasChanged())

hasChanged 条件は、追加の基準と組み合わせることができます。以下のクエリーは、revisionNumber の生成時に MyEntity の水平スライスを返します。これは prop1 が変更されたリビジョンに限定されますが、prop2 には適用されません。

AuditQuery query = getAuditReader().createQuery()

.forEntitiesAtRevision(MyEntity.class, revisionNumber)

.add(AuditEntity.property("prop1").hasChanged())

.add(AuditEntity.property("prop2").hasNotChanged());

作成されたセットには、revisionNumber よりも少ない数字のリビジョンも含まれます。これは、このクエリーを Return all MyEntities changed in revisionNumber with prop1 modified and prop2 untouched として読み取ることができないことを意味します。

以下のクエリーは、forEntitiesModifiedAtRevision クエリーを使用して、この結果が返される方法を示しています。

AuditQuery query = getAuditReader().createQuery()

.forEntitiesModifiedAtRevision(MyEntity.class, revisionNumber)

.add(AuditEntity.property("prop1").hasChanged())

.add(AuditEntity.property("prop2").hasNotChanged());指定リビジョンでのクエリーエンティティーの変更

以下の例は、特定のリビジョンで変更されたエンティティーの基本クエリーを示しています。指定されたリビジョンで変更されたエンティティー名と対応する Java クラスを取得することができます。

Set<Pair<String, Class>> modifiedEntityTypes = getAuditReader()

.getCrossTypeRevisionChangesReader().findEntityTypes(revisionNumber);org.hibernate.envers.CrossTypeRevisionChangesReader からもアクセス可能なクエリーは多数あります。

List<Object> findEntities(Number)-

指定のリビジョンで変更された (追加、更新、削除された) すべての監査済みエンティティーのスナップショットを返します。

n+1SQL クエリーを実行します。nは、指定されたリビジョン内で変更された複数の異なるエンティティークラスです。 List<Object> findEntities(Number, RevisionType)-

変更タイプでフィルターされた特定のリビジョンで変更 (追加、更新、または削除) されたすべての監査済みエンティティーのスナップショットを返します。

n+1SQL クエリーを実行します。nは、指定されたリビジョン内で変更された複数の異なるエンティティークラスです。Map<RevisionType, List<Object>> findEntitiesGroupByRevisionType(Number)-

変更操作 (追加、更新、または削除など) でグループ化されたエンティティースナップショットの一覧が含まれるマップを返します。

3n+1SQL クエリーを実行します。nは、指定されたリビジョン内で変更された複数の異なるエンティティークラスです。

6.5.2. 参照されるエンティティーのプロパティーを使用したエンティティーの関連付けのトラバース

参照されるエンティティーのプロパティーを使用して、クエリー内のエンティティーをトラバースできます。これにより、1 対 1 および多対 1 の関連付けをクエリーできます。

以下の例は、クエリーでエンティティーをトラバースする方法の一部を示しています。

リビジョン番号 1 では、所有者が 20 歳であるか、住所番号 30 に居住している車を見つけます。そして、車のメーカーで設定した結果の順序づけを行います。

List<Car> resultList = auditReader.createQuery() .forEntitiesAtRevision( Car.class, 1 ) .traverseRelation( "owner", JoinType.INNER, "p" ) .traverseRelation( "address", JoinType.INNER, "a" ) .up().up().add( AuditEntity.disjunction().add(AuditEntity.property( "p", "age" ) .eq( 20 ) ).add( AuditEntity.property( "a", "number" ).eq( 30 ) ) ) .addOrder( AuditEntity.property( "make" ).asc() ).getResultList();リビジョン番号 1 では、所有者の年齢と住所番号が同じ車を見つけます。

Car result = (Car) auditReader.createQuery() .forEntitiesAtRevision( Car.class, 1 ) .traverseRelation( "owner", JoinType.INNER, "p" ) .traverseRelation( "address", JoinType.INNER, "a" ) .up().up().add(AuditEntity.property( "p", "age" ) .eqProperty( "a", "number" ) ).getSingleResult();リビジョン番号 1 では、所有者の年齢が 20 歳であるか、所有者がない車すべてを見つけます。

List<Car> resultList = auditReader.createQuery() .forEntitiesAtRevision( Car.class, 1 ) .traverseRelation( "owner", JoinType.LEFT, "p" ) .up().add( AuditEntity.or( AuditEntity.property( "p", "age").eq( 20 ), AuditEntity.relatedId( "owner" ).eq( null ) ) ) .addOrder( AuditEntity.property( "make" ).asc() ).getResultList();リビジョン番号 1 では、メーカーが car3 であり、所有者の年齢が 30 歳であるか、所有者のいない車すべてを見つけます。

List<Car> resultList = auditReader.createQuery() .forEntitiesAtRevision( Car.class, 1 ) .traverseRelation( "owner", JoinType.LEFT, "p" ) .up().add( AuditEntity.and( AuditEntity.property( "make" ).eq( "car3" ), AuditEntity.property( "p", "age" ).eq( 30 ) ) ) .getResultList();リビジョン番号 1 では、メーカーが car3 であるか、所有者の年齢が 10 歳であるか、あるいは所有者がいない車すべてを見つけます。

List<Car> resultList = auditReader.createQuery() .forEntitiesAtRevision( Car.class, 1 ) .traverseRelation( "owner", JoinType.LEFT, "p" ) .up().add( AuditEntity.or( AuditEntity.property( "make" ).eq( "car3" ), AuditEntity.property( "p", "age" ).eq( 10 ) ) ) .getResultList();

6.6. パフォーマンスチューニング

6.6.1. 他のバッチロードアルゴリズム

Hibernate では、join、select、subselect、および batch の 4 つののフェッチストラテジーのいずれかを使用して関連付けのデータを読み込むことができます。これら 4 つのストラテジーにおいて、バッチローディングでは、select フェッチの最適化ストラテジーであるため、これらのストラテジーの外で、パフォーマンスを大幅に向上させることができます。このストラテジーでは、Hibernate はプライマリーキーまたは外部キーのリストを指定して、単一の SELECT ステートメントでエンティティーインスタンスまたはコレクションのバッチを取得します。batch フェッチは、レイジー select フェッチストラテジーの最適化です。

batch フェッチの設定方法は、クラス当たりのレベルまたはコレクション当たりのレベルです。

クラス当たりのレベル

Hibernate がクラス当たりのレベルでデータを読み込む場合は、クエリーの実行時にロードする関連付けのバッチサイズが必要になります。たとえば、ランタイム時に、セッションに 30 個のインスタンスの

carオブジェクトがロードされているとします。各carオブジェクトはownerオブジェクトに属します。すべてのcarオブジェクトを繰り返し処理し、所有者を要求する場合、lazy読み込みでは、Hibernate は所有者ごとに 30 個の select ステートメントを発行します。これはパフォーマンスのボトルネックです。代わりに、Hibernate に対して、クエリーを経由する前に所有者の次のバッチのデータを事前に読み込むように指示することもできます。

ownerオブジェクトがクエリーされると、Hibernate は同じ SELECT ステートメントで多くのこれらのオブジェクトをクエリーします。事前にクエリーする

ownerオブジェクトの数は、設定時に指定されたbatch-sizeパラメーターによって異なります。<class name="owner" batch-size="10"></class>

これにより、Hibernate は、後で必要と予想される 10 個以上の

ownerオブジェクトをクエリーするようになります。ユーザーがcar Aのownerにクエリーすると、car Bのownerはすでにバッチロードの一部として読み込まれている可能性があります。ユーザーがデータベースに移動 (および SELECT ステートメントを実行) する代わりに、実際にcar Bのownerが必要な場合は、現在のセッションから値を取得できます。batch-sizeパラメーターに加えて、Hibernate 4.2.0 ではバッチロードのパフォーマンスを強化する新しい設定項目が導入されました。設定項目はBatch Fetchstyle設定と呼ばれ、hibernate.batch_fetch_styleパラメーターによって指定されます。LEGACY、PADDED、DYNAMIC といった異なるバッチフェッチスタイルがサポートされています。使用するスタイルを指定するには、

org.hibernate.cfg.AvailableSettings#BATCH_FETCH_STYLEを使用します。LEGACY: 読み込みのレガシースタイルでは、

ArrayHelper.getBatchSizes(int)に基づく事前ビルドされたバッチサイズセットが使用されます。バッチは、既存のバッチ可能な識別子の数からの次に小さな事前ビルドされたバッチサイズを使用してロードされます。上記の例で、

batch-sizeが 30 の場合、事前ビルドされたバッチサイズは [30, 15, 10, 9, 8, 7,..., 1] になります。ロード 29 識別子のバッチ処理を試みると、15、10、および 4 のバッチが発生します。対応する SQL クエリーは 3 つあり、各クエリーはデータベースから 15、10、および 4 の所有者 (owner) を読み込みます。PADDED - PADDED は、バッチローディングの LEGACY スタイルに似ています。依然として事前ビルドされたバッチサイズを使用していますが、次に大きなバッチサイズを使用し、追加の識別子プレースホルダーをパディングします。

上記の例と同様に、30 個の owner オブジェクトを初期化する場合、データベースに対してクエリーが実行されるのは 1 つのみとなります。

ただし、29 個の owner オブジェクトが初期化される場合でも、Hibernate は依然としてバッチサイズ 30 の SQL select ステートメントのみを実行し、識別子が連続する追加スペースがパディングされます。

Dynamic - バッチサイズの制限に準拠していますが、このスタイルのバッチロードは、実際に読み込まれるオブジェクト数を使用して SQL SELECT ステートメントを動的に構築します。

たとえば、owner オブジェクトが 30 個で、最大バッチサイズが 30 の場合、30 個の owner オブジェクトを取得する呼び出しは、1 つの SQL SELECT ステートメントになります。35 個を取得する呼び出しは、バッチサイズ 30 と 5 の 2 つの SQL ステートメントになります。Hibernate は、必要な数である 5 を維持するために 第 2 の SQL ステートメントを動的に変更します。また、バッチサイズは制限の 30 のままに保持します。これは、PADDED バージョンとは異なります。第 2 の SQL は PADDED されません。LEGACY スタイルとは異なり、第 2 の SQL ステートメントには固定サイズがなく、次の SQL は動的に作成されます。

クエリーが 30 個の識別子を下回る場合、このスタイルは要求された識別子の数のみを動的に読み込みます。

コレクション当たりのレベル

Hibernate では、上記の各クラス当たりのセクションにリストされているバッチフェッチサイズとスタイルを採用するロードコレクションのバッチ処理も可能です。

前のセクションで使用した例を戻すには、各

ownerオブジェクトが所有するすべてのcarオブジェクトをロードする必要があることを考慮してください。10 個のownerオブジェクトが現行セッションでロードされ、すべての owner で 反復すると、10 個の SELECT ステートメントが生成されます (getCars()メソッドへの呼び出しごと)。Owner のマッピングで cars コレクションのバッチフェッチを有効にすると、Hibernate は以下のようにこれらのコレクションの事前フェッチを実行できます。<class name="Owner"><set name="cars" batch-size="5"></set></class>

そのため、バッチサイズが 10 個で、レガシーバッチスタイルを使用して つのコレクションをロードすると、Hibernate は つの SELECT ステートメントを実行し、各コレクションを取得します。

6.6.2. 変更不可のデータのオブジェクト参照の 2 次レベルのキャッシング

Hibernate は、パフォーマンスを改善するために自動的にデータをメモリーにキャッシュします。これは、特にほとんど変更されないデータに対して、必要なデータベースルックアップ回数を減らすインメモリーキャッシュによって実現されます。

Hibernate は以下の種類のキャッシュを維持します。1 次キャッシュとも呼ばれるプライマリーキャッシュは必須です。このキャッシュは現行セッションと関連付けられ、すべてのリクエストがそのセッションを通過する必要があります。セカンダリーキャッシュとも呼ばれる 2 次キャッシュは任意で、プライマリーキャッシュが参照された後にのみ参照されます。

データは、最初にデータを状態アレイにアセンブルすることで 2 次キャッシュに保存されます。このアレイはディープコピーされ、そのディープコピーがキャッシュに配置されます。その逆は、キャッシュからの読み取りに対して行われます。これは、変更 (変更不能データ) が変更できないデータには適切に機能しますが、変更できないデータには効率的ではありません。

データのディープコピーは、メモリー使用量と処理速度に関する負荷のかかる操作です。大きなデータセットでは、メモリーと処理速度がパフォーマンス制限の要因となります。Hibernate では、変更不能なデータがコピーされるのではなく、参照されるように指定できます。Hibernate は、データセット全体をコピーする代わりに、キャッシュのデータへの参照を保管できるようになりました。

これには、設定 hibernate.cache.use_reference_entries の値を true に変更します。デフォルトでは、hibernate.cache.use_reference_entries は false に設定されています。

hibernate.cache.use_reference_entries が true に設定されている場合は、関連付けのない変更不能なデータオブジェクトは 2 次キャッシュにコピーされず、その参照のみが保存されます。

hibernate.cache.use_reference_entries が true に設定されると、関連付けのある変更不能なデータオブジェクトが 2 次キャッシュにディープコピーされます。

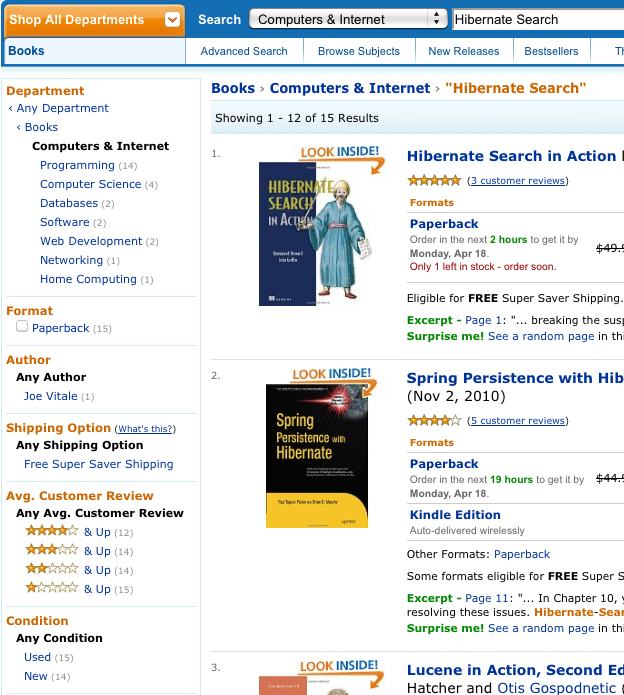

第7章 Hibernate Search

7.1. Hibernate Search の使用

7.1.1. Hibernate Search について

Hibernate Search は、Hibernate アプリケーションに完全なテキスト検索機能を提供します。これは、全文、あいまい、位置情報検索などの SQL ベースのソリューションには適していないアプリケーションの検索に適しています。Hibernate Search は Apache Lucene を全文検索エンジンとして使用しますが、メンテナンスのオーバーヘッドを最小限に抑えるように設計されています。設定が完了したら、インデックス、クラスターリング、およびデータ同期は透過的に維持されるため、ビジネス要件を満たすことができます。

以前のリリースの JBoss EAP には Hibernate 4.2 および Hibernate Search 4.6 が含まれていました。JBoss EAP 7 には Hibernate 5 と Hibernate Search 5.5 が含まれています。

Hibernate Search 5.5 は Java 7 と機能し、Lucene 5.3.x 上に構築されるようになりました。ネイティブ Lucene API を使用している場合は、必ずこのバージョンに合わせてください。

7.1.2. Hibernate Search の概要

Hibernate Search はインデックスコンポーネントとインデックス検索コンポーネントで設定されており、どちらも Apache Lucene によってサポートされます。エンティティーがデータベースから挿入、更新、または削除されるたびに、Hibernate Search は Hibernate イベントシステムからこのイベントを追跡し、インデックスの更新をスケジュール設定します。これらの更新はすべて、Apache Lucene API と直接対話せずに処理されます。その代わりに、基盤の Lucene インデックスとの対話は IndexManager で処理されます。デフォルトでは、IndexManager と Lucene インデックスの間に 1 対 1 の関係があります。IndexManager は、選択した back end、reader strategy および DirectoryProvider を含む特定のインデックス設定を抽象化します。

インデックスが作成されると、基盤の Lucene インフラストラクチャーを処理するのではなく、エンティティーを検索し、管理エンティティーのリストを返すことができます。同じ永続コンテキストが Hibernate と Hibernate Search 間で共有されます。FullTextSession クラスは Hibernate Session クラスの上に構築されるため、アプリケーションコードで HQL、Java Persistence クエリー言語 (JPQL)、またはネイティブクエリーと同じように統一された org.hibernate.Query または javax.persistence.Query API を使用できます。

トランザクションバッチモードは、Java Naming および Directory Interface ベースであるかに関わらず、すべての操作に推奨されます。

Java Naming and Directory Interface または Jakarta Transactions に関わらず、データベースと Hibernate Search の両方に対して、トランザクションで操作を実行することが推奨されます。

Hibernate Search は、アトミック会話として知られる Hibernate または EntityManager の長い会話パターンで完全に機能します。

7.1.3. ディレクトリープロバイダーについて

Hibernate Search インフラストラクチャーの一部である Apache Lucene には、インデックスの保管にディレクトリーという概念があります。Hibernate Search は、Directory Provider 経由で Lucene Directory インスタンスの初期化および設定を処理します。

Directory_provider プロパティーは、インデックスを保存するために使用するディレクトリープロバイダーを指定します。デフォルトのファイルシステムディレクトリープロバイダーは filesystem で、ローカルファイルシステムを使用してインデックスを格納します。

7.1.4. Worker について

Lucene インデックスの更新は、Hibernate Search Worker によって処理されます。これは、コンテキストが終了すると、すべてのエンティティーの変更を受け取り、コンテキストでキューに入れてそれらをキューに適用します。最も一般的なコンテキストはトランザクションですが、エンティティーの変更数または他のアプリケーションイベントの数に依存する可能性があります。

効率性を向上するために、対話はバッチ化され、通常はコンテキストの終了時に適用されます。トランザクション以外では、インデックスの更新操作は実際のデータベース操作の直後に実行されます。継続中のトランザクションの場合、インデックス更新操作はトランザクションのコミットフェーズに対してスケジュール設定され、トランザクションのロールバック時に破棄されます。worker は特定のバッチサイズ制限で設定でき、その後、インデックスはコンテキストに関係なく実行されます。

この手法では、インデックス更新を処理するのに以下のようなメリットがあります。

- パフォーマンス: 操作がバッチで実行されると、Lucene インデックスのパフォーマンスが向上しました。

- ACIDity: 実行されるワークはデータベーストランザクションによって実行されたものと同じスコーピングを持ち、トランザクションがコミットされた場合にのみ実行されます。これは、厳密な意味では ACID ではありませんが、ACID の動作では、ソースからいつでも再構築できるため、完全なテキスト検索インデックスにはあまり役に立ちません。

no scope と transactional という 2 つのバッチモードは、自動コミットとトランザクション動作と同等です。パフォーマンスの観点からは、transactional モードが推奨されます。スコープの選択は透過的に行われます。Hibernate Search はトランザクションの存在を検出し、スコーピングを調整します。

7.1.5. バックエンド設定と操作

7.1.5.1. バックエンド

Hibernate Search は、さまざまなバックエンドを使用してワークのバッチ処理を行います。バックエンドは、設定オプション default.worker.backend に制限されません。このプロパティーは、バックエンド設定の一部である BackendQueueProcessor インターフェイスの実装を指定します。Jakarta Messaging バックエンドなどのバックエンドを設定するには、追加の設定が必要です。

7.1.5.2. Lucene

Lucene モードでは、ノードのすべてのインデックス更新は、ディレクトリープロバイダーを使用して同じノードから Lucene ディレクトリーに対して実行されます。このモードは、クラスター化されていない環境や、共有ディレクトリーストアを持つクラスター環境で使用します。

図7.1 Lucene バックエンド設定

Lucene モードは、ディレクトリーがロックストラテジーを管理するクラスター化またはクラスター化されたアプリケーションをターゲットに設定します。Lucene モードの主な利点は、Lucene クエリーの変更の単純化と即時表示です。Near Real Time (NRT) バックエンドは、クラスター化されていないインデックス設定や共有されていないインデックス設定の代替バックエンドです。

7.1.5.3. Jakarta Messaging

ノードのインデックス更新は Jakarta Messaging キューに送信されます。一意のリーダーはキューを処理し、マスターインデックスを更新します。マスターインデックスはその後、スレーブコピーに定期的に複製され、マスターとスレーブのパターンを確立します。マスターは Lucene インデックスの更新を行います。スレーブは読み取りおよび書き込み操作を受け入れますが、ローカルインデックスコピーの読み取り操作を処理します。マスターは Lucene インデックスの更新のみを行います。更新操作にローカルの変更を適用するのは、マスターのみです。

図7.2 Jakarta Messaging Service バックエンドの設定

このモードは、スループットが重要で、インデックス更新の遅延が許容できるクラスター化された環境をターゲットとします。Jakarta Messaging プロバイダーは信頼性を確保し、スレーブを使用してローカルインデックスコピーを変更します。

7.1.6. リーダーストラテジー

クエリーの実行時に、Hibernate Search はリーダーストラテジーを使用して Apache Lucene インデックスと対話します。頻繁な更新、多くの読み取り、非同期のインデックス更新など、アプリケーションのプロファイルに基づいてリーダーストラテジーを選択します。

7.1.6.1. Shared ストラテジー

shared ストラテジーを使用すると、Hibernate Search は、IndexReader が更新され続ける場合に、複数のクエリーおよびスレッドにわたる特定の Lucene インデックスに対して同じ IndexReader を共有します。IndexReader が更新されない場合は、新しい IndexReader が開かれて提供されます。各 IndexReader は複数の SegmentReaders で設定されています。共有ストラテジーは、前回開いた後に修正または作成されたセグメントを分離し、以前のインスタンスのすでにロードされているセグメントを共有します。これはデフォルトのストラテジーです。

7.1.6.2. Not-shared ストラテジー

non-shared ストラテジーを使用すると、クエリーが実行されるたびに Lucene IndexReader が開かれます。IndexReader の開始と起動は、高価な操作です。そのため、各クエリー実行で IndexReader を開くことは効率的なストラテジーではありません。

7.1.6.3. カスタムリーダーストラテジー

org.hibernate.search.reader.ReaderProvider の実装を使用して、カスタムリーダーストラテジーを作成できます。実装はスレッドセーフである必要があります。

7.2. Configuration (設定)

7.2.1. 最小設定

Hibernate Search は、設定および操作の柔軟性を提供するように設計されており、ほとんどのユースケースに合わせてデフォルト値を慎重に選択しています。少なくとも、Directory Provider とそのプロパティーを設定する必要があります。デフォルトの Directory Provider は filesystem で 、インデックスストレージにローカルファイルシステムを使用します。利用可能な Directory Providers およびその設定の詳細は、DirectoryProvider Configuration を参照してください。

Hibernate を直接使用する場合は、DirectoryProvider などの設定を、設定ファイル (hibernate.properties または ) で設定する必要があります。Jakarta Persistence 経由で Hibernate を使用している場合、設定ファイルは hibernate.cfg.xmlpersistence.xml になります。

その他のリソース

- 利用可能な Directory Providers およびその設定の詳細は、DirectoryProvider Configuration を参照してください。

7.2.2. IndexManager の設定

Hibernate Search は、このインターフェイスにいくつかの実装を提供します。

-

directory-based: LuceneDirectory抽象化を使用してインデックスファイルを管理するデフォルトの実装。 -

near-real-time: コミット時にディスクへの書き込みをフラッシュしないようにします。このインデックスマネージャーはDirectoryベースでもありますが、Lucene のほぼリアルタイムの NRT 機能を使用します。

デフォルト以外の IndexManager を指定するには、以下のプロパティーを指定します。

hibernate.search.[default|<indexname>].indexmanager = near-real-time

7.2.2.1. Directory-based

Directory-based 実装はデフォルトの IndexManager 実装です。これは高度な設定が可能で、リーダーストラテジー、バックエンド、およびディレクトリープロバイダーに個別の設定を可能にします。

7.2.2.2. Near Real Time

NRTIndexManager はデフォルトの IndexManager の拡張機能で、低レイテンシーインデックス書き込みに Lucene NRT、Near Real Time 機能を活用します。ただし、lucene 以外の代替のバックエンドの設定を無視し、Directory で排他的な書き込みロックを取得します。

IndexWriter は、低レイテンシーを提供するため、ディスクへの変更をすべてフラッシュしません。クエリーは、フラッシュされていないインデックスライターバッファーから更新された状態を読み取ることができます。ただし、これは、IndexWriter が強制終了したり、アプリケーションがクラッシュした場合に、インデックスを再構築する必要があるように更新が失われる可能性があることを意味します。

Near Real Time 設定は、上記のデメリットとマスターノードを個別に設定できるため、データが限定されたクラスター化されていない Web サイトに対して推奨されます。

7.2.2.3. Custom

カスタム実装の完全修飾クラス名を指定して、カスタマイズされた IndexManager を設定します。以下のように、実装に no-argument コンストラクターを設定します。

[default|<indexname>].indexmanager = my.corp.myapp.CustomIndexManager

カスタムインデックスマネージャーの実装には、デフォルトの実装と同じコンポーネントは必要ありません。たとえば、Directory インターフェイスを公開しないリモートインデックスサービスに委譲します 。

7.2.3. DirectoryProvider の設定

DirectoryProvider は Lucene Directory に関する Hibernate Search の抽象化で、基盤の Lucene リソースの設定および初期化を処理します。Directory Providers and Their Properties では Hibernate Search で利用可能なディレクトリープロバイダーの一覧と、対応するオプションを表示しています。

インデックス化された各エンティティーは Lucene インデックスに関連付けられます (複数のエンティティーが同じインデックスを共有している場合を除きます)。インデックスの名前は、@Indexed アノテーションの index プロパティーによって指定されます。Index プロパティーが指定されていない場合は、インデックスされたクラスの完全修飾名が名前として使用されます (推奨)。

DirectoryProvider および追加オプションは、接頭辞 hibernate.search.<indexname> を使用して設定できます。名前 default (hibernate.search.default) は予約されており、すべてのインデックスに適用されるプロパティーを定義するために使用できます。Configuring Directory Providers では、hibernate.search.default.directory_provider を使用してデフォルトのディレクトリープロバイダーをファイルシステムに設定する方法を示しています。その後に、hibernate.search.default.indexBase がインデックスのデフォルトのベースディレクトリーを設定します。その結果、エンティティー Status のインデックスが /usr/lucene/indexes/org.hibernate.example.Status に作成されます。

ただし、Rule エンティティーのインデックスは、メモリー内ディレクトリーを使用します。これは、このエンティティーのデフォルトのディレクトリープロバイダーが hibernate.search.Rules.directory_provider プロパティーによって上書きされるためです。

最後に、Action エンティティーは 、hibernate.search.Actions.directory_provider で指定されるカスタムディレクトリープロバイダー CustomDirectoryProvider を使用します。

インデックス名の指定

package org.hibernate.example;

@Indexed

public class Status { ... }

@Indexed(index="Rules")

public class Rule { ... }

@Indexed(index="Actions")

public class Action { ... }

ディレクトリープロバイダーの設定

hibernate.search.default.directory_provider = filesystem hibernate.search.default.indexBase=/usr/lucene/indexes hibernate.search.Rules.directory_provider = ram hibernate.search.Actions.directory_provider = com.acme.hibernate.CustomDirectoryProvider

上記の設定スキームを使用すると、ディレクトリープロバイダーやベースディレクトリーなどの一般的なルールを簡単に定義でき、これらのデフォルトをインデックスごとに後で上書きできます。

ディレクトリープロバイダーおよびそれらのプロパティー

- ram

- None

- Filesystem

ファイルシステムベースのディレクトリー使用されるディレクトリーは <indexBase> /< indexName > です。

- indexBase: ベースディレクトリー

- indexName: @Indexed.index を上書き (シャード化されたインデックスに便利です)

- locking_strategy: オプション。LockFactory Configuration を参照してください。

-

filesystem_access_type: この

DirectoryProviderで使用されるFSDirectory実装の正確なタイプを判別できます。許可される値はauto(デフォルト値。Windows 以外のシステムではNIOFSDirectory、Windwos ではSimpleFSDirectory)、simple (SimpleFSDirectory)、nio (NIOFSDirectory)、mmap (MMapDirectory)を選択します。この設定を変更する前に、これらのディレクトリー実装に関する Java ドキュメントを参照してください。NIOFSDirectoryまたはMMapDirectoryは、パフォーマンスを大幅に向上させる可能性がありますが、問題もあります。

filesystem-masterファイルシステムベースのディレクトリー

filesystemと類似しています。また、定期的にインデックスをソースディレクトリー (コピーディレクトリー) にコピーします。更新期間に推奨される値は (最低 50%)、情報をコピーする時間 (デフォルトは 3600 秒 - 60 分) です。

コピーは、増分コピーメカニズムをベースにしているため、コピーの平均時間が短縮されることに注意してください。

DirectoryProvider は通常、Jakarta Messaging バックエンドクラスターのマスターノードで使用されます。

buffer_size_on_copy最適化は、ご使用のオペレーティングシステムと利用可能な RAM によって異なります。多くユーザーは 16 から 64MB までの値を使用して良好な結果を報告しています。- indexBase: ベースディレクトリー

- indexName: @Indexed.index を上書き (シャード化されたインデックスに便利です)

- sourceBase: ソース (コピー) のベースディレクトリー。

-

source: ソースディレクトリーの接尾辞 (

デフォルトは @Indexed.index)。実際のソースのディレクトリー名は<sourceBase>/<source>です。 - refresh: 更新の間隔 (秒単位) です (コピーは更新の秒数ごとに行われます)。次の refresh 期間が経過してもコピーが進行中であると、次のコピー操作はスキップされます。

- buffer_size_on_copy: 単一の低レベルのコピー命令で移動するメガージの量。デフォルトは 16MB です。

- locking_strategy: オプション。LockFactory Configuration を参照してください。

-

filesystem_access_type: この

DirectoryProviderで使用されるFSDirectory実装の正確なタイプを判別できます。許可される値はauto(デフォルト値。Windows 以外のシステムではNIOFSDirectory、Windwos ではSimpleFSDirectory)、simple (SimpleFSDirectory)、nio (NIOFSDirectory)、mmap (MMapDirectory)を選択します。この設定を変更する前に、これらのディレクトリー実装に関する Java ドキュメントを参照してください。NIOFSDirectoryまたはMMapDirectoryではパフォーマンスが大幅に向上しますが、注意が必要な問題もあります。

filesystem-slaveファイルシステムベースのディレクトリー

filesystemと似ていますが、マスターバージョン (ソース) を定期的に取得します。ロックおよび一貫性のない検索結果を避けるため、2 つのローカルコピーが維持されます。更新期間に推奨される値は (最低 50%)、情報をコピーする時間 (デフォルトは 3600 秒 - 60 分) です。

コピーは、増分コピーメカニズムをベースにしているため、コピーの平均時間が短縮されることに注意してください。refresh 期間が経過してもコピーが進行中であると、次のコピー操作はスキップされます。

DirectoryProvider は通常、Jakarta Messaging バックエンドを使用するスレーブノードに使用されます。

buffer_size_on_copy最適化は、ご使用のオペレーティングシステムと利用可能な RAM によって異なります。多くユーザーは 16 から 64MB までの値を使用して良好な結果を報告しています。- indexBase: ベースディレクトリー

- indexName: @Indexed.index を上書き (シャード化されたインデックスに便利です)

- sourceBase: ソース (コピー) のベースディレクトリー。

-

source: ソースディレクトリーの接尾辞 (

デフォルトは @Indexed.index)。実際のソースのディレクトリー名は<sourceBase>/<source>です。 - refresh: 更新の間隔 (秒単位) です (コピーは更新の秒数ごとに行われます)。

- buffer_size_on_copy: 単一の低レベルのコピー命令で移動するメガージの量。デフォルトは 16MB です。

- locking_strategy: オプション。LockFactory Configuration を参照してください。

- retry_marker_lookup: オプションで、デフォルトは 0 です。Hibernate Search がソースディレクトリーのマーカーファイルをチェックする回数を定義します。試行ごとに 5 秒待機します。

-

retry_initialize_period: オプション。再試行初期化機能を有効にするために整数値を秒単位で設定します。スレーブがマスターインデックスを検出できない場合、アプリケーションがバックグラウンドで起動しないようにせずに再試行します。インデックスの初期化前に実行された FULLTEXT クエリーはブロックされず、空の結果が返されます。オプションを有効にしない、または明示的にゼロに設定すると、再試行タイマーのスケジュール設定ではなく、例外により失敗します。無効なインデックスなしでアプリケーションが起動しないようにし、初期化のタイムアウトを制御するには、代わりに

retry_marker_lookupを参照してください。 -

filesystem_access_type: この

DirectoryProviderで使用されるFSDirectory実装の正確なタイプを判別できます。許可される値は auto (デフォルト値。Windows 以外のシステムではNIOFSDirectory、Windwos ではSimpleFSDirectory)、simple (SimpleFSDirectory)、nio (NIOFSDirectory)、mmap (MMapDirectory)を選択します。この設定を変更する前に、これらのディレクトリー実装に関する Java ドキュメントを参照してください。NIOFSDirectoryまたはMMapDirectoryはパフォーマンスを大幅に向上させる可能性がありますが、問題にも認識する必要があります。

ビルトインディレクトリープロバイダーがニーズに適さない場合は、org.hibernate.store.DirectoryProvider インターフェイスを実装して独自のディレクトリープロバイダーを作成することができます。この場合、プロバイダーの完全修飾クラス名を directory_provider プロパティーに渡します。接頭辞 hibernate.search.<indexname> を使用して追加のプロパティーを渡すことができます。

7.2.4. Worker 設定

workder 設定では、Hibernate Search が Lucene と対話する方法を詳細化することができます。複数のアーキテクチャーコンポーネントと可能な拡張ポイントが存在します。詳しく見てみましょう。

ワーカー設定を使用して、Infinispan クエリーが Lucene と対話する方法を詳細化します。この設定には、いくつかのアーキテクチャーコンポーネントおよび可能な拡張ポイントを使用できます。

まず、Worker があります。Worker インターフェイスの実装は、すべてのエンティティーの変更を受け取り、コンテキストによってそれらをキューに登録し、コンテキストの終了時に適用します。特に ORM との接続で最も直感的なコンテキストはトランザクションです。このため、はデフォルトで TransactionalWorker を使用してトランザクションごとにすべての変更をスコープします。ただし、エンティティーの変更数やその他のアプリケーションライフサイクルイベントなどによってコンテキストが異なるシナリオを想定できます。

表7.1 スコープの設定

| プロパティー | 説明 |

|---|---|

|

|

使用する |

|

|

接頭辞 |

|

|

コンテキストごとにバッチ処理されるインデックス操作の最大数を定義します。制限に達すると、コンテキストが終了していなくてもインデックスがトリガーされます。このプロパティーは、 |

コンテキストが終了すると、インデックスの変更を準備して適用します。これは、新規スレッド内で同期または非同期に実行できます。同期更新には、常にインデックスがデータベースと同期しているという利点があります。一方、非同期の更新は、ユーザーの応答時間を最小限に抑えるのに役立ちます。欠点は、データベースとインデックスの状態間で不一致が生じる可能性があることです。

以下のオプションはインデックスごとに異なる場合があります。実際には、indexName 接頭辞が必要になるか、default を使用してすべてのインデックスのデフォルト値を設定する必要があります。

表7.2 実行設定

| プロパティー | 説明 |

|---|---|

|

|

|

|

| バックエンドは、スレッドプールを使用して、同じトランザクションコンテキスト (またはバッチ) から更新を並行して適用することができます。デフォルト値は 1 です。トランザクションごとに多数の操作がある場合は、大きな値を試すことができます。 |

|

| スレッドプールが不足している場合は、ワークキューの最大数を定義します。非同期実行のみに便利です。デフォルトは infinite です。制限に達すると、ワークはメインスレッドによって行われます。 |

現在、いずれの実行モードであっても、すべての作業は同じ仮想マシン内で行われます。単一仮想マシンの作業合計量は変更されていません。常に、より適切なアプローチ (つまり委任) があります。hibernate.search.default.worker.backend を設定すると、インデックス作業を別のサーバーに送信できます。このオプションも、インデックスごとに異なる方法で設定できます。

表7.3 バックエンドの設定

| プロパティー | 説明 |

|---|---|

|

|

|

- Java Messaging サービスのバックエンド設定

| プロパティー | 説明 |

|

| 必要に応じて InitialContext を開始する Java Naming および Directory Interface プロパティーを定義します。Java Naming and Directory Interface は、Java Messaging サービスのバックエンドによってのみ使用されます。 |

|

|

Java Messaging Service バックエンドには必須です。Java Messaging Service 接続ファクトリーを (Red Hat JBoss Enterprise Application Platform のデフォルトでは |

|

| Java Messaging Service バックエンドには必須です。Java Messaging Service キューを検索する Java Naming and Directory Interface 名を定義します。キューはワークメッセージをポストするために使用されます。 |

おそらく、表示されるプロパティーの一部は関連付けられるため、プロパティー値のすべての組み合わせが適切であるとは限りません。実際には、機能以外の設定を行うことができます。これは、特に、ここに示されるインターフェイスの独自の実装を提供する場合が該当します。独自の Worker または BackendQueueProcessor 実装を作成する前に、既存のコードを調査してください。

7.2.4.1. Jakarta Messaging マスター/スレーブバックエンド

このセクションでは、マスター/スレーブの Hibernate Search アーキテクチャーの設定方法について説明します。

図7.3 Jakarta Messaging バックエンドの設定

7.2.4.2. スレーブノード

すべてのインデックス更新操作は Jakarta Messaging キューに送信されます。インデックスクエリー操作は、ローカルインデックスコピーで実行されます。

Jakarta Messaging スレーブの設定

### slave configuration ## DirectoryProvider # (remote) master location hibernate.search.default.sourceBase = /mnt/mastervolume/lucenedirs/mastercopy # local copy location hibernate.search.default.indexBase = /Users/prod/lucenedirs # refresh every half hour hibernate.search.default.refresh = 1800 # appropriate directory provider hibernate.search.default.directory_provider = filesystem-slave ## Back-end configuration hibernate.search.default.worker.backend = jms hibernate.search.default.worker.jms.connection_factory = /ConnectionFactory hibernate.search.default.worker.jms.queue = queue/hibernatesearch #optional jndi configuration (check your Jakarta Messaging provider for more information) ## Optional asynchronous execution strategy # hibernate.search.default.worker.execution = async # hibernate.search.default.worker.thread_pool.size = 2 # hibernate.search.default.worker.buffer_queue.max = 50

ファイルシステムローカルコピーは、より高速な検索結果を得るために推奨されます。

7.2.4.3. マスターノード

すべてのインデックス更新操作は Jakarta Messaging キューから取得され、実行されます。マスターインデックスは定期的にコピーされます。

Jakarta Messaging キューのインデックス更新操作は実行され、マスターインデックスは定期的にコピーされます。

Jakarta Messaging Service Master 設定

### master configuration ## DirectoryProvider # (remote) master location where information is copied to hibernate.search.default.sourceBase = /mnt/mastervolume/lucenedirs/mastercopy # local master location hibernate.search.default.indexBase = /Users/prod/lucenedirs # refresh every half hour hibernate.search.default.refresh = 1800 # appropriate directory provider hibernate.search.default.directory_provider = filesystem-master ## Back-end configuration #Back-end is the default for Lucene

Hibernate Search フレームワークの設定に加えて、Jakarta Messaging を介してインデックスを処理するようメッセージ駆動 Bean を作成し、設定する必要があります。

メッセージ駆動型 Bean がインデックスキューを処理する

@MessageDriven(activationConfig = {

@ActivationConfigProperty(propertyName="destinationType",

propertyValue="javax.jms.Queue"),

@ActivationConfigProperty(propertyName="destination",

propertyValue="queue/hibernatesearch"),

@ActivationConfigProperty(propertyName="DLQMaxResent", propertyValue="1")

} )

public class MDBSearchController extends AbstractJMSHibernateSearchController

implements MessageListener {

@PersistenceContext EntityManager em;

//method retrieving the appropriate session

protected Session getSession() {

return (Session) em.getDelegate();

}

//potentially close the session opened in #getSession(), not needed here

protected void cleanSessionIfNeeded(Session session)

}

}

この例では、Hibernate Search ソースコードで利用可能な抽象 Jakarta Messaging コントローラークラスから継承し、Jakarta EE MDB を実装します。この実装は例として提供されており、Jakarta EE 以外のメッセージ駆動 Bean を利用するように調整できます。

7.2.5. Lucene インデックスのチューニング

7.2.5.1. Lucene インデックスのパフォーマンスチューニング

Hibernate Search は、mergeFactor、maxMergeDocs、maxBufferedDocs など、基礎となる Lucene IndexWriter に渡される一連のパラメーターを指定することで Lucence インデクスパフォーマンスを調整するのに使用されます。これらのパラメーターは、インデックスベースまたはシャードごとに、すべてのインデックスに適用されるデフォルト値として指定します。

各種ユースケースに合わせて調整できる低レベルの IndexWriter 設定がいくつかあります。これらのパラメーターは、indexwriter キーワードでグループ化されます。

hibernate.search.[default|<indexname>].indexwriter.<parameter_name>

特定のシャード設定の indexwriter 値に値が設定されていないと、Hibernate Search は index セクションをチェックしてから default セクションをチェックします。

以下の表の設定により、Animal インデックスの 2 つ目のシャードにこれらの設定が適用されます。

-

max_merge_docs= 10 -

merge_factor= 20 -

ram_buffer_size= 64MB -

term_index_interval= Lucene default

他のすべての値は、Lucene で定義されたデフォルトを使用します。

デフォルトでは、すべての値は Lucene の独自のデフォルトのままにします。Indexing Performance and Behavior Properties に一覧表示される値は、使用している Lucene のバージョンに応じて異なります。上記の値はバージョン 2.4 に相対的です。

Hibernate Search の以前のバージョンには batch および transaction プロパティーの概念がありました。バックエンドは常に同じ設定を使用して機能するため、これは変わりました。

表7.4 パフォーマンスおよび動作プロパティーのインデックス作成

| プロパティー | 説明 | デフォルト値 |

|---|---|---|

|

|

他のプロセスが同じインデックスに書き込む必要がない場合は |

|

|

|

各インデックスには、インデックスに適用される更新が含まれる個別の pipeline があります。このキューが満杯になると、ブロック操作になります。 |

|

|

| バッファーインメモリー削除の条件が適用され、フラッシュされるまでに最低限必要な削除用語を決定します。時点でバッファーされたドキュメントがメモリーにある場合、ドキュメントはマージされ、新しいセグメントが作成されます。 | Disabled (RAM 使用率によるフラッシュ) |

|

| インデックス作成中にメモリーでバッファーされたドキュメントの量を制御します。RAM が大きいほど消費されます。 | Disabled (RAM 使用率によるフラッシュ) |

|

| セグメント内で許容されるドキュメントの最大数を定義します。値を小さくすると、頻繁に変更されるインデックスでのパフォーマンスが向上します。値を大きくすると、インデックスが頻繁に変更されない場合に検索パフォーマンスが向上します。 | Unlimited (Integer.MAX_VALUE) |

|

| セグメントマージの頻度とサイズを制御します。 挿入時にセグメントインデックスをマージする頻度を決定します。値を小さくすると、インデックス処理時に使用される RAM が少なくなり、最適化されていないインデックスの検索速度が速くなりますが、インデックスの速度は遅くなります。値が大きいと、インデックス時により多くの RAM が使用され、最適化されていないインデックスの検索速度が遅くなるため、インデックスがより速くなります。そのため、大きな値 (> 10) はバッチインデックスの作成に最も適しており、対話的に維持されるインデックスに小さい値 (< 10) が適しています。この値は 2 未満にしないでください。 | 10 |

|

|

セグメントマージの頻度とサイズを制御します。このサイズより小さいセグメント (MB 単位) は常に次のセグメントマージ操作の対象となります。このパラメーターを高く設定しすぎると、マージ操作が頻繁に行われない場合でも、処理にコストがかかる可能性があります。 | 0 MB (実際 ~1K) |

|

| セグメントマージの頻度とサイズを制御します。 このサイズより大きいセグメント (MB 単位) は、大きなセグメントにマージされることはありません。 これにより、メモリー要件が減り、一部のマージ操作が最適な検索速度で回避されます。インデックスの最適化時にこの値は無視されます。

| 無制限 |

|

| セグメントマージの頻度とサイズを制御します。

このサイズよりも大きい (MB 単位) セグメントは、インデックスの最適化中にも大きなセグメントではマージされません (

| 無制限 |

|

| セグメントマージの頻度とサイズを制御します。

|

|

|

| ドキュメントバッファー専用の RAM の容量 (MB 単位) を制御します。Max_buffered_docs を一緒に使用すると、いずれのイベントに対してもフラッシュが発生します。 通常、インデックスのパフォーマンスを上げるには、ドキュメント数ではなく、RAM 使用率によってフラッシュし、RAM バッファーをできるだけ大きく使用するのが最良の方法です。 | 16 MB |

|

| インデックス化された期間の間隔を設定します。 値が大きくなると、IndexReader では使用されるメモリーが少なくなります。しかし、ランダムアクセスが遅くなります。値が小さいと、IndexReader の方がより多くのメモリーが使用され、用語へのランダムアクセスが速くなります。詳細は、Lucene ドキュメントを参照してください。 | 128 |

|

|

複合ファイル形式を使用すると、使用するファイル記述子が少なくなります。欠点は、インデックス作成にかかる時間と一時ディスク容量が多いことです。インデックス処理時間を短縮するために、このパラメーターを

ブール値のパラメーター。 | true |

|

| すべてのエンティティーの変更に Lucene インデックスの更新が必要であるわけではありません。更新されたエンティティープロパティー (dirty プロパティー) すべてがインデックス化されない場合、Hibernate Search はインデックス変更プロセスを省略します。

各更新イベントで呼び出す必要があるカスタムの

この最適化は、

ブール値のパラメーター。 | true |

blackhole バックエンドは 、インデックスのボトルネックを特定するツールとしてのみ、実稼働環境で使用することは意図されていません。

7.2.5.2. Lucene IndexWriter

各種ユースケースに合わせて調整できる低レベルの IndexWriter 設定がいくつかあります。これらのパラメーターは、indexwriter キーワードでグループ化されます。

default.<indexname>.indexwriter.<parameter_name>

シャード設定で indexwriter の値が設定されていない場合、Hibernate Search は index セクションを参照し、デフォルトのセクションを探します。

7.2.5.3. パフォーマンスオプションの設定

以下の設定では、これらの設定が Animal インデックスの 2 つ目のシャードに適用されます。

パフォーマンスオプションの設定例

default.Animals.2.indexwriter.max_merge_docs = 10 default.Animals.2.indexwriter.merge_factor = 20 default.Animals.2.indexwriter.term_index_interval = default default.indexwriter.max_merge_docs = 100 default.indexwriter.ram_buffer_size = 64

-

max_merge_docs= 10 -

merge_factor= 20 -

ram_buffer_size= 64MB -

term_index_interval= Lucene default

他のすべての値は、Lucene で定義されたデフォルトを使用します。

Lucene のデフォルト値が Hibernate Search のデフォルト設定です。したがって、以下の表に記載する値は、使用される Lucene のバージョンによって異なります。上記の値はバージョン 2.4 に相対的です。Lucene インデックスのパフォーマンスに関する詳細は、Lucene のドキュメントを参照してください。

バックエンドは常に同じ設定を使用して動作します。

表7.5 パフォーマンスおよび動作プロパティーのインデックス作成

| プロパティー | 説明 | デフォルト値 |

|---|---|---|

|

|

他のプロセスが同じインデックスに書き込む必要がない場合は |

|

|

|

各インデックスには、インデックスに適用される更新が含まれる個別の pipeline があります。このキューが満杯になると、ブロック操作になります。 |

|

|