Debezium ユーザーガイド

Debezium 1.5 の使用

概要

前書き

Debezium は、データベースの行レベルの変更をキャプチャーする分散サービスのセットで、アプリケーションがそれらの変更を認識し、応答できるようにします。Debezium は、各データベーステーブルにコミットされたすべての行レベルの変更を記録します。各アプリケーションは、対象のトランザクションログを読み取り、発生した順序ですべての操作を確認します。

本ガイドでは、以下の Debezium トピックの使用方法について説明します。

- 1章Debezium の概要

- 2章必要なカスタムリソースのアップグレード

- 3章Db2 の Debezium コネクター

- 4章MongoDB の Debezium コネクター

- 5章MySQL の Debezium コネクター

- 6章Oracle 用 Debezium コネクター (開発者プレビュー)(開発者プレビュー)

- 7章PostgreSQL の Debezium コネクター

- 8章SQL Server の Debezium コネクター

- 9章Debezium の監視

- 10章Debezium のログ機能

- 11章アプリケーション用 Debezium コネクターの設定

- 12章Apache Kafka で交換されたメッセージを修正するためのトランスフォームの適用

多様性を受け入れるオープンソースの強化

Red Hat では、コード、ドキュメント、Web プロパティーにおける配慮に欠ける用語の置き換えに取り組んでいます。まずは、マスター (master)、スレーブ (slave)、ブラックリスト (blacklist)、ホワイトリスト (whitelist) の 4 つの用語の置き換えから始めます。この取り組みは膨大な作業を要するため、今後の複数のリリースで段階的に用語の置き換えを実施して参ります。詳細は、Red Hat CTO である Chris Wright のメッセージをご覧ください。

第1章 Debezium の概要

Debezium は、データベースの変更をキャプチャーする分散サービスのセットです。アプリケーションはこれらの変更を利用し、応答できます。Debezium は、各データベーステーブルの行レベルの変更を 1 つずつ変更イベントレコードにキャプチャーし、これらのレコードを Kafka トピックにストリーミングします。これらのストリームはアプリケーションによって読み取られ、変更イベントレコードは生成された順に提供されます。

詳細は、以下を参照してください。

1.1. Debezium の機能

Debezium は、Apache Kafka Connect のソースコネクターのセットです。各コネクターは、CDC (Change Data Capture) のデータベースの機能を使用して、異なるデータベースから変更を取り込みます。ログベースの CDC は、ポーリングや二重書き込みなどのその他の方法とは異なり、Debezium によって実装されます。

- すべてのデータ変更がキャプチャーされたことを確認します。

- 頻度の高いポーリングに必要な CPU 使用率の増加を防ぎながら、非常に低遅延な変更イベントを生成します。たとえば、MySQL または PostgreSQL の場合、遅延はミリ秒の範囲内になります。

- Last Updated (最終更新日時) の列など、データモデルへの変更は必要ありません。

- 削除をキャプチャー できます。

- データベースの機能や設定に応じて、トランザクション ID や原因となるクエリーなどの古いレコードの状態や追加のメタデータをキャプチャーできます。

詳細は、ブログの記事「Five Advantages of Log-Based Change Data Capture」を参照してください。

Debezium コネクターは、さまざまな関連機能やオプションでデータの変更をキャプチャーします。

- スナップショット: コネクターが起動し、すべてのログが存在していない場合は、任意でデータベースの現在の状態の初期スナップショットを取得できます。通常、これは、データベースが一定期間稼働していて、トランザクションのリカバリーやレプリケーションに不要となったトランザクションログを破棄してしまった場合に該当します。スナップショットを実行するためのモードは複数あります。使用しているコネクターのドキュメントを参照してください。

- フィルター: キャプチャーされたスキーマ、テーブル、およびコラムは include または exclude リストフィルターで設定できます。

- マスク:たとえば、機密データが含まれている場合など、特定の列からの値はマスクできます。

- 監視: ほとんどのコネクターは JMX を使用して監視できます。

使用準備が整った メッセージ変換:

- メッセージルーティング

- コンテンツベースルーティング

- リレーショナルコネクターの新しいレコード状態の抽出

- フィルタリング

- トランザクションアウトボックステーブルから のイベントのルーティング

各コネクターのドキュメントには、コネクター機能と設定オプションの詳細が記載されています。

1.2. Debezium アーキテクチャーの説明

Apache Kafka Connect を使用して Debezium をデプロイします。Kafka Connect は、以下を実装および操作するためのフレームワークおよびランタイムです。

- レコードを Kafka に送信する Debezium などのソースコネクター

- Kafka トピックから他のシステムにレコードを伝播するシンクコネクター

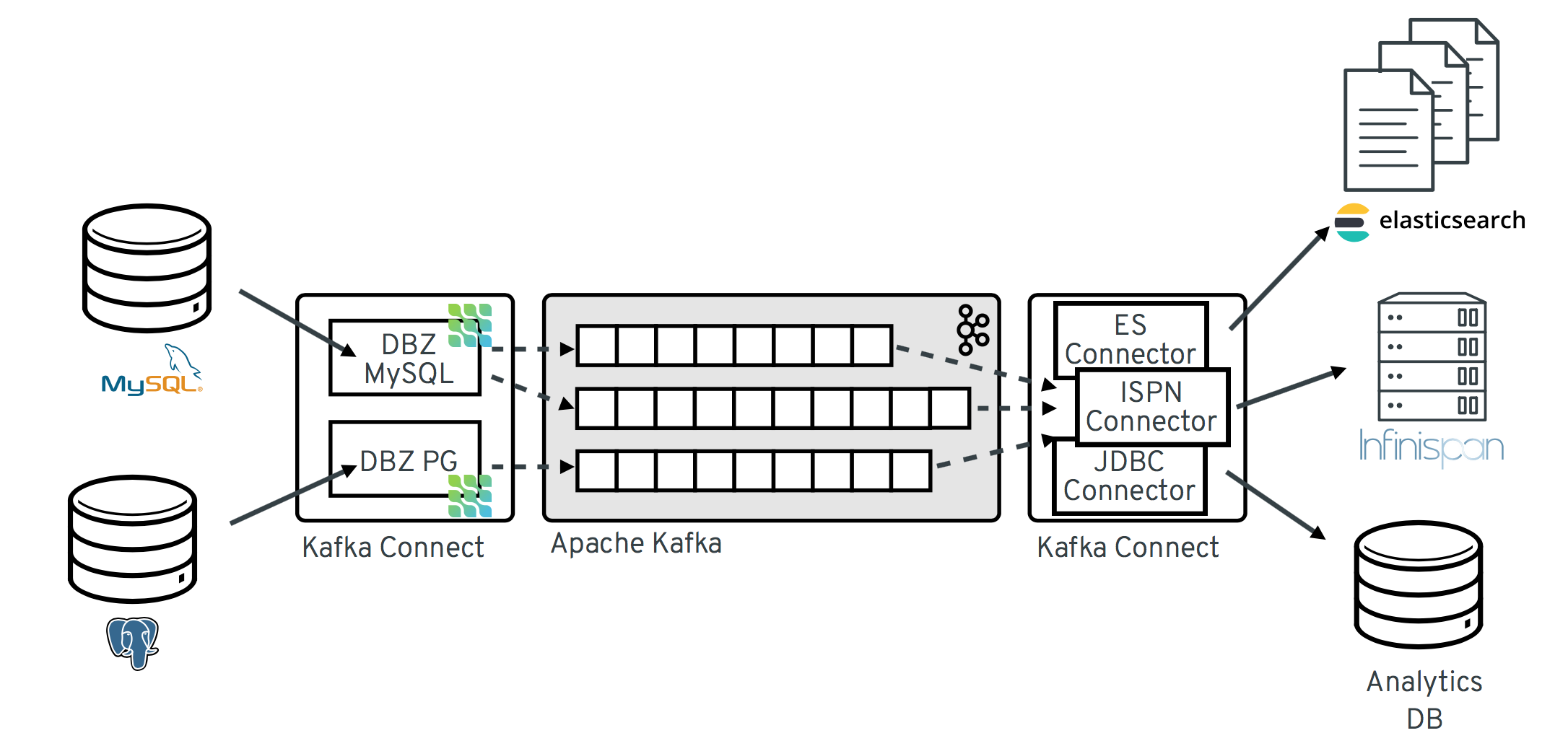

以下の図は、Debezium をベースとした Change Data Capture パイプラインのアーキテクチャーを示しています。

イメージにあるように、MySQL と PostgresSQL の Debezium コネクターは、この 2 種類のデータベースへの変更をキャプチャーするためにデプロイされます。各 Debezium コネクターは、そのソースデータベースへの接続を確立します。

-

MySQL コネクターは、binlog にアクセスするためにクライアントライブラリーを使用します

。 - PostgreSQL コネクターは論理レプリケーションストリームから読み取ります。

Kafka Connect は、Kafka ブローカー以外の別のサービスとして動作します。

デフォルトでは、1 つのデータベースからの変更が、名前がテーブル名に対応する Kafka トピックに書き込まれます。必要に応じて、Debezium のトピック ルーティング変換を設定すると、宛先トピック 名を調整できます。たとえば、以下を実行できます。

- テーブルの名前と名前が異なるトピックへレコードをルーティングする。

- 複数テーブルの変更イベントレコードを単一のトピックにストリーミングする。

変更イベントレコードが Apache Kafka に存在する場合、Kafka Connect エコシステムの異なるコネクターは、Elasticsearch、データウェアハウス、分析システムなどのその他のシステムおよびデータベースや、Infinispan などのキャッシュにレコードをストリーミングできます。選択したシンクコネクターによっては、Debezium の 新しいレコード状態抽出 変換の設定が必要になる場合があります。この Kafka Connect SMT は、Debezium の変更イベントからシンクコネクターに構造 の後ろ を伝播します。これは、デフォルトで伝播される詳細な変更イベントレコードの代わりになります。

第2章 必要なカスタムリソースのアップグレード

Debezium は、AMQ Streams on OpenShift で実行される Apache Kafka クラスターにデプロイされた Kafka コネクタープラグインです。OpenShift CRD v1 を準備するため、現行バージョンの AMQ Streams で、カスタムリソース定義(CRD)API の必要なバージョンが v1beta2 に設定されます。API の v1beta2 バージョンは、以前にサポートされている v1beta1 および API バージョンを置き換えます。AMQ Streams では、v1 alpha1v1alpha 1 および v1beta1 API バージョンのサポートが非推奨になりました。以前のバージョンは、Debezium コネクターの設定に使用する KafkaConnect および KafkaConnector リソースを含むほとんどの AMQ Streams カスタムリソースから削除されました。

v1beta2 API バージョンをベースとする CRD は OpenAPI 構造スキーマを使用します。非推奨の v1alpha1 または v1beta1 API に基づくカスタムリソースは構造スキーマをサポートしないため、現行バージョンの AMQ Streams と互換性がありません。AMQ Streams2021.q3 にアップグレードする前に、既存のカスタムリソースをアップグレードして API バージョン kafka.strimzi.io/v1beta2 を使用する必要があります。AMQ Streams 1.7 にアップグレードした後、カスタムリソースをいつでもアップグレードできます。AMQ Streams2021.q3 以降にアップグレードする前に、v1beta2 API へのアップグレードを完了する必要があります。

CRD およびカスタムリソースのアップグレードを容易にするため、AMQ Streams はそれらを {ApiVersion} と互換性のある形式に自動的にアップグレードする API 変換ツールを提供します。ツールの詳細と、AMQ Streams のアップグレード方法に関する詳細は、「NameDeployStreamsOpenShift」を参照してください。

カスタムリソースの更新要件は、AMQ Streams on OpenShift で実行される Debezium デプロイメントにのみ適用されます。この要件は、Red Hat Enterprise Linux 上の Debezium には適用されません。

第3章 Db2 の Debezium コネクター

Debezium の Db2 コネクターは、Db2 データベースのテーブルで行レベルの変更をキャプチャーできます。このコネクターは、テーブルを「キャプチャーモード」にする SQL ベースのポーリングモデルを使用する、SQL Server の Debezium 実装から大きく影響を受けます。テーブルがキャプチャーモードの場合、Debezium Db2 コネクターは、そのテーブルへの行レベルの更新ごとに変更イベントを生成し、ストリーミングします。

キャプチャーモードのテーブルには、関連する変更テーブルがあり、このテーブルは Db2 によって作成されます。キャプチャーモードのテーブルに対する変更ごとに、Db2 はその変更に関するデータをテーブルの関連する変更データテーブルに追加します。変更データテーブルには、行の各状態のエントリーが含まれます。また、削除に関する特別なエントリーもあります。Debezium Db2 コネクターは変更イベントを変更データテーブルから読み取り、イベントを Kafka トピックに出力します。

Debezium Db2 コネクターが Db2 データベースに初めて接続すると、コネクターが変更をキャプチャーするように設定されたテーブルの整合性スナップショットを読み取ります。デフォルトでは、システム以外のテーブルがすべて対象になります。キャプチャーモードにするテーブルまたはキャプチャーモードから除外するテーブルを指定できるコネクター設定プロパティーがあります。

スナップショットが完了すると、コネクターはコミットされた更新の変更イベントをキャプチャーモードのテーブルに出力し始めます。デフォルトでは、特定のテーブルの変更イベントは、テーブルと同じ名前を持つ Kafka トピックに移動します。アプリケーションとサービスはこれらのトピックから変更イベントを使用します。

コネクターには、Linux 用の Db2 の標準部分として利用できる抽象構文表記 (ASN) ライブラリーを使用する必要があります。ASN ライブラリーを使用するには、IBM InfoSphere Data Replication (IIDR) のライセンスが必要です。ASN ライブラリーを使用するために IIDR をインストールする必要はありません。

Debezium Db2 コネクターを使用するための情報および手順は、以下のように構成されています。

3.1. Debezium Db2 コネクターの概要

Debezium Db2 コネクターは、Db2 で SQL レプリケーションを有効にする ASN Capture/Apply エージェント をベースにしています。キャプチャーエージェントは以下を行います。

- キャプチャーモードであるテーブルの変更データテーブルを生成します。

- キャプチャーモードのテーブルを監視し、更新の変更イベントを対応する変更データテーブルのテーブルに格納します。

Debezium コネクターは SQL インターフェースを使用して変更イベントの変更データテーブルに対してクエリーを実行します。

データベース管理者は、変更をキャプチャーするテーブルをキャプチャーモードにする必要があります。便宜上およびテストを自動化するために、以下の管理タスクをコンパイルして実行するために使用できる Debezium ユーザー定義関数(UDF) が C にあります。

- ASN エージェントの開始、停止、および再初期化。

- テーブルをキャプチャーモードにする。

- レプリケーション (ASN) スキーマと変更データテーブルの作成。

- キャプチャーモードからのテーブルの削除。

また、Db2 制御コマンドを使用してこれらのタスクを実行することもできます。

対象のテーブルがキャプチャーモードになった後、コネクターは対応する変更データテーブルを読み取り、テーブル更新の変更イベントを取得します。コネクターは、変更されたテーブルと同じ名前を持つ Kafka トピックに対して、行レベルの挿入、更新、および削除操作ごとに変更イベントを出力します。これは、変更可能なデフォルトの動作です。クライアントアプリケーションは、対象のデータベーステーブルに対応する Kafka トピックを読み取り、行レベルの各変更イベントに対応できます。

通常、データベース管理者はテーブルのライフサイクルの途中でテーブルをキャプチャーモードにします。つまり、コネクターにはテーブルに加えられたすべての変更の完全な履歴はありません。そのため、Db2 コネクターが最初に特定の Db2 データベースに接続すると、キャプチャーモードである各テーブルで 整合性スナップショット を実行して起動します。コネクターは、スナップショットの完成後に、スナップショットが作成された時点から変更イベントをストリーミングします。これにより、コネクターはキャプチャーモードのテーブルの整合性のあるビューで開始し、スナップショットの実行中に加えられた変更は破棄されません。

Debezium コネクターはフォールトトラレントです。コネクターは変更イベントを読み取りおよび生成すると、変更データテーブルエントリーのログシーケンス番号 (LSN) を記録します。LSN はデータベースログの変更イベントの位置になります。コネクターが何らかの理由で停止した場合 (通信障害、ネットワークの問題、クラッシュなど)、コネクターは再起動後に最後に停止した場所の変更データテーブルの読み取りを続行します。これにはスナップショットが含まれます。つまり、コネクターの停止時にスナップショットが完了しなかった場合、コネクターの再起動時に新しいスナップショットが開始されます。

3.2. Debezium Db2 コネクターの仕組み

Debezium Db2 コネクターを最適に設定および実行するには、コネクターによるスナップショットの実行方法、変更イベントのストリーム方法、Kafka トピック名の決定方法、およびスキーマ変更の処理方法を理解すると便利です。

詳細は以下を参照してください。

3.2.1. Debezium Db2 コネクターによるデータベーススナップショットの実行方法

Db2 のレプリケーション機能は、データベース変更の完全な履歴を保存するようには設計されていません。そのため、Debezium Db2 コネクターが初めてデータベースに接続すると、キャプチャーモードのテーブルの整合性スナップショットを作成し、この状態を Kafka にストリーミングします。これにより、テーブルの内容のベースラインが確立されます。

デフォルトでは、Db2 コネクターがスナップショットを実行すると、以下が実行されます。

-

キャプチャーモードになっているテーブルを判断するため、スナップショットに含まれなければならないテーブルも判断されます。デフォルトでは、システム以外のテーブルはすべてキャプチャーモードになっています。table.

exclude.list やなどのコネクター設定プロパティーを使用すると、キャプチャーモードになるテーブルを指定できます。table.include.list -

キャプチャーモードの各テーブルでロックを取得します。これにより、スナップショットの実行中にこれらのテーブルでスキーマの変更が発生しないようにします。ロックのレベルは、snapshot.

isolation.modeコネクター設定プロパティーによって決定されます。 - サーバーのトランザクションログで、最大 (最新) の LSN の位置を読み取ります。

- キャプチャーモードになっているすべてのテーブルのスキーマをキャプチャーします。コネクターは、内部データベース履歴トピックでこの情報を永続化します。

- 必要に応じて、ステップ 2 で取得したロックを解放します。通常、これらのロックは短期間のみ保持されます。

ステップ 3 で読み取られた LSN の位置で、コネクターはキャプチャーモードテーブルとそれらのスキーマをスキャンします。スキャン中、コネクターは以下を行います。

- スナップショットの開始前に、テーブルが作成されたことを確認します。そうでない場合は、スナップショットはそのテーブルをスキップします。スナップショットが完了し、コネクターが変更イベントの出力を開始した後、コネクターはスナップショットの実行中に作成されたテーブルの変更イベントを生成します。

- キャプチャーモードになっている各テーブルで、各行の 読み取り イベントを生成します。すべての 読み取り イベントには、LSN の位置が含まれ、これはステップ 3 で取得した LSN の位置と同じです。

- テーブルと同じ名前を持つ Kafka トピックに各 読み取り イベントを出力します。

- コネクターオフセットにスナップショットの正常な完了を記録します。

3.2.2. Debezium Db2 コネクターによる変更データテーブルの読み取り方法

スナップショットの完了後、Debezium Db2 コネクターが初めて起動すると、キャプチャーモードである各ソーステーブルの変更データテーブルを識別します。コネクターは各変更データテーブルに対して以下を行います。

- 最後に保存された最大 LSN から現在の最大 LSN の間に作成された変更イベントを読み取ります。

- 各イベントのコミット LSN および変更 LSN に従って、変更イベントを順序付けます。これにより、コネクターはテーブルが変更された順序で変更イベントを出力します。

- コミット LSN および変更 LSN をオフセットとして Kafka Connect に渡します。

- コネクターが Kafka Connect に渡した最大 LSN を保存します。

再起動後、コネクターは停止した場所でオフセット (コミット LSN および変更 LSN) から変更イベントの出力を再開します。コネクターが稼働し、変更イベントを出力している間、キャプチャーモードからテーブルを削除したり、テーブルをキャプチャーモードに追加したりすると、コネクターはこれを検出し、その動作を変更します。

3.2.3. Debezium Db2 変更イベントレコードを受信する Kafka トピックのデフォルト名

デフォルトでは、Db2 コネクターは、単一テーブルのすべての挿入、更新、および削除操作の変更イベントを単一の Kafka トピックに書き込みます。Kafka トピックの名前の形式は次のとおりです。

databaseName.schemaName.tableName

- databaseName

-

database.server.nameコネクター設定プロパティーに指定されたコネクターの論理名。 - schemaName

- 操作が発生したスキーマの名前。

- tableName

- 操作が発生したテーブルの名前。

たとえば、MYSCHEMA スキーマにある PRODUCTS、PRODUCTS_ON_HAND、CUSTOMERS、および ORDER の 4 つのテーブルが含まれる S mydatabase データベースを使用した Db2 インストールについて考えてみましょう。コネクターはイベントを以下の 4 つの Kafka トピックに出力します。

-

mydatabase.MYSCHEMA.PRODUCTS -

mydatabase.MYSCHEMA.PRODUCTS_ON_HAND -

mydatabase.MYSCHEMA.CUSTOMERS -

mydatabase.MYSCHEMA.ORDERS

変更イベントを異なる名前が付けられた Kafka トピックに出力するように Db2 コネクターを設定するには、「指定したトピックへの Debezium イベントレコードのルーティング」を参照してください。

3.2.4. Debezium Db2 コネクターのスキーマ変更トピック

Debezium Db2 コネクターは、キャプチャーモードであるテーブルに対して、スキーマ変更の履歴をデータベース履歴トピックのそのテーブルに保存します。このトピックは内部コネクターの状態を反映するため、使用しないでください。アプリケーションがスキーマの変更を追跡する必要がある場合、パブリックスキーマ変更トピックがあります。スキーマ変更トピックの名前は、コネクター設定に指定された論理サーバー名と同じです。

コネクターがスキーマ変更トピックに出力するメッセージの形式は、初期の状態であり、通知なしに変更される可能性があります。

Debezium は、以下の場合にスキーマ変更トピックにメッセージを出力します。

- 新しいテーブルがキャプチャーモードになる。

- テーブルがキャプチャーモードから削除される。

- データベーススキーマの更新 中に、キャプチャーモードのテーブルのスキーマが変更される。

スキーマ変更トピックへのメッセージには、テーブルスキーマの論理表現が含まれます。以下に例を示します。

{

"schema": {

...

},

"payload": {

"source": {

"version": "1.5.4.Final",

"connector": "db2",

"name": "db2",

"ts_ms": 1588252618953,

"snapshot": "true",

"db": "testdb",

"schema": "DB2INST1",

"table": "CUSTOMERS",

"change_lsn": null,

"commit_lsn": "00000025:00000d98:00a2",

"event_serial_no": null

},

"databaseName": "TESTDB", 1

"schemaName": "DB2INST1",

"ddl": null, 2

"tableChanges": [ 3

{

"type": "CREATE", 4

"id": "\"DB2INST1\".\"CUSTOMERS\"", 5

"table": { 6

"defaultCharsetName": null,

"primaryKeyColumnNames": [ 7

"ID"

],

"columns": [ 8

{

"name": "ID",

"jdbcType": 4,

"nativeType": null,

"typeName": "int identity",

"typeExpression": "int identity",

"charsetName": null,

"length": 10,

"scale": 0,

"position": 1,

"optional": false,

"autoIncremented": false,

"generated": false

},

{

"name": "FIRST_NAME",

"jdbcType": 12,

"nativeType": null,

"typeName": "varchar",

"typeExpression": "varchar",

"charsetName": null,

"length": 255,

"scale": null,

"position": 2,

"optional": false,

"autoIncremented": false,

"generated": false

},

{

"name": "LAST_NAME",

"jdbcType": 12,

"nativeType": null,

"typeName": "varchar",

"typeExpression": "varchar",

"charsetName": null,

"length": 255,

"scale": null,

"position": 3,

"optional": false,

"autoIncremented": false,

"generated": false

},

{

"name": "EMAIL",

"jdbcType": 12,

"nativeType": null,

"typeName": "varchar",

"typeExpression": "varchar",

"charsetName": null,

"length": 255,

"scale": null,

"position": 4,

"optional": false,

"autoIncremented": false,

"generated": false

}

]

}

}

]

}

}表3.1 スキーマ変更トピックに出力されたメッセージのフィールドの説明

| 項目 | フィールド名 | 説明 |

|---|---|---|

| 1 |

| 変更が含まれるデータベースとスキーマを識別します。 |

| 2 |

|

Db2 コネクターの場合は常に |

| 3 |

| DDL コマンドによって生成されるスキーマの変更が含まれる 1 つ以上の項目の配列。 |

| 4 |

| 変更の種類を説明します。値は以下のいずれかになります。

|

| 5 |

| 作成、変更、または破棄されたテーブルの完全な識別子。 |

| 6 |

| 適用された変更後のテーブルメタデータを表します。 |

| 7 |

| テーブルのプライマリーキーを構成する列のリスト。 |

| 8 |

| 変更されたテーブルの各列のメタデータ。 |

スキーマ変更トピックへのメッセージでは、キーはスキーマの変更が含まれるデータベースの名前です。以下の例では、payload フィールドにキーが含まれます。

{

"schema": {

"type": "struct",

"fields": [

{

"type": "string",

"optional": false,

"field": "databaseName"

}

],

"optional": false,

"name": "io.debezium.connector.db2.SchemaChangeKey"

},

"payload": {

"databaseName": "TESTDB"

}

}3.2.5. トランザクション境界を表す Debezium Db2 コネクターによって生成されたイベント

Debezium は、トランザクション境界を表し、変更データイベントメッセージをエンリッチするイベントを生成できます。トランザクション BEGIN および END ごとに、Debezium は以下のフィールドが含まれるイベントを生成します。

-

status:BEGINまたはEND -

id: 一意のトランザクション識別子の文字列表現 -

event_count(ENDイベント用)- トランザクションによって出力されたイベントの合計数 -

data_collections(ENDイベント用)- 指定のデータコレクションからの変更によって出力されたイベントの数を提供するdataのペアの配列。_collectionと event_count

例

{

"status": "BEGIN",

"id": "00000025:00000d08:0025",

"event_count": null,

"data_collections": null

}

{

"status": "END",

"id": "00000025:00000d08:0025",

"event_count": 2,

"data_collections": [

{

"data_collection": "testDB.dbo.tablea",

"event_count": 1

},

{

"data_collection": "testDB.dbo.tableb",

"event_count": 1

}

]

}

コネクターはトランザクションイベントを database.server.name. transaction トピックに出力します。

データ変更イベントのエンリッチメント

トランザクションメタデータを有効にすると、コネクターは変更イベント Envelope を新しい トランザクションフィールドで補完します。このフィールドは、複合フィールドの形式ですべてのイベントに関する情報を提供します。

-

id: 一意のトランザクション識別子の文字列表現 -

total_order: トランザクションによって生成されたすべてのイベントを対象とするイベントの絶対位置。 -

data_collection_order- トランザクションによって出力されたすべてのイベントを対象とするイベントのデータコレクションごとの位置。

以下は、メッセージの例になります。

{

"before": null,

"after": {

"pk": "2",

"aa": "1"

},

"source": {

...

},

"op": "c",

"ts_ms": "1580390884335",

"transaction": {

"id": "00000025:00000d08:0025",

"total_order": "1",

"data_collection_order": "1"

}

}3.3. Debezium Db2 コネクターのデータ変更イベントの説明

Debezium Db2 コネクターは、行レベルの INSERT、UPDATE、および DELETE 操作ごとにデータ変更イベントを生成します。各イベントにはキーと値が含まれます。キーと値の構造は、変更されたテーブルによって異なります。

Debezium および Kafka Connect は、イベントメッセージの継続的なストリーム を中心として設計されています。ただし、これらのイベントの構造は時間の経過とともに変化する可能性があり、コンシューマーによる処理が困難になることがあります。これに対応するために、各イベントにはコンテンツのスキーマが含まれます。スキーマレジストリーを使用している場合は、コンシューマーがレジストリーからスキーマを取得するために使用できるスキーマ ID が含まれます。これにより、各イベントが自己完結型になります。

以下のスケルトン JSON は、変更イベントの基本となる 4 つの部分を示しています。ただし、アプリケーションで使用するために選択した Kafka Connect コンバーターの設定方法によって、変更イベントのこれら 4 部分の表現が決定されます。schema フィールドは、変更イベントが生成されるようにコンバーターを設定した場合のみ変更イベントに含まれます。同様に、イベントキーおよびイベントペイロードは、変更イベントが生成されるようにコンバーターを設定した場合のみ変更イベントに含まれます。JSON コンバーターを使用し、変更イベントの基本となる 4 つの部分すべてを生成するように設定すると、変更イベントの構造は次のようになります。

{

"schema": { 1

...

},

"payload": { 2

...

},

"schema": { 3

...

},

"payload": { 4

...

},

}表3.2 変更イベントの基本内容の概要

| 項目 | フィールド名 | 説明 |

|---|---|---|

| 1 |

|

最初の |

| 2 |

|

最初の |

| 3 |

|

2 つ目の |

| 4 |

|

2 つ目の |

デフォルトでは、コネクターによって、変更イベントレコードがイベントの元のテーブルと同じ名前を持つトピックにストリーミングされます。トピック名 を参照してください。

Debezium Db2 コネクターは、すべての Kafka Connect スキーマ名が Avro スキーマ名の形式 に準拠するようにします。つまり、論理サーバー名はアルファベットまたはアンダースコア (a-z、A-Z、または _) で始まる必要があります。論理サーバー名の残りの各文字と、データベース名とテーブル名の各文字は、アルファベット、数字、またはアンダースコア ( a-z、A-Z、0-9、または \_) でなければなりません。無効な文字がある場合は、アンダースコアに置き換えられます。

論理サーバー名、データベース名、またはテーブル名に無効な文字が含まれ、名前を区別する唯一の文字が無効であると、無効な文字はすべてアンダースコアに置き換えられるため、予期せぬ競合が発生する可能性があります。

また、データベース、スキーマ、およびテーブルの Db2 名では、大文字と小文字を区別することができます。つまり、コネクターは同じ Kafka トピックに複数のテーブルのイベントレコードを出力できます。

詳細は以下を参照してください。

3.3.1. Debezium Db2 変更イベントのキーについて

変更イベントのキーには、変更されたテーブルのキーのスキーマと、変更された行の実際のキーのスキーマが含まれます。スキーマとそれに対応するペイロードの両方には、コネクターによってイベントが作成された時点において、変更されたテーブルの PRIMARY KEY (または一意の制約)の各列のフィールドが含まれます。

以下の 顧客 テーブルについて考えてみましょう。この後に、このテーブルの変更イベントキーの例を示します。

テーブルの例

CREATE TABLE customers ( ID INTEGER IDENTITY(1001,1) NOT NULL PRIMARY KEY, FIRST_NAME VARCHAR(255) NOT NULL, LAST_NAME VARCHAR(255) NOT NULL, EMAIL VARCHAR(255) NOT NULL UNIQUE );

変更イベントキーの例

顧客 テーブルへの変更をキャプチャーするすべての変更イベントには、同じイベントキースキーマがあります。顧客 テーブルに前述の定義がある限り、顧客 テーブルへの変更をキャプチャーする変更イベントのキー構造はすべて以下のようになります。JSON では、以下のようになります。

{

"schema": { 1

"type": "struct",

"fields": [ 2

{

"type": "int32",

"optional": false,

"field": "ID"

}

],

"optional": false, 3

"name": "mydatabase.MYSCHEMA.CUSTOMERS.Key" 4

},

"payload": { 5

"ID": 1004

}

}表3.3 変更イベントキーの説明

| 項目 | フィールド名 | 説明 |

|---|---|---|

| 1 |

|

キーのスキーマ部分は、キーの |

| 2 |

|

各フィールドの名前、タイプ、および必要かどうかなど、 |

| 3 |

|

イベントキーの |

| 4 |

|

キーのペイロードの構造を定義するスキーマの名前。このスキーマは、変更されたテーブルのプライマリーキーの構造を記述します。キースキーマ名の形式は connector-name.database- name.table-name.

|

| 5 |

|

この変更イベントが生成された行のキーが含まれます。この例では、キーに 1 つの |

3.3.2. Debezium Db2 変更イベントの値

変更イベントの値はキーよりも若干複雑です。キーと同様に、値には schema セクションと payload セクションがあります。schema セクションには、ネストされたフィールドを含む、payload セクションの Envelope 構造を記述するスキーマが含まれます。データを作成、更新、または削除する操作のすべての変更イベントには、Envelope 構造を持つ値 payload があります。

変更イベントキーの例を紹介するために使用した、同じサンプルテーブルについて考えてみましょう。

テーブルの例

CREATE TABLE customers ( ID INTEGER IDENTITY(1001,1) NOT NULL PRIMARY KEY, FIRST_NAME VARCHAR(255) NOT NULL, LAST_NAME VARCHAR(255) NOT NULL, EMAIL VARCHAR(255) NOT NULL UNIQUE );

顧客 テーブルのすべての変更イベントのイベント値部分は、同じスキーマを指定します。イベント値のペイロードは、イベント型によって異なります。

作成イベント

以下の例は、顧客 テーブルのデータを作成する操作に対してコネクターによって生成される変更イベントの値の部分を示しています。

{

"schema": { 1

"type": "struct",

"fields": [

{

"type": "struct",

"fields": [

{

"type": "int32",

"optional": false,

"field": "ID"

},

{

"type": "string",

"optional": false,

"field": "FIRST_NAME"

},

{

"type": "string",

"optional": false,

"field": "LAST_NAME"

},

{

"type": "string",

"optional": false,

"field": "EMAIL"

}

],

"optional": true,

"name": "mydatabase.MYSCHEMA.CUSTOMERS.Value", 2

"field": "before"

},

{

"type": "struct",

"fields": [

{

"type": "int32",

"optional": false,

"field": "ID"

},

{

"type": "string",

"optional": false,

"field": "FIRST_NAME"

},

{

"type": "string",

"optional": false,

"field": "LAST_NAME"

},

{

"type": "string",

"optional": false,

"field": "EMAIL"

}

],

"optional": true,

"name": "mydatabase.MYSCHEMA.CUSTOMERS.Value",

"field": "after"

},

{

"type": "struct",

"fields": [

{

"type": "string",

"optional": false,

"field": "version"

},

{

"type": "string",

"optional": false,

"field": "connector"

},

{

"type": "string",

"optional": false,

"field": "name"

},

{

"type": "int64",

"optional": false,

"field": "ts_ms"

},

{

"type": "boolean",

"optional": true,

"default": false,

"field": "snapshot"

},

{

"type": "string",

"optional": false,

"field": "db"

},

{

"type": "string",

"optional": false,

"field": "schema"

},

{

"type": "string",

"optional": false,

"field": "table"

},

{

"type": "string",

"optional": true,

"field": "change_lsn"

},

{

"type": "string",

"optional": true,

"field": "commit_lsn"

},

],

"optional": false,

"name": "io.debezium.connector.db2.Source", 3

"field": "source"

},

{

"type": "string",

"optional": false,

"field": "op"

},

{

"type": "int64",

"optional": true,

"field": "ts_ms"

}

],

"optional": false,

"name": "mydatabase.MYSCHEMA.CUSTOMERS.Envelope" 4

},

"payload": { 5

"before": null, 6

"after": { 7

"ID": 1005,

"FIRST_NAME": "john",

"LAST_NAME": "doe",

"EMAIL": "john.doe@example.org"

},

"source": { 8

"version": "1.5.4.Final",

"connector": "db2",

"name": "myconnector",

"ts_ms": 1559729468470,

"snapshot": false,

"db": "mydatabase",

"schema": "MYSCHEMA",

"table": "CUSTOMERS",

"change_lsn": "00000027:00000758:0003",

"commit_lsn": "00000027:00000758:0005",

},

"op": "c", 9

"ts_ms": 1559729471739 10

}

}表3.4 作成 イベント値フィールドの説明

| 項目 | フィールド名 | 説明 |

|---|---|---|

| 1 |

| 値のペイロードの構造を記述する、値のスキーマ。変更イベントの値スキーマは、コネクターが特定のテーブルに生成するすべての変更イベントで同じになります。 |

| 2 |

|

|

| 3 |

|

|

| 4 |

|

|

| 5 |

|

値の実際のデータ。これは、変更イベントが提供する情報です。 |

| 6 |

|

イベント発生前の行の状態を指定する任意のフィールド。この例では、 |

| 7 |

|

イベント発生後の行の状態を指定する任意のフィールド。この例では、 |

| 8 |

|

イベントのソースメタデータを記述する必須のフィールド。

|

| 9 |

|

コネクターによってイベントが生成される原因となった操作の型を記述する必須文字列。この例では、

|

| 10 |

|

コネクターがイベントを処理した時間を表示する任意のフィールド。この時間は、Kafka Connect タスクを実行している JVM のシステムクロックを基にします。 |

更新イベント

サンプル 顧客 テーブルの更新の変更イベントの値には、そのテーブルの 作成 イベントと同じスキーマがあります。同様に、更新イベント値のペイロードは同じ構造を持ちます。ただし、イベント値ペイロードでは 更新 イベントに異なる値が含まれます。以下は、コネクターが 顧客 テーブルの更新に対して生成するイベントの変更イベント値の例になります。

{

"schema": { ... },

"payload": {

"before": { 1

"ID": 1005,

"FIRST_NAME": "john",

"LAST_NAME": "doe",

"EMAIL": "john.doe@example.org"

},

"after": { 2

"ID": 1005,

"FIRST_NAME": "john",

"LAST_NAME": "doe",

"EMAIL": "noreply@example.org"

},

"source": { 3

"version": "1.5.4.Final",

"connector": "db2",

"name": "myconnector",

"ts_ms": 1559729995937,

"snapshot": false,

"db": "mydatabase",

"schema": "MYSCHEMA",

"table": "CUSTOMERS",

"change_lsn": "00000027:00000ac0:0002",

"commit_lsn": "00000027:00000ac0:0007",

},

"op": "u", 4

"ts_ms": 1559729998706 5

}

}表3.5 更新 イベント値フィールドの説明

| 項目 | フィールド名 | 説明 |

|---|---|---|

| 1 |

|

イベント発生前の行の状態を指定する任意のフィールド。更新 イベント値の |

| 2 |

|

イベント発生後の行の状態を指定する任意のフィールド。構造 |

| 3 |

|

イベントのソースメタデータを記述する必須のフィールド。

|

| 4 |

|

操作の型を記述する必須の文字列。更新 イベント値の |

| 5 |

|

コネクターがイベントを処理した時間を表示する任意のフィールド。この時間は、Kafka Connect タスクを実行している JVM のシステムクロックを基にします。 |

行のプライマリーキー/一意キーの列を更新すると、行のキーの値が変更されます。キーが変更されると、3 つのイベントが Debezium によって出力されます。3 つのイベントとは、DELETE イベント、行の古いキーを持つ 廃棄 (tombstone)、およびそれに続く行の新しいキーを持つイベントです。

削除 イベント

削除 変更イベントの値は、同じテーブルの 作成 および 更新 イベントと同じ スキーマ の部分になります。サンプル 顧客 テーブルの 削除 イベントのイベント値 ペイロード は以下のようになります。

{

"schema": { ... },

},

"payload": {

"before": { 1

"ID": 1005,

"FIRST_NAME": "john",

"LAST_NAME": "doe",

"EMAIL": "noreply@example.org"

},

"after": null, 2

"source": { 3

"version": "1.5.4.Final",

"connector": "db2",

"name": "myconnector",

"ts_ms": 1559730445243,

"snapshot": false,

"db": "mydatabase",

"schema": "MYSCHEMA",

"table": "CUSTOMERS",

"change_lsn": "00000027:00000db0:0005",

"commit_lsn": "00000027:00000db0:0007"

},

"op": "d", 4

"ts_ms": 1559730450205 5

}

}表3.6 削除 イベント値フィールドの説明

| 項目 | フィールド名 | 説明 |

|---|---|---|

| 1 |

|

イベント発生前の行の状態を指定する任意のフィールド。削除 イベント値の |

| 2 |

|

イベント発生後の行の状態を指定する任意のフィールド。削除 イベント値の |

| 3 |

|

イベントのソースメタデータを記述する必須のフィールド。削除 イベント値では、

|

| 4 |

|

操作の型を記述する必須の文字列。 |

| 5 |

|

コネクターがイベントを処理した時間を表示する任意のフィールド。この時間は、Kafka Connect タスクを実行している JVM のシステムクロックを基にします。 |

削除 変更イベントレコードは、この行の削除を処理するために必要な情報を持つコンシューマーを提供します。コンシューマーによっては、削除を適切に処理するために古い値が必要になることがあるため、古い値が含まれます。

Db2 コネクターイベントは、Kafka のログコンパクション と動作するように設計されています。ログコンパクションにより、少なくとも各キーの最新のメッセージが保持される限り、一部の古いメッセージを削除できます。これにより、トピックに完全なデータセットが含まれ、キーベースの状態のリロードに使用できるようにするとともに、 Kafka がストレージ領域を確保できるようにします。

行が削除された場合でも、Kafka は同じキーを持つ以前のメッセージをすべて削除できるため、削除 イベントの値はログコンパクションで動作します。ただし、Kafka が同じキーを持つすべてのメッセージを削除するには、メッセージの値が null である必要があります。これを可能にするために、Debezium の Db2 コネクターは 削除 イベントを出力した後に 、 同じキーと null 値を持つ特別な廃棄(tombstone)イベントを出力します。

3.4. Debezium Db2 コネクターによるデータ型のマッピング方法

Db2 のデータ型の説明は「Db2 SQL Data Types」を参照してください。

Db2 コネクターは、行が存在するテーブルのように構造化されたイベントで行への変更を表します。イベントには、各列の値のフィールドが含まれます。その値がどのようにイベントで示されるかは、列の Db2 のデータ型によって異なります。ここでは、これらのマッピングについて説明します。

詳細は以下を参照してください。

基本型

以下の表では、各 Db2 データ型をイベントフィールドの リテラル型 および セマンティック型にマッピングする方法を説明します。

-

リテラル型 は、Kafka Connect スキーマタイプ(INT

8、INT16、INT32、INT64、FLOAT32、FLOAT64、BOOLEAN、STRING、BYTES、ARRAY、MAP、およびSTRUCT)を使用して値を表す方法を記述します。 - セマンティック型 は、フィールドの Kafka Connect スキーマの名前を使用して、Kafka Connect スキーマがフィールドの 意味 をキャプチャーする方法を記述します。

表3.7 Db2 の基本データ型のマッピング

| DB2 データ型 | リテラル型 (スキーマ型) | セマンティック型 (スキーマ名) および注記 |

|---|---|---|

|

|

| BOOLEAN 型の列のあるテーブルからのみスナップショットを作成できます。現在、Db2 での SQL レプリケーションは BOOLEAN をサポートしないため、Debezium はこれらのテーブルで CDC を実行できません。別の型の使用を検討してください。 |

|

|

| 該当なし |

|

|

| 該当なし |

|

|

| 該当なし |

|

|

| 該当なし |

|

|

| 該当なし |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 該当なし |

|

|

| 該当なし |

|

|

| 該当なし |

|

|

| 該当なし |

|

|

| 該当なし |

|

|

|

|

|

|

|

|

|

|

| 該当なし |

|

|

| 該当なし |

|

|

| 該当なし |

|

|

|

|

列のデフォルト値がある場合は、対応するフィールドの Kafka Connect スキーマに伝達されます。明示的な列値が指定されない限り、変更イベントにはフィールドのデフォルト値が含まれます。そのため、スキーマからデフォルト値を取得する必要はほとんどありません。

時間型

タイムゾーン情報が含まれる Db2 の DATETIMEOFFSET データ型以外に、時間型がマッピングされる仕組みは、time.precision.mode コネクター設定プロパティーの値によって異なります。ここでは、以下のマッピングについて説明します。

time.precision.mode=adaptive

time.precision.mode 設定プロパティーが adaptive に設定されている場合、コネクターは列のデータ型定義に基づいてリテラル型とセマンティック型を決定します。これにより、イベントがデータベースの値を 正確 に表すようになります。

表3.8 time.precision.mode が 適応した場合のマッピング

| DB2 データ型 | リテラル型 (スキーマ型) | セマンティック型 (スキーマ名) および注記 |

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

time.precision.mode=connect

time.precision.mode 設定プロパティーが connect に設定されている場合、コネクターは Kafka Connect の論理型を使用します。これは、コンシューマーが組み込みの Kafka Connect の論理型のみを処理でき、可変精度の時間値を処理できない場合に便利です。ただし、Db2 はマイクロ秒の 10 分の 1 の精度をサポートするため、接続 時間 の精度でコネクターによって生成されたイベントは、データベース列の少数 秒の精度 値が 3 よりも大きい場合に、精度が失われます。

表3.9 time.precision.mode が接続されている場合 のマッピング

| DB2 データ型 | リテラル型 (スキーマ型) | セマンティック型 (スキーマ名) および注記 |

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

タイムスタンプ型

DATETIME、SMALLDATETIME および DATETIME2 タイプは、タイムゾーン情報のないタイムスタンプを表します。このような列は、UTC を基にして同等の Kafka Connect 値に変換されます。たとえば、「2018-06-20 15:13:16.945104」という DATETIME2 の値は「1529507596945104」という io.debezium.time.MicroTimestamp の値で表されます。

Kafka Connect および Debezium を実行している JVM のタイムゾーンは、この変換には影響しません。

表3.10 10 進数型

| DB2 データ型 | リテラル型 (スキーマ型) | セマンティック型 (スキーマ名) および注記 |

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

3.5. Debezium コネクターを実行するための Db2 の設定

Db2 テーブルにコミットされた変更イベントを Debezium がキャプチャーするには、必要な権限を持つ Db2 データベース管理者が、変更データキャプチャー (CDC) のデータベースでテーブルを設定する必要があります。Debezium の実行を開始した後、キャプチャーエージェントの設定を調整してパフォーマンスを最適化できます。

Debezium コネクターと使用するために Db2 を設定する場合の詳細は、以下を参照してください。

3.5.1. 変更データキャプチャーの Db2 テーブルの設定

テーブルをキャプチャーモードにするために、Debezium ではユーザー定義関数 (UDF) のセットが提供されます。ここでは、これらの管理 UDF をインストールおよび実行する手順を説明します。また、Db2 制御コマンドを実行してテーブルをキャプチャーモードにすることもできます。管理者は、Debezium がキャプチャーする各テーブルの CDC を有効にする必要があります。

前提条件

-

db2instl ユーザーとして Db2にログインしている。 - Db2 ホストの $HOME/asncdctools/src ディレクトリーで Debezium 管理 UDF を使用できる。UDF は Debezium サンプルリポジトリーから入手できます。

手順

Db2 で提供される

bldrtnコマンドを使用して、Db2 サーバーホストで Debezium 管理 UDF をコンパイルします。cd $HOME/asncdctools/src

./bldrtn asncdc

データベースが稼働していない場合は起動します。

DB_NAMEは、Debezium が接続するデータベースの名前に置き換えます。db2 start db DB_NAME

JDBC が Db2 メタデータカタログを読み取りできるようにします。

cd $HOME/sqllib/bnd

db2 bind db2schema.bnd blocking all grant public sqlerror continue

データベースが最近バックアップされたことを確認します。ASN エージェントには、読み取りを始める最新の開始点が必要です。バックアップを実行する必要がある場合は、以下のコマンドを実行して、最新のバージョンのみを利用できるようにデータをプルーニングします。古いバージョンのデータを保持する必要がない場合は、バックアップの場所に

dev/nullを指定します。データベースをバックアップします。

DB_NAMEおよびBACK_UP_LOCATIONを適切な値に置き換えます。db2 backup db DB_NAME to BACK_UP_LOCATION

データベースを再起動します。

db2 restart db DB_NAME

データベースに接続して、Debezium 管理 UDF をインストールします。

db2instl ユーザーとしてログインしているため、UDF は db2inst1ユーザーにインストールされている必要があります。db2 connect to DB_NAME

Debezium 管理 UDF をコピーし、その権限を設定します。

cp $HOME/asncdctools/src/asncdc $HOME/sqllib/function

chmod 777 $HOME/sqllib/function

ASN キャプチャーエージェントを開始および停止する Debezium UDF を有効にします。

db2 -tvmf $HOME/asncdctools/src/asncdc_UDF.sql

ASN 制御テーブルを作成します。

$ db2 -tvmf $HOME/asncdctools/src/asncdctables.sql

テーブルをキャプチャーモードに追加し、キャプチャーモードからテーブルを削除する Debezium UDF を有効にします。

$ db2 -tvmf $HOME/asncdctools/src/asncdcaddremove.sql

Db2 サーバーを設定したら、UDF を使用して SQL コマンドで Db2 レプリケーション (ASN) を制御します。UDF によっては戻り値が期待されます。この場合、SQL

VALUEステートメントを使用して呼び出します。その他の UDF には、SQLCALLステートメントを使用します。ASN エージェントを起動します。

VALUES ASNCDC.ASNCDCSERVICES('start','asncdc');テーブルをキャプチャーモードにします。キャプチャーする各テーブルに対して、以下のステートメントを呼び出します。

MYSCHEMAを、キャプチャーモードにするテーブルが含まれるスキーマの名前に置き換えます。同様に、MYTABLEを、キャプチャーモードにするテーブルの名前に置き換えます。CALL ASNCDC.ADDTABLE('MYSCHEMA', 'MYTABLE');ASN サービスを再初期化します。

VALUES ASNCDC.ASNCDCSERVICES('reinit','asncdc');

その他のリソース

3.5.2. Db2 キャプチャーエージェント設定のサーバー負荷およびレイテンシーへの影響

データベース管理者がソーステーブルに対して変更データキャプチャーを有効にすると、キャプチャーエージェントの実行が開始されます。エージェントは新しい変更イベントレコードをトランザクションログから読み取り、イベントレコードをキャプチャーテーブルに複製します。変更がソーステーブルにコミットされてから、対応する変更テーブルに変更が反映される間、常に短いレイテンシーが間隔で発生します。この遅延間隔は、ソーステーブルで変更が発生したときから、Debezium がその変更を Apache Kafka にストリーミングできるようになるまでの差を表します。

データの変更に素早く対応する必要があるアプリケーションについては、ソースとキャプチャーテーブル間で密接に同期を維持するのが理想的です。キャプチャーエージェントを実行してできるだけ迅速に変更イベントを継続的に処理すると、スループットが増加し、レイテンシーが減少するため、イベントの発生後にほぼリアルタイムで新しいイベントレコードが変更テーブルに入力されることを想像するかもしれません。しかし、これは必ずしもそうであるとは限りません。同期を即時に行うとパフォーマンスに影響します。変更エージェントが新しいイベントレコードについてデータベースにクエリーを実行するたびに、データベースホストの CPU 負荷が増加します。サーバーへの負荷が増えると、データベース全体のパフォーマンスに悪影響を及ぼす可能性があり、特にデータベースの使用がピークに達するときにトランザクションの効率が低下する可能性があります。

データベースメトリクスを監視して、サーバーがキャプチャーエージェントのアクティビティーをサポートできなくなるレベルにデータベースが達した場合に認識できるようにすることが重要となります。キャプチャーエージェントの実行中にパフォーマンスの問題が発生した場合は、キャプチャーエージェント設定を調整して CPU の負荷を減らします。

3.5.3. DB2 キャプチャーエージェントの設定パラメーター

Db2 では、IBMSNAP_CAPPARMS テーブルにはキャプチャーエージェントの動作を制御するパラメーターが含まれます。これらのパラメーターの値を調整して、キャプチャープロセスの設定を調整すると、CPU の負荷を減らしながら許容レベルのレイテンシーを維持することができます。

Db2 のキャプチャーエージェントパラメーターの設定方法に関する具体的なガイダンスは、本書の範囲外となります。

IBMSNAP_CAPPARMS テーブルでは、CPU 負荷の削減に最も大きな影響を与えます。

COMMIT_INTERVAL- キャプチャーエージェントがデータを変更データテーブルにコミットするまで待つ期間を秒単位で指定します。

- 値が大きいほど、データベースホストの負荷が減少し、レイテンシーが増加します。

-

デフォルト値は

30です。

SLEEP_INTERVAL- キャプチャーエージェントがアクティブなトランザクションログの最後に到達した後に、新しいコミットサイクルの開始まで待つ期間を秒単位で指定します。

- 値が大きいほど、サーバーの負荷が減少し、レイテンシーが増加します。

-

デフォルト値は

5です。

関連情報

- キャプチャーエージェントパラメーターの詳細は、Db2 のドキュメントを参照してください。

3.6. Debezium Db2 コネクターのデプロイ

Debezium Db2 コネクターをデプロイするには、コネクターファイルを Kafka Connect に追加し、コネクターを実行するカスタムコンテナーを作成して、続いてコネクター設定をコンテナーに追加します。Debezium Db2 コネクターのデプロイに関する詳細は、以下を参照してください。

3.6.1. Debezium Db2 コネクターのデプロイ

Debezium Db2 コネクターをデプロイするには、Debezium コネクターアーカイブが含まれるカスタム Kafka Connect コンテナーイメージをビルドし、続いてこのコンテナーイメージをコンテナーレジストリーにプッシュする必要があります。その後、以下のカスタムリソース (CR) を作成する必要があります。

-

Kafka Connect インスタンスを定義する

KafkaConnectCR。CR のimageプロパティーは、Debezium コネクターを実行するために作成するコンテナーイメージの名前を指定します。この CR を、Red Hat AMQ Streams がデプロイされている OpenShift インスタンスに適用します。AMQ Streams は、Apache Kafka を OpenShift に取り入れる Operator およびイメージを提供します。 -

Debezium Db2 コネクターを定義する

KafkaConnectorCR。この CR をKafkaConnectCR を適用するのと同じ OpenShift インスタンスに適用します。

前提条件

- Db2 が実行中で、Db2 を設定して Debezium コネクターと連携する 手順が完了済みである必要があります。

- AMQ Streams が OpenShift にデプロイされ、Apache Kafka および Kafka Connect を実行している。詳細は、『Deploying and Upgrading AMQ Streams on OpenShift』を参照してください。

- Podman または Docker がインストールされている。

-

Debezium コネクターを実行するコンテナーを追加する予定のコンテナーレジストリー(

quay.ioまたはdocker.ioなど)でコンテナーを作成および管理するアカウントおよびパーミッションがある。

手順

Kafka Connect の Debezium Db2 コンテナーを作成します。

- Debezium Db2 コネクターアーカイブ をダウンロードします。

Debezium Db2 コネクターアーカイブを展開して、コネクタープラグインのディレクトリー構造を作成します。以下に例を示します。

./my-plugins/ ├── debezium-connector-db2 │ ├── ...

registry.redhat.io/amq7/amq-streams-kafka-28-rhel8:1.8.0をベースイメージとして使用する Docker ファイルを作成します。たとえば、ターミナルウィンドウに以下のコマンドを入力します。my-pluginsはプラグインディレクトリーの名前に置き換えます。cat <<EOF >debezium-container-for-db2.yaml 1 FROM registry.redhat.io/amq7/amq-streams-kafka-28-rhel8:1.8.0 USER root:root COPY ./<my-plugins>/ /opt/kafka/plugins/ 2 USER 1001 EOF

このコマンドは、現在のディレクトリーに

debezium-container-for-db2.yamlという名前の Docker ファイルを作成します。前の手順で作成した

debezium-container-for-db2.yamlDocker ファイルからコンテナーイメージをビルドします。ファイルを含むディレクトリーから、ターミナルウィンドウを開き、以下のコマンドのいずれかを入力します。podman build -t debezium-container-for-db2:latest .

docker build -t debezium-container-for-db2:latest .

上記のコマンドは、

debezium-container-for-db2という名前のコンテナーイメージを構築します。カスタムイメージを quay.io などのコンテナーレジストリーまたは内部のコンテナーレジストリーにプッシュします。コンテナーレジストリーは、イメージをデプロイする OpenShift インスタンスで利用できる必要があります。以下のいずれかのコマンドを実行します。

podman push <myregistry.io>/debezium-container-for-db2:latestdocker push <myregistry.io>/debezium-container-for-db2:latest新しい Debezium Db2

KafkaConnectカスタムリソース(CR)を作成します。たとえば、以下の例のようにアノテーションおよびイメージプロパティーを指定するdbz-connect.yamlという名前のKafkaConnectCR を作成します。apiVersion: kafka.strimzi.io/v1beta2 kind: KafkaConnect metadata: name: my-connect-cluster annotations: strimzi.io/use-connector-resources: "true" 1 spec: #... image: debezium-container-for-db2 2以下のコマンドを入力して、

KafkaConnectCR を OpenShift Kafka Connect 環境に適用します。oc create -f dbz-connect.yaml

このコマンドは、Debezium コネクターを実行するために作成したイメージの名前を指定する Kafka Connect インスタンスを追加します。

Debezium Db2 コネクターインスタンスを設定する

KafkaConnectorカスタムリソースを作成します。コネクターの設定プロパティーを指定する a

.yamlファイルで Debezium Db2 コネクターを設定します。コネクター設定は、Debezium に対して、スキーマおよびテーブルのサブセットにイベントを生成するよう指示する可能性があり、または機密性の高い、大きすぎる、または不必要な指定のコラムで Debezium が値を無視、マスク、または切り捨てするようにプロパティーを設定する可能性もあります。以下の例では、ポート

50000で Db2 サーバーホスト192.168.99.100に接続する Debezium コネクターを設定します。このホストには、mydatabaseという名前のデータベースがあり、名前インベントリーが含まれるテーブルはサーバーの論理名です。Db2

inventory-connector.yamlapiVersion: kafka.strimzi.io/v1beta2 kind: KafkaConnector metadata: name: inventory-connector 1 labels: strimzi.io/cluster: my-connect-cluster annotations: strimzi.io/use-connector-resources: 'true' spec: class: io.debezium.connector.db2.Db2Connector 2 tasksMax: 1 3 config: 4 database.hostname: 192.168.99.100 5 database.port: 50000 6 database.user: db2inst1 7 database.password: Password! 8 database.dbname: mydatabase 9 database.server.name: fullfillment 10 database.include.list: public.inventory 11表3.11 コネクター設定の説明

項目 説明 1

Kafka Connect クラスターに登録する場合のコネクターの名前。

2

この Db2 コネクタークラスの名前。

3

1 度に 1 つのタスクのみが動作する必要があります。

4

コネクターの設定。

5

Db2 インスタンスのアドレスであるデータベースホスト。

6

Db2 インスタンスのポート番号。

7

Db2 ユーザーの名前。

8

Db2 ユーザーのパスワード。

9

変更をキャプチャーするデータベースの名前。

10

namespace を形成する Db2 インスタンス/クラスターの論理名で、コネクターが書き込む Kafka トピックの名前、Kafka Connect スキーマ名、および Arvo コネクターが使用される場合に対応する Avro スキーマの namespace で使用 さ れます。

11

Debezium が変更をキャプチャーする必要があるすべてのテーブルのリスト。

Kafka Connect でコネクターインスタンスを作成します。たとえば、

KafkaConnectorリソースをinventory-connector.yamlファイルに保存した場合、以下のコマンドを実行します。oc apply -f inventory-connector.yaml

上記のコマンドは

inventory-connectorを登録し、コネクターはKafkaConnectorCR に定義されているmydatabaseデータベースに対して実行を開始します。コネクターが作成され、起動されたことを確認します。

Kafka Connect ログ出力を表示して、コネクターが作成され、指定データベースの変更のキャプチャーが開始されたことを確認します。

oc logs $(oc get pods -o name -l strimzi.io/cluster=my-connect-cluster)

ログの出力を確認し、Debezium が初回のスナップショットを実行することを確認します。ログには、以下のメッセージと同様の出力が表示されます。

... INFO Starting snapshot for ... ... INFO Snapshot is using user 'debezium' ...

コネクターがエラーがなく正常に起動すると、コネクターが変更をキャプチャーする各テーブルのトピックが作成されます。CR のサンプルでは、

include.listプロパティーに指定されたテーブルのトピックがあります。ダウンストリームアプリケーションは、これらのトピックをサブスクライブできます。以下のコマンドを実行して、コネクターによってトピックが作成されたことを検証します。

oc get kafkatopics

Debezium Db2 コネクターに設定できる設定プロパティーの完全リストは、Db2 コネクタープロパティー を参照してください。

結果

コネクターが起動すると、コネクターが変更 をキャプチャーするように設定された Db2 データベーステーブルの 整合性スナップショット が実行 されます。その後、コネクターは行レベルの操作のデータ変更イベントの生成を開始し、変更イベントレコードを Kafka トピックにストリーミングします。

3.6.2. Debezium Db2 コネクター設定プロパティーの説明

Debezium Db2 コネクターには、アプリケーションに適したコネクター動作を実現するために使用できる設定プロパティーが多数あります。多くのプロパティーにはデフォルト値があります。プロパティーに関する情報は、以下のように構成されています。

- 必要な設定プロパティー

- 高度な設定プロパティー

Debezium がデータベース履歴トピックから読み取るイベントを処理する方法を制御する データベース履歴コネクター設定プロパティー

- データベースドライバーの動作を制御する パススルーデータベースドライバープロパティー

必要な Debezium Db2 コネクター設定プロパティー

以下の設定プロパティーは、デフォルト値がない場合は必須です。

| プロパティー | デフォルト | 説明 |

|---|---|---|

| コネクターの一意名。同じ名前で再登録を試みると失敗します。このプロパティーはすべての Kafka Connect コネクターに必要です。 | ||

|

コネクターの Java クラスの名前。Db2 コネクターには、常に | ||

|

| このコネクターのために作成する必要のあるタスクの最大数。Db2 コネクターは常に単一のタスクを使用するため、この値を使用しません。そのため、デフォルト値は常に許容されます。 | |

| Db2 データベースサーバーの IP アドレスまたはホスト名。 | ||

|

| Db2 データベースサーバーの整数のポート番号。 | |

| Db2 データベースサーバーに接続するための Db2 データベースユーザーの名前。 | ||

| Db2 データベースサーバーへの接続時に使用するパスワード。 | ||

| 変更をストリーミングする Db2 データベースの名前 | ||

| Debezium が変更をキャプチャーするデータベースをホストする特定の Db2 データベースサーバーの namespace を特定および提供する論理名。データベースサーバーの論理名には英数字とアンダースコアのみを使用する必要があります。論理名は、他のコネクター全体で一意となる必要があります。これは、このコネクターからレコードを受信するすべての Kafka トピックのトピック名プレフィックスとして使用されるためです。 | ||

|

コネクターで変更をキャプチャーするテーブルの完全修飾テーブル識別子と一致する正規表現のコンマ区切りリスト (任意)。include リストに含まれていないテーブルの変更はキャプチャーされません。各識別子の形式は schemaName.tableName です。デフォルトでは、コネクターはシステム以外のテーブルすべての変更をキャプチャーします。 | ||

|

コネクターで変更をキャプチャーしないテーブルの完全修飾テーブル識別子と一致する正規表現のコンマ区切りリスト (任意)。コネクターは exclude リストに含まれていないシステム以外のテーブルごとに変更をキャプチャーします。各識別子の形式は schemaName.tableName です。 | ||

| 空の文字列 | 変更イベント値から除外する列の完全修飾名と一致する正規表現のコンマ区切りリスト (任意)。列の完全修飾名の形式は schemaName.tableName.columnName です。プライマリーキー列は、値から除外された場合でも、イベントのキーに常に含まれます。 | |

| 該当なし |

文字ベースの列の完全修飾名と一致する正規表現のコンマ区切りリスト (任意)。列の完全修飾名の形式は schemaName.tableName.columnName です。生成される変更イベントレコードでは、指定された列の値は仮名に置き換えられます。

仮名は、指定された hashAlgorithm と salt を適用すると得られるハッシュ化された値で構成されます。使用されるハッシュ関数に基づいて、参照整合性は維持され、列値は仮名に置き換えられます。サポートされるハッシュ関数は、Java Cryptography Architecture Standard Algorithm Name Documentationの MessageDigest section に説明されています。 column.mask.hash.SHA-256.with.salt.CzQMA0cB5K = inventory.orders.customerName, inventory.shipment.customerName

必要な場合は、仮名は自動的に列の長さに短縮されます。コネクター設定には、異なるハッシュアルゴリズムと salt を指定する複数のプロパティーを含めることができます。 | |

|

|

時間、日付、およびタイムスタンプは、異なる精度の種類で表すことができます。 | |

|

|

削除 イベントの後に廃棄 (tombstone) イベントが続くかどうかを制御します。 | |

|

| コネクターがデータベーススキーマの変更を、データベースサーバー ID と同じ名前の Kafka トピックに公開するかどうかを指定するブール値。各スキーマの変更は、データベース名が含まれるキーと、スキーマ更新を記述する JSON 構造である値で記録されます。これは、コネクターがデータベース履歴を内部で記録する方法には依存しません。 | |

| 該当なし |

文字ベースの列の完全修飾名と一致する正規表現のコンマ区切りリスト (任意)。列の完全修飾名の形式は schemaName.tableName.columnName です。変更イベントレコードでは、これらの列の値がプロパティー名の 長さ によって指定される文字数よりも長い場合は切り捨てられます。単一の設定で、異なる長さを持つ複数のプロパティーを指定できます。長さは正の整数である必要があります(例: | |

| 該当なし |

文字ベースの列の完全修飾名と一致する正規表現のコンマ区切りリスト (任意)。列の完全修飾名の形式は schemaName.tableName.columnName です。変更イベント値では、指定のテーブルコラムの値は アスタリスク ( | |

| 該当なし |

列の完全修飾名と一致する正規表現のコンマ区切りリスト (任意)。列の完全修飾名の形式は、databaseName.tableName.columnName または databaseName.schemaName.tableName.columnName です。 | |

| 該当なし |

一部の列のデータベース固有のデータ型名と一致する正規表現のコンマ区切りリスト (任意)。完全修飾データ型名の形式は、databaseName.tableName.typeName または databaseName.schemaName.tableName.typeName です。 | |

| 空の文字列 |

テーブルの列名と一致する正規表現が含まれるテーブルのセミコロン区切りのリスト。コネクターは、一致する列の値を Kafka トピックに送信する変更イベントレコードのキーフィールドにマップします。これは、テーブルにプライマリーキーがない場合や、プライマリーキーではないフィールドに応じて Kafka トピックで変更イベントレコードを順序付けする場合に便利です。 |

高度なコネクター設定プロパティー

以下の 高度な 設定プロパティーには、ほとんどの状況で機能するデフォルト設定があるため、コネクターの設定で指定する必要はほとんどありません。

| プロパティー | デフォルト | 説明 |

|---|---|---|

|

|

コネクターの起動時にスナップショットを実行する基準を指定します。 | |

|

|

スナップショットの実行中に、トランザクション分離レベルとキャプチャーモードのテーブルをロックする期間を制御します。使用できる値は次のとおりです。 | |

|

|

イベントの処理中にコネクターが例外を処理する方法を指定します。使用できる値は次のとおりです。 | |

|

| コネクターがイベントのバッチの処理を開始する前に、新しい変更イベントの発生を待つ期間をミリ秒単位で指定する正の整数値。デフォルトは 1000 ミリ秒 (1 秒) です。 | |

|

|

ブロッキングキューの最大サイズの正の整数値。コネクターは、データベースログから読み取る変更イベントをブロッキングキューに配置してから Kafka に書き込みます。このキューは、たとえば Kafka へのレコードの書き込みが遅い場合や Kafka が利用できない場合などに、変更データテーブルを読み取るためのバックプレシャーを提供できます。キューに表示されるイベントは、コネクターによって定期的に記録されるオフセットには含まれません。 | |

|

| コネクターが処理するイベントの各バッチの最大サイズを指定する正の整数値。 | |

|

| ブロッキングキューの最大サイズ (バイト単位) の long 値。この機能はデフォルトで無効になっています。正の long 値が設定されると有効になります。 | |

|

|

コネクターがハートビートメッセージを Kafka トピックに送信する頻度を制御します。デフォルトの動作では、コネクターはハートビートメッセージを送信しません。 | |

|

|

コネクターがハートビートメッセージを送信するトピック名のプレフィックスを指定します。このトピック名の形式は | |

| コネクターの起動時にスナップショットを実行するまでコネクターが待つ必要がある間隔 (ミリ秒単位)。クラスターで複数のコネクターを起動する場合、このプロパティーは、コネクターのリバランスが行われる原因となるスナップショットの中断を防ぐのに役立ちます。 | ||

|

| スナップショットの実行中、コネクターは行のバッチでテーブルの内容を読み取ります。このプロパティーは、バッチの行の最大数を指定します。 | |

|

|

スナップショットの実行時に、テーブルロックを取得するまで待つ最大時間 (ミリ秒単位) を指定する正の整数値。コネクターがこの間隔でテーブルロックを取得できないと、スナップショットは失敗します。詳細は「 コネクターによるスナップショットの実行 方法」を参照してください。その他の可能な設定は次のとおりです。 | |

|

スナップショットに含まれるテーブル行を制御します。このプロパティーはスナップショットにのみ影響します。コネクターがログから読み取るイベントには影響しません。schemaName.tableName の形式で完全修飾テーブル名のコンマ区切りリストを指定します。 | ||

|

コネクター設定

| Avro の命名要件 に準拠するためにフィールド名がサニタイズされるかどうかを示します。 | |

|

|

コネクターがトランザクション境界でイベントを生成し、トランザクションメタデータで変更イベントエンベロープを強化するかどうかを決定します。これを行う場合は |

Debezium コネクターデータベース履歴設定プロパティー

Debezium では、コネクターがスキーマ履歴トピックと対話する方法を制御する database.history.* プロパティーのセットを提供します。

以下の表は、Debezium コネクターを設定するための database.history プロパティーについて説明しています。

表3.12 コネクターデータベース履歴設定プロパティー

| プロパティー | デフォルト | 説明 |

|---|---|---|

| コネクターがデータベーススキーマの履歴を保存する Kafka トピックの完全名。 | ||

| Kafka クラスターへの最初の接続を確立するために コネクターが使用するホストとポートのペアの一覧。このコネクションは、コネクターによって以前に保存されたデータベーススキーマ履歴の取得や、ソースデータベースから読み取られる各 DDL ステートメントの書き込みに使用されます。各ペアは、Kafka Connect プロセスによって使用される同じ Kafka クラスターを示す必要があります。 | ||

|

| 永続化されたデータのポーリングが行われている間にコネクターが起動/回復を待つ最大時間 (ミリ秒単位) を指定する整数値。デフォルトは 100 ミリ秒です。 | |

|

|

エラーでコネクターのリカバリーが失敗する前に、コネクターが永続化された履歴データの読み取りを試行する最大回数。データを受信しなかった後に待機する最大時間は recovery. | |

|

|

コネクターが不正または不明なデータベースのステートメントを無視するかどうか、または人が問題を修正するために処理を停止するかどうかを指定するブール値。安全なデフォルトは | |

|

今後のリリースで削除される予定です |

|

コネクターがすべての DDL ステートメントを記録するかどうかを指定するブール値。

安全なデフォルトは |

|

|

コネクターがすべての DDL ステートメントを記録するかどうかを指定するブール値。

安全なデフォルトは |

プロデューサーおよびコンシューマークライアントを設定するためのパススルーデータベース履歴プロパティー

Debezium は Kafka プロデューサーを使用して、データベース履歴トピックにスキーマ変更を書き込みます。同様に、コネクターの起動時に、Kafka コンシューマーを使用してデータベース履歴トピックから読み取ります。database.history. producer.* および プレフィックスで始まるパススルー設定プロパティーのセットに値を割り当てて、Kafka プロデューサーおよびコンシューマークライアントの設定を定義します。パススループロデューサーおよびコンシューマーデータベース履歴プロパティーは、以下の例のようにこれらのクライアントが Kafka ブローカーとの接続をセキュリティー保護する方法など、さまざまな動作を制御します。

database.history.consumer.*

database.history.producer.security.protocol=SSL database.history.producer.ssl.keystore.location=/var/private/ssl/kafka.server.keystore.jks database.history.producer.ssl.keystore.password=test1234 database.history.producer.ssl.truststore.location=/var/private/ssl/kafka.server.truststore.jks database.history.producer.ssl.truststore.password=test1234 database.history.producer.ssl.key.password=test1234 database.history.consumer.security.protocol=SSL database.history.consumer.ssl.keystore.location=/var/private/ssl/kafka.server.keystore.jks database.history.consumer.ssl.keystore.password=test1234 database.history.consumer.ssl.truststore.location=/var/private/ssl/kafka.server.truststore.jks database.history.consumer.ssl.truststore.password=test1234 database.history.consumer.ssl.key.password=test1234

Debezium は、プロパティーを Kafka クライアントに渡す前に、プロパティー名から接頭辞を取り除きます。

Kafka プロデューサー設定プロパティー および Kafka コンシューマー設定プロパティー の詳細は、Kafka のドキュメントを参照してください。

Debezium コネクターパススルーデータベースドライバー設定プロパティー

Debezium コネクターは、データベースドライバーのパススルー設定を提供します。パススルーデータベースプロパティーは、プレフィックス database.* で始まります。たとえば、コネクターは database.foobar=false などのプロパティーを JDBC URL に渡します。

データベース履歴クライアントのパススループロパティー の場合と同様に、Debezium はプロパティーからプレフィックスを取り除き、データベースドライバーに渡します。

3.7. Debezium Db2 コネクターのパフォーマンスの監視

Debezium Db2 コネクターは、Apache ZooKeeper、Apache Kafka、および Kafka Connect によって提供される JMX メトリクスの組み込みサポートに加えて、3 種類のメトリクスを提供します。

- スナップ ショットメトリクス は、スナップショットの実行中にコネクター操作に関する情報を提供します。

- メトリクスのストリーミング は、コネクターが変更をキャプチャーし、変更イベントレコードをストリーミングするときにコネクター操作に関する情報を提供します。

- スキーマ履歴メトリクス は、コネクターのスキーマ履歴の状態に関する情報を提供します。

Debezium モニタリングのドキュメント では、JMX を使用してこれらのメトリクスを公開する方法の詳細を提供します。

3.7.1. Db2 データベースのスナップショット作成時の Debezium の監視

MBean は debezium.db2:type=connector-metrics,context=snapshot,server=<database.server.name> です。

| 属性 | 型 | 説明 |

|---|---|---|

|

| コネクターが読み取りした最後のスナップショットイベント。 | |

|

| コネクターが最新のイベントを読み取りおよび処理してからの経過時間 (ミリ秒単位)。 | |

|

| 前回の開始またはリセット以降にコネクターで確認されたイベントの合計数。 | |

|

| コネクターに設定された include/exclude リストのフィルタリングルールによってフィルターされたイベントの数。 | |

|

| コネクターによって監視されるテーブルの一覧。 | |

|

| snapshotter とメインの Kafka Connect ループの間でイベントを渡すために使用されるキューの長さ。 | |

|

| snapshotter とメインの Kafka Connect ループの間でイベントを渡すために使用されるキューの空き容量。 | |

|

| スナップショットに含まれているテーブルの合計数。 | |

|

| スナップショットによってまだコピーされていないテーブルの数。 | |

|

| スナップショットが起動されたかどうか。 | |

|

| スナップショットが中断されたかどうか。 | |

|

| スナップショットが完了したかどうか。 | |

|

| スナップショットが完了したかどうかに関わらず、これまでスナップショットにかかった時間 (秒単位)。 | |

|

| スナップショットの各テーブルに対してスキャンされる行数が含まれるマップ。テーブルは、処理中に増分がマップに追加されます。スキャンされた 10,000 行ごとに、テーブルの完成時に更新されます。 | |

|

|

キューの最大バッファー (バイト単位)。 | |

|

| キュー内のレコードの現在のデータ (バイト単位)。 |

3.7.2. Debezium Db2 コネクターレコードストリーミングの監視

MBean は debezium.db2:type=connector-metrics,context=streaming,server=<database.server.name> です。

| 属性 | 型 | 説明 |

|---|---|---|

|

| コネクターが読み取られた最後のストリーミングイベント。 | |

|

| コネクターが最新のイベントを読み取りおよび処理してからの経過時間 (ミリ秒単位)。 | |

|

| 前回の開始またはリセット以降にコネクターで確認されたイベントの合計数。 | |

|

| コネクターに設定された include/exclude リストのフィルタリングルールによってフィルターされたイベントの数。 | |

|

| コネクターによって監視されるテーブルの一覧。 | |

|

| ストリーマーとメイン Kafka Connect ループの間でイベントを渡すために使用されるキューの長さ。 | |

|

| ストリーマーとメインの Kafka Connect ループの間でイベントを渡すために使用されるキューの空き容量。 | |

|

| コネクターが現在データベースサーバーに接続されているかどうかを示すフラグ。 | |

|

| 最後の変更イベントのタイムスタンプとそれを処理するコネクターとの間の期間 (ミリ秒単位)。この値は、データベースサーバーとコネクターが稼働しているマシンのクロック間の差異に対応します。 | |

|

| コミットされた処理済みトランザクションの数。 | |

|

| 最後に受信したイベントの位置。 | |

|

| 最後に処理されたトランザクションのトランザクション識別子。 | |

|

| キューの最大バッファー (バイト単位)。 | |

|

| キュー内のレコードの現在のデータ (バイト単位)。 |

3.7.3. Debezium Db2 コネクターのスキーマ履歴の監視

MBean は debezium.db2:type=connector-metrics,context=schema-history,server=<database.server.name> です。

| 属性 | 型 | 説明 |

|---|---|---|

|

|

データベース履歴の状態 | |

|

| リカバリーが開始された時点のエポック秒の時間。 | |

|

| リカバリーフェーズ中に読み取られた変更の数。 | |

|

| リカバリーおよびランタイム中に適用されるスキーマ変更の合計数。 | |

|

| 最後の変更が履歴ストアから復元された時点からの経過時間 (ミリ秒単位)。 | |

|

| 最後の変更が適用された時点からの経過時間 (ミリ秒単位)。 | |

|

| 履歴ストアから復元された最後の変更の文字列表現。 | |

|

| 最後に適用された変更の文字列表現。 |

3.8. Debezium Db2 コネクターの管理

Debezium Db2 コネクターをデプロイしたら、Debezium 管理 UDF を使用して、SQL コマンドで Db2 レプリケーション (ASN) を制御します。UDF によっては戻り値が期待されます。この場合、SQL VALUE ステートメントを使用して呼び出します。その他の UDF には、SQL CALL ステートメントを使用します。

表3.13 Debezium 管理 UDF の説明

| タスク | コマンドおよび注記 |

|---|---|

|

| |

|

| |

|

| |

|

| |

|

| |

|

|

3.9. Debezium コネクターでのキャプチャーモードの Db2 テーブルのスキーマの更新

Debezium Db2 コネクターはスキーマ変更をキャプチャーできますが、スキーマを更新するには、データベース管理者と協力してコネクターが変更イベントの生成を継続するようにする必要があります。これは、Db2 がレプリケーションを実装する方法に必要です。

Db2 のレプリケーション機能は、キャプチャーモードのテーブルごとに、すべての変更が含まれる変更データテーブルをそのソーステーブルに作成します。ただし、変更データテーブルスキーマは静的です。キャプチャーモードのテーブルのスキーマを更新する場合は、対応する変更データテーブルのスキーマを更新する必要もあります。Debezium Db2 コネクターはこれを実行できません。昇格された権限を持つデータベース管理者は、キャプチャーモードのテーブルのスキーマを更新する必要があります。

同じテーブルの新しいスキーマ更新の前に、スキーマ更新の手順を完全に実行することが重要です。そのため、スキーマ更新の手順を 1 度で完了するために、すべての DDL を 1 つのバッチで実行することが推奨されます。

通常、テーブルスキーマを更新する手順は 2 つあります。

それぞれの方法に長所と短所があります。

3.9.1. Debezium Db2 コネクターでのオフラインスキーマ更新の実行

オフラインでスキーマの更新を行う前に、Debezium Db2 コネクターを停止します。これはより安全なスキーマ更新の手順ですが、高可用性の要件のあるアプリケーションには実現できない可能性があります。

前提条件

- スキーマの更新が必要なキャプチャーモードのテーブル 1 つ以上。

手順

- データベースを更新するアプリケーションを一時停止します。

- Debezium コネクターがストリーミングされていない変更イベントレコードをすべてストリーミングするまで待ちます。

- Debezium コネクターを停止します。

- すべての変更をソーステーブルスキーマに適用します。

-

ASN レジスターテーブルで、スキーマが更新されたテーブルを

INACTIVEとしてマーク付けします。 - ASN キャプチャーサービスを再初期化します。

- キャプチャーモードからテーブルを削除する ために Debezium UDF を実行して、キャプチャーモードから古いスキーマを持つソーステーブルを削除 します。

- テーブルをキャプチャーモードに追加する ために Debezium UDF を実行して、新しいスキーマを持つソーステーブルをキャプチャーモードに追加 します。

-

ASN レジスターテーブルで、更新されたソーステーブルを

ACTIVEとしてマーク付けします。 - ASN キャプチャーサービスを再初期化します。

- データベースを更新するアプリケーションを再開します。

- Debezium コネクターを再起動します。

3.9.2. Debezium Db2 コネクターでのオンラインスキーマ更新の実行

オンラインスキーマの更新ではアプリケーションやデータ処理のダウンタイムは必要ありません。そのため、オンラインスキーマの更新を実行する前に Debezium Db2 コネクターを停止しません。また、オンラインスキーマの更新手順は、オフラインスキーマの更新手順よりも簡単です。

ただし、テーブルがキャプチャーモードの場合は、列名の変更後も Db2 レプリケーション機能は引き続き古い列名を使用します。新しい列名は、Debezium の変更イベントでは表示されません。変更イベントにある新しい列名を確認するには、コネクターを再起動する必要があります。

前提条件

- スキーマの更新が必要なキャプチャーモードのテーブル 1 つ以上。

テーブルの最後に列を追加する場合の手順

- 変更するスキーマのソーステーブルをロックします。

-

ASN レジスターテーブルで、ロックされたテーブルを

INACTIVEとしてマーク付けします。 - ASN キャプチャーサービスを再初期化します。

- ソーステーブルのスキーマにすべての変更を適用します。

- 対応する変更データテーブルのスキーマにすべての変更を適用します。

-

ASN レジスターテーブルで、ソーステーブルを

ACTIVEとしてマーク付けします。 - ASN キャプチャーサービスを再初期化します。

- 任意手順:コネクターを再起動して、変更イベントにある更新された列名を確認します。

テーブルの中に列を追加する場合の手順

- 変更するソーステーブルをロックします。

-

ASN レジスターテーブルで、ロックされたテーブルを

INACTIVEとしてマーク付けします。 - ASN キャプチャーサービスを再初期化します。

変更するソーステーブルごとに以下を行います。

- ソーステーブルのデータをエクスポートします。

- ソーステーブルを切り捨てます。

- ソーステーブルを変更して列を追加します。

- エクスポートしたデータを変更したソーステーブルに読み込みます。

- ソーステーブルの対応する変更データテーブルのデータをエクスポートします。

- 変更データテーブルを切り捨てます。

- 変更データテーブルを変更して、列を追加します。

- エクスポートしたデータを変更した変更データテーブルに読み込みます。

-

ASN レジスターテーブルで、テーブルを

INACTIVEとしてマーク付けします。これにより、古い変更データテーブルが非アクティブとしてマーク付けされるため、それらのテーブルにあるデータは保持されますが、更新されなくなります。 - ASN キャプチャーサービスを再初期化します。

- 任意手順:コネクターを再起動して、変更イベントにある更新された列名を確認します。

第4章 MongoDB の Debezium コネクター

Debezium の MongoDB コネクターは、データベースおよびコレクションにおけるドキュメントの変更に対して、MongoDB レプリカセットまたは MongoDB シャードクラスターを追跡し、これらの変更を Kafka トピックのイベントとして記録します。コネクターは、シャードクラスターにおけるシャードの追加または削除、各レプリカセットのメンバーシップの変更、各レプリカセット内の選出、および通信問題の解決待ちを自動的に処理します。

Debezium MongoDB コネクターを使用するための情報および手順は、以下のように構成されています。

4.1. Debezium MongoDB コネクターの概要

MongoDB のレプリケーションメカニズムは冗長性と高可用性を提供し、実稼働環境における MongoDB の実行に推奨される方法です。MongoDB コネクターは、レプリカセットまたはシャードクラスターの変更をキャプチャーします。

MongoDB レプリカセット は、すべてが同じデータのコピーを持つサーバーのセットで構成され、レプリケーションによって、クライアントがレプリカセットの プライマリー のドキュメントに追加したすべての変更が、セカンダリーと呼ばれる別のレプリカセットのサーバーに適用されるようにします。MongoDB のレプリケーションでは、プライマリーが oplog (または操作ログ) に変更を記録した後、各セカンダリーがプライマリーの oplog を読み取って、すべての操作を順番に独自のドキュメントに適用します。新規サーバーをレプリカセットに追加すると、そのサーバーは最初にプライマリーのすべてのデータベースおよびコレクションの スナップショット を実行し、次にプライマリーの oplog を読み取り、スナップショットの開始後に加えられたすべての変更を適用します。この新しいサーバーは、プライマリーの oplog の最後に到達するとセカンダリーになり、クエリーを処理できます。

MongoDB コネクターはこのレプリケーションメカニズムを使用しますが、実際にはレプリカセットのメンバーにはなりません。ただし、MongoDB のセカンダリーと同様に、コネクターはレプリカセットのプライマリーの oplog を常に読み取ります。また、コネクターが初めてレプリカセットを表示するとき、oplog を確認して最後に記録されたトランザクションを取得した後、プライマリーのデータベースおよびコレクションのスナップショットを実行します。すべてのデータがコピーされると、コネクターは oplog から読み取った位置から変更をストリーミングします。MongoDB oplog における操作は べき等 であるため、操作の適用回数に関係なく、同じ最終状態になります。

MongoDB コネクターが変更を処理すると、イベントの発生元となる oplog の位置を定期的に記録します。MongoDB コネクターが停止したときに、最後に処理した oplog の位置を記録するため、再起動時にはその位置からストリーミングが開始されます。つまり、コネクターを停止、アップグレード、または維持でき、後で再起動できます。イベントを何も失うことなく、停止した場所を正確に特定します。当然ながら、MongoDB の oplogs は通常は最大サイズに制限されているため、コネクターを長時間停止しないようにしてください。長時間停止すると、oplog の操作によってはコネクターによって読み取られる前にパージされる可能性があります。この場合、コネクターを再起動すると、不足している oplog 操作が検出され、スナップショットが実行されます。その後、変更のストリーミングが続行されます。

MongoDB コネクターは、レプリカセットのメンバーシップとリーダーシップの変更、シャードクラスター内でのシャードの追加と削除、および通信障害の原因となる可能性のあるネットワーク問題にも非常に寛容です。コネクターは常にレプリカセットのプライマリーノードを使用して変更をストリーミングします。そのため、レプリカセットの選出が行われ、他のノードがプライマリーになると、コネクターはすぐ変更のストリーミングを停止し、新しいプライマリーに接続し、新しいプライマリーを使用して変更のストリーミングを開始します。同様に、コネクターがレプリカセットのプライマリーと通信する際に問題が発生した場合は、再接続を試み (ネットワークまたはレプリカセットを圧倒しないように指数バックオフを使用)、最後に停止した位置から変更のストリーミングを続行します。これにより、コネクターはレプリカセットメンバーシップの変更を動的に調整でき、通信の失敗を自動的に処理できます。

その他のリソース

4.2. Debezium MongoDB コネクターの仕組み

コネクターがサポートする MongoDB トポロジーの概要は、アプリケーションを計画するときに役立ちます。

MongoDB コネクターが設定およびデプロイされると、シードアドレスの MongoDB サーバーに接続して起動し、利用可能な各レプリカセットの詳細を判断します。各レプリカセットには独立した独自の oplog があるため、コネクターはレプリカセットごとに個別のタスクの使用を試みます。コネクターは、使用するタスクの最大数を制限でき、十分なタスクが利用できない場合は、コネクターは各タスクに複数のレプリカセットを割り当てます。ただし、タスクはレプリカセットごとに個別のスレッドを使用します。

シャードクラスターに対してコネクターを実行する場合は、レプリカセットの数よりも大きい tasks.max の値を使用します。これにより、コネクターはレプリカセットごとに 1 つのタスクを作成でき、Kafka Connect が利用可能なワーカープロセス全体でタスクを調整、配布、および管理できるようにします。

Debezium MongoDB コネクターの動作に関する詳細は、以下のトピックを参照してください。

- 「Debezium コネクターでサポートされる MongoDB トポロジー」

- 「Debezium MongoDB コネクターがレプリカセットおよびシャードクラスターに論理名を使用する方法」

- 「Debezium MongoDB コネクターのスナップショット実行方法」

- 「Debezium MongoDB コネクターが変更イベントレコードをストリーミングする方法」

- 「Debezium MongoDB 変更イベントレコードを受信する Kafka トピックのデフォルト名」

- 「イベントキーが Debezium MongoDB コネクターのトピックパーティショニングを制御する方法」

- 「トランザクション境界を表す Debezium MongoDB コネクターによって生成されたイベント」

4.2.1. Debezium コネクターでサポートされる MongoDB トポロジー

MongoDB コネクターは以下の MongoDB トポロジーをサポートします。

- MongoDB レプリカセット

Debezium MongoDB コネクターは単一の MongoDB レプリカセット から変更をキャプチャーできます。実稼働のレプリカセットには、少なくとも 3 つのメンバー が必要です。

レプリカセットで MongoDB コネクターを使用するには、コネクターの

mongodb.hostsプロパティーを使用して、1 つ以上のレプリカセット サーバーのアドレスをシード アドレスとして提供します。コネクターはこれらのシードを使用してレプリカセットに接続した後、レプリカセットからメンバーの完全セットを取得し、どのメンバーがプライマリーであるかを認識します。コネクターは、プライマリーに接続するタスクを開始し、プライマリーの oplog から変更をキャプチャーします。レプリカセットが新しいプライマリーを選出すると、タスクは自動的に新しいプライマリーに切り替えます。注記MongoDB がプロキシーと面する場合 (Docker on OS X や Windows などのように)、クライアントがレプリカセットに接続し、メンバーを検出すると、MongoDB クライアントはプロキシーを有効なメンバーから除外し、プロキシーを経由せずに直接メンバーに接続しようとし、失敗します。

このような場合、コネクターのオプションの

mongodb.members.auto.discover設定プロパティーをfalseに設定し、コネクターに対してメンバーシップの検出を指示し、代わりに最初のシードアドレス(mongodb.hostsプロパティーで指定)をプライマリーノードとして使用するよう指示します。これは機能する可能性がありますが、選出が行われるときに問題が発生します。

- MongoDB のシャードクラスター

MongoDB のシャードクラスター は以下で構成されます。

- レプリカセットとしてデプロイされる 1 つ以上のシャード。

- クラスターの設定サーバーとして動作する個別のレプリカセット。

クライアントが接続し、要求を適切なシャードにルーティングする 1 つ以上の ルーター (

mongosとも呼ばれます)。シャードクラスターで MongoDB コネクターを使用するには、コネクターを設定サーバーレプリカセットのホストアドレスで設定します。コネクターがこのレプリカセットに接続すると、シャードクラスターの設定サーバーとして動作していることを検出し、クラスターでシャードとして使用される各レプリカセットに関する情報を検出した後、各レプリカセットから変更をキャプチャーするために別のタスクを起動します。新しいシャードがクラスターに追加される場合または既存のシャードが削除される場合、コネクターはそのタスクを自動的に調整します。

- MongoDB スタンドアロンサーバー

- スタンドアロンサーバーには oplog がないため、MongoDB コネクターはスタンドアロン MongoDB サーバーの変更を監視できません。スタンドアロンサーバーが 1 つのメンバーを持つレプリカセットに変換されると、コネクターが動作します。

MongoDB は、実稼働でのスタンドアロンサーバーの実行を推奨しません。詳細は、MongoDB のドキュメント を参照してください。

4.2.2. Debezium MongoDB コネクターがレプリカセットおよびシャードクラスターに論理名を使用する方法

コネクター設定プロパティー mongodb.name は、MongoDB レプリカセットまたはシャードクラスター の論理名 として機能します。コネクターは、論理名をさまざまな方法で使用します。すべてトピック名のプレフィックとして使用したり、各レプリカセットの oplog の位置を記録するときに一意の識別子として使用したりします。

一意の論理名を各 MongoDB コネクターに割り当てます。この名前は、ソース MongoDB システムについて意味的に記述する必要があります。アルファベットまたはアンダースコアで始まる論理名を割り当て、英数字またはアンダースコアのみを含めることが推奨されます。

4.2.3. Debezium MongoDB コネクターのスナップショット実行方法

タスクがレプリカセットを使用して起動すると、コネクターの論理名とレプリカセット名を使用して、コネクターが変更の読み取りを停止した位置を示す オフセット を検出します。オフセットが検出され、oplog に存在する場合、タスクは記録されたオフセットの位置から即座に 変更のストリーミング を続行します。

ただし、オフセットが見つからない場合や、oplog にその位置が含まれなくなった場合、タスクは スナップショット を実行してレプリカセットの内容の現在の状態を取得する必要があります。このプロセスは、oplog の現在の位置を記録して開始され、オフセット (スナップショットが開始されたことを示すフラグとともに) として記録します。その後、タスクは各コレクションをコピーし、できるだけ多くのスレッドを生成し( snapshot.max.threads 設定プロパティーの値まで)、この作業を並行して実行します。コネクターは、確認した各ドキュメントの個別の 読み取りイベント を記録します。読み取りイベントにはオブジェクトの識別子、オブジェクトの完全な状態、およびオブジェクトが見つかった MongoDB レプリカセットの ソース 情報が含まれます。ソース情報には、スナップショット中にイベントが生成されたことを示すフラグも含まれます。

このスナップショットは、コネクターのフィルターと一致するすべてのコレクションがコピーされるまで継続されます。タスクのスナップショットが完了する前にコネクターが停止した場合は、コネクターを再起動すると、再びスナップショットを開始します。

コネクターがレプリカセットのスナップショットを実行している間は、タスクの再割り当てと再設定をしないようにします。コネクターはスナップショットの進捗とともにメッセージをログに記録します。最大限の制御を行う場合は、各コネクターに対して Kafka Connect の個別のクラスターを実行します。

4.2.4. Debezium MongoDB コネクターが変更イベントレコードをストリーミングする方法

レプリカセットのコネクタータスクがオフセットを記録した後、オフセットを使用して変更のストリーミングを開始する oplog の位置を判断します。その後、タスクはレプリカセットのプライマリーノードに接続し、その位置から変更のストリーミングを開始します。すべての作成、挿入、および削除操作を処理して Debezium の 変更イベント に変換します。各変更イベントには操作が検出された oplog の位置が含まれ、コネクターはこれを最新のオフセットとして定期的に記録します。オフセットが記録される間隔は、Kafka Connect ワーカー設定プロパティーである offset.flush.interval.ms によって制御されます。

コネクターが正常に停止されると、処理された最後のオフセットが記録され、再起動時にコネクターは停止した場所から続行されます。しかし、コネクターのタスクが予期せず終了した場合、最後にオフセットが記録された後、最後のオフセットが記録される前に、タスクによってイベントが処理および生成されることがあります。再起動時に、コネクターは最後に 記録された オフセットから開始し、クラッシュの前に生成された同じイベントを生成する可能性があります。

通常、Kafka コンシューマーはすべてのメッセージを 1 度だけ 読み取ります。ただし、エラーが発生した場合は、Kafka はコンシューマーが 最低でも 1 回 すべてのメッセージを確認することのみを保証します。したがって、コンシューマーが複数回メッセージを確認することを想定する必要があります。

前述のように、コネクタータスクは常にレプリカセットのプライマリーノードを使用して oplog からの変更をストリーミングし、コネクターが可能な限り最新の操作を確認できるようにし、代わりにセカンダリーが使用された場合よりも短いレイテンシーで変更をキャプチャーできるようにします。レプリカセットが新しいプライマリーを選出すると、コネクターは即座に変更のストリーミングを停止し、新しいプライマリーに接続して、同じ場所にある新しいプライマリーノードから変更のストリーミングを開始します。同様に、コネクターとレプリカセットメンバーとの通信で問題が発生した場合は、レプリカセットが過剰にならないように指数バックオフを使用して再接続を試みます。接続の確立後、停止した場所から変更のストリーミングを続行します。これにより、コネクターはレプリカセットメンバーシップの変更を動的に調整でき、通信障害を自動的に処理できます。

要約すると、MongoDB コネクターはほとんどの状況で実行を継続します。通信の問題により、問題が解決されるまでコネクターが待機する可能性があります。

4.2.5. Debezium MongoDB 変更イベントレコードを受信する Kafka トピックのデフォルト名

MongoDB コネクターは、各コレクションのドキュメントに対するすべての挿入、更新、および削除操作のイベントを 1 つの Kafka トピックに書き込みます。Kafka トピックの名前は常に logicalName.databaseName.collectionName の形式を取ります。logicalName は、mongodb.name 設定プロパティーで指定されるコネクターの 論理名、databaseName は操作が発生したデータベースの名前、collectionName は影響を受けるドキュメントが存在する MongoDB コレクションの名前です。

たとえば、product、product_on_hand、お客様 、 および オーダー の 4 つのコレクションが含まれる インベントリー データベースを含む MongoDB レプリカセットについて考えてみましょう。コネクターが監視このデータベースを監視する場合、コネクターは 以下の 4 つの Kafka トピックでイベントを生成します。

-

fulfillment.inventory.products -

fulfillment.inventory.products_on_hand -

fulfillment.inventory.customers -

fulfillment.inventory.orders

トピック名には、レプリカセット名やシャード名が含まれないことに注意してください。その結果、シャード化コレクションへの変更 (各シャードにコレクションのドキュメントのサブセットが含まれる) はすべて同じ Kafka トピックに移動します。

Kafka を設定して、必要に応じてトピックを自動作成 できます。そうでない場合は、Kafka 管理ツールを使用してコネクターを起動する前にトピックを作成する必要があります。

4.2.6. イベントキーが Debezium MongoDB コネクターのトピックパーティショニングを制御する方法

MongoDB コネクターは、イベントのトピックをどのようにパーティション化するかを明確に決定しません。代わりに、Kafka がイベントキーに基づいてトピックを分割する方法を判断できるようにします。Kafka Connect ワーカー設定で Partitioner 実装の名前を定義することで、Kafka のパーティショニングロジックを変更できます。

Kafka は、1 つのトピックパーティションに書き込まれたイベントのみ、合計順序を維持します。キーでイベントのパーティションを行うと、同じキーを持つすべてのイベントは常に同じパーティションに移動します。これにより、特定のドキュメントのすべてのイベントが常に完全に順序付けされます。

4.2.7. トランザクション境界を表す Debezium MongoDB コネクターによって生成されたイベント

Debezium は、トランザクションメタデータ境界を表すイベントを生成でき、変更データイベントメッセージをエンリッチできます。トランザクション BEGIN および END ごとに、Debezium は以下のフィールドが含まれるイベントを生成します。

status-

BEGINまたはEND id- 一意のトランザクション識別子の文字列表現。

event_count(ENDイベント用)- トランザクションによって出力されるイベントの合計数。

data_collections(ENDイベント用)-

指定のデータコレクションからの変更によって出力されたイベントの数を提供する

dataのペアの配列。_collectionと event_count

以下の例は、典型的なメッセージを示しています。

{

"status": "BEGIN",

"id": "1462833718356672513",

"event_count": null,

"data_collections": null

}

{

"status": "END",

"id": "1462833718356672513",

"event_count": 2,

"data_collections": [

{

"data_collection": "rs0.testDB.collectiona",

"event_count": 1

},

{

"data_collection": "rs0.testDB.collectionb",

"event_count": 1

}

]

}

トランザクションイベントは、<database.server.name>.transaction という名前のトピックに書き込まれます。

変更データイベントのエンリッチメント

トランザクションメタデータを有効にすると、データ message Envelope は新しい トランザクション フィールドでエンリッチされます。このフィールドは、複合フィールドの形式ですべてのイベントに関する情報を提供します。

id- 一意のトランザクション識別子の文字列表現。

total_order- トランザクションによって生成されたすべてのイベントを対象とするイベントの絶対位置。

data_collection_order- トランザクションによって出力されたすべてのイベントを対象とするイベントのデータコレクションごとの位置。

以下は、メッセージの内容の例です。

{

"before": null,

"after": {

"pk": "2",

"aa": "1"

},

"source": {

...

},

"op": "c",

"ts_ms": "1580390884335",

"transaction": {

"id": "1462833718356672513",

"total_order": "1",

"data_collection_order": "1"

}

}4.3. Debezium MongoDB コネクターのデータ変更イベントの説明

Debezium MongoDB コネクターは、データを挿入、更新、または削除する各ドキュメントレベルの操作に対してデータ変更イベントを生成します。各イベントにはキーと値が含まれます。キーと値の構造は、変更されたコレクションによって異なります。

Debezium および Kafka Connect は、イベントメッセージの継続的なストリーム を中心として設計されています。ただし、これらのイベントの構造は時間の経過とともに変化する可能性があり、コンシューマーによる処理が困難になることがあります。これに対応するために、各イベントにはコンテンツのスキーマが含まれます。スキーマレジストリーを使用している場合は、コンシューマーがレジストリーからスキーマを取得するために使用できるスキーマ ID が含まれます。これにより、各イベントが自己完結型になります。

以下のスケルトン JSON は、変更イベントの基本となる 4 つの部分を示しています。ただし、アプリケーションで使用するために選択した Kafka Connect コンバーターの設定方法によって、変更イベントのこれら 4 部分の表現が決定されます。schema フィールドは、変更イベントが生成されるようにコンバーターを設定した場合のみ変更イベントに含まれます。同様に、イベントキーおよびイベントペイロードは、変更イベントが生成されるようにコンバーターを設定した場合のみ変更イベントに含まれます。JSON コンバーターを使用し、変更イベントの基本となる 4 つの部分すべてを生成するように設定すると、変更イベントの構造は次のようになります。

{

"schema": { 1

...

},

"payload": { 2

...

},

"schema": { 3

...

},

"payload": { 4

...

},

}表4.1 変更イベントの基本内容の概要

| 項目 | フィールド名 | 説明 |

|---|---|---|

| 1 |

|

最初の |

| 2 |

|

最初の |

| 3 |

|

2 つ目の |

| 4 |

|

2 つ目の |

デフォルトでは、コネクターによって、変更イベントレコードがイベントの元のコレクションと同じ名前を持つトピックにストリーミングされます。トピック名 を参照してください。

MongoDB コネクターは、すべての Kafka Connect スキーマ名が Avro スキーマ名の形式 に準拠するようにします。つまり、論理サーバー名はアルファベットまたはアンダースコア (a-z、A-Z、または _) で始まる必要があります。論理サーバー名の残りの各文字と、データベース名とコレクション名の各文字は、アルファベット、数字、またはアンダースコア ( a-z、A-Z、0-9、または _) でなければなりません。無効な文字がある場合は、アンダースコアに置き換えられます。

論理サーバー名、データベース名、またはコレクション名に無効な文字が含まれ、名前を区別する唯一の文字が無効であると、無効な文字はすべてアンダースコアに置き換えられるため、予期せぬ競合が発生する可能性があります。

詳細は、以下のトピックを参照してください。

4.3.1. Debezium MongoDB 変更イベントのキー

変更イベントのキーには、変更されたドキュメントのキーのスキーマと、変更されたドキュメントの実際のキーのスキーマが含まれます。特定のコレクションでは、スキーマとそれに対応するペイロードの両方に単一の id フィールドが含まれます。このフィールドの値は、MongoDB Extended JSON のシリアライゼーションの厳格モード から派生する文字列として表されるドキュメントの識別子です。

論理名が meet ment のコネクター、インベントリー データベースが含まれるレプリカセット、および以下のようなドキュメントが含まれる お客様 コレクションについて考えてみましょう。

ドキュメントの例

{

"_id": 1004,

"first_name": "Anne",

"last_name": "Kretchmar",

"email": "annek@noanswer.org"

}

変更イベントキーの例

顧客 コレクションへの変更をキャプチャーするすべての変更イベントには、同じイベントキースキーマがあります。顧客 コレクションに前述の定義がある限り、顧客 コレクションへの変更をキャプチャーする変更イベントのキー構造はすべて以下のようになります。JSON では、以下のようになります。

{

"schema": { 1

"type": "struct",

"name": "fulfillment.inventory.customers.Key", 2

"optional": false, 3

"fields": [ 4

{

"field": "id",

"type": "string",

"optional": false

}

]

},

"payload": { 5

"id": "1004"

}

}表4.2 変更イベントキーの説明

| 項目 | フィールド名 | 説明 |

|---|---|---|

| 1 |

|

キーのスキーマ部分は、キーの |

| 2 |

|

キーのペイロードの構造を定義するスキーマの名前。このスキーマは、変更したドキュメントのキーの構造を説明します。キースキーマ名の形式は connector-name.database- name.collection-name.

|

| 3 |

|

イベントキーの |

| 4 |

|

各フィールドの名前、タイプ、および必要かどうかなど、 |

| 5 |

|

この変更イベントが生成されたドキュメントのキーが含まれます。この例では、キーにはタイプ |

この例では、整数の識別子を持つドキュメントを使用しますが、有効な MongoDB ドキュメント識別子は、ドキュメント識別子を含め、同じように動作します。ドキュメント識別子の場合、イベントキーの payload.id 値は、厳密なモードを使用する MongoDB 拡張 JSON シリアライゼーションとして更新されたドキュメントの original _id フィールドを表す文字列です。以下の表は、異なるタイプの of _id フィールドを表す例を示しています。

表4.3 イベントキーペイロードの document _id フィールドを表す例

| タイプ | mongodb _id 値 | キーのペイロード |

|---|---|---|

| Integer | 1234 |

|

| 浮動小数点 (Float) | 12.34 |

|

| 文字列 | "1234" |

|

| Document |

|

|

| ObjectId |

|

|

| バイナリー |

|

|

4.3.2. Debezium MongoDB 変更イベントの値

変更イベントの値はキーよりも若干複雑です。キーと同様に、値には schema セクションと payload セクションがあります。schema セクションには、ネストされたフィールドを含む、payload セクションの Envelope 構造を記述するスキーマが含まれます。データを作成、更新、または削除する操作のすべての変更イベントには、Envelope 構造を持つ値 payload があります。

変更イベントキーの例を紹介するために使用した、同じサンプルドキュメントについて考えてみましょう。

ドキュメントの例

{

"_id": 1004,

"first_name": "Anne",

"last_name": "Kretchmar",

"email": "annek@noanswer.org"

}

このドキュメントへの変更に対する変更イベントの値部分には、以下の各イベントタイプについて記述されています。

作成イベント

以下の例は、お客様が コレクションにデータを作成する操作に対してコネクターによって生成される変更イベントの値の部分を示しています。

{

"schema": { 1

"type": "struct",

"fields": [

{

"type": "string",

"optional": true,

"name": "io.debezium.data.Json", 2

"version": 1,

"field": "after"

},

{

"type": "string",

"optional": true,

"name": "io.debezium.data.Json",

"version": 1,

"field": "patch"

},

{

"type": "string",

"optional": true,

"name": "io.debezium.data.Json",

"version": 1,

"field": "filter"

},

{

"type": "struct",

"fields": [

{

"type": "string",

"optional": false,

"field": "version"

},

{

"type": "string",

"optional": false,

"field": "connector"

},

{

"type": "string",

"optional": false,

"field": "name"

},

{

"type": "int64",

"optional": false,

"field": "ts_ms"

},

{

"type": "boolean",

"optional": true,

"default": false,

"field": "snapshot"

},

{

"type": "string",

"optional": false,

"field": "db"

},

{

"type": "string",

"optional": false,

"field": "rs"

},

{

"type": "string",

"optional": false,

"field": "collection"

},

{

"type": "int32",

"optional": false,

"field": "ord"

},

{

"type": "int64",

"optional": true,

"field": "h"

}

],

"optional": false,

"name": "io.debezium.connector.mongo.Source", 3

"field": "source"

},

{

"type": "string",

"optional": true,

"field": "op"

},

{

"type": "int64",

"optional": true,

"field": "ts_ms"

}

],

"optional": false,

"name": "dbserver1.inventory.customers.Envelope" 4

},

"payload": { 5

"after": "{\"_id\" : {\"$numberLong\" : \"1004\"},\"first_name\" : \"Anne\",\"last_name\" : \"Kretchmar\",\"email\" : \"annek@noanswer.org\"}", 6

"patch": null,

"source": { 7

"version": "1.5.4.Final",

"connector": "mongodb",

"name": "fulfillment",

"ts_ms": 1558965508000,

"snapshot": false,

"db": "inventory",

"rs": "rs0",

"collection": "customers",

"ord": 31,

"h": 1546547425148721999

},

"op": "c", 8

"ts_ms": 1558965515240 9

}

}表4.4 作成 イベント値フィールドの説明

| 項目 | フィールド名 | 説明 |

|---|---|---|

| 1 |

| 値のペイロードの構造を記述する、値のスキーマ。変更イベントの値スキーマは、コネクターが特定のコレクションに生成するすべての変更イベントで同じになります。 |

| 2 |

|

|

| 3 |

|

|

| 4 |

|

|

| 5 |

|

値の実際のデータ。これは、変更イベントが提供する情報です。 |

| 6 |

|

イベント発生後のドキュメントの状態を指定する任意のフィールド。この例では、 |

| 7 |

| イベントのソースメタデータを記述する必須のフィールド。このフィールドには、イベントの発生元、イベントの発生順序、およびイベントが同じトランザクションの一部であるかどうかなど、このイベントと他のイベントを比較するために使用できる情報が含まれています。ソースメタデータには以下が含まれています。

|

| 8 |

|

コネクターによってイベントが生成される原因となった操作の型を記述する必須文字列。この例では、

|

| 9 |

|

コネクターがイベントを処理した時間を表示する任意のフィールド。この時間は、Kafka Connect タスクを実行している JVM のシステムクロックを基にします。 |

更新イベント

サンプル 顧客 コレクションの更新の変更イベントの値には、そのコレクションの 作成 イベントと同じスキーマがあります。同様に、イベント値のペイロードは同じ構造を持ちます。ただし、イベント値ペイロードでは 更新 イベントに異なる値が含まれます。更新 イベントは after 値を持ちません。その代わりに、以下の 2 つのフィールドがあります。

-

patchは、べき等更新操作の JSON 表現が含まれる文字列フィールドです。 -

filterは、更新の選択基準の JSON 表現が含まれる文字列フィールドです。フィルター文字列には、シャード化コレクションの複数のシャードキーフィールドを含めることができます。

以下は、お客様が コレクションでの更新に対してコネクターによって生成されるイベントの変更イベント値の例になります。

{

"schema": { ... },

"payload": {

"op": "u", 1

"ts_ms": 1465491461815, 2

"patch": "{\"$set\":{\"first_name\":\"Anne Marie\"}}", 3

"filter": "{\"_id\" : {\"$numberLong\" : \"1004\"}}", 4

"source": { 5

"version": "1.5.4.Final",

"connector": "mongodb",

"name": "fulfillment",

"ts_ms": 1558965508000,

"snapshot": true,

"db": "inventory",

"rs": "rs0",

"collection": "customers",

"ord": 6,

"h": 1546547425148721999

}

}

}表4.5 更新 イベント値フィールドの説明

| 項目 | フィールド名 | 説明 |

|---|---|---|

| 1 |

|

コネクターによってイベントが生成される原因となった操作の型を記述する必須文字列。この例では、 |

| 2 |

|

コネクターがイベントを処理した時間を表示する任意のフィールド。この時間は、Kafka Connect タスクを実行している JVM のシステムクロックを基にします。 |

| 3 |

|

ドキュメントへの実際の MongoDB のべき等変更の JSON 文字列表現が含まれます。この例では、更新で |

| 4 |

| 更新するドキュメントの特定に使用された MongoDB 選択基準の JSON 文字列表現が含まれます。 |

| 5 |

| イベントのソースメタデータを記述する必須のフィールド。このフィールドには、同じコレクションの 作成 イベントと同じ情報が含まれますが、oplog の異なる位置からのイベントであるため、値は異なります。ソースメタデータには以下が含まれています。

|

Debezium の変更イベントでは、MongoDB は patch フィールドの内容を提供します。このフィールドの形式は、MongoDB データベースのバージョンによって異なります。したがって、新しい MongoDB データベースバージョンにアップグレードする場合は、形式が変更された可能性があるため注意してください。本書のサンプルは、MongoDB 3.4 から取得したため、ご使用のアプリケーションではイベントの形式が異なる場合があります。

MongoDB の oplog では、更新 イベントには変更されたドキュメントの前 または 後 の状態は含まれません。そのため、Debezium コネクターがこの情報を提供することはできません。ただし、Debezium コネクターは 作成 および 読み取り イベントでドキュメントの開始状態を提供します。ストリームのダウンストリームのコンシューマーは、ドキュメントごとに最新状態を維持し、新しいイベントの状態を保存された状態に比較することで、ドキュメント状態を再構築できます。Debezium コネクターはこの状態を維持できません。

削除 イベント

削除 変更イベントの値は、同じコレクションの 作成 および 更新 イベントと同じ スキーマ の部分になります。削除 イベントの ペイロード 部分には、同じコレクションの 作成 および 更新 イベントとは異なる値が含まれます。特に、削除 イベントには、値が after でも パッチ 値も含まれていません。以下は、お客様 コレクションのドキュメントの 削除 イベントの例になります。

{

"schema": { ... },

"payload": {

"op": "d", 1

"ts_ms": 1465495462115, 2

"filter": "{\"_id\" : {\"$numberLong\" : \"1004\"}}", 3

"source": { 4

"version": "1.5.4.Final",

"connector": "mongodb",

"name": "fulfillment",

"ts_ms": 1558965508000,

"snapshot": true,

"db": "inventory",

"rs": "rs0",

"collection": "customers",

"ord": 6,

"h": 1546547425148721999

}

}

}表4.6 削除 イベント値フィールドの説明

| 項目 | フィールド名 | 説明 |

|---|---|---|

| 1 |

|

操作の型を記述する必須の文字列。 |

| 2 |

|

コネクターがイベントを処理した時間を表示する任意のフィールド。この時間は、Kafka Connect タスクを実行している JVM のシステムクロックを基にします。 |

| 3 |

| 削除するドキュメントの特定に使用された MongoDB 選択基準の JSON 文字列表現が含まれます。 |

| 4 |

| イベントのソースメタデータを記述する必須のフィールド。このフィールドには、同じコレクションの 作成 または 更新 イベントと同じ情報が含まれますが、oplog の異なる位置からのイベントであるため、値は異なります。ソースメタデータには以下が含まれています。

|

MongoDB コネクターイベントは、Kafka ログコンパクション と動作するように設計されています。ログコンパクションにより、少なくとも各キーの最新のメッセージが保持される限り、一部の古いメッセージを削除できます。これにより、トピックに完全なデータセットが含まれ、キーベースの状態のリロードに使用できるようにするとともに、 Kafka がストレージ領域を確保できるようにします。

廃棄 (tombstone) イベント

一意に識別ドキュメントの MongoDB コネクターイベントはすべて同じキーを持ちます。ドキュメントが削除された場合でも、Kafka は同じキーを持つ以前のメッセージをすべて削除できるため、削除 イベントの値はログコンパクションで動作します。ただし、Kafka がそのキーを持つすべてのメッセージを削除するには、メッセージの値が null である必要があります。これを可能にするために、Debezium の MongoDB コネクターは 削除 イベントを出力した後に 、 同じキーと null 値を持つ特別な廃棄(tombstone)イベントを出力します。tombstone イベントは、同じキーを持つすべてのメッセージを削除できることを Kafka に通知します。

4.4. Debezium コネクターと連携する MongoDB の設定

MongoDB コネクターは MongoDB の oplog を使用して変更をキャプチャーするため、コネクターは MongoDB レプリカセットと、各シャードが個別のレプリカセットであるシャードクラスターとのみ動作します。レプリカセット またはシャードクラスターの設定については、MongoDB ドキュメントを参照してください。また、レプリカセットで アクセス制御と認証を有効にする方法についても理解するようにしてください。

oplog が読み取られる admin データベースを読み取るために適切なロールを持つ MongoDB ユーザーも必要です。さらに、ユーザーはシャードクラスターの設定サーバーで設定データベースを読み取り 、 listDatabases 特権アクションを持っている 必要があります。

4.5. Debezium MongoDB コネクターのデプロイ

Debezium MongoDB コネクターをデプロイするには、コネクターファイルを Kafka Connect に追加し、コネクターを実行するカスタムコンテナーを作成して、コネクター設定をコンテナーに追加します。詳細は以下を参照してください。

4.5.1. Debezium MongoDB コネクターのデプロイ

Debezium MongoDB コネクターをデプロイするには、Debezium コネクターアーカイブが含まれるカスタム Kafka Connect コンテナーイメージをビルドし、続いてこのコンテナーイメージをコンテナーレジストリーにプッシュする必要があります。その後、2 つのカスタムリソース (CR) を作成します。

-

Kafka Connect インスタンスを定義する

KafkaConnectCR。CR のimageプロパティーは、Debezium コネクターを実行するために作成するコンテナーイメージの名前を指定します。この CR を、Red Hat AMQ Streams がデプロイされている OpenShift インスタンスに適用します。AMQ Streams は、Apache Kafka を OpenShift に取り入れる Operator およびイメージを提供します。 -

Debezium MongoDB コネクターを定義する

KafkaConnectorCR。この CR をKafkaConnectCR を適用するのと同じ OpenShift インスタンスに適用します。

前提条件

- MongoDB が稼働し、MongoDB を設定して Debezium コネクターと連携する 手順が完了済みである必要があります。

- AMQ Streams が OpenShift にデプロイされ、Apache Kafka および Kafka Connect を実行している。詳細は、『Deploying and Upgrading AMQ Streams on OpenShift』を参照してください。

- Podman または Docker がインストールされている。

-

Debezium コネクターを実行するコンテナーを追加する予定のコンテナーレジストリー(

quay.ioまたはdocker.ioなど)でコンテナーを作成および管理するアカウントおよびパーミッションがある。

手順

Kafka Connect の Debezium MongoDB コンテナーを作成します。

- Debezium MongoDB コネクターアーカイブ をダウンロードします。

Debezium MongoDB コネクターアーカイブを展開して、コネクタープラグインのディレクトリー構造を作成します。以下に例を示します。

./my-plugins/ ├── debezium-connector-mongodb │ ├── ...

registry.redhat.io/amq7/amq-streams-kafka-28-rhel8:1.8.0をベースイメージとして使用する Docker ファイルを作成します。たとえば、ターミナルウィンドウに以下のコマンドを入力します。my-pluginsはプラグインディレクトリーの名前に置き換えます。cat <<EOF >debezium-container-for-mongodb.yaml 1 FROM registry.redhat.io/amq7/amq-streams-kafka-28-rhel8:1.8.0 USER root:root COPY ./<my-plugins>/ /opt/kafka/plugins/ 2 USER 1001 EOF

このコマンドは、現在のディレクトリーに

debezium-container-for-mongodb.yamlという名前の Docker ファイルを作成します。前の手順で作成した

debezium-container-for-mongodb.yamlDocker ファイルからコンテナーイメージをビルドします。ファイルを含むディレクトリーから、ターミナルウィンドウを開き、以下のコマンドのいずれかを入力します。podman build -t debezium-container-for-mongodb:latest .

docker build -t debezium-container-for-mongodb:latest .

上記のコマンドは、

debezium-container-for-mongodbという名前のコンテナーイメージを構築します。カスタムイメージを

quay.ioまたは内部コンテナーレジストリーなどのコンテナーレジストリーにプッシュします。コンテナーレジストリーは、イメージをデプロイする OpenShift インスタンスで利用できる必要があります。以下のいずれかのコマンドを実行します。podman push <myregistry.io>/debezium-container-for-mongodb:latestdocker push <myregistry.io>/debezium-container-for-mongodb:latest新しい Debezium MongoDB

KafkaConnectカスタムリソース(CR)を作成します。たとえば、以下の例のようにアノテーションおよびイメージプロパティーを指定するdbz-connect.yamlという名前のKafkaConnectCR を作成します。apiVersion: kafka.strimzi.io/v1beta2 kind: KafkaConnect metadata: name: my-connect-cluster annotations: strimzi.io/use-connector-resources: "true" 1 spec: #... image: debezium-container-for-mongodb 2以下のコマンドを入力して、

KafkaConnectCR を OpenShift Kafka Connect 環境に適用します。oc create -f dbz-connect.yaml

このコマンドは、Debezium コネクターを実行するために作成したイメージの名前を指定する Kafka Connect インスタンスを追加します。

Debezium MongoDB コネクターインスタンスを設定する

KafkaConnectorカスタムリソースを作成します。コネクターの設定プロパティーを指定する a

.yamlファイルで Debezium MongoDB コネクターを設定します。コネクター設定は、Debezium に対して MongoDB レプリカセットまたはシャードクラスターのサブセットの変更イベントを生成するよう指示することがあります。任意で、不要なコレクションをフィルタリングするプロパティーを設定できます。以下の例では、MongoDB レプリカセット

rs0を192.168.99.100のポート27017に接続し、インベントリーコレクションで生じる変更をキャプチャーする Debezium コネクターを設定します。完全な入力は、レプリカセットの論理名です。MongoDB

inventory-connector.yamlapiVersion: kafka.strimzi.io/v1beta2 kind: KafkaConnector metadata: name: inventory-connector 1 labels: strimzi.io/cluster: my-connect-cluster spec: class: io.debezium.connector.mongodb.MongoDbConnector 2 config: mongodb.hosts: rs0/192.168.99.100:27017 3 mongodb.name: fulfillment 4 collection.include.list: inventory[.]* 5- 1

- コネクターを Kafka Connect に登録するために使用される名前。

- 2

- MongoDB コネクタークラスの名前。

- 3

- MongoDB レプリカセットへの接続に使用するホストアドレス。

- 4

- 生成されたイベントの namespace を形成する MongoDB レプリカセットの論理名。コネクターが書き込む Kafka トピックの名前、Kafka Connect スキーマ名、および Arvo コンバーターが使用される場合に対応する Avro スキーマの namespace のすべてに使用されます。

- 5

- 監視するすべてのコレクションのコレクション namespace (例: <dbName>.<collectionName>) と一致する正規表現のオプションリスト。

Kafka Connect でコネクターインスタンスを作成します。たとえば、

KafkaConnectorリソースをinventory-connector.yamlファイルに保存した場合、以下のコマンドを実行します。oc apply -f inventory-connector.yaml

上記のコマンドは

inventory-connectorを登録し、コネクターはKafkaConnectorCR に定義されているインベントリーコレクションに対して実行を開始します。コネクターが作成され、起動されたことを確認します。