Fuse on OpenShift ガイド

Red Hat Fuse on OpenShift のインストールおよび管理、OpenShift での Fuse アプリケーションの開発およびデプロイ

概要

多様性を受け入れるオープンソースの強化

Red Hat では、コード、ドキュメント、Web プロパティーにおける配慮に欠ける用語の置き換えに取り組んでいます。まずは、マスター (master)、スレーブ (slave)、ブラックリスト (blacklist)、ホワイトリスト (whitelist) の 4 つの用語の置き換えから始めます。この取り組みは膨大な作業を要するため、今後の複数のリリースで段階的に用語の置き換えを実施して参ります。詳細は、Red Hat CTO である Chris Wright のメッセージ をご覧ください。

Red Hat Fuse on OpenShift は、OpenShift Container Platform での Fuse アプリケーションのデプロイを可能にします。

第1章 作業を始める前に

リリースノート

本リリースに関する重要な情報は、リリースノート を参照してください。

バージョンの互換性とサポート

バージョンの互換性とサポートの詳細は、Red Hat JBoss Fuse Supported Configurations を参照してください。

Windows O/S のサポート

Fuse on OpenShift の開発者ツール (oc クライアントおよび Container Development Kit) は、Windows O/S で完全サポートされます。Linux コマンドライン構文で示された例は、Windows コマンドライン構文にしたがって適切に変更すれば、Windows O/S で動作します。

1.1. Fuse スタンドアロンと Fuse on OpenShift の比較

主な機能の違いは次のとおりです。

- Fuse on OpenShift のアプリケーションデプロイメントは、1 つのアプリケーションと、コンテナーイメージ内にパッケージ化された必要なすべてのランタイムコンポーネントで構成されます。アプリケーションはランタイム (実行環境) にデプロイされません。アプリケーションイメージ自体が実行可能なランタイム (実行環境) であり、OpenShift によりデプロイおよび管理されます。

- 各アプリケーションイメージが完全なランタイム環境であるため、OpenShift 環境でのパッチ適用は Fuse スタンドアロンとは異なります。パッチを適用する場合、アプリケーションイメージが再ビルドされ、OpenShift 内に再デプロイされます。主要の OpenShift 管理機能により、ローリングアップグレードやサイドバイサイドデプロイメントを使用して、アップグレード中にアプリケーションの可用性を維持することが可能になります。

- Fuse の Fabric によって提供されるプロビジョニングおよびクラスタリング機能は、Kubernetes および OpenShift の同等の機能に置き換えられました。OpenShift は、アプリケーションのデプロイメントおよびスケーリングの一環として、自動的に子コンテナーを個別に作成および設定するため、手作業でこの作業を行う必要はありません。

- Fabric エンドポイントは OpenShift 環境内で使用されません。代わりに、Kubernetes サービスを使用する必要があります。

- メッセージングサービスは、OpenShift イメージの A-MQ を使用して作成および管理され、Karaf コンテナー内に直接含まれません。Fuse on OpenShift は、camel-amq コンポーネントの強化バージョンを提供し、Kubernetes を介して OpenShift のメッセージングサービスへのシームレスな接続を可能にします。

- Karaf を使用して稼働中の Karaf インスタンスをライブ更新しないようにしてください。アプリケーションコンテナーを再起動またはスケールアップすると、更新は維持されません。これは、イミュータブルアーキテクチャーの基本原則であり、OpenShift 内でスケーラビリティーと柔軟性を実現するために必要となります。

- Red Hat Fuse コンポーネントに直接リンクする Maven 依存関係は Red Hat によってサポートされます。ユーザーが導入したサードパーティー Maven 依存関係はサポートされません。

- SSH エージェントは Apache Karaf マイクロコンテナーに含まれないため、bin/client コンソールクライアントを使用して接続できません。

- プロトコル互換性と Fuse on OpenShift アプリケーション内の Camel コンポーネント: HTTP ベースでない通信は、TLS および SNI を使用して、OpenShift 外部から Fuse サービス (Camel コンシューマーエンドポイント) にルーティング可能である必要があります。

第2章 管理者向けの基本情報

OpenShift の管理者は、以下を行って Fuse on OpenShift デプロイメントの OpenShift クラスターを準備できます。

-

registry.redhat.ioでの認証の設定。 - Fuse on OpenShift イメージおよびテンプレートのインストール。

2.1. コンテナーイメージの registry.redhat.io を使用した認証

Fuse コンテナーイメージを OpenShift にデプロイする前に、registry.redhat.io で認証を設定します。

前提条件

- OpenShift Container Platform クラスターへアクセスできるクラスター管理者権限。

-

OpenShift

ocクライアントツールがインストール済みであること。詳細は、OpenShift CLI のドキュメント を参照してください。

手順

管理者として OpenShift クラスターにログインします。

oc login --user system:admin --token=my-token --server=https://my-cluster.example.com:6443

Fuse をデプロイするプロジェクトを開きます。

oc project myproject

Red Hat Customer Portal アカウントを使用して

docker-registryシークレットを作成し、PULL_SECRET_NAMEをpsi-internal-registryに置き換えて以下を作成します。oc create secret docker-registry psi-internal-registry \ --docker-server=docker-registry.redhat.io \ --docker-username=CUSTOMER_PORTAL_USERNAME \ --docker-password=CUSTOMER_PORTAL_PASSWORD \ --docker-email=EMAIL_ADDRESS

以下の出力が表示されるはずです。

secret/psi-internal-registry created

重要この

docker-registryシークレットを、registry.redhat.ioに対して認証されるすべての OpenShift プロジェクト namespace に作成する必要があります。シークレットをサービスアカウントにリンクして、シークレットをイメージをプルするために使用します。次の例では、

defaultサービスアカウント、builderサービスアカウント、およびdeployerサービスアカウントを使用しています。oc secrets link default psi-internal-registry oc secrets link default psi-internal-registry --for=pull oc secrets link builder psi-internal-registry oc secrets link builder psi-internal-registry --for=pull oc secrets link deployer psi-internal-registry oc secrets link deployer psi-internal-registry --for=pull

サービスアカウント名は、OpenShift Pod が使用する名前と一致する必要があります。

注記Red Hat のユーザー名とパスワードを使用してプルシークレットを作成したくない場合は、レジストリーサービスアカウントを使用して認証トークンを作成できます。

関連情報

コンテナーイメージに対する Red Hat の認証に関する詳細は、以下を参照してください。

2.2. OpenShift 4.x サーバーでの Fuse イメージストリームおよびテンプレートのインストール

Fuse 7.11 では、Fuse on OpenShift イメージストリームおよびテンプレートを IBM Power Systems、IBM Z、および LinuxONE へインストールすることは、サポートされていません。

Fuse on OpenShift Operator でインストールできるコンポーネントのみが IBM Power Systems、IBM Z、および LinuxONE でサポートされます。

OpenShift Container Platform 4.x は、OpenShift namespace で操作する Samples Operator を使用して、Red Hat Enterprise Linux (RHEL) ベースの OpenShift Container Platform イメージストリームおよびテンプレートをインストールおよび更新します。Fuse on OpenShift イメージストリームおよびテンプレートをインストールするには、以下を行います。

- Samples Operator の再設定

Fuse イメージストリームおよびテンプレートを

Skipped Imagestreams and Skipped Templatesフィールドに追加します。- Skipped Imagestreams (スキップされるイメージストリーム): Samples Operator のインベントリーにあるが、クラスター管理者の希望により Operator が無視または管理しないようにするイメージストリーム。

- Skipped Templates (スキップされるテンプレート): Samples Operator のインベントリーにあるが、クラスター管理者の希望により Operator が無視または管理しないようにするテンプレート。

前提条件

- OpenShift サーバーにアクセスできる必要があります。

-

registry.redhat.ioへの認証が設定されている。

手順

- OpenShift 4 サーバーを起動します。

OpenShift サーバーに管理者としてログインします。

oc login --user system:admin --token=my-token --server=https://my-cluster.example.com:6443

docker-registry シークレットを作成したプロジェクトを使用していることを確認します。

oc project openshift

Samples Operator の現在の設定を表示します。

oc get configs.samples.operator.openshift.io -n openshift-cluster-samples-operator -o yaml

Samples Operator が、追加された Fuse テンプレートおよびイメージストリームを無視するよう設定します。

oc edit configs.samples.operator.openshift.io -n openshift-cluster-samples-operator

Fuse imagestreams の Skipped Imagestreams セクションを追加し、Fuse および Spring Boot 2 のテンプレートを Skipped Templates セクションに追加します。

[...] spec: architectures: - x86_64 managementState: Managed skippedImagestreams: - fuse-console-rhel8 - fuse-eap-openshift-jdk8-rhel7 - fuse-eap-openshift-jdk11-rhel8 - fuse-java-openshift-rhel8 - fuse-java-openshift-jdk11-rhel8 - fuse-karaf-openshift-rhel8 - fuse-karaf-openshift-jdk11-rhel8 - fuse-apicurito-generator-rhel8 - fuse-apicurito-rhel8 skippedTemplates: - s2i-fuse711-eap-camel-amq - s2i-fuse711-eap-camel-cdi - s2i-fuse711-eap-camel-cxf-jaxrs - s2i-fuse711-eap-camel-cxf-jaxws - s2i-fuse711-karaf-camel-amq - s2i-fuse711-karaf-camel-log - s2i-fuse711-karaf-camel-rest-sql - s2i-fuse711-karaf-cxf-rest - s2i-fuse711-spring-boot-2-camel-amq - s2i-fuse711-spring-boot-2-camel-config - s2i-fuse711-spring-boot-2-camel-drools - s2i-fuse711-spring-boot-2-camel-infinispan - s2i-fuse711-spring-boot-2-camel-rest-3scale - s2i-fuse711-spring-boot-2-camel-rest-sql - s2i-fuse711-spring-boot-2-camel - s2i-fuse711-spring-boot-2-camel-xa - s2i-fuse711-spring-boot-2-camel-xml - s2i-fuse711-spring-boot-2-cxf-jaxrs - s2i-fuse711-spring-boot-2-cxf-jaxws - s2i-fuse711-spring-boot-2-cxf-jaxrs-xml - s2i-fuse711-spring-boot-2-cxf-jaxws-xml

Fuse on OpenShift イメージストリームをインストールします。

BASEURL=https://raw.githubusercontent.com/jboss-fuse/application-templates/application-templates-2.1.0.fuse-sb2-7_11_1-00016-redhat-00002 oc create -n openshift -f ${BASEURL}/fis-image-streams.jsonFuse on OpenShift のクイックスタートテンプレートをインストールします。

for template in eap-camel-amq-template.json \ eap-camel-cdi-template.json \ eap-camel-cxf-jaxrs-template.json \ eap-camel-cxf-jaxws-template.json \ karaf-camel-amq-template.json \ karaf-camel-log-template.json \ karaf-camel-rest-sql-template.json \ karaf-cxf-rest-template.json ; do oc create -n openshift -f \ ${BASEURL}/quickstarts/${template} doneSpring Boot 2 のクイックスタートテンプレートをインストールします。

for template in spring-boot-2-camel-amq-template.json \ spring-boot-2-camel-config-template.json \ spring-boot-2-camel-drools-template.json \ spring-boot-2-camel-infinispan-template.json \ spring-boot-2-camel-rest-3scale-template.json \ spring-boot-2-camel-rest-sql-template.json \ spring-boot-2-camel-template.json \ spring-boot-2-camel-xa-template.json \ spring-boot-2-camel-xml-template.json \ spring-boot-2-cxf-jaxrs-template.json \ spring-boot-2-cxf-jaxws-template.json \ spring-boot-2-cxf-jaxrs-xml-template.json \ spring-boot-2-cxf-jaxws-xml-template.json ; do oc create -n openshift -f \ ${BASEURL}/quickstarts/${template} done(任意手順) インストールされた Fuse on OpenShift テンプレートを表示します。

oc get template -n openshift

2.3. OpenShift 4.x への API Designer のインストール

Red Hat Fuse on OpenShift では、REST API の設計に使用できる Web ベースの API デザイナーツールである API Designer が提供されます。API Designer Operator を使用すると、OpenShift Container Platform 4.x で API Designer を簡単にインストールおよびアップグレードできます。

OpenShift 管理者として、API Designer Operator を OpenShift プロジェクト (namespace) にインストールします。Operator はインストール後に、選択された namespace で実行されます。しかし、API Designer をサービスとして使用できるようにするには、OpenShift 管理者または開発者が API Designer のインスタンスを作成する必要があります。API Designer サービスによって、API Designer Web コンソールにアクセスするための URL が提供されます。

前提条件

- OpenShift クラスターの管理者権限を持っている必要があります。

-

registry.redhat.ioへの認証が設定されている。

手順

- OpenShift 4.x サーバーを起動します。

- Web ブラウザーで OpenShift コンソールに移動します。ご自分のクレデンシャルでコンソールにログインします。

- Operators をクリックした後、OperatorHub をクリックします。

- 検索フィールドに API Designer と入力します。

- Red Hat Integration - API Designer カードをクリックします。Red Hat Integration - API Designer Operator のインストールページが表示されます。

Install をクリックします。Install Operator ページが開きます。

- Update Channel には、fuse-console-7.11.x を選択します。

- Installation mode では、クラスターの namespace のリストから namespace (プロジェクト) を 1 つ選択します。

Approval Strategy では、Automatic または Manual を選択し、API Designer Operator の更新が OpenShift によってどのように対処されるかを設定します。

- Automatic (自動) 更新を選択した場合、新しいバージョンの API Designer Operator が使用できるようになると、人的な介入なしで OpenShfit Operator Lifecycle Manager (OLM) によって、API Designer の稼働中のインスタンスが自動的にアップグレードされます。

- Manual (手動) 更新を選択した場合、Operator の新しいバージョンが使用できるようになると、OLM によって更新リクエストが作成されます。クラスター管理者は、更新リクエストを手動で承認して、API Designer Operator を新しいバージョンに更新する必要があります。

- Install をクリックして、指定の namespace (プロジェクト) で API Designer Operator を使用できるようにします。

- API Designer がプロジェクトにインストールされていることを確認するには、Operators をクリックした後、Installed Operators をクリックし、リストに Red Hat Integration - API Designer があることを確認します。

次のステップ

API Designer Operator のインストール後、API Designer のインスタンスを作成し、API Designer をサービスとして OpenShift プロジェクトに追加する必要があります。このタスクを実行する方法は 2 つあります。

- OpenShift 管理者は「API Designer をサービスとして OpenShift 4.x プロジェクトに追加」の手順を実行できます。

OpenShift 開発者は、API の設計 に記載されている手順を実行できます。

API Designer サービスによって、API Designer Web コンソールにアクセスするための URL が提供されます。

2.3.1. API Designer をサービスとして OpenShift 4.x プロジェクトに追加

API Designer Operator を OpenShift 4.x プロジェクトにインストールした後、OpenShift 開発者はこれをサービスとして OpenShift プロジェクトに追加できます。開発者が API Designer Web コンソールへアクセスするために使用する URL は API Designer サービスによって提供されます。

OpenShift 開発者が API Designer をサービスとして OpenShift 4.x プロジェクトに追加するための手順は、API の設計 を参照してください。

前提条件

- OpenShift クラスターの管理者権限を持っている必要があります。

- API Designer Operator は現在の OpenShift プロジェクトにインストールされます。

手順

- OpenShift Web コンソールで、Operators をクリックした後、Installed Operators をクリックします。

- Name 列で、Red Hat Integration - API Designer をクリックします。

Provided APIs の Create instance をクリックします。

API Designer インスタンスの最小限の開始テンプレートがあるデフォルトのフォームが開かれます。デフォルト値を使用するか、任意でデフォルト値を編集します。

- Create をクリックし、新しい apicurito-service を作成します。OpenShift は、新しい API Designer サービスの Pod、サービス、およびその他のコンポーネントを起動します。

API Designer サービスが使用できることを確認するには、以下を実行します。

- Operators をクリックした後、Installed Operators をクリックします。

Provided APIs 列で Apicurito CRD をクリックします。

Operator Details ページに、apicurito-service のリストが表示されます。

API Designer を開くには、以下を実行します。

- Networking > Routes の順に選択します。

- 正しいプロジェクトが選択されていることを確認してください。

apicurito-service-ui 行の Location 列で、URL をクリックします。

API Designer Web コンソールが新規ブラウザータブで開きます。

2.3.2. OpenShift 4.x での API Designer のアップグレード

Red Hat OpenShift 4.x では、Red Hat Fuse Operator などの Operator の更新が処理されます。詳細は、OpenShift ドキュメントの Operator を参照してください。

また、Operator の更新によってアプリケーションのアップグレードがトリガーされる可能性があります。アプリケーションのアップグレードの実行方法は、アプリケーションの設定によって異なります。

API Designer アプリケーションでは、API Designer Operator をアップグレードすると、OpenShift によってクラスターの API Designer アプリケーションもアップグレードされます。

API Designer 7.8 から API Designer 7.9 にアップグレードするときに、通常の Operator のアップグレードプロセスは動作しません。API Designer を Fuse 7.8 から Fuse 7.9 にアップグレードするには、7.8 API Designer Operator を削除してから 7.9 API Designer Operator をインストールする必要があります。

2.3.3. API Designer のメータリングラベル

OpenShift の Metering Operator を使用すると、インストールされた API Designer Operator、UI コンポーネント、およびコードジェネレーターを分析し、Red Hat サブスクリプションに準拠しているかどうかを判断することができます。詳細は、OpenShift ドキュメント のメータリングを参照してください。

以下の表は、API Designer のメータリングラベルを示しています。

表2.1 API Designer のメータリングラベル

| ラベル | 使用できる値 |

|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

例

API Designer Operator の例:

apicurito-operator com.company: Red_Hat rht.prod_name: Red_Hat_Integration rht.prod_ver: 7.11 rht.comp: Fuse rht.comp_ver: 7.11 rht.subcomp: fuse-apicurito rht.subcomp_t: infrastructure

API Designer UI コンポーネントの例:

com.company: Red_Hat rht.prod_name: Red_Hat_Integration rht.prod_ver: 7.11 rht.comp: Fuse rht.comp_ver: 7.11 rht.subcomp: apicurito-service-ui rht.subcomp_t: infrastructure

API Designer Generator コンポーネントの例:

com.company: Red_Hat rht.prod_name: Red_Hat_Integration rht.prod_ver: 7.11 rht.comp: Fuse rht.comp_ver: 7.11 rht.subcomp: apicurito-service-generator rht.subcomp_t: infrastructure

2.3.4. 制限された環境で API Designer をインストールする場合の注意事項

制限された環境でインストールされる OpenShift クラスターは、デフォルトでは Red Hat が提供する OperatorHub ソースにアクセスできません。これは、OperatorHub ソースのリモートソースに完全なインターネット接続が必要であるためです。このような環境で API Designer Operator をインストールするには、以下の前提条件を満たす必要があります。

- Operator Lifecycle Manager (OLM) のデフォルトのリモート OperatorHub ソースを無効にします。

- 完全なインターネットアクセスのあるワークステーションを使用して、OperatorHub コンテンツのローカルミラーを作成します。

- OLM を、デフォルトのリモートソースからではなくローカルソースから Operator をインストールし、管理するように設定します。

詳細は、OpenShift ドキュメントの ネットワークが制限された環境での Operator Lifecycle Manager の使用 を参照してください。OperatorHub のローカルミラーを作成したら、次のステップを実行できます。

- OpenShift 4.x への API Designer のインストール の説明にしたがって、ミラーリングされた OperatorHub を使用して API Designer をインストールします。

- API Designer をサービスとして OpenShift 4.x プロジェクトに追加 の説明にしたがって、API Designer をサービスとしてサービスとして追加します。

2.4. OpenShift 4.x での Fuse Console の設定

OpenShift 4.x では、Fuse Console の設定に、インストール、およびデプロイが必要になります。Fuse Console のインストールおよびデプロイには、以下のオプションがあります。

「OperatorHub を使用した OpenShift 4.x での Fuse Console のインストールおよびデプロイ」

特定の namespace で Fuse アプリケーションにアクセスするために、Fuse Console Operator を使用して Fuse Console をインストールおよびデプロイします。Operator は、Fuse Console のセキュリティー保護を処理します。

「コマンドラインを使用した OpenShift 4.x での Fuse Console のインストールおよびデプロイ」

OpenShift クラスターの複数の namespace または特定の namespace にある Fuse アプリケーションにアクセスするために、コマンドラインと Fuse Console テンプレートの 1 つを使用して Fuse Console をインストールおよびデプロイします。デプロイ前にクライアント証明書を生成して、Fuse Console をセキュアにする必要があります。

任意で、「OpenShift 4.x 上の Fuse Console のロールベースアクセス制御」の説明通りに、Fuse Console のロールベースアクセス制御 (RBAC) をカスタマイズすることができます。

2.4.1. OperatorHub を使用した OpenShift 4.x での Fuse Console のインストールおよびデプロイ

OpenShift 4.x に Fuse Console をインストールするには、OpenShift OperatorHub で提供される Fuse Console Operator を使用します。Fuse Console をデプロイするには、インストールされた Operator のインスタンスを作成します。

前提条件

-

コンテナーイメージの

registry.redhat.ioを使用した認証 で説明されているように、registry.redhat.ioでの認証を設定している。 - Fuse Console のロールベースアクセス制御 (RBAC) をカスタマイズする場合は、Fuse Console Operator のインストール先と同じ OpenShift namespace に RBAC 設定マップファイルが必要になる。OpenShift 4.x 上の Fuse Console のロールベースアクセス制御 の説明にしたがって、デフォルトの RBAC 動作を使用する場合は、設定マップファイルを指定する必要はありません。

手順

Fuse Console をインストールおよびデプロイするには、以下を行います。

-

Web ブラウザーで、

cluster admin権限を持つユーザーとして OpenShift コンソールにログインします。 - Operators をクリックした後、OperatorHub をクリックします。

- 検索フィールドウインドウに Fuse Console と入力し、Operator のリストを絞り込みます。

- Fuse Console Operator をクリックします。

Fuse Console Operator インストールウィンドウで Install をクリックします。

Create Operator Subscription フォームが表示されます。

- Update Channel には 7.11.x を選択します。

Installation Mode では、デフォルト (クラスターの特定の namespace) を受け入れます。

operator のインストール後に Fuse Console をデプロイする場合、クラスター上のすべての namespace でアプリケーションを監視するか、Fuse Console operator がインストールされた namespace のみでアプリケーションを監視するかを選択できる点に注意してください。

- Installed Namespace には、Fuse Console Operator をインストールする namespace を選択します。

Update Approval では、Automatic または Manual を選択し、Fuse Console の更新が OpenShift によってどのように対処されるかを設定します。

- Automatic (自動) 更新を選択した場合、新しいバージョンの Fuse Console Operator が使用できるようになると、人的な介入なしで OpenShfit Operator Lifecycle Manager (OLM) によって、Fuse Console の稼働中のインスタンスが自動的にアップグレードされます。

- Manual (手動) 更新を選択した場合、Operator の新しいバージョンが使用できるようになると、OLM によって更新リクエストが作成されます。クラスター管理者は、更新リクエストを手動で承認して、Fuse Console Operator を新しいバージョンに更新する必要があります。

Install をクリックします。

OpenShift によって、Fuse Console Operator が現在の namespace にインストールされます。

- インストールを確認するには、Operators をクリックした後、Installed Operators をクリックします。Operator のリストに Fuse Console が表示されます。

OpenShift Web コンソールで Fuse Console をデプロイするには、以下を行います。

- Installed Operators のリストで、Name 列の Fuse Console をクリックします。

Provided APIs の Operator Details ページで、Create Instance をクリックします。

設定のデフォルト値を使用するか、任意でデフォルト値を編集します。

Fuse Console のパフォーマンスを向上する必要がある場合 (高可用性環境など)、Replicas で Fuse Console に割り当てられた Pod 数を増やすことができます。

Rbac (ロールベースアクセス制御) では、デフォルトの RBAC 動作をカスタマイズする場合や、Fuse Console Operator をインストールした namespace に ConfigMap ファイルがすでに存在する場合にのみ、config Map フィールドに値を指定します。RBAC の詳細は、OpenShift 4.x 上の Fuse Console のロールベースアクセス制御 を参照してください。

Nginx については、Fuse Console Operator インストールのパフォーマンスチューニング を参照してください。

Create をクリックします。

Fuse Console Operator Details ページが開き、デプロイメントの状態が表示されます。

Fuse Console を開くには以下を行います。

namespace デプロイメントの場合: OpenShift Web コンソールで、Fuse Console の operator をインストールしたプロジェクトを開き、Overview を選択します。Project Overview ページで Launcher セクションまで下方向にスクロールし、Fuse Console のリンクをクリックします。

cluster デプロイメントでは、OpenShift Web コンソールのタイトルバーで、グリッドアイコン (

) をクリックします。ポップアップメニューの Red Hat アプリケーション の下にある、Fuse Console の URL リンクをクリックします。

) をクリックします。ポップアップメニューの Red Hat アプリケーション の下にある、Fuse Console の URL リンクをクリックします。

Fuse Console にログインします。

ブラウザーに Authorize Access ページが表示され、必要なパーミッションが表示されます。

Allow selected permissions をクリックします。

Fuse Console がブラウザーで開き、アクセス権限のある Fuse アプリケーション Pod が表示されます。

表示するアプリケーションの Connect をクリックします。

新しいブラウザーウィンドウが開かれ、Fuse Console にアプリケーションが表示されます。

2.4.2. コマンドラインを使用した OpenShift 4.x での Fuse Console のインストールおよびデプロイ

OpenShift 4.x では、次のデプロイメントオプションの 1 つを選択して、コマンドラインから Fuse Console をインストールおよびデプロイできます。

- cluster - Fuse Console は、OpenShift クラスターで複数の namespace (プロジェクト) 全体にデプロイされた Fuse アプリケーションを検索し、接続することができます。このテンプレートをデプロイするには、OpenShift クラスターの管理者ロールが必要です。

- ロールベースアクセス制御のあるクラスター - 設定可能なロールベースアクセス制御 (RBAC) のあるクラスターテンプレート。詳細は、OpenShift 4.x 上の Fuse Console のロールベースアクセス制御 を参照してください。

- namespace - Fuse Console は特定の OpenShift プロジェクト (namespace) にアクセスできます。このテンプレートをデプロイするには、OpenShift プロジェクトの管理者ロールが必要です。

- ロールベースアクセス制御のある namespace - 設定可能な RBAC のある namespace テンプレート。詳細は、OpenShift 4.x 上の Fuse Console のロールベースアクセス制御 を参照してください。

Fuse Console テンプレートのパラメーターリストを表示するには、以下の OpenShift コマンドを実行します。

oc process --parameters -f https://raw.githubusercontent.com/jboss-fuse/application-templates/application-templates-2.1.0.fuse-sb2-7_11_1-00016-redhat-00002/fuse-console-namespace-os4.json

前提条件

- Fuse Console をインストールおよびデプロイする前に、OpenShift 4.x で Fuse Console をセキュア化するための証明書の生成 で説明されているとおりに、サービス署名認証局で署名されたクライアント証明書を生成している。

-

OpenShift クラスターの

cluster adminロールがある。 -

コンテナーイメージの

registry.redhat.ioを使用した認証 で説明されているように、registry.redhat.ioでの認証を設定している。 - OpenShift 4.x サーバーでの Fuse イメージストリームおよびテンプレートのインストール の説明どおりに Fuse Console イメージストリーム (およびその他の Fuse イメージストリーム) がインストールされている。

手順

以下のコマンドを実行してすべてのテンプレートのリストを取得し、Fuse Console イメージストリームがインストールされていることを確認します。

oc get template -n openshift

任意で、すでにインストールされているイメージストリームを新しいリリースタグで更新する場合は、以下のコマンドを使用して openshift namespace に Fuse Console イメージをインポートします。

oc import-image fuse7/fuse-console-rhel8:1.10 --from=registry.redhat.io/fuse7/fuse-console-rhel8:1.10 --confirm -n openshift

以下のコマンドを実行して、Fuse Console の APP_NAME の値を取得します。

oc process --parameters -f TEMPLATE-FILENAME

ここで、

TEMPLATE-FILENAMEは以下のテンプレートのいずれかになります。クラスターテンプレート:

`https://github.com/jboss-fuse/application-templates/blob/application-templates-2.1.0.fuse-sb2-7_11_1-00016-redhat-00002//fuse-console-cluster-os4.json`

設定可能な RBAC のあるクラスターテンプレート:

`https://github.com/jboss-fuse/application-templates/blob/application-templates-2.1.0.fuse-sb2-7_11_1-00016-redhat-00002//fuse-console-cluster-rbac.yml`

namespace テンプレート:

`https://github.com/jboss-fuse/application-templates/blob/application-templates-2.1.0.fuse-sb2-7_11_1-00016-redhat-00002//fuse-console-namespace-os4.json`

設定可能な RBAC のある namespace テンプレート:

`https://github.com/jboss-fuse/application-templates/blob/application-templates-2.1.0.fuse-sb2-7_11_1-00016-redhat-00002//fuse-console-namespace-rbac.yml`

たとえば、設定可能な RBAC のあるクラスターテンプレートの場合は、以下のコマンドを実行します。

oc process --parameters -f https://raw.githubusercontent.com/jboss-fuse/application-templates/application-templates-2.1.0.fuse-sb2-7_11_1-00016-redhat-00002/fuse-console-cluster-rbac.yml

以下のコマンドを使用して、OpenShift 4.x での Fuse Console のセキュア化 で生成した証明書からシークレットを作成し、Fuse Console にマウントします。コマンドの APP_NAME は、Fuse Console アプリケーションの名前に置き換えます。

oc create secret tls APP_NAME-tls-proxying --cert server.crt --key server.key

以下のコマンドを実行して、ローカルにコピーされた Fuse Console テンプレートをベースとした新しいアプリケーションを作成します。コマンドの myproject は OpenShift プロジェクトの名前、mytemp は Fuse Console テンプレートが含まれるローカルディレクトリーへのパス、myhost は Fuse Console にアクセスするホストの名前に置き換えます。

クラスターテンプレートの場合:

oc new-app -n myproject -f https://raw.githubusercontent.com/jboss-fuse/application-templates/application-templates-2.1.0.fuse-sb2-7_11_1-00016-redhat-00002/fuse-console-cluster-os4.json -p ROUTE_HOSTNAME=myhost

RBAC テンプレートのあるクラスターの場合:

oc new-app -n myproject -f https://raw.githubusercontent.com/jboss-fuse/application-templates/application-templates-2.1.0.fuse-sb2-7_11_1-00016-redhat-00002/fuse-console-cluster-rbac.yml -p ROUTE_HOSTNAME=myhost

Namespace テンプレートの場合:

oc new-app -n myproject -f https://raw.githubusercontent.com/jboss-fuse/application-templates/application-templates-2.1.0.fuse-sb2-7_11_1-00016-redhat-00002/fuse-console-namespace-os4.json

RBAC テンプレートのある namespace の場合:

oc new-app -n myproject -f https://raw.githubusercontent.com/jboss-fuse/application-templates/application-templates-2.1.0.fuse-sb2-7_11_1-00016-redhat-00002/fuse-console-namespace-rbac.yml

OpenShift Web コンソールを開くように Fuse Console を設定するには、以下のコマンドを実行して

OPENSHIFT_WEB_CONSOLE_URL環境変数を設定します。oc set env dc/${APP_NAME} OPENSHIFT_WEB_CONSOLE_URL=`oc get -n openshift-config-managed cm console-public -o jsonpath={.data.consoleURL}`以下のコマンドを実行して、Fuse Console デプロイメントの状態と URL を取得します。

oc status

- ブラウザーから Fuse Console にアクセスするには、手順 7. で返される URL (例: https://fuse-console.192.168.64.12.nip.io) を使用します。

2.4.2.1. OpenShift 4.x で Fuse Console をセキュア化するための証明書の生成

OpenShift 4.x で、Fuse Console プロキシーと Jolokia エージェントとの間の接続をセキュアにするには、Fuse Console をデプロイする前にクライアント証明書を生成する必要があります。サービス署名認証局の秘密鍵を使用して、クライアント証明書を署名する必要があります。

この手順は、コマンドラインを使用して Fuse Console をインストールおよびデプロイしている場合に のみ 実行する必要があります。Fuse Console Operator を使用している場合は、Fuse Console Operator がこのタスクを処理します。

各 OpenShift クラスターに別のクライアント証明書を生成し、署名する必要があります。複数のクラスターに同じ証明書を使用しないでください。

前提条件

-

OpenShift クラスターにアクセス可能な

cluster admin権限がある。 複数の OpenShift クラスターの証明書を生成し、現在のディレクトリーに別のクラスターの証明書を生成している場合は、以下のいずれかを実行して、現在のクラスターに別の証明書を生成するようにします。

-

現在のディレクトリーから既存の証明書ファイル (

ca.crt、ca.key、およびca.srl) を削除します。 別の作業ディレクトリーに移動します。たとえば、現在の作業ディレクトリーの名前が

cluster1の場合、新しいcluster2ディレクトリーを作成し、作業ディレクトリーをそのディレクトリーに変更します。mkdir ../cluster2cd ../cluster2

-

現在のディレクトリーから既存の証明書ファイル (

手順

cluster admin 権限を持つユーザーとして OpenShift にログインします。

oc login -u <user_with_cluster_admin_role>

以下のコマンドを実行して、サービス署名認証局のキーを取得します。

以下を実行して、証明書を取得します。

oc get secrets/signing-key -n openshift-service-ca -o "jsonpath={.data['tls\.crt']}" | base64 --decode > ca.crt以下を実行して、秘密鍵を取得します。

oc get secrets/signing-key -n openshift-service-ca -o "jsonpath={.data['tls\.key']}" | base64 --decode > ca.key

Kubernetes certificates administration の説明にしたがって、

easyrsa、openssl、またはcfsslを使用して、クライアント証明書を生成します。以下に、openssl を使用したコマンドの例を示します。

秘密鍵を生成します。

openssl genrsa -out server.key 2048

CSR 設定ファイルを作成します。

cat <<EOT >> csr.conf [ req ] default_bits = 2048 prompt = no default_md = sha256 distinguished_name = dn [ dn ] CN = fuse-console.fuse.svc [ v3_ext ] authorityKeyIdentifier=keyid,issuer:always keyUsage=keyEncipherment,dataEncipherment,digitalSignature extendedKeyUsage=serverAuth,clientAuth EOT

ここでは、

CNパラメーターの値はアプリケーション名とアプリケーションが使用する namespace を参照します。CSR を生成します。

openssl req -new -key server.key -out server.csr -config csr.conf

署名済みの証明書を発行します。

openssl x509 -req -in server.csr -CA ca.crt -CAkey ca.key -CAcreateserial -out server.crt -days 10000 -extensions v3_ext -extfile csr.conf

次のステップ

コマンドラインを使用した OpenShift 4.x での Fuse Console のインストールおよびデプロイ で説明されているように、Fuse Console のシークレットを作成するには、この証明書が必要です。

2.4.3. OpenShift 4.x 上の Fuse Console のロールベースアクセス制御

Fuse Console は、OpenShift によって提供されるユーザー承認に応じてアクセスを推測する、ロールベースアクセス制御 (RBAC) を提供します。Fuse Console では、RBAC はユーザーが Pod で MBean 操作を実行できるかどうかを判断します。

OpenShift の承認に関する詳細は、OpenShift ドキュメントの RBAC の使用によるパーミッションの定義および適用 を参照してください。

Operator を使用して OpenShift に Fuse Console をインストールした場合、ロールベースのアクセスはデフォルトで有効になります。

テンプレートを使用したインストールによって Fuse Console のロールベースアクセスを実装する場合は、RBAC で設定可能なテンプレートの 1 つ (fuse-console-cluster-rbac.yml または fuse-console-namespace-rbac.yml) を使用して、コマンドラインを使用した OpenShift 4.x での Fuse Console のインストールおよびデプロイ の説明どおりに Fuse Console をインストールする必要があります。

Fuse Console RBAC は、OpenShift の Pod リソースでユーザーの verb (動詞) アクセスを利用して、Fuse Console の Pod の MBean 操作にユーザーがアクセスできるかどうかを判断します。デフォルトでは、Fuse Console には 2 つのユーザーロールがあります。

admin

ユーザーが OpenShift で Pod を 更新 できる場合、ユーザーには Fuse Console の admin ロールが付与されます。ユーザーは、Fuse Console で、その Pod に対して 書き込み の MBean 操作を実行できます。

viewer

ユーザーが OpenShift で Pod を 取得 できる場合、ユーザーには Fuse Console の viewer ロールが付与されます。ユーザーは、Fuse Console で、その Pod に対して 読み取り専用 の MBean 操作を実行できます。

RBAC 以外のテンプレートを使用して Fuse Console をインストールした場合、Pod リソースで update verb (動詞) が付与された OpenShift ユーザーのみが Fuse Console の MBeans 操作の実行が許可されます。Pod リソースで get verb (動詞) を付与されたユーザーは、Pod を 表示 できますが、Fuse Console の操作は実行できません。

関連情報

2.4.3.1. OpenShift 4.x での Fuse Console のアクセスロールの判断

Fuse Console のロールベースアクセス制御は、Pod に対するユーザーの OpenShift パーミッションから推測されます。特定のユーザーに付与された Fuse Console のアクセスロールを判断するには、Pod に対してユーザーに付与された OpenShift パーミッションを取得します。

前提条件

- ユーザーの名前を知っている必要があります。

- Pod の名前を知っている必要があります。

手順

ユーザーが Pod に対して Fuse Console の admin ロールを持っているかどうかを確認するには、以下のコマンドを実行してユーザーが OpenShift で Pod を更新できるかどうかを確認します。

oc auth can-i update pods/<pod> --as <user>

応答が

yesの場合、ユーザーはその Pod に対して Fuse Console の admin ロールを持っています。ユーザーは、Fuse Console で、その Pod に対して 書き込み の MBean 操作を実行できます。ユーザーが Pod に対して Fuse Console の viewer ロールを持っているかどうかを確認するには、以下のコマンドを実行してユーザーが OpenShift で Pod を取得できるかどうかを確認します。

oc auth can-i get pods/<pod> --as <user>

応答が

yesの場合、ユーザーはその Pod に対して Fuse Console の viewer ロールを持っています。ユーザーは、Fuse Console で、その Pod に対して 読み取り専用 の MBean 操作を実行できます。コンテキストによっては、Fuse Console でオプションを無効にしたり、ユーザーによる 書き込み MBean 操作の試行時にこのユーザーの操作は許可されないという内容のメッセージを表示したりして、viewer ロールを持つユーザーによる 書き込み MBean 操作が実行されないようにします。応答が

noの場合、ユーザーは Fuse Console のロールにバインドされず、ユーザーは Fuse Console で Pod を確認できません。

2.4.3.2. OpenShift 4.x での Fuse Console へのロールベースアクセスのカスタマイズ

OperatorHub を使用して Fuse Console をインストールした場合、OpenShift 4.x 上の Fuse Console のロールベースアクセス制御 で説明されているように、ロールベースアクセス制御 (RBAC) はデフォルトで有効になります。Fuse Console の RBAC 動作をカスタマイズする場合、Fuse Console をデプロイする前に ConfigMap ファイル (カスタムの RBAC 動作を定義する) を指定する必要があります。カスタム ConfigMap ファイルは、Fuse Console Operator をインストールした namespace に配置する必要があります。

コマンドラインテンプレートを使用して Fuse Console をインストールする場合、deployment-cluster-rbac.yml および deployment-namespace-rbac.yml テンプレートによって、設定ファイル (ACL.yml) が含まれる ConfigMap が作成されます。設定ファイルでは、MBean 操作に許可されるロールが定義されます。

前提条件

-

OperatorHub または Fuse Console の RBAC テンプレート (

deployment-cluster-rbac.ymlまたはdeployment-namespace-rbac.yml) の 1 つを使用して、Fuse Console がインストール済みである必要があります。

手順

Fuse Console の RBAC ロールをカスタマイズする場合は、以下を行います。

コマンドラインを使用して Fuse Console をインストールした場合、インストールテンプレートにはデフォルトの ConfigMap ファイルが含まれるため、次のステップを省略できます。

OperatorHub を使用して Fuse Console をインストールした場合、Fuse Console をデプロイする前に RBAC ConfigMap を作成します。

現在の OpenShift プロジェクトが Fuse Console をインストールするプロジェクトであることを確認します。たとえば、Fuse Console を fusetest プロジェクトにインストールするには、以下のコマンドを実行します。

oc project fusetest

テンプレートから Fuse Console RBAC ConfigMap ファイルを作成するには、以下のコマンドを実行します。

oc process -f https://raw.githubusercontent.com/jboss-fuse/application-templates/2.1.x.sb2.redhat-7-8-x/fuse-console-operator-rbac.yml -p APP_NAME=fuse-console | oc create -f -

以下のコマンドを実行してエディターで ConfigMap を開きます。

oc edit cm $APP_NAME-rbac

以下に例を示します。

oc edit cm fuse-console-rbac

- ファイルを編集します。

- ファイルを保存して変更を適用します。Fuse Console の Pod は OpenShift によって自動的に再起動されます。

2.4.3.3. OpenShift 4.x での Fuse Console のロールベースアクセス制御の無効化

コマンドラインを使用して Fuse Console をインストール し、Fuse Console の RBAC テンプレートのいずれかを指定した場合、Fuse Console の HAWTIO_ONLINE_RBAC_ACL 環境変数は、ロールベースアクセス制御 (RBAC) の ConfigMap 設定ファイルのパスを OpenShift サーバーに渡します。HAWTIO_ONLINE_RBAC_ACL 環境変数が指定されていない場合、RBAC のサポートは無効になり、Pod リソース (OpenShift の) で update verb (動詞) が付与されたユーザーのみが Fuse Console の Pod で MBean 操作を呼び出すことが承認されます。

OperatorHub を使用して Fuse Console をインストールする場合は、ロールベースのアクセスはデフォルトで有効になり、HAWTIO_ONLINE_RBAC_ACL 環境変数は適用されません。

前提条件

コマンドラインを使用して Fuse Console がインストール済みで、Fuse Console の RBAC テンプレート (deployment-cluster-rbac.yml または deployment-namespace-rbac.yml) のいずれかを指定している。

手順

Fuse Console のロールベースのアクセスを無効にするには、以下を実行します。

- OpenShift で、Fuse Console の Deployment Config リソースを編集します。

HAWTIO_ONLINE_RBAC_ACL環境変数の定義をすべて削除します。(値を消去するだけでは不十分です)。

- ファイルを保存して変更を適用します。Fuse Console の Pod は OpenShift によって自動的に再起動されます。

2.4.4. OpenShift 4.x での Fuse Console のアップグレード

Red Hat OpenShift 4.x では、Red Hat Fuse Operator などの Operator の更新が処理されます。詳細は、OpenShift ドキュメントの Operator を参照してください。

その後、アプリケーションの設定方法によっては、Operator の更新でアプリケーションのアップグレードをトリガーできるようになります。

Fuse Console アプリケーションでは、アプリケーションカスタムリソース定義の .spec.version フィールドを編集して、アプリケーションのアップグレードをトリガーすることもできます。

前提条件

- OpenShift クラスターの管理者権限が必要です。

手順

Fuse Console アプリケーションをアップグレードするには、以下を行います。

ターミナルウィンドウで、以下のコマンドを使用してアプリケーションカスタムリソース定義の

.spec.versionフィールドを変更します。oc patch -n <project-name> <custom-resource-name> --type='merge' -p '{"spec":{"version":"1.7.1"}}'以下に例を示します。

oc patch -n myproject hawtio/example-fuseconsole --type='merge' -p '{"spec":{"version":"1.7.1"}}'アプリケーションの状態が更新されたことを確認します。

oc get -n myproject hawtio/example-fuseconsole

応答には、バージョン番号などのアプリケーションに関する情報が表示されます。

NAME AGE URL IMAGE example-fuseconsole 1m https://fuseconsole.192.168.64.38.nip.io docker.io/fuseconsole/online:1.7.1

.spec.versionフィールドの値を変更すると、OpenShift によってアプリケーションが自動的に再デプロイされます。バージョンの変更によってトリガーされた再デプロイの状態をチェックするには、以下を実行します。

oc rollout status deployment.v1.apps/example-fuseconsole

正常にデプロイされた場合は以下の応答が表示されます。

deployment "example-fuseconsole" successfully rolled out

2.4.5. OpenShift 4.x サーバーでの Fuse イメージストリームおよびテンプレートのアップグレード

OpenShift Container Platform 4.x は、OpenShift namespace で操作する Samples Operator を使用して、Red Hat Enterprise Linux (RHEL) ベースの OpenShift Container Platform イメージストリームおよびテンプレートをアップグレードおよび更新します。

Fuse on OpenShift イメージストリームおよびテンプレートをアップグレードするには以下を実行します。

- Samples Operator の再設定

Fuse イメージストリームおよびテンプレートを

Skipped Imagestreams and Skipped Templatesフィールドに追加します。- Skipped Imagestreams (スキップされるイメージストリーム): Samples Operator のインベントリーにあるが、クラスター管理者の希望により Operator が無視または管理しないようにするイメージストリーム。

- Skipped Templates (スキップされるテンプレート): Samples Operator のインベントリーにあるが、クラスター管理者の希望により Operator が無視または管理しないようにするテンプレート。

前提条件

- OpenShift サーバーにアクセスできる必要があります。

-

registry.redhat.ioへの認証が設定されている。

手順

- OpenShift 4 サーバーを起動します。

OpenShift サーバーに管理者としてログインします。

oc login --user system:admin --token=my-token --server=https://my-cluster.example.com:6443

docker-registry シークレットを作成したプロジェクトを使用していることを確認します。

oc project openshift

Samples Operator の現在の設定を表示します。

oc get configs.samples.operator.openshift.io -n openshift-cluster-samples-operator -o yaml

Samples Operator が、追加された Fuse テンプレートおよびイメージストリームを無視するよう設定します。

oc edit configs.samples.operator.openshift.io -n openshift-cluster-samples-operator

Fuse imagestreams の Skipped Imagestreams セクションを追加し、Fuse および Spring Boot 2 のテンプレートを Skipped Templates セクションに追加します。

[...] spec: architectures: - x86_64 managementState: Managed skippedImagestreams: - fuse-console-rhel8 - fuse-eap-openshift-jdk8-rhel7 - fuse-eap-openshift-jdk11-rhel8 - fuse-java-openshift-rhel8 - fuse-java-openshift-jdk11-rhel8 - fuse-karaf-openshift-rhel8 - fuse-karaf-openshift-jdk11-rhel8 - fuse-apicurito-generator-rhel8 - fuse-apicurito-rhel8 skippedTemplates: - s2i-fuse711-eap-camel-amq - s2i-fuse711-eap-camel-cdi - s2i-fuse711-eap-camel-cxf-jaxrs - s2i-fuse711-eap-camel-cxf-jaxws - s2i-fuse711-karaf-camel-amq - s2i-fuse711-karaf-camel-log - s2i-fuse711-karaf-camel-rest-sql - s2i-fuse711-karaf-cxf-rest - s2i-fuse711-spring-boot-2-camel-amq - s2i-fuse711-spring-boot-2-camel-config - s2i-fuse711-spring-boot-2-camel-drools - s2i-fuse711-spring-boot-2-camel-infinispan - s2i-fuse711-spring-boot-2-camel-rest-3scale - s2i-fuse711-spring-boot-2-camel-rest-sql - s2i-fuse711-spring-boot-2-camel - s2i-fuse711-spring-boot-2-camel-xa - s2i-fuse711-spring-boot-2-camel-xml - s2i-fuse711-spring-boot-2-cxf-jaxrs - s2i-fuse711-spring-boot-2-cxf-jaxws - s2i-fuse711-spring-boot-2-cxf-jaxrs-xml - s2i-fuse711-spring-boot-2-cxf-jaxws-xml

Fuse on OpenShift イメージストリームをアップグレードします。

BASEURL=https://raw.githubusercontent.com/jboss-fuse/application-templates/application-templates-2.1.0.fuse-sb2-7_11_1-00016-redhat-00002 oc replace -n openshift -f ${BASEURL}/fis-image-streams.jsonFuse on OpenShift クイックスタートテンプレートをアップグレードします。

for template in eap-camel-amq-template.json \ eap-camel-cdi-template.json \ eap-camel-cxf-jaxrs-template.json \ eap-camel-cxf-jaxws-template.json \ karaf-camel-amq-template.json \ karaf-camel-log-template.json \ karaf-camel-rest-sql-template.json \ karaf-cxf-rest-template.json ; do oc replace -n openshift \ ${BASEURL}/quickstarts/${template} doneSpring Boot 2 クイックスタートテンプレートをアップグレードします。

for template in spring-boot-2-camel-amq-template.json \ spring-boot-2-camel-config-template.json \ spring-boot-2-camel-drools-template.json \ spring-boot-2-camel-infinispan-template.json \ spring-boot-2-camel-rest-3scale-template.json \ spring-boot-2-camel-rest-sql-template.json \ spring-boot-2-camel-template.json \ spring-boot-2-camel-xa-template.json \ spring-boot-2-camel-xml-template.json \ spring-boot-2-cxf-jaxrs-template.json \ spring-boot-2-cxf-jaxws-template.json \ spring-boot-2-cxf-jaxrs-xml-template.json \ spring-boot-2-cxf-jaxws-xml-template.json ; do oc replace -n openshift \ ${BASEURL}/quickstarts/${template} done(オプション) アップグレードされた Fuse on OpenShift テンプレートを表示します。

oc get template -n openshift

2.4.6. OpenShift 4.x での Fuse Console のパフォーマンスチューニング

デフォルトでは、Fuse Console は以下の Nginx 設定を使用します。

-

clientBodyBufferSize: 256k -

proxyBuffers: 16 128k -

subrequestOutputBufferSize: 10m

注記: これらの設定の説明は、Nginx のドキュメント (http://nginx.org/en/docs/dirindex.html) を参照してください。

Fuse Console のパフォーマンスを調整するには、clientBodyBufferSize、proxyBuffers、および subrequestOutputBufferSize 環境変数を設定します。たとえば、Fuse Console を使用して多数の Pod およびルート (合計 100 のルートなど) を監視する場合、Fuse Console の subrequestOutputBufferSize 環境変数を 60m から 100m の間で設定することで、ロードタイムアウトの問題を解決することができます 。

これらの環境変数の設定方法は、OpenShift 4.x に Fuse Console をインストールする方法によって異なります。

- Fuse Console Operator の使用

- Fuse Console テンプレートの使用

2.4.6.1. Fuse Console Operator インストールのパフォーマンスチューニング

Openshift 4.x では、Fuse Console のデプロイ前後に Nginx パフォーマンスチューニング環境変数を設定できます。これを後で行うと、OpenShift は Fuse Console を再デプロイします。

前提条件

-

OpenShift クラスターにアクセス可能な

cluster admin権限がある。 - OperatorHub を使用した OpenShift 4.x での Fuse Console のインストールおよびデプロイの説明どおりに、Fuse Console Operator がインストールされている必要があります。

手順

Fuse Console のデプロイ前後に環境変数を設定できます。

Fuse Console をデプロイする前に環境変数を設定するには、以下を実行します。

- OpenShift Web コンソールから、Fuse Console Operator がインストールされているプロジェクトで、Operators> Installed Operators> Red Hat Integration - Fuse Console を選択します。

- Hawtio タブをクリックし、Create Hawtio をクリックします。

- Create Hawtio ページで、Form ビュー で Config> Nginx セクションまでスクロールダウンします。

Nginx セクションをデプロイメントしてから、環境変数を設定します。以下に例を示します。

- clientBodyBufferSize: 256k

- proxyBuffers: 16 128k

- subrequestOutputBufferSize: 100m

- 設定を保存します。

- Create をクリックして Fuse Console をデプロイします。

- デプロイメントが完了したら、Deployments> fuse-console ページを開いて Environment をクリックし、環境変数がリストにあることを確認します。

Fuse Console のデプロイ後に環境変数を設定するには、以下を実行します。

- OpenShift Web コンソールで、Fuse Console がデプロイされているプロジェクトを開きます。

- Operators> Installed Operators> Red Hat Integration - Fuse Console の順に選択します。

- Hawtio タブをクリックし、fuse-console をクリックします。

- Actions> Edit Hawtio を選択します。

-

Editor ウィンドウで、

specセクションまでスクロールダウンします。 以下のように、

specセクションで、新規のnginxセクションを追加し、1 つ以上の環境変数を指定します。apiVersion: hawt.io/v1alpha1 kind: Hawtio metadata: name: fuse-console spec: type: Namespace nginx: clientBodyBufferSize: 256k proxyBuffers: 16 128k subrequestOutputBufferSize: 100m . . .Save をクリックします。

OpenShift は Fuse Console を再デプロイします。

- 再デプロイメントが完了したら、Workloads> Deployments> fuse-console ページを開いてから Environment をクリックし、リストの環境変数を確認します。

2.4.6.2. Fuse Console テンプレートインストールのパフォーマンスチューニング

Openshift 4.x では、Fuse Console のデプロイ前後に Nginx パフォーマンスチューニング環境変数を設定できます。これを後で行うと、OpenShift は Fuse Console を再デプロイします。

前提条件

-

OpenShift クラスターにアクセス可能な

cluster admin権限がある。 - OpenShift 4.x サーバーでの Fuse イメージストリームおよびテンプレートのインストールの説明どおりに、OpenShift に Fuse Console テンプレートがインストールされている必要があります。

手順

Fuse Console のデプロイ前後に環境変数を設定できます。

Fuse Console をデプロイする前に環境変数を設定するには、以下を実行します。

使用する Fuse Console テンプレートを確認します。

-

クラスターテンプレート (

fuse-console-cluster-os4.json) -

設定可能な RBAC が含まれるクラスターテンプレート (

fuse-console-cluster-rbac.yml) -

namespace テンプレート (

fuse-console-namespace-os4.json) -

設定可能な RBAC が含まれる namespace テンプレート (

fuse-console-namespace-rbac.yml)

-

クラスターテンプレート (

以下の例のように、Fuse Console に使用する Fuse Console テンプレートのローカルコピーを編集し、

NGINX_CLIENT_BODY_BUFFER_SIZE、NGINX_PROXY_BUFFERS、および/またはNGINX_SUBREQUEST_OUTPUT_BUFFER_SIZEの環境変数を追加します。apiVersion: apps.openshift.io/v1 kind: DeploymentConfig metadata: name: fuse-console spec: template: spec: containers: - env: - name: NGINX_CLIENT_BODY_BUFFER_SIZE value: 256k - name: NGINX_PROXY_BUFFERS value: 16 128k - name: NGINX_SUBREQUEST_OUTPUT_BUFFER_SIZE value: 100m- 変更を保存します。

- OpenShift 4.x での Fuse Console の設定の説明にあるように、Fuse Console をインストールおよびデプロイする手順にしたがいます。

Fuse Console のデプロイ後に環境変数を設定するには、以下を実行します。

- ターミナルウィンドウで、OpenShift クラスターにログインします。

Fuse Console がデプロイされているプロジェクトを開きます。たとえば、Fuse Console が

myfuseプロジェクトにデプロイされている場合は、以下のコマンドを使用します。oc project myfuseFuse Console デプロイメントの名前を取得します。

oc get deploymentsこのコマンドは、現在のプロジェクトで実行しているデプロイメントのリストを返します。以下に例を示します。

NAME READY UP-TO-DATE AVAILABLE AGE fuse-console 1/1 1 1 114m

以下のいずれかのコマンドを実行して、Fuse Console デプロイメントの環境変数を設定します。

oc set env dc/fuse-console NGINX_CLIENT_BODY_BUFFER_SIZE="256k" oc set env dc/fuse-console NGINX_PROXY_BUFFERS="16 128k" oc set env dc/fuse-console NGINX_SUBREQUEST_OUTPUT_BUFFER_SIZE="10m"

OpenShift は Fuse Console を再デプロイします。

再デプロイメントが完了したら、環境変数の設定を確認します。

Fuse Console の Pod 名を取得します。

oc get pods

次のコマンドを実行して、環境設定を表示します。

oc exec <fuse-console-podname> -- cat /opt/app-root/etc/nginx.d/nginx-gateway.conf | grep "Performance tuning" -A 3

たとえば、Pod 名が

fuse-console-6646cbbd4c-9rplgである場合は、以下のコマンドを実行します。oc exec fuse-console-6646cbbd4c-9rplg -- cat /opt/app-root/etc/nginx.d/nginx-gateway.conf | grep "Performance tuning" -A 3

2.4.6.3. Fuse Console でアプリケーションを表示するためのパフォーマンスチューニング

Fuse console の強化されたパフォーマンスチューニング機能により、多数の MBean を持つアプリケーションを表示できます。この機能を使用するには、次の手順を実行します。

前提条件

-

OpenShift クラスターにアクセス可能な

cluster admin権限がある。 - OperatorHub を使用した OpenShift 4.x での Fuse Console のインストールおよびデプロイの説明どおりに、Fuse Console Operator がインストールされている必要があります。

手順

アプリケーションのメモリー制限を増やします。

Fuse コンソールに到達する前にアプリケーションが OOM エラーでクラッシュしないように、メモリー制限を (たとえば 256Mi から 512 Mi に) 増やす必要があります。Fuse クイックスタートの場合、アプリケーションの

src/main/jkube/deployment.ymlファイルを編集します。spec: template: spec: containers: - resources: [...] limits: cpu: "1.0" memory: 512Mi- Fuse Console Deployment または DeploymentConfig に十分なメモリー制限があることを確認してください。不十分な場合は、たとえば 200Mi から 512Mi に制限を増やします。

- nginx ログにクライアントへの送信中に「too big subrequest response while sending to client」エラーが表示される場合は、「Fuse Console Operator インストールのパフォーマンスチューニング」 セクションに記載される解決策を適用します。

2.5. OpenShift で Fuse アプリケーションを監視するための Prometheus の設定

2.5.1. Prometheus の概要

Prometheus は、Red Hat OpenShift 環境にデプロイされたサービスの監視に使用できる、システムおよびサービスのオープンソースの監視およびアラートツールキットです。Prometheus は、指定の間隔で設定されたサービスからメトリックを収集および保存します。さらに、ルール式の評価や結果の表示を行い、指定の条件が true になるとアラートをトリガーできます。

Prometheus に対する Red Hat のサポートは、Red Hat 製品ドキュメントに記載されているセットアップと推奨設定に限定されます。

OpenShift サービスを監視するには、エンドポイントを Prometheus 形式に公開するように各サービスを設定する必要があります。このエンドポイントは、メトリックのリストとメトリックの現在の値を提供する HTTP インターフェイスです。Prometheus は定期的にターゲット定義の各エンドポイントをスクレイピングし、収集したデータをそのデータベースに書き込みます。Prometheus は、現在実行中のセッションだけでなく、長期間にわたってデータを収集します。Prometheus は、データ上でクエリーをグラフィカルに可視化し、実行できるように、データを格納します。

2.5.1.1. Prometheus クエリー

Prometheus Web インターフェイスでは、Prometheus Query Language (PromQL) でクエリーを作成して、収集したデータを選択し、集約することができます。

たとえば、以下のクエリーを使用すると、Prometheus が直近の 5 分間に記録したすべての時系列データから、メトリック名が http_requests_total である値をすべて選択することができます。

http_requests_total[5m]

クエリーの結果をさらに定義または絞り込むには、メトリックのラベル (key:value ペア) を指定します。たとえば、以下のクエリーを使用すると、Prometheus が直近の 5 分間に記録したすべて時系列データから、メトリック名が http_requests_total でかつジョブラベルが integration に設定されている値をすべて選択することができます。

http_requests_total{job="integration"}[5m]2.5.1.2. Prometheus データの表示オプション

Prometheus がクエリーの結果を処理する方法を指定できます。

- Prometheus データを表データとして Prometheus の式ブラウザーで表示します。

- Prometheus HTTP API 経由で外部システムで Prometheus データを消費します。

Prometheus データをグラフで表示します。

Prometheus は、収集するデータのデフォルトグラフィカルビューを提供します。Prometheus メトリックを表示するより堅牢なグラフィカルダッシュボードが必要な場合は、Grafana を選択するのが一般的です。

注記Grafana はコミュニティーがサポートする機能です。Grafana をデプロイして Red Hat の製品を監視する設定は、Red Hat の実稼働環境におけるサービスレベルアグリーメント (SLA) の対象外です。

PromQL 言語を使用して、Prometheus の Alertmanager ツール で通知を設定することもできます。

2.5.2. 4.13 用の Prometheus の設定

Prometheus を設定するには、クラスターに Prometheus Operator のカスタムリソース定義をインストールし、Prometheus を Fuse アプリケーションが含まれる OpenShift プロジェクトに追加します。

前提条件

-

OpenShift クラスターにアクセス可能な

cluster admin権限がある。 - Fuse on OpenShift ガイド の説明にしたがって Fuse on OpenShift イメージおよびテンプレートをインストールして、OpenShift クラスターを準備している。

- クラスターで OpenShift プロジェクトを作成し、Fuse アプリケーションをそのプロジェクトに追加されている必要があります。

手順

管理者権限で OpenShift にログインします。

oc login --user system:admin --token=my-token --server=https://my-cluster.example.com:6443

cluster-monitoring-config.ymlという名前のファイルを作成します。apiVersion: v1 kind: ConfigMap metadata: name: cluster-monitoring-config namespace: openshift-monitoring data: config.yaml: | enableUserWorkload: true

クラスターモニタリング設定を openshift-monitoring namespace に適用します。

oc create -f cluster-monitoring-config.yml -n openshift-monitoring

サービスモニター には、Prometheus が OpenShift Container Platform 上の特定のサービスおよびプロジェクト (namespace) のメトリックを収集するための指示が含まれています。

- サービスモニターをインストールするには、以下を実行します。+

oc process -f https://raw.githubusercontent.com/jboss-fuse/application-templates/application-templates-2.1.0.fuse-sb2-7_11_1-00016-redhat-00002/monitors/fuse-servicemonitor.yml -p NAMESPACE=<your-fuse-namespace> -p FUSE_SERVICE_NAME=<fuse-app-name> | oc apply -f -

+ たとえば、myfuseapp という名前の Fuse アプリケーションが含まれる myproject という名前の OpenShift プロジェクト (namespace) を使用する場合は、以下を実行します。

+

例

oc process -f https://raw.githubusercontent.com/jboss-fuse/application-templates/application-templates-2.1.0.fuse-sb2-7_11_1-00016-redhat-00002/monitors/fuse-servicemonitor.yml -p NAMESPACE=myproject -p FUSE_SERVICE_NAME=myfuseapp | oc apply -f -

Prometheus ダッシュボードを開くには、以下を実行します。

- OpenShift コンソールにログインします。

- Prometheus を追加したプロジェクトを開きます。

- 左側のペインで Administrator ビューを選択し、Observe -> Metricsを開きます。

- Prometheus Hostname URL をクリックし、Prometheus ダッシュボードを開きます。

Prometheus の詳細は、Prometheus のドキュメント を参照してください。

2.5.3. OpenShift 環境変数

アプリケーションの Prometheus インスタンスを設定するには、表2.2「Prometheus 環境変数」にリストされている OpenShift 環境変数を設定します。

表2.2 Prometheus 環境変数

| 環境変数 | 説明 | デフォルト |

|---|---|---|

|

| バインドするホストアドレス。 |

|

|

| 設定されている場合、Prometheus のアクティベートを無効にします (空の値をエコーします)。 | Prometheus が有効。 |

|

| 使用するポート。 |

|

|

| ファイル (パスを含む) を Prometheus 設定ファイルとして使用します。 | Camel メトリックが含まれる /opt/prometheus/prometheus-config.yml ファイル。 |

|

| JMX エクスポーター設定に追加する追加オプション。 | 該当なし |

関連情報

Pod の環境変数の設定に関する詳細は、OpenShift 開発者ガイド (https://access.redhat.com/documentation/ja-jp/openshift_container_platform/3.11/html/developer_guide/index) を参照してください。

2.5.4. Prometheus が監視および収集するメトリックの制御

デフォルトでは、Prometheus は Camel によって公開される可能性のあるすべてのメトリックが含まれる設定ファイル (https://raw.githubusercontent.com/jboss-fuse/application-templates/master/prometheus/prometheus-config.yml) を使用します。

Prometheus が監視および収集するアプリケーション内にカスタムメトリックがある場合 (アプリケーションプロセスを実行するオーダーの数など)、独自の設定ファイルを使用できます。識別できるメトリックは、JMX で提供されるメトリックに限定されるため注意してください。

手順

カスタム設定ファイルを使用して、デフォルトの Prometheus 設定では対応されない JMX Bean を公開するには、以下の手順に従います。

カスタム Prometheus 設定ファイルを作成します。デフォルトファイルのコンテンツ (

prometheus-config.ymlhttps://raw.githubusercontent.com/jboss-fuse/application-templates/master/prometheus/prometheus-config.yml) を形式の目安として使用できます。カスタム設定ファイルには任意の名前を使用できます (例:

my-prometheus-config.ymlなど)。-

prometheus 設定ファイル (例:

my-prometheus-config.yml) をアプリケーションのsrc/main/jkube-includesディレクトリーに追加します。 アプリケーション内に

src/main/jkube/deployment.xmlファイルを作成し、設定ファイルに設定された値で AB_JMX_EXPORTER_CONFIG 環境変数のエントリーを追加します。以下に例を示します。spec: template: spec: containers: - resources: requests: cpu: "0.2" limits: cpu: "1.0" env: - name: SPRING_APPLICATION_JSON value: '{"server":{"tomcat":{"max-threads":1}}}' - name: AB_JMX_EXPORTER_CONFIG value: "my-prometheus-config.yml"この環境変数は、Pod レベルでアプリケーションに適用されます。

- アプリケーションの再構築およびデプロイ

2.6. Fuse on OpenShift のメータリングの使用

OCP 4 で利用可能なメータリングツールを使用して、異なるデータソースからメータリングレポートを生成できます。クラスター管理者として、メータリングを使用してクラスターの内容を分析できます。独自のクエリーを作成するか、事前定義 SQL クエリーを使用して、利用可能な異なるデータソースからデータを処理する方法を定義できます。Prometheus をデフォルトのデータソースとして使用すると、Pod、namespace、およびその他ほとんどの Kubernetes リソースのレポートを生成できます。メータリングツールを使用するには、最初にメータリング Operator を OpenShift Container Platform 4.x にインストールし、設定する必要があります。メータリングに関する詳細は メータリング を参照してください。

Fuse on OpenShift のメータリングは IBM Power Systems および IBM Z ではサポートされません。

2.6.1. メータリングリソース

メータリングには、メータリングのデプロイメントやインストール、およびメータリングが提供するレポート機能を管理するために使用できるリソースが多数含まれています。メータリングは以下の CustomResourceDefinition (CRD) を使用して管理されます。

表2.3 メータリングリソース

| 名前 | 説明 |

|---|---|

| MeteringConfig | デプロイメントのメータリングスタックを設定します。メータリング スタックを設定する各コンポーネントを制御するカスタマイズおよび設定オプションが含まれます。 |

| Report | 使用するクエリー、クエリーを実行するタイミングおよび頻度、および結果を保存する場所を制御します。 |

| ReportQuery | ReportDataSource 内に含まれるデータに対して分析を実行するために使用される SQL クエリーが含まれます。 |

| ReportDataSource | ReportQuery および Report で利用可能なデータを制御します。メータリング内で使用できるように複数の異なるデータベースへのアクセスの設定を可能にします。 |

2.6.2. Fuse on OpenShift のメータリングラベル

表2.4 メータリングラベル

| ラベル | 使用できる値 |

|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

2.7. カスタム Grafana ダッシュボードでの Fuse on OpenShift の監視

OpenShift Container Platform 4.6 は、クラスターコンポーネントおよびユーザー定義のワークロードの状態を理解するのに役立つモニタリングダッシュボードを提供します。

前提条件

- クラスターに Prometheus をインストールおよびデプロイしておく必要があります。OpenShift 4 に Grafana をインストールする方法の詳細は https://github.com/jboss-fuse/application-templates/blob/master/monitoring/prometheus.md を参照してください。

- Grafana がインストールおよび設定されている必要があります。

Fuse on OpenShift のカスタムダッシュボード

Fuse on OpenShift に使用できるカスタムダッシュボードは 2 つあります。これらのダッシュボードを使用するには、クラスターに Grafana と Prometheus をインストールおよび設定しておく必要があります。Fuse on OpenShift には 2 種類のダッシュボードサンプルが用意されています。これらのダッシュボードは Fuse Grafana dashboards からインポートできます。

Fuse Pod / インスタンスメトリックダッシュボード

このダッシュボードは、単一の Fuse アプリケーション Pod / インスタンスからメトリックを収集します。

fuse-grafana-dashboard.ymlを使用してダッシュボードをインポートできます。OpenShift の Fuse Pod メトリックダッシュボードのパネルには以下が含まれます。表2.5 Fuse Pod メトリックダッシュボード

タイトル 凡例 クエリー 説明 Process Start Time

-

process_start_time_seconds{pod="$pod"}*1000

処理が開始された時間

Current Memory HEAP

-

sum(jvm_memory_bytes_used{pod="$pod", area="heap"})*100/sum(jvm_memory_bytes_max{pod="$pod", area="heap"})

Fuse によって現在使用されているメモリー

Memory Usage

committed

sum(jvm_memory_bytes_committed{pod="$pod"})

コミットされたメモリー

used

sum(jvm_memory_bytes_used{pod="$pod"})

使用されているメモリー

max

sum(jvm_memory_bytes_max{pod="$pod"})

最大メモリー

Threads

current?

jvm_threads_current{pod="$pod"}

現在のスレッド数

daemon

jvm_threads_daemon{pod="$pod"}

デーモンスレッドの数

peak

jvm_threads_peak{pod="$pod"}

ピークスレッドの数

Camel Exchanges / 1m

Exchanges Completed / 1m

sum(increase(org_apache_camel_ExchangesCompleted{pod="$pod"}[1m]))

1 分あたりの完了した Camel エクスチェンジ

Exchanges Failed / 1m

sum(increase(org_apache_camel_ExchangesFailed{pod="$pod"}[1m]))

1 分あたりの失敗した Camel エクスチェンジ

Exchanges Total / 1m

sum(increase(org_apache_camel_ExchangesTotal{pod="$pod"}[1m]))

1 分あたりの Camel エクスチェンジの合計

Exchanges Inflight

sum(org_apache_camel_ExchangesInflight{pod="$pod"})

現在処理中の Camel エクスチェンジ

Camel Processing Time

Delta Processing Time

sum(org_apache_camel_DeltaProcessingTime{pod="$pod"})

Camel 処理時間のデルタ

Last Processing Time

sum(org_apache_camel_LastProcessingTime{pod="$pod"})

最後の Camel 処理時間

Max Processing Time

sum(org_apache_camel_MaxProcessingTime{pod="$pod"})

Camel の最大処理時間

Min Processing Time

sum(org_apache_camel_MinProcessingTime{pod="$pod"})

Camel の最小処理時間

Mean Processing Time

sum(org_apache_camel_MeanProcessingTime{pod="$pod"})

Camel の平均処理時間

Camel Service Durations

Maximum Duration

sum(org_apache_camel_MaxDuration{pod="$pod"})

Camel のサービス期間

Minimum Duration

sum(org_apache_camel_MinDuration{pod="$pod"})

Camel の最小サービス期間

Mean Duration

sum(org_apache_camel_MeanDuration{pod="$pod"})

Camel の平均サービス期間

Camel Failures & Redeliveries

Redeliveries

sum(org_apache_camel_Redeliveries{pod="$pod"})

再配信の数

Last Processing Time

sum(org_apache_camel_LastProcessingTime{pod="$pod"})

最後の Camel 処理時間

External Redeliveries

sum(org_apache_camel_ExternalRedeliveries{pod="$pod"})

外部再配信の数

Fuse Camel ルートメトリックダッシュボード

このダッシュボードは、Fuse アプリケーションで単一の Camel ルートからメトリックを収集します。

fuse-grafana-dashboard-routes.ymlを使用してダッシュボードをインポートできます。OpenShift の Fuse Camel Route メトリックダッシュボードのパネルには以下が含まれます。表2.6 Fuse Camel ルートメトリックダッシュボード

タイトル 凡例 クエリー 説明 Exchanges per second

-

rate(org_apache_camel_ExchangesTotal{route="\"$route\""}[5m])

1 秒あたりの Camel エクスチェンジの合計

Exchanges Inflight

-

max(org_apache_camel_ExchangesInflight{route="\"$route\""})

現在処理中の Camel エクスチェンジの数

Exchanges failure rate

-

sum(org_apache_camel_ExchangesFailed{route="\"$route\""}) / sum(org_apache_camel_ExchangesTotal{route="\"$route\""})

失敗した Camel エクスチェンジの割合 (パーセント)

Mean processing time

-

org_apache_camel_MeanProcessingTime{route="\"$route\""}

Camel の平均処理時間

Exchanges per second

Failed

rate(org_apache_camel_ExchangesFailed{route="\"$route\""}[5m])

1 秒あたりの失敗したエクスチェンジ

Completed

rate(org_apache_camel_ExchangesCompleted{route="\"$route\""}[5m])

1 秒あたりの完了したエクスチェンジ

Exchanges Inflight

Exchanges Inflight

org_apache_camel_ExchangesInflight{route="\"$route\""}

現在処理中の Camel エクスチェンジ

Processing time

Max

org_apache_camel_MaxProcessingTime{route="\"$route\""}

Camel の最大処理時間

Mean

org_apache_camel_MeanProcessingTime{route="\"$route\""}

Camel の平均処理時間

Min

org_apache_camel_MinProcessingTime{route="\"$route\""}

Camel の最小処理時間

External Redeliveries per second

-

rate(org_apache_camel_ExternalRedeliveries{route="\"$route\""}[5m])

1 秒あたりの外部再配信

Redeliveries per second

-

rate(org_apache_camel_Redeliveries{route="\"$route\""}[5m])

1 秒あたりの再配信

Failures handled per second

-

rate(org_apache_camel_FailuresHandled{route="\"$route\""}[5m])

1 秒あたりに処理された失敗

2.8. OpenShift 3.x サーバーでの Fuse イメージストリームおよびテンプレートのインストール

registry.redhat.io への認証を設定した後、Red Hat Fuse on OpenShift イメージストリームおよびテンプレートをインポートおよび使用します。

手順

- OpenShift サーバーを起動します。

OpenShift サーバーに管理者としてログインします。

oc login -u system:admin

docker-registry シークレットを作成したプロジェクトを使用していることを確認します。

oc project openshift

Fuse on OpenShift イメージストリームをインストールします。

BASEURL=https://raw.githubusercontent.com/jboss-fuse/application-templates/application-templates-2.1.0.fuse-sb2-7_11_1-00016-redhat-00002 oc create -n openshift -f ${BASEURL}/fis-image-streams.jsonクイックスタートテンプレートをインストールします。

for template in eap-camel-amq-template.json \ eap-camel-cdi-template.json \ eap-camel-cxf-jaxrs-template.json \ eap-camel-cxf-jaxws-template.json \ karaf-camel-amq-template.json \ karaf-camel-log-template.json \ karaf-camel-rest-sql-template.json \ karaf-cxf-rest-template.json ; do oc create -n openshift -f \ ${BASEURL}/quickstarts/${template} doneSpring Boot 2 のクイックスタートテンプレートをインストールします。

for template in spring-boot-2-camel-amq-template.json \ spring-boot-2-camel-config-template.json \ spring-boot-2-camel-drools-template.json \ spring-boot-2-camel-infinispan-template.json \ spring-boot-2-camel-rest-3scale-template.json \ spring-boot-2-camel-rest-sql-template.json \ spring-boot-2-camel-template.json \ spring-boot-2-camel-xa-template.json \ spring-boot-2-camel-xml-template.json \ spring-boot-2-cxf-jaxrs-template.json \ spring-boot-2-cxf-jaxws-template.json \ spring-boot-2-cxf-jaxrs-xml-template.json \ spring-boot-2-cxf-jaxws-xml-template.json ; do oc create -n openshift -f \ ${BASEURL}/quickstarts/${template} doneFuse Console のテンプレートをインストールします。

oc create -n openshift -f ${BASEURL}/fis-console-cluster-template.json oc create -n openshift -f ${BASEURL}/fis-console-namespace-template.json注記Fuse Console のデプロイに関する詳細は、OpenShift での Fuse Console の設定 を参照してください。

Apicurito テンプレートをインストールします。

oc create -n openshift -f ${BASEURL}/fuse-apicurito.yml(任意手順): インストールされた Fuse on OpenShift イメージおよびテンプレートを表示します。

oc get template -n openshift

2.8.1. OpenShift 3.11 での Fuse Console の設定

OpenShift 3.11 では、以下のように Fuse Console にアクセスできます。

- プロジェクトで実行しているすべての Fuse コンテナーを監視できるように、Fuse Console を OpenShift プロジェクトに追加する。

- クラスター上のすべてのプロジェクトで稼働中のすべての Fuse コンテナーを監視できるように、Fuse Console を OpenShift クラスターに追加する。

- 実行している単一の Fuse コンテナーを監視できるように、特定の Fuse Pod から Fuse Console を開く。

コマンドラインから Fuse Console テンプレートをデプロイします。

Minishift または CDK ベースの環境変数に Fuse Console をインストールするには、以下の KCS の記事で説明されている手順に従います。

- Minishift または CDK ベースの環境に Fuse Console をインストールするには、KCS 4998441 を参照してください。

- Jolokia 認証を無効にする必要がある場合は、KCS 3988671 で説明されている回避策を参照してください。

前提条件

- Fuse on OpenShift ガイド の説明にしたがって、Fuse Console の Fuse on OpenShift イメージストリームおよびテンプレートをインストールしている。

- Fuse Console のユーザー管理は、OpenShift によって処理されます。

- ロールベースアクセス制御 (デプロイ後に Fuse Console にアクセスするユーザーの場合) は現在 Fuse on OpenShift 3.11 では使用できません。

「OpenShift 3.11 での Fuse Console のデプロイ」

「OpenShift 3.11 の Fuse Console から単一の Fuse Pod を監視」

2.8.1.1. OpenShift 3.11 での Fuse Console のデプロイ

表2.7「Fuse Console テンプレート」は、Fuse アプリケーションのデプロイメントのタイプに応じて、コマンドラインから Fuse Console をデプロイするために使用する OpenShift 3.11 テンプレートについて説明しています。

表2.7 Fuse Console テンプレート

| タイプ | 説明 |

|---|---|

|

| Fuse Console は、複数の namespace またはプロジェクトにまたがってデプロイされた Fuse アプリケーションを検出し、接続することができます。このテンプレートをデプロイするには、OpenShift の cluster-admin ロールが必要です。 |

|

| このテンプレートは、Fuse Console の現在の OpenShift プロジェクト (namespace) へのアクセスを制限するため、単一のテナントデプロイメントとして動作します。このテンプレートをデプロイするには、現在の OpenShift プロジェクトの admin ロールが必要です。 |

任意で以下のコマンドを実行すると、すべてのテンプレートのパラメーターのリストを表示できます。

oc process --parameters -f https://raw.githubusercontent.com/jboss-fuse/application-templates/application-templates-2.1.0.fuse-sb2-7_11_1-00016-redhat-00002/fis-console-namespace-template.json

Fuse Console のテンプレートは、デフォルトでエンドツーエンド暗号化を設定するため、Fuse Console のリクエストはブラウザーからクラスター内のサービスまでエンドツーエンドでセキュア化されます。

前提条件

OpenShift 3.11 のクラスターモードでは、cluster admin ロールとクラスターモードテンプレートが必要です。以下のコマンドを実行します。

oc adm policy add-cluster-role-to-user cluster-admin system:serviceaccount:openshift-infra:template-instance-controller

手順

コマンドラインから Fuse Console をデプロイするには、以下を行います。

以下のコマンドの 1 つを実行して、Fuse Console テンプレートをベースとした新しいアプリケーションを作成します。コマンドの myproject はプロジェクトの名前に置き換えます。

Fuse Console の cluster テンプレートの場合は、以下のようになります。

myhostは Fuse Console にアクセスするホストの名前になります。oc new-app -n myproject -f https://raw.githubusercontent.com/jboss-fuse/application-templates/application-templates-2.1.0.fuse-sb2-7_11_1-00016-redhat-00002/fis-console-cluster-template.json -p ROUTE_HOSTNAME=myhost

Fuse Console の namespace テンプレートの場合は以下のようになります。

oc new-app -n myproject -f https://raw.githubusercontent.com/jboss-fuse/application-templates/application-templates-2.1.0.fuse-sb2-7_11_1-00016-redhat-00002/fis-console-namespace-template.json

注記namespace テンプレートの route_hostname パラメーターは OpenShift によって自動的に生成されるため、省略することが可能です。

以下のコマンドを実行して、Fuse Console デプロイメントの状態と URL を取得します。

oc status

ブラウザーから Fuse Console にアクセスするには、提供される URL を使用します。

以下に例を示します。

2.8.1.2. OpenShift 3.11 の Fuse Console から単一の Fuse Pod を監視

OpenShift 3.11 で実行している Fuse Pod の Fuse Console を開きます。

前提条件

Pod ビューで Fuse Console へのリンクを表示するよう OpenShift を設定するには、Fuse on OpenShift イメージを実行している Pod が

jolokiaに設定された name 属性内で TCP ポートを宣言する必要があります。{ "kind": "Pod", [...] "spec": { "containers": [ { [...] "ports": [ { "name": "jolokia", "containerPort": 8778, "protocol": "TCP" }

手順

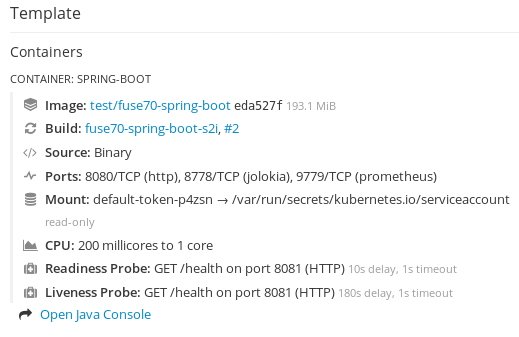

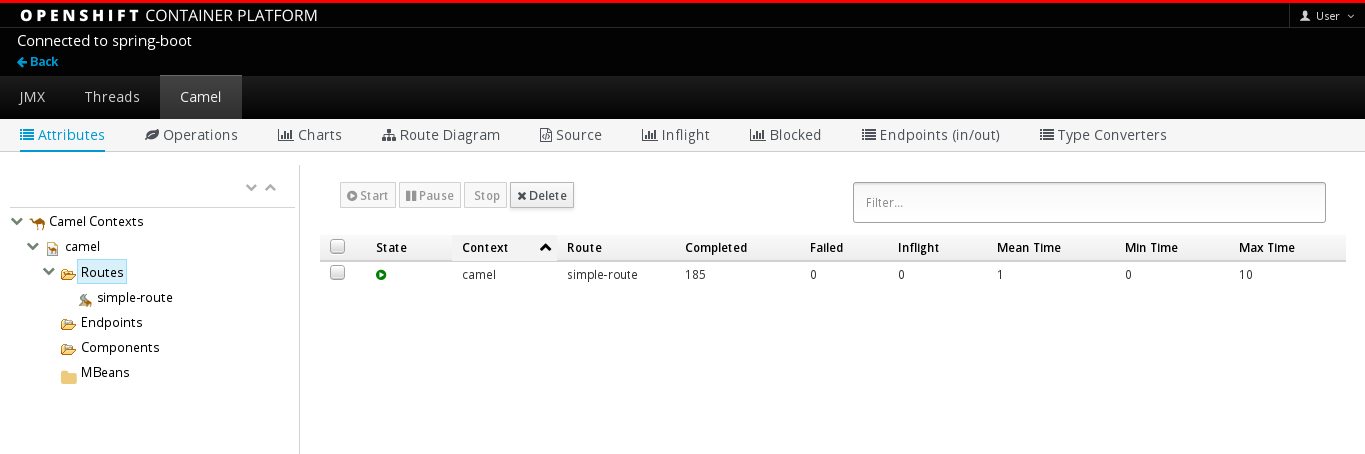

OpenShift プロジェクトの Applications → Pods ビューで、Pod 名をクリックし、実行している Fuse Pod の詳細を表示します。このページの右側に、コンテナーテンプレートの概要が表示されます。

このビューの Open Java Console リンクをクリックし、Fuse Console を開きます。

第3章 制限された環境での Fuse on Openshift のインストール

制限のない環境で Fuse on OpenShift をインストールするには、イメージストリームおよびテンプレートを registry.redhat.io からプルします。インターネットアクセスがないか、これに制限がある実稼働環境では、それが不可能です。ここでは、制限される環境で Fuse on OpenShift をインストールする方法について説明します。

制限された環境でのインストールは現時点で、IBM Power Systems、IBM Z、および LinuxONE ではサポートされていません。

前提条件

- 制限された環境で実行できるように OpenShift サーバーをインストールし、設定している。

3.1. 内部 docker レジストリーの設定

ここでは、イメージのプッシュまたはプルに使用できる、内部 docker レジストリーを設定する方法を説明します。イメージをプルまたはプッシュできる内部 docker レジストリーを設定する必要があります。

手順

内部 ROOT CA をインストールします。

cd /etc/pki/ca-trust/source/anchors sudo curl -O https://password.corp.redhat.com/RH-IT-Root-CA.crt sudo update-ca-trust extract sudo update-ca-trust update

この証明書により、システムがレジストリーに対して自己認証できるようになります。

registry.redhat.ioにログインします。docker login -u USERNAME -p PASSWORD registry.redhat.io

registry.redhat.ioから Fuse on OpenShift イメージをプルします。docker pull registry.redhat.io/fuse7/fuse-java-openshift-rhel8:1.11 docker pull registry.redhat.io/fuse7/fuse-java-openshift-jdk11-rhel8:1.11 docker pull registry.redhat.io/fuse7/fuse-karaf-openshift-rhel8:1.11 docker pull registry.redhat.io/fuse7/fuse-console-rhel8:1.11 docker pull registry.redhat.io/fuse7/fuse-apicurito-rhel8:1.11 docker pull registry.redhat.io/fuse7/fuse-apicurito-generator-rhel8:1.11

プルしたイメージストリームにタグを付けます。

docker tag registry.redhat.io/fuse7/fuse-java-openshift-rhel8:1.11 docker-registry.upshift.redhat.com/fuse7/fuse-java-openshift-rhel8:1.11 docker tag registry.redhat.io/fuse7/fuse-java-openshift-jdk11-rhel8:1.11 docker-registry.upshift.redhat.com/fuse7/fuse-java-openshift-jdk11-rhel8:1.11 docker tag registry.redhat.io/fuse7/fuse-karaf-openshift-rhel8:1.11 docker-registry.upshift.redhat.com/fuse-karaf-openshift-rhel8:1.11 docker tag registry.redhat.io/fuse7/fuse-console-rhel8:1.11 docker-registry.upshift.redhat.com/fuse7-fuse-console-rhel8:1.11 docker tag registry.redhat.io/fuse7/fuse-apicurito-rhel8:1.11 docker-registry.upshift.redhat.com/fuse7-fuse-apicurito-rhel8:1.11 docker tag registry.redhat.io/fuse7/fuse-apicurito-generator-rhel8:1.11 docker-registry.upshift.redhat.com/fuse7-fuse-apicurito-generator-rhel8:1.11

タグを付けたイメージストリームを内部 docker レジストリーにプッシュします。

docker push docker-registry.upshift.redhat.com/fuse7/fuse-java-openshift-rhel8:1.11 docker push docker-registry.upshift.redhat.com/fuse7/fuse-java-openshift-jdk11-rhel8:1.11 docker push docker-registry.upshift.redhat.com/fuse-karaf-openshift-rhel8:1.11 docker push docker-registry.upshift.redhat.com/fuse7-fuse-console-rhel8:1.11 docker push docker-registry.upshift.redhat.com/fuse7-fuse-apicurito-rhel8:1.11 docker push docker-registry.upshift.redhat.com/fuse7-fuse-apicurito-generator-rhel8:1.11

3.2. 内部レジストリーのシークレットの設定

制限された docker レジストリーを設定し、すべてのイメージをプッシュした後、内部レジストリーと通信できるように、制限された OpenShift サーバーを設定する必要があります。

手順

管理者として OpenShift クラスターにログインします。

oc login --user system:admin --token=my-token --server=https://my-cluster.example.com:6443

Fuse をデプロイするプロジェクトを開きます。

oc project myproject

Red Hat Customer Portal アカウントを使用して

docker-registryシークレットを作成し、PULL_SECRET_NAMEをpsi-internal-registryに置き換えて以下を作成します。oc create secret docker-registry psi-internal-registry \ --docker-server=docker-registry.redhat.io \ --docker-username=CUSTOMER_PORTAL_USERNAME \ --docker-password=CUSTOMER_PORTAL_PASSWORD \ --docker-email=EMAIL_ADDRESS

以下の出力が表示されるはずです。

secret/psi-internal-registry created

重要この

docker-registryシークレットを、registry.redhat.ioに対して認証されるすべての OpenShift プロジェクト namespace に作成する必要があります。シークレットをサービスアカウントにリンクして、シークレットをイメージをプルするために使用します。次の例では、

defaultサービスアカウント、builderサービスアカウント、およびdeployerサービスアカウントを使用しています。oc secrets link default psi-internal-registry oc secrets link default psi-internal-registry --for=pull oc secrets link builder psi-internal-registry oc secrets link builder psi-internal-registry --for=pull oc secrets link deployer psi-internal-registry oc secrets link deployer psi-internal-registry --for=pull

サービスアカウント名は、OpenShift Pod が使用する名前と一致する必要があります。

注記Red Hat のユーザー名とパスワードを使用してプルシークレットを作成したくない場合は、レジストリーサービスアカウントを使用して認証トークンを作成できます。

3.3. 制限された環境での Fuse on OpenShift イメージのインストール

fis-image-streams.json ファイルには、Red Hat Fuse on OpenShift の imageStream 定義が含まれます。ただし、すべてのイメージストリームは registry.redhat.io を参照します。psi-internal-registry URL へのすべての registry.redhat.io を変更する必要があります。

手順

Red Hat Fuse on OpenShift イメージストリームの json ファイルをダウンロードします。

curl -o fis-image-streams.json https://raw.githubusercontent.com/jboss-fuse/application-templates/application-templates-2.1.0.fuse-sb2-7_11_1-00016-redhat-00002/fis-image-streams.json

fis-image-streams.jsonファイルを開き、registry.redhat.ioへの参照をすべて特定します。以下に例を示します。{ "name": "1.9", "annotations": { "description": "Red Hat Fuse 7.11 Karaf S2I images.", "openshift.io/display-name": "Red Hat Fuse 7.11 Karaf", "iconClass": "icon-rh-integration", "tags": "builder,jboss-fuse,java,karaf,xpaas,hidden", "supports":"jboss-fuse:7.11.0,java:8,xpaas:1.2", "version": "1.9" }, "referencePolicy": { "type": "Local" }, "from": { "kind": "DockerImage", "name": "registry.redhat.io/fuse7/fuse-karaf-openshift-rhel8:1.11" } },ファイル内のすべての

registry.redhat.io参照をpsi-internal-registryの名前に置き換えます。以下に例を示します。{ "name": "1.9", "annotations": { "description": "Red Hat Fuse 7.11 Karaf S2I images.", "openshift.io/display-name": "Red Hat Fuse 7.11 Karaf", "iconClass": "icon-rh-integration", "tags": "builder,jboss-fuse,java,karaf,xpaas,hidden", "supports":"jboss-fuse:7.11.0,java:8,xpaas:1.2", "version": "1.9" }, "referencePolicy": { "type": "Local" }, "from": { "kind": "DockerImage", "name": "docker-registry.upshift.redhat.com/fuse7/fuse-karaf-openshift-rhel8:1.11" } },すべての参照が置き換えられたら、以下のコマンドを実行して Fuse on OpenShift イメージストリームをインストールします。

oc create -f fis-image-streams.json -n {namespace}

3.4. 内部 Maven リポジトリーの使用

制限された環境では、別の Maven リポジトリーを使用する必要があります。それは、MAVEN_MIRROR_URL という名前のテンプレートパラメーターを使用して指定できます。この MAVEN_MIRROR_URL パラメーターを使用して、コマンドラインから新規アプリケーションを作成することができます。

3.4.1. MAVEN_MIRROR_URL を使用した Spring Boot アプリケーションの実行

この例では、MAVEN_MIRROR_URL を使用して Spring Boot アプリケーションをデプロイおよび実行する方法について説明します。

手順

Spring Boot Camel XML クイックスタートをダウンロードします。

oc create -f ./spring-boot-2-camel-xml-template.json -n openshift

以下のコマンドを入力し、

MAVEN_MIRROR_URLを使用して Spring Boot クイックスタートテンプレートの実行に必要なリソースを作成します。制限された環境では、ローカルリポジトリーの

GIT_REPOおよびGIT_REFパラメーターも指定する必要があります。oc new-app s2i-fuse711-spring-boot-2-camel-xml -n {namespace} -p IMAGE_STREAM_NAMESPACE={namespace} -p MAVEN_MIRROR_URL={Maven mirror URL} -p GIT_REPO={Git Repo URL} -p GIT_REF={Git branch/tag name}これにより、クイックスタートのデプロイメント設定およびビルド設定が作成されます。クイックスタートのデフォルトパラメーターや作成されたリソースの情報はターミナルに表示されます。

3.4.2. OpenShift Maven プラグインを使用した Spring Boot アプリケーションの実行

この例では、内部 Maven リポジトリーを使用して OpenShift Maven プラグインで Spring Boot アプリケーションをデプロイおよび実行する方法を説明します。

手順

OpenShift Maven プラグインでクイックスタートを実行するには、ローカルリポジトリーから Spring Boot 2 camel archetype をダウンロードし、クイックスタートをデプロイします。

{Maven Mirror URL}を Maven ミラーリポジトリーの URL に置き換えます。mvn org.apache.maven.plugins:maven-archetype-plugin:2.4:generate \ -DarchetypeCatalog={Maven Mirror URL}/archetypes/archetypes-catalog/2.2.0.fuse-sb2-7_11_1-00018-redhat-00002/archetypes-catalog-2.2.0.fuse-sb2-7_11_1-00018-redhat-00002-archetype-catalog.xml \ -DarchetypeGroupId=org.jboss.fuse.fis.archetypes \ -DarchetypeArtifactId=spring-boot-camel-xml-archetype -DarchetypeVersion=2.2.0.fuse-sb2-7_11_1-00018-redhat-00002archetype プラグインが対話モードに切り替わり、残りのフィールドの入力を要求されます。

Define value for property 'groupId': : org.example.fis Define value for property 'artifactId': : fuse711-spring-boot2 Define value for property 'version': 1.0-SNAPSHOT: : Define value for property 'package': org.example.fis: : Confirm properties configuration: groupId: org.example.fis artifactId: fuse711-spring-boot version: 1.0-SNAPSHOT package: org.example.fis Y: : Y

-

上記のコマンドが BUILD SUCCESS 状態で終了した場合、

fuse711-spring-boot2サブディレクトリー内に新しい Fuse on OpenShift プロジェクトが作成されているはずです。 これで、

fuse711-spring-boot2プロジェクトをビルドおよびデプロイできるようになりました。OpenShift にログインしている状態で、fuse711-spring-boot2プロジェクトのディレクトリーに移動し、以下のようにプロジェクトをビルドおよびデプロイします。cd fuse711-spring-boot2 mvn oc:deploy -Popenshift

第4章 管理者でないユーザーでの Fuse on OpenShift のインストール

アプリケーションを作成し、OpenShift にデプロイして Fuse on OpenShift の使用を開始することができます。最初に、Fuse on OpenShift イメージおよびテンプレートをインストールする必要があります。

4.1. 管理者でないユーザーでの Fuse on OpenShift イメージおよびテンプレートのインストール

前提条件

- OpenShift サーバーへアクセスできる必要があります。CDK による仮想 OpenShift サーバーまたはリモート OpenShift サーバーのいずれかにアクセスできる必要があります。

-

registry.redhat.ioで認証を設定している。

詳細は、

手順

Fuse on OpenShift プロジェクトのビルドおよびデプロイを準備するため、以下のように OpenShift サーバーにログインします。

oc login -u developer -p developer https://OPENSHIFT_IP_ADDR:8443

IP アドレスは常に同じではないため、

OPENSHIFT_IP_ADDRは OpenShift サーバーの IP アドレスのプレースホルダーになります。この値を実際の IP アドレスに置き換えます。注記開発者パスワードを持つ開発者ユーザーは、CDK による仮想 OpenShift サーバーで自動作成される標準のアカウントです。リモートサーバーにアクセスする場合は、OpenShift 管理者が提供する URL とクレデンシャルを使用します。

test という名前のプロジェクト namespace が存在しない場合は作成します。

oc new-project test

test プロジェクト namespace がすでに存在する場合は、以下のコマンドを使用して切り替えます。

oc project test

Fuse on OpenShift イメージストリームをインストールします。

BASEURL=https://raw.githubusercontent.com/jboss-fuse/application-templates/application-templates-2.1.0.fuse-sb2-7_11_1-00016-redhat-00002 oc create -n test -f ${BASEURL}/fis-image-streams.jsonコマンド出力に、Fuse on OpenShift プロジェクトで使用できるようになった Fuse イメージストリームが表示されます。

クイックスタートテンプレートをインストールします。

BASEURL=https://raw.githubusercontent.com/jboss-fuse/application-templates/application-templates-2.1.0.fuse-sb2-7_11_1-00016-redhat-00002 for template in eap-camel-amq-template.json \ eap-camel-cdi-template.json \ eap-camel-cxf-jaxrs-template.json \ eap-camel-cxf-jaxws-template.json \ karaf-camel-amq-template.json \ karaf-camel-log-template.json \ karaf-camel-rest-sql-template.json \ karaf-cxf-rest-template.json ; do oc create -n test -f \ ${BASEURL}/quickstarts/${template} doneSpring Boot 2 のクイックスタートテンプレートをインストールします。

BASEURL=https://raw.githubusercontent.com/jboss-fuse/application-templates/application-templates-2.1.0.fuse-sb2-7_11_1-00016-redhat-00002 for template in spring-boot-2-camel-amq-template.json \ spring-boot-2-camel-config-template.json \ spring-boot-2-camel-drools-template.json \ spring-boot-2-camel-infinispan-template.json \ spring-boot-2-camel-rest-3scale-template.json \ spring-boot-2-camel-rest-sql-template.json \ spring-boot-2-camel-template.json \ spring-boot-2-camel-xa-template.json \ spring-boot-2-camel-xml-template.json \ spring-boot-2-cxf-jaxrs-template.json \ spring-boot-2-cxf-jaxws-template.json \ spring-boot-2-cxf-jaxrs-xml-template.json \ spring-boot-2-cxf-jaxws-xml-template.json ; do oc create -n openshift -f \ ${BASEURL}/quickstarts/${template} doneFuse Console のテンプレートをインストールします。

oc create -n test -f ${BASEURL}/fis-console-cluster-template.json oc create -n test -f ${BASEURL}/fis-console-namespace-template.json注記Fuse Console のデプロイに関する詳細は、OpenShift での Fuse Console の設定 を参照してください。

(任意手順): インストールされた Fuse on OpenShift イメージおよびテンプレートを表示します。

oc get template -n test

ブラウザーで OpenShift コンソールに移動します。

-

https://OPENSHIFT_IP_ADDR:8443 を使用します。

OPENSHIFT_IP_ADDRは OpenShift サーバーの実際の IP アドレスに置き換えます。 - クレデンシャル (例: ユーザー名 developer とパスワード developer) を使用して OpenShift コンソールにログインします。

-

https://OPENSHIFT_IP_ADDR:8443 を使用します。

第5章 開発者向けの基本情報

5.1. 開発環境の準備

OpenShift サーバーにアクセスできることが、Fuse on OpenShift プロジェクトを開発およびテストするための基本要件になります。基本的な方法は次のとおりです。

5.1.1. ローカルマシンでの CDK (Container Development Kit) のインストール

開発者がすぐに使用したい場合は、Red Hat CDK をローカルマシンにインストールすることが最も実用的な方法です。CDK を使用すると、Red Hat Enterprise Linux (RHEL) 7 上の OpenShift のイメージを実行する仮想マシン (VM) インスタンスを起動できます。CDK のインストールは、次の主なコンポーネントで設定されます。

- 仮想マシン (libvirt、VirtualBox、または Hyper-V)

- コンテナー開発環境を開始および管理する minishift

Red Hat CDK は 開発での使用のみ を目的としています。本番環境などの他の環境での使用を目的としておらず、既知のセキュリティー脆弱性に対応しない場合があります。Docker 形式コンテナー内部でミッションクリティカルなアプリケーションを実行するためのフルサポートを受けるには、アクティブな RHEL 7 または RHEL Atomic サブスクリプションが必要です。詳細は、Support for Red Hat Container Development Kit (CDK) を参照してください。

前提条件

Java バージョン

開発者のマシンに、Fuse 7.11 がサポートするバージョンの Java がインストールされているようにしてください。サポートされる Java バージョンの詳細は Supported Configurations を参照してください。

手順

ローカルマシンに CDK をインストールするには、以下を行います。

- Fuse on OpenShift では、バージョン 3.17 の CDK をインストールすることが推奨されます。CDK 3.17 をインストールおよび使用するための詳細手順は Red Hat CDK 3.17 Getting Started Guide を参照してください。

-

コンテナーイメージの

registry.redhat.ioを使用した認証 の手順に従って、Red Hat エコシステムカタログへのアクセスを取得できるように、OpenShift クレデンシャルを設定します。 2章管理者向けの基本情報 の説明にしたがって、Fuse on OpenShift イメージおよびテンプレートを手作業でインストールします。

注記CDK のバージョンには Fuse on OpenShift イメージおよびテンプレートが事前にインストールされている可能性があります。ただし、OpenShift クレデンシャルの設定後に、Fuse on OpenShift イメージおよびテンプレートをインストール (または更新) する必要があります。

- 本章の例を参照する前に、Red Hat CDK 3.17 Getting Started Guide の内容を読み、理解するようにしてください。

5.1.2. 既存の OpenShift サーバーへのリモートアクセスの取得

IT 部門によってサーバーマシン上に OpenShift クラスターがすでに設定されている可能性があります。この場合、Fuse on OpenShift を使用するには以下の要件を満たしている必要があります。

- サーバーマシンがサポートされるバージョンの OpenShift Container Platform を実行している必要があります (Supported Configurations を参照)。本ガイドの例は、バージョン 3.11 に対してテストされています。

- OpenShift 管理者に、最新の Fuse on OpenShift コンテナーベースイメージと Fuse on OpenShift テンプレートを OpenShift サーバーにインストールするよう依頼します。

- OpenShift 管理者に、通常の開発者権限 (OpenShift プロジェクトを作成、デプロイ、および実行できる権限) を持つユーザーアカウントを作成してもらいます。

-

管理者に、OpenShift サーバーの URL (OpenShift コンソールの閲覧または

ocコマンドラインクライアントを使用した OpenShfit への接続に使用) と、アカウントのログインクレデンシャルを提供するよう依頼します。

5.1.3. クライアント側ツールのインストール

開発者のマシンに以下のツールをインストールすることが推奨されます。

- Apache Maven 3.6.x: OpenShift プロジェクトのローカルビルドに必要です。Apache Maven download ページから適切なパッケージをダウンロードします。バージョン 3.6.x 以上がインストールされているようにしてください。3.6.x 未満のバージョンを使用すると、プロジェクトのビルド時に依存関係の解決に関する問題が発生する可能性があります。

- Git: OpenShift S2I ソースワークフローに必要で、通常 Fuse on OpenShift プロジェクトのソース制御用に推奨されます。Git Downloads ページから適切なパッケージをダウンロードします。

OpenShift client: CDK を使用している場合、シェルに入力する必要があるコマンドを表示する

minishift oc-envを使用して、ocバイナリーを PATH に追加します。oc-envの出力は、OS とシェルのタイプによって異なります。$ minishift oc-env export PATH="/Users/john/.minishift/cache/oc/v1.5.0:$PATH" # Run this command to configure your shell: # eval $(minishift oc-env)

詳細は、CDK 3.17Getting Started Guideの Using the OpenShift Client Binary を参照してください。

CDK を使用しない場合は、CLI Reference の手順にしたがって、

ocクライアントツールをインストールします。(任意) Docker client: 上級ユーザーは Docker クライアントツールがインストールされていると便利である可能性があります (OpenShift サーバー上で実行されている docker デーモンとの通信に使用)。オペレーティングシステム用の特定のバイナリーインストールに関する詳細は、Docker インストール サイトを参照してください。

詳細は、CDK 3.17Getting Started Guideの Reusing the docker Daemon を参照してください。

重要OpenShift サーバーで稼働しているバージョンの OpenShift と互換性のあるバージョンの

ocおよびdockerツールをインストールするようにしてください。

5.1.4. Maven リポジトリーの設定

ローカルマシンで Fuse on OpenShift プロジェクトをビルドするのに必要な archetype とアーティファクトを保持する Maven リポジトリーを設定します。

手順

-

Maven の

settings.xmlファイルを開きます。このファイルは通常、Linux または MacOS の場合は~/.m2/settings.xml、Winsows の場合はDocuments and Settings\<USER_NAME>\.m2\settings.xmlにあります。 以下の Maven リポジトリーを追加します。

-

Maven central:

https://repo1.maven.org/maven2 -

Red Hat GA リポジトリー:

https://maven.repository.redhat.com/ga Red Hat EA リポジトリー:

https://maven.repository.redhat.com/earlyaccess/all上記のリポジトリーは、

settings.xmlファイルの依存関係リポジトリーセクションと、プラグインリポジトリーセクションの両方に追加する必要があります。

-

Maven central:

5.2. Fuse on OpenShift でのアプリケーションの作成およびデプロイ

以下の OpenShift Source-to-Image (S2I) アプリケーション開発ワークフローの 1 つを使用してアプリケーションを作成し、OpenShift にデプロイして、Fuse on OpenShift の使用を開始することができます。

- S2I バイナリーワークフロー

- ビルド入力が バイナリーソース からの S2I です。このワークフローの特徴は、ビルドの一部が開発者自身のマシンで実行されることです。このワークフローはバイナリーパッケージをローカルでビルドした後、バイナリーパッケージを OpenShift に渡します。詳細は、OpenShift Container PlatformBuildsガイドの Binary Source を参照してください。

- S2I ソースワークフロー

- ビルド入力が Git ソース からの S2I です。このワークフローの特徴は、ビルドがすべて OpenShift サーバー上でビルドされることです。詳細は、OpenShift Container PlatformBuildsガイドの Git Source を参照してください。

5.2.1. S2I バイナリーを使用したアプリケーションの作成およびデプロイ

ここでは、OpenShift S2I バイナリーワークフローを使用して、Fuse on OpenShift プロジェクトを作成、ビルド、およびデプロイします。

- JDK11 を使用したクイックスタートの実行

- ランタイム時に JDK11 ベースのイメージを使用する場合は、コンパイル時に正しい JDK11 プロファイルを使用します。JDK11 を使用してクイックスタートをビルドおよびデプロイする場合は、ビルドマシンに JDK11 をインストールし、正しい JDK11 プロファイルを使用してクイックスタートをビルドするようにしてください。

手順

Maven の archetype を使用して、新しい Fuse on OpenShift プロジェクトを作成します。この例では、サンプル Spring Boot Camel プロジェクトを作成する archetype を使用します。新しいシェルプロンプトを開き、以下の Maven コマンドの 1 つを入力します。

すべての S2I クイックスタートにアクセスするには、以下を実行します。

mvn org.apache.maven.plugins:maven-archetype-plugin:2.4:generate \ -DarchetypeCatalog=https://maven.repository.redhat.com/ga/io/fabric8/archetypes/archetypes-catalog/2.2.0.fuse-sb2-7_11_1-00018-redhat-00002/archetypes-catalog-2.2.0.fuse-sb2-7_11_1-00018-redhat-00002-archetype-catalog.xml \ -DarchetypeGroupId=org.jboss.fuse.fis.archetypes \ -DarchetypeVersion=2.2.0.fuse-sb2-7_11_1-00018-redhat-00002

spring-boot-2-camel-xmlクイックスタートのみにアクセスするには、以下を実行します。mvn org.apache.maven.plugins:maven-archetype-plugin:2.4:generate \ -DarchetypeCatalog=https://maven.repository.redhat.com/ga/io/fabric8/archetypes/archetypes-catalog/2.2.0.fuse-sb2-7_11_1-00018-redhat-00002/archetypes-catalog-2.2.0.fuse-sb2-7_11_1-00018-redhat-00002-archetype-catalog.xml \ -DarchetypeGroupId=org.jboss.fuse.fis.archetypes \ -DarchetypeArtifactId=spring-boot-camel-xml-archetype \ -DarchetypeVersion=2.2.0.fuse-sb2-7_11_1-00018-redhat-00002

archetype プラグインが対話モードに切り替わり、残りのフィールドの入力を要求されます。

Define value for property 'groupId': : org.example.fis Define value for property 'artifactId': : fuse711-spring-boot Define value for property 'version': 1.0-SNAPSHOT: : Define value for property 'package': org.example.fis: : Confirm properties configuration: groupId: org.example.fis artifactId: fuse711-spring-boot version: 1.0-SNAPSHOT package: org.example.fis Y: : Y

プロンプトが表示されたら、

org.example.fisをgroupIdの値として入力し、fuse711-spring-bootをartifactIdの値として入力します。残りのフィールドにはデフォルト値を使用します。

-

前のコマンドが

BUILD SUCCESS状態で終了した場合、fuse711-spring-bootサブディレクトリー内に新しい Fuse on OpenShift プロジェクトが作成されているはずです。fuse711-spring-boot/src/main/resources/spring/camel-context.xmlファイルの XML DSL コードを確認します。デモンストレーションコードは、乱数が含まれるメッセージを継続的にログに送信する、シンプルな Camel ルートを定義します。 Fuse on OpenShift プロジェクトのビルドおよびデプロイを準備するため、以下のように OpenShift サーバーにログインします。

oc login -u developer -p developer https://OPENSHIFT_IP_ADDR:8443

IP アドレスは常に同じではないため、

OPENSHIFT_IP_ADDRは OpenShift サーバーの IP アドレスのプレースホルダーになります。この値を実際の IP アドレスに置き換えます。注記developerパスワードを持つdeveloperユーザーは、CDK による仮想 OpenShift サーバーで自動作成される標準のアカウントです。リモートサーバーにアクセスする場合は、OpenShift 管理者が提供する URL とクレデンシャルを使用します。次のように、

openshiftプロジェクトに切り替えます (まだopenshiftプロジェクトにない場合)。oc project openshift

以下のコマンドを実行し、Fuse on OpenShift イメージおよびテンプレートがすでにインストールされ、アクセス可能であることを確認します。

oc get template -n openshift

イメージおよびテンプレートが事前にインストールされていない場合や、提供されたバージョンが古い場合は、Fuse on OpenShift イメージおよびテンプレートを手作業でインストール (または更新) します。Fuse on OpenShift イメージのインストール方法に関する詳細は、2章管理者向けの基本情報 を参照してください。

これで、

fuse711-spring-bootプロジェクトをビルドおよびデプロイできるようになりました。OpenShift にログインしている状態で、fuse711-spring-bootプロジェクトのディレクトリーに移動し、以下のようにプロジェクトをビルドおよびデプロイします。cd fuse711-spring-boot mvn oc:deploy -Popenshift

ビルドに成功すると、以下のような出力が表示されます。