RHEL システムロールを使用した管理タスクおよび設定タスク

Red Hat Ansible Automation Platform Playbook を使用して複数のホストに RHEL をデプロイするための一貫性および反復性のある設定

概要

多様性を受け入れるオープンソースの強化

Red Hat では、コード、ドキュメント、Web プロパティーにおける配慮に欠ける用語の置き換えに取り組んでいます。まずは、マスター (master)、スレーブ (slave)、ブラックリスト (blacklist)、ホワイトリスト (whitelist) の 4 つの用語の置き換えから始めます。この取り組みは膨大な作業を要するため、今後の複数のリリースで段階的に用語の置き換えを実施して参ります。詳細は、Red Hat CTO である Chris Wright のメッセージ を参照してください。

Red Hat ドキュメントへのフィードバック (英語のみ)

Red Hat ドキュメントに関するご意見やご感想をお寄せください。また、改善点があればお知らせください。

特定の文章に関するコメントの送信

- Multi-page HTML 形式でドキュメントを表示し、ページが完全にロードされてから右上隅に Feedback ボタンが表示されていることを確認します。

- カーソルを使用して、コメントを追加するテキスト部分を強調表示します。

- 強調表示されたテキストの近くに表示される Add Feedback ボタンをクリックします。

- フィードバックを追加し、Submit をクリックします。

Bugzilla からのフィードバック送信 (アカウントが必要)

- Bugzilla の Web サイトにログインします。

- Version メニューから正しいバージョンを選択します。

- Summary フィールドにわかりやすいタイトルを入力します。

- Description フィールドに、ドキュメントの改善に関するご意見を記入してください。ドキュメントの該当部分へのリンクも追加してください。

- Submit Bug をクリックします。

第1章 RHEL System Roles を使用するための制御ノードと管理対象ノードの準備

個々の RHEL システムロールを使用してサービスおよび設定を管理する前に、関連するホストを準備します。

1.1. RHEL システムロールの概要

RHEL システムロールは、Ansible ロールおよびモジュールのコレクションです。RHEL システムロールは、複数の RHEL システムをリモートで管理するための設定インターフェイスを提供します。このインターフェイスは、RHEL の複数のバージョンにわたるシステム設定の管理と、新しいメジャーリリースの導入を可能にします。

Red Hat Enterprise Linux 9 のインターフェイスは、現在、以下のロールから設定されます。

- 証明書の発行および更新

-

カーネル設定 (

kernel_settings) -

メトリクス (

metrics) -

Network Bound Disk Encryption クライアントと Network Bound Disk Encryption サーバー (

nbde_clientとnbde_server) -

ネットワーキング (

network) -

Postfix (

postfix) -

SSH クライアント (

ssh) -

SSH サーバー (

sshd) -

システム全体の暗号化ポリシー (

crypto_policies) -

端末セッションの録画 (

tlog)

これらのロールはすべて、AppStream リポジトリーで利用可能な rhel-system-roles パッケージで提供されます。

関連情報

- Red Hat Enterprise Linux (RHEL) System Roles

-

rhel-system-rolesパッケージにより提供される/usr/share/doc/rhel-system-roles/。

1.2. RHEL システムロールの用語

このドキュメントでは、以下の用語を確認できます。

- Ansible Playbook

- Playbook は、Ansible の設定、デプロイメント、およびオーケストレーションの言語です。リモートシステムを強制するポリシーや、一般的な IT プロセスで一連の手順を説明することができます。

- コントロールノード

- Ansible がインストールされているマシン。コマンドおよび Playbook を実行でき、すべてのコントロールノードから /usr/bin/ansible または /usr/bin/ansible-playbook を起動します。Python がインストールされているすべてのコンピューターをコントロールノードとして使用できます。ラップトップ、共有デスクトップ、およびサーバーですべての Ansible を実行できます。ただし、Windows マシンをコントロールノードとして使用することはできません。複数のコントロールノードを使用できます。

- インベントリー

- 管理対象ノードの一覧。インベントリーファイルはホストファイルとも呼ばれます。インベントリーでは、各管理対象ノードに対して IP アドレスなどの情報を指定できます。また、インベントリーは管理ノードを編成し、簡単にスケーリングできるようにグループの作成およびネスト化が可能です。インベントリーについての詳細は、インベントリーの操作セクションを参照してください。

- 管理ノード

- Ansible で管理するネットワークデバイス、サーバー、またはその両方。管理対象ノードは、ホストと呼ばれることもあります。Ansible が管理ノードにはインストールされません。

1.3. コントロールノードの準備

RHEL には、サポート範囲が限定された Ansible Core が AppStream リポジトリーに含まれています。Ansible の追加サポートが必要な場合は、Red Hat に連絡して、Ansible Automation Platform サブスクリプションの詳細を確認してください。

前提条件

- システムをカスタマーポータルに登録している。

-

Red Hat Enterprise Linux Serverサブスクリプションをシステムにアタッチしている。 -

カスタマーポータルアカウントで利用可能な場合は、

Ansible Automation Platformサブスクリプションをシステムにアタッチしている。

手順

rhel-system-rolesパッケージをインストールします。[root@control-node]# dnf install rhel-system-rolesこのコマンドは、

Ansible Coreを依存関係としてインストールします。後で Playbook を管理および実行するために使用するユーザーを作成します。

[root@control-node]# useradd ansible新しく作成した

ansibleユーザーに切り替えます。[root@control-node]# su - ansibleこのユーザーとして残りの手順を実行します。

SSH の公開鍵と秘密鍵を作成します。

[ansible@control-node]$ ssh-keygen Generating public/private rsa key pair. Enter file in which to save the key (/home/ansible/.ssh/id_rsa): password ...

キーファイルの推奨されるデフォルトの場所を使用します。

- オプション:接続を確立するたびに Ansible が SSH キーのパスワードを要求しないように、SSH エージェントを設定します。

~/.ansible.cfgファイルを次の内容で作成します。[defaults] inventory = /home/ansible/inventory remote_user = ansible [privilege_escalation] become = True become_method = sudo become_user = root become_ask_pass = True

この設定により、以下が可能になります。

- Ansible は、指定されたインベントリーファイルでホストを管理します。

-

Ansible は、管理対象ノードへの SSH 接続を確立するときに、

remote_userパラメーターで設定されたアカウントを使用します。 Ansible は

sudoユーティリティーを使用して、rootユーザーとして管理対象ノードでタスクを実行します。セキュリティー上の理由から、管理対象ノードで

sudoを設定して、rootになるリモートユーザーのパスワードの入力を要求します。~/.ansible.cfgでbecome_ask_pass=True設定を指定すると、Playbook の実行時に Ansible によってこのパスワードの入力が求められます。

~/.ansible.cfgファイルの設定は優先度が高く、グローバルな/etc/ansible/ansible.cfgファイルの設定をオーバーライドします。~/inventoryファイルを作成します。たとえば、以下は、3 つのホストとUSという名前の 1 つのホストグループを含む INI 形式のインベントリーファイルです。managed-node-01.example.com [US] managed-node-02.example.com ansible_host=192.0.2.100 managed-node-03.example.com

制御ノードはホスト名を解決できる必要があることに注意してください。DNS サーバーが特定のホスト名を解決できない場合は、ホストエントリーの横に

ansible_hostパラメーターを追加して、その IP アドレスを指定します。

1.4. 管理対象ノードの準備

Ansible は、管理対象ホストでエージェントを使用しません。唯一の要件は、RHEL にデフォルトでインストールされる Python と、管理対象ホストへの SSH アクセスです。

ただし、root ユーザーとして SSH に直接アクセスすると、セキュリティー上のリスクが生じる可能性があります。したがって、管理対象ノードを準備するときは、このノードでローカルユーザーを作成し、sudo ポリシーを設定します。コントロールノードの Ansible は、このアカウントを使用して管理対象ノードにログインし、root などの別のユーザーとして Playbook を実行できます。

前提条件

- 制御ノードを準備している。

手順

ユーザーを作成します。

[root@managed-node-01]# useradd ansible制御ノードは後でこのユーザーを使用して、このホストへの SSH 接続を確立します。

ansibleユーザーにパスワードを設定します。[root@managed-node-01]# passwd ansible Changing password for user ansible. New password: password Retype new password: password passwd: all authentication tokens updated successfully.

Ansible が

sudoを使用してrootユーザーとしてタスクを実行する場合は、このパスワードを入力する必要があります。ansibleユーザーの SSH 公開鍵を管理対象ノードにインストールします。ansibleユーザーとして制御ノードにログインし、SSH 公開鍵を管理対象ノードにコピーします。[ansible@control-node]$ ssh-copy-id managed-node-01.example.com /usr/bin/ssh-copy-id: INFO: Source of key(s) to be installed: "/home/ansible/.ssh/id_rsa.pub" The authenticity of host 'managed-node-01.example.com (192.0.2.100)' can't be established. ECDSA key fingerprint is SHA256:9bZ33GJNODK3zbNhybokN/6Mq7hu3vpBXDrCxe7NAvo. Are you sure you want to continue connecting (yes/no/[fingerprint])? yes /usr/bin/ssh-copy-id: INFO: attempting to log in with the new key(s), to filter out any that are already installed /usr/bin/ssh-copy-id: INFO: 1 key(s) remain to be installed -- if you are prompted now it is to install the new keys ansible@managed-node-01.example.com's password: password Number of key(s) added: 1 Now try logging into the machine, with: "ssh 'managed-node-01.example.com'" and check to make sure that only the key(s) you wanted were added.

制御ノードでコマンドをリモートで実行して、SSH 接続を確認します。

[ansible@control-node]$ ssh managed-node-01.example.com whoami ansible

ansibleユーザーのsudo設定を作成します。visudoコマンドを使用して、/etc/sudoers.d/ansibleファイルを作成および編集します。[root@managed-node-01]# visudo /etc/sudoers.d/ansible通常のエディターと比べて

visudoを使用する利点は、このユーティリティーがファイルをインストールする前に基本的な健全性チェックと解析エラーのチェックを提供することです。/etc/sudoers.d/ansibleファイルで、要件に応じたsudoersポリシーを設定します。次に例を示します。ansibleユーザーのパスワードを入力した後、このホスト上で任意のユーザーおよびグループとしてすべてのコマンドを実行する権限をansibleユーザーに付与するには、以下を使用します。ansible ALL=(ALL) ALLansibleユーザーのパスワードを入力せずに、このホスト上で任意のユーザーおよびグループとしてすべてのコマンドを実行する権限をansibleユーザーに付与するには、以下を使用します。ansible ALL=(ALL) NOPASSWD: ALL

または、セキュリティー要件に合わせてより細かいポリシーを設定します。

sudoersポリシーの詳細は、sudoers (5)man ページを参照してください。

関連情報

- コントロールノードの準備

-

sudoers(5)man ページ

1.5. 制御ノードから管理対象ノードへのアクセスの確認

制御ノードを設定し、管理対象ノードを準備したら、Ansible が管理対象ノードに接続できることをテストします。

制御ノードで ansible ユーザーとしてこの手順を実行します。

前提条件

- 制御ノードの準備 の説明に従って、制御ノードを準備しました。

- 管理対象ノードの準備 の説明に従って、少なくとも 1 つの管理対象ノードを準備しました。

- ホストグループで Playbook を実行する場合、管理対象ノードは制御ノードのインベントリーファイルにリストされます。

手順

Ansible の

pingモジュールを使用して、すべての管理対象ホストでコマンドを実行できることを確認します。[ansible@control-node]$ ansible all -m ping BECOME password: password managed-node-01.example.com | SUCCESS => { "ansible_facts": { "discovered_interpreter_python": "/usr/bin/python3" }, "changed": false, "ping": "pong" } ...

ハードコーディングされた

すべてのホストグループには、インベントリーファイルにリストされているすべてのホストが動的に含まれます。Ansible の

commandモジュールを使用して、管理対象ホストでwhoamiユーティリティーを実行します。[ansible@control-node]$ ansible managed-node-01.example.com -m command -a whoami BECOME password: password managed-node-01.example.com | CHANGED | rc=0 >> root

コマンドが

rootを返す場合は、管理対象ノードでsudoが正しく設定されており、権限昇格が機能しています。

第2章 RHEL システムロールの自動化を有効にするためのパッケージの更新

RHEL 9.0 リリース以降、Ansible Engine はサポートされなくなりました。代わりに、今回以降の RHEL リリースには Ansible Core が含まれます。

RHEL 9.0 の Ansible Core を使用して、Red Hat 製品によって作成または生成された Ansible 自動化コンテンツを有効化できます。

Ansible Core には、ansible-playbook や ansible コマンドなどの Ansible コマンドラインツールと、ビルトイン Ansible プラグイン のセットが含まれています。

2.1. Ansible Engine と Ansible Core の違い

RHEL 8.5 以前のバージョンでは、Ansible Engine 2.9 を含む別の Ansible リポジトリーにアクセスして、Red Hat システムに対して Ansible に基づき自動化を有効にしていました。

Ansible サブスクリプションなしで Ansible Engine を使用する場合、サポート範囲は RHEL システムロール、Insights 修復 Playbook、OpenSCAP Ansible 修復 Playbook などの Red Hat 製品によって作成または生成された AnsiblePlaybook の実行に限定されます。

RHEL 8.6 以降のバージョンでは、Ansible Core が Ansible Engine に置き換わります。ansible-core パッケージは RHEL 9 AppStream リポジトリーに含まれており、Red Hat が提供する自動化コンテンツを有効にします。RHEL での Ansible Core のサポート範囲は、以前の RHEL バージョンと同じです。

- サポートは、RHEL システムロールなど、Red Hat 製品に含まれているか Red Hat 製品によって生成された Ansible Playbook、ロール、モジュール、または Insights によって生成された修復 Playbook に限定されます。

- Ansible Core を使用すると、RHEL システムロールや Insights 修復 Playbook など、サポートされている RHEL Ansible コンテンツのすべての機能を利用できます。

Ansible Engine リポジトリーは RHEL 8.6 でも引き続き使用できます。ただし、セキュリティーまたはバグ修正の更新は受信せず、RHEL 8.6 以降に含まれる Ansible 自動化コンテンツと互換性がない可能性があります。

基盤となるプラットフォームと Core で維持されるモジュールの追加サポートには、Ansible Automation Platform のサブスクリプションが必要です。

2.2. Ansible Engine から Ansible Core への移行

前提条件

1 つ以上の 管理対象ノード (RHEL システムロールで設定するシステム) へのアクセスおよびパーミッション。

- 管理対象ノードが記載されているインベントリーファイルがある。

手順

Ansible Engine をインストールします。

# dnf remove ansibleansible-2-for-rhel-8-x86_64-rpmsリポジトリーを無効にします。# subscription-manager repos --disable ansible-2-for-rhel-8-x86_64-rpmsRHEL 8 AppStream リポジトリーで利用可能な Ansible Core をインストールします。

# dnf install ansible-core

検証

ansible-coreパッケージがシステムに存在することを確認します。# dnf info ansible-core

ansible-core パッケージが実際にシステムに存在する場合、コマンド出力には、パッケージ名、バージョン、リリース、サイズなどに関する情報が表示されます。

Available Packages Name : ansible-core Version : 2.12.2 Release : 1.fc34 Architecture : noarch Size : 2.4 M Source : ansible-core-2.12.2-1.fc34.src.rpm Repository : updates Summary : A radically simple IT automation system URL : http://ansible.com

関連情報

第3章 コレクションのインストールと使用

3.1. Ansible コレクションの概要

Ansible コレクションは、新たな方法で自動化を配布、メンテナーンス、および使用します。Playbook、ロール、モジュール、プラグインなど、複数のタイプの Ansible コンテンツを組み合わせることで、柔軟性とスケーラビリティーが向上します。

Ansible Collections は、従来の RHEL システムロール形式に対するオプションです。Ansible Collection 形式で RHEL システムロールを使用するのは、従来の RHEL システムロール形式での使用とほぼ同じです。相違点は、Ansible Collections は 完全修飾コレクション名 (FQCN) という概念を使用する点です。このコレクション名は、namespace と コレクション名 で設定されます。使用する namespace は redhat で、コレクション名 は rhel_system_roles です。したがって、Kernel Settings の従来の RHEL システムロール形式は rhel-system-roles.kernel_settings として表示されますが、Kernel Settings ロールの fully qualified collection name というコレクションを使用すると redhat.rhel_system_roles.kernel_settings (アンダースコア付き) として表示されます。

namespace と コレクション名 を組み合わせると、確実にオブジェクトが一意になります。また、オブジェクトが競合せずに Ansible Collections および namespace 間で共有されます。

関連情報

- Automation Hub にアクセスして Red Hat 認定コレクションを使用するには、Ansible Automation Platform (AAP サブスクリプション) が必要です。

3.2. コレクションの構造

コレクションは、Ansible コンテンツのパッケージ形式です。データ構造は以下のようになります。

- docs/: 例も含めてコレクションについてまとめたローカルドキュメント。(ロールがドキュメントを提供する場合)

- galaxy.yml: Ansible Collection パッケージに含まれる MANIFEST.json のソースデータ

Playbook/: Playbook はこちらで利用できます。

- tasks/: include_tasks/import_tasks の使用状況に関する task list files を保管します。

plugins/: Ansible プラグインおよびモジュールはすべてこちらの各サブディレクトリーから入手できます。

- modules/:Ansible モジュール

- modules_utils/: モジュール開発用の共通コード

- lookup/: プラグインの検索

- filter/:Jinja2 filter プラグイン

- connection/: 接続プラグインはデフォルトを使用していない場合に必要です。

- roles/: Ansible ロール用ディレクトリー

- tests/: コレクションの内容のテスト

3.3. CLI を使用したコレクションのインストール

コレクションは、Playbook、ロール、モジュール、およびプラグインなど、Ansible コンテンツのディストリビューション形式です。

コレクションは、Ansible Galaxy、ブラウザーまたはコマンドラインを使用してインストールできます。

前提条件

- 1 つ以上の 管理対象ノード へのアクセスとアクセス権。

コントロールノード (このシステムから Red Hat Ansible Core は他のシステムを設定) へのアクセスおよびパーミッション。

コントロールノードでは、

-

ansible-coreパッケージおよびrhel-system-rolesパッケージがインストールされている。 - 管理対象ノードが記載されているインベントリーファイルがある。

-

手順

RPM パッケージからコレクションをインストールします。

# dnf install rhel-system-roles

インストールが完了すると、ロールは redhat.rhel_system_roles.<role_name> として利用できます。また、各ロールのドキュメントは /usr/share/ansible/collections/ansible_collections/redhat/rhel_system_roles/roles/<role_name>/README.md で確認できます。

検証手順

インストールを確認するには、localhost で check モードで kernel_settings ロールを実行します。Ansible package モジュールに必要な --become パラメーターも使用する必要があります。ただし、パラメーターはシステムを変更しません。

以下のコマンドを実行します。

$ ansible-playbook -c local -i localhost, --check --become /usr/share/ansible/collections/ansible_collections/redhat/rhel_system_roles/tests/kernel_settings/tests_default.yml

コマンド出力の最後の行には、値 failed=0 が含まれている必要があります。

localhost の後のコンマは必須です。リストにホストが 1 つしかない場合でも、追加する必要があります。これがないと、ansible-playbook は localhost をファイルまたはディレクトリーとして識別します。

関連情報

-

ansible-playbookの man ページ -

ansible-playbookコマンドの-iオプション

3.4. Automation Hub からのコレクションのインストール

Automation Hub を使用している場合は、Automation Hub でホストされている RHEL システムロールコレクションをインストールできます。

前提条件

- 1 つ以上の 管理対象ノード へのアクセスとアクセス権。

コントロールノード (このシステムから Red Hat Ansible Core は他のシステムを設定) へのアクセスおよびパーミッション。

コントロールノードでは、

-

ansible-coreパッケージおよびrhel-system-rolesパッケージがインストールされている。 - 管理対象ノードが記載されているインベントリーファイルがある。

-

手順

-

ansible.cfg設定ファイルでコンテンツのデフォルトソースとして Red Hat Automation Hub を定義します。コンテンツについては、プライマリーソースとしての Red Hat Automation Hub の設定 を参照してください。 Automation Hub から

redhat.rhel_system_rolesコレクションをインストールします。# ansible-galaxy collection install redhat.rhel_system_rolesインストールが完了すると、ロールは

redhat.rhel_system_roles.<role_name>として利用できます。また、各ロールのドキュメントは/usr/share/ansible/collections/ansible_collections/redhat/rhel_system_roles/roles/<role_name>/README.mdで確認できます。

検証手順

インストールを確認するには、localhost で check モードで kernel_settings ロールを実行します。Ansible package モジュールに必要な --become パラメーターも使用する必要があります。ただし、パラメーターはシステムを変更しません。

以下のコマンドを実行します。

$ ansible-playbook -c local -i localhost, --check --become /usr/share/ansible/collections/ansible_collections/redhat/rhel_system_roles/tests/kernel_settings/tests_default.yml

コマンド出力の最後の行には、値 failed=0 が含まれている必要があります。

localhost の後のコンマは必須です。リストにホストが 1 つしかない場合でも、追加する必要があります。これがないと、ansible-playbook は localhost をファイルまたはディレクトリーとして識別します。

関連情報

-

ansible-playbookの man ページ -

ansible-playbookコマンドの-iオプション

3.5. コレクションを使用した tlog RHEL システムロールのデプロイ

以下の例では、コレクションを使用して Playbook を準備および適用し、一連の個別のマシンにロギングソリューションをデプロイしています。

前提条件

- Galaxy コレクションがインストールされている。

手順

以下の内容を含む新しい

playbook.ymlファイルを作成します。--- - name: Deploy session recording hosts: all vars: tlog_scope_sssd: some tlog_users_sssd: - recordeduser roles: - redhat.rhel-system-roles.tlog詳細は以下のようになります。

tlog_scope_sssd:-

someは、allまたはnoneではなく、特定のユーザーおよびグループのみを録画することを指定します。

-

tlog_users_sssd:-

recordeduserは、セッションを録画するユーザーを指定します。ただし、ユーザーは追加されない点に留意してください。ユーザーを独自に設定する必要があります。

-

オプション: Playbook の構文を確認します。

# ansible-playbook --syntax-check playbook.ymlインベントリーファイルで Playbook を実行します。

# ansible-playbook -i IP_Address /path/to/file/playbook.yml -v

これにより、Playbook は指定したシステムに tlog ロールをインストールします。また、定義したユーザーおよびグループで使用できる SSSD 設定ドロップファイルを作成します。SSSD は、これらのユーザーおよびグループを解析して読み取り、シェルユーザーとして tlog セッションをオーバーレイします。さらに、cockpit パッケージがシステムにインストールされている場合、Playbook は cockpit-session-recording パッケージもインストールします。これは、Web コンソールインターフェイスで録画を表示および再生できるようにする Cockpit モジュールです。

検証手順

/etc/rsyslog.confファイルの構文をテストします。# rsyslogd -N 1 rsyslogd: version 8.1911.0-6.el8, config validation run (level 1), master config /etc/rsyslog.conf rsyslogd: End of config validation run. Bye.

- システムがログにメッセージを送信していることを確認します。

システムで SSSD 設定ドロップファイルが作成されることを確認するには、以下の手順を実行します。

SSSD 設定ドロップファイルが作成されるフォルダーに移動します。

# cd /etc/sssd/conf.dファイルの内容を確認します。

# cat sssd-session-recording.conf

Playbook に設定したパラメーターがファイルに含まれていることが確認できます。

第4章 RHEL の Ansible IPMI モジュール

4.1. rhel_mgmt コレクション

Intelligent Platform Management Interface (IPMI) は、ベースボード管理コントローラー (BMC) デバイスと通信するための一連の標準プロトコルの仕様です。IPMI モジュールを使用すると、ハードウェア管理の自動化を有効にしてサポートできます。IPMI モジュールは次の場所で使用できます。

-

rhel_mgmtコレクション。パッケージ名はansible-collection-redhat-rhel_mgmtです。 -

新しい

ansible-collection-redhat-rhel_mgmtパッケージの一部である RHEL 8 AppStream。

次の IPMI モジュールが rhel_mgmt コレクションで使用可能です。

-

ipmi_boot:起動デバイスの順序管理 -

ipmi_power:マシンの電源管理

IPMI モジュールに使用される必須パラメーターは次のとおりです。

-

ipmi_bootパラメーター:

| モジュール名 | 説明 |

|---|---|

| name | BMC のホスト名または IP アドレス。 |

| password | BMC に接続するためのパスワード |

| bootdev | 次回起動時に使用するデバイス * network * floppy * hd * safe * optical * setup * default |

| User | BMC に接続するためのユーザー名 |

-

ipmi_powerパラメーター:

| モジュール名 | 説明 |

|---|---|

| name | BMC ホスト名または IP アドレス |

| password | BMC に接続するためのパスワード |

| user | BMC に接続するためのユーザー名 |

| State | マシンが目的のステータスにあるかどうかを確認します * on * off * shutdown * reset * boot |

4.2. CLI を使用した rhel mgmt コレクションのインストール

コマンドラインを使用して rhel_mgmt コレクションをインストールできます。

前提条件

-

ansible-coreパッケージがインストールされている。

手順

RPM パッケージからコレクションをインストールします。

# yum install ansible-collection-redhat-rhel_mgmtインストールが完了すると、IPMI モジュールは

redhat.rhel_mgmtAnsible コレクションで使用できるようになります。

関連情報

-

ansible-playbookの man ページ

4.3. ipmi_boot モジュールの使用例

次の例は、Playbook で ipmi_boot モジュールを使用して、次回の起動用に起動デバイスを設定する方法を示しています。わかりやすくするために、ここに示す例では Ansible コントロールホストおよび管理対象ホストと同じホストを使用しているため、Playbook が実行されるのと同じホストでモジュールを実行します。

前提条件

- rhel_mgmt コレクションがインストールされている。

python3-pyghmiパッケージのpyghmiライブラリーが、次のいずれかの場所にインストールされている。- Playbook を実行するホスト。

-

管理対象ホスト。localhost を管理対象ホストとして使用する場合は、代わりに、Playbook を実行するホストに

python3-pyghmiパッケージをインストールします。

- 制御する IPMI BMC は、Playbook を実行するホスト、または管理対象ホスト (localhost を管理対象ホストとして使用していない場合) からネットワーク経由でアクセスできます。モジュールが IPMI プロトコルを使用してネットワーク経由で BMC に接続するため、通常、モジュールによって BMC が設定されているホストはモジュールが実行されているホスト (Ansible 管理対象ホスト) とは異なることに注意してください。

- 適切なレベルのアクセスで BMC にアクセスするためのクレデンシャルがあります。

手順

以下のコンテンツを含む新しい playbook.yml ファイルを作成します。

--- - name: Sets which boot device will be used on next boot hosts: localhost tasks: - redhat.rhel_mgmt.ipmi_boot: name: bmc.host.example.com user: admin_user password: basics bootdev: hdlocalhost に対して Playbook を実行します。

# ansible-playbook playbook.yml

その結果、出力は値 success を返します。

4.4. ipmi_power モジュールの使用例

この例は、Playbook で ipmi_boot モジュールを使用して、システムがオンになっているかどうかを確認する方法を示しています。わかりやすくするために、ここに示す例では Ansible コントロールホストおよび管理対象ホストと同じホストを使用しているため、Playbook が実行されるのと同じホストでモジュールを実行します。

前提条件

- rhel_mgmt コレクションがインストールされている。

python3-pyghmiパッケージのpyghmiライブラリーが、次のいずれかの場所にインストールされている。- Playbook を実行するホスト。

-

管理対象ホスト。localhost を管理対象ホストとして使用する場合は、代わりに、Playbook を実行するホストに

python3-pyghmiパッケージをインストールします。

- 制御する IPMI BMC は、Playbook を実行するホスト、または管理対象ホスト (localhost を管理対象ホストとして使用していない場合) からネットワーク経由でアクセスできます。モジュールが IPMI プロトコルを使用してネットワーク経由で BMC に接続するため、通常、モジュールによって BMC が設定されているホストはモジュールが実行されているホスト (Ansible 管理対象ホスト) とは異なることに注意してください。

- 適切なレベルのアクセスで BMC にアクセスするためのクレデンシャルがあります。

手順

以下のコンテンツを含む新しい playbook.yml ファイルを作成します。

--- - name: Turn the host on hosts: localhost tasks: - redhat.rhel_mgmt.ipmi_power: name: bmc.host.example.com user: admin_user password: basics state: onPlaybook を実行します。

# ansible-playbook playbook.yml

出力は値 true を返します。

第5章 RHEL の Redfish モジュール

デバイスのリモート管理用の Redfish モジュールは、redhat.rhel_mgmt Ansible コレクションの一部になりました。Redfish モジュールを使用すると、標準の HTTPS トランスポートと JSON 形式を使用して、サーバーに関する情報を取得したり、帯域外 (OOB) コントローラーを介してそれらを制御したりして、ベアメタルサーバーとプラットフォームハードウェアで管理の自動化を簡単に使用できます。

5.1. Redfish モジュール

redhat.rhel_mgmt Ansible コレクションは、Redfish 上の Ansible でのハードウェア管理をサポートする Redfish モジュールを提供します。redhat.rhel_mgmt コレクションは ansible-collection-redhat-rhel_mgmt パッケージで利用できます。インストールするには、CLI を使用した redhat.rhel_mgmt コレクションのインストール を参照してください。

次の Redfish モジュールは、redhat.rhel_mgmt コレクションで利用できます。

-

redfish_info:redfish_infoモジュールは、システムインベントリーなどのリモートアウトオブバンド (OOB) コントローラーに関する情報を取得します。 -

redfish_command:redfish_commandモジュールは、ログ管理やユーザー管理などの帯域外 (OOB) コントローラー操作と、システムの再起動、電源のオンとオフなどの電源操作を実行します。 -

redfish_config:redfish_configモジュールは、OOB 設定の変更や BIOS 設定の設定などの OOB コントローラー操作を実行します。

5.2. Redfish モジュールのパラメーター

Redfish モジュールに使用されるパラメーターは次のとおりです。

redfish_info パラメーター: | 説明 |

|---|---|

|

| (必須) - OOB コントローラーのベース URI。 |

|

| (必須) - OOB コントローラーで実行するカテゴリーのリスト。デフォルト値は ["Systems"] です。 |

|

| (必須) - OOB コントローラーで実行するコマンドのリスト。 |

|

| OOB コントローラーへの認証用のユーザー名。 |

|

| OOB コントローラーへの認証用のパスワード。 |

redfish_command パラメーター: | 説明 |

|---|---|

|

| (必須) - OOB コントローラーのベース URI。 |

|

| (必須) - OOB コントローラーで実行するカテゴリーのリスト。デフォルト値は ["Systems"] です。 |

|

| (必須) - OOB コントローラーで実行するコマンドのリスト。 |

|

| OOB コントローラーへの認証用のユーザー名。 |

|

| OOB コントローラーへの認証用のパスワード。 |

redfish_config パラメーター: | 説明 |

|---|---|

|

| (必須) - OOB コントローラーのベース URI。 |

|

| (必須) - OOB コントローラーで実行するカテゴリーのリスト。デフォルト値は ["Systems"] です。 |

|

| (必須) - OOB コントローラーで実行するコマンドのリスト。 |

|

| OOB コントローラーへの認証用のユーザー名。 |

|

| OOB コントローラーへの認証用のパスワード。 |

|

| 更新する BIOS 属性。 |

5.3. redfish_info モジュールの使用

次の例は、Playbook で redfish_info モジュールを使用して CPU インベントリーに関する情報を取得する方法を示しています。わかりやすくするために、ここに示す例では Ansible コントロールホストおよび管理対象ホストと同じホストを使用しているため、Playbook が実行されるのと同じホストでモジュールを実行します。

前提条件

-

redhat.rhel_mgmtコレクションがインストールされます。 -

python3-pyghmiパッケージのpyghmiライブラリーが管理対象ホストにインストールされます。管理対象ホストとして localhost を使用する場合は、Playbook を実行するホストにpython3-pyghmiパッケージをインストールします。 - OOB コントローラーアクセスの詳細。

手順

以下のコンテンツを含む新しい playbook.yml ファイルを作成します。

--- - name: Get CPU inventory hosts: localhost tasks: - redhat.rhel_mgmt.redfish_info: baseuri: "{{ baseuri }}" username: "{{ username }}" password: "{{ password }}" category: Systems command: GetCpuInventory register: resultlocalhost に対して Playbook を実行します。

# ansible-playbook playbook.yml

その結果、出力は CPU インベントリーの詳細を返します。

5.4. redfish_command モジュールの使用

次の例は、playbook で redfish_command モジュールを使用してシステムをオンにする方法を示しています。わかりやすくするために、ここに示す例では Ansible コントロールホストおよび管理対象ホストと同じホストを使用しているため、Playbook が実行されるのと同じホストでモジュールを実行します。

前提条件

-

redhat.rhel_mgmtコレクションがインストールされます。 -

python3-pyghmiパッケージのpyghmiライブラリーが管理対象ホストにインストールされます。管理対象ホストとして localhost を使用する場合は、Playbook を実行するホストにpython3-pyghmiパッケージをインストールします。 - OOB コントローラーアクセスの詳細。

手順

以下のコンテンツを含む新しい playbook.yml ファイルを作成します。

--- - name: Power on system hosts: localhost tasks: - redhat.rhel_mgmt.redfish_command: baseuri: "{{ baseuri }}" username: "{{ username }}" password: "{{ password }}" category: Systems command: PowerOnlocalhost に対して Playbook を実行します。

# ansible-playbook playbook.yml

その結果、システムの電源が入ります。

5.5. redfish_config モジュールの使用

次の例は、Playbook で redfish_config モジュールを使用して、UEFI で起動するようにシステムを設定する方法を示しています。わかりやすくするために、ここに示す例では Ansible コントロールホストおよび管理対象ホストと同じホストを使用しているため、Playbook が実行されるのと同じホストでモジュールを実行します。

前提条件

-

redhat.rhel_mgmtコレクションがインストールされます。 -

python3-pyghmiパッケージのpyghmiライブラリーが管理対象ホストにインストールされます。管理対象ホストとして localhost を使用する場合は、Playbook を実行するホストにpython3-pyghmiパッケージをインストールします。 - OOB コントローラーアクセスの詳細。

手順

以下のコンテンツを含む新しい playbook.yml ファイルを作成します。

--- - name: "Set BootMode to UEFI" hosts: localhost tasks: - redhat.rhel_mgmt.redfish_config: baseuri: "{{ baseuri }}" username: "{{ username }}" password: "{{ password }}" category: Systems command: SetBiosAttributes bios_attributes: BootMode: Uefilocalhost に対して Playbook を実行します。

# ansible-playbook playbook.yml

その結果、システムの起動モードは UEFI に設定されます。

第6章 Ansible ロールを使用したカーネルパラメーターの永続的な設定

kernel_settings ロールを使用して、複数のクライアントにカーネルパラメーターを一度に設定することができます。この解決策は以下のとおりです。

- 効率的な入力設定を持つ使いやすいインターフェイスを提供します。

- すべてのカーネルパラメーターを 1 か所で保持します。

コントロールマシンから kernel_settings ロールを実行すると、カーネルパラメーターはすぐに管理システムに適用され、再起動後も維持されます。

RHEL チャネルで提供される RHEL システムロールは、デフォルトの App Stream リポジトリーの RPM パッケージとして RHEL のお客様が利用できることに注意してください。RHEL システムロールは、Ansible Automation Hub を介して Ansible サブスクリプションを使用しているお客様のコレクションとしても利用できます。

6.1. kernel_settings ロールの概要

RHEL システムロールは、複数のシステムをリモートで管理する、一貫した設定インターフェイスを提供する一連のロールです。

kernel_settings システムロールを使用して、カーネルの自動設定に RHEL システムロールが導入されました。rhel-system-roles パッケージには、このシステムロールと参考ドキュメントも含まれます。

カーネルパラメーターを自動的に 1 つ以上のシステムに適用するには、Playbook で選択したロール変数を 1 つ以上使用して、kernel_settings ロールを使用します。Playbook は人間が判読でき、YAML 形式で記述される 1 つ以上のプレイの一覧です。

kernel_settings ロールを使用して、以下を設定できます。

-

kernel_settings_sysctlロールを使用したカーネルパラメーター -

kernel_settings_sysfsロールを使用したさまざまなカーネルサブシステム、ハードウェアデバイス、およびデバイスドライバー -

systemdサービスマネージャーの CPU アフィニティーを、kernel_settings_systemd_cpu_affinityロール変数を使用してフォーク処理します。 -

kernel_settings_transparent_hugepagesおよびkernel_settings_transparent_hugepages_defragのロール変数を使用したカーネルメモリーサブシステムの Transparent Huge Page

関連情報

-

/usr/share/doc/rhel-system-roles/kernel_settings/ディレクトリーのREADME.mdファイルおよびREADME.htmlファイル - Playbook の使用

- インベントリーの構築方法

6.2. kernel_settings ロールを使用した選択したカーネルパラメーターの適用

以下の手順に従って、Ansible Playbook を準備および適用し、複数の管理システムで永続化の影響でカーネルパラメーターをリモートに設定します。

前提条件

-

root権限がある。 -

RHEL サブスクリプションの資格を取得して、

ansible-coreおよびrhel-system-rolesパッケージをコントロールマシンにインストールしている。 - 管理対象ホストのインベントリーが制御マシンに存在し、Ansible から接続できる。

RHEL 8.0-8.5 では、別の Ansible リポジトリーへのアクセス権を指定されており、Ansible をベースにする自動化用の Ansible Engine 2.9 が含まれています。Ansible Engine には、 ansible、ansible-playbook などのコマンドラインユーティリティー、docker や podman などのコネクター、プラグインとモジュールすべてが含まれています。Ansible Engine を入手してインストールする方法については、Red Hat Ansible Engine をダウンロードしてインストールする方法 を参照してください。

RHEL 8.6 および 9.0 では、Ansible Core (ansible-coreRPM として提供) が導入されました。これには、Ansible コマンドラインユーティリティー、コマンド、および組み込みの Ansible プラグインセットが少し含まれています。App Stream リポジトリーには、ansible-core が含まれていますが、サポートの範囲が限定されています。詳細は、RHEL 9App Stream に含まれている ansible-core パッケージのサポート範囲 を確認してください。

手順

必要に応じて、図の目的で

inventoryファイルを確認します。# cat /home/jdoe/<ansible_project_name>/inventory [testingservers] pdoe@192.168.122.98 fdoe@192.168.122.226 [db-servers] db1.example.com db2.example.com [webservers] web1.example.com web2.example.com 192.0.2.42ファイルは

[testingservers]グループと他のグループを定義します。これにより、特定のシステムセットに対して Ansible をより効果的に実行できます。設定ファイルを作成して、Ansible 操作のデフォルトと特権昇格を設定します。

新しい YAML ファイルを作成し、これをテキストエディターで開きます。以下に例を示します。

# vi /home/jdoe/<ansible_project_name>/ansible.cfg以下の内容をファイルに挿入します。

[defaults] inventory = ./inventory [privilege_escalation] become = true become_method = sudo become_user = root become_ask_pass = true

[defaults]セクションは、管理対象ホストのインベントリーファイルへのパスを指定します。[privilege_escalation]セクションでは、指定した管理対象ホストのユーザー権限がrootに移行されることを定義します。これは、カーネルパラメーターを正常に設定するために必要です。Ansible Playbook を実行すると、ユーザーパスワードの入力が求められます。管理対象ホストへの接続後に、sudoによりrootに自動的に切り替わります。

kernel_settingsロールを使用する Ansible Playbook を作成します。新しい YAML ファイルを作成し、これをテキストエディターで開きます。以下に例を示します。

# vi /home/jdoe/<ansible_project_name>/kernel-roles.ymlこのファイルは Playbook を表し、通常は、

inventoryファイルから選択した特定の管理対象ホストに対して実行される、プレイ とも呼ばれるタスクの順序付きリストが含まれます。以下の内容をファイルに挿入します。

--- - hosts: testingservers name: "Configure kernel settings" roles: - rhel-system-roles.kernel_settings vars: kernel_settings_sysctl: - name: fs.file-max value: 400000 - name: kernel.threads-max value: 65536 kernel_settings_sysfs: - name: /sys/class/net/lo/mtu value: 65000 kernel_settings_transparent_hugepages: madvisenameキーは任意です。任意の文字列をラベルとしてプレイに関連付け、プレイの対象を特定します。プレイのhostsキーは、プレイを実行するホストを指定します。このキーの値または値は、管理対象ホストの個別名またはinventoryファイルで定義されているホストのグループとして指定できます。varsセクションは、設定する必要がある、選択したカーネルパラメーター名および値が含まれる変数の一覧を表します。rolesキーは、varsセクションで説明されているパラメーターおよび値を設定するシステムロールを指定します。注記必要に応じて、Playbook のカーネルパラメーターとその値を変更することができます。

必要に応じて、プレイ内の構文が正しいことを確認します。

# ansible-playbook --syntax-check kernel-roles.yml playbook: kernel-roles.yml以下の例では、Playbook の検証が成功したことを示しています。

Playbook を実行します。

# ansible-playbook kernel-roles.yml ... BECOME password: PLAY [Configure kernel settings] ********************************************************************************** PLAY RECAP ******************************************************************************************************** fdoe@192.168.122.226 : ok=10 changed=4 unreachable=0 failed=0 skipped=6 rescued=0 ignored=0 pdoe@192.168.122.98 : ok=10 changed=4 unreachable=0 failed=0 skipped=6 rescued=0 ignored=0Ansible が Playbook を実行する前に、パスワードの入力を求められます。これにより、管理対象ホストのユーザーが

rootに切り替わります。これは、カーネルパラメーターの設定に必要です。recap セクションは、すべての管理対象ホストのプレイが正常に終了したこと (

failed=0)、および 4 つのカーネルパラメーターが適用されたこと (changed=4) を示しています。- 管理対象ホストを再起動して、影響を受けるカーネルパラメーターをチェックし、変更が適用され、再起動後も維持されていることを確認します。

関連情報

- RHEL System Roles を使用するための制御ノードと管理対象ノードの準備

-

/usr/share/doc/rhel-system-roles/kernel_settings/ディレクトリーのREADME.htmlファイルおよびREADME.mdファイル - インベントリーの構築

- Ansible の設定

- Playbook の使用

- 変数の使用

- ロール

第7章 RHEL システムロールを使用したネットワーク設定

network RHEL System Role を使用して、ネットワーク関連の設定および管理タスクを自動化できます。

7.1. ネットワーク RHEL システムロールとインターフェイス名を使用した静的 IP アドレスでのイーサネット接続設定

network RHEL System Role を使用して、イーサネット接続をリモートで設定できます。

たとえば、以下の手順では、以下の設定で enp7s0 デバイスの NetworkManager 接続プロファイルを作成します。

-

静的 IPv4 アドレス: サブネットマスクが

/24の192.0.2.1 -

静的 IPv6 アドレス -

2001:db8:1::1(/64サブネットマスクあり) -

IPv4 デフォルトゲートウェイ -

192.0.2.254 -

IPv6 デフォルトゲートウェイ -

2001:db8:1::fffe -

IPv4 DNS サーバー -

192.0.2.200 -

IPv6 DNS サーバー -

2001:db8:1::ffbb -

DNS 検索ドメイン -

example.com

Ansible コントロールノードで以下の手順を実行します。

前提条件

- 制御ノードと管理対象ノードを準備している。

- 管理対象ノードで Playbook を実行できるユーザーとして制御ノードにログインします。

-

管理対象ノードへの接続に使用するアカウントには、そのノードに対する

sudo権限があります。 - この Playbook を実行する管理対象のノードまたは管理対象のノードのグループは、Ansible インベントリーファイルにリストされています。

- サーバーに、物理または仮想のイーサネットデバイスが設定されている。

- 管理ノードは、NetworkManager を使用してネットワークを設定します。

手順

~/ethernet-static-IP.ymlなどの Playbook ファイルを次の内容で作成します。--- - name: Configure the network hosts: managed-node-01.example.com tasks: - name: Configure an Ethernet connection with static IP include_role: name: rhel-system-roles.network vars: network_connections: - name: enp7s0 interface_name: enp7s0 type: ethernet autoconnect: yes ip: address: - 192.0.2.1/24 - 2001:db8:1::1/64 gateway4: 192.0.2.254 gateway6: 2001:db8:1::fffe dns: - 192.0.2.200 - 2001:db8:1::ffbb dns_search: - example.com state: upPlaybook を実行します。

# ansible-playbook ~/ethernet-static-IP.yml

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdファイル

7.2. ネットワーク RHEL システムロールとデバイスパスを使用した静的 IP アドレスでのイーサネット接続設定

network RHEL System Role を使用して、イーサネット接続をリモートで設定できます。

デバイスパスは、次のコマンドで識別できます。

# udevadm info /sys/class/net/<device_name> | grep ID_PATH=

たとえば、以下の手順では、PCI ID 0000:00:0[1-3].0 式に一致するが、0000:00:02.0 は一致しないデバイスに対して、以下の設定で NetworkManager 接続プロファイルを作成します。

-

静的 IPv4 アドレス: サブネットマスクが

/24の192.0.2.1 -

静的 IPv6 アドレス -

2001:db8:1::1(/64サブネットマスクあり) -

IPv4 デフォルトゲートウェイ -

192.0.2.254 -

IPv6 デフォルトゲートウェイ -

2001:db8:1::fffe -

IPv4 DNS サーバー -

192.0.2.200 -

IPv6 DNS サーバー -

2001:db8:1::ffbb -

DNS 検索ドメイン -

example.com

Ansible コントロールノードで以下の手順を実行します。

前提条件

- 制御ノードと管理対象ノードを準備している。

- 管理対象ノードで Playbook を実行できるユーザーとして制御ノードにログインします。

-

管理対象ノードへの接続に使用するアカウントには、そのノードに対する

sudo権限があります。 - この Playbook を実行する管理対象のノードまたは管理対象のノードのグループは、Ansible インベントリーファイルにリストされています。

- サーバーに、物理または仮想のイーサネットデバイスが設定されている。

- 管理ノードは、NetworkManager を使用してネットワークを設定します。

手順

~/ethernet-static-IP.ymlなどの Playbook ファイルを次の内容で作成します。--- - name: Configure the network hosts: managed-node-01.example.com tasks: - name: Configure an Ethernet connection with static IP include_role: name: rhel-system-roles.network vars: network_connections: - name: example match: path: - pci-0000:00:0[1-3].0 - &!pci-0000:00:02.0 type: ethernet autoconnect: yes ip: address: - 192.0.2.1/24 - 2001:db8:1::1/64 gateway4: 192.0.2.254 gateway6: 2001:db8:1::fffe dns: - 192.0.2.200 - 2001:db8:1::ffbb dns_search: - example.com state: up

この例の

matchパラメーターは、Ansible が PCI ID0000:00:0[1-3].0に一致するデバイスに再生を適用するが、0000:00:02.0には適用しないことを定義します。使用できる特殊な修飾子およびワイルドカードの詳細は、/usr/share/ansible/roles/rhel-system-roles.network/README.mdファイルーのmatchパラメーターの説明を参照してください。Playbook を実行します。

# ansible-playbook ~/ethernet-static-IP.yml

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdファイル

7.3. ネットワーク RHEL システムロールとインターフェイス名を使用した動的 IP アドレスでのイーサネット接続設定

network RHEL System Role を使用して、イーサネット接続をリモートで設定できます。動的 IP アドレス設定との接続の場合、NetworkManager は、DHCP サーバーから接続の IP 設定を要求します。

Ansible コントロールノードで以下の手順を実行します。

前提条件

- 制御ノードと管理対象ノードを準備している。

- 管理対象ノードで Playbook を実行できるユーザーとして制御ノードにログインします。

-

管理対象ノードへの接続に使用するアカウントには、そのノードに対する

sudo権限があります。 - この Playbook を実行する管理対象のノードまたは管理対象のノードのグループは、Ansible インベントリーファイルにリストされています。

- サーバーに、物理または仮想のイーサネットデバイスが設定されている。

- DHCP サーバーをネットワークで使用できる。

- 管理ノードは、NetworkManager を使用してネットワークを設定します。

手順

~/ethernet-dynamic-IP.ymlなどの Playbook ファイルを次の内容で作成します。--- - name: Configure the network hosts: managed-node-01.example.com tasks: - name: Configure an Ethernet connection with dynamic IP include_role: name: rhel-system-roles.network vars: network_connections: - name: enp7s0 interface_name: enp7s0 type: ethernet autoconnect: yes ip: dhcp4: yes auto6: yes state: upPlaybook を実行します。

# ansible-playbook ~/ethernet-dynamic-IP.yml

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdファイル

7.4. ネットワーク RHEL システムロールとデバイスパスを使用した動的 IP アドレスでのイーサネット接続設定

network RHEL System Role を使用して、イーサネット接続をリモートで設定できます。動的 IP アドレス設定との接続の場合、NetworkManager は、DHCP サーバーから接続の IP 設定を要求します。

デバイスパスは、次のコマンドで識別できます。

# udevadm info /sys/class/net/<device_name> | grep ID_PATH=Ansible コントロールノードで以下の手順を実行します。

前提条件

- 制御ノードと管理対象ノードを準備している。

- 管理対象ノードで Playbook を実行できるユーザーとして制御ノードにログインします。

-

管理対象ノードへの接続に使用するアカウントには、そのノードに対する

sudo権限があります。 - この Playbook を実行する管理対象のノードまたは管理対象のノードのグループは、Ansible インベントリーファイルにリストされています。

- サーバーに、物理または仮想のイーサネットデバイスが設定されている。

- DHCP サーバーをネットワークで使用できる。

- 管理対象ホストは、NetworkManager を使用してネットワークを設定します。

手順

~/ethernet-dynamic-IP.ymlなどの Playbook ファイルを次の内容で作成します。--- - name: Configure the network hosts: managed-node-01.example.com tasks: - name: Configure an Ethernet connection with dynamic IP include_role: name: rhel-system-roles.network vars: network_connections: - name: example match: path: - pci-0000:00:0[1-3].0 - &!pci-0000:00:02.0 type: ethernet autoconnect: yes ip: dhcp4: yes auto6: yes state: upこの例の

matchパラメーターは、Ansible が PCI ID0000:00:0[1-3].0に一致するデバイスに再生を適用するが、0000:00:02.0には適用しないことを定義します。使用できる特殊な修飾子およびワイルドカードの詳細は、/usr/share/ansible/roles/rhel-system-roles.network/README.mdファイルーのmatchパラメーターの説明を参照してください。Playbook を実行します。

# ansible-playbook ~/ethernet-dynamic-IP.yml

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdファイル

7.5. ネットワーク RHEL システムロールを使用した VLAN タギングの設定

network RHEL システムロールを使用して、VLAN タグ付けを設定できます。この例では、イーサネット接続と、このイーサネット接続の上に ID 10 の VLAN を追加します。子デバイスの VLAN 接続には、IP、デフォルトゲートウェイ、および DNS の設定が含まれます。

環境に応じて、プレイを適宜調整します。以下はその例です。

-

ボンディングなどの他の接続でポートとして VLAN を使用する場合は、

ip属性を省略し、子設定で IP 設定を行います。 -

VLAN でチーム、ブリッジ、またはボンディングデバイスを使用するには、

interface_nameと VLAN で使用するポートのtype属性を調整します。

Ansible コントロールノードで以下の手順を実行します。

前提条件

- 制御ノードと管理対象ノードを準備している。

- 管理対象ノードで Playbook を実行できるユーザーとして制御ノードにログインします。

-

管理対象ノードへの接続に使用するアカウントには、そのノードに対する

sudo権限があります。 - この Playbook を実行する管理対象のノードまたは管理対象のノードのグループは、Ansible インベントリーファイルにリストされています。

手順

~/vlan-ethernet.ymlなどの Playbook ファイルを次の内容で作成します。--- - name: Configure the network hosts: managed-node-01.example.com tasks: - name: Configure a VLAN that uses an Ethernet connection include_role: name: rhel-system-roles.network vars: network_connections: # Add an Ethernet profile for the underlying device of the VLAN - name: enp1s0 type: ethernet interface_name: enp1s0 autoconnect: yes state: up ip: dhcp4: no auto6: no # Define the VLAN profile - name: enp1s0.10 type: vlan ip: address: - "192.0.2.1/24" - "2001:db8:1::1/64" gateway4: 192.0.2.254 gateway6: 2001:db8:1::fffe dns: - 192.0.2.200 - 2001:db8:1::ffbb dns_search: - example.com vlan_id: 10 parent: enp1s0 state: upVLAN プロファイルの

parent属性は、enp1s0デバイス上で動作する VLAN を設定します。Playbook を実行します。

# ansible-playbook ~/vlan-ethernet.yml

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdファイル

7.6. ネットワーク RHEL システムロールを使用したネットワークブリッジの設定

network RHEL システムロールを使用して、Linux ブリッジを設定できます。たとえば、2 つのイーサネットデバイスを使用するネットワークブリッジを設定し、IPv4 アドレスおよび IPv6 アドレス、デフォルトゲートウェイ、および DNS 設定を設定します。

Linux ブリッジのポートではなく、ブリッジに IP 設定を指定します。

Ansible コントロールノードで以下の手順を実行します。

前提条件

- 制御ノードと管理対象ノードを準備している。

- 管理対象ノードで Playbook を実行できるユーザーとして制御ノードにログインします。

-

管理対象ノードへの接続に使用するアカウントには、そのノードに対する

sudo権限があります。 - この Playbook を実行する管理対象のノードまたは管理対象のノードのグループは、Ansible インベントリーファイルにリストされています。

- サーバーに、2 つ以上の物理ネットワークデバイスまたは仮想ネットワークデバイスがインストールされている。

手順

~/bridge-ethernet.ymlなどの Playbook ファイルを次の内容で作成します。--- - name: Configure the network hosts: managed-node-01.example.com tasks: - name: Configure a network bridge that uses two Ethernet ports include_role: name: rhel-system-roles.network vars: network_connections: # Define the bridge profile - name: bridge0 type: bridge interface_name: bridge0 ip: address: - "192.0.2.1/24" - "2001:db8:1::1/64" gateway4: 192.0.2.254 gateway6: 2001:db8:1::fffe dns: - 192.0.2.200 - 2001:db8:1::ffbb dns_search: - example.com state: up # Add an Ethernet profile to the bridge - name: bridge0-port1 interface_name: enp7s0 type: ethernet controller: bridge0 port_type: bridge state: up # Add a second Ethernet profile to the bridge - name: bridge0-port2 interface_name: enp8s0 type: ethernet controller: bridge0 port_type: bridge state: upPlaybook を実行します。

# ansible-playbook ~/bridge-ethernet.yml

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdファイル

7.7. ネットワーク RHEL システムロールを使用したネットワークボンディングの設定

network の RHEL システムロールを使用して、Linux ボンディングを設定できます。たとえば、2 つのイーサネットデバイスを使用する active-backup モードでネットワークボンディングを設定し、IPv4 アドレスおよび IPv6 アドレス、デフォルトゲートウェイ、および DNS 設定を設定します。

Linux ボンディングのポートではなく、ボンディングに IP 設定を設定します。

Ansible コントロールノードで以下の手順を実行します。

前提条件

- 制御ノードと管理対象ノードを準備している。

- 管理対象ノードで Playbook を実行できるユーザーとして制御ノードにログインします。

-

管理対象ノードへの接続に使用するアカウントには、そのノードに対する

sudo権限があります。 - この Playbook を実行する管理対象のノードまたは管理対象のノードのグループは、Ansible インベントリーファイルにリストされています。

- サーバーに、2 つ以上の物理ネットワークデバイスまたは仮想ネットワークデバイスがインストールされている。

手順

~/bond-ethernet.ymlなどの Playbook ファイルを次の内容で作成します。--- - name: Configure the network hosts: managed-node-01.example.com tasks: - name: Configure a network bond that uses two Ethernet ports include_role: name: rhel-system-roles.network vars: network_connections: # Define the bond profile - name: bond0 type: bond interface_name: bond0 ip: address: - "192.0.2.1/24" - "2001:db8:1::1/64" gateway4: 192.0.2.254 gateway6: 2001:db8:1::fffe dns: - 192.0.2.200 - 2001:db8:1::ffbb dns_search: - example.com bond: mode: active-backup state: up # Add an Ethernet profile to the bond - name: bond0-port1 interface_name: enp7s0 type: ethernet controller: bond0 state: up # Add a second Ethernet profile to the bond - name: bond0-port2 interface_name: enp8s0 type: ethernet controller: bond0 state: upPlaybook を実行します。

# ansible-playbook ~/bond-ethernet.yml

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdファイル

7.8. ネットワーク RHEL システムロールを使用した IPoIB 接続の設定

network RHEL システムロールを使用して、IP over InfiniBand (IPoIB) デバイスの NetworkManager 接続プロファイルをリモートで作成できます。たとえば、Ansible Playbook を実行して、次の設定で mlx4_ib0 インターフェイスの InfiniBand 接続をリモートで追加します。

-

IPoIB デバイス -

mlx4_ib0.8002 -

パーティションキー

p_key-0x8002 -

静的

IPv4アドレス -192.0.2.1と/24サブネットマスク -

静的

IPv6アドレス -2001:db8:1::1(/64サブネットマスクあり)

Ansible コントロールノードで以下の手順を実行します。

前提条件

- 制御ノードと管理対象ノードを準備している。

- 管理対象のノードで Playbook を実行できるユーザーとして制御ノードにログインしました。

-

管理対象ノードへの接続に使用するアカウントには、そのノードに対する

sudo権限があります。 - この Playbook を実行する管理対象のノードまたは管理対象のノードのグループは、Ansible インベントリーファイルにリストされています。

-

mlx4_ib0という名前の InfiniBand デバイスが管理対象ノードにインストールされます。 - 管理ノードは、NetworkManager を使用してネットワークを設定します。

手順

~/IPoIB.ymlなどの Playbook ファイルを次の内容で作成します。--- - name: Configure the network hosts: managed-node-01.example.com tasks: - name: Configure IPoIB include_role: name: rhel-system-roles.network vars: network_connections: # InfiniBand connection mlx4_ib0 - name: mlx4_ib0 interface_name: mlx4_ib0 type: infiniband # IPoIB device mlx4_ib0.8002 on top of mlx4_ib0 - name: mlx4_ib0.8002 type: infiniband autoconnect: yes infiniband: p_key: 0x8002 transport_mode: datagram parent: mlx4_ib0 ip: address: - 192.0.2.1/24 - 2001:db8:1::1/64 state: upこの例のように

p_keyパラメーターを設定する場合は、IPoIB デバイスでinterface_nameパラメーターを設定しないでください。Playbook を実行します。

# ansible-playbook ~/IPoIB.yml

検証

managed-node-01.example.comホストで、mlx4_ib0.8002デバイスの IP 設定を表示します。# ip address show mlx4_ib0.8002 ... inet 192.0.2.1/24 brd 192.0.2.255 scope global noprefixroute ib0.8002 valid_lft forever preferred_lft forever inet6 2001:db8:1::1/64 scope link tentative noprefixroute valid_lft forever preferred_lft forever

mlx4_ib0.8002デバイスのパーティションキー (P_Key) を表示します。# cat /sys/class/net/mlx4_ib0.8002/pkey 0x8002mlx4_ib0.8002デバイスのモードを表示します。# cat /sys/class/net/mlx4_ib0.8002/mode datagram

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdファイル

7.9. ネットワーク RHEL システムロールを使用した特定のサブネットから別のデフォルトゲートウェイへのトラフィックのルーティング

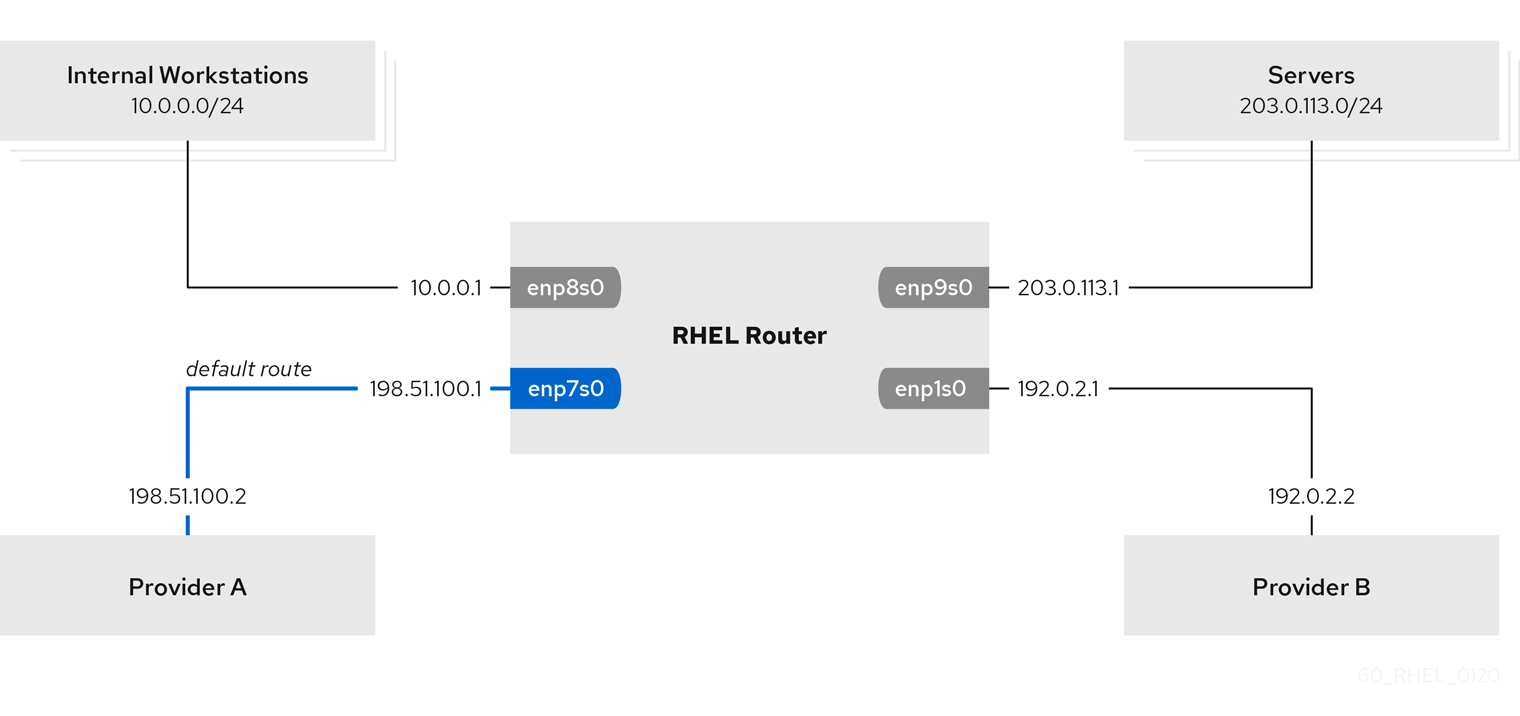

ポリシーベースのルーティングを使用して、特定のサブネットからのトラフィックに対して別のデフォルトゲートウェイを設定できます。たとえば、デフォルトルートを使用してすべてのトラフィックをインターネットプロバイダー A にルーティングするルーターとして RHEL を設定できます。ただし、内部ワークステーションサブネットから受信したトラフィックはプロバイダー B にルーティングされます。

ポリシーベースのルーティングをリモートで複数のノードに設定するには、RHEL network システムロールを使用できます。Ansible コントロールノードで以下の手順を実行します。

この手順では、次のネットワークトポロジーを想定しています。

前提条件

- 制御ノードと管理対象ノードを準備している。

- 管理対象ノードで Playbook を実行できるユーザーとして制御ノードにログインします。

-

管理対象ノードへの接続に使用するアカウントには、そのノードに対する

sudo権限があります。 - この Playbook を実行する管理対象のノードまたは管理対象のノードのグループは、Ansible インベントリーファイルにリストされています。

-

管理対象ノードは、

NetworkManagerおよびfirewalldサービスを使用します。 設定する管理対象ノードには、次の 4 つのネットワークインターフェイスがあります。

-

enp7s0インターフェイスはプロバイダー A のネットワークに接続されます。プロバイダーのネットワークのゲートウェイ IP は198.51.100.2で、ネットワークは/30ネットワークマスクを使用します。 -

enp1s0インターフェイスはプロバイダー B のネットワークに接続されます。プロバイダーのネットワークのゲートウェイ IP は192.0.2.2で、ネットワークは/30ネットワークマスクを使用します。 -

enp8s0インターフェイスは、内部ワークステーションで10.0.0.0/24サブネットに接続されています。 -

enp9s0インターフェイスは、会社のサーバーで203.0.113.0/24サブネットに接続されています。

-

-

内部ワークステーションのサブネット内のホストは、デフォルトゲートウェイとして

10.0.0.1を使用します。この手順では、この IP アドレスをルーターのenp8s0ネットワークインターフェイスに割り当てます。 -

サーバーサブネット内のホストは、デフォルトゲートウェイとして

203.0.113.1を使用します。この手順では、この IP アドレスをルーターのenp9s0ネットワークインターフェイスに割り当てます。

手順

~/pbr.ymlなどの Playbook ファイルを次の内容で作成します。--- - name: Configuring policy-based routing hosts: managed-node-01.example.com tasks: - name: Routing traffic from a specific subnet to a different default gateway include_role: name: rhel-system-roles.network vars: network_connections: - name: Provider-A interface_name: enp7s0 type: ethernet autoconnect: True ip: address: - 198.51.100.1/30 gateway4: 198.51.100.2 dns: - 198.51.100.200 state: up zone: external - name: Provider-B interface_name: enp1s0 type: ethernet autoconnect: True ip: address: - 192.0.2.1/30 route: - network: 0.0.0.0 prefix: 0 gateway: 192.0.2.2 table: 5000 state: up zone: external - name: Internal-Workstations interface_name: enp8s0 type: ethernet autoconnect: True ip: address: - 10.0.0.1/24 route: - network: 10.0.0.0 prefix: 24 table: 5000 routing_rule: - priority: 5 from: 10.0.0.0/24 table: 5000 state: up zone: trusted - name: Servers interface_name: enp9s0 type: ethernet autoconnect: True ip: address: - 203.0.113.1/24 state: up zone: trustedPlaybook を実行します。

# ansible-playbook ~/pbr.yml

検証

内部ワークステーションサブネットの RHEL ホストで、以下を行います。

tracerouteパッケージをインストールします。# dnf install traceroutetracerouteユーティリティーを使用して、インターネット上のホストへのルートを表示します。# traceroute redhat.com traceroute to redhat.com (209.132.183.105), 30 hops max, 60 byte packets 1 10.0.0.1 (10.0.0.1) 0.337 ms 0.260 ms 0.223 ms 2 192.0.2.1 (192.0.2.1) 0.884 ms 1.066 ms 1.248 ms ...コマンドの出力には、ルーターがプロバイダー B のネットワークである

192.0.2.1経由でパケットを送信することが表示されます。

サーバーのサブネットの RHEL ホストで、以下を行います。

tracerouteパッケージをインストールします。# dnf install traceroutetracerouteユーティリティーを使用して、インターネット上のホストへのルートを表示します。# traceroute redhat.com traceroute to redhat.com (209.132.183.105), 30 hops max, 60 byte packets 1 203.0.113.1 (203.0.113.1) 2.179 ms 2.073 ms 1.944 ms 2 198.51.100.2 (198.51.100.2) 1.868 ms 1.798 ms 1.549 ms ...コマンドの出力には、ルーターがプロバイダー A のネットワークである

198.51.100.2経由でパケットを送信することが表示されます。

RHEL システムロールを使用して設定した RHEL ルーターで、次の手順を実行します。

ルールの一覧を表示します。

# ip rule list 0: from all lookup local 5: from 10.0.0.0/24 lookup 5000 32766: from all lookup main 32767: from all lookup default

デフォルトでは、RHEL には、

localテーブル、mainテーブル、およびdefaultテーブルのルールが含まれます。テーブル

5000のルートを表示します。# ip route list table 5000 0.0.0.0/0 via 192.0.2.2 dev enp1s0 proto static metric 100 10.0.0.0/24 dev enp8s0 proto static scope link src 192.0.2.1 metric 102インターフェイスとファイアウォールゾーンを表示します。

# firewall-cmd --get-active-zones external interfaces: enp1s0 enp7s0 trusted interfaces: enp8s0 enp9s0externalゾーンでマスカレードが有効になっていることを確認します。# firewall-cmd --info-zone=external external (active) target: default icmp-block-inversion: no interfaces: enp1s0 enp7s0 sources: services: ssh ports: protocols: masquerade: yes ...

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdファイル

7.10. ネットワーク RHEL システムロールを使用した 802.1X ネットワーク認証による静的イーサネット接続の設定

network RHEL システムロールを使用して、802.1X 規格を使用してクライアントを認証するイーサネット接続の作成を自動化できます。たとえば、Ansible Playbook を実行して、以下の設定で enp1s0 インターフェイスのイーサネット接続をリモートで追加します。

-

静的 IPv4 アドレス: サブネットマスクが

/24の192.0.2.1 -

静的 IPv6 アドレス -

2001:db8:1::1(/64サブネットマスクあり) -

IPv4 デフォルトゲートウェイ -

192.0.2.254 -

IPv6 デフォルトゲートウェイ -

2001:db8:1::fffe -

IPv4 DNS サーバー -

192.0.2.200 -

IPv6 DNS サーバー -

2001:db8:1::ffbb -

DNS 検索ドメイン -

example.com -

TLSExtensible Authentication Protocol (EAP) を使用した 802.1X ネットワーク認証

Ansible コントロールノードで以下の手順を実行します。

前提条件

- 制御ノードと管理対象ノードを準備している。

- 管理対象ノードで Playbook を実行できるユーザーとして制御ノードにログインします。

-

管理対象ノードへの接続に使用するアカウントには、そのノードに対する

sudo権限があります。 - この Playbook を実行する管理対象のノードまたは管理対象のノードのグループは、Ansible インベントリーファイルにリストされています。

- ネットワークは 802.1X ネットワーク認証をサポートしている。

- 管理対象ノードは NetworkManager を使用します。

TLS 認証に必要な以下のファイルがコントロールノードにある。

-

クライアントキーは、

/srv/data/client.keyファイルに保存されます。 -

クライアント証明書は

/srv/data/client.crtファイルに保存されます。 -

認証局 (CA) 証明書は、

/srv/data/ca.crtファイルに保存されます。

-

クライアントキーは、

手順

~/enable-802.1x.ymlなどの Playbook ファイルを次の内容で作成します。--- - name: Configure an Ethernet connection with 802.1X authentication hosts: managed-node-01.example.com tasks: - name: Copy client key for 802.1X authentication copy: src: "/srv/data/client.key" dest: "/etc/pki/tls/private/client.key" mode: 0600 - name: Copy client certificate for 802.1X authentication copy: src: "/srv/data/client.crt" dest: "/etc/pki/tls/certs/client.crt" - name: Copy CA certificate for 802.1X authentication copy: src: "/srv/data/ca.crt" dest: "/etc/pki/ca-trust/source/anchors/ca.crt" - include_role: name: rhel-system-roles.network vars: network_connections: - name: enp1s0 type: ethernet autoconnect: yes ip: address: - 192.0.2.1/24 - 2001:db8:1::1/64 gateway4: 192.0.2.254 gateway6: 2001:db8:1::fffe dns: - 192.0.2.200 - 2001:db8:1::ffbb dns_search: - example.com ieee802_1x: identity: user_name eap: tls private_key: "/etc/pki/tls/private/client.key" private_key_password: "password" client_cert: "/etc/pki/tls/certs/client.crt" ca_cert: "/etc/pki/ca-trust/source/anchors/ca.crt" domain_suffix_match: example.com state: up

Playbook を実行します。

# ansible-playbook ~/enable-802.1x.yml

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdファイル

7.11. network RHEL System Role を使用した 802.1X ネットワーク認証による Wi-Fi 接続の設定

RHEL System Roles を使用すると、wifi 接続の作成を自動化できます。たとえば、Ansible Playbook を使用して、wlp1s0 インターフェイスのワイヤレス接続プロファイルをリモートで追加できます。作成されたプロファイルは、802.1X 標準を使用して、wifi ネットワークに対してクライアントを認証します。Playbook は、DHCP を使用するように接続プロファイルを設定します。静的 IP 設定を設定するには、それに応じて IP ディクショナリーのパラメーターを調整します。

Ansible コントロールノードで以下の手順を実行します。

前提条件

- 制御ノードと管理対象ノードを準備している。

- 管理対象ノードで Playbook を実行できるユーザーとして制御ノードにログインします。

-

管理対象ノードへの接続に使用するアカウントには、そのノードに対する

sudo権限があります。 - この Playbook を実行する管理対象のノードまたは管理対象のノードのグループは、Ansible インベントリーファイルにリストされています。

- ネットワークは 802.1X ネットワーク認証をサポートしている。

-

マネージドノードに

wpa_supplicantパッケージをインストールしました。 - DHCP は、マネージドノードのネットワークで使用できます。

TLS 認証に必要な以下のファイルがコントロールノードにある。

-

クライアントキーは、

/srv/data/client.keyファイルに保存されます。 -

クライアント証明書は

/srv/data/client.crtファイルに保存されます。 -

CA 証明書は

/srv/data/ca.crtファイルに保存されます。

-

クライアントキーは、

手順

~/enable-802.1x.ymlなどの Playbook ファイルを次の内容で作成します。--- - name: Configure a wifi connection with 802.1X authentication hosts: managed-node-01.example.com tasks: - name: Copy client key for 802.1X authentication copy: src: "/srv/data/client.key" dest: "/etc/pki/tls/private/client.key" mode: 0400 - name: Copy client certificate for 802.1X authentication copy: src: "/srv/data/client.crt" dest: "/etc/pki/tls/certs/client.crt" - name: Copy CA certificate for 802.1X authentication copy: src: "/srv/data/ca.crt" dest: "/etc/pki/ca-trust/source/anchors/ca.crt" - block: - import_role: name: linux-system-roles.network vars: network_connections: - name: Configure the Example-wifi profile interface_name: wlp1s0 state: up type: wireless autoconnect: yes ip: dhcp4: true auto6: true wireless: ssid: "Example-wifi" key_mgmt: "wpa-eap" ieee802_1x: identity: "user_name" eap: tls private_key: "/etc/pki/tls/client.key" private_key_password: "password" private_key_password_flags: none client_cert: "/etc/pki/tls/client.pem" ca_cert: "/etc/pki/tls/cacert.pem" domain_suffix_match: "example.com"

Playbook を実行します。

# ansible-playbook ~/enable-802.1x.yml

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdファイル

7.12. ネットワーク RHEL システムロールを使用した既存の接続でのデフォルトゲートウェイの設定

network の RHEL システムロールを使用して、デフォルトゲートウェイを設定できます。

network の RHEL システムロールを使用する再生を実行すると、設定値が再生で指定されたものと一致しない場合に、システムロールが同じ名前の既存の接続プロファイルを上書きします。したがって、IP 設定がすでに存在している場合でも、プレイでネットワーク接続プロファイルの設定全体を指定する必要があります。それ以外の場合は、ロールはこれらの値をデフォルト値にリセットします。

この手順では、すでに存在するかどうかに応じて、以下の設定で enp1s0 接続プロファイルを作成または更新します。

-

静的 IPv4 アドレス -

/24サブネットマスクを持つ198.51.100.20 -

静的 IPv6 アドレス -

2001:db8:1::1(/64サブネットマスクあり) -

IPv4 デフォルトゲートウェイ -

198.51.100.254 -

IPv6 デフォルトゲートウェイ -

2001:db8:1::fffe -

IPv4 DNS サーバー -

198.51.100.200 -

IPv6 DNS サーバー -

2001:db8:1::ffbb -

DNS 検索ドメイン -

example.com

Ansible コントロールノードで以下の手順を実行します。

前提条件

- 制御ノードと管理対象ノードを準備している。

- 管理対象ノードで Playbook を実行できるユーザーとして制御ノードにログインします。

-

管理対象ノードへの接続に使用するアカウントには、そのノードに対する

sudo権限があります。 - この Playbook を実行する管理対象のノードまたは管理対象のノードのグループは、Ansible インベントリーファイルにリストされています。

手順

~/ethernet-connection.ymlなどの Playbook ファイルを次の内容で作成します。--- - name: Configure the network hosts: managed-node-01.example.com tasks: - name: Configure an Ethernet connection with static IP and default gateway include_role: name: rhel-system-roles.network vars: network_connections: - name: enp1s0 type: ethernet autoconnect: yes ip: address: - 198.51.100.20/24 - 2001:db8:1::1/64 gateway4: 198.51.100.254 gateway6: 2001:db8:1::fffe dns: - 198.51.100.200 - 2001:db8:1::ffbb dns_search: - example.com state: upPlaybook を実行します。

# ansible-playbook ~/ethernet-connection.yml

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdファイル

7.13. ネットワーク RHEL システムロールを使用した静的ルートの設定

network RHEL System Role を使用して、静的ルートを設定できます。

network の RHEL システムロールを使用する再生を実行すると、設定値が再生で指定されたものと一致しない場合に、システムロールが同じ名前の既存の接続プロファイルを上書きします。したがって、IP 設定がすでに存在している場合でも、プレイでネットワーク接続プロファイルの設定全体を指定する必要があります。それ以外の場合は、ロールはこれらの値をデフォルト値にリセットします。

この手順では、すでに存在するかどうかに応じて、以下の設定で enp7s0 接続プロファイルを作成または更新します。

-

静的 IPv4 アドレス: サブネットマスクが

/24の192.0.2.1 -

静的 IPv6 アドレス -

2001:db8:1::1(/64サブネットマスクあり) -

IPv4 デフォルトゲートウェイ -

192.0.2.254 -

IPv6 デフォルトゲートウェイ -

2001:db8:1::fffe -

IPv4 DNS サーバー -

192.0.2.200 -

IPv6 DNS サーバー -

2001:db8:1::ffbb -

DNS 検索ドメイン -

example.com 静的ルート:

-

198.51.100.0/24のゲートウェイ192.0.2.10 -

2001:db8:2::/64とゲートウェイ2001:db8:1::10

-

Ansible コントロールノードで以下の手順を実行します。

前提条件

- 制御ノードと管理対象ノードを準備している。

- 管理対象ノードで Playbook を実行できるユーザーとして制御ノードにログインします。

-

管理対象ノードへの接続に使用するアカウントには、そのノードに対する

sudo権限があります。 - この Playbook を実行する管理対象のノードまたは管理対象のノードのグループは、Ansible インベントリーファイルにリストされています。

手順

~/add-static-routes.ymlなどの Playbook ファイルを次の内容で作成します。--- - name: Configure the network hosts: managed-node-01.example.com tasks: - name: Configure an Ethernet connection with static IP and additional routes include_role: name: rhel-system-roles.network vars: network_connections: - name: enp7s0 type: ethernet autoconnect: yes ip: address: - 192.0.2.1/24 - 2001:db8:1::1/64 gateway4: 192.0.2.254 gateway6: 2001:db8:1::fffe dns: - 192.0.2.200 - 2001:db8:1::ffbb dns_search: - example.com route: - network: 198.51.100.0 prefix: 24 gateway: 192.0.2.10 - network: 2001:db8:2:: prefix: 64 gateway: 2001:db8:1::10 state: up

Playbook を実行します。

# ansible-playbook ~/add-static-routes.yml

検証

管理対象ノードで以下を行います。

IPv4 ルートを表示します。

# ip -4 route ... 198.51.100.0/24 via 192.0.2.10 dev enp7s0

IPv6 ルートを表示します。

# ip -6 route ... 2001:db8:2::/64 via 2001:db8:1::10 dev enp7s0 metric 1024 pref medium

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdファイル

7.14. ネットワーク RHEL システムロールを使用した ethtool オフロード機能の設定

network の RHEL システムロールを使用して、NetworkManager 接続の ethtool 機能を設定できます。

network の RHEL システムロールを使用する再生を実行すると、設定値が再生で指定されたものと一致しない場合に、システムロールが同じ名前の既存の接続プロファイルを上書きします。したがって、IP 設定などがすでに存在している場合でも、常にネットワーク接続プロファイルの設定全体をプレイで指定します。それ以外の場合は、ロールはこれらの値をデフォルト値にリセットします。

この手順では、すでに存在するかどうかに応じて、以下の設定で enp1s0 接続プロファイルを作成または更新します。

-

静的

IPv4アドレス -/24サブネットマスクを持つ198.51.100.20 -

静的

IPv6アドレス -2001:db8:1::1(/64サブネットマスクあり) -

IPv4デフォルトゲートウェイ -198.51.100.254 -

IPv6デフォルトゲートウェイ -2001:db8:1::fffe -

IPv4DNS サーバー -198.51.100.200 -

IPv6DNS サーバー -2001:db8:1::ffbb -

DNS 検索ドメイン -

example.com ethtool機能:- 汎用受信オフロード (GRO): 無効

- Generic segmentation offload(GSO): 有効化

- TX stream control transmission protocol (SCTP) segmentation: 無効

Ansible コントロールノードで以下の手順を実行します。

前提条件

- 制御ノードと管理対象ノードを準備している。

- 管理対象ノードで Playbook を実行できるユーザーとして制御ノードにログインします。

-

管理対象ノードへの接続に使用するアカウントには、そのノードに対する

sudo権限があります。 - この Playbook を実行する管理対象のノードまたは管理対象のノードのグループは、Ansible インベントリーファイルにリストされています。

手順

Playbook ファイル (例:

~/configure-ethernet-device-with-ethtool-features.yml) を次の内容で作成します。--- - name: Configure the network hosts: managed-node-01.example.com tasks: - name: Configure an Ethernet connection with ethtool features include_role: name: rhel-system-roles.network vars: network_connections: - name: enp1s0 type: ethernet autoconnect: yes ip: address: - 198.51.100.20/24 - 2001:db8:1::1/64 gateway4: 198.51.100.254 gateway6: 2001:db8:1::fffe dns: - 198.51.100.200 - 2001:db8:1::ffbb dns_search: - example.com ethtool: features: gro: "no" gso: "yes" tx_sctp_segmentation: "no" state: upPlaybook を実行します。

# ansible-playbook ~/configure-ethernet-device-with-ethtool-features.yml

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdファイル

7.15. ネットワーク RHEL システムロールを使用した ethtool 結合設定の設定

network の RHEL システムロールを使用して、NetworkManager 接続の ethtool を設定できます。

network の RHEL システムロールを使用する再生を実行すると、設定値が再生で指定されたものと一致しない場合に、システムロールが同じ名前の既存の接続プロファイルを上書きします。したがって、IP 設定などがすでに存在している場合でも、常にネットワーク接続プロファイルの設定全体をプレイで指定します。それ以外の場合は、ロールはこれらの値をデフォルト値にリセットします。

この手順では、すでに存在するかどうかに応じて、以下の設定で enp1s0 接続プロファイルを作成または更新します。

-

静的 IPv4 アドレス -

/24サブネットマスクを持つ198.51.100.20 -

静的 IPv6 アドレス -

2001:db8:1::1(/64サブネットマスクあり) -

IPv4 デフォルトゲートウェイ -

198.51.100.254 -

IPv6 デフォルトゲートウェイ -

2001:db8:1::fffe -

IPv4 DNS サーバー -

198.51.100.200 -

IPv6 DNS サーバー -

2001:db8:1::ffbb -

DNS 検索ドメイン -

example.com ethtoolcoalesce の設定:-

RX フレーム:

128 -

TX フレーム:

128

-

RX フレーム:

Ansible コントロールノードで以下の手順を実行します。

前提条件

- 制御ノードと管理対象ノードを準備している。

- 管理対象ノードで Playbook を実行できるユーザーとして制御ノードにログインします。

-

管理対象ノードへの接続に使用するアカウントには、そのノードに対する

sudo権限があります。 - この Playbook を実行する管理対象のノードまたは管理対象のノードのグループは、Ansible インベントリーファイルにリストされています。

手順

~/configure-ethernet-device-with-ethtoolcoalesce-settings.ymlなどの Playbook ファイルを次の内容で作成します。--- - name: Configure the network hosts: managed-node-01.example.com tasks: - name: Configure an Ethernet connection with ethtool coalesce settings include_role: name: rhel-system-roles.network vars: network_connections: - name: enp1s0 type: ethernet autoconnect: yes ip: address: - 198.51.100.20/24 - 2001:db8:1::1/64 gateway4: 198.51.100.254 gateway6: 2001:db8:1::fffe dns: - 198.51.100.200 - 2001:db8:1::ffbb dns_search: - example.com ethtool: coalesce: rx_frames: 128 tx_frames: 128 state: upPlaybook を実行します。

# ansible-playbook ~/configure-ethernet-device-with-ethtoolcoalesce-settings.yml

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdファイル

7.16. ネットワーク RHEL システムロールのネットワーク状態

network RHEL システムロールは、Playbook でデバイスを設定するための状態設定をサポートしています。これには、network_state 変数の後に状態設定を使用します。

Playbook で network_state 変数を使用する利点:

- 状態設定で宣言型の方法を使用すると、インターフェイスを設定でき、NetworkManager はこれらのインターフェイスのプロファイルをバックグラウンドで作成します。

-

network_state変数を使用すると、変更が必要なオプションを指定できます。他のすべてのオプションはそのまま残ります。ただし、network_connections変数を使用して、ネットワーク接続プロファイルを変更するには、すべての設定を指定する必要があります。

たとえば、動的 IP アドレス設定でイーサネット接続を作成するには、Playbook で次の vars ブロックを使用します。

| 状態設定を含むプレイブック | 通常のプレイブック |

vars:

network_state:

interfaces:

- name: enp7s0

type: ethernet

state: up

ipv4:

enabled: true

auto-dns: true

auto-gateway: true

auto-routes: true

dhcp: true

ipv6:

enabled: true

auto-dns: true

auto-gateway: true

auto-routes: true

autoconf: true

dhcp: true

|

vars:

network_connections:

- name: enp7s0

interface_name: enp7s0

type: ethernet

autoconnect: yes

ip:

dhcp4: yes

auto6: yes

state: up

|

たとえば、上記のように作成した動的 IP アドレス設定の接続ステータスのみを変更するには、Playbook で次の vars ブロックを使用します。

| 状態設定を含むプレイブック | 通常のプレイブック |

vars:

network_state:

interfaces:

- name: enp7s0

type: ethernet

state: down

|

vars:

network_connections:

- name: enp7s0

interface_name: enp7s0

type: ethernet

autoconnect: yes

ip:

dhcp4: yes

auto6: yes

state: down

|

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdファイル - Nmstate の概要

第8章 システムロールを使用した firewalld の設定

firewall システムロールを使用すると、一度に複数のクライアントに firewalld サービスを設定できます。この解決策は以下のとおりです。

- 入力設定が効率的なインターフェイスを提供する。

-

目的の

firewalldパラメーターを 1 か所で保持する。

コントロールノードで firewall ロールを実行すると、システムロールは firewalld パラメーターを管理対象ノードに即座に適用し、再起動後も維持されます。

8.1. RHEL システムロール firewall の概要

RHEL システムロールは、Ansible 自動化ユーティリティーのコンテンツセットです。このコンテンツは、Ansible 自動化ユーティリティーとともに、複数のシステムをリモートで管理するための一貫した設定インターフェイスを提供します。

firewalld サービスの自動設定に、RHEL システムロールからの rhel-system-roles.firewall ロールが導入されました。rhel-system-roles パッケージには、このシステムロールと参考ドキュメントも含まれます。

firewalld パラメーターを自動化された方法で 1 つ以上のシステムに適用するには、Playbook で firewall システムロール変数を使用します。Playbook は、テキストベースの YAML 形式で記述された 1 つ以上のプレイの一覧です。

インベントリーファイルを使用して、Ansible が設定するシステムセットを定義できます。

firewall ロールを使用すると、以下のような異なる firewalld パラメーターを設定できます。

- ゾーン。

- パケットが許可されるサービス。

- ポートへのトラフィックアクセスの付与、拒否、または削除。

- ゾーンのポートまたはポート範囲の転送。

関連情報

-

/usr/share/doc/rhel-system-roles/firewall/ディレクトリーのREADME.mdファイルおよびREADME.htmlファイル - Playbook の使用

- インベントリーの構築方法

8.2. ファイアウォール RHEL システムロールを使用した firewalld 設定のリセット

firewall RHEL システムロールを使用すると、firewalld 設定をデフォルトの状態にリセットできます。previous:replaced パラメーターを変数リストに追加すると、システムロールは既存のユーザー定義の設定をすべて削除し、firewalld をデフォルトにリセットします。previous:replaced パラメーターを他の設定と組み合わせると、firewall ロールは新しい設定を適用する前に既存の設定をすべて削除します。

Ansible コントロールノードで以下の手順を実行します。

前提条件

- 制御ノードと管理対象ノードを準備している。

- 管理対象ノードで Playbook を実行できるユーザーとして制御ノードにログインします。

-

管理対象ノードへの接続に使用するアカウントには、そのノードに対する

sudo権限があります。 - この Playbook を実行する管理対象のノードまたは管理対象のノードのグループは、Ansible インベントリーファイルにリストされています。

手順

~/reset-firewalld.ymlなどの Playbook ファイルを次の内容で作成します。--- - name: Reset firewalld example hosts: managed-node-01.example.com tasks: - name: Reset firewalld include_role: name: rhel-system-roles.firewall vars: firewall: - previous: replacedPlaybook を実行します。

# ansible-playbook ~/configuring-a-dmz.yml

検証

管理対象ノードで

rootとして次のコマンドを実行し、すべてのゾーンを確認します。# firewall-cmd --list-all-zones

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.firewall/README.md -

ansible-playbook(1) -

firewalld(1)

8.3. 別のローカルポートへの着信トラフィックの転送

firewall ロールを使用すると、複数の管理対象ホストで設定が永続化されるので firewalld パラメーターをリモートで設定できます。

Ansible コントロールノードで以下の手順を実行します。

前提条件

- 制御ノードと管理対象ノードを準備している。

- 管理対象ノードで Playbook を実行できるユーザーとして制御ノードにログインします。

-

管理対象ノードへの接続に使用するアカウントには、そのノードに対する

sudo権限があります。 - この Playbook を実行する管理対象のノードまたは管理対象のノードのグループは、Ansible インベントリーファイルにリストされています。

手順

~/port_forwarding.ymlなどの Playbook ファイルを次の内容で作成します。--- - name: Configure firewalld hosts: managed-node-01.example.com tasks: - name: Forward incoming traffic on port 8080 to 443 include_role: name: rhel-system-roles.firewall vars: firewall: - { forward_port: 8080/tcp;443;, state: enabled, runtime: true, permanent: true }Playbook を実行します。

# ansible-playbook ~/port_forwarding.yml

検証

管理対象ホストで、

firewalld設定を表示します。# firewall-cmd --list-forward-ports

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.firewall/README.md

8.4. システムロールを使用したポートの設定

RHEL firewall システムロールを使用すると、着信トラフィックに対してローカルファイアウォールでポートを開くか、または閉じて、再起動後に新しい設定を永続化できます。たとえば、HTTPS サービスの着信トラフィックを許可するようにデフォルトゾーンを設定できます。

Ansible コントロールノードで以下の手順を実行します。

前提条件

- 制御ノードと管理対象ノードを準備している。

- 管理対象ノードで Playbook を実行できるユーザーとして制御ノードにログインします。

-

管理対象ノードへの接続に使用するアカウントには、そのノードに対する

sudo権限があります。 - この Playbook を実行する管理対象のノードまたは管理対象のノードのグループは、Ansible インベントリーファイルにリストされています。

手順

~/opening-a-port.ymlなどの Playbook ファイルを次の内容で作成します。--- - name: Configure firewalld hosts: managed-node-01.example.com tasks: - name: Allow incoming HTTPS traffic to the local host include_role: name: rhel-system-roles.firewall vars: firewall: - port: 443/tcp service: http state: enabled runtime: true permanent: truepermanent: trueオプションを使用すると、再起動後も新しい設定が維持されます。Playbook を実行します。

# ansible-playbook ~/opening-a-port.yml

検証

管理対象ノードで、

HTTPSサービスに関連付けられた443/tcpポートが開いていることを確認します。# firewall-cmd --list-ports 443/tcp

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.firewall/README.md

8.5. firewalld RHEL システムロールを使用した DMZ firewalld ゾーンの設定

システム管理者は、firewall システムロールを使用して、enp1s0 インターフェイスで dmz ゾーンを設定し、ゾーンへの HTTPS トラフィックを許可できます。これにより、外部ユーザーが Web サーバーにアクセスできるようにします。

Ansible コントロールノードで以下の手順を実行します。

前提条件

- 制御ノードと管理対象ノードを準備している。

- 管理対象ノードで Playbook を実行できるユーザーとして制御ノードにログインします。

-

管理対象ノードへの接続に使用するアカウントには、そのノードに対する

sudo権限があります。 - この Playbook を実行する管理対象のノードまたは管理対象のノードのグループは、Ansible インベントリーファイルにリストされています。

手順

~/configuring-a-dmz.ymlなどの Playbook ファイルを次の内容で作成します。--- - name: Configure firewalld hosts: managed-node-01.example.com tasks: - name: Creating a DMZ with access to HTTPS port and masquerading for hosts in DMZ include_role: name: rhel-system-roles.firewall vars: firewall: - zone: dmz interface: enp1s0 service: https state: enabled runtime: true permanent: truePlaybook を実行します。

# ansible-playbook ~/configuring-a-dmz.yml

検証

管理ノードで、

dmzゾーンに関する詳細情報を表示します。# firewall-cmd --zone=dmz --list-all dmz (active) target: default icmp-block-inversion: no interfaces: enp1s0 sources: services: https ssh ports: protocols: forward: no masquerade: no forward-ports: source-ports: icmp-blocks:

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.firewall/README.md

第9章 システムロールの postfix ロールの変数

postfix ロール変数により、ユーザーは postfix Mail Transfer Agent (MTA) をインストール、設定、および起動できます。

以下のロール変数がこのセクションで定義されています。

-

postfix_conf:サポートされているすべての

postfix設定パラメーターのキーと値のペアが含まれています。初期設定では、このpostfix_confには値が設定されていません。

postfix_conf: relayhost: example.com

シナリオで既存の設定を削除し、必要な設定を Postfix のクリーンインストールの上に適用する必要がある場合は、postfix_conf ディクショナリー内で previous: replaced オプションを指定します。

previous: replaced オプション:

postfix_conf: relayhost: example.com previous: replaced

-

postfix_check:設定変更を検証するために、

postfixの起動時に確認が実行されたかどうかを判断します。デフォルト値は true です。

以下はその例です。

postfix_check: true

-

postfix_backup:設定のバックアップコピーを 1 つ作成するかどうかを決定します。デフォルトでは、

postfix_backupの値は false です。

以前のバックアップを上書きする場合は、以下のコマンドを実行します。

# *cp /etc/postfix/main.cf /etc/postfix/main.cf.backup*

postfix_backup の値を true に変更した場合は、postfix_backup_multiple の値も false に設定する必要があります。

以下はその例です。

postfix_backup: true postfix_backup_multiple: false

- postfix_backup_multiple:ロールが設定のタイムスタンプ付きバックアップコピーを作成するかどうかを決定します。

複数のバックアップコピーを保持するには、次のコマンドを実行します。

# *cp /etc/postfix/main.cf /etc/postfix/main.cf.$(date -Isec)*

デフォルトでは、postfix_backup_multiple の値は true です。postfix_backup_multiple:true 設定は postfix_backup をオーバーライドします。postfix_backup を使用する場合は、postfix_backup_multiple:false を設定する必要があります。

設定パラメーターは削除できません。postfix ロールを実行する前に、postfix_conf を必要なすべてにの設定パラメーター設定し、ファイルモジュールを使用して /etc/postfix/main.cf を削除します。

9.1. 関連情報

-

/usr/share/doc/rhel-system-roles/postfix/README.md

第10章 システムロールを使用した SElinux の設定

10.1. selinux システムロールの概要

RHEL システムロールは、複数の RHEL システムをリモートで管理する一貫した設定インターフェイスを提供する Ansible ロールおよびモジュールの集合です。selinux システムロールでは、以下の操作が可能になります。

- SELinux ブール値、ファイルコンテキスト、ポート、およびログインに関連するローカルポリシーの変更を消去します。

- SELinux ポリシーブール値、ファイルコンテキスト、ポート、およびログインの設定

- 指定されたファイルまたはディレクトリーでファイルコンテキストを復元します。

- SELinux モジュールの管理

以下の表は、selinux システムロールで利用可能な入力変数の概要を示しています。

表10.1 selinux システムロール変数

| ロール変数 | 説明 | CLI の代替手段 |

|---|---|---|

| selinux_policy | ターゲットプロセスまたは複数レベルのセキュリティー保護を保護するポリシーを選択します。 |

|

| selinux_state | SELinux モードを切り替えます。 |

|

| selinux_booleans | SELinux ブール値を有効または無効にします。 |

|

| selinux_fcontexts | SELinux ファイルコンテキストマッピングを追加または削除します。 |

|

| selinux_restore_dirs | ファイルシステムツリー内の SELinux ラベルを復元します。 |

|

| selinux_ports | ポートに SELinux ラベルを設定します。 |

|

| selinux_logins | ユーザーを SELinux ユーザーマッピングに設定します。 |

|

| selinux_modules | SELinux モジュールのインストール、有効化、無効化、または削除を行います。 |

|

rhel-system-roles パッケージによりインストールされる /usr/share/doc/rhel-system-roles/selinux/example-selinux-playbook.yml のサンプル Playbook は、Enforcing モードでターゲットポリシーを設定する方法を示しています。Playbook は、複数のローカルポリシーの変更を適用し、tmp/test_dir/ ディレクトリーのファイルコンテキストを復元します。

selinux ロール変数の詳細は、rhel-system-roles パッケージをインストールし、/usr/share/doc/rhel-system-roles/selinux/ ディレクトリーの README.md または README.html ファイルを参照してください。

関連情報

10.2. selinux システムロールを使用した、複数のシステムでの SELinux 設定の適用

以下の手順に従って、検証した SELinux 設定を使用して Ansible Playbook を準備し、適用します。

前提条件

-

1 つまたは複数の 管理対象ノード へのアクセスとパーミッション (

selinuxシステムロールで設定するシステム)。 コントロールノード (このシステムから Red Hat Ansible Core は他のシステムを設定) へのアクセスおよびパーミッション。

コントロールノードでは、

-

ansible-coreパッケージおよびrhel-system-rolesパッケージがインストールされている。 - 管理対象ノードが記載されているインベントリーファイルがある。

-

RHEL 8.0-8.5 では、別の Ansible リポジトリーへのアクセス権を指定されており、Ansible をベースにする自動化用の Ansible Engine 2.9 が含まれています。Ansible Engine には、ansible、ansible-playbook などのコマンドラインユーティリティー、docker や podman などのコネクター、プラグインとモジュールが多く含まれています。Ansible Engine を入手してインストールする方法については、ナレッジベースの How to download and install Red Hat Ansible Engine を参照してください。

RHEL 8.6 および 9.0 では、Ansible Core (ansible-core パッケージとして提供) が導入されました。これには、Ansible コマンドラインユーティリティー、コマンド、およびビルトイン Ansible プラグインのセットが含まれています。RHEL は、AppStream リポジトリーを介してこのパッケージを提供し、サポート範囲は限定的です。詳細については、ナレッジベースの Scope of support for the Ansible Core package included in the RHEL 9 and RHEL 8.6 and later AppStream repositories を参照してください。

- 管理対象ノードが記載されているインベントリーファイルがある。

手順

Playbook を準備します。ゼロから開始するか、

rhel-system-rolesパッケージの一部としてインストールされたサンプル Playbook を変更してください。# cp /usr/share/doc/rhel-system-roles/selinux/example-selinux-playbook.yml my-selinux-playbook.yml # vi my-selinux-playbook.yml

シナリオに合わせて Playbook の内容を変更します。たとえば、次の部分では、システムが SELinux モジュール

selinux-local-1.ppをインストールして有効にします。selinux_modules: - { path: "selinux-local-1.pp", priority: "400" }- 変更を保存し、テキストエディターを終了します。

host1、host2 および host3 システムで Playbook を実行します。

# ansible-playbook -i host1,host2,host3 my-selinux-playbook.yml

関連情報

-

詳細は、

rhel-system-rolesパッケージをインストールして、/usr/share/doc/rhel-system-roles/selinux/ディレクトリーおよび/usr/share/ansible/roles/rhel-system-roles.selinux/ディレクトリーを参照してください。

第11章 Logging システムロールの使用

システム管理者は、Logging システムロールを使用して、RHEL ホストをロギングサーバーとして設定し、多くのクライアントシステムからログを収集できます。

11.1. Logging システムロール

Logging システムロールを使用すると、ローカルおよびリモートホストにロギング設定をデプロイできます。

Logging システムロールを 1 つ以上のシステムに適用するには、Playbook でロギング設定を定義します。Playbook は、1 つ以上の play の一覧です。Playbook は YAML 形式で表現され、人が判読できるようになっています。Playbook の詳細は、Ansible ドキュメントの Working with playbooks を参照してください。

Playbook に従って設定するシステムのセットは、インベントリーファイル で定義されます。インベントリーの作成および使用に関する詳細は、Ansible ドキュメントの How to build your inventory を参照してください。

ロギングソリューションは、ログと複数のログ出力を読み取る複数の方法を提供します。

たとえば、ロギングシステムは以下の入力を受け取ることができます。

- ローカルファイル

-

systemd/journal - ネットワーク上で別のロギングシステム

さらに、ロギングシステムでは以下を出力できます。

-

/var/logディレクトリーのローカルファイルに保存されているログ - Elasticsearch に送信されたログ

- 別のロギングシステムに転送されたログ

Logging システムロールでは、シナリオに合わせて入出力を組み合わせることができます。たとえば、journal からの入力をローカルのファイルに保存しつつも、複数のファイルから読み込んだ入力を別のロギングシステムに転送してそのローカルのログファイルに保存するようにロギングソリューションを設定できます。

11.2. Logging システムロールのパラメーター

logging システムロール Playbook では、logging_inputs パラメーターで入力を、logging_outputs パラメーターで出力を、そして logging_flows パラメーターで入力と出力の関係を定義します。Logging システムロールは、ロギングシステムの追加設定オプションで、上記の変数を処理します。暗号化を有効にすることもできます。

現在、Logging システムロールで利用可能な唯一のロギングシステムは Rsyslog です。

logging_inputs:ロギングソリューションの入力一覧。-

name:入力の一意の名前。logging_flowsでの使用: 入力一覧および生成されたconfigファイル名の一部で使用されます。 type:入力要素のタイプ。type は、roles/rsyslog/{tasks,vars}/inputs/のディレクトリー名に対応するタスクタイプを指定します。basics:systemdジャーナルまたはunixソケットからの入力を設定する入力。-

kernel_message:trueに設定されている場合は、imklogをロードします。デフォルトはfalseです。 -

use_imuxsock:imjournalの代わりにimuxsockを使用します。デフォルトはfalseです。 -

ratelimit_burst:ratelimit_interval内に出力できるメッセージの最大数。use_imuxsockが false の場合、デフォルトで20000に設定されます。use_imuxsockが true の場合、デフォルトで200に設定されます。 -

ratelimit_interval:ratelimit_burstを評価する間隔。use_imuxsockが false の場合、デフォルトで 600 秒に設定されます。use_imuxsockが true の場合、デフォルトで 0 に設定されます。0 はレート制限がオフであることを示します。 -

persist_state_interval:ジャーナルの状態は、valueメッセージごとに永続化されます。デフォルトは10です。use_imuxsockが false の場合のみ、有効です。

-

-

files:ローカルファイルからの入力を設定する入力。 -

remote:ネットワークを介して他のロギングシステムからの入力を設定する入力。

-

state:設定ファイルの状態。presentまたはabsent。デフォルトはpresentです。

-

logging_outputs:ロギングソリューションの出力一覧。-

files:ローカルファイルへの出力を設定する出力。 -

forwards:別のロギングシステムへの出力を設定する出力。 -

remote_files:別のロギングシステムからの出力をローカルファイルに設定する出力。

-

logging_flows:logging_inputsおよびlogging_outputsの関係を定義するフローの一覧。logging_flows変数には以下が含まれます。-

name:フローの一意の名前。 -

inputs:logging_inputs名の値の一覧。 -

outputs:logging_outputs名の値の一覧。

-

関連情報

-

rhel-system-rolesパッケージでインストールされたドキュメント (/usr/share/ansible/roles/rhel-system-roles.logging/README.html)

11.3. ローカルの Logging システムロールの適用

Ansible Playbook を準備して適用し、別のマシンにロギングソリューションを設定します。各マシンはログをローカルに記録します。

前提条件

-

Logging システムロールを設定する

管理対象ノード1 つ以上へのアクセスおよびパーミッション。 コントロールノード (このシステムから Red Hat Ansible Core は他のシステムを設定) へのアクセスおよびパーミッション。

コントロールノードでは、

-

ansible-coreパッケージおよびrhel-system-rolesパッケージがインストールされている。

-

RHEL 8.0-8.5 では、別の Ansible リポジトリーへのアクセス権を指定されており、Ansible をベースにする自動化用の Ansible Engine 2.9 が含まれています。Ansible Engine には、ansible、ansible-playbook などのコマンドラインユーティリティー、docker や podman などのコネクター、プラグインとモジュールが多く含まれています。Ansible Engine を入手してインストールする方法については、ナレッジベースの How to download and install Red Hat Ansible Engine を参照してください。

RHEL 8.6 および 9.0 では、Ansible Core (ansible-core パッケージとして提供) が導入されました。これには、Ansible コマンドラインユーティリティー、コマンド、およびビルトイン Ansible プラグインのセットが含まれています。RHEL は、AppStream リポジトリーを介してこのパッケージを提供し、サポート範囲は限定的です。詳細については、ナレッジベースの Scope of support for the Ansible Core package included in the RHEL 9 and RHEL 8.6 and later AppStream repositories を参照してください。

- 管理対象ノードが記載されているインベントリーファイルがある。

デプロイメント時にシステムロールが rsyslog をインストールするため、rsyslog パッケージをインストールする必要はありません。

手順

必要なロールを定義する Playbook を作成します。

新しい YAML ファイルを作成し、これをテキストエディターで開きます。以下に例を示します。

# vi logging-playbook.yml以下の内容を挿入します。

--- - name: Deploying basics input and implicit files output hosts: all roles: - rhel-system-roles.logging vars: logging_inputs: - name: system_input type: basics logging_outputs: - name: files_output type: files logging_flows: - name: flow1 inputs: [system_input] outputs: [files_output]

特定のインベントリーで Playbook を実行します。

# ansible-playbook -i inventory-file /path/to/file/logging-playbook.yml詳細は以下のようになります。

-

inventory-fileはインベントリーファイルに置き換えます。 -

logging-playbook.ymlは、使用する Playbook に置き換えます。

-

検証

/etc/rsyslog.confファイルの構文をテストします。# rsyslogd -N 1 rsyslogd: version 8.1911.0-6.el8, config validation run... rsyslogd: End of config validation run. Bye.システムがログにメッセージを送信していることを確認します。

テストメッセージを送信します。

# logger test/var/log/messages ログを表示します。以下に例を示します。# cat /var/log/messages Aug 5 13:48:31 hostname root[6778]: test

`hostname` はクライアントシステムのホスト名です。ログには、logger コマンドを入力したユーザーのユーザー名 (この場合は

root) が含まれていることに注意してください。

11.4. ローカルの Logging システムロールでのログのフィルターリング

rsyslog プロパティーベースのフィルターをもとにログをフィルターするロギングソリューションをデプロイできます。

前提条件

-

Logging システムロールを設定する

管理対象ノード1 つ以上へのアクセスおよびパーミッション。 コントロールノード (このシステムから Red Hat Ansible Core は他のシステムを設定) へのアクセスおよびパーミッション。

コントロールノードでは、

- Red Hat Ansible Core がインストールされている。

-

rhel-system-rolesパッケージがインストールされている。 - 管理対象ノードが記載されているインベントリーファイルがある。

デプロイメント時にシステムロールが rsyslog をインストールするため、rsyslog パッケージをインストールする必要はありません。

手順

以下の内容を含む新しい

playbook.ymlファイルを作成します。--- - name: Deploying files input and configured files output hosts: all roles: - linux-system-roles.logging vars: logging_inputs: - name: files_input type: basics logging_outputs: - name: files_output0 type: files property: msg property_op: contains property_value: error path: /var/log/errors.log - name: files_output1 type: files property: msg property_op: "!contains" property_value: error path: /var/log/others.log logging_flows: - name: flow0 inputs: [files_input] outputs: [files_output0, files_output1]この設定を使用すると、

error文字列を含むメッセージはすべて/var/log/errors.logに記録され、その他のメッセージはすべて/var/log/others.logに記録されます。errorプロパティーの値はフィルターリングする文字列に置き換えることができます。設定に合わせて変数を変更できます。

オプション:Playbook の構文を確認します。

# ansible-playbook --syntax-check playbook.ymlインベントリーファイルで Playbook を実行します。

# ansible-playbook -i inventory_file /path/to/file/playbook.yml

検証

/etc/rsyslog.confファイルの構文をテストします。# rsyslogd -N 1 rsyslogd: version 8.1911.0-6.el8, config validation run... rsyslogd: End of config validation run. Bye.システムが

error文字列を含むメッセージをログに送信していることを確認します。テストメッセージを送信します。

# logger error以下のように

/var/log/errors.logログを表示します。# cat /var/log/errors.log Aug 5 13:48:31 hostname root[6778]: error

hostnameはクライアントシステムのホスト名に置き換えます。ログには、logger コマンドを入力したユーザーのユーザー名 (この場合はroot) が含まれていることに注意してください。

関連情報

-

rhel-system-rolesパッケージでインストールされたドキュメント (/usr/share/ansible/roles/rhel-system-roles.logging/README.html)

11.5. Logging システムロールを使用したリモートロギングソリューションの適用

以下の手順に従って、Red Hat Ansible Core Playbook を準備および適用し、リモートロギングソリューションを設定します。この Playbook では、1 つ以上のクライアントが systemd-journal からログを取得し、リモートサーバーに転送します。サーバーは、remote_rsyslog および remote_files からリモート入力を受信し、リモートホスト名によって名付けられたディレクトリーのローカルファイルにログを出力します。

前提条件

-

Logging システムロールを設定する

管理対象ノード1 つ以上へのアクセスおよびパーミッション。 コントロールノード (このシステムから Red Hat Ansible Core は他のシステムを設定) へのアクセスおよびパーミッション。

コントロールノードでは、

-

ansible-coreパッケージおよびrhel-system-rolesパッケージがインストールされている。 - 管理対象ノードが記載されているインベントリーファイルがある。

-

デプロイメント時にシステムロールが rsyslog をインストールするため、rsyslog パッケージをインストールする必要はありません。

手順

必要なロールを定義する Playbook を作成します。

新しい YAML ファイルを作成し、これをテキストエディターで開きます。以下に例を示します。

# vi logging-playbook.yml以下の内容をファイルに挿入します。