Red Hat Training

A Red Hat training course is available for RHEL 8

第1章 利用可能なストレージオプションの概要

RHEL 8 では、複数のローカル、リモート、およびクラスターベースのストレージオプションを利用できます。

ローカルストレージは、ストレージデバイスがシステムにインストールされているか、システムに直接接続されていることを意味します。

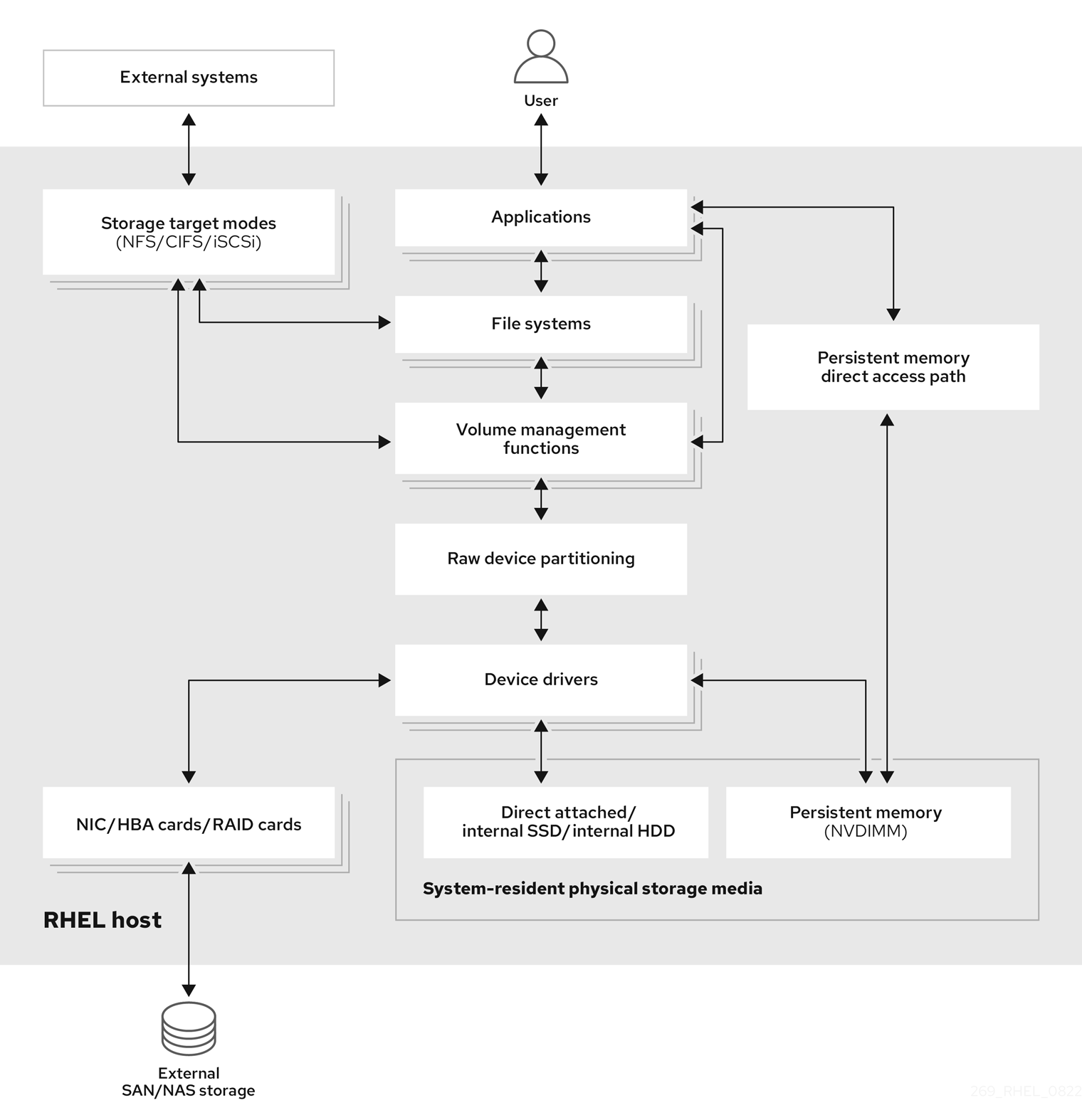

リモートストレージでは、LAN、インターネット、またはファイバーチャネルネットワークを介してデバイスにアクセスします。以下の Red Hat Enterprise Linux ストレージダイアグラムの概要では、さまざまなストレージオプションを説明します。

図1.1 Red Hat Enterprise Linux ストレージダイアグラム (概要)

1.1. ローカルストレージの概要

Red Hat Enterprise Linux 8 は、ローカルストレージオプションを複数提供します。

- 基本的なディスク管理:

partedとfdiskを使用して、ディスクパーティションの作成、変更、削除、および表示を行うことができます。パーティショニングレイアウトの標準は以下のようになります。- マスターブートレコード (MBR)

- BIOS ベースのコンピューターで使用されます。プライマリーパーティション、拡張パーティション、および論理パーティションを作成できます。

- GUID パーティションテーブル (GPT)

- GUID (Globally Unique identifier) を使用し、一意のディスクおよびパーティション GUID を提供します。

パーティションを暗号化するには、LUKS (Linux Unified Key Setup-on-disk-format) を使用します。パーティションを暗号化する場合は、インストール時にオプションを選択し、パスフレーズを入力させるプロンプトを表示します。このパスフレーズにより、暗号化キーのロックが解除されます。

- ストレージ使用オプション

- NVDIMM (Non-Volatile Dual In-line Memory Modules) の管理

- メモリーとストレージの組み合わせです。システムに接続した NVDIMM デバイスで、さまざまな種類のストレージを有効にして管理できます。

- ブロックストレージ管理

- 各ブロックに固有の識別子を持つブロックの形式でデータを保存します。

- ファイルストレージ

- データは、ローカルシステムのファイルレベルに保存されます。これらのデータは、XFS (デフォルト) または ext4 を使用してローカルでアクセスしたり、NFS と SMB を使用してネットワーク上でアクセスできます。

- 論理ボリューム

- 論理ボリュームマネージャー (LVM)

物理デバイスから論理デバイスを作成します。論理ボリューム (LV) は、物理ボリューム (PV) とボリュームグループ (VG) の組み合わせです。LVM の設定には以下が含まれます。

- ハードドライブから PV の作成

- 物理ボリュームからボリュームグループの作成

- ボリュームグループから論理ボリュームを作成すると、マウントポイントが論理ボリュームに割り当てられます。

- VDO (Virtual Data Optimizer)

重複排除、圧縮、およびシンプロビジョニングを使用して、データの削減に使用されます。VDO の下で論理ボリュームを使用すると、次のことができます。

- VDO ボリュームの拡張

- 複数のデバイスにまたがる VDO ボリューム

- ローカルファイルシステム

- XFS

- デフォルトの RHEL ファイルシステム。

- Ext4

- レガシーファイルシステム。

- Stratis

- テクノロジープレビューとして利用可能になりました。Stratis は、高度なストレージ機能に対応する、ユーザーとカーネルのハイブリッドローカルストレージ管理システムです。