Red Hat Training

A Red Hat training course is available for RHEL 8

システムの状態とパフォーマンスの監視と管理

システムのスループット、レイテンシー、および電力消費の最適化

概要

多様性を受け入れるオープンソースの強化

Red Hat では、コード、ドキュメント、Web プロパティーにおける配慮に欠ける用語の置き換えに取り組んでいます。まずは、マスター (master)、スレーブ (slave)、ブラックリスト (blacklist)、ホワイトリスト (whitelist) の 4 つの用語の置き換えから始めます。この取り組みは膨大な作業を要するため、今後の複数のリリースで段階的に用語の置き換えを実施して参ります。詳細は、Red Hat CTO である Chris Wright のメッセージ をご覧ください。

Red Hat ドキュメントへのフィードバック (英語のみ)

Red Hat ドキュメントに関するご意見やご感想をお寄せください。また、改善点があればお知らせください。

Jira からのフィードバック送信 (アカウントが必要)

- Jira の Web サイトにログインします。

- 上部のナビゲーションバーで Create をクリックします。

- Summary フィールドにわかりやすいタイトルを入力します。

- Description フィールドに、ドキュメントの改善に関するご意見を記入してください。ドキュメントの該当部分へのリンクも追加してください。

- ダイアログの下部にある Create をクリックします。

第1章 パフォーマンス監視オプションの概要

以下は、Red Hat Enterprise Linux 8 で利用可能なパフォーマンス監視および設定ツールの一部です。

-

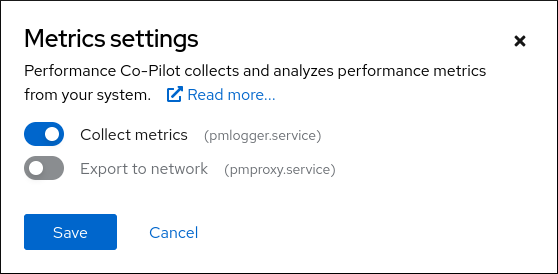

Performance Co-Pilot (

pcp) は、システムレベルのパフォーマンス測定の監視、視覚化、保存、および分析に使用されます。これにより、リアルタイムデータの監視および管理、および履歴データのログと取得が可能になります。 Red Hat Enterprise Linux 8 は、ランレベル

5以外のシステムを監視するためにコマンドラインから使用できる複数のツールを提供します。以下は、ビルトインのコマンドラインツールです。-

topは、procps-ngパッケージで提供されます。これにより、実行中のシステムのプロセスの動的ビューが提供されます。システムの概要や Linux カーネルが現在管理しているタスクのリストなど、さまざまな情報が表示されます。 -

psはprocps-ngパッケージで提供されます。これは、アクティブなプロセスの選択したグループのスナップショットをキャプチャーします。デフォルトでは、検査されたグループは、現在のユーザーが所有し、psコマンドが実行される端末に関連付けられているプロセスに制限されます。 -

仮想メモリーの統計 (

vmstat) は、procps-ngパッケージで提供されます。システムのプロセス、メモリー、ページング、ブロックの入出力、割り込み、および CPU アクティビティーの即時レポートを提供します。 -

System activity reporter (

sar) はsysstatパッケージで提供されます。過去に発生したシステムアクティビティーに関する情報を収集し、報告します。

-

-

perfは、ハードウェアパフォーマンスカウンターとカーネルトレースポイントを使用して、システム上の他のコマンドやアプリケーションの影響を追跡します。 -

bcc-toolsは BPF コンパイラーコレクション (BCC) に使用され ます。これは、カーネルアクティビティーを監視する 100 を超えるeBPFスクリプトを提供します。各ツールの詳細は、ツールの使用方法と、ツールが実行する機能について説明する man ページを参照してください。 -

turbostatはkernel-toolsパッケージで提供されます。Intel 64 プロセッサーのプロセッサートポロジー、周波数、アイドル時の電力状態の統計、温度、および電力使用量について報告します。 -

iostatはsysstatパッケージで提供されます。管理者が物理ディスク間で IO 負荷のバランスを取る方法を決定できるように、システム IO デバイスのロードを監視および報告します。 -

irqbalanceは、システムパフォーマンスを改善するために、複数のプロセッサーにハードウェア割り込みを分散します。 -

ssはソケットに関する統計情報を出力するため、管理者は時間とともにデバイスのパフォーマンスを評価することができます。Red Hat は、Red Hat Enterprise Linux 8 でssovernetstatを使用することを推奨します。 -

numastatはnumactlパッケージで提供されます。デフォルトでは、numastatは、カーネルメモリーアロケーターからノードごとの NUMA ヒットしたシステム統計を表示します。最適なパフォーマンスは、高いnuma_hit値および低いnuma_miss値によって示されます。 -

numadは NUMA アフィニティーの自動管理デーモンです。NUMA リソースの割り当て、管理、システムのパフォーマンスを動的に改善するシステム内の NUMA トポロジーとリソースの使用状況を監視します。 -

SystemTapは、特にカーネルアクティビティーなど、オペレーティングシステムのアクティビティーを監視および分析します。 -

valgrindは、アプリケーションを合成 CPU で実行し、実行中の既存のアプリケーションコードをインストルメント化してアプリケーションを分析します。次に、アプリケーション実行に関連する各プロセスをユーザー指定のファイル、ファイル記述子、またはネットワークソケットに明確に識別するコメントを出力します。また、メモリーリークを見つける場合にも便利です。 -

pqosはintel-cmt-catパッケージで提供されます。最新の Intel プロセッサーで CPU キャッシュとメモリー帯域幅を監視および制御します。

関連情報

-

pcp、top、ps、vmstat、sar、perf、iostat、irqbalance、ss、numastat、numad、valgrind、およびpqosの man ページ -

/usr/share/doc/ディレクトリー - What exactly is the meaning of value "await" reported by iostat?(Red Hat ナレッジベースのアーティクル記事)

- Performance Co-Pilot によるパフォーマンスの監視

第2章 TuneD を使い始める

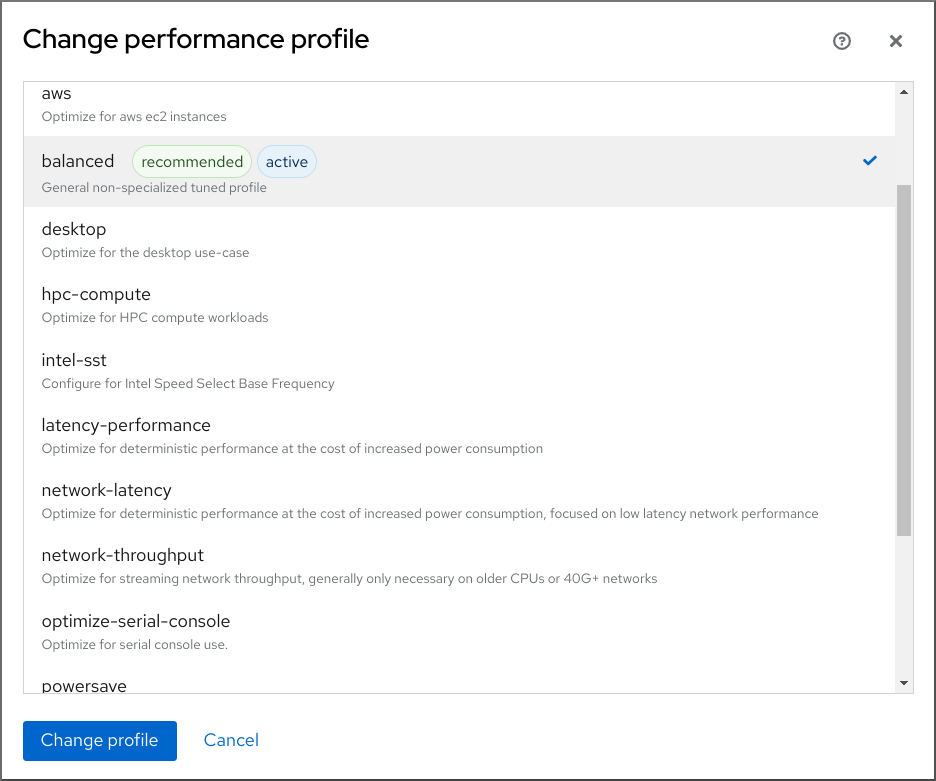

システム管理者は、TuneD アプリケーションを使用して、さまざまなユースケースに合わせてシステムのパフォーマンスプロファイルを最適化できます。

2.1. TuneD の目的

TuneD は、システムを監視し、特定のワークロードでパフォーマンスを最適化するサービスです。TuneD の中核となるのは、さまざまなユースケースに合わせてシステムをチューニングする プロファイル です。

TuneD には、以下のようなユースケース用に定義されたプロファイルが多数同梱されています。

- 高スループット

- 低レイテンシー

- 節電

各プロファイル向けに定義されたルールを変更し、特定のデバイスのチューニング方法をカスタマイズできます。別のプロファイルに切り替えたり、TuneD を非アクティブにすると、以前のプロファイルによるシステム設定への変更はすべて、元の状態に戻ります。

また、TuneD を設定してデバイスの使用状況の変化に対応し、設定を調整して、アクティブなデバイスのパフォーマンスを向上させ、非アクティブなデバイスの消費電力を削減することもできます。

2.2. TuneD プロファイル

システムを詳細に分析することは、非常に時間のかかる作業です。TuneD では、一般的なユースケースに合わせて定義済みのプロファイルを多数提供しています。プロファイルを作成、変更、および削除することも可能です。

TuneD で提供されるプロファイルは、以下のカテゴリーに分類されます。

- 省電力プロファイル

- パフォーマンス重視プロファイル

performance-boosting プロファイルの場合は、次の側面に焦点が置かれます。

- ストレージおよびネットワークに対して少ないレイテンシー

- ストレージおよびネットワークの高い処理能力

- 仮想マシンのパフォーマンス

- 仮想化ホストのパフォーマンス

プロファイル設定の構文

tuned.conf ファイルは、1 つの [main] セクションとプラグインインスタンスを設定するためのその他のセクションが含まれます。ただし、すべてのセクションはオプションです。

ハッシュ記号 (#) で始まる行はコメントです。

関連情報

-

tuned.conf(5)の man ページ

2.3. デフォルトの TuneD プロファイル

インストール時に、システムの最適なプロファイルが自動的に選択されます。現時点では、以下のカスタマイズ可能なルールに従ってデフォルトのプロファイルが選択されます。

| 環境 | デフォルトプロファイル | 目的 |

|---|---|---|

| コンピュートノード |

| 最適なスループットパフォーマンス |

| 仮想マシン |

|

ベストパフォーマンスベストパフォーマンスが重要でない場合は、 |

| その他のケース |

| パフォーマンスと電力消費の調和 |

関連情報

-

tuned.conf(5)の man ページ

2.4. マージされた TuneD プロファイル

試験目的で提供された機能として、複数のプロファイルを一度に選択することができます。TuneD は、読み込み中にマージを試みます。

競合が発生した場合は、最後に指定されたプロファイルの設定が優先されます。

例2.1 仮想ゲストの低消費電力

以下の例では、仮想マシンでの実行でパフォーマンスを最大化するようにシステムが最適化され、同時に、(低消費電力が最優先である場合は) 低消費電力を実現するようにシステムがチューニングされます。

# tuned-adm profile virtual-guest powersave

マージは自動的に行われ、使用されるパラメーターの組み合わせが適切であるかどうかはチェックされません。結果として、この機能は一部のパラメーターを逆に調整する可能性があります。これは逆効果になる可能性があります。たとえば、throughput-performance プロファイルで高スループットにディスクを設定し、同時に、spindown-disk プロファイルでディスクスピンダウンを低い値に設定します。

関連情報

*tuned-adm man ページ* tuned.conf(5) の man ページ

2.5. TuneD プロファイルの場所

TuneD は、次のディレクトリーにプロファイルを保存します。

/usr/lib/tuned/-

ディストリビューション固有のプロファイルは、このディレクトリーに保存されます。各プロファイルには独自のディレクトリーがあります。プロファイルは

tuned.confという名前の主要設定ファイルと、ヘルパースクリプトなどの他の任意のファイルから設定されます。 /etc/tuned/-

プロファイルをカスタマイズする必要がある場合は、プロファイルのカスタマイズに使用されるディレクトリーにプロファイルディレクトリーをコピーします。同じ名前のプロファイルが 2 つある場合、カスタムのプロファイルは、

/etc/tuned/に置かれています。

関連情報

-

tuned.conf(5)の man ページ

2.6. RHEL とともに配布される TuneD プロファイル

以下は、Red Hat Enterprise Linux に TuneD とともにインストールされるプロファイルのリストです。

利用可能な製品固有またはサードパーティーの TuneD プロファイルが複数存在する可能性があります。このようなプロファイルは通常、個別の RPM パッケージで提供されます。

balancedデフォルトの省電力プロファイル。パフォーマンスと電力消費のバランスを取ることが目的です。可能な限り、自動スケーリングと自動チューニングを使用します。唯一の欠点はレイテンシーが増加することです。今回の TuneD リリースでは、CPU、ディスク、オーディオ、およびビデオプラグインを有効にし、

conservativeCPU ガバナーを有効にします。radeon_powersaveオプションは、dpm-balanced値に対応している場合はその値を使用し、それ以外の場合はautoに設定されます。energy_performance_preference属性をnormalの電力設定に変更します。また、scaling_governorポリシー属性をconservativeまたはpowersaveCPU ガバナーのいずれかに変更します。powersave省電力パフォーマンスを最大化するプロファイル。実際の電力消費を最小化するためにパフォーマンスを調整できます。今回の TuneD リリースでは、SATA ホストアダプターの USB 自動サスペンド、WiFi 省電力、および Aggressive Link Power Management (ALPM) の省電力を有効にします。また、ウェイクアップ率が低いシステムのマルチコア省電力がスケジュールされ、

ondemandガバナーがアクティブ化されます。さらに、AC97 音声省電力と、システムに応じて HDA-Intel 省電力 (10 秒のタイムアウト) が有効になります。KMS が有効なサポート対象の Radeon グラフィックカードがシステムに搭載されている場合、プロファイルは自動省電力に設定されます。ASUS Eee PC では、動的な Super Hybrid Engine が有効になります。energy_performance_preference属性をpowersaveまたはpower電力設定に変更します。また、scaling_governorポリシー属性をondemandまたはpowersaveCPU ガバナーのいずれかに変更します。注記場合によっては、

balancedプロファイルの方が、powersaveプロファイルよりも効率的です。定義された量の作業を行う場合 (たとえば、動画ファイルをトランスコードする必要がある場合) を考えてください。トランスコードがフルパワーで実行される場合に、マシンの電力消費が少なくなることがあります。これは、タスクがすぐに完了し、マシンがアイドル状態になり、非常に効率的な省電力モードに自動的に切り替わることがあるためです。その一方で、調整されたマシンでファイルをトランスコードすると、マシンはトランスコード中に少ない電力を消費しますが、処理に時間がかかり、全体的な消費電力は高くなることがあります。

このため、一般的に

balancedプロファイルが優れたオプションになる場合があります。throughput-performance高スループットに最適化されたサーバープロファイル。これにより、節電メカニズムが無効になり、

sysctlが有効になるため、ディスクおよびネットワーク IO のスループットパフォーマンスが向上します。CPU ガバナーはperformanceに設定されます。energy_performance_preferenceおよびscaling_governor属性をperformanceプロファイルに変更します。accelerator-performance-

accelerator-performanceプロファイルには、throughput-performanceプロファイルと同じチューニングが含まれます。さらに、CPU を低い C 状態にロックし、レイテンシーが 100us 未満になるようにします。これにより、GPU などの特定のアクセラレーターのパフォーマンスが向上します。 latency-performance低レイテンシーに最適化されたサーバープロファイル。省電力メカニズムが無効になり、レイテンシーを向上させる

sysctl設定が有効になります。CPU ガバナーはperformanceに設定され、CPU は低い C 状態にロックされます (PM QoS を使用)。energy_performance_preferenceおよびscaling_governor属性をperformanceプロファイルに変更します。network-latency低レイテンシーネットワークチューニング向けプロファイル。

latency-performanceプロファイルに基づきます。さらに、透過的な huge page と NUMA 分散を無効にし、他のいくつかのネットワーク関連のsysctlパラメーターの調整を行います。latency-performanceプロファイルを継承します。また、energy_performance_preferenceおよびscaling_governor属性をperformanceプロファイルに変更します。hpc-compute-

高パフォーマンスコンピューティング向けに最適化されたプロファイル。

latency-performanceプロファイルに基づきます。 network-throughputスループットネットワークチューニング向けプロファイル。

throughput-performanceプロファイルに基づきます。さらに、カーネルネットワークバッファーを増やします。latency-performanceまたはthroughput-performanceプロファイルのいずれかを継承します。また、energy_performance_preferenceおよびscaling_governor属性をperformanceプロファイルに変更します。virtual-guestthroughput-performanceプロファイルに基づく Red Hat Enterprise 8 仮想マシンおよび VMWare ゲスト向けプロファイル。仮想メモリーのスワップの減少や、ディスクの readahead 値の増加などが行われます。ディスクバリアは無効になりません。throughput-performanceプロファイルを継承します。また、energy_performance_preferenceおよびscaling_governor属性をperformanceプロファイルに変更します。virtual-hostthroughput-performanceプロファイルに基づいて仮想ホスト用に設計されたプロファイル。他のタスクの中でも特に、仮想メモリーのスワップを減らし、ディスクの先読み値を増やし、ダーティーページの書き戻しというより積極的な値を可能にします。throughput-performanceプロファイルを継承します。また、energy_performance_preferenceおよびscaling_governor属性をperformanceプロファイルに変更します。oracle-

Oracle データベース向けに最適化されたプロファイルは、

throughput-performanceプロファイルに基づいて読み込まれます。これにより Transparent Huge Page が無効になり、その他のパフォーマンス関連カーネルパラメーターが変更されます。このプロファイルは、tuned-profiles-oracleパッケージで利用できます。 desktop-

balancedプロファイルに基づく、デスクトップに最適化されたプロファイル。対話型アプリケーションの応答を向上させるスケジューラーオートグループが有効になります。 optimize-serial-consoleprintk 値を減らすことで、シリアルコンソールへの I/O アクティビティーを調整するプロファイル。これにより、シリアルコンソールの応答性が向上します。このプロファイルは、他のプロファイルのオーバーレイとして使用することが意図されています。以下に例を示します。

# tuned-adm profile throughput-performance optimize-serial-console

mssql-

Microsoft SQL Server に提供されるプロファイル。

throughput-performanceプロファイルに基づきます。 intel-sstユーザー定義の Intel Speed Select Technology 設定で最適化されたプロファイル。このプロファイルは、他のプロファイルのオーバーレイとして使用することが意図されています。以下に例を示します。

# tuned-adm profile cpu-partitioning intel-sst

2.7. TuneD cpu-partitioning プロファイル

レイテンシーに敏感なワークロード用に Red Hat Enterprise Linux 8 を調整する場合は、cpu-partitioning TuneD プロファイルを使用することが推奨されます。

Red Hat Enterprise Linux 8 以前では、低レイテンシーの Red Hat ドキュメントで、低レイテンシーのチューニングを実現するために必要な低レベルの手順が数多く説明されていました。Red Hat Enterprise Linux 8 では、cpu-partitioning TuneD プロファイルを使用することで、低レイテンシーのチューニングをより効率的に実行できます。このプロファイルは、個々の低レイテンシーアプリケーションの要件に従って簡単にカスタマイズできます。

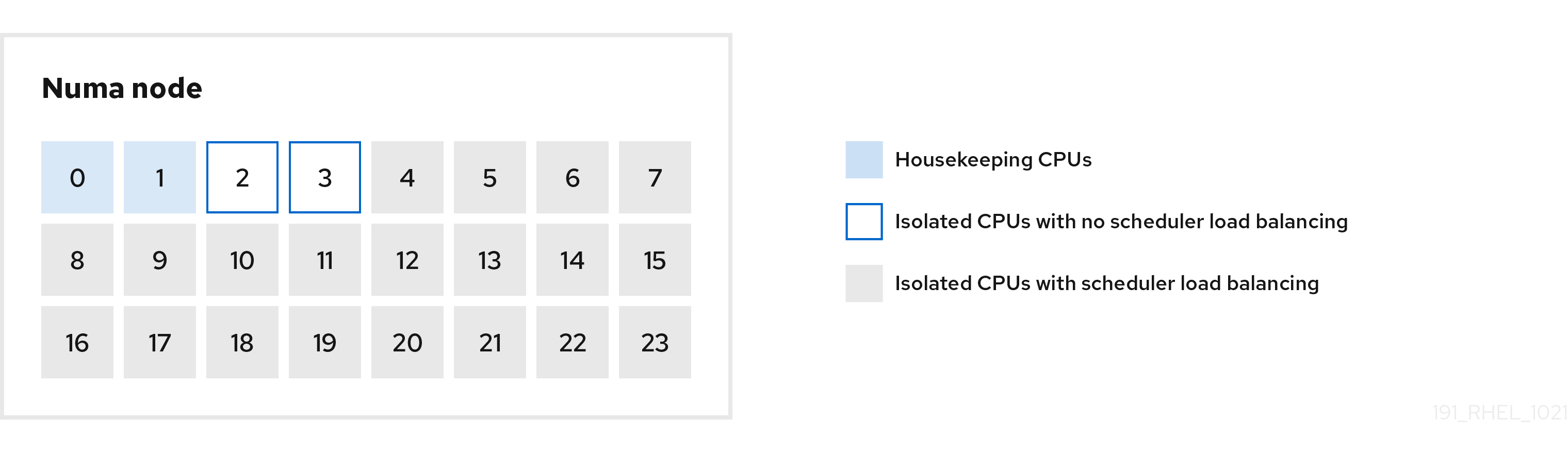

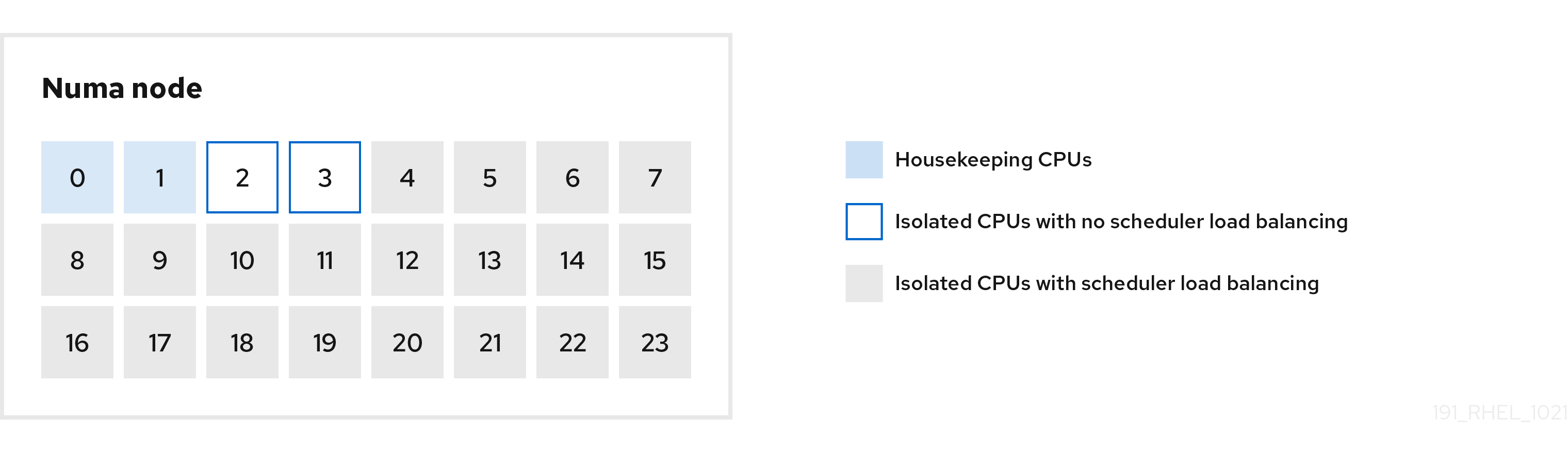

以下の図は、cpu-partitioning プロファイルの使用方法を示す例になります。この例では、CPU とノードのレイアウトを使用します。

図2.1 cpu-partitioning の図

/etc/tuned/cpu-partitioning-variables.conf ファイルで cpu-partitioning プロファイルを設定するには、以下の設定オプションを使用します。

- 負荷分散機能のある分離された CPU

cpu-partitioning の図では、4 から 23 までの番号が付けられたブロックが、デフォルトの分離された CPU です。カーネルスケジューラーのプロセスの負荷分散は、この CPU で有効になります。これは、カーネルスケジューラーの負荷分散を必要とする複数のスレッドを使用した低レイテンシープロセス用に設計されています。

isolated_cores=cpu-listオプションを使用して、/etc/tuned/cpu-partitioning-variables.confファイルで cpu-partitioning プロファイルを設定できます。このオプションは、カーネルスケジューラーの負荷分散を使用する分離する CPU をリスト表示します。分離された CPU のリストはコンマ区切りで表示するか、

3-5のようにハイフンを使用して範囲を指定できます。このオプションは必須です。このリストにない CPU は、自動的にハウスキーピング CPU と見なされます。- 負荷分散を行わずに分離した CPU

cpu-partitioning の図では、2 と 3 の番号が付けられたブロックは、追加のカーネルスケジューラープロセスの負荷分散を提供しない分離された CPU です。

/etc/tuned/cpu-partitioning-variables.confファイルで cpu-partitioning プロファイルを設定するには、no_balance_cores=cpu-listオプションを使用します。このオプションは、カーネルスケジューラーの負荷分散を使用しない CPU を分離するようにリスト表示します。no_balance_coresオプションの指定は任意ですが、このリストの CPU は、isolated_coresリストに記載されている CPU のサブセットである必要があります。このような CPU を使用するアプリケーションスレッドは、各 CPU に個別にピン留めする必要があります。

- ハウスキーピング CPU

-

cpu-partitioning-variables.confファイル内で分離されていない CPU は、自動的にハウスキーピング CPU と見なされます。ハウスキーピング CPU では、すべてのサービス、デーモン、ユーザープロセス、移動可能なカーネルスレッド、割り込みハンドラー、およびカーネルタイマーの実行が許可されます。

関連情報

-

tuned-profiles-cpu-partitioning(7)man ページ

2.8. 低レイテンシーチューニングへの TuneD の cpu-partitioning プロファイルの使用

この手順では、TuneD の cpu-partitioning プロファイルを使用して、低レイテンシーになるようにシステムをチューニングする方法を説明します。これは、cpu-partitioning の図で説明されているように、cpu-partitioning と CPU レイアウトを使用できる低レイテンシーのアプリケーションの例を使用します。

この場合のアプリケーションでは、以下を使用します。

- ネットワークからデータを読み込む 1 つの専用リーダースレッドが、CPU 2 に固定されます。

- このネットワークデータを処理する多数のスレッドは、CPU 4-23 に固定されます。

- 処理されたデータをネットワークに書き込む専用のライタースレッドは、CPU 3 に固定されます。

前提条件

-

yum install tuned-profiles-cpu-partitioningコマンドを root で使用して、cpu-partitioningTuneD プロファイルをインストールしている。

手順

/etc/tuned/cpu-partitioning-variables.confファイルを編集し、以下の内容を追加します。# All isolated CPUs: isolated_cores=2-23 # Isolated CPUs without the kernel’s scheduler load balancing: no_balance_cores=2,3

cpu-partitioningTuneD プロファイルを設定します。# tuned-adm profile cpu-partitioning

再起動

再起動後、システムは、cpu-partitioning の図の分離に従って、低レイテンシーにチューニングされます。このアプリケーションでは、タスクセットを使用して、リーダーおよびライターのスレッドを CPU 2 および 3 に固定し、残りのアプリケーションスレッドを CPU 4-23 に固定できます。

関連情報

-

tuned-profiles-cpu-partitioning(7)man ページ

2.9. cpu-partitioning TuneD プロファイルのカスタマイズ

TuneD プロファイルを拡張して、追加のチューニング変更を行うことができます。

たとえば、cpu-partitioning プロファイルは、cstate=1 を使用する CPU を設定します。cpu-partitioning プロファイルを使用しながら、cstate1 から cstate0 に CPU の cstate を変更するために、以下の手順では my_profile という名前の新しい TuneD プロファイルを説明しています。このプロファイルは、cpu-partitioning プロファイルを継承した後、C state-0 を設定します。

手順

/etc/tuned/my_profileディレクトリーを作成します。# mkdir /etc/tuned/my_profileこのディレクトリーに

tuned.confファイルを作成し、次の内容を追加します。# vi /etc/tuned/my_profile/tuned.conf [main] summary=Customized tuning on top of cpu-partitioning include=cpu-partitioning [cpu] force_latency=cstate.id:0|1新しいプロファイルを使用します。

# tuned-adm profile my_profile

この共有例では、再起動は必要ありません。ただし、my_profile プロファイルの変更を有効にするために再起動が必要な場合は、マシンを再起動します。

関連情報

-

tuned-profiles-cpu-partitioning(7)man ページ

2.10. RHEL とともに配布されるリアルタイムの TuneD プロファイル

リアルタイムプロファイルは、リアルタイムカーネルを実行するシステムを対象としています。特殊なカーネルビルドなしでは、システムはリアルタイムになりません。RHEL では、このプロファイルは追加のリポジトリーから利用できます。

利用できるリアルタイムプロファイルは以下の通りです。

リアルタイムベアメタルのリアルタイムシステムで使用します。

tuned-profiles-realtimeパッケージにより提供されます。これは、RT リポジトリーまたは NFV リポジトリーから入手できます。realtime-virtual-hostリアルタイムに設定された仮想ホストで使用します。

NFV リポジトリーから利用できる

tuned-profiles-nfv-hostパッケージにより提供されます。realtime-virtual-guestリアルタイムに設定された仮想化ゲストで使用します。

NFV リポジトリーから利用できる

tuned-profiles-nfv-guestパッケージにより提供されます。

2.11. TuneD の静的および動的チューニング

TuneD が適用するシステムチューニングの 2 つのカテゴリー (static と dynamic) の違いを理解することは、特定の状況や目的にどちらを使用するかを決定する際に重要です。

- 静的なチューニング

-

主に、事前定義された

sysctl設定およびsysfs設定の適用と、ethtoolなどの複数の設定ツールのワンショットアクティベーションから設定されます。 - 動的チューニング

システムのアップタイム中に、さまざまなシステムコンポーネントがどのように使用されているかを監視します。TuneD は、その監視情報に基づいてシステム設定を動的に調整します。

たとえば、ハードドライブは起動時およびログイン時に頻繁に使用されますが、Web ブラウザーや電子メールクライアントなどのアプリケーションをユーザーが主に使用する場合はほとんど使用されません。同様に、CPU とネットワークデバイスは、異なるタイミングで使用されます。TuneD は、このようなコンポーネントのアクティビティーを監視し、その使用の変化に反応します。

デフォルトでは、動的チューニングは無効になっています。これを有効にするには、

/etc/tuned/tuned-main.confファイルを編集して、dynamic_tuningオプションを1に変更します。TuneD は、システムの統計を定期的に分析してから、その統計を使用してシステムのチューニング設定を更新します。これらの更新間の時間間隔を秒単位で設定するには、update_intervalオプションを使用します。現在実装されている動的チューニングアルゴリズムは、パフォーマンスと省電力のバランスを取ろうとし、パフォーマンスプロファイルで無効になります。各プラグインのダイナミックチューニングは、TuneD プロファイルで有効または無効にできます。

例2.2 ワークステーションでの静的および動的のチューニング

一般的なオフィスワークステーションでは、イーサネットネットワークインターフェイスは常に非アクティブの状態です。少数の電子メールのみが出入りするか、一部の Web ページが読み込まれている可能性があります。

このような負荷の場合、ネットワークインターフェイスはデフォルト設定のように常に最高速度で動作する必要はありません。TuneD には、ネットワークデバイスを監視してチューニングを行うプラグインがあり、これによりこの低いアクティビティーを検出して、自動的にそのインターフェイスの速度を下げることができるため、通常は消費電力が少なくなります。

DVD イメージをダウンロードしているとき、または大きな添付ファイル付きのメールが開いているときなど、インターフェイスのアクティビティーが長期間にわたって増加した場合は、TuneD がこれを検出し、アクティビティーレベルが高い間にインターフェイスの速度を最大に設定します。

この原則は、CPU およびディスクの他のプラグインにも使用されます。

2.12. TuneD の no-daemon モード

TuneD は、常駐メモリーを必要としない no-daemon モードで実行できます。このモードでは、TuneD が設定を適用して終了します。

デフォルトでは、このモードには、以下のように多くの TuneD 機能がないため、no-daemon モードが無効になっています。

- D-Bus サポート

- ホットプラグサポート

- 設定のロールバックサポート

no-daemon モードを有効にするには、/etc/tuned/tuned-main.conf ファイルに以下の行を含めます。

daemon = 0

2.13. TuneD のインストールと有効化

この手順では、TuneD アプリケーションをインストールして有効にし、TuneD プロファイルをインストールして、システムにデフォルトの TuneD プロファイルをあらかじめ設定します。

手順

Tunedパッケージをインストールします。# yum install tuned

Tunedサービスを有効にして開始します。# systemctl enable --now tuned

必要に応じて、リアルタイムシステムのTuneD プロファイルをインストールします。

リアルタイムシステムの Tuned プロファイルの場合は、

rhel-8リポジトリーを有効にします。# subscription-manager repos --enable=rhel-8-for-x86_64-nfv-beta-rpms

インストールします。

# yum install tuned-profiles-realtime tuned-profiles-nfv

TuneDプロファイルが有効であり、適用されていることを確認します。

$ tuned-adm active Current active profile: throughput-performance注記TuneD が自動的にプリセットするアクティブなプロファイルは、マシンのタイプとシステム設定によって異なります。

$ tuned-adm verify Verification succeeded, current system settings match the preset profile. See tuned log file ('/var/log/tuned/tuned.log') for details.

2.14. 利用可能な TuneD プロファイルのリスト表示

この手順では、使用しているシステムで現在利用可能なTuneDプロファイルのリストを表示します。

手順

システムで使用可能なすべてのTuneDプロファイルをリスト表示するには、次を使用します。

$ tuned-adm list Available profiles: - accelerator-performance - Throughput performance based tuning with disabled higher latency STOP states - balanced - General non-specialized TuneD profile - desktop - Optimize for the desktop use-case - latency-performance - Optimize for deterministic performance at the cost of increased power consumption - network-latency - Optimize for deterministic performance at the cost of increased power consumption, focused on low latency network performance - network-throughput - Optimize for streaming network throughput, generally only necessary on older CPUs or 40G+ networks - powersave - Optimize for low power consumption - throughput-performance - Broadly applicable tuning that provides excellent performance across a variety of common server workloads - virtual-guest - Optimize for running inside a virtual guest - virtual-host - Optimize for running KVM guests Current active profile: balanced

現在アクティブなプロファイルのみを表示する場合は、次のコマンドを使用します。

$ tuned-adm active Current active profile: throughput-performance

関連情報

-

tuned-adm(8)の man ページ

2.15. TuneD プロファイルの設定

この手順では、選択した TuneD プロファイルを有効にします。

前提条件

-

TuneDサービスが実行されています。詳細は、TuneD のインストールと有効化 を参照してください。

手順

必要に応じて、TuneD がシステムに最も適したプロファイルを推奨できます。

# tuned-adm recommend throughput-performanceプロファイルをアクティブ化します。

# tuned-adm profile selected-profileまたは、複数のプロファイルの組み合わせをアクティベートできます。

# tuned-adm profile selected-profile1 selected-profile2

例2.3 低消費電力向けに最適化された仮想マシン

以下の例では、仮想マシンでの実行でパフォーマンスを最大化するようにシステムが最適化され、同時に、(低消費電力が最優先である場合は) 低消費電力を実現するようにシステムがチューニングされます。

# tuned-adm profile virtual-guest powersave

お使いのシステムで現在アクティブな TuneD プロファイルを表示します。

# tuned-adm active Current active profile: selected-profileシステムを再起動します。

# reboot

検証手順

TuneD プロファイルが有効であり、適用されていることを確認します。

$ tuned-adm verify Verification succeeded, current system settings match the preset profile. See tuned log file ('/var/log/tuned/tuned.log') for details.

関連情報

-

tuned-adm(8)の man ページ

2.16. TuneD の無効化

この手順では、TuneD を無効にし、影響を受けるすべてのシステム設定を TuneD が変更する前の元の状態にリセットします。

手順

すべてのチューニングを一時的に無効にするには、次のコマンドを実行します。

# tuned-adm off

チューニングは、

TuneDサービスの再起動後に再度適用されます。または、

TuneDサービスを完全に停止して無効にするには、次のようにします。# systemctl disable --now tuned

関連情報

-

tuned-adm(8)の man ページ

第3章 TuneD プロファイルのカスタマイズ

TuneDプロファイルを作成または変更して、ユースケースに合わせてシステムパフォーマンスを最適化できます。

前提条件

- TuneD のインストールと有効化 に詳述されているように、TuneD をインストールおよび有効化します。

3.1. TuneD プロファイル

システムを詳細に分析することは、非常に時間のかかる作業です。TuneD では、一般的なユースケースに合わせて定義済みのプロファイルを多数提供しています。プロファイルを作成、変更、および削除することも可能です。

TuneD で提供されるプロファイルは、以下のカテゴリーに分類されます。

- 省電力プロファイル

- パフォーマンス重視プロファイル

performance-boosting プロファイルの場合は、次の側面に焦点が置かれます。

- ストレージおよびネットワークに対して少ないレイテンシー

- ストレージおよびネットワークの高い処理能力

- 仮想マシンのパフォーマンス

- 仮想化ホストのパフォーマンス

プロファイル設定の構文

tuned.conf ファイルは、1 つの [main] セクションとプラグインインスタンスを設定するためのその他のセクションが含まれます。ただし、すべてのセクションはオプションです。

ハッシュ記号 (#) で始まる行はコメントです。

関連情報

-

tuned.conf(5)の man ページ

3.2. デフォルトの TuneD プロファイル

インストール時に、システムの最適なプロファイルが自動的に選択されます。現時点では、以下のカスタマイズ可能なルールに従ってデフォルトのプロファイルが選択されます。

| 環境 | デフォルトプロファイル | 目的 |

|---|---|---|

| コンピュートノード |

| 最適なスループットパフォーマンス |

| 仮想マシン |

|

ベストパフォーマンスベストパフォーマンスが重要でない場合は、 |

| その他のケース |

| パフォーマンスと電力消費の調和 |

関連情報

-

tuned.conf(5)の man ページ

3.3. マージされた TuneD プロファイル

試験目的で提供された機能として、複数のプロファイルを一度に選択することができます。TuneD は、読み込み中にマージを試みます。

競合が発生した場合は、最後に指定されたプロファイルの設定が優先されます。

例3.1 仮想ゲストの低消費電力

以下の例では、仮想マシンでの実行でパフォーマンスを最大化するようにシステムが最適化され、同時に、(低消費電力が最優先である場合は) 低消費電力を実現するようにシステムがチューニングされます。

# tuned-adm profile virtual-guest powersave

マージは自動的に行われ、使用されるパラメーターの組み合わせが適切であるかどうかはチェックされません。結果として、この機能は一部のパラメーターを逆に調整する可能性があります。これは逆効果になる可能性があります。たとえば、throughput-performance プロファイルで高スループットにディスクを設定し、同時に、spindown-disk プロファイルでディスクスピンダウンを低い値に設定します。

関連情報

*tuned-adm man ページ* tuned.conf(5) の man ページ

3.4. TuneD プロファイルの場所

TuneD は、次のディレクトリーにプロファイルを保存します。

/usr/lib/tuned/-

ディストリビューション固有のプロファイルは、このディレクトリーに保存されます。各プロファイルには独自のディレクトリーがあります。プロファイルは

tuned.confという名前の主要設定ファイルと、ヘルパースクリプトなどの他の任意のファイルから設定されます。 /etc/tuned/-

プロファイルをカスタマイズする必要がある場合は、プロファイルのカスタマイズに使用されるディレクトリーにプロファイルディレクトリーをコピーします。同じ名前のプロファイルが 2 つある場合、カスタムのプロファイルは、

/etc/tuned/に置かれています。

関連情報

-

tuned.conf(5)の man ページ

3.5. TuneD プロファイル間の継承

TuneDプロファイルは、他のプロファイルを基にして、親プロファイルの特定の側面のみを変更できます。

TuneD プロファイルの [main] セクションは、include オプションを認識します。

[main]

include=parent親 プロファイルの設定はすべて、この 子 プロファイルに読み込まれます。以下のセクションでは、子 プロファイルは、親 プロファイルから継承された特定の設定をオーバーライドするか、親 プロファイルに表示されない新しい設定を追加します。

/usr/lib/tuned/ にあらかじめインストールしておいたプロファイルでパラメーターをいくつか調整するだけで、/etc/tuned/ に独自の 子 プロファイルを作成できます。

TuneD のアップグレード後などに、親 プロファイルが更新されると、この変更は 子 プロファイルに反映されます。

例3.2 バランスの取れた省電力プロファイル

以下は、balanced プロファイルを拡張し、すべてのデバイスの Aggressive Link Power Management (ALPM) を最大省電力に設定するカスタムプロファイルの例です。

[main] include=balanced [scsi_host] alpm=min_power

関連情報

-

tuned.conf(5)の man ページ

3.6. TuneD の静的および動的チューニング

TuneD が適用するシステムチューニングの 2 つのカテゴリー (static と dynamic) の違いを理解することは、特定の状況や目的にどちらを使用するかを決定する際に重要です。

- 静的なチューニング

-

主に、事前定義された

sysctl設定およびsysfs設定の適用と、ethtoolなどの複数の設定ツールのワンショットアクティベーションから設定されます。 - 動的チューニング

システムのアップタイム中に、さまざまなシステムコンポーネントがどのように使用されているかを監視します。TuneD は、その監視情報に基づいてシステム設定を動的に調整します。

たとえば、ハードドライブは起動時およびログイン時に頻繁に使用されますが、Web ブラウザーや電子メールクライアントなどのアプリケーションをユーザーが主に使用する場合はほとんど使用されません。同様に、CPU とネットワークデバイスは、異なるタイミングで使用されます。TuneD は、このようなコンポーネントのアクティビティーを監視し、その使用の変化に反応します。

デフォルトでは、動的チューニングは無効になっています。これを有効にするには、

/etc/tuned/tuned-main.confファイルを編集して、dynamic_tuningオプションを1に変更します。TuneD は、システムの統計を定期的に分析してから、その統計を使用してシステムのチューニング設定を更新します。これらの更新間の時間間隔を秒単位で設定するには、update_intervalオプションを使用します。現在実装されている動的チューニングアルゴリズムは、パフォーマンスと省電力のバランスを取ろうとし、パフォーマンスプロファイルで無効になります。各プラグインのダイナミックチューニングは、TuneD プロファイルで有効または無効にできます。

例3.3 ワークステーションでの静的および動的のチューニング

一般的なオフィスワークステーションでは、イーサネットネットワークインターフェイスは常に非アクティブの状態です。少数の電子メールのみが出入りするか、一部の Web ページが読み込まれている可能性があります。

このような負荷の場合、ネットワークインターフェイスはデフォルト設定のように常に最高速度で動作する必要はありません。TuneD には、ネットワークデバイスを監視してチューニングを行うプラグインがあり、これによりこの低いアクティビティーを検出して、自動的にそのインターフェイスの速度を下げることができるため、通常は消費電力が少なくなります。

DVD イメージをダウンロードしているとき、または大きな添付ファイル付きのメールが開いているときなど、インターフェイスのアクティビティーが長期間にわたって増加した場合は、TuneD がこれを検出し、アクティビティーレベルが高い間にインターフェイスの速度を最大に設定します。

この原則は、CPU およびディスクの他のプラグインにも使用されます。

3.7. TuneD プラグイン

プラグインは、TuneD がシステムのさまざまなデバイスを監視または最適化するために使用する TuneD プロファイルのモジュールです。

TuneD では、以下の 2 つのタイプのプラグインを使用します。

- プラグインの監視

モニタリングプラグインは、稼働中のシステムから情報を取得するために使用されます。監視プラグインの出力は、動的チューニング向けチューニングプラグインで使用できます。

監視プラグインは、有効ないずれかのチューニングプラグインでメトリックが必要な場合に必ず自動的にインスタンス化されます。2 つのチューニングプラグインで同じデータが必要な場合は、監視プラグインのインスタンスが 1 つだけ作成され、データが共有されます。

- プラグインのチューニング

- 各チューニングプラグインは、個々のサブシステムをチューニングし、TuneD プロファイルから設定されたいくつかのパラメーターを取得します。各サブシステムには、チューニングプラグインの個別インスタンスで処理される複数のデバイス (複数の CPU やネットワークカードなど) を含めることができます。また、個別デバイスの特定の設定もサポートされます。

TuneD プロファイルのプラグインの構文

プラグインインスタンスが記述されるセクションは、以下のように書式化されます。

[NAME] type=TYPE devices=DEVICES

- NAME

- ログで使用されるプラグインインスタンスの名前です。これは、任意の文字列です。

- TYPE

- チューニングプラグインのタイプです。

- DEVICES

このプラグインインスタンスが処理するデバイスのリストです。

deviceの行には、リスト、ワイルドカード (*)、否定 (!) が含まれます。deviceの行がないと、TYPE のシステムに現在または後で接続されるすべてのデバイスは、プラグインインスタンスにより処理されます。devices=*オプションを使用する場合と同じです。例3.4 ブロックデバイスとプラグインのマッチング

次の例では、

sda、sdbなどsdで始まるすべてのブロックデバイスに一致し、それらに対する境界は無効にしない例になります。[data_disk] type=disk devices=sd* disable_barriers=false

次の例は、

sda1およびsda2を除くすべてのブロックデバイスと一致します。[data_disk] type=disk devices=!sda1, !sda2 disable_barriers=false

プラグインのインスタンスを指定しないと、そのプラグインは有効になりません。

このプラグインがより多くのオプションに対応していると、プラグインセクションでも指定できます。このオプションが指定されておらず、含まれているプラグインでこれまで指定しなかった場合は、デフォルト値が使用されます。

短いプラグイン構文

プラグインインスタンスにカスタム名を付ける必要がなく、設定ファイルにインスタンスの定義が 1 つしかない場合、TuneD は以下の簡単な構文に対応します。

[TYPE] devices=DEVICES

この場合は、type の行を省略することができます。タイプと同様に、インスタンスは名前で参照されます。上記の例は、以下のように書き換えることができます。

例3.5 短い構文を使用したブロックデバイスのマッチング

[disk] devices=sdb* disable_barriers=false

プロファイルで競合するプラグインの定義

include オプションを使用して同じセクションを複数回指定した場合は、設定がマージされます。設定をマージできない場合は、競合がある以前の設定よりも、競合がある最後の定義が優先されます。以前に定義されたものが分からない場合は、replace ブール式オプションを使用して、それを true に設定します。これにより、同じ名前の以前の定義がすべて上書きされ、マージは行われません。

また、enabled=false オプションを指定してプラグインを無効にすることもできます。これは、インスタンスが定義されない場合と同じ効果になります。include オプションから以前の定義を再定義し、カスタムプロファイルでプラグインをアクティブにしない場合には、プラグインを無効にすると便利です。

- 注記

TuneD には、チューニングプロファイルの有効化または無効化の一環として、シェルコマンドを実行する機能が含まれます。これにより、TuneD に統合されていない機能で、TuneD プロファイルを拡張できます。

任意のシェルコマンドは、

scriptプラグインを使用して指定できます。

関連情報

-

tuned.conf(5)の man ページ

3.8. 利用可能な TuneD プラグイン

プラグインの監視

現在、以下の監視プラグインが実装されています。

disk- デバイスおよび測定間隔ごとのディスク負荷 (IO 操作の数) を取得します。

net- ネットワークカードおよび測定間隔ごとのネットワーク負荷 (転送済みパケットの数) を取得します。

load- CPU および測定間隔ごとの CPU 負荷を取得します。

プラグインのチューニング

現在、以下のチューニングプラグインが実装されています。動的チューニングを実装するのは、これらのプラグインの一部のみです。プラグインで対応しているオプションもリスト表示されます。

cpuCPU ガバナーを、

governorオプションで指定された値に設定し、CPU 負荷に応じて、電源管理サービス品質 (PM QoS) CPU ダイレクトメモリーアクセス (DMA) のレイテンシーを動的に変更します。CPU 負荷が

load_thresholdオプションで指定された値よりも小さい場合、レイテンシーはlatency_highオプションで指定した値に設定されます。それ以外では、latency_lowで指定した値に設定されます。レイテンシーを特定の値に強制し、さらに動的に変更しないようにすることもできます。これを行うには、

force_latencyオプションを、必要なレイテンシーの値に設定します。eeepc_sheCPU の負荷に応じて、フロントサイドバス (FSB) の速度を動的に設定します。

この機能は一部のネットブックで利用でき、ASUS Super buf Engine (SHE) としても知られています。

CPU 負荷が

load_threshold_powersaveオプションで指定した値と同じかそれ未満の場合、プラグインは、FSB 速度を、she_powersaveオプションで指定した値に設定します。CPU 負荷がload_threshold_normalオプションで指定した値と同じかそれより上になる場合は、FSB 速度が、she_normalオプションで指定された値に設定されます。この機能のハードウェアサポートを TuneD が検出しない場合、静的チューニングには対応せず、プラグインも透過的に無効になります。

net-

Wake on LAN 機能を、

wake_on_lanオプションで指定した値に設定します。ethtoolユーティリティーと同じ構文を使用します。また、インターフェイスの使用状況に応じてインターフェイス速度が動的に変更します。 sysctlプラグインオプションで指定したさまざまな

sysctl設定を設定します。この構文は、

name=valueです。name は、sysctlユーティリティーが指定した名前と同じです。TuneDで利用可能な別のプラグインで対応していない設定を変更する必要がある場合は、

sysctlプラグインを使用します。他の特定プラグインが、この設定に対応している場合は、そのプラグインを使用することが推奨されます。usbUSB デバイスの autosuspend タイムアウトを、

autosuspendパラメーターで指定した値に設定します。値が

0の場合は、autosuspend が無効になります。vmtransparent_hugepagesオプションの値に合わせて、Transparent Huge Page を有効または無効にします。transparent_hugepagesオプションの有効な値は次のとおりです。- "always"

- "never"

- "madvise"

audio音声コーデックの autosuspend タイムアウトを、

timeoutオプションで指定した値に設定します。現在、

snd_hda_intelコーデックおよびsnd_ac97_codecコーデックに対応しています。値が0の場合は、autosuspend が無効になります。また、ブール値オプションreset_controllerをtrueに設定することにより、コントローラーを強制的にリセットすることもできます。diskelevatorオプションで指定された値にディスクエレベーターを設定します。また、以下も設定します。

-

apmオプションで指定された値への APM -

scheduler_quantumオプションで指定された値へのスケジューラーの量子 -

spindownオプションで指定された値へのディスクスピンダウンタイムアウト -

readaheadパラメーターで指定した値までディスク先読み -

現在のディスクが、

readahead_multiplyオプションで指定した定数を掛けた値に先読みされます。

さらに、このプラグインにより、現在のドライブ使用状況に応じて、ドライブの高度な電力管理設定および spindown タイムアウト設定が動的に変更します。動的チューニングは、ブール値オプション

dynamicにより制御でき、デフォルトで有効になります。-

scsi_hostSCSI ホストのオプションをチューニングします。

Aggressive Link Power Management (ALPM) を、

alpmオプションで指定した値に設定します。mounts-

disable_barriersオプションのブール値に応じて、マウントのバリアを有効または無効にします。 scriptプロファイルの読み込み時またはアンロード時に、外部スクリプトまたはバイナリーを実行します。任意の実行可能ファイルを選択できます。

重要scriptプラグインは、以前のリリースとの互換性を維持するために提供されています。必要な機能をカバーする場合は、他のTuneD プラグインを使用することが推奨されます。TuneD は、以下のいずれかの引数で実行ファイルを呼び出します。

-

プロファイルの読み込み時に

start -

プロファイルのアンロード時に

stop

実行可能ファイルに

stopアクションを適切に実装し、startアクション中に変更したすべての設定を元に戻す必要があります。この手順を行わないと、TuneD プロファイルを変更した後のロールバック手順が機能しません。bash スクリプトは、Bash ライブラリー

/usr/lib/tuned/functionsをインポートし、そこで定義されている関数を使用できます。これらの関数は、TuneD がネイティブに提供していない機能にのみ使用してください。関数名が_wifi_set_power_levelなどのアンダースコアで始まる場合は、将来変更される可能性があるため、関数をプライベートにし、スクリプトでは使用しないでください。プラグイン構造の

scriptパラメーターを使用して、実行ファイルへのパスを指定します。例3.6 プロファイルからの Bash スクリプトの実行

プロファイルディレクトリーに置かれた

script.shという名前の Bash スクリプトを実行するには、次のコマンドを実行します。[script] script=${i:PROFILE_DIR}/script.sh-

プロファイルの読み込み時に

sysfsプラグインオプションで指定したさまざまな

sysfs設定を設定します。構文は

name=valueとなります。name は、使用するsysfsパスです。このプラグインは、他のプラグインで対応していない一部の設定を変更する必要がある場合に使用します。特定のプラグインが必要な設定に対応する場合は、そのプラグインを優先します。

videoビデオカードのさまざまな省電力レベルを設定します。現在、Radeon カードにのみ対応しています。

省電力レベルは、

radeon_powersaveオプションを使用して指定できます。対応している値は次のとおりです。-

default -

auto -

low -

mid -

High -

dynpm -

dpm-battery -

dpm-balanced -

dpm-perfomance

詳細は www.x.org を参照してください。このプラグインは実験的なものであるため、今後のリリースでオプションが変更する可能性があることに注意してください。

-

bootloaderカーネルコマンドラインにオプションを追加します。このプラグインは、GRUB 2 ブートローダーのみに対応しています。

grub2_cfg_fileオプションを使用すると、GRUB 2 設定ファイルの場所を、標準以外のカスタマイズされた場所に指定できます。そのカーネルオプションは、現在の GRUB 設定とそのテンプレートに追加されます。カーネルオプションを有効にするには、システムを再起動する必要があります。

別のプロファイルに切り替えるか、

TuneDサービスを手動で停止すると、追加のオプションが削除されます。システムをシャットダウンまたは再起動しても、カーネルオプションはgrub.cfgファイルに残ります。カーネルオプションは、以下の構文で指定できます。

cmdline=arg1 arg2 ... argN

例3.7 カーネルコマンドラインの変更

たとえば、

quietカーネルオプションを TuneD プロファイルに追加するには、tuned.confファイルに次の行を含めます。[bootloader] cmdline=quiet

以下に、

isolcpus=2オプションをカーネルコマンドラインに追加するカスタムプロファイルの例を示します。[bootloader] cmdline=isolcpus=2

serviceプラグインオプションで指定されたさまざまな

sysvinit、sysv-rc、openrc、およびsystemdサービスを処理します。構文は

service.service_name=command[,file:file]です。サポートされているサービス処理コマンドは次のとおりです。

-

start -

stop -

enable -

disable

コンマ (

,) またはセミコロン (;) を使用して、複数のコマンドを区切ります。ディレクティブの競合の場合、serviceプラグインは最後にリストされたものを使用します。オプションの

file:fileディレクティブを使用して、systemd専用のオーバーレイ設定ファイルfileをインストールします。他の init システムは、このディレクティブを無視します。serviceプラグインは、オーバーレイ設定ファイルを/etc/systemd/system/service_name.service.d/ディレクトリーにコピーします。プロファイルがアンロードされると、serviceプラグインは、これらのディレクトリーが空の場合は削除します。注記serviceプラグインは、systemdinit システム以外の現在のランレベルでのみ動作します。例3.8 オーバーレイファイルを使用した

sendmailサービスの開始および有効化[service] service.sendmail=start,enable,file:${i:PROFILE_DIR}/tuned-sendmail.conf内部変数

${i:PROFILE_DIR}は、プラグインがプロファイルをロードするディレクトリーを指します。-

scheduler- スケジューリングの優先度、CPU コア分離、プロセスアフィニティー、スレッドアフィニティー、および IRQ アフィニティーを調整するためのさまざまなオプションを提供します。

利用可能なさまざまなオプションの詳細は、Functionalities of the scheduler TuneD plug-in を参照してください。

3.9. scheduler TuneD プラグインの機能

scheduler TuneD プラグインを使用して、スケジューリングの優先度、CPU コアの分離、プロセスアフィニティー、スレッドアフィニティー、および IRQ アフィニティーを制御および調整します。

CPU の分離

プロセス、スレッド、および IRQ が特定の CPU を使用しないようにするには、isolated_cores オプションを使用します。これは、プロセスおよびスレッドアフィニティー、IRQ アフィニティーを変更し、IRQ の default_smp_affinity パラメーターを設定します。

CPU アフィニティーマスクは、sched_setaffinity() システムコールの成功を条件として、ps_whitelist オプションに一致するすべてのプロセスとスレッドに対して調整されます。ps_whitelist 正規表現のデフォルト設定は、すべてのプロセスおよびスレッド名に一致する .* です。特定のプロセスおよびスレッドを除外するには、ps_blacklist オプションを使用します。このオプションの値も正規表現として解釈されます。プロセス名とスレッド名は、その正規表現と照合されます。プロファイルロールバックにより、一致するすべてのプロセスとスレッドがすべての CPU で実行され、プロファイルアプリケーションの前に IRQ 設定が復元されます。

ps_whitelist オプションおよび ps_blacklist オプションで、; で区切った複数の正規表現がサポートされます。エスケープされたセミコロン \; はそのまま使用されます。

例3.9 CPUs 2-4 の分離

以下の設定は CPU 2-4 を分離します。ps_blacklist 正規表現に一致するプロセスおよびスレッドは、分離に関係なく任意の CPU を使用できます。

[scheduler] isolated_cores=2-4 ps_blacklist=.*pmd.*;.*PMD.*;^DPDK;.*qemu-kvm.*

IRQ SMP アフィニティー

/proc/irq/default_smp_affinity ファイルには、すべての非アクティブな割り込み要求 (IRQ) ソース用のシステム上のデフォルトのターゲット CPU コアを表すビットマスクが含まれます。IRQ がアクティブまたは割り当てられると、/proc/irq/default_smp_affinity ファイルの値は IRQ のアフィニティービットマスクを決定します。

default_irq_smp_affinity パラメーターは、TuneD が /proc/irq/default_smp_affinity ファイルに書き込むものを制御します。default_irq_smp_affinity パラメーターは、以下の値と動作をサポートします。

calcisolated_coresパラメーターから/proc/irq/default_smp_affinityファイルの内容を計算します。isolated_coresパラメーターの反転は、分離していないコアを計算します。次に、分離されていないコアの交差部分と、

/proc/irq/default_smp_affinityファイルの以前の内容が/proc/irq/default_smp_affinityファイルに書き込まれます。これは、

default_irq_smp_affinityパラメーターが省略された場合のデフォルトの動作です。ignore-

TuneD は、

/proc/irq/default_smp_affinityファイルを変更しません。 - CPU リスト

1などの単一の数値、1,3などのコンマ区切りのリスト、または3-5などの範囲の形式を取ります。CPU リストを展開し、これを

/proc/irq/default_smp_affinityファイルに直接書き込みます。

例3.10 明示的な CPU リストを使用したデフォルトの IRQ smp アフィニティーの設定

以下の例では、明示的な CPU リストを使用して、デフォルトの IRQ SMP アフィニティーを CPU 0 および 2 に設定します。

[scheduler] isolated_cores=1,3 default_irq_smp_affinity=0,2

スケジューリングポリシー

プロセスまたはスレッドのグループのスケジューリングポリシー、優先度、およびアフィニティーを調整するには、以下の構文を使用します。

group.groupname=rule_prio:sched:prio:affinity:regex

ここで rule_prio は、ルールの内部 TuneD 優先度を定義します。ルールは優先度に基づいてソートされます。これは、継承が以前に定義されたルールを並べ替えることができるようにするために必要です。同等の rule_prio ルールは、定義された順序で処理される必要があります。ただし、これは Python インタープリターに依存します。groupname の継承されたルールを無効にするには、以下を使用します。

group.groupname=

sched は以下のいずれかである必要があります。

f- 先入れ先出し (FIFO)

b- バッチ

r- ラウンドロビン

o- その他

*- 変更対象外

affinity は 16 進数での CPU アフィニティーです。変更しない場合は * を使用します。

prio はスケジューリングの優先度です (chrt -m を参照)。

regex は Python の正規表現です。これは、ps -eo cmd コマンドの出力と照合されます。

指定したプロセス名は、複数のグループに一致させることができます。このような場合、最後に一致する regex により、優先順位とスケジューリングポリシーが決まります。

例3.11 スケジューリングポリシーおよび優先度の設定

以下の例では、スケジューリングポリシーと優先度をカーネルスレッドおよびウォッチドッグに設定します。

[scheduler] group.kthreads=0:*:1:*:\[.*\]$ group.watchdog=0:f:99:*:\[watchdog.*\]

scheduler プラグインは、perf イベントループを使用して、新しく作成されたプロセスを識別します。デフォルトでは、perf.RECORD_COMM および perf.RECORD_EXIT のイベントをリッスンします。

perf_process_fork パラメーターを true に設定すると、プラグインに対して perf.RECORD_FORK イベントもリッスンするように指示します。つまり、fork() システムコールによって作成された子プロセスが処理されます。

perf イベントの処理には大量の CPU オーバーヘッドが発生する可能性があります。

スケジューラープラグインの CPU オーバーヘッドは、スケジューラー runtime オプションを使用して 0 に設定することで軽減できます。これにより、動的スケジューラー機能が完全に無効になり、perf イベントは監視されず、処理されません。これによるデメリットは、プロセスとスレッドの調整がプロファイルアプリケーションでのみ実行されることです。

例3.12 動的スケジューラー機能の無効化

以下の例では、CPU 1 と 3 を分離しながら、動的スケジューラー機能を無効にします。

[scheduler] runtime=0 isolated_cores=1,3

mmapped バッファーは perf イベントに使用されます。負荷が大きい場合、このバッファーがオーバーフローする可能性があり、プラグインが欠落しているイベントを開始し、新しく作成されたプロセスを処理しない可能性があります。このような場合は、perf_mmap_pages パラメーターを使用してバッファーサイズを増やします。perf_mmap_pages パラメーターの値は 2 の累乗である必要があります。perf_mmap_pages パラメーターが手動で設定されていない場合は、デフォルト値の 128 が使用されます。

cgroupsを使用した制限

scheduler プラグインは、cgroups v1 を使用したプロセスおよびスレッド制限をサポートします。

cgroup_mount_point オプションは、cgroup ファイルシステムをマウントするパス、または、TuneD のマウントが想定される場所を指定します。設定されていない場合、/sys/fs/cgroup/cpuset が想定されます。

cgroup_groups_init オプションが 1 に設定されている場合、TuneD は、cgroup* オプションで定義されたすべての cgroups を作成および削除します。これがデフォルトの動作です。cgroup_mount_point オプションが 0 に設定されている場合、cgroups は他の方法で事前設定する必要があります。

cgroup_mount_point_init オプションが 1 に設定されている場合、TuneD は cgroup マウントポイントを作成し、削除します。これは cgroup_groups_init = 1 を意味します。cgroup_mount_point_init オプションが 0 に設定されている場合は、他の方法で cgroups マウントポイントを事前設定する必要があります。これがデフォルトの動作です。

cgroup_for_isolated_cores オプションは、isolated_cores オプション機能の cgroup 名です。たとえば、システムに 4 つの CPU がある場合、isolated_cores=1 は、Tuned がすべてのプロセスとスレッドを CPU 0、2、および 3 に移動することを意味します。scheduler プラグインは、計算された CPU アフィニティーを指定された cgroup の cpuset.cpus コントロールファイルに書き込み、一致するすべてのプロセスおよびスレッドをこのグループに移動することで、指定されたコアを分離します。このオプションが設定されていない場合、sched_setaffinity() を使用する従来の cpuset アフィニティーが CPU アフィニティーを設定します。

cgroup.cgroup_name オプションは、任意の cgroups のアフィニティーを定義します。階層的な cgroups を使用することもできますが、階層を正しい順序で指定する必要があります。TuneD は、cgroup_mount_point オプションで指定された場所に cgroup を強制的に配置する点を除き、ここでは健全性チェックを行いません。

group. で始まるスケジューラーオプションの構文が拡張され、16 進数の affinity ではなく、cgroup.cgroup_name が使用されるようになりました。一致するプロセスは cgroup cgroup_name に移動されます。上記のように、cgroup. オプションで定義されていない cgroup を使用することもできます。たとえば、TuneD によって管理されない cgroups などがあります。

すべての cgroup 名は、ピリオド (.) をスラッシュ (/) に置き換えてサニタイズされます。これにより、プラグインが cgroup_mount_point オプションで指定された場所の外部に書き込むことを防ぎます。

例3.13 scheduler プラグインでの cgroups v1 の使用

以下の例では、2 つの cgroups、group1、および group2 を作成します。cgroup group1 アフィニティーを CPU 2 に設定し、cgroup group2 を CPU 0 および 2 に設定します。4 つの CPU 設定を指定すると、isolated_cores=1 オプションはすべてのプロセスとスレッドを CPU コア 0、2、および 3 に移動します。ps_blacklist 正規表現で指定されたプロセスおよびスレッドは移動されません。

[scheduler] cgroup_mount_point=/sys/fs/cgroup/cpuset cgroup_mount_point_init=1 cgroup_groups_init=1 cgroup_for_isolated_cores=group cgroup.group1=2 cgroup.group2=0,2 group.ksoftirqd=0:f:2:cgroup.group1:ksoftirqd.* ps_blacklist=ksoftirqd.*;rcuc.*;rcub.*;ktimersoftd.* isolated_cores=1

cgroup_ps_blacklist オプションは、指定された cgroups に属するプロセスを除外します。このオプションで指定された正規表現は、/proc/PID/cgroups の cgroup 階層と照合されます。コンマ (,) は、正規表現の一致前に cgroups v1 階層を /proc/PID/cgroups から分離します。以下は、正規表現が照合される内容の例です。

10:hugetlb:/,9:perf_event:/,8:blkio:/

複数の正規表現はセミコロン (;) で区切ることができます。セミコロンは論理 or 演算子を表します。

例3.14 cgroups を使用したスケジューラーからのプロセスの除外

以下の例では、scheduler プラグインは、cgroup /daemons に属するプロセスを除いて、すべてのプロセスをコア 1 から移動します。\b 文字列は、単語境界に一致する正規表現のメタ文字です。

[scheduler] isolated_cores=1 cgroup_ps_blacklist=:/daemons\b

以下の例では、scheduler プラグインは、階層 ID が 8 で、controller-list blkio を持つ cgroup に属するすべてのプロセスを除外します。

[scheduler] isolated_cores=1 cgroup_ps_blacklist=\b8:blkio:

最近のカーネルは、一部の sched_ および numa_balancing_ カーネルランタイムパラメーターを sysctl ユーティリティーが管理する /proc/sys/kernel ディレクトリーから、通常は /sys/kernel/debug ディレクトリーにマウントされる debugfs に移動しました。TuneD は、scheduler プラグインを介して以下のパラメーターの抽象化メカニズムを提供します。このメカニズムでは、TuneD は、使用されるカーネルに基づいて、指定された値を正しい場所に書き込みます。

-

sched_min_granularity_ns -

sched_latency_ns -

sched_wakeup_granularity_ns -

sched_tunable_scaling -

sched_migration_cost_ns -

sched_nr_migrate -

numa_balancing_scan_delay_ms -

numa_balancing_scan_period_min_ms -

numa_balancing_scan_period_max_ms numa_balancing_scan_size_mb例3.15 移行を決定するためにタスクの "cache hot" 値を設定します。

古いカーネルで以下のパラメーターを設定すると、

sysctlは500000の値を/proc/sys/kernel/sched_migration_cost_nsファイルに書き込むことを意味します。[sysctl] kernel.sched_migration_cost_ns=500000

これは、最近のカーネルでは、

schedulerプラグインを介して次のパラメーターを設定するのと同じです。[scheduler] sched_migration_cost_ns=500000

つまり、TuneD は

500000の値を/sys/kernel/debug/sched/migration_cost_nsファイルに書き込みます。

3.10. TuneD プロファイルの変数

TuneD プロファイルがアクティブになると、変数は実行時にデプロイメントします。

TuneD変数を使用すると、TuneDプロファイルで必要な入力を減らすことができます。

TuneDプロファイルには事前定義された変数はありません。プロファイルに [variables] セクションを作成し、以下の構文を使用すると、独自の変数を定義できます。

[variables] variable_name=value

プロファイル内の変数の値をデプロイメントするには、以下の構文を使用します。

${variable_name}例3.16 変数を使用した CPU コアの分離

以下の例では、${isolated_cores} 変数が 1,2 にデプロイメントされるため、カーネルは isolcpus=1,2 オプションで起動します。

[variables]

isolated_cores=1,2

[bootloader]

cmdline=isolcpus=${isolated_cores}

変数は個別のファイルで指定できます。たとえば、次の行を tuned.conf に追加できます。

[variables]

include=/etc/tuned/my-variables.conf

[bootloader]

cmdline=isolcpus=${isolated_cores}

isolated_cores=1,2 オプションを /etc/tuned/my-variables.conf ファイルに追加すると、カーネルが isolcpus=1,2 オプションで起動します。

関連情報

-

tuned.conf(5)の man ページ

3.11. TuneD プロファイルの組み込み関数

組み込み関数は、TuneD プロファイルがアクティブになると、実行時に拡張します。

これにより、以下が可能になります。

- さまざまな組み込み関数と、TuneD変数の使用

- Python でカスタム関数を作成し、プラグインの形式でTuneD に追加します。

関数を呼び出すには、以下の構文を使用します。

${f:function_name:argument_1:argument_2}

プロファイルと tuned.conf ファイルが置かれたディレクトリーパスをデプロイメントするには、特殊な構文が必要な PROFILE_DIR 関数を使用します、

${i:PROFILE_DIR}例3.17 変数と組み込み関数を使用した CPU コア分離

次の例では、${non_isolated_cores} 変数は 0,3-5 にデプロイメントされ、cpulist_invert 組み込み関数が 0,3-5 引数で呼び出されます。

[variables]

non_isolated_cores=0,3-5

[bootloader]

cmdline=isolcpus=${f:cpulist_invert:${non_isolated_cores}}

cpulist_invert 関数は、CPU のリストを反転します。6 CPU のマシンでは、反転が 1,2 になり、カーネルは isolcpus=1,2 コマンドラインオプションで起動します。

関連情報

-

tuned.conf(5)の man ページ

3.12. TuneD プロファイルで利用可能な組み込み関数

すべての TuneD プロファイルで、以下の組み込み関数を使用できます。

PROFILE_DIR-

プロファイルと

tuned.confファイルが置かれているディレクトリーパスを返します。 exec- プロセスを実行し、その出力を返します。

assertion- 2 つの引数を比較します。一致しない 場合、関数は最初の引数からテキストをログに記録し、プロファイルの読み込みを中止します。

assertion_non_equal- 2 つの引数を比較します。2 つの引数が 一致する 場合、関数は最初の引数からテキストをログに記録し、プロファイルの読み込みを中止します。

kb2s- キロバイトをディスクセクターに変換します。

s2kb- ディスクセクターをキロバイトに変換します。

strip- 渡されたすべての引数から文字列を作成し、最初と最後の空白の両方を削除します。

virt_checkTuneD が仮想マシン (VM) またはベアメタルのどちらで実行しているかを確認します。

- 仮想マシン内では、この関数が最初の引数を返します。

- ベアメタルでは、この関数は、エラーが発生した場合でも 2 番目の引数を返します。

cpulist_invert-

補完するために CPU のリストを反転します。たとえば、0 から 3 までの番号が付けられた 4 つの CPU を持つシステムでは、リスト

0,2,3の反転は1です。 cpulist2hex- CPU リストを 16 進数の CPU マスクに変換します。

cpulist2hex_invert- CPU リストを 16 進数の CPU マスクに変換し、反転します。

hex2cpulist- 16 進数の CPU マスクを CPU リストに変換します。

cpulist_online- リストからの CPU がオンラインかどうかをチェックします。オンライン CPU のみを含むリストを返します。

cpulist_present- リストに CPU が存在するかどうかを確認します。存在する CPU のみを含むリストを返します。

cpulist_unpack-

1-3,4形式の CPU リストを、1,2,3,4にデプロイメントします。 cpulist_pack-

CPU リストを、

1,2,3,5の形式で1-3,5に圧縮します。

3.13. 新しい TuneD プロファイルの作成

この手順では、カスタムパフォーマンスルールを使用して新しいTuneDプロファイルを作成します。

前提条件

-

TuneDサービスが実行されています。詳細は、TuneD のインストールと有効化 を参照してください。

手順

/etc/tuned/ディレクトリーで、作成するプロファイルと同じ名前の新しいディレクトリー作成します。# mkdir /etc/tuned/my-profile新しいディレクトリーに、ファイル

tuned.confを作成します。必要に応じて、[main]セクションとプラグイン定義を追加します。たとえば、

balancedプロファイルの設定を表示します。[main] summary=General non-specialized TuneD profile [cpu] governor=conservative energy_perf_bias=normal [audio] timeout=10 [video] radeon_powersave=dpm-balanced, auto [scsi_host] alpm=medium_power

プロファイルをアクティベートするには、次のコマンドを実行します。

# tuned-adm profile my-profileTuneD プロファイルが有効であり、システム設定が適用されていることを確認します。

$ tuned-adm active Current active profile: my-profile$ tuned-adm verify Verification succeeded, current system settings match the preset profile. See tuned log file ('/var/log/tuned/tuned.log') for details.

関連情報

-

tuned.conf(5)の man ページ

3.14. 既存の TuneD プロファイルの変更

この手順では、既存のTuneD プロファイルに基づいて変更した子プロファイルを作成します。

前提条件

-

TuneDサービスが実行されています。詳細は、TuneD のインストールと有効化 を参照してください。

手順

/etc/tuned/ディレクトリーで、作成するプロファイルと同じ名前の新しいディレクトリー作成します。# mkdir /etc/tuned/modified-profile新しいディレクトリーに、ファイル

tuned.confを作成し、以下のように[main]セクションを設定します。[main] include=parent-profileparent-profile を、変更しているプロファイルの名前に置き換えます。

プロファイルの変更を含めます。

例3.18 throughput-performance プロファイルでスワップを低減

throughput-perfromanceプロファイルの設定を使用し、vm.swappinessの値を、デフォルトの 10 ではなく 5 に変更するには、以下を使用します。[main] include=throughput-performance [sysctl] vm.swappiness=5

プロファイルをアクティベートするには、次のコマンドを実行します。

# tuned-adm profile modified-profileTuneD プロファイルが有効であり、システム設定が適用されていることを確認します。

$ tuned-adm active Current active profile: my-profile$ tuned-adm verify Verification succeeded, current system settings match the preset profile. See tuned log file ('/var/log/tuned/tuned.log') for details.

関連情報

-

tuned.conf(5)の man ページ

3.15. TuneD を使用したディスクスケジューラーの設定

この手順では、選択したブロックデバイスに特定のディスクスケジューラーを設定するTuneD プロファイルを作成して有効にします。この設定は、システムを再起動しても持続します。

以下のコマンドと設定で、以下の内容を置き換えます。

-

device をブロックデバイスの名前に置き換えます (例:

sdf)。 -

selected-scheduler を、デバイスに設定するディスクスケジューラーに置き換えます (例:

bfq)。

前提条件

-

Tunedサービスがインストールされ、有効になっている。詳細は、TuneD のインストールと有効化 を参照してください。

手順

必要に応じて、プロファイルのベースとなる既存のTuneDプロファイルを選択します。利用可能なプロファイルのリストは、RHEL とともに配布される TuneD プロファイル を参照してください。

現在アクティブなプロファイルを確認するには、次のコマンドを実行します。

$ tuned-adm active

TuneD プロファイルを保持する新しいディレクトリーを作成します。

# mkdir /etc/tuned/my-profile選択したブロックデバイスのシステム固有の識別子を見つけます。

$ udevadm info --query=property --name=/dev/device | grep -E '(WWN|SERIAL)' ID_WWN=0x5002538d00000000_ ID_SERIAL=Generic-_SD_MMC_20120501030900000-0:0 ID_SERIAL_SHORT=20120501030900000

注記この例のコマンドは、指定したブロックデバイスに関連付けられた World Wide Name (WWN) またはシリアル番号として識別されるすべての値を返します。WWN を使用することが推奨されますが、WWN は特定のデバイスで常に利用できる訳ではなく、コマンド例で返される値は、デバイスのシステム固有の ID として使用することが許容されます。

/etc/tuned/my-profile/tuned.conf設定ファイルを作成します。このファイルで、以下のオプションを設定します。必要に応じて、既存のプロファイルを追加します。

[main] include=existing-profileWWN 識別子に一致するデバイスに対して選択したディスクスケジューラーを設定します。

[disk] devices_udev_regex=IDNAME=device system unique id elevator=selected-scheduler

ここでは、以下のようになります。

-

IDNAME を、使用されている識別子名に置き換えます (例:

ID_WWN)。 device system unique id を、選択した識別子の値に置き換えます (例:

0x5002538d00000000)。devices_udev_regexオプションで複数のデバイスに一致させるには、識別子を括弧で囲み、垂直バーで区切ります。devices_udev_regex=(ID_WWN=0x5002538d00000000)|(ID_WWN=0x1234567800000000)

-

IDNAME を、使用されている識別子名に置き換えます (例:

プロファイルを有効にします。

# tuned-adm profile my-profile

検証手順

TuneD プロファイルがアクティブで、適用されていることを確認します。

$ tuned-adm active Current active profile: my-profile$ tuned-adm verify Verification succeeded, current system settings match the preset profile. See TuneD log file ('/var/log/tuned/tuned.log') for details./sys/block/device/queue/schedulerファイルの内容を読み取ります。# cat /sys/block/device/queue/scheduler [mq-deadline] kyber bfq noneファイル名の device を、

sdcなどのブロックデバイス名に置き換えます。アクティブなスケジューラーは、角括弧 (

[]) にリスト表示されます。

関連情報

第4章 tuna インターフェイスを使用したシステムの確認

tuna ツールを使用してスケジューラーの調整可能パラメーターの調整、スレッド優先度の調整、IRQ ハンドラー、CPU コアおよびソケットの分離を行います。tuna は、チューニングタスクを実行する際の複雑性を軽減します。

tuna ツールは、以下の操作を実行します。

- システム上の CPU の表示

- システム上で現在実行中の割り込み要求 (IRQ) の表示

- スレッドに関するポリシーおよび優先度の情報の変更

- システムの現在のポリシーと優先度 の表示

4.1. マグロツールのインストール

tuna ツールは、稼働中のシステムで使用されるように設計されています。これにより、アプリケーション固有の測定ツールで、変更の直後にシステムパフォーマンスを確認および分析できます。

手順

tunaツールをインストールします。# yum install tuna

検証手順

利用可能な

tunaCLI オプションを表示します。# tuna -h

関連情報

-

tuna(8)の man ページ

4.2. tuna ツールを使用したシステムステータスの表示

この手順では、tuna コマンドラインインターフェイス (CLI) ツールを使用してシステムの状態を表示する方法を説明します。

前提条件

- tuna ツールがインストールされている。詳細は、tuna ツールのインストール を参照してください。

手順

現在のポリシーおよび優先度を表示するには、以下を実行します。

# tuna --show_threads thread pid SCHED_ rtpri affinity cmd 1 OTHER 0 0,1 init 2 FIFO 99 0 migration/0 3 OTHER 0 0 ksoftirqd/0 4 FIFO 99 0 watchdog/0PID に対応する特定のスレッドまたはコマンド名と一致する場合は、次のコマンドを実行します。

# tuna --threads=pid_or_cmd_list --show_threadspid_or_cmd_list 引数は、コンマ区切りの PID またはコマンド名パターンのリストです。

-

tunaCLI を使用して CPU をチューニングするには、tuna ツールを使用した CPU のチューニング を参照してください。 -

tunaツールを使用して IRQ をチューニングするには、tuna ツールを使用した IRQ のチューニング を参照してください。 変更した設定を保存するには、以下を実行します。

# tuna --save=filename

このコマンドは、現在実行中のカーネルスレッドのみを保存します。実行していないプロセスは保存されません。

関連情報

-

tuna(8)の man ページ

4.3. tuna ツールを使用した CPU の調整

tuna ツールコマンドは、個別の CPU をターゲットとして指定できます。

tuna ツールを使用すると、以下が可能になります。

CPU の分離- 指定した CPU で実行しているすべてのタスクが、次に利用可能な CPU に移動します。CPU の分離は、すべてのスレッドのアフィニティーマスクから削除することで利用できなくなります。

CPU の追加- 指定された CPU でタスクを実行できるようにします。

CPU の復元- 指定した CPU を以前の設定に戻します。

この手順では、tuna CLI を使用して CPU を調整する方法を説明します。

前提条件

- tuna ツールがインストールされている。詳細は、tuna ツールのインストール を参照してください。

手順

コマンドの影響を受ける CPU のリストを指定するには、次のコマンドを実行します。

# tuna --cpus=cpu_list [command]

cpu_list 引数は、コンマ区切りの CPU 番号のリストです。例:

--cpus=0,2.CPU リストは、--cpus="1-3"の範囲でも指定でき、CPU 1、2、および 3 を選択します。現在の cpu_list に特定の CPU を追加するには、たとえば

--cpus=+0を使用します。[command] を、

--isolateに置き換えます。CPU を分離するには、以下を実行します。

# tuna --cpus=cpu_list --isolate

CPU を指定するには、以下を実行します。

# tuna --cpus=cpu_list --include

4 つ以上のプロセッサーを持つシステムを使用するには、すべての ssh スレッドを CPU 0 および 1 で実行し、CPU 2 および 3 のすべての

httpスレッドを実行する方法を表示します。# tuna --cpus=0,1 --threads=ssh\* \ --move --cpus=2,3 --threads=http\* --move

このコマンドは、以下の操作を順次実行します。

- CPU 0 および 1 を選択します。

-

sshで開始するスレッドをすべて選択します。 -

選択したスレッドを選択した CPU に移動します。tuna は、

sshで始まるスレッドのアフィニティーマスクを適切な CPU に設定します。CPU は、数字で 0 および 1 で表すことができ、16 進マスクでは 0x3 で、またはバイナリーでは 11 として表現できます。 - CPU リストを 2 および 3 にリセットします。

-

httpで始まるすべてのスレッドを選択します。 -

選択したスレッドを指定された CPU に移動します。tuna は、

httpで始まるスレッドのアフィニティーマスクを指定された CPU に設定します。CPU は、16 進マスクで 0xC または 1100 のバイナリーで 2 および 3 で表すこともできます。

検証手順

現在の設定を表示し、変更が想定どおりに実行されたことを確認します。

# tuna --threads=gnome-sc\* --show_threads \ --cpus=0 --move --show_threads --cpus=1 \ --move --show_threads --cpus=+0 --move --show_threads thread ctxt_switches pid SCHED_ rtpri affinity voluntary nonvoluntary cmd 3861 OTHER 0 0,1 33997 58 gnome-screensav thread ctxt_switches pid SCHED_ rtpri affinity voluntary nonvoluntary cmd 3861 OTHER 0 0 33997 58 gnome-screensav thread ctxt_switches pid SCHED_ rtpri affinity voluntary nonvoluntary cmd 3861 OTHER 0 1 33997 58 gnome-screensav thread ctxt_switches pid SCHED_ rtpri affinity voluntary nonvoluntary cmd 3861 OTHER 0 0,1 33997 58 gnome-screensav

このコマンドは、以下の操作を順次実行します。

-

gnome-scスレッドで始まるすべてのスレッドを選択します。 - 選択したスレッドを表示して、ユーザーがアフィニティーマスクと RT の優先度を検証できるようにします。

- CPU 0 を選択します。

-

gnome-scスレッドを指定の CPU 0 に移動します。 - 移動の結果を表示します。

- CPU リストを CPU 1 にリセットします。

-

gnome-scスレッドを指定した CPU (CPU 1) に移動します。 - 移動の結果を表示します。

- CPU リストに CPU 0 を追加します。

-

gnome-scスレッドを、指定した CPU、CPU 0、および 1 に移動します。 - 移動の結果を表示します。

-

関連情報

-

/proc/cpuinfoファイル -

tuna(8)の man ページ

4.4. tuna ツールを使用した IRQ のチューニング

/proc/interrupts ファイルには、IRQ ごとの割り込みの数、割り込みのタイプ、およびその IRQ にあるデバイスの名前が記録されます。

この手順では、tuna ツールを使用して IRQ を調整する方法を説明します。

前提条件

- tuna ツールがインストールされている。詳細は、tuna ツールのインストール を参照してください。

手順

現在の IRQ とそれらのアフィニティーを表示するには、以下を実行します。

# tuna --show_irqs # users affinity 0 timer 0 1 i8042 0 7 parport0 0

コマンドの影響を受ける IRQ のリストを指定するには、次のコマンドを実行します。

# tuna --irqs=irq_list [command]

irq_list 引数は、コンマ区切りの IRQ 番号またはユーザー名パターンのリストです。

[コマンド] を、たとえば

--spredに置き換えます。指定した CPU に割り込みを移動するには、以下を実行します。

# tuna --irqs=128 --show_irqs # users affinity 128 iwlwifi 0,1,2,3 # tuna --irqs=128 --cpus=3 --move

128 を irq_list 引数に置き換え、3 を cpu_list 引数に置き換えます。

cpu_list 引数は、

--cpus=0,2などのコンマ区切り CPU 番号のリストです。詳細は、tuna ツールを使用した CPU の調整 を参照してください。

検証手順

選択した IRQ の状態を、割り込みを指定の CPU に移動してから比較します。

# tuna --irqs=128 --show_irqs # users affinity 128 iwlwifi 3

関連情報

-

/procs/interruptsファイル -

tuna(8)の man ページ

第5章 RHEL システムロールを使用したパフォーマンスの監視

システム管理者は、Ansible Automation Platform コントロールノードで metrics RHEL システムロールを使用して、システムのパフォーマンスを監視できます。

5.1. RHEL システムロールを使用するためのコントロールノードと管理対象ノードの準備

個々の RHEL システムロールを使用してサービスと設定を管理するには、その前に、コントロールノードと管理対象ノードを準備する必要があります。

5.1.1. RHEL 8 でのコントロールノードの準備

RHEL システムロールを使用する前に、コントロールノードを設定する必要があります。次に、このシステムは、Playbook に従ってインベントリーから管理対象ホストを設定します。

前提条件

RHEL 8.6 以降がインストールされている。RHEL のインストールの詳細は、標準 RHEL 8 インストールの実行 を参照してください。

注記RHEL 8.5 以前のバージョンでは、Ansible パッケージは Ansible Core ではなく Ansible Engine を通じて提供され、さまざまなサポートレベルが提供されていました。パッケージは RHEL 8.6 以降の Ansible Automation コンテンツと互換性がない可能性があるため、Ansible Engine は使用しないでください。詳細は、Scope of support for the Ansible Core package included in the RHEL 9 and RHEL 8.6 and later AppStream repositories を参照してください。

- システムはカスタマーポータルに登録されます。

-

Red Hat Enterprise Linux Serverサブスクリプションがシステムにアタッチされている。 -

オプション:

Ansible Automation Platformサブスクリプションがシステムにアタッチされます。

手順

rhel-system-rolesパッケージをインストールします。[root@control-node]# yum install rhel-system-rolesこのコマンドは、

ansible-coreパッケージを依存関係としてインストールします。Playbook を管理および実行するための

ansibleという名前のユーザーを作成します。[root@control-node]# useradd ansible新しく作成した

ansibleユーザーに切り替えます。[root@control-node]# su - ansibleこのユーザーとして残りの手順を実行します。

SSH の公開鍵と秘密鍵を作成します。

[ansible@control-node]$ ssh-keygen Generating public/private rsa key pair. Enter file in which to save the key (/home/ansible/.ssh/id_rsa): Enter passphrase (empty for no passphrase): <password> Enter same passphrase again: <password> ...

キーファイルの推奨されるデフォルトの場所を使用します。

- オプション: 接続を確立するたびに Ansible が SSH キーのパスワードを要求しないように、SSH エージェントを設定します。

~/.ansible.cfgファイルを次の内容で作成します。[defaults] inventory = /home/ansible/inventory remote_user = ansible [privilege_escalation] become = True become_method = sudo become_user = root become_ask_pass = True

注記~/.ansible.cfgファイルの設定は優先度が高く、グローバルな/etc/ansible/ansible.cfgファイルの設定をオーバーライドします。これらの設定を使用して、Ansible は次のアクションを実行します。

- 指定されたインベントリーファイルでホストを管理します。

-

管理対象ノードへの SSH 接続を確立するときに、

remote_userパラメーターで設定されたアカウントを使用します。 -

sudoユーティリティーを使用して、rootユーザーとして管理対象ノードでタスクを実行します。 - Playbook を適用するたびに、リモートユーザーの root パスワードの入力を求められます。これは、セキュリティー上の理由から推奨されます。

管理対象ホストのホスト名をリストする

~/inventoryファイルを INI または YAML 形式で作成します。インベントリーファイルでホストのグループを定義することもできます。たとえば、以下は、3 つのホストとUSという名前の 1 つのホストグループを含む INI 形式のインベントリーファイルです。managed-node-01.example.com [US] managed-node-02.example.com ansible_host=192.0.2.100 managed-node-03.example.com

コントロールノードはホスト名を解決できる必要があることに注意してください。DNS サーバーが特定のホスト名を解決できない場合は、ホストエントリーの横に

ansible_hostパラメーターを追加して、その IP アドレスを指定します。

次のステップ

- 管理対象ノードを準備します。詳細は、管理対象ノードの準備 を参照してください。

5.1.2. 管理対象ノードの準備

管理対象ノードはインベントリーにリストされているシステムであり、Playbook に従ってコントロールノードによって設定されます。管理対象ホストに Ansible をインストールする必要はありません。

前提条件

- コントロールノードを準備している。詳細は、RHEL 8 でのコントロールノードの準備 を参照してください。

コントロールノードから SSH アクセスできる。

重要rootユーザーとしての直接 SSH アクセスはセキュリティーリスクを引き起こします。このリスクを軽減するには、管理対象ノードを準備するときに、このノード上にローカルユーザーを作成し、sudoポリシーを設定します。続いて、コントロールノードの Ansible は、ローカルユーザーアカウントを使用して管理対象ノードにログインし、rootなどの別のユーザーとして Playbook を実行できます。

手順

ansibleという名前のユーザーを作成します。[root@managed-node-01]# useradd ansibleコントロールノードは後でこのユーザーを使用して、このホストへの SSH 接続を確立します。

ansibleユーザーのパスワードを設定します。[root@managed-node-01]# passwd ansible Changing password for user ansible. New password: <password> Retype new password: <password> passwd: all authentication tokens updated successfully.

Ansible が

sudoを使用してrootユーザーとしてタスクを実行する場合は、このパスワードを入力する必要があります。ansibleユーザーの SSH 公開鍵を管理対象ノードにインストールします。ansibleユーザーとしてコントロールノードにログインし、SSH 公開鍵を管理対象ノードにコピーします。[ansible@control-node]$ ssh-copy-id managed-node-01.example.com /usr/bin/ssh-copy-id: INFO: Source of key(s) to be installed: "/home/ansible/.ssh/id_rsa.pub" The authenticity of host 'managed-node-01.example.com (192.0.2.100)' can't be established. ECDSA key fingerprint is SHA256:9bZ33GJNODK3zbNhybokN/6Mq7hu3vpBXDrCxe7NAvo.

プロンプトが表示されたら、

yesと入力して接続します。Are you sure you want to continue connecting (yes/no/[fingerprint])? yes /usr/bin/ssh-copy-id: INFO: attempting to log in with the new key(s), to filter out any that are already installed /usr/bin/ssh-copy-id: INFO: 1 key(s) remain to be installed -- if you are prompted now it is to install the new keysプロンプトが表示されたら、パスワードを入力します。

ansible@managed-node-01.example.com's password: <password> Number of key(s) added: 1 Now try logging into the machine, with: "ssh '<managed-node-01.example.com>'" and check to make sure that only the key(s) you wanted were added.

コントロールノードでコマンドをリモートで実行して、SSH 接続を確認します。

[ansible@control-node]$ ssh <managed-node-01.example.com> whoami ansible

ansibleユーザーのsudo設定を作成します。visudoコマンドを使用して、/etc/sudoers.d/ansibleファイルを作成および編集します。[root@managed-node-01]# visudo /etc/sudoers.d/ansible通常のエディターと比べて

visudoを使用する利点は、このユーティリティーがファイルをインストールする前に基本的な健全性チェックと解析エラーのチェックを提供することです。/etc/sudoers.d/ansibleファイルで、要件に応じたsudoersポリシーを設定します。次に例を示します。ansibleユーザーのパスワードを入力した後、このホスト上で任意のユーザーおよびグループとしてすべてのコマンドを実行する権限をansibleユーザーに付与するには、以下を使用します。ansible ALL=(ALL) ALLansibleユーザーのパスワードを入力せずに、このホスト上で任意のユーザーおよびグループとしてすべてのコマンドを実行する権限をansibleユーザーに付与するには、以下を使用します。ansible ALL=(ALL) NOPASSWD: ALL

または、セキュリティー要件に合わせてより細かいポリシーを設定します。

sudoersポリシーの詳細は、sudoers (5)man ページを参照してください。

検証

すべての管理対象ノード上のコントロールノードからコマンドを実行できることを確認します。

[ansible@control-node]$ ansible all -m ping BECOME password: <password> managed-node-01.example.com | SUCCESS => { "ansible_facts": { "discovered_interpreter_python": "/usr/bin/python3" }, "changed": false, "ping": "pong" } ...

ハードコーディングされたすべてのホストグループには、インベントリーファイルにリストされているすべてのホストが動的に含まれます。

Ansible

commandモジュールを使用して管理対象ホスト上でwhoamiユーティリティーを実行し、権限昇格が正しく機能することを確認します。[ansible@control-node]$ ansible managed-node-01.example.com -m command -a whoami BECOME password: <password> managed-node-01.example.com | CHANGED | rc=0 >> root

コマンドが root を返した場合、管理対象ノード上で

sudoが正しく設定されています。

関連情報

- RHEL 8 でのコントロールノードの準備

-

sudoers(5)man ページ

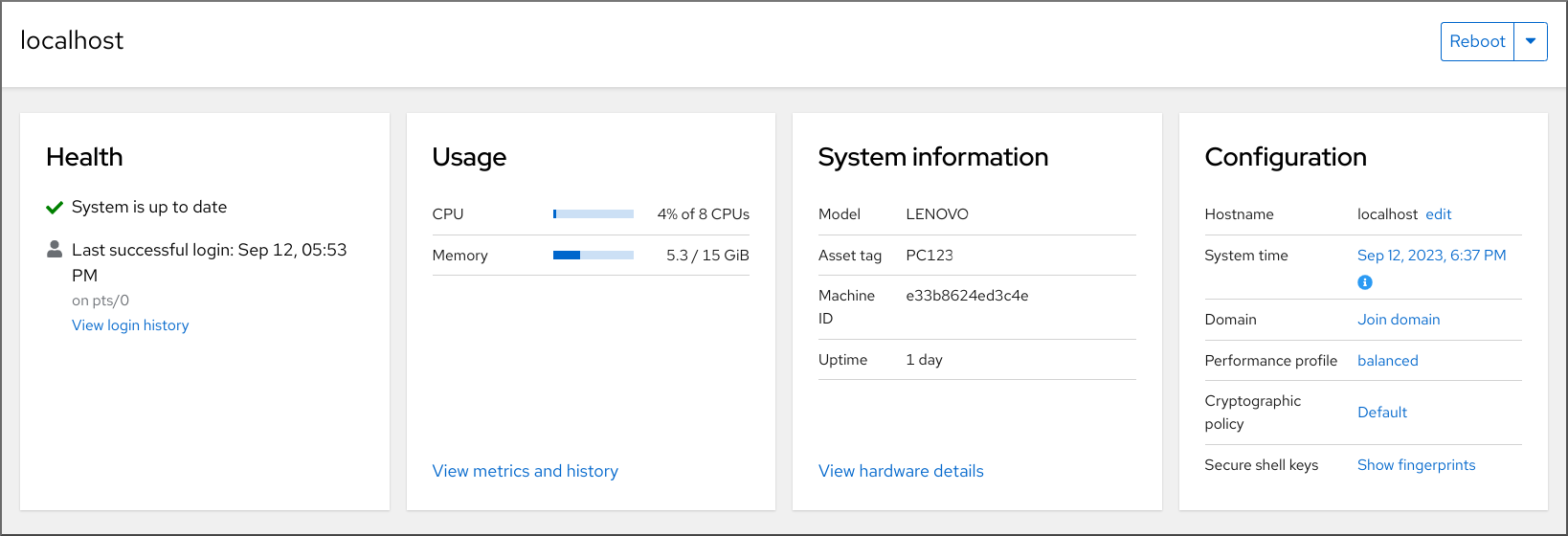

5.2. metrics システムロールの概要

RHEL システムロールは、複数の RHEL システムをリモートで管理する一貫した設定インターフェイスを提供する Ansible ロールおよびモジュールの集合です。metrics システムロールは、ローカルシステムのパフォーマンス分析サービスを設定します。これには、オプションでローカルシステムによって監視されるリモートシステムの一覧が含まれます。metrics システムロールを使用すると、pcp の設定とデプロイメントが Playbook によって処理されるため、pcp を個別に設定せずに、pcp を使用してシステムパフォーマンスを監視できます。

表5.1 metrics システムロール変数

| ロール変数 | 説明 | 使用例 |

|---|---|---|

| metrics_monitored_hosts |

ターゲットホストが分析するリモートホストのリスト。これらのホストにはターゲットホストにメトリックが記録されるため、各ホストの |

|

| metrics_retention_days | 削除前のパフォーマンスデータの保持日数を設定します。 |

|

| metrics_graph_service |

|

|

| metrics_query_service |

|

|

| metrics_provider |

メトリックを提供するために使用するメトリックコレクターを指定します。現在、サポートされている唯一のメトリックプロバイダーは |

|

| metrics_manage_firewall |

|

|

| metrics_manage_selinux |

|

|

metrics_connections で使用されるパラメーターの詳細と、metrics システムロールに関する追加情報は、/usr/share/ansible/roles/rhel-system-roles.metrics/README.md ファイルを参照してください。

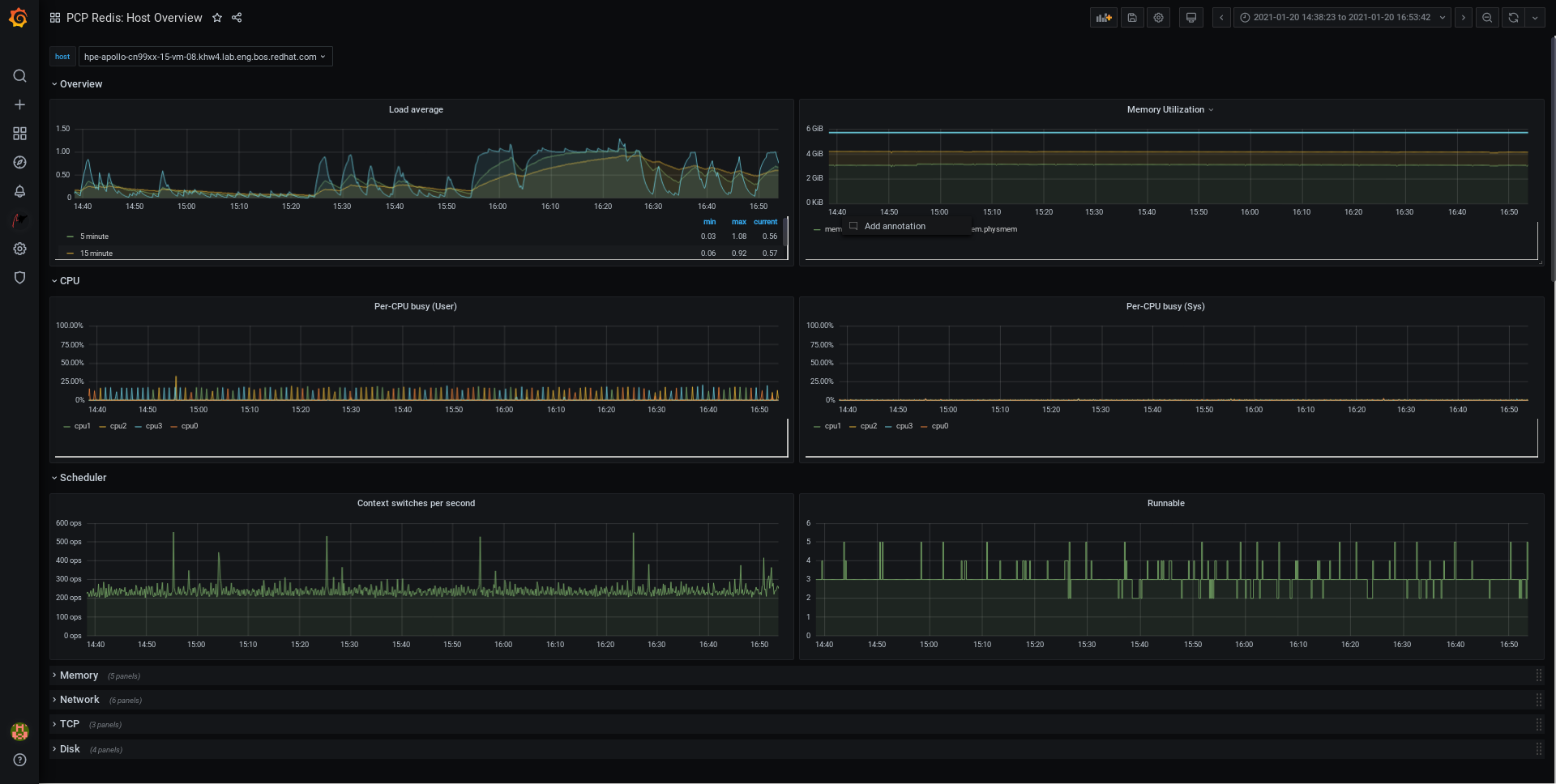

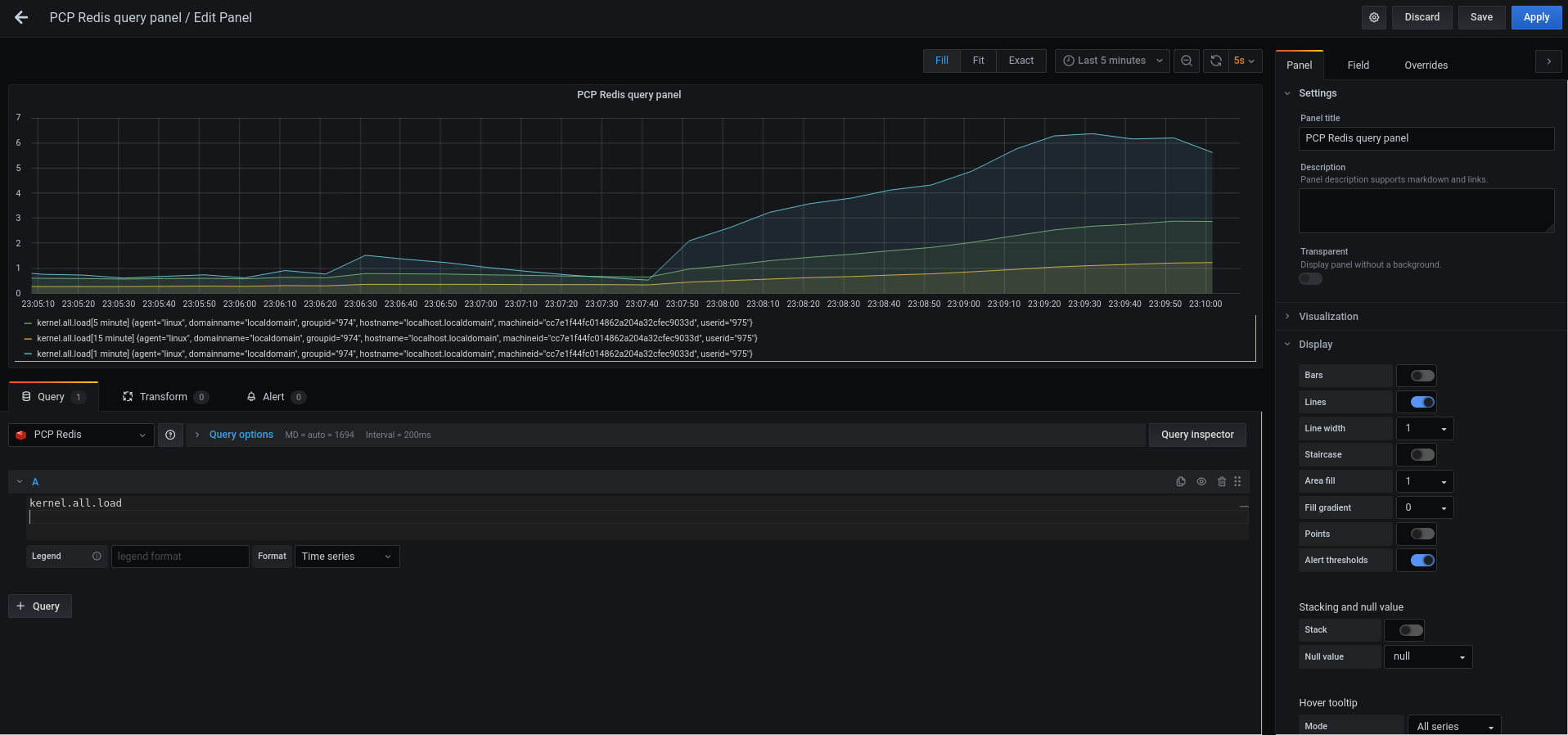

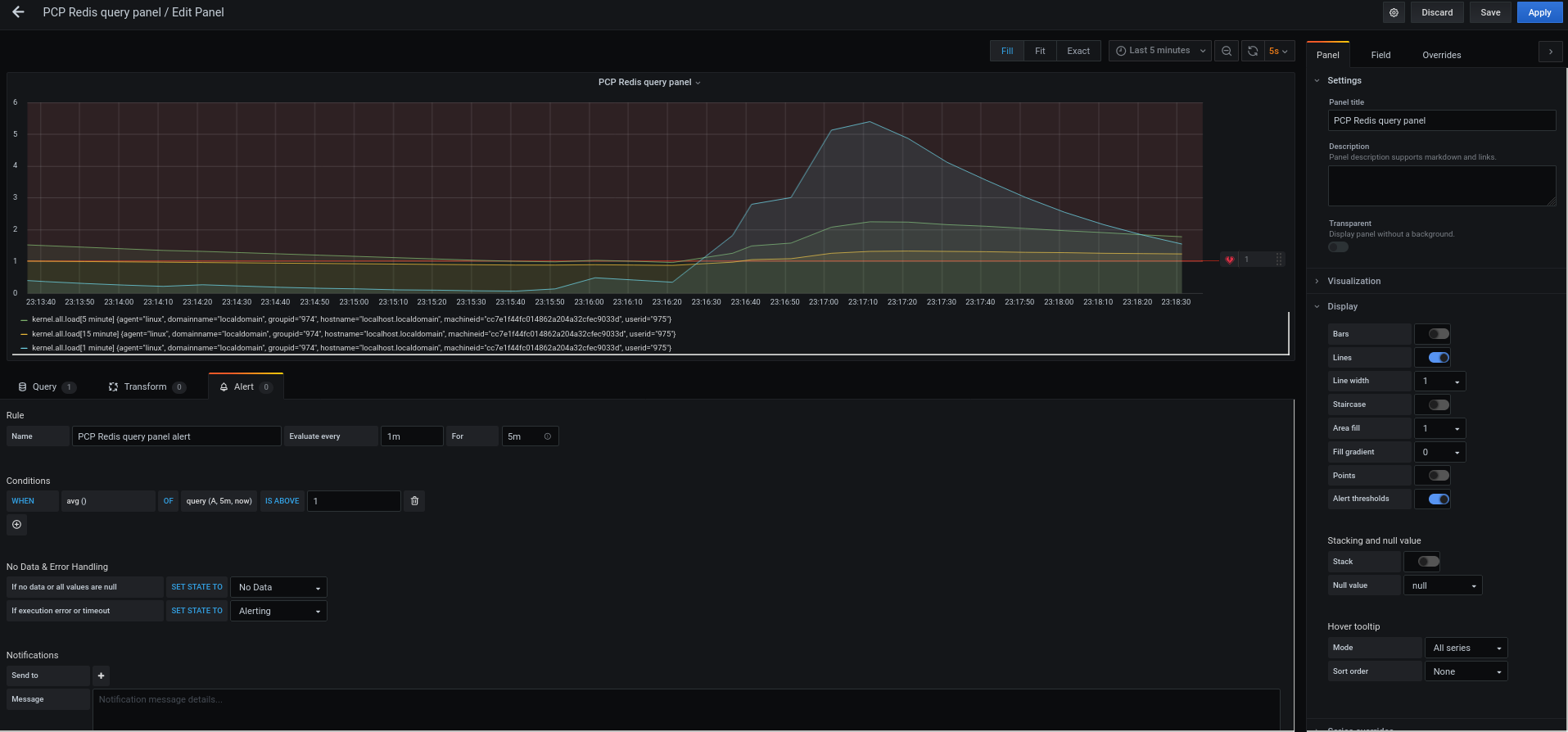

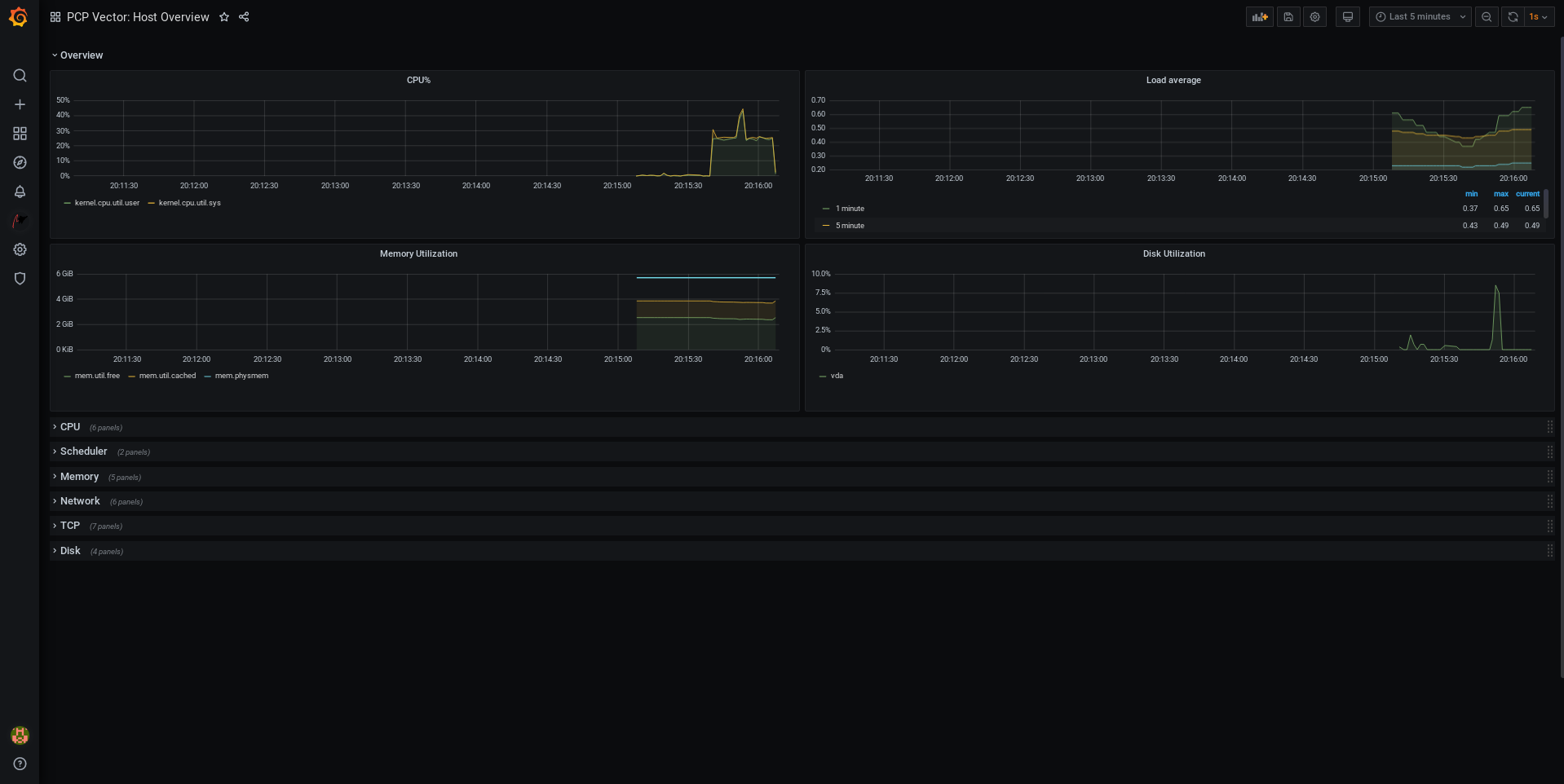

5.3. metrics システムロールを使用した視覚化によるローカルシステムの監視

この手順では、metrics RHEL システムロールを使用してローカルシステムを監視し、Grafana でデータ可視化を同時にプロビジョニングする方法を説明します。

前提条件

- Ansible Core パッケージがコントロールマシンにインストールされている。

-

監視するマシンに

rhel-system-rolesパッケージがインストールされている。

手順

以下のコンテンツをインベントリーに追加して、

/etc/ansible/hostsAnsible インベントリーのlocalhostを設定します。localhost ansible_connection=local

以下の内容を含む Ansible Playbook を作成します。

--- - name: Manage metrics hosts: localhost vars: metrics_graph_service: yes metrics_manage_firewall: true metrics_manage_selinux: true roles: - rhel-system-roles.metricsAnsible Playbook の実行:

# ansible-playbook name_of_your_playbook.yml注記metrics_graph_serviceのブール値がvalue="yes"に設定されているため、Grafanaは自動的にインストールされ、データソースとして追加されたpcpでプロビジョニングされます。metrics_manage_firewallとmetrics_manage_selinuxは両方ともtrueに設定されているため、メトリクスロールはfirewallおよびselinuxシステムロールを使用して、メトリクスロールが使用するポートを管理します。-

マシンで収集されるメトリクスを視覚化するには、Grafana Web UI へのアクセス で説明されているように

grafanaWeb インターフェイスにアクセスします。

5.4. metrics システムロールを使用した自己監視のための個別システムフリートの設定

この手順では、metrics システムロールを使用して、それ自体を監視するマシンフリートの設定方法を説明します。

前提条件

- Ansible Core パッケージがコントロールマシンにインストールされている。

-

Playbook の実行に使用するマシンに

rhel-system-rolesパッケージがインストールされている。 - SSH 接続が確立している。

手順

Playbook 経由で監視するマシンの名前または IP アドレスを、括弧で囲まれた識別グループ名の下にある

/etc/ansible/hostsAnsible インベントリーファイルに追加します。[remotes] webserver.example.com database.example.com

以下の内容を含む Ansible Playbook を作成します。

--- - hosts: remotes vars: metrics_retention_days: 0 metrics_manage_firewall: true metrics_manage_selinux: true roles: - rhel-system-roles.metrics注記metrics_manage_firewallとmetrics_manage_selinuxは両方ともtrueに設定されているため、メトリクスロールはfirewallロールとselinuxロールを使用して、metricsロールが使用するポートを管理します。Ansible Playbook の実行:

# ansible-playbook name_of_your_playbook.yml -kリモートシステムに接続するためのパスワードを求められる

-kです。

5.5. metrics システムロールを使用したローカルマシン経由でのマシンフリートの一元監視

この手順では、grafana を介したデータの視覚化のプロビジョニングおよび redis 経由でのデータのクエリーをしながら、metrics システムロールを使用して、マシンフリートを一元管理するローカルマシンの設定方法を説明します。

前提条件

- Ansible Core パッケージがコントロールマシンにインストールされている。

-

Playbook の実行に使用するマシンに

rhel-system-rolesパッケージがインストールされている。

手順

以下の内容を含む Ansible Playbook を作成します。

--- - hosts: localhost vars: metrics_graph_service: yes metrics_query_service: yes metrics_retention_days: 10 metrics_monitored_hosts: ["database.example.com", "webserver.example.com"] metrics_manage_firewall: yes metrics_manage_selinux: yes roles: - rhel-system-roles.metricsAnsible Playbook の実行:

# ansible-playbook name_of_your_playbook.yml注記metrics_graph_serviceおよびmetrics_query_serviceのブール値はvalue="yes"に設定されているため、grafanaは、redisにインデックス化されたpcpデータの記録のあるデータソースとして追加されたpcpで自動的にインストールおよびプロビジョニングされます。これにより、pcpクエリー言語をデータの複雑なクエリーに使用できます。metrics_manage_firewallとmetrics_manage_selinuxは両方ともtrueに設定されているため、metricsロールはfirewallロールとselinuxロールを使用して、metricsロールが使用するポートを管理します。-

マシンによって一元的に収集されるメトリクスのグラフィック表示とデータのクエリーを行うには、Grafana Web UI へのアクセス で説明されているように

grafanaWeb インターフェイスにアクセスします。

5.6. metrics システムロールを使用したシステム監視中の認証設定

PCP は、Simple Authentication Security Layer (SASL) フレームワークを介して scram-sha-256 認証メカニズムに対応します。metrics RHEL システムロールは、scram-sha-256 認証メカニズムを使用して認証を設定する手順を自動化します。この手順では、metrics RHEL システムロールを使用して、認証を設定する方法を説明します。

前提条件

- Ansible Core パッケージがコントロールマシンにインストールされている。

-

Playbook の実行に使用するマシンに

rhel-system-rolesパッケージがインストールされている。

手順

認証を設定する Ansible Playbook に、以下の変数を追加します。

--- vars: metrics_username: your_username metrics_password: your_password metrics_manage_firewall: true metrics_manage_selinux: true注記metrics_manage_firewallとmetrics_manage_selinuxは両方ともtrueに設定されているため、metricsロールはfirewallロールとselinuxロールを使用して、metricsロールが使用するポートを管理します。Ansible Playbook の実行:

# ansible-playbook name_of_your_playbook.yml

検証手順

sasl設定を確認します。# pminfo -f -h "pcp://ip_adress?username=your_username" disk.dev.read Password: disk.dev.read inst [0 or "sda"] value 19540

ip_adress は、ホストの IP アドレスに置き換える必要があります。

5.7. metrics システムロールを使用した SQL サーバーのメトリクスコレクションの設定と有効化

この手順では、metrics RHEL システムロールを使用して、ローカルシステムの pcp を使用して Microsoft SQL Server のメトリック収集の設定と有効化を自動化する方法を説明します。

前提条件

- Ansible Core パッケージがコントロールマシンにインストールされている。

-

監視するマシンに

rhel-system-rolesパッケージがインストールされている。 - Red Hat Enterprise Linux に Microsoft SQL Server をインストールし、SQL Server への信頼できる接続を確立している。Red Hat に SQL Server をインストールしてデータベースを作成する を参照してください。

- Red Hat Enterprise Linux 用の SQL Server の Microsoft ODBC ドライバーがインストールされている。Red Hat Enterprise Server および Oracle Linux を参照してください。

手順

以下のコンテンツをインベントリーに追加して、

/etc/ansible/hostsAnsible インベントリーのlocalhostを設定します。localhost ansible_connection=local

以下の内容が含まれる Ansible Playbook を作成します。

--- - hosts: localhost vars: metrics_from_mssql: true metrics_manage_firewall: true metrics_manage_selinux: true roles: - role: rhel-system-roles.metrics

注記metrics_manage_firewallとmetrics_manage_selinuxは両方ともtrueに設定されているため、metricsロールはfirewallロールとselinuxロールを使用して、metricsロールが使用するポートを管理します。Ansible Playbook の実行:

# ansible-playbook name_of_your_playbook.yml

検証手順

pcpコマンドを使用して、SQL Server PMDA エージェント (mssql) が読み込まれ、実行されていることを確認します。# pcp platform: Linux rhel82-2.local 4.18.0-167.el8.x86_64 #1 SMP Sun Dec 15 01:24:23 UTC 2019 x86_64 hardware: 2 cpus, 1 disk, 1 node, 2770MB RAM timezone: PDT+7 services: pmcd pmproxy pmcd: Version 5.0.2-1, 12 agents, 4 clients pmda: root pmcd proc pmproxy xfs linux nfsclient mmv kvm mssql jbd2 dm pmlogger: primary logger: /var/log/pcp/pmlogger/rhel82-2.local/20200326.16.31 pmie: primary engine: /var/log/pcp/pmie/rhel82-2.local/pmie.log

関連情報

- Microsoft SQL Server での Performance Co-Pilot の使用に関する詳細は、Red Hat Developers Blog を参照してください。

第6章 PCP の設定

Performance Co-Pilot (PCP) は、システムレベルのパフォーマンス測定を監視、視覚化、保存、および分析するためのツール、サービス、およびライブラリーのスイートです。

6.1. PCP の概要

Python、Perl、C++、および C のインターフェイスを使用したパフォーマンスメトリックを追加できます。分析ツールは、Python、C++、C のクライアント API を直接使用でき、豊富な Web アプリケーションは、JSON インターフェイスを使用して利用可能なすべてのパフォーマンスデータを調べることができます。

ライブ結果とアーカイブされたデータを比較して、データパターンを解析できます。

PCP の機能:

- 軽量の分散アーキテクチャー。複雑なシステムの集中分析に役に立ちます。

- これにより、リアルタイムデータの監視および管理が可能になります。

- これにより、履歴データのログおよび取得が可能になります。

PCP には以下のコンポーネントがあります。

-

Performance Metric Collector Daemon (

pmcd) は、インストールされている Performance Metric Domain Agents (pmda) からパフォーマンスデータを収集します。PMDA は、システムで個別にロードまたはアンロードでき、同じホストの PMCD によって制御されます。 -

pminfoやpmstatなどのさまざまなクライアントツールは、同じホストまたはネットワーク上でこのデータを取得、表示、アーカイブ、処理できます。 -

pcpパッケージは、コマンドラインツールと、基本的な機能を提供します。 -

pcp-guiパッケージは、グラフィカルアプリケーションを提供します。yum install pcp-guiコマンドを実行して、pcp-guiパッケージをインストールします。詳細は、Visually tracing PCP log archives with the PCP Charts application を参照してください。

関連情報

-

pcp(1)の man ページ -

/usr/share/doc/pcp-doc/ディレクトリー - PCP で配布されるシステムサービスおよびツール

- Red Hat カスタマーポータルの PCP (Performance Co-Pilot) に関するナレッジ、チュートリアル、およびホワイトペーパー

- Red Hat ナレッジベース記事 Side-by-side comparison of PCP tools with legacy tools

- PCP アップストリームのドキュメント

6.2. PCP のインストールおよび有効化

PCP の使用を開始するには、必要なパッケージをすべてインストールし、PCP 監視サービスを有効にします。

この手順では、pcp パッケージを使用して PCP をインストールする方法を説明します。PCP のインストールを自動化するには、pcp-zeroconf パッケージを使用してインストールします。pcp-zeroconf を使用して PCP をインストールする方法の詳細は、PCP の pcp-zeroconf での設定 を参照してください。

手順

pcpパッケージをインストールします。# yum install pcp

ホストマシンで

pmcdサービスを有効にして起動します。# systemctl enable pmcd # systemctl start pmcd

検証手順

pmcdプロセスがホストで実行されているかどうかを確認します。# pcp Performance Co-Pilot configuration on workstation: platform: Linux workstation 4.18.0-80.el8.x86_64 #1 SMP Wed Mar 13 12:02:46 UTC 2019 x86_64 hardware: 12 cpus, 2 disks, 1 node, 36023MB RAM timezone: CEST-2 services: pmcd pmcd: Version 4.3.0-1, 8 agents pmda: root pmcd proc xfs linux mmv kvm jbd2

関連情報

-

pmcd(1)の man ページ - PCP で配布されるシステムサービスおよびツール

6.3. 最小限の PCP 設定のデプロイメント

最小 PCP 設定は、Red Hat Enterprise Linux でパフォーマンス統計を収集します。この設定は、詳細な分析のためにデータを収集するために必要な、実稼働システムに最低限のパッケージを追加します。

作成された tar.gz ファイルおよび pmlogger の出力のアーカイブは、さまざまな PCP ツールを使用して解析し、その他のソースのパフォーマンス情報と比較できます。

前提条件

- PCP がインストールされている。詳細は Installing and enabling PCP を参照してください。

手順

pmlogger設定を更新します。# pmlogconf -r /var/lib/pcp/config/pmlogger/config.default

pmcdサービスおよびpmloggerサービスを起動します。# systemctl start pmcd.service # systemctl start pmlogger.service

- 必要な操作を実行して、パフォーマンスデータを記録します。

pmcdサービスおよびpmloggerサービスを停止します。# systemctl stop pmcd.service # systemctl stop pmlogger.service

出力を保存し、ホスト名と現在の日時に基づいて名前が付けられた

tar.gzファイルに保存します。# cd /var/log/pcp/pmlogger/ # tar -czf $(hostname).$(date +%F-%Hh%M).pcp.tar.gz $(hostname)

このファイルをデプロイメントし、PCP ツールを使用してデータを解析します。

関連情報

-

pmlogconf(1)、pmlogger(1)、およびpmcd(1)の man ページ - PCP で配布されるシステムサービスおよびツール

6.4. PCP で配布されるシステムサービスおよびツール

Performance Co-Pilot (PCP) には、パフォーマンスの測定に使用できるさまざまなシステムサービスとツールが含まれます。基本パッケージ pcp には、システムサービスと基本ツールが含まれます。追加のツールは、pcp-system-tools、pcp-gui、および pcp-devel パッケージで提供されます。

PCP で配布されるシステムサービスのロール

pmcd- PMCD (Performance Metric Collector Daemon)

pmie- Performance Metrics In difference Engine

pmlogger- パフォーマンスメトリックロガー。

pmproxy- リアルタイムおよびヒストリカルなパフォーマンスメトリックのプロキシー、時系列クエリー、REST API サービス。

基本 PCP パッケージで配布されるツール

pcp- Performance Co-Pilot インストールの現在のステータスを表示します。

pcp-vmstat- システムパフォーマンスの概要を 5 秒ごとに表示します。プロセス、メモリー、ページング、ブロック IO、トラップ、CPU のアクティビティーに関する情報を表示します。

pmconfig- 設定パラメーターの値を表示します。

pmdiff- パフォーマンスのリグレッションを検索する際に重要と思われる変更について、指定された時間枠で、1 つまたは 2 つのアーカイブのすべてのメトリックの平均値を比較します。

pmdumplog- Performance Co-Pilot アーカイブファイルの制御、メタデータ、インデックス、および状態に関する情報を表示します。

pmfind- ネットワークで PCP サービスを見つけます。

pmie- 一連の演算式、論理式、およびルール式を定期的に評価する推論エンジン。メトリックは、ライブシステムまたは Performance Co-Pilot アーカイブファイルのいずれかから収集されます。

pmieconf-

設定可能な

pmie変数を表示または設定します。 pmiectl-

pmieのプライマリー以外のインスタンスを管理します。 pminfo- パフォーマンスメトリックに関する情報を表示します。メトリックは、ライブシステムまたは Performance Co-Pilot アーカイブファイルのいずれかから収集されます。

pmlc-

アクティブな

pmloggerインスタンスを対話的に設定します。 pmlogcheck- Performance Co-Pilot アーカイブファイルで無効なデータを特定します。

pmlogconf-

pmlogger設定ファイルを作成および変更します。 pmlogctl-

pmloggerのプライマリー以外のインスタンスを管理します。 pmloglabel- Performance Co-Pilot アーカイブファイルのラベルを検証、変更、または修復します。

pmlogsummary- Performance Co-Pilot アーカイブファイルに格納されたパフォーマンスメトリックに関する統計情報を計算します。

pmprobe- パフォーマンスメトリックの可用性を決定します。

pmsocks- ファイアウォールを介して Performance Co-Pilot ホストへのアクセスを許可します。

pmstat- システムパフォーマンスの簡単な概要を定期的に表示します。

pmstore- パフォーマンスメトリックの値を変更します。

pmtrace- トレース PMDA のコマンドラインインターフェイスを提供します。

pmval- パフォーマンスメトリックの現在の値を表示します。

別途インストールする pcp-system-tools パッケージで配布されるツール

pcp-atop- パフォーマンスの観点から最も重要なハードウェアリソース (CPU、メモリー、ディスク、およびネットワーク) のシステムレベルの占有を表示します。

pcp-atopsar-

さまざまなシステムリソースの使用状況に関するシステムレベルのアクティビティーレポートを生成します。このレポートは、

pmloggerまたはpcp-atopの-wオプションを使用してあらかじめ記録された生のログファイルから生成されます。 pcp-dmcache- 設定されたデバイスマッパーキャッシュターゲット (デバイスの IOP、キャッシュデバイスとメタデータデバイスの使用率、各キャッシュデバイスの読み取り/書き込みのヒット率とミス率、比率など) に関する情報を表示します。

pcp-dstat-

一度に 1 台のシステムのメトリックを表示します。複数のシステムのメトリックを表示するには、

--hostオプションを使用します。 pcp-free- システム内の空きメモリーと使用済みメモリーを報告します。

pcp-htop-

システム上で実行されているすべてのプロセスとそのコマンドライン引数を、

topコマンドと同様の形式で表示しますが、縦横にスクロールしたり、マウスで操作したりすることができます。また、プロセスをツリー形式で表示したり、複数のプロセスを選択して一度に処理することもできます。 pcp-ipcs- 呼び出しプロセスが読み取りアクセスできる inter-process communication (IPC) ファシリティーの情報を表示します。

pcp-mpstat- CPU および割り込み関連の統計情報を報告します。

pcp-numastat- カーネルのメモリーアロケータからの NUMA 割り当て統計を表示します。

pcp-pidstat- システム上で動作している個々のタスクやプロセスに関する情報を表示します (CPU パーセンテージ、メモリーやスタックの使用率、スケジューリング、優先度など)。デフォルトでは、ローカルホストのライブデータを報告します。

pcp-shping-

pmdashpingPerformance Metrics Domain Agent (PMDA) がエクスポートした shell-ping サービスメトリクスをサンプリングして報告します。 pcp-ss-

pmdasocketsPMDA が収集したソケットの統計情報を表示します。 pcp-tapestat- テープデバイスの I/O 統計情報を報告します。

pcp-uptime- システムの稼働時間、現在ログオンしているユーザー数、過去 1 分、5 分、15 分のシステム負荷の平均値を表示します。

pcp-verify- Performance Co-Pilot コレクターのインストールのさまざまな側面を検査し、特定の動作モードに対して正しく設定されているかを報告します。

pmiostat-

SCSI デバイス (デフォルト) またはデバイスマッパーデバイス (

-xデバイスマッパーオプションを使用) の I/O 統計情報を報告します。 pmrep- 選択した、簡単にカスタマイズ可能なパフォーマンスメトリック値に関するレポート。

別途インストールする pcp-gui パッケージで配布されるツール

pmchart- Performance Co-Pilot の機能を介して利用可能なパフォーマンスメトリック値を描画します。

pmdumptext- ライブまたは Performance Co-Pilot アーカイブから収集されたパフォーマンスメトリックの値を出力します。

別途インストールする pcp-devel パッケージで配布されるツール

pmclient- PMAPI (Performance Metrics Application Programming Interface) を使用して、高水準のシステムパフォーマンスメトリックを表示します。

pmdbg- 利用可能な Performance Co-Pilot デバッグ制御フラグとその値を表示します。

pmerr- 利用可能な Performance Co-Pilot エラーコードと、それに対応するエラーメッセージを表示します。

6.5. PCP デプロイメントのアーキテクチャー

Performance Co-Pilot (PCP) は、PCP デプロイメントの規模に基づいて、複数のデプロイメントアーキテクチャーをサポートし、高度なセットアップを実現するための多くのオプションを提供します。

Red Hat によって設定された推奨デプロイメント、サイジング係数、および設定オプションに基づいた、利用可能なスケーリングデプロイメントセットアップバリアントには、以下が含まれます。

PCP バージョン 5.3.0 は Red Hat Enterprise Linux 8.4 および Red Hat Enterprise Linux 8 の以前のマイナーバージョンでは利用できないため、Red Hat はローカルホストおよび pmlogger のファームアーキテクチャーを推奨します。

PCP 5.3.0 以前のバージョンにおける pmproxy の既知のメモリーリークについては、Memory leaks in pmproxy in PCP を参照してください。

ローカルホスト各サービスは監視対象のマシン上でローカルに動作します。設定を変更せずにサービスを開始した場合、これがデフォルトのデプロイメントです。この場合、個々のノードを超えたスケーリングはできません。

デフォルトでは、Redis のデプロイメント設定は、スタンドアロン、localhost となっています。しかし、Redis はオプションとして、データを複数のホストで共有する、高可用性と高スケーラビリティを備えたクラスター形態で実行することができます。また、クラウド上に Redis クラスターをデプロイしたり、クラウドベンダーが提供するマネージド Redis クラスターを利用したりすることも可能です。

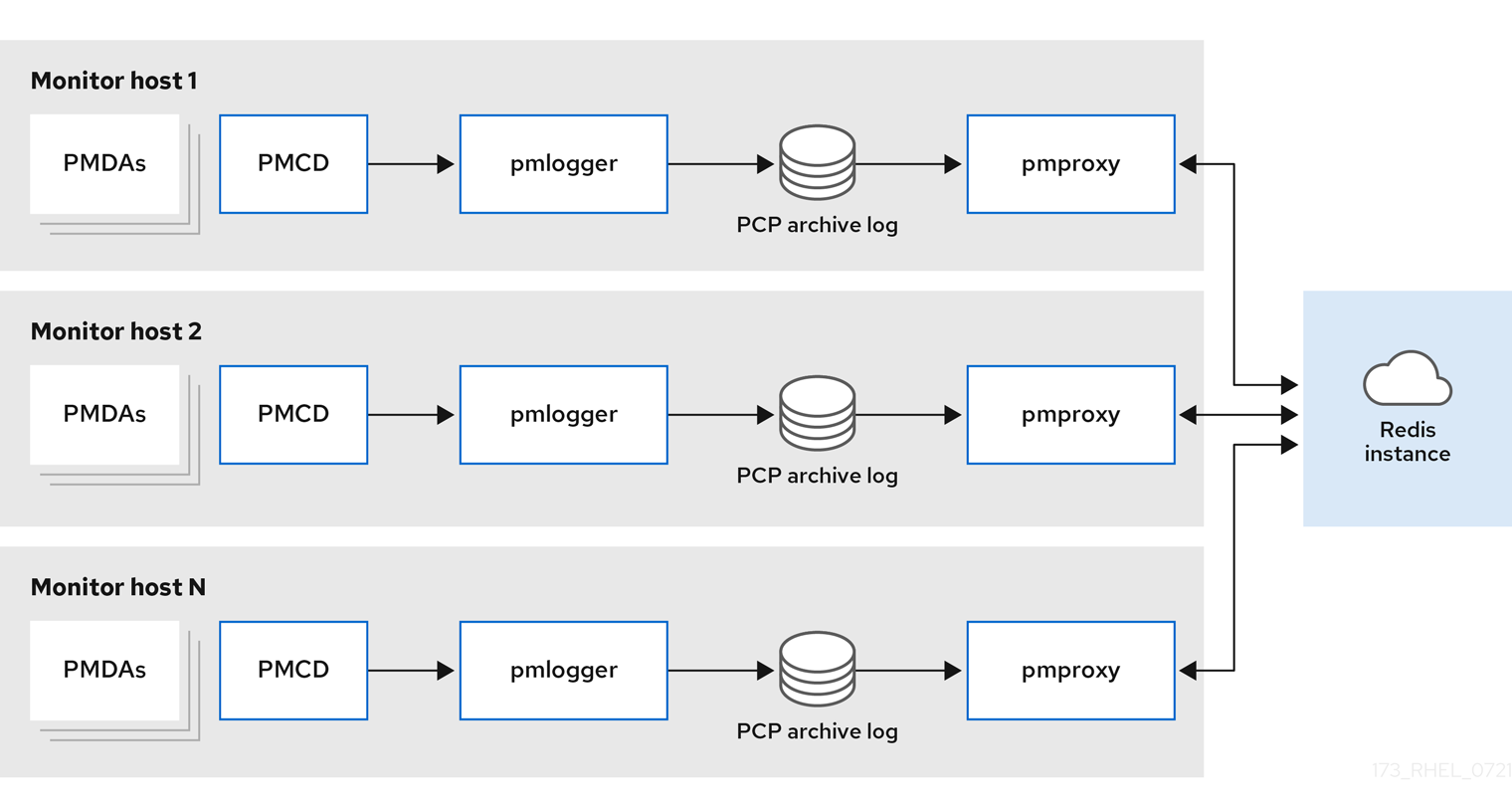

Decentralizedローカルホストと分散型のセットアップの唯一の違いは、集中型の Redis サービスです。このモデルでは、ホストは監視対象の各ホスト上で

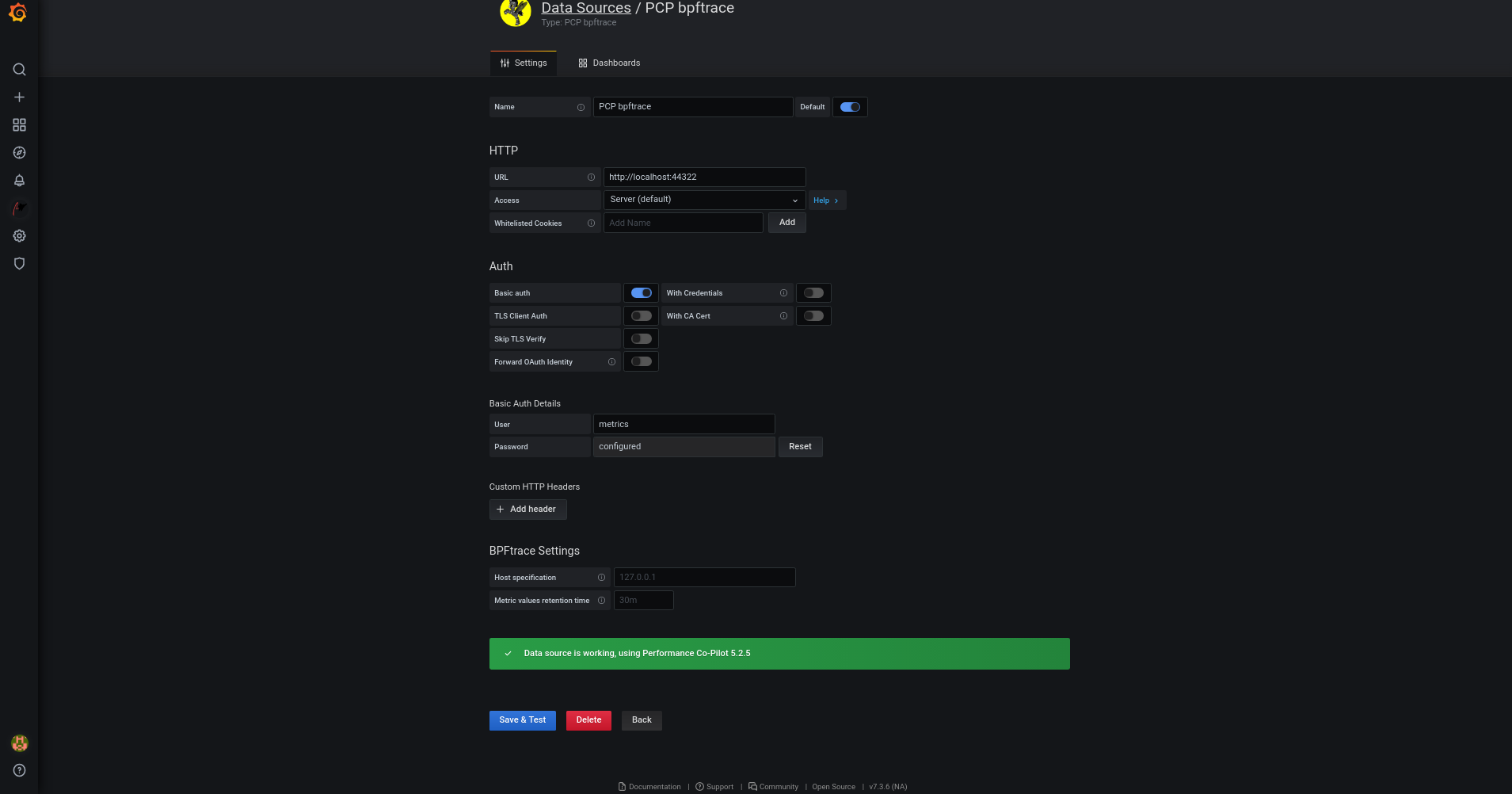

pmloggerサービスを実行し、ローカルのpmcdインスタンスからメトリックを取得します。そして、ローカルのpmproxyサービスは、パフォーマンスメトリックを中央の Redis インスタンスにエクスポートします。図6.1 分散型ロギング

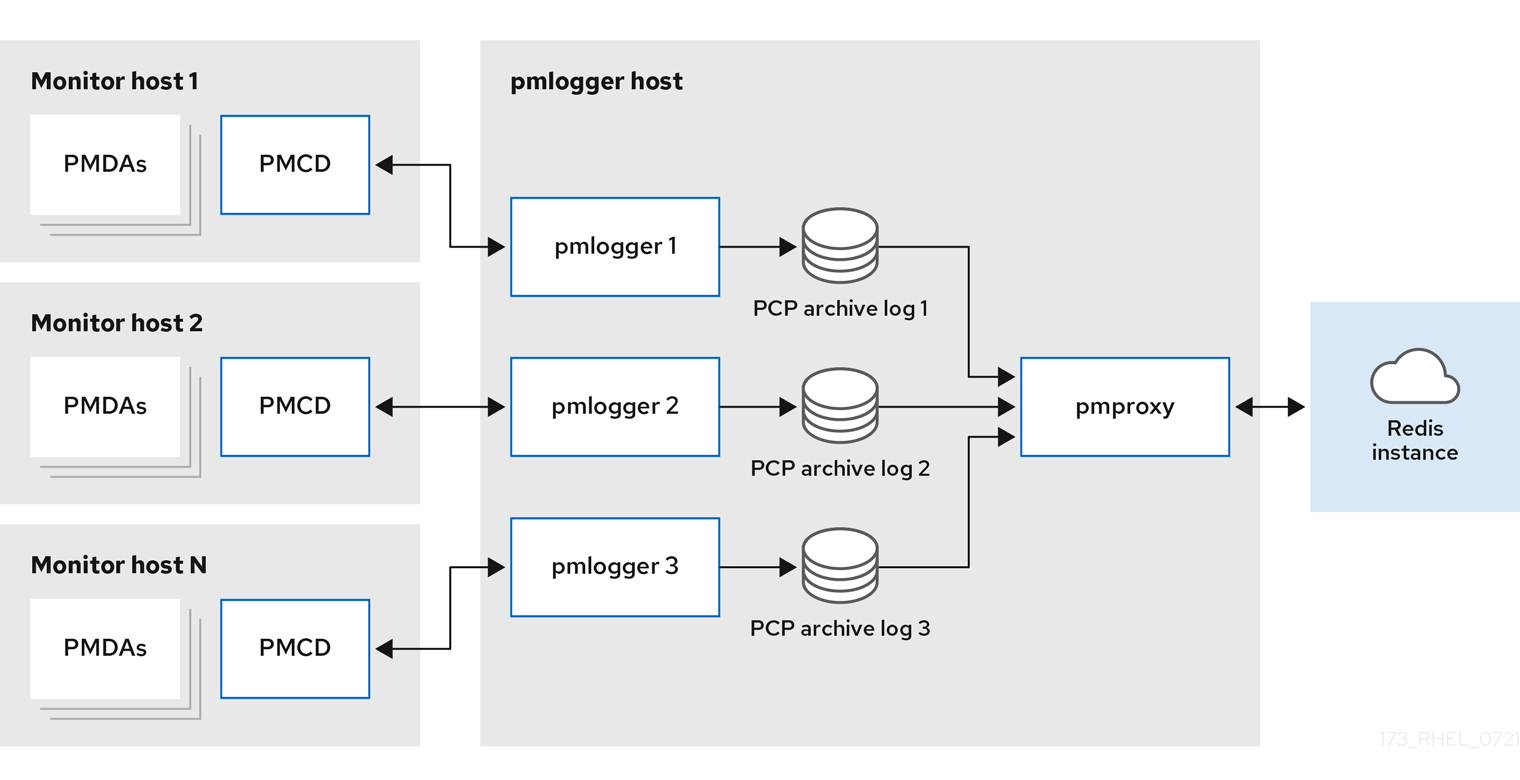

集中型ロギング - pmlogger ファーム監視対象ホストのリソース使用量が制限されている場合、

pmloggerファームというデプロイメントオプションもあります。これは集中型ロギングとも呼ばれます。この設定では、1 つのロガーホストが複数のpmloggerプロセスを実行し、それぞれが異なるリモートpmcdホストからパフォーマンスメトリックを取得するように設定されます。集中ロガーのホストはpmproxyサービスを実行するように設定され、このサービスは、結果として生じる PCP アーカイブズのログを検出し、メトリックデータを Redis インスタンスに読み込みます。図6.2 集中型ロギング - pmlogger ファーム

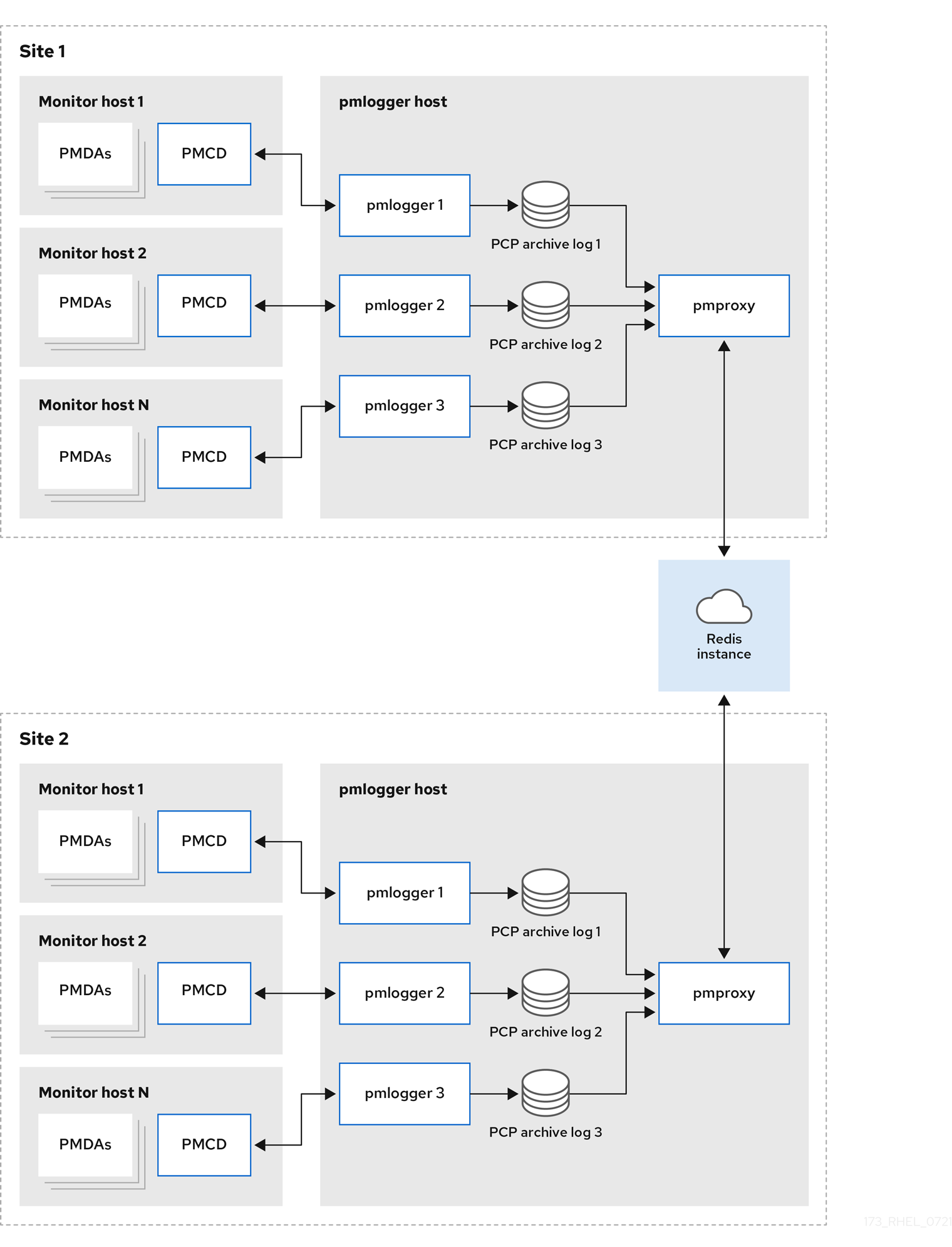

統合型 - 複数の pmlogger ファーム大規模なデプロイメントの場合、Red Hat は複数の

pmloggerファームを統合させてデプロイすることを推奨します。例えば、ラックやデータセンターごとに 1 つのpmloggerファームをデプロイします。各pmloggerファームは、メトリックを中央の Redis インスタンスに読み込みます。図6.3 統合型 - 複数の pmlogger ファーム

デフォルトでは、Redis のデプロイメント設定は、スタンドアロン、localhost となっています。しかし、Redis はオプションとして、データを複数のホストで共有する、高可用性と高スケーラビリティを備えたクラスター形態で実行することができます。また、クラウド上に Redis クラスターをデプロイしたり、クラウドベンダーが提供するマネージド Redis クラスターを利用したりすることも可能です。

関連情報

-

pcp(1)、pmlogger(1)、pmproxy(1)、およびpmcd(1)の man ページ - Recommended deployment architecture

6.6. 推奨されるデプロイメントアーキテクチャー

次の表は、監視するホストの数に応じて推奨されるデプロイメントアーキテクチャーを示しています。

表6.1 推奨されるデプロイメントアーキテクチャー

| ホストの数 (N) | 1-10 | 10-100 | 100-1000 |

|---|---|---|---|

|

| N | N | N |

|

| 1 から N | N/10 から N | N/100 から N |

|

| 1 から N | 1 から N | N/100 から N |

| Redis サーバー | 1 から N | 1 から N/10 | N/100 から N/10 |

| Redis クラスター | No | Maybe | Yes |

| 推奨されるデプロイメント設定 | ローカルホスト、分散型、または集中型のロギング | 分散型、集中型ロギング、または統合型 | 分散型または統合型 |

6.7. サイジングファクター

スケーリングに必要なサイジングファクターは以下のとおりです。

Remote system size-

CPU、ディスク、ネットワーク・インターフェイスおよびその他のハードウェアリソースの数は、集中型ロギングホスト上の各

pmloggerが収集するデータ量に影響します。 Logged Metrics-

ログメトリックの数と種類が重要なロールを果たします。具体的には、

per-process proc.*メトリックには、大きなディスク容量が必要です。たとえば、標準的なpcp-zeroconfの設定で 10 秒のログ取得間隔の場合、proc メトリックなしでは 11MB、proc メトリックありでは 155MB と、係数は 10 倍以上になります。さらに、各メトリックのインスタンス数、たとえば CPU、ブロックデバイス、ネットワークインターフェイスの数なども、必要なストレージ容量に影響を与えます。 Logging Interval-

メトリックのログを取る間隔は、ストレージの要件に影響します。各

pmloggerインスタンスのpmlogger.logファイルには、毎日の PCP アーカイブファイルの予想サイズが書き込まれます。これらの値は圧縮されていない推定値です。PCP のアーカイブは約 10:1 と非常によく圧縮されるため、実際の長期的なディスク容量の要件は、特定のサイトで決定することができます。 pmlogrewrite-

PCP をアップグレードするたびに

pmlogrewriteツールが実行され、旧バージョンと新バージョンの PCP でメトリックのメタデータに変更があった場合、古いアーカイブが書き換えられます。この処理時間は、保存されているアーカイブの数に応じてリニアに変化します。

関連情報

-

pmlogrewrite(1)およびpmlogger(1)の man ページ

6.8. PCP スケーリングの設定オプション

スケーリングに必要な設定オプションを以下に示します。

sysctl and rlimit settings-

アーカイブ検出を有効にすると、

pmproxyは、監視またはログテーリングを行っているすべてのpmloggerに対して 4 つの記述子を必要とし、さらに、サービスログとpmproxyクライアントソケットのための追加のファイル記述子があれば、それも必要となります。各pmloggerプロセスは、リモートのpmcdソケット、アーカイブファイル、サービスログなどのために約 20 個のファイル記述子を使用します。合計すると、約 200 のpmloggerプロセスを実行しているシステムでは、デフォルトの 1024 ソフトの制限を超えてしまいます。pcp-5.3.0以降のpmproxyサービスでは、ソフトリミットがハードリミットに自動的に引き上げられます。以前のバージョンの PCP では、多数のpmloggerプロセスをデプロイする場合、チューニングが必要です。これは、pmloggerのソフトリミットまたはハードリミットを増やすことで実現できます。詳細は、How to set limits (ulimit) for services run by systemd を参照してください。 ローカルアーカイブ-

pmloggerサービスは、ローカルおよびリモートのpmcdのメトリックを/var/log/pcp/pmlogger/ディレクトリーに保存します。ローカルシステムのロギング間隔を制御するには、/etc/pcp/pmlogger/control.d/configfileファイルを更新し、引数に-t Xを追加してください (Xは秒単位のロギング間隔)。どのメトリックを記録するかを設定するには、pmlogconf /var/lib/pcp/config/pmlogger/config.clienthostnameを実行します。このコマンドは、デフォルトのメトリックのセットを含む設定ファイルをデプロイしますが、オプションでさらにカスタマイズすることもできます。古い PCP アーカイブをいつパージするかという保存設定を行うには、/etc/sysconfig/pmlogger_timersfile and specifyPMLOGGER_DAILY_PARAMS="-E -k X"を更新します。ここで、Xは PCP アーカイブを保持する日数です。 Redispmproxyサービスは、pmloggerからのログされたメトリックを Redis インスタンスに送信します。設定ファイル/etc/pcp/pmproxy/pmproxy.confで保持設定を指定する際に使用できる 2 つのオプションを以下に示します。-

stream.expireでは、古いメトリックを削除するまでの期間を指定します (つまり、指定した秒数の間更新されなかったメトリック)。 -

stream.maxlenは、ホストごとに 1 つのメトリックの最大メトリック値の数を指定します。この設定は、保存期間をログ間隔で割ったものでなければなりません。例えば、保存期間が 14 日、ログ間隔が 60 秒の場合は 20160 となります (60*60*24*14/60)。

-

関連情報

-

pmproxy(1)、pmlogger(1)、およびsysctl(8)の man ページ

6.9. 例: 集中ロギングデプロイメントの分析

以下の結果は、集約ロギングセットアップ (pmlogger ファームデプロイメントとも呼ばれる) で集約されています。デフォルトの pcp-zeroconf 5.3.0 インストールでは、各リモートホストが、64 の CPU コア、376 GB RAM、および 1 つのディスクが接続されたサーバーで pmcd を実行している同一のコンテナーインスタンスになります。

ロギング間隔は 10 秒で、リモートノードの proc メトリックは含まれず、メモリー値は Resident Set Size (RSS) の値を参照します。

表6.2 10 秒のロギング間隔の詳細な使用統計

| ホスト数 | 10 | 50 |

|---|---|---|

| 1 日あたりの PCP アーカイブストレージ | 91 MB | 522 MB |

|

| 160 MB | 580 MB |

|

1 日あたりの | 2 MB | 9 MB |

|

| 1.4 GB | 6.3 GB |

| 1 日あたりの Redis メモリー | 2.6 GB | 12 GB |

表6.3 60 秒のロギング間隔で、監視対象ホストに応じて使用されるリソース

| ホスト数 | 10 | 50 | 100 |

|---|---|---|---|

| 1 日あたりの PCP アーカイブストレージ | 20 MB | 120 MB | 271 MB |

|

| 104 MB | 524 MB | 1049 MB |

|

1 日あたりの | 0.38 MB | 1.75 MB | 3.48 MB |

|

| 2.67 GB | 5.5GB | 9 GB |

| 1 日あたりの Redis メモリー | 0.54 GB | 2.65 GB | 5.3 GB |

pmproxy は Redis 要求をキューに入れ、Redis パイプラインを使用して Redis クエリーを高速化します。これにより、メモリー使用率が高くなる可能性があります。この問題をトラブルシューティングする場合は、Troubleshooting high memory usage を参照してください。

6.10. 例: 統合型セットアップデプロイメントの分析

以下の結果が、統合型セットアップ (複数の pmlogger ファームとも呼ばれる) で確認されました。これは、3 つの集中ロギング (pmlogger ファーム) セットアップで設定されます。各 pmlogger ファームは 100 のリモートホスト、つまり合計 300 のホストを監視していました。

pmlogger ファームのこのセットアップは、Redis サーバーがクラスターモードで動作していたことを除いて、60 秒のロギング間隔での

例: 集中ロギングデプロイメントの分析 で説明した設定と同じです。

表6.4 60 秒のロギング間隔で、統合型ホストに応じて使用されるリソース

| 1 日あたりの PCP アーカイブストレージ | pmlogger メモリー | 1 日あたりのネットワーク (In/Out) | pmproxy メモリー | 1 日あたりの Redis メモリー |

|---|---|---|---|---|

| 277 MB | 1058 MB | 15.6 MB / 12.3 MB | 6-8 GB | 5.5 GB |

ここでは、すべての値はホストごとになります。Redis クラスターのノード間通信により、ネットワーク帯域幅が高まります。

6.11. 高メモリー使用率のトラブルシューティング

以下のシナリオでは、メモリー使用率が高くなる可能性があります。

-

pmproxyプロセスは新しい PCP アーカイブの処理がビジーで、Redis の要求および応答を処理するための予備の CPU サイクルがありません。 - Redis ノードまたはクラスターが過負荷になり、時間が経過しても着信要求を処理できません。

pmproxy サービスデーモンは、Redis ストリームを使用し、設定パラメーター (PCP チューニングパラメーター) をサポートします。これは、Redis のメモリー使用量および鍵の保存に影響します。/etc/pcp/pmproxy/pmproxy.conf ファイルには、pmproxy で利用可能な設定オプションと、関連する API がリスト表示されます。

次の手順では、メモリー使用率が高い問題をトラブルシューティングする方法について説明します。

前提条件

pcp-pmda-redisパッケージをインストールします。# yum install pcp-pmda-redis

redis PMDA をインストールします。

# cd /var/lib/pcp/pmdas/redis && ./Install

手順

高いメモリー使用率のトラブルシューティングを行うには、次のコマンドを実行して、

inflight列を確認します。$ pmrep :pmproxy backlog inflight reqs/s resp/s wait req err resp err changed throttled byte count count/s count/s s/s count/s count/s count/s count/s 14:59:08 0 0 N/A N/A N/A N/A N/A N/A N/A 14:59:09 0 0 2268.9 2268.9 28 0 0 2.0 4.0 14:59:10 0 0 0.0 0.0 0 0 0 0.0 0.0 14:59:11 0 0 0.0 0.0 0 0 0 0.0 0.0この列は、Redis リクエストが転送中である数を示しています。つまり、キューに入れられているか送信されており、現時点では応答は受信されていません。

数値が高い場合は、次のいずれかの状態を示します。

-

pmproxyプロセスは新しい PCP アーカイブの処理がビジーで、Redis の要求および応答を処理するための予備の CPU サイクルがありません。 - Redis ノードまたはクラスターが過負荷になり、時間が経過しても着信要求を処理できません。

-

メモリー使用量が多い問題のトラブルシューティングを行うには、このファームの

pmloggerプロセスの数を減らし、別の pmlogger ファームを追加します。統合型 (複数の pmlogger ファームの設定) を使用します。Redis ノードが長時間にわたって CPU を 100% 使用している場合は、パフォーマンスが向上しているホストに移動するか、代わりにクラスター化された Redis 設定を使用します。

pmproxy.redis.*メトリックスを表示するには、次のコマンドを使用します。$ pminfo -ftd pmproxy.redis pmproxy.redis.responses.wait [wait time for responses] Data Type: 64-bit unsigned int InDom: PM_INDOM_NULL 0xffffffff Semantics: counter Units: microsec value 546028367374 pmproxy.redis.responses.error [number of error responses] Data Type: 64-bit unsigned int InDom: PM_INDOM_NULL 0xffffffff Semantics: counter Units: count value 1164 [...] pmproxy.redis.requests.inflight.bytes [bytes allocated for inflight requests] Data Type: 64-bit int InDom: PM_INDOM_NULL 0xffffffff Semantics: discrete Units: byte value 0 pmproxy.redis.requests.inflight.total [inflight requests] Data Type: 64-bit unsigned int InDom: PM_INDOM_NULL 0xffffffff Semantics: discrete Units: count value 0 [...]インフライトのリクエスト数を表示するには、

pmproxy.redis.requests.inflight.totalメトリックスとpmproxy.redis.requests.inflight.bytesメトリックスを参照して、現在のすべてのインフライトの Redis リクエストで占有されているバイト数を表示します。通常、redis 要求キューは 0 ですが、大きな pmlogger ファームの使用量に基づいて構築できます。これによりスケーラビリティーが制限され、