Red Hat Training

A Red Hat training course is available for RHEL 8

さまざまな種類のサーバーのデプロイメント

Web サーバーとリバースプロキシー、ネットワークファイルサービス、データベースサーバー、メールトランスポートエージェント、およびプリンターのセットアップと設定

概要

多様性を受け入れるオープンソースの強化

Red Hat では、コード、ドキュメント、Web プロパティーにおける配慮に欠ける用語の置き換えに取り組んでいます。まずは、マスター (master)、スレーブ (slave)、ブラックリスト (blacklist)、ホワイトリスト (whitelist) の 4 つの用語の置き換えから始めます。この取り組みは膨大な作業を要するため、今後の複数のリリースで段階的に用語の置き換えを実施して参ります。詳細は、Red Hat CTO である Chris Wright のメッセージ をご覧ください。

Red Hat ドキュメントへのフィードバック (英語のみ)

Red Hat ドキュメントに関するご意見やご感想をお寄せください。また、改善点があればお知らせください。

Jira からのフィードバック送信 (アカウントが必要)

- Jira の Web サイトにログインします。

- 上部のナビゲーションバーで Create をクリックします。

- Summary フィールドにわかりやすいタイトルを入力します。

- Description フィールドに、ドキュメントの改善に関するご意見を記入してください。ドキュメントの該当部分へのリンクも追加してください。

- ダイアログの下部にある Create をクリックします。

第1章 Apache HTTP Web サーバーの設定

1.1. Apache HTTP Web サーバーの概要

Web サーバー は、Web 経由でクライアントにコンテンツを提供するネットワークサービスです。これは通常 Web ページを指しますが、他のドキュメントも当てはまります。Web サーバーは、ハイパーテキスト転送プロトコル (HTTP) を使用するため、HTTP サーバーとも呼ばれます。

Apache HTTP Server (httpd) は、Apache Software Foundation が開発したオープンソースの Web サーバーです。

Red Hat Enterprise Linux の以前のリリースからアップグレードする場合は、適切に httpd サービス設定を更新する必要があります。本セクションでは、新たに追加された機能の一部と、以前の設定ファイルの更新を説明します。

1.2. Apache HTTP Server への主な変更点

Apache HTTP Server が、RHEL 7 のバージョン 2.4.6 から、RHEL 8 のバージョン 2.4.37 に更新されました。この更新バージョンには新機能がいくつか含まれていますが、外部モジュールの設定および Application Binary Interface (ABI) のレベルでは、RHEL 7 バージョンとの後方互換性を維持します。

新機能は次のとおりです。

-

httpdモジュール含まれるmod_http2パッケージにより、HTTP/2に対応するようになりました。 -

systemd ソケットのアクティベーションが対応します。詳細は、man ページの

httpd.socket(8)を参照してください。

新しいモジュールが複数追加されています。

-

mod_proxy_hcheck- プロキシーのヘルスチェックモジュール -

mod_proxy_uwsgi- Web Server Gateway Interface (WSGI) プロキシー -

mod_proxy_fdpass- クライアントのソケットを別のプロセスに渡す -

mod_cache_socache- HTTP キャッシュ (例: memcache バックエンドを使用) -

mod_md- ACME プロトコルの SSL/TLS 証明書サービス

-

以下のモジュールはデフォルトで読み込まれるようになりました。

-

mod_request -

mod_macro -

mod_watchdog

-

-

新しいサブパッケージ

httpd-filesystemが追加されています。これには、Apache HTTP Server の基本的なディレクトリーレイアウト (ディレクトリーの適切な権限を含む) が含まれます。 -

インスタンス化されたサービスのサポート

httpd@.serviceが導入されました。詳細は、man ページのhttpd.serviceを参照してください。

-

新しい

httpd-init.serviceが%post scriptに置き換わり、自己署名の鍵ペアmod_sslを作成します。

-

(

Let's Encryptなどの証明書プロバイダーで使用するため) 自動証明書管理環境 (ACME) プロトコルを使用した、TLS 証明書の自動プロビジョニングおよび更新に、mod_mdパッケージで対応するようになりました。 -

Apache HTTP Server が、

PKCS#11モジュールを利用して、ハードウェアのセキュリティートークンから、TLS 証明書および秘密鍵を直接読み込むようになりました。これにより、mod_ssl設定で、PKCS#11URL を使用して、SSLCertificateKeyFileディレクティブおよびSSLCertificateFileディレクティブに、TLS 秘密鍵と、必要に応じて TLS 証明書をそれぞれ指定できるようになりました。 /etc/httpd/conf/httpd.confファイルの新しいListenFreeディレクティブに対応するようになりました。Listenディレクティブと同様、ListenFreeは、サーバーがリッスンする IP アドレス、ポート、または IP アドレスとポートの組み合わせに関する情報を提供します。ただし、ListenFreeを使用すると、IP_FREEBINDソケットオプションがデフォルトで有効になります。したがって、httpdは、ローカルではない IP アドレス、または今はまだ存在していない IP アドレスにバインドすることもできます。これにより、httpdがソケットをリッスンできるようになり、httpdがバインドしようとするときに、基になるネットワークインターフェイスまたは指定した動的 IP アドレスを起動する必要がなくなります。ListenFreeディレクティブは、現在 RHEL 8 でのみ利用できます。ListenFreeの詳細は、以下の表を参照してください。表1.1 ListenFree ディレクティブの構文、状態、およびモジュール

構文 状態 モジュール ListenFree [IP-address:]portnumber [protocol]

MPM

event、worker、prefork、mpm_winnt、mpm_netware、mpmt_os2

その他の主な変更点は次の通りです。

以下のモジュールが削除されました。

-

mod_file_cache mod_nss代わりに

mod_sslを使用します。mod_nssからの移行に関する詳細は、「Apache Web Server 設定で秘密鍵と証明書を使用できるように NSS データベースからの証明書のエクスポート」 を参照してください。-

mod_perl

-

-

RHEL 8 の Apache HTTP Server が使用するデフォルトの DBM 認証データベースのデフォルトタイプが、

SDBMからdb5に変更になりました。 -

Apache HTTP Server の

mod_wsgiモジュールが Python 3 に更新されました。WSGI アプリケーションは Python 3 でしか対応していないため、Python 2 から移行する必要があります。 Apache HTTP Server を使用してデフォルトで設定されたマルチプロセッシングモジュール (MPM) は、マルチプロセスのフォークモデル (

preforkとして知られています) から、高パフォーマンスのマルチスレッドモデルeventに変更しました。スレッドセーフではないサードパーティーのモジュールは、交換または削除する必要があります。設定した MPM を変更するには、

/etc/httpd/conf.modules.d/00-mpm.confファイルを編集します。詳細は、man ページのhttpd.service(8)を参照してください。- suEXEC によりユーザーに許可される最小 UID および GID はそれぞれ 1000 および 500 です (以前は 100 および 100 でした)。

-

/etc/sysconfig/httpdファイルは、httpdサービスへの環境変数の設定に対応するインターフェイスではなくなりました。systemd サービスに、httpd.service(8)の man ページが追加されています。 -

httpdサービスを停止すると、デフォルトで自動停止が使用されます。 -

mod_auth_kerbモジュールが、mod_auth_gssapiモジュールに置き換わりました。

1.3. 設定の更新

Red Hat Enterprise Linux 7 で使用されている Apache HTTP Server バージョンから設定ファイルを更新するには、以下のいずれかのオプションを選択します。

-

/etc/sysconfig/httpdを使用して環境変数を設定する場合は、代わりに systemd ドロップインファイルを作成します。 - サードパーティーのモジュールを使用する場合は、そのモジュールがスレッド化 MPM と互換性があることを確認してください。

- suexec を使用する場合は、ユーザーおよびグループの ID が新しい最小値に合致していることを確認します。

以下のコマンドを使用すると、設定に誤りがないかどうかを確認できます。

# apachectl configtest

Syntax OK1.4. Apache 設定ファイル

デフォルトでは、httpd は起動後に設定ファイルを読み取ります。次の表に、設定ファイルの場所のリストを示します。

表1.2 httpd サービスの設定ファイル

| パス | 詳細 |

|---|---|

|

| 主要設定ファイル。 |

|

| 主要設定ファイル内に含まれている設定ファイル用の補助ディレクトリー。 |

|

| Red Hat Enterprise Linux にパッケージ化されたインストール済みの動的モジュールを読み込む設定ファイルの補助ディレクトリー。デフォルト設定では、この設定ファイルが最初に処理されます。 |

デフォルト設定はほとんどの状況に適していますが、その他の設定オプションを使用することもできます。変更を有効にするには、まず Web サーバーを再起動します。

設定に誤りがないことを確認するには、シェルプロンプトで以下のコマンドを実行します。

# apachectl configtest

Syntax OK間違いからの復元を容易にするため、編集する前にオリジナルファイルのコピーを作成します。

1.5. httpd サービスの管理

本セクションでは、httpd サービスを起動、停止、および再起動する方法を説明します。

前提条件

- Apache HTTP Server がインストールされている。

手順

httpdサービスを起動するには、以下を入力します。# systemctl start httpdhttpdサービスを停止するには、以下を入力します。# systemctl stop httpdhttpdサービスを再起動するには、以下を入力します。# systemctl restart httpd

1.6. シングルインスタンスの Apache HTTP Server 設定

シングルインスタンスの Apache HTTP Server を設定して、静的 HTML コンテンツを提供できます。

Web サーバーに関連付けられた全ドメインにサーバーから同じコンテンツを提供する必要がある場合は、この手順に従います。異なるドメインに異なるコンテンツを提供する場合は、名前ベースの仮想ホストを設定します。詳細は Apache 名ベースの仮想ホストの設定 を参照してください。

手順

httpdパッケージをインストールします。# yum install httpdfirewalldを使用する場合は、ローカルのファイアウォールで TCP ポート80を開きます。# firewall-cmd --permanent --add-port=80/tcp # firewall-cmd --reload

httpdサービスを有効にして起動します。# systemctl enable --now httpd必要に応じて、HTML ファイルを

/var/www/html/ディレクトリーに追加します。注記/var/www/html/にコンテンツを追加する場合には、httpdを実行するユーザーが、デフォルトでファイルとディレクトリーを読み取れるようにする必要があります。コンテンツの所有者は、rootユーザーおよびrootユーザーグループ、または管理者別のユーザーまたはグループのいずれかになります。コンテンツの所有者がrootユーザーおよびrootユーザーグループの場合には、他のユーザーがファイルを読み取れるようにする必要があります。すべてのファイルとディレクトリーの SELinux コンテキストはhttpd_sys_content_tである必要があります。これはデフォルトで/var/wwwディレクトリー内の全コンテンツに適用されます。

検証手順

Web ブラウザーで

http://server_IP_or_host_name/に接続します。/var/www/html/ディレクトリーが空であるか、index.htmlまたはindex.htmファイルが含まれていない場合は、Apache がRed Hat Enterprise Linux Test Pageを表示します。/var/www/html/に異なる名前の HTML ファイルが含まれる場合は、http://server_IP_or_host_name/example.htmlなど、そのファイル名に URL を指定して読み込むことができます。

関連情報

- Apache マニュアル: Apache HTTP サーバーマニュアルのインストール

-

httpd.service(8)man ページを参照してください。

1.7. Apache 名前ベースの仮想ホストの設定

名前ベースの仮想ホストを使用すると、Apache は、サーバーの IP アドレスに解決されるドメイン別に異なるコンテンツを提供できます。

別々のドキュメントルートディレクトリーを使用して、example.com ドメインと example.net ドメインの両方に仮想ホストを設定できます。どちらの仮想ホストも静的 HTML コンテンツを提供します。

前提条件

クライアントおよび Web サーバーは、

example.comおよびexample.netドメインを Web サーバーの IP アドレスに解決します。これらのエントリーは DNS サーバーに手動で追加する必要がある点に注意してください。

手順

httpdパッケージをインストールします。# yum install httpd/etc/httpd/conf/httpd.confファイルを編集します。example.comドメイン向けに以下の仮想ホスト設定を追加します。<VirtualHost *:80> DocumentRoot "/var/www/example.com/" ServerName example.com CustomLog /var/log/httpd/example.com_access.log combined ErrorLog /var/log/httpd/example.com_error.log </VirtualHost>これらの設定は以下を設定します。

-

<VirtualHost *:80>ディレクティブの全設定は、この仮想ホストに固有のものです。 -

DocumentRootは、仮想ホストの Web コンテンツへのパスを設定します。 ServerNameは、この仮想ホストがコンテンツを提供するドメインを設定します。複数のドメインを設定するには、

ServerAliasパラメーターを設定に追加し、追加のドメインをスペース区切りで、このパラメーターに指定します。-

CustomLogは、仮想ホストのアクセスログへのパスを設定します。 ErrorLogは、仮想ホストのエラーログへのパスを設定します。注記Apache は、

ServerNameおよびServerAliasパラメーターに設定したドメインどれにも一致しない要求の場合でも、設定で最初に検出された仮想マシンを使用します。これには、サーバーの IP アドレス対してに送信される要求も含まれます。

-

example.netドメイン向けに同様の仮想ホスト設定を追加します。<VirtualHost *:80> DocumentRoot "/var/www/example.net/" ServerName example.net CustomLog /var/log/httpd/example.net_access.log combined ErrorLog /var/log/httpd/example.net_error.log </VirtualHost>両方の仮想ホストのドキュメントルートを作成します。

# mkdir /var/www/example.com/ # mkdir /var/www/example.net/

DocumentRootパラメーターのパスが/var/www/内にない設定を行う場合は、両方のドキュメントルートにhttpd_sys_content_tコンテキストを設定します。# semanage fcontext -a -t httpd_sys_content_t "/srv/example.com(/.*)?" # restorecon -Rv /srv/example.com/ # semanage fcontext -a -t httpd_sys_content_t "/srv/example.net(/.\*)?" # restorecon -Rv /srv/example.net/

以下のコマンドは、

/srv/example.com/および/srv/example.net/ディレクトリーにhttpd_sys_content_tコンテキストを設定します。policycoreutils-python-utilsパッケージをインストールしてrestoreconコマンドを実行する必要があります。firewalldを使用する場合は、ローカルのファイアウォールでポート80を開きます。# firewall-cmd --permanent --add-port=80/tcp # firewall-cmd --reload

httpdサービスを有効にして起動します。# systemctl enable --now httpd

検証手順

仮想ホストのドキュメントルートごとに異なるサンプルファイルを作成します。

# echo "vHost example.com" > /var/www/example.com/index.html # echo "vHost example.net" > /var/www/example.net/index.html

-

ブラウザーを使用して

http://example.comに接続します。Web サーバーは、example.com仮想ホストからのサンプルファイルを表示します。 -

ブラウザーを使用して

http://example.netに接続します。Web サーバーは、example.net仮想ホストからのサンプルファイルを表示します。

1.8. Apache HTTP Web サーバーの Kerberos 認証の設定

Apache HTTP Web サーバーで Kerberos 認証を実行するために、RHEL 8 は mod_auth_gssapi Apache モジュールを使用します。Generic Security Services API (GSSAPI) は、Kerberos などのセキュリティーライブラリーを使用する要求を行うアプリケーションのインターフェイスです。gssproxy サービスでは、httpd サーバーに特権の分離を実装できます。これにより、セキュリティーの観点からこのプロセスが最適化されます。

削除した mod_auth_kerb モジュールは、mod_auth_gssapi モジュールに置き換わります。

前提条件

-

httpdパッケージおよびgssproxyパッケージがインストールされている。 -

Apache Web サーバーが設定され、

httpdサービスが実行している。

1.8.1. IdM 環境で GSS-Proxy の設定

この手順では、Apache HTTP Web サーバーで Kerberos 認証を実行するように GSS-Proxy を設定する方法を説明します。

手順

サービスプリンシパルを作成し、HTTP/<SERVER_NAME>@realm プリンシパルの

keytabファイルへのアクセスを有効にします。# ipa service-add HTTP/<SERVER_NAME>/etc/gssproxy/http.keytabファイルに保存されているプリンシパルのkeytabを取得します。# ipa-getkeytab -s $(awk '/^server =/ {print $3}' /etc/ipa/default.conf) -k /etc/gssproxy/http.keytab -p HTTP/$(hostname -f)このステップでは、パーミッションを 400 に設定すると、

rootユーザーのみがkeytabファイルにアクセスできます。apacheユーザーは異なります。以下の内容で

/etc/gssproxy/80-httpd.confファイルを作成します。[service/HTTP] mechs = krb5 cred_store = keytab:/etc/gssproxy/http.keytab cred_store = ccache:/var/lib/gssproxy/clients/krb5cc_%U euid = apache

gssproxyサービスを再起動して、有効にします。# systemctl restart gssproxy.service # systemctl enable gssproxy.service

関連情報

-

gssproxy(8)の man ページ -

gssproxy-mech(8)の man ページ -

gssproxy.conf(5)の man ページ

1.8.2. Apache HTTP Web サーバーが共有するディレクトリーに Kerberos 認証の設定

この手順では、/var/www/html/private/ ディレクトリーに Kerberos 認証を設定する方法を説明します。

前提条件

-

gssproxyサービスが設定され、実行されている。

手順

/var/www/html/private/ディレクトリーを保護するようにmod_auth_gssapiを設定します。<Location /var/www/html/private> AuthType GSSAPI AuthName "GSSAPI Login" Require valid-user </Location>

システムユニット設定のドロップインファイルを作成します。

# systemctl edit httpd.service次のパラメーターをシステムのドロップインファイルに追加します。

[Service] Environment=GSS_USE_PROXY=1

systemd設定をリロードします。# systemctl daemon-reloadhttpdサービスを再起動します。# systemctl restart httpd.service

検証手順

Kerberos チケットを取得します。

# kinit- ブラウザーで、保護されているディレクトリーの URL を開きます。

1.9. Apache HTTP サーバーで TLS 暗号化の設定

デフォルトでは、Apache は暗号化されていない HTTP 接続を使用してクライアントにコンテンツを提供します。本セクションでは、TLS 暗号化を有効にし、Apache HTTP Server で頻繁に使用される暗号化関連の設定を行う方法を説明します。

前提条件

- Apache HTTP Server がインストールされ、実行している。

1.9.1. Apache HTTP Server への TLS 暗号化の追加

example.com ドメインの Apache HTTP サーバーで TLS 暗号化を有効にすることができます。

前提条件

- Apache HTTP Server がインストールされ、実行している。

秘密鍵が

/etc/pki/tls/private/example.com.keyファイルに保存されている。秘密鍵および証明書署名要求 (CSR) を作成する方法と、認証局 (CA) からの証明書を要求する方法は、CA のドキュメントを参照してください。または、お使いの CA が ACME プロトコルに対応している場合は、

mod_mdモジュールを使用して、TLS 証明書の取得およびプロビジョニングを自動化できます。-

TLS 証明書は

/etc/pki/tls/certs/example.com.crtファイルに保存されます。別のパスを使用する場合は、この手順で対応する手順を調整します。 -

認証局証明書は

/etc/pki/tls/certs/ca.crtに保存されています。別のパスを使用する場合は、この手順で対応する手順を調整します。 - クライアントおよび Web サーバーは、サーバーのホスト名を Web サーバーの IP アドレスに対して解決します。

手順

mod_sslパッケージをインストールします。# yum install mod_ssl/etc/httpd/conf.d/ssl.confファイルを編集し、以下の設定を<VirtualHost _default_:443>ディレクティブに追加します。サーバー名を設定します。

ServerName example.com

重要サーバー名は、証明書の

Common Nameフィールドに設定されているエントリーと一致している必要があります。必要に応じて、証明書の

Subject Alt Names(SAN) フィールドに追加のホスト名が含まれる場合に、これらのホスト名にも TLS 暗号化を提供するようにmod_sslを設定できます。これを設定するには、ServerAliasesパラメーターと対応する名前を追加します。ServerAlias www.example.com server.example.com秘密鍵、サーバー証明書、および CA 証明書へのパスを設定します。

SSLCertificateKeyFile "/etc/pki/tls/private/example.com.key" SSLCertificateFile "/etc/pki/tls/certs/example.com.crt" SSLCACertificateFile "/etc/pki/tls/certs/ca.crt"

セキュリティー上の理由から、

rootユーザーのみが秘密鍵ファイルにアクセスできるように設定します。# chown root:root /etc/pki/tls/private/example.com.key # chmod 600 /etc/pki/tls/private/example.com.key

警告秘密鍵に権限のないユーザーがアクセスした場合は、証明書を取り消し、新しい秘密鍵を作成し、新しい証明書を要求します。そうでない場合は、TLS 接続が安全ではなくなります。

firewalldを使用する場合は、ローカルのファイアウォールでポート443を開きます。# firewall-cmd --permanent --add-port=443/tcp # firewall-cmd --reload

httpdサービスを再起動します。# systemctl restart httpd注記パスワードで秘密鍵ファイルを保護した場合は、

httpdサービスの起動時に毎回このパスワードを入力する必要があります。

検証手順

-

ブラウザーを使用して、

https://example.comに接続します。

1.9.2. Apache HTTP サーバーでサポートされる TLS プロトコルバージョンの設定

デフォルトでは、RHEL の Apache HTTP Server は、最新のブラウザーにも互換性のある安全なデフォルト値を定義するシステム全体の暗号化ポリシーを使用します。たとえば、DEFAULT ポリシーでは、TLSv1.2 および TLSv1.3 プロトコルバージョンのみが Apache で有効になるように定義します。

Apache HTTP Server がサポートする TLS プロトコルのバージョンを手動で設定できます。たとえば、環境が特定の TLS プロトコルバージョンのみを有効にする必要がある場合には、以下の手順に従います。

-

お使いの環境のクライアントで、セキュリティーの低い

TLS1(TLSv1.0) プロトコルまたはTLS1.1プロトコルも使用できるようにする必要がある場合。 -

Apache が

TLSv1.2プロトコルまたはTLSv1.3プロトコルのみに対応するように設定する場合。

前提条件

- Apache HTTP Server への TLS 暗号化の追加 で説明されているとおり、TLS 暗号化がサーバーで有効になります。

手順

/etc/httpd/conf/httpd.confファイルを編集し、TLS プロトコルバージョンを設定する<VirtualHost>ディレクティブに以下の設定を追加します。たとえば、TLSv1.3プロトコルのみを有効にするには、以下を実行します。SSLProtocol -All TLSv1.3httpdサービスを再起動します。# systemctl restart httpd

検証手順

以下のコマンドを使用して、サーバーが

TLSv1.3に対応していることを確認します。# openssl s_client -connect example.com:443 -tls1_3以下のコマンドを使用して、サーバーが

TLSv1.2に対応していないことを確認します。# openssl s_client -connect example.com:443 -tls1_2サーバーがプロトコルに対応していない場合には、このコマンドは以下のエラーを返します。

140111600609088:error:1409442E:SSL routines:ssl3_read_bytes:tlsv1 alert protocol version:ssl/record/rec_layer_s3.c:1543:SSL alert number 70

- 必要に応じて、他の TLS プロトコルバージョンのコマンドを繰り返し実行します。

関連情報

-

update-crypto-policies(8)の man ページ - Using system-wide cryptographic policies.

-

SSLProtocolパラメーターの詳細については、Apache マニュアルのmod_sslのドキュメント Apache HTTP サーバーマニュアルのインストール を参照してください。

1.9.3. Apache HTTP サーバーで対応している暗号の設定

デフォルトでは、Apache HTTP サーバーは、安全なデフォルト値を定義するシステム全体の暗号化ポリシーを使用します。これは、最近のブラウザーとも互換性があります。システム全体の暗号化で使用可能な暗号化のリストは、/etc/crypto-policies/back-ends/openssl.config ファイルを参照してください。

Apache HTTP Server がサポートする暗号を手動で設定できます。お使いの環境で特定の暗号が必要な場合は、以下の手順に従います。

前提条件

- Apache HTTP Server への TLS 暗号化の追加 で説明されているとおり、TLS 暗号化がサーバーで有効になります。

手順

/etc/httpd/conf/httpd.confファイルを編集し、TLS 暗号を設定する<VirtualHost>ディレクティブにSSLCipherSuiteパラメーターを追加します。SSLCipherSuite "EECDH+AESGCM:EDH+AESGCM:AES256+EECDH:AES256+EDH:!SHA1:!SHA256"この例では、

EECDH+AESGCM、EDH+AESGCM、AES256+EECDH、およびAES256+EDH暗号のみを有効にし、SHA1およびSHA256メッセージ認証コード (MAC) を使用するすべての暗号を無効にします。httpdサービスを再起動します。# systemctl restart httpd

検証手順

Apache HTTP Server が対応する暗号化のリストを表示するには、以下を行います。

nmapパッケージをインストールします。# yum install nmapnmapユーティリティーを使用して、対応している暗号を表示します。# nmap --script ssl-enum-ciphers -p 443 example.com ... PORT STATE SERVICE 443/tcp open https | ssl-enum-ciphers: | TLSv1.2: | ciphers: | TLS_ECDHE_RSA_WITH_AES_256_GCM_SHA384 (ecdh_x25519) - A | TLS_DHE_RSA_WITH_AES_256_GCM_SHA384 (dh 2048) - A | TLS_ECDHE_RSA_WITH_CHACHA20_POLY1305_SHA256 (ecdh_x25519) - A ...

関連情報

-

update-crypto-policies(8)の man ページ - Using system-wide cryptographic policies.

- SSLCipherSuite

1.10. TLS クライアント証明書認証の設定

クライアント証明書認証を使用すると、管理者は、証明書で認証したユーザーのみが Web サーバーのリソースにアクセスできるようにすることが可能です。/var/www/html/Example/ ディレクトリーにクライアント証明書認証を設定できます。

Apache HTTP Server が TLS 1.3 プロトコルを使用する場合、特定のクライアントには追加の設定が必要です。たとえば、Firefox で、about:config メニューの security.tls.enable_post_handshake_auth パラメーターを true に設定します。詳細は、Transport Layer Security version 1.3 in Red Hat Enterprise Linux 8 を参照してください。

前提条件

- Apache HTTP Server への TLS 暗号化の追加 で説明されているとおり、TLS 暗号化がサーバーで有効になります。

手順

/etc/httpd/conf/httpd.confファイルを編集し、以下の設定をクライアント認証を設定する<VirtualHost>ディレクティブに追加します。<Directory "/var/www/html/Example/"> SSLVerifyClient require </Directory>

SSLVerifyClient requireの設定では、/var/www/html/Example/ディレクトリーのコンテンツにクライアントがアクセスする前に、サーバーがクライアント証明書を正常に検証する必要があることを定義します。httpdサービスを再起動します。# systemctl restart httpd

検証手順

curlユーティリティーを使用して、クライアント認証なしでhttps://example.com/Example/URL にアクセスします。$ curl https://example.com/Example/ curl: (56) OpenSSL SSL_read: error:1409445C:SSL routines:ssl3_read_bytes:tlsv13 alert certificate required, errno 0このエラーは、Web サーバーにクライアント証明書認証が必要であることを示しています。

クライアントの秘密鍵と証明書、および CA 証明書を

curlに指定して、クライアント認証で同じ URL にアクセスします。$ curl --cacert ca.crt --key client.key --cert client.crt https://example.com/Example/要求に成功すると、

curlは/var/www/html/Example/ディレクトリーに保存されているindex.htmlファイルを表示します。

関連情報

1.11. ModSecurity を使用した Web サーバー上の Web アプリケーションの保護

ModSecurity は、Apache、Nginx、IIS などのさまざまな Web サーバーでサポートされているオープンソースの Web アプリケーションファイアウォール (WAF) であり、Web アプリケーションのセキュリティーリスクを軽減します。ModSecurity は、サーバーを設定するためのカスタマイズ可能なルールセットを提供します。

mod_security-crs パッケージには、クロス Web サイトスクリプティング、不正なユーザーエージェント、SQL インジェクション、トロイの木馬、セッションハイジャック、およびその他の不正使用に対するルールを含むコアルールセット (CRS) が含まれています。

1.11.1. Apache 用 ModSecurity Web ベースアプリケーションファイアウォールのデプロイ

ModSecurity をデプロイして、Web サーバー上で Web ベースアプリケーションの実行に関連するリスクを軽減するには、Apache HTTP サーバー用の mod_security および mod_security_crs パッケージをインストールします。mod_security_crs パッケージは、ModSecurity Web ベースのアプリケーションファイアウォール (WAF) モジュールのコアルールセット (CRS) を提供します。

手順

mod_security、mod_security_crs、およびhttpdパッケージをインストールします。# yum install -y mod_security mod_security_crs httpdhttpdサーバーを起動します。# systemctl restart httpd

検証

ModSecurity Web ベースアプリケーションファイアウォールが Apache HTTPサーバーで有効になっていることを確認します。

# httpd -M | grep security security2_module (shared)/etc/httpd/modsecurity.d/activated_rules/ディレクトリーにmod_security_crsによって提供されるルールが含まれていることを確認します。# ls /etc/httpd/modsecurity.d/activated_rules/ ... REQUEST-921-PROTOCOL-ATTACK.conf REQUEST-930-APPLICATION-ATTACK-LFI.conf ...

1.11.2. ModSecurity へのカスタムルールの追加

ModSecurity コアルールセット (CRS) に含まれるルールがシナリオに適合せず、追加の攻撃の可能性を防ぎたい場合は、カスタムルールを ModSecurity Web ベースアプリケーションファイアウォールで使用されるルールセットに追加できます。次の例は、単純なルールの追加を示しています。より複雑なルールを作成するには、ModSecurity Wiki Web サイトのリファレンスマニュアルを参照してください。

前提条件

- ModSecurity for Apache がインストールされ、有効になっている。

手順

任意のテキストエディターで

/etc/httpd/conf.d/mod_security.confファイルを開きます。以下はその例です。# vi /etc/httpd/conf.d/mod_security.confSecRuleEngine Onで始まる行の後に、次のサンプルルールを追加します。SecRule ARGS:data "@contains evil" "deny,status:403,msg:'param data contains evil data',id:1"

前のルールでは、

dataパラメーターにevilの文字列が含まれている場合、ユーザーによるリソースの使用を禁止しています。- 変更を保存し、エディターを終了します。

httpdサーバーを再起動します。# systemctl restart httpd

検証

test.htmlページを作成します。# echo "mod_security test" > /var/www/html/test.htmlhttpdサーバーを再起動します。# systemctl restart httpdHTTP リクエストの

GET変数に悪意のあるデータが含まれないtest.htmlをリクエストします。$ curl http://localhost/test.html?data=good mod_security testHTTP リクエストの

GET変数に悪意のあるデータが含まれるtest.htmlをリクエストします。$ curl localhost/test.html?data=xxxevilxxx <!DOCTYPE HTML PUBLIC "-//IETF//DTD HTML 2.0//EN"> <html><head> <title>403 Forbidden</title> </head><body> <h1>Forbidden</h1> <p>You do not have permission to access this resource.</p> </body></html>/var/log/httpd/error_logファイルを確認し、param data containing an evil dataメッセージでアクセスを拒否するログエントリーを見つけます。[Wed May 25 08:01:31.036297 2022] [:error] [pid 5839:tid 139874434791168] [client ::1:45658] [client ::1] ModSecurity: Access denied with code 403 (phase 2). String match "evil" at ARGS:data. [file "/etc/httpd/conf.d/mod_security.conf"] [line "4"] [id "1"] [msg "param data contains evil data"] [hostname "localhost"] [uri "/test.html"] [unique_id "Yo4amwIdsBG3yZqSzh2GuwAAAIY"]

関連情報

1.12. Apache HTTP Server のマニュアルのインストール

Apache HTTP Server のマニュアルをインストールできます。このマニュアルには、以下のような詳細なドキュメントが含まれます。

- 設定パラメーターおよびディレクティブ

- パフォーマンスチューニング

- 認証設定

- モジュール

- コンテンツのキャッシュ

- セキュリティーに関するヒント

- TLS 暗号化の設定

マニュアルをインストールした後は、Web ブラウザーを使用して表示できます。

前提条件

- Apache HTTP Server がインストールされ、実行している。

手順

httpd-manualパッケージをインストールします。# yum install httpd-manual必要に応じて、デフォルトでは、Apache HTTP Server に接続するすべてのクライアントはマニュアルを表示できます。

192.0.2.0/24サブネットなど、特定の IP 範囲へのアクセスを制限するには、/etc/httpd/conf.d/manual.confファイルを編集し、Require ip 192.0.2.0/24設定を<Directory "/usr/share/httpd/manual">ディレクティブに追加します。<Directory "/usr/share/httpd/manual"> ... Require ip 192.0.2.0/24 ... </Directory>httpdサービスを再起動します。# systemctl restart httpd

検証手順

-

Apache HTTP Server のマニュアルを表示するには、Web ブラウザーで

http://host_name_or_IP_address/manual/に接続します。

1.13. Apache モジュールの操作

httpd サービスはモジュラーアプリケーションであり、多数の 動的共有オブジェクト (DSO) で拡張できます。動的共有オブジェクト は、必要に応じて実行時に動的にロードまたはアンロードできるモジュールです。これらのモジュールは /usr/lib64/httpd/modules/ ディレクトリーにあります。

1.13.1. DSO モジュールのロード

管理者は、サーバーがロードするモジュールを設定することにより、サーバーに含める機能を選択できます。特定の DSO モジュールを読み込むには、LoadModule ディレクティブを使用します。別のパッケージが提供するモジュールは、多くの場合、/etc/httpd/conf.modules.d/ ディレクトリーに独自の設定ファイルがあることに注意してください。

前提条件

-

httpdパッケージをインストールしている。

手順

/etc/httpd/conf.modules.d/ディレクトリーの設定ファイルでモジュール名を検索します。# grep mod_ssl.so /etc/httpd/conf.modules.d/*モジュール名が見つかった設定ファイルを編集し、モジュールの

LoadModuleディレクティブをコメント解除します。LoadModule ssl_module modules/mod_ssl.soRHEL パッケージがモジュールを提供していないなどの理由でモジュールが見つからなかった場合は、次のディレクティブを使用して

/etc/httpd/conf.modules.d/30-example.confなどの設定ファイルを作成します。LoadModule ssl_module modules/<custom_module>.sohttpdサービスを再起動します。# systemctl restart httpd

1.13.2. カスタム Apache モジュールのコンパイル

独自のモジュールを作成し、モジュールのコンパイルに必要なインクルードファイル、ヘッダーファイル、および APache eXtenSion (apxs) ユーティリティーを含む httpd-devel パッケージを使用してビルドできます。

前提条件

-

httpd-develパッケージがインストールされている。

手順

次のコマンドでカスタムモジュールをビルドします。

# apxs -i -a -c module_name.c

検証手順

- DSO モジュールのロード で説明されている方法でモジュールをロードします。

1.14. Apache Web Server 設定で秘密鍵と証明書を使用できるように NSS データベースからの証明書のエクスポート

RHEL 8 では Apache Web Server に mod_nss モジュールが提供されなくなります。Red Hat は mod_ssl モジュールの使用を推奨します。たとえば、RHEL 7 から RHEL 8 へ Web サーバーを移行したなどして、秘密鍵と証明書を Network Security Services (NSS) データベースに保存する場合は、以下の手順に従って、Privacy Enhanced Mail (PEM) 形式の鍵および証明書を抽出します。次に Apache HTTP サーバーでの TLS 暗号化の設定 で説明されているとおり、mod_ssl 設定でファイルを使用できます。

この手順では、NSS データベースが /etc/httpd/alias/ に保存され、エクスポートした秘密鍵と証明書を /etc/pki/tls/ ディレクトリーに保存することを前提としています。

前提条件

- 秘密鍵、証明書、および認証局 (CA) の証明書は NSS データベースに保存されます。

手順

NSS データベースの証明書をリスト表示します。

# certutil -d /etc/httpd/alias/ -L Certificate Nickname Trust Attributes SSL,S/MIME,JAR/XPI Example CA C,, Example Server Certificate u,u,u

次の手順では、証明書のニックネームが必要です。

秘密鍵を抽出するには、鍵を PKCS #12 ファイルに一時的にエクスポートする必要があります。

秘密鍵に関連付けられた証明書のニックネームを使用して、鍵を PKCS #12 ファイルにエクスポートします。

# pk12util -o /etc/pki/tls/private/export.p12 -d /etc/httpd/alias/ -n "Example Server Certificate" Enter password for PKCS12 file: password Re-enter password: password pk12util: PKCS12 EXPORT SUCCESSFUL

PKCS #12 ファイルにパスワードを設定する必要があります。次の手順では、このパスワードが必要です。

PKCS #12 ファイルから秘密鍵をエクスポートします。

# openssl pkcs12 -in /etc/pki/tls/private/export.p12 -out /etc/pki/tls/private/server.key -nocerts -nodes Enter Import Password: password MAC verified OK

PKCS #12 の一時ファイルを削除します。

# rm /etc/pki/tls/private/export.p12

/etc/pki/tls/private/server.keyにパーミッションを設定し、rootユーザーのみがこのファイルにアクセスできるようにします。# chown root:root /etc/pki/tls/private/server.key # chmod 0600 /etc/pki/tls/private/server.key

NSS データベースのサーバー証明書のニックネームを使用して CA 証明書をエクスポートします。

# certutil -d /etc/httpd/alias/ -L -n "Example Server Certificate" -a -o /etc/pki/tls/certs/server.crt/etc/pki/tls/certs/server.crtにパーミッションを設定し、rootユーザーのみがこのファイルにアクセスできるようにします。# chown root:root /etc/pki/tls/certs/server.crt # chmod 0600 /etc/pki/tls/certs/server.crt

NSS データベースの CA 証明書のニックネームを使用して、CA 証明書をエクスポートします。

#certutil -d /etc/httpd/alias/ -L -n "Example CA" -a -o /etc/pki/tls/certs/ca.crtApache HTTP サーバーでの TLS 暗号化の設定 に従い、Apache Web サーバーを設定します。

-

SSLCertificateKeyFileパラメーターを/etc/pki/tls/private/server.keyに設定します。 -

SSLCertificateFileパラメーターを/etc/pki/tls/certs/server.crtに設定します。 -

SSLCACertificateFileパラメーターを/etc/pki/tls/certs/ca.crtに設定します。

-

関連情報

-

certutil(1)man ページ -

pk12util(1)の man ページ -

pkcs12(1ssl)の man ページ

1.15. 関連情報

-

httpd(8) -

httpd.service(8) -

httpd.conf(5) -

apachectl(8) - GSS-Proxy を使用した Apache httpd の操作。

- PKCS #11 で暗号化ハードウェアを使用するようにアプリケーションを設定

第2章 NGINX の設定および設定

NGINX は、次のように使用できる高パフォーマンスなモジュラーサーバーです。

- Web サーバー

- リバースプロキシー

- ロードバランサー

本セクションでは、このシナリオで NGINX を行う方法を説明します。

2.1. NGINX のインストールおよび準備

Red Hat は、アプリケーションストリームを使用して NGINX の異なるバージョンを提供します。以下を実行できます。

- ストリームを選択し、NGINX をインストールします。

- ファイアウォールで必要なポートを開きます。

-

nginxサービスの有効化および開始

デフォルト設定を使用すると、NGINX はポート 80 の Web サーバーとして実行され、/usr/share/nginx/html/ ディレクトリーからコンテンツを提供します。

前提条件

- RHEL 8 がインストールされている。

- ホストが Red Hat カスタマーポータルにサブスクライブしている。

-

firewalldサービスが有効化され、開始されている。

手順

利用可能な NGINX モジュールストリームを表示します。

# yum module list nginx Red Hat Enterprise Linux 8 for x86_64 - AppStream (RPMs) Name Stream Profiles Summary nginx 1.14 [d] common [d] nginx webserver nginx 1.16 common [d] nginx webserver ... Hint: [d]efault, [e]nabled, [x]disabled, [i]nstalledデフォルト以外のストリームをインストールする場合は、そのストリームを選択します。

# yum module enable nginx:stream_versionnginxパッケージをインストールします。# yum install nginxNGINX がファイアウォールでサービスを提供するポートを開きます。たとえば、

firewalldで HTTP (ポート 80) および HTTPS (ポート 443) のデフォルトポートを開くには、次のコマンドを実行します。# firewall-cmd --permanent --add-port={80/tcp,443/tcp} # firewall-cmd --reload

nginxサービスがシステムの起動時に自動的に起動するようにします。# systemctl enable nginx必要に応じて、

nginxサービスを起動します。# systemctl start nginxデフォルト設定を使用しない場合は、この手順を省略し、サービスを起動する前に NGINX を適切に設定します。

検証手順

yumユーティリティーを使用して、nginxパッケージがインストールされていることを確認します。# yum list installed nginx Installed Packages nginx.x86_64 1:1.14.1-9.module+el8.0.0+4108+af250afe @rhel-8-for-x86_64-appstream-rpmsNGINX がサービスを提供するポートが firewalld で開いていることを確認します。

# firewall-cmd --list-ports 80/tcp 443/tcpnginxサービスが有効になっていることを確認します。# systemctl is-enabled nginx enabled

関連情報

- Subscription Manager の詳細は、Subscription Manager の使用および設定 ガイドを参照してください。

- アプリケーションストリーム、モジュール、およびインストールパッケージの詳細は、ユーザー空間コンポーネントのインストール、管理、および削除 を参照してください。

- ファイアウォールの設定に関する詳細は、ネットワークのセキュリティー保護 を参照してください。

2.2. ドメインごとに異なるコンテンツを提供する Web サーバーとしての NGINX の設定

デフォルトでは、NGINX は Web サーバーとして機能し、サーバーの IP アドレスに関連付けられた全ドメイン名のクライアントに、同じコンテンツを提供します。この手順では、NGINX を設定する方法を説明します。

-

/var/www/example.com/ディレクトリーのコンテンツで、example.comドメインに対するリクエストに対応する。 -

/var/www/example.net/ディレクトリーのコンテンツで、example.netドメインに対するリクエストに対応する。 -

その他の全リクエスト (たとえば、サーバーの IP アドレスまたはサーバーの IP アドレスに関連付けられたその他のドメイン) に

/usr/share/nginx/html/ディレクトリーのコンテンツを指定します。

前提条件

- NGINX がインストールされている

クライアントおよび Web サーバーは、

example.comおよびexample.netドメインを Web サーバーの IP アドレスに解決します。これらのエントリーは DNS サーバーに手動で追加する必要がある点に注意してください。

手順

/etc/nginx/nginx.confファイルを編集します。デフォルトでは、

/etc/nginx/nginx.confファイルには catch-all 設定がすでに含まれています。設定からこの部分を削除した場合は、以下のserverブロックを/etc/nginx/nginx.confファイルのhttpブロックに追加し直します。server { listen 80 default_server; listen [::]:80 default_server; server_name _; root /usr/share/nginx/html; }これらの設定は以下を設定します。

-

listenディレクティブは、サービスがリッスンする IP アドレスとポートを定義します。この場合、NGINX は IPv4 と IPv6 の両方のアドレスのポート80でリッスンします。default_serverパラメーターは、NGINX がこのserverブロックを IP アドレスとポートに一致するリクエストのデフォルトとして使用していることを示します。 -

server_nameパラメーターは、このserverブロックに対応するホスト名を定義します。server_nameを_に設定すると、このserverブロックのホスト名を受け入れるように NGINX を設定します。 -

rootディレクティブは、このserverブロックの Web コンテンツへのパスを設定します。

-

example.comドメインの同様のserverブロックをhttpブロックに追加します。server { server_name example.com; root /var/www/example.com/; access_log /var/log/nginx/example.com/access.log; error_log /var/log/nginx/example.com/error.log; }-

access_logディレクティブは、このドメインに別のアクセスログファイルを定義します。 -

error_logディレクティブは、このドメインに別のエラーログファイルを定義します。

-

example.netドメインの同様のserverブロックをhttpブロックに追加します。server { server_name example.net; root /var/www/example.net/; access_log /var/log/nginx/example.net/access.log; error_log /var/log/nginx/example.net/error.log; }

両方のドメインのルートディレクトリーを作成します。

# mkdir -p /var/www/example.com/ # mkdir -p /var/www/example.net/

両方のルートディレクトリーに

httpd_sys_content_tコンテキストを設定します。# semanage fcontext -a -t httpd_sys_content_t "/var/www/example.com(/.*)?" # restorecon -Rv /var/www/example.com/ # semanage fcontext -a -t httpd_sys_content_t "/var/www/example.net(/.\*)?" # restorecon -Rv /var/www/example.net/

これらのコマンドは、

/var/www/example.com/ディレクトリーおよび/var/www/example.net/ディレクトリーにhttpd_sys_content_tコンテキストを設定します。policycoreutils-python-utilsパッケージをインストールしてrestoreconコマンドを実行する必要があります。両方のドメインのログディレクトリーを作成します。

# mkdir /var/log/nginx/example.com/ # mkdir /var/log/nginx/example.net/

nginxサービスを再起動します。# systemctl restart nginx

検証手順

仮想ホストのドキュメントルートごとに異なるサンプルファイルを作成します。

# echo "Content for example.com" > /var/www/example.com/index.html # echo "Content for example.net" > /var/www/example.net/index.html # echo "Catch All content" > /usr/share/nginx/html/index.html

-

ブラウザーを使用して

http://example.comに接続します。Web サーバーは、/var/www/example.com/index.htmlファイルからのサンプルコンテンツを表示します。 -

ブラウザーを使用して

http://example.netに接続します。Web サーバーは、/var/www/example.net/index.htmlファイルからのサンプルコンテンツを表示します。 -

ブラウザーを使用して

http://IP_address_of_the_serverに接続します。Web サーバーは、/usr/share/nginx/html/index.htmlファイルからのサンプルコンテンツを表示します。

2.3. NGINX Web サーバーへの TLS 暗号化の追加

example.com ドメインの NGINX Web サーバーで TLS 暗号化を有効にすることができます。

前提条件

- NGINX がインストールされている。

秘密鍵が

/etc/pki/tls/private/example.com.keyファイルに保存されている。秘密鍵および証明書署名要求 (CSR) を作成する方法と、認証局 (CA) からの証明書を要求する方法は、CA のドキュメントを参照してください。

-

TLS 証明書は

/etc/pki/tls/certs/example.com.crtファイルに保存されます。別のパスを使用する場合は、この手順で対応する手順を調整します。 - CA 証明書がサーバーの TLS 証明書ファイルに追加されている。

- クライアントおよび Web サーバーは、サーバーのホスト名を Web サーバーの IP アドレスに対して解決します。

-

ポート

443が、ローカルのファイアウォールで開放されている。

手順

/etc/nginx/nginx.confファイルを編集し、設定のhttpブロックに以下のserverブロックを追加します。server { listen 443 ssl; server_name example.com; root /usr/share/nginx/html; ssl_certificate /etc/pki/tls/certs/example.com.crt; ssl_certificate_key /etc/pki/tls/private/example.com.key; }セキュリティー上の理由から、

rootユーザーのみが秘密鍵ファイルにアクセスできるように設定します。# chown root:root /etc/pki/tls/private/example.com.key # chmod 600 /etc/pki/tls/private/example.com.key

警告秘密鍵に権限のないユーザーがアクセスした場合は、証明書を取り消し、新しい秘密鍵を作成し、新しい証明書を要求します。そうでない場合は、TLS 接続が安全ではなくなります。

nginxサービスを再起動します。# systemctl restart nginx

検証手順

-

ブラウザーを使用して、

https://example.comに接続します。

2.4. HTTP トラフィックのリバースプロキシーとしての NGINX の設定

NGINX Web サーバーは、HTTP トラフィックのリバースプロキシーとして機能するように設定できます。たとえば、この機能を使用すると、リモートサーバーの特定のサブディレクトリーに要求を転送できます。クライアント側からは、クライアントはアクセス先のホストからコンテンツを読み込みます。ただし、NGINX は実際のコンテンツをリモートサーバーから読み込み、クライアントに転送します。

この手順では、Web サーバーの /example ディレクトリーへのトラフィックを、URL https://example.com に転送する方法を説明します。

前提条件

- NGINX は、NGINX のインストールと準備 の説明に従ってインストールされます。

- 必要に応じて、TLS 暗号化がリバースプロキシーで有効になっている。

手順

/etc/nginx/nginx.confファイルを編集し、リバースプロキシーを提供するserverブロックに以下の設定を追加します。location /example { proxy_pass https://example.com; }locationブロックでは、NGINX が/exampleディレクトリー内の全要求をhttps://example.comに渡すことを定義します。SELinux ブール値パラメーター

httpd_can_network_connectを1に設定して、SELinux が NGINX がトラフィックを転送できるように設定します。# setsebool -P httpd_can_network_connect 1nginxサービスを再起動します。# systemctl restart nginx

検証手順

-

ブラウザーを使用して

http://host_name/exampleに接続すると、https://example.comの内容が表示されます。

2.5. NGINX の HTTP ロードバランサーとしての設定

NGINX リバースプロキシー機能を使用してトラフィックを負荷分散できます。この手順では、HTTP ロードバランサーとして NGINX を設定して、アクティブな接続数が最も少ないサーバーがどれかを基にして、要求を異なるサーバーに送信する方法を説明します。どちらのサーバーも利用できない場合には、この手順でフォールバックを目的とした 3 番目のホストも定義します。

前提条件

- NGINX は、NGINX のインストールと準備 の説明に従ってインストールされます。

手順

/etc/nginx/nginx.confファイルを編集し、以下の設定を追加します。http { upstream backend { least_conn; server server1.example.com; server server2.example.com; server server3.example.com backup; } server { location / { proxy_pass http://backend; } } }backendという名前のホストグループのleast_connディレクティブは、アクティブな接続数が最も少ないサーバーがどれかを基にして、NGINX が要求をserver1.example.comまたはserver2.example.comに送信することを定義します。NGINX は、他の 2 つのホストが利用できない場合は、server3.example.comのみをバックアップとして使用します。proxy_passディレクティブをhttp://backendに設定すると、NGINX はリバースプロキシーとして機能し、backendホストグループを使用して、このグループの設定に基づいて要求を配信します。least_conn負荷分散メソッドの代わりに、以下を指定することができます。- ラウンドロビンを使用し、サーバー全体で要求を均等に分散する方法はありません。

-

ip_hash: クライアントの IPv4 アドレスのオクテットの内、最初の 3 つ、または IPv6 アドレス全体から計算されたハッシュに基づいて、あるクライアントアドレスから同じサーバーに要求を送信します。 -

hash: ユーザー定義のキーに基づいてサーバーを判断します。これは、文字列、変数、または両方の組み合わせになります。consistentパラメーターは、ユーザー定義のハッシュ化された鍵の値に基づいて、NGINX がすべてのサーバーに要求を分散するように設定します。 -

random: 無作為に選択されたサーバーに要求を送信します。

nginxサービスを再起動します。# systemctl restart nginx

2.6. 関連情報

- 公式の NGINX のドキュメントについては、https://nginx.org/en/docs/ を参照してください。Red Hat はこのドキュメントを管理しておらず、インストールした NGINX バージョンで機能しない可能性があることに注意してください。

- PKCS #11 で暗号化ハードウェアを使用するようにアプリケーションを設定

第3章 Samba をサーバーとして使用

Samba は、Red Hat Enterprise Linux にサーバーメッセージブロック (SMB) プロトコルを実装します。SMB プロトコルは、ファイル共有、共有プリンターなど、サーバーのリソースにアクセスするのに使用されます。また、Samba は、Microsoft Windows が使用する分散コンピューティング環境のリモートプロシージャコール (DCE RPC) のプロトコルを実装します。

Samba は以下のように実行できます。

- Active Directory (AD) または NT4 ドメインメンバー

- スタンドアロンサーバー

NT4 プライマリードメインコントローラー (PDC) またはバックアップドメインコントローラー (BDC)

注記Red Hat は、NT4 ドメインに対応する Windows バージョンの既存のインストールでのみ、PDC モードおよび BDC モードをサポートします。Red Hat では、新しい Samba NT4 ドメインを設定しないことを推奨します。これは、Windows 7 および Windows Server 2008 R2 以降の Microsoft オペレーティングシステムが NT4 ドメインに対応していないためです。

Red Hat は、Samba を AD ドメインコントローラー (DC) として実行することはサポートしていません。

インストールモードとは関係なく、必要に応じてディレクトリーやプリンターを共有できます。これにより、Samba がファイルサーバーおよびプリントサーバーとして機能できるようになります。

3.1. さまざまな Samba サービスおよびモードについて

samba パッケージは複数のサービスを提供します。環境と設定するシナリオに応じて、これらのサービスが 1 つ以上必要となり、Samba をさまざまなモードで設定します。

3.1.1. Samba サービス

Samba は以下のサービスを提供します。

smbdこのサービスは、SMB プロトコルを使用してファイル共有およびプリントサービスを提供します。また、サービスは、リソースのロックと、接続ユーザーの認証を担当します。ドメインメンバーを認証するには、

smbdにwinbinddが必要です。smbsystemdサービスが起動し、smbdデーモンが停止します。smbdサービスを使用するには、sambaパッケージをインストールします。nmbdこのサービスは、NetBIOS over IPv4 プロトコルを使用してホスト名および IP 解決を提供します。名前解決に加え、

nmbdサービスで SMB ネットワークを参照して、ドメイン、作業グループ、ホスト、ファイル共有、およびプリンターを探すことができます。このため、サービスはこの情報をブロードキャストクライアントに直接報告するか、ローカルまたはマスターのブラウザーに転送します。nmbsystemdサービスは、nmbdデーモンを起動し、停止します。最近の SMB ネットワークは、クライアントおよび IP アドレスの解決に DNS を使用することに注意してください。Kerberos の場合は、稼働中の DNS 設定が必要です。

nmbdサービスを使用するには、sambaパッケージをインストールします。winbinddこのサービスは、ローカルシステムの AD または NT4 のドメインユーザーおよびグループを使用する Name Service Switch (NSS) のインターフェイスを提供します。これにより、たとえばドメインユーザーを、Samba サーバーにホストされるサービスや他のローカルサービスに認証できます。

winbindsystemdサービスは、winbinddデーモンを開始および停止します。Samba をドメインメンバーとして設定する場合は、

smbdサービスの前にwinbinddを起動する必要があります。そうしないと、ドメインユーザーおよびグループはローカルシステムで使用できなくなります。winbinddサービスを使用するには、samba-winbindパッケージをインストールします。重要Red Hat は、ドメインユーザーおよびグループをローカルシステムに提供するために、Samba を、

winbinddサービスを使用するサーバーとして実行することのみをサポートします。Windows アクセス制御リスト (ACL) のサポート、NT LAN Manager (NTLM) のフォールバックがないなど、特定の制限により、SSSD に対応しません。

3.1.2. Samba セキュリティーサービス

/etc/samba/smb.conf ファイルの [global] セクションの security パラメーターは、Samba がサービスに接続しているユーザーを認証する方法を管理します。Samba をインストールするモードに応じて、パラメーターは異なる値に設定する必要があります。

- AD ドメインメンバーに、

security = adsを設定する。 このモードでは、Samba は Kerberos を使用して AD ユーザーを認証します。

Samba をドメインメンバーとして設定する方法の詳細については、Samba を AD ドメインメンバーサーバーとして設定 を参照してください。

- スタンドアロンサーバーで、

security = userを設定する。 このモードでは、Samba がローカルデータベースを使用して接続ユーザーを認証します。

Samba をスタンドアロンサーバーとしてセットアップする方法の詳細については、スタンドアロンサーバーとしての Samba の設定 を参照してください。

- NT4 PDC または BDC に

security = userを設定する。 - Samba は、このモードでは、ユーザーをローカルまたは LDAP データベースに認証します。

- NT4 ドメインメンバーで、

security = domainを設定する。 Samba は、このモードでは、NT4 PDC または BDC にユーザーを接続する認証を行います。このモードは、AD ドメインメンバーには使用できません。

Samba をドメインメンバーとして設定する方法の詳細については、Samba を AD ドメインメンバーサーバーとして設定 を参照してください。

関連情報

-

smb.conf(5)man ページのsecurityパラメーター

3.1.3. Samba サービスおよび Samba クライアントユーティリティーが設定を読み込み、再読み込みするシナリオ

以下は、Samba サービスおよびユーティリティーによる設定の読み込み、再読み込み時について説明します。

Samba サービスは、設定を再読み込みする時:

- 3 分ごとに自動更新

-

手動要求の場合に

smbcontrol all reload-configコマンドを実行するとします。

- Samba クライアントユーティリティーは、起動時にのみ設定を読み取ります。

security などの特定のパラメーターの適用には、smb サービスの再起動が必要です。再読み込みだけでは十分ではないことに注意してください。

関連情報

-

smb.conf(5)man ページのHow configuration changes are applyセクション -

smbd(8)、nmbd(8)、およびwinbindd(8)man ページ

3.1.4. 安全な方法での Samba 設定の編集

Samba サービスは、3 分ごとに設定を自動的に再読み込みします。testparm ユーティリティーでの設定の検証前にサービスが変更を再読み込みしないように、安全な方法で Samba 設定を編集できます。

前提条件

- Samba がインストールされている。

手順

/etc/samba/smb.confファイルのコピーを作成します。# cp /etc/samba/smb.conf /etc/samba/samba.conf.copy- コピーして作成したファイルを編集し、必要な変更を加えます。

/etc/samba/samba.conf.copyファイルの設定を確認します。# testparm -s /etc/samba/samba.conf.copytestparmがエラーを報告した場合は、修正してもう一度コマンドを実行します。/etc/samba/smb.confファイルを新しい設定に上書きします。# mv /etc/samba/samba.conf.copy /etc/samba/smb.confSamba サービスが設定を自動的に再読み込みするか、手動で設定を再読み込みするまで待ちます。

# smbcontrol all reload-config

3.2. testparm ユーティリティーを使用した smb.conf ファイルの検証

testparm ユーティリティーは、/etc/samba/smb.conf ファイルの Samba 設定が正しいことを確認します。このユーティリティーは、無効なパラメーターおよび値を検出しますが、ID マッピングなどの間違った設定も検出します。testparm が問題を報告しないと、Samba サービスは /etc/samba/smb.conf ファイルを正常に読み込みます。testparm は、設定されたサービスが利用可能であること、または期待通りに機能するかを確認できないことに注意してください。

Red Hat では、このファイルの変更後に毎回 testparm を使用して、/etc/samba/smb.conf ファイルを検証することが推奨されます。

前提条件

- Samba をインストールしている。

-

/etc/samba/smb.confファイルが存在する。

手順

rootユーザーでtestparmユーティリティーを実行します。# testparm Load smb config files from /etc/samba/smb.conf rlimit_max: increasing rlimit_max (1024) to minimum Windows limit (16384) Unknown parameter encountered: "log levell" Processing section "[example_share]" Loaded services file OK. ERROR: The idmap range for the domain * (tdb) overlaps with the range of DOMAIN (ad)! Server role: ROLE_DOMAIN_MEMBER Press enter to see a dump of your service definitions # Global parameters [global] ... [example_share] ...

上記の出力例では、存在しないパラメーターと間違った ID マッピングの設定が報告されます。

-

testparmが設定内の間違ったパラメーター、値、またはその他のエラーを報告する場合は、問題を修正してから再度ユーティリティーを実行してください。

3.3. Samba をスタンドアロンサーバーとして設定

Samba は、ドメインのメンバーではないサーバーとして設定できます。このインストールモードでは、Samba はユーザーを中央 DC ではなくローカルデータベースに認証します。また、ゲストアクセスを有効にして、ユーザーが、認証なしで 1 つまたは複数のサービスに接続できるようにすることもできます。

3.3.1. スタンドアロンサーバーのサーバー設定の設定

Samba スタンドアロンサーバーのサーバー設定を設定できます。

手順

sambaパッケージをインストールします。# yum install samba/etc/samba/smb.confファイルを編集して、以下のパラメーターを設定します。[global] workgroup = Example-WG netbios name = Server security = user log file = /var/log/samba/%m.log log level = 1

この設定では、

Example-WGワークグループに、スタンドアロンサーバー (Server) を定義します。また、この設定により最小レベル (1) でのログ記録が可能になり、ログファイルは/var/log/samba/ディレクトリーに保存されます。Samba は、log fileパラメーターの%mマクロを、接続しているクライアントの NetBIOS 名までデプロイメントします。これにより、クライアントごとに個別のログファイルが有効になります。オプションで、ファイルまたはプリンターの共有を設定します。参照:

/etc/samba/smb.confファイルを検証します。# testparm認証が必要な共有を設定する場合は、ユーザーアカウントを作成します。

詳細は ローカルユーザーアカウントの作成および有効化 を参照してください。

firewall-cmdユーティリティーを使用して必要なポートを開き、ファイアウォール設定を再読み込みします。# firewall-cmd --permanent --add-service=samba # firewall-cmd --reload

smbサービスを有効にして起動します。# systemctl enable --now smb

関連情報

-

smb.conf(5)man ページ

3.3.2. ローカルユーザーアカウントの作成および有効化

共有への接続時にユーザーが認証を行えるようにするには、オペレーティングシステムと Samba データベースの両方で Samba ホストにアカウントを作成する必要があります。Samba では、ファイルシステムオブジェクトでアクセス制御リスト (ACL) を検証するオペレーティングシステムアカウントと、接続ユーザーの認証を行う Samba アカウントが必要です。

passdb backend = tdbsam のデフォルト設定を使用すると、Samba はユーザーアカウントを /var/lib/samba/private/passdb.tdb データベースに保存します。

example という名前のローカル Samba ユーザーを作成できます。

前提条件

- Samba が、スタンドアロンサーバーとしてインストールされている。

手順

オペレーティングシステムアカウントを作成します。

# useradd -M -s /sbin/nologin exampleこのコマンドは、ホームディレクトリーを作成せずに、

exampleアカウントを追加します。アカウントが Samba への認証のみに使用される場合は、/sbin/nologinコマンドをシェルとして割り当て、アカウントがローカルでログインしないようにします。オペレーティングシステムのアカウントにパスワードを設定して、これを有効にします。

# passwd example Enter new UNIX password:

passwordRetype new UNIX password:passwordpasswd: password updated successfullySamba は、オペレーティングシステムのアカウントに設定されたパスワードを使用して認証を行いません。ただし、アカウントを有効にするには、パスワードを設定する必要があります。アカウントが無効になると、そのユーザーが接続した時に Samba がアクセスを拒否します。

Samba データベースにユーザーを追加し、そのアカウントにパスワードを設定します。

# smbpasswd -a example New SMB password:

passwordRetype new SMB password:passwordAdded user example.このアカウントを使用して Samba 共有に接続する場合に、このパスワードを使用して認証を行います。

Samba アカウントを有効にします。

# smbpasswd -e example Enabled user example.

3.4. Samba ID マッピングの理解および設定

Windows ドメインは、ユーザーおよびグループを一意のセキュリティー識別子 (SID) で区別します。ただし、Linux では、ユーザーおよびグループごとに一意の UID と GID が必要です。Samba をドメインメンバーとして実行する場合は、winbindd サービスが、ドメインユーザーおよびグループに関する情報をオペレーティングシステムに提供します。

winbindd サービスが、ユーザーおよびグループの一意の ID を Linux に提供するようにするには、/etc/samba/smb.conf ファイルで ID マッピングを設定する必要があります。

- ローカルデータベース (デフォルトドメイン)

- Samba サーバーがメンバーになっている AD または NT4 のドメイン

- ユーザーがこの Samba サーバーのリソースにアクセスする必要のある信頼ドメイン

Samba は、特定の設定に対して異なる ID マッピングバックエンドを提供します。最も頻繁に使用されるバックエンドは、以下の通りです。

| バックエンド | ユースケース |

|---|---|

|

|

|

|

| AD ドメインのみ |

|

| AD ドメインおよび NT4 ドメイン |

|

|

AD、NT4、および |

3.4.1. Samba ID 範囲の計画

Linux の UID および GID を AD に保存するか、Samba がそれを生成するように設定するかに関係なく、各ドメイン設定には、他のドメインと重複しない一意の ID 範囲が必要です。

重複する ID 範囲を設定すると、Samba が正常に機能しなくなります。

例3.1 一意の ID 範囲

以下は、デフォルト (*)、AD-DOM、および TRUST-DOM のドメインの非オーバーランディングの ID マッピング範囲を示しています。

[global] ... idmap config * : backend = tdb idmap config * : range = 10000-999999 idmap config AD-DOM:backend = rid idmap config AD-DOM:range = 2000000-2999999 idmap config TRUST-DOM:backend = rid idmap config TRUST-DOM:range = 4000000-4999999

1 つのドメインに割り当てられるのは 1 つの範囲だけです。したがって、ドメイン範囲間で十分な容量を残しておきます。これにより、ドメインが拡大した場合に、後で範囲を拡張できます。

後で別の範囲をドメインに割り当てると、このユーザーおよびグループが作成したファイルおよびディレクトリーの所有権が失われます。

3.4.2. * デフォルトドメイン

ドメイン環境では、以下の各 ID マッピング設定を追加します。

- Samba サーバーがメンバーとなっているドメイン

- Samba サーバーにアクセスできる信頼された各ドメイン

ただし、Samba が、その他のすべてのオブジェクトに、デフォルトドメインから ID を割り当てます。これには以下が含まれます。

- ローカルの Samba ユーザーおよびグループ

-

Samba の組み込みアカウントおよびグループ (

BUILTIN\Administratorsなど)

Samba が正常に機能できるようにするには、説明に従ってデフォルトのドメインを設定する必要があります。

割り当てられた ID を永続的に格納するには、デフォルトのドメインバックエンドを書き込み可能にする必要があります。

デフォルトドメインには、以下のいずれかのバックエンドを使用できます。

tdbデフォルトのドメインを、

tdbバックエンドを使用するように設定する場合は、ID 範囲を設定します。この ID 範囲には、将来作成されるオブジェクトや、定義されたドメイン ID マッピング設定には含まれないオブジェクトを追加できます。たとえば、

/etc/samba/smb.confファイルの[global]セクションで以下を設定します。idmap config * : backend = tdb idmap config * : range = 10000-999999

詳細は、TDB ID マッピングバックエンドの使用 を参照してください。

autoridautoridバックエンドを使用するように、デフォルトのドメインを設定する場合、ドメイン用の ID マッピング設定を追加するかどうかは任意になります。たとえば、

/etc/samba/smb.confファイルの[global]セクションで以下を設定します。idmap config * : backend = autorid idmap config * : range = 10000-999999

詳細は、autorid ID マッピングバックエンドの使用 を参照してください。

3.4.3. tdb ID マッピングバックエンドの使用

winbindd サービスは、デフォルトで書き込み可能な tdb ID マッピングバックエンドを使用して、セキュリティー識別子 (SID)、UID、および GID のマッピングテーブルを格納します。これには、ローカルユーザー、グループ、組み込みプリンシパルが含まれます。

このバックエンドは、* デフォルトドメインにのみ使用してください。以下に例を示します。

idmap config * : backend = tdb idmap config * : range = 10000-999999

関連情報

3.4.4. ad ID マッピングバックエンドの使用

ad ID マッピングバックエンドを使用するように Samba AD メンバーを設定できます。

ad ID マッピングバックエンドは、読み取り専用 API を実装し、AD からアカウントおよびグループの情報を読み取ります。これには、以下の利点があります。

- ユーザーとグループの全設定は、AD に集中的に保存されます。

- ユーザーおよびグループの ID は、このバックエンドを使用するすべての Samba サーバーで一貫しています。

- ID は、破損する可能性のあるローカルデータベースには保存されないため、ファイルの所有権は失われません。

ad ID マッピングバックエンドは、一方向の信頼を使用する Active Directory ドメインに対応していません。一方向の信頼で Active Directory のドメインメンバーを設定する場合は、tdb、 rid、または autorid のいずれかの ID マッピングバックエンドを使用します。

ad バックエンドは、AD から以下の属性を読み込みます。

| AD 属性名 | オブジェクトの種類 | マッピング先 |

|---|---|---|

|

| ユーザーおよびグループ | オブジェクトのユーザー名またはグループ名 |

|

| ユーザー | ユーザー ID (UID) |

|

| グループ | グループ ID (GID) |

|

| ユーザー | ユーザーのシェルのパス |

|

| ユーザー | ユーザーのホームディレクトリーのパス |

|

| ユーザー | プライマリーグループ ID |

[a]

idmap config DOMAIN:unix_nss_info = yes を設定している場合に限り、Samba がこの属性を読み込みます。

[b]

idmap config DOMAIN:unix_primary_group = yes を設定している場合に限り、Samba がこの属性を読み込みます。

| ||

前提条件

-

ユーザーおよびグループはいずれも、AD で一意の ID が設定され、ID が、

/etc/samba/smb.confファイルで設定されている範囲内にある。ID が範囲外にあるオブジェクトは、Samba サーバーでは利用できません。 - ユーザーおよびグループには、AD ですべての必須属性が設定されている。必要な属性がないと、ユーザーまたはグループは Samba サーバーで使用できなくなります。必要な属性は、設定によって異なります。前提条件:

- Samba をインストールしている。

-

ID マッピングを除く Samba 設定が

/etc/samba/smb.confファイルにある。

手順

/etc/samba/smb.confファイルの[global]セクションを編集します。デフォルトドメイン (

*) に ID マッピング設定が存在しない場合は追加します。以下に例を示します。idmap config * : backend = tdb idmap config * : range = 10000-999999AD ドメインの

adID マッピングバックエンドを有効にします。idmap config DOMAIN : backend = adAD ドメインのユーザーおよびグループに割り当てられている ID の範囲を設定します。以下に例を示します。

idmap config DOMAIN : range = 2000000-2999999

重要この範囲は、このサーバーの他のドメイン設定と重複させることはできません。また、この範囲には、今後割り当てられる ID がすべて収まる大きさを設定する必要があります。詳細は、Samba ID 範囲の計画 を参照してください。

Samba が AD から属性を読み取る際に RFC 2307 スキーマを使用するように設定します。

idmap config DOMAIN : schema_mode = rfc2307Samba が、対応する AD 属性からログインシェルおよびユーザーホームディレクトリーのパスを読み取るようにする場合は、以下を設定します。

idmap config DOMAIN : unix_nss_info = yesまたは、すべてのユーザーに適用される、ドメイン全体のホームディレクトリーのパスおよびログインシェルを統一して設定できます。以下に例を示します。

template shell = /bin/bash template homedir = /home/%U

デフォルトでは、Samba は、ユーザーオブジェクトの

primaryGroupID属性を、Linux のユーザーのプライマリーグループとして使用します。または、代わりにgidNumber属性に設定されている値を使用するように Samba を設定できます。idmap config DOMAIN : unix_primary_group = yes

/etc/samba/smb.confファイルを検証します。# testparmSamba 設定を再読み込みします。

# smbcontrol all reload-config

関連情報

- * デフォルトドメイン

-

smb.conf(5)およびidmap_ad(8)man ページ -

smb.conf(5)man ページのVARIABLE SUBSTITUTIONSセクション

3.4.5. rid ID マッピングバックエンドの使用

rid ID マッピングバックエンドを使用するように Samba ドメインメンバーを設定できます。

Samba は、Windows SID の相対識別子 (RID) を使用して、Red Hat Enterprise Linux で ID を生成できます。

RID は、SID の最後の部分です。たとえば、ユーザーの SID が S-1-5-21-5421822485-1151247151-421485315-30014 の場合、対応する RID は 30014 になります。

rid ID マッピングバックエンドは、AD ドメインおよび NT4 ドメインのアルゴリズムマッピングスキームに基づいてアカウントおよびグループの情報を計算する読み取り専用 API を実装します。バックエンドを設定する場合は、idmap config DOMAIN : range パラメーターで、RID の最小値および最大値を設定する必要があります。Samba は、このパラメーターで設定される RID の最小値および最大値を超えるユーザーまたはグループをマッピングしません。

読み取り専用のバックエンドとして、rid は、BUILTIN グループなど、新しい ID を割り当てることができません。したがって、* デフォルトドメインにはこのバックエンドを使用しないでください。

rid バックエンドを使用した利点

- 設定された範囲内の RID があるドメインユーザーとグループはすべて、自動的にドメインメンバーで利用可能になります。

- ID、ホームディレクトリー、およびログインシェルを手動で割り当てる必要はありません。

rid バックエンドを使用した場合の短所

- すべてのドメインユーザーは、割り当てられた同じログインシェルとホームディレクトリーを取得します。ただし、変数を使用できます。

-

同じ ID 範囲設定で

ridバックエンドを使用している Samba ドメインメンバーでは、ユーザー ID とグループ ID が同じになります。 - ドメインメンバーで個々のユーザーまたはグループを除外して、利用できないようにすることはできません。設定されている範囲外にあるユーザーとグループのみが除外されます。

-

異なるドメインのオブジェクトの RID が同じ場合は、

winbinddサービスが ID の計算に使用する式に基づき、複数ドメインの環境で重複する ID が発生する場合があります。

前提条件

- Samba をインストールしている。

-

ID マッピングを除く Samba 設定が

/etc/samba/smb.confファイルにある。

手順

/etc/samba/smb.confファイルの[global]セクションを編集します。デフォルトドメイン (

*) に ID マッピング設定が存在しない場合は追加します。以下に例を示します。idmap config * : backend = tdb idmap config * : range = 10000-999999ドメインの

ridID マッピングバックエンドを有効にします。idmap config DOMAIN : backend = rid今後割り当てられるすべての RID が収まる大きさの範囲を設定します。以下に例を示します。

idmap config DOMAIN : range = 2000000-2999999

Samba は、そのドメインの RID がその範囲内にないユーザーおよびグループを無視します。

重要この範囲は、このサーバーの他のドメイン設定と重複させることはできません。また、この範囲には、今後割り当てられる ID がすべて収まる大きさを設定する必要があります。詳細は、Samba ID 範囲の計画 を参照してください。

すべてのマッピングユーザーに割り当てられるシェルおよびホームディレクトリーのパスを設定します。以下に例を示します。

template shell = /bin/bash template homedir = /home/%U

/etc/samba/smb.confファイルを検証します。# testparmSamba 設定を再読み込みします。

# smbcontrol all reload-config

関連情報

- * デフォルトドメイン

-

smb.conf(5)man ページのVARIABLE SUBSTITUTIONSセクション -

RID からのローカル ID の計算については、

idmap_rid(8)man ページを参照してください。

3.4.6. autorid ID マッピングバックエンドの使用

autorid ID マッピングバックエンドを使用するように Samba ドメインメンバーを設定できます。

autorid バックエンドは、rid ID マッピングバックエンドと同様の動作をしますが、異なるドメインに対して自動的に ID を割り当てることができます。これにより、以下の状況で autorid バックエンドを使用できます。

-

*デフォルトドメインのみ -

*デフォルトドメインと追加のドメインでは、追加のドメインごとに ID マッピング設定を作成する必要はありません。 - 特定のドメインのみ

デフォルトドメインに autorid を使用する場合は、ドメイン用の ID マッピング設定を追加するかどうかは任意です。

このセクションの一部は、Samba Wiki に公開されているドキュメント idmap config autorid に掲載されています。ライセンスは、CC BY 4.0 にあります。著者および貢献者は、Wiki ページの history タブを参照してください。

autorid バックエンドを使用した利点

- 設定された範囲内に計算した UID と GID があるすべてのドメインユーザーおよびグループは、ドメインメンバーで自動的に利用可能になります。

- ID、ホームディレクトリー、およびログインシェルを手動で割り当てる必要はありません。

- 複数ドメイン環境内の複数のオブジェクトが同じ RID を持つ場合でも、重複する ID はありません。

短所

- Samba ドメインメンバー間では、ユーザー ID とグループ ID は同じではありません。

- すべてのドメインユーザーは、割り当てられた同じログインシェルとホームディレクトリーを取得します。ただし、変数を使用できます。

- ドメインメンバーで個々のユーザーまたはグループを除外して、利用できないようにすることはできません。計算された UID または GID が、設定された範囲外にあるユーザーとグループのみが除外されます。

前提条件

- Samba をインストールしている。

-

ID マッピングを除く Samba 設定が

/etc/samba/smb.confファイルにある。

手順

/etc/samba/smb.confファイルの[global]セクションを編集します。*デフォルトドメインのautoridID マッピングバックエンドを有効にします。idmap config * : backend = autorid

既存および将来の全オブジェクトに ID を割り当てられる大きさの範囲を設定します。以下に例を示します。

idmap config * : range = 10000-999999Samba は、このドメインで計算した ID が範囲内にないユーザーおよびグループを無視します。

警告範囲を設定し、Samba がそれを使用して開始してからは、範囲の上限を小さくすることはできません。範囲にその他の変更を加えると、新しい ID 割り当てが発生し、ファイルの所有権が失われる可能性があります。

必要に応じて、範囲サイズを設定します。以下に例を示します。

idmap config * : rangesize = 200000Samba は、

idmap config * : rangeパラメーターに設定されている範囲からすべての ID を取得するまで、各ドメインのオブジェクトにこの数の連続 ID を割り当てます。注記rangesize を設定する場合は、適宜範囲を調整する必要があります。この範囲は rangesize の倍数である必要があります。

すべてのマッピングユーザーに割り当てられるシェルおよびホームディレクトリーのパスを設定します。以下に例を示します。

template shell = /bin/bash template homedir = /home/%U

必要に応じて、ドメイン用の ID マッピング設定を追加します。個別のドメインの設定が利用できない場合、Samba は以前に設定した

*デフォルトドメインのautoridバックエンド設定を使用して ID を計算します。重要この範囲は、このサーバーの他のドメイン設定と重複させることはできません。また、この範囲には、今後割り当てられる ID がすべて収まる大きさを設定する必要があります。詳細は、Samba ID 範囲の計画 を参照してください。

/etc/samba/smb.confファイルを検証します。# testparmSamba 設定を再読み込みします。

# smbcontrol all reload-config

関連情報

-

idmap_autorid(8)man ページのTHE MAPPING FORMULASセクション -

idmap_autorid(8)man ページのrangesizeパラメーターの説明 -

smb.conf(5)man ページのVARIABLE SUBSTITUTIONSセクション

3.5. Samba を AD ドメインメンバーサーバーとして設定

AD または NT4 のドメインを実行している場合は、Samba を使用して Red Hat Enterprise Linux サーバーをメンバーとしてドメインに追加し、以下を取得します。

- その他のドメインメンバーのドメインリソースにアクセスする

-

sshdなどのローカルサービスに対してドメインユーザーを認証する - サーバーにホストされているディレクトリーおよびプリンターを共有して、ファイルサーバーおよびプリントサーバーとして動作する

3.5.1. RHEL システムの AD ドメインへの参加

Samba Winbind は、Red Hat Enterprise Linux (RHEL) システムを Active Directory (AD) に接続するための System Security Services Daemon (SSSD) の代替手段です。realmd を使用して Samba Winbind を設定することで、RHEL システムを AD ドメインに参加させることができます。

手順

AD で Kerberos 認証に非推奨の RC4 暗号化タイプが必要な場合は、RHEL でこの暗号のサポートを有効にします。

# update-crypto-policies --set DEFAULT:AD-SUPPORT以下のパッケージをインストールします。

# yum install realmd oddjob-mkhomedir oddjob samba-winbind-clients \ samba-winbind samba-common-tools samba-winbind-krb5-locator

ドメインメンバーでディレクトリーまたはプリンターを共有するには、

sambaパッケージをインストールします。# yum install samba既存の Samba 設定ファイル

/etc/samba/smb.confをバックアップします。# mv /etc/samba/smb.conf /etc/samba/smb.conf.bakドメインに参加します。たとえば、ドメイン

ad.example.comに参加するには、以下のコマンドを実行します。# realm join --membership-software=samba --client-software=winbind ad.example.com上記のコマンドを使用すると、

realmユーティリティーが自動的に以下を実行します。-

ad.example.comドメインのメンバーシップに/etc/samba/smb.confファイルを作成します。 -

ユーザーおよびグループの検索用の

winbindモジュールを、/etc/nsswitch.confファイルに追加します。 -

/etc/pam.d/ディレクトリーの PAM (プラグ可能な認証モジュール) 設定ファイルを更新します。 -

winbindサービスを起動し、システムの起動時にサービスを起動できるようにします。

-

-

必要に応じて、

/etc/samba/smb.confファイルの別の ID マッピングバックエンド、またはカスタマイズした ID マッピングを設定します。詳細は、SambaID マッピングの理解と設定 を参照してください。 winbindサービスが稼働していることを確認します。# systemctl status winbind ... Active: active (running) since Tue 2018-11-06 19:10:40 CET; 15s ago重要Samba がドメインのユーザーおよびグループの情報をクエリーできるようにするには、

smbを起動する前にwinbindサービスを実行する必要があります。sambaパッケージをインストールしてディレクトリーおよびプリンターを共有している場合は、smbサービスを有効化して開始します。# systemctl enable --now smb-

必要に応じて、Active Directory へのローカルログインを認証する場合は、

winbind_krb5_localauthプラグインを有効にします。MIT Kerberos 用のローカル承認プラグインの使用

検証手順

AD ドメインの AD 管理者アカウントなど、AD ユーザーの詳細を表示します。

# getent passwd "AD\administrator" AD\administrator:*:10000:10000::/home/administrator@AD:/bin/bashAD ドメイン内のドメインユーザーグループのメンバーをクエリーします。

# getent group "AD\Domain Users" AD\domain users:x:10000:user1,user2オプションで、ファイルやディレクトリーに権限を設定する際に、ドメインのユーザーおよびグループを使用できることを確認します。たとえば、

/srv/samba/example.txtファイルの所有者をAD\administratorに設定し、グループをAD\Domain Usersに設定するには、以下のコマンドを実行します。# chown "AD\administrator":"AD\Domain Users" /srv/samba/example.txtKerberos 認証が期待どおりに機能することを確認します。

AD ドメインメンバーで、

administrator@AD.EXAMPLE.COMプリンシパルのチケットを取得します。# kinit administrator@AD.EXAMPLE.COMキャッシュされた Kerberos チケットを表示します。

# klist Ticket cache: KCM:0 Default principal: administrator@AD.EXAMPLE.COM Valid starting Expires Service principal 01.11.2018 10:00:00 01.11.2018 20:00:00 krbtgt/AD.EXAMPLE.COM@AD.EXAMPLE.COM renew until 08.11.2018 05:00:00

利用可能なドメインの表示:

# wbinfo --all-domains BUILTIN SAMBA-SERVER AD

関連情報

- 非推奨の RC4 暗号化を使用しない場合は、AD で AES 暗号化タイプを有効にすることができます。詳細は、

- GPO を使用した Active Directory で AES 暗号化タイプの有効化

-

realm(8)man ページ

3.5.2. MIT Kerberos 用のローカル承認プラグインの使用

winbind サービスは、Active Directory ユーザーをドメインメンバーに提供します。特定の状況では、管理者が、ドメインメンバーで実行している SSH サーバーなどのローカルサービスに対して、ドメインユーザーが認証を行えるようにします。Kerberos を使用してドメインユーザーを認証している場合は、winbind サービスを介して、winbind_krb5_localauth プラグインが Kerberos プリンシパルを Active Directory アカウントに正しくマッピングできるようにします。

たとえば、Active Directory ユーザーの sAMAccountName 属性を EXAMPLE に設定し、小文字のユーザー名でユーザーがログインしようとすると、Kerberos はユーザー名を大文字で返します。その結果、エントリーは認証の失敗に一致しません。

winbind_krb5_localauth プラグインを使用すると、アカウント名が正しくマッピングされます。これは GSSAPI 認証にのみ適用され、初期のチケット付与チケット (TGT) の取得には該当しません。

前提条件

- Samba が Active Directory のメンバーとして設定されている。

- Red Hat Enterprise Linux が、Active Directory に対してログイン試行を認証している。

-

winbindサービスが実行している。

手順

/etc/krb5.conf ファイルを編集し、以下のセクションを追加します。

[plugins]

localauth = {

module = winbind:/usr/lib64/samba/krb5/winbind_krb5_localauth.so

enable_only = winbind

}関連情報

-

winbind_krb5_localauth(8)man ページ.

3.6. IdM ドメインメンバーでの Samba の設定

Red Hat Identity Management (IdM) ドメインに参加しているホスト上で Samba をセットアップできます。IdM のユーザー、および可能であれば、信頼された Active Directory (AD) ドメインのユーザーは、Samba が提供する共有およびプリンターサービスにアクセスできます。

IdM ドメインメンバーで Samba を使用する機能は、テクノロジープレビュー機能で、特定の制限が含まれています。たとえば、IdM 信頼コントローラーは Active Directory グローバルカタログサービスをサポートしておらず、分散コンピューティング環境/リモートプロシージャコール (DCE/RPC) プロトコルを使用した IdM グループの解決をサポートしていません。結果として、AD ユーザーは、他の IdM クライアントにログインしている場合、IdM クライアントでホストされている Samba 共有とプリンターにのみアクセスできます。Windows マシンにログインしている AD ユーザーは、IdM ドメインメンバーでホストされている Samba 共有にアクセスできません。

IdM ドメインメンバーに Samba をデプロイしているお客様は、ぜひ Red Hat にフィードバックをお寄せください。

AD ドメインのユーザーが Samba によって提供される共有およびプリンターサービスにアクセスする必要がある場合は、AES 暗号化タイプが AD になっていることを確認してください。詳細は、GPO を使用した Active Directory での AES 暗号化タイプの有効化 を参照してください。

前提条件

- ホストは、クライアントとして IdM ドメインに参加している。

- IdM サーバーとクライアントの両方が RHEL 8.1 以降で実行されている必要がある。

3.6.1. Samba をドメインメンバーにインストールするための IdM ドメインの準備

IdM クライアントに Samba を設定する前に、IdM サーバーで ipa-adtrust-install ユーティリティーを使用して IdM ドメインを準備する必要があります。

ipa-adtrust-install コマンドを自動的に実行するシステムは、AD 信頼コントローラーになります。ただし、ipa-adtrust-install は、IdM サーバーで 1 回のみ実行する必要があります。

前提条件

- IdM サーバーがインストールされている。

- パッケージをインストールし、IdM サービスを再起動するには、root 権限が必要です。

手順

必要なパッケージをインストールします。

[root@ipaserver ~]# yum install ipa-server-trust-ad samba-clientIdM 管理ユーザーとして認証します。

[root@ipaserver ~]# kinit adminipa-adtrust-installユーティリティーを実行します。[root@ipaserver ~]# ipa-adtrust-install統合 DNS サーバーとともに IdM がインストールされていると、DNS サービスレコードが自動的に作成されます。

IdM が統合 DNS サーバーなしで IdM をインストールすると、

ipa-adtrust-installは、続行する前に DNS に手動で追加する必要があるサービスレコードのリストを出力します。スクリプトにより、

/etc/samba/smb.confがすでに存在し、書き換えられることが求められます。WARNING: The smb.conf already exists. Running ipa-adtrust-install will break your existing Samba configuration. Do you wish to continue? [no]:

yesこのスクリプトは、従来の Linux クライアントが信頼できるユーザーと連携できるようにする互換性プラグインである

slapi-nisプラグインを設定するように求めるプロンプトを表示します。Do you want to enable support for trusted domains in Schema Compatibility plugin? This will allow clients older than SSSD 1.9 and non-Linux clients to work with trusted users. Enable trusted domains support in slapi-nis? [no]:

yesプロンプトが表示されたら、IdM ドメインの NetBIOS 名を入力するか、Enter を押して提案された名前を使用します。

Trust is configured but no NetBIOS domain name found, setting it now. Enter the NetBIOS name for the IPA domain. Only up to 15 uppercase ASCII letters, digits and dashes are allowed. Example: EXAMPLE. NetBIOS domain name [IDM]:

SID 生成タスクを実行して、既存ユーザーに SID を作成するように求められます。

Do you want to run the ipa-sidgen task? [no]:

yesこれはリソースを集中的に使用するタスクであるため、ユーザー数が多い場合は別のタイミングで実行できます。

(必要に応じて) デフォルトでは、Windows Server 2008 以降での動的 RPC ポートの範囲は

49152-65535として定義されます。ご使用の環境に異なる動的 RPC ポート範囲を定義する必要がある場合は、Samba が異なるポートを使用するように設定し、ファイアウォール設定でそのポートを開くように設定します。以下の例では、ポート範囲を55000-65000に設定します。[root@ipaserver ~]# net conf setparm global 'rpc server dynamic port range' 55000-65000 [root@ipaserver ~]# firewall-cmd --add-port=55000-65000/tcp [root@ipaserver ~]# firewall-cmd --runtime-to-permanent

ipaサービスを再起動します。[root@ipaserver ~]# ipactl restartsmbclientユーティリティーを使用して、Samba が IdM からの Kerberos 認証に応答することを確認します。[root@ipaserver ~]#

smbclient -L server.idm.example.com -U user_name --use-kerberos=requiredlp_load_ex: changing to config backend registry Sharename Type Comment --------- ---- ------- IPC$ IPC IPC Service (Samba 4.15.2) ...

3.6.2. IdM クライアントでの Samba サーバーのインストールおよび設定

IdM ドメインに登録されたクライアントに Samba をインストールして設定できます。

前提条件

- IdM サーバーとクライアントの両方が RHEL 8.1 以降で実行されている必要がある。

- IdM ドメインは、ドメインメンバーに Samba をインストールするための IdM ドメインの準備 の説明に従って準備されます。

- IdM に AD で設定された信頼がある場合は、Kerberos の AES 暗号化タイプを有効にします。たとえば、グループポリシーオブジェクト (GPO) を使用して、AES 暗号化の種類を有効にします。詳細は、GPO を使用した Active Directory での AES 暗号化の有効化 を参照してください。

手順

ipa-client-sambaパッケージをインストールします。[root@idm_client]# yum install ipa-client-sambaipa-client-sambaユーティリティーを使用して、クライアントを準備し、初期 Samba 設定を作成します。[root@idm_client]# ipa-client-samba Searching for IPA server... IPA server: DNS discovery Chosen IPA master: idm_server.idm.example.com SMB principal to be created: cifs/idm_client.idm.example.com@IDM.EXAMPLE.COM NetBIOS name to be used: IDM_CLIENT Discovered domains to use: Domain name: idm.example.com NetBIOS name: IDM SID: S-1-5-21-525930803-952335037-206501584 ID range: 212000000 - 212199999 Domain name: ad.example.com NetBIOS name: AD SID: None ID range: 1918400000 - 1918599999 Continue to configure the system with these values? [no]: yes Samba domain member is configured. Please check configuration at /etc/samba/smb.conf and start smb and winbind services

デフォルトでは、

ipa-client-sambaは、ユーザーが接続したときにそのユーザーのホームディレクトリーを動的に共有するために、/etc/samba/smb.confファイルに[homes]セクションが自動的に追加されます。ユーザーがこのサーバーにホームディレクトリーがない場合、または共有したくない場合は、/etc/samba/smb.confから次の行を削除します。[homes] read only = noディレクトリーとプリンターを共有します。詳細は、以下を参照してください。

ローカルファイアウォールで Samba クライアントに必要なポートを開きます。

[root@idm_client]# firewall-cmd --permanent --add-service=samba-client [root@idm_client]# firewall-cmd --reload

smbサービスおよびwinbindサービスを有効にして開始します。[root@idm_client]# systemctl enable --now smb winbind

検証手順

samba-client パッケージがインストールされている別の IdM ドメインメンバーで次の検証手順を実行します。

Kerberos 認証を使用して、Samba サーバー上の共有をリスト表示します。

$

smbclient -L idm_client.idm.example.com -U user_name --use-kerberos=requiredlp_load_ex: changing to config backend registry Sharename Type Comment --------- ---- ------- example Disk IPC$ IPC IPC Service (Samba 4.15.2) ...

関連情報

-

ipa-client-samba(1)の man ページ

3.6.3. IdM が新しいドメインを信頼する場合は、ID マッピング設定を手動で追加

Samba では、ユーザーがリソースにアクセスする各ドメインの ID マッピング設定が必要です。IdM クライアントで実行している既存の Samba サーバーでは、管理者が Active Directory (AD) ドメインに新しい信頼を追加した後、ID マッピング設定を手動で追加する必要があります。

前提条件

- IdM クライアントで Samba を設定している。その後、IdM に新しい信頼が追加されている。

- Kerberos の暗号化タイプ DES および RC4 は、信頼できる AD ドメインで無効にしている。セキュリティー上の理由から、RHEL 8 はこのような弱い暗号化タイプに対応していません。

手順

ホストのキータブを使用して認証します。

[root@idm_client]# kinit -kipa idrange-findコマンドを使用して、新しいドメインのベース ID と ID 範囲のサイズの両方を表示します。たとえば、次のコマンドはad.example.comドメインの値を表示します。[root@idm_client]# ipa idrange-find --name="AD.EXAMPLE.COM_id_range" --raw --------------- 1 range matched --------------- cn: AD.EXAMPLE.COM_id_range ipabaseid: 1918400000 ipaidrangesize: 200000 ipabaserid: 0 ipanttrusteddomainsid: S-1-5-21-968346183-862388825-1738313271 iparangetype: ipa-ad-trust ---------------------------- Number of entries returned 1 ----------------------------

次の手順で、

ipabaseid属性およびipaidrangesize属性の値が必要です。使用可能な最高の ID を計算するには、次の式を使用します。

maximum_range = ipabaseid + ipaidrangesize - 1

前の手順の値を使用すると、

ad.example.comドメインで使用可能な最大 ID は1918599999(1918400000 + 200000 - 1) です。/etc/samba/smb.confファイルを編集し、ドメインの ID マッピング設定を[global]セクションに追加します。idmap config AD : range = 1918400000 - 1918599999 idmap config AD : backend = sss

ipabaseid属性の値を最小値として指定し、前の手順で計算された値を範囲の最大値として指定します。smbサービスおよびwinbindサービスを再起動します。[root@idm_client]# systemctl restart smb winbind

検証手順

Kerberos 認証を使用して、Samba サーバー上の共有をリスト表示します。

$

smbclient -L idm_client.idm.example.com -U user_name --use-kerberos=requiredlp_load_ex: changing to config backend registry Sharename Type Comment --------- ---- ------- example Disk IPC$ IPC IPC Service (Samba 4.15.2) ...

3.6.4. 関連情報

3.7. POSIX ACL を使用した Samba ファイル共有の設定

Samba は、Linux サービスとして、POSIX ACL との共有に対応します。chmod などのユーティリティーを使用して、Samba サーバーの権限をローカルに管理できます。拡張属性に対応するファイルシステムに共有が保存されている場合は、複数のユーザーおよびグループで ACL を定義できます。

代わりにきめ細かい Windows ACL を使用する必要がある場合は、Windows ACL を使用する共有の設定 を参照してください。

このセクションの一部は、Samba Wiki に公開されているドキュメント Setting up a Share Using POSIX ACLs に掲載されています。ライセンスは、CC BY 4.0 にあります。著者および貢献者は、Wiki ページの history タブを参照してください。

3.7.1. POSIX ACL を使用する共有の追加

/srv/samba/example/ ディレクトリーのコンテンツを提供し、POSIX ACL を使用する example という名前の共有を作成できます。

前提条件

Samba が、以下のいずれかのモードで設定されている。

手順

ディレクトリーが存在しない場合は作成します。以下に例を示します。

# mkdir -p /srv/samba/example/SELinux を、

enforcingモードで実行する場合は、そのディレクトリーにsamba_share_tコンテキストを設定します。# semanage fcontext -a -t samba_share_t "/srv/samba/example(/.*)?" # restorecon -Rv /srv/samba/example/

ディレクトリーにファイルシステムの ACL を設定します。詳細は、以下を参照してください。

/etc/samba/smb.confファイルにサンプル共有を追加します。たとえば、共有の write-enabled を追加するには、次のコマンドを実行します。[example] path = /srv/samba/example/ read only = no

注記ファイルシステムの ACL に関係なく、

read only = noを設定しないと、Samba がディレクトリーを読み取り専用モードで共有します。/etc/samba/smb.confファイルを検証します。# testparmfirewall-cmdユーティリティーを使用して必要なポートを開き、ファイアウォール設定を再読み込みします。# firewall-cmd --permanent --add-service=samba # firewall-cmd --reload

smbサービスを再起動します。# systemctl restart smb

3.7.2. POSIX ACL を使用する Samba 共有での標準的な Linux ACL の設定

Linux の標準 ACL は、所有者、グループ、その他の未定義ユーザーの権限の設定に対応します。ユーティリティーの chown、chgrp、および chmod を使用して ACL を更新できます。正確な制御が必要な場合は、より複雑な POSIX ACL を使用します。以下を参照してください。

Setting extended ACLs on a Samba share that uses POSIX ACLs.

以下の手順では、/srv/samba/example/ ディレクトリーの所有者を root ユーザーに設定し、Domain Users グループに読み取りおよび書き込みの権限を付与して、他のすべてのユーザーのアクセスを拒否します。

前提条件

- ACL を設定する Samba 共有がある。

手順

# chown root:"Domain Users" /srv/samba/example/ # chmod 2770 /srv/samba/example/

ディレクトリーで set-group-ID (SGID) ビットを有効にすると、新しいディレクトリーエントリーを作成したユーザーのプライマリーグループに設定する通常の動作の代わりに、すべての新しいファイルとサブディレクトリーのデフォルトグループが、そのディレクトリーグループのデフォルトグループに自動的に設定されます。

関連情報

-

chown(1)およびchmod(1)の man ページ

3.7.3. POSIX ACL を使用する Samba 共有での拡張 ACL の設定

共有ディレクトリーが保存されているファイルシステムが拡張 ACL に対応している場合は、それを使用して複雑な権限を設定できます。拡張 ACL には、複数のユーザーおよびグループの権限を指定できます。

拡張 POSIX ACL を使用すると、複数のユーザーおよびグループで複雑な ACL を設定できます。ただし、設定できるのは以下の権限のみです。

- アクセスなし

- 読み取りアクセス

- 書き込みアクセス

- 完全な制御

フォルダーの作成やデータの追加 など、詳細な Windows 権限が必要な場合は、Windows ACL を使用するように共有を設定します。Windows ACL で共有の設定

以下の手順では、共有で拡張 ACL を有効にする方法を説明します。また、拡張 ACL の設定例も含まれています。

前提条件

- ACL を設定する Samba 共有がある。

手順

/etc/samba/smb.confファイルの共有セクションで以下のパラメーターを有効にして、拡張 ACL の ACL 継承を有効にします。inherit acls = yes

詳細は、man ページの

smb.conf(5)のパラメーターの説明を参照してください。smbサービスを再起動します。# systemctl restart smbディレクトリーの ACL を設定します。以下に例を示します。

例3.2 拡張 ACL の設定

以下の手順は、

/srv/samba/example/ディレクトリーに対して、Domain Adminsグループに読み取り、書き込み、および実行の権限、Domain Usersグループに対する読み取りおよび実行の権限を設定し、その他の全員のアクセスを拒否します。ユーザーアカウントのプライマリーグループへの自動許可権限を無効にします。

# setfacl -m group::--- /srv/samba/example/ # setfacl -m default:group::--- /srv/samba/example/

ディレクトリーのプライマリーグループは、さらに動的な

CREATOR GROUPプリンシパルにマッピングされます。Samba 共有で拡張 POSIX ACL を使用すると、このプリンシパルは自動的に追加され、削除できません。ディレクトリーに権限を設定します。

Domain Adminsグループに読み取り、書き込み、および実行の権限を付与します。# setfacl -m group:"DOMAIN\Domain Admins":rwx /srv/samba/example/Domain Usersグループに読み取りおよび実行の権限を付与します。# setfacl -m group:"DOMAIN\Domain Users":r-x /srv/samba/example/その他の ACL エントリーに権限を設定し、その他の ACL エントリーに一致しないユーザーへのアクセスを拒否します。# setfacl -R -m other::--- /srv/samba/example/

この設定は、このディレクトリーにのみ適用されます。Windows では、これらの ACL は

このフォルダーのみのモードにマッピングされます。前の手順で設定した権限を、このディレクトリーに作成した新規ファイルシステムのオブジェクトから継承できるようにするには、以下のコマンドを実行します。

# setfacl -m default:group:"DOMAIN\Domain Admins":rwx /srv/samba/example/ # setfacl -m default:group:"DOMAIN\Domain Users":r-x /srv/samba/example/ # setfacl -m default:other::--- /srv/samba/example/

この設定では、プリンシパルの

このフォルダーのみモードが、このフォルダー、サブフォルダー、およびファイルに設定されます。

Samba は、手順に設定されている権限を、以下の Windows ACL にマッピングします。

プリンシパル アクセス 適用先 Domain\Domain Admins

完全な制御

このフォルダー、サブフォルダー、およびファイル

Domain\Domain Users

読み取りおよび実行

このフォルダー、サブフォルダー、およびファイル

Everyone[a]なし

このフォルダー、サブフォルダー、およびファイル

owner (Unix User\owner) [b]

完全な制御

このフォルダーのみ

primary_group (Unix User\primary_group) [c]

なし

このフォルダーのみ

完全な制御

サブフォルダーおよびファイルのみ

なし

サブフォルダーおよびファイルのみ

[a] Samba は、このプリンシパルの権限をその他の ACL エントリーからマッピングします。[b] Samba は、ディレクトリーの所有者をこのエントリーにマッピングします。[c] Samba は、ディレクトリーのプライマリーグループをこのエントリーにマッピングします。[d] 新規ファイルシステムオブジェクトでは、作成者はこのプリンシパルの権限を自動的に継承します。[e] POSIX ACL を使用する共有では、このプリンシパルの設定または削除には対応していません。[f] 新規ファイルシステムオブジェクトの場合、作成者のプライマリーグループは、自動的にこのプリンシパルの権限を継承します。

3.8. POSIX ACL を使用する共有への権限の設定

必要に応じて、Samba 共有へのアクセスを制限または許可するには、/etc/samba/smb.conf ファイルの共有のセクションに特定のパラメーターを設定します。

共有ベースの権限は、ユーザー、グループ、またはホストが共有にアクセスできるかどうかを管理します。この設定は、ファイルシステムの ACL には影響しません。

共有ベースの設定を使用して共有へのアクセスを制限します。たとえば、特定のホストからのアクセスを拒否します。

前提条件

- POSIX ACL との共有が設定されている。

3.8.1. ユーザーおよびグループに基づいた共有アクセスの設定

ユーザーおよびグループに基づいたアクセス制御により、特定のユーザーおよびグループの共有へのアクセスを許可または拒否できます。

前提条件

- ユーザーまたはグループベースのアクセスを設定する Samba 共有がある。

手順

たとえば、

Domain Usersグループの全メンバーが、ユーザーアカウントのアクセスが拒否されている時に共有にアクセスできるようにするには、共有の設定に以下のパラメーターを追加します。valid users = +DOMAIN\"Domain Users" invalid users = DOMAIN\user

無効なユーザーパラメーターの優先度は、有効なユーザーパラメーターよりも高くなります。たとえば、ユーザーアカウントがDomain Usersグループのメンバーである場合に上述の例を使用すると、このアカウントへのアクセスは拒否されます。Samba 設定を再読み込みします。

# smbcontrol all reload-config

関連情報

-

smb.conf(5)man ページ

3.8.2. ホストベースの共有アクセスの設定

ホストベースのアクセス制御により、クライアントのホスト名、IP アドレス、または IP 範囲に基づいて、共有へのアクセスを許可または拒否できます。

以下の手順では、IP アドレスの 127.0.0.1、IP 範囲の 192.0.2.0/24、およびホストの client1.example.com を有効にして共有にアクセスする方法と、client2.example.com ホストへのアクセスを拒否する方法を説明します。

前提条件

- ホストベースのアクセスを設定する Samba 共有がある。

手順

以下のパラメーターを、

/etc/samba/smb.confファイルの共有の設定に追加します。hosts allow = 127.0.0.1 192.0.2.0/24 client1.example.com hosts deny = client2.example.com

hosts denyパラメーターは、hosts allowよりも優先順位が高くなります。たとえば、client1.example.comがhosts allowパラメーターにリスト表示されている IP アドレスに解決すると、このホストへのアクセスは拒否されます。Samba 設定を再読み込みします。

# smbcontrol all reload-config

関連情報

-

smb.conf(5)man ページ

3.9. Windows ACL で共有の設定

Samba は、共有およびファイルシステムオブジェクトへの Windows ACL の設定に対応します。これを使用すると、以下が可能になります。

- きめ細かな Windows ACL を使用する

- Windows を使用して共有権限およびファイルシステムの ACL を管理する

または、POSIX ACL を使用するように共有を設定することもできます。詳細は、POSIX ACL を使用する Samba ファイル共有の設定 を参照してください。

このセクションの一部は、Samba Wiki に公開されているドキュメント Setting up a Share Using Windows ACLs に掲載されています。ライセンスは、CC BY 4.0 にあります。著者および貢献者は、Wiki ページの history タブを参照してください。

3.9.1. SeDiskPrivilege 特権の付与

Windows ACL を使用する共有に対する権限を設定できるのは、SeDiskOperatorPrivilege 特権が付与されているユーザーおよびグループのみです。

手順

たとえば、

SeDiskOperatorPrivilege特権をDOMAIN\Domain Adminsグループに付与するには、以下のコマンドを実行します。# net rpc rights grant "DOMAIN\Domain Admins" SeDiskOperatorPrivilege -U "DOMAIN\administrator" Enter DOMAIN\administrator's password: Successfully granted rights.

注記ドメイン環境では、

SeDiskOperatorPrivilegeをドメイングループに付与します。これにより、ユーザーのグループメンバーシップを更新し、権限を集中的に管理できます。SeDiskOperatorPrivilegeが付与されているすべてのユーザーおよびグループをリスト表示するには、以下のコマンドを実行します。# net rpc rights list privileges SeDiskOperatorPrivilege -U "DOMAIN\administrator" Enter administrator's password: SeDiskOperatorPrivilege: BUILTIN\Administrators DOMAIN\Domain Admins

3.9.2. Windows ACL サポートの有効化

Windows ACL に対応する共有を設定するには、Samba でこの機能を有効にする必要があります。

前提条件

- ユーザー共有が Samba サーバーに設定されている。

手順

すべての共有に対してグローバルに有効にするには、次の設定を

/etc/samba/smb.confファイルの[global]セクションに追加します。vfs objects = acl_xattr map acl inherit = yes store dos attributes = yes

または、共有のセクションに同じパラメーターを追加して、個別の共有に対して Windows ACL サポートを有効にできます。

smbサービスを再起動します。# systemctl restart smb

3.9.3. Windows ACL を使用する共有の追加

/srv/samba/example/ ディレクトリーのコンテンツを共有し、Windows ACL を使用する example という名前の共有を作成できます。

手順

ディレクトリーが存在しない場合は作成します。以下に例を示します。

# mkdir -p /srv/samba/example/SELinux を、

enforcingモードで実行する場合は、そのディレクトリーにsamba_share_tコンテキストを設定します。# semanage fcontext -a -t samba_share_t "/srv/samba/example(/.)?"* # restorecon -Rv /srv/samba/example/

/etc/samba/smb.confファイルにサンプル共有を追加します。たとえば、共有の write-enabled を追加するには、次のコマンドを実行します。[example] path = /srv/samba/example/ read only = no

注記ファイルシステムの ACL に関係なく、

read only = noを設定しないと、Samba がディレクトリーを読み取り専用モードで共有します。すべての共有の

[global]セクションで Windows ACL サポートを有効にしていない場合は、以下のパラメーターを[example]セクションに追加して、この共有に対してこの機能を有効にします。vfs objects = acl_xattr map acl inherit = yes store dos attributes = yes

/etc/samba/smb.confファイルを検証します。# testparmfirewall-cmdユーティリティーを使用して必要なポートを開き、ファイアウォール設定を再読み込みします。# firewall-cmd --permanent --add-service=samba # firewall-cmd --reload

smbサービスを再起動します。# systemctl restart smb

3.9.4. Windows ACL を使用する共有の共有権限とファイルシステム ACL の管理

Windows ACL を使用する Samba 共有で共有権限およびファイルシステムの ACL を管理するには、コンピューターの管理 などの Windows アプリケーションを使用します。詳細は、Windows のドキュメントを参照してください。または、smbcacls ユーティリティーを使用して ACL を管理します。

Windows からファイルシステムの権限を変更するには、SeDiskOperatorPrivilege 権限が付与されたアカウントを使用する必要があります。

3.10. smbcacls で SMB 共有上の ACL の管理

smbcacls ユーティリティーは、SMB 共有に保存されたファイルおよびディレクトリーの ACL をリスト表示、設定、および削除できます。smbcacls を使用して、ファイルシステムの ACL を管理できます。

- 高度な Windows ACL または POSIX ACL を使用するローカルまたはリモートの Samba サーバー

- Red Hat Enterprise Linux で、Windows でホストされる共有の ACL をリモートで管理

3.10.1. アクセス制御エントリー

ファイルシステムオブジェクトの各 ACL エントリーには、以下の形式のアクセス制御エントリー (ACE) が含まれます。

security_principal:access_right/inheritance_information/permissions

例3.3 アクセス制御エントリー

AD\Domain Users グループに、Windows 上の このフォルダー、サブフォルダー、およびファイル に適用される 変更 権限がある場合、ACL には以下の ACE が含まれます。

AD\Domain Users:ALLOWED/OI|CI/CHANGE

ACE には、以下が含まれます。

- セキュリティープリンシパル

- セキュリティープリンシパルは、ACL の権限が適用されるユーザー、グループ、または SID です。

- アクセス権

-

オブジェクトへのアクセスが許可または拒否されるかどうかを定義します。値は

ALLOWEDまたはDENIEDです。 - 継承情報

次の値を取ります。

表3.1 継承の設定

値 詳細 マップ先 OIオブジェクトの継承

このフォルダーおよびファイル

CIコンテナーの継承

このフォルダーおよびサブフォルダー

IO継承のみ

ACE は、現在のファイルまたはディレクトリーには適用されません。

ID継承済

親ディレクトリーから ACE が継承されました。

また、値は以下のように組み合わせることができます。

表3.2 継承設定の組み合わせ

値の組み合わせ Windows の 適用先設定にマップします。OI|CIこのフォルダー、サブフォルダー、およびファイル

OI|CI|IOサブフォルダーおよびファイルのみ

CI|IOサブディレクトリーのみ

OI|IOファイルのみ

- 権限

この値は、Windows の権限または

smbcaclsエイリアスを表す 16 進値になります。1 つ以上の Windows の権限を表す 16 進値。

次の表に、Windows の高度な権限とそれに対応する値を 16 進法で表示します。

表3.3 Windows の権限とそれに対応する smbcacls 値を 16 進法で設定

Windows の権限 16 進値 完全な制御

0x001F01FFフォルダーのスキャンおよびファイルの実行

0x00100020フォルダーのリスト表示 / データの読み取り

0x00100001属性の読み取り

0x00100080拡張属性の読み取り

0x00100008ファイルの作成/データの書き込み

0x00100002フォルダーの作成/データの追加

0x00100004属性の書き込み

0x00100100拡張属性の書き込み

0x00100010サブフォルダーおよびファイルの削除

0x00100040削除

0x00110000権限の読み取り

0x00120000権限の変更

0x00140000所有権の取得

0x00180000ビット単位の

OR演算を使用すると、複数の権限を 1 つの 16 進値として組み合わせることができます。詳細は、ACE マスク計算 を参照してください。smbcaclsエイリアス。以下の表には、利用可能なエイリアスが表示されます。表3.4 既存の smbcacls エイリアスとそれに対応する Windows の権限

smbcaclsエイリアスWindows の権限へのマッピング -R読み取り

READ読み取りおよび実行

W主な機能:

- ファイルの作成/データの書き込み

- フォルダーの作成/データの追加

- 属性の書き込み

- 拡張属性の書き込み

- 権限の読み取り

D削除

%P権限の変更

O所有権の取得

Xスキャン / 実行

CHANGE修正

FULL完全な制御

注記権限を設定する際に、1 文字のエイリアスを組み合わせることができます。たとえば、Windows の権限の

ReadおよびDeleteを適用するようにRDを設定できます。ただし、1 文字以外のエイリアスを複数組み合わせたり、エイリアスと 16 進値を組み合わせることはできません。

3.10.2. smbcacls を使用した ACL の表示

SMB 共有で ACL を表示するには、smbcacls ユーティリティーを使用します。--add などの操作パラメーターを付けずに smbcacls を実行すると、ユーティリティーは、ファイルシステムオブジェクトの ACL を表示します。

手順

たとえば、//server/example 共有のルートディレクトリーの ACL をリスト表示するには、以下のコマンドを実行します。

# smbcacls //server/example / -U "DOMAIN\administrator"

Enter DOMAIN\administrator's password:

REVISION:1

CONTROL:SR|PD|DI|DP

OWNER:AD\Administrators

GROUP:AD\Domain Users

ACL:AD\Administrator:ALLOWED/OI|CI/FULL

ACL:AD\Domain Users:ALLOWED/OI|CI/CHANGE

ACL:AD\Domain Guests:ALLOWED/OI|CI/0x00100021コマンドの出力は以下のようになります。

-

REVISION- セキュリティー記述子の内部 Windows NT ACL リビジョン -

CONTROL- セキュリティー記述子の制御 -

OWNER- セキュリティー記述子の所有者の名前または SID -

GROUP- セキュリティー記述子のグループの名前または SID -

ACLエントリー。詳細は、アクセス制御エントリー を参照してください。

3.10.3. ACE マスク計算

ほとんどの場合、ACE を追加または更新するときは、既存の smbcacls エイリアスとそれに対応する Windows アクセス許可に リストされている smbcacls エイリアスを使用します。

ただし、Windows の権限と それに対応する smbcacls 値を 16 進法でリストしたように高度な Windows の権限 を設定する場合は、ビット単位の OR 操作を使用して正しい値を計算する必要があります。以下のシェルコマンドを使用して値を計算できます。

# echo $(printf '0x%X' $(( hex_value_1 | hex_value_2 | ... )))例3.4 ACE マスクの計算

以下の権限を設定します。

- フォルダーのスキャン / ファイルの実行 (0x00100020)

- フォルダーのリスト表示 / データの読み取り (0x00100001)

- 属性の読み取り (0x00100080)

以前の権限の 16 進値を計算するには、以下を入力します。

# echo $(printf '0x%X' $(( 0x00100020 | 0x00100001 | 0x00100080 )))

0x1000A1ACE を設定または更新する場合は、戻り値を使用します。

3.10.4. smbcacls を使用した ACL の追加、更新、および削除

smbcacls ユーティリティーに渡すパラメーターに応じて、ファイルまたはディレクトリーから ACL を追加、更新、および削除できます。

ACL の追加

このフォルダー、サブフォルダー、およびファイル の CHANGE 権限を AD\Domain Users グループに付与する //server/example 共有のルートに ACL を追加するには、以下のコマンドを実行します。

# smbcacls //server/example / -U "DOMAIN\administrator --add ACL:"AD\Domain Users":ALLOWED/OI|CI/CHANGEACL の更新

ACL の更新は、新しい ACL の追加に似ています。ACL を更新する場合は、--modify パラメーターと既存のセキュリティープリンシパルを使用して ACL を上書きします。smbcacls が ACL リスト内でセキュリティープリンシパルを検出すると、ユーティリティーは権限を更新します。これを行わないと、以下のエラーでコマンドが失敗します。

ACL for SID principal_name not found

たとえば、AD\Domain Users グループの権限を更新し、このフォルダー、サブフォルダー、およびファイル の READ に設定するには、以下のコマンドを実行します。

# smbcacls //server/example / -U "DOMAIN\administrator --modify ACL:"AD\Domain Users":ALLOWED/OI|CI/READACL の削除

ACL を削除するには、正確な ACL を持つ --delete パラメーターを smbcacls ユーティリティーに渡します。以下に例を示します。

# smbcacls //server/example / -U "DOMAIN\administrator --delete ACL:"AD\Domain Users":ALLOWED/OI|CI/READ3.11. ユーザーが Samba サーバーのディレクトリーを共有できるようにする

Samba サーバーでは、root 権限なしでユーザーがディレクトリーを共有できるように設定できます。

3.11.1. ユーザーの共有機能の有効化

ユーザーがディレクトリーを共有できるようにするには、管理者が Samba でユーザー共有を有効にする必要があります。

たとえば、ローカルの example グループのメンバーのみがユーザー共有を作成できるようにするには、以下を実行します。

手順

ローカルの

exampleグループが存在しない場合は作成します。# groupadd exampleユーザー共有の定義を保存し、その権限を正しく設定するために、Samba 用のディレクトリーを準備します。以下に例を示します。

ディレクトリーを作成します。

# mkdir -p /var/lib/samba/usershares/exampleグループの書き込み権限を設定します。# chgrp example /var/lib/samba/usershares/ # chmod 1770 /var/lib/samba/usershares/

- このディレクトリーの他のユーザーが保存したファイルの名前変更や削除を禁止するように sticky ビットを設定します。

/etc/samba/smb.confファイルを編集し、以下を[global]セクションに追加します。ユーザー共有の定義を保存するように設定したディレクトリーのパスを設定します。以下に例を示します。

usershare path = /var/lib/samba/usershares/

このサーバーで Samba を作成できるユーザー共有の数を設定します。以下に例を示します。

usershare max shares = 100

usershare max sharesパラメーターにデフォルトの0を使用すると、ユーザー共有が無効になります。必要に応じて、ディレクトリーの絶対パスのリストを設定します。たとえば、Samba が

/dataディレクトリーおよび/srvディレクトリーのサブディレクトリーの共有のみを許可するように設定するには、以下を設定します。usershare prefix allow list = /data /srv

設定可能なユーザー共有関連のパラメーターのリストは、man ページの

smb.conf(5)のUSERSHARESセクションを参照してください。/etc/samba/smb.confファイルを検証します。# testparmSamba 設定を再読み込みします。

# smbcontrol all reload-configこれで、ユーザーが、ユーザー共有を作成できるようになりました。

3.11.2. ユーザー共有の追加

Samba でユーザー共有機能を有効にすると、ユーザーは net usershare add コマンドを実行して、root 権限なしで Samba サーバーのディレクトリーを共有できます。

net usershare add コマンドの構文:

net usershare add share_name path [[ comment ] | [ ACLs ]] [ guest_ok=y|n ]

ユーザー共有の作成時に ACL を設定する場合は、ACL の前に comment パラメーターを指定する必要があります。空のコメントを設定するには、空の文字列を二重引用符で囲みます。

管理者が、/etc/samba/smb.conf ファイルの [global] セクションで usershare allow guests = yes に設定すると、ユーザーはユーザー共有上でのみゲストアクセスを有効にできることに注意してください。

例3.5 ユーザー共有の追加

ユーザーが、Samba サーバーで /srv/samba/ ディレクトリーを共有する場合があります。共有には、example という名前を付け、コメントを設定しないようにし、ゲストユーザーがアクセスできるようにします。また、共有権限は、AD\Domain Users グループへのフルアクセスと、その他のユーザーへの読み取り権限を設定する必要があります。この共有を追加するには、そのユーザーで以下を実行します。

$ net usershare add example /srv/samba/ "" "AD\Domain Users":F,Everyone:R guest_ok=yes3.11.3. ユーザー共有の設定の更新

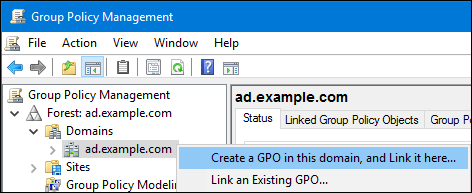

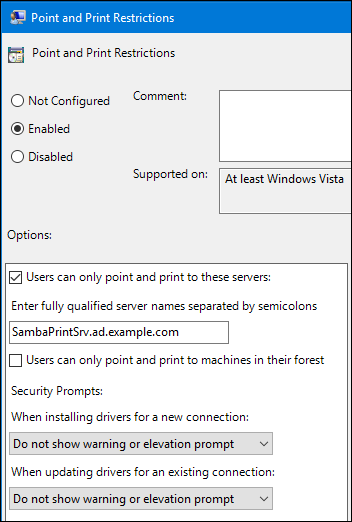

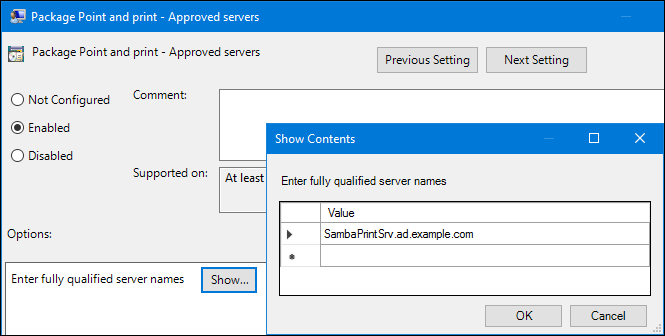

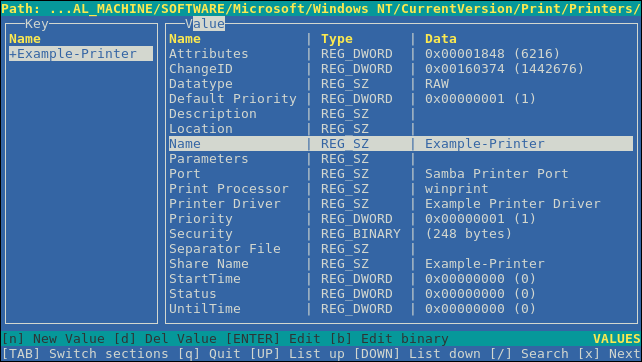

ユーザー共有の設定を更新するには、同じ共有名と新しい設定で net usershare add コマンドを使用して共有を上書きします。ユーザー共有の追加 を参照します。