Red Hat Training

A Red Hat training course is available for Red Hat Enterprise Linux

Cluster Suite の概要

Red Hat Enterprise Linux 5 対応の Red Hat Cluster Suite

エディッション 3

概要

はじめに

- 『Red Hat Enterprise Linux インストールガイド』 — Red Hat Enterprise Linux 5 のインストールに関する 情報を提供します。

- 『Red Hat Enterprise Linux 』 — Red Hat Enterprise Linux 5 の導入、設定、及び管理についての 情報を提供します。

- 『Red Hat Cluster の設定と管理』 — Red Hat Cluster コンポーネントの インストール、設定、及び管理に関する情報を提供します。

- 『LVM Administrator's Guide: Configuration and Administration』 — Provides a description of the Logical Volume Manager (LVM), including information on running LVM in a clustered environment.

- 『Global File System: 設定と管理』 — Red Hat GFS (Red Hat Global File System) のインストール、設定、及び維持に関する情報を提供します。

- 『Global File System 2 : 設定と管理』 — Red Hat GFS2 (Red Hat Global File System 2) のインストール、設定、維持に関する情報を提供します。

- 『デバイスマッパーマルチパスの使用法』 — Red Hat Enterprise Linux 5 に於ける デバイスマッパーマルチパス機能の使用についての情報を提供します。

- 『Global File System を持つ GNBD の使用法』 — Red Hat GFS を 持つ GNBD (Global Network Block Device)の使用法に関する概要を提供します。

- 『Linux 仮想サーバー管理』 — LVS (Linux Virtual Server)での 高度パフォーマンスシステムとサービスの設定に関する情報を提供します。

- 『Red Hat Cluster Suite リリースノート』 — Red Hat クラスタセット の 現在のリリースノートに関する情報を提供します。

1. フィードバック

Cluster_Suite_Overview(EN)-5 (2008-12-11T15:49)

第1章 Red Hat Cluster Suite 概要

1.1. クラスタの基礎

- ストレージ

- ハイアベイラビリティ(高度可用性)

- ロードバランシング

- ハイパフォーマンス

注記

1.2. Red Hat Cluster Suite Introduction

- クラスタインフラストラクチャ — クラスタとして一緒に動作するように ノード群に基本的な機能:設定ファイル管理、メンバーシップ管理、ロック管理、及び フェンシングを提供します。

- ハイアベイラビリティサービス管理 — 1つのノードが操作不能になった場合に そのクラスタノードから別のクラスタノードにサービスのフェイルオーバーを提供します。

- クラスタ管理ツール — Red Hat クラスタのセッティング、設定、及び管理の為の 設定/管理ツールです。このツールは、クラスタインフラストラクチャコンポーネント、ハイアベイラビリティとサービス管理のコンポーネント、及びストレージで使用するための物です。

- LVS (Linux Virtual Server)— IP ロードバランシングを提供する Routing ソフトウェアです。 LVS は LVS サーバー群の背後にある実サーバー(real server)に対してクライアント要求を均等に分配する 冗長サーバーのペアとして稼働します。

- Red Hat GFS (Global File System) — Red Hat Cluster Suite と共に使用する為のクラスタファイルシステム を提供します。GFS の使用により複数ノードは、ストレージがローカル的に各クラスタノードに 接続しているかのようにブロックレベルでストレージを共有することができるようになります。

- CLVM (Cluster Logical Volume Manager)— クラスタストレージの ボリューム管理を提供します。

注記

When you create or modify a CLVM volume for a clustered environment, you must ensure that you are running theclvmddaemon. For further information, refer to 「クラスタ論理ボリュームマネージャ」. - GNBD (Global Network Block Device)— ブロックレベルストレージをイーサネットに エキスポートする GFS の補助コンポーネントです。これはブロックレベルのストレージを Red Hat GFS で使用可能にする経済的な方法です。

図1.1 Red Hat Cluster Suite Introduction

注記

1.3. Cluster Infrastructure

- クラスタ管理

- ロック管理

- Fencing

- クラスタ設定管理

1.3.1. クラスタ管理

注記

図1.2 CMAN/DLM Overview

1.3.2. ロック管理

1.3.3. Fencing

fenced.

fenced はそのノードを フェンス(遮断)します。他のインフラストラクチャ コンポーネントはどんな行動を取るべきか判定します — 即ち、復元に必要となるすべてを実行します。 例えば、DLM と GFS はノード故障の通知を受けると、fenced が故障ノードの フェンスを完了したことを検知するまで活動を休止します。故障ノードが フェンスされたことを確認した時点で DLM と GFS はその復元を実行します。DLM は故障ノードのロックを解除し、GFS は故障ノードの ジャーナルを取り戻します。

- パワーフェンシング — 操作不能なノードの電源を切る為にパワーコントローラを使用する フェンシング 方法。

- ファイバーチャンネルスイッチ フェンシング — 操作不能なノードにストレージを 接続するようなファイバーチャンネルポートを無効にする フェンシング 方法。

- GNBD fencing — A fencing method that disables an inoperable node's access to a GNBD server.

- 他のフェンシング — 操作不能なノードの I/O や電源を無効にする他のフェンシング 方法が数種あり、 その中には IBM Bladecenters、PAP、DRAC/MC、HP ILO、 IPMI、IBM RSA II、その他が含まれます。

図1.3 Power Fencing Example

図1.4 Fibre Channel Switch Fencing Example

図1.5 Fencing a Node with Dual Power Supplies

図1.6 Fencing a Node with Dual Fibre Channel Connections

1.3.4. クラスタ設定システム

図1.7 CCS Overview

図1.8 Accessing Configuration Information

/etc/cluster/cluster.conf) は、以下のようなクラスタ特性を説明する XML ファイルです。

- クラスタ名 — ノードがクラスタに参加した時点、又はクラスタから フェンスされた時点の クラスタ名、クラスタ設定ファイルの改訂レベル、及び基本 フェンスタイミングプロパティを 表示します。

- クラスタ — クラスタの各ノードを表示して、それぞれのノードのノード名、 ノード ID、定員投票数、及び フェンシング 方法を指定します。

- フェンスデバイス — クラスタ内のフェンスデバイスを表示します。パラメータは フェンスデバイスのタイプに応じて変化します。例えば、フェンスデバイスで使用されるパワー コントローラ用には、クラスタ設定がパワーコントローラの名前、その IP アドレス、ログイン、 及びパスワードを定義します。

- 管理されたリソース — クラスタサービスを作成するのに必要なリソースを表示します。 管理されたリソースには、フェイルオーバードメインの定義、リソース(例、IP アドレス)、 及びサービスが含まれています。それと共に、管理されたリソースはクラスタサービスと、 クラスタサービスのフェイルオーバー動作を定義します。

1.4. ハイアベイラビリティサービス管理

rgmanager は、新規状態の アプリケーションでコールドフェイルオーバーを実装します。Red Hat クラスタ内では、アプリケーションは 他のクラスタリソースと一緒に設定されて、ハイアベイラビリティクラスタサービスを構成します。 ハイアベイラビリティクラスタサービスは、クラスタクライアントに表面的な邪魔をせずに1つのノードから 別のノードにフェイルオーバーをすることが出来ます。クラスタサービスフェイルオーバーは、クラスタ ノードが失敗したり、又はクラスタシステム管理者がサービスを1つのクラスタから別のクラスタに移動 した場合に発動します。(例えば、クラスタノードの計画停止など)

注記

図1.9 フェイルオーバードメイン

- IP アドレスリソース — IP アドレス 10.10.10.201.

- An application resource named "httpd-content" — a web server application init script

/etc/init.d/httpd(specifyinghttpd). - A file system resource — Red Hat GFS named "gfs-content-webserver".

図1.10 Web Server Cluster Service Example

1.5. Red Hat GFS

- データインフラストラクチャの簡素化

- クラスタ全体の為にアプリケーションのインストールとパッチ。

- アプリケーションデータの冗長コピー(複製)の必要性の排除

- 多くのクライアントによるデータへの同時 read/write アクセスの有効化

- バックアップと災害時復帰の簡素化(1つのファイルシステムのみをバックアップ、又は 復帰)

- ストレージリソース使用の最大化、ストレージ管理コストの最小化

- パーティション毎ではなく、全体としてストレージを管理

- データ複製の必要性解消で総合的ストレージ需要の低減

- 随時サーバーやストレージを追加して無段階的にクラスタを拡張

- パーティション設定ストレージに複雑な技術は不要

- 共通ファイルシステムにマウントすることで随時サーバーをクラスタに追加

注記

1.5.1. より良いパフォーマンスとスケーラビリティ

図1.11 GFS with a SAN

1.5.2. パフォーマンス、スケーラビリティ、経済価格

図1.12 GFS and GNBD with a SAN

1.5.3. 経済性とパフォーマンス

図1.13 ストレージに直接接続の GFS と GNBD

1.6. クラスタ論理ボリュームマネージャ

clvmd. clvmd is a daemon that provides clustering extensions to the standard LVM2 tool set and allows LVM2 commands to manage shared storage. clvmd runs in each cluster node and distributes LVM metadata updates in a cluster, thereby presenting each cluster node with the same view of the logical volumes (refer to 図1.14「CLVM Overview」). Logical volumes created with CLVM on shared storage are visible to all nodes that have access to the shared storage. CLVM allows a user to configure logical volumes on shared storage by locking access to physical storage while a logical volume is being configured. CLVM uses the lock-management service provided by the cluster infrastructure (refer to 「Cluster Infrastructure」).

注記

clvmd) か高可用論理ボリューム管理エージェント (HA-LVM) が稼働していなければなりません。運用上の理由で clvmd デーモン や HA-LVM を使用できない場合や、適切なエンタイトルメントを持っていない場合は、データ破損の恐れがあるため共有ディスク上で単一インスタンスの LVM を使用しないでください。ご質問やご不明な点などがありましたら、Red Hat のサービス担当者までご連絡ください。

注記

/etc/lvm/lvm.conf に 少々の変更をする必要があります。

図1.14 CLVM Overview

図1.15 LVM Graphical User Interface

図1.16 Conga LVM Graphical User Interface

図1.17 Creating Logical Volumes

1.7. グローバルネットワークブロックデバイス

図1.18 GNBD 概要

1.8. Linux 仮想サーバー

- 実サーバー全部に渡ってロードのバランスを取る

- それぞれの実サーバー上のサービスの統合性を確認する

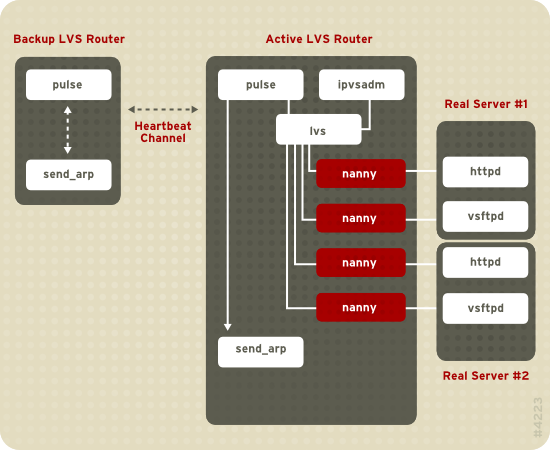

図1.19 Components of a Running LVS Cluster

pulse デーモンはアクティブとバックアップの両方の LVS router で稼働します。 バックアップ LVS router 上では pulse は、アクティブ router の公共 インターフェイスに ハートビート(heartbeat) を送信し、アクティブ router が 正常に機能していることを確認します。アクティブ LVS router 上では pulse は lvs デーモンを開始して、バックアップ LVS router からの ハートビート のクエリに反応します。

lvs デーモンは ipvsadm ユーティリティを コールしてカーネル内の IPVS (IP Virtual Server) routing 表の設定と管理をします。そしてそれぞれの 実サーバー上で設定済みの各仮想サーバーの為の nanny プロセスを開始します。 それぞれの nanny プロセスは1つの実サーバー上で設定済のサービスの状態を チェックし、lvs デーモンに対し、その実サーバー上のサービスが正常であるかどうかを 伝えます。異常動作が検知された場合、lvs デーモンは、IPVS routing 表から その実サーバーを排除するように ipvsadm に指示します。

send_arp をコールして、全ての仮想 IP アドレスを、バックアップ LVS router の NIC ハードウェアアドレス(MAC アドレス)に再割り当てをして、コマンドを 公共とプライベートの両方のネットワークインターフェイスを通じてアクティブ LVS router に送信して アクティブ LVS router 上の lvs デーモンをシャットダウンし、更に バックアップ LVS router 上の lvs デーモンを開始して設定済仮想サーバーからの 要求を受理することにより、フェイルオーバーに取り掛かります。

- 実サーバー全体に渡ってデータの同期を取る。

- 共有データアクセス用のトポロジーへ第三レイヤーを追加する。

rsync などの プログラムを使用して、決まった間隔で全てのノードに渡って変更データを複製することもできます。しかし、 ユーザーが頻繁にファイルをアップロードしたりデータベーストランザクションを発行したりする環境では、 スクリプトの使用、又はデータ同期化用の rsync コマンドは効率的に機能しません。 そのため、多くのアップロードやデータベーストランザクションや同様のトラフィックを持つ実サーバーには、 three-tiered トポロジー がデータ同期化に最適となります。

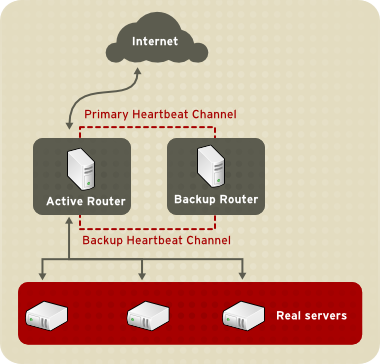

1.8.1. Two-Tier LVS Topology

図1.20 Two-Tier LVS Topology

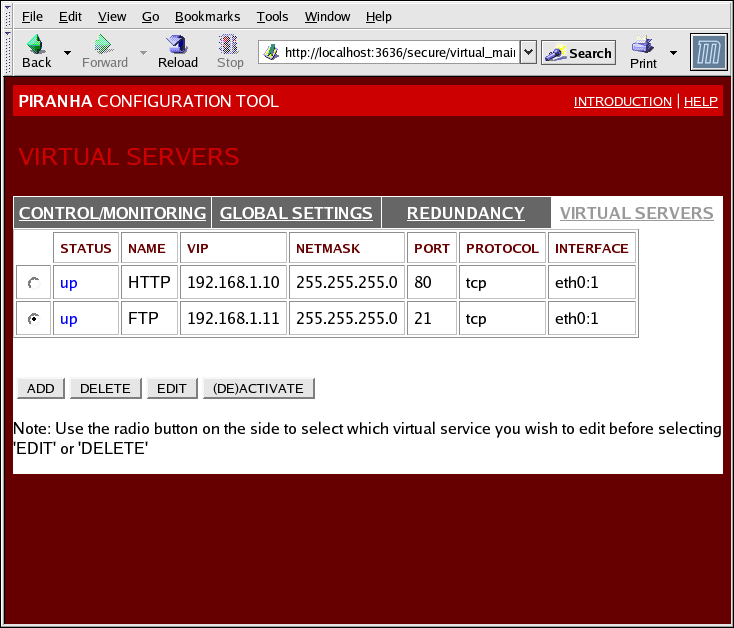

eth0:1 にエイリアス化することができます。別の方法としては、各仮想サーバーは サービス毎に別のデバイスと関連付けすることが出来ます。例えば、HTTP トラフィックは eth0:1 上で、そして FTP トラフィックは eth0:2 上で処理することができます。

- ラウンドロビンスケジューリング(Round-Robin Scheduling) — 各要求を順番に実サーバー群に 配布していきます。 このアルゴリズムを使用すると、全ての実サーバーが、容量やロードに関係無く同等に 取り扱われることになります。

- 能力別ラウンドロビンスケジューリング(Weighted Round-Robin Scheduling )— 各要求を順番に実サーバー群に配布して行きますが、より大きな能力を持つサーバーにより 多くの仕事を提出します。この能力は、先ずユーザー割り当ての能力値で表示され、その後 動的なロード情報によって上下に調節されます。これは、サーバー群内に決定的な能力の差が存在する場合に適切な選択となります。しかし、要求のロードが劇的に変化した場合、大能力として 割り当てられたサーバーがその公平な要求分担以上に反応する可能性があります。

- 最低稼働機接続 (Least-Connection)— より少ないアクティブ接続を持つ実サーバーに、より多くの要求を分配します。これは動的スケジューリングアルゴリズムの一種で、要求ロードに多くの変動がある場合に より良い選択となるものです。各サーバーノードがおよそ同等の能力を持つ実サーバー群に最適です。 実サーバーが別々の能力を持っている場合は、能力別最低稼働機接続スケジューリング(weighted least-connection scheduling)が最適な選択となります。

- 能力別最低稼働機接続スケジューリング(weighted least-connection scheduling)(デフォルト) — 能力と比較して少ないアクティブ接続を持つサーバーにより多くの要求を分配します。この能力はユーザー設定の分別により表示されており、動的ロード情報によって上下に調節されます。能力分別の追加により、このアルゴリズムは 実サーバー群が異なる能力のハードウェアを含んでいる場合に理想的になります。

- ローカリティベース最低稼働機接続スケジューリング(Locality-Based Least-Connection Scheduling )— 目的地 IP に対して少ないアクティブ接続を持つサーバーに、より多くの要求を分配します。このアルゴリズムは プロキシキャッシュサーバークラスタ内で使用するためのものです。これは目的地サーバーが能力以上に 稼働していないで、そのロードの半分しか担当していないサーバーがない場合に その IP アドレス用のパケットをそのアドレスのサーバーに回送します。その場合、 IP アドレス は最低稼働の実サーバーに割り当てられます。

- 複製スケジューリング付きローカリティベース最低稼働機接続スケジューリング (Locality-Based Least-Connection Scheduling with Replication Scheduling )— 目的地 IP に対して少ないアクティブ接続を持つサーバーに、より多くの要求を分配します。この アルゴリズムもプロキシキャッシュサーバークラスタ内で使用するためのものです。ローカリティベース 最低稼働機接続スケジューリングとの相異点は、目的地 IP アドレスを実サーバーノードのサブセットに マッピングすることです。要求は最低数の接続を持つサブセット内のサーバーへ回送されます。この 目的地 IP の全てのノードがそれらの能力以上に稼働している場合、実サーバー群全体から最低接続を持つ 実サーバーをその目的地 IP 用の実サーバーのサブセットへ追加することにより、目的地 IPアドレス用に新規の サーバーを複製します。そして実サーバーのサブセットからは最大ロードを持つノードを排除して過大複製を 防止します。

- ソースハッシュスケジューリング(Source Hash Scheduling)— 静的ハッシュ表内の ソース IP を観察して実サーバー群に要求を分配します。このアルゴリズムは複数ファイアウォールを 持つ LVS router 用のものです。

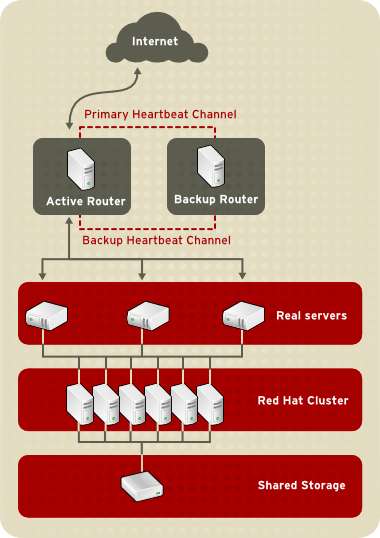

1.8.2. Three-Tier LVS Topology

図1.21 Three-Tier LVS Topology

1.8.3. Routing の方法

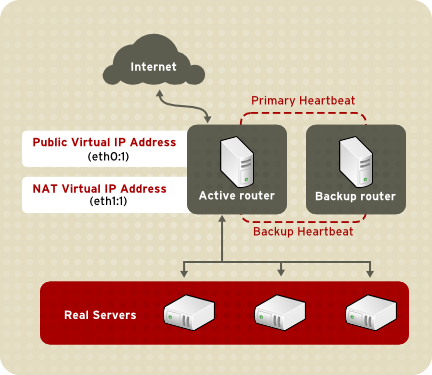

1.8.3.1. NAT Routing

図1.22 LVS Implemented with NAT Routing

1.8.3.2. ダイレクト routing

図1.23 LVS Implemented with Direct Routing

arptables パケットフィルタリングツールを使用することで 達成できます。

1.8.4. 固執とファイアウォールマーク

1.8.4.1. Persistence

1.8.4.2. ファイアウォールマーク

1.9. クラスタ管理ツール

1.9.1. Conga

- クラスタとストレージの管理用単独ウェブインターフェイス

- クラスタデータとサポートパッケージの自動化した導入

- 既存のクラスタとの簡単な統合

- 再認証の不要

- クラスタステータスとログの統合

- ユーザー権限に関するきめ細かな制御

- ホームベース — コンピュータの追加と削除、ユーザーの追加と削除、 及び、ユーザー特権の設定の為のツールを提供します。システム管理者のみがこのタブにアクセスを 許可されます。

- クラスタ — クラスタの作成と設定用のツールを提供します。 luci の各インスタンスが、その luci で セットアップされたクラスタを一覧表示します。システム管理者がこのタブ上のすべてのクラスタを 管理します。他のユーザーは、そのユーザーが管理する権限(管理者が許可)を持つクラスタのみを 管理することができます。

- ストレージ — ストレージのリモート管理の為のツールを 提供します。このタブ上のツールで、クラスタに所属するかしないかに関係無くいずれかのコンピュータ上の ストレージを管理することができます。

図1.24 luci ホームベース タブ

図1.25 luci クラスタ タブ

図1.26 luci ストレージ タブ

1.9.2. クラスタ管理 GUI

system-config-cluster cluster administration graphical user interface (GUI) available with Red Hat Cluster Suite. The GUI is for use with the cluster infrastructure and the high-availability service management components (refer to 「Cluster Infrastructure」 and 「ハイアベイラビリティサービス管理」). The GUI consists of two major functions: the Cluster Configuration Tool and the Cluster Status Tool. The Cluster Configuration Tool provides the capability to create, edit, and propagate the cluster configuration file (/etc/cluster/cluster.conf). The Cluster Status Tool provides the capability to manage high-availability services. The following sections summarize those functions.

1.9.2.1. Cluster Configuration Tool

図1.27 Cluster Configuration Tool

/etc/cluster/cluster.conf) 内のクラスタ設定コンポーネントを、左側パネルの階級式グラフィカル表示で 示します。コンポーネント名の左側にある三角のアイコンはこのコンポーネントに割り当てられた単数、又は複数の 従属コンポーネントを持つことを示します。この三角アイコンをクリックすると、そのコンポーネントの ツリー配下の部分が 展開したり、閉じたりします。GUI 内に表示されたコンポーネントは以下のように 要約できます:

- クラスタノード — クラスタノードを表示します。ノードは、 クラスタノード の下に従属要素として名前別に表示されます。右枠の 下部(プロパティ の下)にある設定ボタンを使用すると、ノードの追加、 ノードの削除、ノードプロパティの編集、そして各ノードの フェンシングメソッドの設定が可能になります。

- フェンスデバイス — フェンスデバイスを表示します。フェンスデバイスは フェンスデバイス群 の下に従属要素として表示されています。右枠の下部 (プロパティ の下)にある設定ボタンを使用すると、フェンスデバイスの追加、 フェンスデバイスの削除、フェンスデバイスプロパティの編集が可能になります。フェンスデバイスは 各ノード用に フェンシング (このノード用の フェンシング管理 ボタンで)を 設定する前に先に定義付けをする必要があります。

- 管理されたリソース — フェイルオーバードメイン、リソース、 及びサービスを表示します。

- フェイルオーバードメイン — ノード故障の事態にハイアベイラビリティサービスを 実行する為に使用されるクラスタノードの単独、又は複数のサブセットを設定する為のものです。 フェイルオーバードメインは フェイルオーバードメイン群 の下に従属要素として 示されています。右枠の下部(プロパティ の下)にある設定ボタンを使用すると、 フェイルオーバードメインの作成(フェイルオーバードメイン が選択された場合)や、 フェイルオーバードメインプロパティの編集(フェイルオーバードメインが選択された場合)が可能になります。

- リソース — ハイアベイラビリティサービスで使用される共有リソースの設定の ためのものです。共有リソースはファイルシステム、IP アドレス、NFS マウントとエキスポート、そして クラスタ内のどのハイアベイラビリティサービスにも利用できるユーザー作成のスクリプトで構成されます。 リソースは リソース群 の下に従属要素として示してあります。右枠の下部 (プロパティ の下)にある設定ボタンを使用すると、リソースの作成 (リソース が選択された場合)や、リソースプロパティの編集 (リソースが選択された場合)が可能になります。

注記

Cluster Configuration Tool はプライベートリソースも設定する能力を 提供します。プライベートリソースとは、1つのサービスでの使用のみに設定されるリソースのことです。 プライベートリソースは GUI で サービス コンポーネント内で設定する ことができます。 - サービス — ハイアベイラビリティサービスを作成し設定するためのものです。 サービスはリソース(共有かプライベート)の割り当て、フェイルオーバードメインの割り当て、 そしてサービスの復元ポリシーの定義付けにより設定されます。サービスは サービス群 の下に従属要素として示してあります。右枠の下部(プロパティ の下)にある 設定ボタンを使用すると、サービスの作成(サービス が選択された場合)や サービスプロパティの編集(サービスが選択された場合)が可能になります。

1.9.2.2. Cluster Status Tool

図1.28 Cluster Status Tool

/etc/cluster/cluster.conf) によって決定されます。 Cluster Status Tool を使用して、ハイアベイラビリティサービスの 有効化、無効化、再開始、又は移動などが実行できます。

1.9.3. コマンドライン管理ツール

system-config-cluster Cluster Administration GUI, command line tools are available for administering the cluster infrastructure and the high-availability service management components. The command line tools are used by the Cluster Administration GUI and init scripts supplied by Red Hat. 表1.1「コマンドラインツール」 summarizes the command line tools.

表1.1 コマンドラインツール

| コマンドラインツール | 使用物 | 目的 |

|---|---|---|

ccs_tool — クラスタ設定システムツール | Cluster Infrastructure | ccs_tool はクラスタ設定ファイルへのオンライン更新をする為の プログラムです。クラスタインフラストラクチャコンポーネントの作成と編集(例えば、クラスタの作成、 ノードの追加と削除)の機能を提供します。このツールに関する詳細情報については ccs_tool(8) man ページを 参照してください。 |

cman_tool — クラスタ管理ツール | Cluster Infrastructure | cman_tool は CMAN クラスタマネージャを管理するプログラムです。 これはクラスタに参加、クラスタから退出、ノードのキル、又はクラスタ内のノードの予想定数員投票への 変更などの機能を提供します。このツールに関する詳細情報には、cman_tool(8) man ページを参照して 下さい。 |

fence_tool — フェンス ツール | Cluster Infrastructure | fence_tool はデフォルトフェンスドメインに参加したり退出したりする為の プログラムです。これは特にフェンスデーモン (fenced) を開始してドメインに参加し、fenced をキルしてドメインから 退出をします。このツールに関する詳細情報には、fence_tool(8) man ページを参照してください。 |

clustat — クラスタステータスユーティリティ | ハイアベイラビリティサービス管理コンポーネント | clustat コマンドはクラスタのステータスを表示します。これは メンバーシップ情報、定員数表示、及び全ての設定済ユーザーサービスの状態を示します。 このツールに関する詳細情報については clustat(8) man ページを参照してください。 |

clusvcadm — クラスタユーザーサービス管理ユーティリティ | ハイアベイラビリティサービス管理コンポーネント | clusvcadm コマンドの使用で、クラスタ内のハイアベイラビリティサービスの 有効化、無効化、転送、及び再起動ができるようになります。このツールに関する詳細情報については clusvcadm(8) man ページを参照してください。 |

1.10. Linux 仮想サーバー管理 GUI

/etc/sysconfig/ha/lvs.cf の作成への形成化したアプローチを提供します。

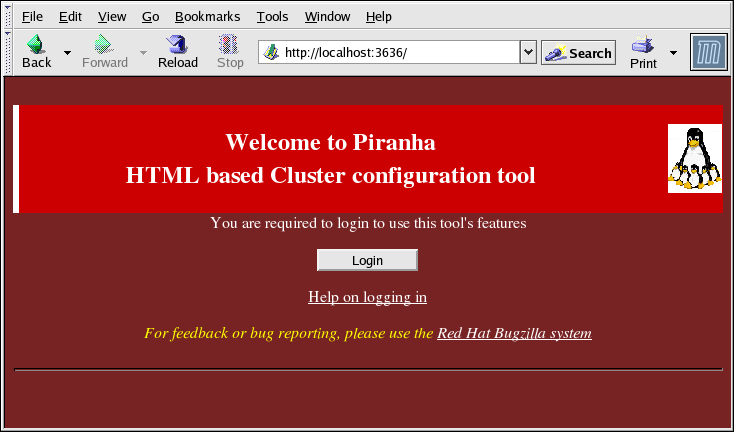

piranha-gui サービスが必要です。ウェブブラウザを 使用すれば、ローカル、又はリモートで Piranha Configuration Tool にアクセスすることが できます。URL: http://localhost:3636 の使用でローカルでアクセスできます。 ホスト名、又は実 IP アドレスに続く :3636 の使用で、リモートでアクセスできます。 リモートで Piranha Configuration Tool にアクセスしている場合、root ユーザーとしてアクティブ LVS router への ssh 接続が必要になります。

図1.29 The Welcome Panel

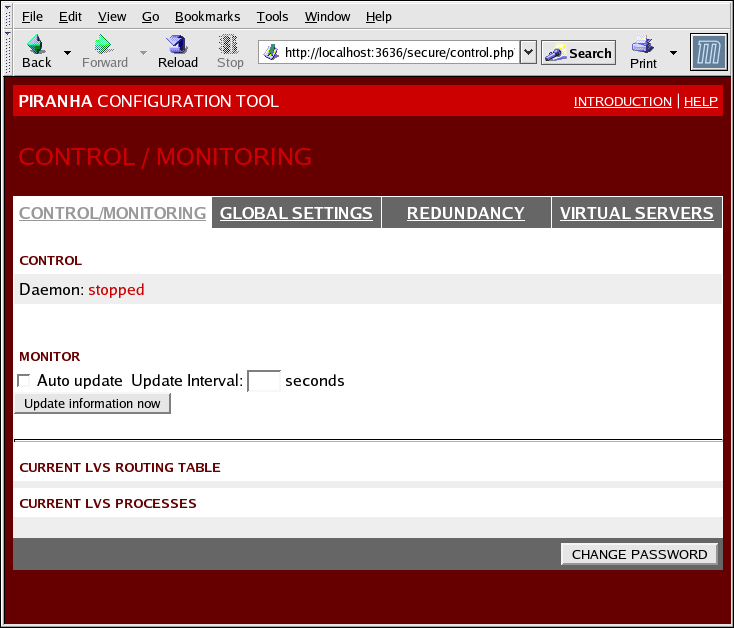

1.10.1. CONTROL/MONITORING

pulse デーモンのステータス、LVS routing 表、 及び、LVS 派生の nanny プロセスを表示します。

図1.30 The CONTROL/MONITORING Panel

- Auto update

- 秒単位間隔で更新 テキストボックス(デフォルト値は 10秒)内に 設定されたユーザー設定の間隔で自動的に更新されるステータス表示を有効にします。10秒以下の間隔で自動更新を設定することは推奨できません。そのような設定をすると、 ページが頻繁に更新をし過ぎて、自動更新 間隔を再設定するのが 困難になります。この問題に遭遇した場合は、単にもう一つのパネルをクリックして、 その後に 制御/監視 に戻ります。

- Update information now

- ステータス情報の手動更新を提供します。

- CHANGE PASSWORD

- このボタンをクリックすると、Piranha Configuration Tool 用の管理パスワードの 変更に関する情報があるヘルプ画面に移動します。

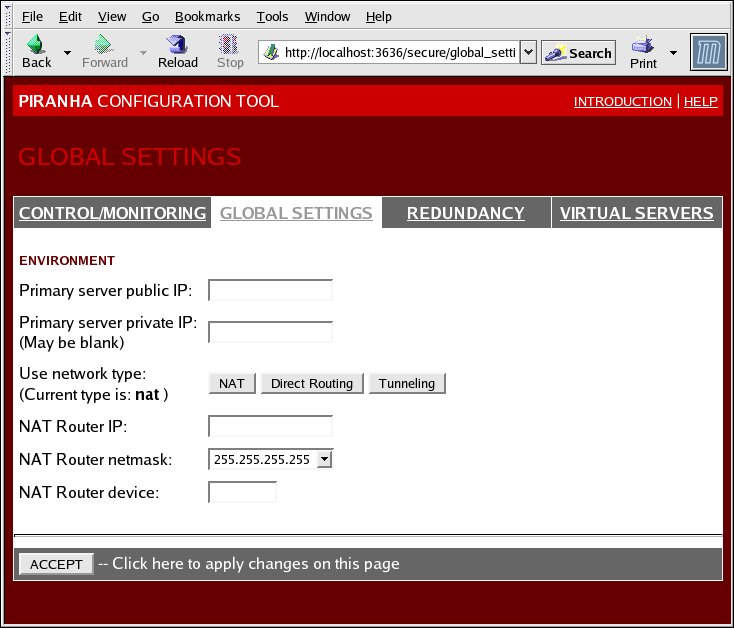

1.10.2. GLOBAL SETTINGS

図1.31 The GLOBAL SETTINGS Panel

- Primary server public IP

- 主要 LVS ノード用の公共 rout 可能な 実 IP アドレス。

- Primary server private IP

- 主要 LVS ノード上の代替ネットワークインターフェイスの為の実 IP アドレスです。このアドレスは バックアップ router 用の代替ハートビートチャンネル専用として使用されます。

- Use network type

- Selects で NAT routing の選択

- NAT Router IP

- このテキストフィールド内のプライベート浮動 IPです。この 浮動 IP は実サーバー用の ゲートウェイとして使用されるものです。

- NAT Router netmask

- If the NAT router's floating IP needs a particular netmask, select it from drop-down list.

- NAT Router device

eth1:1などの浮動 IP アドレス用のネットワークインターフェイスデバイス名を定義します。

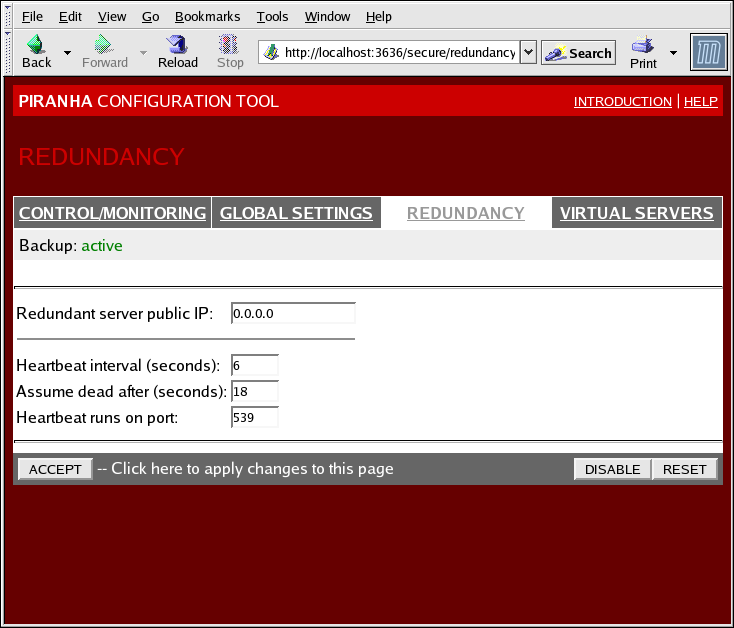

1.10.3. REDUNDANCY

図1.32 The REDUNDANCY Panel

- Redundant server public IP

- バックアップ LVS router 用の公共 実 IP アドレス

- Redundant server private IP

- The backup router's private real IP address.

- Heartbeat Interval (seconds)

- ハートビートの間隔 — バックアップノードが主要 LVS ノードの機能ステータスをチェックする 間隔 — を秒数で設定します。

- Assume dead after (seconds)

- 主要 LVS ノードが指定秒数後に反応しないと、バックアップ LVS router ノードがフェイルオーバーを 開始します。

- Heartbeat runs on port

- ハートビートが主要 LVS ノードと交信するためのポートを設定します。ここが空白の場合、デフォルトでは 539 にセットされています。

1.10.4. VIRTUAL SERVERS

図1.33 The VIRTUAL SERVERS Panel

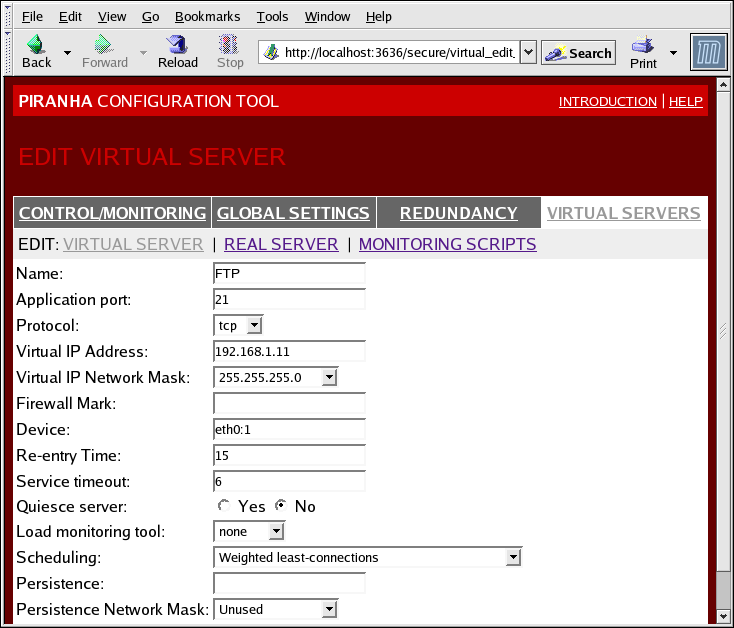

1.10.4.1. 仮想サーバー サブセクション

図1.34 The VIRTUAL SERVERS Subsection

- Name

- 仮想サーバーを識別する為の説明的名前です。この名前はマシンのホスト名ではない ですから、説明的で判り易くします。HTTP などの仮想サーバーによって使用されるプロトコルを参照する名前も 可能です。

- Application port

- サービスアプリケーションがそれを通じてリッスンするポートの番号。

- Protocol

- ドロップダウンメニュー内に UDP か TCP の選択を提供します。

- Virtual IP Address

- The virtual server's floating IP address.

- Virtual IP Network Mask

- ドロップダウンメニュー内のこの仮想サーバー用のネットマスク。

- Firewall Mark

- 複数ポートプロトコルを束ねる場合、又は別々でも関連したプロトコル用の複数ポート仮想サーバーを 作成する場合に、入力するファイアウォールマーク用の整数です。

- Device

- 仮想 IP アドレス フィールド内に定義された浮動 IP アドレスをバインドするネットワークデバイスの名前です。公共浮動 IP アドレスは公共ネットワークに接続されたイーサネットインターフェイスに エイリアス化する必要があります。

- Re-entry Time

- 実サーバー故障後にアクティブ LVS router が、実サーバーを使用する試みをするまでの 秒数を定義する整数値です。

- Service Timeout

- 実サーバーが停止してしまって利用不可と判定されるまでの秒数を定義した整数値です。

- Quiesce server

- Quiesce サーバー ラジオボタンが選択されている時には、最低稼働機接続の表がゼロに再設定されており、新規の実サーバーノードがオンラインに来るとまるで全ての実サーバーが初めてクラスタに追加されるかのように、アクティブ LVS router が 要求を出すことができます。このオプションは新規サーバーが、クラスタに参加する時に多数の接続で負荷超過になることを防止します。

- Load monitoring tool

- LVS router は、

rup又はruptimeを使用することで 各種実サーバー上のロードを監視することができます。ドロップダウンメニューからrupが選択されると、各実サーバーはrstatdサービスを実行することになります。ruptimeが選択されると、各実サーバーはrwhodサービスを実行することになります。 - Scheduling

- ドロップダウンメニューからの優先スケジューリングアルゴリズムです。デフォルトでは、

能力別最低稼働機接続(Weighted least-connection)になります。 - 固執

- クライアントのトランザクション中に仮想サーバーへの固執接続が必要な場合に使用されます。 このテキストフィールド内には、接続時間切れまでの許容不活動時間を秒数で指定します。

- Persistence Network Mask

- 固執を特定のサブネットへ限定するために、ドロップダウンメニューから適切な ネットワークマスクを選択します。

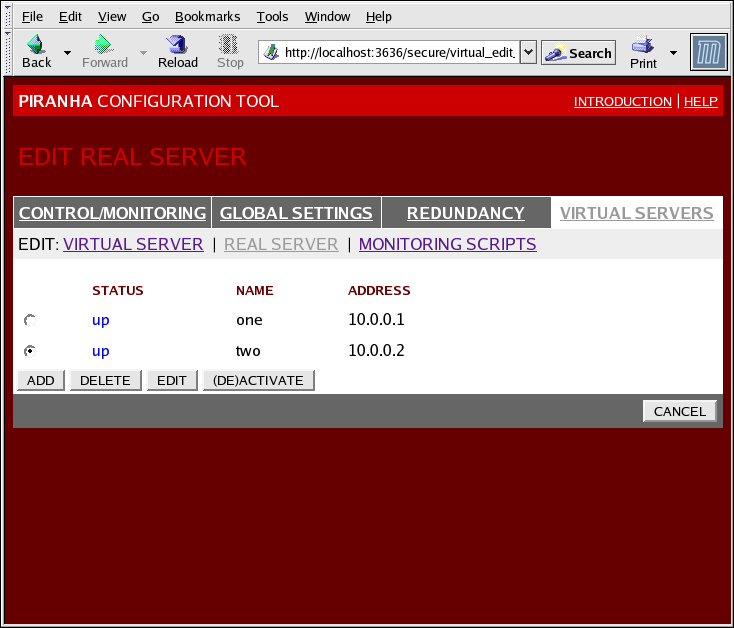

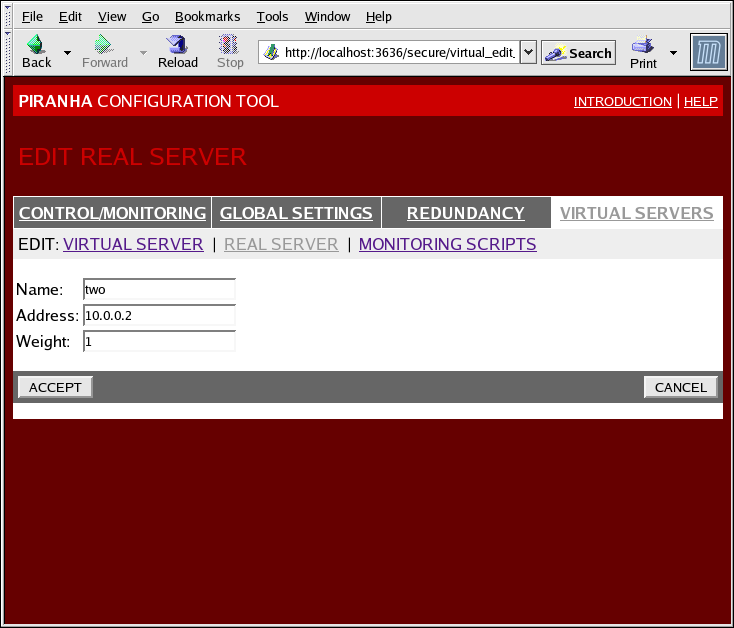

1.10.4.2. 実サーバー サブセクション

図1.35 The REAL SERVER Subsection

図1.36 The REAL SERVER Configuration Panel

- Name

- 実サーバー用の説明的名前

注記

この名前は、マシンのホスト名ではありません。 判り易くて認識し易い名前にしてください。 - Address

- The real server's IP address. Since the listening port is already specified for the associated virtual server, do not add a port number.

- Weight

- An integer value indicating this host's capacity relative to that of other hosts in the pool. The value can be arbitrary, but treat it as a ratio in relation to other real servers.

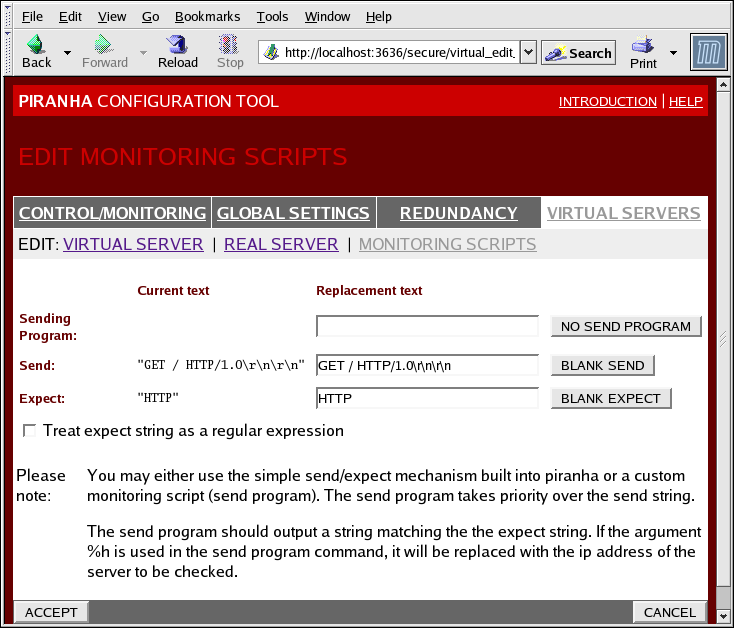

1.10.4.3. EDIT MONITORING SCRIPTS Subsection

図1.37 The EDIT MONITORING SCRIPTS Subsection

- Sending Program

- より高度なサービス確認の為に、このフィールドを使用してサービス確認スクリプトへの パスを指定することができます。この機能は、HTTPS や SSL などの動的に変化するデータを 必要とするサービスに特に役に立ちます。この機能を使用するには、テキスト応答を返すスクリプトを書いて、それを実行ファイルとして 設定して、送信プログラム フィールド内にそこまでのパスを入力 します。

注記

外部プログラムが 送信プログラム フィールドに入った場合は、 送信 フィールドは無視されます。 - Send

- このフィールド内の各実サーバーに送信する為の

nannyデーモン用の ストリングです。デフォルトで「送信」フィールドは HTTP 用に完了しています。ユーザーの ニーズに応じてこの値は変更することが出来ます。このフィールドを空白のまま残すと、nannyデーモンはポートを開く試みをして、それが成功すると サービスが実行中だと想定します。このフィールドには、1つの送信シーケンスのみが許可されます。そしてそれは 表示可能な ASCII 文字と以下のようなエスケープ文字のみを含むことが出来ます:- 新しい行の為の \n

- 改行の為の \r

- タブの為の \t

- 次に続く文字をエスケープする \

- Expect

- サーバーが正常に機能している場合に、サーバーが返すテキスト応答です。ユーザーが 送信プログラムを書いた場合は、それが成功した時に送信するように指示している 応答を入力してください。

第2章 Red Hat Cluster Suite コンポーネントの要約

2.1. クラスタコンポーネント

表2.1 Red Hat Cluster Suite ソフトウェアサブシステムコンポーネント

| 機能 | コンポーネント | 説明 |

|---|---|---|

| Conga | luci | リモート管理システム - 管理ステーション |

ricci | リモート管理システム - 管理下ステーション | |

| Cluster Configuration Tool | system-config-cluster | グラフィカル環境でクラスタ設定の管理に使用するコマンド。 |

| CLVM (Cluster Logical Volume Manager) | clvmd | LVM メタデータを分配するデーモンはクラスタ全域に渡り更新をします。これはクラスタ内の 全てのノードで稼働中である必要があり、クラスタ内ノードの1つでこのデーモンが稼働していない 場合は、エラーが発生します。 |

lvm | LVM2 ツール。LVM2 用のコマンドラインツールを提供します。 | |

system-config-lvm | LVM2 用のグラフィカルユーザーインターフェイスを提供します。 | |

lvm.conf | LVM 設定ファイル。完全なパスは /etc/lvm/lvm.conf. です。 | |

| CCS (Cluster Configuration System) | ccs_tool | ccs_tool はクラスタ設定システム(CCS) の一部です。 これは、CCS 設定ファイルのオンラインアップデートを実行するのに使用されます。更に、 クラスタ設定ファイルを GFS 6.0 (及びそれ以降) で作成された CCS アーカイブから Red Hat Cluster Suite のこのリリースで使用される XML 形式設定形式にアップグレードするのにも 使用されます。 |

ccs_test | ccsd を介して設定ファイルから情報を取り出すのに使用される 診断とテストのコマンド。 | |

ccsd | 全てのクラスタノードで稼働し、クラスタソフトウェアに設定ファイルデータを 提供する CCS デーモン。 | |

cluster.conf | これがクラスタ設定ファイルです。完全なパスは /etc/cluster/cluster.conf | |

| CMAN (Cluster Manager) | cman.ko | CMAN 用のカーネルモジュール |

cman_tool | これは、CMAN に対する管理用フロントエンドです。CMAN の開始と停止をし、投票(votes)などの内部パラメータの変更をすることができます。 | |

dlm_controld | カーネル内の dlm を管理する為の cman init スクリプトで開始されるデーモン; ユーザーによる使用はありません。 | |

gfs_controld | カーネル内の gfs を管理する為の cman init スクリプトで開始されるデーモン; ユーザーによる使用はありません。 | |

group_tool | フェンシング、 DLM、 GFS 及びデバグ情報取得に関連したグループのリストを得るのに使用 されます; RHEL 4 で cman_tool services 提供したものを 含みます。 | |

groupd | openais/cman と dlm_controld/gfs_controld/fenced の間にインターフェイスを与える為に cman init スクリプトで開始されるデーモン; ユーザーによる使用はありません。 | |

libcman.so.<version number> | cman.ko と交流する必要のあるプログラム用のライブラリ。 | |

| rgmanager (Resource Group Manager) | clusvcadm | 手動で、クラスタ内のユーザーサービスを有効化、無効化、移動、再開始するのに使用されるコマンド。 |

clustat | ノードメンバーシップと実行中のサービスを含むクラスタのステータス表示に使用される コマンド。 | |

clurgmgrd | サービスの開始、無効化、移動、再開始を含むユーザーサービス要求の処理に使用されるデーモン。 | |

clurmtabd | クラスタ化した NFS マウント表の処理に使用されるデーモン。 | |

| Fence | fence_apc | APC パワースイッチ用の フェンス エージェント |

fence_bladecenter | Telnet インターフェイスのある IBM Bladecenter 用の フェンス エージェント | |

fence_bullpap | Bull Novascale PAP (Platform Administration Processor)インターフェイス用の フェンス エージェント | |

fence_drac | Dell Remote Access Card 用の フェンシング エージェント | |

fence_ipmilan | LAN 上にある IPMI(Intelligent Platform Management Interface)で制御されるマシン用の フェンス エージェント | |

fence_wti | WTI パワースイッチ用の フェンス エージェント | |

fence_brocade | Brocade ファイバーチャンネルスイッチ用の フェンス エージェント | |

fence_mcdata | McData ファイバーチャンネルスイッチ用の フェンス エージェント | |

fence_vixel | Vixel ファイバーチャンネルスイッチ用の フェンス エージェント | |

fence_sanbox2 | SANBox2 ファイバーチャンネルスイッチ用の フェンス エージェント | |

fence_ilo | HP ILO インターフェイス用の フェンス エージェント(旧名 fence_rib) | |

fence_rsa | IBM RSA II 用の I/O フェンシング エージェント | |

fence_gnbd | GNBD ストレージで使用される フェンス エージェント | |

fence_scsi | SCSI 固執予約用の I/O フェンシング エージェント。 | |

fence_egenera | Egenera BladeFrame システムで使用される フェンス エージェント | |

fence_manual | 手動交流の為の フェンス エージェント。注記: このコンポーネントは実稼働環境用にはサポートがありません。 | |

fence_ack_manual | fence_manual エージェント用のユーザーインターフェイス。 | |

fence_node | 単独ノード上で I/O フェンシング を実行するプログラム。 | |

fence_xvm | Xen 仮想マシン用の I/O フェンシング エージェント | |

fence_xvmd | Xen 仮想マシン用の I/O フェンシング エージェントホスト。 | |

fence_tool | フェンス ドメインに参加と退出をするプログラム。 | |

fenced | I/O フェンシング デーモン | |

| DLM | libdlm.so.<version number> | DLM (Distributed Lock Manager)サポート用のライブラリ |

| GFS | gfs.ko | GFS ファイルシステムを実装するカーネルモジュールであり、GFS クラスタノード上に ロードされます。 |

gfs_fsck | アンマウントされた GFS ファイルシステムを修理するコマンド | |

gfs_grow | マウントされた GFS ファイルシステムを拡張するコマンド | |

gfs_jadd | マウントした GFS ファイルシステムへジャーナルを追加するコマンド | |

gfs_mkfs | ストレージデバイス上に GFS ファイルシステムを作成するコマンド | |

gfs_quota | マウントした GFS ファイルシステム上で割り当てを管理するコマンド | |

gfs_tool | GFS ファイルシステムを設定、又はチューンするコマンド。このコマンドは ファイルシステムについて種々の情報を収集することもできます。 | |

mount.gfs | mount(8) と呼ばれるマウントヘルパー; ユーザーによる使用はありません。 | |

| GNBD | gnbd.ko | クライアント上で GNBD デバイスドライバーを実装するカーネルモジュール |

gnbd_export | GNBD サーバー上で GNBD の作成、エキスポート、及び管理をするコマンド | |

gnbd_import | GNBD クライアント上で GNBD のインポートと管理をするコマンド | |

gnbd_serv | ノードがローカルストレージをネットワーク上にエキスポートできるようにするサーバーデーモン。 | |

| LVS | pulse | This is the controlling process which starts all other daemons related to LVS routers. At boot time, the daemon is started by the /etc/rc.d/init.d/pulse script. It then reads the configuration file /etc/sysconfig/ha/lvs.cf. On the active LVS router, pulse starts the LVS daemon. On the backup router, pulse determines the health of the active router by executing a simple heartbeat at a user-configurable interval. If the active LVS router fails to respond after a user-configurable interval, it initiates failover. During failover, pulse on the backup LVS router instructs the pulse daemon on the active LVS router to shut down all LVS services, starts the send_arp program to reassign the floating IP addresses to the backup LVS router's MAC address, and starts the lvs daemon. |

lvsd | lvs デーモンは、 pulse によって コールされるとアクティブな LVS router 上で稼働します。このデーモンは設定ファイル /etc/sysconfig/ha/lvs.cf を読み込み、IPVS routing 表の構築と維持の為に ipvsadm ユーティリティをコールし、そして各設定済の LVS サービスの 為に nanny プロセスを割り当てます。nanny が 実サーバーの停止を報告した場合、lvs は ipvsadm に対して、IPVS routing 表からその実サーバーを取り除くように指示します。 | |

ipvsadm | このサービスはカーネル内の IPVS routing 表をアップデートします。 lvs デーモンは、ipvsadm をコールすることにより、 LVS をセットアップして管理し、IPVS routing 表内のエントリの追加、変更、削除をします。 | |

nanny | nanny 監視デーモンはアクティブな LVS router 上で稼働します。 このデーモンを通じて、アクティブな LVS router はそれぞれの実サーバーの健全性を決定し、 オプションとして、その担当負荷を監視します。別のプロセスがそれぞれの実サーバー上で定義された 各サービス用に稼働します。 | |

lvs.cf | これは、LVS 設定ファイルです。このファイル用の完全パスは /etc/sysconfig/ha/lvs.cf です。直接的に、又は間接的に全てのデーモンは このファイルからその設定情報を取り寄せます。 | |

| Piranha Configuration Tool | これは、LVS の監視、設定、及び管理用のウェブベースのツールです。これが /etc/sysconfig/ha/lvs.cf LVS 設定ファイルを維持する為の デフォルトのツールとなります。 | |

send_arp | このプログラムは、浮動 IP アドレスがフェイルオーバーの間に1つのノードから別の ノードに移動する場合に ARP ブロードキャストを送信します。 | |

| Quorum ディスク | qdisk | CMAN / Linux クラスタ用のディスクベースの定員数(quorum)デーモン。 |

mkqdisk | クラスタ Quorum ディスクユーティリティ。 | |

qdiskd | クラスタ Quorum ディスクデーモン。 |

2.2. Man ページ

- クラスタインフラストラクチャ

- ccs_tool (8) - CCS 設定ファイルのオンライン更新をするのに使用されるツール

- ccs_test (8) - クラスタ設定システムを実行する為の診断ツール

- ccsd (8) - CCS クラスタ設定ファイルにアクセスするのに使用するデーモン

- ccs (7) - クラスタ設定システム

- cman_tool (8) - クラスタ管理ツール

- cluster.conf [cluster] (5) - クラスタ製品用の設定ファイル

- qdisk (5) - CMAN / Linux-クラスタ用のディスクベースの定員数(quorum)デーモン

- mkqdisk (8) -クラスタ Quorum ディスクユーティリティ

- qdiskd (8) - クラスタ Quorum ディスクデーモン

- fence_ack_manual (8) - 手動 I/O フェンシング の一部として演算子によって実行されるプログラム

- fence_apc (8) - APC MasterSwitch 用の I/O フェンシング エージェント

- fence_bladecenter (8) - IBM Bladecenter 用の I/O フェンシング エージェント

- fence_brocade (8) - Brocade FC スイッチ用の I/O フェンシング エージェント

- fence_bullpap (8) - PAP 管理コンソールにより制御されている Bull FAME アーキテクチャ用の I/O フェンシング エージェント

- fence_drac (8) - Dell リモートアクセスカード用の フェンシング エージェント

- fence_egenera (8) - Egenera BladeFrame 用の I/O フェンシング エージェント

- fence_gnbd (8) - GNBD ベースの GFS クラスタ用の I/O フェンシング エージェント

- fence_ilo (8) - HP Integrated Lights Out カード用の I/O フェンシング エージェント

- fence_ipmilan (8) - IPMI over LAN で制御されているマシン用の I/O フェンシング エージェント

- fence_manual (8) - 手動 I/O フェンシング の一部として fenced により実行されるプログラム

- fence_mcdata (8) - McData FC スイッチ用の I/O フェンシング エージェント

- fence_node (8) - 単独ノード上で I/O フェンシング を実行するプログラム

- fence_rib (8) - Compaq Remote Insight Lights Out カード用の I/O フェンシング エージェント

- fence_rsa (8) - IBM RSA II 用の I/O フェンシング エージェント

- fence_sanbox2 (8) - QLogic SANBox2 FC スイッチ用の I/O フェンシング エージェント

- fence_scsi (8) - SCSI 固執予約用の I/O フェンシング エージェント

- fence_tool (8) - fence ドメインに参加と退出をするプログラム

- fence_vixel (8) - Vixel FC スイッチ用の I/O フェンシング エージェント

- fence_wti (8) - WTI ネットワークパワースイッチ用の I/O フェンシング エージェント

- fence_xvm (8) - Xen 仮想マシン用の I/O フェンシング エージェント

- fence_xvmd (8) - Xen 仮想マシン用の I/O フェンシング エージェントホスト

- fenced (8) - I/O フェンシング デーモン

- ハイアベイラビリティサービス管理

- clusvcadm (8) - クラスタユーザーサービス管理ユーティリティ

- clustat (8) - クラスタステータスユーティリティ

- Clurgmgrd [clurgmgrd] (8) - リソースグループ(クラスタサービス)マネージャデーモン

- clurmtabd (8) - クラスタ NFS リモートマウント表デーモン

- GFS

- gfs_fsck (8) - オフライン GFS ファイルシステムチェッカー

- gfs_grow (8) - GFS ファイルシステムの拡張

- gfs_jadd (8) - ジャーナルを GFS ファイルシステムに追加

- gfs_mount (8) - GFS マウントオプション

- gfs_quota (8) - GFS ディスク割り当てを処理

- gfs_tool (8) - gfs ioctl コールへのインターフェイス

- clvm (Cluster Logical Volume Manager)

- clvmd (8) - クラスタ LVM デーモン

- lvm (8) - LVM2 ツール

- lvm.conf [lvm] (5) - LVM2 用の設定ファイル

- lvmchange (8) - 論理ボリュームマネージャの属性を変更

- pvcreate (8) - LVM による使用の為のディスク、又はパーティションの初期化

- lvs (8) - 論理ボリュームに関するレポート情報

- GNBD (Global Network Block Device)

- gnbd_export (8) - GNBD をエキスポートする為のインターフェイス

- gnbd_import (8) - クライアント上の GNBD ブロックデバイスを処理

- gnbd_serv (8) - gnbd サーバーデーモン

- LVS

- pulse (8) - クラスタノードの健全性を監視するハートビートデーモン

- lvs.cf [lvs] (5) - lvs 用の設定ファイル

- lvscan (8) - 論理ボリューム用のスキャン(全ディスク)

- lvsd (8) - Red Hat クラスタリングサービスを制御するデーモン

- ipvsadm (8) - Linux 仮想サーバー管理

- ipvsadm-restore (8) - 標準入力から IPVS 表を復元

- ipvsadm-save (8) - IPVS 表を標準出力に保存

- nanny (8) - クラスタ内のサービスステータスを監視するツール

- send_arp (8) - 新しい IP アドレス / MAC アドレスマッピングのネットワークを通知するツール

2.3. 互換ハードウェア

付録A 改訂履歴

| 改訂履歴 | |||

|---|---|---|---|

| 改訂 3-7.400 | 2013-10-31 | Rüdiger Landmann | |

| |||

| 改訂 3-7 | 2012-07-18 | Anthony Towns | |

| |||

| 改訂 1.0-0 | Tue Jan 20 2008 | Paul Kennedy | |

| |||

索引

C

- cluster

- displaying status, Cluster Status Tool

- cluster administration

- displaying cluster and service status, Cluster Status Tool

- cluster component compatible hardware, 互換ハードウェア

- cluster component man pages, Man ページ

- cluster components table, クラスタコンポーネント

- Cluster Configuration Tool

- accessing, Cluster Configuration Tool

- cluster service

- displaying status, Cluster Status Tool

- command line tools table, コマンドライン管理ツール

- compatible hardware

- cluster components, 互換ハードウェア

- Conga

- overview, Conga

- Conga overview, Conga

F

- feedback, フィードバック

L

- LVS

- direct routing

- requirements, hardware, ダイレクト routing

- requirements, network, ダイレクト routing

- requirements, software, ダイレクト routing

- routing methods

- NAT, Routing の方法

- three tiered

- high-availability cluster, Three-Tier LVS Topology

M

- man pages

- cluster components, Man ページ

N

- NAT

- routing methods, LVS, Routing の方法

- network address translation (参照 NAT)

O

- overview

- economy, Red Hat GFS

- performance, Red Hat GFS

- scalability, Red Hat GFS

P

- Piranha Configuration Tool

- CONTROL/MONITORING, CONTROL/MONITORING

- EDIT MONITORING SCRIPTS Subsection, EDIT MONITORING SCRIPTS Subsection

- GLOBAL SETTINGS, GLOBAL SETTINGS

- login panel, Linux 仮想サーバー管理 GUI

- necessary software, Linux 仮想サーバー管理 GUI

- REAL SERVER subsection, 実サーバー サブセクション

- REDUNDANCY, REDUNDANCY

- VIRTUAL SERVER subsection, VIRTUAL SERVERS

- Firewall Mark , 仮想サーバー サブセクション

- Persistence , 仮想サーバー サブセクション

- Scheduling , 仮想サーバー サブセクション

- Virtual IP Address , 仮想サーバー サブセクション

- VIRTUAL SERVERS, VIRTUAL SERVERS

R

- Red Hat Cluster Suite

- components, クラスタコンポーネント

T

- table

- cluster components, クラスタコンポーネント

- command line tools, コマンドライン管理ツール