Object Gateway 設定および管理ガイド

Ceph Storage Object Gateway の設定および管理

概要

第1章 概要

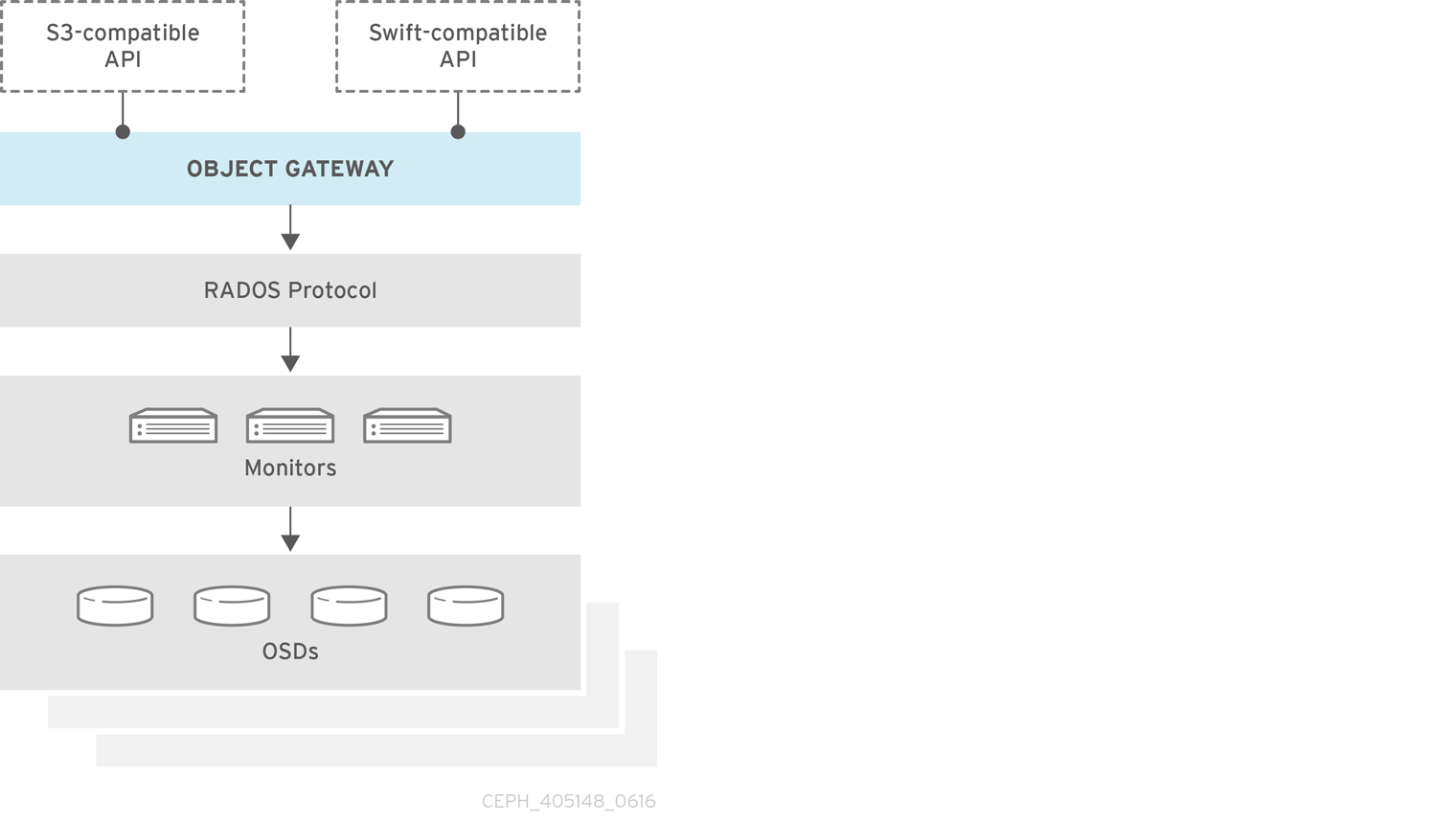

Ceph Object Gateway は RADOS ゲートウェイ (RGW) としても知られている、librados 上に構築されたオブジェクトストレージインターフェイスで、RESTful ゲートウェイを Ceph ストレージクラスターに提供します。Ceph Object Gateway は以下の 2 つのインターフェイスをサポートします。

- S3 準拠: Amazon S3 RESTful API の大規模なサブセットと互換性のあるインターフェイスでオブジェクトストレージ機能を提供します。

- Swift 準拠: OpenStack Swift API の大規模なサブセットと互換性のあるインターフェイスでオブジェクトストレージ機能を提供します。

Ceph Object Gateway は、Ceph Storage Cluster と対話するためのサーバーです。OpenStack Swift および Amazon S3 と互換性のあるインターフェイスを提供するため、Ceph Object Gateway には独自のユーザー管理があります。Ceph Object Gateway は、Ceph ブロックデバイスクライアントからのデータを保存するために使用される同じ Ceph ストレージクラスターにデータを保存できますが、これには別個のプールが使用され、別の CRUSH 階層も使用される可能性があります。S3 および Swift API は共通の名前空間を共有するため、1 つの API でデータを作成し、これを別の API で取得することができます。

RGW で使用されるプールで RADOS スナップショットを使用しないでください。使用すると、望ましくないデータ不整合が発生する可能性があります。

第2章 設定

2.1. Beast および CivetWeb フロントエンドの Web サーバー

Ceph Object Gateway は、フロントエンドとして Beast および CivetWeb を提供します。どちらも C/C++ 埋め込み Web サーバーです。

Beast

Red Hat Ceph Storage 4 以降、Beast はデフォルトのフロントエンド Web サーバーです。Red Hat Ceph Storage 3 からアップグレードすると、rgw_frontends パラメーターが自動的に Beast に変更になります。Beast は Boost.Beast C++ ライブラリーを使用して HTTP を解析し、Boost.Asio を使用して非同期ネットワーク I/O を行います。

CivetWeb

Red Hat Ceph Storage 3 では、CivetWeb がデフォルトのフロントエンドですが、それに応じて rgw_frontends オプションを設定して Beast を使用することもできます。CivetWeb は、Mongoose プロジェクトのフォークである HTTP ライブラリーです。

2.2. Beast フロントエンドの使用

Ceph Object Gateway は、CivetWeb および Beast 埋め込み HTTP サーバーをフロントエンドとして提供します。Beast フロントエンドは、HTTP 解析に Boost.Beast ライブラリーを使用し、非同期ネットワーク I/O に Boost.Asio ライブラリーを使用します。Red Hat Ceph Storage バージョン 3.x では、CivetWeb がデフォルトのフロントエンドとなり、Beast フロントエンドは Red Hat Ceph Storage 設定ファイルの rgw_frontends で指定する必要があります。Red Hat Ceph Storage バージョン 4.0 の時点で、Beast フロントエンドはデフォルトであり、Red Hat Ceph Storage 3.x からのアップグレードにより、rgw_frontends パラメーターが自動的に Beast に変更になります。

関連情報

2.3. Beast 設定オプション

以下の Beast 設定オプションは、RADOS Gateway の Ceph 設定ファイルの組み込み Web サーバーに渡すことができます。それぞれのオプションにはデフォルト値があります。値の指定がない場合は、デフォルト値が空になります。

| オプション | 説明 | デフォルト |

|---|---|---|

|

|

| 空 |

|

| SSL 対応のエンドポイントに使用する SSL 証明書ファイルへのパス。ファイルが複数の項目を含む PEM ファイルである場合、順番は重要です。ファイルは、RGW サーバーキーで始まり、次に中間証明書、最後に C A 証明書となる必要があります。 | 空 |

|

|

SSL 対応のエンドポイントに使用される秘密鍵ファイルへのオプションのパス。 | 空 |

|

| 一部の環境でのパフォーマンスの最適化。 | 空 |

|

| Beast フロントエンドの明示的な要求タイムアウトを設定します。より大きな要求タイムアウトを設定すると、ゲートウェイは低速のクライアント (たとえば、待ち時間の長いネットワークを介して接続されたクライアント) に対してより耐性を持つようになります。 | 65 |

SSL を使用する Beast オプションのある /etc/ceph/ceph.conf ファイルの例:

... [client.rgw.node1] rgw frontends = beast ssl_endpoint=192.168.0.100:443 ssl_certificate=<path to SSL certificate>

デフォルトでは、Beast フロントエンドは、サーバーによって処理されるすべての要求を記録するアクセスログラインを RADOS Gateway ログファイルに書き込みます。

関連情報

- 詳細は、Beast フロントエンド を参照してください。

2.4. CivetWeb ポートの変更

Ansible を使用して Ceph Object Gateway をインストールすると、ポート 8080 で実行するように CivetWeb が設定されます。Ansible は、Ceph 設定ファイルに以下のような行を追加することでこれを行います。

rgw frontends = civetweb port=192.168.122.199:8080 num_threads=100

Ceph 設定ファイルに rgw frontends = civetweb 行が含まれていない場合、Ceph Object Gateway はポート 7480 をリッスンします。rgw_frontends = civetweb 行が含まれているがポートが指定されていない場合、Ceph Object Gateway はポート 80 をリッスンします。

Ansible は、Ceph Object Gateway がポート 8080 をリッスンするように設定し、Red Hat Ceph Storage 4 をインストールするためのサポート対象の方法として ceph-ansible を使用するため、ポート 8080 は Red Hat Ceph Storage 4 ドキュメントのデフォルトのポートとみなされます。

前提条件

- 稼働中の Red Hat Ceph Storage 4.1 クラスターがある。

- Ceph Object Gateway ノードがある。

手順

-

ゲートウェイノードで、

/etc/ceph/ディレクトリーで Ceph 設定ファイルを開きます。 以下の例のような Ceph Object Gateway (RGW) クライアントセクションを見つけます。

[client.rgw.gateway-node1] host = gateway-node1 keyring = /var/lib/ceph/radosgw/ceph-rgw.gateway-node1/keyring log file = /var/log/ceph/ceph-rgw-gateway-node1.log rgw frontends = civetweb port=192.168.122.199:8080 num_threads=100

[client.rgw.gateway-node1]の見出しは、Ceph Storage Cluster クライアントを設定する時に Ceph 設定ファイルのこの部分を特定します。クライアントタイプはrgwで識別される Ceph Object Gateway で、ノードの名前はgateway-node1です。デフォルトの Ansible 設定ポート

8080を80に変更するには、rgw frontends行を編集します。rgw frontends = civetweb port=192.168.122.199:80 num_threads=100

rgw_frontendsキーと値のペアのport=port-numberの間に空白がないことを確認します。ポートを変更する他のゲートウェイノードでこの手順を繰り返します。

各ゲートウェイノードから Ceph Object Gateway サービスを再起動して、新規ポートの設定を有効にします。

# systemctl restart ceph-radosgw.target

各ゲートウェイノードのファイアウォールで、設定したポートが開いていることを確認します。

# firewall-cmd --list-all

ポートが開かない場合は、ポートを追加し、ファイアウォール設定を再読み込みします。

# firewall-cmd --zone=public --add-port 80/tcp --permanent # firewall-cmd --reload

2.5. Civetweb での SSL の使用

Red Hat Ceph Storage 1 では、Ceph Object Gateway に対する Civetweb SSL サポートは HAProxy および keepalived に依存していました。Red Hat Ceph Storage 2 以降のリリースでは、Civetweb は OpenSSL ライブラリーを使用して Transport Layer Security (TLS) を提供できます。

実稼働デプロイメントでは HAProxy および keepalived を使用して HAProxy で SSL 接続を終了する 必要があります。小規模から中規模の テストおよび実稼働前 デプロイメントに のみ、Civetweb で SSL を使用することが推奨されます。

Civetweb で SSL を使用するには、ゲートウェイノードのホスト名と一致する認証局 (CA) から証明書を取得します。Red Hat は、subject alternate name フィールドがあり、S3-style サブドメインで使用するワイルドカードを持つ CA から証明書を取得することを推奨します。

Civetweb では、鍵、サーバー証明書、およびその他の認証局または中間証明書が 1 つの .pem ファイルに必要です。

.pem ファイルには秘密鍵が含まれます。.pem ファイルを不正アクセスから保護します。

SSL にポートを設定するには、ポート番号を rgw_frontends に追加し、ポート番号に s を追加して、セキュアなポートであることを示します。さらに、.pem ファイルへのパスを含む ssl_certificate を追加します。以下に例を示します。

[client.rgw.{hostname}]

rgw_frontends = "civetweb port=443s ssl_certificate=/etc/ceph/private/server.pem"2.6. Civetweb 設定オプション

以下の Civetweb 設定オプションは、RADOS Gateway の Ceph 設定ファイルの組み込み Web サーバーへ渡すことができます。それぞれのオプションにはデフォルト値があり、値が指定されていない場合は、デフォルト値が空になります。

| オプション | 説明 | デフォルト |

|---|---|---|

|

| アクセスログ用のファイルへのパス。完全パスまたは現在の作業ディレクトリーに関連しているかのいずれか。存在しない場合 (デフォルト)、アクセスはログに記録されません。 | 空 |

|

| エラーログ用のファイルへのパス。完全パスまたは現在の作業ディレクトリーに関連しているかのいずれか。存在しない場合 (デフォルト)、エラーはログに記録されません。 | 空 |

|

| ワーカースレッドの数。Civetweb は、別のスレッドで各着信接続を処理します。そのため、このオプションの値は、事実上、Civetweb が処理できる同時 HTTP 接続の数になります。 | 50 |

|

| ネットワーク読み取り操作およびネットワーク書き込み操作のタイムアウト (ミリ秒単位)。クライアントが長時間実行される接続を維持する場合は、この値を増やすか、keep-alive メッセージを (より適切に) 使用します。 | 30000 |

このオプションの一部が設定された /etc/ceph/ceph.conf ファイルの例を以下に示します。

... [client.rgw.node1] rgw frontends = civetweb request_timeout_ms=30000 error_log_file=/var/log/radosgw/civetweb.error.log access_log_file=/var/log/radosgw/civetweb.access.log

CivetWeb および Beast フロントエンドはどちらも、サーバーによって処理されるすべての要求のアクセスログ行記録を RADOS ゲートウェイログファイルに書き込みます。

2.7. DNS へのワイルドカードの追加

S3 スタイルのサブドメイン (例: bucket-name.domain-name.com) で Ceph を使用するには、ceph-radosgw デーモンがドメイン名を解決するために使用する DNS サーバーの DNS レコードにワイルドカードを追加します。

dnsmasq の場合は、ホスト名の先頭にドット (.) を付けた以下のアドレス設定を追加します。

address=/.{hostname-or-fqdn}/{host-ip-address}以下に例を示します。

address=/.gateway-node1/192.168.122.75

bind の場合は、ワイルドカードを DNS レコードに追加します。以下に例を示します。

$TTL 604800

@ IN SOA gateway-node1. root.gateway-node1. (

2 ; Serial

604800 ; Refresh

86400 ; Retry

2419200 ; Expire

604800 ) ; Negative Cache TTL

;

@ IN NS gateway-node1.

@ IN A 192.168.122.113

* IN CNAME @

DNS サーバーを再起動して、サブドメインを使用してサーバーに ping し、ceph-radosgw デーモンがサブドメイン要求を処理できるようにします。

ping mybucket.{hostname}以下に例を示します。

ping mybucket.gateway-node1

DNS サーバーがローカルマシンにある場合は、ローカルマシンのネームサーバーエントリーを追加して /etc/resolv.conf を変更しないといけない場合があります。

最後に、rgw_dns_name = {hostname} 設定を使用して、Ceph 設定ファイルの適切な [client.rgw.{instance}] セクションに DNS サーバーのホスト名またはアドレスを指定します。以下に例を示します。

[client.rgw.rgw1.rgw0]

...

rgw_dns_name = {hostname}

ベストプラクティスとして、管理ノードや ceph-ansible などの一元的な場所で Ceph 設定ファイルを変更し、必要に応じて設定ファイルを再配布し、クラスター全体で一貫性を確保します。

最後に、Ceph Object Gateway を再起動して DNS 設定を有効にします。

2.8. ロギングおよびデバッグ出力の調整

設定手順を完了したら、ログの出力を確認して、ニーズを満たしていることを確認してください。設定に問題が発生した場合には、Ceph 設定ファイルの [global] セクションでメッセージおよびデバッグメッセージを増やし、ゲートウェイを再起動して設定の問題のトラブルシューティングを行うことができます。以下に例を示します。

[global] #append the following in the global section. debug ms = 1 debug civetweb = 20

RGW デバッグログの場合は、Ceph 設定ファイルの [client.rgw.{instance}] セクションに以下のパラメーターを追加します。

[client.rgw.rgw1.rgw0] ... debug rgw = 20

実行時に設定を変更することも可能です。以下に例を示します。

# ceph tell osd.0 injectargs --debug_civetweb 10/20

Ceph ログファイルは、デフォルトで /var/log/ceph に保存されています。

ロギングおよびデバッグに関する一般的な情報は、Red Hat Ceph Storage 設定ガイドの Ceph デバッグおよびログ設定 セクションを参照してください。

2.9. S3 サーバー側の暗号化

Ceph Object Gateway は、S3 アプリケーションプログラムインターフェイス (API) のアップロードされたオブジェクトのサーバー側の暗号化をサポートします。サーバー側の暗号化とは、S3 クライアントが暗号化されていない形式で HTTP 経由でデータを送信し、Ceph Object Gateway はそのデータを暗号化した形式で Red Hat Ceph Storage に保存することを意味します。

Red Hat は、Static Large Object (SLO) または Dynamic Large Object (DLO) の S3 オブジェクト暗号化をサポートしません。

暗号化を使用するには、クライアントリクエストは、SSL 接続上でリクエストを送信する 必要があります。Red Hat は、Ceph Object Gateway が SSL を使用しない限り、クライアントからの S3 暗号化をサポートしません。ただし、テスト目的で、管理者は、ランタイム時に rgw_crypt_require_ssl 設定を false に設定し、Ceph 設定ファイルで false に設定して、Ansible 設定ファイルで false に設定し、Ceph Object Gateway の Ansible Playbook を再生して、テスト中に SSL を無効にすることができます。

実稼働環境では、SSL 経由で暗号化された要求を送信できない場合があります。このような場合は、サーバー側の暗号化で HTTP を使用して要求を送信します。

サーバー側の暗号化で HTTP を設定する方法は、以下の関連情報セクションを参照してください。

暗号化キーの管理には、以下の 2 つのオプションがあります。

お客様提供のキー

お客様が提供する鍵を使用する場合、S3 クライアントは暗号鍵を各リクエストと共に渡して、暗号化されたデータの読み取りまたは書き込みを行います。これらのキーを管理するのは、お客様の責任です。各オブジェクトの暗号化に使用する Ceph Object Gateway の鍵を覚えておく必要があります。

Ceph Object Gateway は、Amazon SSE-C 仕様に従って、S3 API で顧客提供のキー動作を実装します。

お客様がキー管理を処理し、S3 クライアントはキーを Ceph Object Gateway に渡すため、Ceph Object Gateway ではこの暗号化モードをサポートするための特別な設定は必要ありません。

キー管理サービス

キー管理サービスを使用する場合、セキュアなキー管理サービスはキーを格納し、Ceph Object Gateway はデータの暗号化または復号の要求に対応するためにキーをオンデマンドで取得します。

Ceph Object Gateway は、Amazon SSE-KMS 仕様に従って S3 API にキー管理サービスの動作を実装します。

現時点で、テスト済み鍵管理の実装は HashiCorp Vault および OpenStack Barbican です。ただし、OpenStack Barbican はテクノロジープレビューであるため、実稼働システムでの使用はサポートされません。

2.10. サーバー側の暗号化要求

実稼働環境では、クライアントはプロキシーを介して Ceph Object Gateway に接続されることがよくあります。このプロキシーは、複数の Ceph Object Gateway に接続するため、ロードバランサーと呼ばれます。クライアントが Ceph Object Gateway に要求を送信する場合、ロードバランサーはこれらの要求を複数の Ceph Object Gateway にルーティングし、ワークロードを配布します。

このような設定では、ロードバランサーでも、ロードバランサーと複数の Ceph Object Gateways の間でも、SSL の終了が発生する可能性があります。通信は HTTP のみを使用して行われます。サーバー側の暗号化要求を受け入れるように Ceph Object Gateway を設定するには、Configuring server-side encryption を参照してください。

2.11. サーバー側の暗号化の設定

ストレージ管理者は、SSL 経由で暗号化された要求を送信できない場合に、HTTP を使用して Ceph Object Gateway に要求を送信するようにサーバー側の暗号化を設定できます。

以下の手順では、HAProxy をプロキシーおよびロードバランサーとして使用します。

前提条件

- ストレージクラスター内のすべてのノードへの root レベルのアクセス。

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Ceph Object Gateway がインストールされている。

- HAProxy がインストールされている。

手順

haproxy.cfgファイルを編集します。例

frontend http_web bind *:80 mode http default_backend rgw frontend rgw-https bind *:443 ssl crt /etc/ssl/private/example.com.pem default_backend rgw backend rgw balance roundrobin mode http server rgw1 10.0.0.71:8080 check server rgw2 10.0.0.80:8080 checkhttpフロントエンドへのアクセスを許可する行をコメントアウトし、代わりにhttpsフロントエンドを使用するように HAProxy に指示する手順を追加します。例

# frontend http_web # bind *:80 # mode http # default_backend rgw frontend rgw-https bind *:443 ssl crt /etc/ssl/private/example.com.pem http-request set-header X-Forwarded-Proto https if { ssl_fc } http-request set-header X-Forwarded-Proto https # here we set the incoming HTTPS port on the load balancer (eg : 443) http-request set-header X-Forwarded-Port 443 default_backend rgw backend rgw balance roundrobin mode http server rgw1 10.0.0.71:8080 check server rgw2 10.0.0.80:8080 checkクラスターのすべてのノードで、以下のパラメーターを Ceph 設定ファイルの

[global]セクションに追加します。rgw_trust_forwarded_https=true

HAProxy を有効にして起動します。

[root@haproxy]# systemctl enable haproxy [root@haproxy]# systemctl start haproxy

Ansible の実行時に

rgw_trust_forwarded_https=trueが Ceph 設定ファイルから削除されないようにするには、ceph-ansibleall.ymlファイルを編集し、ceph_conf_overrides / globalセクションのrgw_trust_forwarded_httpsをtrueに設定します。ceph_conf_overrides: global: rgw_trust_forwarded_https: true- 変更が完了したら、ceph-ansible Playbook を実行して、すべての Ceph ノードの設定を更新します。

2.12. HashiCorp Vault

ストレージ管理者は、Ceph Object Gateway で使用するために、キー、パスワード、および証明書を HAshiCorp Vault に安全に保存できます。HashiCorp Vault は、Ceph Object Gateway で使用されるサーバー側の暗号化にセキュアなキー管理サービスを提供します。

基本的なワークフロー:

- クライアントは、オブジェクトのキー ID に基づいて Vault からシークレットキーの作成を要求します。

- クライアントはオブジェクトのキー ID を持つオブジェクトを Ceph Object Gateway にアップロードします。

- 次に、Ceph Object Gateway は Vault から新規に作成されたシークレットキーを要求します。

- Vault は、Ceph Object Gateway に秘密鍵を返して要求に応えます。

- これで、Ceph Object Gateway は、新しい秘密鍵を使用してオブジェクトを暗号化できます。

- 暗号化が完了すると、オブジェクトが Ceph OSD に保存されます。

Red Hat は、弊社のテクノロジーパートナーと協力して、本書をお客様にサービスとして提供します。ただし、Red Hat はこの製品のサポートを提供しません。この製品の技術的なサポートが必要な場合は、Hashicorp にサポートを依頼してください。

2.12.1. 前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Ceph Object Gateway ソフトウェアのインストール。

- HashiCorp Vault ソフトウェアのインストール。

2.12.2. Vault のシークレットエンジン

HashiCorp Vault は、データを生成、保存、または暗号化するためのシークレットエンジンを複数提供します。アプリケーションプログラミングインターフェイス (API) は、データに対するアクションを求めるデータ呼び出しをシークレットエンジンに送信し、シークレットエンジンはそのアクション要求の結果を返します。

Ceph Object Gateway は、HashiCorp Vault シークレットエンジンの 2 つをサポートします。

- キー/値のバージョン 2

- Transit

キー/値のバージョン 2

Key/Value シークレットエンジンは、ディスク上の Vault 内にランダムのシークレットを保存します。kv エンジンのバージョン 2 では、設定可能な数のバージョン数をキーに指定できます。デフォルトのバージョン数は 10 です。バージョンを削除しても元のデータは削除されませんが、データが削除されたことになり、削除されたバージョンを元に戻すことができます。鍵名は文字列にする必要があります。また、コマンドラインインターフェイスの使用時に、エンジンは文字列以外の値を文字列に変換します。文字列以外の値を保持するには、JSON ファイルを指定するか、HTTP アプリケーションプログラミングインターフェイス (API) を使用します。

アクセス制御リスト (ACL) ポリシーの場合、キー/値のシークレットエンジンは 作成 機能と 更新 機能の違いを認識します。

Transit

Transit シークレットエンジンは、移動データで暗号化機能を実行します。Transit シークレットエンジンはハッシュを生成したり、ランダムバイトのソースとなったり、データの署名や検証を行うことができます。Vault は、Transit シークレットエンジンの使用時にデータを保存しません。Transit シークレットエンジンは、複数の目的で同じ鍵を使用できるようにすることで鍵導出をサポートします。また、transit シークレットエンジンは鍵バージョン管理をサポートします。Transit シークレットエンジンは、以下のキータイプをサポートします。

aes128-gcm96- 128 ビットの AES キーと 96 ビットのノンスを備えた AES-GCM。暗号化、復号、鍵導出、および収束暗号化をサポートします。

aes256-gcm96- 256 ビットの AES キーと 96 ビットのノンスを備えた AES-GCM。暗号化、復号、鍵導出、および収束暗号化 (デフォルト) をサポートします。

chacha20-poly1305- 256 ビットキーの ChaCha20-Poly1305。暗号化、復号、鍵導出、および収束暗号化をサポートします。

ed25519- Ed25519。署名、署名の検証、および鍵導出をサポートします。

ecdsa-p256- 曲線 P-256 を使用した ECDSA。署名および署名の検証をサポートします。

ecdsa-p384- 曲線 P-384 を使用した ECDSA。署名および署名の検証をサポートします。

ecdsa-p521- 曲線 P-521 を使用した ECDSA。署名および署名の検証をサポートします。

rsa-2048- 2048 ビット RSA 鍵、暗号化、復号、署名、および署名の検証をサポートします。

rsa-3072- 3072 ビット RSA 鍵。暗号化、復号、署名、および署名の検証をサポートします。

rsa-4096- 4096 ビットの RSA 鍵。暗号化、復号、署名、および署名の検証をサポートします。

関連情報

- 詳細は、Vault のプロジェクトサイトにある KV Secrets Engine ドキュメントを参照してください。

- 詳細は、Vault のプロジェクトサイトにある Transport Secrets Engine ドキュメントを参照してください。

2.12.3. Vault の認証

HashiCorp Vault は、複数のタイプの認証メカニズムをサポートします。Ceph Object Gateway は現在、Vault エージェントとトークン認証メソッドをサポートしています。Ceph Object Gateway は rgw_crypt_vault_auth オプションおよび rgw_crypt_vault_addr オプションを使用して HashiCorp Vault を使用するように設定します。

トークン

トークン認証方法により、ユーザーはトークンを使用して認証できます。新規トークンの作成、トークンごとのシークレットの取り消し、およびその他の多くのトークン操作が可能です。トークンストアを使用すると、他の認証方法をバイパスできます。トークン認証方法を使用する場合は、rgw_crypt_vault_token_file オプションも使用する必要があります。トークンファイルは、Ceph Object Gateway でのみ読み取り可能です。また、特定のパスからのキーリングの取得を可能にする制限されたポリシーを持つ Vault トークンを使用する必要があります。

Red Hat は、実稼働環境でのトークン認証の使用を推奨していません。

Vault エージェント

Vault エージェントは、クライアントノードで実行するデーモンで、トークンの更新と共にクライアント側のキャッシュを提供します。Vault エージェントは、通常 Ceph Object Gateway ノードで実行されます。

関連情報

- 詳細は、Vault のプロジェクトサイトにある Token Auth Method ドキュメントを参照してください。

- 詳細は、Vault のプロジェクトサイトにある Vault Agent ドキュメントを参照してください。

2.12.4. Vault の namespace

HashiCorp Vault をエンタープライズサービスとして使用すると、組織内のチームが使用可能な分離された名前空間の一元管理が提供されます。これらの分離された名前空間環境は テナント と呼ばれ、組織内のチームがこれらの テナント を使用して、ポリシー、シークレット、ID を他のチームから分離することができます。Vault の名前空間機能は、単一インフラストラクチャー内からセキュアなマルチテナンシーをサポートします。

関連情報

- 詳細は、Vault のプロジェクトサイトにある Vault Enterprise Namespaces ドキュメントを参照してください。

2.12.5. Vault を使用するために Ceph Object Gateway の設定

Ceph Object Gateway が HashiCorp Vault を使用するように設定するには、暗号化キーストアとして設定する必要があります。現在、Ceph Object Gateway は 2 つの異なるシークレットエンジンと、2 つの異なる認証方法をサポートしています。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Ceph Object Gateway ソフトウェアのインストール。

- Ceph Object Gateway ノードへのルートレベルのアクセス。

手順

Ceph 設定ファイル (デフォルトでは

/etc/ceph/ceph.conf) を編集するためにを開き、Vault を暗号化キーストアとして有効にします。rgw_crypt_s3_kms_backend = vault

[client.radosgw.INSTANCE_NAME]セクションで、Token または Vault エージェントのいずれかの Vault 認証メソッドを選択します。Token を使用している場合は、以下の行を追加します。

rgw_crypt_vault_auth = token rgw_crypt_vault_token_file = /etc/ceph/vault.token rgw_crypt_vault_addr = http://VAULT_SERVER:8200Vault エージェント を使用している場合は、以下の行を追加します。

rgw_crypt_vault_auth = agent rgw_crypt_vault_addr = http://VAULT_SERVER:8100

[client.radosgw.INSTANCE_NAME]セクションで、Key/Value または Transit のいずれかの Vault シークレットエンジンを選択します。Key/Value を使用している場合は、以下の行を追加します。

rgw_crypt_vault_secret_engine = kv

Transit を使用している場合は、以下の行を追加します。

rgw_crypt_vault_secret_engine = transit

必要に応じて、

[client.radosgw.INSTANCE_NAME]セクションで、暗号化キーを取得する Vault 名前空間を設定できます。rgw_crypt_vault_namespace = NAME_OF_THE_NAMESPACEパス接頭辞を設定し、Ceph Object Gateway が Vault から暗号化キーを取得する場所を制限します。

例

rgw_crypt_vault_prefix = /v1/secret/data

エクスポート可能な Transit キーの場合、以下のように接頭辞パスを設定します。

rgw_crypt_vault_prefix = /v1/transit/export/encryption-key

Vault サーバーのドメイン名が

vault-serverである場合は、Ceph Object Gateway は以下の URL から暗号化されたトランジションキーを取得します。例

http://vault-server:8200/v1/transit/export/encryption-key

- 変更を Ceph 設定ファイルに保存します。

関連情報

- 詳細は、Red Hat Ceph Storage Object Gateway 設定および管理ガイドの Vault 向けシークレットエンジン セクションを参照してください。

- 詳細は、Red Hat Ceph Storage Object Gateway 設定および管理ガイドの Vault 向け認証 セクションを参照してください。

2.12.6. kv エンジンを使用したキーの作成

HashiCorp Vault Key/Value シークレットエンジン (kv) を設定し、Ceph Object Gateway で使用するためのキーを作成できるようにします。シークレットは、kv シークレットエンジンのキーと値のペアとして保存されます。

サーバー側の暗号化のキーは 256 ビットの長さで、base64 を使用してエンコードする必要があります。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- HashiCorp Vault ソフトウェアのインストール。

- HashiCorp Vault ノードへの root レベルのアクセス。

手順

キー/値 バージョン 2 シークレットエンジンを有効にします。

[root@vault ~]# vault secrets enable kv-v2

新しいキーを作成します。

構文

vault kv put secret/PROJECT_NAME/BUCKET_NAME key=$(openssl rand -base64 32)

例

[root@vault ~]# vault kv put secret/myproject/mybucketkey key=$(openssl rand -base64 32) ====== Metadata ====== Key Value --- ----- created_time 2020-02-21T17:01:09.095824999Z deletion_time n/a destroyed false version 1

2.12.7. 転送エンジンを使用した鍵の作成

HashiCorp Vault 遷移シークレットエンジン (transit) を設定して、Ceph Object Gateway で使用するキーを作成できるようにします。Ceph Object Gateway でサーバー側の暗号化に使用するためには、Transit シークレットエンジンで作成した鍵がエクスポート可能である必要があります。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- HashiCorp Vault ソフトウェアのインストール。

- HashiCorp Vault ノードへの root レベルのアクセス。

手順

Transit シークレットエンジンを有効にします。

[root@vault ~]# vault secrets enable transit

新しいエクスポート可能なキーを作成します。

構文

vault write -f transit/keys/BUCKET_NAME exportable=true例

[root@vault ~]# vault write -f transit/keys/mybucketkey exportable=true

注記デフォルトでは、上記のコマンドは

aes256-gcm96タイプキーを作成します。キーの作成を確認します。

構文

vault read transit/export/encryption-key/BUCKET_NAME/VERSION_NUMBER

例

[root@vault ~]# vault read transit/export/encryption-key/mybucketkey/1 Key Value --- ----- keys map[1:-gbTI9lNpqv/V/2lDcmH2Nq1xKn6FPDWarCmFM2aNsQ=] name mybucketkey type aes256-gcm96

注記キーバージョンを含む完全なキーパスを指定する必要があります。

2.12.8. AWS および Vault を使用したオブジェクトのアップロード

Ceph Object Gateway にオブジェクトをアップロードする際に、Ceph Object Gateway は Vault からキーを取得し、そのオブジェクトをバケットに暗号化して保存します。オブジェクトのダウンロード要求が行われると、Ceph Object Gateway は Vault から対応するキーを自動的に取得し、オブジェクトを復号します。

URL は、rgw_crypt_vault_addr オプションと、rgw_crypt_vault_prefix オプションで設定されたパス接頭辞を使用して構築されます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- Ceph Object Gateway ソフトウェアのインストール。

- HashiCorp Vault ソフトウェアのインストール。

- Ceph Object Gateway クライアントノードへのアクセス。

- Amazon Web Services (AWS) へのアクセス。

手順

AWS コマンドラインクライアントを使用して、オブジェクトをアップロードします。

例

[user@client ~]$ aws --endpoint=http://radosgw:8000 s3 cp plaintext.txt s3://mybucket/encrypted.txt --sse=aws:kms --sse-kms-key-id myproject/mybucketkey

注記例で使用するキーフェッチ URL は

http://vault-server:8200/v1/secret/data/myproject/mybucketkeyです。

2.12.9. 関連情報

- 詳細は、Vault のプロジェクトサイトにある Install Vault ドキュメントを参照してください。

2.13. ゲートウェイのテスト

REST インターフェイスを使用するには、まず S3 インターフェイス用に初期 Ceph Object Gateway ユーザーを作成します。次に、Swift インターフェイスのサブユーザーを作成します。作成されたユーザーがゲートウェイにアクセスできるかどうかを確認する必要があります。

2.13.1. S3 ユーザーの作成

ゲートウェイをテストするには、S3 ユーザーを作成し、ユーザーアクセスを付与します。man radosgw-admin コマンドは、追加のコマンドオプションに関する情報を提供します。

マルチサイトのデプロイメントでは、マスターゾーングループのマスターゾーンにあるホストでユーザーを作成します。

前提条件

-

rootまたはsudoアクセス - Ceph Object Gateway がインストールされていること

手順

S3 ユーザーを作成します。

radosgw-admin user create --uid=name --display-name="First User"name を、S3 ユーザーの名前に置き換えます。以下に例を示します。

[root@master-zone]# radosgw-admin user create --uid="testuser" --display-name="First User" { "user_id": "testuser", "display_name": "First User", "email": "", "suspended": 0, "max_buckets": 1000, "auid": 0, "subusers": [], "keys": [ { "user": "testuser", "access_key": "CEP28KDIQXBKU4M15PDC", "secret_key": "MARoio8HFc8JxhEilES3dKFVj8tV3NOOYymihTLO" } ], "swift_keys": [], "caps": [], "op_mask": "read, write, delete", "default_placement": "", "placement_tags": [], "bucket_quota": { "enabled": false, "check_on_raw": false, "max_size": -1, "max_size_kb": 0, "max_objects": -1 }, "user_quota": { "enabled": false, "check_on_raw": false, "max_size": -1, "max_size_kb": 0, "max_objects": -1 }, "temp_url_keys": [], "type": "rgw" }出力を確認し、

access_keyおよびsecret_keyの値に JSON エスケープ文字 (\) が含まれていないことを確認します。これらの値はアクセスの検証に必要ですが、値に JSON エスケープ文字が含まれる場合、特定のクライアントは処理できません。この問題を修正するには、以下のアクションのいずれかを実行します。- JSON エスケープ文字を削除します。

- 文字列を引用符でカプセル化します。

- キーを再生成し、JSON エスケープ文字が含まれていないことを確認します。

- キーおよびシークレットを手動で指定します。

正引きスラッシュ

/は有効な文字であるため、削除しないでください。

2.13.2. Swift ユーザーの作成

Swift インターフェイスをテストするには、Swift サブユーザーを作成します。Swift ユーザーの作成は 2 つの手順です。最初のステップでは、ユーザーを作成します。次のステップでは、秘密鍵を作成します。

マルチサイトのデプロイメントでは、マスターゾーングループのマスターゾーンにあるホストでユーザーを作成します。

前提条件

- Ceph Object Gateway のインストール

- Ceph Object Gateway ノードへのルートレベルのアクセス。

手順

Swift ユーザーを作成します。

構文

radosgw-admin subuser create --uid=NAME --subuser=NAME:swift --access=full

NAME を Swift ユーザー名に置き換えます。以下に例を示します。

例

[root@rgw]# radosgw-admin subuser create --uid=testuser --subuser=testuser:swift --access=full { "user_id": "testuser", "display_name": "First User", "email": "", "suspended": 0, "max_buckets": 1000, "auid": 0, "subusers": [ { "id": "testuser:swift", "permissions": "full-control" } ], "keys": [ { "user": "testuser", "access_key": "O8JDE41XMI74O185EHKD", "secret_key": "i4Au2yxG5wtr1JK01mI8kjJPM93HNAoVWOSTdJd6" } ], "swift_keys": [ { "user": "testuser:swift", "secret_key": "13TLtdEW7bCqgttQgPzxFxziu0AgabtOc6vM8DLA" } ], "caps": [], "op_mask": "read, write, delete", "default_placement": "", "placement_tags": [], "bucket_quota": { "enabled": false, "check_on_raw": false, "max_size": -1, "max_size_kb": 0, "max_objects": -1 }, "user_quota": { "enabled": false, "check_on_raw": false, "max_size": -1, "max_size_kb": 0, "max_objects": -1 }, "temp_url_keys": [], "type": "rgw" }シークレットキーを作成します。

構文

radosgw-admin key create --subuser=NAME:swift --key-type=swift --gen-secretNAME を Swift ユーザー名に置き換えます。以下に例を示します。

例

[root@rgw]# radosgw-admin key create --subuser=testuser:swift --key-type=swift --gen-secret { "user_id": "testuser", "display_name": "First User", "email": "", "suspended": 0, "max_buckets": 1000, "auid": 0, "subusers": [ { "id": "testuser:swift", "permissions": "full-control" } ], "keys": [ { "user": "testuser", "access_key": "O8JDE41XMI74O185EHKD", "secret_key": "i4Au2yxG5wtr1JK01mI8kjJPM93HNAoVWOSTdJd6" } ], "swift_keys": [ { "user": "testuser:swift", "secret_key": "a4ioT4jEP653CDcdU8p4OuhruwABBRZmyNUbnSSt" } ], "caps": [], "op_mask": "read, write, delete", "default_placement": "", "placement_tags": [], "bucket_quota": { "enabled": false, "check_on_raw": false, "max_size": -1, "max_size_kb": 0, "max_objects": -1 }, "user_quota": { "enabled": false, "check_on_raw": false, "max_size": -1, "max_size_kb": 0, "max_objects": -1 }, "temp_url_keys": [], "type": "rgw" }

2.13.3. S3 アクセスのテスト

S3 アクセスを検証するには、Python テストスクリプトを作成し、実行する必要があります。S3 アクセステストスクリプトは radosgw に接続し、新規バケットを作成し、すべてのバケットを一覧表示します。aws_access_key_id および aws_secret_access_key の値は、radosgw_admin コマンドで返される access_key および secret_key の値から取得されます。

出力にはメタデータを維持するための追加の json フィールドが含まれるため、システムユーザーはゾーン全体に対する root 権限を持っている必要があります。

前提条件

-

rootまたはsudoアクセス - Ceph Object Gateway がインストールされている。

- S3 ユーザーが作成されました。

手順

Red Hat Enterprise Linux 7 の共通リポジトリーと RedHat Enterprise Linux 8 の高可用性リポジトリーを有効にします。

Red Hat Enterprise Linux 7

# subscription-manager repos --enable=rhel-7-server-rh-common-rpms

Red Hat Enterprise Linux 8

# subscription-manager repos --enable=rhel-8-for-x86_64-highavailability-rpms

python-botoパッケージをインストールします。Red Hat Enterprise Linux 7

# yum install python-boto

Red Hat Enterprise Linux 8

# dnf install python3-boto3

Python スクリプトを作成します。

vi s3test.py

ファイルに以下のコンテンツを追加します。

Red Hat Enterprise Linux 7

import boto import boto.s3.connection access_key = 'ACCESS' secret_key = 'SECRET' boto.config.add_section('s3') conn = boto.connect_s3( aws_access_key_id = access_key, aws_secret_access_key = secret_key, host = 's3.ZONE.hostname', port = PORT, is_secure=False, calling_format = boto.s3.connection.OrdinaryCallingFormat(), ) bucket = conn.create_bucket('my-new-bucket') for bucket in conn.get_all_buckets(): print "{name}\t{created}".format( name = bucket.name, created = bucket.creation_date, )

Red Hat Enterprise Linux 8

import boto3 endpoint = "" # enter the endpoint URL along with the port "http://URL:_PORT_" access_key = 'ACCESS' secret_key = 'SECRET' s3 = boto3.client( 's3', endpoint_url=endpoint, aws_access_key_id=access_key, aws_secret_access_key=secret_key ) s3.create_bucket(Bucket='my-new-bucket') response = s3.list_buckets() for bucket in response['Buckets']: print("{name}\t{created}".format( name = bucket['Name'], created = bucket['CreationDate'] ))

-

ZONEは、ゲートウェイサービスを設定したホストのゾーン名に置き換えます。つまり、gateway hostです。host` の設定が DNS で解決されていることを確認します。`PORTは、ゲートウェイのポート番号に置き換えます。 -

ACCESSおよびSECRETは、Red Hat Ceph Storage Object Gateway 設定および管理ガイドの S3 ユーザーの作成 セクションのaccess_keyおよびsecret_keyの値に置き換えます。

-

スクリプトを実行します。

Red Hat Enterprise Linux 7

python s3test.py

Red Hat Enterprise Linux 8

python3 s3test.py

出力例:

my-new-bucket 2021-08-16T17:09:10.000Z

2.13.4. Swift アクセスのテスト

Swift アクセスは、swift コマンドラインクライアントを使用して検証できます。man swift コマンドは、利用可能なコマンドラインオプションの詳細を提供します。

swift クライアントをインストールするには、以下のコマンドを実行します。

sudo yum install python-setuptools sudo easy_install pip sudo pip install --upgrade setuptools sudo pip install --upgrade python-swiftclient

swift アクセスをテストするには、以下のコマンドを実行します。

swift -A http://{IP ADDRESS}:{port}/auth/1.0 -U testuser:swift -K '{swift_secret_key}' list

{IP ADDRESS} を、ゲートウェイサーバーのパブリック IP アドレスに置き換え、{swift_secret_key} を、swift ユーザーに対して実行した radosgw-admin key create コマンドの出力にある値に置き換えます。{port} を、Civetweb で使用しているポート番号に置き換えてください (例: デフォルトは 8080 です)。ポートを置き換えない場合、デフォルトはポート 80 になります。

以下に例を示します。

swift -A http://10.19.143.116:8080/auth/1.0 -U testuser:swift -K '244+fz2gSqoHwR3lYtSbIyomyPHf3i7rgSJrF/IA' list

出力は以下のようになります。

my-new-bucket

2.14. HAProxy/keepalived の設定

Ceph Object Gateway では、Object Gateway の多数のインスタンスを 1 つのゾーンに割り当てることができます。これにより、負荷が増大するとスケールアウトすることができます。つまり、同じゾーングループおよびゾーンとなりますが、HAProxy/keepalived を使用するためにフェデレーションされたアーキテクチャーは必要ありません。各 Ceph Object Gateway インスタンスには独自の IP アドレスがあるため、HAProxy および keepalived を使用して、Ceph Object Gateway サーバー全体で負荷のバランスを取ることができます。

HAProxy および keepalived のもう 1 つのユースケースは、HAProxy サーバーで HTTPS を終了することです。HAProxy サーバーを使用して HAProxy サーバーで HTTPS を終了でき、HAProxy サーバーと Civetweb ゲートウェイインスタンスの間で HTTP を使用できます。

本セクションでは、Red Hat Enterprise Linux 7 向けの HAProxy および keepalived の設定を説明します。

Red Hat Enterprise Linux 8 の場合は、keepalived パッケージおよび haproxy パッケージをインストールして、ロードバランサーをインストールします。How do we need any additional subscription for Load Balancing on Red Hat Enterprise Linux 8? を参照してください。詳細については、ナレッジベースアーティクルを参照してください。

2.14.1. HAProxy/keepalived の前提条件

Ceph Object Gateway で HA プロキシーを設定するには、以下が必要です。

- 稼働中の Ceph クラスター

-

ポート

80で実行されるように設定している同じゾーン内の少なくとも 2 つの Ceph Object Gateway サーバー。簡単なインストール手順に従うと、ゲートウェイインスタンスはデフォルトで同じゾーングループおよびゾーンに置かれます。フェデレーションアーキテクチャーを使用している場合は、インスタンスが同じゾーングループとゾーンにあることを確認してください。 -

HAProxy および

keepalivedの場合は少なくとも 2 台のサーバー。

本セクションでは、少なくとも 2 つの Ceph Object Gateway サーバーが実行されていることを前提とし、ポート 80 でテストスクリプトを実行する際に、このいずれかのサーバーからの有効な応答を取得していることを前提としています。

HAProxy および keepalived の詳細な説明は、ロードバランサーの管理 を参照してください。

2.14.2. HAProxy ノードの準備

以下の設定は、haproxy と haproxy2 という名前の 2 つの HAProxy ノードと、rgw1 と rgw2 という名前の 2 台の Ceph Object Gateway サーバーを前提としています。希望の命名規則を使用できます。少なくとも 2 つの HAProxy ノードで以下の手順を実行します。

- Red Hat Enterprise Linux 7 をインストールします。

ノードを登録します。

[root@haproxy]# subscription-manager register

RHEL サーバーリポジトリーを有効にします。

[root@haproxy]# subscription-manager repos --enable=rhel-7-server-rpms

サーバーを更新します。

[root@haproxy]# yum update -y

-

必要に応じて管理ツール (

wget、vimなど) をインストールします。 ポート

80を開きます。[root@haproxy]# firewall-cmd --zone=public --add-port 80/tcp --permanent [root@haproxy]# firewall-cmd --reload

HTTPS の場合は、ポート

443を開きます。[root@haproxy]# firewall-cmd --zone=public --add-port 443/tcp --permanent [root@haproxy]# firewall-cmd --reload

必要なポートに接続します。

[root@haproxy]# semanage port -m -t http_cache_port_t -p tcp 8081

2.14.3. keepalived のインストールと設定

少なくとも 2 つの HAProxy ノードで以下の手順を実行します。

前提条件

- 少なくとも 2 つの HAProxy ノード

- 少なくとも 2 つの Object Gateway ノード

手順

keepalivedをインストールします。[root@haproxy]# yum install -y keepalived

両方の HAProxy ノードで

keepalivedを設定します。[root@haproxy]# vim /etc/keepalived/keepalived.conf

設定ファイルには、

haproxyプロセスを確認するスクリプトがあります。vrrp_script chk_haproxy { script "killall -0 haproxy" # check the haproxy process interval 2 # every 2 seconds weight 2 # add 2 points if OK }次に、マスターロードバランサーとバックアップロードバランサーのインスタンスは、ネットワークインターフェイスとして

eno1を使用します。また、仮想 IP アドレス (192.168.1.20) も割り当てます。マスターロードバランサーノード

vrrp_instance RGW { state MASTER # might not be necessary. This is on the Master LB node. @main interface eno1 priority 100 advert_int 1 interface eno1 virtual_router_id 50 @main unicast_src_ip 10.8.128.43 80 unicast_peer { 10.8.128.53 } authentication { auth_type PASS auth_pass 1111 } virtual_ipaddress { 192.168.1.20 } track_script { chk_haproxy } } virtual_server 192.168.1.20 80 eno1 { #populate correct interface delay_loop 6 lb_algo wlc lb_kind dr persistence_timeout 600 protocol TCP real_server 10.8.128.43 80 { # ip address of rgw2 on physical interface, haproxy listens here, rgw listens to localhost:8080 or similar weight 100 TCP_CHECK { # perhaps change these to a HTTP/SSL GET? connect_timeout 3 } } real_server 10.8.128.53 80 { # ip address of rgw3 on physical interface, haproxy listens here, rgw listens to localhost:8080 or similar weight 100 TCP_CHECK { # perhaps change these to a HTTP/SSL GET? connect_timeout 3 } } }バックアップロードバランサーノード

vrrp_instance RGW { state BACKUP # might not be necessary? priority 99 advert_int 1 interface eno1 virtual_router_id 50 unicast_src_ip 10.8.128.53 80 unicast_peer { 10.8.128.43 } authentication { auth_type PASS auth_pass 1111 } virtual_ipaddress { 192.168.1.20 } track_script { chk_haproxy } } virtual_server 192.168.1.20 80 eno1 { #populate correct interface delay_loop 6 lb_algo wlc lb_kind dr persistence_timeout 600 protocol TCP real_server 10.8.128.43 80 { # ip address of rgw2 on physical interface, haproxy listens here, rgw listens to localhost:8080 or similar weight 100 TCP_CHECK { # perhaps change these to a HTTP/SSL GET? connect_timeout 3 } } real_server 10.8.128.53 80 { # ip address of rgw3 on physical interface, haproxy listens here, rgw listens to localhost:8080 or similar weight 100 TCP_CHECK { # perhaps change these to a HTTP/SSL GET? connect_timeout 3 } } }keepalivedサービスを有効にして開始します。[root@haproxy]# systemctl enable keepalived [root@haproxy]# systemctl start keepalived

関連情報

-

keepalivedの設定に関する詳しい説明は、Keepalived を使用した初期ロードバランサーの設定 を参照してください。

2.14.4. HAProxy のインストールおよび設定

少なくとも 2 つの HAProxy ノードで以下の手順を実行します。

haproxyをインストールします。[root@haproxy]# yum install haproxy

SELinux および HTTP に対して

haproxyを設定します。[root@haproxy]# vim /etc/firewalld/services/haproxy-http.xml

以下の行を追加します。

<?xml version="1.0" encoding="utf-8"?> <service> <short>HAProxy-HTTP</short> <description>HAProxy load-balancer</description> <port protocol="tcp" port="80"/> </service>

rootとして、正しい SELinux コンテキストとファイルパーミッションをhaproxy-http.xmlファイルに割り当てます。[root@haproxy]# cd /etc/firewalld/services [root@haproxy]# restorecon haproxy-http.xml [root@haproxy]# chmod 640 haproxy-http.xml

HTTPS を使用する場合は、SELinux および HTTPS に対して

haproxyを設定します。[root@haproxy]# vim /etc/firewalld/services/haproxy-https.xml

以下の行を追加します。

<?xml version="1.0" encoding="utf-8"?> <service> <short>HAProxy-HTTPS</short> <description>HAProxy load-balancer</description> <port protocol="tcp" port="443"/> </service>

rootで、正しい SELinux コンテキストとファイルパーミッションをhaproxy-https.xmlファイルに割り当てます。# cd /etc/firewalld/services # restorecon haproxy-https.xml # chmod 640 haproxy-https.xml

HTTPS を使用する場合は、SSL のキーを生成します。証明書がない場合は、自己署名証明書を使用できます。キーを生成するには、Red Hat Enterprise Linux 7 のシステム管理者のガイドの 新しい鍵および証明書の生成 セクションを参照してください。

最後に、証明書と鍵を PEM ファイルに格納します。

[root@haproxy]# cat example.com.crt example.com.key > example.com.pem [root@haproxy]# cp example.com.pem /etc/ssl/private/

haproxyを設定します。[root@haproxy]# vim /etc/haproxy/haproxy.cfg

globalおよびdefaultsは変更しない可能性があります。defaultsセクションの後に、frontendセクションおよびbackendセクションを設定する必要があります。以下に例を示します。frontend http_web bind *:80 mode http default_backend rgw frontend rgw-https bind *:443 ssl crt /etc/ssl/private/example.com.pem default_backend rgw backend rgw balance roundrobin mode http server rgw1 10.0.0.71:80 check server rgw2 10.0.0.80:80 checkHAProxy 設定の詳細な説明は、HAProxy 設定 を参照してください。

haproxyの有効化/起動[root@haproxy]# systemctl enable haproxy [root@haproxy]# systemctl start haproxy

2.14.5. HAProxy 設定のテスト

HAProxy ノードで、keepalived 設定からの仮想 IP アドレスが表示されることを確認します。

[root@haproxy]# ip addr show

calamari ノードで、ロードバランサー設定経由でゲートウェイノードにアクセスできるかどうかを確認します。以下に例を示します。

[root@haproxy]# wget haproxy

上記のコマンドの結果は以下のコマンドと同じになるはずです。

[root@haproxy]# wget rgw1

以下の内容を含む index.html ファイルを返す場合は、次のコマンドを実行します。

<?xml version="1.0" encoding="UTF-8"?> <ListAllMyBucketsResult xmlns="http://s3.amazonaws.com/doc/2006-03-01/"> <Owner> <ID>anonymous</ID> <DisplayName></DisplayName> </Owner> <Buckets> </Buckets> </ListAllMyBucketsResult>

その後、設定が正常に機能します。

2.15. 静的 Web ホスティング用のゲートウェイの設定

従来の Web ホストでは、各 Web サイトに Web サーバーをを設定する必要があります。これは、コンテンツが動的に変更されない場合、リソースは効率的に使用されない可能性があります。Ceph Object Gateway は、S3 バケットで静的 Web サイトをホストできます。つまり、PHP、サーブレット、データベース、nodejs などのサーバー側のサービスを使用しないサイトです。このアプローチは、サイトごとに Web サーバーを備えた仮想マシンをセットアップするよりも、はるかに経済的です。

2.15.1. 静的 Web ホストの前提条件

静的 Web ホストには、1 つ以上の実行中の Ceph Storage Cluster が必要です。また、静的 Web サイト用に 2 つ以上の Ceph Object Gateway インスタンスが必要です。Red Hat は、各ゾーンに HAProxy/keepalived によって負荷分散された複数のゲートウェイインスタンスがあることを前提としています。

HAProxy/keepalived の詳細は、HAProxy/keepalived の設定 を参照してください。

Red Hat は、Ceph Object Gateway インスタンスを使用した標準の S3/Swift API と静的 Web ホストの両方を同時にデプロイすることはサポート されません。

2.15.2. 静的 Web ホストの要件

静的 Web ホスティング機能は独自の API を使用するため、S3 バケットで静的 Web サイトを使用するようにゲートウェイを設定するには、以下が必要です。

- S3 静的 Web ホストでは、Ceph Object Gateway インスタンスが使用され、標準の S3/Swift API のユースケースに使用されるインスタンスと区別されます。

- S3 静的 Web サイトをホストするゲートウェイインスタンスは、標準の S3/Swift API ゲートウェイインスタンスとは別の重複しないドメイン名を持っている必要があります。

- S3 静的 Web サイトをホストするゲートウェイインスタンスは、標準の S3/Swift API ゲートウェイインスタンスとは別のパブリック向け IP アドレスを使用する必要があります。

- S3 静的 Web サイトをホストするゲートウェイインスタンスは負荷分散し、必要に応じて HAProxy/keepalived を使用して SSL を終了します。

2.15.3. 静的 Web ホストゲートウェイの設定

静的 Web ホスト用のゲートウェイを有効にするには、Ceph 設定ファイルを編集して以下の設定を追加します。

[client.rgw.<STATIC-SITE-HOSTNAME>] ... rgw_enable_static_website = true rgw_enable_apis = s3, s3website rgw_dns_name = objects-zonegroup.domain.com rgw_dns_s3website_name = objects-website-zonegroup.domain.com rgw_resolve_cname = true ...

rgw_enable_static_website 設定は true にする必要があります。rgw_enable_apis 設定 は s3website API を有効にする必要があります。rgw_dns_name 設定および rgw_dns_s3website_name 設定は、完全修飾ドメインを提供する必要があります。サイトが標準的な名前の拡張子を使用する場合は、rgw_resolve_cname を true に設定します。

rgw_dns_name および rgw_dns_s3website_name の完全修飾ドメイン名は重複 しないでください。

2.15.4. 静的 Web ホスティング DNS 設定

以下は、想定される DNS 設定の例です。最初の 2 行は、標準の S3 インターフェイスを使用してゲートウェイインスタンスのドメインを指定し、それぞれ IPv4 アドレスおよび IPv6 アドレスを指しています。3 行目は、正規名の拡張を使用して S3 バケットのワイルドカード CNAME 設定を提供します。4 番目と 5 番目の行は、S3 の Web サイトインターフェイスを使用してゲートウェイインスタンスのドメインを指定し、それぞれ IPv4 アドレスおよび IPv6 アドレスを参照します。

objects-zonegroup.domain.com. IN A 192.0.2.10 objects-zonegroup.domain.com. IN AAAA 2001:DB8::192:0:2:10 *.objects-zonegroup.domain.com. IN CNAME objects-zonegroup.domain.com. objects-website-zonegroup.domain.com. IN A 192.0.2.20 objects-website-zonegroup.domain.com. IN AAAA 2001:DB8::192:0:2:20

最初の 2 行にある IP アドレスは、4 番目と 5 行目の IP アドレスとは異なります。

マルチサイト設定で Ceph Object Gateway を使用している場合は、ルーティングソリューションを使用してトラフィックをクライアントに最も近いゲートウェイにルーティングすることを検討してください。

Amazon Web Service (AWS) では、ホスト名に一致するように静的 Web ホストバケットが必要です。Ceph は DNS を設定するいくつかの方法を提供し、プロキシーに適合する証明書がある場合に HTTPS は機能します。

サブドメインのバケットのホスト名

AWS 形式の S3 サブドメインを使用するには、DNS エントリーでワイルドカードを使用し、要求を任意のバケットにリダイレクトできます。DNS エントリーは以下のようになります。

*.objects-website-zonegroup.domain.com. IN CNAME objects-website-zonegroup.domain.com.

以下の方法でバケット名にアクセスします。

http://bucket1.objects-website-zonegroup.domain.com

バケット名は bucket1 です。

一致しないバケットのホスト名

Ceph は、リクエストにバケット名を含めずにドメイン名をバケットへのマッピングをサポートします。これは Ceph Object Gateway に固有のものです。ドメイン名を使用してバケットにアクセスするには、ドメイン名をバケット名にマップします。DNS エントリーは以下のようになります。

www.example.com. IN CNAME bucket2.objects-website-zonegroup.domain.com.

バケット名は bucket2 です。

以下の方法でバケットにアクセスします。

http://www.example.com

CNAME を使用した長いバケットのホスト名

AWS は通常、ドメイン名に一致するバケット名を必要とします。CNAME を使用して静的 Web ホストに DNS を設定するには、DNS エントリーは以下のようになります。

www.example.com. IN CNAME www.example.com.objects-website-zonegroup.domain.com.

以下の方法でバケットにアクセスします。

http://www.example.com

CNAME のない長いバケットのホスト名

DNS 名には、SOA、NS、MX、TXT などの他の非 CNAME レコードが含まれている場合、DNS レコードはドメイン名を IP アドレスに直接マップする必要があります。以下に例を示します。

www.example.com. IN A 192.0.2.20 www.example.com. IN AAAA 2001:DB8::192:0:2:20

以下の方法でバケットにアクセスします。

http://www.example.com

2.15.5. 静的 Web ホストサイトの作成

静的 Web サイトを作成するには、以下の手順を実行します。

-

S3 バケットを作成します。バケット名は、Web サイトのドメイン名と同じである場合があります。たとえば、

mysite.comのバケット名はmysite.comになります。これは AWS に必要ですが、Ceph には必要ありません。詳細は DNS 設定 を参照してください。 -

静的 Web コンテンツをバケットにアップロードします。コンテンツには、HTML、CSS、クライアント側の JavaScript、イメージ、音声/ビデオコンテンツなどのダウンロード可能なファイルが含まれる場合があります。Web サイトには

index.htmlファイルが必要で、error.htmlファイルも利用できます。 - Web サイトの内容を確認します。この時点で、バケットの作成者のみがコンテンツにアクセスできます。

- ファイルにパーミッションを設定し、それらが一般に公開されるようにします。

2.16. NFS-Ganesha への名前空間のエクスポート

Red Hat Ceph Storage 3 以降では、Ceph Object Gateway は、実稼働システムに NFS バージョン 3 および NFS バージョン 4.1 を使用して、S3 オブジェクト名前空間をエクスポートする機能を提供します。

NFS Ganesha 機能は一般的な使用ではなく、S3 クラウドへの移行のみを目的としています。

Red Hat Ceph Storage は、バージョン付けされたバケットの NFS エクスポートをサポートしません。

この実装は、UNIX 形式のパス名を S3 バケットおよびオブジェクトにマッピングする Amazon Web Services (AWS) 階層名前空間の規則に準拠しています。アタッチされた名前空間のトップレベルは、存在する場合は NFSv4 疑似 root に従属し、Ceph Object Gateway S3 バケットで設定されます。バケットは、NFS ディレクトリーとして表されます。バケット内のオブジェクトは、S3 規則に従って、NFS ファイルおよびディレクトリー階層として表示されます。ファイルおよびディレクトリーを作成する操作はサポートされています。

ハードリンクまたはソフトリンクの作成または削除は、サポートされていません。バケットまたはディレクトリーでの名前変更操作の実行は NFS 経由ではサポートされていませんが、ファイルでの名前変更はディレクトリー内およびディレクトリー間、およびファイルシステムと NFS マウント間でサポートされています。ファイルの名前変更操作は、NFS 上で行う場合、ターゲットディレクトリーを変更し、通常は完全な readdir を強制的に更新するため、コストが高くなります。

NFS マウントを使用したファイルの編集はサポートされていません。

Ceph Object Gateway では、アプリケーションがオフセット 0 からファイルの終わりまで順番に書き込む必要があります。順不同で書き込もうとすると、アップロード操作が失敗します。この問題を回避するには、ファイルを NFS 領域にコピーする際に、cp、cat、rsync などのユーティリティーを使用します。常に sync オプションでマウントします。

NFS を使用する Ceph Object Gateway は、Gateway サーバーのインプロセスライブラリーパッケージと、NFS-Ganesha NFS サーバーの File System Abstraction Layer (FSAL) 名前空間ドライバーに基づいています。ランタイム時に、NFS を使用する Ceph Object Gateway デーモンのインスタンスは、Civetweb HTTP サービスがない場合でも、完全な Ceph Object Gateway デーモンと NFS-Ganesha インスタンスを単一のプロセスで結合します。この機能を使用するには、NFS-Ganesha バージョン 2.3.2 以降をデプロイします。

NFS-Ganesha (nfs-ganesha-rgw) インスタンスを含むホストで 作業を開始する前に および NFS-Ganesha インスタンス のステップを実行します。

複数の NFS ゲートウェイの実行

各 NFS-Ganesha インスタンスは完全なゲートウェイエンドポイントとして機能しますが、HTTP サービスをエクスポートするように NFS-Ganesha インスタンスを設定できないという制限が現時点であります。通常のゲートウェイインスタンスと同様に、任意の数の NFS-Ganesha インスタンスを起動し、クラスターから同じまたは異なるリソースをエクスポートできます。これにより、NFS-Ganesha インスタンスのクラスターリングが可能になります。ただし、これは高可用性を意味するものではありません。

通常のゲートウェイインスタンスと NFS-Ganesha インスタンスが同じデータリソースと重複している場合、標準の S3 API から、およびエクスポートされた NFS-Ganesha インスタンスを介してアクセスできます。NFS-Ganesha インスタンスを同じホスト上の Ceph Object Gateway インスタンスと同じ場所に配置できます。

作業を開始する前に

- NFS-Ganesha を実行する前に、NFS-Ganesha を実行するホストで実行中のカーネル NFS サービスインスタンスをすべて無効にします。NFS-Ganesha は、別の NFS インスタンスが実行している場合は起動しません。

rootで Red Hat Ceph Storage Tools リポジトリーを有効にします。Red Hat Enterprise Linux 7

# subscription-manager repos --enable=rhel-7-server-rhceph-4-tools-rpms

Red Hat Enterprise Linux 8

# subscription-manager repos --enable=rhceph-4-tools-for-rhel-8-x86_64-rpms

rpcbindサービスが実行していることを確認します。# systemctl start rpcbind

注記rpcbindを提供するrpcbindパッケージは通常、デフォルトでインストールされます。そうでない場合は、最初にパッケージをインストールします。NFS の

rpcbindの使用方法の詳細は、Red Hat Enterprise Linux 7 のストレージ管理ガイドの 必要なサービス セクションを参照してください。nfs-serviceサービスが実行中である場合は、これを停止して無効にします。# systemctl stop nfs-server.service # systemctl disable nfs-server.service

NFS-Ganesha インスタンスの設定

nfs-ganesha-rgwパッケージをインストールします。# yum install nfs-ganesha-rgw

Ceph Monitor ノードから NFS-Ganesha ホストの

/etc/ceph/ディレクトリーに Ceph 設定ファイルをコピーし、必要に応じて編集します。# scp <mon-host>:/etc/ceph/ceph.conf <nfs-ganesha-rgw-host>:/etc/ceph

注記Ceph 設定ファイルには、有効な

[client.rgw.{instance-name}]セクションと、rgw_data、keyring、rgw_frontendsなど、必要なさまざまな Gateway 設定変数が含まれている必要があります。有効な S3 バケットの命名要件に準拠していない Swift コンテナーをエクスポートする場合は、Ceph 設定ファイルの[client.rgw]セクションでrgw_relaxed_s3_bucket_namesをtrueに設定します。たとえば、Swift コンテナー名にアンダースコアが含まれる場合、これは有効な S3 バケット名ではなく、rgw_relaxed_s3_bucket_namesがtrueに設定されていない限り同期されません。NFS 外にオブジェクトおよびバケットを追加すると、これらのオブジェクトは、デフォルトでrgw_nfs_namespace_expire_secsによって設定された時間に NFS 名前空間に表示されます。デフォルトでは約 5 分です。Ceph 設定ファイルのrgw_nfs_namespace_expire_secsのデフォルト値を上書きして、更新レートを変更します。NFS-Ganesha 設定ファイルを開きます。

# vim /etc/ganesha/ganesha.conf

FSAL(File System Abstraction Layer) ブロックを使用してEXPORTセクションを設定します。ID、S3 ユーザー ID、S3 アクセスキー、およびシークレットを指定します。NFSv4 の場合は、以下のようになります。EXPORT { Export_ID={numeric-id}; Path = "/"; Pseudo = "/"; Access_Type = RW; SecType = "sys"; NFS_Protocols = 4; Transport_Protocols = TCP; Squash = No_Root_Squash; FSAL { Name = RGW; User_Id = {s3-user-id}; Access_Key_Id ="{s3-access-key}"; Secret_Access_Key = "{s3-secret}"; } }Pathオプションは、エクスポートを見つける場所を Ganesha に指示します。VFS FSAL の場合は、これはサーバーの名前空間内の場所になります。他の FSAL の場合は、その FSAL の名前空間が管理するファイルシステム内の場所になる可能性があります。たとえば、CephFSAL を使用して CephFS ボリューム全体をエクスポートする場合、Pathは/になります。Pseudoオプションは、Ganesha に対して NFS v4 の擬似ファイルシステムの名前空間内にエクスポートを配置するよう指示します。NFS v4 は、エクスポートの実際の場所に対応しない疑似名前空間を構築する可能性があるサーバーを指定し、その疑似ファイルシステムの一部は NFS サーバーのレルム内にのみ存在し、物理ディレクトリーに対応しない可能性があります。さらに、NFS v4 サーバーはすべてのエクスポートを 1 つの名前空間に配置します。単一のエクスポートを疑似ファイルシステムの root としてエクスポートすることは可能ですが、複数のエクスポートを疑似ファイルシステムに配置する方がはるかに一般的です。従来の VFS では、多くの場合、Pseudoの場所はPathの場所と同じです。/をPathとして使用して CephFS エクスポート例に戻る場合、複数のエクスポートが必要な場合は、エクスポートにPseudoオプションが他にない可能性があります。たとえば、/cephです。NFSv3 に対応する

EXPORTブロックには、NFS_Protocols設定でバージョン 3 を含める必要があります。さらに、NFSv3 は、UDP トランスポートをサポートする最後のメジャーバージョンになります。標準の初期バージョンには UDP が含まれていましたが、RFC 7530 ではその使用が禁止されています。UDP を有効にするには、Transport_Protocols設定に追加します。以下に例を示します。EXPORT { ... NFS_Protocols = 3,4; Transport_Protocols = UDP,TCP; ... }SecType = sys;を設定することで、クライアントは Kerberos 認証なしで接続できます。Squash = No_Root_Squash;を設定すると、ユーザーは NFS マウント内のディレクトリー所有権を変更できます。従来の OS ネイティブ NFS 4.1 クライアントを使用する NFS クライアントは通常、移行先サーバーの

pseudofsroot で定義されるエクスポートされたファイルシステムのフェデレーションされた名前空間を表示します。これらの任意の数を Ceph Object Gateway エクスポートに指定できます。各エクスポートには、

name、User_Id、Access_Key、およびSecret_Access_Keyという独自のタプルがあり、指定されたユーザーが確認できるオブジェクトの名前空間のプロキシーを作成します。ganesha.confのエクスポートには、NFSV4ブロックを含めることもできます。Red Hat Ceph Storage では、idmapperプログラムを設定する代わりに、Allow_Numeric_OwnersパラメーターおよびOnly_Numberic_Ownersパラメーターサポートされます。NFSV4 { Allow_Numeric_Owners = true; Only_Numeric_Owners = true; }NFS_CORE_PARAMブロックを設定します。NFS_CORE_PARAM{ mount_path_pseudo = true; }mount_path_pseudo設定設定は、trueに設定すると、NFS v3 および NFS v4.x のマウントが同じサーバー側パスを使用してエクスポートに到達させます。mount -o vers=3 <IP ADDRESS>:/export /mnt mount -o vers=4 <IP ADDRESS>:/export /mntPath Pseudo Tag Mechanism Mount /export/test1 /export/test1 test1 v3 Pseudo mount -o vers=3 server:/export/test1 /export/test1 /export/test1 test1 v3 Tag mount -o vers=3 server:test1 /export/test1 /export/test1 test1 v4 Pseudo mount -o vers=4 server:/export/test1 / /export/ceph1 ceph1 v3 Pseudo mount -o vers=3 server:/export/ceph1 / /export/ceph1 ceph1 v3 Tag mount -o vers=3 server:ceph1 / /export/ceph1 ceph1 v4 Pseudo mount -o vers=4 server:/export/ceph1 / /export/ceph2 ceph2 v3 Pseudo mount -o vers=3 server:/export/ceph2 / /export/ceph2 ceph2 v3 Tag mount -o vers=3 server:ceph2 / /export/ceph2 ceph2 v4 Pseudo mount -o vers=4

mount_path_pseudoの設定設定をfalseに設定すると、NFS v3 はPathオプションを使用し、NFS v4.x マウントはPseudoオプションを使用します。Path Pseudo Tag Mechanism Mount /export/test1 /export/test1 test1 v3 Path mount -o vers=3 server:/export/test1 /export/test1 /export/test1 test1 v3 Tag mount -o vers=3 server:test1 /export/test1 /export/test1 test1 v4 Pseudo mount -o vers=4 server:/export/test1 / /export/ceph1 ceph1 v3 Path mount -o vers=3 server:/ / /export/ceph1 ceph1 v3 Tag mount -o vers=3 server:ceph1 / /export/ceph1 ceph1 v4 Pseudo mount -o vers=4 server:/export/ceph1 / /export/ceph2 ceph2 v3 Path not accessible / /export/ceph2 ceph2 v3 Tag mount -o vers=3 server:ceph2 / /export/ceph2 ceph2 v4 Pseudo mount -o vers=4 server:/export/ceph2

RGWセクションを設定します。インスタンスの名前を指定し、Ceph 設定ファイルへのパスを指定し、任意の初期化引数を指定します。RGW { name = "client.rgw.{instance-name}"; ceph_conf = "/etc/ceph/ceph.conf"; init_args = "--{arg}={arg-value}"; }-

/etc/ganesha/ganesha.conf設定ファイルを保存します。 nfs-ganeshaサービスを有効にして開始します。# systemctl enable nfs-ganesha # systemctl start nfs-ganesha

擬似ディレクトリーが非常に大きい場合には、

ceph.confファイルの設定可能なパラメーターrgw_nfs_s3_fast_attrsをtrueに設定して、名前をイミュータブルかつ加速します。rgw_nfs_s3_fast_attrs= true

各ゲートウェイノードから Ceph Object Gateway サービスを再起動します。

# systemctl restart ceph-radosgw.target

NFSv4 クライアントの設定

名前空間にアクセスするには、設定された NFS-Ganesha エクスポートをローカルの POSIX 名前空間で必要な場所にマウントします。前述のように、この実装には固有の制限がいくつかあります。

- NFS 4.1 以降のプロトコルフレーバーのみがサポートされます。

-

書き込み順序を設定するには、

syncマウントオプションを使用します。

NFS-Ganesha エクスポートをマウントするには、クライアントホストの /etc/fstab ファイルに以下のエントリーを追加します。

<ganesha-host-name>:/ <mount-point> nfs noauto,soft,nfsvers=4.1,sync,proto=tcp 0 0

NFS-Ganesha ホスト名とクライアントのマウントポイントへのパスを指定します。

NFS-Ganesha エクスポートを正常にマウントするには、クライアントに /sbin/mount.nfs ファイルが存在する必要があります。nfs-tools パッケージはこのファイルを提供します。多くの場合、パッケージはデフォルトでインストールされています。ただし、nfs-tools パッケージがクライアントにインストールされていることを確認し、インストールされていない場合はインストールします。

NFS の詳細は、Red Hat Enterprise Linux 7 のストレージ管理ガイドの ネットワークファイルシステム (NFS) の章を参照してください。

NFSv3 クライアントの設定

マウントオプションとして nfsvers=3 および noacl を指定して、Linux クライアントが NFSv3 でマウントされるように設定できます。UDP をトランスポートとして使用するには、proto=udp をマウントオプションに追加します。ただし、TCP が推奨されるプロトコルです。

<ganesha-host-name>:/ <mount-point> nfs noauto,noacl,soft,nfsvers=3,sync,proto=tcp 0 0

NFS Ganesha EXPORT ブロックの Protocols 設定をバージョン 3 に設定し、マウントがバージョン 3 を UDP で使用する場合は Transports 設定を UDP に設定します。

NFSv3 はクライアントの OPEN および CLOSE 操作をファイルサーバーに通信しないため、RGW NFS はこれらの操作を使用して、ファイルのアップロードトランザクションの開始と終了をマークすることはできません。代わりに、RGW NFS は、オフセット 0 でファイルに最初の書き込みが送信されたときに新しいアップロードを開始しようとし、ファイルへの新しい書き込みが一定期間 (デフォルトでは 10 秒) 見られなかったときにアップロードを終了します。この値を変更するには、Ceph 設定ファイルの RGW セクションに rgw_nfs_write_completion_interval_s の値を設定します。

第3章 管理

管理者は、radosgw-admin コマンドラインインターフェイスを使用して Ceph Object Gateway を管理できます。

- 管理データストレージ

- ストレージポリシー

- インデックスのないバケット

- バケットシャード化

- 圧縮

- ユーザー管理

- クォータ管理

- 用途

- バケット管理

- バケットライフサイクル

- Ceph Object Gateway データレイアウト

- Object Gateway データレイアウトパラメーター

- STS での属性ベースのアクセス制御 (ABAC) のセッションタグ

- Ceph Object Gateway のガベージコレクションの最適化

- Ceph Object Gateway のデータオブジェクトストレージの最適化

- Ceph Object Gateway およびマルチファクター認証

- Ansible を使用した Ceph Object Gateway の削除

3.1. 管理データストレージ

Ceph Object Gateway は、インスタンスのゾーン設定で定義された一連のプールに管理データを保存します。たとえば、後続のセクションで説明したバケット、ユーザー、ユーザークォータおよび使用状況の統計は、Ceph Storage Cluster のプールに保存されます。デフォルトでは、Ceph Object Gateway は以下のプールを作成し、それらをデフォルトゾーンにマッピングします。

-

.rgw.root -

.default.rgw.control -

.default.rgw.meta -

.default.rgw.log -

.default.rgw.buckets.index -

.default.rgw.buckets.data -

.default.rgw.buckets.non-ec

CRUSH ルールセットと配置グループの数を設定できるように、これらのプールを手動で作成することを検討してください。一般的な設定では、Ceph Object Gateway の管理データを格納するプールは、管理データに 10 個のプールがあるため、多くの場合、同じ CRUSH ルールセットを使用し、使用する配置グループの数を少なくします。詳細は、Red Hat Ceph Storage 4 の場合は、プール および ストレージ戦略 ガイドを参照してください。

また、配置グループの計算の詳細については、Ceph Placement Groups(PGs)per Pool Calculator も参照してください。mon_pg_warn_max_per_osd 設定は、プールに過剰な配置グループを割り当てると警告します (つまりデフォルトでは 300)。この値は、ニーズやハードウェアの能力に合わせて調整することができ、n は OSD あたりの PG の最大数です。

mon_pg_warn_max_per_osd = n

3.2. ストレージポリシーの作成

Ceph Object Gateway は配置ターゲットを特定し、配置ターゲットに関連付けられたプールにバケットおよびオブジェクトを保存することで、クライアントバケットとオブジェクトデータを保存します。配置ターゲットを設定しておらず、インスタンスのゾーン設定内のプールにマッピングすると、Ceph Object Gateway はデフォルトのターゲットとプールを使用します (例: default_placement)。

ストレージポリシーは、Ceph Object Gateway クライアントに対し、ストレージストラテジーにアクセスする手段を提供します。つまり、SSD、SAS ドライブ、SATA ドライブなどの特定のタイプのストレージをターゲットに設定する機能があります。持続性、レプリケーション、イレイジャーコーディングなどを確保するための特定の方法。詳細は、Red Hat Ceph Storage 4 の ストレージ戦略 を参照してください。

ストレージポリシーを作成するには、以下の手順に従います。

-

必要なストレージストラテジーを使用して、新しいプールの

.rgw.buckets.specialを作成します。たとえば、イレイジャーコーディング、特定の CRUSH ルールセット、レプリカ数、およびpg_num数およびpgp_num数でカスタマイズしたプールなどです。 ゾーングループの設定を取得して、これをファイルに保存します (例:

zonegroup.json)。構文

[root@master-zone]# radosgw-admin zonegroup --rgw-zonegroup=<zonegroup_name> get > zonegroup.json

例

[root@master-zone]# radosgw-admin zonegroup --rgw-zonegroup=default get > zonegroup.json

zonegroup.jsonファイルのplacement_targetの下に、特別なspecial-placementを追加します。{ "name": "default", "api_name": "", "is_master": "true", "endpoints": [], "hostnames": [], "master_zone": "", "zones": [{ "name": "default", "endpoints": [], "log_meta": "false", "log_data": "false", "bucket_index_max_shards": 11 }], "placement_targets": [{ "name": "default-placement", "tags": [] }, { "name": "special-placement", "tags": [] }], "default_placement": "default-placement" }変更された

zonegroup.jsonファイルでゾーングループを設定します。[root@master-zone]# radosgw-admin zonegroup set < zonegroup.json

ゾーン設定を取得して、これをファイル (例:

zone.json) に保存します。[root@master-zone]# radosgw-admin zone get > zone.json

ゾーンファイルを編集し、

placement_poolに新しい配置ポリシーキーを追加します。{ "domain_root": ".rgw", "control_pool": ".rgw.control", "gc_pool": ".rgw.gc", "log_pool": ".log", "intent_log_pool": ".intent-log", "usage_log_pool": ".usage", "user_keys_pool": ".users", "user_email_pool": ".users.email", "user_swift_pool": ".users.swift", "user_uid_pool": ".users.uid", "system_key": { "access_key": "", "secret_key": "" }, "placement_pools": [{ "key": "default-placement", "val": { "index_pool": ".rgw.buckets.index", "data_pool": ".rgw.buckets", "data_extra_pool": ".rgw.buckets.extra" } }, { "key": "special-placement", "val": { "index_pool": ".rgw.buckets.index", "data_pool": ".rgw.buckets.special", "data_extra_pool": ".rgw.buckets.extra" } }] }新しいゾーン設定を設定します。

[root@master-zone]# radosgw-admin zone set < zone.json

ゾーングループのマップを更新します。

[root@master-zone]# radosgw-admin period update --commit

special-placementエントリーはplacement_targetとして一覧表示されます。

要求の実行時にストレージポリシーを指定するには、以下を実行します。

以下に例を示します。

$ curl -i http://10.0.0.1/swift/v1/TestContainer/file.txt -X PUT -H "X-Storage-Policy: special-placement" -H "X-Auth-Token: AUTH_rgwtxxxxxx"

3.3. インデックスレスバケットの作成

作成されたバケットがバケットインデックスを使用せずに、オブジェクトのインデックスを格納する、つまりインデックスレスバケットを配置先として設定することができます。データのレプリケーションや一覧表示を使用しない配置ターゲットは、インデックスレスバケットを実装することができます。インデックスレスバケットは、配置ターゲットが特定のバケット内のオブジェクトを追跡しないメカニズムです。これにより、オブジェクト書き込みが発生するたびに発生するリソース競合が削除され、Ceph Object Gateway が Ceph Storage クラスターに必要なラウンドトリップの数を減らします。これにより、同時操作や、小規模のオブジェクト書き込みパフォーマンスに正当な影響を与える可能性があります。

配置ポリシーにインデックスがないバケットで操作を実行すると、Ceph Object Gateway デーモンがクラッシュすることが確認されています。したがって、Red Hat はこの配置ポリシーを使用することを推奨していません。

バケットインデックスはバケットの正しい状態を反映せず、これらのバケットを一覧表示してもオブジェクトの一覧を正しく返しません。これは複数の機能に影響します。具体的には、バケットインデックスが変更情報の保存に使用されていないため、これらのバケットはマルチゾーン環境では同期されません。この機能にはバケットインデックスが必要になるため、Red Hat は、インデックスレスバケットで S3 オブジェクトバージョン管理を使用することは推奨されません。

インデックスレスバケットを使用すると、単一バケットのオブジェクトの最大数の上限が削除されます。

インデックスレスバケットのオブジェクトは NFS から一覧表示できません。

前提条件

- 実行中で正常な Red Hat Ceph Storage クラスター

- Ceph Object Gateway ソフトウェアのインストール。

- Ceph Object Gateway ノードへのルートレベルのアクセス。

手順

新しい配置ターゲットをゾーングループに追加します。

例

[root@rgw ~]# radosgw-admin zonegroup placement add --rgw-zonegroup="default" \ --placement-id="indexless-placement"

新しい配置ターゲットをゾーンに追加します。

例

[root@rgw ~]# radosgw-admin zone placement add --rgw-zone="default" \ --placement-id="indexless-placement" \ --data-pool="default.rgw.buckets.data" \ --index-pool="default.rgw.buckets.index" \ --data_extra_pool="default.rgw.buckets.non-ec" \ --placement-index-type="indexless"

ゾーングループのデフォルト配置を

indexless-placementに設定します。例

[root@rgw ~]# radosgw-admin zonegroup placement default --placement-id "indexless-placement"

この例では、

indexless-placementターゲットで作成されたバケットはインデックスレスバケットです。クラスターがマルチサイト設定にある場合は、期間を更新し、コミットします。

例

[root@rgw ~]# radosgw-admin period update --commit

Ceph Object Gateway デーモンを再起動して、変更を適用します。

例

[root@rgw ~]# systemctl restart ceph-radosgw.target

3.4. バケットシャーディングの設定

Ceph Object Gateway は、バケットインデックスデータをインデックスプール (index_pool) に格納します。デフォルトは .rgw.buckets.index です。バケットあたりの最大オブジェクト数のクオータを設定せずに、クライアントが数十万から数百万のオブジェクトを 1 つのバケットに入れると、インデックスプールのパフォーマンスが著しく低下します。

バケットインデックスのシャーディング は、バケットあたりのオブジェクト数が多い場合のパフォーマンスのボトルネックを防ぐのに役立ちます。Red Hat Ceph Storage 4.1 以降、バケットインデックスシャードのデフォルト数である bucket_index_max_shards が 1 から 11 に変更されました。この変更により、小さなバケットへの書き込みスループットが増加し、動的な再シャーディングの開始を遅らせることができます。この変更は、新規バケットおよびデプロイメントにのみ影響します。

Red Hat では、計算されたシャード数に最も近い素数をシャード数とすることを推奨しています。素数であるバケットインデックスシャードは、シャード間でバケットインデックスエントリーを均等に分配する上で、より効果的に機能する傾向があります。たとえば、7001 個のバケットインデックスシャードは素数であるため、7000 個のシャードよりも優れています。

バケットインデックスのシャード化を設定するには、以下を実行します。

-

単純な設定の新規バケットの場合は、

rgw_override_bucket_index_max_shardsオプションを使用します。「簡易設定でのバケットインデックスシャードの設定」 を参照してください。 -

マルチサイト設定の新規バケットの場合は、

bucket_index_max_shardsオプションを使用します。「マルチサイト設定でのバケットインデックスのシャード化の設定」 を参照してください。

バケットを再シャード化するには、以下を実行します。

- 動的な場合:「バケットインデックスの動的再シャーディング」を参照してください。

- 手動の場合:「バケットインデックスの手動再シャーディング」を参照してください。

- マルチサイト設定で手動の場合:マルチサイトでのバケットの手動再シャーディング を参照してください。

3.4.1. バケットシャーディングの制限

注意して、以下の制限を使用してください。お使いのハードウェアの選択には影響があるため、この要件を Red Hat アカウントチームと常に相談してください。

シャード化が必要になる前の 1 つのバケット内のオブジェクトの最大数

Red Hat では、バケットインデックスシャードあたり最大 102,400 オブジェクトを推奨しています。シャーディングを最大限に活用するには、Ceph Object Gateway バケットインデックスプールの十分な数の OSD を提供します。

Ceph OSD は現在、インデックス化されたストレージのキー範囲が 200,000 を超えると警告します。結果として、シャードあたりのオブジェクト数が 200,000 に近づくと、そのような警告が表示されます。設定によっては、値は大きくなる可能性があり、調整可能です。

シャード化を使用する場合の最大オブジェクト数

動的バケットの再シャーディングのデフォルトのバケットインデックスシャード数は 1999 です。この値は最大 65521 シャードまで変更できます。値が 1999 のバケットインデックスシャードは、バケット内の合計オブジェクト数が 204697600 で、値が 65521 のシャードは、オブジェクト数が 6709350400 であることが分かります。

以前のテストに基づいて、現在サポートされているバケットインデックスシャードの最大数は 65521 です。Red Hat の品質保証は、バケットシャーディングで完全なスケーラビリティーテストを実施していません。

バケットインデックスシャードの数が 1999 を超える場合には、通常の S3 クライアントはバケットの内容を一覧表示できない可能性があります。カスタムクライアントは、順序付けられていないリストを要求して任意の数のシャードにスケーリングできます。

3.4.2. バケットのライフサイクルの並列スレッド処理

Red Hat Ceph Storage 4.1 の新機能により、バケットライフサイクルの並列スレッド処理が可能になりました。この並列化は、Ceph Object Gateway インスタンスの数に応じてスケーリングされ、順序が適切なインデックスシャードの列挙を数列に置き換えます。デフォルトのロックタイムアウトは 60 秒から 90 秒に拡張されました。各 Ceph Object Gateway インスタンスに対して並行して実行できるように、ライフサイクルワーカースレッドを調整するように、新たな調整可能なオプションが追加されました。

rgw_lc_max_worker

このオプションは、並行して実行するライフサイクルワーカースレッドの数を指定し、バケットおよびインデックスシャードを同時に処理します。rgw_lc_max_worker オプションのデフォルト値は 3 です。

rgw_lc_max_wp_worker

このオプションは、各ライフサイクルワーカーのワークプールのスレッド数を指定します。このオプションを使用すると、各バケットの処理を加速することができます。rgw_lc_max_wp_worker オプションのデフォルト値は 3 です。

関連情報

- 詳細は、Red Hat Ceph Storage 設定ガイドの Ceph 設定ファイル セクションを参照してください。

3.4.3. 簡易設定でのバケットインデックスシャードの設定

すべての新規バケットでバケットインデックスシャードを有効にし、設定するには、rgw_override_bucket_index_max_shards パラメーターを使用します。パラメーターを次のように設定します。

-

バケットインデックスシャード化を無効にする場合は

0。これがデフォルト値になります。 -

0より大きい値を有効にすると、バケットシャード化が有効になり、シャードの最大数が設定されます。

前提条件

- バケットシャード化の制限 を読んでいる。

手順

推奨されるシャード数を計算します。これを行うには、以下の式を使用します。

number of objects expected in a bucket / 100,000

シャードの最大数は 65521 であることに注意してください。

Ceph 設定ファイルに

rgw_override_bucket_index_max_shardsを追加します。rgw_override_bucket_index_max_shards = valuevalue を、直前の手順で計算したシャードの推奨数に置き換えます。以下に例を示します。

rgw_override_bucket_index_max_shards = 12

-

Ceph Object Gateway のすべてのインスタンスにバケットインデックスシャードを設定するには、

[global]セクションにrgw_override_bucket_index_max_shardsを追加します。 -

Ceph Object Gateway の特定のインスタンスに対してのみバケットインデックスのシャーディングを設定するには、インスタンスの下に

rgw_override_bucket_index_max_shardsを追加します。

-

Ceph Object Gateway のすべてのインスタンスにバケットインデックスシャードを設定するには、

Ceph Object Gateway を再起動します。

# systemctl restart ceph-radosgw.target

3.4.4. マルチサイト設定でのバケットインデックスのシャード化の設定

マルチサイト設定では、各ゾーンに異なる index_pool を設定して、フェイルオーバーを管理できます。1 つのゾーングループのゾーンに一貫したシャード数を設定するには、そのゾーングループの設定に bucket_index_max_shards を設定します。パラメーターを次のように設定します。

パラメーターを次のように設定します。

-

バケットインデックスシャーディングを無効にするには

0、bucket_index_max_shardsのデフォルト値は11です。 -

0より大きい値を有効にすると、バケットシャード化が有効になり、シャードの最大数が設定されます。

SSD ベースの OSD の CRUSH ルールセットにインデックスプール (該当する場合は各ゾーン) をマッピングすることも、バケットインデックスのパフォーマンスに役立つ可能性があります。

前提条件

- バケットシャード化の制限 を読んでいる。

手順

推奨されるシャード数を計算します。これを行うには、以下の式を使用します。

number of objects expected in a bucket / 100,000

シャードの最大数は 65521 であることに注意してください。

ゾーングループ設定を

zonegroup.jsonファイルに展開します。$ radosgw-admin zonegroup get > zonegroup.json

zonegroup.jsonファイルで、名前付きゾーンごとにbucket_index_max_shardsを設定します。bucket_index_max_shards = VALUEvalue を、直前の手順で計算したシャードの推奨数に置き換えます。以下に例を示します。

bucket_index_max_shards = 12

ゾーングループをリセットします。

$ radosgw-admin zonegroup set < zonegroup.json

期間を更新します。

$ radosgw-admin period update --commit

3.4.5. バケットインデックスの動的再シャーディング

動的バケットの再シャーディングのプロセスは、すべての Ceph Object Gateway バケットを定期的にチェックし、再シャーディングを必要とするバケットを検出します。バケットが rgw_max_objs_per_shard パラメーターで指定された値よりも大きい場合、Ceph Object Gateway はバックグラウンドでバケットを動的に再シャードします。rgw_max_objs_per_shard のデフォルト値は、シャードごとに 100k オブジェクトです。

デフォルト値は、回転するディスクに保存されているバケットインデックスのエクスペリエンスに基づいています。フラッシュメディアでバケットインデックスを使用する最新のセットアップでは、バケットインデックスシャードあたりの最大オブジェクト数の値が高くなる場合があります。

アップグレードされたシングルサイト設定では、ゾーンやゾーングループに変更を加えることなく、バケットインデックスの動的再シャーディングが期待どおりに機能します。シングルサイト設定は、以下のいずれかです。

- レルムのないデフォルトのゾーン設定。

- レルムが 1 つ以上あるデフォルト以外の設定。

- 複数レルムのシングルサイト設定。

前提条件

- バケットシャード化の制限 を読んでいる。

手順

バケットインデックスの動的再シャーディングを有効にするには、以下を実行します。

-

Ceph 設定ファイルの

rgw_dynamic_resharding設定をtrue(デフォルト値) に設定します。 任意です。必要に応じて、Ceph 設定ファイルの以下のパラメーターを変更します。

-

rgw_reshard_num_logs: 再シャードログのシャードの数。デフォルト値は16です。 -

rgw_reshard_bucket_lock_duration: リシャード中にバケットのロックの期間。デフォルト値は360秒です。 -

rgw_dynamic_resharding: 動的リシャードを有効または無効にします。デフォルト値はtrueです。 -

rgw_max_objs_per_shard: シャードごとのオブジェクトの最大数。デフォルト値は、シャードごとに100000オブジェクトです。 -

rgw_reshard_thread_interval: 再シャード処理のラウンド間の最大時間。デフォルト値は600秒です。

-

-

Ceph 設定ファイルの

バケットを再シャーディングキューに追加するには、以下を実行します。

radosgw-admin reshard add --bucket bucket --num-shards number

以下を置き換えます。

- bucket を、再シャードするバケットの名前に

- number を、新しいシャード数に

以下に例を示します。

$ radosgw-admin reshard add --bucket data --num-shards 10

再シャーディングキューを一覧表示するには、以下を実行します。

$ radosgw-admin reshard list

バケットの再シャーディングステータスを確認するには、以下のコマンドを実行します。

radosgw-admin reshard status --bucket bucket以下を置き換えます。

- bucket を、再シャードするバケットの名前に

以下に例を示します。

$ radosgw-admin reshard status --bucket data

再シャーディングキューのエントリーを即座に処理するには、以下を実行します。

$ radosgw-admin reshard process

保留中のバケットの再シャーディングをキャンセルするには、以下を実行します。

radosgw-admin reshard cancel --bucket bucket以下を置き換えます。

- bucket を、保留中のバケットの名前に置き換えます。

以下に例を示します。

$ radosgw-admin reshard cancel --bucket data

重要保留中 の再シャード操作のみをキャンセルできます。継続中 のリシャード操作をキャンセルしないでください。

- Red Hat Ceph Storage 3.1 およびそれ以前のバージョンを使用している場合は、再シャーディング後の古いインスタンスのクリーニング のセクションで説明されているように、古いバケットエントリーを削除します。

3.4.6. バケットインデックスの手動再シャーディング

バケットのサイズが初期設定に対して最適化されている場合は、radosgw-admin bucket reshard コマンドを使用してバケットインデックスプールを再シャードします。このコマンドは、以下のようになります。

- 指定されたバケットのバケットインデックスオブジェクトの新しいセットを作成します。

- これらのバケットインデックスオブジェクトにオブジェクトエントリーを分散します。

- 新規バケットインスタンスを作成します。

- 新規インデックス操作すべてが新規バケットインデックスを通過するように、新しいバケットインスタンスをバケットとリンクします。

- 古いバケット ID および新しいバケット ID をコマンド出力に出力します。

この手順は、簡単な設定でのみ使用してください。マルチサイト設定でシャードバケットを再シャードするには、マルチサイトを使用した手動によるバケットのリシャード化 を参照してください。

前提条件

- バケットシャード化の制限 を読んでいる。

手順

元のバケットインデックスをバックアップします。

radosgw-admin bi list --bucket=bucket > bucket.list.backup

以下を置き換えます。

- bucket を、再シャードするバケットの名前に

たとえば、

dataという名前のバケットの場合は、以下を入力します。$ radosgw-admin bi list --bucket=data > data.list.backup

バケットインデックスを再シャード化します。

radosgw-admin bucket reshard --bucket=bucket --num-shards=number

以下を置き換えます。

- bucket を、再シャードするバケットの名前に

- number を、新しいシャード数に

たとえば、

dataという名前のバケットおよび必要なシャード数が 100 の場合は、以下を入力します。$ radosgw-admin bucket reshard --bucket=data --num-shards=100

- Red Hat Ceph Storage 3.1 およびそれ以前のバージョンを使用している場合は、再シャーディング後の古いインスタンスのクリーニング のセクションで説明されているように、古いバケットエントリーを削除します。

3.4.7. 再シャーディングを行った後に古いインスタンスの消去

Red Hat Ceph Storage 3.1 以前のバージョンでは、再シャーディングプロセスでは、バケットエントリーの古いインスタンスは自動的にクリーンアップされません。これらの古いインスタンスは、手動でクリーンアップされない場合にクラスターのパフォーマンスに影響を与える可能性があります。

この手順は、マルチサイトクラスターではない単純な設定にのみ使用するようにしてください。

前提条件

- Ceph Object Gateway がインストールされている。

手順

古いインスタンスを一覧表示します。

$ radosgw-admin reshard stale-instances list

古いインスタンスを削除します。

$ radosgw-admin reshard stale-instances rm

3.5. 圧縮の有効化

Ceph Object Gateway は、Ceph の圧縮プラグインを使用してアップロードしたオブジェクトのサーバー側の圧縮をサポートします。これには、以下が含まれます。

-

zlib: サポート対象。 -

snappy: テクノロジープレビュー。 -

zstd: テクノロジープレビュー。

圧縮プラグイン snappy および zstd はテクノロジープレビュー機能であり、Red Hat が品質保証テストを完了していないため、完全にはサポートされていません。

設定

ゾーンの配置ターゲットで圧縮を有効にするには、--compression=<type> オプションを radosgw-admin zone placement modify コマンドに指定します。圧縮 type は、新しいオブジェクトデータの書き込み時に使用する圧縮プラグインの名前を指します。

圧縮される各オブジェクトは圧縮タイプを保存します。設定を変更しても、既存の圧縮オブジェクトを展開します。また、Ceph Object Gateway は強制的に既存オブジェクトを再圧縮する訳ではありません。

この圧縮設定は、この配置ターゲットを使用してバケットにアップロードされるすべての新規オブジェクトに適用されます。

ゾーンの配置ターゲットで圧縮を無効にするには、--compression=<type> オプションを radosgw-admin zone placement modify コマンドに指定して、空の文字列または none を指定します。

以下に例を示します。

$ radosgw-admin zone placement modify --rgw-zone=default --placement-id=default-placement --compression=zlib

{

...

"placement_pools": [

{

"key": "default-placement",

"val": {

"index_pool": "default.rgw.buckets.index",

"data_pool": "default.rgw.buckets.data",

"data_extra_pool": "default.rgw.buckets.non-ec",

"index_type": 0,

"compression": "zlib"

}

}

],

...

}圧縮の有効化または無効化後に Ceph Object Gateway インスタンスを再起動して、変更を反映します。

Ceph Object Gateway は デフォルト ゾーンとプールのセットを作成します。実稼働デプロイメントの場合は、実稼働用 Ceph Object Gateway の レルムの作成 セクションを参照してください。Multisite も参照してください。

統計

既存のコマンドおよび API は、圧縮されていないデータに基づいてオブジェクトおよびバケットサイズを引き続き報告しますが、radosgw-admin bucket stats コマンドには指定されたバケットの圧縮統計が含まれます。

$ radosgw-admin bucket stats --bucket=<name>

{

...

"usage": {

"rgw.main": {

"size": 1075028,

"size_actual": 1331200,

"size_utilized": 592035,

"size_kb": 1050,

"size_kb_actual": 1300,

"size_kb_utilized": 579,

"num_objects": 104

}

},

...

}

size_utilized フィールドおよび size_kb_utilized フィールドは、それぞれ圧縮データの合計サイズをバイト単位で表します。

3.6. ユーザー管理

Ceph Object Storage ユーザー管理とは、Ceph Storage Cluster のクライアントアプリケーションとしての Ceph Object Gateway ではなく、Ceph Object Storage サービスのクライアントアプリケーションであるユーザーを指します。クライアントアプリケーションが Ceph Object Gateway サービスと対話できるようにするには、ユーザー、アクセスキー、およびシークレットを作成する必要があります。

ユーザータイプが 2 つあります。

- User: user という用語は、S3 インターフェイスのユーザーを反映しています。

- Subuser: subuser という用語は、Swift インターフェイスのユーザーを反映しています。サブユーザーがユーザーに関連付けられています。

ユーザーとサブユーザーを作成、変更、表示、一時停止、および削除できます。

マルチサイトデプロイメントでユーザーを管理する場合は、常にマスターゾーングループのマスターゾーン内の Ceph Object Gateway ノードで radosgw-admin コマンドを実行して、ユーザーがマルチサイトクラスター全体で同期するようにします。マルチサイトクラスター上のユーザーをセカンダリーゾーンまたはセカンダリーゾーングループから作成、変更、または削除しないでください。このドキュメントでは、マスターゾーングループのマスターゾーンにあるホストのコマンドライン規則として [root@master-zone]# を使用しています。

ユーザーおよびサブユーザー ID の作成に加え、ユーザーの表示名およびメールアドレスを追加することができます。キーおよびシークレットを指定するか、キーおよびシークレットを自動的に生成できます。キーを生成または指定した際には、ユーザー ID が S3 キータイプに対応し、サブユーザー ID が Swift キータイプに対応することに注意してください。Swift キーには、アクセスレベルの read、write、readwrite、および full もあります。

ユーザー管理コマンドライン構文は、通常、パターン user <command> <user-id> に従います。ここで、<user-id> は、--uid= オプションの後にユーザー ID (S3) が続くか、--subuser= オプションの後にユーザー名 (Swift) が続きます。以下に例を示します。

[root@master-zone]# radosgw-admin user <create|modify|info|rm|suspend|enable|check|stats> <--uid={id}|--subuser={name}> [other-options]実行するコマンドによっては、追加のオプションが必要になる場合があります。

3.6.1. マルチテナンシー

Red Hat Ceph Storage 2 以降では、Ceph Object Gateway は S3 および Swift API の両方に対するマルチテナンシーをサポートします。この場合、各ユーザーとバケットはテナント下に置かれます。 マルチテナンシーは、複数のテナントが共通のバケット名 (例: test、main など) を使用している場合に、名前空間のクラッシュを防ぎます。

各ユーザーとバケットはテナントの下にあります。下位互換性のために、空の名前を持つレガシーテナントが追加されます。テナントを具体的に指定せずにバケットを参照する場合は常に、Swift API はレガシーテナントを想定します。既存のユーザーもレガシーテナントに保存されるため、以前のリリースと同様にバケットとオブジェクトにアクセスします。

このようなテナントの場合、テナント自体には何の操作もありません。ユーザーが管理されている場合には、必要に応じて表示および非表示になります。明示的なテナントを持つユーザーを作成、変更、および削除するには、追加のオプション --tenant を指定するか、radosgw-admin コマンドのパラメーターで構文 "<tenant>$<user>" を使用します。

S3 用のユーザー testx$tester を作成するには、以下を実行します。

[root@master-zone]# radosgw-admin --tenant testx --uid tester \

--display-name "Test User" --access_key TESTER \

--secret test123 user create

Swift のユーザー testx$tester を作成するには、以下のいずれかを実行します。

[root@master-zone]# radosgw-admin --tenant testx --uid tester \

--display-name "Test User" --subuser tester:swift \

--key-type swift --access full subuser create

[root@master-zone]# radosgw-admin key create --subuser 'testx$tester:swift' \

--key-type swift --secret test123明示的なテナントを持つサブユーザーは、シェルで引用する必要がありました。

3.6.2. ユーザーの作成

user create コマンドを使用して S3-interface ユーザーを作成します。ユーザー ID と表示名を指定する必要があります。メールアドレスを指定することもできます。key または secret を指定しないと、radosgw-admin によって自動的に生成されます。ただし、生成されたキー/シークレットのペアを使用しない場合は、キーやシークレットを指定できます。

[root@master-zone]# radosgw-admin user create --uid=<id> \ [--key-type=<type>] [--gen-access-key|--access-key=<key>]\ [--gen-secret | --secret=<key>] \ [--email=<email>] --display-name=<name>

以下に例を示します。

[root@master-zone]# radosgw-admin user create --uid=janedoe --display-name="Jane Doe" --email=jane@example.com

{ "user_id": "janedoe",

"display_name": "Jane Doe",

"email": "jane@example.com",

"suspended": 0,

"max_buckets": 1000,

"auid": 0,

"subusers": [],

"keys": [

{ "user": "janedoe",

"access_key": "11BS02LGFB6AL6H1ADMW",

"secret_key": "vzCEkuryfn060dfee4fgQPqFrncKEIkh3ZcdOANY"}],

"swift_keys": [],

"caps": [],

"op_mask": "read, write, delete",

"default_placement": "",

"placement_tags": [],

"bucket_quota": { "enabled": false,

"max_size_kb": -1,

"max_objects": -1},

"user_quota": { "enabled": false,

"max_size_kb": -1,

"max_objects": -1},

"temp_url_keys": []}

キーの出力を確認します。radosgw-admin が JSON エスケープ (\) 文字を生成することがあり、一部のクライアントは JSON エスケープ文字の処理方法を知りません。対処法には、JSON エスケープ文字 (\) の削除、文字列の引用符でのカプセル化、キーの再生成、JSON エスケープ文字が含まれていないことの確認、またはキーとシークレットの手動指定が含まれます。

3.6.3. サブユーザーの作成

サブユーザー (Swift インターフェイス) を作成するには、ユーザー ID (--uid={username})、サブユーザー ID、およびサブユーザーのアクセスレベルを指定する必要があります。key または secret を指定しないと、radosgw-admin によって自動的に生成されます。ただし、生成されたキー/シークレットのペアを使用しない場合は、キーやシークレットを指定できます。

アクセス制御ポリシーも含まれるため、full は readwrite ではありません。

[root@master-zone]# radosgw-admin subuser create --uid={uid} --subuser={uid} --access=[ read | write | readwrite | full ]以下に例を示します。

[root@master-zone]# radosgw-admin subuser create --uid=janedoe --subuser=janedoe:swift --access=full

{ "user_id": "janedoe",

"display_name": "Jane Doe",

"email": "jane@example.com",

"suspended": 0,

"max_buckets": 1000,

"auid": 0,

"subusers": [

{ "id": "janedoe:swift",

"permissions": "full-control"}],

"keys": [

{ "user": "janedoe",

"access_key": "11BS02LGFB6AL6H1ADMW",

"secret_key": "vzCEkuryfn060dfee4fgQPqFrncKEIkh3ZcdOANY"}],

"swift_keys": [],

"caps": [],

"op_mask": "read, write, delete",

"default_placement": "",

"placement_tags": [],

"bucket_quota": { "enabled": false,

"max_size_kb": -1,

"max_objects": -1},

"user_quota": { "enabled": false,

"max_size_kb": -1,

"max_objects": -1},

"temp_url_keys": []}3.6.4. ユーザー情報の取得

ユーザーに関する情報を取得するには、user info ユーザー ID (--uid={username}) を指定します。

[root@master-zone]# radosgw-admin user info --uid=janedoe

テナントユーザーに関する情報を取得するには、ユーザー ID とテナントの名前の両方を指定します。

[root@master-zone]# radosgw-admin user info --uid=janedoe --tenant=test

3.6.5. ユーザー情報の変更

ユーザーに関する情報を変更するには、ユーザー ID (--uid={username}) と変更する属性を指定する必要があります。変更は通常、キーとシークレット、電子メールアドレス、表示名、およびアクセスレベルに対して行われます。以下に例を示します。

[root@master-zone]# radosgw-admin user modify --uid=janedoe --display-name="Jane E. Doe"

サブユーザーの値を変更するには、subuser modify とサブユーザー ID を指定します。以下に例を示します。

[root@master-zone]# radosgw-admin subuser modify --subuser=janedoe:swift --access=full

3.6.6. ユーザーの有効化および一時停止

ユーザーを作成すると、ユーザーはデフォルトで有効になります。ただし、ユーザー特権を一時停止して、後で再度有効にすることができます。ユーザーを一時停止するには、user suspend とユーザー ID を指定します。

[root@master-zone]# radosgw-admin user suspend --uid=johndoe

一時停止ユーザーを再度有効にするには、user enable とユーザー ID を指定します。

[root@master-zone]# radosgw-admin user enable --uid=johndoe

ユーザーを無効にすると、サブユーザーが無効になります。

3.6.7. ユーザーの削除

ユーザーを削除すると、ユーザーとサブユーザーはシステムから削除されます。ただし、必要に応じてサブユーザーのみを削除できます。ユーザー (およびサブユーザー) を削除するには、user rm とユーザー ID を指定します。

[root@master-zone]# radosgw-admin user rm --uid=<uid> [--purge-keys] [--purge-data]

以下に例を示します。

[root@master-zone]# radosgw-admin user rm --uid=johndoe --purge-data

サブユーザーのみを削除するには、subuser rm およびサブユーザー名を指定します。

[root@master-zone]# radosgw-admin subuser rm --subuser=johndoe:swift --purge-keys

オプションには以下が含まれます。

-

データのパージ:

--purge-dataオプションは、UID に関連付けられたすべてのデータをパージします。 -

Purge Keys:

--purge-keysオプションは、UID に関連付けられたすべてのキーをパージします。

3.6.8. サブユーザーの削除

サブユーザーを削除すると、Swift インターフェイスへのアクセスが削除されます。ユーザーはシステムに残ります。Ceph Object Gateway: サブユーザーを削除するには、subuser rm およびサブユーザー ID を指定します。

[root@master-zone]# radosgw-admin subuser rm --subuser=johndoe:test

オプションには以下が含まれます。

-

Purge Keys:

--purge-keysオプションは、UID に関連付けられたすべてのキーをパージします。

3.6.9. ユーザーの名前変更

ユーザーの名前を変更するには、radosgw-admin user rename コマンドを使用します。このコマンドにかかる時間は、ユーザーが持つバケットおよびオブジェクトの数によって異なります。この数字が大きい場合、Red Hat は、screen パッケージが提供する Screen ユーティリティーでコマンドを使用することを推奨します。

前提条件

- 稼働中の Ceph クラスター。

-

rootまたはsudoアクセス - インストールされた Ceph Object Gateway

手順

ユーザーの名前を変更します。

radosgw-admin user rename --uid=current-user-name --new-uid=new-user-name

たとえば、名前

user1をuser2に変更するには、以下を実行します。# radosgw-admin user rename --uid=user1 --new-uid=user2 { "user_id": "user2", "display_name": "user 2", "email": "", "suspended": 0, "max_buckets": 1000, "auid": 0, "subusers": [], "keys": [ { "user": "user2", "access_key": "59EKHI6AI9F8WOW8JQZJ", "secret_key": "XH0uY3rKCUcuL73X0ftjXbZqUbk0cavD11rD8MsA" } ], "swift_keys": [], "caps": [], "op_mask": "read, write, delete", "default_placement": "", "placement_tags": [], "bucket_quota": { "enabled": false, "check_on_raw": false, "max_size": -1, "max_size_kb": 0, "max_objects": -1 }, "user_quota": { "enabled": false, "check_on_raw": false, "max_size": -1, "max_size_kb": 0, "max_objects": -1 }, "temp_url_keys": [], "type": "rgw" }ユーザーがテナント内にある場合は、ユーザー名とテナントの両方を指定します。

構文

radosgw-admin user rename --uid user-name --new-uid new-user-name --tenant tenant

たとえば、

testテナント内のuser1の名前をuser2に変更するには、以下を実行します。例

# radosgw-admin user rename --uid=test$user1 --new-uid=test$user2 --tenant test 1000 objects processed in tvtester1. Next marker 80_tVtester1_99 2000 objects processed in tvtester1. Next marker 64_tVtester1_44 3000 objects processed in tvtester1. Next marker 48_tVtester1_28 4000 objects processed in tvtester1. Next marker 2_tVtester1_74 5000 objects processed in tvtester1. Next marker 14_tVtester1_53 6000 objects processed in tvtester1. Next marker 87_tVtester1_61 7000 objects processed in tvtester1. Next marker 6_tVtester1_57 8000 objects processed in tvtester1. Next marker 52_tVtester1_91 9000 objects processed in tvtester1. Next marker 34_tVtester1_74 9900 objects processed in tvtester1. Next marker 9_tVtester1_95 1000 objects processed in tvtester2. Next marker 82_tVtester2_93 2000 objects processed in tvtester2. Next marker 64_tVtester2_9 3000 objects processed in tvtester2. Next marker 48_tVtester2_22 4000 objects processed in tvtester2. Next marker 32_tVtester2_42 5000 objects processed in tvtester2. Next marker 16_tVtester2_36 6000 objects processed in tvtester2. Next marker 89_tVtester2_46 7000 objects processed in tvtester2. Next marker 70_tVtester2_78 8000 objects processed in tvtester2. Next marker 51_tVtester2_41 9000 objects processed in tvtester2. Next marker 33_tVtester2_32 9900 objects processed in tvtester2. Next marker 9_tVtester2_83 { "user_id": "test$user2", "display_name": "User 2", "email": "", "suspended": 0, "max_buckets": 1000, "auid": 0, "subusers": [], "keys": [ { "user": "test$user2", "access_key": "user2", "secret_key": "123456789" } ], "swift_keys": [], "caps": [], "op_mask": "read, write, delete", "default_placement": "", "placement_tags": [], "bucket_quota": { "enabled": false, "check_on_raw": false, "max_size": -1, "max_size_kb": 0, "max_objects": -1 }, "user_quota": { "enabled": false, "check_on_raw": false, "max_size": -1, "max_size_kb": 0, "max_objects": -1 }, "temp_url_keys": [], "type": "rgw" }ユーザーの名前が正常に変更されたことを確認します。

構文

radosgw-admin user info --uid=new-user-name以下に例を示します。

例

# radosgw-admin user info --uid=user2

ユーザーがテナント内にある場合は、tenant$user-name 形式を使用します。

radosgw-admin user info --uid=tenant$new-user-name

# radosgw-admin user info --uid=test$user2

関連情報

-

man ページの

screen(1)

3.6.10. キーの作成

ユーザーのキーを作成するには、key create を指定する必要があります。ユーザーには、ユーザー ID と s3 キータイプを指定します。サブユーザーのキーを作成するには、サブユーザー ID と swift キータイプを指定する必要があります。以下に例を示します。

[root@master-zone]# radosgw-admin key create --subuser=johndoe:swift --key-type=swift --gen-secret

{ "user_id": "johndoe",

"rados_uid": 0,

"display_name": "John Doe",

"email": "john@example.com",

"suspended": 0,

"subusers": [

{ "id": "johndoe:swift",

"permissions": "full-control"}],

"keys": [

{ "user": "johndoe",

"access_key": "QFAMEDSJP5DEKJO0DDXY",

"secret_key": "iaSFLDVvDdQt6lkNzHyW4fPLZugBAI1g17LO0+87"}],

"swift_keys": [

{ "user": "johndoe:swift",

"secret_key": "E9T2rUZNu2gxUjcwUBO8n\/Ev4KX6\/GprEuH4qhu1"}]}3.6.11. アクセスキーの追加および削除

ユーザーおよびサブユーザーには、S3 インターフェイスおよび Swift インターフェイスを使用するためのアクセスキーが必要です。ユーザーまたはサブユーザーを作成し、アクセスキーおよびシークレットを指定しない場合、キーおよびシークレットが自動的に生成されます。キーを作成し、アクセスキーやシークレットを指定または生成することができます。アクセスキーおよびシークレットを削除することもできます。オプションには以下が含まれます。

-

--secret=<key>は、秘密鍵を指定します (例: 手動で生成)。 -

--geen-access-keyは、ランダムなアクセスキーを生成します (デフォルトでは S3 ユーザー用)。 -

--geen-secretは、ランダムな秘密鍵を生成します。 -

--key-type=<type>は、キータイプを指定します。オプションは swift、s3 です。

キーを追加するには、ユーザーを指定します。

[root@master-zone]# radosgw-admin key create --uid=johndoe --key-type=s3 --gen-access-key --gen-secret

鍵とシークレットを指定することもできます。

アクセスキーを削除するには、ユーザーとキーを指定する必要があります。

特定ユーザーのアクセスキーを検索します。

[root@master-zone]# radosgw-admin user info --uid=<testid>

アクセスキーは、出力の

"access_key"値になります。以下に例を示します。$ radosgw-admin user info --uid=johndoe { "user_id": "johndoe", ... "keys": [ { "user": "johndoe", "access_key": "0555b35654ad1656d804", "secret_key": "h7GhxuBLTrlhVUyxSPUKUV8r/2EI4ngqJxD7iBdBYLhwluN30JaT3Q==" } ], ... }前の手順のユーザー ID とアクセスキーを指定して、アクセスキーを削除します。

[root@master-zone]# radosgw-admin key rm --uid=<user_id> --access-key <access_key>

以下に例を示します。

[root@master-zone]# radosgw-admin key rm --uid=johndoe --access-key 0555b35654ad1656d804

3.6.12. 管理機能の追加および削除

Ceph Storage Cluster は、ユーザーが REST API を介して管理機能を実行できるようにする管理 API を提供します。デフォルトでは、ユーザーはこの API にアクセスできません。ユーザーが管理機能を実行できるようにするには、ユーザーに管理機能を提供します。

ユーザーに管理機能を追加するには、以下を実行します。

[root@master-zone]# radosgw-admin caps add --uid={uid} --caps={caps}ユーザー、バケット、メタデータ、および使用状況 (使用率) に、読み取り、書き込み、またはすべての機能を追加できます。以下に例を示します。

--caps="[users|buckets|metadata|usage|zone]=[*|read|write|read, write]"

以下に例を示します。

[root@master-zone]# radosgw-admin caps add --uid=johndoe --caps="users=*"

ユーザーから管理機能を削除するには、以下のコマンドを実行します。

[root@master-zone]# radosgw-admin caps remove --uid=johndoe --caps={caps}3.7. クォータ管理

Ceph Object Gateway を使用すると、ユーザーが所有するユーザーおよびバケットにクォータを設定することができます。クォータには、バケットのオブジェクトの最大数と、メガバイト単位のストレージの最大サイズが含まれます。

-

Bucket:

--bucketオプションでは、ユーザーが所有するバケットのクォータを指定できます。 -

Maximum Objects:

--max-objects設定では、オブジェクトの最大数を指定できます。負の値を設定すると、この設定が無効になります。 -

Maximum Size:

--max-sizeオプションでは、バイトの最大数のクォータを指定できます。負の値を設定すると、この設定が無効になります。 -

Quota Scope: