Red Hat Training

A Red Hat training course is available for OpenShift Container Platform

アプリケーション

OpenShift Container Platform 4.1 でのアプリケーションの作成および管理

概要

第1章 プロジェクト

1.1. プロジェクトの使用

プロジェクト を使用することにより、あるユーザーコミュニティーは、他のコミュニティーと切り離された状態で独自のコンテンツを整理し、管理することができます。

openshift- および kube- で始まる名前のプロジェクトはデフォルトプロジェクトです。これらのプロジェクトは、Pod として実行されるクラスターコンポーネントおよび他のインフラストラクチャーコンポーネントをホストします。そのため、OpenShift Container Platform では oc new-project コマンドを使用して openshift- または kube- で始まる名前のプロジェクトを作成することができません。クラスター管理者は、oc adm new-project コマンドを使用してこれらのプロジェクトを作成できます。

1.1.1. Web コンソールを使用したプロジェクトの作成

クラスター管理者が許可する場合、新規プロジェクトを作成できます。

openshift- および kube- で始まる名前のプロジェクトは OpenShift Container Platform によって重要 (Critical) と見なされます。そのため、OpenShift Container Platform では、Web コンソールを使用して openshift- で始まる名前のプロジェクトを作成することはできません。

手順

- Home → Projects に移動します。

- Create Project をクリックします。

- プロジェクトの詳細を入力します。

- Create をクリックします。

1.1.2. CLI を使用したプロジェクトの作成

クラスター管理者が許可する場合、新規プロジェクトを作成できます。

openshift- および kube- で始まる名前のプロジェクトは OpenShift Container Platform によって重要 (Critical) と見なされます。そのため、OpenShift Container Platform では oc new-project コマンドを使用して openshift- または kube- で始まる名前のプロジェクトを作成することができません。クラスター管理者は、oc adm new-project コマンドを使用してこれらのプロジェクトを作成できます。

手順

- 以下を実行します。

$ oc new-project <project_name> \

--description="<description>" --display-name="<display_name>"例:

$ oc new-project hello-openshift \

--description="This is an example project" \

--display-name="Hello OpenShift"作成できるプロジェクトの数は、システム管理者によって制限される場合があります。上限に達すると、新規プロジェクトを作成できるように既存プロジェクトを削除しなければならない場合があります。

1.1.3. Web コンソールを使用したプロジェクトの表示

手順

- Home → Projects に移動します。

表示するプロジェクトを選択します。

このページで、Resources ボタンをクリックしてプロジェクトのワークロードを確認し、Dashboard ボタンをクリックしてプロジェクトについてのメトリクスおよび詳細情報を確認します。

1.1.4. CLI を使用したプロジェクトの表示

プロジェクトを表示する際は、認証ポリシーに基づいて、表示アクセスのあるプロジェクトだけを表示できるように制限されます。

手順

プロジェクトの一覧を表示するには、以下を実行します。

$ oc get projects

CLI 操作について現在のプロジェクトから別のプロジェクトに切り換えることができます。その後の操作についてはすべて指定のプロジェクトが使用され、プロジェクトスコープのコンテンツの操作が実行されます。

$ oc project <project_name>

1.1.5. プロジェクトへの追加

手順

- Home → Projects に移動します。

- プロジェクトを選択します。

- Project Status メニューの右上にある Add をクリックし、指定のオプションから選択します。

1.1.6. Web コンソールを使用したプロジェクトステータスの確認

手順

- Home → Projects に移動します。

- ステータスを確認するプロジェクトを選択します。

1.1.7. CLI を使用したプロジェクトステータスの確認

手順

以下を実行します。

$ oc status

このコマンドは、コンポーネントとそれらの各種の関係を含む現在のプロジェクトの概要を示します。

1.1.8. Web コンソールを使用したプロジェクトの削除

手順

- Home → Projects に移動します。

- プロジェクトの一覧から削除するプロジェクトを見つけます。

- プロジェクト一覧の右端にあるメニューから Delete Project を選択します。プロジェクトを削除するパーミッションがない場合は、Delete Project オプションがグレーアウトするため、オプションをクリックすることができません。

1.1.9. CLI を使用したプロジェクトの削除

プロジェクトを削除する際に、サーバーはプロジェクトのステータスを Active から Terminating に更新します。次に、サーバーは Terminating 状態のプロジェクトからすべてのコンテンツをクリアしてから、最終的にプロジェクトを削除します。プロジェクトのステータスが Terminating の場合、新規のコンテンツをプロジェクトに追加することはできません。プロジェクトは CLI または Web コンソールから削除できます。

手順

以下を実行します。

$ oc delete project <project_name>

1.2. 別のユーザーとしてのプロジェクトの作成

権限の借用機能により、別のユーザーとしてプロジェクトを作成することができます。

1.2.1. API の権限借用

OpenShift Container Platform API への要求を、別のユーザーから発信されているかのように設定できます。詳細は、Kubernetes ドキュメントの「User impersonation」を参照してください。

1.2.2. プロジェクト作成時のユーザー権限の借用

プロジェクト要求を作成する際に別のユーザーの権限を借用できます。system:authenticated:oauth はプロジェクト要求を作成できる唯一のブートストラップグループであるため、そのグループの権限を借用する必要があります。

手順

別のユーザーの代わりにプロジェクト要求を作成するには、以下を実行します。

$ oc new-project <project> --as=<user> \ --as-group=system:authenticated --as-group=system:authenticated:oauth

1.3. プロジェクト作成の設定

OpenShift Container Platform では、プロジェクト は関連するオブジェクトをグループ分けし、分離するために使用されます。Web コンソールまたは oc new-project コマンドを使用して新規プロジェクトの作成要求が実行されると、OpenShift Container Platform のエンドポイントは、カスタマイズ可能なテンプレートに応じてプロジェクトをプロビジョニングするために使用されます。

クラスター管理者は、開発者やサービスアカウントが独自のプロジェクトを作成し、プロジェクトの セルフプロビジョニング を実行することを許可し、その方法を設定できます。

1.3.1. プロジェクト作成について

OpenShift Container Platform API サーバーは、クラスターのプロジェクト設定リソースの projectRequestTemplate パラメーターで識別されるプロジェクトテンプレートに基づいて新規プロジェクトを自動的にプロビジョニングします。パラメーターが定義されない場合、API サーバーは要求される名前でプロジェクトを作成するデフォルトテンプレートを作成し、要求するユーザーをプロジェクトの admin (管理者) ロールに割り当てます。

プロジェクト要求が送信されると、API はテンプレートで以下のパラメーターを置き換えます。

表1.1 デフォルトのプロジェクトテンプレートパラメーター

| パラメーター | 説明 |

|---|---|

|

| プロジェクトの名前。必須。 |

|

| プロジェクトの表示名。空にできます。 |

|

| プロジェクトの説明。空にできます。 |

|

| 管理ユーザーのユーザー名。 |

|

| 要求するユーザーのユーザー名。 |

API へのアクセスは、self-provisioner ロールと self-provisioners のクラスターロールバインディングで開発者に付与されます。デフォルトで、このロールはすべての認証された開発者が利用できます。

1.3.2. 新規プロジェクトのテンプレートの変更

クラスター管理者は、デフォルトのプロジェクトテンプレートを変更し、新規プロジェクトをカスタム要件に基づいて作成することができます。

独自のカスタムプロジェクトテンプレートを作成するには、以下を実行します。

手順

-

cluster-admin権限を持つユーザーとしてのログイン。 デフォルトのプロジェクトテンプレートを生成します。

$ oc adm create-bootstrap-project-template -o yaml > template.yaml

-

オブジェクトを追加するか、または既存オブジェクトを変更することにより、テキストエディターで生成される

template.yamlファイルを変更します。 プロジェクトテンプレートは、

openshift-confignamespace に作成される必要があります。変更したテンプレートを読み込みます。$ oc create -f template.yaml -n openshift-config

Web コンソールまたは CLI を使用し、プロジェクト設定リソースを編集します。

Web コンソールの使用

- Administration → Cluster Settings ページに移動します。

- Global Configuration をクリックし、すべての設定リソースを表示します。

- Project のエントリーを見つけ、Edit YAML をクリックします。

CLI の使用

project.config.openshift.io/clusterリソースを編集します。$ oc edit project.config.openshift.io/cluster

specセクションを、projectRequestTemplateおよびnameパラメーターを組み込むように更新し、アップロードされたプロジェクトテンプレートの名前を設定します。デフォルト名はproject-requestです。カスタムプロジェクトテンプレートを含むプロジェクト設定リソース

apiVersion: config.openshift.io/v1 kind: Project metadata: ... spec: projectRequestTemplate: name: <template_name>- 変更を保存した後、変更が正常に適用されたことを確認するために、新しいプロジェクトを作成します。

1.3.3. プロジェクトのセルフプロビジョニングの無効化

認証されたユーザーグループによる新規プロジェクトのセルフプロビジョニングを禁止することができます。

手順

-

cluster-admin権限を持つユーザーとしてのログイン。 以下のコマンドを実行して、

self-provisionersクラスターロールバインディングの使用を確認します。$ oc describe clusterrolebinding.rbac self-provisioners Name: self-provisioners Labels: <none> Annotations: rbac.authorization.kubernetes.io/autoupdate=true Role: Kind: ClusterRole Name: self-provisioner Subjects: Kind Name Namespace ---- ---- --------- Group system:authenticated:oauth

self-provisionersセクションのサブジェクトを確認します。self-provisionerクラスターロールをグループsystem:authenticated:oauthから削除します。self-provisionersクラスターロールバインディングがself-provisionerロールのみをsystem:authenticated:oauthグループにバインドする場合、以下のコマンドを実行します。$ oc patch clusterrolebinding.rbac self-provisioners -p '{"subjects": null}'self-provisionersクラスターロールバインディングがself-provisionerロールをsystem:authenticated:oauthグループ以外のユーザー、グループまたはサービスアカウントにバインドする場合、以下のコマンドを実行します。$ oc adm policy \ remove-cluster-role-from-group self-provisioner \ system:authenticated:oauth

ロールへの自動更新を防ぐには、

self-provisionersクラスターロールバインディングを編集します。自動更新により、クラスターロールがデフォルトの状態にリセットされます。CLI を使用してロールバインディングを更新するには、以下を実行します。

以下のコマンドを実行します。

$ oc edit clusterrolebinding.rbac self-provisioners

表示されるロールバインディングで、以下の例のように

rbac.authorization.kubernetes.io/autoupdateパラメーター値をfalseに設定します。apiVersion: authorization.openshift.io/v1 kind: ClusterRoleBinding metadata: annotations: rbac.authorization.kubernetes.io/autoupdate: "false" ...

単一コマンドを使用してロールバインディングを更新するには、以下を実行します。

$ oc patch clusterrolebinding.rbac self-provisioners -p '{ "metadata": { "annotations": { "rbac.authorization.kubernetes.io/autoupdate": "false" } } }'

認証されたユーザーとしてログインし、プロジェクトのセルフプロビジョニングを実行できないことを確認します。

$ oc new-project test Error from server (Forbidden): You may not request a new project via this API.

組織に固有のより有用な説明を提供できるようこのプロジェクト要求メッセージをカスタマイズすることを検討します。

1.3.4. プロジェクト要求メッセージのカスタマイズ

プロジェクトのセルフプロビジョニングを実行できない開発者またはサービスアカウントが Web コンソールまたは CLI を使用してプロジェクト作成要求を行う場合、以下のエラーメッセージがデフォルトで返されます。

You may not request a new project via this API.

クラスター管理者はこのメッセージをカスタマイズできます。これを、組織に固有の新規プロジェクトの要求方法の情報を含むように更新することを検討します。以下は例になります。

-

プロジェクトを要求するには、システム管理者 (

projectname@example.com) に問い合わせてください。 -

新規プロジェクトを要求するには、

https://internal.example.com/openshift-project-requestにあるプロジェクト要求フォームに記入します。

プロジェクト要求メッセージをカスタマイズするには、以下を実行します。

手順

Web コンソールまたは CLI を使用し、プロジェクト設定リソースを編集します。

Web コンソールの使用

- Administration → Cluster Settings ページに移動します。

- Global Configuration をクリックし、すべての設定リソースを表示します。

- Project のエントリーを見つけ、Edit YAML をクリックします。

CLI の使用

-

cluster-admin権限を持つユーザーとしてのログイン。 project.config.openshift.io/clusterリソースを編集します。$ oc edit project.config.openshift.io/cluster

-

specセクションを、projectRequestMessageパラメーターを含むように更新し、値をカスタムメッセージに設定します。カスタムプロジェクト要求メッセージを含むプロジェクト設定リソース

apiVersion: config.openshift.io/v1 kind: Project metadata: ... spec: projectRequestMessage: <message_string>

例:

apiVersion: config.openshift.io/v1 kind: Project metadata: ... spec: projectRequestMessage: To request a project, contact your system administrator at projectname@example.com.

- 変更を保存した後に、プロジェクトをセルフプロビジョニングできない開発者またはサービスアカウントとして新規プロジェクトの作成を試行し、変更が正常に適用されていることを確認します。

第2章 Operator

2.1. Operator について

概念的に、Operator は人間の運用上のナレッジを使用し、これをコンシューマーと簡単に共有できるソフトウェアにエンコードします。

Operator は、ソフトウェアの他の部分を実行する運用上の複雑さを軽減するソフトウェアの特定の部分で構成されます。Operator はソフトウェアベンダーのエンジニアリングチームの拡張機能のように動作し、(OpenShift Container Platform などの) Kubernetes 環境を監視し、その最新状態に基づいてリアルタイムの意思決定を行います。高度な Operator はアップグレードをシームレスに実行し、障害に自動的に対応するように設計されており、時間の節約のためにソフトウェアのバックアッププロセスを省略するなどのショートカットを実行することはありません。

技術的には、Operator は Kubernetes アプリケーションをパッケージ化し、デプロイし、管理する方法です。

Kubernetes アプリケーションは、Kubernetes にデプロイされ、Kubernetes API および kubectl または oc ツールを使用して管理されるアプリケーションです。Kubernetes を最大限に活用するには、Kubernetes 上で実行されるアプリケーションを提供し、管理するために拡張できるように一連の総合的な API が必要です。Operator は、Kubernetes 上でこのタイプのアプリケーションを管理するランタイムと見なすことができます。

2.1.1. Operator を使用する理由

Operator は以下を提供します。

- インストールおよびアップグレードの反復性。

- すべてのシステムコンポーネントの継続的なヘルスチェック。

- OpenShift コンポーネントおよび ISV コンテンツの OTA (Over-the-air) 更新。

- フィールドエンジニアからの知識をカプセル化し、1 または 2 ユーザーだけでなく、すべてのユーザーに展開する場所。

- Kubernetes にデプロイする理由

- Kubernetes (延長線上で考えると OpenShift Container Platform も含まれる) には、シークレットの処理、負荷分散、サービスの検出、自動スケーリングなどの、オンプレミスおよびクラウドプロバイダーで機能する、複雑な分散システムをビルドするために必要なすべてのプリミティブが含まれます。

- アプリケーションを Kubernetes API および

kubectlツールで管理する理由 -

これらの API は機能的に充実しており、すべてのプラットフォームのクライアントを持ち、クラスターのアクセス制御/監査機能にプラグインします。Operator は Kubernetes の拡張メカニズム、カスタムリソース定義 (CRD、Custom Resource Definition ) を使用するので、

MongoDBなどのカスタムオブジェクトはビルトインされた、ネイティブ Kubernetes オブジェクトのように表示され、機能します。 - Operator とサービスブローカーとの比較

- サービスブローカーは、アプリケーションのプログラムによる検出およびデプロイメントを行うための 1 つの手段です。ただし、これは長期的に実行されるプロセスではないため、アップグレード、フェイルオーバー、またはスケーリングなどの Day 2 オペレーションを実行できません。カスタマイズおよびチューニング可能なパラメーターはインストール時に提供されるのに対し、Operator はクラスターの最新の状態を常に監視します。クラスター外のサービスを使用する場合は、これらをサービスブローカーで使用できますが、Operator もこれらのクラスター外のサービスに使用できます。

2.1.2. Operator Framework

Operator Framework は、上記のカスタマーエクスペリエンスに関連して提供されるツールおよび機能のファミリーです。これは、コードを作成するためだけにあるのではなく、Operator のテスト、実行、および更新などの重要な機能を実行します。Operator Framework コンポーネントは、これらの課題に対応するためのオープンソースツールで構成されています。

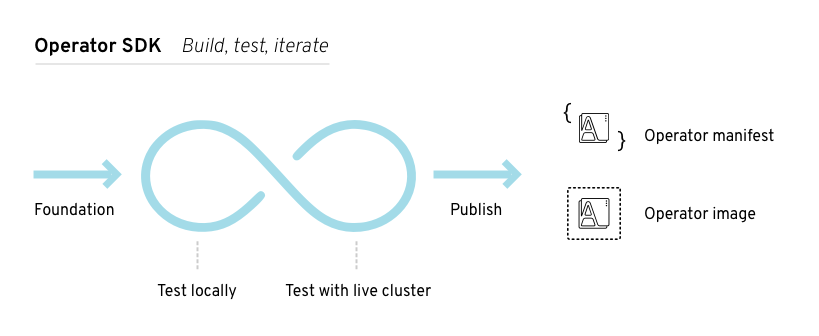

- Operator SDK

- Kubernetes API の複雑性を把握していなくても、それぞれの専門知識に基づいて独自の Operator のブートストラップ、ビルド、テストおよびパッケージ化を実行できるよう Operator の作成者を支援します。

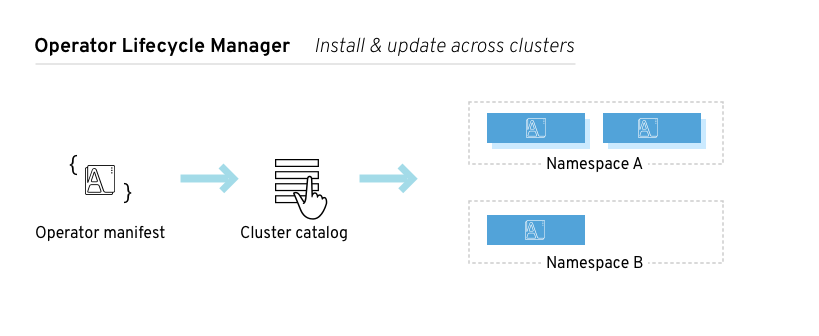

- Operator Lifecycle Manager

- クラスター内の Operator のインストール、アップグレード、ロールベースのアクセス制御 (RBAC) を制御します。OpenShift Container Platform 4.1 ではデフォルトでデプロイされます。

- Operator Metering

- クラスター上で Day 2 管理についての Operator の運用上のメトリクスを収集し、使用状況のメトリクスを集計します。

- OperatorHub

- クラスター上で Operator を検出し、インストールするための Web コンソールです。OpenShift Container Platform 4.1 ではデフォルトでデプロイされます。

これらのツールは組み立て可能なツールとして設計されているため、役に立つと思われるツールを使用できます。

2.1.3. Operator 成熟度モデル

Operator 内にカプセル化されている管理ロジックの複雑さのレベルはさまざまです。また、このロジックは通常 Operator によって表されるサービスのタイプによって大きく変わります。

ただし、大半の Operator に含まれる特定の機能セットについては、Operator のカプセル化された操作の成熟度を一般化することができます。このため、以下の Operator 成熟度モデルは、 Operator の一般的な Day 2 オペレーションについての 5 つのフェーズの成熟度を定義しています。

図2.1 Operator 成熟度モデル

上記のモデルでは、これらの機能を Operator SDK の Helm、Go、および Ansible 機能で最適に開発する方法も示します。

2.2. Operator Lifecycle Manager について

以下では、OpenShift Container Platform における Operator Lifecycle Manager (OLM) のワークフローおよびアーキテクチャーの概要を説明します。

2.2.1. Operator Lifecycle Manager の概要

OpenShift Container Platform 4.1 では、 Operator Lifecycle Manager (OLM) を使用することにより、ユーザーはすべての Operator およびクラスター全体で実行される関連サービスをインストールし、更新し、管理することができます。これは、Kubernetes のネイティブアプリケーション (Operator) を効果的かつ自動化された拡張可能な方法で管理するために設計されたオープンソースツールキットの Operator Framework の一部です。

図2.2 Operator Lifecycle Manager ワークフロー

OLM は OpenShift Container Platform 4.1 でデフォルトで実行されます。OpenShift Container Platform Web コンソールは、クラスター管理者が Operator をインストールしたり、クラスターで利用可能な Operator のカタログを使用できるように特定のプロジェクトアクセスを付与したりするのに使用する管理画面を提供します。

開発者の場合には、セルフサービスを使用することで、専門的な知識がなくてもデータベースのインスタンスのプロビジョニングや設定、またモニタリング、ビッグデータサービスなどを実行できます。 Operator にそれらに関するナレッジが織り込まれているためです。

2.2.2. ClusterServiceVersion (CSV)

ClusterServiceVersion (CSV) は、Operator Lifecycle Manager (OLM) のクラスターでの Operator の実行を支援する Operator メタデータから作成される YAML マニフェストです。これは、ユーザーインターフェースにロゴ、説明、およびバージョンなどの情報を設定するために使用される Operator コンテナーイメージを伴うメタデータです。また、これは Operator が必要とする RBAC ルールやそれが管理したり、依存したりするカスタムリース(Custom Resource、CR) などの、Operator を実行するために必要な技術情報の情報源にもなります。

CSV は以下で構成されます。

- メタデータ

アプリケーションメタデータ:

- 名前、説明、バージョン (semver 準拠)、リンク、ラベル、アイコンなど

- インストールストラテジー

タイプ: Deployment

- サービスアカウントおよび必要なパーミッションのセット

- Deployment のセット。

- Custom Resource Definitions (CRDs)

- タイプ

- Owned: サービスで管理されます。

- Required: サービスが実行されるためにクラスターに存在する必要があります。

- Resources: Operator が対話するリソースの一覧です。

- Descriptors: 意味情報を提供するために CRD 仕様およびステータスフィールドにアノテーションを付けます。

2.2.3. Operator Lifecycle Manager アーキテクチャー

Operator Lifecycle Manager (OLM) は、OLM Operator およびカタログ Operator の 2 つの Operator で構成されています。

これらの Operator はそれぞれ OLM フレームワークのベースとなるカスタムリソース定義(CRD) を管理します。

表2.1 OLM およびカタログ Operator で管理される CRD

| リソース | 短縮名 | 所有する Operator | 説明 |

|---|---|---|---|

| ClusterServiceVersion |

| OLM | アプリケーションのメタデータ: 名前、バージョン、アイコン、必須リソース、インストールなど。 |

| InstallPlan |

| カタログ | CSV を自動的にインストールするか、またはアップグレードするために作成されるリソースの計算された一覧。 |

| CatalogSource |

| カタログ | CSV、CRD、およびアプリケーションを定義するパッケージのリポジトリー。 |

| Subscription |

| カタログ | パッケージのチャネルを追跡して CSV を最新の状態に保ちます。 |

| OperatorGroup |

| OLM | 同じ namespace にデプロイされたすべての Operator を OperatorGroup オブジェクトとして設定し、namespace の一覧またはクラスター全体でカスタムリソース (CR) を監視します。 |

これらの Operator はそれぞれリソースも作成します。

表2.2 OLM およびカタログ Operator によって作成されるリソース

| リソース | 所有する Operator |

|---|---|

| Deployment | OLM |

| ServiceAccount | |

| (Cluster)Role | |

| (Cluster)RoleBinding | |

| Custom Resource Definition (CRD) | カタログ |

| ClusterServiceVersion (CSV) |

2.2.3.1. OLM Operator

OLM Operator は、CSV で指定された必須リソースがクラスター内にあることが確認された後に CSV リソースで定義されるアプリケーションをデプロイします。

OLM Operator は必須リソースの作成には関与せず、ユーザーが CLI を使用してこれらのリソースを手動で作成したり、カタログ Operator を使用してこれらのリソースを作成することを選択することができます。このタスクの分離により、アプリケーションに OLM フレームワークをどの程度活用するかに関連してユーザーによる追加機能の購入を可能にします。

OLM Operator はすべての namespace を監視するように設定されることが多い一方で、それらすべてが別々の namespace を管理する限り、他の OLM Operator と並行して操作することができます。

OLM Operator のワークフロー

namespace で ClusterServiceVersion (CSV) の有無を確認し、要件を満たしていることを確認します。その場合、CSV のインストールストラテジーを実行します。

注記CSV は、インストールストラテジーの実行を可能にするには、OperatorGroup のアクティブなメンバーである必要があります。

2.2.3.2. カタログ Operator

カタログ Operator は CSV およびそれらが指定する必須リソースを解決し、インストールします。また、 CatalogSource でチャネル内のパッケージへの更新の有無を確認し、それらを利用可能な最新バージョンに (オプションで自動的に) アップグレードします。

チャネル内のパッケージを追跡する必要のあるユーザーは、必要なパッケージ、チャネル、および更新のプルに使用する CatalogSource を設定する Subscription リソースを作成します。 更新が見つかると、ユーザーに代わって適切な InstallPlan の namespace への書き込みが行われます。

また、ユーザーは必要な CSV および承認ストラテジーの名前を含む InstallPlan リソースを直接作成でき、カタログ Operator はすべての必須リソースの作成の実行計画を作成します。これが承認されると、カタログ Operator はすべてのリソースを InstallPlan に作成します。 その後、これが単独で OLM Operator の要件を満たすと、CSV のインストールに移行します。

カタログ Operator のワークフロー

- 名前でインデックス化される CRD および CSV のキャッシュがあることを確認します。

ユーザーによって作成された未解決の InstallPlan の有無を確認します。

- 要求される名前に一致する CSV を検索し、これを解決済みリソースとして追加します。

- 管理対象または必須の CRD のそれぞれについて、これを解決済みリソースとして追加します。

- 必須 CRD のそれぞれについて、これを管理する CSV を検索します。

- 解決済みの InstallPlan の有無を確認し、それについての検出されたすべてのリソースを作成します (ユーザーによって、または自動的に承認される場合)。

- CatalogSource および Subscription の有無を確認し、それらに基づいて InstallPlan を作成します。

2.2.3.3. カタログレジストリー

カタログレジストリーは、クラスター内での作成用に CSV および CRD を保存し、パッケージおよびチャネルについてのメタデータを保存します。

パッケージマニフェスト は、パッケージアイデンティティーを CSV のセットに関連付けるカタログレジストリー内のエントリーです。パッケージ内で、チャネルは特定の CSV を参照します。CSV は置き換え対象の CSV を明示的に参照するため、パッケージマニフェストはカタログ Operator に対し、CSV をチャネル内の最新バージョンに更新するために必要なすべての情報を提供します (各中間バージョンをステップスルー)。

2.2.4. OperatorGroup

OperatorGroup は、マルチテナント設定を OLM でインストールされた Operator に提供する OLM リソースです。OperatorGroup は、そのメンバー Operator に必要な RBAC アクセスを生成する際に使用するターゲット namespace のセットを選択します。ターゲット namespace のセットは、CSV の olm.targetNamespaces アノテーションに保存されるカンマ区切りの文字列によって指定されます。このアノテーションは、メンバー Operator の CSV インスタンスに適用され、それらのデプロインメントに展開されます。

2.2.4.1. OperatorGroup メンバーシップ

Operator は、以下の条件が true の場合に OperatorGroup の メンバー とみなされます。

- Operator の CSV が OperatorGroup と同じ namespace にある。

- Operator の CSV の InstallMode は OperatorGroup がターゲットに設定する namespace のセットをサポートする。

InstallMode は InstallModeType フィールドおよびブール値の Supported フィールドで構成される。CSV の仕様には、4 つの固有の InstallModeTypes の InstallMode のセットを含めることができます。

表2.3 InstallMode およびサポートされる OperatorGroup

| InstallMode タイプ | 説明 |

|---|---|

|

| Operator は、独自の namespace を選択する OperatorGroup のメンバーにすることができます。 |

|

| Operator は 1 つの namespace を選択する OperatorGroup のメンバーにすることができます。 |

|

| Operator は複数の namespace を選択する OperatorGroup のメンバーにすることができます。 |

|

|

Operator はすべての namespace を選択する OperatorGroup のメンバーにすることができます (ターゲット namespace 設定は空の文字列 |

CSV の仕様が InstallModeType のエントリーを省略する場合、そのタイプは暗黙的にこれをサポートする既存エントリーによってサポートが示唆されない限り、サポートされないものとみなされます。

2.2.4.1.1. OperatorGroup メンバーシップのトラブルシューティング

-

複数の OperatorGroup が単一の namespace にある場合、その namespace で作成されるすべての CSV は

TooManyOperatorGroupsの理由で失敗状態に切り替わります。この理由で失敗状態になる CSV は、それらの namespace の OperatorGroup 数が 1 になると保留状態に切り替わります。 -

CSV の InstallMode がその namespace で OperatorGroup のターゲット namespace 選択をサポートしない場合、CSV は

UnsupportedOperatorGroupの理由で失敗状態に切り替わります。この理由で失敗した状態にある CSV は、 OperatorGroup のターゲット namespace の選択がサポートされる設定に変更されるか、または CSV の InstallMode が OperatorGroup の target namespace 選択をサポートするように変更される場合に保留状態に切り替わります。

2.2.4.2. ターゲット namespace の選択

spec.selector フィールドでラベルセレクターを使用して OperatorGroup の namespace のセットを指定します。

apiVersion: operators.coreos.com/v1

kind: OperatorGroup

metadata:

name: my-group

namespace: my-namespace

spec:

selector:

matchLabels:

cool.io/prod: "true"

さらに、spec.targetNamespaces フィールドを使用してターゲット namespace に名前を明示的に指定することもできます。

apiVersion: operators.coreos.com/v1 kind: OperatorGroup metadata: name: my-group namespace: my-namespace spec: targetNamespaces: - my-namespace - my-other-namespace - my-other-other-namespace

spec.targetNamespaces と spec.selector の両方が定義されている場合、 spec.selector は無視されます。

または、spec.selector と spec.targetNamespaces の両方を省略し、global OperatorGroup を指定できます。 これにより、すべての namespace が選択されます。

apiVersion: operators.coreos.com/v1 kind: OperatorGroup metadata: name: my-group namespace: my-namespace

解決済みの一覧の選択された namespace は OperatorGroup の status.namespaces フィールドに表示されます。グローバル OperatorGroup の status.namespace には空の文字列 ("") が含まれます。 これは、消費する Operator に対し、すべての namespace を監視するように示唆します。

2.2.4.3. OperatorGroup CSV アノテーション

OperatorGroup のメンバー CSV には以下のアノテーションがあります。

| アノテーション | 説明 |

|---|---|

|

| OperatorGroup の名前が含まれます。 |

|

| OperatorGroup の namespace が含まれます。 |

|

| OperatorGroup のターゲット namespace 選択を一覧表示するカンマ区切りの文字列が含まれます。 |

olm.targetNamespaces 以外のすべてのアノテーションがコピーされた CSV と共に含まれます。olm.targetNamespaces アノテーションをコピーされた CSV で省略すると、テナント間のターゲット namespace の重複が回避されます。

2.2.4.4. 提供される API アノテーション

OperatorGroup によって提供される GroupVersionKinds (GVK) についての情報が olm.providedAPIs アノテーションに表示されます。アノテーションの値は、カンマで区切られた <kind>.<version>.<group> で構成される文字列です。OperatorGroup のすべてのアクティブメンバーの CSV によって提供される CRD および APIService の GVK が含まれます。

PackageManifest リソースを提供する単一のアクティブメンバー CSV を含む OperatorGroup の以下の例を確認してください。

apiVersion: operators.coreos.com/v1

kind: OperatorGroup

metadata:

annotations:

olm.providedAPIs: PackageManifest.v1alpha1.packages.apps.redhat.com

name: olm-operators

namespace: local

...

spec:

selector: {}

serviceAccount:

metadata:

creationTimestamp: null

targetNamespaces:

- local

status:

lastUpdated: 2019-02-19T16:18:28Z

namespaces:

- local2.2.4.5. ロールベースのアクセス制御

OperatorGroup の作成時に、3 つの ClusterRole が生成されます。それぞれには、以下の示すように ClusterRoleSelector がラベルに一致するように設定された単一の AggregationRule が含まれます。

| ClusterRole | 一致するラベル |

|---|---|

|

|

|

|

|

|

|

|

|

以下の RBAC リソースは、CSV が AllNamespaces InstallMode のあるすべての namespace を監視しており、理由が InterOperatorGroupOwnerConflict の失敗状態にない限り、CSV が OperatorGroup のアクティブメンバーになる際に生成されます。

表2.4 CRD からの各 API リソース用に生成された ClusterRole

| ClusterRole | 設定 |

|---|---|

|

|

集計ラベル:

|

|

|

集計ラベル:

|

|

|

集計ラベル:

|

|

|

Verbs on

集計ラベル:

|

表2.5 APIService からの各 API リソース用に生成された ClusterRole

| ClusterRole | 設定 |

|---|---|

|

|

集計ラベル:

|

|

|

集計ラベル:

|

|

|

集計ラベル:

|

追加のロールおよびロールバインディング

-

CSV が

*が含まれる 1 つのターゲット namespace を定義する場合、ClusterRole と対応する ClusterRoleBinding が CSV のパーミッションフィールドに定義されるパーミッションごとに生成されます。生成されたすべてのリソースにはolm.owner: <csv_name>およびolm.owner.namespace: <csv_namespace>ラベルが付与されます。 -

CSV が

*が含まれる 1 つのターゲット namespace を定義 しない 場合、olm.owner: <csv_name>およびolm.owner.namespace: <csv_namespace>ラベルの付いた Operator namespace にあるすべてのロールおよびロールバインディングがターゲット namespace にコピーされます。

2.2.4.6. コピーされる CSV

OLM は、それぞれの OperatorGroup のターゲット namespace に、OperatorGroup のすべてのアクティブな CSV のコピーを作成します。コピーされる CSV の目的は、ユーザーに対して、特定の Operator が作成されるリソースを監視するように設定されたターゲット namespace について通知することにあります。コピーされる CSV にはステータスの理由 Copied があり、それらのソース CSV のステータスに一致するように更新されます。olm.targetNamespaces アノテーションは、クラスター上でコピーされる CSV が作成される前に取られます。ターゲット namespace 選択を省略すると、テナント間のターゲット namespace の重複が回避されます。コピーされる CSV はそれらのソース CSV が存在しなくなるか、またはそれらのソース CSV が属する OperatorGroup がコピーされた CSV の namespace をターゲットに設定しなくなると削除されます。

2.2.4.7. 静的 OperatorGroup

OperatorGroup はその spec.staticProvidedAPIs フィールドが true に設定されると 静的 になります。その結果、OLM は OperatorGroup の olm.providedAPIs アノテーションを変更しません。つまり、これを事前に設定することができます。これは、ユーザーが OperatorGroup を使用して namespace のセットでリソースの競合を防ぐ必要がある場合で、それらのリソースの API を提供するアクティブなメンバーの CSV がない場合に役立ちます。

以下は、something.cool.io/cluster-monitoring: "true" アノテーションのある、すべての namespace の Prometheus リソースを保護する OperatorGroup の例です。

apiVersion: operators.coreos.com/v1

kind: OperatorGroup

metadata:

name: cluster-monitoring

namespace: cluster-monitoring

annotations:

olm.providedAPIs: Alertmanager.v1.monitoring.coreos.com,Prometheus.v1.monitoring.coreos.com,PrometheusRule.v1.monitoring.coreos.com,ServiceMonitor.v1.monitoring.coreos.com

spec:

staticProvidedAPIs: true

selector:

matchLabels:

something.cool.io/cluster-monitoring: "true"2.2.4.8. OperatorGroup の交差部分

2 つの OperatorGroup は、それらのターゲット namespace セットの交差部分が空のセットではなく、olm.providedAPIs アノテーションで定義されるそれらの指定 API セットの交差部分が空のセットではない場合に、 交差部分のある指定 API があると見なされます。

これによって生じ得る問題として、交差部分のある指定 API を持つ複数の OperatorGroup は、一連の交差部分のある namespace で同じリソースに関して競合関係になる可能性があります。

交差ルールを確認すると、OperatorGroup の namespace は常に選択されたターゲット namespace の一部として組み込まれます。

2.2.4.8.1. 交差のルール

アクティブメンバーの CSV が同期する際はいつでも、OLM はクラスターで、CSV の OperatorGroup とそれ以外のすべての OperatorGroup 間に交差部分のある指定 API のセットについてクエリーします。その後、OLM はそのセットが空のセットであるかどうかを確認します。

trueであり、CSV の指定 API が OperatorGroup のサブセットである場合:- 移行を継続します。

trueであり、CSV の指定 API が Operator Group のサブセット ではない 場合:OperatorGroup が静的である場合:

- CSV に属するすべてのデプロイメントをクリーンアップします。

-

ステータスの理由

CannotModifyStaticOperatorGroupProvidedAPIsのある失敗状態に CSV を移行します。

OperatorGroup が静的 ではない 場合:

-

OperatorGroup の

olm.providedAPIsアノテーションを、それ自体と CSV の指定 API の集合に置き換えます。

-

OperatorGroup の

falseであり、CSV の指定 API が OperatorGroupt のサブセット ではない 場合:- CSV に属するすべてのデプロイメントをクリーンアップします。

-

ステータスの理由

InterOperatorGroupOwnerConflictのある失敗状態に CSV を移行します。

falseであり、CSV の提供された API が OperatorGroup のサブセットである場合:OperatorGroup が静的である場合:

- CSV に属するすべてのデプロイメントをクリーンアップします。

-

ステータスの理由

CannotModifyStaticOperatorGroupProvidedAPIsのある失敗状態に CSV を移行します。

OperatorGroup が静的 ではない 場合:

-

OperatorGroup の

olm.providedAPIsアノテーションを、それ自体と CSV の指定 API 間の差異部分に置き換えます。

-

OperatorGroup の

OperatorGroup によって生じる失敗状態は非終了状態です。

以下のアクションは、OperatorGroup が同期するたびに実行されます。

- アクティブメンバーの CSV の指定 API のセットは、クラスターから計算されます。コピーされた CSV は無視されることに注意してください。

-

クラスターセットは

olm.providedAPIsと比較され、olm.providedAPIsに追加の API が含まれる場合は、それらの API がプルーニングされます。 - すべての namespace で同じ API を提供するすべての CSV は再びキューに入れられます。これにより、交差部分のあるグループ間の競合する CSV に対して、それらの競合が競合する CSV のサイズ変更または削除のいずれかによって解決されている可能性があることが通知されます。

2.2.5. メトリクス

OLM は、Prometheus ベースの OpenShift Container Platform クラスターモニタリングスタックで使用される特定の OLM 固有のリソースを公開します。

表2.6 OLM によって公開されるメトリクス

| 名前 | 説明 |

|---|---|

|

| 正常に登録された CSV の数。 |

|

| InstallPlan の数。 |

|

| サブスクリプションの数。 |

|

| CatalogSource の単調 (monotonic) カウント。 |

2.3. OperatorHub について

以下では、OperatorHub のアーキテクチャーについて説明します。

2.3.1. OperatorHub の概要

OperatorHub は OpenShift Container Platform Web コンソールで利用でき、クラスター管理者が Operator を検出し、インストールするために使用するインターフェースです。1 回のクリックで、Operator はクラスター外のソースからプルでき、クラスター上でインストールされ、サブスクライブされ、エンジニアリングチームが Operator Lifecycle Manager (OLM) を使用してデプロイメント環境で製品をセルフサービスで管理される状態にすることができます。

クラスター管理者は、以下のカテゴリーにグループ化された OperatorSource から選択することができます。

| カテゴリー | 説明 |

|---|---|

| Red Hat Operator | Red Hat によってパッケージ化され、出荷される Red Hat 製品。Red Hat によってサポートされます。 |

| 認定 Operator | 大手独立系ソフトウェアベンダー (ISV) の製品。Red Hat は ISV とのパートナーシップにより、パッケージ化および出荷を行います。ISV によってサポートされます。 |

| コミュニティー Operator | operator-framework/community-operators GitHub リポジトリーで関連するエンティティーによってメンテナンスされる、オプションで表示可能になるソフトウェア。正式なサポートはありません。 |

| カスタム Operator | 各自でクラスターに追加する Operator。カスタム Operator を追加しない場合、カスタムカテゴリーは Web コンソールの OperatorHub 上に表示されません。 |

OperatorHub コンポーネントは、デフォルトで OpenShift Container Platform の openshift-marketplace namespace に Operator としてインストールされ、実行されます。

2.3.2. OperatorHub アーキテクチャー

OperatorHub コンポーネントの Operator は、OperatorSource および CatalogSourceConfig の 2 つのカスタムリソース定義 (CRD) を管理します。

一部の OperatorSource および CatalogSourceConfig 情報は OperatorHub ユーザーインターフェースで公開されますが、それらのファイルは独自の Operator を作成するユーザーによってのみ直接使用されます。

2.3.2.1. OperatorSource

それぞれの Operator について、OperatorSource は Operator バンドルを保存するために使用される外部データストアを定義するために使用されます。単純な OperatorSource には以下が含まれます。

| フィールド | Description |

|---|---|

|

|

データストアをアプリケーションレジストリーとして識別するために、 |

|

|

現時点で、Quay は OperatorHub によって使用される外部データストアであるため、エンドポイントは Quay.io |

|

|

コミュニティー Operator の場合、これは |

|

| オプションとして、Operator の OperatorHub ユーザーインターフェースに表示される名前に設定されます。 |

|

| オプションとして、Operator をパブリッシュする個人または組織に設定され、これが OperatorHub に表示されるようにします。 |

2.3.2.2. CatalogSourceConfig

Operator の CatalogSourceConfig は、クラスター上の OperatorSource にある Operator を有効にするために使用されます。

単純な CatalogSourceConfig は以下を特定します。

| フィールド | 説明 |

|---|---|

|

|

|

|

| Operator の内容を構成するパッケージのカンマ区切りの一覧です。 |

2.4. Operator のクラスターへの追加

以下では、クラスター管理者を対象に、Operator の OpenShift Container Platform クラスターへのインストールについて説明します。

2.4.1. OperatorHub からの Operator のインストール

クラスター管理者は、OpenShift Container Platform Web コンソールまたは CLI を使用して OperatorHub から Operator をインストールできます。その後、Operator を 1 つまたは複数の namespace にサブスクライブし、クラスター上で開発者が使用できるようにできます。

インストール時に、Operator の以下の初期設定を判別する必要があります。

- インストールモード

- All namespaces on the cluster (default) を選択して Operator をすべての namespace にインストールするか、または (利用可能な場合は) 個別の namespace を選択し、選択された namespace のみに Operator をインストールします。この例では、All namespaces… を選択し、Operator がすべてのユーザーおよびプロジェクトで利用可能な状態にします。

- 更新チャネル

- Operator が複数のチャネルで利用可能な場合、サブスクライブするチャネルを選択できます。たとえば、(利用可能な場合に) stable チャネルからデプロイするには、これを一覧から選択します。

- 承認ストラテジー

- 自動 (Automatic) または手動 (Manual) のいずれかの更新を選択します。インストールされた Operator について自動更新を選択する場合、Operator の新規バージョンが利用可能になると、Operator Lifecycle Manager (OLM) は人の介入なしに、Operator の実行中のインスタンスを自動的にアップグレードします。手動更新を選択する場合、Operator の新規バージョンが利用可能になると、OLM は更新要求を作成します。クラスター管理者は、Operator が新規バージョンに更新されるように更新要求を手動で承認する必要があります。

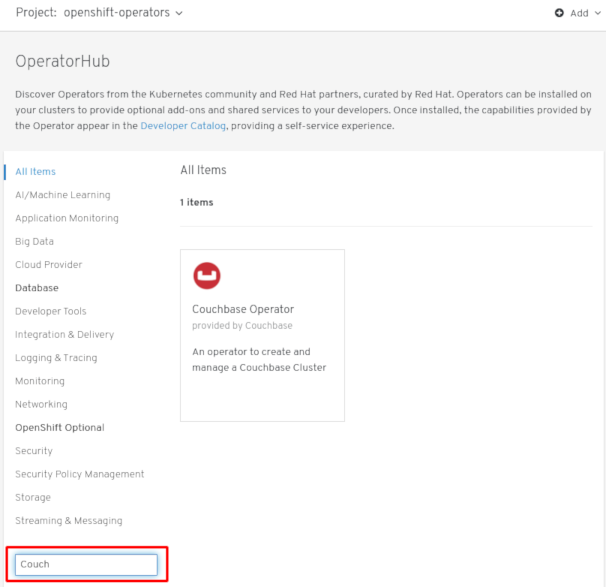

2.4.1.1. Web コンソールを使用した OperatorHub からのインストール

この手順では、Couchbase Operator をサンプルとして使用し、OpenShift Container Platform Web コンソールを使用して、OperatorHub から Operator をインストールし、これにサブスクライブします。

前提条件

-

cluster-adminパーミッションを持つアカウントを使用して OpenShift Container Platform クラスターにアクセスできること。

手順

- Web コンソールで、Catalog → OperatorHub ページに移動します。

スクロールするか、またはキーワードを Filter by keyword ボックスに入力し (この場合は

Couchbase)、必要な Operator を見つけます。図2.3 キーワードによる Operator のフィルター

- Operator を選択します。コミュニティー Operator の場合、Red Hat がそれらの Operator を認定していないことについての警告が出されます。作業を継続する前に、この警告を確認してください。Operator についての情報が表示されます。

- Operator についての情報を確認してから、Install をクリックします。

Create Operator Subscription ページで以下を実行します。

以下のいずれかを選択します。

-

All namespaces on the cluster (default) は、デフォルトの

openshift-operatorsnamespace で Operator をインストールし、クラスターのすべての namespace を監視し、Operator をこれらの namespace に対して利用可能にします。このオプションは常に選択可能です。 - A specific namespace on the cluster では、Operator をインストールする特定の単一 namespace を選択できます。Operator は監視のみを実行し、この単一 namespace で使用されるように利用可能になります。

-

All namespaces on the cluster (default) は、デフォルトの

- Update Channel を選択します (複数を選択できる場合)。

- 前述のように、自動 (Automatic) または 手動 (Manual) の承認ストラテジーを選択します。

- Subscribe をクリックし、Operator をこの OpenShift Container Platform クラスターの選択した namespace で利用可能にします。

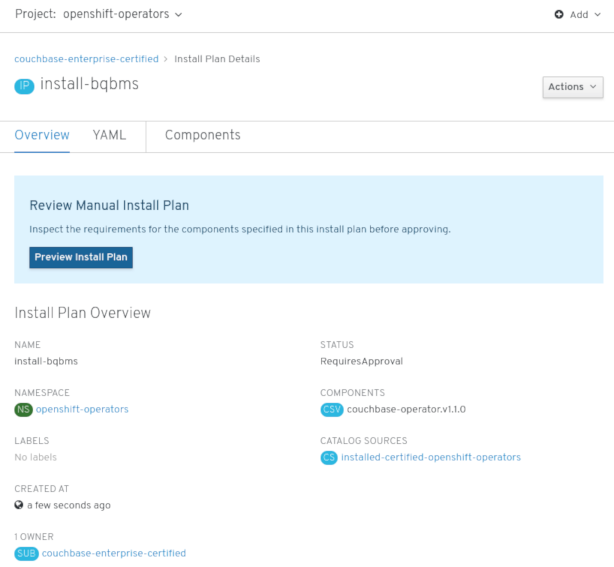

Catalog → Operator Management ページから、Operator サブスクリプションのインストールおよびアップグレードの進捗をモニターできます。

手動の承認ストラテジーを選択している場合、Subscription のアップグレードステータスは、その Install Plan を確認し、承認するまで Upgrading のままになります。

図2.4 Install Plan ページからの手動による承認

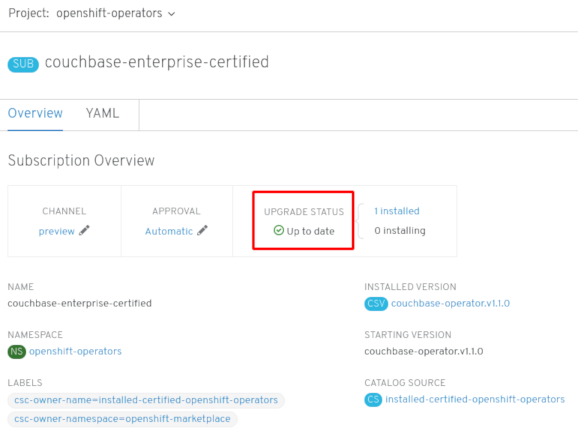

Install Plan ページでの承認後に、Subscription のアップグレードステータスは Up to date に移行します。

自動承認ストラテジーを選択している場合、アップグレードステータスは、介入なしに Up to date に解決するはずです。

図2.5 Subscription のアップグレードステータス「 Up to date」

サブスクリプションのアップグレードステータスが Up to date になった後に、Catalog → Installed Operators を選択して Couchbase ClusterServiceVersion (CSV) が表示され、その ステータス が最終的に関連する namespace で InstallSucceeded に解決することを確認します。

注記All namespaces… インストールモードの場合、ステータスは

openshift-operatorsnamespace で InstallSucceeded になりますが、他の namespace でチェックする場合、ステータスは Copied になります。上記通りにならない場合:

- Catalog → Operator Management ページに切り替え、Operator Subscriptions および Install Plans タブで、 Status の下に失敗またはエラーがあるかどうかを確認します。

-

Pod のログを

openshift-operatorsプロジェクトで確認します (または、A specific namespace… インストールモードが選択されている場合は別の関連する namespace) で確認します。これは、さらにトラブルシューティングする問題を報告する Workloads → Pods ページから実行します。

2.4.1.2. CLI を使用した OperatorHub からのインストール

OpenShift Container Platform Web コンソールを使用する代わりに、CLI を使用して OperatorHub から Operator をインストールできます。oc コマンドを使用して CatalogSourceConfig オブジェクトを作成または更新してから、Subscription オブジェクトを追加します。

この手順の Web コンソールバージョンは、 CatalogSourceConfig および Subscription オブジェクトの作成を、1 つのステップで実行されるかのように背後で処理します。

前提条件

-

cluster-adminパーミッションを持つアカウントを使用して OpenShift Container Platform クラスターにアクセスできること。 - oc コマンドをローカルシステムにインストールする。

手順

OperatorHub からクラスターで利用できる Operator の一覧を表示します。

$ oc get packagemanifests -n openshift-marketplace NAME AGE amq-streams 14h packageserver 15h couchbase-enterprise 14h mongodb-enterprise 14h etcd 14h myoperator 14h ...

クラスターを有効にする Operator を特定するには、 CatalogSourceConfig オブジェクト YAML ファイル (

csc.cr.yamlなど) を作成します。直前の手順 (couchbase-enterprise または etcd など) に記載されている 1 つ以上のパッケージを含めます。以下は例になります。CatalogSourceConfig のサンプル

apiVersion: operators.coreos.com/v1 kind: CatalogSourceConfig metadata: name: example namespace: openshift-marketplace spec: targetNamespace: openshift-operators 1 packages: myoperator 2

Operator は、

targetNamespaceに指定される namespace で CatalogSourceConfig から CatalogSource を生成します。CatalogSourceConfig を作成し、選択された namespace で指定した Operator を有効にします。

$ oc apply -f csc.cr.yaml

namesapace を Operator にサブスクライブするためにサブスクリプションオブジェクト YAML ファイル (

myoperator-sub.yamlなど) を作成します。選択する namesapce には installMode (AllNamespaces または SingleNamespace モード) に一致する OperatorGroup がなければなないことに注意してください。Subscription の例

apiVersion: operators.coreos.com/v1alpha1 kind: Subscription metadata: name: myoperator namespace: openshift-operators spec: channel: alpha name: myoperator 1 source: example 2 sourceNamespace: openshift-operators

Subscription オブジェクトを作成します。

$ oc apply -f myoperator-sub.yaml

この時点で、OLM は選択した Operator を認識します。Operator の ClusterServiceVersion (CSV) はターゲット namespace に表示され、Operator で指定される API は作成用に利用可能になります。

後に追加の Operator をインストールする必要がある場合、以下を実行します。

CatalogSourceConfig ファイル (この例では

csc.cr.yaml) を追加のパッケージで更新します。以下は例になります。更新された CatalogSourceConfig のサンプル

apiVersion: operators.coreos.com/v1 kind: CatalogSourceConfig metadata: name: example namespace: openshift-marketplace spec: targetNamespace: global packages: myoperator,another-operator 1- 1

- 既存のパッケージリストに新規パッケージを追加します。

CatalogSourceConfig オブジェクトを更新します。

$ oc apply -f csc.cr.yaml

- 新規 Operator 用に追加の Subscription オブジェクトを作成します。

追加リソース

-

OperatorHub を使用してカスタム Operator をクラスターにインストールするには、まず Operator アーティファクトを Quay.io にアップロードし、次に独自の

OperatorSourceをクラスターに追加します。オプションで、シークレットを Operator に追加して認証を指定できます。その後、他の Operator と同様に Operator をクラスターで管理できます。これらの手順については、「 Testing Operators」を参照してください。

2.5. クラスターからの Operator の削除

クラスターから Operator を削除 (アンインストール) するには、サブスクライブされた namespace からこれを削除するためにサブスクリプションを削除できます。クリーンな状態にする必要がある場合は、Operator CSV およびデプロイメントを削除してから CatalogSourceConfig で Operator のエントリーを削除することもできます。以下では、Web コンソールまたはコマンドラインのいずれかを使用してクラスターから Operator を削除する方法について説明しています。

2.5.1. Web コンソールの使用によるクラスターからの Operator の削除

Web コンソールでインストールされた Operator を選択された namespace から削除するには、以下の手順を実行します。

手順

削除する Operator を選択します。これを実行するために使用できる 2 つのパスがあります。

Catalog → OperatorHub ページの使用:

-

スクロールするか、またはキーワードを Filter by keyword box に入力し (この場合は

jaeger)、必要な Operator を見つけてこれをクリックします。 - Uninstall をクリックします。

-

スクロールするか、またはキーワードを Filter by keyword box に入力し (この場合は

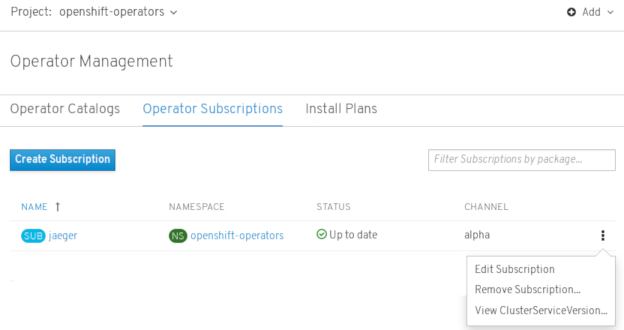

Catalog → Operator Management ページから:

-

Project 一覧から Operator がインストールされている namespace を選択します。クラスター全体の Operator の場合、デフォルトは

openshift-operatorsです。 Operator Subscriptions タブから、削除する必要のある Operator を見つけ (この例では

jaeger)、 Options メニュー

- Remove Subscription をクリックします。

-

Project 一覧から Operator がインストールされている namespace を選択します。クラスター全体の Operator の場合、デフォルトは

- Remove Subscription 画面でプロンプトが出されたら、インストールに関連するすべてのコンポーネントを削除する必要がある場合には、Also completely remove the jaeger Operator from the selected namespace チェックボックスをオプションで選択します。これにより CSV が削除され、次に Operator に関連付けられた Pod、Deployment、CRD および CR が削除されます。

- Remove を選択します。この Operator は実行を停止し、更新を受信しなくなります。

Operator がインストールされなくなるか、更新を受信しなくなっても、その Operator は依然として Operator Catalogs 一覧に表示され、再度サブスクライブできる状態になります。Operator をこの一覧から削除するには、コマンドラインで CatalogSourceConfig の Operator のエントリーを削除できます (「CLI の使用によるクラスターからの Operator の削除」の最後の手順を参照)。

2.5.2. CLI の使用によるクラスターからの Operator の削除

OpenShift Container Platform Web コンソールを使用する代わりに、CLI を使用して Operator をクラスターから削除できます。これは、Subscription および ClusterServiceVersion を targetNamespace から削除し、 CatalogSourceConfig を編集して Operator のパッケージ名を削除することで実行できます。

前提条件

-

cluster-adminパーミッションを持つアカウントを使用して OpenShift Container Platform クラスターにアクセスできること。 -

ocコマンドをローカルシステムにインストールすること。

手順

この例では、2 つの Operator (Jaeger および Descheduler) が openshift-operators namespace にインストールされています。ここでは、Descheduler を削除させずに Jaeger を削除することを目標とします。

サブスクライブされた Operator (例:

jaeger) の現行バージョンをcurrentCSVフィールドで確認します。$ oc get subscription jaeger -n openshift-operators -o yaml | grep currentCSV currentCSV: jaeger-operator.v1.8.2

Operator の Subscription (例:

jaeger) を削除します。$ oc delete subscription jaeger -n openshift-operators subscription.operators.coreos.com "jaeger" deleted

直前の手順で

currentCSV値を使用し、ターゲット namespace の Operator の CSV を削除します。$ oc delete clusterserviceversion jaeger-operator.v1.8.2 -n openshift-operators clusterserviceversion.operators.coreos.com "jaeger-operator.v1.8.2" deleted

CatalogSourceConfigリソースの内容を表示し、specセクションでパッケージの一覧を確認します。$ oc get catalogsourceconfig -n openshift-marketplace \ installed-community-openshift-operators -o yamlたとえば、spec セクションは以下のように表示されるかもしれません。

CatalogSourceConfig のサンプル

spec: csDisplayName: Community Operators csPublisher: Community packages: jaeger,descheduler targetNamespace: openshift-operators

以下の 2 つの方法のいずれかで Operator を CatalogSourceConfig から削除します。

複数の Operator がある場合、CatalogSourceConfig リソースを編集し、Operator のパッケージを削除します。

$ oc edit catalogsourceconfig -n openshift-marketplace \ installed-community-openshift-operators以下のようにパッケージを

packages行から削除します。CatalogSourceConfig で変更されたパッケージの例

packages: descheduler

変更を保存すると、

marketplace-operatorが CatalogSourceConfig を調整します。CatalogSourceConfig に 1 つの Operator のみがある場合、以下のように CatalogSourceConfig 全体を削除してこれを削除することができます。

$ oc delete catalogsourceconfig -n openshift-marketplace \ installed-community-openshift-operators

2.6. インストールされた Operator からのアプリケーションの作成

以下では、開発者を対象に、OpenShift Container Platform 4.1 Web コンソールを使用して、インストールされた Operator からアプリケーションを作成する例を示します。

2.6.1. Operator を使用した etcd クラスターの作成

この手順では、Operator Lifecycle Manager (OLM) で管理される etcd Operator を使用した新規 etcd クラスターの作成について説明します。

前提条件

- OpenShift Container Platform 4.1 クラスターへのアクセス

- 管理者によってクラスターにすでにインストールされている etcd Operator

手順

- この手順を実行するために OpenShift Container Platform Web コンソールで新規プロジェクトを作成します。この例では、my-etcd というプロジェクトを使用します。

Catalogs → Installed Operators ページに移動します。クラスター管理者によってクラスターにインストールされ、使用可能にされた Operator が ClusterServiceVersion (CSV) の一覧としてここに表示されます。CSV は Operator によって提供されるソフトウェアを起動し、管理するために使用されます。

ヒント以下を使用して、CLI でこの一覧を取得できます。

$ oc get csv

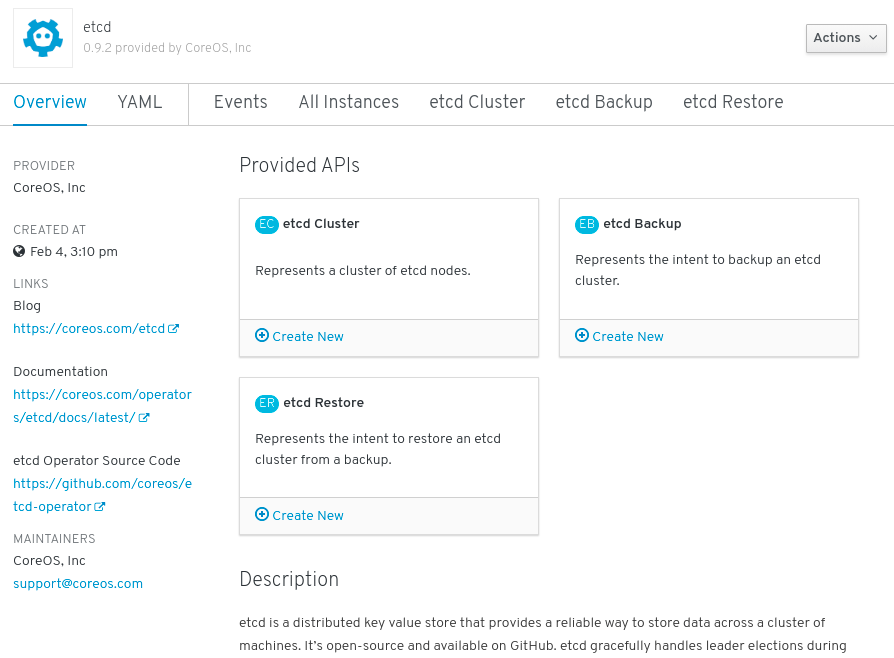

Installed Operators ページで、Copied をクリックしてから、etcd Operator をクリックして詳細情報および選択可能なアクションを表示します。

図2.6 etcd Operator の概要

Provided APIs に表示されているように、この Operator は 3 つの新規リソースタイプを利用可能にします。これには、etcd クラスター (

EtcdClusterリソース) のタイプが含まれます。これらのオブジェクトは、DeploymentsまたはReplicaSetsなどの組み込み済みのネイティブ Kubernetes オブジェクトと同様に機能しますが、これらには etcd を管理するための固有のロジックが含まれます。新規 etcd クラスターを作成します。

- etcd Cluster API ボックスで、Create New をクリックします。

-

次の画面では、クラスターのサイズなど

EtcdClusterオブジェクトのテンプレートを起動する最小条件への変更を加えることができます。ここでは Create をクリックして確定します。これにより、Operator がトリガーされ、Pod、サービス、および新規 etcd クラスターの他のコンポーネントが起動します。

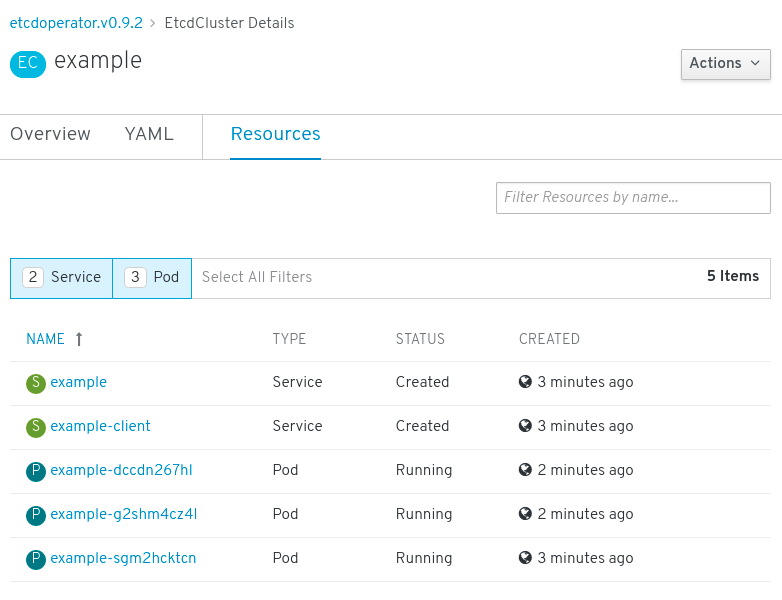

Resources タブをクリックして、プロジェクトに Operator によって自動的に作成され、設定された数多くのリソースが含まれることを確認します。

図2.7 etcd Operator リソース

Kubernetes サービスが作成され、プロジェクトの他の Pod からデータベースにアクセスできることを確認します。

所定プロジェクトで

editロールを持つすべてのユーザーは、クラウドサービスのようにセルフサービス方式でプロジェクトにすでに作成されている Operator によって管理されるアプリケーションのインスタンス (この例では etcd クラスター) を作成し、管理し、削除することができます。この機能を持つ追加のユーザーを有効にする必要がある場合、プロジェクト管理者は以下のコマンドを使用してこのロールを追加できます。$ oc policy add-role-to-user edit <user> -n <target_project>

これで、etcd クラスターは Pod が正常でなくなったり、クラスターのノード間で移行する際の障害に対応し、データのリバランスを行います。最も重要な点として、適切なアクセスを持つクラスター管理者または開発者は独自のアプリケーションでデータベースを簡単に使用できるようになります。

2.7. カスタムリソース定義からのリソースの管理

以下では、開発者がカスタムリソース定義 (CRD) にあるカスタムリソース (CR) をどのように管理できるかについて説明します。

2.7.1. カスタムリソース定義

Kubernetes API では、リソースは特定の種類の API オブジェクトのコレクションを保管するエンドポイントです。たとえば、ビルトインされた Pod リソースには Pod オブジェクトのコレクションが含まれます。

カスタムリソース定義 (CRD) オブジェクトは、クラスター内に新規の固有オブジェクト Kind を定義し、Kubernetes API サーバーにそのライフサイクル全体を処理させます。

カスタムリソース (CR) オブジェクトは、クラスター管理者によってクラスターに追加された CRD から作成され、すべてのクラスターユーザーが新規リソースタイプをプロジェクトに追加できるようにします。

Operator はとりわけ CRD を必要な RBAC ポリシーおよび他のソフトウェア固有のロジックでパッケージ化することで CRD を利用します。またクラスター管理者は、Operator のライフサイクル外にあるクラスターに CRD を手動で追加でき、これらをすべてのユーザーに利用可能にすることができます。

クラスター管理者のみが CRD を作成できる一方で、開発者は CRD への読み取りおよび書き込みパーミッションがある場合には、既存の CRD から CR を作成することができます。

2.7.2. ファイルからのカスタムリソースの作成

カスタムリソース定義 (CRD) がクラスターに追加された後に、クラスターリソース (CR) は CR 仕様を使用するファイルを使って CLI で作成できます。

前提条件

- CRD がクラスター管理者によってクラスターに追加されている。

手順

CR の YAML ファイルを作成します。以下の定義例では、

cronSpecとimageのカスタムフィールドがKind: CronTabのCR に設定されます。このKindは、CRD オブジェクトのspec.kindフィールドから取得します。CR の YAML ファイルサンプル

apiVersion: "stable.example.com/v1" 1 kind: CronTab 2 metadata: name: my-new-cron-object 3 finalizers: 4 - finalizer.stable.example.com spec: 5 cronSpec: "* * * * /5" image: my-awesome-cron-image

ファイルの作成後に、オブジェクトを作成します。

$ oc create -f <file_name>.yaml

2.7.3. カスタムリソースの検査

CLI を使用してクラスターに存在するカスタムリソース (CR) オブジェクトを検査できます。

前提条件

- CR オブジェクトがアクセスできる namespace にあること。

手順

CR の特定の

Kindについての情報を取得するには、以下を実行します。$ oc get <kind>

例:

$ oc get crontab NAME KIND my-new-cron-object CronTab.v1.stable.example.com

リソース名では大文字と小文字が区別されず、CRD で定義される単数形または複数形のいずれか、および任意の短縮名を指定できます。例:

$ oc get crontabs $ oc get crontab $ oc get ct

CR の未加工の YAML データを確認することもできます。

$ oc get <kind> -o yaml

$ oc get ct -o yaml apiVersion: v1 items: - apiVersion: stable.example.com/v1 kind: CronTab metadata: clusterName: "" creationTimestamp: 2017-05-31T12:56:35Z deletionGracePeriodSeconds: null deletionTimestamp: null name: my-new-cron-object namespace: default resourceVersion: "285" selfLink: /apis/stable.example.com/v1/namespaces/default/crontabs/my-new-cron-object uid: 9423255b-4600-11e7-af6a-28d2447dc82b spec: cronSpec: '* * * * /5' 1 image: my-awesome-cron-image 2

第3章 アプリケーションライフサイクル管理

3.1. アプリケーションの作成

OpenShift Container Platform CLI を使用して、ソースまたはバイナリーコード、イメージおよびテンプレートを含むコンポーネントから OpenShift Container Platform アプリケーションを作成できます。

new-app で作成したオブジェクトのセットは、ソースリポジトリー、イメージまたはテンプレートなどのインプットとして渡されるアーティファクトによって異なります。

3.1.1. CLI を使用したアプリケーションの作成

3.1.1.1. ソースコードからのアプリケーションの作成

new-app コマンドを使用して、ローカルまたはリモート Git リポジトリーのソースコードからアプリケーションを作成できます。

new-app コマンドは、ビルド設定を作成し、これはソースコードから新規のアプリケーションイメージを作成します。new-app コマンドは通常、デプロイメント設定を作成して新規のイメージをデプロイするほか、サービスを作成してイメージを実行するデプロイメントへの負荷分散したアクセスを提供します。

OpenShift Container Platform は、Pipeline または Source ビルドストラテジーのいずれを使用すべきかを自動的に検出します。また、Source ビルドの場合は、適切な言語のビルダーイメージを検出します。

3.1.1.1.1. ローカル

ローカルディレクトリーの Git リポジトリーを使用してアプリケーションを作成するには、以下を実行します。

$ oc new-app /<path to source code>

ローカル Git リポジトリーを使用する場合には、リポジトリーで OpenShift Container Platform クラスターがアクセス可能な URL を参照する origin という名前のリモートリポジトリーが必要です。認識されているリモートがない場合は、new-app コマンドを実行してバイナリービルドを作成します。

3.1.1.1.2. リモート

リモート Git リポジトリーを使用してアプリケーションを作成するには、以下を実行します。

$ oc new-app https://github.com/sclorg/cakephp-ex

プライベートのリモート Git リポジトリーを使用してアプリケーションを作成するには、以下を実行します。

$ oc new-app https://github.com/youruser/yourprivaterepo --source-secret=yoursecret

プライベートリモート Git リポジトリーを使用する場合には、--source-secret フラグを使用して、既存のソースクローンのシークレットを指定できます。このシークレットは、BuildConfig に挿入され、リポジトリーにアクセスできるようになります。

--context-dir フラグを指定することで、ソースコードリポジトリーのサブディレクトリーを使用できます。リモート Git リポジトリーおよびコンテキストサブディレクトリーを使用してアプリケーションを作成する場合は、以下を実行します。

$ oc new-app https://github.com/sclorg/s2i-ruby-container.git \

--context-dir=2.0/test/puma-test-app

また、リモート URL を指定する場合は、以下のように URL の最後に #<branch_name> を追加することで、使用する Git ブランチを指定できます。

$ oc new-app https://github.com/openshift/ruby-hello-world.git#beta4

3.1.1.1.3. ビルドストラテジーの検出

新規アプリケーションの作成時に Jenkinsfile がソースリポジトリーのルート または指定されたコンテキストディレクトリーに存在する場合に、OpenShift Container Platform は Pipeline ビルドストラテジーを生成します。

それ以外の場合は、ソースビルドストラテジーが生成されます。

ビルドストラテジーを上書きするには、--strategy フラグを pipeline または sourceのいずれかに設定します。

$ oc new-app /home/user/code/myapp --strategy=docker

oc コマンドを使用するには、ビルドソースを含むファイルがリモートの git リポジトリーで利用可能である必要があります。すべてのソースビルドには、git remote -v を使用する必要があります。

3.1.1.1.4. 言語の検出

Source ビルドストラテジーを使用する場合に、new-app はリポジトリーのルート または指定したコンテキストディレクトリーに特定のファイルが存在するかどうかで、使用する言語ビルダーを判別しようとします。

表3.1 new-app が検出する言語

| 言語 | ファイル |

|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

言語の検出後、new-app は OpenShift Container Platform サーバーで、検出言語と一致する supports アノテーションを持つイメージストリームタグを検索するか、または検出された言語の名前に一致するイメージストリームを検索します。一致するものが見つからない場合には、new-app は Docker Hub レジストリー で名前をベースにした検出言語と一致するイメージの検索を行います。

~ をセパレーターとして使用し、イメージ (イメージストリームまたはコンテナーの仕様) とリポジトリーを指定して、特定のソースリポジトリーにビルダーが使用するイメージを上書きすることができます。この方法を使用すると、ビルドストラテジーの検出および言語の検出は実行されない点に留意してください。

たとえば、リモートリポジトリーのソースを使用して myproject/my-ruby イメージストリームを作成する場合は、以下を実行します。

$ oc new-app myproject/my-ruby~https://github.com/openshift/ruby-hello-world.git

ローカルリポジトリーのソースを使用して `openshift/ruby-20-centos7:latest ` コンテナーのイメージストリームを作成する場合は、以下を実行します。

$ oc new-app openshift/ruby-20-centos7:latest~/home/user/code/my-ruby-app

言語の検出では、リポジトリーのクローンを作成し、検査できるように Git クライアントをローカルにインストールする必要があります。Git が使用できない場合、<image>~<repository> 構文を指定し、リポジトリーで使用するビルダーイメージを指定して言語の検出手順を回避することができます。

-i <image> <repository> 呼び出しでは、アーティファクトのタイプを判別するために new-app が repository のクローンを試行する必要があります。そのため、これは Git が利用できない場合には失敗します。

-i <image> --code <repository> 呼び出しでは、image がソースコードのビルダーとして使用されるか、またはデータベースイメージの場合のように別個にデプロイされる必要があるかどうかを判別するために、new-app が repository のクローンを作成する必要があります。

3.1.1.2. イメージからアプリケーションを作成する方法

既存のイメージからアプリケーションのデプロイが可能です。イメージは、OpenShift Container Platform サーバー内のイメージストリーム、指定したレジストリー内のイメージ、またはローカルの Docker サーバー内のイメージから取得できます。

new-app コマンドは、渡された引数に指定されたイメージの種類を判断しようとします。ただし、イメージが、--docker-image 引数を使用したコンテナーイメージなのか、または -i|--image 引数を使用したイメージストリームなのかを、new-app に明示的に指示できます。

ローカル Docker リポジトリーからイメージを指定した場合、同じイメージが OpenShift Container Platform のクラスターノードでも利用できることを確認する必要があります。

3.1.1.2.1. DockerHub MySQL イメージ

たとえば、DockerHub MySQL イメージからアプリケーションを作成するには、以下を実行します。

$ oc new-app mysql

3.1.1.2.2. プライベートレジストリーのイメージ

プライベートのレジストリーのイメージを使用してアプリケーションを作成し、コンテナーイメージの仕様全体を以下のように指定します。

$ oc new-app myregistry:5000/example/myimage

3.1.1.2.3. 既存のイメージストリームおよびオプションの イメージストリームタグ

既存のイメージストリームおよびオプションのイメージストリームタグでアプリケーションを作成します。

$ oc new-app my-stream:v1

3.1.1.3. テンプレートからのアプリケーションの作成

テンプレート名を引数として指定することで、事前に保存したテンプレートまたはテンプレートファイルからアプリケーションを作成することができます。たとえば、サンプルアプリケーションテンプレートを保存し、これを利用してアプリケーションを作成できます。

保存したテンプレートからアプリケーションを作成します。以下は例になります。

$ oc create -f examples/sample-app/application-template-stibuild.json $ oc new-app ruby-helloworld-sample

事前に OpenShift Container Platform に保存することなく、ローカルファイルシステムでテンプレートを直接使用するには、-f|--file 引数を使用します。以下は例になります。

$ oc new-app -f examples/sample-app/application-template-stibuild.json

3.1.1.3.1. テンプレートパラメーター

テンプレートをベースとするアプリケーションを作成する場合、以下の -p|--param 引数を使用してテンプレートで定義したパラメーター値を設定します。

$ oc new-app ruby-helloworld-sample \

-p ADMIN_USERNAME=admin -p ADMIN_PASSWORD=mypassword

パラメーターをファイルに保存しておいて、--param-file を指定して、テンプレートをインスタンス化する時にこのファイルを使用することができます。標準入力からパラメーターを読み込む場合は、以下のように--param-file=- を使用します。

$ cat helloworld.params ADMIN_USERNAME=admin ADMIN_PASSWORD=mypassword $ oc new-app ruby-helloworld-sample --param-file=helloworld.params $ cat helloworld.params | oc new-app ruby-helloworld-sample --param-file=-

3.1.1.4. アプリケーション作成の変更

new-app コマンドは、OpenShift Container Platform オブジェクトを生成します。このオブジェクトにより、作成されるアプリケーションがビルドされ、デプロイされ、実行されます。通常、これらのオブジェクトは現在のプロジェクトに作成され、これらのオブジェクトには入力ソースリポジトリーまたはインプットイメージから派生する名前が割り当てられます。ただし、new-app でこの動作を変更することができます。

表3.2 new-app 出力オブジェクト

| オブジェクト | 説明 |

|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

| その他 | テンプレートのインスタンスを作成する際に、他のオブジェクトをテンプレートに基づいて生成できます。 |

3.1.1.4.1. 環境変数の指定

テンプレート、ソースまたはイメージからアプリケーションを生成する場合、-e|--env 引数を使用し、ランタイムに環境変数をアプリケーションコンテナーに渡すことができます。

$ oc new-app openshift/postgresql-92-centos7 \

-e POSTGRESQL_USER=user \

-e POSTGRESQL_DATABASE=db \

-e POSTGRESQL_PASSWORD=password

変数は、--env-file 引数を使用してファイルから読み取ることもできます。

$ cat postgresql.env POSTGRESQL_USER=user POSTGRESQL_DATABASE=db POSTGRESQL_PASSWORD=password $ oc new-app openshift/postgresql-92-centos7 --env-file=postgresql.env

さらに --env-file=- を使用することで、標準入力で環境変数を指定することもできます。

$ cat postgresql.env | oc new-app openshift/postgresql-92-centos7 --env-file=-

-e|--env または --env-file 引数で渡される環境変数では、new-app 処理の一環として作成される BuildConfig オブジェクトは更新されません。

3.1.1.4.2. ビルド環境変数の指定

テンプレート、ソースまたはイメージからアプリケーションを生成する場合、--build-env 引数を使用し、ランタイムに環境変数をビルドコンテナーに渡すことができます。

$ oc new-app openshift/ruby-23-centos7 \

--build-env HTTP_PROXY=http://myproxy.net:1337/ \

--build-env GEM_HOME=~/.gem

変数は、--build-env-file 引数を使用してファイルから読み取ることもできます。

$ cat ruby.env HTTP_PROXY=http://myproxy.net:1337/ GEM_HOME=~/.gem $ oc new-app openshift/ruby-23-centos7 --build-env-file=ruby.env

さらに --build-env-file=- を使用して、環境変数を標準入力で指定することもできます。

$ cat ruby.env | oc new-app openshift/ruby-23-centos7 --build-env-file=-

3.1.1.4.3. ラベルの指定

ソース、イメージ、またはテンプレートからアプリケーションを生成する場合、-l|--label 引数を使用し、作成されたオブジェクトにラベルを追加できます。ラベルを使用すると、アプリケーションに関連するオブジェクトを一括で選択、設定、削除することが簡単になります。

$ oc new-app https://github.com/openshift/ruby-hello-world -l name=hello-world

3.1.1.4.4. 作成前の出力の表示

new-app コマンドの実行に関するドライランを確認するには、yaml または json の値と共に -o|--output 引数を使用できます。次にこの出力を使用して、作成されるオブジェクトのプレビューまたは編集可能なファイルへのリダイレクトを実行できます。問題がなければ、oc create を使用して OpenShift Container Platform オブジェクトを作成できます。

new-app アーティファクトをファイルに出力するには、これらを編集し、作成します。

$ oc new-app https://github.com/openshift/ruby-hello-world \

-o yaml > myapp.yaml

$ vi myapp.yaml

$ oc create -f myapp.yaml3.1.1.4.5. 別名でのオブジェクトの作成

通常 new-app で作成されるオブジェクトの名前はソースリポジトリーまたは生成に使用されたイメージに基づいて付けられます。コマンドに --name フラグを追加することで、生成されたオブジェクトの名前を設定できます。

$ oc new-app https://github.com/openshift/ruby-hello-world --name=myapp

3.1.1.4.6. 別のプロジェクトでのオブジェクトの作成

通常 new-app は現在のプロジェクトにオブジェクトを作成します。ただし、-n|--namespace 引数を使用して、別のプロジェクトにオブジェクトを作成することができます。

$ oc new-app https://github.com/openshift/ruby-hello-world -n myproject

3.1.1.4.7. 複数のオブジェクトの作成

new-app コマンドは、複数のパラメーターを new-app に指定して複数のアプリケーションを作成できます。コマンドラインで指定するラベルは、単一コマンドで作成されるすべてのオブジェクトに適用されます。環境変数は、ソースまたはイメージから作成されたすべてのコンポーネントに適用されます。

ソースリポジトリーおよび Docker Hub イメージからアプリケーションを作成するには、以下を実行します。

$ oc new-app https://github.com/openshift/ruby-hello-world mysql

ソースコードリポジトリーおよびビルダーイメージが別個の引数として指定されている場合、new-app はソースコードリポジトリーのビルダーとしてそのビルダーイメージを使用します。これを意図していない場合は、~ セパレーターを使用してソースに必要なビルダーイメージを指定します。

3.1.1.4.8. 単一 Pod でのイメージとソースのグループ化

new-app コマンドにより、単一 Pod に複数のイメージをまとめてデプロイできます。イメージのグループ化を指定するには + セパレーターを使用します。--group コマンドライン引数をグループ化する必要のあるイメージを指定する際に使用することもできます。ソースリポジトリーからビルドされたイメージを別のイメージと共にグループ化するには、そのビルダーイメージをグループで指定します。

$ oc new-app ruby+mysql

ソースからビルドされたイメージと外部のイメージをまとめてデプロイするには、以下を実行します。

$ oc new-app \

ruby~https://github.com/openshift/ruby-hello-world \

mysql \

--group=ruby+mysql3.1.1.4.9. イメージ、テンプレート、および他の入力の検索

イメージ、テンプレート、および oc new-app コマンドの他の入力内容を検索するには、--search フラグおよび --list フラグを追加します。たとえば、PHP を含むすべてのイメージまたはテンプレートを検索するには、以下を実行します。

$ oc new-app --search php

第4章 サービスブローカー

4.1. サービスカタログのインストール

サービスカタログは OpenShift Container Platform 4 では非推奨になっています。同等または強化された機能は Operator Framework および Operator Lifecycle Manager (OLM) で提供されます。

4.1.1. サービスカタログについて

マイクロサービスベースのアプリケーションを開発して、クラウドネイティブのプラットフォームで実行する場合には、サービスプロバイダーやプラットフォームに合わせて、異なるリソースをプロビジョニングし、その位置情報 (coordinate)、認証情報および設定を共有する数多くの方法を利用できます。

開発者がよりシームレスに作業できるように、OpenShift Container Platform には Kubernetes 向けの Open Service Broker API (OSB API) の実装である サービスカタログ が含まれています。これにより、OpenShift Container Platform にデプロイされているアプリケーションをさまざまな種類のサービスブローカーに接続できます。

サービスカタログでは、クラスター管理者が 1 つの API 仕様を使用して、複数のプラットフォームを統合できます。OpenShift Container Platform Web コンソールは、サービスカタログにサービスブローカーによって提供されるクラスターサービスカタログを表示するので、ユーザーはこれらのサービスをそれぞれのアプリケーションで使用できるようにサービスの検出やインスタンス化を実行できます。

結果として、サービスのユーザーは異なるプロバイダーが提供する異なるタイプのサービスを簡単かつ一貫して使用できるという利点が得られます。また、サービスプロバイダーは、複数のプラットフォームにアクセスできる統合ポイントという利点を得られます。

サービスカタログは、OpenShift Container Platform 4 ではデフォルトでインストールされません。

4.1.2. サービスカタログのインストール

OpenShift Ansible Broker またはテンプレートサービスブローカーからサービスを使用することを計画する場合、以下の手順を実行してサービスカタログをインストールする必要があります。

サービスカタログの API サーバーおよびコントローラーマネージャーのカスタムリソースは OpenShift Container Platform にデフォルトで作成されますが、初期の状態は managementState がRemoved になります。サービスカタログをインストールするには、それらのリソースの managementState を Managed に変更する必要があります。

手順

サービスカタログ API サーバーを有効にします。

以下のコマンドを使用して、サービスカタログ API サーバーリソースを編集します。

$ oc edit servicecatalogapiservers

specの下で、managementStateフィールドをManagedに設定します。spec: logLevel: Normal managementState: Managed

変更を適用するためにファイルを保存します。

Operator はサービスカタログ API サーバーコンポーネントをインストールします。OpenShift Container Platform 4 の時点では、このコンポーネントは

openshift-service-catalog-apiservernamespace にインストールされます。

サービスカタログコントローラーマネージャーを有効にします。

以下のコマンドを使用して、サービスカタログコントローラーマネージャーのリソースを編集します。

$ oc edit servicecatalogcontrollermanagers

specの下で、managementStateフィールドをManagedに設定します。spec: logLevel: Normal managementState: Managed

変更を適用するためにファイルを保存します。

Operator はサービスカタログコントローラーマネージャーをインストールします。OpenShift Container Platform 4 の時点で、このコンポーネントは

openshift-service-catalog-controller-managernamespace にインストールされます。

4.1.3. サービスカタログのインストール

サービスカタログをアンインストールするには、サービスカタログの API サーバーの managementState を変更し、コントローラーマネージャーのリソース Managed から Removed に変更する必要があります。

手順

サービスカタログ API サーバーを無効にします。

以下のコマンドを使用して、サービスカタログ API サーバーリソースを編集します。

$ oc edit servicecatalogapiservers

specの下で、managementStateフィールドをRemovedに設定します。spec: logLevel: Normal managementState: Removed

- 変更を適用するためにファイルを保存します。

サービスカタログコントローラーマネージャーを無効にします。

以下のコマンドを使用して、サービスカタログコントローラーマネージャーのリソースを編集します。

$ oc edit servicecatalogcontrollermanagers

specの下で、managementStateフィールドをRemovedに設定します。spec: logLevel: Normal managementState: Removed

- 変更を適用するためにファイルを保存します。

サービスカタログを無効にした後に削除しようとする際に、プロジェクトが「Terminatin」状態になることに関連する既知の問題があります。回避策については、『OpenShift Container Platform 4.1 Release Notes』を参照してください。(BZ#1746174)

4.2. テンプレートサービスブローカーのインストール

テンプレートサービスブローカーをインストールし、これが提供するテンプレートアプリケーションへのアクセスを取得します。

テンプレートサービスブローカーは OpenShift Container Platform 4 では非推奨になっています。同等または強化された機能は Operator Framework および Operator Lifecycle Manager (OLM) で提供されます。

前提条件

4.2.1. テンプレートサービスブローカーについて

テンプレートサービスブローカー は、サービスカタログに対し、初期リリース以降 OpenShift Container Platform に同梱されるデフォルトのインスタントアプリケーションおよびクイックスタートテンプレートを可視化します。さらにテンプレートサービスブローカーは、Red Hat、クラスター管理者、またはユーザーないしはサードパーティーベンダーのいずれかが作成する OpenShift Container Platform テンプレートのいずれのコンテンツもサービスとして利用可能にすることができます。

デフォルトで、テンプレートサービスブローカーは openshift プロジェクトからグローバルに利用できるオブジェクトを表示します。また、これはクラスター管理者が選択する他のプロジェクトを監視するように設定することもできます。

テンプレートサービスブローカーは、OpenShift Container Platform 4 ではデフォルトでインストールされません。

4.2.2. テンプレートサービスブローカー Operator のインストール

前提条件

- サービスカタログがインストールされていること。

手順

以下の手順では、Web コンソールを使用してテンプレートサービスブローカー Operator をインストールします。

namespace を作成します。

- Web コンソールで Administration → Namespaces に移動し、Create Namespace をクリックします。

Name フィールドに

openshift-template-service-brokerを入力し、Create をクリックします。注記namespace は

openshift-で開始する必要があります。

-

Catalog → OperatorHub ページに移動します。

openshift-template-service-brokerプロジェクトが選択されていることを確認します。 - Template Service Broker Operator を選択します。

- Operator についての情報を確認してから、Install をクリックします。

- デフォルトの選択を確認し、Subscribe をクリックします。

次に、テンプレートサービスブローカーを起動し、これが提供するテンプレートアプリケーションへのアクセスを取得します。

4.2.3. テンプレートサービスブローカーの起動

テンプレートサービスブローカー Operator のインストール後に、以下の手順でテンプレートサービスブローカーを起動します。

前提条件

- サービスカタログがインストールされていること。

- テンプレートサービスブローカー Operator がインストールされていること。

手順

-

Web コンソールで Catalog → Installed Operators に移動し、

openshift-template-service-brokerプロジェクトを選択します。 - Template Service Broker Operator を選択します。

- Provided APIs で、Template Service Broker について Create New をクリックします。

- デフォルトの YAML を確認し、Create をクリックします。

テンプレートサービスブローカーが起動していることを確認します。

テンプレートサービスブローカーの起動後に、Catalog → Developer Catalog に移動し、Service Class チェックボックスを選択して利用可能なテンプレートアプリケーションを表示できます。テンプレートサービスブローカーが起動し、テンプレートアプリケーションが利用可能になるまで数分の時間がかかる場合があります。

これらのサービスクラスが表示されない場合は、以下の項目のステータスを確認できます。

テンプレートサービスブローカー Pod のステータス

-

openshift-template-service-broker プロジェクトの Workloads → Pods ページから、

apiserver-で起動する Pod のステータスが Running であり、Ready の準備状態であることを確認します。

-

openshift-template-service-broker プロジェクトの Workloads → Pods ページから、

クラスターサービスブローカーのステータス

- Catalog → Broker Management → Service Brokers ページから、template-service-broker サービスブローカーのステータスが Ready であることを確認します。

サービスカタログコントローラーマネージャー Pod のログ

-

openshift-service-catalog-controller-manager プロジェクトの Workloads → Pods ページから、それぞれの Pod のログを確認し、

Successfully fetched catalog entries from brokerのメッセージと共にログエントリーが表示されていることを確認します。

-

openshift-service-catalog-controller-manager プロジェクトの Workloads → Pods ページから、それぞれの Pod のログを確認し、

4.3. テンプレートアプリケーションのプロビジョニング

4.3.1. テンプレートアプリケーションのプロビジョニング

以下の手順では、テンプレートサービスブローカーによって利用可能にされたサンプル PostgreSQL テンプレートアプリケーションをプロビジョニングします。

前提条件

- サービスカタログがインストールされていること。

- テンプレートサービスブローカーがインストールされていること。

手順

プロジェクトを作成します。

- Web コンソールで、Home → Projects に移動し、Create Project をクリックします。

-

test-postgresqlを Name フィールドに入力し、Create をクリックします。

サービスインスタンスを作成します。

- Catalog → Developer Catalog ページに移動します。

- PostgreSQL (Ephemeral) テンプレートアプリケーションを選択し、Create Service Instance をクリックします。

- デフォルトの選択を確認し、それ以外の必要なフィールドを設定してから Create をクリックします。

Catalog → Provisioned Services に移動し、postgresql-ephemeral サービスインスタンスが作成され、ステータスが Ready であることを確認します。

Home → Events ページで進捗を確認できます。しばらくすると、postgresql-ephemeral のイベントが「The instance was provisioned successfully」というメッセージと共に表示されるはずです。

サービスバインディングを作成します。

- Provisioned Services ページから、postgresql-ephemeral をクリックし、Create Service Binding をクリックします。

デフォルトのサービスバインディング名を確認し、Create をクリックします。

これにより、指定された名前を使用してバインディングの新規シークレットが作成されます。

作成されたシークレットを確認します。

- Workloads → Secrets に移動し、postgresql-ephemeral という名前のシークレットが作成されていることを確認します。

- postgresql-ephemeral をクリックし、他のアプリへのバインディングに使用されるキーと値のペアを Data セクションで確認します。

4.4. テンプレートサービスブローカーのアンインストール

テンプレートサービスブローカーは、これが提供するテンプレートアプリケーションへのアクセスを必要としなくなった場合にアンインストールできます。

テンプレートサービスブローカーは OpenShift Container Platform 4 では非推奨になっています。同等または強化された機能は Operator Framework および Operator Lifecycle Manager (OLM) で提供されます。

4.4.1. テンプレートサービスブローカーのアンインストール

以下の手順では、Web コンソールを使用してテンプレートサービスブローカーおよび Operator をアンインストールします。

クラスターにテンプレートサービスブローカーからプロビジョニングされたサービスがある場合には、これをアンインストールしないでください。アンインストールすると、サービスを管理しようとする際にエラーが生じる可能性があります。

前提条件

- テンプレートサービスブローカーがインストールされていること。

手順

この手順では、テンプレートサービスブローカーが openshift-template-service-broker プロジェクトにインストールされていることを前提とします。

テンプレートサービスブローカーのアンインストール

- Catalog → Installed Operators に移動し、ドロップダウンメニューから openshift-template-service-broker プロジェクトを選択します。

- Template Service Broker Operator をクリックします。

- Template Service Broker タブを選択します。

- template-service-broker をクリックします。

- Actions ドロップダウンメニューから、Delete Template Service Broker を選択します。

確認ポップアップ画面から Delete をクリックします。

テンプレートサービスブローカーのアンインストールが終了し、テンプレートアプリケーションは Developer Catalog からすぐに削除されます。

テンプレートサービスブローカー Operator のアンインストール

- Catalog → Operator Management に移動し、ドロップダウンメニューから openshift-template-service-broker プロジェクトを選択します。

- Template Service Broker Operator の View subscription をクリックします。

- templateservicebroker を選択します。

- Actions ドロップダウンメニューから、Remove Subscription を選択します。

Also completely remove the templateservicebroker Operator from the selected namespace の横にあるチェックボックスにチェックが付けられていることを確認し、Remove をクリックします。

テンプレートサービスブローカー Operator がクラスターにインストールされていない状態になります。

テンプレートサービスブローカーのアンインストール後に、ユーザーはテンプレートサービスブローカーによって提供されるテンプレートアプリケーションにアクセスできなくなります。

4.5. OpenShift Ansible Broker のインストール

OpenShift Ansible Broker をインストールし、これが提供するサービスバンドルへのアクセスを取得します。

OpenShift Ansible Broker は OpenShift Container Platform 4 では非推奨になっています。同等または強化された機能は Operator Framework および Operator Lifecycle Manager (OLM) で提供されます。

前提条件

4.5.1. OpenShift Ansible Broker について

OpenShift Ansible Broker は、Ansible playbook bundles (APB) で定義されるアプリケーションを管理する Open Service Broker (OSB) API の実装です。APB は、OpenShift Container Platform のコンテナーアプリケーションを定義し、配信する方法を提供し、Ansible ランタイムと共にコンテナーイメージに組み込まれた Ansible Playbook のバンドルで構成されています。APB は Ansible を活用し、複雑なデプロイメントを自動化する標準メカニズムを構築します。

OpenShift Ansible Brokerは、以下の基本的なワークフローに従います。

- ユーザーは、OpenShift Container Platform Web コンソールを使用してサービスカタログから利用可能なアプリケーションの一覧を要求します。

- サービスカタログは、OpenShift Ansible Broker から利用可能なアプリケーションの一覧を要求します。

- OpenShift Ansible Broker は定義されたコンテナーイメージレジストリーと通信し、利用可能な APB の情報を得ます。

- ユーザーは特定の APB をプロビジョニングする要求を実行します。

- OpenShift Ansible Broker は、APB でプロビジョニングメソッドを呼び出して、ユーザーのプロビジョニング要求に対応します。

OpenShift Ansible Broker は、OpenShift Container Platform 4 ではデフォルトでインストールされません。

4.5.1.1. Ansible Playbook Bundle

Ansible Playbook Bundle (APB) は、Ansible ロールおよび Playbook の既存の投資を活用できるようにする軽量アプリケーション定義です。

APB は、名前の付いた Playbook が含まれる単純なディレクトリーを使用し、プロビジョニングやバインドなどの OSB API アクションを実行します。apb.yml ファイルで定義するメタデータには、デプロイメント時に使用する必須/任意のパラメーターの一覧が含まれています。

4.5.2. OpenShift Ansible Service Broker Operator のインストール

前提条件

- サービスカタログがインストールされていること。

手順

以下の手順では、Web コンソールを使用して OpenShift Ansible Service Broker Operator をインストールします。

namespace を作成します。

- Web コンソールで Administration → Namespaces に移動し、Create Namespace をクリックします。

openshift-ansible-service-brokerを Name フィールドに、openshift.io/cluster-monitoring=trueを Labels フィールドに入力し、Create をクリックします。注記namespace は

openshift-で開始する必要があります。

クラスターのロールバインディングを作成します。

- Administration → Role Bindings に移動し、Create Binding をクリックします。

- Binding Type については、Cluster-wide Role Binding (ClusterRoleBinding) を選択します。

-

Role Binding については、

ansible-service-brokerを Name フィールドに入力します。 - Role については、admin を選択します。

-

Subject については、Service Account オプションを選択し、

openshift-ansible-service-brokernamespace を選択してopenshift-ansible-service-broker-operatorを Subject Name フィールドに入力します。 - Create をクリックします。

Red Hat Container Catalog に接続するためにシークレットを作成します。

-

Workloads → Secrets に移動します。

openshift-ansible-service-brokerプロジェクトが選択されていることを確認します。 - Create → Key/Value Secret をクリックします。

-

asb-registry-authを シークレット名 として入力します。 -

usernameの Key および Red Hat Container Catalog ユーザー名の Value を追加します。 -

Add Key/Value をクリックし、

passwordの Key および Red Hat Container Catalog パスワードの Value を追加します。 - Create をクリックします。

-

Workloads → Secrets に移動します。

-

Catalog → OperatorHub ページに移動します。

openshift-ansible-service-brokerプロジェクトが選択されていることを確認します。 - OpenShift Ansible Service Broker Operator を選択します。

- Operator についての情報を確認してから、Install をクリックします。

- デフォルトの選択を確認し、Subscribe をクリックします。

次に、OpenShift Ansible Broker を起動し、これが提供するサービスバンドルへのアクセスを取得します。

4.5.3. OpenShift Ansible Broker の起動

OpenShift Ansible Broker Operator のインストール後に、以下の手順で OpenShift Ansible Broker を起動します。

前提条件

- サービスカタログがインストールされていること。

- OpenShift Ansible Service Broker Operator がインストールされていること。

手順

-

Web コンソールで Catalog → Installed Operators に移動し、

openshift-ansible-service-brokerプロジェクトを選択します。 - OpenShift Ansible Service Broker Operator を選択します。

- Provided APIs で、Automation Broker について Create New をクリックします。

以下を、提供されているデフォルトの YAML の

specフィールドに追加します。registry: - name: rhcc type: rhcc url: https://registry.redhat.io auth_type: secret auth_name: asb-registry-authこれは、OpenShift Ansible Service Broker Operator のインストール時に作成されたシークレットを参照します。これにより、Red Hat Container Catalog に接続できます。

- 追加の OpenShift Ansible Broker 設定オプションを設定し、Create をクリックします。

OpenShift Ansible Broker が起動したことを確認します。

OpenShift Ansible Broker の起動後に、Catalog → Developer Catalog に移動し、Service Class チェックボックスを選択して利用可能なサービスバンドルを表示できます。OpenShift Ansible Broker が起動し、サービスバンドルが利用可能になるまで数分の時間がかかる場合があります。

これらのサービスクラスが表示されない場合は、以下の項目のステータスを確認できます。

OpenShift Ansible Broker Pod のステータス

-

openshift-ansible-service-broker プロジェクトの Workloads → Pods ページから、

asb-で起動する Pod のステータスが Running であり、Ready の準備状態であることを確認します。

-

openshift-ansible-service-broker プロジェクトの Workloads → Pods ページから、

クラスターサービスブローカーのステータス

- Catalog → Broker Management → Service Brokers ページから、ansible-service-broker サービスブローカーのステータスが Ready であることを確認します。

サービスカタログコントローラーマネージャー Pod のログ

-

openshift-service-catalog-controller-manager プロジェクトの Workloads → Pods ページから、それぞれの Pod のログを確認し、

Successfully fetched catalog entries from brokerのメッセージと共にログエントリーが表示されていることを確認します。

-

openshift-service-catalog-controller-manager プロジェクトの Workloads → Pods ページから、それぞれの Pod のログを確認し、

4.5.3.1. OpenShift Ansible Broker 設定オプション

OpenShift Ansible Broker の以下のオプションを設定できます。

表4.1 OpenShift Ansible Broker 設定オプション

| YAML キー | 説明 | デフォルト値 |

|---|---|---|

|

| Broker インスタンスを特定するために使用される名前。 |

|

|

| Broker が置かれている namespace。 |

|

|

| Broker に使用されている完全修飾イメージ。 |

|

|

| Broker イメージ自体に使用されるプルポリシー。 |

|

|

| Broker のデプロイメントに使用されるノードセレクター文字列。 |

|

|

| Broker レジストリー設定の yaml 一覧として表現される。これにより、ユーザーは Broker が検出し、APB の取得に使用するイメージレジストリーを設定できます。 | デフォルトレジストリー配列 を参照してください。 |

|

| Broker のログに使用されるログレベル。 |

|

|

| APB Pod に使用されるプルポリシー。 |

|

|

| APB を実行するために使用されるサービスアカウントに付与されるロール。 |

|

|

| APB の完了後に APB を実行するために作成された一時 namespace が削除されたかどうか (結果の如何は問わない)。 |

|

|

| 結果がエラーの場合のみ、APB の完了後に APB を実行するために作成された一時 namespace が削除されたかどうか。 |

|

|

| Broker が起動時にブートストラップルーチンを実行する必要があるかどうか。 |

|

|

| APB のインベントリーを更新する Broker ブートストラップ間の間隔。 |

|

|

| Experimental: バインド操作時に APB を実行する Broker を切り替えます。 |

|

|

|

APB の実行中に、Broker がユーザーのパーミッションをエスカレートするかどうか。これは、Broker が起点となるユーザー承認を実行してユーザーが APB サンドボックスに付与されたパーミッションを持つようにするため、通常は |

|

|

| Broker が受信する低レベル HTTP 要求を出力するかどうか。 |

|

registries のデフォルト配列

- type: rhcc name: rhcc url: https://registry.redhat.io white_list: - ".*-apb$" auth_type: secret auth_name: asb-registry-auth

4.6. OpenShift Ansible Broker の設定

OpenShift Ansible Broker は OpenShift Container Platform 4 では非推奨になっています。同等または強化された機能は Operator Framework および Operator Lifecycle Manager (OLM) で提供されます。

4.6.1. OpenShift Ansible Broker の設定

以下の手順では、OpenShift Ansible Broker の設定をカスタマイズします。

前提条件

- OpenShift Ansible Broker がインストールされていること。

手順

この手順では、ansible-service-broker を OpenShift Ansible Broker 名前とインストール先のプロジェクトの両方に使用していることを前提とします。

-

Web コンソールで Catalog → Installed Operators に移動し、

ansible-service-brokerプロジェクトを選択します。 - OpenShift Ansible Service Broker Operator を選択します。

-

Automation Broker タブで、

ansible-service-brokerを選択します。 YAML タブの

specフィールドの下で OpenShift Ansible Broker 設定オプションを追加するか、または更新します。以下は例になります。

spec: keepNamespace: true sandboxRole: edit

- Save をクリックして変更を適用します。

4.6.1.1. OpenShift Ansible Broker 設定オプション

OpenShift Ansible Broker の以下のオプションを設定できます。

表4.2 OpenShift Ansible Broker 設定オプション

| YAML キー | 説明 | デフォルト値 |

|---|---|---|

|

| Broker インスタンスを特定するために使用される名前。 |

|

|

| Broker が置かれている namespace。 |

|

|

| Broker に使用されている完全修飾イメージ。 |

|

|

| Broker イメージ自体に使用されるプルポリシー。 |

|

|

| Broker のデプロイメントに使用されるノードセレクター文字列。 |

|

|

| Broker レジストリー設定の yaml 一覧として表現される。これにより、ユーザーは Broker が検出し、APB の取得に使用するイメージレジストリーを設定できます。 | デフォルトレジストリー配列を参照してください。 |

|

| Broker のログに使用されるログレベル。 |

|

|

| APB Pod に使用されるプルポリシー。 |

|

|

| APB を実行するために使用されるサービスアカウントに付与されるロール。 |

|

|

| APB の完了後に APB を実行するために作成された一時 namespace が削除されたかどうか (結果の如何は問わない)。 |

|

|

| 結果がエラーの場合のみ、APB の完了後に APB を実行するために作成された一時 namespace が削除されたかどうか。 |

|

|

| Broker が起動時にブートストラップルーチンを実行する必要があるかどうか。 |

|

|

| APB のインベントリーを更新する Broker ブートストラップ間の間隔。 |

|

|

| Experimental: バインド操作時に APB を実行する Broker を切り替えます。 |

|

|

|

APB の実行中に、Broker がユーザーのパーミッションをエスカレートするかどうか。これは、Broker が起点となるユーザー承認を実行してユーザーが APB サンドボックスに付与されたパーミッションを持つようにするため、通常は |

|

|

| Broker が受信する低レベル HTTP 要求を出力するかどうか。 |

|

registries のデフォルト配列

- type: rhcc name: rhcc url: https://registry.redhat.io white_list: - ".*-apb$" auth_type: secret auth_name: asb-registry-auth

4.6.2. OpenShift Ansible Broker のモニタリング設定

Prometheus が OpenShift Ansible Broker をモニターできるようにするには、以下のリソースを作成して、OpenShift Ansible Broker がインストールされている namespace にアクセスできるように Prometheus にパーミッションを付与する必要があります。

前提条件

OpenShift Ansible Broker がインストールされていること。

注記この手順では、OpenShift Ansible Broker が

openshift-ansible-service-brokernamespace にインストールされていることを前提とします。

手順

ロールを作成します。

- Administration → Roles に移動し、Create Role をクリックします。

エディターで YAML を以下に置き換えます。

apiVersion: rbac.authorization.k8s.io/v1 kind: Role metadata: name: prometheus-k8s namespace: openshift-ansible-service-broker rules: - apiGroups: - "" resources: - services - endpoints - pods verbs: - get - list - watch

- Create をクリックします。

ロールバインディングを作成します。

- Administration → Role Bindings に移動し、Create Binding をクリックします。

- Binding Type について、Namespace Role Binding (RoleBinding) を選択します。

-

Role Binding について、

prometheus-k8sを Name フィールドに、openshift-ansible-service-brokerを Namespace フィールドに入力します。 - Role について、prometheus-k8s を選択します。

-

Subject について、Service Account オプションを選択し、

openshift-monitoringnamespace を選択してからprometheus-k8sを Subject Name フィールドに入力します。 - Create をクリックします。

Prometheus は OpenShift Ansible Broker メトリクスにアクセスできるようになります。

4.7. サービスバンドルのプロビジョニング

4.7.1. サービスバンドルのプロビジョニング

以下の手順では、OpenShift Ansible Broker で利用可能にされている PostgreSQL サービスバンドル (APB) のサンプルをプロビジョニングします。

前提条件

- サービスカタログがインストールされていること。

- OpenShift Ansible Broker がインストールされていること。

手順

プロジェクトを作成します。

- Web コンソールで、Home → Projects に移動し、Create Project をクリックします。

-

test-postgresql-apbを Name フィールドに入力し、Create をクリックします。

サービスインスタンスを作成します。

- Catalog → Developer Catalog ページに移動します。

- PostgreSQL (APB) サービスバンドルを選択し、Create Service Instance をクリックします。

- デフォルトの選択を確認し、それ以外の必要なフィールドを設定してから Create をクリックします。

Catalog → Provisioned Services に移動し、dh-postgresql-apb サービスインスタンスが作成され、ステータスが Ready であることを確認します。

Home → Events ページで進捗を確認できます。しばらくすると、dh-postgresql-apb のイベントが「The instance was provisioned successfully」というメッセージと共に表示されるはずです。

サービスバインディングを作成します。

- Provisioned Services ページから、dh-postgresql-apb をクリックし、Create Service Binding をクリックします。

デフォルトのサービスバインディング名を確認し、Create をクリックします。

これにより、指定された名前を使用してバインディングの新規シークレットが作成されます。

作成されたシークレットを確認します。

- Workloads → Secrets に移動し、dh-postgresql-apb という名前のシークレットが作成されていることを確認します。

- dh-postgresql-apb をクリックし、他のアプリへのバインディングに使用されるキーと値のペアを Data セクションで確認します。

4.8. OpenShift Ansible Broker のアンインストール

OpenShift Ansible Broker は、これが提供するサービスバンドルへのアクセスが必要なくなった場合にアンインストールできます。

OpenShift Ansible Broker は OpenShift Container Platform 4 では非推奨になっています。同等または強化された機能は Operator Framework および Operator Lifecycle Manager (OLM) で提供されます。

4.8.1. OpenShift Ansible Broker のアンインストール

以下の手順では、Web コンソールを使用して OpenShift Ansible Broker およびその Operator をアンインストールします。

クラスターに OpenShift Ansible Broker からプロビジョニングされたサービスがある場合には、これをアンインストールしないでください。アンインストールすると、サービスを管理しようとする際にエラーが生じる可能性があります。

前提条件

- OpenShift Ansible Broker がインストールされていること。

手順

この手順では、OpenShift Ansible Broker が openshift-ansible-service-broker プロジェクトにインストールされていることを前提とします。

OpenShift Ansible Broker をアンインストールします。

- Catalog → Installed Operators に移動し、ドロップダウンメニューから openshift-ansible-service-broker プロジェクトを選択します。

- OpenShift Ansible Service Broker Operator をクリックします。

- Automation Broker タブを選択します。

- ansible-service-broker をクリックします。

- Actions ドロップダウンメニューから、Delete Automation Broker を選択します。

確認ポップアップ画面から Delete をクリックします。

OpenShift Ansible Broker のアンインストールが終了し、サービスバンドルは Developer Catalog からすぐに削除されます。

OpenShift Ansible Service Broker Operator のアンインストール

- Catalog → Operator Management に移動し、ドロップダウンメニューから openshift-ansible-service-broker プロジェクトを選択します。

- OpenShift Ansible Broker Operator の View subscription をクリックします。

- automationbroker を選択します。

- Actions ドロップダウンメニューから、Remove Subscription を選択します。

Also completely remove the automationbroker Operator from the selected namespace の横にあるチェックボックスにチェックが付けられていることを確認し、Remove をクリックします。

OpenShift Ansible Service Broker Operator がクラスターにインストールされていない状態になります。

OpenShift Ansible Broker のアンインストール後に、ユーザーは OpenShift Ansible Broker で提供されるサービス バンドルにアクセスできなくなります。

第5章 Deployment

5.1. Deployment および DeploymentConfig について

OpenShift Container Platform の Deployment および DeploymentConfig は、一般的なユーザーアプリケーションに対する詳細な管理を行うためのよく似ているものの、異なる 2 つの方法を提供します。これらは、以下の個別の API オブジェクトで構成されています。

- アプリケーションの特定のコンポーネントの必要な状態を記述する、Pod テンプレートとしての DeploymentConfig または Deployment。

- DeploymentConfig には 1 つまたは複数の ReplicationController が使用され、これには Pod テンプレートとしての DeploymentConfig の特定の時点の状態のレコードが含まれます。同様に、Deployment には ReplicationController を継承する 1 つ以上の ReplicaSet が使用されます。

- アプリケーションの特定バージョンのインスタンスを表す 1 つ以上の Pod。

5.1.1. デプロイメントのビルディングブロック

Deployment および DeploymentConfig は、それぞれビルディングブロックとして、ネイティブ Kubernetes API オブジェクトの ReplicationController および ReplicaSet の使用によって有効にされます。

ユーザーは、DeploymentConfig または Deployment によって所有される ReplicationController、ReplicaSet、または Pod を操作する必要はありません。デプロイメントシステムは変更を適切に伝播します。

既存のデプロイメントストラテジーが特定のユースケースに適さない場合で、デプロイメントのライフサイクル期間中に複数の手順を手動で実行する必要がある場合は、カスタムデプロイメントストラテジーを作成することを検討してください。

以下のセクションでは、これらのオブジェクトの詳細情報を提供します。

5.1.1.1. ReplicationController

ReplicationController は、Pod の指定された数のレプリカが常時実行されるようにします。Pod が終了するか、または削除される場合、ReplicationController 定義された数を満たすように追加のインスタンス化を行います。同様に、必要以上の数の Pod が実行されている場合には、定義された数に一致させるために必要な数の Pod を削除します。

ReplicationController 設定は以下で構成されています。

- 必要なレプリカ数 (これはランタイム時に調整可能)。

- レプリケートされた Pod の作成時に使用する Pod 定義。

- 管理された Pod を特定するためのセレクター。

セレクターは、ReplicationController が管理する Pod に割り当てられるラベルセットです。これらのラベルは、Pod 定義に組み込まれ、ReplicationController がインスタンス化します。ReplicationController は、必要に応じて調整できるよう、セレクターを使用してすでに実行中の Pod 数を判別します。

ReplicationController は、負荷またはトラフィックに基づいて自動スケーリングを実行せず、追跡も実行しません。この場合は、レプリカ数を外部の自動スケーラーで調整する必要があります。

以下は ReplicationController 定義の例です。

apiVersion: v1 kind: ReplicationController metadata: name: frontend-1 spec: replicas: 1 1 selector: 2 name: frontend template: 3 metadata: labels: 4 name: frontend 5 spec: containers: - image: openshift/hello-openshift name: helloworld ports: - containerPort: 8080 protocol: TCP restartPolicy: Always

5.1.1.2. ReplicaSet

ReplicationController と同様に、ReplicaSet は、指定された数の Pod レプリカが特定の時点で実行されるようにするネイティブの Kubernetes API オブジェクトです。ReplicaSet と ReplicationController の相違点は、ReplicaSet ではセットベースのセレクター要件をサポートし、レプリケーションコントローラーは等価ベースのセレクター要件のみをサポートする点です。

カスタム更新のオーケストレーションが必要な場合や、更新が全く必要のない場合にのみ ReplicaSet を使用します。それ以外は Deployment を使用します。ReplicaSet は個別に使用できますが、Pod の作成/削除/更新のオーケストレーションを実行するためにデプロイメントで使用されます。Deployment は ReplicaSet を自動的に管理し、Pod に宣言型の更新を加えるので、作成する ReplicaSet を手動で管理する必要はありません。

以下は、ReplicaSet 定義の例になります。

apiVersion: apps/v1

kind: ReplicaSet

metadata:

name: frontend-1

labels:

tier: frontend

spec:

replicas: 3

selector: 1

matchLabels: 2

tier: frontend

matchExpressions: 3

- {key: tier, operator: In, values: [frontend]}

template:

metadata:

labels:

tier: frontend

spec:

containers:

- image: openshift/hello-openshift

name: helloworld

ports:

- containerPort: 8080

protocol: TCP

restartPolicy: Always5.1.2. DeploymentConfig

ReplicationController ベースにビルドされた OpenShift Container Platform は、DeploymentConfig の概念に基づいてソフトウェア開発およびデプロイメントライフサイクルの拡張サポートを追加します。最も単純なケースでは、DeploymentConfig は新規の ReplicationController を作成し、これに Pod を起動させます。

ただし、DeploymentConfig の OpenShift Container Platform デプロイメントは、イメージの既存デプロイメントから新規デプロイメントに移行する機能を提供し、ReplicationController の作成前後に実行されるフックも定義します。

DeploymentConfig デプロイメントシステムは以下の機能を提供します。

- アプリケーションを実行するためのテンプレートである DeploymentConfig。

- イベントへの対応として自動化されたデプロイメントを駆動するトリガー。

- 直前のバージョンから新規バージョンに移行するためのユーザーによるカスタマイズが可能なデプロイメントストラテジー。ストラテジーは通常デプロイメントプロセスと呼ばれ、Pod 内で実行されます。

- デプロイメントのライフサイクル中の異なる時点でカスタム動作を実行するためのフックのセット (ライフサイクルフック)。

- デプロイメントの失敗時に手動または自動でロールバックをサポートするためのアプリケーションのバージョン管理。

- レプリケーションの手動および自動スケーリング。

DeploymentConfig を作成すると、ReplicationController が、DeploymentConfig の Pod テンプレートとして作成されます。DeploymentConfig が変更されると、最新の Pod テンプレートで新しい ReplicationController が作成され、デプロイメントプロセスが実行されて以前の ReplicationController のスケールダウン、および新規 ReplicationController のスケールアップが行われます。

アプリケーションのインスタンスは、作成時にサービスローダーバランサーやルーターに対して自動的に追加/削除されます。アプリケーションが正常なシャットダウン機能をサポートしている限り、アプリケーションが TERM シグナルを受け取ると、実行中のユーザー接続が通常通り完了できるようにすることができます。

OpenShift Container Platform DeploymentConfig オブジェクトは以下の詳細を定義します。

-

ReplicationController定義の要素。 - 新規デプロイメントの自動作成のトリガー。

- デプロイメント間の移行ストラテジー。

- ライフサイクルフック。

デプロイヤー Pod は、デプロイメントがトリガーされるたびに、手動または自動であるかを問わず、(古い ReplicationController のスケールダウン、新規 ReplicationController のスケールアップおよびフックの実行などの) デプロイメントを管理します。デプロイメント Pod は、Deployment のログを維持するために Deployment の完了後は無期限で保持されます。デプロイメントが別のものに置き換えられる場合、以前の ReplicationController は必要に応じて簡単なロールバックを有効にできるように保持されます。

DeploymentConfig 定義の例

apiVersion: v1

kind: DeploymentConfig

metadata:

name: frontend

spec:

replicas: 5

selector:

name: frontend

template: { ... }

triggers:

- type: ConfigChange 1

- imageChangeParams:

automatic: true

containerNames:

- helloworld