Gestion des périphériques de stockage

Déploiement et configuration du stockage à nœud unique dans Red Hat Enterprise Linux 9

Résumé

Rendre l'open source plus inclusif

Red Hat s'engage à remplacer les termes problématiques dans son code, sa documentation et ses propriétés Web. Nous commençons par ces quatre termes : master, slave, blacklist et whitelist. En raison de l'ampleur de cette entreprise, ces changements seront mis en œuvre progressivement au cours de plusieurs versions à venir. Pour plus de détails, voir le message de notre directeur technique Chris Wright.

Fournir un retour d'information sur la documentation de Red Hat

Nous apprécions vos commentaires sur notre documentation. Faites-nous savoir comment nous pouvons l'améliorer.

Soumettre des commentaires sur des passages spécifiques

- Consultez la documentation au format Multi-page HTML et assurez-vous que le bouton Feedback apparaît dans le coin supérieur droit après le chargement complet de la page.

- Utilisez votre curseur pour mettre en évidence la partie du texte que vous souhaitez commenter.

- Cliquez sur le bouton Add Feedback qui apparaît près du texte en surbrillance.

- Ajoutez vos commentaires et cliquez sur Submit.

Soumettre des commentaires via Bugzilla (compte requis)

- Connectez-vous au site Web de Bugzilla.

- Sélectionnez la version correcte dans le menu Version.

- Saisissez un titre descriptif dans le champ Summary.

- Saisissez votre suggestion d'amélioration dans le champ Description. Incluez des liens vers les parties pertinentes de la documentation.

- Cliquez sur Submit Bug.

Chapitre 1. Aperçu des options de stockage disponibles

Il existe plusieurs options de stockage local, distant et en grappe disponibles sur Red Hat Enterprise Linux 8.

Le stockage local implique que les périphériques de stockage sont soit installés sur le système, soit directement attachés au système.

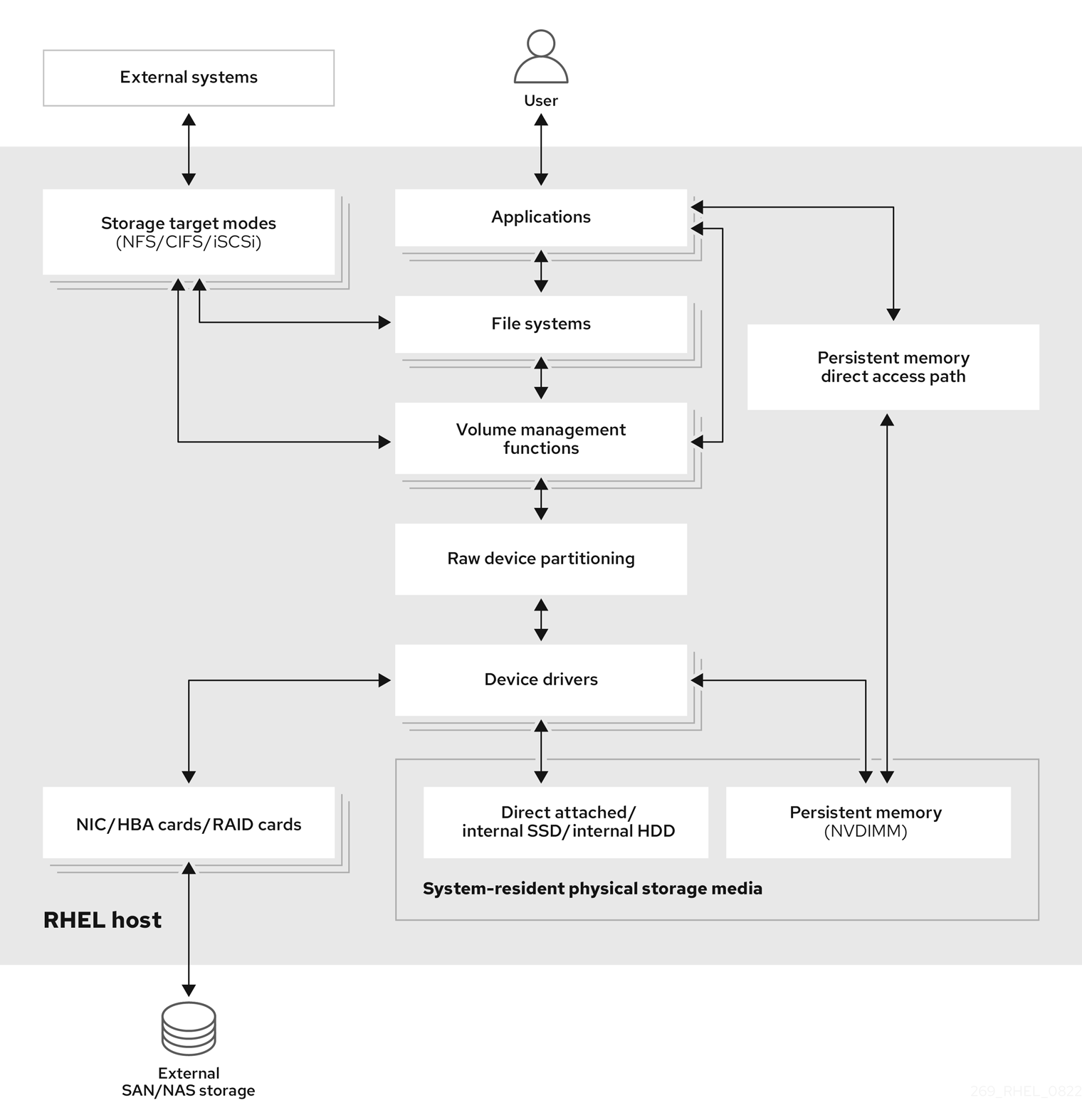

Dans le cas du stockage à distance, l'accès aux périphériques se fait par le biais d'un réseau local, d'Internet ou d'un réseau Fibre Channel. Le diagramme de stockage de haut niveau suivant de Red Hat Enterprise Linux décrit les différentes options de stockage.

Figure 1.1. Diagramme de stockage de haut niveau de Red Hat Enterprise Linux

1.1. Vue d'ensemble du stockage local

Red Hat Enterprise Linux 9 offre plusieurs options de stockage local.

- Administration de base des disques

En utilisant

partedetfdisk, vous pouvez créer, modifier, supprimer et visualiser des partitions de disque. Les normes d'agencement des partitions sont les suivantes :- Master Boot Record (MBR)

- Il est utilisé avec les ordinateurs basés sur le BIOS. Vous pouvez créer des partitions primaires, étendues et logiques.

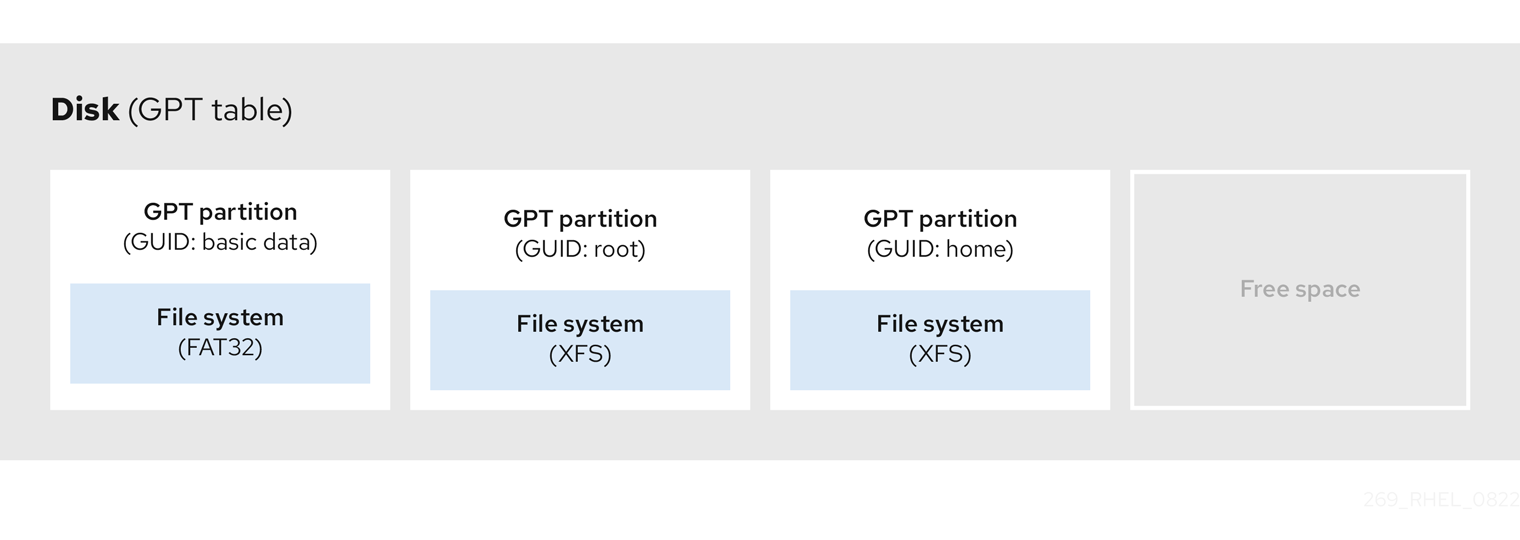

- Table de partition GUID (GPT)

- Il utilise l'identifiant unique global (GUID) et fournit un GUID unique pour le disque et la partition.

Pour chiffrer la partition, vous pouvez utiliser Linux Unified Key Setup-on-disk-format (LUKS). Pour chiffrer la partition, sélectionnez l'option pendant l'installation et l'invite s'affiche pour saisir la phrase de passe. Cette phrase de passe déverrouille la clé de chiffrement.

- Options de consommation de stockage

- Gestion des modules de mémoire double en ligne non volatile (NVDIMM)

- Il s'agit d'une combinaison de mémoire et de stockage. Vous pouvez activer et gérer différents types de stockage sur les périphériques NVDIMM connectés à votre système.

- Gestion du stockage par blocs

- Les données sont stockées sous forme de blocs, chaque bloc ayant un identifiant unique.

- Stockage de fichiers

- Les données sont stockées au niveau des fichiers sur le système local. Il est possible d'accéder à ces données localement en utilisant XFS (par défaut) ou ext4, et sur un réseau en utilisant NFS et SMB.

- Volumes logiques

- Gestionnaire de volume logique (LVM)

Il crée des périphériques logiques à partir de périphériques physiques. Le volume logique (LV) est une combinaison des volumes physiques (PV) et des groupes de volumes (VG). La configuration de LVM comprend

- Création de PV à partir des disques durs.

- Création de VG à partir de PV.

- Création d'un LV à partir du VG et attribution de points de montage au LV.

- Optimiseur de données virtuelles (VDO)

Il est utilisé pour la réduction des données au moyen de la déduplication, de la compression et de l'approvisionnement fin. L'utilisation de LV ci-dessous aide à :

- Extension du volume de la VDO

- Répartition du volume VDO sur plusieurs appareils

- Systèmes de fichiers locaux

- XFS

- Le système de fichiers par défaut de RHEL.

- Ext4

- Un ancien système de fichiers.

- Stratis

- Il est disponible en tant qu'aperçu technologique. Stratis est un système hybride de gestion du stockage local par l'utilisateur et le noyau qui prend en charge des fonctions de stockage avancées.

1.2. Aperçu du stockage à distance

Vous trouverez ci-dessous les options de stockage à distance disponibles dans Red Hat Enterprise Linux 8 :

- Options de connectivité de stockage

- iSCSI

- RHEL 9 utilise l'outil targetcli pour ajouter, supprimer, afficher et surveiller les interconnexions de stockage iSCSI.

- Fibre Channel (FC)

RHEL 9 fournit les pilotes Fibre Channel natifs suivants :

-

lpfc -

qla2xxx -

Zfcp

-

- Mémoire non volatile Express (NVMe)

Une interface qui permet à l'utilitaire du logiciel hôte de communiquer avec les disques d'état solide. Utilisez les types de transport de tissu suivants pour configurer NVMe sur les tissus :

- NVMe sur des tissus utilisant l'accès direct à la mémoire à distance (RDMA).

- NVMe sur les réseaux utilisant Fibre Channel (FC)

- Device Mapper multipathing (DM Multipath)

- Permet de configurer plusieurs chemins d'E/S entre les nœuds de serveur et les baies de stockage dans un seul appareil. Ces chemins d'E/S sont des connexions SAN physiques qui peuvent inclure des câbles, des commutateurs et des contrôleurs distincts.

- Système de fichiers en réseau

- NFS

- PME

1.3. Vue d'ensemble du système de fichiers GFS2

Le système de fichiers Red Hat Global File System 2 (GFS2) est un système de fichiers en grappe symétrique de 64 bits qui fournit un espace de noms partagé et gère la cohérence entre plusieurs nœuds partageant un périphérique de bloc commun. Un système de fichiers GFS2 est destiné à fournir un ensemble de fonctionnalités aussi proche que possible d'un système de fichiers local, tout en appliquant une cohérence de cluster complète entre les nœuds. Pour ce faire, les nœuds utilisent un système de verrouillage à l'échelle de la grappe pour les ressources du système de fichiers. Ce schéma de verrouillage utilise des protocoles de communication tels que TCP/IP pour échanger des informations de verrouillage.

Dans certains cas, l'API du système de fichiers Linux ne permet pas de rendre totalement transparente la nature groupée de GFS2 ; par exemple, les programmes utilisant des verrous POSIX dans GFS2 doivent éviter d'utiliser la fonction GETLK car, dans un environnement groupé, l'ID du processus peut être celui d'un nœud différent dans le groupe. Dans la plupart des cas, cependant, la fonctionnalité d'un système de fichiers GFS2 est identique à celle d'un système de fichiers local.

Le module complémentaire de stockage résilient de Red Hat Enterprise Linux fournit GFS2 et dépend du module complémentaire de haute disponibilité de Red Hat Enterprise Linux pour fournir la gestion de cluster requise par GFS2.

Le module du noyau gfs2.ko implémente le système de fichiers GFS2 et est chargé sur les nœuds du cluster GFS2.

Pour obtenir les meilleures performances de GFS2, il est important de prendre en compte les considérations de performance qui découlent de la conception sous-jacente. Tout comme un système de fichiers local, GFS2 s'appuie sur le cache de pages pour améliorer les performances grâce à la mise en cache locale des données fréquemment utilisées. Afin de maintenir la cohérence entre les nœuds du cluster, le contrôle du cache est assuré par la machine d'état glock.

Ressources supplémentaires

1.4. Vue d'ensemble du stockage en grappe

Red Hat Gluster Storage (RHGS) est une plateforme de stockage définie par logiciel qui peut être déployée en grappes. Elle regroupe les ressources de stockage sur disque de plusieurs serveurs en un seul espace de noms global. GlusterFS est un système de fichiers distribué open source qui convient aux solutions cloud et hybrides.

Les volumes constituent la base de GlusterFS et répondent à différentes exigences. Chaque volume est une collection de briques, qui sont des unités de base de stockage représentées par un répertoire d'exportation sur un serveur dans le pool de stockage de confiance.

Les types de volumes GlusterFS suivants sont disponibles :

- Distributed GlusterFS volume est le volume par défaut où chaque fichier est stocké dans une brique et où le fichier ne peut pas être partagé entre différentes briques.

- Replicated GlusterFS volume réplique les données de l'utilisateur, de sorte que si une brique tombe en panne, les données restent accessibles.

- Distributed replicated GlusterFS volume est un volume hybride qui répartit les répliques sur un grand nombre de systèmes. Il convient aux environnements où l'évolutivité et la fiabilité du stockage sont essentielles.

Ressources supplémentaires

1.5. Aperçu du stockage Ceph

Red Hat Ceph Storage (RHCS) est une plateforme de stockage évolutive, ouverte et définie par logiciel qui combine la version la plus stable du système de stockage Ceph avec une plateforme de gestion Ceph, des utilitaires de déploiement et des services d'assistance.

Red Hat Ceph Storage est conçu pour l'infrastructure en nuage et le stockage d'objets à l'échelle du web. Les clusters de Red Hat Ceph Storage sont constitués des types de nœuds suivants :

- Nœud d'administration Red Hat Ceph Storage Ansible

Ce type de nœud agit comme le nœud d'administration Ceph traditionnel pour les versions précédentes de Red Hat Ceph Storage. Ce type de nœud offre les fonctions suivantes :

- Gestion centralisée des grappes de stockage

- Les fichiers de configuration Ceph et les clés

- Optionnellement, des dépôts locaux pour l'installation de Ceph sur des nœuds qui ne peuvent pas accéder à l'Internet pour des raisons de sécurité

- Surveiller les nœuds

Chaque nœud de surveillance exécute le démon de surveillance (

ceph-mon), qui conserve une copie de la carte de la grappe. La carte de la grappe comprend la topologie de la grappe. Un client qui se connecte au cluster Ceph récupère la copie actuelle de la carte du cluster à partir du moniteur, ce qui lui permet de lire et d'écrire des données dans le cluster.ImportantCeph peut fonctionner avec un moniteur ; cependant, pour assurer une haute disponibilité dans un cluster de production, Red Hat ne prendra en charge que les déploiements avec au moins trois nœuds de moniteurs. Red Hat recommande de déployer un total de 5 moniteurs Ceph pour les clusters de stockage dépassant 750 OSD.

- Nœuds OSD

Chaque nœud OSD (Object Storage Device) exécute le démon Ceph OSD (

ceph-osd), qui interagit avec les disques logiques attachés au nœud. Ceph stocke les données sur ces nœuds OSD.Ceph peut fonctionner avec très peu de nœuds OSD, trois par défaut, mais les clusters de production réalisent de meilleures performances à partir d'échelles modestes, par exemple 50 OSD dans un cluster de stockage. Idéalement, un cluster Ceph possède plusieurs nœuds OSD, ce qui permet d'isoler les domaines de défaillance en créant la carte CRUSH.

- Nœuds MDS

-

Chaque nœud du serveur de métadonnées (MDS) exécute le démon MDS (

ceph-mds), qui gère les métadonnées relatives aux fichiers stockés dans le système de fichiers Ceph (CephFS). Le démon MDS coordonne également l'accès au cluster partagé. - Nœud de passerelle d'objets

-

Le nœud Ceph Object Gateway exécute le démon Ceph RADOS Gateway (

ceph-radosgw), et est une interface de stockage d'objets construite au-dessus delibradospour fournir aux applications une passerelle RESTful vers les clusters de stockage Ceph. La passerelle Ceph Object Gateway prend en charge deux interfaces : - S3

- Fournit des fonctionnalités de stockage d'objets avec une interface compatible avec un large sous-ensemble de l'API RESTful Amazon S3.

- Swift

- Fournit des fonctionnalités de stockage d'objets avec une interface compatible avec un large sous-ensemble de l'API Swift d'OpenStack.

Ressources supplémentaires

Chapitre 2. Gestion du stockage local à l'aide des rôles système RHEL

Pour gérer LVM et les systèmes de fichiers locaux (FS) à l'aide d'Ansible, vous pouvez utiliser le rôle storage, qui est l'un des rôles système RHEL disponibles dans RHEL 9.

L'utilisation du rôle storage vous permet d'automatiser l'administration des systèmes de fichiers sur les disques et les volumes logiques sur plusieurs machines et sur toutes les versions de RHEL à partir de RHEL 7.7.

Pour plus d'informations sur les rôles système RHEL et leur application, voir Introduction aux rôles système RHEL.

2.1. Introduction au rôle du système RHEL storage

Le rôle de storage peut être géré :

- Systèmes de fichiers sur des disques qui n'ont pas été partitionnés

- Groupes de volumes LVM complets, y compris leurs volumes logiques et leurs systèmes de fichiers

- Volumes RAID MD et leurs systèmes de fichiers

Le rôle storage vous permet d'effectuer les tâches suivantes :

- Créer un système de fichiers

- Supprimer un système de fichiers

- Monter un système de fichiers

- Démonter un système de fichiers

- Créer des groupes de volumes LVM

- Supprimer les groupes de volumes LVM

- Créer des volumes logiques

- Supprimer des volumes logiques

- Créer des volumes RAID

- Supprimer des volumes RAID

- Créer des groupes de volumes LVM avec RAID

- Supprimer les groupes de volumes LVM avec RAID

- Créer des groupes de volumes LVM cryptés

- Créer des volumes logiques LVM avec RAID

2.2. Paramètres qui identifient un périphérique de stockage dans le rôle de système RHEL storage

Votre configuration du rôle storage n'affecte que les systèmes de fichiers, les volumes et les pools que vous avez répertoriés dans les variables suivantes.

storage_volumesListe des systèmes de fichiers sur tous les disques non partitionnés à gérer.

storage_volumespeut également inclure des volumesraid.Les partitions ne sont actuellement pas prises en charge.

storage_poolsListe des pools à gérer.

Actuellement, le seul type de pool pris en charge est LVM. Avec LVM, les pools représentent des groupes de volumes (VG). Sous chaque pool se trouve une liste de volumes à gérer par le rôle. Avec LVM, chaque volume correspond à un volume logique (LV) avec un système de fichiers.

2.3. Exemple de script Ansible pour créer un système de fichiers XFS sur un périphérique bloc

Cette section fournit un exemple de script Ansible. Ce playbook applique le rôle storage pour créer un système de fichiers XFS sur un périphérique bloc à l'aide des paramètres par défaut.

Le rôle storage peut créer un système de fichiers uniquement sur un disque entier non partitionné ou sur un volume logique (LV). Il ne peut pas créer le système de fichiers sur une partition.

Exemple 2.1. Un playbook qui crée XFS sur /dev/sdb

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: xfs

roles:

- rhel-system-roles.storage-

Le nom du volume (

barefsdans l'exemple) est actuellement arbitraire. Le rôlestorageidentifie le volume par l'unité de disque répertoriée sous l'attributdisks:. -

Vous pouvez omettre la ligne

fs_type: xfscar XFS est le système de fichiers par défaut dans RHEL 9. Pour créer le système de fichiers sur un LV, fournissez la configuration LVM sous l'attribut

disks:, y compris le groupe de volumes qui l'entoure. Pour plus de détails, voir Example Ansible playbook to manage logical volumes.Ne pas fournir le chemin d'accès au dispositif LV.

Ressources supplémentaires

-

Le fichier

/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.4. Exemple de playbook Ansible pour monter un système de fichiers de manière persistante

Cette section fournit un exemple de plan de jeu Ansible. Ce playbook applique le rôle storage pour monter immédiatement et de manière persistante un système de fichiers XFS.

Exemple 2.2. Un playbook qui monte un système de fichiers sur /dev/sdb vers /mnt/data

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: xfs

mount_point: /mnt/data

roles:

- rhel-system-roles.storage-

Cette procédure ajoute le système de fichiers au fichier

/etc/fstabet monte immédiatement le système de fichiers. -

Si le système de fichiers sur le périphérique

/dev/sdbou le répertoire du point de montage n'existent pas, la séquence les crée.

Ressources supplémentaires

-

Le fichier

/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.5. Exemple de script Ansible pour la gestion des volumes logiques

Cette section fournit un exemple de manuel de jeu Ansible. Ce playbook applique le rôle storage pour créer un volume logique LVM dans un groupe de volumes.

Exemple 2.3. Un playbook qui crée un volume logique mylv dans le groupe de volumes myvg

- hosts: all

vars:

storage_pools:

- name: myvg

disks:

- sda

- sdb

- sdc

volumes:

- name: mylv

size: 2G

fs_type: ext4

mount_point: /mnt/data

roles:

- rhel-system-roles.storageLe groupe de volumes

myvgse compose des disques suivants :-

/dev/sda -

/dev/sdb -

/dev/sdc

-

-

Si le groupe de volumes

myvgexiste déjà, la procédure ajoute le volume logique au groupe de volumes. -

Si le groupe de volumes

myvgn'existe pas, le playbook le crée. -

La procédure crée un système de fichiers Ext4 sur le volume logique

mylvet monte de manière persistante le système de fichiers à l'adresse/mnt.

Ressources supplémentaires

-

Le fichier

/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.6. Exemple de script Ansible pour activer l'élimination des blocs en ligne

Cette section fournit un exemple de manuel de jeu Ansible. Ce playbook applique le rôle storage pour monter un système de fichiers XFS avec l'option d'élimination des blocs en ligne activée.

Exemple 2.4. Un playbook qui active l'élimination des blocs en ligne sur /mnt/data/

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: xfs

mount_point: /mnt/data

mount_options: discard

roles:

- rhel-system-roles.storageRessources supplémentaires

- Exemple de playbook Ansible pour monter un système de fichiers de manière persistante

-

Le fichier

/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.7. Exemple de script Ansible pour créer et monter un système de fichiers Ext4

Cette section fournit un exemple de script Ansible. Ce playbook applique le rôle storage pour créer et monter un système de fichiers Ext4.

Exemple 2.5. Un playbook qui crée Ext4 sur /dev/sdb et le monte dans /mnt/data

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: ext4

fs_label: label-name

mount_point: /mnt/data

roles:

- rhel-system-roles.storage-

Le playbook crée le système de fichiers sur le disque

/dev/sdb. -

Le playbook monte de manière persistante le système de fichiers dans le répertoire

/mnt/datarépertoire. -

L'étiquette du système de fichiers est

label-name.

Ressources supplémentaires

-

Le fichier

/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.8. Exemple de script Ansible pour créer et monter un système de fichiers ext3

Cette section fournit un exemple de script Ansible. Ce playbook applique le rôle storage pour créer et monter un système de fichiers Ext3.

Exemple 2.6. Un playbook qui crée Ext3 sur /dev/sdb et le monte à l'adresse /mnt/data

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: ext3

fs_label: label-name

mount_point: /mnt/data

roles:

- rhel-system-roles.storage-

Le playbook crée le système de fichiers sur le disque

/dev/sdb. -

Le playbook monte de manière persistante le système de fichiers dans le répertoire

/mnt/datarépertoire. -

L'étiquette du système de fichiers est

label-name.

Ressources supplémentaires

-

Le fichier

/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.9. Exemple de playbook Ansible pour redimensionner un système de fichiers Ext4 ou Ext3 existant à l'aide du rôle de système RHEL storage

Cette section fournit un exemple de plan de jeu Ansible. Ce playbook applique le rôle storage pour redimensionner un système de fichiers Ext4 ou Ext3 existant sur un périphérique bloc.

Exemple 2.7. Un playbook qui configure un seul volume sur un disque

---

- name: Create a disk device mounted on /opt/barefs

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- /dev/sdb

size: 12 GiB

fs_type: ext4

mount_point: /opt/barefs

roles:

- rhel-system-roles.storage-

Si le volume de l'exemple précédent existe déjà, pour redimensionner le volume, vous devez exécuter le même playbook, mais avec une valeur différente pour le paramètre

size. Par exemple, vous devez exécuter le même playbook, mais avec une valeur différente pour le paramètre :

Exemple 2.8. Un playbook qui redimensionne ext4 sur /dev/sdb

---

- name: Create a disk device mounted on /opt/barefs

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- /dev/sdb

size: 10 GiB

fs_type: ext4

mount_point: /opt/barefs

roles:

- rhel-system-roles.storage- Le nom du volume (barefs dans l'exemple) est actuellement arbitraire. Le rôle Stockage identifie le volume par l'unité de disque listée dans l'attribut disks :.

L'utilisation de l'action Resizing dans d'autres systèmes de fichiers peut détruire les données de l'appareil sur lequel vous travaillez.

Ressources supplémentaires

-

Le fichier

/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.10. Exemple de playbook Ansible pour redimensionner un système de fichiers existant sur LVM à l'aide du rôle système storage RHEL

Cette section fournit un exemple de script Ansible. Ce playbook applique le rôle système storage RHEL pour redimensionner un volume logique LVM avec un système de fichiers.

L'utilisation de l'action Resizing dans d'autres systèmes de fichiers peut détruire les données de l'appareil sur lequel vous travaillez.

Exemple 2.9. Un playbook qui redimensionne les volumes logiques mylv1 et myvl2 existants dans le groupe de volumes myvg

---

- hosts: all

vars:

storage_pools:

- name: myvg

disks:

- /dev/sda

- /dev/sdb

- /dev/sdc

volumes:

- name: mylv1

size: 10 GiB

fs_type: ext4

mount_point: /opt/mount1

- name: mylv2

size: 50 GiB

fs_type: ext4

mount_point: /opt/mount2

- name: Create LVM pool over three disks

include_role:

name: rhel-system-roles.storageCette procédure redimensionne les systèmes de fichiers existants suivants :

-

Le système de fichiers Ext4 sur le volume

mylv1, qui est monté sur/opt/mount1, est redimensionné à 10 GiB. -

Le système de fichiers Ext4 sur le volume

mylv2, qui est monté sur/opt/mount2, est redimensionné à 50 GiB.

-

Le système de fichiers Ext4 sur le volume

Ressources supplémentaires

-

Le fichier

/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.11. Exemple de playbook Ansible pour créer un volume d'échange à l'aide du rôle de système RHEL storage

Cette section fournit un exemple de script Ansible. Ce playbook applique le rôle storage pour créer un volume d'échange, s'il n'existe pas, ou pour modifier le volume d'échange, s'il existe déjà, sur un périphérique de bloc en utilisant les paramètres par défaut.

Exemple 2.10. Un playbook qui crée ou modifie un XFS existant sur /dev/sdb

---

- name: Create a disk device with swap

- hosts: all

vars:

storage_volumes:

- name: swap_fs

type: disk

disks:

- /dev/sdb

size: 15 GiB

fs_type: swap

roles:

- rhel-system-roles.storage-

Le nom du volume (

swap_fsdans l'exemple) est actuellement arbitraire. Le rôlestorageidentifie le volume par l'unité de disque répertoriée sous l'attributdisks:.

Ressources supplémentaires

-

Le fichier

/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.12. Configuration d'un volume RAID à l'aide du rôle de système de stockage

Avec le rôle de système storage, vous pouvez configurer un volume RAID sur RHEL en utilisant Red Hat Ansible Automation Platform et Ansible-Core. Créez un playbook Ansible avec les paramètres pour configurer un volume RAID en fonction de vos besoins.

Conditions préalables

- Le paquetage Ansible Core est installé sur la machine de contrôle.

-

Le paquetage

rhel-system-rolesest installé sur le système à partir duquel vous souhaitez exécuter le playbook. -

Vous disposez d'un fichier d'inventaire détaillant les systèmes sur lesquels vous souhaitez déployer un volume RAID à l'aide du rôle de système

storage.

Procédure

Créez un nouveau fichier playbook.yml avec le contenu suivant :

--- - name: Configure the storage hosts: managed-node-01.example.com tasks: - name: Create a RAID on sdd, sde, sdf, and sdg include_role: name: rhel-system-roles.storage vars: storage_safe_mode: false storage_volumes: - name: data type: raid disks: [sdd, sde, sdf, sdg] raid_level: raid0 raid_chunk_size: 32 KiB mount_point: /mnt/data state: presentAvertissementLes noms de périphériques peuvent changer dans certaines circonstances, par exemple lorsque vous ajoutez un nouveau disque à un système. Par conséquent, pour éviter toute perte de données, n'utilisez pas de noms de disques spécifiques dans le guide de lecture.

Facultatif : Vérifiez la syntaxe du playbook :

# ansible-playbook --syntax-check playbook.ymlExécutez le manuel de jeu :

# ansible-playbook -i inventory.file /path/to/file/playbook.yml

Ressources supplémentaires

-

Le fichier

/usr/share/ansible/roles/rhel-system-roles.storage/README.md - Préparation d'un nœud de contrôle et de nœuds gérés à l'utilisation des rôles système RHEL

2.13. Configuration d'un pool LVM avec RAID à l'aide du rôle système storage RHEL

Avec le rôle de système storage, vous pouvez configurer un pool LVM avec RAID sur RHEL à l'aide de Red Hat Ansible Automation Platform. Dans cette section, vous apprendrez à configurer un playbook Ansible avec les paramètres disponibles pour configurer un pool LVM avec RAID.

Conditions préalables

- Le paquetage Ansible Core est installé sur la machine de contrôle.

-

Le paquetage

rhel-system-rolesest installé sur le système à partir duquel vous souhaitez exécuter le playbook. -

Vous disposez d'un fichier d'inventaire détaillant les systèmes sur lesquels vous souhaitez configurer un pool LVM avec RAID à l'aide du rôle de système

storage.

Procédure

Créez un nouveau fichier

playbook.ymlavec le contenu suivant :- hosts: all vars: storage_safe_mode: false storage_pools: - name: my_pool type: lvm disks: [sdh, sdi] raid_level: raid1 volumes: - name: my_pool size: "1 GiB" mount_point: "/mnt/app/shared" fs_type: xfs state: present roles: - name: rhel-system-roles.storageNotePour créer un pool LVM avec RAID, vous devez spécifier le type de RAID à l'aide du paramètre

raid_level.Facultatif. Vérifier la syntaxe du playbook.

# ansible-playbook --syntax-check playbook.ymlExécutez le playbook sur votre fichier d'inventaire :

# ansible-playbook -i inventory.file /path/to/file/playbook.yml

Ressources supplémentaires

-

Le fichier

/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.14. Exemple de playbook Ansible pour compresser et dédupliquer un volume VDO sur LVM à l'aide du rôle système storage RHEL

Cette section fournit un exemple de plan de jeu Ansible. Ce playbook applique le rôle système storage RHEL pour activer la compression et la déduplication des volumes logiques (LVM) à l'aide de Virtual Data Optimizer (VDO).

Exemple 2.11. Un playbook qui crée un volume mylv1 LVM VDO dans le groupe de volumes myvg

---

- name: Create LVM VDO volume under volume group 'myvg'

hosts: all

roles:

-rhel-system-roles.storage

vars:

storage_pools:

- name: myvg

disks:

- /dev/sdb

volumes:

- name: mylv1

compression: true

deduplication: true

vdo_pool_size: 10 GiB

size: 30 GiB

mount_point: /mnt/app/shared

Dans cet exemple, les pools compression et deduplication sont réglés sur true, ce qui spécifie que le VDO est utilisé. Les paragraphes suivants décrivent l'utilisation de ces paramètres :

-

Le site

deduplicationest utilisé pour dédupliquer les données dupliquées stockées sur le volume de stockage. - La compression est utilisée pour comprimer les données stockées sur le volume de stockage, ce qui permet d'augmenter la capacité de stockage.

-

Le paramètre vdo_pool_size indique la taille réelle du volume sur le périphérique. La taille virtuelle du volume VDO est définie par le paramètre

size. NOTE : En raison de l'utilisation du rôle de stockage de LVM VDO, un seul volume par pool peut utiliser la compression et la déduplication.

2.15. Création d'un volume chiffré LUKS2 à l'aide du rôle système storage RHEL

Vous pouvez utiliser le rôle storage pour créer et configurer un volume chiffré avec LUKS en exécutant un manuel de jeu Ansible.

Conditions préalables

-

Accès et autorisations à un ou plusieurs nœuds gérés, qui sont des systèmes que vous souhaitez configurer avec le rôle de système

crypto_policies. - Un fichier d'inventaire, qui répertorie les nœuds gérés.

-

Accès et permissions à un nœud de contrôle, qui est un système à partir duquel Red Hat Ansible Core configure d'autres systèmes. Sur le nœud de contrôle, les paquets

ansible-coreetrhel-system-rolessont installés.

RHEL 8.0-8.5 donne accès à un dépôt Ansible distinct qui contient Ansible Engine 2.9 pour l'automatisation basée sur Ansible. Ansible Engine contient des utilitaires de ligne de commande tels que ansible, ansible-playbook, des connecteurs tels que docker et podman, ainsi que de nombreux plugins et modules. Pour plus d'informations sur la manière d'obtenir et d'installer Ansible Engine, consultez l'article de la base de connaissances Comment télécharger et installer Red Hat Ansible Engine.

RHEL 8.6 et 9.0 ont introduit Ansible Core (fourni en tant que paquetage ansible-core ), qui contient les utilitaires de ligne de commande Ansible, les commandes et un petit ensemble de plugins Ansible intégrés. RHEL fournit ce paquetage par l'intermédiaire du dépôt AppStream, et sa prise en charge est limitée. Pour plus d'informations, consultez l'article de la base de connaissances intitulé Scope of support for the Ansible Core package included in the RHEL 9 and RHEL 8.6 and later AppStream repositories (Portée de la prise en charge du package Ansible Core inclus dans les dépôts AppStream RHEL 9 et RHEL 8.6 et versions ultérieures ).

Procédure

Créez un nouveau fichier

playbook.ymlavec le contenu suivant :- hosts: all vars: storage_volumes: - name: barefs type: disk disks: - sdb fs_type: xfs fs_label: label-name mount_point: /mnt/data encryption: true encryption_password: your-password roles: - rhel-system-roles.storageVous pouvez également ajouter les autres paramètres de cryptage tels que

encryption_key,encryption_cipher,encryption_key_size, etencryption_luksversion dans le fichier playbook.yml.Facultatif : Vérifier la syntaxe du playbook :

# ansible-playbook --syntax-check playbook.ymlExécutez le playbook sur votre fichier d'inventaire :

# ansible-playbook -i inventory.file /path/to/file/playbook.yml

Vérification

Visualiser l'état du cryptage :

# cryptsetup status sdb /dev/mapper/sdb is active and is in use. type: LUKS2 cipher: aes-xts-plain64 keysize: 512 bits key location: keyring device: /dev/sdb [...]

Vérifiez le volume crypté LUKS créé :

# cryptsetup luksDump /dev/sdb Version: 2 Epoch: 6 Metadata area: 16384 [bytes] Keyslots area: 33521664 [bytes] UUID: a4c6be82-7347-4a91-a8ad-9479b72c9426 Label: (no label) Subsystem: (no subsystem) Flags: allow-discards Data segments: 0: crypt offset: 33554432 [bytes] length: (whole device) cipher: aes-xts-plain64 sector: 4096 [bytes] [...]Consultez les paramètres

cryptsetupdans le fichierplaybook.ymlque le rôlestorageprend en charge :# cat ~/playbook.yml - hosts: all vars: storage_volumes: - name: foo type: disk disks: - nvme0n1 fs_type: xfs fs_label: label-name mount_point: /mnt/data encryption: true #encryption_password: passwdpasswd encryption_key: /home/passwd_key encryption_cipher: aes-xts-plain64 encryption_key_size: 512 encryption_luks_version: luks2 roles: - rhel-system-roles.storage

Ressources supplémentaires

- Chiffrement des blocs de données à l'aide de LUKS

-

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdfichier

2.16. Exemple de playbook Ansible pour exprimer les tailles de volume de pool en pourcentage à l'aide du rôle de système RHEL storage

Cette section fournit un exemple de manuel de jeu Ansible. Ce manuel applique le rôle de système storage pour vous permettre d'exprimer la taille des volumes LVM (Logical Manager Volumes) en pourcentage de la taille totale du pool.

Exemple 2.12. Un playbook qui exprime la taille des volumes en pourcentage de la taille totale du pool

---

- name: Express volume sizes as a percentage of the pool's total size

hosts: all

roles

- rhel-system-roles.storage

vars:

storage_pools:

- name: myvg

disks:

- /dev/sdb

volumes:

- name: data

size: 60%

mount_point: /opt/mount/data

- name: web

size: 30%

mount_point: /opt/mount/web

- name: cache

size: 10%

mount_point: /opt/cache/mountCet exemple spécifie la taille des volumes LVM en pourcentage de la taille du pool, par exemple : "60%". En outre, vous pouvez également spécifier la taille des volumes LVM en pourcentage de la taille du pool dans une taille lisible par l'homme du système de fichiers, par exemple : "10g" ou "50 GiB".

2.17. Ressources supplémentaires

-

/usr/share/doc/rhel-system-roles/storage/ -

/usr/share/ansible/roles/rhel-system-roles.storage/

Chapitre 3. Partitions de disque

Pour diviser un disque en une ou plusieurs zones logiques, utilisez l'utilitaire de partitionnement du disque. Il permet de gérer séparément chaque partition.

3.1. Vue d'ensemble des partitions

Le disque dur stocke les informations relatives à l'emplacement et à la taille de chaque partition dans la table de partition. En utilisant les informations de la table de partition, le système d'exploitation traite chaque partition comme un disque logique. Voici quelques-uns des avantages du partitionnement de disque :

- Réduire la probabilité d'oublis administratifs des volumes physiques

- Assurer une sauvegarde suffisante

- Assurer une gestion efficace des disques

3.2. Considérations à prendre en compte avant de modifier les partitions d'un disque

Avant de créer, de supprimer ou de redimensionner des partitions de disque, tenez compte des aspects suivants.

Sur un périphérique, le type de table de partition détermine le nombre et la taille maximum des partitions individuelles.

Nombre maximum de partitions :

Sur un appareil formaté avec la table de partition Master Boot Record (MBR), vous pouvez avoir :

- Jusqu'à quatre partitions primaires.

Jusqu'à trois partitions primaires, une partition étendue

- Plusieurs partitions logiques au sein de la partition étendue

Sur un appareil formaté avec GUID Partition Table (GPT), vous pouvez avoir :

Jusqu'à 128 partitions, si vous utilisez l'utilitaire

parted.- Bien que la spécification GPT autorise davantage de partitions en augmentant la taille réservée de la table de partition, l'utilitaire parted limite la zone requise pour 128 partitions.

Taille maximale des partitions :

Sur un appareil formaté avec la table de partition Master Boot Record (MBR):

- Si vous utilisez des lecteurs à secteur de 512b, la taille maximale est de 2 TiB.

- Si vous utilisez des lecteurs à secteur 4k, la taille maximale est de 16 TiB.

Sur un appareil formaté avec le logiciel GUID Partition Table (GPT):

- Lors de l'utilisation de lecteurs à secteurs de 512b, la taille maximale est de 8 ZiB.

- Si vous utilisez des lecteurs à secteur 4k, la taille maximale est de 64 ZiB.

En utilisant l'utilitaire parted, vous pouvez spécifier la taille de la partition en utilisant plusieurs suffixes différents :

MiB, GiB, or TiB

- Taille exprimée en puissance de 2.

- Le point de départ de la partition est aligné sur le secteur exact spécifié par la taille.

- Le point final est aligné sur la taille spécifiée moins 1 secteur.

MB, GB, or TB:

- Taille exprimée en puissances de 10.

- Les points de départ et d'arrivée sont alignés sur la moitié de l'unité spécifiée. Par exemple, ±500KB lorsque le suffixe MB est utilisé.

Cette section ne couvre pas la table de partition DASD, qui est spécifique à l'architecture IBM Z.

Ressources supplémentaires

3.3. Comparaison des types de tables de partition

Pour activer les partitions sur un périphérique, formatez un périphérique bloc avec différents types de tables de partition. Le tableau suivant compare les propriétés des différents types de tables de partition que vous pouvez créer sur un périphérique de bloc.

Tableau 3.1. Types de tables de partition

| Table de partition | Nombre maximal de partitions | Taille maximale de la partition |

|---|---|---|

| Master Boot Record (MBR) | 4 partitions primaires, ou 3 partitions primaires et 1 partition étendue avec 12 partitions logiques | 2TiB |

| Table de partition GUID (GPT) | 128 | 8ZiB |

3.4. Partitions de disque MBR

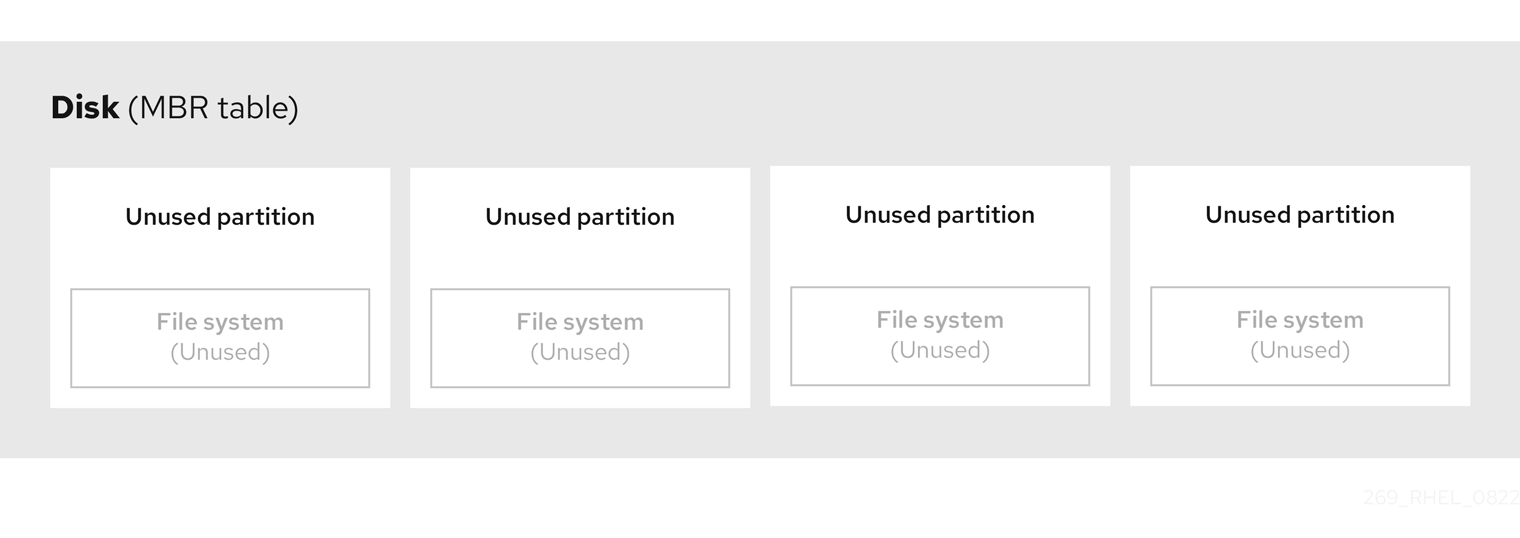

La table de partition est stockée au tout début du disque, avant tout système de fichiers ou toute donnée utilisateur. Pour un exemple plus clair, la table de partition est présentée comme étant séparée dans les diagrammes suivants.

Figure 3.1. Disque avec table de partition MBR

Comme le montre le schéma précédent, la table de partition est divisée en quatre sections de quatre partitions primaires inutilisées. Une partition primaire est une partition sur un disque dur qui ne contient qu'une seule unité logique (ou section). Chaque unité logique contient les informations nécessaires pour définir une seule partition, ce qui signifie que la table de partitions ne peut pas définir plus de quatre partitions primaires.

Chaque entrée de la table de partition contient des caractéristiques importantes de la partition :

- Les points du disque où la partition commence et se termine

-

L'état de la partition, étant donné qu'une seule partition peut être signalée comme étant

active - Le type de partition

Les points de départ et d'arrivée définissent la taille et l'emplacement de la partition sur le disque. Certains chargeurs de démarrage de systèmes d'exploitation utilisent l'indicateur active. Cela signifie que le système d'exploitation de la partition marquée "active" est démarré.

Le type est un nombre qui identifie l'utilisation prévue d'une partition. Certains systèmes d'exploitation utilisent le type de partition pour :

- Indique un type de système de fichiers spécifique

- Marquer la partition comme étant associée à un système d'exploitation particulier

- Indiquer que la partition contient un système d'exploitation amorçable

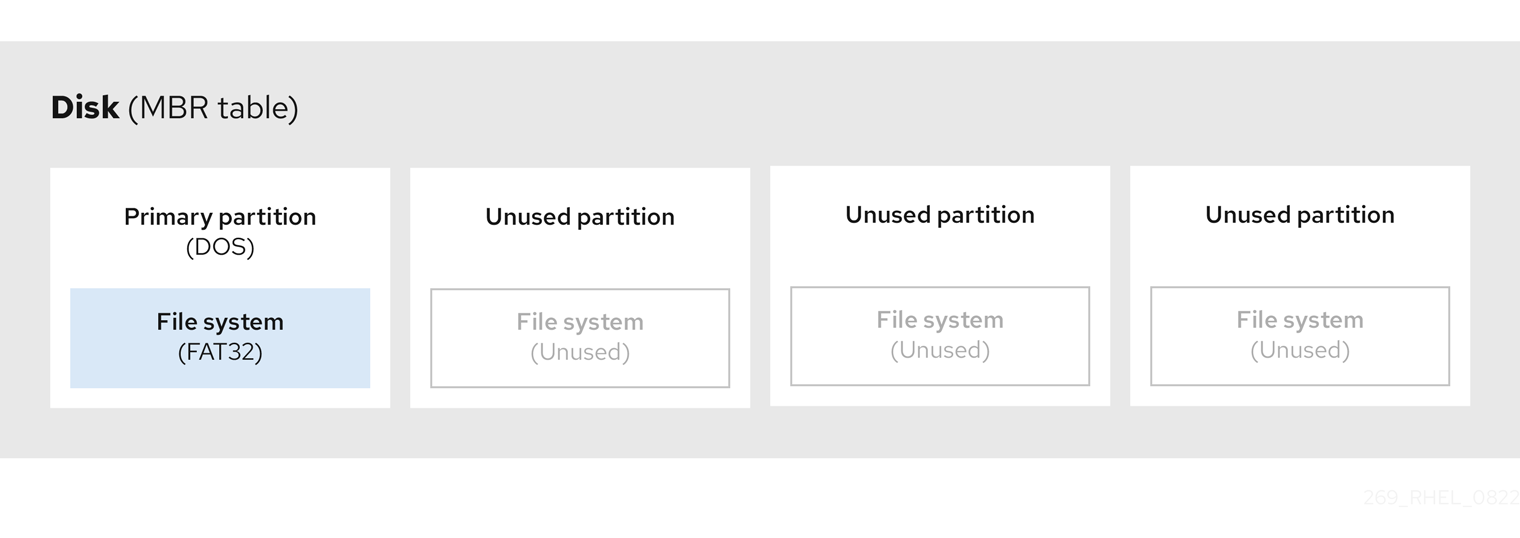

Le diagramme suivant montre un exemple de disque avec une seule partition. Dans cet exemple, la première partition est étiquetée en tant que type de partition DOS:

Figure 3.2. Disque avec une seule partition

Ressources supplémentaires

3.5. Partitions MBR étendues

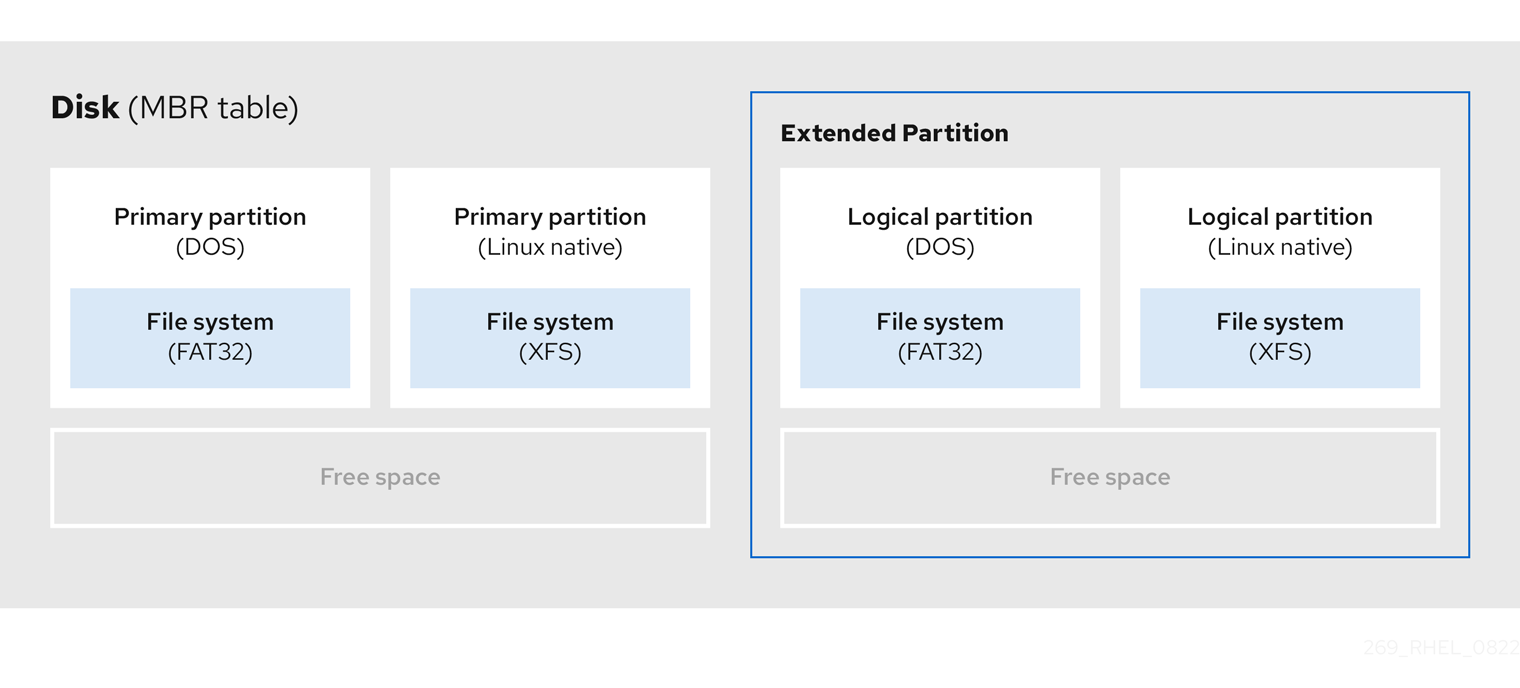

Pour créer des partitions supplémentaires, si nécessaire, définissez le type sur extended.

Une partition étendue est similaire à une unité de disque. Elle possède sa propre table de partition, qui pointe vers une ou plusieurs partitions logiques, entièrement contenues dans la partition étendue. Le diagramme suivant montre une unité de disque avec deux partitions primaires et une partition étendue contenant deux partitions logiques, ainsi qu'un espace libre non partitionné.

Figure 3.3. Disque avec deux partitions primaires et une partition étendue MBR

Vous ne pouvez avoir que quatre partitions primaires et étendues, mais il n'y a pas de limite fixe au nombre de partitions logiques. Pour limiter l'accès aux partitions dans Linux, une seule unité de disque permet un maximum de 15 partitions logiques.

3.6. Types de partitions MBR

Le tableau ci-dessous présente une liste des types de partitions MBR les plus couramment utilisés et les nombres hexadécimaux qui les représentent.

Tableau 3.2. Types de partitions MBR

| MBR partition type | Value | MBR partition type | Value |

| Vide | 00 | Novell Netware 386 | 65 |

| DOS 12-bit FAT | 01 | PIC/IX | 75 |

| Racine XENIX | O2 | Ancien MINIX | 80 |

| XENIX usr | O3 | Linux/MINUX | 81 |

| DOS 16-bit ⇐32M | 04 | Linux swap | 82 |

| Prolongé | 05 | Linux natif | 83 |

| DOS 16 bits >=32 | 06 | Linux étendu | 85 |

| OS/2 HPFS | 07 | Amibe | 93 |

| AIX | 08 | Amibe BBT | 94 |

| AIX bootable | 09 | BSD/386 | a5 |

| Gestionnaire d'amorçage OS/2 | 0a | OpenBSD | a6 |

| Win95 FAT32 | 0b | NEXTSTEP | a7 |

| Win95 FAT32 (LBA) | 0c | BSDI fs | b7 |

| Win95 FAT16 (LBA) | 0e | Échange BSDI | b8 |

| Win95 étendu (LBA) | 0f | Syrinx | c7 |

| Venix 80286 | 40 | CP/M | db |

| Novell | 51 | Accès DOS | e1 |

| Botte PRep | 41 | DOS R/O | e3 |

| GNU HURD | 63 | DOS secondaire | f2 |

| Novell Netware 286 | 64 | BBT | ff |

3.7. Table de partition GUID

La table de partition GUID (GPT) est un schéma de partitionnement basé sur l'identifiant unique global (GUID).

GPT traite les limitations de la table de partition MBR (Mater Boot Record). La table de partition MBR ne peut pas prendre en charge un espace de stockage supérieur à 2 TiB, soit environ 2,2 To. En revanche, GPT prend en charge les disques durs de plus grande capacité. La taille maximale d'un disque adressable est de 8 ZiB, si l'on utilise des disques durs de 512b, et de 64 ZiB, si l'on utilise des disques durs de 4096b. En outre, par défaut, GPT prend en charge la création de 128 partitions primaires au maximum. Il est possible d'étendre le nombre maximal de partitions primaires en allouant plus d'espace à la table de partition.

Un GPT a des types de partitions basés sur des GUID. Certaines partitions nécessitent un GUID spécifique. Par exemple, la partition système pour les chargeurs de démarrage EFI (Extensible Firmware Interface) nécessite le GUID C12A7328-F81F-11D2-BA4B-00A0C93EC93B.

Les disques GPT utilisent l'adressage par blocs logiques (LBA) et une disposition de partition comme suit :

- Pour assurer la rétrocompatibilité avec les disques MBR, le système réserve le premier secteur (LBA 0) de GPT aux données MBR et applique le nom "MBR protecteur".

GPT primaire

- L'en-tête commence sur le deuxième bloc logique (LBA 1) du périphérique. L'en-tête contient le GUID du disque, l'emplacement de la table de partition primaire, l'emplacement de l'en-tête GPT secondaire et les sommes de contrôle CRC32 de lui-même et de la table de partition primaire. Il spécifie également le nombre d'entrées de partition dans la table.

- Par défaut, le GPT primaire comprend 128 entrées de partition. Chaque partition a une taille d'entrée de 128 octets, un GUID de type de partition et un GUID de partition unique.

GPT secondaire

- Pour la récupération, elle est utile comme table de sauvegarde au cas où la table de partition primaire serait corrompue.

- Le dernier secteur logique du disque contient l'en-tête GPT secondaire et récupère les informations GPT, au cas où l'en-tête primaire serait corrompu.

Il contient

- Le GUID du disque

- Emplacement de la table de partition secondaire et de l'en-tête GPT primaire

- Somme de contrôle CRC32 de lui-même

- La table de partition secondaire

- Le nombre d'entrées de partition possibles

Figure 3.4. Disque avec table de partition GUID

Pour que l'installation du chargeur de démarrage sur un disque GPT réussisse, une partition de démarrage du BIOS doit être présente. La réutilisation n'est possible que si le disque contient déjà une partition d'amorçage du BIOS. Cela inclut les disques initialisés par le programme d'installation Anaconda.

3.8. Types de partition

Il existe plusieurs façons de gérer les types de partitions :

-

L'utilitaire

fdiskprend en charge l'ensemble des types de partition en spécifiant des codes hexadécimaux. -

L'utilitaire de génération d'unités

systemd-gpt-auto-generatorutilise le type de partition pour identifier et monter automatiquement les périphériques. L'utilitaire

parteddétermine le type de partition à l'aide de flags. L'utilitairepartedne gère que les types de partitions de type Cératine, par exemple LVM, swap ou RAID.L'utilitaire

partedpermet de définir les drapeaux suivants :-

boot -

root -

swap -

hidden -

raid -

lvm -

lba -

legacy_boot -

irst -

esp -

palo

-

Sur Red Hat Enterprise Linux 9 avec parted 3.5, vous pouvez utiliser les drapeaux supplémentaires chromeos_kernel et bls_boot.

L'utilitaire parted accepte facultativement un argument de type de système de fichiers lors de la création d'une partition. Voir Créer une partition avec parted

pour une liste des conditions requises. Utilisez la valeur pour :

- Définir les drapeaux de partition sur le MBR.

-

Définissez le type d'UUID de la partition sur GPT. Par exemple, les types de systèmes de fichiers

swap,fatouhfsdéfinissent des GUID différents. La valeur par défaut est le GUID de données Linux.

L'argument ne modifie pas le système de fichiers sur la partition. Il ne fait que différencier les drapeaux et les GUID pris en charge.

Les types de systèmes de fichiers suivants sont pris en charge :

-

xfs -

ext2 -

ext3 -

ext4 -

fat16 -

fat32 -

hfs -

hfs -

linux-swap -

ntfs -

reiserfs

3.9. Schéma de dénomination des partitions

Red Hat Enterprise Linux utilise un système de dénomination basé sur les fichiers, avec des noms de fichiers sous la forme de /dev/xxyN.

Les noms de périphériques et de partitions sont constitués de la structure suivante :

/dev/-

Nom du répertoire qui contient tous les fichiers de l'appareil. Les disques durs contiennent des partitions ; les fichiers représentant toutes les partitions possibles se trouvent donc à l'adresse

/dev. xx- Les deux premières lettres du nom de la partition indiquent le type de périphérique qui contient la partition.

y-

Cette lettre indique le périphérique spécifique contenant la partition. Par exemple,

/dev/sdapour le premier disque dur et/dev/sdbpour le second. Vous pouvez utiliser plus de lettres dans les systèmes comportant plus de 26 disques, par exemple,/dev/sdaa1. N-

La dernière lettre indique le numéro de la partition. Les quatre premières partitions (primaires ou étendues) sont numérotées de

1à4. Les partitions logiques commencent à5. Par exemple,/dev/sda3est la troisième partition primaire ou étendue du premier disque dur, et/dev/sdb6est la deuxième partition logique du deuxième disque dur. La numérotation des partitions de disque ne s'applique qu'aux tables de partition MBR. Notez que N ne signifie pas toujours partition.

Même si Red Hat Enterprise Linux peut identifier et se référer à all types de partitions de disque, il peut ne pas être en mesure de lire le système de fichiers et donc d'accéder aux données stockées sur chaque type de partition. Cependant, dans de nombreux cas, il est possible d'accéder avec succès aux données d'une partition dédiée à un autre système d'exploitation.

3.10. Points de montage et partitions de disque

Dans Red Hat Enterprise Linux, chaque partition constitue une partie du stockage, nécessaire pour prendre en charge un seul ensemble de fichiers et de répertoires. Le montage d'une partition rend le stockage de cette partition disponible, en commençant par le répertoire spécifié, connu sous le nom de mount point.

Par exemple, si la partition /dev/sda5 est montée sur /usr/, cela signifie que tous les fichiers et répertoires sous /usr/ résident physiquement sur /dev/sda5. Le fichier /usr/share/doc/FAQ/txt/Linux-FAQ réside sur /dev/sda5, alors que le fichier /etc/gdm/custom.conf n'y réside pas.

Si l'on poursuit l'exemple, il est également possible qu'un ou plusieurs répertoires situés sous /usr/ soient des points de montage pour d'autres partitions. Par exemple, /usr/local/man/whatis réside sur /dev/sda7, plutôt que sur /dev/sda5, si /usr/local comprend une partition /dev/sda7 montée.

Chapitre 4. Commencer avec les partitions

Le partitionnement du disque permet de diviser un disque en une ou plusieurs zones logiques, ce qui permet de travailler sur chaque partition séparément. Le disque dur stocke les informations relatives à l'emplacement et à la taille de chaque partition dans la table de partition. Grâce à cette table, chaque partition apparaît comme un disque logique au système d'exploitation. Vous pouvez alors lire et écrire sur ces disques individuels.

Pour une vue d'ensemble des avantages et des inconvénients de l'utilisation de partitions sur des périphériques en bloc, voir Quels sont les avantages et les inconvénients de l'utilisation du partitionnement sur des LUN, soit directement, soit avec LVM entre les deux ?

4.1. Création d'une table de partition sur un disque avec parted

Utilisez l'utilitaire parted pour formater plus facilement un périphérique en mode bloc avec une table de partition.

Le formatage d'un périphérique bloc avec une table de partition supprime toutes les données stockées sur le périphérique.

Procédure

Démarrer l'interpréteur de commandes interactif

parted:# parted block-deviceDéterminez s'il existe déjà une table de partition sur le périphérique :

# (parted) print

Si l'appareil contient déjà des partitions, celles-ci seront supprimées au cours des étapes suivantes.

Créez la nouvelle table de partition :

# (parted) mklabel table-typeRemplacez table-type par le type de table de partition prévu :

-

msdospour MBR -

gptpour GPT

-

Exemple 4.1. Création d'une table de partition GUID (GPT)

Pour créer une table GPT sur le disque, utilisez la commande suivante

# (parted) mklabel gpt

Les modifications commencent à s'appliquer après l'entrée de cette commande.

Affichez la table de partition pour confirmer qu'elle est créée :

# (parted) print

Quitter le shell

parted:# (parted) quit

Ressources supplémentaires

-

parted(8)man page.

4.2. Affichage de la table de partition avec parted

Affichez la table de partition d'un périphérique de bloc pour voir la disposition des partitions et des détails sur les partitions individuelles. Vous pouvez afficher la table de partition d'un périphérique de bloc à l'aide de l'utilitaire parted.

Procédure

Lancez l'utilitaire

parted. Par exemple, la sortie suivante répertorie le périphérique/dev/sda:# parted /dev/sda

Affichez la table de partition :

# (parted) print Model: ATA SAMSUNG MZNLN256 (scsi) Disk /dev/sda: 256GB Sector size (logical/physical): 512B/512B Partition Table: msdos Disk Flags: Number Start End Size Type File system Flags 1 1049kB 269MB 268MB primary xfs boot 2 269MB 34.6GB 34.4GB primary 3 34.6GB 45.4GB 10.7GB primary 4 45.4GB 256GB 211GB extended 5 45.4GB 256GB 211GB logical

Facultatif : Passez à l'appareil que vous souhaitez examiner ensuite :

# (parted) select block-device

Pour une description détaillée de la sortie de la commande d'impression, voir ce qui suit :

Model: ATA SAMSUNG MZNLN256 (scsi)- Le type de disque, le fabricant, le numéro de modèle et l'interface.

Disk /dev/sda: 256GB- Le chemin d'accès au périphérique de bloc et la capacité de stockage.

Partition Table: msdos- Le type d'étiquette du disque.

Number-

Le numéro de la partition. Par exemple, la partition portant le numéro de mineur 1 correspond à

/dev/sda1. StartetEnd- L'emplacement sur l'appareil où la partition commence et se termine.

Type- Les types valides sont les suivants : métadonnées, libre, primaire, étendu ou logique.

File system-

Le type de système de fichiers. Si le champ

File systemd'un périphérique n'affiche aucune valeur, cela signifie que son type de système de fichiers est inconnu. L'utilitairepartedne peut pas reconnaître le système de fichiers sur les périphériques cryptés. Flags-

Liste les drapeaux définis pour la partition. Les drapeaux disponibles sont

boot,root,swap,hidden,raid,lvmoulba.

Ressources supplémentaires

-

parted(8)man page.

4.3. Création d'une partition avec parted

En tant qu'administrateur système, vous pouvez créer de nouvelles partitions sur un disque à l'aide de l'utilitaire parted.

Les partitions requises sont swap, /boot/, et / (root).

Conditions préalables

- Une table de partition sur le disque.

- Si la partition que vous souhaitez créer est supérieure à 2 To, formatez le disque à l'aide de la commande GUID Partition Table (GPT).

Procédure

Lancez l'utilitaire

parted:# parted block-deviceAffichez la table de partition actuelle pour déterminer s'il y a suffisamment d'espace libre :

# (parted) print

- Redimensionnez la partition si l'espace libre est insuffisant.

À partir de la table de partition, déterminez

- Les points de départ et d'arrivée de la nouvelle partition.

- Dans le cas du MBR, quel type de partition doit être utilisé.

Créez la nouvelle partition :

# (parted) mkpart part-type name fs-type start end

-

Remplacez part-type par

primary,logicalouextended. Cela ne s'applique qu'à la table de partition MBR. - Remplacez name par un nom de partition arbitraire. Cela est nécessaire pour les tables de partition GPT.

-

Remplacez fs-type par

xfs,ext2,ext3,ext4,fat16,fat32,hfs,hfs,linux-swap,ntfs, oureiserfs. Le paramètre fs-type est facultatif. Notez que l'utilitairepartedne crée pas le système de fichiers sur la partition. -

Remplacez start et end par les tailles qui déterminent les points de départ et d'arrivée de la partition, en comptant à partir du début du disque. Vous pouvez utiliser des suffixes de taille, tels que

512MiB,20GiB, ou1.5TiB. La taille par défaut est en mégaoctets.

Exemple 4.2. Création d'une petite partition primaire

Pour créer une partition primaire de 1024MiB à 2048MiB sur une table MBR, utilisez :

# (parted) mkpart primary 1024MiB 2048MiB

Les modifications commencent à s'appliquer après la saisie de la commande.

-

Remplacez part-type par

Affichez la table de partition pour confirmer que la partition créée se trouve dans la table de partition avec le type de partition, le type de système de fichiers et la taille corrects :

# (parted) print

Quitter le shell

parted:# (parted) quit

Enregistrer le nouveau nœud de l'appareil :

# udevadm settle

Vérifiez que le noyau reconnaît la nouvelle partition :

# cat /proc/partitions

Ressources supplémentaires

4.4. Définir un type de partition avec fdisk

Vous pouvez définir un type de partition ou un drapeau à l'aide de l'utilitaire fdisk.

Conditions préalables

- Une partition sur le disque.

Procédure

Démarrer l'interpréteur de commandes interactif

fdisk:# fdisk block-deviceAffichez la table de partition actuelle pour déterminer le numéro de la partition mineure :

Commande (m pour l'aide) : printVous pouvez voir le type de partition actuel dans la colonne

Typeet son ID de type correspondant dans la colonneId.Entrez la commande de type de partition et sélectionnez une partition à l'aide de son numéro mineur :

Command (m for help): type Partition number (1,2,3 default 3): 2

Facultatif : Afficher la liste en codes hexadécimaux :

Code hexagonal (tapez L pour obtenir la liste de tous les codes) : LDéfinir le type de partition :

Code hexagonal (tapez L pour obtenir la liste de tous les codes) : 8eÉcrivez vos modifications et quittez le shell

fdisk:Command (m for help): write The partition table has been altered. Syncing disks.Vérifiez vos modifications :

# fdisk --list block-device

4.5. Redimensionnement d'une partition avec parted

À l'aide de l'utilitaire parted, étendez une partition pour utiliser l'espace disque inutilisé ou réduisez une partition pour utiliser sa capacité à d'autres fins.

Conditions préalables

- Sauvegardez les données avant de réduire une partition.

- Si la partition que vous souhaitez créer est supérieure à 2 To, formatez le disque à l'aide de la commande GUID Partition Table (GPT).

- Si vous souhaitez réduire la partition, réduisez d'abord le système de fichiers de manière à ce qu'il ne soit pas plus grand que la partition redimensionnée.

XFS ne prend pas en charge le rétrécissement.

Procédure

Lancez l'utilitaire

parted:# parted block-deviceAfficher la table de partition actuelle :

# (parted) print

À partir de la table de partition, déterminez

- Le numéro mineur de la partition.

- L'emplacement de la partition existante et son nouveau point d'arrivée après le redimensionnement.

Redimensionner la partition :

# (parted) resizepart 1 2GiB

- Remplacez 1 par le numéro mineur de la partition que vous redimensionnez.

-

Remplacez 2 par la taille qui détermine le nouveau point final de la partition redimensionnée, en comptant à partir du début du disque. Vous pouvez utiliser des suffixes de taille, tels que

512MiB,20GiB, ou1.5TiB. La taille par défaut est en mégaoctets.

Affichez la table de partition pour confirmer que la partition redimensionnée se trouve dans la table de partition avec la taille correcte :

# (parted) print

Quitter le shell

parted:# (parted) quit

Vérifiez que le noyau enregistre la nouvelle partition :

# cat /proc/partitions

- Facultatif : si vous avez étendu la partition, étendez également le système de fichiers qu'elle contient.

Ressources supplémentaires

4.6. Suppression d'une partition avec parted

À l'aide de l'utilitaire parted, vous pouvez supprimer une partition de disque pour libérer de l'espace disque.

La suppression d'une partition efface toutes les données qui y sont stockées.

Procédure

Démarrer l'interpréteur de commandes interactif

parted:# parted block-device-

Remplacez block-device par le chemin d'accès au périphérique sur lequel vous souhaitez supprimer une partition : par exemple,

/dev/sda.

-

Remplacez block-device par le chemin d'accès au périphérique sur lequel vous souhaitez supprimer une partition : par exemple,

Affichez la table de partition actuelle pour déterminer le numéro mineur de la partition à supprimer :

(parted) print

Retirer la partition :

(paré) rm minor-number- Remplacez minor-number par le numéro mineur de la partition que vous souhaitez supprimer.

Les modifications commencent à s'appliquer dès que vous entrez cette commande.

Vérifiez que vous avez supprimé la partition de la table de partition :

(parted) print

Quitter le shell

parted:(parted) quit

Vérifiez que le noyau enregistre la suppression de la partition :

# cat /proc/partitions

-

Supprimez la partition du fichier

/etc/fstab, si elle est présente. Trouvez la ligne qui déclare la partition supprimée et supprimez-la du fichier. Régénérez les unités de montage pour que votre système enregistre la nouvelle configuration

/etc/fstab:# systemctl daemon-reload

Si vous avez supprimé une partition d'échange ou des éléments de LVM, supprimez toutes les références à la partition dans la ligne de commande du noyau :

Liste les options actives du noyau et vérifie si l'une d'entre elles fait référence à la partition supprimée :

# grubby --info=ALL

Supprime les options du noyau qui font référence à la partition supprimée :

# grubby --update-kernel=ALL --remove-args="option"

Pour enregistrer les changements dans le système de démarrage anticipé, reconstruisez le système de fichiers

initramfs:# dracut --force --verbose

Ressources supplémentaires

-

parted(8)page de manuel

Chapitre 5. Stratégies de repartitionnement d'un disque

Il existe différentes approches pour repartitionner un disque. Parmi celles-ci, citons

- De l'espace libre non partitionné est disponible.

- Une partition inutilisée est disponible.

- Il y a de l'espace libre dans une partition activement utilisée.

Les exemples suivants sont simplifiés pour plus de clarté et ne reflètent pas la disposition exacte des partitions lors de l'installation de Red Hat Enterprise Linux.

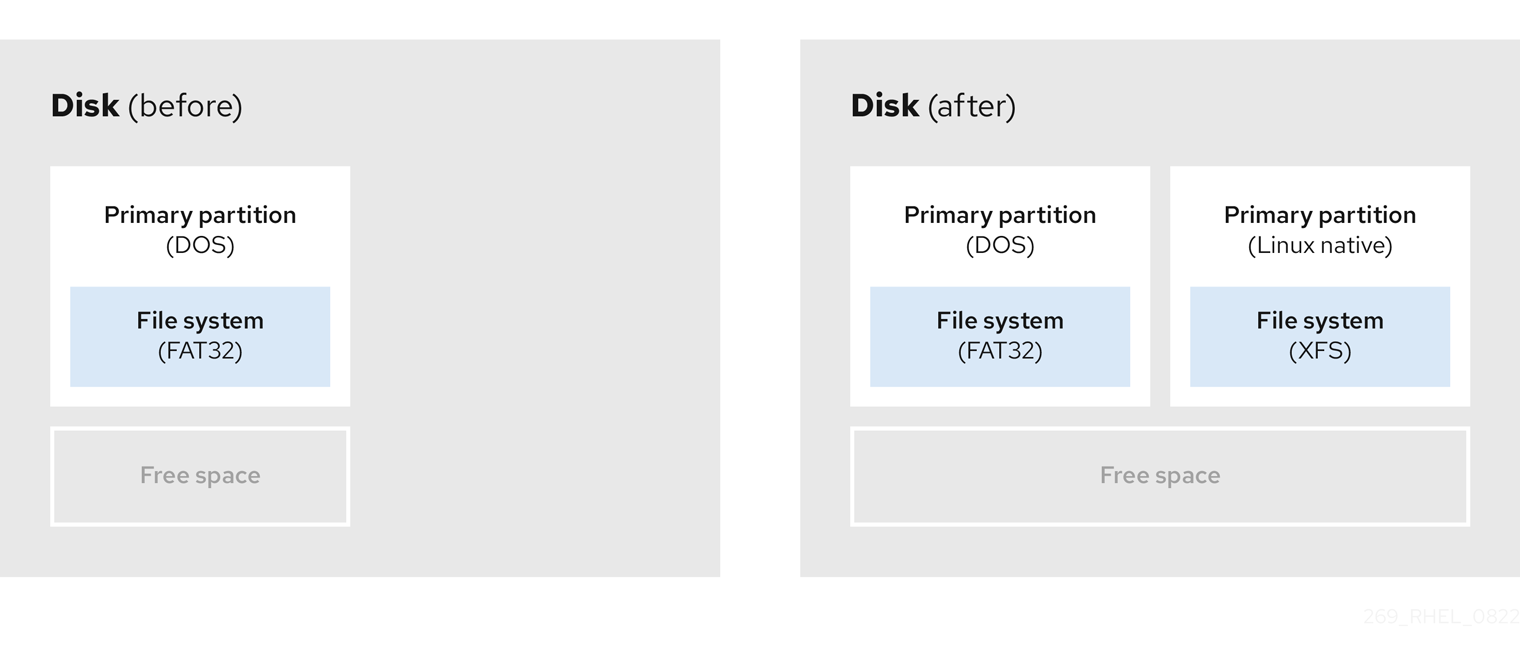

5.1. Utilisation de l'espace libre non partitionné

Les partitions déjà définies qui ne couvrent pas la totalité du disque dur laissent un espace non alloué qui ne fait partie d'aucune partition définie. Le diagramme suivant montre à quoi cela peut ressembler.

Figure 5.1. Disque avec espace libre non partitionné

Le premier diagramme représente un disque avec une partition primaire et une partition non définie avec de l'espace non alloué. Le deuxième diagramme représente un disque avec deux partitions définies avec de l'espace alloué.

Un disque dur inutilisé entre également dans cette catégorie. La seule différence est que all l'espace ne fait partie d'aucune partition définie.

Sur un nouveau disque, vous pouvez créer les partitions nécessaires à partir de l'espace inutilisé. La plupart des systèmes d'exploitation préinstallés sont configurés pour occuper tout l'espace disponible sur un disque.

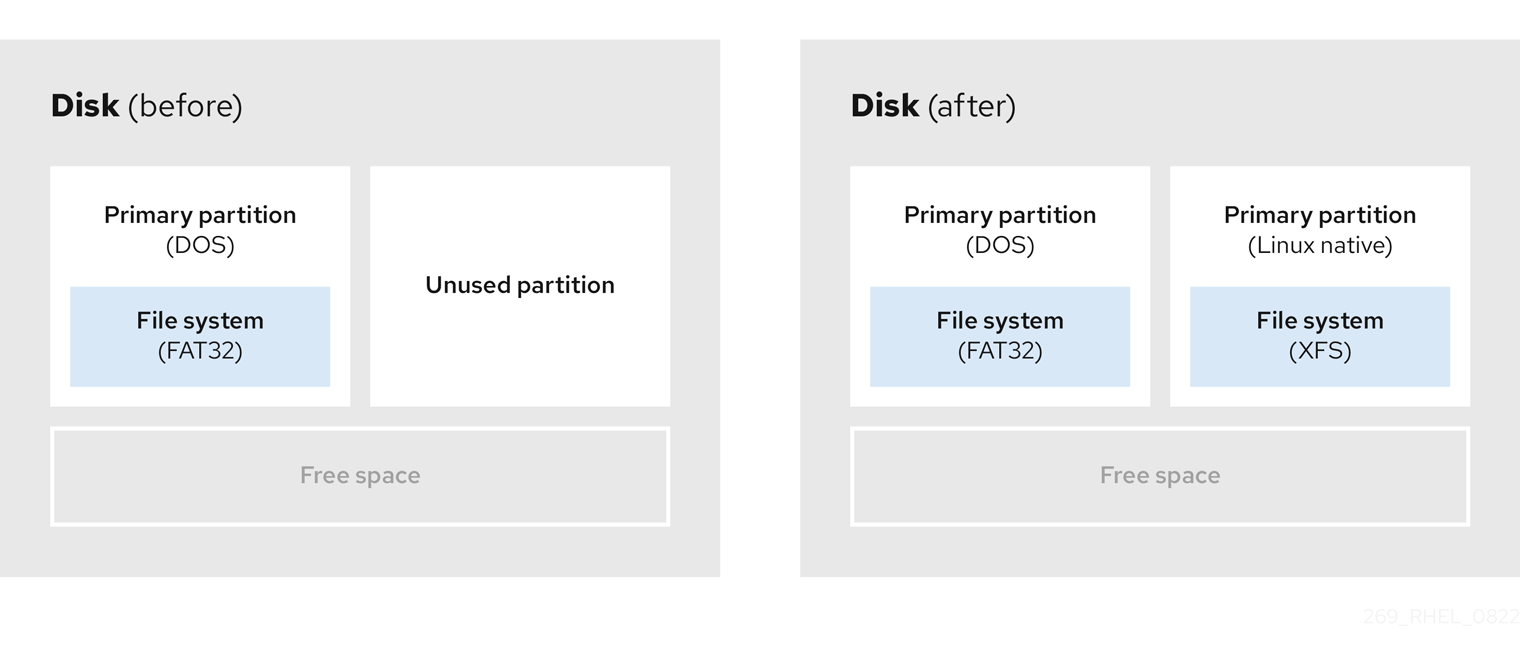

5.2. Utilisation de l'espace d'une partition inutilisée

Dans l'exemple suivant, le premier diagramme représente un disque avec une partition inutilisée. Le deuxième diagramme représente la réallocation d'une partition inutilisée pour Linux.

Figure 5.2. Disque avec une partition inutilisée

Pour utiliser l'espace alloué à la partition inutilisée, supprimez la partition et créez la partition Linux appropriée à la place. Vous pouvez également, au cours du processus d'installation, supprimer la partition inutilisée et créer manuellement de nouvelles partitions.

5.3. Utilisation de l'espace libre d'une partition active

Ce processus peut être difficile à gérer car une partition active, qui est déjà utilisée, contient l'espace libre nécessaire. Dans la plupart des cas, les disques durs des ordinateurs équipés de logiciels préinstallés contiennent une partition plus grande contenant le système d'exploitation et les données.

Si vous souhaitez utiliser un système d'exploitation (SE) sur une partition active, vous devez réinstaller le SE. Sachez que certains ordinateurs, qui incluent des logiciels préinstallés, ne comprennent pas de support d'installation pour réinstaller le système d'exploitation d'origine. Vérifiez si cela s'applique à votre système d'exploitation avant de détruire une partition d'origine et l'installation du système d'exploitation.

Pour optimiser l'utilisation de l'espace libre disponible, vous pouvez utiliser les méthodes de repartitionnement destructif ou non destructif.

5.3.1. Repartitionnement destructeur

Le repartitionnement destructif détruit la partition de votre disque dur et crée plusieurs partitions plus petites à la place. Sauvegardez toutes les données nécessaires de la partition d'origine, car cette méthode supprime l'intégralité du contenu.

Après avoir créé une partition plus petite pour votre système d'exploitation existant, vous pouvez.. :

- Réinstaller le logiciel.

- Restaurez vos données.

- Démarrez l'installation de Red Hat Enterprise Linux.

Le diagramme suivant est une représentation simplifiée de l'utilisation de la méthode de répartition destructive.

Figure 5.3. Action de repartitionnement destructive sur le disque

Cette méthode supprime toutes les données précédemment stockées dans la partition d'origine.

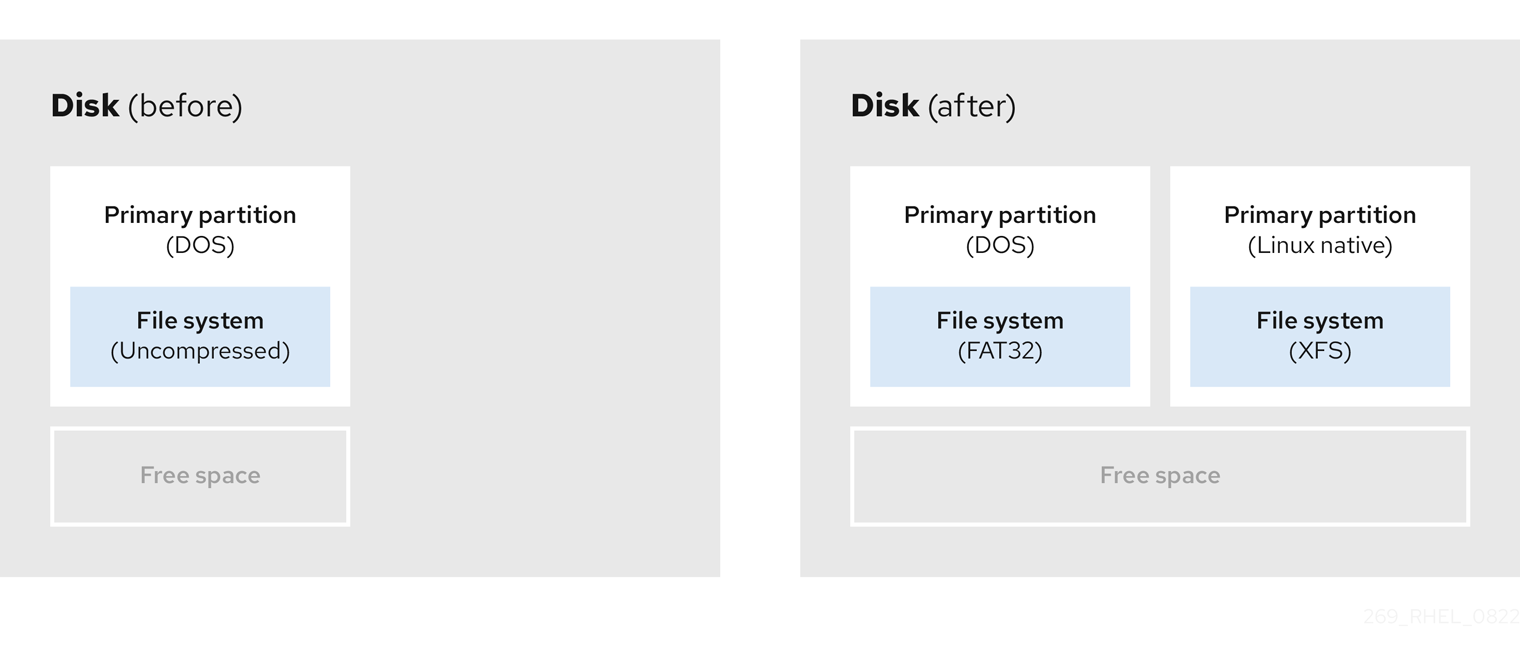

5.3.2. Repartitionnement non destructif

Le repartitionnement non destructif redimensionne les partitions, sans perte de données. Cette méthode est fiable, mais le temps de traitement est plus long pour les disques de grande taille.

Voici une liste de méthodes qui peuvent aider à initier un repartitionnement non destructif.

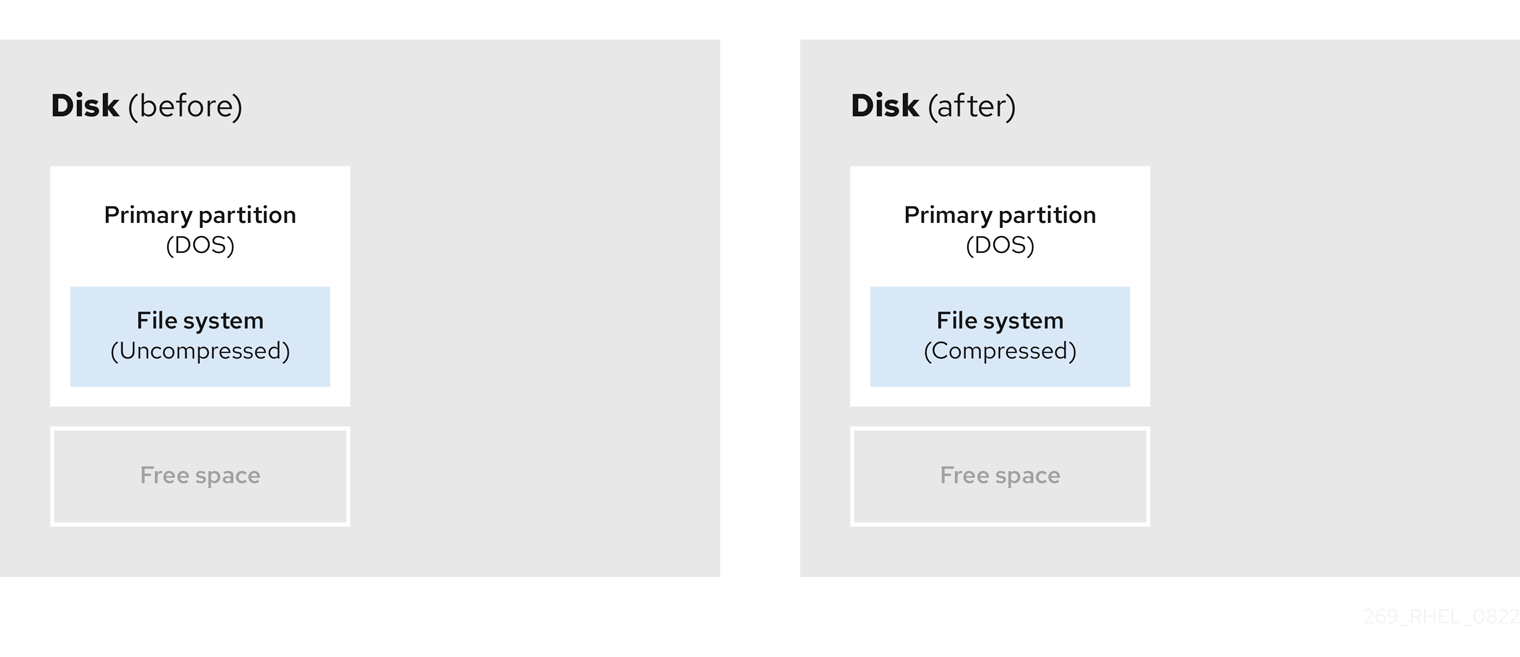

- Compression des données existantes

L'emplacement de stockage de certaines données ne peut être modifié. Cela peut empêcher le redimensionnement d'une partition à la taille requise et, en fin de compte, conduire à un processus de repartition destructeur. La compression des données dans une partition existante peut vous aider à redimensionner vos partitions en fonction des besoins. Elle peut également vous aider à maximiser l'espace libre disponible.

Le diagramme suivant est une représentation simplifiée de ce processus.

Figure 5.4. Compression des données sur un disque

Pour éviter toute perte de données, créez une sauvegarde avant de poursuivre le processus de compression.

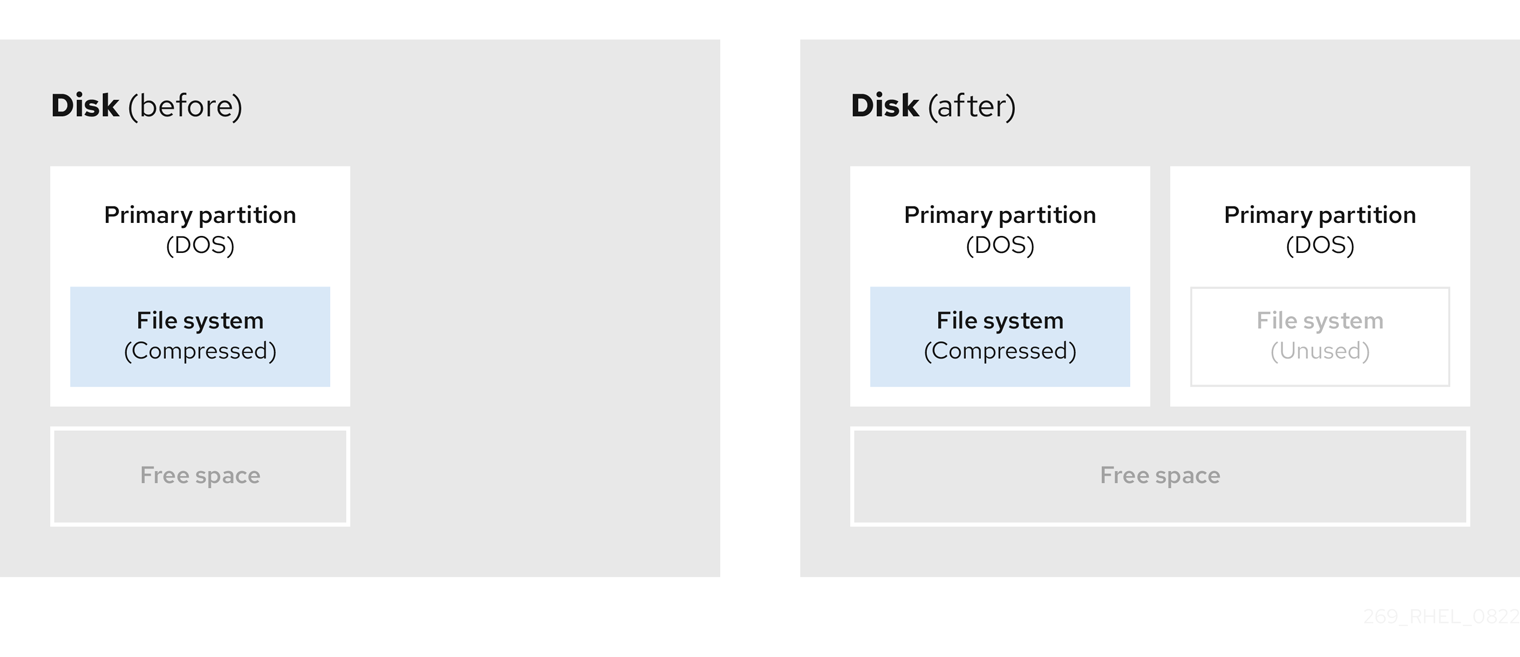

- Redimensionner la partition existante

En redimensionnant une partition existante, vous pouvez libérer de l'espace. Les résultats peuvent varier en fonction du logiciel de redimensionnement utilisé. Dans la majorité des cas, vous pouvez créer une nouvelle partition non formatée du même type que la partition d'origine.

Les étapes à suivre après le redimensionnement peuvent dépendre du logiciel que vous utilisez. Dans l'exemple suivant, la meilleure pratique consiste à supprimer la nouvelle partition DOS (Disk Operating System) et à créer une partition Linux à la place. Vérifiez ce qui convient le mieux à votre disque avant de lancer le processus de redimensionnement.

Figure 5.5. Redimensionnement d'une partition sur un disque

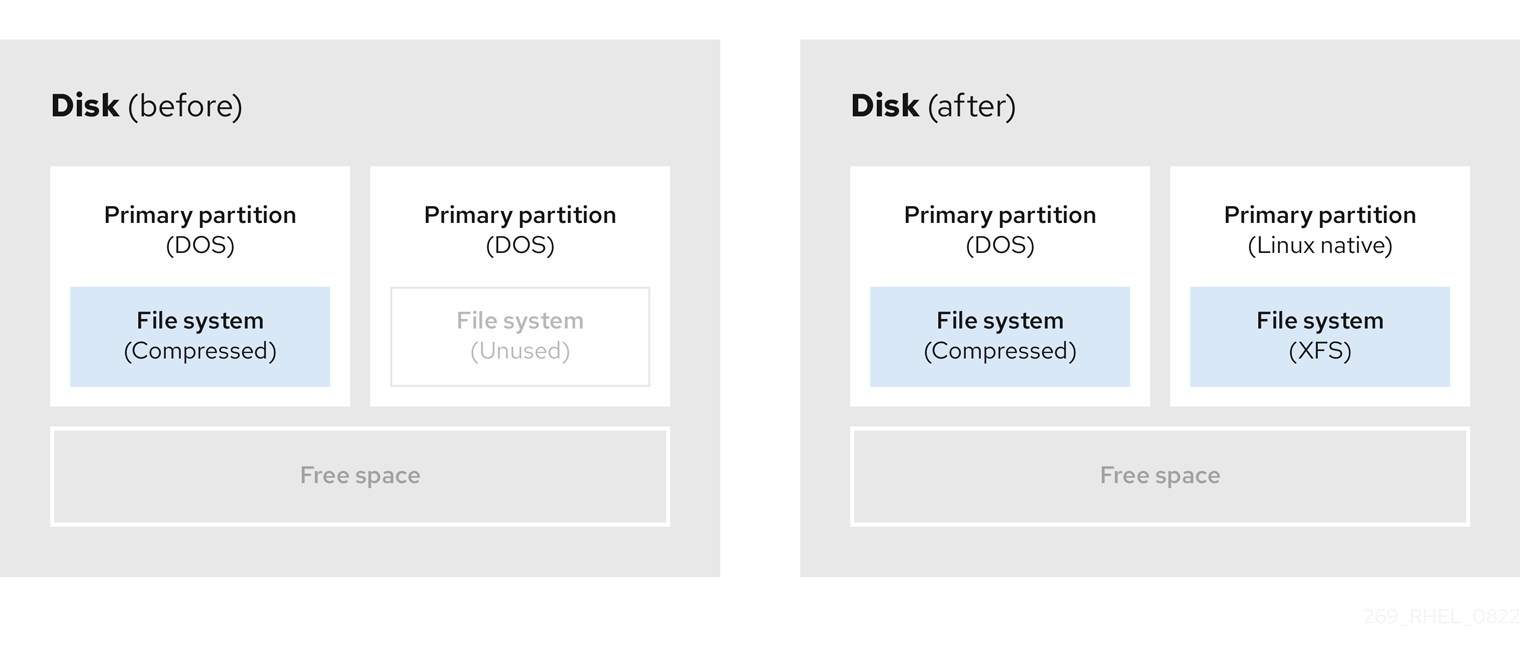

- Facultatif : Créer de nouvelles partitions

Certains logiciels de redimensionnement prennent en charge les systèmes basés sur Linux. Dans ce cas, il n'est pas nécessaire de supprimer la partition nouvellement créée après le redimensionnement. La création d'une nouvelle partition après le redimensionnement dépend du logiciel utilisé.

Le diagramme suivant représente l'état du disque avant et après la création d'une nouvelle partition.

Figure 5.6. Disque avec configuration finale de la partition

Chapitre 6. Configuration d'une cible iSCSI

Red Hat Enterprise Linux utilise l'interpréteur de commandes targetcli comme interface de ligne de commande pour effectuer les opérations suivantes :

- Ajouter, supprimer, visualiser et surveiller les interconnexions de stockage iSCSI pour utiliser le matériel iSCSI.

- Exporter vers des systèmes distants des ressources de stockage locales sauvegardées par des fichiers, des volumes, des périphériques SCSI locaux ou des disques RAM.

L'outil targetcli a une présentation arborescente et comprend une complétion de tabulation intégrée, un support d'auto-complétion et une documentation en ligne.

6.1. Installation de targetcli

Installez l'outil targetcli pour ajouter, surveiller et supprimer les interconnexions de stockage iSCSI.

Procédure

Installer l'outil

targetcli:# dnf install targetcli

Démarrer le service cible :

# systemctl start target

Configurer la cible pour qu'elle démarre au moment du démarrage :

# systemctl enable target

Ouvrez le port

3260dans le pare-feu et rechargez la configuration du pare-feu :# firewall-cmd --permanent --add-port=3260/tcp Success # firewall-cmd --reload Success

Vérification

Voir le site

targetcli:# targetcli /> ls o- /........................................[...] o- backstores.............................[...] | o- block.................[Storage Objects: 0] | o- fileio................[Storage Objects: 0] | o- pscsi.................[Storage Objects: 0] | o- ramdisk...............[Storage Objects: 0] o- iscsi...........................[Targets: 0] o- loopback........................[Targets: 0]

Ressources supplémentaires

-

targetcli(8)page de manuel

6.2. Création d'une cible iSCSI

La création d'une cible iSCSI permet à l'initiateur iSCSI du client d'accéder aux périphériques de stockage du serveur. Les cibles et les initiateurs ont tous deux des noms d'identification uniques.

Conditions préalables

-

Installation et exécution de

targetcli. Pour plus d'informations, voir Installation de targetcli.

Procédure

Naviguez jusqu'au répertoire iSCSI :

/> iscsi/

NoteLa commande

cdest utilisée pour changer de répertoire ainsi que pour répertorier le chemin à emprunter.Utilisez l'une des options suivantes pour créer une cible iSCSI :

Création d'une cible iSCSI à l'aide d'un nom de cible par défaut :

/iscsi> create Created target iqn.2003-01.org.linux-iscsi.hostname.x8664:sn.78b473f296ff Created TPG1

Création d'une cible iSCSI à l'aide d'un nom spécifique :

/iscsi> create iqn.2006-04.com.example:444 Created target iqn.2006-04.com.example:444 Created TPG1 Here

iqn.2006-04.com.example:444is target_iqn_nameRemplacer iqn.2006-04.com.example:444 par le nom spécifique de la cible.

Vérifier la cible nouvellement créée :

/iscsi> ls o- iscsi.......................................[1 Target] o- iqn.2006-04.com.example:444................[1 TPG] o- tpg1...........................[enabled, auth] o- acls...............................[0 ACL] o- luns...............................[0 LUN] o- portals.........................[0 Portal]

Ressources supplémentaires

-

targetcli(8)page de manuel

6.3. backstore iSCSI

Un backstore iSCSI permet de prendre en charge différentes méthodes de stockage des données d'un LUN exporté sur la machine locale. La création d'un objet de stockage définit les ressources utilisées par le backstore.

Un administrateur peut choisir l'un des périphériques de stockage suivants pris en charge par Linux-IO (LIO) :

fileiobackstore-

Créez un objet de stockage

fileiosi vous utilisez des fichiers ordinaires du système de fichiers local comme images disque. Pour créer un backstorefileio, voir Création d'un objet de stockage fileio. blockbackstore-

Créez un objet de stockage

blocksi vous utilisez un périphérique bloc local et un périphérique logique. Pour créer un backstoreblock, voir Création d'un objet de stockage en bloc. pscsibackstore-

Créez un objet de stockage

pscsisi votre objet de stockage prend en charge la transmission directe des commandes SCSI. Pour créer un backstorepscsi, voir Création d'un objet de stockage pscsi. ramdiskbackstore-

Créez un objet de stockage

ramdisksi vous souhaitez créer un périphérique RAM temporaire. Pour créer un backstoreramdisk, voir Création d'un objet de stockage disque RAM Memory Copy.

Ressources supplémentaires

-

targetcli(8)page de manuel

6.4. Création d'un objet de stockage fileio

fileio peuvent prendre en charge les opérations write_back ou write_thru. L'opération write_back active le cache du système de fichiers local. Elle améliore les performances mais augmente le risque de perte de données.

Il est recommandé d'utiliser write_back=false pour désactiver l'opération write_back au profit de l'opération write_thru.

Conditions préalables

-

Installation et exécution de

targetcli. Pour plus d'informations, voir Installation de targetcli.

Procédure

Naviguez vers le site

fileio/à partir du répertoirebackstores/:/> backstores/fileio

Créer un objet de stockage

fileio:/backstores/fileio> create file1 /tmp/disk1.img 200M write_back=false Created fileio file1 with size 209715200

Vérification

Vérifiez l'objet de stockage

fileiocréé :/backstores/fileio> ls

Ressources supplémentaires

-

targetcli(8)page de manuel

6.5. Création d'un objet de stockage en bloc

Le pilote de bloc permet d'utiliser avec Linux-IO (LIO) n'importe quel périphérique de bloc apparaissant dans le répertoire /sys/block/. Cela inclut les périphériques physiques tels que les disques durs, les disques SSD, les CD et les DVD, et les périphériques logiques tels que les volumes RAID logiciels ou matériels, ou les volumes LVM.

Conditions préalables

-

Installation et exécution de

targetcli. Pour plus d'informations, voir Installation de targetcli.

Procédure

Naviguez vers le site

block/à partir du répertoirebackstores/:/> backstores/block/

Créer un backstore

block:/backstores/block> create name=block_backend dev=/dev/sdb Generating a wwn serial. Created block storage object block_backend using /dev/vdb.

Vérification

Vérifiez l'objet de stockage

blockcréé :/backstores/block> ls

NoteVous pouvez également créer un backstore

blocksur un volume logique.

Ressources supplémentaires

-

targetcli(8)page de manuel

6.6. Création d'un objet de stockage pscsi

Vous pouvez configurer, en tant que backstore, tout objet de stockage qui prend en charge la transmission directe des commandes SCSI sans émulation SCSI, et avec un périphérique SCSI sous-jacent qui apparaît avec lsscsi dans le site /proc/scsi/scsi, tel qu'un disque dur SAS. Ce sous-système prend en charge les systèmes SCSI-3 et supérieurs.

pscsi ne doivent être utilisées que par des utilisateurs expérimentés. Les commandes SCSI avancées telles que l'affectation d'unités logiques asymétriques (ALUA) ou les réservations persistantes (par exemple, celles utilisées par VMware ESX et vSphere) ne sont généralement pas implémentées dans le micrologiciel du périphérique et peuvent provoquer des dysfonctionnements ou des pannes. En cas de doute, utilisez plutôt block backstore pour les configurations de production.

Conditions préalables

-

Installation et exécution de

targetcli. Pour plus d'informations, voir Installation de targetcli.

Procédure

Naviguez vers le site

pscsi/à partir du répertoirebackstores/:/> backstores/pscsi/

Créez un backstore

pscsipour un périphérique SCSI physique, un périphérique TYPE_ROM utilisant/dev/sr0dans cet exemple :/backstores/pscsi> create name=pscsi_backend dev=/dev/sr0 Generating a wwn serial. Created pscsi storage object pscsi_backend using /dev/sr0

Vérification

Vérifiez l'objet de stockage

pscsicréé :/backstores/pscsi> ls

Ressources supplémentaires

-

targetcli(8)page de manuel

6.7. Création d'un objet de stockage sur disque RAM de type Memory Copy

Les disques RAM à copie de mémoire (ramdisk) fournissent des disques RAM avec une émulation SCSI complète et des mappages de mémoire séparés utilisant la copie de mémoire pour les initiateurs. Cela permet des sessions multiples et est particulièrement utile pour un stockage de masse rapide et volatile à des fins de production.

Conditions préalables

-

Installation et exécution de

targetcli. Pour plus d'informations, voir Installation de targetcli.

Procédure

Naviguez vers le site

ramdisk/à partir du répertoirebackstores/:/> backstores/ramdisk/

Créez un disque RAM backstore de 1 Go :

/backstores/ramdisk> create name=rd_backend size=1GB Generating a wwn serial. Created rd_mcp ramdisk rd_backend with size 1GB.

Vérification

Vérifiez l'objet de stockage

ramdiskcréé :/backstores/ramdisk> ls

Ressources supplémentaires

-

targetcli(8)page de manuel

6.8. Création d'un portail iSCSI

La création d'un portail iSCSI ajoute une adresse IP et un port à la cible qui reste activée.

Conditions préalables

-

Installation et exécution de

targetcli. Pour plus d'informations, voir Installation de targetcli. - Une cible iSCSI associée à un groupe de portail cible (TPG). Pour plus d'informations, voir Création d'une cible iSCSI.

Procédure

Naviguez jusqu'au répertoire TPG :

/iscsi> iqn.2006-04.example:444/tpg1/

Utilisez l'une des options suivantes pour créer un portail iSCSI :

La création d'un portail par défaut utilise le port iSCSI par défaut