Gestion des systèmes de fichiers

Créer, modifier et administrer des systèmes de fichiers dans Red Hat Enterprise Linux 9

Résumé

Rendre l'open source plus inclusif

Red Hat s'engage à remplacer les termes problématiques dans son code, sa documentation et ses propriétés Web. Nous commençons par ces quatre termes : master, slave, blacklist et whitelist. En raison de l'ampleur de cette entreprise, ces changements seront mis en œuvre progressivement au cours de plusieurs versions à venir. Pour plus de détails, voir le message de notre directeur technique Chris Wright.

Fournir un retour d'information sur la documentation de Red Hat

Nous apprécions vos commentaires sur notre documentation. Faites-nous savoir comment nous pouvons l'améliorer.

Soumettre des commentaires sur des passages spécifiques

- Consultez la documentation au format Multi-page HTML et assurez-vous que le bouton Feedback apparaît dans le coin supérieur droit après le chargement complet de la page.

- Utilisez votre curseur pour mettre en évidence la partie du texte que vous souhaitez commenter.

- Cliquez sur le bouton Add Feedback qui apparaît près du texte en surbrillance.

- Ajoutez vos commentaires et cliquez sur Submit.

Soumettre des commentaires via Bugzilla (compte requis)

- Connectez-vous au site Web de Bugzilla.

- Sélectionnez la version correcte dans le menu Version.

- Saisissez un titre descriptif dans le champ Summary.

- Saisissez votre suggestion d'amélioration dans le champ Description. Incluez des liens vers les parties pertinentes de la documentation.

- Cliquez sur Submit Bug.

Chapitre 1. Aperçu des systèmes de fichiers disponibles

Le choix du système de fichiers approprié à votre application est une décision importante en raison du grand nombre d'options disponibles et des compromis qu'elles impliquent.

Les sections suivantes décrivent les systèmes de fichiers que Red Hat Enterprise Linux 9 inclut par défaut, ainsi que des recommandations sur le système de fichiers le plus approprié pour votre application.

1.1. Types de systèmes de fichiers

Red Hat Enterprise Linux 9 prend en charge une variété de systèmes de fichiers (FS). Les différents types de systèmes de fichiers résolvent différents types de problèmes, et leur utilisation est spécifique à l'application. Au niveau le plus général, les systèmes de fichiers disponibles peuvent être regroupés dans les principaux types suivants :

Tableau 1.1. Types de systèmes de fichiers et leurs cas d'utilisation

| Type | Système de fichiers | Attributs et cas d'utilisation |

|---|---|---|

| Disque ou FS local | XFS | XFS est le système de fichiers par défaut de RHEL. Étant donné qu'il présente les fichiers sous forme d'extensions, il est moins vulnérable à la fragmentation que ext4. Red Hat recommande de déployer XFS en tant que système de fichiers local à moins qu'il n'y ait des raisons spécifiques de faire autrement : par exemple, la compatibilité ou des cas particuliers concernant la performance. |

| ext4 | ext4 a l'avantage de la longévité sous Linux. Par conséquent, il est pris en charge par presque toutes les applications Linux. Dans la plupart des cas, il rivalise avec XFS en termes de performances. ext4 est couramment utilisé pour les répertoires personnels. | |

| FS en réseau ou client-serveur | NFS | Utiliser NFS pour partager des fichiers entre plusieurs systèmes sur le même réseau. |

| PME | Utiliser SMB pour le partage de fichiers avec les systèmes Microsoft Windows. | |

| Stockage partagé ou disque partagé FS | GFS2 | GFS2 fournit un accès partagé en écriture aux membres d'une grappe de calcul. L'accent est mis sur la stabilité et la fiabilité, avec l'expérience fonctionnelle d'un système de fichiers local autant que possible. SAS Grid, Tibco MQ, IBM Websphere MQ et Red Hat Active MQ ont été déployés avec succès sur GFS2. |

| FS à gestion de volume | Stratis (aperçu technologique) | Stratis est un gestionnaire de volume basé sur une combinaison de XFS et de LVM. L'objectif de Stratis est d'émuler les capacités offertes par les systèmes de fichiers de gestion de volume tels que Btrfs et ZFS. Il est possible de construire cette pile manuellement, mais Stratis réduit la complexité de la configuration, met en œuvre les meilleures pratiques et consolide les informations d'erreur. |

1.2. Systèmes de fichiers locaux

Les systèmes de fichiers locaux sont des systèmes de fichiers qui s'exécutent sur un seul serveur local et sont directement attachés au stockage.

Par exemple, un système de fichiers local est le seul choix possible pour les disques internes SATA ou SAS, et il est utilisé lorsque votre serveur dispose de contrôleurs RAID matériels internes avec des disques locaux. Les systèmes de fichiers locaux sont également les systèmes de fichiers les plus couramment utilisés sur le stockage attaché au SAN lorsque le périphérique exporté sur le SAN n'est pas partagé.

Tous les systèmes de fichiers locaux sont conformes à POSIX et sont entièrement compatibles avec toutes les versions de Red Hat Enterprise Linux prises en charge. Les systèmes de fichiers conformes à POSIX prennent en charge un ensemble bien défini d'appels système, tels que read(), write(), et seek().

Du point de vue du programmeur d'applications, il y a relativement peu de différences entre les systèmes de fichiers locaux. Les différences les plus notables du point de vue de l'utilisateur sont liées à l'évolutivité et aux performances. Lorsque vous envisagez de choisir un système de fichiers, réfléchissez à sa taille, aux caractéristiques uniques qu'il doit posséder et à ses performances dans le cadre de votre charge de travail.

- Systèmes de fichiers locaux disponibles

- XFS

- ext4

1.3. Le système de fichiers XFS

XFS est un système de fichiers de journalisation 64 bits hautement évolutif, performant, robuste et mature qui prend en charge des fichiers et des systèmes de fichiers très volumineux sur un seul hôte. Il s'agit du système de fichiers par défaut de Red Hat Enterprise Linux 9. XFS a été développé au début des années 1990 par SGI et fonctionne depuis longtemps sur des serveurs et des baies de stockage de très grande taille.

Les caractéristiques de XFS sont les suivantes

- Fiabilité

- La journalisation des métadonnées, qui garantit l'intégrité du système de fichiers après une panne du système en conservant un enregistrement des opérations du système de fichiers qui peut être rejoué lorsque le système est redémarré et que le système de fichiers est remonté

- Contrôle étendu de la cohérence des métadonnées au moment de l'exécution

- Utilitaires de réparation évolutifs et rapides

- Journalisation des quotas. Cela évite d'avoir à effectuer de longs contrôles de cohérence des quotas après une panne.

- Évolutivité et performance

- Taille du système de fichiers pris en charge jusqu'à 1024 TiB

- Capacité à prendre en charge un grand nombre d'opérations simultanées

- Indexation B-tree pour l'extensibilité de la gestion de l'espace libre

- Algorithmes sophistiqués de lecture anticipée des métadonnées

- Optimisations pour les charges de travail liées à la vidéo en continu

- Systèmes d'allocation

- Allocation basée sur l'étendue

- Politiques d'allocation tenant compte des bandes

- Attribution retardée

- Pré-affectation de l'espace

- Inodes alloués dynamiquement

- Autres caractéristiques

- Copies de fichiers basées sur des liens hypertextes

- Utilitaires de sauvegarde et de restauration étroitement intégrés

- Défragmentation en ligne

- Croissance du système de fichiers en ligne

- Capacités de diagnostic complètes

-

Attributs étendus (

xattr). Cela permet au système d'associer plusieurs paires nom/valeur supplémentaires par fichier. - Quotas de projet ou de répertoire. Cela permet de restreindre les quotas sur une arborescence de répertoires.

- Horodatage à la seconde près

Caractéristiques de performance

XFS est très performant sur les grands systèmes avec des charges de travail d'entreprise. Un système de grande taille est un système doté d'un nombre relativement élevé de CPU, de plusieurs HBA et de connexions à des baies de disques externes. XFS est également performant sur les systèmes plus petits qui ont une charge de travail d'E/S parallèle et multithread.

XFS est relativement peu performant pour les charges de travail à fil unique et à forte intensité de métadonnées : par exemple, une charge de travail qui crée ou supprime un grand nombre de petits fichiers en un seul fil.

1.4. Le système de fichiers ext4

Le système de fichiers ext4 est la quatrième génération de la famille des systèmes de fichiers ext. Il s'agit du système de fichiers par défaut dans Red Hat Enterprise Linux 6.

Le pilote ext4 peut lire et écrire sur les systèmes de fichiers ext2 et ext3, mais le format du système de fichiers ext4 n'est pas compatible avec les pilotes ext2 et ext3.

ext4 ajoute plusieurs fonctionnalités nouvelles et améliorées, telles que

- Taille du système de fichiers pris en charge : jusqu'à 50 TiB

- Métadonnées basées sur l'étendue

- Attribution retardée

- Somme de contrôle du journal

- Grand support de stockage

Les métadonnées basées sur l'étendue et les fonctions d'allocation différée offrent un moyen plus compact et plus efficace de suivre l'espace utilisé dans un système de fichiers. Ces fonctionnalités améliorent les performances du système de fichiers et réduisent l'espace consommé par les métadonnées. L'allocation différée permet au système de fichiers de différer la sélection de l'emplacement permanent des données utilisateur nouvellement écrites jusqu'à ce que les données soient transférées sur le disque. Cela permet d'améliorer les performances, car les allocations sont plus importantes et plus contiguës, ce qui permet au système de fichiers de prendre des décisions sur la base d'informations plus précises.

Le temps de réparation du système de fichiers à l'aide de l'utilitaire fsck dans ext4 est beaucoup plus rapide que dans ext2 et ext3. Certaines réparations de systèmes de fichiers ont permis de multiplier les performances par six.

1.5. Comparaison entre XFS et ext4

XFS est le système de fichiers par défaut de RHEL. Cette section compare l'utilisation et les fonctionnalités de XFS et ext4.

- Comportement en cas d'erreur de métadonnées

-

Dans ext4, vous pouvez configurer le comportement lorsque le système de fichiers rencontre des erreurs de métadonnées. Le comportement par défaut consiste à poursuivre l'opération. Lorsque XFS rencontre une erreur de métadonnées irrécupérable, il ferme le système de fichiers et renvoie l'erreur

EFSCORRUPTED. - Quotas

Dans ext4, vous pouvez activer les quotas lors de la création du système de fichiers ou ultérieurement sur un système de fichiers existant. Vous pouvez ensuite configurer l'application des quotas à l'aide d'une option de montage.

Les quotas XFS ne sont pas une option de remontage. Vous devez activer les quotas lors du montage initial.

L'exécution de la commande

quotachecksur un système de fichiers XFS n'a aucun effet. La première fois que vous activez la comptabilisation des quotas, XFS vérifie automatiquement les quotas.- Redimensionnement du système de fichiers

- XFS ne dispose d'aucun utilitaire permettant de réduire la taille d'un système de fichiers. Vous ne pouvez qu'augmenter la taille d'un système de fichiers XFS. En comparaison, ext4 permet à la fois d'étendre et de réduire la taille d'un système de fichiers.

- Numéros d'inodes

Le système de fichiers ext4 ne prend pas en charge plus de232 inodes.

XFS alloue dynamiquement des inodes. Un système de fichiers XFS ne peut pas manquer d'inodes tant qu'il y a de l'espace libre sur le système de fichiers.

Certaines applications ne peuvent pas gérer correctement les numéros d'inodes supérieurs à232 sur un système de fichiers XFS. Ces applications peuvent entraîner l'échec des appels stat 32 bits avec la valeur de retour

EOVERFLOW. Le numéro d'inode dépasse232 dans les conditions suivantes :- Le système de fichiers est supérieur à 1 TiB avec des inodes de 256 octets.

- Le système de fichiers est supérieur à 2 TiB avec des inodes de 512 octets.

Si votre application échoue avec de grands nombres d'inodes, montez le système de fichiers XFS avec l'option

-o inode32pour imposer des nombres d'inodes inférieurs à232. Notez que l'utilisation de l'optioninode32n'affecte pas les inodes déjà alloués avec des numéros de 64 bits.Importantnot N'utilisez pas l'option

inode32à moins qu'un environnement spécifique ne l'exige. L'optioninode32modifie le comportement de l'allocation. Par conséquent, l'erreurENOSPCpeut se produire si aucun espace n'est disponible pour allouer des inodes dans les blocs de disque inférieurs.

1.6. Choix d'un système de fichiers local

Pour choisir un système de fichiers qui réponde aux exigences de votre application, vous devez comprendre le système cible sur lequel vous allez déployer le système de fichiers. Les questions suivantes peuvent vous aider à prendre votre décision :

- Avez-vous un grand serveur ?

- Vous avez des besoins importants en matière de stockage ou vous disposez d'un disque SATA local et lent ?

- Quel type de charge de travail d'E/S attendez-vous de votre application ?

- Quels sont vos besoins en termes de débit et de latence ?

- Quelle est la stabilité de votre serveur et de votre matériel de stockage ?

- Quelle est la taille habituelle de vos fichiers et de vos données ?

- En cas de défaillance du système, combien de temps d'arrêt pouvez-vous subir ?

Si votre serveur et votre périphérique de stockage sont de grande taille, XFS est le meilleur choix. Même avec des baies de stockage plus petites, XFS fonctionne très bien lorsque la taille moyenne des fichiers est importante (par exemple, des centaines de mégaoctets).

Si votre charge de travail actuelle a bien fonctionné avec ext4, vous et vos applications devraient bénéficier d'un environnement très familier.

Le système de fichiers ext4 a tendance à mieux fonctionner sur les systèmes dont la capacité d'E/S est limitée. Il est plus performant sur une bande passante limitée (moins de 200 Mo/s) et jusqu'à une capacité d'environ 1 000 IOPS. Pour tout ce qui a une capacité supérieure, XFS a tendance à être plus rapide.

XFS consomme environ deux fois plus de CPU par opération de métadonnées que ext4, donc si vous avez une charge de travail liée au CPU avec peu de concurrence, ext4 sera plus rapide. En général, ext4 est meilleur si une application utilise un seul thread de lecture/écriture et des fichiers de petite taille, tandis que XFS brille lorsqu'une application utilise plusieurs threads de lecture/écriture et des fichiers plus volumineux.

Vous ne pouvez pas réduire un système de fichiers XFS. Si vous avez besoin de pouvoir réduire le système de fichiers, envisagez d'utiliser ext4, qui prend en charge la réduction hors ligne.

En général, Red Hat vous recommande d'utiliser XFS à moins que vous n'ayez un cas d'utilisation spécifique pour ext4. Vous devriez également mesurer les performances de votre application spécifique sur votre serveur cible et votre système de stockage afin de vous assurer que vous choisissez le type de système de fichiers approprié.

Tableau 1.2. Résumé des recommandations relatives aux systèmes de fichiers locaux

| Scénario | Système de fichiers recommandé |

|---|---|

| Pas de cas d'utilisation particulier | XFS |

| Grand serveur | XFS |

| Dispositifs de stockage de grande taille | XFS |

| Fichiers volumineux | XFS |

| E/S multithreadées | XFS |

| E/S monotâches | ext4 |

| Capacité d'E/S limitée (moins de 1000 IOPS) | ext4 |

| Largeur de bande limitée (moins de 200 Mo/s) | ext4 |

| Charge de travail liée à l'unité centrale | ext4 |

| Prise en charge de la réduction hors ligne | ext4 |

1.7. Systèmes de fichiers en réseau

Les systèmes de fichiers en réseau, également appelés systèmes de fichiers client/serveur, permettent aux systèmes clients d'accéder aux fichiers stockés sur un serveur partagé. Cela permet à plusieurs utilisateurs sur plusieurs systèmes de partager des fichiers et des ressources de stockage.

Ces systèmes de fichiers sont construits à partir d'un ou plusieurs serveurs qui exportent un ensemble de systèmes de fichiers vers un ou plusieurs clients. Les nœuds clients n'ont pas accès au stockage en bloc sous-jacent, mais interagissent avec le stockage à l'aide d'un protocole qui permet un meilleur contrôle d'accès.

- Systèmes de fichiers réseau disponibles

- Le système de fichiers client/serveur le plus courant pour les clients RHEL est le système de fichiers NFS. RHEL fournit à la fois un composant serveur NFS pour exporter un système de fichiers local sur le réseau et un client NFS pour importer ces systèmes de fichiers.

- RHEL comprend également un client CIFS qui prend en charge les célèbres serveurs de fichiers Microsoft SMB pour l'interopérabilité avec Windows. Le serveur Samba de l'espace utilisateur fournit aux clients Windows un service Microsoft SMB à partir d'un serveur RHEL.

1.8. Systèmes de fichiers à stockage partagé

Les systèmes de fichiers à stockage partagé, parfois appelés systèmes de fichiers en grappe, permettent à chaque serveur de la grappe d'accéder directement à un périphérique de bloc partagé via un réseau de stockage local (SAN).

- Comparaison avec les systèmes de fichiers en réseau

- Comme les systèmes de fichiers client/serveur, les systèmes de fichiers à stockage partagé fonctionnent sur un ensemble de serveurs qui sont tous membres d'une grappe. Toutefois, contrairement à NFS, aucun serveur ne fournit d'accès aux données ou aux métadonnées aux autres membres : chaque membre de la grappe a un accès direct au même périphérique de stockage ( shared storage) et tous les nœuds de la grappe accèdent au même ensemble de fichiers.

- Concurrence

La cohérence du cache est essentielle dans un système de fichiers en grappe pour garantir la cohérence et l'intégrité des données. Il doit exister une version unique de tous les fichiers d'une grappe, visible par tous les nœuds de la grappe. Le système de fichiers doit empêcher les membres de la grappe de mettre à jour le même bloc de stockage en même temps et de provoquer une corruption des données. Pour ce faire, les systèmes de fichiers à stockage partagé utilisent un mécanisme de verrouillage large de la grappe pour arbitrer l'accès au stockage en tant que mécanisme de contrôle de la concurrence. Par exemple, avant de créer un nouveau fichier ou d'écrire dans un fichier ouvert sur plusieurs serveurs, le composant du système de fichiers sur le serveur doit obtenir le bon verrou.

Les systèmes de fichiers en grappe doivent fournir un service hautement disponible tel qu'un serveur web Apache. Tout membre de la grappe aura une vue parfaitement cohérente des données stockées dans leur système de fichiers sur disque partagé, et toutes les mises à jour seront arbitrées correctement par les mécanismes de verrouillage.

- Caractéristiques de performance

Les systèmes de fichiers à disque partagé ne sont pas toujours aussi performants que les systèmes de fichiers locaux fonctionnant sur le même système, en raison du coût de calcul de la surcharge de verrouillage. Les systèmes de fichiers à disque partagé fonctionnent bien avec les charges de travail où chaque nœud écrit presque exclusivement sur un ensemble particulier de fichiers qui ne sont pas partagés avec d'autres nœuds ou lorsqu'un ensemble de fichiers est partagé presque exclusivement en lecture seule sur un ensemble de nœuds. Il en résulte un minimum d'invalidation du cache entre les nœuds, ce qui permet d'optimiser les performances.

La mise en place d'un système de fichiers sur disque partagé est complexe, et le réglage d'une application pour qu'elle fonctionne bien sur un système de fichiers sur disque partagé peut s'avérer difficile.

- Systèmes de fichiers de stockage partagé disponibles

- Red Hat Enterprise Linux fournit le système de fichiers GFS2. GFS2 est étroitement intégré au module complémentaire de haute disponibilité de Red Hat Enterprise Linux et au module complémentaire de stockage résilient.

Red Hat Enterprise Linux prend en charge GFS2 sur des grappes dont la taille varie de 2 à 16 nœuds.

1.9. Choisir entre les systèmes de fichiers en réseau et les systèmes de fichiers à stockage partagé

Lorsque vous choisissez entre un système de fichiers en réseau et un système de stockage partagé, tenez compte des points suivants :

- Les systèmes de fichiers en réseau basés sur NFS sont un choix extrêmement courant et populaire pour les environnements qui fournissent des serveurs NFS.

- Les systèmes de fichiers en réseau peuvent être déployés à l'aide de technologies de réseau à très hautes performances comme Infiniband ou 10 Gigabit Ethernet. Cela signifie que vous ne devriez pas vous tourner vers des systèmes de fichiers de stockage partagé uniquement pour obtenir une bande passante brute vers votre stockage. Si la vitesse d'accès est primordiale, utilisez NFS pour exporter un système de fichiers local tel que XFS.

- Les systèmes de fichiers à stockage partagé ne sont pas faciles à mettre en place ou à maintenir, c'est pourquoi vous ne devez les déployer que lorsque vous ne pouvez pas assurer la disponibilité requise avec des systèmes de fichiers locaux ou en réseau.

- Un système de fichiers de stockage partagé dans un environnement en grappe permet de réduire les temps d'arrêt en éliminant les étapes de démontage et de montage qui doivent être effectuées lors d'un scénario typique de basculement impliquant le déplacement d'un service à haute disponibilité.

Red Hat vous recommande d'utiliser des systèmes de fichiers réseau à moins que vous ne disposiez d'un cas d'utilisation spécifique pour les systèmes de fichiers de stockage partagé. Utilisez les systèmes de fichiers de stockage partagé principalement pour les déploiements qui doivent fournir des services de haute disponibilité avec un temps d'arrêt minimal et qui ont des exigences strictes en matière de niveau de service.

1.10. Systèmes de fichiers gérant les volumes

Les systèmes de fichiers à gestion de volume intègrent l'ensemble de la pile de stockage à des fins de simplicité et d'optimisation de la pile.

- Systèmes de fichiers disponibles pour la gestion des volumes

- Red Hat Enterprise Linux 9 fournit le gestionnaire de volume Stratis en tant qu'aperçu technologique. Stratis utilise XFS comme couche de système de fichiers et l'intègre avec LVM, Device Mapper et d'autres composants.

Stratis a été publié pour la première fois dans Red Hat Enterprise Linux 8.0. Il a été conçu pour combler le vide créé par l'abandon de Btrfs par Red Hat. Stratis 1.0 est un gestionnaire de volume intuitif, basé sur une ligne de commande, qui peut effectuer des opérations de gestion de stockage importantes tout en dissimulant la complexité à l'utilisateur :

- Gestion des volumes

- Création d'une piscine

- Pools de stockage légers

- Instantanés

- Cache de lecture automatisé

Stratis offre des fonctionnalités puissantes, mais il lui manque actuellement certaines capacités d'autres offres auxquelles il pourrait être comparé, telles que Btrfs ou ZFS. En particulier, il ne prend pas en charge les CRC avec autoguérison.

Chapitre 2. Gestion du stockage local à l'aide des rôles système RHEL

Pour gérer LVM et les systèmes de fichiers locaux (FS) à l'aide d'Ansible, vous pouvez utiliser le rôle storage, qui est l'un des rôles système RHEL disponibles dans RHEL 9.

L'utilisation du rôle storage vous permet d'automatiser l'administration des systèmes de fichiers sur les disques et les volumes logiques sur plusieurs machines et sur toutes les versions de RHEL à partir de RHEL 7.7.

Pour plus d'informations sur les rôles système RHEL et leur application, voir Introduction aux rôles système RHEL.

2.1. Introduction au rôle du système RHEL storage

Le rôle de storage peut être géré :

- Systèmes de fichiers sur des disques qui n'ont pas été partitionnés

- Groupes de volumes LVM complets, y compris leurs volumes logiques et leurs systèmes de fichiers

- Volumes RAID MD et leurs systèmes de fichiers

Le rôle storage vous permet d'effectuer les tâches suivantes :

- Créer un système de fichiers

- Supprimer un système de fichiers

- Monter un système de fichiers

- Démonter un système de fichiers

- Créer des groupes de volumes LVM

- Supprimer les groupes de volumes LVM

- Créer des volumes logiques

- Supprimer des volumes logiques

- Créer des volumes RAID

- Supprimer des volumes RAID

- Créer des groupes de volumes LVM avec RAID

- Supprimer les groupes de volumes LVM avec RAID

- Créer des groupes de volumes LVM cryptés

- Créer des volumes logiques LVM avec RAID

2.2. Paramètres qui identifient un périphérique de stockage dans le rôle de système RHEL storage

Votre configuration du rôle storage n'affecte que les systèmes de fichiers, les volumes et les pools que vous avez répertoriés dans les variables suivantes.

storage_volumesListe des systèmes de fichiers sur tous les disques non partitionnés à gérer.

storage_volumespeut également inclure des volumesraid.Les partitions ne sont actuellement pas prises en charge.

storage_poolsListe des pools à gérer.

Actuellement, le seul type de pool pris en charge est LVM. Avec LVM, les pools représentent des groupes de volumes (VG). Sous chaque pool se trouve une liste de volumes à gérer par le rôle. Avec LVM, chaque volume correspond à un volume logique (LV) avec un système de fichiers.

2.3. Exemple de script Ansible pour créer un système de fichiers XFS sur un périphérique bloc

Cette section fournit un exemple de script Ansible. Ce playbook applique le rôle storage pour créer un système de fichiers XFS sur un périphérique bloc à l'aide des paramètres par défaut.

Le rôle storage peut créer un système de fichiers uniquement sur un disque entier non partitionné ou sur un volume logique (LV). Il ne peut pas créer le système de fichiers sur une partition.

Exemple 2.1. Un playbook qui crée XFS sur /dev/sdb

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: xfs

roles:

- rhel-system-roles.storage-

Le nom du volume (

barefsdans l'exemple) est actuellement arbitraire. Le rôlestorageidentifie le volume par l'unité de disque répertoriée sous l'attributdisks:. -

Vous pouvez omettre la ligne

fs_type: xfscar XFS est le système de fichiers par défaut dans RHEL 9. Pour créer le système de fichiers sur un LV, fournissez la configuration LVM sous l'attribut

disks:, y compris le groupe de volumes qui l'entoure. Pour plus de détails, voir Example Ansible playbook to manage logical volumes.Ne pas fournir le chemin d'accès au dispositif LV.

Ressources supplémentaires

-

Le fichier

/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.4. Exemple de playbook Ansible pour monter un système de fichiers de manière persistante

Cette section fournit un exemple de plan de jeu Ansible. Ce playbook applique le rôle storage pour monter immédiatement et de manière persistante un système de fichiers XFS.

Exemple 2.2. Un playbook qui monte un système de fichiers sur /dev/sdb vers /mnt/data

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: xfs

mount_point: /mnt/data

roles:

- rhel-system-roles.storage-

Cette procédure ajoute le système de fichiers au fichier

/etc/fstabet monte immédiatement le système de fichiers. -

Si le système de fichiers sur le périphérique

/dev/sdbou le répertoire du point de montage n'existent pas, la séquence les crée.

Ressources supplémentaires

-

Le fichier

/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.5. Exemple de script Ansible pour la gestion des volumes logiques

Cette section fournit un exemple de manuel de jeu Ansible. Ce playbook applique le rôle storage pour créer un volume logique LVM dans un groupe de volumes.

Exemple 2.3. Un playbook qui crée un volume logique mylv dans le groupe de volumes myvg

- hosts: all

vars:

storage_pools:

- name: myvg

disks:

- sda

- sdb

- sdc

volumes:

- name: mylv

size: 2G

fs_type: ext4

mount_point: /mnt/data

roles:

- rhel-system-roles.storageLe groupe de volumes

myvgse compose des disques suivants :-

/dev/sda -

/dev/sdb -

/dev/sdc

-

-

Si le groupe de volumes

myvgexiste déjà, la procédure ajoute le volume logique au groupe de volumes. -

Si le groupe de volumes

myvgn'existe pas, le playbook le crée. -

La procédure crée un système de fichiers Ext4 sur le volume logique

mylvet monte de manière persistante le système de fichiers à l'adresse/mnt.

Ressources supplémentaires

-

Le fichier

/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.6. Exemple de script Ansible pour activer l'élimination des blocs en ligne

Cette section fournit un exemple de manuel de jeu Ansible. Ce playbook applique le rôle storage pour monter un système de fichiers XFS avec l'option d'élimination des blocs en ligne activée.

Exemple 2.4. Un playbook qui active l'élimination des blocs en ligne sur /mnt/data/

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: xfs

mount_point: /mnt/data

mount_options: discard

roles:

- rhel-system-roles.storageRessources supplémentaires

- Exemple de playbook Ansible pour monter un système de fichiers de manière persistante

-

Le fichier

/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.7. Exemple de script Ansible pour créer et monter un système de fichiers Ext4

Cette section fournit un exemple de script Ansible. Ce playbook applique le rôle storage pour créer et monter un système de fichiers Ext4.

Exemple 2.5. Un playbook qui crée Ext4 sur /dev/sdb et le monte dans /mnt/data

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: ext4

fs_label: label-name

mount_point: /mnt/data

roles:

- rhel-system-roles.storage-

Le playbook crée le système de fichiers sur le disque

/dev/sdb. -

Le playbook monte de manière persistante le système de fichiers dans le répertoire

/mnt/datarépertoire. -

L'étiquette du système de fichiers est

label-name.

Ressources supplémentaires

-

Le fichier

/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.8. Exemple de script Ansible pour créer et monter un système de fichiers ext3

Cette section fournit un exemple de script Ansible. Ce playbook applique le rôle storage pour créer et monter un système de fichiers Ext3.

Exemple 2.6. Un playbook qui crée Ext3 sur /dev/sdb et le monte à l'adresse /mnt/data

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: ext3

fs_label: label-name

mount_point: /mnt/data

roles:

- rhel-system-roles.storage-

Le playbook crée le système de fichiers sur le disque

/dev/sdb. -

Le playbook monte de manière persistante le système de fichiers dans le répertoire

/mnt/datarépertoire. -

L'étiquette du système de fichiers est

label-name.

Ressources supplémentaires

-

Le fichier

/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.9. Exemple de playbook Ansible pour redimensionner un système de fichiers Ext4 ou Ext3 existant à l'aide du rôle de système RHEL storage

Cette section fournit un exemple de plan de jeu Ansible. Ce playbook applique le rôle storage pour redimensionner un système de fichiers Ext4 ou Ext3 existant sur un périphérique bloc.

Exemple 2.7. Un playbook qui configure un seul volume sur un disque

---

- name: Create a disk device mounted on /opt/barefs

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- /dev/sdb

size: 12 GiB

fs_type: ext4

mount_point: /opt/barefs

roles:

- rhel-system-roles.storage-

Si le volume de l'exemple précédent existe déjà, pour redimensionner le volume, vous devez exécuter le même playbook, mais avec une valeur différente pour le paramètre

size. Par exemple, vous devez exécuter le même playbook, mais avec une valeur différente pour le paramètre :

Exemple 2.8. Un playbook qui redimensionne ext4 sur /dev/sdb

---

- name: Create a disk device mounted on /opt/barefs

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- /dev/sdb

size: 10 GiB

fs_type: ext4

mount_point: /opt/barefs

roles:

- rhel-system-roles.storage- Le nom du volume (barefs dans l'exemple) est actuellement arbitraire. Le rôle Stockage identifie le volume par l'unité de disque listée dans l'attribut disks :.

L'utilisation de l'action Resizing dans d'autres systèmes de fichiers peut détruire les données de l'appareil sur lequel vous travaillez.

Ressources supplémentaires

-

Le fichier

/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.10. Exemple de playbook Ansible pour redimensionner un système de fichiers existant sur LVM à l'aide du rôle système storage RHEL

Cette section fournit un exemple de script Ansible. Ce playbook applique le rôle système storage RHEL pour redimensionner un volume logique LVM avec un système de fichiers.

L'utilisation de l'action Resizing dans d'autres systèmes de fichiers peut détruire les données de l'appareil sur lequel vous travaillez.

Exemple 2.9. Un playbook qui redimensionne les volumes logiques mylv1 et myvl2 existants dans le groupe de volumes myvg

---

- hosts: all

vars:

storage_pools:

- name: myvg

disks:

- /dev/sda

- /dev/sdb

- /dev/sdc

volumes:

- name: mylv1

size: 10 GiB

fs_type: ext4

mount_point: /opt/mount1

- name: mylv2

size: 50 GiB

fs_type: ext4

mount_point: /opt/mount2

- name: Create LVM pool over three disks

include_role:

name: rhel-system-roles.storageCette procédure redimensionne les systèmes de fichiers existants suivants :

-

Le système de fichiers Ext4 sur le volume

mylv1, qui est monté sur/opt/mount1, est redimensionné à 10 GiB. -

Le système de fichiers Ext4 sur le volume

mylv2, qui est monté sur/opt/mount2, est redimensionné à 50 GiB.

-

Le système de fichiers Ext4 sur le volume

Ressources supplémentaires

-

Le fichier

/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.11. Exemple de playbook Ansible pour créer un volume d'échange à l'aide du rôle de système RHEL storage

Cette section fournit un exemple de script Ansible. Ce playbook applique le rôle storage pour créer un volume d'échange, s'il n'existe pas, ou pour modifier le volume d'échange, s'il existe déjà, sur un périphérique de bloc en utilisant les paramètres par défaut.

Exemple 2.10. Un playbook qui crée ou modifie un XFS existant sur /dev/sdb

---

- name: Create a disk device with swap

- hosts: all

vars:

storage_volumes:

- name: swap_fs

type: disk

disks:

- /dev/sdb

size: 15 GiB

fs_type: swap

roles:

- rhel-system-roles.storage-

Le nom du volume (

swap_fsdans l'exemple) est actuellement arbitraire. Le rôlestorageidentifie le volume par l'unité de disque répertoriée sous l'attributdisks:.

Ressources supplémentaires

-

Le fichier

/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.12. Configuration d'un volume RAID à l'aide du rôle de système de stockage

Avec le rôle de système storage, vous pouvez configurer un volume RAID sur RHEL en utilisant Red Hat Ansible Automation Platform et Ansible-Core. Créez un playbook Ansible avec les paramètres pour configurer un volume RAID en fonction de vos besoins.

Conditions préalables

- Le paquetage Ansible Core est installé sur la machine de contrôle.

-

Le paquetage

rhel-system-rolesest installé sur le système à partir duquel vous souhaitez exécuter le playbook. -

Vous disposez d'un fichier d'inventaire détaillant les systèmes sur lesquels vous souhaitez déployer un volume RAID à l'aide du rôle de système

storage.

Procédure

Créez un nouveau fichier playbook.yml avec le contenu suivant :

--- - name: Configure the storage hosts: managed-node-01.example.com tasks: - name: Create a RAID on sdd, sde, sdf, and sdg include_role: name: rhel-system-roles.storage vars: storage_safe_mode: false storage_volumes: - name: data type: raid disks: [sdd, sde, sdf, sdg] raid_level: raid0 raid_chunk_size: 32 KiB mount_point: /mnt/data state: presentAvertissementLes noms de périphériques peuvent changer dans certaines circonstances, par exemple lorsque vous ajoutez un nouveau disque à un système. Par conséquent, pour éviter toute perte de données, n'utilisez pas de noms de disques spécifiques dans le guide de lecture.

Facultatif : Vérifiez la syntaxe du playbook :

# ansible-playbook --syntax-check playbook.ymlExécutez le manuel de jeu :

# ansible-playbook -i inventory.file /path/to/file/playbook.yml

Ressources supplémentaires

-

Le fichier

/usr/share/ansible/roles/rhel-system-roles.storage/README.md - Préparation d'un nœud de contrôle et de nœuds gérés à l'utilisation des rôles système RHEL

2.13. Configuration d'un pool LVM avec RAID à l'aide du rôle système storage RHEL

Avec le rôle de système storage, vous pouvez configurer un pool LVM avec RAID sur RHEL à l'aide de Red Hat Ansible Automation Platform. Dans cette section, vous apprendrez à configurer un playbook Ansible avec les paramètres disponibles pour configurer un pool LVM avec RAID.

Conditions préalables

- Le paquetage Ansible Core est installé sur la machine de contrôle.

-

Le paquetage

rhel-system-rolesest installé sur le système à partir duquel vous souhaitez exécuter le playbook. -

Vous disposez d'un fichier d'inventaire détaillant les systèmes sur lesquels vous souhaitez configurer un pool LVM avec RAID à l'aide du rôle de système

storage.

Procédure

Créez un nouveau fichier

playbook.ymlavec le contenu suivant :- hosts: all vars: storage_safe_mode: false storage_pools: - name: my_pool type: lvm disks: [sdh, sdi] raid_level: raid1 volumes: - name: my_pool size: "1 GiB" mount_point: "/mnt/app/shared" fs_type: xfs state: present roles: - name: rhel-system-roles.storageNotePour créer un pool LVM avec RAID, vous devez spécifier le type de RAID à l'aide du paramètre

raid_level.Facultatif. Vérifier la syntaxe du playbook.

# ansible-playbook --syntax-check playbook.ymlExécutez le playbook sur votre fichier d'inventaire :

# ansible-playbook -i inventory.file /path/to/file/playbook.yml

Ressources supplémentaires

-

Le fichier

/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.14. Exemple de playbook Ansible pour compresser et dédupliquer un volume VDO sur LVM à l'aide du rôle système storage RHEL

Cette section fournit un exemple de plan de jeu Ansible. Ce playbook applique le rôle système storage RHEL pour activer la compression et la déduplication des volumes logiques (LVM) à l'aide de Virtual Data Optimizer (VDO).

Exemple 2.11. Un playbook qui crée un volume mylv1 LVM VDO dans le groupe de volumes myvg

---

- name: Create LVM VDO volume under volume group 'myvg'

hosts: all

roles:

-rhel-system-roles.storage

vars:

storage_pools:

- name: myvg

disks:

- /dev/sdb

volumes:

- name: mylv1

compression: true

deduplication: true

vdo_pool_size: 10 GiB

size: 30 GiB

mount_point: /mnt/app/shared

Dans cet exemple, les pools compression et deduplication sont réglés sur true, ce qui spécifie que le VDO est utilisé. Les paragraphes suivants décrivent l'utilisation de ces paramètres :

-

Le site

deduplicationest utilisé pour dédupliquer les données dupliquées stockées sur le volume de stockage. - La compression est utilisée pour comprimer les données stockées sur le volume de stockage, ce qui permet d'augmenter la capacité de stockage.

-

Le paramètre vdo_pool_size indique la taille réelle du volume sur le périphérique. La taille virtuelle du volume VDO est définie par le paramètre

size. NOTE : En raison de l'utilisation du rôle de stockage de LVM VDO, un seul volume par pool peut utiliser la compression et la déduplication.

2.15. Création d'un volume chiffré LUKS2 à l'aide du rôle système storage RHEL

Vous pouvez utiliser le rôle storage pour créer et configurer un volume chiffré avec LUKS en exécutant un manuel de jeu Ansible.

Conditions préalables

-

Accès et autorisations à un ou plusieurs nœuds gérés, qui sont des systèmes que vous souhaitez configurer avec le rôle de système

crypto_policies. - Un fichier d'inventaire, qui répertorie les nœuds gérés.

-

Accès et permissions à un nœud de contrôle, qui est un système à partir duquel Red Hat Ansible Core configure d'autres systèmes. Sur le nœud de contrôle, les paquets

ansible-coreetrhel-system-rolessont installés.

RHEL 8.0-8.5 donne accès à un dépôt Ansible distinct qui contient Ansible Engine 2.9 pour l'automatisation basée sur Ansible. Ansible Engine contient des utilitaires de ligne de commande tels que ansible, ansible-playbook, des connecteurs tels que docker et podman, ainsi que de nombreux plugins et modules. Pour plus d'informations sur la manière d'obtenir et d'installer Ansible Engine, consultez l'article de la base de connaissances Comment télécharger et installer Red Hat Ansible Engine.

RHEL 8.6 et 9.0 ont introduit Ansible Core (fourni en tant que paquetage ansible-core ), qui contient les utilitaires de ligne de commande Ansible, les commandes et un petit ensemble de plugins Ansible intégrés. RHEL fournit ce paquetage par l'intermédiaire du dépôt AppStream, et sa prise en charge est limitée. Pour plus d'informations, consultez l'article de la base de connaissances intitulé Scope of support for the Ansible Core package included in the RHEL 9 and RHEL 8.6 and later AppStream repositories (Portée de la prise en charge du package Ansible Core inclus dans les dépôts AppStream RHEL 9 et RHEL 8.6 et versions ultérieures ).

Procédure

Créez un nouveau fichier

playbook.ymlavec le contenu suivant :- hosts: all vars: storage_volumes: - name: barefs type: disk disks: - sdb fs_type: xfs fs_label: label-name mount_point: /mnt/data encryption: true encryption_password: your-password roles: - rhel-system-roles.storageVous pouvez également ajouter les autres paramètres de cryptage tels que

encryption_key,encryption_cipher,encryption_key_size, etencryption_luksversion dans le fichier playbook.yml.Facultatif : Vérifier la syntaxe du playbook :

# ansible-playbook --syntax-check playbook.ymlExécutez le playbook sur votre fichier d'inventaire :

# ansible-playbook -i inventory.file /path/to/file/playbook.yml

Vérification

Visualiser l'état du cryptage :

# cryptsetup status sdb /dev/mapper/sdb is active and is in use. type: LUKS2 cipher: aes-xts-plain64 keysize: 512 bits key location: keyring device: /dev/sdb [...]

Vérifiez le volume crypté LUKS créé :

# cryptsetup luksDump /dev/sdb Version: 2 Epoch: 6 Metadata area: 16384 [bytes] Keyslots area: 33521664 [bytes] UUID: a4c6be82-7347-4a91-a8ad-9479b72c9426 Label: (no label) Subsystem: (no subsystem) Flags: allow-discards Data segments: 0: crypt offset: 33554432 [bytes] length: (whole device) cipher: aes-xts-plain64 sector: 4096 [bytes] [...]Consultez les paramètres

cryptsetupdans le fichierplaybook.ymlque le rôlestorageprend en charge :# cat ~/playbook.yml - hosts: all vars: storage_volumes: - name: foo type: disk disks: - nvme0n1 fs_type: xfs fs_label: label-name mount_point: /mnt/data encryption: true #encryption_password: passwdpasswd encryption_key: /home/passwd_key encryption_cipher: aes-xts-plain64 encryption_key_size: 512 encryption_luks_version: luks2 roles: - rhel-system-roles.storage

Ressources supplémentaires

- Chiffrement des blocs de données à l'aide de LUKS

-

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdfichier

2.16. Exemple de playbook Ansible pour exprimer les tailles de volume de pool en pourcentage à l'aide du rôle de système RHEL storage

Cette section fournit un exemple de manuel de jeu Ansible. Ce manuel applique le rôle de système storage pour vous permettre d'exprimer la taille des volumes LVM (Logical Manager Volumes) en pourcentage de la taille totale du pool.

Exemple 2.12. Un playbook qui exprime la taille des volumes en pourcentage de la taille totale du pool

---

- name: Express volume sizes as a percentage of the pool's total size

hosts: all

roles

- rhel-system-roles.storage

vars:

storage_pools:

- name: myvg

disks:

- /dev/sdb

volumes:

- name: data

size: 60%

mount_point: /opt/mount/data

- name: web

size: 30%

mount_point: /opt/mount/web

- name: cache

size: 10%

mount_point: /opt/cache/mountCet exemple spécifie la taille des volumes LVM en pourcentage de la taille du pool, par exemple : "60%". En outre, vous pouvez également spécifier la taille des volumes LVM en pourcentage de la taille du pool dans une taille lisible par l'homme du système de fichiers, par exemple : "10g" ou "50 GiB".

2.17. Ressources supplémentaires

-

/usr/share/doc/rhel-system-roles/storage/ -

/usr/share/ansible/roles/rhel-system-roles.storage/

Chapitre 3. Montage des partages NFS

En tant qu'administrateur système, vous pouvez monter des partages NFS distants sur votre système pour accéder à des données partagées.

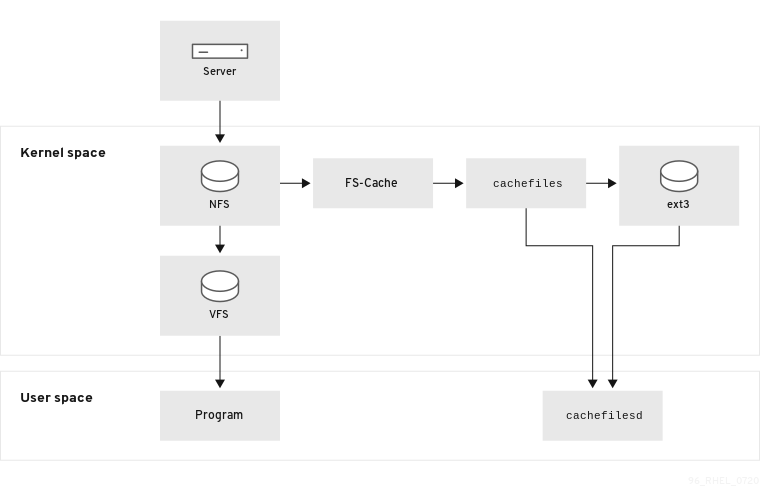

3.1. Introduction à NFS

Cette section explique les concepts de base du service NFS.

Un système de fichiers réseau (NFS) permet aux hôtes distants de monter des systèmes de fichiers sur un réseau et d'interagir avec ces systèmes de fichiers comme s'ils étaient montés localement. Cela vous permet de consolider les ressources sur des serveurs centralisés sur le réseau.

Le serveur NFS se réfère au fichier de configuration /etc/exports pour déterminer si le client est autorisé à accéder aux systèmes de fichiers exportés. Une fois cette vérification effectuée, toutes les opérations sur les fichiers et les répertoires sont accessibles à l'utilisateur.

3.2. Versions NFS prises en charge

Cette section répertorie les versions de NFS prises en charge par Red Hat Enterprise Linux et leurs fonctionnalités.

Actuellement, Red Hat Enterprise Linux 9 prend en charge les versions majeures suivantes de NFS :

- La version 3 de NFS (NFSv3) prend en charge les écritures asynchrones sûres et est plus robuste que la version précédente NFSv2 en ce qui concerne la gestion des erreurs. Elle prend également en charge les tailles de fichiers et les décalages de 64 bits, ce qui permet aux clients d'accéder à plus de 2 Go de données de fichiers.

-

NFS version 4 (NFSv4) fonctionne à travers les pare-feu et sur Internet, ne nécessite plus de service

rpcbind, prend en charge les listes de contrôle d'accès (ACL) et utilise des opérations avec état.

NFS version 2 (NFSv2) n'est plus pris en charge par Red Hat.

Version NFS par défaut

La version par défaut de NFS dans Red Hat Enterprise Linux 9 est 4.2. Les clients NFS tentent de monter en utilisant NFSv4.2 par défaut, et reviennent à NFSv4.1 lorsque le serveur ne prend pas en charge NFSv4.2. Le montage revient ensuite à NFSv4.0, puis à NFSv3.

Caractéristiques des versions mineures de NFS

Voici les caractéristiques de NFSv4.2 dans Red Hat Enterprise Linux 9 :

- Copie côté serveur

-

Permet au client NFS de copier efficacement des données sans gaspiller les ressources du réseau à l'aide de l'appel système

copy_file_range(). - Fichiers épars

-

Permet aux fichiers d'avoir un ou plusieurs holes, qui sont des blocs de données non alloués ou non initialisés composés uniquement de zéros. L'opération

lseek()dans NFSv4.2 prend en chargeseek_hole()etseek_data(), ce qui permet aux applications de déterminer l'emplacement des trous dans le fichier clairsemé. - Réservation d'espace

-

Permet aux serveurs de stockage de réserver de l'espace libre, ce qui empêche les serveurs de manquer d'espace. NFSv4.2 prend en charge l'opération

allocate()pour réserver de l'espace, l'opérationdeallocate()pour libérer de l'espace et l'opérationfallocate()pour pré-allouer ou désallouer de l'espace dans un fichier. - NFS étiqueté

- Renforce les droits d'accès aux données et active les étiquettes SELinux entre un client et un serveur pour des fichiers individuels sur un système de fichiers NFS.

- Amélioration de la mise en page

-

Fournit l'opération

layoutstats(), qui permet à certains serveurs NFS parallèles (pNFS) de collecter de meilleures statistiques de performance.

Voici les caractéristiques de NFSv4.1 :

- Améliore les performances et la sécurité du réseau, et inclut également la prise en charge côté client de pNFS.

- Ne nécessite plus de connexion TCP distincte pour les rappels, ce qui permet à un serveur NFS d'accorder des délégations même lorsqu'il ne peut pas contacter le client : par exemple, en cas d'interférence due à la NAT ou à un pare-feu.

- La sémantique "exactement une fois" (sauf pour les opérations de redémarrage) permet d'éviter un problème antérieur dans lequel certaines opérations renvoyaient parfois un résultat inexact si une réponse était perdue et que l'opération était envoyée deux fois.

3.3. Services requis par les SNF

Cette section répertorie les services système qui sont nécessaires à l'exécution d'un serveur NFS ou au montage de partages NFS. Red Hat Enterprise Linux démarre ces services automatiquement.

Red Hat Enterprise Linux utilise une combinaison de support au niveau du noyau et de processus de service pour fournir le partage de fichiers NFS. Toutes les versions de NFS reposent sur des appels de procédure à distance (RPC) entre les clients et les serveurs. Pour partager ou monter des systèmes de fichiers NFS, les services suivants fonctionnent ensemble en fonction de la version de NFS mise en œuvre :

nfsd- Module du noyau du serveur NFS qui traite les demandes de systèmes de fichiers NFS partagés.

rpcbind-

Accepte les réservations de ports des services RPC locaux. Ces ports sont ensuite mis à disposition (ou annoncés) pour que les services RPC distants correspondants puissent y accéder. Le service

rpcbindrépond aux demandes de services RPC et établit des connexions avec le service RPC demandé. Ce service n'est pas utilisé avec NFSv4. rpc.mountd-

Ce processus est utilisé par un serveur NFS pour traiter les demandes

MOUNTdes clients NFSv3. Il vérifie que le partage NFS demandé est actuellement exporté par le serveur NFS et que le client est autorisé à y accéder. Si la demande de montage est autorisée, le servicenfs-mountdrépond avec un statut "Success" et fournit au client NFS le File-Handle pour ce partage NFS. rpc.nfsd-

Ce processus permet de définir les versions et les protocoles NFS explicitement annoncés par le serveur. Il travaille avec le noyau Linux pour répondre aux demandes dynamiques des clients NFS, par exemple en fournissant des threads de serveur à chaque fois qu'un client NFS se connecte. Ce processus correspond au service

nfs-server. lockd- Il s'agit d'un thread du noyau qui s'exécute à la fois sur les clients et les serveurs. Il implémente le protocole Network Lock Manager (NLM), qui permet aux clients NFSv3 de verrouiller des fichiers sur le serveur. Il est démarré automatiquement à chaque fois que le serveur NFS est exécuté et qu'un système de fichiers NFS est monté.

rpc.statd-

Ce processus met en œuvre le protocole RPC Network Status Monitor (NSM), qui notifie les clients NFS lorsqu'un serveur NFS est redémarré sans avoir été arrêté de manière gracieuse. Le service

rpc-statdest démarré automatiquement par le servicenfs-serveret ne nécessite pas de configuration de la part de l'utilisateur. Il n'est pas utilisé avec NFSv4. rpc.rquotad-

Ce processus fournit des informations sur les quotas d'utilisateurs pour les utilisateurs distants. Le service

rpc-rquotad, qui est fourni par le paquetagequota-rpc, doit être démarré par l'utilisateur lorsque le paquetagenfs-serverest démarré. rpc.idmapdCe processus fournit des appels ascendants aux clients et aux serveurs NFSv4, qui établissent une correspondance entre les noms NFSv4 sur le fil (chaînes de caractères sous la forme de

user@domain) et les UID et GID locaux. Pour queidmapdfonctionne avec NFSv4, le fichier/etc/idmapd.confdoit être configuré. Il faut au moins spécifier le paramètreDomain, qui définit le domaine de mappage NFSv4. Si le domaine de mappage NFSv4 est identique au nom de domaine DNS, ce paramètre peut être ignoré. Le client et le serveur doivent être d'accord sur le domaine de mappage NFSv4 pour que le mappage d'ID fonctionne correctement.Seul le serveur NFSv4 utilise

rpc.idmapd, qui est lancé par le servicenfs-idmapd. Le client NFSv4 utilise l'utilitairenfsidmap, basé sur un trousseau de clés, qui est appelé par le noyau à la demande pour effectuer le mappage des identifiants. En cas de problème avecnfsidmap, le client revient à l'utilisation derpc.idmapd.

Les services RPC avec NFSv4

Les protocoles de montage et de verrouillage ont été incorporés dans le protocole NFSv4. Le serveur écoute également sur le port TCP 2049 bien connu. Ainsi, NFSv4 n'a pas besoin d'interagir avec les services rpcbind, lockd et rpc-statd. Le service nfs-mountd est toujours nécessaire sur le serveur NFS pour configurer les exportations, mais il n'est impliqué dans aucune opération sur le fil.

Ressources supplémentaires

3.4. Formats des noms d'hôtes NFS

Cette section décrit les différents formats que vous pouvez utiliser pour spécifier un hôte lors du montage ou de l'exportation d'un partage NFS.

Vous pouvez spécifier l'hôte dans les formats suivants :

- Machine unique

L'un ou l'autre des éléments suivants :

- Un nom de domaine complet (qui peut être résolu par le serveur)

- Nom d'hôte (qui peut être résolu par le serveur)

- Une adresse IP.

- Réseaux IP

L'un ou l'autre des formats suivants est valable :

-

a.b.c.d/zoùa.b.c.dest le réseau etzest le nombre de bits du masque de réseau ; par exemple192.168.0.0/24. -

a.b.c.d/netmaskoùa.b.c.dest le réseau etnetmaskest le masque de réseau ; par exemple,192.168.100.8/255.255.255.0.

-

- Netgroups

-

Le format

@group-nameoùgroup-nameest le nom du groupe net NIS.

3.5. Installation de NFS

Cette procédure installe tous les paquets nécessaires pour monter ou exporter des partages NFS.

Procédure

Installez le paquetage

nfs-utils:# dnf install nfs-utils

3.6. Découvrir les exportations NFS

Cette procédure permet de découvrir les systèmes de fichiers exportés par un serveur NFSv3 ou NFSv4 donné.

Procédure

Avec n'importe quel serveur prenant en charge NFSv3, utilisez l'utilitaire

showmount:$ showmount --exports my-server Export list for my-server /exports/foo /exports/bar

Avec n'importe quel serveur supportant NFSv4, montez le répertoire racine et regardez autour de vous :

# mount my-server:/ /mnt/ # ls /mnt/ exports # ls /mnt/exports/ foo bar

Sur les serveurs qui supportent à la fois NFSv4 et NFSv3, les deux méthodes fonctionnent et donnent les mêmes résultats.

Ressources supplémentaires

-

showmount(8)page de manuel

3.7. Montage d'un partage NFS avec mount

Monter un partage NFS exporté d'un serveur à l'aide de l'utilitaire mount.

Vous pouvez rencontrer des conflits dans votre NFSv4 clientid et leur expiration soudaine si vos clients NFS ont le même nom d'hôte court. Pour éviter toute expiration soudaine de votre NFSv4 clientid, vous devez utiliser des noms d'hôte uniques pour les clients NFS ou configurer l'identifiant sur chaque conteneur, en fonction du système que vous utilisez. Pour plus d'informations, consultez l'article de la base de connaissances NFSv4 clientid was expired suddenly due to use same hostname on several NFS clients .

Procédure

Pour monter un partage NFS, utilisez la commande suivante :

# mount -t nfs -o options host:/remote/export /local/directory

Cette commande utilise les variables suivantes :

- options

- Liste d'options de montage délimitée par des virgules.

- host

- Le nom d'hôte, l'adresse IP ou le nom de domaine complet du serveur exportant le système de fichiers que vous souhaitez monter.

- /remote/export

- Le système de fichiers ou le répertoire exporté du serveur, c'est-à-dire le répertoire que vous souhaitez monter.

- /local/directory

- L'emplacement du client où /remote/export est monté.

Ressources supplémentaires

- Options de montage NFS courantes.

- Formats des noms d'hôtes NFS.

- Montage d'un système de fichiers avec mount.

-

mount(8)page de manuel -

exports(5)page de manuel

3.8. Options de montage NFS courantes

Les options suivantes sont couramment utilisées lors du montage de partages NFS. Vous pouvez utiliser ces options avec les commandes manuelles mount, les paramètres /etc/fstab et autofs.

lookupcache=mode-

Spécifie comment le noyau doit gérer son cache d'entrées de répertoire pour un point de montage donné. Les arguments valides pour mode sont

all,none, oupositive. nfsvers=versionSpécifie la version du protocole NFS à utiliser, où version est

3,4,4.0,4.1, ou4.2. Ceci est utile pour les hôtes qui exécutent plusieurs serveurs NFS, ou pour désactiver les tentatives de montage avec des versions inférieures. Si aucune version n'est spécifiée, NFS utilise la version la plus élevée prise en charge par le noyau et l'utilitairemount.L'option

versest identique ànfsverset est incluse dans cette version pour des raisons de compatibilité.noacl- Désactive tous les traitements ACL. Cela peut s'avérer nécessaire lors de l'interface avec des versions plus anciennes de Red Hat Enterprise Linux, Red Hat Linux ou Solaris, car la technologie ACL la plus récente n'est pas compatible avec les systèmes plus anciens.

nolock- Désactive le verrouillage des fichiers. Ce paramètre est parfois nécessaire lors de la connexion à de très vieux serveurs NFS.

noexec- Empêche l'exécution des binaires sur les systèmes de fichiers montés. Ceci est utile si le système monte un système de fichiers non-Linux contenant des binaires incompatibles.

nosuid-

Désactive les bits

set-user-identifieretset-group-identifier. Cela empêche les utilisateurs distants d'obtenir des privilèges plus élevés en exécutant un programmesetuid. port=num-

Spécifie la valeur numérique du port du serveur NFS. Si num est

0(valeur par défaut),mountdemande au servicerpcbindde l'hôte distant le numéro de port à utiliser. Si le service NFS de l'hôte distant n'est pas enregistré auprès de son servicerpcbind, le numéro de port NFS standard (TCP 2049) est utilisé à la place. rsize=numetwsize=numCes options définissent le nombre maximal d'octets à transférer lors d'une seule opération de lecture ou d'écriture NFS.

Il n'y a pas de valeur fixe par défaut pour

rsizeetwsize. Par défaut, NFS utilise la plus grande valeur possible prise en charge par le serveur et le client. Dans Red Hat Enterprise Linux 9, la valeur maximale pour le client et le serveur est de 1 048 576 octets. Pour plus de détails, consultez l'article Quelles sont les valeurs par défaut et maximales pour rsize et wsize avec les montages NFS ? KBase.sec=flavorsSaveurs de sécurité à utiliser pour accéder aux fichiers de l'exportation montée. La valeur flavors est une liste séparée par deux points d'une ou plusieurs saveurs de sécurité.

Par défaut, le client tente de trouver une variante de sécurité prise en charge à la fois par le client et le serveur. Si le serveur ne prend en charge aucune des saveurs sélectionnées, l'opération de montage échoue.

Saveurs disponibles :

-

sec=sysutilise les UID et GID UNIX locaux. Ceux-ci utilisentAUTH_SYSpour authentifier les opérations NFS. -

sec=krb5utilise Kerberos V5 au lieu des UID et GID UNIX locaux pour authentifier les utilisateurs. -

sec=krb5iutilise Kerberos V5 pour l'authentification des utilisateurs et effectue un contrôle d'intégrité des opérations NFS à l'aide de sommes de contrôle sécurisées afin d'empêcher la falsification des données. -

sec=krb5putilise Kerberos V5 pour l'authentification des utilisateurs, le contrôle d'intégrité et le chiffrement du trafic NFS afin d'empêcher le reniflage du trafic. Il s'agit du paramètre le plus sûr, mais c'est aussi celui qui entraîne le plus de surcoût en termes de performances.

-

tcp- Indique au montage NFS d'utiliser le protocole TCP.

Ressources supplémentaires

-

mount(8)page de manuel -

nfs(5)page de manuel

3.9. Ressources supplémentaires

Chapitre 4. Exportation de partages NFS

En tant qu'administrateur système, vous pouvez utiliser le serveur NFS pour partager un répertoire sur votre système via le réseau.

4.1. Introduction à NFS

Cette section explique les concepts de base du service NFS.

Un système de fichiers réseau (NFS) permet aux hôtes distants de monter des systèmes de fichiers sur un réseau et d'interagir avec ces systèmes de fichiers comme s'ils étaient montés localement. Cela vous permet de consolider les ressources sur des serveurs centralisés sur le réseau.

Le serveur NFS se réfère au fichier de configuration /etc/exports pour déterminer si le client est autorisé à accéder aux systèmes de fichiers exportés. Une fois cette vérification effectuée, toutes les opérations sur les fichiers et les répertoires sont accessibles à l'utilisateur.

4.2. Versions NFS prises en charge

Cette section répertorie les versions de NFS prises en charge par Red Hat Enterprise Linux et leurs fonctionnalités.

Actuellement, Red Hat Enterprise Linux 9 prend en charge les versions majeures suivantes de NFS :

- La version 3 de NFS (NFSv3) prend en charge les écritures asynchrones sûres et est plus robuste que la version précédente NFSv2 en ce qui concerne la gestion des erreurs. Elle prend également en charge les tailles de fichiers et les décalages de 64 bits, ce qui permet aux clients d'accéder à plus de 2 Go de données de fichiers.

-

NFS version 4 (NFSv4) fonctionne à travers les pare-feu et sur Internet, ne nécessite plus de service

rpcbind, prend en charge les listes de contrôle d'accès (ACL) et utilise des opérations avec état.

NFS version 2 (NFSv2) n'est plus pris en charge par Red Hat.

Version NFS par défaut

La version par défaut de NFS dans Red Hat Enterprise Linux 9 est 4.2. Les clients NFS tentent de monter en utilisant NFSv4.2 par défaut, et reviennent à NFSv4.1 lorsque le serveur ne prend pas en charge NFSv4.2. Le montage revient ensuite à NFSv4.0, puis à NFSv3.

Caractéristiques des versions mineures de NFS

Voici les caractéristiques de NFSv4.2 dans Red Hat Enterprise Linux 9 :

- Copie côté serveur

-

Permet au client NFS de copier efficacement des données sans gaspiller les ressources du réseau à l'aide de l'appel système

copy_file_range(). - Fichiers épars

-

Permet aux fichiers d'avoir un ou plusieurs holes, qui sont des blocs de données non alloués ou non initialisés composés uniquement de zéros. L'opération

lseek()dans NFSv4.2 prend en chargeseek_hole()etseek_data(), ce qui permet aux applications de déterminer l'emplacement des trous dans le fichier clairsemé. - Réservation d'espace

-

Permet aux serveurs de stockage de réserver de l'espace libre, ce qui empêche les serveurs de manquer d'espace. NFSv4.2 prend en charge l'opération

allocate()pour réserver de l'espace, l'opérationdeallocate()pour libérer de l'espace et l'opérationfallocate()pour pré-allouer ou désallouer de l'espace dans un fichier. - NFS étiqueté

- Renforce les droits d'accès aux données et active les étiquettes SELinux entre un client et un serveur pour des fichiers individuels sur un système de fichiers NFS.

- Amélioration de la mise en page

-

Fournit l'opération

layoutstats(), qui permet à certains serveurs NFS parallèles (pNFS) de collecter de meilleures statistiques de performance.

Voici les caractéristiques de NFSv4.1 :

- Améliore les performances et la sécurité du réseau, et inclut également la prise en charge côté client de pNFS.

- Ne nécessite plus de connexion TCP distincte pour les rappels, ce qui permet à un serveur NFS d'accorder des délégations même lorsqu'il ne peut pas contacter le client : par exemple, en cas d'interférence due à la NAT ou à un pare-feu.

- La sémantique "exactement une fois" (sauf pour les opérations de redémarrage) permet d'éviter un problème antérieur dans lequel certaines opérations renvoyaient parfois un résultat inexact si une réponse était perdue et que l'opération était envoyée deux fois.

4.3. Les protocoles TCP et UDP dans NFSv3 et NFSv4

NFSv4 nécessite l'utilisation du protocole de contrôle de transmission (TCP) sur un réseau IP.

NFSv3 pouvait également utiliser le protocole User Datagram Protocol (UDP) dans les versions antérieures de Red Hat Enterprise Linux. Dans Red Hat Enterprise Linux 9, NFS via UDP n'est plus pris en charge. Par défaut, UDP est désactivé dans le serveur NFS.

4.4. Services requis par les SNF

Cette section répertorie les services système qui sont nécessaires à l'exécution d'un serveur NFS ou au montage de partages NFS. Red Hat Enterprise Linux démarre ces services automatiquement.

Red Hat Enterprise Linux utilise une combinaison de support au niveau du noyau et de processus de service pour fournir le partage de fichiers NFS. Toutes les versions de NFS reposent sur des appels de procédure à distance (RPC) entre les clients et les serveurs. Pour partager ou monter des systèmes de fichiers NFS, les services suivants fonctionnent ensemble en fonction de la version de NFS mise en œuvre :

nfsd- Module du noyau du serveur NFS qui traite les demandes de systèmes de fichiers NFS partagés.

rpcbind-

Accepte les réservations de ports des services RPC locaux. Ces ports sont ensuite mis à disposition (ou annoncés) pour que les services RPC distants correspondants puissent y accéder. Le service

rpcbindrépond aux demandes de services RPC et établit des connexions avec le service RPC demandé. Ce service n'est pas utilisé avec NFSv4. rpc.mountd-

Ce processus est utilisé par un serveur NFS pour traiter les demandes

MOUNTdes clients NFSv3. Il vérifie que le partage NFS demandé est actuellement exporté par le serveur NFS et que le client est autorisé à y accéder. Si la demande de montage est autorisée, le servicenfs-mountdrépond avec un statut "Success" et fournit au client NFS le File-Handle pour ce partage NFS. rpc.nfsd-

Ce processus permet de définir les versions et les protocoles NFS explicitement annoncés par le serveur. Il travaille avec le noyau Linux pour répondre aux demandes dynamiques des clients NFS, par exemple en fournissant des threads de serveur à chaque fois qu'un client NFS se connecte. Ce processus correspond au service

nfs-server. lockd- Il s'agit d'un thread du noyau qui s'exécute à la fois sur les clients et les serveurs. Il implémente le protocole Network Lock Manager (NLM), qui permet aux clients NFSv3 de verrouiller des fichiers sur le serveur. Il est démarré automatiquement à chaque fois que le serveur NFS est exécuté et qu'un système de fichiers NFS est monté.

rpc.statd-

Ce processus met en œuvre le protocole RPC Network Status Monitor (NSM), qui notifie les clients NFS lorsqu'un serveur NFS est redémarré sans avoir été arrêté de manière gracieuse. Le service

rpc-statdest démarré automatiquement par le servicenfs-serveret ne nécessite pas de configuration de la part de l'utilisateur. Il n'est pas utilisé avec NFSv4. rpc.rquotad-

Ce processus fournit des informations sur les quotas d'utilisateurs pour les utilisateurs distants. Le service

rpc-rquotad, qui est fourni par le paquetagequota-rpc, doit être démarré par l'utilisateur lorsque le paquetagenfs-serverest démarré. rpc.idmapdCe processus fournit des appels ascendants aux clients et aux serveurs NFSv4, qui établissent une correspondance entre les noms NFSv4 sur le fil (chaînes de caractères sous la forme de

user@domain) et les UID et GID locaux. Pour queidmapdfonctionne avec NFSv4, le fichier/etc/idmapd.confdoit être configuré. Il faut au moins spécifier le paramètreDomain, qui définit le domaine de mappage NFSv4. Si le domaine de mappage NFSv4 est identique au nom de domaine DNS, ce paramètre peut être ignoré. Le client et le serveur doivent être d'accord sur le domaine de mappage NFSv4 pour que le mappage d'ID fonctionne correctement.Seul le serveur NFSv4 utilise

rpc.idmapd, qui est lancé par le servicenfs-idmapd. Le client NFSv4 utilise l'utilitairenfsidmap, basé sur un trousseau de clés, qui est appelé par le noyau à la demande pour effectuer le mappage des identifiants. En cas de problème avecnfsidmap, le client revient à l'utilisation derpc.idmapd.

Les services RPC avec NFSv4

Les protocoles de montage et de verrouillage ont été incorporés dans le protocole NFSv4. Le serveur écoute également sur le port TCP 2049 bien connu. Ainsi, NFSv4 n'a pas besoin d'interagir avec les services rpcbind, lockd et rpc-statd. Le service nfs-mountd est toujours nécessaire sur le serveur NFS pour configurer les exportations, mais il n'est impliqué dans aucune opération sur le fil.

Ressources supplémentaires

4.5. Formats des noms d'hôtes NFS

Cette section décrit les différents formats que vous pouvez utiliser pour spécifier un hôte lors du montage ou de l'exportation d'un partage NFS.

Vous pouvez spécifier l'hôte dans les formats suivants :

- Machine unique

L'un ou l'autre des éléments suivants :

- Un nom de domaine complet (qui peut être résolu par le serveur)

- Nom d'hôte (qui peut être résolu par le serveur)

- Une adresse IP.

- Réseaux IP

L'un ou l'autre des formats suivants est valable :

-

a.b.c.d/zoùa.b.c.dest le réseau etzest le nombre de bits du masque de réseau ; par exemple192.168.0.0/24. -

a.b.c.d/netmaskoùa.b.c.dest le réseau etnetmaskest le masque de réseau ; par exemple,192.168.100.8/255.255.255.0.

-

- Netgroups

-

Le format

@group-nameoùgroup-nameest le nom du groupe net NIS.

4.6. Configuration du serveur NFS

Cette section décrit la syntaxe et les options de deux façons de configurer les exportations sur un serveur NFS :

-

Modification manuelle du fichier de configuration

/etc/exports -

Utilisation de l'utilitaire

exportfssur la ligne de commande

4.6.1. Le fichier de configuration /etc/exports

Le fichier /etc/exports contrôle les systèmes de fichiers qui sont exportés vers des hôtes distants et spécifie des options. Il suit les règles syntaxiques suivantes :

- Les lignes vides sont ignorées.

-

Pour ajouter un commentaire, commencez une ligne par le signe dièse (

#). -

Vous pouvez entourer les lignes longues d'une barre oblique inverse (

\). - Chaque système de fichiers exporté doit se trouver sur sa propre ligne.

- Toute liste d'hôtes autorisés placée après un système de fichiers exporté doit être séparée par des caractères d'espacement.

- Les options pour chacun des hôtes doivent être placées entre parenthèses directement après l'identifiant de l'hôte, sans espace entre l'hôte et la première parenthèse.

Entrée de l'exportation

Chaque entrée d'un système de fichiers exporté a la structure suivante :

export host(options)

Il est également possible de spécifier plusieurs hôtes, ainsi que des options spécifiques pour chacun d'entre eux. Pour ce faire, il faut les énumérer sur la même ligne sous la forme d'une liste délimitée par des espaces, chaque nom d'hôte étant suivi de ses options respectives (entre parenthèses), comme dans l'exemple suivant :

export host1(options1) host2(options2) host3(options3)

Dans cette structure :

- export

- Le répertoire exporté

- host

- L'hôte ou le réseau vers lequel l'exportation est partagée

- options

- Les options à utiliser pour l'hôte

Exemple 4.1. Un simple fichier /etc/exports

Dans sa forme la plus simple, le fichier /etc/exports spécifie uniquement le répertoire exporté et les hôtes autorisés à y accéder :

/exported/directory bob.example.com

Ici, bob.example.com peut monter /exported/directory/ à partir du serveur NFS. Comme aucune option n'est spécifiée dans cet exemple, NFS utilise les options par défaut.

Le format du fichier /etc/exports est très précis, notamment en ce qui concerne l'utilisation du caractère espace. N'oubliez pas de toujours séparer les systèmes de fichiers exportés des hôtes et les hôtes les uns des autres par un caractère espace. Cependant, il ne doit pas y avoir d'autres caractères d'espacement dans le fichier, sauf sur les lignes de commentaires.

Par exemple, les deux lignes suivantes n'ont pas la même signification :

/home bob.example.com(rw) /home bob.example.com (rw)

La première ligne autorise uniquement les utilisateurs de bob.example.com à accéder en lecture et en écriture au répertoire /home. La deuxième ligne permet aux utilisateurs de bob.example.com de monter le répertoire en lecture seule (par défaut), tandis que le reste du monde peut le monter en lecture/écriture.

Options par défaut

Les options par défaut pour une entrée d'exportation sont les suivantes :

ro- Le système de fichiers exporté est en lecture seule. Les hôtes distants ne peuvent pas modifier les données partagées sur le système de fichiers. Pour permettre aux hôtes d'apporter des modifications au système de fichiers (c'est-à-dire de lire et d'écrire), spécifiez l'option rw.

sync-

Le serveur NFS ne répondra pas aux demandes avant que les modifications apportées par les demandes précédentes ne soient écrites sur le disque. Pour activer les écritures asynchrones, spécifiez l'option

async. wdelay-

Le serveur NFS retardera l'écriture sur le disque s'il soupçonne qu'une autre demande d'écriture est imminente. Cela peut améliorer les performances car cela réduit le nombre de fois où le disque doit être accédé par des commandes d'écriture distinctes, réduisant ainsi la surcharge d'écriture. Pour désactiver cette fonction, spécifiez l'option

no_wdelay, qui n'est disponible que si l'option sync par défaut est également spécifiée. root_squashCela empêche les utilisateurs root connectés à distance (et non localement) d'avoir les privilèges root ; au lieu de cela, le serveur NFS leur attribue l'ID utilisateur

nobody. Cela a pour effet de réduire les pouvoirs de l'utilisateur racine distant à ceux de l'utilisateur local le plus bas, empêchant ainsi toute écriture non autorisée sur le serveur distant. Pour désactiver l'écrasement de la racine, spécifiez l'optionno_root_squash.Pour écraser tous les utilisateurs distants (y compris root), utilisez l'option

all_squash. Pour spécifier les ID d'utilisateur et de groupe que le serveur NFS doit attribuer aux utilisateurs distants d'un hôte particulier, utilisez les optionsanonuidetanongid, respectivement, comme dans l'exemple ci-dessous :export host(anonuid=uidanongid=gid)

Ici, uid et gid sont respectivement le numéro d'identification de l'utilisateur et le numéro d'identification du groupe. Les options

anonuidetanongidvous permettent de créer un compte d'utilisateur et de groupe spécial pour les utilisateurs NFS distants à partager.

Par défaut, les listes de contrôle d'accès (ACL) sont prises en charge par NFS sous Red Hat Enterprise Linux. Pour désactiver cette fonctionnalité, spécifiez l'option no_acl lors de l'exportation du système de fichiers.

Options par défaut et options prioritaires

Chaque valeur par défaut de chaque système de fichiers exporté doit être explicitement remplacée. Par exemple, si l'option rw n'est pas spécifiée, le système de fichiers exporté est partagé en lecture seule. Voici un exemple de ligne provenant de /etc/exports qui remplace deux options par défaut :

/another/exported/directory 192.168.0.3(rw,async)

Dans cet exemple, 192.168.0.3 peut monter /another/exported/directory/ en lecture et en écriture, et toutes les écritures sur disque sont asynchrones.

4.6.2. L'utilitaire exportfs

L'utilitaire exportfs permet à l'utilisateur root d'exporter ou de non-exporter sélectivement des répertoires sans redémarrer le service NFS. Lorsqu'il dispose des options appropriées, l'utilitaire exportfs écrit les systèmes de fichiers exportés sur /var/lib/nfs/xtab. Étant donné que le service nfs-mountd se réfère au fichier xtab lorsqu'il décide des privilèges d'accès à un système de fichiers, les modifications apportées à la liste des systèmes de fichiers exportés prennent effet immédiatement.

Options courantes d'exportfs

Voici une liste des options couramment utilisées pour exportfs:

-r-

Provoque l'exportation de tous les répertoires répertoriés dans