Tâches d'administration et de configuration à l'aide des rôles système dans RHEL

Configuration cohérente et reproductible des déploiements RHEL sur plusieurs hôtes à l'aide des playbooks de Red Hat Ansible Automation Platform

Résumé

Rendre l'open source plus inclusif

Red Hat s'engage à remplacer les termes problématiques dans son code, sa documentation et ses propriétés Web. Nous commençons par ces quatre termes : master, slave, blacklist et whitelist. En raison de l'ampleur de cette entreprise, ces changements seront mis en œuvre progressivement au cours de plusieurs versions à venir. Pour plus de détails, voir le message de notre directeur technique Chris Wright.

Fournir un retour d'information sur la documentation de Red Hat

Nous apprécions vos commentaires sur notre documentation. Faites-nous savoir comment nous pouvons l'améliorer.

Soumettre des commentaires sur des passages spécifiques

- Consultez la documentation au format Multi-page HTML et assurez-vous que le bouton Feedback apparaît dans le coin supérieur droit après le chargement complet de la page.

- Utilisez votre curseur pour mettre en évidence la partie du texte que vous souhaitez commenter.

- Cliquez sur le bouton Add Feedback qui apparaît près du texte en surbrillance.

- Ajoutez vos commentaires et cliquez sur Submit.

Soumettre des commentaires via Bugzilla (compte requis)

- Connectez-vous au site Web de Bugzilla.

- Sélectionnez la version correcte dans le menu Version.

- Saisissez un titre descriptif dans le champ Summary.

- Saisissez votre suggestion d'amélioration dans le champ Description. Incluez des liens vers les parties pertinentes de la documentation.

- Cliquez sur Submit Bug.

Chapitre 1. Préparation d'un nœud de contrôle et de nœuds gérés à l'utilisation des rôles système RHEL

Avant de pouvoir utiliser des rôles système RHEL individuels pour gérer des services et des paramètres, préparez les hôtes concernés.

1.1. Introduction aux rôles du système RHEL

Rôles système RHEL est une collection de rôles et de modules Ansible. RHEL System Roles fournit une interface de configuration pour gérer à distance plusieurs systèmes RHEL. L'interface permet de gérer les configurations des systèmes sur plusieurs versions de RHEL, ainsi que d'adopter de nouvelles versions majeures.

Sur Red Hat Enterprise Linux 9, l'interface se compose actuellement des rôles suivants :

- Délivrance et renouvellement du certificat

-

Paramètres du noyau (

kernel_settings) -

Métriques (

metrics) -

Client Network Bound Disk Encryption et serveur Network Bound Disk Encryption (

nbde_clientetnbde_server) -

Mise en réseau (

network) -

Postfix (

postfix) -

Client SSH (

ssh) -

Serveur SSH (

sshd) -

Politiques cryptographiques à l'échelle du système (

crypto_policies) -

Enregistrement de la session du terminal (

tlog)

Tous ces rôles sont fournis par le paquetage rhel-system-roles disponible dans le dépôt AppStream.

Ressources supplémentaires

- Rôles du système Red Hat Enterprise Linux (RHEL)

-

/usr/share/doc/rhel-system-roles/fournie par le paquetrhel-system-roles.

1.2. Terminologie des rôles système RHEL

Vous trouverez les termes suivants dans cette documentation :

- Playbook Ansible

- Les playbooks sont le langage de configuration, de déploiement et d'orchestration d'Ansible. Ils peuvent décrire une politique que vous voulez que vos systèmes distants appliquent, ou un ensemble d'étapes dans un processus informatique général.

- Nœud de contrôle

- Toute machine sur laquelle Ansible est installé. Vous pouvez exécuter des commandes et des playbooks en invoquant /usr/bin/ansible ou /usr/bin/ansible-playbook, à partir de n'importe quel nœud de contrôle. Vous pouvez utiliser n'importe quel ordinateur sur lequel Python est installé comme nœud de contrôle - les ordinateurs portables, les ordinateurs de bureau partagés et les serveurs peuvent tous exécuter Ansible. Cependant, vous ne pouvez pas utiliser une machine Windows comme nœud de contrôle. Vous pouvez avoir plusieurs nœuds de contrôle.

- Inventaire

- Une liste des nœuds gérés. Un fichier d'inventaire est aussi parfois appelé "fichier d'hôte". Votre inventaire peut spécifier des informations telles que l'adresse IP de chaque nœud géré. Un inventaire peut également organiser les nœuds gérés, en créant et en imbriquant des groupes pour faciliter la mise à l'échelle. Pour en savoir plus sur l'inventaire, consultez la section Travailler avec l'inventaire.

- Nœuds gérés

- Les dispositifs réseau, les serveurs ou les deux que vous gérez avec Ansible. Les nœuds gérés sont aussi parfois appelés "hôtes". Ansible n'est pas installé sur les nœuds gérés.

1.3. Préparation d'un nœud de contrôle

RHEL inclut Ansible Core dans le référentiel AppStream avec une portée de support limitée. Si vous avez besoin d'une assistance supplémentaire pour Ansible, contactez Red Hat pour en savoir plus sur l'abonnement Ansible Automation Platform.

Conditions préalables

- Vous avez enregistré le système sur le portail client.

-

Vous avez attaché un abonnement

Red Hat Enterprise Linux Serverau système. -

S'il est disponible dans votre compte Portail Client, vous avez attaché un abonnement

Ansible Automation Platformau système.

Procédure

Installez le paquetage

rhel-system-roles:[root@control-node]# dnf install rhel-system-rolesCette commande installe

Ansible Coreen tant que dépendance.Créez un utilisateur que vous utiliserez par la suite pour gérer et exécuter les playbooks :

[root@control-node]# useradd ansiblePassez à l'utilisateur nouvellement créé

ansible:[root@control-node]# su - ansibleEffectuez le reste de la procédure en tant qu'utilisateur.

Créer une clé publique et privée SSH

[ansible@control-node]$ ssh-keygen Generating public/private rsa key pair. Enter file in which to save the key (/home/ansible/.ssh/id_rsa): password ...

Utilisez l'emplacement par défaut proposé pour le fichier clé.

- Facultatif : Configurez un agent SSH pour empêcher Ansible de vous demander le mot de passe de la clé SSH à chaque fois que vous établissez une connexion.

Créez le fichier

~/.ansible.cfgavec le contenu suivant :[defaults] inventory = /home/ansible/inventory remote_user = ansible [privilege_escalation] become = True become_method = sudo become_user = root become_ask_pass = True

Avec ces paramètres :

- Ansible gère les hôtes dans le fichier d'inventaire spécifié.

-

Ansible utilise le compte défini dans le paramètre

remote_userlorsqu'il établit des connexions SSH aux nœuds gérés. Ansible utilise l'utilitaire

sudopour exécuter des tâches sur les nœuds gérés en tant qu'utilisateurroot.Pour des raisons de sécurité, configurez

sudosur les nœuds gérés afin d'exiger la saisie du mot de passe de l'utilisateur distant pour devenirroot. En spécifiant le paramètrebecome_ask_pass=Truedans~/.ansible.cfg, Ansible demande ce mot de passe lorsque vous exécutez un playbook.

Les paramètres du fichier

~/.ansible.cfgont une priorité plus élevée et remplacent les paramètres du fichier global/etc/ansible/ansible.cfg.Créez le fichier

~/inventory. Par exemple, voici un fichier d'inventaire au format INI avec trois hôtes et un groupe d'hôtes nomméUS:managed-node-01.example.com [US] managed-node-02.example.com ansible_host=192.0.2.100 managed-node-03.example.com

Notez que le nœud de contrôle doit être en mesure de résoudre les noms d'hôte. Si le serveur DNS ne peut pas résoudre certains noms d'hôtes, ajoutez le paramètre

ansible_hostà côté de l'entrée de l'hôte pour spécifier son adresse IP.

Ressources supplémentaires

- Étendue de la prise en charge du package Ansible Core inclus dans les référentiels AppStream RHEL 9 et RHEL 8.6 et versions ultérieures

- Comment enregistrer et abonner un système au portail client de Red Hat à l'aide du gestionnaire d'abonnements ?

-

La page de manuel

ssh-keygen(1) - Se connecter à des machines distantes avec des clés SSH en utilisant ssh-agent

- Paramètres de configuration d'Ansible

- Comment constituer votre inventaire

1.4. Préparation d'un nœud géré

Ansible n'utilise pas d'agent sur les hôtes gérés. Les seules exigences sont Python, qui est installé par défaut sur RHEL, et un accès SSH à l'hôte géré.

Toutefois, l'accès SSH direct en tant qu'utilisateur root peut constituer un risque pour la sécurité. Par conséquent, lorsque vous préparez un nœud géré, vous créez un utilisateur local sur ce nœud et configurez une politique sudo. Ansible sur le nœud de contrôle peut alors utiliser ce compte pour se connecter au nœud géré et exécuter des playbooks en tant qu'utilisateurs différents, tels que root.

Conditions préalables

- Vous avez préparé le nœud de contrôle.

Procédure

Créer un utilisateur :

[root@managed-node-01]# useradd ansibleLe nœud de contrôle utilise ensuite cet utilisateur pour établir une connexion SSH avec cet hôte.

Définir un mot de passe pour l'utilisateur

ansible:[root@managed-node-01]# passwd ansible Changing password for user ansible. New password: password Retype new password: password passwd: all authentication tokens updated successfully.

Vous devez saisir ce mot de passe lorsque Ansible utilise

sudopour effectuer des tâches en tant qu'utilisateurroot.Installez la clé publique SSH de l'utilisateur

ansiblesur le nœud géré :Connectez-vous au nœud de contrôle en tant qu'utilisateur

ansibleet copiez la clé publique SSH sur le nœud géré :[ansible@control-node]$ ssh-copy-id managed-node-01.example.com /usr/bin/ssh-copy-id: INFO: Source of key(s) to be installed: "/home/ansible/.ssh/id_rsa.pub" The authenticity of host 'managed-node-01.example.com (192.0.2.100)' can't be established. ECDSA key fingerprint is SHA256:9bZ33GJNODK3zbNhybokN/6Mq7hu3vpBXDrCxe7NAvo. Are you sure you want to continue connecting (yes/no/[fingerprint])? yes /usr/bin/ssh-copy-id: INFO: attempting to log in with the new key(s), to filter out any that are already installed /usr/bin/ssh-copy-id: INFO: 1 key(s) remain to be installed -- if you are prompted now it is to install the new keys ansible@managed-node-01.example.com's password: password Number of key(s) added: 1 Now try logging into the machine, with: "ssh 'managed-node-01.example.com'" and check to make sure that only the key(s) you wanted were added.

Exécutez à distance une commande sur le nœud de contrôle pour vérifier la connexion SSH :

[ansible@control-node]$ ssh managed-node-01.example.com whoami ansible

Créer une configuration

sudopour l'utilisateuransible:Utilisez la commande

visudopour créer et modifier le fichier/etc/sudoers.d/ansible:[root@managed-node-01]# visudo /etc/sudoers.d/ansibleL'avantage d'utiliser

visudoplutôt qu'un éditeur normal est que cet utilitaire fournit des contrôles de base et vérifie les erreurs d'analyse avant d'installer le fichier.Configurez une politique

sudoersdans le fichier/etc/sudoers.d/ansiblequi réponde à vos besoins, par exemple :Pour autoriser l'utilisateur

ansibleà exécuter toutes les commandes en tant qu'utilisateur et groupe sur cet hôte après avoir saisi le mot de passe de l'utilisateuransible, utilisez l'option suivante :ansible ALL=(ALL) ALLPour autoriser l'utilisateur

ansibleà exécuter toutes les commandes en tant qu'utilisateur et groupe sur cet hôte sans saisir le mot de passe de l'utilisateuransible, utilisez la commande suivanteansible ALL=(ALL) NOPASSWD: ALL

Vous pouvez également configurer une politique plus fine qui correspond à vos exigences en matière de sécurité. Pour plus d'informations sur les politiques de

sudoers, voir la page de manuelsudoers(5).

Ressources supplémentaires

- Préparation du nœud de contrôle

-

La page de manuel

sudoers(5)

1.5. Vérification de l'accès du nœud de contrôle aux nœuds gérés

Après avoir configuré le nœud de contrôle et préparé les nœuds gérés, testez qu'Ansible peut se connecter aux nœuds gérés.

Effectuez cette procédure en tant qu'utilisateur ansible sur le nœud de contrôle.

Conditions préalables

- Vous avez préparé le nœud de contrôle comme indiqué dans la section Préparation d'un nœud de contrôle.

- Vous avez préparé au moins un nœud géré comme décrit dans la section Préparation d'un nœud géré.

- Si vous souhaitez exécuter des livres de lecture sur des groupes d'hôtes, le nœud géré est répertorié dans le fichier d'inventaire du nœud de contrôle.

Procédure

Utilisez le module Ansible

pingpour vérifier que vous pouvez exécuter des commandes sur tous les hôtes gérés :[ansible@control-node]$ ansible all -m ping BECOME password: password managed-node-01.example.com | SUCCESS => { "ansible_facts": { "discovered_interpreter_python": "/usr/bin/python3" }, "changed": false, "ping": "pong" } ...

Le groupe d'hôtes

allcodé en dur contient dynamiquement tous les hôtes répertoriés dans le fichier d'inventaire.Utilisez le module Ansible

commandpour exécuter l'utilitairewhoamisur un hôte géré :[ansible@control-node]$ ansible managed-node-01.example.com -m command -a whoami BECOME password: password managed-node-01.example.com | CHANGED | rc=0 >> root

Si la commande renvoie

root, vous avez correctement configurésudosur les nœuds gérés et l'escalade des privilèges fonctionne.

Chapitre 2. Mise à jour des paquets pour permettre l'automatisation des rôles système RHEL

À partir de la version RHEL 9.0, Ansible Engine n'est plus pris en charge. À la place, cette version de RHEL et les suivantes incluent Ansible Core.

Vous pouvez utiliser Ansible Core dans RHEL 9.0 pour activer le contenu d'automatisation Ansible écrit ou généré par les produits Red Hat.

Ansible Core contient des outils de ligne de commande Ansible, tels que les commandes ansible-playbook et ansible, ainsi qu'un petit ensemble de plugins Ansible intégrés.

2.1. Différences entre Ansible Engine et Ansible Core

Dans RHEL 8.5 et les versions antérieures, vous aviez accès à un dépôt Ansible séparé qui contenait Ansible Engine 2.9 pour permettre l'automatisation basée sur Ansible sur votre système Red Hat.

L'étendue de l'assistance, lors de l'utilisation d'Ansible Engine sans abonnement Ansible, est limitée à l'exécution des playbooks Ansible créés ou générés par les produits Red Hat, tels que RHEL System Roles, Insights remediation playbooks, et OpenSCAP Ansible remediation playbooks.

Dans RHEL 8.6 et les versions ultérieures, Ansible Core remplace Ansible Engine. Le paquetage ansible-core est inclus dans le référentiel AppStream de RHEL 9 pour activer le contenu d'automatisation fourni par Red Hat. L'étendue de la prise en charge d'Ansible Core dans RHEL reste la même que dans les versions antérieures de RHEL :

- Le support est limité à tous les playbooks, rôles et modules Ansible qui sont inclus ou générés par un produit Red Hat, tels que RHEL System Roles, ou les playbooks de remédiation générés par Insights.

- Avec Ansible Core, vous bénéficiez de toutes les fonctionnalités du contenu Ansible RHEL pris en charge, telles que les rôles système RHEL et les playbooks de remédiation Insights.

Le référentiel Ansible Engine est toujours disponible dans RHEL 8.6 ; cependant, il ne recevra aucune mise à jour de sécurité ou de correction de bogues et pourrait ne pas être compatible avec le contenu d'automatisation Ansible inclus dans RHEL 8.6 et les versions ultérieures.

Vous avez besoin d'un abonnement à Ansible Automation Platform pour bénéficier d'un support supplémentaire pour la plateforme sous-jacente et les modules maintenus par le Core.

Ressources supplémentaires

2.2. Migration d'Ansible Engine vers Ansible Core

Conditions préalables

Accès et autorisations à un ou plusieurs managed nodes, qui sont des systèmes que vous souhaitez configurer avec les rôles système RHEL.

- Un fichier d'inventaire qui répertorie les nœuds gérés.

Procédure

Désinstaller Ansible Engine :

# dnf remove ansibleDésactiver le dépôt

ansible-2-for-rhel-8-x86_64-rpms:# subscription-manager repos --disable ansible-2-for-rhel-8-x86_64-rpmsInstallez Ansible Core qui est disponible dans le dépôt RHEL 8 AppStream :

# dnf install ansible-core

Vérification

Vérifiez que le paquet

ansible-coreest présent dans votre système :# dnf info ansible-core

Si le paquet ansible-core est effectivement présent dans votre système, la sortie de la commande contient des informations sur le nom du paquet, sa version, son édition, sa taille, etc :

Available Packages Name : ansible-core Version : 2.12.2 Release : 1.fc34 Architecture : noarch Size : 2.4 M Source : ansible-core-2.12.2-1.fc34.src.rpm Repository : updates Summary : A radically simple IT automation system URL : http://ansible.com

Ressources supplémentaires

Chapitre 3. Installation et utilisation des collections

3.1. Introduction aux collections Ansible

Les collections Ansible sont la nouvelle façon de distribuer, de maintenir et de consommer l'automatisation. En combinant plusieurs types de contenu Ansible tels que des playbooks, des rôles, des modules et des plugins, vous pouvez bénéficier d'améliorations en termes de flexibilité et d'évolutivité.

Les collections Ansible sont une option au format traditionnel des rôles système RHEL. L'utilisation des Rôles système RHEL dans le format Ansible Collection est presque la même que dans le format traditionnel des Rôles système RHEL. La différence est que les collections Ansible utilisent le concept de fully qualified collection name (FQCN), qui se compose d'un namespace et d'un collection name. Le namespace que nous utilisons est le redhat et le collection name est le rhel_system_roles. Ainsi, alors que le format traditionnel RHEL System Roles pour le rôle Kernel Settings est présenté sous la forme rhel-system-roles.kernel_settings (avec des tirets), l'utilisation de la collection fully qualified collection name pour le rôle Kernel Settings serait présentée sous la forme redhat.rhel_system_roles.kernel_settings (avec des traits de soulignement).

La combinaison d'un namespace et d'un collection name garantit l'unicité des objets. Elle garantit également que les objets sont partagés entre les collections Ansible et les espaces de noms sans aucun conflit.

Ressources supplémentaires

- Pour utiliser les collections certifiées Red Hat en accédant à Automation Hub, vous devez disposer d'un abonnement à Ansible Automation Platform (AAP).

3.2. Structure des collections

Les collections sont un format de paquetage pour le contenu Ansible. La structure des données est la suivante :

- docs/ : documentation locale pour la collection, avec des exemples, si le rôle fournit la documentation

- galaxy.yml : données sources pour le fichier MANIFEST.json qui fera partie du paquetage Ansible Collection

playbooks/ : les playbooks sont disponibles ici

- tasks/ : contient les "fichiers de listes de tâches" pour l'utilisation de include_tasks/import_tasks

plugins/ : tous les plugins et modules Ansible sont disponibles ici, chacun dans son sous-répertoire

- modules/ : Modules Ansible

- modules_utils/ : code commun pour le développement de modules

- lookup/ : recherche d'un plugin

- filter/ : Plugin de filtre Jinja2

- connection/ : plugins de connexion requis si vous n'utilisez pas le plugin par défaut

- roles/ : répertoire des rôles Ansible

- tests/ : tests pour le contenu de la collection

3.3. Installation des collections à l'aide de l'interface de programmation

Les collections sont un format de distribution pour le contenu Ansible qui peut inclure des playbooks, des rôles, des modules et des plugins.

Vous pouvez installer Collections par l'intermédiaire d'Ansible Galaxy, du navigateur ou de la ligne de commande.

Conditions préalables

- Accès et autorisations à une ou plusieurs managed nodes.

Accès et permissions à un control node, qui est un système à partir duquel Red Hat Ansible Core configure d'autres systèmes.

Sur le nœud de contrôle :

-

Les paquets

ansible-coreetrhel-system-rolessont installés. - Un fichier d'inventaire qui répertorie les nœuds gérés.

-

Les paquets

Procédure

Installez la collection via un paquetage RPM :

# dnf install rhel-system-roles

Une fois l'installation terminée, les rôles sont disponibles à l'adresse redhat.rhel_system_roles.<role_name>. En outre, vous pouvez trouver la documentation de chaque rôle à l'adresse /usr/share/ansible/collections/ansible_collections/redhat/rhel_system_roles/roles/<role_name>/README.md.

Verification steps

Pour vérifier l'installation, exécutez le rôle kernel_settings avec le mode check sur votre hôte local. Vous devez également utiliser le paramètre --become car il est nécessaire pour le module Ansible package. Cependant, ce paramètre ne modifiera pas votre système :

Exécutez la commande suivante :

$ ansible-playbook -c local -i localhost, --check --become /usr/share/ansible/collections/ansible_collections/redhat/rhel_system_roles/tests/kernel_settings/tests_default.yml

La dernière ligne de la sortie de la commande doit contenir la valeur failed=0.

La virgule après localhost est obligatoire. Vous devez l'ajouter même s'il n'y a qu'un seul hôte dans la liste. Sans elle, ansible-playbook identifierait localhost comme un fichier ou un répertoire.

Ressources supplémentaires

-

La page de manuel

ansible-playbook. -

L'option

-ide la commandeansible-playbook

3.4. Installation des collections à partir d'Automation Hub

Si vous utilisez le Hub d'automatisation, vous pouvez installer la collection de rôles système RHEL hébergée sur le Hub d'automatisation.

Conditions préalables

- Accès et autorisations à une ou plusieurs managed nodes.

Accès et permissions à un control node, qui est un système à partir duquel Red Hat Ansible Core configure d'autres systèmes.

Sur le nœud de contrôle :

-

Les paquets

ansible-coreetrhel-system-rolessont installés. - Un fichier d'inventaire qui répertorie les nœuds gérés.

-

Les paquets

Procédure

-

Définissez Red Hat Automation Hub comme source de contenu par défaut dans le fichier de configuration

ansible.cfg. Voir Configurer Red Hat Automation Hub en tant que source primaire de contenu . Installez la collection

redhat.rhel_system_rolesà partir du Hub d'automatisation :# ansible-galaxy collection install redhat.rhel_system_rolesUne fois l'installation terminée, les rôles sont disponibles à l'adresse

redhat.rhel_system_roles.<role_name>. En outre, vous pouvez trouver la documentation de chaque rôle à l'adresse/usr/share/ansible/collections/ansible_collections/redhat/rhel_system_roles/roles/<role_name>/README.md.

Verification steps

Pour vérifier l'installation, exécutez le rôle kernel_settings avec le mode check sur votre hôte local. Vous devez également utiliser le paramètre --become car il est nécessaire pour le module Ansible package. Cependant, ce paramètre ne modifiera pas votre système :

Exécutez la commande suivante :

$ ansible-playbook -c local -i localhost, --check --become /usr/share/ansible/collections/ansible_collections/redhat/rhel_system_roles/tests/kernel_settings/tests_default.yml

La dernière ligne de la sortie de la commande doit contenir la valeur failed=0.

La virgule après localhost est obligatoire. Vous devez l'ajouter même s'il n'y a qu'un seul hôte dans la liste. Sans elle, ansible-playbook identifierait localhost comme un fichier ou un répertoire.

Ressources supplémentaires

-

La page de manuel

ansible-playbook. -

L'option

-ide la commandeansible-playbook

3.5. Déploiement du rôle de système tlog RHEL à l'aide de collections

Voici un exemple utilisant Collections pour préparer et appliquer un playbook afin de déployer une solution de journalisation sur un ensemble de machines distinctes.

Conditions préalables

- Une collection Galaxy est installée.

Procédure

Créez un nouveau fichier

playbook.ymlavec le contenu suivant :--- - name: Deploy session recording hosts: all vars: tlog_scope_sssd: some tlog_users_sssd: - recordeduser roles: - redhat.rhel-system-roles.tlogOù ?

tlog_scope_sssd:-

somespécifie que vous souhaitez enregistrer uniquement certains utilisateurs et groupes, pasallounone.

-

tlog_users_sssd:-

recordeduserspécifie l'utilisateur à partir duquel vous souhaitez enregistrer une session. Notez que cette fonction n'ajoute pas l'utilisateur à votre place. Vous devez définir l'utilisateur vous-même.

-

Optionnellement, vérifier la syntaxe du playbook.

# ansible-playbook --syntax-check playbook.ymlExécutez le playbook sur votre fichier d'inventaire :

# ansible-playbook -i IP_Address /path/to/file/playbook.yml -v

Par conséquent, le playbook installe le rôle tlog sur le système que vous avez spécifié. Il crée également un fichier de dépôt de configuration SSSD qui peut être utilisé par les utilisateurs et les groupes que vous définissez. SSSD analyse et lit ces utilisateurs et groupes pour superposer la session tlog en tant qu'utilisateur shell. En outre, si le paquet cockpit est installé sur le système, le playbook installe également le paquet cockpit-session-recording, qui est un module Cockpit vous permettant de visualiser et de lire des enregistrements dans l'interface de la console Web.

Verification steps

Tester la syntaxe du fichier

/etc/rsyslog.conf:# rsyslogd -N 1 rsyslogd: version 8.1911.0-6.el8, config validation run (level 1), master config /etc/rsyslog.conf rsyslogd: End of config validation run. Bye.

- Vérifiez que le système envoie des messages au journal :

Pour vérifier que le fichier de dépôt de configuration SSSD est créé dans le système, procédez comme suit :

Naviguez jusqu'au dossier dans lequel le fichier de dépôt de la configuration SSSD a été créé :

# cd /etc/sssd/conf.dVérifier le contenu du fichier :

# cat sssd-session-recording.conf

Vous pouvez voir que le fichier contient les paramètres que vous avez définis dans le playbook.

Chapitre 4. Modules Ansible IPMI dans RHEL

4.1. La collection rhel_mgmt

L'interface de gestion de plate-forme intelligente (IPMI) est une spécification d'un ensemble de protocoles standard pour communiquer avec les dispositifs de contrôleur de gestion de carte de base (BMC). Les modules IPMI vous permettent d'activer et de prendre en charge l'automatisation de la gestion du matériel. Les modules IPMI sont disponibles en :

-

La collection

rhel_mgmt. Le nom du paquet estansible-collection-redhat-rhel_mgmt. -

L'AppStream RHEL 8, qui fait partie du nouveau paquet

ansible-collection-redhat-rhel_mgmt.

Les modules IPMI suivants sont disponibles dans la collection rhel_mgmt :

-

ipmi_boot: Gestion de l'ordre des périphériques de démarrage -

ipmi_power: Gestion de l'énergie pour les machines

Les paramètres obligatoires utilisés pour les modules IPMI sont les suivants :

-

ipmi_bootparamètres :

| Nom du module | Description |

|---|---|

| nom | Nom d'hôte ou adresse IP du BMC |

| password | Mot de passe pour se connecter au BMC |

| bootdev | Dispositif à utiliser lors du prochain démarrage * réseau * disquette * hd * sûr * optique * configuration * par défaut |

| User | Nom d'utilisateur pour se connecter au BMC |

-

ipmi_powerparamètres :

| Nom du module | Description |

|---|---|

| nom | Nom d'hôte ou adresse IP du BMC |

| password | Mot de passe pour se connecter au BMC |

| utilisateur | Nom d'utilisateur pour se connecter au BMC |

| État | Vérifier si la machine est dans l'état souhaité * sur * éteint * arrêt * réinitialiser * botte |

4.2. Installation de la collection rhel mgmt à l'aide du CLI

Vous pouvez installer la collection rhel_mgmt à l'aide de la ligne de commande.

Conditions préalables

-

Le paquet

ansible-coreest installé.

Procédure

Installez la collection via un paquetage RPM :

# yum install ansible-collection-redhat-rhel_mgmtUne fois l'installation terminée, les modules IPMI sont disponibles dans la collection Ansible

redhat.rhel_mgmt.

Ressources supplémentaires

-

La page de manuel

ansible-playbook.

4.3. Exemple d'utilisation du module ipmi_boot

L'exemple suivant montre comment utiliser le module ipmi_boot dans un playbook pour définir un périphérique de démarrage pour le prochain démarrage. Pour des raisons de simplicité, les exemples utilisent le même hôte que l'hôte de contrôle Ansible et l'hôte géré, ce qui permet d'exécuter les modules sur le même hôte que celui où le playbook est exécuté.

Conditions préalables

- La collection rhel_mgmt est installée.

La bibliothèque

pyghmidu paquetpython3-pyghmiest installée dans l'un des emplacements suivants :- L'hôte sur lequel vous exécutez le manuel de jeu.

-

L'hôte géré. Si vous utilisez localhost comme hôte géré, installez le paquetage

python3-pyghmisur l'hôte où vous exécutez le playbook à la place.

- La BMC IPMI que vous souhaitez contrôler est accessible via le réseau depuis l'hôte sur lequel vous exécutez le playbook, ou l'hôte géré (si vous n'utilisez pas localhost comme hôte géré). Notez que l'hôte dont la BMC est configurée par le module est généralement différent de l'hôte où le module est exécuté (l'hôte géré par Ansible), car le module contacte la BMC sur le réseau en utilisant le protocole IPMI.

- Vous disposez d'informations d'identification vous permettant d'accéder à BMC avec un niveau d'accès approprié.

Procédure

Créez un nouveau fichier playbook.yml avec le contenu suivant :

--- - name: Sets which boot device will be used on next boot hosts: localhost tasks: - redhat.rhel_mgmt.ipmi_boot: name: bmc.host.example.com user: admin_user password: basics bootdev: hdExécuter le playbook contre localhost :

# ansible-playbook playbook.yml

En conséquence, la sortie renvoie la valeur "success".

4.4. Exemple avec le module ipmi_power

Cet exemple montre comment utiliser le module ipmi_boot dans un playbook pour vérifier si le système est allumé. Pour des raisons de simplicité, les exemples utilisent le même hôte que l'hôte de contrôle Ansible et l'hôte géré, ce qui permet d'exécuter les modules sur le même hôte que celui où le playbook est exécuté.

Conditions préalables

- La collection rhel_mgmt est installée.

La bibliothèque

pyghmidu paquetpython3-pyghmiest installée dans l'un des emplacements suivants :- L'hôte sur lequel vous exécutez le manuel de jeu.

-

L'hôte géré. Si vous utilisez localhost comme hôte géré, installez le paquetage

python3-pyghmisur l'hôte où vous exécutez le playbook à la place.

- La BMC IPMI que vous souhaitez contrôler est accessible via le réseau depuis l'hôte sur lequel vous exécutez le playbook, ou l'hôte géré (si vous n'utilisez pas localhost comme hôte géré). Notez que l'hôte dont la BMC est configurée par le module est généralement différent de l'hôte où le module est exécuté (l'hôte géré par Ansible), car le module contacte la BMC sur le réseau en utilisant le protocole IPMI.

- Vous disposez d'informations d'identification vous permettant d'accéder à BMC avec un niveau d'accès approprié.

Procédure

Créez un nouveau fichier playbook.yml avec le contenu suivant :

--- - name: Turn the host on hosts: localhost tasks: - redhat.rhel_mgmt.ipmi_power: name: bmc.host.example.com user: admin_user password: basics state: onExécuter le cahier des charges :

# ansible-playbook playbook.yml

La sortie renvoie la valeur "true".

Chapitre 5. Les modules Redfish dans RHEL

Les modules Redfish pour la gestion à distance de périphériques font désormais partie de la collection Ansible de redhat.rhel_mgmt. Avec les modules Redfish, vous pouvez facilement utiliser l'automatisation de la gestion sur les serveurs bare-metal et le matériel de plate-forme en obtenant des informations sur les serveurs ou en les contrôlant via un contrôleur hors bande (OOB), en utilisant le transport HTTPS standard et le format JSON.

5.1. Les modules Redfish

La collection Ansible redhat.rhel_mgmt fournit les modules Redfish pour prendre en charge la gestion du matériel dans Ansible via Redfish. La collection redhat.rhel_mgmt est disponible dans le paquetage ansible-collection-redhat-rhel_mgmt. Pour l'installer, voir Installation de la collection redhat.rhel_mgmt à l'aide du CLI.

Les modules Redfish suivants sont disponibles dans la collection redhat.rhel_mgmt:

-

redfish_info: Le moduleredfish_inforécupère des informations sur le contrôleur hors bande (OOB) distant, telles que l'inventaire des systèmes. -

redfish_command: Le moduleredfish_commandeffectue des opérations de contrôle hors bande (OOB) telles que la gestion des journaux et des utilisateurs, ainsi que des opérations d'alimentation telles que le redémarrage du système, la mise sous tension et la mise hors tension. -

redfish_config: Le moduleredfish_configeffectue les opérations du contrôleur OOB telles que la modification de la configuration OOB ou le réglage de la configuration BIOS.

5.2. Paramètres des modules Redfish

Les paramètres utilisés pour les modules Redfish sont les suivants :

redfish_info paramètres : | Description |

|---|---|

|

| (Obligatoire) - URI de base du contrôleur OOB. |

|

| (Obligatoire) - Liste des catégories à exécuter sur le contrôleur OOB. La valeur par défaut est ["Systems"]. |

|

| (Obligatoire) - Liste des commandes à exécuter sur le contrôleur OOB. |

|

| Nom d'utilisateur pour l'authentification auprès du contrôleur OOB. |

|

| Mot de passe pour l'authentification au contrôleur OOB. |

redfish_command paramètres : | Description |

|---|---|

|

| (Obligatoire) - URI de base du contrôleur OOB. |

|

| (Obligatoire) - Liste des catégories à exécuter sur le contrôleur OOB. La valeur par défaut est ["Systems"]. |

|

| (Obligatoire) - Liste des commandes à exécuter sur le contrôleur OOB. |

|

| Nom d'utilisateur pour l'authentification auprès du contrôleur OOB. |

|

| Mot de passe pour l'authentification au contrôleur OOB. |

redfish_config paramètres : | Description |

|---|---|

|

| (Obligatoire) - URI de base du contrôleur OOB. |

|

| (Obligatoire) - Liste des catégories à exécuter sur le contrôleur OOB. La valeur par défaut est ["Systems"]. |

|

| (Obligatoire) - Liste des commandes à exécuter sur le contrôleur OOB. |

|

| Nom d'utilisateur pour l'authentification auprès du contrôleur OOB. |

|

| Mot de passe pour l'authentification au contrôleur OOB. |

|

| Attributs du BIOS à mettre à jour. |

5.3. Utilisation du module redfish_info

L'exemple suivant montre comment utiliser le module redfish_info dans un playbook pour obtenir des informations sur l'inventaire des CPU. Pour des raisons de simplicité, l'exemple utilise le même hôte que l'hôte de contrôle Ansible et l'hôte géré, ce qui permet d'exécuter les modules sur le même hôte que celui où le playbook est exécuté.

Conditions préalables

-

La collection

redhat.rhel_mgmtest installée. -

La bibliothèque

pyghmidu paquetagepython3-pyghmiest installée sur l'hôte géré. Si vous utilisez localhost comme hôte géré, installez le paquetagepython3-pyghmisur l'hôte où vous exécutez le playbook. - Détails de l'accès au contrôleur OOB.

Procédure

Créez un nouveau fichier playbook.yml avec le contenu suivant :

--- - name: Get CPU inventory hosts: localhost tasks: - redhat.rhel_mgmt.redfish_info: baseuri: "{{ baseuri }}" username: "{{ username }}" password: "{{ password }}" category: Systems command: GetCpuInventory register: resultExécuter le playbook contre localhost :

# ansible-playbook playbook.yml

En conséquence, la sortie renvoie les détails de l'inventaire de l'unité centrale.

5.4. Utilisation du module redfish_command

L'exemple suivant montre comment utiliser le module redfish_command dans un playbook pour allumer un système. Pour des raisons de simplicité, l'exemple utilise le même hôte que l'hôte de contrôle Ansible et l'hôte géré, ce qui permet d'exécuter les modules sur le même hôte que celui où le playbook est exécuté.

Conditions préalables

-

La collection

redhat.rhel_mgmtest installée. -

La bibliothèque

pyghmidu paquetagepython3-pyghmiest installée sur l'hôte géré. Si vous utilisez localhost comme hôte géré, installez le paquetagepython3-pyghmisur l'hôte où vous exécutez le playbook. - Détails de l'accès au contrôleur OOB.

Procédure

Créez un nouveau fichier playbook.yml avec le contenu suivant :

--- - name: Power on system hosts: localhost tasks: - redhat.rhel_mgmt.redfish_command: baseuri: "{{ baseuri }}" username: "{{ username }}" password: "{{ password }}" category: Systems command: PowerOnExécuter le playbook contre localhost :

# ansible-playbook playbook.yml

Le système se met alors en marche.

5.5. Utilisation du module redfish_config

L'exemple suivant montre comment utiliser le module redfish_config dans un playbook pour configurer un système afin qu'il démarre avec l'UEFI. Pour des raisons de simplicité, l'exemple utilise le même hôte que l'hôte de contrôle Ansible et l'hôte géré, ce qui permet d'exécuter les modules sur le même hôte que celui où le playbook est exécuté.

Conditions préalables

-

La collection

redhat.rhel_mgmtest installée. -

La bibliothèque

pyghmidu paquetagepython3-pyghmiest installée sur l'hôte géré. Si vous utilisez localhost comme hôte géré, installez le paquetagepython3-pyghmisur l'hôte où vous exécutez le playbook. - Détails de l'accès au contrôleur OOB.

Procédure

Créez un nouveau fichier playbook.yml avec le contenu suivant :

--- - name: "Set BootMode to UEFI" hosts: localhost tasks: - redhat.rhel_mgmt.redfish_config: baseuri: "{{ baseuri }}" username: "{{ username }}" password: "{{ password }}" category: Systems command: SetBiosAttributes bios_attributes: BootMode: UefiExécuter le playbook contre localhost :

# ansible-playbook playbook.yml

Par conséquent, le mode de démarrage du système est réglé sur UEFI.

Chapitre 6. Utiliser les rôles Ansible pour configurer de façon permanente les paramètres du noyau

Vous pouvez utiliser le rôle kernel_settings pour configurer les paramètres du noyau sur plusieurs clients à la fois. Cette solution :

- Fournit une interface conviviale avec des paramètres d'entrée efficaces.

- Conserve tous les paramètres du noyau en un seul endroit.

Après avoir exécuté le rôle kernel_settings à partir de la machine de contrôle, les paramètres du noyau sont appliqués immédiatement aux systèmes gérés et persistent à travers les redémarrages.

Notez que les rôles système RHEL livrés sur les canaux RHEL sont disponibles pour les clients RHEL sous forme de paquetage RPM dans le référentiel AppStream par défaut. Les rôles système RHEL sont également disponibles sous forme de collection pour les clients ayant des abonnements Ansible via Ansible Automation Hub.

6.1. Introduction au rôle kernel_settings

RHEL System Roles est un ensemble de rôles qui fournit une interface de configuration cohérente pour gérer à distance plusieurs systèmes.

Les rôles système RHEL ont été introduits pour les configurations automatisées du noyau à l'aide du rôle système kernel_settings. Le paquet rhel-system-roles contient ce rôle système, ainsi que la documentation de référence.

Pour appliquer les paramètres du noyau sur un ou plusieurs systèmes de manière automatisée, utilisez le rôle kernel_settings avec une ou plusieurs de ses variables de rôle de votre choix dans un playbook. Un playbook est une liste d'un ou plusieurs jeux lisibles par l'homme et écrits au format YAML.

Le rôle kernel_settings vous permet de configurer :

-

Les paramètres du noyau en utilisant la variable de rôle

kernel_settings_sysctl -

Divers sous-systèmes du noyau, périphériques matériels et pilotes de périphériques utilisant la variable de rôle

kernel_settings_sysfs -

L'affinité du processeur pour le gestionnaire de service

systemdet les processus qui en découlent en utilisant la variable de rôlekernel_settings_systemd_cpu_affinity -

Le sous-système de mémoire du noyau utilise les variables de rôle

kernel_settings_transparent_hugepagesetkernel_settings_transparent_hugepages_defragpour rendre les hugepages transparentes

Ressources supplémentaires

-

README.mdetREADME.htmldans le répertoire/usr/share/doc/rhel-system-roles/kernel_settings/ - Travailler avec des playbooks

- Comment constituer votre inventaire

6.2. Application des paramètres sélectionnés du noyau à l'aide du rôle kernel_settings

Suivez ces étapes pour préparer et appliquer un playbook Ansible afin de configurer à distance les paramètres du noyau avec un effet persistant sur plusieurs systèmes d'exploitation gérés.

Conditions préalables

-

Vous avez les autorisations

root. -

En vertu de votre abonnement RHEL, vous avez installé les paquets

ansible-coreetrhel-system-rolessur la machine de contrôle. - Un inventaire des hôtes gérés est présent sur la machine de contrôle et Ansible peut s'y connecter.

RHEL 8.0 - 8.5 donne accès à un dépôt Ansible séparé qui contient Ansible Engine 2.9 pour l'automatisation basée sur Ansible. Ansible Engine contient des utilitaires de ligne de commande tels que ansible, ansible-playbook; des connecteurs tels que docker et podman; et tout l'univers des plugins et des modules. Pour plus d'informations sur la manière d'obtenir et d'installer Ansible Engine, reportez-vous à la section Comment télécharger et installer Red Hat Ansible Engine ?

RHEL 8.6 et 9.0 a introduit Ansible Core (fourni en tant que ansible-core RPM), qui contient les utilitaires de ligne de commande Ansible, les commandes et un petit ensemble de plugins Ansible intégrés. Le dépôt AppStream fournit ansible-core, qui a une portée de support limitée. Pour en savoir plus, consultez le document Scope of support for the ansible-core package included in the RHEL 9 AppStream.

Procédure

Si vous le souhaitez, vous pouvez consulter le fichier

inventoryà des fins d'illustration :# cat /home/jdoe/<ansible_project_name>/inventory [testingservers] pdoe@192.168.122.98 fdoe@192.168.122.226 [db-servers] db1.example.com db2.example.com [webservers] web1.example.com web2.example.com 192.0.2.42Ce fichier définit le groupe

[testingservers]et d'autres groupes. Il vous permet d'exécuter Ansible plus efficacement sur un ensemble spécifique de systèmes.Créer un fichier de configuration pour définir les valeurs par défaut et l'escalade des privilèges pour les opérations Ansible.

Créez un nouveau fichier YAML et ouvrez-le dans un éditeur de texte, par exemple :

# vi /home/jdoe/<ansible_project_name>/ansible.cfgInsérez le contenu suivant dans le fichier :

[defaults] inventory = ./inventory [privilege_escalation] become = true become_method = sudo become_user = root become_ask_pass = true

La section

[defaults]indique un chemin d'accès au fichier d'inventaire des hôtes gérés. La section[privilege_escalation]définit que les privilèges de l'utilisateur doivent passer àrootsur les hôtes gérés spécifiés. Ceci est nécessaire pour une configuration réussie des paramètres du noyau. Lorsque le playbook Ansible est exécuté, vous serez invité à saisir le mot de passe de l'utilisateur. L'utilisateur passe automatiquement àrootpar le biais desudoaprès s'être connecté à un hôte géré.

Créer un playbook Ansible qui utilise le rôle

kernel_settings.Créez un nouveau fichier YAML et ouvrez-le dans un éditeur de texte, par exemple :

# vi /home/jdoe/<ansible_project_name>/kernel-roles.ymlCe fichier représente un playbook et contient généralement une liste ordonnée de tâches, également appelées plays, qui sont exécutées contre des hôtes gérés spécifiques sélectionnés dans votre fichier

inventory.Insérez le contenu suivant dans le fichier :

--- - hosts: testingservers name: "Configure kernel settings" roles: - rhel-system-roles.kernel_settings vars: kernel_settings_sysctl: - name: fs.file-max value: 400000 - name: kernel.threads-max value: 65536 kernel_settings_sysfs: - name: /sys/class/net/lo/mtu value: 65000 kernel_settings_transparent_hugepages: madviseLa clé

nameest facultative. Elle associe une chaîne arbitraire à la pièce en tant qu'étiquette et identifie l'objet de la pièce. La cléhostsde la pièce spécifie les hôtes contre lesquels la pièce est exécutée. La ou les valeurs de cette clé peuvent être fournies sous forme de noms individuels d'hôtes gérés ou de groupes d'hôtes tels que définis dans le fichierinventory.La section

varsreprésente une liste de variables contenant les noms des paramètres du noyau sélectionnés et les valeurs auxquelles ils doivent être définis.La clé

rolesspécifie le rôle du système qui va configurer les paramètres et les valeurs mentionnés dans la sectionvars.NoteVous pouvez modifier les paramètres du noyau et leurs valeurs dans le playbook en fonction de vos besoins.

En option, vérifiez que la syntaxe de votre pièce est correcte.

# ansible-playbook --syntax-check kernel-roles.yml playbook: kernel-roles.ymlCet exemple montre la vérification réussie d'un playbook.

Exécutez votre cahier des charges.

# ansible-playbook kernel-roles.yml ... BECOME password: PLAY [Configure kernel settings] ********************************************************************************** PLAY RECAP ******************************************************************************************************** fdoe@192.168.122.226 : ok=10 changed=4 unreachable=0 failed=0 skipped=6 rescued=0 ignored=0 pdoe@192.168.122.98 : ok=10 changed=4 unreachable=0 failed=0 skipped=6 rescued=0 ignored=0Avant qu'Ansible n'exécute votre playbook, vous allez être invité à saisir votre mot de passe afin qu'un utilisateur sur les hôtes gérés puisse être basculé sur

root, ce qui est nécessaire pour configurer les paramètres du noyau.La section récapitulative montre que la lecture s'est terminée avec succès (

failed=0) pour tous les hôtes gérés, et que 4 paramètres du noyau ont été appliqués (changed=4).- Redémarrez les hôtes gérés et vérifiez les paramètres du noyau concernés pour vous assurer que les changements ont été appliqués et qu'ils persistent après les redémarrages.

Ressources supplémentaires

- Préparation d'un nœud de contrôle et de nœuds gérés à l'utilisation des rôles système RHEL

-

README.htmletREADME.mddans le répertoire/usr/share/doc/rhel-system-roles/kernel_settings/ - Constituez votre inventaire

- Configuration d'Ansible

- Travailler avec des Playbooks

- Utilisation de variables

- Rôles

Chapitre 7. Configuration des paramètres réseau à l'aide des rôles système RHEL

Vous pouvez automatiser les tâches de configuration et de gestion liées au réseau en utilisant le rôle de système network RHEL.

7.1. Configuration d'une connexion Ethernet avec une adresse IP statique en utilisant le rôle de système RHEL avec un nom d'interface

Vous pouvez configurer à distance une connexion Ethernet à l'aide de network RHEL System Role.

Par exemple, la procédure ci-dessous crée un profil de connexion NetworkManager pour le périphérique enp7s0 avec les paramètres suivants :

-

Une adresse IPv4 statique -

192.0.2.1avec un masque de sous-réseau/24 -

Une adresse IPv6 statique -

2001:db8:1::1avec un masque de sous-réseau/64 -

Une passerelle par défaut IPv4 -

192.0.2.254 -

Une passerelle par défaut IPv6 -

2001:db8:1::fffe -

Un serveur DNS IPv4 -

192.0.2.200 -

Un serveur DNS IPv6 -

2001:db8:1::ffbb -

Un domaine de recherche DNS -

example.com

Effectuez cette procédure sur le nœud de contrôle Ansible.

Conditions préalables

- Vous avez préparé le nœud de contrôle et les nœuds gérés.

- Vous êtes connecté au nœud de contrôle en tant qu'utilisateur pouvant exécuter des séquences sur les nœuds gérés.

-

Le compte que vous utilisez pour vous connecter aux nœuds gérés dispose des autorisations

sudo. - Les nœuds gérés ou les groupes de nœuds gérés sur lesquels vous souhaitez exécuter cette séquence sont répertoriés dans le fichier d'inventaire Ansible.

- Un périphérique Ethernet physique ou virtuel existe dans la configuration du serveur.

- Les nœuds gérés utilisent NetworkManager pour configurer le réseau.

Procédure

Créez un fichier playbook, par exemple

~/ethernet-static-IP.ymlavec le contenu suivant :--- - name: Configure the network hosts: managed-node-01.example.com tasks: - name: Configure an Ethernet connection with static IP include_role: name: rhel-system-roles.network vars: network_connections: - name: enp7s0 interface_name: enp7s0 type: ethernet autoconnect: yes ip: address: - 192.0.2.1/24 - 2001:db8:1::1/64 gateway4: 192.0.2.254 gateway6: 2001:db8:1::fffe dns: - 192.0.2.200 - 2001:db8:1::ffbb dns_search: - example.com state: upExécutez le manuel de jeu :

# ansible-playbook ~/ethernet-static-IP.yml

Ressources supplémentaires

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdfichier

7.2. Configuration d'une connexion Ethernet avec une adresse IP statique en utilisant le rôle de système RHEL avec un chemin d'accès aux périphériques

Vous pouvez configurer à distance une connexion Ethernet à l'aide de network RHEL System Role.

Vous pouvez identifier le chemin d'accès à l'appareil à l'aide de la commande suivante :

# udevadm info /sys/class/net/<device_name> | grep ID_PATH=

Par exemple, la procédure ci-dessous crée un profil de connexion NetworkManager avec les paramètres suivants pour le périphérique qui correspond à l'expression PCI ID 0000:00:0[1-3].0, mais pas 0000:00:02.0:

-

Une adresse IPv4 statique -

192.0.2.1avec un masque de sous-réseau/24 -

Une adresse IPv6 statique -

2001:db8:1::1avec un masque de sous-réseau/64 -

Une passerelle par défaut IPv4 -

192.0.2.254 -

Une passerelle par défaut IPv6 -

2001:db8:1::fffe -

Un serveur DNS IPv4 -

192.0.2.200 -

Un serveur DNS IPv6 -

2001:db8:1::ffbb -

Un domaine de recherche DNS -

example.com

Effectuez cette procédure sur le nœud de contrôle Ansible.

Conditions préalables

- Vous avez préparé le nœud de contrôle et les nœuds gérés.

- Vous êtes connecté au nœud de contrôle en tant qu'utilisateur pouvant exécuter des séquences sur les nœuds gérés.

-

Le compte que vous utilisez pour vous connecter aux nœuds gérés dispose des autorisations

sudo. - Les nœuds gérés ou les groupes de nœuds gérés sur lesquels vous souhaitez exécuter cette séquence sont répertoriés dans le fichier d'inventaire Ansible.

- Un périphérique Ethernet physique ou virtuel existe dans la configuration du serveur.

- Les nœuds gérés utilisent NetworkManager pour configurer le réseau.

Procédure

Créez un fichier playbook, par exemple

~/ethernet-static-IP.ymlavec le contenu suivant :--- - name: Configure the network hosts: managed-node-01.example.com tasks: - name: Configure an Ethernet connection with static IP include_role: name: rhel-system-roles.network vars: network_connections: - name: example match: path: - pci-0000:00:0[1-3].0 - &!pci-0000:00:02.0 type: ethernet autoconnect: yes ip: address: - 192.0.2.1/24 - 2001:db8:1::1/64 gateway4: 192.0.2.254 gateway6: 2001:db8:1::fffe dns: - 192.0.2.200 - 2001:db8:1::ffbb dns_search: - example.com state: up

Le paramètre

matchdans cet exemple définit qu'Ansible applique la pièce aux périphériques qui correspondent à l'ID PCI0000:00:0[1-3].0, mais pas à0000:00:02.0. Pour plus de détails sur les modificateurs spéciaux et les jokers que vous pouvez utiliser, consultez la description du paramètrematchdans le fichier/usr/share/ansible/roles/rhel-system-roles.network/README.md.Exécutez le manuel de jeu :

# ansible-playbook ~/ethernet-static-IP.yml

Ressources supplémentaires

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdfichier

7.3. Configuration d'une connexion Ethernet avec une adresse IP dynamique en utilisant le rôle de système RHEL avec un nom d'interface

Vous pouvez configurer à distance une connexion Ethernet à l'aide du rôle de système RHEL network. Pour les connexions avec des paramètres d'adresse IP dynamiques, NetworkManager demande les paramètres IP pour la connexion à partir d'un serveur DHCP.

Effectuez cette procédure sur le nœud de contrôle Ansible.

Conditions préalables

- Vous avez préparé le nœud de contrôle et les nœuds gérés.

- Vous êtes connecté au nœud de contrôle en tant qu'utilisateur pouvant exécuter des séquences sur les nœuds gérés.

-

Le compte que vous utilisez pour vous connecter aux nœuds gérés dispose des autorisations

sudo. - Les nœuds gérés ou les groupes de nœuds gérés sur lesquels vous souhaitez exécuter cette séquence sont répertoriés dans le fichier d'inventaire Ansible.

- Un périphérique Ethernet physique ou virtuel existe dans la configuration du serveur.

- Un serveur DHCP est disponible dans le réseau

- Les nœuds gérés utilisent NetworkManager pour configurer le réseau.

Procédure

Créez un fichier playbook, par exemple

~/ethernet-dynamic-IP.ymlavec le contenu suivant :--- - name: Configure the network hosts: managed-node-01.example.com tasks: - name: Configure an Ethernet connection with dynamic IP include_role: name: rhel-system-roles.network vars: network_connections: - name: enp7s0 interface_name: enp7s0 type: ethernet autoconnect: yes ip: dhcp4: yes auto6: yes state: upExécutez le manuel de jeu :

# ansible-playbook ~/ethernet-dynamic-IP.yml

Ressources supplémentaires

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdfichier

7.4. Configuration d'une connexion Ethernet avec une adresse IP dynamique en utilisant le rôle de système RHEL avec un chemin d'accès de périphérique

Vous pouvez configurer à distance une connexion Ethernet à l'aide du rôle de système RHEL network. Pour les connexions avec des paramètres d'adresse IP dynamiques, NetworkManager demande les paramètres IP pour la connexion à partir d'un serveur DHCP.

Vous pouvez identifier le chemin d'accès à l'appareil à l'aide de la commande suivante :

# udevadm info /sys/class/net/<device_name> | grep ID_PATH=Effectuez cette procédure sur le nœud de contrôle Ansible.

Conditions préalables

- Vous avez préparé le nœud de contrôle et les nœuds gérés.

- Vous êtes connecté au nœud de contrôle en tant qu'utilisateur pouvant exécuter des séquences sur les nœuds gérés.

-

Le compte que vous utilisez pour vous connecter aux nœuds gérés dispose des autorisations

sudo. - Les nœuds gérés ou les groupes de nœuds gérés sur lesquels vous souhaitez exécuter cette séquence sont répertoriés dans le fichier d'inventaire Ansible.

- Un périphérique Ethernet physique ou virtuel existe dans la configuration du serveur.

- Un serveur DHCP est disponible dans le réseau.

- Les hôtes gérés utilisent NetworkManager pour configurer le réseau.

Procédure

Créez un fichier playbook, par exemple

~/ethernet-dynamic-IP.ymlavec le contenu suivant :--- - name: Configure the network hosts: managed-node-01.example.com tasks: - name: Configure an Ethernet connection with dynamic IP include_role: name: rhel-system-roles.network vars: network_connections: - name: example match: path: - pci-0000:00:0[1-3].0 - &!pci-0000:00:02.0 type: ethernet autoconnect: yes ip: dhcp4: yes auto6: yes state: upLe paramètre

matchdans cet exemple définit qu'Ansible applique la pièce aux périphériques qui correspondent à l'ID PCI0000:00:0[1-3].0, mais pas à0000:00:02.0. Pour plus de détails sur les modificateurs spéciaux et les jokers que vous pouvez utiliser, consultez la description du paramètrematchdans le fichier/usr/share/ansible/roles/rhel-system-roles.network/README.md.Exécutez le manuel de jeu :

# ansible-playbook ~/ethernet-dynamic-IP.yml

Ressources supplémentaires

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdfichier

7.5. Configuration du marquage VLAN à l'aide du rôle de système RHEL du réseau

Vous pouvez utiliser le rôle de système network RHEL pour configurer le marquage VLAN. Cet exemple ajoute une connexion Ethernet et un VLAN avec l'ID 10 au-dessus de cette connexion Ethernet. En tant que périphérique enfant, la connexion VLAN contient l'IP, la passerelle par défaut et les configurations DNS.

En fonction de votre environnement, ajustez le jeu en conséquence. Par exemple :

-

Pour utiliser le VLAN comme port dans d'autres connexions, telles qu'un lien, omettre l'attribut

ipet définir la configuration IP dans la configuration enfant. -

Pour utiliser des périphériques team, bridge ou bond dans le VLAN, adaptez les attributs

interface_nameettypedes ports que vous utilisez dans le VLAN.

Effectuez cette procédure sur le nœud de contrôle Ansible.

Conditions préalables

- Vous avez préparé le nœud de contrôle et les nœuds gérés.

- Vous êtes connecté au nœud de contrôle en tant qu'utilisateur pouvant exécuter des séquences sur les nœuds gérés.

-

Le compte que vous utilisez pour vous connecter aux nœuds gérés dispose des autorisations

sudo. - Les nœuds gérés ou les groupes de nœuds gérés sur lesquels vous souhaitez exécuter cette séquence sont répertoriés dans le fichier d'inventaire Ansible.

Procédure

Créez un fichier playbook, par exemple

~/vlan-ethernet.ymlavec le contenu suivant :--- - name: Configure the network hosts: managed-node-01.example.com tasks: - name: Configure a VLAN that uses an Ethernet connection include_role: name: rhel-system-roles.network vars: network_connections: # Add an Ethernet profile for the underlying device of the VLAN - name: enp1s0 type: ethernet interface_name: enp1s0 autoconnect: yes state: up ip: dhcp4: no auto6: no # Define the VLAN profile - name: enp1s0.10 type: vlan ip: address: - "192.0.2.1/24" - "2001:db8:1::1/64" gateway4: 192.0.2.254 gateway6: 2001:db8:1::fffe dns: - 192.0.2.200 - 2001:db8:1::ffbb dns_search: - example.com vlan_id: 10 parent: enp1s0 state: upL'attribut

parentdu profil VLAN configure le VLAN pour qu'il fonctionne au-dessus du dispositifenp1s0.Exécutez le manuel de jeu :

# ansible-playbook ~/vlan-ethernet.yml

Ressources supplémentaires

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdfichier

7.6. Configuration d'un pont réseau à l'aide du rôle de système RHEL de réseau

Vous pouvez utiliser le rôle système network RHEL pour configurer un pont Linux. Par exemple, vous pouvez l'utiliser pour configurer un pont réseau qui utilise deux périphériques Ethernet et définit les adresses IPv4 et IPv6, les passerelles par défaut et la configuration DNS.

Définir la configuration IP sur le pont et non sur les ports du pont Linux.

Effectuez cette procédure sur le nœud de contrôle Ansible.

Conditions préalables

- Vous avez préparé le nœud de contrôle et les nœuds gérés.

- Vous êtes connecté au nœud de contrôle en tant qu'utilisateur pouvant exécuter des séquences sur les nœuds gérés.

-

Le compte que vous utilisez pour vous connecter aux nœuds gérés dispose des autorisations

sudo. - Les nœuds gérés ou les groupes de nœuds gérés sur lesquels vous souhaitez exécuter cette séquence sont répertoriés dans le fichier d'inventaire Ansible.

- Deux ou plusieurs périphériques réseau physiques ou virtuels sont installés sur le serveur.

Procédure

Créez un fichier playbook, par exemple

~/bridge-ethernet.ymlavec le contenu suivant :--- - name: Configure the network hosts: managed-node-01.example.com tasks: - name: Configure a network bridge that uses two Ethernet ports include_role: name: rhel-system-roles.network vars: network_connections: # Define the bridge profile - name: bridge0 type: bridge interface_name: bridge0 ip: address: - "192.0.2.1/24" - "2001:db8:1::1/64" gateway4: 192.0.2.254 gateway6: 2001:db8:1::fffe dns: - 192.0.2.200 - 2001:db8:1::ffbb dns_search: - example.com state: up # Add an Ethernet profile to the bridge - name: bridge0-port1 interface_name: enp7s0 type: ethernet controller: bridge0 port_type: bridge state: up # Add a second Ethernet profile to the bridge - name: bridge0-port2 interface_name: enp8s0 type: ethernet controller: bridge0 port_type: bridge state: upExécutez le manuel de jeu :

# ansible-playbook ~/bridge-ethernet.yml

Ressources supplémentaires

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdfichier

7.7. Configuration d'une liaison réseau à l'aide du rôle de système RHEL réseau

Vous pouvez utiliser le site network RHEL System Roles pour configurer un lien Linux. Par exemple, vous pouvez l'utiliser pour configurer un lien réseau en mode de sauvegarde active qui utilise deux périphériques Ethernet et définit des adresses IPv4 et IPv6, des passerelles par défaut et une configuration DNS.

Définir la configuration IP sur le lien et non sur les ports du lien Linux.

Effectuez cette procédure sur le nœud de contrôle Ansible.

Conditions préalables

- Vous avez préparé le nœud de contrôle et les nœuds gérés.

- Vous êtes connecté au nœud de contrôle en tant qu'utilisateur pouvant exécuter des séquences sur les nœuds gérés.

-

Le compte que vous utilisez pour vous connecter aux nœuds gérés dispose des autorisations

sudo. - Les nœuds gérés ou les groupes de nœuds gérés sur lesquels vous souhaitez exécuter cette séquence sont répertoriés dans le fichier d'inventaire Ansible.

- Deux ou plusieurs périphériques réseau physiques ou virtuels sont installés sur le serveur.

Procédure

Créez un fichier playbook, par exemple

~/bond-ethernet.ymlavec le contenu suivant :--- - name: Configure the network hosts: managed-node-01.example.com tasks: - name: Configure a network bond that uses two Ethernet ports include_role: name: rhel-system-roles.network vars: network_connections: # Define the bond profile - name: bond0 type: bond interface_name: bond0 ip: address: - "192.0.2.1/24" - "2001:db8:1::1/64" gateway4: 192.0.2.254 gateway6: 2001:db8:1::fffe dns: - 192.0.2.200 - 2001:db8:1::ffbb dns_search: - example.com bond: mode: active-backup state: up # Add an Ethernet profile to the bond - name: bond0-port1 interface_name: enp7s0 type: ethernet controller: bond0 state: up # Add a second Ethernet profile to the bond - name: bond0-port2 interface_name: enp8s0 type: ethernet controller: bond0 state: upExécutez le manuel de jeu :

# ansible-playbook ~/bond-ethernet.yml

Ressources supplémentaires

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdfichier

7.8. Configuration d'une connexion IPoIB à l'aide du rôle de réseau RHEL System Role

Vous pouvez utiliser le rôle système network RHEL pour créer à distance des profils de connexion NetworkManager pour les périphériques IP over InfiniBand (IPoIB). Par exemple, ajoutez à distance une connexion InfiniBand pour l'interface mlx4_ib0 avec les paramètres suivants en exécutant un playbook Ansible :

-

Un dispositif IPoIB -

mlx4_ib0.8002 -

Une clé de partition

p_key-0x8002 -

Une adresse statique

IPv4-192.0.2.1avec un masque de sous-réseau/24 -

Une adresse statique

IPv6-2001:db8:1::1avec un masque de sous-réseau/64

Effectuez cette procédure sur le nœud de contrôle Ansible.

Conditions préalables

- Vous avez préparé le nœud de contrôle et les nœuds gérés.

- Vous vous êtes connecté au nœud de contrôle en tant qu'utilisateur pouvant exécuter des sélections sur les nœuds gérés.

-

Le compte que vous utilisez pour vous connecter aux nœuds gérés dispose des autorisations

sudo. - Les nœuds gérés ou les groupes de nœuds gérés sur lesquels vous souhaitez exécuter cette séquence sont répertoriés dans le fichier d'inventaire Ansible.

-

Un périphérique InfiniBand nommé

mlx4_ib0est installé dans les nœuds gérés. - Les nœuds gérés utilisent NetworkManager pour configurer le réseau.

Procédure

Créez un fichier playbook, par exemple

~/IPoIB.ymlavec le contenu suivant :--- - name: Configure the network hosts: managed-node-01.example.com tasks: - name: Configure IPoIB include_role: name: rhel-system-roles.network vars: network_connections: # InfiniBand connection mlx4_ib0 - name: mlx4_ib0 interface_name: mlx4_ib0 type: infiniband # IPoIB device mlx4_ib0.8002 on top of mlx4_ib0 - name: mlx4_ib0.8002 type: infiniband autoconnect: yes infiniband: p_key: 0x8002 transport_mode: datagram parent: mlx4_ib0 ip: address: - 192.0.2.1/24 - 2001:db8:1::1/64 state: upSi vous définissez un paramètre

p_keycomme dans cet exemple, ne définissez pas de paramètreinterface_namesur le périphérique IPoIB.Exécutez le manuel de jeu :

# ansible-playbook ~/IPoIB.yml

Vérification

Sur l'hôte

managed-node-01.example.com, affichez les paramètres IP du périphériquemlx4_ib0.8002:# ip address show mlx4_ib0.8002 ... inet 192.0.2.1/24 brd 192.0.2.255 scope global noprefixroute ib0.8002 valid_lft forever preferred_lft forever inet6 2001:db8:1::1/64 scope link tentative noprefixroute valid_lft forever preferred_lft forever

Affichez la clé de partition (P_Key) de l'appareil

mlx4_ib0.8002:# cat /sys/class/net/mlx4_ib0.8002/pkey 0x8002Affiche le mode de l'appareil

mlx4_ib0.8002:# cat /sys/class/net/mlx4_ib0.8002/mode datagram

Ressources supplémentaires

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdfichier

7.9. Routage du trafic d'un sous-réseau spécifique vers une passerelle par défaut différente en utilisant le rôle de système RHEL du réseau

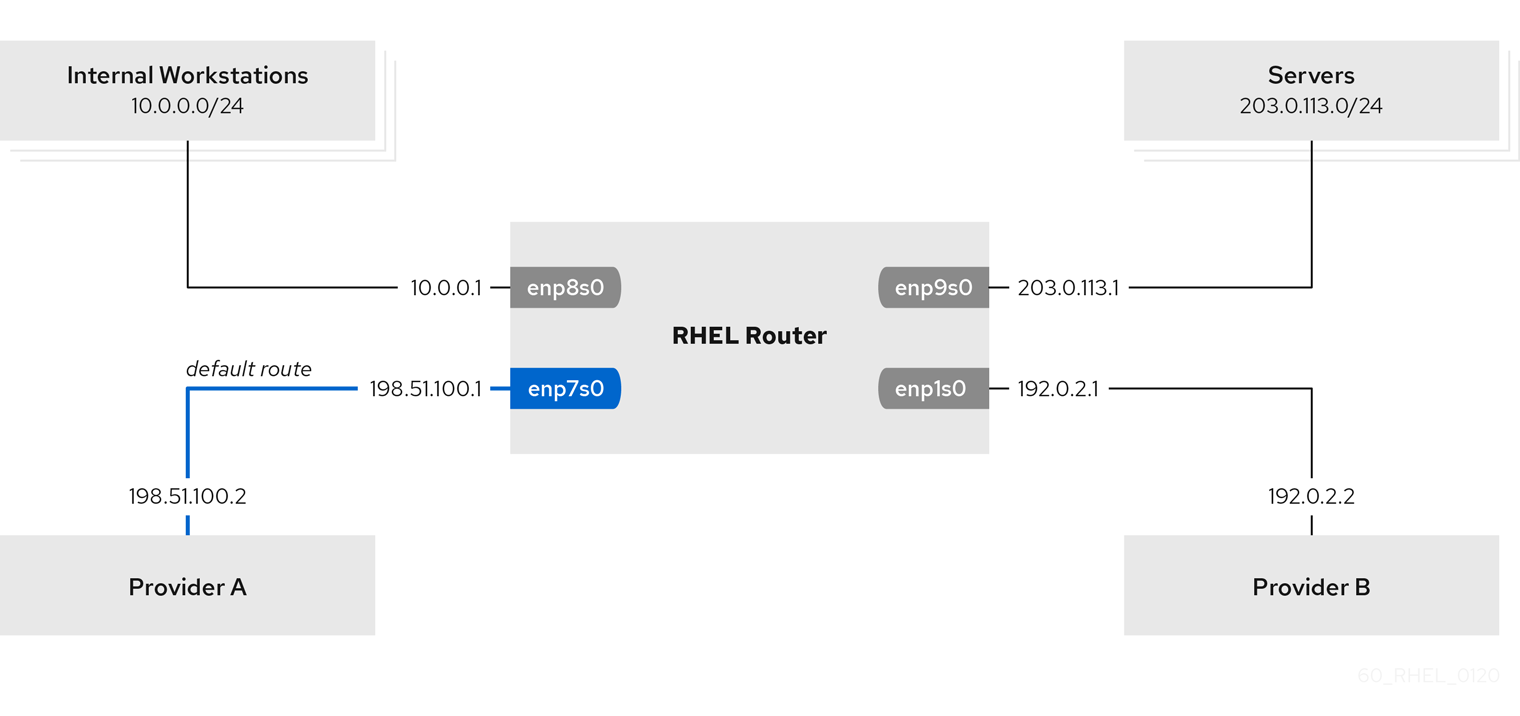

Vous pouvez utiliser le routage basé sur des règles pour configurer une passerelle par défaut différente pour le trafic provenant de certains sous-réseaux. Par exemple, vous pouvez configurer RHEL comme un routeur qui, par défaut, achemine tout le trafic vers le fournisseur d'accès Internet A à l'aide de la route par défaut. Toutefois, le trafic reçu du sous-réseau des postes de travail internes est acheminé vers le fournisseur B.

Pour configurer le routage basé sur des stratégies à distance et sur plusieurs nœuds, vous pouvez utiliser le rôle système RHEL network. Effectuez cette procédure sur le nœud de contrôle Ansible.

Cette procédure suppose la topologie de réseau suivante :

Conditions préalables

- Vous avez préparé le nœud de contrôle et les nœuds gérés.

- Vous êtes connecté au nœud de contrôle en tant qu'utilisateur pouvant exécuter des séquences sur les nœuds gérés.

-

Le compte que vous utilisez pour vous connecter aux nœuds gérés dispose des autorisations

sudosur ces nœuds. - Les nœuds gérés ou les groupes de nœuds gérés sur lesquels vous souhaitez exécuter cette séquence sont répertoriés dans le fichier d'inventaire Ansible.

-

Les nœuds gérés utilisent les services

NetworkManageretfirewalld. Les nœuds gérés que vous souhaitez configurer possèdent quatre interfaces réseau :

-

L'interface

enp7s0est connectée au réseau du fournisseur A. L'IP de la passerelle dans le réseau du fournisseur est198.51.100.2, et le réseau utilise un masque de réseau/30. -

L'interface

enp1s0est connectée au réseau du fournisseur B. L'IP de la passerelle dans le réseau du fournisseur est192.0.2.2, et le réseau utilise un masque de réseau/30. -

L'interface

enp8s0est connectée au sous-réseau10.0.0.0/24avec des postes de travail internes. -

L'interface

enp9s0est connectée au sous-réseau203.0.113.0/24où se trouvent les serveurs de l'entreprise.

-

L'interface

-

Les hôtes du sous-réseau des postes de travail internes utilisent

10.0.0.1comme passerelle par défaut. Dans la procédure, vous attribuez cette adresse IP à l'interface réseauenp8s0du routeur. -

Les hôtes du sous-réseau du serveur utilisent

203.0.113.1comme passerelle par défaut. Dans la procédure, vous attribuez cette adresse IP à l'interface réseauenp9s0du routeur.

Procédure

Créez un fichier playbook, par exemple

~/pbr.yml, avec le contenu suivant :--- - name: Configuring policy-based routing hosts: managed-node-01.example.com tasks: - name: Routing traffic from a specific subnet to a different default gateway include_role: name: rhel-system-roles.network vars: network_connections: - name: Provider-A interface_name: enp7s0 type: ethernet autoconnect: True ip: address: - 198.51.100.1/30 gateway4: 198.51.100.2 dns: - 198.51.100.200 state: up zone: external - name: Provider-B interface_name: enp1s0 type: ethernet autoconnect: True ip: address: - 192.0.2.1/30 route: - network: 0.0.0.0 prefix: 0 gateway: 192.0.2.2 table: 5000 state: up zone: external - name: Internal-Workstations interface_name: enp8s0 type: ethernet autoconnect: True ip: address: - 10.0.0.1/24 route: - network: 10.0.0.0 prefix: 24 table: 5000 routing_rule: - priority: 5 from: 10.0.0.0/24 table: 5000 state: up zone: trusted - name: Servers interface_name: enp9s0 type: ethernet autoconnect: True ip: address: - 203.0.113.1/24 state: up zone: trustedExécutez le manuel de jeu :

# ansible-playbook ~/pbr.yml

Vérification

Sur un hôte RHEL dans le sous-réseau des stations de travail internes :

Installez le paquetage

traceroute:# dnf install tracerouteUtilisez l'utilitaire

traceroutepour afficher l'itinéraire vers un hôte sur Internet :# traceroute redhat.com traceroute to redhat.com (209.132.183.105), 30 hops max, 60 byte packets 1 10.0.0.1 (10.0.0.1) 0.337 ms 0.260 ms 0.223 ms 2 192.0.2.1 (192.0.2.1) 0.884 ms 1.066 ms 1.248 ms ...La sortie de la commande indique que le routeur envoie des paquets sur

192.0.2.1, qui est le réseau du fournisseur B.

Sur un hôte RHEL dans le sous-réseau du serveur :

Installez le paquetage

traceroute:# dnf install tracerouteUtilisez l'utilitaire

traceroutepour afficher l'itinéraire vers un hôte sur Internet :# traceroute redhat.com traceroute to redhat.com (209.132.183.105), 30 hops max, 60 byte packets 1 203.0.113.1 (203.0.113.1) 2.179 ms 2.073 ms 1.944 ms 2 198.51.100.2 (198.51.100.2) 1.868 ms 1.798 ms 1.549 ms ...La sortie de la commande indique que le routeur envoie des paquets sur

198.51.100.2, qui est le réseau du fournisseur A.

Sur le routeur RHEL que vous avez configuré à l'aide du rôle de système RHEL :

Affichez la liste des règles :

# ip rule list 0: from all lookup local 5: from 10.0.0.0/24 lookup 5000 32766: from all lookup main 32767: from all lookup default

Par défaut, RHEL contient des règles pour les tables

local,main, etdefault.Afficher les itinéraires dans la table

5000:# ip route list table 5000 0.0.0.0/0 via 192.0.2.2 dev enp1s0 proto static metric 100 10.0.0.0/24 dev enp8s0 proto static scope link src 192.0.2.1 metric 102Affichez les interfaces et les zones de pare-feu :

# firewall-cmd --get-active-zones external interfaces: enp1s0 enp7s0 trusted interfaces: enp8s0 enp9s0Vérifiez que le masquage est activé dans la zone

external:# firewall-cmd --info-zone=external external (active) target: default icmp-block-inversion: no interfaces: enp1s0 enp7s0 sources: services: ssh ports: protocols: masquerade: yes ...

Ressources supplémentaires

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdfichier

7.10. Configuration d'une connexion Ethernet statique avec authentification réseau 802.1X à l'aide du rôle de système RHEL réseau

À l'aide du rôle système network RHEL, vous pouvez automatiser la création d'une connexion Ethernet qui utilise la norme 802.1X pour authentifier le client. Par exemple, ajoutez à distance une connexion Ethernet pour l'interface enp1s0 avec les paramètres suivants en exécutant un script Ansible :

-

Une adresse IPv4 statique -

192.0.2.1avec un masque de sous-réseau/24 -

Une adresse IPv6 statique -

2001:db8:1::1avec un masque de sous-réseau/64 -

Une passerelle par défaut IPv4 -

192.0.2.254 -

Une passerelle par défaut IPv6 -

2001:db8:1::fffe -

Un serveur DNS IPv4 -

192.0.2.200 -

Un serveur DNS IPv6 -

2001:db8:1::ffbb -

Un domaine de recherche DNS -

example.com -

802.1X authentification réseau utilisant le protocole d'authentification extensible (EAP)

TLS

Effectuez cette procédure sur le nœud de contrôle Ansible.

Conditions préalables

- Vous avez préparé le nœud de contrôle et les nœuds gérés.

- Vous êtes connecté au nœud de contrôle en tant qu'utilisateur pouvant exécuter des séquences sur les nœuds gérés.

-

Le compte que vous utilisez pour vous connecter aux nœuds gérés dispose des autorisations

sudo. - Les nœuds gérés ou les groupes de nœuds gérés sur lesquels vous souhaitez exécuter cette séquence sont répertoriés dans le fichier d'inventaire Ansible

- Le réseau prend en charge l'authentification réseau 802.1X.

- Les nœuds gérés utilisent NetworkManager.

Les fichiers suivants, nécessaires à l'authentification TLS, existent sur le nœud de contrôle :

-

La clé du client est stockée dans le fichier

/srv/data/client.key. -

Le certificat du client est stocké dans le fichier

/srv/data/client.crt. -

Le certificat de l'autorité de certification (CA) est stocké dans le fichier

/srv/data/ca.crt.

-

La clé du client est stockée dans le fichier

Procédure

Créez un fichier playbook, par exemple

~/enable-802.1x.ymlavec le contenu suivant :--- - name: Configure an Ethernet connection with 802.1X authentication hosts: managed-node-01.example.com tasks: - name: Copy client key for 802.1X authentication copy: src: "/srv/data/client.key" dest: "/etc/pki/tls/private/client.key" mode: 0600 - name: Copy client certificate for 802.1X authentication copy: src: "/srv/data/client.crt" dest: "/etc/pki/tls/certs/client.crt" - name: Copy CA certificate for 802.1X authentication copy: src: "/srv/data/ca.crt" dest: "/etc/pki/ca-trust/source/anchors/ca.crt" - include_role: name: rhel-system-roles.network vars: network_connections: - name: enp1s0 type: ethernet autoconnect: yes ip: address: - 192.0.2.1/24 - 2001:db8:1::1/64 gateway4: 192.0.2.254 gateway6: 2001:db8:1::fffe dns: - 192.0.2.200 - 2001:db8:1::ffbb dns_search: - example.com ieee802_1x: identity: user_name eap: tls private_key: "/etc/pki/tls/private/client.key" private_key_password: "password" client_cert: "/etc/pki/tls/certs/client.crt" ca_cert: "/etc/pki/ca-trust/source/anchors/ca.crt" domain_suffix_match: example.com state: up

Exécutez le manuel de jeu :

# ansible-playbook ~/enable-802.1x.yml

Ressources supplémentaires

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdfichier

7.11. Configurer une connexion wifi avec l'authentification réseau 802.1X en utilisant le rôle réseau RHEL System Role

À l'aide des rôles système RHEL, vous pouvez automatiser la création d'une connexion wifi. Par exemple, vous pouvez ajouter à distance un profil de connexion sans fil pour l'interface wlp1s0 à l'aide d'un playbook Ansible. Le profil créé utilise la norme 802.1X pour authentifier le client sur un réseau wifi. Le playbook configure le profil de connexion pour utiliser DHCP. Pour configurer des paramètres IP statiques, adaptez les paramètres du dictionnaire ip en conséquence.

Effectuez cette procédure sur le nœud de contrôle Ansible.

Conditions préalables

- Vous avez préparé le nœud de contrôle et les nœuds gérés.

- Vous êtes connecté au nœud de contrôle en tant qu'utilisateur pouvant exécuter des séquences sur les nœuds gérés.

-

Le compte que vous utilisez pour vous connecter aux nœuds gérés dispose des autorisations

sudo. - Les nœuds gérés ou les groupes de nœuds gérés sur lesquels vous souhaitez exécuter cette séquence sont répertoriés dans le fichier d'inventaire Ansible.

- Le réseau prend en charge l'authentification réseau 802.1X.

-

Vous avez installé le paquetage

wpa_supplicantsur le nœud géré. - DHCP est disponible dans le réseau du nœud géré.

Les fichiers suivants, nécessaires à l'authentification TLS, existent sur le nœud de contrôle :

-

La clé du client est stockée dans le fichier

/srv/data/client.key. -

Le certificat du client est stocké dans le fichier

/srv/data/client.crt. -

Le certificat d'autorité de certification est stocké dans le fichier

/srv/data/ca.crt.

-

La clé du client est stockée dans le fichier

Procédure

Créez un fichier playbook, par exemple