Support des conteneurs Windows pour OpenShift

Guide des conteneurs Red Hat OpenShift pour Windows

Résumé

Chapitre 1. Aperçu de la prise en charge de Windows Containers par Red Hat OpenShift

La prise en charge de Windows Containers par Red Hat OpenShift est une fonctionnalité offrant la possibilité d'exécuter des nœuds de calcul Windows dans un cluster OpenShift Container Platform. Ceci est possible en utilisant Red Hat Windows Machine Config Operator (WMCO) pour installer et gérer les nœuds Windows. Avec un abonnement Red Hat, vous pouvez obtenir un support pour l'exécution de charges de travail Windows dans OpenShift Container Platform. Les instances Windows déployées par le WMCO sont configurées avec le moteur d'exécution de conteneur containerd. Pour plus d'informations, consultez les notes de mise à jour.

Vous pouvez ajouter des nœuds Windows en créant un ensemble de machines de calcul ou en spécifiant des instances Window BYOH (Bring-Your-Own-Host) existantes par le biais d'une carte de configuration.

Les ensembles de machines de calcul ne sont pas pris en charge pour les clusters bare metal ou agnostiques vis-à-vis des fournisseurs.

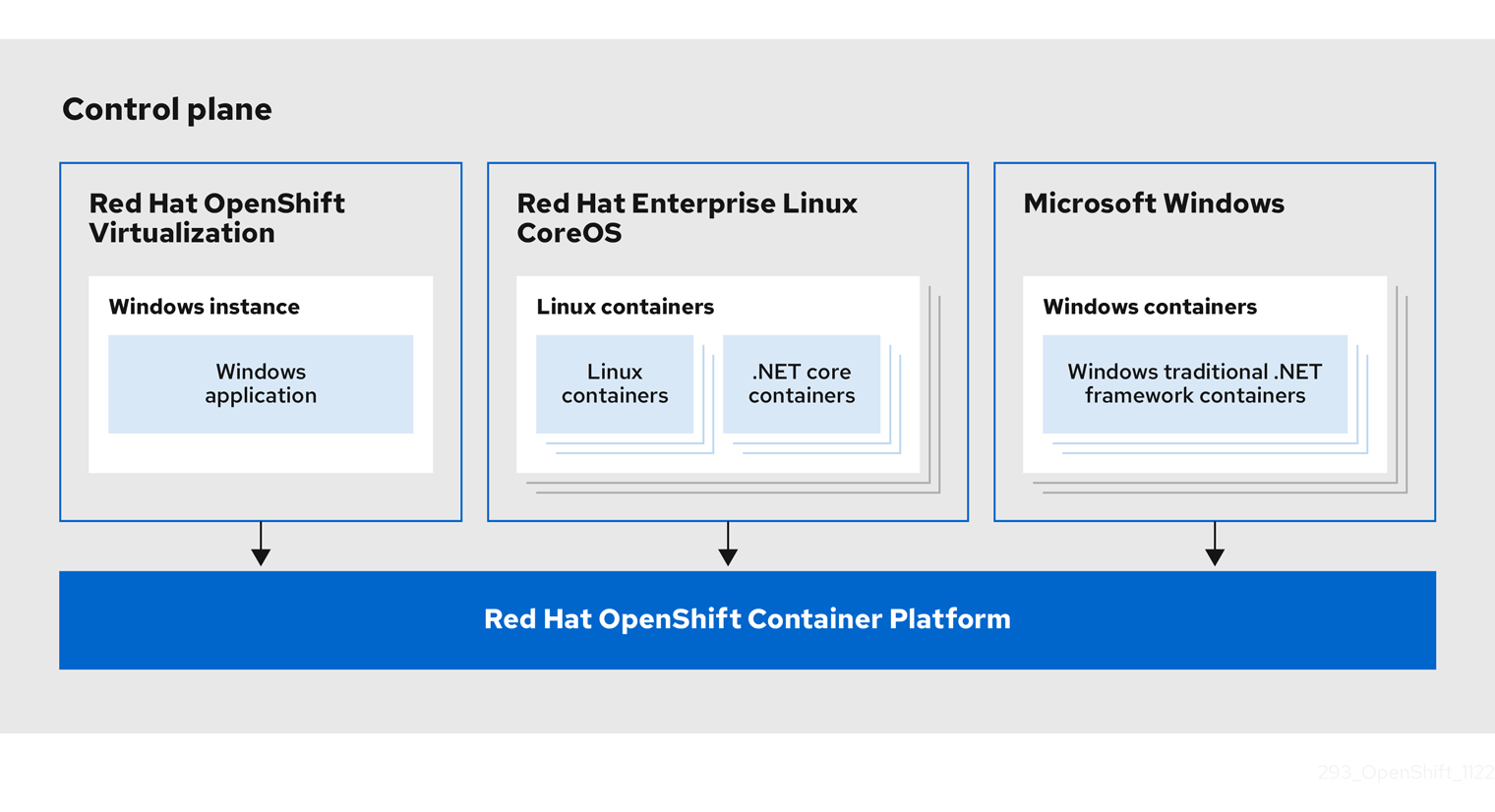

Pour les charges de travail incluant à la fois Linux et Windows, OpenShift Container Platform vous permet de déployer des charges de travail Windows s'exécutant sur des conteneurs Windows Server tout en fournissant des charges de travail Linux traditionnelles hébergées sur Red Hat Enterprise Linux CoreOS (RHCOS) ou Red Hat Enterprise Linux (RHEL). Pour plus d'informations, voir démarrer avec les charges de travail de conteneurs Windows.

Vous avez besoin du WMCO pour exécuter des charges de travail Windows dans votre cluster. Le WMCO orchestre le processus de déploiement et de gestion des charges de travail Windows sur un cluster. Pour plus d'informations, voir comment activer les charges de travail Windows en conteneur.

Vous pouvez créer un objet Windows MachineSet pour créer des jeux de machines Windows d'infrastructure et des machines connexes afin de pouvoir déplacer les charges de travail Windows prises en charge vers les nouvelles machines Windows. Vous pouvez créer un objet Windows MachineSet sur plusieurs plateformes.

Vous pouvez planifier des charges de travail Windows sur des nœuds de calcul Windows.

Vous pouvez effectuer des mises à niveau de l'opérateur Windows Machine Config pour vous assurer que vos nœuds Windows disposent des dernières mises à jour.

Vous pouvez supprimer un nœud Windows en supprimant une machine spécifique.

Vous pouvez utiliser les instances Windows BYOH (Bring-Your-Own-Host) pour réutiliser les VMs Windows Server et les amener sur OpenShift Container Platform. Les instances Windows BYOH sont utiles aux utilisateurs qui cherchent à atténuer les perturbations majeures en cas de mise hors ligne d'un serveur Windows. Vous pouvez utiliser les instances Windows BYOH en tant que nœuds sur OpenShift Container Platform 4.8 et les versions ultérieures.

Vous pouvez désactiver les charges de travail des conteneurs Windows en procédant comme suit :

- Désinstallation de l'opérateur Windows Machine Config

- Suppression de l'espace de noms Windows Machine Config Operator

Chapitre 2. Notes de version sur la prise en charge de Windows Containers par Red Hat OpenShift

2.1. À propos de la prise en charge de Windows Containers par Red Hat OpenShift

La prise en charge de Windows Containers par Red Hat OpenShift permet d'exécuter des nœuds de calcul Windows dans un cluster OpenShift Container Platform. L'exécution des charges de travail Windows est possible en utilisant Red Hat Windows Machine Config Operator (WMCO) pour installer et gérer les nœuds Windows. Lorsque des nœuds Windows sont disponibles, vous pouvez exécuter des charges de travail de conteneurs Windows dans OpenShift Container Platform.

Les notes de version pour la prise en charge de Windows Containers par Red Hat OpenShift suivent le développement de WMCO, qui fournit toutes les capacités de charge de travail des conteneurs Windows dans OpenShift Container Platform.

2.2. Obtenir de l'aide

La prise en charge de Red Hat OpenShift pour Windows Containers est fournie et disponible en tant que composant optionnel et installable. La prise en charge de Red Hat OpenShift pour Windows Containers ne fait pas partie de l'abonnement à OpenShift Container Platform. Elle nécessite un abonnement Red Hat supplémentaire et est prise en charge conformément à l'étendue de la couverture et aux accords de niveau de service.

Vous devez disposer de cet abonnement séparé pour bénéficier de la prise en charge de Red Hat OpenShift pour les conteneurs Windows. Sans cet abonnement Red Hat supplémentaire, le déploiement de charges de travail de conteneurs Windows dans des clusters de production n'est pas pris en charge. Vous pouvez demander de l'aide via le portail client de Red Hat.

Pour plus d'informations, consultez le document Red Hat OpenShift Container Platform Life Cycle Policy pour la prise en charge de Windows Containers par Red Hat OpenShift.

Si vous ne disposez pas de cet abonnement Red Hat supplémentaire, vous pouvez utiliser le Community Windows Machine Config Operator, une distribution qui ne bénéficie pas d'un support officiel.

2.3. Notes de version pour Red Hat Windows Machine Config Operator 7.0.1

Cette version du WMCO fournit de nouvelles fonctionnalités et des corrections de bugs pour l'exécution de nœuds de calcul Windows dans un cluster OpenShift Container Platform. Les composants du WMCO 7.0.1 ont été publiés dans RHBA-2023:0748.

2.3.1. Bug fixes

-

Auparavant, WMCO 7.0.0 ne prenait pas en charge l'exécution dans un espace de noms autre que

openshift-windows-machine-operator. Avec cette correction, vous pouvez exécuter WMCO dans un espace de noms personnalisé et mettre à niveau les clusters qui ont WMCO installé dans un espace de noms personnalisé. (OCPBUGS-5065)

2.4. Notes de version pour Red Hat Windows Machine Config Operator 7.0.0

Cette version du WMCO fournit de nouvelles fonctionnalités et des corrections de bugs pour l'exécution de nœuds de calcul Windows dans un cluster OpenShift Container Platform. Les composants du WMCO 7.0.0 ont été publiés dans RHSA-2022:9096.

2.4.1. Nouvelles fonctionnalités et améliorations

2.4.1.1. Windows Instance Config Daemon (WICD)

Le Windows Instance Config Daemon (WICD) effectue désormais un grand nombre de tâches qui étaient auparavant exécutées par le Windows Machine Config Bootstrapper (WMCB). Le WICD est installé sur vos nœuds Windows. Les utilisateurs n'ont pas besoin d'interagir avec le WICD et ne devraient pas constater de différence dans le fonctionnement de WMCO.

2.4.1.2. Prise en charge des clusters fonctionnant sur Google Cloud Platform

Vous pouvez désormais exécuter des nœuds Windows Server 2022 sur un cluster installé sur Google Cloud Platform (GCP). Vous pouvez créer un objet Windows MachineSet sur GCP pour héberger des nœuds de calcul Windows Server 2022. Pour plus d'informations, voir Création d'un objet Windows MachineSet sur vSphere.

2.4.2. Bug fixes

- Auparavant, le redémarrage du WMCO dans un cluster avec des nœuds Windows en cours d'exécution entraînait la suppression du point de terminaison de l'exportateur Windows. De ce fait, chaque nœud Windows ne pouvait pas rapporter de données métriques. Après cette correction, le point de terminaison est conservé lorsque le WMCO est redémarré. Par conséquent, les données de métriques sont rapportées correctement après le redémarrage de WMCO. (BZ#2107261)

- Auparavant, le test visant à déterminer si le service antivirus Windows Defender est en cours d'exécution vérifiait de manière incorrecte tout processus dont le nom commençait par Windows Defender, quel que soit son état. Cela entraînait une erreur lors de la création d'exclusions de pare-feu pour containerd sur des instances sans Windows Defender installé. Cette correction vérifie désormais la présence du processus spécifique en cours d'exécution associé au service antivirus Windows Defender. Par conséquent, le WMCO peut configurer correctement les instances Windows en tant que nœuds, que Windows Defender soit installé ou non. (OCPBUGS-3573)

2.4.3. Problèmes connus

Les limitations connues suivantes ont été annoncées après la publication précédente de WMCO :

- OpenShift Serverless, Horizontal Pod Autoscaling et Vertical Pod Autoscaling ne sont pas pris en charge sur les nœuds Windows.

- La prise en charge de Red Hat OpenShift pour les conteneurs Windows ne prend pas en charge l'ajout de nœuds Windows à un cluster par le biais d'un port trunk. La seule configuration réseau prise en charge pour l'ajout de nœuds Windows est un port d'accès qui transporte le trafic pour le VLAN.

-

WMCO 7.0.0 ne prend pas en charge l'exécution dans un espace de noms autre que

openshift-windows-machine-operator. Si vous utilisez un espace de noms personnalisé, il est recommandé de ne pas mettre à niveau WMCO 7.0.0, mais plutôt WMCO 7.0.1 lorsqu'il sera disponible. Si votre OCM est configuré avec la stratégie d'approbation des mises à jour Automatic, vous devez la remplacer par Manual pour l'OCM 7.0.0. Consultez les instructions d'installation pour plus d'informations sur la modification de la stratégie d'approbation.

Ressources supplémentaires

Voir la liste complète des limitations connues

2.5. Conditions préalables pour Windows Machine Config Operator

Les informations suivantes détaillent les versions de plate-forme, les versions de Windows Server et les configurations de réseau prises en charge par l'opérateur Windows Machine Config. Consultez la documentation vSphere pour toute information concernant uniquement cette plateforme.

2.5.1. Plateformes et versions de Windows Server supportées par WMCO 7.0.0

Le tableau suivant énumère les versions de Windows Server prises en charge par WMCO 6.0.0, en fonction de la plate-forme applicable. Les versions de Windows Server qui ne figurent pas dans la liste ne sont pas prises en charge et toute tentative d'utilisation entraînera des erreurs. Pour éviter ces erreurs, n'utilisez que la version appropriée à votre plate-forme.

| Plate-forme | Version de Windows Server prise en charge |

|---|---|

| Amazon Web Services (AWS) | Windows Server 2019, version 1809 |

| Microsoft Azure |

|

| VMware vSphere | Windows Server 2022, OS Build 20348.681 ou version ultérieure |

| Google Cloud Platform (GCP) | Windows Server 2022, OS Build 20348.681 ou version ultérieure |

| Métal nu ou fournisseur agnostique |

|

2.5.2. Réseaux pris en charge

La mise en réseau hybride avec OVN-Kubernetes est la seule configuration de mise en réseau prise en charge. Voir les ressources supplémentaires ci-dessous pour plus d'informations sur cette fonctionnalité. Les tableaux suivants indiquent le type de configuration réseau et les versions de Windows Server à utiliser en fonction de votre plateforme. Vous devez spécifier la configuration réseau lorsque vous installez le cluster. Sachez que le réseau OpenShift SDN est le réseau par défaut pour les clusters OpenShift Container Platform. Cependant, OpenShift SDN n'est pas pris en charge par WMCO.

Tableau 2.1. Soutien à la mise en réseau des plates-formes

| Plate-forme | Réseaux pris en charge |

|---|---|

| Amazon Web Services (AWS) | Réseau hybride avec OVN-Kubernetes |

| Microsoft Azure | Réseau hybride avec OVN-Kubernetes |

| VMware vSphere | Réseau hybride avec OVN-Kubernetes avec un port VXLAN personnalisé |

| Google Cloud Platform (GCP) | Réseau hybride avec OVN-Kubernetes |

| Métal nu ou fournisseur agnostique | Réseau hybride avec OVN-Kubernetes |

Tableau 2.2. Prise en charge des serveurs Windows hybrides OVN-Kubernetes

2.6. Limites connues

Notez les limitations suivantes lorsque vous travaillez avec des nœuds Windows gérés par le WMCO (nœuds Windows) :

Les fonctionnalités suivantes d'OpenShift Container Platform ne sont pas prises en charge sur les nœuds Windows :

- Constructions d'images

- OpenShift Pipelines

- OpenShift Service Mesh

- Surveillance OpenShift des projets définis par l'utilisateur

- OpenShift Serverless

- Mise à l'échelle horizontale du pod

- Mise à l'échelle automatique des nacelles verticales

Les fonctionnalités Red Hat suivantes ne sont pas prises en charge sur les nœuds Windows :

- Les nœuds Windows ne prennent pas en charge l'extraction d'images de conteneurs à partir de registres privés. Vous pouvez utiliser des images provenant de registres publics ou prélever les images.

- Les nœuds Windows ne prennent pas en charge les charges de travail créées à l'aide de configurations de déploiement. Vous pouvez utiliser un déploiement ou une autre méthode pour déployer les charges de travail.

- Les nœuds Windows ne sont pas pris en charge dans les grappes qui utilisent un proxy à l'échelle de la grappe. En effet, le WMCO n'est pas en mesure d'acheminer le trafic via la connexion proxy pour les charges de travail.

- Les nœuds Windows ne sont pas pris en charge dans les grappes qui se trouvent dans un environnement déconnecté.

- La prise en charge de Red Hat OpenShift pour les conteneurs Windows ne prend pas en charge l'ajout de nœuds Windows à un cluster par le biais d'un port trunk. La seule configuration réseau prise en charge pour l'ajout de nœuds Windows est un port d'accès qui transporte le trafic pour le VLAN.

- La prise en charge de Red Hat OpenShift pour Windows Containers ne prend en charge que les pilotes de stockage in-tree pour tous les fournisseurs de cloud.

Kubernetes a identifié les limitations suivantes des fonctionnalités des nœuds:

- Les pages volumineuses ne sont pas prises en charge pour les conteneurs Windows.

- Les conteneurs privilégiés ne sont pas pris en charge pour les conteneurs Windows.

- Kubernetes a identifié plusieurs problèmes de compatibilité des API.

Chapitre 3. Comprendre les charges de travail des conteneurs Windows

La prise en charge de Red Hat OpenShift pour les conteneurs Windows fournit une prise en charge intégrée pour l'exécution de conteneurs Microsoft Windows Server sur OpenShift Container Platform. Pour ceux qui administrent des environnements hétérogènes avec un mélange de charges de travail Linux et Windows, OpenShift Container Platform vous permet de déployer des charges de travail Windows exécutées sur des conteneurs Windows Server tout en fournissant des charges de travail Linux traditionnelles hébergées sur Red Hat Enterprise Linux CoreOS (RHCOS) ou Red Hat Enterprise Linux (RHEL).

Le multi-tenant pour les clusters qui ont des nœuds Windows n'est pas pris en charge. L'utilisation hostile du multi-tenant introduit des problèmes de sécurité dans tous les environnements Kubernetes. Des fonctionnalités de sécurité supplémentaires, telles que les politiques de sécurité des pods ou un contrôle d'accès basé sur les rôles (RBAC) plus fin pour les nœuds, rendent les exploits plus difficiles. Toutefois, si vous choisissez d'exécuter des charges de travail multi-tenant hostiles, un hyperviseur est la seule option de sécurité que vous devriez utiliser. Le domaine de sécurité de Kubernetes englobe l'ensemble du cluster, et non un nœud individuel. Pour ces types de charges de travail multi-locataires hostiles, vous devez utiliser des clusters physiquement isolés.

Les conteneurs Windows Server permettent d'isoler les ressources à l'aide d'un noyau partagé, mais ne sont pas destinés à être utilisés dans des scénarios de multi-location hostile. Les scénarios qui impliquent une multi-location hostile doivent utiliser les conteneurs isolés Hyper-V pour isoler fortement les locataires.

3.1. Conditions préalables pour Windows Machine Config Operator

Les informations suivantes détaillent les versions de plate-forme, les versions de Windows Server et les configurations de réseau prises en charge par l'opérateur Windows Machine Config. Consultez la documentation vSphere pour toute information concernant uniquement cette plateforme.

3.1.1. Plateformes et versions de Windows Server supportées par WMCO 7.0.0

Le tableau suivant énumère les versions de Windows Server prises en charge par WMCO 6.0.0, en fonction de la plate-forme applicable. Les versions de Windows Server qui ne figurent pas dans la liste ne sont pas prises en charge et toute tentative d'utilisation entraînera des erreurs. Pour éviter ces erreurs, n'utilisez que la version appropriée à votre plate-forme.

| Plate-forme | Version de Windows Server prise en charge |

|---|---|

| Amazon Web Services (AWS) | Windows Server 2019, version 1809 |

| Microsoft Azure |

|

| VMware vSphere | Windows Server 2022, OS Build 20348.681 ou version ultérieure |

| Google Cloud Platform (GCP) | Windows Server 2022, OS Build 20348.681 ou version ultérieure |

| Métal nu ou fournisseur agnostique |

|

3.1.2. Réseaux pris en charge

La mise en réseau hybride avec OVN-Kubernetes est la seule configuration de mise en réseau prise en charge. Voir les ressources supplémentaires ci-dessous pour plus d'informations sur cette fonctionnalité. Les tableaux suivants indiquent le type de configuration réseau et les versions de Windows Server à utiliser en fonction de votre plateforme. Vous devez spécifier la configuration réseau lorsque vous installez le cluster. Sachez que le réseau OpenShift SDN est le réseau par défaut pour les clusters OpenShift Container Platform. Cependant, OpenShift SDN n'est pas pris en charge par WMCO.

Tableau 3.1. Soutien à la mise en réseau des plates-formes

| Plate-forme | Réseaux pris en charge |

|---|---|

| Amazon Web Services (AWS) | Réseau hybride avec OVN-Kubernetes |

| Microsoft Azure | Réseau hybride avec OVN-Kubernetes |

| VMware vSphere | Réseau hybride avec OVN-Kubernetes avec un port VXLAN personnalisé |

| Google Cloud Platform (GCP) | Réseau hybride avec OVN-Kubernetes |

| Métal nu ou fournisseur agnostique | Réseau hybride avec OVN-Kubernetes |

Tableau 3.2. Prise en charge des serveurs Windows hybrides OVN-Kubernetes

Ressources supplémentaires

3.2. Gestion de la charge de travail Windows

Pour exécuter des charges de travail Windows dans votre cluster, vous devez d'abord installer le Windows Machine Config Operator (WMCO). Le WMCO est un opérateur basé sur Linux qui s'exécute sur le plan de contrôle et les nœuds de calcul basés sur Linux. Il orchestre le processus de déploiement et de gestion des charges de travail Windows sur un cluster.

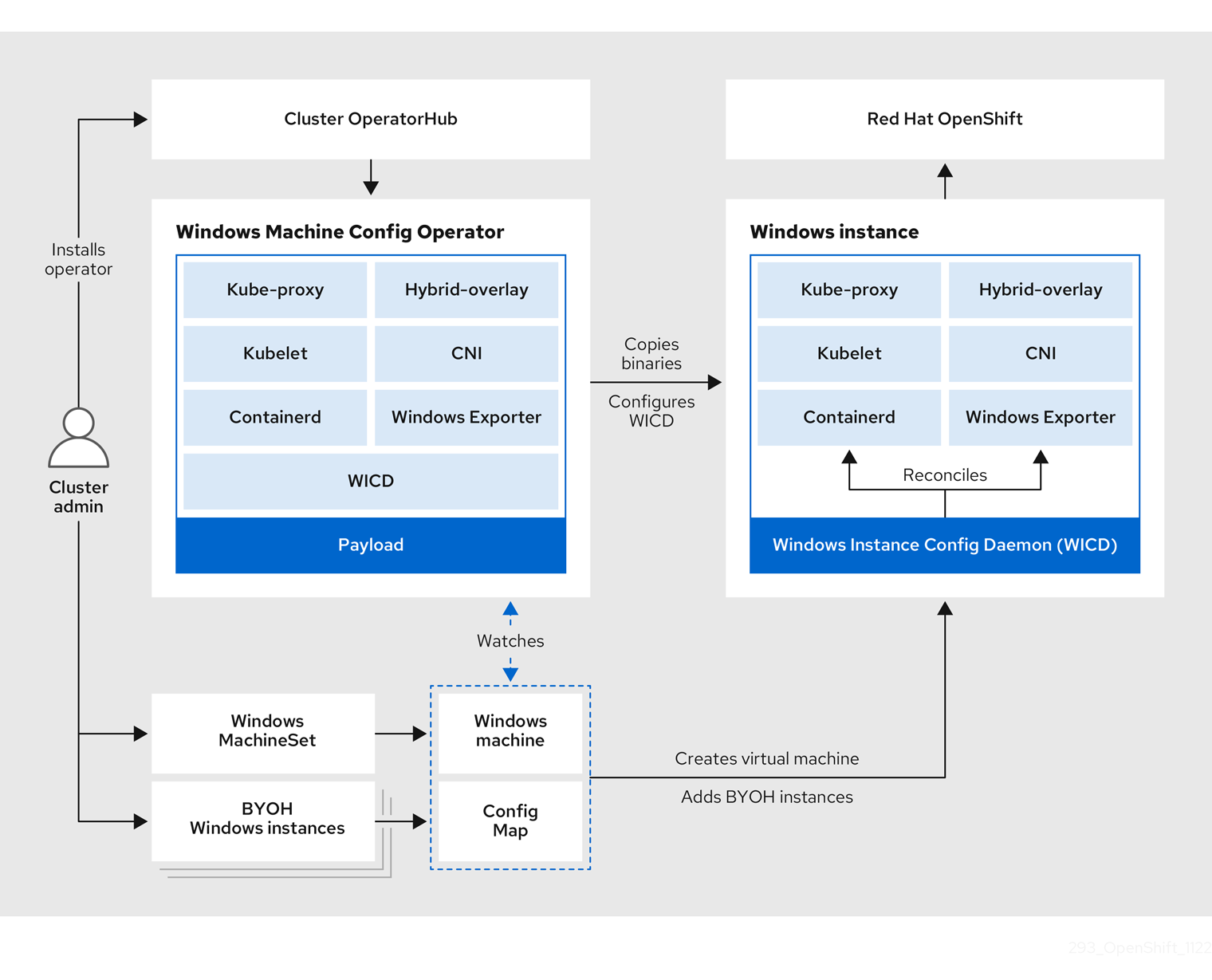

Figure 3.1. Conception WMCO

Avant de déployer des charges de travail Windows, vous devez créer un nœud de calcul Windows et le faire rejoindre le cluster. Le nœud Windows héberge les charges de travail Windows dans un cluster et peut fonctionner avec d'autres nœuds de calcul basés sur Linux. Vous pouvez créer un nœud de calcul Windows en créant un ensemble de machines de calcul Windows pour héberger des machines de calcul Windows Server. Vous devez appliquer une étiquette spécifique à Windows à l'ensemble de machines de calcul qui spécifie une image de système d'exploitation Windows.

Le WMCO recherche les machines portant le label Windows. Une fois qu'un ensemble de machines de calcul Windows est détecté et que ses machines respectives sont approvisionnées, le WMCO configure la machine virtuelle (VM) Windows sous-jacente afin qu'elle puisse rejoindre le cluster en tant que nœud de calcul.

Figure 3.2. Charges de travail mixtes Windows et Linux

L'OCMW attend un secret prédéterminé dans son espace de noms contenant une clé privée qui est utilisée pour interagir avec l'instance Windows. L'OCMW vérifie la présence de ce secret au moment du démarrage et crée un secret de données utilisateur que vous devez référencer dans l'objet Windows MachineSet que vous avez créé. Ensuite, l'OCMW remplit le secret de données utilisateur avec une clé publique qui correspond à la clé privée. Avec ces données en place, le cluster peut se connecter à la VM Windows en utilisant une connexion SSH.

Une fois que le cluster a établi une connexion avec la VM Windows, vous pouvez gérer le nœud Windows de la même manière qu'un nœud Linux.

La console web d'OpenShift Container Platform offre la plupart des fonctionnalités de surveillance pour les nœuds Windows qui sont disponibles pour les nœuds Linux. Cependant, la possibilité de surveiller les graphiques de charge de travail pour les pods s'exécutant sur des nœuds Windows n'est pas disponible pour le moment.

L'ordonnancement des charges de travail Windows sur un nœud Windows peut se faire à l'aide des pratiques habituelles d'ordonnancement de pods telles que les taints, les tolérances et les sélecteurs de nœuds. Vous pouvez également différencier vos charges de travail Windows des charges de travail Linux et des autres charges de travail en version Windows en utilisant un objet RuntimeClass.

3.3. Services de nœuds Windows

Les services suivants, spécifiques à Windows, sont installés sur chaque nœud Windows :

| Service | Description |

|---|---|

| kubelet | Enregistre le nœud Windows et gère son état. |

| Plugins d'interface de réseau de conteneurs (CNI) | Expose la mise en réseau pour les nœuds Windows. |

| Windows Instance Config Daemon (WICD) | Maintient l'état de tous les services s'exécutant sur l'instance Windows afin de garantir que l'instance fonctionne comme un nœud de travail. |

| Exportation des métriques Prometheus à partir des nœuds Windows | |

| Interagit avec la plateforme cloud Azure sous-jacente. | |

| hybride-overlay | Crée le service de réseau hôte (HNS) de la plateforme OpenShift Container. |

| kube-proxy | Maintient les règles du réseau sur les nœuds permettant la communication avec l'extérieur. |

| containerd container runtime | Gère le cycle de vie complet des conteneurs. |

3.4. Limites connues

Notez les limitations suivantes lorsque vous travaillez avec des nœuds Windows gérés par le WMCO (nœuds Windows) :

Les fonctionnalités suivantes d'OpenShift Container Platform ne sont pas prises en charge sur les nœuds Windows :

- Constructions d'images

- OpenShift Pipelines

- OpenShift Service Mesh

- Surveillance OpenShift des projets définis par l'utilisateur

- OpenShift Serverless

- Mise à l'échelle horizontale du pod

- Mise à l'échelle automatique des nacelles verticales

Les fonctionnalités Red Hat suivantes ne sont pas prises en charge sur les nœuds Windows :

- Les nœuds Windows ne prennent pas en charge l'extraction d'images de conteneurs à partir de registres privés. Vous pouvez utiliser des images provenant de registres publics ou prélever les images.

- Les nœuds Windows ne prennent pas en charge les charges de travail créées à l'aide de configurations de déploiement. Vous pouvez utiliser un déploiement ou une autre méthode pour déployer les charges de travail.

- Les nœuds Windows ne sont pas pris en charge dans les grappes qui utilisent un proxy à l'échelle de la grappe. En effet, le WMCO n'est pas en mesure d'acheminer le trafic via la connexion proxy pour les charges de travail.

- Les nœuds Windows ne sont pas pris en charge dans les grappes qui se trouvent dans un environnement déconnecté.

- La prise en charge de Red Hat OpenShift pour les conteneurs Windows ne prend pas en charge l'ajout de nœuds Windows à un cluster par le biais d'un port trunk. La seule configuration réseau prise en charge pour l'ajout de nœuds Windows est un port d'accès qui transporte le trafic pour le VLAN.

- La prise en charge de Red Hat OpenShift pour Windows Containers ne prend en charge que les pilotes de stockage in-tree pour tous les fournisseurs de cloud.

Kubernetes a identifié les limitations suivantes des fonctionnalités des nœuds:

- Les pages volumineuses ne sont pas prises en charge pour les conteneurs Windows.

- Les conteneurs privilégiés ne sont pas pris en charge pour les conteneurs Windows.

- Kubernetes a identifié plusieurs problèmes de compatibilité des API.

Chapitre 4. Permettre les charges de travail des conteneurs Windows

Avant d'ajouter des charges de travail Windows à votre cluster, vous devez installer le Windows Machine Config Operator (WMCO), qui est disponible dans l'OperatorHub d'OpenShift Container Platform. Le WMCO orchestre le processus de déploiement et de gestion des charges de travail Windows sur un cluster.

Le double NIC n'est pas supporté sur les instances Windows gérées par WMCO.

Conditions préalables

-

Vous avez accès à un cluster OpenShift Container Platform en utilisant un compte avec des permissions

cluster-admin. -

Vous avez installé l'OpenShift CLI (

oc). -

Vous avez installé votre cluster à l'aide d'une infrastructure fournie par l'installateur ou à l'aide d'une infrastructure fournie par l'utilisateur avec le champ

platform: nonedéfini dans votre fichierinstall-config.yaml. - Vous avez configuré la mise en réseau hybride avec OVN-Kubernetes pour votre cluster. Cette opération doit être réalisée lors de l'installation de votre cluster. Pour plus d'informations, voir Configuration de la mise en réseau hybride.

- Vous exécutez un cluster OpenShift Container Platform version 4.6.8 ou ultérieure.

Les instances Windows déployées par le WMCO sont configurées avec le runtime containerd. Comme le WMCO installe et gère le runtime, il est recommandé de ne pas installer manuellement containerd sur les nœuds.

Ressources supplémentaires

- Pour connaître l'ensemble des conditions préalables à l'utilisation de Windows Machine Config Operator, voir Comprendre les charges de travail des conteneurs Windows.

4.1. Installation de l'opérateur Windows Machine Config

Vous pouvez installer le Windows Machine Config Operator en utilisant la console web ou OpenShift CLI (oc).

Le WMCO n'est pas pris en charge dans les clusters qui utilisent un proxy à l'échelle du cluster car le WMCO n'est pas en mesure d'acheminer le trafic via la connexion proxy pour les charges de travail.

4.1.1. Installation de Windows Machine Config Operator à l'aide de la console web

Vous pouvez utiliser la console web d'OpenShift Container Platform pour installer le Windows Machine Config Operator (WMCO).

Le double NIC n'est pas supporté sur les instances Windows gérées par WMCO.

Procédure

- Depuis la perspective Administrator dans la console web de OpenShift Container Platform, naviguez jusqu'à la page Operators → OperatorHub.

-

Utilisez la boîte Filter by keyword pour rechercher

Windows Machine Config Operatordans le catalogue. Cliquez sur la tuile Windows Machine Config Operator. - Examinez les informations relatives à l'opérateur et cliquez sur Install.

Sur la page Install Operator:

- Sélectionnez le canal stable comme Update Channel. Le canal stable permet d'installer la dernière version stable du WMCO.

- Le site Installation Mode est préconfiguré car le WMCO doit être disponible dans un seul espace de noms.

-

Choisissez l'espace de noms Installed Namespace pour le WMCO. L'espace de noms par défaut recommandé par l'opérateur est

openshift-windows-machine-config-operator. - Cliquez sur la case à cocher Enable Operator recommended cluster monitoring on the Namespace pour activer la surveillance des clusters pour le WMCO.

Sélectionnez un site Approval Strategy.

- La stratégie Automatic permet à Operator Lifecycle Manager (OLM) de mettre automatiquement à jour l'opérateur lorsqu'une nouvelle version est disponible.

- La stratégie Manual exige qu'un utilisateur disposant des informations d'identification appropriées approuve la mise à jour de l'opérateur.

Cliquez sur Install. Le WMCO figure désormais sur la page Installed Operators.

NoteL'OCMW est installé automatiquement dans l'espace de noms que vous avez défini, comme

openshift-windows-machine-config-operator.- Vérifiez que le site Status affiche Succeeded pour confirmer que l'installation de l'OCMW a réussi.

4.1.2. Installation de l'opérateur Windows Machine Config à l'aide du CLI

Vous pouvez utiliser la CLI OpenShift (oc) pour installer le Windows Machine Config Operator (WMCO).

Le double NIC n'est pas supporté sur les instances Windows gérées par WMCO.

Procédure

Créer un espace de noms pour le WMCO.

Créer un fichier YAML de l'objet

Namespacepour le WMCO. Par exemple,wmco-namespace.yaml:apiVersion: v1 kind: Namespace metadata: name: openshift-windows-machine-config-operator 1 labels: openshift.io/cluster-monitoring: "true" 2

Créer l'espace de noms :

oc create -f <nom-de-fichier>.yaml

Par exemple :

$ oc create -f wmco-namespace.yaml

Créez le groupe d'opérateurs pour le WMCO.

Créer un fichier YAML de l'objet

OperatorGroup. Par exemple,wmco-og.yaml:apiVersion: operators.coreos.com/v1 kind: OperatorGroup metadata: name: windows-machine-config-operator namespace: openshift-windows-machine-config-operator spec: targetNamespaces: - openshift-windows-machine-config-operator

Créez le groupe Opérateur :

oc create -f <nom-de-fichier>.yaml

Par exemple :

$ oc create -f wmco-og.yaml

Abonnement de l'espace de noms à l'OCMF.

Créer un fichier YAML de l'objet

Subscription. Par exemple,wmco-sub.yaml:apiVersion: operators.coreos.com/v1alpha1 kind: Subscription metadata: name: windows-machine-config-operator namespace: openshift-windows-machine-config-operator spec: channel: "stable" 1 installPlanApproval: "Automatic" 2 name: "windows-machine-config-operator" source: "redhat-operators" 3 sourceNamespace: "openshift-marketplace" 4

- 1

- Spécifiez

stablecomme canal. - 2

- Définissez une stratégie d'approbation. Vous pouvez définir

AutomaticouManual. - 3

- Spécifiez la source du catalogue

redhat-operators, qui contient les manifestes de paquetswindows-machine-config-operator. Si votre OpenShift Container Platform est installée sur un réseau restreint, également connu sous le nom de cluster déconnecté, indiquez le nom de l'objetCatalogSourceque vous avez créé lors de la configuration de l'Operator LifeCycle Manager (OLM). - 4

- Espace de noms de la source de catalogue. Utilisez

openshift-marketplacepour les sources de catalogue par défaut d'OperatorHub.

Créer l'abonnement :

oc create -f <nom-de-fichier>.yaml

Par exemple :

$ oc create -f wmco-sub.yaml

Le WMCO est maintenant installé sur le site

openshift-windows-machine-config-operator.

Vérifier l'installation de WMCO :

$ oc get csv -n openshift-windows-machine-config-operator

Exemple de sortie

NAME DISPLAY VERSION REPLACES PHASE windows-machine-config-operator.2.0.0 Windows Machine Config Operator 2.0.0 Succeeded

4.2. Configuration d'un secret pour l'opérateur de configuration de la machine Windows

Pour exécuter le Windows Machine Config Operator (WMCO), vous devez créer un secret dans l'espace de noms WMCO contenant une clé privée. Cette clé est nécessaire pour permettre à l'OCMW de communiquer avec la machine virtuelle Windows (VM).

Conditions préalables

- Vous avez installé Windows Machine Config Operator (WMCO) à l'aide d'Operator Lifecycle Manager (OLM).

- Vous avez créé un fichier codé PEM contenant une clé RSA.

Procédure

Définir le secret requis pour accéder aux machines virtuelles Windows :

$ oc create secret generic cloud-private-key --from-file=private-key.pem=${HOME}/.ssh/<key> \ -n openshift-windows-machine-config-operator 1

- 1

- Vous devez créer la clé privée dans l'espace de noms WMCO, comme

openshift-windows-machine-config-operator.

Il est recommandé d'utiliser une clé privée différente de celle utilisée lors de l'installation du cluster.

4.3. Ressources supplémentaires

Chapitre 5. Création d'objets Windows MachineSet

5.1. Création d'un objet Windows MachineSet sur AWS

Vous pouvez créer un objet Windows MachineSet à des fins spécifiques dans votre cluster OpenShift Container Platform sur Amazon Web Services (AWS). Par exemple, vous pouvez créer des ensembles de machines Windows d'infrastructure et des machines connexes afin de pouvoir déplacer les charges de travail Windows de support vers les nouvelles machines Windows.

Conditions préalables

- Vous avez installé Windows Machine Config Operator (WMCO) à l'aide d'Operator Lifecycle Manager (OLM).

Vous utilisez un serveur Windows pris en charge comme image du système d'exploitation.

Utilisez la commande suivante

awspour interroger les images AMI valides :$ aws ec2 describe-images --region <aws region name> --filters "Name=name,Values=Windows_Server-2019*English*Full*Containers*" "Name=is-public,Values=true" --query "reverse(sort_by(Images, &CreationDate))[*].{name : Name, id : ImageId}" --output table

5.1.1. Vue d'ensemble de l'API Machine

L'API Machine est une combinaison de ressources primaires basées sur le projet Cluster API en amont et de ressources OpenShift Container Platform personnalisées.

Pour les clusters OpenShift Container Platform 4.12, l'API Machine effectue toutes les actions de gestion du provisionnement de l'hôte du nœud une fois l'installation du cluster terminée. Grâce à ce système, OpenShift Container Platform 4.12 offre une méthode de provisionnement élastique et dynamique au-dessus d'une infrastructure de cloud public ou privé.

Les deux principales ressources sont les suivantes

- Machines

-

Unité fondamentale décrivant l'hôte d'un nœud. Une machine possède une spécification

providerSpec, qui décrit les types de nœuds de calcul proposés par les différentes plateformes de cloud computing. Par exemple, un type de machine pour un nœud de travail sur Amazon Web Services (AWS) peut définir un type de machine spécifique et les métadonnées requises. - Jeux de machines

MachineSetles ressources sont des groupes de machines de calcul. Les ensembles de machines de calcul sont aux machines de calcul ce que les ensembles de répliques sont aux pods. Si vous avez besoin de plus de machines de calcul ou si vous devez les réduire, vous modifiez le champreplicasde la ressourceMachineSetpour répondre à vos besoins en matière de calcul.AvertissementLes machines du plan de contrôle ne peuvent pas être gérées par des ensembles de machines de calcul.

Les ensembles de machines du plan de contrôle fournissent des capacités de gestion pour les machines du plan de contrôle prises en charge qui sont similaires à celles que les ensembles de machines de calcul fournissent pour les machines de calcul.

Pour plus d'informations, voir "Gestion des machines du plan de contrôle".

Les ressources personnalisées suivantes ajoutent des capacités supplémentaires à votre cluster :

- Machine autoscaler

La ressource

MachineAutoscalermet automatiquement à l'échelle les machines de calcul dans un nuage. Vous pouvez définir les limites minimales et maximales de mise à l'échelle pour les nœuds d'un ensemble de machines de calcul spécifié, et l'autoscaler de machines maintient cette plage de nœuds.L'objet

MachineAutoscalerprend effet après l'existence d'un objetClusterAutoscaler. Les ressourcesClusterAutoscaleretMachineAutoscalersont mises à disposition par l'objetClusterAutoscalerOperator.- Cluster autoscaler

Cette ressource est basée sur le projet de cluster autoscaler en amont. Dans l'implémentation d'OpenShift Container Platform, elle est intégrée à l'API Machine en étendant l'API compute machine set. Vous pouvez utiliser le cluster autoscaler pour gérer votre cluster de la manière suivante :

- Définir des limites d'échelle à l'échelle du cluster pour les ressources telles que les cœurs, les nœuds, la mémoire et les GPU

- Définir la priorité afin que le cluster donne la priorité aux pods et que de nouveaux nœuds ne soient pas mis en ligne pour des pods moins importants

- Définir la politique de mise à l'échelle de manière à pouvoir augmenter les nœuds mais pas les diminuer

- Bilan de santé de la machine

-

La ressource

MachineHealthCheckdétecte lorsqu'une machine n'est pas saine, la supprime et, sur les plates-formes prises en charge, crée une nouvelle machine.

Dans OpenShift Container Platform version 3.11, il n'était pas possible de déployer facilement une architecture multizone car le cluster ne gérait pas le provisionnement des machines. À partir de la version 4.1 d'OpenShift Container Platform, ce processus est plus facile. Chaque ensemble de machines de calcul est limité à une seule zone, de sorte que le programme d'installation envoie des ensembles de machines de calcul à travers les zones de disponibilité en votre nom. Ainsi, comme votre calcul est dynamique, et en cas de défaillance d'une zone, vous disposez toujours d'une zone pour rééquilibrer vos machines. Dans les régions Azure globales qui ne disposent pas de plusieurs zones de disponibilité, vous pouvez utiliser des ensembles de machines pour garantir une haute disponibilité. L'autoscaler assure l'équilibrage du meilleur effort pendant toute la durée de vie d'un cluster.

5.1.2. Exemple de YAML pour un objet Windows MachineSet sur AWS

Cet exemple YAML définit un objet Windows MachineSet fonctionnant sur Amazon Web Services (AWS) sur lequel le Windows Machine Config Operator (WMCO) peut réagir.

apiVersion: machine.openshift.io/v1beta1

kind: MachineSet

metadata:

labels:

machine.openshift.io/cluster-api-cluster: <infrastructure_id> 1

name: <infrastructure_id>-windows-worker-<zone> 2

namespace: openshift-machine-api

spec:

replicas: 1

selector:

matchLabels:

machine.openshift.io/cluster-api-cluster: <infrastructure_id> 3

machine.openshift.io/cluster-api-machineset: <infrastructure_id>-windows-worker-<zone> 4

template:

metadata:

labels:

machine.openshift.io/cluster-api-cluster: <infrastructure_id> 5

machine.openshift.io/cluster-api-machine-role: worker

machine.openshift.io/cluster-api-machine-type: worker

machine.openshift.io/cluster-api-machineset: <infrastructure_id>-windows-worker-<zone> 6

machine.openshift.io/os-id: Windows 7

spec:

metadata:

labels:

node-role.kubernetes.io/worker: "" 8

providerSpec:

value:

ami:

id: <windows_container_ami> 9

apiVersion: awsproviderconfig.openshift.io/v1beta1

blockDevices:

- ebs:

iops: 0

volumeSize: 120

volumeType: gp2

credentialsSecret:

name: aws-cloud-credentials

deviceIndex: 0

iamInstanceProfile:

id: <infrastructure_id>-worker-profile 10

instanceType: m5a.large

kind: AWSMachineProviderConfig

placement:

availabilityZone: <zone> 11

region: <region> 12

securityGroups:

- filters:

- name: tag:Name

values:

- <infrastructure_id>-worker-sg 13

subnet:

filters:

- name: tag:Name

values:

- <infrastructure_id>-private-<zone> 14

tags:

- name: kubernetes.io/cluster/<infrastructure_id> 15

value: owned

userDataSecret:

name: windows-user-data 16

namespace: openshift-machine-api- 1 3 5 10 13 14 15

- Spécifiez l'ID de l'infrastructure qui est basé sur l'ID du cluster que vous avez défini lorsque vous avez approvisionné le cluster. Vous pouvez obtenir l'ID d'infrastructure en exécutant la commande suivante :

$ oc get -o jsonpath='{.status.infrastructureName}{"\n"}' infrastructure cluster - 2 4 6

- Spécifiez l'ID de l'infrastructure, l'étiquette du travailleur et la zone.

- 7

- Configurez l'ensemble de machines de calcul comme une machine Windows.

- 8

- Configurez le nœud Windows en tant que machine de calcul.

- 9

- Indiquez l'identifiant AMI d'une image Windows prise en charge dans laquelle un moteur d'exécution de conteneur est installé.

- 11

- Spécifiez la zone AWS, comme

us-east-1a. - 12

- Spécifiez la région AWS, comme

us-east-1. - 16

- Créé par le WMCO lorsqu'il configure la première machine Windows. Ensuite, le site

windows-user-dataest disponible pour tous les ensembles de machines de calcul suivants.

5.1.3. Création d'un ensemble de machines de calcul

En plus des ensembles de machines de calcul créés par le programme d'installation, vous pouvez créer vos propres ensembles pour gérer dynamiquement les ressources de calcul des machines pour les charges de travail spécifiques de votre choix.

Conditions préalables

- Déployer un cluster OpenShift Container Platform.

-

Installez le CLI OpenShift (

oc). -

Connectez-vous à

ocen tant qu'utilisateur disposant de l'autorisationcluster-admin.

Procédure

Créez un nouveau fichier YAML contenant l'échantillon de ressources personnalisées (CR) de l'ensemble de machines de calcul et nommé

<file_name>.yaml.Veillez à définir les valeurs des paramètres

<clusterID>et<role>.Facultatif : si vous n'êtes pas sûr de la valeur à définir pour un champ spécifique, vous pouvez vérifier un ensemble de machines de calcul existant dans votre cluster.

Pour répertorier les ensembles de machines de calcul de votre cluster, exécutez la commande suivante :

$ oc get machinesets -n openshift-machine-api

Exemple de sortie

NAME DESIRED CURRENT READY AVAILABLE AGE agl030519-vplxk-worker-us-east-1a 1 1 1 1 55m agl030519-vplxk-worker-us-east-1b 1 1 1 1 55m agl030519-vplxk-worker-us-east-1c 1 1 1 1 55m agl030519-vplxk-worker-us-east-1d 0 0 55m agl030519-vplxk-worker-us-east-1e 0 0 55m agl030519-vplxk-worker-us-east-1f 0 0 55m

Pour afficher les valeurs d'une ressource personnalisée (CR) d'un ensemble de machines de calcul spécifique, exécutez la commande suivante :

$ oc get machineset <machineset_name> \ -n openshift-machine-api -o yaml

Exemple de sortie

apiVersion: machine.openshift.io/v1beta1 kind: MachineSet metadata: labels: machine.openshift.io/cluster-api-cluster: <infrastructure_id> 1 name: <infrastructure_id>-<role> 2 namespace: openshift-machine-api spec: replicas: 1 selector: matchLabels: machine.openshift.io/cluster-api-cluster: <infrastructure_id> machine.openshift.io/cluster-api-machineset: <infrastructure_id>-<role> template: metadata: labels: machine.openshift.io/cluster-api-cluster: <infrastructure_id> machine.openshift.io/cluster-api-machine-role: <role> machine.openshift.io/cluster-api-machine-type: <role> machine.openshift.io/cluster-api-machineset: <infrastructure_id>-<role> spec: providerSpec: 3 ...- 1

- L'ID de l'infrastructure du cluster.

- 2

- Une étiquette de nœud par défaut.Note

Pour les clusters disposant d'une infrastructure fournie par l'utilisateur, un ensemble de machines de calcul ne peut créer que des machines de type

workeretinfra. - 3

- Les valeurs de la section

<providerSpec>du CR de l'ensemble de machines de calcul sont spécifiques à la plate-forme. Pour plus d'informations sur les paramètres<providerSpec>dans le CR, consultez l'exemple de configuration du CR de l'ensemble de machines de calcul pour votre fournisseur.

Créez un CR

MachineSeten exécutant la commande suivante :oc create -f <nom_du_fichier>.yaml

Vérification

Affichez la liste des ensembles de machines de calcul en exécutant la commande suivante :

$ oc get machineset -n openshift-machine-api

Exemple de sortie

NAME DESIRED CURRENT READY AVAILABLE AGE agl030519-vplxk-windows-worker-us-east-1a 1 1 1 1 11m agl030519-vplxk-worker-us-east-1a 1 1 1 1 55m agl030519-vplxk-worker-us-east-1b 1 1 1 1 55m agl030519-vplxk-worker-us-east-1c 1 1 1 1 55m agl030519-vplxk-worker-us-east-1d 0 0 55m agl030519-vplxk-worker-us-east-1e 0 0 55m agl030519-vplxk-worker-us-east-1f 0 0 55m

Lorsque le nouveau jeu de machines de calcul est disponible, les valeurs

DESIREDetCURRENTcorrespondent. Si le jeu de machines de calcul n'est pas disponible, attendez quelques minutes et exécutez à nouveau la commande.

5.1.4. Ressources supplémentaires

- Pour plus d'informations sur la gestion des jeux de machines, voir la section Machine management.

5.2. Création d'un objet Windows MachineSet sur Azure

Vous pouvez créer un objet Windows MachineSet à des fins spécifiques dans votre cluster OpenShift Container Platform sur Microsoft Azure. Par exemple, vous pouvez créer des ensembles de machines Windows d'infrastructure et des machines connexes afin de pouvoir déplacer les charges de travail Windows de support vers les nouvelles machines Windows.

Conditions préalables

- Vous avez installé Windows Machine Config Operator (WMCO) à l'aide d'Operator Lifecycle Manager (OLM).

- Vous utilisez un serveur Windows pris en charge comme image du système d'exploitation.

5.2.1. Vue d'ensemble de l'API Machine

L'API Machine est une combinaison de ressources primaires basées sur le projet Cluster API en amont et de ressources OpenShift Container Platform personnalisées.

Pour les clusters OpenShift Container Platform 4.12, l'API Machine effectue toutes les actions de gestion du provisionnement de l'hôte du nœud une fois l'installation du cluster terminée. Grâce à ce système, OpenShift Container Platform 4.12 offre une méthode de provisionnement élastique et dynamique au-dessus d'une infrastructure de cloud public ou privé.

Les deux principales ressources sont les suivantes

- Machines

-

Unité fondamentale décrivant l'hôte d'un nœud. Une machine possède une spécification

providerSpec, qui décrit les types de nœuds de calcul proposés par les différentes plateformes de cloud computing. Par exemple, un type de machine pour un nœud de travail sur Amazon Web Services (AWS) peut définir un type de machine spécifique et les métadonnées requises. - Jeux de machines

MachineSetles ressources sont des groupes de machines de calcul. Les ensembles de machines de calcul sont aux machines de calcul ce que les ensembles de répliques sont aux pods. Si vous avez besoin de plus de machines de calcul ou si vous devez les réduire, vous modifiez le champreplicasde la ressourceMachineSetpour répondre à vos besoins en matière de calcul.AvertissementLes machines du plan de contrôle ne peuvent pas être gérées par des ensembles de machines de calcul.

Les ensembles de machines du plan de contrôle fournissent des capacités de gestion pour les machines du plan de contrôle prises en charge qui sont similaires à celles que les ensembles de machines de calcul fournissent pour les machines de calcul.

Pour plus d'informations, voir "Gestion des machines du plan de contrôle".

Les ressources personnalisées suivantes ajoutent des capacités supplémentaires à votre cluster :

- Machine autoscaler

La ressource

MachineAutoscalermet automatiquement à l'échelle les machines de calcul dans un nuage. Vous pouvez définir les limites minimales et maximales de mise à l'échelle pour les nœuds d'un ensemble de machines de calcul spécifié, et l'autoscaler de machines maintient cette plage de nœuds.L'objet

MachineAutoscalerprend effet après l'existence d'un objetClusterAutoscaler. Les ressourcesClusterAutoscaleretMachineAutoscalersont mises à disposition par l'objetClusterAutoscalerOperator.- Cluster autoscaler

Cette ressource est basée sur le projet de cluster autoscaler en amont. Dans l'implémentation d'OpenShift Container Platform, elle est intégrée à l'API Machine en étendant l'API compute machine set. Vous pouvez utiliser le cluster autoscaler pour gérer votre cluster de la manière suivante :

- Définir des limites d'échelle à l'échelle du cluster pour les ressources telles que les cœurs, les nœuds, la mémoire et les GPU

- Définir la priorité afin que le cluster donne la priorité aux pods et que de nouveaux nœuds ne soient pas mis en ligne pour des pods moins importants

- Définir la politique de mise à l'échelle de manière à pouvoir augmenter les nœuds mais pas les diminuer

- Bilan de santé de la machine

-

La ressource

MachineHealthCheckdétecte lorsqu'une machine n'est pas saine, la supprime et, sur les plates-formes prises en charge, crée une nouvelle machine.

Dans OpenShift Container Platform version 3.11, il n'était pas possible de déployer facilement une architecture multizone car le cluster ne gérait pas le provisionnement des machines. À partir de la version 4.1 d'OpenShift Container Platform, ce processus est plus facile. Chaque ensemble de machines de calcul est limité à une seule zone, de sorte que le programme d'installation envoie des ensembles de machines de calcul à travers les zones de disponibilité en votre nom. Ainsi, comme votre calcul est dynamique, et en cas de défaillance d'une zone, vous disposez toujours d'une zone pour rééquilibrer vos machines. Dans les régions Azure globales qui ne disposent pas de plusieurs zones de disponibilité, vous pouvez utiliser des ensembles de machines pour garantir une haute disponibilité. L'autoscaler assure l'équilibrage du meilleur effort pendant toute la durée de vie d'un cluster.

5.2.2. Exemple de YAML pour un objet Windows MachineSet sur Azure

Cet exemple YAML définit un objet Windows MachineSet fonctionnant sur Microsoft Azure et sur lequel le Windows Machine Config Operator (WMCO) peut réagir.

apiVersion: machine.openshift.io/v1beta1

kind: MachineSet

metadata:

labels:

machine.openshift.io/cluster-api-cluster: <infrastructure_id> 1

name: <windows_machine_set_name> 2

namespace: openshift-machine-api

spec:

replicas: 1

selector:

matchLabels:

machine.openshift.io/cluster-api-cluster: <infrastructure_id> 3

machine.openshift.io/cluster-api-machineset: <windows_machine_set_name> 4

template:

metadata:

labels:

machine.openshift.io/cluster-api-cluster: <infrastructure_id> 5

machine.openshift.io/cluster-api-machine-role: worker

machine.openshift.io/cluster-api-machine-type: worker

machine.openshift.io/cluster-api-machineset: <windows_machine_set_name> 6

machine.openshift.io/os-id: Windows 7

spec:

metadata:

labels:

node-role.kubernetes.io/worker: "" 8

providerSpec:

value:

apiVersion: azureproviderconfig.openshift.io/v1beta1

credentialsSecret:

name: azure-cloud-credentials

namespace: openshift-machine-api

image: 9

offer: WindowsServer

publisher: MicrosoftWindowsServer

resourceID: ""

sku: 2019-Datacenter-with-Containers

version: latest

kind: AzureMachineProviderSpec

location: <location> 10

managedIdentity: <infrastructure_id>-identity 11

networkResourceGroup: <infrastructure_id>-rg 12

osDisk:

diskSizeGB: 128

managedDisk:

storageAccountType: Premium_LRS

osType: Windows

publicIP: false

resourceGroup: <infrastructure_id>-rg 13

subnet: <infrastructure_id>-worker-subnet

userDataSecret:

name: windows-user-data 14

namespace: openshift-machine-api

vmSize: Standard_D2s_v3

vnet: <infrastructure_id>-vnet 15

zone: "<zone>" 16- 1 3 5 11 12 13 15

- Spécifiez l'ID de l'infrastructure qui est basé sur l'ID du cluster que vous avez défini lorsque vous avez approvisionné le cluster. Vous pouvez obtenir l'ID d'infrastructure en exécutant la commande suivante :

$ oc get -o jsonpath='{.status.infrastructureName}{"\n"}' infrastructure cluster - 2 4 6

- Indiquez le nom de l'ensemble de machines de calcul Windows. Les noms de machines Windows sur Azure ne peuvent pas comporter plus de 15 caractères. Par conséquent, le nom de l'ensemble de machines de calcul ne peut pas dépasser 9 caractères, en raison de la façon dont les noms de machines sont générés à partir de ce nom.

- 7

- Configurez l'ensemble de machines de calcul comme une machine Windows.

- 8

- Configurez le nœud Windows en tant que machine de calcul.

- 9

- Spécifiez une offre d'image

WindowsServerqui définit l'UGS2019-Datacenter-with-Containers. - 10

- Spécifiez la région Azure, comme

centralus. - 14

- Créé par le WMCO lorsqu'il configure la première machine Windows. Ensuite, le site

windows-user-dataest disponible pour tous les ensembles de machines de calcul suivants. - 16

- Indiquez la zone de votre région où placer les machines. Assurez-vous que votre région prend en charge la zone que vous spécifiez.

5.2.3. Création d'un ensemble de machines de calcul

En plus des ensembles de machines de calcul créés par le programme d'installation, vous pouvez créer vos propres ensembles pour gérer dynamiquement les ressources de calcul des machines pour les charges de travail spécifiques de votre choix.

Conditions préalables

- Déployer un cluster OpenShift Container Platform.

-

Installez le CLI OpenShift (

oc). -

Connectez-vous à

ocen tant qu'utilisateur disposant de l'autorisationcluster-admin.

Procédure

Créez un nouveau fichier YAML contenant l'échantillon de ressources personnalisées (CR) de l'ensemble de machines de calcul et nommé

<file_name>.yaml.Veillez à définir les valeurs des paramètres

<clusterID>et<role>.Facultatif : si vous n'êtes pas sûr de la valeur à définir pour un champ spécifique, vous pouvez vérifier un ensemble de machines de calcul existant dans votre cluster.

Pour répertorier les ensembles de machines de calcul de votre cluster, exécutez la commande suivante :

$ oc get machinesets -n openshift-machine-api

Exemple de sortie

NAME DESIRED CURRENT READY AVAILABLE AGE agl030519-vplxk-worker-us-east-1a 1 1 1 1 55m agl030519-vplxk-worker-us-east-1b 1 1 1 1 55m agl030519-vplxk-worker-us-east-1c 1 1 1 1 55m agl030519-vplxk-worker-us-east-1d 0 0 55m agl030519-vplxk-worker-us-east-1e 0 0 55m agl030519-vplxk-worker-us-east-1f 0 0 55m

Pour afficher les valeurs d'une ressource personnalisée (CR) d'un ensemble de machines de calcul spécifique, exécutez la commande suivante :

$ oc get machineset <machineset_name> \ -n openshift-machine-api -o yaml

Exemple de sortie

apiVersion: machine.openshift.io/v1beta1 kind: MachineSet metadata: labels: machine.openshift.io/cluster-api-cluster: <infrastructure_id> 1 name: <infrastructure_id>-<role> 2 namespace: openshift-machine-api spec: replicas: 1 selector: matchLabels: machine.openshift.io/cluster-api-cluster: <infrastructure_id> machine.openshift.io/cluster-api-machineset: <infrastructure_id>-<role> template: metadata: labels: machine.openshift.io/cluster-api-cluster: <infrastructure_id> machine.openshift.io/cluster-api-machine-role: <role> machine.openshift.io/cluster-api-machine-type: <role> machine.openshift.io/cluster-api-machineset: <infrastructure_id>-<role> spec: providerSpec: 3 ...- 1

- L'ID de l'infrastructure du cluster.

- 2

- Une étiquette de nœud par défaut.Note

Pour les clusters disposant d'une infrastructure fournie par l'utilisateur, un ensemble de machines de calcul ne peut créer que des machines de type

workeretinfra. - 3

- Les valeurs de la section

<providerSpec>du CR de l'ensemble de machines de calcul sont spécifiques à la plate-forme. Pour plus d'informations sur les paramètres<providerSpec>dans le CR, consultez l'exemple de configuration du CR de l'ensemble de machines de calcul pour votre fournisseur.

Créez un CR

MachineSeten exécutant la commande suivante :oc create -f <nom_du_fichier>.yaml

Vérification

Affichez la liste des ensembles de machines de calcul en exécutant la commande suivante :

$ oc get machineset -n openshift-machine-api

Exemple de sortie

NAME DESIRED CURRENT READY AVAILABLE AGE agl030519-vplxk-windows-worker-us-east-1a 1 1 1 1 11m agl030519-vplxk-worker-us-east-1a 1 1 1 1 55m agl030519-vplxk-worker-us-east-1b 1 1 1 1 55m agl030519-vplxk-worker-us-east-1c 1 1 1 1 55m agl030519-vplxk-worker-us-east-1d 0 0 55m agl030519-vplxk-worker-us-east-1e 0 0 55m agl030519-vplxk-worker-us-east-1f 0 0 55m

Lorsque le nouveau jeu de machines de calcul est disponible, les valeurs

DESIREDetCURRENTcorrespondent. Si le jeu de machines de calcul n'est pas disponible, attendez quelques minutes et exécutez à nouveau la commande.

5.2.4. Ressources supplémentaires

- Pour plus d'informations sur la gestion des jeux de machines, voir la section Machine management.

5.3. Création d'un objet Windows MachineSet sur vSphere

Vous pouvez créer un objet Windows MachineSet à des fins spécifiques dans votre cluster OpenShift Container Platform sur VMware vSphere. Par exemple, vous pouvez créer des ensembles de machines Windows d'infrastructure et des machines connexes afin de pouvoir déplacer les charges de travail Windows de support vers les nouvelles machines Windows.

Conditions préalables

- Vous avez installé Windows Machine Config Operator (WMCO) à l'aide d'Operator Lifecycle Manager (OLM).

- Vous utilisez un serveur Windows pris en charge comme image du système d'exploitation.

5.3.1. Vue d'ensemble de l'API Machine

L'API Machine est une combinaison de ressources primaires basées sur le projet Cluster API en amont et de ressources OpenShift Container Platform personnalisées.

Pour les clusters OpenShift Container Platform 4.12, l'API Machine effectue toutes les actions de gestion du provisionnement de l'hôte du nœud une fois l'installation du cluster terminée. Grâce à ce système, OpenShift Container Platform 4.12 offre une méthode de provisionnement élastique et dynamique au-dessus d'une infrastructure de cloud public ou privé.

Les deux principales ressources sont les suivantes

- Machines

-

Unité fondamentale décrivant l'hôte d'un nœud. Une machine possède une spécification

providerSpec, qui décrit les types de nœuds de calcul proposés par les différentes plateformes de cloud computing. Par exemple, un type de machine pour un nœud de travail sur Amazon Web Services (AWS) peut définir un type de machine spécifique et les métadonnées requises. - Jeux de machines

MachineSetles ressources sont des groupes de machines de calcul. Les ensembles de machines de calcul sont aux machines de calcul ce que les ensembles de répliques sont aux pods. Si vous avez besoin de plus de machines de calcul ou si vous devez les réduire, vous modifiez le champreplicasde la ressourceMachineSetpour répondre à vos besoins en matière de calcul.AvertissementLes machines du plan de contrôle ne peuvent pas être gérées par des ensembles de machines de calcul.

Les ensembles de machines du plan de contrôle fournissent des capacités de gestion pour les machines du plan de contrôle prises en charge qui sont similaires à celles que les ensembles de machines de calcul fournissent pour les machines de calcul.

Pour plus d'informations, voir "Gestion des machines du plan de contrôle".

Les ressources personnalisées suivantes ajoutent des capacités supplémentaires à votre cluster :

- Machine autoscaler

La ressource

MachineAutoscalermet automatiquement à l'échelle les machines de calcul dans un nuage. Vous pouvez définir les limites minimales et maximales de mise à l'échelle pour les nœuds d'un ensemble de machines de calcul spécifié, et l'autoscaler de machines maintient cette plage de nœuds.L'objet

MachineAutoscalerprend effet après l'existence d'un objetClusterAutoscaler. Les ressourcesClusterAutoscaleretMachineAutoscalersont mises à disposition par l'objetClusterAutoscalerOperator.- Cluster autoscaler

Cette ressource est basée sur le projet de cluster autoscaler en amont. Dans l'implémentation d'OpenShift Container Platform, elle est intégrée à l'API Machine en étendant l'API compute machine set. Vous pouvez utiliser le cluster autoscaler pour gérer votre cluster de la manière suivante :

- Définir des limites d'échelle à l'échelle du cluster pour les ressources telles que les cœurs, les nœuds, la mémoire et les GPU

- Définir la priorité afin que le cluster donne la priorité aux pods et que de nouveaux nœuds ne soient pas mis en ligne pour des pods moins importants

- Définir la politique de mise à l'échelle de manière à pouvoir augmenter les nœuds mais pas les diminuer

- Bilan de santé de la machine

-

La ressource

MachineHealthCheckdétecte lorsqu'une machine n'est pas saine, la supprime et, sur les plates-formes prises en charge, crée une nouvelle machine.

Dans OpenShift Container Platform version 3.11, il n'était pas possible de déployer facilement une architecture multizone car le cluster ne gérait pas le provisionnement des machines. À partir de la version 4.1 d'OpenShift Container Platform, ce processus est plus facile. Chaque ensemble de machines de calcul est limité à une seule zone, de sorte que le programme d'installation envoie des ensembles de machines de calcul à travers les zones de disponibilité en votre nom. Ainsi, comme votre calcul est dynamique, et en cas de défaillance d'une zone, vous disposez toujours d'une zone pour rééquilibrer vos machines. Dans les régions Azure globales qui ne disposent pas de plusieurs zones de disponibilité, vous pouvez utiliser des ensembles de machines pour garantir une haute disponibilité. L'autoscaler assure l'équilibrage du meilleur effort pendant toute la durée de vie d'un cluster.

5.3.2. Préparer votre environnement vSphere pour les charges de travail des conteneurs Windows

Vous devez préparer votre environnement vSphere pour les charges de travail des conteneurs Windows en créant l'image dorée vSphere Windows VM et en activant la communication avec le serveur API interne pour le WMCO.

5.3.2.1. Création de l'image dorée de la VM Windows vSphere

Créez une image dorée de machine virtuelle (VM) Windows vSphere.

Conditions préalables

- Vous avez créé une paire de clés privée/publique, qui est utilisée pour configurer l'authentification basée sur les clés dans le serveur OpenSSH. La clé privée doit également être configurée dans l'espace de noms Windows Machine Config Operator (WMCO). Cela est nécessaire pour permettre à l'opérateur de configuration de la machine Windows de communiquer avec la VM Windows. Voir la section "Configuration d'un secret pour l'opérateur de configuration de la machine Windows" pour plus de détails.

Vous devez utiliser les commandes Microsoft PowerShell dans plusieurs cas lors de la création de votre VM Windows. Dans ce guide, les commandes PowerShell se distinguent par le préfixe PS C:\>.

Procédure

- Sélectionnez une version de Windows Server compatible. Actuellement, la version stable de Windows Machine Config Operator (WMCO) prend en charge Windows Server 2022 Long-Term Servicing Channel avec le correctif KB5012637 pour la mise en réseau des conteneurs au niveau du système d'exploitation.

Créez une nouvelle VM dans le client vSphere en utilisant l'image dorée de la VM avec une version compatible de Windows Server. Pour plus d'informations sur les versions compatibles, consultez la section "Windows Machine Config Operator prerequisites" des notes de mise à jour "Red Hat OpenShift support for Windows Containers release notes"

ImportantLa version du matériel virtuel de votre VM doit répondre aux exigences de l'infrastructure d'OpenShift Container Platform. Pour plus d'informations, voir la section " VMware vSphere infrastructure requirements " dans la documentation d'OpenShift Container Platform. Vous pouvez également consulter la documentation de VMware sur les versions matérielles des machines virtuelles.

- Installez et configurez VMware Tools version 11.0.6 ou supérieure sur la VM Windows. Voir la documentation de VMware Tools pour plus d'informations.

Après avoir installé VMware Tools sur la VM Windows, vérifiez les points suivants :

Le fichier

C:\ProgramData\VMware\VMware Tools\tools.confexiste avec l'entrée suivante :exclude-nics=

Si le fichier

tools.confn'existe pas, il est créé avec l'optionexclude-nicsdécommentée et définie comme une valeur vide.Cette entrée garantit que le vNIC cloné généré sur la VM Windows par la superposition hybride n'est pas ignoré.

La VM Windows a une adresse IP valide dans vCenter :

C:\N> ipconfig

Le service Windows VMTools est en cours d'exécution :

PS C:\N> Get-Service -Name VMTools | Select Status, StartType

- Installez et configurez le serveur OpenSSH sur la VM Windows. Voir la documentation de Microsoft sur l'installation d'OpenSSH pour plus de détails.

Configurez l'accès SSH pour un utilisateur administratif. Pour ce faire, consultez la documentation de Microsoft sur l'utilisateur administratif.

ImportantLa clé publique utilisée dans les instructions doit correspondre à la clé privée que vous créerez plus tard dans l'espace de noms WMCO et qui contient votre secret. Voir la section "Configuration d'un secret pour l'opérateur de configuration Windows Machine" pour plus de détails.

Vous devez créer une nouvelle règle de pare-feu dans la VM Windows qui autorise les connexions entrantes pour les journaux de conteneurs. Exécutez la commande PowerShell suivante pour créer la règle de pare-feu sur le port TCP 10250 :

PS C:\N> New-NetFirewallRule -DisplayName \N "ContainerLogsPort" -LocalPort 10250 -Enabled True -Direction Inbound -Protocol TCP -Action Allow -EdgeTraversalPolicy Allow

- Clonez la machine virtuelle Windows pour en faire une image réutilisable. Pour plus de détails, consultez la documentation VMware sur le clonage d'une machine virtuelle existante.

Dans la VM Windows clonée, exécutez l'outil Windows Sysprep:

C:\N> C:\NWindows\NSystem32\NSysprep\Nsysprep.exe /generalize /oobe /shutdown /unattend:<path_to_unattend.xml> 1- 1

- Indiquez le chemin d'accès à votre fichier

unattend.xml.

NoteLe nombre de fois où vous pouvez exécuter la commande

sysprepsur une image Windows est limité. Consultez la documentation de Microsoft pour plus d'informations.Un exemple

unattend.xmlest fourni, qui contient toutes les modifications nécessaires pour l'OCMF. Vous devez modifier cet exemple ; il ne peut pas être utilisé directement.Exemple 5.1. Exemple

unattend.xml<?xml version="1.0" encoding="UTF-8"?> <unattend xmlns="urn:schemas-microsoft-com:unattend"> <settings pass="specialize"> <component xmlns:wcm="http://schemas.microsoft.com/WMIConfig/2002/State" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" name="Microsoft-Windows-International-Core" processorArchitecture="amd64" publicKeyToken="31bf3856ad364e35" language="neutral" versionScope="nonSxS"> <InputLocale>0409:00000409</InputLocale> <SystemLocale>en-US</SystemLocale> <UILanguage>en-US</UILanguage> <UILanguageFallback>en-US</UILanguageFallback> <UserLocale>en-US</UserLocale> </component> <component xmlns:wcm="http://schemas.microsoft.com/WMIConfig/2002/State" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" name="Microsoft-Windows-Security-SPP-UX" processorArchitecture="amd64" publicKeyToken="31bf3856ad364e35" language="neutral" versionScope="nonSxS"> <SkipAutoActivation>true</SkipAutoActivation> </component> <component xmlns:wcm="http://schemas.microsoft.com/WMIConfig/2002/State" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" name="Microsoft-Windows-SQMApi" processorArchitecture="amd64" publicKeyToken="31bf3856ad364e35" language="neutral" versionScope="nonSxS"> <CEIPEnabled>0</CEIPEnabled> </component> <component xmlns:wcm="http://schemas.microsoft.com/WMIConfig/2002/State" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" name="Microsoft-Windows-Shell-Setup" processorArchitecture="amd64" publicKeyToken="31bf3856ad364e35" language="neutral" versionScope="nonSxS"> <ComputerName>winhost</ComputerName> 1 </component> </settings> <settings pass="oobeSystem"> <component xmlns:wcm="http://schemas.microsoft.com/WMIConfig/2002/State" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" name="Microsoft-Windows-Shell-Setup" processorArchitecture="amd64" publicKeyToken="31bf3856ad364e35" language="neutral" versionScope="nonSxS"> <AutoLogon> <Enabled>false</Enabled> 2 </AutoLogon> <OOBE> <HideEULAPage>true</HideEULAPage> <HideLocalAccountScreen>true</HideLocalAccountScreen> <HideOEMRegistrationScreen>true</HideOEMRegistrationScreen> <HideOnlineAccountScreens>true</HideOnlineAccountScreens> <HideWirelessSetupInOOBE>true</HideWirelessSetupInOOBE> <NetworkLocation>Work</NetworkLocation> <ProtectYourPC>1</ProtectYourPC> <SkipMachineOOBE>true</SkipMachineOOBE> <SkipUserOOBE>true</SkipUserOOBE> </OOBE> <RegisteredOrganization>Organization</RegisteredOrganization> <RegisteredOwner>Owner</RegisteredOwner> <DisableAutoDaylightTimeSet>false</DisableAutoDaylightTimeSet> <TimeZone>Eastern Standard Time</TimeZone> <UserAccounts> <AdministratorPassword> <Value>MyPassword</Value> 3 <PlainText>true</PlainText> </AdministratorPassword> </UserAccounts> </component> </settings> </unattend>- 1

- Spécifiez le site

ComputerName, qui doit respecter la spécification des noms de Kubernetes. Ces spécifications s'appliquent également à la personnalisation du système d'exploitation invité effectuée sur le modèle résultant lors de la création de nouvelles VM. - 2

- Désactiver la connexion automatique pour éviter le problème de sécurité lié au fait de laisser un terminal ouvert avec des privilèges d'administrateur au démarrage. Il s'agit de la valeur par défaut, qui ne doit pas être modifiée.

- 3

- Remplacez l'espace réservé

MyPasswordpar le mot de passe du compte administrateur. Cela permet d'éviter que le compte Administrateur intégré ait un mot de passe vide par défaut. Suivez les meilleures pratiques de Microsoft pour choisir un mot de passe.

Une fois l'outil Sysprep terminé, la VM Windows s'éteint. Vous ne devez plus utiliser ou mettre sous tension cette VM.

- Convertir la VM Windows en modèle dans vCenter.

5.3.2.1.1. Ressources supplémentaires

5.3.2.2. Activation de la communication avec le serveur API interne pour le WMCO sur vSphere

Le Windows Machine Config Operator (WMCO) télécharge les fichiers de configuration Ignition à partir du point de terminaison du serveur API interne. Vous devez activer la communication avec le serveur API interne pour que votre machine virtuelle Windows (VM) puisse télécharger les fichiers de configuration Ignition et que le kubelet sur la VM configurée puisse uniquement communiquer avec le serveur API interne.

Conditions préalables

- Vous avez installé un cluster sur vSphere.

Procédure

-

Ajoutez une nouvelle entrée DNS pour

api-int.<cluster_name>.<base_domain>qui pointe vers l'URL du serveur API externeapi.<cluster_name>.<base_domain>. Il peut s'agir d'un CNAME ou d'un enregistrement A supplémentaire.

Le point de terminaison API externe a déjà été créé dans le cadre de l'installation initiale du cluster sur vSphere.

5.3.3. Exemple de YAML pour un objet Windows MachineSet sur vSphere

Cet exemple YAML définit un objet Windows MachineSet fonctionnant sur VMware vSphere sur lequel le Windows Machine Config Operator (WMCO) peut réagir.

apiVersion: machine.openshift.io/v1beta1

kind: MachineSet

metadata:

labels:

machine.openshift.io/cluster-api-cluster: <infrastructure_id> 1

name: <windows_machine_set_name> 2

namespace: openshift-machine-api

spec:

replicas: 1

selector:

matchLabels:

machine.openshift.io/cluster-api-cluster: <infrastructure_id> 3

machine.openshift.io/cluster-api-machineset: <windows_machine_set_name> 4

template:

metadata:

labels:

machine.openshift.io/cluster-api-cluster: <infrastructure_id> 5

machine.openshift.io/cluster-api-machine-role: worker

machine.openshift.io/cluster-api-machine-type: worker

machine.openshift.io/cluster-api-machineset: <windows_machine_set_name> 6

machine.openshift.io/os-id: Windows 7

spec:

metadata:

labels:

node-role.kubernetes.io/worker: "" 8

providerSpec:

value:

apiVersion: vsphereprovider.openshift.io/v1beta1

credentialsSecret:

name: vsphere-cloud-credentials

diskGiB: 128 9

kind: VSphereMachineProviderSpec

memoryMiB: 16384

network:

devices:

- networkName: "<vm_network_name>" 10

numCPUs: 4

numCoresPerSocket: 1

snapshot: ""

template: <windows_vm_template_name> 11

userDataSecret:

name: windows-user-data 12

workspace:

datacenter: <vcenter_datacenter_name> 13

datastore: <vcenter_datastore_name> 14

folder: <vcenter_vm_folder_path> 15

resourcePool: <vsphere_resource_pool> 16

server: <vcenter_server_ip> 17- 1 3 5

- Spécifiez l'ID de l'infrastructure qui est basé sur l'ID du cluster que vous avez défini lorsque vous avez approvisionné le cluster. Vous pouvez obtenir l'ID d'infrastructure en exécutant la commande suivante :

$ oc get -o jsonpath='{.status.infrastructureName}{"\n"}' infrastructure cluster - 2 4 6

- Spécifiez le nom de l'ensemble de machines de calcul Windows. Le nom de l'ensemble de machines de calcul ne peut pas comporter plus de 9 caractères, en raison de la manière dont les noms de machines sont générés dans vSphere.

- 7

- Configurez l'ensemble de machines de calcul comme une machine Windows.

- 8

- Configurez le nœud Windows en tant que machine de calcul.

- 9

- Spécifiez la taille du disque de machine virtuelle vSphere (VMDK).Note

Ce paramètre ne définit pas la taille de la partition Windows. Vous pouvez redimensionner la partition Windows en utilisant le fichier

unattend.xmlou en créant l'image dorée de la machine virtuelle (VM) vSphere Windows avec la taille de disque requise. - 10

- Spécifiez le réseau VM vSphere sur lequel déployer l'ensemble de machines de calcul. Ce réseau VM doit se trouver là où d'autres machines de calcul Linux résident dans le cluster.

- 11

- Indiquez le chemin complet du modèle de VM Windows vSphere à utiliser, par exemple

golden-images/windows-server-template. Le nom doit être unique.ImportantN'indiquez pas le modèle original de la VM. Le modèle de VM doit rester désactivé et doit être cloné pour les nouvelles machines Windows. Le démarrage du modèle de VM configure le modèle de VM en tant que VM sur la plateforme, ce qui l'empêche d'être utilisé comme modèle auquel les ensembles de machines de calcul peuvent appliquer des configurations.

- 12

- Le site

windows-user-dataest créé par le WMCO lors de la configuration de la première machine Windows. Par la suite, le sitewindows-user-dataest disponible pour tous les ensembles de machines de calcul suivants. - 13

- Spécifiez le centre de données vCenter sur lequel déployer l'ensemble de machines de calcul.

- 14

- Spécifiez le Datastore vCenter sur lequel déployer l'ensemble de machines de calcul.

- 15

- Indiquez le chemin d'accès au dossier vSphere VM dans vCenter, par exemple

/dc1/vm/user-inst-5ddjd. - 16

- Facultatif : Spécifiez le pool de ressources vSphere pour vos machines virtuelles Windows.

- 17

- Spécifiez l'IP du serveur vCenter ou le nom de domaine complet.

5.3.4. Création d'un ensemble de machines de calcul

En plus des ensembles de machines de calcul créés par le programme d'installation, vous pouvez créer vos propres ensembles pour gérer dynamiquement les ressources de calcul des machines pour les charges de travail spécifiques de votre choix.

Conditions préalables

- Déployer un cluster OpenShift Container Platform.

-

Installez le CLI OpenShift (

oc). -

Connectez-vous à

ocen tant qu'utilisateur disposant de l'autorisationcluster-admin.

Procédure

Créez un nouveau fichier YAML contenant l'échantillon de ressources personnalisées (CR) de l'ensemble de machines de calcul et nommé

<file_name>.yaml.Veillez à définir les valeurs des paramètres

<clusterID>et<role>.Facultatif : si vous n'êtes pas sûr de la valeur à définir pour un champ spécifique, vous pouvez vérifier un ensemble de machines de calcul existant dans votre cluster.

Pour répertorier les ensembles de machines de calcul de votre cluster, exécutez la commande suivante :

$ oc get machinesets -n openshift-machine-api

Exemple de sortie

NAME DESIRED CURRENT READY AVAILABLE AGE agl030519-vplxk-worker-us-east-1a 1 1 1 1 55m agl030519-vplxk-worker-us-east-1b 1 1 1 1 55m agl030519-vplxk-worker-us-east-1c 1 1 1 1 55m agl030519-vplxk-worker-us-east-1d 0 0 55m agl030519-vplxk-worker-us-east-1e 0 0 55m agl030519-vplxk-worker-us-east-1f 0 0 55m

Pour afficher les valeurs d'une ressource personnalisée (CR) d'un ensemble de machines de calcul spécifique, exécutez la commande suivante :

$ oc get machineset <machineset_name> \ -n openshift-machine-api -o yaml

Exemple de sortie

apiVersion: machine.openshift.io/v1beta1 kind: MachineSet metadata: labels: machine.openshift.io/cluster-api-cluster: <infrastructure_id> 1 name: <infrastructure_id>-<role> 2 namespace: openshift-machine-api spec: replicas: 1 selector: matchLabels: machine.openshift.io/cluster-api-cluster: <infrastructure_id> machine.openshift.io/cluster-api-machineset: <infrastructure_id>-<role> template: metadata: labels: machine.openshift.io/cluster-api-cluster: <infrastructure_id> machine.openshift.io/cluster-api-machine-role: <role> machine.openshift.io/cluster-api-machine-type: <role> machine.openshift.io/cluster-api-machineset: <infrastructure_id>-<role> spec: providerSpec: 3 ...- 1

- L'ID de l'infrastructure du cluster.

- 2

- Une étiquette de nœud par défaut.Note

Pour les clusters disposant d'une infrastructure fournie par l'utilisateur, un ensemble de machines de calcul ne peut créer que des machines de type

workeretinfra. - 3

- Les valeurs de la section

<providerSpec>du CR de l'ensemble de machines de calcul sont spécifiques à la plate-forme. Pour plus d'informations sur les paramètres<providerSpec>dans le CR, consultez l'exemple de configuration du CR de l'ensemble de machines de calcul pour votre fournisseur.

Créez un CR

MachineSeten exécutant la commande suivante :oc create -f <nom_du_fichier>.yaml

Vérification

Affichez la liste des ensembles de machines de calcul en exécutant la commande suivante :

$ oc get machineset -n openshift-machine-api

Exemple de sortie