Stockage

Configurer et gérer le stockage dans OpenShift Container Platform

Résumé

Chapitre 1. Aperçu du stockage sur OpenShift Container Platform

OpenShift Container Platform prend en charge plusieurs types de stockage, à la fois pour les fournisseurs sur site et dans le nuage. Vous pouvez gérer le stockage des conteneurs pour les données persistantes et non persistantes dans un cluster OpenShift Container Platform.

1.1. Glossaire des termes courants pour le stockage sur OpenShift Container Platform

Ce glossaire définit les termes communs utilisés dans le contenu du stockage.

- Modes d'accès

Les modes d'accès aux volumes décrivent les capacités des volumes. Vous pouvez utiliser les modes d'accès pour faire correspondre la réclamation de volume persistant (PVC) et le volume persistant (PV). Voici des exemples de modes d'accès :

- ReadWriteOnce (RWO)

- ReadOnlyMany (ROX)

- ReadWriteMany (RWX)

- ReadWriteOncePod (RWOP) (lecture-écriture-unique)

- Cendres

- Le service de stockage de blocs pour Red Hat OpenStack Platform (RHOSP) qui gère l'administration, la sécurité et la planification de tous les volumes.

- Carte de configuration

-

Une carte de configuration permet d'injecter des données de configuration dans les pods. Vous pouvez référencer les données stockées dans une carte de configuration dans un volume de type

ConfigMap. Les applications fonctionnant dans un pod peuvent utiliser ces données. - Interface de stockage de conteneurs (CSI)

- Une spécification d'API pour la gestion du stockage des conteneurs à travers différents systèmes d'orchestration de conteneurs (CO).

- Provisionnement dynamique

- Le cadre vous permet de créer des volumes de stockage à la demande, ce qui évite aux administrateurs de clusters de devoir préprovisionner le stockage persistant.

- Stockage éphémère

- Les pods et les conteneurs peuvent avoir besoin d'un stockage local temporaire ou transitoire pour leur fonctionnement. La durée de vie de ce stockage éphémère ne dépasse pas la durée de vie du pod individuel, et ce stockage éphémère ne peut pas être partagé entre les pods.

- Canal à fibres

- Technologie de réseau utilisée pour transférer des données entre les centres de données, les serveurs informatiques, les commutateurs et le stockage.

- FlexVolume

- FlexVolume est une interface de plugin hors arborescence qui utilise un modèle basé sur l'exécution pour s'interfacer avec les pilotes de stockage. Vous devez installer les binaires du pilote FlexVolume dans un chemin d'accès prédéfini au plugin de volume sur chaque nœud et, dans certains cas, sur les nœuds du plan de contrôle.

- fsGroup

- Le paramètre fsGroup définit l'identifiant du groupe de systèmes de fichiers d'un pod.

- iSCSI

- Internet Small Computer Systems Interface (iSCSI) est une norme de réseau de stockage basée sur le protocole Internet qui permet de relier des installations de stockage de données. Un volume iSCSI permet de monter un volume iSCSI (SCSI over IP) existant dans votre Pod.

- chemin d'accès

- Un volume hostPath dans un cluster OpenShift Container Platform monte un fichier ou un répertoire du système de fichiers du nœud hôte dans votre pod.

- Clé KMS

- Le service de gestion des clés (KMS) vous aide à atteindre le niveau de cryptage requis pour vos données dans différents services. Vous pouvez utiliser la clé KMS pour crypter, décrypter et recrypter les données.

- Volumes locaux

- Un volume local représente un périphérique de stockage local monté, tel qu'un disque, une partition ou un répertoire.

- NFS

- Un système de fichiers réseau (NFS) qui permet aux hôtes distants de monter des systèmes de fichiers sur un réseau et d'interagir avec ces systèmes de fichiers comme s'ils étaient montés localement. Cela permet aux administrateurs système de consolider les ressources sur des serveurs centralisés sur le réseau.

- OpenShift Data Foundation

- Un fournisseur de stockage persistant agnostique pour OpenShift Container Platform prenant en charge le stockage de fichiers, de blocs et d'objets, que ce soit en interne ou dans des clouds hybrides

- Stockage permanent

- Les pods et les conteneurs peuvent nécessiter un stockage permanent pour leur fonctionnement. OpenShift Container Platform utilise le cadre de volume persistant (PV) de Kubernetes pour permettre aux administrateurs de cluster de provisionner le stockage persistant pour un cluster. Les développeurs peuvent utiliser le PVC pour demander des ressources PV sans avoir de connaissances spécifiques sur l'infrastructure de stockage sous-jacente.

- Volumes persistants (PV)

- OpenShift Container Platform utilise le cadre de volume persistant (PV) de Kubernetes pour permettre aux administrateurs de cluster de provisionner le stockage persistant pour un cluster. Les développeurs peuvent utiliser le PVC pour demander des ressources PV sans avoir de connaissances spécifiques sur l'infrastructure de stockage sous-jacente.

- Revendications de volumes persistants (PVC)

- Vous pouvez utiliser un PVC pour monter un PersistentVolume dans un Pod. Vous pouvez accéder au stockage sans connaître les détails de l'environnement en nuage.

- Cosse

- Un ou plusieurs conteneurs avec des ressources partagées, telles que le volume et les adresses IP, fonctionnant dans votre cluster OpenShift Container Platform. Un pod est la plus petite unité de calcul définie, déployée et gérée.

- Politique de récupération

-

Une politique qui indique au cluster ce qu'il doit faire du volume après qu'il a été libéré. La politique de récupération d'un volume peut être

Retain,Recycle, ouDelete. - Contrôle d'accès basé sur les rôles (RBAC)

- Le contrôle d'accès basé sur les rôles (RBAC) est une méthode de régulation de l'accès aux ressources informatiques ou réseau basée sur les rôles des utilisateurs individuels au sein de votre organisation.

- Applications sans état

- Une application sans état est un programme d'application qui n'enregistre pas les données du client générées au cours d'une session pour les utiliser lors de la session suivante avec ce client.

- Applications avec état

-

Une application avec état est un programme d'application qui enregistre des données sur un disque de stockage persistant. Un serveur, un client et des applications peuvent utiliser un stockage sur disque persistant. Vous pouvez utiliser l'objet

Statefulsetdans OpenShift Container Platform pour gérer le déploiement et la mise à l'échelle d'un ensemble de Pods, et fournir des garanties sur l'ordre et l'unicité de ces Pods. - Provisionnement statique

- Un administrateur de cluster crée un certain nombre de PV. Les PV contiennent les détails du stockage. Les PV existent dans l'API Kubernetes et sont disponibles à la consommation.

- Stockage

- OpenShift Container Platform prend en charge de nombreux types de stockage, à la fois pour les fournisseurs sur site et dans le nuage. Vous pouvez gérer le stockage des conteneurs pour les données persistantes et non persistantes dans un cluster OpenShift Container Platform.

- Classe de stockage

- Une classe de stockage permet aux administrateurs de décrire les classes de stockage qu'ils proposent. Les différentes classes peuvent correspondre à des niveaux de qualité de service, à des politiques de sauvegarde ou à des politiques arbitraires déterminées par les administrateurs du cluster.

- Volumes de disques de machines virtuelles (VMDK) de VMware vSphere

- Virtual Machine Disk (VMDK) est un format de fichier qui décrit des conteneurs pour les disques durs virtuels utilisés dans les machines virtuelles.

1.2. Types de stockage

Le stockage sur OpenShift Container Platform se divise en deux catégories, à savoir le stockage éphémère et le stockage persistant.

1.2.1. Stockage éphémère

Les pods et les conteneurs sont de nature éphémère ou transitoire et sont conçus pour des applications sans état. Le stockage éphémère permet aux administrateurs et aux développeurs de mieux gérer le stockage local pour certaines de leurs opérations. Pour plus d'informations sur la présentation, les types et la gestion du stockage éphémère, voir Comprendre le stockage éphémère.

1.2.2. Stockage permanent

Les applications avec état déployées dans des conteneurs nécessitent un stockage persistant. OpenShift Container Platform utilise un cadre de stockage pré-provisionné appelé volumes persistants (PV) pour permettre aux administrateurs de cluster de provisionner le stockage persistant. Les données contenues dans ces volumes peuvent exister au-delà du cycle de vie d'un pod individuel. Les développeurs peuvent utiliser des réclamations de volumes persistants (PVC) pour demander des exigences de stockage. Pour plus d'informations sur la présentation, la configuration et le cycle de vie du stockage persistant, voir Comprendre le stockage persistant.

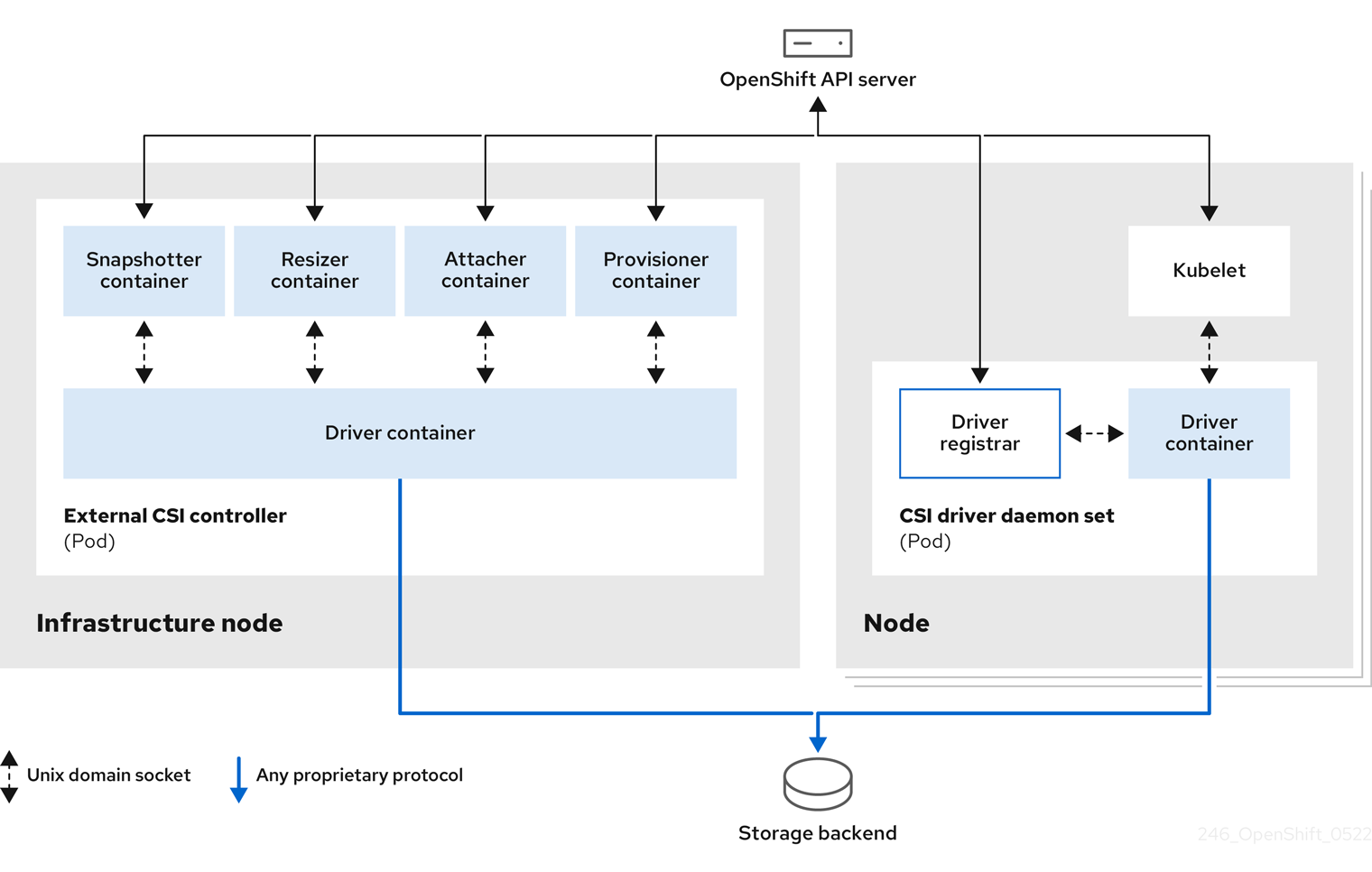

1.3. Interface de stockage de conteneurs (CSI)

CSI est une spécification d'API pour la gestion du stockage des conteneurs dans différents systèmes d'orchestration de conteneurs (CO). Vous pouvez gérer les volumes de stockage dans les environnements natifs de conteneurs, sans avoir de connaissances spécifiques sur l'infrastructure de stockage sous-jacente. Grâce à l'ICS, le stockage fonctionne uniformément dans les différents systèmes d'orchestration de conteneurs, quels que soient les fournisseurs de stockage que vous utilisez. Pour plus d'informations sur l'interface CSI, voir Utilisation de l'interface de stockage de conteneurs (CSI).

1.4. Provisionnement dynamique

Le provisionnement dynamique vous permet de créer des volumes de stockage à la demande, ce qui évite aux administrateurs de cluster de devoir préprovisionner le stockage. Pour plus d'informations sur le provisionnement dynamique, voir Provisionnement dynamique.

Chapitre 2. Comprendre le stockage éphémère

2.1. Vue d'ensemble

En plus du stockage persistant, les pods et les conteneurs peuvent avoir besoin d'un stockage local éphémère ou transitoire pour leur fonctionnement. La durée de vie de ce stockage éphémère ne dépasse pas la durée de vie du pod individuel, et ce stockage éphémère ne peut pas être partagé entre les pods.

Les pods utilisent un stockage local éphémère pour l'espace d'effacement, la mise en cache et les journaux. Les problèmes liés à l'absence de comptabilisation et d'isolation du stockage local sont notamment les suivants :

- Les pods ne peuvent pas détecter la quantité de stockage local dont ils disposent.

- Les pods ne peuvent pas demander de stockage local garanti.

- Le stockage local est une ressource qui fonctionne au mieux.

- Les pods peuvent être expulsés parce que d'autres pods remplissent le stockage local, après quoi les nouveaux pods ne sont pas admis jusqu'à ce qu'une quantité suffisante de stockage soit récupérée.

Contrairement aux volumes persistants, le stockage éphémère n'est pas structuré et l'espace est partagé entre tous les pods fonctionnant sur un nœud, en plus d'autres utilisations par le système, le runtime de conteneur et OpenShift Container Platform. Le cadre de stockage éphémère permet aux pods de spécifier leurs besoins de stockage locaux transitoires. Il permet également à OpenShift Container Platform de planifier les pods le cas échéant et de protéger le nœud contre une utilisation excessive du stockage local.

Si le cadre de stockage éphémère permet aux administrateurs et aux développeurs de mieux gérer le stockage local, le débit d'E/S et la latence ne sont pas directement affectés.

2.2. Types de stockage éphémère

Le stockage local éphémère est toujours disponible dans la partition primaire. Il existe deux manières de créer la partition primaire : la partition racine et la partition d'exécution.

Racine

Cette partition contient le répertoire racine des kubelets, /var/lib/kubelet/ par défaut, et le répertoire /var/log/. Cette partition peut être partagée entre les pods utilisateurs, le système d'exploitation et les démons du système Kubernetes. Cette partition peut être consommée par les pods via les volumes EmptyDir, les journaux de conteneurs, les couches d'images et les couches inscriptibles dans les conteneurs. Kubelet gère l'accès partagé et l'isolation de cette partition. Cette partition est éphémère et les applications ne peuvent pas s'attendre à des accords de niveau de service (SLA) en matière de performances, tels que l'IOPS du disque, à partir de cette partition.

Temps d'exécution

Il s'agit d'une partition optionnelle que les runtimes peuvent utiliser pour les systèmes de fichiers superposés. OpenShift Container Platform tente d'identifier et de fournir un accès partagé ainsi qu'une isolation à cette partition. Les couches d'images de conteneurs et les couches inscriptibles sont stockées ici. Si la partition d'exécution existe, la partition root ne contient aucune couche d'image ni aucun autre stockage accessible en écriture.

2.3. Gestion du stockage éphémère

Les administrateurs de cluster peuvent gérer le stockage éphémère au sein d'un projet en fixant des quotas qui définissent les plages limites et le nombre de demandes de stockage éphémère pour tous les pods dans un état non terminal. Les développeurs peuvent également définir des demandes et des limites sur cette ressource de calcul au niveau du pod et du conteneur.

Vous pouvez gérer le stockage éphémère local en spécifiant des demandes et des limites. Chaque conteneur d'un module peut spécifier les éléments suivants :

-

spec.containers[].resources.limits.ephemeral-storage -

spec.containers[].resources.requests.ephemeral-storage

Les limites et les demandes de stockage éphémère sont mesurées en nombre d'octets. Vous pouvez exprimer le stockage sous la forme d'un nombre entier simple ou d'un nombre à virgule fixe en utilisant l'un de ces suffixes : E, P, T, G, M, k. Vous pouvez également utiliser les équivalents en puissance de deux : Ei, Pi, Ti, Gi, Mi, Ki. Par exemple, les quantités suivantes représentent toutes approximativement la même valeur : 128974848, 129e6, 129M, et 123Mi. Le cas des suffixes est significatif. Si vous spécifiez 400 m de stockage éphémère, cela demande 0,4 octet, plutôt que 400 mégaoctets (400Mi) ou 400 mégaoctets (400M), ce qui était probablement l'intention.

L'exemple suivant montre un pod avec deux conteneurs. Chaque conteneur demande 2 Go de stockage éphémère local. Chaque conteneur a une limite de 4 Go de stockage éphémère local. Par conséquent, le module a une demande de 4 Go de stockage éphémère local et une limite de 8 Go de stockage éphémère local.

apiVersion: v1

kind: Pod

metadata:

name: frontend

spec:

containers:

- name: app

image: images.my-company.example/app:v4

resources:

requests:

ephemeral-storage: "2Gi" 1

limits:

ephemeral-storage: "4Gi" 2

volumeMounts:

- name: ephemeral

mountPath: "/tmp"

- name: log-aggregator

image: images.my-company.example/log-aggregator:v6

resources:

requests:

ephemeral-storage: "2Gi" 3

volumeMounts:

- name: ephemeral

mountPath: "/tmp"

volumes:

- name: ephemeral

emptyDir: {}Ce paramètre de la spécification des pods affecte la façon dont l'ordonnanceur prend une décision sur la programmation des pods, ainsi que la façon dont kubelet évince les pods. Tout d'abord, l'ordonnanceur s'assure que la somme des demandes de ressources des conteneurs programmés est inférieure à la capacité du nœud. Dans ce cas, le pod ne peut être assigné à un nœud que si son stockage éphémère disponible (ressource allouable) est supérieur à 4 Go.

Deuxièmement, au niveau du conteneur, puisque le premier conteneur fixe une limite de ressources, le gestionnaire d'expulsion kubelet mesure l'utilisation du disque de ce conteneur et expulse le pod si l'utilisation du stockage de ce conteneur dépasse sa limite (4GiB). Au niveau du pod, kubelet calcule une limite de stockage globale pour le pod en additionnant les limites de tous les conteneurs de ce pod. Dans ce cas, l'utilisation totale du stockage au niveau du pod est la somme de l'utilisation du disque de tous les conteneurs plus les volumes emptyDir du pod. Si cette utilisation totale dépasse la limite de stockage globale du pod (4 Go), le kubelet marque également le pod pour éviction.

Pour plus d'informations sur la définition des quotas pour les projets, voir Paramétrage des quotas par projet.

2.4. Surveillance du stockage éphémère

Vous pouvez utiliser /bin/df comme outil pour surveiller l'utilisation du stockage éphémère sur le volume où se trouvent les données des conteneurs éphémères, c'est-à-dire /var/lib/kubelet et /var/lib/containers. L'espace disponible pour /var/lib/kubelet est affiché lorsque vous utilisez la commande df si /var/lib/containers est placé sur un disque séparé par l'administrateur du cluster.

Pour afficher les valeurs lisibles par l'homme de l'espace utilisé et de l'espace disponible dans /var/lib, entrez la commande suivante :

$ df -h /var/lib

La sortie montre l'utilisation du stockage éphémère dans /var/lib:

Exemple de sortie

Filesystem Size Used Avail Use% Mounted on /dev/sda1 69G 32G 34G 49% /

Chapitre 3. Comprendre le stockage persistant

3.1. Vue d'ensemble du stockage persistant

La gestion du stockage est un problème distinct de la gestion des ressources informatiques. OpenShift Container Platform utilise le cadre de volume persistant (PV) de Kubernetes pour permettre aux administrateurs de cluster de provisionner le stockage persistant pour un cluster. Les développeurs peuvent utiliser des réclamations de volume persistant (PVC) pour demander des ressources PV sans avoir de connaissances spécifiques sur l'infrastructure de stockage sous-jacente.

Les PVC sont spécifiques à un projet et sont créés et utilisés par les développeurs comme moyen d'utiliser un PV. Les ressources PV en elles-mêmes ne sont pas limitées à un seul projet ; elles peuvent être partagées sur l'ensemble du cluster OpenShift Container Platform et réclamées à partir de n'importe quel projet. Une fois qu'un PV est lié à un PVC, il ne peut plus être lié à d'autres PVC. Cela a pour effet de limiter un PV lié à un seul espace de noms, celui du projet de liaison.

Les PV sont définis par un objet API PersistentVolume, qui représente un élément de stockage existant dans la grappe, provisionné de manière statique par l'administrateur de la grappe ou de manière dynamique à l'aide d'un objet StorageClass. Il s'agit d'une ressource de la grappe tout comme un nœud est une ressource de la grappe.

Les PV sont des plugins de volume comme Volumes, mais leur cycle de vie est indépendant de tout pod individuel qui utilise le PV. Les objets PV capturent les détails de la mise en œuvre du stockage, qu'il s'agisse de NFS, d'iSCSI ou d'un système de stockage spécifique au fournisseur de cloud.

La haute disponibilité du stockage dans l'infrastructure est laissée au fournisseur de stockage sous-jacent.

Les PVC sont définis par un objet API PersistentVolumeClaim, qui représente une demande de stockage de la part d'un développeur. Il est similaire à un pod dans la mesure où les pods consomment des ressources de nœuds et les PVC des ressources de PV. Par exemple, les pods peuvent demander des niveaux de ressources spécifiques, tels que le CPU et la mémoire, tandis que les PVC peuvent demander une capacité de stockage et des modes d'accès spécifiques. Par exemple, ils peuvent être montés une fois en lecture-écriture ou plusieurs fois en lecture seule.

3.2. Cycle de vie d'un volume et d'une revendication

Les PV sont des ressources dans le cluster. Les PVC sont des demandes pour ces ressources et agissent également comme des contrôles de réclamation pour la ressource. L'interaction entre les PV et les PVC a le cycle de vie suivant.

3.2.1. Mise à disposition d'un espace de stockage

En réponse aux demandes d'un développeur défini dans un PVC, un administrateur de cluster configure un ou plusieurs provisionneurs dynamiques qui fournissent du stockage et un PV correspondant.

Un administrateur de cluster peut également créer à l'avance un certain nombre de PV qui contiennent les détails du stockage réel disponible pour l'utilisation. Les PV existent dans l'API et peuvent être utilisés.

3.2.2. Lier les créances

Lorsque vous créez un PVC, vous demandez une quantité spécifique de stockage, vous spécifiez le mode d'accès requis et vous créez une classe de stockage pour décrire et classer le stockage. La boucle de contrôle du maître surveille les nouveaux PVC et lie le nouveau PVC à un PV approprié. S'il n'existe pas de PV approprié, un provisionneur de la classe de stockage en crée un.

La taille de tous les PV peut dépasser la taille de votre PVC. Cela est particulièrement vrai pour les PV provisionnés manuellement. Pour minimiser l'excès, OpenShift Container Platform se lie au plus petit PV qui correspond à tous les autres critères.

Les demandes restent indéfiniment non liées si un volume correspondant n'existe pas ou ne peut pas être créé avec un provisionneur disponible desservant une classe de stockage. Les demandes sont liées au fur et à mesure que des volumes correspondants sont disponibles. Par exemple, un cluster avec de nombreux volumes de 50Gi provisionnés manuellement ne correspondrait pas à un PVC demandant 100Gi. Le PVC peut être lié lorsqu'un PV de 100Gi est ajouté au cluster.

3.2.3. Utiliser des cosses et des PV revendiquées

Les modules utilisent les revendications comme des volumes. Le cluster inspecte la revendication pour trouver le volume lié et monte ce volume pour un pod. Pour les volumes qui prennent en charge plusieurs modes d'accès, vous devez spécifier le mode qui s'applique lorsque vous utilisez la revendication comme volume dans un module.

Une fois que vous avez une revendication et que cette revendication est liée, le PV lié vous appartient aussi longtemps que vous en avez besoin. Vous pouvez planifier des pods et accéder aux PV revendiqués en incluant persistentVolumeClaim dans le bloc de volumes du pod.

Si vous attachez des volumes persistants qui ont un nombre élevé de fichiers à des pods, ces pods peuvent échouer ou prendre beaucoup de temps à démarrer. Pour plus d'informations, voir Lors de l'utilisation de volumes persistants avec un nombre élevé de fichiers dans OpenShift, pourquoi les pods ne démarrent-ils pas ou prennent-ils un temps excessif pour atteindre l'état "Ready" ?

3.2.4. Protection des objets de stockage en cours d'utilisation

La fonction de protection des objets de stockage en cours d'utilisation garantit que les PVC utilisés activement par un pod et les PV liés aux PVC ne sont pas supprimés du système, ce qui pourrait entraîner une perte de données.

La protection des objets de stockage en cours d'utilisation est activée par défaut.

Un PVC est utilisé activement par un pod lorsqu'il existe un objet Pod qui utilise le PVC.

Si un utilisateur supprime un PVC qui est utilisé activement par un pod, le PVC n'est pas supprimé immédiatement. La suppression du PVC est reportée jusqu'à ce que le PVC ne soit plus utilisé activement par aucun pod. De même, si un administrateur de cluster supprime un PV lié à un PVC, le PV n'est pas supprimé immédiatement. La suppression de la PV est reportée jusqu'à ce que la PV ne soit plus liée à un PVC.

3.2.5. Libération d'un volume persistant

Lorsque vous avez terminé avec un volume, vous pouvez supprimer l'objet PVC de l'API, ce qui permet la récupération de la ressource. Le volume est considéré comme libéré lorsque la demande est supprimée, mais il n'est pas encore disponible pour une autre demande. Les données du demandeur précédent restent sur le volume et doivent être traitées conformément à la politique.

3.2.6. Politique de récupération des volumes persistants

La politique de récupération d'un volume persistant indique au cluster ce qu'il doit faire du volume après sa libération. La politique de récupération d'un volume peut être Retain, Recycle, ou Delete.

-

Retainpermet la récupération manuelle de la ressource pour les plugins de volume qui la prennent en charge. -

Recyclerecycle le volume dans le pool de volumes persistants non liés une fois qu'il est libéré de sa réclamation.

La politique de récupération de Recycle est obsolète dans OpenShift Container Platform 4. Le provisionnement dynamique est recommandé pour une fonctionnalité équivalente et meilleure.

-

Deletereclaim policy supprime à la fois l'objetPersistentVolumed'OpenShift Container Platform et la ressource de stockage associée dans l'infrastructure externe, comme AWS EBS ou VMware vSphere.

Les volumes approvisionnés dynamiquement sont toujours supprimés.

3.2.7. Récupération manuelle d'un volume persistant

Lorsqu'une demande de volume persistant (PVC) est supprimée, le volume persistant (PV) existe toujours et est considéré comme "libéré". Cependant, le PV n'est pas encore disponible pour une autre demande, car les données du demandeur précédent restent sur le volume.

Procédure

Pour récupérer manuellement le PV en tant qu'administrateur de cluster :

Supprimer le PV.

oc delete pv <pv-name> $ oc delete pv <pv-name>

La ressource de stockage associée dans l'infrastructure externe, telle qu'un volume AWS EBS, GCE PD, Azure Disk ou Cinder, existe toujours après la suppression du PV.

- Nettoyer les données sur le support de stockage associé.

- Supprimer le bien de stockage associé. Pour réutiliser le même bien de stockage, il est possible de créer un nouveau PV avec la définition du bien de stockage.

Le PV récupéré est maintenant disponible pour être utilisé par un autre PVC.

3.2.8. Modification de la politique de récupération d'un volume persistant

Pour modifier la politique de récupération d'un volume persistant :

Dressez la liste des volumes persistants de votre cluster :

$ oc get pv

Exemple de sortie

NAME CAPACITY ACCESSMODES RECLAIMPOLICY STATUS CLAIM STORAGECLASS REASON AGE pvc-b6efd8da-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim1 manual 10s pvc-b95650f8-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim2 manual 6s pvc-bb3ca71d-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim3 manual 3s

Choisissez l'un de vos volumes persistants et modifiez sa politique de récupération :

$ oc patch pv <nom-de-votre-pv> -p '{"spec":{"persistentVolumeReclaimPolicy":\N-"Retain"}''Vérifiez que le volume persistant que vous avez choisi a la bonne politique :

$ oc get pv

Exemple de sortie

NAME CAPACITY ACCESSMODES RECLAIMPOLICY STATUS CLAIM STORAGECLASS REASON AGE pvc-b6efd8da-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim1 manual 10s pvc-b95650f8-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Delete Bound default/claim2 manual 6s pvc-bb3ca71d-b7b5-11e6-9d58-0ed433a7dd94 4Gi RWO Retain Bound default/claim3 manual 3s

Dans la sortie précédente, le volume lié à la revendication

default/claim3a maintenant une politique de récupérationRetain. Le volume ne sera pas automatiquement supprimé lorsqu'un utilisateur supprimera la revendicationdefault/claim3.

3.3. Volumes persistants

Chaque PV contient un spec et un status, qui sont les spécifications et l'état du volume, par exemple :

PersistentVolume exemple de définition d'objet

apiVersion: v1 kind: PersistentVolume metadata: name: pv0001 1 spec: capacity: storage: 5Gi 2 accessModes: - ReadWriteOnce 3 persistentVolumeReclaimPolicy: Retain 4 ... status: ...

3.3.1. Types de PV

OpenShift Container Platform prend en charge les plugins de volumes persistants suivants :

- Disque AliCloud

- AWS Elastic Block Store (EBS)

- AWS Elastic File Store (EFS)

- Disque Azure

- Fichier Azure

- Cendres

- Fibre Channel

- Disque persistant GCP

- Dépôt de fichiers GCP

- IBM VPC Block

- Chemin d'accès

- iSCSI

- Volume local

- NFS

- OpenStack Manille

- Red Hat OpenShift Data Foundation

- VMware vSphere

3.3.2. Capacité

En général, un volume persistant (PV) a une capacité de stockage spécifique. Celle-ci est définie à l'aide de l'attribut capacity du PV.

Actuellement, la capacité de stockage est la seule ressource qui peut être définie ou demandée. À l'avenir, les attributs pourront inclure l'IOPS, le débit, etc.

3.3.3. Modes d'accès

Un volume persistant peut être monté sur un hôte de n'importe quelle manière prise en charge par le fournisseur de ressources. Les fournisseurs ont des capacités différentes et les modes d'accès de chaque PV sont définis en fonction des modes spécifiques pris en charge par ce volume particulier. Par exemple, NFS peut prendre en charge plusieurs clients en lecture-écriture, mais un PV NFS spécifique peut être exporté sur le serveur en lecture seule. Chaque PV dispose de son propre ensemble de modes d'accès décrivant ses capacités spécifiques.

Les demandes sont associées à des volumes dont les modes d'accès sont similaires. Les deux seuls critères de correspondance sont les modes d'accès et la taille. Les modes d'accès d'une demande représentent une requête. Par conséquent, il se peut que l'on vous accorde plus, mais jamais moins. Par exemple, si une requête demande RWO, mais que le seul volume disponible est un PV NFS (RWO ROX RWX), la requête correspondra alors à NFS parce qu'il prend en charge RWO.

Les correspondances directes sont toujours tentées en premier. Les modes du volume doivent correspondre ou contenir plus de modes que ce que vous avez demandé. La taille doit être supérieure ou égale à celle attendue. Si deux types de volumes, tels que NFS et iSCSI, disposent du même ensemble de modes d'accès, l'un ou l'autre peut correspondre à une demande avec ces modes. Il n'y a pas d'ordre entre les types de volumes et il n'y a aucun moyen de choisir un type plutôt qu'un autre.

Tous les volumes présentant les mêmes modes sont regroupés, puis triés par taille, du plus petit au plus grand. Le relieur récupère le groupe dont les modes correspondent et itère sur chacun d'entre eux, par ordre de taille, jusqu'à ce qu'une taille corresponde.

Le tableau suivant énumère les modes d'accès :

Tableau 3.1. Modes d'accès

| Mode d'accès | Abréviation CLI | Description |

|---|---|---|

| ReadWriteOnce |

| Le volume peut être monté en lecture-écriture par un seul nœud. |

| ReadOnlyMany |

| Le volume peut être monté en lecture seule par de nombreux nœuds. |

| Lecture/écriture/nombre |

| Le volume peut être monté en lecture-écriture par de nombreux nœuds. |

Les modes d'accès aux volumes sont des descripteurs des capacités des volumes. Il ne s'agit pas de contraintes imposées. Le fournisseur de stockage est responsable des erreurs d'exécution résultant d'une utilisation non valide de la ressource.

Par exemple, NFS propose le mode d'accès ReadWriteOnce. Vous devez marquer les revendications comme read-only si vous voulez utiliser la capacité ROX du volume. Les erreurs dans le fournisseur apparaissent au moment de l'exécution comme des erreurs de montage.

les volumes iSCSI et Fibre Channel ne disposent actuellement d'aucun mécanisme de clôture. Vous devez vous assurer que les volumes ne sont utilisés que par un seul nœud à la fois. Dans certaines situations, comme la vidange d'un nœud, les volumes peuvent être utilisés simultanément par deux nœuds. Avant de vider le nœud, assurez-vous d'abord que les pods qui utilisent ces volumes sont supprimés.

Tableau 3.2. Modes d'accès pris en charge pour les PV

| Plugin de volume | ReadWriteOnce [1] | ReadOnlyMany | Lecture/écriture/nombre |

|---|---|---|---|

| Disque AliCloud |

✅ |

- |

- |

| AWS EBS [2] |

✅ |

- |

- |

| AWS EFS |

✅ |

✅ |

✅ |

| Fichier Azure |

✅ |

✅ |

✅ |

| Disque Azure |

✅ |

- |

- |

| Cendres |

✅ |

- |

- |

| Fibre Channel |

✅ |

✅ |

- |

| Disque persistant GCP |

✅ |

- |

- |

| Dépôt de fichiers GCP |

✅ |

✅ |

✅ |

| Chemin d'accès |

✅ |

- |

- |

| Disque IBM VPC |

✅ |

- |

- |

| iSCSI |

✅ |

✅ |

- |

| Volume local |

✅ |

- |

- |

| NFS |

✅ |

✅ |

✅ |

| OpenStack Manille |

- |

- |

✅ |

| Red Hat OpenShift Data Foundation |

✅ |

- |

✅ |

| VMware vSphere |

✅ |

- |

✅ [3] |

- Les volumes ReadWriteOnce (RWO) ne peuvent pas être montés sur plusieurs nœuds. Si un nœud tombe en panne, le système n'autorise pas le montage du volume RWO attaché sur un nouveau nœud, car il est déjà affecté au nœud en panne. Si vous obtenez un message d'erreur d'attachement multiple, forcez la suppression du pod sur un nœud arrêté ou en panne afin d'éviter toute perte de données dans les charges de travail critiques, par exemple lorsque des volumes dynamiques persistants sont attachés.

- Utilisez une stratégie de déploiement par recréation pour les pods qui dépendent d'AWS EBS.

- Si l'environnement vSphere sous-jacent prend en charge le service de fichiers vSAN, l'opérateur vSphere Container Storage Interface (CSI) Driver Operator installé par OpenShift Container Platform prend en charge le provisionnement des volumes ReadWriteMany (RWX). Si le service de fichiers vSAN n'est pas configuré et que vous demandez RWX, le volume n'est pas créé et une erreur est consignée. Pour plus d'informations, voir "Using Container Storage Interface" → "VMware vSphere CSI Driver Operator".

3.3.4. Phase

Les volumes peuvent être trouvés dans l'une des phases suivantes :

Tableau 3.3. Phases du volume

| Phase | Description |

|---|---|

| Disponible | Une ressource libre qui n'est pas encore liée à une demande. |

| Liaison | Le volume est relié à une réclamation. |

| Libéré | La demande a été supprimée, mais la ressource n'a pas encore été récupérée par le cluster. |

| Échec | La récupération automatique du volume a échoué. |

Vous pouvez afficher le nom du PVC lié à la PV en exécutant la commande suivante

$ oc get pv <pv-claim>

3.3.4.1. Options de montage

Vous pouvez spécifier des options de montage lors du montage d'un PV en utilisant l'attribut mountOptions.

Par exemple :

Exemple d'options de montage

apiVersion: v1

kind: PersistentVolume

metadata:

name: pv0001

spec:

capacity:

storage: 1Gi

accessModes:

- ReadWriteOnce

mountOptions: 1

- nfsvers=4.1

nfs:

path: /tmp

server: 172.17.0.2

persistentVolumeReclaimPolicy: Retain

claimRef:

name: claim1

namespace: default

- 1

- Les options de montage spécifiées sont utilisées lors du montage du PV sur le disque.

Les types de PV suivants prennent en charge les options de montage :

- AWS Elastic Block Store (EBS)

- Disque Azure

- Fichier Azure

- Cendres

- Disque persistant de la CME

- iSCSI

- Volume local

- NFS

- Red Hat OpenShift Data Foundation (Ceph RBD uniquement)

- VMware vSphere

Les PV Fibre Channel et HostPath ne prennent pas en charge les options de montage.

Ressources supplémentaires

3.4. Demandes de volume persistantes

Chaque objet PersistentVolumeClaim contient un spec et un status, qui correspondent à la spécification et à l'état de la revendication de volume persistant (PVC), par exemple :

PersistentVolumeClaim exemple de définition d'objet

kind: PersistentVolumeClaim apiVersion: v1 metadata: name: myclaim 1 spec: accessModes: - ReadWriteOnce 2 resources: requests: storage: 8Gi 3 storageClassName: gold 4 status: ...

3.4.1. Classes de stockage

Les revendications peuvent éventuellement demander une classe de stockage spécifique en spécifiant le nom de la classe de stockage dans l'attribut storageClassName. Seuls les PV de la classe demandée, ceux qui ont le même storageClassName que le PVC, peuvent être liés au PVC. L'administrateur de cluster peut configurer des provisionneurs dynamiques pour desservir une ou plusieurs classes de stockage. L'administrateur de cluster peut créer un PV à la demande qui correspond aux spécifications du PVC.

L'opérateur de stockage en cluster peut installer une classe de stockage par défaut en fonction de la plate-forme utilisée. Cette classe de stockage est détenue et contrôlée par l'opérateur. Elle ne peut pas être supprimée ou modifiée au-delà de la définition des annotations et des étiquettes. Si vous souhaitez un comportement différent, vous devez définir une classe de stockage personnalisée.

L'administrateur du cluster peut également définir une classe de stockage par défaut pour tous les PVC. Lorsqu'une classe de stockage par défaut est configurée, le PVC doit demander explicitement des annotations StorageClass ou storageClassName définies sur "" pour être lié à un PV sans classe de stockage.

Si plusieurs classes de stockage sont marquées comme étant par défaut, un PVC ne peut être créé que si l'adresse storageClassName est explicitement spécifiée. Par conséquent, une seule classe de stockage doit être définie par défaut.

3.4.2. Modes d'accès

Les revendications utilisent les mêmes conventions que les volumes pour demander un stockage avec des modes d'accès spécifiques.

3.4.3. Ressources

Les demandes, telles que les pods, peuvent demander des quantités spécifiques d'une ressource. Dans ce cas, il s'agit d'une demande de stockage. Le même modèle de ressource s'applique aux volumes et aux demandes.

3.4.4. Réclamations en volume

Les pods accèdent au stockage en utilisant la revendication comme un volume. Les revendications doivent exister dans le même espace de noms que le module qui les utilise. Le cluster trouve la revendication dans l'espace de noms du module et l'utilise pour obtenir le site PersistentVolume qui soutient la revendication. Le volume est monté sur l'hôte et dans le module, par exemple :

Monter le volume sur l'hôte et dans le pod exemple

kind: Pod

apiVersion: v1

metadata:

name: mypod

spec:

containers:

- name: myfrontend

image: dockerfile/nginx

volumeMounts:

- mountPath: "/var/www/html" 1

name: mypd 2

volumes:

- name: mypd

persistentVolumeClaim:

claimName: myclaim 3

- 1

- Chemin d'accès pour monter le volume à l'intérieur du module.

- 2

- Nom du volume à monter. Ne montez pas sur la racine du conteneur,

/, ni sur un chemin identique sur l'hôte et le conteneur. Cela peut corrompre votre système hôte si le conteneur est suffisamment privilégié, comme l'hôte/dev/ptsfiles. Vous pouvez monter l'hôte en toute sécurité en utilisant/host. - 3

- Nom du PVC, qui existe dans le même espace de noms, à utiliser.

3.5. Prise en charge des volumes de blocs

OpenShift Container Platform peut provisionner statiquement des volumes de blocs bruts. Ces volumes n'ont pas de système de fichiers et peuvent offrir des avantages en termes de performances pour les applications qui écrivent directement sur le disque ou qui mettent en œuvre leur propre service de stockage.

Les volumes de blocs bruts sont provisionnés en spécifiant volumeMode: Block dans les spécifications PV et PVC.

Les pods utilisant des volumes de blocs bruts doivent être configurés pour autoriser les conteneurs privilégiés.

Le tableau suivant indique quels plugins de volume prennent en charge les volumes de blocs.

Tableau 3.4. Prise en charge des volumes de blocs

| Plugin de volume | Approvisionnement manuel | Approvisionnement dynamique | Entièrement pris en charge |

|---|---|---|---|

| Disque AliCloud | ✅ | ✅ | ✅ |

| AWS EBS | ✅ | ✅ | ✅ |

| AWS EFS | |||

| Disque Azure | ✅ | ✅ | ✅ |

| Fichier Azure | |||

| Cendres | ✅ | ✅ | ✅ |

| Fibre Channel | ✅ | ✅ | |

| PCG | ✅ | ✅ | ✅ |

| Chemin d'accès | |||

| Disque IBM VPC | ✅ | ✅ | ✅ |

| iSCSI | ✅ | ✅ | |

| Volume local | ✅ | ✅ | |

| NFS | |||

| Red Hat OpenShift Data Foundation | ✅ | ✅ | ✅ |

| VMware vSphere | ✅ | ✅ | ✅ |

L'utilisation de l'un des volumes de blocs qui peuvent être provisionnés manuellement, mais qui ne sont pas fournis comme étant entièrement pris en charge, est une fonctionnalité d'aperçu technologique uniquement. Les fonctionnalités de l'aperçu technologique ne sont pas prises en charge par les accords de niveau de service (SLA) de production de Red Hat et peuvent ne pas être complètes sur le plan fonctionnel. Red Hat ne recommande pas leur utilisation en production. Ces fonctionnalités offrent un accès anticipé aux fonctionnalités des produits à venir, ce qui permet aux clients de tester les fonctionnalités et de fournir un retour d'information pendant le processus de développement.

Pour plus d'informations sur la portée de l'assistance des fonctionnalités de l'aperçu technologique de Red Hat, voir Portée de l'assistance des fonctionnalités de l'aperçu technologique.

3.5.1. Exemples de volumes de blocs

Exemple de PV

apiVersion: v1

kind: PersistentVolume

metadata:

name: block-pv

spec:

capacity:

storage: 10Gi

accessModes:

- ReadWriteOnce

volumeMode: Block 1

persistentVolumeReclaimPolicy: Retain

fc:

targetWWNs: ["50060e801049cfd1"]

lun: 0

readOnly: false

- 1

volumeModedoit être fixé àBlockpour indiquer que ce PV est un volume de blocs bruts.

Exemple de PVC

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: block-pvc

spec:

accessModes:

- ReadWriteOnce

volumeMode: Block 1

resources:

requests:

storage: 10Gi

- 1

volumeModedoit être fixé àBlockpour indiquer qu'un PVC de bloc brut est demandé.

Pod exemple de spécification

apiVersion: v1

kind: Pod

metadata:

name: pod-with-block-volume

spec:

containers:

- name: fc-container

image: fedora:26

command: ["/bin/sh", "-c"]

args: [ "tail -f /dev/null" ]

volumeDevices: 1

- name: data

devicePath: /dev/xvda 2

volumes:

- name: data

persistentVolumeClaim:

claimName: block-pvc 3

- 1

volumeDevicesau lieu devolumeMounts, est utilisé pour les périphériques en bloc. Seules les sourcesPersistentVolumeClaimpeuvent être utilisées avec des volumes de blocs bruts.- 2

devicePathau lieu demountPath, représente le chemin vers le dispositif physique où le bloc brut est mappé dans le système.- 3

- La source du volume doit être de type

persistentVolumeClaimet doit correspondre au nom du PVC comme prévu.

Tableau 3.5. Valeurs acceptées pour volumeMode

| Valeur | Défaut |

|---|---|

| Système de fichiers | Oui |

| Bloc | Non |

Tableau 3.6. Scénarios de liaison pour les volumes de blocs

PV volumeMode | PVC volumeMode | Résultat de la liaison |

|---|---|---|

| Système de fichiers | Système de fichiers | Relier |

| Non spécifié | Non spécifié | Relier |

| Système de fichiers | Non spécifié | Relier |

| Non spécifié | Système de fichiers | Relier |

| Bloc | Bloc | Relier |

| Non spécifié | Bloc | Pas de lien |

| Bloc | Non spécifié | Pas de lien |

| Système de fichiers | Bloc | Pas de lien |

| Bloc | Système de fichiers | Pas de lien |

Les valeurs non spécifiées entraînent la valeur par défaut de Filesystem.

3.6. Utilisation de fsGroup pour réduire les délais d'attente des pods

Si un volume de stockage contient de nombreux fichiers (~1.000.000 ou plus), vous pouvez rencontrer des dépassements de temps de pod.

Cela peut se produire car, par défaut, OpenShift Container Platform modifie récursivement la propriété et les permissions pour le contenu de chaque volume afin qu'il corresponde à l'adresse fsGroup spécifiée dans l'adresse securityContext d'un pod lorsque ce volume est monté. Pour les gros volumes, la vérification et la modification de la propriété et des autorisations peuvent prendre du temps, ce qui ralentit le démarrage du pod. Vous pouvez utiliser le champ fsGroupChangePolicy à l'intérieur d'un securityContext pour contrôler la façon dont OpenShift Container Platform vérifie et gère la propriété et les permissions pour un volume.

fsGroupChangePolicy définit le comportement à adopter pour modifier la propriété et les autorisations du volume avant de l'exposer à l'intérieur d'un module. Ce champ ne s'applique qu'aux types de volumes qui prennent en charge la propriété et les autorisations contrôlées par fsGroup. Ce champ a deux valeurs possibles :

-

OnRootMismatch: Ne modifiez les autorisations et la propriété que si les autorisations et la propriété du répertoire racine ne correspondent pas aux autorisations prévues pour le volume. Cela peut permettre de raccourcir le temps nécessaire pour modifier la propriété et les autorisations d'un volume afin de réduire les délais d'attente des pods. -

Always: Toujours modifier l'autorisation et la propriété du volume lorsqu'un volume est monté.

fsGroupChangePolicy exemple

securityContext:

runAsUser: 1000

runAsGroup: 3000

fsGroup: 2000

fsGroupChangePolicy: "OnRootMismatch" 1

...

- 1

OnRootMismatchspécifie qu'il faut ignorer le changement récursif de permission, ce qui permet d'éviter les problèmes de dépassement de délai pour les pods.

Le champ fsGroupChangePolicy n'a aucun effet sur les types de volumes éphémères, tels que secret, configMap et emptydir.

Chapitre 4. Configuration du stockage persistant

4.1. Stockage persistant à l'aide d'AWS Elastic Block Store

OpenShift Container Platform prend en charge les volumes AWS Elastic Block Store (EBS). Vous pouvez approvisionner votre cluster OpenShift Container Platform avec un stockage persistant en utilisant Amazon EC2.

Le cadre de volume persistant Kubernetes permet aux administrateurs de provisionner un cluster avec un stockage persistant et donne aux utilisateurs un moyen de demander ces ressources sans avoir aucune connaissance de l'infrastructure sous-jacente. Vous pouvez provisionner dynamiquement des volumes AWS EBS. Les volumes persistants ne sont pas liés à un seul projet ou espace de noms ; ils peuvent être partagés à travers le cluster OpenShift Container Platform. Les demandes de volumes persistants sont spécifiques à un projet ou à un espace de noms et peuvent être demandées par les utilisateurs. Vous pouvez définir une clé KMS pour chiffrer les volumes persistants des conteneurs sur AWS.

OpenShift Container Platform utilise par défaut un plug-in in-tree, ou non-Container Storage Interface (CSI) pour provisionner le stockage AWS EBS. Dans les prochaines versions d'OpenShift Container Platform, les volumes provisionnés à l'aide des plug-ins in-tree existants sont prévus pour une migration vers leur pilote CSI équivalent.

La migration automatique de l'ICS doit être transparente. La migration ne modifie pas la façon dont vous utilisez tous les objets API existants, tels que les volumes persistants, les réclamations de volumes persistants et les classes de stockage. Pour plus d'informations sur la migration, voir Migration automatique CSI.

Après la migration complète, les plugins in-tree seront éventuellement supprimés dans les futures versions d'OpenShift Container Platform.

La haute disponibilité du stockage dans l'infrastructure est laissée au fournisseur de stockage sous-jacent.

Pour OpenShift Container Platform, la migration automatique d'AWS EBS in-tree vers le pilote Container Storage Interface (CSI) est disponible en tant que fonctionnalité d'aperçu technologique (TP). Lorsque la migration est activée, les volumes provisionnés à l'aide du pilote in-tree existant sont automatiquement migrés pour utiliser le pilote AWS EBS CSI. Pour plus d'informations, voir la fonctionnalité de migration automatique CSI.

4.1.1. Création de la classe de stockage EBS

Les classes de stockage sont utilisées pour différencier et délimiter les niveaux de stockage et les utilisations. En définissant une classe de stockage, les utilisateurs peuvent obtenir des volumes persistants provisionnés dynamiquement.

4.1.2. Création de la revendication de volume persistant

Conditions préalables

Le stockage doit exister dans l'infrastructure sous-jacente avant de pouvoir être monté en tant que volume dans OpenShift Container Platform.

Procédure

- Dans la console OpenShift Container Platform, cliquez sur Storage → Persistent Volume Claims.

- Dans l'aperçu des réclamations relatives aux volumes persistants, cliquez sur Create Persistent Volume Claim.

Définissez les options souhaitées sur la page qui s'affiche.

- Sélectionnez la classe de stockage précédemment créée dans le menu déroulant.

- Saisissez un nom unique pour la créance de stockage.

- Sélectionner le mode d'accès. Cette sélection détermine l'accès à la lecture et à l'écriture pour l'unité de stockage.

- Définir la taille de la demande de stockage.

- Cliquez sur Create pour créer la demande de volume persistant et générer un volume persistant.

4.1.3. Format du volume

Avant que OpenShift Container Platform ne monte le volume et ne le transmette à un conteneur, il vérifie que le volume contient un système de fichiers tel que spécifié par le paramètre fsType dans la définition du volume persistant. Si le périphérique n'est pas formaté avec le système de fichiers, toutes les données du périphérique sont effacées et le périphérique est automatiquement formaté avec le système de fichiers donné.

Cette vérification permet d'utiliser des volumes AWS non formatés en tant que volumes persistants, car OpenShift Container Platform les formate avant la première utilisation.

4.1.4. Nombre maximal de volumes EBS sur un nœud

Par défaut, OpenShift Container Platform prend en charge un maximum de 39 volumes EBS attachés à un nœud. Cette limite est cohérente avec les limites de volume AWS. La limite de volume dépend du type d'instance.

En tant qu'administrateur de cluster, vous devez utiliser soit des volumes in-tree, soit des volumes Container Storage Interface (CSI) et leurs classes de stockage respectives, mais jamais les deux types de volumes en même temps. Le nombre maximum de volumes EBS attachés est compté séparément pour les volumes in-tree et CSI, ce qui signifie que vous pouvez avoir jusqu'à 39 volumes EBS de chaque type.

Pour plus d'informations sur l'accès à des options de stockage supplémentaires, telles que les instantanés de volume, qui ne sont pas possibles avec les plug-ins de volume dans l'arborescence, voir AWS Elastic Block Store CSI Driver Operator.

4.1.5. Chiffrer les volumes persistants des conteneurs sur AWS avec une clé KMS

La définition d'une clé KMS pour chiffrer les volumes persistants des conteneurs sur AWS est utile lorsque vous disposez de directives explicites en matière de conformité et de sécurité lors du déploiement sur AWS.

Conditions préalables

- L'infrastructure sous-jacente doit contenir un espace de stockage.

- Vous devez créer une clé KMS client sur AWS.

Procédure

Créer une classe de stockage :

$ cat << EOF | oc create -f - apiVersion: storage.k8s.io/v1 kind: StorageClass metadata: name: <storage-class-name> 1 parameters: fsType: ext4 2 encrypted: "true" kmsKeyId: keyvalue 3 provisioner: ebs.csi.aws.com reclaimPolicy: Delete volumeBindingMode: WaitForFirstConsumer EOF

- 1

- Spécifie le nom de la classe de stockage.

- 2

- Système de fichiers créé sur des volumes provisionnés.

- 3

- Spécifie le nom complet de la ressource Amazon (ARN) de la clé à utiliser pour chiffrer le volume persistant du conteneur. Si vous ne fournissez pas de clé, mais que le champ

encryptedest défini surtrue, la clé KMS par défaut est utilisée. Voir Finding the key ID and key ARN on A WS dans la documentation AWS.

Créez une revendication de volume persistant (PVC) avec la classe de stockage spécifiant la clé KMS :

$ cat << EOF | oc create -f - apiVersion: v1 kind: PersistentVolumeClaim metadata: name: mypvc spec: accessModes: - ReadWriteOnce volumeMode: Filesystem storageClassName: <storage-class-name> resources: requests: storage: 1Gi EOFCréer des conteneurs de charge de travail pour utiliser le PVC :

$ cat << EOF | oc create -f - kind: Pod metadata: name: mypod spec: containers: - name: httpd image: quay.io/centos7/httpd-24-centos7 ports: - containerPort: 80 volumeMounts: - mountPath: /mnt/storage name: data volumes: - name: data persistentVolumeClaim: claimName: mypvc EOF

4.1.6. Ressources supplémentaires

- Voir AWS Elastic Block Store CSI Driver Operator pour plus d'informations sur l'accès à des options de stockage supplémentaires, telles que les instantanés de volume, qui ne sont pas possibles avec les plugins de volume dans l'arborescence.

4.2. Stockage persistant avec Azure

OpenShift Container Platform prend en charge les volumes de disques Microsoft Azure. Vous pouvez approvisionner votre cluster OpenShift Container Platform avec un stockage persistant en utilisant Azure. Une certaine familiarité avec Kubernetes et Azure est supposée. Le cadre de volume persistant de Kubernetes permet aux administrateurs de provisionner un cluster avec un stockage persistant et donne aux utilisateurs un moyen de demander ces ressources sans avoir aucune connaissance de l'infrastructure sous-jacente. Les volumes Azure Disk peuvent être approvisionnés de manière dynamique. Les volumes persistants ne sont pas liés à un seul projet ou à un seul espace de noms ; ils peuvent être partagés à travers le cluster OpenShift Container Platform. Les demandes de volumes persistants sont spécifiques à un projet ou à un espace de noms et peuvent être demandées par les utilisateurs.

OpenShift Container Platform utilise par défaut un plugin in-tree (non-CSI) pour provisionner le stockage Azure Disk.

Dans les prochaines versions d'OpenShift Container Platform, les volumes provisionnés à l'aide des plugins in-tree existants sont prévus pour une migration vers leur pilote CSI équivalent. La migration automatique CSI devrait être transparente. La migration ne modifie pas la façon dont vous utilisez tous les objets API existants, tels que les volumes persistants, les réclamations de volumes persistants et les classes de stockage. Pour plus d'informations sur la migration, voir Migration automatique CSI.

Après la migration complète, les plugins in-tree seront éventuellement supprimés dans les futures versions d'OpenShift Container Platform.

La haute disponibilité du stockage dans l'infrastructure est laissée au fournisseur de stockage sous-jacent.

Ressources supplémentaires

4.2.1. Création de la classe de stockage Azure

Les classes de stockage sont utilisées pour différencier et délimiter les niveaux de stockage et les utilisations. En définissant une classe de stockage, les utilisateurs peuvent obtenir des volumes persistants provisionnés dynamiquement.

Procédure

- Dans la console OpenShift Container Platform, cliquez sur Storage → Storage Classes.

- Dans l'aperçu de la classe de stockage, cliquez sur Create Storage Class.

Définissez les options souhaitées sur la page qui s'affiche.

- Entrez un nom pour référencer la classe de stockage.

- Saisissez une description facultative.

- Sélectionnez la politique de récupération.

Sélectionnez

kubernetes.io/azure-diskdans la liste déroulante.-

Saisissez le type de compte de stockage. Cela correspond au niveau SKU de votre compte de stockage Azure. Les options valides sont

Premium_LRS,Standard_LRS,StandardSSD_LRSetUltraSSD_LRS. Saisissez le type de compte. Les options valables sont

shared,dedicated,etmanaged.ImportantRed Hat ne prend en charge que l'utilisation de

kind: Manageddans la classe de stockage.Avec

SharedetDedicated, Azure crée des disques non gérés, tandis qu'OpenShift Container Platform crée un disque géré pour les disques du système d'exploitation de la machine (racine). Mais comme Azure Disk ne permet pas l'utilisation de disques gérés et non gérés sur un nœud, les disques non gérés créés avecSharedouDedicatedne peuvent pas être attachés aux nœuds d'OpenShift Container Platform.

-

Saisissez le type de compte de stockage. Cela correspond au niveau SKU de votre compte de stockage Azure. Les options valides sont

- Saisissez des paramètres supplémentaires pour la classe de stockage si vous le souhaitez.

- Cliquez sur Create pour créer la classe de stockage.

Ressources supplémentaires

4.2.2. Création de la revendication de volume persistant

Conditions préalables

Le stockage doit exister dans l'infrastructure sous-jacente avant de pouvoir être monté en tant que volume dans OpenShift Container Platform.

Procédure

- Dans la console OpenShift Container Platform, cliquez sur Storage → Persistent Volume Claims.

- Dans l'aperçu des réclamations relatives aux volumes persistants, cliquez sur Create Persistent Volume Claim.

Définissez les options souhaitées sur la page qui s'affiche.

- Sélectionnez la classe de stockage précédemment créée dans le menu déroulant.

- Saisissez un nom unique pour la créance de stockage.

- Sélectionner le mode d'accès. Cette sélection détermine l'accès à la lecture et à l'écriture pour l'unité de stockage.

- Définir la taille de la demande de stockage.

- Cliquez sur Create pour créer la demande de volume persistant et générer un volume persistant.

4.2.3. Format du volume

Avant que OpenShift Container Platform ne monte le volume et ne le transmette à un conteneur, il vérifie qu'il contient un système de fichiers tel que spécifié par le paramètre fsType dans la définition du volume persistant. Si le périphérique n'est pas formaté avec le système de fichiers, toutes les données du périphérique sont effacées et le périphérique est automatiquement formaté avec le système de fichiers donné.

Cela permet d'utiliser des volumes Azure non formatés comme volumes persistants, car OpenShift Container Platform les formate avant la première utilisation.

4.2.4. Ensembles de machines qui déploient des machines avec des ultra-disques utilisant des PVC

Vous pouvez créer un jeu de machines fonctionnant sur Azure qui déploie des machines avec des ultra-disques. Les disques ultra sont des systèmes de stockage haute performance destinés à être utilisés avec les charges de travail les plus exigeantes.

Le plugin in-tree et le pilote CSI prennent tous deux en charge l'utilisation des PVC pour activer les ultra-disques. Vous pouvez également déployer des machines avec des ultra-disques en tant que disques de données sans créer de PVC.

Ressources supplémentaires

4.2.4.1. Création de machines avec ultra-disques à l'aide de jeux de machines

Vous pouvez déployer des machines avec des ultra-disques sur Azure en modifiant votre fichier YAML de configuration des machines.

Conditions préalables

- Disposer d'un cluster Microsoft Azure existant.

Procédure

Copiez une ressource personnalisée (CR) Azure

MachineSetexistante et modifiez-la en exécutant la commande suivante :oc edit machineset <machine-set-name> $ oc edit machineset <machine-set-name>

où

<machine-set-name>est l'ensemble de machines que vous voulez provisionner avec des ultra-disques.Ajouter les lignes suivantes aux endroits indiqués :

apiVersion: machine.openshift.io/v1beta1 kind: MachineSet spec: template: spec: metadata: labels: disk: ultrassd 1 providerSpec: value: ultraSSDCapability: Enabled 2Créez un jeu de machines à l'aide de la configuration mise à jour en exécutant la commande suivante :

oc create -f <machine-set-name>.yaml

Créez une classe de stockage contenant la définition YAML suivante :

apiVersion: storage.k8s.io/v1 kind: StorageClass metadata: name: ultra-disk-sc 1 parameters: cachingMode: None diskIopsReadWrite: "2000" 2 diskMbpsReadWrite: "320" 3 kind: managed skuname: UltraSSD_LRS provisioner: disk.csi.azure.com 4 reclaimPolicy: Delete volumeBindingMode: WaitForFirstConsumer 5

- 1

- Indiquez le nom de la classe de stockage. Cette procédure utilise

ultra-disk-scpour cette valeur. - 2

- Spécifiez le nombre d'IOPS pour la classe de stockage.

- 3

- Spécifiez le débit en MBps pour la classe de stockage.

- 4

- Pour Azure Kubernetes Service (AKS) version 1.21 ou ultérieure, utilisez

disk.csi.azure.com. Pour les versions antérieures d'AKS, utilisezkubernetes.io/azure-disk. - 5

- Facultatif : Ce paramètre permet d'attendre la création du module qui utilisera le disque.

Créez une revendication de volume persistant (PVC) pour référencer la classe de stockage

ultra-disk-scqui contient la définition YAML suivante :apiVersion: v1 kind: PersistentVolumeClaim metadata: name: ultra-disk 1 spec: accessModes: - ReadWriteOnce storageClassName: ultra-disk-sc 2 resources: requests: storage: 4Gi 3

Créez un pod qui contient la définition YAML suivante :

apiVersion: v1 kind: Pod metadata: name: nginx-ultra spec: nodeSelector: disk: ultrassd 1 containers: - name: nginx-ultra image: alpine:latest command: - "sleep" - "infinity" volumeMounts: - mountPath: "/mnt/azure" name: volume volumes: - name: volume persistentVolumeClaim: claimName: ultra-disk 2

Vérification

Validez la création des machines en exécutant la commande suivante :

$ oc get machines

Les machines doivent être dans l'état

Running.Pour une machine en cours d'exécution et à laquelle un nœud est attaché, validez la partition en exécutant la commande suivante :

$ oc debug node/<node-name> -- chroot /host lsblk

Dans cette commande,

oc debug node/<node-name>démarre un shell de débogage sur le nœud<node-name>et transmet une commande à--. La commande passéechroot /hostpermet d'accéder aux binaires du système d'exploitation hôte sous-jacent, etlsblkmontre les périphériques de bloc attachés à la machine du système d'exploitation hôte.

Prochaines étapes

Pour utiliser un ultra disque à partir d'un pod, créez une charge de travail qui utilise le point de montage. Créez un fichier YAML similaire à l'exemple suivant :

apiVersion: v1 kind: Pod metadata: name: ssd-benchmark1 spec: containers: - name: ssd-benchmark1 image: nginx ports: - containerPort: 80 name: "http-server" volumeMounts: - name: lun0p1 mountPath: "/tmp" volumes: - name: lun0p1 hostPath: path: /var/lib/lun0p1 type: DirectoryOrCreate nodeSelector: disktype: ultrassd

4.2.4.2. Ressources de dépannage pour les ensembles de machines qui activent les ultra-disques

Utilisez les informations de cette section pour comprendre et résoudre les problèmes que vous pourriez rencontrer.

4.2.4.2.1. Impossible de monter une revendication de volume persistant soutenue par un ultra disque

En cas de problème lors du montage d'une revendication de volume persistant soutenue par un ultra disque, le pod reste bloqué à l'état ContainerCreating et une alerte est déclenchée.

Par exemple, si le paramètre additionalCapabilities.ultraSSDEnabled n'est pas défini sur la machine qui soutient le nœud qui héberge le module, le message d'erreur suivant apparaît :

StorageAccountType UltraSSD_LRS can be used only when additionalCapabilities.ultraSSDEnabled is set.

Pour résoudre ce problème, décrivez le pod en exécutant la commande suivante :

oc -n <stuck_pod_namespace> describe pod <stuck_pod_name>

4.3. Stockage persistant à l'aide d'Azure File

OpenShift Container Platform prend en charge les volumes de fichiers Microsoft Azure. Vous pouvez approvisionner votre cluster OpenShift Container Platform avec un stockage persistant en utilisant Azure. Une certaine familiarité avec Kubernetes et Azure est supposée.

Le cadre de volume persistant Kubernetes permet aux administrateurs de provisionner un cluster avec un stockage persistant et donne aux utilisateurs un moyen de demander ces ressources sans avoir aucune connaissance de l'infrastructure sous-jacente. Vous pouvez approvisionner les volumes Azure File de manière dynamique.

Les volumes persistants ne sont pas liés à un seul projet ou espace de noms, et vous pouvez les partager à travers le cluster OpenShift Container Platform. Les revendications de volumes persistants sont spécifiques à un projet ou à un espace de noms, et peuvent être demandées par les utilisateurs pour être utilisées dans des applications.

La haute disponibilité du stockage dans l'infrastructure est laissée au fournisseur de stockage sous-jacent.

Les volumes Azure File utilisent le bloc de messages du serveur.

Dans les prochaines versions d'OpenShift Container Platform, les volumes provisionnés à l'aide des plugins in-tree existants sont prévus pour une migration vers leur pilote CSI équivalent. La migration automatique CSI devrait être transparente. La migration ne modifie pas la façon dont vous utilisez tous les objets API existants, tels que les volumes persistants, les réclamations de volumes persistants et les classes de stockage. Pour plus d'informations sur la migration, voir Migration automatique CSI.

Après la migration complète, les plugins in-tree seront éventuellement supprimés dans les futures versions d'OpenShift Container Platform.

Ressources supplémentaires

4.3.1. Créer la demande de volume persistant de partage de fichiers Azure

Pour créer la revendication de volume persistant, vous devez d'abord définir un objet Secret qui contient le compte et la clé Azure. Ce secret est utilisé dans la définition de PersistentVolume et sera référencé par la revendication de volume persistant pour être utilisé dans les applications.

Conditions préalables

- Un partage de fichiers Azure existe.

- Les informations d'identification permettant d'accéder à ce partage, en particulier le compte de stockage et la clé, sont disponibles.

Procédure

Créez un objet

Secretqui contient les informations d'identification d'Azure File :$ oc create secret generic <secret-name> --from-literal=azurestorageaccountname=<storage-account> \ 1 --from-literal=azurestorageaccountkey=<storage-account-key> 2

Créez un objet

PersistentVolumequi fait référence à l'objetSecretque vous avez créé :apiVersion: "v1" kind: "PersistentVolume" metadata: name: "pv0001" 1 spec: capacity: storage: "5Gi" 2 accessModes: - "ReadWriteOnce" storageClassName: azure-file-sc azureFile: secretName: <secret-name> 3 shareName: share-1 4 readOnly: false

Créez un objet

PersistentVolumeClaimqui correspond au volume persistant que vous avez créé :apiVersion: "v1" kind: "PersistentVolumeClaim" metadata: name: "claim1" 1 spec: accessModes: - "ReadWriteOnce" resources: requests: storage: "5Gi" 2 storageClassName: azure-file-sc 3 volumeName: "pv0001" 4

- 1

- Le nom de la demande de volume persistant.

- 2

- La taille de cette demande de volume persistant.

- 3

- Nom de la classe de stockage utilisée pour approvisionner le volume persistant. Spécifiez la classe de stockage utilisée dans la définition de

PersistentVolume. - 4

- Le nom de l'objet

PersistentVolumeexistant qui fait référence au partage de fichiers Azure.

4.3.2. Monter le partage de fichiers Azure dans un pod

Une fois que la demande de volume persistant a été créée, elle peut être utilisée à l'intérieur par une application. L'exemple suivant montre le montage de ce partage à l'intérieur d'un pod.

Conditions préalables

- Il existe une revendication de volume persistant qui est mappée au partage de fichiers Azure sous-jacent.

Procédure

Créer un pod qui monte la revendication de volume persistant existante :

apiVersion: v1 kind: Pod metadata: name: pod-name 1 spec: containers: ... volumeMounts: - mountPath: "/data" 2 name: azure-file-share volumes: - name: azure-file-share persistentVolumeClaim: claimName: claim1 3

- 1

- Le nom du pod.

- 2

- Le chemin pour monter le partage de fichiers Azure à l'intérieur du module. Ne montez pas à la racine du conteneur,

/, ou tout autre chemin qui est le même dans l'hôte et le conteneur. Cela peut corrompre votre système hôte si le conteneur est suffisamment privilégié, comme l'hôte/dev/ptsfiles. Vous pouvez monter l'hôte en toute sécurité en utilisant/host. - 3

- Le nom de l'objet

PersistentVolumeClaimqui a été créé précédemment.

4.4. Stockage persistant à l'aide de Cinder

OpenShift Container Platform prend en charge OpenStack Cinder. Une certaine familiarité avec Kubernetes et OpenStack est supposée.

Les volumes Cinder peuvent être provisionnés dynamiquement. Les volumes persistants ne sont pas liés à un projet ou à un espace de noms unique ; ils peuvent être partagés à travers le cluster OpenShift Container Platform. Les demandes de volumes persistants sont spécifiques à un projet ou à un espace de noms et peuvent être demandées par les utilisateurs.

OpenShift Container Platform utilise par défaut un plugin in-tree (non-CSI) pour provisionner le stockage Cinder.

Dans les prochaines versions d'OpenShift Container Platform, les volumes provisionnés à l'aide des plugins in-tree existants sont prévus pour une migration vers leur pilote CSI équivalent. La migration automatique CSI devrait être transparente. La migration ne modifie pas la façon dont vous utilisez tous les objets API existants, tels que les volumes persistants, les réclamations de volumes persistants et les classes de stockage. Pour plus d'informations sur la migration, voir Migration automatique CSI.

Après la migration complète, les plugins in-tree seront éventuellement supprimés dans les futures versions d'OpenShift Container Platform.

Ressources supplémentaires

- Pour plus d'informations sur la façon dont OpenStack Block Storage assure la gestion du stockage en bloc persistant pour les disques durs virtuels, voir OpenStack Cinder.

4.4.1. Approvisionnement manuel avec Cinder

Le stockage doit exister dans l'infrastructure sous-jacente avant de pouvoir être monté en tant que volume dans OpenShift Container Platform.

Conditions préalables

- OpenShift Container Platform configuré pour Red Hat OpenStack Platform (RHOSP)

- Volume de cendres ID

4.4.1.1. Création du volume persistant

Vous devez définir votre volume persistant (PV) dans une définition d'objet avant de le créer dans OpenShift Container Platform :

Procédure

Enregistrez votre définition d'objet dans un fichier.

cinder-persistentvolume.yaml

apiVersion: "v1" kind: "PersistentVolume" metadata: name: "pv0001" 1 spec: capacity: storage: "5Gi" 2 accessModes: - "ReadWriteOnce" cinder: 3 fsType: "ext3" 4 volumeID: "f37a03aa-6212-4c62-a805-9ce139fab180" 5

- 1

- Le nom du volume utilisé par les réclamations de volumes persistants ou les pods.

- 2

- La quantité de stockage allouée à ce volume.

- 3

- Indique

cinderpour les volumes Cinder de Red Hat OpenStack Platform (RHOSP). - 4

- Le système de fichiers qui est créé lorsque le volume est monté pour la première fois.

- 5

- Le volume Cinder à utiliser.

ImportantNe modifiez pas la valeur du paramètre

fstypeaprès le formatage et l'approvisionnement du volume. La modification de cette valeur peut entraîner une perte de données et une défaillance du pod.Créez le fichier de définition d'objet que vous avez enregistré à l'étape précédente.

$ oc create -f cinder-persistentvolume.yaml

4.4.1.2. Formatage de volumes persistants

Vous pouvez utiliser des volumes Cinder non formatés comme PV car OpenShift Container Platform les formate avant la première utilisation.

Avant qu'OpenShift Container Platform ne monte le volume et ne le transmette à un conteneur, le système vérifie qu'il contient un système de fichiers tel que spécifié par le paramètre fsType dans la définition du PV. Si le périphérique n'est pas formaté avec le système de fichiers, toutes les données du périphérique sont effacées et le périphérique est automatiquement formaté avec le système de fichiers donné.

4.4.1.3. Sécurité des volumes Cinder

Si vous utilisez des PV Cinder dans votre application, configurez la sécurité pour leurs configurations de déploiement.

Conditions préalables

-

Il faut créer un CCN qui utilise la stratégie

fsGroupappropriée.

Procédure

Créez un compte de service et ajoutez-le au SCC :

oc create serviceaccount <service_account> $ oc create serviceaccount <service_account>

$ oc adm policy add-scc-to-user <new_scc> -z <service_account> -n <project>

Dans la configuration du déploiement de votre application, indiquez le nom du compte de service et

securityContext:apiVersion: v1 kind: ReplicationController metadata: name: frontend-1 spec: replicas: 1 1 selector: 2 name: frontend template: 3 metadata: labels: 4 name: frontend 5 spec: containers: - image: openshift/hello-openshift name: helloworld ports: - containerPort: 8080 protocol: TCP restartPolicy: Always serviceAccountName: <service_account> 6 securityContext: fsGroup: 7777 7

- 1

- Le nombre de copies du module à exécuter.

- 2

- Le sélecteur d'étiquettes du module à exécuter.

- 3

- Un modèle pour le module que le contrôleur crée.

- 4

- Les étiquettes sur le pod. Elles doivent inclure les étiquettes du sélecteur d'étiquettes.

- 5

- La longueur maximale du nom après expansion des paramètres est de 63 caractères.

- 6

- Spécifie le compte de service que vous avez créé.

- 7

- Spécifie une adresse

fsGrouppour les pods.

4.5. Stockage persistant à l'aide de Fibre Channel

OpenShift Container Platform prend en charge Fibre Channel, ce qui vous permet de provisionner votre cluster OpenShift Container Platform avec un stockage persistant à l'aide de volumes Fibre Channel. Une certaine familiarité avec Kubernetes et Fibre Channel est supposée.

Le stockage persistant utilisant Fibre Channel n'est pas pris en charge sur les infrastructures basées sur l'architecture ARM.

Le cadre de volume persistant Kubernetes permet aux administrateurs de provisionner un cluster avec un stockage persistant et donne aux utilisateurs un moyen de demander ces ressources sans avoir aucune connaissance de l'infrastructure sous-jacente. Les volumes persistants ne sont pas liés à un seul projet ou espace de noms ; ils peuvent être partagés à travers le cluster OpenShift Container Platform. Les demandes de volumes persistants sont spécifiques à un projet ou à un espace de noms et peuvent être demandées par les utilisateurs.

La haute disponibilité du stockage dans l'infrastructure est laissée au fournisseur de stockage sous-jacent.

Ressources supplémentaires

4.5.1. Provisionnement

Pour provisionner des volumes Fibre Channel à l'aide de l'API PersistentVolume, les éléments suivants doivent être disponibles :

-

Le site

targetWWNs(tableau des noms mondiaux des cibles Fibre Channel). - Un numéro de LUN valide.

- Le type de système de fichiers.

Un volume persistant et un LUN ont une correspondance univoque entre eux.

Conditions préalables

- Les LUN Fibre Channel doivent exister dans l'infrastructure sous-jacente.

PersistentVolume définition de l'objet

apiVersion: v1

kind: PersistentVolume

metadata:

name: pv0001

spec:

capacity:

storage: 1Gi

accessModes:

- ReadWriteOnce

fc:

wwids: [scsi-3600508b400105e210000900000490000] 1

targetWWNs: ['500a0981891b8dc5', '500a0981991b8dc5'] 2

lun: 2 3

fsType: ext4

- 1

- Identificateurs mondiaux (WWID). Soit FC

wwidsou une combinaison de FCtargetWWNsetlundoit être défini, mais pas les deux simultanément. L'identifiant WWID FC est recommandé par rapport à la cible WWN car il est garanti unique pour chaque périphérique de stockage et indépendant du chemin utilisé pour accéder au périphérique. L'identifiant WWID peut être obtenu en émettant une requête SCSI pour récupérer les données vitales d'identification du produit (page 0x83) ou le numéro de série de l'unité (page 0x80). Les WWID FC sont identifiés comme/dev/disk/by-id/pour référencer les données sur le disque, même si le chemin d'accès au périphérique change et même si l'on accède au périphérique à partir de différents systèmes. - 2 3

- Les WWN Fibre Channel sont identifiés par

/dev/disk/by-path/pci-<IDENTIFIER>-fc-0x<WWN>-lun-<LUN#>, mais il n'est pas nécessaire de fournir une partie du chemin menant àWWN, y compris0x, et tout ce qui suit, y compris-(trait d'union).

La modification de la valeur du paramètre fstype après le formatage et l'approvisionnement du volume peut entraîner une perte de données et une défaillance du pod.

4.5.1.1. Appliquer les quotas de disque

Utilisez les partitions LUN pour appliquer les quotas de disque et les contraintes de taille. Chaque LUN est mappé à un seul volume persistant, et des noms uniques doivent être utilisés pour les volumes persistants.

L'application de quotas de cette manière permet à l'utilisateur final de demander un stockage persistant d'une quantité spécifique, par exemple 10Gi, et d'obtenir un volume correspondant d'une capacité égale ou supérieure.

4.5.1.2. Sécurité des volumes Fibre Channel

Les utilisateurs demandent du stockage avec une demande de volume persistant. Cette demande n'existe que dans l'espace de noms de l'utilisateur et ne peut être référencée que par un module de ce même espace de noms. Toute tentative d'accès à un volume persistant à travers un espace de noms entraîne l'échec du pod.

Chaque LUN Fibre Channel doit être accessible par tous les nœuds du cluster.

4.6. Stockage persistant à l'aide de FlexVolume