Sécurité et conformité

Apprendre et gérer la sécurité pour OpenShift Container Platform

Résumé

Chapitre 1. Sécurité et conformité de la plateforme OpenShift Container

1.1. Aperçu de la sécurité

Il est important de comprendre comment sécuriser correctement les différents aspects de votre cluster OpenShift Container Platform.

Sécurité des conteneurs

Un bon point de départ pour comprendre la sécurité d'OpenShift Container Platform est de revoir les concepts de la section Comprendre la sécurité des conteneurs. Cette section et les suivantes fournissent un aperçu de haut niveau des mesures de sécurité des conteneurs disponibles dans OpenShift Container Platform, y compris les solutions pour la couche hôte, la couche de conteneur et d'orchestration, et la couche de construction et d'application. Ces sections comprennent également des informations sur les sujets suivants :

- Pourquoi la sécurité des conteneurs est importante et comment elle se compare aux normes de sécurité existantes.

- Quelles mesures de sécurité des conteneurs sont fournies par la couche hôte (RHCOS et RHEL) et lesquelles sont fournies par OpenShift Container Platform.

- Comment évaluer le contenu de vos conteneurs et les sources de vulnérabilité.

- Comment concevoir votre processus de construction et de déploiement pour vérifier de manière proactive le contenu des conteneurs.

- Comment contrôler l'accès aux conteneurs par l'authentification et l'autorisation.

- Comment le réseau et le stockage attaché sont sécurisés dans OpenShift Container Platform.

- Solutions conteneurisées pour la gestion des API et le SSO.

Audit

L'audit d'OpenShift Container Platform fournit un ensemble chronologique d'enregistrements pertinents pour la sécurité, documentant la séquence des activités qui ont affecté le système par des utilisateurs individuels, des administrateurs ou d'autres composants du système. Les administrateurs peuvent configurer la politique des journaux d'audit et visualiser les journaux d'audit.

Certificats

Les certificats sont utilisés par divers composants pour valider l'accès au cluster. Les administrateurs peuvent remplacer le certificat d'entrée par défaut, ajouter des certificats de serveur API ou ajouter un certificat de service.

Vous pouvez également consulter plus de détails sur les types de certificats utilisés par le cluster :

- Certificats fournis par l'utilisateur pour le serveur API

- Certificats de procuration

- Certificats d'AC de service

- Certificats de nœuds

- Certificats Bootstrap

- certificats etcd

- Certificats OLM

- Certificats agrégés pour les clients de l'API

- Certificats d'opérateur de configuration de machine

- Certificats fournis par l'utilisateur pour l'entrée par défaut

- Certificats d'ingérence

- Surveillance et journalisation des clusters Certificats des composants de l'opérateur

- Certificats du plan de contrôle

Cryptage des données

Vous pouvez activer le chiffrement etcd pour votre cluster afin de fournir une couche supplémentaire de sécurité des données. Par exemple, cela peut aider à protéger la perte de données sensibles si une sauvegarde etcd est exposée à des parties incorrectes.

Analyse de la vulnérabilité

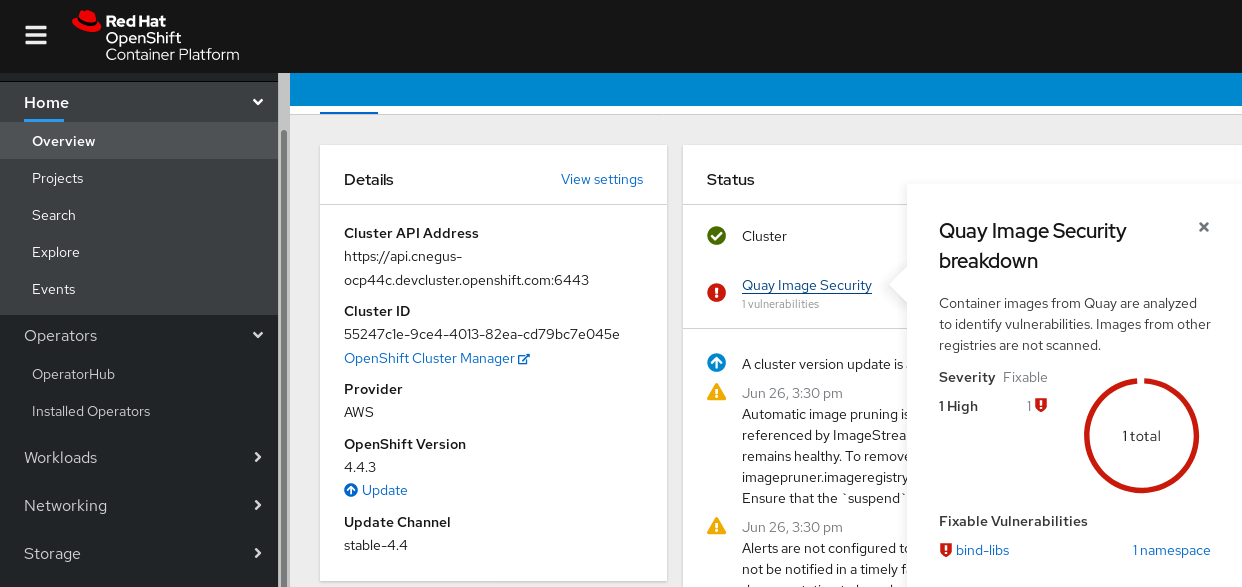

Les administrateurs peuvent utiliser Red Hat Quay Container Security Operator pour exécuter des analyses de vulnérabilité et examiner les informations sur les vulnérabilités détectées.

1.2. Aperçu de la conformité

Pour de nombreux clients d'OpenShift Container Platform, la préparation réglementaire, ou la conformité, est requise à un certain niveau avant que tout système puisse être mis en production. Cette préparation réglementaire peut être imposée par des normes nationales, des normes industrielles ou le cadre de gouvernance d'entreprise de l'organisation.

Contrôle de conformité

Les administrateurs peuvent utiliser l'opérateur de conformité pour effectuer des analyses de conformité et recommander des remédiations pour tout problème détecté. Le pluginoc-compliance est un plugin OpenShift CLI (oc) qui fournit un ensemble d'utilitaires pour interagir facilement avec l'Opérateur de Conformité.

Contrôle de l'intégrité des fichiers

Les administrateurs peuvent utiliser l'opérateur d'intégrité des fichiers pour exécuter en permanence des contrôles d'intégrité des fichiers sur les nœuds de la grappe et fournir un journal des fichiers qui ont été modifiés.

1.3. Ressources supplémentaires

Chapitre 2. Sécurité des conteneurs

2.1. Comprendre la sécurité des conteneurs

La sécurisation d'une application conteneurisée repose sur plusieurs niveaux de sécurité :

La sécurité des conteneurs commence par une image de conteneur de base fiable et se poursuit tout au long du processus de construction du conteneur, à mesure qu'il se déplace dans votre pipeline CI/CD.

ImportantPar défaut, les flux d'images ne sont pas mis à jour automatiquement. Ce comportement par défaut peut créer un problème de sécurité car les mises à jour de sécurité des images référencées par un flux d'images ne se produisent pas automatiquement. Pour plus d'informations sur la manière de remplacer ce comportement par défaut, voir Configuration de l'importation périodique des imagestreamtags.

- Lorsqu'un conteneur est déployé, sa sécurité dépend de son fonctionnement sur des systèmes d'exploitation et des réseaux sécurisés, et de l'établissement de frontières solides entre le conteneur lui-même et les utilisateurs et hôtes qui interagissent avec lui.

- Le maintien de la sécurité dépend de la capacité à analyser les images des conteneurs pour détecter les vulnérabilités et à disposer d'un moyen efficace de corriger et de remplacer les images vulnérables.

Au-delà de ce qu'une plateforme telle qu'OpenShift Container Platform offre, votre organisation aura probablement ses propres exigences en matière de sécurité. Un certain niveau de vérification de la conformité pourrait être nécessaire avant même d'introduire OpenShift Container Platform dans votre centre de données.

De même, vous devrez peut-être ajouter vos propres agents, des pilotes matériels spécialisés ou des fonctions de chiffrement à OpenShift Container Platform, avant qu'elle ne puisse répondre aux normes de sécurité de votre organisation.

Ce guide fournit un aperçu de haut niveau des mesures de sécurité des conteneurs disponibles dans OpenShift Container Platform, y compris des solutions pour la couche hôte, la couche conteneur et orchestration, et la couche de construction et d'application. Il vous oriente ensuite vers la documentation spécifique d'OpenShift Container Platform pour vous aider à mettre en œuvre ces mesures de sécurité.

Ce guide contient les informations suivantes :

- Pourquoi la sécurité des conteneurs est importante et comment elle se compare aux normes de sécurité existantes.

- Quelles mesures de sécurité des conteneurs sont fournies par la couche hôte (RHCOS et RHEL) et lesquelles sont fournies par OpenShift Container Platform.

- Comment évaluer le contenu de vos conteneurs et les sources de vulnérabilité.

- Comment concevoir votre processus de construction et de déploiement pour vérifier de manière proactive le contenu des conteneurs.

- Comment contrôler l'accès aux conteneurs par l'authentification et l'autorisation.

- Comment le réseau et le stockage attaché sont sécurisés dans OpenShift Container Platform.

- Solutions conteneurisées pour la gestion des API et le SSO.

L'objectif de ce guide est de comprendre les avantages incroyables en matière de sécurité de l'utilisation d'OpenShift Container Platform pour vos charges de travail conteneurisées et comment l'ensemble de l'écosystème Red Hat joue un rôle dans la sécurisation et le maintien des conteneurs. Il vous aidera également à comprendre comment vous pouvez vous engager avec OpenShift Container Platform pour atteindre les objectifs de sécurité de votre organisation.

2.1.1. Qu'est-ce qu'un conteneur ?

Les conteneurs regroupent une application et toutes ses dépendances dans une image unique qui peut passer du développement au test, puis à la production, sans changement. Un conteneur peut faire partie d'une application plus vaste qui travaille en étroite collaboration avec d'autres conteneurs.

Les conteneurs assurent la cohérence entre les environnements et les cibles de déploiement multiples : serveurs physiques, machines virtuelles (VM) et nuages privés ou publics.

Voici quelques-uns des avantages de l'utilisation de conteneurs :

| Infrastructure | Applications |

|---|---|

| Processus d'application en bac à sable sur un noyau partagé du système d'exploitation Linux | Paqueter mon application et toutes ses dépendances |

| Plus simple, plus léger et plus dense que les machines virtuelles | Déployer dans n'importe quel environnement en quelques secondes et activer CI/CD |

| Portable dans différents environnements | Accéder facilement aux composants conteneurisés et les partager |

Pour en savoir plus sur les conteneurs Linux, consultez la section Comprendre les conteneurs Linux du portail client Red Hat. Pour en savoir plus sur les outils de conteneur RHEL, voir Construire, exécuter et gérer des conteneurs dans la documentation produit RHEL.

2.1.2. Qu'est-ce que OpenShift Container Platform ?

L'automatisation du déploiement, de l'exécution et de la gestion des applications conteneurisées est le travail d'une plateforme telle qu'OpenShift Container Platform. À la base, OpenShift Container Platform s'appuie sur le projet Kubernetes pour fournir le moteur d'orchestration des conteneurs sur de nombreux nœuds dans des centres de données évolutifs.

Kubernetes est un projet qui peut fonctionner avec différents systèmes d'exploitation et des composants complémentaires qui n'offrent aucune garantie de prise en charge par le projet. Par conséquent, la sécurité des différentes plateformes Kubernetes peut varier.

OpenShift Container Platform est conçu pour verrouiller la sécurité de Kubernetes et intégrer la plateforme avec une variété de composants étendus. Pour ce faire, OpenShift Container Platform s'appuie sur le vaste écosystème Red Hat de technologies open source qui comprend les systèmes d'exploitation, l'authentification, le stockage, la mise en réseau, les outils de développement, les images de conteneurs de base et de nombreux autres composants.

OpenShift Container Platform peut tirer parti de l'expérience de Red Hat dans la découverte et le déploiement rapide de correctifs pour les vulnérabilités dans la plateforme elle-même ainsi que dans les applications conteneurisées fonctionnant sur la plateforme. L'expérience de Red Hat s'étend également à l'intégration efficace de nouveaux composants à OpenShift Container Platform au fur et à mesure de leur disponibilité et à l'adaptation des technologies aux besoins individuels des clients.

Ressources supplémentaires

2.2. Comprendre la sécurité des hôtes et des machines virtuelles

Les conteneurs et les machines virtuelles permettent de séparer les applications exécutées sur un hôte du système d'exploitation lui-même. Comprendre RHCOS, qui est le système d'exploitation utilisé par OpenShift Container Platform, vous aidera à voir comment les systèmes hôtes protègent les conteneurs et les hôtes les uns des autres.

2.2.1. Sécuriser les conteneurs sur Red Hat Enterprise Linux CoreOS (RHCOS)

Les conteneurs simplifient le déploiement de nombreuses applications sur le même hôte, en utilisant le même noyau et le même moteur d'exécution pour chaque conteneur. Les applications peuvent appartenir à de nombreux utilisateurs et, parce qu'elles sont séparées, elles peuvent fonctionner simultanément avec des versions différentes, voire incompatibles, de ces applications sans aucun problème.

Dans Linux, les conteneurs ne sont qu'un type spécial de processus, de sorte que la sécurisation des conteneurs est similaire à bien des égards à la sécurisation de n'importe quel autre processus en cours d'exécution. Un environnement pour l'exécution de conteneurs commence par un système d'exploitation capable de sécuriser le noyau de l'hôte vis-à-vis des conteneurs et des autres processus s'exécutant sur l'hôte, ainsi que de sécuriser les conteneurs les uns vis-à-vis des autres.

Étant donné qu'OpenShift Container Platform 4.12 fonctionne sur des hôtes RHCOS, avec la possibilité d'utiliser Red Hat Enterprise Linux (RHEL) comme nœuds de travail, les concepts suivants s'appliquent par défaut à tout cluster OpenShift Container Platform déployé. Ces fonctionnalités de sécurité RHEL sont au cœur de ce qui rend l'exécution de conteneurs dans OpenShift Container Platform plus sûre :

- Linux namespaces les conteneurs permettent de créer une abstraction d'une ressource système globale particulière afin qu'elle apparaisse comme une instance distincte pour les processus au sein d'un espace de noms. Par conséquent, plusieurs conteneurs peuvent utiliser simultanément la même ressource informatique sans créer de conflit. Les espaces de noms des conteneurs qui sont séparés de l'hôte par défaut comprennent la table de montage, la table de processus, l'interface réseau, l'utilisateur, le groupe de contrôle, l'UTS et les espaces de noms IPC. Les conteneurs qui ont besoin d'un accès direct aux espaces de noms de l'hôte doivent disposer d'autorisations élevées pour demander cet accès. Voir Overview of Containers in Red Hat Systems dans la documentation sur les conteneurs de RHEL 8 pour plus de détails sur les types d'espaces de noms.

- SELinux fournit une couche de sécurité supplémentaire pour isoler les conteneurs les uns des autres et de l'hôte. SELinux permet aux administrateurs d'appliquer des contrôles d'accès obligatoires (MAC) pour chaque utilisateur, application, processus et fichier.

Disabling SELinux on RHCOS is not supported.

- CGroups (groupes de contrôle) limitent, comptabilisent et isolent l'utilisation des ressources (CPU, mémoire, E/S disque, réseau, etc.) d'un ensemble de processus. Les groupes de contrôle sont utilisés pour s'assurer que les conteneurs situés sur le même hôte ne sont pas affectés les uns par les autres.

- Secure computing mode (seccomp) peuvent être associés à un conteneur pour restreindre les appels système disponibles. Voir la page 94 du OpenShift Security Guide pour plus de détails sur seccomp.

- Le déploiement de conteneurs à l'aide de RHCOS réduit la surface d'attaque en minimisant l'environnement hôte et en l'adaptant aux conteneurs. Le moteur de conteneurs CRI-O réduit encore cette surface d'attaque en implémentant uniquement les fonctionnalités requises par Kubernetes et OpenShift Container Platform pour exécuter et gérer les conteneurs, contrairement à d'autres moteurs de conteneurs qui implémentent des fonctionnalités autonomes orientées vers le poste de travail.

RHCOS est une version de Red Hat Enterprise Linux (RHEL) spécialement configurée pour fonctionner en tant que plan de contrôle (maître) et nœuds de travail sur les clusters OpenShift Container Platform. RHCOS est donc réglé pour exécuter efficacement les charges de travail de conteneurs, ainsi que les services Kubernetes et OpenShift Container Platform.

Pour mieux protéger les systèmes RHCOS dans les clusters OpenShift Container Platform, la plupart des conteneurs, à l'exception de ceux qui gèrent ou surveillent le système hôte lui-même, doivent s'exécuter en tant qu'utilisateur non root. L'abaissement du niveau de privilège ou la création de conteneurs avec le moins de privilèges possible est la meilleure pratique recommandée pour protéger vos propres clusters OpenShift Container Platform.

Ressources supplémentaires

- Comment les nœuds appliquent les contraintes de ressources

- Gestion des contraintes liées au contexte de sécurité

- Plateformes prises en charge pour les clusters OpenShift

- Requirements for a cluster with user-provisioned infrastructure

- Choix de la configuration de RHCOS

- Allumage

- Arguments du noyau

- Modules du noyau

- Cryptographie FIPS

- Cryptage des disques

- Service de l'heure chronologique

- À propos du service de mise à jour OpenShift

2.2.2. Comparaison entre la virtualisation et les conteneurs

La virtualisation traditionnelle offre un autre moyen de séparer les environnements d'application sur le même hôte physique. Cependant, les machines virtuelles fonctionnent différemment des conteneurs. La virtualisation repose sur un hyperviseur qui fait tourner des machines virtuelles invitées (VM), chacune d'entre elles ayant son propre système d'exploitation (OS), représenté par un noyau en cours d'exécution, ainsi que l'application en cours d'exécution et ses dépendances.

Avec les VM, l'hyperviseur isole les invités les uns des autres et du noyau hôte. Moins de personnes et de processus ont accès à l'hyperviseur, ce qui réduit la surface d'attaque sur le serveur physique. Cela dit, la sécurité doit toujours être surveillée : une VM invitée pourrait être en mesure d'utiliser les bogues de l'hyperviseur pour accéder à une autre VM ou au noyau hôte. Et lorsque le système d'exploitation doit être corrigé, il doit l'être sur toutes les machines virtuelles invitées qui l'utilisent.

Les conteneurs peuvent être exécutés à l'intérieur de machines virtuelles invitées, et il peut y avoir des cas d'utilisation où cela est souhaitable. Par exemple, vous pouvez déployer une application traditionnelle dans un conteneur, peut-être pour transférer une application dans le nuage.

La séparation des conteneurs sur un seul hôte offre toutefois une solution de déploiement plus légère, plus flexible et plus facile à mettre à l'échelle. Ce modèle de déploiement est particulièrement adapté aux applications "cloud-native". Les conteneurs sont généralement beaucoup plus petits que les VM et consomment moins de mémoire et de CPU.

Voir Linux Containers Compared to KVM Virtualization dans la documentation sur les conteneurs de RHEL 7 pour en savoir plus sur les différences entre les conteneurs et les machines virtuelles.

2.2.3. Sécuriser OpenShift Container Platform

Lorsque vous déployez OpenShift Container Platform, vous avez le choix entre une infrastructure fournie par l'installateur (il existe plusieurs plateformes disponibles) et votre propre infrastructure fournie par l'utilisateur. Certaines configurations de bas niveau liées à la sécurité, telles que l'activation de la conformité FIPS ou l'ajout de modules de noyau requis au premier démarrage, peuvent bénéficier d'une infrastructure fournie par l'utilisateur. De même, l'infrastructure fournie par l'utilisateur est appropriée pour les déploiements déconnectés d'OpenShift Container Platform.

Gardez à l'esprit que, lorsqu'il s'agit d'apporter des améliorations de sécurité et d'autres changements de configuration à OpenShift Container Platform, les objectifs doivent inclure :

- Garder les nœuds sous-jacents aussi génériques que possible. Vous voulez pouvoir facilement jeter et faire tourner des nœuds similaires rapidement et de manière prescriptive.

- Gérer autant que possible les modifications apportées aux nœuds par l'intermédiaire d'OpenShift Container Platform, plutôt que d'apporter des modifications directes et ponctuelles aux nœuds.

Pour atteindre ces objectifs, la plupart des modifications de nœuds doivent être effectuées lors de l'installation par Ignition ou ultérieurement à l'aide de MachineConfigs qui sont appliquées à des ensembles de nœuds par l'opérateur de configuration de la machine. Voici quelques exemples de modifications de configuration liées à la sécurité que vous pouvez effectuer de cette manière :

- Ajouter des arguments au noyau

- Ajouter des modules au noyau

- Prise en charge de la cryptographie FIPS

- Configuration du cryptage des disques

- Configuration du service chronologique

En plus de l'opérateur de configuration des machines, il existe plusieurs autres opérateurs disponibles pour configurer l'infrastructure d'OpenShift Container Platform qui sont gérés par l'opérateur de version de cluster (CVO). Le CVO est capable d'automatiser de nombreux aspects des mises à jour des clusters d'OpenShift Container Platform.

2.3. Durcissement du RHCOS

RHCOS a été créé et optimisé pour être déployé dans OpenShift Container Platform avec peu ou pas de changements nécessaires sur les nœuds RHCOS. Chaque organisation qui adopte OpenShift Container Platform a ses propres exigences en matière de renforcement du système. En tant que système RHEL auquel ont été ajoutées des modifications et des fonctionnalités spécifiques à OpenShift (telles que Ignition, ostree et un site /usr en lecture seule pour assurer une immutabilité limitée), RHCOS peut être renforcé comme n'importe quel système RHEL. La différence réside dans la manière dont vous gérez le durcissement.

L'une des principales caractéristiques d'OpenShift Container Platform et de son moteur Kubernetes est de pouvoir faire évoluer rapidement les applications et l'infrastructure à la hausse et à la baisse, selon les besoins. À moins que cela ne soit inévitable, vous ne voulez pas apporter de modifications directes à RHCOS en vous connectant à un hôte et en ajoutant des logiciels ou en modifiant des paramètres. Vous souhaitez que l'installateur et le plan de contrôle d'OpenShift Container Platform gèrent les modifications apportées au RHCOS afin que de nouveaux nœuds puissent être mis en service sans intervention manuelle.

Ainsi, si vous souhaitez renforcer les nœuds RHCOS dans OpenShift Container Platform pour répondre à vos besoins en matière de sécurité, vous devez prendre en compte à la fois les éléments à renforcer et la manière de procéder à ce renforcement.

2.3.1. Choisir ce qu'il faut durcir dans le RHCOS

Le guide de renforcement de la sécurité de RHEL 8 décrit la manière dont vous devez aborder la sécurité pour tout système RHEL.

Ce guide vous explique comment aborder la cryptographie, évaluer les vulnérabilités et les menaces qui pèsent sur différents services. De même, vous apprendrez à analyser les normes de conformité, à vérifier l'intégrité des fichiers, à effectuer des audits et à chiffrer les périphériques de stockage.

Si vous savez quelles caractéristiques vous souhaitez renforcer, vous pouvez alors décider de la manière de les renforcer dans le RHCOS.

2.3.2. Choix du durcissement du RHCOS

La modification directe des systèmes RHCOS dans OpenShift Container Platform est déconseillée. Il faut plutôt penser à modifier les systèmes dans des pools de nœuds, tels que les nœuds de travail et les nœuds de plan de contrôle. Lorsqu'un nouveau nœud est nécessaire, dans les installations non bare metal, vous pouvez demander un nouveau nœud du type que vous souhaitez et il sera créé à partir d'une image RHCOS plus les modifications que vous avez créées précédemment.

Il est possible de modifier RHCOS avant l'installation, pendant l'installation et une fois que le cluster est opérationnel.

2.3.2.1. Durcissement avant installation

Pour les installations bare metal, vous pouvez ajouter des fonctionnalités de renforcement à RHCOS avant de commencer l'installation d'OpenShift Container Platform. Par exemple, vous pouvez ajouter des options de noyau lorsque vous démarrez le programme d'installation de RHCOS pour activer ou désactiver des fonctions de sécurité, telles que divers booléens SELinux ou des paramètres de bas niveau, tels que le multithreading symétrique.

La désactivation de SELinux sur les nœuds RHCOS n'est pas prise en charge.

Bien que les installations RHCOS bare metal soient plus difficiles, elles offrent la possibilité de mettre en place des modifications du système d'exploitation avant de commencer l'installation d'OpenShift Container Platform. Cela peut s'avérer important lorsque vous devez vous assurer que certaines fonctionnalités, telles que le chiffrement des disques ou des paramètres réseau spéciaux, sont configurées le plus tôt possible.

2.3.2.2. Durcissement pendant l'installation

Vous pouvez interrompre le processus d'installation d'OpenShift Container Platform et modifier les configs Ignition. Grâce aux configs Ignition, vous pouvez ajouter vos propres fichiers et services systemd aux nœuds RHCOS. Vous pouvez également apporter des modifications de base liées à la sécurité au fichier install-config.yaml utilisé pour l'installation. Le contenu ajouté de cette manière est disponible au premier démarrage de chaque nœud.

2.3.2.3. Durcissement après le démarrage du cluster

Une fois que le cluster OpenShift Container Platform est opérationnel, il y a plusieurs façons d'appliquer des fonctionnalités de durcissement au RHCOS :

-

Daemon set : Si vous avez besoin qu'un service s'exécute sur chaque nœud, vous pouvez l'ajouter à l'aide d'un objet Kubernetes

DaemonSet. -

Machine config :

MachineConfigobjets contiennent un sous-ensemble de configurations Ignition dans le même format. En appliquant les configurations de machine à tous les nœuds de travailleur ou de plan de contrôle, vous pouvez vous assurer que le prochain nœud du même type qui est ajouté au cluster bénéficie des mêmes modifications.

Toutes les fonctionnalités mentionnées ici sont décrites dans la documentation du produit OpenShift Container Platform.

Ressources supplémentaires

- Guide de sécurité OpenShift

- Choix de la configuration de RHCOS

- Modification des nœuds

- Création manuelle du fichier de configuration de l'installation

- Création du manifeste Kubernetes et des fichiers de configuration Ignition

- Installation de RHCOS à l'aide d'une image ISO

- Personnalisation des nœuds

- Ajouter des arguments de noyau aux nœuds

-

Paramètres de configuration de l'installation - voir

fips - Support for FIPS cryptography

- Composants cryptographiques du noyau RHEL

2.4. Signatures d'images de conteneurs

Red Hat fournit des signatures pour les images dans les registres de conteneurs Red Hat. Ces signatures peuvent être automatiquement vérifiées lors de leur transfert vers les clusters d'OpenShift Container Platform 4 à l'aide de l'opérateur de configuration de machine (MCO).

Quay.io sert la plupart des images qui composent OpenShift Container Platform, et seule l'image release est signée. Les images release font référence aux images approuvées d'OpenShift Container Platform, ce qui offre un certain degré de protection contre les attaques de la chaîne d'approvisionnement. Cependant, certaines extensions d'OpenShift Container Platform, telles que la journalisation, la surveillance et le maillage de services, sont livrées en tant qu'opérateurs à partir de l'Operator Lifecycle Manager (OLM). Ces images sont livrées à partir du registre d'images de conteneurs Red Hat Ecosystem Catalog.

Pour vérifier l'intégrité de ces images entre les registres Red Hat et votre infrastructure, activez la vérification des signatures.

2.4.1. Activation de la vérification des signatures pour les registres de conteneurs Red Hat

L'activation de la validation des signatures de conteneurs pour les registres de conteneurs Red Hat nécessite l'écriture d'un fichier de politique de vérification des signatures spécifiant les clés pour vérifier les images à partir de ces registres. Pour les nœuds RHEL8, les registres sont déjà définis par défaut dans /etc/containers/registries.d.

Procédure

Créer un fichier de configuration Butane,

51-worker-rh-registry-trust.bu, contenant la configuration nécessaire pour les nœuds de travail.NoteSee "Creating machine configs with Butane" for information about Butane.

variant: openshift version: 4.12.0 metadata: name: 51-worker-rh-registry-trust labels: machineconfiguration.openshift.io/role: worker storage: files: - path: /etc/containers/policy.json mode: 0644 overwrite: true contents: inline: | { "default": [ { "type": "insecureAcceptAnything" } ], "transports": { "docker": { "registry.access.redhat.com": [ { "type": "signedBy", "keyType": "GPGKeys", "keyPath": "/etc/pki/rpm-gpg/RPM-GPG-KEY-redhat-release" } ], "registry.redhat.io": [ { "type": "signedBy", "keyType": "GPGKeys", "keyPath": "/etc/pki/rpm-gpg/RPM-GPG-KEY-redhat-release" } ] }, "docker-daemon": { "": [ { "type": "insecureAcceptAnything" } ] } } }Utiliser Butane pour générer un fichier YAML de configuration de la machine,

51-worker-rh-registry-trust.yaml, contenant le fichier à écrire sur le disque des nœuds de travail :$ butane 51-worker-rh-registry-trust.bu -o 51-worker-rh-registry-trust.yaml

Appliquer la configuration de la machine créée :

$ oc apply -f 51-worker-rh-registry-trust.yaml

Vérifier que le pool de configuration de la machine de travail a été déployé avec la nouvelle configuration de la machine :

Vérifiez que la nouvelle configuration de la machine a été créée :

$ oc get mc

Exemple de sortie

NAME GENERATEDBYCONTROLLER IGNITIONVERSION AGE 00-master a2178ad522c49ee330b0033bb5cb5ea132060b0a 3.2.0 25m 00-worker a2178ad522c49ee330b0033bb5cb5ea132060b0a 3.2.0 25m 01-master-container-runtime a2178ad522c49ee330b0033bb5cb5ea132060b0a 3.2.0 25m 01-master-kubelet a2178ad522c49ee330b0033bb5cb5ea132060b0a 3.2.0 25m 01-worker-container-runtime a2178ad522c49ee330b0033bb5cb5ea132060b0a 3.2.0 25m 01-worker-kubelet a2178ad522c49ee330b0033bb5cb5ea132060b0a 3.2.0 25m 51-master-rh-registry-trust 3.2.0 13s 51-worker-rh-registry-trust 3.2.0 53s 1 99-master-generated-crio-seccomp-use-default 3.2.0 25m 99-master-generated-registries a2178ad522c49ee330b0033bb5cb5ea132060b0a 3.2.0 25m 99-master-ssh 3.2.0 28m 99-worker-generated-crio-seccomp-use-default 3.2.0 25m 99-worker-generated-registries a2178ad522c49ee330b0033bb5cb5ea132060b0a 3.2.0 25m 99-worker-ssh 3.2.0 28m rendered-master-af1e7ff78da0a9c851bab4be2777773b a2178ad522c49ee330b0033bb5cb5ea132060b0a 3.2.0 8s rendered-master-cd51fd0c47e91812bfef2765c52ec7e6 a2178ad522c49ee330b0033bb5cb5ea132060b0a 3.2.0 24m rendered-worker-2b52f75684fbc711bd1652dd86fd0b82 a2178ad522c49ee330b0033bb5cb5ea132060b0a 3.2.0 24m rendered-worker-be3b3bce4f4aa52a62902304bac9da3c a2178ad522c49ee330b0033bb5cb5ea132060b0a 3.2.0 48s 2

Vérifier que le pool de configuration de la machine travailleuse est mis à jour avec la nouvelle configuration de la machine :

$ oc get mcp

Exemple de sortie

NAME CONFIG UPDATED UPDATING DEGRADED MACHINECOUNT READYMACHINECOUNT UPDATEDMACHINECOUNT DEGRADEDMACHINECOUNT AGE master rendered-master-af1e7ff78da0a9c851bab4be2777773b True False False 3 3 3 0 30m worker rendered-worker-be3b3bce4f4aa52a62902304bac9da3c False True False 3 0 0 0 30m 1- 1

- Lorsque le champ

UPDATINGestTrue, le pool de configuration de la machine est mis à jour avec la nouvelle configuration de la machine. Lorsque le champ devientFalse, le pool de configuration de la machine du travailleur est passé à la nouvelle configuration de la machine.

Si votre cluster utilise des nœuds de travail RHEL7, lorsque le pool de configuration de la machine de travail est mis à jour, créez des fichiers YAML sur ces nœuds dans le répertoire

/etc/containers/registries.d, qui spécifient l'emplacement des signatures détachées pour un serveur de registre donné. L'exemple suivant ne fonctionne que pour les images hébergées dansregistry.access.redhat.cometregistry.redhat.io.Démarrez une session de débogage sur chaque nœud de travail RHEL7 :

oc debug node/<node_name>

Changez votre répertoire racine en

/host:sh-4.2# chroot /host

Créez un fichier

/etc/containers/registries.d/registry.redhat.io.yamlcontenant les éléments suivants :docker: registry.redhat.io: sigstore: https://registry.redhat.io/containers/sigstoreCréez un fichier

/etc/containers/registries.d/registry.access.redhat.com.yamlcontenant les éléments suivants :docker: registry.access.redhat.com: sigstore: https://access.redhat.com/webassets/docker/content/sigstore- Quitter la session de débogage.

2.4.2. Vérification de la configuration de la vérification de la signature

Après avoir appliqué les configurations de machine au cluster, le Machine Config Controller détecte le nouvel objet MachineConfig et génère une nouvelle version de rendered-worker-<hash>.

Conditions préalables

- Vous avez activé la vérification des signatures en utilisant un fichier de configuration de la machine.

Procédure

Sur la ligne de commande, exécutez la commande suivante pour afficher des informations sur un travailleur donné :

$ oc describe machineconfigpool/worker

Exemple de résultat de la surveillance initiale des travailleurs

Name: worker Namespace: Labels: machineconfiguration.openshift.io/mco-built-in= Annotations: <none> API Version: machineconfiguration.openshift.io/v1 Kind: MachineConfigPool Metadata: Creation Timestamp: 2019-12-19T02:02:12Z Generation: 3 Resource Version: 16229 Self Link: /apis/machineconfiguration.openshift.io/v1/machineconfigpools/worker UID: 92697796-2203-11ea-b48c-fa163e3940e5 Spec: Configuration: Name: rendered-worker-f6819366eb455a401c42f8d96ab25c02 Source: API Version: machineconfiguration.openshift.io/v1 Kind: MachineConfig Name: 00-worker API Version: machineconfiguration.openshift.io/v1 Kind: MachineConfig Name: 01-worker-container-runtime API Version: machineconfiguration.openshift.io/v1 Kind: MachineConfig Name: 01-worker-kubelet API Version: machineconfiguration.openshift.io/v1 Kind: MachineConfig Name: 51-worker-rh-registry-trust API Version: machineconfiguration.openshift.io/v1 Kind: MachineConfig Name: 99-worker-92697796-2203-11ea-b48c-fa163e3940e5-registries API Version: machineconfiguration.openshift.io/v1 Kind: MachineConfig Name: 99-worker-ssh Machine Config Selector: Match Labels: machineconfiguration.openshift.io/role: worker Node Selector: Match Labels: node-role.kubernetes.io/worker: Paused: false Status: Conditions: Last Transition Time: 2019-12-19T02:03:27Z Message: Reason: Status: False Type: RenderDegraded Last Transition Time: 2019-12-19T02:03:43Z Message: Reason: Status: False Type: NodeDegraded Last Transition Time: 2019-12-19T02:03:43Z Message: Reason: Status: False Type: Degraded Last Transition Time: 2019-12-19T02:28:23Z Message: Reason: Status: False Type: Updated Last Transition Time: 2019-12-19T02:28:23Z Message: All nodes are updating to rendered-worker-f6819366eb455a401c42f8d96ab25c02 Reason: Status: True Type: Updating Configuration: Name: rendered-worker-d9b3f4ffcfd65c30dcf591a0e8cf9b2e Source: API Version: machineconfiguration.openshift.io/v1 Kind: MachineConfig Name: 00-worker API Version: machineconfiguration.openshift.io/v1 Kind: MachineConfig Name: 01-worker-container-runtime API Version: machineconfiguration.openshift.io/v1 Kind: MachineConfig Name: 01-worker-kubelet API Version: machineconfiguration.openshift.io/v1 Kind: MachineConfig Name: 99-worker-92697796-2203-11ea-b48c-fa163e3940e5-registries API Version: machineconfiguration.openshift.io/v1 Kind: MachineConfig Name: 99-worker-ssh Degraded Machine Count: 0 Machine Count: 1 Observed Generation: 3 Ready Machine Count: 0 Unavailable Machine Count: 1 Updated Machine Count: 0 Events: <none>Exécutez à nouveau la commande

oc describe:$ oc describe machineconfigpool/worker

Exemple de sortie après la mise à jour du travailleur

... Last Transition Time: 2019-12-19T04:53:09Z Message: All nodes are updated with rendered-worker-f6819366eb455a401c42f8d96ab25c02 Reason: Status: True Type: Updated Last Transition Time: 2019-12-19T04:53:09Z Message: Reason: Status: False Type: Updating Configuration: Name: rendered-worker-f6819366eb455a401c42f8d96ab25c02 Source: API Version: machineconfiguration.openshift.io/v1 Kind: MachineConfig Name: 00-worker API Version: machineconfiguration.openshift.io/v1 Kind: MachineConfig Name: 01-worker-container-runtime API Version: machineconfiguration.openshift.io/v1 Kind: MachineConfig Name: 01-worker-kubelet API Version: machineconfiguration.openshift.io/v1 Kind: MachineConfig Name: 51-worker-rh-registry-trust API Version: machineconfiguration.openshift.io/v1 Kind: MachineConfig Name: 99-worker-92697796-2203-11ea-b48c-fa163e3940e5-registries API Version: machineconfiguration.openshift.io/v1 Kind: MachineConfig Name: 99-worker-ssh Degraded Machine Count: 0 Machine Count: 3 Observed Generation: 4 Ready Machine Count: 3 Unavailable Machine Count: 0 Updated Machine Count: 3 ...NoteLe paramètre

Observed Generationindique un nombre accru basé sur la génération de la configuration produite par le contrôleur. Ce contrôleur met à jour cette valeur même s'il ne parvient pas à traiter la spécification et à générer une révision. La valeurConfiguration Sourcerenvoie à la configuration51-worker-rh-registry-trust.Confirmez l'existence du fichier

policy.jsonà l'aide de la commande suivante :$ oc debug node/<node> -- chroot /host cat /etc/containers/policy.json

Exemple de sortie

Starting pod/<node>-debug ... To use host binaries, run `chroot /host` { "default": [ { "type": "insecureAcceptAnything" } ], "transports": { "docker": { "registry.access.redhat.com": [ { "type": "signedBy", "keyType": "GPGKeys", "keyPath": "/etc/pki/rpm-gpg/RPM-GPG-KEY-redhat-release" } ], "registry.redhat.io": [ { "type": "signedBy", "keyType": "GPGKeys", "keyPath": "/etc/pki/rpm-gpg/RPM-GPG-KEY-redhat-release" } ] }, "docker-daemon": { "": [ { "type": "insecureAcceptAnything" } ] } } }Confirmez l'existence du fichier

registry.redhat.io.yamlà l'aide de la commande suivante :$ oc debug node/<node> -- chroot /host cat /etc/containers/registries.d/registry.redhat.io.yaml

Exemple de sortie

Starting pod/<node>-debug ... To use host binaries, run `chroot /host` docker: registry.redhat.io: sigstore: https://registry.redhat.io/containers/sigstoreConfirmez l'existence du fichier

registry.access.redhat.com.yamlà l'aide de la commande suivante :$ oc debug node/<node> -- chroot /host cat /etc/containers/registries.d/registry.access.redhat.com.yaml

Exemple de sortie

Starting pod/<node>-debug ... To use host binaries, run `chroot /host` docker: registry.access.redhat.com: sigstore: https://access.redhat.com/webassets/docker/content/sigstore

2.4.3. Ressources supplémentaires

2.5. Comprendre la conformité

Pour de nombreux clients d'OpenShift Container Platform, la préparation réglementaire, ou la conformité, est requise à un certain niveau avant que tout système puisse être mis en production. Cette préparation réglementaire peut être imposée par des normes nationales, des normes industrielles ou le cadre de gouvernance d'entreprise de l'organisation.

2.5.1. Comprendre la conformité et la gestion des risques

La conformité FIPS est l'un des éléments les plus critiques requis dans les environnements hautement sécurisés, afin de garantir que seules les technologies cryptographiques prises en charge sont autorisées sur les nœuds.

The use of FIPS Validated / Modules in Process cryptographic libraries is only supported on OpenShift Container Platform deployments on the x86_64 architecture.

Pour comprendre le point de vue de Red Hat sur les cadres de conformité d'OpenShift Container Platform, reportez-vous au chapitre Gestion des risques et préparation aux réglementations du livre-guide sur la sécurité d'OpenShift.

Ressources supplémentaires

2.6. Sécuriser le contenu des conteneurs

Pour garantir la sécurité du contenu de vos conteneurs, vous devez commencer par des images de base fiables, telles que les Red Hat Universal Base Images, et ajouter des logiciels fiables. Pour vérifier la sécurité continue de vos images de conteneurs, il existe des outils Red Hat et des outils tiers pour analyser les images.

2.6.1. Sécurisation à l'intérieur du conteneur

Les applications et les infrastructures sont composées d'éléments facilement disponibles, dont beaucoup sont des logiciels libres tels que le système d'exploitation Linux, JBoss Web Server, PostgreSQL et Node.js.

Des versions conteneurisées de ces paquets sont également disponibles. Cependant, vous devez savoir d'où proviennent les paquets, quelles sont les versions utilisées, qui les a construits et s'ils contiennent du code malveillant.

Voici quelques questions auxquelles il faut répondre :

- Ce qui se trouve à l'intérieur des conteneurs risque-t-il de compromettre votre infrastructure ?

- Existe-t-il des vulnérabilités connues dans la couche applicative ?

- Les couches du système d'exécution et du système d'exploitation sont-elles à jour ?

En construisant vos conteneurs à partir des images de base universelles de Red Hat (UBI), vous êtes assuré d'avoir une base pour vos images de conteneurs qui consiste en les mêmes logiciels emballés par RPM que ceux inclus dans Red Hat Enterprise Linux. Aucun abonnement n'est nécessaire pour utiliser ou redistribuer les images UBI.

Pour assurer la sécurité continue des conteneurs eux-mêmes, les fonctions d'analyse de sécurité, utilisées directement à partir de RHEL ou ajoutées à OpenShift Container Platform, peuvent vous alerter lorsqu'une image que vous utilisez présente des vulnérabilités. L'analyse d'image OpenSCAP est disponible dans RHEL et Red Hat Quay Container Security Operator peut être ajouté pour vérifier les images de conteneurs utilisées dans OpenShift Container Platform.

2.6.2. Créer des images redistribuables avec UBI

Pour créer des applications conteneurisées, vous commencez généralement par une image de base fiable qui offre les composants habituellement fournis par le système d'exploitation. Il s'agit notamment des bibliothèques, des utilitaires et des autres fonctionnalités que l'application s'attend à trouver dans le système de fichiers du système d'exploitation.

Les images de base universelles de Red Hat (UBI) ont été créées pour encourager toute personne construisant ses propres conteneurs à commencer par une image entièrement constituée de paquets rpm Red Hat Enterprise Linux et d'autres contenus. Ces images UBI sont régulièrement mises à jour pour tenir compte des correctifs de sécurité et sont libres d'utilisation et de redistribution avec des images de conteneurs construites pour inclure vos propres logiciels.

Effectuez une recherche dans le catalogue de l'écosystème Red Hat pour trouver et vérifier l'état de différentes images UBI. En tant que créateur d'images de conteneurs sécurisés, vous pourriez être intéressé par ces deux types généraux d'images UBI :

-

UBI: Il existe des images UBI standard pour RHEL 7 et 8 (

ubi7/ubietubi8/ubi), ainsi que des images minimales basées sur ces systèmes (ubi7/ubi-minimaletubi8/ubi-mimimal). Toutes ces images sont préconfigurées pour pointer vers des dépôts libres de logiciels RHEL que vous pouvez ajouter aux images de conteneurs que vous construisez, en utilisant les commandes standardyumetdnf. Red Hat encourage l'utilisation de ces images sur d'autres distributions, telles que Fedora et Ubuntu. -

Red Hat Software Collections: Faites une recherche dans le catalogue de l'écosystème Red Hat pour

rhscl/afin de trouver des images créées pour être utilisées en tant qu'images de base pour des types d'applications spécifiques. Par exemple, il existe des images rhscl Apache httpd (rhscl/httpd-*), Python (rhscl/python-*), Ruby (rhscl/ruby-*), Node.js (rhscl/nodejs-*) et Perl (rhscl/perl-*).

Gardez à l'esprit que si les images UBI sont librement disponibles et redistribuables, la prise en charge de ces images par Red Hat n'est disponible que par le biais d'abonnements aux produits Red Hat.

Voir Utilisation des images de base universelles de Red Hat dans la documentation de Red Hat Enterprise Linux pour obtenir des informations sur la manière d'utiliser et de construire sur des images UBI standard, minimales et init.

2.6.3. Analyse de sécurité dans RHEL

Pour les systèmes Red Hat Enterprise Linux (RHEL), l'analyse OpenSCAP est disponible à partir du paquetage openscap-utils. Dans RHEL, vous pouvez utiliser la commande openscap-podman pour rechercher les vulnérabilités dans les images. Voir Recherche de vulnérabilités dans les conteneurs et les images de conteneurs dans la documentation de Red Hat Enterprise Linux.

OpenShift Container Platform vous permet d'exploiter les scanners RHEL dans le cadre de votre processus CI/CD. Par exemple, vous pouvez intégrer des outils d'analyse statique du code qui testent les failles de sécurité dans votre code source et des outils d'analyse de la composition des logiciels qui identifient les bibliothèques open source afin de fournir des métadonnées sur ces bibliothèques, telles que les vulnérabilités connues.

2.6.3.1. Analyse des images OpenShift

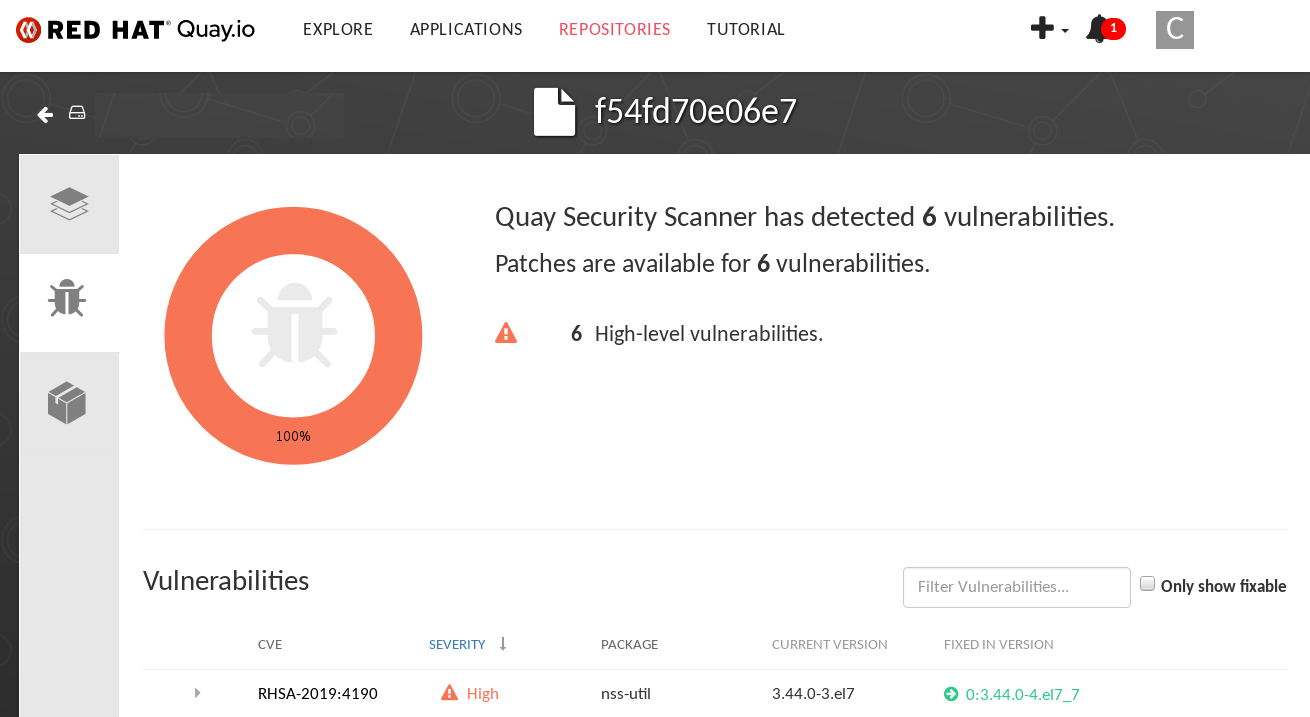

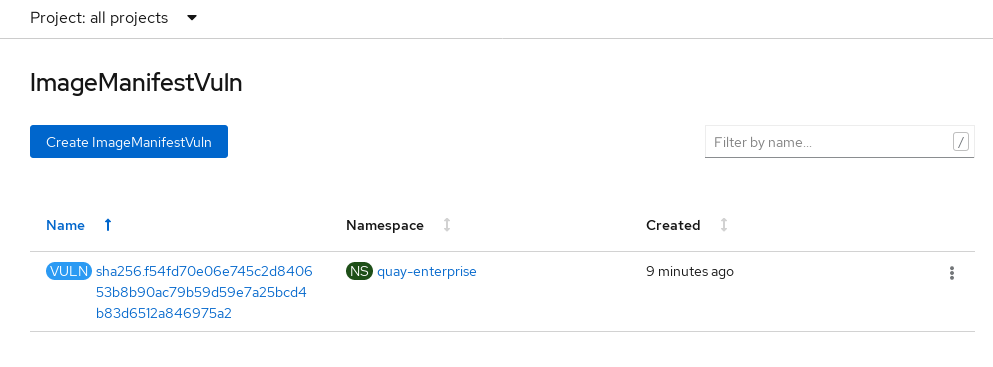

Pour les images de conteneurs qui sont exécutées dans OpenShift Container Platform et qui sont tirées des registres Red Hat Quay, vous pouvez utiliser un opérateur pour lister les vulnérabilités de ces images. L'opérateur Red Hat Quay Container Security peut être ajouté à OpenShift Container Platform pour fournir des rapports de vulnérabilité pour les images ajoutées aux espaces de noms sélectionnés.

L'analyse des images de conteneurs pour Red Hat Quay est effectuée par l'analyseur de sécurité Clair. Dans Red Hat Quay, Clair peut rechercher et signaler les vulnérabilités dans les images construites à partir des logiciels des systèmes d'exploitation RHEL, CentOS, Oracle, Alpine, Debian et Ubuntu.

2.6.4. Intégration de l'analyse externe

OpenShift Container Platform utilise les annotations d'objets pour étendre les fonctionnalités. Les outils externes, tels que les scanners de vulnérabilité, peuvent annoter les objets image avec des métadonnées pour résumer les résultats et contrôler l'exécution du pod. Cette section décrit le format reconnu de cette annotation afin qu'elle puisse être utilisée de manière fiable dans les consoles pour afficher des données utiles aux utilisateurs.

2.6.4.1. Métadonnées de l'image

Il existe différents types de données relatives à la qualité de l'image, notamment les vulnérabilités des paquets et le respect des licences des logiciels libres. En outre, il peut y avoir plus d'un fournisseur de ces métadonnées. C'est pourquoi le format d'annotation suivant a été réservé :

quality.images.openshift.io/<qualityType>.<providerId> : {}Tableau 2.1. Format des clés d'annotation

| Composant | Description | Valeurs acceptables |

|---|---|---|

|

| Type de métadonnées |

|

|

| Chaîne d'identification du prestataire |

|

2.6.4.1.1. Exemples de clés d'annotation

quality.images.openshift.io/vulnerability.blackduck: {}

quality.images.openshift.io/vulnerability.jfrog: {}

quality.images.openshift.io/license.blackduck: {}

quality.images.openshift.io/vulnerability.openscap: {}La valeur de l'annotation de la qualité de l'image est une donnée structurée qui doit respecter le format suivant :

Tableau 2.2. Format des valeurs d'annotation

| Field | Nécessaire ? | Description | Type |

|---|---|---|---|

|

| Oui | Nom d'affichage du prestataire | String |

|

| Oui | Horodatage de l'analyse | String |

|

| Non | Brève description | String |

|

| Oui | URL de la source d'information ou de plus amples détails. Requis pour que l'utilisateur puisse valider les données. | String |

|

| Non | Version du scanner | String |

|

| Non | Conformité réussie ou échouée | Booléen |

|

| Non | Résumé des problèmes constatés | Liste (voir tableau ci-dessous) |

Le champ summary doit respecter le format suivant :

Tableau 2.3. Format de la valeur du champ résumé

| Field | Description | Type |

|---|---|---|

|

| Afficher le libellé du composant (par exemple, "critique", "important", "modéré", "faible" ou "santé") | String |

|

| Données relatives à ce composant (par exemple, nombre de vulnérabilités trouvées ou score) | String |

|

|

Indice de composant permettant d'ordonner et d'attribuer une représentation graphique. La valeur est comprise entre | Integer |

|

| URL de la source d'information pour plus de détails. En option. | String |

2.6.4.1.2. Exemples de valeurs d'annotation

Cet exemple montre une annotation OpenSCAP pour une image avec des données de résumé de vulnérabilité et un booléen de conformité :

Annotation OpenSCAP

{

"name": "OpenSCAP",

"description": "OpenSCAP vulnerability score",

"timestamp": "2016-09-08T05:04:46Z",

"reference": "https://www.open-scap.org/930492",

"compliant": true,

"scannerVersion": "1.2",

"summary": [

{ "label": "critical", "data": "4", "severityIndex": 3, "reference": null },

{ "label": "important", "data": "12", "severityIndex": 2, "reference": null },

{ "label": "moderate", "data": "8", "severityIndex": 1, "reference": null },

{ "label": "low", "data": "26", "severityIndex": 0, "reference": null }

]

}

Cet exemple montre la section Images de conteneurs du catalogue de l'écosystème Red Hat pour une image avec des données d'index de santé avec une URL externe pour des détails supplémentaires :

Annotation du catalogue de l'écosystème Red Hat

{

"name": "Red Hat Ecosystem Catalog",

"description": "Container health index",

"timestamp": "2016-09-08T05:04:46Z",

"reference": "https://access.redhat.com/errata/RHBA-2016:1566",

"compliant": null,

"scannerVersion": "1.2",

"summary": [

{ "label": "Health index", "data": "B", "severityIndex": 1, "reference": null }

]

}

2.6.4.2. Annoter les objets de l'image

Alors que les objets de flux d'images sont ce que l'utilisateur final d'OpenShift Container Platform utilise, les objets d'images sont annotés avec des métadonnées de sécurité. Les objets image sont de type "cluster-scoped", c'est-à-dire qu'ils pointent vers une seule image qui peut être référencée par de nombreux flux d'images et tags.

2.6.4.2.1. Exemple de commande CLI annotate

Remplacez <image> par un condensé d'image, par exemple sha256:401e359e0f45bfdcf004e258b72e253fd07fba8cc5c6f2ed4f4608fb119ecc2:

$ oc annotate image <image> \

quality.images.openshift.io/vulnerability.redhatcatalog='{ \

"name": "Red Hat Ecosystem Catalog", \

"description": "Container health index", \

"timestamp": "2020-06-01T05:04:46Z", \

"compliant": null, \

"scannerVersion": "1.2", \

"reference": "https://access.redhat.com/errata/RHBA-2020:2347", \

"summary": "[ \

{ "label": "Health index", "data": "B", "severityIndex": 1, "reference": null } ]" }'2.6.4.3. Contrôler l'exécution des pods

Utilisez la politique d'image images.openshift.io/deny-execution pour contrôler par programme si une image peut être exécutée.

2.6.4.3.1. Exemple d'annotation

annotations: images.openshift.io/deny-execution: true

2.6.4.4. Référence d'intégration

Dans la plupart des cas, les outils externes tels que les scanners de vulnérabilité développent un script ou un plugin qui surveille les mises à jour de l'image, effectue l'analyse et annote l'objet image associé avec les résultats. Généralement, cette automatisation fait appel aux API REST d'OpenShift Container Platform 4.12 pour écrire l'annotation. Voir OpenShift Container Platform REST APIs pour des informations générales sur les API REST.

2.6.4.4.1. Exemple d'appel à l'API REST

L'exemple d'appel suivant, qui utilise curl, remplace la valeur de l'annotation. Veillez à remplacer les valeurs de <token>, <openshift_server>, <image_id>, et <image_annotation>.

Appel de l'API du correctif

$ curl -X PATCH \

-H "Authorization: Bearer <token>" \

-H "Content-Type: application/merge-patch+json" \

https://<openshift_server>:6443/apis/image.openshift.io/v1/images/<image_id> \

--data '{ <image_annotation> }'

Voici un exemple de données de charge utile sur le site PATCH:

Données d'appel de correctifs

{

"metadata": {

"annotations": {

"quality.images.openshift.io/vulnerability.redhatcatalog":

"{ 'name': 'Red Hat Ecosystem Catalog', 'description': 'Container health index', 'timestamp': '2020-06-01T05:04:46Z', 'compliant': null, 'reference': 'https://access.redhat.com/errata/RHBA-2020:2347', 'summary': [{'label': 'Health index', 'data': '4', 'severityIndex': 1, 'reference': null}] }"

}

}

}

Ressources supplémentaires

2.7. Utiliser les registres de conteneurs en toute sécurité

Les registres de conteneurs stockent les images des conteneurs :

- Rendre les images accessibles aux autres

- Organiser les images dans des référentiels qui peuvent inclure plusieurs versions d'une image

- Il est possible de limiter l'accès aux images en fonction de différentes méthodes d'authentification ou de les rendre accessibles au public

Il existe des registres de conteneurs publics, tels que Quay.io et Docker Hub, où de nombreuses personnes et organisations partagent leurs images. Le Red Hat Registry propose des images Red Hat et partenaires prises en charge, tandis que le Red Hat Ecosystem Catalog propose des descriptions détaillées et des contrôles de santé pour ces images. Pour gérer votre propre registre, vous pouvez acheter un registre de conteneurs tel que Red Hat Quay.

Du point de vue de la sécurité, certains registres proposent des fonctions spéciales pour vérifier et améliorer la santé de vos conteneurs. Par exemple, Red Hat Quay propose une analyse des vulnérabilités des conteneurs avec Clair Security Scanner, des déclencheurs de construction pour reconstruire automatiquement les images lorsque le code source est modifié dans GitHub et d'autres emplacements, et la possibilité d'utiliser le contrôle d'accès basé sur les rôles (RBAC) pour sécuriser l'accès aux images.

2.7.1. Savoir d'où viennent les conteneurs ?

Il existe des outils que vous pouvez utiliser pour analyser et suivre le contenu de vos images de conteneurs téléchargées et déployées. Cependant, il existe de nombreuses sources publiques d'images de conteneurs. Lorsque vous utilisez des registres de conteneurs publics, vous pouvez ajouter une couche de protection en utilisant des sources fiables.

2.7.2. Conteneurs immuables et certifiés

La consommation des mises à jour de sécurité est particulièrement importante lors de la gestion de immutable containers. Les conteneurs immuables sont des conteneurs qui ne seront jamais modifiés en cours d'exécution. Lorsque vous déployez des conteneurs immuables, vous n'intervenez pas dans le conteneur en cours d'exécution pour remplacer un ou plusieurs binaires. D'un point de vue opérationnel, vous reconstruisez et redéployez une image de conteneur mise à jour pour remplacer un conteneur au lieu de le modifier.

Les images certifiées par Red Hat sont les suivantes :

- Absence de vulnérabilités connues dans les composants ou les couches de la plate-forme

- Compatible avec toutes les plateformes RHEL, du bare metal au cloud

- Supporté par Red Hat

La liste des vulnérabilités connues est en constante évolution, vous devez donc suivre le contenu de vos images de conteneurs déployées, ainsi que les images nouvellement téléchargées, au fil du temps. Vous pouvez utiliser les Red Hat Security Advisories (RHSA ) pour vous avertir de tout problème récemment découvert dans les images de conteneurs certifiées par Red Hat, et vous diriger vers l'image mise à jour. Vous pouvez également consulter le catalogue de l'écosystème Red Hat pour rechercher ces problèmes et d'autres problèmes liés à la sécurité pour chaque image Red Hat.

2.7.3. Obtenir des conteneurs à partir du Red Hat Registry et de l'Ecosystem Catalog

Red Hat répertorie les images de conteneurs certifiées pour les produits Red Hat et les offres des partenaires dans la section Images de conteneurs du catalogue de l'écosystème Red Hat. À partir de ce catalogue, vous pouvez voir les détails de chaque image, y compris le CVE, les listes de paquets logiciels et les scores de santé.

Les images Red Hat sont en fait stockées dans ce que l'on appelle le Red Hat Registry, qui est représenté par un registre de conteneurs public (registry.access.redhat.com) et un registre authentifié (registry.redhat.io). Les deux comprennent fondamentalement le même ensemble d'images de conteneurs, registry.redhat.io comprenant quelques images supplémentaires qui nécessitent une authentification avec les informations d'identification de l'abonnement Red Hat.

Le contenu des conteneurs est surveillé par Red Hat pour détecter les vulnérabilités et est mis à jour régulièrement. Lorsque Red Hat publie des mises à jour de sécurité, telles que des correctifs pour glibc, DROWN, ou Dirty Cow, toutes les images de conteneurs affectées sont également reconstruites et poussées vers le Red Hat Registry.

Red Hat utilise une adresse health index pour refléter le risque de sécurité de chaque conteneur fourni par le catalogue de l'écosystème Red Hat. Étant donné que les conteneurs consomment des logiciels fournis par Red Hat et le processus d'errata, les conteneurs anciens et périmés ne sont pas sûrs, tandis que les nouveaux conteneurs sont plus sûrs.

Pour illustrer l'âge des conteneurs, le Red Hat Ecosystem Catalog utilise un système de classement. Une note de fraîcheur est une mesure des errata de sécurité les plus anciens et les plus graves disponibles pour une image. \L'image "A" est plus à jour que l'image "F". Voir les notes de l'Indice de santé des conteneurs utilisées dans le Catalogue de l'écosystème Red Hat pour plus de détails sur ce système de notation.

Consultez le Centre de sécurité des produits Red Hat pour obtenir des détails sur les mises à jour de sécurité et les vulnérabilités liées aux logiciels Red Hat. Consultez les avis de sécurité de Red Hat pour rechercher des avis spécifiques et des CVE.

2.7.4. Registre des conteneurs OpenShift

OpenShift Container Platform inclut OpenShift Container Registry, un registre privé fonctionnant comme un composant intégré de la plateforme que vous pouvez utiliser pour gérer vos images de conteneurs. L'OpenShift Container Registry fournit des contrôles d'accès basés sur les rôles qui vous permettent de gérer qui peut tirer et pousser quelles images de conteneurs.

OpenShift Container Platform prend également en charge l'intégration avec d'autres registres privés que vous utilisez peut-être déjà, tels que Red Hat Quay.

Ressources supplémentaires

2.7.5. Stockage de conteneurs à l'aide de Red Hat Quay

Red Hat Quay est un produit de registre de conteneurs de qualité professionnelle de Red Hat. Le développement de Red Hat Quay se fait par le biais du projet Quay en amont. Red Hat Quay peut être déployé sur site ou via la version hébergée de Red Hat Quay sur Quay.io.

Les fonctionnalités de Red Hat Quay relatives à la sécurité sont les suivantes :

- Time machine: Permet aux images comportant des balises anciennes d'expirer après une période définie ou en fonction d'un délai d'expiration choisi par l'utilisateur.

- Repository mirroring: Vous permet de mettre en miroir d'autres registres pour des raisons de sécurité, comme l'hébergement d'un référentiel public sur Red Hat Quay derrière le pare-feu d'une entreprise, ou pour des raisons de performance, afin de garder les registres plus près de l'endroit où ils sont utilisés.

- Action log storage: Sauvegarder la sortie des journaux de Red Hat Quay dans le stockage Elasticsearch pour permettre une recherche et une analyse ultérieures.

- Clair security scanning: Analyser les images par rapport à diverses bases de données de vulnérabilités Linux, en fonction de l'origine de chaque image de conteneur.

- Internal authentication: Utilisez la base de données locale par défaut pour gérer l'authentification RBAC à Red Hat Quay ou choisissez entre LDAP, Keystone (OpenStack), l'authentification personnalisée JWT ou l'authentification par jeton d'application externe.

- External authorization (OAuth): Autoriser l'accès à Red Hat Quay à partir de GitHub, GitHub Enterprise ou Google Authentication.

- Access settings: Générer des jetons pour permettre l'accès à Red Hat Quay à partir de docker, rkt, l'accès anonyme, les comptes créés par l'utilisateur, les mots de passe client cryptés, ou l'autocomplétion du préfixe du nom d'utilisateur.

L'intégration de Red Hat Quay avec OpenShift Container Platform se poursuit, avec plusieurs opérateurs OpenShift Container Platform particulièrement intéressants. L'opérateur Quay Bridge vous permet de remplacer le registre d'images interne d'OpenShift par Red Hat Quay. L'opérateur Red Hat Quay Container Security Operator vous permet de vérifier les vulnérabilités des images exécutées dans OpenShift Container Platform qui ont été extraites des registres Red Hat Quay.

2.8. Sécuriser le processus de construction

Dans un environnement de conteneurs, le processus de construction du logiciel est l'étape du cycle de vie où le code de l'application est intégré aux bibliothèques d'exécution requises. La gestion de ce processus est essentielle pour sécuriser la pile logicielle.

2.8.1. Construire une fois, déployer partout

L'utilisation d'OpenShift Container Platform comme plateforme standard pour les constructions de conteneurs vous permet de garantir la sécurité de l'environnement de construction. L'adhésion à la philosophie "construire une fois, déployer partout" permet de s'assurer que le produit du processus de construction est exactement ce qui est déployé en production.

Il est également important de maintenir l'immuabilité de vos conteneurs. Vous ne devez pas patcher les conteneurs en cours d'exécution, mais les reconstruire et les redéployer.

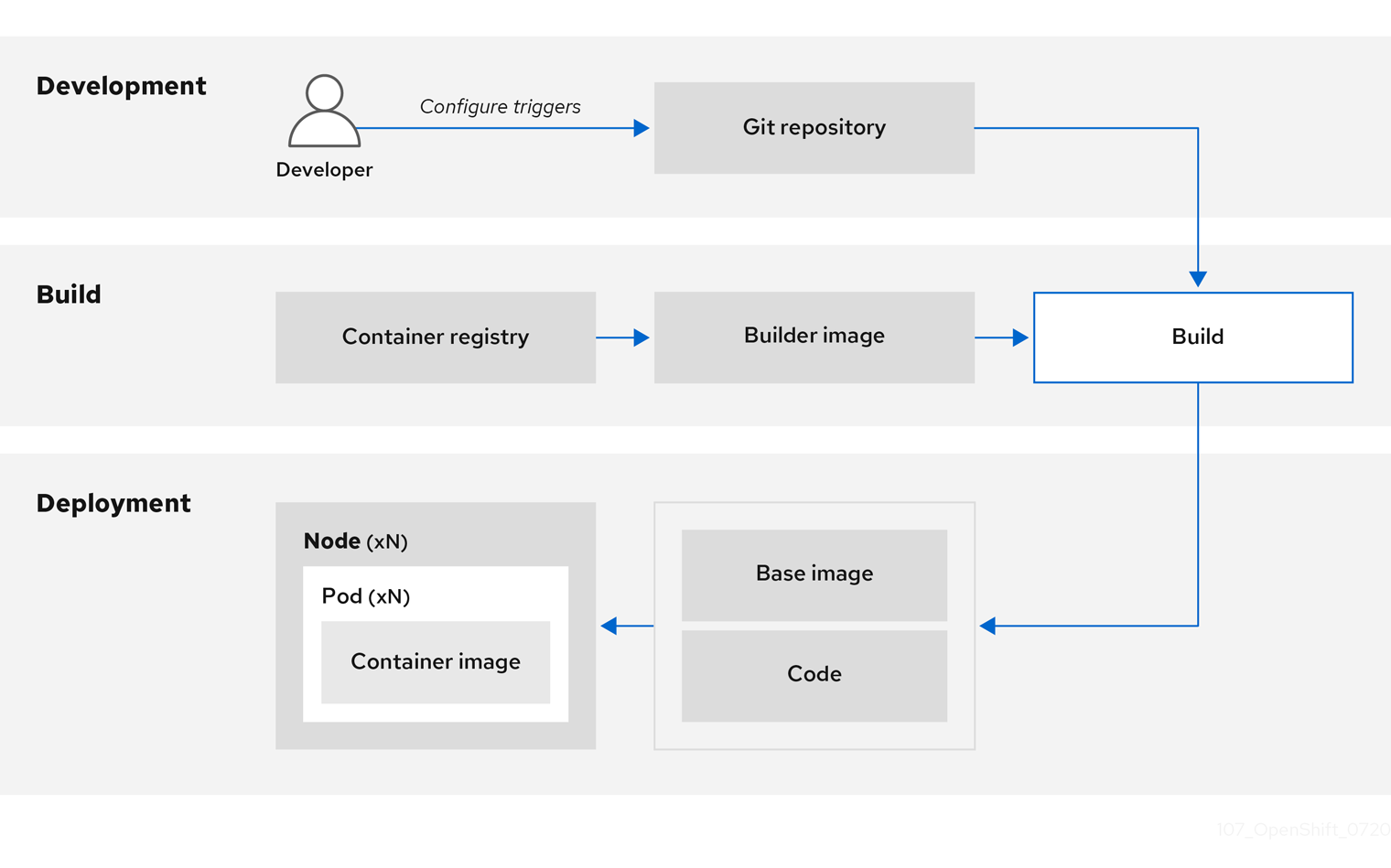

Au fur et à mesure que votre logiciel passe par les étapes de construction, de test et de production, il est important que les outils qui composent votre chaîne d'approvisionnement en logiciels soient fiables. La figure suivante illustre le processus et les outils qui pourraient être incorporés dans une chaîne d'approvisionnement de logiciels de confiance pour les logiciels conteneurisés :

OpenShift Container Platform peut être intégrée à des référentiels de code fiables (tels que GitHub) et à des plateformes de développement (telles que Che) pour créer et gérer du code sécurisé. Les tests unitaires peuvent s'appuyer sur Cucumber et JUnit. Vous pouvez inspecter vos conteneurs pour détecter les vulnérabilités et les problèmes de conformité avec Anchore ou Twistlock, et utiliser des outils d'analyse d'images tels qu'AtomicScan ou Clair. Des outils tels que Sysdig peuvent assurer une surveillance continue de vos applications conteneurisées.

2.8.2. Gestion des constructions

Vous pouvez utiliser Source-to-Image (S2I) pour combiner le code source et les images de base. Builder images utilise S2I pour permettre à vos équipes de développement et d'exploitation de collaborer sur un environnement de construction reproductible. Avec les images S2I de Red Hat disponibles en tant qu'images de base universelles (UBI), vous pouvez désormais redistribuer librement vos logiciels avec des images de base construites à partir de véritables paquets RHEL RPM. Red Hat a supprimé les restrictions d'abonnement pour permettre cela.

Lorsque les développeurs livrent du code avec Git pour une application utilisant des images de construction, OpenShift Container Platform peut exécuter les fonctions suivantes :

- Déclencher, à l'aide de webhooks sur le dépôt de code ou d'un autre processus d'intégration continue automatisé, l'assemblage automatique d'une nouvelle image à partir des artefacts disponibles, de l'image du constructeur S2I et du code nouvellement livré.

- Déployer automatiquement l'image nouvellement créée pour la tester.

- Promouvoir l'image testée vers la production où elle peut être déployée automatiquement à l'aide d'un processus CI.

Vous pouvez utiliser le registre intégré OpenShift Container Registry pour gérer l'accès aux images finales. Les images S2I et les images natives sont automatiquement poussées vers votre OpenShift Container Registry.

En plus de Jenkins for CI, vous pouvez également intégrer votre propre environnement de construction et de CI à OpenShift Container Platform à l'aide d'API RESTful, ainsi qu'utiliser n'importe quel registre d'images compatible avec l'API.

2.8.3. Sécuriser les entrées lors de la construction

Dans certains cas, les opérations de compilation nécessitent des informations d'identification pour accéder à des ressources dépendantes, mais il n'est pas souhaitable que ces informations d'identification soient disponibles dans l'image finale de l'application produite par la compilation. Vous pouvez définir des secrets d'entrée à cette fin.

Par exemple, lorsque vous créez une application Node.js, vous pouvez configurer votre miroir privé pour les modules Node.js. Pour télécharger des modules à partir de ce miroir privé, vous devez fournir un fichier .npmrc personnalisé pour la construction qui contient une URL, un nom d'utilisateur et un mot de passe. Pour des raisons de sécurité, vous ne devez pas exposer vos informations d'identification dans l'image de l'application.

Dans cet exemple, vous pouvez ajouter un secret de saisie à un nouvel objet BuildConfig:

Créer le secret, s'il n'existe pas :

$ oc create secret generic secret-npmrc --from-file=.npmrc=~/.npmrc

Cela crée un nouveau secret nommé

secret-npmrc, qui contient le contenu encodé en base64 du fichier~/.npmrc.Ajoutez le secret à la section

sourcedans l'objet existantBuildConfig:source: git: uri: https://github.com/sclorg/nodejs-ex.git secrets: - destinationDir: . secret: name: secret-npmrcPour inclure le secret dans un nouvel objet

BuildConfig, exécutez la commande suivante :$ oc new-build \ openshift/nodejs-010-centos7~https://github.com/sclorg/nodejs-ex.git \ --build-secret secret-npmrc

2.8.4. Concevoir votre processus de construction

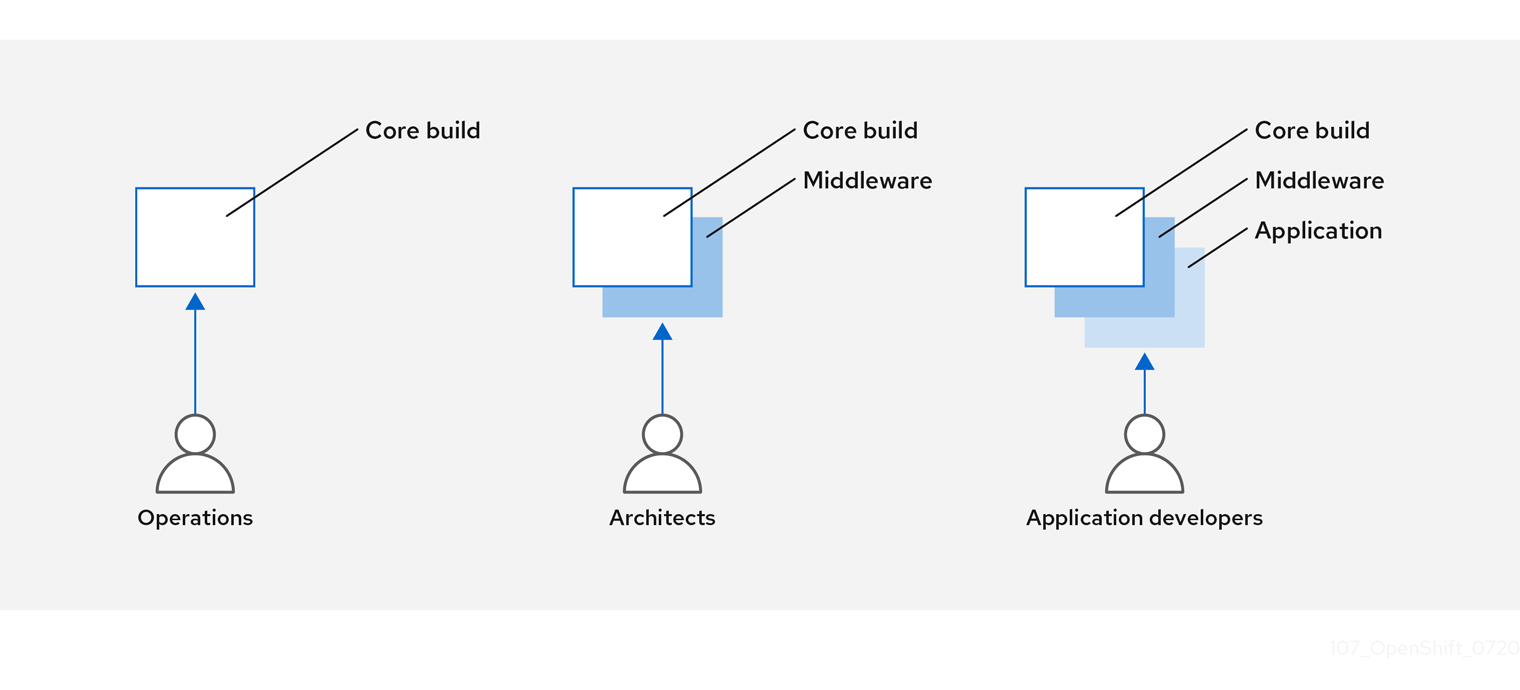

Vous pouvez concevoir votre gestion d'image de conteneur et votre processus de construction pour utiliser des couches de conteneur afin de pouvoir séparer le contrôle.

Par exemple, une équipe d'exploitation gère les images de base, tandis que les architectes gèrent les logiciels intermédiaires, les moteurs d'exécution, les bases de données et d'autres solutions. Les développeurs peuvent alors se concentrer sur les couches applicatives et sur l'écriture du code.

Comme de nouvelles vulnérabilités sont identifiées chaque jour, vous devez vérifier de manière proactive le contenu des conteneurs au fil du temps. Pour ce faire, vous devez intégrer des tests de sécurité automatisés dans votre processus de construction ou d'intégration. Par exemple :

- SAST / DAST - Outils de test de sécurité statique et dynamique.

- Des scanners permettant de vérifier en temps réel les vulnérabilités connues. Les outils de ce type cataloguent les paquets open source dans votre conteneur, vous informent des vulnérabilités connues et vous mettent à jour lorsque de nouvelles vulnérabilités sont découvertes dans des paquets précédemment analysés.

Votre processus d'intégration des données doit inclure des politiques qui signalent les constructions présentant des problèmes découverts par les analyses de sécurité, afin que votre équipe puisse prendre les mesures appropriées pour résoudre ces problèmes. Vous devez signer vos conteneurs personnalisés pour vous assurer que rien n'est altéré entre la construction et le déploiement.

En utilisant la méthodologie GitOps, vous pouvez utiliser les mêmes mécanismes CI/CD pour gérer non seulement les configurations de vos applications, mais aussi votre infrastructure OpenShift Container Platform.

2.8.5. Construire des applications Knative sans serveur

En s'appuyant sur Kubernetes et Kourier, vous pouvez construire, déployer et gérer des applications sans serveur en utilisant OpenShift Serverless dans OpenShift Container Platform.

Comme pour les autres builds, vous pouvez utiliser les images S2I pour construire vos conteneurs, puis les servir à l'aide des services Knative. Visualisez les builds d'applications Knative via la vue Topology de la console web OpenShift Container Platform.

2.8.6. Ressources supplémentaires

2.9. Déployer des conteneurs

Vous pouvez utiliser diverses techniques pour vous assurer que les conteneurs que vous déployez contiennent le dernier contenu de qualité de production et qu'ils n'ont pas été altérés. Ces techniques comprennent la mise en place de déclencheurs de construction pour intégrer le code le plus récent et l'utilisation de signatures pour s'assurer que le conteneur provient d'une source fiable et n'a pas été modifié.

2.9.1. Contrôler les déploiements de conteneurs avec des déclencheurs

Si quelque chose se produit au cours du processus de construction, ou si une vulnérabilité est découverte après le déploiement d'une image, vous pouvez utiliser des outils pour un déploiement automatisé, basé sur des règles, afin de remédier à la situation. Vous pouvez utiliser des déclencheurs pour reconstruire et remplacer les images, en garantissant le processus de conteneurs immuables, au lieu de patcher les conteneurs en cours d'exécution, ce qui n'est pas recommandé.

Par exemple, vous construisez une application en utilisant trois couches d'images de conteneurs : le noyau, l'intergiciel et les applications. Un problème est découvert dans l'image core et cette image est reconstruite. Une fois la construction terminée, l'image est poussée vers votre OpenShift Container Registry. OpenShift Container Platform détecte que l'image a changé et reconstruit et déploie automatiquement l'image de l'application, en fonction des déclencheurs définis. Ce changement incorpore les bibliothèques corrigées et garantit que le code de production est identique à l'image la plus récente.

Vous pouvez utiliser la commande oc set triggers pour définir un déclencheur de déploiement. Par exemple, pour définir un déclencheur de déploiement appelé déploiement-exemple :

$ oc set triggers deploy/deployment-example \

--from-image=example:latest \

--containers=web2.9.2. Contrôle des sources d'images pouvant être déployées

Il est important que les images prévues soient effectivement déployées, que les images et leur contenu proviennent de sources fiables et qu'elles n'aient pas été modifiées. La signature cryptographique fournit cette assurance. OpenShift Container Platform permet aux administrateurs de clusters d'appliquer une politique de sécurité plus ou moins large, en fonction de l'environnement de déploiement et des exigences de sécurité. Deux paramètres définissent cette politique :

- un ou plusieurs registres, avec un espace de noms de projet optionnel

- le type de confiance, tel qu'accepter, rejeter ou exiger une ou plusieurs clés publiques

Vous pouvez utiliser ces paramètres de stratégie pour autoriser, refuser ou exiger une relation de confiance pour des registres entiers, des parties de registres ou des images individuelles. En utilisant des clés publiques de confiance, vous pouvez vous assurer que la source est vérifiée cryptographiquement. Les règles de stratégie s'appliquent aux nœuds. La stratégie peut être appliquée uniformément à tous les nœuds ou ciblée en fonction des charges de travail des différents nœuds (par exemple, construction, zone ou environnement).

Exemple de fichier de politique de signature d'image

{

"default": [{"type": "reject"}],

"transports": {

"docker": {

"access.redhat.com": [

{

"type": "signedBy",

"keyType": "GPGKeys",

"keyPath": "/etc/pki/rpm-gpg/RPM-GPG-KEY-redhat-release"

}

]

},

"atomic": {

"172.30.1.1:5000/openshift": [

{

"type": "signedBy",

"keyType": "GPGKeys",

"keyPath": "/etc/pki/rpm-gpg/RPM-GPG-KEY-redhat-release"

}

],

"172.30.1.1:5000/production": [

{

"type": "signedBy",

"keyType": "GPGKeys",

"keyPath": "/etc/pki/example.com/pubkey"

}

],

"172.30.1.1:5000": [{"type": "reject"}]

}

}

}

La politique peut être enregistrée sur un nœud sous le nom de /etc/containers/policy.json. La meilleure façon d'enregistrer ce fichier sur un nœud est d'utiliser un nouvel objet MachineConfig. Cet exemple applique les règles suivantes :

-

Exiger que les images du Red Hat Registry (

registry.access.redhat.com) soient signées par la clé publique de Red Hat. -

Exiger que les images de votre OpenShift Container Registry dans l'espace de noms

openshiftsoient signées par la clé publique Red Hat. -

Exigez que les images de votre OpenShift Container Registry dans l'espace de noms

productionsoient signées par la clé publique deexample.com. -

Rejeter tous les autres registres non spécifiés dans la définition globale de

default.

2.9.3. Utilisation des transports de signature

Un transport de signature est un moyen de stocker et de récupérer le blob de signature binaire. Il existe deux types de transport de signature.

-

atomic: Géré par l'API de la plateforme OpenShift Container. -

docker: Servi en tant que fichier local ou par un serveur web.

L'API OpenShift Container Platform gère les signatures qui utilisent le type de transport atomic. Vous devez stocker les images qui utilisent ce type de signature dans votre OpenShift Container Registry. Comme l'API docker/distribution extensions découvre automatiquement le point de terminaison de la signature de l'image, aucune configuration supplémentaire n'est nécessaire.

Les signatures qui utilisent le type de transport docker sont servies par un serveur de fichiers ou un serveur web local. Ces signatures sont plus souples ; vous pouvez servir des images à partir de n'importe quel registre d'images de conteneurs et utiliser un serveur indépendant pour fournir des signatures binaires.

Cependant, le type de transport docker nécessite une configuration supplémentaire. Vous devez configurer les nœuds avec l'URI du serveur de signatures en plaçant des fichiers YAML aux noms arbitraires dans un répertoire du système hôte, /etc/containers/registries.d par défaut. Les fichiers de configuration YAML contiennent un URI de registre et un URI de serveur de signatures, ou sigstore:

Exemple de fichier registries.d

docker:

access.redhat.com:

sigstore: https://access.redhat.com/webassets/docker/content/sigstore

Dans cet exemple, le Red Hat Registry, access.redhat.com, est le serveur de signatures qui fournit des signatures pour le type de transport docker. Son URI est défini dans le paramètre sigstore. Vous pouvez nommer ce fichier /etc/containers/registries.d/redhat.com.yaml et utiliser l'opérateur Machine Config pour placer automatiquement le fichier sur chaque nœud de votre cluster. Aucun redémarrage de service n'est nécessaire puisque les fichiers Policy et registries.d sont chargés dynamiquement par le runtime du conteneur.

2.9.4. Création de secrets et de cartes de configuration

Le type d'objet Secret fournit un mécanisme pour contenir des informations sensibles telles que les mots de passe, les fichiers de configuration du client OpenShift Container Platform, les fichiers dockercfg et les informations d'identification du référentiel source privé. Les secrets découplent le contenu sensible des pods. Vous pouvez monter des secrets dans des conteneurs à l'aide d'un plugin de volume ou le système peut utiliser des secrets pour effectuer des actions au nom d'un pod.

Par exemple, pour ajouter un secret à votre configuration de déploiement afin qu'il puisse accéder à un référentiel d'images privé, procédez comme suit :

Procédure

- Connectez-vous à la console web de OpenShift Container Platform.

- Créer un nouveau projet.

-

Naviguez jusqu'à Resources → Secrets et créez un nouveau secret. Définissez

Secret TypesurImage SecretetAuthentication TypesurImage Registry Credentialspour saisir les informations d'identification permettant d'accéder à un référentiel d'images privé. -

Lors de la création d'une configuration de déploiement (par exemple, à partir de la page Add to Project → Deploy Image ), donnez à

Pull Secretla valeur de votre nouveau secret.

Les cartes de configuration sont similaires aux secrets, mais elles sont conçues pour permettre de travailler avec des chaînes qui ne contiennent pas d'informations sensibles. L'objet ConfigMap contient des paires clé-valeur de données de configuration qui peuvent être consommées dans des pods ou utilisées pour stocker des données de configuration pour des composants du système tels que les contrôleurs.

2.9.5. Automatiser le déploiement continu

Vous pouvez intégrer votre propre outil de déploiement continu (CD) à OpenShift Container Platform.

En tirant parti de CI/CD et d'OpenShift Container Platform, vous pouvez automatiser le processus de reconstruction de l'application afin d'intégrer les dernières corrections, de tester et de veiller à ce qu'elle soit déployée partout dans l'environnement.

Ressources supplémentaires

2.10. Sécuriser la plate-forme de conteneurs

Les API d'OpenShift Container Platform et de Kubernetes sont essentielles pour automatiser la gestion des conteneurs à grande échelle. Les API sont utilisées pour :

- Valider et configurer les données pour les pods, les services et les contrôleurs de réplication.

- Effectuer la validation du projet sur les demandes entrantes et invoquer les déclencheurs sur d'autres composants majeurs du système.

Les fonctionnalités liées à la sécurité dans OpenShift Container Platform qui sont basées sur Kubernetes comprennent :

- Multitenancy, qui combine les contrôles d'accès basés sur les rôles et les politiques de réseau pour isoler les conteneurs à plusieurs niveaux.

- Les plugins d'admission, qui forment des frontières entre une API et ceux qui font des demandes à l'API.

OpenShift Container Platform utilise des opérateurs pour automatiser et simplifier la gestion des fonctions de sécurité au niveau de Kubernetes.

2.10.1. Isolement des conteneurs avec multitenancy

La multitenance permet aux applications d'un cluster OpenShift Container Platform appartenant à plusieurs utilisateurs et s'exécutant sur plusieurs hôtes et espaces de noms de rester isolées les unes des autres et des attaques extérieures. Vous obtenez la multitenance en appliquant le contrôle d'accès basé sur les rôles (RBAC) aux espaces de noms Kubernetes.