Évolutivité et performance

Mise à l'échelle de votre cluster OpenShift Container Platform et optimisation des performances dans les environnements de production

Résumé

Chapitre 1. Pratiques recommandées en matière de performance et d'évolutivité

Cette rubrique fournit des pratiques recommandées en matière de performances et d'évolutivité pour OpenShift Container Platform.

1.1. Pratiques recommandées pour la mise à l'échelle du cluster

Les conseils de cette section ne s'appliquent qu'aux installations intégrant un fournisseur de services en nuage.

Appliquez les meilleures pratiques suivantes pour faire évoluer le nombre de machines de travail dans votre cluster OpenShift Container Platform. Vous faites évoluer les machines de travail en augmentant ou en diminuant le nombre de répliques définies dans l'ensemble de machines de travail.

Lors de l'extension de la grappe à un plus grand nombre de nœuds :

- Répartir les nœuds dans toutes les zones disponibles pour une plus grande disponibilité.

- Ne pas dépasser 25 à 50 machines à la fois.

- Envisagez de créer de nouveaux ensembles de machines de calcul dans chaque zone disponible avec des types d'instance alternatifs de taille similaire afin d'atténuer les contraintes de capacité périodiques des fournisseurs. Par exemple, sur AWS, utilisez m5.large et m5d.large.

Les fournisseurs de cloud peuvent mettre en place un quota pour les services API. Il convient donc de faire évoluer progressivement le cluster.

Le contrôleur peut ne pas être en mesure de créer les machines si les répliques dans les ensembles de machines de calcul sont réglées sur des nombres plus élevés en une seule fois. Le nombre de requêtes que la plateforme cloud, sur laquelle OpenShift Container Platform est déployée, est capable de traiter a un impact sur le processus. Le contrôleur commencera à faire plus de requêtes en essayant de créer, de vérifier et de mettre à jour l'état des machines. La plateforme cloud sur laquelle OpenShift Container Platform est déployée a des limites de requêtes API ; des requêtes excessives peuvent conduire à des échecs de création de machines en raison des limitations de la plateforme cloud.

Activez les contrôles de santé des machines lorsque vous passez à un grand nombre de nœuds. En cas de défaillance, les contrôles de santé surveillent l'état des machines et les réparent automatiquement.

Lors de la mise à l'échelle de grappes importantes et denses vers un nombre inférieur de nœuds, cela peut prendre beaucoup de temps car le processus implique la vidange ou l'expulsion des objets s'exécutant sur les nœuds qui sont terminés en parallèle. En outre, le client peut commencer à limiter les requêtes s'il y a trop d'objets à expulser. Les taux de requêtes par seconde (QPS) et de rafales par défaut du client sont actuellement fixés à 5 et 10 respectivement. Ces valeurs ne peuvent pas être modifiées dans OpenShift Container Platform.

1.2. Dimensionnement des nœuds du plan de contrôle

Les besoins en ressources des nœuds du plan de contrôle dépendent du nombre et du type de nœuds et d'objets dans le cluster. Les recommandations suivantes concernant la taille des nœuds du plan de contrôle sont basées sur les résultats d'un test focalisé sur la densité du plan de contrôle, ou Cluster-density. Ce test crée les objets suivants dans un nombre donné d'espaces de noms :

- 1 flux d'images

- 1 construire

-

5 déploiements, avec 2 répliques de pods à l'état

sleep, montant chacun 4 secrets, 4 cartes de configuration et 1 volume d'API descendant - 5 services, chacun pointant vers les ports TCP/8080 et TCP/8443 d'un des déploiements précédents

- 1 itinéraire menant au premier des services précédents

- 10 secrets contenant 2048 caractères aléatoires

- 10 cartes de configuration contenant 2048 caractères aléatoires

| Number of worker nodes | Densité de la grappe (espaces nominatifs) | Cœurs de l'unité centrale | Mémoire (GB) |

|---|---|---|---|

| 24 | 500 | 4 | 16 |

| 120 | 1000 | 8 | 32 |

| 252 | 4000 | 16, mais 24 si l'on utilise le plug-in réseau OVN-Kubernetes | 64, mais 128 si l'on utilise le plug-in réseau OVN-Kubernetes |

| 501, mais non testé avec le plug-in réseau OVN-Kubernetes | 4000 | 16 | 96 |

Les données du tableau ci-dessus sont basées sur une plateforme de conteneurs OpenShift fonctionnant au-dessus d'AWS, utilisant des instances r5.4xlarge comme nœuds de plan de contrôle et des instances m5.2xlarge comme nœuds de travail.

Dans un grand cluster dense comprenant trois nœuds de plan de contrôle, l'utilisation du processeur et de la mémoire augmente lorsque l'un des nœuds est arrêté, redémarré ou tombe en panne. Les pannes peuvent être dues à des problèmes inattendus d'alimentation, de réseau, d'infrastructure sous-jacente, ou à des cas intentionnels où le cluster est redémarré après avoir été arrêté pour réduire les coûts. Les deux nœuds restants du plan de contrôle doivent gérer la charge afin d'être hautement disponibles, ce qui entraîne une augmentation de l'utilisation des ressources. Ce phénomène se produit également lors des mises à niveau, car les nœuds du plan de contrôle sont isolés, vidés et redémarrés en série pour appliquer les mises à jour du système d'exploitation, ainsi que la mise à jour des opérateurs du plan de contrôle. Pour éviter les défaillances en cascade, maintenez l'utilisation globale des ressources CPU et mémoire sur les nœuds du plan de contrôle à un maximum de 60 % de la capacité disponible afin de gérer les pics d'utilisation des ressources. Augmentez l'UC et la mémoire des nœuds du plan de contrôle en conséquence pour éviter les temps d'arrêt potentiels dus au manque de ressources.

Le dimensionnement des nœuds varie en fonction du nombre de nœuds et d'objets dans la grappe. Il dépend également de la création active d'objets sur la grappe. Pendant la création des objets, le plan de contrôle est plus actif en termes d'utilisation des ressources que lorsque les objets sont dans la phase running.

Operator Lifecycle Manager (OLM) s'exécute sur les nœuds du plan de contrôle et son empreinte mémoire dépend du nombre d'espaces de noms et d'opérateurs installés par l'utilisateur qu'OLM doit gérer sur la grappe. Les nœuds du plan de contrôle doivent être dimensionnés en conséquence afin d'éviter les pertes de mémoire (OOM kills). Les points de données suivants sont basés sur les résultats des tests de maximisation des grappes.

| Nombre d'espaces de noms | Mémoire OLM au repos (GB) | Mémoire OLM avec 5 opérateurs utilisateurs installés (GB) |

|---|---|---|

| 500 | 0.823 | 1.7 |

| 1000 | 1.2 | 2.5 |

| 1500 | 1.7 | 3.2 |

| 2000 | 2 | 4.4 |

| 3000 | 2.7 | 5.6 |

| 4000 | 3.8 | 7.6 |

| 5000 | 4.2 | 9.02 |

| 6000 | 5.8 | 11.3 |

| 7000 | 6.6 | 12.9 |

| 8000 | 6.9 | 14.8 |

| 9000 | 8 | 17.7 |

| 10,000 | 9.9 | 21.6 |

Vous pouvez modifier la taille des nœuds du plan de contrôle dans un cluster OpenShift Container Platform 4.12 en cours d'exécution pour les configurations suivantes uniquement :

- Clusters installés avec une méthode d'installation fournie par l'utilisateur.

- Clusters AWS installés avec une méthode d'installation d'infrastructure fournie par l'installateur.

- Les clusters qui utilisent un jeu de machines du plan de contrôle pour gérer les machines du plan de contrôle.

Pour toutes les autres configurations, vous devez estimer le nombre total de nœuds et utiliser la taille de nœud suggérée pour le plan de contrôle lors de l'installation.

Les recommandations sont basées sur les points de données capturés sur les clusters OpenShift Container Platform avec OpenShift SDN comme plugin réseau.

Dans OpenShift Container Platform 4.12, la moitié d'un cœur de CPU (500 millicores) est désormais réservée par le système par défaut par rapport à OpenShift Container Platform 3.11 et aux versions précédentes. Les tailles sont déterminées en tenant compte de cela.

1.2.1. Sélection d'un type d'instance Amazon Web Services plus important pour les machines du plan de contrôle

Si les machines du plan de contrôle d'un cluster Amazon Web Services (AWS) ont besoin de plus de ressources, vous pouvez sélectionner un type d'instance AWS plus important pour les machines du plan de contrôle.

La procédure pour les clusters qui utilisent un jeu de machines du plan de contrôle est différente de la procédure pour les clusters qui n'utilisent pas de jeu de machines du plan de contrôle.

Si vous n'êtes pas sûr de l'état de la CR ControlPlaneMachineSet dans votre cluster, vous pouvez vérifier l'état de la CR.

1.2.1.1. Modifier le type d'instance Amazon Web Services à l'aide d'un jeu de machines du plan de contrôle

Vous pouvez modifier le type d'instance Amazon Web Services (AWS) que vos machines du plan de contrôle utilisent en mettant à jour la spécification dans la ressource personnalisée (CR) de l'ensemble de machines du plan de contrôle.

Conditions préalables

- Votre cluster AWS utilise un jeu de machines de plan de contrôle.

Procédure

Modifiez le jeu de machines CR de votre plan de contrôle en exécutant la commande suivante :

$ oc --namespace openshift-machine-api edit controlplanemachineset.machine.openshift.io cluster

Modifiez la ligne suivante sous le champ

providerSpec:providerSpec: value: ... instanceType: <compatible_aws_instance_type> 1- 1

- Spécifiez un type d'instance AWS plus important avec la même base que la sélection précédente. Par exemple, vous pouvez remplacer

m6i.xlargeparm6i.2xlargeoum6i.4xlarge.

Enregistrez vos modifications.

-

Pour les clusters qui utilisent la stratégie de mise à jour par défaut

RollingUpdate, l'opérateur propage automatiquement les modifications à votre configuration du plan de contrôle. -

Pour les clusters configurés pour utiliser la stratégie de mise à jour

OnDelete, vous devez remplacer manuellement les machines du plan de contrôle.

-

Pour les clusters qui utilisent la stratégie de mise à jour par défaut

Ressources supplémentaires

1.2.1.2. Modifier le type d'instance Amazon Web Services à l'aide de la console AWS

Vous pouvez modifier le type d'instance Amazon Web Services (AWS) utilisé par les machines du plan de contrôle en mettant à jour le type d'instance dans la console AWS.

Conditions préalables

- Vous avez accès à la console AWS avec les permissions nécessaires pour modifier l'Instance EC2 de votre cluster.

-

Vous avez accès au cluster OpenShift Container Platform en tant qu'utilisateur ayant le rôle

cluster-admin.

Procédure

- Ouvrez la console AWS et récupérez les instances des machines du plan de contrôle.

Choisissez une instance de machine de plan de contrôle.

- Pour la machine de plan de contrôle sélectionnée, sauvegardez les données etcd en créant un instantané etcd. Pour plus d'informations, voir "Sauvegarde de etcd".

- Dans la console AWS, arrêtez l'instance de machine du plan de contrôle.

- Sélectionnez l'instance arrêtée et cliquez sur Actions → Instance Settings → Change instance type.

-

Remplacez l'instance par un type plus grand, en veillant à ce que le type soit de la même base que la sélection précédente, et appliquez les modifications. Par exemple, vous pouvez remplacer

m6i.xlargeparm6i.2xlargeoum6i.4xlarge. - Démarrer l'instance.

-

Si votre cluster OpenShift Container Platform possède un objet

Machinecorrespondant à l'instance, mettez à jour le type d'instance de l'objet pour qu'il corresponde au type d'instance défini dans la console AWS.

- Répétez ce processus pour chaque machine du plan de contrôle.

Ressources supplémentaires

1.3. Pratiques recommandées pour etcd

Comme etcd écrit des données sur le disque et y conserve des propositions, ses performances dépendent de celles du disque. Bien que etcd ne soit pas particulièrement gourmand en E/S, il a besoin d'un périphérique de bloc à faible latence pour des performances et une stabilité optimales. Comme le protocole de consensus d'etcd dépend du stockage persistant des métadonnées dans un journal (WAL), etcd est sensible à la latence de l'écriture sur disque. Les disques lents et l'activité du disque par d'autres processus peuvent causer de longues latences de synchronisation.

Ces latences peuvent amener etcd à manquer des battements de cœur, à ne pas livrer de nouvelles propositions sur le disque à temps et, en fin de compte, à subir des dépassements de délai de requête et des pertes de leader temporaires. Des latences d'écriture élevées entraînent également une lenteur de l'API OpenShift, ce qui affecte les performances du cluster. Pour ces raisons, évitez de colocaliser d'autres charges de travail sur les nœuds du plan de contrôle.

En termes de latence, exécutez etcd au-dessus d'un périphérique bloc qui peut écrire au moins 50 IOPS de 8000 octets de long séquentiellement. C'est-à-dire avec une latence de 10 ms, en gardant à l'esprit que etcd utilise fdatasync pour synchroniser chaque écriture dans le WAL. Pour les clusters très chargés, 500 IOPS séquentiels de 8000 octets (2 ms) sont recommandés. Pour mesurer ces chiffres, vous pouvez utiliser un outil d'analyse comparative, tel que fio.

Pour obtenir de telles performances, exécutez etcd sur des machines soutenues par des disques SSD ou NVMe avec une faible latence et un débit élevé. Considérons les disques d'état solide (SSD) à cellule à niveau unique (SLC), qui fournissent 1 bit par cellule de mémoire, sont durables et fiables, et sont idéaux pour les charges de travail à forte intensité d'écriture.

Les caractéristiques suivantes du disque dur permettent d'optimiser les performances du système etcd :

- Faible latence pour permettre une lecture rapide.

- Écritures à large bande passante pour des compactions et des défragmentations plus rapides.

- Lecture à large bande passante pour une reprise plus rapide en cas de défaillance.

- Les disques d'état solide sont une sélection minimale, mais les disques NVMe sont préférables.

- Matériel de qualité serveur provenant de différents fabricants pour une plus grande fiabilité.

- Technologie RAID 0 pour des performances accrues.

- Disques etcd dédiés. Ne placez pas de fichiers journaux ou d'autres charges de travail lourdes sur les disques etcd.

Évitez les configurations NAS ou SAN et les disques en rotation. Effectuez toujours des analyses comparatives à l'aide d'utilitaires tels que fio. Surveillez en permanence les performances de la grappe au fur et à mesure qu'elles augmentent.

Évitez d'utiliser le protocole NFS (Network File System) ou d'autres systèmes de fichiers basés sur le réseau.

Certaines mesures clés à surveiller sur un cluster OpenShift Container Platform déployé sont p99 of etcd disk write ahead log duration et le nombre de changements de leader etcd. Utilisez Prometheus pour suivre ces métriques.

La taille des bases de données des membres etcd peut varier dans un cluster au cours des opérations normales. Cette différence n'affecte pas les mises à niveau du cluster, même si la taille du leader est différente de celle des autres membres.

Pour valider le matériel pour etcd avant ou après la création du cluster OpenShift Container Platform, vous pouvez utiliser fio.

Conditions préalables

- Les moteurs d'exécution de conteneurs tels que Podman ou Docker sont installés sur la machine que vous testez.

-

Les données sont écrites sur le chemin

/var/lib/etcd.

Procédure

Exécutez fio et analysez les résultats :

Si vous utilisez Podman, exécutez cette commande :

$ sudo podman run --volume /var/lib/etcd:/var/lib/etcd:Z quay.io/openshift-scale/etcd-perf

Si vous utilisez Docker, exécutez cette commande :

$ sudo docker run --volume /var/lib/etcd:/var/lib/etcd:Z quay.io/openshift-scale/etcd-perf

La sortie indique si le disque est assez rapide pour héberger etcd en comparant le 99ème percentile de la métrique fsync capturée lors de l'exécution pour voir si elle est inférieure à 10 ms. Voici quelques-unes des métriques etcd les plus importantes qui peuvent être affectées par les performances d'E/S :

-

etcd_disk_wal_fsync_duration_seconds_bucketla métrique indique la durée de la synchronisation WAL de etcd -

etcd_disk_backend_commit_duration_seconds_bucketla métrique indique la durée de latence du commit du backend etcd -

etcd_server_leader_changes_seen_totalrapports métriques le leader change

Comme etcd réplique les requêtes entre tous les membres, ses performances dépendent fortement de la latence des entrées/sorties du réseau. Des latences réseau élevées entraînent des battements de cœur etcd plus longs que le délai d'élection, ce qui se traduit par des élections de leaders qui perturbent le cluster. Une mesure clé à surveiller sur un cluster OpenShift Container Platform déployé est le 99e percentile de la latence des pairs du réseau etcd sur chaque membre du cluster etcd. Utilisez Prometheus pour suivre cette métrique.

La métrique histogram_quantile(0.99, rate(etcd_network_peer_round_trip_time_seconds_bucket[2m])) indique le temps d'aller-retour pour que etcd finisse de répliquer les requêtes des clients entre les membres. Assurez-vous qu'il est inférieur à 50 ms.

1.4. Déplacer etcd sur un autre disque

Vous pouvez déplacer etcd d'un disque partagé vers un disque séparé afin d'éviter ou de résoudre les problèmes de performances.

Conditions préalables

-

L'adresse

MachineConfigPooldoit correspondre à l'adressemetadata.labels[machineconfiguration.openshift.io/role]. Cela s'applique à un contrôleur, à un travailleur ou à un pool personnalisé. -

Le périphérique de stockage auxiliaire du nœud, tel que

/dev/sdb, doit correspondre à sdb. Modifiez cette référence à tous les endroits du fichier.

Cette procédure ne permet pas de déplacer des parties du système de fichiers racine, telles que /var/, vers un autre disque ou une autre partition sur un nœud installé.

L'opérateur de configuration de machine (MCO) est chargé de monter un disque secondaire pour un stockage de conteneur OpenShift Container Platform 4.12.

Procédez comme suit pour déplacer etcd vers un autre périphérique :

Procédure

Créez un fichier YAML

machineconfignomméetcd-mc.ymlet ajoutez les informations suivantes :apiVersion: machineconfiguration.openshift.io/v1 kind: MachineConfig metadata: labels: machineconfiguration.openshift.io/role: master name: 98-var-lib-etcd spec: config: ignition: version: 3.2.0 systemd: units: - contents: | [Unit] Description=Make File System on /dev/sdb DefaultDependencies=no BindsTo=dev-sdb.device After=dev-sdb.device var.mount Before=systemd-fsck@dev-sdb.service [Service] Type=oneshot RemainAfterExit=yes ExecStart=/usr/lib/systemd/systemd-makefs xfs /dev/sdb TimeoutSec=0 [Install] WantedBy=var-lib-containers.mount enabled: true name: systemd-mkfs@dev-sdb.service - contents: | [Unit] Description=Mount /dev/sdb to /var/lib/etcd Before=local-fs.target Requires=systemd-mkfs@dev-sdb.service After=systemd-mkfs@dev-sdb.service var.mount [Mount] What=/dev/sdb Where=/var/lib/etcd Type=xfs Options=defaults,prjquota [Install] WantedBy=local-fs.target enabled: true name: var-lib-etcd.mount - contents: | [Unit] Description=Sync etcd data if new mount is empty DefaultDependencies=no After=var-lib-etcd.mount var.mount Before=crio.service [Service] Type=oneshot RemainAfterExit=yes ExecCondition=/usr/bin/test ! -d /var/lib/etcd/member ExecStart=/usr/sbin/setenforce 0 ExecStart=/bin/rsync -ar /sysroot/ostree/deploy/rhcos/var/lib/etcd/ /var/lib/etcd/ ExecStart=/usr/sbin/setenforce 1 TimeoutSec=0 [Install] WantedBy=multi-user.target graphical.target enabled: true name: sync-var-lib-etcd-to-etcd.service - contents: | [Unit] Description=Restore recursive SELinux security contexts DefaultDependencies=no After=var-lib-etcd.mount Before=crio.service [Service] Type=oneshot RemainAfterExit=yes ExecStart=/sbin/restorecon -R /var/lib/etcd/ TimeoutSec=0 [Install] WantedBy=multi-user.target graphical.target enabled: true name: restorecon-var-lib-etcd.serviceCréez la configuration de la machine en entrant les commandes suivantes :

$ oc login -u ${ADMIN} -p ${ADMINPASSWORD} ${API} ... output omitted ...$ oc create -f etcd-mc.yml machineconfig.machineconfiguration.openshift.io/98-var-lib-etcd created

$ oc login -u ${ADMIN} -p ${ADMINPASSWORD} ${API} [... output omitted ...]$ oc create -f etcd-mc.yml machineconfig.machineconfiguration.openshift.io/98-var-lib-etcd created

Les nœuds sont mis à jour et redémarrés. Une fois le redémarrage terminé, les événements suivants se produisent :

- Un système de fichiers XFS est créé sur le disque spécifié.

-

Le disque est monté sur

/var/lib/etc. -

Le contenu de

/sysroot/ostree/deploy/rhcos/var/lib/etcdest synchronisé avec/var/lib/etcd. -

Une restauration des étiquettes de

SELinuxest forcée pour/var/lib/etcd. - L'ancien contenu n'est pas supprimé.

Une fois que les nœuds sont sur un disque séparé, mettez à jour le fichier de configuration de la machine,

etcd-mc.ymlavec les informations suivantes :apiVersion: machineconfiguration.openshift.io/v1 kind: MachineConfig metadata: labels: machineconfiguration.openshift.io/role: master name: 98-var-lib-etcd spec: config: ignition: version: 3.2.0 systemd: units: - contents: | [Unit] Description=Mount /dev/sdb to /var/lib/etcd Before=local-fs.target Requires=systemd-mkfs@dev-sdb.service After=systemd-mkfs@dev-sdb.service var.mount [Mount] What=/dev/sdb Where=/var/lib/etcd Type=xfs Options=defaults,prjquota [Install] WantedBy=local-fs.target enabled: true name: var-lib-etcd.mountAppliquez la version modifiée qui supprime la logique de création et de synchronisation du périphérique en entrant la commande suivante :

$ oc replace -f etcd-mc.yml

L'étape précédente empêche les nœuds de redémarrer.

Ressources supplémentaires

1.5. Défragmentation des données etcd

Pour les clusters importants et denses, etcd peut souffrir de mauvaises performances si l'espace-clé devient trop grand et dépasse le quota d'espace. Maintenez et défragmentez périodiquement etcd pour libérer de l'espace dans le magasin de données. Surveillez les métriques etcd dans Prometheus et défragmentez-le si nécessaire ; sinon, etcd peut déclencher une alarme à l'échelle de la grappe qui la met en mode de maintenance n'acceptant que les lectures et les suppressions de clés.

Surveillez ces paramètres clés :

-

etcd_server_quota_backend_bytesce qui correspond à la limite actuelle du quota -

etcd_mvcc_db_total_size_in_use_in_bytesqui indique l'utilisation réelle de la base de données après un compactage de l'historique -

etcd_mvcc_db_total_size_in_bytesqui indique la taille de la base de données, y compris l'espace libre en attente de défragmentation

Défragmenter les données etcd pour récupérer de l'espace disque après des événements qui provoquent la fragmentation du disque, comme le compactage de l'historique etcd.

Le compactage de l'historique est effectué automatiquement toutes les cinq minutes et laisse des trous dans la base de données back-end. Cet espace fragmenté peut être utilisé par etcd, mais n'est pas disponible pour le système de fichiers hôte. Vous devez défragmenter etcd pour rendre cet espace disponible au système de fichiers hôte.

La défragmentation se produit automatiquement, mais vous pouvez également la déclencher manuellement.

La défragmentation automatique est une bonne chose dans la plupart des cas, car l'opérateur etcd utilise les informations sur les clusters pour déterminer l'opération la plus efficace pour l'utilisateur.

1.5.1. Défragmentation automatique

L'opérateur etcd défragmente automatiquement les disques. Aucune intervention manuelle n'est nécessaire.

Vérifiez que le processus de défragmentation s'est déroulé correctement en consultant l'un de ces journaux :

- journaux etcd

- cluster-etcd-operator pod

- statut de l'opérateur journal des erreurs

La défragmentation automatique peut provoquer une défaillance de l'élection du leader dans divers composants de base d'OpenShift, tels que le gestionnaire de contrôleur Kubernetes, ce qui déclenche un redémarrage du composant défaillant. Le redémarrage est inoffensif et déclenche le basculement vers la prochaine instance en cours d'exécution ou le composant reprend le travail après le redémarrage.

Exemple de sortie de journal pour une défragmentation réussie

le membre etcd a été défragmenté : <member_name>, memberID : <member_id>

Exemple de sortie de journal pour une défragmentation infructueuse

échec de la défragmentation sur le membre : <member_name>, memberID : <member_id>: <error_message>

1.5.2. Défragmentation manuelle

Une alerte Prometheus vous indique si vous devez utiliser la défragmentation manuelle. L'alerte s'affiche dans deux cas :

- Lorsque etcd utilise plus de 50 % de son espace disponible pendant plus de 10 minutes

- Lorsque etcd utilise activement moins de 50 % de la taille totale de sa base de données pendant plus de 10 minutes

Vous pouvez également déterminer si une défragmentation est nécessaire en vérifiant la taille de la base de données etcd en Mo qui sera libérée par la défragmentation avec l'expression PromQL : (etcd_mvcc_db_total_size_in_bytes - etcd_mvcc_db_total_size_in_use_in_bytes)/1024/1024

La défragmentation de etcd est une action bloquante. Le membre etcd ne répondra pas tant que la défragmentation ne sera pas terminée. Pour cette raison, attendez au moins une minute entre les actions de défragmentation sur chacun des pods pour permettre au cluster de récupérer.

Suivez cette procédure pour défragmenter les données etcd sur chaque membre etcd.

Conditions préalables

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

cluster-admin.

Procédure

Déterminer quel membre etcd est le leader, car le leader doit être défragmenté en dernier.

Obtenir la liste des pods etcd :

$ oc -n openshift-etcd get pods -l k8s-app=etcd -o wide

Exemple de sortie

etcd-ip-10-0-159-225.example.redhat.com 3/3 Running 0 175m 10.0.159.225 ip-10-0-159-225.example.redhat.com <none> <none> etcd-ip-10-0-191-37.example.redhat.com 3/3 Running 0 173m 10.0.191.37 ip-10-0-191-37.example.redhat.com <none> <none> etcd-ip-10-0-199-170.example.redhat.com 3/3 Running 0 176m 10.0.199.170 ip-10-0-199-170.example.redhat.com <none> <none>

Choisissez un pod et exécutez la commande suivante pour déterminer quel membre etcd est le leader :

$ oc rsh -n openshift-etcd etcd-ip-10-0-159-225.example.redhat.com etcdctl endpoint status --cluster -w table

Exemple de sortie

Defaulting container name to etcdctl. Use 'oc describe pod/etcd-ip-10-0-159-225.example.redhat.com -n openshift-etcd' to see all of the containers in this pod. +---------------------------+------------------+---------+---------+-----------+------------+-----------+------------+--------------------+--------+ | ENDPOINT | ID | VERSION | DB SIZE | IS LEADER | IS LEARNER | RAFT TERM | RAFT INDEX | RAFT APPLIED INDEX | ERRORS | +---------------------------+------------------+---------+---------+-----------+------------+-----------+------------+--------------------+--------+ | https://10.0.191.37:2379 | 251cd44483d811c3 | 3.4.9 | 104 MB | false | false | 7 | 91624 | 91624 | | | https://10.0.159.225:2379 | 264c7c58ecbdabee | 3.4.9 | 104 MB | false | false | 7 | 91624 | 91624 | | | https://10.0.199.170:2379 | 9ac311f93915cc79 | 3.4.9 | 104 MB | true | false | 7 | 91624 | 91624 | | +---------------------------+------------------+---------+---------+-----------+------------+-----------+------------+--------------------+--------+

D'après la colonne

IS LEADERde cette sortie, le point d'extrémitéhttps://10.0.199.170:2379est le leader. En faisant correspondre ce point d'extrémité avec la sortie de l'étape précédente, le nom de pod du leader estetcd-ip-10-0-199-170.example.redhat.com.

Défragmenter un membre etcd.

Se connecter au conteneur etcd en cours d'exécution, en indiquant le nom d'un pod qui est not le leader :

$ oc rsh -n openshift-etcd etcd-ip-10-0-159-225.example.redhat.com

Désactivez la variable d'environnement

ETCDCTL_ENDPOINTS:sh-4.4# unset ETCDCTL_ENDPOINTS

Défragmenter le membre etcd :

sh-4.4# etcdctl --command-timeout=30s --endpoints=https://localhost:2379 defrag

Exemple de sortie

Finished defragmenting etcd member[https://localhost:2379]

En cas d'erreur de temporisation, augmentez la valeur de

--command-timeoutjusqu'à ce que la commande réussisse.Vérifiez que la taille de la base de données a été réduite :

sh-4.4# etcdctl endpoint status -w table --cluster

Exemple de sortie

+---------------------------+------------------+---------+---------+-----------+------------+-----------+------------+--------------------+--------+ | ENDPOINT | ID | VERSION | DB SIZE | IS LEADER | IS LEARNER | RAFT TERM | RAFT INDEX | RAFT APPLIED INDEX | ERRORS | +---------------------------+------------------+---------+---------+-----------+------------+-----------+------------+--------------------+--------+ | https://10.0.191.37:2379 | 251cd44483d811c3 | 3.4.9 | 104 MB | false | false | 7 | 91624 | 91624 | | | https://10.0.159.225:2379 | 264c7c58ecbdabee | 3.4.9 | 41 MB | false | false | 7 | 91624 | 91624 | | 1 | https://10.0.199.170:2379 | 9ac311f93915cc79 | 3.4.9 | 104 MB | true | false | 7 | 91624 | 91624 | | +---------------------------+------------------+---------+---------+-----------+------------+-----------+------------+--------------------+--------+Cet exemple montre que la taille de la base de données pour ce membre etcd est maintenant de 41 Mo, alors qu'elle était de 104 Mo au départ.

Répétez ces étapes pour vous connecter à chacun des autres membres etcd et les défragmenter. Défragmentez toujours le leader en dernier.

Attendez au moins une minute entre les actions de défragmentation pour permettre au pod etcd de se rétablir. Tant que le pod etcd n'est pas rétabli, le membre etcd ne répond pas.

Si des alarmes

NOSPACEont été déclenchées en raison du dépassement du quota d'espace, effacez-les.Vérifiez s'il y a des alarmes sur

NOSPACE:sh-4.4# etcdctl alarm list

Exemple de sortie

memberID:12345678912345678912 alarm:NOSPACE

Effacer les alarmes :

sh-4.4# etcdctl alarm disarm

Prochaines étapes

Après la défragmentation, si etcd utilise toujours plus de 50 % de son espace disponible, envisagez d'augmenter le quota de disque pour etcd.

1.6. Dimensionnement des nœuds d'infrastructure

Infrastructure nodes sont des nœuds étiquetés pour exécuter des éléments de l'environnement OpenShift Container Platform. Les besoins en ressources des nœuds d'infrastructure dépendent de l'âge du cluster, des nœuds et des objets du cluster, car ces facteurs peuvent entraîner une augmentation du nombre de métriques ou de séries temporelles dans Prometheus. Les recommandations suivantes concernant la taille des nœuds d'infrastructure sont basées sur les résultats observés lors des tests de densité des clusters détaillés dans la section Control plane node sizing, où la pile de surveillance et le contrôleur d'entrée par défaut ont été déplacés vers ces nœuds.

| Number of worker nodes | Densité des clusters, ou nombre d'espaces de noms | Cœurs de l'unité centrale | Mémoire (GB) |

|---|---|---|---|

| 27 | 500 | 4 | 24 |

| 120 | 1000 | 8 | 48 |

| 252 | 4000 | 16 | 128 |

| 501 | 4000 | 32 | 128 |

En général, trois nœuds d'infrastructure sont recommandés par grappe.

Ces recommandations de dimensionnement doivent être utilisées à titre indicatif. Prometheus est une application très gourmande en mémoire ; l'utilisation des ressources dépend de divers facteurs, notamment du nombre de nœuds, d'objets, de l'intervalle de récupération des métriques Prometheus, des métriques ou des séries temporelles, et de l'âge du cluster. En outre, l'utilisation des ressources du routeur peut également être affectée par le nombre d'itinéraires et la quantité/le type de requêtes entrantes.

Ces recommandations ne s'appliquent qu'aux nœuds d'infrastructure hébergeant les composants d'infrastructure Monitoring, Ingress et Registry installés lors de la création du cluster.

Dans OpenShift Container Platform 4.12, la moitié d'un cœur de CPU (500 millicores) est désormais réservée par le système par défaut par rapport à OpenShift Container Platform 3.11 et aux versions précédentes. Cela influe sur les recommandations de dimensionnement énoncées.

1.7. Ressources supplémentaires

Chapitre 2. Pratiques d'hébergement recommandées pour les environnements IBM zSystems & IBM(R) LinuxONE

Cette rubrique fournit des pratiques d'hébergement recommandées pour OpenShift Container Platform sur IBM zSystems et IBM® LinuxONE.

L'architecture s390x est unique à bien des égards. Par conséquent, certaines recommandations formulées ici peuvent ne pas s'appliquer à d'autres plates-formes.

Sauf indication contraire, ces pratiques s'appliquent aux installations z/VM et Red Hat Enterprise Linux (RHEL) KVM sur IBM zSystems et IBM® LinuxONE.

2.1. Gestion du surengagement de l'unité centrale

Dans un environnement IBM zSystems hautement virtualisé, vous devez planifier avec soin la configuration et le dimensionnement de l'infrastructure. L'une des caractéristiques les plus importantes de la virtualisation est la possibilité de surcharger les ressources, c'est-à-dire d'allouer aux machines virtuelles plus de ressources qu'il n'y en a réellement au niveau de l'hyperviseur. Cela dépend beaucoup de la charge de travail et il n'existe pas de règle d'or applicable à toutes les configurations.

En fonction de votre configuration, tenez compte des meilleures pratiques suivantes concernant le surengagement du processeur :

- Au niveau du LPAR (hyperviseur PR/SM), évitez d'attribuer tous les cœurs physiques (IFL) disponibles à chaque LPAR. Par exemple, avec quatre IFL physiques disponibles, vous ne devriez pas définir trois LPAR avec quatre IFL logiques chacun.

- Vérifier et comprendre les parts et les poids des LPAR.

- Un nombre excessif de processeurs virtuels peut nuire aux performances. Ne définissez pas plus de processeurs virtuels pour un invité que de processeurs logiques définis pour le LPAR.

- Configurez le nombre de processeurs virtuels par invité en fonction de la charge de travail maximale, pas plus.

- Commencez par une petite quantité et surveillez la charge de travail. Augmentez progressivement le nombre de vCPU si nécessaire.

- Toutes les charges de travail ne se prêtent pas à des taux de surengagement élevés. Si la charge de travail est intensive en termes de CPU, vous ne pourrez probablement pas atteindre des ratios élevés sans problèmes de performance. Les charges de travail plus intensives en E/S peuvent conserver des performances constantes même avec des ratios de surengagement élevés.

2.2. Désactiver les grandes pages transparentes

Les pages volumineuses transparentes (THP) tentent d'automatiser la plupart des aspects de la création, de la gestion et de l'utilisation des pages volumineuses. Comme THP gère automatiquement les pages volumineuses, cela n'est pas toujours optimal pour tous les types de charges de travail. THP peut entraîner une régression des performances, car de nombreuses applications gèrent elles-mêmes les pages volumineuses. Par conséquent, envisagez de désactiver THP.

2.3. Améliorer les performances du réseau avec Receive Flow Steering

Receive Flow Steering (RFS) étend Receive Packet Steering (RPS) en réduisant davantage la latence du réseau. Le RFS est techniquement basé sur le RPS et améliore l'efficacité du traitement des paquets en augmentant le taux de réussite du cache de l'unité centrale. Pour ce faire, et en plus de tenir compte de la longueur de la file d'attente, RFS détermine l'unité centrale la plus pratique pour le calcul, de sorte que les occurrences dans la mémoire cache ont plus de chances de se produire au sein de l'unité centrale. Ainsi, le cache de l'unité centrale est moins invalidé et nécessite moins de cycles pour le reconstruire. Cela peut contribuer à réduire le temps d'exécution du traitement des paquets.

2.3.1. Utiliser l'opérateur de configuration de la machine (MCO) pour activer le RFS

Procédure

Copiez l'exemple de profil MCO suivant dans un fichier YAML. Par exemple,

enable-rfs.yaml:apiVersion: machineconfiguration.openshift.io/v1 kind: MachineConfig metadata: labels: machineconfiguration.openshift.io/role: worker name: 50-enable-rfs spec: config: ignition: version: 2.2.0 storage: files: - contents: source: data:text/plain;charset=US-ASCII,%23%20turn%20on%20Receive%20Flow%20Steering%20%28RFS%29%20for%20all%20network%20interfaces%0ASUBSYSTEM%3D%3D%22net%22%2C%20ACTION%3D%3D%22add%22%2C%20RUN%7Bprogram%7D%2B%3D%22/bin/bash%20-c%20%27for%20x%20in%20/sys/%24DEVPATH/queues/rx-%2A%3B%20do%20echo%208192%20%3E%20%24x/rps_flow_cnt%3B%20%20done%27%22%0A filesystem: root mode: 0644 path: /etc/udev/rules.d/70-persistent-net.rules - contents: source: data:text/plain;charset=US-ASCII,%23%20define%20sock%20flow%20enbtried%20for%20%20Receive%20Flow%20Steering%20%28RFS%29%0Anet.core.rps_sock_flow_entries%3D8192%0A filesystem: root mode: 0644 path: /etc/sysctl.d/95-enable-rps.confCréer le profil MCO :

$ oc create -f enable-rfs.yaml

Vérifiez qu'une entrée nommée

50-enable-rfsest répertoriée :$ oc get mc

Pour désactiver, entrez :

$ oc delete mc 50-enable-rfs

2.4. Choisissez votre configuration de réseau

La pile réseau est l'un des composants les plus importants pour un produit basé sur Kubernetes comme OpenShift Container Platform. Pour les installations IBM zSystems, la configuration du réseau dépend de l'hyperviseur de votre choix. En fonction de la charge de travail et de l'application, la meilleure adaptation change généralement avec le cas d'utilisation et le modèle de trafic.

En fonction de votre configuration, tenez compte des meilleures pratiques suivantes :

- Envisagez toutes les options concernant les dispositifs de mise en réseau afin d'optimiser votre schéma de trafic. Explorez les avantages d'OSA-Express, RoCE Express, HiperSockets, z/VM VSwitch, Linux Bridge (KVM), et d'autres encore, afin de déterminer l'option la plus avantageuse pour votre installation.

- Utilisez toujours la dernière version disponible de la carte d'interface réseau. Par exemple, OSA Express 7S 10 GbE montre une grande amélioration par rapport à OSA Express 6S 10 GbE avec les types de charges de travail transactionnelles, bien que les deux soient des adaptateurs 10 GbE.

- Chaque commutateur virtuel ajoute une couche de latence supplémentaire.

- L'équilibreur de charge joue un rôle important dans la communication réseau en dehors du cluster. Envisagez d'utiliser un équilibreur de charge matériel de niveau production si cette fonction est essentielle pour votre application.

- OpenShift Container Platform SDN introduit des flux et des règles qui ont un impact sur les performances du réseau. Veillez à prendre en compte les affinités et les placements de pods, afin de bénéficier de la localité des services où la communication est critique.

- Équilibrer le compromis entre performance et fonctionnalité.

2.5. Garantir des performances de disque élevées avec HyperPAV sur z/VM

Les périphériques DASD et ECKD sont des types de disques couramment utilisés dans les environnements IBM zSystems. Dans une configuration typique d'OpenShift Container Platform dans des environnements z/VM, les disques DASD sont généralement utilisés pour prendre en charge le stockage local des nœuds. Vous pouvez configurer des périphériques alias HyperPAV pour fournir plus de débit et de meilleures performances d'E/S pour les disques DASD qui prennent en charge les invités z/VM.

L'utilisation d'HyperPAV pour les périphériques de stockage locaux permet d'améliorer considérablement les performances. Cependant, vous devez être conscient qu'il existe un compromis entre le débit et les coûts de l'unité centrale.

2.5.1. Utiliser le Machine Config Operator (MCO) pour activer les alias HyperPAV dans les nœuds utilisant des minidisques z/VM full-pack

Pour les configurations OpenShift Container Platform basées sur z/VM qui utilisent des minidisques full-pack, vous pouvez tirer parti de l'avantage des profils MCO en activant les alias HyperPAV dans tous les nœuds. Vous devez ajouter des configurations YAML pour le plan de contrôle et les nœuds de calcul.

Procédure

Copiez l'exemple de profil MCO suivant dans un fichier YAML pour le nœud du plan de contrôle. Par exemple,

05-master-kernelarg-hpav.yaml:$ cat 05-master-kernelarg-hpav.yaml apiVersion: machineconfiguration.openshift.io/v1 kind: MachineConfig metadata: labels: machineconfiguration.openshift.io/role: master name: 05-master-kernelarg-hpav spec: config: ignition: version: 3.1.0 kernelArguments: - rd.dasd=800-805Copiez l'exemple de profil MCO suivant dans un fichier YAML pour le nœud de calcul. Par exemple,

05-worker-kernelarg-hpav.yaml:$ cat 05-worker-kernelarg-hpav.yaml apiVersion: machineconfiguration.openshift.io/v1 kind: MachineConfig metadata: labels: machineconfiguration.openshift.io/role: worker name: 05-worker-kernelarg-hpav spec: config: ignition: version: 3.1.0 kernelArguments: - rd.dasd=800-805NoteVous devez modifier les arguments de

rd.dasdpour qu'ils correspondent aux identifiants des appareils.Créer les profils MCO :

$ oc create -f 05-master-kernelarg-hpav.yaml

$ oc create -f 05-worker-kernelarg-hpav.yaml

Pour désactiver, entrez :

$ oc delete -f 05-master-kernelarg-hpav.yaml

$ oc delete -f 05-worker-kernelarg-hpav.yaml

2.6. Recommandations pour RHEL KVM sur les hôtes IBM zSystems

L'optimisation d'un environnement de serveurs virtuels KVM dépend fortement des charges de travail des serveurs virtuels et des ressources disponibles. La même action qui améliore les performances dans un environnement peut avoir des effets négatifs dans un autre. Trouver le meilleur équilibre pour un environnement particulier peut s'avérer difficile et implique souvent des expérimentations.

La section suivante présente quelques bonnes pratiques lors de l'utilisation d'OpenShift Container Platform avec RHEL KVM sur les environnements IBM zSystems et IBM® LinuxONE.

2.6.1. Utiliser plusieurs files d'attente pour les interfaces réseau VirtIO

Avec plusieurs unités centrales virtuelles, vous pouvez transférer des paquets en parallèle si vous prévoyez plusieurs files d'attente pour les paquets entrants et sortants. Utilisez l'attribut queues de l'élément driver pour configurer plusieurs files d'attente. Spécifiez un nombre entier d'au moins 2 qui ne dépasse pas le nombre de CPU virtuels du serveur virtuel.

L'exemple de spécification suivant configure deux files d'attente d'entrée et de sortie pour une interface réseau :

<interface type="direct">

<source network="net01"/>

<model type="virtio"/>

<driver ... queues="2"/>

</interface>Les files d'attente multiples sont conçues pour améliorer les performances d'une interface réseau, mais elles utilisent également des ressources de mémoire et d'unité centrale. Commencez par définir deux files d'attente pour les interfaces très fréquentées. Essayez ensuite de définir deux files d'attente pour les interfaces à faible trafic ou plus de deux files d'attente pour les interfaces très fréquentées.

2.6.2. Utiliser des threads d'E/S pour vos blocs virtuels

Pour que les périphériques de blocs virtuels utilisent des threads d'E/S, vous devez configurer un ou plusieurs threads d'E/S pour le serveur virtuel et chaque périphérique de bloc virtuel doit utiliser l'un de ces threads d'E/S.

L'exemple suivant indique que <iothreads>3</iothreads> doit configurer trois threads d'E/S, avec les ID de threads décimaux consécutifs 1, 2 et 3. Le paramètre iothread="2" spécifie l'élément du pilote de l'unité de disque qui doit utiliser le fil d'exécution d'E/S avec l'ID 2.

Exemple de spécification d'un fil d'E/S

... <domain> <iothreads>3</iothreads>1 ... <devices> ... <disk type="block" device="disk">2 <driver ... iothread="2"/> </disk> ... </devices> ... </domain>

Les threads peuvent augmenter les performances des opérations d'E/S pour les périphériques de disque, mais ils utilisent également de la mémoire et des ressources de l'unité centrale. Vous pouvez configurer plusieurs périphériques pour qu'ils utilisent le même thread. Le meilleur mappage des threads aux périphériques dépend des ressources disponibles et de la charge de travail.

Commencez par un petit nombre de fils d'entrée/sortie. Souvent, un seul thread d'E/S pour tous les périphériques de disque est suffisant. Ne configurez pas plus de threads que le nombre de CPU virtuels et ne configurez pas de threads inactifs.

Vous pouvez utiliser la commande virsh iothreadadd pour ajouter des threads d'E/S avec des ID de threads spécifiques à un serveur virtuel en cours d'exécution.

2.6.3. Éviter les périphériques SCSI virtuels

Ne configurez les périphériques SCSI virtuels que si vous avez besoin d'adresser le périphérique par le biais d'interfaces spécifiques SCSI. Configurez l'espace disque en tant que périphériques de bloc virtuels plutôt qu'en tant que périphériques SCSI virtuels, indépendamment de la sauvegarde sur l'hôte.

Cependant, vous pouvez avoir besoin d'interfaces spécifiques SCSI pour :

- LUN d'un lecteur de bandes SCSI sur l'hôte.

- Un fichier ISO de DVD sur le système de fichiers de l'hôte qui est monté sur un lecteur de DVD virtuel.

2.6.4. Configurer la mise en cache du disque par l'invité

Configurez vos périphériques de disque pour que la mise en cache soit effectuée par l'invité et non par l'hôte.

Assurez-vous que l'élément pilote de l'unité de disque inclut les paramètres cache="none" et io="native".

<disk type="block" device="disk">

<driver name="qemu" type="raw" cache="none" io="native" iothread="1"/>

...

</disk>2.6.5. Exclure le dispositif de ballon de mémoire

À moins que vous n'ayez besoin d'une taille de mémoire dynamique, ne définissez pas de périphérique de ballon de mémoire et assurez-vous que libvirt n'en crée pas un pour vous. Incluez le paramètre memballoon en tant qu'enfant de l'élément devices dans votre fichier XML de configuration de domaine.

Vérifier la liste des profils actifs :

<memballoon model="none"/>

2.6.6. Ajuster l'algorithme de migration de l'unité centrale de l'ordonnanceur de l'hôte

Ne modifiez pas les paramètres de l'ordonnanceur si vous n'êtes pas un expert qui en comprend les implications. N'appliquez pas de modifications aux systèmes de production sans les avoir testées et avoir confirmé qu'elles ont l'effet escompté.

Le paramètre kernel.sched_migration_cost_ns spécifie un intervalle de temps en nanosecondes. Après la dernière exécution d'une tâche, le cache de l'unité centrale est considéré comme ayant un contenu utile jusqu'à l'expiration de cet intervalle. L'augmentation de cet intervalle permet de réduire le nombre de migrations de tâches. La valeur par défaut est 500000 ns.

Si le temps d'inactivité du CPU est plus élevé que prévu lorsqu'il y a des processus exécutables, essayez de réduire cet intervalle. Si les tâches passent trop souvent d'un CPU ou d'un nœud à l'autre, essayez de l'augmenter.

Pour définir dynamiquement l'intervalle à 60000 ns, entrez la commande suivante :

# sysctl kernel.sched_migration_cost_ns=60000

Pour modifier de façon permanente la valeur de 60000 ns, ajoutez l'entrée suivante à /etc/sysctl.conf:

kernel.sched_migration_cost_ns=60000

2.6.7. Désactiver le contrôleur cpuset cgroup

Ce paramètre ne s'applique qu'aux hôtes KVM dotés de cgroups version 1. Pour activer le hotplug du processeur sur l'hôte, désactivez le contrôleur cgroup.

Procédure

-

Ouvrez

/etc/libvirt/qemu.confavec l'éditeur de votre choix. -

Allez à la ligne

cgroup_controllers. - Dupliquez la ligne entière et supprimez le premier signe numérique (#) de la copie.

Retirez l'entrée

cpuseten procédant comme suit :cgroup_controllers = [ "cpu", "devices", "memory", "blkio", "cpuacct" ]

Pour que le nouveau paramètre prenne effet, vous devez redémarrer le démon libvirtd :

- Arrêter toutes les machines virtuelles.

Exécutez la commande suivante :

# systemctl restart libvirtd

- Redémarrer les machines virtuelles.

Ce paramètre persiste lors des redémarrages de l'hôte.

2.6.8. Régler la période d'interrogation des CPU virtuels inactifs

Lorsqu'un processeur virtuel est inactif, KVM recherche les conditions de réveil du processeur virtuel avant d'allouer la ressource hôte. Vous pouvez spécifier l'intervalle de temps pendant lequel l'interrogation a lieu dans sysfs à l'adresse /sys/module/kvm/parameters/halt_poll_ns. Pendant la durée spécifiée, l'interrogation réduit la latence de réveil de l'unité centrale virtuelle au détriment de l'utilisation des ressources. En fonction de la charge de travail, une durée d'interrogation plus longue ou plus courte peut être bénéfique. L'intervalle de temps est spécifié en nanosecondes. La valeur par défaut est de 50000 ns.

Pour optimiser la consommation de l'unité centrale, entrez une petite valeur ou écrivez 0 pour désactiver l'interrogation :

# echo 0 > /sys/module/kvm/paramètres/halt_poll_ns

Pour optimiser la latence, par exemple pour les charges de travail transactionnelles, saisissez une valeur élevée :

# echo 80000 > /sys/module/kvm/paramètres/halt_poll_ns

Ressources supplémentaires

Chapitre 3. Utilisation de l'opérateur Node Tuning

Découvrez l'opérateur d'optimisation des nœuds et la manière dont vous pouvez l'utiliser pour gérer l'optimisation au niveau des nœuds en orchestrant le démon d'optimisation.

3.1. À propos de l'opérateur Node Tuning

L'opérateur d'optimisation des nœuds vous aide à gérer l'optimisation au niveau des nœuds en orchestrant le démon TuneD et à obtenir des performances à faible latence en utilisant le contrôleur de profil de performance. La majorité des applications à hautes performances nécessitent un certain niveau de réglage du noyau. Le Node Tuning Operator offre une interface de gestion unifiée aux utilisateurs de sysctls au niveau des nœuds et plus de flexibilité pour ajouter des réglages personnalisés en fonction des besoins de l'utilisateur.

L'opérateur gère le démon TuneD conteneurisé pour OpenShift Container Platform en tant qu'ensemble de démons Kubernetes. Il s'assure que la spécification de réglage personnalisé est transmise à tous les démons TuneD conteneurisés s'exécutant dans le cluster dans le format que les démons comprennent. Les démons s'exécutent sur tous les nœuds du cluster, un par nœud.

Les paramètres de niveau nœud appliqués par le démon TuneD conteneurisé sont annulés lors d'un événement qui déclenche un changement de profil ou lorsque le démon TuneD conteneurisé se termine de manière élégante en recevant et en gérant un signal de fin.

L'opérateur de réglage des nœuds utilise le contrôleur de profil de performance pour mettre en œuvre un réglage automatique afin d'obtenir des performances de faible latence pour les applications OpenShift Container Platform. L'administrateur du cluster configure un profil de performance pour définir des paramètres au niveau du nœud, tels que les suivants :

- Mise à jour du noyau vers kernel-rt.

- Choix des unités centrales de traitement pour l'entretien ménager.

- Choix des unités centrales pour l'exécution des charges de travail.

Actuellement, la désactivation de l'équilibrage de la charge du CPU n'est pas prise en charge par cgroup v2. Par conséquent, il se peut que vous n'obteniez pas le comportement souhaité des profils de performance si vous avez activé cgroup v2. L'activation de cgroup v2 n'est pas recommandée si vous utilisez des profils de performance.

L'opérateur Node Tuning fait partie de l'installation standard d'OpenShift Container Platform à partir de la version 4.1.

Dans les versions antérieures d'OpenShift Container Platform, l'opérateur Performance Addon était utilisé pour mettre en œuvre un réglage automatique afin d'obtenir des performances de faible latence pour les applications OpenShift. Dans OpenShift Container Platform 4.11 et les versions ultérieures, cette fonctionnalité fait partie de l'opérateur Node Tuning.

3.2. Accéder à un exemple de spécification de l'opérateur Node Tuning

Cette procédure permet d'accéder à un exemple de spécification de l'opérateur de réglage des nœuds.

Procédure

Exécutez la commande suivante pour accéder à un exemple de spécification de l'opérateur Node Tuning :

$ oc get Tuned/default -o yaml -n openshift-cluster-node-tuning-operator

Le CR par défaut est destiné à fournir un réglage standard au niveau du nœud pour la plateforme OpenShift Container Platform et il ne peut être modifié que pour définir l'état de gestion de l'opérateur. Toute autre modification personnalisée de la CR par défaut sera écrasée par l'opérateur. Pour un réglage personnalisé, créez vos propres CR réglés. Les CR nouvellement créés seront combinés avec le CR par défaut et les réglages personnalisés appliqués aux nœuds d'OpenShift Container Platform en fonction des étiquettes de nœuds ou de pods et des priorités de profil.

Bien que dans certaines situations, la prise en charge des étiquettes de pods puisse être un moyen pratique de fournir automatiquement les réglages nécessaires, cette pratique est déconseillée et fortement déconseillée, en particulier dans les clusters à grande échelle. Le CR Tuned par défaut est livré sans correspondance d'étiquettes de pods. Si un profil personnalisé est créé avec la correspondance des étiquettes de pods, alors la fonctionnalité sera activée à ce moment-là. La fonctionnalité d'étiquetage de pods sera obsolète dans les versions futures de l'opérateur de tuning de nœuds.

3.3. Profils par défaut définis sur un cluster

Les profils par défaut définis sur un cluster sont les suivants.

apiVersion: tuned.openshift.io/v1

kind: Tuned

metadata:

name: default

namespace: openshift-cluster-node-tuning-operator

spec:

profile:

- data: |

[main]

summary=Optimize systems running OpenShift (provider specific parent profile)

include=-provider-${f:exec:cat:/var/lib/tuned/provider},openshift

name: openshift

recommend:

- profile: openshift-control-plane

priority: 30

match:

- label: node-role.kubernetes.io/master

- label: node-role.kubernetes.io/infra

- profile: openshift-node

priority: 40

Depuis OpenShift Container Platform 4.9, tous les profils OpenShift TuneD sont livrés avec le package TuneD. Vous pouvez utiliser la commande oc exec pour voir le contenu de ces profils :

$ oc exec $tuned_pod -n openshift-cluster-node-tuning-operator -- find /usr/lib/tuned/openshift{,-control-plane,-node} -name tuned.conf -exec grep -H ^ {} \;3.4. Vérification de l'application des profils TuneD

Vérifiez les profils TuneD appliqués à votre nœud de cluster.

$ oc get profile -n openshift-cluster-node-tuning-operator

Exemple de sortie

NAME TUNED APPLIED DEGRADED AGE master-0 openshift-control-plane True False 6h33m master-1 openshift-control-plane True False 6h33m master-2 openshift-control-plane True False 6h33m worker-a openshift-node True False 6h28m worker-b openshift-node True False 6h28m

-

NAME: Nom de l'objet Profil. Il y a un objet Profil par nœud et leurs noms correspondent. -

TUNED: Nom du profil TuneD à appliquer. -

APPLIED(True) si le démon TuneD a appliqué le profil souhaité. (True/False/Unknown). -

DEGRADEDle profil TuneD peut être modifié par l'intermédiaire de l'adresse suivante :Truesi des erreurs ont été signalées lors de l'application du profil TuneD (True/False/Unknown). -

AGE: Temps écoulé depuis la création de l'objet Profil.

3.5. Spécification de réglage personnalisé

La ressource personnalisée (CR) de l'opérateur comporte deux sections principales. La première section, profile:, est une liste de profils TuneD et de leurs noms. La seconde, recommend:, définit la logique de sélection des profils.

Plusieurs spécifications de réglage personnalisées peuvent coexister en tant que CR multiples dans l'espace de noms de l'opérateur. L'existence de nouveaux CR ou la suppression d'anciens CR est détectée par l'Opérateur. Toutes les spécifications de réglage personnalisées existantes sont fusionnées et les objets appropriés pour les démons TuneD conteneurisés sont mis à jour.

Management state

L'état de gestion de l'opérateur est défini en ajustant le CR accordé par défaut. Par défaut, l'opérateur est en état de gestion et le champ spec.managementState n'est pas présent dans le CR accordé par défaut. Les valeurs valides pour l'état de gestion de l'opérateur sont les suivantes :

- Géré : l'opérateur met à jour ses opérandes au fur et à mesure que les ressources de configuration sont mises à jour

- Non géré : l'opérateur ignore les changements apportés aux ressources de configuration

- Retiré : l'opérateur retire ses opérandes et les ressources qu'il a fournies

Profile data

La section profile: dresse la liste des profils TuneD et de leurs noms.

profile:

- name: tuned_profile_1

data: |

# TuneD profile specification

[main]

summary=Description of tuned_profile_1 profile

[sysctl]

net.ipv4.ip_forward=1

# ... other sysctl's or other TuneD daemon plugins supported by the containerized TuneD

# ...

- name: tuned_profile_n

data: |

# TuneD profile specification

[main]

summary=Description of tuned_profile_n profile

# tuned_profile_n profile settingsRecommended profiles

La logique de sélection de profile: est définie par la section recommend: du CR. La section recommend: est une liste d'éléments permettant de recommander les profils sur la base d'un critère de sélection.

recommend: <recommend-item-1> # ... <recommend-item-n>

Les différents éléments de la liste :

- machineConfigLabels: 1 <mcLabels> 2 match: 3 <match> 4 priority: <priority> 5 profile: <tuned_profile_name> 6 operand: 7 debug: <bool> 8 tunedConfig: reapply_sysctl: <bool> 9

- 1

- En option.

- 2

- Un dictionnaire d'étiquettes clé/valeur

MachineConfig. Les clés doivent être uniques. - 3

- En cas d'omission, la correspondance des profils est présumée, sauf si un profil ayant une priorité plus élevée correspond en premier ou si

machineConfigLabelsest défini. - 4

- Une liste facultative.

- 5

- Ordre de priorité des profils. Les chiffres les plus bas signifient une priorité plus élevée (

0est la priorité la plus élevée). - 6

- Un profil TuneD à appliquer sur un match. Par exemple

tuned_profile_1. - 7

- Configuration facultative de l'opérande.

- 8

- Active ou désactive le débogage du démon TuneD. Les options sont

truepour on oufalsepour off. La valeur par défaut estfalse. - 9

- Active ou désactive la fonctionnalité

reapply_sysctlpour le démon TuneD. Les options sonttruepour on etfalsepour off.

<match> est une liste optionnelle définie récursivement comme suit :

- label: <label_name> 1 value: <label_value> 2 type: <label_type> 3 <match> 4

- 1

- Nom de l'étiquette du nœud ou du pod.

- 2

- Valeur facultative de l'étiquette du nœud ou du pod. Si elle est omise, la présence de

<label_name>suffit à établir une correspondance. - 3

- Type d'objet facultatif (

nodeoupod). En cas d'omission,nodeest considéré comme tel. - 4

- Une liste facultative

<match>.

Si <match> n'est pas omis, toutes les sections imbriquées <match> doivent également être évaluées à true. Sinon, false est supposé et le profil avec la section <match> correspondante ne sera pas appliqué ou recommandé. Par conséquent, l'imbrication (sections <match> enfant) fonctionne comme un opérateur logique ET. Inversement, si un élément de la liste <match> correspond, toute la liste <match> est évaluée à true. La liste agit donc comme un opérateur logique OU.

Si machineConfigLabels est défini, la correspondance basée sur le pool de configuration de la machine est activée pour l'élément de liste recommend: donné. <mcLabels> spécifie les étiquettes d'une configuration de la machine. La configuration de la machine est créée automatiquement pour appliquer les paramètres de l'hôte, tels que les paramètres de démarrage du noyau, pour le profil <tuned_profile_name>. Il s'agit de trouver tous les pools de configuration de machine dont le sélecteur de configuration de machine correspond à <mcLabels> et de définir le profil <tuned_profile_name> sur tous les nœuds auxquels sont attribués les pools de configuration de machine trouvés. Pour cibler les nœuds qui ont à la fois un rôle de maître et de travailleur, vous devez utiliser le rôle de maître.

Les éléments de la liste match et machineConfigLabels sont reliés par l'opérateur logique OR. L'élément match est évalué en premier, en court-circuit. Par conséquent, s'il est évalué à true, l'élément machineConfigLabels n'est pas pris en compte.

Lors de l'utilisation de la correspondance basée sur le pool de configuration machine, il est conseillé de regrouper les nœuds ayant la même configuration matérielle dans le même pool de configuration machine. Si cette pratique n'est pas respectée, les opérandes TuneD peuvent calculer des paramètres de noyau contradictoires pour deux nœuds ou plus partageant le même pool de configuration de machine.

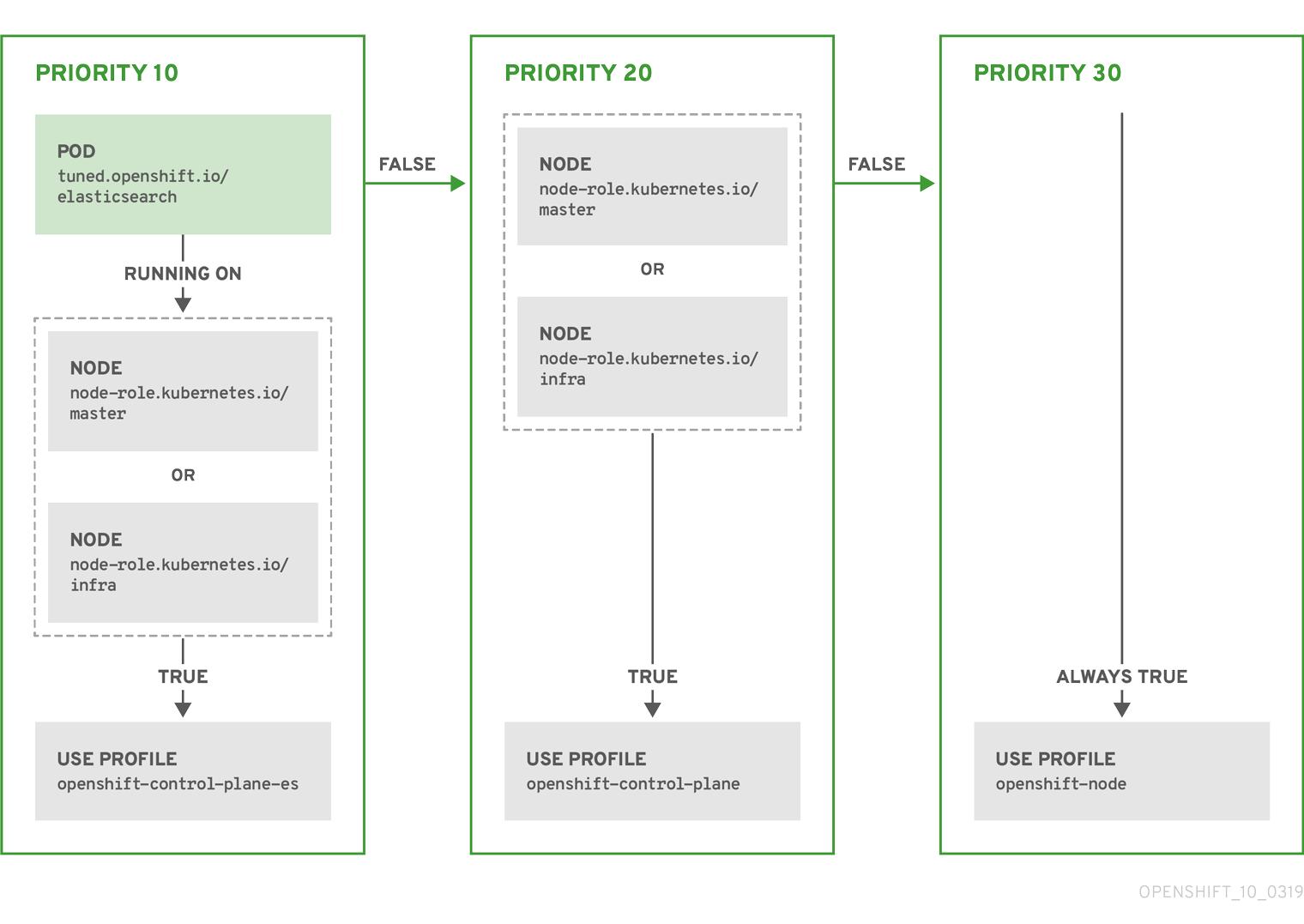

Exemple : correspondance basée sur l'étiquette d'un nœud ou d'un pod

- match:

- label: tuned.openshift.io/elasticsearch

match:

- label: node-role.kubernetes.io/master

- label: node-role.kubernetes.io/infra

type: pod

priority: 10

profile: openshift-control-plane-es

- match:

- label: node-role.kubernetes.io/master

- label: node-role.kubernetes.io/infra

priority: 20

profile: openshift-control-plane

- priority: 30

profile: openshift-node

Le CR ci-dessus est traduit pour le démon TuneD conteneurisé dans son fichier recommend.conf en fonction des priorités du profil. Le profil ayant la priorité la plus élevée (10) est openshift-control-plane-es et, par conséquent, il est considéré en premier. Le démon TuneD conteneurisé fonctionnant sur un nœud donné vérifie s'il existe un pod fonctionnant sur le même nœud avec l'étiquette tuned.openshift.io/elasticsearch définie. Si ce n'est pas le cas, toute la section <match> est évaluée comme false. S'il existe un pod avec le label, pour que la section <match> soit évaluée comme true, le label du nœud doit également être node-role.kubernetes.io/master ou node-role.kubernetes.io/infra.

Si les étiquettes du profil ayant la priorité 10 correspondent, le profil openshift-control-plane-es est appliqué et aucun autre profil n'est pris en considération. Si la combinaison d'étiquettes nœud/pod ne correspond pas, le deuxième profil le plus prioritaire (openshift-control-plane) est pris en compte. Ce profil est appliqué si le pod TuneD conteneurisé fonctionne sur un nœud avec les étiquettes node-role.kubernetes.io/master ou node-role.kubernetes.io/infra.

Enfin, le profil openshift-node a la priorité la plus basse de 30. Il ne contient pas la section <match> et, par conséquent, correspondra toujours. Il sert de profil fourre-tout pour définir le profil openshift-node si aucun autre profil ayant une priorité plus élevée ne correspond à un nœud donné.

Exemple : correspondance basée sur le pool de configuration de la machine

apiVersion: tuned.openshift.io/v1

kind: Tuned

metadata:

name: openshift-node-custom

namespace: openshift-cluster-node-tuning-operator

spec:

profile:

- data: |

[main]

summary=Custom OpenShift node profile with an additional kernel parameter

include=openshift-node

[bootloader]

cmdline_openshift_node_custom=+skew_tick=1

name: openshift-node-custom

recommend:

- machineConfigLabels:

machineconfiguration.openshift.io/role: "worker-custom"

priority: 20

profile: openshift-node-custom

Pour minimiser les redémarrages de nœuds, il faut étiqueter les nœuds cibles avec une étiquette que le sélecteur de nœuds du pool de configuration de la machine fera correspondre, puis créer le Tuned CR ci-dessus et enfin créer le pool de configuration de la machine personnalisé lui-même.

Cloud provider-specific TuneD profiles

Avec cette fonctionnalité, tous les nœuds spécifiques à un fournisseur de Cloud peuvent commodément se voir attribuer un profil TuneD spécifiquement adapté à un fournisseur de Cloud donné sur un cluster OpenShift Container Platform. Cela peut être accompli sans ajouter d'étiquettes de nœuds supplémentaires ou regrouper les nœuds dans des pools de configuration de machines.

Cette fonctionnalité tire parti des valeurs de l'objet de nœud spec.providerID sous la forme de <cloud-provider>://<cloud-provider-specific-id> et écrit le fichier /var/lib/tuned/provider avec la valeur <cloud-provider> dans les conteneurs d'opérandes NTO. Le contenu de ce fichier est ensuite utilisé par TuneD pour charger le profil provider-<cloud-provider> s'il existe.

Le profil openshift dont les profils openshift-control-plane et openshift-node héritent des paramètres est maintenant mis à jour pour utiliser cette fonctionnalité grâce à l'utilisation du chargement conditionnel de profil. Ni NTO ni TuneD ne fournissent actuellement de profils spécifiques aux fournisseurs de Cloud. Cependant, il est possible de créer un profil personnalisé provider-<cloud-provider> qui sera appliqué à tous les nœuds de cluster spécifiques au fournisseur de cloud.

Exemple de profil de fournisseur GCE Cloud

apiVersion: tuned.openshift.io/v1

kind: Tuned

metadata:

name: provider-gce

namespace: openshift-cluster-node-tuning-operator

spec:

profile:

- data: |

[main]

summary=GCE Cloud provider-specific profile

# Your tuning for GCE Cloud provider goes here.

name: provider-gce

En raison de l'héritage des profils, tout paramètre spécifié dans le profil provider-<cloud-provider> sera remplacé par le profil openshift et ses profils enfants.

3.6. Exemples de réglages personnalisés

Using TuneD profiles from the default CR

La CR suivante applique un réglage personnalisé au niveau du nœud pour les nœuds OpenShift Container Platform dont l'étiquette tuned.openshift.io/ingress-node-label est définie sur n'importe quelle valeur.

Exemple : réglage personnalisé à l'aide du profil openshift-control-plane TuneD

apiVersion: tuned.openshift.io/v1

kind: Tuned

metadata:

name: ingress

namespace: openshift-cluster-node-tuning-operator

spec:

profile:

- data: |

[main]

summary=A custom OpenShift ingress profile

include=openshift-control-plane

[sysctl]

net.ipv4.ip_local_port_range="1024 65535"

net.ipv4.tcp_tw_reuse=1

name: openshift-ingress

recommend:

- match:

- label: tuned.openshift.io/ingress-node-label

priority: 10

profile: openshift-ingress

Les auteurs de profils personnalisés sont fortement encouragés à inclure les profils de démon TuneD par défaut fournis avec le CR Tuned par défaut. L'exemple ci-dessus utilise le profil par défaut openshift-control-plane.

Using built-in TuneD profiles

Étant donné le succès du déploiement de l'ensemble des démons gérés par NTO, les opérandes TuneD gèrent tous la même version du démon TuneD. Pour obtenir la liste des profils TuneD intégrés pris en charge par le démon, interrogez n'importe quel module TuneD de la manière suivante :

$ oc exec $tuned_pod -n openshift-cluster-node-tuning-operator -- find /usr/lib/tuned/ -name tuned.conf -printf '%h\n' | sed 's|^.*/||'

Vous pouvez utiliser les noms de profil ainsi récupérés dans votre spécification de réglage personnalisé.

Exemple : utilisation du profil TuneD intégré de hpc-compute

apiVersion: tuned.openshift.io/v1

kind: Tuned

metadata:

name: openshift-node-hpc-compute

namespace: openshift-cluster-node-tuning-operator

spec:

profile:

- data: |

[main]

summary=Custom OpenShift node profile for HPC compute workloads

include=openshift-node,hpc-compute

name: openshift-node-hpc-compute

recommend:

- match:

- label: tuned.openshift.io/openshift-node-hpc-compute

priority: 20

profile: openshift-node-hpc-compute

En plus du profil intégré hpc-compute, l'exemple ci-dessus inclut le profil du démon openshift-node TuneD fourni avec le CR Tuned par défaut afin d'utiliser un réglage spécifique à OpenShift pour les nœuds de calcul.

3.7. Plugins de démon TuneD pris en charge

À l'exception de la section [main], les plugins TuneD suivants sont pris en charge lors de l'utilisation des profils personnalisés définis dans la section profile: du CR Tuned :

- audio

- cpu

- disque

- eeepc_she

- modules

- montures

- net

- planificateur

- scsi_host

- selinux

- sysctl

- sysfs

- uSB

- vidéo

- vm

- chargeur de démarrage

Certains de ces plugins offrent une fonctionnalité d'accord dynamique qui n'est pas prise en charge. Les plugins TuneD suivants ne sont actuellement pas pris en charge :

- scénario

- systemd

Le plugin TuneD bootloader est actuellement pris en charge sur les nœuds de travail Red Hat Enterprise Linux CoreOS (RHCOS) 8.x. Pour les nœuds de travail Red Hat Enterprise Linux (RHEL) 7.x, le plugin de chargeur de démarrage TuneD n'est actuellement pas pris en charge.

Voir Plugins TuneD disponibles et Démarrer avec TuneD pour plus d'informations.

3.8. Configuration de l'optimisation des nœuds dans un cluster hébergé

Les plans de contrôle hébergés sont une fonctionnalité d'aperçu technologique uniquement. Les fonctionnalités de l'aperçu technologique ne sont pas prises en charge par les accords de niveau de service (SLA) de production de Red Hat et peuvent ne pas être complètes sur le plan fonctionnel. Red Hat ne recommande pas de les utiliser en production. Ces fonctionnalités offrent un accès anticipé aux fonctionnalités des produits à venir, ce qui permet aux clients de tester les fonctionnalités et de fournir un retour d'information pendant le processus de développement.

Pour plus d'informations sur la portée de l'assistance des fonctionnalités de l'aperçu technologique de Red Hat, voir Portée de l'assistance des fonctionnalités de l'aperçu technologique.

Pour définir le réglage au niveau du nœud sur les nœuds de votre cluster hébergé, vous pouvez utiliser l'opérateur de réglage des nœuds. Dans les plans de contrôle hébergés, vous pouvez configurer l'optimisation des nœuds en créant des cartes de configuration contenant des objets Tuned et en référençant ces cartes de configuration dans vos pools de nœuds.

Procédure

Créez une carte de configuration contenant un manifeste accordé valide et faites référence à ce manifeste dans un pool de nœuds. Dans l'exemple suivant, un manifeste

Tuneddéfinit un profil qui attribue la valeur 55 àvm.dirty_ratiosur les nœuds contenant l'étiquette de nœudtuned-1-node-labelavec n'importe quelle valeur. Enregistrez le manifesteConfigMapsuivant dans un fichier nommétuned-1.yaml:apiVersion: v1 kind: ConfigMap metadata: name: tuned-1 namespace: clusters data: tuning: | apiVersion: tuned.openshift.io/v1 kind: Tuned metadata: name: tuned-1 namespace: openshift-cluster-node-tuning-operator spec: profile: - data: | [main] summary=Custom OpenShift profile include=openshift-node [sysctl] vm.dirty_ratio="55" name: tuned-1-profile recommend: - priority: 20 profile: tuned-1-profileNoteSi vous n'ajoutez pas d'étiquettes à une entrée de la section

spec.recommendde la spécification accordée, la correspondance basée sur le pool de nœuds est supposée, de sorte que le profil de priorité le plus élevé de la sectionspec.recommendest appliqué aux nœuds du pool. Bien que vous puissiez obtenir une correspondance plus fine basée sur les étiquettes de nœuds en définissant une valeur d'étiquette dans la section Tuned.spec.recommend.match, les étiquettes de nœuds ne seront pas conservées lors d'une mise à niveau, à moins que vous ne définissiez la valeur.spec.management.upgradeTypedu pool de nœuds surInPlace.Créez l'objet

ConfigMapdans le cluster de gestion :$ oc --kubeconfig="$MGMT_KUBECONFIG" create -f tuned-1.yaml

Faites référence à l'objet

ConfigMapdans le champspec.tuningConfigde la réserve de nœuds, soit en modifiant une réserve de nœuds, soit en en créant une. Dans cet exemple, nous supposons que vous n'avez qu'un seulNodePool, nomménodepool-1, qui contient 2 nœuds.apiVersion: hypershift.openshift.io/v1alpha1 kind: NodePool metadata: ... name: nodepool-1 namespace: clusters ... spec: ... tuningConfig: - name: tuned-1 status: ...NoteVous pouvez référencer la même carte de configuration dans plusieurs pools de nœuds. Dans les plans de contrôle hébergés, l'opérateur d'accord de nœud ajoute un hachage du nom du pool de nœuds et de l'espace de noms au nom des CR accordés pour les distinguer. En dehors de ce cas, ne créez pas plusieurs profils TuneD du même nom dans différents CR accordés pour le même cluster hébergé.

Vérification

Maintenant que vous avez créé l'objet ConfigMap qui contient un manifeste Tuned et que vous l'avez référencé dans un manifeste NodePool, l'opérateur Node Tuning synchronise les objets Tuned dans le cluster hébergé. Vous pouvez vérifier quels objets Tuned sont définis et quels profils TuneD sont appliqués à chaque nœud.

Liste des objets

Tuneddans le cluster hébergé :$ oc --kubeconfig="$HC_KUBECONFIG" get Tuneds -n openshift-cluster-node-tuning-operator

Exemple de sortie

NAME AGE default 7m36s rendered 7m36s tuned-1 65s

Liste des objets

Profiledans le cluster hébergé :$ oc --kubeconfig="$HC_KUBECONFIG" get Profiles -n openshift-cluster-node-tuning-operator

Exemple de sortie

NAME TUNED APPLIED DEGRADED AGE nodepool-1-worker-1 tuned-1-profile True False 7m43s nodepool-1-worker-2 tuned-1-profile True False 7m14s

NoteSi aucun profil personnalisé n'est créé, le profil

openshift-nodeest appliqué par défaut.Pour confirmer que le réglage a été appliqué correctement, lancez un shell de débogage sur un nœud et vérifiez les valeurs sysctl :

$ oc --kubeconfig="$HC_KUBECONFIG" debug node/nodepool-1-worker-1 -- chroot /host sysctl vm.dirty_ratio

Exemple de sortie

vm.dirty_ratio = 55

3.9. Réglage avancé des nœuds pour les clusters hébergés en définissant les paramètres de démarrage du noyau

Les plans de contrôle hébergés sont une fonctionnalité d'aperçu technologique uniquement. Les fonctionnalités de l'aperçu technologique ne sont pas prises en charge par les accords de niveau de service (SLA) de production de Red Hat et peuvent ne pas être complètes sur le plan fonctionnel. Red Hat ne recommande pas de les utiliser en production. Ces fonctionnalités offrent un accès anticipé aux fonctionnalités des produits à venir, ce qui permet aux clients de tester les fonctionnalités et de fournir un retour d'information pendant le processus de développement.

Pour plus d'informations sur la portée de l'assistance des fonctionnalités de l'aperçu technologique de Red Hat, voir Portée de l'assistance des fonctionnalités de l'aperçu technologique.

Pour des réglages plus avancés dans les plans de contrôle hébergés, qui nécessitent la définition de paramètres d'amorçage du noyau, vous pouvez également utiliser l'opérateur de réglage des nœuds. L'exemple suivant montre comment créer un pool de nœuds avec d'énormes pages réservées.

Procédure

Créez un objet

ConfigMapqui contient un manifeste d'objetTunedpour la création de 10 pages énormes d'une taille de 2 Mo. Enregistrez ce manifesteConfigMapdans un fichier nommétuned-hugepages.yaml:apiVersion: v1 kind: ConfigMap metadata: name: tuned-hugepages namespace: clusters data: tuning: | apiVersion: tuned.openshift.io/v1 kind: Tuned metadata: name: hugepages namespace: openshift-cluster-node-tuning-operator spec: profile: - data: | [main] summary=Boot time configuration for hugepages include=openshift-node [bootloader] cmdline_openshift_node_hugepages=hugepagesz=2M hugepages=50 name: openshift-node-hugepages recommend: - priority: 20 profile: openshift-node-hugepagesNoteLe champ

.spec.recommend.matchest intentionnellement laissé vide. Dans ce cas, l'objetTunedest appliqué à tous les nœuds du pool de nœuds dans lequel l'objetConfigMapest référencé. Regroupez les nœuds ayant la même configuration matérielle dans le même pool de nœuds. Sinon, les opérandes TuneD peuvent calculer des paramètres de noyau contradictoires pour deux nœuds ou plus qui partagent le même pool de nœuds.Créez l'objet

ConfigMapdans le cluster de gestion :$ oc --kubeconfig="$MGMT_KUBECONFIG" create -f tuned-hugepages.yaml

Créez un fichier YAML de manifeste

NodePool, personnalisez le type de mise à niveau deNodePoolet faites référence à l'objetConfigMapque vous avez créé dans la sectionspec.tuningConfig. Créez le manifesteNodePoolet enregistrez-le dans un fichier nomméhugepages-nodepool.yamlà l'aide du CLIhypershift:NODEPOOL_NAME=hugepages-example INSTANCE_TYPE=m5.2xlarge NODEPOOL_REPLICAS=2 hypershift create nodepool aws \ --cluster-name $CLUSTER_NAME \ --name $NODEPOOL_NAME \ --node-count $NODEPOOL_REPLICAS \ --instance-type $INSTANCE_TYPE \ --render > hugepages-nodepool.yamlDans le fichier

hugepages-nodepool.yaml, définissez.spec.management.upgradeTypecommeInPlace, et définissez.spec.tuningConfigcomme faisant référence à l'objettuned-hugepagesConfigMapque vous avez créé.apiVersion: hypershift.openshift.io/v1alpha1 kind: NodePool metadata: name: hugepages-nodepool namespace: clusters ... spec: management: ... upgradeType: InPlace ... tuningConfig: - name: tuned-hugepagesNotePour éviter de recréer inutilement des nœuds lorsque vous appliquez les nouveaux objets