Mise en réseau

Configuration et gestion de la mise en réseau des clusters

Résumé

Chapitre 1. About networking

Red Hat OpenShift Networking est un écosystème de fonctionnalités, de plugins et de capacités de mise en réseau avancées qui étendent la mise en réseau de Kubernetes avec les fonctionnalités avancées liées à la mise en réseau dont votre cluster a besoin pour gérer son trafic réseau pour un ou plusieurs clusters hybrides. Cet écosystème de capacités de mise en réseau intègre l'entrée, la sortie, l'équilibrage de charge, le débit haute performance, la sécurité, la gestion du trafic inter- et intra-cluster et fournit un outil d'observabilité basé sur les rôles pour réduire ses complexités naturelles.

La liste suivante met en évidence certaines des fonctionnalités de Red Hat OpenShift Networking les plus couramment utilisées et disponibles sur votre cluster :

Réseau primaire du cluster fourni par l'un des plugins Container Network Interface (CNI) suivants :

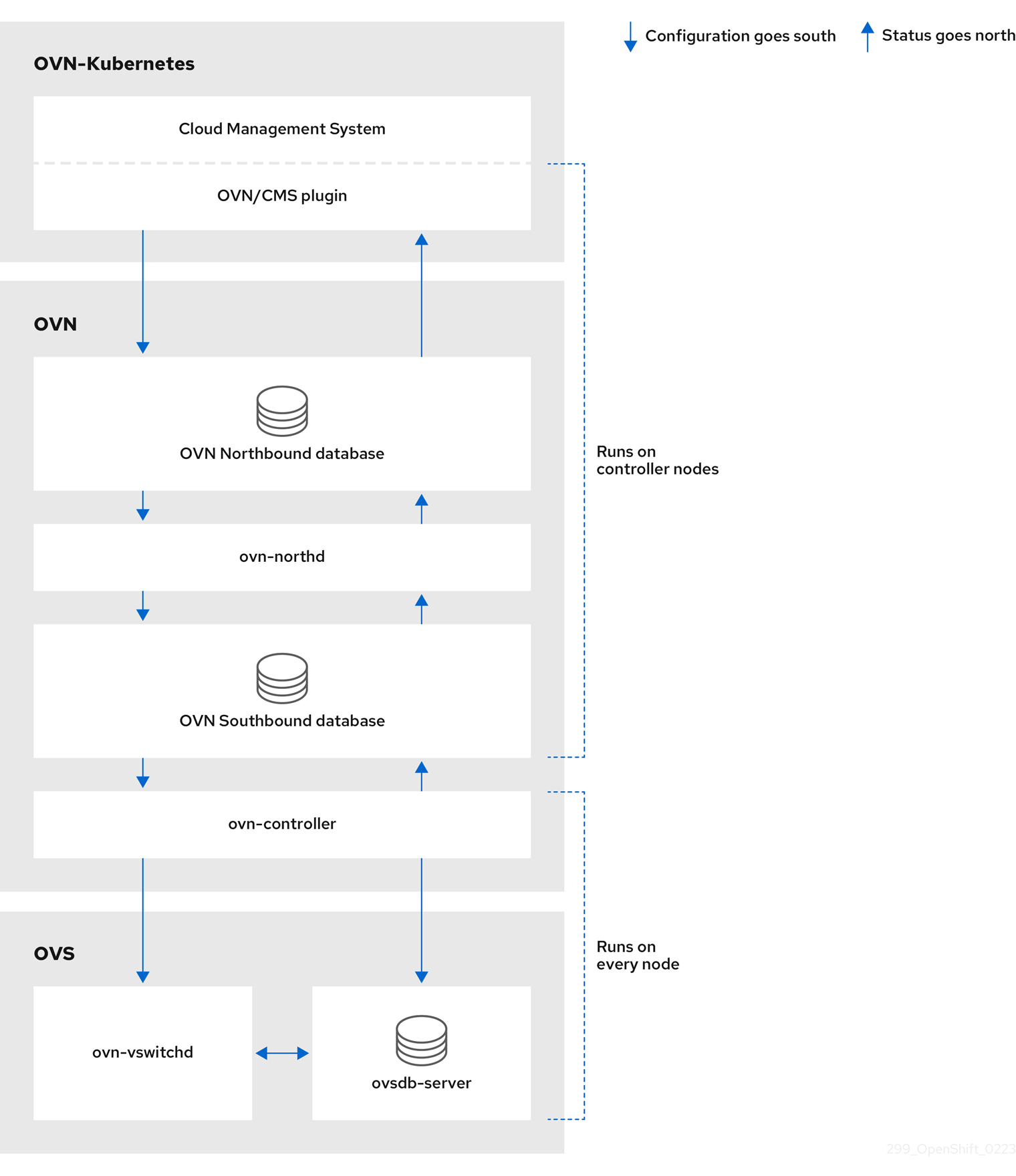

- Plugin réseau OVN-Kubernetes, le plugin par défaut est le plugin réseau OVN-Kubernetes

- Plugin réseau SDN OpenShift, une alternative optionnelle

- Plugins de réseaux primaires alternatifs certifiés par des tiers

- Opérateur de réseau en grappe pour la gestion des plugins de réseau

- Opérateur d'entrée pour le trafic web crypté TLS

- Opérateur DNS pour l'attribution des noms

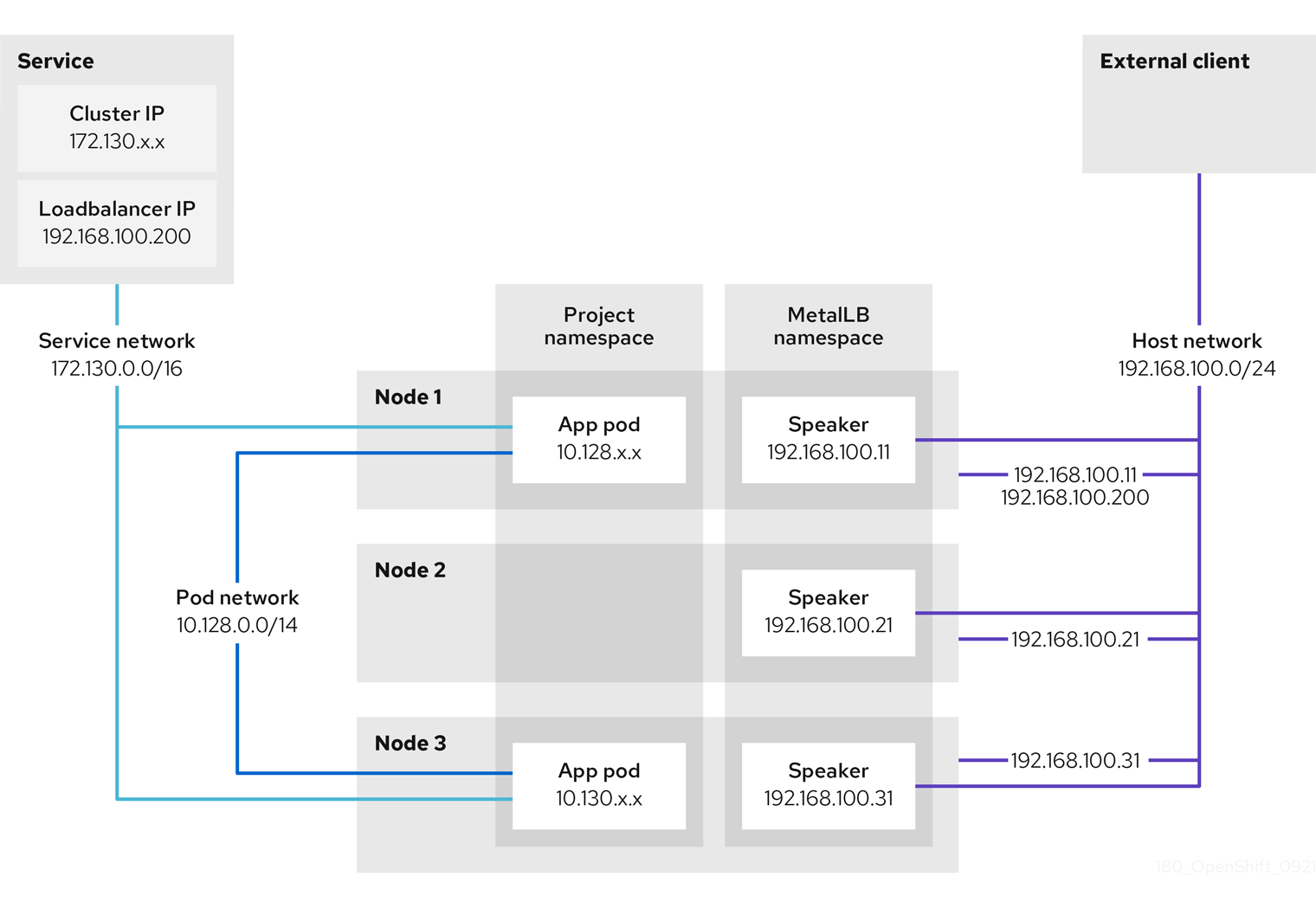

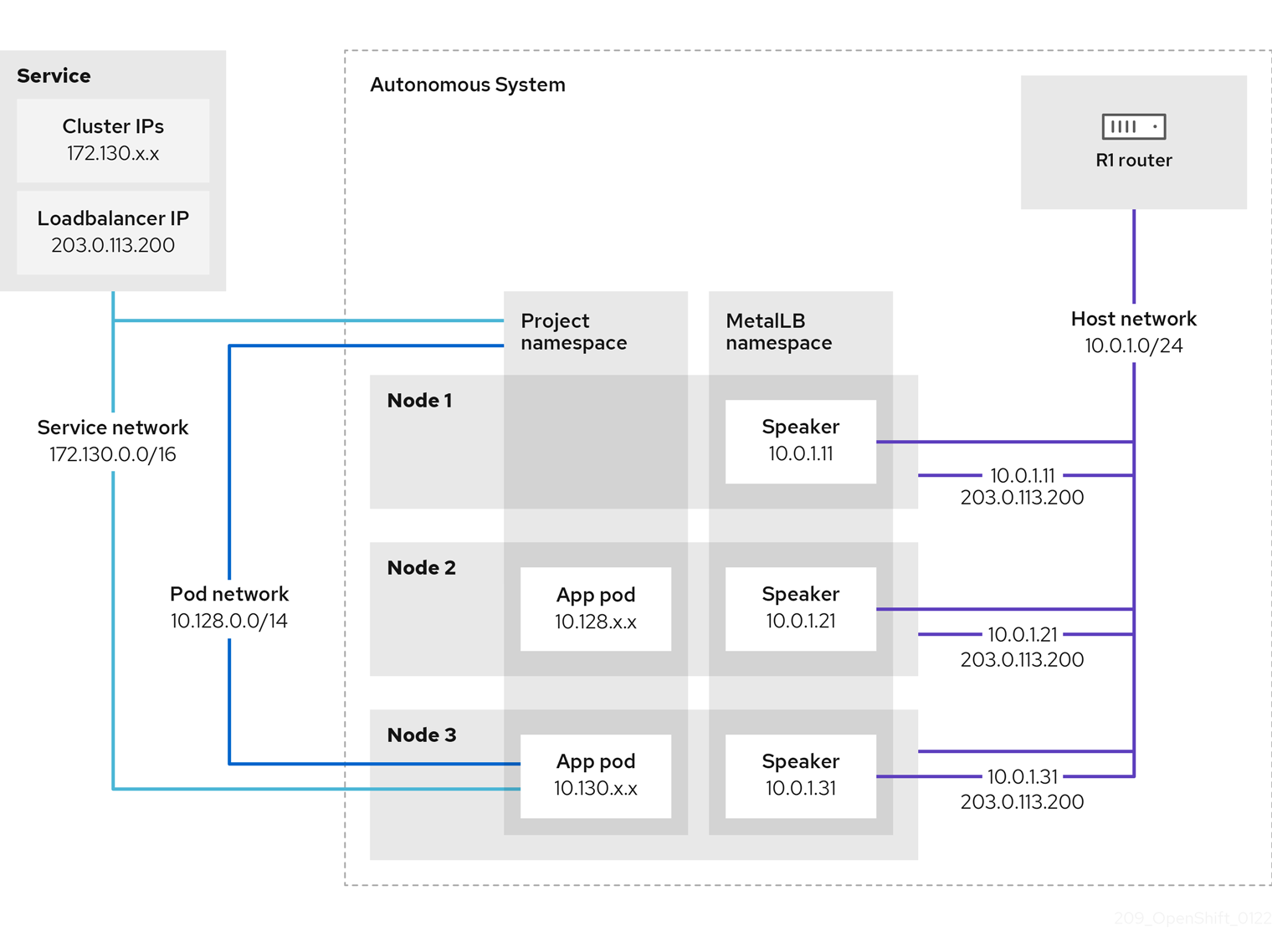

- MetalLB Operator pour l'équilibrage de la charge de trafic sur les clusters bare metal

- Prise en charge du basculement IP pour une haute disponibilité

- Prise en charge supplémentaire des réseaux matériels grâce à plusieurs plugins CNI, notamment pour les réseaux matériels macvlan, ipvlan et SR-IOV

- IPv4, IPv6 et adressage double pile

- Clusters hybrides Linux-Windows pour les charges de travail basées sur Windows

- Red Hat OpenShift Service Mesh pour la découverte, l'équilibrage de charge, l'authentification de service à service, la reprise sur panne, les métriques et la surveillance des services

- OpenShift à nœud unique

- Opérateur d'observabilité du réseau pour le débogage et l'analyse du réseau

- Technologies Submariner et Red Hat Application Interconnect pour la mise en réseau entre clusters

Chapitre 2. Comprendre la mise en réseau

Les administrateurs de clusters disposent de plusieurs options pour exposer au trafic externe les applications qui s'exécutent au sein d'un cluster et pour sécuriser les connexions réseau :

- Types de services, tels que les ports de nœuds ou les équilibreurs de charge

-

Les ressources de l'API, telles que

IngressetRoute

Par défaut, Kubernetes attribue à chaque pod une adresse IP interne pour les applications qui s'exécutent dans le pod. Les pods et leurs conteneurs peuvent fonctionner en réseau, mais les clients extérieurs au cluster n'ont pas accès au réseau. Lorsque vous exposez votre application au trafic externe, le fait de donner à chaque module sa propre adresse IP signifie que les modules peuvent être traités comme des hôtes physiques ou des machines virtuelles en termes d'allocation de ports, de mise en réseau, de nommage, de découverte de services, d'équilibrage de charge, de configuration d'applications et de migration.

Certaines plateformes en nuage proposent des API de métadonnées qui écoutent l'adresse IP 169.254.169.254, une adresse IP locale dans le bloc CIDR d'IPv4 169.254.0.0/16.

Ce bloc CIDR n'est pas accessible depuis le réseau de pods. Les pods qui ont besoin d'accéder à ces adresses IP doivent recevoir un accès au réseau hôte en définissant le champ spec.hostNetwork dans la spécification du pod sur true.

Si vous autorisez un hôte pod à accéder au réseau, vous lui accordez un accès privilégié à l'infrastructure réseau sous-jacente.

2.1. OpenShift Container Platform DNS

Si vous exécutez plusieurs services, tels que des services front-end et back-end à utiliser avec plusieurs pods, des variables d'environnement sont créées pour les noms d'utilisateur, les IP de service, etc. afin que les pods front-end puissent communiquer avec les services back-end. Si le service est supprimé et recréé, une nouvelle adresse IP peut lui être attribuée, ce qui oblige à recréer les pods frontaux pour récupérer les valeurs mises à jour de la variable d'environnement IP du service. En outre, le service back-end doit être créé avant tous les pods front-end pour garantir que l'IP du service est générée correctement et qu'elle peut être fournie aux pods front-end en tant que variable d'environnement.

Pour cette raison, OpenShift Container Platform dispose d'un DNS intégré de sorte que les services peuvent être atteints par le DNS du service ainsi que par l'IP/port du service.

2.2. Opérateur Ingress de la plateforme de conteneurs OpenShift

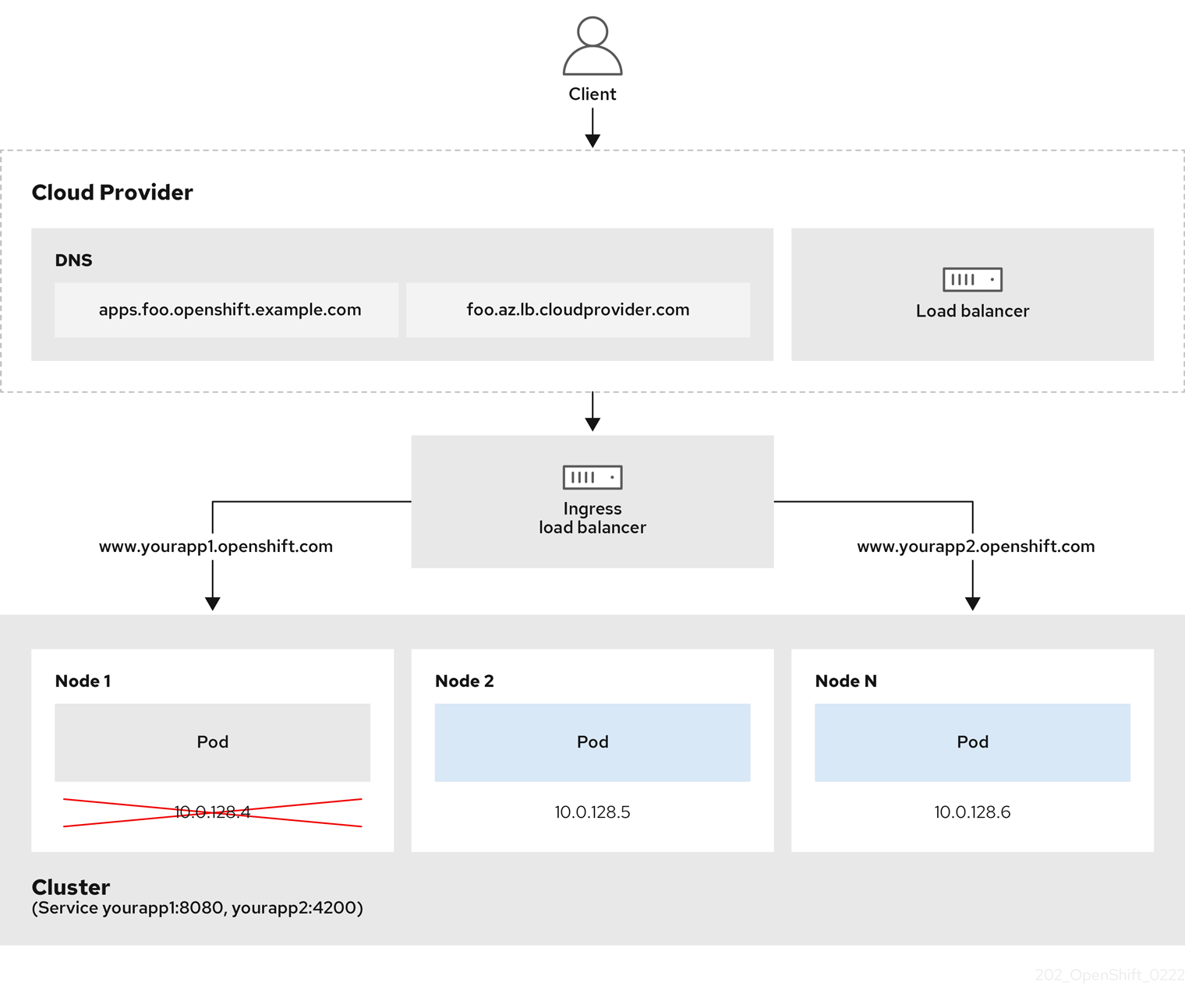

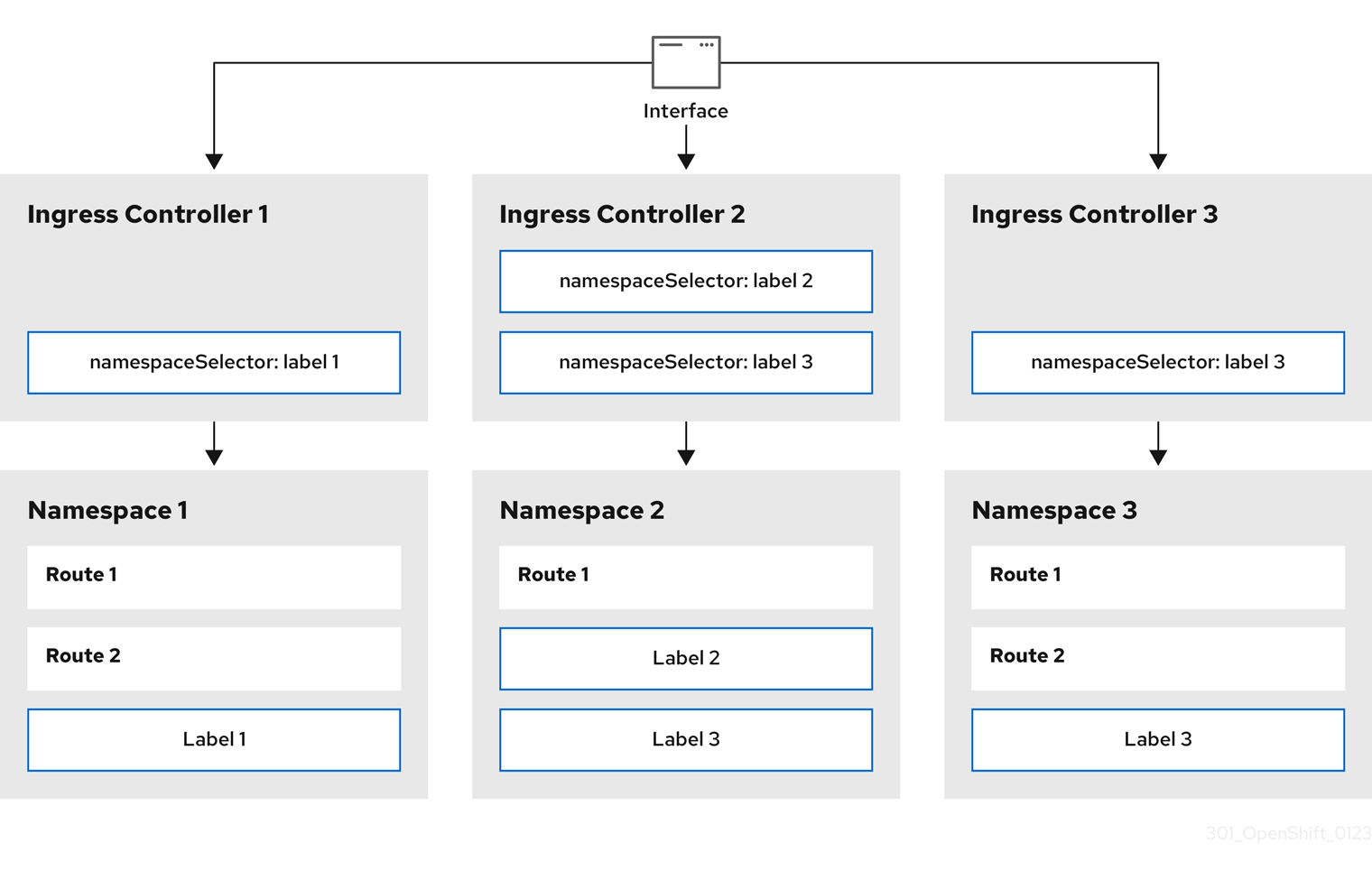

Lorsque vous créez votre cluster OpenShift Container Platform, les pods et les services s'exécutant sur le cluster se voient attribuer chacun leur propre adresse IP. Les adresses IP sont accessibles aux autres pods et services fonctionnant à proximité, mais ne sont pas accessibles aux clients extérieurs. L'opérateur d'ingestion (Ingress Operator) met en œuvre l'API IngressController et est le composant responsable de l'activation de l'accès externe aux services de cluster d'OpenShift Container Platform.

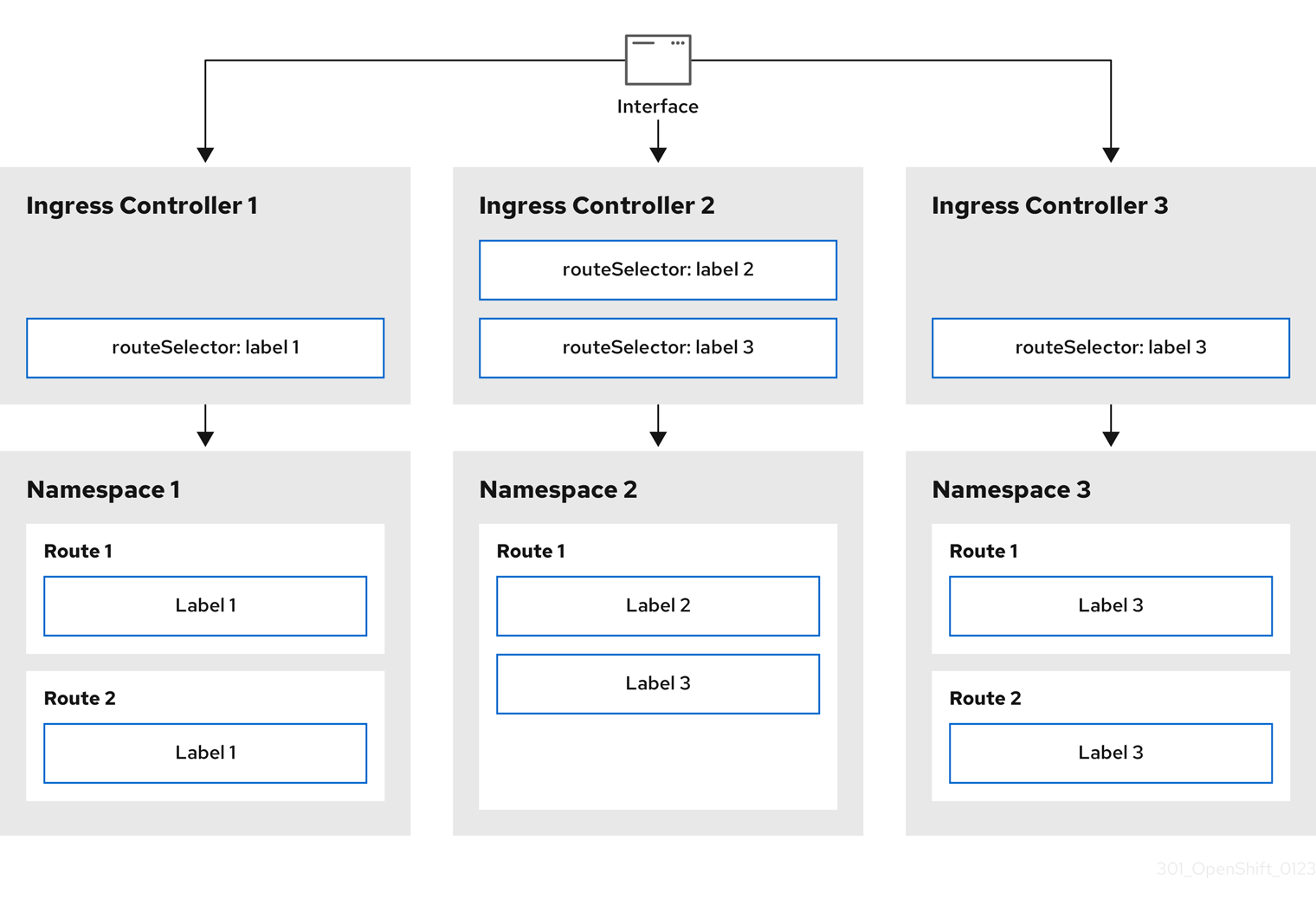

L'opérateur d'ingestion permet aux clients externes d'accéder à votre service en déployant et en gérant un ou plusieurs contrôleurs d'ingestion basés sur HAProxy pour gérer le routage. Vous pouvez utiliser l'opérateur d'ingestion pour acheminer le trafic en spécifiant les ressources OpenShift Container Platform Route et Kubernetes Ingress. Les configurations au sein du contrôleur d'ingestion, telles que la possibilité de définir le type endpointPublishingStrategy et l'équilibrage de charge interne, fournissent des moyens de publier les points d'extrémité du contrôleur d'ingestion.

2.2.1. Comparaison des itinéraires et des entrées

La ressource Kubernetes Ingress dans OpenShift Container Platform met en œuvre le contrôleur Ingress avec un service de routeur partagé qui s'exécute en tant que pod dans le cluster. La façon la plus courante de gérer le trafic Ingress est d'utiliser le contrôleur Ingress. Vous pouvez faire évoluer et répliquer ce pod comme n'importe quel autre pod ordinaire. Ce service de routeur est basé sur HAProxy, qui est une solution d'équilibreur de charge open source.

La route OpenShift Container Platform fournit le trafic Ingress aux services dans le cluster. Les routes offrent des fonctionnalités avancées qui peuvent ne pas être prises en charge par les contrôleurs d'entrée Kubernetes standard, telles que le recryptage TLS, le passage TLS et le fractionnement du trafic pour les déploiements bleu-vert.

Le trafic entrant accède aux services du cluster par l'intermédiaire d'une route. Les routes et les entrées sont les principales ressources permettant de gérer le trafic entrant. Ingress offre des fonctionnalités similaires à celles d'une route, telles que l'acceptation de demandes externes et leur délégation en fonction de la route. Cependant, avec Ingress, vous ne pouvez autoriser que certains types de connexions : HTTP/2, HTTPS et identification du nom du serveur (SNI), et TLS avec certificat. Dans OpenShift Container Platform, les routes sont générées pour répondre aux conditions spécifiées par la ressource Ingress.

2.3. Glossaire des termes courants pour la mise en réseau de OpenShift Container Platform

Ce glossaire définit les termes courants utilisés dans le contenu des réseaux.

- l'authentification

- Pour contrôler l'accès à un cluster OpenShift Container Platform, un administrateur de cluster peut configurer l'authentification des utilisateurs et s'assurer que seuls les utilisateurs approuvés accèdent au cluster. Pour interagir avec un cluster OpenShift Container Platform, vous devez vous authentifier auprès de l'API OpenShift Container Platform. Vous pouvez vous authentifier en fournissant un jeton d'accès OAuth ou un certificat client X.509 dans vos demandes à l'API OpenShift Container Platform.

- Opérateur d'équilibreur de charge AWS

-

L'opérateur AWS Load Balancer (ALB) déploie et gère une instance de

aws-load-balancer-controller. - Opérateur de réseau en grappe

- L'opérateur de réseau de cluster (CNO) déploie et gère les composants du réseau de cluster dans un cluster OpenShift Container Platform. Cela inclut le déploiement du plugin réseau Container Network Interface (CNI) sélectionné pour le cluster lors de l'installation.

- carte de configuration

-

Une carte de configuration permet d'injecter des données de configuration dans les pods. Vous pouvez référencer les données stockées dans une carte de configuration dans un volume de type

ConfigMap. Les applications fonctionnant dans un pod peuvent utiliser ces données. - ressource personnalisée (CR)

- Un CR est une extension de l'API Kubernetes. Vous pouvez créer des ressources personnalisées.

- DNS

- Cluster DNS est un serveur DNS qui sert les enregistrements DNS pour les services Kubernetes. Les conteneurs démarrés par Kubernetes incluent automatiquement ce serveur DNS dans leurs recherches DNS.

- Opérateur DNS

- L'opérateur DNS déploie et gère CoreDNS pour fournir un service de résolution de noms aux pods. Cela permet la découverte de services Kubernetes basée sur le DNS dans OpenShift Container Platform.

- déploiement

- Un objet de ressource Kubernetes qui maintient le cycle de vie d'une application.

- domaine

- Le domaine est un nom DNS géré par le contrôleur d'entrée.

- évacuation

- Processus de partage de données vers l'extérieur par le biais du trafic sortant d'un réseau à partir d'un pod.

- Opérateur DNS externe

- L'opérateur DNS externe déploie et gère ExternalDNS pour fournir la résolution de nom pour les services et les routes du fournisseur DNS externe à OpenShift Container Platform.

- Itinéraire basé sur HTTP

- Une route basée sur HTTP est une route non sécurisée qui utilise le protocole de routage HTTP de base et expose un service sur un port d'application non sécurisé.

- Entrée

- La ressource Kubernetes Ingress dans OpenShift Container Platform met en œuvre le contrôleur Ingress avec un service de routeur partagé qui s'exécute en tant que pod dans le cluster.

- Contrôleur d'entrée

- L'opérateur d'ingestion gère les contrôleurs d'ingestion. L'utilisation d'un contrôleur d'ingestion est le moyen le plus courant d'autoriser l'accès externe à un cluster OpenShift Container Platform.

- l'infrastructure fournie par l'installateur

- Le programme d'installation déploie et configure l'infrastructure sur laquelle le cluster fonctionne.

- kubelet

- Un agent de nœud primaire qui s'exécute sur chaque nœud du cluster pour s'assurer que les conteneurs s'exécutent dans un pod.

- Opérateur NMState de Kubernetes

- L'opérateur Kubernetes NMState fournit une API Kubernetes pour effectuer une configuration réseau basée sur l'état à travers les nœuds du cluster OpenShift Container Platform avec NMState.

- kube-proxy

- Kube-proxy est un service proxy qui s'exécute sur chaque nœud et aide à mettre des services à la disposition de l'hôte externe. Il aide à transmettre les demandes aux bons conteneurs et est capable d'effectuer un équilibrage primitif de la charge.

- équilibreurs de charge

- OpenShift Container Platform utilise des répartiteurs de charge pour communiquer depuis l'extérieur du cluster avec les services s'exécutant dans le cluster.

- Opérateur MetalLB

-

En tant qu'administrateur de cluster, vous pouvez ajouter l'opérateur MetalLB à votre cluster afin que lorsqu'un service de type

LoadBalancerest ajouté au cluster, MetalLB puisse ajouter une adresse IP externe pour le service. - multidiffusion

- Avec la multidiffusion IP, les données sont diffusées simultanément à de nombreuses adresses IP.

- espaces nominatifs

- Un espace de noms isole des ressources système spécifiques qui sont visibles par tous les processus. À l'intérieur d'un espace de noms, seuls les processus membres de cet espace peuvent voir ces ressources.

- la mise en réseau

- Informations sur le réseau d'un cluster OpenShift Container Platform.

- nœud

- Une machine de travail dans le cluster OpenShift Container Platform. Un nœud est soit une machine virtuelle (VM), soit une machine physique.

- Opérateur Ingress de la plateforme de conteneurs OpenShift

-

L'opérateur d'ingestion met en œuvre l'API

IngressControlleret est le composant responsable de l'accès externe aux services d'OpenShift Container Platform. - nacelle

- Un ou plusieurs conteneurs avec des ressources partagées, telles que le volume et les adresses IP, fonctionnant dans votre cluster OpenShift Container Platform. Un pod est la plus petite unité de calcul définie, déployée et gérée.

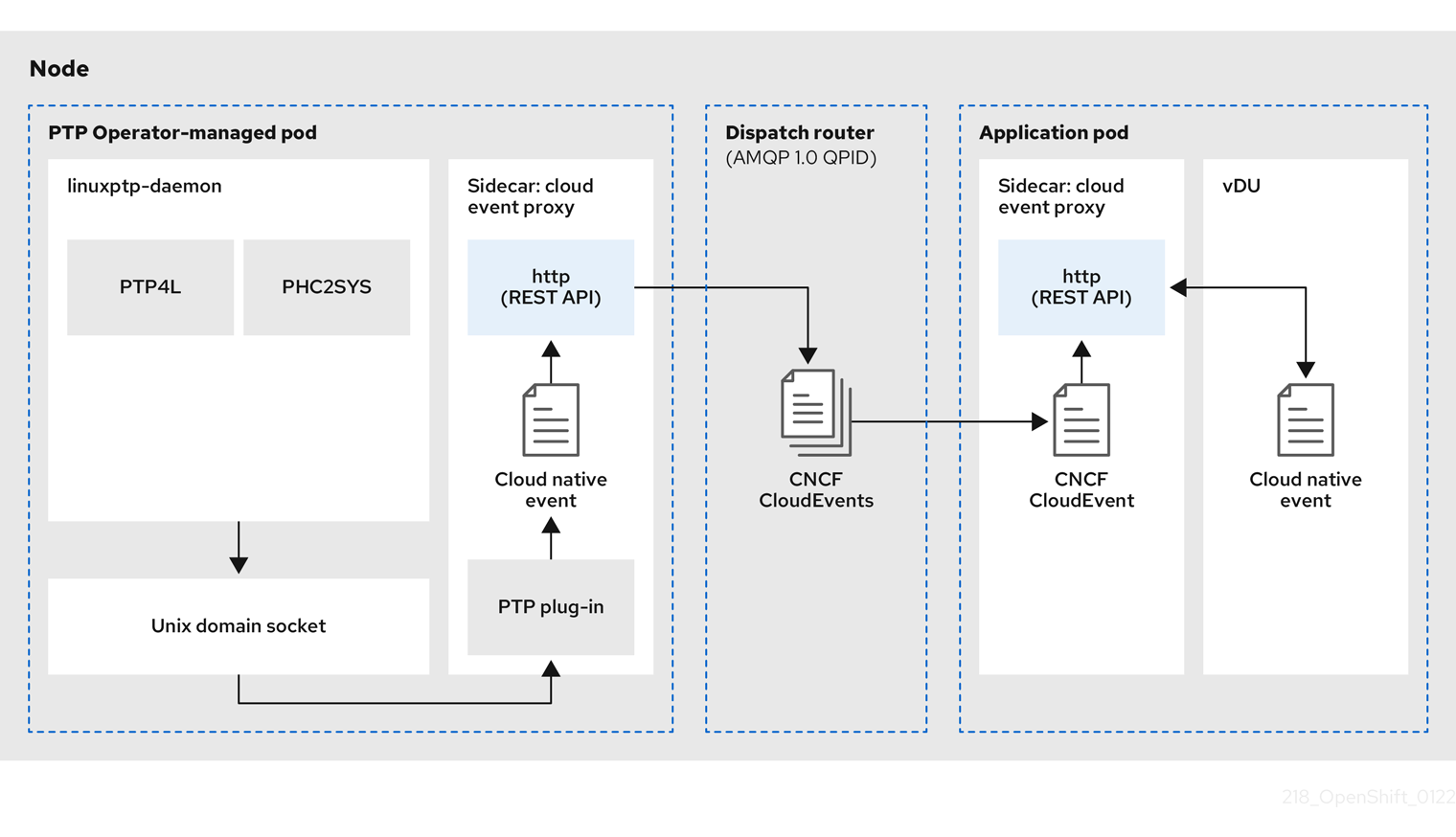

- Opérateur PTP

-

L'opérateur PTP crée et gère les services

linuxptp. - itinéraire

- La route OpenShift Container Platform fournit le trafic Ingress aux services dans le cluster. Les routes offrent des fonctionnalités avancées qui peuvent ne pas être prises en charge par les contrôleurs d'entrée Kubernetes standard, telles que le recryptage TLS, le passage TLS et le fractionnement du trafic pour les déploiements bleu-vert.

- mise à l'échelle

- Augmentation ou diminution de la capacité des ressources.

- service

- Expose une application en cours d'exécution sur un ensemble de pods.

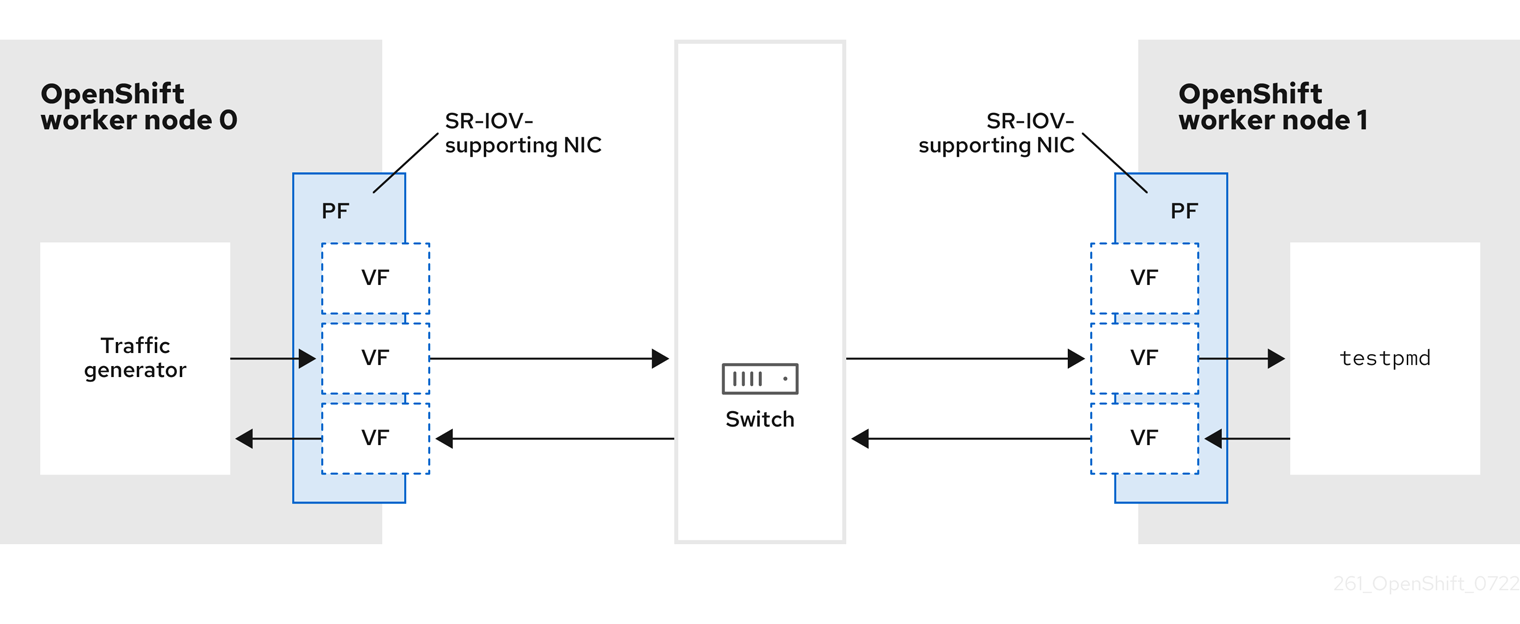

- Opérateur de réseau de virtualisation d'E/S à racine unique (SR-IOV)

- L'opérateur de réseau SR-IOV (Single Root I/O Virtualization) gère les périphériques réseau SR-IOV et les attachements réseau dans votre cluster.

- les réseaux définis par logiciel (SDN)

- OpenShift Container Platform utilise une approche de mise en réseau définie par logiciel (SDN) pour fournir un réseau de cluster unifié qui permet la communication entre les pods à travers le cluster OpenShift Container Platform.

- Protocole de transmission de contrôle de flux (SCTP)

- SCTP est un protocole fiable basé sur des messages qui fonctionne sur un réseau IP.

- souillure

- Les taches et les tolérances garantissent que les pods sont planifiés sur les nœuds appropriés. Vous pouvez appliquer un ou plusieurs taints à un nœud.

- tolérance

- Vous pouvez appliquer des tolérances aux modules. Les tolérances permettent à l'ordonnanceur de programmer des pods dont les taches correspondent.

- console web

- Une interface utilisateur (UI) pour gérer OpenShift Container Platform.

Chapitre 3. Accès aux hôtes

Apprenez à créer un hôte bastion pour accéder aux instances OpenShift Container Platform et aux nœuds du plan de contrôle à l'aide d'un accès shell sécurisé (SSH).

3.1. Accès aux hôtes sur Amazon Web Services dans un cluster d'infrastructure provisionné par l'installateur

Le programme d'installation d'OpenShift Container Platform ne crée pas d'adresses IP publiques pour les instances Amazon Elastic Compute Cloud (Amazon EC2) qu'il provisionne pour votre cluster OpenShift Container Platform. Pour pouvoir accéder par SSH à vos hôtes OpenShift Container Platform, vous devez suivre cette procédure.

Procédure

-

Créez un groupe de sécurité qui autorise l'accès SSH au nuage privé virtuel (VPC) créé par la commande

openshift-install. - Créez une instance Amazon EC2 sur l'un des sous-réseaux publics créés par le programme d'installation.

Associez une adresse IP publique à l'instance Amazon EC2 que vous avez créée.

Contrairement à l'installation d'OpenShift Container Platform, vous devez associer l'instance Amazon EC2 que vous avez créée à une paire de clés SSH. Le système d'exploitation que vous choisissez pour cette instance n'a pas d'importance, car elle servira simplement de bastion SSH pour relier l'internet au VPC de votre cluster OpenShift Container Platform. L'Amazon Machine Image (AMI) que vous utilisez a son importance. Avec Red Hat Enterprise Linux CoreOS (RHCOS), par exemple, vous pouvez fournir des clés via Ignition, comme le fait le programme d'installation.

Une fois que vous avez provisionné votre instance Amazon EC2 et que vous pouvez y accéder par SSH, vous devez ajouter la clé SSH que vous avez associée à votre installation d'OpenShift Container Platform. Cette clé peut être différente de la clé de l'instance bastion, mais ce n'est pas obligatoire.

NoteL'accès SSH direct n'est recommandé que pour la reprise après sinistre. Lorsque l'API Kubernetes est réactive, exécutez plutôt des pods privilégiés.

-

Exécutez

oc get nodes, inspectez la sortie et choisissez l'un des nœuds qui est un maître. Le nom d'hôte ressemble àip-10-0-1-163.ec2.internal. À partir de l'hôte SSH Bastion que vous avez déployé manuellement dans Amazon EC2, connectez-vous en SSH à l'hôte du plan de contrôle. Veillez à utiliser la même clé SSH que celle spécifiée lors de l'installation :

$ ssh -i <ssh-key-path> core@<master-hostname>

Chapitre 4. Aperçu des opérateurs de réseaux

OpenShift Container Platform prend en charge plusieurs types d'opérateurs de mise en réseau. Vous pouvez gérer la mise en réseau du cluster à l'aide de ces opérateurs de mise en réseau.

4.1. Opérateur de réseau en grappe

L'opérateur de réseau de cluster (CNO) déploie et gère les composants du réseau de cluster dans un cluster OpenShift Container Platform. Cela inclut le déploiement du plugin réseau Container Network Interface (CNI) sélectionné pour le cluster lors de l'installation. Pour plus d'informations, voir Cluster Network Operator dans OpenShift Container Platform.

4.2. Opérateur DNS

L'opérateur DNS déploie et gère CoreDNS pour fournir un service de résolution de noms aux pods. Cela permet la découverte de services Kubernetes basés sur le DNS dans OpenShift Container Platform. Pour plus d'informations, voir DNS Operator dans OpenShift Container Platform.

4.3. Opérateur d'entrée

Lorsque vous créez votre cluster OpenShift Container Platform, les pods et les services fonctionnant sur le cluster se voient attribuer des adresses IP. Les adresses IP sont accessibles à d'autres pods et services fonctionnant à proximité, mais ne sont pas accessibles aux clients externes. L'opérateur d'ingestion met en œuvre l'API du contrôleur d'ingestion et est responsable de l'activation de l'accès externe aux services du cluster OpenShift Container Platform. Pour plus d'informations, voir Ingress Operator dans OpenShift Container Platform.

4.4. Opérateur DNS externe

L'opérateur DNS externe déploie et gère ExternalDNS pour fournir la résolution de nom pour les services et les routes du fournisseur DNS externe à OpenShift Container Platform. Pour plus d'informations, voir Comprendre l'opérateur DNS externe.

4.5. Opérateur du pare-feu du nœud d'entrée

L'opérateur du pare-feu du nœud d'entrée utilise un filtre de paquets Berkley étendu (eBPF) et un plugin eXpress Data Path (XDP) pour traiter les règles du pare-feu du nœud, mettre à jour les statistiques et générer des événements pour le trafic abandonné. L'opérateur gère les ressources du pare-feu du nœud d'entrée, vérifie la configuration du pare-feu, n'autorise pas les règles mal configurées susceptibles d'empêcher l'accès au cluster et charge les programmes XDP du pare-feu du nœud d'entrée sur les interfaces sélectionnées dans l'objet ou les objets de la règle. Pour plus d'informations, voir Comprendre l'opérateur de pare-feu de nœud d'entrée

Chapitre 5. Opérateur de réseau de clusters dans OpenShift Container Platform

Le Cluster Network Operator (CNO) déploie et gère les composants du réseau de cluster sur un cluster OpenShift Container Platform, y compris le plugin réseau Container Network Interface (CNI) sélectionné pour le cluster lors de l'installation.

5.1. Opérateur de réseau en grappe

L'opérateur de réseau de cluster met en œuvre l'API network du groupe d'API operator.openshift.io. L'opérateur déploie le plugin réseau OVN-Kubernetes, ou le plugin de fournisseur de réseau que vous avez sélectionné lors de l'installation du cluster, à l'aide d'un ensemble de démons.

Procédure

L'opérateur de réseau de cluster est déployé lors de l'installation en tant que Kubernetes Deployment.

Exécutez la commande suivante pour afficher l'état du déploiement :

$ oc get -n openshift-network-operator deployment/network-operator

Exemple de sortie

NAME READY UP-TO-DATE AVAILABLE AGE network-operator 1/1 1 1 56m

Exécutez la commande suivante pour afficher l'état de l'opérateur de réseau de cluster :

$ oc get clusteroperator/network

Exemple de sortie

NAME VERSION AVAILABLE PROGRESSING DEGRADED SINCE network 4.5.4 True False False 50m

Les champs suivants fournissent des informations sur l'état de l'opérateur :

AVAILABLE,PROGRESSING, etDEGRADED. Le champAVAILABLEestTruelorsque l'opérateur de réseau de groupe signale un état de disponibilité.

5.2. Visualisation de la configuration du réseau de la grappe

Chaque nouvelle installation d'OpenShift Container Platform possède un objet network.config nommé cluster.

Procédure

Utilisez la commande

oc describepour afficher la configuration du réseau de la grappe :$ oc describe network.config/cluster

Exemple de sortie

Name: cluster Namespace: Labels: <none> Annotations: <none> API Version: config.openshift.io/v1 Kind: Network Metadata: Self Link: /apis/config.openshift.io/v1/networks/cluster Spec: 1 Cluster Network: Cidr: 10.128.0.0/14 Host Prefix: 23 Network Type: OpenShiftSDN Service Network: 172.30.0.0/16 Status: 2 Cluster Network: Cidr: 10.128.0.0/14 Host Prefix: 23 Cluster Network MTU: 8951 Network Type: OpenShiftSDN Service Network: 172.30.0.0/16 Events: <none>

5.3. Visualisation du statut de l'opérateur de réseau de cluster

Vous pouvez inspecter l'état et afficher les détails de l'opérateur de réseau de cluster à l'aide de la commande oc describe.

Procédure

Exécutez la commande suivante pour afficher l'état de l'opérateur de réseau de cluster :

$ oc describe clusteroperators/network

5.4. Visualisation des journaux de l'opérateur de réseau de clusters

Vous pouvez consulter les journaux de l'opérateur de réseau de cluster à l'aide de la commande oc logs.

Procédure

Exécutez la commande suivante pour afficher les journaux de l'opérateur de réseau de cluster :

$ oc logs --namespace=openshift-network-operator deployment/network-operator

5.5. Cluster Network Operator configuration

The configuration for the cluster network is specified as part of the Cluster Network Operator (CNO) configuration and stored in a custom resource (CR) object that is named cluster. The CR specifies the fields for the Network API in the operator.openshift.io API group.

The CNO configuration inherits the following fields during cluster installation from the Network API in the Network.config.openshift.io API group and these fields cannot be changed:

clusterNetwork- IP address pools from which pod IP addresses are allocated.

serviceNetwork- IP address pool for services.

defaultNetwork.type- Cluster network plugin, such as OpenShift SDN or OVN-Kubernetes.

Après l'installation du cluster, vous ne pouvez pas modifier les champs énumérés dans la section précédente.

You can specify the cluster network plugin configuration for your cluster by setting the fields for the defaultNetwork object in the CNO object named cluster.

5.5.1. Cluster Network Operator configuration object

The fields for the Cluster Network Operator (CNO) are described in the following table:

Tableau 5.1. Cluster Network Operator configuration object

| Field | Type | Description |

|---|---|---|

|

|

|

The name of the CNO object. This name is always |

|

|

| A list specifying the blocks of IP addresses from which pod IP addresses are allocated and the subnet prefix length assigned to each individual node in the cluster. For example: spec:

clusterNetwork:

- cidr: 10.128.0.0/19

hostPrefix: 23

- cidr: 10.128.32.0/19

hostPrefix: 23

Cette valeur est prête à l'emploi et héritée de l'objet |

|

|

| A block of IP addresses for services. The OpenShift SDN and OVN-Kubernetes network plugins support only a single IP address block for the service network. For example: spec: serviceNetwork: - 172.30.0.0/14

Cette valeur est prête à l'emploi et héritée de l'objet |

|

|

| Configures the network plugin for the cluster network. |

|

|

| The fields for this object specify the kube-proxy configuration. If you are using the OVN-Kubernetes cluster network plugin, the kube-proxy configuration has no effect. |

defaultNetwork object configuration

The values for the defaultNetwork object are defined in the following table:

Tableau 5.2. defaultNetwork object

| Field | Type | Description |

|---|---|---|

|

|

|

Either Note OpenShift Container Platform uses the OVN-Kubernetes network plugin by default. |

|

|

| This object is only valid for the OpenShift SDN network plugin. |

|

|

| This object is only valid for the OVN-Kubernetes network plugin. |

Configuration for the OpenShift SDN network plugin

The following table describes the configuration fields for the OpenShift SDN network plugin:

Tableau 5.3. openshiftSDNConfig object

| Field | Type | Description |

|---|---|---|

|

|

| Le mode d'isolation du réseau pour OpenShift SDN. |

|

|

| L'unité de transmission maximale (MTU) pour le réseau superposé VXLAN. Cette valeur est normalement configurée automatiquement. |

|

|

|

Le port à utiliser pour tous les paquets VXLAN. La valeur par défaut est |

Vous ne pouvez modifier la configuration du plugin réseau de votre cluster que lors de l'installation du cluster.

Example OpenShift SDN configuration

defaultNetwork:

type: OpenShiftSDN

openshiftSDNConfig:

mode: NetworkPolicy

mtu: 1450

vxlanPort: 4789

Configuration for the OVN-Kubernetes network plugin

The following table describes the configuration fields for the OVN-Kubernetes network plugin:

Tableau 5.4. ovnKubernetesConfig object

| Field | Type | Description |

|---|---|---|

|

|

| L'unité de transmission maximale (MTU) pour le réseau superposé Geneve (Generic Network Virtualization Encapsulation). Cette valeur est normalement configurée automatiquement. |

|

|

| Le port UDP pour le réseau superposé de Geneve. |

|

|

| Si le champ est présent, IPsec est activé pour le cluster. |

|

|

| Specify a configuration object for customizing network policy audit logging. If unset, the defaults audit log settings are used. |

|

|

| Optional: Specify a configuration object for customizing how egress traffic is sent to the node gateway. Note While migrating egress traffic, you can expect some disruption to workloads and service traffic until the Cluster Network Operator (CNO) successfully rolls out the changes. |

|

|

If your existing network infrastructure overlaps with the

For example, if the This field cannot be changed after installation. |

The default value is |

|

|

If your existing network infrastructure overlaps with the This field cannot be changed after installation. |

The default value is |

Tableau 5.5. policyAuditConfig object

| Field | Type | Description |

|---|---|---|

|

| entier |

The maximum number of messages to generate every second per node. The default value is |

|

| entier |

The maximum size for the audit log in bytes. The default value is |

|

| chaîne de caractères | One of the following additional audit log targets:

|

|

| chaîne de caractères |

The syslog facility, such as |

Tableau 5.6. gatewayConfig object

| Field | Type | Description |

|---|---|---|

|

|

|

Set this field to

This field has an interaction with the Open vSwitch hardware offloading feature. If you set this field to |

Vous ne pouvez modifier la configuration de votre plugin de réseau de cluster que lors de l'installation du cluster, à l'exception du champ gatewayConfig qui peut être modifié lors de l'exécution en tant qu'activité post-installation.

Example OVN-Kubernetes configuration with IPSec enabled

defaultNetwork:

type: OVNKubernetes

ovnKubernetesConfig:

mtu: 1400

genevePort: 6081

ipsecConfig: {}

kubeProxyConfig object configuration

The values for the kubeProxyConfig object are defined in the following table:

Tableau 5.7. kubeProxyConfig object

| Field | Type | Description |

|---|---|---|

|

|

|

The refresh period for Note

Because of performance improvements introduced in OpenShift Container Platform 4.3 and greater, adjusting the |

|

|

|

The minimum duration before refreshing kubeProxyConfig:

proxyArguments:

iptables-min-sync-period:

- 0s

|

5.5.2. Exemple de configuration de l'opérateur de réseau en grappe

Une configuration CNO complète est spécifiée dans l'exemple suivant :

Exemple d'objet Opérateur de réseau en grappe

apiVersion: operator.openshift.io/v1 kind: Network metadata: name: cluster spec: clusterNetwork: 1 - cidr: 10.128.0.0/14 hostPrefix: 23 serviceNetwork: 2 - 172.30.0.0/16 defaultNetwork: 3 type: OpenShiftSDN openshiftSDNConfig: mode: NetworkPolicy mtu: 1450 vxlanPort: 4789 kubeProxyConfig: iptablesSyncPeriod: 30s proxyArguments: iptables-min-sync-period: - 0s

5.6. Ressources supplémentaires

Chapitre 6. Opérateur DNS dans OpenShift Container Platform

L'opérateur DNS déploie et gère CoreDNS pour fournir un service de résolution de noms aux pods, permettant la découverte de services Kubernetes basés sur le DNS dans OpenShift Container Platform.

6.1. Opérateur DNS

L'opérateur DNS met en œuvre l'API dns du groupe d'API operator.openshift.io. L'opérateur déploie CoreDNS à l'aide d'un ensemble de démons, crée un service pour l'ensemble de démons et configure le kubelet pour demander aux pods d'utiliser l'adresse IP du service CoreDNS pour la résolution de noms.

Procédure

L'opérateur DNS est déployé lors de l'installation avec un objet Deployment.

Utilisez la commande

oc getpour afficher l'état du déploiement :$ oc get -n openshift-dns-operator deployment/dns-operator

Exemple de sortie

NAME READY UP-TO-DATE AVAILABLE AGE dns-operator 1/1 1 1 23h

Utilisez la commande

oc getpour afficher l'état de l'opérateur DNS :$ oc get clusteroperator/dns

Exemple de sortie

NAME VERSION AVAILABLE PROGRESSING DEGRADED SINCE dns 4.1.0-0.11 True False False 92m

AVAILABLEPROGRESSINGet fournissent des informations sur l'état de l'opérateur. est lorsqu'au moins un pod de l'ensemble de démons CoreDNS signale une condition d'état .DEGRADEDAVAILABLETrueAvailable

6.2. Modification de l'état de gestion de l'opérateur DNS

DNS gère le composant CoreDNS afin de fournir un service de résolution de noms pour les pods et les services dans le cluster. L'adresse managementState de l'opérateur DNS est définie par défaut sur Managed, ce qui signifie que l'opérateur DNS gère activement ses ressources. Vous pouvez le changer en Unmanaged, ce qui signifie que l'opérateur DNS ne gère pas ses ressources.

Les cas d'utilisation suivants concernent la modification de l'opérateur DNS managementState:

-

Vous êtes un développeur et vous voulez tester un changement de configuration pour voir s'il corrige un problème dans CoreDNS. Vous pouvez empêcher l'opérateur DNS d'écraser le correctif en définissant

managementStatesurUnmanaged. -

Vous êtes un administrateur de cluster et vous avez signalé un problème avec CoreDNS, mais vous devez appliquer une solution de contournement jusqu'à ce que le problème soit résolu. Vous pouvez définir le champ

managementStatede l'opérateur DNS surUnmanagedpour appliquer la solution de contournement.

Procédure

Changer

managementStateOpérateur DNS :oc patch dns.operator.openshift.io default --type merge --patch '{"spec":{"managementState":"Unmanaged"}}'

6.3. Contrôle du placement des pods DNS

L'opérateur DNS dispose de deux ensembles de démons : l'un pour CoreDNS et l'autre pour gérer le fichier /etc/hosts. Le jeu de démons pour /etc/hosts doit être exécuté sur chaque hôte de nœud afin d'ajouter une entrée au registre d'images de cluster pour prendre en charge l'extraction d'images. Les politiques de sécurité peuvent interdire la communication entre les paires de nœuds, ce qui empêche le jeu de démons pour CoreDNS de s'exécuter sur chaque nœud.

En tant qu'administrateur de cluster, vous pouvez utiliser un sélecteur de nœud personnalisé pour configurer le jeu de démons pour CoreDNS afin qu'il s'exécute ou non sur certains nœuds.

Conditions préalables

-

Vous avez installé le CLI

oc. -

Vous êtes connecté au cluster avec un utilisateur disposant des privilèges

cluster-admin.

Procédure

Pour empêcher la communication entre certains nœuds, configurez le champ

spec.nodePlacement.nodeSelectorAPI :Modifier l'objet Opérateur DNS nommé

default:$ oc edit dns.operator/default

Spécifiez un sélecteur de nœuds qui n'inclut que les nœuds du plan de contrôle dans le champ

spec.nodePlacement.nodeSelectorAPI :spec: nodePlacement: nodeSelector: node-role.kubernetes.io/worker: ""

Pour permettre au démon défini pour CoreDNS de fonctionner sur les nœuds, configurez une taint et une toleration :

Modifier l'objet Opérateur DNS nommé

default:$ oc edit dns.operator/default

Spécifier une clé d'altération et une tolérance pour l'altération :

spec: nodePlacement: tolerations: - effect: NoExecute key: "dns-only" operators: Equal value: abc tolerationSeconds: 3600 1- 1

- Si l'erreur est

dns-only, elle peut être tolérée indéfiniment. Vous pouvez omettretolerationSeconds.

6.4. Afficher le DNS par défaut

Chaque nouvelle installation d'OpenShift Container Platform possède un site dns.operator nommé default.

Procédure

Utilisez la commande

oc describepour afficher les paramètres par défautdns:$ oc describe dns.operator/default

Exemple de sortie

Name: default Namespace: Labels: <none> Annotations: <none> API Version: operator.openshift.io/v1 Kind: DNS ... Status: Cluster Domain: cluster.local 1 Cluster IP: 172.30.0.10 2 ...

Pour connaître le CIDR de service de votre cluster, utilisez la commande

oc get:$ oc get networks.config/cluster -o jsonpath='{$.status.serviceNetwork}'

Exemple de sortie

[172.30.0.0/16]

6.5. Utilisation de la redirection DNS

Vous pouvez utiliser la redirection DNS pour remplacer la configuration de la redirection par défaut dans le fichier /etc/resolv.conf de la manière suivante :

- Spécifiez les serveurs de noms pour chaque zone. Si la zone transférée est le domaine Ingress géré par OpenShift Container Platform, le serveur de noms en amont doit être autorisé pour le domaine.

- Fournir une liste de serveurs DNS en amont.

- Modifier la politique de transfert par défaut.

Une configuration de transfert DNS pour le domaine par défaut peut comporter à la fois les serveurs par défaut spécifiés dans le fichier /etc/resolv.conf et les serveurs DNS en amont.

Procédure

Modifier l'objet Opérateur DNS nommé

default:$ oc edit dns.operator/default

Cela permet à l'opérateur de créer et de mettre à jour la carte de configuration nommée

dns-defaultavec des blocs de configuration de serveur supplémentaires basés surServer. Si aucun des serveurs ne dispose d'une zone correspondant à la requête, la résolution de noms revient aux serveurs DNS en amont.Configuration de la redirection DNS

apiVersion: operator.openshift.io/v1 kind: DNS metadata: name: default spec: servers: - name: example-server 1 zones: 2 - example.com forwardPlugin: policy: Random 3 upstreams: 4 - 1.1.1.1 - 2.2.2.2:5353 upstreamResolvers: 5 policy: Random 6 upstreams: 7 - type: SystemResolvConf 8 - type: Network address: 1.2.3.4 9 port: 53 10

- 1

- Doit être conforme à la syntaxe du nom de service

rfc6335. - 2

- Doit être conforme à la définition d'un sous-domaine dans la syntaxe du nom de service

rfc1123. Le domaine de cluster,cluster.local, n'est pas un sous-domaine valide pour le champzones. - 3

- Définit la politique de sélection des résolveurs en amont. La valeur par défaut est

Random. Vous pouvez également utiliser les valeursRoundRobin, etSequential. - 4

- Un maximum de 15

upstreamsest autorisé parforwardPlugin. - 5

- Facultatif. Vous pouvez l'utiliser pour remplacer la stratégie par défaut et transmettre la résolution DNS aux résolveurs DNS spécifiés (résolveurs en amont) pour le domaine par défaut. Si vous ne fournissez pas de résolveurs en amont, les requêtes de nom DNS sont envoyées aux serveurs situés à l'adresse

/etc/resolv.conf. - 6

- Détermine l'ordre dans lequel les serveurs en amont sont sélectionnés pour l'interrogation. Vous pouvez spécifier l'une de ces valeurs :

RandomRoundRobin, ouSequential. La valeur par défaut estSequential. - 7

- Facultatif. Vous pouvez l'utiliser pour fournir des résolveurs en amont.

- 8

- Vous pouvez spécifier deux types de

upstreams-SystemResolvConfetNetwork.SystemResolvConfconfigure l'amont pour utiliser/etc/resolv.confetNetworkdéfinit unNetworkresolver. Vous pouvez spécifier l'un ou l'autre ou les deux. - 9

- Si le type spécifié est

Network, vous devez fournir une adresse IP. Le champaddressdoit être une adresse IPv4 ou IPv6 valide. - 10

- Si le type spécifié est

Network, vous pouvez éventuellement indiquer un port. Le champportdoit avoir une valeur comprise entre1et65535. Si vous ne spécifiez pas de port pour l'amont, le port 853 est utilisé par défaut.

Lorsque vous travaillez dans un environnement très réglementé, vous pouvez avoir besoin de sécuriser le trafic DNS lorsque vous transmettez des requêtes à des résolveurs en amont, afin de garantir un trafic DNS supplémentaire et la confidentialité des données. Les administrateurs de clusters peuvent configurer la sécurité de la couche transport (TLS) pour les requêtes DNS transmises.

Configuration du transfert DNS avec TLS

apiVersion: operator.openshift.io/v1 kind: DNS metadata: name: default spec: servers: - name: example-server 1 zones: 2 - example.com forwardPlugin: transportConfig: transport: TLS 3 tls: caBundle: name: mycacert serverName: dnstls.example.com 4 policy: Random 5 upstreams: 6 - 1.1.1.1 - 2.2.2.2:5353 upstreamResolvers: 7 transportConfig: transport: TLS tls: caBundle: name: mycacert serverName: dnstls.example.com upstreams: - type: Network 8 address: 1.2.3.4 9 port: 53 10

- 1

- Doit être conforme à la syntaxe du nom de service

rfc6335. - 2

- Doit être conforme à la définition d'un sous-domaine dans la syntaxe du nom de service

rfc1123. Le domaine de cluster,cluster.local, n'est pas un sous-domaine valide pour le champzones. Le domaine de cluster,cluster.local, est unsubdomainnon valide pourzones. - 3

- Lors de la configuration de TLS pour les requêtes DNS transférées, le champ

transportdoit avoir la valeurTLS. Par défaut, CoreDNS met en cache les connexions transférées pendant 10 secondes. CoreDNS maintiendra une connexion TCP ouverte pendant ces 10 secondes si aucune requête n'est émise. Dans le cas de clusters importants, assurez-vous que votre serveur DNS est conscient du fait qu'il pourrait recevoir de nombreuses nouvelles connexions à maintenir ouvertes, car vous pouvez initier une connexion par nœud. Configurez votre hiérarchie DNS en conséquence pour éviter les problèmes de performance. - 4

- Lors de la configuration de TLS pour les requêtes DNS transmises, il s'agit d'un nom de serveur obligatoire utilisé dans le cadre de l'indication du nom du serveur (SNI) pour valider le certificat du serveur TLS en amont.

- 5

- Définit la politique de sélection des résolveurs en amont. La valeur par défaut est

Random. Vous pouvez également utiliser les valeursRoundRobin, etSequential. - 6

- Il est obligatoire. Vous pouvez l'utiliser pour fournir des résolveurs en amont. Un maximum de 15 entrées

upstreamsest autorisé par entréeforwardPlugin. - 7

- Facultatif. Vous pouvez l'utiliser pour remplacer la stratégie par défaut et transmettre la résolution DNS aux résolveurs DNS spécifiés (résolveurs en amont) pour le domaine par défaut. Si vous ne fournissez pas de résolveurs en amont, les requêtes de nom DNS sont envoyées aux serveurs situés à l'adresse

/etc/resolv.conf. - 8

Networkindique que ce résolveur en amont doit traiter les demandes transférées séparément des résolveurs en amont répertoriés dans/etc/resolv.conf. Seul le typeNetworkest autorisé en cas d'utilisation de TLS et vous devez fournir une adresse IP.- 9

- Le champ

addressdoit être une adresse IPv4 ou IPv6 valide. - 10

- Vous pouvez optionnellement fournir un port. La valeur de

portdoit être comprise entre1et65535. Si vous ne spécifiez pas de port pour l'amont, le port 853 est utilisé par défaut.

NoteSi

serversest indéfini ou invalide, la carte de configuration ne contient que le serveur par défaut.Afficher la carte de configuration :

$ oc get configmap/dns-default -n openshift-dns -o yaml

Exemple de ConfigMap DNS basé sur l'exemple précédent de DNS

apiVersion: v1 data: Corefile: | example.com:5353 { forward . 1.1.1.1 2.2.2.2:5353 } bar.com:5353 example.com:5353 { forward . 3.3.3.3 4.4.4.4:5454 1 } .:5353 { errors health kubernetes cluster.local in-addr.arpa ip6.arpa { pods insecure upstream fallthrough in-addr.arpa ip6.arpa } prometheus :9153 forward . /etc/resolv.conf 1.2.3.4:53 { policy Random } cache 30 reload } kind: ConfigMap metadata: labels: dns.operator.openshift.io/owning-dns: default name: dns-default namespace: openshift-dns- 1

- Les modifications apportées au site

forwardPlugindéclenchent une mise à jour continue de l'ensemble des démons CoreDNS.

Ressources supplémentaires

- Pour plus d'informations sur la redirection DNS, voir la documentation CoreDNS forward.

6.6. Statut de l'opérateur DNS

Vous pouvez inspecter l'état et afficher les détails de l'opérateur DNS à l'aide de la commande oc describe.

Procédure

Consulter l'état de l'opérateur DNS :

$ oc describe clusteroperators/dns

6.7. Journaux de l'opérateur DNS

Vous pouvez consulter les journaux de l'opérateur DNS à l'aide de la commande oc logs.

Procédure

Consulter les journaux de l'opérateur DNS :

$ oc logs -n openshift-dns-operator deployment/dns-operator -c dns-operator

6.8. Configuration du niveau de journalisation de CoreDNS

Vous pouvez configurer le niveau du journal CoreDNS pour déterminer la quantité de détails dans les messages d'erreur enregistrés. Les valeurs valides pour le niveau de journalisation du CoreDNS sont Normal, Debug, et Trace. La valeur par défaut logLevel est Normal.

Le plugin d'erreurs est toujours activé. Les paramètres suivants de logLevel donnent lieu à des réponses d'erreur différentes :

-

logLevel:Normalactive la classe "erreurs" :log . { class error }. -

logLevel:Debugactive la classe "denial" :log . { class denial error }. -

logLevel:Traceactive la classe "all" :log . { class all }.

Procédure

Pour remplacer

logLevelparDebug, entrez la commande suivante :$ oc patch dnses.operator.openshift.io/default -p '{"spec":{"logLevel":"Debug"}}' --type=mergePour remplacer

logLevelparTrace, entrez la commande suivante :$ oc patch dnses.operator.openshift.io/default -p '{"spec":{"logLevel":"Trace"}}' --type=merge

Vérification

Pour s'assurer que le niveau de journalisation souhaité a été défini, vérifiez la carte de configuration :

$ oc get configmap/dns-default -n openshift-dns -o yaml

6.9. Configuration du niveau de journalisation de l'opérateur CoreDNS

Les administrateurs de clusters peuvent configurer le niveau de journal de l'opérateur afin de localiser plus rapidement les problèmes DNS d'OpenShift. Les valeurs valides pour operatorLogLevel sont Normal, Debug, et Trace. Trace contient les informations les plus détaillées. La valeur par défaut de operatorlogLevel est Normal. Il existe sept niveaux de journalisation pour les problèmes : Trace, Debug, Info, Warning, Error, Fatal et Panic. Une fois le niveau de journalisation défini, les entrées de journal correspondant à ce niveau de gravité ou à un niveau supérieur seront enregistrées.

-

operatorLogLevel: "Normal"setlogrus.SetLogLevel("Info"). -

operatorLogLevel: "Debug"setlogrus.SetLogLevel("Debug"). -

operatorLogLevel: "Trace"setlogrus.SetLogLevel("Trace").

Procédure

Pour remplacer

operatorLogLevelparDebug, entrez la commande suivante :$ oc patch dnses.operator.openshift.io/default -p '{"spec":{"operatorLogLevel":"Debug"}}' --type=mergePour remplacer

operatorLogLevelparTrace, entrez la commande suivante :$ oc patch dnses.operator.openshift.io/default -p '{"spec":{"operatorLogLevel":"Trace"}}' --type=merge

6.10. Optimisation du cache CoreDNS

Vous pouvez configurer la durée maximale de la mise en cache réussie ou non, également connue sous le nom de mise en cache positive ou négative, effectuée par CoreDNS. Le réglage de la durée de la mise en cache des réponses aux requêtes DNS peut réduire la charge des résolveurs DNS en amont.

Procédure

Modifiez l'objet Opérateur DNS nommé

defaulten exécutant la commande suivante :$ oc edit dns.operator.openshift.io/default

Modifier les valeurs de mise en cache de la durée de vie (TTL) :

Configuration de la mise en cache DNS

apiVersion: operator.openshift.io/v1 kind: DNS metadata: name: default spec: cache: positiveTTL: 1h 1 negativeTTL: 0.5h10m 2- 1

- La valeur de la chaîne

1hest convertie en nombre de secondes par CoreDNS. Si ce champ est omis, la valeur est supposée être0set le cluster utilise la valeur interne par défaut de900scomme solution de repli. - 2

- La valeur de la chaîne peut être une combinaison d'unités telles que

0.5h10met est convertie en nombre de secondes par CoreDNS. Si ce champ est omis, la valeur est supposée être0set le cluster utilise la valeur interne par défaut de30scomme solution de repli.

AvertissementLa définition de champs TTL de faible valeur peut entraîner une augmentation de la charge sur le cluster, sur les résolveurs en amont, ou sur les deux.

Chapitre 7. Opérateur Ingress dans OpenShift Container Platform

7.1. Opérateur Ingress de la plateforme de conteneurs OpenShift

Lorsque vous créez votre cluster OpenShift Container Platform, les pods et les services s'exécutant sur le cluster se voient attribuer chacun leur propre adresse IP. Les adresses IP sont accessibles aux autres pods et services fonctionnant à proximité, mais ne sont pas accessibles aux clients extérieurs. L'opérateur d'ingestion (Ingress Operator) met en œuvre l'API IngressController et est le composant responsable de l'activation de l'accès externe aux services de cluster d'OpenShift Container Platform.

L'opérateur d'ingestion permet aux clients externes d'accéder à votre service en déployant et en gérant un ou plusieurs contrôleurs d'ingestion basés sur HAProxy pour gérer le routage. Vous pouvez utiliser l'opérateur d'ingestion pour acheminer le trafic en spécifiant les ressources OpenShift Container Platform Route et Kubernetes Ingress. Les configurations au sein du contrôleur d'ingestion, telles que la possibilité de définir le type endpointPublishingStrategy et l'équilibrage de charge interne, fournissent des moyens de publier les points d'extrémité du contrôleur d'ingestion.

7.2. L'actif de configuration Ingress

Le programme d'installation génère un bien avec une ressource Ingress dans le groupe API config.openshift.io, cluster-ingress-02-config.yml.

Définition YAML de la ressource Ingress

apiVersion: config.openshift.io/v1 kind: Ingress metadata: name: cluster spec: domain: apps.openshiftdemos.com

Le programme d'installation stocke cette ressource dans le fichier cluster-ingress-02-config.yml du répertoire manifests/. Cette ressource Ingress définit la configuration de l'ensemble du cluster pour Ingress. Cette configuration d'Ingress est utilisée comme suit :

- L'opérateur d'entrée utilise le domaine de la configuration d'entrée du cluster comme domaine pour le contrôleur d'entrée par défaut.

-

L'opérateur OpenShift API Server utilise le domaine de la configuration Ingress du cluster. Ce domaine est également utilisé lors de la génération d'un hôte par défaut pour une ressource

Routequi ne spécifie pas d'hôte explicite.

7.3. Paramètres de configuration du contrôleur d'entrée

La ressource ingresscontrollers.operator.openshift.io offre les paramètres de configuration suivants.

| Paramètres | Description |

|---|---|

|

|

La valeur

S'il est vide, la valeur par défaut est |

|

|

|

|

|

Sur GCP, AWS et Azure, vous pouvez configurer les champs

Si elle n'est pas définie, la valeur par défaut est basée sur

Pour la plupart des plateformes, la valeur

|

|

|

La valeur

The secret must contain the following keys and data: *

S'il n'est pas défini, un certificat générique est automatiquement généré et utilisé. Le certificat est valable pour le contrôleur d'entrée Le certificat en cours d'utilisation, qu'il soit généré ou spécifié par l'utilisateur, est automatiquement intégré au serveur OAuth intégré à OpenShift Container Platform. |

|

|

|

|

|

|

|

|

Si ce n'est pas le cas, les valeurs par défaut sont utilisées. Note

Le paramètre nodePlacement:

nodeSelector:

matchLabels:

kubernetes.io/os: linux

tolerations:

- effect: NoSchedule

operator: Exists |

|

|

Si elle n'est pas définie, la valeur par défaut est basée sur la ressource

Lors de l'utilisation des types de profil

La version TLS minimale pour les contrôleurs d'entrée est Note

Les codes et la version TLS minimale du profil de sécurité configuré sont reflétés dans l'état Important

L'opérateur d'entrée convertit le TLS |

|

|

Le sous-champ |

|

|

|

|

|

|

|

|

En définissant

Par défaut, la politique est définie sur

En définissant Ces ajustements ne s'appliquent qu'aux itinéraires en clair, terminés par les bords et recryptés, et uniquement lors de l'utilisation du protocole HTTP/1.

Pour les en-têtes de requête, ces ajustements ne sont appliqués qu'aux itinéraires qui ont l'annotation |

|

|

|

|

|

|

|

|

Pour tout cookie que vous souhaitez capturer, les paramètres suivants doivent figurer dans votre configuration

Par exemple : httpCaptureCookies:

- matchType: Exact

maxLength: 128

name: MYCOOKIE

|

|

|

httpCaptureHeaders:

request:

- maxLength: 256

name: Connection

- maxLength: 128

name: User-Agent

response:

- maxLength: 256

name: Content-Type

- maxLength: 256

name: Content-Length

|

|

|

|

|

|

Le type

|

|

|

Le type

Ces connexions proviennent de sondes de santé d'équilibreurs de charge ou de connexions spéculatives de navigateurs web (préconnexion) et peuvent être ignorées sans risque. Cependant, ces demandes peuvent être causées par des erreurs de réseau, de sorte que la définition de ce champ à |

Tous les paramètres sont facultatifs.

7.3.1. Profils de sécurité TLS du contrôleur d'entrée

Les profils de sécurité TLS permettent aux serveurs de déterminer les algorithmes de chiffrement qu'un client peut utiliser lorsqu'il se connecte au serveur.

7.3.1.1. Comprendre les profils de sécurité TLS

Vous pouvez utiliser un profil de sécurité TLS (Transport Layer Security) pour définir les algorithmes TLS requis par les différents composants d'OpenShift Container Platform. Les profils de sécurité TLS d'OpenShift Container Platform sont basés sur les configurations recommandées par Mozilla.

Vous pouvez spécifier l'un des profils de sécurité TLS suivants pour chaque composant :

Tableau 7.1. Profils de sécurité TLS

| Profile | Description |

|---|---|

|

| Ce profil est destiné à être utilisé avec des clients ou des bibliothèques anciens. Il est basé sur l'ancienne configuration recommandée pour la rétrocompatibilité.

Le profil Note Pour le contrôleur d'entrée, la version minimale de TLS passe de 1.0 à 1.1. |

|

| Ce profil est la configuration recommandée pour la majorité des clients. Il s'agit du profil de sécurité TLS par défaut pour le contrôleur d'entrée, le kubelet et le plan de contrôle. Le profil est basé sur la configuration recommandée pour la compatibilité intermédiaire.

Le profil |

|

| Ce profil est destiné à être utilisé avec des clients modernes qui n'ont pas besoin de rétrocompatibilité. Ce profil est basé sur la configuration recommandée pour la compatibilité moderne.

Le profil |

|

| Ce profil permet de définir la version de TLS et les algorithmes de chiffrement à utiliser. Avertissement

Soyez prudent lorsque vous utilisez un profil |

Lorsque l'on utilise l'un des types de profil prédéfinis, la configuration effective du profil est susceptible d'être modifiée entre les versions. Par exemple, si l'on spécifie l'utilisation du profil intermédiaire déployé dans la version X.Y.Z, une mise à niveau vers la version X.Y.Z 1 peut entraîner l'application d'une nouvelle configuration de profil, ce qui se traduit par un déploiement.

7.3.1.2. Configuration du profil de sécurité TLS pour le contrôleur d'entrée

Pour configurer un profil de sécurité TLS pour un contrôleur d'entrée, modifiez la ressource personnalisée (CR) IngressController afin de spécifier un profil de sécurité TLS prédéfini ou personnalisé. Si aucun profil de sécurité TLS n'est configuré, la valeur par défaut est basée sur le profil de sécurité TLS défini pour le serveur API.

Exemple de CR IngressController qui configure le profil de sécurité TLS Old

apiVersion: operator.openshift.io/v1

kind: IngressController

...

spec:

tlsSecurityProfile:

old: {}

type: Old

...

Le profil de sécurité TLS définit la version minimale de TLS et les algorithmes de chiffrement TLS pour les connexions TLS des contrôleurs d'entrée.

Les chiffres et la version TLS minimale du profil de sécurité TLS configuré sont indiqués dans la ressource personnalisée (CR) IngressController sous Status.Tls Profile et dans le profil de sécurité TLS configuré sous Spec.Tls Security Profile. Pour le profil de sécurité TLS Custom, les algorithmes de chiffrement spécifiques et la version TLS minimale sont répertoriés sous les deux paramètres.

L'image du contrôleur d'entrée HAProxy prend en charge TLS 1.3 et le profil Modern.

L'opérateur d'entrée convertit également le TLS 1.0 d'un profil Old ou Custom en 1.1.

Conditions préalables

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

cluster-admin.

Procédure

Modifiez le CR

IngressControllerdans le projetopenshift-ingress-operatorpour configurer le profil de sécurité TLS :$ oc edit IngressController default -n openshift-ingress-operator

Ajouter le champ

spec.tlsSecurityProfile:Exemple de CR

IngressControllerpour un profilCustomapiVersion: operator.openshift.io/v1 kind: IngressController ... spec: tlsSecurityProfile: type: Custom 1 custom: 2 ciphers: 3 - ECDHE-ECDSA-CHACHA20-POLY1305 - ECDHE-RSA-CHACHA20-POLY1305 - ECDHE-RSA-AES128-GCM-SHA256 - ECDHE-ECDSA-AES128-GCM-SHA256 minTLSVersion: VersionTLS11 ...- 1

- Spécifiez le type de profil de sécurité TLS (

Old,Intermediate, ouCustom). La valeur par défaut estIntermediate. - 2

- Spécifiez le champ approprié pour le type sélectionné :

-

old: {} -

intermediate: {} -

custom:

-

- 3

- Pour le type

custom, spécifiez une liste de chiffrements TLS et la version TLS minimale acceptée.

- Enregistrez le fichier pour appliquer les modifications.

Vérification

Vérifiez que le profil est défini dans le CR

IngressController:$ oc describe IngressController default -n openshift-ingress-operator

Exemple de sortie

Name: default Namespace: openshift-ingress-operator Labels: <none> Annotations: <none> API Version: operator.openshift.io/v1 Kind: IngressController ... Spec: ... Tls Security Profile: Custom: Ciphers: ECDHE-ECDSA-CHACHA20-POLY1305 ECDHE-RSA-CHACHA20-POLY1305 ECDHE-RSA-AES128-GCM-SHA256 ECDHE-ECDSA-AES128-GCM-SHA256 Min TLS Version: VersionTLS11 Type: Custom ...

7.3.1.3. Configuration de l'authentification mutuelle TLS

Vous pouvez configurer le contrôleur d'entrée pour activer l'authentification mutuelle TLS (mTLS) en définissant une valeur spec.clientTLS. La valeur clientTLS configure le contrôleur d'entrée pour qu'il vérifie les certificats des clients. Cette configuration comprend la définition d'une valeur clientCA, qui est une référence à une carte de configuration. La carte de configuration contient le paquet de certificats CA codé PEM utilisé pour vérifier le certificat d'un client. En option, vous pouvez configurer une liste de filtres de sujet de certificat.

Si la valeur clientCA indique un point de distribution de liste de révocation de certificats (CRL) X509v3, l'opérateur d'entrée télécharge la CRL et configure le contrôleur d'entrée pour qu'il en prenne acte. Les demandes qui ne fournissent pas de certificats valides sont rejetées.

Conditions préalables

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

cluster-admin.

Procédure

Créer une carte de configuration dans l'espace de noms

openshift-config:$ oc create configmap router-ca-certs-default --from-file=ca-bundle.pem=client-ca.crt -n openshift-config

NoteLa clé de données de la carte de configuration doit être

ca-bundle.pem, et la valeur des données doit être un certificat d'autorité de certification au format PEM.Modifiez la ressource

IngressControllerdans le projetopenshift-ingress-operator:$ oc edit IngressController default -n openshift-ingress-operator

Ajoutez le champ spec.clientTLS et ses sous-champs pour configurer le TLS mutuel :

Exemple de CR

IngressControllerpour un profilclientTLSqui spécifie des modèles de filtrageapiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: clientTLS: clientCertificatePolicy: Required clientCA: name: router-ca-certs-default allowedSubjectPatterns: - "^/CN=example.com/ST=NC/C=US/O=Security/OU=OpenShift$"

7.4. Afficher le contrôleur d'entrée par défaut

L'opérateur d'ingestion est une fonctionnalité essentielle d'OpenShift Container Platform et est activé d'emblée.

Chaque nouvelle installation d'OpenShift Container Platform a un ingresscontroller nommé default. Il peut être complété par des contrôleurs d'ingestion supplémentaires. Si l'adresse ingresscontroller par défaut est supprimée, l'opérateur d'ingestion la recréera automatiquement dans la minute qui suit.

Procédure

Affichez le contrôleur d'entrée par défaut :

$ oc describe --namespace=openshift-ingress-operator ingresscontroller/default

7.5. Visualiser l'état de l'opérateur d'entrée

Vous pouvez visualiser et contrôler l'état de votre opérateur d'entrée.

Procédure

Consultez votre statut d'opérateur d'entrée :

$ oc describe clusteroperators/ingress

7.6. Consulter les journaux du contrôleur d'entrée

Vous pouvez consulter les journaux du contrôleur d'ingérence.

Procédure

Consultez les journaux du contrôleur d'ingérence :

oc logs --namespace=openshift-ingress-operator deployments/ingress-operator -c <container_name>

7.7. Afficher l'état du contrôleur d'entrée

Vous pouvez consulter l'état d'un contrôleur d'entrée particulier.

Procédure

Consulter l'état d'un contrôleur d'entrée :

oc describe --namespace=openshift-ingress-operator ingresscontroller/<name> $ oc describe --namespace=openshift-ingress-operator ingresscontroller/<name>

7.8. Configuration du contrôleur d'entrée

7.8.1. Définition d'un certificat personnalisé par défaut

En tant qu'administrateur, vous pouvez configurer un contrôleur d'entrée pour qu'il utilise un certificat personnalisé en créant une ressource Secret et en modifiant la ressource personnalisée (CR) IngressController.

Conditions préalables

- Vous devez disposer d'une paire certificat/clé dans des fichiers codés PEM, où le certificat est signé par une autorité de certification de confiance ou par une autorité de certification de confiance privée que vous avez configurée dans une infrastructure de clés publiques (PKI) personnalisée.

Votre certificat répond aux exigences suivantes :

- Le certificat est valable pour le domaine d'entrée.

-

Le certificat utilise l'extension

subjectAltNamepour spécifier un domaine de remplacement, tel que*.apps.ocp4.example.com.

Vous devez avoir un CR

IngressController. Vous pouvez utiliser le CR par défaut :$ oc --namespace openshift-ingress-operator get ingresscontrollers

Exemple de sortie

NAME AGE default 10m

Si vous avez des certificats intermédiaires, ils doivent être inclus dans le fichier tls.crt du secret contenant un certificat par défaut personnalisé. L'ordre est important lors de la spécification d'un certificat ; indiquez votre (vos) certificat(s) intermédiaire(s) après le(s) certificat(s) de serveur.

Procédure

Ce qui suit suppose que le certificat personnalisé et la paire de clés se trouvent dans les fichiers tls.crt et tls.key dans le répertoire de travail actuel. Remplacez les noms de chemin réels par tls.crt et tls.key. Vous pouvez également remplacer custom-certs-default par un autre nom lorsque vous créez la ressource Secret et que vous y faites référence dans le CR IngressController.

Cette action entraînera le redéploiement du contrôleur d'entrée, à l'aide d'une stratégie de déploiement continu.

Créez une ressource Secret contenant le certificat personnalisé dans l'espace de noms

openshift-ingressà l'aide des fichierstls.crtettls.key.$ oc --namespace openshift-ingress create secret tls custom-certs-default --cert=tls.crt --key=tls.key

Mettre à jour la CR du contrôleur d'ingestion pour qu'elle fasse référence au nouveau secret du certificat :

$ oc patch --type=merge --namespace openshift-ingress-operator ingresscontrollers/default \ --patch '{"spec":{"defaultCertificate":{"name":"custom-certs-default"}}}'Vérifier que la mise à jour a été effective :

$ echo Q |\ openssl s_client -connect console-openshift-console.apps.<domain>:443 -showcerts 2>/dev/null |\ openssl x509 -noout -subject -issuer -enddate

où :

<domain>- Spécifie le nom de domaine de base pour votre cluster.

Exemple de sortie

subject=C = US, ST = NC, L = Raleigh, O = RH, OU = OCP4, CN = *.apps.example.com issuer=C = US, ST = NC, L = Raleigh, O = RH, OU = OCP4, CN = example.com notAfter=May 10 08:32:45 2022 GM

AstuceVous pouvez également appliquer le code YAML suivant pour définir un certificat par défaut personnalisé :

apiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: defaultCertificate: name: custom-certs-defaultLe nom du secret du certificat doit correspondre à la valeur utilisée pour mettre à jour le CR.

Une fois que le CR du contrôleur d'ingestion a été modifié, l'opérateur d'ingestion met à jour le déploiement du contrôleur d'ingestion afin d'utiliser le certificat personnalisé.

7.8.2. Suppression d'un certificat personnalisé par défaut

En tant qu'administrateur, vous pouvez supprimer un certificat personnalisé pour lequel vous avez configuré un contrôleur d'entrée.

Conditions préalables

-

Vous avez accès au cluster en tant qu'utilisateur ayant le rôle

cluster-admin. -

Vous avez installé l'OpenShift CLI (

oc). - Vous avez précédemment configuré un certificat par défaut personnalisé pour le contrôleur d'entrée.

Procédure

Pour supprimer le certificat personnalisé et restaurer le certificat fourni avec OpenShift Container Platform, entrez la commande suivante :

$ oc patch -n openshift-ingress-operator ingresscontrollers/default \ --type json -p $'- op: remove\n path: /spec/defaultCertificate'

Il peut y avoir un délai pendant que le cluster réconcilie la nouvelle configuration du certificat.

Vérification

Pour confirmer que le certificat original du cluster est restauré, entrez la commande suivante :

$ echo Q | \ openssl s_client -connect console-openshift-console.apps.<domain>:443 -showcerts 2>/dev/null | \ openssl x509 -noout -subject -issuer -enddate

où :

<domain>- Spécifie le nom de domaine de base pour votre cluster.

Exemple de sortie

subject=CN = *.apps.<domain> issuer=CN = ingress-operator@1620633373 notAfter=May 10 10:44:36 2023 GMT

7.8.3. Mise à l'échelle automatique d'un contrôleur d'entrée

Mettre automatiquement à l'échelle un contrôleur d'entrée pour répondre dynamiquement aux exigences de performance ou de disponibilité du routage, telles que l'exigence d'augmenter le débit. La procédure suivante fournit un exemple de mise à l'échelle du contrôleur par défaut IngressController.

Le Custom Metrics Autoscaler est une fonctionnalité d'aperçu technologique uniquement. Les fonctionnalités de l'aperçu technologique ne sont pas prises en charge par les accords de niveau de service (SLA) de production de Red Hat et peuvent ne pas être complètes sur le plan fonctionnel. Red Hat ne recommande pas de les utiliser en production. Ces fonctionnalités offrent un accès anticipé aux fonctionnalités des produits à venir, ce qui permet aux clients de tester les fonctionnalités et de fournir un retour d'information pendant le processus de développement.

Pour plus d'informations sur la portée de l'assistance des fonctionnalités de l'aperçu technologique de Red Hat, voir Portée de l'assistance des fonctionnalités de l'aperçu technologique.

Conditions préalables

-

Vous avez installé l'OpenShift CLI (

oc). -

Vous avez accès à un cluster OpenShift Container Platform en tant qu'utilisateur ayant le rôle

cluster-admin. - L'opérateur Custom Metrics Autoscaler est installé.

Procédure

Créez un projet dans l'espace de noms

openshift-ingress-operatoren exécutant la commande suivante :$ oc project openshift-ingress-operator

Activer la surveillance d'OpenShift pour des projets définis par l'utilisateur en créant et en appliquant une carte de configuration :

Créez un nouvel objet

ConfigMap,cluster-monitoring-config.yaml:cluster-monitoring-config.yaml

apiVersion: v1 kind: ConfigMap metadata: name: cluster-monitoring-config namespace: openshift-monitoring data: config.yaml: | enableUserWorkload: true 1- 1

- Lorsqu'il est défini sur

true, le paramètreenableUserWorkloadpermet la surveillance de projets définis par l'utilisateur dans un cluster.

Appliquez la carte de configuration en exécutant la commande suivante :

$ oc apply -f cluster-monitoring-config.yaml

Créez un compte de service pour vous authentifier auprès de Thanos en exécutant la commande suivante :

$ oc create serviceaccount thanos && oc describe serviceaccount thanos

Exemple de sortie

Name: thanos Namespace: openshift-ingress-operator Labels: <none> Annotations: <none> Image pull secrets: thanos-dockercfg-b4l9s Mountable secrets: thanos-dockercfg-b4l9s Tokens: thanos-token-c422q Events: <none>

Définir un objet

TriggerAuthenticationdans l'espace de nomsopenshift-ingress-operatoren utilisant le jeton du compte de service.Définissez la variable

secretqui contient le secret en exécutant la commande suivante :$ secret=$(oc get secret | grep thanos-token | head -n 1 | awk '{ print $1 }')Créez l'objet

TriggerAuthenticationet transmettez la valeur de la variablesecretau paramètreTOKEN:$ oc process TOKEN="$secret" -f - <<EOF | oc apply -f - apiVersion: template.openshift.io/v1 kind: Template parameters: - name: TOKEN objects: - apiVersion: keda.sh/v1alpha1 kind: TriggerAuthentication metadata: name: keda-trigger-auth-prometheus spec: secretTargetRef: - parameter: bearerToken name: \${TOKEN} key: token - parameter: ca name: \${TOKEN} key: ca.crt EOF

Créer et appliquer un rôle pour la lecture des métriques de Thanos :

Créez un nouveau rôle,

thanos-metrics-reader.yaml, qui lit les métriques des pods et des nœuds :thanos-metrics-reader.yaml

apiVersion: rbac.authorization.k8s.io/v1 kind: Role metadata: name: thanos-metrics-reader rules: - apiGroups: - "" resources: - pods - nodes verbs: - get - apiGroups: - metrics.k8s.io resources: - pods - nodes verbs: - get - list - watch - apiGroups: - "" resources: - namespaces verbs: - get

Appliquez le nouveau rôle en exécutant la commande suivante :

$ oc apply -f thanos-metrics-reader.yaml

Ajoutez le nouveau rôle au compte de service en entrant les commandes suivantes :

$ oc adm policy add-role-to-user thanos-metrics-reader -z thanos --role=namespace=openshift-ingress-operator

$ oc adm policy -n openshift-ingress-operator add-cluster-role-to-user cluster-monitoring-view -z thanos

NoteL'argument

add-cluster-role-to-usern'est requis que si vous utilisez des requêtes inter-espaces de noms. L'étape suivante utilise une requête de l'espace de nomskube-metricsqui nécessite cet argument.Créez un nouveau fichier YAML

ScaledObject,ingress-autoscaler.yaml, qui cible le déploiement du contrôleur d'ingestion par défaut :Exemple

ScaledObjectdéfinitionapiVersion: keda.sh/v1alpha1 kind: ScaledObject metadata: name: ingress-scaler spec: scaleTargetRef: 1 apiVersion: operator.openshift.io/v1 kind: IngressController name: default envSourceContainerName: ingress-operator minReplicaCount: 1 maxReplicaCount: 20 2 cooldownPeriod: 1 pollingInterval: 1 triggers: - type: prometheus metricType: AverageValue metadata: serverAddress: https://<example-cluster>:9091 3 namespace: openshift-ingress-operator 4 metricName: 'kube-node-role' threshold: '1' query: 'sum(kube_node_role{role="worker",service="kube-state-metrics"})' 5 authModes: "bearer" authenticationRef: name: keda-trigger-auth-prometheus

- 1

- La ressource personnalisée que vous ciblez. Dans ce cas, il s'agit du contrôleur Ingress.

- 2

- Facultatif : Le nombre maximal de répliques. Si vous omettez ce champ, le maximum par défaut est fixé à 100 répliques.

- 3

- L'adresse et le port du cluster.

- 4

- L'espace de noms de l'opérateur d'entrée.

- 5

- Cette expression correspond au nombre de nœuds de travail présents dans la grappe déployée.

ImportantSi vous utilisez des requêtes inter-espace, vous devez cibler le port 9091 et non le port 9092 dans le champ

serverAddress. Vous devez également disposer de privilèges élevés pour lire les métriques à partir de ce port.Appliquez la définition de ressource personnalisée en exécutant la commande suivante :

$ oc apply -f ingress-autoscaler.yaml

Vérification

Vérifiez que le contrôleur d'entrée par défaut est mis à l'échelle pour correspondre à la valeur renvoyée par la requête

kube-state-metricsen exécutant les commandes suivantes :Utilisez la commande

greppour rechercher des répliques dans le fichier YAML du contrôleur d'entrée :$ oc get ingresscontroller/default -o yaml | grep replicas:

Exemple de sortie

replicas: 3

Obtenir les pods dans le projet

openshift-ingress:$ oc get pods -n openshift-ingress

Exemple de sortie

NAME READY STATUS RESTARTS AGE router-default-7b5df44ff-l9pmm 2/2 Running 0 17h router-default-7b5df44ff-s5sl5 2/2 Running 0 3d22h router-default-7b5df44ff-wwsth 2/2 Running 0 66s

Ressources supplémentaires

- Permettre le suivi de projets définis par l'utilisateur

- Installation de l'autoscaler de métriques personnalisé

- Comprendre les métriques personnalisées Autoscaler trigger authentications

- Configurer l'autoscaler de métriques personnalisé pour utiliser la surveillance de OpenShift Container Platform

- Comprendre comment ajouter des autoscalers de métriques personnalisés

7.8.4. Mise à l'échelle d'un contrôleur d'entrée

Mettre à l'échelle manuellement un contrôleur d'entrée pour répondre aux exigences de performance de routage ou de disponibilité telles que l'exigence d'augmenter le débit. Les commandes oc sont utilisées pour mettre à l'échelle la ressource IngressController. La procédure suivante fournit un exemple de mise à l'échelle de la ressource par défaut IngressController.

La mise à l'échelle n'est pas une action immédiate, car il faut du temps pour créer le nombre souhaité de répliques.

Procédure

Affichez le nombre actuel de répliques disponibles pour le site par défaut

IngressController:$ oc get -n openshift-ingress-operator ingresscontrollers/default -o jsonpath='{$.status.availableReplicas}'Exemple de sortie

2

Adaptez la version par défaut

IngressControllerau nombre de répliques souhaité à l'aide de la commandeoc patch. L'exemple suivant met à l'échelle le serveur par défautIngressControlleravec 3 réplicas :$ oc patch -n openshift-ingress-operator ingresscontroller/default --patch '{"spec":{"replicas": 3}}' --type=mergeExemple de sortie

ingresscontroller.operator.openshift.io/default patched

Vérifiez que la valeur par défaut de

IngressControllerest adaptée au nombre de répliques que vous avez spécifié :$ oc get -n openshift-ingress-operator ingresscontrollers/default -o jsonpath='{$.status.availableReplicas}'Exemple de sortie

3

AstuceVous pouvez également appliquer le fichier YAML suivant pour adapter un contrôleur d'ingestion à trois répliques :

apiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: replicas: 3 1- 1

- Si vous avez besoin d'un nombre différent de répliques, modifiez la valeur de

replicas.

7.8.5. Configuration de la journalisation des accès d'entrée

Vous pouvez configurer le contrôleur d'entrée pour activer les journaux d'accès. Si vous avez des clusters qui ne reçoivent pas beaucoup de trafic, vous pouvez enregistrer les logs dans un sidecar. Si vous avez des clusters à fort trafic, pour éviter de dépasser la capacité de la pile de journalisation ou pour intégrer une infrastructure de journalisation en dehors d'OpenShift Container Platform, vous pouvez transmettre les journaux à un point d'extrémité syslog personnalisé. Vous pouvez également spécifier le format des journaux d'accès.

La journalisation des conteneurs est utile pour activer les journaux d'accès sur les clusters à faible trafic lorsqu'il n'y a pas d'infrastructure de journalisation Syslog existante, ou pour une utilisation à court terme lors du diagnostic de problèmes avec le contrôleur d'entrée.

Syslog est nécessaire pour les clusters à fort trafic où les logs d'accès pourraient dépasser la capacité de la pile OpenShift Logging, ou pour les environnements où toute solution de logging doit s'intégrer à une infrastructure de logging Syslog existante. Les cas d'utilisation de Syslog peuvent se chevaucher.

Conditions préalables

-

Connectez-vous en tant qu'utilisateur disposant des privilèges

cluster-admin.

Procédure

Configurer l'enregistrement des accès entrants à un sidecar.

Pour configurer la journalisation des accès entrants, vous devez spécifier une destination à l'aide de

spec.logging.access.destination. Pour spécifier la journalisation vers un conteneur sidecar, vous devez spécifierContainerspec.logging.access.destination.type. L'exemple suivant est une définition de contrôleur d'entrée qui enregistre vers une destinationContainer:apiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: replicas: 2 logging: access: destination: type: ContainerLorsque vous configurez le contrôleur d'entrée pour qu'il se connecte à un sidecar, l'opérateur crée un conteneur nommé

logsdans le pod du contrôleur d'entrée :$ oc -n openshift-ingress logs deployment.apps/router-default -c logs

Exemple de sortie

2020-05-11T19:11:50.135710+00:00 router-default-57dfc6cd95-bpmk6 router-default-57dfc6cd95-bpmk6 haproxy[108]: 174.19.21.82:39654 [11/May/2020:19:11:50.133] public be_http:hello-openshift:hello-openshift/pod:hello-openshift:hello-openshift:10.128.2.12:8080 0/0/1/0/1 200 142 - - --NI 1/1/0/0/0 0/0 "GET / HTTP/1.1"

Configurer la journalisation de l'accès à l'entrée vers un point de terminaison Syslog.

Pour configurer la journalisation des accès d'entrée, vous devez spécifier une destination à l'aide de