Boîte à outils de migration pour conteneurs

Migration vers OpenShift Container Platform 4

Résumé

Chapitre 1. À propos de Migration Toolkit for Containers

Le Migration Toolkit for Containers (MTC) vous permet de migrer des charges de travail d'applications avec état entre les clusters d'OpenShift Container Platform 4 à la granularité d'un espace de noms.

Si vous migrez depuis OpenShift Container Platform 3, voir À propos de la migration d'OpenShift Container Platform 3 vers 4 et Installer l'opérateur Legacy Migration Toolkit for Containers sur OpenShift Container Platform 3.

Vous pouvez migrer des applications au sein d'un même cluster ou entre clusters en utilisant la migration d'état.

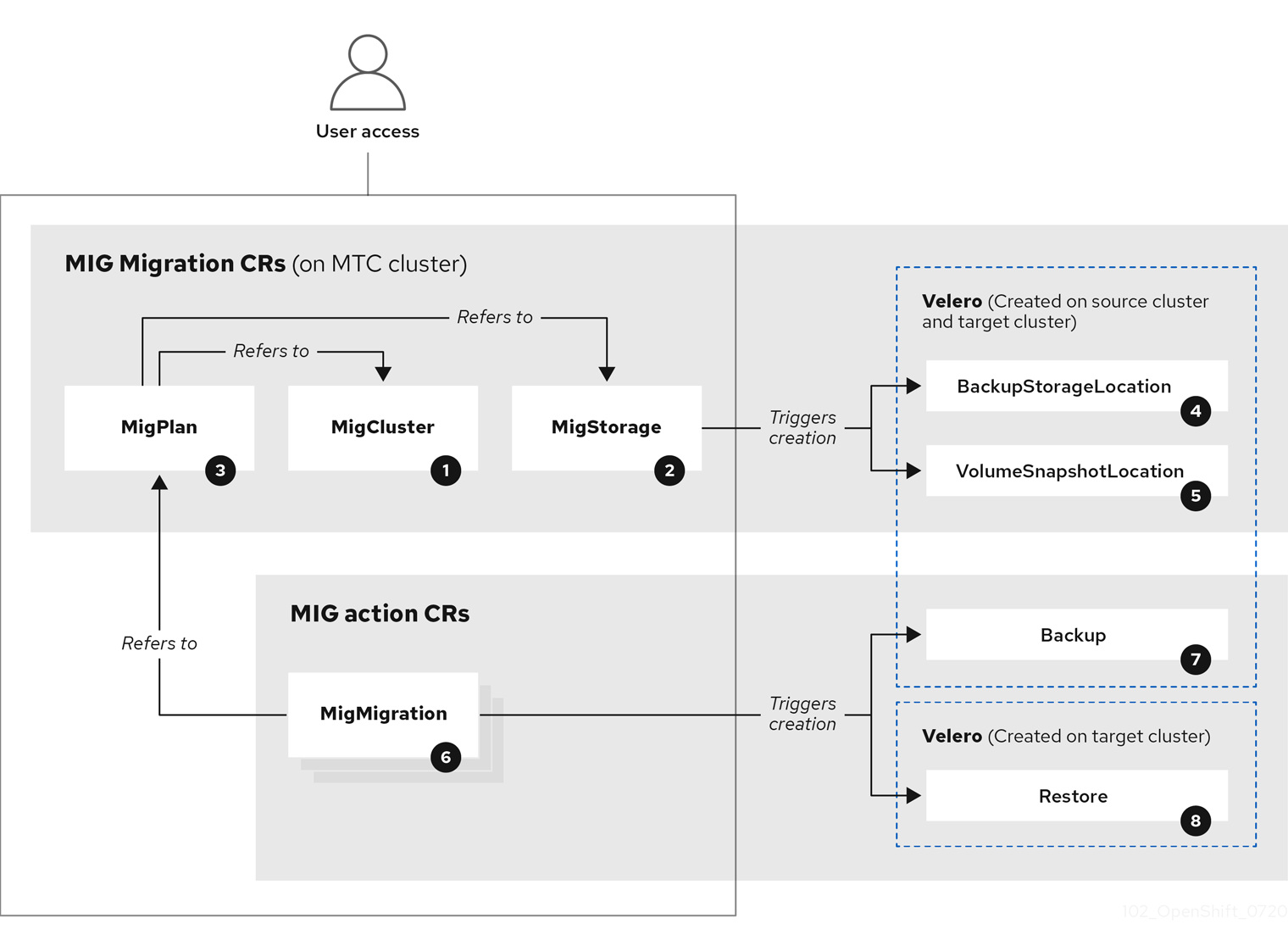

MTC fournit une console Web et une API, en fonction des ressources personnalisées de Kubernetes, pour vous aider à contrôler la migration et à minimiser les temps d’arrêt des applications.

La console MTC est installée par défaut sur le cluster cible. Vous pouvez configurer le Migration Toolkit for Containers Operator pour qu'il installe la console sur un cluster distant.

Voir Options de migration avancées pour plus d'informations sur les sujets suivants :

- Automatiser votre migration avec les crochets de migration et l'API MTC.

- Configuration de votre plan de migration pour exclure des ressources, prendre en charge les migrations à grande échelle et activer le redimensionnement automatique des PV pour la migration directe des volumes.

1.1. Terminologie

Tableau 1.1. Terminologie MTC

| Terme | Définition |

|---|---|

| Cluster source | Cluster à partir duquel les applications sont migrées. |

| Cluster de destination[1] | Cluster vers lequel les applications sont migrées. |

| Un référentiel de réplication | Stockage d’objets utilisé pour la copie d’images, de volumes et d’objets Kubernetes pendant la migration indirecte ou pour des objets Kubernetes pendant la migration directe de volumes ou d’images. Le référentiel de réplication doit être accessible à tous les clusters. |

| Cluster hôte |

Cluster sur lequel le pod Le cluster hôte n’a pas besoin d’une route de registre exposée pour la migration directe des images. |

| Cluster distant | Un cluster distant est généralement le cluster source, mais ce n’est pas obligatoire.

Un cluster distant nécessite une ressource personnalisée Un cluster distant nécessite une route de registre sécurisée exposée pour la migration directe des images. |

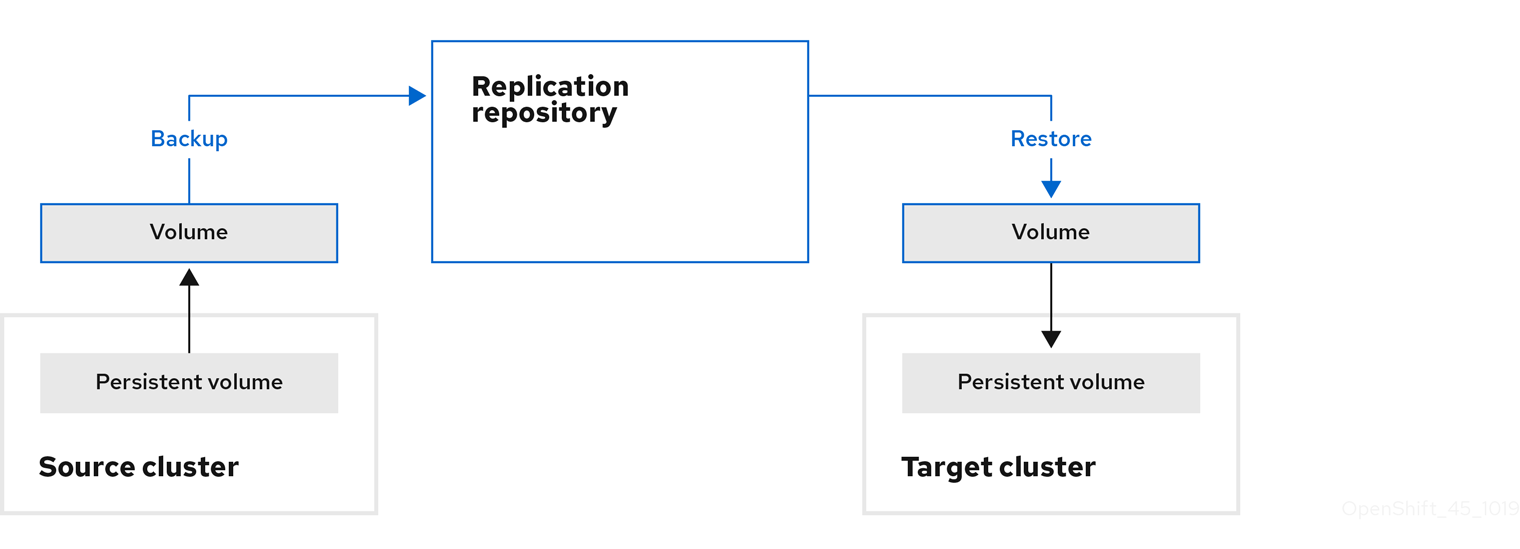

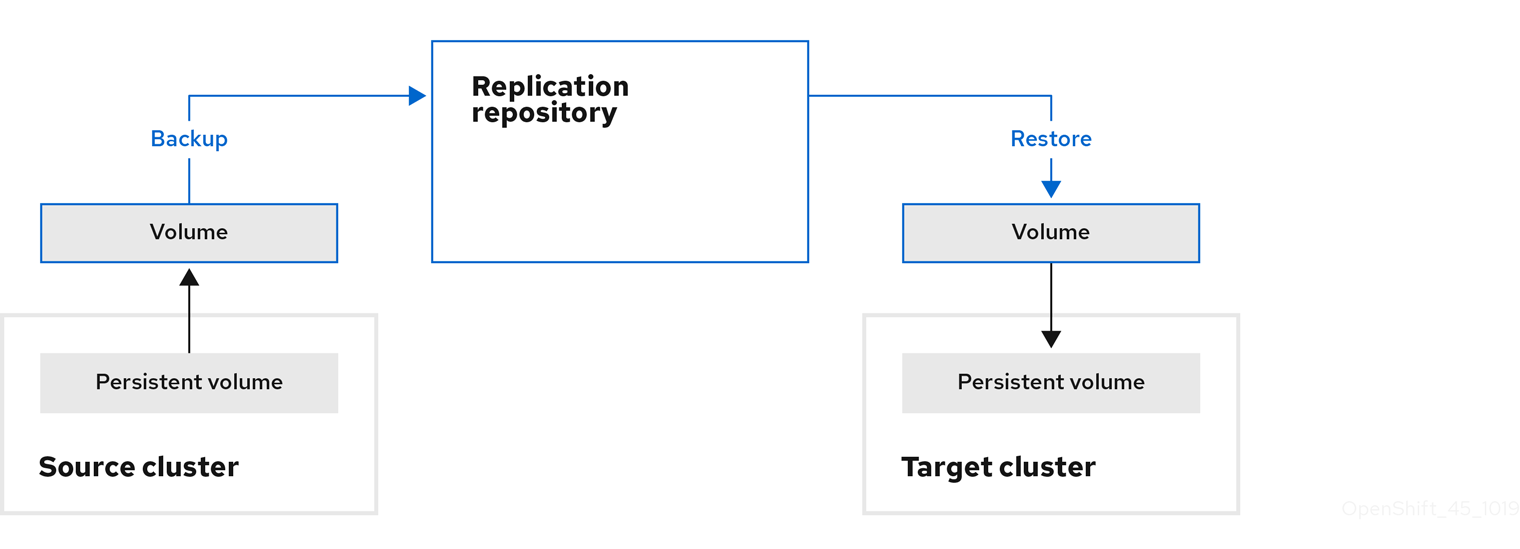

| Migration indirecte | Les images, volumes et objets Kubernetes sont copiés du cluster source vers le référentiel de réplication, puis du référentiel de réplication vers le cluster de destination. |

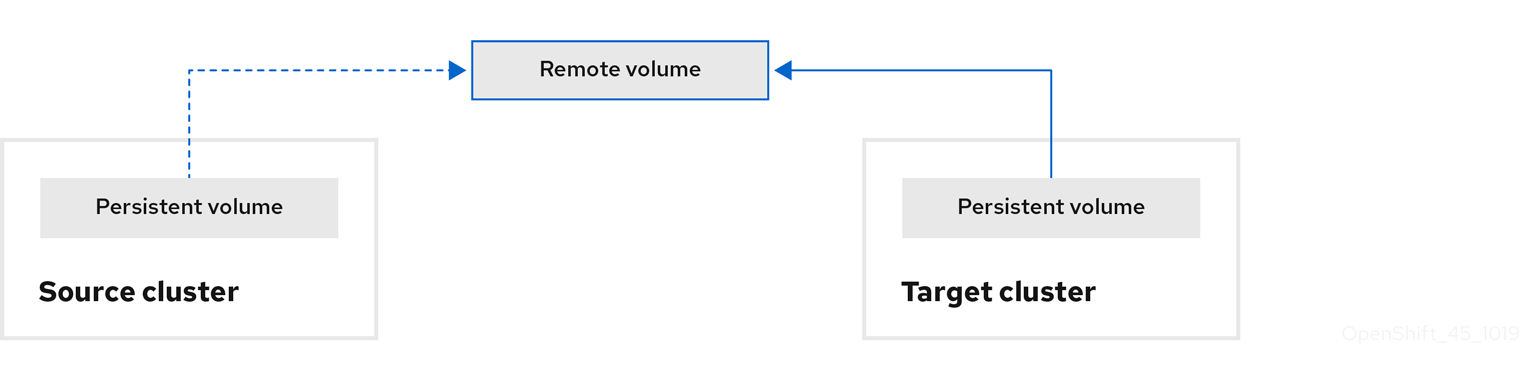

| Migration directe des volumes | Les volumes persistants sont copiés directement du cluster source vers le cluster de destination. |

| Migration directe des images | Les images sont copiées directement du cluster source vers le cluster de destination. |

| Migration par étapes | Les données sont copiées vers le cluster de destination sans arrêter l’application. Le fait d’exécuter plusieurs fois une migration par étapes réduit la durée de la migration à basculement. |

| Migration à basculement | L’application est arrêtée sur le cluster source et ses ressources sont migrées vers le cluster de destination. |

| Migration d’état | L'état de l'application est migré en copiant les demandes de volumes persistants spécifiques vers le cluster de destination. |

| Migration de retour | La migration de retour annule une migration terminée. |

1 Appelez le cluster cible dans la console Web MTC.

1.2. Flux de travail MTC

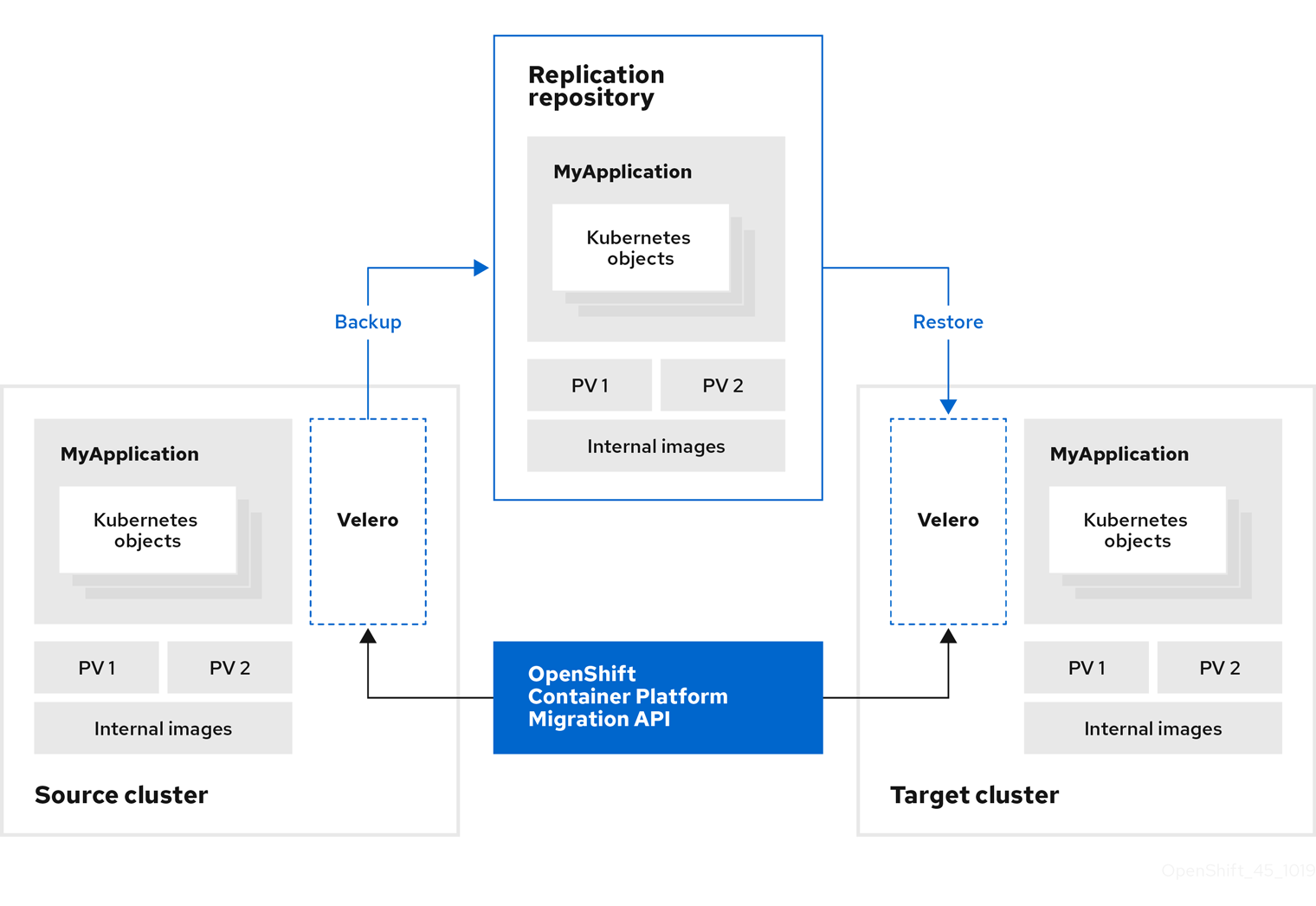

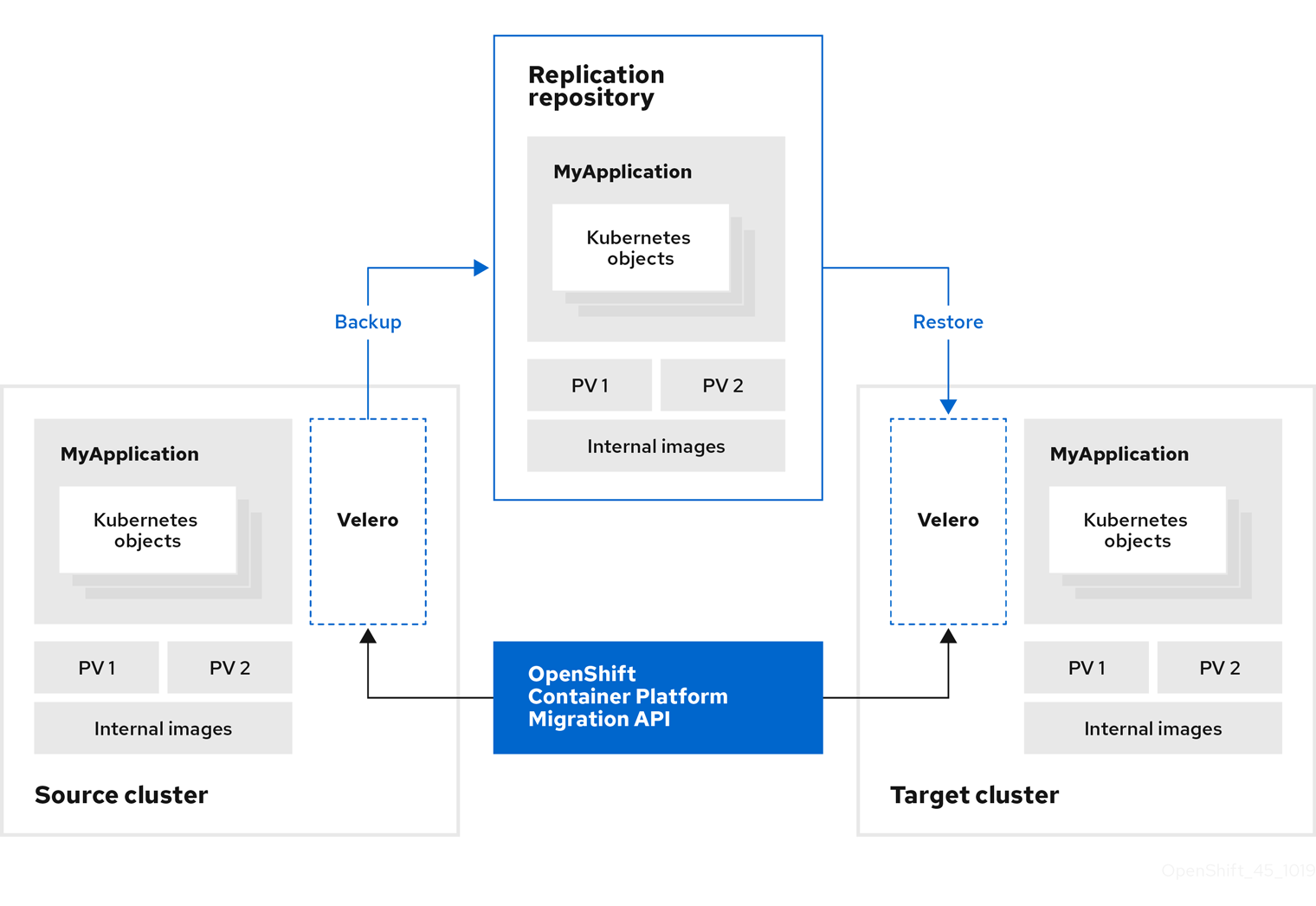

Vous pouvez migrer des ressources Kubernetes, des données de volumes persistants et des images de conteneurs internes vers OpenShift Container Platform 4.12 en utilisant la console web Migration Toolkit for Containers (MTC) ou l'API Kubernetes.

MTC fait migrer les ressources suivantes :

- Un espace de nommage spécifié dans un plan de migration.

Des ressources délimitées par l’espace de nommage : lorsque MTC migre un espace de nommage, il migre l’ensemble des objets et ressources qui y sont associés, comme les services ou les pods. De plus, si une ressource qui existe dans l’espace de nommage, mais pas au niveau du cluster, dépend d’une ressource existant au niveau du cluster, MTC migre les deux.

Par exemple, une contrainte de contexte de sécurité (SCC) est une ressource qui existe au niveau du cluster et un compte de service (SA) est une ressource qui existe au niveau de l'espace de noms. Si un SA existe dans un espace de noms que le MTC migre, le MTC localise automatiquement tous les SCC qui sont liés au SA et migre également ces SCC. De même, le CTM migre les volumes persistants qui sont liés aux revendications de volumes persistants de l'espace de noms.

NoteEn fonction de la ressource, il se peut que les ressources délimitées par le cluster doivent faire l’objet d’une migration manuelle.

- Ressources personnalisées (CR) et définitions de ressources personnalisées (CRD) : MTC migre automatiquement les CR et CRD au niveau de l’espace de nommage.

La procédure de migration d’une application à l’aide de la console Web MTC comprend les étapes suivantes :

Installez l’opérateur Migration Toolkit for Containers sur tous les clusters.

Vous pouvez installer l’opérateur Migration Toolkit for Containers dans un environnement restreint avec un accès Internet limité, voire aucun accès Internet. Les clusters source et cible doivent disposer d’un accès réseau entre eux et vers un registre miroir.

Configurez le référentiel de réplication, un stockage d’objets intermédiaire que MTC utilise pour la migration des données.

Les clusters source et cible doivent disposer d’un accès réseau au référentiel de réplication pendant la migration. Si vous utilisez un serveur mandateur, vous devez le configurer pour qu’il autorise le trafic réseau entre le référentiel de réplication et les clusters.

- Ajoutez le cluster source à la console Web MTC.

- Ajoutez le référentiel de réplication à la console Web MTC.

Créez un plan de migration, avec l’une des options de migration de données suivantes :

Copy : MTC copie les données du cluster source vers le référentiel de réplication, et du référentiel de réplication vers le cluster cible.

NoteSi vous utilisez la migration directe d’images ou de volumes, les images ou les volumes sont copiés directement du cluster source vers le cluster cible.

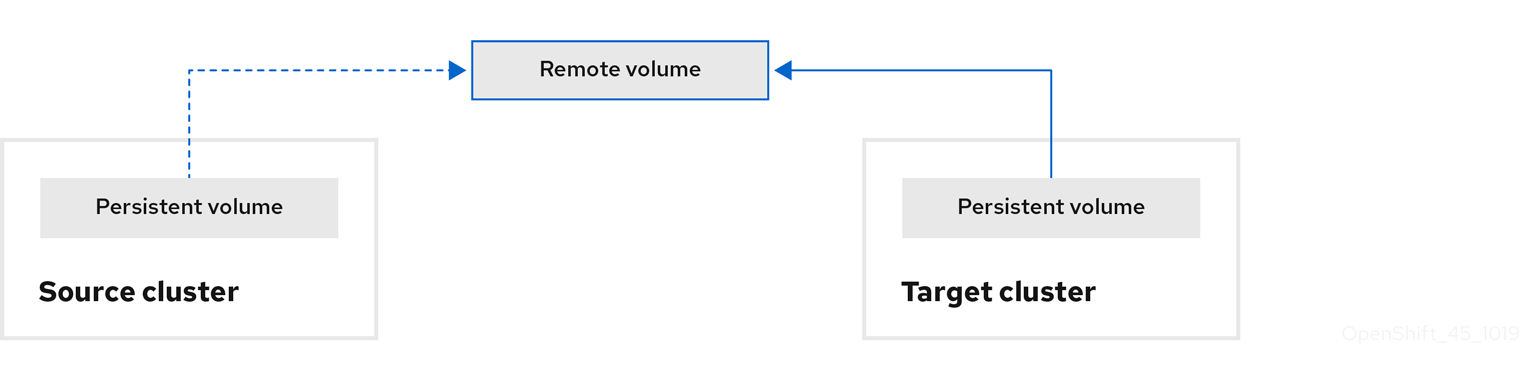

Move : MTC démonte un volume distant (NFS, par exemple) du cluster source, crée une ressource PV sur le cluster cible pointant vers le volume distant, puis monte le volume distant sur le cluster cible. Les applications qui s’exécutent sur le cluster cible utilisent le même volume distant que celui qui était utilisé par le cluster source. Le volume distant doit être accessible aux clusters source et cible.

NoteBien que le référentiel de réplication n’apparaisse pas dans ce diagramme, il est requis dans le cadre de la migration.

Exécutez le plan de migration, avec l’une des options suivantes :

L’option Stage copie les données vers le cluster cible sans arrêter l’application.

Une migration par étapes peut être exécutée plusieurs fois afin que la plupart des données soient copiées sur la cible avant la migration. L’exécution d’une ou plusieurs migrations par étapes réduit la durée de la migration à basculement.

L’option Cutover arrête l’application sur le cluster source et déplace les ressources vers le cluster cible.

Facultatif : vous pouvez décocher la case Halt transactions on the source cluster during migration.

1.3. À propos des méthodes de copie des données

Migration Toolkit for Containers (MTC) prend en charge les méthodes de copie des données de cliché et du système de fichiers pour faire migrer les données du cluster source vers le cluster cible. Vous pouvez choisir une méthode adaptée à votre environnement et prise en charge par votre fournisseur de stockage.

1.3.1. Méthode de copie du système de fichiers

MTC copie les fichiers de données du cluster source vers le référentiel de réplication, et de là vers le cluster cible.

La méthode de copie du système de fichiers utilise Restic pour la migration indirecte ou Rsync pour la migration directe des volumes.

Tableau 1.2. Résumé de la méthode de copie du système de fichiers

| Avantages | Limites |

|---|---|

|

|

La migration des PV Restic et Rsync suppose que les PV pris en charge sont uniquement volumeMode=filesystem. L'utilisation de volumeMode=Block pour la migration du système de fichiers est prise en charge par not.

1.3.2. Méthode de copie de cliché

MTC copie un cliché des données du cluster source dans le référentiel de réplication d’un fournisseur de cloud. Les données sont restaurées sur le cluster cible.

La méthode de copie de cliché peut être utilisée avec Amazon Web Services, Google Cloud Provider et Microsoft Azure.

Tableau 1.3. Résumé de la méthode de copie de cliché

| Avantages | Limites |

|---|---|

|

|

1.4. Migration directe d’images et de volumes

Vous pouvez utiliser la migration directe d’images (DIM) et la migration directe de volumes (DVM) pour faire migrer directement des images et des données du cluster source vers le cluster cible.

Si vous exécutez DVM avec des nœuds situés dans des zones de disponibilité différentes, la migration risque d’échouer, car les pods migrés ne peuvent pas accéder à la revendication de volume persistant.

DIM et DVM présentent des avantages significatifs en termes de performances, car les étapes intermédiaires de sauvegarde des fichiers du cluster source vers le référentiel de réplication et de restauration des fichiers du référentiel de réplication vers le cluster cible sont ignorées. Les données sont transférées avec Rsync.

DIM et DVM présentent d’autres conditions préalables.

Chapitre 2. Notes de publication de Migration Toolkit for Containers

Les notes de version de Migration Toolkit for Containers (MTC) décrivent les nouvelles fonctionnalités et améliorations, les fonctionnalités obsolètes et les problèmes connus.

Le MTC vous permet de migrer les charges de travail des applications entre les clusters OpenShift Container Platform à la granularité d'un espace de noms.

Vous pouvez migrer d'OpenShift Container Platform 3 à 4.12 et entre les clusters d'OpenShift Container Platform 4.

MTC fournit une console Web et une API, en fonction des ressources personnalisées de Kubernetes, pour vous aider à contrôler la migration et à minimiser les temps d’arrêt des applications.

Pour plus d'informations sur la politique de support pour MTC, voir OpenShift Application and Cluster Migration Solutions, part of the Red Hat OpenShift Container Platform Life Cycle Policy.

2.1. Notes de publication de Migration Toolkit for Containers 1.7

2.1.1. Nouvelles fonctionnalités et améliorations

Cette version comporte les nouvelles fonctionnalités et améliorations suivantes :

- L'opérateur Migration Toolkit for Containers (MTC) dépend maintenant de l'opérateur OpenShift API for Data Protection (OADP). Lorsque vous installez l'opérateur MTC, le gestionnaire du cycle de vie de l'opérateur (OLM) installe automatiquement l'opérateur OADP dans le même espace de noms.

-

Vous pouvez migrer d'un cluster source situé derrière un pare-feu vers un cluster de destination basé sur le cloud en établissant un tunnel réseau entre les deux clusters à l'aide de la commande

crane tunnel-api. - Conversion des classes de stockage dans la console web MTC : Vous pouvez convertir la classe de stockage d'un volume persistant (PV) en le migrant au sein du même cluster.

2.1.2. Problèmes connus

Cette version présente les problèmes connus suivants :

-

MigPlanla ressource personnalisée n'affiche pas d'avertissement lorsqu'un AWS gp2 PVC n'a pas d'espace disponible. (BZ#1963927) - Les transferts de données directs et indirects ne fonctionnent pas si le stockage de destination est un PV provisionné dynamiquement par AWS Elastic File System (EFS). Cela est dû aux limitations du pilote AWS EFS Container Storage Interface (CSI). (BZ#2085097)

- Le stockage en bloc pour IBM Cloud doit se trouver dans la même zone de disponibilité. Voir la FAQ IBM sur le stockage de blocs pour le cloud privé virtuel.

2.2. Notes de publication de Migration Toolkit for Containers 1.6

2.2.1. Nouvelles fonctionnalités et améliorations

Cette version comporte les nouvelles fonctionnalités et améliorations suivantes :

- Migration d'état : Vous pouvez effectuer des migrations répétables, uniquement d'état, en sélectionnant des réclamations de volumes persistants (PVC) spécifiques.

- \Notification "Nouvelle version de l'opérateur disponible" : La page Clusters de la console web MTC affiche une notification lorsqu'un nouvel opérateur de Migration Toolkit for Containers est disponible.

2.2.2. Fonctionnalités obsolètes

Les fonctionnalités suivantes sont obsolètes :

- La version 1.4 du MTC n'est plus prise en charge.

2.2.3. Problèmes connus

Cette version présente les problèmes connus suivants :

-

Sur OpenShift Container Platform 3.10, le pod

MigrationControllerprend trop de temps à redémarrer. Le rapport Bugzilla contient une solution de contournement. (BZ#1986796) -

Stageles pods échouent lors de la migration directe de volume à partir d'un cluster source OpenShift Container Platform classique sur IBM Cloud. Le plugin de stockage en bloc IBM ne permet pas de monter le même volume sur plusieurs pods du même nœud. Par conséquent, les PVC ne peuvent pas être montés sur les pods Rsync et sur les pods d'application simultanément. Pour résoudre ce problème, arrêtez les pods d'application avant la migration. (BZ#1887526) -

MigPlanla ressource personnalisée n'affiche pas d'avertissement lorsqu'un AWS gp2 PVC n'a pas d'espace disponible. (BZ#1963927) - Le stockage en bloc pour IBM Cloud doit se trouver dans la même zone de disponibilité. Voir la FAQ IBM sur le stockage de blocs pour le cloud privé virtuel.

2.3. Notes de publication de Migration Toolkit for Containers 1.5

2.3.1. Nouvelles fonctionnalités et améliorations

Cette version comporte les nouvelles fonctionnalités et améliorations suivantes :

- L'arbre Migration resource sur la page Migration details de la console web a été amélioré avec des ressources supplémentaires, des événements Kubernetes et des informations d'état en direct pour la surveillance et le débogage des migrations.

- La console web peut prendre en charge des centaines de plans de migration.

- Un espace de noms source peut être mappé à un espace de noms cible différent dans un plan de migration. Auparavant, l'espace de noms source était associé à un espace de noms cible portant le même nom.

- Les phases d'accrochage et les informations sur l'état sont affichées dans la console web au cours d'une migration.

- Le nombre de tentatives Rsync est affiché dans la console web pendant la migration directe de volumes.

- Le redimensionnement du volume persistant (PV) peut être activé pour la migration directe de volumes afin de garantir que le cluster cible ne manque pas d'espace disque.

- Le seuil qui déclenche le redimensionnement des PV est configurable. Auparavant, le redimensionnement des PV se produisait lorsque l'utilisation du disque dépassait 97 %.

- Velero a été mis à jour à la version 1.6, qui apporte de nombreuses corrections et améliorations.

- Les clients Kubernetes mis en cache peuvent être activés pour améliorer les performances.

2.3.2. Fonctionnalités obsolètes

Les fonctionnalités suivantes sont obsolètes :

- Les versions 1.2 et 1.3 de MTC ne sont plus prises en charge.

-

La procédure de mise à jour des API obsolètes a été supprimée de la section "troubleshooting" de la documentation car la commande

oc convertest obsolète.

2.3.3. Problèmes connus

Cette version présente les problèmes connus suivants :

-

Le stockage Microsoft Azure est indisponible si vous créez plus de 400 plans de migration. La ressource personnalisée

MigStorageaffiche le message suivant :The request is being throttled as the limit has been reached for operation type. (BZ#1977226) - Si une migration échoue, le plan de migration ne conserve pas les paramètres personnalisés de volume persistant (PV) pour les pods mis en veille. Vous devez annuler manuellement la migration, supprimer le plan de migration et en créer un nouveau avec vos paramètres de volume persistant. (BZ#1784899)

-

Le redimensionnement des PV ne fonctionne pas comme prévu pour le stockage AWS gp2 à moins que la valeur de

pv_resizing_thresholdsoit égale ou supérieure à 42 %. (BZ#1973148) Le redimensionnement des PV ne fonctionne pas avec les clusters sources OpenShift Container Platform 3.7 et 3.9 dans les scénarios suivants :

- L'application a été installée après l'installation de MTC.

Un pod d'application a été reprogrammé sur un autre nœud après l'installation de MTC.

OpenShift Container Platform 3.7 et 3.9 ne prend pas en charge la fonctionnalité Mount Propagation qui permet à Velero de monter automatiquement les PV dans le pod

Restic. La ressource personnalisée (CR)MigAnalyticne parvient pas à collecter les données PV du podResticet signale les ressources comme étant0. La CRMigPlanaffiche un état similaire à ce qui suit :Exemple de sortie

status: conditions: - category: Warn lastTransitionTime: 2021-07-15T04:11:44Z message: Failed gathering extended PV usage information for PVs [nginx-logs nginx-html], please see MigAnalytic openshift-migration/ocp-24706-basicvolmig-migplan-1626319591-szwd6 for details reason: FailedRunningDf status: "True" type: ExtendedPVAnalysisFailedPour activer le redimensionnement des PV, vous pouvez redémarrer manuellement le daemonset Restic sur le cluster source ou redémarrer les pods

Resticsur les mêmes nœuds que l'application. Si vous ne redémarrez pas Restic, vous pouvez exécuter la migration de volume directe sans redimensionnement de PV. (BZ#1982729)

2.3.4. Modifications techniques

Cette version comporte les modifications techniques suivantes :

- L'ancien Migration Toolkit for Containers Operator version 1.5.1 est installé manuellement sur OpenShift Container Platform versions 3.7 à 4.5.

- Le Migration Toolkit for Containers Operator version 1.5.1 est installé sur OpenShift Container Platform versions 4.6 et ultérieures à l'aide de l'Operator Lifecycle Manager.

Chapitre 3. Installation de Migration Toolkit for Containers

Vous pouvez installer le Migration Toolkit for Containers (MTC) sur OpenShift Container Platform 4.

Pour installer MTC sur OpenShift Container Platform 3, voir Installation de l'opérateur Legacy Migration Toolkit for Containers sur OpenShift Container Platform 3.

Par défaut, la console web MTC et le pod Migration Controller s'exécutent sur le cluster cible. Vous pouvez configurer le manifeste de ressources personnalisé Migration Controller pour exécuter la console web MTC et le module Migration Controller sur un cluster distant.

Après avoir installé MTC, vous devez configurer un stockage d’objets à utiliser comme référentiel de réplication.

Pour désinstaller MTC, voir Désinstallation de MTC et suppression des ressources.

3.1. Instructions relatives à la compatibilité

Vous devez installer l’opérateur Migration Toolkit for Containers (MTC) compatible avec votre version d’OpenShift Container Platform.

Définitions

- ancienne plate-forme

- OpenShift Container Platform 4.5 et antérieures.

- plate-forme moderne

- OpenShift Container Platform 4.6 et plus.

- opérateur historique

- L'opérateur MTC est conçu pour les plates-formes existantes.

- opérateur moderne

- L'opérateur MTC est conçu pour les plateformes modernes.

- groupe de contrôle

- Le cluster qui exécute le contrôleur MTC et l'interface graphique.

- groupe distant

- Un cluster source ou destination pour une migration qui exécute Velero. Le cluster de contrôle communique avec les clusters distants via l'API Velero pour piloter les migrations.

Tableau 3.1. Compatibilité MTC : Migration à partir d'une plateforme existante

| OpenShift Container Platform 4.5 ou version antérieure | OpenShift Container Platform 4.6 ou version ultérieure | |

|---|---|---|

| Version stable de MTC | MTC 1.7.z

Opérateur Legacy 1.7 : Installer manuellement avec le fichier Important Ce cluster ne peut pas être le cluster de contrôle. | MTC 1.7.z

Installer avec OLM, canal |

Il existe des cas limites dans lesquels des restrictions de réseau empêchent les clusters modernes de se connecter à d'autres clusters impliqués dans la migration. Par exemple, lors de la migration d'un cluster OpenShift Container Platform 3.11 sur site vers un cluster OpenShift Container Platform moderne dans le cloud, où le cluster moderne ne peut pas se connecter au cluster OpenShift Container Platform 3.11.

Avec MTC 1.7, si l'un des clusters distants ne peut pas communiquer avec le cluster de contrôle en raison de restrictions réseau, utilisez la commande crane tunnel-api.

Avec la version stable de MTC, bien que vous deviez toujours désigner le cluster le plus moderne comme cluster de contrôle, dans ce cas précis, il est possible de désigner le cluster hérité comme cluster de contrôle et de pousser les charges de travail vers le cluster distant.

3.2. Installation de l'opérateur Legacy Migration Toolkit for Containers sur OpenShift Container Platform 4.2 à 4.5

Vous pouvez installer manuellement l'ancien Migration Toolkit for Containers Operator sur OpenShift Container Platform versions 4.2 à 4.5.

Conditions préalables

-

Vous devez être connecté en tant qu’utilisateur avec les privilèges

cluster-adminsur tous les clusters. -

Vous devez avoir accès à

registry.redhat.io. -

Il faut que

podmansoit installé.

Procédure

Connectez-vous à

registry.redhat.ioavec vos informations d’identification du Portail Client de Red Hat :$ sudo podman login registry.redhat.io

Téléchargez le fichier

operator.ymlen entrant la commande suivante :$ sudo podman cp $(sudo podman create \ registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.7):/operator.yml ./

Téléchargez le fichier

controller.ymlen entrant la commande suivante :$ sudo podman cp $(sudo podman create \ registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.7):/controller.yml ./

- Connectez-vous à votre cluster source OpenShift Container Platform.

Vérifiez que le cluster peut s’authentifier auprès de

registry.redhat.io:$ oc run test --image registry.redhat.io/ubi8 --command sleep infinity

Créer l’objet « Migration Toolkit for Containers Operator » :

$ oc create -f operator.yml

Exemple de sortie

namespace/openshift-migration created rolebinding.rbac.authorization.k8s.io/system:deployers created serviceaccount/migration-operator created customresourcedefinition.apiextensions.k8s.io/migrationcontrollers.migration.openshift.io created role.rbac.authorization.k8s.io/migration-operator created rolebinding.rbac.authorization.k8s.io/migration-operator created clusterrolebinding.rbac.authorization.k8s.io/migration-operator created deployment.apps/migration-operator created Error from server (AlreadyExists): error when creating "./operator.yml": rolebindings.rbac.authorization.k8s.io "system:image-builders" already exists 1 Error from server (AlreadyExists): error when creating "./operator.yml": rolebindings.rbac.authorization.k8s.io "system:image-pullers" already exists- 1

- Vous pouvez ignorer les messages

Error from server (AlreadyExists). Ils sont causés par le Migration Toolkit for Containers Operator qui crée des ressources pour des versions antérieures d'OpenShift Container Platform 4 qui sont fournies dans des versions ultérieures.

Créez l’objet

MigrationController:$ oc create -f controller.yml

Vérifiez que les pods MTC sont en cours d’exécution :

$ oc get pods -n openshift-migration

3.3. Installation de l'opérateur Migration Toolkit for Containers sur OpenShift Container Platform 4.12

Vous installez le Migration Toolkit for Containers Operator sur OpenShift Container Platform 4.12 en utilisant le Operator Lifecycle Manager.

Conditions préalables

-

Vous devez être connecté en tant qu’utilisateur avec les privilèges

cluster-adminsur tous les clusters.

Procédure

- Dans la console Web OpenShift Container Platform, cliquez sur Operators → OperatorHub.

- Utilisez le champ Filter by keyword pour rechercher Migration Toolkit for Containers Operator.

- Sélectionnez Migration Toolkit for Containers Operator et cliquez ensuite sur Install.

Cliquez sur Install.

Sur la page Installed Operators, Migration Toolkit for Containers Operator apparaît dans le projet openshift-migration avec l’état Succeeded.

- Cliquez sur Migration Toolkit for Containers Operator.

- Sous Provided APIs, recherchez la vignette Migration Controller et cliquez ensuite sur Create Instance.

- Cliquez sur Create.

- Cliquez sur Workloads → Pods pour vérifier que les pods MTC sont bien en cours d’exécution.

3.4. Configuration du proxy

Dans le cas d’OpenShift Container Platform 4.1 et versions antérieures, vous devez configurer les proxies dans le manifeste de la ressource personnalisée (CR) MigrationController après avoir installé l’opérateur Migration Toolkit for Containers, car ces versions ne prennent pas en charge un objet proxy à l’échelle du cluster.

Pour OpenShift Container Platform 4.2 à 4.12, le Migration Toolkit for Containers (MTC) hérite des paramètres de proxy à l'échelle du cluster. Vous pouvez modifier les paramètres du proxy si vous souhaitez remplacer les paramètres du proxy à l'échelle du cluster.

3.4.1. Migration directe des volumes

La migration directe des volumes (DVM) a été introduite dans MTC 1.4.2. DVM ne prend en charge qu'un seul proxy. Le cluster source ne peut pas accéder à la route du cluster cible si ce dernier se trouve également derrière un proxy.

Si vous souhaitez effectuer un DVM à partir d'un cluster source situé derrière un proxy, vous devez configurer un proxy TCP qui fonctionne au niveau de la couche transport et transmet les connexions SSL de manière transparente sans les décrypter et les recrypter à l'aide de leurs propres certificats SSL. Un proxy Stunnel est un exemple de ce type de proxy.

3.4.1.1. Configuration du proxy TCP pour le DVM

Vous pouvez établir une connexion directe entre le cluster source et le cluster cible via un proxy TCP et configurer la variable stunnel_tcp_proxy dans le CR MigrationController pour utiliser le proxy :

apiVersion: migration.openshift.io/v1alpha1 kind: MigrationController metadata: name: migration-controller namespace: openshift-migration spec: [...] stunnel_tcp_proxy: http://username:password@ip:port

La migration directe de volume (DVM) ne prend en charge que l'authentification de base pour le proxy. En outre, la DVM ne fonctionne que derrière des proxys qui peuvent tunneliser une connexion TCP de manière transparente. Les mandataires HTTP/HTTPS en mode man-in-the-middle ne fonctionnent pas. Les proxys existants à l'échelle du cluster peuvent ne pas prendre en charge ce comportement. Par conséquent, les paramètres du proxy pour DVM sont intentionnellement différents de la configuration habituelle du proxy dans MTC.

3.4.1.2. Pourquoi utiliser un proxy TCP plutôt qu'un proxy HTTP/HTTPS ?

Vous pouvez activer DVM en exécutant Rsync entre le cluster source et le cluster cible via une route OpenShift. Le trafic est chiffré à l'aide de Stunnel, un proxy TCP. Le Stunnel fonctionnant sur le cluster source initie une connexion TLS avec le Stunnel cible et transfère les données sur un canal crypté.

Les proxys HTTP/HTTPS à l'échelle du cluster dans OpenShift sont généralement configurés en mode man-in-the-middle où ils négocient leur propre session TLS avec les serveurs extérieurs. Cependant, cela ne fonctionne pas avec Stunnel. Stunnel exige que sa session TLS ne soit pas modifiée par le proxy, faisant essentiellement du proxy un tunnel transparent qui transmet simplement la connexion TCP telle quelle. Vous devez donc utiliser un proxy TCP.

3.4.1.3. Problème connu

La migration échoue avec l'erreur Upgrade request required

Le contrôleur de migration utilise le protocole SPDY pour exécuter des commandes dans des modules distants. Si le cluster distant se trouve derrière un proxy ou un pare-feu qui ne prend pas en charge le protocole SPDY, le contrôleur de migration ne parvient pas à exécuter les commandes à distance. La migration échoue avec le message d'erreur Upgrade request required. Solution : Utilisez un proxy qui prend en charge le protocole SPDY.

Outre la prise en charge du protocole SPDY, le proxy ou le pare-feu doit également transmettre l'en-tête HTTP Upgrade au serveur API. Le client utilise cet en-tête pour ouvrir une connexion websocket avec le serveur API. Si l'en-tête Upgrade est bloqué par le proxy ou le pare-feu, la migration échoue avec le message d'erreur Upgrade request required. Solution : Assurez-vous que le proxy transmet l'en-tête Upgrade.

3.4.2. Optimiser les politiques de réseau pour les migrations

OpenShift prend en charge la restriction du trafic vers ou depuis les pods à l'aide de NetworkPolicy ou EgressFirewalls en fonction du plugin réseau utilisé par le cluster. Si l'un des espaces de noms source impliqués dans une migration utilise de tels mécanismes pour restreindre le trafic réseau vers les pods, les restrictions peuvent par inadvertance arrêter le trafic vers les pods Rsync pendant la migration.

Les pods Rsync fonctionnant sur les clusters source et cible doivent se connecter l'un à l'autre via une route OpenShift. Les objets NetworkPolicy ou EgressNetworkPolicy existants peuvent être configurés pour exempter automatiquement les pods Rsync de ces restrictions de trafic.

3.4.2.1. Configuration de la politique de réseau

3.4.2.1.1. Trafic de sortie des pods Rsync

Vous pouvez utiliser les étiquettes uniques des modules Rsync pour autoriser le trafic sortant de ces modules si la configuration de NetworkPolicy dans les espaces de noms source ou destination bloque ce type de trafic. La stratégie suivante autorise le trafic de sortie all à partir des modules Rsync dans l'espace de noms :

apiVersion: networking.k8s.io/v1

kind: NetworkPolicy

metadata:

name: allow-all-egress-from-rsync-pods

spec:

podSelector:

matchLabels:

owner: directvolumemigration

app: directvolumemigration-rsync-transfer

egress:

- {}

policyTypes:

- Egress3.4.2.1.2. Trafic entrant vers les pods Rsync

apiVersion: networking.k8s.io/v1

kind: NetworkPolicy

metadata:

name: allow-all-egress-from-rsync-pods

spec:

podSelector:

matchLabels:

owner: directvolumemigration

app: directvolumemigration-rsync-transfer

ingress:

- {}

policyTypes:

- Ingress3.4.2.2. Configuration de la politique de réseau EgressNetworkPolicy

L'objet EgressNetworkPolicy ou Egress Firewalls sont des constructions OpenShift conçues pour bloquer le trafic de sortie du cluster.

Contrairement à l'objet NetworkPolicy, le pare-feu Egress fonctionne au niveau du projet car il s'applique à tous les modules de l'espace de noms. Par conséquent, les étiquettes uniques des pods Rsync n'exemptent pas uniquement les pods Rsync des restrictions. Cependant, vous pouvez ajouter les plages CIDR du cluster source ou cible à la règle Allow de la politique afin qu'une connexion directe puisse être établie entre deux clusters.

En fonction du cluster dans lequel le pare-feu de sortie est présent, vous pouvez ajouter la plage CIDR de l'autre cluster pour autoriser le trafic de sortie entre les deux :

apiVersion: network.openshift.io/v1

kind: EgressNetworkPolicy

metadata:

name: test-egress-policy

namespace: <namespace>

spec:

egress:

- to:

cidrSelector: <cidr_of_source_or_target_cluster>

type: Deny3.4.2.3. Choix d'autres points d'arrivée pour le transfert de données

Par défaut, DVM utilise une route OpenShift Container Platform comme point final pour transférer les données PV vers les clusters de destination. Vous pouvez choisir un autre type de point d'extrémité pris en charge, si les topologies de cluster le permettent.

Pour chaque cluster, vous pouvez configurer un point de terminaison en définissant la variable rsync_endpoint_type sur le cluster destination approprié dans votre MigrationController CR :

apiVersion: migration.openshift.io/v1alpha1 kind: MigrationController metadata: name: migration-controller namespace: openshift-migration spec: [...] rsync_endpoint_type: [NodePort|ClusterIP|Route]

3.4.2.4. Configuration de groupes supplémentaires pour les pods Rsync

Lorsque vos PVC utilisent un stockage partagé, vous pouvez configurer l'accès à ce stockage en ajoutant des groupes supplémentaires aux définitions de pods Rsync afin que les pods autorisent l'accès :

Tableau 3.2. Groupes supplémentaires pour les pods Rsync

| Variable | Type | Défaut | Description |

|---|---|---|---|

|

| chaîne de caractères | Non défini | Liste séparée par des virgules des groupes supplémentaires pour les pods Rsync source |

|

| chaîne de caractères | Non défini | Liste de groupes supplémentaires séparés par des virgules pour les pods Rsync cibles |

Exemple d'utilisation

Le CR MigrationController peut être mis à jour pour définir les valeurs de ces groupes supplémentaires :

spec: src_supplemental_groups: "1000,2000" target_supplemental_groups: "2000,3000"

3.4.3. Configuration des proxies

Conditions préalables

-

Vous devez être connecté en tant qu’utilisateur avec les privilèges

cluster-adminsur tous les clusters.

Procédure

Procurez-vous le manifeste du CR

MigrationController:$ oc get migrationcontroller <migration_controller> -n openshift-migration

Mettez à jour les paramètres du proxy :

apiVersion: migration.openshift.io/v1alpha1 kind: MigrationController metadata: name: <migration_controller> namespace: openshift-migration ... spec: stunnel_tcp_proxy: http://<username>:<password>@<ip>:<port> 1 noProxy: example.com 2

Faites précéder un domaine du signe

.pour ne faire correspondre que les sous-domaines. Par exemple,.y.comcorrespond àx.y.com, mais pas ày.com. Utilisez*pour ignorer le proxy pour toutes les destinations. Si vous mettez à l’échelle des workers qui ne sont pas inclus dans le réseau défini par le champnetworking.machineNetwork[].cidrà partir de la configuration d’installation, vous devez les ajouter à cette liste pour éviter les problèmes de connexion.Ce champ est ignoré si ni le champ

httpProxyni le champhttpsProxyne sont définis.-

Enregistrez le manifeste en tant que

migration-controller.yaml. Appliquez le manifeste mis à jour :

$ oc replace -f migration-controller.yaml -n openshift-migration

Pour plus d'informations, voir Configuration du proxy pour l'ensemble du cluster.

3.4.4. Exécuter Rsync en tant que root ou non-root

Cette section s'applique uniquement lorsque vous travaillez avec l'API OpenShift, et non avec la console web.

Les environnements OpenShift ont le contrôleur PodSecurityAdmission activé par défaut. Ce contrôleur exige des administrateurs de cluster qu'ils appliquent les normes de sécurité des pods au moyen d'étiquettes d'espace de noms. Toutes les charges de travail du cluster sont censées exécuter l'un des niveaux de normes de sécurité pods suivants : Privileged Baseline ou Restricted. Chaque cluster dispose de son propre ensemble de règles par défaut.

Pour garantir la réussite du transfert de données dans tous les environnements, Migration Toolkit for Containers (MTC) 1.7.5 a introduit des changements dans les pods Rsync, notamment l'exécution des pods Rsync en tant qu'utilisateur non root par défaut. Cela garantit que le transfert de données est possible même pour les charges de travail qui ne nécessitent pas nécessairement des privilèges plus élevés. Cette modification a été apportée parce qu'il est préférable d'exécuter les charges de travail avec le niveau de privilèges le plus bas possible.

3.4.4.1. Remplacer manuellement l'opération non racine par défaut pour le transfert de données

Bien que l'exécution des pods Rsync en tant qu'utilisateur non root fonctionne dans la plupart des cas, le transfert de données peut échouer lorsque vous exécutez des charges de travail en tant qu'utilisateur root du côté de la source. MTC propose deux façons de remplacer manuellement l'opération non-root par défaut pour le transfert de données :

- Configurer toutes les migrations pour exécuter un pod Rsync en tant que root sur le cluster de destination pour toutes les migrations.

- Exécuter un pod Rsync en tant que root sur le cluster de destination par migration.

Dans les deux cas, vous devez définir les étiquettes suivantes du côté source de tous les espaces de noms qui exécutent des charges de travail avec des privilèges plus élevés avant la migration : enforce, audit, et warn.

Pour en savoir plus sur l'admission à la sécurité des pods et la définition des valeurs des étiquettes, voir Contrôle de la synchronisation de l'admission à la sécurité des pods.

3.4.4.2. Configurer le MigrationController CR en tant que root ou non-root pour toutes les migrations

Par défaut, Rsync s'exécute en tant que non-root.

Sur le cluster de destination, vous pouvez configurer le CR MigrationController pour qu'il exécute Rsync en tant que root.

Procédure

Configurez le CR

MigrationControllercomme suit :apiVersion: migration.openshift.io/v1alpha1 kind: MigrationController metadata: name: migration-controller namespace: openshift-migration spec: [...] migration_rsync_privileged: true

Cette configuration s'appliquera à toutes les migrations futures.

3.4.4.3. Configurer le CR MigMigration en tant que root ou non-root par migration

Sur le cluster de destination, vous pouvez configurer le CR MigMigration pour qu'il exécute Rsync en tant que root ou non-root, avec les options non-root suivantes :

- En tant qu'identifiant d'utilisateur spécifique (UID)

- En tant qu'identifiant de groupe spécifique (GID)

Procédure

Pour exécuter Rsync en tant que root, configurez le CR

MigMigrationselon cet exemple :apiVersion: migration.openshift.io/v1alpha1 kind: MigMigration metadata: name: migration-controller namespace: openshift-migration spec: [...] runAsRoot: true

Pour exécuter Rsync en tant qu'identifiant d'utilisateur (UID) ou de groupe (GID) spécifique, configurez le CR

MigMigrationselon cet exemple :apiVersion: migration.openshift.io/v1alpha1 kind: MigMigration metadata: name: migration-controller namespace: openshift-migration spec: [...] runAsUser: 10010001 runAsGroup: 3

3.5. Configuration d’un référentiel de réplication

Vous devez configurer un stockage d’objets à utiliser comme référentiel de réplication. Migration Toolkit for Containers (MTC) copie les données du cluster source vers le référentiel de réplication, puis du référentiel de réplication vers le cluster cible.

MTC prend en charge les méthodes de copie de données du système de fichiers et des instantanés pour la migration des données du cluster source vers le cluster cible. Sélectionnez une méthode adaptée à votre environnement et prise en charge par votre fournisseur de stockage.

MTC prend en charge les fournisseurs de stockage suivants :

- Passerelle d'objets multicloud

- Services Web d'Amazon S3

- Google Cloud Platform

- Blob Microsoft Azure

- Stockage d’objets S3 générique ; Minio ou Ceph S3, par exemple

3.5.1. Conditions préalables

- Tous les clusters doivent disposer d’un accès réseau ininterrompu au référentiel de réplication.

- Si vous utilisez un serveur mandateur avec un référentiel de réplication hébergé en interne, vous devez vous assurer que le proxy autorise l’accès au référentiel de réplication.

3.5.2. Récupération des informations d’identification de Multicloud Object Gateway

Vous devez récupérer les informations d’identification de Multicloud Object Gateway (MCG) et le point d’accès S3 afin de configurer MCG comme référentiel de réplication pour Migration Toolkit for Containers (MTC). Vous devez récupérer les informations d’identification de Multicloud Object Gateway (MCG) afin de créer une ressource personnalisée (CR) Secret pour OADP (OpenShift API for Data Protection).

MCG est un composant d'OpenShift Data Foundation.

Conditions préalables

- Vous devez déployer OpenShift Data Foundation en utilisant le guide de déploiement OpenShift Data Foundation approprié.

Procédure

Obtenez le point de terminaison S3,

AWS_ACCESS_KEY_IDetAWS_SECRET_ACCESS_KEYen exécutant la commandedescribesur la ressource personnaliséeNooBaa.Vous utilisez ces informations d’identification pour ajouter MCG comme référentiel de réplication.

3.5.3. Configuration d’Amazon Web Services

Vous configurez le stockage d’objets Amazon Web Services (AWS) S3 comme référentiel de réplication pour Migration Toolkit for Containers (MTC).

Conditions préalables

- Il faut que la CLI AWS soit déjà installée.

- Le compartiment de stockage AWS S3 doit être accessible aux clusters source et cible.

Si vous utilisez la méthode de copie de cliché :

- Vous devez avoir accès à EC2 Elastic Block Storage (EBS).

- Les clusters source et cible doivent se trouver dans la même région.

- Les clusters source et cible doivent avoir la même classe de stockage.

- La classe de stockage doit être compatible avec les instantanés.

Procédure

Définissez la variable

BUCKET:$ BUCKET=<your_bucket>

Définissez la variable

REGION:$ REGION=<your_region>

Créez un compartiment AWS S3 :

$ aws s3api create-bucket \ --bucket $BUCKET \ --region $REGION \ --create-bucket-configuration LocationConstraint=$REGION 1- 1

us-east-1ne prend pas en charge la contrainte d’emplacement (LocationConstraint). Si votre région estus-east-1, omettez--create-bucket-configuration LocationConstraint=$REGION.

Créez un utilisateur IAM :

$ aws iam create-user --user-name velero 1- 1

- Si vous souhaitez utiliser Velero pour sauvegarder plusieurs clusters avec plusieurs compartiments S3, créez un nom d’utilisateur unique pour chaque cluster.

Créez un fichier

velero-policy.json:$ cat > velero-policy.json <<EOF { "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "ec2:DescribeVolumes", "ec2:DescribeSnapshots", "ec2:CreateTags", "ec2:CreateVolume", "ec2:CreateSnapshot", "ec2:DeleteSnapshot" ], "Resource": "*" }, { "Effect": "Allow", "Action": [ "s3:GetObject", "s3:DeleteObject", "s3:PutObject", "s3:AbortMultipartUpload", "s3:ListMultipartUploadParts" ], "Resource": [ "arn:aws:s3:::${BUCKET}/*" ] }, { "Effect": "Allow", "Action": [ "s3:ListBucket", "s3:GetBucketLocation", "s3:ListBucketMultipartUploads" ], "Resource": [ "arn:aws:s3:::${BUCKET}" ] } ] } EOFAttachez les politiques pour donner à l'utilisateur

veleroles permissions minimales nécessaires :$ aws iam put-user-policy \ --user-name velero \ --policy-name velero \ --policy-document file://velero-policy.json

Créez une clé d’accès pour l’utilisateur

velero:$ aws iam create-access-key --user-name velero

Exemple de sortie

{ "AccessKey": { "UserName": "velero", "Status": "Active", "CreateDate": "2017-07-31T22:24:41.576Z", "SecretAccessKey": <AWS_SECRET_ACCESS_KEY>, "AccessKeyId": <AWS_ACCESS_KEY_ID> } }Enregistrez

AWS_SECRET_ACCESS_KEYetAWS_ACCESS_KEY_ID. Vous utilisez les informations d’identification pour ajouter AWS comme référentiel de réplication.

3.5.4. Configuration de Google Cloud Platform

Vous configurez un compartiment de stockage Google Cloud Platform (GCP) comme référentiel de réplication pour Migration Toolkit for Containers (MTC).

Conditions préalables

-

Il faut que les outils CLI

gcloudetgsutilsoient déjà installés. Pour plus d’informations, consultez la documentation de Google Cloud. - Le compartiment de stockage GCP doit être accessible aux clusters source et cible.

Si vous utilisez la méthode de copie de cliché :

- Les clusters source et cible doivent se trouver dans la même région.

- Les clusters source et cible doivent avoir la même classe de stockage.

- La classe de stockage doit être compatible avec les instantanés.

Procédure

Connectez-vous à GCP :

$ gcloud auth login

Définissez la variable

BUCKET:$ BUCKET=<bucket> 1- 1

- Indiquez le nom de votre compartiment.

Créez le compartiment de stockage :

$ gsutil mb gs://$BUCKET/

Définissez la variable

PROJECT_IDsur votre projet actif :$ PROJECT_ID=$(gcloud config get-value project)

Créez un compte de service :

$ gcloud iam service-accounts create velero \ --display-name "Velero service account"Répertoriez vos comptes de service :

$ gcloud iam service-accounts list

Définissez la variable

SERVICE_ACCOUNT_EMAILpour qu’elle corresponde à sa valeuremail:$ SERVICE_ACCOUNT_EMAIL=$(gcloud iam service-accounts list \ --filter="displayName:Velero service account" \ --format 'value(email)')Attachez les politiques pour donner à l'utilisateur

veleroles permissions minimales nécessaires :$ ROLE_PERMISSIONS=( compute.disks.get compute.disks.create compute.disks.createSnapshot compute.snapshots.get compute.snapshots.create compute.snapshots.useReadOnly compute.snapshots.delete compute.zones.get )Créez le rôle personnalisé

velero.server:$ gcloud iam roles create velero.server \ --project $PROJECT_ID \ --title "Velero Server" \ --permissions "$(IFS=","; echo "${ROLE_PERMISSIONS[*]}")"Ajoutez une liaison de stratégie IAM au projet :

$ gcloud projects add-iam-policy-binding $PROJECT_ID \ --member serviceAccount:$SERVICE_ACCOUNT_EMAIL \ --role projects/$PROJECT_ID/roles/velero.serverMettez à jour le compte de service IAM :

$ gsutil iam ch serviceAccount:$SERVICE_ACCOUNT_EMAIL:objectAdmin gs://${BUCKET}Enregistrez les clés du compte de service IAM dans le fichier

credentials-velerodu répertoire actuel :$ gcloud iam service-accounts keys create credentials-velero \ --iam-account $SERVICE_ACCOUNT_EMAILVous utilisez le fichier

credentials-veleropour ajouter GCP comme référentiel de réplication.

3.5.5. Configuration de Microsoft Azure

Vous configurez un conteneur de stockage Microsoft Azure Blob comme référentiel de réplication pour Migration Toolkit for Containers (MTC).

Conditions préalables

- Il faut que la CLI Azure soit déjà installée.

- Le conteneur de stockage Azure Blob doit être accessible aux clusters source et cible.

Si vous utilisez la méthode de copie de cliché :

- Les clusters source et cible doivent se trouver dans la même région.

- Les clusters source et cible doivent avoir la même classe de stockage.

- La classe de stockage doit être compatible avec les instantanés.

Procédure

Connectez-vous à Azure :

$ az login

Définissez la variable

AZURE_RESOURCE_GROUP:$ AZURE_RESOURCE_GROUP=Velero_Backups

Créez un groupe de ressources Azure :

$ az group create -n $AZURE_RESOURCE_GROUP --location CentralUS 1- 1

- Indiquez votre emplacement.

Définissez la variable

AZURE_STORAGE_ACCOUNT_ID:$ AZURE_STORAGE_ACCOUNT_ID="velero$(uuidgen | cut -d '-' -f5 | tr '[A-Z]' '[a-z]')"

Créez un compte de stockage Azure :

$ az storage account create \ --name $AZURE_STORAGE_ACCOUNT_ID \ --resource-group $AZURE_RESOURCE_GROUP \ --sku Standard_GRS \ --encryption-services blob \ --https-only true \ --kind BlobStorage \ --access-tier HotDéfinissez la variable

BLOB_CONTAINER:$ BLOB_CONTAINER=velero

Créez un conteneur de stockage Azure Blob :

$ az storage container create \ -n $BLOB_CONTAINER \ --public-access off \ --account-name $AZURE_STORAGE_ACCOUNT_ID

Créez des informations d’identification et un principal de service pour

velero:$ AZURE_SUBSCRIPTION_ID=`az account list --query '[?isDefault].id' -o tsv` \ AZURE_TENANT_ID=`az account list --query '[?isDefault].tenantId' -o tsv` \ AZURE_CLIENT_SECRET=`az ad sp create-for-rbac --name "velero" \ --role "Contributor" --query 'password' -o tsv` \ AZURE_CLIENT_ID=`az ad sp list --display-name "velero" \ --query '[0].appId' -o tsv`

Enregistrez les informations d’identification du principal du service dans le fichier

credentials-velero:$ cat << EOF > ./credentials-velero AZURE_SUBSCRIPTION_ID=${AZURE_SUBSCRIPTION_ID} AZURE_TENANT_ID=${AZURE_TENANT_ID} AZURE_CLIENT_ID=${AZURE_CLIENT_ID} AZURE_CLIENT_SECRET=${AZURE_CLIENT_SECRET} AZURE_RESOURCE_GROUP=${AZURE_RESOURCE_GROUP} AZURE_CLOUD_NAME=AzurePublicCloud EOFVous utilisez le fichier

credentials-veleropour ajouter Azure comme référentiel de réplication.

3.5.6. Ressources supplémentaires

3.6. Désinstallation de MTC et suppression de ressources

Vous pouvez désinstaller Migration Toolkit for Containers (MTC) et supprimer ses ressources afin de nettoyer le cluster.

La suppression des CRD velero entraîne la suppression de Velero du cluster.

Conditions préalables

-

Vous devez être connecté en tant qu’utilisateur avec les privilèges

cluster-admin.

Procédure

Supprimez la ressource personnalisée (CR)

MigrationControllersur tous les clusters :$ oc delete migrationcontroller <migration_controller>

- Désinstallez l’opérateur Migration Toolkit for Containers sur OpenShift Container Platform 4 en utilisant Operator Lifecycle Manager.

Supprimez les ressources délimitées par le cluster sur tous les clusters en exécutant les commandes suivantes :

Définitions de ressources personnalisées (CRD)

migration:$ oc delete $(oc get crds -o name | grep 'migration.openshift.io')

CRD

velero:$ oc delete $(oc get crds -o name | grep 'velero')

Rôles de cluster

migration:$ oc delete $(oc get clusterroles -o name | grep 'migration.openshift.io')

Rôle de cluster

migration-operator:$ oc delete clusterrole migration-operator

Rôles de cluster

velero:$ oc delete $(oc get clusterroles -o name | grep 'velero')

Liaisons de rôles de cluster

migration:$ oc delete $(oc get clusterrolebindings -o name | grep 'migration.openshift.io')

Liaisons de rôles de cluster

migration-operator:$ oc delete clusterrolebindings migration-operator

Liaisons de rôles de cluster

velero:$ oc delete $(oc get clusterrolebindings -o name | grep 'velero')

Chapitre 4. Installation de Migration Toolkit for Containers dans un environnement réseau restreint

Vous pouvez installer le Migration Toolkit for Containers (MTC) sur OpenShift Container Platform 4 dans un environnement réseau restreint en effectuant les procédures suivantes :

Créer un catalogue d'opérateurs en miroir.

Ce processus crée un fichier

mapping.txt, qui contient le mappage entre l'imageregistry.redhat.ioet votre image de registre miroir. Le fichiermapping.txtest nécessaire pour installer l'opérateur legacy Migration Toolkit for Containers sur un cluster source OpenShift Container Platform 4.2 à 4.5.Installez l'opérateur Migration Toolkit for Containers sur le cluster cible OpenShift Container Platform 4.12 en utilisant Operator Lifecycle Manager.

Par défaut, la console web MTC et le pod

Migration Controllers'exécutent sur le cluster cible. Vous pouvez configurer le manifeste de ressources personnaliséMigration Controllerpour exécuter la console web MTC et le moduleMigration Controllersur un cluster distant.Installez le Migration Toolkit for Containers Operator sur le cluster source :

- OpenShift Container Platform 4.6 ou version ultérieure : Installez l'opérateur Migration Toolkit for Containers en utilisant Operator Lifecycle Manager.

- OpenShift Container Platform 4.2 à 4.5 : Installez l'ancien Migration Toolkit for Containers Operator à partir de l'interface de ligne de commande.

- Configurez le stockage d’objets à utiliser comme référentiel de réplication.

Pour installer MTC sur OpenShift Container Platform 3, voir Installation de l'ancien opérateur Migration Toolkit for Containers sur OpenShift Container Platform 3.

Pour désinstaller MTC, voir Désinstallation de MTC et suppression des ressources.

4.1. Instructions relatives à la compatibilité

Vous devez installer l’opérateur Migration Toolkit for Containers (MTC) compatible avec votre version d’OpenShift Container Platform.

Définitions

- ancienne plate-forme

- OpenShift Container Platform 4.5 et antérieures.

- plate-forme moderne

- OpenShift Container Platform 4.6 et plus.

- opérateur historique

- L'opérateur MTC est conçu pour les plates-formes existantes.

- opérateur moderne

- L'opérateur MTC est conçu pour les plateformes modernes.

- groupe de contrôle

- Le cluster qui exécute le contrôleur MTC et l'interface graphique.

- groupe distant

- Un cluster source ou destination pour une migration qui exécute Velero. Le cluster de contrôle communique avec les clusters distants via l'API Velero pour piloter les migrations.

Tableau 4.1. Compatibilité MTC : Migration à partir d'une plateforme existante

| OpenShift Container Platform 4.5 ou version antérieure | OpenShift Container Platform 4.6 ou version ultérieure | |

|---|---|---|

| Version stable de MTC | MTC 1.7.z

Opérateur Legacy 1.7 : Installer manuellement avec le fichier Important Ce cluster ne peut pas être le cluster de contrôle. | MTC 1.7.z

Installer avec OLM, canal |

Il existe des cas limites dans lesquels des restrictions de réseau empêchent les clusters modernes de se connecter à d'autres clusters impliqués dans la migration. Par exemple, lors de la migration d'un cluster OpenShift Container Platform 3.11 sur site vers un cluster OpenShift Container Platform moderne dans le cloud, où le cluster moderne ne peut pas se connecter au cluster OpenShift Container Platform 3.11.

Avec MTC 1.7, si l'un des clusters distants ne peut pas communiquer avec le cluster de contrôle en raison de restrictions réseau, utilisez la commande crane tunnel-api.

Avec la version stable de MTC, bien que vous deviez toujours désigner le cluster le plus moderne comme cluster de contrôle, dans ce cas précis, il est possible de désigner le cluster hérité comme cluster de contrôle et de pousser les charges de travail vers le cluster distant.

4.2. Installation de l'opérateur Migration Toolkit for Containers sur OpenShift Container Platform 4.12

Vous installez le Migration Toolkit for Containers Operator sur OpenShift Container Platform 4.12 en utilisant le Operator Lifecycle Manager.

Conditions préalables

-

Vous devez être connecté en tant qu’utilisateur avec les privilèges

cluster-adminsur tous les clusters. - Vous devez créer un catalogue opérateur à partir d’une image miroir dans un registre local.

Procédure

- Dans la console Web OpenShift Container Platform, cliquez sur Operators → OperatorHub.

- Utilisez le champ Filter by keyword pour rechercher Migration Toolkit for Containers Operator.

- Sélectionnez Migration Toolkit for Containers Operator et cliquez ensuite sur Install.

Cliquez sur Install.

Sur la page Installed Operators, Migration Toolkit for Containers Operator apparaît dans le projet openshift-migration avec l’état Succeeded.

- Cliquez sur Migration Toolkit for Containers Operator.

- Sous Provided APIs, recherchez la vignette Migration Controller et cliquez ensuite sur Create Instance.

- Cliquez sur Create.

- Cliquez sur Workloads → Pods pour vérifier que les pods MTC sont bien en cours d’exécution.

4.3. Installation de l'opérateur Legacy Migration Toolkit for Containers sur OpenShift Container Platform 4.2 à 4.5

Vous pouvez installer manuellement l'ancien Migration Toolkit for Containers Operator sur OpenShift Container Platform versions 4.2 à 4.5.

Conditions préalables

-

Vous devez être connecté en tant qu’utilisateur avec les privilèges

cluster-adminsur tous les clusters. -

Vous devez avoir accès à

registry.redhat.io. -

Il faut que

podmansoit installé. -

Vous devez disposer d’un poste de travail Linux avec un accès réseau pour pouvoir télécharger des fichiers à partir de

registry.redhat.io. - Vous devez créer une image miroir du catalogue opérateur.

- Vous devez installer le Migration Toolkit for Containers Operator à partir du catalogue Operator miroité sur OpenShift Container Platform 4.12.

Procédure

Connectez-vous à

registry.redhat.ioavec vos informations d’identification du Portail Client de Red Hat :$ sudo podman login registry.redhat.io

Téléchargez le fichier

operator.ymlen entrant la commande suivante :$ sudo podman cp $(sudo podman create \ registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.7):/operator.yml ./

Téléchargez le fichier

controller.ymlen entrant la commande suivante :$ sudo podman cp $(sudo podman create \ registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.7):/controller.yml ./

Exécutez la commande suivante pour obtenir le mappage de l’image de l’opérateur :

$ grep openshift-migration-legacy-rhel8-operator ./mapping.txt | grep rhmtc

Le fichier

mapping.txta été créé lorsque vous avez mis en miroir le catalogue opérateur. La sortie illustre le mappage entre l’imageregistry.redhat.ioet votre image de registre miroir.Exemple de sortie

registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator@sha256:468a6126f73b1ee12085ca53a312d1f96ef5a2ca03442bcb63724af5e2614e8a=<registry.apps.example.com>/rhmtc/openshift-migration-legacy-rhel8-operator

Mettez à jour les valeurs

imagepour les conteneursansibleetoperator, ainsi que la valeurREGISTRYdans le fichieroperator.yml:containers: - name: ansible image: <registry.apps.example.com>/rhmtc/openshift-migration-legacy-rhel8-operator@sha256:<468a6126f73b1ee12085ca53a312d1f96ef5a2ca03442bcb63724af5e2614e8a> 1 ... - name: operator image: <registry.apps.example.com>/rhmtc/openshift-migration-legacy-rhel8-operator@sha256:<468a6126f73b1ee12085ca53a312d1f96ef5a2ca03442bcb63724af5e2614e8a> 2 ... env: - name: REGISTRY value: <registry.apps.example.com> 3- Connectez-vous à votre cluster source OpenShift Container Platform.

Créer l’objet « Migration Toolkit for Containers Operator » :

$ oc create -f operator.yml

Exemple de sortie

namespace/openshift-migration created rolebinding.rbac.authorization.k8s.io/system:deployers created serviceaccount/migration-operator created customresourcedefinition.apiextensions.k8s.io/migrationcontrollers.migration.openshift.io created role.rbac.authorization.k8s.io/migration-operator created rolebinding.rbac.authorization.k8s.io/migration-operator created clusterrolebinding.rbac.authorization.k8s.io/migration-operator created deployment.apps/migration-operator created Error from server (AlreadyExists): error when creating "./operator.yml": rolebindings.rbac.authorization.k8s.io "system:image-builders" already exists 1 Error from server (AlreadyExists): error when creating "./operator.yml": rolebindings.rbac.authorization.k8s.io "system:image-pullers" already exists- 1

- Vous pouvez ignorer les messages

Error from server (AlreadyExists). Ils sont causés par le Migration Toolkit for Containers Operator qui crée des ressources pour des versions antérieures d'OpenShift Container Platform 4 qui sont fournies dans des versions ultérieures.

Créez l’objet

MigrationController:$ oc create -f controller.yml

Vérifiez que les pods MTC sont en cours d’exécution :

$ oc get pods -n openshift-migration

4.4. Configuration du proxy

Dans le cas d’OpenShift Container Platform 4.1 et versions antérieures, vous devez configurer les proxies dans le manifeste de la ressource personnalisée (CR) MigrationController après avoir installé l’opérateur Migration Toolkit for Containers, car ces versions ne prennent pas en charge un objet proxy à l’échelle du cluster.

Pour OpenShift Container Platform 4.2 à 4.12, le Migration Toolkit for Containers (MTC) hérite des paramètres de proxy à l'échelle du cluster. Vous pouvez modifier les paramètres du proxy si vous souhaitez remplacer les paramètres du proxy à l'échelle du cluster.

4.4.1. Migration directe des volumes

La migration directe des volumes (DVM) a été introduite dans MTC 1.4.2. DVM ne prend en charge qu'un seul proxy. Le cluster source ne peut pas accéder à la route du cluster cible si ce dernier se trouve également derrière un proxy.

Si vous souhaitez effectuer un DVM à partir d'un cluster source situé derrière un proxy, vous devez configurer un proxy TCP qui fonctionne au niveau de la couche transport et transmet les connexions SSL de manière transparente sans les décrypter et les recrypter à l'aide de leurs propres certificats SSL. Un proxy Stunnel est un exemple de ce type de proxy.

4.4.1.1. Configuration du proxy TCP pour le DVM

Vous pouvez établir une connexion directe entre le cluster source et le cluster cible via un proxy TCP et configurer la variable stunnel_tcp_proxy dans le CR MigrationController pour utiliser le proxy :

apiVersion: migration.openshift.io/v1alpha1 kind: MigrationController metadata: name: migration-controller namespace: openshift-migration spec: [...] stunnel_tcp_proxy: http://username:password@ip:port

La migration directe de volume (DVM) ne prend en charge que l'authentification de base pour le proxy. En outre, la DVM ne fonctionne que derrière des proxys qui peuvent tunneliser une connexion TCP de manière transparente. Les mandataires HTTP/HTTPS en mode man-in-the-middle ne fonctionnent pas. Les proxys existants à l'échelle du cluster peuvent ne pas prendre en charge ce comportement. Par conséquent, les paramètres du proxy pour DVM sont intentionnellement différents de la configuration habituelle du proxy dans MTC.

4.4.1.2. Pourquoi utiliser un proxy TCP plutôt qu'un proxy HTTP/HTTPS ?

Vous pouvez activer DVM en exécutant Rsync entre le cluster source et le cluster cible via une route OpenShift. Le trafic est chiffré à l'aide de Stunnel, un proxy TCP. Le Stunnel fonctionnant sur le cluster source initie une connexion TLS avec le Stunnel cible et transfère les données sur un canal crypté.

Les proxys HTTP/HTTPS à l'échelle du cluster dans OpenShift sont généralement configurés en mode man-in-the-middle où ils négocient leur propre session TLS avec les serveurs extérieurs. Cependant, cela ne fonctionne pas avec Stunnel. Stunnel exige que sa session TLS ne soit pas modifiée par le proxy, faisant essentiellement du proxy un tunnel transparent qui transmet simplement la connexion TCP telle quelle. Vous devez donc utiliser un proxy TCP.

4.4.1.3. Problème connu

La migration échoue avec l'erreur Upgrade request required

Le contrôleur de migration utilise le protocole SPDY pour exécuter des commandes dans des modules distants. Si le cluster distant se trouve derrière un proxy ou un pare-feu qui ne prend pas en charge le protocole SPDY, le contrôleur de migration ne parvient pas à exécuter les commandes à distance. La migration échoue avec le message d'erreur Upgrade request required. Solution : Utilisez un proxy qui prend en charge le protocole SPDY.

Outre la prise en charge du protocole SPDY, le proxy ou le pare-feu doit également transmettre l'en-tête HTTP Upgrade au serveur API. Le client utilise cet en-tête pour ouvrir une connexion websocket avec le serveur API. Si l'en-tête Upgrade est bloqué par le proxy ou le pare-feu, la migration échoue avec le message d'erreur Upgrade request required. Solution : Assurez-vous que le proxy transmet l'en-tête Upgrade.

4.4.2. Optimiser les politiques de réseau pour les migrations

OpenShift prend en charge la restriction du trafic vers ou depuis les pods à l'aide de NetworkPolicy ou EgressFirewalls en fonction du plugin réseau utilisé par le cluster. Si l'un des espaces de noms source impliqués dans une migration utilise de tels mécanismes pour restreindre le trafic réseau vers les pods, les restrictions peuvent par inadvertance arrêter le trafic vers les pods Rsync pendant la migration.

Les pods Rsync fonctionnant sur les clusters source et cible doivent se connecter l'un à l'autre via une route OpenShift. Les objets NetworkPolicy ou EgressNetworkPolicy existants peuvent être configurés pour exempter automatiquement les pods Rsync de ces restrictions de trafic.

4.4.2.1. Configuration de la politique de réseau

4.4.2.1.1. Trafic de sortie des pods Rsync

Vous pouvez utiliser les étiquettes uniques des modules Rsync pour autoriser le trafic sortant de ces modules si la configuration de NetworkPolicy dans les espaces de noms source ou destination bloque ce type de trafic. La stratégie suivante autorise le trafic de sortie all à partir des modules Rsync dans l'espace de noms :

apiVersion: networking.k8s.io/v1

kind: NetworkPolicy

metadata:

name: allow-all-egress-from-rsync-pods

spec:

podSelector:

matchLabels:

owner: directvolumemigration

app: directvolumemigration-rsync-transfer

egress:

- {}

policyTypes:

- Egress4.4.2.1.2. Trafic entrant vers les pods Rsync

apiVersion: networking.k8s.io/v1

kind: NetworkPolicy

metadata:

name: allow-all-egress-from-rsync-pods

spec:

podSelector:

matchLabels:

owner: directvolumemigration

app: directvolumemigration-rsync-transfer

ingress:

- {}

policyTypes:

- Ingress4.4.2.2. Configuration de la politique de réseau EgressNetworkPolicy

L'objet EgressNetworkPolicy ou Egress Firewalls sont des constructions OpenShift conçues pour bloquer le trafic de sortie du cluster.

Contrairement à l'objet NetworkPolicy, le pare-feu Egress fonctionne au niveau du projet car il s'applique à tous les modules de l'espace de noms. Par conséquent, les étiquettes uniques des pods Rsync n'exemptent pas uniquement les pods Rsync des restrictions. Cependant, vous pouvez ajouter les plages CIDR du cluster source ou cible à la règle Allow de la politique afin qu'une connexion directe puisse être établie entre deux clusters.

En fonction du cluster dans lequel le pare-feu de sortie est présent, vous pouvez ajouter la plage CIDR de l'autre cluster pour autoriser le trafic de sortie entre les deux :

apiVersion: network.openshift.io/v1

kind: EgressNetworkPolicy

metadata:

name: test-egress-policy

namespace: <namespace>

spec:

egress:

- to:

cidrSelector: <cidr_of_source_or_target_cluster>

type: Deny4.4.2.3. Choix d'autres points d'arrivée pour le transfert de données

Par défaut, DVM utilise une route OpenShift Container Platform comme point final pour transférer les données PV vers les clusters de destination. Vous pouvez choisir un autre type de point d'extrémité pris en charge, si les topologies de cluster le permettent.

Pour chaque cluster, vous pouvez configurer un point de terminaison en définissant la variable rsync_endpoint_type sur le cluster destination approprié dans votre MigrationController CR :

apiVersion: migration.openshift.io/v1alpha1 kind: MigrationController metadata: name: migration-controller namespace: openshift-migration spec: [...] rsync_endpoint_type: [NodePort|ClusterIP|Route]

4.4.2.4. Configuration de groupes supplémentaires pour les pods Rsync

Lorsque vos PVC utilisent un stockage partagé, vous pouvez configurer l'accès à ce stockage en ajoutant des groupes supplémentaires aux définitions de pods Rsync afin que les pods autorisent l'accès :

Tableau 4.2. Groupes supplémentaires pour les pods Rsync

| Variable | Type | Défaut | Description |

|---|---|---|---|

|

| chaîne de caractères | Non défini | Liste séparée par des virgules des groupes supplémentaires pour les pods Rsync source |

|

| chaîne de caractères | Non défini | Liste de groupes supplémentaires séparés par des virgules pour les pods Rsync cibles |

Exemple d'utilisation

Le CR MigrationController peut être mis à jour pour définir les valeurs de ces groupes supplémentaires :

spec: src_supplemental_groups: "1000,2000" target_supplemental_groups: "2000,3000"

4.4.3. Configuration des proxies

Conditions préalables

-

Vous devez être connecté en tant qu’utilisateur avec les privilèges

cluster-adminsur tous les clusters.

Procédure

Procurez-vous le manifeste du CR

MigrationController:$ oc get migrationcontroller <migration_controller> -n openshift-migration

Mettez à jour les paramètres du proxy :

apiVersion: migration.openshift.io/v1alpha1 kind: MigrationController metadata: name: <migration_controller> namespace: openshift-migration ... spec: stunnel_tcp_proxy: http://<username>:<password>@<ip>:<port> 1 noProxy: example.com 2

Faites précéder un domaine du signe

.pour ne faire correspondre que les sous-domaines. Par exemple,.y.comcorrespond àx.y.com, mais pas ày.com. Utilisez*pour ignorer le proxy pour toutes les destinations. Si vous mettez à l’échelle des workers qui ne sont pas inclus dans le réseau défini par le champnetworking.machineNetwork[].cidrà partir de la configuration d’installation, vous devez les ajouter à cette liste pour éviter les problèmes de connexion.Ce champ est ignoré si ni le champ

httpProxyni le champhttpsProxyne sont définis.-

Enregistrez le manifeste en tant que

migration-controller.yaml. Appliquez le manifeste mis à jour :

$ oc replace -f migration-controller.yaml -n openshift-migration

Pour plus d'informations, voir Configuration du proxy pour l'ensemble du cluster.

4.5. Exécuter Rsync en tant que root ou non-root

Cette section s'applique uniquement lorsque vous travaillez avec l'API OpenShift, et non avec la console web.

Les environnements OpenShift ont le contrôleur PodSecurityAdmission activé par défaut. Ce contrôleur exige des administrateurs de cluster qu'ils appliquent les normes de sécurité des pods au moyen d'étiquettes d'espace de noms. Toutes les charges de travail du cluster sont censées exécuter l'un des niveaux de normes de sécurité pods suivants : Privileged Baseline ou Restricted. Chaque cluster dispose de son propre ensemble de règles par défaut.

Pour garantir la réussite du transfert de données dans tous les environnements, Migration Toolkit for Containers (MTC) 1.7.5 a introduit des changements dans les pods Rsync, notamment l'exécution des pods Rsync en tant qu'utilisateur non root par défaut. Cela garantit que le transfert de données est possible même pour les charges de travail qui ne nécessitent pas nécessairement des privilèges plus élevés. Cette modification a été apportée parce qu'il est préférable d'exécuter les charges de travail avec le niveau de privilèges le plus bas possible.

Remplacer manuellement l'opération non root par défaut pour le transfert de données

Bien que l'exécution des pods Rsync en tant qu'utilisateur non root fonctionne dans la plupart des cas, le transfert de données peut échouer lorsque vous exécutez des charges de travail en tant qu'utilisateur root du côté de la source. MTC propose deux façons de remplacer manuellement l'opération non-root par défaut pour le transfert de données :

- Configurer toutes les migrations pour exécuter un pod Rsync en tant que root sur le cluster de destination pour toutes les migrations.

- Exécuter un pod Rsync en tant que root sur le cluster de destination par migration.

Dans les deux cas, vous devez définir les étiquettes suivantes du côté source de tous les espaces de noms qui exécutent des charges de travail avec des privilèges plus élevés avant la migration : enforce, audit, et warn.

Pour en savoir plus sur l'admission à la sécurité des pods et la définition des valeurs des étiquettes, voir Contrôle de la synchronisation de l'admission à la sécurité des pods.

4.5.1. Configurer le MigrationController CR en tant que root ou non-root pour toutes les migrations

Par défaut, Rsync s'exécute en tant que non-root.

Sur le cluster de destination, vous pouvez configurer le CR MigrationController pour qu'il exécute Rsync en tant que root.

Procédure

Configurez le CR

MigrationControllercomme suit :apiVersion: migration.openshift.io/v1alpha1 kind: MigrationController metadata: name: migration-controller namespace: openshift-migration spec: [...] migration_rsync_privileged: true

Cette configuration s'appliquera à toutes les migrations futures.

4.5.2. Configurer le CR MigMigration en tant que root ou non-root par migration

Sur le cluster de destination, vous pouvez configurer le CR MigMigration pour qu'il exécute Rsync en tant que root ou non-root, avec les options non-root suivantes :

- En tant qu'identifiant d'utilisateur spécifique (UID)

- En tant qu'identifiant de groupe spécifique (GID)

Procédure

Pour exécuter Rsync en tant que root, configurez le CR

MigMigrationselon cet exemple :apiVersion: migration.openshift.io/v1alpha1 kind: MigMigration metadata: name: migration-controller namespace: openshift-migration spec: [...] runAsRoot: true

Pour exécuter Rsync en tant qu'identifiant d'utilisateur (UID) ou de groupe (GID) spécifique, configurez le CR

MigMigrationselon cet exemple :apiVersion: migration.openshift.io/v1alpha1 kind: MigMigration metadata: name: migration-controller namespace: openshift-migration spec: [...] runAsUser: 10010001 runAsGroup: 3

4.6. Configuration d’un référentiel de réplication

Multicloud Object Gateway est la seule option prise en charge pour un environnement réseau restreint.

MTC prend en charge les méthodes de copie de données du système de fichiers et des instantanés pour la migration des données du cluster source vers le cluster cible. Vous pouvez sélectionner une méthode adaptée à votre environnement et prise en charge par votre fournisseur de stockage.

4.6.1. Conditions préalables

- Tous les clusters doivent disposer d’un accès réseau ininterrompu au référentiel de réplication.

- Si vous utilisez un serveur mandateur avec un référentiel de réplication hébergé en interne, vous devez vous assurer que le proxy autorise l’accès au référentiel de réplication.

4.6.2. Récupération des informations d’identification de Multicloud Object Gateway

Vous devez récupérer les informations d’identification de Multicloud Object Gateway (MCG) afin de créer une ressource personnalisée (CR) Secret pour OADP (OpenShift API for Data Protection).

MCG est un composant d'OpenShift Data Foundation.

Conditions préalables

- Vous devez déployer OpenShift Data Foundation en utilisant le guide de déploiement OpenShift Data Foundation approprié.

Procédure

-

Obtenez le point de terminaison S3,

AWS_ACCESS_KEY_IDetAWS_SECRET_ACCESS_KEYen exécutant la commandedescribesur la ressource personnaliséeNooBaa.

4.6.3. Ressources supplémentaires

- Disconnected environment dans la documentation de Red Hat OpenShift Data Foundation.

- Flux de travail du CTM

- A propos des méthodes de copie de données

- Ajouter un référentiel de réplication à la console web MTC

4.7. Désinstallation de MTC et suppression de ressources

Vous pouvez désinstaller Migration Toolkit for Containers (MTC) et supprimer ses ressources afin de nettoyer le cluster.

La suppression des CRD velero entraîne la suppression de Velero du cluster.

Conditions préalables

-

Vous devez être connecté en tant qu’utilisateur avec les privilèges

cluster-admin.

Procédure

Supprimez la ressource personnalisée (CR)

MigrationControllersur tous les clusters :$ oc delete migrationcontroller <migration_controller>

- Désinstallez l’opérateur Migration Toolkit for Containers sur OpenShift Container Platform 4 en utilisant Operator Lifecycle Manager.

Supprimez les ressources délimitées par le cluster sur tous les clusters en exécutant les commandes suivantes :

Définitions de ressources personnalisées (CRD)

migration:$ oc delete $(oc get crds -o name | grep 'migration.openshift.io')

CRD

velero:$ oc delete $(oc get crds -o name | grep 'velero')

Rôles de cluster

migration:$ oc delete $(oc get clusterroles -o name | grep 'migration.openshift.io')

Rôle de cluster

migration-operator:$ oc delete clusterrole migration-operator

Rôles de cluster

velero:$ oc delete $(oc get clusterroles -o name | grep 'velero')

Liaisons de rôles de cluster

migration:$ oc delete $(oc get clusterrolebindings -o name | grep 'migration.openshift.io')

Liaisons de rôles de cluster

migration-operator:$ oc delete clusterrolebindings migration-operator

Liaisons de rôles de cluster

velero:$ oc delete $(oc get clusterrolebindings -o name | grep 'velero')

Chapitre 5. Mise à niveau de Migration Toolkit for Containers

Vous pouvez mettre à niveau le Migration Toolkit for Containers (MTC) sur OpenShift Container Platform 4.12 en utilisant Operator Lifecycle Manager.

Vous pouvez mettre à jour MTC sur OpenShift Container Platform 4.5, et les versions antérieures, en réinstallant l'ancien Migration Toolkit for Containers Operator.

Si vous effectuez une mise à niveau à partir de MTC version 1.3, vous devez effectuer une procédure supplémentaire pour mettre à jour la ressource personnalisée (CR) MigPlan.

5.1. Mise à jour du Migration Toolkit for Containers sur OpenShift Container Platform 4.12

Vous pouvez mettre à niveau le Migration Toolkit for Containers (MTC) sur OpenShift Container Platform 4.12 en utilisant le Operator Lifecycle Manager.

Conditions préalables

-

Vous devez être connecté en tant qu’utilisateur avec les privilèges

cluster-admin.

Procédure

Dans la console OpenShift Container Platform, accédez à Operators → Installed Operators.