L'architecture

Vue d'ensemble de l'architecture d'OpenShift Container Platform

Résumé

Chapitre 1. Aperçu de l'architecture

OpenShift Container Platform est une plateforme de conteneurs Kubernetes basée sur le cloud. La fondation d'OpenShift Container Platform est basée sur Kubernetes et partage donc la même technologie. Pour en savoir plus sur OpenShift Container Platform et Kubernetes, voir l'architecture du produit.

1.1. Glossaire des termes courants relatifs à l'architecture d'OpenShift Container Platform

Ce glossaire définit les termes communs utilisés dans le contenu de l'architecture.

- politiques d'accès

- Ensemble de rôles qui déterminent la manière dont les utilisateurs, les applications et les entités d'une grappe interagissent les uns avec les autres. Une politique d'accès renforce la sécurité de la grappe.

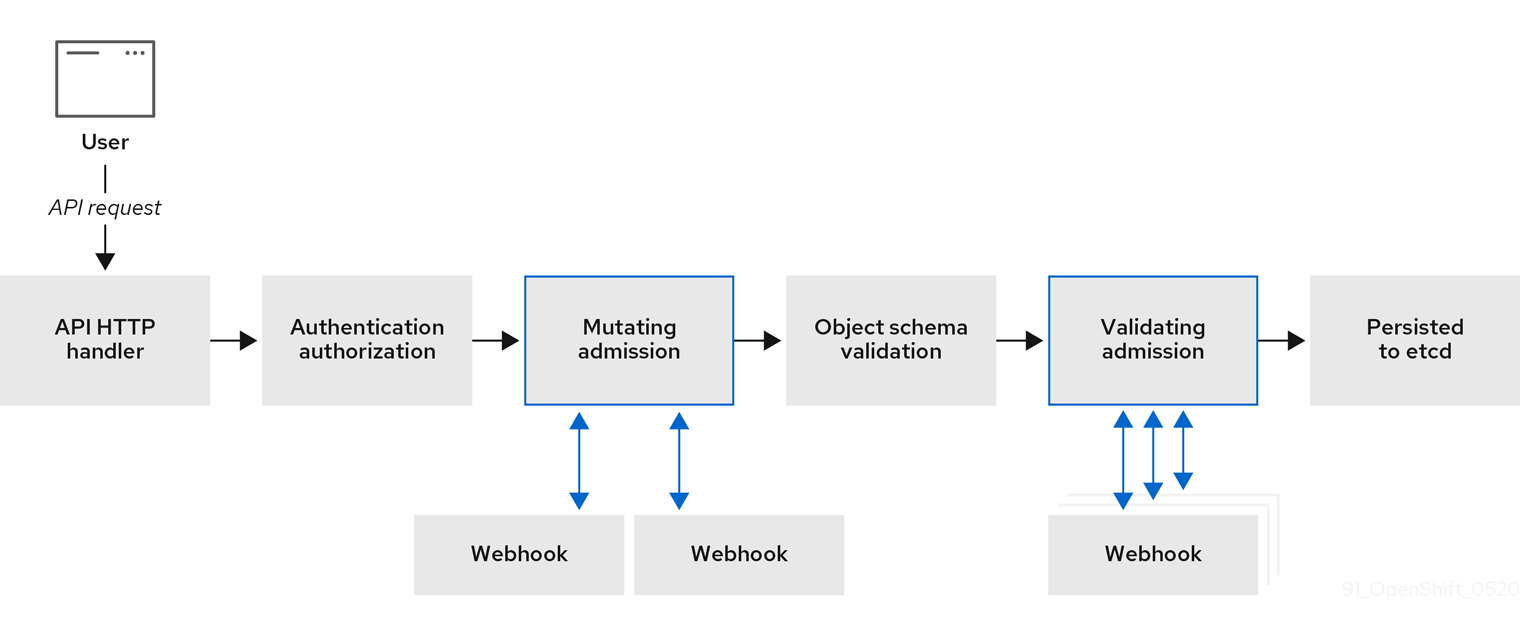

- plugins d'admission

- Les plugins d'admission appliquent des politiques de sécurité, des limitations de ressources ou des exigences de configuration.

- l'authentification

- Pour contrôler l'accès à un cluster OpenShift Container Platform, un administrateur de cluster peut configurer l'authentification des utilisateurs et s'assurer que seuls les utilisateurs approuvés accèdent au cluster. Pour interagir avec un cluster OpenShift Container Platform, vous devez vous authentifier auprès de l'API OpenShift Container Platform. Vous pouvez vous authentifier en fournissant un jeton d'accès OAuth ou un certificat client X.509 dans vos demandes à l'API OpenShift Container Platform.

- amorçage

- Une machine temporaire qui exécute Kubernetes minimal et déploie le plan de contrôle d'OpenShift Container Platform.

- les demandes de signature de certificat (CSR)

- Une ressource demande à un signataire désigné de signer un certificat. Cette demande peut être approuvée ou refusée.

- Opérateur de version de cluster (CVO)

- Un opérateur qui vérifie avec le service de mise à jour d'OpenShift Container Platform les mises à jour valides et les chemins de mise à jour basés sur les versions actuelles des composants et les informations dans le graphe.

- nœuds de calcul

- Nœuds chargés d'exécuter les charges de travail pour les utilisateurs de la grappe. Les nœuds de calcul sont également appelés nœuds de travail.

- dérive de la configuration

- Situation dans laquelle la configuration d'un nœud ne correspond pas à ce que la configuration de la machine spécifie.

- conteneurs

- Il s'agit d'images légères et exécutables composées d'un logiciel et de toutes ses dépendances. Comme les conteneurs virtualisent le système d'exploitation, vous pouvez les exécuter n'importe où, que ce soit dans un centre de données, un nuage public ou privé ou votre hôte local.

- moteur d'orchestration de conteneurs

- Logiciel qui automatise le déploiement, la gestion, la mise à l'échelle et la mise en réseau des conteneurs.

- charges de travail en conteneur

- Applications conditionnées et déployées dans des conteneurs.

- groupes de contrôle (cgroups)

- Répartit les ensembles de processus en groupes afin de gérer et de limiter les ressources consommées par les processus.

- plan de contrôle

- Une couche d'orchestration de conteneurs qui expose l'API et les interfaces pour définir, déployer et gérer le cycle de vie des conteneurs. Les plans de contrôle sont également connus sous le nom de machines de plan de contrôle.

- CRI-O

- Une implémentation native de l'exécution des conteneurs Kubernetes qui s'intègre au système d'exploitation pour offrir une expérience Kubernetes efficace.

- déploiement

- Un objet de ressource Kubernetes qui maintient le cycle de vie d'une application.

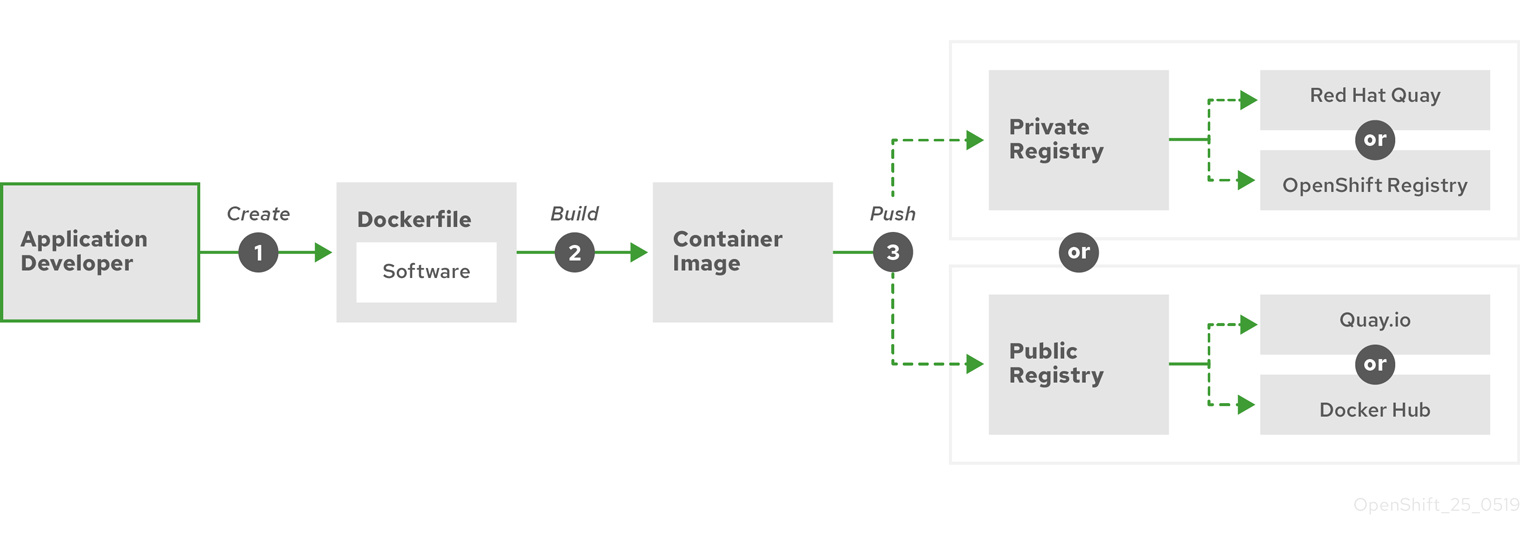

- Fichier Docker

- Fichier texte contenant les commandes utilisateur à exécuter sur un terminal pour assembler l'image.

- avions de contrôle hébergés

Fonctionnalité d'OpenShift Container Platform qui permet d'héberger un plan de contrôle sur le cluster OpenShift Container Platform à partir de son plan de données et de ses travailleurs. Ce modèle effectue les actions suivantes :

- Optimiser les coûts d'infrastructure requis pour les plans de contrôle.

- Améliorer le temps de création des clusters.

- Permettre l'hébergement du plan de contrôle en utilisant les primitives de haut niveau natives de Kubernetes. Par exemple, les déploiements, les ensembles avec état.

- Permettre une forte segmentation du réseau entre le plan de contrôle et les charges de travail.

- les déploiements de nuages hybrides

- Des déploiements qui offrent une plateforme cohérente dans les environnements bare metal, virtuels, privés et publics. Cela permet de gagner en rapidité, en agilité et en portabilité.

- Allumage

- Utilitaire utilisé par RHCOS pour manipuler les disques lors de la configuration initiale. Il effectue des tâches courantes sur les disques, notamment le partitionnement des disques, le formatage des partitions, l'écriture de fichiers et la configuration des utilisateurs.

- l'infrastructure fournie par l'installateur

- Le programme d'installation déploie et configure l'infrastructure sur laquelle le cluster fonctionne.

- kubelet

- Un agent de nœud primaire qui s'exécute sur chaque nœud du cluster pour s'assurer que les conteneurs s'exécutent dans un pod.

- manifeste kubernetes

- Spécifications d'un objet API Kubernetes dans un format JSON ou YAML. Un fichier de configuration peut inclure des déploiements, des cartes de configuration, des secrets, des ensembles de démons.

- Machine Config Daemon (MCD)

- Un démon qui vérifie régulièrement que les nœuds n'ont pas changé de configuration.

- Opérateur de configuration de machine (MCO)

- Un opérateur qui applique la nouvelle configuration aux machines de votre cluster.

- pools de configuration de machines (MCP)

- Groupe de machines, telles que les composants du plan de contrôle ou les charges de travail des utilisateurs, qui sont basées sur les ressources qu'elles gèrent.

- métadonnées

- Informations supplémentaires sur les artefacts de déploiement de clusters.

- microservices

- Une approche de l'écriture de logiciels. Les applications peuvent être séparées en composants les plus petits, indépendants les uns des autres, en utilisant des microservices.

- registre miroir

- Un registre qui contient le miroir des images d'OpenShift Container Platform.

- applications monolithiques

- Applications autonomes, construites et conditionnées en une seule pièce.

- espaces nominatifs

- Un espace de noms isole des ressources système spécifiques qui sont visibles par tous les processus. À l'intérieur d'un espace de noms, seuls les processus membres de cet espace peuvent voir ces ressources.

- la mise en réseau

- Informations sur le réseau du cluster OpenShift Container Platform.

- nœud

- Une machine de travail dans le cluster OpenShift Container Platform. Un nœud est soit une machine virtuelle (VM), soit une machine physique.

- Service de mise à jour de la plateforme OpenShift Container (OSUS)

- Pour les clusters disposant d'un accès à Internet, Red Hat Enterprise Linux (RHEL) fournit des mises à jour over-the-air en utilisant un service de mise à jour OpenShift Container Platform en tant que service hébergé situé derrière des API publiques.

- OpenShift CLI (

oc) - Un outil de ligne de commande pour exécuter des commandes OpenShift Container Platform sur le terminal.

- OpenShift Dédié

- Une offre de plateforme de conteneurs RHEL OpenShift gérée sur Amazon Web Services (AWS) et Google Cloud Platform (GCP). OpenShift Dedicated se concentre sur la création et la mise à l'échelle d'applications.

- Registre d'images OpenShift

- Un registre fourni par OpenShift Container Platform pour gérer les images.

- Opérateur

- La méthode préférée pour empaqueter, déployer et gérer une application Kubernetes dans un cluster OpenShift Container Platform. Un opérateur prend les connaissances opérationnelles humaines et les encode dans un logiciel qui est emballé et partagé avec les clients.

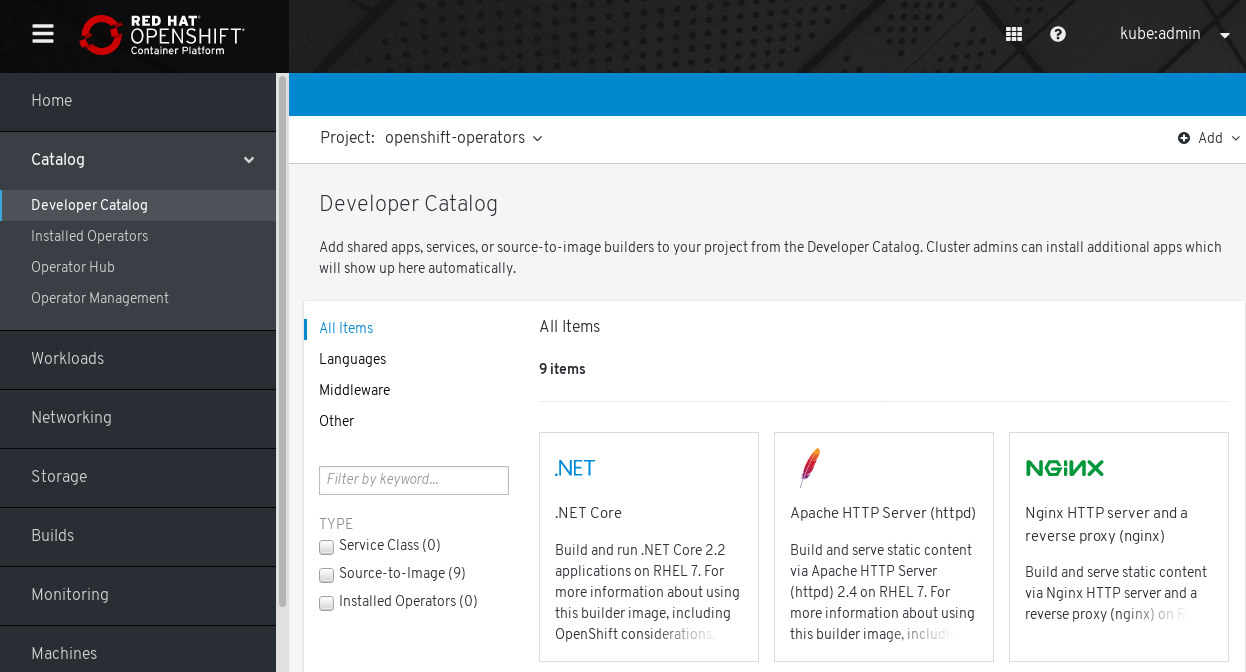

- OperatorHub

- Une plateforme qui contient divers opérateurs OpenShift Container Platform à installer.

- Gestionnaire du cycle de vie des opérateurs (OLM)

- OLM vous aide à installer, mettre à jour et gérer le cycle de vie des applications natives Kubernetes. OLM est une boîte à outils open source conçue pour gérer les opérateurs de manière efficace, automatisée et évolutive.

- OSTree

- Un système de mise à jour pour les systèmes d'exploitation basés sur Linux qui effectue des mises à jour atomiques d'arborescences complètes de systèmes de fichiers. OSTree suit les modifications significatives apportées à l'arborescence du système de fichiers à l'aide d'un magasin d'objets adressables et est conçu pour compléter les systèmes de gestion de paquets existants.

- les mises à jour OTA (over-the-air)

- Le service de mise à jour d'OpenShift Container Platform (OSUS) fournit des mises à jour over-the-air à OpenShift Container Platform, y compris Red Hat Enterprise Linux CoreOS (RHCOS).

- nacelle

- Un ou plusieurs conteneurs avec des ressources partagées, telles que le volume et les adresses IP, fonctionnant dans votre cluster OpenShift Container Platform. Un pod est la plus petite unité de calcul définie, déployée et gérée.

- registre privé

- OpenShift Container Platform peut utiliser n'importe quel serveur mettant en œuvre l'API de registre d'images de conteneurs comme source de l'image, ce qui permet aux développeurs de pousser et de tirer leurs images de conteneurs privées.

- registre public

- OpenShift Container Platform peut utiliser n'importe quel serveur mettant en œuvre l'API de registre d'images de conteneurs comme source de l'image, ce qui permet aux développeurs de pousser et de tirer leurs images de conteneurs publics.

- RHEL OpenShift Container Platform Cluster Manager

- Un service géré où vous pouvez installer, modifier, exploiter et mettre à niveau vos clusters OpenShift Container Platform.

- RHEL Quay Container Registry

- Un registre de conteneurs Quay.io qui fournit la plupart des images de conteneurs et des opérateurs aux clusters OpenShift Container Platform.

- contrôleurs de réplication

- Une ressource qui indique combien de répliques de pods sont nécessaires pour fonctionner en même temps.

- le contrôle d'accès basé sur les rôles (RBAC)

- Contrôle de sécurité essentiel pour garantir que les utilisateurs et les charges de travail des clusters n'ont accès qu'aux ressources nécessaires à l'exécution de leur rôle.

- itinéraire

- Les routes exposent un service permettant l'accès réseau aux pods à partir d'utilisateurs et d'applications extérieurs à l'instance d'OpenShift Container Platform.

- mise à l'échelle

- L'augmentation ou la diminution de la capacité des ressources.

- service

- Un service expose une application en cours d'exécution sur un ensemble de pods.

- Image source-image (S2I)

- Une image créée sur la base du langage de programmation du code source de l'application dans OpenShift Container Platform pour déployer des applications.

- stockage

- OpenShift Container Platform prend en charge de nombreux types de stockage, à la fois pour les fournisseurs sur site et dans le nuage. Vous pouvez gérer le stockage des conteneurs pour les données persistantes et non persistantes dans un cluster OpenShift Container Platform.

- Télémétrie

- Un composant pour collecter des informations telles que la taille, la santé et l'état de OpenShift Container Platform.

- modèle

- Un template décrit un ensemble d'objets qui peuvent être paramétrés et traités pour produire une liste d'objets à créer par OpenShift Container Platform.

- l'infrastructure fournie par l'utilisateur

- Vous pouvez installer OpenShift Container Platform sur l'infrastructure que vous fournissez. Vous pouvez utiliser le programme d'installation pour générer les ressources nécessaires au provisionnement de l'infrastructure du cluster, créer l'infrastructure du cluster, puis déployer le cluster sur l'infrastructure que vous avez fournie.

- console web

- Une interface utilisateur (UI) pour gérer OpenShift Container Platform.

- nœud de travail

- Nœuds chargés d'exécuter les charges de travail pour les utilisateurs de la grappe. Les nœuds de travail sont également appelés nœuds de calcul.

Ressources complémentaires

- Pour plus d'informations sur la mise en réseau, voir OpenShift Container Platform networking.

- Pour plus d'informations sur le stockage, voir OpenShift Container Platform storage.

- Pour plus d'informations sur l'authentification, voir OpenShift Container Platform authentication.

- Pour plus d'informations sur Operator Lifecycle Manager (OLM), voir OLM.

- Pour plus d'informations sur la journalisation, voir OpenShift Container Platform Logging.

- Pour plus d'informations sur les mises à jour OTA, voir Mise à jour des clusters OpenShift Container Platform.

1.2. A propos de l'installation et des mises à jour

En tant qu'administrateur de cluster, vous pouvez utiliser le programme d'installation d' OpenShift Container Platform pour installer et déployer un cluster en utilisant l'une des méthodes suivantes :

- Infrastructure fournie par l'installateur

- Infrastructure fournie par l'utilisateur

1.3. À propos du plan de contrôle

Le plan de contrôle gère les nœuds de travail et les pods de votre cluster. Vous pouvez configurer les nœuds à l'aide de pools de configuration de machines (MCP). Les MCP sont des groupes de machines, tels que les composants du plan de contrôle ou les charges de travail des utilisateurs, qui sont basés sur les ressources qu'ils gèrent. OpenShift Container Platform attribue différents rôles aux hôtes. Ces rôles définissent la fonction d'une machine dans un cluster. Le cluster contient des définitions pour les types de rôles standard de plan de contrôle et de travailleur.

Vous pouvez utiliser les opérateurs pour emballer, déployer et gérer les services sur le plan de contrôle. Les opérateurs sont des composants importants dans OpenShift Container Platform car ils fournissent les services suivants :

- Effectuer des contrôles de santé

- Fournir des moyens de surveiller les applications

- Gérer les mises à jour en direct

- S'assurer que les applications restent dans l'état spécifié

1.4. A propos des applications conteneurisées pour les développeurs

En tant que développeur, vous pouvez utiliser différents outils, méthodes et formats pour développer votre application conteneurisée en fonction de vos besoins spécifiques, par exemple :

- Utiliser divers outils de construction, images de base et options de registre pour créer une application conteneurisée simple.

- Utilisez les composants de soutien tels que OperatorHub et les modèles pour développer votre application.

- Empaqueter et déployer votre application en tant qu'opérateur.

Vous pouvez également créer un manifeste Kubernetes et le stocker dans un dépôt Git. Kubernetes fonctionne avec des unités de base appelées pods. Un pod est une instance unique d'un processus en cours d'exécution dans votre cluster. Les pods peuvent contenir un ou plusieurs conteneurs. Vous pouvez créer un service en regroupant un ensemble de pods et leurs politiques d'accès. Les services fournissent des adresses IP internes permanentes et des noms d'hôtes que d'autres applications peuvent utiliser lors de la création et de la destruction des pods. Kubernetes définit les charges de travail en fonction du type de votre application.

1.5. À propos de Red Hat Enterprise Linux CoreOS (RHCOS) et Ignition

En tant qu'administrateur de cluster, vous pouvez effectuer les tâches suivantes de Red Hat Enterprise Linux CoreOS (RHCOS) :

- Découvrez la nouvelle génération de systèmes d'exploitation de conteneurs à usage unique.

- Choisir comment configurer Red Hat Enterprise Linux CoreOS (RHCOS)

Choisissez comment déployer Red Hat Enterprise Linux CoreOS (RHCOS) :

- Déploiement fourni par l'installateur

- Déploiement à la demande de l'utilisateur

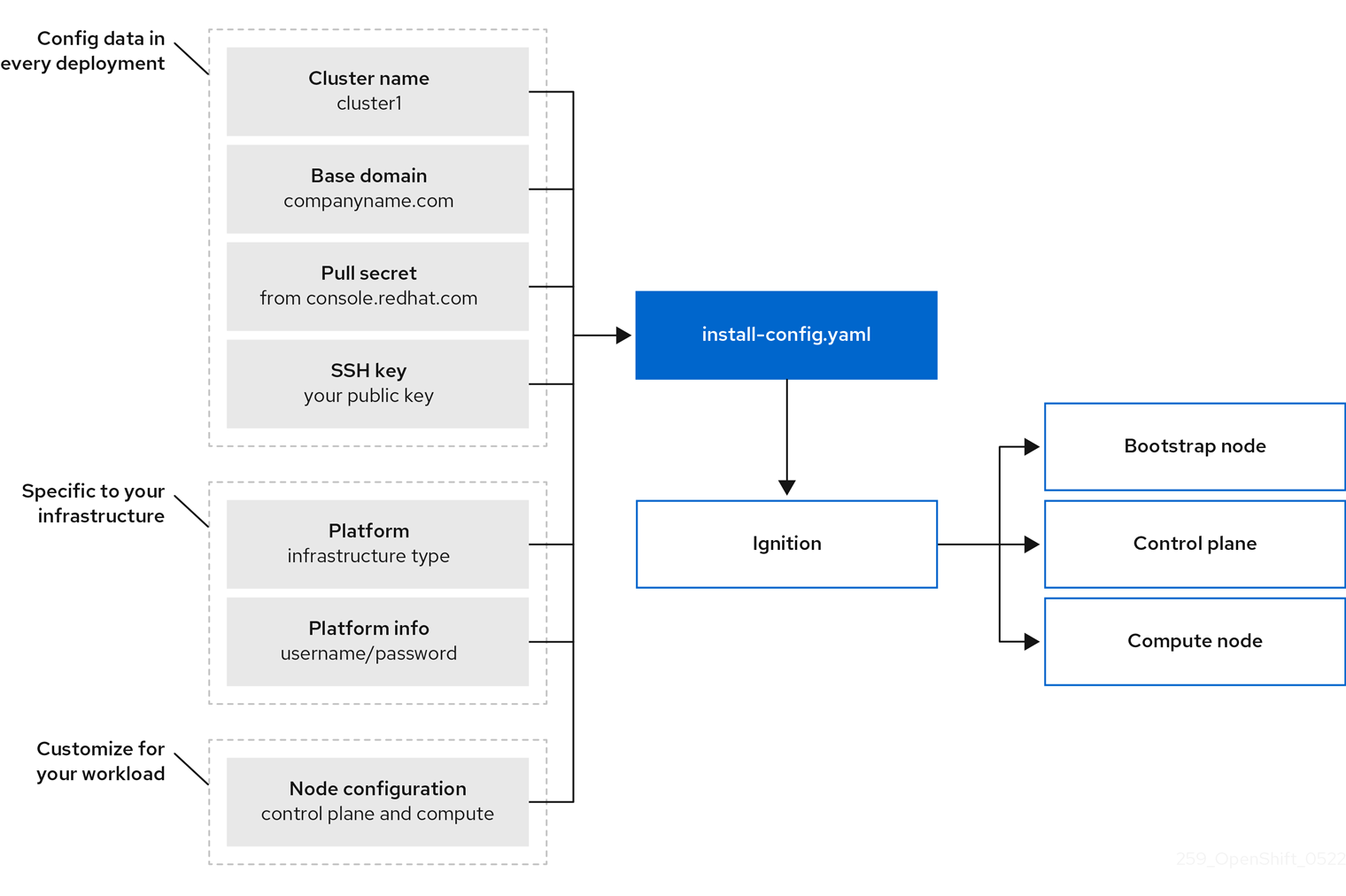

Le programme d'installation d'OpenShift Container Platform crée les fichiers de configuration Ignition dont vous avez besoin pour déployer votre cluster. Red Hat Enterprise Linux CoreOS (RHCOS) utilise Ignition lors de la configuration initiale pour effectuer des tâches de disque communes, telles que le partitionnement, le formatage, l'écriture de fichiers et la configuration des utilisateurs. Lors du premier démarrage, Ignition lit sa configuration à partir du média d'installation ou de l'emplacement que vous avez spécifié et applique la configuration aux machines.

Vous pouvez apprendre comment fonctionne Ignition, le processus pour une machine Red Hat Enterprise Linux CoreOS (RHCOS) dans un cluster OpenShift Container Platform, voir les fichiers de configuration d'Ignition, et modifier la configuration d'Ignition après une installation.

1.6. A propos des plugins d'admission

Vous pouvez utiliser les plugins d'admission pour réguler le fonctionnement d'OpenShift Container Platform. Une fois qu'une demande de ressource est authentifiée et autorisée, les plugins d'admission interceptent la demande de ressource vers l'API maître afin de valider les demandes de ressources et de s'assurer que les politiques de mise à l'échelle sont respectées. Les plugins d'admission sont utilisés pour appliquer les politiques de sécurité, les limitations de ressources ou les exigences de configuration.

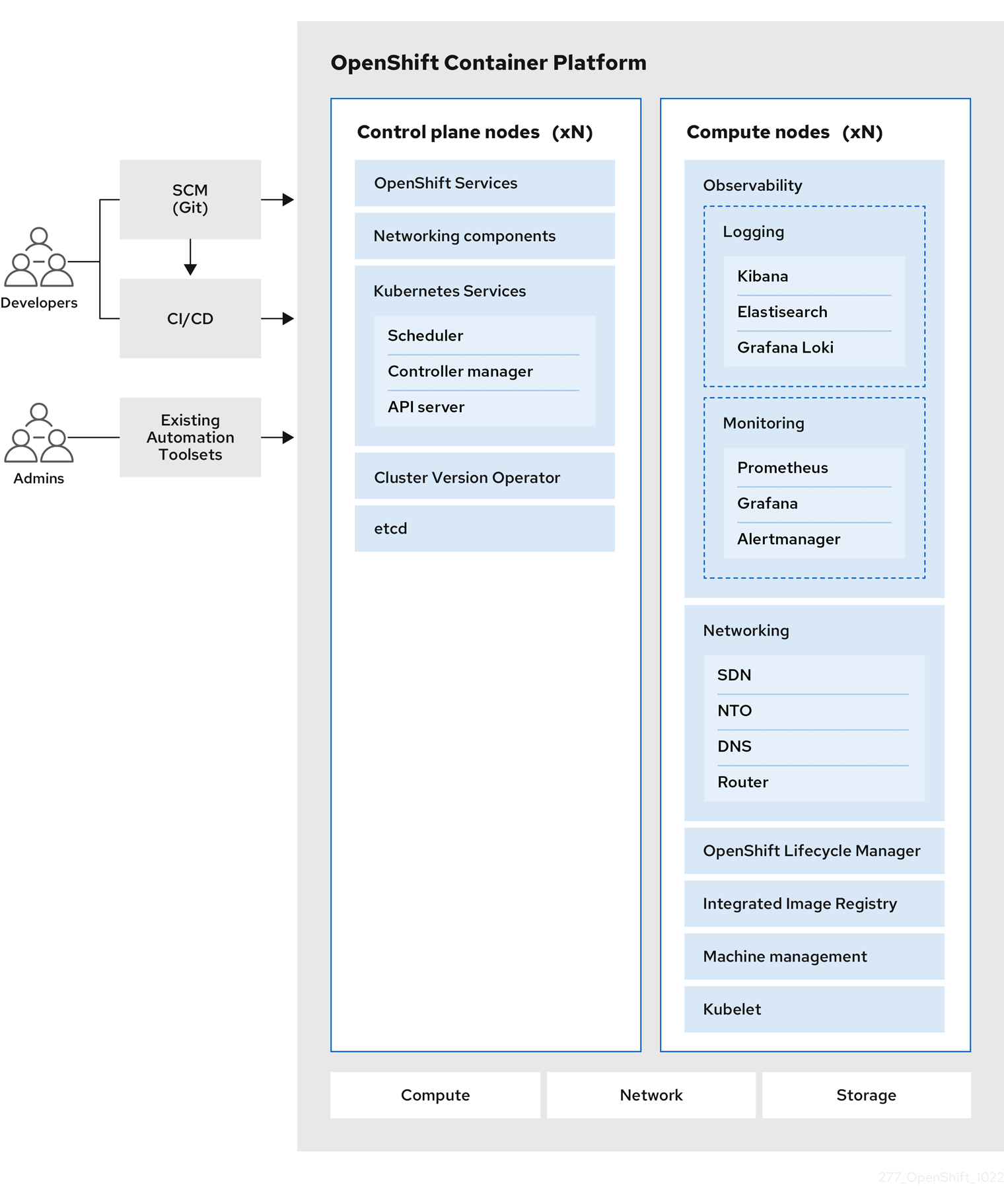

Chapitre 2. Architecture de la plateforme de conteneurs OpenShift

2.1. Introduction à OpenShift Container Platform

OpenShift Container Platform est une plateforme de développement et d'exécution d'applications conteneurisées. Elle est conçue pour permettre aux applications et aux centres de données qui les prennent en charge de passer de quelques machines et applications à des milliers de machines desservant des millions de clients.

Avec son fondement dans Kubernetes, OpenShift Container Platform incorpore la même technologie qui sert de moteur aux télécommunications massives, à la vidéo en continu, aux jeux, à la banque et à d'autres applications. Sa mise en œuvre dans les technologies ouvertes Red Hat vous permet d'étendre vos applications conteneurisées au-delà d'un seul cloud à des environnements sur site et multicloud.

2.1.1. À propos de Kubernetes

Bien que les images de conteneurs et les conteneurs qui s'exécutent à partir d'elles soient les principaux éléments constitutifs du développement d'applications modernes, leur exécution à grande échelle nécessite un système de distribution fiable et flexible. Kubernetes est la norme de facto pour l'orchestration des conteneurs.

Kubernetes est un moteur d'orchestration de conteneurs open source permettant d'automatiser le déploiement, la mise à l'échelle et la gestion des applications conteneurisées. Le concept général de Kubernetes est assez simple :

- Commencez par un ou plusieurs nœuds de travail pour exécuter les charges de travail des conteneurs.

- Gérer le déploiement de ces charges de travail à partir d'un ou plusieurs nœuds du plan de contrôle.

- Envelopper les conteneurs dans une unité de déploiement appelée pod. L'utilisation de pods fournit des métadonnées supplémentaires avec le conteneur et offre la possibilité de regrouper plusieurs conteneurs dans une seule entité de déploiement.

- Créer des types d'actifs particuliers. Par exemple, les services sont représentés par un ensemble de pods et une politique qui définit comment y accéder. Cette politique permet aux conteneurs de se connecter aux services dont ils ont besoin, même s'ils ne disposent pas des adresses IP spécifiques de ces services. Les contrôleurs de réplication sont une autre ressource spéciale qui indique combien de répliques de pods sont nécessaires pour fonctionner à un moment donné. Vous pouvez utiliser cette capacité pour adapter automatiquement votre application à la demande actuelle.

En quelques années seulement, Kubernetes a connu une adoption massive dans le cloud et sur site. Le modèle de développement open source permet à de nombreuses personnes d'étendre Kubernetes en mettant en œuvre différentes technologies pour des composants tels que le réseau, le stockage et l'authentification.

2.1.2. Les avantages des applications conteneurisées

L'utilisation d'applications conteneurisées présente de nombreux avantages par rapport aux méthodes de déploiement traditionnelles. Alors que les applications étaient autrefois censées être installées sur des systèmes d'exploitation comprenant toutes leurs dépendances, les conteneurs permettent à une application de transporter ses dépendances avec elle. La création d'applications conteneurisées offre de nombreux avantages.

2.1.2.1. Avantages du système d'exploitation

Les conteneurs utilisent de petits systèmes d'exploitation Linux dédiés sans noyau. Leur système de fichiers, leur réseau, leurs cgroups, leurs tables de processus et leurs espaces de noms sont distincts du système Linux hôte, mais les conteneurs peuvent s'intégrer aux hôtes de manière transparente si nécessaire. Le fait d'être basé sur Linux permet aux conteneurs d'utiliser tous les avantages qui viennent avec le modèle de développement open source d'innovation rapide.

Chaque conteneur utilisant un système d'exploitation dédié, vous pouvez déployer sur le même hôte des applications nécessitant des dépendances logicielles conflictuelles. Chaque conteneur transporte ses propres logiciels dépendants et gère ses propres interfaces, telles que les réseaux et les systèmes de fichiers, de sorte que les applications n'ont jamais besoin d'entrer en concurrence pour ces actifs.

2.1.2.2. Avantages en termes de déploiement et de mise à l'échelle

Si vous utilisez des mises à jour en continu entre les versions majeures de votre application, vous pouvez améliorer continuellement vos applications sans temps d'arrêt tout en conservant la compatibilité avec la version actuelle.

Vous pouvez également déployer et tester une nouvelle version d'une application parallèlement à la version existante. Si le conteneur passe les tests avec succès, il suffit de déployer d'autres nouveaux conteneurs et de supprimer les anciens.

Étant donné que toutes les dépendances logicielles d'une application sont résolues dans le conteneur lui-même, vous pouvez utiliser un système d'exploitation standardisé sur chaque hôte de votre centre de données. Il n'est pas nécessaire de configurer un système d'exploitation spécifique pour chaque hôte d'application. Lorsque votre centre de données a besoin de plus de capacité, vous pouvez déployer un autre système hôte générique.

De même, la mise à l'échelle des applications conteneurisées est simple. OpenShift Container Platform offre une méthode simple et standard de mise à l'échelle de tout service conteneurisé. Par exemple, si vous créez des applications sous la forme d'un ensemble de microservices plutôt que de grandes applications monolithiques, vous pouvez mettre à l'échelle les microservices individuellement pour répondre à la demande. Cette capacité vous permet de ne faire évoluer que les services nécessaires au lieu de l'ensemble de l'application, ce qui peut vous permettre de répondre aux demandes de l'application tout en utilisant un minimum de ressources.

2.1.3. Aperçu de la plateforme OpenShift Container

OpenShift Container Platform apporte à Kubernetes des améliorations prêtes pour l'entreprise, notamment les suivantes :

- Déploiements dans le nuage hybride. Vous pouvez déployer des clusters OpenShift Container Platform sur diverses plateformes de cloud public ou dans votre centre de données.

- Technologie Red Hat intégrée. Les principaux composants d'OpenShift Container Platform proviennent de Red Hat Enterprise Linux (RHEL) et des technologies Red Hat connexes. OpenShift Container Platform bénéficie des initiatives intenses de test et de certification des logiciels de qualité d'entreprise de Red Hat.

- Modèle de développement à source ouverte. Le développement est réalisé de manière ouverte et le code source est disponible dans des dépôts de logiciels publics. Cette collaboration ouverte favorise l'innovation et le développement rapides.

Bien que Kubernetes excelle dans la gestion de vos applications, il ne spécifie ni ne gère les exigences au niveau de la plateforme ou les processus de déploiement. Des outils et des processus de gestion de plateforme puissants et flexibles sont des avantages importants qu'offre OpenShift Container Platform 4.12. Les sections suivantes décrivent certaines caractéristiques et avantages uniques d'OpenShift Container Platform.

2.1.3.1. Système d'exploitation personnalisé

OpenShift Container Platform utilise Red Hat Enterprise Linux CoreOS (RHCOS), un système d'exploitation orienté conteneur spécialement conçu pour l'exécution d'applications conteneurisées à partir d'OpenShift Container Platform et fonctionne avec de nouveaux outils pour offrir une installation rapide, une gestion basée sur l'opérateur et des mises à niveau simplifiées.

Le RHCOS comprend

- Ignition, qu'OpenShift Container Platform utilise comme configuration système de premier démarrage pour démarrer et configurer les machines.

- CRI-O, une implémentation native du runtime de conteneur Kubernetes qui s'intègre étroitement avec le système d'exploitation pour fournir une expérience Kubernetes efficace et optimisée. CRI-O permet d'exécuter, d'arrêter et de redémarrer les conteneurs. Il remplace entièrement le moteur de conteneurs Docker, qui était utilisé dans OpenShift Container Platform 3.

- Kubelet, le principal agent de nœud pour Kubernetes qui est responsable du lancement et de la surveillance des conteneurs.

Dans OpenShift Container Platform 4.12, vous devez utiliser RHCOS pour toutes les machines du plan de contrôle, mais vous pouvez utiliser Red Hat Enterprise Linux (RHEL) comme système d'exploitation pour les machines de calcul, qui sont également connues sous le nom de machines de travail. Si vous choisissez d'utiliser les machines de calcul RHEL, vous devrez effectuer davantage de maintenance système que si vous utilisez RHCOS pour toutes les machines du cluster.

2.1.3.2. Processus d'installation et de mise à jour simplifié

Avec OpenShift Container Platform 4.12, si vous disposez d'un compte avec les bonnes autorisations, vous pouvez déployer un cluster de production dans les clouds pris en charge en exécutant une seule commande et en fournissant quelques valeurs. Vous pouvez également personnaliser votre installation dans le nuage ou installer votre cluster dans votre centre de données si vous utilisez une plateforme prise en charge.

Pour les clusters qui utilisent RHCOS pour toutes les machines, la mise à jour ou la mise à niveau d'OpenShift Container Platform est un processus simple et hautement automatisé. Comme OpenShift Container Platform contrôle entièrement les systèmes et les services qui s'exécutent sur chaque machine, y compris le système d'exploitation lui-même, à partir d'un plan de contrôle central, les mises à niveau sont conçues pour devenir des événements automatiques. Si votre cluster contient des machines de travail RHEL, le plan de contrôle bénéficie du processus de mise à jour rationalisé, mais vous devez effectuer davantage de tâches pour mettre à niveau les machines RHEL.

2.1.3.3. Autres caractéristiques clés

Les opérateurs sont à la fois l'unité fondamentale de la base de code d'OpenShift Container Platform 4.12 et un moyen pratique de déployer des applications et des composants logiciels pour que vos applications les utilisent. Dans OpenShift Container Platform, les opérateurs servent de fondation à la plateforme et éliminent le besoin de mises à niveau manuelles des systèmes d'exploitation et des applications du plan de contrôle. Les opérateurs d'OpenShift Container Platform tels que le Cluster Version Operator et le Machine Config Operator permettent une gestion simplifiée, à l'échelle du cluster, de ces composants critiques.

L'Operator Lifecycle Manager (OLM) et l'OperatorHub permettent de stocker et de distribuer des opérateurs aux personnes qui développent et déploient des applications.

Le Red Hat Quay Container Registry est un registre de conteneurs Quay.io qui fournit la plupart des images de conteneurs et des opérateurs aux clusters OpenShift Container Platform. Quay.io est une version du registre public de Red Hat Quay qui stocke des millions d'images et de tags.

Parmi les autres améliorations apportées à Kubernetes dans OpenShift Container Platform, citons les améliorations apportées au réseau défini par logiciel (SDN), à l'authentification, à l'agrégation des journaux, à la surveillance et au routage. OpenShift Container Platform offre également une console web complète et l'interface CLI (oc) personnalisée d'OpenShift.

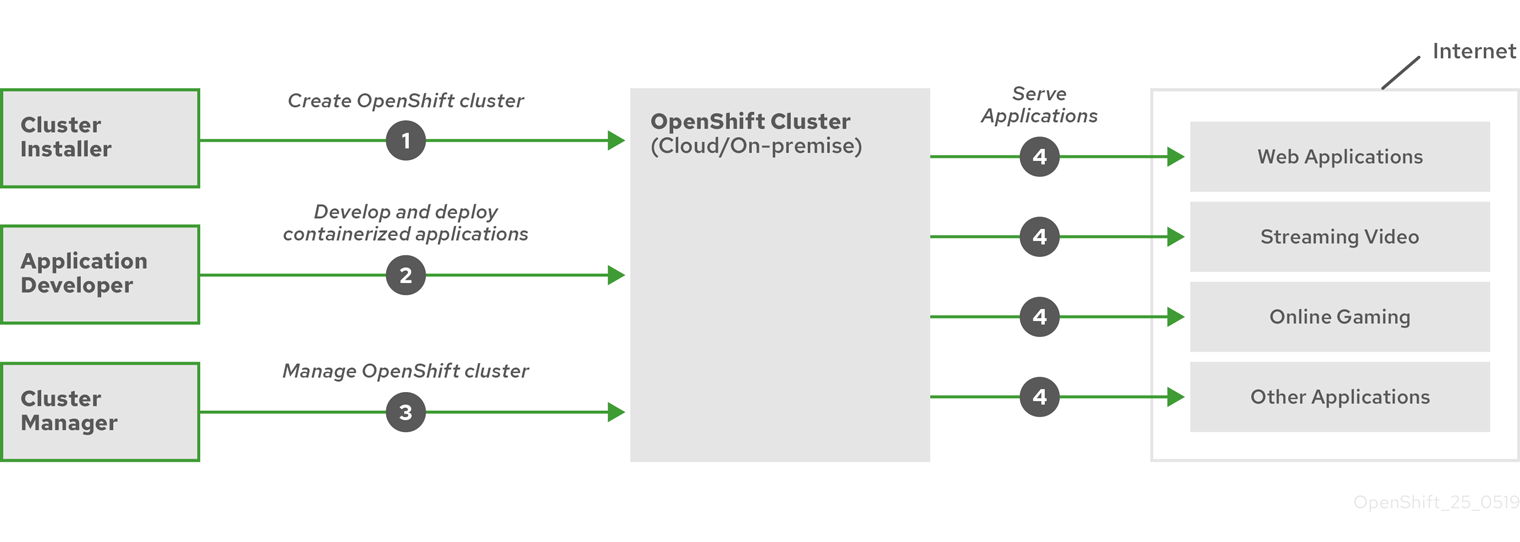

2.1.3.4. Cycle de vie d'OpenShift Container Platform

La figure suivante illustre le cycle de vie de base d'OpenShift Container Platform :

- Créer un cluster OpenShift Container Platform

- Gestion de la grappe

- Développement et déploiement d'applications

- Extension des applications

Figure 2.1. Vue d'ensemble de la plateforme OpenShift Container Platform

2.1.4. Accès à l'internet pour OpenShift Container Platform

Dans OpenShift Container Platform 4.12, vous devez avoir accès à Internet pour installer votre cluster.

Vous devez disposer d'un accès à l'internet pour :

- Accédez à OpenShift Cluster Manager Hybrid Cloud Console pour télécharger le programme d'installation et effectuer la gestion des abonnements. Si le cluster dispose d'un accès internet et que vous ne désactivez pas Telemetry, ce service donne automatiquement des droits à votre cluster.

- Accédez à Quay.io pour obtenir les paquets nécessaires à l'installation de votre cluster.

- Obtenir les paquets nécessaires pour effectuer les mises à jour de la grappe.

Si votre cluster ne peut pas avoir d'accès direct à l'internet, vous pouvez effectuer une installation en réseau restreint sur certains types d'infrastructure que vous fournissez. Au cours de ce processus, vous téléchargez le contenu requis et l'utilisez pour remplir un registre miroir avec les paquets d'installation. Avec certains types d'installation, l'environnement dans lequel vous installez votre cluster ne nécessite pas d'accès à Internet. Avant de mettre à jour le cluster, vous mettez à jour le contenu du registre miroir.

Chapitre 3. Installation et mise à jour

3.1. A propos de l'installation d'OpenShift Container Platform

Le programme d'installation d'OpenShift Container Platform propose quatre méthodes pour déployer un cluster :

- Interactive: Vous pouvez déployer un cluster à l'aide du programme d'installation assistée basé sur le web. C'est l'approche recommandée pour les clusters avec des réseaux connectés à l'internet. L'installateur assisté est le moyen le plus simple d'installer OpenShift Container Platform, il fournit des valeurs par défaut intelligentes et effectue des validations avant l'installation du cluster. Il fournit également une API RESTful pour l'automatisation et les scénarios de configuration avancés.

- Local Agent-based: Vous pouvez déployer un cluster localement avec le programme d'installation basé sur un agent pour les réseaux fermés ou restreints. Il offre de nombreux avantages par rapport à l'installateur assisté, mais vous devez d'abord télécharger et configurer l'installateur basé sur un agent. La configuration s'effectue à l'aide d'une interface de ligne de commande. Cette approche est idéale pour les réseaux fermés ou restreints.

- Automated: Vous pouvez déployer une grappe sur une infrastructure fournie par le programme d'installation et la grappe qu'elle maintient. Le programme d'installation utilise le contrôleur de gestion de carte de base (BMC) de chaque hôte de cluster pour le provisionnement. Vous pouvez déployer des clusters avec des réseaux connectés ou restreints.

- Full control: Vous pouvez déployer une grappe sur une infrastructure que vous préparez et entretenez, ce qui offre un maximum de possibilités de personnalisation. Vous pouvez déployer des clusters avec des réseaux connectés ou restreints.

Les grappes présentent les caractéristiques suivantes :

- Une infrastructure hautement disponible, sans point de défaillance unique, est disponible par défaut.

- Les administrateurs gardent le contrôle sur les mises à jour qui sont appliquées et sur le moment où elles le sont.

3.1.1. A propos du programme d'installation

Vous pouvez utiliser le programme d'installation pour déployer chaque type de cluster. Le programme d'installation génère des ressources principales telles que les fichiers de configuration Ignition pour le bootstrap, le plan de contrôle (maître) et les machines de travail. Vous pouvez démarrer un cluster OpenShift Container Platform avec ces trois configurations et une infrastructure correctement configurée.

Le programme d'installation d'OpenShift Container Platform utilise un ensemble de cibles et de dépendances pour gérer les installations de clusters. Le programme d'installation a un ensemble de cibles qu'il doit atteindre, et chaque cible a un ensemble de dépendances. Comme chaque objectif ne concerne que ses propres dépendances, le programme d'installation peut agir pour atteindre plusieurs objectifs en parallèle, l'objectif final étant un cluster en cours d'exécution. Le programme d'installation reconnaît et utilise les composants existants au lieu d'exécuter des commandes pour les créer à nouveau, car le programme respecte les dépendances.

Figure 3.1. Cibles et dépendances pour l'installation d'OpenShift Container Platform

3.1.2. À propos de Red Hat Enterprise Linux CoreOS (RHCOS)

Après l'installation, chaque machine du cluster utilise Red Hat Enterprise Linux CoreOS (RHCOS) comme système d'exploitation. RHCOS est la version d'hôte de conteneur immuable de Red Hat Enterprise Linux (RHEL) et comporte un noyau RHEL avec SELinux activé par défaut. Il inclut kubelet, qui est l'agent de nœud Kubernetes, et le runtime de conteneur CRI-O, qui est optimisé pour Kubernetes.

Chaque machine du plan de contrôle dans un cluster OpenShift Container Platform 4.12 doit utiliser RHCOS, qui comprend un outil critique de provisionnement au premier démarrage appelé Ignition. Cet outil permet au cluster de configurer les machines. Les mises à jour du système d'exploitation sont fournies sous la forme d'une image de conteneur amorçable, utilisant OSTree comme backend, qui est déployée dans le cluster par le Machine Config Operator. Les modifications réelles du système d'exploitation sont effectuées sur place sur chaque machine en tant qu'opération atomique à l'aide de rpm-ostree. Ensemble, ces technologies permettent à OpenShift Container Platform de gérer le système d'exploitation comme n'importe quelle autre application sur le cluster, en effectuant des mises à jour sur place qui maintiennent l'ensemble de la plateforme à jour. Ces mises à jour sur place peuvent réduire la charge des équipes d'exploitation.

Si vous utilisez RHCOS comme système d'exploitation pour toutes les machines de la grappe, celle-ci gère tous les aspects de ses composants et de ses machines, y compris le système d'exploitation. Pour cette raison, seuls le programme d'installation et l'opérateur de configuration des machines peuvent modifier les machines. Le programme d'installation utilise les fichiers de configuration Ignition pour définir l'état exact de chaque machine, et le Machine Config Operator effectue d'autres modifications sur les machines, telles que l'application de nouveaux certificats ou de nouvelles clés, après l'installation.

3.1.3. Plateformes prises en charge pour les clusters OpenShift Container Platform

Dans OpenShift Container Platform 4.12, vous pouvez installer un cluster qui utilise une infrastructure fournie par l'installateur sur les plateformes suivantes :

- Amazon Web Services (AWS)

- Google Cloud Platform (GCP)

- Microsoft Azure

- Microsoft Azure Stack Hub

Red Hat OpenStack Platform (RHOSP) versions 16.1 et 16.2

- La dernière version d'OpenShift Container Platform supporte à la fois la dernière version RHOSP longue durée et la version intermédiaire. Pour une compatibilité complète avec les versions RHOSP, voir la matrice de prise en charge d'OpenShift Container Platform sur RHOSP.

- IBM Cloud VPC

- Nutanix

- Red Hat Virtualization (RHV)

- VMware vSphere

- Cloud VMware (VMC) sur AWS

- Nuage d'Alibaba

- Métal nu

Pour ces clusters, toutes les machines, y compris l'ordinateur sur lequel vous exécutez le processus d'installation, doivent avoir un accès direct à Internet afin d'extraire des images pour les conteneurs de la plate-forme et de fournir des données télémétriques à Red Hat.

Après l'installation, les modifications suivantes ne sont pas prises en charge :

- Mélanger les plates-formes des fournisseurs d'informatique en nuage

- Mélange de composants de fournisseurs de cloud, comme l'utilisation d'un cadre de stockage persistant d'une plate-forme différente de celle sur laquelle le cluster est installé

Dans OpenShift Container Platform 4.12, vous pouvez installer un cluster qui utilise l'infrastructure fournie par l'utilisateur sur les plateformes suivantes :

- AWS

- L'azur

- Hub Azure Stack

- PCG

- RHOSP versions 16.1 et 16.2

- RHV

- VMware vSphere

- Cloud VMware sur AWS

- Métal nu

- IBM zSystems ou IBM® LinuxONE

- IBM Power

Selon les cas pris en charge pour la plateforme, les installations sur une infrastructure fournie par l'utilisateur vous permettent d'exécuter des machines avec un accès complet à Internet, de placer votre cluster derrière un proxy ou d'effectuer une installation sur restricted network installation. Dans une installation en réseau restreint, vous pouvez télécharger les images nécessaires à l'installation d'un cluster, les placer dans un registre miroir et utiliser ces données pour installer votre cluster. Alors que vous avez besoin d'un accès à Internet pour extraire les images des conteneurs de plateforme, avec une installation en réseau restreint sur vSphere ou une infrastructure bare metal, vos machines de cluster n'ont pas besoin d'un accès direct à Internet.

La page OpenShift Container Platform 4.x Tested Integrations contient des détails sur les tests d'intégration pour différentes plateformes.

3.1.4. Processus d'installation

À l'exception de l'installateur assisté, lorsque vous installez un cluster OpenShift Container Platform, vous téléchargez le programme d'installation à partir de la page du fournisseur d'infrastructure approprié sur le site OpenShift Cluster Manager. Ce site gère :

- API REST pour les comptes

- Les jetons de registre, qui sont les secrets d'extraction que vous utilisez pour obtenir les composants requis

- L'enregistrement du cluster, qui associe l'identité du cluster à votre compte Red Hat afin de faciliter la collecte de données d'utilisation

Dans OpenShift Container Platform 4.12, le programme d'installation est un fichier binaire Go qui effectue une série de transformations de fichiers sur un ensemble de ressources. La façon dont vous interagissez avec le programme d'installation diffère en fonction de votre type d'installation.

- Pour déployer une grappe avec le programme d'installation assistée, vous devez configurer les paramètres de la grappe à l'aide du programme d'installation assistée. Il n'y a pas de programme d'installation à télécharger et à configurer. Une fois la configuration terminée, vous téléchargez une ISO de découverte et démarrez les machines du cluster avec cette image. Vous pouvez installer des clusters avec l'installateur assisté sur Nutanix, vSphere, et bare metal avec une intégration complète, et d'autres plateformes sans intégration. Si vous installez sur du bare metal, vous devez fournir toute l'infrastructure et les ressources du cluster, y compris le réseau, l'équilibrage de charge, le stockage et les machines individuelles du cluster.

- Pour déployer des grappes avec le programme d'installation basé sur un agent, vous devez d'abord télécharger le programme d'installation basé sur un agent. Ensuite, vous configurez la grappe et générez une image de découverte. Vous démarrez les machines de la grappe avec l'image de découverte, qui installe un agent qui communique avec le programme d'installation et gère le provisionnement pour vous au lieu d'interagir avec le programme d'installation ou de configurer vous-même une machine de provisionnement. Vous devez fournir l'ensemble de l'infrastructure et des ressources du cluster, y compris le réseau, l'équilibrage de la charge, le stockage et les machines individuelles du cluster. Cette approche est idéale pour les environnements réseau restreints ou fermés.

- Pour les clusters dont l'infrastructure est fournie par l'installateur, vous déléguez le démarrage et le provisionnement de l'infrastructure au programme d'installation au lieu de le faire vous-même. Le programme d'installation crée tous les réseaux, machines et systèmes d'exploitation nécessaires à la prise en charge du cluster, sauf si vous procédez à une installation sur métal nu. Dans ce cas, vous devez fournir l'ensemble de l'infrastructure et des ressources du cluster, y compris la machine de démarrage, la mise en réseau, l'équilibrage de la charge, le stockage et les machines individuelles du cluster.

- Si vous fournissez et gérez l'infrastructure de votre cluster, vous devez fournir l'ensemble de l'infrastructure et des ressources du cluster, y compris la machine de démarrage, le réseau, l'équilibrage de la charge, le stockage et les machines individuelles du cluster.

Le programme d'installation utilise trois ensembles de fichiers lors de l'installation : un fichier de configuration d'installation nommé install-config.yaml, des manifestes Kubernetes et des fichiers de configuration Ignition pour vos types de machines.

Il est possible de modifier Kubernetes et les fichiers de configuration Ignition qui contrôlent le système d'exploitation RHCOS sous-jacent pendant l'installation. Cependant, aucune validation n'est disponible pour confirmer l'adéquation des modifications que vous apportez à ces objets. Si vous modifiez ces objets, vous risquez de rendre votre cluster non fonctionnel. En raison de ce risque, la modification des fichiers de configuration de Kubernetes et d'Ignition n'est pas prise en charge, à moins que vous ne suiviez des procédures documentées ou que l'assistance de Red Hat vous ait demandé de le faire.

Le fichier de configuration de l'installation est transformé en manifestes Kubernetes, puis les manifestes sont enveloppés dans des fichiers de configuration Ignition. Le programme d'installation utilise ces fichiers de configuration Ignition pour créer le cluster.

Les fichiers de configuration de l'installation sont tous élagués lorsque vous exécutez le programme d'installation. Veillez donc à sauvegarder tous les fichiers de configuration que vous souhaitez réutiliser.

Vous ne pouvez pas modifier les paramètres définis lors de l'installation, mais vous pouvez modifier de nombreux attributs du cluster après l'installation.

Le processus d'installation avec le programme d'installation assistée

L'installation à l'aide du programme d'installation assistée implique la création d'une configuration de cluster de manière interactive à l'aide de l'interface utilisateur Web ou de l'API RESTful. L'interface utilisateur du programme d'installation assistée vous invite à saisir les valeurs requises et fournit des valeurs par défaut raisonnables pour les autres paramètres, sauf si vous les modifiez dans l'interface utilisateur ou à l'aide de l'API. Le programme d'installation assistée génère une image de découverte que vous téléchargez et utilisez pour démarrer les machines du cluster. L'image installe RHCOS et un agent, et l'agent gère le provisionnement pour vous. Vous pouvez installer OpenShift Container Platform avec l'installateur assisté et l'intégration complète sur Nutanix, vSphere et bare metal, et sur d'autres plateformes sans intégration.

OpenShift Container Platform gère tous les aspects du cluster, y compris le système d'exploitation lui-même. Chaque machine démarre avec une configuration qui référence les ressources hébergées dans le cluster qu'elle rejoint. Cette configuration permet au cluster de se gérer lui-même au fur et à mesure que les mises à jour sont appliquées.

Si possible, utilisez cette fonction pour éviter d'avoir à télécharger et à configurer le programme d'installation basé sur un agent.

Le processus d'installation d'une infrastructure basée sur des agents

L'installation à l'aide d'un agent est similaire à l'utilisation du programme d'installation assistée, à ceci près que vous devez d'abord télécharger et installer le programme d'installation à l'aide d'un agent. L'installation à l'aide d'un agent est recommandée lorsque vous souhaitez bénéficier de tous les avantages de l'installateur assisté, mais que vous devez effectuer l'installation sur un réseau isolé ou déconnecté.

Si possible, utilisez cette fonctionnalité pour éviter d'avoir à créer une machine de provisionnement avec une VM de démarrage et de provisionner et maintenir l'infrastructure du cluster.

Le processus d'installation avec l'infrastructure fournie par l'installateur

Le type d'installation par défaut utilise une infrastructure fournie par l'installateur. Par défaut, le programme d'installation agit comme un assistant d'installation, vous demandant les valeurs qu'il ne peut pas déterminer lui-même et fournissant des valeurs par défaut raisonnables pour les paramètres restants. Vous pouvez également personnaliser le processus d'installation pour prendre en charge des scénarios d'infrastructure avancés. Le programme d'installation fournit l'infrastructure sous-jacente pour le cluster.

Vous pouvez installer soit un cluster standard, soit un cluster personnalisé. Dans le cas d'un cluster standard, vous fournissez les informations minimales nécessaires à l'installation du cluster. Avec un cluster personnalisé, vous pouvez spécifier plus de détails sur la plateforme, tels que le nombre de machines que le plan de contrôle utilise, le type de machine virtuelle que le cluster déploie, ou la plage CIDR pour le réseau de service Kubernetes.

Si possible, utilisez cette fonction pour éviter d'avoir à approvisionner et à maintenir l'infrastructure du cluster. Dans tous les autres environnements, vous utilisez le programme d'installation pour générer les ressources nécessaires à l'approvisionnement de votre infrastructure de cluster.

Avec les clusters d'infrastructure provisionnés par l'installateur, OpenShift Container Platform gère tous les aspects du cluster, y compris le système d'exploitation lui-même. Chaque machine démarre avec une configuration qui référence les ressources hébergées dans le cluster qu'elle rejoint. Cette configuration permet au cluster de se gérer lui-même au fur et à mesure que les mises à jour sont appliquées.

Le processus d'installation avec l'infrastructure fournie par l'utilisateur

Vous pouvez également installer OpenShift Container Platform sur une infrastructure que vous fournissez. Vous utilisez le programme d'installation pour générer les ressources nécessaires au provisionnement de l'infrastructure du cluster, créer l'infrastructure du cluster, puis déployer le cluster sur l'infrastructure que vous avez fournie.

Si vous n'utilisez pas l'infrastructure fournie par le programme d'installation, vous devez gérer et maintenir les ressources du cluster vous-même, y compris :

- L'infrastructure sous-jacente pour le plan de contrôle et les machines de calcul qui composent le cluster

- Équilibreurs de charge

- Mise en réseau du cluster, y compris les enregistrements DNS et les sous-réseaux requis

- Stockage pour l'infrastructure et les applications de la grappe

Si votre cluster utilise une infrastructure fournie par l'utilisateur, vous avez la possibilité d'ajouter des machines de calcul RHEL à votre cluster.

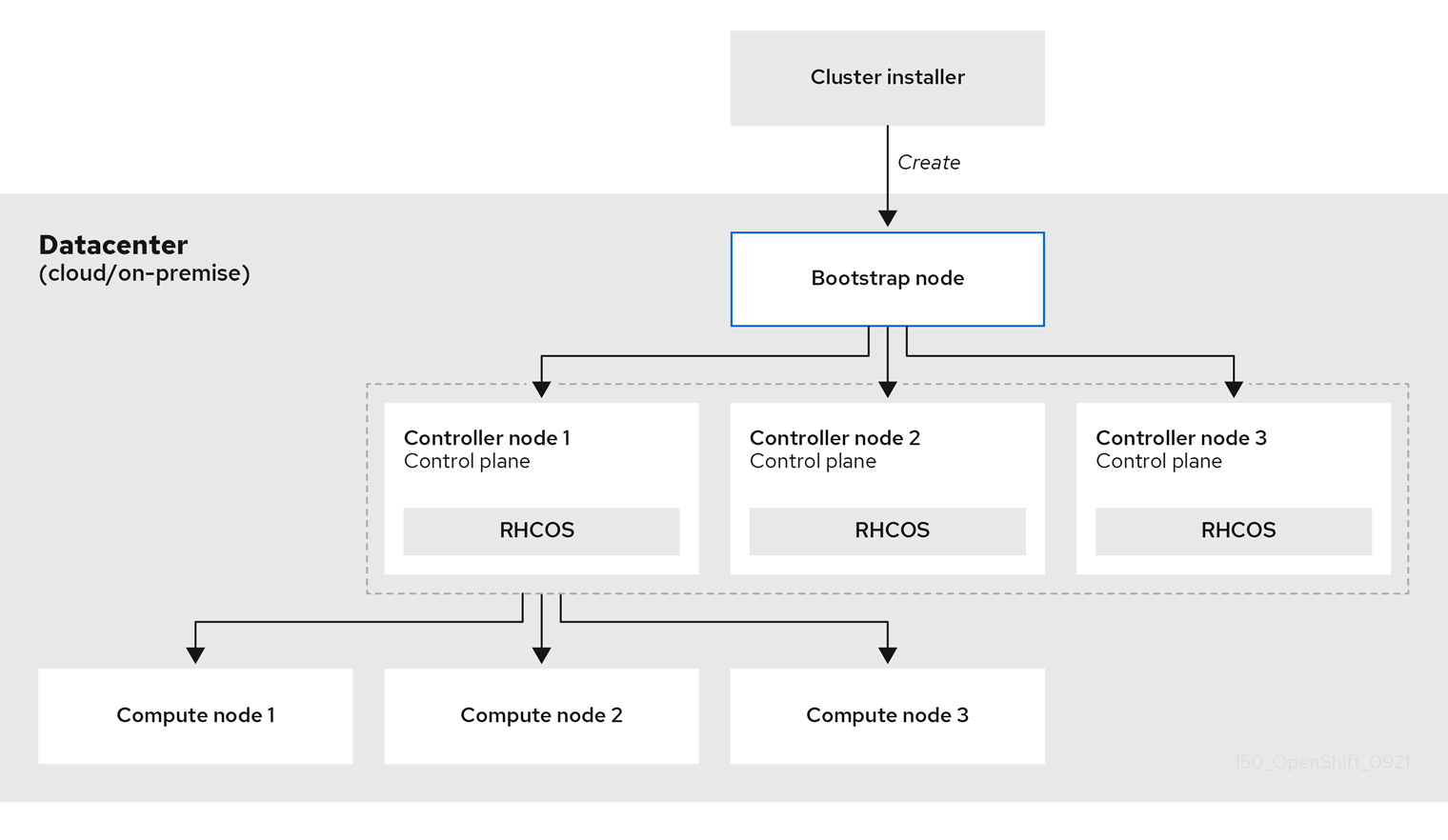

Détails de la procédure d'installation

Parce que chaque machine du cluster nécessite des informations sur le cluster lorsqu'elle est provisionnée, OpenShift Container Platform utilise une machine temporaire bootstrap lors de la configuration initiale pour fournir les informations nécessaires au plan de contrôle permanent. Elle démarre en utilisant un fichier de configuration Ignition qui décrit comment créer le cluster. La machine d'amorçage crée les machines du plan de contrôle qui constituent le plan de contrôle. Les machines du plan de contrôle créent ensuite les machines de calcul, également appelées machines de travail. La figure suivante illustre ce processus :

Figure 3.2. Création du bootstrap, du plan de contrôle et des machines de calcul

Après l'initialisation des machines de la grappe, la machine bootstrap est détruite. Tous les clusters utilisent le processus d'amorçage pour initialiser le cluster, mais si vous fournissez l'infrastructure pour votre cluster, vous devez effectuer de nombreuses étapes manuellement.

-

Les fichiers de configuration d'Ignition générés par le programme d'installation contiennent des certificats qui expirent après 24 heures et qui sont renouvelés à ce moment-là. Si le cluster est arrêté avant le renouvellement des certificats et qu'il est redémarré après l'expiration des 24 heures, le cluster récupère automatiquement les certificats expirés. L'exception est que vous devez approuver manuellement les demandes de signature de certificat (CSR) de

node-bootstrapperen attente pour récupérer les certificats de kubelet. Pour plus d'informations, consultez la documentation relative à Recovering from expired control plane certificates. - Il est recommandé d'utiliser les fichiers de configuration Ignition dans les 12 heures suivant leur génération, car le certificat de 24 heures tourne entre 16 et 22 heures après l'installation du cluster. En utilisant les fichiers de configuration Ignition dans les 12 heures, vous pouvez éviter l'échec de l'installation si la mise à jour du certificat s'exécute pendant l'installation.

L'amorçage d'une grappe comprend les étapes suivantes :

- La machine bootstrap démarre et commence à héberger les ressources distantes nécessaires au démarrage des machines du plan de contrôle. (Nécessite une intervention manuelle si vous approvisionnez l'infrastructure)

- La machine d'amorçage démarre un cluster etcd à nœud unique et un plan de contrôle Kubernetes temporaire.

- Les machines du plan de contrôle récupèrent les ressources distantes à partir de la machine d'amorçage et terminent le démarrage. (Nécessite une intervention manuelle si vous approvisionnez l'infrastructure)

- Le plan de contrôle temporaire planifie le plan de contrôle de production sur les machines du plan de contrôle de production.

- L'opérateur de version de cluster (CVO) se met en ligne et installe l'opérateur etcd. L'opérateur etcd met à l'échelle etcd sur tous les nœuds du plan de contrôle.

- Le plan de contrôle temporaire s'arrête et passe le contrôle au plan de contrôle de production.

- La machine d'amorçage injecte les composants d'OpenShift Container Platform dans le plan de contrôle de la production.

- Le programme d'installation arrête la machine de démarrage. (Nécessite une intervention manuelle si vous approvisionnez l'infrastructure)

- Le plan de contrôle met en place les nœuds de calcul.

- Le plan de contrôle installe des services supplémentaires sous la forme d'un ensemble d'opérateurs.

Le résultat de ce processus de démarrage est un cluster OpenShift Container Platform en cours d'exécution. Le cluster télécharge et configure ensuite les autres composants nécessaires au fonctionnement quotidien, y compris la création de machines de calcul dans les environnements pris en charge.

Champ d'application de l'installation

Le programme d'installation d'OpenShift Container Platform est volontairement restreint. Il est conçu pour être simple et garantir le succès de l'installation. Vous pouvez effectuer de nombreuses autres tâches de configuration une fois l'installation terminée.

Ressources complémentaires

- Voir Personnalisations de cluster disponibles pour plus de détails sur les ressources de configuration d'OpenShift Container Platform.

3.2. À propos du service de mise à jour OpenShift

L'OpenShift Update Service (OSUS) fournit des recommandations de mise à jour à OpenShift Container Platform, y compris Red Hat Enterprise Linux CoreOS (RHCOS). Il fournit un graphique, ou diagramme, qui contient le site vertices des opérateurs de composants et le site edges qui les relie. Les arêtes du graphique indiquent les versions que vous pouvez mettre à jour en toute sécurité. Les sommets sont des charges utiles de mise à jour qui spécifient l'état prévu des composants du cluster géré.

Le Cluster Version Operator (CVO) dans votre cluster vérifie avec l'OpenShift Update Service pour voir les mises à jour valides et les chemins de mise à jour basés sur les versions actuelles des composants et les informations dans le graphique. Lorsque vous demandez une mise à jour, le CVO utilise l'image de la version de cette mise à jour pour mettre à jour votre cluster. Les artefacts de version sont hébergés dans Quay en tant qu'images de conteneur.

Pour permettre à OpenShift Update Service de ne fournir que des mises à jour compatibles, un pipeline de vérification des versions pilote l'automatisation. Chaque artefact de version est vérifié pour sa compatibilité avec les plateformes cloud et les architectures système prises en charge, ainsi qu'avec d'autres packages de composants. Une fois que le pipeline a confirmé l'adéquation d'une version, l'OpenShift Update Service vous informe qu'elle est disponible.

Le service de mise à jour d'OpenShift affiche toutes les mises à jour recommandées pour votre cluster actuel. Si un chemin de mise à jour n'est pas recommandé par OpenShift Update Service, cela peut être dû à un problème connu avec la mise à jour ou la version cible.

Deux contrôleurs fonctionnent en mode de mise à jour continue. Le premier contrôleur met continuellement à jour les manifestes de charge utile, applique les manifestes au cluster et produit l'état de déploiement contrôlé des opérateurs pour indiquer s'ils sont disponibles, en cours de mise à niveau ou s'ils ont échoué. Le second contrôleur interroge le service de mise à jour OpenShift pour déterminer si des mises à jour sont disponibles.

Seule la mise à niveau vers une version plus récente est prise en charge. L'inversion ou le retour à une version antérieure de votre cluster n'est pas pris en charge. Si votre mise à jour échoue, contactez l'assistance Red Hat.

Au cours du processus de mise à jour, le MCO (Machine Config Operator) applique la nouvelle configuration aux machines de votre cluster. Le MCO bloque le nombre de nœuds spécifié dans le champ maxUnavailable du pool de configuration de la machine et les marque comme étant indisponibles. Par défaut, cette valeur est définie sur 1. Le MCO met à jour les nœuds concernés par ordre alphabétique de zone, sur la base de l'étiquette topology.kubernetes.io/zone. Si une zone comporte plusieurs nœuds, les nœuds les plus anciens sont mis à jour en premier. Pour les nœuds qui n'utilisent pas de zones, comme dans les déploiements bare metal, les nœuds sont mis à niveau par âge, les nœuds les plus anciens étant mis à jour en premier. Le MCO met à jour le nombre de nœuds spécifié par le champ maxUnavailable du pool de configuration de la machine à la fois. Le MCO applique ensuite la nouvelle configuration et redémarre la machine.

Si vous utilisez des machines Red Hat Enterprise Linux (RHEL) en tant que travailleurs, le MCO ne met pas à jour le kubelet car vous devez d'abord mettre à jour l'API OpenShift sur les machines.

Avec la spécification de la nouvelle version appliquée à l'ancien kubelet, la machine RHEL ne peut pas revenir à l'état Ready. Vous ne pouvez pas terminer la mise à jour tant que les machines ne sont pas disponibles. Toutefois, le nombre maximal de nœuds indisponibles est défini de manière à ce que les opérations normales du cluster puissent se poursuivre avec ce nombre de machines hors service.

Le service de mise à jour OpenShift est composé d'un opérateur et d'une ou plusieurs instances d'application.

3.3. Politique de soutien aux opérateurs non gérés

Le site management state d'un opérateur détermine si celui-ci gère activement les ressources de son composant dans le cluster comme prévu. Si un opérateur est dans l'état unmanaged, il ne réagit pas aux changements de configuration et ne reçoit pas de mises à jour.

Bien que cela puisse être utile dans les clusters de non-production ou lors du débogage, les opérateurs dans un état non géré ne sont pas pris en charge et l'administrateur du cluster assume le contrôle total des configurations et des mises à niveau des composants individuels.

Un opérateur peut être placé dans un état non géré à l'aide des méthodes suivantes :

Individual Operator configuration

Chaque opérateur dispose d'un paramètre

managementStatedans sa configuration. Il est possible d'y accéder de différentes manières, en fonction de l'opérateur. Par exemple, l'opérateur de journalisation de Red Hat OpenShift accomplit ceci en modifiant une ressource personnalisée (CR) qu'il gère, tandis que l'opérateur d'échantillons de clusters utilise une ressource de configuration à l'échelle du cluster.La modification du paramètre

managementStateenUnmanagedsignifie que l'opérateur ne gère pas activement ses ressources et qu'il ne prendra aucune mesure concernant le composant en question. Certains opérateurs peuvent ne pas supporter cet état de gestion car il pourrait endommager le cluster et nécessiter une récupération manuelle.AvertissementLe passage d'opérateurs individuels à l'état

Unmanagedrend ce composant et cette fonctionnalité particuliers non pris en charge. Les problèmes signalés doivent être reproduits dans l'étatManagedpour que l'assistance soit assurée.Cluster Version Operator (CVO) overrides

Le paramètre

spec.overridespeut être ajouté à la configuration de l'OVC pour permettre aux administrateurs de fournir une liste de dérogations au comportement de l'OVC pour un composant. La définition du paramètrespec.overrides[].unmanagedàtruepour un composant bloque les mises à niveau du cluster et alerte l'administrateur lorsqu'une dérogation de l'OVC a été définie :Disabling ownership via cluster version overrides prevents upgrades. Please remove overrides before continuing.

AvertissementLa mise en place d'une surcharge CVO place l'ensemble du cluster dans un état non supporté. Les problèmes signalés doivent être reproduits après la suppression de toute surcharge pour que l'assistance soit assurée.

3.4. Prochaines étapes

Chapitre 4. Red Hat OpenShift Cluster Manager

Red Hat OpenShift Cluster Manager est un service géré dans lequel vous pouvez installer, modifier, exploiter et mettre à niveau vos clusters Red Hat OpenShift. Ce service vous permet de travailler avec tous les clusters de votre organisation à partir d'un seul tableau de bord.

OpenShift Cluster Manager vous guide dans l'installation d'OpenShift Container Platform, de Red Hat OpenShift Service on AWS (ROSA) et de clusters OpenShift Dedicated. Il est également responsable de la gestion des clusters OpenShift Container Platform après l'auto-installation, ainsi que de vos clusters ROSA et OpenShift Dedicated.

Vous pouvez utiliser OpenShift Cluster Manager pour effectuer les actions suivantes :

- Créer de nouveaux clusters

- Afficher les détails et les métriques des clusters

- Gérez vos grappes en effectuant des tâches telles que la mise à l'échelle, la modification des étiquettes des nœuds, la mise en réseau et l'authentification

- Gérer le contrôle d'accès

- Contrôler les grappes d'entreprises

- Mise à jour du calendrier

4.1. Accès à Red Hat OpenShift Cluster Manager

Vous pouvez accéder à OpenShift Cluster Manager avec votre compte OpenShift configuré.

Conditions préalables

- Vous avez un compte qui fait partie d'une organisation OpenShift.

- Si vous créez un cluster, votre organisation a spécifié un quota.

Procédure

- Connectez-vous à OpenShift Cluster Manager Hybrid Cloud Console en utilisant vos identifiants de connexion.

4.2. Actions générales

En haut à droite de la page du cluster, l'utilisateur peut effectuer certaines actions sur l'ensemble du cluster :

- Open console lance une console web qui permet au propriétaire du cluster d'envoyer des commandes au cluster.

- Actions permet au propriétaire de la grappe de renommer le nom d'affichage de la grappe, de modifier la quantité d'équilibreurs de charge et de stockage persistant sur la grappe, le cas échéant, de définir manuellement le nombre de nœuds et de supprimer la grappe.

- Refresh force le rafraîchissement de la grappe.

4.3. Onglets de la grappe

La sélection d'une grappe active et installée affiche les onglets associés à cette grappe. Les onglets suivants s'affichent une fois l'installation du cluster terminée :

- Vue d'ensemble

- Contrôle d'accès

- Compléments

- Mise en réseau

- Conseiller en matière d'information

- Pools de machines

- Soutien

- Paramètres

4.3.1. Onglet Vue d'ensemble

L'onglet Overview fournit des informations sur la façon dont votre cluster a été configuré :

- Cluster ID est l'identification unique de la grappe créée. Cet identifiant peut être utilisé lors de l'émission de commandes vers le cluster à partir de la ligne de commande.

- Type indique la version d'OpenShift utilisée par le cluster.

- Region est la région du serveur.

- Provider indique le fournisseur de cloud sur lequel le cluster a été construit.

- Availability indique le type de zone de disponibilité utilisé par le cluster, soit simple, soit multizone.

- Version est la version d'OpenShift installée sur le cluster. Si une mise à jour est disponible, vous pouvez la mettre à jour à partir de ce champ.

- Created at indique la date et l'heure de création du cluster.

- Owner identifie la personne qui a créé le cluster et qui dispose des droits de propriété.

- Subscription type indique le modèle d'abonnement sélectionné lors de la création.

- Infrastructure type est le type de compte utilisé par le cluster.

- Status affiche l'état actuel du cluster.

- Total vCPU indique le nombre total de CPU virtuels disponibles pour ce cluster.

- Total memory indique la mémoire totale disponible pour cette grappe.

- Load balancers

- Persistent storage affiche la quantité de stockage disponible sur ce cluster.

- Nodes indique les nœuds réels et les nœuds souhaités dans la grappe. Ces chiffres peuvent ne pas correspondre en raison de la mise à l'échelle de la grappe.

- Network indique l'adresse et les préfixes pour la connectivité réseau.

- Resource usage de l'onglet affiche les ressources en cours d'utilisation avec un graphique.

- Advisor recommendations donne des indications sur la sécurité, les performances, la disponibilité et la stabilité. Cette section nécessite l'utilisation de la fonctionnalité de santé à distance. Voir Utiliser Insights pour identifier les problèmes de votre cluster.

- Cluster history montre tout ce qui a été fait avec le cluster, y compris la création et l'identification d'une nouvelle version.

4.3.2. Onglet Contrôle d'accès

L'onglet Access control permet au propriétaire du cluster de configurer un fournisseur d'identité, d'accorder des autorisations élevées et d'attribuer des rôles à d'autres utilisateurs.

Conditions préalables

- Vous devez être le propriétaire de la grappe ou disposer des autorisations nécessaires pour attribuer des rôles à la grappe.

Procédure

- Sélectionnez le bouton Grant role.

- Saisissez l'identifiant du compte Red Hat de l'utilisateur auquel vous souhaitez attribuer un rôle sur le cluster.

- Sélectionnez le bouton Grant role dans la boîte de dialogue.

- La boîte de dialogue se ferme et l'utilisateur sélectionné affiche l'accès "Éditeur de cluster".

4.3.3. Onglet Add-ons

L'onglet Add-ons affiche tous les modules optionnels qui peuvent être ajoutés au cluster. Sélectionnez l'extension souhaitée, puis Install sous la description de l'extension qui s'affiche.

4.3.4. Onglet Insights Advisor

L'onglet Insights Advisor utilise la fonctionnalité Remote Health de OpenShift Container Platform pour identifier et atténuer les risques en matière de sécurité, de performance, de disponibilité et de stabilité. Voir Utiliser Insights pour identifier les problèmes de votre cluster dans la documentation d'OpenShift Container Platform.

4.3.5. Onglet pools de machines

L'onglet Machine pools permet au propriétaire du cluster de créer de nouveaux pools de machines, si le quota disponible est suffisant, ou de modifier un pool de machines existant.

La sélection de More options > Scale ouvre la boîte de dialogue "Edit node count" (Modifier le nombre de nœuds). Dans cette boîte de dialogue, vous pouvez modifier le nombre de nœuds par zone de disponibilité. Si la mise à l'échelle automatique est activée, vous pouvez également définir la plage de mise à l'échelle automatique.

4.3.6. Onglet Support

Dans l'onglet Support, vous pouvez ajouter des contacts de notification pour les personnes qui doivent recevoir les notifications du cluster. Le nom d'utilisateur ou l'adresse électronique que vous fournissez doit se rapporter à un compte d'utilisateur dans l'organisation Red Hat où le cluster est déployé.

Toujours à partir de cet onglet, vous pouvez ouvrir un dossier de support pour demander une assistance technique pour votre cluster.

4.3.7. Onglet Paramètres

L'onglet Settings offre quelques options au propriétaire du cluster :

- Monitoringqui est activée par défaut, permet d'établir des rapports sur des actions définies par l'utilisateur. Voir Comprendre la pile de surveillance.

- Update strategy vous permet de déterminer si le cluster se met automatiquement à jour un certain jour de la semaine à une heure donnée ou si toutes les mises à jour sont planifiées manuellement.

- Node draining définit la durée pendant laquelle les charges de travail protégées sont respectées lors des mises à jour. Une fois cette durée écoulée, le nœud est supprimé de force.

- Update status indique la version actuelle et si des mises à jour sont disponibles.

4.4. Ressources complémentaires

- Pour la documentation complète d'OpenShift Cluster Manager, voir la documentation d'OpenShift Cluster Manager.

Chapitre 5. À propos du moteur multicluster pour l'opérateur Kubernetes

L'un des défis de la mise à l'échelle des environnements Kubernetes est la gestion du cycle de vie d'un parc croissant. Pour relever ce défi, vous pouvez utiliser le moteur multicluster pour l'opérateur Kubernetes (MCE). L'opérateur offre des fonctionnalités de cycle de vie complet pour les clusters OpenShift Container Platform gérés et une gestion partielle du cycle de vie pour d'autres distributions Kubernetes. Il est disponible de deux manières :

- En tant qu'opérateur autonome que vous installez dans le cadre de votre abonnement à OpenShift Container Platform ou OpenShift Kubernetes Engine

- Dans le cadre de la gestion avancée des clusters de Red Hat pour Kubernetes

5.1. Gestion des clusters avec le moteur multicluster sur OpenShift Container Platform

Lorsque vous activez le moteur multicluster sur OpenShift Container Platform, vous bénéficiez des fonctionnalités suivantes :

- Les plans de contrôle hébergés, qui est une fonctionnalité basée sur le projet HyperShift. Avec un plan de contrôle hébergé centralisé, vous pouvez exploiter des clusters OpenShift Container Platform de manière hyperscale.

- Hive, qui fournit des clusters OpenShift Container Platform autogérés au hub et complète les configurations initiales pour ces clusters.

- l'agent klusterlet, qui enregistre les clusters gérés auprès du hub.

- Infrastructure Operator, qui gère le déploiement du service assisté pour orchestrer les installations d'OpenShift Container Platform sur site en bare metal et vSphere, telles que SNO on bare metal. L'opérateur d'infrastructure inclut le zero touch provisioning (ZTP), qui automatise entièrement la création de clusters sur bare metal et le provisioning vSphere avec des workflows GitOps pour gérer les déploiements et les changements de configuration.

- Gestion des clusters ouverts, qui fournit des ressources pour gérer les clusters Kubernetes.

Le moteur multicluster est inclus dans votre abonnement de support OpenShift Container Platform et est livré séparément de la charge utile principale. Pour commencer à utiliser le moteur multicluster, vous déployez le cluster OpenShift Container Platform et installez ensuite l'opérateur. Pour plus d'informations, voir la documentation d'installation.

5.2. Gestion de clusters avec Red Hat Advanced Cluster Management

Si vous avez besoin de capacités de gestion de cluster au-delà de ce qu'OpenShift Container Platform avec le moteur multicluster peut fournir, envisagez Red Hat Advanced Cluster Management. Le moteur multicluster fait partie intégrante de Red Hat Advanced Cluster Management et est activé par défaut.

5.3. Ressources complémentaires

Pour obtenir la documentation complète du moteur multicluster, consultez la documentation du moteur multicluster, qui fait partie de la documentation du produit pour Red Hat Advanced Cluster Management.

Chapitre 6. Architecture du plan de contrôle

Le site control plane, qui est composé de machines de plan de contrôle, gère le cluster OpenShift Container Platform. Les machines du plan de contrôle gèrent les charges de travail sur les machines de calcul, qui sont également connues sous le nom de machines de travail. Le cluster lui-même gère toutes les mises à niveau des machines grâce aux actions du Cluster Version Operator (CVO), du Machine Config Operator et d'un ensemble d'opérateurs individuels.

6.1. Gestion de la configuration des nœuds avec des pools de configuration de machines

Les machines qui exécutent des composants du plan de contrôle ou des charges de travail utilisateur sont divisées en groupes en fonction des types de ressources qu'elles gèrent. Ces groupes de machines sont appelés pools de configuration de machines (MCP). Chaque MCP gère un ensemble de nœuds et les configurations de machines correspondantes. Le rôle du nœud détermine le MCP auquel il appartient ; le MCP régit les nœuds en fonction de l'étiquette de rôle qui lui a été attribuée. Les nœuds d'un MCP ont la même configuration, ce qui signifie que les nœuds peuvent être agrandis ou réduits en fonction de l'augmentation ou de la diminution de la charge de travail.

Par défaut, deux MCP sont créés par le cluster lors de son installation : master et worker. Chaque MCP par défaut a une configuration définie appliquée par le MCO (Machine Config Operator), qui est responsable de la gestion des MCP et de la facilitation des mises à niveau des MCP. Vous pouvez créer des MCP supplémentaires, ou des pools personnalisés, pour gérer les nœuds dont les cas d'utilisation personnalisés dépassent les types de nœuds par défaut.

Les pools personnalisés sont des pools qui héritent de la configuration du pool de travail. Ils utilisent n'importe quelle configuration de machine ciblée pour le worker pool, mais ajoutent la possibilité de déployer des changements uniquement ciblés sur le custom pool. Étant donné qu'un pool personnalisé hérite de la configuration du worker pool, toute modification apportée au worker pool est également appliquée au custom pool. Les pools personnalisés qui n'héritent pas de leur configuration du pool de travailleurs ne sont pas pris en charge par le MCO.

Un nœud ne peut être inclus que dans un seul MCP. Si un nœud possède plusieurs étiquettes correspondant à plusieurs MCP, comme worker,infra, il est géré par le pool personnalisé infra, et non par le pool de travail. Les pools personnalisés sont prioritaires dans la sélection des nœuds à gérer en fonction des étiquettes des nœuds ; les nœuds qui n'appartiennent pas à un pool personnalisé sont gérés par le pool de travail.

Il est recommandé d'avoir un pool personnalisé pour chaque rôle de nœud que vous souhaitez gérer dans votre cluster. Par exemple, si vous créez des nœuds infra pour gérer des charges de travail infra, il est recommandé de créer un MCP infra personnalisé pour regrouper ces nœuds. Si vous appliquez une étiquette de rôle infra à un nœud de travailleur pour qu'il ait la double étiquette worker,infra, mais que vous n'avez pas de MCP infra personnalisé, le MCO le considère comme un nœud de travailleur. Si vous retirez l'étiquette worker d'un nœud et que vous appliquez l'étiquette infra sans le regrouper dans un pool personnalisé, le nœud n'est pas reconnu par le MCO et n'est pas géré par le cluster.

Tout nœud étiqueté avec le rôle infra qui exécute uniquement des charges de travail infra n'est pas pris en compte dans le nombre total d'abonnements. Le MCP qui gère un nœud infra est mutuellement exclusif de la manière dont le cluster détermine les frais d'abonnement ; l'étiquetage d'un nœud avec le rôle infra approprié et l'utilisation de taints pour empêcher les charges de travail utilisateur d'être planifiées sur ce nœud sont les seules conditions requises pour éviter les frais d'abonnement pour les charges de travail infra.

Le MCO applique les mises à jour des pools de manière indépendante ; par exemple, si une mise à jour affecte tous les pools, les nœuds de chaque pool sont mis à jour parallèlement les uns aux autres. Si vous ajoutez un pool personnalisé, les nœuds de ce pool tentent également de se mettre à jour simultanément avec les nœuds maître et subordonné.

Il peut arriver que la configuration d'un nœud ne corresponde pas entièrement à ce que la configuration de la machine actuellement appliquée spécifie. Cet état est appelé configuration drift. Le Machine Config Daemon (MCD) vérifie régulièrement que les nœuds ne présentent pas de dérive de configuration. Si le MCD détecte une dérive de la configuration, le MCO marque le nœud degraded jusqu'à ce qu'un administrateur corrige la configuration du nœud. Un nœud dégradé est en ligne et opérationnel, mais il ne peut pas être mis à jour.

Ressources complémentaires

6.2. Rôles des machines dans OpenShift Container Platform

OpenShift Container Platform attribue aux hôtes différents rôles. Ces rôles définissent la fonction de la machine au sein du cluster. Le cluster contient des définitions pour les types de rôles standard master et worker.

Le cluster contient également la définition du rôle bootstrap. La machine d'amorçage n'étant utilisée que lors de l'installation de la grappe, sa fonction est expliquée dans la documentation relative à l'installation de la grappe.

6.2.1. Compatibilité entre le plan de contrôle et l'hôte du nœud

La version d'OpenShift Container Platform doit correspondre entre l'hôte du plan de contrôle et l'hôte du nœud. Par exemple, dans un cluster 4.12, tous les hôtes du plan de contrôle doivent être 4.12 et tous les nœuds doivent être 4.12.

Les décalages temporaires lors des mises à niveau de clusters sont acceptables. Par exemple, lors de la mise à niveau d'OpenShift Container Platform 4.11 à 4.12, certains nœuds passeront à la version 4.12 avant d'autres. Un décalage prolongé des hôtes du plan de contrôle et des hôtes des nœuds peut exposer les machines de calcul plus anciennes à des bogues et à des fonctionnalités manquantes. Les utilisateurs doivent résoudre les hôtes de plan de contrôle et les hôtes de nœuds asymétriques dès que possible.

Le service kubelet ne doit pas être plus récent que kube-apiserver, et peut être jusqu'à deux versions mineures plus anciennes selon que la version de votre OpenShift Container Platform est paire ou impaire. Le tableau ci-dessous indique la compatibilité de version appropriée :

| Version d'OpenShift Container Platform | Prise en charge kubelet skew |

|---|---|

| Versions mineures de OpenShift Container Platform [1] | Jusqu'à une version plus ancienne |

| Même les versions mineures de OpenShift Container Platform [2] | Jusqu'à deux versions plus anciennes |

- Par exemple, OpenShift Container Platform 4.9, 4.11.

- Par exemple, OpenShift Container Platform 4.8, 4.10, 4.12.

6.2.2. Travailleurs en grappe

Dans un cluster Kubernetes, les nœuds de travail sont l'endroit où les charges de travail réelles demandées par les utilisateurs de Kubernetes s'exécutent et sont gérées. Les nœuds de travail annoncent leur capacité et le planificateur, qui est un service de plan de contrôle, détermine sur quels nœuds démarrer les pods et les conteneurs. D'importants services sont exécutés sur chaque nœud de travail, notamment CRI-O, le moteur de conteneurs ; Kubelet, le service qui accepte et exécute les demandes d'exécution et d'arrêt des charges de travail des conteneurs ; un proxy de service, qui gère la communication entre les pods et les travailleurs ; et le runtime de conteneur de bas niveau runC ou crun (Technology Preview), qui crée et exécute les conteneurs.

Pour plus d'informations sur l'activation de crun au lieu de runC par défaut, voir la documentation relative à la création d'un CR ContainerRuntimeConfig.