Red Hat Training

A Red Hat training course is available for RHEL 8

Supervisión y gestión del estado y el rendimiento del sistema

Optimización del rendimiento, la latencia y el consumo de energía del sistema

Resumen

Hacer que el código abierto sea más inclusivo

Red Hat se compromete a sustituir el lenguaje problemático en nuestro código, documentación y propiedades web. Estamos empezando con estos cuatro términos: maestro, esclavo, lista negra y lista blanca. Debido a la enormidad de este esfuerzo, estos cambios se implementarán gradualmente a lo largo de varias versiones próximas. Para más detalles, consulte el mensaje de nuestro CTO Chris Wright.

Proporcionar comentarios sobre la documentación de Red Hat

Agradecemos su opinión sobre nuestra documentación. Por favor, díganos cómo podemos mejorarla. Para ello:

Para comentarios sencillos sobre pasajes concretos:

- Asegúrese de que está viendo la documentación en el formato Multi-page HTML. Además, asegúrese de ver el botón Feedback en la esquina superior derecha del documento.

- Utilice el cursor del ratón para resaltar la parte del texto que desea comentar.

- Haga clic en la ventana emergente Add Feedback que aparece debajo del texto resaltado.

- Siga las instrucciones mostradas.

Para enviar comentarios más complejos, cree un ticket de Bugzilla:

- Vaya al sitio web de Bugzilla.

- Como componente, utilice Documentation.

- Rellene el campo Description con su sugerencia de mejora. Incluya un enlace a la(s) parte(s) pertinente(s) de la documentación.

- Haga clic en Submit Bug.

Capítulo 1. Resumen de las opciones de supervisión del rendimiento

Las siguientes son algunas de las herramientas de monitorización y configuración del rendimiento disponibles en Red Hat Enterprise Linux 8:

-

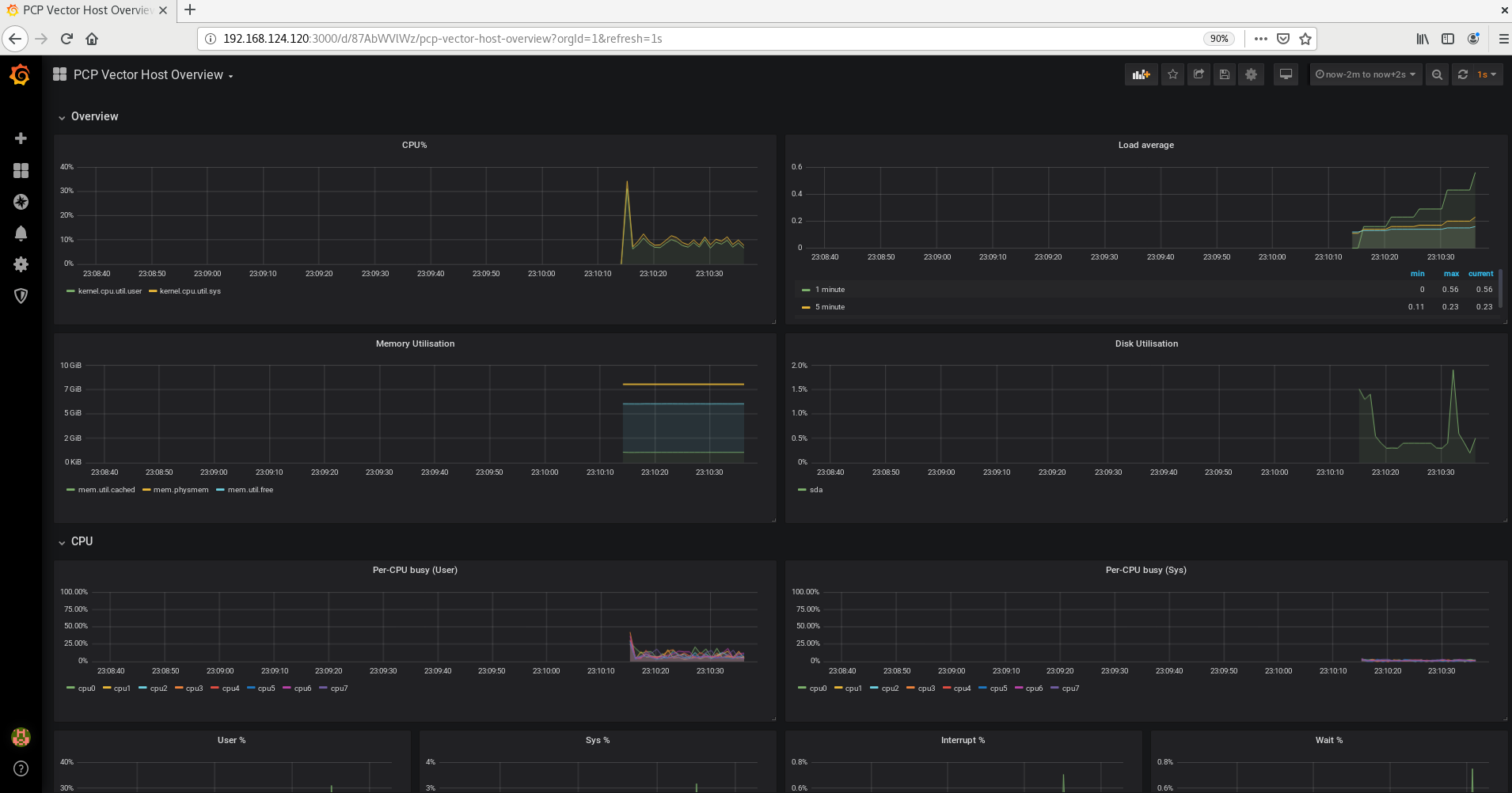

Performance Co-Pilot (

pcp) se utiliza para supervisar, visualizar, almacenar y analizar las mediciones de rendimiento a nivel de sistema. Permite la supervisión y gestión de datos en tiempo real, así como el registro y la recuperación de datos históricos. Red Hat Enterprise Linux 8 proporciona varias herramientas que se pueden utilizar desde la línea de comandos para supervisar un sistema fuera del nivel de ejecución 5. Las siguientes son las herramientas de línea de comandos incorporadas:

-

topes proporcionado por el paqueteprocps-ng. Ofrece una visión dinámica de los procesos de un sistema en ejecución. Muestra una variedad de información, incluyendo un resumen del sistema y una lista de tareas que están siendo gestionadas por el núcleo de Linux. -

pses proporcionado por el paqueteprocps-ng. Captura una instantánea de un grupo selecto de procesos activos. Por defecto, el grupo examinado se limita a los procesos que son propiedad del usuario actual y que están asociados a la terminal donde se ejecuta el comandops. -

Las estadísticas de la memoria virtual (

vmstat) son proporcionadas por el paqueteprocps-ng. Proporciona informes instantáneos de los procesos del sistema, la memoria, la paginación, la entrada/salida de bloques, las interrupciones y la actividad de la CPU. -

El reportero de actividad del sistema (

sar) es proporcionado por el paquetesysstat. Recoge y reporta información sobre la actividad del sistema que ha ocurrido hasta el momento en el día actual.

-

-

perfutiliza contadores de rendimiento del hardware y puntos de rastreo del kernel para rastrear el impacto de otros comandos y aplicaciones en un sistema. -

bcc-toolsse utiliza para BPF Compiler Collection (BCC). Proporciona más de 100 scriptseBPFque monitorizan las actividades del kernel. Para más información sobre cada una de estas herramientas, consulte la página man que describe cómo utilizarlas y qué funciones realizan. -

turbostates proporcionado por el paquetekernel-tools. Informa sobre la topología del procesador, la frecuencia, las estadísticas de estado de energía en reposo, la temperatura y el uso de energía en los procesadores Intel 64. -

iostates proporcionado por el paquetesysstat. Supervisa e informa sobre la carga de dispositivos de entrada/salida del sistema para ayudar a los administradores a tomar decisiones sobre cómo equilibrar la carga de entrada/salida entre los discos físicos. -

irqbalancedistribuye las interrupciones de hardware entre los procesadores para mejorar el rendimiento del sistema. -

ssimprime información estadística sobre los sockets, permitiendo a los administradores evaluar el rendimiento del dispositivo a lo largo del tiempo. Red Hat recomienda el uso desssobrenetstaten Red Hat Enterprise Linux 8. -

numastates proporcionado por el paquetenumactl. Por defecto,numastatmuestra las estadísticas del sistema NUMA por nodo desde el asignador de memoria del kernel. El rendimiento óptimo se indica con valores altos denuma_hity bajos denuma_miss. -

numades un demonio de gestión automática de afinidad NUMA. Supervisa la topología NUMA y el uso de recursos dentro de un sistema que mejora dinámicamente la asignación de recursos NUMA, la gestión y, por tanto, el rendimiento del sistema. -

SystemTapsupervisa y analiza las actividades del sistema operativo, especialmente las del núcleo. -

valgrindanaliza las aplicaciones ejecutándolas en una CPU sintética e instrumentando el código de la aplicación existente mientras se ejecuta. A continuación, imprime comentarios que identifican claramente cada proceso involucrado en la ejecución de la aplicación en un archivo especificado por el usuario, un descriptor de archivo o un socket de red. También es útil para encontrar fugas de memoria. -

pqoses proporcionado por el paqueteintel-cmt-cat. Supervisa y controla la caché de la CPU y el ancho de banda de la memoria en los procesadores Intel recientes.

Recursos adicionales

-

Para más información, consulte las páginas man de

pcp,top,ps,vmstat,sar,perf,iostat,irqbalance,ss,numastat,numad,valgrind, ypqos. -

Para más información sobre

pcp, consulte la documentación del directorio/usr/share/doc/. -

Para más información sobre el valor

awaity lo que puede causar que sus valores sean altos, vea el artículo de la Base de Conocimiento de Red Hat: ¿Qué significa exactamente el valor \ "await" reportado por iostat?

Capítulo 2. Cómo empezar con Tuned

Como administrador del sistema, puede utilizar la aplicación Tuned para optimizar el perfil de rendimiento de su sistema para una variedad de casos de uso.

2.1. El objetivo de Tuned

Tuned es un servicio que monitoriza tu sistema y optimiza el rendimiento bajo determinadas cargas de trabajo. El núcleo de Tuned es profiles, que ajusta su sistema para diferentes casos de uso.

Tuned se distribuye con una serie de perfiles predefinidos para casos de uso como:

- Alto rendimiento

- Baja latencia

- Ahorro de energía

Es posible modificar las reglas definidas para cada perfil y personalizar la forma de ajustar un dispositivo concreto. Cuando se cambia a otro perfil o se desactiva Tuned, todos los cambios realizados en la configuración del sistema por el perfil anterior vuelven a su estado original.

También puedes configurar Tuned para que reaccione a los cambios en el uso de los dispositivos y ajuste la configuración para mejorar el rendimiento de los dispositivos activos y reducir el consumo de energía de los inactivos.

2.2. Perfiles afinados

Un análisis detallado de un sistema puede llevar mucho tiempo. Tuned ofrece una serie de perfiles predefinidos para casos de uso típicos. También puedes crear, modificar y eliminar perfiles.

Los perfiles proporcionados con Tuned se dividen en las siguientes categorías:

- Perfiles de ahorro de energía

- Perfiles que aumentan el rendimiento

Los perfiles para aumentar el rendimiento incluyen perfiles que se centran en los siguientes aspectos:

- Baja latencia para el almacenamiento y la red

- Alto rendimiento para el almacenamiento y la red

- Rendimiento de la máquina virtual

- Rendimiento del host de virtualización

El perfil por defecto

Durante la instalación, se selecciona automáticamente el mejor perfil para su sistema. Actualmente, el perfil por defecto se selecciona según las siguientes reglas personalizables:

| Medio ambiente | Perfil por defecto | Objetivo |

|---|---|---|

| Nodos de cálculo |

| El mejor rendimiento de la producción |

| Máquinas virtuales |

|

El mejor rendimiento. Si no te interesa el mejor rendimiento, puedes cambiarlo por el perfil |

| Otros casos |

| Rendimiento y consumo de energía equilibrados |

Perfiles fusionados

Como característica experimental, es posible seleccionar más perfiles a la vez. Tuned intentará fusionarlos durante la carga.

Si hay conflictos, la configuración del último perfil especificado tiene prioridad.

Ejemplo 2.1. Bajo consumo de energía en un huésped virtual

El siguiente ejemplo optimiza el sistema para que se ejecute en una máquina virtual para obtener el mejor rendimiento y, al mismo tiempo, lo ajusta para que tenga un bajo consumo de energía, mientras que el bajo consumo de energía es la prioridad:

# tuned-adm profile virtual-guest powersave

La fusión se realiza automáticamente sin comprobar si la combinación de parámetros resultante tiene sentido. En consecuencia, la función podría ajustar algunos parámetros en sentido contrario, lo que podría ser contraproducente: por ejemplo, ajustar el disco para un alto rendimiento mediante el perfil throughput-performance y, al mismo tiempo, ajustar el spindown del disco al valor bajo mediante el perfil spindown-disk.

La ubicación de los perfiles

Tuned almacena los perfiles en los siguientes directorios:

/usr/lib/tuned/-

Los perfiles específicos de la distribución se almacenan en el directorio. Cada perfil tiene su propio directorio. El perfil consiste en el archivo de configuración principal llamado

tuned.conf, y opcionalmente otros archivos, por ejemplo scripts de ayuda. /etc/tuned/-

Si necesita personalizar un perfil, copie el directorio del perfil en el directorio que se utiliza para los perfiles personalizados. Si hay dos perfiles con el mismo nombre, se utiliza el perfil personalizado situado en

/etc/tuned/.

La sintaxis de la configuración del perfil

El archivo tuned.conf puede contener una sección [main] y otras secciones para configurar las instancias del plug-in. Sin embargo, todas las secciones son opcionales.

Las líneas que comienzan con el signo de almohadilla (#) son comentarios.

Recursos adicionales

-

La página de manual

tuned.conf(5).

2.3. Perfiles ajustados distribuidos con RHEL

La siguiente es una lista de perfiles que se instalan con Tuned en Red Hat Enterprise Linux.

Puede haber más perfiles específicos de productos o de terceros en Tuned. Dichos perfiles suelen ser proporcionados por paquetes RPM independientes.

balanced-

El perfil de ahorro de energía por defecto. Pretende ser un compromiso entre el rendimiento y el consumo de energía. Utiliza el autoescalado y el autoajuste siempre que es posible. El único inconveniente es el aumento de la latencia. En la versión actual de Tuned, habilita los plugins de CPU, disco, audio y vídeo, y activa el regulador de CPU

conservative. La opciónradeon_powersaveutiliza el valor dedpm-balancedsi está soportado, de lo contrario se establece enauto. powersaveUn perfil para obtener el máximo rendimiento de ahorro de energía. Puede limitar el rendimiento para minimizar el consumo real de energía. En la versión actual de Tuned, permite la suspensión automática de USB, el ahorro de energía de WiFi y el ahorro de energía de la Gestión de Energía de Enlaces Agresivos (ALPM) para los adaptadores de host SATA. También programa el ahorro de energía de los núcleos múltiples para los sistemas con una baja tasa de despertar y activa el regulador

ondemand. Activa el ahorro de energía de audio AC97 o, dependiendo de tu sistema, el ahorro de energía HDA-Intel con un tiempo de espera de 10 segundos. Si tu sistema contiene una tarjeta gráfica Radeon compatible con KMS activado, el perfil la configura para el ahorro de energía automático. En los ASUS Eee PC, se habilita un Super Hybrid Engine dinámico.NotaEn algunos casos, el perfil

balancedes más eficaz que el perfilpowersave.Considere que hay una cantidad definida de trabajo que debe realizarse, por ejemplo, un archivo de vídeo que debe ser transcodificado. Su máquina puede consumir menos energía si la transcodificación se hace a plena potencia, porque la tarea termina rápidamente, la máquina empieza a estar en reposo y puede pasar automáticamente a modos de ahorro de energía muy eficientes. Por otro lado, si transcodificas el archivo con una máquina estrangulada, la máquina consume menos energía durante la transcodificación, pero el proceso tarda más y la energía total consumida puede ser mayor.

Por ello, el perfil

balancedpuede ser generalmente una mejor opción.throughput-performance-

Un perfil de servidor optimizado para un alto rendimiento. Desactiva los mecanismos de ahorro de energía y activa los ajustes de

sysctlque mejoran el rendimiento del disco y la red IO. El gobernador de la CPU está configurado enperformance. latency-performance-

Un perfil de servidor optimizado para una baja latencia. Desactiva los mecanismos de ahorro de energía y habilita los ajustes de

sysctlque mejoran la latencia. El gobernador de la CPU está configurado enperformancey la CPU está bloqueada en los estados de baja C (por PM QoS). network-latency-

Un perfil para el ajuste de la red de baja latencia. Se basa en el perfil

latency-performance. Además, desactiva las páginas enormes transparentes y el equilibrio NUMA, y ajusta otros parámetros relacionados con la redsysctl. network-throughput-

Un perfil para el ajuste de la red de rendimiento. Se basa en el perfil

throughput-performance. Además, aumenta los búferes de red del núcleo. virtual-guest-

Un perfil diseñado para máquinas virtuales de Red Hat Enterprise Linux 8 y huéspedes de VMWare basado en el perfil

throughput-performanceque, entre otras tareas, disminuye el intercambio de memoria virtual y aumenta los valores de readahead de disco. No desactiva las barreras de disco. virtual-host-

Un perfil diseñado para hosts virtuales basado en el perfil

throughput-performanceque, entre otras tareas, disminuye el swappiness de la memoria virtual, aumenta los valores de readahead del disco y permite un valor más agresivo de writeback de páginas sucias. oracle-

Un perfil optimizado para las cargas de bases de datos Oracle basado en el perfil

throughput-performance. Además, desactiva las páginas enormes transparentes y modifica otros parámetros del kernel relacionados con el rendimiento. Este perfil lo proporciona el paquetetuned-profiles-oracle. desktop-

Un perfil optimizado para ordenadores de sobremesa, basado en el perfil

balanced. Además, permite los autogrupos del programador para mejorar la respuesta de las aplicaciones interactivas. cpu-partitioningEl perfil

cpu-partitioningdivide las CPUs del sistema en CPUs aisladas y de mantenimiento. Para reducir el jitter y las interrupciones en una CPU aislada, el perfil borra la CPU aislada de los procesos del espacio de usuario, los hilos móviles del kernel, los gestores de interrupciones y los temporizadores del kernel.Una CPU de mantenimiento puede ejecutar todos los servicios, procesos de shell e hilos del kernel.

Puede configurar el perfil de

cpu-partitioningen el archivo/etc/tuned/cpu-partitioning-variables.conf. Las opciones de configuración son:isolated_cores=cpu-list-

Enumera las CPUs a aislar. La lista de CPUs aisladas está separada por comas o el usuario puede especificar el rango. Se puede especificar un rango utilizando un guión, como

3-5. Esta opción es obligatoria. Cualquier CPU que falte en esta lista se considera automáticamente una CPU de mantenimiento. no_balance_cores=cpu-list-

Enumera las CPUs que no son consideradas por el kernel durante el balanceo de carga de procesos en todo el sistema. Esta opción es opcional. Suele ser la misma lista que

isolated_cores.

Para más información sobre

cpu-partitioning, consulte la página de manualtuned-profiles-cpu-partitioning(7).postgresql-

Un perfil optimizado para cargas de bases de datos PostgreSQL basado en el perfil

throughput-performance. Además, deshabilita las páginas enormes transparentes y modifica otros parámetros del kernel relacionados con el rendimiento. Este perfil es proporcionado por el paquetetuned-profiles-postgresql.

Perfiles en tiempo real

Los perfiles de tiempo real están pensados para sistemas que ejecutan el kernel de tiempo real. Sin una compilación especial del kernel, no configuran el sistema para que sea en tiempo real. En RHEL, los perfiles están disponibles en repositorios adicionales.

Están disponibles los siguientes perfiles en tiempo real:

realtimeUtilización en sistemas bare-metal en tiempo real.

Proporcionado por el paquete

tuned-profiles-realtime, que está disponible en los repositorios RT o NFV.realtime-virtual-hostUtilizar en un host de virtualización configurado para tiempo real.

Proporcionado por el paquete

tuned-profiles-nfv-host, que está disponible en el repositorio NFV.realtime-virtual-guestUso en un huésped de virtualización configurado para tiempo real.

Proporcionado por el paquete

tuned-profiles-nfv-guest, que está disponible en el repositorio NFV.

2.4. Sintonización estática y dinámica en Tuned

Esta sección explica la diferencia entre las dos categorías de ajuste del sistema que aplica Tuned: static y dynamic.

- Sintonización estática

-

Consiste principalmente en la aplicación de los ajustes predefinidos de

sysctlysysfsy en la activación puntual de varias herramientas de configuración comoethtool. - Sintonización dinámica

Observa cómo se utilizan los distintos componentes del sistema durante todo el tiempo de funcionamiento del mismo. Tuned ajusta la configuración del sistema de forma dinámica basándose en esa información de supervisión.

Por ejemplo, el disco duro se utiliza mucho durante el arranque y el inicio de sesión, pero apenas se usa después, cuando el usuario puede trabajar principalmente con aplicaciones como navegadores web o clientes de correo electrónico. Del mismo modo, la CPU y los dispositivos de red se utilizan de forma diferente en distintos momentos. Tuned supervisa la actividad de estos componentes y reacciona a los cambios en su uso.

Por defecto, el ajuste dinámico está desactivado. Para activarla, edite el archivo

/etc/tuned/tuned-main.confy cambie la opcióndynamic_tuningpor1. A continuación, Tuned analiza periódicamente las estadísticas del sistema y las utiliza para actualizar los ajustes del sistema. Para configurar el intervalo de tiempo en segundos entre estas actualizaciones, utilice la opciónupdate_interval.Los algoritmos de ajuste dinámico implementados actualmente intentan equilibrar el rendimiento y el ahorro de energía, por lo que están desactivados en los perfiles de rendimiento. El ajuste dinámico para plug-ins individuales puede activarse o desactivarse en los perfiles de Tuned.

Ejemplo 2.2. Ajuste estático y dinámico en una estación de trabajo

En una estación de trabajo típica de oficina, la interfaz de red Ethernet está inactiva la mayor parte del tiempo. Sólo entran y salen algunos correos electrónicos o se cargan algunas páginas web.

Para este tipo de cargas, la interfaz de red no tiene que funcionar a toda velocidad todo el tiempo, como lo hace por defecto. Tuned dispone de un complemento de monitorización y ajuste para dispositivos de red que puede detectar esta baja actividad y reducir automáticamente la velocidad de esa interfaz, lo que suele traducirse en un menor consumo de energía.

Si la actividad en la interfaz aumenta durante un periodo de tiempo prolongado, por ejemplo, porque se está descargando una imagen de DVD o se abre un correo electrónico con un archivo adjunto de gran tamaño, Tuned lo detecta y ajusta la velocidad de la interfaz al máximo para ofrecer el mejor rendimiento mientras el nivel de actividad es alto.

Este principio se utiliza también para otros complementos para la CPU y los discos.

2.5. Modo sin demonio ajustado

Puede ejecutar Tuned en el modo no-daemon, que no requiere ninguna memoria residente. En este modo, Tuned aplica la configuración y sale.

Por defecto, el modo no-daemon está desactivado porque en este modo faltan muchas de las funciones de Tuned, entre ellas:

- Soporte de D-Bus

- Soporte de conexión en caliente

- Soporte de retroceso para los ajustes

Para activar el modo no-daemon, incluya la siguiente línea en el archivo /etc/tuned/tuned-main.conf:

daemon = 0

2.6. Instalación y habilitación de Tuned

Este procedimiento instala y habilita la aplicación Tuned, instala los perfiles de Tuned y preestablece un perfil predeterminado de Tuned para su sistema.

Procedimiento

Instale el paquete

tuned:# yum install tuned

Habilite e inicie el servicio

tuned:# systemctl enable --now tuned

Opcionalmente, instale los perfiles de Tuned para los sistemas en tiempo real:

# yum install tuned-profiles-realtime tuned-profiles-nfv

Verifique que el perfil Tuned esté activo y aplicado:

$ tuned-adm active Current active profile: balanced$ tuned-adm verify Verfication succeeded, current system settings match the preset profile. See tuned log file ('/var/log/tuned/tuned.log') for details.

2.7. Listado de perfiles disponibles en Tuned

Este procedimiento enumera todos los perfiles de Tuned que están actualmente disponibles en su sistema.

Procedimiento

Para listar todos los perfiles disponibles de Tuned en su sistema, utilice:

$ tuned-adm list Available profiles: - balanced - General non-specialized tuned profile - desktop - Optimize for the desktop use-case - latency-performance - Optimize for deterministic performance at the cost of increased power consumption - network-latency - Optimize for deterministic performance at the cost of increased power consumption, focused on low latency network performance - network-throughput - Optimize for streaming network throughput, generally only necessary on older CPUs or 40G+ networks - powersave - Optimize for low power consumption - throughput-performance - Broadly applicable tuning that provides excellent performance across a variety of common server workloads - virtual-guest - Optimize for running inside a virtual guest - virtual-host - Optimize for running KVM guests Current active profile: balanced

Para mostrar sólo el perfil actualmente activo, utilice:

$ tuned-adm active Current active profile: balanced

Recursos adicionales

-

La página de manual

tuned-adm(8).

2.8. Cómo establecer un perfil de sintonía

Este procedimiento activa un perfil seleccionado de Tuned en su sistema.

Requisitos previos

-

El servicio

tunedestá funcionando. Consulte Sección 2.6, “Instalación y habilitación de Tuned” para más detalles.

Procedimiento

Opcionalmente, puede dejar que Tuned le recomiende el perfil más adecuado para su sistema:

# tuned-adm recommend balancedActivar un perfil:

# perfil tuned-adm selected-profileTambién puede activar una combinación de varios perfiles:

# perfil tuned-adm profile1 profile2

Ejemplo 2.3. Una máquina virtual optimizada para un bajo consumo de energía

El siguiente ejemplo optimiza el sistema para que se ejecute en una máquina virtual con el mejor rendimiento y al mismo tiempo lo ajusta para que tenga un bajo consumo de energía, mientras que el bajo consumo de energía es la prioridad:

# tuned-adm profile virtual-guest powersave

Vea el perfil activo actual de Tuned en su sistema:

# tuned-adm active Current active profile: selected-profileReinicie el sistema:

# rebote

Pasos de verificación

Compruebe que el perfil Tuned está activo y aplicado:

$ tuned-adm verify Verfication succeeded, current system settings match the preset profile. See tuned log file ('/var/log/tuned/tuned.log') for details.

Recursos adicionales

-

La página de manual

tuned-adm(8)

2.9. Desactivación de Tuned

Este procedimiento desactiva Tuned y restablece todos los ajustes del sistema afectados a su estado original antes de que Tuned los modificara.

Procedimiento

Para desactivar todas las sintonías temporalmente:

# tuned-adm off

Los ajustes se aplican de nuevo tras el reinicio del servicio

tuned.O bien, para detener y desactivar el servicio

tunedde forma permanente:# systemctl disable --now tuned

Recursos adicionales

-

La página de manual

tuned-adm(8).

2.10. Información relacionada

-

La página de manual

tuned(8) -

La página de manual

tuned-adm(8) - Página web del proyecto Tuned: https://tuned-project.org/

Capítulo 3. Personalización de los perfiles Tuned

Puede crear o modificar los perfiles de Tuned para optimizar el rendimiento del sistema para su caso de uso previsto.

Requisitos previos

- Instale y active Tuned como se describe en Sección 2.6, “Instalación y habilitación de Tuned”.

3.1. Perfiles afinados

Un análisis detallado de un sistema puede llevar mucho tiempo. Tuned ofrece una serie de perfiles predefinidos para casos de uso típicos. También puedes crear, modificar y eliminar perfiles.

Los perfiles proporcionados con Tuned se dividen en las siguientes categorías:

- Perfiles de ahorro de energía

- Perfiles que aumentan el rendimiento

Los perfiles para aumentar el rendimiento incluyen perfiles que se centran en los siguientes aspectos:

- Baja latencia para el almacenamiento y la red

- Alto rendimiento para el almacenamiento y la red

- Rendimiento de la máquina virtual

- Rendimiento del host de virtualización

El perfil por defecto

Durante la instalación, se selecciona automáticamente el mejor perfil para su sistema. Actualmente, el perfil por defecto se selecciona según las siguientes reglas personalizables:

| Medio ambiente | Perfil por defecto | Objetivo |

|---|---|---|

| Nodos de cálculo |

| El mejor rendimiento de la producción |

| Máquinas virtuales |

|

El mejor rendimiento. Si no te interesa el mejor rendimiento, puedes cambiarlo por el perfil |

| Otros casos |

| Rendimiento y consumo de energía equilibrados |

Perfiles fusionados

Como característica experimental, es posible seleccionar más perfiles a la vez. Tuned intentará fusionarlos durante la carga.

Si hay conflictos, la configuración del último perfil especificado tiene prioridad.

Ejemplo 3.1. Bajo consumo de energía en un huésped virtual

El siguiente ejemplo optimiza el sistema para que se ejecute en una máquina virtual para obtener el mejor rendimiento y, al mismo tiempo, lo ajusta para que tenga un bajo consumo de energía, mientras que el bajo consumo de energía es la prioridad:

# tuned-adm profile virtual-guest powersave

La fusión se realiza automáticamente sin comprobar si la combinación de parámetros resultante tiene sentido. En consecuencia, la función podría ajustar algunos parámetros en sentido contrario, lo que podría ser contraproducente: por ejemplo, ajustar el disco para un alto rendimiento mediante el perfil throughput-performance y, al mismo tiempo, ajustar el spindown del disco al valor bajo mediante el perfil spindown-disk.

La ubicación de los perfiles

Tuned almacena los perfiles en los siguientes directorios:

/usr/lib/tuned/-

Los perfiles específicos de la distribución se almacenan en el directorio. Cada perfil tiene su propio directorio. El perfil consiste en el archivo de configuración principal llamado

tuned.conf, y opcionalmente otros archivos, por ejemplo scripts de ayuda. /etc/tuned/-

Si necesita personalizar un perfil, copie el directorio del perfil en el directorio que se utiliza para los perfiles personalizados. Si hay dos perfiles con el mismo nombre, se utiliza el perfil personalizado situado en

/etc/tuned/.

La sintaxis de la configuración del perfil

El archivo tuned.conf puede contener una sección [main] y otras secciones para configurar las instancias del plug-in. Sin embargo, todas las secciones son opcionales.

Las líneas que comienzan con el signo de almohadilla (#) son comentarios.

Recursos adicionales

-

La página de manual

tuned.conf(5).

3.2. Herencia entre perfiles Tuned

Tuned los perfiles pueden basarse en otros perfiles y modificar sólo algunos aspectos de su perfil principal.

La sección [main] de los perfiles Tuned reconoce la opción include:

[main]

include=parentTodos los ajustes del parent se cargan en este perfil child. En las siguientes secciones, el perfil child puede anular ciertos ajustes heredados del parent o añadir nuevos ajustes que no están presentes en el perfil parent perfil.

Puede crear su propio perfil child en el directorio /etc/tuned/ basándose en un perfil preinstalado en /usr/lib/tuned/ con sólo algunos parámetros ajustados.

Si el parent perfil se actualiza, por ejemplo, tras una actualización de Tuned, los cambios se reflejan en el perfil de child.

Ejemplo 3.2. Un perfil de ahorro de energía basado en el equilibrio

A continuación se muestra un ejemplo de perfil personalizado que amplía el perfil balanced y establece la gestión de energía de enlace agresiva (ALPM) para todos los dispositivos al máximo de ahorro de energía.

[main] include=balanced [scsi_host] alpm=min_power

Recursos adicionales

-

La página de manual

tuned.conf(5)

3.3. Sintonización estática y dinámica en Tuned

Esta sección explica la diferencia entre las dos categorías de ajuste del sistema que aplica Tuned: static y dynamic.

- Sintonización estática

-

Consiste principalmente en la aplicación de los ajustes predefinidos de

sysctlysysfsy en la activación puntual de varias herramientas de configuración comoethtool. - Sintonización dinámica

Observa cómo se utilizan los distintos componentes del sistema durante todo el tiempo de funcionamiento del mismo. Tuned ajusta la configuración del sistema de forma dinámica basándose en esa información de supervisión.

Por ejemplo, el disco duro se utiliza mucho durante el arranque y el inicio de sesión, pero apenas se usa después, cuando el usuario puede trabajar principalmente con aplicaciones como navegadores web o clientes de correo electrónico. Del mismo modo, la CPU y los dispositivos de red se utilizan de forma diferente en distintos momentos. Tuned supervisa la actividad de estos componentes y reacciona a los cambios en su uso.

Por defecto, el ajuste dinámico está desactivado. Para activarla, edite el archivo

/etc/tuned/tuned-main.confy cambie la opcióndynamic_tuningpor1. A continuación, Tuned analiza periódicamente las estadísticas del sistema y las utiliza para actualizar los ajustes del sistema. Para configurar el intervalo de tiempo en segundos entre estas actualizaciones, utilice la opciónupdate_interval.Los algoritmos de ajuste dinámico implementados actualmente intentan equilibrar el rendimiento y el ahorro de energía, por lo que están desactivados en los perfiles de rendimiento. El ajuste dinámico para plug-ins individuales puede activarse o desactivarse en los perfiles de Tuned.

Ejemplo 3.3. Ajuste estático y dinámico en una estación de trabajo

En una estación de trabajo típica de oficina, la interfaz de red Ethernet está inactiva la mayor parte del tiempo. Sólo entran y salen algunos correos electrónicos o se cargan algunas páginas web.

Para este tipo de cargas, la interfaz de red no tiene que funcionar a toda velocidad todo el tiempo, como lo hace por defecto. Tuned dispone de un complemento de monitorización y ajuste para dispositivos de red que puede detectar esta baja actividad y reducir automáticamente la velocidad de esa interfaz, lo que suele traducirse en un menor consumo de energía.

Si la actividad en la interfaz aumenta durante un periodo de tiempo prolongado, por ejemplo, porque se está descargando una imagen de DVD o se abre un correo electrónico con un archivo adjunto de gran tamaño, Tuned lo detecta y ajusta la velocidad de la interfaz al máximo para ofrecer el mejor rendimiento mientras el nivel de actividad es alto.

Este principio se utiliza también para otros complementos para la CPU y los discos.

3.4. Complementos afinados

Los plug-ins son módulos en los perfiles de Tuned que Tuned utiliza para supervisar u optimizar diferentes dispositivos en el sistema.

Tuned utiliza dos tipos de plug-ins:

- plug-ins de monitorización

- plug-ins de afinación

Control de los plug-ins

Los plug-ins de monitorización se utilizan para obtener información de un sistema en funcionamiento. La salida de los plug-ins de monitorización puede ser utilizada por los plug-ins de ajuste para el ajuste dinámico.

Los plug-ins de monitorización se instancian automáticamente siempre que sus métricas sean necesarias para cualquiera de los plug-ins de ajuste habilitados. Si dos plug-ins de ajuste necesitan los mismos datos, sólo se crea una instancia del plug-in de monitorización y se comparten los datos.

Plug-ins de sintonía

Cada plug-in de sintonización sintoniza un subsistema individual y toma varios parámetros que se rellenan a partir de los perfiles sintonizados. Cada subsistema puede tener varios dispositivos, como múltiples CPUs o tarjetas de red, que son manejados por instancias individuales de los plug-ins de ajuste. También se admiten ajustes específicos para dispositivos individuales.

Sintaxis de los plug-ins en los perfiles Tuned

Las secciones que describen las instancias del plug-in tienen el siguiente formato:

[NAME] type=TYPE devices=DEVICES

- NOMBRE

- es el nombre de la instancia del complemento tal y como se utiliza en los registros. Puede ser una cadena arbitraria.

- TIPO

- es el tipo de complemento de afinación.

- DISPOSITIVOS

es la lista de dispositivos que maneja esta instancia de plug-in.

La línea

devicespuede contener una lista, un comodín (*) y la negación (!). Si no hay una líneadevices, todos los dispositivos presentes o posteriormente conectados en el sistema del TYPE son manejados por la instancia del complemento. Esto es lo mismo que utilizar la opcióndevices=*.Ejemplo 3.4. Combinación de dispositivos en bloque con un complemento

El siguiente ejemplo coincide con todos los dispositivos de bloque que empiezan por

sd, comosdaosdb, y no desactiva las barreras en ellos:[data_disk] type=disk devices=sd* disable_barriers=false

El siguiente ejemplo coincide con todos los dispositivos de bloque excepto

sda1ysda2:[data_disk] type=disk devices=!sda1, !sda2 disable_barriers=false

Si no se especifica ninguna instancia de un complemento, el complemento no está activado.

Si el complemento admite más opciones, también pueden especificarse en la sección del complemento. Si no se especifica la opción y no se ha especificado previamente en el complemento incluido, se utiliza el valor por defecto.

Sintaxis breve del plug-in

Si no necesita nombres personalizados para la instancia del complemento y sólo hay una definición de la instancia en su archivo de configuración, Tuned admite la siguiente sintaxis corta:

[TYPE] devices=DEVICES

En este caso, es posible omitir la línea type. La instancia es entonces referida con un nombre, el mismo que el tipo. El ejemplo anterior podría entonces reescribirse en:

Ejemplo 3.5. Correspondencia de los dispositivos de bloque mediante la sintaxis corta

[disk] devices=sdb* disable_barriers=false

Definiciones de plug-in conflictivas en un perfil

Si la misma sección se especifica más de una vez utilizando la opción include, las configuraciones se fusionan. Si no se pueden fusionar debido a un conflicto, la última definición en conflicto anula la configuración anterior. Si no sabe qué se definió anteriormente, puede utilizar la opción booleana replace y establecerla como true. Esto hace que todas las definiciones anteriores con el mismo nombre se sobrescriban y la fusión no se produzca.

También puede desactivar el complemento especificando la opción enabled=false. Esto tiene el mismo efecto que si la instancia nunca se hubiera definido. Desactivar el complemento es útil si está redefiniendo la definición anterior desde la opción include y no quiere que el complemento esté activo en su perfil personalizado.

Funcionalidad no implementada en ningún plug-in

Tuned incluye la capacidad de ejecutar cualquier comando de shell como parte de la activación o desactivación de un perfil de ajuste. Esto permite ampliar los perfiles de Tuned con funcionalidades que aún no se han integrado en Tuned.

Puede especificar comandos de shell arbitrarios utilizando el complemento script.

Recursos adicionales

-

La página de manual

tuned.conf(5)

3.5. Plug-ins disponibles en Tuned

Esta sección enumera todos los plug-ins de monitorización y ajuste disponibles actualmente en Tuned.

Control de los plug-ins

En la actualidad, se han implementado los siguientes complementos de supervisión:

disk- Obtiene la carga del disco (número de operaciones IO) por dispositivo e intervalo de medición.

net- Obtiene la carga de red (número de paquetes transferidos) por tarjeta de red e intervalo de medición.

load- Obtiene la carga de la CPU por CPU e intervalo de medición.

Plug-ins de sintonía

Actualmente, se han implementado los siguientes plug-ins de sintonización. Sólo algunos de estos plug-ins implementan el ajuste dinámico. También se enumeran las opciones que admiten los plug-ins:

cpuEstablece el gobernador de la CPU al valor especificado por la opción

governory cambia dinámicamente la latencia de acceso directo a la memoria (DMA) de la CPU de la calidad del servicio de gestión de la energía (PM QoS) según la carga de la CPU.Si la carga de la CPU es inferior al valor especificado por la opción

load_threshold, la latencia se establece en el valor especificado por la opciónlatency_high, en caso contrario se establece en el valor especificado porlatency_low.También puede forzar la latencia a un valor específico y evitar que siga cambiando dinámicamente. Para ello, establezca la opción

force_latencyen el valor de latencia deseado.eeepc_sheAjusta dinámicamente la velocidad del bus frontal (FSB) en función de la carga de la CPU.

Esta característica se puede encontrar en algunos netbooks y también se conoce como ASUS Super Hybrid Engine (SHE).

Si la carga de la CPU es menor o igual al valor especificado por la opción

load_threshold_powersave, el complemento establece la velocidad del FSB al valor especificado por la opciónshe_powersave. Si la carga de la CPU es mayor o igual al valor especificado por la opciónload_threshold_normal, establece la velocidad del FSB al valor especificado por la opciónshe_normal.La sintonización estática no es compatible y el complemento se desactiva de forma transparente si Tuned no detecta el soporte de hardware para esta función.

net-

Configura la funcionalidad Wake-on-LAN con los valores especificados por la opción

wake_on_lan. Utiliza la misma sintaxis que la utilidadethtool. También cambia dinámicamente la velocidad de la interfaz según la utilización de la misma. sysctlEstablece varios ajustes de

sysctlespecificados por las opciones del plug-in.La sintaxis es

name=value, donde name es el mismo que el nombre proporcionado por la utilidadsysctl.Utilice el plug-in

sysctlsi necesita cambiar los ajustes del sistema que no están cubiertos por otros plug-ins disponibles en Tuned. Si los ajustes están cubiertos por algunos plug-ins específicos, prefiera estos plug-ins.usbEstablece el tiempo de espera de autosuspensión de los dispositivos USB al valor especificado por el parámetro

autosuspend.El valor

0significa que la suspensión automática está desactivada.vmActiva o desactiva las páginas enormes transparentes en función del valor de la opción

transparent_hugepages.Los valores válidos de la opción

transparent_hugepagesson:- "Siempre"

- "nunca"

- "madvise\N"

audioEstablece el tiempo de espera de autosuspensión para los códecs de audio al valor especificado por la opción

timeout.Actualmente, se admiten los códecs

snd_hda_intelysnd_ac97_codec. El valor0significa que la autosuspensión está desactivada. También puede forzar el reinicio del controlador estableciendo la opción booleanareset_controlleratrue.diskEstablece el elevador de disco al valor especificado por la opción

elevator.También se fija:

-

APM al valor especificado por la opción

apm -

Cuántica del programador al valor especificado por la opción

scheduler_quantum -

Tiempo de espera del disco al valor especificado por la opción

spindown -

La cabeza de disco al valor especificado por el parámetro

readahead -

La cabeza de lectura del disco actual a un valor multiplicado por la constante especificada por la opción

readahead_multiply

Además, este plug-in cambia dinámicamente la gestión avanzada de la energía y la configuración del tiempo de espera de la unidad en función de la utilización actual de la unidad. El ajuste dinámico puede controlarse mediante la opción booleana

dynamicy está activado por defecto.-

APM al valor especificado por la opción

scsi_hostOpciones de sintonía para los hosts SCSI.

Establece la gestión de energía de enlace agresiva (ALPM) al valor especificado por la opción

alpm.mounts-

Activa o desactiva las barreras para los montajes según el valor booleano de la opción

disable_barriers. scriptEjecuta un script o binario externo cuando se carga o descarga el perfil. Puede elegir un ejecutable arbitrario.

ImportanteEl plug-in

scriptse proporciona principalmente para la compatibilidad con versiones anteriores. Prefiera otros plug-ins de Tuned si cubren la funcionalidad requerida.Tuned llama al ejecutable con uno de los siguientes argumentos:

-

startal cargar el perfil -

stopal descargar el perfil

Debe implementar correctamente la acción

stopen su ejecutable y revertir todos los ajustes que haya cambiado durante la acciónstart. De lo contrario, el paso de reversión después de cambiar su perfil Tuned no funcionará.Los scripts Bash pueden importar la biblioteca Bash

/usr/lib/tuned/functionsy utilizar las funciones allí definidas. Utilice estas funciones sólo para la funcionalidad que no es proporcionada de forma nativa por Tuned. Si el nombre de una función comienza con un guión bajo, como_wifi_set_power_level, considera que la función es privada y no la uses en tus scripts, porque podría cambiar en el futuro.Especifique la ruta del ejecutable utilizando el parámetro

scripten la configuración del plug-in.Ejemplo 3.6. Ejecución de un script Bash desde un perfil

Para ejecutar un script Bash llamado

script.shque se encuentra en el directorio del perfil, utilice:[script] script=${i:PROFILE_DIR}/script.sh-

sysfsEstablece varios ajustes de

sysfsespecificados por las opciones del plug-in.La sintaxis es

name=value, donde name es la ruta de acceso asysfs.Utilice este plugin en caso de que necesite cambiar algunos ajustes que no están cubiertos por otros plug-ins. Prefiera plug-ins específicos si cubren los ajustes necesarios.

videoEstablece varios niveles de ahorro de energía en las tarjetas de vídeo. Actualmente, sólo son compatibles las tarjetas Radeon.

El nivel de powersave se puede especificar mediante la opción

radeon_powersave. Los valores admitidos son:-

default -

auto -

low -

mid -

high -

dynpm -

dpm-battery -

dpm-balanced -

dpm-perfomance

Para más detalles, consulte www.x.org. Tenga en cuenta que este complemento es experimental y la opción podría cambiar en futuras versiones.

-

bootloaderAñade opciones a la línea de comandos del kernel. Este complemento sólo es compatible con el cargador de arranque GRUB 2.

Se puede especificar una ubicación no estándar del archivo de configuración de GRUB 2 mediante la opción

grub2_cfg_file.Las opciones del kernel se añaden a la configuración actual de GRUB y sus plantillas. Es necesario reiniciar el sistema para que las opciones del kernel surtan efecto.

Si se cambia a otro perfil o se detiene manualmente el servicio

tunedse eliminan las opciones adicionales. Si apagas o reinicias el sistema, las opciones del kernel persisten en el archivogrub.cfg.Las opciones del kernel se pueden especificar con la siguiente sintaxis:

cmdline=arg1 arg2 .. argN

Ejemplo 3.7. Modificación de la línea de comandos del kernel

Por ejemplo, para añadir la opción del núcleo

quieta un perfil Tuned, incluya las siguientes líneas en el archivotuned.conf:[bootloader] cmdline=quiet

El siguiente es un ejemplo de un perfil personalizado que añade la opción

isolcpus=2a la línea de comandos del kernel:[bootloader] cmdline=isolcpus=2

3.6. Variables y funciones integradas en los perfiles Tuned

Las variables y las funciones incorporadas se amplían en tiempo de ejecución cuando se activa un perfil Tuned.

El uso de las variables de Tuned reduce la cantidad de datos necesarios en los perfiles de Tuned. También puede:

- Utilizar varias funciones incorporadas junto con las variables de Tuned

- Crear funciones personalizadas en Python y añadirlas a Tuned en forma de plug-ins

Variables

No hay variables predefinidas en los perfiles de Tuned. Puede definir sus propias variables creando la sección [variables] en un perfil y utilizando la siguiente sintaxis:

[variables] variable_name=value

Para ampliar el valor de una variable en un perfil, utilice la siguiente sintaxis:

${variable_name}Ejemplo 3.8. Aislamiento de los núcleos de la CPU mediante variables

En el siguiente ejemplo, la variable ${isolated_cores} se expande a 1,2; por lo que el kernel arranca con la opción isolcpus=1,2:

[variables]

isolated_cores=1,2

[bootloader]

cmdline=isolcpus=${isolated_cores}

Las variables se pueden especificar en un archivo separado. Por ejemplo, puede añadir las siguientes líneas a tuned.conf:

[variables]

include=/etc/tuned/my-variables.conf

[bootloader]

cmdline=isolcpus=${isolated_cores}

Si añade la opción isolated_cores=1,2 al archivo /etc/tuned/my-variables.conf, el kernel arranca con la opción isolcpus=1,2.

Funciones

Para llamar a una función, utilice la siguiente sintaxis:

${f:function_name:argument_1:argument_2}

Para ampliar la ruta del directorio donde se encuentran el perfil y el archivo tuned.conf, utilice la función PROFILE_DIR, que requiere una sintaxis especial:

${i:PROFILE_DIR}Ejemplo 3.9. Aislamiento de los núcleos de la CPU mediante variables y funciones incorporadas

En el siguiente ejemplo, la variable ${non_isolated_cores} se expande a 0,3-5, y la función incorporada cpulist_invert se llama con el argumento 0,3-5:

[variables]

non_isolated_cores=0,3-5

[bootloader]

cmdline=isolcpus=${f:cpulist_invert:${non_isolated_cores}}

La función cpulist_invert invierte la lista de CPUs. Para una máquina de 6 CPUs, la inversión es 1,2, y el kernel arranca con la opción de línea de comandos isolcpus=1,2.

Recursos adicionales

-

La página de manual

tuned.conf(5)

3.7. Funciones incorporadas disponibles en los perfiles Tuned

Las siguientes funciones incorporadas están disponibles en todos los perfiles de Tuned:

PROFILE_DIR-

Devuelve la ruta del directorio donde se encuentran el perfil y el archivo

tuned.conf. exec- Ejecuta un proceso y devuelve su salida.

assertion- Compara dos argumentos. Si son do not match, la función registra el texto del primer argumento y aborta la carga del perfil.

assertion_non_equal- Compara dos argumentos. Si son match, la función registra el texto del primer argumento y aborta la carga del perfil.

kb2s- Convierte los kilobytes en sectores de disco.

s2kb- Convierte los sectores del disco en kilobytes.

strip- Crea una cadena a partir de todos los argumentos pasados y elimina los espacios en blanco iniciales y finales.

virt_checkComprueba si Tuned se está ejecutando dentro de una máquina virtual (VM) o en el metal desnudo:

- Dentro de una VM, la función devuelve el primer argumento.

- En bare metal, la función devuelve el segundo argumento, incluso en caso de error.

cpulist_invert-

Invierte una lista de CPUs para hacer su complemento. Por ejemplo, en un sistema con 4 CPUs, numeradas del 0 al 3, la inversión de la lista

0,2,3es1. cpulist2hex- Convierte una lista de CPU en una máscara de CPU hexadecimal.

cpulist2hex_invert- Convierte una lista de CPU en una máscara de CPU hexadecimal y la invierte.

hex2cpulist- Convierte una máscara de CPU hexadecimal en una lista de CPU.

cpulist_online- Comprueba si las CPUs de la lista están conectadas. Devuelve la lista que contiene sólo las CPUs en línea.

cpulist_present- Comprueba si las CPUs de la lista están presentes. Devuelve la lista que contiene sólo las CPUs presentes.

cpulist_unpack-

Descompone una lista de CPU en forma de

1-3,4a1,2,3,4. cpulist_pack-

Empaqueta una lista de CPU en forma de

1,2,3,5a1-3,5.

3.8. Creación de nuevos perfiles Tuned

Este procedimiento crea un nuevo perfil Tuned con reglas de rendimiento personalizadas.

Requisitos previos

-

El servicio

tunedestá instalado y funcionando. Consulte Sección 2.6, “Instalación y habilitación de Tuned” para obtener más detalles.

Procedimiento

En el directorio

/etc/tuned/, cree un nuevo directorio con el mismo nombre que el perfil que desea crear:# mkdir /etc/tuned/my-profileEn el nuevo directorio, cree un archivo llamado

tuned.conf. Añada en él una sección[main]y definiciones de plug-in, según sus necesidades.Por ejemplo, véase la configuración del perfil

balanced:[main] summary=General non-specialized tuned profile [cpu] governor=conservative energy_perf_bias=normal [audio] timeout=10 [video] radeon_powersave=dpm-balanced, auto [scsi_host] alpm=medium_power

Para activar el perfil, utilice:

# perfil tuned-adm my-profileCompruebe que el perfil Tuned está activo y que se aplican los ajustes del sistema:

$ tuned-adm active Current active profile: my-profile$ tuned-adm verify Verfication succeeded, current system settings match the preset profile. See tuned log file ('/var/log/tuned/tuned.log') for details.

Recursos adicionales

-

La página de manual

tuned.conf(5)

3.9. Modificación de los perfiles Tuned existentes

Este procedimiento crea un perfil hijo modificado basado en un perfil existente Tuned.

Requisitos previos

-

El servicio

tunedestá instalado y funcionando. Consulte Sección 2.6, “Instalación y habilitación de Tuned” para obtener más detalles.

Procedimiento

En el directorio

/etc/tuned/, cree un nuevo directorio con el mismo nombre que el perfil que desea crear:# mkdir /etc/tuned/modified-profileEn el nuevo directorio, cree un archivo llamado

tuned.conf, y configure la sección[main]como sigue:[main] include=parent-profileSustituya parent-profile por el nombre del perfil que está modificando.

Incluya las modificaciones de su perfil.

Ejemplo 3.10. Disminución de la caducidad en el perfil de rendimiento de la producción

Para utilizar la configuración del perfil

throughput-performancey cambiar el valor devm.swappinessa 5, en lugar del 10 predeterminado, utilice:[main] include=throughput-performance [sysctl] vm.swappiness=5

Para activar el perfil, utilice:

# perfil tuned-adm modified-profileCompruebe que el perfil Tuned está activo y que se aplican los ajustes del sistema:

$ tuned-adm active Current active profile: my-profile$ tuned-adm verify Verfication succeeded, current system settings match the preset profile. See tuned log file ('/var/log/tuned/tuned.log') for details.

Recursos adicionales

-

La página de manual

tuned.conf(5)

3.10. Configuración del programador de discos mediante Tuned

Este procedimiento crea y habilita un perfil Tuned que establece un programador de disco determinado para los dispositivos de bloque seleccionados. La configuración persiste a través de los reinicios del sistema.

En los siguientes comandos y la configuración, reemplazar:

-

device con el nombre del dispositivo de bloque, por ejemplo

sdf -

selected-scheduler con el programador de discos que se desea establecer para el dispositivo, por ejemplo

bfq

Requisitos previos

El servicio

tunedestá instalado y habilitado.Para más detalles, consulte Sección 2.6, “Instalación y habilitación de Tuned”.

Procedimiento

Opcional: Seleccione un perfil existente de Tuned en el que se basará su perfil. Para ver una lista de perfiles disponibles, consulte Sección 2.3, “Perfiles ajustados distribuidos con RHEL”.

Para ver qué perfil está actualmente activo, utilice:

$ tuned-adm active

Cree un nuevo directorio para albergar su perfil de Tuned:

# mkdir /etc/tuned/my-profileBusca el identificador único del sistema del dispositivo de bloque seleccionado:

$ udevadm info --query=property --name=/dev/device | grep -E '(WWN|SERIAL)' ID_WWN=0x5002538d00000000 ID_SERIAL=Generic-_SD_MMC_20120501030900000-0:0 ID_SERIAL_SHORT=20120501030900000

NotaEl comando de este ejemplo devolverá todos los valores identificados como World Wide Name (WWN) o número de serie asociados al dispositivo de bloque especificado. Aunque es preferible utilizar un WWN, el WWN no siempre está disponible para un dispositivo determinado y cualquier valor devuelto por el comando del ejemplo es aceptable para utilizarlo como el device system unique ID.

Cree el

/etc/tuned/my-profile/tuned.confarchivo de configuración. En el archivo, establezca las siguientes opciones:Opcional: Incluir un perfil existente:

[main] include=existing-profileEstablece el programador de discos seleccionado para el dispositivo que coincide con el identificador WWN:

[disk] devices_udev_regex=IDNAME=device system unique id elevator=selected-scheduler

-

Sustituya IDNAME por el nombre del identificador utilizado (por ejemplo,

ID_WWN). -

Sustituya device system unique id por el valor del identificador elegido (por ejemplo,

0x5002538d00000000).

Para hacer coincidir varios dispositivos en la opción

devices_udev_regex, encierre los identificadores entre paréntesis y sepárelos con barras verticales:-

Sustituya IDNAME por el nombre del identificador utilizado (por ejemplo,

devices_udev_regex=(ID_WWN=0x5002538d00000000)|(ID_WWN=0x1234567800000000)

Habilita tu perfil:

# perfil tuned-adm my-profileCompruebe que el perfil Tuned está activo y aplicado:

$ tuned-adm active Current active profile: my-profile$ tuned-adm verify Verification succeeded, current system settings match the preset profile. See tuned log file ('/var/log/tuned/tuned.log') for details.

Recursos adicionales

- Para más información sobre la creación de un perfil Tuned, consulte Capítulo 3, Personalización de los perfiles Tuned.

3.11. Información relacionada

-

La página de manual

tuned.conf(5) - Página web del proyecto Tuned: https://tuned-project.org/

Capítulo 4. Revisión de un sistema mediante la interfaz del atún

Utilice la herramienta tuna para ajustar los programadores, la prioridad de los hilos, los gestores de IRQ y aislar los núcleos de la CPU y los sockets. Tuna reduce la complejidad de las tareas de ajuste.

4.1. Instalación de la herramienta del atún

La herramienta tuna está diseñada para ser utilizada en un sistema en funcionamiento. Esto permite que las herramientas de medición específicas de la aplicación vean y analicen el rendimiento del sistema inmediatamente después de realizar los cambios.

La herramienta tuna realiza las siguientes operaciones:

- Enumera las CPUs de un sistema

- Enumera las solicitudes de interrupción (IRQ) que se ejecutan actualmente en un sistema

- Cambia la política y la información de prioridad de los hilos

- Muestra las políticas y prioridades actuales de un sistema

Procedimiento

Para instalar la herramienta

tuna:# yum install tuna

Para mostrar las opciones de la CLI disponibles en

tuna:# tuna -h

Recursos adicionales

-

La página de manual

tuna.

4.2. Visualización del estado del sistema mediante la herramienta tuna

Este procedimiento describe cómo ver el estado del sistema utilizando la herramienta de interfaz de línea de comandos (CLI) tuna.

Requisitos previos

- La herramienta de la tuna está instalada. Para más información, consulte Sección 4.1, “Instalación de la herramienta del atún”.

Procedimiento

Para ver las políticas y prioridades actuales:

# tuna --show_threads thread pid SCHED_ rtpri affinity cmd 1 OTHER 0 0,1 init 2 FIFO 99 0 migration/0 3 OTHER 0 0 ksoftirqd/0 4 FIFO 99 0 watchdog/0Para ver un hilo específico correspondiente a un PID o que coincida con un nombre de comando:

# tuna --threads=pid_or_cmd_list --show_threadsEl argumento pid_or_cmd_list es una lista de PIDs o patrones de nombres de comandos separados por comas.

-

Para ajustar las CPUs mediante la CLI

tuna, consulte Sección 4.3, “Ajuste de las CPUs con la herramienta tuna”. -

Para ajustar las IRQs utilizando la herramienta

tuna, consulte Sección 4.4, “Ajuste de las IRQs con la herramienta tuna”. Para guardar la configuración modificada:

# tuna --save=nombredearchivo

Este comando sólo guarda los hilos del kernel que se están ejecutando. Los procesos que no se están ejecutando no se guardan.

Recursos adicionales

-

La página de manual

tuna. -

El comando

tuna -hmuestra las opciones de la CLI disponibles.

4.3. Ajuste de las CPUs con la herramienta tuna

Los comandos de la herramienta tuna pueden dirigirse a CPUs individuales. Usando la herramienta tuna, puedes:

Isolate CPUs- Todas las tareas que se ejecutan en la CPU especificada se mueven a la siguiente CPU disponible. Aislar una CPU hace que no esté disponible eliminándola de la máscara de afinidad de todos los hilos.

Include CPUs- Permite que las tareas se ejecuten en la CPU especificada

Restore CPUs- Restaura la CPU especificada a su configuración anterior.

Este procedimiento describe cómo afinar las CPUs utilizando la CLI de tuna.

Requisitos previos

- La herramienta de la tuna está instalada. Para más información, consulte Sección 4.1, “Instalación de la herramienta del atún”.

Procedimiento

Para especificar la lista de CPUs que se verán afectadas por un comando:

# tuna --cpus=cpu_list [command]

El argumento cpu_list es una lista de números de CPU separados por comas. Por ejemplo,

--cpus=0,2. Las listas de CPU también pueden especificarse en un rango, por ejemplo--cpus=”1-3”que seleccionaría las CPUs 1, 2 y 3.Para añadir una CPU específica a la actual cpu_list, por ejemplo, utilice

--cpus= 0.Sustituya [command] por, por ejemplo,

--isolate.Para aislar una CPU:

# tuna --cpus=cpu_list --isolate

Para incluir una CPU:

# tuna --cpus=cpu_list --include

Para utilizar un sistema con cuatro o más procesadores, muestre cómo hacer que todos los hilos de ssh se ejecuten en la CPU 0 y 1, y todos los hilos de

httpen la CPU 2 y 3:# tuna --cpus=0,1 --threads=ssh\* \ --move --cpus=2,3 --threads=http\* --move

Este comando realiza las siguientes operaciones de forma secuencial:

- Selecciona las CPUs 0 y 1.

-

Selecciona todos los hilos que empiezan por

ssh. - Mueve los hilos seleccionados a las CPUs seleccionadas. Tuna establece la máscara de afinidad de los hilos que comienzan con ssh a las CPUs apropiadas. Las CPUs pueden ser expresadas numéricamente como 0 y 1, en máscara hexadecimal como 0x3, o en binario como 11.

- Restablece la lista de CPUs en 2 y 3.

-

Selecciona todos los hilos que empiezan por

http. -

Mueve los hilos seleccionados a las CPUs especificadas. Tuna establece la máscara de afinidad de los hilos que comienzan con

httpa las CPUs especificadas. Las CPUs pueden expresarse numéricamente como 2 y 3, en máscara hexadecimal como 0xC, o en binario como 1100.

Pasos de verificación

Para mostrar la configuración actual y verificar que los cambios se realizaron como se esperaba:

# tuna --threads=gnome-sc\* --show_threads \ --cpus=0 --move --show_threads --cpus=1 \ --move --show_threads --cpus=+0 --move --show_threads thread ctxt_switches pid SCHED_ rtpri affinity voluntary nonvoluntary cmd 3861 OTHER 0 0,1 33997 58 gnome-screensav thread ctxt_switches pid SCHED_ rtpri affinity voluntary nonvoluntary cmd 3861 OTHER 0 0 33997 58 gnome-screensav thread ctxt_switches pid SCHED_ rtpri affinity voluntary nonvoluntary cmd 3861 OTHER 0 1 33997 58 gnome-screensav thread ctxt_switches pid SCHED_ rtpri affinity voluntary nonvoluntary cmd 3861 OTHER 0 0,1 33997 58 gnome-screensav

Este comando realiza las siguientes operaciones de forma secuencial:

-

Selecciona todos los hilos que comienzan con los hilos de

gnome-sc. - Muestra los hilos seleccionados para que el usuario pueda verificar su máscara de afinidad y su prioridad RT.

- Selecciona la CPU 0.

-

Mueve los hilos de

gnome-sca la CPU especificada, CPU 0. - Muestra el resultado del movimiento.

- Restablece la lista de CPUs en 1.

-

Mueve los hilos de

gnome-sca la CPU especificada, CPU 1. - Muestra el resultado del movimiento.

- Añade la CPU 0 a la lista de CPUs.

-

Mueve los hilos de

gnome-sca las CPUs especificadas, CPUs 0 y 1. - Muestra el resultado del movimiento.

-

Selecciona todos los hilos que comienzan con los hilos de

Recursos adicionales

-

El archivo

/proc/cpuinfo. -

La página de manual

tuna. -

El comando

tuna -hmuestra las opciones de la CLI disponibles.

4.4. Ajuste de las IRQs con la herramienta tuna

El archivo /proc/interrupts registra el número de interrupciones por IRQ, el tipo de interrupción y el nombre del dispositivo que se encuentra en esa IRQ. Este procedimiento describe cómo afinar las IRQs utilizando la herramienta tuna.

Requisitos previos

- La herramienta de la tuna está instalada. Para más información, consulte Sección 4.1, “Instalación de la herramienta del atún”.

Procedimiento

Para ver las IRQs actuales y su afinidad:

# tuna --show_irqs # users affinity 0 timer 0 1 i8042 0 7 parport0 0

Para especificar la lista de IRQs que serán afectadas por un comando:

# tuna --irqs=irq_list [command]

El argumento irq_list es una lista de números IRQ separados por comas o patrones de nombres de usuario.

Sustituya [command] por, por ejemplo,

--isolate.Para mover una interrupción a una CPU especificada:

# tuna --irqs=128 --show_irqs # users affinity 128 iwlwifi 0,1,2,3 # tuna --irqs=128 --cpus=3 --move

Sustituye 128 por el argumento irq_list y 3 por el argumento cpu_list.

El argumento cpu_list es una lista de números de CPU separados por comas, por ejemplo,

--cpus=0,2. Para más información, véase Sección 4.3, “Ajuste de las CPUs con la herramienta tuna”.

Pasos de verificación

Compara el estado de las IRQs seleccionadas antes y después de mover cualquier interrupción a una CPU especificada:

# tuna --irqs=128 --show_irqs # users affinity 128 iwlwifi 3

Recursos adicionales

-

El archivo

/procs/interrupts. -

La página de manual

tuna. -

El comando

tuna -hmuestra las opciones de la CLI disponibles.

Capítulo 5. Supervisión del rendimiento mediante RHEL System Roles

5.1. Introducción a los roles del sistema RHEL

RHEL System Roles es una colección de roles y módulos de Ansible. RHEL System Roles proporciona una interfaz de configuración para gestionar de forma remota varios sistemas RHEL. La interfaz permite gestionar las configuraciones del sistema en varias versiones de RHEL, así como adoptar nuevas versiones principales.

En Red Hat Enterprise Linux 8, la interfaz consta actualmente de los siguientes roles:

- kdump

- red

- selinux

- almacenamiento

- certificado

- kernel_settings

- registro

- métrica

- nbde_client y nbde_server

- timesync

- tlog

Todos estos roles son proporcionados por el paquete rhel-system-roles disponible en el repositorio AppStream.

Recursos adicionales

- Para obtener una visión general de las funciones del sistema RHEL, consulte el artículo de la base de conocimientos de Red Hat Enterprise Linux (RHEL) sobre las funciones del sistema.

-

Para obtener información sobre una función concreta, consulte la documentación en el directorio

/usr/share/doc/rhel-system-roles. Esta documentación se instala automáticamente con el paqueterhel-system-roles.

5.2. Terminología de los roles del sistema RHEL

Puede encontrar los siguientes términos en esta documentación:

Terminología de los roles del sistema

- Libro de jugadas de Ansible

- Los playbooks son el lenguaje de configuración, despliegue y orquestación de Ansible. Pueden describir una política que desea que sus sistemas remotos apliquen, o un conjunto de pasos en un proceso general de TI.

- Nodo de control

- Cualquier máquina con Ansible instalado. Puedes ejecutar comandos y playbooks, invocando /usr/bin/ansible o /usr/bin/ansible-playbook, desde cualquier nodo de control. Puedes usar cualquier ordenador que tenga Python instalado como nodo de control: ordenadores portátiles, escritorios compartidos y servidores pueden ejecutar Ansible. Sin embargo, no puedes usar una máquina Windows como nodo de control. Puedes tener varios nodos de control.

- Inventario

- Una lista de nodos gestionados. Un archivo de inventario también se llama a veces "archivo de host". Su inventario puede especificar información como la dirección IP para cada nodo gestionado. Un inventario también puede organizar los nodos gestionados, creando y anidando grupos para facilitar el escalado. Para obtener más información sobre el inventario, consulte la sección Trabajar con el inventario.

- Nodos gestionados

- Los dispositivos de red, servidores, o ambos, que gestionas con Ansible. Los nodos gestionados también se denominan a veces "hosts". Ansible no se instala en los nodos gestionados.

5.3. Instalación de RHEL System Roles en su sistema

Este párrafo es la introducción del módulo del procedimiento: una breve descripción del procedimiento.

Requisitos previos

- Tiene una suscripción a Red Hat Ansible Engine. Consulte el procedimiento ¿Cómo descargo e instalo Red Hat Ansible Engine?

- Tienes los paquetes de Ansible instalados en el sistema que quieres usar como nodo de control:

Procedimiento

Instale el paquete

rhel-system-rolesen el sistema que desea utilizar como nodo de control:# yum install rhel-system-roles

Si no dispone de una suscripción a Red Hat Ansible Engine, puede utilizar una versión soportada limitada de Red Hat Ansible Engine proporcionada con su suscripción a Red Hat Enterprise Linux. En este caso, siga estos pasos:

Habilite el repositorio del motor Ansible de RHEL:

# subscription-manager refresh # subscription-manager repos --enable ansible-2-for-rhel-8-x86_64-rpms

Instale el motor Ansible:

# yum install ansible

Como resultado, puede crear un libro de jugadas de Ansible.

Recursos adicionales

- Para obtener una visión general de las funciones del sistema RHEL, consulte las funciones del sistema Red Hat Enterprise Linux (RHEL)

- Para obtener información más detallada sobre el uso del comando ansible-playbook, consulte la página man de ansible-playbook.

5.4. Aplicar un papel

El siguiente procedimiento describe cómo aplicar un rol particular.

Requisitos previos

El paquete

rhel-system-rolesestá instalado en el sistema que se quiere utilizar como nodo de control:# yum install rhel-system-rolesEl repositorio del motor Ansible está habilitado y el paquete

ansibleestá instalado en el sistema que desea utilizar como nodo de control. Necesita el paqueteansiblepara ejecutar playbooks que utilicen RHEL System Roles.Si no dispone de una suscripción a Red Hat Ansible Engine, puede utilizar una versión soportada limitada de Red Hat Ansible Engine proporcionada con su suscripción a Red Hat Enterprise Linux. En este caso, siga estos pasos:

Habilite el repositorio del motor Ansible de RHEL:

# subscription-manager refresh # subscription-manager repos --enable ansible-2-for-rhel-8-x86_64-rpms

Instale el motor Ansible:

# yum install ansible

- Si tiene una suscripción a Red Hat Ansible Engine, siga el procedimiento descrito en ¿Cómo descargo e instalo Red Hat Ansible Engine?

Puedes crear un playbook de Ansible.

Los playbooks representan el lenguaje de configuración, despliegue y orquestación de Ansible. Mediante el uso de playbooks, puedes declarar y gestionar configuraciones de máquinas remotas, desplegar múltiples máquinas remotas u orquestar pasos de cualquier proceso manual ordenado.

Un playbook es una lista de uno o más

plays. Cadaplaypuede incluir variables, tareas o roles de Ansible.Los libros de jugadas son legibles para las personas y se expresan en el formato

YAML.Para más información sobre los playbooks, consulte la documentación de Ansible.

Procedimiento

Cree un playbook de Ansible que incluya el rol requerido.

El siguiente ejemplo muestra cómo utilizar los roles a través de la opción

roles:para un determinadoplay:--- - hosts: webservers roles: - rhel-system-roles.network - rhel-system-roles.timesyncPara más información sobre el uso de roles en los playbooks, consulte la documentación de Ansible.

Consulte los ejemplos de Ansible para ver ejemplos de playbooks.

NotaCada rol incluye un archivo README, que documenta cómo usar el rol y los valores de los parámetros soportados. También puede encontrar un ejemplo de libro de jugadas para un rol en particular en el directorio de documentación del rol. Este directorio de documentación se proporciona por defecto con el paquete

rhel-system-roles, y se puede encontrar en la siguiente ubicación:/usr/share/doc/rhel-system-roles/SUBSYSTEM/Sustituya SUBSYSTEM por el nombre del rol requerido, como

selinux,kdump,network,timesync, ostorage.Verifique la sintaxis del libro de jugadas:

#

ansible-playbook --syntax-check name.of.the.playbookEl comando

ansible-playbookofrece una opción--syntax-checkque puede utilizar para verificar la sintaxis de un libro de jugadas.Ejecute el libro de jugadas en los hosts seleccionados ejecutando el comando

ansible-playbook:#

ansible-playbook -i name.of.the.inventory name.of.the.playbookUn inventario es una lista de sistemas con los que trabaja Ansible. Para más información sobre cómo crear un inventario y cómo trabajar con él, consulte la documentación de Ansible.

Si no tiene un inventario, puede crearlo en el momento de ejecutar

ansible-playbook:Si sólo tiene un host de destino contra el que desea ejecutar el libro de jugadas, utilice:

# ansible-playbook -i host1, name.of.the.playbookSi tiene varios hosts de destino contra los que desea ejecutar el libro de jugadas, utilice:

# ansible-playbook -i host1,host2,....,hostn name.of.the.playbook

Recursos adicionales

-

Para obtener información más detallada sobre el uso del comando

ansible-playbook, consulte la página de manualansible-playbook.

5.5. Introducción a la función del sistema de métricas

RHEL System Roles es una colección de roles y módulos de Ansible que proporcionan una interfaz de configuración consistente para gestionar remotamente múltiples sistemas RHEL. El rol de sistema de métricas configura los servicios de análisis de rendimiento para el sistema local y, opcionalmente, incluye una lista de sistemas remotos que deben ser supervisados por el sistema local. El rol de sistema de métricas le permite utilizar pcp para supervisar el rendimiento de sus sistemas sin tener que configurar pcp por separado, ya que la configuración y el despliegue de pcp son gestionados por el libro de jugadas.

Tabla 5.1. Variables de rol del sistema de métricas

| Variable de rol | Descripción | Ejemplo de uso |

|---|---|---|

| metrics_monitored_hosts |

Lista de hosts remotos que serán analizados por el host de destino. Estos hosts tendrán métricas registradas en el host de destino, así que asegúrese de que existe suficiente espacio en disco debajo de |

|

| metrics_retention_days | Configura el número de días de retención de datos de rendimiento antes de su eliminación. |

|

| servicio_gráfico_métrico |

Una bandera booleana que permite que el host se configure con servicios para la visualización de datos de rendimiento a través de |

|

| metrics_query_service |

Un indicador booleano que permite configurar el host con servicios de consulta de series temporales para consultar las métricas registradas de |

|

| metrics_provider |

Especifica qué colector de métricas se utilizará para proporcionar métricas. Actualmente, |

|

Recursos adicionales

-

para obtener detalles sobre los parámetros utilizados en

metrics_connectionse información adicional sobre el rol del sistema de métricas, consulte el archivo/usr/share/ansible/roles/rhel-system-roles.metrics/README.md.

5.6. Uso de la función de sistema de métricas para supervisar su sistema local con visualización

Este procedimiento describe cómo utilizar el rol de sistema RHEL de métricas para supervisar su sistema local y, al mismo tiempo, aprovisionar la visualización de datos a través de grafana.

Requisitos previos

- Tiene instalado Red Hat Ansible Engine en la máquina que desea supervisar.

-

Tiene el paquete

rhel-system-rolesinstalado en la máquina que desea supervisar.

Procedimiento

Configure

localhosten el inventario de/etc/ansible/hostsAnsible añadiendo el siguiente contenido al inventario:localhost ansible_connection=local

Cree un playbook de Ansible con el siguiente contenido:

--- - hosts: localhost vars: metrics_graph_service: yes roles: - rhel-system-roles.metricsEjecute el libro de jugadas de Ansible:

# ansible-playbook name_of_your_playbook.ymlNotaDado que el booleano

metrics_graph_serviceestá configurado con el valor="sí",grafanase instala y aprovisiona automáticamente conpcpañadido como fuente de datos.-

Para ver la visualización de las métricas que se recopilan en su máquina, acceda a la interfaz web

grafanacomo se describe en Acceso a la interfaz web de Grafana.

5.7. Utilizar la función de sistema de métrica para configurar una flota de sistemas individuales que se supervisen a sí mismos

Este procedimiento describe cómo utilizar el rol de sistema de métricas para configurar una flota de máquinas para que se monitoreen a sí mismas.

Requisitos previos

- Tiene instalado Red Hat Ansible Engine en la máquina que desea utilizar para ejecutar el libro de jugadas.

-

Tienes el paquete

rhel-system-rolesinstalado en la máquina que quieres usar para ejecutar el playbook.

Procedimiento

Añada el nombre o la IP de las máquinas que desea supervisar a través del libro de jugadas al archivo de inventario de Ansible

/etc/ansible/hostsbajo un nombre de grupo identificativo encerrado entre paréntesis:[remotes] webserver.example.com database.example.com

Cree un playbook de Ansible con el siguiente contenido:

--- - hosts: remotes vars: metrics_retention_days: 0 roles: - rhel-system-roles.metricsEjecute el libro de jugadas de Ansible:

# ansible-playbook name_of_your_playbook.yml

5.8. Uso del rol de sistema de métrica para supervisar una flota de máquinas de forma centralizada a través de su máquina local

Este procedimiento describe cómo utilizar el rol de sistema de métricas para configurar su máquina local para supervisar de forma centralizada una flota de máquinas, a la vez que proporciona la visualización de los datos a través de grafana y la consulta de los datos a través de redis.

Requisitos previos

- Tiene instalado Red Hat Ansible Engine en la máquina que desea utilizar para ejecutar el libro de jugadas.

-

Tienes el paquete

rhel-system-rolesinstalado en la máquina que quieres usar para ejecutar el playbook.

Procedimiento

Cree un playbook de Ansible con el siguiente contenido:

--- - hosts: localhost vars: metrics_graph_service: yes metrics_query_service: yes metrics_retention_days: 10 metrics_monitored_hosts: ["database.example.com", "webserver.example.com"] roles: - rhel-system-roles.metricsEjecute el libro de jugadas de Ansible:

# ansible-playbook name_of_your_playbook.ymlNotaDado que los booleanos

metrics_graph_serviceymetrics_query_serviceestán configurados con el valor="sí",grafanase instala automáticamente y se aprovisiona conpcpañadido como fuente de datos con el registro de datospcpindexado enredis, lo que permite utilizar el lenguaje de consultapcppara realizar consultas complejas de los datos.-

Para ver la representación gráfica de las métricas que se recopilan de forma centralizada por su máquina y para consultar los datos, acceda a la interfaz web

grafanacomo se describe en Acceso a la interfaz web de Grafana.

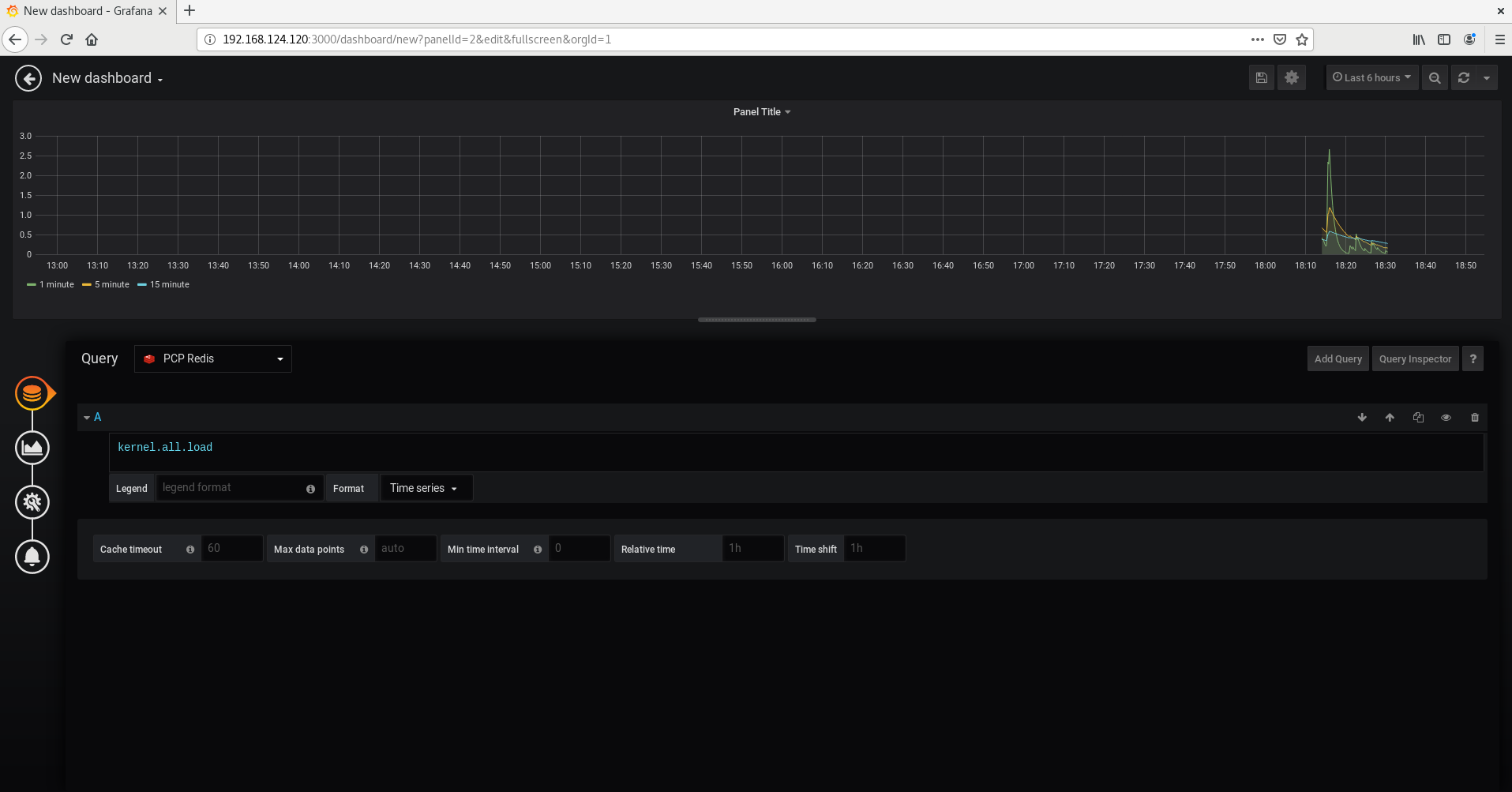

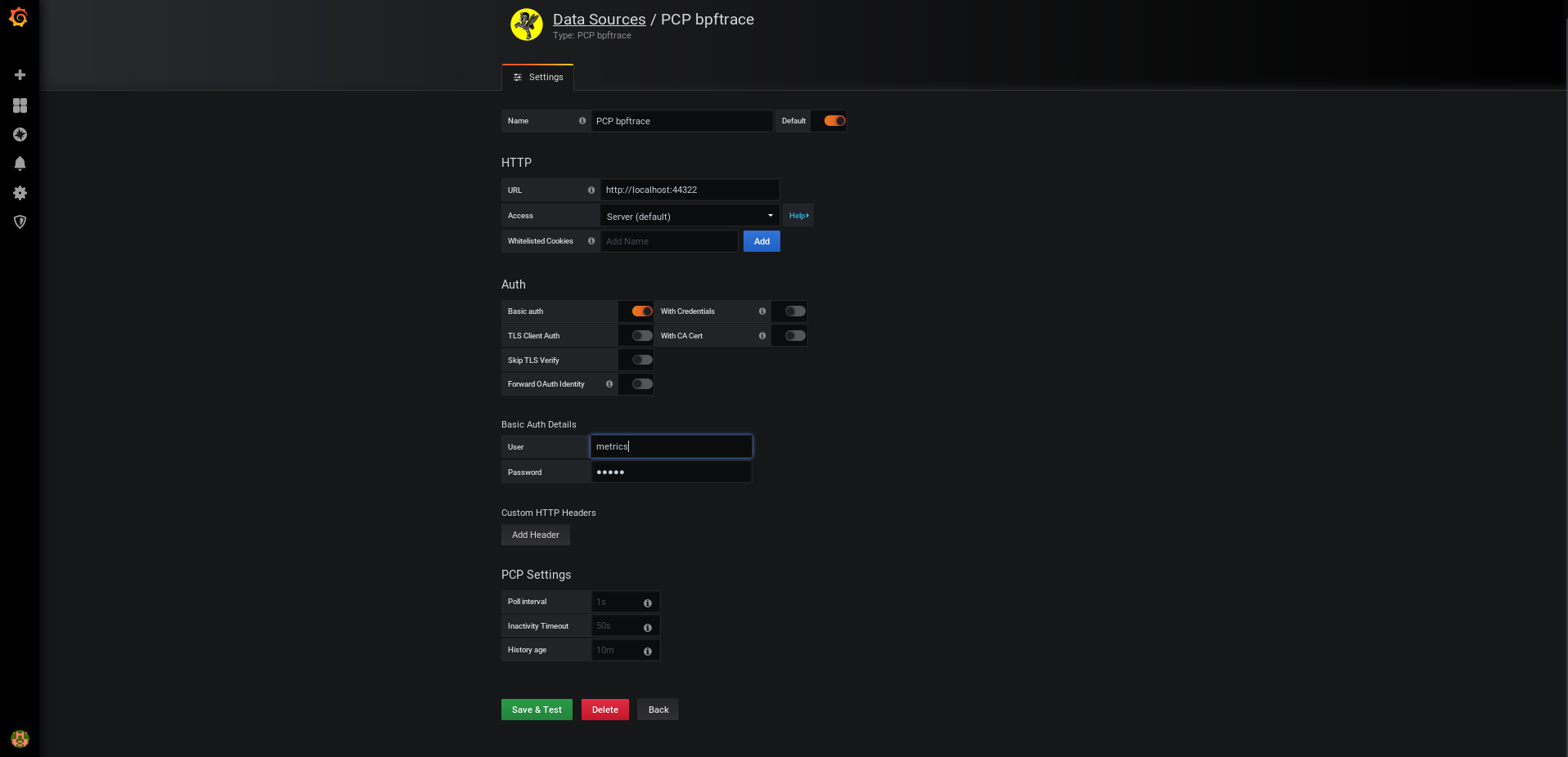

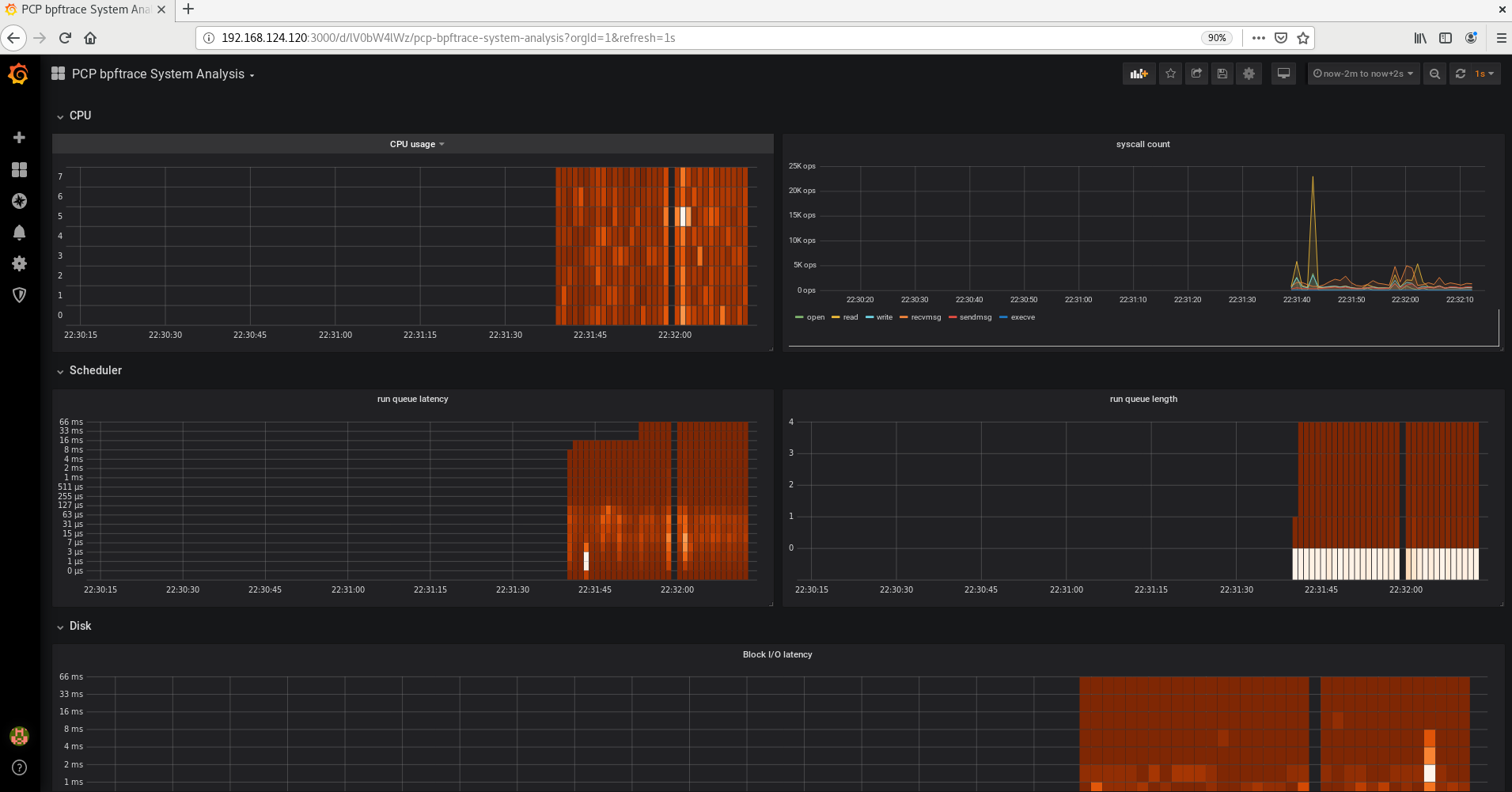

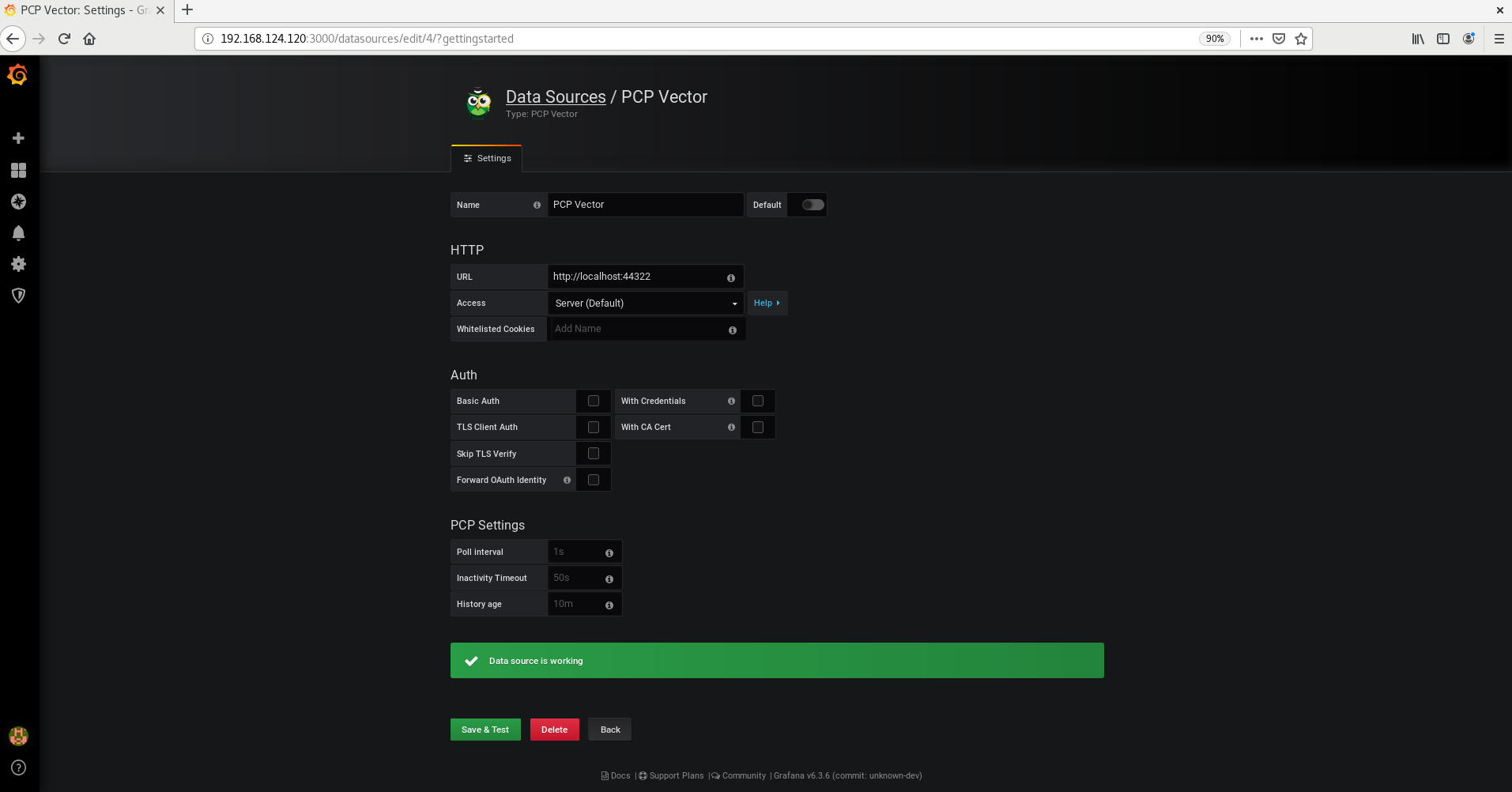

Capítulo 6. Supervisión del rendimiento con Performance Co-Pilot