Red Hat Training

A Red Hat training course is available for RHEL 8

Gestión de dispositivos de almacenamiento

Implantación y configuración del almacenamiento de un solo nodo en Red Hat Enterprise Linux 8

Resumen

Hacer que el código abierto sea más inclusivo

Red Hat se compromete a sustituir el lenguaje problemático en nuestro código, documentación y propiedades web. Estamos empezando con estos cuatro términos: maestro, esclavo, lista negra y lista blanca. Debido a la enormidad de este esfuerzo, estos cambios se implementarán gradualmente a lo largo de varias versiones próximas. Para más detalles, consulte el mensaje de nuestro CTO Chris Wright.

Proporcionar comentarios sobre la documentación de Red Hat

Agradecemos su opinión sobre nuestra documentación. Por favor, díganos cómo podemos mejorarla. Para ello:

Para comentarios sencillos sobre pasajes concretos:

- Asegúrese de que está viendo la documentación en el formato Multi-page HTML. Además, asegúrese de ver el botón Feedback en la esquina superior derecha del documento.

- Utilice el cursor del ratón para resaltar la parte del texto que desea comentar.

- Haga clic en la ventana emergente Add Feedback que aparece debajo del texto resaltado.

- Siga las instrucciones mostradas.

Para enviar comentarios más complejos, cree un ticket de Bugzilla:

- Vaya al sitio web de Bugzilla.

- Como componente, utilice Documentation.

- Rellene el campo Description con su sugerencia de mejora. Incluya un enlace a la(s) parte(s) pertinente(s) de la documentación.

- Haga clic en Submit Bug.

Capítulo 1. Resumen de las opciones de almacenamiento disponibles

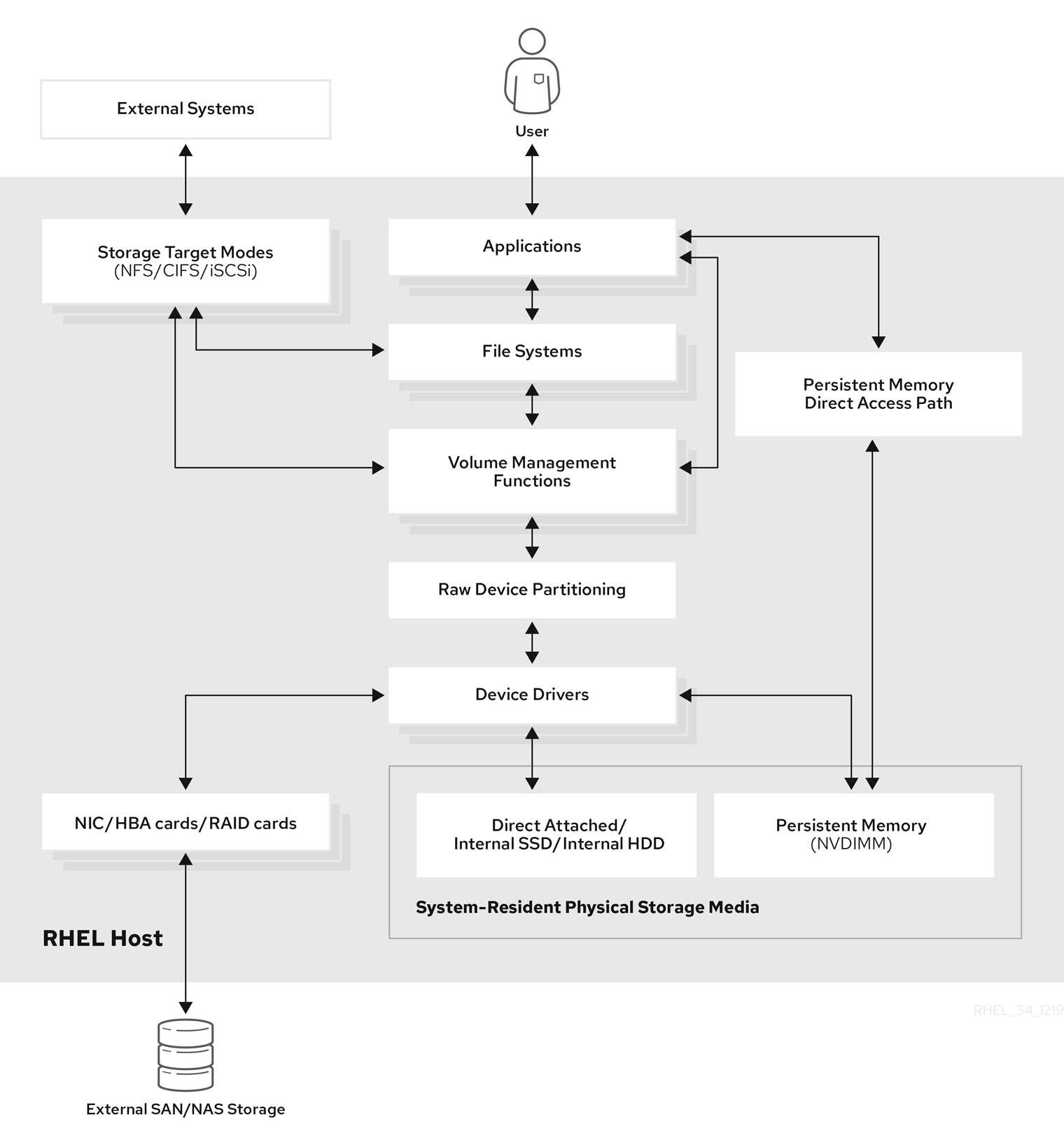

Este capítulo describe los tipos de almacenamiento que están disponibles en Red Hat Enterprise Linux 8. Red Hat Enterprise Linux ofrece una variedad de opciones para gestionar el almacenamiento local y para conectarse al almacenamiento remoto. Figura 1.1, “Diagrama de almacenamiento de alto nivel de Red Hat Enterprise Linux” describe las diferentes opciones de almacenamiento:

Figura 1.1. Diagrama de almacenamiento de alto nivel de Red Hat Enterprise Linux

1.1. Opciones de almacenamiento local

A continuación se muestran las opciones de almacenamiento local disponibles en Red Hat Enterprise Linux 8:

- Administración básica de discos

Usando parted y fdisk, puedes crear, modificar, borrar y ver las particiones. A continuación se muestran las normas de distribución de las particiones:

- Registro de arranque maestro (MBR)

- Se utiliza con ordenadores basados en BIOS. Puede crear particiones primarias, extendidas y lógicas.

- Tabla de partición GUID (GPT)

- Utiliza un identificador único global (GUID) y proporciona un GUID único de disco y de partición.

Para cifrar la partición, puede utilizar la configuración de clave unificada de Linux en formato de disco (LUKS). Para encriptar la partición, seleccione la opción durante la instalación y se le pedirá que introduzca la frase de contraseña. Esta frase de contraseña desbloquea la clave de cifrado.

- Opciones de consumo de almacenamiento

- Gestión de los módulos de memoria doble en línea no volátil (NVDIMM)

- Es una combinación de memoria y almacenamiento. Puede habilitar y gestionar varios tipos de almacenamiento en los dispositivos NVDIMM conectados a su sistema.

- Gestión del almacenamiento en bloque

- Los datos se almacenan en forma de bloques en los que cada bloque tiene un identificador único.

- Almacenamiento de archivos

- Los datos se almacenan a nivel de archivo en el sistema local. Se puede acceder a estos datos localmente utilizando XFS (por defecto) o ext4, y a través de una red utilizando NFS y SMB.

- Volúmenes lógicos

- Gestor de volúmenes lógicos (LVM)

Crea dispositivos lógicos a partir de dispositivos físicos. El volumen lógico (LV) es una combinación de los volúmenes físicos (PV) y los grupos de volúmenes (VG). La configuración de LVM incluye:

- Creación de PV desde los discos duros.

- Creación de VG a partir de la PV.

- Creación de LV a partir del VG asignando puntos de montaje al LV.

- Optimizador virtual de datos (VDO)

Se utiliza para la reducción de datos mediante el uso de la deduplicación, la compresión y el thin provisioning. El uso de LV por debajo de VDO ayuda en:

- Ampliación del volumen de VDO

- Extensión del volumen VDO en varios dispositivos

- Sistemas de archivos locales

- XFS

- El sistema de archivos por defecto de RHEL.

- Ext4

- Un sistema de archivos heredado.

- Stratis

- Está disponible como Technology Preview. Stratis es un sistema híbrido de gestión del almacenamiento local de usuario y núcleo que admite funciones de almacenamiento avanzadas.

1.2. Opciones de almacenamiento remoto

A continuación se muestran las opciones de almacenamiento remoto disponibles en Red Hat Enterprise Linux 8:

- Opciones de conectividad de almacenamiento

- iSCSI

- RHEL 8 utiliza la herramienta targetcli para añadir, eliminar, ver y supervisar las interconexiones de almacenamiento iSCSI.

- Canal de fibra (FC)

Red Hat Enterprise Linux 8 proporciona los siguientes controladores nativos de canal de fibra:

-

lpfc -

qla2xxx -

Zfcp

-

- Memoria no volátil Express (NVMe)

Una interfaz que permite a la utilidad de software del host comunicarse con las unidades de estado sólido. Utilice los siguientes tipos de transporte de tejido para configurar NVMe sobre tejidos:

- NVMe sobre tejidos utilizando el Acceso Directo a Memoria Remota (RDMA).

- NVMe sobre telas utilizando Fibre Channel (FC)

- Device Mapper multipathing (DM Multipath)

- Permite configurar múltiples rutas de E/S entre nodos de servidor y matrices de almacenamiento en un único dispositivo. Estas rutas de E/S son conexiones físicas de SAN que pueden incluir cables, conmutadores y controladores independientes.

- Sistema de archivos en red

- NFS

- SMB

1.3. Solución en clúster del sistema de archivos GFS2

El sistema de archivos Red Hat Global File System 2 (GFS2) es un sistema de archivos de cluster simétrico de 64 bits que proporciona un espacio de nombres compartido y gestiona la coherencia entre múltiples nodos que comparten un dispositivo de bloques común. Un sistema de archivos GFS2 pretende ofrecer un conjunto de características lo más parecido posible a un sistema de archivos local y, al mismo tiempo, reforzar la coherencia total del clúster entre los nodos. Para lograrlo, los nodos emplean un esquema de bloqueo en todo el clúster para los recursos del sistema de archivos. Este esquema de bloqueo utiliza protocolos de comunicación como TCP/IP para intercambiar información de bloqueo.

En algunos casos, la API del sistema de archivos de Linux no permite que la naturaleza agrupada de GFS2 sea totalmente transparente; por ejemplo, los programas que utilizan bloqueos POSIX en GFS2 deben evitar el uso de la función GETLK ya que, en un entorno agrupado, el ID del proceso puede corresponder a un nodo diferente del clúster. Sin embargo, en la mayoría de los casos, la funcionalidad de un sistema de archivos GFS2 es idéntica a la de un sistema de archivos local.

El complemento de almacenamiento resistente de Red Hat Enterprise Linux (RHEL) proporciona GFS2 y depende del complemento de alta disponibilidad de RHEL para proporcionar la gestión de clústeres que requiere GFS2.

El módulo del kernel gfs2.ko implementa el sistema de archivos GFS2 y se carga en los nodos de cluster GFS2.

Para obtener el mejor rendimiento de GFS2, es importante tener en cuenta las consideraciones de rendimiento que se derivan del diseño subyacente. Al igual que un sistema de archivos local, GFS2 se basa en la caché de páginas para mejorar el rendimiento mediante el almacenamiento en caché local de los datos más utilizados. Para mantener la coherencia entre los nodos del clúster, el control de la caché lo proporciona la máquina de estado glock.

Recursos adicionales

- Para obtener más información sobre los sistemas de archivos GFS2, consulte la documentación Configuración de los sistemas de archivos GFS2.

1.4. Soluciones agrupadas

Esta sección proporciona una visión general de las opciones en clúster como Red Hat Gluster Storage (RHGS) o Red Hat Ceph Storage (RHCS).

1.4.1. Opción de Red Hat Gluster Storage

Red Hat Gluster Storage (RHGS) es una plataforma de almacenamiento definida por software. Agrega recursos de almacenamiento en disco de múltiples servidores en un único espacio de nombres global. GlusterFS es un sistema de archivos distribuido de código abierto. Es adecuado para soluciones en la nube e híbridas.

GlusterFS se compone de diferentes tipos de volumen, que son la base de GlusterFS y proporcionan diferentes requisitos. El volumen es una colección de los ladrillos, que son el espacio de almacenamiento en sí.

Los siguientes son los tipos de volumen GlusterFS:

- Distributed GlusterFS volume es el volumen por defecto. En este caso cada archivo se almacena en un ladrillo y no puede ser compartido entre diferentes ladrillos.

- el tipoReplicated GlusterFS volume mantiene las réplicas de los datos. En este caso, si un ladrillo falla, el usuario puede seguir accediendo a los datos.

- Distributed replicated GlusterFS volume es un volumen híbrido que distribuye réplicas en un gran número de sistemas. Es adecuado para el entorno en el que los requisitos para escalar el almacenamiento y la alta fiabilidad son críticos.

Recursos adicionales

- Para más información sobre RHGS, consulte el Manual de administración del almacenamiento gluster de Red Hat.

1.4.2. Opción de Red Hat Ceph Storage

Red Hat Ceph Storage (RHCS) es una plataforma de almacenamiento escalable, abierta y definida por software que combina la versión más estable del sistema de almacenamiento Ceph con una plataforma de gestión Ceph, utilidades de implantación y servicios de soporte.

Red Hat Ceph Storage está diseñado para la infraestructura de nube y el almacenamiento de objetos a escala web. Los clústeres de Red Hat Ceph Storage constan de los siguientes tipos de nodos:

- Nodo de administración de Red Hat Ceph Storage Ansible

Este tipo de nodo actúa como lo hacía el nodo tradicional de administración de Ceph en las versiones anteriores de Red Hat Ceph Storage. Este tipo de nodo proporciona las siguientes funciones:

- Gestión centralizada del clúster de almacenamiento

- Los archivos de configuración y las claves de Ceph

- Opcionalmente, repositorios locales para instalar Ceph en nodos que no pueden acceder a Internet por razones de seguridad

- Monitorear los nodos

Cada nodo monitor ejecuta el demonio monitor (

ceph-mon), que mantiene una copia maestra del mapa del cluster. El mapa del cluster incluye la topología del cluster. Un cliente que se conecta al clúster Ceph recupera la copia actual del mapa del clúster desde el monitor, lo que permite al cliente leer y escribir datos en el clúster.ImportanteCeph puede funcionar con un solo monitor; sin embargo, para asegurar una alta disponibilidad en un cluster de producción, Red Hat sólo soportará implementaciones con al menos tres nodos de monitorización. Red Hat recomienda desplegar un total de 5 monitores Ceph para clusters de almacenamiento que superen los 750 OSD.

- Nodos OSD

Cada nodo de Dispositivo de Almacenamiento de Objetos (OSD) ejecuta el demonio Ceph OSD (

ceph-osd), que interactúa con los discos lógicos conectados al nodo. Ceph almacena los datos en estos nodos OSD.Ceph puede funcionar con muy pocos nodos OSD, que por defecto son tres, pero los clusters de producción obtienen un mejor rendimiento a partir de escalas modestas, por ejemplo 50 OSD en un cluster de almacenamiento. Lo ideal es que un clúster Ceph tenga varios nodos OSD, lo que permite crear dominios de fallo aislados mediante la creación del mapa CRUSH.

- Nodos MDS

-

Cada nodo del Servidor de Metadatos (MDS) ejecuta el demonio MDS (

ceph-mds), que gestiona los metadatos relacionados con los archivos almacenados en el Sistema de Archivos Ceph (CephFS). El demonio MDS también coordina el acceso al clúster compartido. - Nodo de la pasarela de objetos

-

El nodo Ceph Object Gateway ejecuta el demonio Ceph RADOS Gateway (

ceph-radosgw), y es una interfaz de almacenamiento de objetos construida sobrelibradospara proporcionar a las aplicaciones una puerta de enlace RESTful a los clusters de almacenamiento Ceph. El Ceph Object Gateway soporta dos interfaces: - S3

- Proporciona la funcionalidad de almacenamiento de objetos con una interfaz que es compatible con un gran subconjunto de la API RESTful de Amazon S3.

- Swift

- Proporciona funcionalidad de almacenamiento de objetos con una interfaz que es compatible con un gran subconjunto de la API de OpenStack Swift.

Recursos adicionales

- Para más información sobre RHCS, consulte la documentación de Red Hat Ceph Storage.

Capítulo 2. Gestión del almacenamiento local mediante los roles de sistema de RHEL

Para gestionar LVM y sistemas de archivos locales (FS) mediante Ansible, puede utilizar el rol storage, que es uno de los roles de sistema RHEL disponibles en RHEL 8.

El uso del rol storage le permite automatizar la administración de sistemas de archivos en discos y volúmenes lógicos en múltiples máquinas y en todas las versiones de RHEL a partir de RHEL 7.7.

Para más información sobre los Roles del Sistema RHEL y cómo aplicarlos, vea Introducción a los Roles del Sistema RHEL.

2.1. Introducción a la función de almacenamiento

La función storage puede gestionar:

- Sistemas de archivos en discos que no han sido particionados

- Grupos de volúmenes LVM completos, incluyendo sus volúmenes lógicos y sistemas de archivos

Con el rol storage puede realizar las siguientes tareas:

- Crear un sistema de archivos

- Eliminar un sistema de archivos

- Montar un sistema de archivos

- Desmontar un sistema de archivos

- Crear grupos de volúmenes LVM

- Eliminar grupos de volúmenes LVM

- Crear volúmenes lógicos

- Eliminar volúmenes lógicos

- Crear volúmenes RAID

- Eliminar volúmenes RAID

- Crear pools LVM con RAID

- Eliminar pools LVM con RAID

2.2. Parámetros que identifican un dispositivo de almacenamiento en el rol de sistema de almacenamiento

La configuración de su rol en storage afecta sólo a los sistemas de archivos, volúmenes y pools que se enumeran en las siguientes variables.

storage_volumesLista de sistemas de archivos en todos los discos no particionados que se van a gestionar.

Actualmente, las particiones no son compatibles.

storage_poolsLista de piscinas a gestionar.

Actualmente el único tipo de pool soportado es LVM. Con LVM, los pools representan grupos de volúmenes (VGs). Bajo cada pool hay una lista de volúmenes que deben ser gestionados por el rol. Con LVM, cada volumen corresponde a un volumen lógico (LV) con un sistema de archivos.

2.3. Ejemplo de playbook de Ansible para crear un sistema de archivos XFS en un dispositivo de bloques

Esta sección proporciona un ejemplo de libro de jugadas de Ansible. Este libro de jugadas aplica el rol storage para crear un sistema de archivos XFS en un dispositivo de bloques utilizando los parámetros predeterminados.

El rol storage puede crear un sistema de archivos sólo en un disco entero no particionado o en un volumen lógico (LV). No puede crear el sistema de archivos en una partición.

Ejemplo 2.1. Un playbook que crea XFS en /dev/sdb

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: xfs

roles:

- rhel-system-roles.storage-

El nombre del volumen (

barefsen el ejemplo) es actualmente arbitrario. El rolstorageidentifica el volumen por el dispositivo de disco listado bajo el atributodisks:. -

Puede omitir la línea

fs_type: xfsporque XFS es el sistema de archivos por defecto en RHEL 8. Para crear el sistema de archivos en un LV, proporcione la configuración de LVM bajo el atributo

disks:, incluyendo el grupo de volúmenes que lo rodea. Para obtener más detalles, consulte Ejemplo de libro de jugadas de Ansible para gestionar volúmenes lógicos.No proporcione la ruta de acceso al dispositivo LV.

Recursos adicionales

-

Para más detalles sobre los parámetros utilizados en el rol de sistema

storage, consulte el archivo/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.4. Ejemplo de playbook de Ansible para montar persistentemente un sistema de archivos

Esta sección proporciona un ejemplo de libro de jugadas de Ansible. Este libro de jugadas aplica el rol storage para montar de forma inmediata y persistente un sistema de archivos XFS.

Ejemplo 2.2. Un playbook que monta un sistema de archivos en /dev/sdb a /mnt/data

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: xfs

mount_point: /mnt/data

roles:

- rhel-system-roles.storage-

Este libro de jugadas añade el sistema de archivos al archivo

/etc/fstab, y monta el sistema de archivos inmediatamente. -

Si el sistema de archivos del dispositivo

/dev/sdbo el directorio del punto de montaje no existen, el libro de jugadas los crea.

Recursos adicionales

-

Para más detalles sobre los parámetros utilizados en el rol de sistema

storage, consulte el archivo/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.5. Ejemplo de libro de jugadas de Ansible para gestionar volúmenes lógicos

Esta sección proporciona un ejemplo de libro de jugadas de Ansible. Este libro de jugadas aplica el rol storage para crear un volumen lógico LVM en un grupo de volúmenes.

Ejemplo 2.3. Un libro de jugadas que crea un volumen lógico mylv en el grupo de volúmenes myvg

- hosts: all

vars:

storage_pools:

- name: myvg

disks:

- sda

- sdb

- sdc

volumes:

- name: mylv

size: 2G

fs_type: ext4

mount_point: /mnt

roles:

- rhel-system-roles.storageEl grupo de volúmenes

myvgestá formado por los siguientes discos:-

/dev/sda -

/dev/sdb -

/dev/sdc

-

-

Si el grupo de volumen

myvgya existe, el libro de jugadas añade el volumen lógico al grupo de volumen. -

Si el grupo de volumen

myvgno existe, el libro de jugadas lo crea. -

El libro de jugadas crea un sistema de archivos Ext4 en el volumen lógico

mylv, y monta persistentemente el sistema de archivos en/mnt.

Recursos adicionales

-

Para más detalles sobre los parámetros utilizados en el rol de sistema

storage, consulte el archivo/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.6. Ejemplo de libro de jugadas de Ansible para activar el descarte de bloques en línea

Esta sección proporciona un ejemplo de libro de jugadas de Ansible. Este libro de jugadas aplica el rol storage para montar un sistema de archivos XFS con el descarte de bloques en línea activado.

Ejemplo 2.4. Un libro de jugadas que permite descartar bloques en línea en /mnt/data/

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: xfs

mount_point: /mnt/data

mount_options: discard

roles:

- rhel-system-roles.storageRecursos adicionales

- Este libro de jugadas también realiza todas las operaciones del ejemplo de montaje persistente descrito en Sección 2.4, “Ejemplo de playbook de Ansible para montar persistentemente un sistema de archivos”.

-

Para más detalles sobre los parámetros utilizados en el rol de sistema

storage, consulte el archivo/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.7. Ejemplo de playbook Ansible para crear y montar un sistema de archivos Ext4

Esta sección proporciona un ejemplo de libro de jugadas de Ansible. Este libro de jugadas aplica el rol storage para crear y montar un sistema de archivos Ext4.

Ejemplo 2.5. Un playbook que crea Ext4 en /dev/sdb y lo monta en /mnt/data

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: ext4

fs_label: label-name

mount_point: /mnt/data

roles:

- rhel-system-roles.storage-

El libro de jugadas crea el sistema de archivos en el disco

/dev/sdb. -

El libro de jugadas monta persistentemente el sistema de archivos en el directorio

/mnt/datadirectorio. -

La etiqueta del sistema de archivos es

label-name.

Recursos adicionales

-

Para más detalles sobre los parámetros utilizados en el rol de sistema

storage, consulte el archivo/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.8. Ejemplo de playbook de Ansible para crear y montar un sistema de archivos ext3

Esta sección proporciona un ejemplo de libro de jugadas de Ansible. Este libro de jugadas aplica el rol storage para crear y montar un sistema de archivos Ext3.

Ejemplo 2.6. Un playbook que crea Ext3 en /dev/sdb y lo monta en /mnt/data

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: ext3

fs_label: label-name

mount_point: /mnt/data

roles:

- rhel-system-roles.storage-

El libro de jugadas crea el sistema de archivos en el disco

/dev/sdb. -

El libro de jugadas monta persistentemente el sistema de archivos en el directorio

/mnt/datadirectorio. -

La etiqueta del sistema de archivos es

label-name.

Recursos adicionales

-

Para más detalles sobre los parámetros utilizados en el rol de sistema

storage, consulte el archivo/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.9. Configuración de un volumen RAID mediante el rol de sistema de almacenamiento

Con el rol de sistema storage, puede configurar un volumen RAID en RHEL utilizando Red Hat Ansible Automation Platform. En esta sección aprenderá a configurar un playbook de Ansible con los parámetros disponibles para configurar un volumen RAID que se adapte a sus necesidades.

Requisitos previos

Tiene instalado Red Hat Ansible Engine en el sistema desde el que desea ejecutar el libro de jugadas.

NotaNo es necesario tener Red Hat Ansible Automation Platform instalado en los sistemas en los que se desea implementar la solución

storage.-

Tienes el paquete

rhel-system-rolesinstalado en el sistema desde el que quieres ejecutar el playbook. -

Tienes un archivo de inventario que detalla los sistemas en los que quieres desplegar un volumen RAID usando el rol de sistema

storage.

Procedimiento

Cree un nuevo

playbook.ymlarchivo con el siguiente contenido:- hosts: all vars: storage_safe_mode: false storage_volumes: - name: data type: raid disks: [sdd, sde, sdf, sdg] raid_level: raid0 raid_chunk_size: 32 KiB mount_point: /mnt/data state: present roles: - name: rhel-system-roles.storageAvisoLos nombres de los dispositivos pueden cambiar en determinadas circunstancias; por ejemplo, cuando se añade un nuevo disco a un sistema. Por lo tanto, para evitar la pérdida de datos, no se recomienda utilizar nombres de discos específicos en el libro de jugadas.

Opcional. Verificar la sintaxis del libro de jugadas.

# ansible-playbook --syntax-check playbook.ymlEjecute el libro de jugadas en su archivo de inventario:

# ansible-playbook -i inventory.file /path/to/file/playbook.yml

Recursos adicionales

- Para obtener más información sobre RAID, consulte Gestión de RAID.

-

Para obtener detalles sobre los parámetros utilizados en el rol del sistema de almacenamiento, consulte el archivo

/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.10. Configuración de un pool LVM con RAID utilizando el rol de sistema de almacenamiento

Con el rol de sistema storage, puede configurar un pool LVM con RAID en RHEL utilizando Red Hat Ansible Automation Platform. En esta sección aprenderá a configurar un playbook Ansible con los parámetros disponibles para configurar un pool LVM con RAID.

Requisitos previos

Tiene instalado Red Hat Ansible Engine en el sistema desde el que desea ejecutar el libro de jugadas.

NotaNo es necesario tener Red Hat Ansible Automation Platform instalado en los sistemas en los que se desea implementar la solución

storage.-

Tienes el paquete

rhel-system-rolesinstalado en el sistema desde el que quieres ejecutar el playbook. -

Tienes un archivo de inventario que detalla los sistemas en los que quieres configurar un pool LVM con RAID utilizando el rol de sistema

storage.

Procedimiento

Cree un nuevo

playbook.ymlarchivo con el siguiente contenido:- hosts: all vars: storage_safe_mode: false storage_pools: - name: my_pool type: lvm disks: [sdh, sdi] raid_level: raid1 volumes: - name: my_pool size: "1 GiB" mount_point: "/mnt/app/shared" fs_type: xfs state: present roles: - name: rhel-system-roles.storageNotaPara crear un pool LVM con RAID, debes especificar el tipo de RAID utilizando el parámetro

raid_level.Opcional. Verificar la sintaxis del libro de jugadas.

# ansible-playbook --syntax-check playbook.ymlEjecute el libro de jugadas en su archivo de inventario:

# ansible-playbook -i inventory.file /path/to/file/playbook.yml

Recursos adicionales

- Para obtener más información sobre RAID, consulte Gestión de RAID.

-

Para obtener detalles sobre los parámetros utilizados en el rol del sistema de almacenamiento, consulte el archivo

/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.11. Creación de un volumen encriptado LUKS utilizando el rol de almacenamiento

Puede utilizar el rol storage para crear y configurar un volumen encriptado con LUKS ejecutando un playbook de Ansible.

Requisitos previos

Tiene instalado Red Hat Ansible Engine en el sistema desde el que desea ejecutar el libro de jugadas.

NotaNo es necesario tener Red Hat Ansible Automation Platform instalado en los sistemas en los que se desea crear el volumen.

-

Tiene el paquete

rhel-system-rolesinstalado en el controlador Ansible. - Dispone de un archivo de inventario en el que se detallan los sistemas en los que desea desplegar un volumen encriptado LUKS mediante el rol de sistema de almacenamiento.

Procedimiento

Cree un nuevo

playbook.ymlarchivo con el siguiente contenido:- hosts: all vars: storage_volumes: - name: barefs type: disk disks: - sdb fs_type: xfs fs_label: label-name mount_point: /mnt/data encryption: true encryption_password: your-password roles: - rhel-system-roles.storageOpcional. Verificar la sintaxis del libro de jugadas:

# ansible-playbook --syntax-check playbook.ymlEjecute el libro de jugadas en su archivo de inventario:

# ansible-playbook -i inventory.file /path/to/file/playbook.yml

Recursos adicionales

- Para más información sobre LUKS, véase 17. Cifrado de dispositivos de bloque mediante LUKS..

-

Para más detalles sobre los parámetros utilizados en el rol de sistema

storage, consulte el archivo/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

Recursos adicionales

Para más información, instale el paquete

rhel-system-rolesy consulte los siguientes directorios:-

/usr/share/doc/rhel-system-roles/storage/ -

/usr/share/ansible/roles/rhel-system-roles.storage/

-

Capítulo 3. Cómo empezar con las particiones

Como administrador del sistema, puede utilizar los siguientes procedimientos para crear, eliminar y modificar varios tipos de particiones de disco.

Para obtener una visión general de las ventajas y desventajas de utilizar particiones en dispositivos de bloque, consulte el siguiente artículo de KBase: https://access.redhat.com/solutions/163853.

3.1. Visualización de la tabla de particiones

Como administrador del sistema, puede mostrar la tabla de particiones de un dispositivo de bloque para ver la disposición de las particiones y los detalles sobre las particiones individuales.

3.1.1. Visualización de la tabla de particiones con parted

Este procedimiento describe cómo ver la tabla de particiones en un dispositivo de bloque utilizando la utilidad parted.

Procedimiento

Inicie el shell interactivo

parted:# parted block-device-

Sustituya block-device por la ruta del dispositivo que desea examinar: por ejemplo,

/dev/sda.

-

Sustituya block-device por la ruta del dispositivo que desea examinar: por ejemplo,

Ver la tabla de particiones:

Impresión (parcial)

Opcionalmente, utilice el siguiente comando para cambiar a otro dispositivo que desee examinar a continuación:

(separado) seleccionar block-device

Recursos adicionales

-

La página de manual

parted(8).

3.1.2. Ejemplo de salida de parted print

Esta sección proporciona un ejemplo de salida del comando print en el shell parted y describe los campos de la salida.

Ejemplo 3.1. Salida del comando print

Model: ATA SAMSUNG MZNLN256 (scsi) Disk /dev/sda: 256GB Sector size (logical/physical): 512B/512B Partition Table: msdos Disk Flags: Number Start End Size Type File system Flags 1 1049kB 269MB 268MB primary xfs boot 2 269MB 34.6GB 34.4GB primary 3 34.6GB 45.4GB 10.7GB primary 4 45.4GB 256GB 211GB extended 5 45.4GB 256GB 211GB logical

A continuación se describen los campos:

Model: ATA SAMSUNG MZNLN256 (scsi)- El tipo de disco, el fabricante, el número de modelo y la interfaz.

Disk /dev/sda: 256GB- La ruta del archivo al dispositivo de bloque y la capacidad de almacenamiento.

Partition Table: msdos- El tipo de etiqueta del disco.

Number-

El número de la partición. Por ejemplo, la partición con número menor 1 corresponde a

/dev/sda1. StartyEnd- La ubicación en el dispositivo donde comienza y termina la partición.

Type- Los tipos válidos son metadatos, libre, primario, extendido o lógico.

File system-

El tipo de sistema de archivos. Si el campo

File systemde un dispositivo no muestra ningún valor, significa que su tipo de sistema de archivos es desconocido. La utilidadpartedno puede reconocer el sistema de archivos de los dispositivos cifrados. Flags-

Enumera las banderas establecidas para la partición. Las banderas disponibles son

boot,root,swap,hidden,raid,lvm, olba.

3.2. Creación de una tabla de particiones en un disco

Como administrador del sistema, puede formatear un dispositivo de bloque con diferentes tipos de tablas de partición para permitir el uso de particiones en el dispositivo.

Al formatear un dispositivo de bloque con una tabla de particiones se borran todos los datos almacenados en el dispositivo.

3.2.1. Consideraciones antes de modificar las particiones de un disco

Esta sección enumera los puntos clave a tener en cuenta antes de crear, eliminar o redimensionar las particiones.

Esta sección no cubre la tabla de particiones DASD, que es específica de la arquitectura IBM Z. Para obtener información sobre DASD, consulte:

- Configuración de una instancia de Linux en IBM Z

- El artículo Lo que debe saber sobre DASD en el Centro de Conocimiento de IBM

El número máximo de particiones

El número de particiones en un dispositivo está limitado por el tipo de tabla de particiones:

En un dispositivo formateado con la tabla de particiones Master Boot Record (MBR), puede tener cualquiera de los dos:

- Hasta cuatro particiones primarias, o

- Hasta tres particiones primarias, una partición extendida y múltiples particiones lógicas dentro de la extendida.

-

En un dispositivo formateado con el GUID Partition Table (GPT), el número máximo de particiones es 128. Aunque la especificación GPT permite más particiones aumentando el área reservada para la tabla de particiones, la práctica común utilizada por la utilidad

partedes limitarla a un área suficiente para 128 particiones.

Red Hat recomienda que, a menos que tenga una razón para hacer lo contrario, debería at least crear las siguientes particiones: swap, /boot/, y / (raíz).

El tamaño máximo de una partición

El tamaño de una partición en un dispositivo está limitado por el tipo de tabla de particiones:

- En un dispositivo formateado con la tabla de particiones Master Boot Record (MBR), el tamaño máximo es de 2TiB.

- En un dispositivo formateado con el GUID Partition Table (GPT), el tamaño máximo es de 8ZiB.

Si quieres crear una partición mayor de 2TiB, el disco debe estar formateado con GPT.

Alineación de tamaños

La utilidad parted le permite especificar el tamaño de la partición utilizando varios sufijos diferentes:

- MiB, GiB o TiB

Tamaño expresado en potencias de 2.

- El punto inicial de la partición se alinea con el sector exacto especificado por el tamaño.

- El punto final se alinea con el tamaño especificado menos 1 sector.

- MB, GB o TB

Tamaño expresado en potencias de 10.

El punto inicial y final se alinea dentro de la mitad de la unidad especificada: por ejemplo, ±500KB cuando se utiliza el sufijo MB.

3.2.2. Comparación de los tipos de tablas de partición

Esta sección compara las propiedades de los diferentes tipos de tablas de partición que se pueden crear en un dispositivo de bloque.

Tabla 3.1. Tipos de tablas de partición

| Tabla de partición | Número máximo de particiones | Tamaño máximo de la partición |

|---|---|---|

| Registro de arranque maestro (MBR) | 4 primarios, o 3 primarios y 12 lógicos dentro de una partición extendida | 2TiB |

| Tabla de partición GUID (GPT) | 128 | 8ZiB |

3.2.3. Particiones de disco MBR

Los diagramas de este capítulo muestran que la tabla de particiones está separada del disco real. Sin embargo, esto no es del todo exacto. En realidad, la tabla de particiones se almacena al principio del disco, antes de cualquier sistema de archivos o datos de usuario, pero para mayor claridad, están separados en los siguientes diagramas.

Figura 3.1. Disco con tabla de partición MBR

Como muestra el diagrama anterior, la tabla de particiones se divide en cuatro secciones de cuatro particiones primarias. Una partición primaria es una partición en un disco duro que sólo puede contener una unidad lógica (o sección). Cada sección puede contener la información necesaria para definir una sola partición, lo que significa que la tabla de particiones no puede definir más de cuatro particiones.

Cada entrada de la tabla de particiones contiene varias características importantes de la partición:

- Los puntos del disco donde comienza y termina la partición.

- Si la partición es active. Sólo se puede marcar una partición como active.

- El tipo de partición.

Los puntos inicial y final definen el tamaño de la partición y su ubicación en el disco. El indicador "activo" es utilizado por los cargadores de arranque de algunos sistemas operativos. En otras palabras, el sistema operativo en la partición que está marcada como "activa" es arrancado, en este caso.

El tipo es un número que identifica el uso previsto de la partición. Algunos sistemas operativos utilizan el tipo de partición para denotar un tipo de sistema de archivos específico, para marcar la partición como asociada a un sistema operativo concreto, para indicar que la partición contiene un sistema operativo de arranque, o alguna combinación de las tres.

El siguiente diagrama muestra un ejemplo de una unidad con una sola partición:

Figura 3.2. Disco con una sola partición

La única partición en este ejemplo está etiquetada como DOS. Esta etiqueta muestra el tipo de partición, siendo DOS una de las más comunes.

3.2.4. Particiones MBR extendidas

En caso de que cuatro particiones sean insuficientes para sus necesidades, puede utilizar las particiones extendidas para crear particiones adicionales. Puede hacerlo configurando el tipo de partición como "Extendida".

Una partición extendida es como una unidad de disco en sí misma - tiene su propia tabla de particiones, que apunta a una o más particiones (ahora llamadas particiones lógicas, en contraposición a las cuatro particiones primarias), contenidas completamente dentro de la propia partición extendida. El siguiente diagrama muestra una unidad de disco con una partición primaria y una partición extendida que contiene dos particiones lógicas (junto con algo de espacio libre sin particionar):

Figura 3.3. Disco con una partición MBR primaria y otra extendida

Como esta figura implica, hay una diferencia entre las particiones primarias y las lógicas - sólo puede haber hasta cuatro particiones primarias y extendidas, pero no hay un límite fijo para el número de particiones lógicas que pueden existir. Sin embargo, debido a la forma en que se accede a las particiones en Linux, no se pueden definir más de 15 particiones lógicas en una sola unidad de disco.

3.2.5. Tipos de partición MBR

La siguiente tabla muestra una lista de algunos de los tipos de partición MBR más utilizados y los números hexadecimales utilizados para representarlos.

Tabla 3.2. Tipos de partición MBR

| MBR partition type | Value | MBR partition type | Value |

| Vacío | 00 | Novell Netware 386 | 65 |

| DOS 12-bit FAT | 01 | PIC/IX | 75 |

| Raíz de XENIX | O2 | Antiguo MINIX | 80 |

| XENIX usr | O3 | Linux/MINUX | 81 |

| DOS 16 bits ⇐32M | 04 | Intercambio en Linux | 82 |

| Extendido | 05 | Linux nativo | 83 |

| DOS 16 bits >=32 | 06 | Linux ampliado | 85 |

| OS/2 HPFS | 07 | Amoeba | 93 |

| AIX | 08 | Amoeba BBT | 94 |

| AIX de arranque | 09 | BSD/386 | a5 |

| Gestor de arranque de OS/2 | 0a | OpenBSD | a6 |

| Win95 FAT32 | 0b | NEXTSTEP | a7 |

| Win95 FAT32 (LBA) | 0c | BSDI fs | b7 |

| Win95 FAT16 (LBA) | 0e | Intercambio BSDI | b8 |

| Win95 Extended (LBA) | 0f | Syrinx | c7 |

| Venix 80286 | 40 | CP/M | db |

| Novell | 51 | Acceso al DOS | e1 |

| Bota PRep | 41 | DOS R/O | e3 |

| GNU HURD | 63 | DOS secundario | f2 |

| Novell Netware 286 | 64 | BBT | ff |

3.2.6. Tabla de partición GUID

La tabla de partición GUID (GPT) es un esquema de partición basado en el uso de un identificador único global (GUID). La GPT se desarrolló para hacer frente a las limitaciones de la tabla de partición MBR, especialmente con el limitado espacio de almacenamiento máximo direccionable de un disco. A diferencia de MBR, que no puede direccionar un almacenamiento mayor de 2 TiB (equivalente a unos 2,2 TB), GPT se utiliza con discos duros de mayor tamaño; el tamaño máximo direccionable del disco es de 2,2 ZiB. Además, GPT, por defecto, permite crear hasta 128 particiones primarias. Este número puede ampliarse asignando más espacio a la tabla de particiones.

Una GPT tiene tipos de partición basados en GUIDs. Tenga en cuenta que ciertas particiones requieren un GUID específico. Por ejemplo, la partición del sistema para los cargadores de arranque EFI requiere el GUID C12A7328-F81F-11D2-BA4B-00A0C93EC93B.

Los discos GPT utilizan el direccionamiento lógico de bloques (LBA) y la disposición de las particiones es la siguiente:

- Para mantener la compatibilidad con los discos MBR, el primer sector (LBA 0) de GPT está reservado para los datos de MBR y se llama "MBR protector".

- La cabecera GPT primaria comienza en el segundo bloque lógico (LBA 1) del dispositivo. La cabecera contiene el GUID del disco, la ubicación de la tabla de particiones primaria, la ubicación de la cabecera GPT secundaria, y las sumas de comprobación CRC32 de sí misma y de la tabla de particiones primaria. También especifica el número de entradas de partición en la tabla.

- La GPT primaria incluye, por defecto 128 entradas de partición, cada una con un tamaño de entrada de 128 bytes, su GUID de tipo de partición y su GUID de partición única.

- La GPT secundaria es idéntica a la GPT primaria. Se utiliza principalmente como una tabla de respaldo para la recuperación en caso de que la tabla de partición primaria se corrompa.

- La cabecera secundaria de GPT se encuentra en el último sector lógico del disco y puede utilizarse para recuperar la información de GPT en caso de que la cabecera primaria esté dañada. Contiene el GUID del disco, la ubicación de la tabla de particiones secundarias y la cabecera GPT primaria, las sumas de comprobación CRC32 de sí mismo y de la tabla de particiones secundarias, y el número de posibles entradas de partición.

Figura 3.4. Disco con una tabla de partición GUID

Debe haber una partición de arranque de la BIOS para que el gestor de arranque se instale con éxito en un disco que contenga una tabla de particiones GPT (GUID). Esto incluye los discos inicializados por Anaconda. Si el disco ya contiene una partición de arranque del BIOS, se puede reutilizar.

3.2.7. Creación de una tabla de particiones en un disco con partición

Este procedimiento describe cómo formatear un dispositivo de bloque con una tabla de particiones utilizando la utilidad parted.

Procedimiento

Inicie el shell interactivo

parted:# parted block-device-

Sustituya block-device por la ruta del dispositivo en el que desea crear una tabla de particiones: por ejemplo,

/dev/sda.

-

Sustituya block-device por la ruta del dispositivo en el que desea crear una tabla de particiones: por ejemplo,

Determine si ya existe una tabla de particiones en el dispositivo:

Impresión (parcial)

Si el dispositivo ya contiene particiones, se eliminarán en los siguientes pasos.

Cree la nueva tabla de partición:

(parted) mklabel table-typeSustituya table-type por el tipo de tabla de partición deseado:

-

msdospara MBR -

gptpara GPT

-

Ejemplo 3.2. Creación de una tabla GPT

Por ejemplo, para crear una tabla GPT en el disco, utilice:

(parted) mklabel gpt

Los cambios empiezan a producirse en cuanto se introduce este comando, así que revísalo antes de ejecutarlo.

Ver la tabla de particiones para confirmar que la tabla de particiones existe:

Impresión (parcial)

Salga del shell

parted:(separada) dejar de fumar

Recursos adicionales

-

La página de manual

parted(8).

Próximos pasos

- Crear particiones en el dispositivo. Consulte Sección 3.3, “Crear una partición” para obtener más detalles.

3.3. Crear una partición

Como administrador del sistema, puedes crear nuevas particiones en un disco.

3.3.1. Consideraciones antes de modificar las particiones de un disco

Esta sección enumera los puntos clave a tener en cuenta antes de crear, eliminar o redimensionar las particiones.

Esta sección no cubre la tabla de particiones DASD, que es específica de la arquitectura IBM Z. Para obtener información sobre DASD, consulte:

- Configuración de una instancia de Linux en IBM Z

- El artículo Lo que debe saber sobre DASD en el Centro de Conocimiento de IBM

El número máximo de particiones

El número de particiones en un dispositivo está limitado por el tipo de tabla de particiones:

En un dispositivo formateado con la tabla de particiones Master Boot Record (MBR), puede tener cualquiera de los dos:

- Hasta cuatro particiones primarias, o

- Hasta tres particiones primarias, una partición extendida y múltiples particiones lógicas dentro de la extendida.

-

En un dispositivo formateado con el GUID Partition Table (GPT), el número máximo de particiones es 128. Aunque la especificación GPT permite más particiones aumentando el área reservada para la tabla de particiones, la práctica común utilizada por la utilidad

partedes limitarla a un área suficiente para 128 particiones.

Red Hat recomienda que, a menos que tenga una razón para hacer lo contrario, debería at least crear las siguientes particiones: swap, /boot/, y / (raíz).

El tamaño máximo de una partición

El tamaño de una partición en un dispositivo está limitado por el tipo de tabla de particiones:

- En un dispositivo formateado con la tabla de particiones Master Boot Record (MBR), el tamaño máximo es de 2TiB.

- En un dispositivo formateado con el GUID Partition Table (GPT), el tamaño máximo es de 8ZiB.

Si quieres crear una partición mayor de 2TiB, el disco debe estar formateado con GPT.

Alineación de tamaños

La utilidad parted le permite especificar el tamaño de la partición utilizando varios sufijos diferentes:

- MiB, GiB o TiB

Tamaño expresado en potencias de 2.

- El punto inicial de la partición se alinea con el sector exacto especificado por el tamaño.

- El punto final se alinea con el tamaño especificado menos 1 sector.

- MB, GB o TB

Tamaño expresado en potencias de 10.

El punto inicial y final se alinea dentro de la mitad de la unidad especificada: por ejemplo, ±500KB cuando se utiliza el sufijo MB.

3.3.2. Tipos de partición

Esta sección describe diferentes atributos que especifican el tipo de una partición.

Tipos de partición o banderas

El tipo de partición, o bandera, es utilizado por un sistema en ejecución sólo en raras ocasiones. Sin embargo, el tipo de partición es importante para los generadores sobre la marcha, como systemd-gpt-auto-generator, que utilizan el tipo de partición para, por ejemplo, identificar y montar automáticamente los dispositivos.

-

La utilidad

partedproporciona cierto control de los tipos de partición mediante la asignación del tipo de partición a flags. La utilidad parted sólo puede manejar ciertos tipos de partición: por ejemplo LVM, swap o RAID. -

La utilidad

fdiskadmite toda la gama de tipos de partición especificando códigos hexadecimales.

Tipo de sistema de archivos de la partición

La utilidad parted acepta opcionalmente un argumento de tipo de sistema de archivos al crear una partición. El valor se utiliza para:

- Establecer las banderas de la partición en MBR, o

-

Establezca el tipo de UUID de la partición en GPT. Por ejemplo, los tipos de sistema de archivos

swap,fat, ohfsestablecen diferentes GUIDs. El valor por defecto es el GUID de datos de Linux.

El argumento no modifica el sistema de archivos de la partición de ninguna manera. Sólo diferencia entre las banderas o GUIDs soportados.

Se admiten los siguientes tipos de sistemas de archivos:

-

xfs -

ext2 -

ext3 -

ext4 -

fat16 -

fat32 -

hfs -

hfs -

linux-swap -

ntfs -

reiserfs

3.3.3. Esquema de nomenclatura de las particiones

Red Hat Enterprise Linux utiliza un esquema de nomenclatura basado en archivos, con nombres de archivos en forma de /dev/xxyN.

Los nombres de dispositivos y particiones tienen la siguiente estructura:

/dev/-

Este es el nombre del directorio en el que se encuentran todos los archivos del dispositivo. Como las particiones se colocan en los discos duros, y los discos duros son dispositivos, los archivos que representan todas las posibles particiones se encuentran en

/dev. xx-

Las dos primeras letras del nombre de las particiones indican el tipo de dispositivo en el que se encuentra la partición, normalmente

sd. y-

Esta letra indica en qué dispositivo se encuentra la partición. Por ejemplo,

/dev/sdapara el primer disco duro,/dev/sdbpara el segundo, y así sucesivamente. En sistemas con más de 26 discos, puede utilizar más letras. Por ejemplo,/dev/sdaa1. N-

La letra final indica el número que representa la partición. Las cuatro primeras particiones (primarias o extendidas) están numeradas de

1a4. Las particiones lógicas comienzan en5. Por ejemplo,/dev/sda3es la tercera partición primaria o extendida en el primer disco duro, y/dev/sdb6es la segunda partición lógica en el segundo disco duro. La numeración de las particiones de la unidad sólo se aplica a las tablas de partición MBR. Tenga en cuenta que N no siempre significa partición.

Incluso si Red Hat Enterprise Linux puede identificar y referirse a all tipos de particiones de disco, podría no ser capaz de leer el sistema de archivos y por lo tanto acceder a los datos almacenados en cada tipo de partición. Sin embargo, en muchos casos, es posible acceder con éxito a los datos de una partición dedicada a otro sistema operativo.

3.3.4. Puntos de montaje y particiones de disco

En Red Hat Enterprise Linux, cada partición se utiliza para formar parte del almacenamiento necesario para soportar un único conjunto de archivos y directorios. Esto se hace utilizando el proceso conocido como mounting, que asocia una partición con un directorio. El montaje de una partición hace que su almacenamiento esté disponible a partir del directorio especificado, conocido como mount point.

Por ejemplo, si la partición /dev/sda5 está montada en /usr/, eso significaría que todos los archivos y directorios bajo /usr/ residen físicamente en /dev/sda5. Así, el archivo /usr/share/doc/FAQ/txt/Linux-FAQ se almacenaría en /dev/sda5, mientras que el archivo /etc/gdm/custom.conf no.

Continuando con el ejemplo, también es posible que uno o más directorios por debajo de /usr/ sean puntos de montaje para otras particiones. Por ejemplo, una partición /dev/sda7 podría ser montada en /usr/local, lo que significa que /usr/local/man/whatis residiría entonces en /dev/sda7 en lugar de /dev/sda5.

3.3.5. Creación de una partición con parted

Este procedimiento describe cómo crear una nueva partición en un dispositivo de bloque utilizando la utilidad parted.

Requisitos previos

- Hay una tabla de particiones en el disco. Para obtener detalles sobre cómo formatear el disco, consulte Sección 3.2, “Creación de una tabla de particiones en un disco”.

- Si la partición que quiere crear es mayor de 2TiB, el disco debe estar formateado con la tabla de particiones GUID (GPT).

Procedimiento

Inicie el shell interactivo

parted:# parted block-device-

Sustituya block-device por la ruta del dispositivo en el que desea crear una partición: por ejemplo,

/dev/sda.

-

Sustituya block-device por la ruta del dispositivo en el que desea crear una partición: por ejemplo,

Vea la tabla de particiones actual para determinar si hay suficiente espacio libre:

Impresión (parcial)

- Si no hay suficiente espacio libre, puede redimensionar una partición existente. Para más información, consulte Sección 3.5, “Cambiar el tamaño de una partición”.

A partir de la tabla de particiones, determinar:

- Los puntos inicial y final de la nueva partición

- En MBR, qué tipo de partición debe ser.

Crea la nueva partición:

(parted) mkpart part-type name fs-type start end

-

Sustituya part-type con

primary,logical, oextendeden base a lo que haya decidido de la tabla de particiones. Esto se aplica sólo a la tabla de particiones MBR. - Sustituya name con un nombre de partición arbitrario. Esto es necesario para las tablas de partición GPT.

-

Sustituir fs-type por cualquiera de los siguientes:

xfs,ext2,ext3,ext4,fat16,fat32,hfs,hfs,linux-swap,ntfs, oreiserfs. El parámetro fs-type es opcional. Tenga en cuenta quepartedno crea el sistema de archivos en la partición. -

Sustituya start y end con los tamaños que determinan los puntos inicial y final de la partición, contando desde el principio del disco. Puede utilizar sufijos de tamaño, como

512MiB,20GiB, o1.5TiB. El tamaño por defecto es de megabytes.

Ejemplo 3.3. Creación de una pequeña partición primaria

Por ejemplo, para crear una partición primaria de 1024MiB hasta 2048MiB en una tabla MBR, utilice:

(parted) mkpart primary 1024MiB 2048MiB

Los cambios empiezan a producirse en cuanto se introduce este comando, así que revísalo antes de ejecutarlo.

-

Sustituya part-type con

Vea la tabla de particiones para confirmar que la partición creada está en la tabla de particiones con el tipo de partición, el tipo de sistema de archivos y el tamaño correctos:

Impresión (parcial)

Salga del shell

parted:(separada) dejar de fumar

Utilice el siguiente comando para esperar a que el sistema registre el nuevo nodo de dispositivo:

# udevadm settle

Verifique que el kernel reconoce la nueva partición:

# cat /proc/partitions

Recursos adicionales

-

La página de manual

parted(8).

3.3.6. Establecer un tipo de partición con fdisk

Este procedimiento describe cómo establecer un tipo de partición, o bandera, utilizando la utilidad fdisk.

Requisitos previos

- Hay una partición en el disco.

Procedimiento

Inicie el shell interactivo

fdisk:# fdisk block-device-

Sustituya block-device por la ruta del dispositivo en el que desea establecer un tipo de partición: por ejemplo,

/dev/sda.

-

Sustituya block-device por la ruta del dispositivo en el que desea establecer un tipo de partición: por ejemplo,

Ver la tabla de particiones actual para determinar el número de partición menor:

Comando (m de ayuda) printPuede ver el tipo de partición actual en la columna

Typey su correspondiente ID de tipo en la columnaId.Introduzca el comando de tipo de partición y seleccione una partición utilizando su número menor:

Command (m for help): type Partition number (1,2,3 default 3): 2

Opcionalmente, enumera los códigos hexadecimales disponibles:

Código hexadecimal (escriba L para listar todos los códigos) LEstablezca el tipo de partición:

Código hexadecimal (escriba L para listar todos los códigos) 8eEscriba sus cambios y salga del shell

fdisk:Command (m for help): write The partition table has been altered. Syncing disks.Verifique los cambios:

# fdisk --list block-device

3.4. Eliminar una partición

Como administrador del sistema, puede eliminar una partición de disco que ya no se utilice para liberar espacio en el disco.

Al eliminar una partición se borran todos los datos almacenados en ella.

3.4.1. Consideraciones antes de modificar las particiones de un disco

Esta sección enumera los puntos clave a tener en cuenta antes de crear, eliminar o redimensionar las particiones.

Esta sección no cubre la tabla de particiones DASD, que es específica de la arquitectura IBM Z. Para obtener información sobre DASD, consulte:

- Configuración de una instancia de Linux en IBM Z

- El artículo Lo que debe saber sobre DASD en el Centro de Conocimiento de IBM

El número máximo de particiones

El número de particiones en un dispositivo está limitado por el tipo de tabla de particiones:

En un dispositivo formateado con la tabla de particiones Master Boot Record (MBR), puede tener cualquiera de los dos:

- Hasta cuatro particiones primarias, o

- Hasta tres particiones primarias, una partición extendida y múltiples particiones lógicas dentro de la extendida.

-

En un dispositivo formateado con el GUID Partition Table (GPT), el número máximo de particiones es 128. Aunque la especificación GPT permite más particiones aumentando el área reservada para la tabla de particiones, la práctica común utilizada por la utilidad

partedes limitarla a un área suficiente para 128 particiones.

Red Hat recomienda que, a menos que tenga una razón para hacer lo contrario, debería at least crear las siguientes particiones: swap, /boot/, y / (raíz).

El tamaño máximo de una partición

El tamaño de una partición en un dispositivo está limitado por el tipo de tabla de particiones:

- En un dispositivo formateado con la tabla de particiones Master Boot Record (MBR), el tamaño máximo es de 2TiB.

- En un dispositivo formateado con el GUID Partition Table (GPT), el tamaño máximo es de 8ZiB.

Si quieres crear una partición mayor de 2TiB, el disco debe estar formateado con GPT.

Alineación de tamaños

La utilidad parted le permite especificar el tamaño de la partición utilizando varios sufijos diferentes:

- MiB, GiB o TiB

Tamaño expresado en potencias de 2.

- El punto inicial de la partición se alinea con el sector exacto especificado por el tamaño.

- El punto final se alinea con el tamaño especificado menos 1 sector.

- MB, GB o TB

Tamaño expresado en potencias de 10.

El punto inicial y final se alinea dentro de la mitad de la unidad especificada: por ejemplo, ±500KB cuando se utiliza el sufijo MB.

3.4.2. Eliminación de una partición con parted

Este procedimiento describe cómo eliminar una partición de disco utilizando la utilidad parted.

Procedimiento

Inicie el shell interactivo

parted:# parted block-device-

Sustituya block-device por la ruta del dispositivo en el que desea eliminar una partición: por ejemplo,

/dev/sda.

-

Sustituya block-device por la ruta del dispositivo en el que desea eliminar una partición: por ejemplo,

Ver la tabla de particiones actual para determinar el número menor de la partición a eliminar:

Impresión (parcial)

Retire la partición:

(separado) rm minor-number-

Sustituya minor-number por el número menor de la partición que desea eliminar: por ejemplo,

3.

Los cambios empiezan a producirse en cuanto se introduce este comando, así que revísalo antes de ejecutarlo.

-

Sustituya minor-number por el número menor de la partición que desea eliminar: por ejemplo,

Confirme que la partición se ha eliminado de la tabla de particiones:

Impresión (parcial)

Salga del shell

parted:(separada) dejar de fumar

Verifique que el kernel sabe que la partición ha sido eliminada:

# cat /proc/partitions

-

Elimine la partición del archivo

/etc/fstabsi está presente. Encuentre la línea que declara la partición eliminada, y elimínela del archivo. Regenere las unidades de montaje para que su sistema registre la nueva configuración de

/etc/fstab:# systemctl daemon-reload

Si ha eliminado una partición swap o ha eliminado partes de LVM, elimine todas las referencias a la partición de la línea de comandos del kernel en el archivo

/etc/default/gruby regenere la configuración de GRUB:En un sistema basado en BIOS:

# grub2-mkconfig --output=/etc/grub2.cfg

En un sistema basado en UEFI:

# grub2-mkconfig --output=/etc/grub2-efi.cfg

Para registrar los cambios en el sistema de arranque temprano, reconstruya el sistema de archivos

initramfs:# dracut --force --verbose

Recursos adicionales

-

La página de manual

parted(8)

3.5. Cambiar el tamaño de una partición

Como administrador del sistema, puede ampliar una partición para utilizar el espacio de disco no utilizado, o reducir una partición para utilizar su capacidad para diferentes propósitos.

3.5.1. Consideraciones antes de modificar las particiones de un disco

Esta sección enumera los puntos clave a tener en cuenta antes de crear, eliminar o redimensionar las particiones.

Esta sección no cubre la tabla de particiones DASD, que es específica de la arquitectura IBM Z. Para obtener información sobre DASD, consulte:

- Configuración de una instancia de Linux en IBM Z

- El artículo Lo que debe saber sobre DASD en el Centro de Conocimiento de IBM

El número máximo de particiones

El número de particiones en un dispositivo está limitado por el tipo de tabla de particiones:

En un dispositivo formateado con la tabla de particiones Master Boot Record (MBR), puede tener cualquiera de los dos:

- Hasta cuatro particiones primarias, o

- Hasta tres particiones primarias, una partición extendida y múltiples particiones lógicas dentro de la extendida.

-

En un dispositivo formateado con el GUID Partition Table (GPT), el número máximo de particiones es 128. Aunque la especificación GPT permite más particiones aumentando el área reservada para la tabla de particiones, la práctica común utilizada por la utilidad

partedes limitarla a un área suficiente para 128 particiones.

Red Hat recomienda que, a menos que tenga una razón para hacer lo contrario, debería at least crear las siguientes particiones: swap, /boot/, y / (raíz).

El tamaño máximo de una partición

El tamaño de una partición en un dispositivo está limitado por el tipo de tabla de particiones:

- En un dispositivo formateado con la tabla de particiones Master Boot Record (MBR), el tamaño máximo es de 2TiB.

- En un dispositivo formateado con el GUID Partition Table (GPT), el tamaño máximo es de 8ZiB.

Si quieres crear una partición mayor de 2TiB, el disco debe estar formateado con GPT.

Alineación de tamaños

La utilidad parted le permite especificar el tamaño de la partición utilizando varios sufijos diferentes:

- MiB, GiB o TiB

Tamaño expresado en potencias de 2.

- El punto inicial de la partición se alinea con el sector exacto especificado por el tamaño.

- El punto final se alinea con el tamaño especificado menos 1 sector.

- MB, GB o TB

Tamaño expresado en potencias de 10.

El punto inicial y final se alinea dentro de la mitad de la unidad especificada: por ejemplo, ±500KB cuando se utiliza el sufijo MB.

3.5.2. Redimensionar una partición con parted

Este procedimiento redimensiona una partición de disco utilizando la utilidad parted.

Requisitos previos

Si quieres reducir una partición, haz una copia de seguridad de los datos que están almacenados en ella.

AvisoReducir una partición puede provocar la pérdida de datos en la partición.

- Si quiere redimensionar una partición para que sea mayor de 2TiB, el disco debe estar formateado con la tabla de particiones GUID (GPT). Para más detalles sobre cómo formatear el disco, consulte Sección 3.2, “Creación de una tabla de particiones en un disco”.

Procedimiento

- Si quiere reducir la partición, reduzca primero el sistema de archivos en ella para que no sea mayor que la partición redimensionada. Tenga en cuenta que XFS no admite la contracción.

Inicie el shell interactivo

parted:# parted block-device-

Sustituya block-device por la ruta del dispositivo en el que desea redimensionar una partición: por ejemplo,

/dev/sda.

-

Sustituya block-device por la ruta del dispositivo en el que desea redimensionar una partición: por ejemplo,

Ver la tabla de particiones actual:

Impresión (parcial)

A partir de la tabla de particiones, determinar:

- El número menor de la partición

- La ubicación de la partición existente y su nuevo punto final tras el redimensionamiento

Redimensiona la partición:

(parted) resizepart minor-number new-end

-

Sustituya minor-number por el número menor de la partición que está redimensionando: por ejemplo,

3. -

Sustituya new-end con el tamaño que determina el nuevo punto final de la partición redimensionada, contando desde el principio del disco. Puede utilizar sufijos de tamaño, como

512MiB,20GiB, o1.5TiB. El tamaño por defecto es de megabytes.

Ejemplo 3.4. Ampliar una partición

Por ejemplo, para ampliar una partición situada al principio del disco para que tenga un tamaño de 2GiB, utilice:

(parted) resizepart 1 2GiB

Los cambios empiezan a producirse en cuanto se introduce este comando, así que revísalo antes de ejecutarlo.

-

Sustituya minor-number por el número menor de la partición que está redimensionando: por ejemplo,

Vea la tabla de particiones para confirmar que la partición redimensionada está en la tabla de particiones con el tamaño correcto:

Impresión (parcial)

Salga del shell

parted:(separada) dejar de fumar

Verifique que el kernel reconoce la nueva partición:

# cat /proc/partitions

- Si ha ampliado la partición, amplíe también el sistema de archivos en ella. Consulte (referencia) para más detalles.

Recursos adicionales

-

La página de manual

parted(8).

3.6. Estrategias para reparticionar un disco

Hay varias maneras de reparticionar un disco. En esta sección se analizan los siguientes enfoques posibles:

- Hay espacio libre sin particionar

- Se dispone de una partición no utilizada

- Hay espacio libre en una partición utilizada activamente

Tenga en cuenta que esta sección discute los conceptos mencionados anteriormente sólo teóricamente y no incluye ningún paso de procedimiento sobre cómo realizar la repartición del disco paso a paso.

Las ilustraciones siguientes están simplificadas en aras de la claridad y no reflejan la disposición exacta de las particiones que encontrará cuando instale realmente Red Hat Enterprise Linux.

3.6.1. Uso del espacio libre no particionado

En esta situación, las particiones ya definidas no abarcan todo el disco duro, dejando espacio sin asignar que no forma parte de ninguna partición definida. El siguiente diagrama muestra cómo podría ser esto:

Figura 3.5. Disco con espacio libre no particionado

En el ejemplo anterior, el primer diagrama representa un disco con una partición primaria y una partición indefinida con espacio no asignado, y el segundo diagrama representa un disco con dos particiones definidas con espacio asignado.

Un disco duro no utilizado también entra en esta categoría. La única diferencia es que all el espacio no forma parte de ninguna partición definida.

En cualquier caso, puede crear las particiones necesarias a partir del espacio no utilizado. Este escenario es más probable para un disco nuevo. La mayoría de los sistemas operativos preinstalados están configurados para ocupar todo el espacio disponible en una unidad de disco.

3.6.2. Utilizar el espacio de una partición no utilizada

En este caso, puede tener una o más particiones que ya no utilice. El siguiente diagrama ilustra esta situación.

Figura 3.6. Disco con una partición no utilizada

En el ejemplo anterior, el primer diagrama representa un disco con una partición no utilizada, y el segundo diagrama representa la reasignación de una partición no utilizada para Linux.

En esta situación, puede utilizar el espacio asignado a la partición no utilizada. Debe eliminar la partición y luego crear la(s) partición(es) Linux apropiada(s) en su lugar. Puede eliminar la partición no utilizada y crear manualmente nuevas particiones durante el proceso de instalación.

3.6.3. Utilizar el espacio libre de una partición activa

Esta es la situación más común. También es la más difícil de manejar, porque incluso si tiene suficiente espacio libre, actualmente está asignado a una partición que ya está en uso. Si has comprado un ordenador con software preinstalado, lo más probable es que el disco duro tenga una gran partición con el sistema operativo y los datos.

Además de añadir un nuevo disco duro a su sistema, puede elegir entre repartición destructiva y no destructiva.

3.6.3.1. Repartición destructiva

Esto elimina la partición y crea varias más pequeñas en su lugar. Debes hacer una copia de seguridad completa porque cualquier dato en la partición original se destruye. Cree dos copias de seguridad, utilice la verificación (si está disponible en su software de copia de seguridad) e intente leer los datos de la copia de seguridad before borrando la partición.

Si se instaló un sistema operativo en esa partición, deberá reinstalarlo si quiere utilizar también ese sistema. Tenga en cuenta que algunos ordenadores que se venden con sistemas operativos preinstalados pueden no incluir los medios de instalación para reinstalar el sistema operativo original. Debes comprobar si esto se aplica a tu sistema before y destruir la partición original y su instalación del sistema operativo.

Después de crear una partición más pequeña para su sistema operativo existente, puede reinstalar el software, restaurar sus datos e iniciar su instalación de Red Hat Enterprise Linux.

Figura 3.7. Acción destructiva de repartición en disco

Cualquier dato presente previamente en la partición original se pierde.

3.6.3.2. Repartición no destructiva

Con la repartición no destructiva se ejecuta un programa que hace más pequeña una partición grande sin perder ninguno de los archivos almacenados en esa partición. Este método suele ser fiable, pero puede llevar mucho tiempo en unidades grandes.

El proceso de repartición no destructiva es sencillo y consta de tres pasos:

- Compresión y copia de seguridad de los datos existentes

- Redimensionar la partición existente

- Crear nueva(s) partición(es)

Cada paso se describe con más detalle.

3.6.3.2.1. Compresión de datos existentes

El primer paso es comprimir los datos de la partición existente. La razón para hacer esto es reorganizar los datos para maximizar el espacio libre disponible en el "final" de la partición.

Figura 3.8. Compresión en disco

En el ejemplo anterior, el primer diagrama representa el disco antes de la compresión, y el segundo diagrama después de la compresión.

Este paso es crucial. Sin él, la ubicación de los datos podría impedir que la partición se redimensionara en la medida deseada. Tenga en cuenta que algunos datos no se pueden mover. En este caso, se restringe severamente el tamaño de sus nuevas particiones, y podría verse obligado a reparticionar destructivamente su disco.

3.6.3.2.2. Redimensionar la partición existente

La siguiente figura muestra el proceso real de redimensionamiento. Aunque el resultado real de la operación de redimensionamiento varía, dependiendo del software utilizado, en la mayoría de los casos el espacio recién liberado se utiliza para crear una partición sin formato del mismo tipo que la partición original.

Figura 3.9. Redimensionamiento de la partición en el disco

En el ejemplo anterior, el primer diagrama representa la partición antes del redimensionamiento, y el segundo diagrama después del redimensionamiento.

Es importante entender lo que el software de redimensionamiento que usas hace con el espacio recién liberado, para que puedas tomar los pasos apropiados. En el caso ilustrado aquí, lo mejor sería borrar la nueva partición DOS y crear la o las particiones Linux apropiadas.

3.6.3.2.3. Creación de nuevas particiones

Como se mencionó en el ejemplo Redimensionamiento de la partición existente, podría ser necesario o no crear nuevas particiones. Sin embargo, a menos que su software de redimensionamiento soporte sistemas con Linux instalado, es probable que deba eliminar la partición que se creó durante el proceso de redimensionamiento.

Figura 3.10. Disco con la configuración final de la partición

En el ejemplo anterior, el primer diagrama representa el disco antes de la configuración, y el segundo diagrama después de la configuración.

Capítulo 4. Visión general de los atributos de nomenclatura persistente

Como administrador del sistema, usted necesita referirse a los volúmenes de almacenamiento utilizando atributos de nomenclatura persistentes para construir configuraciones de almacenamiento que sean confiables a través de múltiples arranques del sistema.

4.1. Desventajas de los atributos de denominación no persistentes

Red Hat Enterprise Linux proporciona varias formas de identificar los dispositivos de almacenamiento. Es importante utilizar la opción correcta para identificar cada dispositivo cuando se utiliza para evitar acceder inadvertidamente al dispositivo equivocado, particularmente cuando se instalan o reformatean unidades.

Tradicionalmente, los nombres no persistentes en forma de /dev/sd(major number)(minor number) se utilizan en Linux para referirse a los dispositivos de almacenamiento. El rango de números mayores y menores y los nombres sd asociados se asignan a cada dispositivo cuando se detecta. Esto significa que la asociación entre el rango de números mayores y menores y los nombres sd asociados puede cambiar si el orden de detección del dispositivo cambia.

Este cambio en el ordenamiento podría ocurrir en las siguientes situaciones:

- La paralelización del proceso de arranque del sistema detecta los dispositivos de almacenamiento en un orden diferente con cada arranque del sistema.

-

Un disco no se enciende o no responde a la controladora SCSI. Esto hace que no sea detectado por la sonda normal de dispositivos. El disco no es accesible para el sistema y los dispositivos subsiguientes tendrán su rango de números mayores y menores, incluyendo los nombres asociados

sddesplazados hacia abajo. Por ejemplo, si un disco normalmente referido comosdbno es detectado, un disco normalmente referido comosdcaparecerá comosdb. -

Un controlador SCSI (adaptador de bus de host, o HBA) no se inicializa, lo que provoca que no se detecten todos los discos conectados a ese HBA. A todos los discos conectados a los HBA comprobados posteriormente se les asignan diferentes rangos de números mayores y menores, y diferentes nombres asociados

sd. - El orden de inicialización del controlador cambia si hay diferentes tipos de HBA en el sistema. Esto hace que los discos conectados a esos HBAs sean detectados en un orden diferente. Esto también puede ocurrir si los HBA se mueven a diferentes ranuras PCI en el sistema.

-

Los discos conectados al sistema con adaptadores de canal de fibra, iSCSI o FCoE pueden ser inaccesibles en el momento en que se comprueban los dispositivos de almacenamiento, debido a que una matriz de almacenamiento o un interruptor intermedio están apagados, por ejemplo. Esto puede ocurrir cuando un sistema se reinicia después de un fallo de alimentación, si la matriz de almacenamiento tarda más en ponerse en línea que el sistema en arrancar. Aunque algunos controladores de Canal de Fibra soportan un mecanismo para especificar un mapeo persistente de SCSI target ID a WWPN, esto no hace que se reserven los rangos de números mayores y menores, y los nombres asociados

sd; sólo proporciona números SCSI target ID consistentes.

Estas razones hacen que no sea deseable utilizar el rango de números mayores y menores o los nombres asociados de sd al referirse a los dispositivos, como en el archivo /etc/fstab. Existe la posibilidad de que se monte el dispositivo incorrecto y se produzca una corrupción de datos.

Ocasionalmente, sin embargo, sigue siendo necesario referirse a los nombres de sd incluso cuando se utiliza otro mecanismo, como cuando se informan errores de un dispositivo. Esto se debe a que el núcleo de Linux utiliza los nombres de sd (y también las tuplas SCSI host/channel/target/LUN) en los mensajes del núcleo relativos al dispositivo.

4.2. Sistema de archivos e identificadores de dispositivos

Esta sección explica la diferencia entre los atributos persistentes que identifican los sistemas de archivos y los dispositivos de bloque.

Identificadores del sistema de archivos

Los identificadores del sistema de archivos están vinculados a un sistema de archivos concreto creado en un dispositivo de bloques. El identificador también se almacena como parte del sistema de archivos. Si copias el sistema de archivos a un dispositivo diferente, sigue llevando el mismo identificador del sistema de archivos. Por otro lado, si reescribes el dispositivo, por ejemplo, formateándolo con la utilidad mkfs, el dispositivo pierde el atributo.

Los identificadores del sistema de archivos son:

- Identificador único (UUID)

- Etiqueta

Identificadores de dispositivos

Los identificadores de dispositivo están vinculados a un dispositivo de bloque: por ejemplo, un disco o una partición. Si se reescribe el dispositivo, por ejemplo, formateándolo con la utilidad mkfs, el dispositivo mantiene el atributo, porque no se almacena en el sistema de archivos.

Los identificadores de los dispositivos son:

- Identificador mundial (WWID)

- UUID de la partición

- Número de serie

Recomendaciones

- Algunos sistemas de archivos, como los volúmenes lógicos, abarcan varios dispositivos. Red Hat recomienda acceder a estos sistemas de archivos utilizando identificadores de sistemas de archivos en lugar de identificadores de dispositivos.

4.3. Nombres de dispositivos gestionados por el mecanismo udev en /dev/disk/

Esta sección enumera los diferentes tipos de atributos de nomenclatura persistente que el servicio udev proporciona en el directorio /dev/disk/.

El mecanismo udev se utiliza para todo tipo de dispositivos en Linux, no sólo para los dispositivos de almacenamiento. En el caso de los dispositivos de almacenamiento, Red Hat Enterprise Linux contiene reglas udev que crean enlaces simbólicos en el directorio /dev/disk/. Esto le permite referirse a los dispositivos de almacenamiento por:

- Su contenido

- Un identificador único

- Su número de serie.

Aunque los atributos de nomenclatura de udev son persistentes, en el sentido de que no cambian por sí solos en los reinicios del sistema, algunos también son configurables.

4.3.1. Identificadores del sistema de archivos

El atributo UUID en /dev/disk/by-uuid/

Las entradas de este directorio proporcionan un nombre simbólico que hace referencia al dispositivo de almacenamiento mediante un unique identifier (UUID) en el contenido (es decir, los datos) almacenado en el dispositivo. Por ejemplo:

/dev/disco/por-uuid/3e6be9de-8139-11d1-9106-a43f08d823a6

Puede utilizar el UUID para referirse al dispositivo en el archivo /etc/fstab utilizando la siguiente sintaxis:

UUID=3e6be9de-8139-11d1-9106-a43f08d823a6Puedes configurar el atributo UUID al crear un sistema de archivos, y también puedes cambiarlo posteriormente.

El atributo Label en /dev/disk/by-label/

Las entradas de este directorio proporcionan un nombre simbólico que hace referencia al dispositivo de almacenamiento mediante un label en el contenido (es decir, los datos) almacenado en el dispositivo.

Por ejemplo:

/dev/disco/por-etiqueta/Boot

Puede utilizar la etiqueta para referirse al dispositivo en el archivo /etc/fstab utilizando la siguiente sintaxis: