Red Hat Training

A Red Hat training course is available for RHEL 8

Managing, monitoring, and updating the kernel

Guía para la gestión del kernel de Linux en Red Hat Enterprise Linux 8

Resumen

Hacer que el código abierto sea más inclusivo

Red Hat se compromete a sustituir el lenguaje problemático en nuestro código, documentación y propiedades web. Estamos empezando con estos cuatro términos: maestro, esclavo, lista negra y lista blanca. Debido a la enormidad de este esfuerzo, estos cambios se implementarán gradualmente a lo largo de varias versiones próximas. Para más detalles, consulte el mensaje de nuestro CTO Chris Wright.

Proporcionar comentarios sobre la documentación de Red Hat

Agradecemos su opinión sobre nuestra documentación. Por favor, díganos cómo podemos mejorarla. Para ello:

Para comentarios sencillos sobre pasajes concretos:

- Asegúrese de que está viendo la documentación en el formato Multi-page HTML. Además, asegúrese de ver el botón Feedback en la esquina superior derecha del documento.

- Utilice el cursor del ratón para resaltar la parte del texto que desea comentar.

- Haga clic en la ventana emergente Add Feedback que aparece debajo del texto resaltado.

- Siga las instrucciones mostradas.

Para enviar comentarios más complejos, cree un ticket de Bugzilla:

- Vaya al sitio web de Bugzilla.

- Como componente, utilice Documentation.

- Rellene el campo Description con su sugerencia de mejora. Incluya un enlace a la(s) parte(s) pertinente(s) de la documentación.

- Haga clic en Submit Bug.

Capítulo 1. El RPM del núcleo de Linux

Las siguientes secciones describen el paquete RPM del kernel de Linux proporcionado y mantenido por Red Hat.

1.1. Qué es un RPM

Un paquete RPM es un archivo que contiene otros archivos y sus metadatos (información sobre los archivos que necesita el sistema).

En concreto, un paquete RPM consiste en el archivo cpio.

El archivo cpio contiene:

- Archivos

Cabecera del RPM (metadatos del paquete)

El gestor de paquetes

rpmutiliza estos metadatos para determinar las dependencias, dónde instalar los archivos y otra información.

Tipos de paquetes RPM

Hay dos tipos de paquetes RPM. Ambos tipos comparten el formato de archivo y las herramientas, pero tienen contenidos diferentes y sirven para fines distintos:

Fuente RPM (SRPM)

Un SRPM contiene el código fuente y un archivo SPEC, que describe cómo construir el código fuente en un RPM binario. Opcionalmente, también se incluyen los parches del código fuente.

RPM binario

Un RPM binario contiene los binarios construidos a partir de las fuentes y los parches.

1.2. Visión general del paquete RPM del núcleo de Linux

El RPM kernel es un metapaquete que no contiene ningún archivo, sino que asegura que los siguientes subpaquetes se instalen correctamente:

-

kernel-core- contiene un número mínimo de módulos del kernel necesarios para la funcionalidad principal. Este subpaquete por sí solo podría utilizarse en entornos virtualizados y de nube para proporcionar un kernel de Red Hat Enterprise Linux 8 con un tiempo de arranque rápido y un tamaño de disco reducido. -

kernel-modules- contiene más módulos del kernel. -

kernel-modules-extra- contiene módulos del kernel para hardware raro.

El pequeño conjunto de subpaquetes de kernel tiene como objetivo proporcionar una superficie de mantenimiento reducida a los administradores de sistemas, especialmente en entornos virtualizados y en la nube.

Los otros paquetes comunes del kernel son, por ejemplo:

-

kernel-debug- Contiene un núcleo con numerosas opciones de depuración habilitadas para el diagnóstico del núcleo, a expensas de un rendimiento reducido. -

kernel-tools- Contiene herramientas para manipular el núcleo de Linux y documentación de apoyo. -

kernel-devel- Contiene las cabeceras del kernel y los archivos makefiles suficientes para construir módulos contra el paquetekernel. -

kernel-abi-whitelists- Contiene información relativa a la ABI del kernel de Red Hat Enterprise Linux, incluyendo una lista de símbolos del kernel que necesitan los módulos externos del kernel de Linux y un complemento deyumpara ayudar a su aplicación. -

kernel-headers- Incluye los archivos de cabecera C que especifican la interfaz entre el núcleo de Linux y las bibliotecas y programas del espacio de usuario. Los archivos de cabecera definen estructuras y constantes que son necesarias para construir la mayoría de los programas estándar.

1.3. Visualización del contenido del paquete del núcleo

El siguiente procedimiento describe cómo ver el contenido del paquete del kernel y sus subpaquetes sin instalarlos utilizando el comando rpm.

Requisitos previos

-

Obtenido

kernel,kernel-core,kernel-modules,kernel-modules-extrapaquetes RPM para su arquitectura de CPU

Procedimiento

Lista de módulos para

kernel:$ rpm -qlp <kernel_rpm>(contains no files) …Lista de módulos para

kernel-core:$ rpm -qlp <kernel-core_rpm>… /lib/modules/4.18.0-80.el8.x86_64/kernel/fs/udf/udf.ko.xz /lib/modules/4.18.0-80.el8.x86_64/kernel/fs/xfs /lib/modules/4.18.0-80.el8.x86_64/kernel/fs/xfs/xfs.ko.xz /lib/modules/4.18.0-80.el8.x86_64/kernel/kernel /lib/modules/4.18.0-80.el8.x86_64/kernel/kernel/trace /lib/modules/4.18.0-80.el8.x86_64/kernel/kernel/trace/ring_buffer_benchmark.ko.xz /lib/modules/4.18.0-80.el8.x86_64/kernel/lib /lib/modules/4.18.0-80.el8.x86_64/kernel/lib/cordic.ko.xz …Lista de módulos para

kernel-modules:$ rpm -qlp <kernel-modules_rpm>… /lib/modules/4.18.0-80.el8.x86_64/kernel/drivers/infiniband/hw/mlx4/mlx4_ib.ko.xz /lib/modules/4.18.0-80.el8.x86_64/kernel/drivers/infiniband/hw/mlx5/mlx5_ib.ko.xz /lib/modules/4.18.0-80.el8.x86_64/kernel/drivers/infiniband/hw/qedr/qedr.ko.xz /lib/modules/4.18.0-80.el8.x86_64/kernel/drivers/infiniband/hw/usnic/usnic_verbs.ko.xz /lib/modules/4.18.0-80.el8.x86_64/kernel/drivers/infiniband/hw/vmw_pvrdma/vmw_pvrdma.ko.xz …Lista de módulos para

kernel-modules-extra:$ rpm -qlp <kernel-modules-extra_rpm>… /lib/modules/4.18.0-80.el8.x86_64/extra/net/sched/sch_cbq.ko.xz /lib/modules/4.18.0-80.el8.x86_64/extra/net/sched/sch_choke.ko.xz /lib/modules/4.18.0-80.el8.x86_64/extra/net/sched/sch_drr.ko.xz /lib/modules/4.18.0-80.el8.x86_64/extra/net/sched/sch_dsmark.ko.xz /lib/modules/4.18.0-80.el8.x86_64/extra/net/sched/sch_gred.ko.xz …

Recursos adicionales

-

Para obtener información sobre cómo utilizar el comando

rpmen el RPMkernelya instalado, incluidos sus subpaquetes, consulte la página del manualrpm(8). - Introducción a RPM packages

Capítulo 2. Actualización del kernel con yum

Las siguientes secciones aportan información sobre el kernel de Linux proporcionado y mantenido por Red Hat (kernel de Red Hat), y sobre cómo mantener el kernel de Red Hat actualizado. Como consecuencia, el sistema operativo tendrá todas las últimas correcciones de errores, mejoras de rendimiento y parches que garantizan la compatibilidad con el nuevo hardware.

2.1. Qué es el núcleo

El kernel es la parte central de un sistema operativo Linux, que gestiona los recursos del sistema y proporciona la interfaz entre el hardware y las aplicaciones de software. El kernel de Red Hat es un kernel personalizado basado en el kernel principal de Linux que los ingenieros de Red Hat desarrollan y endurecen con un enfoque en la estabilidad y la compatibilidad con las últimas tecnologías y hardware.

Antes de que Red Hat publique una nueva versión del kernel, éste debe pasar una serie de rigurosas pruebas de control de calidad.

Los kernels de Red Hat están empaquetados en el formato RPM para que sean fáciles de actualizar y verificar por el yum gestor de paquetes.

Los kernels que no han sido compilados por Red Hat son not soportados por Red Hat.

2.2. Qué es yum

Esta sección se refiere a la descripción del yum package manager.

Recursos adicionales

-

Para más información sobre

yum, consulte las secciones correspondientes de Configuring basic system settings.

2.3. Actualización del kernel

El siguiente procedimiento describe cómo actualizar el kernel utilizando el yum gestor de paquetes.

Procedimiento

Para actualizar el kernel, utilice lo siguiente:

# yum update kernelEste comando actualiza el kernel junto con todas las dependencias a la última versión disponible.

- Reinicie su sistema para que los cambios surtan efecto.

Cuando actualice de Red Hat Enterprise Linux 7 a Red Hat Enterprise Linux 8, siga las secciones relevantes del Upgrading from RHEL 7 to RHEL 8 documento.

2.4. Instalación del kernel

El siguiente procedimiento describe cómo instalar nuevos kernels utilizando el yum gestor de paquetes.

Procedimiento

Para instalar una versión específica del kernel, utilice lo siguiente:

# yum install kernel-{version}

Recursos adicionales

- Para obtener una lista de los núcleos disponibles, consulte Red Hat Code Browser.

- Para obtener una lista de las fechas de lanzamiento de versiones específicas del núcleo, consulte this article.

Capítulo 3. Gestión de los módulos del núcleo

Las siguientes secciones explican qué son los módulos del núcleo, cómo mostrar su información y cómo realizar tareas administrativas básicas con los módulos del núcleo.

3.1. Introducción a los módulos del núcleo

El kernel de Red Hat Enterprise Linux puede ser extendido con piezas opcionales de funcionalidad adicional, llamadas módulos del kernel, sin tener que reiniciar el sistema. En Red Hat Enterprise Linux 8, los módulos del kernel son código extra del kernel que se construye en archivos de objetos comprimidos en <KERNEL_MODULE_NAME>.ko.xz.

Las funcionalidades más comunes habilitadas por los módulos del kernel son:

- Controlador de dispositivo que añade compatibilidad con el nuevo hardware

-

Soporte para un sistema de archivos como

GFS2oNFS - Llamadas al sistema

En los sistemas modernos, los módulos del núcleo se cargan automáticamente cuando se necesitan. Sin embargo, en algunos casos es necesario cargar o descargar los módulos manualmente.

Al igual que el propio núcleo, los módulos pueden tomar parámetros que personalicen su comportamiento si es necesario.

Se proporcionan herramientas para inspeccionar qué módulos se están ejecutando actualmente, qué módulos están disponibles para cargar en el núcleo y qué parámetros acepta un módulo. Las herramientas también proporcionan un mecanismo para cargar y descargar módulos del kernel en el kernel en ejecución.

3.2. Introducción a la especificación del cargador de arranque

La especificación BootLoader (BLS) define un esquema y el formato de archivo para gestionar la configuración del cargador de arranque para cada opción de arranque en el directorio drop-in sin necesidad de manipular los archivos de configuración del cargador de arranque. A diferencia de los enfoques anteriores, cada entrada de arranque está ahora representada por un archivo de configuración separado en el directorio drop-in. El directorio drop-in amplía su configuración sin necesidad de editar o regenerar los archivos de configuración. El BLS extiende este concepto para las entradas del menú de arranque.

Utilizando BLS, puedes gestionar las opciones del menú del cargador de arranque añadiendo, eliminando o editando archivos individuales de entrada de arranque en un directorio. Esto hace que el proceso de instalación del kernel sea significativamente más sencillo y consistente en las diferentes arquitecturas.

La herramienta grubby es una fina envoltura de script alrededor del BLS y soporta los mismos argumentos y opciones de grubby. Ejecuta el dracut para crear una imagen inicial de ramdisk. Con esta configuración, los archivos de configuración del núcleo del gestor de arranque son estáticos y no se modifican después de la instalación del kernel.

Esta premisa es particularmente relevante en Red Hat Enterprise Linux 8 porque no se utiliza el mismo gestor de arranque en todas las arquitecturas. GRUB2 se utiliza en la mayoría de ellas como el ARM de 64 bits, pero las variantes little-endian de IBM Power Systems con Open Power Abstraction Layer (OPAL) utiliza Petitboot y la arquitectura IBM Z utiliza zipl.

Recursos adicionales

-

Para más información sobre la utilidad de

grubby, consulte Qué es el grubby. - Para más detalles sobre las entradas de arranque, consulte Qué son las entradas de arranque

-

Para más detalles, consulte la página del manual

grubby(8).

3.3. Dependencias de los módulos del núcleo

Algunos módulos del kernel a veces dependen de uno o más módulos del kernel. El archivo /lib/modules/<KERNEL_VERSION>/modules.dep contiene una lista completa de las dependencias de los módulos del núcleo para la versión respectiva del mismo.

El archivo de dependencias es generado por el programa depmod, que forma parte del paquete kmod. Muchas de las utilidades proporcionadas por kmod tienen en cuenta las dependencias de los módulos a la hora de realizar operaciones, por lo que el seguimiento de las dependencias de manual rara vez es necesario.

El código de los módulos del kernel se ejecuta en el espacio del kernel en modo no restringido. Por ello, debes tener en cuenta qué módulos estás cargando.

Recursos adicionales

-

Para más información sobre

/lib/modules/<KERNEL_VERSION>/modules.dep, consulte la página del manualmodules.dep(5). -

Para más detalles, incluyendo la sinopsis y las opciones de

depmod, consulte la página del manualdepmod(8).

3.4. Listado de los módulos del kernel actualmente cargados

El siguiente procedimiento describe cómo ver los módulos del kernel actualmente cargados.

Requisitos previos

-

El paquete

kmodestá instalado.

Procedimiento

Para listar todos los módulos del kernel actualmente cargados, ejecute

$ lsmod Module Size Used by fuse 126976 3 uinput 20480 1 xt_CHECKSUM 16384 1 ipt_MASQUERADE 16384 1 xt_conntrack 16384 1 ipt_REJECT 16384 1 nft_counter 16384 16 nf_nat_tftp 16384 0 nf_conntrack_tftp 16384 1 nf_nat_tftp tun 49152 1 bridge 192512 0 stp 16384 1 bridge llc 16384 2 bridge,stp nf_tables_set 32768 5 nft_fib_inet 16384 1 …En el ejemplo anterior:

- La primera columna proporciona la names de los módulos cargados actualmente.

- La segunda columna muestra la cantidad de memory por módulo en kilobytes.

- La última columna muestra el número y, opcionalmente, los nombres de los módulos que son dependent en un módulo particular.

Recursos adicionales

-

Para más información sobre

kmod, consulte el archivo/usr/share/doc/kmod/READMEo la página del manuallsmod(8).

3.5. Listado de todos los kernels instalados

El siguiente procedimiento describe cómo utilizar la herramienta de línea de comandos grubby para listar las entradas de arranque de GRUB2.

Procedimiento

Para listar las entradas de arranque del kernel:

Para listar las entradas de arranque del kernel, ejecute

# grubby --info=ALL | grep titleEl comando muestra las entradas de arranque del kernel. El campo

kernelmuestra la ruta del kernel.El siguiente procedimiento describe cómo utilizar la utilidad

grubbypara listar todos los kernels instalados en sus sistemas utilizando la línea de comandos del kernel.

Como ejemplo, considere la lista grubby-8.40-17, en el menú Grub2 tanto en las instalaciones BLS como en las que no lo son.

Procedimiento

Para listar todos los módulos del kernel instalados:

Ejecute el siguiente comando:

# grubby --info=ALL | grep titleLa lista de todos los kernels instalados se muestra de la siguiente manera:

title=Red Hat Enterprise Linux (4.18.0-20.el8.x86_64) 8.0 (Ootpa) title=Red Hat Enterprise Linux (4.18.0-19.el8.x86_64) 8.0 (Ootpa) title=Red Hat Enterprise Linux (4.18.0-12.el8.x86_64) 8.0 (Ootpa) title=Red Hat Enterprise Linux (4.18.0) 8.0 (Ootpa) title=Red Hat Enterprise Linux (0-rescue-2fb13ddde2e24fde9e6a246a942caed1) 8.0 (Ootpa)

La salida anterior muestra la lista de todos los kernels instalados para grubby-8.40-17, utilizando el menú Grub2.

3.6. Establecer un núcleo por defecto

El siguiente procedimiento describe cómo establecer un núcleo específico como predeterminado utilizando la herramienta de línea de comandos grubby y GRUB2.

Procedimiento

- Configurar el kernel como predeterminado, utilizando la herramienta

grubby -

Ejecute el siguiente comando para establecer el kernel como predeterminado utilizando la herramienta

grubby:

# grubby --set-default $kernel_pathEl comando utiliza como argumento un ID de máquina sin el sufijo

.conf.NotaEl ID de la máquina se encuentra en el directorio

/boot/loader/entries/.-

Ejecute el siguiente comando para establecer el kernel como predeterminado utilizando la herramienta

- Establecer el núcleo por defecto, utilizando el argumento

id -

Enumera las entradas de arranque utilizando el argumento

idy luego establece un núcleo previsto como predeterminado:

# grubby --info ALL | grep id # grubby --set-default /boot/vmlinuz-<version>.<architecture>

NotaPara listar las entradas de arranque utilizando el argumento

title, ejecute el comando# grubby --info=ALL | grep titlecomando.-

Enumera las entradas de arranque utilizando el argumento

- Establecer el kernel por defecto sólo para el siguiente arranque

-

Ejecute el siguiente comando para establecer el kernel por defecto sólo para el próximo reinicio utilizando el comando

grub2-reboot:

# grub2-reboot <index|title|id>AvisoEstablezca el kernel por defecto sólo para el siguiente arranque con cuidado. La instalación de nuevos RPM del kernel, kernels autoconstruidos y la adición manual de las entradas al directorio

/boot/loader/entries/pueden cambiar los valores del índice.-

Ejecute el siguiente comando para establecer el kernel por defecto sólo para el próximo reinicio utilizando el comando

3.7. Visualización de información sobre los módulos del kernel

Cuando se trabaja con un módulo del núcleo, es posible que se quiera ver más información sobre ese módulo. Este procedimiento describe cómo mostrar información adicional sobre los módulos del núcleo.

Requisitos previos

-

El paquete

kmodestá instalado.

Procedimiento

Para mostrar información sobre cualquier módulo del kernel, ejecute

$ modinfo <KERNEL_MODULE_NAME> For example: $ modinfo virtio_net filename: /lib/modules/4.18.0-94.el8.x86_64/kernel/drivers/net/virtio_net.ko.xz license: GPL description: Virtio network driver rhelversion: 8.1 srcversion: 2E9345B281A898A91319773 alias: virtio:d00000001v* depends: net_failover intree: Y name: virtio_net vermagic: 4.18.0-94.el8.x86_64 SMP mod_unload modversions … parm: napi_weight:int parm: csum:bool parm: gso:bool parm: napi_tx:bool

El comando

modinfomuestra información detallada sobre el módulo del núcleo especificado. Puede consultar información sobre todos los módulos disponibles, independientemente de si están cargados o no. Las entradas deparmmuestran los parámetros que el usuario puede establecer para el módulo, y qué tipo de valor esperan.NotaCuando introduzca el nombre de un módulo del núcleo, no añada la extensión

.ko.xzal final del nombre. Los nombres de los módulos del núcleo no tienen extensiones; sus archivos correspondientes sí.

Recursos adicionales

-

Para más información sobre el

modinfo, consulte la página del manualmodinfo(8).

3.8. Carga de módulos del kernel en tiempo de ejecución del sistema

La forma óptima de ampliar la funcionalidad del núcleo de Linux es cargando módulos del núcleo. El siguiente procedimiento describe cómo utilizar el comando modprobe para encontrar y cargar un módulo del kernel en el kernel que se está ejecutando actualmente.

Requisitos previos

- Permisos de la raíz

-

El paquete

kmodestá instalado. - El módulo del núcleo correspondiente no está cargado. Para asegurarse de ello, liste los módulos del kernel cargados.

Procedimiento

Seleccione un módulo del kernel que desee cargar.

Los módulos se encuentran en el directorio

/lib/modules/$(uname -r)/kernel/<SUBSYSTEM>/.Cargue el módulo del kernel correspondiente:

# modprobe <MODULE_NAME>NotaCuando introduzca el nombre de un módulo del núcleo, no añada la extensión

.ko.xzal final del nombre. Los nombres de los módulos del núcleo no tienen extensiones; sus archivos correspondientes sí.Opcionalmente, verifique que se cargó el módulo correspondiente:

$ lsmod | grep <MODULE_NAME>Si el módulo se ha cargado correctamente, este comando muestra el módulo del kernel correspondiente. Por ejemplo:

$ lsmod | grep serio_raw serio_raw 16384 0

Los cambios descritos en este procedimiento will not persist después de reiniciar el sistema.

Recursos adicionales

-

Para más detalles sobre

modprobe, consulte la página del manualmodprobe(8).

3.9. Descarga de módulos del kernel en tiempo de ejecución del sistema

A veces, se encuentra que necesita descargar ciertos módulos del kernel del kernel en ejecución. El siguiente procedimiento describe cómo utilizar el comando modprobe para encontrar y descargar un módulo del kernel en tiempo de ejecución del sistema del kernel actualmente cargado.

Requisitos previos

- Permisos de la raíz

-

El paquete

kmodestá instalado.

Procedimiento

Ejecute el comando

lsmody seleccione un módulo del kernel que desee descargar.Si un módulo del núcleo tiene dependencias, descárguelas antes de descargar el módulo del núcleo. Para más detalles sobre la identificación de módulos con dependencias, consulte Sección 3.4, “Listado de los módulos del kernel actualmente cargados”.

Descargue el módulo del kernel correspondiente:

# modprobe -r <MODULE_NAME>Cuando introduzca el nombre de un módulo del núcleo, no añada la extensión

.ko.xzal final del nombre. Los nombres de los módulos del núcleo no tienen extensiones; sus archivos correspondientes sí.AvisoNo descargue los módulos del kernel cuando sean utilizados por el sistema en funcionamiento. Hacerlo puede llevar a un sistema inestable o no operativo.

Opcionalmente, verifique que el módulo correspondiente fue descargado:

$ lsmod | grep <MODULE_NAME>Si el módulo se ha descargado con éxito, este comando no muestra ninguna salida.

Después de terminar este procedimiento, los módulos del kernel que están definidos para cargarse automáticamente en el arranque, will not stay unloaded después de reiniciar el sistema. Para obtener información sobre cómo contrarrestar este resultado, consulte Evitar que los módulos del kernel se carguen automáticamente al arrancar el sistema.

Recursos adicionales

-

Para más detalles sobre

modprobe, consulte la página del manualmodprobe(8).

3.10. Carga automática de los módulos del kernel en el arranque del sistema

El siguiente procedimiento describe cómo configurar un módulo del kernel para que se cargue automáticamente durante el proceso de arranque.

Requisitos previos

- Permisos de la raíz

-

El paquete

kmodestá instalado.

Procedimiento

Seleccione un módulo del kernel que desee cargar durante el proceso de arranque.

Los módulos se encuentran en el directorio

/lib/modules/$(uname -r)/kernel/<SUBSYSTEM>/.Crear un archivo de configuración para el módulo:

# echo <MODULE_NAME> > /etc/modules-load.d/<MODULE_NAME>.confNotaCuando introduzca el nombre de un módulo del núcleo, no añada la extensión

.ko.xzal final del nombre. Los nombres de los módulos del núcleo no tienen extensiones; sus archivos correspondientes sí.Opcionalmente, después de reiniciar, verifique que se cargó el módulo correspondiente:

$ lsmod | grep <MODULE_NAME>El comando de ejemplo anterior debería tener éxito y mostrar el módulo del kernel correspondiente.

Los cambios descritos en este procedimiento will persist después de reiniciar el sistema.

Recursos adicionales

-

Para más detalles sobre la carga de módulos del kernel durante el proceso de arranque, consulte la página del manual

modules-load.d(5).

3.11. Evitar que los módulos del kernel se carguen automáticamente al arrancar el sistema

El siguiente procedimiento describe cómo añadir un módulo del kernel a una denylist para que no se cargue automáticamente durante el proceso de arranque.

Requisitos previos

- Permisos de la raíz

-

El paquete

kmodestá instalado. - Asegúrese de que un módulo del núcleo en una lista de denegación no es vital para la configuración actual de su sistema.

Procedimiento

Seleccione un módulo del kernel que quiera poner en una denylist:

$ lsmod Module Size Used by fuse 126976 3 xt_CHECKSUM 16384 1 ipt_MASQUERADE 16384 1 uinput 20480 1 xt_conntrack 16384 1 …El comando

lsmodmuestra una lista de módulos cargados en el kernel que se está ejecutando actualmente.Alternativamente, identifique un módulo del kernel no cargado que quiera evitar que se cargue potencialmente.

Todos los módulos del núcleo se encuentran en el directorio

/lib/modules/<KERNEL_VERSION>/kernel/<SUBSYSTEM>/.

Crear un archivo de configuración para una lista de denegación:

# vim /etc/modprobe.d/blacklist.conf # Blacklists <KERNEL_MODULE_1> blacklist <MODULE_NAME_1> install <MODULE_NAME_1> /bin/false # Blacklists <KERNEL_MODULE_2> blacklist <MODULE_NAME_2> install <MODULE_NAME_2> /bin/false # Blacklists <KERNEL_MODULE_n> blacklist <MODULE_NAME_n> install <MODULE_NAME_n> /bin/false …

El ejemplo muestra el contenido del archivo

blacklist.conf, editado por el editorvim. La líneablacklistasegura que el módulo del kernel relevante no se cargará automáticamente durante el proceso de arranque. El comandoblacklist, sin embargo, no evita que el módulo se cargue como dependencia de otro módulo del kernel que no esté en una denylist. Por lo tanto, la líneainstallhace que se ejecute el/bin/falseen lugar de instalar un módulo.Las líneas que comienzan con un signo de almohadilla son comentarios para hacer el archivo más legible.

NotaCuando introduzca el nombre de un módulo del núcleo, no añada la extensión

.ko.xzal final del nombre. Los nombres de los módulos del núcleo no tienen extensiones; sus archivos correspondientes sí.Cree una copia de seguridad de la imagen inicial del ramdisk actual antes de reconstruirlo:

# cp /boot/initramfs-$(uname -r).img /boot/initramfs-$(uname -r).bak.$(date %m-\r%H%M%S).imgEl comando anterior crea una imagen de copia de seguridad

initramfsen caso de que la nueva versión tenga un problema inesperado.Alternativamente, cree una copia de seguridad de otra imagen inicial de ramdisk que corresponda a la versión del kernel para la que quiere poner los módulos del kernel en una denylist:

# cp /boot/initramfs-<SOME_VERSION>.img /boot/initramfs-<SOME_VERSION>.img.bak.$(date %m-\r%H%M%S)

Genera una nueva imagen inicial de ramdisk para reflejar los cambios:

# dracut -f -vSi está construyendo una imagen inicial de ramdisk para una versión de kernel diferente a la que está arrancando actualmente, especifique tanto el destino

initramfscomo la versión del kernel:# dracut -f -v /boot/initramfs-<TARGET_VERSION>.img <CORRESPONDING_TARGET_KERNEL_VERSION>

Reinicia el sistema:

$ reboot

Los cambios descritos en este procedimiento will take effect and persist después de reiniciar el sistema. Si coloca incorrectamente un módulo clave del kernel en una lista de denegación, puede enfrentarse a un sistema inestable o no operativo.

Recursos adicionales

-

Para más detalles sobre la utilidad

dracut, consulte la página del manualdracut(8).

3.12. Firma de módulos del kernel para el arranque seguro

Puede mejorar la seguridad de su sistema utilizando módulos del kernel firmados. Las siguientes secciones describen cómo autofirmar los módulos del kernel construidos de forma privada para su uso con RHEL 8 en sistemas de construcción basados en UEFI en los que está habilitado el arranque seguro. Estas secciones también proporcionan una visión general de las opciones disponibles para importar su clave pública en un sistema de destino en el que desee desplegar sus módulos del kernel.

Para firmar y cargar los módulos del kernel, es necesario:

Si el Arranque Seguro está habilitado, los cargadores de arranque del sistema operativo UEFI, el kernel de Red Hat Enterprise Linux y todos los módulos del kernel tienen que ser firmados con una clave privada y autenticados con la clave pública correspondiente. Si no están firmados y autenticados, el sistema no podrá terminar el proceso de arranque.

La distribución RHEL 8 incluye:

- Cargadores de arranque firmados

- Granos firmados

- Módulos del kernel firmados

Además, el cargador de arranque de primera etapa firmado y el kernel firmado incluyen claves públicas de Red Hat incrustadas. Estos binarios ejecutables firmados y las claves incrustadas permiten que RHEL 8 se instale, arranque y ejecute con las claves de la Autoridad de Certificación de Arranque Seguro de Microsoft UEFI que son proporcionadas por el firmware UEFI en los sistemas que soportan el Arranque Seguro UEFI. Tenga en cuenta que no todos los sistemas basados en UEFI incluyen soporte para Secure Boot.

Requisitos previos

Para poder firmar módulos del kernel construidos externamente, instale en el sistema de compilación las utilidades que se indican en la siguiente tabla.

Tabla 3.1. Servicios públicos necesarios

| Utilidad | Proporcionado por el paquete | Utilizado en | Propósito |

|---|---|---|---|

|

|

| Sistema de construcción | Genera un par de claves X.509 públicas y privadas |

|

|

| Sistema de construcción | Archivo ejecutable utilizado para firmar un módulo del kernel con la clave privada |

|

|

| Sistema objetivo | Utilidad opcional utilizada para inscribir manualmente la clave pública |

|

|

| Sistema objetivo | Utilidad opcional utilizada para mostrar las claves públicas en el llavero del sistema |

El sistema de compilación, donde se construye y firma el módulo del kernel, no necesita tener habilitado el arranque seguro de UEFI y ni siquiera necesita ser un sistema basado en UEFI.

3.12.1. Autenticación de módulos del núcleo con claves X.509

En RHEL 8, cuando se carga un módulo del núcleo, éste comprueba la firma del módulo con las claves públicas X.509 del llavero del sistema del núcleo (.builtin_trusted_keys) y del llavero de la plataforma del núcleo (.platform). El llavero .platform contiene claves de proveedores de plataforma de terceros y claves públicas personalizadas. Las claves del llavero del sistema del kernel .blacklist están excluidas de la verificación. Las siguientes secciones ofrecen una visión general de las fuentes de claves, los llaveros y ejemplos de claves cargadas de diferentes fuentes en el sistema. Además, puedes ver cómo autenticar un módulo del kernel.

3.12.1.1. Requisitos de autentificación

Es necesario cumplir ciertas condiciones para cargar módulos del kernel en sistemas con la funcionalidad UEFI Secure Boot activada.

Si el arranque seguro de UEFI está activado o si se ha especificado el parámetro de kernel module.sig_enforce:

-

Sólo puede cargar aquellos módulos del kernel firmados cuyas firmas fueron autenticadas contra claves del llavero del sistema (

.builtin_trusted_keys) y del llavero de la plataforma (.platform). -

La clave pública no debe estar en el llavero de claves revocadas del sistema (

.blacklist).

Si el arranque seguro de UEFI está desactivado y no se ha especificado el parámetro de kernel module.sig_enforce:

- Puedes cargar módulos del núcleo sin firmar y módulos del núcleo firmados sin clave pública.

Si el sistema no está basado en UEFI o si el arranque seguro de UEFI está desactivado:

-

En

.builtin_trusted_keysy.platformsólo se cargan las claves incrustadas en el núcleo. - No se puede aumentar ese conjunto de claves sin reconstruir el núcleo.

Tabla 3.2. Requisitos de autentificación del módulo del kernel para la carga

| Módulo firmado | Clave pública encontrada y firma válida | Estado de arranque seguro UEFI | sig_enforce | Carga del módulo | Núcleo contaminado |

|---|---|---|---|---|---|

| Sin firma | - | No habilitado | No habilitado | Tiene éxito | Sí |

| No habilitado | Activado | Falla | - | ||

| Activado | - | Falla | - | ||

| Firmado | No | No habilitado | No habilitado | Tiene éxito | Sí |

| No habilitado | Activado | Falla | - | ||

| Activado | - | Falla | - | ||

| Firmado | Sí | No habilitado | No habilitado | Tiene éxito | No |

| No habilitado | Activado | Tiene éxito | No | ||

| Activado | - | Tiene éxito | No |

3.12.1.2. Fuentes de claves públicas

Durante el arranque, el kernel carga claves X.509 de un conjunto de almacenes de claves persistentes en los siguientes llaveros:

-

El llavero del sistema (

.builtin_trusted_keys) -

El llavero

.platform -

El sistema

.blacklistllavero

Tabla 3.3. Fuentes de los llaveros del sistema

| Fuente de claves X.509 | El usuario puede añadir llaves | Estado de arranque seguro UEFI | Teclas cargadas durante el arranque |

|---|---|---|---|

| Integrado en el núcleo | No | - |

|

| UEFI Secure Boot "db" | Limitado | No habilitado | No |

| Activado |

| ||

|

Integrado en el cargador de arranque | No | No habilitado | No |

| Activado |

| ||

| Lista de claves del propietario de la máquina (MOK) | Sí | No habilitado | No |

| Activado |

|

.builtin_trusted_keys:

- un llavero que se construye en el arranque

- contiene claves públicas de confianza

-

los privilegios de

rootson necesarios para ver las claves

.platform:

- un llavero que se construye en el arranque

- contiene claves de proveedores de plataformas de terceros y claves públicas personalizadas

-

los privilegios de

rootson necesarios para ver las claves

.blacklist

- un llavero con claves X.509 que han sido revocadas

-

un módulo firmado por una clave de

.blacklistfallará la autenticación incluso si su clave pública está en.builtin_trusted_keys

UEFI Secure Boot db:

- una base de datos de firmas

- almacena las claves (hashes) de las aplicaciones UEFI, los controladores UEFI y los cargadores de arranque

- las llaves se pueden cargar en la máquina

UEFI Secure Boot dbx:

- una base de datos de firmas revocadas

- impide que se carguen las llaves

-

las claves revocadas de esta base de datos se añaden al llavero

.blacklist

3.12.1.3. Generar un par de claves públicas y privadas

Necesita generar un par de claves X.509 públicas y privadas para tener éxito en sus esfuerzos de utilizar módulos del kernel en un sistema habilitado para el Arranque Seguro. Más tarde utilizará la clave privada para firmar el módulo del kernel. También tendrá que añadir la clave pública correspondiente a la Clave del Propietario de la Máquina (MOK) para el Arranque Seguro para validar el módulo firmado.

Algunos de los parámetros para esta generación de pares de claves se especifican mejor con un archivo de configuración.

Procedimiento

Crear un archivo de configuración con parámetros para la generación de pares de claves:

# cat << EOF > configuration_file.config [ req ] default_bits = 4096 distinguished_name = req_distinguished_name prompt = no string_mask = utf8only x509_extensions = myexts [ req_distinguished_name ] O = Organization CN = Organization signing key emailAddress = E-mail address [ myexts ] basicConstraints=critical,CA:FALSE keyUsage=digitalSignature subjectKeyIdentifier=hash authorityKeyIdentifier=keyid EOF

Cree un par de claves públicas y privadas X.509 como se muestra en el siguiente ejemplo:

# openssl req -x509 -new -nodes -utf8 -sha256 -days 36500 \ -batch -config configuration_file.config -outform DER \ -out my_signing_key_pub.der \ -keyout my_signing_key.privLa clave pública se escribirá en el archivo

my_signing_key_pub.dery la clave privada se escribirá en el archivomy_signing_key.privarchivo.ImportanteEn RHEL 8, las fechas de validez del par de claves son importantes. La clave no caduca, pero el módulo del núcleo debe ser firmado dentro del período de validez de su clave de firma. Por ejemplo, una clave que sólo es válida en 2019 puede utilizarse para autenticar un módulo del núcleo firmado en 2019 con esa clave. Sin embargo, los usuarios no pueden utilizar esa clave para firmar un módulo del núcleo en 2020.

Opcionalmente, puede revisar las fechas de validez de sus claves públicas como en el ejemplo siguiente:

# openssl x509 -inform der -text -noout -in <my_signing_key_pub.der> Validity Not Before: Feb 14 16:34:37 2019 GMT Not After : Feb 11 16:34:37 2029 GMT- Registre su clave pública en todos los sistemas en los que desee autenticarse y cargue su módulo del kernel.

Aplique fuertes medidas de seguridad y políticas de acceso para proteger el contenido de su clave privada. En las manos equivocadas, la clave podría utilizarse para comprometer cualquier sistema que esté autenticado por la clave pública correspondiente.

Recursos adicionales

-

Para más información sobre la utilidad

openssl, consulte la página del manualopenssl(1). -

Para más información sobre el uso de

openssl, consulte el RHEL Security Guide - Para más detalles sobre la inscripción de claves públicas en los sistemas de destino, consulte Sección 3.12.3.2, “Añadir manualmente la clave pública a la lista MOK”.

3.12.2. Ejemplo de salida de los llaveros del sistema

Puedes mostrar información sobre las llaves de los llaveros del sistema utilizando la utilidad keyctl.

El siguiente es un ejemplo abreviado de la salida de los llaveros .builtin_trusted_keys, .platform, y .blacklist de un sistema RHEL 8 donde el arranque seguro UEFI está habilitado.

# keyctl list %:.builtin_trusted_keys 6 keys in keyring: ...asymmetric: Red Hat Enterprise Linux Driver Update Program (key 3): bf57f3e87... ...asymmetric: Red Hat Secure Boot (CA key 1): 4016841644ce3a810408050766e8f8a29... ...asymmetric: Microsoft Corporation UEFI CA 2011: 13adbf4309bd82709c8cd54f316ed... ...asymmetric: Microsoft Windows Production PCA 2011: a92902398e16c49778cd90f99e... ...asymmetric: Red Hat Enterprise Linux kernel signing key: 4249689eefc77e95880b... ...asymmetric: Red Hat Enterprise Linux kpatch signing key: 4d38fd864ebe18c5f0b7... # keyctl list %:.platform 4 keys in keyring: ...asymmetric: VMware, Inc.: 4ad8da0472073... ...asymmetric: Red Hat Secure Boot CA 5: cc6fafe72... ...asymmetric: Microsoft Windows Production PCA 2011: a929f298e1... ...asymmetric: Microsoft Corporation UEFI CA 2011: 13adbf4e0bd82... # keyctl list %:.blacklist 4 keys in keyring: ...blacklist: bin:f5ff83a... ...blacklist: bin:0dfdbec... ...blacklist: bin:38f1d22... ...blacklist: bin:51f831f...

El llavero .builtin_trusted_keys de arriba muestra la adición de dos claves de la UEFI Secure Boot \ "db", así como la Red Hat Secure Boot (CA key 1), que está incrustado en el cargador de arranque shim.efi.

El siguiente ejemplo muestra la salida de la consola del kernel. Los mensajes identifican las claves con una fuente relacionada con UEFI Secure Boot. Estos incluyen UEFI Secure Boot db, shim incrustado, y la lista MOK.

# dmesg | grep 'EFI: Loaded cert'

[5.160660] EFI: Loaded cert 'Microsoft Windows Production PCA 2011: a9290239...

[5.160674] EFI: Loaded cert 'Microsoft Corporation UEFI CA 2011: 13adbf4309b...

[5.165794] EFI: Loaded cert 'Red Hat Secure Boot (CA key 1): 4016841644ce3a8...Recursos adicionales

-

Para más información sobre

keyctl, consulte la página del manualkeyctl(1). -

Para más información sobre

dmesg, consulte la página del manualdmesg(1).

3.12.3. Inscripción de la clave pública en el sistema de destino

Cuando RHEL 8 arranca en un sistema basado en UEFI con Secure Boot activado, el kernel carga en el llavero del sistema (.builtin_trusted_keys) todas las claves públicas que están en la base de datos de claves db de Secure Boot. Al mismo tiempo, el kernel excluye las claves de la base de datos dbx de claves revocadas. Las secciones siguientes describen diferentes maneras de importar una clave pública en un sistema de destino para que el llavero del sistema (.builtin_trusted_keys) sea capaz de utilizar la clave pública para autenticar un módulo del kernel.

3.12.3.1. Imagen de firmware de fábrica que incluye la clave pública

Para facilitar la autenticación de su módulo de kernel en sus sistemas, considere solicitar a su proveedor de sistemas que incorpore su clave pública en la base de datos de claves de arranque seguro de UEFI en su imagen de firmware de fábrica.

3.12.3.2. Añadir manualmente la clave pública a la lista MOK

La función de la llave del propietario de la máquina (MOK) se puede utilizar para ampliar la base de datos de claves de arranque seguro de UEFI. Cuando RHEL 8 arranca en un sistema habilitado para UEFI con Secure Boot activado, las claves de la lista MOK también se añaden al llavero del sistema (.builtin_trusted_keys) además de las claves de la base de datos de claves. Las claves de la lista MOK también se almacenan de forma persistente y segura de la misma manera que las claves de la base de datos de Secure Boot, pero se trata de dos instalaciones distintas. La facilidad MOK es soportada por shim.efi, MokManager.efi, grubx64.efi, y la utilidad mokutil.

La inscripción de una clave MOK requiere la interacción manual de un usuario en la consola del sistema UEFI en cada sistema de destino. Sin embargo, la instalación MOK proporciona un método conveniente para probar los pares de claves recién generados y probar los módulos del kernel firmados con ellos.

Procedimiento

Solicite la adición de su clave pública a la lista MOK:

# mokutil --import my_signing_key_pub.derSe le pedirá que introduzca y confirme una contraseña para esta solicitud de inscripción en el MOK.

Reinicie la máquina.

La solicitud de inscripción de clave MOK pendiente será notada por

shim.efiy lanzaráMokManager.efipara permitirle completar la inscripción desde la consola UEFI.Introduzca la contraseña que ha asociado previamente a esta solicitud y confirme la inscripción.

Su clave pública se añade a la lista MOK, que es persistente.

Una vez que una clave está en la lista MOK, se propagará automáticamente al llavero del sistema en este y en los siguientes arranques cuando el arranque seguro UEFI esté habilitado.

3.12.4. Firma de los módulos del kernel con la clave privada

Los usuarios pueden obtener mayores beneficios de seguridad en sus sistemas cargando módulos del kernel firmados si el mecanismo de arranque seguro de UEFI está habilitado. Las siguientes secciones describen cómo firmar los módulos del kernel con la clave privada.

Requisitos previos

- Ha generado un par de claves públicas y privadas y conoce las fechas de validez de sus claves públicas. Para más detalles, consulte Sección 3.12.1.3, “Generar un par de claves públicas y privadas”.

- Ha registrado su clave pública en el sistema de destino. Para más detalles, consulte Sección 3.12.3, “Inscripción de la clave pública en el sistema de destino”.

- Tienes un módulo del kernel en formato de imagen ELF disponible para firmar.

Procedimiento

Ejecute la utilidad

sign-filecon los parámetros que se muestran en el siguiente ejemplo:# /usr/src/kernels/$(uname -r)/scripts/sign-file \ sha256 \ my_signing_key.priv \ my_signing_key_pub.der \ my_module.kosign-filecalcula y añade la firma directamente a la imagen ELF en su archivo de módulo del kernel. La utilidadmodinfopuede utilizarse para mostrar información sobre la firma del módulo del núcleo, si está presente.NotaLa firma anexa no está contenida en una sección de la imagen ELF y no es una parte formal de la imagen ELF. Por lo tanto, utilidades como

readelfno podrán mostrar la firma en su módulo del kernel.Su módulo del kernel está ahora listo para ser cargado. Tenga en cuenta que su módulo del kernel firmado también se puede cargar en sistemas en los que el arranque seguro de UEFI está deshabilitado o en un sistema no UEFI. Esto significa que no necesita proporcionar una versión firmada y otra sin firmar de su módulo del kernel.

ImportanteEn RHEL 8, las fechas de validez del par de claves son importantes. La clave no caduca, pero el módulo del kernel debe ser firmado dentro del periodo de validez de su clave de firma. La utilidad

sign-fileno le advertirá de esto. Por ejemplo, una clave que sólo es válida en 2019 puede utilizarse para autenticar un módulo del núcleo firmado en 2019 con esa clave. Sin embargo, los usuarios no pueden utilizar esa clave para firmar un módulo del núcleo en 2020.

Recursos adicionales

-

Para más detalles sobre el uso de

modinfopara obtener información sobre los módulos del núcleo, consulte Sección 3.7, “Visualización de información sobre los módulos del kernel”.

3.12.5. Carga de módulos del kernel firmados

Una vez que su clave pública está inscrita en el llavero del sistema (.builtin_trusted_keys) y en la lista MOK, y después de haber firmado el módulo del núcleo respectivo con su clave privada, puede finalmente cargar su módulo del núcleo firmado con el comando modprobe como se describe en la siguiente sección.

Requisitos previos

- Ha generado el par de claves públicas y privadas. Para más detalles, consulte Sección 3.12.1.3, “Generar un par de claves públicas y privadas”.

- Ha registrado la clave pública en el llavero del sistema. Para más detalles, consulte Sección 3.12.3.2, “Añadir manualmente la clave pública a la lista MOK”.

- Ha firmado un módulo del kernel con la clave privada. Para más detalles, consulte Sección 3.12.4, “Firma de los módulos del kernel con la clave privada”.

Procedimiento

Compruebe que sus claves públicas están en el llavero del sistema:

# keyctl list %:.builtin_trusted_keysCopie el módulo del núcleo en el directorio

/extra/del núcleo que desee:# cp my_module.ko /lib/modules/$(uname -r)/extra/Actualizar la lista de dependencias modulares:

# depmod -aCargue el módulo del kernel y compruebe que se ha cargado correctamente:

# modprobe -v my_module # lsmod | grep my_module

Opcionalmente, para cargar el módulo en el arranque, añádalo al archivo

/etc/modules-loaded.d/my_module.conf:# echo "my_module" > /etc/modules-load.d/my_module.conf

Recursos adicionales

- Para más información sobre la carga de módulos del núcleo, consulte las secciones correspondientes de Capítulo 3, Gestión de los módulos del núcleo.

Capítulo 4. Configuración de los parámetros de la línea de comandos del kernel

Los parámetros de la línea de comandos del kernel son una forma de cambiar el comportamiento de ciertos aspectos del kernel de Red Hat Enterprise Linux en el momento del arranque. Como administrador del sistema, usted tiene el control total sobre las opciones que se establecen en el arranque. Ciertos comportamientos del kernel sólo pueden establecerse en el momento del arranque, por lo que entender cómo hacer estos cambios es una habilidad clave para la administración.

Optar por cambiar el comportamiento del sistema modificando los parámetros de la línea de comandos del kernel puede tener efectos negativos en su sistema. Por lo tanto, debería probar los cambios antes de desplegarlos en producción. Para obtener más orientación, póngase en contacto con el Soporte de Red Hat.

4.1. Comprender los parámetros de la línea de comandos del kernel

Los parámetros de la línea de comandos del kernel se utilizan para la configuración del tiempo de arranque de:

- El núcleo de Red Hat Enterprise Linux

- El disco RAM inicial

- Las características del espacio del usuario

Los parámetros del tiempo de arranque del kernel se utilizan a menudo para sobrescribir los valores por defecto y para establecer configuraciones específicas del hardware.

Por defecto, los parámetros de la línea de comandos del kernel para los sistemas que utilizan el gestor de arranque GRUB2 se definen en la variable kernelopts del archivo /boot/grub2/grubenv para todas las entradas de arranque del kernel.

Para IBM Z, los parámetros de la línea de comandos del kernel se almacenan en el archivo de configuración de la entrada de arranque porque el cargador de arranque zipl no admite variables de entorno. Por lo tanto, no se puede utilizar la variable de entorno kernelopts.

Recursos adicionales

-

Para más información sobre los parámetros de la línea de comandos del kernel que puede modificar, consulte las páginas de manual

kernel-command-line(7),bootparam(7)ydracut.cmdline(7). -

Para más información sobre la variable

kernelopts, consulte el artículo de la base de conocimientos, Cómo instalar y arrancar kernels personalizados en Red Hat Enterprise Linux 8.

4.2. Lo que es mugriento

grubby es una utilidad para manipular archivos de configuración específicos del cargador de arranque.

Puede utilizar grubby también para cambiar la entrada de arranque por defecto, y para añadir/eliminar argumentos de una entrada de menú de GRUB2.

Para más detalles, consulte la página del manual grubby(8).

4.3. Qué son las entradas de arranque

Una entrada de arranque es una colección de opciones que se almacenan en un archivo de configuración y están vinculadas a una versión particular del kernel. En la práctica, tiene al menos tantas entradas de arranque como núcleos instalados tenga su sistema. El archivo de configuración de la entrada de arranque se encuentra en el directorio /boot/loader/entries/ y puede tener el siguiente aspecto:

6f9cc9cb7d7845d49698c9537337cedc-4.18.0-5.el8.x86_64.conf

El nombre del archivo anterior consiste en un ID de máquina almacenado en el archivo /etc/machine-id, y una versión del kernel.

El archivo de configuración de la entrada de arranque contiene información sobre la versión del kernel, la imagen inicial del ramdisk y la variable de entorno kernelopts, que contiene los parámetros de la línea de comandos del kernel. El contenido de una configuración de entrada de arranque se puede ver a continuación:

title Red Hat Enterprise Linux (4.18.0-74.el8.x86_64) 8.0 (Ootpa) version 4.18.0-74.el8.x86_64 linux /vmlinuz-4.18.0-74.el8.x86_64 initrd /initramfs-4.18.0-74.el8.x86_64.img $tuned_initrd options $kernelopts $tuned_params id rhel-20190227183418-4.18.0-74.el8.x86_64 grub_users $grub_users grub_arg --unrestricted grub_class kernel

La variable de entorno kernelopts se define en el archivo /boot/grub2/grubenv.

Recursos adicionales

Para más información sobre la variable kernelopts, consulte el artículo de la base de conocimientos Cómo instalar y arrancar kernels personalizados en Red Hat Enterprise Linux 8.

4.4. Configuración de los parámetros de la línea de comandos del kernel

Para ajustar el comportamiento de su sistema desde las primeras etapas del proceso de arranque, necesita establecer ciertos parámetros de la línea de comandos del kernel.

Esta sección explica cómo cambiar los parámetros de la línea de comandos del kernel en varias arquitecturas de CPU.

4.4.1. Cambio de los parámetros de la línea de comandos del kernel para todas las entradas de arranque

Este procedimiento describe cómo cambiar los parámetros de la línea de comandos del kernel para todas las entradas de arranque de su sistema.

Requisitos previos

-

Compruebe que las utilidades

grubbyyziplestán instaladas en su sistema.

Procedimiento

Para añadir un parámetro:

# grubby --update-kernel=ALL --args="<NEW_PARAMETER>"Para los sistemas que utilizan el gestor de arranque GRUB2, el comando actualiza el archivo

/boot/grub2/grubenvañadiendo un nuevo parámetro del kernel a la variablekerneloptsde ese archivo.En los IBM Z que utilizan el cargador de arranque zIPL, el comando añade un nuevo parámetro del kernel a cada

/boot/loader/entries/<ENTRY>.confarchivo.-

En IBM Z, ejecute el comando

ziplsin opciones para actualizar el menú de arranque.

-

En IBM Z, ejecute el comando

Para eliminar un parámetro:

# grubby --update-kernel=ALL --remove-args="<PARAMETER_TO_REMOVE>"-

En IBM Z, ejecute el comando

ziplsin opciones para actualizar el menú de arranque.

-

En IBM Z, ejecute el comando

Recursos adicionales

- Para más información sobre los parámetros de la línea de comandos del kernel, consulte Sección 4.1, “Comprender los parámetros de la línea de comandos del kernel”.

-

Para obtener información sobre la utilidad

grubby, consulte la página del manualgrubby(8). -

Para ver más ejemplos de cómo utilizar

grubby, consulte la página grubby tool. -

Para obtener información sobre la utilidad

zipl, consulte la página del manualzipl(8).

4.4.2. Cambio de los parámetros de la línea de comandos del kernel para una sola entrada de arranque

Este procedimiento describe cómo cambiar los parámetros de la línea de comandos del kernel para una sola entrada de arranque en su sistema.

Requisitos previos

-

Compruebe que las utilidades

grubbyyziplestán instaladas en su sistema.

Procedimiento

Para añadir un parámetro:

# grubby --update-kernel=/boot/vmlinuz-$(uname -r) --args="<NEW_PARAMETER>"-

En IBM Z, ejecute el comando

ziplsin opciones para actualizar el menú de arranque.

-

En IBM Z, ejecute el comando

Para eliminar un parámetro utilice lo siguiente:

# grubby --update-kernel=/boot/vmlinuz-$(uname -r) --remove-args="<PARAMETER_TO_REMOVE>"-

En IBM Z, ejecute el comando

ziplsin opciones para actualizar el menú de arranque.

-

En IBM Z, ejecute el comando

En los sistemas que utilizan el archivo grub.cfg, existe, por defecto, el parámetro options para cada entrada de arranque del kernel, que se establece en la variable kernelopts. Esta variable se define en el archivo de configuración /boot/grub2/grubenv.

En sistemas GRUB2:

-

Si los parámetros de la línea de comandos del kernel se modifican para todas las entradas de arranque, la utilidad

grubbyactualiza la variablekerneloptsen el archivo/boot/grub2/grubenv. -

Si los parámetros de la línea de comandos del kernel se modifican para una sola entrada de arranque, la variable

kerneloptsse expande, los parámetros del kernel se modifican y el valor resultante se almacena en el archivo/boot/loader/entries/<RELEVANT_KERNEL_BOOT_ENTRY.conf>de la entrada de arranque respectiva.

En los sistemas zIPL:

-

grubbymodifica y almacena los parámetros de la línea de comandos del kernel de una entrada individual de arranque del kernel en el archivo/boot/loader/entries/<ENTRY>.confarchivo.

Recursos adicionales

- Para más información sobre los parámetros de la línea de comandos del kernel, consulte Sección 4.1, “Comprender los parámetros de la línea de comandos del kernel”.

-

Para obtener información sobre la utilidad

grubby, consulte la página del manualgrubby(8). -

Para ver más ejemplos de cómo utilizar

grubby, consulte la página grubby tool. -

Para obtener información sobre la utilidad

zipl, consulte la página del manualzipl(8).

Capítulo 5. Configuración de los parámetros del núcleo en tiempo de ejecución

Como administrador del sistema, puede modificar muchas facetas del comportamiento del kernel de Red Hat Enterprise Linux en tiempo de ejecución. Esta sección describe cómo configurar los parámetros del kernel en tiempo de ejecución utilizando el comando sysctl y modificando los archivos de configuración en los directorios /etc/sysctl.d/ y /proc/sys/.

5.1. Qué son los parámetros del núcleo

Los parámetros del kernel son valores que se pueden ajustar mientras el sistema está en funcionamiento. No es necesario reiniciar o recompilar el kernel para que los cambios surtan efecto.

Es posible dirigirse a los parámetros del núcleo a través de:

-

El comando

sysctl -

El sistema de archivos virtual montado en el directorio

/proc/sys/ -

Los archivos de configuración en el directorio

/etc/sysctl.d/

Los sintonizables se dividen en clases según el subsistema del kernel. Red Hat Enterprise Linux tiene las siguientes clases de sintonizables:

Tabla 5.1. Tabla de clases sysctl

| Clase ajustable | Subsistema |

|---|---|

| abi | Dominios de ejecución y personalidades |

| cripto | Interfaces criptográficas |

| depurar | Interfaces de depuración del núcleo |

| dev | Información específica del dispositivo |

| fs | Ajustes globales y específicos del sistema de archivos |

| núcleo | Ajustes globales del kernel |

| red | Redes sintonizables |

| sunrpc | Sun Remote Procedure Call (NFS) |

| usuario | Límites del espacio de nombres del usuario |

| vm | Ajuste y gestión de la memoria, los búferes y la caché |

Recursos adicionales

-

Para más información sobre

sysctl, consulte las páginas del manualsysctl(8). -

Para más información sobre

/etc/sysctl.d/, consulte las páginas del manualsysctl.d(5).

5.2. Configuración de los parámetros del kernel en tiempo de ejecución

La configuración de los parámetros del kernel en un sistema de producción requiere una planificación cuidadosa. Los cambios no planificados pueden hacer que el kernel sea inestable, requiriendo un reinicio del sistema. Verifique que está utilizando opciones válidas antes de cambiar cualquier valor del kernel.

5.2.1. Configurar temporalmente los parámetros del kernel con sysctl

El siguiente procedimiento describe cómo utilizar el comando sysctl para establecer temporalmente los parámetros del kernel en tiempo de ejecución. El comando también es útil para listar y filtrar sintonizables.

Requisitos previos

- Introducción a los parámetros del núcleo

- Permisos de la raíz

Procedimiento

Para listar todos los parámetros y sus valores, utilice lo siguiente:

# sysctl -aNotaEl comando

# sysctl -amuestra los parámetros del kernel, que pueden ajustarse en tiempo de ejecución y en tiempo de arranque.Para configurar un parámetro temporalmente, utilice el comando como en el siguiente ejemplo:

# sysctl <TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE>El comando de ejemplo anterior cambia el valor del parámetro mientras el sistema está en funcionamiento. Los cambios surten efecto inmediatamente, sin necesidad de reiniciar el sistema.

NotaLos cambios vuelven a ser por defecto después de reiniciar el sistema.

Recursos adicionales

-

Para más información sobre

sysctl, consulte la página del manualsysctl(8). -

Para modificar permanentemente los parámetros del kernel, utilice el comando

sysctlpara escribir los valores en el archivo/etc/sysctl.confo realice cambios manuales en los archivos de configuración en el directorio/etc/sysctl.d/.

5.2.2. Configurar los parámetros del kernel de forma permanente con sysctl

El siguiente procedimiento describe cómo utilizar el comando sysctl para establecer permanentemente los parámetros del kernel.

Requisitos previos

- Introducción a los parámetros del núcleo

- Permisos de la raíz

Procedimiento

Para listar todos los parámetros, utilice lo siguiente:

# sysctl -aEl comando muestra todos los parámetros del kernel que se pueden configurar en tiempo de ejecución.

Para configurar un parámetro de forma permanente:

# sysctl -w <TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE> >> /etc/sysctl.confEl comando de ejemplo cambia el valor sintonizable y lo escribe en el archivo

/etc/sysctl.conf, que anula los valores por defecto de los parámetros del kernel. Los cambios tienen efecto inmediato y persistente, sin necesidad de reiniciar.

Para modificar permanentemente los parámetros del kernel, también puede realizar cambios manuales en los archivos de configuración del directorio /etc/sysctl.d/.

Recursos adicionales

-

Para más información sobre

sysctl, consulte las páginas del manualsysctl(8)ysysctl.conf(5). -

Para más información sobre el uso de los archivos de configuración en el directorio

/etc/sysctl.d/para realizar cambios permanentes en los parámetros del kernel, consulte la sección Uso de los archivos de configuración en /etc/sysctl.d/ para ajustar los parámetros del kernel.

5.2.3. Uso de los archivos de configuración en /etc/sysctl.d/ para ajustar los parámetros del kernel

El siguiente procedimiento describe cómo modificar manualmente los archivos de configuración en el directorio /etc/sysctl.d/ para establecer permanentemente los parámetros del kernel.

Requisitos previos

- Introducción a los parámetros del núcleo

- Permisos de la raíz

Procedimiento

Cree un nuevo archivo de configuración en

/etc/sysctl.d/:# vim /etc/sysctl.d/<some_file.conf>Incluya los parámetros del núcleo, uno por línea, como sigue:

<TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE><TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE>- Guarde el archivo de configuración.

Reinicie la máquina para que los cambios surtan efecto.

Alternativamente, para aplicar los cambios sin reiniciar, ejecute:

# sysctl -p /etc/sysctl.d/<some_file.conf>Este comando le permite leer los valores del archivo de configuración, que creó anteriormente.

Recursos adicionales

-

Para más información sobre

sysctl, consulte la página del manualsysctl(8). -

Para más información sobre

/etc/sysctl.d/, consulte la página del manualsysctl.d(5).

5.2.4. Configurar los parámetros del kernel temporalmente a través de /proc/sys/

El siguiente procedimiento describe cómo configurar los parámetros del kernel temporalmente a través de los archivos del directorio del sistema de archivos virtual /proc/sys/.

Requisitos previos

- Introducción a los parámetros del núcleo

- Permisos de la raíz

Procedimiento

Identifique un parámetro del núcleo que desee configurar:

# ls -l /proc/sys/<TUNABLE_CLASS>/Los archivos con permisos de escritura devueltos por el comando pueden utilizarse para configurar el kernel. Los archivos con permisos de sólo lectura proporcionan información sobre la configuración actual.

Asigna un valor objetivo al parámetro del núcleo:

# echo <TARGET_VALUE> > /proc/sys/<TUNABLE_CLASS>/<PARAMETER>El comando realiza cambios de configuración que desaparecerán una vez que se reinicie el sistema.

Opcionalmente, verifique el valor del parámetro del núcleo recién establecido:

# cat /proc/sys/<TUNABLE_CLASS>/<PARAMETER>

Recursos adicionales

-

Para modificar permanentemente los parámetros del kernel, utilice el comando

sysctlo realice cambios manuales en los archivos de configuración en el directorio/etc/sysctl.d/.

5.3. Mantener desactivados los parámetros de pánico del kernel en entornos virtualizados

Cuando configure un entorno virtualizado en Red Hat Enterprise Linux 8 (RHEL 8), no debe habilitar los parámetros del kernel softlockup_panic y nmi_watchdog, ya que el entorno virtualizado puede desencadenar un soft lockup espurio que no debería requerir un pánico del sistema.

En las siguientes secciones se explican las razones de este consejo resumiendo:

- Qué causa un bloqueo suave.

- Describe los parámetros del kernel que controlan el comportamiento de un sistema en un bloqueo suave.

- Explicación de cómo pueden activarse los bloqueos blandos en un entorno virtualizado.

5.3.1. ¿Qué es un bloqueo suave?

Un bloqueo suave es una situación causada generalmente por un error, cuando una tarea se ejecuta en el espacio del núcleo en una CPU sin reprogramar. La tarea tampoco permite que ninguna otra tarea se ejecute en esa CPU en particular. Como resultado, se muestra una advertencia al usuario a través de la consola del sistema. Este problema también se conoce como disparo de bloqueo suave.

Recursos adicionales

- Para conocer el motivo técnico de un bloqueo suave, ejemplos de mensajes de registro y otros detalles, consulte lo siguiente Knowledge Article.

5.3.2. Parámetros que controlan el pánico del núcleo

Los siguientes parámetros del kernel pueden establecerse para controlar el comportamiento del sistema cuando se detecta un bloqueo suave.

- softlockup_panic

Controla si el kernel entrará en pánico o no cuando se detecte un bloqueo suave.

Tipo Valor Efecto Entero

0

el kernel no entra en pánico al bloquearse suavemente

Entero

1

el kernel entra en pánico al bloquearse suavemente

Por defecto, en RHEL8 este valor es 0.

Para entrar en pánico, el sistema necesita detectar primero un bloqueo duro. La detección se controla con el parámetro

nmi_watchdog.- nmi_watchdog

Controla si los mecanismos de detección de bloqueos (

watchdogs) están activos o no. Este parámetro es de tipo entero.Valor Efecto 0

desactiva el detector de bloqueo

1

permite la detección de bloqueo

El detector de bloqueos duros supervisa cada CPU en cuanto a su capacidad de respuesta a las interrupciones.

- watchdog_thresh

Controla la frecuencia del watchdog

hrtimer, los eventos NMI y los umbrales de bloqueo suave/duro.Umbral por defecto Umbral de bloqueo suave 10 segundos

2 *

watchdog_threshSi este parámetro se pone a cero, se desactiva la detección de bloqueos por completo.

Recursos adicionales

-

Para más información sobre

nmi_watchdogysoftlockup_panic, consulte el Softlockup detector and hardlockup detector documento. -

Para más detalles sobre

watchdog_thresh, consulte el Kernel sysctl documento.

5.3.3. Bloqueos suaves espurios en entornos virtualizados

El bloqueo suave que se produce en los hosts físicos, tal y como se describe en Sección 5.3.1, “¿Qué es un bloqueo suave?”, suele representar un fallo del kernel o del hardware. El mismo fenómeno que ocurre en los sistemas operativos invitados en entornos virtualizados puede representar una falsa advertencia.

Una gran carga de trabajo en un host o una alta contención sobre algún recurso específico, como la memoria, suele provocar un disparo de bloqueo suave espurio. Esto se debe a que el host puede programar la salida de la CPU del huésped durante un periodo superior a 20 segundos. Entonces, cuando la CPU del huésped se programa de nuevo para ejecutarse en el host, experimenta un time jump que dispara los temporizadores debidos. Los temporizadores incluyen también el watchdog hrtimer, que puede, en consecuencia, informar de un bloqueo suave en la CPU huésped.

Debido a que un soft lockup en un entorno virtualizado puede ser espurio, no debe habilitar los parámetros del kernel que causarían un pánico en el sistema cuando se reporta un soft lockup en una CPU huésped.

Para entender los bloqueos suaves en los invitados, es esencial saber que el anfitrión programa el invitado como una tarea, y el invitado entonces programa sus propias tareas.

Recursos adicionales

- Para conocer la definición de bloqueo suave y los tecnicismos de su funcionamiento, véase Sección 5.3.1, “¿Qué es un bloqueo suave?”.

- Para conocer los componentes de los entornos virtualizados de RHEL 8 y su interacción, consulte RHEL 8 virtual machine components and their interaction.

5.4. Ajuste de los parámetros del núcleo para los servidores de bases de datos

Existen diferentes conjuntos de parámetros del kernel que pueden afectar al rendimiento de determinadas aplicaciones de bases de datos. Las siguientes secciones explican qué parámetros del kernel hay que configurar para asegurar un funcionamiento eficiente de los servidores de bases de datos y de las bases de datos.

5.4.1. Introducción a los servidores de bases de datos

Un servidor de base de datos es un dispositivo de hardware que tiene una cierta cantidad de memoria principal, y una aplicación de base de datos (DB) instalada. Esta aplicación de base de datos proporciona servicios como medio para escribir los datos almacenados en la memoria principal, que suele ser pequeña y costosa, en archivos de base de datos (DB). Estos servicios se prestan a múltiples clientes en una red. Puede haber tantos servidores de BD como lo permita la memoria principal y el almacenamiento de una máquina.

Red Hat Enterprise Linux 8 proporciona las siguientes aplicaciones de bases de datos:

- MariaDB 10.3

- MySQL 8.0

- PostgreSQL 10

- PostgreSQL 9.6

- PostgreSQL 12 - disponible desde RHEL 8.1.1

5.4.2. Parámetros que afectan al rendimiento de las aplicaciones de bases de datos

Los siguientes parámetros del kernel afectan al rendimiento de las aplicaciones de bases de datos.

- fs.aio-max-nr

Define el número máximo de operaciones de E/S asíncronas que el sistema puede manejar en el servidor.

NotaAumentar el parámetro

fs.aio-max-nrno produce ningún cambio adicional más allá de aumentar el límite de aio.- fs.file-max

Define el número máximo de manejadores de archivos (nombres de archivos temporales o IDs asignados a archivos abiertos) que el sistema soporta en cualquier instancia.

El kernel asigna dinámicamente los manejadores de archivo cada vez que un manejador de archivo es solicitado por una aplicación. Sin embargo, el núcleo no libera estos manejadores de archivo cuando son liberados por la aplicación. El kernel recicla estos manejadores de archivo en su lugar. Esto significa que, con el tiempo, el número total de manejadores de archivo asignados aumentará aunque el número de manejadores de archivo utilizados actualmente sea bajo.

- kernel.shmall

-

Define el número total de páginas de memoria compartida que se pueden utilizar en todo el sistema. Para utilizar toda la memoria principal, el valor del parámetro

kernel.shmalldebe ser ≤ tamaño total de la memoria principal. - kernel.shmmax

- Define el tamaño máximo en bytes de un único segmento de memoria compartida que un proceso Linux puede asignar en su espacio de direcciones virtual.

- kernel.shmmni

- Define el número máximo de segmentos de memoria compartida que puede manejar el servidor de la base de datos.

- net.ipv4.ip_local_port_range

- Define el rango de puertos que el sistema puede utilizar para los programas que quieren conectarse a un servidor de base de datos sin un número de puerto específico.

- net.core.rmem_default

- Define la memoria del socket de recepción por defecto a través del Protocolo de Control de Transmisión (TCP).

- net.core.rmem_max

- Define la memoria máxima del socket de recepción a través del Protocolo de Control de Transmisión (TCP).

- net.core.wmem_default

- Define la memoria del socket de envío por defecto a través del Protocolo de Control de Transmisión (TCP).

- net.core.wmem_max

- Define la memoria máxima del socket de envío a través del Protocolo de Control de Transmisión (TCP).

- vm.dirty_bytes / vm.dirty_ratio

-

Define un umbral en bytes / en porcentaje de memoria sucia a partir del cual se inicia un proceso que genera datos sucios en la función

write().

Either vm.dirty_bytes or vm.dirty_ratio se puede especificar a la vez.

- vm.dirty_background_bytes / vm.dirty_background_ratio

- Define un umbral en bytes / en porcentaje de memoria sucia a partir del cual el núcleo intenta escribir activamente datos sucios en el disco duro.

Either vm.dirty_background_bytes or vm.dirty_background_ratio se puede especificar a la vez.

- vm.dirty_writeback_centisecs

Define un intervalo de tiempo entre los despertares periódicos de los hilos del kernel responsables de escribir los datos sucios en el disco duro.

Estos parámetros del núcleo se miden en centésimas de segundo.

- vm.dirty_expire_centisecs

Define el tiempo después del cual los datos sucios son lo suficientemente viejos para ser escritos en el disco duro.

Estos parámetros del núcleo se miden en centésimas de segundo.

Recursos adicionales

- Para la explicación de las devoluciones de datos sucios, cómo funcionan y qué parámetros del kernel se relacionan con ellos, vea el Dirty pagecache writeback and vm.dirty parameters documento.

Capítulo 6. Introducción al registro del núcleo

Los archivos de registro son archivos que contienen mensajes sobre el sistema, incluyendo el kernel, los servicios y las aplicaciones que se ejecutan en él. El sistema de registro en Red Hat Enterprise Linux está basado en el protocolo incorporado syslog. Varias utilidades utilizan este sistema para registrar eventos y organizarlos en archivos de registro. Estos archivos son útiles cuando se audita el sistema operativo o se solucionan problemas.

6.1. ¿Qué es el buffer del núcleo?

Durante el proceso de arranque, la consola proporciona mucha información importante sobre la fase inicial del arranque del sistema. Para evitar la pérdida de los primeros mensajes, el kernel utiliza lo que se llama un buffer de anillo. Este búfer almacena todos los mensajes, incluidos los de arranque, generados por la función printk() dentro del código del kernel. Los mensajes del ring buffer del kernel son leídos y almacenados en archivos de registro en el almacenamiento permanente, por ejemplo, por el servicio syslog.

El buffer mencionado anteriormente es una estructura de datos cíclica que tiene un tamaño fijo, y está codificado en el núcleo. Los usuarios pueden mostrar los datos almacenados en la memoria intermedia del núcleo a través del comando dmesg o del archivo /var/log/boot.log. Cuando el ring buffer está lleno, los nuevos datos sobrescriben los antiguos.

Recursos adicionales

-

Para más información sobre

syslog, consulte la página del manualsyslog(2). -

Para más detalles sobre cómo examinar o controlar los mensajes del registro de arranque con

dmesg, consulte la página del manualdmesg(1).

6.2. Papel de printk en los niveles de registro y en el registro del núcleo

Cada mensaje que el kernel reporta tiene un nivel de registro asociado que define la importancia del mensaje. El buffer del kernel, como se describe en Sección 6.1, “¿Qué es el buffer del núcleo?”, recoge los mensajes del kernel de todos los niveles de registro. Es el parámetro kernel.printk el que define qué mensajes del buffer se imprimen en la consola.

Los valores del nivel de registro se desglosan en este orden:

- 0 - Emergencia del núcleo. El sistema es inutilizable.

- 1 - Alerta del núcleo. Hay que actuar inmediatamente.

- 2 - El estado del núcleo se considera crítico.

- 3 - Condición de error general del kernel.

- 4 - Condición de advertencia general del núcleo.

- 5 - Aviso del núcleo de una condición normal pero significativa.

- 6 - Mensaje informativo del kernel.

- 7 - Mensajes de nivel de depuración del kernel.

Por defecto, kernel.printk en RHEL 8 contiene los siguientes cuatro valores:

# sysctl kernel.printk

kernel.printk = 7 4 1 7Los cuatro valores definen lo siguiente:

- valor. Nivel de registro de la consola, define la prioridad más baja de los mensajes impresos en la consola.

- valor. Nivel de registro por defecto para los mensajes sin un nivel de registro explícito asociado a ellos.

- valor. Establece la configuración del nivel de registro más bajo posible para el nivel de registro de la consola.

valor. Establece el valor por defecto para el nivel de registro de la consola en el momento del arranque.

Cada uno de estos valores define una regla diferente para manejar los mensajes de error.

El valor por defecto 7 4 1 7 printk permite una mejor depuración de la actividad del kernel. Sin embargo, cuando se combina con una consola en serie, esta configuración printk es capaz de causar intensas ráfagas de E/S que podrían llevar a que un sistema RHEL deje de responder temporalmente. Para evitar estas situaciones, establecer un valor printk de 4 4 1 7 suele funcionar, pero a costa de perder la información de depuración adicional.

Tenga en cuenta también que ciertos parámetros de la línea de comandos del kernel, como quiet o debug, cambian los valores por defecto de kernel.printk.

Recursos adicionales

-

Para más información sobre

kernel.printky los niveles de registro, consulte la página del manualsyslog(2).

Capítulo 7. Instalación y configuración de kdump

7.1. Qué es kdump

kdump es un servicio que proporciona un mecanismo de volcado de fallos. El servicio permite guardar el contenido de la memoria del sistema para su posterior análisis. kdump utiliza la llamada al sistema kexec para arrancar en el segundo núcleo (un capture kernel) sin reiniciar; y luego captura el contenido de la memoria del núcleo accidentado (un crash dump o un vmcore) y lo guarda. El segundo núcleo reside en una parte reservada de la memoria del sistema.

Un volcado del kernel puede ser la única información disponible en caso de fallo del sistema (un error crítico). Por lo tanto, asegurarse de que kdump está operativo es importante en entornos de misión crítica. Red Hat aconseja que los administradores de sistemas actualicen y prueben regularmente kexec-tools en su ciclo normal de actualización del kernel. Esto es especialmente importante cuando se implementan nuevas características del kernel.

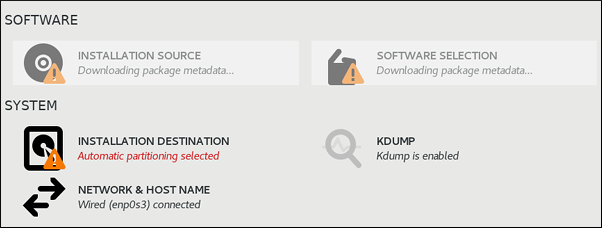

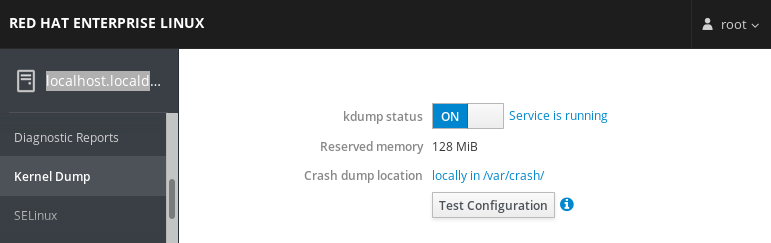

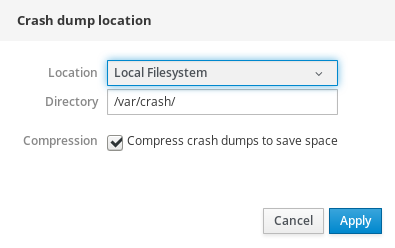

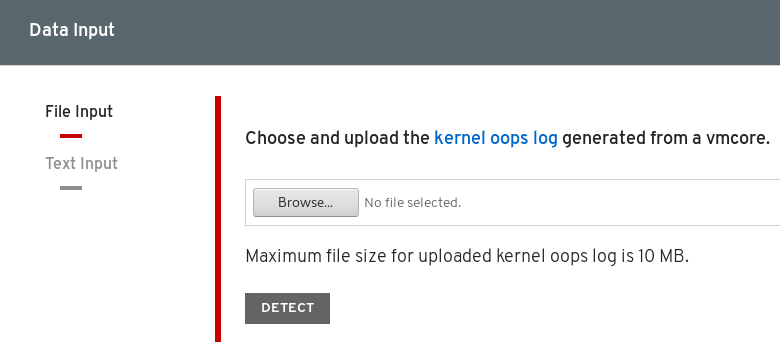

7.2. Instalación de kdump

En muchos casos, el servicio kdump está instalado y activado por defecto en las nuevas instalaciones de Red Hat Enterprise Linux. El instalador de Anaconda instalador proporciona una pantalla para la configuración de kdump cuando se realiza una instalación interactiva utilizando la interfaz gráfica o de texto. La pantalla del instalador se titula Kdump y está disponible desde la pantalla principal Installation Summary, y sólo permite una configuración limitada - sólo puede seleccionar si kdump está activado y cuánta memoria está reservada.