Red Hat Training

A Red Hat training course is available for RHEL 8

Configuración y gestión de la virtualización

Configuración de su anfitrión, creación y administración de máquinas virtuales, y comprensión de las características de virtualización en Red Hat Enterprise Linux 8

Resumen

Hacer que el código abierto sea más inclusivo

Red Hat se compromete a sustituir el lenguaje problemático en nuestro código, documentación y propiedades web. Estamos empezando con estos cuatro términos: maestro, esclavo, lista negra y lista blanca. Debido a la enormidad de este esfuerzo, estos cambios se implementarán gradualmente a lo largo de varias versiones próximas. Para más detalles, consulte el mensaje de nuestro CTO Chris Wright.

Proporcionar comentarios sobre la documentación de Red Hat

Agradecemos su opinión sobre nuestra documentación. Por favor, díganos cómo podemos mejorarla. Para ello:

Para comentarios sencillos sobre pasajes concretos:

- Asegúrese de que está viendo la documentación en el formato Multi-page HTML. Además, asegúrese de ver el botón Feedback en la esquina superior derecha del documento.

- Utilice el cursor del ratón para resaltar la parte del texto que desea comentar.

- Haga clic en la ventana emergente Add Feedback que aparece debajo del texto resaltado.

- Siga las instrucciones mostradas.

Para enviar comentarios más complejos, cree un ticket de Bugzilla:

- Vaya al sitio web de Bugzilla.

- Como componente, utilice Documentation.

- Rellene el campo Description con su sugerencia de mejora. Incluya un enlace a la(s) parte(s) pertinente(s) de la documentación.

- Haga clic en Submit Bug.

Capítulo 1. Virtualización en RHEL 8 - una visión general

Si no está familiarizado con el concepto de virtualización o su implementación en Linux, las siguientes secciones proporcionan una visión general de la virtualización en RHEL 8: sus fundamentos, ventajas, componentes y otras posibles soluciones de virtualización proporcionadas por Red Hat.

1.1. ¿Qué es la virtualización?

RHEL 8 proporciona la funcionalidad virtualization, que permite a una máquina que ejecuta RHEL 8 host múltiples máquinas virtuales (VMs), también conocidas como guests. Las VMs utilizan el hardware físico y los recursos informáticos del host para ejecutar un sistema operativo virtualizado independiente (guest OS) como un proceso de espacio de usuario en el sistema operativo del host.

En otras palabras, la virtualización permite tener sistemas operativos dentro de los sistemas operativos.

Las máquinas virtuales le permiten probar con seguridad configuraciones y funciones de software, ejecutar software heredado u optimizar la eficiencia de la carga de trabajo de su hardware. Para obtener más información sobre las ventajas, consulte Sección 1.2, “Ventajas de la virtualización”.

Para más información sobre lo que es la virtualización, consulte el Portal del Cliente de Red Hat.

Para probar la virtualización en RHEL 8, consulte Capítulo 2, Introducción a la virtualización.

Además de la virtualización de RHEL 8, Red Hat ofrece una serie de soluciones de virtualización especializadas, cada una con un enfoque y características diferentes para el usuario. Para más información, consulte Sección 1.5, “Soluciones de virtualización de Red Hat”.

1.2. Ventajas de la virtualización

El uso de máquinas virtuales (VM) tiene las siguientes ventajas en comparación con el uso de máquinas físicas:

Flexible and fine-grained allocation of resources

Una VM se ejecuta en una máquina anfitriona, que suele ser física, y también se puede asignar hardware físico para que lo utilice el SO invitado. Sin embargo, la asignación de recursos físicos a la VM se realiza a nivel de software, por lo que es muy flexible. Una VM utiliza una fracción configurable de la memoria, las CPU o el espacio de almacenamiento del host, y esa configuración puede especificar solicitudes de recursos muy precisas.

Por ejemplo, lo que el SO huésped ve como su disco puede ser representado como un archivo en el sistema de archivos del host, y el tamaño de ese disco está menos restringido que los tamaños disponibles para los discos físicos.

Software-controlled configurations

Toda la configuración de una VM se guarda como datos en el host, y está bajo el control del software. Por lo tanto, una VM puede ser fácilmente creada, eliminada, clonada, migrada, operada remotamente o conectada a un almacenamiento remoto.

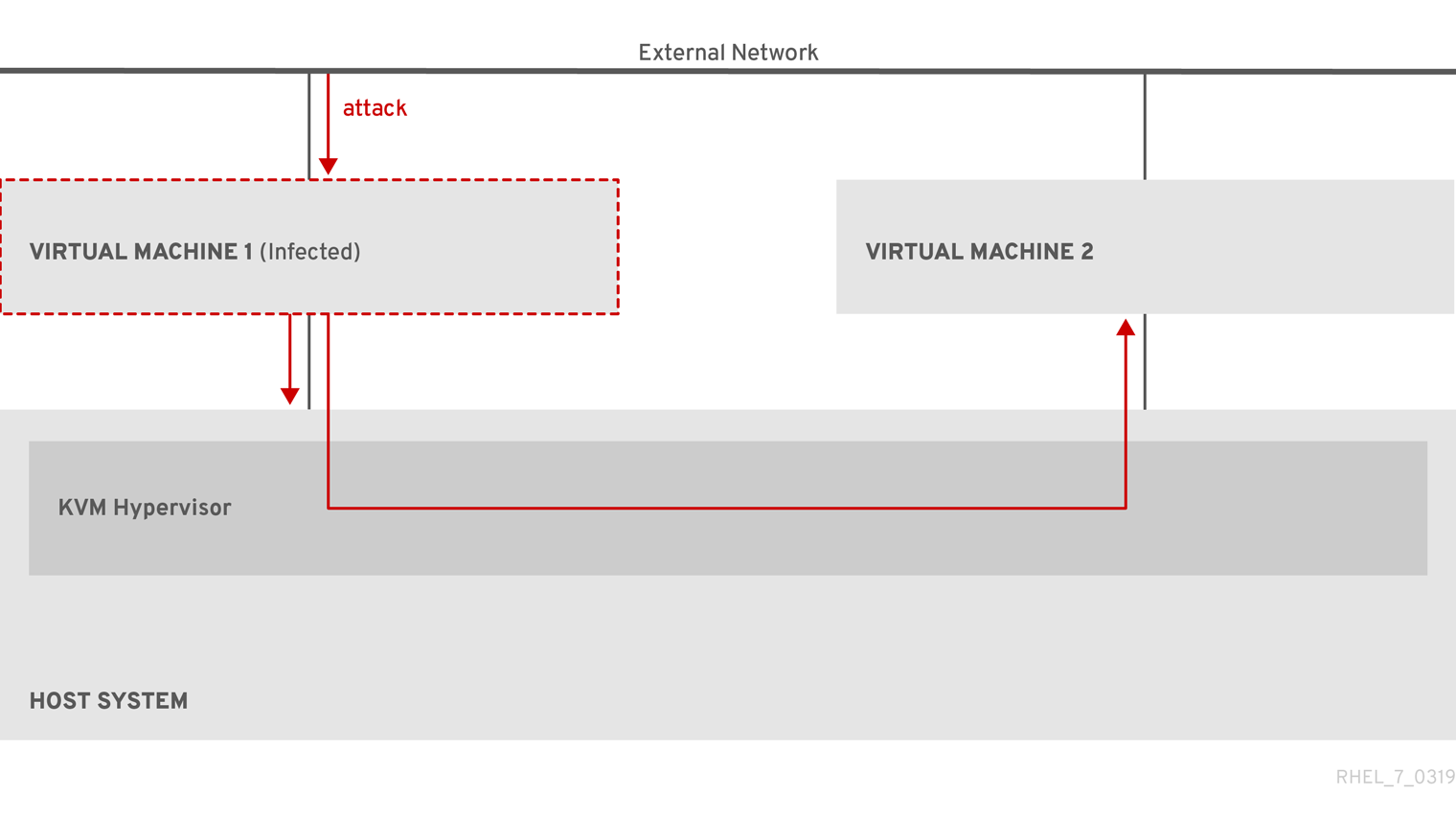

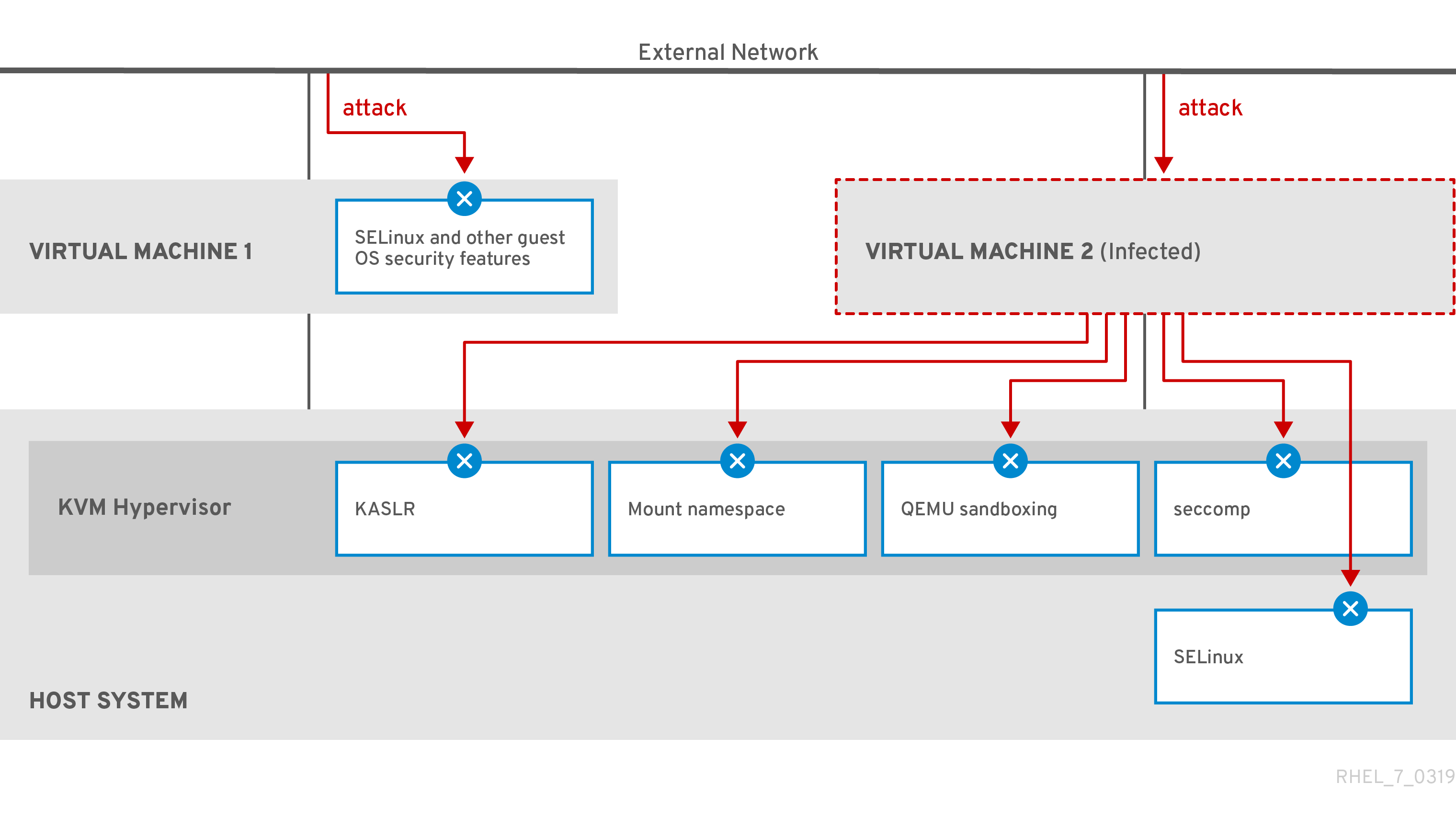

Separation from the host

Un sistema operativo invitado se ejecuta en un núcleo virtualizado, separado del sistema operativo anfitrión. Esto significa que se puede instalar cualquier sistema operativo en una máquina virtual, e incluso si el sistema operativo invitado se vuelve inestable o se ve comprometido, el host no se ve afectado de ninguna manera.

Space and cost efficiency

Una sola máquina física puede albergar un gran número de máquinas virtuales. Por lo tanto, evita la necesidad de contar con varias máquinas físicas para realizar las mismas tareas y, por lo tanto, reduce los requisitos de espacio, energía y mantenimiento asociados al hardware físico.

Software compatibility

Dado que una máquina virtual puede utilizar un sistema operativo diferente al de su anfitrión, la virtualización permite ejecutar aplicaciones que no fueron publicadas originalmente para su sistema operativo anfitrión. Por ejemplo, utilizando un sistema operativo invitado RHEL 6, puede ejecutar aplicaciones publicadas para RHEL 6 en un sistema anfitrión RHEL 8.

NotaNo todos los sistemas operativos están soportados como SO invitado en un host RHEL 8. Para más detalles, consulte Sección 20.2, “Características recomendadas en la virtualización de RHEL 8”.

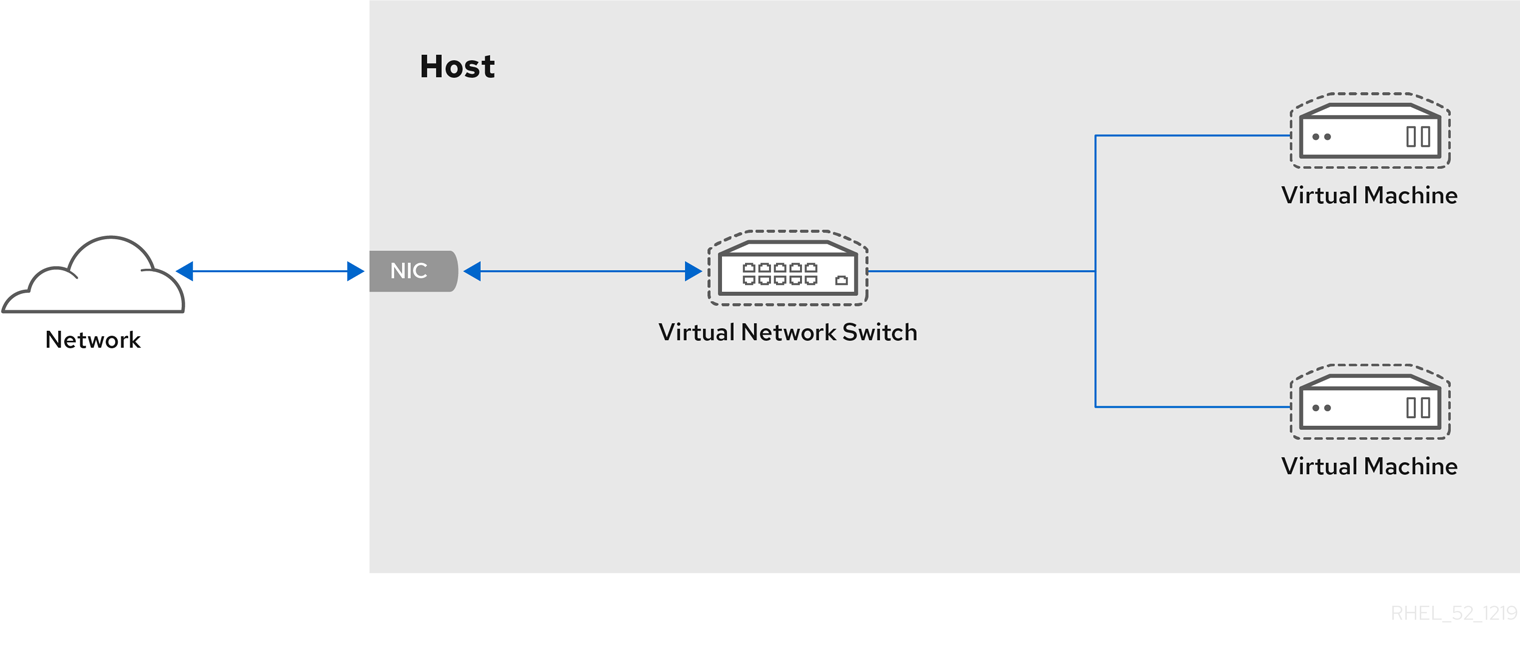

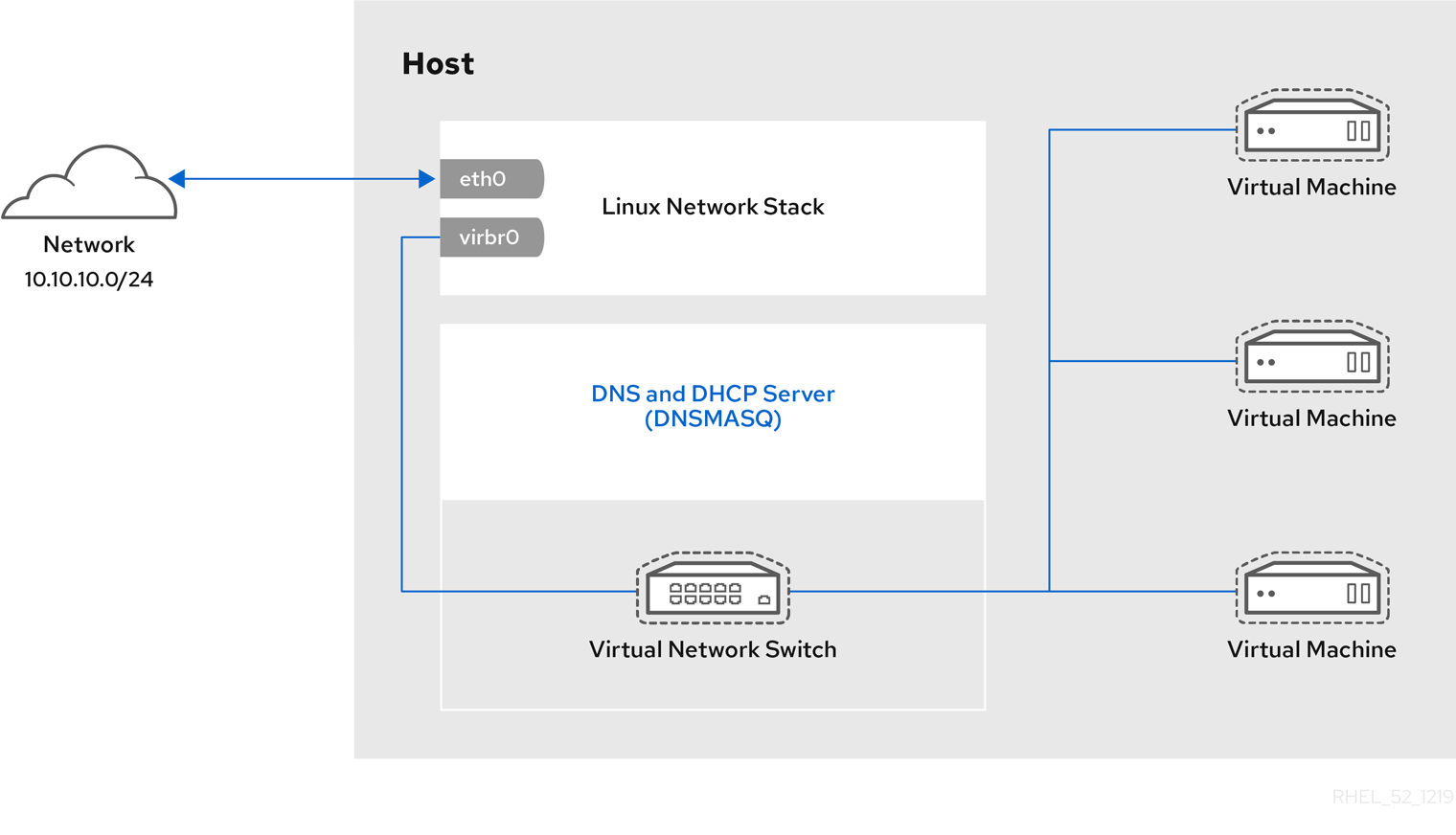

1.3. Componentes de la máquina virtual y su interacción

La virtualización en RHEL 8 consta de los siguientes componentes principales de software:

Hipervisor

La base de la creación de máquinas virtuales (VMs) en RHEL 8 es el hypervisor, una capa de software que controla el hardware y permite la ejecución de múltiples sistemas operativos en una máquina anfitriona.

El hipervisor incluye el módulo Kernel-based Virtual Machine (KVM) y los controladores del kernel de virtualización, como virtio y vfio. Estos componentes garantizan que el kernel Linux de la máquina anfitriona proporcione recursos para la virtualización al software del espacio de usuario.

A nivel de espacio de usuario, el emulador QEMU simula una plataforma de hardware virtualizada completa en la que puede ejecutarse el sistema operativo invitado, y gestiona cómo se asignan los recursos en el host y se presentan al invitado.

Además, el paquete de software libvirt sirve como capa de gestión y comunicación, facilitando la interacción con QEMU, aplicando reglas de seguridad y proporcionando una serie de herramientas adicionales para configurar y ejecutar las máquinas virtuales.

Configuración XML

Un archivo de configuración XML basado en el host (también conocido como archivo domain XML ) determina todos los ajustes y dispositivos de una VM específica. La configuración incluye:

- Metadatos como el nombre de la VM, la zona horaria y otra información sobre la VM.

- Una descripción de los dispositivos en la VM, incluyendo CPUs virtuales (vCPUS), dispositivos de almacenamiento, dispositivos de entrada/salida, tarjetas de interfaz de red y otro hardware, real y virtual.

- Ajustes de la VM como la cantidad máxima de memoria que puede utilizar, ajustes de reinicio y otros ajustes sobre el comportamiento de la VM.

Para más información sobre el contenido de una configuración XML, consulte el ejemplo de configuración XML de VM.

Interacción de los componentes

Cuando se inicia una VM, el hipervisor utiliza la configuración XML para crear una instancia de la VM como un proceso de espacio de usuario en el host. El hipervisor también hace que el proceso de la VM sea accesible a las interfaces basadas en el host, como las utilidades virsh, virt-install, y guestfish, o la GUI de la consola web.

Cuando se utilizan estas herramientas de virtualización, libvirt traduce su entrada en instrucciones para QEMU. QEMU comunica las instrucciones a KVM, que se asegura de que el kernel asigne adecuadamente los recursos necesarios para llevar a cabo las instrucciones. Como resultado, QEMU puede ejecutar los cambios correspondientes en el espacio de usuario, como crear o modificar una VM, o realizar una acción en el sistema operativo invitado de la VM.

Aunque QEMU es un componente esencial de la arquitectura, no está pensado para ser utilizado directamente en los sistemas RHEL 8, debido a cuestiones de seguridad. Por lo tanto, el uso de los comandos de qemu-* no está soportado por Red Hat, y se recomienda encarecidamente interactuar con QEMU utilizando libvirt.

Para más información sobre las interfaces basadas en el host, consulte Sección 1.4, “Herramientas e interfaces para la gestión de la virtualización”.

Figura 1.1. Arquitectura de virtualización de RHEL 8

1.4. Herramientas e interfaces para la gestión de la virtualización

Puede gestionar la virtualización en RHEL 8 mediante la interfaz de línea de comandos (CLI) o varias interfaces gráficas de usuario (GUI).

Interfaz de línea de comandos

La CLI es el método más potente para gestionar la virtualización en RHEL 8. Los principales comandos de la CLI para la gestión de máquinas virtuales (VM) son:

virsh - Una versátil utilidad de línea de comandos de virtualización y shell con una gran variedad de propósitos, dependiendo de los argumentos proporcionados. Por ejemplo:

-

Iniciar y apagar una VM -

virsh startyvirsh shutdown -

Listado de máquinas virtuales disponibles -

virsh list -

Creación de una VM a partir de un archivo de configuración -

virsh create -

Entrar en un shell de virtualización -

virsh

Para más información, consulte la página de manual

virsh(1).-

Iniciar y apagar una VM -

-

virt-install- Una utilidad CLI para crear nuevas VMs. Para más información, consulte la página de manualvirt-install(1). -

virt-xml- Una utilidad para editar la configuración de una VM. -

guestfish- Una utilidad para examinar y modificar imágenes de disco de VM. Para más información, consulte la página de manualguestfish(1).

Interfaces gráficas

Puede utilizar las siguientes interfaces gráficas para gestionar la virtualización en RHEL 8:

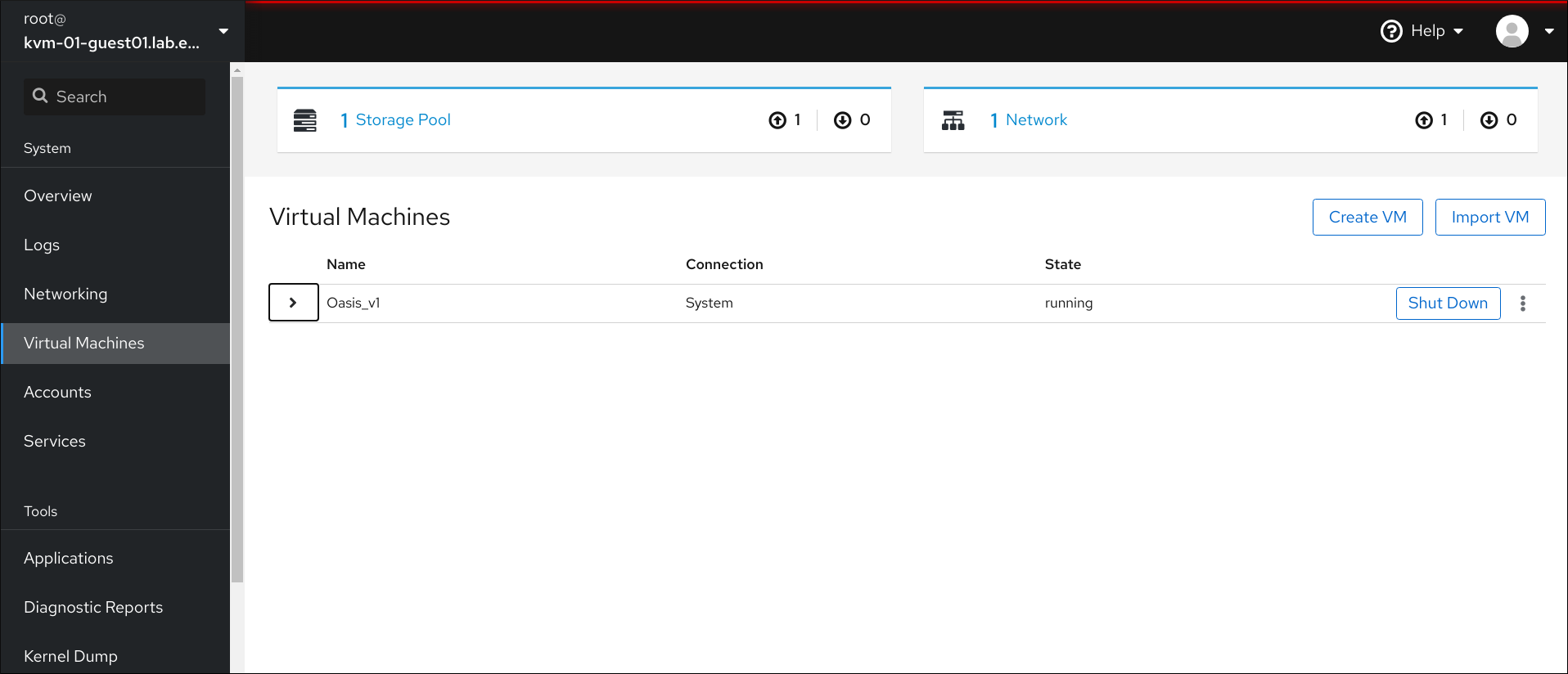

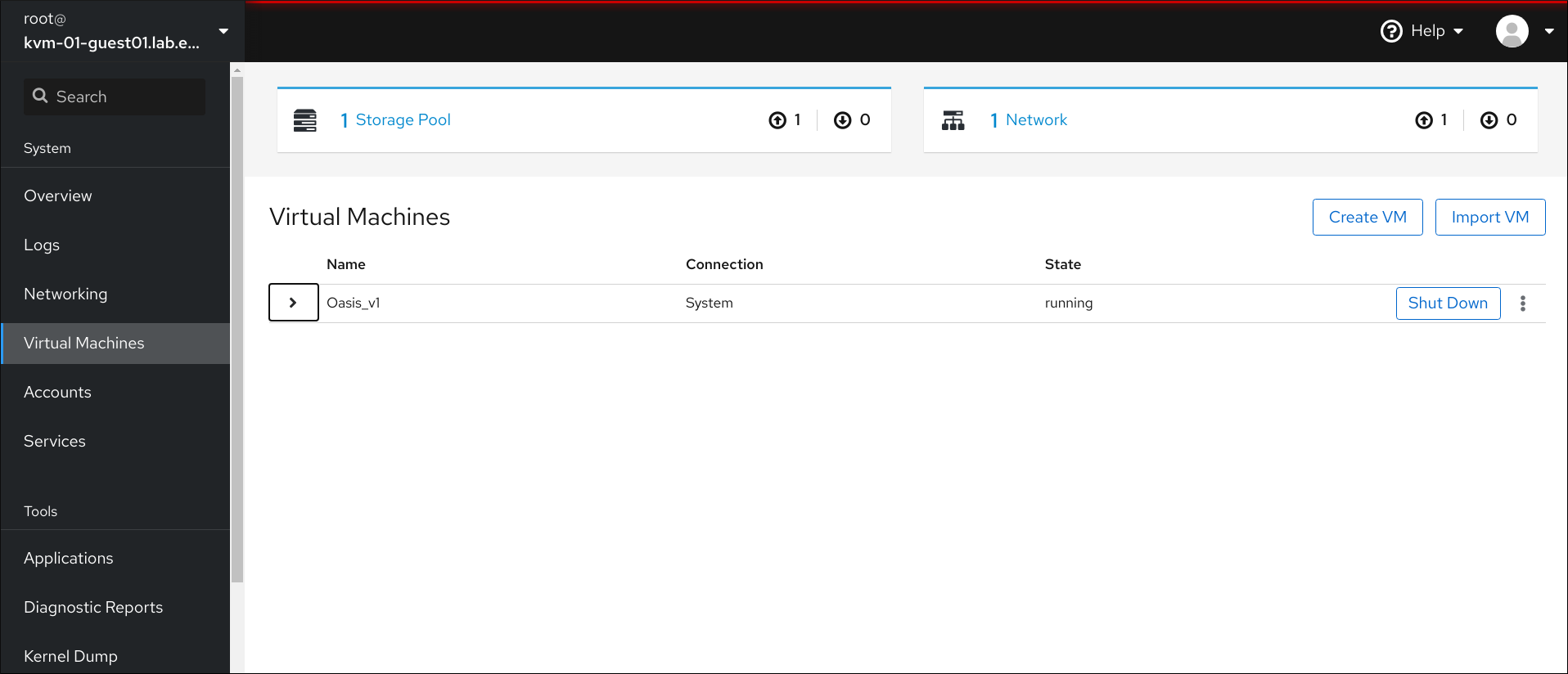

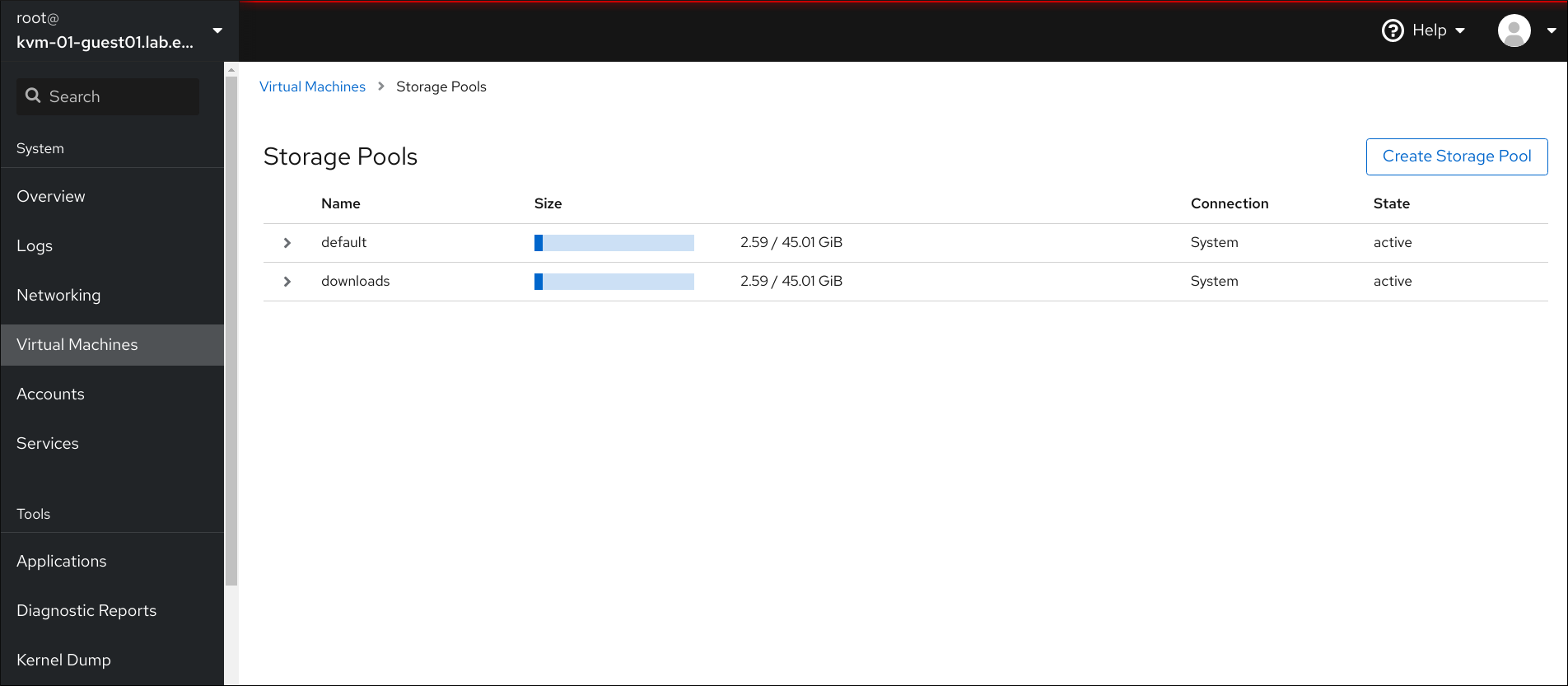

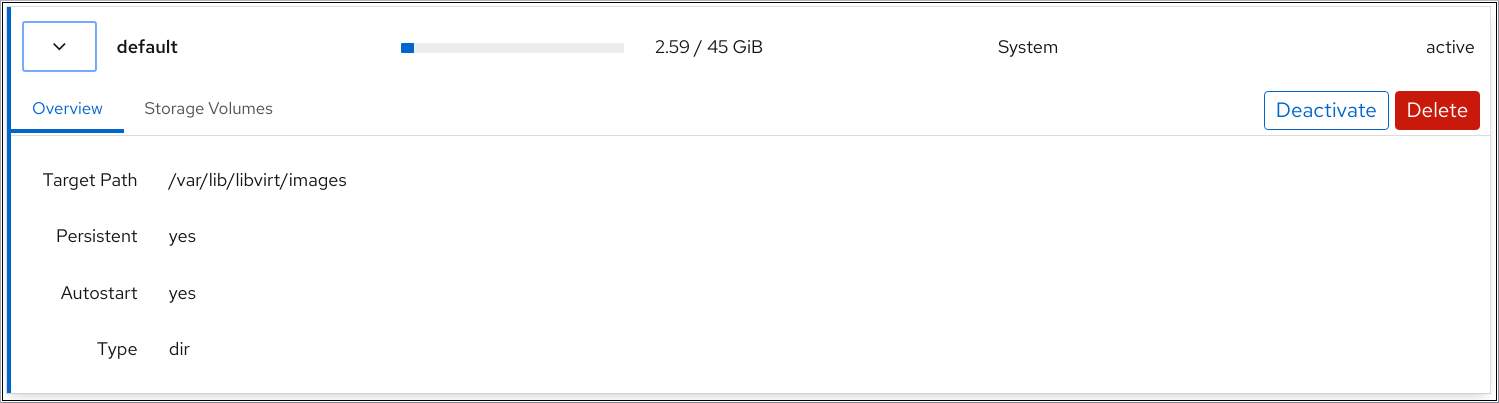

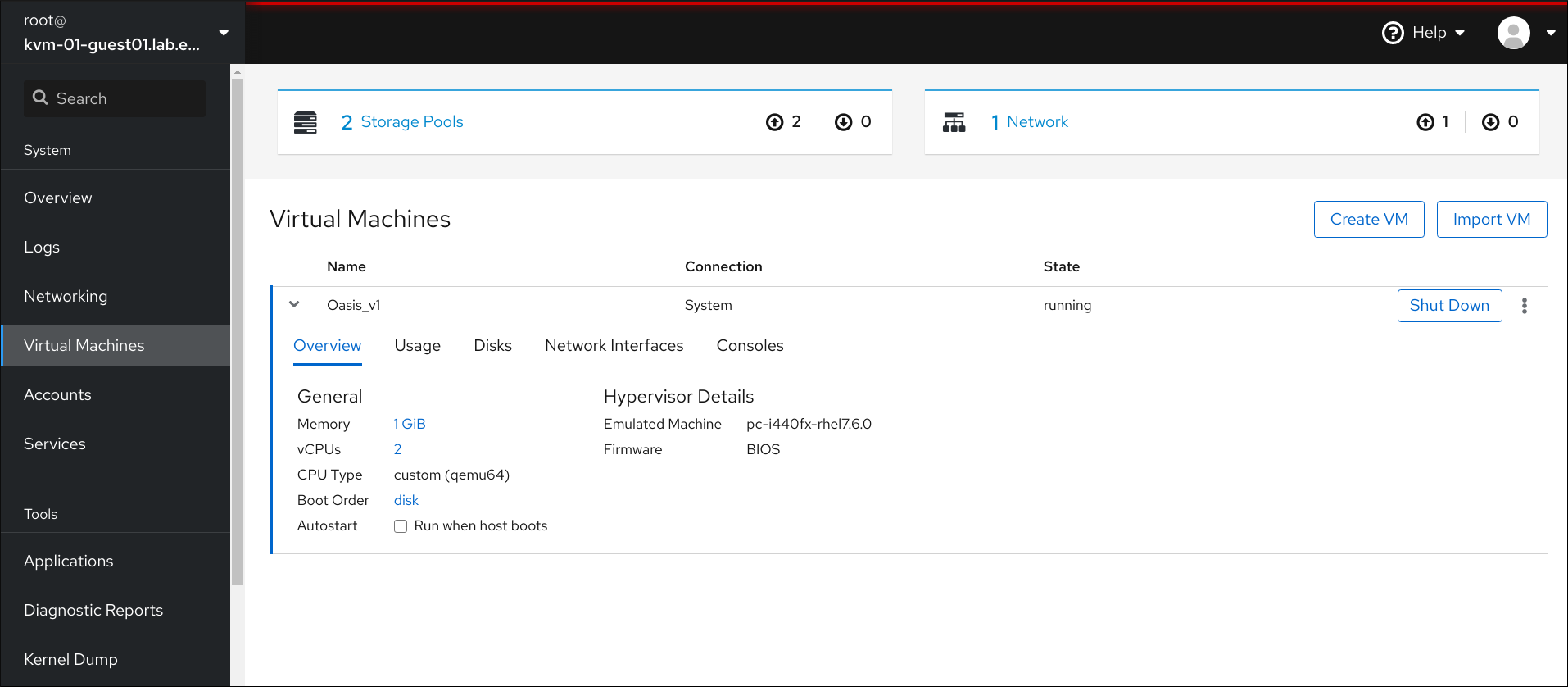

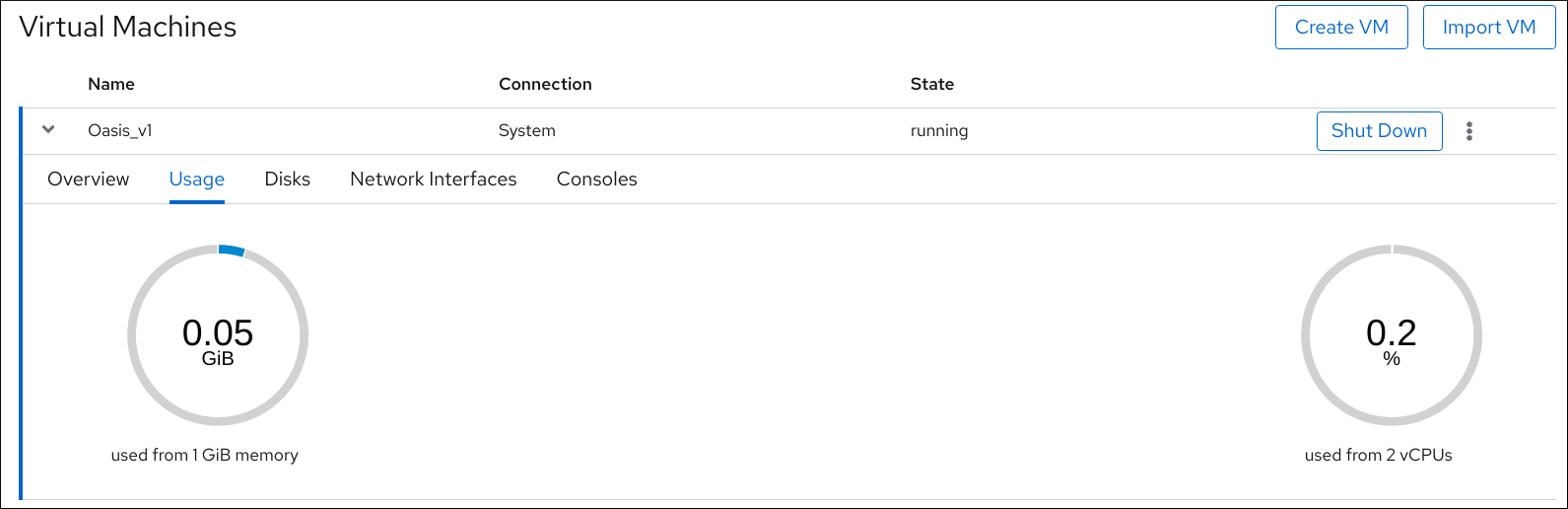

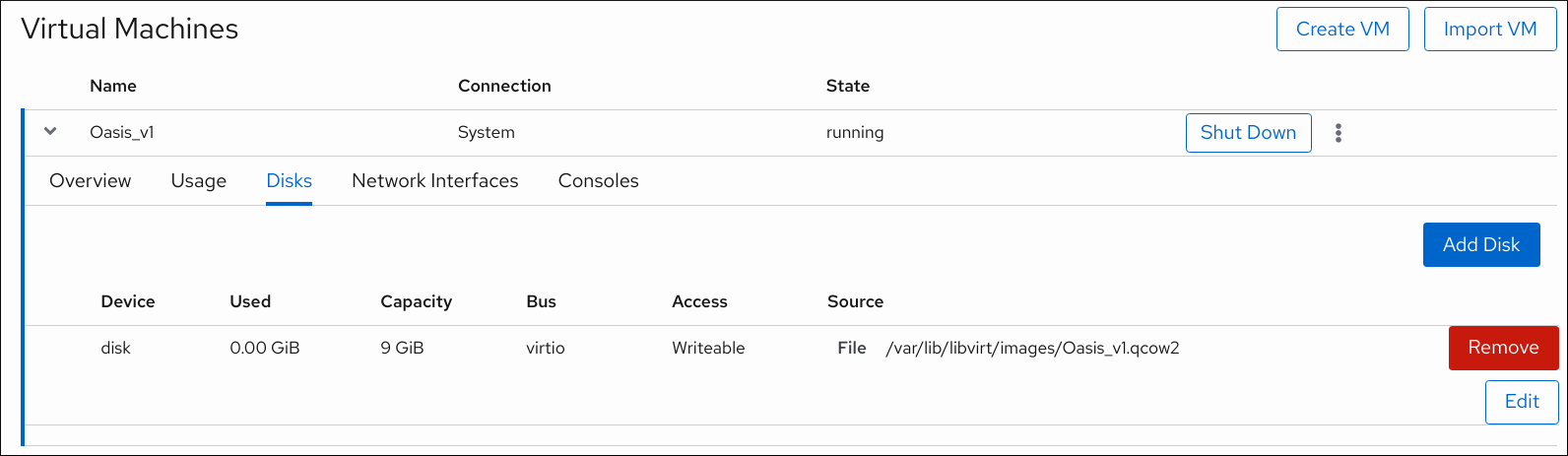

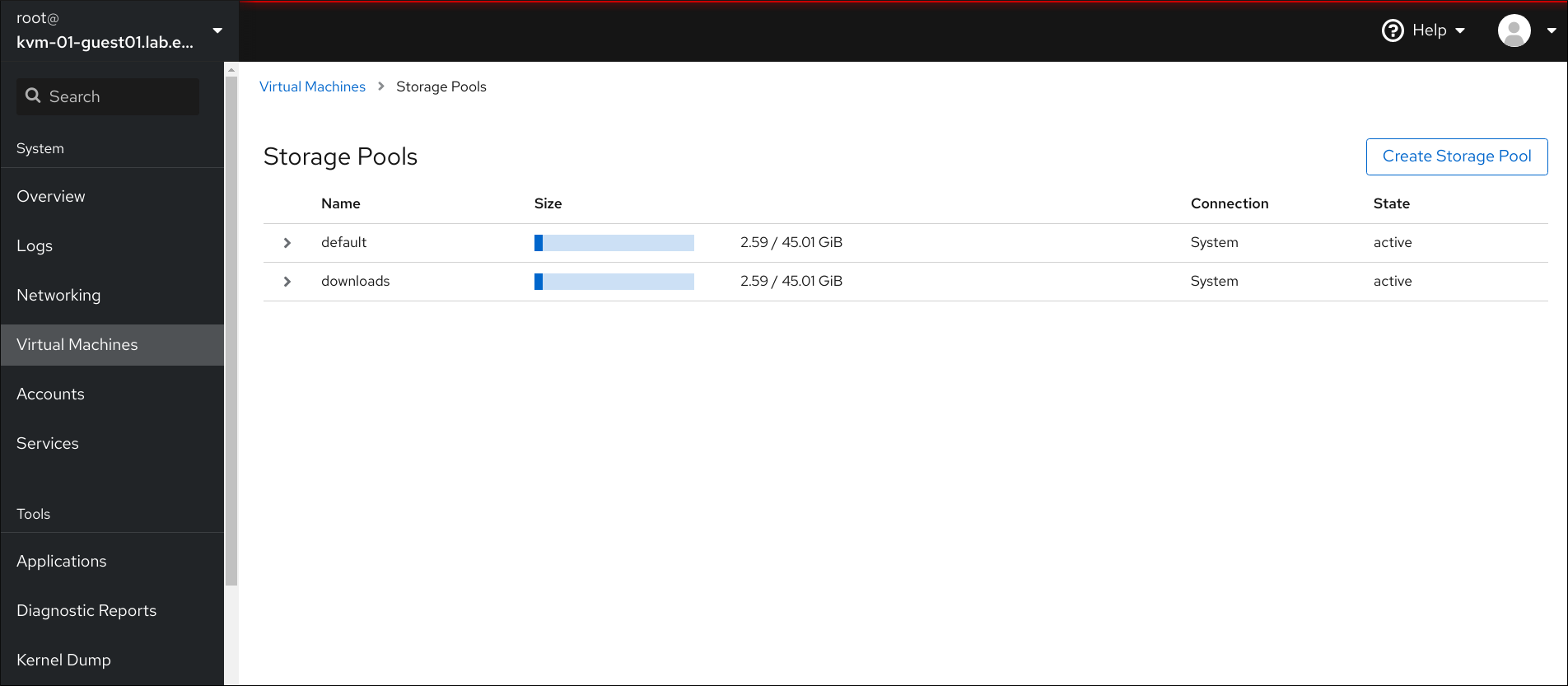

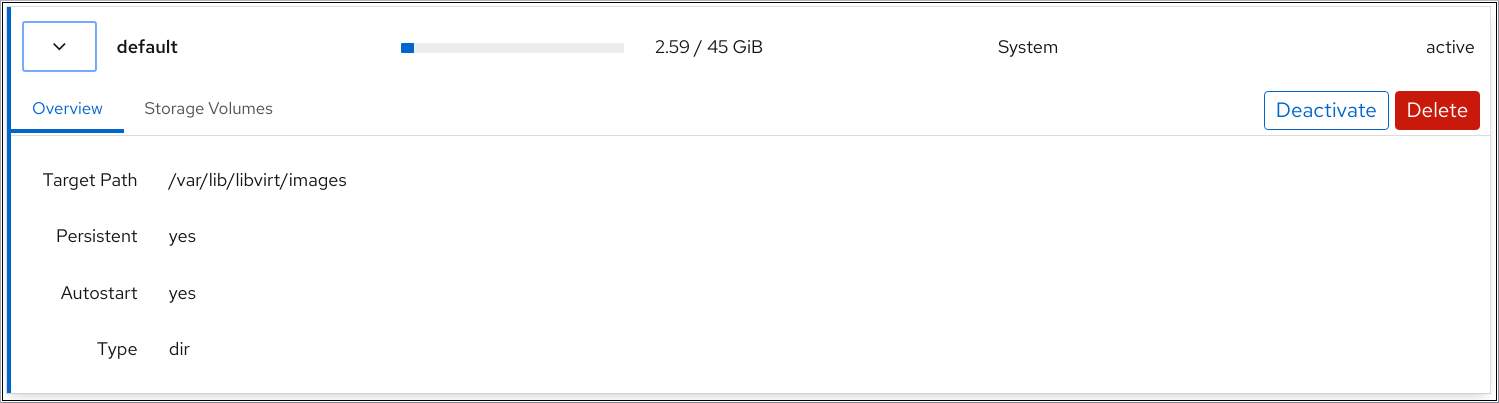

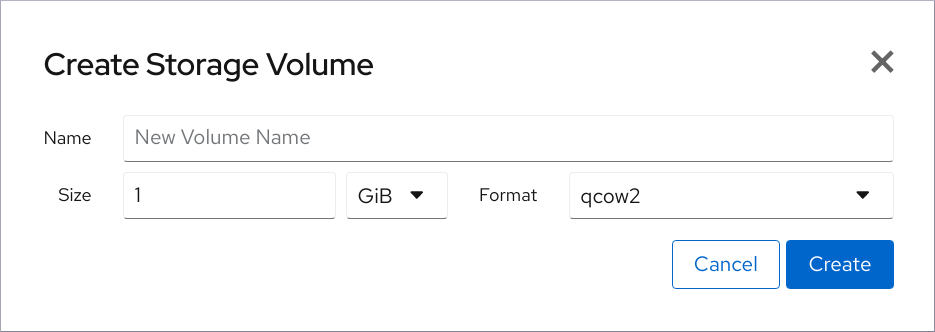

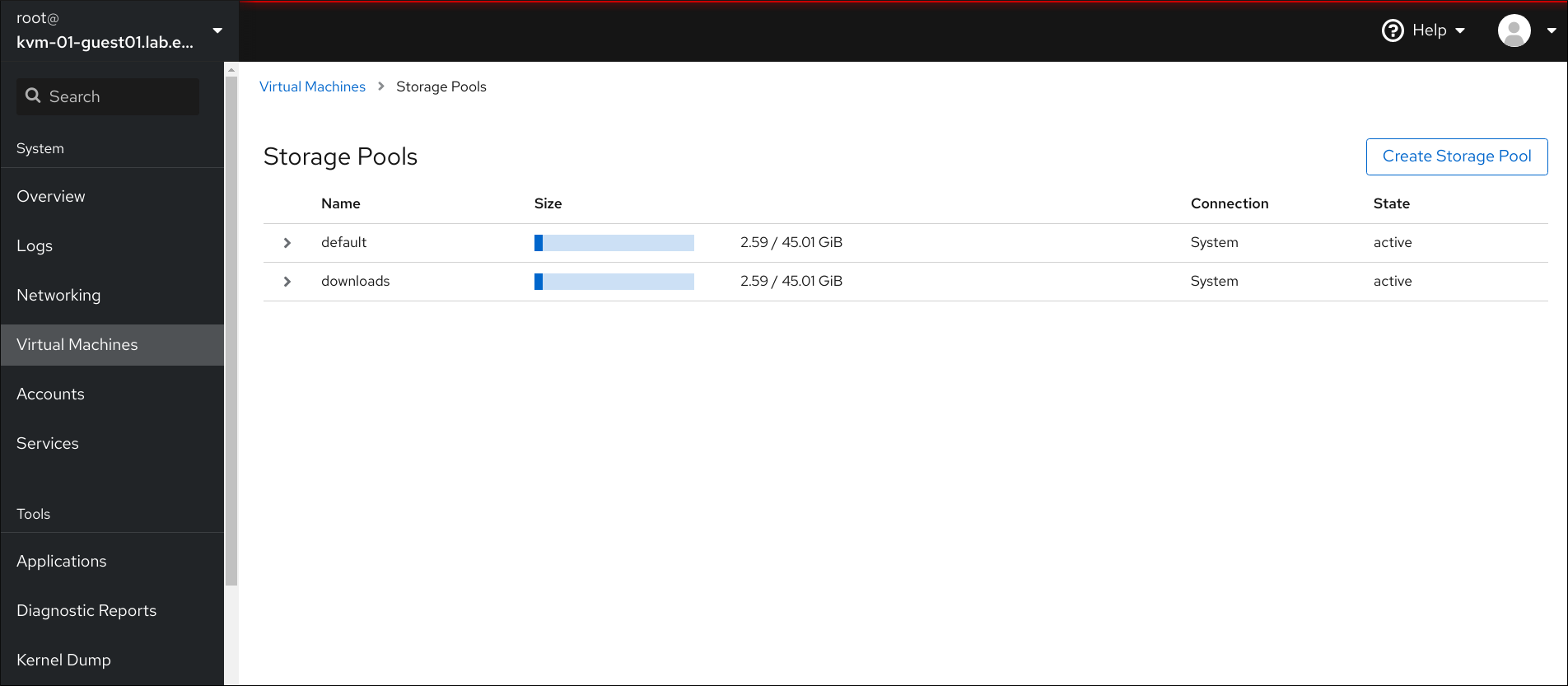

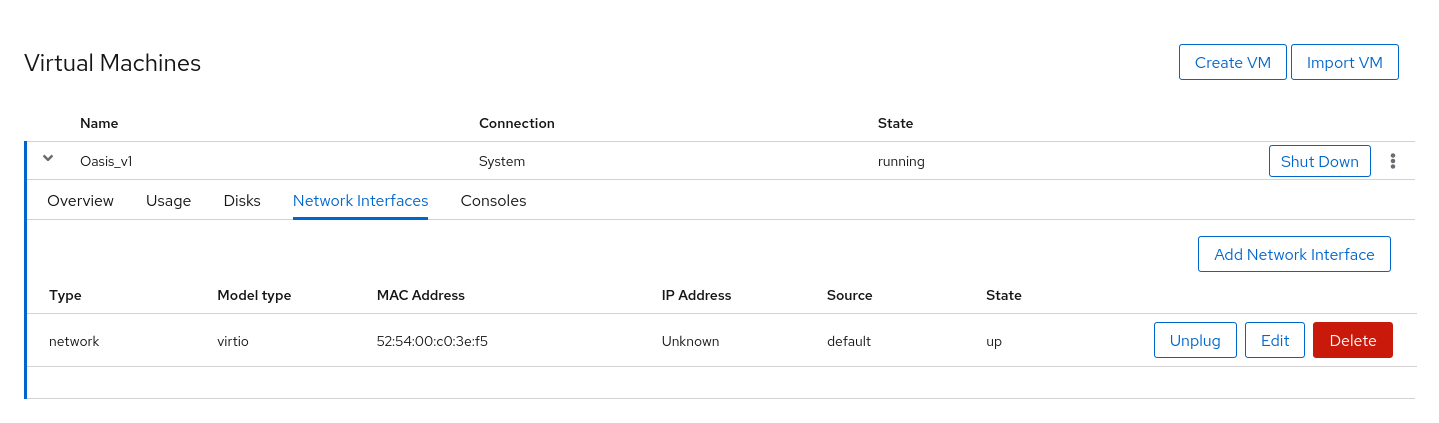

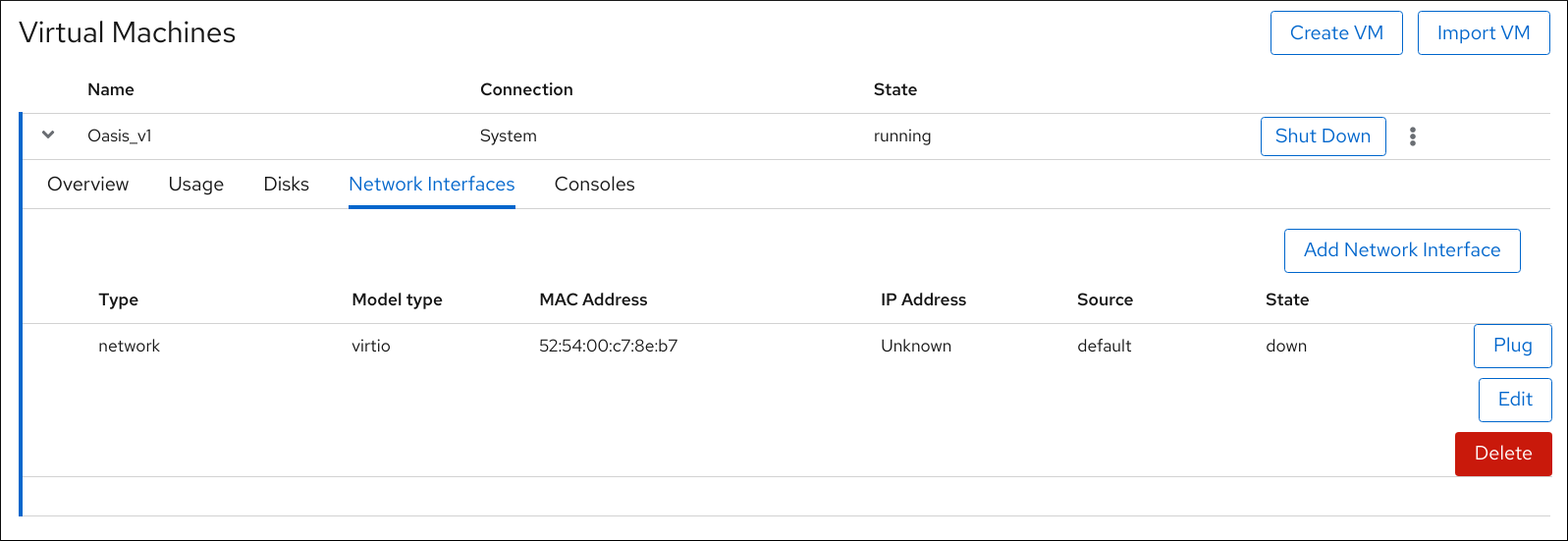

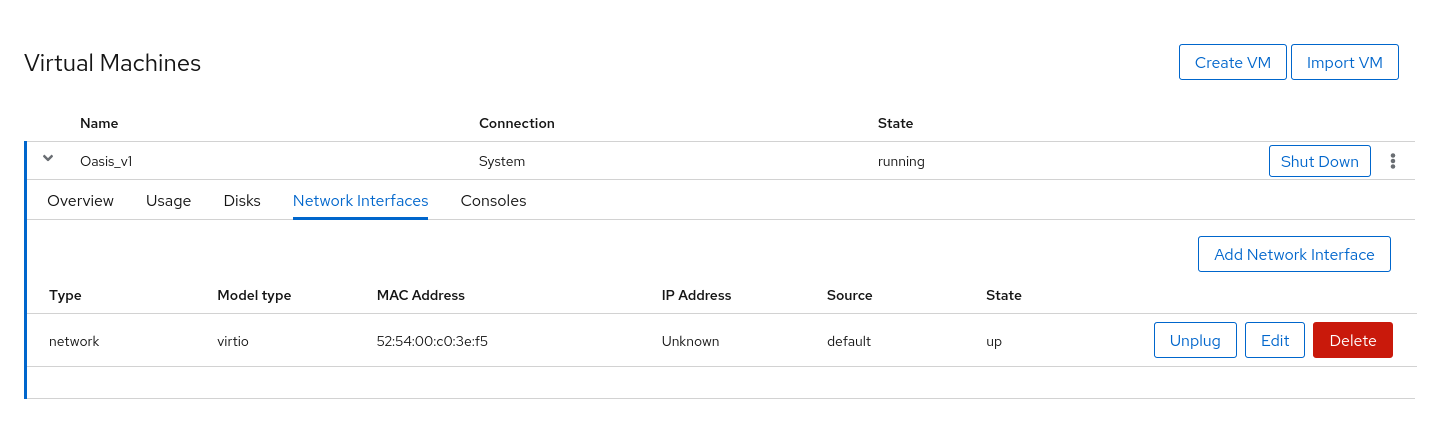

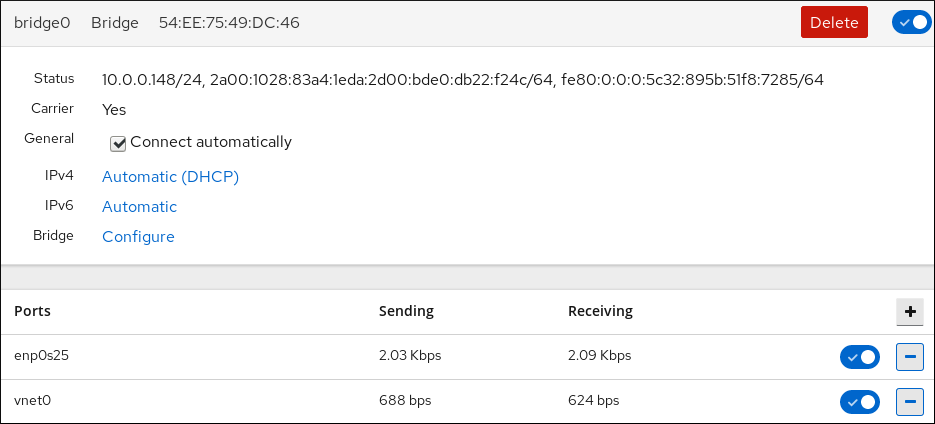

El RHEL 8 web console, también conocido como Cockpit, proporciona una interfaz gráfica de usuario accesible de forma remota y fácil de usar para gestionar las máquinas virtuales y los hosts de virtualización.

Para obtener instrucciones sobre la gestión básica de la virtualización con la consola web, consulte Capítulo 5, Gestión de máquinas virtuales en la consola web.

La aplicación Virtual Machine Manager (virt-manager) proporciona una interfaz gráfica de usuario especializada para gestionar las máquinas virtuales y los hosts de virtualización.

ImportanteAunque sigue siendo compatible con RHEL 8, virt-manager ha quedado obsoleto. La consola web está destinada a convertirse en su reemplazo en una versión posterior. Por lo tanto, se recomienda que se familiarice con la consola web para gestionar la virtualización en una GUI.

Sin embargo, en RHEL 8, es posible que algunas funciones sólo sean accesibles desde virt-manager o desde la línea de comandos. Para más detalles, consulte Sección 5.4, “Diferencias entre las funciones de virtualización en Virtual Machine Manager y la consola web”.

La aplicación Gnome Boxes es una interfaz gráfica ligera para ver y acceder a máquinas virtuales y sistemas remotos. Gnome Boxes está diseñado principalmente para su uso en sistemas de escritorio.

ImportanteGnome Boxes se proporciona como parte del entorno de escritorio GNOME y es compatible con RHEL 8, pero Red Hat recomienda que se utilice la consola web para gestionar la virtualización en una GUI.

Recursos adicionales

- Para obtener instrucciones sobre la gestión básica de la virtualización mediante la CLI y la GUI, consulte Capítulo 2, Introducción a la virtualización.

1.5. Soluciones de virtualización de Red Hat

Los siguientes productos de Red Hat están construidos sobre las características de virtualización de RHEL 8 y amplían las capacidades de virtualización de KVM disponibles en RHEL 8. Además, muchas limitaciones de la virtualización de RHEL 8 no se aplican a estos productos:

- Red Hat Virtualization (RHV)

RHV está diseñado para ofrecer escalabilidad y rendimiento de clase empresarial, y permite la gestión de toda la infraestructura virtual, incluidos los hosts, las máquinas virtuales, las redes, el almacenamiento y los usuarios desde una interfaz gráfica centralizada.

Red Hat Virtualization puede ser utilizado por las empresas que ejecutan grandes implementaciones o aplicaciones de misión crítica. Entre los ejemplos de grandes implantaciones adecuadas para Red Hat Virtualization se encuentran las bases de datos, las plataformas comerciales y los sistemas de mensajería que deben funcionar de forma continua sin ningún tiempo de inactividad.

Para más información sobre Red Hat Virtualization, consulte el Portal del Cliente de Red Hat o el conjunto de documentación de Red Hat Virtualization.

Para descargar una versión de evaluación de 60 días totalmente compatible con Red Hat Virtualization, consulte https://access.redhat.com/products/red-hat-virtualization/evaluation

- Red Hat OpenStack Platform (RHOSP)

Red Hat OpenStack Platform ofrece una base integrada para crear, implementar y escalar una nube OpenStack pública o privada segura y fiable.

Para más información sobre Red Hat OpenStack Platform, consulte el Portal del Cliente de Red Hat o el conjunto de documentación de Red Hat OpenStack Platform.

Para más detalles sobre las características de virtualización no soportadas en RHEL pero sí en RHV o RHOSP, consulte Sección 20.3, “Características no soportadas en la virtualización de RHEL 8”.

Además, algunos productos de Red Hat proporcionan operating-system-level virtualization, también conocido como containerization:

- Los contenedores son instancias aisladas del sistema operativo anfitrión y operan sobre un núcleo de sistema operativo existente. Para más información sobre los contenedores, consulte el Portal del Cliente de Red Hat.

- Los contenedores no tienen la versatilidad de la virtualización KVM, pero son más ligeros y flexibles de manejar. Para una comparación más detallada, consulte la Introducción a los contenedores de Linux.

Capítulo 2. Introducción a la virtualización

Para empezar a utilizar la virtualización en RHEL 8, siga los siguientes pasos. El método por defecto para esto es utilizar la interfaz de línea de comandos (CLI), pero para la comodidad del usuario, algunos de los pasos se pueden completar en la GUI de la consola web.

- Habilite el módulo de virtualización e instale los paquetes de virtualización - véase Sección 2.1, “Habilitación de la virtualización”.

Crear una máquina virtual (VM):

- Para la CLI, véase Sección 2.2.1, “Creación de máquinas virtuales mediante la interfaz de línea de comandos”.

- Para la interfaz gráfica de usuario, véase Sección 2.2.2, “Creación de máquinas virtuales e instalación de sistemas operativos invitados mediante la consola web”.

Inicie la máquina virtual:

- Para la CLI, véase Sección 2.3.1, “Iniciar una máquina virtual mediante la interfaz de línea de comandos”.

- Para la interfaz gráfica de usuario, véase Sección 2.3.2, “Iniciar máquinas virtuales mediante la consola web”.

Conéctate a la VM:

- Para la CLI, véase Sección 2.4.3, “Conexión a una máquina virtual mediante SSH” o Sección 2.4.2, “Abrir la consola gráfica de una máquina virtual con Virt Viewer”.

- Para la interfaz gráfica de usuario, véase Sección 2.4.1, “Interacción con las máquinas virtuales mediante la consola web”.

Actualmente, la consola web sólo proporciona un subconjunto de funciones de gestión de máquinas virtuales, por lo que se recomienda utilizar la línea de comandos para el uso avanzado de la virtualización en RHEL 8.

2.1. Habilitación de la virtualización

Para utilizar la virtualización en RHEL 8, debe activar el módulo de virtualización, instalar los paquetes de virtualización y asegurarse de que su sistema está configurado para alojar máquinas virtuales (VM).

Requisitos previos

- Red Hat Enterprise Linux 8 está instalado y registrado en su máquina anfitriona.

Su sistema cumple los siguientes requisitos de hardware para funcionar como host de virtualización:

- La arquitectura de su máquina anfitriona soporta la virtualización KVM.

Los siguientes recursos mínimos del sistema están disponibles:

- 6 GB de espacio libre en disco para el host, más otros 6 GB para cada máquina virtual prevista.

- 2 GB de RAM para el host, más otros 2 GB para cada máquina virtual prevista.

Procedimiento

Instale los paquetes del módulo de virtualización de RHEL 8:

# yum module install virtInstale los paquetes

virt-installyvirt-viewer:# yum install virt-install virt-viewerInicie el servicio

libvirtd.# systemctl start libvirtdCompruebe que su sistema está preparado para ser un host de virtualización:

# virt-host-validate [...] QEMU: Checking for device assignment IOMMU support : PASS QEMU: Checking if IOMMU is enabled by kernel : WARN (IOMMU appears to be disabled in kernel. Add intel_iommu=on to kernel cmdline arguments) LXC: Checking for Linux >= 2.6.26 : PASS [...] LXC: Checking for cgroup 'blkio' controller mount-point : PASS LXC: Checking if device /sys/fs/fuse/connections exists : FAIL (Load the 'fuse' module to enable /proc/ overrides)Si todas las comprobaciones de virt-host-validate devuelven un valor de

PASS, su sistema está preparado para crear máquinas virtuales.Si alguna de las comprobaciones devuelve un valor de

FAIL, siga las instrucciones mostradas para solucionar el problema.Si alguna de las comprobaciones devuelve un valor de

WARN, considere seguir las instrucciones mostradas para mejorar las capacidades de virtualización.

Información adicional

Tenga en cuenta que si la virtualización no está soportada por su CPU anfitriona, virt-host-validate genera la siguiente salida:

QEMU: Comprobando la virtualización del hardware: FAIL (Sólo hay CPUs emuladas, el rendimiento será significativamente limitado)

Sin embargo, al intentar crear máquinas virtuales en un sistema anfitrión de este tipo, se producirá un fallo, en lugar de tener problemas de rendimiento.

2.2. Creación de máquinas virtuales

Para crear una máquina virtual (VM) en RHEL 8, utilice la interfaz de línea de comandos o la consola web de RHEL 8.

Requisitos previos

- La virtualización está instalada y habilitada en su sistema.

Tiene una cantidad suficiente de recursos del sistema para asignar a sus VMs, como espacio en disco, RAM o CPUs. Los valores recomendados pueden variar significativamente en función de las tareas previstas y la carga de trabajo de las máquinas virtuales.

AvisoLa instalación desde un dispositivo de CD-ROM o DVD-ROM del host no es posible en RHEL 8. Si selecciona un CD-ROM o DVD-ROM como fuente de instalación cuando utiliza cualquier método de instalación de VM disponible en RHEL 8, la instalación fallará. Para más información, consulte la Base de conocimientos de Red Hat.

2.2.1. Creación de máquinas virtuales mediante la interfaz de línea de comandos

Para crear una máquina virtual (VM) en su host RHEL 8 utilizando la utilidad virt-install, siga las siguientes instrucciones.

Requisitos previos

- La virtualización está activada en su sistema anfitrión.

Una fuente de instalación del sistema operativo (SO) está disponible localmente o en una red. Puede ser uno de los siguientes:

- Una imagen ISO de un medio de instalación

- Una imagen de disco de una instalación VM existente

- Opcional: Se puede proporcionar un archivo Kickstart para una configuración más rápida y sencilla de la instalación.

Procedimiento

Para crear una VM e iniciar la instalación de su sistema operativo, utilice el comando virt-install, junto con los siguientes argumentos obligatorios:

- El nombre de la nueva máquina

- La cantidad de memoria asignada

- El número de CPUs virtuales asignadas (vCPUs)

- El tipo y el tamaño del almacenamiento asignado

- El tipo y la ubicación de la fuente de instalación del sistema operativo

Según el método de instalación elegido, las opciones y valores necesarios pueden variar. Consulte los ejemplos siguientes:

Lo siguiente crea una VM llamada demo-guest1 que instala el SO Windows 10 desde una imagen ISO almacenada localmente en el archivo /home/username/Downloads/Win10install.iso. A esta VM también se le asignan 2048 MiB de RAM y 2 vCPUs, y se configura automáticamente un disco virtual qcow2 de 80 GiB para la VM.

# virt-install --name demo-guest1 --memory 2048 --vcpus 2 --disk size=80 --os-variant win10 --cdrom /home/username/Downloads/Win10install.isoLo siguiente crea una VM llamada demo-guest2 que utiliza la imagen /home/username/Downloads/rhel8.iso para ejecutar un SO RHEL 8 desde un CD en vivo. No se asigna espacio en disco a esta VM, por lo que los cambios realizados durante la sesión no se conservarán. Además, la VM se asigna con 4096 MiB de RAM y 4 vCPUs.

# virt-install --name demo-guest2 --memory 4096 --vcpus 4 --disk none --livecd --os-variant rhel8.0 --cdrom /home/username/Downloads/rhel8.isoLo siguiente crea una VM RHEL 8 llamada demo-guest3 que se conecta a una imagen de disco existente, /home/username/backup/disk.qcow2. Esto es similar a mover físicamente un disco duro entre máquinas, por lo que el sistema operativo y los datos disponibles para demo-guest3 están determinados por cómo se manejó la imagen anteriormente. Además, esta VM está asignada con 2048 MiB de RAM y 2 vCPUs.

# virt-install --name demo-guest3 --memory 2048 --vcpus 2 --os-variant rhel8.0 --import --disk /home/username/backup/disk.qcow2Tenga en cuenta que la opción

--os-variantes muy recomendable cuando se importa una imagen de disco. Si no se proporciona, el rendimiento de la VM creada se verá afectado negativamente.Lo siguiente crea una VM llamada demo-guest4 que se instala desde la

http://example.com/OS-installURL. Para que la instalación se inicie con éxito, la URL debe contener un árbol de instalación del SO que funcione. Además, el SO se configura automáticamente utilizando el archivo kickstart de /home/username/ks.cfg. Esta VM también está asignada con 2048 MiB de RAM, 2 vCPUs, y un disco virtual qcow2 de 160 GiB.# virt-install --name demo-guest4 --memory 2048 --vcpus 2 --disk size=160 --os-variant rhel8.0 --location http://example.com/OS-install --initrd-inject /home/username/ks.cfg --extra-args="ks=file:/ks.cfg console=tty0 console=ttyS0,115200n8"Lo siguiente crea una VM llamada demo-guest5 que se instala desde un archivo de imagen

RHEL8.isoen modo de sólo texto, sin gráficos. Conecta la consola del huésped a la consola serial. La VM tiene 16384 MiB de memoria, 16 vCPUs, y 280 GiB de disco. Este tipo de instalación es útil cuando se conecta a un host a través de un enlace de red lento.# virt-install --name demo-guest5 --memory 16384 --vcpus 16 --disk size=280 --os-variant rhel8.0 --location RHEL8.iso --graphics none --extra-args='console=ttyS0'Lo siguiente crea una VM llamada demo-guest6, que tiene la misma configuración que demo-guest5, pero reside en el host remoto 10.0.0.1.

# virt-install --connect qemu ssh://root@10.0.0.1/system --name demo-guest6 --memory 16384 --vcpus 16 --disk size=280 --os-variant rhel8.0 --location RHEL8.iso --graphics none --extra-args='console=ttyS0'

Si la VM se crea con éxito, se abre una ventana de virt-viewer con una consola gráfica de la VM y se inicia la instalación del SO huésped.

Solución de problemas

Si

virt-installfalla con un errorcannot find default network:Asegúrese de que el paquete libvirt-daemon-config-network está instalado:

# yum info libvirt-daemon-config-network Installed Packages Name : libvirt-daemon-config-network [...]Compruebe que la red por defecto

libvirtestá activa y configurada para iniciarse automáticamente:# virsh net-list --all Name State Autostart Persistent -------------------------------------------- default active yes yesSi no lo está, active la red por defecto y configúrela para que se inicie automáticamente:

# virsh net-autostart default Network default marked as autostarted # virsh net-start default Network default started

Si la activación de la red por defecto falla con el siguiente error, el paquete libvirt-daemon-config-network no se ha instalado correctamente.

error: failed to get network 'default' error: Network not found: no network with matching name 'default'

Para solucionarlo, vuelva a instalar libvirt-daemon-config-network.

# yum reinstall libvirt-daemon-config-networkSi la activación de la red por defecto falla con un error similar al siguiente, se ha producido un conflicto entre la subred de la red por defecto y una interfaz existente en el host.

error: Failed to start network default error: internal error: Network is already in use by interface ens2

Para solucionarlo, utilice el comando

virsh net-edit defaulty cambie los valores de 192.168.122.* en la configuración a una subred que no esté ya en uso en el host.

Recursos adicionales

- Se pueden especificar otras opciones para virt-install para configurar aún más la VM y su instalación del SO. Para más detalles, consulte la página man virt-install.

- Si ya tiene una VM funcional, puede clonarla para crear rápidamente una nueva VM con la misma configuración y datos. Para más detalles, consulte Capítulo 8, Clonación de máquinas virtuales.

2.2.2. Creación de máquinas virtuales e instalación de sistemas operativos invitados mediante la consola web

Para gestionar máquinas virtuales (VMs) en una GUI en un host RHEL 8, utilice la consola web. Las siguientes secciones proporcionan información sobre cómo utilizar la consola web de RHEL 8 para crear máquinas virtuales e instalar sistemas operativos invitados en ellas.

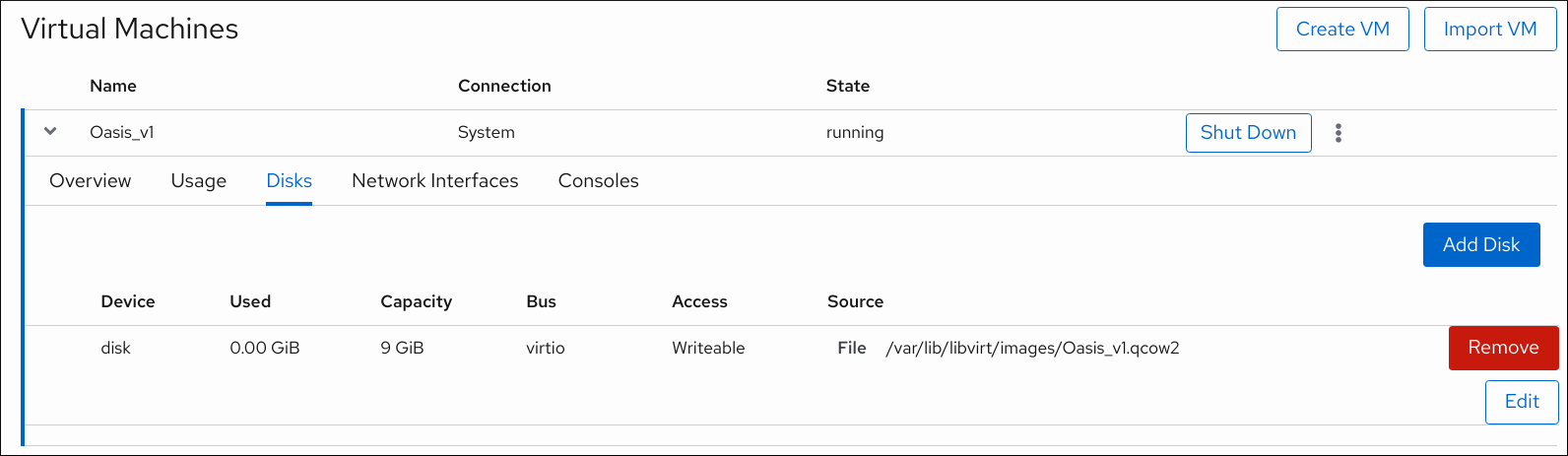

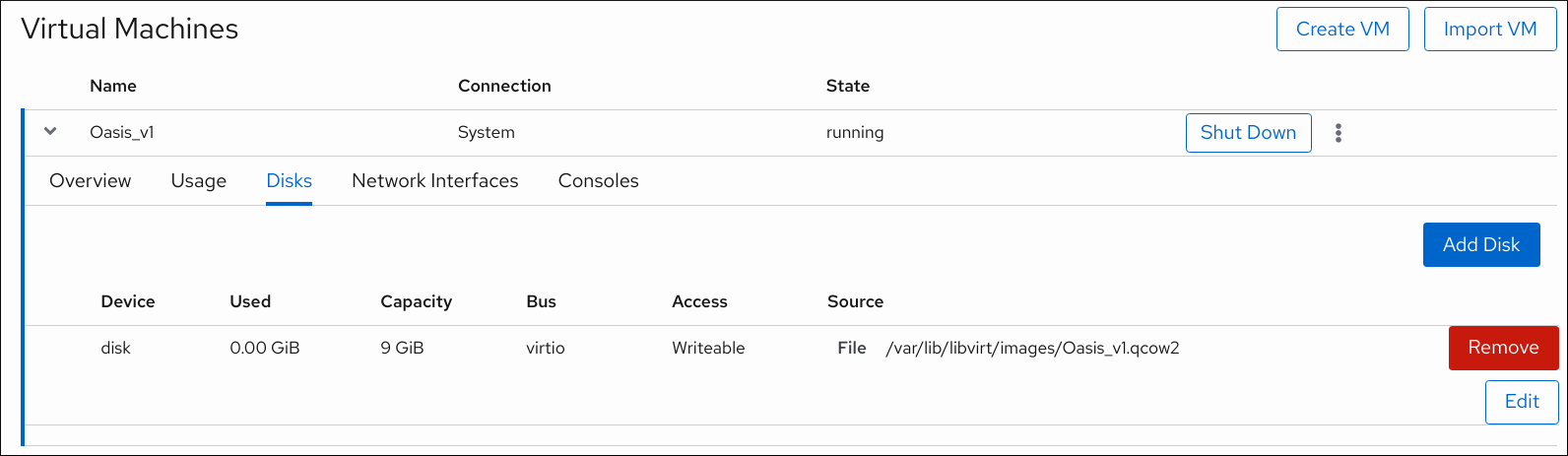

2.2.2.1. Creación de máquinas virtuales mediante la consola web

Para crear una máquina virtual (VM) en el equipo anfitrión al que está conectada la consola web, siga las siguientes instrucciones.

Requisitos previos

- Para utilizar la consola web para gestionar las máquinas virtuales, instale el complemento VM de la consola web.

- Tiene una cantidad suficiente de recursos del sistema para asignar a sus VMs, como espacio en disco, RAM o CPUs. Los valores recomendados pueden variar significativamente en función de las tareas previstas y la carga de trabajo de las máquinas virtuales.

Procedimiento

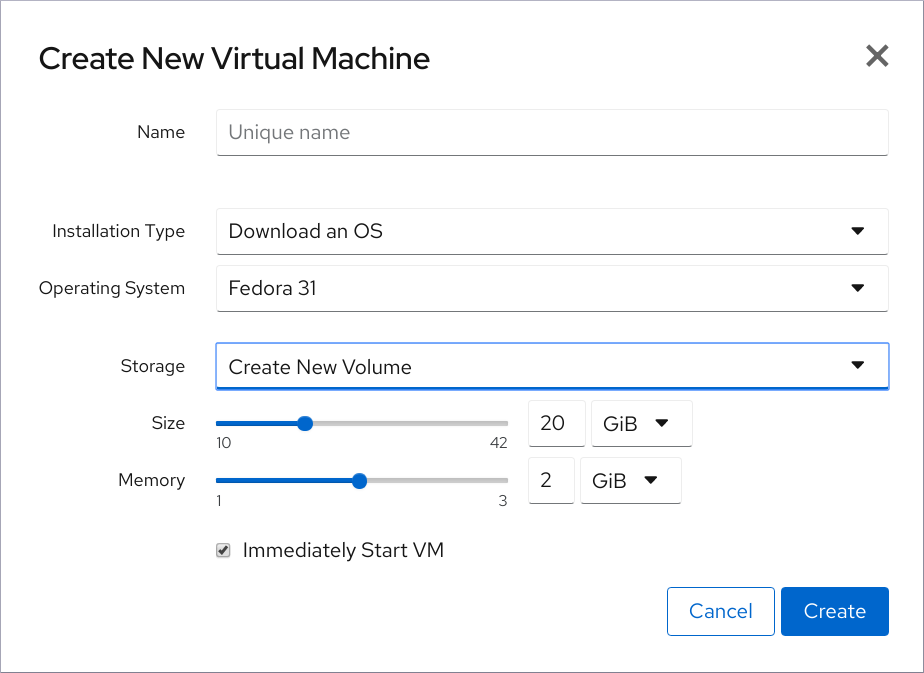

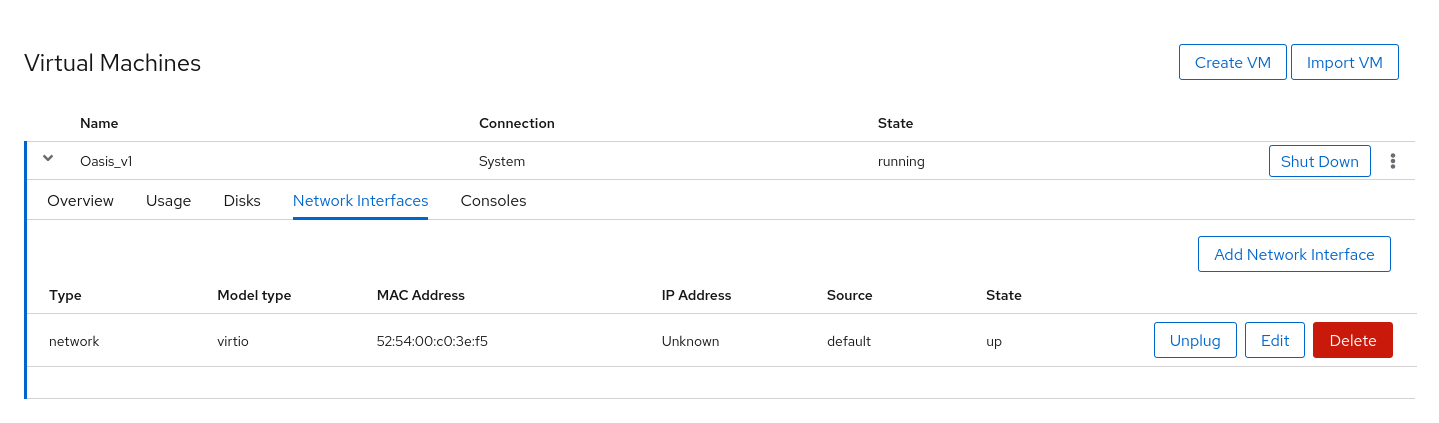

En la interfaz de Máquinas Virtuales de la consola web, haga clic en Create VM.

Aparece el cuadro de diálogo Crear nueva máquina virtual.

Introduzca la configuración básica de la VM que desea crear.

- Name - El nombre de la máquina virtual.

- Installation Type - La instalación puede utilizar un medio de instalación local, una URL, un arranque de red PXE o descargar un sistema operativo de un conjunto limitado de sistemas operativos.

- Operating System - El sistema operativo de la VM. Tenga en cuenta que Red Hat sólo ofrece soporte para un conjunto limitado de sistemas operativos para huéspedes.

- Storage - El tipo de almacenamiento con el que configurar la VM.

- Size - La cantidad de espacio de almacenamiento con la que configurar la VM.

- Memory - La cantidad de memoria con la que configurar la VM.

- Run unattended installation - Si se ejecuta o no la instalación sin supervisión.

- Immediately Start VM - Si la VM se iniciará o no inmediatamente después de ser creada.

Haga clic en Crear.

Se crea la VM. Si se selecciona la casilla Immediately Start VM, la VM se iniciará inmediatamente y comenzará a instalar el sistema operativo invitado.

Recursos adicionales

- Para obtener información sobre la instalación de un sistema operativo en una VM, consulte Sección 2.2.2.3, “Instalación de sistemas operativos invitados mediante la consola web”.

2.2.2.2. Creación de máquinas virtuales mediante la importación de imágenes de disco a través de la consola web

Para crear una máquina virtual (VM) importando una imagen de disco de una instalación VM existente, siga las siguientes instrucciones.

Requisitos previos

- Para utilizar la consola web para gestionar las máquinas virtuales, instale el complemento VM de la consola web.

- Tiene una cantidad suficiente de recursos del sistema para asignar a sus VMs, como espacio en disco, RAM o CPUs. Los valores recomendados pueden variar significativamente en función de las tareas previstas y la carga de trabajo de las máquinas virtuales.

- Asegúrese de tener una imagen de disco de una instalación de VM existente

Procedimiento

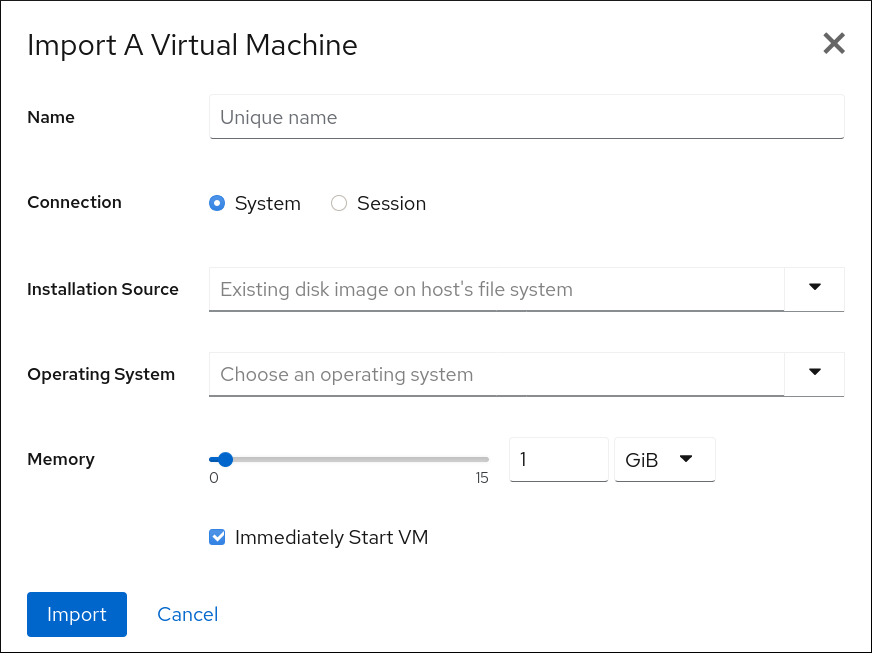

En la interfaz de Máquinas Virtuales de la consola web, haga clic en Import VM.

Aparece el cuadro de diálogo Importar una máquina virtual.

Introduzca la configuración básica de la VM que desea crear.

- Name - El nombre de la máquina virtual.

- Connection - El tipo de conexión libvirt, sistema o sesión.

- Installation Source - La imagen de disco existente de una VM en el sistema anfitrión.

- Operating System - El sistema operativo de la VM. Tenga en cuenta que Red Hat sólo ofrece soporte para un conjunto limitado de sistemas operativos para huéspedes.

- Memory - La cantidad de memoria con la que configurar la VM.

- Immediately Start VM - Si la VM se iniciará o no inmediatamente después de ser creada.

- Haga clic en Importar.

2.2.2.3. Instalación de sistemas operativos invitados mediante la consola web

La primera vez que se carga una máquina virtual (VM), se debe instalar un sistema operativo en la VM.

Si la casilla Immediately Start VM del diálogo Crear nueva máquina virtual está marcada, la rutina de instalación del sistema operativo se inicia automáticamente cuando se crea la VM.

Requisitos previos

- Para utilizar la consola web para gestionar las máquinas virtuales, instale el complemento VM de la consola web.

- Debe haber una máquina virtual en la que instalar un sistema operativo.

Procedimiento

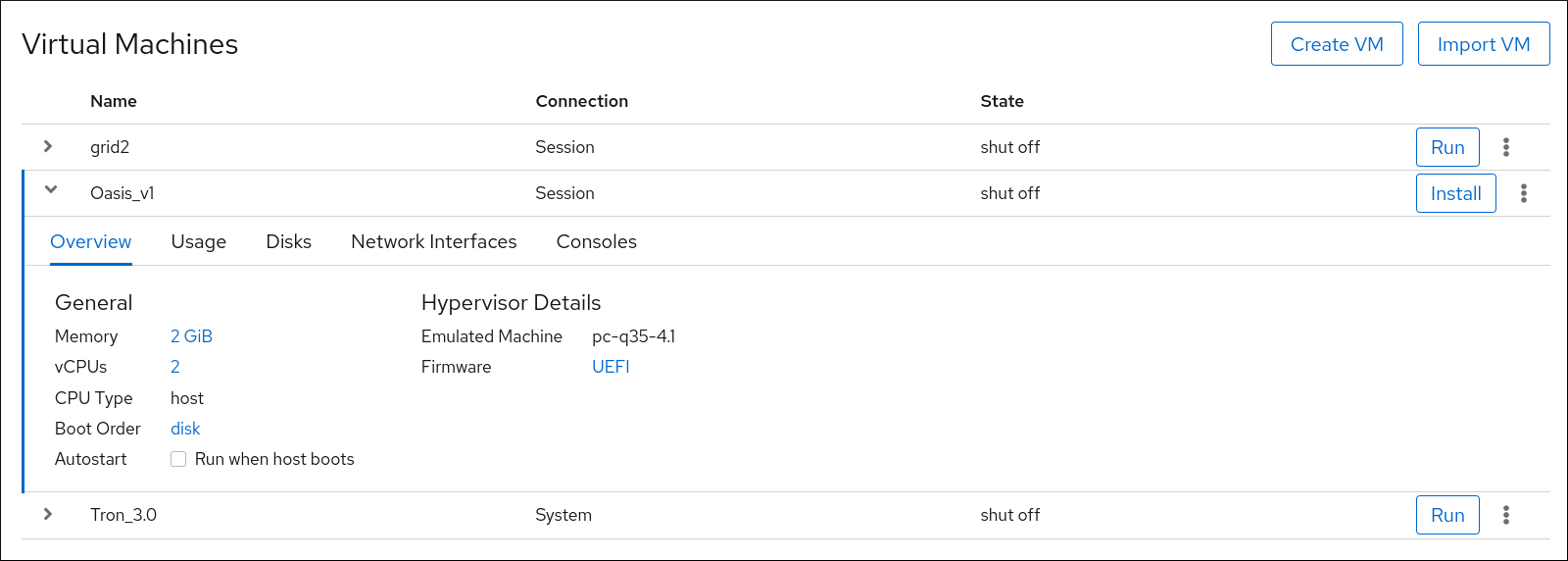

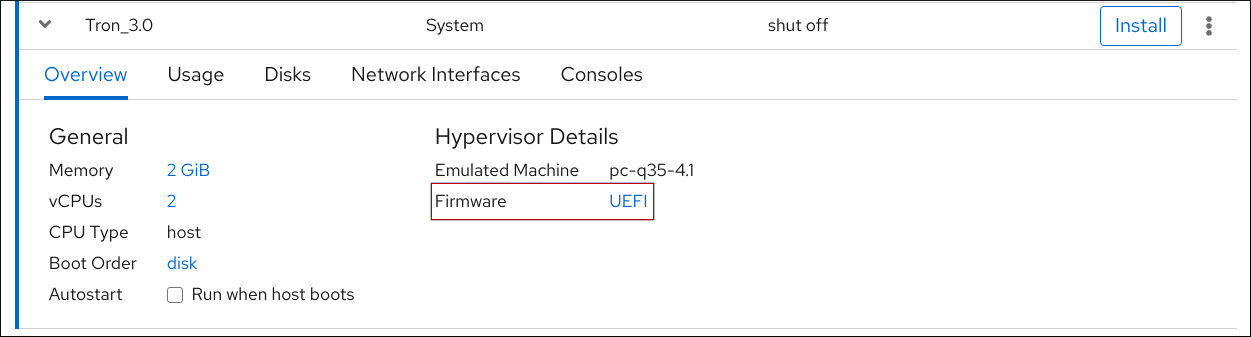

En la interfaz de máquinas virtuales, haga clic en la fila de la máquina virtual en la que desea instalar un sistema operativo invitado.

La fila se expande para revelar el panel de Visión General con información básica sobre la VM seleccionada y controles para instalar y eliminar la VM.

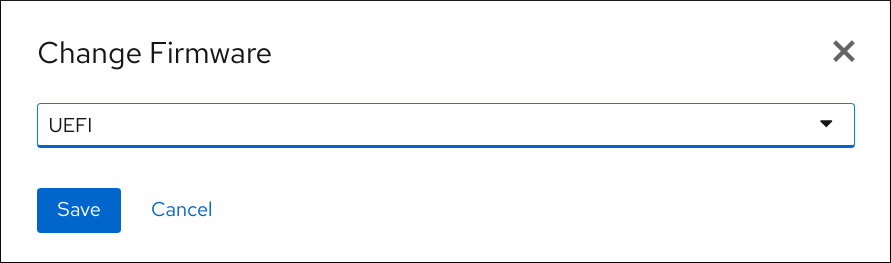

Optional: Cambiar el firmware.

NotaPuede cambiar el firmware sólo si no ha seleccionado la casilla Immediately Start VM en el cuadro de diálogo Create New Virtual Machine, y el sistema operativo no ha sido ya instalado en la VM.

Haga clic en el firmware resaltado.

En la ventana de cambio de firmware, seleccione el firmware deseado.

- Haga clic en Guardar.

Haga clic en Instalar.

La rutina de instalación del sistema operativo se ejecuta en la consola de la VM.

Solución de problemas

- Si la rutina de instalación falla, la VM debe ser borrada y recreada.

2.3. Iniciar máquinas virtuales

Para iniciar una máquina virtual (VM) en RHEL 8, puede utilizar la interfaz de línea de comandos o la GUI de la consola web.

Requisitos previos

- Antes de poder iniciar una VM, ésta debe ser creada e, idealmente, también instalada con un SO. Para obtener instrucciones para hacerlo, consulte Sección 2.2, “Creación de máquinas virtuales”.

2.3.1. Iniciar una máquina virtual mediante la interfaz de línea de comandos

Puede utilizar la interfaz de línea de comandos para iniciar una máquina virtual (VM) apagada o restaurar una VM guardada. Siga el procedimiento siguiente.

Requisitos previos

- Una VM inactiva que ya está definida.

- El nombre de la máquina virtual.

Para las máquinas virtuales remotas:

- La dirección IP del host donde se encuentra la VM.

- Privilegios de acceso a la raíz del host.

Procedimiento

Para una VM local, utilice la utilidad

virsh start.Por ejemplo, el siguiente comando inicia la VM demo-guest1.

# virsh start demo-guest1 Domain demo-guest1 startedPara una VM ubicada en un host remoto, utilice la utilidad

virsh startjunto con la conexión SSH de QEMU al host.Por ejemplo, el siguiente comando inicia la VM demo-guest1 en el host 192.168.123.123.

# virsh -c qemu+ssh://root@192.168.123.123/system start demo-guest1 root@192.168.123.123's password: Last login: Mon Feb 18 07:28:55 2019 Domain demo-guest1 started

Recursos adicionales

-

Para más argumentos

virsh start, utilicevirsh start --help. - Para simplificar la gestión de las máquinas virtuales en hosts remotos, consulte la modificación de la configuración de libvirt y SSH.

-

Puede utilizar la utilidad

virsh autostartpara configurar una VM para que se inicie automáticamente cuando el host arranque. Para obtener más información sobre el arranque automático, consulte la página de ayudavirsh autostart.

2.3.2. Iniciar máquinas virtuales mediante la consola web

Si una máquina virtual (VM) está en el estado shut off, puede iniciarla utilizando la consola web de RHEL 8.

Requisitos previos

- Una VM inactiva que ya está definida.

- El nombre de la máquina virtual.

- Para utilizar la consola web para gestionar las máquinas virtuales, instale el complemento VM de la consola web.

Procedimiento

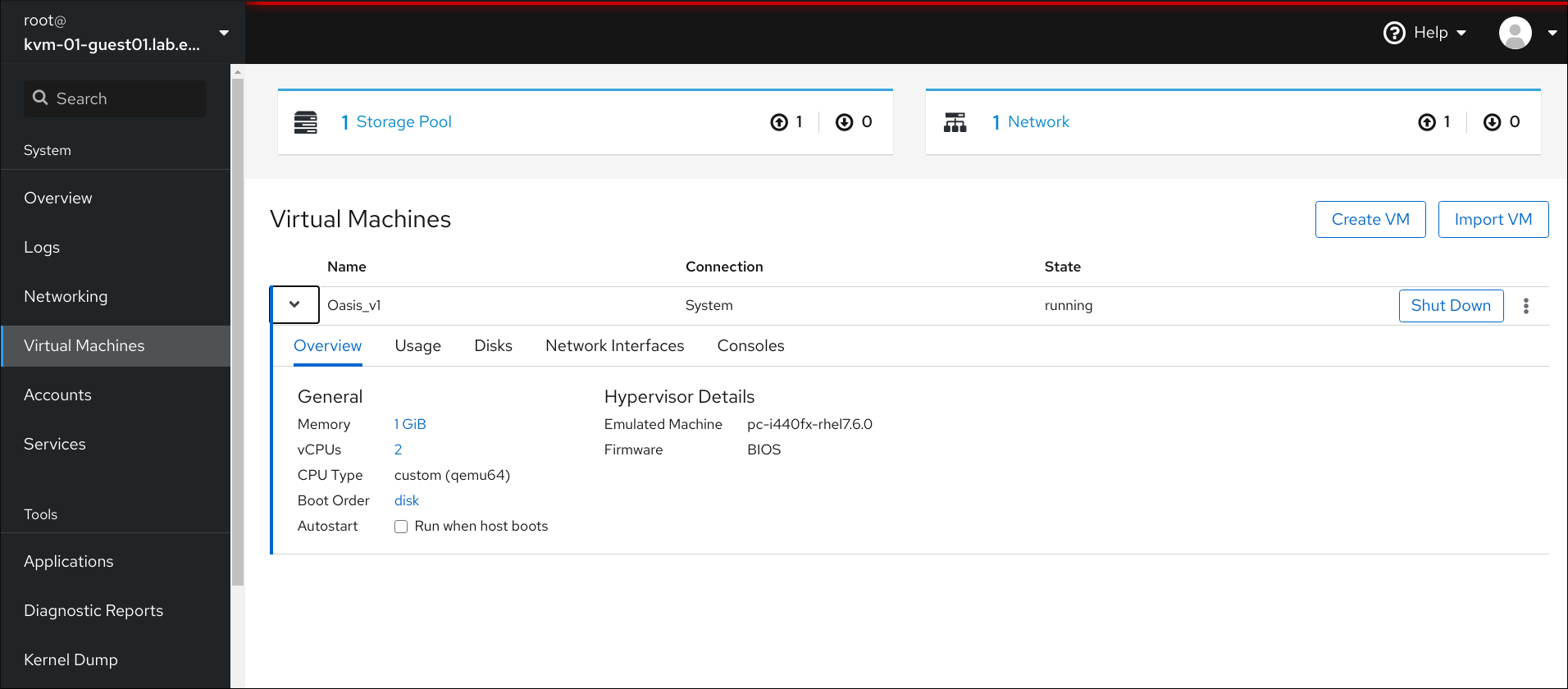

En la interfaz de máquinas virtuales, haga clic en la fila de la máquina virtual que desea iniciar.

La fila se expande para revelar el panel de Visión General con información básica sobre la VM seleccionada y controles para apagar y eliminar la VM.

Haga clic en Ejecutar.

La VM se inicia, y puedes conectarte a su consola o salida gráfica.

-

Optional: Para configurar la VM para que se inicie automáticamente cuando se inicie el host, haga clic en la casilla

Autostart.

Recursos adicionales

- Para obtener información sobre cómo apagar una máquina virtual, consulte Sección 2.5.2.1, “Apagado de máquinas virtuales en la consola web”.

- Para obtener información sobre cómo reiniciar una máquina virtual, consulte Sección 2.5.2.2, “Reinicio de máquinas virtuales mediante la consola web”.

- Para obtener información sobre el envío de una interrupción no enmascarable a una VM, consulte Sección 2.5.2.3, “Envío de interrupciones no enmascarables a las máquinas virtuales mediante la consola web”.

2.4. Conexión a máquinas virtuales

Para interactuar con una máquina virtual (VM) en RHEL 8, es necesario conectarse a ella realizando una de las siguientes acciones:

- Cuando utilice la interfaz de la consola web, utilice el panel de Máquinas Virtuales en la interfaz de la consola web. Para obtener más información, consulte Sección 2.4.1, “Interacción con las máquinas virtuales mediante la consola web”.

- Si necesita interactuar con una pantalla gráfica de la VM sin utilizar la consola web, utilice la aplicación Virt Viewer. Para más detalles, consulte Sección 2.4.2, “Abrir la consola gráfica de una máquina virtual con Virt Viewer”.

- Cuando no es posible o no es necesaria una visualización gráfica, utilice una conexión de terminal SSH.

- Cuando la máquina virtual no es accesible desde su sistema utilizando una red, utilice la consola virsh.

Si las máquinas virtuales a las que se conecta están en un host remoto en lugar de uno local, puede configurar opcionalmente su sistema para un acceso más conveniente a los hosts remotos.

Requisitos previos

- Las máquinas virtuales con las que se quiere interactuar están instaladas e iniciadas.

2.4.1. Interacción con las máquinas virtuales mediante la consola web

Para interactuar con una máquina virtual (VM) en la consola web de RHEL 8, es necesario conectarse a la consola de la VM. Esto incluye tanto las consolas gráficas como las seriales.

- Para interactuar con la interfaz gráfica de la VM en la consola web, utilice la consola gráfica.

- Para interactuar con la interfaz gráfica de la VM en un visor remoto, utilice la consola gráfica de los visores remotos.

- Para interactuar con la CLI de la VM en la consola web, utilice la consola serie.

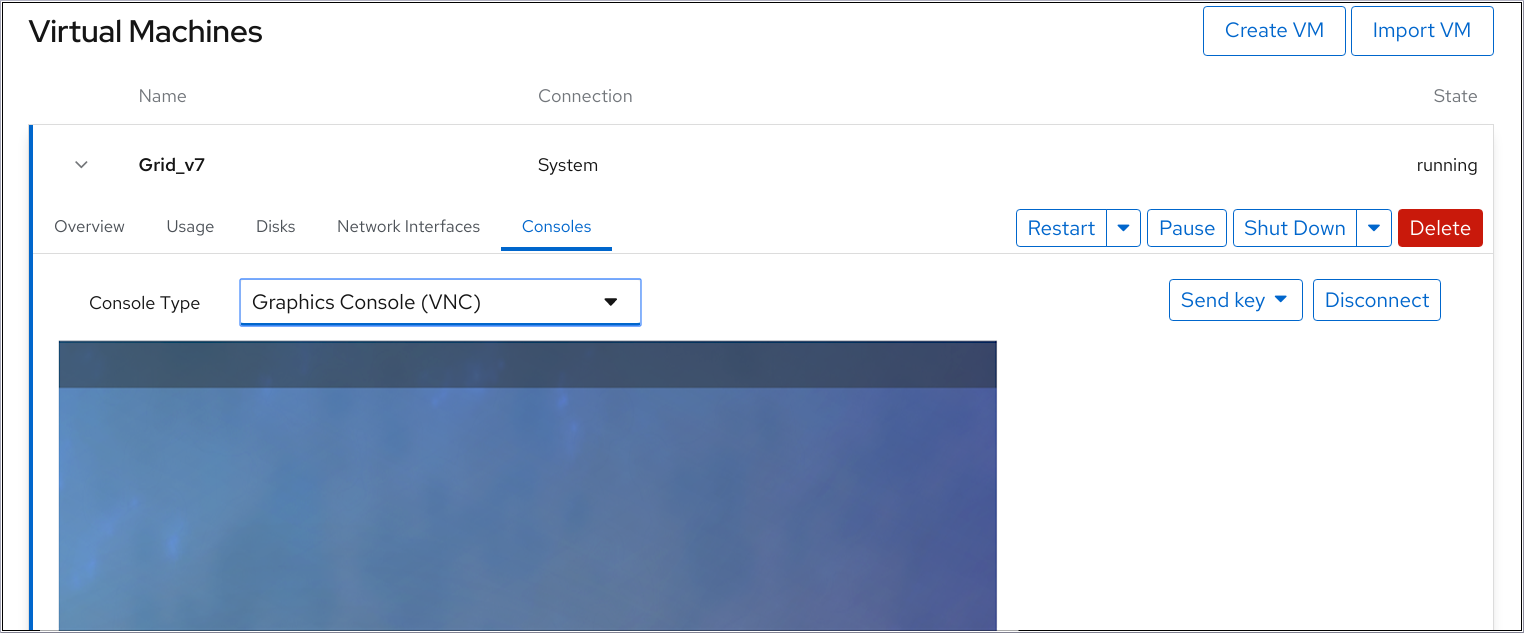

2.4.1.1. Visualización de la consola gráfica de la máquina virtual en la consola web

Mediante la interfaz de la consola de la máquina virtual (VM), puede ver la salida gráfica de una VM seleccionada en la consola web de RHEL 8.

Requisitos previos

- Para utilizar la consola web para gestionar las máquinas virtuales, instale el complemento VM de la consola web.

- Asegúrese de que tanto el host como la VM admiten una interfaz gráfica.

Procedimiento

En la interfaz de máquinas virtuales, haga clic en la fila de la máquina virtual cuya consola gráfica desee ver.

La fila se expande para revelar el panel de Visión General con información básica sobre la VM seleccionada y controles para apagar y eliminar la VM.

Haga clic en Consolas.

La consola gráfica aparece en la interfaz web.

Puede interactuar con la consola de la VM utilizando el ratón y el teclado de la misma manera que interactúa con una máquina real. La pantalla de la consola de la VM refleja las actividades que se realizan en la VM.

El host en el que se ejecuta la consola web puede interceptar determinadas combinaciones de teclas, como Ctrl+Alt+Del, impidiendo que se envíen a la VM.

Para enviar estas combinaciones de teclas, haga clic en el menú Enviar tecla y seleccione la secuencia de teclas que desea enviar.

Por ejemplo, para enviar la combinación Ctrl+Alt+Del a la VM, haga clic en el menú de la tecla Enviar y seleccione la entrada del menú Ctrl Alt Supr.

Recursos adicionales

- Para obtener instrucciones sobre la visualización de la consola gráfica en un visor remoto, consulte Sección 2.4.1.2, “Visualización de la consola gráfica en un visor remoto mediante la consola web”.

- Para obtener instrucciones sobre la visualización de la consola serie en la consola web, consulte Sección 2.4.1.3, “Visualización de la consola de serie de la máquina virtual en la consola web”.

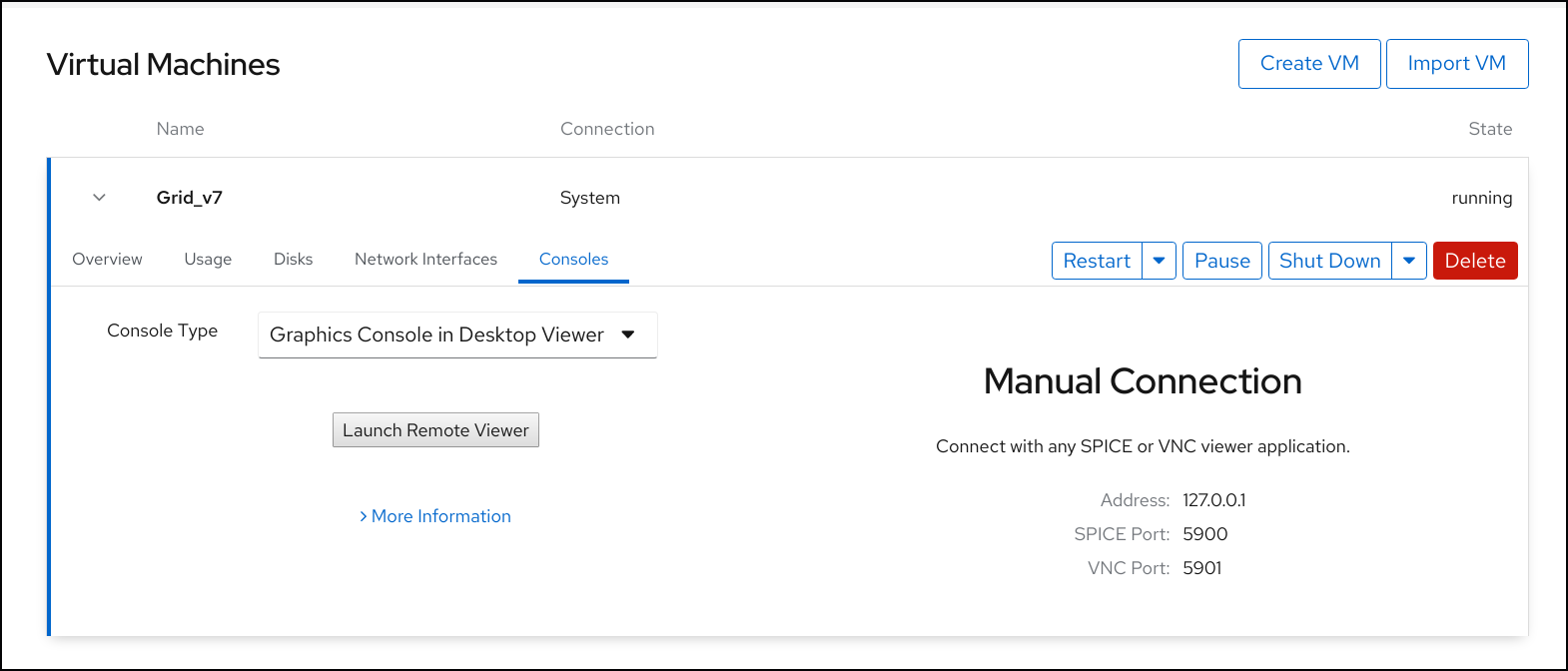

2.4.1.2. Visualización de la consola gráfica en un visor remoto mediante la consola web

Puede ver la consola gráfica de una máquina virtual (VM) seleccionada en un visor remoto, como virt-viewer. Para obtener instrucciones, consulte más abajo.

Puedes lanzar Virt Viewer desde la consola web. Otros visores remotos VNC y SPICE se pueden lanzar manualmente.

Requisitos previos

- Para utilizar la consola web para gestionar las máquinas virtuales, instale el complemento VM de la consola web.

- Asegúrese de que tanto el host como la VM admiten una interfaz gráfica.

Antes de poder ver la consola gráfica en Virt Viewer, Virt Viewer debe estar instalado en la máquina a la que está conectada la consola web.

Para ver la información sobre la instalación de Virt Viewer, seleccione la Consola de Gráficos en el Tipo de Consola del Visor de Escritorio y haga clic en More Information en la ventana de Consolas.

Algunas extensiones y complementos del navegador no permiten que la consola web abra el Virt Viewer.

Procedimiento

En la interfaz de máquinas virtuales, haga clic en la fila de la máquina virtual cuya consola gráfica desee ver.

La fila se expande para revelar el panel de Visión General con información básica sobre la VM seleccionada y controles para apagar y eliminar la VM.

Haga clic en Consolas.

La consola gráfica aparece en la interfaz web.

Seleccione la consola de gráficos en el tipo de consola del visor de escritorio.

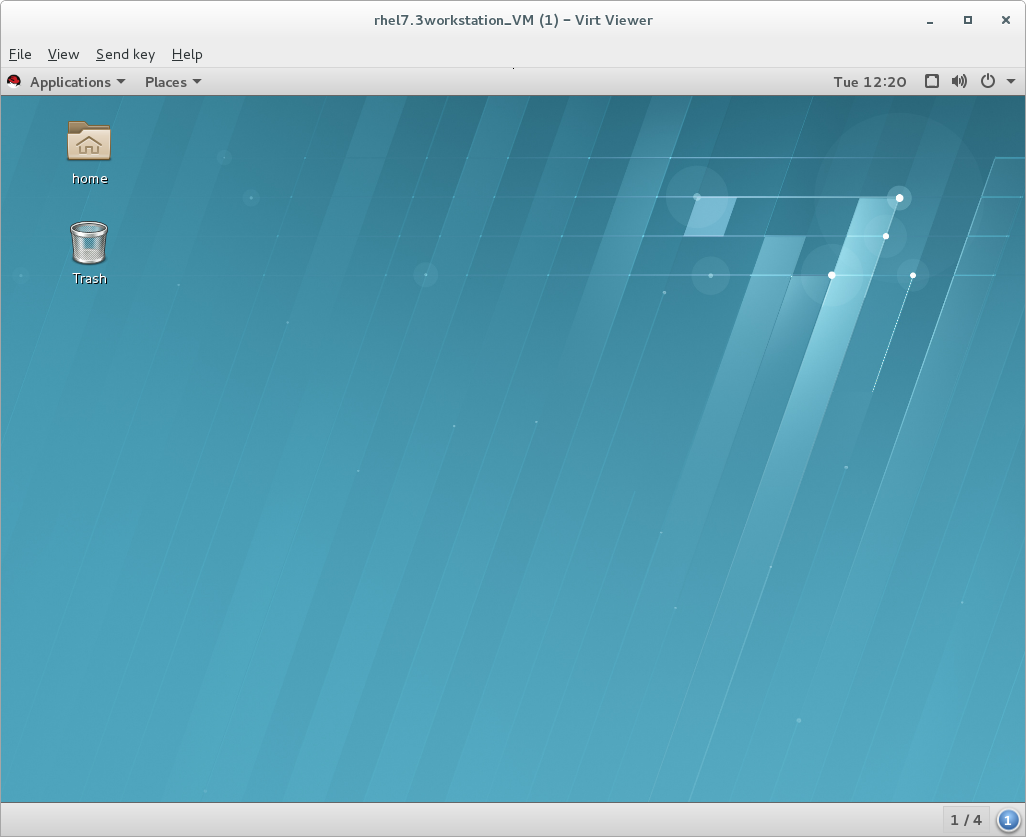

Haga clic en Lanzar el Visor Remoto.

La consola gráfica aparece en Virt Viewer.

Puede interactuar con la consola de la VM utilizando el ratón y el teclado de la misma manera que interactúa con una máquina real. La pantalla de la consola de la VM refleja las actividades que se realizan en la VM.

El servidor en el que se ejecuta la consola web puede interceptar determinadas combinaciones de teclas, como Ctrl+Alt+Del, impidiendo que se envíen a la VM.

Para enviar estas combinaciones de teclas, haga clic en el menú Enviar tecla y seleccione la secuencia de teclas que desea enviar.

Por ejemplo, para enviar la combinación Ctrl+Alt+Del a la VM, haga clic en el menú de la tecla Enviar y seleccione la entrada del menú Ctrl Alt Supr.

Solución de problemas

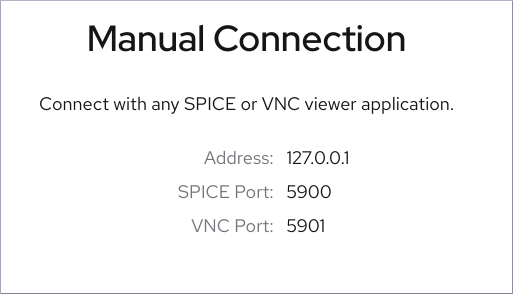

Si el lanzamiento de una consola gráfica del visor remoto en la consola web no funciona o no es óptimo, puede utilizar la información de

Manual Connection, que aparece en la parte derecha del panel de la consola gráfica.

Introduzca la información en una aplicación de visualización SPICE o VNC, como Virt Viewer.

Recursos adicionales

- Para obtener instrucciones sobre la visualización de la consola gráfica en la consola web, consulte Sección 2.4.1.1, “Visualización de la consola gráfica de la máquina virtual en la consola web”.

- Para obtener instrucciones sobre la visualización de la consola serie en la consola web, consulte Sección 2.4.1.3, “Visualización de la consola de serie de la máquina virtual en la consola web”.

2.4.1.3. Visualización de la consola de serie de la máquina virtual en la consola web

Puede ver la consola serie de una máquina virtual (VM) seleccionada en la consola web de RHEL 8. Esto es útil cuando la máquina anfitriona o la VM no están configuradas con una interfaz gráfica.

Requisitos previos

- Para utilizar la consola web para gestionar las máquinas virtuales, instale el complemento VM de la consola web.

Procedimiento

En el panel de máquinas virtuales, haga clic en la fila de la máquina virtual cuya consola de serie desea ver.

La fila se expande para revelar el panel de Visión General con información básica sobre la VM seleccionada y controles para apagar y eliminar la VM.

Haga clic en Consolas.

La consola gráfica aparece en la interfaz web.

Seleccione el Tipo de Consola Serial.

La consola serie aparece en la interfaz web.

Puedes desconectar y volver a conectar la consola serie de la VM.

- Para desconectar la consola serie de la VM, haga clic en Desconectar.

- Para volver a conectar la consola serie a la VM, haga clic en Reconectar.

Recursos adicionales

- Para obtener instrucciones sobre la visualización de la consola gráfica en la consola web, consulte Sección 2.4.1.1, “Visualización de la consola gráfica de la máquina virtual en la consola web”.

- Para obtener instrucciones sobre la visualización de la consola gráfica en un visor remoto, consulte Sección 2.4.1.2, “Visualización de la consola gráfica en un visor remoto mediante la consola web”.

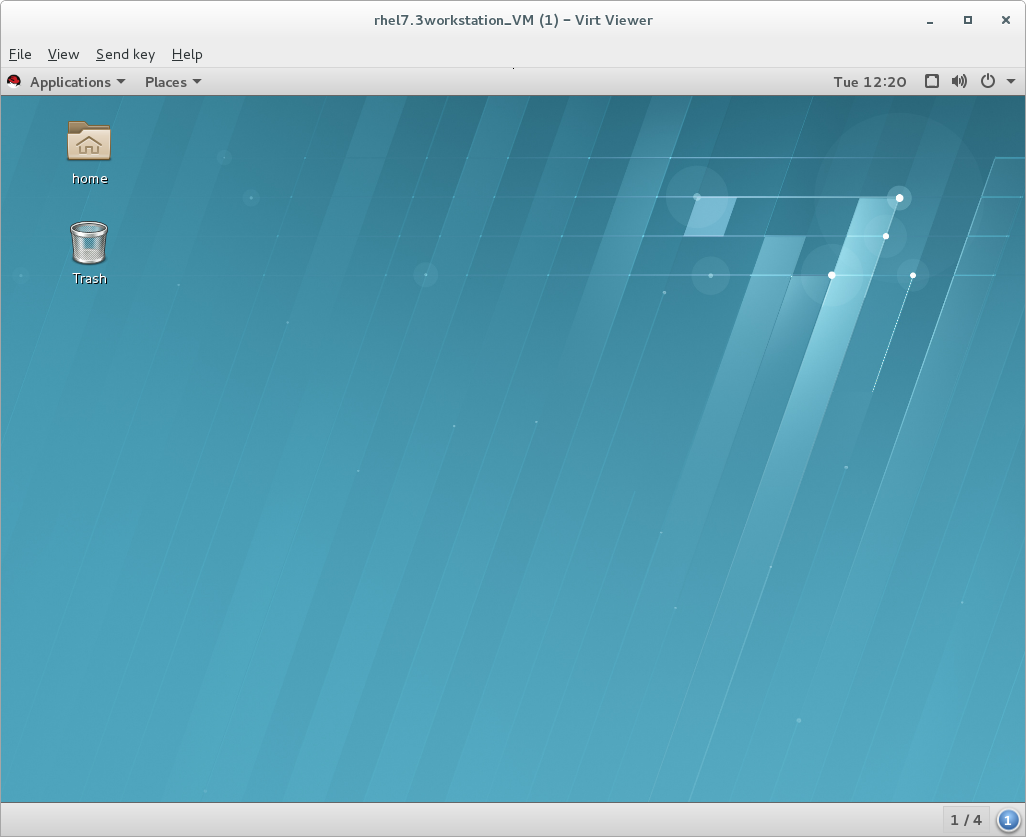

2.4.2. Abrir la consola gráfica de una máquina virtual con Virt Viewer

Para conectarse a una consola gráfica de una máquina virtual (VM) KVM y abrirla en la aplicación de escritorio Virt Viewer, siga el siguiente procedimiento.

Requisitos previos

- Tu sistema, así como la máquina virtual a la que te conectas, deben soportar pantallas gráficas.

- Si la VM de destino se encuentra en un host remoto, se necesita conexión y privilegios de acceso de root al host.

- Optional: Si la VM de destino se encuentra en un host remoto, configure su libvirt y SSH para un acceso más conveniente a los hosts remotos.

Procedimiento

Para conectarse a una VM local, utilice el siguiente comando y sustituya guest-name por el nombre de la VM a la que desea conectarse:

# virt-viewer guest-namePara conectarse a una VM remota, utilice el comando

virt-viewercon el protocolo SSH. Por ejemplo, el siguiente comando se conecta como root a una VM llamada guest-name, ubicada en el sistema remoto 10.0.0.1. La conexión también requiere la autenticación de root para 10.0.0.1.# virt-viewer --direct --connect qemu+ssh://root@10.0.0.1/system guest-name root@10.0.0.1's password:

Si la conexión funciona correctamente, la visualización de la VM se muestra en la ventana Virt Viewer.

Puede interactuar con la consola de la VM utilizando el ratón y el teclado de la misma manera que interactúa con una máquina real. La pantalla de la consola de la VM refleja las actividades que se realizan en la VM.

Recursos adicionales

-

Para más información sobre el uso de Virt Viewer, consulte la página man

virt-viewer. - La conexión a las máquinas virtuales en un host remoto puede simplificarse modificando la configuración de libvirt y SSH.

- Para la gestión de las máquinas virtuales en una GUI interactiva en RHEL 8, puede utilizar la interfaz de la consola web. Para obtener más información, consulte Sección 2.4.1, “Interacción con las máquinas virtuales mediante la consola web”.

2.4.3. Conexión a una máquina virtual mediante SSH

Para interactuar con el terminal de una máquina virtual (VM) utilizando el protocolo de conexión SSH, siga el siguiente procedimiento:

Requisitos previos

- Tiene conexión de red y privilegios de acceso a la raíz de la máquina virtual de destino.

- Si la VM de destino se encuentra en un host remoto, también tiene privilegios de conexión y acceso de root a ese host.

El componente

libvirt-nssestá instalado y habilitado en el host de la máquina virtual. Si no lo está, haga lo siguiente:Instale el paquete

libvirt-nss:# yum install libvirt-nssEdite el archivo

/etc/nsswitch.confy añadalibvirt_guesta la líneahosts:[...] passwd: compat shadow: compat group: compat hosts: files libvirt_guest dns [...]

Procedimiento

Optional: Cuando se conecte a una máquina virtual remota, primero debe conectarse mediante SSH a su host físico. El siguiente ejemplo demuestra la conexión a una máquina anfitriona 10.0.0.1 utilizando sus credenciales de root:

# ssh root@10.0.0.1 root@10.0.0.1's password: Last login: Mon Sep 24 12:05:36 2018 root~#Utilice el nombre de la VM y las credenciales de acceso del usuario para conectarse a ella. Por ejemplo, lo siguiente se conecta a la VM "testguest1" Utilizando sus credenciales de root:

# ssh root@testguest1 root@testguest1's password: Last login: Wed Sep 12 12:05:36 2018 root~]#

Solución de problemas

Si no conoce el nombre de la VM, puede listar todas las VMs disponibles en el host utilizando el comando

virsh list --all:# virsh list --all Id Name State ---------------------------------------------------- 2 testguest1 running - testguest2 shut off

2.4.4. Abrir la consola de serie de una máquina virtual

Utilizando el comando virsh console, es posible conectarse a la consola serie de una máquina virtual (VM).

Esto es útil cuando la VM:

- No proporciona protocolos VNC o SPICE, y por lo tanto no ofrece visualización de vídeo para las herramientas GUI.

- No tiene conexión de red, por lo que no se puede interactuar con él mediante SSH.

Requisitos previos

La VM debe tener la consola serie configurada en su línea de comandos del kernel. Para verificar esto, la salida del comando

cat /proc/cmdlineen la VM debe incluir console=ttyS0. Por ejemplo:# cat /proc/cmdline BOOT_IMAGE=/vmlinuz-3.10.0-948.el7.x86_64 root=/dev/mapper/rhel-root ro console=tty0 console=ttyS0,9600n8 rd.lvm.lv=rhel/root rd.lvm.lv=rhel/swap rhgbSi la consola serial no está configurada correctamente en una VM, al usar virsh console para conectarse a la VM, se conecta a una consola huésped que no responde. Sin embargo, puedes salir de la consola que no responde utilizando el acceso directo Ctrl ].

Para configurar la consola serial en la VM, haga lo siguiente:

-

En la máquina virtual, edite el archivo

/etc/default/gruby añada console=ttyS0 a la línea que comienza con GRUB_CMDLINE_LINUX. Borre las opciones del kernel que puedan impedir que sus cambios surtan efecto.

# grub2-editenv - unset kerneloptsRecarga la configuración de Grub:

# grub2-mkconfig -o /boot/grub2/grub.cfg Generating grub configuration file ... Found linux image: /boot/vmlinuz-3.10.0-948.el7.x86_64 Found initrd image: /boot/initramfs-3.10.0-948.el7.x86_64.img [...] done- Reinicie la máquina virtual.

-

En la máquina virtual, edite el archivo

Procedimiento

En su sistema anfitrión, utilice el comando

virsh console. El siguiente ejemplo se conecta a la VM guest1, si el controlador libvirt soporta el manejo seguro de la consola:# virsh console guest1 --safe Connected to domain guest1 Escape character is ^] Subscription-name Kernel 3.10.0-948.el7.x86_64 on an x86_64 localhost login:

- Puedes interactuar con la consola virsh de la misma manera que con una interfaz de línea de comandos estándar.

Recursos adicionales

- Para más información sobre la consola serie de la VM, consulte la página man de virsh.

2.4.5. Configuración de un acceso fácil a los hosts de virtualización remotos

Cuando se gestionan máquinas virtuales en un sistema anfitrión remoto utilizando las utilidades de libvirt, se recomienda utilizar la sintaxis -c qemu ssh://root@hostname/system. Por ejemplo, para utilizar el comando virsh list como root en el host 10.0.0.1:

# virsh -c qemu+ssh://root@10.0.0.1/system list

root@10.0.0.1's password:

Last login: Mon Feb 18 07:28:55 2019

Id Name State

---------------------------------

1 remote-guest runningSin embargo, para mayor comodidad, puede eliminar la necesidad de especificar los detalles de la conexión en su totalidad modificando la configuración de SSH y libvirt. Por ejemplo, podrás hacer:

# virsh -c remote-host list

root@10.0.0.1's password:

Last login: Mon Feb 18 07:28:55 2019

Id Name State

---------------------------------

1 remote-guest runningPara habilitar esta mejora, siga las siguientes instrucciones.

Procedimiento

Edite o cree el archivo

~/.ssh/configy añada lo siguiente, donde host-alias es un nombre abreviado asociado a un host remoto específico, y hosturl es la dirección URL del host.Host host-alias User root Hostname hosturl

Por ejemplo, lo siguiente configura el alias tyrannosaurus para root@10.0.0.1:

Host tyrannosaurus User root Hostname 10.0.0.1Edita o crea el archivo

/etc/libvirt/libvirt.conf, y añade lo siguiente, donde qemu-host-alias es un alias de host que las utilidades QEMU y libvirt asociarán con el host previsto:uri_aliases = [ "qemu-host-alias=qemu+ssh://host-alias/system", ]

Por ejemplo, lo siguiente utiliza el alias tyrannosaurus configurado en el paso anterior para configurar el alias t-rex, que significa

qemu ssh://10.0.0.1/system:uri_aliases = [ "t-rex=qemu+ssh://tyrannosaurus/system", ]

Como resultado, puede gestionar las VMs remotas utilizando utilidades basadas en libvirt en el sistema local con un parámetro añadido

-c qemu-host-aliasparámetro. Esto realiza automáticamente los comandos a través de SSH en el host remoto.Por ejemplo, a continuación se enumeran las máquinas virtuales del host remoto 10.0.0.1, cuya conexión se configuró como t-rex en los pasos anteriores:

$ virsh -c t-rex list root@10.0.0.1's password: Last login: Mon Feb 18 07:28:55 2019 Id Name State --------------------------------- 1 velociraptor runningOptional: Si desea utilizar las utilidades de libvirt exclusivamente en un único host remoto, también puede establecer una conexión específica como objetivo por defecto para las utilidades basadas en libvirt. Para ello, edite el archivo

/etc/libvirt/libvirt.confy establezca el valor del parámetrouri_defaulten qemu-host-alias. Por ejemplo, lo siguiente utiliza el alias de host t-rex configurado en los pasos anteriores como objetivo por defecto de libvirt.# These can be used in cases when no URI is supplied by the application # (@uri_default also prevents probing of the hypervisor driver). # uri_default = "t-rex"

Como resultado, todos los comandos basados en libvirt se ejecutarán automáticamente en el host remoto especificado.

$ virsh list root@10.0.0.1's password: Last login: Mon Feb 18 07:28:55 2019 Id Name State --------------------------------- 1 velociraptor runningSin embargo, esto no es recomendable si también quiere gestionar máquinas virtuales en su host local o en diferentes hosts remotos.

Recursos adicionales

Al conectarse a un host remoto, puede evitar tener que proporcionar la contraseña de root al sistema remoto. Para ello, utilice uno o varios de los siguientes métodos:

- Configurar el acceso SSH basado en claves al host remoto.

- Utilice la multiplexación de la conexión SSH para conectarse al sistema remoto.

- Configure un ticket de autenticación kerberos en el sistema remoto. Para obtener instrucciones, consulte Autenticación Kerberos en Gestión de identidades.

Entre las utilidades que pueden utilizar la opción

-c(o--connect) y la configuración de acceso al host remoto descrita anteriormente se encuentran:- virt-install

- virt-viewer

- virsh

- virt-manager

2.5. Apagado de máquinas virtuales

Para apagar una máquina virtual en ejecución en Red Hat Enterprise Linux 8, utilice la interfaz de línea de comandos o la GUI de la consola web.

2.5.1. Apagar una máquina virtual mediante la interfaz de línea de comandos

Para apagar una máquina virtual (VM) con capacidad de respuesta, realice una de las siguientes acciones:

- Utilice un comando de apagado apropiado para el SO invitado mientras esté conectado al mismo.

Utilice el comando

virsh shutdownen el host:Si la VM está en un host local:

# virsh shutdown demo-guest1 Domain demo-guest1 is being shutdownSi la VM está en un host remoto, en este ejemplo 10.0.0.1:

# virsh -c qemu+ssh://root@10.0.0.1/system shutdown demo-guest1 root@10.0.0.1's password: Last login: Mon Feb 18 07:28:55 2019 Domain demo-guest1 is being shutdown

Para forzar el cierre de un huésped, por ejemplo, si no responde, utilice el comando virsh destroy en el host:

# virsh destroy demo-guest1

Domain demo-guest1 destroyed

El comando virsh destroy no borra o elimina la configuración de la VM o las imágenes de disco. Sólo destruye la instancia de la VM en ejecución. Sin embargo, en casos raros, este comando puede causar la corrupción del sistema de archivos de la VM, por lo que el uso de virsh destroy sólo se recomienda si todos los demás métodos de apagado han fallado.

2.5.2. Apagado y reinicio de máquinas virtuales mediante la consola web

Utilizando la consola web de RHEL 8, puede apagar o reiniciar las máquinas virtuales en funcionamiento. También puede enviar una interrupción no enmascarable a una máquina virtual que no responda.

2.5.2.1. Apagado de máquinas virtuales en la consola web

Si una máquina virtual (VM) está en el estado running, puede apagarla utilizando la consola web de RHEL 8.

Requisitos previos

- Para utilizar la consola web para gestionar las máquinas virtuales, instale el complemento VM de la consola web.

Procedimiento

En la interfaz de máquinas virtuales, haga clic en la fila de la máquina virtual que desea apagar.

La fila se expande para revelar el panel de Visión General con información básica sobre la VM seleccionada y controles para apagar y eliminar la VM.

Haga clic en Apagar.

La máquina virtual se apaga.

Solución de problemas

- Si la VM no se apaga, haga clic en el botón Menú ⋮ junto al botón Apagar y seleccione Forzar apagado.

- Para apagar una máquina virtual que no responde, también puede enviar una interrupción no enmascarable. Para más información, consulte Sección 2.5.2.3, “Envío de interrupciones no enmascarables a las máquinas virtuales mediante la consola web”.

Recursos adicionales

- Para obtener información sobre cómo iniciar una máquina virtual, consulte Sección 2.3.2, “Iniciar máquinas virtuales mediante la consola web”.

- Para obtener información sobre cómo reiniciar una máquina virtual, consulte Sección 2.5.2.2, “Reinicio de máquinas virtuales mediante la consola web”.

2.5.2.2. Reinicio de máquinas virtuales mediante la consola web

Si una máquina virtual (VM) está en el estado running, puede reiniciarla utilizando la consola web de RHEL 8.

Requisitos previos

- Para utilizar la consola web para gestionar las máquinas virtuales, instale el complemento VM de la consola web.

Procedimiento

En la interfaz de máquinas virtuales, haga clic en la fila de la máquina virtual que desea reiniciar.

La fila se expande para revelar el panel de Visión General con información básica sobre la VM seleccionada y controles para apagar y eliminar la VM.

Haga clic en Reiniciar.

La máquina virtual se apaga y se reinicia.

Solución de problemas

- Si la VM no se reinicia, haga clic en el botón Menú ⋮ junto al botón Reiniciar y seleccione Forzar reinicio.

- Para reiniciar una máquina virtual que no responde, también puede enviar una interrupción no enmascarable. Para más información, consulte Sección 2.5.2.3, “Envío de interrupciones no enmascarables a las máquinas virtuales mediante la consola web”.

Recursos adicionales

- Para obtener información sobre cómo iniciar una máquina virtual, consulte Sección 2.3.2, “Iniciar máquinas virtuales mediante la consola web”.

- Para obtener información sobre cómo apagar una máquina virtual, consulte Sección 2.5.2.1, “Apagado de máquinas virtuales en la consola web”.

2.5.2.3. Envío de interrupciones no enmascarables a las máquinas virtuales mediante la consola web

El envío de una interrupción no enmascarable (NMI) puede hacer que una máquina virtual (VM) que no responde responda o se apague. Por ejemplo, puede enviar la Ctrl+Alt+Del NMI a una VM que no responde a la entrada estándar.

Requisitos previos

- Para utilizar la consola web para gestionar las máquinas virtuales, instale el complemento VM de la consola web.

Procedimiento

En la interfaz de máquinas virtuales, haga clic en la fila de la máquina virtual a la que desea enviar un NMI.

La fila se expande para revelar el panel de Visión General con información básica sobre la VM seleccionada y controles para apagar y eliminar la VM.

Haz clic en el botón Menú ⋮ junto al botón Apagar y selecciona Enviar interrupción no enmascarable.

Se envía un NMI a la VM.

Recursos adicionales

- Para obtener información sobre cómo iniciar una máquina virtual, consulte Sección 2.3.2, “Iniciar máquinas virtuales mediante la consola web”.

- Para obtener información sobre cómo reiniciar una máquina virtual, consulte Sección 2.5.2.2, “Reinicio de máquinas virtuales mediante la consola web”.

- Para obtener información sobre cómo apagar una máquina virtual, consulte Sección 2.5.2.1, “Apagado de máquinas virtuales en la consola web”.

2.6. Eliminación de máquinas virtuales

Para eliminar máquinas virtuales en Red Hat Enterprise Linux 8, utilice la interfaz de línea de comandos o la GUI de la consola web.

2.6.1. Eliminación de máquinas virtuales mediante la interfaz de línea de comandos

Para eliminar una máquina virtual (VM), puede eliminar su configuración XML y los archivos de almacenamiento asociados del host utilizando la línea de comandos. Siga el procedimiento siguiente:

Requisitos previos

- Haz una copia de seguridad de los datos importantes de la máquina virtual.

- Apague la máquina virtual.

- Asegúrese de que ninguna otra máquina virtual utilice el mismo almacenamiento asociado.

Procedimiento

Utilice la utilidad

virsh undefine.Por ejemplo, el siguiente comando elimina la VM guest1, sus volúmenes de almacenamiento asociados y la RAM no volátil, si la hay.

# virsh undefine guest1 --remove-all-storage --nvram Domain guest1 has been undefined Volume 'vda'(/home/images/guest1.qcow2) removed.

Recursos adicionales

-

Para otros argumentos de

virsh undefine, utilicevirsh undefine --helpo consulte la página de manualvirsh.

2.6.2. Eliminación de máquinas virtuales mediante la consola web

Para eliminar una máquina virtual (VM) y sus archivos de almacenamiento asociados del host al que está conectada la consola web de RHEL 8, siga el siguiente procedimiento:

Requisitos previos

- Para utilizar la consola web para gestionar las máquinas virtuales, instale el complemento VM de la consola web.

- Haz una copia de seguridad de los datos importantes de la máquina virtual.

- Apague la máquina virtual.

- Asegúrese de que ninguna otra máquina virtual utilice el mismo almacenamiento asociado.

Procedimiento

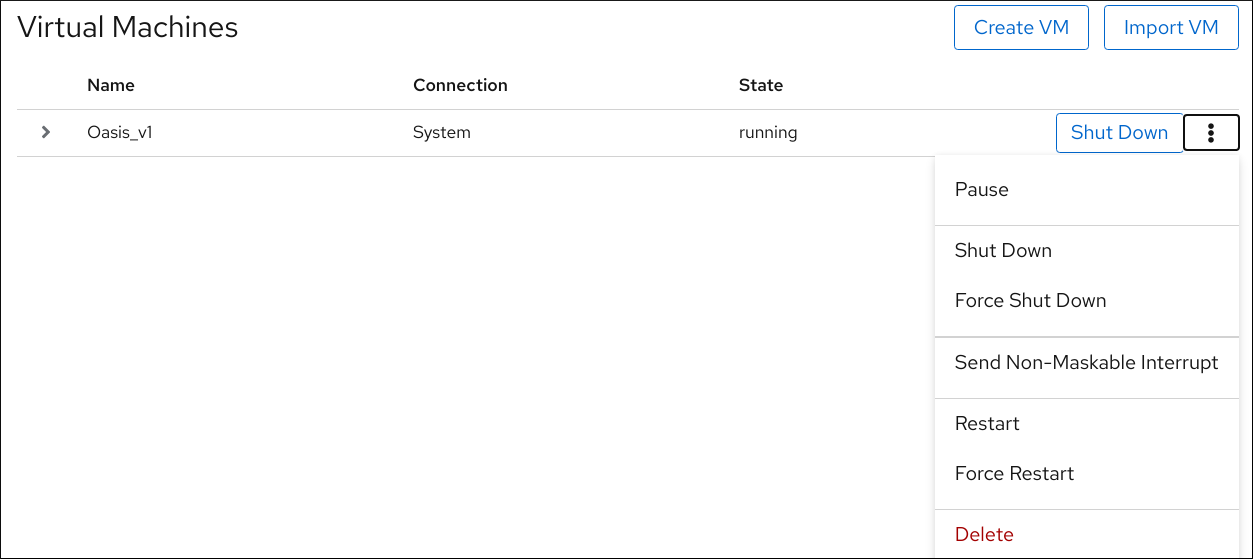

En la interfaz de Máquinas Virtuales, haga clic en el botón Menú ⋮ de la VM que desea eliminar.

Aparece un menú desplegable con controles para varias operaciones de VM.

Haga clic en Eliminar.

Aparece un diálogo de confirmación.

- Optional: Para eliminar todos o algunos de los archivos de almacenamiento asociados a la VM, seleccione las casillas de verificación junto a los archivos de almacenamiento que desee eliminar.

Haga clic en Eliminar.

La VM y los archivos de almacenamiento seleccionados se eliminan.

2.7. Información relacionada

La información anterior se aplica a las arquitecturas AMD64 e Intel 64. Si desea utilizar la virtualización de RHEL8 en otras arquitecturas soportadas, se necesitan diferentes procedimientos de configuración y ciertas características pueden estar restringidas o funcionar de manera diferente. Para más detalles, consulte la sección correspondiente más abajo:

Capítulo 3. Introducción a la virtualización en IBM POWER

Puede utilizar la virtualización KVM cuando utilice RHEL 8 en hardware IBM POWER8 o POWER9. Sin embargo, habilitar el hipervisor K VM en su sistema requiere pasos adicionales en comparación con la virtualización en arquitecturas AMD64 e Intel64. Algunas características de virtualización de RHEL 8 también tienen una funcionalidad diferente o restringida en IBM POWER.

Aparte de la información de las siguientes secciones, el uso de la virtualización en IBM POWER funciona igual que en AMD64 e Intel 64. Por lo tanto, puede consultar otra documentación de virtualización de RHEL 8 para obtener más información sobre el uso de la virtualización en IBM POWER.

3.1. Habilitación de la virtualización en IBM POWER

Para configurar un hipervisor KVM y crear máquinas virtuales (VM) en un sistema IBM POWER8 o IBM POWER9 que ejecute RHEL 8, siga las siguientes instrucciones.

Requisitos previos

- RHEL 8 está instalado y registrado en su máquina anfitriona.

Los siguientes recursos mínimos del sistema están disponibles:

- 6 GB de espacio libre en disco para el host, más otros 6 GB para cada máquina virtual prevista.

- 2 GB de RAM para el host, más otros 2 GB para cada máquina virtual prevista.

Su tipo de máquina con CPU debe soportar la virtualización IBM POWER.

Para comprobarlo, consulte la información de la plataforma en su archivo

/proc/cpuinfo.# grep ^platform /proc/cpuinfo/ platform : PowerNVSi la salida de este comando incluye la entrada

PowerNV, está ejecutando un tipo de máquina PowerNV y puede utilizar la virtualización en IBM POWER.

Procedimiento

Cargar el módulo del kernel KVM-HV

# modprobe kvm_hvCompruebe que el módulo del kernel KVM está cargado

# lsmod | grep kvmSi KVM se ha cargado con éxito, la salida de este comando incluye

kvm_hv.Instale los paquetes en el módulo de virtualización:

# yum module install virtInstale el paquete

virt-install:# yum install virt-installInicie el servicio

libvirtd.# systemctl start libvirtdCompruebe que su sistema está preparado para ser un host de virtualización:

# virt-host-validate [...] QEMU: Checking if device /dev/vhost-net exists : PASS QEMU: Checking if device /dev/net/tun exists : PASS QEMU: Checking for cgroup 'memory' controller support : PASS QEMU: Checking for cgroup 'memory' controller mount-point : PASS [...] QEMU: Checking for cgroup 'blkio' controller support : PASS QEMU: Checking for cgroup 'blkio' controller mount-point : PASS QEMU: Checking if IOMMU is enabled by kernel : PASSSi todas las comprobaciones de virt-host-validate devuelven un valor de

PASS, su sistema está preparado para crear máquinas virtuales.Si alguna de las comprobaciones devuelve un valor de

FAIL, siga las instrucciones mostradas para solucionar el problema.Si alguna de las comprobaciones devuelve un valor de

WARN, considere seguir las instrucciones mostradas para mejorar las capacidades de virtualización.

Información adicional

Tenga en cuenta que si la virtualización no está soportada por su CPU anfitriona, virt-host-validate genera la siguiente salida:

QEMU: Comprobando la virtualización del hardware: FAIL (Sólo hay CPUs emuladas, el rendimiento será significativamente limitado)

Sin embargo, al intentar crear máquinas virtuales en un sistema anfitrión de este tipo, se producirá un fallo, en lugar de tener problemas de rendimiento.

3.2. En qué se diferencia la virtualización en IBM POWER de la de AMD64 e Intel 64

La virtualización KVM en RHEL 8 en sistemas IBM POWER es diferente de KVM en sistemas AMD64 e Intel 64 en varios aspectos, especialmente:

- Requisitos de memoria

- Las máquinas virtuales en IBM POWER consumen más memoria. Por lo tanto, la asignación de memoria mínima recomendada para una máquina virtual (VM) en un host IBM POWER es de 2 GB de RAM.

- Protocolos de visualización

El protocolo SPICE no es compatible con los sistemas IBM POWER. Para mostrar la salida gráfica de una VM, utilice el protocolo

VNC. Además, sólo se admiten los siguientes dispositivos de tarjetas gráficas virtuales:-

vga- sólo se admite en el modo-vga stdy no en el modo-vga cirrus. -

virtio-vga -

virtio-gpu

-

- SMBIOS

- La configuración de SMBIOS no está disponible.

- Errores de asignación de memoria

Las máquinas virtuales POWER8, incluidas las del modo de compatibilidad, pueden fallar con un error similar al siguiente:

qemu-kvm: No se ha podido asignar el HPT de KVM de orden 33 (intente con un maxmem menor): No se puede asignar memoria

Esto es mucho más probable que ocurra en las máquinas virtuales que utilizan RHEL 7.3 y anteriores como sistema operativo invitado.

Para solucionar el problema, aumente la reserva de memoria CMA disponible para la tabla de páginas hash (HPT) del huésped añadiendo

kvm_cma_resv_ratio=memorya la línea de comandos del kernel del huésped, donde memory es el porcentaje de la memoria del huésped que debe reservarse para el pool de CMA (por defecto es 5).- Páginas enormes

Las páginas enormes transparentes (THP) no proporcionan ninguna ventaja de rendimiento notable en las máquinas virtuales IBM POWER8. Sin embargo, las máquinas virtuales IBM POWER9 pueden beneficiarse de las THP como se esperaba.

Además, el tamaño de las páginas enormes estáticas en los sistemas IBM POWER8 es de 16 MiB y 16 GiB, frente a 2 MiB y 1 GiB en AMD64, Intel 64 e IBM POWER9. Como consecuencia, para migrar una VM configurada con páginas enormes estáticas desde un host IBM POWER8 a un host IBM POWER9, primero debe configurar páginas enormes de 1 GiB en la VM.

- kvm-reloj

-

El servicio

kvm-clockno tiene que ser configurado para la gestión del tiempo en las máquinas virtuales en IBM POWER9. - pvpanic

Los sistemas IBM POWER9 no soportan el dispositivo

pvpanic. Sin embargo, una funcionalidad equivalente está disponible y activada por defecto en esta arquitectura. Para activarla en una VM, utilice el elemento de configuración XML<on_crash>con el valorpreserve.Además, asegúrese de eliminar el elemento

<panic>de la sección<devices>, ya que su presencia puede hacer que la máquina virtual no arranque en los sistemas IBM POWER.- Host de un solo hilo

- En los sistemas IBM POWER8, la máquina anfitriona debe ejecutarse en single-threaded mode para soportar las máquinas virtuales. Esto se configura automáticamente si se instalan los paquetes qemu-kvm. Sin embargo, las máquinas virtuales que se ejecutan en hosts de un solo hilo pueden seguir utilizando varios hilos.

- Dispositivos periféricos

Varios dispositivos periféricos admitidos en los sistemas AMD64 e Intel 64 no son compatibles con los sistemas IBM POWER, o bien se admite un dispositivo diferente como sustitución.

-

Los dispositivos utilizados para la jerarquía PCI-E, incluidos

ioh3420yxio3130-downstream, no son compatibles. Esta funcionalidad se sustituye por múltiples puentes raíz PCI independientes proporcionados por el dispositivospapr-pci-host-bridge. - Los controladores PCI UHCI y EHCI no son compatibles. Utilice en su lugar las controladoras OHCI y XHCI.

-

Los dispositivos IDE, incluyendo el CD-ROM virtual IDE (

ide-cd) y el disco virtual IDE (ide-hd), no son compatibles. Utilice en su lugar los dispositivosvirtio-scsiyvirtio-blk. -

Los NIC PCI emulados (

rtl8139) no son compatibles. Utilice el dispositivovirtio-neten su lugar. -

Los dispositivos de sonido, incluyendo

intel-hda,hda-output, yAC97, no son compatibles. -

Los dispositivos de redirección USB, incluyendo

usb-rediryusb-tablet, no son compatibles.

-

Los dispositivos utilizados para la jerarquía PCI-E, incluidos

- v2v y p2v

-

Las utilidades

virt-v2vyvirt-p2vsólo son compatibles con la arquitectura AMD64 e Intel 64, y no se proporcionan en IBM POWER.

Fuentes adicionales

- Para una comparación de las características de virtualización soportadas y no soportadas en las arquitecturas de sistema soportadas por Red Hat, consulte Sección 20.5, “Una visión general de la compatibilidad con las funciones de virtualización”.

Capítulo 4. Introducción a la virtualización en IBM Z

Puede utilizar la virtualización KVM cuando utilice RHEL 8 en hardware IBM Z. Sin embargo, habilitar el hipervisor K VM en su sistema requiere pasos adicionales en comparación con la virtualización en arquitecturas AMD64 e Intel 64. Algunas características de virtualización de RHEL 8 también tienen una funcionalidad diferente o restringida en IBM Z.

Aparte de la información de las siguientes secciones, el uso de la virtualización en IBM Z funciona igual que en AMD64 e Intel 64. Por lo tanto, puede ver otra documentación de virtualización de RHEL 8 para obtener más información al utilizar la virtualización en IBM Z.

4.1. Habilitación de la virtualización en IBM Z

Para configurar un hipervisor KVM y crear máquinas virtuales (VM) en un sistema IBM Z que ejecute RHEL 8, siga las siguientes instrucciones.

Requisitos previos

- RHEL 8 está instalado y registrado en su máquina anfitriona.

Los siguientes recursos mínimos del sistema están disponibles:

- 6 GB de espacio libre en disco para el host, más otros 6 GB para cada máquina virtual prevista.

- 2 GB de RAM para el host, más otros 2 GB para cada máquina virtual prevista.

- Su sistema host IBM Z utiliza una CPU z13 o posterior.

RHEL 8 se instala en una partición lógica (LPAR). Además, la LPAR admite las funciones de virtualización de start-interpretive execution (SIE).

Para comprobarlo, busque

sieen su archivo/proc/cpuinfo.# grep sie /proc/cpuinfo/ features : esan3 zarch stfle msa ldisp eimm dfp edat etf3eh highgprs te sie

Procedimiento

Cargue el módulo del kernel KVM:

# modprobe kvmCompruebe que el módulo del kernel KVM está cargado:

# lsmod | grep kvmSi KVM se ha cargado con éxito, la salida de este comando incluye

kvm:Instale los paquetes en el módulo de virtualización:

# yum module install virtInstale el paquete

virt-install:# yum install virt-installInicie el servicio

libvirtd.# systemctl start libvirtdCompruebe que su sistema está preparado para ser un host de virtualización:

# virt-host-validate [...] QEMU: Checking if device /dev/kvm is accessible : PASS QEMU: Checking if device /dev/vhost-net exists : PASS QEMU: Checking if device /dev/net/tun exists : PASS QEMU: Checking for cgroup 'memory' controller support : PASS QEMU: Checking for cgroup 'memory' controller mount-point : PASS [...]Si todas las comprobaciones de virt-host-validate devuelven un valor de

PASS, su sistema está preparado para crear máquinas virtuales.Si alguna de las comprobaciones devuelve un valor de

FAIL, siga las instrucciones mostradas para solucionar el problema.Si alguna de las comprobaciones devuelve un valor de

WARN, considere seguir las instrucciones mostradas para mejorar las capacidades de virtualización.

Información adicional

Tenga en cuenta que si la virtualización no está soportada por su CPU anfitriona, virt-host-validate genera la siguiente salida:

QEMU: Comprobando la virtualización del hardware: FAIL (Sólo hay CPUs emuladas, el rendimiento será significativamente limitado)

Sin embargo, al intentar crear máquinas virtuales en un sistema anfitrión de este tipo, se producirá un fallo, en lugar de tener problemas de rendimiento.

4.2. En qué se diferencia la virtualización en IBM Z de la de AMD64 e Intel 64

La virtualización KVM en RHEL 8 en sistemas IBM Z difiere de KVM en sistemas AMD64 e Intel 64 en lo siguiente:

- No hay salida gráfica

-

La visualización de la salida gráfica de la VM no es posible cuando se conecta a la VM utilizando el protocolo VNC. Esto se debe a que la utilidad

gnome-desktopno es compatible con IBM Z. Además, el protocolo de visualización SPICE no funciona en IBM Z. - Dispositivos PCI y USB

Los dispositivos virtuales PCI y USB no son compatibles con IBM Z. Esto también significa que

virtio-*-pcino están soportados, y que en su lugar se deben utilizar dispositivosvirtio-*-ccwdeben ser utilizados en su lugar. Por ejemplo, utilicevirtio-net-ccwen lugar devirtio-net-pci.Tenga en cuenta que se admite la conexión directa de dispositivos PCI, también conocida como PCI passthrough.

- Sistema operativo invitado soportado

- Red Hat sólo admite máquinas virtuales alojadas en IBM Z si utilizan RHEL 7 o RHEL 8 como sistema operativo invitado.

- Orden de arranque del dispositivo

IBM Z no soporta el elemento de configuración

<boot dev='device'>Elemento de configuración XML. Para definir el orden de arranque del dispositivo, utilice el elemento<boot order='number'>en la sección<devices>del XML. Por ejemplo:<disk type='file' device='disk'> <driver name='qemu' type='qcow2'/> <source file='/path/to/qcow2'/> <target dev='vda' bus='virtio'/> <address type='ccw' cssid='0xfe' ssid='0x0' devno='0x0000'/> <boot order='2'> </disk>

NotaEl uso de

<boot order='number'>para la gestión del orden de arranque también es preferible en hosts AMD64 e Intel 64.- Memoria de conexión en caliente

- Añadir memoria a una VM en ejecución no es posible en IBM Z. Tenga en cuenta que eliminar memoria de una VM en ejecución (memory hot unplug) tampoco es posible en IBM Z, así como en AMD64 e Intel 64.

- Topología NUMA

-

La topología de acceso no uniforme a la memoria (NUMA) para las CPU no es compatible con

libvirten IBM Z. Por lo tanto, el ajuste del rendimiento de las vCPU utilizando NUMA no es posible en estos sistemas. - vfio-ap

- Las máquinas virtuales en un host IBM Z pueden utilizar el passthrough de dispositivos criptográficos vfio-ap, que no está soportado en otras arquitecturas.

- SMBIOS

- La configuración de SMBIOS no está disponible en IBM Z.

- Dispositivos de vigilancia

Si utiliza dispositivos de vigilancia en su VM en un host IBM Z, utilice el modelo

diag288. Por ejemplo:<devices> <watchdog model='diag288' action='poweroff'/> </devices>

- kvm-reloj

-

El servicio

kvm-clockes específico de los sistemas AMD64 e Intel 64, y no es necesario configurarlo para la gestión del tiempo de las máquinas virtuales en IBM Z. - v2v y p2v

-

Las utilidades

virt-v2vyvirt-p2vsólo son compatibles con la arquitectura AMD64 e Intel 64, y no se proporcionan en IBM Z. - Virtualización anidada

- La creación de máquinas virtuales anidadas requiere una configuración diferente en IBM Z que en AMD64 e Intel 64. Para más detalles, consulte Capítulo 18, Creación de máquinas virtuales anidadas.

Fuentes adicionales

- Para una comparación de las características de virtualización soportadas y no soportadas en las arquitecturas de sistema soportadas por Red Hat, consulte Sección 20.5, “Una visión general de la compatibilidad con las funciones de virtualización”.

4.3. Información relacionada

Cuando se configura una VM en un sistema IBM Z, se recomienda proteger el SO invitado de la vulnerabilidad \ "Spectre\ ". Para ello, utilice el comando

virsh editpara modificar la configuración XML de la VM y configurar su CPU de una de las siguientes maneras:Utilice el modelo de CPU del host, por ejemplo, como se indica a continuación:

<cpu mode='host-model' check='partial'> <model fallback='allow'/> </cpu>

Esto hace que las funciones

ppa15ybpbestén disponibles para el huésped si el host las soporta.Si utiliza un modelo de host específico, añada las funciones

ppa15ypbp. El siguiente ejemplo utiliza el modelo de CPU zEC12:<cpu mode='custom' match='exact' check='partial'> <model fallback='allow'>zEC12</model> <feature policy='force' name='ppa15'/> <feature policy='force' name='bpb'/> </cpu>Tenga en cuenta que cuando utilice la función

ppa15con los modelos de CPUz114yz196en una máquina anfitriona que utilice una CPU z12, también deberá utilizar el último nivel de microcódigo (paquete 95 o posterior).

- Tenga en cuenta que la ejecución de KVM en el sistema operativo z/VM no es compatible.

- Para obtener información sobre cómo adjuntar dispositivos DASD a las máquinas virtuales en los hosts IBM Z, consulte Sección 10.9, “Adjuntar dispositivos DASD a máquinas virtuales en IBM Z”.

- Para obtener instrucciones sobre el uso del cifrado de hardware de IBM Z en las máquinas virtuales, consulte Sección 15.7, “Adjuntar coprocesadores criptográficos a máquinas virtuales en IBM Z”.

- Para obtener instrucciones sobre la configuración de IBM Z Secure Execution para sus máquinas virtuales, consulte Sección 15.6, “Configuración de IBM Secure Execution en IBM Z”.