Red Hat Training

A Red Hat training course is available for RHEL 8

Configuración y gestión de volúmenes lógicos

Una guía para la configuración y gestión de volúmenes lógicos LVM

Resumen

Hacer que el código abierto sea más inclusivo

Red Hat se compromete a sustituir el lenguaje problemático en nuestro código, documentación y propiedades web. Estamos empezando con estos cuatro términos: maestro, esclavo, lista negra y lista blanca. Debido a la enormidad de este esfuerzo, estos cambios se implementarán gradualmente a lo largo de varias versiones próximas. Para más detalles, consulte el mensaje de nuestro CTO Chris Wright.

Proporcionar comentarios sobre la documentación de Red Hat

Agradecemos su opinión sobre nuestra documentación. Por favor, díganos cómo podemos mejorarla. Para ello:

Para comentarios sencillos sobre pasajes concretos:

- Asegúrese de que está viendo la documentación en el formato Multi-page HTML. Además, asegúrese de ver el botón Feedback en la esquina superior derecha del documento.

- Utilice el cursor del ratón para resaltar la parte del texto que desea comentar.

- Haga clic en la ventana emergente Add Feedback que aparece debajo del texto resaltado.

- Siga las instrucciones mostradas.

Para enviar comentarios más complejos, cree un ticket de Bugzilla:

- Vaya al sitio web de Bugzilla.

- Como componente, utilice Documentation.

- Rellene el campo Description con su sugerencia de mejora. Incluya un enlace a la(s) parte(s) pertinente(s) de la documentación.

- Haga clic en Submit Bug.

Capítulo 1. Volúmenes lógicos

La gestión de volúmenes crea una capa de abstracción sobre el almacenamiento físico, lo que permite crear volúmenes de almacenamiento lógico. Esto proporciona una flexibilidad mucho mayor en varios aspectos que el uso del almacenamiento físico directamente. Además, la configuración del almacenamiento de hardware se oculta al software, por lo que se puede redimensionar y mover sin detener las aplicaciones ni desmontar los sistemas de archivos. Esto puede reducir los costes operativos.

Los volúmenes lógicos ofrecen las siguientes ventajas sobre el uso directo del almacenamiento físico:

Capacidad flexible

Cuando se utilizan volúmenes lógicos, los sistemas de archivos pueden extenderse a través de varios discos, ya que se pueden agregar discos y particiones en un único volumen lógico.

Grupos de almacenamiento redimensionables

Puede ampliar los volúmenes lógicos o reducir su tamaño con simples comandos de software, sin necesidad de reformatear y reparticionar los dispositivos de disco subyacentes.

Reubicación de datos en línea

Para implementar subsistemas de almacenamiento más nuevos, más rápidos o más resistentes, puede mover los datos mientras el sistema está activo. Los datos se pueden reorganizar en los discos mientras éstos están en uso. Por ejemplo, puede vaciar un disco intercambiable en caliente antes de retirarlo.

Una cómoda denominación de los dispositivos

Los volúmenes de almacenamiento lógico se pueden gestionar en grupos definidos por el usuario y con nombres personalizados.

Separación de discos

Puede crear un volumen lógico que reparta los datos entre dos o más discos. Esto puede aumentar drásticamente el rendimiento.

Volúmenes en espejo

Los volúmenes lógicos proporcionan una forma conveniente de configurar una réplica para sus datos.

Instantáneas de volumen

Mediante el uso de volúmenes lógicos, puede tomar instantáneas de dispositivos para realizar copias de seguridad consistentes o para probar el efecto de los cambios sin afectar a los datos reales.

Volúmenes finos

Los volúmenes lógicos pueden tener un aprovisionamiento ligero. Esto le permite crear volúmenes lógicos que son más grandes que los extensiones disponibles.

Volúmenes de caché

Un volumen lógico de caché utiliza un pequeño volumen lógico formado por dispositivos de bloques rápidos (como las unidades SSD) para mejorar el rendimiento de un volumen lógico más grande y lento, almacenando los bloques más utilizados en el volumen lógico más pequeño y rápido.

1.1. Visión general de la arquitectura LVM

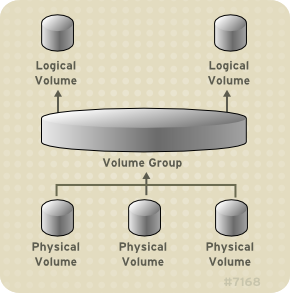

La unidad de almacenamiento físico subyacente de un volumen lógico LVM es un dispositivo de bloque como una partición o un disco completo. Este dispositivo se inicializa como un LVM physical volume (PV).

Para crear un volumen lógico LVM, los volúmenes físicos se combinan en un volume group (VG). Esto crea una reserva de espacio en disco a partir de la cual se pueden asignar volúmenes lógicos LVM (LVs). Este proceso es análogo a la forma en que los discos se dividen en particiones. Un volumen lógico es utilizado por los sistemas de archivos y las aplicaciones (como las bases de datos).

Figura 1.1, “Componentes del volumen lógico LVM” muestra los componentes de un volumen lógico LVM simple:

Figura 1.1. Componentes del volumen lógico LVM

1.2. Volúmenes físicos

La unidad de almacenamiento físico subyacente de un volumen lógico LVM es un dispositivo de bloques, como una partición o un disco completo. Para utilizar el dispositivo para un volumen lógico LVM, el dispositivo debe ser inicializado como un volumen físico (PV). La inicialización de un dispositivo de bloque como volumen físico coloca una etiqueta cerca del inicio del dispositivo.

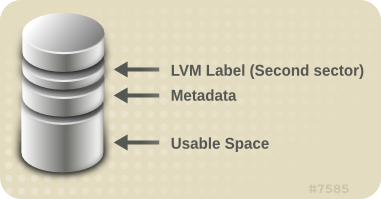

Por defecto, la etiqueta LVM se coloca en el segundo sector de 512 bytes. Puede sobrescribir este valor por defecto colocando la etiqueta en cualquiera de los primeros 4 sectores cuando cree el volumen físico. Esto permite que los volúmenes LVM coexistan con otros usuarios de estos sectores, si es necesario.

Una etiqueta LVM proporciona una correcta identificación y ordenación de dispositivos para un dispositivo físico, ya que los dispositivos pueden aparecer en cualquier orden al arrancar el sistema. Una etiqueta LVM permanece persistente a través de los reinicios y a través de un clúster.

La etiqueta LVM identifica el dispositivo como un volumen físico LVM. Contiene un identificador único aleatorio (el UUID) para el volumen físico. También almacena el tamaño del dispositivo de bloque en bytes, y registra dónde se almacenarán los metadatos LVM en el dispositivo.

Los metadatos LVM contienen los detalles de configuración de los grupos de volúmenes LVM en su sistema. Por defecto, se mantiene una copia idéntica de los metadatos en cada área de metadatos en cada volumen físico dentro del grupo de volúmenes. Los metadatos LVM son pequeños y se almacenan como ASCII.

Actualmente LVM permite almacenar 0, 1 o 2 copias idénticas de sus metadatos en cada volumen físico. El valor por defecto es 1 copia. Una vez que configure el número de copias de metadatos en el volumen físico, no podrá cambiar ese número posteriormente. La primera copia se almacena al principio del dispositivo, poco después de la etiqueta. Si hay una segunda copia, se coloca al final del dispositivo. Si accidentalmente sobrescribes el área al principio de tu disco escribiendo en un disco diferente al que pretendías, una segunda copia de los metadatos al final del dispositivo te permitirá recuperar los metadatos.

1.2.1. Disposición del volumen físico LVM

Figura 1.2, “Disposición del volumen físico” muestra la disposición de un volumen físico LVM. La etiqueta LVM está en el segundo sector, seguido por el área de metadatos, seguido por el espacio utilizable en el dispositivo.

En el núcleo de Linux (y a lo largo de este documento), se considera que los sectores tienen un tamaño de 512 bytes.

Figura 1.2. Disposición del volumen físico

1.2.2. Múltiples particiones en un disco

LVM le permite crear volúmenes físicos a partir de particiones de disco. Red Hat recomienda que cree una sola partición que cubra todo el disco para etiquetarlo como un volumen físico LVM por las siguientes razones:

Conveniencia administrativa

Es más fácil hacer un seguimiento del hardware de un sistema si cada disco real sólo aparece una vez. Esto es particularmente cierto si un disco falla. Además, múltiples volúmenes físicos en un solo disco pueden causar una advertencia del kernel sobre tipos de partición desconocidos en el arranque.

Rendimiento de las franjas

LVM no puede decir que dos volúmenes físicos están en el mismo disco físico. Si crea un volumen lógico rayado cuando dos volúmenes físicos están en el mismo disco físico, las rayas podrían estar en diferentes particiones del mismo disco. Esto resultaría en una disminución del rendimiento en lugar de un aumento.

Aunque no se recomienda, puede haber circunstancias específicas en las que necesite dividir un disco en volúmenes físicos LVM separados. Por ejemplo, en un sistema con pocos discos puede ser necesario mover los datos alrededor de las particiones cuando se está migrando un sistema existente a volúmenes LVM. Además, si tienes un disco muy grande y quieres tener más de un grupo de volúmenes para propósitos administrativos, entonces es necesario particionar el disco. Si tiene un disco con más de una partición y ambas particiones están en el mismo grupo de volúmenes, tenga cuidado de especificar qué particiones se incluirán en un volumen lógico al crear volúmenes rayados.

1.3. Grupos de volumen

Los volúmenes físicos se combinan en grupos de volúmenes (VG). Esto crea una reserva de espacio en disco a partir de la cual se pueden asignar volúmenes lógicos.

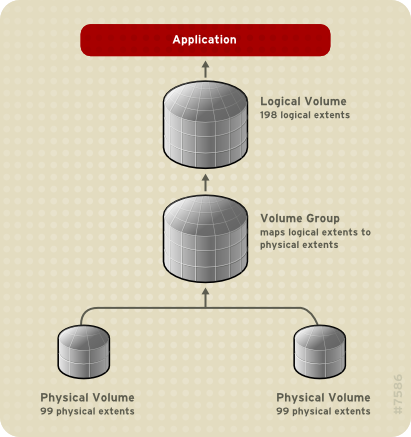

Dentro de un grupo de volúmenes, el espacio de disco disponible para la asignación se divide en unidades de tamaño fijo llamadas extensiones. Una extensión es la unidad más pequeña de espacio que se puede asignar. Dentro de un volumen físico, los extents se denominan extents físicos.

Un volumen lógico se asigna en extensiones lógicas del mismo tamaño que las extensiones físicas. El tamaño de la extensión es, por tanto, el mismo para todos los volúmenes lógicos del grupo de volúmenes. El grupo de volúmenes asigna las extensiones lógicas a extensiones físicas.

1.4. Volúmenes lógicos LVM

En LVM, un grupo de volúmenes se divide en volúmenes lógicos. Un administrador puede aumentar o reducir los volúmenes lógicos sin destruir los datos, a diferencia de las particiones de disco estándar. Si los volúmenes físicos de un grupo de volúmenes están en unidades separadas o en matrices RAID, los administradores también pueden repartir un volumen lógico entre los dispositivos de almacenamiento.

Puede perder datos si reduce un volumen lógico a una capacidad inferior a la que requieren los datos del volumen. Para garantizar la máxima flexibilidad, cree volúmenes lógicos que satisfagan sus necesidades actuales y deje el exceso de capacidad de almacenamiento sin asignar. Puede ampliar de forma segura los volúmenes lógicos para utilizar el espacio no asignado, en función de sus necesidades.

En los sistemas AMD, Intel, ARM y servidores IBM Power Systems, el gestor de arranque no puede leer volúmenes LVM. Debes hacer una partición de disco estándar, no LVM, para tu partición /boot. En IBM Z, el cargador de arranque zipl soporta /boot en volúmenes lógicos LVM con mapeo lineal. Por defecto, el proceso de instalación siempre crea las particiones / y swap dentro de volúmenes LVM, con una partición /boot separada en un volumen físico.

Las siguientes secciones describen los diferentes tipos de volúmenes lógicos.

1.4.1. Volúmenes lineales

Un volumen lineal agrega el espacio de uno o más volúmenes físicos en un volumen lógico. Por ejemplo, si tiene dos discos de 60 GB, puede crear un volumen lógico de 120 GB. El almacenamiento físico se concatena.

La creación de un volumen lineal asigna un rango de extensiones físicas a un área de un volumen lógico en orden. Por ejemplo, como se muestra en Figura 1.3, “Mapa de extensión” las extensiones lógicas 1 a 99 podrían asignarse a un volumen físico y las extensiones lógicas 100 a 198 podrían asignarse a un segundo volumen físico. Desde el punto de vista de la aplicación, hay un dispositivo que tiene 198 extensiones.

Figura 1.3. Mapa de extensión

Los volúmenes físicos que componen un volumen lógico no tienen que ser del mismo tamaño. Figura 1.4, “Volumen lineal con volúmenes físicos desiguales” muestra el grupo de volúmenes VG1 con un tamaño de extensión física de 4MB. Este grupo de volúmenes incluye 2 volúmenes físicos llamados PV1 y PV2. Los volúmenes físicos están divididos en unidades de 4MB, ya que ese es el tamaño de extensión. En este ejemplo, PV1 tiene un tamaño de 200 extensiones (800MB) y PV2 tiene un tamaño de 100 extensiones (400MB). Puedes crear un volumen lineal de cualquier tamaño entre 1 y 300 extensiones (4MB a 1200MB). En este ejemplo, el volumen lineal llamado LV1 tiene un tamaño de 300 extensiones.

Figura 1.4. Volumen lineal con volúmenes físicos desiguales

Puedes configurar más de un volumen lógico lineal del tamaño que necesites a partir del pool de extensiones físicas. Figura 1.5, “Múltiples volúmenes lógicos” muestra el mismo grupo de volúmenes que en Figura 1.4, “Volumen lineal con volúmenes físicos desiguales”, pero en este caso se han extraído dos volúmenes lógicos del grupo de volúmenes: LV1, que tiene un tamaño de 250 extensiones (1000MB) y LV2 que tiene un tamaño de 50 extensiones (200MB).

Figura 1.5. Múltiples volúmenes lógicos

1.4.2. Volúmenes lógicos rayados

Cuando se escriben datos en un volumen lógico LVM, el sistema de archivos distribuye los datos entre los volúmenes físicos subyacentes. Puedes controlar la forma en que se escriben los datos en los volúmenes físicos creando un volumen lógico dividido. Para grandes lecturas y escrituras secuenciales, esto puede mejorar la eficiencia de la E/S de los datos.

El striping mejora el rendimiento escribiendo los datos en un número predeterminado de volúmenes físicos en forma de round-robin. Con el striping, la E/S puede realizarse en paralelo. En algunas situaciones, esto puede resultar en una ganancia de rendimiento casi lineal por cada volumen físico adicional en la franja.

La siguiente ilustración muestra los datos que se están separando en tres volúmenes físicos. En esta figura:

- la primera franja de datos se escribe en el primer volumen físico

- la segunda franja de datos se escribe en el segundo volumen físico

- la tercera franja de datos se escribe en el tercer volumen físico

- la cuarta franja de datos se escribe en el primer volumen físico

En un volumen lógico rayado, el tamaño de la raya no puede superar el tamaño de una extensión.

Figura 1.6. Separación de datos en tres PV

Los volúmenes lógicos rayados pueden ampliarse concatenando otro conjunto de dispositivos al final del primer conjunto. Sin embargo, para ampliar un volumen lógico rayado, debe haber suficiente espacio libre en el conjunto de volúmenes físicos subyacentes que conforman el grupo de volúmenes para soportar la raya. Por ejemplo, si tienes una franja de dos direcciones que utiliza todo un grupo de volúmenes, añadir un solo volumen físico al grupo de volúmenes no te permitirá ampliar la franja. En su lugar, debes añadir al menos dos volúmenes físicos al grupo de volúmenes.

1.4.3. Volúmenes lógicos RAID

LVM soporta los niveles RAID 0, 1, 4, 5, 6 y 10.

Un volumen RAID LVM tiene las siguientes características:

- Los volúmenes lógicos RAID creados y gestionados por LVM aprovechan los controladores del kernel Multiple Devices (MD).

- Puede dividir temporalmente las imágenes RAID1 de la matriz y volver a fusionarlas en la matriz más tarde.

- Los volúmenes RAID de LVM admiten instantáneas.

Agrupaciones

Los volúmenes lógicos RAID no son conscientes del cluster.

Aunque puede crear y activar volúmenes lógicos RAID exclusivamente en una máquina, no puede activarlos simultáneamente en más de una máquina.

Subvolúmenes

Cuando se crea un volumen lógico RAID, LVM crea un subvolumen de metadatos de una extensión por cada subvolumen de datos o de paridad del array.

Por ejemplo, la creación de una matriz RAID1 de 2 vías da como resultado dos subvolúmenes de metadatos (lv_rmeta_0 y lv_rmeta_1) y dos subvolúmenes de datos (lv_rimage_0 y lv_rimage_1). Del mismo modo, la creación de una franja de 3 vías (más un dispositivo de paridad implícito) RAID4 da como resultado 4 subvolúmenes de metadatos (lv_rmeta_0, lv_rmeta_1, lv_rmeta_2, y lv_rmeta_3) y 4 subvolúmenes de datos (lv_rimage_0, lv_rimage_1, lv_rimage_2, y lv_rimage_3).

Integridad

Se pueden perder datos cuando falla un dispositivo RAID o cuando se produce una corrupción blanda. La corrupción blanda en el almacenamiento de datos implica que los datos recuperados de un dispositivo de almacenamiento son diferentes de los datos escritos en ese dispositivo. Añadir integridad a un RAID LV ayuda a mitigar o prevenir la corrupción blanda. Para saber más sobre la corrupción blanda y cómo añadir integridad a un RAID LV, consulte Sección 10.6, “Uso de la integridad de DM con RAID LV”.

1.4.4. Volúmenes lógicos de aprovisionamiento fino (volúmenes finos)

Los volúmenes lógicos pueden tener un aprovisionamiento ligero. Esto le permite crear volúmenes lógicos que son más grandes que los extensiones disponibles. Mediante el aprovisionamiento fino, puede gestionar un pool de almacenamiento de espacio libre, conocido como thin pool, que puede asignarse a un número arbitrario de dispositivos cuando lo necesiten las aplicaciones. A continuación, puede crear dispositivos que se pueden vincular al thin pool para su posterior asignación cuando una aplicación escriba realmente en el volumen lógico. El thin pool puede ampliarse dinámicamente cuando sea necesario para una asignación rentable del espacio de almacenamiento.

Los volúmenes ligeros no son compatibles con los nodos de un clúster. La reserva delgada y todos sus volúmenes delgados deben activarse exclusivamente en un solo nodo del clúster.

Al utilizar el thin provisioning, un administrador de almacenamiento puede sobrecomprometer el almacenamiento físico, evitando a menudo la necesidad de comprar almacenamiento adicional. Por ejemplo, si diez usuarios solicitan cada uno un sistema de archivos de 100 GB para su aplicación, el administrador de almacenamiento puede crear lo que parece ser un sistema de archivos de 100 GB para cada usuario, pero que está respaldado por menos almacenamiento real que se utiliza sólo cuando se necesita. Cuando se utiliza el thin provisioning, es importante que el administrador de almacenamiento supervise el pool de almacenamiento y añada más capacidad si empieza a llenarse.

Para asegurarse de que todo el espacio disponible puede ser utilizado, LVM soporta el descarte de datos. Esto permite reutilizar el espacio que antes utilizaba un archivo descartado u otro rango de bloques.

Los volúmenes delgados ofrecen soporte para una nueva implementación de volúmenes lógicos de copia en escritura (COW), que permiten que muchos dispositivos virtuales compartan los mismos datos en el grupo delgado.

1.4.5. Volúmenes de instantáneas

La función de instantáneas de LVM proporciona la capacidad de crear imágenes virtuales de un dispositivo en un instante determinado sin causar una interrupción del servicio. Cuando se realiza un cambio en el dispositivo original (el origen) después de tomar una instantánea, la función de instantánea hace una copia del área de datos modificada tal y como estaba antes del cambio para poder reconstruir el estado del dispositivo.

LVM soporta instantáneas de aprovisionamiento ligero.

Dado que una instantánea sólo copia las áreas de datos que cambian después de la creación de la instantánea, la función de instantánea requiere una cantidad mínima de almacenamiento. Por ejemplo, con un origen que se actualiza raramente, el 3-5 % de la capacidad del origen es suficiente para mantener la instantánea.

Las copias instantáneas de un sistema de archivos son copias virtuales, no una copia de seguridad real de un sistema de archivos. Las instantáneas no sustituyen a un procedimiento de copia de seguridad.

El tamaño de la instantánea gobierna la cantidad de espacio reservado para almacenar los cambios en el volumen de origen. Por ejemplo, si haces una instantánea y luego sobrescribes completamente el origen, la instantánea tendría que ser al menos tan grande como el volumen de origen para mantener los cambios. Es necesario dimensionar una instantánea de acuerdo con el nivel de cambio esperado. Así, por ejemplo, una instantánea de corta duración de un volumen de lectura, como /usr, necesitaría menos espacio que una instantánea de larga duración de un volumen que ve un mayor número de escrituras, como /home.

Si una instantánea se llena, la instantánea deja de ser válida, ya que no puede seguir los cambios en el volumen de origen. Debe controlar regularmente el tamaño de la instantánea. Sin embargo, las instantáneas son totalmente redimensionables, por lo que si tienes capacidad de almacenamiento puedes aumentar el tamaño del volumen de la instantánea para evitar que se pierda. A la inversa, si ves que el volumen de la instantánea es más grande de lo que necesitas, puedes reducir el tamaño del volumen para liberar espacio que necesitan otros volúmenes lógicos.

Cuando se crea un sistema de archivos de instantánea, el acceso de lectura y escritura completo al origen sigue siendo posible. Si se modifica un chunk en una instantánea, ese chunk se marca y nunca se copia del volumen original.

La función de instantáneas tiene varios usos:

- Normalmente, se toma una instantánea cuando se necesita realizar una copia de seguridad en un volumen lógico sin detener el sistema en vivo que está actualizando continuamente los datos.

-

Puede ejecutar el comando

fscken un sistema de archivos de instantánea para comprobar la integridad del sistema de archivos y determinar si el sistema de archivos original requiere una reparación del sistema de archivos. - Dado que la instantánea es de lectura/escritura, puede probar las aplicaciones contra los datos de producción tomando una instantánea y ejecutando pruebas contra la instantánea, dejando los datos reales intactos.

- Puede crear volúmenes LVM para utilizarlos con Red Hat Virtualization. Las instantáneas LVM se pueden utilizar para crear instantáneas de imágenes de huéspedes virtuales. Estas instantáneas pueden proporcionar una forma conveniente de modificar los huéspedes existentes o crear nuevos huéspedes con un mínimo de almacenamiento adicional.

Puedes utilizar la opción --merge del comando lvconvert para fusionar una instantánea con su volumen de origen. Una de las aplicaciones de esta función es realizar la reversión del sistema si has perdido datos o archivos o si necesitas restaurar tu sistema a un estado anterior. Después de fusionar el volumen de la instantánea, el volumen lógico resultante tendrá el nombre, el número menor y el UUID del volumen de origen y la instantánea fusionada se eliminará.

1.4.6. Volúmenes instantáneos de aprovisionamiento ligero

Red Hat Enterprise Linux proporciona soporte para volúmenes de instantáneas de aprovisionamiento delgado. Los volúmenes de instantáneas delgadas permiten que muchos dispositivos virtuales sean almacenados en el mismo volumen de datos. Esto simplifica la administración y permite compartir datos entre volúmenes de instantáneas.

Como para todos los volúmenes de instantánea LVM, así como para todos los volúmenes finos, los volúmenes finos de instantánea no son compatibles con los nodos de un clúster. El volumen de instantánea debe activarse exclusivamente en un solo nodo del clúster.

Los volúmenes de instantáneas delgadas proporcionan los siguientes beneficios:

- Un volumen delgado de instantáneas puede reducir el uso del disco cuando hay varias instantáneas del mismo volumen de origen.

- Si hay varias instantáneas del mismo origen, una escritura en el origen provocará una operación COW para conservar los datos. Aumentar el número de instantáneas del origen no debería suponer una ralentización importante.

- Los volúmenes finos de instantáneas pueden utilizarse como origen de volumen lógico para otra instantánea. Esto permite una profundidad arbitraria de instantáneas recursivas (instantáneas de instantáneas de instantáneas...).

- Una instantánea de un volumen lógico delgado también crea un volumen lógico delgado. Esto no consume espacio de datos hasta que se requiera una operación COW, o hasta que se escriba la propia instantánea.

- Un volumen delgado de instantáneas no necesita ser activado con su origen, por lo que un usuario puede tener sólo el origen activo mientras hay muchos volúmenes de instantáneas inactivos del origen.

- Cuando se elimina el origen de un volumen de instantáneas de aprovisionamiento ligero, cada instantánea de ese volumen de origen se convierte en un volumen de aprovisionamiento ligero independiente. Esto significa que, en lugar de fusionar una instantánea con su volumen de origen, puedes optar por eliminar el volumen de origen y luego crear una nueva instantánea con aprovisionamiento ligero utilizando ese volumen independiente como volumen de origen para la nueva instantánea.

Aunque hay muchas ventajas en el uso de volúmenes delgados de instantáneas, hay algunos casos de uso para los que la antigua función de volumen de instantáneas LVM puede ser más apropiada para sus necesidades:

- No se puede cambiar el tamaño del chunk de un thin pool. Si el thin pool tiene un tamaño de chunk grande (por ejemplo, 1MB) y necesita una instantánea de corta duración para la que un tamaño de chunk tan grande no es eficiente, puede optar por utilizar la función de instantáneas antiguas.

- No se puede limitar el tamaño de un volumen de instantánea delgada; la instantánea utilizará todo el espacio de la reserva delgada, si es necesario. Esto puede no ser apropiado para sus necesidades.

En general, debe tener en cuenta los requisitos específicos de su sitio web a la hora de decidir qué formato de instantánea utilizar.

1.4.7. Volúmenes de caché

LVM admite el uso de dispositivos de bloque rápidos (como las unidades SSD) como cachés de retroescritura o escritura para dispositivos de bloque más grandes y lentos. Los usuarios pueden crear volúmenes lógicos de caché para mejorar el rendimiento de sus volúmenes lógicos existentes o crear nuevos volúmenes lógicos de caché compuestos por un dispositivo pequeño y rápido acoplado a un dispositivo grande y lento.

Capítulo 2. Gestión del almacenamiento local mediante los roles de sistema de RHEL

Para gestionar LVM y sistemas de archivos locales (FS) mediante Ansible, puede utilizar el rol storage, que es uno de los roles de sistema RHEL disponibles en RHEL 8.

El uso del rol storage le permite automatizar la administración de sistemas de archivos en discos y volúmenes lógicos en múltiples máquinas y en todas las versiones de RHEL a partir de RHEL 7.7.

Para más información sobre los Roles del Sistema RHEL y cómo aplicarlos, vea Introducción a los Roles del Sistema RHEL.

2.1. Introducción a la función de almacenamiento

La función storage puede gestionar:

- Sistemas de archivos en discos que no han sido particionados

- Grupos de volúmenes LVM completos, incluyendo sus volúmenes lógicos y sistemas de archivos

Con el rol storage puede realizar las siguientes tareas:

- Crear un sistema de archivos

- Eliminar un sistema de archivos

- Montar un sistema de archivos

- Desmontar un sistema de archivos

- Crear grupos de volúmenes LVM

- Eliminar grupos de volúmenes LVM

- Crear volúmenes lógicos

- Eliminar volúmenes lógicos

- Crear volúmenes RAID

- Eliminar volúmenes RAID

- Crear pools LVM con RAID

- Eliminar pools LVM con RAID

2.2. Parámetros que identifican un dispositivo de almacenamiento en el rol de sistema de almacenamiento

La configuración de su rol en storage afecta sólo a los sistemas de archivos, volúmenes y pools que se enumeran en las siguientes variables.

storage_volumesLista de sistemas de archivos en todos los discos no particionados que se van a gestionar.

Actualmente, las particiones no son compatibles.

storage_poolsLista de piscinas a gestionar.

Actualmente el único tipo de pool soportado es LVM. Con LVM, los pools representan grupos de volúmenes (VGs). Bajo cada pool hay una lista de volúmenes que deben ser gestionados por el rol. Con LVM, cada volumen corresponde a un volumen lógico (LV) con un sistema de archivos.

2.3. Ejemplo de playbook de Ansible para crear un sistema de archivos XFS en un dispositivo de bloques

Esta sección proporciona un ejemplo de libro de jugadas de Ansible. Este libro de jugadas aplica el rol storage para crear un sistema de archivos XFS en un dispositivo de bloques utilizando los parámetros predeterminados.

El rol storage puede crear un sistema de archivos sólo en un disco entero no particionado o en un volumen lógico (LV). No puede crear el sistema de archivos en una partición.

Ejemplo 2.1. Un playbook que crea XFS en /dev/sdb

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: xfs

roles:

- rhel-system-roles.storage-

El nombre del volumen (

barefsen el ejemplo) es actualmente arbitrario. El rolstorageidentifica el volumen por el dispositivo de disco listado bajo el atributodisks:. -

Puede omitir la línea

fs_type: xfsporque XFS es el sistema de archivos por defecto en RHEL 8. Para crear el sistema de archivos en un LV, proporcione la configuración de LVM bajo el atributo

disks:, incluyendo el grupo de volúmenes que lo rodea. Para obtener más detalles, consulte Ejemplo de libro de jugadas de Ansible para gestionar volúmenes lógicos.No proporcione la ruta de acceso al dispositivo LV.

Recursos adicionales

-

Para más detalles sobre los parámetros utilizados en el rol de sistema

storage, consulte el archivo/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.4. Ejemplo de playbook de Ansible para montar persistentemente un sistema de archivos

Esta sección proporciona un ejemplo de libro de jugadas de Ansible. Este libro de jugadas aplica el rol storage para montar de forma inmediata y persistente un sistema de archivos XFS.

Ejemplo 2.2. Un playbook que monta un sistema de archivos en /dev/sdb a /mnt/data

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: xfs

mount_point: /mnt/data

roles:

- rhel-system-roles.storage-

Este libro de jugadas añade el sistema de archivos al archivo

/etc/fstab, y monta el sistema de archivos inmediatamente. -

Si el sistema de archivos del dispositivo

/dev/sdbo el directorio del punto de montaje no existen, el libro de jugadas los crea.

Recursos adicionales

-

Para más detalles sobre los parámetros utilizados en el rol de sistema

storage, consulte el archivo/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.5. Ejemplo de libro de jugadas de Ansible para gestionar volúmenes lógicos

Esta sección proporciona un ejemplo de libro de jugadas de Ansible. Este libro de jugadas aplica el rol storage para crear un volumen lógico LVM en un grupo de volúmenes.

Ejemplo 2.3. Un libro de jugadas que crea un volumen lógico mylv en el grupo de volúmenes myvg

- hosts: all

vars:

storage_pools:

- name: myvg

disks:

- sda

- sdb

- sdc

volumes:

- name: mylv

size: 2G

fs_type: ext4

mount_point: /mnt

roles:

- rhel-system-roles.storageEl grupo de volúmenes

myvgestá formado por los siguientes discos:-

/dev/sda -

/dev/sdb -

/dev/sdc

-

-

Si el grupo de volumen

myvgya existe, el libro de jugadas añade el volumen lógico al grupo de volumen. -

Si el grupo de volumen

myvgno existe, el libro de jugadas lo crea. -

El libro de jugadas crea un sistema de archivos Ext4 en el volumen lógico

mylv, y monta persistentemente el sistema de archivos en/mnt.

Recursos adicionales

-

Para más detalles sobre los parámetros utilizados en el rol de sistema

storage, consulte el archivo/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.6. Ejemplo de libro de jugadas de Ansible para activar el descarte de bloques en línea

Esta sección proporciona un ejemplo de libro de jugadas de Ansible. Este libro de jugadas aplica el rol storage para montar un sistema de archivos XFS con el descarte de bloques en línea activado.

Ejemplo 2.4. Un libro de jugadas que permite descartar bloques en línea en /mnt/data/

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: xfs

mount_point: /mnt/data

mount_options: discard

roles:

- rhel-system-roles.storageRecursos adicionales

- Este libro de jugadas también realiza todas las operaciones del ejemplo de montaje persistente descrito en Ejemplo de libro de jugadas de Ansible para montar persistentemente un sistema de archivos.

-

Para más detalles sobre los parámetros utilizados en el rol de sistema

storage, consulte el archivo/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.7. Ejemplo de playbook Ansible para crear y montar un sistema de archivos Ext4

Esta sección proporciona un ejemplo de libro de jugadas de Ansible. Este libro de jugadas aplica el rol storage para crear y montar un sistema de archivos Ext4.

Ejemplo 2.5. Un playbook que crea Ext4 en /dev/sdb y lo monta en /mnt/data

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: ext4

fs_label: label-name

mount_point: /mnt/data

roles:

- rhel-system-roles.storage-

El libro de jugadas crea el sistema de archivos en el disco

/dev/sdb. -

El libro de jugadas monta persistentemente el sistema de archivos en el directorio

/mnt/datadirectorio. -

La etiqueta del sistema de archivos es

label-name.

Recursos adicionales

-

Para más detalles sobre los parámetros utilizados en el rol de sistema

storage, consulte el archivo/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.8. Ejemplo de playbook de Ansible para crear y montar un sistema de archivos ext3

Esta sección proporciona un ejemplo de libro de jugadas de Ansible. Este libro de jugadas aplica el rol storage para crear y montar un sistema de archivos Ext3.

Ejemplo 2.6. Un playbook que crea Ext3 en /dev/sdb y lo monta en /mnt/data

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: ext3

fs_label: label-name

mount_point: /mnt/data

roles:

- rhel-system-roles.storage-

El libro de jugadas crea el sistema de archivos en el disco

/dev/sdb. -

El libro de jugadas monta persistentemente el sistema de archivos en el directorio

/mnt/datadirectorio. -

La etiqueta del sistema de archivos es

label-name.

Recursos adicionales

-

Para más detalles sobre los parámetros utilizados en el rol de sistema

storage, consulte el archivo/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.9. Configuración de un volumen RAID mediante el rol de sistema de almacenamiento

Con el rol de sistema storage, puede configurar un volumen RAID en RHEL utilizando Red Hat Ansible Automation Platform. En esta sección aprenderá a configurar un playbook de Ansible con los parámetros disponibles para configurar un volumen RAID que se adapte a sus necesidades.

Requisitos previos

Tiene instalado Red Hat Ansible Engine en el sistema desde el que desea ejecutar el libro de jugadas.

NotaNo es necesario tener Red Hat Ansible Automation Platform instalado en los sistemas en los que se desea implementar la solución

storage.-

Tienes el paquete

rhel-system-rolesinstalado en el sistema desde el que quieres ejecutar el playbook. -

Tienes un archivo de inventario que detalla los sistemas en los que quieres desplegar un volumen RAID usando el rol de sistema

storage.

Procedimiento

Cree un nuevo

playbook.ymlarchivo con el siguiente contenido:- hosts: all vars: storage_safe_mode: false storage_volumes: - name: data type: raid disks: [sdd, sde, sdf, sdg] raid_level: raid0 raid_chunk_size: 32 KiB mount_point: /mnt/data state: present roles: - name: rhel-system-roles.storageAvisoLos nombres de los dispositivos pueden cambiar en determinadas circunstancias; por ejemplo, cuando se añade un nuevo disco a un sistema. Por lo tanto, para evitar la pérdida de datos, no se recomienda utilizar nombres de discos específicos en el libro de jugadas.

Opcional. Verificar la sintaxis del libro de jugadas.

# ansible-playbook --syntax-check playbook.ymlEjecute el libro de jugadas en su archivo de inventario:

# ansible-playbook -i inventory.file /path/to/file/playbook.yml

Recursos adicionales

- Para obtener más información sobre RAID, consulte Gestión de RAID.

-

Para obtener detalles sobre los parámetros utilizados en el rol del sistema de almacenamiento, consulte el archivo

/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.10. Configuración de un pool LVM con RAID utilizando el rol de sistema de almacenamiento

Con el rol de sistema storage, puede configurar un pool LVM con RAID en RHEL utilizando Red Hat Ansible Automation Platform. En esta sección aprenderá a configurar un playbook Ansible con los parámetros disponibles para configurar un pool LVM con RAID.

Requisitos previos

Tiene instalado Red Hat Ansible Engine en el sistema desde el que desea ejecutar el libro de jugadas.

NotaNo es necesario tener Red Hat Ansible Automation Platform instalado en los sistemas en los que se desea implementar la solución

storage.-

Tienes el paquete

rhel-system-rolesinstalado en el sistema desde el que quieres ejecutar el playbook. -

Tienes un archivo de inventario que detalla los sistemas en los que quieres configurar un pool LVM con RAID utilizando el rol de sistema

storage.

Procedimiento

Cree un nuevo

playbook.ymlarchivo con el siguiente contenido:- hosts: all vars: storage_safe_mode: false storage_pools: - name: my_pool type: lvm disks: [sdh, sdi] raid_level: raid1 volumes: - name: my_pool size: "1 GiB" mount_point: "/mnt/app/shared" fs_type: xfs state: present roles: - name: rhel-system-roles.storageNotaPara crear un pool LVM con RAID, debes especificar el tipo de RAID utilizando el parámetro

raid_level.Opcional. Verificar la sintaxis del libro de jugadas.

# ansible-playbook --syntax-check playbook.ymlEjecute el libro de jugadas en su archivo de inventario:

# ansible-playbook -i inventory.file /path/to/file/playbook.yml

Recursos adicionales

- Para obtener más información sobre RAID, consulte Gestión de RAID.

-

Para obtener detalles sobre los parámetros utilizados en el rol del sistema de almacenamiento, consulte el archivo

/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.11. Creación de un volumen encriptado LUKS utilizando el rol de almacenamiento

Puede utilizar el rol storage para crear y configurar un volumen encriptado con LUKS ejecutando un playbook de Ansible.

Requisitos previos

Tiene instalado Red Hat Ansible Engine en el sistema desde el que desea ejecutar el libro de jugadas.

NotaNo es necesario tener Red Hat Ansible Automation Platform instalado en los sistemas en los que se desea crear el volumen.

-

Tiene el paquete

rhel-system-rolesinstalado en el controlador Ansible. - Dispone de un archivo de inventario en el que se detallan los sistemas en los que desea desplegar un volumen encriptado LUKS mediante el rol de sistema de almacenamiento.

Procedimiento

Cree un nuevo

playbook.ymlarchivo con el siguiente contenido:- hosts: all vars: storage_volumes: - name: barefs type: disk disks: - sdb fs_type: xfs fs_label: label-name mount_point: /mnt/data encryption: true encryption_password: your-password roles: - rhel-system-roles.storageOpcional. Verificar la sintaxis del libro de jugadas:

# ansible-playbook --syntax-check playbook.ymlEjecute el libro de jugadas en su archivo de inventario:

# ansible-playbook -i inventory.file /path/to/file/playbook.yml

Recursos adicionales

- Para más información sobre LUKS, véase 17. Cifrado de dispositivos de bloque mediante LUKS..

-

Para más detalles sobre los parámetros utilizados en el rol de sistema

storage, consulte el archivo/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

Recursos adicionales

Para más información, instale el paquete

rhel-system-rolesy consulte los siguientes directorios:-

/usr/share/doc/rhel-system-roles/storage/ -

/usr/share/ansible/roles/rhel-system-roles.storage/

-

Capítulo 3. Despliegue de LVM

Los siguientes procedimientos representan la configuración básica para volúmenes lógicos LVM en un sistema operativo recién instalado.

3.1. Creación de un volumen físico LVM

Este procedimiento describe cómo crear y etiquetar volúmenes físicos (PV) LVM.

Requisitos previos

-

El paquete

lvm2está instalado.

Procedimiento

Para crear varios volúmenes físicos, utilice los nombres de los dispositivos delimitados por espacios como argumentos del comando

pvcreate:# pvcreate /dev/vdb1 /dev/vdb2

Esto coloca una etiqueta en /dev/vdb1 y /dev/vdb2, marcándolos como volúmenes físicos pertenecientes a LVM.

Para más información, consulte la página de manual

pvcreate.

3.2. Creación de un grupo de volúmenes LVM

Este procedimiento describe cómo crear un grupo de volúmenes LVM (VG).

Requisitos previos

-

El paquete

lvm2está instalado. - Se crean uno o más volúmenes físicos. Consulte las instrucciones de cómo hacerlo en Sección 3.1, “Creación de un volumen físico LVM”.

Procedimiento

Para crear un grupo de volúmenes, utilice el siguiente comando:

# vgcreate myvg /dev/vdb1 /dev/vdb2

Esto crea un VG con el nombre de myvg. Los PVs /dev/vdb1 y /dev/vdb2 son el nivel de almacenamiento base para el VG myvg.

Para más información, consulte la página de manual

vgcreate.

Es posible ampliar la VG anterior con los PV más adelante. Para ampliar una VG, utilice el siguiente comando:

# vgextend myvg /dev/vdb3

3.3. Creación de un volumen lógico LVM

Este procedimiento describe cómo crear un volumen lógico LVM (LV).

Requisitos previos

-

El paquete

lvm2está instalado. - Se crea el grupo de volúmenes. Consulte las instrucciones sobre cómo hacerlo en Sección 3.2, “Creación de un grupo de volúmenes LVM”.

Procedimiento

Para crear un volumen lógico, utilice el siguiente comando:

# lvcreate -n lv01 -L 500M myvg

La opción

-npermite al usuario establecer el nombre del BT en lv01. La opción-Lpermite al usuario establecer el tamaño del BT en unidades de Mb en este ejemplo, pero es posible utilizar cualquier otra unidad. El tipo de BT es lineal por defecto, pero el usuario puede especificar el tipo deseado utilizando la opción--type.ImportanteEl comando fallará si el VG no tiene un número suficiente de extensiones físicas libres para el tamaño y tipo solicitados.

Para más información, consulte la página de manual

lvcreate.

Capítulo 4. Configuración de volúmenes lógicos LVM

Los siguientes procedimientos proporcionan ejemplos de tareas básicas de administración de LVM.

4.1. Uso de los comandos de la CLI

Las siguientes secciones describen algunas características operativas generales de los comandos de la CLI de LVM.

Especificación de unidades en un argumento de línea de comandos

Cuando se requieren tamaños en un argumento de la línea de comandos, las unidades siempre se pueden especificar explícitamente. Si no se especifica una unidad, se asume una por defecto, normalmente KB o MB. Los comandos de la CLI de LVM no aceptan fracciones.

Cuando se especifican unidades en un argumento de la línea de comandos, LVM no distingue entre mayúsculas y minúsculas; especificar M o m es equivalente, por ejemplo, y se utilizan potencias de 2 (múltiplos de 1024). Sin embargo, cuando se especifica el argumento --units en un comando, las minúsculas indican que las unidades están en múltiplos de 1024 mientras que las mayúsculas indican que las unidades están en múltiplos de 1000.

Especificación de grupos de volúmenes y volúmenes lógicos

Tenga en cuenta lo siguiente cuando especifique grupos de volúmenes o volúmenes lógicos en un comando CLI de LVM.

-

Cuando los comandos toman como argumento nombres de grupos de volúmenes o volúmenes lógicos, el nombre completo de la ruta es opcional. Un volumen lógico llamado

lvol0en un grupo de volúmenes llamadovg0puede ser especificado comovg0/lvol0. - Cuando se requiera una lista de grupos de volúmenes pero se deje vacía, se sustituirá por una lista de todos los grupos de volúmenes.

-

Cuando se requiere una lista de volúmenes lógicos pero se da un grupo de volúmenes, se sustituirá por una lista de todos los volúmenes lógicos de ese grupo de volúmenes. Por ejemplo, el comando

lvdisplay vg0mostrará todos los volúmenes lógicos del grupo de volúmenesvg0.

Aumentar la verbosidad de la salida

Todos los comandos LVM aceptan un argumento -v, que puede ser introducido varias veces para aumentar la verbosidad de la salida. Los siguientes ejemplos muestran la salida por defecto del comando lvcreate.

# lvcreate -L 50MB new_vg

Rounding up size to full physical extent 52.00 MB

Logical volume "lvol0" created

El siguiente comando muestra la salida del comando lvcreate con el argumento -v.

# lvcreate -v -L 50MB new_vg

Rounding up size to full physical extent 52.00 MB

Archiving volume group "new_vg" metadata (seqno 1).

Creating logical volume lvol0

Creating volume group backup "/etc/lvm/backup/new_vg" (seqno 2).

Activating logical volume new_vg/lvol0.

activation/volume_list configuration setting not defined: Checking only host tags for new_vg/lvol0.

Creating new_vg-lvol0

Loading table for new_vg-lvol0 (253:0).

Resuming new_vg-lvol0 (253:0).

Wiping known signatures on logical volume "new_vg/lvol0"

Initializing 4.00 KiB of logical volume "new_vg/lvol0" with value 0.

Logical volume "lvol0" created

Los argumentos -vv, -vvv y -vvvv muestran cada vez más detalles sobre la ejecución del comando. El argumento -vvvv proporciona la máxima cantidad de información en este momento. El siguiente ejemplo muestra las primeras líneas de salida del comando lvcreate con el argumento -vvvv especificado.

# lvcreate -vvvv -L 50MB new_vg

#lvmcmdline.c:913 Processing: lvcreate -vvvv -L 50MB new_vg

#lvmcmdline.c:916 O_DIRECT will be used

#config/config.c:864 Setting global/locking_type to 1

#locking/locking.c:138 File-based locking selected.

#config/config.c:841 Setting global/locking_dir to /var/lock/lvm

#activate/activate.c:358 Getting target version for linear

#ioctl/libdm-iface.c:1569 dm version OF [16384]

#ioctl/libdm-iface.c:1569 dm versions OF [16384]

#activate/activate.c:358 Getting target version for striped

#ioctl/libdm-iface.c:1569 dm versions OF [16384]

#config/config.c:864 Setting activation/mirror_region_size to 512

...Visualización de la ayuda para los comandos de la CLI de LVM

Puede mostrar la ayuda para cualquiera de los comandos de la CLI de LVM con el argumento --help del comando.

# commandname --help

Para mostrar la página de manual de un comando, ejecute el comando man:

# man commandname

El comando man lvm proporciona información general en línea sobre LVM.

4.2. Creación de un volumen lógico LVM en tres discos

Este procedimiento de ejemplo crea un volumen lógico LVM llamado mylv que consiste en los discos en /dev/sda1, /dev/sdb1, y /dev/sdc1.

Para utilizar los discos en un grupo de volúmenes, etiquételos como volúmenes físicos LVM con el comando

pvcreate.AvisoEste comando destruye cualquier dato en

/dev/sda1,/dev/sdb1, y/dev/sdc1.#

pvcreate /dev/sda1 /dev/sdb1 /dev/sdc1Physical volume "/dev/sda1" successfully created Physical volume "/dev/sdb1" successfully created Physical volume "/dev/sdc1" successfully createdCrea un grupo de volúmenes que consiste en los volúmenes físicos LVM que has creado. El siguiente comando crea el grupo de volúmenes

myvg.#

vgcreate myvg /dev/sda1 /dev/sdb1 /dev/sdc1Volume group "myvg" successfully createdPuede utilizar el comando

vgspara mostrar los atributos del nuevo grupo de volúmenes.#

vgsVG #PV #LV #SN Attr VSize VFree myvg 3 0 0 wz--n- 51.45G 51.45GCrea el volumen lógico a partir del grupo de volúmenes que has creado. El siguiente comando crea el volumen lógico

mylva partir del grupo de volumenmyvg. Este ejemplo crea un volumen lógico que utiliza 2 gigabytes del grupo de volúmenes.#

lvcreate -L 2G -n mylv myvgLogical volume "mylv" createdCrea un sistema de archivos en el volumen lógico. El siguiente comando crea un sistema de archivos

ext4en el volumen lógico.#

mkfs.ext4 /dev/myvg/mylvmke2fs 1.44.3 (10-July-2018) Creating filesystem with 524288 4k blocks and 131072 inodes Filesystem UUID: 616da032-8a48-4cd7-8705-bd94b7a1c8c4 Superblock backups stored on blocks: 32768, 98304, 163840, 229376, 294912 Allocating group tables: done Writing inode tables: done Creating journal (16384 blocks): done Writing superblocks and filesystem accounting information: doneLos siguientes comandos montan el volumen lógico e informan del uso del espacio en disco del sistema de archivos.

#

mount /dev/myvg/mylv /mnt#dfFilesystem 1K-blocks Used Available Use% Mounted on /dev/mapper/myvg-mylv 1998672 6144 1871288 1% /mnt

4.3. Creación de un volumen lógico RAID0 (rayado)

Un volumen lógico RAID0 reparte los datos del volumen lógico entre varios subvolúmenes de datos en unidades de tamaño de franja.

El formato del comando para crear un volumen RAID0 es el siguiente.

lvcreate --type raid0[_meta] --stripes Stripes --stripesize StripeSize VolumeGroup [PhysicalVolumePath...]

Tabla 4.1. Parámetros de creación del comando RAID0

| Parámetro | Descripción |

|---|---|

|

|

Especificando |

|

| Especifica el número de dispositivos en los que se repartirá el volumen lógico. |

|

| Especifica el tamaño de cada franja en kilobytes. Es la cantidad de datos que se escribe en un dispositivo antes de pasar al siguiente. |

|

| Especifica el grupo de volúmenes a utilizar. |

|

| Especifica los dispositivos a utilizar. Si no se especifica, LVM elegirá el número de dispositivos especificados por la opción Stripes, uno para cada franja. |

Este procedimiento de ejemplo crea un volumen lógico RAID0 de LVM llamado mylv que separa los datos en los discos en /dev/sda1, /dev/sdb1, y /dev/sdc1.

Etiquete los discos que utilizará en el grupo de volúmenes como volúmenes físicos LVM con el comando

pvcreate.AvisoEste comando destruye cualquier dato en

/dev/sda1,/dev/sdb1, y/dev/sdc1.#

pvcreate /dev/sda1 /dev/sdb1 /dev/sdc1Physical volume "/dev/sda1" successfully created Physical volume "/dev/sdb1" successfully created Physical volume "/dev/sdc1" successfully createdCrear el grupo de volumen

myvg. El siguiente comando crea el grupo de volúmenesmyvg.#

vgcreate myvg /dev/sda1 /dev/sdb1 /dev/sdc1Volume group "myvg" successfully createdPuede utilizar el comando

vgspara mostrar los atributos del nuevo grupo de volúmenes.#

vgsVG #PV #LV #SN Attr VSize VFree myvg 3 0 0 wz--n- 51.45G 51.45GCrea un volumen lógico RAID0 a partir del grupo de volúmenes que has creado. El siguiente comando crea el volumen RAID0

mylva partir del grupo de volúmenesmyvg. Este ejemplo crea un volumen lógico que tiene un tamaño de 2 gigabytes, con tres franjas y un tamaño de franja de 4 kilobytes.#

lvcreate --type raid0 -L 2G --stripes 3 --stripesize 4 -n mylv myvgRounding size 2.00 GiB (512 extents) up to stripe boundary size 2.00 GiB(513 extents). Logical volume "mylv" created.Cree un sistema de archivos en el volumen lógico RAID0. El siguiente comando crea un sistema de archivos

ext4en el volumen lógico.#

mkfs.ext4 /dev/myvg/mylvmke2fs 1.44.3 (10-July-2018) Creating filesystem with 525312 4k blocks and 131376 inodes Filesystem UUID: 9d4c0704-6028-450a-8b0a-8875358c0511 Superblock backups stored on blocks: 32768, 98304, 163840, 229376, 294912 Allocating group tables: done Writing inode tables: done Creating journal (16384 blocks): done Writing superblocks and filesystem accounting information: doneLos siguientes comandos montan el volumen lógico e informan del uso del espacio en disco del sistema de archivos.

#

mount /dev/myvg/mylv /mnt#dfFilesystem 1K-blocks Used Available Use% Mounted on /dev/mapper/myvg-mylv 2002684 6168 1875072 1% /mnt

4.4. Renombrar volúmenes lógicos LVM

Este procedimiento cambia el nombre de un volumen lógico existente utilizando la interfaz LVM de la línea de comandos.

Procedimiento

- Si el volumen lógico está actualmente montado, desmonte el volumen.

Si el volumen lógico existe en un entorno de clúster, desactive el volumen lógico en todos los nodos en los que esté activo. Utilice el siguiente comando en cada uno de esos nodos:

[root@node-n]# lvchange --activate n vg-name/lv-name

Utilice la utilidad

lvrenamepara renombrar un volumen lógico existente:# lvrename vg-name original-lv-name new-lv-name

Opcionalmente, puede especificar las rutas completas de los dispositivos:

# lvrename /dev/vg-name/original-lv-name /dev/vg-name/new-lv-name

Recursos adicionales

-

La página de manual

lvrename(8)

4.5. Eliminación de un disco de un volumen lógico

Estos procedimientos de ejemplo muestran cómo se puede eliminar un disco de un volumen lógico existente, ya sea para reemplazar el disco o para utilizar el disco como parte de un volumen diferente. Para eliminar un disco, primero debes mover los extensiones del volumen físico LVM a un disco o conjunto de discos diferente.

4.5.1. Mover extensiones a volúmenes físicos existentes

En este ejemplo, el volumen lógico se distribuye en cuatro volúmenes físicos en el grupo de volúmenes myvg.

# pvs -o+pv_used

PV VG Fmt Attr PSize PFree Used

/dev/sda1 myvg lvm2 a- 17.15G 12.15G 5.00G

/dev/sdb1 myvg lvm2 a- 17.15G 12.15G 5.00G

/dev/sdc1 myvg lvm2 a- 17.15G 12.15G 5.00G

/dev/sdd1 myvg lvm2 a- 17.15G 2.15G 15.00G

Estos ejemplos mueven los extensiones fuera de /dev/sdb1 para que pueda ser eliminado del grupo de volúmenes.

Si hay suficientes extensiones libres en los otros volúmenes físicos del grupo de volúmenes, puedes ejecutar el comando

pvmoveen el dispositivo que quieres eliminar sin otras opciones y las extensiones se distribuirán a los otros dispositivos.En un clúster, el comando

pvmovesólo puede mover el volumen lógico que está activo exclusivamente en un solo nodo.#

pvmove /dev/sdb1/dev/sdb1: Moved: 2.0% ... /dev/sdb1: Moved: 79.2% ... /dev/sdb1: Moved: 100.0%Después de que el comando

pvmovehaya terminado de ejecutarse, la distribución de extensiones es la siguiente:#

pvs -o+pv_usedPV VG Fmt Attr PSize PFree Used /dev/sda1 myvg lvm2 a- 17.15G 7.15G 10.00G /dev/sdb1 myvg lvm2 a- 17.15G 17.15G 0 /dev/sdc1 myvg lvm2 a- 17.15G 12.15G 5.00G /dev/sdd1 myvg lvm2 a- 17.15G 2.15G 15.00GUtilice el comando

vgreducepara eliminar el volumen físico/dev/sdb1del grupo de volúmenes.#

vgreduce myvg /dev/sdb1Removed "/dev/sdb1" from volume group "myvg" # pvs PV VG Fmt Attr PSize PFree /dev/sda1 myvg lvm2 a- 17.15G 7.15G /dev/sdb1 lvm2 -- 17.15G 17.15G /dev/sdc1 myvg lvm2 a- 17.15G 12.15G /dev/sdd1 myvg lvm2 a- 17.15G 2.15G

Ahora el disco puede ser eliminado físicamente o asignado a otros usuarios.

4.5.2. Mover extensiones a un nuevo disco

En este ejemplo, el volumen lógico se distribuye en tres volúmenes físicos en el grupo de volúmenes myvg como sigue:

# pvs -o+pv_used

PV VG Fmt Attr PSize PFree Used

/dev/sda1 myvg lvm2 a- 17.15G 7.15G 10.00G

/dev/sdb1 myvg lvm2 a- 17.15G 15.15G 2.00G

/dev/sdc1 myvg lvm2 a- 17.15G 15.15G 2.00G

Este procedimiento de ejemplo mueve las extensiones de /dev/sdb1 a un nuevo dispositivo, /dev/sdd1.

Crear un nuevo volumen físico desde

/dev/sdd1.#

pvcreate /dev/sdd1Physical volume "/dev/sdd1" successfully createdAñade el nuevo volumen físico

/dev/sdd1al grupo de volumen existentemyvg.#

vgextend myvg /dev/sdd1Volume group "myvg" successfully extended #pvs -o+pv_usedPV VG Fmt Attr PSize PFree Used /dev/sda1 myvg lvm2 a- 17.15G 7.15G 10.00G /dev/sdb1 myvg lvm2 a- 17.15G 15.15G 2.00G /dev/sdc1 myvg lvm2 a- 17.15G 15.15G 2.00G /dev/sdd1 myvg lvm2 a- 17.15G 17.15G 0Utilice el comando

pvmovepara mover los datos de/dev/sdb1a/dev/sdd1.#

pvmove /dev/sdb1 /dev/sdd1/dev/sdb1: Moved: 10.0% ... /dev/sdb1: Moved: 79.7% ... /dev/sdb1: Moved: 100.0% #pvs -o+pv_usedPV VG Fmt Attr PSize PFree Used /dev/sda1 myvg lvm2 a- 17.15G 7.15G 10.00G /dev/sdb1 myvg lvm2 a- 17.15G 17.15G 0 /dev/sdc1 myvg lvm2 a- 17.15G 15.15G 2.00G /dev/sdd1 myvg lvm2 a- 17.15G 15.15G 2.00GDespués de haber movido los datos fuera de

/dev/sdb1, puede eliminarlos del grupo de volúmenes.#

vgreduce myvg /dev/sdb1Removed "/dev/sdb1" from volume group "myvg"

Ahora puede reasignar el disco a otro grupo de volúmenes o eliminar el disco del sistema.

4.6. Configuración de números de dispositivos persistentes

Los números de dispositivo mayor y menor se asignan dinámicamente al cargar el módulo. Algunas aplicaciones funcionan mejor si el dispositivo de bloque se activa siempre con el mismo número de dispositivo (mayor y menor). Puede especificarlos con los comandos lvcreate y lvchange utilizando los siguientes argumentos:

--persistente y --mayor major --menor minor

Utilice un número menor grande para estar seguro de que no se ha asignado ya a otro dispositivo de forma dinámica.

Si está exportando un sistema de archivos usando NFS, especificar el parámetro fsid en el archivo de exportación puede evitar la necesidad de establecer un número de dispositivo persistente dentro de LVM.

4.7. Especificación del tamaño de extensión de LVM

Cuando se utilizan volúmenes físicos para crear un grupo de volúmenes, su espacio de disco se divide en extensiones de 4MB, por defecto. Esta extensión es la cantidad mínima por la que el volumen lógico puede aumentar o disminuir su tamaño. Un gran número de extensiones no tendrá ningún impacto en el rendimiento de E/S del volumen lógico.

Puedes especificar el tamaño de extensión con la opción -s del comando vgcreate si el tamaño de extensión por defecto no es adecuado. Puedes poner límites al número de volúmenes físicos o lógicos que puede tener el grupo de volúmenes utilizando los argumentos -p y -l del comando vgcreate.

4.8. Gestión de los volúmenes lógicos LVM mediante los roles de sistema de RHEL

Esta sección describe cómo aplicar el rol storage para realizar las siguientes tareas:

- Crear un volumen lógico LVM en un grupo de volúmenes compuesto por varios discos.

- Crea un sistema de archivos ext4 con una etiqueta determinada en el volumen lógico.

- Montar persistentemente el sistema de archivos ext4.

Requisitos previos

-

Un libro de jugadas de Ansible que incluye el rol

storage

Para obtener información sobre cómo aplicar un libro de jugadas de Ansible, consulte Aplicar un rol.

4.8.1. Ejemplo de libro de jugadas de Ansible para gestionar volúmenes lógicos

Esta sección proporciona un ejemplo de libro de jugadas de Ansible. Este libro de jugadas aplica el rol storage para crear un volumen lógico LVM en un grupo de volúmenes.

Ejemplo 4.1. Un libro de jugadas que crea un volumen lógico mylv en el grupo de volúmenes myvg

- hosts: all

vars:

storage_pools:

- name: myvg

disks:

- sda

- sdb

- sdc

volumes:

- name: mylv

size: 2G

fs_type: ext4

mount_point: /mnt

roles:

- rhel-system-roles.storageEl grupo de volúmenes

myvgestá formado por los siguientes discos:-

/dev/sda -

/dev/sdb -

/dev/sdc

-

-

Si el grupo de volumen

myvgya existe, el libro de jugadas añade el volumen lógico al grupo de volumen. -

Si el grupo de volumen

myvgno existe, el libro de jugadas lo crea. -

El libro de jugadas crea un sistema de archivos Ext4 en el volumen lógico

mylv, y monta persistentemente el sistema de archivos en/mnt.

Recursos adicionales

-

Para más detalles sobre los parámetros utilizados en el rol de sistema

storage, consulte el archivo/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

4.8.2. Recursos adicionales

-

Para obtener más información sobre el rol

storage, consulte Gestión del almacenamiento local mediante los roles de sistema de RHEL.

4.9. Eliminación de volúmenes lógicos LVM

Este procedimiento elimina un volumen lógico existente utilizando la interfaz LVM de la línea de comandos.

Los siguientes comandos eliminan el volumen lógico /dev/vg-name/lv-name del grupo de volúmenes vg-name.

Procedimiento

- Si el volumen lógico está actualmente montado, desmonte el volumen.

Si el volumen lógico existe en un entorno de clúster, desactive el volumen lógico en todos los nodos en los que esté activo. Utilice el siguiente comando en cada uno de esos nodos:

[root@node-n]# lvchange --activate n vg-name/lv-name

Elimine el volumen lógico utilizando la utilidad

lvremove:# lvremove /dev/vg-name/lv-name Do you really want to remove active logical volume "lv-name"? [y/n]: y Logical volume "lv-name" successfully removed

NotaEn este caso, el volumen lógico no ha sido desactivado. Si se desactiva explícitamente el volumen lógico antes de eliminarlo, no se vería el aviso que verifica si se quiere eliminar un volumen lógico activo.

Recursos adicionales

-

La página de manual

lvremove(8)

Capítulo 5. Modificar el tamaño de un volumen lógico

Después de crear un volumen lógico, puedes modificar el tamaño del volumen.

5.1. Crecimiento de los volúmenes lógicos

Para aumentar el tamaño de un volumen lógico, utilice el comando lvextend.

Al ampliar el volumen lógico, puedes indicar cuánto quieres ampliar el volumen, o qué tamaño quieres que tenga después de ampliarlo.

El siguiente comando amplía el volumen lógico /dev/myvg/homevol a 12 gigabytes.

# lvextend -L12G /dev/myvg/homevol

lvextend -- extending logical volume "/dev/myvg/homevol" to 12 GB

lvextend -- doing automatic backup of volume group "myvg"

lvextend -- logical volume "/dev/myvg/homevol" successfully extended

El siguiente comando añade otro gigabyte al volumen lógico /dev/myvg/homevol.

# lvextend -L+1G /dev/myvg/homevol

lvextend -- extending logical volume "/dev/myvg/homevol" to 13 GB

lvextend -- doing automatic backup of volume group "myvg"

lvextend -- logical volume "/dev/myvg/homevol" successfully extended

Al igual que con el comando lvcreate, puedes utilizar el argumento -l del comando lvextend para especificar el número de extensiones en las que aumentar el tamaño del volumen lógico. También puedes utilizar este argumento para especificar un porcentaje del grupo de volúmenes, o un porcentaje del espacio libre restante en el grupo de volúmenes. El siguiente comando extiende el volumen lógico llamado testlv para llenar todo el espacio no asignado en el grupo de volumen myvg.

# lvextend -l +100%FREE /dev/myvg/testlv

Extending logical volume testlv to 68.59 GB

Logical volume testlv successfully resizedDespués de haber ampliado el volumen lógico es necesario aumentar el tamaño del sistema de archivos para que coincida.

Por defecto, la mayoría de las herramientas de redimensionamiento de sistemas de archivos aumentarán el tamaño del sistema de archivos hasta el tamaño del volumen lógico subyacente, por lo que no hay que preocuparse de especificar el mismo tamaño para cada uno de los dos comandos.

5.2. Crecimiento de un sistema de archivos en un volumen lógico

Para hacer crecer un sistema de archivos en un volumen lógico, realiza los siguientes pasos:

Determine si hay suficiente espacio sin asignar en el grupo de volúmenes existente para ampliar el volumen lógico. Si no es así, realice el siguiente procedimiento:

-

Cree un nuevo volumen físico con el comando

pvcreate. -

Utilice el comando

vgextendpara ampliar el grupo de volúmenes que contiene el volumen lógico con el sistema de archivos que está creciendo para incluir el nuevo volumen físico.

-

Cree un nuevo volumen físico con el comando

-

Una vez que el grupo de volúmenes sea lo suficientemente grande como para incluir el sistema de archivos más grande, amplíe el volumen lógico con el comando

lvresize. - Redimensiona el sistema de archivos del volumen lógico.

Tenga en cuenta que puede utilizar la opción -r del comando lvresize para ampliar el volumen lógico y redimensionar el sistema de archivos subyacente con un solo comando

5.3. Reducción de volúmenes lógicos

Puede reducir el tamaño de un volumen lógico con el comando lvreduce.

La reducción no es compatible con un sistema de archivos GFS2 o XFS, por lo que no se puede reducir el tamaño de un volumen lógico que contenga un sistema de archivos GFS2 o XFS.

Si el volumen lógico que está reduciendo contiene un sistema de archivos, para evitar la pérdida de datos debe asegurarse de que el sistema de archivos no está utilizando el espacio del volumen lógico que se está reduciendo. Por este motivo, se recomienda utilizar la opción --resizefs del comando lvreduce cuando el volumen lógico contenga un sistema de archivos. Cuando se utiliza esta opción, el comando lvreduce intenta reducir el sistema de archivos antes de reducir el volumen lógico. Si la reducción del sistema de archivos falla, como puede ocurrir si el sistema de archivos está lleno o el sistema de archivos no admite la reducción, el comando lvreduce fallará y no intentará reducir el volumen lógico.

En la mayoría de los casos, el comando lvreduce advierte sobre la posible pérdida de datos y pide una confirmación. Sin embargo, no debes confiar en estos avisos de confirmación para evitar la pérdida de datos porque en algunos casos no verás estos avisos, como cuando el volumen lógico está inactivo o no se utiliza la opción --resizefs.

Tenga en cuenta que el uso de la opción --test del comando lvreduce no indica si la operación es segura, ya que esta opción no comprueba el sistema de archivos ni prueba el redimensionamiento del sistema de archivos.

El siguiente comando reduce el volumen lógico lvol1 en el grupo de volúmenes vg00 a 64 megabytes. En este ejemplo, lvol1 contiene un sistema de archivos, que este comando redimensiona junto con el volumen lógico. Este ejemplo muestra la salida del comando.

# lvreduce --resizefs -L 64M vg00/lvol1

fsck from util-linux 2.23.2

/dev/mapper/vg00-lvol1: clean, 11/25688 files, 8896/102400 blocks

resize2fs 1.42.9 (28-Dec-2013)

Resizing the filesystem on /dev/mapper/vg00-lvol1 to 65536 (1k) blocks.

The filesystem on /dev/mapper/vg00-lvol1 is now 65536 blocks long.

Size of logical volume vg00/lvol1 changed from 100.00 MiB (25 extents) to 64.00 MiB (16 extents).

Logical volume vg00/lvol1 successfully resized.Especificar el signo - antes del valor de redimensionamiento indica que el valor se restará del tamaño real del volumen lógico. El siguiente ejemplo muestra el comando que utilizarías si, en lugar de reducir un volumen lógico a un tamaño absoluto de 64 megabytes, quisieras reducir el volumen en un valor de 64 megabytes.

# lvreduce --resizefs -L -64M vg00/lvol15.4. Ampliación de un volumen lógico rayado

Para aumentar el tamaño de un volumen lógico rayado, debe haber suficiente espacio libre en los volúmenes físicos subyacentes que componen el grupo de volúmenes para soportar la raya. Por ejemplo, si tienes una franja de dos direcciones que utiliza todo un grupo de volúmenes, añadir un solo volumen físico al grupo de volúmenes no te permitirá ampliar la franja. En su lugar, debes añadir al menos dos volúmenes físicos al grupo de volúmenes.

Por ejemplo, considere un grupo de volumen vg que consiste en dos volúmenes físicos subyacentes, como se muestra con el siguiente comando vgs.

# vgs

VG #PV #LV #SN Attr VSize VFree

vg 2 0 0 wz--n- 271.31G 271.31GPuedes crear una franja utilizando todo el espacio del grupo de volúmenes.

#lvcreate -n stripe1 -L 271.31G -i 2 vgUsing default stripesize 64.00 KB Rounding up size to full physical extent 271.31 GB Logical volume "stripe1" created #lvs -a -o +devicesLV VG Attr LSize Origin Snap% Move Log Copy% Devices stripe1 vg -wi-a- 271.31G /dev/sda1(0),/dev/sdb1(0)

Observe que el grupo de volúmenes ya no tiene espacio libre.

# vgs

VG #PV #LV #SN Attr VSize VFree

vg 2 1 0 wz--n- 271.31G 0El siguiente comando agrega otro volumen físico al grupo de volúmenes, que entonces tiene 135 gigabytes de espacio adicional.

#vgextend vg /dev/sdc1Volume group "vg" successfully extended #vgsVG #PV #LV #SN Attr VSize VFree vg 3 1 0 wz--n- 406.97G 135.66G

En este punto no se puede ampliar el volumen lógico rayado hasta el tamaño completo del grupo de volúmenes, porque se necesitan dos dispositivos subyacentes para rayar los datos.

# lvextend vg/stripe1 -L 406G

Using stripesize of last segment 64.00 KB

Extending logical volume stripe1 to 406.00 GB

Insufficient suitable allocatable extents for logical volume stripe1: 34480

more requiredPara ampliar el volumen lógico rayado, añada otro volumen físico y luego amplíe el volumen lógico. En este ejemplo, habiendo añadido dos volúmenes físicos al grupo de volúmenes podemos ampliar el volumen lógico hasta el tamaño completo del grupo de volúmenes.

#vgextend vg /dev/sdd1Volume group "vg" successfully extended #vgsVG #PV #LV #SN Attr VSize VFree vg 4 1 0 wz--n- 542.62G 271.31G #lvextend vg/stripe1 -L 542GUsing stripesize of last segment 64.00 KB Extending logical volume stripe1 to 542.00 GB Logical volume stripe1 successfully resized

Si no tiene suficientes dispositivos físicos subyacentes para ampliar el volumen lógico rayado, es posible ampliar el volumen de todas formas si no importa que la ampliación no esté rayada, lo que puede dar lugar a un rendimiento desigual. Cuando se añade espacio al volumen lógico, la operación por defecto es utilizar los mismos parámetros de striping del último segmento del volumen lógico existente, pero se pueden anular esos parámetros. El siguiente ejemplo amplía el volumen lógico rayado existente para utilizar el espacio libre restante después de que falle el comando inicial lvextend.

#lvextend vg/stripe1 -L 406GUsing stripesize of last segment 64.00 KB Extending logical volume stripe1 to 406.00 GB Insufficient suitable allocatable extents for logical volume stripe1: 34480 more required #lvextend -i1 -l+100%FREE vg/stripe1

Capítulo 6. Gestión de grupos de volúmenes LVM

Esta sección describe los comandos que realizan los distintos aspectos de la administración de grupos de volumen.

6.1. Grupos de volumen

Los volúmenes físicos se combinan en grupos de volúmenes (VG). Esto crea una reserva de espacio en disco a partir de la cual se pueden asignar volúmenes lógicos.

Dentro de un grupo de volúmenes, el espacio de disco disponible para la asignación se divide en unidades de tamaño fijo llamadas extensiones. Una extensión es la unidad más pequeña de espacio que se puede asignar. Dentro de un volumen físico, los extents se denominan extents físicos.

Un volumen lógico se asigna en extensiones lógicas del mismo tamaño que las extensiones físicas. El tamaño de la extensión es, por tanto, el mismo para todos los volúmenes lógicos del grupo de volúmenes. El grupo de volúmenes asigna las extensiones lógicas a extensiones físicas.

6.2. Visualización de los grupos de volumen

Hay dos comandos que puedes utilizar para mostrar las propiedades de los grupos de volumen LVM: vgs y vgdisplay. El comando vgscan, que escanea todos los dispositivos de bloque LVM soportados en el sistema en busca de grupos de volúmenes, también se puede utilizar para mostrar los grupos de volúmenes existentes.

El comando vgs proporciona información de grupos de volúmenes de forma configurable, mostrando una línea por grupo de volúmenes. El comando vgs proporciona un gran control del formato, y es útil para la creación de scripts.

El comando vgdisplay muestra las propiedades del grupo de volúmenes (como tamaño, extensiones, número de volúmenes físicos, etc.) de forma fija. El siguiente ejemplo muestra la salida del comando vgdisplay para el grupo de volumen new_vg. Si no se especifica un grupo de volúmenes, se muestran todos los grupos de volúmenes existentes.

# vgdisplay new_vg

--- Volume group ---

VG Name new_vg

System ID

Format lvm2

Metadata Areas 3

Metadata Sequence No 11

VG Access read/write

VG Status resizable

MAX LV 0

Cur LV 1

Open LV 0

Max PV 0

Cur PV 3

Act PV 3

VG Size 51.42 GB

PE Size 4.00 MB

Total PE 13164

Alloc PE / Size 13 / 52.00 MB

Free PE / Size 13151 / 51.37 GB

VG UUID jxQJ0a-ZKk0-OpMO-0118-nlwO-wwqd-fD5D32

El siguiente ejemplo muestra la salida del comando vgscan.

# vgscan

Reading all physical volumes. This may take a while...

Found volume group "new_vg" using metadata type lvm2

Found volume group "officevg" using metadata type lvm26.3. Combinación de grupos de volumen

Para combinar dos grupos de volúmenes en un único grupo de volúmenes, utiliza el comando vgmerge. Puedes combinar un volumen inactivo "de origen" con un volumen activo o inactivo "de destino" si los tamaños de extensión física del volumen son iguales y los resúmenes de volumen físico y lógico de ambos grupos de volumen se ajustan a los límites de los grupos de volumen de destino.

El siguiente comando fusiona el grupo de volúmenes inactivo my_vg en el grupo de volúmenes activo o inactivo databases dando información verbosa en tiempo de ejecución.

# vgmerge -v databases my_vg6.4. Dividir un grupo de volúmenes

En este procedimiento de ejemplo, un grupo de volumen existente consta de tres volúmenes físicos. Si hay suficiente espacio no utilizado en los volúmenes físicos, se puede crear un nuevo grupo de volúmenes sin añadir nuevos discos.

En la configuración inicial, el volumen lógico mylv se extrae del grupo de volúmenes myvg, que a su vez consta de tres volúmenes físicos, /dev/sda1, /dev/sdb1 y /dev/sdc1.

Tras completar este procedimiento, el grupo de volúmenes myvg estará formado por /dev/sda1 y /dev/sdb1. Un segundo grupo de volúmenes, yourvg, estará formado por /dev/sdc1.

Utilice el comando

pvscanpara determinar cuánto espacio libre hay actualmente en el grupo de volúmenes.#

pvscanPV /dev/sda1 VG myvg lvm2 [17.15 GB / 0 free] PV /dev/sdb1 VG myvg lvm2 [17.15 GB / 12.15 GB free] PV /dev/sdc1 VG myvg lvm2 [17.15 GB / 15.80 GB free] Total: 3 [51.45 GB] / in use: 3 [51.45 GB] / in no VG: 0 [0 ]Mueve todas las extensiones físicas utilizadas en

/dev/sdc1a/dev/sdb1con el comandopvmove. El comandopvmovepuede tardar mucho en ejecutarse.En un clúster, el comando

pvmovesólo puede mover el volumen lógico que está activo exclusivamente en un solo nodo.#

pvmove /dev/sdc1 /dev/sdb1/dev/sdc1: Moved: 14.7% /dev/sdc1: Moved: 30.3% /dev/sdc1: Moved: 45.7% /dev/sdc1: Moved: 61.0% /dev/sdc1: Moved: 76.6% /dev/sdc1: Moved: 92.2% /dev/sdc1: Moved: 100.0%Después de mover los datos, puede ver que todo el espacio en

/dev/sdc1está libre.#

pvscanPV /dev/sda1 VG myvg lvm2 [17.15 GB / 0 free] PV /dev/sdb1 VG myvg lvm2 [17.15 GB / 10.80 GB free] PV /dev/sdc1 VG myvg lvm2 [17.15 GB / 17.15 GB free] Total: 3 [51.45 GB] / in use: 3 [51.45 GB] / in no VG: 0 [0 ]Para crear el nuevo grupo de volumen

yourvg, utilice el comandovgsplitpara dividir el grupo de volumenmyvg.El siguiente comando divide el grupo de volumen

yourvgdel grupo de volumenmyvg, moviendo el volumen físico/dev/sdc1al nuevo grupo de volumenyourvg.#

lvchange -a n /dev/myvg/mylv#vgsplit myvg yourvg /dev/sdc1Volume group "yourvg" successfully split from "myvg"Puede utilizar el comando

vgspara ver los atributos de los dos grupos de volúmenes.#

vgsVG #PV #LV #SN Attr VSize VFree myvg 2 1 0 wz--n- 34.30G 10.80G yourvg 1 0 0 wz--n- 17.15G 17.15GDespués de crear el nuevo grupo de volúmenes, cree el nuevo volumen lógico

yourlv.#

lvcreate -L 5G -n yourlv yourvgLogical volume "yourlv" createdCrea un sistema de archivos en el nuevo volumen lógico y móntalo.

#

mkfs.ext4 /dev/yourvg/yourlvmke2fs 1.44.3 (10-July-2018) Creating filesystem with 524288 4k blocks and 131072 inodes Filesystem UUID: 616da032-8a48-4cd7-8705-bd94b7a1c8c4 Superblock backups stored on blocks: 32768, 98304, 163840, 229376, 294912 Allocating group tables: done Writing inode tables: done Creating journal (16384 blocks): done Writing superblocks and filesystem accounting information: done #mount /dev/yourvg/yourlv /mnt

6.5. Renombrar grupos de volúmenes LVM

Este procedimiento cambia el nombre de un grupo de volúmenes existente utilizando la interfaz LVM de la línea de comandos.

Procedimiento

Si el grupo de volúmenes existe en un entorno de clúster, desactive el grupo de volúmenes en todos los nodos en los que esté activo. Utilice el siguiente comando en cada uno de esos nodos:

[root@node-n]# vgchange --activate n vg-nameUtilice la utilidad

vgrenamepara renombrar un grupo de volúmenes existente:# vgrename original-vg-name new-vg-name

Opcionalmente, puede especificar las rutas completas de los dispositivos:

# vgrename /dev/original-vg-name /dev/new-vg-name

Recursos adicionales

-