Red Hat Training

A Red Hat training course is available for Red Hat Enterprise Linux

Sicherheitshandbuch

Anleitung zur Sicherung von Red Hat Enterprise Linux

Ausgabe 1.5

Red Hat Inc.

Zusammenfassung

Kapitel 1. Überblick über Sicherheit

Anmerkung

/lib-Verzeichnis. Wenn Sie 64-bit Systeme verwenden, befinden sich einige der genannten Dateien stattdessen in /lib64.

1.1. Einführung in Sicherheit

1.1.1. Definition von Computersicherheit

1.1.1.1. Anfänge der Computersicherheit

1.1.1.2. Heutige Sicherheit

- Jeden Tag werden etwa 225 schwerwiegende Fälle von Sicherheitsverletzungen an das CERT-Koordinationszentrum an der Carnegie Mellon Universität gemeldet.[6]

- Die Anzahl der bei CERT gemeldeten Vorfälle stieg sprunghaft von 52.658 im Jahre 2001 auf 82.094 in 2002 und auf 137.529 in 2003 an.[7]

- Laut dem FBI wurde der Schaden durch Computerkriminalität für US-amerikanische Unternehmen für das Jahr 2006 auf 67,2 Milliarden US-Dollar geschätzt. [8]

- Nur 23% der Befragten haben Richtlinien zur Verwendung von Web 2.0 Technologien. Diese Technologien wie z. B. Twitter, Facebook und LinkedIn bieten zwar einen bequemen Weg für Unternehmen und Privatpersonen zur Kommunikation und Zusammenarbeit, öffnen gleichzeitig aber auch neue Schwachstellen, insbesondere das mögliche Durchsickern vertraulicher Daten.

- Sogar während der kürzlichen Finanzkrise in 2009 waren die in der Befragung festgestellten Sicherheitsbudgets im Vergleich zu den Vorjahren etwa gleich geblieben oder gestiegen (fast 2 von 3 Befragten erwarteten gleichbleibende oder steigende Ausgaben). Das sind gute Neuigkeiten, da es den Wert widerspiegelt, den Unternehmen heutzutage auf Datensicherheit legen.

1.1.1.3. Standardisierung der Sicherheit

- Vertraulichkeit — Vertrauliche Informationen dürfen nur für im vornherein festgelegte Einzelpersonen verfügbar sein. Unautorisierte Übertragung und Verwendung von Informationen muss verhindert werden. So stellt zum Beispiel die Vertraulichkeit von Informationen sicher, dass persönliche oder finanzielle Details von Kunden nicht von Unbefugten für böswillige Zwecke wie Identitätsraub oder Kreditbetrug missbraucht werden können.

- Integrität — Informationen dürfen nicht derart verändert werden, dass sie unvollständig oder falsch werden. Unbefugte müssen daran gehindert werden, vertrauliche Informationen ändern oder zerstören zu können.

- Verfügbarkeit — Informationen müssen jederzeit für befugte Personen zugänglich sein. Verfügbarkeit ist die Garantie dafür, dass Informationen mit einer vereinbarten Häufigkeit und rechtzeitig abgerufen werden können. Dies wird häufig in Prozent gemessen und formell in Service-Level-Agreements (SLAs) zwischen Netzwerkservice-Anbietern und deren Geschäftskunden festgelegt.

1.1.2. SELinux

1.1.3. Sicherheitskontrollen

- Physische Kontrolle

- Technische Kontrolle

- Administrative Kontrolle

1.1.3.1. Physische Kontrolle

- Überwachungskameras

- Bewegungs- oder Wärmemelder

- Sicherheitspersonal

- Ausweise

- Verriegelte Stahltüren

- Biometrie (z. B. Erkennung von Fingerabdrücken, Stimme, Gesicht, Iris, Handschrift oder andere automatisierte Methoden, um die Identität von Personen nachzuweisen)

1.1.3.2. Technische Kontrollen

- Verschlüsselung

- Smart Cards

- Netzwerkauthentifizierung

- Zugangskontrolllisten (ACLs)

- Software zur Prüfung der Dateiintegrität

1.1.3.3. Administrative Kontrollen

- Schulung und Aufklärung

- Katastrophenvorbereitung und Wiederherstellungspläne

- Personaleinstellungs- und Separations-Strategien

- Mitarbeiterregistrierung und Buchhaltung

1.1.4. Fazit

1.2. Schwachstellenanalyse

- Die Kompetenz der Mitarbeiter, die für die Konfiguration, Überwachung und Wartung dieser Technologien verantwortlich sind.

- Die Fähigkeit, Dienste und Kernel schnell und effizient mit Patches versehen und aktualisieren zu können.

- Die Fähigkeit der Verantwortlichen, konstante Wachsamkeit im Netzwerk auszuüben.

1.2.1. Denken wie der Feind

1.2.2. Definition von Analyse und Test

Warnung

- Proaktiver Fokus auf Informationssicherheit

- Auffinden potenzieller Schwachstellen, bevor diese von Angreifern gefunden werden

- Resultiert normalerweise darin, dass Systeme aktuell gehalten und mit Patches versehen werden

- Fördert Wachstum und hilft bei der Entwicklung von Mitarbeiterkompetenz

- Vermindert finanzielle Verluste und negative Presse

1.2.2.1. Entwickeln einer Methodik

- http://www.isecom.org/osstmm/ The Open Source Security Testing Methodology Manual (OSSTMM)

- http://www.owasp.org/ The Open Web Application Security Project

1.2.3. Bewerten der Tools

1.2.3.1. Scannen von Hosts mit Nmap

1.2.3.1.1. Verwendung von Nmap

nmap gefolgt vom Hostnamen oder der IP-Adresse des zu scannenden Computers ein.

nmap foo.example.comInteresting ports on foo.example.com: Not shown: 1710 filtered ports PORT STATE SERVICE 22/tcp open ssh 53/tcp open domain 80/tcp open http 113/tcp closed auth

1.2.3.2. Nessus

Anmerkung

1.2.3.3. Nikto

1.2.3.4. Für Ihre zukünftigen Bedürfnisse vorausplanen

1.3. Angreifer und Schwachstellen

1.3.1. Ein kurzer geschichtlicher Überblick über Hacker

1.3.1.1. Grauzonen

1.3.2. Bedrohungen der Netzwerksicherheit

1.3.2.1. Unsichere Architekturen

1.3.2.1.1. Broadcast-Netzwerke

1.3.2.1.2. Zentralisierte Server

1.3.3. Bedrohungen der Serversicherheit

1.3.3.1. Unbenutzte Dienste und offene Ports

1.3.3.2. Dienste ohne Patches

1.3.3.3. Unaufmerksame Administration

1.3.3.4. Von Natur aus unsichere Dienste

1.3.4. Bedrohungen der Arbeitsplatzrechner- und Heim-PC-Sicherheit

1.3.4.1. Unsichere Passwörter

1.3.4.2. Anfällige Client-Applikationen

1.4. Häufige Sicherheitslücken und Angriffe

Tabelle 1.1. Häufige Sicherheitslücken

| Sicherheitslücke | Beschreibung | Anmerkungen | |||

|---|---|---|---|---|---|

| Null- oder Standardpasswort | Das Leerlassen von administrativen Passwörtern oder das Verwenden von Standardpasswörtern des Herstellers. Dies betrifft häufig Hardware wie Router und Firewalls, jedoch können auch einige Dienste, die unter Linux laufen, standardmäßige Administratorenpasswörter enthalten (Red Hat Enterprise Linux wird jedoch nicht mit diesen ausgeliefert). |

| |||

| Gemeinsam genutzte Standardschlüssel | Sichere Dienste werden manchmal mit standardmäßigen Sicherheitsschlüsseln für Entwicklung oder zu Evaluierungszwecken ausgeliefert. Werden diese Schlüssel nicht geändert und auf einer Produktionsumgebung im Internet platziert, kann jeder Benutzer mit denselben Standardschlüsseln auf diese Ressourcen mit gemeinsam genutzten Schlüsseln und damit auf alle sensiblen Informationen darin zugreifen. |

| |||

| IP-Spoofing | Eine sich entfernt befindliche Maschine verhält sich wie ein Knoten im lokalen Netzwerk, findet Schwachstellen auf Ihrem Server und installiert ein Backdoor-Programm oder einen Trojaner, um Kontrolle über Ihre Netzwerkressourcen zu erlangen. |

| |||

| Abhören | Das Sammeln von Daten, die zwischen zwei aktiven Knoten auf einem Netzwerk ausgetauscht werden, indem die Verbindung dieser beiden Knoten abgehört wird. |

| |||

| Schwachstellen von Diensten | Ein Angreifer findet einen Fehler oder ein Schlupfloch in einem Dienst, der über das Internet läuft. Durch diese Schwachstelle kann der Angreifer das gesamte System und alle Daten darauf sowie weitere Systeme im Netzwerk kompromittieren. |

| |||

| Schwachstellen von Applikationen | Angreifer finden Fehler in Applikationen von Desktops und Arbeitsplatzrechnern (wie z. B. E-Mail-Clients) und führen willkürlich Code aus, implantieren Trojaner für zukünftige Attacken oder bringen Systeme zum Absturz. Noch größerer Schaden kann angerichtet werden, falls der kompromittierte Arbeitsplatzrechner administrative Berechtigungen für den Rest des Netzwerks besitzt. |

| |||

| Denial-of-Service (DoS) Angriffe | Ein Angreifer bzw. eine Gruppe von Angreifern koordiniert eine Attacke auf ein Netzwerk oder auf Serverressourcen eines Unternehmens, bei der unbefugte Pakete an den Zielcomputer (entweder Server, Router oder Arbeitsplatzrechner) gesendet werden. Dies macht die Ressource für berechtigte Benutzer nicht verfügbar. |

|

1.5. Sicherheitsaktualisierungen

1.5.1. Aktualisieren von Paketen

Anmerkung

1.5.2. Verifizieren von signierten Paketen

/mnt/cdrom eingehängt, können Sie den folgenden Befehl zum Importieren des Schlüssels in den Schlüsselbund (engl. "Keyring", eine Datenbank bestehend aus vertrauenswürdigen Schlüsseln auf dem System) verwenden.

rpm --import /mnt/cdrom/RPM-GPG-KEYrpm -qa gpg-pubkey*gpg-pubkey-db42a60e-37ea5438rpm -qi, gefolgt von der Ausgabe des vorherigen Befehls, in diesem Beispiel also:

rpm -qi gpg-pubkey-db42a60e-37ea5438rpm -K /tmp/updates/*.rpmgpg OK. Ist dies nicht der Fall, überprüfen Sie, ob Sie den richtigen öffentlichen Schlüssel von Red Hat verwenden und verifizieren Sie die Quelle des Inhalts. Pakete, welche die GPG-Verifizierung nicht bestehen, sollten nicht installiert werden, da sie möglicherweise von Dritten verändert wurden.

1.5.3. Installieren von signierten Paketen

rpm -Uvh /tmp/updates/*.rpmrpm -ivh /tmp/updates/<kernel-package>rpm -e <old-kernel-package>Anmerkung

Wichtig

1.5.4. Anwenden der Änderungen

Anmerkung

- Applikationen

- Bei User-Space-Applikationen handelt es sich um alle Programme, die durch einen Systembenutzer gestartet werden können. Für gewöhnlich laufen diese Anwendungen nur, wenn ein Benutzer, ein Skript oder ein automatisiertes Dienstprogramm diese startet, und sie werden in der Regel nicht für längere Zeit ausgeführt.Wird solch eine User-Space-Applikation aktualisiert, stoppen Sie alle Instanzen dieser Anwendung auf dem System und starten Sie das Programm erneut, um die aktualisierte Version zu verwenden.

- Kernel

- Der Kernel ist die Kern-Software-Komponente für das Red Hat Enterprise Linux Betriebssystem. Er verwaltet den Zugriff auf den Speicher, den Prozessor und auf Peripheriegeräte, und plant sämtliche Aufgaben.Aufgrund seiner zentralen Rolle kann der Kernel nur durch ein Herunterfahren des Computers neu gestartet werden. Daher kann eine aktualisierte Version des Kernels erst verwendet werden, wenn das System neu gestartet wird.

- Gemeinsam verwendete Bibliotheken

- Gemeinsam verwendete Bibliotheken sind Einheiten von Code, wie z. B.

glibc, die von einer Reihe von Applikationen und Software-Programmen gemeinsam verwendet werden. Applikationen, die gemeinsam verwendete Bibliotheken nutzen, laden normalerweise den gemeinsamen Code beim Starten der Anwendungen, so dass alle Applikationen, die die aktualisierte Bibliothek verwenden, neu gestartet werden müssen.Um festzustellen, welche laufenden Applikationen mit einer bestimmten Bibliothek verknüpft sind, verwenden Sie den Befehllsofwie im folgenden Beispiel:lsof /lib/libwrap.so*Dieser Befehl gibt eine Liste aller laufenden Programme aus, die TCP-Wrappers für die Host-Zugangskontrolle verwenden. Alle aufgelisteten Programme müssen angehalten und neu gestartet werden, wenn dastcp_wrappers-Paket aktualisiert wird. - SysV-Dienste

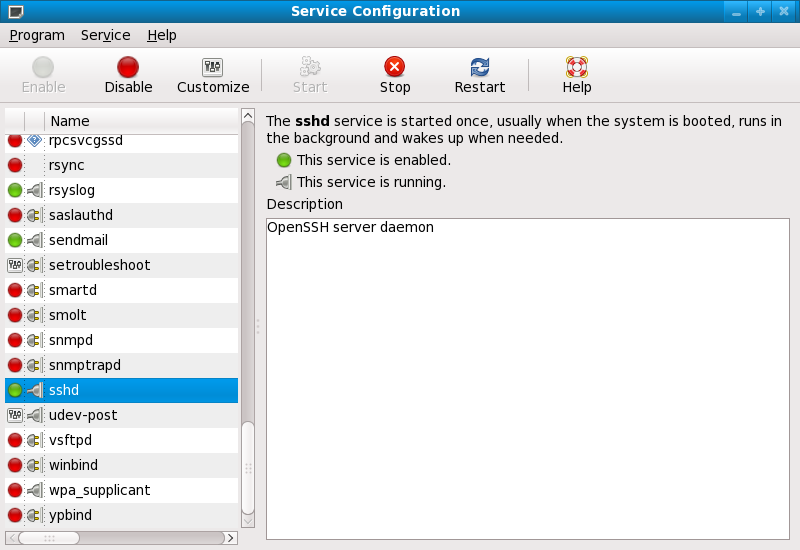

- SysV-Dienste sind persistente Server-Programme, die während des Bootens gestartet werden. Beispiele für SysV-Dienste sind

sshd,vsftpdundxinetd.Da diese Programme normalerweise im Speicher verbleiben, solange der Rechner läuft, muss jeder aktualisierte SysV-Dienst nach der Aktualisierung des Pakets angehalten und neu gestartet werden. Dies kann über das Tool zur Dienstkonfiguration oder durch Anmelden als Root via Shell-Prompt und Ausführen des Befehls/sbin/serviceerreicht werden, wie im folgenden Beispiel veranschaulicht:/sbin/service <service-name> restartErsetzen Sie im obigen Beispiel <service-name> durch den Namen des Dienstes, wie z. B.sshd. xinetd-Dienste- Dienste, die vom Super-Dienst

xinetdgesteuert werden, werden nur ausgeführt, wenn eine aktive Verbindung vorliegt. Vonxinetdgesteuert werden z. B. die Telnet, IMAP und POP3-Dienste.Daxinetdjedesmal neue Instanzen dieser Dienste startet, wenn eine neue Anfrage empfangen wird, werden die Verbindungen, die nach einer Aktualisierung entstehen, durch die aktualisierte Software gesteuert. Bestehen jedoch zu dem Zeitpunkt, an dem vonxinetdverwaltete Dienste aktualisiert werden, aktive Verbindungen, so werden diese noch von der älteren Version der Software bedient.Um ältere Instanzen eines bestimmtenxinetd-Dienstes zu stoppen, aktualisieren Sie das Paket für den Dienst und stoppen Sie anschließend alle aktuell laufenden Prozesse. Mit dem Befehlpskönnen Sie feststellen, welche Prozesse laufen. Geben Sie dann den Befehlkilloderkillallein, um alle aktuellen Instanzen dieses Dienstes zu stoppen.Wenn zum Beispiel Sicherheits-Errata für dieimap-Pakete herausgegeben werden, aktualisieren Sie die Pakete und geben Sie danach folgenden Befehl als Root ein:ps aux | grep imapDieser Befehl gibt alle aktiven IMAP-Sitzungen aus. Einzelne Sitzungen können dann mithilfe des folgenden Befehls beendet werden:kill <PID>Falls das Beenden der Sitzung damit fehlschlägt, verwenden Sie stattdessen folgenden Befehl:kill -9 <PID>Ersetzen Sie im obigen Beispiel <PID> durch die Prozess-Identifikationsnummer (zu finden in der zweiten Spalte desps-Befehls) der fraglichen IMAP-Sitzung.Um alle aktiven IMAP-Sitzungen zu beenden, geben Sie den folgenden Befehl ein:killall imapd

Kapitel 2. Sichern Ihres Netzwerks

2.1. Sicherheit eines Arbeitsplatzrechners

2.1.1. Beurteilung der Arbeitsplatzrechner-Sicherheit

- BIOS und Bootloader-Sicherheit — Kann ein unbefugter Benutzer physisch auf den Rechner zugreifen und in den Einzelbenutzer- oder Rettungsmodus booten, ohne dass nach einem Passwort gefragt wird?

- Passwortsicherheit — Wie sicher sind die Passwörter für die Benutzeraccounts auf dem Rechner?

- Administrative Kontrolle — Wer hat alles einen Account auf dem System, und wie viel administrative Kontrolle wird diesen Accounts gewährt?

- Verfügbare Netzwerkdienste — Welche Dienste horchen auf dem Netzwerk auf Anfragen, und sollten diese überhaupt aktiv sein?

- Persönliche Firewalls — Welche Art von Firewall, wenn überhaupt, ist nötig?

- Kommunikationstools mit erweiterter Sicherheit — Welche Tools sollten zur Kommunikation zwischen Arbeitsplatzrechnern verwendet werden, und welche sollten vermieden werden?

2.1.2. BIOS und Bootloader-Sicherheit

2.1.2.1. BIOS-Passwörter

- Änderungen an den BIOS-Einstellungen verhindern — Hat ein Eindringling Zugang zum BIOS, kann dieser den Bootvorgang von einer Diskette oder einer CD-ROM festlegen. Dies ermöglicht dann, in den Rettungsmodus oder Einzelbenutzermodus zu gelangen und von hier aus schädliche Prozesse auf dem System zu starten oder sensible Daten zu kopieren.

- System-Boot verhindern — Einige BIOS erlauben Ihnen, den Bootvorgang selbst mit einem Passwort zu schützen. Ist dies aktiviert, muss ein Passwort eingegeben werden, bevor das BIOS den Bootloader startet.

2.1.2.1.1. Sicherung von nicht-x86-Plattformen

2.1.2.2. Bootloader-Passwörter

- Zugang zum Einzelbenutzermodus verhindern — Wenn Angreifer in den Einzelbenutzermodus booten können, werden diese automatisch zu Root-Benutzern, ohne nach dem Root-Passwort gefragt zu werden.

- Zugang zur GRUB-Konsole verhindern — Wenn der Rechner GRUB als Bootloader verwendet, kann ein Angreifer die GRUB-Editor-Schnittstelle verwenden, um die Konfiguration zu ändern oder Informationen mithilfe des

cat-Befehls zu sammeln. - Zugang zu unsicheren Betriebssystemen verhindern — Haben Sie ein Dual-Boot-System, kann ein Angreifer während des Bootens ein Betriebssystem wie zum Beispiel DOS auswählen, das Zugangskontrollen und Dateiberechtigungen ignoriert.

2.1.2.2.1. Passwortschutz für GRUB

/sbin/grub-md5-crypt/boot/grub/grub.conf. Öffnen Sie die Datei und fügen Sie die nachfolgende Zeile unterhalb der timeout-Zeile im Hauptabschnitt des Dokuments ein:

password --md5 <password-hash>/sbin/grub-md5-crypt[12] ausgegeben wurde.

/boot/grub/grub.conf bearbeiten.

title-Zeile des Betriebssystems, das sie absichern möchten, und fügen Sie direkt darunter eine Zeile mit der lock-Direktive ein.

title DOS lockWarnung

password-Zeile im Hauptabschnitt der /boot/grub/grub.conf-Datei vorhanden sein, damit diese Methode funktionieren kann. Andernfalls kann ein Angreifer auf den GRUB-Editor zugreifen und die lock-Zeile entfernen.

lock-Zeile gefolgt von einer Passwortzeile in den Absatz ein.

title DOS lock password --md5 <password-hash>2.1.3. Passwortsicherheit

/etc/passwd-Datei gespeichert, wodurch das System potenziell für Angriffe verwundbar wird, bei denen Passwörter offline geknackt werden. Erlangt ein Angreifer als regulärer Benutzer Zugriff auf das System, kann er die /etc/passwd-Datei auf seinen eigenen Rechner kopieren und diverse Programme zum Knacken von Passwörtern darüber laufen lassen. Befindet sich ein unsicheres Passwort in der Datei, ist es nur eine Frage der Zeit, bis es von diesen Programmen geknackt wird.

/etc/shadow gespeichert werden, die nur vom Root-Benutzer gelesen werden kann.

2.1.3.1. Erstellen sicherer Passwörter

- Verwenden Sie nicht nur Wörter oder Zahlen — Sie sollten für ein Passwort nicht ausschließlich Wörter oder ausschließlich Zahlen verwenden.Hier einige Beispiele für unsichere Passwörter:

- 8675309

- juan

- hackme

- Verwenden Sie keine erkennbaren Wörter — Wörter wie Namen, im Wörterbuch stehende Wörter oder Begriffe aus Fernsehsendungen oder Romanen sollten vermieden werden, auch wenn diese am Ende mit Zahlen versehen werden.Hier einige Beispiele für unsichere Passwörter:

- john1

- DS-9

- mentat123

- Verwenden Sie keine Wörter in anderen Sprachen — Programme zum Knacken von Passwörtern prüfen oft anhand von Wortlisten, die Wörterbücher in anderen Sprachen umfassen. Sich für sichere Passwörter auf Fremdsprachen zu verlassen ist daher häufig wenig hilfreich.Hier einige Beispiele für unsichere Passwörter:

- cheguevara

- bienvenido1

- 1dummkopf

- Verwenden Sie keine Hacker-Begriffe — Glauben Sie nicht, dass Sie auf der sicheren Seite sind, wenn Sie Hacker-Begriffe — auch l337 (LEET) genannt — für Ihre Passwörter verwenden. Viele Wortlisten enthalten LEET-Begriffe.Hier einige Beispiele für unsichere Passwörter:

- H4X0R

- 1337

- Verwenden Sie keine persönlichen Informationen — Vermeiden Sie die Verwendung von persönlichen Informationen in Ihren Passwörtern. Wenn der Angreifer Sie kennt, kann er Ihr Passwort leichter herausfinden. Sehen Sie nachfolgend eine Liste mit zu vermeidenden Informationen beim Erstellen eines Passworts:Hier einige Beispiele für unsichere Passwörter:

- Ihren Namen

- Den Namen von Haustieren

- Die Namen von Familienmitgliedern

- Jegliche Geburtstage

- Ihre Telefonnummer oder Postleitzahl

- Drehen Sie keine erkennbaren Wörter um — Gute Passwortprogramme überprüfen gemeinsprachliche Wörter auch rückwärts, das Invertieren von schlechten Passwörtern machen diese also nicht sicherer.Hier einige Beispiele für unsichere Passwörter:

- R0X4H

- nauj

- 9-DS

- Schreiben Sie sich Ihr Passwort nicht auf — Bewahren Sie Ihr Passwort niemals auf Papier auf. Es ist wesentlich sicherer, sich das Passwort zu merken.

- Verwenden Sie nie das gleiche Passwort für alle Ihre Rechner — Es ist wichtig, dass Sie separate Passwörter für jeden Recher erstellen. So sind nicht alle Rechner auf einen Schlag betroffen, falls ein System einem Angriff zum Opfer fällt.

- Das Passwort sollte mindestens acht Zeichen enthalten — Je länger das Passwort, desto besser. Wenn Sie MD5-Passwörter verwenden, sollten diese 15 Zeichen oder mehr enthalten. DES-Passwörter sollten die maximale Länge nutzen (acht Zeichen).

- Mischen Sie Groß- und Kleinbuchstaben — In Red Hat Enterprise Linux wird Groß- und Kleinschreibung unterschieden, mischen Sie daher Groß- und Kleinbuchstaben, um die Sicherheit des Passworts zu erhöhen.

- Mischen Sie Buchstaben und Zahlen — Das Hinzufügen von Zahlen, insbesondere in der Mitte des Passwortes (nicht nur am Anfang oder Ende), verstärkt die Sicherheit des Passworts.

- Verwenden Sie Sonderzeichen — Nicht-alphanumerische Zeichen wie z. B. &, $ und > können die Sicherheit des Passworts signifikant erhöhen (nicht möglich für DES-Passwörter).

- Wählen Sie ein Passwort, das Sie sich leicht merken können — selbst das beste Passwort hilft Ihnen nicht weiter, wenn Sie sich nicht daran erinnern können. Verwenden Sie daher Akronyme oder andere mnemonische Techniken, um sich das Passwort zu merken.

2.1.3.1.1. Methode zur Erstellung sicherer Passwörter

- Überlegen Sie sich einen leicht zu merkenden Satz, wie zum Beispiel:"over the river and through the woods, to grandmother's house we go."

- Verwandeln Sie dies als Nächstes in ein Akronym (einschließlich der Satzzeichen).

otrattw,tghwg. - Machen Sie das Passwort komplexer, indem Sie Buchstaben durch Zahlen und Sonderzeichen austauschen. Ersetzen Sie zum Beispiel

tdurch7undadurch das at-Symbol (@):o7r@77w,7ghwg. - Machen Sie es noch komplexer, indem Sie mindestens einen Buchstaben groß schreiben, zum Beispiel

H.o7r@77w,7gHwg. - Und bitte verwenden Sie nicht unser Beispielpasswort für Ihre Systeme.

2.1.3.2. Erstellen von Benutzerpasswörtern innerhalb eines Unternehmens

2.1.3.2.1. Erzwingen sicherer Passwörter

passwd tun, die Pluggable Authentication Manager (PAM) unterstützt und daher prüft, ob ein Passwort zu kurz oder anderweitig zu unsicher ist. Diese Prüfung erfolgt mit dem pam_cracklib.so-PAM-Modul. Da PAM anpassbar ist, ist es möglich, weitere Passwort-Integritätsprüfer hinzuzufügen wie z. B. pam_passwdqc (erhältlich unter http://www.openwall.com/passwdqc/) oder ein neues Modul zu schreiben. Eine Liste erhältlicher PAM-Module finden Sie unter http://www.kernel.org/pub/linux/libs/pam/modules.html. Weitere Informationen über PAM finden Sie unter Managing Single Sign-On and Smart Cards.

- John The Ripper — Ein schnelles und flexibles Passwort-Cracking-Programm. Es ermöglicht die Verwendung mehrerer Wortlisten und ist fähig zum Brute-Force Passwort-Cracking. Es ist unter http://www.openwall.com/john/ erhältlich.

- Crack — Die vielleicht bekannteste Passwort-Cracking-Software. Crack ist ebenfalls sehr schnell, jedoch nicht so einfach zu verwenden wie John The Ripper. Es ist unter http://www.crypticide.com/alecm/security/crack/c50-faq.html erhältlich.

- Slurpie — Slurpie funktioniert ähnlich wie John The Ripper und Crack, ist jedoch darauf ausgelegt, auf mehreren Computern gleichzeitig zu laufen und ermöglicht so einen verteilten Passwort-Cracking-Angriff. Es ist erhältlich unter http://www.ussrback.com/distributed.htm, zusammen mit einer Reihe anderer Tools zur Bewertung der Sicherheit bei verteilten Passwort-Cracking-Angriffen.

Warnung

2.1.3.2.2. Passphrasen

2.1.3.2.3. Passwortalterung

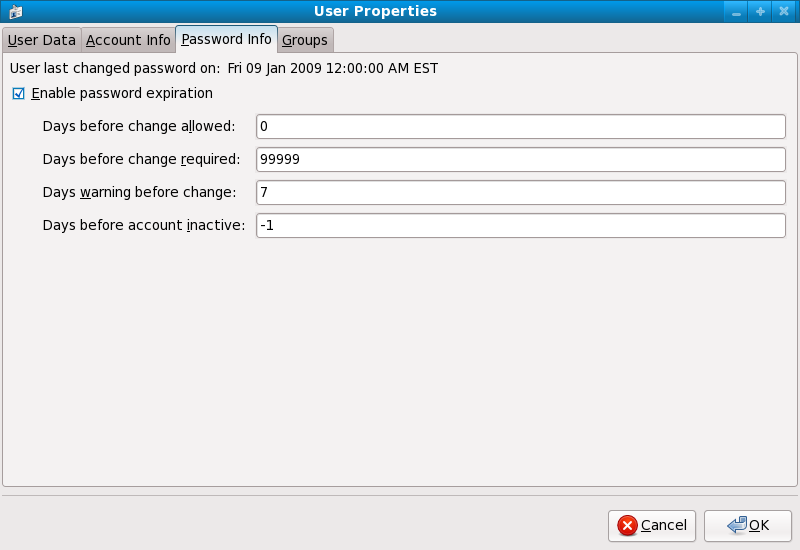

chage oder die grafische Benutzerverwaltung (system-config-users).

-M des chage-Befehls legt die maximale Anzahl von Tagen fest, für die das Passwort gültig ist. Wenn Sie zum Beispiel festlegen wollen, dass ein Benutzerpasswort nach 90 Tagen ungültig wird, geben Sie den folgenden Befehl ein:

chage -M 90 <username>99999 nach der Option -M (dies entspricht etwas mehr als 273 Jahren).

chage auch im interaktiven Modus verwenden, um mehrere Details der Passwortalterung und des Benutzerkontos zu ändern. Verwenden Sie folgenden Befehl für den interaktiven Modus:

chage <username>[root@myServer ~]# chage davido Changing the aging information for davido Enter the new value, or press ENTER for the default Minimum Password Age [0]: 10 Maximum Password Age [99999]: 90 Last Password Change (YYYY-MM-DD) [2006-08-18]: Password Expiration Warning [7]: Password Inactive [-1]: Account Expiration Date (YYYY-MM-DD) [1969-12-31]: [root@myServer ~]#

- Klicken Sie im System-Menü auf der oberen Menüleiste auf Administration und anschließend auf Benutzer und Gruppen, um die Benutzerverwaltung anzuzeigen. Alternativ können Sie dazu auch den Befehl

system-config-usersan einem Shell-Prompt eingeben. - Klicken Sie auf den Benutzer-Reiter und wählen Sie den gewünschten Benutzer aus der Liste aus.

- Klicken Sie auf Eigenschaften in der Werkzeugleiste, um das Dialogfeld mit den Benutzereigenschaften anzuzeigen (oder wählen Sie Eigenschaften aus dem Datei-Menü).

- Klicken Sie auf den Passwort-Info-Reiter und markieren Sie das Auswahlkästchen Ablauf des Passworts aktivieren.

- Geben Sie im Feld Verbleibende Tage bis zur Änderung den gewünschten Wert ein und klicken Sie anschließend auf OK.

Abbildung 2.1. Angeben der Optionen zur Passwortalterung

2.1.4. Administrative Kontrolle

sudo oder su. Ein setuid-Programm ist ein Programm, das mit der Benutzer-ID (UID) des Besitzers dieses Programms ausgeführt wird, statt mit der Benutzer-ID desjenigen Benutzers, der dieses Programm ausführt. Solche Programme sind durch ein s im Besitzerabschnitt eines ausführlichen Listings gekennzeichnet, wie im folgenden Beispiel veranschaulicht:

-rwsr-xr-x 1 root root 47324 May 1 08:09 /bin/suAnmerkung

s kann ein Groß- oder Kleinbuchstabe sein. Falls es ein Großbuchstabe ist, bedeutet dies, dass das darunterliegende Berechtigungs-Bit nicht gesetzt ist.

pam_console.so können einige Vorgänge, die normalerweise nur dem Root-Benutzer erlaubt sind, wie z. B. das Neustarten und Einhängen von Wechseldatenträgern, dem ersten Benutzer erlaubt werden, der sich an der physischen Konsole anmeldet (siehe auch Managing Single Sign-On and Smart Cards für weitere Informationen über das pam_console.so-Modul). Andere wichtige Systemadministrationsaufgaben wie das Ändern von Netzwerkeinstellungen, Konfigurieren einer neuen Maus oder das Einhängen von Netzwerkgeräten sind jedoch ohne Administratorrechte nicht möglich, weshalb Systemadministratoren entscheiden müssen, in welchem Umfang die Benutzer in ihrem Netzwerk administrative Kontrolle erhalten sollen.

2.1.4.1. Gewähren von Root-Zugriff

- Fehlkonfiguration des Rechners — Benutzer mit Root-Rechten können ihre Computer unter Umständen falsch konfigurieren und benötigen dann Hilfe, oder schlimmer noch, können Sicherheitslücken öffnen, ohne dies zu merken.

- Ausführen unsicherer Dienste — Benutzer mit Root-Berechtigungen können unsichere Dienste, wie zum Beispiel FTP oder Telnet auf ihrem Rechner ausführen und dadurch Benutzernamen und Passwörter einem Risiko aussetzen, da diese im Klartext über das Netzwerk verschickt werden.

- Als Root E-Mail-Anhänge öffnen — Wenn auch selten, so gibt es doch E-Mail-Viren, die Linux angreifen. Dies wird jedoch nur dann zum Problem, wenn sie als Root ausgeführt werden.

2.1.4.2. Verwehren von Root-Zugriff

Tabelle 2.1. Methoden zum Deaktivieren des Root-Accounts

| Methode | Beschreibung | Effekt | Keine Auswirkung auf | |||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Ändern der Root-Shell | Bearbeiten Sie die /etc/passwd-Datei und ändern Sie die Shell von /bin/bash auf /sbin/nologin. |

|

| |||||||||||||||

| Deaktivieren des Root-Zugriffs über Konsolengeräte (tty) | Eine leere /etc/securetty-Datei verhindert die Anmeldung als Root auf jeglichen am Computer angeschlossenen Geräten. |

|

| |||||||||||||||

| Deaktivieren von SSH-Logins als Root | Bearbeiten Sie die Datei /etc/ssh/sshd_config und setzen Sie den PermitRootLogin-Parameter auf no. |

|

| |||||||||||||||

| Mit PAM den Root-Zugang zu Diensten einschränken. | Bearbeiten Sie die Datei für den Zieldienst im Verzeichnis /etc/pam.d/. Stellen Sie sicher, dass die pam_listfile.so zur Authentifizierung erforderlich ist.[a] |

|

| |||||||||||||||

[a]

Siehe Abschnitt 2.1.4.2.4, »Deaktivieren von PAM für Root« für Einzelheiten.

| ||||||||||||||||||

2.1.4.2.1. Deaktivieren der Root-Shell

/etc/passwd-Datei auf /sbin/nologin setzen. Dies verhindert Zugang zum Root-Account über Befehle, die eine Shell benötigen, wie zum Beispiel su oder ssh.

Wichtig

sudo-Befehl, können weiterhin auf den Root-Account zugreifen.

2.1.4.2.2. Deaktivieren von Root-Anmeldungen

/etc/securetty bearbeiten. In dieser Datei werden alle Geräte aufgelistet, an denen sich der Root-Benutzer anmelden darf. Existiert die Datei nicht, darf sich der Root-Benutzer über jedes beliebige Kommunikationsgerät auf dem System anmelden, sei es über eine Konsole oder eine Raw-Netzwerkschnittstelle. Dies stellt ein Risiko dar, da ein Benutzer sich über Telnet am Computer als Root anmelden kann, wobei die Passwörter im Klartext über das Netzwerk versendet werden. Standardmäßig erlaubt die Red Hat Enterprise Linux Datei /etc/securetty dem Root-Benutzer nur, sich an der mit dem Rechner direkt verbundenen Konsole anzumelden. Um das Anmelden von Root zu verhindern, löschen Sie den Inhalt dieser Datei, indem Sie folgenden Befehl eingeben:

echo > /etc/securettyWarnung

/etc/securetty-Datei verhindert nicht, dass der Root-Benutzer sich von außen über die OpenSSH Toolsuite anmeldet, da die Konsole erst nach der Authentifizierung geöffnet wird.

2.1.4.2.3. Deaktivieren von Root SSH-Anmeldungen

/etc/ssh/sshd_config) bearbeiten. Ändern Sie folgende Zeile:

PermitRootLogin yesPermitRootLogin nokill -HUP `cat /var/run/sshd.pid`2.1.4.2.4. Deaktivieren von PAM für Root

/lib/security/pam_listfile.so-Modul eine größere Flexibilität in der Ablehnung bestimmter Accounts. Mithilfe dieses Moduls kann der Administrator eine Liste von Benutzern festlegen, denen die Anmeldung nicht gestattet ist. Unten finden Sie ein Beispiel, wie das Modul für den vsftpd-FTP-Server in der /etc/pam.d/vsftpd PAM-Konfigurationsdatei verwendet werden kann (das \ Zeichen am Ende der ersten Zeile im folgenden Beispiel ist nicht nötig, wenn die Direktive auf einer Zeile steht):

auth required /lib/security/pam_listfile.so item=user \ sense=deny file=/etc/vsftpd.ftpusers onerr=succeed

/etc/vsftpd.ftpusers zu lesen und allen hier aufgeführten Benutzern Zugang zum Dienst zu verbieten. Der Administrator kann den Namen dieser Datei ändern und separate Listen für jeden Dienst oder eine einzige zentrale Liste für die Zugriffsverweigerung für mehrere Dienste führen.

/etc/pam.d/pop und /etc/pam.d/imap für Mail-Clients oder /etc/pam.d/ssh für SSH-Clients hinzugefügt werden.

2.1.4.3. Beschränken des Root-Zugangs

su oder sudo gewähren.

2.1.4.3.1. Der su-Befehl

su-Befehl ausführt, wird er nach dem Root-Passwort gefragt und erhält nach erfolgreicher Authentifizierung ein Root-Shell-Prompt.

su-Befehl ist der Benutzer tatsächlich der Root-Benutzer und hat vollständigen administrativen Zugriff auf das System[13]. Nachdem der Benutzer auf diese Weise zum Root-Benutzer geworden ist, kann er mit dem Befehl su zu jedem anderen Benutzer im System wechseln, ohne nach einem Passwort gefragt zu werden.

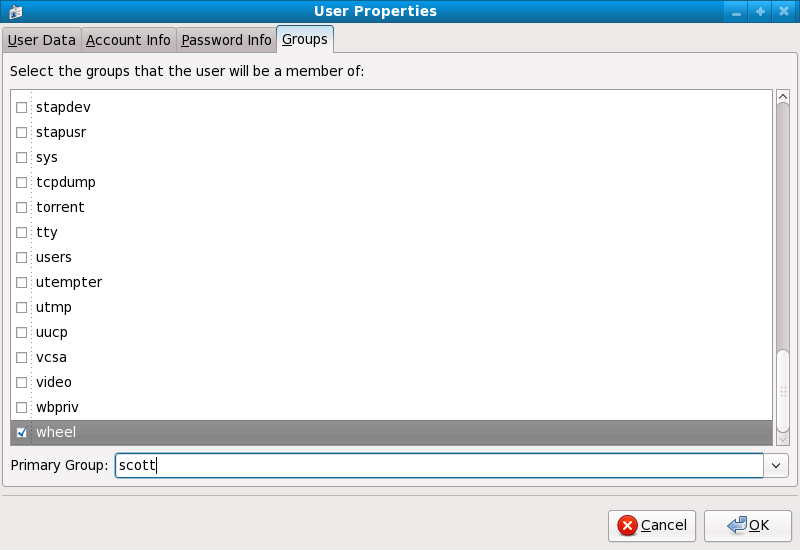

usermod -G wheel <username>wheel-Gruppe hinzufügen möchten.

- Klicken Sie im System-Menü auf der oberen Menüleiste auf Administration und anschließend auf Benutzer und Gruppen, um die Benutzerverwaltung anzuzeigen. Alternativ können Sie dazu auch den Befehl

system-config-usersan einem Shell-Prompt eingeben. - Klicken Sie auf den Benutzer-Reiter und wählen Sie den gewünschten Benutzer aus der Liste aus.

- Klicken Sie auf Eigenschaften in der Werkzeugleiste, um das Dialogfeld mit den Benutzereigenschaften anzuzeigen (oder wählen Sie Eigenschaften aus dem Datei-Menü).

- Klicken Sie auf den Gruppen-Reiter, markieren Sie das Auswahlkästchen für die "wheel"-Gruppe und klicken Sie anschließend auf OK. Siehe Abbildung 2.2, »Hinzufügen von Benutzern zur "wheel"-Gruppe.«.

Abbildung 2.2. Hinzufügen von Benutzern zur "wheel"-Gruppe.

su (/etc/pam.d/su) in einem Texteditor und entfernen Sie die Kommentierung # von der folgenden Zeile:

auth required /lib/security/$ISA/pam_wheel.so use_uid

wheel dieses Programm nutzen.

Anmerkung

wheel-Gruppe.

2.1.4.3.2. Der sudo-Befehl

sudo-Befehl bietet eine weitere Methode, Benutzern administrativen Zugang zu gewähren. Wenn ein vertrauenswürdiger Benutzer einem administrativen Befehl den sudo-Befehl voranstellt, wird dieser nach seinem eigenen Passwort gefragt. Nach erfolgreicher Authentifizierung und vorausgesetzt, dass der Befehl erlaubt ist, wird der administrative Befehl wie von einem Root-Benutzer ausgeführt.

sudo-Befehls lautet wie folgt:

sudo <command>mount.

Wichtig

sudo-Befehls sollten sicherstellen, dass sie sich abmelden, bevor Sie sich von Ihrem Rechner entfernen, da Sudoers den Befehl innerhalb von fünf Minuten erneut ausführen können, ohne nach einem Passwort gefragt zu werden. Diese Einstellung kann mithilfe der Konfigurationsdatei /etc/sudoers geändert werden.

sudo-Befehl ermöglicht einen hohen Grad an Flexibilität. So können z. B. nur Benutzer, die in der Konfigurationsdatei /etc/sudoers aufgeführt sind, den Befehl sudo ausführen; dieser Befehl wird dann in der Shell des Benutzers ausgeführt, und nicht in der Root-Shell. Dies bedeutet, das die Root-Shell vollständig deaktiviert werden kann, wie in Abschnitt 2.1.4.2.1, »Deaktivieren der Root-Shell « gezeigt.

sudo-Befehl liefert auch ein umfangreiches Audit-Protokoll. Jede erfolgreiche Authentifizierung wird in die Datei /var/log/messages geschrieben, und der ausgeführte Befehl samt Benutzername wird in die Datei /var/log/secure geschrieben.

sudo-Befehls ist, dass ein Administrator verschiedenen Benutzern Zugang zu bestimmten Befehlen basierend auf deren Bedürfnissen geben kann.

sudo-Konfigurationsdatei /etc/sudoers bearbeiten wollen, sollten dazu den Befehl visudo verwenden.

visudo ein und fügen Sie eine Zeile ähnlich der folgenden in den Abschnitt für die Benutzerrechte ein:

juan ALL=(ALL) ALLjuan den sudo-Befehl auf jedem Host für jeden Befehl ausführen kann.

sudo:

%users localhost=/sbin/shutdown -h now/sbin/shutdown -h now ausführen kann, solange dieser auf der Konsole ausgeführt wird.

sudoers-Handbuchseite enthält eine detaillierte Liste aller Optionen für diese Datei.

2.1.5. Verfügbare Netzwerkdienste

2.1.5.1. Risiken für Dienste

- Denial-of-Service-Angriff (DoS) — Indem ein System mit Anfragen überflutet wird, kann ein Denial-of-Service-Angriff ein System zum völligen Stillstand bringen, da das System versucht, jede Anfrage zu protokollieren und zu beantworten.

- Distributed-Denial-of-Service-Angriff (DDoS) — Eine Art von DoS-Angriff, bei dem mehrere infizierte Rechner (oft Tausende) missbraucht werden, um einen koordinierten Angriff auf einen Dienst durchzuführen und diesen mit Anfragen zu überfluten.

- Skript-Angriff — Wenn ein Server Skripte zum Ausführen von serverseitigen Aufgaben verwendet, wie es Webserver gewöhnlich tun, kann ein Cracker durch nicht-sachgemäß erstellte Skripte einen Angriff initiieren. Diese Skript-Angriffe können zu einem Pufferüberlauf führen oder es dem Angreifer ermöglichen, Dateien auf dem Server zu ändern.

- Pufferüberlauf-Angriff — Dienste, die sich auf Ports 0 bis 1023 verbinden, müssen als administrativer Benutzer ausgeführt werden. Hat die Applikation einen Pufferüberlauf, kann ein Angreifer Zugang zum System erlangen als der Benutzer, der den Daemon ausführt. Da Pufferüberläufe existieren, können Cracker mit automatisierten Tools das System auf Schwachstellen prüfen. Sobald diese dann Zugang zum System haben, können sie mithilfe automatisierter Root-Kits den Zugang zum System aufrecht erhalten.

Anmerkung

Wichtig

2.1.5.2. Identifizieren und Konfigurieren von Diensten

cupsd— Der standardmäßige Druckerserver für Red Hat Enterprise Linux.lpd— Ein alternativer Druckerserver.xinetd— Ein Super-Server, der die Verbindungen zu einer Reihe untergeordneter Server, wie zum Beispielgssftpundtelnetsteuert.sendmail— Der Sendmail Mail Transport Agent (MTA) ist standardmäßig aktiviert, horcht jedoch nur auf Verbindungen von localhost.sshd— Der OpenSSH Server, ein sicherer Ersatz für Telnet.

cupsd nicht ausführen. Das gleiche gilt für portmap. Wenn Sie keine NFSv3-Datenträger einhängen oder NIS (den ypbind-Dienst) nicht verwenden, sollte Portmap deaktiviert werden.

Abbildung 2.3. Tool zur Dienstkonfiguration

2.1.5.3. Unsichere Dienste

- Unverschlüsselte Übertragung von Benutzernamen und Passwörtern über ein Netzwerk — Viele ältere Protokolle, wie beispielsweise Telnet und FTP, verschlüsseln die Authentifizierung nicht und sollten möglichst deaktiviert werden.

- Unverschlüsselte Übertragung von sensiblen Daten über ein Netzwerk — Viele Protokolle übertragen Daten unverschlüsselt über das Netzwerk. Zu diesen Protokollen gehört unter anderem Telnet, FTP, HTTP und SMTP. Viele Netzwerkdateisysteme wie z. B. NFS und SMB übertragen ebenfalls Informationen unverschlüsselt über das Netzwerk. Es liegt in der Verantwortung des Benutzers, einzuschränken, welche Art von Daten bei der Verwendung dieser Protokolle übertragen werden.Auch Remote-Speicherabbildungsdienste wie

netdumpübertragen den Speicherinhalt unverschlüsselt über das Netzwerk. Speicherauszüge können Passwörter, oder schlimmer noch, Datenbankeinträge und andere sensible Informationen enthalten.Andere Dienste wiefingerundrwhodgeben Informationen über Benutzer im System preis.

rlogin, rsh, telnet und vsftpd.

rlogin, rsh und telnet) sollten zugunsten von SSH vermieden werden. Siehe Abschnitt 2.1.7, »Kommunikationstools mit verbesserter Sicherheit« für weitere Informationen über sshd.

fingerauthd(in früheren Red Hat Enterprise Linux Releasesidentdgenannt)netdumpnetdump-servernfsrwhodsendmailsmb(Samba)yppasswddypservypxfrd

2.1.6. Persönliche Firewalls

Wichtig

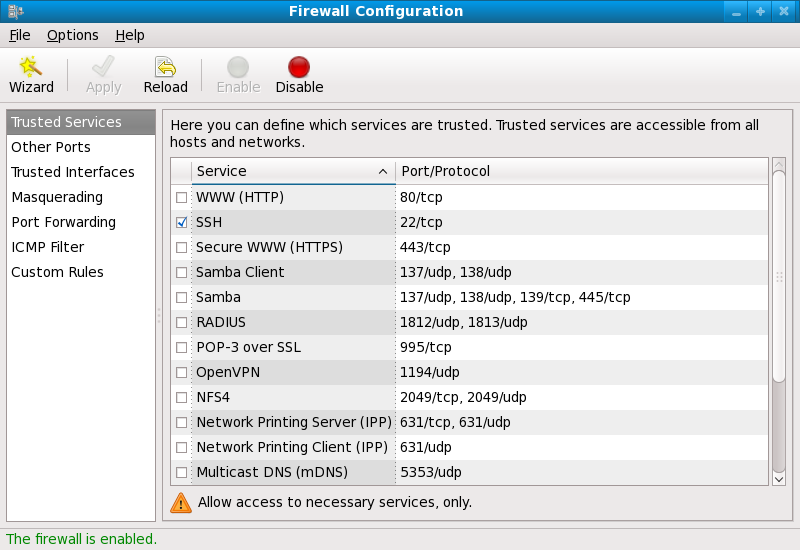

system-config-securitylevel). Dieses Tool erzeugt breite iptables-Regeln für eine allgemeine Firewall, unter Verwendung einer grafischen Benutzeroberfläche.

iptables die bessere Wahl. Weitere Informationen finden Sie unter Abschnitt 2.5, »Firewalls«. Einen umfassenden Leitfaden zum iptables-Befehl finden Sie unter Abschnitt 2.6, »IPTables«.

2.1.7. Kommunikationstools mit verbesserter Sicherheit

- OpenSSH — Eine offene Implementierung des SSH-Protokolls zur Verschlüsselung von Netzwerkkommunikation.

- Gnu Privacy Guard (GPG) — Eine offene Implementierung der PGP (Pretty Good Privacy) Verschlüsselungsapplikation zur Verschlüsselung von Daten.

telnet und rsh. OpenSSH umfasst einen Netzwerkdienst namens sshd und drei Befehlszeilen-Client-Applikationen:

ssh— Ein sicherer Client für den Zugriff auf Remote-Konsolen.scp— Ein sicherer Befehl für Remote-Copy.sftp— Ein sicherer Pseudo-FTP-Client, der interaktive Dateiübertragung ermöglicht.

Wichtig

sshd-Dienst von Natur aus sicher ist, muss dieser Dienst auf dem neuesten Stand gehalten werden, um Sicherheitsgefährdungen zu vermeiden. Unter Abschnitt 1.5, »Sicherheitsaktualisierungen« finden Sie weitere Informationen zu diesem Thema.

2.2. Server-Sicherheit

- Halten Sie alle Dienste auf dem neuesten Stand, um vor den neuesten Bedrohungen geschützt zu sein.

- Verwenden Sie nach Möglichkeit sichere Protokolle.

- Wenn möglich, sollte immer nur eine Maschine eine Art von Netzwerkdienst bereitstellen.

- Überwachen Sie alle Server sorgfältig auf verdächtige Aktivitäten.

2.2.1. Sichern von Diensten mit TCP-Wrappern und xinetd

xinetd verwendet werden, einem Super-Serverdienst, der zusätzliche Zugriffs-, Protokollierungs-, Binding-, Umleitungs- und Ressourcenkontrolle bietet.

Anmerkung

xinetd zu verwenden, um eine Redundanz innerhalb der Dienst-Zugangskontrollen zu erreichen. Für mehr Information über das Einrichten von Firewalls mit IPTables-Befehlen siehe Abschnitt 2.5, »Firewalls«.

2.2.1.1. Erhöhung der Sicherheit mit TCP-Wrappern

hosts_options-Handbuchseite. Werfen Sie zudem einen Blick auf die xinetd.conf-Handbuchseite, erhältlich online unter http://linux.die.net/man/5/xinetd.conf, für Informationen über verfügbare Flags, die Sie als Optionen auf einen Dienst anwenden können.

2.2.1.1.1. TCP-Wrapper und Verbindungsbanner

banner.

vsftpd implementiert. Erstellen Sie zunächst einmal eine Bannerdatei. Es ist unerheblich, wo diese sich auf dem System befindet, muss aber den gleichen Namen wie der Daemon tragen. In diesem Beispiel heißt die Datei /etc/banners/vsftpd und enthält die folgende Zeile:

220-Hello, %c 220-All activity on ftp.example.com is logged. 220-Inappropriate use will result in your access privileges being removed.

%c-Token liefert eine Reihe von Client-Informationen wie den Benutzernamen und Hostnamen, oder den Benutzernamen und die IP-Adresse, um die Verbindung noch abschreckender zu machen.

/etc/hosts.allow ein:

vsftpd : ALL : banners /etc/banners/ 2.2.1.1.2. TCP-Wrapper und Warnung vor Angriffen

spawn-Direktive vor weiteren Angriffen von diesem Host oder Netzwerk warnen.

/etc/hosts.deny einfügen, wird der Verbindungsversuch abgewiesen und in einer speziellen Datei aufgezeichnet:

ALL : 206.182.68.0 : spawn /bin/echo `date` %c %d >> /var/log/intruder_alert %d-Token gibt den Namen des Dienstes an, auf den der Angreifer zugreifen wollte.

spawn-Direktive in die Datei /etc/hosts.allow ein.

Anmerkung

spawn-Direktive jeden beliebigen Shell-Befehl ausführt, können Sie ein spezielles Skript schreiben, das den Administrator im Falle eines Verbindungsversuchs eines bestimmten Clients mit dem Server benachrichtigt oder eine Reihe von Befehlen ausführt.

2.2.1.1.3. TCP-Wrapper und erweiterte Protokollierung

severity angehoben werden.

emerg-Flag anstelle des Standard-Flags info in die Protokolldatei ein und verweigern Sie die Verbindung.

/etc/hosts.deny ein:

in.telnetd : ALL : severity emerg authpriv-Protokollierungs-Facility verwendet, jedoch wird die Priorität vom Standardwert info auf emerg angehoben, wodurch Protokollnachrichten direkt auf der Konsole ausgegeben werden.

2.2.1.2. Erhöhen der Sicherheit mit xinetd

xinetd dazu eingesetzt werden kann, einen so genannten Trap-Dienst einzurichten sowie die verfügbaren Ressourcen für jeden xinetd-Dienst zu kontrollieren. Das Setzen von Ressourcengrenzen kann dabei helfen, Denial of Service (DoS)-Angriffe zu unterbinden. Eine Liste der verfügbaren Optionen finden Sie auf den Handbuchseiten zu xinetd und xinetd.conf.

2.2.1.2.1. Aufstellen einer Falle

xinetd ist die Fähigkeit, Hosts zu einer globalen no_access-Liste hinzufügen zu können. Den Hosts auf dieser Liste werden Verbindungen zu Diensten, die von xinetd verwaltet werden, für einen bestimmten Zeitraum oder bis xinetd neu gestartet wird, verweigert. Dies wird durch den SENSOR-Parameter erreicht. Mithilfe dieses einfachen Verfahrens können Sie Hosts blockieren, die den Server auf offene Ports absuchen.

SENSOR ist die Auswahl eines Dienstes, den Sie voraussichtlich nicht anderweitig brauchen werden. In diesem Beispiel wird Telnet ausgewählt.

/etc/xinetd.d/telnet und ändern Sie die Zeile flags folgendermaßen um:

flags = SENSOR

deny_time = 30

deny_time-Attribut sind FOREVER, wodurch eine Verbindung solange verweigert wird, bis xinetd neu gestartet wird, und NEVER, wodurch die Verbindung zugelassen und protokolliert wird.

disable = no

SENSOR eine gute Methode ist, Verbindungen von böswilligen Hosts zu erkennen und zu stoppen, hat es jedoch zwei Nachteile:

- Es hilft nicht gegen heimliches Scannen (Stealth Scans).

- Ein Angreifer, der weiß, dass ein

SENSORaktiviert ist, kann eine DoS-Attacke gegen bestimmte Hosts ausführen, indem er ihre IP-Adressen fälscht und sich mit dem verbotenen Port verbindet.

2.2.1.2.2. Kontrollieren von Server-Ressourcen

xinetd ist die Fähigkeit, für die von ihm kontrollierten Dienste Ressourcengrenzen festzulegen.

cps = <number_of_connections> <wait_period>— Begrenzt die Frequenz der eingehenden Verbindungen. Diese Direktive akzeptiert zwei Parameter:<number_of_connections>— Die Anzahl der zu verarbeitenden Verbindungen pro Sekunde. Falls die Frequenz der eingehenden Verbindungen diesen Wert überschreitet, wird der Dienst zeitweise deaktiviert. Der Standardwert ist fünfzig (50).<wait_period>— Gibt die Anzahl der Sekunden an, die gewartet werden soll, bevor der Dienst nach dessen Deaktivierung neu gestartet werden soll. Die Standardzeitspanne beträgt zehn (10) Sekunden.

instances = <number_of_connections>— Gibt die Gesamtzahl aller erlaubten Verbindungen zu einem Dienst an. Diese Direktive akzeptiert entweder einen ganzzahligen Wert oderUNLIMITED.per_source = <number_of_connections>— Gibt die Anzahl der Verbindungen an, die pro Host zu einem Dienst erlaubt sind. Diese Direktive akzeptiert entweder einen ganzzahligen Wert oderUNLIMITED.rlimit_as = <number[K|M]>— Gibt die Größe des Speicheradressraums in Kilobyte oder Megabyte an, die der Dienst in Anspruch nehmen kann kann. Diese Direktive akzeptiert entweder einen ganzzahligen Wert oderUNLIMITED.rlimit_cpu = <number_of_seconds>— Gibt die Zeit in Sekunden an, die ein Dienst die CPU beanspruchen kann. Diese Direktive akzeptiert entweder einen ganzzahligen Wert oderUNLIMITED.

xinetd-Dienst das gesamte System überschwemmt und einen Denial-of-Service verursacht.

2.2.2. Sichern von Portmap

portmap-Dienst ist ein Daemon zur dynamischen Port-Zuweisung für RPC-Dienste wie NIS und NFS. Er besitzt schwache Authentifizierungsmechanismen und hat die Fähigkeit, einen großen Bereich an Ports für die von ihm kontrollierten Dienste zuzuweisen. Aus diesen Gründen ist Portmap schwer zu sichern.

Anmerkung

portmap betrifft lediglich NFSv2- und NFSv3-Implementationen, da Portmap für NFSv4 nicht mehr länger erforderlich ist. Wenn Sie einen NFSv2- oder NFSv3-Server implementieren möchten, dann ist portmap demnach erforderlich und der folgende Abschnitt für Sie wichtig.

2.2.2.1. Schützen von Portmap mit TCP-Wrappern

portmap-Dienst einzusetzen, da Portmap selbst keine integrierte Authentifizierungsmöglichkeit bietet.

2.2.2.2. Schützen von Portmap mit IPTables

portmap-Dienst weiter einzuschränken, ist es sinnvoll, IPTables-Regeln zum Server hinzuzufügen, die den Zugriff auf bestimmte Netzwerke einschränken.

portmap-Dienst verwendet wird) vom 192.168.0/24 Netzwerk. Der zweite Befehl erlaubt TCP-Verbindungen auf demselben Port vom lokalen Host, was für den sgi_fam-Dienst für Nautilus benötigt wird. Alle anderen Pakete werden abgelehnt.

iptables -A INPUT -p tcp ! -s 192.168.0.0/24 --dport 111 -j DROP iptables -A INPUT -p tcp -s 127.0.0.1 --dport 111 -j ACCEPT

iptables -A INPUT -p udp ! -s 192.168.0.0/24 --dport 111 -j DROP

Anmerkung

2.2.3. Sichern von NIS

ypserv, der zusammen mit portmap und anderen zugehörigen Diensten verwendet wird, um Informationen zu Benutzernamen, Passwörtern und anderen sensiblen Daten an jeden beliebigen Computer innerhalb dessen Domain weiterzugeben.

/usr/sbin/rpc.yppasswdd— Auchyppasswdd-Dienst genannt. Dieser Daemon ermöglicht es Benutzern, ihre NIS-Passwörter zu ändern./usr/sbin/rpc.ypxfrd— Auchypxfrd-Dienst genannt. Dieser Daemon ist für den NIS-Map-Transfer über das Netzwerk verantwortlich./usr/sbin/yppush— Diese Applikation verbreitet geänderte NIS-Datenbanken an mehrere NIS-Server./usr/sbin/ypserv— Dies ist der NIS-Server-Daemon.

portmap-Dienst wie in Abschnitt 2.2.2, »Sichern von Portmap« beschrieben sichern und dann weitere Bereiche wie z. B. Netzwerkplanung angehen.

2.2.3.1. Planen Sie das Netzwerk sorgfältig

2.2.3.2. Verwenden Sie passwortähnliche NIS-Domain-Namen und Hostnamen

/etc/passwd-Map:

ypcat -d <NIS_domain> -h <DNS_hostname> passwd

/etc/shadow durch folgenden Befehl einsehen:

ypcat -d <NIS_domain> -h <DNS_hostname> shadow

Anmerkung

/etc/shadow nicht innerhalb einer NIS-Map gespeichert.

o7hfawtgmhwg.domain.com. Erstellen Sie auf die gleiche Weise einen anderen, zufallsgenerierten NIS-Domain-Namen. Hierdurch wird es einem Angreifer erheblich erschwert, Zugang zum NIS-Server zu erlangen.

2.2.3.3. Bearbeiten Sie die Datei /var/yp/securenets

/var/yp/securenets leer ist oder nicht existiert (dies ist z. B. nach einer Standardinstallation der Fall). Als Erstes sollten Sie ein Netzmaske/Netzwerkpaar in der Datei hinterlegen, damit ypserv nur auf Anfragen des richtigen Netzwerks reagiert.

/var/yp/securenets-Datei:

255.255.255.0 192.168.0.0

Warnung

/var/yp/securenets erstellt zu haben.

2.2.3.4. Weisen Sie statische Ports zu und nutzen Sie IPTables-Regeln

rpc.yppasswdd — dem Daemon, der Benutzern das Ändern ihrer Login-Passwörter erlaubt. Indem Sie den anderen beiden NIS-Server-Daemons, rpc.ypxfrd und ypserv, Ports zuweisen, können Sie Firewall-Regeln erstellen, um die NIS-Server-Daemons noch mehr vor Angriffen zu schützen.

/etc/sysconfig/network hinzu:

YPSERV_ARGS="-p 834" YPXFRD_ARGS="-p 835"

iptables -A INPUT -p ALL ! -s 192.168.0.0/24 --dport 834 -j DROP iptables -A INPUT -p ALL ! -s 192.168.0.0/24 --dport 835 -j DROP

Anmerkung

2.2.3.5. Verwenden Sie Kerberos-Authentifizierung

/etc/shadow-Map über das Netzwerk verschickt wird, sobald sich ein Benutzer an einem Computer anmeldet. Wenn ein Angreifer Zugang zu einer NIS-Domain erhält und Datenverkehr über das Netzwerk abfängt, können somit Benutzernamen und Passwort-Hashes unbemerkt gesammelt werden. Mit genügend Zeit kann dann ein Programm zum Knacken von Passwörtern schwache Passwörter ermitteln, wodurch ein Angreifer auf einen gültigen Account im Netzwerk zugreifen kann.

2.2.4. Sichern von NFS

Wichtig

portmap-Dienst, wie im Abschnitt 2.2.2, »Sichern von Portmap« beschrieben. Der NFS-Datenverkehr benutzt statt UDP nunmehr TCP in allen Versionen und erfordert TCP bei der Verwendung von NFSv4. NFSv4 beinhaltet nun Kerberos Benutzer- und Gruppenauthentifizierung als Teil des RPCSEC_GSS Kernel-Moduls. Informationen über portmap sind jedoch nach wie vor enthalten, da Red Hat Enterprise Linux 6 auch noch NFSv2 und NFSv3 unterstützt, die portmap einsetzen.

2.2.4.1. Planen Sie das Netzwerk sorgfältig

2.2.4.2. Vermeiden Sie Syntaxfehler

/etc/exports-Datei, welche Dateisysteme für welche Hosts exportiert werden sollen. Achten Sie darauf, dass Sie keine überflüssigen Leerstellen beim Bearbeiten dieser Datei einfügen.

/etc/exports legt fest, dass der Host bob.example.com Lese- und Schreibberechtigung auf das gemeinsam genutzte Verzeichnis /tmp/nfs/ erhält.

/tmp/nfs/ bob.example.com(rw)

/etc/exports legt dagegen fest, dass der Host bob.example.com lediglich Leseberechtigung besitzt, allerdings jeder andere Host Lese- und Schreibberechtigung hat, und das wegen eines einzelnen Leerzeichens nach dem Hostnamen.

/tmp/nfs/ bob.example.com (rw)

showmount-Befehl zu prüfen:

showmount -e <hostname>

2.2.4.3. Verwenden Sie nicht die Option no_root_squash

nfsnobody um, einen unprivilegierten Benutzer-Account. Auf diese Weise gehören alle von Root erstellten Dateien dem Benutzer nfsnobody, wodurch das Laden von Programmen mit gesetztem Setuid-Bit verhindert wird.

no_root_squash verwendet wird, können Remote-Root-Benutzer jede Datei in dem gemeinsamen Dateisystem verändern und dabei mit Trojanern infizierte Anwendungen hinterlassen, die von anderen Benutzern unbeabsichtigt ausgeführt werden.

2.2.4.4. NFS Firewall-Konfiguration

MOUNTD_PORT— TCP und UDP Port für mountd (rpc.mountd)STATD_PORT— TCP und UDP Port für status (rpc.statd)LOCKD_TCPPORT— TCP Port für nlockmgr (rpc.lockd)LOCKD_UDPPORT— UDP Port für nlockmgr (rpc.lockd)

rpcinfo -p auf dem NFS-Server aus um zu überprüfen, welche Ports und RPC-Programme verwendet werden.

2.2.5. Sicherung des Apache HTTP-Server

chown root <directory_name>

chmod 755 <directory_name>

/etc/httpd/conf/httpd.conf):

FollowSymLinks- Diese Direktive ist standardmäßig aktiviert, seien Sie also vorsichtig, wenn Sie symbolische Links zum Document-Root des Webservers erstellen. Es ist zum Beispiel keine gute Idee, einen symbolischen Link zu

/anzugeben. Indexes- Diese Direktive ist standardmäßig aktiviert, ist jedoch unter Umständen nicht wünschenswert. Wenn Sie nicht möchten, dass Benutzer Dateien auf dem Server durchsuchen, ist es sinnvoll, diese Direktive zu entfernen.

UserDir- Die

UserDir-Direktive ist standardmäßig deaktiviert, da sie das Vorhandensein eines Benutzer-Accounts im System bestätigen kann. Wenn Sie das Durchsuchen von Verzeichnissen auf dem Server durch Benutzer erlauben möchten, sollten Sie die folgenden Direktiven verwenden:UserDir enabled UserDir disabled root

Diese Direktiven aktivieren das Durchsuchen von Verzeichnissen für alle Benutzerverzeichnisse außer/root. Wenn Sie Benutzer zu der Liste deaktivierter Accounts hinzufügen möchten, können Sie eine durch Leerstellen getrennte Liste der Benutzer in die ZeileUserDir disabledeinfügen.

Wichtig

IncludesNoExec-Direktive. Standardmäßig kann das Modul Server-Side Includes (SSI) keine Befehle ausführen. Es wird davon abgeraten, diese Einstellungen zu ändern, außer wenn unbedingt notwendig, da dies einem Angreifer ermöglichen könnte, Befehle auf dem System auszuführen.

2.2.6. Sichern von FTP

gssftpd— Ein Kerberos-fähiger,xinetd-basierter FTP-Daemon, der keine Authentifizierungsinformationen über das Netzwerk überträgt.- Red Hat Content Accelerator (

tux) — Ein Kernel-Space Webserver mit FTP-Fähigkeiten. vsftpd— Eine eigenständige, sicherheitsorientierte Implementierung des FTP-Dienstes.

vsftpd-FTP-Dienstes.

2.2.6.1. FTP-Grußbanner

vsftpd zu ändern, fügen Sie die folgende Direktive zu /etc/vsftpd/vsftpd.conf-Datei hinzu:

ftpd_banner=<insert_greeting_here>

/etc/banners/. Die Bannerdatei für FTP-Verbindungen in diesem Beispiel ist /etc/banners/ftp.msg. Das nachfolgende Beispiel zeigt, wie eine derartige Datei aussehen kann:

######### # Hello, all activity on ftp.example.com is logged. #########

Anmerkung

220, wie in Abschnitt 2.2.1.1.1, »TCP-Wrapper und Verbindungsbanner« beschrieben, zu beginnen.

vsftpd auf diese Grußbanner-Datei zu verweisen, fügen Sie folgende Direktive zu /etc/vsftpd/vsftpd.conf hinzu:

banner_file=/etc/banners/ftp.msg

2.2.6.2. Anonymer Zugang

/var/ftp/-Verzeichnisses aktiviert den anonymen Account.

vsftpd-Pakets. Dieses Paket erstellt einen Verzeichnisbaum für anonyme Benutzer und vergibt anonymen Benutzern lediglich Leseberechtigungen für Verzeichnisse.

Warnung

2.2.6.2.1. Anonymes Hochladen

/var/ftp/pub/ anzulegen.

mkdir /var/ftp/pub/upload

chmod 730 /var/ftp/pub/upload

drwx-wx--- 2 root ftp 4096 Feb 13 20:05 upload

Warnung

vsftpd die folgende Zeile in die Datei /etc/vsftpd/vsftpd.conf ein:

anon_upload_enable=YES

2.2.6.3. Benutzer-Accounts

vsftpd zu deaktivieren, fügen Sie die folgende Direktive zu /etc/vsftpd/vsftpd.conf hinzu:

local_enable=NO

2.2.6.3.1. Einschränken von Benutzer-Accounts

sudo-Berechtigungen, am Zugriff auf den FTP-Server zu hindern, ist durch eine PAM-Listendatei, wie unter Abschnitt 2.1.4.2.4, »Deaktivieren von PAM für Root« beschrieben. Die PAM-Konfigurationsdatei für vsftpd ist /etc/pam.d/vsftpd.

vsftpd zu deaktivieren, fügen Sie den Benutzernamen zu /etc/vsftpd/ftpusers hinzu.

2.2.6.4. TCP-Wrapper für die Zugriffskontrolle

2.2.7. Sichern von Sendmail

2.2.7.1. Einschränken von Denial-of-Service-Angriffen

/etc/mail/sendmail.mc mit Grenzwerten versehen, kann die Wirksamkeit solcher Angriffe stark abgeschwächt werden.

confCONNECTION_RATE_THROTTLE— Die Anzahl der Verbindungen, die der Server pro Sekunde empfangen kann. Standardmäßig begrenzt Sendmail die Zahl der Verbindungen nicht. Wird eine Grenze gesetzt, werden darüber hinaus gehende Verbindungen verzögert.confMAX_DAEMON_CHILDREN— Die maximale Anzahl von untergeordneten Prozessen, die vom Server erzeugt werden können. Standardmäßig begrenzt Sendmail die Anzahl der untergeordneten Prozesse nicht. Wird eine Grenze gesetzt, werden alle darüber hinaus gehenden Verbindungen verzögert.confMIN_FREE_BLOCKS— Die minimale Anzahl freier Blöcke, die für den Server zur Verfügung stehen müssen, um E-Mail empfangen zu können. Der Standard beträgt 100 Blöcke.confMAX_HEADERS_LENGTH— Die maximal akzeptierte Größe (in Bytes) für einen Nachrichten-Header.confMAX_MESSAGE_SIZE— Die maximal akzeptierte Größe (in Bytes) pro Nachricht.

2.2.7.2. NFS und Sendmail

/var/spool/mail/, auf einem durch NFS gemeinsam genutzten Datenträger ab.

Anmerkung

SECRPC_GSS-Kernel-Modul keine UID-basierte Authentifizierung anwendet. Allerdings sollten Sie dennoch das Mail-Spool-Verzeichnis nicht auf einem durch NFS gemeinsam genutzten Datenträger ablegen.

2.2.7.3. Nur-Mail Benutzer

/etc/passwd sollten auf /sbin/nologin gesetzt sein (evtl. unter Ausnahme des Root-Benutzers).

2.2.8. Überprüfen der horchenden Ports

netstat -an oder lsof -i abzufragen. Diese Methode ist deshalb unzuverlässiger, da derartige Programme sich nicht vom Netzwerk aus mit dem Computer verbinden, sondern vielmehr prüfen, was auf dem System ausgeführt wird. Aus diesen Grund sind diese Anwendungen häufig Ziel für Ersetzungen durch Angreifer. Bei dieser Methode versuchen Cracker, ihre Spuren zu verwischen, wenn diese unbefugt Netzwerkports geöffnet haben, indem sie die Anwendungen netstat und lsof durch ihre eigenen, modifizierten Versionen ersetzen.

nmap.

nmap -sT -O localhost

Starting Nmap 4.68 ( http://nmap.org ) at 2009-03-06 12:08 EST Interesting ports on localhost.localdomain (127.0.0.1): Not shown: 1711 closed ports PORT STATE SERVICE 22/tcp open ssh 25/tcp open smtp 111/tcp open rpcbind 113/tcp open auth 631/tcp open ipp 834/tcp open unknown 2601/tcp open zebra 32774/tcp open sometimes-rpc11 Device type: general purpose Running: Linux 2.6.X OS details: Linux 2.6.17 - 2.6.24 Uptime: 4.122 days (since Mon Mar 2 09:12:31 2009) Network Distance: 0 hops OS detection performed. Please report any incorrect results at http://nmap.org/submit/ . Nmap done: 1 IP address (1 host up) scanned in 1.420 seconds

portmap ausführt, da der Dienst sunrpc vorhanden ist. Es wird jedoch auch ein unbekannter Dienst auf Port 834 ausgeführt. Um zu prüfen, ob dieser Port zu der offiziellen Liste bekannter Dienste gehört, geben Sie Folgendes ein:

cat /etc/services | grep 834

netstat oder lsof Informationen über den Port ab. Um Port 834 mithilfe von netstat zu prüfen, geben Sie folgenden Befehl ein:

netstat -anp | grep 834

tcp 0 0 0.0.0.0:834 0.0.0.0:* LISTEN 653/ypbind

netstat aufgeführt wird, ist ein gutes Zeichen, da ein Cracker, der einen Port heimlich auf einem geknackten System öffnet, das Anzeigen des Ports durch diesen Befehl höchstwahrscheinlich nicht zulassen würde. Des Weiteren zeigt die Option [p] die Prozess-ID (PID) des Dienstes an, der diesen Port geöffnet hat. In diesem Fall gehört der offene Port zu ypbind (NIS), ein RPC-Dienst, der zusammen mit dem portmap-Dienst läuft.

lsof-Befehl zeigt ähnliche Informationen wie der netstat-Befehl an, denn er kann offene Ports auch Diensten zuordnen:

lsof -i | grep 834

ypbind 653 0 7u IPv4 1319 TCP *:834 (LISTEN) ypbind 655 0 7u IPv4 1319 TCP *:834 (LISTEN) ypbind 656 0 7u IPv4 1319 TCP *:834 (LISTEN) ypbind 657 0 7u IPv4 1319 TCP *:834 (LISTEN)

lsof, netstat, nmap und services für weitere Informationen.

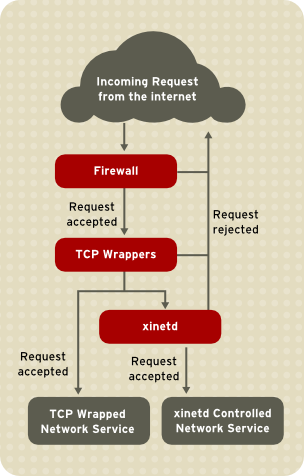

2.3. TCP-Wrapper und xinetd

iptables-basierte Firewall etwa filtert alle unerwünschten Netzwerkpakete im Netzwerkstapel des Kernels heraus. Für Netzwerkdienste, die davon Gebrauch machen, fügt TCP Wrapper eine zusätzliche Schutzschicht hinzu, indem dieser definiert, welchen Hosts es erlaubt ist mit Netzwerkdiensten zu verbinden, die von TCP Wrappern geschützt werden, und welchen nicht. Einer dieser durch TCP Wrapper geschützten Netzwerkdienste ist der xinetd Super-Server. Dieser Dienst wird Super-Server genannt, da er Verbindungen zu einer Untergruppe von Netzwerkdiensten steuert und die Zugriffskontrolle weiter verfeinert.

Abbildung 2.4. Zugriffskontrolle zu Netzwerkdiensten

xinetd bei der Zugriffskontrolle auf Netzwerkdienste sowie mit Wegen, wie mithilfe dieser Tools die Verwaltung der Protokollierung und der Anwendung verbessern werden kann. Weitere Informationen zum Einsatz von Firewalls mit iptables finden Sie unter Abschnitt 2.6, »IPTables«.

2.3.1. TCP Wrappers

tcp_wrappers und tcp_wrappers-libs) sind standardmäßig installiert und stellen Host-basierte Zugriffskontrolle für Netzwerkdienste zur Verfügung. Die wichtigste Komponente in diesen Paketen ist die /lib/libwrap.a oder /lib64/libwrap.a-Bibliothek. Im Wesentlichen handelt es sich bei einem von TCP Wrappern kontrollierten Dienst um einen Dienst, der mit der libwrap.a-Bibliothek kompiliert wurde.

/etc/hosts.allow und /etc/hosts.deny) untersuchen um festzustellen, ob eine Verbindung des Clients erlaubt ist. In den meisten Fällen schreibt er anschließend mithilfe des syslog-Daemons (syslogd) den Namen des anfordernden Hosts und Dienstes in /var/log/secure oder /var/log/messages.

libwrap.a-Bibliothek verbunden. Zu diesen Applikationen gehören /usr/sbin/sshd, /usr/sbin/sendmail und /usr/sbin/xinetd.

Anmerkung

libwrap.a verknüpft ist, geben Sie folgenden Befehl als Root-Benutzer ein:

ldd <binary-name> | grep libwrap

libwrap.a verknüpft.

/usr/sbin/sshd mit libwrap.a verknüpft ist:

[root@myServer ~]# ldd /usr/sbin/sshd | grep libwrap

libwrap.so.0 => /lib/libwrap.so.0 (0x00655000)

[root@myServer ~]#2.3.1.1. Vorteile von TCP-Wrappern

- Transparenz für sowohl Client als auch den TCP-wrapped Netzwerkdienst — Weder der sich verbindende Client noch der wrapped Netzwerkdienst merken, dass TCP-Wrapper in Einsatz sind. Verbindungsversuche von berechtigten Benutzern werden protokolliert und mit dem geforderten Dienst verbunden, während Verbindungsversuche unzulässiger Clients fehlschlagen.

- Zentralisierte Verwaltung mehrerer Protokolle — TCP-Wrapper arbeiten unabhängig von den Netzwerkdiensten, die sie schützen. Dadurch können sich mehrere Server-Applikationen einen gemeinsamen Satz von Konfigurationsdateien der Zugriffskontrolle teilen, was die Verwaltung vereinfacht.

2.3.2. TCP-Wrapper Konfigurationsdateien

/etc/hosts.allow/etc/hosts.deny

- Er referenziert

/etc/hosts.allow— Der TCP-wrapped Dienst analysiert die/etc/hosts.allow-Datei sequentiell und wendet die erste Regel an, die für diesen Dienst festgelegt wurde. Wenn eine passende Regel ausfindig gemacht werden kann, erlaubt der Dienst die Verbindung. Wenn nicht, geht er zum nächsten Schritt über. - Er referenziert

/etc/hosts.deny— Der TCP-wrapped Dienst analysiert die/etc/hosts.deny-Datei sequentiell. Wenn eine passende Regel ausfindig gemacht werden kann, lehnt der Dienst die Verbindung ab. Wenn nicht, wird der Zugang zu diesem Dienst bewilligt.

- Da Zugriffsregeln in

hosts.allowzuerst angewendet werden, haben diese Vorrang vor den Regeln inhosts.deny. Sollte der Zugriff zu einem Dienst inhosts.allowerlaubt sein, so wird eine den Zugriff auf diesen Dienst verbietende Regel inhosts.denyignoriert. - Da alle Regeln von oben nach unten abgearbeitet werden, wird lediglich die erste auf einen Dienst passende Regel angewendet, weshalb die Reihenfolge der Regeln extrem wichtig ist.

- Sollte keine Regel für den Dienst gefunden werden oder keine der beiden Dateien vorhanden sein, so wird der Zugriff zu diesem Dienst gewährt.

- TCP-wrapped Dienste speichern Regeln für die Hosts-Zugriffsdateien nicht zwischen. Jegliche Änderungen an

hosts.allowoderhosts.denytreten daher auch ohne Neustart der Netzwerkdienste sofort in Kraft.

Warnung

/var/log/messages oder /var/log/secure protokolliert. Dies ist auch der Fall für Regeln, die ohne Backslash-Zeichen auf mehrere Zeilen umgebrochen sind. Das folgende Beispiel zeigt den relevanten Teil einer Protokollmeldung für eine durch genannte Gründe fehlerhafte Regel:

warning: /etc/hosts.allow, line 20: missing newline or line too long

2.3.2.1. Formatierung von Zugriffsregeln

/etc/hosts.allow and /etc/hosts.deny ist identisch. Jede Regel muss in einer neuen Zeile beginnen. Leere Zeilen oder Zeilen, die mit dem Rautenzeichen (#) beginnen, werden ignoriert.

<daemon list>: <client list> [: <option>: <option>: ...]

- <daemon list> — Eine kommagetrennte Liste mit Prozessnamen (nicht Dienstnamen) oder der

ALL-Platzhalter. Die Daemon-Liste akzeptiert auch Operatoren (siehe Abschnitt 2.3.2.1.4, »Operatoren«) für größere Flexibilität. - <client list> — Eine kommagetrennte Liste mit Hostnamen, Host-IP-Adressen, bestimmten Zeichenketten oder Platzhaltern, die die von der Regel betroffenen Hosts spezifizieren. Die Client-Liste akzeptiert auch Operatoren (siehe Abschnitt 2.3.2.1.4, »Operatoren«) für größere Flexibilität.

- <option> — Eine optionale Aktion oder durch Doppelpunkte getrennte Liste von Aktionen, die ausgeführt werden, wenn eine Regel angewendet wird. Optionsfelder unterstützen Expansionen, führen Shell-Befehle aus, gewähren Zugriff oder lehnen diesen ab, und ändern das Protokollierungsverhalten.

Anmerkung

vsftpd : .example.com

vsftpd) von jedem Host in der example.com-Domain Ausschau zu halten. Wird diese Regel in hosts.allow eingefügt, so wird die Verbindung angenommen. Wird diese Regel dagegen in hosts.deny eingefügt, so wird die Verbindung abgelehnt.

sshd : .example.com \ : spawn /bin/echo `/bin/date` access denied>>/var/log/sshd.log \ : deny

sshd) von einem Host in der example.com-Domain der echo-Befehl ausgeführt wird (der den Verbindungsversuch in eine spezielle Protokolldatei schreibt) und die Verbindung abgelehnt wird. Da die optionale deny-Direktive verwendet wird, wird diese Zeile den Zugriff ablehnen, auch wenn sie in der hosts.allow-Datei erscheint. Für einen detaillierteren Überblick der Optionen, siehe Abschnitt 2.3.2.2, »Optionsfelder«.

2.3.2.1.1. Platzhalter

ALL— Stimmt mit allen Werten überein. Kann sowohl für die Daemon-Liste als auch für die Client-Liste verwendet werden.LOCAL— Stimmt mit jedem Host überein, der keinen Punkt (.) enthält, wie z. B. localhost.KNOWN— Stimmt mit jedem Host überein, dessen Host-Name und Host-Adresse oder der Benutzer bekannt sind.UNKNOWN— Stimmt mit jedem Host überein, dessen Host-Name und Host-Adresse oder der Benutzer unbekannt sind.PARANOID— Stimmt mit jedem Host überein, dessen Host-Name nicht mit der Host-Adresse übereinstimmt.

Wichtig

KNOWN, UNKNOWN und PARANOID sollten mit Vorsicht verwendet werden, da deren ordnungsgemäßer Betrieb von einem funktionierenden DNS-Server abhängt. Ein Problem bei der Namensauflösung kann eine Zugriffsverweigerung auf Dienste für berechtigte Benutzer zur Folge haben.

2.3.2.1.2. Muster

- Hostname beginnt mit einem Punkt (.) — Ein Punkt am Anfang eines Host-Namens bewirkt, dass auf alle Host-Rechner, die in diesem Hostnamen enden, die Regel angewendet wird. Das folgende Beispiel trifft auf jeden Host in der

example.comDomain zu:ALL : .example.com

- IP-Adresse endet mit einem Punkt (.) — Ein Punkt am Ende einer IP-Adresse bewirkt, dass auf alle Hosts, deren IP-Adresse mit derselben numerischen Gruppe beginnt, die Regel angewendet wird. Das folgende Beispiel trifft auf jeden Host im

192.168.x.x-Netzwerk zu:ALL : 192.168.

- IP-Adresse/Netzmaske-Paar — Netzmasken-Ausdrücke können auch als ein Muster verwendet werden, um den Zugriff zu einer bestimmten Gruppe von IP-Adressen zu regeln. Das folgende Beispiel trifft auf alle Hosts mit einer Adresse zwischen

192.168.0.0und192.168.1.255zu:ALL : 192.168.0.0/255.255.254.0

Wichtig

Wenn im IPv4-Adressraum gearbeitet wird, werden paarweise Deklarationen von Adresse/Präfixlänge (prefixlen) (CIDR-Notation) nicht unterstützt. Lediglich IPv6-Regeln können dieses Format verwenden. - [IPv6 Adresse]/prefixlen Paar — [net]/prefixlen Paare können auch als Muster verwendet werden, um den Zugriff zu einer bestimmten Gruppe von IPv6-Adressen zu regeln. Das folgende Beispiel trifft auf jeden Host mit einem Adressbereich von

3ffe:505:2:1::bis3ffe:505:2:1:ffff:ffff:ffff:ffffzu:ALL : [3ffe:505:2:1::]/64

- Ein Sternchen (*) — Sternchen können für komplette Gruppen von Host-Namen oder IP-Adressen verwendet werden, solange diese nicht in einer Client-Liste verwendet werden, die bereits andere Arten von Muster verwendet. Das folgende Beispiel trifft auf alle Hosts in der

example.com-Domain zu:ALL : *.example.com

- Der Schrägstrich (/) — Wenn die Client-Liste mit einem Schrägstrich beginnt, wird diese als Dateiname behandelt. Dies ist nützlich, wenn Regeln benötigt werden, die eine große Anzahl von Hosts angeben. Das folgende Beispiel verweist TCP-Wrapper auf die

/etc/telnet.hosts-Datei für alle Telnet-Verbindungen:in.telnetd : /etc/telnet.hosts

hosts_access(5)-Handbuchseite.

Warnung

2.3.2.1.3. Portmap und TCP Wrappers

Portmaps Implementierung von TCP-Wrappern unterstützt keine Namensauflösung, was bedeutet, dass portmap keine Host-Namen zur Identifizierung von Hosts verwenden kann. Daher müssen Regeln für die Zugriffskontrolle für Portmap in hosts.allow oder hosts.deny IP-Adressen oder den Schlüsselbegriff ALL für die Spezifizierung von Hosts verwenden.

portmap-Zugriffskontrollregeln werden nicht sofort wirksam. Sie müssen ggf. den portmap-Dienst neu starten.

portmap abhängt, bedenken Sie diese Einschränkungen.

2.3.2.1.4. Operatoren

EXCEPT. Dieser kann sowohl in der Daemon- als auch in der Client-Liste einer Regel verwendet werden.

EXCEPT-Operator erlaubt spezifische Ausnahmen an breiter gefächerten Treffern in einer Regel.

hosts.allow-Datei ist es allen example.com Hosts gestattet, sich mit allen Diensten mit Ausnahme von cracker.example.com zu verbinden:

ALL: .example.com EXCEPT cracker.example.com

hosts.allow-Datei können Clients des 192.168.0.x-Netzwerks alle Dienste benutzen, mit der Ausnahme von FTP:

ALL EXCEPT vsftpd: 192.168.0.

Anmerkung

EXCEPT-Operatoren zu vermeiden. Dadurch können andere Administratoren schnell die gewünschten Dateien durchsuchen, um zu sehen, welche Hosts Zugriff und welche keinen Zugriff auf bestimmte Dienste haben sollen, ohne dass mehrere EXCEPT-Operatoren berücksichtigt werden müssen.

2.3.2.2. Optionsfelder

2.3.2.2.1. Protokollierung

severity-Direktive verwendet wird.

example.com-Domain in die standardmäßige Protokoll-Facility authpriv syslog geschrieben (da kein Facility-Wert angegeben ist), und dies mit einer Priorität von emerg:

sshd : .example.com : severity emerg

severity-Option anzugeben. Das folgende Beispiel protokolliert alle SSH-Verbindungsversuche von Hosts aus der example.com-Domain zur local0-Facility, mit einer Priorität von alert:

sshd : .example.com : severity local0.alert

Anmerkung

syslogd) nicht dazu konfiguriert ist, an die local0-Facility zu protokollieren. Weitere Informationen zur Konfiguration von benutzerdefinierten Facilitys finden Sie auf der syslog.conf-Handbuchseite.

2.3.2.2.2. Zugriffskontrolle

allow oder deny-Direktive als letzte Option hinzufügen.

client-1.example.com, lehnen aber Verbindungsversuche von client-2.example.com ab:

sshd : client-1.example.com : allow sshd : client-2.example.com : deny

hosts.allow oder in hosts.deny. Einige Administratoren finden diese Art, die Zugriffsregeln zu organisieren, einfacher.

2.3.2.2.3. Shell-Befehle

spawn— Startet einen Shell-Befehl als untergeordneten Prozess. Diese Direktive kann Aufgaben wie/usr/sbin/safe_fingerdurchführen, um weitere Informationen über den anfragenden Client zu erhalten oder spezielle Protokolldateien mit demecho-Befehl erzeugen.Im folgenden Beispiel werden Clients, die von derexample.com-Domain aus auf einen Telnet-Dienst zuzugreifen versuchen, unbemerkt in einer speziellen Protokolldatei aufgezeichnet:in.telnetd : .example.com \ : spawn /bin/echo `/bin/date` from %h>>/var/log/telnet.log \ : allow

twist— Ersetzt den angeforderten Dienst durch den angegebenen Befehl. Diese Direktive wird oft verwendet, um Fallen für potenzielle Eindringlinge zu stellen. Es kann auch dazu verwendet werden, um Nachrichten an verbindende Clients zu senden. Dietwist-Direktive muss am Ende der Regelzeile stehen.Im folgenden Beispiel wird Clients, die von derexample.com-Domain aus auf einen FTP-Dienst zuzugreifen versuchen, mithilfe desecho-Befehls eine Nachricht gesendet:vsftpd : .example.com \ : twist /bin/echo "421 This domain has been black-listed. Access denied!"

hosts_options Handbuchseite.

2.3.2.2.4. Erweiterungen

spawn und twist-Direktiven verwendet werden, liefern Informationen über den Client, den Server sowie die beteiligten Prozesse.

%a— Die IP-Adresse des Clients.%A— Die IP-Adresse des Servers.%c— Verschiedene Client-Informationen, wie zum Beispiel der Benutzer- und Host-Name oder der Benutzername und die IP-Adresse.%d— Der Name des Daemon-Prozesses.%h— Der Host-Name des Clients (oder IP-Adresse, wenn der Host-Name nicht verfügbar ist).%H— Der Host-Name des Servers (oder IP-Adresse, wenn der Host-Name nicht verfügbar ist).%n— Der Host-Name des Clients. Wenn dieser nicht verfügbar ist, so wirdunknownausgegeben. Wenn der Host-Name und die Host-Adresse des Clients nicht übereinstimmen, wirdparanoidausgegeben.%N— Der Host-Name des Servers. Wenn dieser nicht verfügbar ist, wirdunknownausgegeben. Wenn der Host-Name und die Host-Adresse des Servers nicht übereinstimmen, wirdparanoidausgegeben.%p— Die ID des Daemon-Prozesses.%s— Verschiedene Server-Informationen, wie zum Beispiel der Daemon-Prozess und die Host- oder IP-Adresse des Servers.%u— Der Benutzername des Clients. Wenn dieser nicht verfügbar ist, wirdunknownausgegeben.

spawn-Befehl, um den Client-Host in einer benutzerdefinierten Protokolldatei zu identifizieren.

sshd) von einem Host in der example.com-Domain unternommen werden, führen Sie den echo-Befehl aus, um den Versuch in eine spezielle Protokolldatei zu schreiben, einschließlich des Host-Namens des Clients (unter Verwendung der %h-Erweiterung):

sshd : .example.com \ : spawn /bin/echo `/bin/date` access denied to %h>>/var/log/sshd.log \ : deny

example.com-Domain aus zuzugreifen versuchen, mitgeteilt, dass diese vom Server ausgeschlossen wurden:

vsftpd : .example.com \ : twist /bin/echo "421 %h has been banned from this server!"

hosts_access (man 5 hosts_access) sowie der Handbuchseite für hosts_options.

2.3.3. xinetd

xinetd-Daemon ist ein TCP-wrapped Super-Dienst, der den Zugriff auf eine Reihe gängiger Netzwerkdienste wie FTP, IMAP und Telnet steuert. Er bietet außerdem dienstspezifische Konfigurationsoptionen zur Zugriffskontrolle, erweiterte Protokollierung, Binding, Umleitungen sowie Ressourcenverwaltung.

xinetd gesteuerten Netzwerkdienst unternimmt, so erhält der Super-Dienst die Anfrage und prüft auf Zugriffskontrollregeln der TCP-Wrapper.

xinetd, dass die Verbindung unter den eigenen Zugriffsregeln für diesen Dienst gestattet ist. Es wird auch geprüft, ob dem Dienst mehr Ressourcen zugewiesen werden können und dass keine definierten Regeln verletzt werden.

xinetd eine Instanz des angefragten Dienstes und gibt die Kontrolle über die Verbindung daran ab. Sobald die Verbindung besteht, greift xinetd nicht weiter in die Kommunikation zwischen Client Host und Server ein.

2.3.4. xinetd-Konfigurationsdateien

xinetd lauten wie folgt:

/etc/xinetd.conf— Die allgemeinexinetd-Konfigurationsdatei./etc/xinetd.d/— Das Verzeichnis, das alle dienstspezifischen Dateien enthält.

2.3.4.1. Die /etc/xinetd.conf-Datei

/etc/xinetd.conf-Datei enthält allgemeine Konfigurationseinstellungen, die sich auf jeden Dienst unter der Kontrolle von xinetd auswirken. Bei jedem Start des xinetd-Dienstes wird diese Datei gelesen. Damit Konfigurationsänderungen wirksam werden, muss der Administrator den xinetd-Dienst also neu starten. Nachfolgend sehen Sie ein Beispiel für eine /etc/xinetd.conf-Datei:

defaults

{

instances = 60

log_type = SYSLOG authpriv

log_on_success = HOST PID

log_on_failure = HOST

cps = 25 30

}

includedir /etc/xinetd.dxinetd:

instances— Legt die Höchstzahl von Anfragen fest, diexinetdgleichzeitig bearbeiten kann.log_type— Weistxinetdan, dieauthpriv-Facillity zu verwenden, die Protokolleinträge in die/var/log/secure-Datei schreibt. Das Hinzufügen einer Direktive wieFILE /var/log/xinetdlogwürde eine benutzerdefinierte Protokolldatei mit dem Namenxinetdlogim/var/log/-Verzeichnis erstellen.log_on_success— Weistxinetddazu an, erfolgreiche Verbindungsversuche zu protokollieren. Standardmäßig werden die Remote-Host-IP-Adresse und die ID des Servers, der die Anfrage verarbeitet, aufgezeichnet.log_on_failure— Weistxinetddazu an, fehlgeschlagene oder abgewiesene Verbindungsversuche zu protokollieren.cps— Weistxinetddazu an, für einen bestimmten Dienst nicht mehr als 25 Verbindungen pro Sekunde zuzulassen. Wenn diese Grenze erreicht ist, wird der Dienst für 30 Sekunden ausgesetzt.includedir/etc/xinetd.d/— Enthält Optionen der dienstspezifischen Konfigurationsdateien im Verzeichnis/etc/xinetd.d/. Weitere Informationen zu diesem Verzeichnis finden Sie unter Abschnitt 2.3.4.2, »Das /etc/xinetd.d/-Verzeichnis«.

Anmerkung

log_on_success und log_on_failure in /etc/xinetd.conf werden oftmals von den dienstspezifischen Protokolldateien geändert. Aus diesem Grund können mehr Informationen in der Protokolldatei eines Dienstes angezeigt werden, als die /etc/xinetd.conf-Datei angibt. Weitere Informationen diesbezüglich finden Sie unter Abschnitt 2.3.4.3.1, »Protokolloptionen«.

2.3.4.2. Das /etc/xinetd.d/-Verzeichnis

/etc/xinetd.d/-Verzeichnis enthält die Konfigurationsdateien für jeden einzelnen Dienst, der von xinetd verwaltet wird sowie die Namen der Dateien, die mit dem Dienst zusammenhängen. Wie auch xinetd.conf wird diese Datei nur gelesen, wenn der xinetd-Dienst gestartet wird. Um Änderungen wirksam werden zu lassen, muss der Administrator den xinetd-Dienst daher neu starten.

/etc/xinetd.d/-Verzeichnis verwenden dieselben Konventionen und Optionen wie /etc/xinetd.conf. Der Hauptgrund dafür, dass sich diese in eigenen Konfigurationsdateien befinden, ist zur einfacheren Anpassung und um Auswirkungen auf andere Dienste möglichst zu vermeiden.