Red Hat Training

A Red Hat training course is available for Red Hat Enterprise Linux

Virtualization

A reference guide for virsch, xm, vmm and xend.

Ausgabe 2.0

Zusammenfassung

Red Hat Enterprise Linux mit der Komponente Virtualization_Guide bei Bugzilla ( http://bugzilla.redhat.com/bugzilla/) ein.

Kapitel 1. Red Hat Virtualisierung-Systemarchitektur

Kapitel 2. Unterstützung von Betriebssystemen

- Intel VT-x- oder AMD-V Pacifica- und Vanderpool-Technologie für volle und Paravirtualisierung,

- Intel VT-i für ia64,

- Linux- und UNIX-Betriebssysteme, inklusive NetBSD, FreeBSD und Solaris,

- Microsoft Windows as an unmodified guest operating system with Intel Vanderpool or AMD's Pacifica technology.

grep vmx /proc/cpuinfo

flags : fpu tsc msr pae mce cx8 apic mtrr mca cmov pat pse36 clflush dts acpi mmx fxsr sse sse2 ss ht tm syscall nx lm constant_tsc pni monitor ds_cpl vmx est tm2 cx16 xtpr lahf_lm

grep svm /proc/cpuinfo cat /proc/cpuinfo | grep svm

flags : fpu tsc msr pae mce cx8 apic mtrr mca cmov pat pse36 clflush dt acpi mmx fxsr sse sse2 ss ht tm syscall nx mmtext fxsr_opt rdtscp lm 3dnowext pni cx16 lahf_lm cmp_legacy svm cr8_legacy

Anmerkung

Kapitel 3. Hardwareunterstützung

- Celeron

- Pentium II

- Pentium III

- Pentium IV

- Xeon

- AMD Athlon

- AMD Duron

mem=32G anhängen. Dieses Beispiel zeigt, wie die passenden Parameter in der Datei grub.conf aktiviert werden:

title Red Hat Enterprise Linux Server (2.6.18-4.elxen) root (hd0, 0) kernel /xen.gz-2.6.18-4-el5 mem=32G module /vmlinuz -2.6.18-4.el5xen ro root=LABEL=/ module /initrd-2.6.18-4.el5xen.img

grep pae /proc/cpuinfo

flags : fpu tsc msr pae mce cx8 apic mtrr mca cmov pat pse36 mmx fxsr sse syscall mmtext 3dnowext 3dnow up ts

Kapitel 4. Systemanforderungen der Red Hat Virtualisierung

- Eine funktionierende Red Hat RHEL 5 Linux-Distribution,

- Ein funktionierender GRUB-Bootloader,

- Root-Zugriff,

- Ein Prozessor der P6-Klasse (oder früher),

- Die Linux-"bridge-utils",

- Die Linux Hotplug-Systeme,

- Eine Installation der zlib-Bibliothek zur Entwicklung,

- Python 2.2 Laufzeitumgebung,

- Die "initscripts" (die Initialisierungsskripte).

Anmerkung

xen-ia64-guest-firmware package to run a fully virtualized guest. This package is provided in the Supplementary CD and is not installed by default.

Kapitel 5. Booten des Systems

service xend start

chkconfig xend, wenn Sie den Start des xend zur Bootzeit aktivieren möchten.

Kapitel 6. GRUB-Konfiguration

/boot/grub/grub.conf) is used to create a list of operating systems to boot in GRUB's menu interface. When you install the kernel-xen RPM, a post script adds kernel-xen entries to the GRUB configuration file. You can edit the grub.conf file and enable the following GRUB parameter:

title Red Hat Enterprise Linux Server (2.6.18-3.el5xen) root (hd0; 0) kernel /xen.gz.-2.6.18-3.el5 module /vmlinuz-2.6..18-3.el5xen ro root=/dev/VolGroup00/LogVol00 rhgb quiet module /initrd-2.6.18-3. el5xenxen.img

initrd-Image und den Linux-Kernel. Da sich der Kernel-Eintrag oberhalb der anderen Einträge befindet, wird der Kernel zuerst in den Speicher geladen. Der Bootloader sendet (und empfängt) Kommandozeilenparameter an und vom Hypervisor und dem Linux-Kernel. Dieser Beispieleintrag zeigt, wie Sie den Speicher des Linux-Kernels der Domain0 auf 800 MB beschränken:

title Red Hat Enterprise Linux Server (2.6.18-3.el5xen) root (hd0; 0) kernel /xen.gz.-2.6.18-3.el5 dom0_mem=800M module /vmlinuz-2.6..18-3.el5xen ro root=/dev/VolGroup00/LogVol00 rhgb quiet module /initrd-2.6.18-3. el5xenxen.img

mem

com1=115200, 8n1

dom0_mem

dom0_max_vcpus

acpi

/* **** Linux config options: propagated to domain0 ****/ /* "acpi=off": Disables both ACPI table parsing and interpreter. */ /* "acpi=force": Overrides the disable blacklist. */ /* "acpi=strict": Disables out-of-spec workarounds. */ /* "acpi=ht": Limits ACPI from boot-time to enable HT. */ /* "acpi=noirq": Disables ACPI interrupt routing. */

noacpi

Kapitel 7. Booten einer Gast-Domain

xm können Sie Gast-Domains booten. Alternativ können Sie virsh und den Virtual Machine Manager verwenden, um die Gäste zu booten. Eine Voraussetzung für das Booten einer Gast-Domain ist die vorherige Installation eines Gast-Hosts. Nachfolgendes Beispiel verwendet den Sub-Befehl xm create :

# xm create -c guestdomain1

guestdomain1 ist die Konfigurationsdatei für die Domain, die Sie booten. Die Option -c verbindet sich nach dem Booten mit der eigentlichen Konsole.

Kapitel 8. Starten/Stoppen einer Domain zur Bootzeit

/etc/xen/ platzieren. Alle Domains, die Sie zur Bootzeit starten möchten, müssen mit /etc/xen/auto symbolisch verlinkt sein.

chkconfig xendomains on

chkconfig xendomains on startet Domains nicht automatisch. Stattdessen startet es die Domains beim nächsten Start des Systems.

chkconfig xendomains off

chkconfig xendomains off fährt Domains beim nächsten Start des Systems herunter.

Kapitel 9. Konfigurationsdateien

/etc/xen directory.

Tabelle 9.1. Red Hat Virtualisierung Konfigurationsdateien

| Element | Beschreibung |

|---|---|

|

pae

|

Gibt die Konfigurationsdaten der physikalischen Adresserweiterung an.

|

|

apic

|

Gibt die Konfigurationsdaten des erweiterten, programmierbaren Interrupt-Controllers an.

|

|

memory

|

Gibt die Speichergröße in Megabytes an.

|

|

vcpus

|

Gibt die Anzahl der virtuellen CPUs an.

|

|

console

|

Gibt die Portnummern an, an welche die Konsolen der Domain exportiert werden.

|

|

nic

|

Gibt die Anzahl der virtuellen Netzwerkschnittstellen an.

|

|

vif

|

Lists the randomly-assigned MAC addresses and bridges assigned to use for the domain's network addresses.

|

|

disk

|

Listet die Blockgeräte auf, die für die Domain exportiert werden sollen und exportiert physikalische Geräte für eine Domain mit schreibgeschützten Zugriff.

|

|

dhcp

|

Aktiviert das Netzwerk unter Verwendung von DHCP.

|

|

netmask

|

Gibt die konfigurierten IP-Netzmasken an.

|

|

gateway

|

Gibt die konfigurierten IP-Gateways.

|

|

acpi

|

Gibt die Konfigurationsdaten der ACPI-Schnittstelle an.

|

Kapitel 10. CPUs verwalten

Kapitel 11. Migration einer Domain

xm migrate domain-id [destination domain]

xm migrate domain-id -l [destination domain]

Kapitel 12. Konfiguration zur Verwendung in einem Netzwerk

dom0 by a point to point link. These devices are vif <domid> and <vifid>. vif1.0 for the first interface in domain 1; vif3.1 for the second interface in domain 3.

network-bridge and vif-bridge. xend calls these scripts when certain events occur. Arguments can be passed to the scripts to provide additional contextual information. These scripts are located in the /etc/xen/scripts directory. You can change script properties by modifying the xend-config.sxp configuration file located in the /etc/xen directory.

network-bridge — Wenn xend gestartet oder gestoppt wird, initialisiert oder deaktiviert dieses Skript das virtuelle Netzwerk. Anschließend wird durch die Initialisierung der Konfiguration die Bridge xen—br0 erstellt und eth0 auf diese Bridge verschoben, während gleichzeitig das Routing angepasst wird. Wenn sich xend schließlich beendet, entfernt dieses Skript die Bridge und entfernt eth0. Dabei wird die ursprüngliche IP- und Routing-Konfiguration wiederhergestellt.

vif-bridge - Dieses Skript wird für jede virtuelle Schnittstelle auf der Domain aufgerufen. Es konfiguriert Firewall-Regeln und kann vif zur entsprechenden Bridge hinzufügen.

network-route, network-nat, vif-route, und vif-nat. Diese Skripte können auch durch angepasste Varianten ersetzt werden.

Kapitel 13. Domain0 absichern

- Führen Sie die Minimalanzahl an notwendigen Diensten aus. Sie sollten nicht zu viele Jobs und Dienste in domain0 einbinden. Je weniger Dienste auf domain0 laufen, desto höher ist das Sicherheitslevel.

- Aktivieren Sie SELinux zur Unterstützung der Absicherung von domain0.

- Verwenden Sie eine Firewall, um den Datenverkehr zu domain0 einzuschränken. Sie können eine Firewall mit "default-reject"-Regeln einrichten, welche domain0 gegen Attacken absichert. Weiterhin ist es wichtig, Dienste mit Netzwerkbindung zu limitieren.

- Erlauben Sie normalen Benutzern den Zugriff auf domain0 nicht. Wenn Sie normalen Benutzern den Zugriff auf domain0 gestatten, laufen Sie Gefahr, domain0 angreifbar zu machen. Beachten Sie, dass domain0 privilegiert ist, so dass das Bewilligen von unprivilegierten Accounts das Sicherheitslevel kompromittieren kann.

Kapitel 14. Speicherplatz

Kapitel 15. Das Verwalten von virtuellen Maschinen mit "virsh"

xend/qemu auszuführen, sollten Sie xend/qemu als Dienst aktivieren. Nach der Anpassung der entsprechenden Konfigurationsdatei, starten Sie das System neu und xend/qemu wird als Dienst ausgeführt. Mit Hilfe von "virsh" können Sie Skripte bei der Arbeit mit virtuellen Maschine verwenden. Wie das xm-Tool lässt sich virsh auf Kommandozeilenebene ausführen.

15.1. Verbindung mit einem Hypervisor

virsh connect <name>

<name> is the machine name of the hypervisor. If you want to initiate a read—only connection, append the above command with —readonly.

15.2. Erstellen einer virtuellen Maschine

virsh create <path to XML configuration file>

15.3. Konfiguration eines XML-Dump

virsh dumpxml [domain-id | domain-name | domain-uuid]

stdout . If you save the data to a file, you can use the create option to recreate the virtual machine.

15.4. Anhalten einer virtuellen Maschine

virsh suspend [domain-id | domain-name |domain-uuid]

resume option.

15.5. Fortsetzen einer virtuellen Maschine

virsh resume [domain-id | domain-name | domain-uuid]

suspend- und resume-Schleife festgehalten.

15.6. Speichern einer virtuellen Maschine

virsh save [domain-name][domain-id | domain-uuid][filename]

restore option.

15.7. Wiederherstellen einer virtuellen Maschine

virsh save option:

virsh restore [filename]

15.8. Herunterfahren einer virtuellen Maschine

virsh shutdown [domain-id | domain-name | domain-uuid]

on_shutdown der Datei xmdomain.cfg modifizieren.

15.9. Neustart einer virtuellen Maschine

virsh reboot [domain-id | domain-name | domain-uuid]

on_reboot der Datei xmdomain.cfg modifizieren.

15.10. Entfernen einer Domain

virsh destroy [domain-name | domain-id | domain-uuid]

destroy option only when the virtual machine's operating system is non-responsive. For a paravirtualized virtual machine, you should use the shutdown option.

15.11. Konvertierung eines Domain-Namens in eine Domain-ID

virsh domid [domain-name | domain-uuid]

15.12. Konvertierung einer Domain-ID in einen Domain-Namen

virsh domname [domain-name | domain-uuid]

15.13. Konvertierung eines Domain-Namens in eine UUID

virsh domuuid [domain-id | domain-uuid]

15.14. Anzeige der Informationen einer virtuellen Maschine

virsh dominfo [domain-id | domain-name | domain-uuid]

15.15. Anzeige von Knoten-Informationen

virsh nodeinfo

CPU model x86_64 CPU (s) 8 CPU frequency 2895 Mhz CPU socket(s) 2 Core(s) per socket 2 Threads per core: 2 Numa cell(s) 1 Memory size: 1046528 kb

15.16. Anzeige der virtuellen Maschinen

virsh list domain-name [ ——inactive | —— -all]

——inactive listet inaktive Domains (Domains, die definiert wurden, aber derzeit nicht aktiv sind) auf. Die Option — -all listet alle Domains auf, egal ob aktiv oder nicht. Die Ausgabe sollte in etwa wie in folgendem Beispiel aussehen:

ID Name State ———————————————— 0 Domain0 running 1 Domain202 paused 2 Domain010 inactive 3 Domain9600 crashed

running lists domains currently active on the CPU blocked lists domains that are blocked paused lists domains that are suspended shutdown lists domains that are in process of shutting down shutoff lists domains that are completely down. crashed lists domains that are crashed

15.17. Darstellung von Informationen zur virtuellen CPU

virsh vcpuinfo [domain-id | domain-name | domain-uuid]

15.18. Konfiguration der Affinität einer virtuellen CPU

virsh vcpupin [domain-id | domain-name | domain-uuid] [vcpu] , [cpulist]

[vcpu] die Zahl der virtuellen VCPU darstellt und [cpulist] die Anzahl der physikalischen CPUs auflistet.

15.19. Konfiguration der Anzahl virtueller CPUs

virsh setvcpus [domain-name | domain-id | domain-uuid] [count]

15.20. Konfiguration der Speicherzuweisung

virsh setmem [domain-id | domain-name] [count]

[count] in kilobytes. Note that the new count cannot exceed the amount you specified when you created the Virtual Machine. Values lower than 64 MB probably won't work. You can adjust the Virtual Machine memory as necessary.

15.21. Konfiguration des maximalen Speichers

virsh setmaxmem [domain-name | domain-id | domain-uuid] [count]

15.22. Managing Virtual Networks

virsh net-list

[root@domain ~]# virsh net-list Name State Autostart ----------------------------------------- default active yes vnet1 active yes vnet2 active yes

virsh net-dumpxml [vnet name]

[root@domain ~]# virsh net-dumpxml vnet1

<network>

<name>vnet1</name>

<uuid>98361b46-1581-acb7-1643-85a412626e70</uuid>

<forward dev='eth0'/>

<bridge name='vnet0' stp='on' forwardDelay='0' />

<ip address='192.168.100.1' netmask='255.255.255.0'>

<dhcp>

<range start='192.168.100.128' end='192.168.100.254' />

</dhcp>

</ip>

</network>

virsh net-autostart [network name]— Autostart a network specified as [network name]virsh net-create [XML file]— Generates and starts a new network using a preexisting XML filevirsh net-define [XML file]— Generates a new network from a preexisting XML file without starting itvirsh net-destroy [network name]— Destroy a network specified as [network name]virsh net-name [network UUID]— Convert a specified [network UUID] to a network namevirsh net-uuid [network name— Convert a specified [network name] to a network UUIDvirsh net-start [name of an inactive network]— Starts a previously undefined inactive networkvirsh net-undefine [name of an inactive network]— Undefine an inactive network

Kapitel 16. Das Verwalten virtueller Maschinen unter Verwendung von xend

xend-config.sxp, die sich im Verzeichnis etc/xen befindet, bearbeiten. Nachfolgend finden Sie die Parameter, die Sie in der Konfigurationsdatei xend-config.sxp aktivieren oder deaktivieren können:

Tabelle 16.1. Die xend-Konfigurationsparameter der Red Hat Virtualisierung

| Element | Beschreibung |

|---|---|

|

console-limit

|

Determines the console server's memory buffer limit and assigns values on a per-domain basis

|

|

min-mem

|

Bestimmt die minimale Anzahl an Megabytes, die für domain0 reserviert werden (wenn Sie 0 eingeben, ändert sich der Wert nicht)

|

|

dom0 cpus

|

Bestimmt die Zahl der von domain0 verwendeten CPUs (mindestens 1 CPU wird standardmäßig zugewiesen)

|

|

enable-dump

|

Bestimmt, dass im Falle eines Absturzes ein Dump aktiviert wird (Standard ist 0)

|

|

external-migration-tool

|

Bestimmt das Skript oder die Anwendung, die die externe Gerätemigration handhabt (die Skripte müssen sich in

etc/xen/scripts/external-device-migrate befinden)

|

|

logfile

|

Bestimmt den Ort der Protokolldatei (standardmäßig

/var/log/xend.log)

|

|

loglevel

|

Filtert die Werte des Protokollmodus aus: DEBUG, INFO, WARNING, ERROR oder CRITICAL (standardmäßig DEBUG)

|

|

network-script

|

Bestimmt das Skript, dass die Netzwerkumgebung aktiviert (Skripte müssen sich im Verzeichnis

etc/xen/scripts befinden)

|

|

xend-http-server

|

Aktiviert den HTTP-Stream Paket-Management-Server (standardmäßig "no")

|

|

xend-unix-server

|

Aktiviert den UNIX Domain-Socket-Server (ein Socket-Server ist ein Kommunikationsendpunkt, der Lowlevel-Netzwerkverbindungen handhabt und einkommende Verbindungen akzeptiert oder abweist)

|

|

xend-relocation-server

|

Aktiviert den Umzugsserver für maschinenübergreifende Migrationen (standardmäßig "no")

|

|

xend-unix-path

|

Bestimmt den Ort, an dem der Befehl

xend-unix-server Daten ausgibt (standardmäßig var/lib/xend/xend-socket)

|

|

xend-port

|

Bestimmt den Port, den der HTTP-Management-Server verwendet (standardmäßig 8000)

|

|

xend-relocation-port

|

Bestimmt den Port, den der Umzugsserver verwendet (standardmäßig 8002)

|

|

xend-relocation-address

|

Bestimmt die Adressen der virtuellen Maschine, die für die Systemmigration gestattet sind

|

|

xend-address

|

Bestimmt die Adresse, mit der sich der Domain-Socket-Server verbindet.

|

service xend start

service xend stop

service xend restart

service xend status

Kapitel 17. Die Verwaltung virtueller Maschinen mit dem Virtual Machine Manager

17.1. Die Architektur des Virtual Machine Manager

17.2. Das Fenster "Verbindung öffnen"

test:///default in the URL field beneath. Once in test mode, you can connect to a libvirt dummy hypervisor. Note that although the Remote Xen host screen is visible, the functionality to connect to such a host is not implemented into Red Hat Enterprise Linux 5.1.

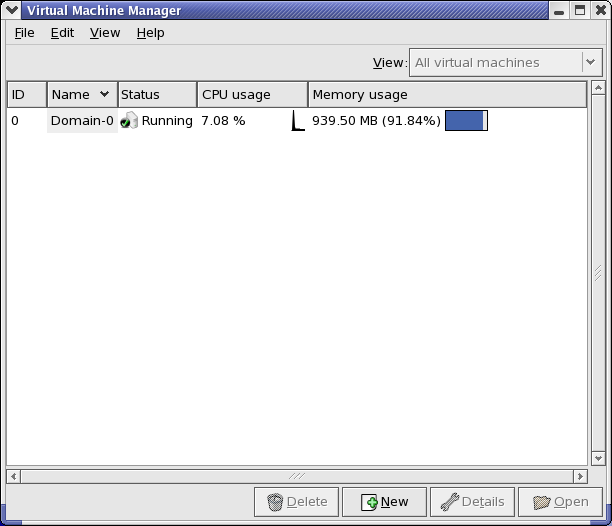

Abbildung 17.1. Virtual Machine Manager Connection window

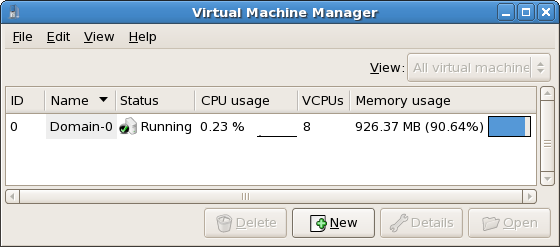

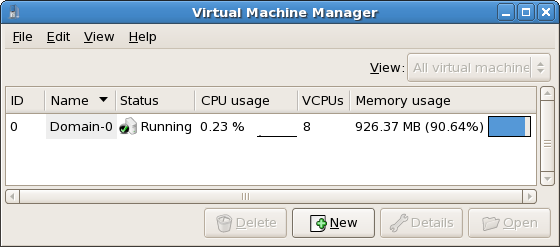

17.3. Das Fenster "Virtual Machine Manager"

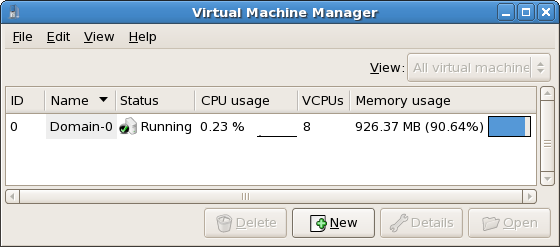

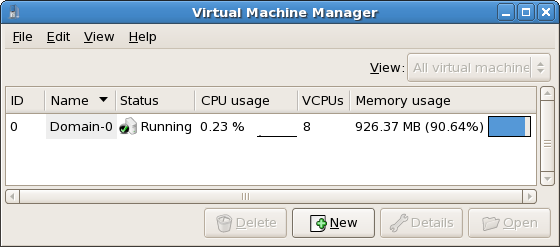

Abbildung 17.2. Virtual Machine Manager main window

17.4. Das Fenster "Details zur virtuellen Maschine"

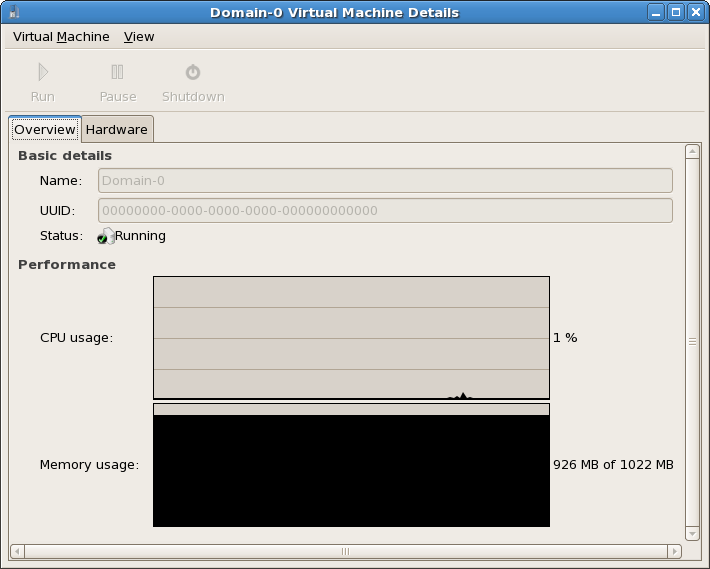

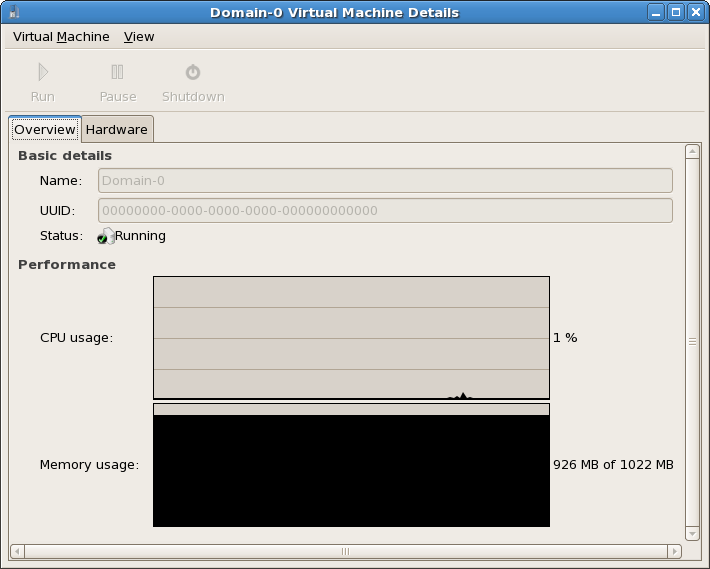

Abbildung 17.3. Virtual Machine Manager Details window

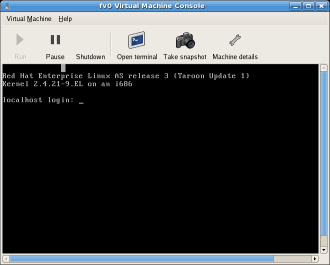

17.5. Die grafische Konsole einer virtuellen Maschine

Abbildung 17.4. Das Fenster "Grafische Konsole"

17.6. Starting the Virtual Machine Manager

Systemwerkzeuge im Menü Anwendungen und wählen den Virtual Machine Manager.

Abbildung 17.5. Starting the Virtual Machine Manager

17.7. Erstellen einer neuen virtuellen Maschine

- Neue Domains zu erstellen.

- Configure or adjust a domain's resource allocation and virtual hardware.

- Die Leistung und Statistiken zur Nutzung von Ressourcen von laufenden Domains zusammenzufassen.

- Graphen, die Leistung und die Nutzung von Ressourcen über einen bestimmten Zeitraum darstellen, anzuzeigen.

- Das eingebundene (embedded) Darstellungsprogramm des VNC-Client, welches der Gast-Domain eine umfassende grafische Konsole bietet, zu verwenden.

Anmerkung

Prozedur 17.1. Ein Gast-Betriebssystem erstellen

- Wählen Sie Systemwerkzeuge aus dem Menü Anwendungen und dann anschließend Virtual Machine Manager.Das Hauptfenster "Virtual Machine Manager" erscheint.

Abbildung 17.6. Virtual Machine Manager window

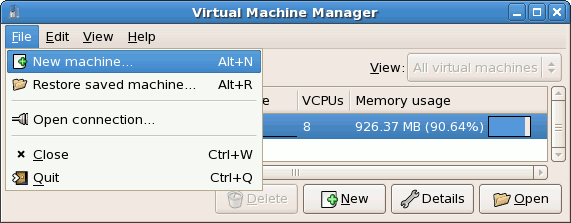

- Wählen Sie Neue Maschine aus dem Menü Datei.

Abbildung 17.7. Eine neue Maschine auswählen

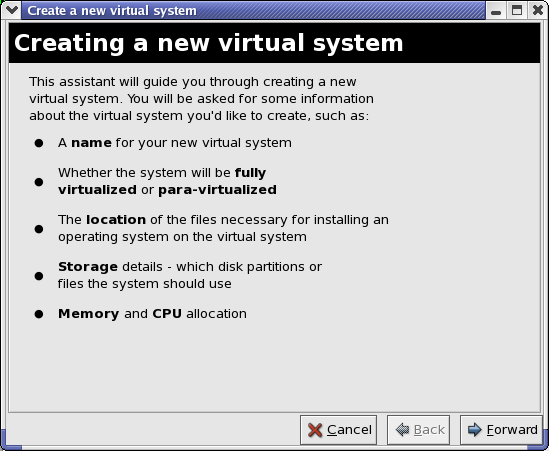

Der Wizard zur Erstellung eines neuen virtuellen Systems erscheint. - Click Forward.

Abbildung 17.8. Wizard zur Erstellung eines neuen virtuellen Systems

- Enter the name of the new virtual system and then click Forward.

Abbildung 17.9. Benennung des virtuellen Systems

- Geben Sie den Ort Ihrer Installationsmedien an. Der Ort der Kickstart-Datei ist optional. Klicken Sie anschließend auf Weiter.

Abbildung 17.10. Ort der Installationsmedien

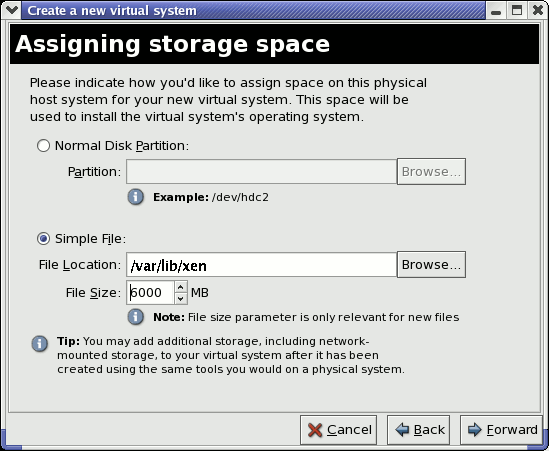

- Installieren Sie entweder auf eine physikalische Plattenpartition oder installieren Sie in ein virtuelles Dateisystem innerhalb einer Datei.

Anmerkung

Nachfolgendes Beispiel installiert ein virtuelles System innerhalb einer Datei.SELinux policy only allows xen disk images to reside in/var/lib/xen/images.Open a terminal and create the /xen directory and set the SELinux policy with the commandrestorecon -v /xen. Specify your location and the size of the virtual disk, then click Forward.

Abbildung 17.11. Zuweisen von Speicherplatz

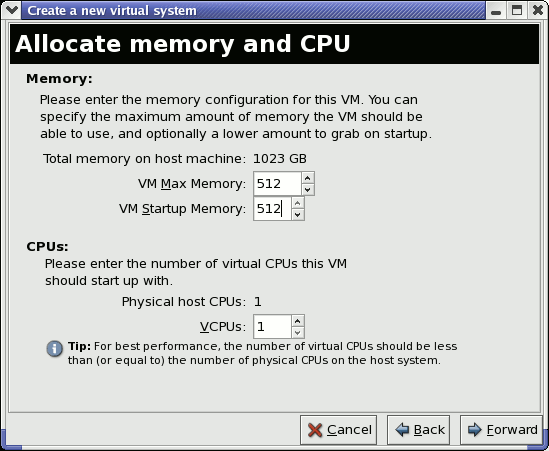

- Select memory to allocate the guest and the number of virtual CPUs then click Forward.

Abbildung 17.12. Speicher und CPU zuweisen

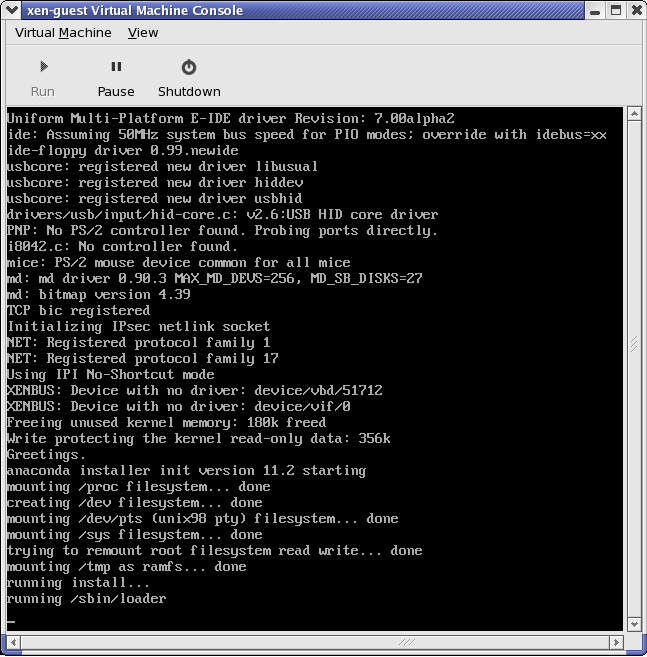

- Select Forward to open a console and the files start to install.

Abbildung 17.13. Speicher und CPU zuweisen

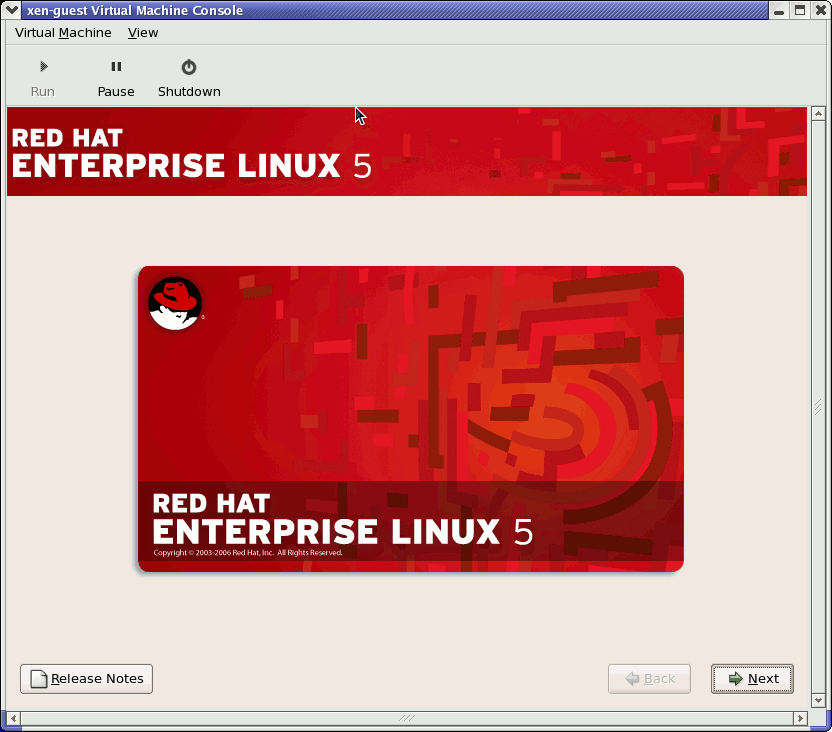

- Schließen Sie Ihre Installation in dem zur Verfügung gestellten Fenster ab.

Abbildung 17.14. Die Installation beginnt...

Warnung

When installing Red Hat Enterprise Linux 5.1 on a fully virtualized guest, do not use thekernel-xenkernel. Using this kernel on fully virtualized guests can cause your system to hang.If you are using an Installation Number when installing Red Hat Enterprise Linux 5.1 on a fully virtualized guest, be sure to deselect theVirtualizationpackage group during the installation. TheVirtualizationpackage group option installs thekernel-xenkernel.Note that paravirtualized guests are not affected by this issue. Paravirtualized guests always use thekernel-xenkernel. - Type

xm create -c xen-guestto start the Red Hat Enterprise Linux 5.1 guest. Right click on the guest in the Virtual Machine Manager and choose Open to open a virtual console.

Abbildung 17.15. Red Hat Enterprise Linux 5.1 (guest)

- Geben Sie Benutzernamen und Passwort ein, um mit der Benutzung des Virtual Machine Manager fortzufahren.

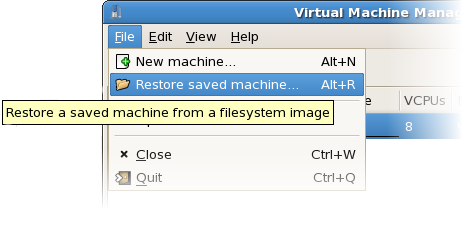

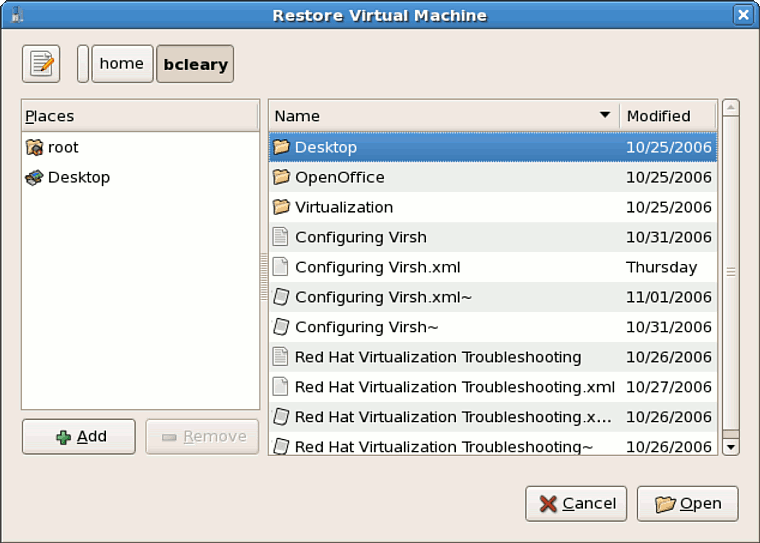

17.8. Eine gespeicherte Maschine wiederherstellen

- Wählen Sie aus dem Menü Datei die Option Eine gespeicherte Maschine wiederherstellen.

Abbildung 17.16. Restoring a Virtual Machine

- Das Hauptfenster "Virtuelle Maschine wiederherstellen" erscheint.

Abbildung 17.17. Auswahl von gespeicherten Sitzungen virtueller Maschinen

- Begeben Sie sich in das korrekte Verzeichnis und wählen Sie die gespeicherte Sitzungsdatei.

- Klicken Sie auf Öffnen.

Abbildung 17.18. Die wiederhergestellte Sitzung des Virtual Machine Manager

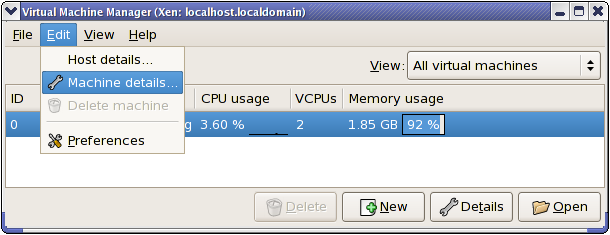

17.9. Displaying Virtual Machine Details

- Heben Sie im Hauptfenster des Virtual Machine Manager die virtuelle Maschine, die Sie ansehen möchten, hervor.

Abbildung 17.19. Auswahl einer anzuzeigenden virtuellen Maschine

- Wählen Sie Maschinendetails aus dem Menü Bearbeiten des Virtual Machine Manager (oder klicken Sie auf die Schaltfläche Details am unteren Rand des Hauptfensters des Virtual Machine Manager).

Abbildung 17.20. Anzeige des Detail-Menüs der virtuellen Maschine

Das Fenster für den Überblick über die Details der virtuellen Maschine erscheint. Dieses Fenster fasst die Verwendung von CPU und Speicher für die von Ihnen angegebene(n)Domain(s) zusammen.

Abbildung 17.21. Anzeige des Detail-Überblicks der virtuellen Maschine

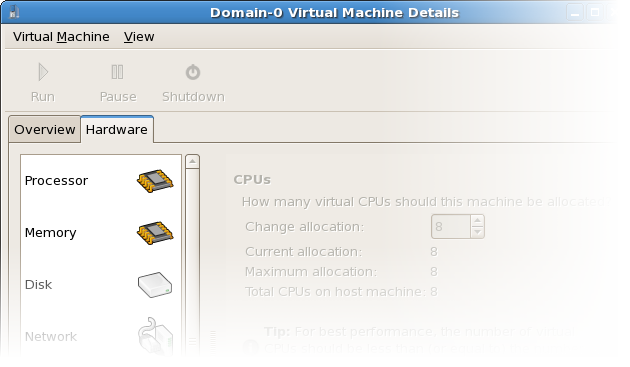

- Klicken Sie im Fenster "Details der virtuellen Maschine" auf den Reiter Hardware.Das Fenster für die Hardware-Details der virtuellen Maschine erscheint.

Abbildung 17.22. Anzeige der Hardware-Details der virtuellen Maschine

- Um die derzeitige Zuweisung von Prozessorspeicher zu betrachten oder zu verändern, klicken Sie auf Prozessor auf dem Reiter Hardware.

Abbildung 17.23. Anzeige der Prozessorzuweisung

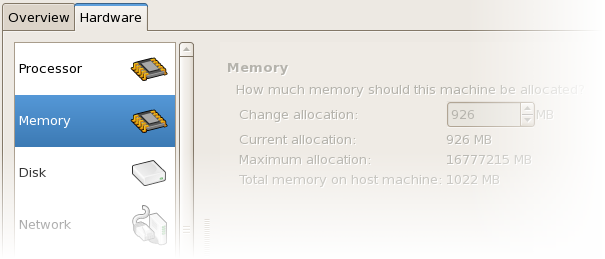

- Um die derzeitige Zuweisung von Arbeitsspeicher zu betrachten oder zu verändern, klicken Sie auf Speicher auf dem Reiter Hardware.

Abbildung 17.24. Anzeige der Arbeitsspeicherzuweisung

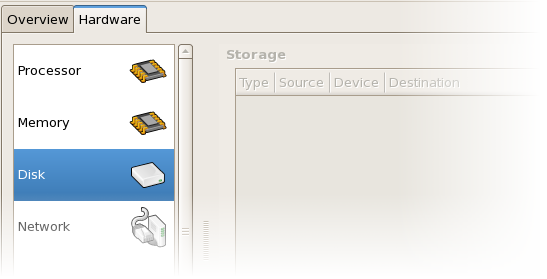

- Um die derzeitige Festplattenkonfiguration zu betrachten oder zu verändern, klicken Sie auf Platte auf dem Reiter Hardware.

Abbildung 17.25. Anzeige der Festplattenkonfiguration

- Um die derzeitige Netzwerkkonfiguration zu betrachten oder zu verändern, klicken Sie auf Netzwerk auf dem Reiter Hardware.

Abbildung 17.26. Anzeige der Netzwerkkonfiguration

17.10. Configuring Status Monitoring

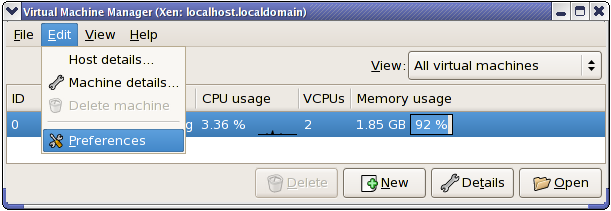

- Wählen Sie Präferenzen aus dem Menü Bearbeiten.

Abbildung 17.27. Modifizieren der Präferenzen der virtuellen Maschine

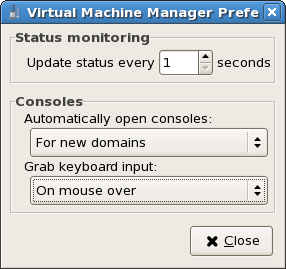

Das Fenster "Präferenzen" des Virtual Machine Manager erscheint. - Geben Sie in der Auswahlbox der Statusüberwachung die Zeit (in Sekunden) an, die Sie für das System-Update festlegen möchten.

Abbildung 17.28. Configuring Status Monitoring

- Geben Sie im Konsolenbereich an, wie eine Konsole geöffnet werden soll und legen Sie ein Eingabegerät fest.

17.11. Anzeige der Domain-ID

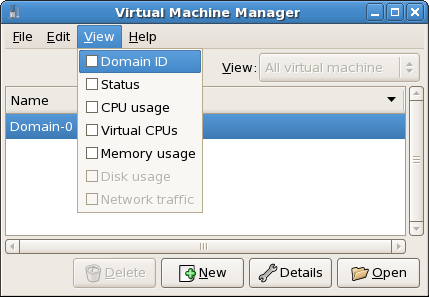

- Wählen Sie das Kontrollkästchen Domain-ID aus dem Menü Anzeigen.

Abbildung 17.29. Anzeige von Domain-IDs

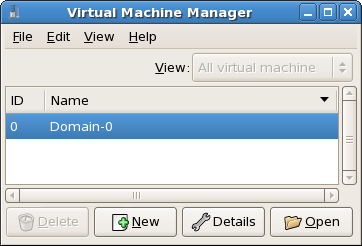

- The Virtual Machine Manager lists the Domain ID's for all domains on your system.

Abbildung 17.30. Anzeige von Domain-IDs

17.12. Anzeige des Status der virtuellen Maschine

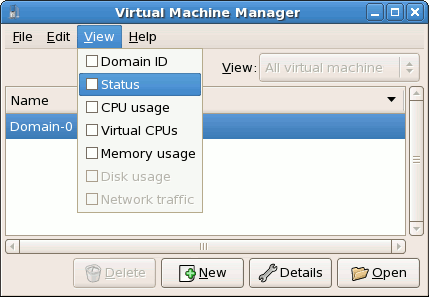

- Wählen Sie das Kontrollkästchen Status aus dem Menü Ansicht.

Abbildung 17.31. Anzeige des Status der virtuellen Maschine

- Der Virtual Machine Manager listet den Status aller virtuellen Maschinen auf Ihrem System auf.

Abbildung 17.32. Anzeige des Status der virtuellen Maschine

17.13. Virtuelle CPUs anzeigen

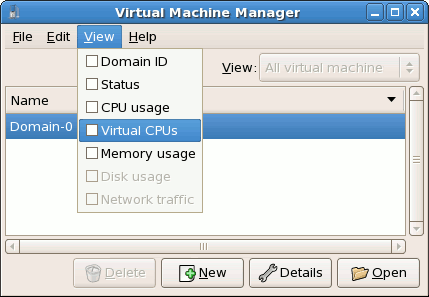

- Wählen Sie aus dem Menü Anzeigen das Kontrollkästchen Virtuelle CPUs.

Abbildung 17.33. Virtuelle CPUs anzeigen

- Der Virtual Machine Manager listet die virtuellen CPUs für alle virtuellen Maschinen auf Ihrem System auf.

Abbildung 17.34. Virtuelle CPUs anzeigen

17.14. Anzeigen der CPU-Auslastung

- Wählen Sie das Kontrollkästchen CPU-Auslastung aus dem Menü Anzeige.

Abbildung 17.35. Anzeigen der CPU-Auslastung

- Der Virtual Maschine Manager listet den Anteil der CPU-Auslastung in Prozent für alle virtuellen Maschinen auf Ihrem System auf.

Abbildung 17.36. Anzeigen der CPU-Auslastung

17.15. Anzeigen des Speicherverbrauchs

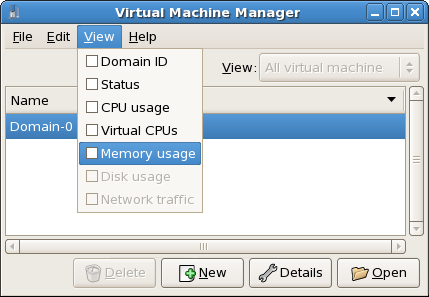

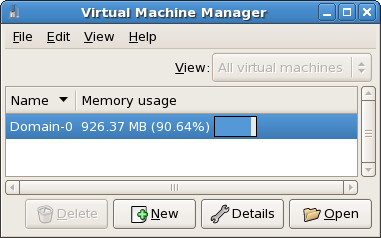

- Wählen Sie aus dem Menü Anzeigen das Kontrollkästchen Speicherbelegung.

Abbildung 17.37. Anzeigen des Speicherverbrauchs

- Der Virtual Maschine Manager listet den Anteil des Speicherverbrauchs (in Megabytes) für alle virtuellen Maschinen auf Ihrem System auf.

Abbildung 17.38. Anzeigen des Speicherverbrauchs

17.16. Managing a Virtual Network

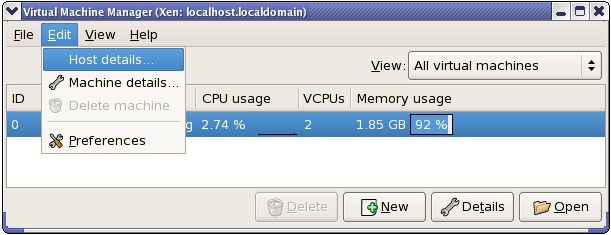

- From the Edit menu, select Host Details.

Abbildung 17.39. Selecting Host Details

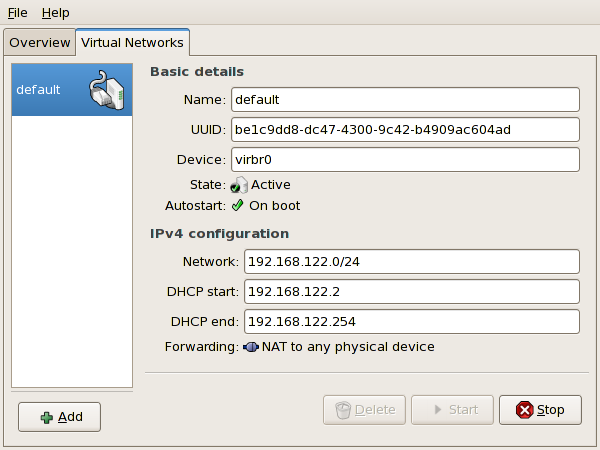

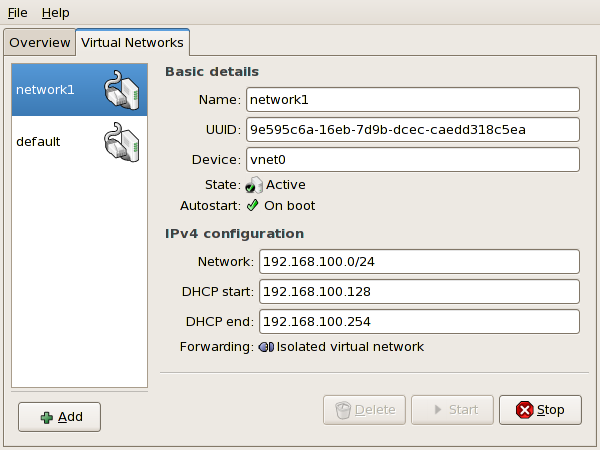

- This will open the Host Details menu. Click the Virtual Networks tab.

Abbildung 17.40. Virtual Network Configuration

- All available virtual networks are listed on the left-hand box of the menu. You can edit the configuration of a virtual network by selecting it from this box and editing as you see fit.

17.17. Creating a Virtual Network

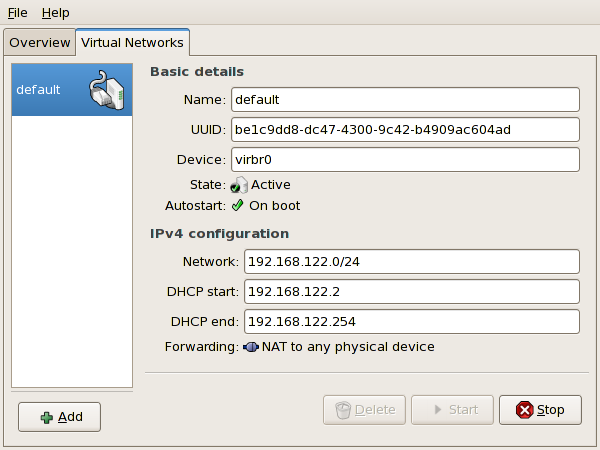

- Open the Host Details menu (refer to Abschnitt 17.16, »Managing a Virtual Network«) and click the Add button.

Abbildung 17.41. Virtual Network Configuration

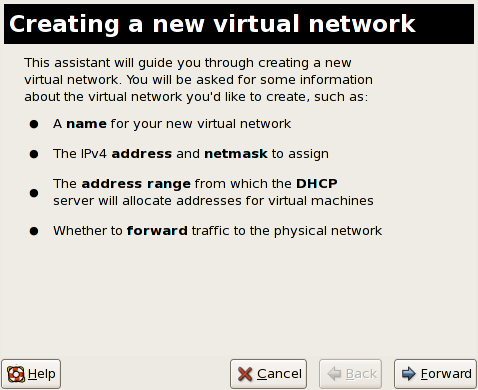

This will open the Create a new virtual network menu. Click Forward to continue.

Abbildung 17.42. Creating a new virtual network

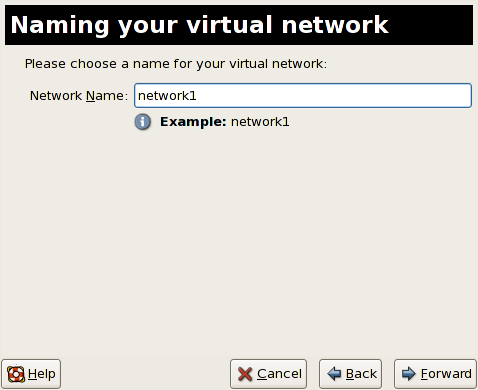

- Enter an appropriate name for your virtual network and click Forward.

Abbildung 17.43. Naming your virtual network

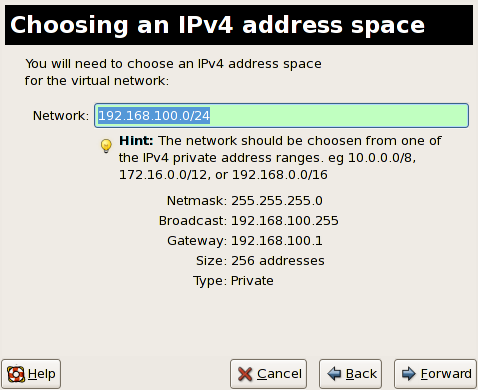

- Enter an IPv4 address space for your virtual network and click Forward.

Abbildung 17.44. Choosing an IPv4 address space

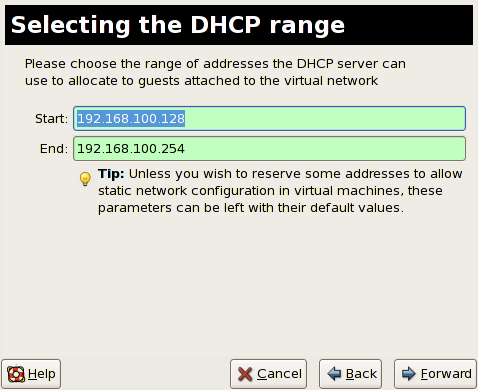

- Define the DHCP range for your virtual network by specifying a Start and End range of IP addresses. Click Forward to continue.

Abbildung 17.45. Selecting the DHCP range

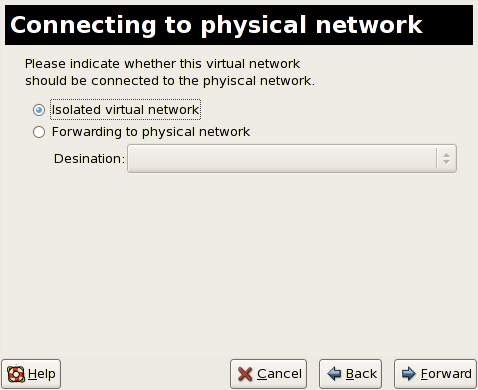

- Select how the virtual network should connect to the physical network.

Abbildung 17.46. Connecting to physical network

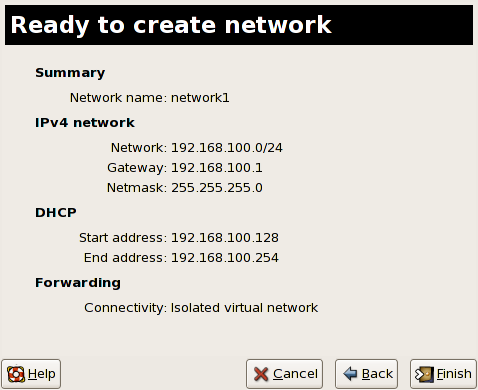

If you select Forwarding to physical network, choose whether the Destination should be NAT to any physical device or NAT to physical device eth0.Click Forward to continue. - You are now ready to create the network. Check the configuration of your network and click Finish.

Abbildung 17.47. Ready to create network

- The new virtual network is now available in the Virtual Network tab of the Host Details menu.

Abbildung 17.48. New virtual network is now available

Kapitel 18. Red Hat Virtualisierung Problembehandlung

18.1. Überblick über Protokolldateien und deren Speicherorten

- Das Haupt-Konfigurationsverzeichnis von Red Hat Virtualisierung ist

/etc/xen/. Dieses Verzeichnis enthält denxend-Daemon und andere Konfigurationsdateien der virtuellen Maschine. Außerdem befinden sich hier die Dateien der Netzwerkskripte (im Unterverzeichnis/scripts). - Alle der eigentlichen Protokolldateien selbst, die Sie zu Zwecken der Problembehandlung heranziehen können, befinden sich im Verzeichnis

/var/log/xen.

- Sie sollten außerdem wissen, dass sich das standardmäßige Verzeichnis für alle dateibasierten Disk-Images der virtuellen Maschine im Verzeichnis

/var/lib/xenbefindet. - Informationen zur Red Hat Virtualisierung bezüglich des

/proc-Dateisystems befinden sich im Verzeichnis/proc/xen/.

18.2. Beschreibungen der Protokolldateien

xend-Daemon und dem qemu-dm-Prozess ausgestattet. Beide Dienstprogramme schreiben mehrere Protokolldateien in das Verzeichnis /var/log/xen/:

xend.logist die Protokolldatei, die sämtliche Daten enthält, die vomxend-Daemon gesammelt werden, unabhängig davon, ob es sich um ein Systemereignis oder eine durch den Betreiber initiierte Aktion handelt. Alle Vorgänge (wie beispielsweise create, shutdown, destroy, etc.) erscheinen hier.xend.logist normalerweise die erste Anlaufstelle, wenn Sie versuchen, Performanz- oder Ereignisprobleme ausfindig zu machen. Diese Datei enthält detaillierte Einträge und Umstände der Fehlermeldungen.xend-debug.logist die Protokolldatei, die Einträge von Ereignisfehlern desxendbeinhaltet, sowie des Virtualisierungs-Subsystems (wie beispielsweise Framebuffer, Python-Skripte, etc.).

xen-hotplug-logist die Protokolldatei, die Daten von Hotplug-Ereignissen beinhaltet. Falls ein Gerät oder ein Netzwerkskript sich nicht online setzen lässt, wird dieses Ereignis hier festgehalten.qemu-dm.[PID].logist die Protokolldatei, die vomqemu-dm-Prozess für jeden voll virtualisierten Gast erstellt wird. Bei der Verwendung dieser Protokolldatei müssen Sie die Prozess-ID (PID) des vorhandenenqemu-dm-Prozesses mit Hilfe des Befehlspsermitteln, um Prozess-Argumente zur Unterscheidung desqemu-dm-Prozesses auf der virtuellen Maschine zu untersuchen. Beachten Sie bitte, dass Sie das [PID]-Symbol mit der tatsächlichen PID desqemu-dm-Prozesses ersetzen müssen.

virt-manager.log untersuchen, welche sich im Verzeichnis /.virt-manager befindet. Beachten Sie bitte, dass der Inhalt dieser Protokolldatei bei jedem Neustart des Virtuelle Maschine Manager überschrieben wird. Stellen Sie daher sicher, dass Sie eine Sicherungskopie der Datei virt-manager.log erstellen, bevor Sie den Virtuelle Maschine Manager nach einem Systemfehler neu starten.

18.3. Speicherorte wichtiger Verzeichnisse

- Die Images virtueller Maschinen befinden sich im Verzeichnis

/var/lib/xen/images.

- Wenn Sie den

xend-Daemon neu starten, aktualisiert dieser diexend-database, die sich im Verzeichnis/var/lib/xen/xend-dbbefindet.

- Speicherauszüge (Dumps) virtueller Maschinen (die Sie mit dem Befehl

xm dump-coredurchführen) befinden sich im Verzeichnis/var/lib/xen/dumps.

- Das Verzeichnis

/etc/xenenthält die Konfigurationsdateien, die Sie zur Verwaltung der Systemressourcen verwenden. Die Konfigurationsdatei desxend-Daemon heißtxend-config.sxp, und Sie können diese Datei dazu verwenden, systemweite Änderungen zu implementieren und die Netzwerk-Callouts zu konfigurieren.

- Die

proc-Befehle sind eine weitere Quelle, die Sie zur Sammlung von Systeminformationen heranziehen können. Diese proc-Einträge befinden sich im Verzeichnis/proc/xen:

/proc/xen/capabilities

/proc/xen/balloon

/proc/xen/xenbus/

18.4. Tools zur Problembehandlung

xentopxm dmesgxm logvmstatiostatlsof

XenOprofilesystemTapcrashsysrqsysrq tsysrq w

ifconfigtcpdumpbrctl

brctl ist ein Netzwerk-Tool, das die Konfiguration der Ethernet-Bridge im Virtualisierungs-Linux-Kernel untersucht und konfiguriert. Sie müssen Root-Zugriff besitzen, um diese Beispielbefehle ausführen zu können:

# brctl show bridge-name bridge-id STP enabled interfaces ----------------------------------------------------------------------------- xenbr0 8000.feffffff no vif13.0 xenbr1 8000.ffffefff yes pddummy0 xenbr2 8000.ffffffef no vif0.0 # brctl showmacs xenbr0 port-no mac-addr local? ageing timer 1 fe:ff:ff:ff:ff: yes 0.00 2 fe:ff:ff:fe:ff: yes 0.00 # brctl showstp xenbr0 xenbr0 bridge-id 8000.fefffffffff designated-root 8000.fefffffffff root-port 0 path-cost 0 max-age 20.00 bridge-max-age 20.00 hello-time 2.00 bridge-hello-time 2.00 forward-delay 0.00 bridge-forward-delay 0.00 ageing-time 300.01 hello-timer 1.43 tcn-timer 0.00 topology-change-timer 0.00 gc-timer 0.02

18.5. Problembehandlung mit Hilfe der Protokolldateien

xend.log file contains the same basic information as when you run the xm log command. It resides in the /var/log/ directory. Here is an example log entry for when you create a domain running a kernel:

[2006-12-27 02:23:02 xend] ERROR (SrvBase: 163) op=create: Error creating domain: (0, 'Error')

Traceback (most recent call list)

File "/usr/lib/python2.4/site-packages/xen/xend/server/SrvBase.py" line 107 in_perform val = op_method (op,req)

File

"/usr/lib/python2.4/site-packages/xen/xend/server/SrvDomainDir.py line 71 in op_create

raise XendError ("Error creating domain: " + str(ex))

XendError: Error creating domain: (0, 'Error')

xend-debug.log ist sehr nützlich für Systemadministratoren, da sie noch detailliertere Informationen, als xend.log enthält. Nachfolgend finden Sie dieselben Fehlerdaten für dasselbe Problem bei der Erstellung einer Kernel-Domain:

ERROR: Will only load images built for Xen v3.0 ERROR: Actually saw: GUEST_OS=netbsd, GUEST_VER=2.0, XEN_VER=2.0; LOADER=generic, BSD_SYMTAB' ERROR: Error constructing guest OS

18.6. Problembehandlung mit der seriellen Konsole

grub.conf modifizieren, so dass eine serielle 38400-bps Konsole auf com1 /dev/ttyS0 aktiviert wird:

title Red Hat Enterprise Linix (2.6.18-8.2080_RHEL5xen0)

root (hd0,2)

kernel /xen.gz-2.6.18-8.el5 com1=38400,8n1

module /vmlinuz-2.618-8.el5xen ro root=LABEL=/rhgb quiet console=xvc console=tty xencons=xvc

module /initrd-2.6.18-8.el5xen.img

sync_console can help determine a problem that causes hangs with asynchronous hypervisor console output, and the "pnpacpi=off" works around a problem that breaks input on the serial console. The parameters "console=ttyS0" and "console=tty" means that kernel errors get logged with on both the normal VGA console and on the serial console. Then you can install and set up ttywatch to capture the data on a remote host connected by a standard null-modem cable. For example, on the remote host you could type:

ttywatch --name myhost --port /dev/ttyS0

/dev/ttyS0 in die Datei /var/log/ttywatch/myhost.log um.

18.7. Konsolenzugriff für paravirtualisierte Gäste

xm console [domain name or number]

domain100 einen laufenden Namen oder eine Nummer repräsentiert. Sie können weiterhin den Virtuelle Maschine Manager dazu verwenden, die virtuelle Textkonsole anzuzeigen. Wählen Sie Serielle Konsole im Fenster Virtuelle Maschine Details aus dem Menü Anzeigen.

18.8. Zugriff auf die Konsole des Gasts bei voller Virtualisierung

grub.conf file, and include the 'console =ttyS0 console=tty0' parameter. This ensures that the kernel messages are sent to the virtual serial console (and the normal graphical console). If you plan to use the virtual serial console in a full virtualized guest, you must edit the configuration file in the /etc/xen/ directory. On the host domain, you can then access the text console by typing:

xm console

18.9. Implementierung einer LUN-Persistenz

udev verwenden, um LUN-Persistenz zu implementieren. Bevor Sie die LUN-Persistenz auf Ihrem System implementieren stellen Sie sicher, dass sie die passenden UUIDs erhalten. Sobald Sie diese erhalten, können Sie die LUN-Persistenz konfigurieren, indem Sie die Datei scsi_id bearbeiten, die sich im Verzeichnis /etc befindet. Sobald Sie diese Datei in einem Texteditor geöffnet haben, müssen Sie die folgende Zeile auskommentieren:

# options=-b

# options=-g

# scsi_id -g -s /block/sdc

[root@devices] # scsi_id -g -s /block/sdc *3600a0b80001327510000015427b625e*

20-names.rules bearbeiten, die sich im Verzeichnis /etc/udev/rules.d befindet. Die Regeln zur Benennung der Geräte, die Sie hier erstellen, sollten das folgende Format besitzen:

# KERNEL="sd*", BUS="scsi", PROGRAM="sbin/scsi_id", RESULT="UUID", NAME="devicename"

KERNEL="sd*", BUS="scsi", PROGRAM="sbin/scsi_id", RESULT="3600a0b80001327510000015427b625e ", NAME="mydevicename"

/dev/sd* übereinstimmen, zu aktivieren, um die festgelegten UUID zu untersuchen. Wird ein passendes Gerät gefunden, wird ein Geräteknoten mit der Bezeichnung /dev/devicename erstellt. In diesem Beispiel ist der Geräteknoten /dev/mydevice. Abschließend müssen Sie noch die Datei rc.local, die sich im Verzeichnis /etc befindet, an diesen Pfad anhängen:

/sbin/start_udev

multipath.conf, die sich im Verzeichnis /etc/ befindet, bearbeiten:

multipath {

wwid 3600a0b80001327510000015427b625e

alias oramp1

}

multipath {

wwid 3600a0b80001327510000015427b6

alias oramp2

}

multipath {

wwid 3600a0b80001327510000015427b625e

alias oramp3

}

multipath {

wwid 3600a0b80001327510000015427b625e

alias oramp4

}

/dev/mpath/oramp1, /dev/mpath/oramp2, /dev/mpath/oramp3 und dev/mpath/oramp4. Diese Geräte befinden sich im Verzeichnis /dev/mpath. Die LUN-Namen bleiben auch über Neustarts hinaus bestehen, da Alias-Namen auf den wwid (weltweiten ID) der LUNs erstellt werden.

18.10. Hinweise in Zusammenhang mit SELinux

# semanage fcontext -a -t xen_image _t -f -b /dev/sda2 # restorecon /dev/sda2

xend_disable_trans versetzt xend nach einem Neustart des Daemon in einen unbeschränkten Modus. Es ist besser, den Schutz für einen einzelnen Daemon zu deaktivieren, als für das gesamte System. Es wird empfohlen, dass Sie Verzeichnisse wie xen_image_t, die Sie an anderer Stelle verwenden werden, nicht neu kennzeichnen.

18.11. Zugriff auf Daten auf einem Plattenimage eines Gasts

yum install kpartx kpartx -av /dev/xen/guest1 add map guest1p1 : 0 208782 linear /dev/xen/guest1 63 add map guest1p2: 0 16563015 linear /dev/xen/guest1 208845

# kpartx -a /dev/xen/guest1 #vgscan Reading all physical volumes . This may take a while... Found volume group "VolGroup00" using metadata type 1vm2 # vgchange -ay VolGroup00 2 logical volume(s) in volume group VolGroup00 now active. # lvs LV VG Attr Lsize Origin Snap% Move Log Copy% LogVol00 VolGroup00 -wi-a- 5.06G LogVol01 VolGroup00 -wi-a- 800.00M # mount /dev/VolGroup00/LogVol00 /mnt/ .... #umount /mnt/ #vgchange -an VolGroup00 #kpartx -d /dev/xen/guest1

vgchange -an zu deaktivieren, die Partitionen mit kpartx-d zu entfernen und das Loop-Gerät mit losetup -d zu löschen, wenn Sie fertig sind.

18.12. Häufige Situationen bei der Problembehandlung

xend -Dienst zu starten, passiert nichts. Beim Eintippen von xm list1 erhalten Sie folgende Meldung:

Error: Error connecting to xend: Connection refused. Is xend running?

xend start manuell auszuführen, erhalten Sie weitere Fehler:

Error: Could not obtain handle on privileged command interfaces (2 = No such file or directory) Traceback (most recent call last:) File "/usr/sbin/xend/", line 33 in ? from xen.xend.server. import SrvDaemon File "/usr/lib/python2.4/site-packages/xen/xend/server/SrvDaemon.py" , line 26 in ? from xen.xend import XendDomain File "/usr//lib/python2.4/site-packages/xen/xend/XendDomain.py" , line 33, in ? from xen.xend import XendDomainInfo File "/usr/lib/python2.4/site-packages/xen/xend/image.py" , line37, in ? import images File "/usr/lib/python2.4/site-packages/xen/xend/image.py" , line30, in ? xc = xen.lowlevel.xc.xc () RuntimeError: (2, 'No such file or directory' )

xen-hypervisor-Kernel ist. Um dies zu korrigieren, müssen Sie den xen-hypervisor-Kernel zum Zeitpunkt des Bootens auswählen (oder den xen-hypervisor-Kernel als Standard in Ihrer Datei grub.conf definieren.

18.13. Fehler des Loop-Geräts

/etc/modprobe.conf anpassen. Wenn Sie die Datei modprobe.conf anpassen, müssen Sie die folgende Zeile einbinden:

options loop max_loop=64

phy: block device oder tap:aio dateigestützte Geräte auf paravirtuellen Systemen, sowie phy: device oder file: file gestützte Geräte für volle Virtualisierung verwenden.

18.14. Fehler bei der Erstellung eines Gasts

"Invalid argument" error message. This usually means that the kernel image you are trying to boot is incompatible with the hypervisor. An example of this would be if you were attempting to run a non-PAE FC5 kernel on a PAE only FC6 hypervisor.

grub.conf gleich zurück auf einen Bare-Metal-Kernel gesetzt, anstatt auf den Virtualisierungs-Kernel.

/etc/sysconfig/kernel/ befindet, entsprechend anpassen. Sie müssen sicherstellen, dass der Parameter kernel-xen als Standard-Option in der Datei gb.conf gesetzt ist.

18.15. Fehler bezüglich der seriellen Konsole

grub.conf modifizieren und die "com port"-Parameter wie folgt ändern:

serial --unit=1 --speed=115200

title RHEL5 i386 Xen (2.6.18-1.2910.el5xen) root (hd0, 8) kernel /boot/xen.gz-2.6.18-1.2910.el5 com2=115200,8n1 module /boot/vmlinuz-2.6.18-1.2910.el5xen to root=LABEL=RHEL5_i386 console=tty console=ttyS1115200 module /boot/initrd-2.8.6.18-12910.el5xen.img title RHEL5 i386 xen (2.6.18.-1.2910.el5xen root (hd0, 8) kernel /boot/xen.gz-2.6.18-1.2910.el5 com2=115200 console=com2l module /boot/vmlinuz2.6.18-1.2910.el5xen to root=LABEL=RHEL5_i386 console=xvc xencons=xvc module /boot/ititrd-2.6.18-1.2910.el5xen.img

grub.conf sollte Ihre serielle Konsole korrekt funktionieren. Sie sollten in der Lage sein, jede beliebige Zahl für ttyS zu verwenden, und es sollte wie ttyS0 funktionieren.

18.16. Fehler der Netzwerkbrücke

/etc/sysconfig/network-scripts . You should use a process to setup multiple Xen bridges. This is an example config file for a second NIC called 'eth1' :

#/etc/sysconfig/network-scripts/fcfg-eth1 DEVICE=eth1 BOOTPROTO=static ONBOOT=yes USERCTL=no IPV6INIT=no PEERDNS=yes TYPE=Ethernet NETMASK=255.255.255.0 IPADDR=10.1.1.1 GATEWAY=10.1.1.254 ARP=yes

/etc/xen/scripts/network-bridge nach /etc/xen/scripts/network-bridge.xen.

/etc/xen/xend-config.sxp and add a line to your new network bridge script (this example uses "network-virtualization-multi-bridge" ).

xend-config.sxp sollte die neue Zeile Ihr neues Skript wiedergeben:

network-script network-xen-multi-bridge

network-script network-bridge

xenbr0 und xenbr1) und fügt diese entsprechend zu eth1 und eth0 hinzu:

# !/bin/sh

# network-xen-multi-bridge

# Exit if anything goes wrong

set -e

# First arg is operation.

OP=$1

shift

script=/etc/xen/scripts/network-bridge.xen

case ${OP} in

start)

$script start vifnum=1 bridge=xenbr1 netdev=eth1

$script start vifnum=0 bridge=xenbr0 netdev=eth0

;;

stop)

$script stop vifnum=1 bridge=xenbr1 netdev=eth1

$script stop vifnum=0 bridge=xenbr0 netdev=eth0

;;

status)

$script status vifnum=1 bridge=xenbr1 netdev=eth1

$script status vifnum=0 bridge=xenbr0 netdev=eth0

;;

*)

echo 'Unknown command: ' ${OP}

echo 'Valid commands are: start, stop, status'

exit 1

esac

18.17. Laptop-Konfigurationen

ifcfg-dummy0 und befindet sich im Verzeichnis /etc/sysconfig/network-scripts/:

DEVICE =dummy0 BOOTPROTO=none ONBOOT=yes USERCTL=no IPV6INIT=no PEERDNS=yes TYPE=Ethernet NETMASK=255.255.255.0 IPADDR=10.1.1.1 ARP=yes

xenbr0 mit dummy0 verknüpfen, um Netzwerkverbindungen auch dann zu ermöglichen, falls keine Verbindung mit dem physikalischen Netzwerk besteht.

xend-config.sxp file. You must locate the ( network-script 'network-bridge' bridge=xenbr0 ) section and add include this in the end of the line:

netdev=dummy0

/etc/sysconfig/ directory to reflect the example below:

NETWORKING=yes HOSTNAME=localhost.localdomain GATEWAY=10.1.1.1 IPADDR=10.1.1.10 NETMASK=255.255.255.0

S99XenLaptopNAT, die sich im Verzeichnis /etc/rc3.d befindet, so anpassen, dass sie dem nachfolgenden Beispiel entspricht:

#!/bin/bash

#

# XenLaptopNAT Startup script for Xen on Laptops

#

# chkconfig: - 99 01

# description: Start NAT for Xen Laptops

#

# PATH=/usr/bin:/sbin:/bin:/usr/sbin

# export PATH

GATEWAYDEV=`ip route | grep default | awk {'print $5'}`

iptables -F

case "$1" in

start)

if test -z "$GATEWAYDEV"; then

echo "No gateway device found"

else

echo "Masquerading using $GATEWAYDEV"

/sbin/iptables -t nat -A POSTROUTING -o $GATEWAYDEV -j MASQUERADE

fi

echo "Enabling IP forwarding"

echo 1 > /proc/sys/net/ipv4/ip_forward

echo "IP forwarding set to `cat /proc/sys/net/ipv4/ip_forward`"

echo "done."

;;

*)

echo "Usage: $0 {start|restart|status}"

;;

esac

/etc/rc3.d/S99XenLaptopNAT erstellen.

modprobe.conf müssen Sie die folgenden Zeilen einbinden:

alias dummy0 dummy options dummy numdummies=1

18.18. Starting Domains Automatically During System Boot

/etc/xen/auto modifizieren. Diese Datei verweist auf die Konfigurationsdateien des Gasts, die Sie automatisch starten müssen. Der Prozess bei Inbetriebnahme ist serialisiert, was bedeutet, dass je höher die Zahl der Gäste, desto länger dauert der Boot-Prozess. Nachfolgendes Beispiel zeigt Ihnen, wie symbolische Links für den Gast rhel5vm01 verwendet werden:

[root@python xen]# cd /etc/xen [root@python xen]# cd auto [root@python auto]# ls [root@python auto]# ln -s ../rhel5vm01 . [root@python auto]# ls -l lrwxrwxrwx 1 root root 14 Dec 14 10:02 rhel5vm01 -> ../rhel5vm01 [root@python auto]#

18.19. Modifizierung von Domain0

grub.conf configuration file, that resides in the /etc directory. Because of the large number of domains to manage, many system administrators prefer to use the 'cut and paste' method when editing grub.conf . If you do this, make sure that you include all five lines in the Virtualization entry (or this will create system errors). If you require Xen hypervisor specific values, you must add them to the 'xen' line. This example represents a correct grub.conf Virtualization entry:

# boot=/dev/sda/

default=0

timeout=15

#splashimage=(hd0, 0)/grub/splash.xpm.gz

hiddenmenu

serial --unit=0 --speed=115200 --word=8 --parity=no --stop=1

terminal --timeout=10 serial console

title Red Hat Enterprise Linux Server (2.6.17-1.2519.4.21. el5xen)

root (hd0, 0)

kernel /xen.gz-2.6.17-1.2519.4.21.el5 com1=115200,8n1

module /vmlinuz-2.6.17-1.2519.4.21el5xen ro root=/dev/VolGroup00/LogVol00

module /initrd-2.6.17-1.2519.4.21.el5xen.img

'dom0_mem=256M' . This example represents the respective grub.conf xen entry:

# boot=/dev/sda

default=0

timeout=15

#splashimage=(hd0,0)/grubs/splash.xpm.gz

hiddenmenu

serial --unit=0 --speed =115200 --word=8 --parity=no --stop=1

terminal --timeout=10 serial console

title Red Hat Enterprise Linux Server (2.6.17-1.2519.4.21. el5xen)

root (hd0,0)

kernel /xen.gz-2.6.17-1.2519.4.21.el5 com1=115200,8n1 dom0_mem=256MB

module /vmlinuz-2.6.17-1.2519.4.21.el5xen ro

root=/dev/VolGroup00/LogVol00

module /initrd-2.6.17-1.2519.4.21.el5xen.img

18.20. Konfigurationsdateien des Gasts

name = "rhel5vm01"

memory = "2048"

disk = ['tap:aio:/xen/images/rhel5vm01.dsk,xvda,w',]

vif = ["type=ieomu, mac=00:16:3e:09:f0:12 bridge=xenbr0',

"type=ieomu, mac=00:16:3e:09:f0:13 ]

vnc = 1

vncunused = 1

uuid = "302bd9ce-4f60-fc67-9e40-7a77d9b4e1ed"

bootloader = "/usr/bin/pygrub"

vcpus=2

on_reboot = "restart"

on_crash = "restart"

serial="pty" is the default for the configuration file. This configuration file example is for a fully-virtualized guest:

name = "rhel5u5-86_64" builder = "hvm" memory = 500 disk = ['file:/xen/images/rhel5u5-x86_64.dsk.hda,w'] vif = [ 'type=ioemu, mac=00:16:3e:09:f0:12, bridge=xenbr0', 'type=ieomu, mac=00:16:3e:09:f0:13, bridge=xenbr1'] uuid = "b10372f9-91d7-ao5f-12ff-372100c99af5' device_model = "/usr/lib64/xen/bin/qemu-dm" kernel = "/usr/lib/xen/boot/hvmloader/" vnc = 1 vncunused = 1 apic = 1 acpi = 1 pae = 1 vcpus =1 serial ="pty" # enable serial console on_boot = 'restart'

18.21. Klonen von Gast-Konfigurationsdateien

uuidgen(1) command). Then for the vif entries you must define a unique MAC address for each guest (if you are copying a guest configuration from an existing guest, you can create a script to handle it). For the xen bridge information, if you move an existing guest configuration file to a new host, you must update the xenbr entry to match your local networking configuration. For the Device entries, you must modify the entries in the 'disk=' section to point to the correct guest image.

/etc/sysconfig/network file to match the new guest's hostname.

/etc/sysconfig/network-scripts/ifcfg-eth0 so abändern, dass diese mit der Ausgabe von ifconfig eth0 übereinstimmt. Falls Sie statische IP-Adressen verwenden, müssen Sie den IPADDR-Eintrag abändern.

18.22. Erstellen eines Skripts zur Generierung von MAC-Adressen

#! /usr/bin/python # macgen.py script generates a MAC address for Xen guests # import random mac = [ 0x00, 0x16, 0x3e, random.randint(0x00, 0x7f), random.randint(0x00, 0xff), random.randint(0x00, 0xff) ] print ':'.join(map(lambda x: "%02x" % x, mac)) Generates e.g.: 00:16:3e:66:f5:77 to stdout

18.23. Konfiguration einer Echtzeitmigration einer virtuellen Maschine

xm migrate command). Live migration can be done from the same command. However there are some additional modifications that you must do to the xend-config configuration file. This example identifies the entries that you must modify to ensure a successful migration:

(xend-relocation-server yes)- The default for this parameter is 'no', which keeps the relocation/migration server deactivated (unless on a trusted network) and the domain virtual memory is exchanged in raw form without encryption.

(xend-relocation-port 8002)- Dieser Parameter bestimmt den Port, den

xendfür die Migration verwendet. Dieser Wert ist korrekt. Stellen Sie jedoch sicher, den Kommentar davor zu löschen. (xend-relocation-address )- Dieser Parameter stellt die Adresse dar, die auf die Socket-Verbindungen bei derRelocation horcht, nachdem Sie den

xend-relocation-serveraktivieren. Beim Horchen schränkt es die Migration auf eine bestimmte Schnittstelle ein. (xend-relocation-hosts-allow )- This parameter controls the host that communicates with the relocation port. If the value is empty, then all incoming connections are allowed. You must change this to a space-separated sequences of regular expressions (such as

xend-relocation-hosts-allow- '^localhost\\.localdomain$'). A host with a fully qualified domain name or IP address that matches these expressions are accepted.

18.24. Interpretation von Fehlermeldungen

failed domain creation due to memory shortage, unable to balloon domain0

xend.log auf diesen Fehler überprüfen:

[2006-12-21] 20:33:31 xend 3198] DEBUG (balloon:133) Balloon: 558432 Kib free; 0 to scrub; need 1048576; retries: 20 [2006-12-21] 20:33:31 xend. XendDomainInfo 3198] ERROR (XendDomainInfo: 202 Domain construction failed

xm list Domain0 command. If domain0 is not ballooned down, you can use the command "xm mem-set Domain-0 NewMemSize" to check memory.

wrong kernel image: non-PAE kernel on a PAE

[root@smith]# xm create -c va base Using config file "va-base" Error: (22, 'invalid argument') [2006-12-14 14:55:46 xend.XendDomainInfo 3874] ERRORs (XendDomainInfo:202) Domain construction failed Traceback (most recent call last) File "/usr/lib/python2.4/site-packages/xen/xend/XendDomainInfo.py", line 195 in create vm.initDomain() File " /usr/lib/python2.4/site-packages/xen/xend/XendDomainInfo.py", line 1363 in initDomain raise VmError(str(exn)) VmError: (22, 'Invalid argument') [2006-12-14 14:55:46 xend.XendDomainInfo 3874] DEBUG (XenDomainInfo: 1449] XendDlomainInfo.destroy: domin=1 [2006-12-14 14:55:46 xend.XendDomainInfo 3874] DEBUG (XenDomainInfo: 1457] XendDlomainInfo.destroy:Domain(1)

Unable to open a connection to the Xen hypervisor or daemon

/etc/hosts existiert. Überprüfen Sie diese Datei und stellen Sie sicher, dass der "localhost"-Eintrag aktiviert ist. Nachfolgend finden Sie ein Beispiel eines falschen "localhost"-Eintrags:

# Do not remove the following line, or various programs # that require network functionality will fail. localhost.localdomain localhost

# Do not remove the following line, or various programs # that require network functionality will fail. 127.0.0.1 localhost.localdomain localhost localhost.localdomain. localhost

xen-xend.log):

Bridge xenbr1 does not exist!

[root@trumble virt]# xm create r5b2-mySQL01 Using config file " r5b2-mySQL01" Going to boot Red Hat Enterprise Linux Server (2.6.18.-1.2747 .el5xen) kernel: /vmlinuz-2.6.18-12747.el5xen initrd: /initrd-2.6.18-1.2747.el5xen.img Error: Device 0 (vif) could not be connected. Hotplug scripts not working.

xend.log die folgenden Fehler auf:

[2006-11-14 15:07:08 xend 3875] DEBUG (DevController:143) Waiting for devices vif [2006-11-14 15:07:08 xend 3875] DEBUG (DevController:149) Waiting for 0 [2006-11-14 15:07:08 xend 3875] DEBUG (DevController:464) hotplugStatusCallback /local/domain/0/backend/vif/2/0/hotplug-status [2006-11-14 15:08:09 xend.XendDomainInfo 3875] DEBUG (XendDomainInfo:1449) XendDomainInfo.destroy: domid=2 [2006-11-14 15:08:09 xend.XendDomainInfo 3875] DEBUG (XendDomainInfo:1457) XendDomainInfo.destroyDomain(2) [2006-11-14 15:07:08 xend 3875] DEBUG (DevController:464) hotplugStatusCallback /local/domain/0/backend/vif/2/0/hotplug-status

vif ändern. Wenn Sie den vif-Eintrag der Konfigurationsdatei lokalisieren, vorausgesetzt, Sie verwenden xenbr0 als die Standardbrücke, stellen Sie sicher, dass der passende Eintrag dem Folgenden entspricht:

# vif = ['mac=00:16:3e:49:1d:11, bridge=xenbr0',]

[root@python xen]# xm shutdown win2k3xen12 [root@python xen]# xm create win2k3xen12 Using config file "win2k3xen12". /usr/lib64/python2.4/site-packages/xenxm/opts.py:520: Deprecation Warning: Non ASCII character '\xc0' in file win2k3xen12 on line 1, but no encoding declared; see http://www.python.org/peps/pep-0263.html for details execfile (defconfig, globs, locs,) Error: invalid syntax 9win2k3xen12, line1)

18.25. Online-Quellen zur Problembehandlung

- Red Hat Virtualization Center

http://www.openvirtualization.com

- Red Hat Enterprise Linux 5 Beta 2 Dokumentation

http://www.redhat.com/docs/manuals/enterprise/RHEL-5-manual/index.html

- Libvirt API

http://www.libvirt.org

- virt-manager Projekt Homepage

http://virt-manager.et.redhat.com

- Xen Community Center

http://www.xensource.com/xen/xen/

- Überblick über Virtualisierungstechnologien

http://virt.kernelnewbies.org

- Technologieprojekte in der Entwicklung

http://et.redhat.com

Kapitel 19. Zusätzliche Quellen

19.1. Hilfreiche Web-Sites

- http://www.cl.cam.ac.uk/research/srg/netos/xen/ — Die Projekt-Website des Xen™ paravirtualisierten Maschinen-Managers, von der Red Hat Virtualization abgeleitet ist. Die Site pflegt die Upstream Xen-Projekt-Binärdateien und den Quellcode und enthält weiterhin Informationen, Überblick über Architekturen, Dokumentation und verwandte Links zu Xen und die damit verbundenen Technologien.

- http://www.libvirt.org/ — Die offizielle Web-Site für die

libvirtVirtualisierungs-Programmierschnittstelle (API), die mit dem Virtualisierungs-Framework auf einem Host-Betriebssystem interagiert. - http://virt-manager.et.redhat.com/ — Die Projekt-Web-Site für den Virtual Machine Manager (virt-manager), der grafischen Anwendung zur Verwaltung von virtuellen Maschinen.

19.2. Installierte Dokumentation

/usr/share/doc/xen-<version-number>/—. This directory contains a wealth of information about the Xen para-virtualization hypervisor and associated management tools, including a look at various example configurations, hardware-specific information, and the current Xen upstream user documentation.man virshand/usr/share/doc/libvirt-<version-number>— Contains subcommands and options for thevirshvirtual machine management utility as well as comprehensive information about thelibvirtvirtualization library API./usr/share/doc/gnome-applet-vm-<version-number>— Documentation for the GNOME graphical panel applet that monitors and manages locally-running virtual machines./usr/share/doc/libvirt-python-<version-number>— Provides details on the Python bindings for thelibvirtlibrary. Thelibvirt-pythonpackage allows python developers to create programs that interface with thelibvirtvirtualization management library./usr/share/doc/python-virtinst-<version-number>— Provides documentation on thevirt-installcommand that helps in starting installations of Fedora and Red Hat Enterprise Linux related distributions inside of virtual machines./usr/share/doc/virt-manager-<version-number>— Provides documentation on the Virtual Machine Manager, which provides a graphical tool for administering virtual machines.

Anhang A. Lab 1

- Um zu ermitteln, ob Ihre CPU eine Unterstützung für PAE bietet, tippen Sie:

grep pae /proc/cpuinfo - Die folgende Ausgabe zeigt eine CPU mit PAE-Unterstützung. Falls der Befehl nichts zurückgibt, dann besitzt die CPU keine PAE-Unterstützung. Alle Übungen im Rahmen des Labs erfordern eine i386-CPU mit PAE-Erweiterung oder x86_64 oder ia64, um fortfahren zu können.

flags : fpu vme de pse tsc msr pae mce cx8 apic mtrr pge mca cmov pat clflush dts acpi mmx fxsr sse sse2 ss tm pbe nx up est tm2

virt-install.

virt-install installieren.

- Um Ihren Red Hat Enterprise Linux 5 Beta 2 Xen-Gast zu installieren, geben Sie am Befehlsprompt ein:

virt-install. - Antworten Sie auf die Frage, ob Sie einen voll virtualisierten Gast installieren möchten, mit:

no. - Geben Sie

rhel5b2-pv1als den Namen Ihrer virtuellen Maschine an. - Geben Sie 500 für Ihre Speicherzuweisung ein.

- Geben Sie

/xen/rhel5b2-pv1.imgfür Ihre Platte (Image des Gasts) ein. - Geben Sie "6" für die Größe Ihrer Platte ein (Image des Gasts).

- Geben Sie

yesein, um die grafische Unterstützung zu aktivieren. - Geben Sie

nfs:server:/path/to/rhel5b2als Ihre Installationsquelle ein. - Die Installation beginnt nun. Fahren Sie wie üblich mit der Installation fort.

- Nachdem die Installation abgeschlossen ist, geben Sie

/etc/xen/rhel5b2-pv1ein und führen die folgenden Änderungen durch: #vnc=1#vncunused=1sdl=1 - Verwenden Sie einen Texteditor, um

/etc/inittabzu modifizieren und hängen folgendes an diese Datei an:init5.#id:3:initdefault:id:5:initdefault:

virt-manager.

virt-manager installieren.

- Um Ihren Red Hat Linux 5 Beta 2 Xen-Gast zu installieren, geben Sie am Befehlsprompt ein:

virt-manager. - Wählen Sie "Lokaler Xen-Host" im Fenster "Verbindung öffnen" und klicken Sie auf Verbinden.

- Start Red Hat's Virtual Machine Manager application, and from the File menu, click on New.

- Klicken Sie auf Weiter.

- Geben Sie

rhel5b2-pv2als den Namen Ihres Systems ein, und klicken Sie auf Weiter. - Wählen Sie Paravirtualisiert, und klicken Sie auf Weiter.

- Geben Sie

nfs:server:/path/to/rhel5b2als URL Ihrer Installationsquelle ein und klicken Sie auf Weiter. - Wählen Sie

Einfache Dateiund geben Sie/xen/rhel5b2-pv2.imgfür die Position Ihrer Datei ein. Wählen Sie 6000 MB und klicken Sie auf Weiter. - Wählen Sie 500 für den Start Ihrer VM und als Maximalen Speicher und klicken Sie auf Weiter.

- Klicken Sie auf Beenden.

- To determine if your CPU has Intel-VT or AMD-V support, type the following command:

egrep -e 'vmx|svm' /proc/cpuinfo - Die folgende Ausgabe zeigt eine CPU mit Intel-VT-Unterstützung:

.flags : fpu tsc msr pae mce cx8 apic mtrr mca cmov pat clflush dts acpi mmx fxsr sse sse2 ss ht tm pbe constant_tsc pni monitor vmx est tm2 xtprFalls der Befehl nichts zurückgibt, dann besitzt die CPU keine Unterstützung für Intel-VT oder AMD-V. - Um zu ermitteln, ob Ihre CPU eine Unterstützung für Intel-VT oder AMD-V besitzt, geben Sie folgenden Befehl ein:

cat /sys/hypervisor/properties/capabilities

- The following output shows that Intel-VT support has been enabled in the BIOS. If the command returns nothing, then go into the BIOS Setup Utlility and look for a setting related to 'Virtualization', i.e. 'Intel(R) Virtualization Technology' under 'CPU' section on a IBM T60p. Enable and save the setting and do a power off to take effect.

xen-3.0-x86_32p hvm-3.0-x86_32 hvm-3.0-x86_32p

virt-install installieren.

- Um Ihren Red Hat Enterprise Linux 5 Beta 2 Xen-Gast zu installieren, geben Sie am Befehlsprompt ein:

virt-install. - Wenn Sie dazu aufgefordert werden, einen voll virtualisierten Gast zu installieren, geben Sie

yesein. - Geben Sie

rhel5b2-pv2als den Namen Ihrer virtuellen Maschine an. - Geben Sie 500 für Ihre Speicherzuweisung ein.

- Geben Sie

/xen/rhel5b2-fv1.imgfür Ihre Platte (Image des Gasts) ein. - Geben Sie "6" für die Größe Ihrer Platte ein (Image des Gasts).

- Geben Sie

yesein, um die grafische Unterstützung zu aktivieren. - Geben Sie

/dev/cdromfür das virtuelle CD-Image ein. - The VNC viewer appears within the installation window. If there is an error message that says “main: Unable to connect to host: Connection refused (111)”, then type the following command to proceed:

vncviewer localhost:5900. VNC port 5900 refers to the first Xen guest that is running on VNC. If it doesn't work, you might need to use 5901, 5902, etc.

virt-install installieren.

- Um Ihren Red Hat Linux 5 Beta 2 Xen-Gast zu installieren, geben Sie am Befehlsprompt ein:

virt-manager. - Wählen Sie "Lokaler Xen-Host" im Fenster Verbindung öffnen und klicken Sie auf Verbinden.

- Start Red Hat's Virtual Machine Monitor application, and from the File menu, click on New.

- Klicken Sie auf Weiter.

- Geben Sie

rhel5b2-pv2als den Namen Ihres Systems ein, und klicken Sie auf Weiter. - Wählen Sie "Voll virtualisiert" aus und klicken Sie auf Weiter.

- Geben Sie entweder CD-ROM oder DVD an, sowie den Pfad zu den Installationsmedien. Geben Sie die Position des ISO-Images an, falls Sie von einem ISO-Image installieren. Klicken Sie auf Weiter.

- Wählen Sie "Einfache Datei" und geben Sie

/xen/rhel5b2-fv2.imgfür die Position Ihrer Datei ein. Wählen Sie 6000 MB und klicken Sie auf Weiter. - Wählen Sie 500 für den Start Ihrer VM und als Maximalen Speicher und klicken Sie auf Weiter.

- Klicken Sie auf Beenden.

- Das Fenster für die Konsole der virtuellen Maschine erscheint.

virt-manager.

virt-manager installieren:

- Es gelten hier dieselben Anweisungen, wie für Lab-Sequenz 6.

virt-manager

virt-manager installieren:

- Es gelten hier dieselben Anweisungen, wie für Lab-Sequenz 6.

virt-manager.

virt-manager installieren:

- Um Windows XP auf Ihrem Red Hat Enterprise Linux 5 Host zu installieren, geben Sie am Befehlsprompt ein:

virt-manager. - Wählen Sie "Lokaler Xen-Host" im Fenster Verbindung öffnen und klicken Sie auf Verbinden.

- Start Red Hat's Virtual Machine Manager application, and from the File menu click on New.

- Klicken Sie auf Weiter.

- Geben Sie

winxpals den Namen Ihres Systems ein, und klicken Sie auf Weiter. - Wählen Sie "Voll virtualisiert" aus und klicken Sie auf Weiter.

- Geben Sie entweder CD-ROM oder DVD an, sowie den Pfad zu den Installationsmedien. Geben Sie die Position des ISO-Images an, falls Sie von einem ISO-Image installieren. Klicken Sie auf Weiter.

- Wählen Sie "Einfache Datei" und geben Sie

/xen/winxp.imgfür die Position Ihrer Datei ein. Wählen Sie 6000 MB und klicken Sie auf Weiter. - Wählen Sie 1024 für den Start Ihrer VM und als Maximalen Speicher. Wählen Sie 2 für VCPUs und klicken Sie auf Weiter.

- Klicken Sie auf Beenden.

- Das Fenster für die Konsole der virtuellen Maschine erscheint. Fahren Sie wie gewohnt fort und schließen die Installation ab.

- Wählen Sie das Formatieren der

C:\-Partition mit dem FAT-Dateisystemformat. Red Hat Enterprise Linux 5 wird nicht mit NTFS-Kernelmodulen geliefert. Das Einhängen oder das Schreiben von Dateien auf das Xen-Gast-Image ist möglicherweise nicht so einfach, wie wenn Sie die Patition im NTFS-Dateisystemformat formatieren würden. - Nachdem Sie das System zum ersten Mal neu starten, bearbeiten Sie das

winxp-Gast-Image:losetup /dev/loop0 /xen/winxp.imgkpartx -av /dev/loop0mount /dev/mapper/loop0p1 /mntcp -prv $WINDOWS/i386 /mnt/. Dies behebt ein Problem, auf das sie ansonsten möglicherweise zu einem späteren Zeitpunkt der Windows-Installation stoßen würden. - Starten Sie den Xen-Gast manuell neu, indem sie Folgendes eingeben:

xm create -c winxp/. - Wählen Sie den

winxp-Xen-Gast im Fenster des Virtual Machine Manager aus und klicken Sie auf Öffnen. - Das Fenster für die Konsole der virtuellen Maschine erscheint. Fahren Sie wie gewohnt fort und schließen die Installation ab.

- Whenever a 'Files Needed' dialog box appears, change the path

GLOBALROOT\DEVICE\CDROM0\I386toC:\I386. Depending on your installation, you may or may not see this problem. You may be prompted for missing files during the installation. Changing the path toC:\I386should compensate for this problem. - Falls die Xen-Gastkonsole einfriert, klicken Sie auf

shutdownund nehmen die folgenden Änderungen an /etc/xen/winxp vor:#vnc=1#vncunused=1sdl=1#vcpus=2 - Wiederholen Sie Schritt 14 und fahren Sie wie gewohnt mit der Installation fort.

Anhang B. Lab 2

host1 und host2 .

xm) und kommuniziert mit xend. Um die Live-Migration zwischen zwei Maschinen zu aktivieren, müssen Sie diesen so konfigurieren, dass er Live-Migration unterstützt:

- Gehen Sie wie folgt vor, um eine Sicherung Ihrer Datei

xend-config.sxpdurchzuführen:cp -pr /etc/xen/xend-config.sxp /etc/xen/xend-config.sxp.default - Bearbeiten Sie

/etc/xen/xend-config.sxpund nehmen Sie folgende Änderungen vor:#(xend-unix-server yes)(xend-relocation-server yes)(xend-relocation-port 8002)(xend-relocation-address '')(xend-relocation-hosts-allow '')#(xend-relocation-hosts-allow '^localhost$ ^localhost\\.localdomain$') - Starten Sie

xend:serviceundxend restartneu.

- Bearbeiten Sie

/etc/exportsund fügen folgende Zeile ein:/xen *(rw,sync,no_root_squash)/ - Speichern Sie

/etc/exportsund starten den NFS-Server neu. Stellen Sie sicher, dass der NFS-Server standardmäßig startet:service nfs start; chkconfig nfs on. - Nachdem Starten des NFS-Servers auf

host1können wir diesen anschließend auf host2 mounten:mount host1:/xen. - Starten Sie nun den Xen-Gast auf

host1und wählen Siefc6-pv1(oderfc6-pv2von Lab 1):xm create -c fc6-pv1

- Laden Sie das Tar-Archiv

gnump3d-2.9.9.9.tar.bz2vonhttp://www.gnump3d.org/herunter. Entpacken Sie das Archiv und kompilieren und installieren im Verzeichnisgnump3d-2.9.9.9/die gnump3d-Anwendung:tar xvjf gnump3d-2.9.9.9.tar.bz2; cd gnump3d-2.9.9.9/; make install. - Create a

/home/mp3directory and copy TruthHappens.ogg from Red Hat's Truth Happens page tomkdir /home/mp3wget -c http://www.redhat.com/v/ogg/TruthHappens.ogg - Starten Sie den Streaming-Server mit folgendem Befehl

command:gnump3d

- Starten Sie den Movie Player auf einem der beiden Xen-Hosts. Falls dieser nicht installiert ist, installieren Sie die "totem" und "iso-codecs" RPMs, bevor Sie den Movie Player ausführen. Klicken Sie auf Anwendungen, dann Audio & Video und schließlich auf Movie Player.

- Klicken Sie auf "Film" und anschließend auf "Ort öffnen". Geben Sie http://guest:8888/TruthHappens.ogg ein.

- Starten Sie das Abspielen der Datei

TruthHappens.oggauf einem der beiden Xen-Hosts. - Führen Sie die Live-Migration von

host1aufhost2durch:xm migrate –live fc6-pv1 host2

- Öffnen Sie mehrere Fenster-Terminals auf beiden Xen-Hosts mit Hilfe des folgenden Befehls:

watch -n1 xm list

- Beobachten Sie, wie die Live-Migration beginnt. Beachten Sie, wie lange die Fertigstellung der Migration braucht.

gdm starts up. Run VNC viewer and connect to the Xen guest. Play with the Xen guest when the live migration occurs. Attempt to pause/resume, and save/restore the Xen guest and observe what happens to the VNC viewer. If you connect to the VNC viewer via localhost:590x, and do a live migration, you won't be able to connect to the VNC viewer again when it dies. This is a known bug.

Anhang C. Revisionsgeschichte

| Versionsgeschichte | ||||

|---|---|---|---|---|

| Version 2.0-11.400 | 2013-10-31 | Rüdiger Landmann | ||

| ||||

| Version 2.0-11 | 2012-07-18 | Anthony Towns | ||

| ||||

| Version 5.1.0-10 | Fri Aug 3 2007 | Michael Hideo Smith | ||

| ||||